├── README.md

├── framework

├── vSphere体系架构.md

├── 网络虚拟化.md

├── 虚拟化架构、特点及优势.md

└── 虚拟地址的理解.md

├── papers

├── 01_Emerging_Virtualization_Technology.pdf

├── 02_HYPERVISOR_FOR_VIRTUALIZATION_IN_PRIVATE_CLOUD.pdf

├── 03_Secure_Virtualization_for_Cloud_Environment_Using_Hypervisor-based_Technology.pdf

├── 04_OPERATING_SYSTEM_VIRTUALIZATION_IN_THE_EDUCATION_OF_COMPUTER_SCIENCE_STUDENTS.pdf

├── 05_Virtualization_Technologies_and_Cloud_Securityadvantages,issues,and_perspectives.pdf

├── 06_Xen_and_the_Art_of_Virtualization.pdf

├── 07_Analysis_of_Virtualization_Technologies_for_High_Performance_Computing_Environments.pdf

├── 08_Research_on_Cloud_Computing_Based_on_Storage_Virtualization_in_Data_Center.pdf

├── 09_Architecture_for_Technology_Transformation.pdf

├── 10_A_Study_On_Virtualization_Techniques_And_Challenges_In_Cloud_Computing.pdf

├── 11_Virtual_Machine_Security_Guidelines_Version_1.0.pdf

├── 12_Comparative_Performance_Analysis_of_the_Virtualization_Technologies_in_Cloud_Computing.pdf

├── 13_Improving_Business_Performance_by_Employing_VirtualizationTechnology_A_Case_Study_in_the_Financial_Sector.pdf

├── 14_Consolidation_Using_Oracle's_SPARCVirtualization_Technologies.pdf

├── 15-Development_of_a_virtualization_systems_architecture_course_for_t.pdf

├── 16_Educational_Infrastructure_Using_Virtualization_Technologies_Experience_at_Kaunas_University_of_Technology.pdf

├── 17_Comparative_Study_of_Virtual_Machine_Software_Packages_with_Real_Operating_System.pdf

├── 18_Dell_EMC_Unity_Virtualization_Integration.pdf

├── 19_A_Study_On_Virtualization_And_Virtual_Machines.pdf

├── 20_Review_on_Virtualization_for_Cloud_Computing.pdf

├── 21_A_Survey_on_Virtualization_and_Hypervisor-based_Technology_in_Cloud_Computing_Environment.pdf

├── 22_STUDY_ON_VIRTUALIZATION_TECHNOLOGY_AND_ITS_IMPORTANCE_IN_CLOUD_COMPUTING_ENVIRONMENT.pdf

├── 23_Research_on_the_Virtualization_Technology_in_Cloud_Computing_Environment.pdf

├── 24_Research_and_Development_on_Network_Virtualization_Technologies_in_Japan.pdf

├── 25_Eliminate_Software_Development_and_Testing_Constraints_with_Service_Virtualization.pdf

├── 26_Network_Virtualization_A_Data_Plane_Perspective.pdf

├── 27_A_taxonomy_of_virtualization_technologies.pdf

├── 28_Network_Functions_Virtualisation.pdf

├── 29_Recommendations_of_the_National_Institute_of_Standards_and_Technology.pdf

├── 30_Big_Data_Virtualization_Why_and_How.pdf

├── 31_Server_Virtualization_Technology_and_ltsLatest_Trends.pdf

├── 32_Virtualization_Technologies_for_Cars_Solutions_to_increase_safety_and_security_of_vehicular_ECUs.pdf

├── 33_Virtualization_and_Future_Technologies.pdf

├── 34_Virtualization_and_the_Computer_Architecture.pdf

├── 35_Virtualization_Introduction_QSM_White_Paper.pdf

├── 36_Security_Implications_of_Different_Virtualization_Approaches_for_Secure_Cyber_Architectures.pdf

├── 37_Server_Virtualization_A_Step_Toward_Cost_Efficiency_and_Business_Agility.pdf

├── 38_Performance_Implications_of_Virtualization.pdf

├── 39_State-of-the-Art_of_Virtualization,_its_Security_Threats_and_Deployment_Models.pdf

├── 40_HMI_&_Virtualization_in_Process_Automation.pdf

├── 41_Terra_A_Virtual_Machine-Based_Platform_for_Trusted_Computing.pdf

├── 42_Research_on_Virtualization_Technology_for_Real-time_Reconfigurable_Systems.pdf

├── 43_A_Survey_on_Virtualization_Technologies.pdf

├── 44_Intel_Virtualization_Technology.pdf

├── 45_EXPERIENCES_WITH_VIRTUALIZATION_TECHNOLOGY_IN_EDUCATION.pdf

├── 46_VIRTUALIZATION_IN_CLOUD_COMPUTING.pdf

├── 47_Systematic_Study_of_Virtualization.pdf

├── 48_Virtualization_in_Cloud_Computing__Developments_and_Trends.pdf

├── 49_Virtualization_Overview.pdf

├── 50_ArcGIS_Pro_Virtualization.pdf

├── 51_Intel®_Virtualization_Technology(VT)_in_Converged_Application_Platforms.pdf

├── 52_Virtualization_Technology_Whitepaper-Infrastructure_to_Perform_Static_Tools_and_Binary_Analysis.pdf

├── 53_A_Survey_on_Virtual_Machine_Security.pdf

├── 54_Intel®_Virtualization_Technology_Hardware_Support_for_Efficient_Processor_Virtualization.pdf

├── 55_Network_functions_virtualization.pdf

├── 56_BEYOND_VIRTUALIZATION_The_MontaVista_Approach_to_Multi-core_SoC_Resource_Allocation_and_Control.pdf

├── 57_A_PRINCIPLED_TECHNOLOGIES_WHITE_PAPER.pdf

├── 58_Data_Virtualization–Flexible_Technology_for_the_Agile_Enterprise.pdf

├── 59_Top_5_Things_You_Need_in_a_Virtualization_Management_Solution.pdf

├── 60_The_IBM_Advantage_for_Implementing_the_Virtualization_Reference_Architecture.pdf

└── README.md

├── product

├── KVM简介及安装.md

├── OpenStack介绍及原理.md

├── OpenStack知识体系.md

├── P8整理的OpenStack构架,希望能帮助到你.md

├── Xen虚拟化详解.md

├── vmm执行基本流程.md

├── 操作系统级虚拟化实现.md

├── 系统级虚拟化实现.md

├── 虚拟化技术.md

├── 虚拟化技术概要之VMM结构.md

├── 虚拟化的必要性.md

└── 软件模拟虚拟化、全虚拟化、半虚拟化、硬件辅助虚拟化和容器.md

├── vedio

└── README.md

└── virtualization_type

├── README.md

├── cpu_virtualization

├── CPU的三种虚拟化机制.md

└── CPU虚拟化.md

├── io_virtualization

├── IO虚拟化.md

├── IO虚拟化三种形式.md

├── IO虚拟化基本原理.md

└── IO虚拟化面临的问题及解决方案.md

├── memory_virtualization

├── KVM内存虚拟化.md

├── 内存虚拟化-shadow实现.md

├── 内存虚拟化.md

└── 内存虚拟化影子页表技术和EPT技术.md

├── storage_virtualization

├── Neutron实现网络虚拟化.md

├── 什么是文件虚拟化(File Virtualization)

├── 在Linux平台使用mhVTL虚拟化磁带库.md

├── 块虚拟化.md

├── 基于主机的虚拟化存储应用及注意事项.md

├── 带内虚拟化和带外虚拟化.md

├── 文件系统虚拟化解决方案.md

├── 磁盘虚拟化.md

└── 详解存储子系统的虚拟化.md

├── 全虚拟化和半虚拟化.md

├── 虚拟化之四种网络模型.md

├── 虚拟化五种类型.md

├── 虚拟化技术.md

├── 虚拟化技术分类.md

├── 虚拟化架构图.md

└── 虚拟化的分类

/framework/vSphere体系架构.md:

--------------------------------------------------------------------------------

1 | # vSphere 体系架构

2 |

3 | ## 1. vSphere 体系

4 |

5 |

6 |

7 |

8 |

9 | ### 1.1 VMware vSphere 6组件

10 | #### 1.1.1 VMware ESXi

11 | vSphere 早期版本存在ESX,ESX:虚拟机平台管理程序,ESX包含了一个VMware Kernel(虚拟化管理内核)和一个命令行式的Service Console(服务控制台)(vSphere 4.1将是最后一个包含ESX版本的平台,其后续版本仅将包含ESXi)

12 | ESXi(又名vSphere Hypervisor):基本功能同ESX,但ESXi仅保留管理内核(VMKernel)以及VMM而不再包含服务控制台(用vCLI 或 PowerCLI替代其大部分功能),所以体积很小,可安装在嵌入式设备如U盘上。

13 |

14 | #### 1.1.2 VMware vCenter Server

15 | 虚拟化平台管理中心控制系统,有windows和linux版,

16 |

17 | #### 1.1.3 vSphere Update Manager

18 | vSphere环境升级,打补丁的工具,

19 |

20 | #### 1.1.4 VMware vSphere Client和vSphere Web Client

21 | vSphere客户端,

22 |

23 | #### 1.1.5 vRealize Orchestrator(原名vCenter Orchestrator)

24 | 自动化引擎,建立工作流的工具---任务编排器

25 |

26 | #### 1.1.6 VMware Data Protection

27 | 数据保护-----备份虚拟机

28 |

29 | #### 1.1.7 vSphere with Operations Management(单独购买或购买套件)

30 | 监控和管理的工具

31 |

32 | ### 1.2 产品与特性

33 | #### 1.2.1 VMware ESXi

34 | #### 1.2.2 VMware vCenter Server

35 | #### 1.2.3 vSphere Update Manager

36 | #### 1.2.4 VMware vSphere Client and vSphere Web Client

37 | #### 1.2.5 VMware vShield Zones

38 | #### 1.2.6 VMware vCenter Orchestrator

39 | #### 1.2.7 vSphere Virtual Symmetric Multi-Processing

40 | #### 1.2.8 vSphere vMotion and Storage vMotion

41 | #### 1.2.9 vSphere Distributed Resource Scheduler

42 | #### 1.2.10 vSphere Storage DRS

43 | #### 1.2.11 Storage I/O Control and Network I/O Control

44 | #### 1.2.12 Profile-Driven Storage

45 | #### 1.2.13 vSphere High Availability

46 | #### 1.2.14 vSphere Fault Tolerance

47 | #### 1.2.15 vSphere Storage APIs(应用程序接口)for Data Protection and VMware Data Recovery

48 |

49 | ### 1.3 必须使用vCenter Server才能支持的特性

50 | #### 1.3.1 virtual machine templates(虚拟机模版)

51 | #### 1.3.2 role-based access controls (基于角色的访问控制)

52 | #### 1.3.3 fine-grained resource allocation controls (粒度的资源关联控制)

53 | #### 1.3.4 VMware Vmotion (在线迁移)

54 | #### 1.3.5 VMware Distributed Resource Scheduler (分布式资源调度)

55 | #### 1.3.6 VMware High Availability (高可用性)

56 | #### 1.3.7 VMware Fault Tolerance (容错)

57 | #### 1.3.8 Enhanced VMotion Compatibility (EVC) (增强vMotion兼容性)

58 | #### 1.3.9 Host profiles (主机脚本)

59 | #### 1.3.10 vNetwork Distributed Switches (分布式交换机)

60 | #### 1.3.11 Storage and Network I/O Control (存储和网络I/O控制)

61 | #### 1.3.12 Sphere Storage DRS (存储分布式资源调度)

62 |

63 |

64 | VMware虚拟化拓扑图:

65 |

66 |

67 |

68 |

69 | ## 2. 传统架构VS虚拟化

70 | 6.0与5.5版本的对比:

71 |

72 |

73 |

74 |

75 |

76 | 传统物理基础架构: 虚拟化架构:

77 |

78 |

79 |

80 |

81 |

82 |

83 |

84 |

85 |

86 |

87 |

88 |

89 |

90 |

91 |

92 |

93 |

94 |

95 |

96 |

97 |

98 |

99 |

100 |

101 |

102 |

103 |

104 |

105 |

106 |

107 |

108 |

109 |

110 |

111 |

112 |

113 | ## 3. 虚拟化的优势

114 | ### 3.1 虚拟化优点:

115 | 优点1:提高硬件整合率:虚拟化使得低利用率的服务器负载整合到一台服务器,安全可靠地达到很高的硬件利用率

116 | 优点2:快速部署服务器

117 | 优点3:降低整体投资成本(TCO)将不同应用负载虚拟化使得用户可以大大减少服务器的数量典型的平均整合比率在8:1到15:1

118 | 优点4:节能降耗

119 | 优点5:提高了系统可用性物理主机被虚拟化后,计算资源均被池化。当资源池里一个节点发生故障时,运行在其上的虚拟机将自动迁移到健康的物理主机上。

120 |

121 | ## 4. VMware vSphere 方案概览

122 | ### 4.1 基于vSphere的虚拟数据中心基础架构

123 | vSphere 可加快现有数据中心向云计算的转变,同时还支持兼容的公有云服务,从而为业界唯一的混合云模式奠定了基础。vSphere,许多群体称之为“ESXi”,即底层虚拟化管理程序体系结构的名称,这是一种采用尖端技术的裸机虚拟化管理程序。

124 | vSphere 是市场上最先进的虚拟化管理程序,具有许多独特的功能和特性,其中包括:

125 | #### 1.4.1.1 磁盘空间占用量小,因此可以缩小受攻击面并减少补丁程序数量

126 | #### 1.4.1.2 不依赖操作系统,并采用加强型驱动程序

127 | #### 1.4.1.3 具备高级内存管理功能,能够消除重复内存页或压缩内存页

128 | #### 1.4.1.4 通过集成式的集群文件系统提供高级存储管理功能

129 | #### 1.4.1.5 高I/O可扩展性可消除I/O瓶颈

130 |

131 |

132 |

133 | 基于VMware vSphere 的虚拟数据中心由基本物理构建块(例如x86 虚拟化服务器、存储器网络和阵列、IP 网络、管理服务器和桌面客户端)组成。

134 |

135 | ### 4.2 vSphere 数据中心的物理拓扑

136 |

137 |

138 | vSphere 数据中心拓扑包括下列组件:

139 | #### 1.4.2.6 计算服务器:ESXi主机群,在祼机上运行ESXi 的业界标准 x86 服务器。ESXi 软件为虚拟机提供资源,并运行虚拟机。每台计算服务器在虚拟环境中均称为独立主机。可以将许多配置相似的x86 服务器组合在一起,并与相同的网络和存储子系统连接,以便提供虚拟环境中的资源集合(称为群集)。

140 | #### 1.4.2.7 存储网络和阵列光纤通道:SAN 阵列、iSCSI SAN 阵列和 NAS 阵列是广泛应用的存储技术,VMware vSphere支持这些技术以满足不同数据中心的存储需求。

141 | #### 1.4.2.8 IP 网络:每台计算服务器都可以有多个物理网络适配器,为整个VMware vSphere 数据中心提供高带宽和可靠的网络连接。

142 | #### 1.4.2.9 vCenter Server: vCenter Server 为数据中心提供一个单一控制点

143 | #### 1.4.2.10 管理客户端:这些界面包括VMware vSphere Client (vSphere Client)、vSphere Web Client(用于通过 Web 浏览器访问)或 vSphere Command-Line Interface (vSphere CLI)。

144 |

145 | ### 4.3 ESXi架构和组件

146 | 如下图所示,从体系结构来说ESXi包含虚拟化层和虚拟机,而虚拟化层有两个重要组成部分:虚拟化管理程序VMkernel和虚拟机监视器VMM(守护进程)。ESXi主机可以通过vSphere Client、vCLI、API/SDK和CIM接口接入管理。

147 | 1. VMkernel 是虚拟化的核心和推动力,由VMware 开发并提供与其他操作系统提供的功能类似的某些功能,如进程创建和控制、信令、文件系统和进程线程。VMkernel控制和管理服务器的实际资源,它用资源管理器排定VM顺序,为它们动态分配CPU时间、内存和磁盘及网络访问。它还包含了物理服务器各种组件的设备驱动器——例如,网卡和磁盘控制卡、VMFS文件系统和虚拟交换机。VMkernel 专用于支持运行多个虚拟机及提供如下核心功能:

148 | 资源调度----->CPU、内存

149 | I/O 堆栈----->网卡、存储

150 | 设备驱动程序------>网卡等

151 |

152 | 2. 每个 ESXi 主机的关键组件是一个称为VMM 的进程(守护进程)。对于每个已开启的虚拟机,将在VMkernel中运行一个 VMM。虚拟机开始运行时,控制权将转交给VMM,然后由 VMM 依次执行虚拟机发出的指令。VMkernel 将设置系统状态,以便VMM 可以直接在硬件上运行。然而,虚拟机中的操作系统并不了解此次控制权转交,而会认为自己是在硬件上运行。VMM 使虚拟机可以像物理机一样运行,而同时仍与主机和其他虚拟机保持隔离。因此,如果单台虚拟机崩溃,主机本身以及主机上的其他虚拟机将不受任何影响。

153 |

154 | ### 4.4 虚拟机的组件:操作系统、VMware Tools 以及虚拟资源和硬件。

155 | #### 1.4.4.1 操作系统

156 | 虚拟机与所有标准x86 操作系统和应用程序完全兼容。在一台物理主机的不同虚拟机里,可以根据应用需求同时运行不同的x86操作系统,彼此之间不会冲突,且对x86操作系统无需进行任何修改。

157 | #### 1.4.4.2 Vmware Tools

158 | VMware Tools 是一套实用程序,能够提高虚拟机的客户操作系统的性能,并改善对虚拟机的管理。VMwareTools 服务是一项在客户操作系统内执行各种功能的服务。该服务在客户操作系统启动时自动启动。该服务可执行的功能包括:

159 |

160 | ①将消息从 ESXi 主机传送到客户操作系统。

161 | ②向ESXi主机发送心跳信号,使其知道客户操作系统正在运行。

162 | ③实现客户操作系统与主机操作系统之间的时间同步。

163 | ④在虚拟机中运行脚本并执行命令。

164 | ⑤为使用 VMware VIX API 创建的与客户操作系统绑定的调用提供支持,除Mac OS X 客户操作系统外。

165 | ⑥允许指针在 Windows 客户操作系统的客户机和Workstation 之间自由移动。

166 | ⑦帮助创建 Windows 客户操作系统中由特定备份应用程序使用的快照。

167 | ⑧在客户操作系统中安装 VMware Tools 后,它还会提供 VMware 设备驱动程序,包括 SVGA 显示驱动程序、用于某些客户操作系统的 vmxnet 网络连接驱动程序、用于某些客户操作系统的 BusLogic SCSI 或 LSI Logic驱动程序、用于在虚拟机之间进行有效内存分配的内存控制驱动程序、用于将 I/O 置于静默状态(使用VMware Data Recovery 或 VMware vStorage API for Data Recovery)以进行备份的同步驱动程序、用于实现文件夹共享的内核模块以及 VMware 鼠标驱动程序。

168 | ⑨各种驱动程序:

169 |

170 | ### 4.3 虚拟硬件

171 | 每个虚拟机都有虚拟硬件,这些虚拟硬件在所安装的客户操作系统及其应用中显示为物理硬件。每个客户操作系统都能识别出常规硬件设备,但它并不知道这些设备实际上是虚拟设备。虚拟机具有统一的硬件(少数选项可以由系统管理员控制)。统一硬件使得虚拟机可以跨vSphere 主机进行迁移

172 |

173 |

174 |

175 |

176 |

177 |

178 |

179 |

180 |

181 |

182 |

183 |

184 |

185 |

--------------------------------------------------------------------------------

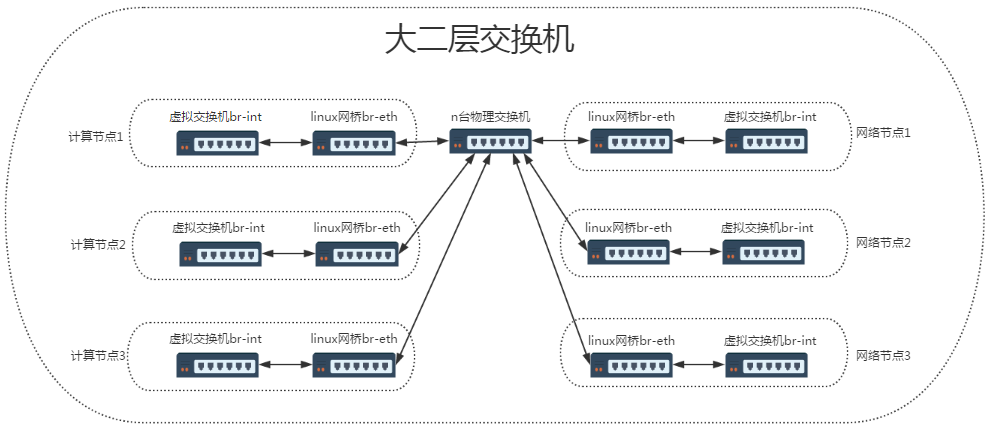

/framework/网络虚拟化.md:

--------------------------------------------------------------------------------

1 | # 网络虚拟化

2 |

3 | ## 前言

4 |

5 | 网络虚拟化相对计算、存储虚拟化来说是比较抽象的,以我们在学校书本上学的那点网络知识来理解网络虚拟化可能是不够的。

6 | 在我们的印象中,网络就是由各种网络设备(如交换机、路由器)相连组成的一个网状结构,世界上的任何两个人都可以通过网络建立起连接。

7 | 带着这样一种思路去理解网络虚拟化可能会感觉云里雾里——这样一个庞大的网络如何实现虚拟化?

8 | 其实,网络虚拟化更多关注的是数据中心网络、主机网络这样比较「细粒度」的网络,所谓细粒度,是相对来说的,是深入到某一台物理主机之上的网络结构来谈的。

9 | 如果把传统的网络看作「宏观网络」的话,那网络虚拟化关注的就是「微观网络」。网络虚拟化的目的,是要节省物理主机的网卡设备资源。从资源这个角度去理解,可能会比较好理解一点。

10 |

11 | ## 传统网络架构

12 | 在传统网络环境中,一台物理主机包含一个或多个网卡(NIC),要实现与其他物理主机之间的通信,需要通过自身的 NIC 连接到外部的网络设施,如交换机上,如下图所示。

13 |

14 |

15 |

16 |

17 |

18 |

19 | 这种架构下,为了对应用进行隔离,往往是将一个应用部署在一台物理设备上,这样会存在两个问题,1)是某些应用大部分情况可能处于空闲状态,2)是当应用增多的时候,只能通过增加物理设备来解决扩展性问题。不管怎么样,这种架构都会对物理资源造成极大的浪费。

20 |

21 | ## 虚拟化网络架构

22 | 为了解决这个问题,可以借助虚拟化技术对一台物理资源进行抽象,将一张物理网卡虚拟成多张虚拟网卡(vNIC),通过虚拟机来隔离不同的应用。

23 | 这样对于上面的问题 1),可以利用虚拟化层 Hypervisor 的调度技术,将资源从空闲的应用上调度到繁忙的应用上,达到资源的合理利用;针对问题 2),可以根据物理设备的资源使用情况进行横向扩容,除非设备资源已经用尽,否则没有必要新增设备。这种架构如下所示。

24 |

25 |

26 |

27 |

28 |

29 |

30 |

31 | 其中虚拟机与虚拟机之间的通信,由虚拟交换机完成,虚拟网卡和虚拟交换机之间的链路也是虚拟的链路,整个主机内部构成了一个虚拟的网络,如果虚拟机之间涉及到三层的网络包转发,则又由另外一个角色——虚拟路由器来完成。

32 | 一般,这一整套虚拟网络的模块都可以独立出去,由第三方来完成,如其中比较出名的一个解决方案就是 Open vSwitch(OVS)。

33 | OVS 的优势在于它基于 SDN 的设计原则,方便虚拟机集群的控制与管理,另外就是它分布式的特性,可以「透明」地实现跨主机之间的虚拟机通信,如下是跨主机启用 OVS 通信的图示。

34 |

35 |

36 |

37 |

38 |

39 | 总结下来,网络虚拟化主要解决的是虚拟机构成的网络通信问题,完成的是各种网络设备的虚拟化,如网卡、交换设备、路由设备等。

40 |

41 | ## Linux 下网络设备虚拟化的几种形式

42 | 为了完成虚拟机在同主机和跨主机之间的通信,需要借助某种“桥梁”来完成用户态到内核态(Guest 到 Host)的数据传输,这种桥梁的角色就是由虚拟的网络设备来完成,上面介绍了一个第三方的开源方案——OVS,它其实是一个融合了各种虚拟网络设备的集大成者,是一个产品级的解决方案。

43 | 但 Linux 本身由于虚拟化技术的演进,也集成了一些虚拟网络设备的解决方案,主要有以下几种:

44 |

45 | ### (1)TAP/TUN/VETH

46 | TAP/TUN 是 Linux 内核实现的一对虚拟网络设备,TAP 工作在二层,TUN 工作在三层。Linux 内核通过 TAP/TUN 设备向绑定该设备的用户空间程序发送数据,反之,用户空间程序也可以像操作物理网络设备那样,向 TAP/TUN 设备发送数据。

47 | 基于 TAP 驱动,即可实现虚拟机 vNIC 的功能,虚拟机的每个 vNIC 都与一个 TAP 设备相连,vNIC 之于 TAP 就如同 NIC 之于 eth。

48 | 当一个 TAP 设备被创建时,在 Linux 设备文件目录下会生成一个对应的字符设备文件,用户程序可以像打开一个普通文件一样对这个文件进行读写。

49 | 比如,当对这个 TAP 文件执行 write 操作时,相当于 TAP 设备收到了数据,并请求内核接受它,内核收到数据后将根据网络配置进行后续处理,处理过程类似于普通物理网卡从外界收到数据。当用户程序执行 read 请求时,相当于向内核查询 TAP 设备是否有数据要发送,有的话则发送,从而完成 TAP 设备的数据发送。

50 | TUN 则属于网络中三层的概念,数据收发过程和 TAP 是类似的,只不过它要指定一段 IPv4 地址或 IPv6 地址,并描述其相关的配置信息,其数据处理过程也是类似于普通物理网卡收到三层 IP 报文数据。

51 | VETH 设备总是成对出现,一端连着内核协议栈,另一端连着另一个设备,一个设备收到内核发送的数据后,会发送到另一个设备上去,这种设备通常用于容器中两个 namespace 之间的通信。

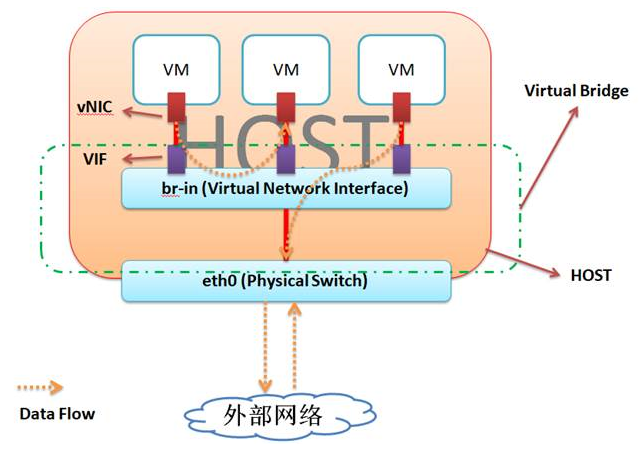

52 |

53 | ### (2)Bridge#

54 | Bridge 也是 Linux 内核实现的一个工作在二层的虚拟网络设备,但不同于 TAP/TUN 这种单端口的设备,Bridge 实现为多端口,本质上是一个虚拟交换机,具备和物理交换机类似的功能。

55 | Bridge 可以绑定其他 Linux 网络设备作为从设备,并将这些从设备虚拟化为端口,当一个从设备被绑定到 Bridge 上时,就相当于真实网络中的交换机端口上插入了一根连有终端的网线。

56 | 如下图所示,Bridge 设备 br0 绑定了实际设备 eth0 和 虚拟设备设备 tap0/tap1,当这些从设备接收到数据时,会发送给 br0 ,br0 会根据 MAC 地址与端口的映射关系进行转发。

57 |

58 |

59 |

60 |

61 |

62 | 因为 Bridge 工作在二层,所以绑定到它上面的从设备 eth0、tap0、tap1 均不需要设 IP,但是需要为 br0 设置 IP,因为对于上层路由器来说,这些设备位于同一个子网,需要一个统一的 IP 将其加入路由表中。

63 | 这里有人可能会有疑问,Bridge 不是工作在二层吗,为什么会有 IP 的说法?其实 Bridge 虽然工作在二层,但它只是 Linux 网络设备抽象的一种,能设 IP 也不足为奇。

64 | 对于实际设备 eth0 来说,本来它是有自己的 IP 的,但是绑定到 br0 之后,其 IP 就失效了,就和 br0 共享一个 IP 网段了,在设路由表的时候,就需要将 br0 设为目标网段的地址。

65 |

66 | ## 总结

67 | 传统网络架构到虚拟化的网络架构,可以看作是宏观网络到微观网络的过渡

68 | TAP/TUN/VETH、Bridge 这些虚拟的网络设备是 Linux 为了实现网络虚拟化而实现的网络设备模块,很多的云开源项目的网络功能都是基于这些技术做的,比如 Neutron、Docker network 等。

69 | OVS 是一个开源的成熟的产品级分布式虚拟交换机,基于 SDN 的思想,被大量应用在生产环境中。

70 |

--------------------------------------------------------------------------------

/framework/虚拟化架构、特点及优势.md:

--------------------------------------------------------------------------------

1 | # 虚拟化架构、特点及优势

2 |

3 | # 1. 虚拟化架构

4 |

5 | 根据在整个系统中的位置不同,虚拟化架构分为以下几种:

6 | * 寄居虚拟化架构

7 | * 裸金属虚拟化架构

8 | * 操作系统虚拟化架构

9 | * 混合虚拟化架构

10 |

11 | 1) 寄居虚拟化架构

12 | 寄居虚拟化架构指在宿主操作系统之上安装和运行虚拟化程序,依赖于宿主操作系统对设备的支持和物理资源的管理。(类似 Vmware Workstation 的程序)

13 |

14 |

15 | 2) 裸金属虚拟化架构

16 | 裸金属虚拟化架构指直接在硬件上面安装虚拟化软件,再在其上安装操作系统和应用,依赖虚拟层内核和服务器控制台进行管理。

17 |

18 |

19 | 3) 操作系统虚拟化架构

20 | 操作系统虚拟化架构在操作系统层面增加虚拟服务器功能。操作系统虚拟化架构把单个的操作系统划分为多个容器,使用容器管理器来进行管理。

21 | 宿主操作系统负责在多个虚拟服务器(即容器)之间分配硬件资源,并且让这些服务器彼此独立。

22 |

23 | 4) 混合虚拟化架构

24 | 混合虚拟化架构将一个内核级驱动器插入到宿主操作系统内核。这个驱动器作为虚拟硬件管理器来协调虚拟机和宿主操作系统之间的硬件访问。

25 |

26 |

27 | # 2. 虚拟化特点

28 | 虚拟化具有以下特点:

29 | * 分区:对物理机分区,可实现在单一物理机上同时运行多个虚拟机。

30 | * 隔离:同一物理机上多个虚拟机相互隔离。

31 | * 封装:整个虚拟机执行环境封装在独立文件中。

32 | * 独立:虚拟机无须修改,可运行在任何物理机上。

33 |

--------------------------------------------------------------------------------

/framework/虚拟地址的理解.md:

--------------------------------------------------------------------------------

1 | # 虚拟地址的理解

2 |

3 | 在进入正题前先来谈谈操作系统内存管理机制的发展历程,了解这些有利于我们更好的理解目前操作系统的内存管理机制。

4 |

5 | ## 1. 早期的内存分配机制

6 |

7 | 在 早期的计算机中,要运行一个程序,会把这些程序全都装入内存,程序都是直接运行在内存上的,也就是说程序中访问的内存地址都是实际的物理内存地址。当计算机同时运行多个程序时,必须保证这些程序用到的内存总量要小于计算机实际物理内存的大小。那当程序同时运行多个程序时,操作系统是如何为这些程序分配内存 的呢?下面通过实例来说明当时的内存分配方法:

8 |

9 | 某台计算机总的内存大小是 128M ,现在同时运行两个程序 A 和 B , A 需占用内存 10M , B 需占用内存 110 。计算机在给程序分配内存时会采取这样的方法:先将内存中的前 10M 分配给程序 A ,接着再从内存中剩余的 118M 中划分出 110M 分配给程序 B 。这种分配方法可以保证程序 A 和程序 B 都能运行,但是这种简单的内存分配策略问题很多。

10 |

11 |

12 | 图1 早期的内存分配方法

13 |

14 | * 问题 1 :进程地址空间不隔离。由于程序都是直接访问物理内存,所以恶意程序可以随意修改别的进程的内存数据,以达到破坏的目的。有些非恶意的,但是有 bug 的程序也可能不小心修改了其它程序的内存数据,就会导致其它程序的运行出现异常。这种情况对用户来说是无法容忍的,因为用户希望使用计算机的时候,其中一个任务失败了,至少不能影响其它的任务。

15 | * 问题 2 :内存使用效率低。在 A 和 B 都运行的情况下,如果用户又运行了程序 C ,而程序 C 需要 20M 大小的内存才能运行,而此时系统只剩下 8M 的空间可供使用,所以此时系统必须在已运行的程序中选择一个将该程序的数据暂时拷贝到硬盘上,释放出部分空间来供程序 C 使用,然后再将程序 C 的数据全部装入内存中运行。可以想象得到,在这个过程中,有大量的数据在装入装出,导致效率十分低下。

16 | * 问题 3 :程序运行的地址不确定。当内存中的剩余空间可以满足程序 C 的要求后,操作系统会在剩余空间中随机分配一段连续的 20M 大小的空间给程序 C 使用,因为是随机分配的,所以程序运行的地址是不确定的。

17 |

18 | ## 2. 分段

19 |

20 | 为 了解决上述问题,人们想到了一种变通的方法,就是增加一个中间层,利用一种间接的地址访问方法访问物理内存。按照这种方法,程序中访问的内存地址不再是实际的物理内存地址,而是一个虚拟地址,然后由操作系统将这个虚拟地址映射到适当的物理内存地址上。这样,只要操作系统处理好虚拟地址到物理内存地址的映 射,就可以保证不同的程序最终访问的内存地址位于不同的区域,彼此没有重叠,就可以达到内存地址空间隔离的效果。

21 | 当创建一个进程时,操作系统会为该进程分配一个 4GB 大小的虚拟进程地址空间。之所以是 4GB ,是因为在 32 位的操作系统中,一个指针长度是 4 字节,而 4 字节指针的寻址能力是从 0x00000000~0xFFFFFFFF ,最大值 0xFFFFFFFF 表示的即为 4GB 大小的容量。与虚拟地址空间相对的,还有一个物理地址空间,这个地址空间对应的是真实的物理内存。如果你的计算机上安装了 512M 大小的内存,那么这个物理地址空间表示的范围是 0x00000000~0x1FFFFFFF 。当操作系统做虚拟地址到物理地址映射时,只能映射到这一范围,操作系统也只会映射到这一范围。当进程创建时,每个进程都会有一个自己的 4GB 虚拟地址空间。要注意的是这个 4GB 的地址空间是“虚拟”的,并不是真实存在的,而且每个进程只能访问自己虚拟地址空间中的数据,无法访问别的进程中的数据,通过这种方法实现了进程间的地址隔离。那是不是这 4GB 的虚拟地址空间应用程序可以随意使用呢?很遗憾,在 Windows 系统下,这个虚拟地址空间被分成了 4 部分: NULL 指针区、用户区、 64KB 禁入区、内核区。应用程序能使用的只是用户区而已,大约 2GB 左右 ( 最大可以调整到 3GB) 。内核区为 2GB ,内核区保存的是系统线程调度、内存管理、设备驱动等数据,这部分数据供所有的进程共享,但应用程序是不能直接访问的。

22 |

23 | 人们之所以要创建一个虚拟地址空间,目的是为了解决进程地址空间隔离的问题。但程序要想执行,必须运行在真实的内存上,所以,必须在虚拟地址与物理地址间建立一种映射关系。这样,通过映射机制,当程序访问虚拟地址空间上的某个地址值时,就相当于访问了物理地址空间中的另一个值。人们想到了一种分段 (Sagmentation) 的方法,它的思想是在虚拟地址空间和物理地址空间之间做一一映射。比如说虚拟地址空间中某个10M 大小的空间映射到物理地址空间中某个10M 大小的空间,可以多对一,就是说可虚拟地址的多个10M大小的空间可以映射到相同的物理地址空间的某个10M。这种思想理解起来并不难,操作系统保证不同进程的地址空间被映射到物理地址空间中不同的区域上,这样每个进程最终访问到的

24 | 物理地址空间都是彼此分开的。通过这种方式,就实现了进程间的地址隔离。还是以实例说明,假设有两个进程 A 和 B ,进程 A 所需内存大小为 10M ,其虚拟地址空间分布在 0x00000000 到 0x00A00000 ,进程 B 所需内存为 100M ,其虚拟地址空间分布为 0x00000000 到 0x06400000 。那么按照分段的映射方法,进程 A 在物理内存上映射区域为 0x00100000 到 0x00B00000 ,,进程 B 在物理内存上映射区域为 0x00C00000 到 0x07000000 。于是进程 A 和进程 B 分别被映射到了不同的内存区间,彼此互不重叠,实现了地址隔离。从应用程序的角度看来,进程 A 的地址空间就是分布在 0x00000000 到 0x00A00000 ,在做开发时,开发人员只需访问这段区间上的地址即可。应用程序并不关心进程 A 究竟被映射到物理内存的那块区域上了,所以程序的运行地址也就是相当于说是确定的了。 图二显示的是分段方式

25 | 的内存映射方法。

26 |

27 |

28 |

29 | 图2 分段方式的内存映射方法

30 |

31 | 这种分段的映射方法虽然解决了上述中的问题一和问题三,但并没能解决问题二,即内存的使用效率问题。在分段的映射方法中,每次换入换出内存的都是整个程序,这样会造成大量的磁盘访问操作,导致效率低下。所以这种映射方法还是稍显粗糙,粒度比较大。实际上,程序的运行有局部性特点,在某个时间段内,程序只是访 问程序的一小部分数据,也就是说,程序的大部分数据在一个时间段内都不会被用到。基于这种情况,人们想到了粒度更小的内存分割和映射方法,这种方法就是分页 (Paging) 。

32 |

33 | ## 3. 分页

34 |

35 | 分页的基本方法是,将地址空间分成许多的页。每页的大小由 CPU 决定,然后由操作系统选择页的大小。目前 Inter 系列的 CPU 支持 4KB 或 4MB 的页大小,而 PC 上目前都选择使用 4KB 。按这种选择, 4GB 虚拟地址空间共可以分成 1048576 个页, 512M 的物理内存可以分为 131072 个页。显然虚拟空间的页数要比物理空间的页数多得多。

36 |

37 | 在分段的方法中,每次程序运行时总是把程序全部装入内存,而分页的方法则有所不同。分页的思想是程序运行时用到哪页就为哪页分配内存,没用到的页暂时保留在硬盘上。当用到这些页时再在物理地址空间中为这些页分配内存,然后建立虚拟地址空间中的页和刚分配的物理内存页间的映射。

38 |

39 | 下面通过介绍一个可执行文件的装载过程来说明分页机制的实现方法。一个可执行文件 (PE 文件 ) 其实就是一些编译链接好的数据和指令的集合,它也会被分成很多页,在 PE 文件执行的过程中,它往内存中装载的单位就是页。当一个 PE 文件被执行时,操作系统会先为该程序创建一个 4GB 的进程虚拟地址空间。前面介绍过,虚拟地址空间只是一个中间层而已,它的功能是利用一种映射机制将虚拟地址空间映射到物理地址空间,所以,创建 4GB 虚拟地址空间其实并不是要真的创建空间,只是要创建那种映射机制所需要的数据结构而已,这种数据结构就是页目和页表。

40 |

41 | 当创建完虚拟地址空间所需要的数据结构后,进程开始读取 PE 文件的第一页。在 PE 文件的第一页包含了 PE 文件头和段表等信息,进程根据文件头和段表等信息,将 PE 文件中所有的段一一映射到虚拟地址空间中相应的页 (PE 文件中的段的长度都是页长的整数倍 ) 。这时 PE 文件的真正指令和数据还没有被装入内存中,操作系统只是根据 PE 文件的头部等信息建立了 PE 文件和进程虚拟地址空间中页的映射关系而已。当 CPU 要访问程序中用到的某个虚拟地址时,当 CPU 发现该地址并没有相相关联的物理地址时, CPU 认为该虚拟地址所在的页面是个空页面, CPU 会认为这是个页错误 (Page Fault) , CPU 也就知道了操作系统还未给该 PE 页面分配内存, CPU 会将控制权交还给操作系统。操作系统于是为该 PE 页面在物理空间中分配一个页面,然后再将这个物理页面与虚拟空间中的虚拟页面映射起来,然后将控制权再还给进程,进程从刚才发生页错误的位置重新开始执行。由于此时已为 PE 文件的那个页面分配了内存,所以就不会发生页错误了。随着程序的执行,页错误会不断地产生,操作系统也会为进程分配相应的物理页面来满足进程执行的需求。

42 |

43 | 分页方法的核心思想就是当可执行文件执行到第 x 页时,就为第 x 页分配一个内存页 y ,然后再将这个内存页添加到进程虚拟地址空间的映射表中 , 这个映射表就相当于一个 y=f(x) 函数。应用程序通过这个映射表就可以访问到 x 页关联的 y 页了。

44 |

45 | # 总结:

46 | 32 位的CPU 的寻址空间是4G , 所以虚拟内存的最大值为4G , 而windows 操作系统把这4G 分成2 部分, 即2G 的用户空间和2G 的系统空间, 系统空间是各个进程所共享的, 他存放的是操作系统及一些内核对象等, 而用户空间是分配给各个进程使用的, 用户空间包括用: 程序代码和数据, 堆, 共享库, 栈。

47 |

--------------------------------------------------------------------------------

/papers/01_Emerging_Virtualization_Technology.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/01_Emerging_Virtualization_Technology.pdf

--------------------------------------------------------------------------------

/papers/02_HYPERVISOR_FOR_VIRTUALIZATION_IN_PRIVATE_CLOUD.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/02_HYPERVISOR_FOR_VIRTUALIZATION_IN_PRIVATE_CLOUD.pdf

--------------------------------------------------------------------------------

/papers/03_Secure_Virtualization_for_Cloud_Environment_Using_Hypervisor-based_Technology.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/03_Secure_Virtualization_for_Cloud_Environment_Using_Hypervisor-based_Technology.pdf

--------------------------------------------------------------------------------

/papers/04_OPERATING_SYSTEM_VIRTUALIZATION_IN_THE_EDUCATION_OF_COMPUTER_SCIENCE_STUDENTS.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/04_OPERATING_SYSTEM_VIRTUALIZATION_IN_THE_EDUCATION_OF_COMPUTER_SCIENCE_STUDENTS.pdf

--------------------------------------------------------------------------------

/papers/05_Virtualization_Technologies_and_Cloud_Securityadvantages,issues,and_perspectives.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/05_Virtualization_Technologies_and_Cloud_Securityadvantages,issues,and_perspectives.pdf

--------------------------------------------------------------------------------

/papers/06_Xen_and_the_Art_of_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/06_Xen_and_the_Art_of_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/07_Analysis_of_Virtualization_Technologies_for_High_Performance_Computing_Environments.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/07_Analysis_of_Virtualization_Technologies_for_High_Performance_Computing_Environments.pdf

--------------------------------------------------------------------------------

/papers/08_Research_on_Cloud_Computing_Based_on_Storage_Virtualization_in_Data_Center.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/08_Research_on_Cloud_Computing_Based_on_Storage_Virtualization_in_Data_Center.pdf

--------------------------------------------------------------------------------

/papers/09_Architecture_for_Technology_Transformation.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/09_Architecture_for_Technology_Transformation.pdf

--------------------------------------------------------------------------------

/papers/10_A_Study_On_Virtualization_Techniques_And_Challenges_In_Cloud_Computing.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/10_A_Study_On_Virtualization_Techniques_And_Challenges_In_Cloud_Computing.pdf

--------------------------------------------------------------------------------

/papers/11_Virtual_Machine_Security_Guidelines_Version_1.0.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/11_Virtual_Machine_Security_Guidelines_Version_1.0.pdf

--------------------------------------------------------------------------------

/papers/12_Comparative_Performance_Analysis_of_the_Virtualization_Technologies_in_Cloud_Computing.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/12_Comparative_Performance_Analysis_of_the_Virtualization_Technologies_in_Cloud_Computing.pdf

--------------------------------------------------------------------------------

/papers/13_Improving_Business_Performance_by_Employing_VirtualizationTechnology_A_Case_Study_in_the_Financial_Sector.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/13_Improving_Business_Performance_by_Employing_VirtualizationTechnology_A_Case_Study_in_the_Financial_Sector.pdf

--------------------------------------------------------------------------------

/papers/14_Consolidation_Using_Oracle's_SPARCVirtualization_Technologies.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/14_Consolidation_Using_Oracle's_SPARCVirtualization_Technologies.pdf

--------------------------------------------------------------------------------

/papers/15-Development_of_a_virtualization_systems_architecture_course_for_t.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/15-Development_of_a_virtualization_systems_architecture_course_for_t.pdf

--------------------------------------------------------------------------------

/papers/16_Educational_Infrastructure_Using_Virtualization_Technologies_Experience_at_Kaunas_University_of_Technology.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/16_Educational_Infrastructure_Using_Virtualization_Technologies_Experience_at_Kaunas_University_of_Technology.pdf

--------------------------------------------------------------------------------

/papers/17_Comparative_Study_of_Virtual_Machine_Software_Packages_with_Real_Operating_System.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/17_Comparative_Study_of_Virtual_Machine_Software_Packages_with_Real_Operating_System.pdf

--------------------------------------------------------------------------------

/papers/18_Dell_EMC_Unity_Virtualization_Integration.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/18_Dell_EMC_Unity_Virtualization_Integration.pdf

--------------------------------------------------------------------------------

/papers/19_A_Study_On_Virtualization_And_Virtual_Machines.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/19_A_Study_On_Virtualization_And_Virtual_Machines.pdf

--------------------------------------------------------------------------------

/papers/20_Review_on_Virtualization_for_Cloud_Computing.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/20_Review_on_Virtualization_for_Cloud_Computing.pdf

--------------------------------------------------------------------------------

/papers/21_A_Survey_on_Virtualization_and_Hypervisor-based_Technology_in_Cloud_Computing_Environment.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/21_A_Survey_on_Virtualization_and_Hypervisor-based_Technology_in_Cloud_Computing_Environment.pdf

--------------------------------------------------------------------------------

/papers/22_STUDY_ON_VIRTUALIZATION_TECHNOLOGY_AND_ITS_IMPORTANCE_IN_CLOUD_COMPUTING_ENVIRONMENT.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/22_STUDY_ON_VIRTUALIZATION_TECHNOLOGY_AND_ITS_IMPORTANCE_IN_CLOUD_COMPUTING_ENVIRONMENT.pdf

--------------------------------------------------------------------------------

/papers/23_Research_on_the_Virtualization_Technology_in_Cloud_Computing_Environment.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/23_Research_on_the_Virtualization_Technology_in_Cloud_Computing_Environment.pdf

--------------------------------------------------------------------------------

/papers/24_Research_and_Development_on_Network_Virtualization_Technologies_in_Japan.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/24_Research_and_Development_on_Network_Virtualization_Technologies_in_Japan.pdf

--------------------------------------------------------------------------------

/papers/25_Eliminate_Software_Development_and_Testing_Constraints_with_Service_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/25_Eliminate_Software_Development_and_Testing_Constraints_with_Service_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/26_Network_Virtualization_A_Data_Plane_Perspective.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/26_Network_Virtualization_A_Data_Plane_Perspective.pdf

--------------------------------------------------------------------------------

/papers/27_A_taxonomy_of_virtualization_technologies.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/27_A_taxonomy_of_virtualization_technologies.pdf

--------------------------------------------------------------------------------

/papers/28_Network_Functions_Virtualisation.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/28_Network_Functions_Virtualisation.pdf

--------------------------------------------------------------------------------

/papers/29_Recommendations_of_the_National_Institute_of_Standards_and_Technology.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/29_Recommendations_of_the_National_Institute_of_Standards_and_Technology.pdf

--------------------------------------------------------------------------------

/papers/30_Big_Data_Virtualization_Why_and_How.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/30_Big_Data_Virtualization_Why_and_How.pdf

--------------------------------------------------------------------------------

/papers/31_Server_Virtualization_Technology_and_ltsLatest_Trends.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/31_Server_Virtualization_Technology_and_ltsLatest_Trends.pdf

--------------------------------------------------------------------------------

/papers/32_Virtualization_Technologies_for_Cars_Solutions_to_increase_safety_and_security_of_vehicular_ECUs.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/32_Virtualization_Technologies_for_Cars_Solutions_to_increase_safety_and_security_of_vehicular_ECUs.pdf

--------------------------------------------------------------------------------

/papers/33_Virtualization_and_Future_Technologies.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/33_Virtualization_and_Future_Technologies.pdf

--------------------------------------------------------------------------------

/papers/34_Virtualization_and_the_Computer_Architecture.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/34_Virtualization_and_the_Computer_Architecture.pdf

--------------------------------------------------------------------------------

/papers/35_Virtualization_Introduction_QSM_White_Paper.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/35_Virtualization_Introduction_QSM_White_Paper.pdf

--------------------------------------------------------------------------------

/papers/36_Security_Implications_of_Different_Virtualization_Approaches_for_Secure_Cyber_Architectures.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/36_Security_Implications_of_Different_Virtualization_Approaches_for_Secure_Cyber_Architectures.pdf

--------------------------------------------------------------------------------

/papers/37_Server_Virtualization_A_Step_Toward_Cost_Efficiency_and_Business_Agility.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/37_Server_Virtualization_A_Step_Toward_Cost_Efficiency_and_Business_Agility.pdf

--------------------------------------------------------------------------------

/papers/38_Performance_Implications_of_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/38_Performance_Implications_of_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/39_State-of-the-Art_of_Virtualization,_its_Security_Threats_and_Deployment_Models.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/39_State-of-the-Art_of_Virtualization,_its_Security_Threats_and_Deployment_Models.pdf

--------------------------------------------------------------------------------

/papers/40_HMI_&_Virtualization_in_Process_Automation.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/40_HMI_&_Virtualization_in_Process_Automation.pdf

--------------------------------------------------------------------------------

/papers/41_Terra_A_Virtual_Machine-Based_Platform_for_Trusted_Computing.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/41_Terra_A_Virtual_Machine-Based_Platform_for_Trusted_Computing.pdf

--------------------------------------------------------------------------------

/papers/42_Research_on_Virtualization_Technology_for_Real-time_Reconfigurable_Systems.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/42_Research_on_Virtualization_Technology_for_Real-time_Reconfigurable_Systems.pdf

--------------------------------------------------------------------------------

/papers/43_A_Survey_on_Virtualization_Technologies.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/43_A_Survey_on_Virtualization_Technologies.pdf

--------------------------------------------------------------------------------

/papers/44_Intel_Virtualization_Technology.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/44_Intel_Virtualization_Technology.pdf

--------------------------------------------------------------------------------

/papers/45_EXPERIENCES_WITH_VIRTUALIZATION_TECHNOLOGY_IN_EDUCATION.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/45_EXPERIENCES_WITH_VIRTUALIZATION_TECHNOLOGY_IN_EDUCATION.pdf

--------------------------------------------------------------------------------

/papers/46_VIRTUALIZATION_IN_CLOUD_COMPUTING.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/46_VIRTUALIZATION_IN_CLOUD_COMPUTING.pdf

--------------------------------------------------------------------------------

/papers/47_Systematic_Study_of_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/47_Systematic_Study_of_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/48_Virtualization_in_Cloud_Computing__Developments_and_Trends.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/48_Virtualization_in_Cloud_Computing__Developments_and_Trends.pdf

--------------------------------------------------------------------------------

/papers/49_Virtualization_Overview.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/49_Virtualization_Overview.pdf

--------------------------------------------------------------------------------

/papers/50_ArcGIS_Pro_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/50_ArcGIS_Pro_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/51_Intel®_Virtualization_Technology(VT)_in_Converged_Application_Platforms.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/51_Intel®_Virtualization_Technology(VT)_in_Converged_Application_Platforms.pdf

--------------------------------------------------------------------------------

/papers/52_Virtualization_Technology_Whitepaper-Infrastructure_to_Perform_Static_Tools_and_Binary_Analysis.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/52_Virtualization_Technology_Whitepaper-Infrastructure_to_Perform_Static_Tools_and_Binary_Analysis.pdf

--------------------------------------------------------------------------------

/papers/53_A_Survey_on_Virtual_Machine_Security.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/53_A_Survey_on_Virtual_Machine_Security.pdf

--------------------------------------------------------------------------------

/papers/54_Intel®_Virtualization_Technology_Hardware_Support_for_Efficient_Processor_Virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/54_Intel®_Virtualization_Technology_Hardware_Support_for_Efficient_Processor_Virtualization.pdf

--------------------------------------------------------------------------------

/papers/55_Network_functions_virtualization.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/55_Network_functions_virtualization.pdf

--------------------------------------------------------------------------------

/papers/56_BEYOND_VIRTUALIZATION_The_MontaVista_Approach_to_Multi-core_SoC_Resource_Allocation_and_Control.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/56_BEYOND_VIRTUALIZATION_The_MontaVista_Approach_to_Multi-core_SoC_Resource_Allocation_and_Control.pdf

--------------------------------------------------------------------------------

/papers/57_A_PRINCIPLED_TECHNOLOGIES_WHITE_PAPER.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/57_A_PRINCIPLED_TECHNOLOGIES_WHITE_PAPER.pdf

--------------------------------------------------------------------------------

/papers/58_Data_Virtualization–Flexible_Technology_for_the_Agile_Enterprise.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/58_Data_Virtualization–Flexible_Technology_for_the_Agile_Enterprise.pdf

--------------------------------------------------------------------------------

/papers/59_Top_5_Things_You_Need_in_a_Virtualization_Management_Solution.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/59_Top_5_Things_You_Need_in_a_Virtualization_Management_Solution.pdf

--------------------------------------------------------------------------------

/papers/60_The_IBM_Advantage_for_Implementing_the_Virtualization_Reference_Architecture.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/0voice/Introduce_to_virtualization/484f02f54d9eb016bb9807846e527f9d40c11306/papers/60_The_IBM_Advantage_for_Implementing_the_Virtualization_Reference_Architecture.pdf

--------------------------------------------------------------------------------

/papers/README.md:

--------------------------------------------------------------------------------

1 | #

2 |

--------------------------------------------------------------------------------

/product/KVM简介及安装.md:

--------------------------------------------------------------------------------

1 | # KVM简介及安装

2 |

3 | ## 1. KVM 介绍

4 |

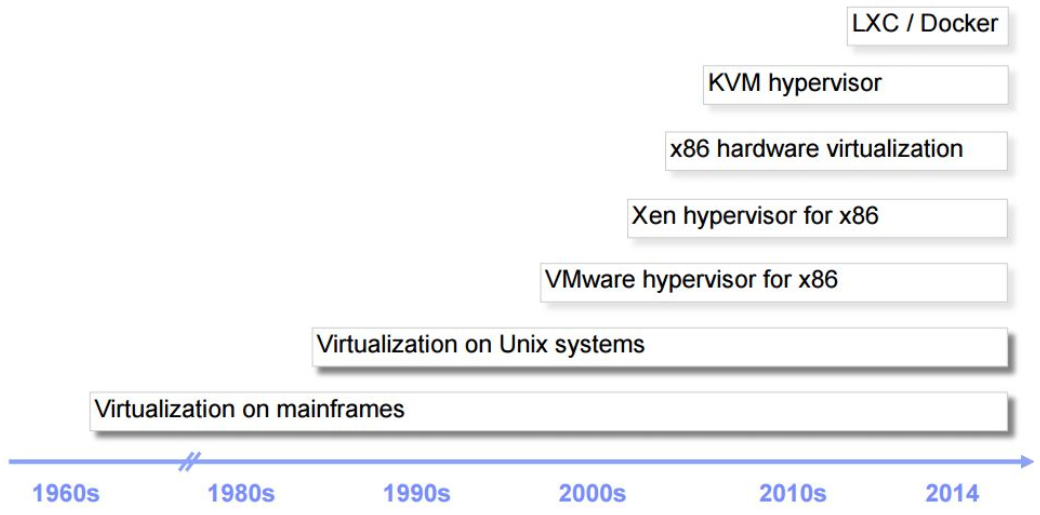

5 | ### 1.1 虚拟化简史

6 |

7 |

8 | 其中,KVM 全称是 基于内核的虚拟机(Kernel-based Virtual Machine),它是Linux 的一个内核模块,该内核模块使得 Linux 变成了一个 Hypervisor:

9 |

10 | 它由 Quramnet 开发,该公司于 2008年被 Red Hat 收购。

11 | 它支持 x86 (32 and 64 位), s390, Powerpc 等 CPU。

12 | 它从 Linux 2.6.20 起就作为一模块被包含在 Linux 内核中。

13 | 它需要支持虚拟化扩展的 CPU。

14 | 它是完全开源的。官网。

15 | 本文介绍的是基于 X86 CPU 的 KVM。

16 |

17 | ### 1.2 KVM 架构

18 |

19 | KVM 是基于虚拟化扩展(Intel VT 或者 AMD-V)的 X86 硬件的开源的 Linux 原生的全虚拟化解决方案。KVM 中,虚拟机被实现为常规的 Linux 进程,由标准 Linux 调度程序进行调度;虚机的每个虚拟 CPU 被实现为一个常规的 Linux 线程。这使得 KMV 能够使用 Linux 内核的已有功能。

20 | 但是,KVM 本身不执行任何硬件模拟,需要用户空间程序通过 /dev/kvm 接口设置一个客户机虚拟服务器的地址空间,向它提供模拟 I/O,并将它的视频显示映射回宿主的显示屏。目前这个应用程序是 QEMU。

21 |

22 | Linux 上的用户空间、内核空间和虚机:

23 |

24 |

25 | * Guest:客户机系统,包括CPU(vCPU)、内存、驱动(Console、网卡、I/O 设备驱动等),被 KVM 置于一种受限制的 CPU 模式下运行。

26 | * KVM:运行在内核空间,提供 CPU 和内存的虚级化,以及客户机的 I/O 拦截。Guest 的 I/O 被 KVM 拦截后,交给 QEMU 处理。

27 | * QEMU:修改过的被 KVM 虚机使用的 QEMU 代码,运行在用户空间,提供硬件 I/O 虚拟化,通过 IOCTL /dev/kvm 设备和 KVM 交互。

28 |

29 | #### KVM 是实现拦截虚机的 I/O 请求的原理:

30 |

31 | 现代 CPU 本身实现了对特殊指令的截获和重定向的硬件支持,甚至新硬件会提供额外的资源来帮助软件实现对关键硬件资源的虚拟化从而提高性能。以 X86 平台为例,支持虚拟化技术的 CPU 带有特别优化过的指令集来控制虚拟化过程。通过这些指令集,VMM 很容易将客户机置于一种受限制的模式下运行,一旦客户机试图访问物理资源,硬件会暂停客户机运行,将控制权交回给 VMM 处理。VMM 还可以利用硬件的虚级化增强机制,将客户机在受限模式下对一些特定资源的访问,完全由硬件重定向到 VMM 指定的虚拟资源,整个过程不需要暂停客户机的运行和 VMM 的参与。由于虚拟化硬件提供全新的架构,支持操作系统直接在上面运行,无需进行二进制转换,减少了相关的性能开销,极大简化了VMM的设计,使得VMM性能更加强大。从 2005 年开始,Intel 在其处理器产品线中推广 Intel Virtualization Technology 即 IntelVT 技术。

32 |

33 | #### QEMU-KVM:

34 |

35 | 其实 QEMU 原本不是 KVM 的一部分,它自己就是一个纯软件实现的虚拟化系统,所以其性能低下。但是,QEMU 代码中包含整套的虚拟机实现,包括处理器虚拟化,内存虚拟化,以及 KVM需要使用到的虚拟设备模拟(网卡、显卡、存储控制器和硬盘等)。 为了简化代码,KVM 在 QEMU 的基础上做了修改。VM 运行期间,QEMU 会通过 KVM 模块提供的系统调用进入内核,由 KVM 负责将虚拟机置于处理的特殊模式运行。当虚机进行 I/O 操作时,KVM 会从上次系统调用出口处返回 QEMU,由 QEMU 来负责解析和模拟这些设备。 从 QEMU 角度看,也可以说是 QEMU 使用了 KVM 模块的虚拟化功能,为自己的虚机提供了硬件虚拟化加速。除此以外,虚机的配置和创建、虚机运行所依赖的虚拟设备、虚机运行时的用户环境和交互,以及一些虚机的特定技术比如动态迁移,都是 QEMU 自己实现的。

36 |

37 | #### KVM:

38 | KVM 内核模块在运行时按需加载进入内核空间运行。KVM 本身不执行任何设备模拟,需要 QEMU 通过 /dev/kvm 接口设置一个 GUEST OS 的地址空间,向它提供模拟的 I/O 设备,并将它的视频显示映射回宿主机的显示屏。它是KVM 虚机的核心部分,其主要功能是初始化 CPU 硬件,打开虚拟化模式,然后将虚拟客户机运行在虚拟机模式下,并对虚机的运行提供一定的支持。以在 Intel 上运行为例,KVM 模块被加载的时候,它:

39 | 1. 首先初始化内部的数据结构;

40 | 2. 做好准备后,KVM 模块检测当前的 CPU,然后打开 CPU 控制及存取 CR4 的虚拟化模式开关,并通过执行 VMXON 指令将宿主操作系统置于虚拟化模式的根模式;

41 | 3. 最后,KVM 模块创建特殊设备文件 /dev/kvm 并等待来自用户空间的指令。

42 |

43 | 接下来的虚机的创建和运行将是 QEMU 和 KVM 相互配合的过程。两者的通信接口主要是一系列针对特殊设备文件 /dev/kvm 的 IOCTL 调用。其中最重要的是创建虚机。它可以理解成KVM 为了某个特定的虚机创建对应的内核数据结构,同时,KVM 返回一个文件句柄来代表所创建的虚机。

44 |

45 | 针对该句柄的调用可以对虚机做相应地管理,比如创建用户空间虚拟地址和客户机物理地址、真实物理地址之间的映射关系,再比如创建多个 vCPU。KVM 为每一个 vCPU 生成对应的文件句柄,对其相应地 IOCTL 调用,就可以对vCPU进行管理。其中最重要的就是“执行虚拟处理器”。通过它,虚机在 KVM 的支持下,被置于虚拟化模式的非根模式下,开始执行二进制指令。在非根模式下,所有敏感的二进制指令都被CPU捕捉到,CPU 在保存现场之后自动切换到根模式,由 KVM 决定如何处理。

46 |

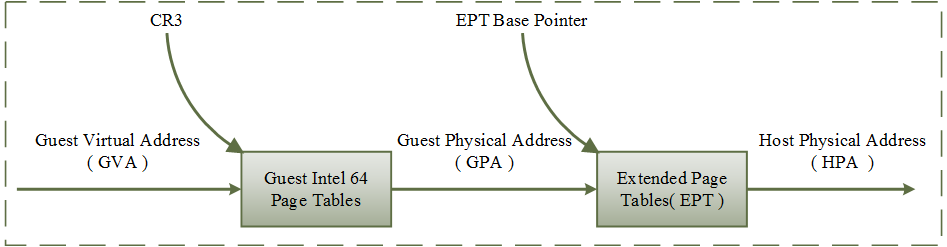

47 | 除了 CPU 的虚拟化,内存虚拟化也由 KVM 实现。实际上,内存虚拟化往往是一个虚机实现中最复杂的部分。CPU 中的内存管理单元 MMU 是通过页表的形式将程序运行的虚拟地址转换成实际物理地址。在虚拟机模式下,MMU 的页表则必须在一次查询的时候完成两次地址转换。因为除了将客户机程序的虚拟地址转换了客户机的物理地址外,还要将客户机物理地址转化成真实物理地址。

48 |

49 | ## 2. KVM 的功能列表

50 |

51 | KVM 所支持的功能包括:

52 | * 支持 CPU 和 memory 超分(Overcommit)

53 | * 支持半虚拟化 I/O (virtio)

54 | * 支持热插拔 (cpu,块设备、网络设备等)

55 | * 支持对称多处理(Symmetric Multi-Processing,缩写为 SMP )

56 | * 支持实时迁移(Live Migration)

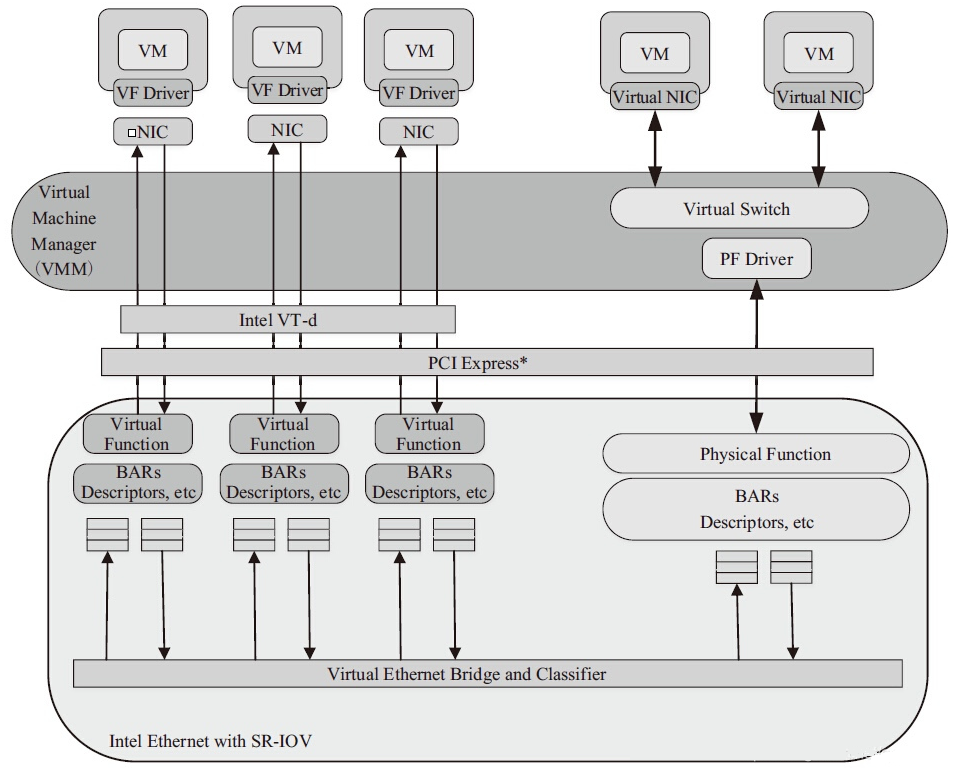

57 | * 支持 PCI 设备直接分配和 单根 I/O 虚拟化 (SR-IOV)

58 | * 支持 内核同页合并 (KSM )

59 | * 支持 NUMA (Non-Uniform Memory Access,非一致存储访问结构 )

60 |

61 | ## 3. KVM 工具集合

62 |

63 | * libvirt:操作和管理KVM虚机的虚拟化 API,使用 C 语言编写,可以由 Python,Ruby, Perl, PHP, Java 等语言调用。可以操作包括 KVM,vmware,XEN,Hyper-v, LXC 等在内的多种 Hypervisor。

64 | * Virsh:基于 libvirt 的 命令行工具 (CLI)

65 | * Virt-Manager:基于 libvirt 的 GUI 工具

66 | * virt-v2v:虚机格式迁移工具

67 | * virt-* 工具:包括 Virt-install (创建KVM虚机的命令行工具), Virt-viewer (连接到虚机屏幕的工具),Virt-clone(虚机克隆工具),virt-top 等

68 | * sVirt:安全工具

69 |

70 | ## 4. RedHat Linux KVM 安装

71 |

72 | RedHat 有两款产品提供 KVM 虚拟化:

73 | * Red Hat Enterprise Linux:适用于小的环境,提供数目较少的KVM虚机。最新的版本包括 6.5 和 7.0.

74 | * Red Hat Enterprise Virtualization (RHEV):提供企业规模的KVM虚拟化环境,包括更简单的管理、HA,性能优化和其它高级功能。最新的版本是 3.0.

75 |

76 | RedHat Linux KVM:

77 | * KVM 由 libvirt API 和基于该 API的一组工具进行管理和控制

78 | * KVM 支持系统资源超分,包括内存和CPU的超分。RedHat Linux 最多支持物理 CPU 内核总数的10倍数目的虚拟CPU,但是不支持在一个虚机上分配超过物理CPU内核总数的虚拟CPU。

79 | 支持 KSM (Kenerl Same-page Merging 内核同页合并)

80 |

81 | RedHat Linux KVM 有如下两种安装方式:

82 |

83 | ### 4.1 在安装 RedHat Linux 时安装 KVM

84 |

85 | 选择安装类型为 Virtualizaiton Host :

86 |

87 |

88 | 可以选择具体的 KVM 客户端、平台和工具:

89 |

90 |

91 | ### 4.2 在已有的 RedHat Linux 中安装 KVM

92 |

93 | 这种安装方式要求该系统已经被注册,否则会报错:

94 |

95 | ```C

96 | [root@rh65 ~]# yum install qemu-kvm qemu-img

97 | Loaded plugins: product-id, refresh-packagekit, security, subscription-manager

98 | This system is not registered to Red Hat Subscription Management. You can use subscription-manager to register.

99 | Setting up Install Process

100 | Nothing to do

101 | ```

102 |

103 | 你至少需要安装 qemu-kvm qemu-img 这两个包。

104 |

105 | ```C

106 | # yum install qemu-kvm qemu-img

107 | ```

108 |

109 | 你还可以安装其它工具包:

110 | ```C

111 | # yum install virt-manager libvirt libvirt-python python-virtinst libvirt-client

112 | ```

113 |

114 | ### 4.3 QEMU/KVM 代码下载编译安装

115 | #### 4.3.1 QEMU/KVM 的代码结构

116 | QEMU/KVM 的代码包括几个部分:

117 | * (1)KVM 内核模块是 Linux 内核的一部分。通常 Linux 比较新的发行版(2.6.20+)都包含了 KVM 内核,也可以从这里得到。比如在我的RedHat 6.5 上:

118 | ```C

119 | [root@rh65 isoimages]# uname -r

120 | 2.6.32-431.el6.x86_64

121 | [root@rh65 isoimages]# modprobe -l | grep kvm

122 | kernel/arch/x86/kvm/kvm.ko

123 | kernel/arch/x86/kvm/kvm-intel.ko

124 | kernel/arch/x86/kvm/kvm-amd.ko

125 | ```

126 | * (2)用户空间的工具即 qemu-kvm。qemu-kvm 是 KVM 项目从 QEMU 新拉出的一个分支(看这篇文章)。在 QEMU 1.3 版本之前,QEMU 和 QEMU-KVM 是有区别的,但是从 2012 年底 GA 的 QEMU 1.3 版本开始,两者就完全一样了。

127 | * (3)Linux Guest OS virtio 驱动,也是较新的Linux 内核的一部分了。

128 | * (4)Windows Guest OS virtio 驱动,可以从这里下载。

129 |

130 | #### 4.3.2 安装 QEMU

131 |

132 | RedHat 6.5 上自带的 QEMU 太老,0.12.0 版本,最新版本都到了 2.* 了。

133 | * (1). 参考 这篇文章,将 RedHat 6.5 的 ISO 文件当作本地源

134 |

135 | ```C

136 | mount -o loop soft/rhel-server-6.4-x86_64-dvd.iso /mnt/rhel6/

137 |

138 | vim /etc/fstab

139 | => /root/isoimages/soft/RHEL6.5-20131111.0-Server-x86_64-DVD1.iso /mnt/rhel6 iso9660 ro,loop

140 | [root@rh65 qemu-2.3.0]# cat /etc/yum.repos.d/local.repo

141 | [local]

142 | name=local

143 | baseurl=file:///mnt/rhel6/

144 | enabled=1

145 | gpgcjeck=0

146 |

147 |

148 | yum clean all

yum update

149 |

150 | ```

151 |

152 | * (2). 安装依赖包包

153 | ```C

154 | yum install gcc

155 | yum install autoconf

156 | yum install autoconf automake libtool

157 | yum install -y glib*

158 | yum install zlib*

159 | ```

160 |

161 | * (3). 从 http://wiki.qemu.org/Download 下载代码,上传到我的编译环境 RedHat 6.5.

162 | ```C

163 | tar -jzvf qemu-2.3.0.tar.bz2

164 | cd qemu-2.3.0

165 | ./configure

166 | make -j 4

167 | make install

168 | ```

169 |

170 | * (4). 安装完成

171 | ```C

172 | [root@rh65 qemu-2.3.0]# /usr/local/bin/qemu-x86_64 -version

173 | qemu-x86_64 version 2.3.0, Copyright (c) 2003-2008 Fabrice Bellard

174 | ```

175 |

176 | * (5). 为方便起见,创建一个link

177 | ```C

178 | ln -s /usr/bin/qemu-system-x86_64 /usr/bin/qemu-kvm

179 | ```

180 |

181 | #### 4.3.3 安装 libvirt

182 | 可以从 libvirt 官网下载安装包。最新的版本是 0.10.2.

183 |

184 | ## 5. 创建 KVM 虚机的几种方式

185 | ### 5.1 使用 virt-install 命令

186 | ```C

187 | virt-install \

188 | --name=guest1-rhel5-64 \

189 | --file=/var/lib/libvirt/images/guest1-rhel5-64.dsk \

190 | --file-size=8 \

191 | --nonsparse --graphics spice \

192 | --vcpus=2 --ram=2048 \

193 | --location=http://example1.com/installation_tree/RHEL5.6-Serverx86_64/os \

194 | --network bridge=br0 \

195 | --os-type=linux \

196 | --os-variant=rhel5.4

197 | ```

198 |

199 | ### 5.2 使用 virt-manager 工具

200 |

201 |

202 | 使用 VMM GUI 创建的虚机的xml 定义文件在 /etc/libvirt/qemu/ 目录中。

203 |

204 | ### 5.3 使用 qemu-img 和 qemu-kvm 命令行方式安装

205 | (1)创建一个空的qcow2格式的镜像文件

206 | ```C

207 | qemu-img create -f qcow2 windows-master.qcow2 10G

208 | ```

209 | (2)启动一个虚机,将系统安装盘挂到 cdrom,安装操作系统

210 | ```C

211 | qemu-kvm -hda windows-master.qcow2 -m 512 -boot d -cdrom /home/user/isos/en_winxp_pro_with_sp2.iso

212 | ```

213 |

214 | (3)现在你就拥有了一个带操作系统的镜像文件。你可以以它为模板创建新的镜像文件。使用模板的好处是,它会被设置为只读所以可以免于破坏。

215 | ```C

216 | qemu-img create -b windows-master.qcow2 -f qcow2 windows-clone.qcow2

217 | ```

218 |

219 | (4)你可以在新的镜像文件上启动虚机了

220 | ```C

221 | qemu-kvm -hda windows-clone.qcow2 -m 400

222 | ```

223 |

224 | ### 5.4 通过 OpenStack Nova 使用 libvirt API 通过编程方式来创建虚机

225 |

226 |

227 |

228 |

229 |

230 |

231 |

232 |

233 |

234 |

235 |

236 |

237 |

238 |

239 |

240 |

241 |

242 |

243 |

244 |

245 |

246 |

247 |

248 |

249 |

250 |

251 |

252 |

253 |

254 |

--------------------------------------------------------------------------------

/product/OpenStack介绍及原理.md:

--------------------------------------------------------------------------------

1 | # OpenStack介绍及原理

2 |

3 | ## 什么是openstack

4 | OpenStack 是一系列开源工具(或开源项目)的组合,主要使用池化虚拟资源来构建和管理私有云及公共云。其中的六个项目主要负责处理核心云计算服务,包括计算、网络、存储、身份和镜像服务。还有另外十多个可选项目,用户可把它们捆绑打包,用来创建独特、可部署的云架构。

5 |

6 | ## 云计算模式

7 | 1. IaaS:基础设施即服务(个人比较习惯的):用户通过网络获取虚机、存储、网络,然后用户根据自己的需求操作获取的资源

8 | 2. PaaS:平台即服务:将软件研发平台作为一种服务, 如Eclipse/Java编程平台,服务商提供编程接口/运行平台等

9 | 3. SaaS:软件即服务 :将软件作为一种服务通过网络提供给用户,如web的电子邮件、HR系统、订单管理系统、客户关系系统等。用户无需购买软件,而是向提供商租用基于web的软件,来管理企业经营活动

10 |

11 | ## OpenStack 中有哪些项目?

12 | OpenStack 架构由大量开源项目组成。其中包含 6 个稳定可靠的核心服务,用于处理计算、网络、存储、身份和镜像; 同时,还为用户提供了十多种开发成熟度各异的可选服务。OpenStack 的 6 个核心服务主要担纲系统的基础架构,其余项目则负责管理控制面板、编排、裸机部署、信息传递、容器及统筹管理等操作。

13 |

14 | * keystone:Keystone 认证所有 OpenStack 服务并对其进行授权。同时,它也是所有服务的端点目录。

15 | * glance:Glance 可存储和检索多个位置的虚拟机磁盘镜像。

16 | * nova:是一个完整的 OpenStack 计算资源管理和访问工具,负责处理规划、创建和删除操作。

17 | * neutron:Neutron 能够连接其他 OpenStack 服务并连接网络。

18 | * dashboard:web管理界面

19 | * Swift: 是一种高度容错的对象存储服务,使用 RESTful API 来存储和检索非结构数据对象。

20 | * Cinder 通过自助服务 API 访问持久块存储。

21 | * Ceilometer:计费

22 | * Heat:编排

23 |

24 | OpenStack基本架构

25 |

26 |

27 | 通过消息队列和数据库,各个组件可以相互调用,互相通信。每个项目都有各自的特性,大而全的架构并非适合每一个用户,如Glance在最早的A、B版本中并没有实际出现应用,Nova可以脱离镜像服务独立运行。当用户的云计算规模大到需要管理多种镜像时,才需要像Glance这样的组件。

28 |

29 | OpenStack的逻辑架构

30 |

31 |

32 |

33 | Openstack创建实例的流程

34 | 1. 通过登录界面dashboard或命令行CLI通过RESTful API向keystone获取认证信息。

35 | 2. keystone通过用户请求认证信息,并生成auth-token返回给对应的认证请求。

36 |

37 |

38 |

39 | 3. 然后携带auth-token通过RESTful API向nova-api发送一个boot instance的请求。

40 |

41 |

42 |

43 | 4. nova-api接受请求后向keystone发送认证请求,查看token是否为有效用户和token。

44 | 5. keystone验证token是否有效,将结果返回给nova-api。

45 |

46 |

47 |

48 | 6. 通过认证后nova-api和数据库通讯,初始化新建虚拟机的数据库记录。

49 |

50 |

51 |

52 |

53 |

54 |

--------------------------------------------------------------------------------

/product/OpenStack知识体系.md:

--------------------------------------------------------------------------------

1 | # OpenStack知识体系

2 |

3 | ## 第1章:OpenStack介绍

4 | * OpenStack定义

5 | * OpenStack架构

6 |

7 | ## 第2章:OpenStack实验环境部署

8 | * 安装方法与工具概述

9 | * 实验环境安装

10 |

11 | ## 第3章:验证授权与服务编目-Keystone

12 | * Keystone原理

13 | * 什么是Keystone?

14 | * Keystone的主要功能

15 | * Keystone的概念

16 | * 示例:Keystone与其它服务交互的流程

17 | * 实验:

18 | * 启用启动服务器后,DevStack的启动

19 | * 通过图形界面的Horizon访问Openstack

20 | * 通过命令行访问Openstack

21 | * 通过REST API访问OpenStack

22 | * 管理项目、用户、角色

23 |

24 | ## 第4章:镜像服务-Glance

25 | * 什么是Image

26 | * Glance原理

27 | * Glance体系结构

28 | * Glace支持的镜像格式和容器

29 | * 镜像的属性、权限与状态

30 | * 制作镜像的思路

31 | * 实验:

32 | * 考察现有镜像(GUI、CLI)

33 | * 上传新的镜像(GUI、CLI)

34 | * 修改镜像属性(仅能用CLI)

35 | * 删除镜像

36 |

37 | ## 第5章:计算服务-Nova

38 | * Nova原理

39 | * Nova体系结构

40 | * Nova组件功能与交互流程

41 | * 实例类型

42 | * 计算节点的选择调度与Driver架构

43 | * 实验:

44 | * 实例创建与控制

45 | * 实例的操作(GUI、CLI)

46 | * 启动与关闭

47 | * 重新启动

48 | * 锁定与解锁

49 | * 暂停与挂起

50 | * 大小调整

51 | * 废弃与取回

52 | * 删除

53 |

54 | ## 第6章:块存储服务-Cinder

55 | * 创建实例时存储的选项

56 | * Cinder原理

57 | * Cinder体系结构

58 | * Cinder组件交互流程

59 | * Cinder的调度算法

60 | * Cinder-volume的Driver架构

61 | * 实验:

62 | * 创建卷

63 | * 连接卷到实例

64 | * 分离卷

65 | * 扩展卷

66 | * 卷的快照

67 | * 删除卷

68 | * NFS Volume Provider

69 |

70 | ## 第7章:网络服务-Neutron(基础)

71 | * Neutron原理:

72 | * 概述与功能

73 | * 基本概念与架构

74 | * Neutron Server分层模型

75 | * ML2 Core Plugin与Agent

76 | * Service Plugin与Agent

77 | * 实验:

78 | * 配置Linuxbridge

79 | * 创建Local Nertwork(Linuxbridge)

80 | * 创建Flat Nertwork(Linuxbridge)

81 | * 配置DHCP Agent

82 | * 创建VLAN Network(Linuxbridge)

83 | * 创建Routing (Linuxbridge)

84 |

85 |

--------------------------------------------------------------------------------

/product/P8整理的OpenStack构架,希望能帮助到你.md:

--------------------------------------------------------------------------------

1 | # P8整理的OpenStack构架,希望能帮助到你

2 |

3 | ## 1. OpenStack介绍

4 | OpenStack既是一个社区,也是一个项目和一个开源软件,提供开放源码软件,建立公共和私有云,它提供了一个部署云的操作平台或工具集,其宗旨在于:帮助组织运行为虚拟计算或存储服务的云,为公有云、私有云,也为大云、小云提供可扩展的、灵活的云计算。

5 | OpenStackd开源项目由社区维护,包括OpenStack计算(代号为Nova),OpenStack对象存储(代号为Swift),并OpenStack镜像服务(代号Glance)的集合。 OpenStack提供了一个操作平台,或工具包,用于编排云。

6 |

7 | 下面列出Openstack的详细构架图

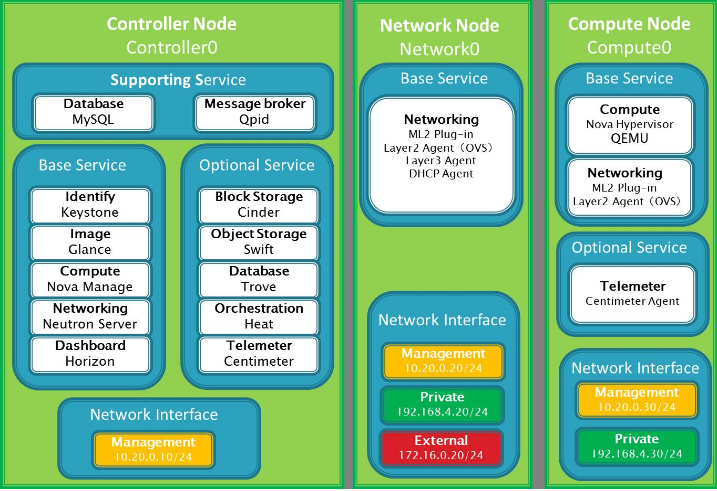

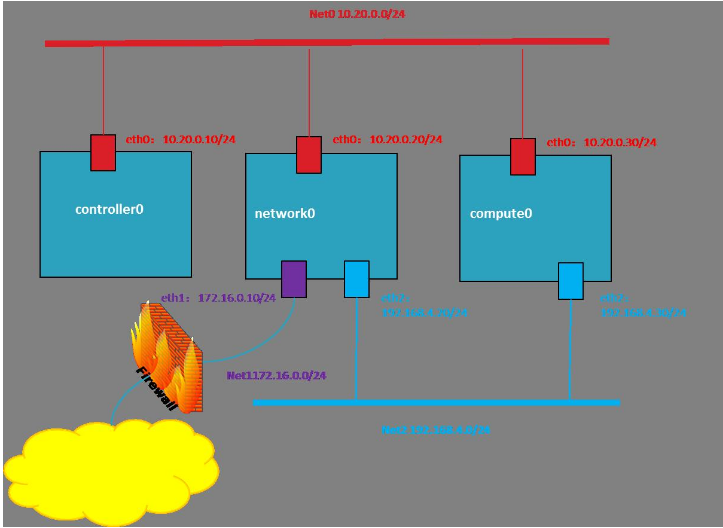

8 |

9 |

10 |

11 | Openstack的网络拓扑结构图

12 |

13 |

14 |

15 | [500篇关于虚拟化的经典资料,含CPU虚拟化,磁盘虚拟化,内存虚拟化,IO虚拟化](https://github.com/0voice/Introduce_to_virtualization)

16 |

17 | 整个OpenStack是由控制节点,计算节点,网络节点,存储节点四大部分组成。(这四个节点也可以安装在一台机器上,单机部署)

18 | 其中:

19 | * 控制节点负责对其余节点的控制,包含虚拟机建立,迁移,网络分配,存储分配等等

20 | * 计算节点负责虚拟机运行

21 | * 网络节点负责对外网络与内网络之间的通信

22 | * 存储节点负责对虚拟机的额外存储管理等等

23 |

24 | ## 2. 控制节点架构:

25 | 控制节点包括以下服务

26 | * 管理支持服务

27 | * 基础管理服务

28 | * 扩展管理服务

29 |

30 | ### 1. 管理支持服务包含MySQL与Qpid两个服务

31 | MySQL:数据库作为基础/扩展服务产生的数据存放的地方

32 | Qpid:消息代理(也称消息中间件)为其他各种服务之间提供了统一的消息通信服务

33 |

34 | ### 2. 基础管理服务包含Keystone,Glance,Nova,Neutron,Horizon五个服务

35 | Keystone:认证管理服务,提供了其余所有组件的认证信息/令牌的管理,创建,修改等等,使用MySQL作为统一的数据库

36 | Glance:镜像管理服务,提供了对虚拟机部署的时候所能提供的镜像的管理,包含镜像的导入,格式,以及制作相应的模板

37 | Nova:计算管理服务,提供了对计算节点的Nova的管理,使用Nova-API进行通信

38 | Neutron:网络管理服务,提供了对网络节点的网络拓扑管理,同时提供Neutron在Horizon的管理面板

39 | Horizon:控制台服务,提供了以Web的形式对所有节点的所有服务的管理,通常把该服务称为DashBoard

40 |

41 | ### 3. 扩展管理服务包含Cinder,Swift,Trove,Heat,Centimeter五个服务

42 | Cinder:提供管理存储节点的Cinder相关,同时提供Cinder在Horizon中的管理面板

43 | Swift:提供管理存储节点的Swift相关,同时提供Swift在Horizon中的管理面板

44 | Trove:提供管理数据库节点的Trove相关,同时提供Trove在Horizon中的管理面板

45 | Heat:提供了基于模板来实现云环境中资源的初始化,依赖关系处理,部署等基本操作,也可以解决自动收缩,负载均衡等高级特性。

46 | Centimeter:提供对物理资源以及虚拟资源的监控,并记录这些数据,对该数据进行分析,在一定条件下触发相应动作控制节点一般来说只需要一个网络端口用于通信/管理各个节点

47 |

48 | ## 3. 网络节点架构

49 | 网络节点仅包含Neutron服务

50 | Neutron:负责管理私有网段与公有网段的通信,以及管理虚拟机网络之间的通信/拓扑,管理虚拟机之上的防火等等

51 | 网络节点包含三个网络端口

52 | eth0:用于与控制节点进行通信

53 | eth1:用于与除了控制节点之外的计算/存储节点之间的通信

54 | eth2:用于外部的虚拟机与相应网络之间的通信

55 |

56 | ## 4. 计算节点架构

57 | 计算节点包含Nova,Neutron,Telemeter三个服务

58 |

59 | * 1. 基础服务

60 | Nova:提供虚拟机的创建,运行,迁移,快照等各种围绕虚拟机的服务,并提供API与控制节点对接,由控制节点下发任务

61 | Neutron:提供计算节点与网络节点之间的通信服务

62 |

63 | * 2. 扩展服务

64 | Telmeter:提供计算节点的监控代理,将虚拟机的情况反馈给控制节点,是Centimeter的代理服务

65 | 计算节点包含最少两个网络端口

66 | eth0:与控制节点进行通信,受控制节点统一调配

67 | eth1:与网络节点,存储节点进行通信

68 |

69 | ## 5. 存储节点架构

70 | 存储节点包含Cinder,Swift等服务

71 | Cinder:块存储服务,提供相应的块存储,简单来说,就是虚拟出一块磁盘,可以挂载到相应的虚拟机之上,不受文件系统等因素影响,对虚拟机来说,这个操作就像是新加了一块硬盘,可以完成对磁盘的任何操作,包括挂载,卸载,格式化,转换文件系统等等操作,大多应用于虚拟机空间不足的情况下的空间扩容等等

72 | Swift:对象存储服务,提供相应的对象存储,简单来说,就是虚拟出一块磁盘空间,可以在这个空间当中存放文件,也仅仅只能存放文件,不能进行格式化,转换文件系统,大多应用于云磁盘/文件

73 | 存储节点包含最少两个网络接口

74 | eth0:与控制节点进行通信,接受控制节点任务,受控制节点统一调配

75 | eth1:与计算/网络节点进行通信,完成控制节点下发的各类任务

76 |

77 | ## 6. Openstack的各个组件作用及关系

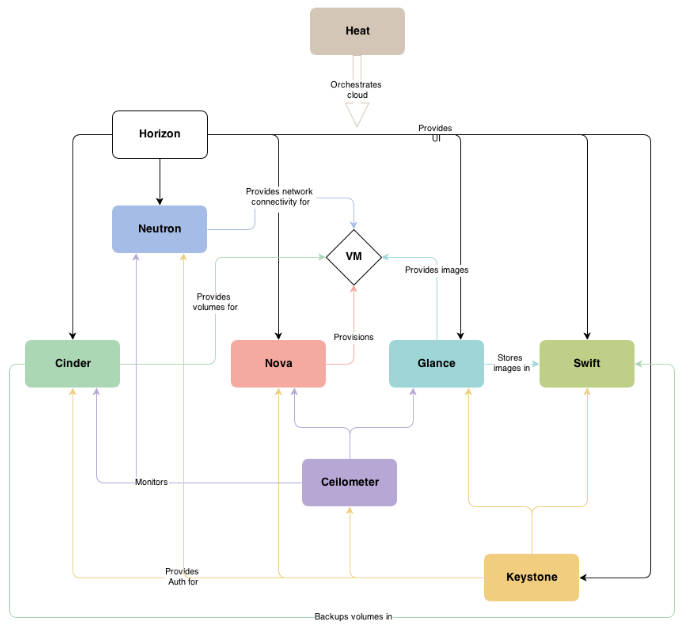

78 | Openstack发展至今,总共集成了下面几个组件:

79 | * Nova - 计算服务

80 | * Neutron-网络服务

81 | * Swift - 对象存储服务

82 | * Cinder-块存储服务

83 | * Glance - 镜像服务

84 | * Keystone - 认证服务

85 | * Horizon - UI服务

86 | * Ceilometer-监控服务

87 | * Heat-集群服务

88 | * Trove-数据库服务

89 |

90 | 组件间的关系图如下:

91 |

92 |

93 |

94 | ## 7. 重要组件介绍

95 | ### 7.1 OpenStack认证服务(Keystone)

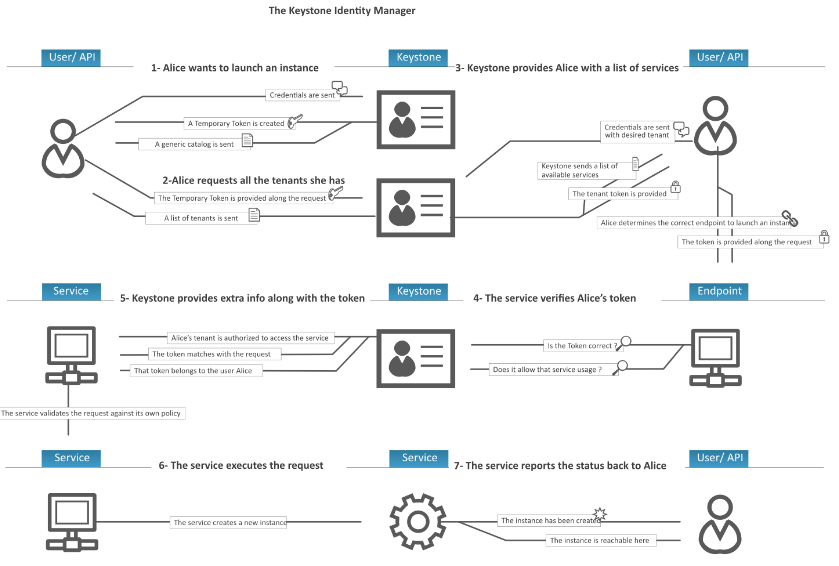

96 | Keystone为所有的OpenStack组件提供认证和访问策略服务,它依赖自身REST(基于Identity API)系统进行工作,主要对(但不限于)Swift、Glance、Nova等进行认证与授权。事实上,授权通过对动作消息来源者请求的合法性进行鉴定。下图显示了身份认证服务流程:

97 |

98 |

99 |

100 |

101 | Keystone采用两种授权方式,一种基于用户名/密码,另一种基于令牌(Token)。

102 |

103 | 除此之外,Keystone提供以下三种服务:

104 | * 令牌服务:含有授权用户的授权信息

105 | * 目录服务:含有用户合法操作的可用服务列表

106 | * 策略服务:利用Keystone具体指定用户或群组某些访问权限

107 |

108 | keystone认证服务注意点:

109 |

110 | 服务入口:如Nova、Swift和Glance一样每个OpenStack服务都拥有一个指定的端口和专属的URL,我们称其为入口(endpoints)。

111 |

112 | 区位:在某个数据中心,一个区位具体指定了一处物理位置。在典型的云架构中,如果不是所有的服务都访问分布式数据中心或服务器的话,则也称其为区位。

113 |

114 | 用户:Keystone授权使用者

115 | > PS:代表一个个体,OpenStack以用户的形式来授权服务给它们。用户拥有证书(credentials),且可能分配给一个或多个租户。经过验证后,会为每个单独的租户提供一个特定的令牌。

116 | 服务:总体而言,任何通过Keystone进行连接或管理的组件都被称为服务。举个例子,我们可以称Glance为Keystone的服务。

117 | 角色:为了维护安全限定,就云内特定用户可执行的操作而言,该用户关联的角色是非常重要的。

118 | > PS:一个角色是应用于某个租户的使用权限集合,以允许某个指定用户访问或使用特定操作。角色是使用权限的逻辑分组,它使得通用的权限可以简单地分组并绑定到与某个指定租户相关的用户。

119 | 租间:租间指的是具有全部服务入口并配有特定成员角色的一个项目。

120 | > PS:一个租间映射到一个Nova的“project-id”,在对象存储中,一个租间可以有多个容器。根据不同的安装方式,一个租间可以代表一个客户、帐号、组织或项目。

121 |

122 | ### 7.2 OpenStack计算设施----Nova

123 | Nova是OpenStack计算的弹性控制器。OpenStack云实例生命期所需的各种动作都将由Nova进行处理和支撑,这就意味着Nova以管理平台的身份登场,负责管理整个云的计算资源、网络、授权及测度。虽然Nova本身并不提供任何虚拟能力,但是它将使用libvirt API与虚拟机的宿主机进行交互。Nova通过Web服务API来对外提供处理接口,而且这些接口与Amazon的Web服务接口是兼容的。

124 |

125 | 功能及特点:

126 | * 实例生命周期管理

127 | * 计算资源管理

128 | * 网络与授权管理

129 | * 基于REST的API

130 | * 异步连续通信

131 | * 支持各种宿主:Xen、XenServer/XCP、KVM、UML、VMware vSphere及Hyper-V

132 |

133 | Nova弹性云(OpenStack计算部件)包含以下主要部分:

134 | * API Server(nova-api)

135 | * 消息队列(rabbit-mq server)

136 | * 运算工作站(nova-compute)

137 | * 网络控制器(nova-network)

138 | * 卷管理(nova-volume)

139 | * 调度器(nova-scheduler)

140 |

141 | 解释如下:

142 | 1. API服务器(nova-api)

143 | API服务器提供了云设施与外界交互的接口,它是外界用户对云实施管理的唯一通道。通过使用web服务来调用各种EC2的API,接着API服务器便通过消息队列把请求送达至云内目标设施进行处理。作为对EC2-api的替代,用户也可以使用OpenStack的原生API,我们把它叫做“OpenStack API”。

144 |

145 | 2. 消息队列(Rabbit MQ Server)

146 | OpenStack内部在遵循AMQP(高级消息队列协议)的基础上采用消息队列进行通信。Nova对请求应答进行异步调用,当请求接收后便则立即触发一个回调。由于使用了异步通信,不会有用户的动作被长置于等待状态。例如,启动一个实例或上传一份镜像的过程较为耗时,API调用就将等待返回结果而不影响其它操作,在此异步通信起到了很大作用,使整个系统变得更加高效。

147 |

148 | 3. 调度器(nova-scheduler)

149 | 调度器负责把nova-API调用送达给目标。调度器以名为“nova-schedule”的守护进程方式运行,并根据调度算法从可用资源池中恰当地选择运算服务器。有很多因素都可以影响调度结果,比如负载、内存、子节点的远近、CPU架构等等。强大的是nova调度器采用的是可插入式架构。

150 |

151 | 目前nova调度器使用了几种基本的调度算法:

152 | * 随机化:主机随机选择可用节点;

153 | * 可用化:与随机相似,只是随机选择的范围被指定;

154 | * 简单化:应用这种方式,主机选择负载最小者来运行实例。负载数据可以从别处获得,如负载均衡服务器。

155 |

156 | 4. 运算工作站(nova-compute)

157 | 运算工作站的主要任务是管理实例的整个生命周期。他们通过消息队列接收请求并执行,从而对实例进行各种操作。在典型实际生产环境下,会架设许多运算工作站,根据调度算法,一个实例可以在可用的任意一台运算工作站上部署。

158 |

159 | 5. 网络控制器(nova-network)

160 | 网络控制器处理主机的网络配置,例如IP地址分配,配置项目VLAN,设定安全群组以及为计算节点配置网络。

161 |

162 | 6. 卷工作站(nova-volume)

163 | 卷工作站管理基于LVM的 实例卷,它能够为一个实例创建、删除、附加卷,也可以从一个实例中分离卷。卷管理为何如此重要?因为它提供了一种保持实例持续存储的手段,比如当结束一个 实例后,根分区如果是非持续化的,那么对其的任何改变都将丢失。可是,如果从一个实例中将卷分离出来,或者为这个实例附加上卷的话,即使实例被关闭,数据 仍然保存其中。这些数据可以通过将卷附加到原实例或其他实例的方式而重新访问。

164 |

165 | 因此,为了日后访问,重要数据务必要写入卷中。这种应用对于数据服务器实例的存储而言,尤为重要。

166 |

167 | ### 7.3 OpenStack镜像服务器----Glance

168 | OpenStack镜像服务器是一套虚拟机镜像发现、注册、检索系统,我们可以将镜像存储到以下任意一种存储中:

169 | * 本地文件系统(默认)

170 | * S3直接存储

171 | * S3对象存储(作为S3访问的中间渠道)

172 | * OpenStack对象存储等等。

173 |

174 | 功能及特点:

175 | 提供镜像相关服务。

176 |

177 | Glance构件:

178 | 1. Glance-API:

179 | 主要负责接收响应镜像管理命令的Restful请求,分析消息请求信息并分发其所带的命令(如新增,删除,更新等)。默认绑定端口是9292。

180 | 2. Glance-Registry:

181 | 主要负责接收响应镜像元数据命令的Restful请求。分析消息请求信息并分发其所带的命令(如获取元数据,更新元数据等)。默认绑定的端口是9191。

182 |

183 | ### 7.4 OpenStack存储设施----Swift

184 | Swift为OpenStack提供一种分布式、持续虚拟对象存储,它类似于Amazon Web Service的S3简单存储服务。Swift具有跨节点百级对象的存储能力。Swift内建冗余和失效备援管理,也能够处理归档和媒体流,特别是对大数据(千兆字节)和大容量(多对象数量)的测度非常高效。

185 |

186 | swift功能及特点:

187 | * 海量对象存储

188 | * 大文件(对象)存储

189 | * 数据冗余管理

190 | * 归档能力-----处理大数据集

191 | * 为虚拟机和云应用提供数据容器

192 | * 处理流媒体

193 | * 对象安全存储

194 | * 备份与归档

195 | * 良好的可伸缩性

196 |

197 | * Swift组件

198 | * Swift账户

199 | * Swift容器

200 | * Swift对象

201 | * Swift代理

202 | * Swift RING

203 |

204 | #### Swift代理服务器

205 | 用户都是通过Swift-API与代理服务器进行交互,代理服务器正是接收外界请求的门卫,它检测合法的实体位置并路由它们的请求。

206 | 此外,代理服务器也同时处理实体失效而转移时,故障切换的实体重复路由请求。

207 |

208 | #### Swift对象服务器

209 | 对象服务器是一种二进制存储,它负责处理本地存储中的对象数据的存储、检索和删除。对象都是文件系统中存放的典型的二进制文件,具有扩展文件属性的元数据(xattr)。

210 |

211 | 注意:xattr格式被Linux中的ext3/4,XFS,Btrfs,JFS和ReiserFS所支持,但是并没有有效测试证明在XFS,JFS,ReiserFS,Reiser4和ZFS下也同样能运行良好。不过,XFS被认为是当前最好的选择。

212 |

213 | #### Swift容器服务器

214 | 容器服务器将列出一个容器中的所有对象,默认对象列表将存储为SQLite文件(译者注:也可以修改为MySQL,安装中就是以MySQL为例)。容器服务器也会统计容器中包含的对象数量及容器的存储空间耗费。

215 |

216 | #### Swift账户服务器

217 | 账户服务器与容器服务器类似,将列出容器中的对象。

218 |

219 | #### Ring(索引环)

220 | Ring容器记录着Swift中物理存储对象的位置信息,它是真实物理存储位置的实体名的虚拟映射,类似于查找及定位不同集群的实体真实物理位置的索引服务。这里所谓的实体指账户、容器、对象,它们都拥有属于自己的不同的Rings。

221 |

222 | ### 7.5 OpenStack管理的Web接口----Horizon

223 | Horizon是一个用以管理、控制OpenStack服务的Web控制面板,它可以管理实例、镜像、创建密匙对,对实例添加卷、操作Swift容器等。除此之外,用户还可以在控制面板中使用终端(console)或VNC直接访问实例。

224 |

225 | 总之,Horizon具有如下一些特点:

226 | * 实例管理:创建、终止实例,查看终端日志,VNC连接,添加卷等

227 | * 访问与安全管理:创建安全群组,管理密匙对,设置浮动IP等

228 | * 偏好设定:对虚拟硬件模板可以进行不同偏好设定

229 | * 镜像管理:编辑或删除镜像

230 | 查看服务目录

231 | * 管理用户、配额及项目用途

232 | * 用户管理:创建用户等

233 | * 卷管理:创建卷和快照

234 | * 对象存储处理:创建、删除容器和对象

235 | 为项目下载环境变量

236 |

--------------------------------------------------------------------------------

/product/Xen虚拟化详解.md:

--------------------------------------------------------------------------------

1 | # Xen虚拟化详解

2 |

3 | ## 1. Xen虚拟化模型

4 |

5 | ### 1.1 Xen相关概念

6 | Xen是由剑桥大学计算机实验室开发的一个开源项目。是一个直接运行在计算机硬件之上的用以替代操作系统的软件层,它能够在计算机硬件上并发的运行多个客户操作系统(Guest OS)。目前已经在开源社区中得到了极大的推动。

7 | Xen支持x86、x86-64、安腾( Itanium)、Power PC和ARM多种处理器,因此Xen可以在大量的计算设备上运行,目前Xen支持Linux、NetBSD、FreeBSD、Solaris、 Windows和其他常用的操作系统作为客户操作系统在其管理程序上运行。硬件之上

8 | Xen只对CPU和mem进行驱动,对IO没有驱动,

9 | Linux对新型IO设备的驱动能力,没有Windows强,应为硬件厂商,首先会开发Windows版本的驱动。

10 |

11 | 第一安装好的Guest的作用:

12 | 1. 管理其他Guest的接口

13 | 2. 提供驱动IO程序

14 |

15 | 其他Guest使用CPU和内存向Xen Hypervisor请求,使用IO设备,向domain 0发起请求。

16 | IO设备的模拟,Qemu实现

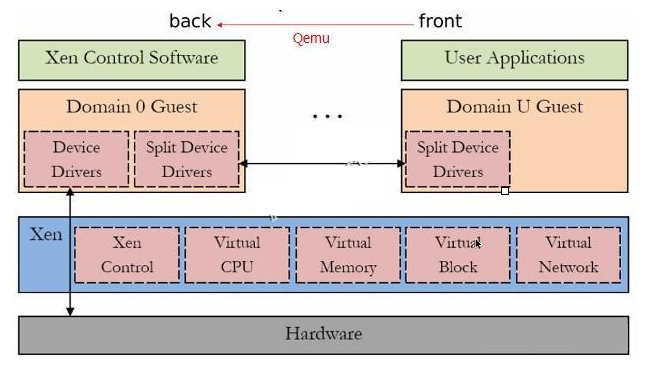

17 | 图Xen架构:

18 |

19 |

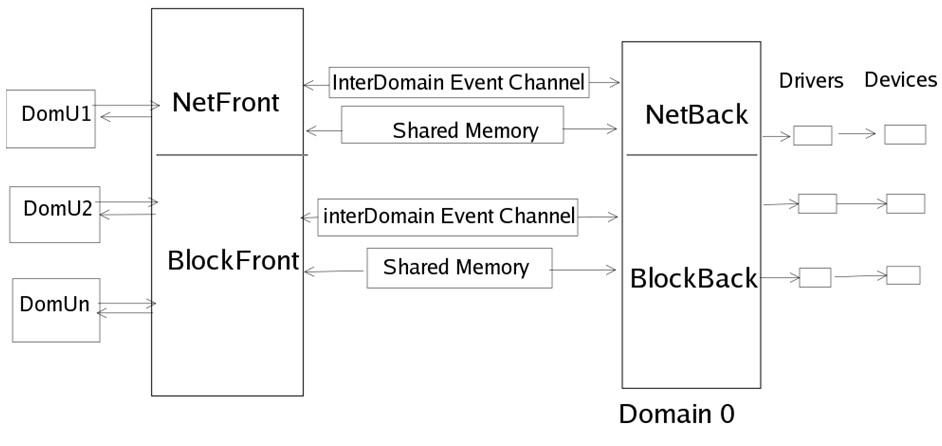

20 | Domain 0:Privileged Domain //特权虚拟机:Dom0;特权域 直接驱动IO硬件设备;与DomU交互;Linux-2.6.37内核开始直接运行在Dom0上;

21 | 修改过的Linux kernel,运行在Hypervisor之上。

22 | Domain 0 在Xen中担任管理员的角色,它负责管理其他虚拟客户机。

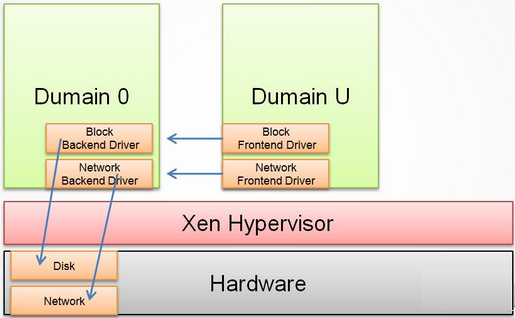

23 | 在Domain 0中包含两个驱动程序,用于支持其他客户虚拟机对于网络和硬盘的访问请求。这两个驱动分别是Network Backend Driver和Block Backend Driver。

24 | Network Backend Driver直接与本地的网络硬件进行通信,用于处理来自Domain U客户机的所有关于网络的虚拟机请求。根据Domain U发出的请求Block Backend Driver直接与本地的存储设备进行通信然后,将数据读写到存储设备上。

25 | 图Dom-0

26 |

27 |

28 | Domain U :Unprivileged Domain //非特权域 其他虚拟机;直接驱动IO硬件设备;Linux-2.6.24+内核开始支持

29 | 无论是半虚拟化Domain U还是完全虚拟化Domain U,作为客户虚拟机系统,Domain U在Xen Hypervisor上运行并行的存在多个,他们之间相互独立,每个Domain U都拥有自己所能操作的虚拟资源(如:内存,磁盘等)。而且允许单独一个Domain U进行重启和关机操作而不影响其他Domain U。

30 | 图Dom-u

31 |

32 |

33 | Xen Hypervisor:虚拟化技术通过在现有平台(机器)上添加一层薄的虚拟机监控程序(Virtual Machine Monitor,简称 VMM)软件而实现对系统的虚拟化,如虚拟处理器,虚拟内存管理器(MMU)和虚拟 I/O 系统等。虚拟机监控程序又被称之为监管程序(Hypervisor)。

34 | 控制虚拟机,并进行CPU和mem的分配。 Xen Hypervisor不负责处理诸如网络、外部存储设备、视频或其他通用的I/O处理。

35 |

36 | ### 1.2 Xen虚拟化类型

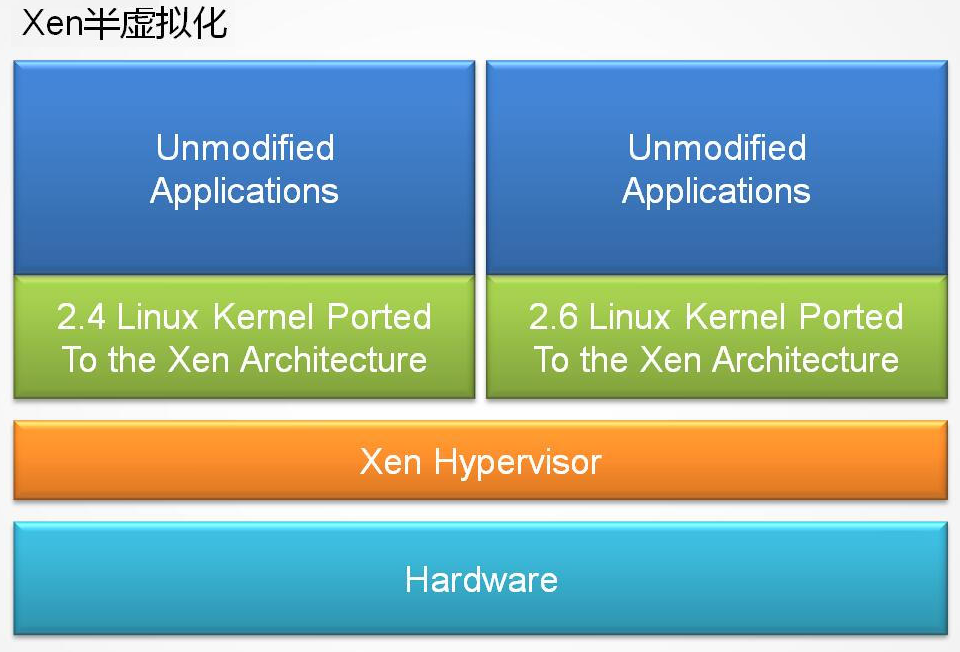

37 | 半虚拟化:

38 | 半虚拟化(Paravirtualization)有些资料称为“超虚拟化”,简称为PV,Guest Os知道自己运行在Xen Hypervisor上而不是硬件上。同时也可以识别出其他运行在相同环境中的客户虚拟机。

39 | 需要修改Guest.Kernel,不需要修改Guest上的Application

40 | 图半-1-2

41 |

42 |

43 |

44 |

45 |

46 |

47 | 全虚拟化:

48 | 完全虚拟化(Hardware Virtual Machine)又称“硬件虚拟化”,简称HVM,Guest OS任务自己运行在硬件上,无法感知其他Guest OS

49 | 在Xen Hypervisor运行的完全虚拟化虚拟机,所运行的操作系统都是标准的操作系统,即:无需任何修改的操作系统版本。同时也需要提供特殊的硬件设备。

50 | Xen上虚拟的Windows虚拟机必须采用完全虚拟化技术。

51 | 图全-2-1

52 |

53 |

54 |

55 |

56 | ### 1.3 PV-HVM

57 | CPU全虚拟化,IO半虚拟化

58 | 为了提高性能,完全虚拟化的Guests可以使用特殊的半虚拟设备驱动程序(PVHVM或PV-on-HVM驱动)。这些驱动程序在HVM环境下优化的PV驱动,模拟的磁盘和网络IO旁路运行,从而让你的PV在HVM中有更好的性能。

59 | 注意:Xen项目PV(半虚拟化)的Guest自动使用PV驱动;不需要这些驱动,因为已经使用优化的驱动程序。PVHVM只会在HVM(全虚拟化)Guest中需要

60 | 图P-1-2

61 |

62 |

63 |

64 |

65 | ## 2. Xen的体系架构和运行机制

66 |

67 | ### 2.1 Xen体系架构

68 | Xen 的 VMM ( Xen Hyperviso ) 位于操作系统和硬件之间,负责为上层运行的操作系统内核提供虚拟化的硬件资源,负责管理和分配这些资源,并确保上层虚拟机(称为域 Domain)之间的相互隔离。Xen采用混合模式,因而设定了一个特权域用以辅助Xen管理其他的域,并提供虚拟的资源服务,该特权域称为Domain 0,而其余的域则称为Domain U。

69 | Xen向Domain提供了一个抽象层,其中包含了管理和虚拟硬件的API。Domain 0内部包含了真实的设备驱动(原生设备驱动),可直接访问物理硬件,负责与 Xen 提供的管理 API 交互,并通过用户模式下的管理工具来管理 Xen 的虚拟机环境。

70 | Xen2.0之后,引入了分离设备驱动模式。该模式在每个用户域中建立前端(front end)设备,在特权域(Dom0)中建立后端(back end)设备。所有的用户域操作系统像使用普通设备一样向前端设备发送请求,而前端设备通过IO请求描述符(IO descripror ring)和设备通道(device channel)将这些请求以及用户域的身份信息发送到处于特权域中的后端设备。这种体系将控制信息传递和数据传递分开处理。

71 | 在Xen体系结构设计中,后端设别运行的特权域被赋予一个特有的名字---隔离设备域(Isolation Device Domain, IDD),而在实际设计中,IDD 就处在Dom0中。所有的真实硬件访问都由特权域的后端设备调用本地设备驱动 (native device drive)发起。前端设备的设计十分简单,只需要完成数据的转发操作,由于它们不是真实的设备驱动程序,所以也不用进行请求调度操作。而运行在IDD中 的后端设备,可以利用Linux的现有设备驱动来完成硬件访问,需要增加的只是IO请求的桥接功能---能完成任务的分发和回送。

72 |

73 | 图2-1

74 |

75 |

76 | ### 2.2 不同虚拟技术的运行机制

77 | 半虚拟化技术:

78 | 采用半虚拟化技术的虚拟机操作系统能够识别到自己是运行在Xen Hypervisor而非直接运行于硬件之上,并且也可以识别到在相同的机器上运行的其他虚拟机系统。而且运行的操作系统都需要进行相应的修改。

79 | 半虚拟化客户机(Domain U PV Guests)包含两个用于操作网络和磁盘的驱动程序,PV Network Driver 和PV Block Driver。

80 | PV Network Driver负责为Domain U提供网络访问功能。PV Block Driver负责为Domain U提供磁盘操作功能。

81 | 图3-1

82 |

83 |

84 | 完全虚拟化技术:

85 | 完全虚拟化客户机(Domain U HVM Guests)运行的是标准版本的操作系统,因此其操作系统中不存在半虚拟化驱动程序(PV Driver),但是在每个完全虚拟化客户机都会在Domain 0中存在一个特殊的精灵程序,称作:Qemu-DM,Qemu-DM帮助完全虚拟化客户机(Domain U HVM Guest)获取网络和磁盘的访问操作。

86 | 完全虚拟化客户机必须和在普通硬件环境下一样进行初始化,所以需要在其中加入一个特殊的软件Xen virtual firmware,来模拟操作系统启动时所需要的BIOS。

87 |

88 | 图3-2

89 |

90 |

91 | ### 2.3 Domain 管理和控制

92 | Linux精灵程序分类为“管理”和“控制”两大类。这些服务支撑着整个虚拟环境的管理和控制操作,并且存在于Domain 0虚拟机中。

93 | 注:为了清晰的描述Xen的运行流程,画图时将精灵程序放在Domain 0外部来描述,但事实上所有精灵程序都存在于Domain 0 之中

94 | XenD)

95 | Xend精灵线程是一个Python应用程序,它作为Xen环境的系统管理员。它利用Libxenctrl类库向Xen Hypervisor发出请求。

96 | 所有Xend处理的请求都是由XM工具使用XML RPC接口发送过来的。

97 | 图3-3

98 |

99 |

100 | Xm)

101 | 用于将用户输入通过XML RPC接口传递到Xend中的命令行工具。

102 |

103 | Xenstored)

104 | Xenstored精灵程序用于维护注册信息,这些信息包括内存和在连接Domain 0和所有其他Domain U之间的事件通道。Domain 0虚拟机利用这些注册信息来与系统中其他虚拟机建立设备通道,即帮助Domain U虚拟机访问硬件资源。

105 |

106 | Libxenctrl)

107 | Libxenctrl是C程序类库,用于让Xend具有通过Domain 0与Xen Hypervisor进行交互的能力。在Domain 0中存在一个特殊的驱动程序称作privcmd,它将请求发送给Hypervisor。

108 |

109 | 图3-4

110 |

111 | qemu-DM)