├── README.md

├── ✍ 文章

├── 18张图揭秘高性能Linux服务器内存池技术是如何实现的.md

├── 5 useful tools to detect memory leaks with examples.md

├── 59问:内存管理.md

├── C++ 实现高性能内存池.md

├── C++中内存管理之new、delete.md

├── Linux 内存占用分析的几个方法,你知道几个?.md

├── Linux: large-memory management histories.md

├── Linux中的内存管理机制.md

├── Linux虚拟内存管理,MMU机制,原来如此.md

├── Looking at kmalloc() and the SLUB Memory Allocator.md

├── Memory Management in OS: Contiguous, Swapping, Fragmentation.md

├── Memory Management in Operating System.md

├── Nginx 内存池管理.md

├── Operating System - Memory Management.md

├── Virtual Memory in OS: What is, Demand Paging, Advantages.md

├── Why Do We Need Virtual Memory?.md

├── glibc2.23 ptmalloc 原理概述.md

├── linux 内核(5.4.81)—内存管理模块源码分析.md

├── linux内存管理---详解.md

├── malloc和free的实现原理解析.md

├── 【性能优化】高效内存池的设计与实现.md

├── 一文了解,Linux内存管理,malloc、free 实现原理.md

├── 一文带你了解,虚拟内存、内存分页、分段、段页式内存管理.md

├── 一文让你看懂内存与CPU之间的关系.md

├── 为什么linux需要虚拟内存.md

├── 内存泄漏的在线排查.md

├── 内存碎片之外部碎片与内部碎片.md

├── 内存管理-内核态内存映射.md

├── 内存管理-物理内存空间管理.md

├── 内存管理-用户态内存映射.md

├── 内存管理之内存映射.md

├── 内存管理之内核空间和用户空间.md

├── 内存管理之分页.md

├── 内存管理系列一:启动简介.md

├── 内存管理系列七:slub初始化.md

├── 内存管理系列三:MMU前CPU初始化及打开MMU.md

├── 内存管理系列九:slub申请内存.md

├── 内存管理系列二十一:内存回收入口.md

├── 内存管理系列二十二:内存回收核心流程.md

├── 内存管理系列二十:内存压缩算法之数据同步.md

├── 内存管理系列二:创建启动阶段的页表.md

├── 内存管理系列五:alloc_pages从伙伴系统申请空间简易流程.md

├── 内存管理系列八:slub创建.md

├── 内存管理系列六:伙伴系统之buffered_rmqueue.md

├── 内存管理系列十一:slub销毁.md

├── 内存管理系列十七:内存池.md

├── 内存管理系列十三:VMA操作.md

├── 内存管理系列十九:内存压缩算法.md

├── 内存管理系列十二:vmalloc内存机制.md

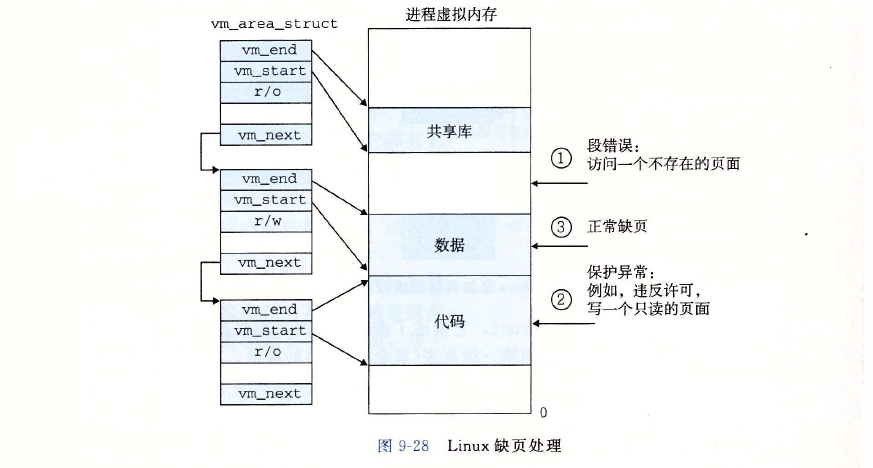

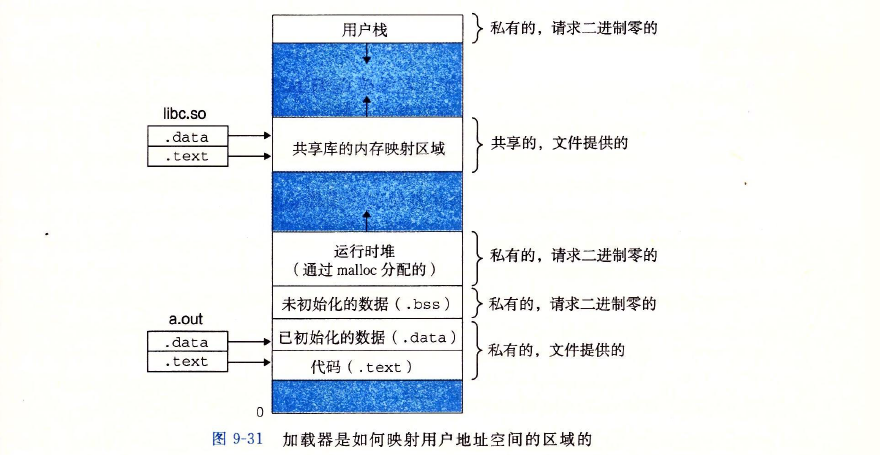

├── 内存管理系列十五:do_page_fault缺页中断.md

├── 内存管理系列十八:内存回收之LRU链表.md

├── 内存管理系列十六:反向映射RMAP.md

├── 内存管理系列十四:brk.md

├── 内存管理系列十:slub回收.md

├── 内存管理系列四:setup_arch简介(内存管理初始化).md

├── 内存管理(一):硬件原理 和 分页管理.md

├── 内存管理(三):进程的内存消耗和泄漏.md

├── 内存管理(二):内存的动态申请和释放.md

├── 内存管理(五):其他工程问题以及调优.md

├── 内存管理(四):内存与IO的交换.md

├── 图解 Linux 内存性能优化核心思想.md

├── 多核心Linux内核路径优化的不二法门之-slab与伙伴系统.md

├── 尽情阅读,技术进阶,详解mmap原理.md

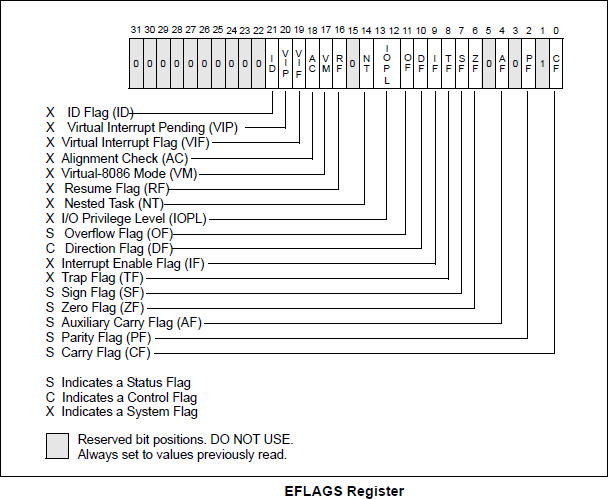

├── 常用寄存器总结.md

├── 浅谈Linux内存管理机制.md

├── 深入浅出linux内存管理(一).md

├── 深入浅出linux内存管理(二).md

├── 深入理解 Linux 内存子系统.md

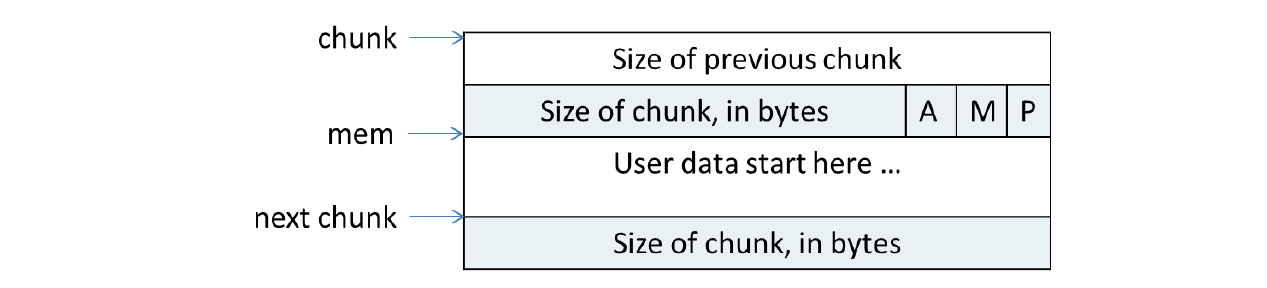

├── 深入理解 glibc malloc:内存分配器实现原理.md

├── 虚拟地址空间——MMU.md

└── 进程的虚拟内存空间.md

├── 内存管理-用户态内存映射.md

├── 内存管理知识点总结.pdf

└── 📁论文

├── ARM的虚拟内存管理技术的研究.caj

├── C语言的内存漏洞分析与研究.pdf

├── FreeRTOS内存管理方案的分析与改进.pdf

├── Linux Memory Management.pdf

├── Linux内存管理分析与研究.pdf

├── Linux内存管理的设计与实现.pdf

├── Linux内核中内存池的实现及应用.pdf

├── Linux内核中动态内存检测机制的研究.pdf

├── Linux内核伙伴系统分析.pdf

├── Linux内核内存池实现研究.pdf

├── Linux实时内存的研究与实现.pdf

├── Linux操作系统内核分析与研究.pdf

├── Memory Management 101: Introduction to Memory Management in Linux.pdf

├── Memory Management in Linux.pdf

├── Memory Management.pdf

├── NUMA架构内多个节点间访存延时平衡的内存分配策略.pdf

├── Nginx Slab算法研究.pdf

├── TCP_IP协议栈的轻量级多线程实现.caj

├── Understanding the Linux Understanding the Linux.pdf

├── VC中利用内存映射文件实现进程间通信的方法.pdf

├── Virtual Memory Management Techniques in 2.6 Kernel and Challenges.pdf

├── Visual C 中利用内存映射文件在进程之间共享数据.pdf

├── 《Linux Physical Memory Page Allocation》.pdf

├── 一个内存分配器的设计和实现.pdf

├── 一种Linux内存管理机制.pdf

├── 一种TLB结构优化方法.pdf

├── 一种优化的伙伴系统存储管理算法设计.pdf

├── 一种基于虚拟机的动态内存泄露检测方法.pdf

├── 一种提高Linux内存管理实时性的设计方案.pdf

├── 一种改进的Linux内存分配机制.pdf

├── 一种改进的伙伴系统内存管理方法.pdf

├── 一种跨平台内存池的设计与实现.pdf

├── 一种高效的池式内存管理器的设计.pdf

├── 云计算平台中多虚拟机内存协同优化策略研.pdf

├── 云计算平台中多虚拟机内存协同优化策略研究.pdf

├── 内存管理机制的高效实现研究.pdf

├── 分页存储管理系统中内存有效访问时间的计算.pdf

├── 利用内存映射连续性提高TLB地址覆盖范围的技术评测.pdf

├── 动态内存分配器研究综述.pdf

├── 动态存储管理机制的改进及实现.pdf

├── 基于C 的高效内存池的设计与实现.pdf

├── 基于C 自定义内存分配器的实现.pdf

├── 基于Linux内核的动态内存管理机制的实现.pdf

├── 基于Linux内核页表构建内核隔离空间的研究及实现.pdf

├── 基于RDMA和NVM的大数据系统一致性协议研究.pdf

├── 基于RDMA高速网络的高性能分布式系统.pdf

├── 基于RelayFS的内核态内存泄露的检测和跟踪.pdf

├── 基于linux用户态可自控缓冲区管理设计与实现.pdf

├── 基于multimap映射的动态内存分配算法探究.pdf

├── 基于云计算虚拟化平台的内存管理研究.pdf

├── 基于内存池的空间数据调度算法.pdf

├── 多核系统内存管理算法的研究.pdf

├── 实时系统内存管理方案的设计与实现.pdf

├── 对linux伙伴系统及其反碎片机制的研究.pdf

├── 嵌入式实时系统动态内存分配管理器的设计与实现.pdf

├── 并发数据结构及其在动态内存管理中的应用.pdf

├── 应用协同的进程组内存管理支撑技术.pdf

├── 支持高性能IPC的内存管理策略研究.pdf

├── 有效的C 内存泄露检测方法.pdf

├── 浅析伙伴系统的分配与回收.pdf

├── 用户态内存管理关键技术研究.pdf

├── 申威处理器页表结构Cache的优化研究与实现.pdf

├── 虚拟化系统中的内存管理优化.pdf

├── 面向Linux内核空间的内存分配隔离方法的研究与实现.pdf

└── 页面分配器的研究与实现.pdf

/✍ 文章/18张图揭秘高性能Linux服务器内存池技术是如何实现的.md:

--------------------------------------------------------------------------------

1 | 大家生活中肯定都有这样的经验,那就是大众化的产品都比较便宜,但便宜的大众产品就是一个词,普通;而可以定制的产品一般都价位不凡,这种定制的产品注定不会在大众中普及,因此定制产品就是一个词,独特。

2 |

3 | 有的同学可能会有疑问,你不是要聊技术吗?怎么又说起消费了?

4 |

5 | 原来技术也有大众货以及定制品。

6 |

7 |

8 |

9 | **通用 VS 定制**

10 |

11 | 作为程序员(C/C++)我们知道申请内存使用的是malloc,malloc其实就是一个通用的大众货,什么场景下都可以用,**但是什么场景下都可以用就意味着什么场景下都不会有很高的性能**。

12 |

13 |

14 |

15 | malloc性能不高的原因一在于其没有为特定场景做优化,除此之外还在于malloc看似简单,但是其调用过程是很复杂的,一次malloc的调用过程可能需要经过操作系统的配合才能完成。

16 |

17 | 那么调用malloc时底层都发生了什么呢?简单来说会有这样典型的几个步骤:

18 |

19 | 1. malloc开始搜索空闲内存块,如果能找到一块大小合适的就分配出去

20 | 2. 如果malloc找不到一块合适的空闲内存,那么调用brk等系统调用扩大堆区从而获得更多的空闲内存

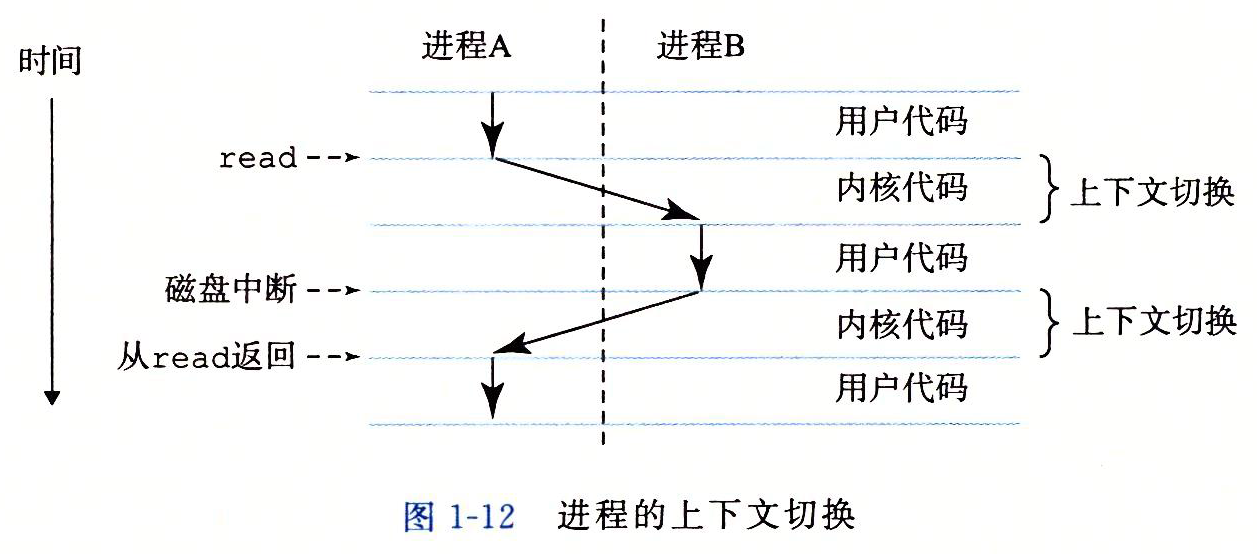

21 | 3. malloc调用brk后开始转入内核态,此时操作系统中的虚拟内存系统开始工作,扩大进程的堆区,注意额外扩大的这一部分内存仅仅是虚拟内存,操作系统并没有为此分配真正的物理内存

22 | 4. brk执行结束后返回到malloc,从内核态切换到用户态,malloc找到一块合适的空闲内存后返回

23 |

24 |

25 |

26 | 以上就是一次内存申请的完整过程,我们可以看到,**一次内存申请过程其实是非常复杂的,**关于这个问题的详细讨论你可以参考这里。

27 |

28 | 既然每次分配内存都要经过这么复杂的过程,**那么如果程序大量使用malloc申请内存那么该程序注定无法获得高性能**。

29 |

30 | 幸好,除了大众货的malloc,我们还可以私人定制,也就是针对特定场景自己来维护内存申请和分配,**这就是高性能高并发必备的内存池技术**。

31 |

32 |

33 |

34 |

35 | ##### **内存池技术有什么特殊的吗?**

36 |

37 | 有的同学可能会说,等等,那malloc和这里提到的内存池技术有什么区别呢?

38 |

39 | 第一个区别在于我们所说的malloc其实是标准库的一部分,位于标准库这一层;而内存池是应用程序的一部分。

40 |

41 |

42 |

43 | 其次在于定位,我们自己实现的malloc其实也是定位**通用性**的,通用性的内存分配器设计实现往往比较复杂,但是内存池技术就不一样了,**内存池技术专用于某个特定场景**,以此优化程序性能,但内存池技术的通用性是很差的,在一种场景下有很高性能的内存池基本上没有办法在其它场景也能获得高性能,甚至根本就不能用于其它场景,这就是内存池这种技术的定位。

44 |

45 |

46 |

47 | 那么内存池技术是怎样优化性能的呢?

48 |

49 |

50 |

51 |

52 | ##### **内存池技术原理**

53 |

54 | 简单来说,内存池技术一次性获取到大块内存,然后在其之上自己管理内存的申请和释放,这样就**绕过了标准库以及操作系统**:

55 |

56 |

57 |

58 | 也就是说,通过内存池,一次内存的申请再也不用去绕一大圈了。

59 |

60 | 除此之外,我们可以根据特定的使用模式来进一步优化,比如在服务器端,每次用户请求需要创建的对象可能就那几种,那么这时我们就可以在自己的内存池上**提前创建**出这些对象,当业务逻辑需要时就从内存池中申请已经创建好的对象,使用完毕后还回内存池。

61 |

62 | 因此我们可以看到,这种为某些应用场景定制的内存池相比通用的比如malloc内存分配器会有大的优势。

63 |

64 | 接下来我们就着手实现一个。

65 |

66 |

67 |

68 |

69 | ##### **实现内存池的考虑**

70 |

71 | 值得注意的是,内存池实际上有很多的实现方法,在这里我们还是以服务器端编程为例来说明。

72 |

73 | 假设你的服务器程序非常简单,处理用户请求时只使用一种对象(数据结构),那么最简单的就是我们提前申请出一堆来,使用的时候拿出一个,使用完后还回去:

74 |

75 |

76 |

77 | 怎么样,足够简单吧!这样的内存池只能分配特定对象(数据结构),当然这样的内存池需要自己维护哪些对象是已经被分配出去的,哪些是还没有被使用的。

78 |

79 | 但是,在这里我们可以实现一个稍微复杂一些的,那就是可以申请不同大小的内存,而且由于是服务器端编程,那么一次用户请求过程中我们只申请内存,只有当用户请求处理完毕后**一次性释放所有内存**,从而将内存申请释放的开销降低到最小。

80 |

81 | 因此,你可以看到,内存池的设计都是针对特定场景的。

82 |

83 | 现在,有了初步的设计,接下来就是细节了。

84 |

85 |

86 |

87 |

88 | ##### **数据结构**

89 |

90 | 为了能够分配大小可变的对象,显然我们需要管理空闲内存块,我们可以用一个链表把所有内存块链接起来,然后使用一个指针来记录当前空闲内存块的位置,如图所示:

91 |

92 |

93 |

94 | 从图中我们可以看到,有两个空闲内存块,空闲内存之间使用链表链接起来,每个内存块都是前一个的2倍,也就是说,当内存池中的空闲内存不足以分配时我们就向malloc申请内存,只不过其大小是前一个的2倍:

95 |

96 |

97 |

98 | 其次,我们有一个指针free_ptr,指向接下来的空闲内存块起始位置,当向内存池分配内存时找到free_ptr并判断当前内存池剩余空闲是否足够就可以了,有就分配出去并修改free_ptr,否则向malloc再次成倍申请内存。

99 |

100 | 从这里的设计可以看出,我们的内存池其实是不会提供类似free这样的内存释放函数的,如果要释放内存,那么会一次性将整个内存池释放掉,这一点和通用的内存分配器是不一样。

101 |

102 | 现在,我们可以分配内存了,还有一个问题是所有内存池设计不得不考虑的,那就是线程安全,这个话题你可以参考这里。

103 |

104 |

105 |

106 |

107 | ##### **线程安全**

108 |

109 | 显然,内存池不应该局限在单线程场景,那我们的内存池要怎样实现线程安全呢?

110 |

111 | 有的同学可能会说这还不简单,直接给内存池一把锁保护就可以了。

112 |

113 |

114 |

115 | 这种方法是不是可行呢?还是那句话,It depends,要看情况。

116 |

117 | 如果你的程序有大量线程申请释放内存,那么这种方案下锁的竞争将会非常激烈,线程这样的场景下使用该方案不会有很好的性能。

118 |

119 | 那么还有没有一种更好的办法吗?答案是肯定的。

120 |

121 |

122 |

123 |

124 | ##### **线程局部存储**

125 |

126 | 既然多线程使用线程池存在竞争问题,那么干脆我们为每个线程维护一个内存池就好了,这样多线程间就不存在竞争问题了。

127 |

128 | 那么我们该怎样为每个线程维护一个内存池呢?

129 |

130 | 线程局部存储,Thread Local Storage正是用于解决这一类问题的,什么是线程局部存储呢?

131 |

132 | 简单说就是,我们可以创建一个全局变量,因此所有线程都可以使用该全局变量,但与此同时,我们将该全局变量声明为线程私有存储,那么这时虽然所有线程依然看似使用同一个全局变量,但该全局变量在每个线程中都有自己的副本,**变量指向的值是线程私有的**,相互之间不会干扰。

133 |

134 |

135 |

136 | 关于线程局部存储,可以参考这里。

137 |

138 | 假设这个全局变量是一个整数,变量名字为global_value,初始值为100,那么当线程A将global_value修改为200时,线程B看到的global_value的值依然为100,只有线程A看到的global_value为200,这就是线程局部存储的作用。

139 |

140 |

141 |

142 |

143 | ##### **线程局部存储+内存池**

144 |

145 | 有了线程局部存储问题就简单了,我们可以将内存池声明为线程局部存储,这样每个线程都只会操作属于自己的内存池,这样就再也不会有锁竞争问题了。

146 |

147 |

148 |

149 | 注意,虽然这里给出了线程局部存储的设计,但并不是说加锁的方案就比不上线程局部存储方案,还是那句话,一切要看使用场景,如果加锁的方案够用,那么我们就没有必要绞尽脑汁的去用其它方案,因为加锁的方案更简单,代码也更容易维护。

150 |

151 | 还需要提醒的是,这里只是给出了内存池的一种实现方法,并不是说所有内存池都要这么设计,内存池可以简单也可复杂,一切要看实际场景,这一点也需要注意。

152 |

153 |

154 |

155 |

156 | ##### **其它内存池形式**

157 |

158 | 到目前为止我们给出了两种内存池的设计方法,第一种是提前创建出一堆需要的对象(数据结构),自己维护好哪些对象(数据结构)可用哪些已被分配;第二种可以申请任意大小的内存空间,使用过程中只申请不释放,最后一次性释放。这两种内存池天然适用于服务器端编程。

159 |

160 | 最后我们再来介绍一种内存池实现技术,这种内存池会提前申请出一大段内存,然后将这一大段内存切分为大小相同的小内存块:

161 |

162 |

163 |

164 | 然后我们自己来维护这些被切分出来的小内存块哪些是空闲的哪些是已经被分配的,比如我们可以使用栈这种数据结构,最初把所有空闲内存块地址push到栈中,分配内存是就pop出来一个,用户使用完毕后再push回栈里。

165 |

166 |

167 |

168 | 从这里的设计我们可以看出,这种内存池有一个限制,这个限制就是说**程序申请的最大内存不能超过这里内存块的大小**,否则不足以装下用户数据,这需要我们对程序所涉及的业务非常了解才可以。

169 |

170 | 用户申请到内存后根据需要将其塑造成特定对象(数据结构)。

171 |

172 | 关于线程安全的问题,可以同样采用线程局部存储的方式来实现:

173 |

174 |

175 |

176 |

177 |

178 |

179 | ##### **一个有趣的问题**

180 |

181 | 除了线程安全,这里还有一个非常有趣的问题,那就是如果线程A申请的对象被线程B拿去释放,我们的内存池该怎么处理呢?

182 |

183 | 这个问题之所以有趣是因为我们**必须知道该内存属于哪个线程的局部存储,但申请的内存本身并不能告诉你这样的信息**。

184 |

185 | 有的同学可能会说这还不简单,不就是一个指针到另一个指针的映射吗,直接用map之类存起来就好了,但问题并没有这么简单,原因就在于如果我们切分的内存块很小,那么会存在大量内存块,这就需要存储大量的映射关系,有没有办法改进呢?

186 |

187 | 改进方法是这样的,一般来说,我们申请到的大段内存其实是会按照特定大小进行内存对齐,我们假设总是按照4K字节对齐,那么该大段内存的起始地址后12个bit(4K = 2^12)为总是0,比如地址0x9abcd**000**,同时我们也假设申请到的大段内存大小也是4K:

188 |

189 |

190 |

191 | 那么我们就能知道该大段内存中的各个小内存块起始地址除了后12个bit位外都是一样的:

192 |

193 |

194 |

195 | 这样拿到任意一个内存的地址我们就能知道对应的大段内存的起始地址,只需要简单的将后12个bit置为0即可,有了大段内存的起始地址剩下的就简单了,我们可以在大段内存中的最后保存对应的线程局部存储信息:

196 |

197 |

198 |

199 | **这样我们对任意一个内存块地址进行简单的位运算就可以得到对应的线程局部存储信息**,大大减少了维护映射信息对内存的占用。

200 |

201 |

202 |

203 |

204 | ##### **总结**

205 |

206 | 内存池是高性能服务器中常见的一种优化技术,在这里我们介绍了三种实现方法,值得注意的是,内存池实现没有统一标准,一切都要根据具体场景定制,因此我们可以看到内存池设计是有针对性的,当然其反面就是不具备通用性。

207 |

208 | 希望本文对大家理解内存池有所帮助。

209 |

--------------------------------------------------------------------------------

/✍ 文章/Linux中的内存管理机制.md:

--------------------------------------------------------------------------------

1 | 程序在运行时所有的数据结构的分配都是在堆和栈上进行的,而堆和栈都是建立在内存之上。内存作为现代计算机运行的核心,CPU可以直接访问的通用存储只有内存和处理器内置的寄存器,所有的代码都需要装载到内存之后才能让CPU通过指令寄存器找到相应的地址进行访问。

2 |

3 | ## 地址空间和MMU

4 |

5 | 内存管理单元(MMU)是硬件提供的最底层的内存管理机制,是CPU的一部分,用来管理内存的控制线路,提供把虚拟地址映射为物理地址的能力。

6 |

7 | 在x86体系结构下,CPU对内存的寻址都是通过分段方式进行的。其工作流程为:CPU生成逻辑地址并交给分段单元。分段单元为每个逻辑地址生成一个线性地址。然后线性地址交给分页单元,以生成内存的物理地址。因此也就是分段和分页单元组成了内存管理单元(MMU)。

8 |

9 |

10 |

11 | 其中: + 虚拟地址:在段中的偏移地址 + 线性地址:在某个段中“基地址+偏移地址”得出的地址 + 物理地址:在x86中,MMU还提供了分页机制,假如没有开启分页机制,那么线性地址就等于物理地址;否则还需要经过分页机制换算后线性地址才能转换成物理地址。 一个段是由“基地址+段界限(该段长度)+类型”组成,主要确定了段的起始地址,段的界限长度和确定段的属性如是否可读、可写、段的基本粒度单位、表述该段是数据段还是代码段等。 分段允许进程的物理地址空间是非连续的,分页则是提供这一优势的另外一种内存管理方案,并且**分页避免了外部碎片和紧缩,分段却不可以**。在x86体系中MMU支持多级的分页模型,主要分为以下三种情况: 1. 32为系统分为2级分页模型 2. 32位系统开启了物理地址扩展模式(PAE),则分为3级分页模型 3. 64位系统分为4级分页模型 80x86的分页机制由CR0中的PG位开启,若PG=0则禁用分页机制,也就是直接将线性地址作为物理地址。32位的线性地址主要分为三个部分:

12 |

13 |

14 |

15 | * 22-31位指向页目录表中的某一项,页目录表中的每一项存有4子节地址指向页表。所以页表目录大小为4 * 210 = 4K

16 | * 12-21位指向页表中的某一项,页表大小与页目录表相同为4K

17 | * 一个物理页为4K,刚好0-11位指向页表中的偏移,一个页表刚好4K(212)

18 |

19 | 页表和页目录表可以存放在内存的任何地方,当分页机制开启后,需要让CR3寄存器指向页目录表的起始地址。

20 |

21 | > CR0-CR4这五个寄存器为系统内的控制寄存器,与分页机制密切相关。

22 | > CR0控制寄存器是一些特殊的寄存器,可以控制CPU的一些重要特性;

23 | > CR1是未定义的控制寄存器,供将来使用;

24 | > CR2是页故障线性地址寄存器,保存最后一次出现页故障的全32位线性地址;

25 | > CR3是页目录基址寄存器,保存页目录表的物理地址(页目录表总是放在4k为单位的存储器边界上,因此其低12位总为0不起作用,即使写上内容也不会被理会)

26 | > CR4在Pentium系列(包括486后期版本)处理器中才出现,处理事务包括何时启用虚拟8086模式等。

27 |

28 | ### Linux中的分段与分页

29 |

30 | MMU在保护模式下分段数据主要定义在GDT中。

31 |

32 | ```c

33 | //arch/x86/kernel/cpu/common.c

34 |

35 | DEFINE_PER_CPU_PAGE_ALIGNED(struct gdt_page, gdt_page) = { .gdt = {

36 | ...

37 | [GDT_ENTRY_KERNEL_CS] = GDT_ENTRY_INIT(0xc09a, 0, 0xfffff), //代码段

38 | [GDT_ENTRY_KERNEL_DS] = GDT_ENTRY_INIT(0xc092, 0, 0xfffff), //数据段

39 | [GDT_ENTRY_DEFAULT_USER_CS] = GDT_ENTRY_INIT(0xc0fa, 0, 0xfffff),

40 | [GDT_ENTRY_DEFAULT_USER_DS] = GDT_ENTRY_INIT(0xc0f2, 0, 0xfffff),

41 | ...

42 | } };

43 | EXPORT_PER_CPU_SYMBOL_GPL(gdt_page);

44 | ```

45 |

46 | 通过代码可知道这些段的基地址都是0,界限为4G。说明Linux只定义了一个段,并没有真正利用分段机制。

47 |

48 | Linux中只用了一个段,而且基地址从0开始,那么在程序中使用的虚地址就是线性地址了。Linux为了兼容64位、32位及其PAE扩展情况,在代码中通过4级分页机制来做兼容。

49 |

50 | ## Linux的内存分配与管理

51 |

52 | 在32位的x86设备中,Linux为每个进程分配的虚拟地址空间都是0-4GB,其中

53 |

54 | * 0-3GB用于用户态使用

55 | * 3GB-3GB+896MB映射到物理地址的0-896MB处,作为内核态地址空间

56 | * 3GB+896MB-4GB之间的128MB空间用于vmalloc保留区域,该区域用于kmalloc、kmap固定地址映射等功能,可以让内核访问高端物理地址空间

57 |

58 |

59 |

60 | Linux中进程的地址空间由mm_struct来描述,一个进程只会有一个mm_struct。系统中的内核态是共享的,不会发生缺页中断或者访问用户进程空间,所以内核线程的task_struct->mm为NULL。

61 |

62 | 页表的分配分为两个部分:

63 |

64 | 1、内核页表,也就是在系统启动中,最后会在paging_init函数中,把ZONE_DMA和ZONE_NORMAL区域的物理页面与虚拟地址空间的3GB-3GB+896MB进行直接映射

65 | 2、内核高端地址和用户态地址,都是通过MMU机制修改线性地址(虚拟地址)和物理地址的映射关系,然后刷新页表缓存来达到的

66 |

67 | > 物理内存中ZONE_DMA的范围是0-16MB,该区域的物理页面专门供IO设备的DMA使用,之所以要单独管理DMA的物理页面,是因为DMA使用物理地址访问内存不经过MMU,并且需要连续的缓冲区。为了能够提供物理上的连续缓冲区,必须从物理地址专门划分出一段区域用于DMA。 ZONE_NORMAL的范围是16MB-896MB,该区域的物理页面是内核能够直接使用的。 ZONE_HIGHMEM的范围是896MB-结束,该区域即高端内存,内核不能直接使用。

68 |

69 | ### 伙伴系统

70 | 对于物理内存经过频繁地申请和释放后会产生外部碎片,Linux通过伙伴系统来解决外部碎片的问题。

71 |

72 | 满足:

73 | 1.具有相同的大小;

74 | 2.物理地址连续条件的两个块为伙伴。主要实现思路位伙伴系统在申请内存的时候让最小的块满足申请的需求,在归还的时候,尽量让连续的小块内存伙伴合并成大块,降低外部碎片出现的可能性。

75 |

76 | 在Linux系统中伙伴系统维护了11个块链表,每个块链表分别包含了大小为20-211个连续的物理页。对1024个页的最大请求对应着4MB大小的连续RAM块。每个快的第一个页框的物理地址就是该块大小的整数倍。如大小为16个页框的块,其起始地址为16×212(212=4KB这是一个页的大小)的倍数。

77 |

78 | 系统在初始化的时候把内各节点各区域都释放到伙伴系统中,每个区域还维护了per-cpu高速缓存来处理单页的分配,各个区域都通过伙伴算法进行物理内存的分配。

79 |

80 | ### slab分配器

81 |

82 | Linux系统通过伙伴算法解决了外部碎片的问题,此外还提供了slab分配器来处理内部碎片的问题。slab分配器也是一种内存预分配机制,是一种空间换时间的做法,并且其假定从slab分配器中获得的内存都是比页还小的小内存块。

83 |

84 |

85 |

86 | slab的设计思想就是把若干的页框合在一起形成一大存储块——slab,并在这个slab中只存储同一类数据,这样就可以在这个slab内部打破页的界限,以该类型数据的大小来定义分配粒度,存放多个数据,这样就可以尽可能地减少页内碎片了。在Linux中,多个存储同类数据的slab的集合叫做一类对象的缓冲区——cache。注意,这不是硬件的那个cache,只是借用这个名词而已。

87 |

88 | Linux中slab的可分为以下三种状态:

89 |

90 | 1、slabs_full:该链表中slab已经完全分配出去

91 | 2、slabs_free:该链表中的slab都是空闲可分配状态

92 | 3、labs_partial:该链表中的slab部分已经被分配出去了

93 |

94 | 其中slab代表物理地址连续的内存块,由1-N个物理页面组成,在一个slab中可以分配多个object对象。

95 |

96 | slab的优点:

97 |

98 | * 内核通常依赖于对小对象的分配,它们会在系统生命周期内进行无数次分配。slab 缓存分配器通过对类似大小的对象进行缓存而提供这种功能,从而避免了常见的碎片问题;

99 | * slab 分配器还支持通用对象的初始化,从而避免了为同一目的而对一个对象重复进行初始化;

100 | * slab 分配器还可以支持硬件缓存对齐和着色,这允许不同缓存中的对象占用相同的缓存行,从而提高缓存的利用率并获得更好的性能。

101 |

102 | slab的缺点:

103 |

104 | * 较多复杂的队列管理。在slab分配器中存在众多的队列,例如针对处理器的本地缓存队列,slab中空闲队列,每个slab处于一个特定状态的队列之中。

105 | * slab管理数据和队列的存储开销比较大。每个slab需要一个struct slab数据结构和一个管理者kmem_bufctl_t型的数组。当对象体积较小时,该数组将造成较大的开销(比如对象大小为32字节时,将浪费1/8空间)。同时,缓冲区针对节点和处理器的队列也会浪费不少内存。

106 | * 缓冲区回收、性能调试调优比较复杂。

107 |

108 |

109 | ### 内核态内存管理

110 |

111 | 根据之前的的Linux的内存管理机制,即伙伴系统和slab分配器。对于内核态的内存分配主要通过函数kmalloc和vmalloc完成。

112 |

113 |

114 |

115 | 其中kmalloc函数可以为内核申请连续物理地址的内存空间,由于kmalloc是基于slab分配器实现的,所以比较适合较小块的内存申请。kmalloc函数的调用过程为:`kmalloc->__kmalloc->__do_kmalloc`,其中`__do_kmalloc`的实现主要分为两步:

116 |

117 | 1、通过`kmalloc_slab`找到一个合适的`kmem_cache`缓存

118 | 2、通过`slab_alloc`向slab分配器申请对象内存空间

119 |

120 | Linux提供的vmalloc函数可以获得连续的虚拟空间,但是其物理内存不一定连续。vmalloc函数的调用过程为:`vmalloc->__vmalloc_node_flags->__vmalloc_node->__vmalloc_node_range`。其中`__vmalloc_node_range`函数也分为两步:

121 |

122 | 1、通过`__get_vm_area_node`分配一个可用的虚拟地址空间

123 | 2、`__vmalloc_node_range`通过`alloc_pages`一页一页申请物理内存,再为刚才申请的虚拟地址空间分配物理页表映射

124 |

125 |

126 |

--------------------------------------------------------------------------------

/✍ 文章/Linux虚拟内存管理,MMU机制,原来如此.md:

--------------------------------------------------------------------------------

1 | ## MMU

2 |

3 | 现代操作系统普遍采用虚拟内存管理(Virtual Memory Management)机制,这需要处理器中的MMU(Memory Management Unit,内存管理单元)提供支持。

4 |

5 | 首先引入 PA 和 VA 两个概念。

6 |

7 | ## PA

8 |

9 | 如果处理器没有MMU,或者有MMU但没有启用,CPU执行单元发出的内存地址将直接传到芯片引脚上,被内存芯片(以下称为物理内存,以便与虚拟内存区分)接收,这称为PA(Physical Address,以下简称PA),如下图所示。

10 |

11 |

12 |

13 |

14 | ## VA

15 | 如果处理器启用了MMU,CPU执行单元发出的内存地址将被MMU截获,从CPU到MMU的地址称为虚拟地址(Virtual Address,以下简称VA),而MMU将这个地址翻译成另一个地址发到CPU芯片的外部地址引脚上,也就是将VA映射成PA,如下图所示。

16 |

17 |

18 |

19 | 如果是32位处理器,则内地址总线是32位的,与CPU执行单元相连(图中只是示意性地画了4条地址线),而经过MMU转换之后的外地址总线则不一定是32位的。也就是说,虚拟地址空间和物理地址空间是独立的,32位处理器的虚拟地址空间是4GB,而物理地址空间既可以大于也可以小于4GB。

20 |

21 | MMU将VA映射到PA是以页(Page)为单位的,32位处理器的页尺寸通常是4KB。例如,MMU可以通过一个映射项将VA的一页0xb7001000~0xb7001fff映射到PA的一页0x2000~0x2fff,如果CPU执行单元要访问虚拟地址0xb7001008,则实际访问到的物理地址是0x2008。物理内存中的页称为物理页面或者页帧(Page Frame)。虚拟内存的哪个页面映射到物理内存的哪个页帧是通过页表(Page Table)来描述的,页表保存在物理内存中,MMU会查找页表来确定一个VA应该映射到什么PA。

22 |

23 | ## 进程地址空间

24 |

25 |

26 |

27 | x86平台的虚拟地址空间是0x0000 0000~0xffff ffff,大致上前3GB(0x0000 0000~0xbfff ffff)是用户空间,后1GB(0xc000 0000~0xffff ffff)是内核空间。

28 |

29 | Text Segmest 和 Data Segment

30 |

31 | * Text Segment,包含.text段、.rodata段、.plt段等。是从/bin/bash加载到内存的,访问权限为r-x。

32 | * Data Segment,包含.data段、.bss段等。也是从/bin/bash加载到内存的,访问权限为rw-。

33 |

34 | ## 堆和栈

35 |

36 | * 堆(heap):堆说白了就是电脑内存中的剩余空间,malloc函数动态分配内存是在这里分配的。在动态分配内存时堆空间是可以向高地址增长的。堆空间的地址上限称为Break,堆空间要向高地址增长就要抬高Break,映射新的虚拟内存页面到物理内存,这是通过系统调用brk实现的,malloc函数也是调用brk向内核请求分配内存的。

37 | * 栈(stack):栈是一个特定的内存区域,其中高地址的部分保存着进程的环境变量和命令行参数,低地址的部分保存函数栈帧,栈空间是向低地址增长的,但显然没有堆空间那么大的可供增长的余地,因为实际的应用程序动态分配大量内存的并不少见,但是有几十层深的函数调用并且每层调用都有很多局部变量的非常少见。

38 |

39 | 如果写程序的时候没有注意好内存的分配问题,在堆和栈这两个地方可能产生以下几种问题:

40 |

41 | 1、内存泄露:如果你在一个函数里通过 malloc 在堆里申请了一块空间,并在栈里声明一个指针变量保存它,那么当该函数结束时,该函数的成员变量将会被释放,包括这个指针变量,那么这块空间也就找不回来了,也就无法得到释放。久而久之,可能造成下面的内存泄露问题。

42 | 2、栈溢出:如果你放太多数据到栈中(例如大型的结构体和数组),那么就可能会造成“栈溢出”(Stack Overflow)问题,程序也将会终止。为了避免这个问题,在声明这类变量时应使用 malloc 申请堆的空间。

43 | 3、野指针 和 段错误:如果一个指针所指向的空间已经被释放,此时再试图用该指针访问已经被释放了的空间将会造成“段错误”(Segment Fault)问题。此时指针已经变成野指针,应该及时手动将野指针置空。

44 |

45 | ## 虚拟内存管理的作用

46 |

47 | 1、虚拟内存管理可以控制物理内存的访问权限。物理内存本身是不限制访问的,任何地址都可以读写,而操作系统要求不同的页面具有不同的访问权限,这是利用CPU模式和MMU的内存保护机制实现的。

48 | 2、虚拟内存管理最主要的作用是让每个进程有独立的地址空间。所谓独立的地址空间是指,不同进程中的同一个VA被MMU映射到不同的PA,并且在某一个进程中访问任何地址都不可能访问到另外一个进程的数据,这样使得任何一个进程由于执行错误指令或恶意代码导致的非法内存访问都不会意外改写其它进程的数据,不会影响其它进程的运行,从而保证整个系统的稳定性。另一方面,每个进程都认为自己独占整个虚拟地址空间,这样链接器和加载器的实现会比较容易,不必考虑各进程的地址范围是否冲突。

49 |

50 |

51 |

52 | 3、VA到PA的映射会给分配和释放内存带来方便,物理地址不连续的几块内存可以映射成虚拟地址连续的一块内存。比如要用malloc分配一块很大的内存空间,虽然有足够多的空闲物理内存,却没有足够大的连续空闲内存,这时就可以分配多个不连续的物理页面而映射到连续的虚拟地址范围。

53 |

54 |

55 |

56 | 4、一个系统如果同时运行着很多进程,为各进程分配的内存之和可能会大于实际可用的物理内存,虚拟内存管理使得这种情况下各进程仍然能够正常运行。因为各进程分配的只不过是虚拟内存的页面,这些页面的数据可以映射到物理页面,也可以临时保存到磁盘上而不占用物理页面,在磁盘上临时保存虚拟内存页面的可能是一个磁盘分区,也可能是一个磁盘文件,称为交换设备(Swap Device)。当物理内存不够用时,将一些不常用的物理页面中的数据临时保存到交换设备,然后这个物理页面就认为是空闲的了,可以重新分配给进程使用,这个过程称为换出(Page out)。如果进程要用到被换出的页面,就从交换设备再加载回物理内存,这称为换入(Page in)。换出和换入操作统称为换页(Paging),因此:\[\mbox{系统中可分配的内存总量} = \mbox{物理内存的大小} + \mbox{交换设备的大小}\]

57 |

58 | 如下图所示。第一张图是换出,将物理页面中的数据保存到磁盘,并解除地址映射,释放物理页面。第二张图是换入,从空闲的物理页面中分配一个,将磁盘暂存的页面加载回内存,并建立地址映射。

59 |

60 |

61 |

62 | ## malloc 和 free

63 |

64 | C标准库函数malloc可以在堆空间动态分配内存,它的底层通过brk系统调用向操作系统申请内存。动态分配的内存用完之后可以用free释放,更准确地说是归还给malloc,这样下次调用malloc时这块内存可以再次被分配。

65 |

66 | ```c

67 | #include

68 |

69 | void *malloc(size_t size);

70 | 返回值:成功返回所分配内存空间的首地址,出错返回NULL

71 |

72 | void free(void *ptr);

73 | ```

74 |

75 | malloc的参数size表示要分配的字节数,如果分配失败(可能是由于系统内存耗尽)则返回NULL。由于malloc函数不知道用户拿到这块内存要存放什么类型的数据,所以返回通用指针void *,用户程序可以转换成其它类型的指针再访问这块内存。malloc函数保证它返回的指针所指向的地址满足系统的对齐要求,例如在32位平台上返回的指针一定对齐到4字节边界,以保证用户程序把它转换成任何类型的指针都能用。

76 | 动态分配的内存用完之后可以用free释放掉,传给free的参数正是先前malloc返回的内存块首地址。

77 |

78 | **示例**

79 |

80 | ```c

81 | #include

82 | #include

83 | #include

84 |

85 | typedef struct {

86 | int number;

87 | char *msg;

88 | } unit_t;

89 |

90 | int main(void)

91 | {

92 | unit_t *p = malloc(sizeof(unit_t));

93 |

94 | if (p == NULL) {

95 | printf("out of memory\n");

96 | exit(1);

97 | }

98 | p->number = 3;

99 | p->msg = malloc(20);

100 | strcpy(p->msg, "Hello world!");

101 | printf("number: %d\nmsg: %s\n", p->number, p->msg);

102 | free(p->msg);

103 | free(p);

104 | p = NULL;

105 |

106 | return 0;

107 | }

108 | ```

109 |

110 | **说明**

111 |

112 | * `unit_t *p = malloc(sizeof(unit_t))`;这一句,等号右边是`void *`类型,等号左边是`unit_t *`类型,编译器会做隐式类型转换,我们讲过`void *`类型和任何指针类型之间可以相互隐式转换。

113 | * 虽然内存耗尽是很不常见的错误,但写程序要规范,malloc之后应该判断是否成功。以后要学习的大部分系统函数都有成功的返回值和失败的返回值,每次调用系统函数都应该判断是否成功。

114 | * `free(p)`;之后,p所指的内存空间是归还了,但是p的值并没有变,因为从free的函数接口来看根本就没法改变p的值,p现在指向的内存空间已经不属于用户,换句话说,p成了野指针,为避免出现野指针,我们应该在`free(p)`;之后手动置`p = NULL`;。

115 | * 应该先`free(p->msg)`,再`free(p)`。如果先`free(p)`,p成了野指针,就不能再通过`p->msg`访问内存了。

116 |

117 | ## 内存泄漏

118 |

119 | 如果一个程序长年累月运行(例如网络服务器程序),并且在循环或递归中调用malloc分配内存,则必须有free与之配对,分配一次就要释放一次,否则每次循环都分配内存,分配完了又不释放,就会慢慢耗尽系统内存,这种错误称为内存泄漏(Memory Leak)。另外,malloc返回的指针一定要保存好,只有把它传给free才能释放这块内存,如果这个指针丢失了,就没有办法free这块内存了,也会造成内存泄漏。例如:

120 |

121 | ```c

122 | void foo(void)

123 | {

124 | char *p = malloc(10);

125 | ...

126 | }

127 | ```

128 |

129 | foo函数返回时要释放局部变量p的内存空间,它所指向的内存地址就丢失了,这10个字节也就没法释放了。内存泄漏的Bug很难找到,因为它不会像访问越界一样导致程序运行错误,少量内存泄漏并不影响程序的正确运行,大量的内存泄漏会使系统内存紧缺,导致频繁换页,不仅影响当前进程,而且把整个系统都拖得很慢。

130 |

131 | 关于malloc和free还有一些特殊情况。malloc(0)这种调用也是合法的,也会返回一个非NULL的指针,这个指针也可以传给free释放,但是不能通过这个指针访问内存。free(NULL)也是合法的,不做任何事情,但是free一个野指针是不合法的,例如先调用malloc返回一个指针p,然后连着调用两次free§;,则后一次调用会产生运行时错误。

132 |

--------------------------------------------------------------------------------

/✍ 文章/Virtual Memory in OS: What is, Demand Paging, Advantages.md:

--------------------------------------------------------------------------------

1 | ## What is Virtual Memory?

2 |

3 | **Virtual Memory** is a storage mechanism which offers user an illusion of having a very big main memory. It is done by treating a part of secondary memory as the main memory. In Virtual memory, the user can store processes with a bigger size than the available main memory.

4 |

5 | Therefore, instead of loading one long process in the main memory, the OS loads the various parts of more than one process in the main memory. Virtual memory is mostly implemented with demand paging and demand segmentation.

6 |

7 | In this Operating system tutorial, you will learn:

8 |

9 | - [What is Virtual Memory?](https://www.guru99.com/virtual-memory-in-operating-system.html#1)

10 | - [How Virtual Memory Works?](https://www.guru99.com/virtual-memory-in-operating-system.html#2)

11 | - [What is Demand Paging?](https://www.guru99.com/virtual-memory-in-operating-system.html#3)

12 | - [Types of Page replacement methods](https://www.guru99.com/virtual-memory-in-operating-system.html#4)

13 | - [FIFO Page Replacement](https://www.guru99.com/virtual-memory-in-operating-system.html#5)

14 | - [Optimal Algorithm](https://www.guru99.com/virtual-memory-in-operating-system.html#6)

15 | - [LRU Page Replacement](https://www.guru99.com/virtual-memory-in-operating-system.html#7)

16 | - [Advantages of Virtual Memory](https://www.guru99.com/virtual-memory-in-operating-system.html#8)

17 | - [Disadvantages of Virtual Memory](https://www.guru99.com/virtual-memory-in-operating-system.html#9)

18 |

19 | ## Why Need Virtual Memory?

20 |

21 | Here, are reasons for using virtual memory:

22 |

23 | - Whenever your computer doesn’t have space in the physical memory it writes what it needs to remember to the hard disk in a swap file as virtual memory.

24 | - If a computer running Windows needs more memory/RAM, then installed in the system, it uses a small portion of the hard drive for this purpose.

25 |

26 | ## How Virtual Memory Works?

27 |

28 | In the modern world, virtual memory has become quite common these days. It is used whenever some pages require to be loaded in the main memory for the execution, and the memory is not available for those many pages.

29 |

30 | So, in that case, instead of preventing pages from entering in the main memory, the OS searches for the RAM space that are minimum used in the recent times or that are not referenced into the secondary memory to make the space for the new pages in the main memory.

31 |

32 | Let’s understand virtual memory management with the help of one example.

33 |

34 | ### For example:

35 |

36 | Let’s assume that an OS requires 300 MB of memory to store all the running programs. However, there’s currently only 50 MB of available physical memory stored on the RAM.

37 |

38 | - The OS will then set up 250 MB of virtual memory and use a program called the Virtual Memory Manager(VMM) to manage that 250 MB.

39 | - So, in this case, the VMM will create a file on the hard disk that is 250 MB in size to store extra memory that is required.

40 | - The OS will now proceed to address memory as it considers 300 MB of real memory stored in the RAM, even if only 50 MB space is available.

41 | - It is the job of the VMM to manage 300 MB memory even if just 50 MB of real memory space is available.

42 |

43 | ## What is Demand Paging?

44 |

45 |

46 |

47 | A demand paging mechanism is very much similar to a paging system with swapping where processes stored in the secondary memory and pages are loaded only on demand, not in advance.

48 |

49 | So, when a context switch occurs, the OS never copy any of the old program’s pages from the disk or any of the new program’s pages into the main memory. Instead, it will start executing the new program after loading the first page and fetches the program’s pages, which are referenced.

50 |

51 | During the program execution, if the program references a page that may not be available in the main memory because it was swapped, then the processor considers it as an invalid memory reference. That’s because the page fault and transfers send control back from the program to the OS, which demands to store page back into the memory.

52 |

53 | ## Types of Page Replacement Methods

54 |

55 | Here, are some important Page replacement methods

56 |

57 | - FIFO

58 | - Optimal Algorithm

59 | - LRU Page Replacement

60 |

61 | ## FIFO Page Replacement

62 |

63 | FIFO (First-in-first-out) is a simple implementation method. In this method, memory selects the page for a replacement that has been in the virtual address of the memory for the longest time.

64 |

65 | ### Features:

66 |

67 | - Whenever a new page loaded, the page recently comes in the memory is removed. So, it is easy to decide which page requires to be removed as its identification number is always at the FIFO stack.

68 | - The oldest page in the main memory is one that should be selected for replacement first.

69 |

70 | ## Optimal Algorithm

71 |

72 | The optimal page replacement method selects that page for a replacement for which the time to the next reference is the longest.

73 |

74 | ### Features:

75 |

76 | - Optimal algorithm results in the fewest number of page faults. This algorithm is difficult to implement.

77 | - An optimal page-replacement algorithm method has the lowest page-fault rate of all algorithms. This algorithm exists and which should be called MIN or OPT.

78 | - Replace the page which unlike to use for a longer period of time. It only uses the time when a page needs to be used.

79 |

80 | ## LRU Page Replacement

81 |

82 | The full form of LRU is the Least Recently Used page. This method helps OS to find page usage over a short period of time. This algorithm should be implemented by associating a counter with an even- page.

83 |

84 | ### How does it work?

85 |

86 | - Page, which has not been used for the longest time in the main memory, is the one that will be selected for replacement.

87 | - Easy to implement, keep a list, replace pages by looking back into time.

88 |

89 | ### Features:

90 |

91 | - The LRU replacement method has the highest count. This counter is also called aging registers, which specify their age and how much their associated pages should also be referenced.

92 | - The page which hasn’t been used for the longest time in the main memory is the one that should be selected for replacement.

93 | - It also keeps a list and replaces pages by looking back into time.

94 |

95 | ### Fault rate

96 |

97 | Fault rate is a frequency with which a designed system or component fails. It is expressed in failures per unit of time. It is denoted by the Greek letter ? (lambda).

98 |

99 | ## Advantages of Virtual Memory

100 |

101 | Here, are pros/benefits of using Virtual Memory:

102 |

103 | - Virtual memory helps to gain speed when only a particular segment of the program is required for the execution of the program.

104 | - It is very helpful in implementing a multiprogramming environment.

105 | - It allows you to run more applications at once.

106 | - It helps you to fit many large programs into smaller programs.

107 | - Common data or code may be shared between memory.

108 | - Process may become even larger than all of the physical memory.

109 | - Data / code should be read from disk whenever required.

110 | - The code can be placed anywhere in physical memory without requiring relocation.

111 | - More processes should be maintained in the main memory, which increases the effective use of CPU.

112 | - Each page is stored on a disk until it is required after that, it will be removed.

113 | - It allows more applications to be run at the same time.

114 | - There is no specific limit on the degree of multiprogramming.

115 | - Large programs should be written, as virtual address space available is more compared to physical memory.

116 |

117 | ## Disadvantages of Virtual Memory

118 |

119 | Here, are drawbacks/cons of using virtual memory:

120 |

121 | - Applications may run slower if the system is using virtual memory.

122 | - Likely takes more time to switch between applications.

123 | - Offers lesser hard drive space for your use.

124 | - It reduces system stability.

125 | - It allows larger applications to run in systems that don’t offer enough physical RAM alone to run them.

126 | - It doesn’t offer the same performance as RAM.

127 | - It negatively affects the overall performance of a system.

128 | - Occupy the storage space, which may be used otherwise for long term data storage.

129 |

130 | ## Summary:

131 |

132 | - Virtual Memory is a storage mechanism which offers user an illusion of having a very big main memory.

133 | - Virtual memory is needed whenever your computer doesn’t have space in the physical memory

134 | - A demand paging mechanism is very much similar to a paging system with swapping where processes stored in the secondary memory and pages are loaded only on demand, not in advance.

135 | - Important Page replacement methods are 1) FIFO 2) Optimal Algorithm 3) LRU Page Replacement.

136 | - In FIFO (First-in-first-out) method, memory selects the page for a replacement that has been in the virtual address of the memory for the longest time.

137 | - The optimal page replacement method selects that page for a replacement for which the time to the next reference is the longest.

138 | - LRU method helps OS to find page usage over a short period of time.

139 | - Virtual memory helps to gain speed when only a particular segment of the program is required for the execution of the program.

140 | - Applications may run slower if the system is using virtual memory.

141 |

--------------------------------------------------------------------------------

/✍ 文章/Why Do We Need Virtual Memory?.md:

--------------------------------------------------------------------------------

1 | ## 1. Overview

2 |

3 | In this tutorial, we’ll learn about the virtual memory concept in operating systems (OS). **We’ll examine the problems that form the main motivation for the creation of virtual memory.** Finally, we’ll explain the purpose of using this feature in an OS.

4 |

5 | ## 2. Motivation

6 |

7 | Computers are designed to be able to execute many programs, each operating on different amounts of data. Operating systems are expected to exploit better computer resources, guaranteeing fast and efficient processing.

8 |

9 | Three main problems cause the processing to be slow in terms of time and consumed memory. Since we store data in bytes in the disk, the CPU must load the needed data into RAM when executing programs.

10 |

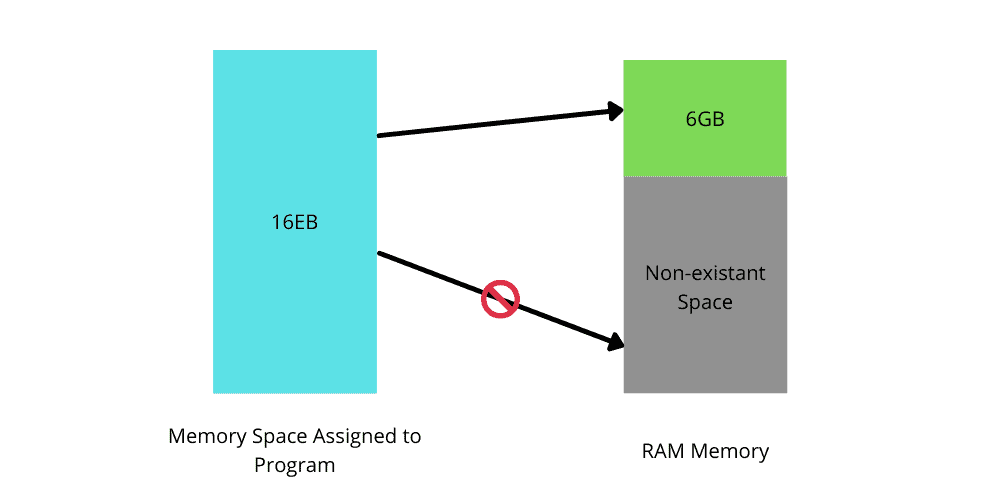

11 | While being executed, an OS allows a program to use a certain range of addresses from RAM. Suppose this space is  bits, which means an expected RAM size of  (Exabyte) is required here.

12 |

13 | Now let’s assume that the OS already reserved a portion of it (), but the computer has less memory than the required RAM. **Trying to use addresses that are out of range will crash the computer.**

14 |

15 | Furthermore, it’s not feasible for an OS to have the capacity of such a large RAM:

16 |

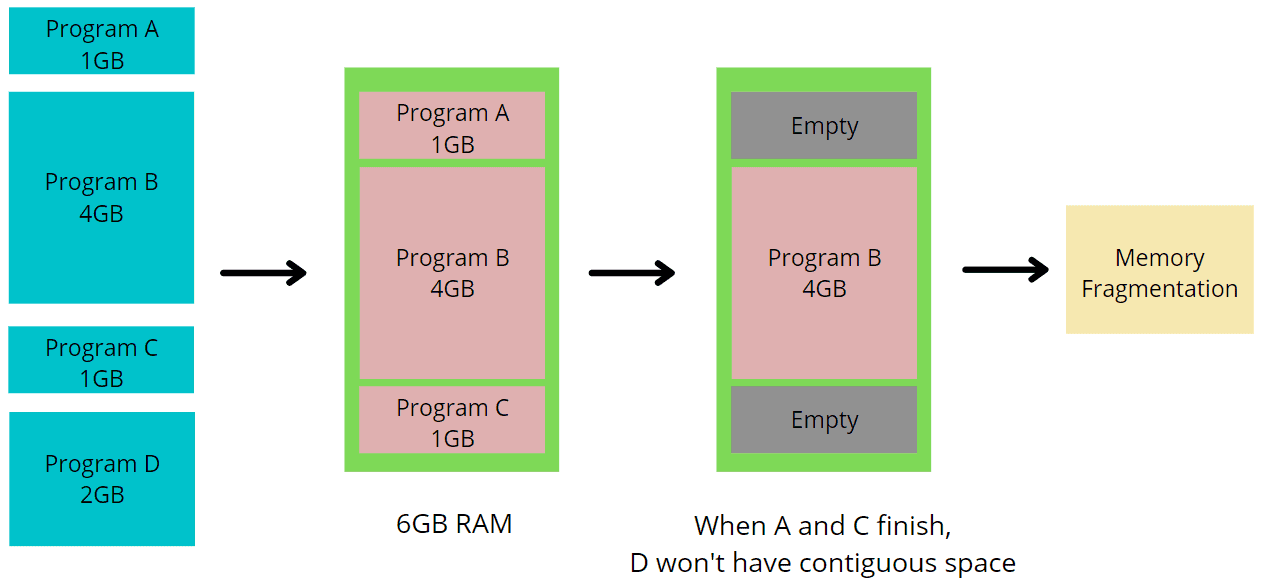

17 | When executing multiple programs simultaneously, an OS will assign each one of them a continuous partition of RAM, allowing them to be processed at the same time. Now let’s assume that two programs finished their execution. If the space freed up by the two programs is not [continuous](https://en.wikipedia.org/wiki/Continuous_memory), and not enough for other programs to run, the RAM will have holes in different places. **This results in** **[memory fragmentation](https://en.wikipedia.org/wiki/Fragmentation_(computing)):**

18 |

19 |

20 |

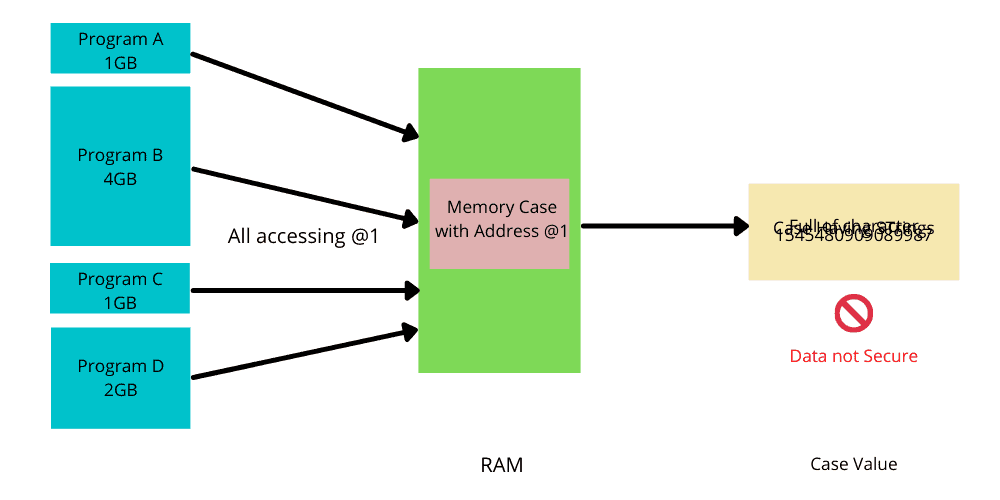

21 | Since many programs are executed simultaneously, more than one program can access the same case of memory. **To change their value, these programs can collide with each other, corrupt the memory, or crash the system.** The figure below shows how data can be easily corrupted when accessed by multiple programs:

22 |

23 | ## 3. Introduction to Virtual Memory

24 |

25 | **Virtual Memory is a technique aiming to solve memory’s physical shortages by using the secondary memory so that an OS considers it as a part of the main memory.** Virtual memory is temporary memory. The size of the virtual memory storage depends on the addressing scheme used by an OS and the available secondary memory.

26 |

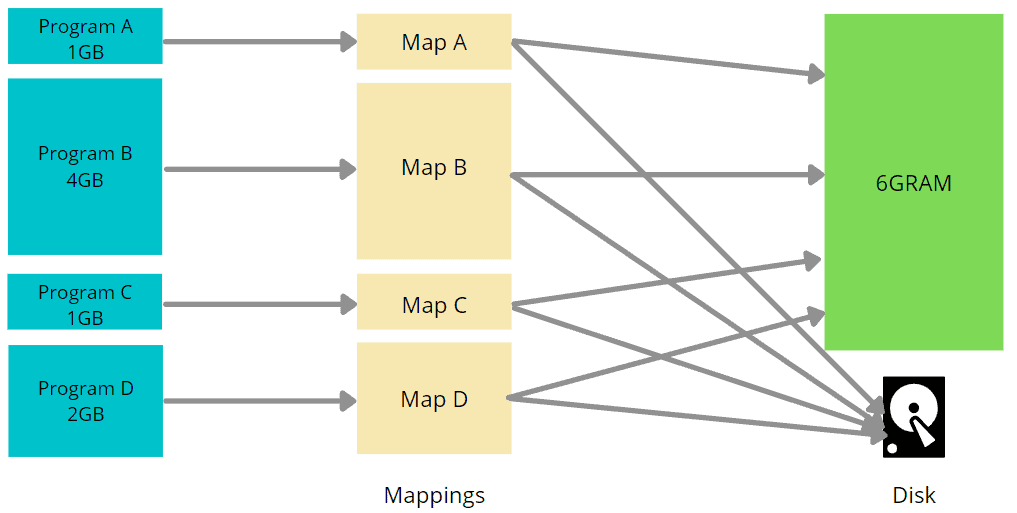

27 | Virtual memory maps program addresses into RAM addresses. If no more space is available, these addresses will be mapped into the disk:

28 |

29 |

30 |

31 | **The main advantage of virtual memory is that an OS can load programs larger than its physical memory.** It makes an impression to the users that the computer has unlimited memory. It also provides [memory protection](https://en.wikipedia.org/wiki/Memory_protection).

32 |

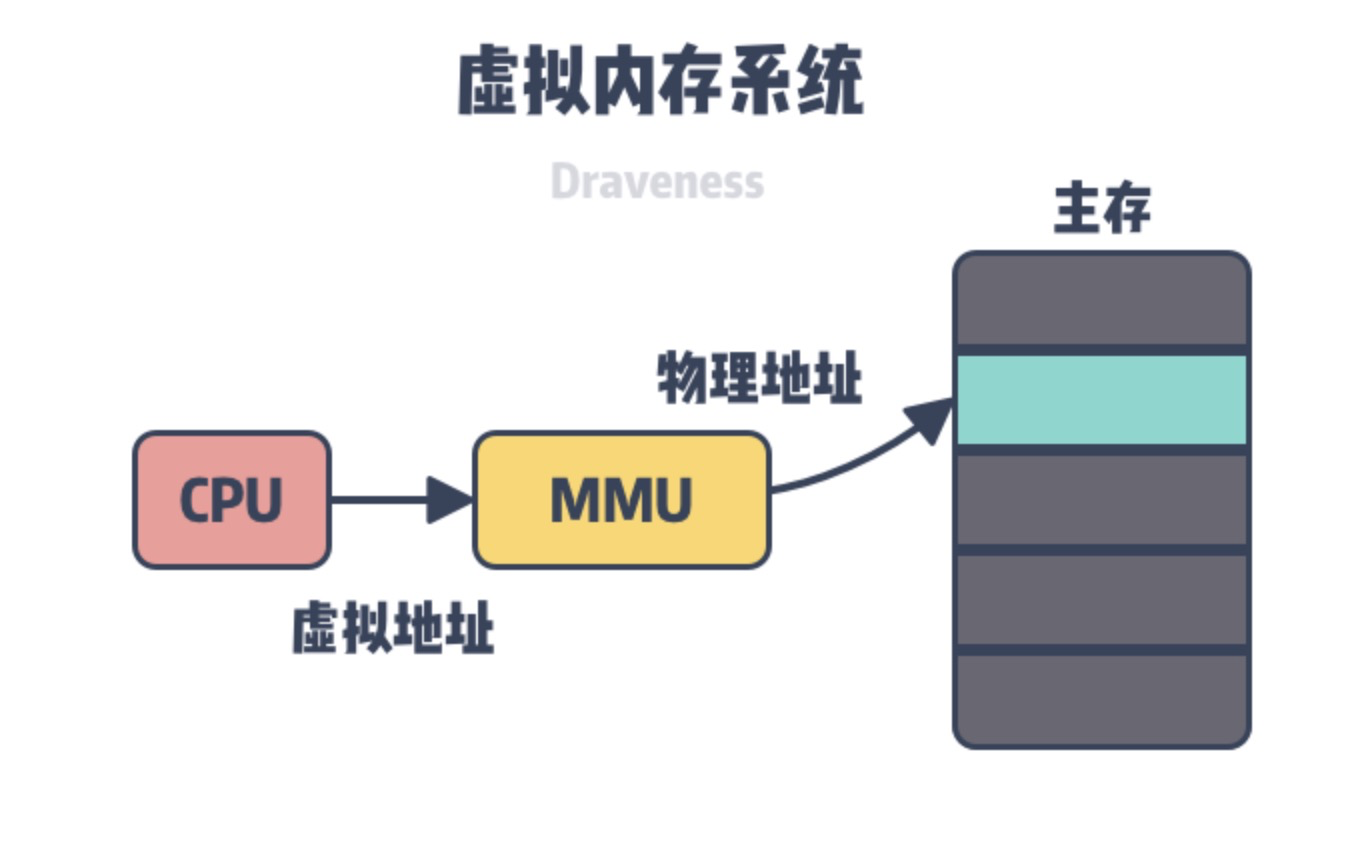

33 | In order to realize the mapping operations, virtual memory needs to use [page tables and translations](https://www.baeldung.com/cs/virtual-memory). Page Tables are a data structure that stores page tables known as page table entry (PTE). Page tables’ goal is to map virtual addresses to physical addresses. It is a contiguous block and the smallest unit of virtual memory.

34 |

35 | Creating memory pages consists of partitioning them into [equal-sized frames](https://en.wikipedia.org/wiki/Page_(computer_memory)). Each frame refers to each physical address frame number, a frame offset, or an absolute address.

36 |

37 | The translation is the process of transforming a virtual address to a physical address using page tables:

38 |

39 | **To make the process of reading data faster, virtual memory can use [cache memory](https://en.wikipedia.org/wiki/CPU_cache).** Since physical caches don’t guarantee a fast process, we use virtual caches. The CPU is directly connected to the cache, and it looks up the virtual addresses in it while avoiding translation. Translation will occur only if an address isn’t found. Eventually, each program has its own virtual cache:

40 |

41 |

42 |

43 | ## 4. Why Do We Need Virtual Memory?

44 |

45 | Virtual memory plays an important role in a modern-day OS. This section will discuss some of the crucial reasons why an OS needs to use virtual memory.

46 |

47 | ### 4.1. Memory Space Problem

48 |

49 | **Virtual memory makes it easy to share code; therefore, we don’t have to keep several copies of the same code.** With virtual memory, different virtual addresses can map to the same location in the physical memory. Consequently, we don’t have to store multiple copies of the same code in the main memory.

50 |

51 | RAM is very costly. As a result, the use of a very large RAM is not a feasible solution to alleviate any need for storage allocation. **Assigning a virtual memory for each program and mapping addresses to the disk eliminates space problems.**

52 |

53 | In the case of a binary file, when we load them in an OS, each function reserves a fixed address in the main memory. **If virtual memory doesn’t exist, we can’t load more than one program in the main memory.** This means that without virtual memory, we can only run one program at a time. This is because each program might have to use different functions that may point to the same addresses in RAM.

54 |

55 | ### 4.2. Data Security

56 |

57 | **Another important issue is data security.** In general, a program can guess another program’s physical address and gain access to sensitive and secret data.

58 |

59 | If an OS uses the virtual memory technique, even if some programs have to access the same address, they all have different mappings. This ensures that they will access different addresses in the RAM or the disk. This is how virtual memory enables data security.

60 |

61 | **It also provides position independence to the data.** We can store data at any position in the main memory.

62 |

63 | ### 4.3. Memory Fragmentation and Errors

64 |

65 | **Virtual memory facilitates each program with its own mapping.** The data space won’t have to be continuous, and each program can store data wherever it wants.

66 |

67 | **It also facilitates debugging and provides options for checking various features, like unallocated memory and null pointers.**

68 |

69 | Let’s assume that two or more applications are running in an OS at the same time. All of these applications use the direct addresses of RAM. If one of the applications results in an error, like [memory error](https://en.wikipedia.org/wiki/Out_of_memory), while running, this could destroy and take down the other applications.

70 |

71 | Some physical devices, like video RAM, might reserve some memory addresses prior, depending on the hardware used in the computer. If the OS starts loading programs without knowing the reserved addresses, the OS may read and write to the reserved addresses. This can result in physically breaking the plugged-in devices. Virtual memory helps the OS to avoid these issues.

72 |

73 | ## 5. Conclusion

74 |

75 | In this article, we discussed virtual memory in detail. We started our discussion by describing some of the motivations for using virtual memory in OS. Then we gave a general overview of the virtual memory concept. Finally, we explained why we need virtual memory in OS.

76 |

--------------------------------------------------------------------------------

/✍ 文章/一文了解,Linux内存管理,malloc、free 实现原理.md:

--------------------------------------------------------------------------------

1 | ## malloc / free 简介

2 |

3 | ```c

4 | void *malloc(size_t size)

5 | void free(void *ptr)

6 | ```

7 | `malloc` 分配指定大小的内存空间,返回一个指向该空间的指针。大小以字节为单位。返回 `void*` 指针,需要强制类型转换后才能引用其中的值。

8 | `free` 释放一个由 `malloc` 所分配的内存空间。`ptr` 指向一个要释放内存的内存块,该指针应当是之前调用 `malloc` 的返回值。

9 |

10 | 使用示例:

11 |

12 | ```c

13 | int* ptr;

14 | ptr = (int*)malloc(10 * sizeof(int)); /* 进行强制类型转换 */

15 | free(ptr);

16 | ```

17 |

18 | ## 动态内存分配的系统调用:`brk / sbrk`

19 |

20 | 动态分配的内存都在堆中,堆从低地址向高地址增长:

21 |

22 |

23 |

24 | Linux 提供了两个系统调用 `brk` 和 `sbrk`:

25 |

26 | ```c

27 | int brk(void *addr);

28 | void *sbrk(intptr_t increment);

29 | ```

30 |

31 | `brk` 用于返回堆的顶部地址;`sbrk` 用于扩展堆,通过参数 `increment` 指定要增加的大小,如果扩展成功,返回 `brk` 的旧值。如果 `increment` 为零,返回 `brk` 的当前值。

32 |

33 | 我们不会直接通过 `brk` 或 `sbrk` 来分配堆内存,而是先通过 `sbrk` 扩展堆,将这部分空闲内存空间作为缓冲池,然后通过 `malloc / free` 管理缓冲池中的内存。这是一种池化思想,能够避免频繁的系统调用,提高程序性能。

34 |

35 | ## malloc / free 实现思路

36 |

37 | `malloc` 使用空闲链表组织堆中的空闲区块,空闲链表有时也用双向链表实现。每个空闲区块都有一个相同的首部,称为“内存控制块” `mem_control_block`,其中记录了空闲区块的元信息,比如指向下一个分配块的指针、当前分配块的长度、或者当前区块是否已经被分配出去。这个首部对于程序是不可见的,`malloc `返回的是紧跟在首部后面的地址,即可用空间的起始地址。

38 |

39 | `malloc` 分配时会搜索空闲链表,根据匹配原则,找到一个大于等于所需空间的空闲区块,然后将其分配出去,返回这部分空间的指针。如果没有这样的内存块,则向操作系统申请扩展堆内存。注意,返回的指针是从可用空间开始的,而不是从首部开始的:

40 |

41 |

42 |

43 | malloc 所实际使用的内存匹配算法有很多,执行时间和内存消耗各有不同。到底使用哪个匹配算法,取决于实现。常见的内存匹配算法有:

44 |

45 | * 最佳适应法

46 | * 最差适应法

47 | * 首次适应法

48 | * 下一个适应法

49 |

50 | free 会将区块重新插入到空闲链表中。free 只接受一个指针,却可以释放恰当大小的内存,这是因为在分配的区域的首部保存了该区域的大小。

51 |

52 | ## malloc 的实现方式一:显式空闲链表 + 整块分配

53 |

54 | malloc 的实现方式有很多种。最简单的方法是使用一个链表来管理所有已分配和未分配的内存块,在每个内存块的首部记录当前块的大小、当前区块是否已经被分配出去。首部对应这样的结构体:

55 |

56 | ```c

57 | struct mem_control_block {

58 | int is_available; // 是否可用(如果还没被分配出去,就是 1)

59 | int size; // 实际空间的大小

60 | };

61 | ```

62 |

63 | 使用首次适应法进行分配:遍历整个链表,找到第一个未被分配、大小合适的内存块;如果没有这样的内存块,则向操作系统申请扩展堆内存。

64 |

65 | 下面是这种实现方式的代码:

66 |

67 | ```c

68 | int has_initialized = 0; // 初始化标志

69 | void *managed_memory_start; // 指向堆底(内存块起始位置)

70 | void *last_valid_address; // 指向堆顶

71 |

72 | void malloc_init() {

73 | // 这里不向操作系统申请堆空间,只是为了获取堆的起始地址

74 | last_valid_address = sbrk(0);

75 | managed_memory_start = last_valid_address;

76 | has_initialized = 1;

77 | }

78 |

79 | void *malloc(long numbytes) {

80 | void *current_location; // 当前访问的内存位置

81 | struct mem_control_block *current_location_mcb; // 只是作了一个强制类型转换

82 | void *memory_location; // 这是要返回的内存位置。初始时设为

83 | // 0,表示没有找到合适的位置

84 | if (!has_initialized) {

85 | malloc_init();

86 | }

87 | // 要查找的内存必须包含内存控制块,所以需要调整 numbytes 的大小

88 | numbytes = numbytes + sizeof(struct mem_control_block);

89 | // 初始时设为 0,表示没有找到合适的位置

90 | memory_location = 0;

91 | /* Begin searching at the start of managed memory */

92 | // 从被管理内存的起始位置开始搜索

93 | // managed_memory_start 是在 malloc_init 中通过 sbrk() 函数设置的

94 | current_location = managed_memory_start;

95 | while (current_location != last_valid_address) {

96 | // current_location 是一个 void 指针,用来计算地址;

97 | // current_location_mcb 是一个具体的结构体类型

98 | // 这两个实际上是一个含义

99 | current_location_mcb = (struct mem_control_block *)current_location;

100 | if (current_location_mcb->is_available) {

101 | if (current_location_mcb->size >= numbytes) {

102 | // 找到一个可用、大小适合的内存块

103 | current_location_mcb->is_available = 0; // 设为不可用

104 | memory_location = current_location; // 设置内存地址

105 | break;

106 | }

107 | }

108 | // 否则,当前内存块不可用或过小,移动到下一个内存块

109 | current_location = current_location + current_location_mcb->size;

110 | }

111 | // 循环结束,没有找到合适的位置,需要向操作系统申请更多内存

112 | if (!memory_location) {

113 | // 扩展堆

114 | sbrk(numbytes);

115 | // 新的内存的起始位置就是 last_valid_address 的旧值

116 | memory_location = last_valid_address;

117 | // 将 last_valid_address 后移 numbytes,移动到整个内存的最右边界

118 | last_valid_address = last_valid_address + numbytes;

119 | // 初始化内存控制块 mem_control_block

120 | current_location_mcb = memory_location;

121 | current_location_mcb->is_available = 0;

122 | current_location_mcb->size = numbytes;

123 | }

124 | // 最终,memory_location 保存了大小为 numbyte的内存空间,

125 | // 并且在空间的开始处包含了一个内存控制块,记录了元信息

126 | // 内存控制块对于用户而言应该是透明的,因此返回指针前,跳过内存分配块

127 | memory_location = memory_location + sizeof(struct mem_control_block);

128 | // 返回内存块的指针

129 | return memory_location;

130 | }

131 | ```

132 |

133 | 对应的free实现:

134 |

135 | ```c

136 | void free(void *ptr) { // ptr 是要回收的空间

137 | struct mem_control_block *free;

138 | free = ptr - sizeof(struct mem_control_block); // 找到该内存块的控制信息的地址

139 | free->is_available = 1; // 该空间置为可用

140 | return;

141 | }

142 | ```

143 |

144 | 这种方法的缺点是:

145 |

146 | 1、已分配和未分配的内存块位于同一个链表中,每次分配都需要从头到尾遍历

147 | 2、采用首次适应法,内存块会被整体分配,容易产生较多内部碎片

148 |

149 | ## malloc 的实现方式二:显式空闲链表 + 按需分配

150 |

151 | 这种实现方式维护一个空闲块链表,只包含未分配的内存块。malloc 分配时会搜索空闲链表,找到第一个大于等于所需空间的空闲区块,然后从该区块的尾部取出所需要的空间,剩余空间还是存在空闲链表中;如果该区块的剩余部分不足以放下首部信息,则直接将其从空闲链表摘除。最后返回这部分空间的指针。

152 | 下面是这种实现方式的几个示例:

153 |

154 |

155 |

156 |

157 |

158 |

159 |

160 | 通过 free 释放内存时,会将内存块加入到空闲链表中,并将前后相邻的空闲内存合并,这时使用双向链表管理空闲链表就很有用了。

161 |

162 | 和第一种方式相比,这种方式的优点主要是:

163 | * 空闲链表中只包含未被分配的内存块,节省遍历开销

164 | * 只分配必须大小的空间,避免内存浪费

165 |

166 | 这种方式的缺点是:多次调用 malloc 后,空闲内存被切成很多的小内存片段,产生较多外部碎片,会导致用户在申请内存使用时,找不到足够大的内存空间。这时需要进行内存整理,将连续的空闲内存合并,但是这会降低函数性能。

167 |

168 | 注意:内存紧凑在这里一般是不可用的,因为这会改变之前 malloc 返回的空间的地址。

169 |

170 | ## malloc 的实现方式三:分离的空闲链表

171 |

172 | 上面的两种分配方法,分配时间都和空闲块的数量成线性关系。

173 |

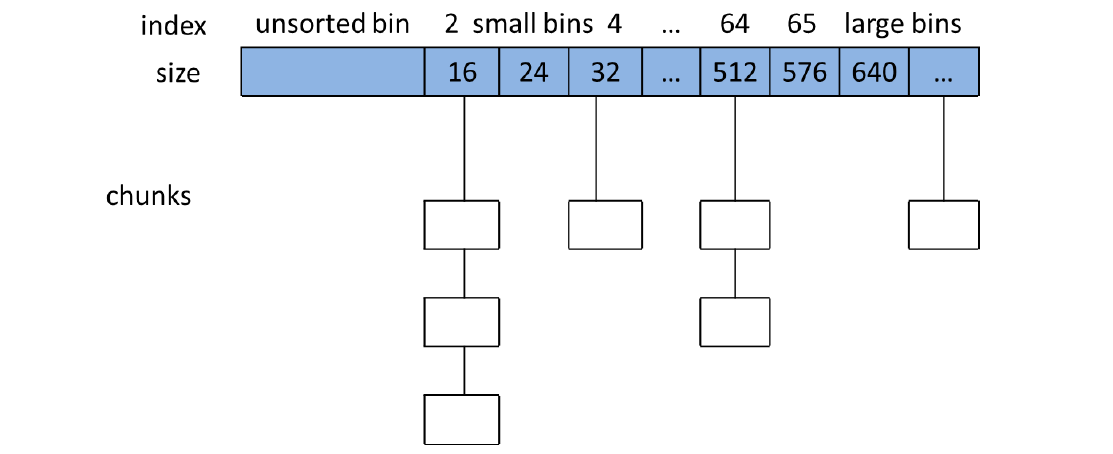

174 | 另一种实现方式是分离存储,即维护多个空闲链表,其中每个链表中的块有大致相等或者相同的大小。一般常见的是根据 2 的幂来划分块大小。分配时,可以直接在某个空闲链表里搜索合适的块。如果没有找到合适的块与之匹配,就搜索下一个链表,以此类推。

175 |

176 | ### 简单分离存储

177 |

178 | 每个大小类的空闲链表包含大小相等的块。分配时,从某个空闲链表取下一块,或者向操作系统请求内存片并分割成大小相等的块,形成新的链表。释放时,只需要简单的将块插入到相应空闲链表的前面。

179 |

180 | 优点一是分配和释放只需要在链表头进行操作,都是常数时间,二是因为每个块大小都是固定的,所以只需要一个 next 指针,不需要额外的控制信息,节省空间。缺点是容易造成内部碎片和外部碎片。内部碎片显而易见,因为每个块都是整体分配的,不会被分割。外部碎片在这样的模式下很容易产生:应用频繁地申请和释放较小大小的内存块,由于这些内存块不会合并,所以系统维护了大量小内存块形成的空闲链表,而没有多余空间来分配大内存块,导致产生外部碎片。

181 |

182 | ### 分离适配

183 | 这种方法同样维护了多个空闲链表,只不过每个链表中的块是大致相等的大小,比如每个链表中的块大小范围可能是:

184 |

185 | * 1

186 | * 2

187 | * 3~4

188 | * 5~8

189 | * …

190 | * 1025~2048

191 | * 2049~4096

192 | * 4097~∞

193 |

194 | 在分配的时候,需要先根据申请内存的大小选择适当的空闲链表,然后遍历该链表,根据匹配算法(如首次适应)寻找合适的块。如果找到一个块,将其分割(可选),并将剩余部分插入到适当的空闲链表中。如果找不到合适的块,则查找下一个更大的大小类的空闲链表,以此类推,直到找到或者向操作系统申请额外的堆内存。在释放一个块时,合并前后相邻的空闲块,并将结果放到相应的空闲链表中。

195 |

196 | 分离适配方法是一种常见的选择,C 标准库中提供的 GNU malloc 包就是采用的这种方法。这种方法既快速,对内存的使用也很有效率。由于搜索被限制在堆的某个部分而不是整个堆,所以搜索时间减少了。内存利用率也得到了改善,避免大量内部碎片和外部碎片。

197 |

198 | ### 伙伴系统

199 |

200 | 伙伴系统是分离适配的一种特例。它的每个大小类的空闲链表包含大小相等的块,并且大小都是 2 的幂。最开始时,全局只有一个大小为 2m2m 字的空闲块,2m2m 是堆的大小。

201 |

202 | 假设分配的块的大小都是 2 的幂,为了分配一个大小为 2k2k 的块,需要找到大小恰好是 2k2k 的空闲块。如果找到,则整体分配。如果没有找到,则将刚好比它大的块分割成两块,每个剩下的半块(也叫做伙伴)被放置在相应的空闲链表中,以此类推,直到得到大小恰好是 2k2k 的空闲块。释放一个大小为 2k2k 的块时,将其与空闲的伙伴合并,得到新的更大的块,以此类推,直到伙伴已分配时停止合并。

203 |

204 | 伙伴系统分配器的主要优点是它的快速搜索和快速合并。主要缺点是要求块大小为 2 的幂可能导致显著的内部碎片。因此,伙伴系统分配器不适合通用目的的工作负载。然而,对于某些特定应用的工作负载,其中块大小预先知道是 2 的幂,伙伴系统分配器就很有吸引力了。

205 |

206 | ### tcmalloc

207 |

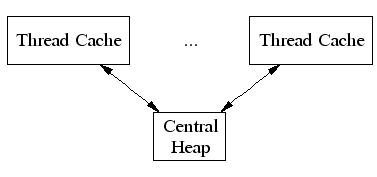

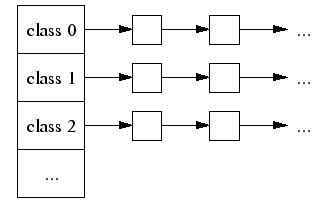

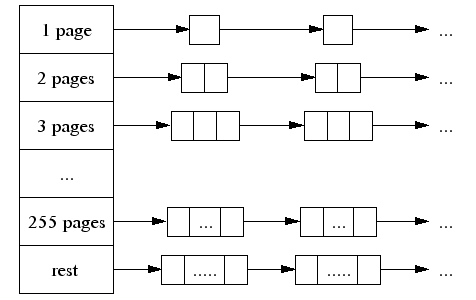

208 | tcmalloc 是 Google 开发的内存分配器,全称 Thread-Caching Malloc,即线程缓存的 malloc,实现了高效的多线程内存管理。

209 |

210 | tcmalloc 主要利用了池化思想来管理内存分配。对于每个线程,都有自己的私有缓存池,内部包含若干个不同大小的内存块。对于一些小容量的内存申请,可以使用线程的私有缓存;私有缓存不足或大容量内存申请时再从全局缓存中进行申请。在线程内分配时不需要加锁,因此在多线程的情况下可以大大提高分配效率。

211 |

212 | ## 总结

213 | malloc 使用链表管理内存块。malloc 有多种实现方式,在不同场景下可能会使用不同的匹配算法。

214 |

215 | malloc 分配的空间中包含一个首部来记录控制信息,因此它分配的空间要比实际需要的空间大一些。这个首部对用户而言是透明的,malloc 返回的是紧跟在首部后面的地址,即可用空间的起始地址。

216 |

217 | malloc 分配的函数应该是字对齐的。在 32 位模式中,malloc 返回的块总是 8 的倍数。在 64 位模式中,该地址总是 16 的倍数。最简单的方式是先让堆的起始位置字对齐,然后始终分配字大小倍数的内存。

218 |

219 | malloc 只分配几种固定大小的内存块,可以减少外部碎片,简化对齐实现,降低管理成本。

220 |

221 | free 只需要传递一个指针就可以释放内存,空间大小可以从首部读取。

222 |

223 |

224 |

225 |

226 |

227 |

228 |

229 |

--------------------------------------------------------------------------------

/✍ 文章/为什么linux需要虚拟内存.md:

--------------------------------------------------------------------------------

1 | 操作系统中的CPU和主存都是稀缺资源,所有运行在当前操作系统的进程会共享系统中的CPU和内存资源,操作系统会使用CPU调度器分配CPU事件并引入虚拟内存管理物理内存。

2 |

3 | 虚拟内存是操作系统物理内存和进程之间的中间层,它为进程隐藏了物理内存这一概念,为进程提供了更加简洁和易用的接口以及更加复杂的功能。

4 |

5 |

6 |

7 |

8 |

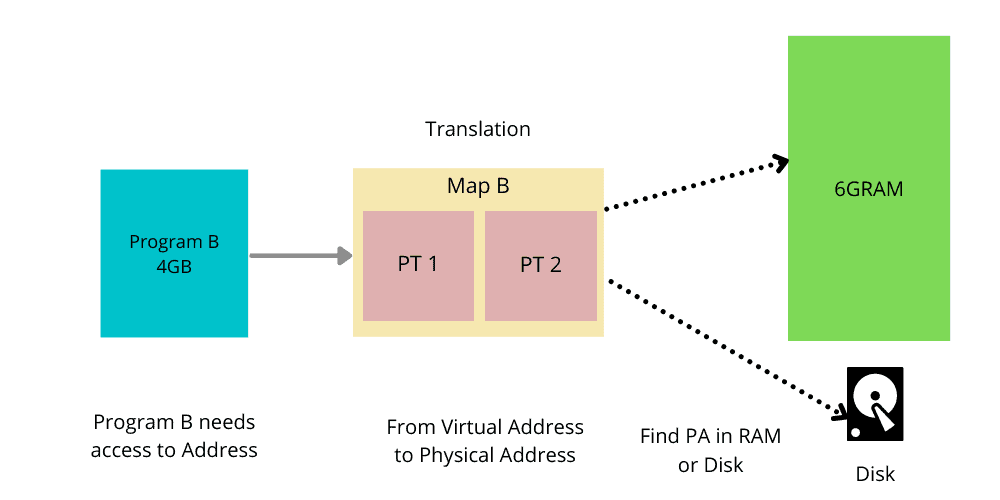

9 | 早期的操作系统中,进程会直接使用目标内存的物理地址直接访问主存中的内容,然而现代的操作系统都引入了虚拟内存,进程持有的虚拟地址会经过内存管理单元(MMU)的转换为物理地址,然后通过物理地址访问内存

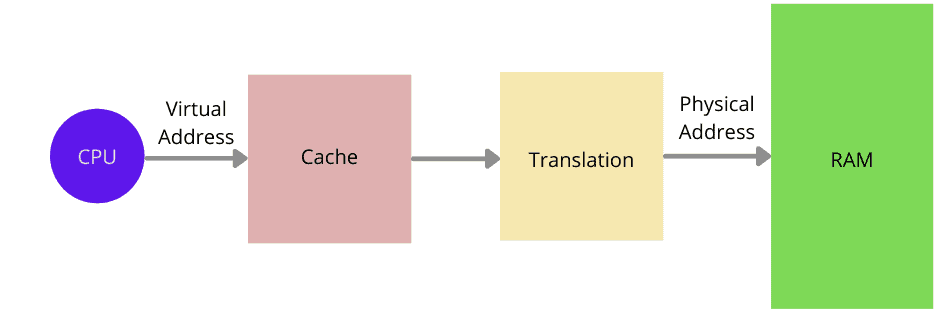

10 |

11 |

12 |

13 | 主存是相对比较稀缺的资源,虽然顺序读取只比磁盘快1各数量级,但是它能提供极快的随机访问速度,从内存上随机读取数据的速度是磁盘的100000倍。

14 |

15 | 操作系统以页作为单位管理内存,当进程发现需要访问的数据不在内存时,操作系统会以页的方式加载到内存中,这个过程是MMU完成的。

16 |

17 | 虚拟内存起到了以下三个非常关键的作用:

18 |

19 | - 虚拟内存可以利用磁盘起到缓存的作用,提高进程访问指定内存的速度。

20 | - 虚拟内存可以为进程提供独立的内存空间,简化程序的链接、加载过程并通过动态库共享内存。

21 |

22 | - 虚拟内存可以控制进程对物理内存的访问,隔离不同进程的访问权限,提高系统的安全性。

23 |

24 |

25 |

26 | ## 缓存

27 |

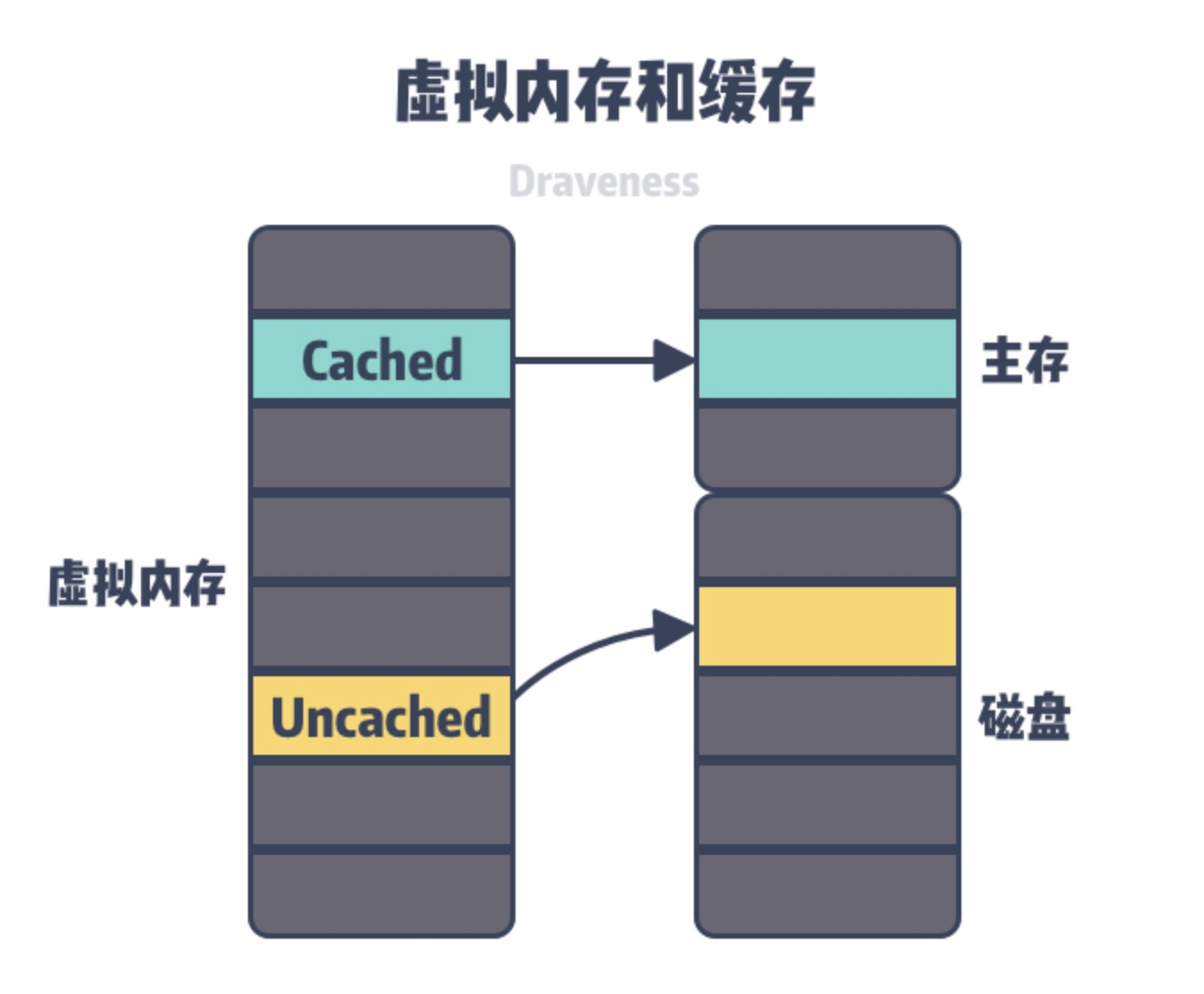

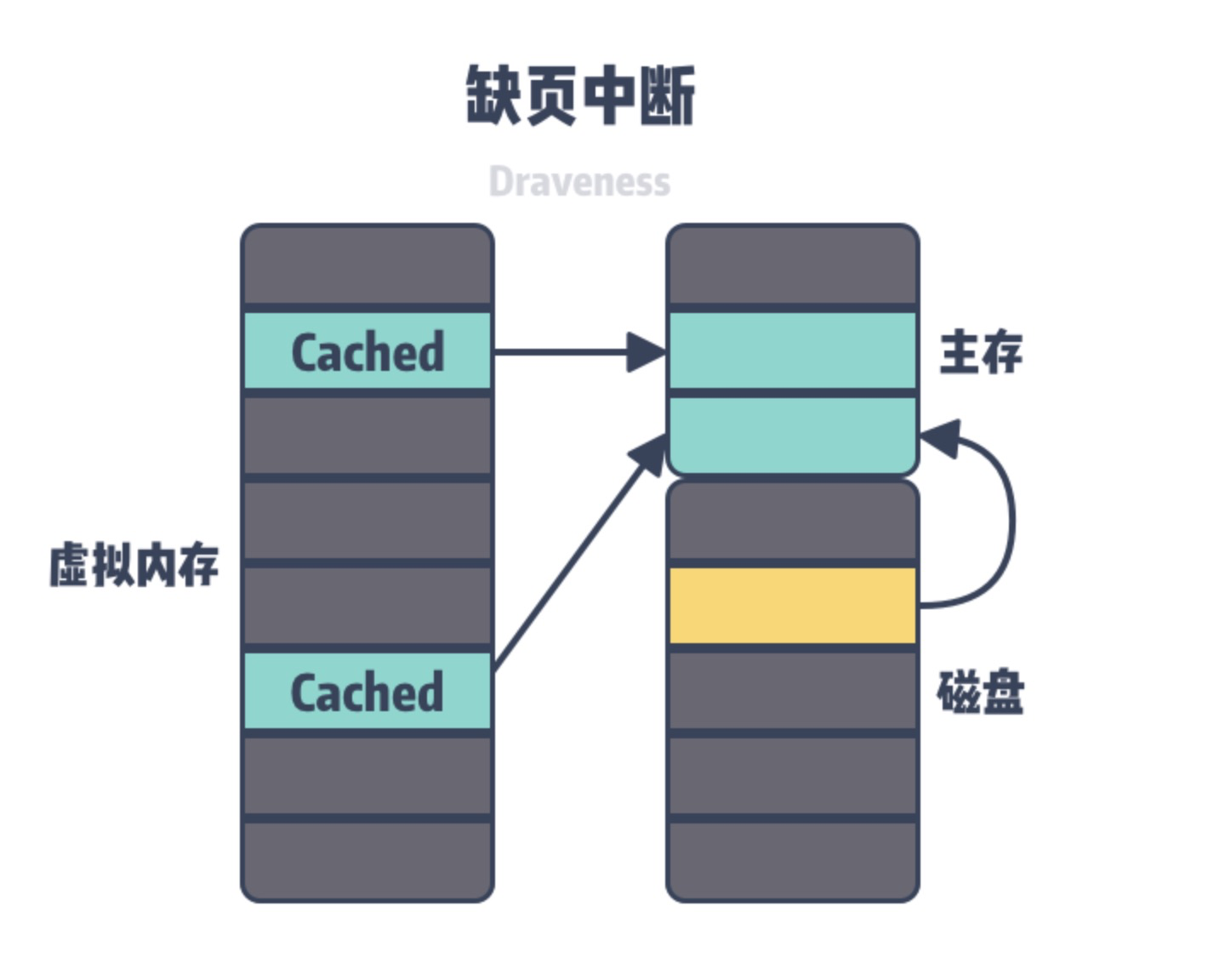

28 | 我们可以把虚拟内存看作是磁盘上的一片空间,当这片空间的一部分访问比较频繁时,这部分数据会以页为单位缓存到主存中以加速CPU访问数据的性能,虚拟内存利用空间较大的磁盘存储作为内存并是使用主存缓存进行加速,**让上层认为操作系统的内存很大而且很快,然而区域很大的磁盘并不快,而很快的内存也并不大。**

29 |

30 |

31 |

32 | 虚拟内存中的虚拟页可能处于以下三中状况——未分配、未缓存和已缓存,其中未分配的内存页事没有被进程申请使用的,也就是空闲的虚拟内存,不占用虚拟内存磁盘的任何空间,未缓存和已缓存的内存页分别表示已经加载到主存中的内存页和仅加载到磁盘中的内存页。

33 |

34 | 当用户程序访问未被缓存的虚拟页时候=,硬件就会触发缺页中断,在部分情况下,被访问的页面已经加载到物理内存中,但是用户程序的页表并不存在该对应关系,这时候我们只需要在页表中建立虚拟内存到物理内存的关系;在其他情况下,操作系统需要把磁盘上未被缓存的虚拟页加载到物理内存中。

35 |

36 |

37 |

38 | 因为主内存的空间是有限的,当主内存中不包含可以使用的空间时,操作系统会选择合适的物理内存驱除回磁盘,为新的内存让出位置,选择待驱除的页的过程在操作系统中叫做页面替换。缺页中断和页面替换都是操作系统调页算法的一部分。

39 |

40 | ## 内存管理

41 |

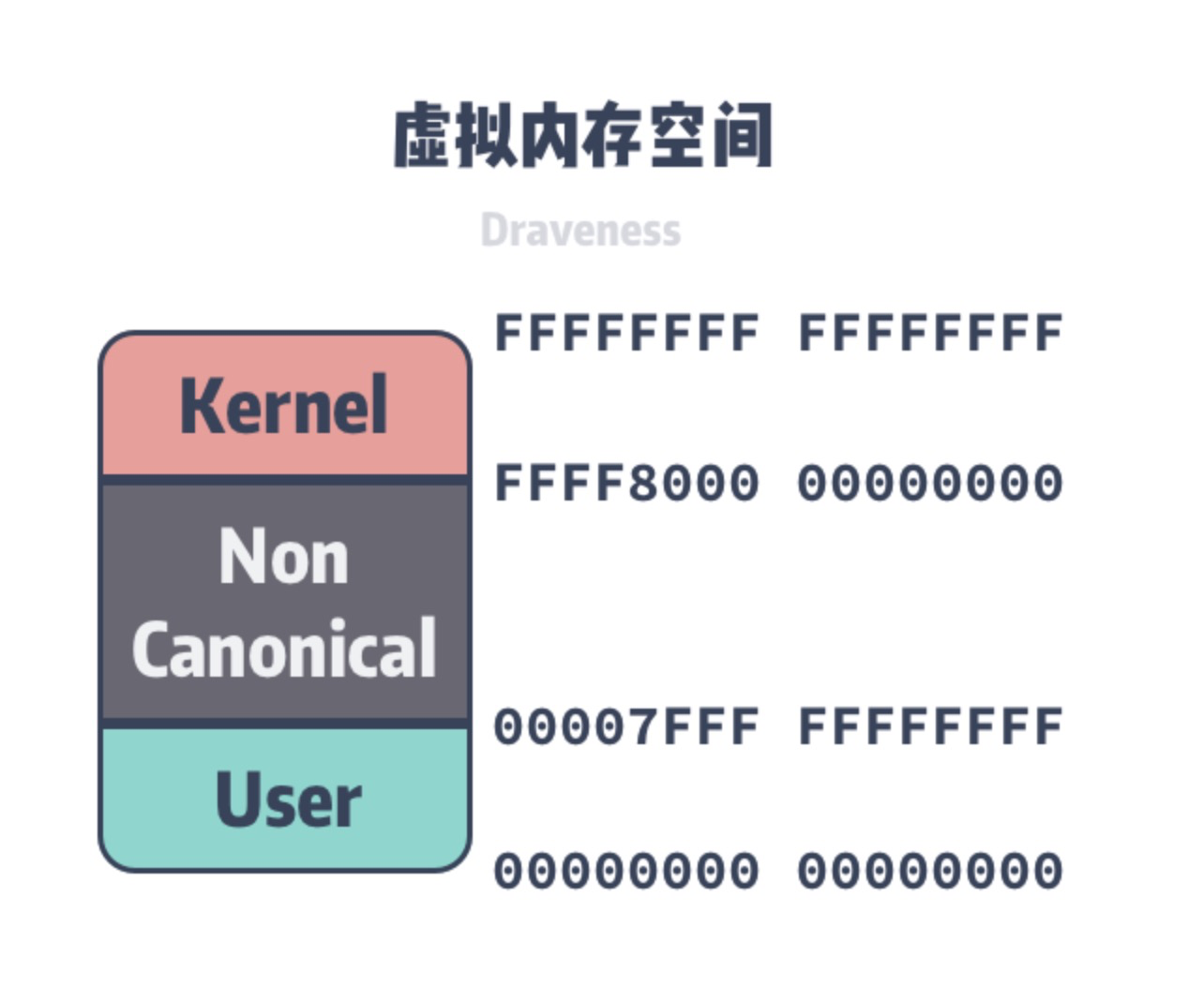

42 | 虚拟内存可以为正在运行的进程提供独立的内存空间,制造一种每个进程的内存都是独立的假象。在64位的操作系统上,每个进程都由256TiB的内存空间,内核和用户空间分别占128TiB。�因为每个进程的虚拟内存空间是完全独立的。

43 |

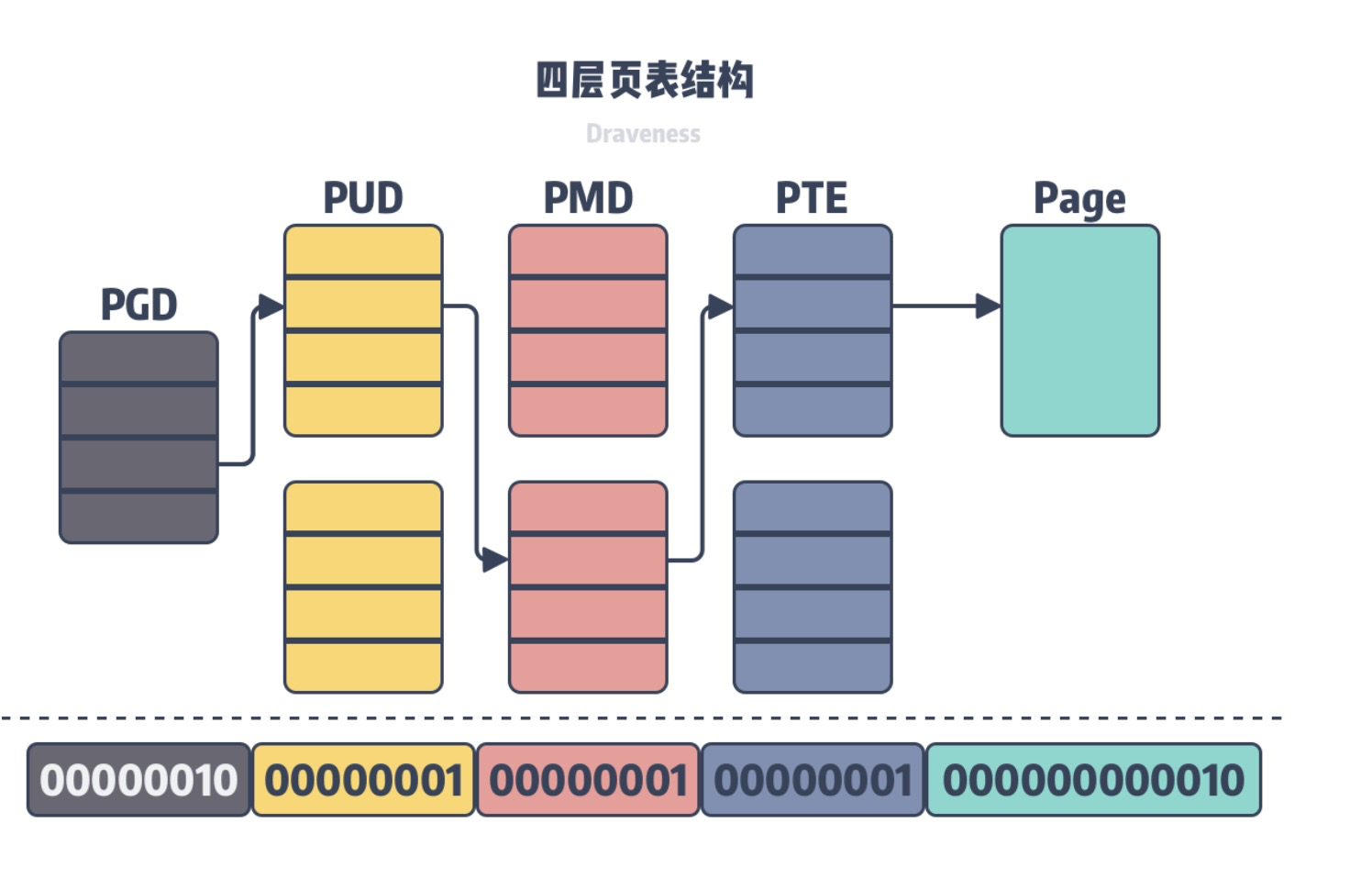

44 | 虚拟内存只是操作系统中的逻辑结构,应用程序最终还是需要访问物理内存或磁盘上的内容,因为操作系统加了一个虚拟内存的中间层,所以我们也需要为进程实现地址翻译器,实现从虚拟地址到物理地址的转换,页表是虚拟内存系统中重要的数据结构,每一个进程的页表中都存储了从虚拟内存到物理内存的映射关系,为了存储64位系统中128TiB虚拟内存的映射数据,Linux在2.6.10中引入了四层的页表来辅助虚拟地址的转换,在4.11中引入了五层的页表结构。

45 |

46 |

47 |

48 | 在上图所示的四层页表结构中,操作系统会使用最低的12位作为页面的偏移量,剩下的32位会分四组分别表示当前层级在上一层的索引,所有的虚拟地址都可以用上述的多层页表查找到对应的物理地址。

49 |

50 | 所以多个进程可以通过虚拟内存共享物理内存。在Linux中调用fork的时候,实际上只复制了父进程的页表。父子进程会通过不同的页表指向相同的物理内存。

51 |

52 |

53 |

54 | 虚拟内存不仅可以在fork时用于共享进程的物理内存,提供写时复制的机制。还能共享一些常见的动态库减少物理内存的占用、所有的进程都可能调用相同的操作系统内核代码,而C语言也会调用相同的标准库。

55 |

56 | 除了能够共享内存之外,独立的虚拟内存空间也会简化内存的分配过程,当用户程序向操作系统申请堆内存时,操作系统可以分配几个连续的虚拟页,但是这些虚拟页对应到物理内存中不连续的页。

57 |

58 | ## 内存保护

59 |

60 | 操作系统中的用户程序不应该修改只读的代码段,也不应该读取或修改内核中的代码和数据结构或者访问私有的的以及其他的进程的内存,如果无法对用户程序的内存访问进行限制,攻击者就可以访问和修改其他进程的内存影响系统的安全。

61 |

62 | 如果每一个进程都持有独立的虚拟空间,那么虚拟内存中页表可以理解为进程和物理页的连接表,其中可以存储进程和物理页之间的访问关系,包括读权限、写权限和执行权限:

63 |

64 |

65 |

66 | MMU可以决定当前进程是否是否有权限访问目标的物理内存,这样我们就最终将权限管理的功能全部收敛到虚拟内存系统中。

67 |

68 | # 总结

69 |

70 | Linux中为什么需要虚拟内存:

71 |

72 | - 虚拟内存可以结合磁盘和物理内存的优势为进程提供看起来速度足够块并且容量足够大的存储

73 | - 虚拟内存可以为进程提供独立的内存空间并引入多层的页表结构将虚拟内存翻译为物理内存,进程之间可以互相共享物理内存减少开销,也能简化程序的链接、装载以及内存分配过程

74 |

75 | - 虚拟内存可以控制进程对物理内存的访问、隔离不同进程的访问权限,提高系统的安全性

76 |

77 |

--------------------------------------------------------------------------------

/✍ 文章/内存碎片之外部碎片与内部碎片.md:

--------------------------------------------------------------------------------

1 | “内存碎片”描述了一个系统中所有不可用的空闲内存。这些资源之所以仍然未被使用,是因为负责分配内存的分配器使这些内存无法使用,原因在于空闲内存以小而不连续方式出现在不同的位置,内存分配器无法将这些内存利用起来分配给新的进程。由于分配方法决定内存碎片是否是一个问题,因此内存分配器在保证空闲资源可用性方面扮演着重要的角色。

2 |

3 | ## 内部碎片与外部碎片

4 |

5 | ### 内部碎片

6 |

7 |

8 |

9 | [](https://jacktang816.github.io/img/unix/memoryFragmentation/internalFragmentation.gif)

10 |

11 | 内部碎片是由于系统分配给进程的空间大于其所申请的大小,处于(操作系统分配的用于装载某一进程的内存)区域内部或页面内部的存储块,占有这些区域或页面的进程并不使用这个存储块。而在进程占有这块存储块时,系统无法利用它。直到进程释放它,或进程结束时,系统才有可能利用这个存储块。

12 |

13 |

14 |

15 | ### 外部碎片

16 |

17 |

18 |

19 | [](https://jacktang816.github.io/img/unix/memoryFragmentation/externalFragmentation.gif)

20 |

21 | 外部碎片指的是还没有被分配出去(不属于任何进程),但由于太小了无法分配给申请内存空间的新进程的内存空闲区域,即处于任何两个已分配区域或页面之间的空闲存储块。这些存储块的总和可以满足当前申请的长度要求,但是由于它们的地址不连续或其他原因,使得系统无法满足当前申请。

22 |

23 |

24 |

25 | ## 内存碎片产生的原因

26 |

27 | - 内部碎片的产生

28 | 因为所有的内存分配必须起始于可被 4、8 或 16 整除(视处理器体系结构而定)的地址或者因为MMU的分页机制的限制,决定内存分配算法仅能把预定大小的内存块分配给客户。假设当某个客户请求一个 43 字节的内存块时,因为没有适合大小的内存,所以它可能会获得 44字节、48字节等稍大一点的字节,因此由所需大小四舍五入而产生的多余空间就叫内部碎片。

29 | - 外部碎片的产生

30 | 频繁的分配与回收物理页面会导致大量的、连续且小的页面块夹杂在已分配的页面中间,就会产生外部碎片。假设有一块一共有100个单位的连续空闲内存空间,范围是0-99。如果你从中申请一块内存,如10个单位,那么申请出来的内存块就为0-9区间。这时候你继续申请一块内存,比如说5个单位大,第二块得到的内存块就应该为10-14区间。如果你把第一块内存块释放,然后再申请一块大于10个单位的内存块,比如说20个单位。因为刚被释放的内存块不能满足新的请求,所以只能从15开始分配出20个单位的内存块。现在整个内存空间的状态是0-9空闲,10-14被占用,15-24被占用,25-99空闲。其中0-9就是一个内存碎片了。如果10-14一直被占用,而以后申请的空间都大于10个单位,那么0-9就永远用不上了,变成外部碎片。

31 |

32 | ## 内存分配方式

33 |

34 | ### 连续分配

35 |

36 | 首先讲连续分配方式。连续分配方式出现的时间比较早,曾广泛应用于20世纪60~70年代的OS中,但是它至今仍然在内存管理方式中占有一席之地,原因在于它实现起来比较方便,所需的硬件支持最少。连续分配方式又可细分为四种:单一连续分配、固定分区分配、动态分区分配和动态重定位分区分配。

37 |

38 | 其中**固定分区分配方式**,因为分区固定,所以缺乏灵活性,即当程序太小时,会造成内存空间的浪费(内部碎片);程序太大时,一个分区又不足以容纳,致使程序无法运行。但尽管如此,当一台计算机去控制多个相同对象的时候,由于这些对象内存大小相同,所以完全可以采用这种内存管理方式,而且是最高效的。这里我们可以看出存储器管理机制的多面性:即没有那种存储器管理机制是完全没有用的,在适合的场合下,一种被认为最不合理的分配方案却可能称为最高效的分配方案。一切都要从实际问题出发,进行设计。

39 |

40 | 为了解决固定分区分配方式的缺乏灵活性,出现了**动态分配方式**。动态分配方式采用一些寻表的方式,查找能符合程序需要的空闲内存分区。但代价是增加了系统运行的开销,而且内存空闲表本身是一个文件,必然会占用一部分宝贵的内存资源,而且有些算法还会增加**内存碎片**。

41 |

42 | **可重定位分区分配**通过对程序实现成定位,从而可以将内存块进行搬移,将小块拼成大块,将小空闲“紧凑”成大空闲,腾出较大的内存以容纳新的程序进程。但是拼凑过程的开销较大。

43 |

44 | ### 基本分页存储管理方式

45 |

46 | 连续分配方式会形成许多“碎片”,虽然可以通过“紧凑”方式将许多碎片拼接成可用的大块空间,但须为之付出很大开销。所以提出了“离散分配方式”的想法。如果离散分配的基本单位是页,则称为分页管理方式;如果离散分配的基本单位是段,则称为分段管理方式。

47 |

48 | 分页存储管理是将一个进程的逻辑地址空间分成若干个大小相等的片,称为页面或页,并为各页加以编号,从0开始,如第0页、第1页等。相应地,也把内存空间分成与页面相同大小的若干个存储块,称为(物理)块或页框(frame),也同样为它们加以编号,如0#块、1#块等等。在为进程分配内存时,以块为单位将进程中的若干个页分别装入到多个可以不相邻接的物理块中。**由于进程的最后一页经常装不满一块而形成了不可利用的碎片,称之为“页内碎片”。**

49 |

50 | 在分页系统中,允许将进程的各个页离散地存储在内存不同的物理块中,但系统应能保证进程的正确运行,即能在内存中找到每个页面所对应的物理块。为此,系统又为每个进程建立了一张**页面映射表**,简称页表。在进程地址空间内的所有页,依次在页表中有一页表项,其中记录了相应页在内存中对应的物理块号。在配置了页表后,进程执行时,通过查找该表,即可找到每页在内存中的物理块号。可见,页表的**作用是实现从页号到物理块号的地址映射(逻辑地址向物理地址的映射)**。

51 |

52 | 页表的功能可由一组专门的寄存器来实现。由于寄存器成本较高,且大多数现代计算机的页表又很大,使页表项总数可达几千甚至几十万个,显然这些页表项不可能都用寄存器来实现,因此,页表大多驻留在内存中。因为一个进程可以通过它的PCB来时时保存自己的状态,等到CPU要处理它的时候才将PCB交给寄存器,所以,系统中虽然可以运行多个进程,但也只需要一个页表寄存器就可以了。

53 |

54 | 由于页表是存放在内存中的,这使得CPU在每存取一个数据时,都要两次访问内存。为了提高地址变换速度,在地址变化机构中增设了一个具有并行查询能力的缓冲寄存器,又称为“联想寄存器”(TLB)。

55 |

56 | 在单级页表的基础上,为了适应非常大的逻辑地址空间,出现了两级和多级页表,但是,他们的原理和单级页表是一样的,只不过为了适应地址变换层次的增加,需要在地址变换机构中增设外层的页表寄存器。

57 |

58 | ### 基本分段存储管理方式

59 |

60 | 分段存储管理方式的目的,主要是为了满足用户(程序员)在编程和使用上多方面的要求,其中有些要求是其他几种存储管理方式所难以满足的。因此,这种存储管理方式已成为当今所有存储管理方式的基础。

61 |

62 | (1)方便编程:通常,用户把自己的作业按照逻辑关系划分为若干个段,每个段都是从0开始编址,并有自己的名字和长度。因此,希望要访问的逻辑地址是由段名(段号)和段内偏移量(段内地址)决定的。

63 |

64 | (2)信息共享:分页系统中的“页”只是存放信息的物理单位(块),并无完整的意义,不便于实现共享;然而段却是信息的逻辑单位。由此可知,为了实现段的共享,希望存储器管理能与用户程序分段的组织方式相适应。

65 |

66 | (3)信息保护:信息保护同样是对信息的逻辑单位进行保护,因此,分段管理方式能更有效和方便的实现信息保护功能。

67 |

68 | (4)动态增长:在实际应用中,往往有些段,特别是数据段,在使用过程中会不断地增长,而事先又无法确切地知道数据段会增长到多大。前面的几种存储管理方式都难以应付这种动态增长的情况,分段存储管理方式能较好的解决这一问题。

69 |

70 | (5)动态链接:动态链接是指在作业运行之前,并不把几个目标程序段链接起来。要运行时,先将主程序所对应的目标程序装入内存并启动运行,当运行过程中又需要调用某段时,才将该段(目标程序)调入内存并进行链接。可见,动态链接也要求以段作为管理的单位。

71 |

72 | #### 分页和分段的主要区别

73 |

74 | 分页和分段系统都采用离散分配方式,且都要通过地址映射机构来实现地址变换。但在概念上两者完全不同,主要表现在3个方面:

75 |

76 | (1)页是信息的物理单位,分页是为实现离散分配方式,**消减外部碎片**,提高内存的利用率(没有外部碎片)。分页仅仅是由于系统管理的需要而不是用户的需要。段则是信息的逻辑单位,它含有一组其意义相对完整的信息。分段的目的是为了更好的满足用户的需要。

77 |

78 | (2)页的大小固定且由系统决定,由系统把逻辑地址划分为页号和页内地址两部分,是由机器硬件实现的,因而在系统中只能有一种大小的页面;而**段的长度不固定**,决定于用户所编写的程序,通常由编译程序在对源程序进行编译时,根据信息的性质来划分。

79 |

80 | (3)分页的作业地址空间是一维的,即单一的线性地址空间,程序员只需利用一个记忆符,即可表示一个地址;而分段的作业地址空间是二维的,程序员在标识一个地址时,既需给出段名,又需给出段内地址。

81 |

82 | ### 段页式存储管理方式

83 |

84 | 前面所介绍的分页和分段存储管理方式都各有优缺点。分页系统能有效地提高内存利用率,而分段系统则能很好地满足用户需求。我们希望能够把两者的优点结合,于是出现了段页式存储管理方式。

85 |

86 | 段页式系统的基本原理是分段和分页原理的结合,即先将用户程序分成若干个段,再把每个段分成若干个页,并为每一个段赋予一个段名。在段页式系统中,地址结构由段号、段内页号和页内地址三部分所组成。和前两种存储管理方式相同,段页式存储管理方式同样需要增设联想寄存器(TLB)。

87 |

--------------------------------------------------------------------------------

/✍ 文章/内存管理系列一:启动简介.md:

--------------------------------------------------------------------------------

1 | > 本系列所有文章转载自:https://pzh2386034.github.io/Black-Jack/

2 | > 在bootloader将控制权交给linux kernel前,需要完成下面几个动作

3 |

4 | - 初始化系统中ram,并将ram信息告知kernel

5 | - 准备好device tree blob, 并将首地址写到x0寄存器

6 | - 解压内核(option)

7 | - MMU=off, D-cache=off

8 |

9 | ### 介绍几个关于内核位置的宏,在启动过程中,经常会用到

10 |

11 | - `#define __PHYS_OFFSET (KERNEL_START - TEXT_OFFSET)` : kernel space 首地址

12 | - `KERNEL_START: _text=PAGE_OFFSET + TEXT_OFFSET` : kernel开始运行的虚拟地址(内核正文段开始的虚拟地址)

13 | - `TEXT_OFFSET` : 内核正文地址距离kernel space首地址的偏移量

14 | 1. 对于arm32,该空间一般为32kb(0x8000),用于保存内核页表(process id = 0的pgd), 以及bootloader和kernel间参数传递

15 | 2. 对于arm64, 该空间一般为512kb(0x80000)

16 | - `PAGE_OFFSET` : 目前看和`__PHYS_OFFSET`一样,均表示kernel space首地址

17 |

18 | ## 启动代码分析

19 |

20 | ## 常见arm指令

21 |

22 | - `ldr: ldr r0, [r1]`r0=* r1;将r1指向的内容存入r0

23 | 1. `ldr r0 0x12345678` : 把0x12345678这个地址中的值存放到r0中, r0=*(0x12345678)

24 | 2. `ldr r0, =0x12345678`: 此时ldr是个伪指令,功能类似mov,r0=0x12345678

25 | - `str`:`str r0 [r1, #4]`\* (r1+4) = r0;将r0中内容存入r1+4中的地址

26 | 1. .macro str_l, src, sym, tmp

27 | 2. adrp \tmp \sym

28 | 3. str \src, [\tmp, :lo12:\sym]

29 | - `str`: `str r0 [r1] , #4` *r1=r0; r1=r1+4; 将r0中内容存入r1中的地址,并将新地址r1+8存入r1

30 | - adr: 小范围地址读取指令,将基于pc相对偏移的地址值读取到寄存器中(距离pc 1m以内)

31 | 1. 原理:将符号的21位偏移,加上pc,结果写入到寄存器中

32 | - adr_l: 将符号地址转变为运行时地址(通过pc relative offset形式)

33 | 1. .macro ldr_l, dst, sym

34 | 2. adrp \dst, \sym

35 | 3. ldr \dst, [\dst, :lo12:\sym]

36 | - `adrp`: 以页为单位的大范围地址读取指令,通过该指令可以获得符号的物理地址,当然是page对齐的

37 | - `mrs`: 处理器模式切换指令,从指定寄存器读取到临时寄存器

38 | - `msr`: 写模式到指定寄存器

39 | - `bic`: `bic x0, x0, #0xF000 0000 0000 0000`: 位清除,将x0的高4位清除

40 | - `rsb`: `rsb x0, x0, #123`: x0=1280-x0

41 | - `ldp,stp`: load/store pair; `ldp x8, x2, [x0, #0x10]` : x0 += 0x10, x8 = *(x0), x2 = *(x0 + 0x8); `stp x9, x8, [x4]` : *(x4) = x9, *(x4 + 8) = x9;

42 | - `b,bl,blx,bx`: 分别为跳转指令, 带返回值的跳转指令, 带返回和状态切换的跳转指令, 带状态切换的跳转指令

43 |

44 | ## head.s中入口函数stext

45 |

46 | ```assembly

47 | ENTRY(stext)

48 | bl preserve_boot_args //(1)根据arm64规范,保存x0-x3寄存器;在setup_arch函数中会访问boot_args进行校验

49 | bl el2_setup // Drop to EL1, w20=cpu_boot_mode, (2)判断启动模式为EL1或是EL2,EL2表示支持虚拟化,KVM模块可以顺利启动

50 | adrp x24, __PHYS_OFFSET //将__PHYS_OFFSET保存到x24中

51 | bl set_cpu_boot_mode_flag //见下一篇解释

52 |

53 | bl __vet_fdt //对bootloader传递给kernel的fdt参数进行校验;1. 是否8字节对齐;2. 是否在kernel space的前512M内

54 | bl __create_page_tables // x25=TTBR0, x26=TTBR1, 见下一篇解释

55 | /*

56 | * The following calls CPU setup code, see arch/arm64/mm/proc.S for

57 | * details.

58 | * On return, the CPU will be ready for the MMU to be turned on and

59 | * the TCR will have been set.

60 | */

61 | ldr x27, =__mmap_switched // address to jump to after

62 | // MMU has been enabled

63 | adr_l lr, __enable_mmu // return (PIC) address

64 | b __cpu_setup // initialise processor

65 | ENDPROC(stext)

66 | ```

67 |

68 | ## preserve_boot_args

69 |

70 | ```assembly

71 | /*

72 | * Preserve the arguments passed by the bootloader in x0 .. x3

73 | * 保存x0-x3寄存器,是为了符合arm64规范:x0必须为dtb物理地址,x1-x3必须为0

74 | * 在setup_arch函数中会访问boot_args并进行校验

75 | */

76 | preserve_boot_args:

77 | mov x21, x0 // x21=FDT, 将dtb的地址暂存在x21中

78 |

79 | adr_l x0, boot_args // record the contents of, 将boot_args首地址保存在x0中

80 | stp x21, x1, [x0] // x0 .. x3 at kernel entry, 将x21,x1分别保存在boot_args[0], boot_args[1]

81 | stp x2, x3, [x0, #16] //将x2,x3分别保存在boot_args[2], boot_args[3]

82 |

83 | dmb sy // needed before dc ivac with

84 | // MMU off

85 |

86 | add x1, x0, #0x20 // 4 x 8 bytes, 将boot_args非参数首地址赋给x1,即x0是boot_args这段memory的首地址,x1是末尾的地址

87 | b __inval_cache_range // tail call, 将x0, x1地址段对应的cacheline设定为无效

88 | ENDPROC(preserve_boot_args)

89 | ```

90 |

91 | ## el2_setup

92 |

93 | ```unix-assembly

94 | /*

95 | * end early head section, begin head code that is also used for

96 | * hotplug and needs to have the same protections as the text region

97 | */

98 | .section ".text","ax"

99 | /*

100 | * If we're fortunate enough to boot at EL2, ensure that the world is

101 | * sane before dropping to EL1.

102 | *

103 | * Returns either BOOT_CPU_MODE_EL1 or BOOT_CPU_MODE_EL2 in x20 if

104 | * booted in EL1 or EL2 respectively.

105 | * 判断cpu模式,只拿部分为例

106 | */

107 | ENTRY(el2_setup)

108 | mrs x0, CurrentEL

109 | cmp x0, #CurrentEL_EL2 //判断是否处于EL2

110 | b.ne 1f //如果不是,则跳转到1f

111 | mrs x0, sctlr_el2 //从sctlr_el2读取模式到寄存器

112 | CPU_BE( orr x0, x0, #(1 << 25) ) // Set the EE bit for EL2

113 | CPU_LE( bic x0, x0, #(1 << 25) ) // Clear the EE bit for EL2

114 | msr sctlr_el2, x0

115 | b 2f

116 | 1: mrs x0, sctlr_el1 //执行到这,说明为EL1模式

117 | CPU_BE( orr x0, x0, #(3 << 24) ) // Set the EE and E0E bits for EL1

118 | CPU_LE( bic x0, x0, #(3 << 24) ) // Clear the EE and E0E bits for EL1

119 | msr sctlr_el1, x0

120 | mov w20, #BOOT_CPU_MODE_EL1 // This cpu booted in EL1

121 | isb

122 | ret

123 | .........

124 | ENDPROC(el2_setup)

125 | ```

126 |

127 | ## set_cpu_boot_mode_flag

128 |

129 | ```unix-assembly

130 | /*

131 | * Sets the __boot_cpu_mode flag depending on the CPU boot mode passed

132 | * in x20. See arch/arm64/include/asm/virt.h for more info.

133 | * 执行完el2_setup后,w20保存了exception level

134 | * 分析__boot_cpu_mode的定义,可以有如下结论:

135 | * 1. 如果cpu启动的时候是EL1 mode,会修改变量__boot_cpu_mode A域,将其修改为BOOT_CPU_MODE_EL1

136 | * 2. 如果cpu启动的时候是EL2 mode,会修改变量__boot_cpu_mode B域,将其修改为BOOT_CPU_MODE_EL2

137 | * ENTRY(__boot_cpu_mode)

138 | * .long BOOT_CPU_MODE_EL2--------A

139 | * .long BOOT_CPU_MODE_EL1--------B

140 | */

141 | ENTRY(set_cpu_boot_mode_flag)

142 | adr_l x1, __boot_cpu_mode

143 | cmp w20, #BOOT_CPU_MODE_EL2

144 | b.ne 1f

145 | add x1, x1, #4 //el1模式走这里,修改x1的地址为B域

146 | 1: str w20, [x1] // This CPU has booted in EL1, *x1=w20;

147 | dmb sy

148 | dc ivac, x1 // Invalidate potentially stale cache line

149 | ret

150 | ENDPROC(set_cpu_boot_mode_flag)

151 | ```

152 |

153 | ## __vet_fdt

154 |

155 | ```unix-assembly

156 | /*

157 | * Determine validity of the x21 FDT pointer.

158 | * The dtb must be 8-byte aligned and live in the first 512M of memory.

159 | * 见document/boot.txt要求

160 | * 在512m内是为了在保证kernel space的首地址和fdt首地址在一个pud entry中

161 | */

162 | __vet_fdt:

163 | tst x21, #0x7 //校验x21是否为8字节对齐

164 | b.ne 1f

165 | cmp x21, x24 //是否在小于kernel space的首地址

166 | b.lt 1f

167 | mov x0, #(1 << 29)

168 | add x0, x0, x24

169 | cmp x21, x0

170 | b.ge 1f //是否大于kernel space首地址+512M

171 | ret

172 | 1:

173 | mov x21, #0 //fdt地址有误,清零

174 | ret

175 | ENDPROC(__vet_fdt)

176 | ```

177 |

178 | 参考文档:

179 |

180 | 1. Documentation/arm64/booting.txt

181 | 2. http://www.wowotech.net/armv8a_arch/arm64_initialize_1.html

182 | 3. https://www.jianshu.com/p/4b68f45065c6

183 |

184 |

--------------------------------------------------------------------------------

/✍ 文章/内存管理系列七:slub初始化.md:

--------------------------------------------------------------------------------

1 | ## 前沿

2 |

3 | ### 往篇回顾

4 |

5 | 在前两篇中,主要介绍了alloc_pages正常情况下,如果从伙伴系统获得内存;简单来说有如下几步:

6 |

7 | - 正常情况下,alloc_pages->get_page_from_freelist会使用low阀值遍历zonelist尝试分配, 分两次遍历,首先尝试只从preferred_zone所在node中的zone分配;

8 | 1. 如果某个zone检查水位不足,则会触发起进行内存回收zone_reclaim后,再尝试检查其水位是否符合要求;

9 | - 在get_page_from_freelist中,如果某个zone经过区间、水位校验通过后调用buffered_rmqueue申请内存;

10 | - 在buffered_rmqueue会区分order

11 | 1. order=0,尝试从CPU缓存中分配, 如果CPU缓存中没有空闲内存,则使用rmqueue_bulk从伙伴系统中申请bulk个order=0的空闲内存;

12 | 2. order>0, 尝试从zone的伙伴系统中分配内存__rmqueue(), 从free_list[order]开始找空闲内存(__rmqueue_smallest),找不到则尝试更高一阶,直到找到为止;

13 | - 如果使用__rmqueue()从free_list中获取空闲页失败,则调用__rmqueue_fallback从migratetype的fallback列表中依次尝试分配;

14 | 1. 为了反碎片,从备用mirgratetype中获取到的内存会首先尝试移动到希望的mirgratype;

15 | 2. 从备用mirgratetype获取内存,是从高阶order=10到低阶进行尝试的;这种机制应该也是为了反碎片;

16 | - 如果以上都没有成功,则会进行第二次get_page_from_freelist, 这次尝试所有zonelist中的zone;

17 | - 如果第二次遍历zonelist也失败,则会触发慢速分配__alloc_pages_slowpath,并修改水位阀值为min;

18 |

19 | ### slub简介

20 |

21 | #### 与slab的比较

22 |

23 | - slub来源于slab,slab对于小内存分配管理有不错的表现;但是对于大型的NUMA系统,slab的管理开销会成倍增大,导致异常臃肿;

24 | - slub摒弃了slab的一些管理数据,以及着色概念(为了避免CPU硬件高速缓存频繁换入换出,在一个kmem_cache中的slab的前端空闲区域嵌入空闲偏移);

25 | - node结点对应的 kmem_cache_node->colour_next * kmem_cache->colour_off 就得到了偏移量(kmem_cache.colour_off * kmem_cache.node[NODE_ID].colour_next);

26 | - colour_next++,当colour_next等于kmem_cache中的colour时,colour_next置0(kmem_cache.node[NODE_ID].colour_next++);

27 | - slab根据状态划分了3个链表–full,partial和free. slub分配器做了简化,去掉了free链表,对于空闲的slab,slub分配器选择直接将其释放;

28 | - 在NUMA架构上,slub分配器较slab做了简化;

29 |

30 | ### 本篇主要内容

31 |

32 | > 本篇主要分析slub分配器初始化过程,该阶段的主要任务是初始化用于kmalloc的gerneral cache:struct kmem_cache *kmalloc_caches[KMALLOC_SHIFT_HIGH + 1];其中KMALLOC_SHIFT_HIGH=14

33 |

34 | ## 代码分析

35 |

36 | ### size_index数组及kmem_caches数据关系

37 |

38 | - size_index数组中存储的是gerneral cache的编号;

39 | - 要根据Object size大小来定位合适的gerneral cache,直接用size/8 - 1;

40 | 1. 例如:size=48 ===> 对应size_index的下标=49/8-1=5;

41 | 2. size_index[5] == 6, 对应kmem_cache[6], 其中的slub size 为 64;

42 | 3. 即:如果你要申请一个object size=49的slub,真正给你返回的是一个object size=64的slub;

43 | - linux在Mem_init()函数中完成bootmem到伙伴系统的转移后,随即开始slub初始化

44 |

45 | ### kmem_cache_init

46 |

47 | ```c

48 | start_kernel->mm_init()->kmem_cache_init

49 |

50 | /*

51 | * 1. 通过create_boot_cache创建"kmem_cache", "kmem_cache_node" slab,后续结构体struct kmem_cache, struct kmem_cache_node的内存申请都会分别通过这两个slab完成;

52 | * 2. register_hotmemory_notifier()注册热插拔内存内核通知链回调函数用于热插拔内存处理?

53 | * 3. 完成"kmem_cache", "kmem_cache_node" slab创建后,要刷新各个node中slab的相应指针;

54 | * 4. 在create_kmalloc_caches完成 size_index和kmem_caches的映射,并对kmem_cache结构体指针用create_kmalloc_caches创建slab, 进行初始化;

55 | * 5. 置slab_state=up;

56 | */

57 | void __init kmem_cache_init(void)

58 | {

59 | //声明静态变量,存储临时kmem_cache管理结构

60 | static __initdata struct kmem_cache boot_kmem_cache,

61 | boot_kmem_cache_node;

62 |

63 | if (debug_guardpage_minorder())

64 | slub_max_order = 0;

65 |

66 | kmem_cache_node = &boot_kmem_cache_node;

67 | kmem_cache = &boot_kmem_cache;

68 | /*

69 | * 创建一个slub, size: sizeof(struct kmem_cache_node), name: "kmem_cache_node", 置引用次数refcount=-1

70 | * 其中核心函数__kmem_cache_create在下一篇中分析,其关键作用是把kmem_cache结构初始化

71 | * 申请slub缓冲区,管理数据放在临时结构体中

72 | */

73 | create_boot_cache(kmem_cache_node, "kmem_cache_node",

74 | sizeof(struct kmem_cache_node), SLAB_HWCACHE_ALIGN);

75 | /* 注册热插拔内存内核通知链回调函数用于热插拔内存处理,注册到memory_chain上 */

76 | register_hotmemory_notifier(&slab_memory_callback_nb);

77 |

78 | /* 将初始化进度改为PARTIAL,表示已经可以分配struct kmem_cache_node */

79 | slab_state = PARTIAL;

80 |

81 | create_boot_cache(kmem_cache, "kmem_cache",

82 | offsetof(struct kmem_cache, node) +

83 | nr_node_ids * sizeof(struct kmem_cache_node *),

84 | SLAB_HWCACHE_ALIGN);

85 | /*

86 | * boot_kmem_cache和boot_kmem_cache_node中的内容拷贝到新申请的对象中,并修正其余node slab中相关指针

87 | * 从而完成了struct kmem_cache和struct kmem_cache_node管理结构的bootstrap(自引导)

88 | */

89 | kmem_cache = bootstrap(&boot_kmem_cache);

90 |

91 | kmem_cache_node = bootstrap(&boot_kmem_cache_node);

92 |

93 | /* Now we can use the kmem_cache to allocate kmalloc slabs */

94 | create_kmalloc_caches(0);

95 |

96 | #ifdef CONFIG_SMP

97 | /* 注册内核通知链回调函数,注册到cpu_chain上 */

98 | register_cpu_notifier(&slab_notifier);

99 | #endif

100 |

101 | pr_info("SLUB: HWalign=%d, Order=%d-%d, MinObjects=%d, CPUs=%d, Nodes=%d\n",

102 | cache_line_size(),

103 | slub_min_order, slub_max_order, slub_min_objects,

104 | nr_cpu_ids, nr_node_ids);

105 | }

106 | ```

107 |

108 | ### bootstrap

109 |

110 | ```c

111 | /*

112 | * 从刚才挂在临时结构的缓冲区中申请kmem_cache的kmem_cache,并将管理数据拷贝到新申请的内存中

113 | * 将临时kmem_cache向最终kmem_cache迁移,并修正其余node slab中相关指针,使其指向最终kmem_cache

114 | */

115 | static struct kmem_cache * __init bootstrap(struct kmem_cache *static_cache)

116 | {

117 | int node;

118 | /*

119 | * kmem_cache_zalloc()->kmem_cache_alloc()->slab_alloc(), slab_alloc函数后面会分析

120 | * 为create_boot_cache()初始化创建的kmem_cache申请slub空间

121 | */

122 | struct kmem_cache *s = kmem_cache_zalloc(kmem_cache, GFP_NOWAIT);

123 | struct kmem_cache_node *n;

124 | /* 将bootstrap()入参的kmem_cache结构数据memcpy()至申请的空间中 */

125 | memcpy(s, static_cache, kmem_cache->object_size);

126 |

127 | /*

128 | * 刷新cpu的slab信息

129 | */

130 | __flush_cpu_slab(s, smp_processor_id());

131 | /*

132 | * 要将新的kmem_cache地址刷新到各个内存管理节点node的slab中

133 | * 通过for_each_kmem_cache_node()遍历各个内存管理节点node,获取各个节点的kmem_cache_node,如果不为空:

134 | * 遍历其中部分满的slab链表,修正每个slab指向kmem_cache的指针;

135 | * 如果开启debug,则对满的slab链表也遍历

136 | */

137 | for_each_kmem_cache_node(s, node, n) {

138 | struct page *p;

139 |

140 | list_for_each_entry(p, &n->partial, lru)

141 | p->slab_cache = s;

142 |

143 | #ifdef CONFIG_SLUB_DEBUG

144 | list_for_each_entry(p, &n->full, lru)

145 | p->slab_cache = s;

146 | #endif

147 | }

148 | slab_init_memcg_params(s);

149 | /* 将kmem_cache添加到全局slab_caches链表中 */

150 | list_add(&s->list, &slab_caches);

151 | return s;

152 | }

153 | ```

154 |

155 | ### create_kmalloc_caches

156 |

157 | ```c

158 | /*

159 | * 1. 根据KMALLOC_MIN_SIZE大小,对size_index全局数组中数据进行改变

160 | * 对于slub分配算法而言,KMALLOC_MIN_SIZE为1 << KMALLOC_SHIFT_LOW,其中KMALLOC_SHIFT_LOW为3,则KMALLOC_MIN_SIZE为8

161 | * 因此size_index中数据不会改变

162 | * 2. 循环调用 create_kmalloc_cache 初始化 kmalloc_caches 结构体数组====>到这,完成了size_index和kmalloc_caches的映射

163 | * 3. 创建完后,将slab_state置为up

164 | * 4. 将kmem_cache的name成员进行初始化

165 | * 5. 如果配置了CONFIG_ZONE_DMA, 则初始化创建kmalloc_dma_caches

166 | */

167 | void __init create_kmalloc_caches(unsigned long flags)

168 | {

169 | int i;

170 |

171 | /* 保证kmalloc允许的最小对象大小不能大于256,且该值必须是2的整数幂 */

172 | BUILD_BUG_ON(KMALLOC_MIN_SIZE > 256 ||

173 | (KMALLOC_MIN_SIZE & (KMALLOC_MIN_SIZE - 1)));

174 | /* 对大小在8byte与KMALLOC_MIN_SIZE之间的对象,将其在size_index数组的索引设置为KMALLOC_SHIFT_LOW */

175 | for (i = 8; i < KMALLOC_MIN_SIZE; i += 8) {

176 | int elem = size_index_elem(i);

177 |

178 | if (elem >= ARRAY_SIZE(size_index))

179 | break;

180 | size_index[elem] = KMALLOC_SHIFT_LOW;

181 | }

182 |

183 | if (KMALLOC_MIN_SIZE >= 64) {

184 | /* KMALLOC_MIN_SIZE=8,不会进入该分支 */

185 | for (i = 64 + 8; i <= 96; i += 8)

186 | size_index[size_index_elem(i)] = 7;

187 |

188 | }

189 |

190 | if (KMALLOC_MIN_SIZE >= 128) {

191 | /* KMALLOC_MIN_SIZE=8,不会进入该分支 */

192 | for (i = 128 + 8; i <= 192; i += 8)

193 | size_index[size_index_elem(i)] = 8;

194 | }

195 | /*

196 | * 循环调用 create_kmalloc_cache 初始化 kmalloc_caches 结构体数组

197 | * KMALLOC_SHIFT_HIGH=12,但是size_index最大只到7阶,高阶的怎么处理?

198 | * create_kmalloc_cache:

199 | * 1. 通过kmem_cache_zalloc申请一个kmem_cache对象

200 | * 2. 通过create_boot_cache()创建slab

201 | * 3. 将创建的slab添加到slab_caches中

202 | */

203 | for (i = KMALLOC_SHIFT_LOW; i <= KMALLOC_SHIFT_HIGH; i++) {

204 | if (!kmalloc_caches[i]) {

205 | kmalloc_caches[i] = create_kmalloc_cache(NULL,

206 | 1 << i, flags);

207 | }

208 | if (KMALLOC_MIN_SIZE <= 32 && !kmalloc_caches[1] && i == 6)

209 | kmalloc_caches[1] = create_kmalloc_cache(NULL, 96, flags);

210 |

211 | if (KMALLOC_MIN_SIZE <= 64 && !kmalloc_caches[2] && i == 7)

212 | kmalloc_caches[2] = create_kmalloc_cache(NULL, 192, flags);

213 | }

214 |

215 | /* Kmalloc array is now usable */

216 | slab_state = UP;

217 | /* 将kmem_cache的name成员进行初始化 */

218 | for (i = 0; i <= KMALLOC_SHIFT_HIGH; i++) {

219 | struct kmem_cache *s = kmalloc_caches[i];

220 | char *n;

221 |

222 | if (s) {

223 | n = kasprintf(GFP_NOWAIT, "kmalloc-%d", kmalloc_size(i));

224 |

225 | BUG_ON(!n);

226 | s->name = n;

227 | }

228 | }

229 |

230 | #ifdef CONFIG_ZONE_DMA

231 | for (i = 0; i <= KMALLOC_SHIFT_HIGH; i++) {

232 | struct kmem_cache *s = kmalloc_caches[i];

233 |

234 | if (s) {

235 | int size = kmalloc_size(i);

236 | char *n = kasprintf(GFP_NOWAIT,

237 | "dma-kmalloc-%d", size);

238 |

239 | BUG_ON(!n);

240 | kmalloc_dma_caches[i] = create_kmalloc_cache(n,

241 | size, SLAB_CACHE_DMA | flags);

242 | }

243 | }

244 | #endif

245 | }

246 | #endif /* !CONFIG_SLOB */

247 | ```

248 |

249 |

--------------------------------------------------------------------------------

/✍ 文章/内存管理系列三:MMU前CPU初始化及打开MMU.md:

--------------------------------------------------------------------------------

1 | > 上一篇中,详细分析了MMU打开前,为MMU打开后能正常启动linux kernel进行了3块区域的section map; 本篇聚焦为打开MMU而进行的CPU初始化, 主要内容:

2 |

3 | - cache和TLB处理

4 | - memory attributes lookup table的创建

5 | - SCTLR_EL1、TCR_EL1的设定(详细见参考资料)

6 |

7 | ## 首先介绍icache, dcache

8 |

9 | ### icache: 指令cache(instruction cache)

10 |

11 | - 由cp15协处理器中控制寄存器1的第12位控制,一般在MMU开启之后被使用

12 | - icache一般有512个entry,每个16 bytes;如果miss cache, 则从内存中读取指令,且触发`8-word linefill`, 将该指令所在区域8 word写进某个entry

13 |

14 | ### dcache: 数据cache

15 |

16 | - ARM dcache架构由cache存储器和写缓冲器(write-buffer)组成,其中写缓冲器是CACHE按照FIFO原则向主存写的缓冲处理器

17 | - 一般来说CACHEABILITY和BUFFERABILITY都是可以配置的,所以,一块存储区域可以配置成下面4种方式:NCNB CNB NCB CB(例: ip map都采用NCNB)

18 | - DCaches使用的是虚拟地址,它的大小是16KB,它被分成512行(entry), 每行8个字(8 words,32Bits)。每行有两个修改标志位(dirty bits),第一个标志位标识前4个字,第二个标志位标识后4个字,同时每行中还有一个TAG 地址(标签地址)和一个valid bit

19 |

20 | ## memory type

21 |

22 | 在上一篇中,我们主要分析了新建slub的过程,入口函数是`kmem_cache_create`,主要内容如下:

6 |