├── file

├── C++面试题集锦.pdf

├── 20200415.md

├── linux命令.md

├── 20200412.md

├── 阿里面试真题解析之进程线程的区别.md

├── 字节面试真题解析之协程.md

├── 百度面试真题解析之Zero Copy技术.md

├── 阿里面试真题解析之并发安全的map.md

├── 阿里面试真题解析之互斥锁和自旋锁相关问题.md

├── 阿里面试真题解析之内存对齐.md

├── 腾讯面试真题解析之epoll.md

├── 20200302.md

├── 阿里面试真题解析之C++相关问题.md

├── 20200301.md

├── 20200515.md

├── 20200413.md

├── 20200305.md

├── 20200226.md

├── other.md

├── 20200320.md

├── c++笔记.md

├── 20200227.md

└── 20200228.md

├── .idea

├── IE.iml

├── encodings.xml

├── vcs.xml

├── misc.xml

└── modules.xml

├── CMakeLists.txt

├── main.cpp

├── time_heap.h

├── test.cpp

├── README.md

└── time_heap.cpp

/file/C++面试题集锦.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/834810071/IE/HEAD/file/C++面试题集锦.pdf

--------------------------------------------------------------------------------

/.idea/IE.iml:

--------------------------------------------------------------------------------

1 |

2 |

--------------------------------------------------------------------------------

/.idea/encodings.xml:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

--------------------------------------------------------------------------------

/file/20200415.md:

--------------------------------------------------------------------------------

1 | ### [快手C++基础架构凉经](https://www.nowcoder.com/discuss/401870?type=0&order=0&pos=7&page=1)

2 |

3 | #### 1.写出short类型-1的十六进制表示(0xffff)

4 |

5 | #### 2.虚拟地址、逻辑地址、物理地址区别与联系

6 |

7 |

--------------------------------------------------------------------------------

/.idea/vcs.xml:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

5 |

6 |

--------------------------------------------------------------------------------

/.idea/misc.xml:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

5 |

6 |

7 |

--------------------------------------------------------------------------------

/.idea/modules.xml:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

--------------------------------------------------------------------------------

/CMakeLists.txt:

--------------------------------------------------------------------------------

1 | cmake_minimum_required(VERSION 3.13)

2 | project(IE)

3 |

4 | set(CMAKE_CXX_STANDARD 14)

5 |

6 | set(lib

7 | test.cpp

8 | time_heap.cpp

9 | time_heap.h)

10 |

11 | add_library(Lib ${lib})

12 |

13 | add_executable(IE main.cpp)

14 | add_executable(test test.cpp)

15 | add_executable(epoll epoll源码注释.c)

16 |

17 | target_link_libraries(IE Lib pthread)

18 | target_link_libraries(test Lib pthread)

--------------------------------------------------------------------------------

/main.cpp:

--------------------------------------------------------------------------------

1 | #include

2 | #include

3 | #include

4 | #include

5 | #include

6 | #include

7 | #include

8 |

9 | using namespace std;

10 |

11 |

12 | int main()

13 | {

14 | string str;

15 | cin >> str;

16 | if (str.length() >= 100)

17 | {

18 | cout << " " << endl;

19 | return 0;

20 | }

21 | unordered_set s;

22 |

23 | for (int i = 0; i < str.length(); ++i)

24 | {

25 | if (s.count(str[i]))

26 | {

27 | cout << str[i] << endl;

28 | return 0;

29 | }

30 | else

31 | {

32 | s.insert(str[i]);

33 | }

34 | }

35 | cout << " " << endl;

36 | return 0;

37 | }

--------------------------------------------------------------------------------

/file/linux命令.md:

--------------------------------------------------------------------------------

1 | **history** : 历史命令

2 |

3 | **ctrl + p**: 前一个历史命令

4 |

5 | **ctrl + n** : 下一个历史命令

6 |

7 | **ctrl + h** :删除光标前字符

8 |

9 | **ctrl + d** : 删除光标所在字符

10 |

11 | **ctrl + a** : 移动到行首

12 |

13 | **ctrl + e**: 移动到行尾

14 |

15 | **cd** : 目录切 换

16 |

17 | * **cd -** : 在相邻的两个目录互相切换

18 | * **cd ~**: home 目录

19 |

20 | **ls**: 目录查看

21 |

22 | **$**:代表普通用户

23 |

24 | **#** : 超级用户

25 |

26 | * **exit** : 退出

27 |

28 | **mkdir** : 创建目录

29 |

30 | * **make -p name ** : 创建嵌套目录

31 |

32 | **touch** **echo** **vi** : 创建文件

33 |

34 | **rmdir** : 删除空目录

35 |

36 | **rm -rf** : 删除目录

37 |

38 | * **rm -ri** : 删除时给提示

39 |

40 | **cp**: 拷贝文件

41 |

42 | * 文件存在会覆盖

43 | * **cp -r** : 递归拷贝目录

44 |

45 | **cat** : 查看文件内容

46 |

47 | **more** : 查看文件内容

48 |

49 | * 空格翻页 : 只能往后看

50 |

51 | **less** : 查看文件内容

52 |

53 | * **ctrl + p** : 向前翻页

54 |

55 | **head** : 查看前几行

56 |

57 | **tail** : 查看后几行

58 |

59 | **ln**: 创建硬链接

60 |

61 | **ln -s**: 创建软链接

62 |

63 | **wc** : 查看文件信息

64 |

65 | **od**: 查看二进制文件信息

66 |

67 | **du** : 查看目录大小

68 |

69 | **df** : 查看磁盘信息

70 |

71 | **chmod**:查看和修改文件权限

72 |

73 | **chgrp**: 修改文件所属的组

74 |

75 | **find 查找目录 -name "文件名"** : 查找文件名

76 |

77 | **find 查找目录 -size 文件大小** : 查找文件名

78 |

79 | * -10k : < 10k

80 | * +10k: > 10k

81 |

82 | **grep -r "查找的内容" 查找路径** : 按文件内容查找

83 |

84 | **mount 设备名字 挂载位置** : 挂载u盘

85 |

86 | **sudo fdisk -l** : 查看硬盘设备

87 |

--------------------------------------------------------------------------------

/file/20200412.md:

--------------------------------------------------------------------------------

1 | ### [2019 秋招 C++ 个人面经集合(包含 cvte、BIGO、老虎、网易、拼夕夕等)](https://leetcode-cn.com/circle/article/kqWT9f/)

2 |

3 | ### 1. KMP

4 |

5 | 参考:[字符串匹配的KMP算法]([http://www.ruanyifeng.com/blog/2013/05/Knuth%E2%80%93Morris%E2%80%93Pratt_algorithm.html](http://www.ruanyifeng.com/blog/2013/05/Knuth–Morris–Pratt_algorithm.html))

6 |

7 | [从头到尾彻底理解KMP](https://blog.csdn.net/v_JULY_v/article/details/7041827)

8 |

9 | #### 2. 函数传值的方式?

10 |

11 | * 按值传递(pass by value) value

12 | * 地址传递(pass by pointer) *value

13 | * 引用传递(pass by reference) &value

14 |

15 | #### 3.[C++ 内存分区,未初始化的全局变量放在哪?](https://blog.csdn.net/jirryzhang/article/details/79518408)[如果编译了在二进制文件里会有他的位置吗?](https://blog.csdn.net/qq_38880380/article/details/79459195)

16 |

17 | C语言在内存中一共分为如下几个区域,分别是:

18 |

19 | 1. 内存栈区: 存放局部变量名;

20 | 2. 内存堆区: 存放new或者malloc出来的对象;

21 | 3. 常数区: 存放局部变量或者全局变量的值;

22 | 4. 静态区: 用于存放全局变量或者静态变量;

23 | 5. 代码区:二进制代码。

24 | 知道如上一些内存分配机制,有助于我们理解指针的概念。

25 |

26 | C/C++不提供垃圾回收机制,因此需要对堆中的数据进行及时销毁,防止内存泄漏,使用free和delete销毁new和malloc申请的堆内存,而栈内存是动态释放。

27 |

28 | 全局变量、静态局部变量保存在全局数据区,初始化的和未初始化的分别保存在一起;

29 |

30 | 普通局部变量保存在堆栈中;

31 |

32 |

33 | **全局变量和局部变量初始化与不初始化的区别**

34 | 即int x 和 int x=0的区别。

35 |

36 | int x =0; 跟 int x; 的效果看起来是一样的。但其实这里面的差别很大,强烈建议大家所有的全局变量都要初始化,他们的主要差别如下:

37 |

38 | 编译器在编译的时候针对这两种情况会产生两种符号放在目标文件的符号表中,对于初始化的,叫强符号,未初始化的,叫弱符号。连接器在连接目标文件的时候,如果遇到两个重名符号,会有以下处理规

39 | 则:

40 | 1、如果有多个重名的强符号,则报错。

41 | 2、如果有一个强符号,多个弱符号,则以强符号为准。

42 | 3、如果没有强符号,但有多个重名的弱符号,则任选一个弱符号。

--------------------------------------------------------------------------------

/time_heap.h:

--------------------------------------------------------------------------------

1 | //

2 | // Created by jxq on 20-4-7.

3 | //

4 |

5 | #ifndef IE_TIME_HEAP_H

6 | #define IE_TIME_HEAP_H

7 |

8 | #pragma once

9 |

10 | #include

11 | #include

12 | #include

13 | #include

14 |

15 | const int BUFFER_SIZE = 64;

16 |

17 | class heap_timer;

18 |

19 | //用户数据,绑定socket和定时器

20 | struct client_data

21 | {

22 | sockaddr_in address;

23 | int sockfd;

24 | char buf[BUFFER_SIZE];

25 | heap_timer *timer;

26 | };

27 |

28 | //定时器

29 | class heap_timer

30 | {

31 | public:

32 | heap_timer(int delay)

33 | {

34 | expire = time(NULL) + delay;

35 | }

36 | public:

37 | time_t expire;//定时器生效绝对时间

38 | void (*cb_func)(client_data*); //定时器回调函数

39 | client_data* user_data;//客户端数据

40 | };

41 |

42 | //时间堆

43 | class time_heap

44 | {

45 | public:

46 | //构造之一:初始化一个大小为cap的空堆

47 | time_heap(int cap);

48 | //构造之二:用已用数组来初始化堆

49 | time_heap(heap_timer** init_array,int size,int capacity);

50 | //销毁时间堆

51 | ~time_heap();

52 | //添加定时器timer

53 | int add_timer(heap_timer *timer);

54 | //删除定时器timer

55 | void del_timer(heap_timer *timer);

56 | //获得顶部的定时器

57 | heap_timer * top()const;

58 | //删除顶部的定时器

59 | void pop_timer();

60 | //心跳函数

61 | void tick();

62 | //堆是否为空

63 | bool empty()const;

64 | //最小堆的下操作,

65 | //确保堆数组中认第hole个节点作为根的子树拥有最小堆性质

66 | void percolate_down(int hole);

67 |

68 | //将堆数组容量扩大1倍

69 | void resize();

70 | private:

71 | heap_timer **array; //堆数组

72 | int capacity; //堆数组的空量

73 | int cur_size; //堆数组当前包含元素个数

74 | };

75 |

76 |

77 | #endif //IE_TIME_HEAP_H

78 |

--------------------------------------------------------------------------------

/test.cpp:

--------------------------------------------------------------------------------

1 | #include

2 | #include

3 | #include

4 | #include

5 | #include

6 | #include

7 |

8 | using namespace std;

9 |

10 | class A

11 | {

12 | public:

13 | A(int l) : l(l)

14 | {

15 |

16 | }

17 | A(int v, int l) : val(v), l(l)

18 | {

19 |

20 | }

21 | int val;

22 | int l;

23 |

24 | };

25 |

26 | bool cmp(A a, A b)

27 | {

28 | if (a.val == b.val)

29 | {

30 | return a.l < b.l;

31 | }

32 | return a.val > b.val;

33 | }

34 |

35 | int main()

36 | {

37 | int len;

38 | cin >> len;

39 | vector arr;

40 | string lens, vs;

41 | cin >> lens;

42 | cin >> vs;

43 | int s = 0;

44 | for (int i = 0; i < lens.size(); ++i)

45 | {

46 | if (lens[i] == ',')

47 | {

48 | arr.push_back(A(atoi(lens.substr(s, i).c_str())));

49 | s = i+1;

50 | }

51 | }

52 | arr.push_back(A(atoi(lens.substr(s).c_str())));

53 | s = 0;

54 | int t = 0;

55 | for (int i = 0; i < vs.size(); ++i)

56 | {

57 | if (vs[i] == ',')

58 | {

59 | arr[t++].val = atoi(vs.substr(s).c_str());

60 | s = i+1;

61 | }

62 | }

63 | arr[t++].val = atoi(vs.substr(s).c_str());

64 |

65 | int res = 0;

66 | sort(arr.begin(), arr.end(), cmp);

67 | int cur = len;

68 | for (int i = 0; i < arr.size(); ++i)

69 | {

70 | if (arr[i].l <= cur)

71 | {

72 | cur -= arr[i].l;

73 | res += arr[i].val;

74 | }

75 | else

76 | {

77 | break;

78 | }

79 | }

80 | cout << res << endl;

81 | return 0;

82 | }

--------------------------------------------------------------------------------

/file/阿里面试真题解析之进程线程的区别.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 我们都知道进程是系统进行资源分配和调度的一个独立单位。线程是进程的一个实体,是CPU调度的基本单位。线程自己基本上不拥有系统资源,但是它可与同属一个进程的其他的线程共享进程所拥有的全部资源。由于线程比进程更小,基本上不拥有系统资源,线程上下文切换比进程上下文切换要快得多,所以线程调度的开销就会小得多,从而可以显著提高系统资源的利用率和吞吐量。**但是对于为什么线程上下文切换比进程要快以及进程线程上下文切换到底做了哪些事情大多数人并不是特别清楚。**本节将结合阿里面试真题,对线程和进程的区别做一个总结。

4 |

5 | # 进程

6 |

7 | 进程是一个具有一定独立功能的程序在一个数据集上的一次动态执行的过程,是操作系统进行资源分配和调度的一个独立单位,是应用程序运行的载体。进程一般由**程序,数据集合和进程控制块**三部分组成。

8 |

9 | # 线程

10 |

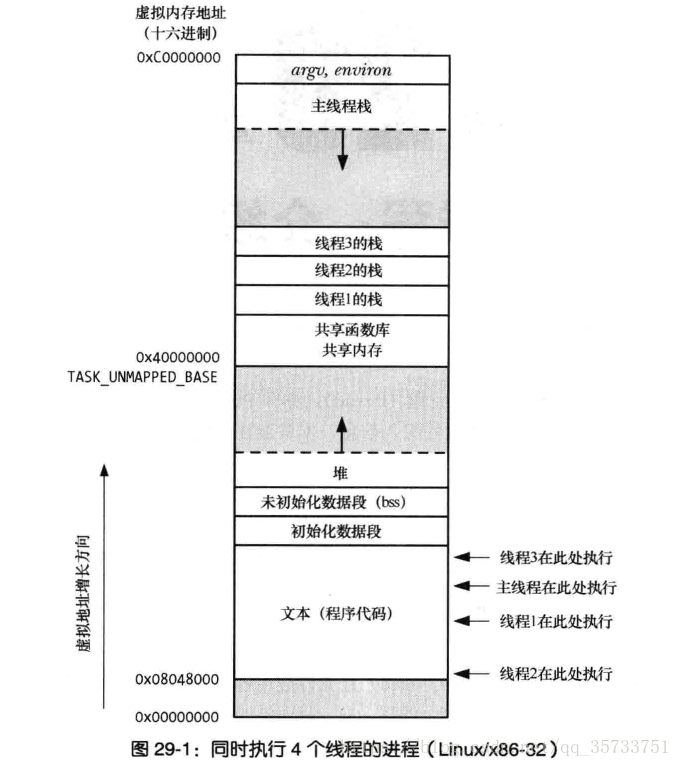

11 | 线程是操作系统调度的最小单位。一个进程可以包含多个线程,每个线程可以看做一个独立的逻辑流,线程也称为轻量级进程。在Linux下其实原本并没有线程的概念,线程和进程对于操作系统都是一样的调度,都有具有自己独立的task_struct(进程描述符),也都有自己独立的pid,但是线程可以共享同一内存地址空间、代码段、全局变量、同一打开文件集合等等。

12 |

13 | # 进程切换的开销

14 |

15 | 开销分成两种:

16 |

17 | 1.直接开销

18 |

19 | 2.间接开销

20 |

21 | ### 直接开销:

22 |

23 | 1. **切换页表全局目录**

24 | 2. 切换**内核态堆栈**

25 | 3. 切换硬件上下文:寄存器当中的数据

26 | 4. 刷新TLB

27 | 5. 执行操作系统调度器的代码

28 |

29 | ### **间接开销:**

30 |

31 | 间接开销指的是由于切换到一个新进程后,各种缓存对于新的进程而言未命中的概率非常大。进程如果跨CPU调度,那么之前的TLB、L1、L2、L3缓存因为运行的进程已经变了,缓存所带来的空间局部性和时间局部性的优势失效,当前缓存起来的代码、数据失效。这将导致新进程需要重新从内存当中获取数据和代码,并将其缓存起来。从而导致穿透到内存的**IO**会变多,由于CPU和内存读取速度的差异很大,这部分带来的开销也非常大。

32 |

33 | ####

34 |

35 | # 线程切换的开销

36 |

37 | **线程切换和进程切换之间的主要区别在于**:

38 |

39 | 1. 在线程切换期间,虚拟内存空间保持不变。

40 | 2. 进程切换期间,TLB会被刷新,从而使内存访问在一段时间内变得更加昂贵。

41 |

42 | ####

43 |

44 | # 进程线程的本质区别

45 |

46 | 1.进程**更安全**,一个进程完全不会影响另外的进程。

47 |

48 | 2.进程间通信比线程间**通信的性能差**很多。

49 |

50 | 3.线程切换开销更低。

51 |

52 | ####

53 |

54 | # 阿里面试真题

55 |

56 | ### 1.进程切换开销有哪些?

57 |

58 | 答:分为直接开销和间接开销 (具体答案参见上文)

59 |

60 | 解析:此处考察的不仅仅是书本上简单的上下文切换开销,需要对直接开销和间接开销的具体内容有比较好的理解,尤其需要回答出缓存失效带来的额外开销,此问题属于对计算机体系结构的考察。

61 |

62 | ### 2.线程共享哪些进程的资源?

63 |

64 | 答: 1.进程代码段 ; 2.进程的公有数据; 3.进程打开的**文件描述符;** 4.信号的处理器; 5.进程的当前目录;6.进程用户ID与进程组ID。

65 |

66 | ### 3.线程独立的资源有哪些?

67 |

68 | 答:1.线程ID;2.寄存器组的值;3.线程栈;4.错误返回码;5.线程的信号屏蔽码;6.线程的优先级。

69 |

70 | ### 4.说一说你知道的多线程和多进程的场景?

71 |

72 | 答:多进程场景比如 Nginx,一个 Master 多个 Worker,进程间只进行有限的通信,并不传递数据,每个进程使用IO多路复用去管理事件,是一个典型的多进程场景。

73 |

74 | 多线程场景比如一些web server,每到达一个请求使用一个线程去处理请求,在链接数量不大的情况下,比进程开销低很多,还可以使用线程池去优化创建和销毁线程的开销。

75 |

76 | ### 5.除了进程和线程你还知道哪些概念?

77 |

78 | 答:协程。协程是用户级线程,比如Golang当中原生支持协程概念,在用户空态去调度协程,维护和操作系统线程的多对多的关系。

79 |

80 | # 总结

81 |

82 | 1.多线程之间堆内存共享,线程间通信可以直接基于共享内存来实现,比多进程之间通信更轻量。

83 |

84 | 2.多线程之间切换**不需要切换虚拟内存空间、文件描述符**等,所以线程的上下文切换也比多进程轻量。

85 |

86 | 3.由于进程之间空间相互独立,多进程比多线程更安全,一个进程基本上不会影响另外一个进程。

87 |

88 | 4.一般不同任务间需要大量的通信,使用多线程的场景比多进程多。但是多进程有更高的容错性,一个进程的崩溃不会导致整个系统的崩溃,在任务安全性较高的情况下,采用多进程。

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # IE [Typera软件阅读]

2 |

3 | 面经记录 -- 见[file](https://github.com/834810071/IE/tree/master/file)文件夹

4 |

5 | [个人牛客面经记录](https://www.nowcoder.com/profile/8447408/myDiscussPost)

6 |

7 | ```java

8 | 面试官一来我啪的就站起来了,很快啊!然后上来就是手写二分查找,两个有序队列实现堆栈,两数之和,

9 | 我全都写完了啊,写完了以后自然是传统面试以点到为止,后面几道求空间复杂度和时间复杂度算法就没做了,

10 | 因为几道题,按传统答题点到为止我已经不会做了。

11 |

12 | 面试官说他是乱出的,他可不是乱出的啊,数据结构,算法分析,训练有素,

13 | 后来他说他以前是阿里p8,看来是有备而来!面试官不讲武德,来,骗!来,偷袭!我工作一年多的菜狗,这好吗,这不好,

14 | 我劝这位面试官耗子尾汁,好好反思,以后不要再犯这要的聪明,小聪明啊。

15 |

16 | 面试要以和为贵,不要搞-窝里斗~ 谢谢朋友们!

17 | ```

18 |

19 | 推荐: [C/C++ 技术面试基础知识总结,包括语言、程序库、数据结构、算法、系统、网络、链接装载库等知识及面试经验、招聘、内推等信息。](https://github.com/huihut/interview)

20 |

21 | [后台开发相关知识](https://github.com/twomonkeyclub/BackEnd)

22 |

23 | [计算机基础(计算机网络/操作系统/数据库/Git...)面试问题全面总结,包含详细的follow-up question以及答案;全部采用【问题+追问+答案】的形式,即拿即用,直击互联网大厂面试rocket;可用于模拟面试、面试前复习、短期内快速备战面试...](https://github.com/wolverinn/Waking-Up)

24 |

25 | [面试常见问题汇总](https://github.com/Making-It/CS_Review)

26 |

27 | [2020 grinninggringrinninggringrinning 秋招笔试面试合集,以及2019届公司真题模拟题集 & 附上自己的后端指南,computermortar_board包括(C/C++基础、数据结构、算法、操作系统computer、计算机网络、MySQL、shell(ps:sed、awk、grep))](https://github.com/Apriluestc/2020)

28 |

29 | [笔试面试知识整理](https://github.com/HIT-Alibaba/interview)

30 |

31 | [MeiK](https://meik2333.com/posts)

32 |

33 | [专注于分享算法,计算机基础(包括计算机网络,操作系统,MySQL等),无论是应付面试,还是提升自己地内功,这里都能帮到你](https://github.com/iamshuaidi/algo-basic)

34 |

35 | [Learning](https://github.com/loversgzl/Learning)

36 |

37 | [c++](https://github.com/WhiteNotWolf/Skill-Notes)

38 |

39 | [「Java学习+面试指南」一份涵盖大部分Java程序员所需要掌握的核心知识。准备 Java 面试,首选 JavaGuide!](https://github.com/Snailclimb/JavaGuide)

40 |

41 | [C/C++学习,后端开发进阶指南。](https://github.com/balloonwj/CppGuide)

42 |

43 | [《互联网面试笔记》收集和分析互联网常见面试题,并将这些面试知识整理成文方便大家查阅。主要是面向java程序员,但基础知识部分不同语言程序员(c,c++,python等)都可以参考。---持续更新中, 欢迎编辑~](https://github.com/zhengjianglong915/note-of-interview)

44 |

45 | [后端架构师技术图谱](https://github.com/xingshaocheng/architect-awesome)

46 |

47 | [从Java基础、JavaWeb基础到常用的框架再到面试题都有完整的教程,几乎涵盖了Java后端必备的知识点](https://github.com/ZhongFuCheng3y/3y)

48 |

49 | [C++那些事](https://github.com/Light-City/CPlusPlusThings)

50 |

51 | [【Java面试+Java学习指南】 一份涵盖大部分Java程序员所需要掌握的核心知识。](https://github.com/AobingJava/JavaFamily)

52 |

53 | [About

54 | 涵盖C++ Primer 5th、 effective C++ 、 STL api和demos C++ 基础知识与理论、 智能指针、C++11、 Git教程 Linux命令 Unix操作系统(进程、线程、内存管理、信号)计算机网络、 数据结构(排序、查找)、数据库、、C++对象模型、 设计模式、算法(《剑指offer》、leetcode、lintcode、hihocoder、《王道程序员求职宝典》)、面试题、嵌入式相关等](https://github.com/yzhu798/CodingInterviewsNotes)

55 |

56 | [fullstack tutorial 2020,后台技术栈/架构师之路/全栈开发社区,春招/秋招/校招/面试](https://github.com/frank-lam/fullstack-tutorial)

57 |

--------------------------------------------------------------------------------

/file/字节面试真题解析之协程.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 在第12节当中我们介绍了面试当中常考的进程和线程相关的问题,除了进程和线程之外,协程相关的问题在面试当中出现的频次越来越高,尤其是在一些使用Golang作为主要后端开发语言的大厂当中。本节我将以字节面试真题为例讲解协程相关知识。

4 |

5 | # 并发模型

6 |

7 | 要理解协程的出现,首先需要了解网络服务器并发模型有哪些:

8 |

9 | ### **1.简单多线程模型**:

10 |

11 | 该模型采用一个连接一个线程的模式,对于每一个连接都需要一个单独的线程去处理业务逻辑。

12 |

13 | ### **2.半同步半异步模**型:

14 |

15 | 单独一个IO线程来异步处理各种网络IO,比如使用IO多路复用技术。同时使用线程池来同步处理每个请求,业务逻辑部分交给线程池当中的工作线程处理。

16 |

17 | ### **3.全异步模型**:

18 |

19 | 该模型在网络IO部分和业务逻辑处理部分都是异步的,不会因为IO而导致程序阻塞,通过一个线程就处理所有的任务,由于避免了多线程的开销问题,能够**最大程度利用计算机的性能**,但是将给程序员带来编程的巨大困难,因为业务逻辑的编写将非常难以理解。

20 |

21 | # 协程

22 |

23 | **我们知道线程可以看做轻量级进程,而协程简单来说可以看做更轻量级的线程。**不同的语言有不同的协程实现,比如Golang原生支持协程,Python的Greenlet,C++的第三方库libgo等等。如同一个进程可以拥有多个线程,一个线程也可以拥有多个协程。如同线程是进程的一种优化,协程也可以看做线程的进一步优化。

24 |

25 | ### **协程内存开销:**

26 |

27 | 以Golang为例,协程初始化创建的时候为其分配的栈有2KB,而线程栈一般为8M左右。如果对每个连接创建一个协程去处理,100万并发请求只需要2G内存,而如果用线程模型则需要8T,所以对于相同的内存而言,使用协程可以支持的并发量比线程多很多。

28 |

29 | ### **协程的实现:**

30 |

31 | 以Golang为例,会在启动用户main函数之前启动runtime等几个协程。简单来说,runtime会维护用户级协程和操作系统线程的多对多的映射关系,Golang抽象出G,P,M的概念,将协程的调度完全实现在用户态的runtime当中:

32 |

33 | M: Machine,简单理解为操作系统线程;

34 |

35 | G: Goroutine,协程;

36 |

37 | P: Processor,处理器抽象,协调多个个G在某一个M上执行。

38 |

39 | 有兴趣的话可以去看看Golang在协程方面的设计和实现。

40 |

41 | # 字节跳动面试真题解析

42 |

43 | ### 1.协程的切换在什么时候?

44 |

45 | 答:1.当Golang当中协程在执行一些阻塞调用,例如网络IO,磁盘IO函数会发生协程切换;

46 |

47 | 2.Golang当中协程的切换时间片是10ms,当协程连续执行超过10ms时会被runtime调度器切换;

48 |

49 | 3.当协程主动交出执行权限时也会发生协程切换,比如协程主动sleep。

50 |

51 | 分析:该问题是考察对于协程切换的理解,协程切换和操作系统线程切换有所不同,线程的切换由操作系统在内核态切换,同时操作系统支持时间片以及优先级调度,但是协程并不支持优先级调度。

52 |

53 | ### 2.如何实现协程的自动切换?说出你的想法。

54 |

55 | 答:可以使用任务队列维护协程和操作系统线程的映射关系,封装各种io函数,当这些封装的函数被程序使用的时候,内部使用操作系统的异步io函数,当异步io函数表示阻塞时,将当前协程放入任务队列,切换执行任务其他可执行的协程。

56 |

57 | 分析:这个问题是一个发散性问题,如果不了解协程实现可以通过类比的方式进行回答,言之有理即可。

58 |

59 | ### 3.Golang当中的协程是占用一个CPU还是会被调度到不同的CPU?

60 |

61 | 答:会被调度到不同的CPU。

62 |

63 | 分析:协程和线程是多对多的关系,一个协程的运行实际还是会绑定到一个操作系统线程,而线程的调度是操作系统决定的,任何一个线程在没有特殊限制的情况下可能会被调度到任何一个CPU上运行,而协程和线程是由runtime动态绑定的,所以协程也可能在任何一个CPU上运行。

64 |

65 | ### 4.协程和线程的区别?

66 |

67 | 答:1.线程是操作系统调度的最小单元,线程是由操作系统调度。但是操作系统对于协程是无感知的,协程的调度 是在用户态而非由操作系统在内核态调度。

68 |

69 | 2.相比创建一个线程而言,创建一个协程的开销非常小。

70 |

71 | 3.协程之间的切换开销相比线程间切换开销低很多。

72 |

73 | 4.协程比线程支持更大的并发量。

74 |

75 | 5.协程不支持抢占,因为操作系统有时间片概念,所以线程是支持优先级和抢占的,但是协程是在用户态实 现,协程是非抢占式调度。在任务调度上,协程是弱于线程的。

76 |

77 | 分析:本题属于概念性问题,回答全面即可。

78 |

79 | ### 5.**协程适合哪些场景?**

80 |

81 | 答:协程适合以下特点的场景

82 |

83 | 1.高并发场景:每秒钟需要处理成千上万的用户请求;

84 |

85 | 2.高网络IO场景:服务经常需要从其它机器获取数据,进行网络IO;

86 |

87 | 3.低计算场景:CPU密集型计算比较少。

88 |

89 | 分析:本题考查协程的应用场景。无论是网络IO,还是磁盘IO,远远慢于CPU的操作速度,所以往往需要CPU去等待IO操作完成。同步IO下系统需要切换线程,但是由于大量的线程切换带来了大量的性能的浪费,尤其是IO密集型的程序。而异步IO可以减少线程切换带来性能损失,但是编程模式并不符合人类思维。所以使用协程既可以解决线程切换开销大的问题,也可以符合人类编程的思维。

90 |

91 | ### 6.说一说你对于协程的理解?

92 |

93 | 答:由于现在系统的并发量越来越大,一开始的简单多线程模型已经不能很好的应对高并发场景,因为线程的切换开销已经成为了瓶颈。由于epoll的出现,IO多路复用的并发模式可以极大的提升系统的性能,但是这种IO多路复用的方式虽然提升的运行效率但是对于程序员而言这种编程模型非常难以理解,开发效率低且代码调试困难。此时协程就成了2者的一种折中方案,协程解决了操作系统线程切换和创建销毁开销大的问题,同时又可以以简单的编程模式开发,提升系统的效率的同时也没有降低太多编程难度。

94 |

95 | 分析:本题也是发散性问题,对一个概念的理解,我认为从其产生的原因和其能够解决的问题这两个角度进行回答是比较合适的。

96 |

97 | # 总结

98 |

99 | 本节总结了协程的概念,结合我在面试字节跳动过程当中遇到的问题进行解答。

--------------------------------------------------------------------------------

/file/百度面试真题解析之Zero Copy技术.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 在我秋招面试过程当中,关于Zero Copy的问题一共出现了3次。对于一个程序员来说,当一个问题出现了3次那么就需要重视和总结,事不过三。本节我会对Zero Copy做一个介绍,并结合百度面试真题进行解析。

4 |

5 | ####

6 |

7 | # 系统级IO

8 |

9 | 要理解Zero Copy技术的出现,首先需要知道什么是系统级IO。Linux系统级IO分为:

10 |

11 | 1.标准IO库

12 |

13 | 2.IO系统调用

14 |

15 | 3.网络IO库

16 |

17 | ### **IO系统调用**:

18 |

19 | Linux标准访问文件方式是通过两个系统调用实现的:read()和write(),这两个系统调用在**用户态都是没有缓冲**。当用户进程使用read 和 write 读写Linux的文件时,进程会从用户态进入内核态,通过I/O操作读取文件中的数据。

20 |

21 | **read ():**

22 |

23 | ```c

24 | ssize_t read(int fd, void * buf, size_t count);

25 | ```

26 |

27 | read()会把参数fd所指的文件传送count 个字节到buf 指针所指的内存中。

28 |

29 | **write():**

30 |

31 | ```c

32 | ssize_t write (int fd, const void * buf, size_t count);

33 | ```

34 |

35 | write()会把参数buf所指的内存写入count个字节到参数放到所指的文件内。

36 |

37 | 举例来说,要写入数据到文件上时,内核先将数据写入到内核中所设的缓冲当中;假如这个缓冲储存器的长度是100字节,调用系统函数write时,假设每次要写入的数据的长度为10个字节,那么你几要调用10次write函数才能将内核缓冲区写满;此时数据还是在缓冲区,并没有写入到磁盘,缓冲区满了之后,才真正进行实际上的IO操作,将数据写入磁盘。因为内存和磁盘读取速度的巨大差异,采用内核缓存可以减少磁盘IO的次数,提升磁盘IO的效率。

38 |

39 | ### **标准IO库:**

40 |

41 | 标准IO库是基于IO系统调用实现的,优化了对系统调用的使用方式。引入标准IO库有以下几个原因:

42 |

43 | 1.因为IO系统调用的使用方式非常底层,需要指定读写的count以及buf,使用比较麻烦,所以标准IO库对IO系统调用进行封装。

44 |

45 | 2.因为read 和 write 等底层系统调用需要在**用户态**和**内核态**之间切换,如果每次读写的数据很少,那么切换带来的开销将大大降低IO的效率,所以标准IO库在用户态也引入了缓冲机制,提升了性能。

46 |

47 | 3.IO系统调用在不同的操作系统之间是不能通用的,但是标准IO库在不同的平台几乎是一致的,这就增强了可移植性。

48 |

49 | **常见的标准IO库函数:**

50 |

51 | fopen、fclose、fwrite、fread、ffulsh、fseek等等。

52 |

53 | #### ** **

54 |

55 | # **Zero-Copy**

56 |

57 | 零拷贝技术是指计算机执行操作时,CPU不需要先将数据从某处内存复制到另一个特定区域。这种技术通常用于通过网络传输文件时**节省CPU周期和内存带宽**。举例来说,如果要从磁盘当中读取一个文件并通过网络发送它,传统方式下每个读/写周期都需要复制两次数据和切换两次上下文,而**数据的复制都需要依靠CPU**。

58 |

59 | ### 1.Linux 2.1内核引入**sendfile函数**:

60 |

61 | sendfile通过一次系统调用完成了文件的传送,通过sendfile发送文件只需要一次系统调用,当调用sendfile时数据的拷贝路径如下:

62 |

63 | 第一次拷贝:将数据从磁盘读取到内核缓冲区中;

64 |

65 | 第二次拷贝:将数据从内核缓冲区拷贝到socket buffer中;

66 |

67 | 第三次拷贝:将数据从socket buffer拷贝到网卡设备中发送;

68 |

69 | ### **2.Linux2.4 内核对sendfile做了进一步的改进:**

70 |

71 | 改进后的数据拷贝处理路径如下:

72 |

73 | 第一次拷贝:将文件从磁盘拷贝到内核缓冲区中,不再将内核缓冲区的数据拷贝到socket buffer,而是向socket buffer中写入当前要发送的数据在内核缓冲区中的位置和偏移量;

74 |

75 | 第二次拷贝:根据socket buffer中的位置和偏移量,直接将内核缓冲区的数据copy到网卡设备中;

76 |

77 | ####

78 |

79 | # 百度面试真题

80 |

81 | 现在有一个用户需要**读取磁盘文件上的内容然后将其通过网络**发送出去,假设使用IO系统调用read/write

82 |

83 | ### 1.这个过程当中,数据经过几次拷贝?

84 |

85 | 答:在这个过程中经历了4次数据copy的过程,路径如下:

86 |

87 | 第一次数据拷贝:调用read时,文件从磁盘拷贝到了内核缓冲区;

88 |

89 | 第二次数据拷贝:数据从内核缓冲区拷贝到用户内存缓冲区;

90 |

91 | 第三次数据拷贝:调用write时,将用户内存缓冲区的数据内容拷贝到内核模式下的socket的buffer中;

92 |

93 | 第四次数据拷贝:最后将内核模式下的socket buffer的数据拷贝到网卡设备中;

94 |

95 | ### 2.这个过程当中,出现了几次用户态和内核态的切换?

96 |

97 | 答:在这个过程中经历了4次用户态和内核态的切换:

98 |

99 | 第一次切换:调用read时用户态切换到内核态;

100 |

101 | 第二次切换:read调用返回,内核态切换回用户态;

102 |

103 | 第三次切换:调用write时用户态切换到内核态;

104 |

105 | 第四次切换:write返回时内核态切换到用户态;

106 |

107 | ### 3.这个过程当中,需要几次系统调用?

108 |

109 | 答:这个过程当中经历了2次系统调用,分别是read和write系统调用。

110 |

111 | ### 4.有什么方法可以优化这个过程?

112 |

113 | 答:使用zero copy,避免数据在用户态的拷贝以及减少系统调用次数。

114 |

115 | # 结论

116 |

117 | 每次IO请求,内核态和用户态的切换开销以及数据的拷贝开销会严重降低性能,所以Zero-Copy技术可以来去掉用户态多余的数据拷贝,大大提高了应用程序的性能,并且减少了内核态和用户态的上下文的切换。对于Zero-copy需要记住以下2点:

118 |

119 | 1. Zero-copy可以将读取磁盘文件网络传输的上下文切换的次数从4次降低到2次;数据拷贝次数从4次降低到2次;

120 | 2. Zero-copy是针对内核来说,数据在内核模式下是无拷贝过程,并不是指整个过程数据没有拷贝。

--------------------------------------------------------------------------------

/file/阿里面试真题解析之并发安全的map.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 秋招面阿里的时候被问到一个这样的问题:

4 |

5 | > 平时你使用过map么?是并发安全的么?如何实现一个并发安全的map? 考虑过效率么?

6 |

7 | 相信大家平时使用最多的结构就是各种hash map了,无论哪种语言都有自身提供的实现,比如Java当中的HashMap,Golang当中的Sync.Map等等。在技术面试当中,对于hash Map实现的考察非常频繁。本文将从阿里的面试真题切入,结合相关代码简要的介绍几种实现并发安全的map的方法。

8 |

9 | # 阿里面试真题再现:

10 |

11 | ### 1.普通的map是并发安全的么?

12 |

13 | 答:不是并发安全的,在并发访问的过程当中会出现竞争,导致数据不一致。

14 |

15 | ### 2.unordered_map 和 map的区别?

16 |

17 | 答:unordered_map是基于哈希实现的,查找和插入开销都是O(1),而map是基于红黑树实现的,查找和插入的开销都是O(logn)。

18 |

19 | ### 3.如何实现一个并发安全的map?

20 |

21 | 答:1.封装读写锁实现;

22 |

23 | 2.分段锁实现;

24 |

25 | 3.读写分离实现;

26 |

27 | 解析:

28 |

29 | #### **方法1**:通过将读写锁和非并发安全的map封装在一起,实现一个并发安全的map结构。

30 |

31 | 如下面go语言的一个简单的实现,将一个并发不安全的map和一个读写锁结合,对于读写操作的接口进行封装。

32 |

33 | ```go

34 | type MyMap struct {

35 | sync.RWMutex

36 | mp map[interface{}]interface{}

37 | ...

38 | }

39 |

40 | func (m *MyMap) Read(key interface{}) interface{} {

41 | m.RLock()

42 | value := m.mp[key]

43 | m.RUnlock()

44 | return value

45 | }

46 |

47 | func (m *MyMap) Write(key, value interface{}) {

48 | m.Lock()

49 | m.mp[key] = value

50 | m.Unlock()

51 | }

52 | ```

53 |

54 | 优势:

55 |

56 | 1. 实现简单,几行代码就可以实现。

57 | 2. 并发量很小,或者竞争使用map的情况较少时对性能的影响并不大。

58 |

59 | 缺点:

60 |

61 | 锁的粒度太大。举例来说,线程A调用Write方法写key1的时候锁住了map,此时线程B调用Read方法,读取和key1不相关的key2时就会被阻塞。当并发量增大时,该方案带来的线程阻塞等待的开销会很大,在高并发情况下就需要进行优化。

62 |

63 | #### **方法2:** **锁分段技术**

64 |

65 | 相比方法1使用全局锁的方式,锁分段技术将数据分段存储,给每一段数据配一把锁。实现思路:当线程需要读取map当中某个key的时候,线程不会对整个map进行加锁操作,而是先通过hash取模来找到该key存放在哪一个分段中,然后对这个分段进行加锁,因为每一段数据使用不同的锁,所以对该分段加锁不会阻塞其他分段的读写。分段锁的设计目的是细化锁的粒度,减少线程间锁竞争的次数,从而可以有效的提高并发访问效率。

66 |

67 | 举例来说,分段锁实现的map的主要逻辑如下:

68 |

69 | ```go

70 | type MyConcurrentMap []*Shard

71 |

72 | // 分片Shard

73 | type Shard struct {

74 | items map[string]interface{}

75 | mu sync.RWMutex

76 | }

77 |

78 | //根据给定的key获取其对应的段

79 | func (m MyConcurrentMap) GetShard(key string) *Shared {

80 | h := hash(key) //对key求hash code

81 | return m[h%SHARD_COUNT]//SHARD_COUNT为预设的Shard的个数

82 |

83 | }

84 |

85 | //Set方法

86 | func (m MyConcurrentMap) Set(key string, value interface{}) {

87 | shard := m.GetShard(key)

88 | shard.mu.Lock()

89 | shard.items[key] = value

90 | shard.Unlock()

91 | }

92 |

93 | //Get方法

94 | func (m MyConcurrentMap) Get(key string) (interface{}, bool) {

95 | shard := m.GetShard(key)

96 | shard.mu.RLock()

97 | val, ok := shard.items[key]

98 | shard.mu.RUnlock()

99 | return val, ok

100 | }

101 | ```

102 |

103 | 优势:

104 |

105 | 相比方法1,并发访问效率有很大提升。

106 |

107 | 缺点:

108 |

109 | 对于map扩缩容时比较麻烦,因为shard的个数需要预先设定。

110 |

111 | #### **方法3**:**读写分离+原子操作**

112 |

113 | sync.Map是Golang1.9引入的并发安全的map,以下代码节选自sync.Map的实现:

114 |

115 | ```go

116 | //sync.Map的实现

117 | type Map struct {

118 | mu Mutex

119 | read atomic.Value // readOnly

120 | dirty map[interface{}]*entry

121 | misses int

122 | }

123 | ```

124 |

125 | 上述结构当中,read 只提供读,dirty 负责写。read 主要用于实现无锁操作,而 dirty 的操作是由 Mutex来保护。简单来说就是,当从map当中读取数据时会先从read当中读取数据,如果read当中可以获取该数据则无锁读取,当无法从read当中读取到时则从dirty当中加锁读取。该方案也是为了减少加锁操作,提升并发访问的效率,具体的实现可以看sync.Map的源码,这里篇幅有限不再赘述。

126 |

127 | 优势:

128 |

129 | 1. 通过冗余的两个数据结构(read、dirty),减少频繁加锁对性能的影响。**典型的空间换时间的做法。**

130 | 2. 将锁的粒度更加的细小到数据的状态上,减少锁操作。

131 | 3. 更好的拓展性,没有分段锁在扩缩容时的烦恼。

132 |

133 | 缺点:

134 |

135 | sync.Map的实现方式并不适用于大量写出现的场景,原因:

136 |

137 | - 大量的写会导致read当中读取不到数据,从而加锁读dirty,性能退化。

138 | - 大量写会导致read的miss不断提升,**导致dirty不断提升为read,导致性能下降

139 | **

140 |

141 | ###

142 |

143 | ### 4.如何考虑并发读写map的效率?

144 |

145 | 答:具体的场景需要具体分析,一般来说需要先分析对于map的使用场景,是读多写少还是更新多但是创建少,可以对不同的场景进行特殊的优化。一般常用的技巧就是减小锁的粒度,使用无锁操作代替加锁的方式,使用读写分离的方式等等。

--------------------------------------------------------------------------------

/file/阿里面试真题解析之互斥锁和自旋锁相关问题.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 在多处理器系统环境中需要保护资源避免由于并发带来的资源访问竞争导致的问题,就需要互斥访问,也就是需要引入锁的机制。只有获取了锁的进程才能访问资源。互斥锁和自旋锁是两种代表性的锁。在实际面试当中对于锁相关的问题出现的频率较高,一般涉及到并发访问,线程安全,线程同步相关问题就会问到互斥锁和自旋锁。本文将先对互斥锁和自旋锁的作用,实现以及使用场景做一个重点分析,然后例举6道我在面试阿里时的真题进行分析。

4 |

5 | # 多线程并发访问问题

6 |

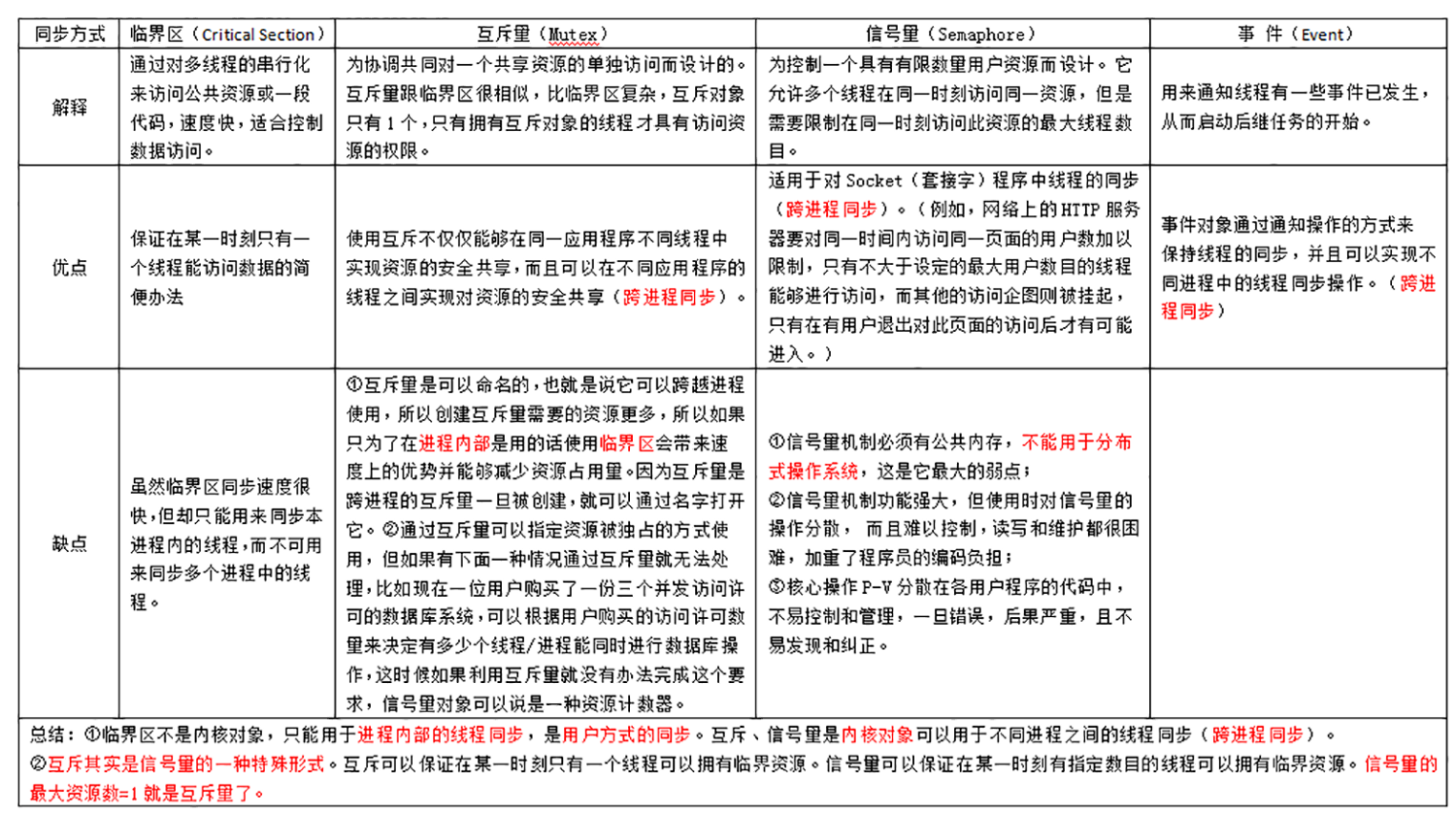

7 | 当多个线程并发访问共享资源时,有可能产生并发访问的安全性问题,可能会导致共享资源被破坏,导致非预期的结果。比如C++ STL当中的vector,map等等都是非并发安全的容器。如果想要解决并发访问的安全性问题就需要引入线程同步机制。

8 |

9 | 线程间同步指的是:当有一个线程在对共享资源进行操作时,其他线程都不可以对这个资源进行操作,直到该线程完成操作。简单来说,就是线程之间需要达到协同一致。

10 |

11 | 一般线程间同步机制有:共享内存,信号量机制,锁机制,信号机制等等。其中对于锁的使用是最普遍的方式。

12 |

13 | # **互斥锁:**

14 |

15 | ### **互斥锁的作用:**

16 |

17 | 互斥锁是为实现保护共享资源而提出一种锁机制。采用互斥锁保护临界区,防止竞争条件出现。当某个线程无法获取互斥锁时,该线程会被挂起,当其他线程释放互斥锁后,操作系统会唤醒被挂起在这个锁上的线程,让其运行。

18 |

19 | ### **互斥锁的实现:**

20 |

21 | 在Linux下互斥锁的实现是通过futex这个基础组件。

22 |

23 | 互斥锁加锁解锁开销很大,需要从用户态切换到内核态,上下文切换以及涉及缓存的更新等等。通常很多同步操作发生的时候并没有竞争的产生,此时上述开销就没有必要。考虑到这个因素,futex通过用户空间的共享内存以及原子操作,在共享的资源不存在竞争的时候,不会进行系统调用而是只有当竞争出现的情况下再进行系统调用陷入内核。进程或者线程在没有竞争的情况下可以立刻获取锁。具体来说,futex的优化方式如下:

24 |

25 | futex将同步过程分为两个部分,一部分由内核完成,一部分由用户态完成;如果同步时没有竞争发生,那么完全在用户态处理;否则,进入内核态进行处理。**减少系统调用的次数,来提高系统的性能是一种合理的优化方式。**

26 |

27 | ### **互斥锁的使用场景:**

28 |

29 | 1. 解决线程安全问题,一次只能一个线程访问被保护的资源。

30 | 2. 被保护资源需要睡眠,那么可以使用互斥锁。

31 |

32 | # **自旋锁:**

33 |

34 | ### **自旋锁的作用:**

35 |

36 | 自旋锁也是为实现保护共享资源而提出一种锁机制。自旋锁不会引起调用线程阻塞,如果自旋锁已经被别的线程持有,调用线程就一直循环检测是否该自旋锁已经被释放。

37 |

38 | ### **自旋锁的特点**:

39 |

40 | 1. 线程不会阻塞,不会在内核态和用户态之间进行切换。

41 | 2. 消耗 CPU: 因为自旋锁会不断的去检测是否可以获得锁,会一直处于这样的循环当中,这个逻辑的处理过程消耗的 CPU相对其实际功能来说是浪费的。

42 |

43 | ### **自旋锁的实现:**

44 |

45 | CAS(compare and swap) 是实现自旋锁的基础。CAS 的实现基于硬件平台的指令。

46 |

47 | **CAS**涉及到三个操作数:

48 |

49 | - 需要读写的内存值 value1

50 | - 进行比较的值 value2

51 | - 拟写入的新值 value3

52 |

53 | 当且仅当 value1 的值等于 value2时,CAS通过原子方式用新值value3来更新value1的值,否则不会执行任何操作。可以理解为线程会不停的执行一个while循环进行CAS操作,直到达成条件。

54 |

55 | ### **自旋锁的使用场景:**

56 |

57 | 1. 如果预计线程持有锁的时间比较短,相比使用互斥锁两次上下文切换的开销而言,自旋锁消耗的CPU更少的情况下,那么使用自旋锁比互斥锁更高效。

58 | 2. 如果代码当中经常需要加锁但是实际情况下产生竞争的情况比较少此时可以使用自旋锁进行优化。

59 | 3. 被保护的共享资源需要在中断上下文访问,就必须使用自旋锁。

60 |

61 | # 原子操作

62 |

63 | ### **原子操作的作用:**

64 |

65 | 原子操作是不可被中断的一个或者一系列操作,原子操作可以避免操作被进程/线程的调度打断,原子操作的过程当中不会出现上下文的切换,保证操作的完整性。同时在多处理器的环境下,原子操作也保证了多处理器之间对内存访问的原子性。

66 |

67 | ### **原子操作的实现:**

68 |

69 | 原子操作主要是通过硬件操作的方式实现。**在x86 平台上,CPU提供了在指令执行期间对**总线加锁的手段,通过将总线锁住,保证其他CPU无法在同一时刻操作内存,从而保证操作的原子性。同时由于缓存的存在,原子操作也需要缓存锁来提供复杂内存情况下的实现。

70 |

71 | # 阿里面试真题

72 |

73 | ### **问题1:你知道哪些锁?**

74 |

75 | 答:互斥锁,自旋锁,读写锁,行锁,表锁,乐观锁,悲观锁。

76 |

77 | 互斥锁:实现互斥操作最简单的方案

78 |

79 | 自旋锁:无锁操作,比较耗费CPU

80 |

81 | 读写锁:适合读多写少的场景

82 |

83 | 行锁:数据库当中细粒度的一种锁实现,只锁一行数据,锁粒度相对较低

84 |

85 | 表锁:数据库当中粗粒度的一种锁实现,锁整张表,锁粒度较大

86 |

87 | 乐观锁:当线程去获取数据的时候,乐观地认为别的线程不会修改数据,不对对数据加锁。在更新数据的时候会去通过数据的version(版本号)来判断,如果数据被修改了就拒绝更新。

88 |

89 | 悲观锁:当线程去获取数据的时候,悲观地以为别的线程会去修改数据,所以线程每次获取数据的时候都会加锁。

90 |

91 | 解析:在回答有哪些锁的时候,可以同时对每种锁的特点和作用进行介绍;如果对某些锁的实现有比较深入的了解,可以做更多的介绍,比如以某种语言下某种锁的具体实现方式,特点以及优缺点等等。

92 |

93 |

94 |

95 | ### **问题2:锁的作用是什么?**

96 |

97 | 答:锁的作用是为了控制并发访问的安全性。

98 |

99 | 解析:为了避免由于并发带来的资源访问竞争导致的问题,就需要互斥访问,所以需要引入锁机制。

100 |

101 | ### **问题3:自旋锁和互斥锁的使用场景的区别是什么?**

102 |

103 | 答:互斥锁使用场景:被保护资源需要睡眠,那么只能使用互斥锁或者信号量,不能使用自旋锁。

104 |

105 | 自旋锁使用场景:锁的持有时间非常短或者被保护的共享资源需要在中断上下文访问。

106 |

107 | ### **问题4:如何提升并发访问当中锁的性能?**

108 |

109 | 答:有以下几种方案:

110 |

111 | 1. 减小锁的粒度:比如锁分段技术

112 | 2. 减少锁持有的时间

113 | 3. 可以使用自旋锁或者原子操作优化使用互斥锁的地方

114 | 4. 读多写少的情况下可以使用特定功能的锁比如读写锁优化互斥锁

115 | 5. 读写分离,对读和写的操作采用分离的方式实现

116 |

117 | 解析:一般在问到Java当中HashMap的实现,Golang当中Sync.Map的实现时,就是对并发访问当中提升锁的性能方式的考察。

118 |

119 |

120 |

121 | ### **问题5:分布式场景下一般使用什么样的锁?**

122 |

123 | 答:可以使用分布式锁,比如使用ETCD来做分布式锁。

124 |

125 | 解析:分布式锁一般使用版本号和watch机制去实现。

126 |

127 | ### **问题6:互斥锁的开销有哪些?**

128 |

129 | 答: 线程(进程)在申请锁时,从用户态切换到内核态,申请到锁之后从内核态返回用户态,这个过程会产生两次上下文切换;线程(进程)在使用完资源后释放锁,从用户态切换到内核态,操作系统会唤醒阻塞等待锁的其他进程,线程(进程)返回用户态,这个过程也会产生两次上下文的切换;而进程上下文切换又包含直接消耗和间接消耗:

130 |

131 | 1. 直接消耗包括CPU寄存器保存和加载

132 | 2. 间接消耗包括TLB的刷新等等

133 |

134 | # 总结

135 |

136 | 互斥锁的使用是非常重量级的,在一些可以满足自旋锁使用的场景可以使用自旋锁可以优化性能!理解自旋锁和互斥锁的使用场景,也有助于优化并发访问的性能。

--------------------------------------------------------------------------------

/file/阿里面试真题解析之内存对齐.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 阿里的面试非常的喜欢问体系结构相关的问题。比如我在秋招面阿里云polardb团队终面当中被问到的这个问题:

4 |

5 | > 你知道什么是内存对齐以及为什么要内存对齐么?

6 |

7 | 相信大家都思考或者看到过这个问题,看似离我们平时写代码很远的细节却能考察出我们对计算机体系结构的了解,这也是为什么在阿里的面试当中会出现这个问题的原因。接下来我将会通过几个例子讲解我对内存对齐的理解,然后以阿里面试真题为例对内存对齐相关问题进行解析。

8 |

9 | ####

10 |

11 | # 内存对齐

12 |

13 | 内存对齐:**编译器**将程序中的每个“数据单元”安排在适当的位置上。

14 |

15 | 简单理解:按照**某种规则**将我们定义的结构体成员放在合适的地址偏移位置上存储。

16 |

17 | **举一个例子:**

18 |

19 | ```c++

20 | //32位系统

21 | #include

22 | using namespace std;

23 |

24 | struct{

25 | int x;

26 | char y;

27 | }s;

28 |

29 | int main()

30 | {

31 | cout << sizeof(s) << endl;

32 | return 0;

33 | }

34 | ```

35 |

36 | **问题:上述代码的输出是多少?**

37 |

38 | 答案:8

39 |

40 |

41 |

42 | 为什么要额外的3字节去填充这个结构体?一个原本5字节的结构现在变成8 字节,几乎扩大了 2 倍的存储空间,这样的空间开销是否值得?又是什么样的原因导致这样的设计?

43 |

44 | ####

45 |

46 | # 内存对齐的原因

47 |

48 | ### 1.内存以**字节为单位**:

49 |

50 | 内存是以字节为单位存储,但是处理器并不会按照一个字节为单位去存取内存。处理器存取内存是块为单位,块的大小可以是2,4,8,16字节大小,这样的存取单位称为**内存存取粒度**。如果在64位的机器上,不论CPU是要读取第0个字节还是要读取第1个字节,在硬件上传输的信号都是一样的。因为它都会把地址0到地址7,这8个字节全部读到CPU,只是当我们是需要读取第0个字节时,丢掉后面7个字节,当我们是需要读取第1个字节,丢掉第1个和后面6个字节。所以对于计算机硬件来说,内存只能通过特定的对齐地址进行访问。

51 |

52 | ### 2.**内存存取效率:**

53 |

54 | 从内存存取效率方面考虑,内存对齐的情况下可以提升CPU存取内存的效率。比如有一个整型变量(4 字节),现在有一块内存单元: 地址从 0~7。这个整型变量从 地址为 1 的位置开始占据了 1,2,3,4 这 4 个字节。 现在处理器需要读取这个整型变量。假设处理器是 4 字节 4 字节的读取,所以从 0 开始读读取 0,1,2,3发现并没有读完整这个变量,那么需要再读一次,读取 4,5,6,7。然后对两次读取的结果进行处理,提取出 1,2,3,4 地址的内容。需要**两次**访问内存,同时通过一些**逻辑计算**才能得到最终的结果。如果进行内存对齐,将这个整型变量放在从0开始的地址存放,那么CPU只需要一次内存读取,并且没有额外的逻辑计算。可见内存对齐之后存取的效率提升了1倍。

55 |

56 | ####

57 |

58 | # 面试真题

59 |

60 | ### **1.C++当中一个空的结构体或者类的对象的大小是多少?**

61 |

62 | 答案: 空的类或者结构体的大小是1个字节,因为C++当中每个实例在内存中都有一个独一无二的地址,为了达到这个目的,编译器往往会给一个空类隐含的加一个字节,这样空类在实例化后在内存得到了独一无二的地址。

63 |

64 | ### 2.结构体成员的声明顺序会影响结构体的大小么?比如下面两个结构体A,B他们大小是多少?

65 |

66 | ```cpp

67 | struct A // sizeof (A) == 12

68 | {

69 | char b;

70 | int a;

71 | char c;

72 | };

73 | struct B // sizeof (B) == 8

74 | {

75 | char b;

76 | char c;

77 | int a;

78 | };

79 | ```

80 |

81 | 答案:成员声明顺序会影响结构体大小。

82 |

83 | ### 3.内存对齐的作用是什么?

84 |

85 | 答案:提升性能:减少CPU读取内存的次数,提升程序执行的**效率**

86 |

87 |

88 |

89 | 上图是CPU和几种存储之间的存取速度在这30多年的发展对比(图片来自CMU的深入理解计算机系统课程)。内存就是上述的DRAM存储,CPU的速度和内存 的速度之间差距接近1000倍,3个数量级的差距。可见如果能够减少对内存的读取次数可以极大的提升程序的执 行效率。**移植原因:**有的硬件体系不支持非对齐内存地址的电路系统.当遇到非对齐内存地址的存取时,它将抛出一个异常,可能导致程序崩溃。

90 |

91 | ### 4.内存对齐的原则是什么?

92 |

93 | 答:三原则:

94 |

95 | 1. 结构体变量的**起始地址**能够被其最宽的成员大小整除;

96 | 2. 结构体每个成员相对于**起始地址的偏移**能够被其**自身大小整除**,如果不能则在**前一个成员后面**补充空白字节;

97 | 3. 结构体总体大小能够**被最宽的成员的大小**整除,如不能则在**后面**补充空白字节;

98 |

99 | 分析:编译器在编译的时候是可以指定对齐大小的,实际使用的有效对齐其实是取指定大小和自身大小的最小值,一般默认的对齐大小是4。可以通过预编译命令#pragma pack(n)。除了上述3原则之外还有其他的对齐规则:计算机体系结构当中缓存是很重要的一环,CPU不是直接读取内存而是读取缓存:高速缓冲存储器。其作用是为了更好的利用局部性原理,减少CPU访问主存的次数。因为存取内存相对存取缓存是慢很多的,cache也可以看做是一种空间换时间的做法。实际读取内存的是缓存。所以内存对齐有的时候还需要考虑缓存更新的读取策略,一些规则如下:

100 |

101 | 1.对较大结构体进行cache line对齐:Cache与内存交换的最小单位为cache line。一个cache line大小以64字节为例。当我们的结构体大小没有与64字节对齐时,一个结构体可能就要占用比原本需要更多的cache line,同时还会带来**错误共享**问题,大家可以自行google。

102 |

103 | 2.对只读字段和读写字段分离对齐: 只读字段和读写字段分离对齐的目的是为了让只读字段和读写字段分别存储在缓存的不同cache line中,使得读写字段的淘汰尽量少的影响只读字段,因为只读字段不会被改变所以应该尽量少的被缓存换出。

104 |

105 | ### 5.什么是指令乱序?

106 |

107 | 答:从编译器的角度其实是对我们写的代码的一种优化,按照机器的角度讲一些指令代码执行顺序进行改变,优化程序实际执行的效率。

108 |

109 | 分析:之所以出现编译器乱序优化是因为**编译器能在很大范围内进行代码分析,**从而做出更优的执行策略,可以充分利用处理器的乱序执行功能。

110 |

111 | 指令乱序的问题:编译器优化产生的指令乱序可能会导致多线程程序产生意外的结果。

112 |

113 | 6.如何解决指令乱序问题?

114 |

115 | 答:**内存屏障。**

116 |

117 | 分析:内存屏障,是一类同步指令,是对内存随机访问的操作中的一个同步点。此点之前的所有读写操作都执行后才可以开始执行此点之后的操作。因为指令乱序执行的存在,就需要内存屏障保证程序执行的可靠。

118 |

119 | # 总结

120 |

121 | **通过填充字段padding使得结构体大小与机器字倍数对齐是一种常见的做法。**显然内存对齐是会浪费一些空间的。但是这种空间上得浪费却可以减少存取的时间。这是典型的一种以空间换时间的做法。在内存越来越便宜的今天,这一点点的空间上的浪费就不算什么了。**因为访问内存的速度对于处理来说是非常非常的慢, 内存访问速率对于现在 CPU 来说越来越跟不上, 额外的内存访问无疑是浪费 CPU的。**本节简要介绍了内存对齐的概念并结合我在面试阿里云过程当中遇到的问题进行解答。

--------------------------------------------------------------------------------

/time_heap.cpp:

--------------------------------------------------------------------------------

1 | //

2 | // Created by jxq on 20-4-7.

3 | //

4 |

5 | #include "time_heap.h"

6 |

7 | time_heap::time_heap(int cap):capacity(cap),cur_size(0)

8 | {

9 | //创建数组

10 | array = new heap_timer*[capacity];

11 | if(!array)

12 | {

13 | fprintf(stderr,"init heap faild");

14 | return ;

15 | }

16 | for(int i=0;i=0;--i)

47 | {

48 | percolate_down(i);

49 | }

50 | }

51 | }

52 |

53 |

54 | time_heap::~time_heap()

55 | {

56 | for(int i=0;i= capacity)

70 | {

71 | resize();

72 | }

73 |

74 | ////新插入一个元素,当前堆大小加1, hole是新建空穴的位置

75 | int hole = cur_size++;

76 | int parent = 0;

77 | //对从空穴到根节点的路径上的所有节点执行上虑操作

78 | for(;hole>0;hole=parent)

79 | {

80 | parent = (hole-1)/2;

81 |

82 | if(array[parent]->expire <= timer->expire)

83 | {

84 | break;

85 | }

86 | array[hole] = array[parent];

87 | }

88 | array[hole] = timer;

89 | return 0;

90 | }

91 |

92 | void time_heap::del_timer(heap_timer* timer)

93 | {

94 | if(!timer)

95 | return ;

96 | timer->cb_func = NULL;

97 | }

98 |

99 | heap_timer* time_heap::top()const

100 | {

101 | if(empty())

102 | {

103 | return NULL;

104 | }

105 | return array[0];

106 | }

107 |

108 | void time_heap::pop_timer()

109 | {

110 | if(empty())

111 | {

112 | return ;

113 | }

114 | if(array[0])

115 | {

116 | delete array[0];

117 | //将原来的堆顶元素替换为堆数组中最后一个元素

118 | array[0] = array[--cur_size];

119 |

120 | //对新的堆顶元素执行以下操作

121 | percolate_down(0);

122 | }

123 |

124 | }

125 |

126 |

127 | void time_heap::tick()

128 | {

129 | heap_timer *tmp = array[0];

130 | time_t cur = time(NULL);

131 | //循环处理定时器

132 | while(!empty())

133 | {

134 | if(!tmp)

135 | {

136 | break;

137 | }

138 | //如果堆顶定时没有到期,则退出循环

139 | if(tmp->expire > cur)

140 | {

141 | break;

142 | }

143 | //否则执行堆顶定时器中的回调函数

144 | if(array[0]->cb_func)

145 | {

146 | array[0]->cb_func(array[0]->user_data);

147 | }

148 | //删除堆顶元素,同时生成新的堆顶定时器

149 | pop_timer();

150 | tmp = array[0];

151 | }

152 | }

153 |

154 |

155 | void time_heap::percolate_down(int hole)

156 | {

157 | heap_timer *tmp = array[hole];

158 | int child = 0;

159 | for(;((hole*2)+1) <= (cur_size-1);hole = child)

160 | {

161 | child = hole*2+1; // 左子树

162 | if(child < (cur_size-1) && array[child+1]->expire < array[child]->expire)

163 | {

164 | ++child;

165 | }

166 |

167 | if(array[child]->expire < tmp->expire)

168 | {

169 | array[hole] = array[child];

170 | }

171 | else

172 | {

173 | /* code */

174 | break;

175 | }

176 |

177 | }

178 | array[hole] = tmp;

179 | }

180 |

181 |

182 | void time_heap::resize()

183 | {

184 | heap_timer **tmp = new heap_timer*[2* capacity];

185 | for(int i=0;i<(2*capacity);i++)

186 | {

187 | tmp[i] = NULL;

188 | }

189 |

190 | if(!tmp)

191 | {

192 | fprintf(stderr,"resize() faild");

193 | return ;

194 | }

195 |

196 | capacity = 2*capacity;

197 | for(int i=0;i

33 |

34 | int select(int nfds,fd_set *readset,fd_set *writeset,fd_set *exceptset, struct timeval *timeout);

35 | ```

36 |

37 | nfds参数指定被监听的文件描述符的总数;readset,writeset,exceptset参数分别是可读,可写和异常事件对应的文件描述符集合;而fd_set结构体由一个整形数组组成,该数组每一位标记了一个文件描述符,该数组的上限有宏FD_SETSIZE指定;timeout是select的超时时间。

38 |

39 | **select机制的缺点**

40 |

41 | 1. 每次调用select,都需要把监听的文件描述符集合fd_set从用户态拷贝到内核态,从算法角度来说就是O(n)的时间开销。

42 | 2. 每次调用select调用返回之后都需要遍历所有文件描述符,判断哪些文件描述符有读写事件发生,这也是O(n)的时间开销。

43 | 3. 内核对被监控的文件描述符集合大小做了限制,并且这个是通过宏控制的,大小不可改变(限制为1024)。

44 |

45 | # poll

46 |

47 | 1997年出现了poll系统调用,和select类似,poll也是在指定时间内监听多个文件描述符。

48 |

49 | 函数原型:

50 |

51 | ```c

52 | #include

53 | int poll(struct pollfd *fds, nfds_t nfds, int timeout);

54 | ```

55 |

56 | 优化:poll改变了文件描述符集合的描述方式,通过一个pollfd数组向内核传递需要关注的事件,没有描述符个数的限制.

57 |

58 | ```c

59 | typedef struct pollfd {

60 | int fd;

61 | short events;

62 | short revents;

63 | } pollfd_t;

64 | ```

65 |

66 | ####

67 |

68 | # epoll

69 |

70 | Linux2.6内核实现了epoll,函数原型如下:

71 |

72 | ```c

73 | #include

74 |

75 | int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

76 | ```

77 |

78 | epoll是Linux特有的I/O复用函数。对于select的几个问题,epoll的优化策略如下:

79 |

80 | 1.epoll使用一个文件描述符管理多个描述符,将用户关心的文件描述符的事件存放到内核的一个事件表中,这样在用户空间和内核空间只需一次拷贝,不用每次调用都重复传入文件描述符集合。

81 |

82 | 2.在epoll_wait函数返回时,无须遍历整个被侦听的描述符集,只要遍历那些被内核IO事件异步唤醒而加入就绪队列的描述符集合就行,这样就避免了无效的遍历。

83 |

84 | 简单来说,在用户进程通过epoll_ctl系统调用向内核注册需要监听的事件,使用epoll_wait开启I/O多路复用,epoll为每个文件描述符指定一个回调函数,当设备就绪,就会调用这个回调函数,而这个回调函数会把就绪的文件描述符加入一个就绪链表,唤醒等待在这个epoll_wait上的进程,用户进程只需要遍历这个就绪链表就可以进行下一步处理。同时内核通过红黑树的结构存储这些文件描述符,提升查找的效率。

85 |

86 | ####

87 |

88 | # 腾讯面试真题

89 |

90 | ### 1.说一下epoll的好处

91 |

92 | 答:epoll解决了select和poll在文件描述符集合拷贝和遍历上的问题,能够在一个进程当中监听多个文件描述符,并且十分高效。

93 |

94 | ### 2.epoll和select之间的区别?

95 |

96 | 答:1.epoll不需要每次调用的时候都在用户态和内核态拷贝文件描述符集合,而select需要。

97 |

98 | 2.epoll在内核态通过红黑树和回调的方式处理文件描述符,返回时只需要遍历就绪链表即可,而select通过数 组的方式处理,每次需要遍历整个数组判断哪些文件描述符就绪。

99 |

100 | 3.epoll使用maxevents参数指定最多监听的文件描述符的个数,最多可以到达系统允许打开的最大文件描述 符个数,而select允许监听的最大文件描述符熟练有限制。

101 |

102 | 4.epoll可以工作在高效的ET模式,而select只能工作在相对低效的LT模式。

103 |

104 | 5.epoll使用的是回调的方式将就绪文件描述符插入就绪链表,返回时用户只需要O(1)的时间开销寻找就绪事 件,而select采用轮询的方式,需要O(n)的时间开销。

105 |

106 | ### 3.epoll需要在用户态和内核态拷贝数据么?

107 |

108 | 答:在注册监听事件时从用户态将数据传入内核态;当返回时需要将就绪队列的内容拷贝到用户空间。

109 |

110 | ### 4.epoll的实现知道么?在内核当中是什么样的数据结构进行存储,每个操作的时间复杂度是多少?

111 |

112 | 答:在内核当中是以红黑树的方式组织监听的事件,查询开销是O(logn)。采用回调的方式检测就绪事件,时间复杂的位O(1);

113 |

114 | ### 5.epoll的水平触发和边沿触发有什么区别?

115 |

116 | 答:**水平触发(Level Trigger):是eopll的**默认工作模式,当epoll_wait检测到某文件描述符上有事件发生,并通知应用程序之后,应用程序可以不立即处理该事件,当下次调用epoll_wait时,epoll_wait还会再次向应用程序通知此事件,直到该事件被应用程序处理。

117 |

118 | 边缘触发(Edge Trigger): 当epoll_wait检测到某文件描述符上有事件发生,并通知应用程序之后,应用程序必须立即处理该事件。如果应用程序不处理,下次调用epoll_wait时,epoll_wait不会再次通知此事件。

119 |

120 | ET模式很大程度上减少了epoll事件被重复触发的次数,因此效率比LT模式下高。

121 |

122 | ### 6.什么是EPOLLONESHOT事件?

123 |

124 | 答:注册了EPOLLONESHOT事件的文件描述符,操作系统只能触发该文件描述符上注册的最多一个就绪事件,并且只触发一次。该处理方式保证了当一个线程正在处理该文件描述符上的就绪事件时,其他线程无法操作该文件描述符。

125 |

126 | # 总结

127 |

128 | epoll的出现是由于历史的原因,在十几年前前并发量不大的情况下select和poll已经可以解决那时的问题,而随着并发量越来越大,select和poll就暴露出设计的问题,从而一步一步优化,这也是符合程序设计的思路,先解决当前问题,再考虑优化。三者对比总结如下:

129 |

130 | | 系统调用 | select | poll | epoll |

131 | | ---------------------------------- | ---------------------------------- | ---------------------------------- | ------------------------------------------ |

132 | | 查找就绪文件描述符的操作时间复杂的 | O(n) | O(n) | O(1) |

133 | | 最大支持的文件描述符数量 | 有最大限制一般为1024 | 最多可达系统文件描述符上限 | 最多可达系统文件描述符上限 |

134 | | 工作模式 | LT | LT | LT,ET |

135 | | 效率对比 | 调用时需要O(n)的文件描述符集合拷贝 | 调用时需要O(n)的文件描述符集合拷贝 | 只在添加描述符时拷贝,调用无需额外拷贝开销 |

136 |

137 | 本节主要介绍了epoll和select,poll的区别,并结合腾讯的面试真题对epoll相关问题进行解答。

--------------------------------------------------------------------------------

/file/20200302.md:

--------------------------------------------------------------------------------

1 | ## [vivo面试(软件工程师(后端方向))](https://www.nowcoder.com/discuss/197881)

2 |

3 | ### 1. 线程池

4 |

5 | ## 基础概念

6 |

7 | **线程池:** 当进行并行的任务作业操作时,线程的建立与销毁的开销是,阻碍性能进步的关键,因此线程池,由此产生。使用多个线程,无限制循环等待队列,进行计算和操作。帮助快速降低和减少性能损耗。

8 |

9 | ## 线程池的组成

10 |

11 | 1. 线程池管理器:初始化和创建线程,启动和停止线程,调配任务;管理线程池

12 | 2. 工作线程:线程池中等待并执行分配的任务

13 | 3. 任务接口:添加任务的接口,以提供工作线程调度任务的执行。

14 | 4. 任务队列:用于存放没有处理的任务,提供一种缓冲机制,同时具有调度功能,高优先级的任务放在队列前面

15 |

16 | 参考:[C++线程池](https://wangpengcheng.github.io/2019/05/17/cplusplus_theadpool/)

17 |

18 | ### 2. hashmap

19 |

20 |

21 |

22 |

23 |

24 |

25 |

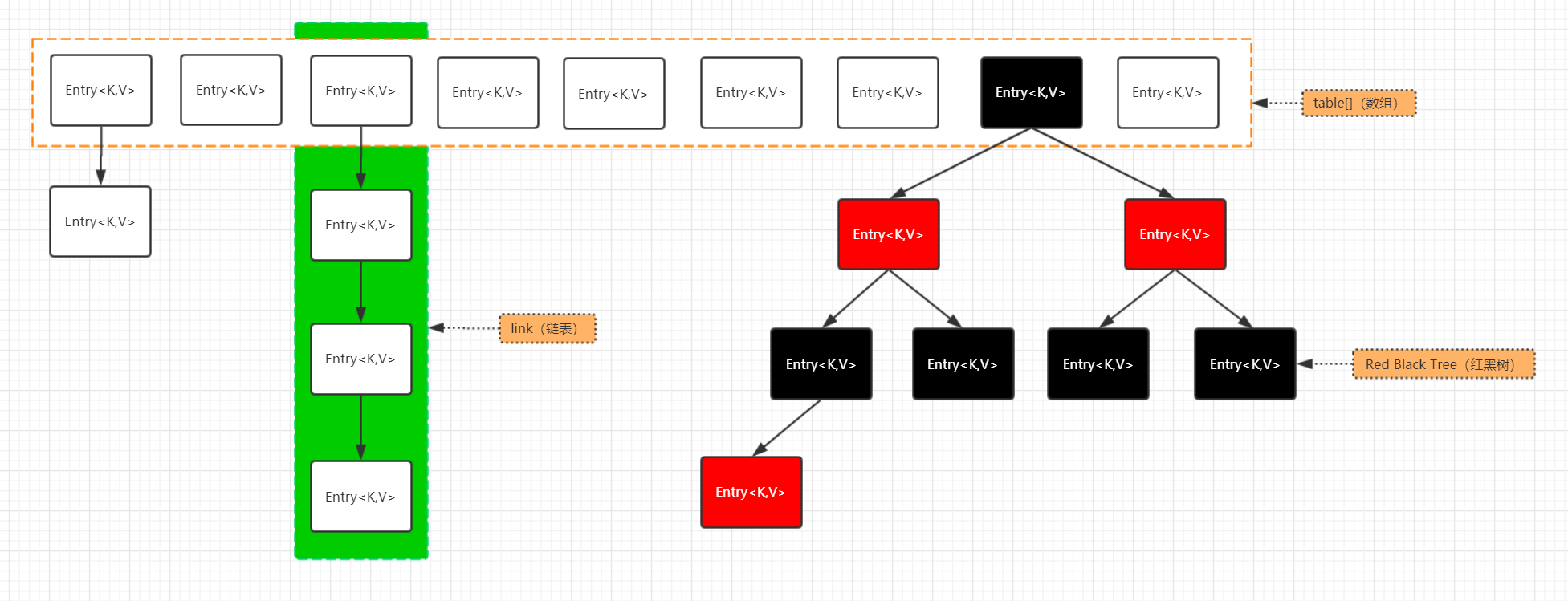

26 | **HashMap由数组加链表组成的,数组是HashMap的哈希桶,链表则是为解决哈希碰撞而存在的,如果定位到的数组位置不含链表(即哈希桶中只有一个Entry),那么对于查找,添加等操作很快,仅需一次寻址即可(数组根据下标寻址,速度很快);如果定位到的数组包含链表,对于添加操作,其时间复杂度为O(n),首先遍历链表,存在即覆盖,否则新增;对于查找操作来讲,也需遍历链表,然后通过key对象的equals方法逐一比较查找。所以,性能考虑,HashMap中的链表出现越少,性能就会越好。(其实也就是key的哈希值越离散,Entry就会尽可能的均匀分布,出现链表的概率也就越低)**

27 |

28 | 参考:[HashMap的底层实现]([https://lushunjian.github.io/blog/2019/01/02/HashMap%E7%9A%84%E5%BA%95%E5%B1%82%E5%AE%9E%E7%8E%B0/](https://lushunjian.github.io/blog/2019/01/02/HashMap的底层实现/))

29 |

30 | ### [3. 三次握手+四次挥手]([https://interview.huihut.com/#/?id=tcp-%e4%b8%89%e6%ac%a1%e6%8f%a1%e6%89%8b%e5%bb%ba%e7%ab%8b%e8%bf%9e%e6%8e%a5](https://interview.huihut.com/#/?id=tcp-三次握手建立连接))

31 |

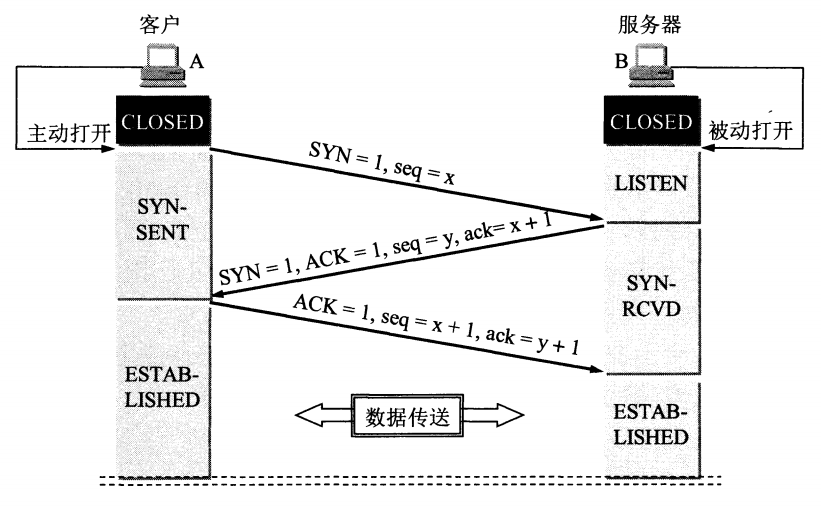

32 | ##### [TCP 三次握手建立连接](https://interview.huihut.com/#/?id=tcp-三次握手建立连接)

33 |

34 |

35 |

36 | 【TCP 建立连接全过程解释】

37 |

38 | 1. 客户端发送 SYN 给服务器,说明客户端请求建立连接;

39 | 2. 服务端收到客户端发的 SYN,并回复 SYN+ACK 给客户端(同意建立连接);

40 | 3. 客户端收到服务端的 SYN+ACK 后,回复 ACK 给服务端(表示客户端收到了服务端发的同意报文);

41 | 4. 服务端收到客户端的 ACK,连接已建立,可以数据传输。

42 |

43 | ##### [TCP 为什么要进行三次握手?](https://interview.huihut.com/#/?id=tcp-为什么要进行三次握手?)

44 |

45 | 【答案一】因为信道不可靠,而 TCP 想在不可靠信道上建立可靠地传输,那么三次通信是理论上的最小值。(而 UDP 则不需建立可靠传输,因此 UDP 不需要三次握手。)

46 |

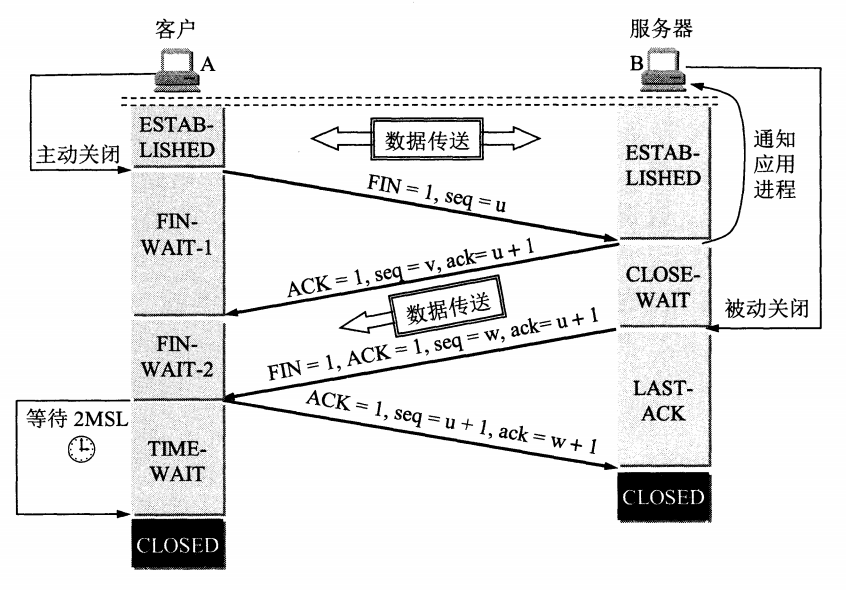

47 | ##### [TCP 四次挥手释放连接](https://interview.huihut.com/#/?id=tcp-四次挥手释放连接)

48 |

49 |

50 |

51 | 【TCP 释放连接全过程解释】

52 |

53 | 1. 客户端发送 FIN 给服务器,说明客户端不必发送数据给服务器了(请求释放从客户端到服务器的连接);

54 | 2. 服务器接收到客户端发的 FIN,并回复 ACK 给客户端(同意释放从客户端到服务器的连接);

55 | 3. 客户端收到服务端回复的 ACK,此时从客户端到服务器的连接已释放(但服务端到客户端的连接还未释放,并且客户端还可以接收数据);

56 | 4. 服务端继续发送之前没发完的数据给客户端;

57 | 5. 服务端发送 FIN+ACK 给客户端,说明服务端发送完了数据(请求释放从服务端到客户端的连接,就算没收到客户端的回复,过段时间也会自动释放);

58 | 6. 客户端收到服务端的 FIN+ACK,并回复 ACK 给客户端(同意释放从服务端到客户端的连接);

59 | 7. 服务端收到客户端的 ACK 后,释放从服务端到客户端的连接。

60 |

61 | ##### [TCP 为什么要进行四次挥手?](https://interview.huihut.com/#/?id=tcp-为什么要进行四次挥手?)

62 |

63 | 【问题一】TCP 为什么要进行四次挥手? / 为什么 TCP 建立连接需要三次,而释放连接则需要四次?

64 |

65 | 【答案一】因为 TCP 是全双工模式,客户端请求关闭连接后,客户端向服务端的连接关闭(一二次挥手),服务端继续传输之前没传完的数据给客户端(数据传输),服务端向客户端的连接关闭(三四次挥手)。所以 TCP 释放连接时服务器的 ACK 和 FIN 是分开发送的(中间隔着数据传输),而 TCP 建立连接时服务器的 ACK 和 SYN 是一起发送的(第二次握手),所以 TCP 建立连接需要三次,而释放连接则需要四次。

66 |

67 | 【问题二】为什么 TCP 连接时可以 ACK 和 SYN 一起发送,而释放时则 ACK 和 FIN 分开发送呢?(ACK 和 FIN 分开是指第二次和第三次挥手)

68 |

69 | 【答案二】因为客户端请求释放时,服务器可能还有数据需要传输给客户端,因此服务端要先响应客户端 FIN 请求(服务端发送 ACK),然后数据传输,传输完成后,服务端再提出 FIN 请求(服务端发送 FIN);而连接时则没有中间的数据传输,因此连接时可以 ACK 和 SYN 一起发送。

70 |

71 | 【问题三】为什么客户端释放最后需要 TIME-WAIT 等待 2MSL 呢?

72 |

73 | 【答案三】

74 |

75 | 1. 为了保证客户端发送的最后一个 ACK 报文能够到达服务端。若未成功到达,则服务端超时重传 FIN+ACK 报文段,客户端再重传 ACK,并重新计时。

76 | 2. 防止已失效的连接请求报文段出现在本连接中。TIME-WAIT 持续 2MSL 可使本连接持续的时间内所产生的所有报文段都从网络中消失,这样可使下次连接中不会出现旧的连接报文段。

77 |

78 |

79 |

80 | ### 4.有两个场景,一个是计算密集型服务,一个是I/O密集型服务,分别设计两个线程池,哪个要设计线程池更大些?线程池设计多大合适?

81 |

82 | * 对于cpu密集型的任务来说,线程数等于cpu数是最好的了,

83 | * 对于I/O密集型的任务来说,线程数等于IO任务数是最佳的. **多**

84 | * **在处理I/O密集型任务的时候,线程数大于当前核数的情况下确实会更快的处理完任务;**

85 | * **在处理CPU密集型任务的时候,线程数保持和当前核数一致的情况下也确实会更快的处理完任务。**

86 |

87 | ### 5. mysql的内联接和外联接的区别?

88 |

89 | - 内连接(inner join): 只连接匹配的行

90 |

91 | - 左外连接(left join): 包含左边表的全部行(不管右边的表中是否存在与它们匹配的行),以及右边表中全部匹配的行

92 |

93 | - 右外连接(right join): 包含右边表的全部行(不管左边的表中是否存在与它们匹配的行),以及左边表中全部匹配的行

94 |

95 | ```sql

96 | 例子:

97 | a表 id name b表 id job parent_id

98 | 1 张3 1 23 1

99 | 2 李四 2 34 2

100 | 3 王武 3 34 4

101 |

102 | a.id同parent_id 存在关系

103 |

104 | 内连接

105 | select a.*,b.* from a inner join b on a.id=b.parent_id

106 |

107 | 结果是

108 | 1 张3 1 23 1

109 | 2 李四 2 34 2

110 |

111 | 左连接

112 | select a.*,b.* from a left join b on a.id=b.parent_id

113 |

114 | 结果是

115 | 1 张3 1 23 1

116 | 2 李四 2 34 2

117 | 3 王武 null

118 |

119 | 右连接

120 | select a.*,b.* from a right join b on a.id=b.parent_id

121 |

122 | 结果是

123 | 1 张3 1 23 1

124 | 2 李四 2 34 2

125 | null 3 34 4

126 |

127 | 完全连接

128 | select a.*,b.* from a full join b on a.id=b.parent_id

129 |

130 | 结果是

131 | 1 张3 1 23 1

132 | 2 李四 2 34 2

133 | null 3 34 4

134 | 3 王武 null

135 | ```

136 |

137 |

138 |

139 | 参考:[SQL 左外连接,右外连接,全连接,内连接](https://www.cnblogs.com/youzhangjin/archive/2009/05/22/1486982.html)

140 |

141 | ### 6. linux查看占用某个端口的进程号的命令

142 |

143 | linux 下查看进程占用端口:

144 | (1)查看程序对应的进程号: **ps -ef | grep 进程名字**

145 |

146 | (2)查看进程号所占用的端口号:**netstat -nltp | grep 进程号**

147 |

148 | ubuntu :查看进程占用端口号:netstat -anp | grep pid

149 |

150 | **linux 下查看端口号所使用的进程号:**

151 | (1)使用 lsof 命令:**lsof -i:端口号**

152 |

153 | ### 7. linux中tar -zxvf中zxvf各代表什么含义?

154 |

155 | * -z: 支持gzip解压文件

156 | * -x: 从压缩文件中提取文件

157 | * -v: 显示操作过程

158 | * -f: 指定压缩文件

--------------------------------------------------------------------------------

/file/阿里面试真题解析之C++相关问题.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | 阿里虽然是国内Java的第一大厂但是并非所有的业务都是由Java支撑,很多服务和中下层的存储,计算,网络服务,大规模的分布式任务都是由C++编写。在阿里所有部门当中对C++考察最深的可能就是阿里云。在此我将以我今年实习和秋招面试阿里云的真题进行分析,通过真题对面试当中遇到的C++问题进行解答。

4 |

5 |

6 |

7 | # C++面试重点

8 |

9 | 我本人是以C++作为主编程语言。C++是后台开发以及基础架构方向使用较多的语言之一。在我所有的面试当中,对于C++语言的考察主要集中在以下几点:

10 | 1.STL 容器相关实现

11 | 2.C++新特性的了解

12 | 3.多态和虚函数的实现

13 | 4.指针的使用

14 |

15 | # 阿里面试真题再现

16 |

17 | ### **问题1:**现在假设有一个编译好的C++程序,编译没有错误,但是运行时报错,报错如下:你正在调用一个纯虚函数(Pure virtual function call error),请问导致这个错误的原因可能是什么?

18 |

19 | 答:纯虚函数调用错误一般由以下几种原因导致:

20 |

21 | 1. 从基类构造函数直接调用虚函数。

22 | 2. 从基类析构函数直接调用虚函数。

23 | 3. 从基类构造函数间接调用虚函数。

24 | 4. 从基类析构函数间接调用虚函数。

25 | 5. 通过悬空指针调用虚函数。

26 |

27 | 其中1,2编译器会检测到此类错误。3,4,5编译器无法检测出此类情况,会在运行时报错。

28 |

29 | 直接调用指的是函数内部直接调用虚函数,间接调用指的是函数内部调用其他的非虚函数内部直接或间接调用了虚函数。

30 |

31 |

32 |

33 | **解析:**

34 |

35 | **首先对关键知识点进行回顾:虚函数表,对象构造和析构过程**

36 |

37 | **虚函数表vtbl:**

38 |

39 | 1. 编译器在**编译时期**为每个带虚函数的类创建一份虚函数表

40 | 2. 实例化对象时, 编译器自动将类对象的虚表指针指向这个虚函数表

41 |

42 | **构造一个派生类对象的过程:**

43 |

44 | 1.构造基类部分:

45 |

46 | 1. 将实例的虚表指针指向基类的vtbl

47 | 2. 构造基类的成员变量

48 | 3. 执行基类的构造函数函数体

49 |

50 | 2.递归构造派生类部分:

51 |

52 | 1. 将实例的虚表指针指向派生类vtbl

53 | 2. 构造派生类的成员变量

54 | 3. 执行派生类的构造函数体

55 |

56 | **析构一个派生类对象的过程:**

57 |

58 | 1.递归析构派生类部分:

59 |

60 | 1. 将实例的虚表指针指向派生类vtbl

61 | 2. 执行派生类的析构函数体

62 | 3. 析构派生类的成员变量

63 |

64 | 2.析构基类部分:

65 |

66 | 1. 将实例的虚表指针指向基类的vtbl

67 | 2. 执行基类的析构函数函数体

68 | 3. 析构基类的成员变量

69 |

70 | 由以上可知在构造函数和析构函数执行函数体过程时,实例的虚表指针指向的是构造函数和析构函数本身所属的那部分的类的虚函数表,此时执行的虚函数都实际调用的是该类本身的虚函数,所以如果在基类的析构或者构造函数当中调用虚函数且该虚函数本身在基类当中是纯虚函数那么就会出现纯虚函数调用。

71 |

72 | 可以运行如下代码进行验证:

73 |

74 | ```c++

75 | #include

76 | using namespace std;

77 |

78 | class Parent {

79 | public:

80 | virtual void virtualFunc() = 0;

81 | void helper() {

82 | virtualFunc();

83 | }

84 | virtual ~Parent(){

85 | helper();

86 | }

87 | };

88 |

89 | class Child : public Parent{

90 | public:

91 | void virtualFunc() {

92 | cout << "Child" << endl;

93 | }

94 | virtual ~Child(){}

95 | };

96 |

97 |

98 | int main() {

99 |

100 | Child child;

101 | return 0;

102 | }

103 | ```

104 |

105 | 运行时报错:libc++abi.dylib: Pure virtual function called!

106 |

107 | **通过悬空指针调用虚函数:**

108 |

109 | 悬空指针:指针最初指向的内存已经被释放了的一种指针, 访问"不安全可控"的内存区域将导致未定义的行为。

110 |

111 | 如下代码显示了悬空指针调用虚函数的典型案例:

112 |

113 | ```c++

114 | #include

115 | using namespace std;

116 |

117 | class Parent {

118 | public:

119 | virtual void virtualFunc() = 0;

120 | void testFunc(){};

121 | virtual ~Parent(){

122 | testFunc();

123 | };

124 | };

125 |

126 | class Child : public Parent{

127 | public:

128 | virtual void virtualFunc() {

129 | cout << "Child-VirtualFunc-call" << endl;

130 | }

131 | virtual ~Child(){};

132 | };

133 |

134 |

135 | int main() {

136 |

137 | Parent* child = new Child();

138 | Parent* p = child;

139 | //p此时可以成功的调用Child的virtualFunc输出"Child-VirtualFunc-call"

140 | p->virtualFunc();

141 | delete child;

142 | //在delete child之后p就是一个悬空指针

143 | p->virtualFunc();

144 |

145 | return 0;

146 | }

147 | ```

148 |

149 | 上述代码当中,p指向一个前对象,该对象已经被delete。根据C++标准,它是“未定义的”:意味着任何事情都可能发生:程序可能崩溃,或者继续运行,行为可能因编译器而异,或因计算机而异,或运行时不同。有几种常见的可能性:

150 |

151 | - 内存可能被标记为已释放。任何访问它的尝试都将立即标记为使用了悬空指针。

152 | - 内存可能被故意加密。释放后,内存管理系统可能会将类似垃圾的值写入内存。

153 | - 内存可能会被重用。如果在删除对象和使用悬空指针之间执行了其他代码,则内存分配系统可能已经从旧对象使用的部分或全部内存中创建了一个新对象。如果幸运的话,这看起来就像垃圾,程序立即崩溃。否则,该程序可能会在某个时间之后崩溃。

154 | - 内存可能完全保留,没有变化。

155 |

156 | 最后一种情况就是此时对象的虚表指针指向的是基类的虚函数表,此时调用的是纯虚函数。

157 |

158 |

159 |

160 | ### **问题2:**是先构造父类的虚表指针还是先构造父类的成员?

161 |

162 | 答:由问题1解析可知先构造虚表指针再构造成员变量。

163 |

164 | 对于本类来说:先设定本类虚表指针->执行初始化列表->调用成员变量构造函数->执行本身构造函数体

165 |

166 | ### **问题3**:在构造实例过程当中一部分是初始化列表一部分是在函数体内,你能说一下这些的顺序是什么?差别是什么和this指针构造的顺序

167 |

168 | 答:初始化列表当中的先初始化,然后才是函数体内代码被执行。构造函数本身也只是一个函数,执行构造函数时所有成员其实都已经初始化完成。this指针属于对象,初始化列表在构造函数之前执行,在对象还没有构造完成前,使用this指针,编译器无法识别。所以this指针在初始化列表当中不应当使用,在构造函数体内部可以使用。

169 |

170 | 解析:构造函数的执行可以分成两个阶段:

171 |

172 | - 初始化阶段:所有类类型的成员都会在初始化阶段初始化,即使该成员没有出现在构造函数的初始化列表中。

173 | - 计算赋值阶段:一般用于执行构造函数体内的赋值操作。

174 |

175 | 可以使用如下代码进行验证:

176 |

177 | ```c++

178 | #include

179 | using namespace std;

180 |

181 | class Test1 {

182 | public:

183 | Test1(){

184 | cout << "Construct Test1" << endl;

185 | }

186 | Test1& operator = (const Test1& t1) {

187 | cout << "Assignment for Test1" << endl;

188 | this->a = t1.a;

189 | return *this;

190 | }

191 | int a ;

192 | };

193 |

194 | class Test2 {

195 | public:

196 | Test1 test1;

197 | Test2(Test1 &t1) {

198 | cout << "构造函数体开始" << endl;

199 | test1 = t1 ;

200 | cout << "构造函数体结束" << endl;

201 | }

202 | };

203 |

204 | int main() {

205 | Test1 t1;

206 | Test2 test(t1);

207 | return 0;

208 | }

209 | ```

210 |

211 | 输出:

212 |

213 | ```

214 | Construct Test1

215 | Construct Test1

216 | 构造函数体开始

217 | assignment for Test1

218 | 构造函数体结束

219 | ```

220 |

221 | 可以看出Test2在构造函数体执行之前已经使用了Test1的默认构造函数初始化好了t1。

222 |

223 | ### **问题4**:初始化列表的写法和顺序有没有什么关系?

224 |

225 | 答:成员初始化的顺序和它们在类定义中出现的顺序一致,构造函数初始值列表中的前后位置不会影响实际的初始化顺序。当数据成员是 const 、引用,或者属于某种未提供默认构造函数的类类型的话,就必须通过构造函数的初始值列表为这些成员提供初始值,否则就会引发错误。

226 |

227 | ### **问题5**:如果父类有一个虚函数叫func_A,子类也实现这个函数,在子类的构造函数当中去调用这个func_A,运行的是谁的实现?

228 |

229 | 答:运行的是子类的实现。因为子类构造函数调用的时候对象的虚表指针指向的是子类的虚函数表,因为子类实现了func_A所以调用的是子类自己的func_A。

230 |

231 | ### **问题6**:虚表指针和构造函数体那个先被构造?

232 |

233 | 答:虚表指针先构造。

234 |

235 | ### **问题7**:c++运行构造函数的时候虚函数表被构造出来了么?

236 |

237 | 答:构造出来了。因为虚函数表是在编译时由编译器创建,在运行时肯定已经创建完成。

238 |

239 | ### **问题8**:在普通的函数当中调用虚函数和在构造函数当中调用虚函数有什么区别?

240 |

241 | 答:普调函数当中调用虚函数是希望运行时多态。而在构造函数当中不应该去调用虚函数因为构造函数当中调用的就是本类型当中的虚函数,无法达到运行时多态的作用。

242 |

243 | ### **问题9**:成员变量,虚函数表指针的位置是怎么排布?

244 |

245 | 答:如果一个类带有虚函数,那么该类实例对象的内存布局如下:首先是一个虚函数指针,接下来是该类的成员变量,按照成员在类当中声明的顺序排布,整体对象的大小由于内存对齐会有空白补齐。其次如果基类没有虚函数但是子类含有虚函数此时内存子类对象的内存排布也是先虚函数表指针再各个成员。如果将子类指针转换成基类指针此时编译器会根据偏移做转换。

246 |

247 | 可以使用如下代码验证:

248 |

249 | ```c++

250 | #include

251 | using namespace std;

252 |

253 | class Parent{

254 | public:

255 | int a;

256 | int b;

257 | };

258 |

259 | class Child:public Parent{

260 | public:

261 | virtual void test(){}

262 | int c;

263 | };

264 |

265 | int main() {

266 | Child c = Child();

267 | Parent p = Child();

268 | cout << sizeof(c) << endl;//24

269 | cout << sizeof(p) << endl;//8

270 |

271 | Child* cc = new Child();

272 | Parent* pp = cc;

273 | cout << cc << endl;//0x7fbe98402a50

274 | cout << pp << endl;//0x7fbe98402a58

275 | cout << &(cc->a) << endl;//0x7fbe98402a58

276 | cout << &(cc->b) << endl;//0x7fbe98402a5c

277 | cout << &(cc->c) << endl;//0x7fbe98402a60

278 | return 0;

279 | }

280 | ```

281 |

282 | 输出:

283 |

284 | ```

285 | 24

286 | 8

287 | 0x7fbe98402a50

288 | 0x7fbe98402a58

289 | 0x7fbe98402a58

290 | 0x7fbe98402a5c

291 | 0x7fbe98402a60

292 | ```

293 |

294 | 我的测试环境是64位,所以指针为8个字节。转换之后pp和cc相差一个虚表指针的偏移。

295 |

296 | # 总结

297 |

298 | 阿里考察C++的问题集中在以下几点:

299 |

300 | 1. 虚函数的实现

301 | 2. 虚函数使用出现的问题原因

302 | 3. 带有虚函数的类对象的构造和析构过程

303 | 4. 对象的内存布局

304 | 5. 虚函数的缺点:相比普通函数,虚函数调用需要2次跳转,会降低CPU缓存的命中率。运行时绑定,编译器不好优化。

--------------------------------------------------------------------------------

/file/20200301.md:

--------------------------------------------------------------------------------

1 | ## [vivo提前批武汉站C++后端面经](https://www.nowcoder.com/discuss/197908)

2 |

3 | ### 1. linux中查询一个文件第三列并按顺序显示

4 |

5 | ```

6 | cat filename | awk '{print $1 }' // 第一列

7 | cat filename | awk 'NR==1' // 第一行

8 | ```

9 |

10 | ### 2.const,static,volatile

11 |

12 | ### [const](https://interview.huihut.com/#/?id=const)

13 |

14 | #### [作用](https://interview.huihut.com/#/?id=作用)

15 |

16 | 1. 修饰变量,说明该变量不可以被改变;

17 | 2. 修饰指针,分为指向常量的指针和指针常量;

18 | 3. 常量引用,经常用于形参类型,即避免了拷贝,又避免了函数对值的修改;

19 | 4. 修饰成员函数,说明该成员函数内不能修改成员变量。

20 | 5. 指向常量的指针:const int * a;int const *a; 常量指针int *const a;

21 |

22 | ### [static](https://interview.huihut.com/#/?id=static)

23 |

24 | #### [作用](https://interview.huihut.com/#/?id=作用-1)

25 |

26 | 1. 修饰普通变量,修改变量的存储区域和生命周期,使变量存储在静态区,在 main 函数运行前就分配了空间,如果有初始值就用初始值初始化它,如果没有初始值系统用默认值初始化它。

27 | 2. 修饰普通函数,表明函数的作用范围,仅在定义该函数的文件内才能使用。在多人开发项目时,为了防止与他人命名空间里的函数重名,可以将函数定位为 static。

28 | 3. 修饰成员变量,修饰成员变量使所有的对象只保存一个该变量,而且不需要生成对象就可以访问该成员。

29 | 4. 修饰成员函数,修饰成员函数使得不需要生成对象就可以访问该函数,但是在 static 函数内不能访问非静态成员。

30 |

31 | ### [volatile](https://interview.huihut.com/#/?id=volatile)

32 |

33 | ```cpp

34 | volatile int i = 10;

35 | ```

36 |

37 | - **不可优化性.** volatile 关键字是一种类型修饰符,用它声明的类型变量表示不可以被某些编译器未知的因素(操作系统、硬件、其它线程等)更改。所以使用 volatile 告诉编译器不应对这样的对象进行优化。

38 | - **易变性.**volatile 关键字声明的变量,每次访问时都必须从内存中取出值(没有被 volatile 修饰的变量,可能由于编译器的优化,从 CPU 寄存器中取值)

39 | - const 可以是 volatile (如只读的状态寄存器)

40 | - 指针可以是 volatile

41 |

42 | ### 3. 内存对齐

43 |

44 | ### 一、什么是内存对齐

45 |

46 | **内存对齐(Memory alignment)**,也叫字节对齐。

47 |

48 | 现代计算机中内存空间都是按照 byte 划分的,从理论上讲似乎对任何类型的变量的访问可以从任何地址开始,但实际情况是在访问特定类型变量的时候经常在特定的内存地址访问,这就需要各种类型数据按照一定的规则在空间上排列,而不是顺序的一个接一个的排放,这就是对齐。会要求这些数据的首地址的值是某个数k(通常它为4或8)的倍数,这就是所谓的内存对齐。

49 |

50 | ### 二、为什么要内存对齐

51 |

52 | 之所以要内存对齐,有两方面的原因:

53 |

54 | - **平台原因**:各个硬件平台对存储空间的处理上有很大的不同。一些平台对某些特定类型的数据只能从某些特定地址开始存取。————- 比如,有些架构的CPU在访问 一个没有进行对齐的变量的时候会发生错误,那么在这种架构下编程必须保证字节对齐。

55 | - **性能原因**:内存对齐可以提高存取效率。————- 比如,有些平台每次读都是从偶地址开始,如果一个int型(假设为32位系统)如果存放在偶地址开始的地方,那么一个读周期就可以读出这32bit,而如果存放在奇地址开始的地方,就需要2个读周期,并对两次读出的结果的高低字节进行拼凑才能得到该32bit数据。

56 |

57 | 参考:[C/C++内存对齐](https://songlee24.github.io/2014/09/20/memory-alignment/)

58 |

59 | ### 4.模板的编译过程

60 |

61 | 当编译器遇到一个template时,不能够立马为他产生机器代码,它必须等到template被指定某种类型。也就是说,函数模板和类模板的完整定义将出现在template被使用的每一个角落.

62 |

63 | 对于不同的编译器,其对模板的编译和链接技术也会有所不同,其中一个常用的技术称之为Smart,其基本原理如下:

64 |

65 | 1. 模板编译时,以每个cpp文件为编译单位,实例化该文件中的函数模板和类模板

66 | 2. 链接器在链接每个目标文件时,会检测是否存在相同的实例;有存在相同的实例版本,则删除一个重复的实例,保证模板实例化没有重复存在。

67 |

68 |

69 |

70 | ### 5. 多线程常用的函数

71 |

72 | * 创建线程

73 |

74 | ```cpp

75 | #include

76 | pthread_create (thread, attr, start_routine, arg)

77 | ```

78 |

79 | * 终止线程

80 |

81 | ```c

82 | #include

83 | pthread_exit (status)

84 | ```

85 |

86 | * 连接和分离

87 |

88 | ```c

89 | pthread_join (threadid, status)

90 | pthread_detach (threadid)

91 | ```

92 |

93 | * ```c

94 | pthread_t pthread_self(void);

95 | ```

96 |

97 | * ```c

98 | int pthread_cancel(pthread_t thread);

99 | ```

100 |

101 | ### 6. 线程锁

102 |

103 | 线程之间的锁有:**互斥锁**、**条件锁**、**自旋锁**、**读写锁**、**递归锁**、**原子锁**

104 |

105 | * 互斥锁:互斥锁用于控制多个线程对他们之间共享资源互斥访问的一个信号量。

106 |

107 | ```c

108 | #include

109 | pthread_mutex_init(pthread_mutex_t* mutex, const pthread_mutexattr_t* mutexattr);

110 | pthread_mutex_destroy(pthread_mutex_t* mutex);

111 | pthread_mutex_lock(pthread_mutex_t* mutex);

112 | pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER;

113 | pthread_mutex_unlock(pthread_mutex_t* mutex);

114 | ```

115 |

116 | * 条件锁:条件锁就是所谓的条件变量,某一个线程因为某个条件为满足时可以使用条件变量使改程序处于阻塞状态。一旦条件满足以“信号量”的方式唤醒一个因为该条件而被阻塞的线程。

117 |

118 | ```c

119 | #include

120 | pthread_cond_init(pthread_cond_t* condition, const pthread_condattr_t* condattr);

121 | pthread_cond_destroy(pthread_cond_t* condition);

122 | pthread_cond_wait(pthread_cond_t* cond, pthread_mutex_t* mutex);

123 | pthread_cond_t condition = PTHREAD_COND_INITIALIZER

124 | ```

125 |

126 | * 自旋锁:假设我们有一个两个处理器core1和core2计算机,现在在这台计算机上运行的程序中有两个线程:T1和T2分别在处理器core1和core2上运行,两个线程之间共享着一个资源。

127 |

128 | 首先我们说明互斥锁的工作原理,**互斥锁是是一种sleep-waiting的锁**。假设线程T1获取互斥锁并且正在core1上运行时,此时线程T2也想要获取互斥锁(pthread_mutex_lock),但是由于T1正在使用互斥锁使得T2被阻塞。当T2处于阻塞状态时,T2被放入到等待队列中去,处理器core2会去处理其他任务而不必一直等待(忙等)。也就是说处理器不会因为线程阻塞而空闲着,它去处理其他事务去了。

129 |

130 | 而自旋锁就不同了,**自旋锁是一种busy-waiting的锁**。也就是说,如果T1正在使用自旋锁,而T2也去申请这个自旋锁,此时T2肯定得不到这个自旋锁。与互斥锁相反的是,此时运行T2的处理器core2会一直不断地循环检查锁是否可用(自旋锁请求),直到获取到这个自旋锁为止。

131 |

132 | ```c

133 | #include

134 | spin_lock_init(spinlock_t *x);

135 | spin_lock(x);

136 | spin_unlock(x);

137 | spin_trylock(x);

138 | spin_is_locked(x);

139 | ```

140 |

141 | * 读写锁

142 |

143 | ```c

144 | #include

145 | int pthread_rwlock_init(pthread_rwlock_t* rwlock, const pthread_rwlockattr_t* attr);

146 | int pthread_rwlock_rdlock(pthread_rwlock_t* rwlock);

147 | int pthread_rwlock_wrlock(pthread_rwlock_t* rwlock);

148 | int pthread_rwlock_unlock(pthread_rwlock_t* rwlock);

149 | int pthread_rwlock_destroy(pthread_rwlock_t* rwlock);

150 | ```

151 |

152 | 参考:[c++线程中的几种锁](https://blog.csdn.net/bian_qing_quan11/article/details/73734157)

153 |

154 | [多线程编程之读写锁](https://blog.csdn.net/lovecodeless/article/details/24968369)

155 |

156 | ### [7.单例模式]([https://github.com/twomonkeyclub/BackEnd/blob/master/%E8%AE%A1%E7%AE%97%E6%9C%BA%E5%9F%BA%E7%A1%80%E7%9F%A5%E8%AF%86/%E5%9F%BA%E6%9C%AC%E6%89%8B%E5%86%99%E4%BB%A3%E7%A0%81/%E5%8D%95%E4%BE%8B%E6%A8%A1%E5%BC%8F.cpp](https://github.com/twomonkeyclub/BackEnd/blob/master/计算机基础知识/基本手写代码/单例模式.cpp))

157 |

158 | ```c

159 | #include

160 |

161 | using namespace std;

162 |

163 | class single{

164 | private:

165 | static single* p;

166 | single(){}

167 | ~single(){}

168 |

169 | public:

170 | static single* getinstance();

171 |

172 | };

173 | single* single::p = new single();

174 | single* single::getinstance(){

175 | return p;

176 | }

177 |

178 | int main(){

179 |

180 | single *p1 = single::getinstance();

181 | single *p2 = single::getinstance();

182 |

183 | if (p1 == p2)

184 | cout << "same" << endl;

185 |

186 | system("pause");

187 | return 0;

188 | }

189 | ```

190 |

191 |

192 |

193 | ```c

194 | class Singleton{

195 | public:

196 | // 注意返回的是引用。

197 | static Singleton& getInstance(){

198 | static Singleton m_instance; //局部静态变量

199 | return m_instance;

200 | }

201 | private:

202 | Singleton(); //私有构造函数,不允许使用者自己生成对象

203 | Singleton(const Singleton& other);

204 | };

205 | ```

206 |

207 |

208 |

209 | ```c

210 |

211 | class Lock

212 | {

213 | private:

214 | CCriticalSection m_cs;

215 | public:

216 | Lock(CCriticalSection cs) : m_cs(cs)

217 | {

218 | m_cs.Lock();

219 | }

220 | ~Lock()

221 | {

222 | m_cs.Unlock();

223 | }

224 | };

225 |

226 | class Singleton

227 | {

228 | private:

229 | Singleton();

230 | Singleton(const Singleton &);

231 | Singleton& operator = (const Singleton &);

232 |

233 | public:

234 | static Singleton *Instantialize();

235 | static Singleton *pInstance;

236 | static CCriticalSection cs;

237 | };

238 |

239 | Singleton* Singleton::pInstance = 0;

240 |

241 | Singleton* Singleton::Instantialize()

242 | {

243 | if(pInstance == NULL)

244 | { //double check

245 | Lock lock(cs); //用lock实现线程安全,用资源管理类,实现异常安全

246 | //使用资源管理类,在抛出异常的时候,资源管理类对象会被析构,析构总是发生的无论是因为异常抛出还是语句块结束。

247 | if(pInstance == NULL)

248 | {

249 | pInstance = new Singleton();

250 | }

251 | }

252 | return pInstance;

253 | }

254 | ```

255 |

256 | 参考:[设计模式之单例模式(c++版)](https://segmentfault.com/a/1190000015950693)

257 |

258 | [C++中的单例模式](https://blog.csdn.net/Hackbuteer1/article/details/7460019)

--------------------------------------------------------------------------------

/file/20200515.md:

--------------------------------------------------------------------------------

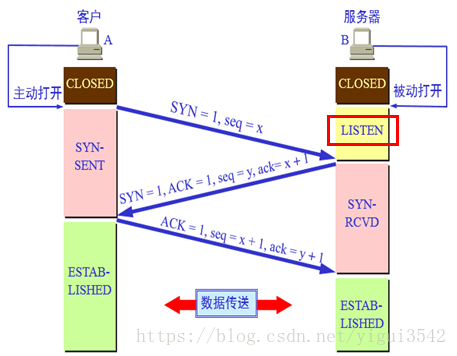

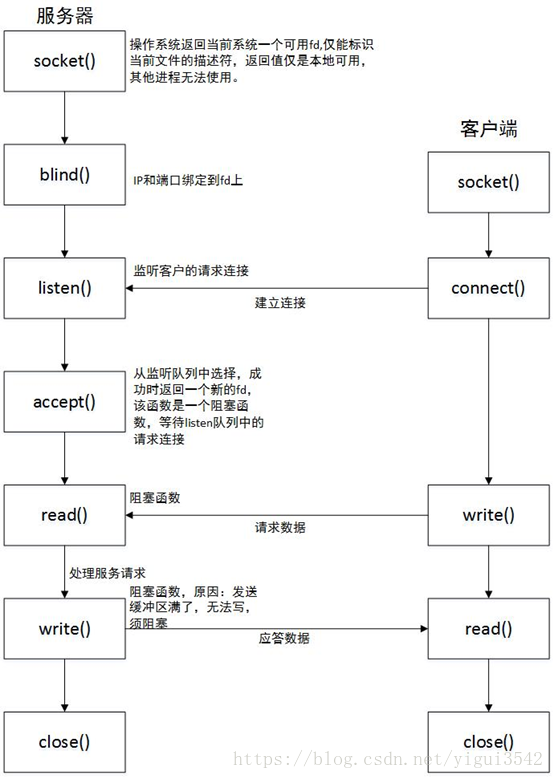

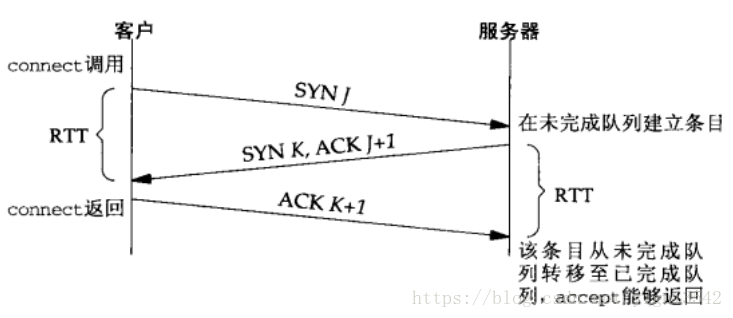

1 | ### [1. 三次握手及其对应的函数](https://blog.csdn.net/yigui3542/article/details/81099255)

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

12 |

13 | 1.客户端调用connect()函数,此时客户端会向服务端发送SYN

14 |

15 | 2.服务端收到SYN后,会从listen()函数返回SYN+ACK

16 |

17 | 3.客户端收到connect()函数的返回,之后向服务端发送最后一个ACK

18 |

19 | 4.服务端收到最后一个ACK以后,将该连接请求从未完成连接队列放入已完成连接队列中,等待accept()从该队列中取出

20 |

21 | ### [2.HTTP与TCP的区别和联系](https://blog.csdn.net/u013485792/article/details/52100533)

22 |

23 | **1、TCP连接**

24 | 手机能够使用联网功能是因为手机底层实现了TCP/IP协议,可以使手机终端通过无线网络建立TCP连接。TCP协议可以对上层网络提供接口,使上层网络数据的传输建立在“无差别”的网络之上。

25 | 建立起一个TCP连接需要经过“三次握手”:

26 |

27 | * 第一次握手:客户端发送syn包(syn=j)到服务器,并进入SYN_SEND状态,等待服务器确认;

28 | * 第二次握手:服务器收到syn包,必须确认客户的SYN(ack=j+1),同时自己也发送一个SYN包(syn=k),即SYN+ACK包,此时服务器进入SYN_RECV状态;

29 | * 第三次握手:客户端收到服务器的SYN+ACK包,向服务器发送确认包ACK(ack=k+1),此包发送完毕,客户端和服务器进入ESTABLISHED状态,完成三次握手。

30 | 握手过程中传送的包里不包含数据,三次握手完毕后,客户端与服务器才正式开始传送数据。理想状态下,TCP连接一旦建立,在通信双方中的任何一方主动关闭连 接之前,TCP 连接都将被一直保持下去。断开连接时服务器和客户端均可以主动发起断开TCP连接的请求,断开过程需要经过“四次握手”(过程就不细写 了,就是服务器和客户端交互,最终确定断开)

31 |

32 | **2、HTTP连接**

33 | HTTP协议即超文本传送协议(Hypertext Transfer Protocol ),是Web联网的基础,也是手机联网常用的协议之一,HTTP协议是建立在TCP协议之上的一种应用。

34 | **HTTP连接最显著的特点是客户端发送的每次请求都需要服务器回送响应,在请求结束后,会主动释放连接。从建立连接到关闭连接的过程称为“一次连接”。**

35 | 1)在HTTP 1.0中,客户端的每次请求都要求建立一次单独的连接,在处理完本次请求后,就自动释放连接。

36 |

37 | 2)在HTTP 1.1中则可以在一次连接中处理多个请求,并且多个请求可以重叠进行,不需要等待一个请求结束后再发送下一个请求。

38 |

39 | 由于HTTP在每次请求结束后都会主动释放连接,因此HTTP连接是一种“短连接”,要保持客户端程序的在线状态,需要不断地向服务器发起连接请求。通常的 做法是即时不需要获得任何数据,客户端也保持每隔一段固定的时间向服务器发送一次“保持连接”的请求,服务器在收到该请求后对客户端进行回复,表明知道客 户端“在线”。若服务器长时间无法收到客户端的请求,则认为客户端“下线”,若客户端长时间无法收到服务器的回复,则认为网络已经断开。

40 |

41 | * ### TCP就是单纯建立连接,不涉及任何我们需要请求的实际数据,简单的传输。http是用来收发数据,即实际应用上来的。

42 |

43 | 三、总结

44 |

45 | * TCP是底层通讯协议,定义的是数据传输和连接方式的规范;

46 | * HTTP是应用层协议,定义的是传输数据的内容的规范;

47 | * HTTP协议中的数据是利用TCP协议传输的,所以支持HTTP也就一定支持TCP ;

48 | * HTTP支持的是www服务 而TCP/IP是协议, 是Internet国际互联网络的基础,是网络中使用的基本的通信协议。

49 | * TCP/IP实际上是一组协议,它包括上百个各种功能的协议,如:远程登录、文件传输和电子邮件等,而TCP协议和IP协议是保证数据完整传输的两个基本的重要协议。通常说TCP/IP是Internet协议族,而不单单是TCP和IP。

50 |

51 | ### [3 中间人攻击](https://www.jianshu.com/p/a825de42ccbc)

52 |

53 | **1、SSL证书欺骗攻击**

54 |

55 | * 伪造证书

56 |

57 | **2 SSL剥离攻击(SSLStrip)**

58 |

59 | * 中间人攻击者在劫持了客户端与服务端的HTTP会话后,将HTTP页面里面所有的 https:// 超链接都换成 http:// ,用户在点击相应的链接时,是使用HTTP协议来进行访问

60 |

61 | **3 针对SSL算法进行攻击**

62 |

63 | ### [4. 读写锁的几种实现方式-互斥量,信号量,条件变量](https://blog.csdn.net/juzihongle1/article/details/78014999)

64 |

65 | 1. 直接使用读写锁

66 |

67 | ```c

68 | #include

69 |

70 | pthread_rwlock_t rwlock = PTHREAD_RWLOCK_INITIALIZER; // 定义和初始化读写锁

71 |

72 | 写模式:

73 | pthread_rwlock_wrlock(&rwlock); // 加写锁

74 | 写写写...

75 | pthread_rwlock_unlock(&rwlock); // 解锁

76 |

77 | 读模式:

78 | pthread_rwlock_rdlock(&rwlock); // 加读锁

79 | 读读读...

80 | pthread_rwlock_unlock(&rwlock); // 解锁

81 | ```

82 |

83 | 2. 用条件变量实现读写锁 (条件变量 + 互斥锁 + 两个变量记录读/写数量)

84 |

85 | ```c

86 | #include

87 |

88 | pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER; // 定义和初始化互斥锁

89 | pthread_cond_t cond = PTHREAD_COND_INITIALIZER; // 定义和初始化条件变量

90 | int w = 0, r = 0;

91 |

92 | 写模式

93 | pthread_mutex_lock(&mutex); // 枷锁

94 | while (w != 0 || r > 0)

95 | {

96 | pthread_cond_wait(&cond, &mutex); // 等待条件变量成立

97 | }

98 | w = 1;

99 | pthread_mutex_unlock(&mutex); // 解锁

100 |

101 | 写写写...

102 |

103 | pthread_mutex_lock(&mutex); // 枷锁

104 | w = 0;

105 | pthread_cond_broadcast(&cond); // 唤醒其他因条件变量而产生阻塞

106 | pthread_mutex_unlock(&mutex); // 解锁

107 |

108 |

109 | 读模式

110 | pthread_mutex_lock(&mutex); // 枷锁

111 | while (w != 0)

112 | {

113 | pthread_cond_wait(&cond, mutex);

114 | }

115 | ++r;

116 | pthread_mutex_unlock(&mutex);

117 |

118 | 读读读...

119 |

120 | pthread_mutex_lock(&mutex);

121 | --r;

122 | if (r == 0)

123 | {

124 | pthread_cond_broadcast(&cond); // 唤醒

125 | }

126 | pthread_mutex_unlock(&mutex);

127 | ```

128 |

129 | ```c

130 | mutex m_mutex;

131 | condition_variable m_cond;

132 | int w = 0, r = 0;

133 |

134 | 写模式

135 | m_mutex.lock();// 枷锁

136 | while (w != 0 || r > 0)

137 | {

138 | m_cond.wait(m_mutex); // 等待条件变量成立

139 | }

140 | w = 1;

141 | m_mutex.unlock(); // 解锁

142 |

143 | 写写写...

144 |

145 | m_mutex.lock();// 枷锁

146 | w = 0;

147 | m_cond.notify_all(); // 唤醒其他因条件变量而产生阻塞

148 | m_mutex.unlock(); // 解锁

149 |

150 |

151 | 读模式

152 | m_mutex.lock(); // 枷锁

153 | while (w != 0)

154 | {

155 | m_cond.wait(m_mutex);

156 | }

157 | ++r;

158 | m_mutex.unlock();

159 |

160 | 读读读...

161 |

162 | m_mutex.lock();

163 | --r;

164 | if (r == 0)

165 | {

166 | m_cond.notify_all(); // 唤醒

167 | }

168 | m_mutex.unlock();

169 | ```

170 |

171 | 3. 互斥锁 (两个互斥锁 + 一个记录读数量变量)

172 |

173 | ```c

174 | #include

175 | pthread_mutex_t r_mutex = PTHREAD_MUTEX_INITIALIZER;

176 | pthread_mutex_t w_mutex = PTHREAD_MUTEX_INITIALIZER;

177 | int r = 0; // 记录读者个数

178 |

179 | 写模式

180 | pthread_mutex_lock(&w_mutex);

181 | 写写写...

182 | pthread_mutex_unlock(&w_mutex);

183 |

184 | 读模式

185 | pthread_mutex_lock(&r_mutex);

186 | if (r == 0)

187 | {

188 | pthread_mutex_lock(&w_mutex);

189 | }

190 | ++r;

191 | pthread_mutex_unlock(&r_mutex);

192 |

193 | 读读读

194 |

195 | pthread_mutex_lock(&r_lock);

196 | --r;

197 | if (r == 0)

198 | {

199 | pthread_mutex_unlock(&w_mutex);

200 | }