├── docs

├── 数据库

│ ├── MySQL的锁.md

│ ├── Redis

│ │ ├── Redlock分布式锁.md

│ │ ├── 如何做可靠的分布式锁,Redlock真的可行么.md

│ │ └── Redis持久化.md

│ ├── 面试必备之乐观锁与悲观锁.md

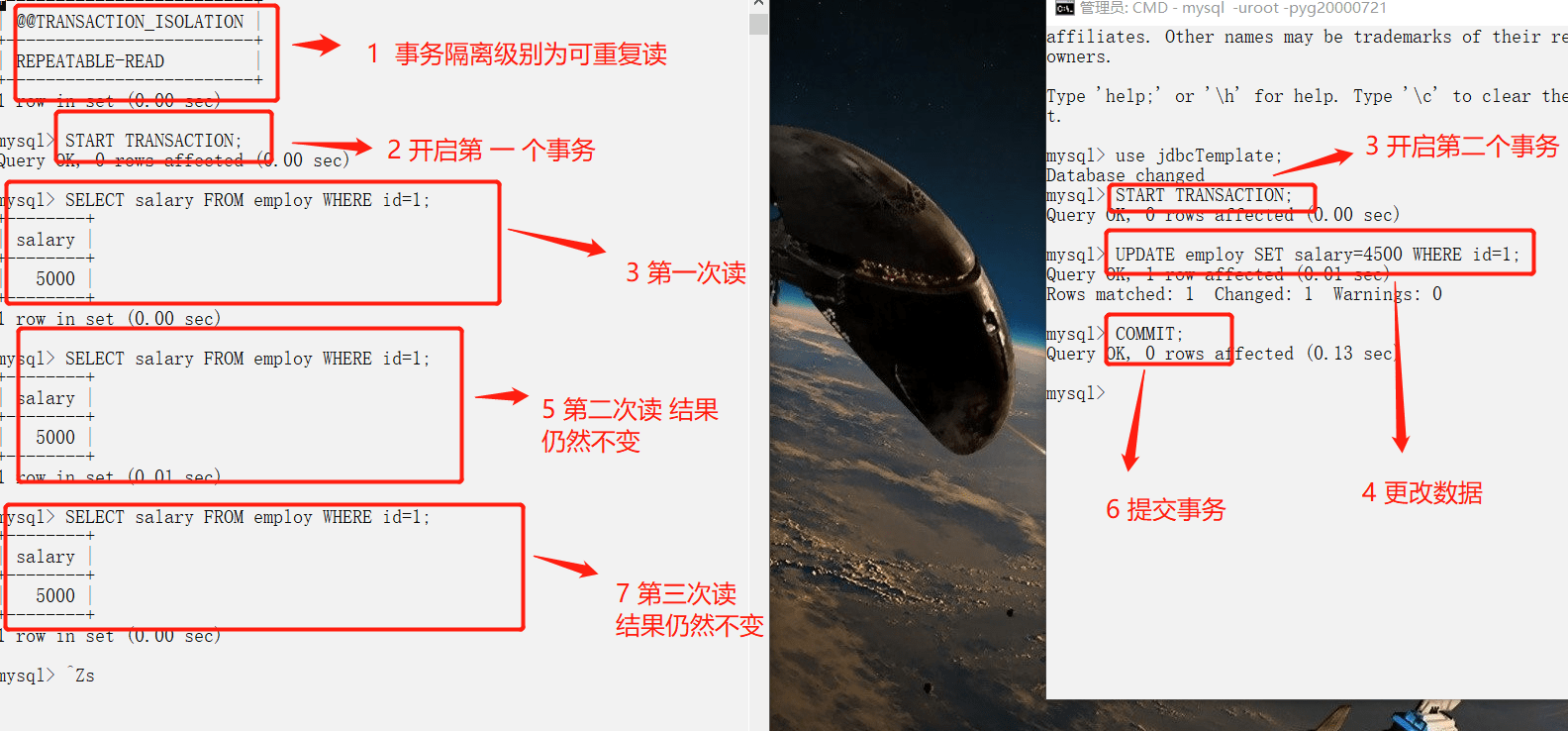

│ ├── 事务隔离级别(图文详解).md

│ ├── 一条sql语句在mysql中如何执行的.md

│ ├── MySQL事务及其ACID特性.md

│ └── MySQL索引.md

├── img

│ ├── 640.webp

│ ├── 642.webp

│ ├── 643.webp

│ ├── 644.webp

│ ├── 645.webp

│ ├── 646.webp

│ ├── 650.webp

│ ├── 651.webp

│ ├── 652.webp

│ ├── 653.webp

│ ├── 654.webp

│ ├── 655.webp

│ ├── 656.webp

│ ├── 657.webp

│ ├── 658.webp

│ ├── 659.webp

│ ├── 660.webp

│ ├── 661.webp

│ ├── 662.webp

│ ├── 663.webp

│ ├── 664.webp

│ ├── 665.webp

│ ├── 666.webp

│ ├── 667.webp

│ ├── 668.webp

│ ├── 669.webp

│ ├── 670.webp

│ ├── 671.webp

│ ├── 672.webp

│ ├── 700.webp

│ ├── 701.webp

│ ├── 702.png

│ ├── 705.jpg

│ ├── cs-2.png

│ ├── cs-bit.png

│ ├── cs-dp.png

│ ├── cs-gdyx.png

│ ├── cs-hash.png

│ ├── cs-heap.png

│ ├── cs-hs.png

│ ├── cs-link.png

│ ├── cs-sdyx.png

│ ├── cs-sj.png

│ ├── cs-str.png

│ ├── cs-sx.png

│ ├── cs-tx.png

│ ├── img_1.jpg

│ ├── img_10.png

│ ├── img_11.png

│ ├── img_12.png

│ ├── img_13.png

│ ├── img_14.jpg

│ ├── img_14.png

│ ├── img_15.jpg

│ ├── img_15.png

│ ├── img_16.jpg

│ ├── img_17.jpg

│ ├── img_18.jpg

│ ├── img_2.jpg

│ ├── img_3.png

│ ├── img_4.jpg

│ ├── img_5.png

│ ├── img_6.jpg

│ ├── img_7.jpg

│ ├── img_8.gif

│ ├── img_9.png

│ ├── tcp+udp.jpg

│ ├── 665webp.webp

│ ├── cs-array.png

│ ├── cs-2search.png

│ ├── 16b44d429a3051ac.webp

│ ├── 16b44d429a580edc.webp

│ ├── 16b44d429c540956.webp

│ ├── 16b44d429d15079d.webp

│ ├── 16b44d429dc9de16.webp

│ ├── 16b44d429e563f79.webp

│ ├── 16b44d431d021bc8.webp

│ ├── 16b44d435181da78.webp

│ ├── 16b44d4362c33e1b.webp

│ ├── 16b44d436380e5e7.webp

│ ├── 16b44d4367801b29.webp

│ ├── 16b44d436b021664.webp

│ ├── 16b44d4392909e0f.webp

│ ├── 16b44d43957d7cd9.webp

│ ├── 16b44d43967a3ee7.webp

│ ├── 16b44d43af436644.webp

│ ├── 16b44d43afc607f8.webp

│ ├── 16b44d43b87632d3.webp

│ ├── 16b44d43cbc31b5a.webp

│ ├── 16b44d43cc3e7792.webp

│ ├── 16b44d43d3d4dc49.webp

│ ├── 1454031-20190410222131829-793976539.png

│ ├── 1454031-20190410222744803-621774735.png

│ ├── 1454031-20190416205427730-1477237969.png

│ ├── 1454031-20190416213935585-1678554014.png

│ ├── 1454031-20190421223327003-2058879216.png

│ ├── 1454031-20190421224640224-1042940039.png

│ └── 1454031-20190421224720018-809378807.png

├── 简历与面经

│ ├── BATJrealInterviewExperience

│ │ ├── 深信服Python开发2018-8.md

│ │ ├── 字节跳动python后台开发面经2018-12.md

│ │ ├── 5面阿里,终获offer.md

│ │ └── 蚂蚁金服实习生面经总结(已拿口头offer).md

│ ├── 简历模板.md

│ ├── PreparingForInterview

│ │ ├── 如果面试官问你“你有什么问题问我吗?”时,你该如何回答.md

│ │ ├── interviewPrepare.md

│ │ ├── JavaInterviewLibrary.md

│ │ ├── JavaProgrammerNeedKnow.md

│ │ └── 程序员的简历之道.md

│ └── 手把手教你用Markdown写一份高质量的简历.md

├── 数据结构与算法

│ ├── LeetCode高频率题目.md

│ ├── 算法学习资源推荐.md

│ ├── 面试官问你什么B树和B+树,把这篇文章丢给他.md

│ ├── 动态规划.md

│ ├── 数据结构.md

│ ├── Backtracking-NQueens.md

│ └── 公司真题.md

├── 系统设计

│ ├── 设计模式简述.md

│ ├── website-architecture

│ │ ├── 8 张图读懂大型网站技术架构.md

│ │ └── 分布式.md

│ ├── data-communication

│ │ ├── summary.md

│ │ ├── message-queue.md

│ │ ├── RocketMQ-Questions.md

│ │ └── dubbo.md

│ ├── 设计模式.md

│ ├── ZooKeeper

│ │ └── ZooKeeper数据模型和常见命令.md

│ └── authority-certification

│ │ └── basis-of-authority-certification.md

├── Python

│ ├── Python实现常见排序算法.py

│ ├── Flask请求流程.md

│ └── Python进程通信.md

├── 计算机网络

│ └── HTTPS中的TLS.md

└── tools

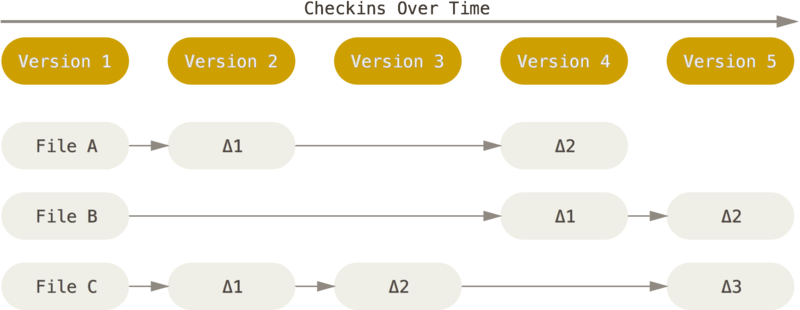

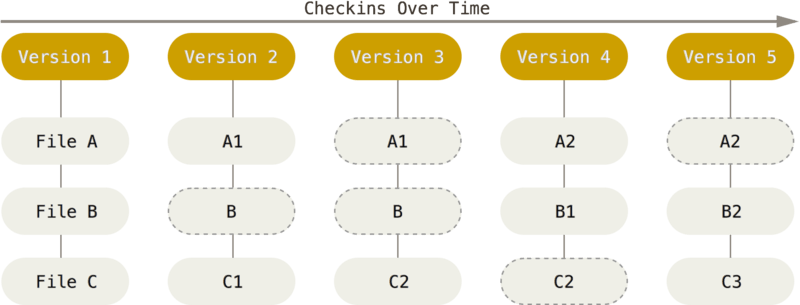

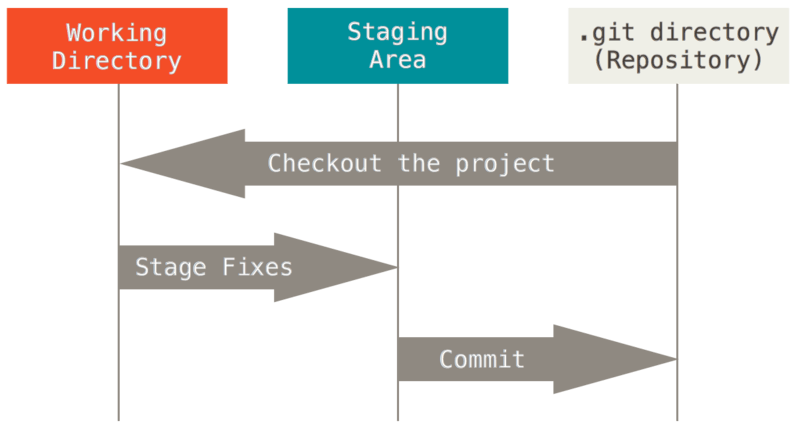

│ ├── Git.md

│ └── Docker.md

├── .idea

└── vcs.xml

├── README.md

└── test.py

/docs/数据库/MySQL的锁.md:

--------------------------------------------------------------------------------

1 | https://blog.csdn.net/weixin_42358062/article/details/80731501

2 |

--------------------------------------------------------------------------------

/docs/img/640.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/640.webp

--------------------------------------------------------------------------------

/docs/img/642.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/642.webp

--------------------------------------------------------------------------------

/docs/img/643.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/643.webp

--------------------------------------------------------------------------------

/docs/img/644.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/644.webp

--------------------------------------------------------------------------------

/docs/img/645.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/645.webp

--------------------------------------------------------------------------------

/docs/img/646.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/646.webp

--------------------------------------------------------------------------------

/docs/img/650.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/650.webp

--------------------------------------------------------------------------------

/docs/img/651.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/651.webp

--------------------------------------------------------------------------------

/docs/img/652.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/652.webp

--------------------------------------------------------------------------------

/docs/img/653.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/653.webp

--------------------------------------------------------------------------------

/docs/img/654.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/654.webp

--------------------------------------------------------------------------------

/docs/img/655.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/655.webp

--------------------------------------------------------------------------------

/docs/img/656.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/656.webp

--------------------------------------------------------------------------------

/docs/img/657.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/657.webp

--------------------------------------------------------------------------------

/docs/img/658.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/658.webp

--------------------------------------------------------------------------------

/docs/img/659.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/659.webp

--------------------------------------------------------------------------------

/docs/img/660.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/660.webp

--------------------------------------------------------------------------------

/docs/img/661.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/661.webp

--------------------------------------------------------------------------------

/docs/img/662.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/662.webp

--------------------------------------------------------------------------------

/docs/img/663.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/663.webp

--------------------------------------------------------------------------------

/docs/img/664.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/664.webp

--------------------------------------------------------------------------------

/docs/img/665.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/665.webp

--------------------------------------------------------------------------------

/docs/img/666.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/666.webp

--------------------------------------------------------------------------------

/docs/img/667.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/667.webp

--------------------------------------------------------------------------------

/docs/img/668.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/668.webp

--------------------------------------------------------------------------------

/docs/img/669.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/669.webp

--------------------------------------------------------------------------------

/docs/img/670.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/670.webp

--------------------------------------------------------------------------------

/docs/img/671.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/671.webp

--------------------------------------------------------------------------------

/docs/img/672.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/672.webp

--------------------------------------------------------------------------------

/docs/img/700.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/700.webp

--------------------------------------------------------------------------------

/docs/img/701.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/701.webp

--------------------------------------------------------------------------------

/docs/img/702.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/702.png

--------------------------------------------------------------------------------

/docs/img/705.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/705.jpg

--------------------------------------------------------------------------------

/docs/img/cs-2.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-2.png

--------------------------------------------------------------------------------

/docs/img/cs-bit.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-bit.png

--------------------------------------------------------------------------------

/docs/img/cs-dp.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-dp.png

--------------------------------------------------------------------------------

/docs/img/cs-gdyx.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-gdyx.png

--------------------------------------------------------------------------------

/docs/img/cs-hash.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-hash.png

--------------------------------------------------------------------------------

/docs/img/cs-heap.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-heap.png

--------------------------------------------------------------------------------

/docs/img/cs-hs.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-hs.png

--------------------------------------------------------------------------------

/docs/img/cs-link.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-link.png

--------------------------------------------------------------------------------

/docs/img/cs-sdyx.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-sdyx.png

--------------------------------------------------------------------------------

/docs/img/cs-sj.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-sj.png

--------------------------------------------------------------------------------

/docs/img/cs-str.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-str.png

--------------------------------------------------------------------------------

/docs/img/cs-sx.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-sx.png

--------------------------------------------------------------------------------

/docs/img/cs-tx.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-tx.png

--------------------------------------------------------------------------------

/docs/img/img_1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_1.jpg

--------------------------------------------------------------------------------

/docs/img/img_10.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_10.png

--------------------------------------------------------------------------------

/docs/img/img_11.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_11.png

--------------------------------------------------------------------------------

/docs/img/img_12.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_12.png

--------------------------------------------------------------------------------

/docs/img/img_13.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_13.png

--------------------------------------------------------------------------------

/docs/img/img_14.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_14.jpg

--------------------------------------------------------------------------------

/docs/img/img_14.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_14.png

--------------------------------------------------------------------------------

/docs/img/img_15.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_15.jpg

--------------------------------------------------------------------------------

/docs/img/img_15.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_15.png

--------------------------------------------------------------------------------

/docs/img/img_16.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_16.jpg

--------------------------------------------------------------------------------

/docs/img/img_17.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_17.jpg

--------------------------------------------------------------------------------

/docs/img/img_18.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_18.jpg

--------------------------------------------------------------------------------

/docs/img/img_2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_2.jpg

--------------------------------------------------------------------------------

/docs/img/img_3.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_3.png

--------------------------------------------------------------------------------

/docs/img/img_4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_4.jpg

--------------------------------------------------------------------------------

/docs/img/img_5.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_5.png

--------------------------------------------------------------------------------

/docs/img/img_6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_6.jpg

--------------------------------------------------------------------------------

/docs/img/img_7.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_7.jpg

--------------------------------------------------------------------------------

/docs/img/img_8.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_8.gif

--------------------------------------------------------------------------------

/docs/img/img_9.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/img_9.png

--------------------------------------------------------------------------------

/docs/img/tcp+udp.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/tcp+udp.jpg

--------------------------------------------------------------------------------

/docs/img/665webp.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/665webp.webp

--------------------------------------------------------------------------------

/docs/img/cs-array.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-array.png

--------------------------------------------------------------------------------

/docs/img/cs-2search.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/cs-2search.png

--------------------------------------------------------------------------------

/docs/img/16b44d429a3051ac.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429a3051ac.webp

--------------------------------------------------------------------------------

/docs/img/16b44d429a580edc.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429a580edc.webp

--------------------------------------------------------------------------------

/docs/img/16b44d429c540956.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429c540956.webp

--------------------------------------------------------------------------------

/docs/img/16b44d429d15079d.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429d15079d.webp

--------------------------------------------------------------------------------

/docs/img/16b44d429dc9de16.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429dc9de16.webp

--------------------------------------------------------------------------------

/docs/img/16b44d429e563f79.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d429e563f79.webp

--------------------------------------------------------------------------------

/docs/img/16b44d431d021bc8.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d431d021bc8.webp

--------------------------------------------------------------------------------

/docs/img/16b44d435181da78.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d435181da78.webp

--------------------------------------------------------------------------------

/docs/img/16b44d4362c33e1b.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d4362c33e1b.webp

--------------------------------------------------------------------------------

/docs/img/16b44d436380e5e7.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d436380e5e7.webp

--------------------------------------------------------------------------------

/docs/img/16b44d4367801b29.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d4367801b29.webp

--------------------------------------------------------------------------------

/docs/img/16b44d436b021664.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d436b021664.webp

--------------------------------------------------------------------------------

/docs/img/16b44d4392909e0f.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d4392909e0f.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43957d7cd9.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43957d7cd9.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43967a3ee7.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43967a3ee7.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43af436644.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43af436644.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43afc607f8.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43afc607f8.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43b87632d3.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43b87632d3.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43cbc31b5a.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43cbc31b5a.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43cc3e7792.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43cc3e7792.webp

--------------------------------------------------------------------------------

/docs/img/16b44d43d3d4dc49.webp:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/16b44d43d3d4dc49.webp

--------------------------------------------------------------------------------

/docs/img/1454031-20190410222131829-793976539.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190410222131829-793976539.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190410222744803-621774735.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190410222744803-621774735.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190416205427730-1477237969.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190416205427730-1477237969.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190416213935585-1678554014.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190416213935585-1678554014.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190421223327003-2058879216.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190421223327003-2058879216.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190421224640224-1042940039.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190421224640224-1042940039.png

--------------------------------------------------------------------------------

/docs/img/1454031-20190421224720018-809378807.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ChangAn223/Python-Interview/HEAD/docs/img/1454031-20190421224720018-809378807.png

--------------------------------------------------------------------------------

/.idea/vcs.xml:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

5 |

6 |

--------------------------------------------------------------------------------

/docs/简历与面经/BATJrealInterviewExperience/深信服Python开发2018-8.md:

--------------------------------------------------------------------------------

1 | 【一面】

2 |

3 | 1、进程、线程、协程的定义及区别。

4 |

5 | 2、装饰器

6 |

7 | 3、Python进程通信

8 |

9 | 4、Django登陆流程

10 |

11 | 5、了解的数据结构有哪些?

12 |

13 | 6、哈希?

14 |

15 | 7、从文件查找除出现次数最多的前十的个字符。

--------------------------------------------------------------------------------

/docs/数据结构与算法/LeetCode高频率题目.md:

--------------------------------------------------------------------------------

1 |

2 | 来自:https://www.nowcoder.com/discuss/292850

3 |

4 |

5 | ### 动态规划

6 |

7 |

8 | ### 堆

9 |

10 |

11 | ### 二叉树

12 |

13 |

14 | ### 二分查找

15 |

16 |

17 | ### 广度优先搜索

18 |

19 |

20 | ### 哈希表

21 |

22 |

23 | ### 回溯算法

24 |

25 |

26 | ### 链表

27 |

28 |

29 | ### 设计

30 |

31 |

32 | ### 深度优先搜索

33 |

34 |

35 | ### 数学

36 |

37 |

38 |

39 | ### 数组

40 |

41 |

42 | ### 贪心算法

43 |

44 |

45 | ### 位运算

46 |

47 |

48 | ### 字符串

49 |

50 |

51 |

--------------------------------------------------------------------------------

/docs/系统设计/设计模式简述.md:

--------------------------------------------------------------------------------

1 | ## 设计模式

2 |

3 | 三大设计模式:创建型模式、结构型模式、行为模式

4 |

5 | ### 1.创建型模式

6 |

7 | #### 1.1单例模式

8 | 一个类只能创建一个实例,多次创建则返回同一个对象。Python中的import导入就是单例的,因为只会导入一次。

9 |

10 | #### 1.2工厂模式

11 | 解决对象创建问题,

12 |

13 | #### 1.3构造模式

14 | 控制复杂对象的创建

15 |

16 | **工厂模式与构造模式的区别:**

17 | 工厂模式时直接返回一个对象,构造模式允许定义一些复杂的属性之后再返回这个对象。

18 |

19 | #### 1.4原型模式

20 | 通过原型的克隆创建新的对象,类似Linux中fork创建进程。

21 | 可以使用相同的原型,通过修改部分属性来创建实例,适用于于一些创建实例开销大的地方

22 |

23 | #### 1.5对象池模式

24 | 预先分配同一类型的一组实例

25 |

26 | #### 1.6惰性计算模式

27 | 延迟计算(Python的property),直到访问该属性时才做相应操作。

28 |

29 | ### 2.结构型设计模式

30 |

31 | #### 2.1装饰器模式

32 | 不必通过子类化来扩展功能,Python中的装饰器就是装饰器模式。

33 |

34 | #### 2.2代理模式

35 | 把一个对象的操作代理到另一个对象中。通过代理对象间接去操作该对象。(作用:代码分层,解决一些安全问题如不暴露原接口)

36 |

37 | #### 2.3适配器模式

38 | 通过一个间接层适配统一的接口,把不同的对象的接口适配到同一个接口上。

39 |

40 | #### 2.4外观模式

41 | 简化复杂对象的访问问题

42 |

43 | #### 2.5享元模式

44 | 通过对象复用改善资源利用(如对象池,数据库连接池)

45 |

46 | #### 2.6MVC模式

47 | 解耦展示逻辑和业务逻辑,Model-View-Controller,基本Web框架都是这种模式。

48 |

49 | ### 3.行为型模式

50 |

51 | #### 3.1迭代器模式

52 | 通过统一的接口迭代对象。(如Python中的for循环迭代遍历可迭代对象)

53 |

54 | #### 3.2观察者模式

55 | 对象发生改变时,观察者执行相应的动作。(最常用的实现方式:发布/订阅方式。)也可通过回调等方式实现,事件发生则调用相应的回调函数。

56 |

57 | #### 3.3策略模式

58 | 针对不同的输入采用不同的策略。对外采用统一的接口,对内根据输入采用不同的执行策略。

--------------------------------------------------------------------------------

/docs/Python/Python实现常见排序算法.py:

--------------------------------------------------------------------------------

1 | def bubblesort(list):

2 | length = len(list)

3 | for i in range(1, length):

4 | flag = True

5 | for j in range(length - i):

6 | if list[j] > list[j + 1]:

7 | list[j], list[j + 1] = list[j + 1], list[j]

8 | flag = False

9 | if flag:

10 | return list

11 | return list

12 |

13 |

14 | def selectionsort(list):

15 | length = len(list)

16 | for i in range(length):

17 | minindex = i

18 | for j in range(i + 1, length):

19 | if list[j] < list[minindex]:

20 | minindex = j

21 | if i != minindex:

22 | list[i], list[minindex] = list[minindex], list[i]

23 | return list

24 |

25 |

26 | def insertsort(list):

27 | length = len(list)

28 | for i in range(1, length):

29 | for j in range(i, 0, -1):

30 | if list[j] < list[j - 1]:

31 | list[j], list[j - 1] = list[j - 1], list[j]

32 | return list

33 |

34 |

35 | def quicksort(list, start, end):

36 | if start < end:

37 | mid = start

38 | left, right = start, end

39 | while left < right:

40 | while list[left] < list[mid] and left < right:

41 | left += 1

42 | while list[right] >= list[mid] and left < right:

43 | right -= 1

44 | if left < right:

45 | list[left], list[right] = list[right], list[left]

46 | list[mid], list[left] = list[left], list[mid]

47 | quicksort(list, start, mid - 1)

48 | quicksort(list, mid + 1, end)

49 |

50 |

51 | def shellsort(list):

52 | pass

--------------------------------------------------------------------------------

/docs/简历与面经/BATJrealInterviewExperience/字节跳动python后台开发面经2018-12.md:

--------------------------------------------------------------------------------

1 | 抖音/火山 后台开发三面

2 | 作者:甘梅地瓜

3 | 链接:https://www.nowcoder.com/discuss/148961

4 | 来源:牛客网

5 |

6 | 【一面】

7 |

8 | (一面小哥蛮年轻的,看起来不太爱说话,不过人特温柔,问的问题也都很友好)

9 | 0、自我介绍 (之前有过实习经历,主要写python和go balabala

10 | 1、get post的区别 put delete 知道吗 put和post (安全 幂等 长度 状态balabala)

11 | 2、innodb为什么用b+树 ?多路树的好处?(说了下比较好控制高度 查询稳定 又说了一下对比b树的优势balabala)

12 | 为什么控制高度?(连续读磁盘 效率高)

13 | 详细描述b+?(以innodb索引为例给他画了下)

14 | 3、tcp为什么三次连接 二次 四次?

15 | 4、innodb 数据隔离级别 (四个隔离级别说了下 顺带把脏读 幻读 不可重复度说了下)

16 | 5、设计题 一个高并发定时执行任务:实现一个方法 接受一个任务以及它要开始执行的时间,定时执行这些任务,会有很多任务(设计了个数据结构用空间换时间,后来又问有没有别的方法,我当时脑袋一抽说要不就开goroutine,不过任务太多就爆了。后来回去想想 可以用优先队列)

17 | 6、redis (问了些基础

18 | 7、输入一个url 整个过程 返回结果和渲染是同时的吗 (我从七层分别说了下 又问我返回结果和渲染是同时的吗 ,我说不是 然后扯到http2.0服务端推送上

19 | 8、http 1.X 2.0区别 ( 帧 流 推送 头部压缩 安全性等等 ,答得有些乱

20 | 9、链表 奇位上升偶位下降 整合成升序链表 (非常友好的题了

21 | 10、gaplock mvcc mvcc 用处 (mvcc 结合之前的实习经验说了一下 ,gaplock听过 不过完全没了解)

22 | 一面结束 觉得自己说的还行 等二面的时候突然开始紧张

23 |

24 | 【二面】

25 |

26 | 1、LRU实现、插入操作、 描述数据结构如何变化 (说双向链表加哈希,在双向链表上做lru,加哈希表是为了快速定位要移动的节点)

27 | 2、实现哈希表 冲突过多的时候如何解决 (扩容

28 | 3、redis zset 数据结构描述 (之前看过黄建宏的redis设计与实现原理(强推,还有redis实战),答得还比较轻松,zset是一个字典加跳表 又详细描述(画)了下跳表

29 | 4、大数加法 链表 (也很友好了

30 | 5、zset 除了用跳表 还可以用什么实现 (想了想 可以红黑树,不过说完我就赶紧说 可是红黑树我不会实现,提前认怂,面试官就笑了,他说不用实现别怕)

31 | 如何用红黑树如何实现zrange by score (我第一反应是加个双向链表,但是没有想好到底怎么和红黑树连起来 。后来面试官提示,可以在红黑树里加索引)

32 | 二面面试官刚开始感觉很严肃 其实人很nice 。没让我问问题,直接让我等下一个面试官

33 |

34 | 【三面】

35 |

36 | 1、Tcp: 拔网线之后连接是否存在 为什么 (记得tcp的长连接是有一个类似心跳检测的机制,忘了叫啥了,面试官问我心跳检测是在传输层吗还是应用层 ,我说应用层有心跳检测,但tcp那层也有类似的,后来回来看了下tcp的保活,跟我当时说的差不多,就是名词没想起来)

37 | 2、联合索引:b+树是什么状态 (画了一下,面试官反复问我高度什么的,我说高度没有影响,说了最左前缀 )

38 | 3、寻找中位数 ( 堆

39 | 4、一棵树 寻找节点中最长路径 (动规

40 | 5、sql语句

41 | 6、 操作系统如何识别tcp连接

--------------------------------------------------------------------------------

/docs/数据结构与算法/算法学习资源推荐.md:

--------------------------------------------------------------------------------

1 | 我比较推荐大家可以刷一下 Leetcode ,我自己平时没事也会刷一下,我觉得刷 Leetcode 不仅是为了能让你更从容地面对面试中的手撕算法问题,更可以提高你的编程思维能力、解决问题的能力以及你对某门编程语言 API 的熟练度。当然牛客网也有一些算法题,我下面也整理了一些。

2 |

3 | ## LeetCode

4 |

5 | - [LeetCode(中国)官网](https://leetcode-cn.com/)

6 |

7 | - [如何高效地使用 LeetCode](https://leetcode-cn.com/articles/%E5%A6%82%E4%BD%95%E9%AB%98%E6%95%88%E5%9C%B0%E4%BD%BF%E7%94%A8-leetcode/)

8 |

9 |

10 | ## 牛客网

11 |

12 | - [牛客网官网](https://www.nowcoder.com)

13 | - [剑指offer编程题](https://www.nowcoder.com/ta/coding-interviews)

14 |

15 | - [2017校招真题](https://www.nowcoder.com/ta/2017test)

16 | - [华为机试题](https://www.nowcoder.com/ta/huawei)

17 |

18 |

19 | ## 公司真题

20 |

21 | - [ 网易2018校园招聘编程题真题集合](https://www.nowcoder.com/test/6910869/summary)

22 | - [ 网易2018校招内推编程题集合](https://www.nowcoder.com/test/6291726/summary)

23 | - [2017年校招全国统一模拟笔试(第五场)编程题集合](https://www.nowcoder.com/test/5986669/summary)

24 | - [2017年校招全国统一模拟笔试(第四场)编程题集合](https://www.nowcoder.com/test/5507925/summary)

25 | - [2017年校招全国统一模拟笔试(第三场)编程题集合](https://www.nowcoder.com/test/5217106/summary)

26 | - [2017年校招全国统一模拟笔试(第二场)编程题集合](https://www.nowcoder.com/test/4546329/summary)

27 | - [ 2017年校招全国统一模拟笔试(第一场)编程题集合](https://www.nowcoder.com/test/4236887/summary)

28 | - [百度2017春招笔试真题编程题集合](https://www.nowcoder.com/test/4998655/summary)

29 | - [网易2017春招笔试真题编程题集合](https://www.nowcoder.com/test/4575457/summary)

30 | - [网易2017秋招编程题集合](https://www.nowcoder.com/test/2811407/summary)

31 | - [网易有道2017内推编程题](https://www.nowcoder.com/test/2385858/summary)

32 | - [ 滴滴出行2017秋招笔试真题-编程题汇总](https://www.nowcoder.com/test/3701760/summary)

33 | - [腾讯2017暑期实习生编程题](https://www.nowcoder.com/test/1725829/summary)

34 | - [今日头条2017客户端工程师实习生笔试题](https://www.nowcoder.com/test/1649301/summary)

35 | - [今日头条2017后端工程师实习生笔试题](https://www.nowcoder.com/test/1649268/summary)

36 |

37 |

38 |

39 |

40 |

41 |

42 |

43 |

44 |

45 |

46 |

47 |

48 |

49 |

50 |

51 |

52 |

53 |

--------------------------------------------------------------------------------

/docs/简历与面经/简历模板.md:

--------------------------------------------------------------------------------

1 | # 联系方式

2 |

3 | - 手机:

4 | - Email:

5 | - 微信:

6 |

7 | # 个人信息

8 |

9 | - 姓名/性别/出生日期

10 | - 本科/xxx计算机系xxx专业/英语六级

11 | - 技术博客:[http://snailclimb.top/](http://snailclimb.top/)

12 | - 荣誉奖励:获得了什么奖(获奖时间)

13 | - Github:[https://github.com/Snailclimb ](https://github.com/Snailclimb)

14 | - Github Resume: [http://resume.github.io/?Snailclimb](http://resume.github.io/?Snailclimb)

15 | - 期望职位:Java 研发程序员/大数据工程师(Java后台开发为首选)

16 | - 期望城市:xxx城市

17 |

18 |

19 | # 项目经历

20 |

21 | ## xxx项目

22 |

23 | ### 项目描述

24 |

25 | 介绍该项目是做什么的、使用到了什么技术以及你对项目整体设计的一个感受

26 |

27 | ### 责任描述

28 |

29 | 主要可以从下面三点来写:

30 |

31 | 1. 在这个项目中你负责了什么、做了什么、担任了什么角色

32 | 2. 从这个项目中你学会了那些东西,使用到了那些技术,学会了那些新技术的使用

33 | 3. 另外项目描述中,最好可以体现自己的综合素质,比如你是如何协调项目组成员协同开发的或者在遇到某一个棘手的问题的时候你是如何解决的。

34 |

35 | # 开源项目和技术文章

36 |

37 | ## 开源项目

38 |

39 | - [Java-Guide](https://github.com/Snailclimb/Java-Guide) :一份涵盖大部分Java程序员所需要掌握的核心知识。Star:3.9K; Fork:0.9k。

40 |

41 |

42 | ## 技术文章推荐

43 |

44 | - [可能是把Java内存区域讲的最清楚的一篇文章](https://juejin.im/post/5b7d69e4e51d4538ca5730cb)

45 | - [搞定JVM垃圾回收就是这么简单](https://juejin.im/post/5b85ea54e51d4538dd08f601)

46 | - [前端&后端程序员必备的Linux基础知识](https://juejin.im/post/5b3b19856fb9a04fa42f8c71)

47 | - [可能是把Docker的概念讲的最清楚的一篇文章](https://juejin.im/post/5b260ec26fb9a00e8e4b031a)

48 |

49 |

50 | # 校园经历(可选)

51 |

52 | ## 2016-2017

53 |

54 | 担任学校社团-致深社副会长,主要负责团队每周活动的组建以及每周例会的主持。

55 |

56 | ## 2017-2018

57 | 担任学校传媒组织:“长江大学在线信息传媒”的副站长以及安卓组成员。主要负责每周例会主持、活动策划以及学校校园通APP的研发工作。

58 |

59 |

60 | # 技能清单

61 |

62 | 以下均为我熟练使用的技能

63 |

64 | - Web开发:PHP/Hack/Node

65 | - Web框架:ThinkPHP/Yaf/Yii/Lavarel/LazyPHP

66 | - 前端框架:Bootstrap/AngularJS/EmberJS/HTML5/Cocos2dJS/ionic

67 | - 前端工具:Bower/Gulp/SaSS/LeSS/PhoneGap

68 | - 数据库相关:MySQL/PgSQL/PDO/SQLite

69 | - 版本管理、文档和自动化部署工具:Svn/Git/PHPDoc/Phing/Composer

70 | - 单元测试:PHPUnit/SimpleTest/Qunit

71 | - 云和开放平台:SAE/BAE/AWS/微博开放平台/微信应用开发

72 |

73 | # 自我评价(可选)

74 |

75 | 自我发挥。切记不要过度自夸!!!

76 |

77 |

78 | ### 感谢您花时间阅读我的简历,期待能有机会和您共事。

79 |

80 |

--------------------------------------------------------------------------------

/docs/系统设计/website-architecture/8 张图读懂大型网站技术架构.md:

--------------------------------------------------------------------------------

1 | > 本文是作者读 《大型网站技术架构》所做的思维导图,在这里分享给各位,公众号(JavaGuide)后台回复:“架构”。即可获得下面图片的源文件以及思维导图源文件!

2 |

3 |

4 |

5 | - [1. 大型网站架构演化](#1-大型网站架构演化)

6 | - [2. 大型架构模式](#2-大型架构模式)

7 | - [3. 大型网站核心架构要素](#3-大型网站核心架构要素)

8 | - [4. 瞬时响应:网站的高性能架构](#4-瞬时响应网站的高性能架构)

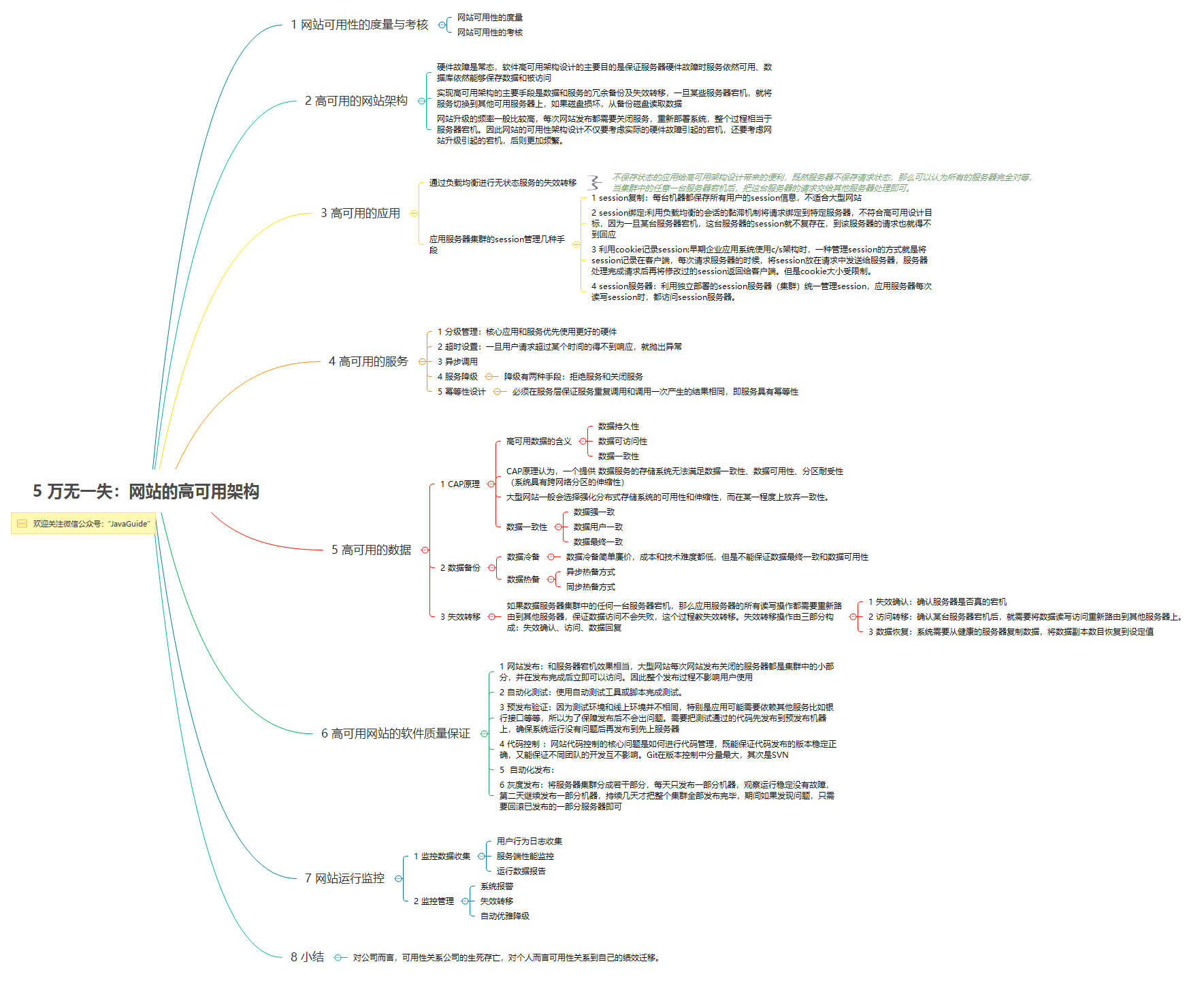

9 | - [5. 万无一失:网站的高可用架构](#5-万无一失网站的高可用架构)

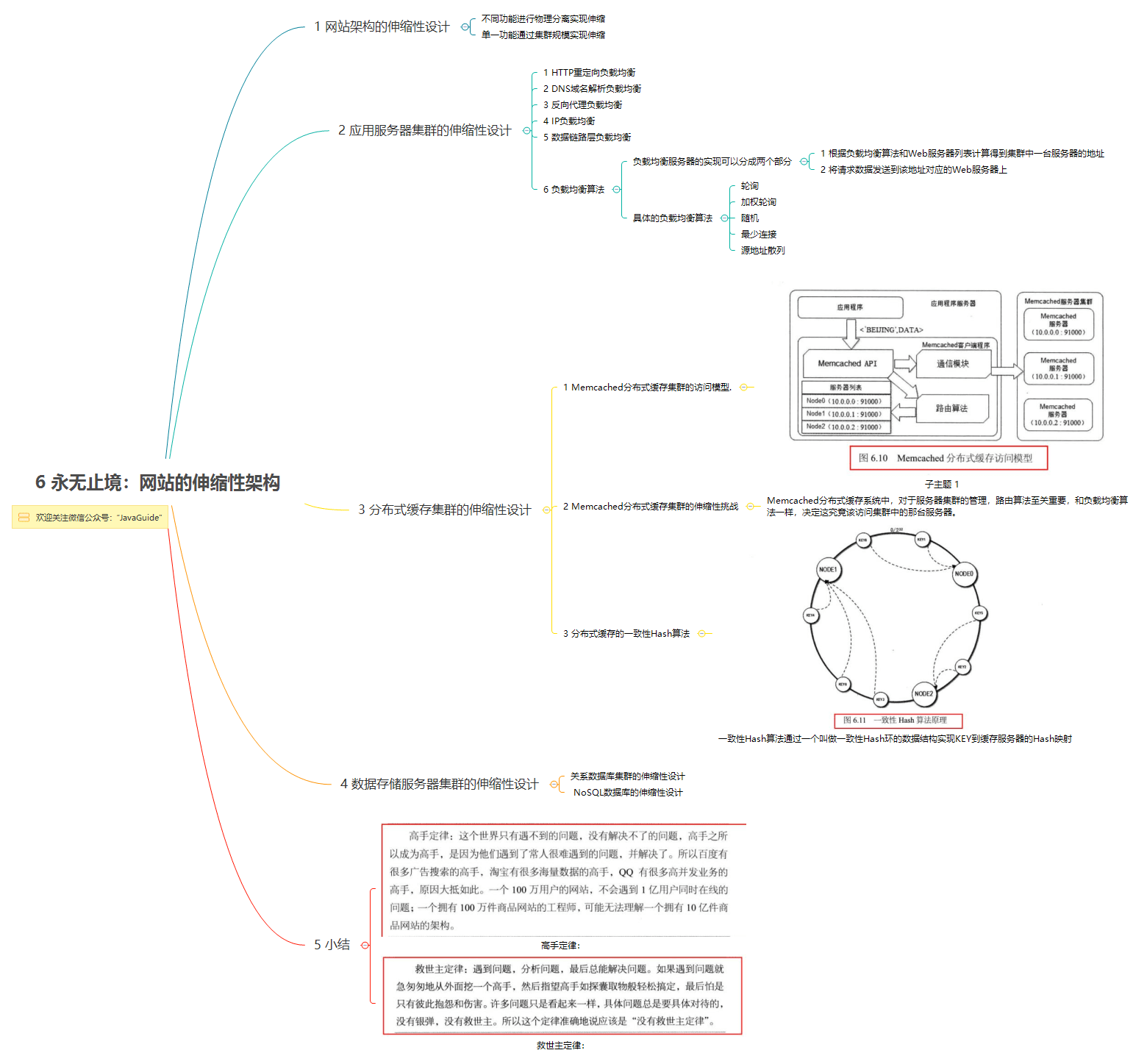

10 | - [6. 永无止境:网站的伸缩性架构](#6-永无止境网站的伸缩性架构)

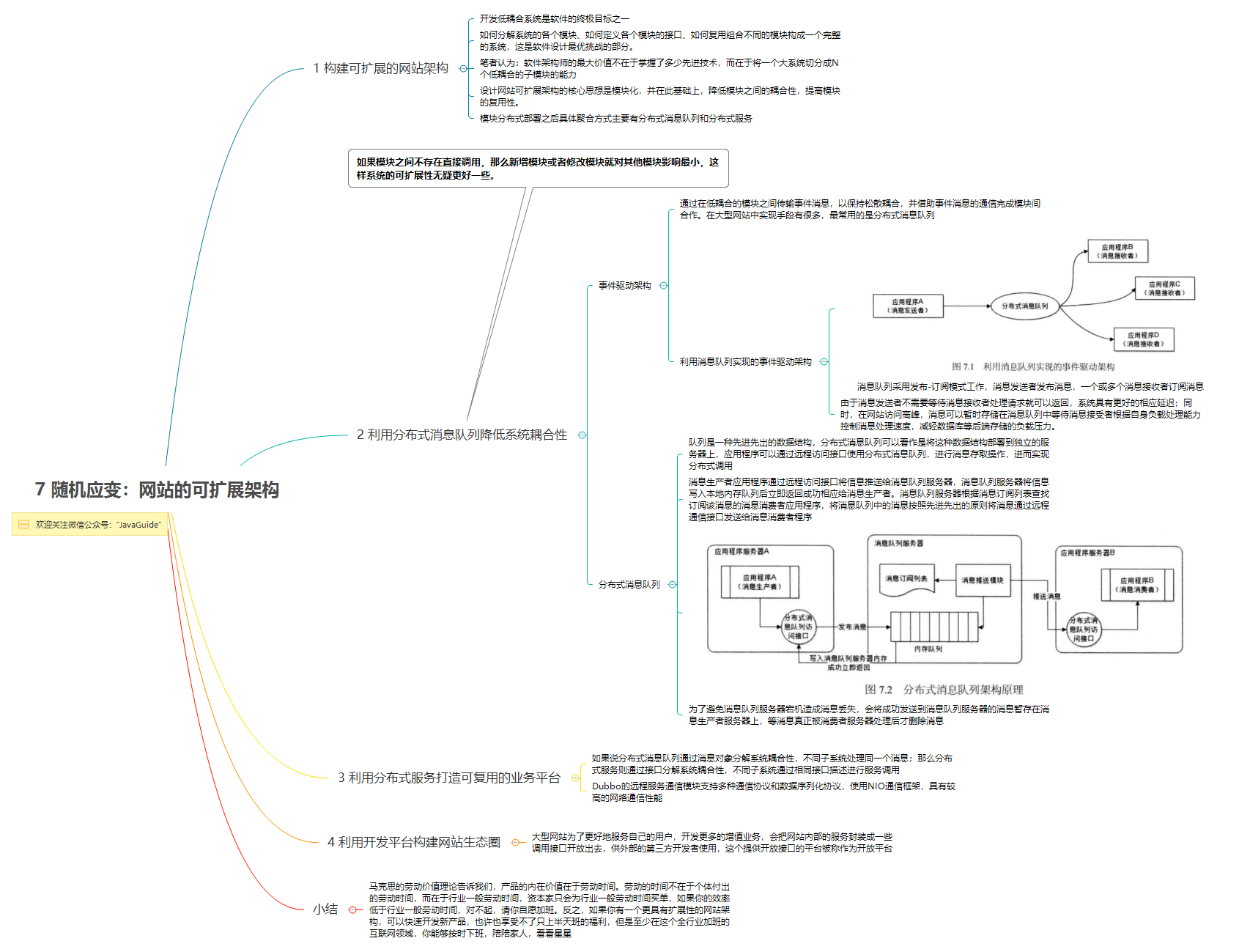

11 | - [7. 随机应变:网站的可扩展性架构](#7-随机应变网站的可扩展性架构)

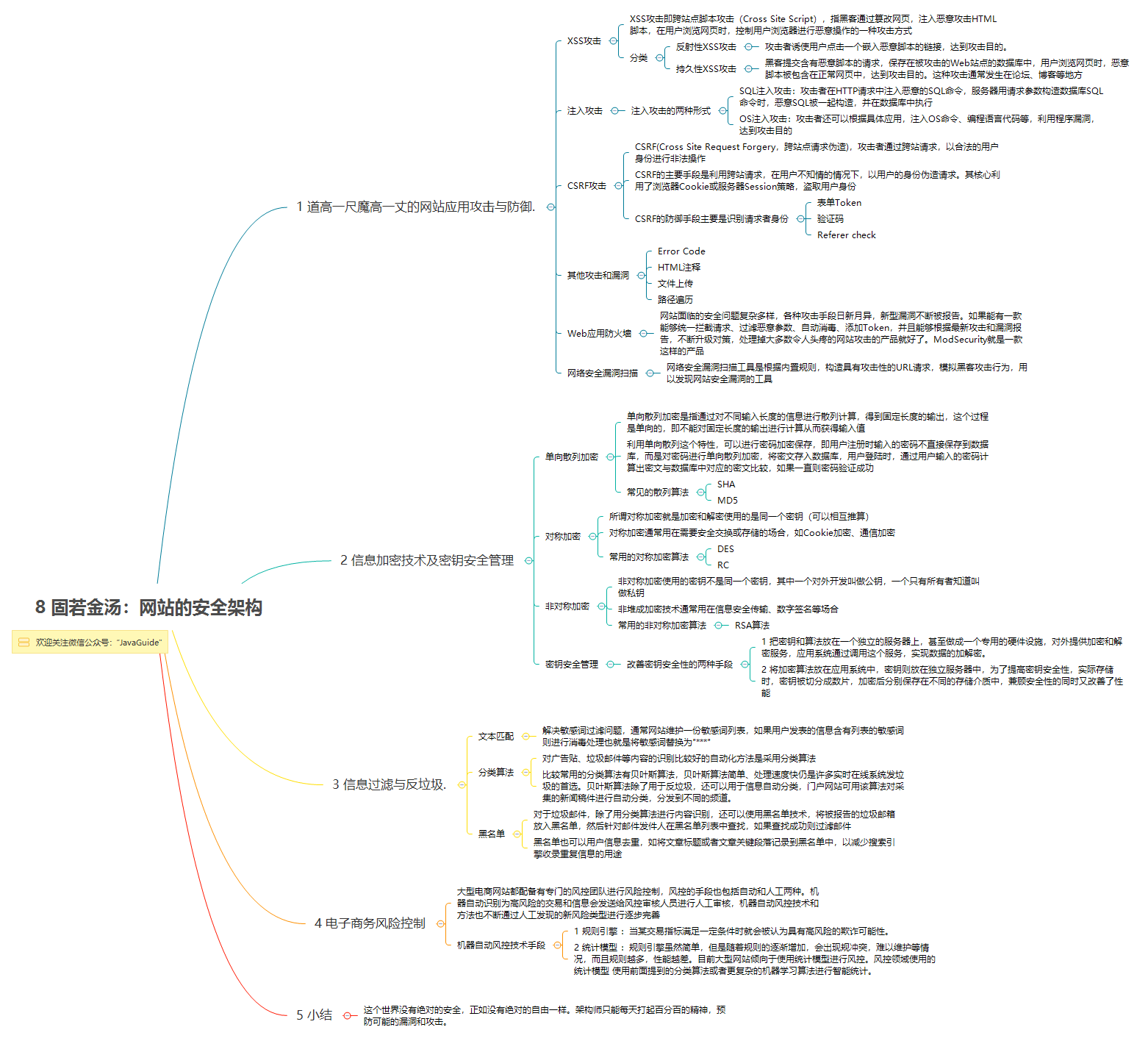

12 | - [8. 固若金汤:网站的安全机构](#8-固若金汤网站的安全机构)

13 |

14 |

15 |

16 |

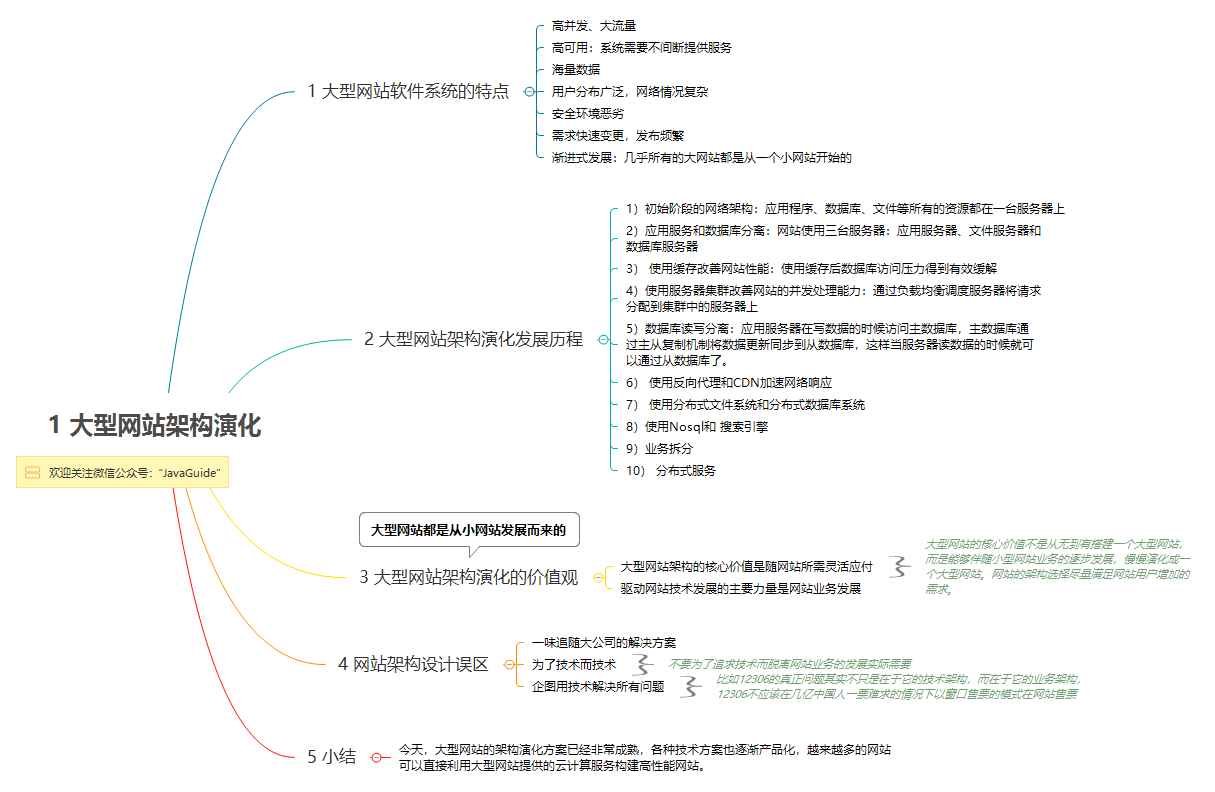

17 | ### 1. 大型网站架构演化

18 |

19 |

20 |

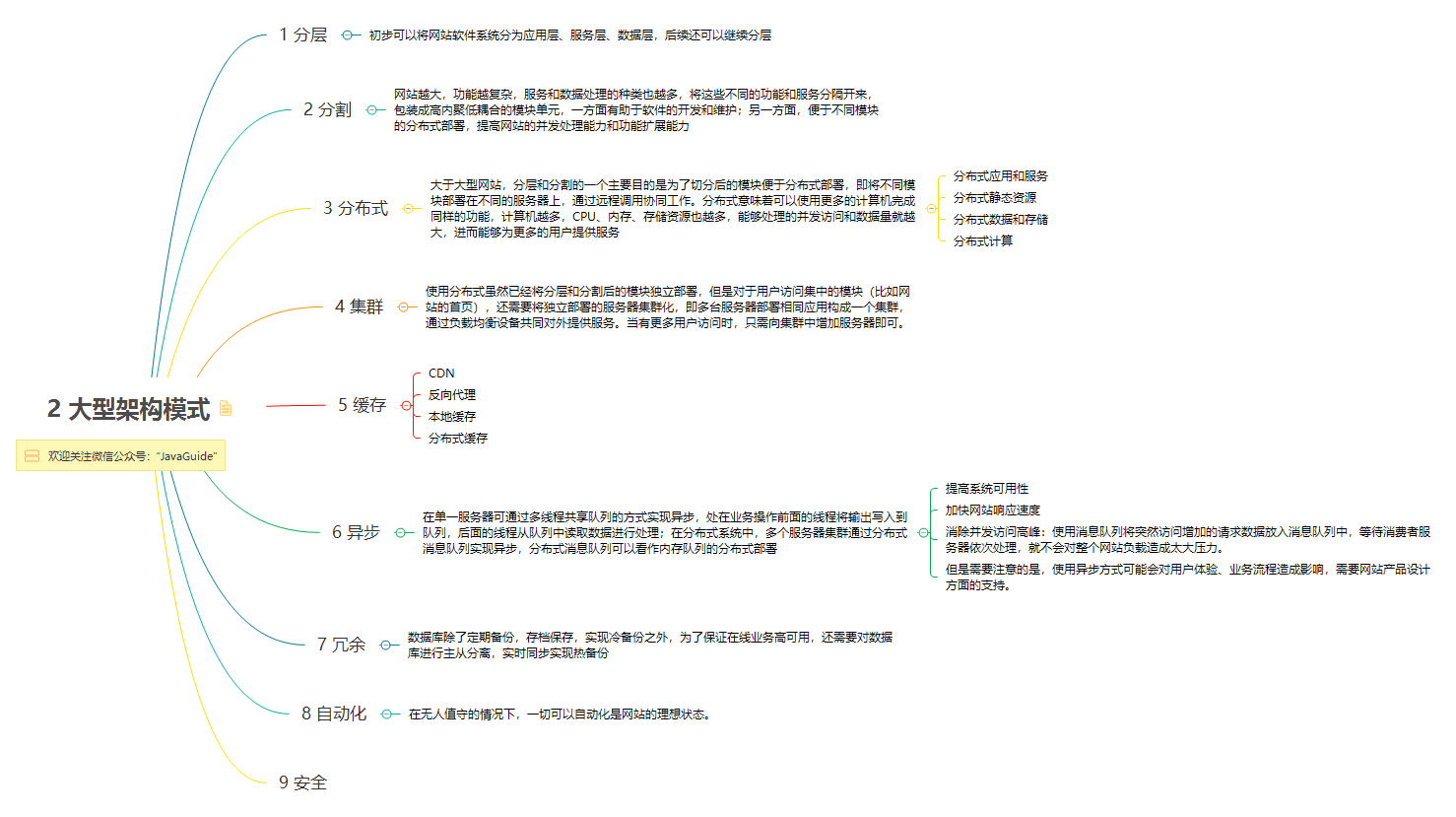

21 | ### 2. 大型架构模式

22 |

23 |

24 |

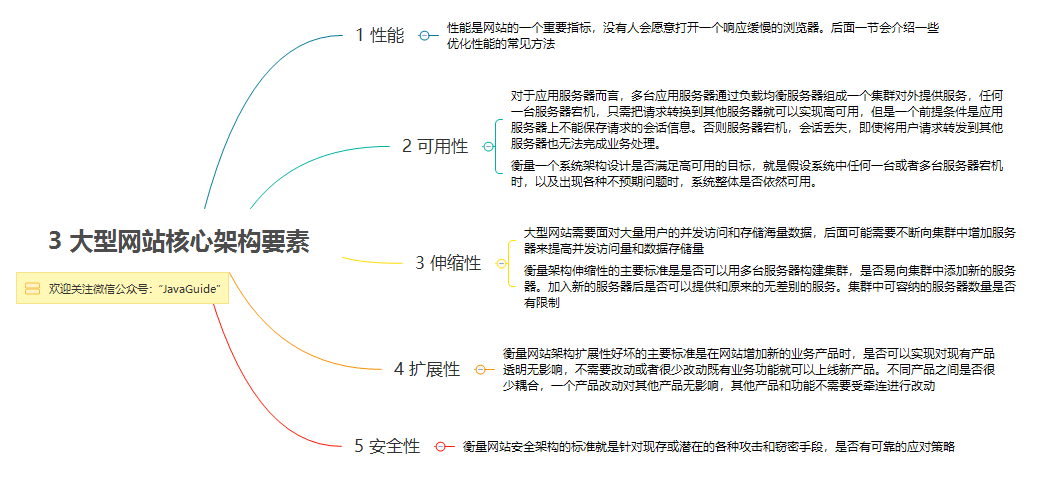

25 | ### 3. 大型网站核心架构要素

26 |

27 |

28 |

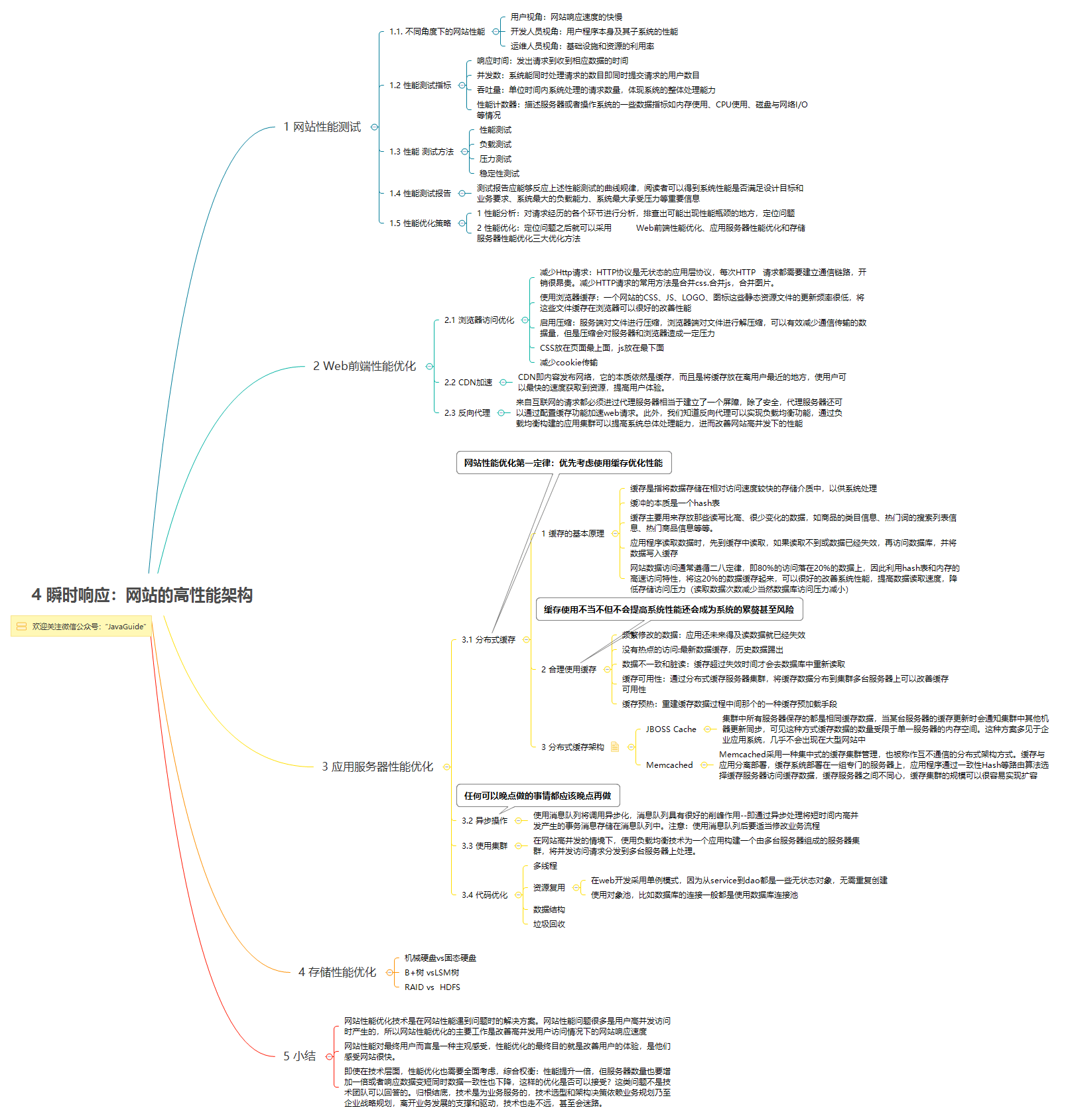

29 | ### 4. 瞬时响应:网站的高性能架构

30 |

31 |

32 |

33 | ### 5. 万无一失:网站的高可用架构

34 |

35 |

36 |

37 | ### 6. 永无止境:网站的伸缩性架构

38 |

39 |

40 |

41 | ### 7. 随机应变:网站的可扩展性架构

42 |

43 |

44 |

45 | ### 8. 固若金汤:网站的安全机构

46 |

47 |

48 |

--------------------------------------------------------------------------------

/docs/数据库/Redis/Redlock分布式锁.md:

--------------------------------------------------------------------------------

1 | 这篇文章主要是对 Redis 官方网站刊登的 [Distributed locks with Redis](https://redis.io/topics/distlock) 部分内容的总结和翻译。

2 |

3 | ## 什么是 RedLock

4 |

5 | Redis 官方站这篇文章提出了一种权威的基于 Redis 实现分布式锁的方式名叫 *Redlock*,此种方式比原先的单节点的方法更安全。它可以保证以下特性:

6 |

7 | 1. 安全特性:互斥访问,即永远只有一个 client 能拿到锁

8 | 2. 避免死锁:最终 client 都可能拿到锁,不会出现死锁的情况,即使原本锁住某资源的 client crash 了或者出现了网络分区

9 | 3. 容错性:只要大部分 Redis 节点存活就可以正常提供服务

10 |

11 | ## 怎么在单节点上实现分布式锁

12 |

13 | > SET resource_name my_random_value NX PX 30000

14 |

15 | 主要依靠上述命令,该命令仅当 Key 不存在时(NX保证)set 值,并且设置过期时间 3000ms (PX保证),值 my_random_value 必须是所有 client 和所有锁请求发生期间唯一的,释放锁的逻辑是:

16 |

17 | ```lua

18 | if redis.call("get",KEYS[1]) == ARGV[1] then

19 | return redis.call("del",KEYS[1])

20 | else

21 | return 0

22 | end

23 | ```

24 |

25 | 上述实现可以避免释放另一个client创建的锁,如果只有 del 命令的话,那么如果 client1 拿到 lock1 之后因为某些操作阻塞了很长时间,此时 Redis 端 lock1 已经过期了并且已经被重新分配给了 client2,那么 client1 此时再去释放这把锁就会造成 client2 原本获取到的锁被 client1 无故释放了,但现在为每个 client 分配一个 unique 的 string 值可以避免这个问题。至于如何去生成这个 unique string,方法很多随意选择一种就行了。

26 |

27 | ## Redlock 算法

28 |

29 | 算法很易懂,起 5 个 master 节点,分布在不同的机房尽量保证可用性。为了获得锁,client 会进行如下操作:

30 |

31 | 1. 得到当前的时间,微秒单位

32 | 2. 尝试顺序地在 5 个实例上申请锁,当然需要使用相同的 key 和 random value,这里一个 client 需要合理设置与 master 节点沟通的 timeout 大小,避免长时间和一个 fail 了的节点浪费时间

33 | 3. 当 client 在大于等于 3 个 master 上成功申请到锁的时候,且它会计算申请锁消耗了多少时间,这部分消耗的时间采用获得锁的当下时间减去第一步获得的时间戳得到,如果锁的持续时长(lock validity time)比流逝的时间多的话,那么锁就真正获取到了。

34 | 4. 如果锁申请到了,那么锁真正的 lock validity time 应该是 origin(lock validity time) - 申请锁期间流逝的时间

35 | 5. 如果 client 申请锁失败了,那么它就会在少部分申请成功锁的 master 节点上执行释放锁的操作,重置状态

36 |

37 | ## 失败重试

38 |

39 | 如果一个 client 申请锁失败了,那么它需要稍等一会在重试避免多个 client 同时申请锁的情况,最好的情况是一个 client 需要几乎同时向 5 个 master 发起锁申请。另外就是如果 client 申请锁失败了它需要尽快在它曾经申请到锁的 master 上执行 unlock 操作,便于其他 client 获得这把锁,避免这些锁过期造成的时间浪费,当然如果这时候网络分区使得 client 无法联系上这些 master,那么这种浪费就是不得不付出的代价了。

40 |

41 | ## 放锁

42 |

43 | 放锁操作很简单,就是依次释放所有节点上的锁就行了

44 |

45 | ## 性能、崩溃恢复和 fsync

46 |

47 | 如果我们的节点没有持久化机制,client 从 5 个 master 中的 3 个处获得了锁,然后其中一个重启了,这是注意 **整个环境中又出现了 3 个 master 可供另一个 client 申请同一把锁!** 违反了互斥性。如果我们开启了 AOF 持久化那么情况会稍微好转一些,因为 Redis 的过期机制是语义层面实现的,所以在 server 挂了的时候时间依旧在流逝,重启之后锁状态不会受到污染。但是考虑断电之后呢,AOF部分命令没来得及刷回磁盘直接丢失了,除非我们配置刷回策略为 fsnyc = always,但这会损伤性能。解决这个问题的方法是,当一个节点重启之后,我们规定在 max TTL 期间它是不可用的,这样它就不会干扰原本已经申请到的锁,等到它 crash 前的那部分锁都过期了,环境不存在历史锁了,那么再把这个节点加进来正常工作。

48 |

--------------------------------------------------------------------------------

/docs/系统设计/website-architecture/分布式.md:

--------------------------------------------------------------------------------

1 | - ### 一 分布式系统的经典基础理论

2 |

3 | [分布式系统的经典基础理论](https://blog.csdn.net/qq_34337272/article/details/80444032)

4 |

5 | 本文主要是简单的介绍了三个常见的概念: **分布式系统设计理念** 、 **CAP定理** 、 **BASE理论** ,关于分布式系统的还有很多很多东西。

6 |

7 |

8 | - ### 二 分布式事务

9 | 分布式事务就是指事务的参与者、支持事务的服务器、资源服务器以及事务管理器分别位于不同的分布式系统的不同节点之上。以上是百度百科的解释,简单的说,就是一次大的操作由不同的小操作组成,这些小的操作分布在不同的服务器上,且属于不同的应用,分布式事务需要保证这些小操作要么全部成功,要么全部失败。本质上来说,分布式事务就是为了保证不同数据库的数据一致性。

10 | * [深入理解分布式事务](http://www.codeceo.com/article/distributed-transaction.html)

11 | * [分布式事务?No, 最终一致性](https://zhuanlan.zhihu.com/p/25933039)

12 | * [聊聊分布式事务,再说说解决方案](https://www.cnblogs.com/savorboard/p/distributed-system-transaction-consistency.html)

13 |

14 |

15 | - ### 三 分布式系统一致性

16 | [分布式服务化系统一致性的“最佳实干”](https://www.jianshu.com/p/1156151e20c8)

17 |

18 | - ### 四 一致性协议/算法

19 | 早在1898年就诞生了著名的 **Paxos经典算法** (**Zookeeper就采用了Paxos算法的近亲兄弟Zab算法**),但由于Paxos算法非常难以理解、实现、排错。所以不断有人尝试简化这一算法,直到2013年才有了重大突破:斯坦福的Diego Ongaro、John Ousterhout以易懂性为目标设计了新的一致性算法—— **Raft算法** ,并发布了对应的论文《In Search of an Understandable Consensus Algorithm》,到现在有十多种语言实现的Raft算法框架,较为出名的有以Go语言实现的Etcd,它的功能类似于Zookeeper,但采用了更为主流的Rest接口。

20 | * [图解 Paxos 一致性协议](https://mp.weixin.qq.com/s?__biz=MzI0NDI0MTgyOA==&mid=2652037784&idx=1&sn=d8c4f31a9cfb49ee91d05bb374e5cdd5&chksm=f2868653c5f10f45fc4a64d15a5f4163c3e66c00ed2ad334fa93edb46671f42db6752001f6c0#rd)

21 | * [图解分布式协议-RAFT](http://ifeve.com/raft/)

22 | * [Zookeeper ZAB 协议分析](https://dbaplus.cn/news-141-1875-1.html)

23 |

24 | - ### 五 分布式存储

25 |

26 | **分布式存储系统将数据分散存储在多台独立的设备上**。传统的网络存储系统采用集中的存储服务器存放所有数据,存储服务器成为系统性能的瓶颈,也是可靠性和安全性的焦点,不能满足大规模存储应用的需要。分布式网络存储系统采用可扩展的系统结构,利用多台存储服务器分担存储负荷,利用位置服务器定位存储信息,它不但提高了系统的可靠性、可用性和存取效率,还易于扩展。

27 |

28 | * [分布式存储系统概要](http://witchiman.top/2017/05/05/distributed-system/)

29 |

30 | - ### 六 分布式计算

31 |

32 | **所谓分布式计算是一门计算机科学,它研究如何把一个需要非常巨大的计算能力才能解决的问题分成许多小的部分,然后把这些部分分配给许多计算机进行处理,最后把这些计算结果综合起来得到最终的结果。**

33 | 分布式网络存储技术是将数据分散的存储于多台独立的机器设备上。分布式网络存储系统采用可扩展的系统结构,利用多台存储服务器分担存储负荷,利用位置服务器定位存储信息,不但解决了传统集中式存储系统中单存储服务器的瓶颈问题,还提高了系统的可靠性、可用性和扩展性。

34 |

35 | * [关于分布式计算的一些概念](https://blog.csdn.net/qq_34337272/article/details/80549020)

36 |

37 |

--------------------------------------------------------------------------------

/docs/Python/Flask请求流程.md:

--------------------------------------------------------------------------------

1 | ## Flask请求流程

2 |

3 | http请求-->Ngix-->WSGI-->web框架

4 |

5 | 请求进入Flask,flask调用__call__方法:

6 | ```python

7 | def __call__(self, environ, start_response):

8 | """The WSGI server calls the Flask application object as the

9 | WSGI application. This calls :meth:`wsgi_app` which can be

10 | wrapped to applying middleware."""

11 | return self.wsgi_app(environ, start_response)

12 | ```

13 |

14 | 实际调用wsgi_app方法:

15 | ```python

16 | def wsgi_app(self, environ, start_response):

17 | """..."""

18 | ctx = self.request_context(environ)

19 | error = None

20 | try:

21 | try:

22 | ctx.push()

23 | response = self.full_dispatch_request()

24 | except Exception as e:

25 | error = e

26 | response = self.handle_exception(e)

27 | except: # noqa: B001

28 | error = sys.exc_info()[1]

29 | raise

30 | return response(environ, start_response)

31 | finally:

32 | if self.should_ignore_error(error):

33 | error = None

34 | ctx.auto_pop(error)

35 | ```

36 |

37 | 首先调用request_context方法创建请求上下文ctx。然后做相应的处理,最后请求上下文ctx出栈。

38 | 可任意看到其实request_contect方法实际上就是创建返回的请求上下文对象RequestContext。

39 |

40 | ```python

41 | def request_context(self, environ):

42 | """..."""

43 | return RequestContext(self, environ)

44 | ```

45 |

46 | 进入RequestContext去看,就是封装了一个Request对象,并提供了push,pop方法。

47 |

48 | ```python

49 | class RequestContext(object):

50 | def __init__(self, app, environ, request=None, session=None):...

51 |

52 | def push(self):...

53 |

54 | def pop(self, exc=_sentinel):...

55 | ```

56 |

57 | 创建了请求上下文对象,接下来调用 ctx.push()方法将它推入栈中,full_dispatch_request()方法就是对请求进行分发,更具请求调用相应的视图函数做处理,得到响应内容,再将响应返回。最后是调用ctx.auto_pop方法将这个请求上下文推出栈(auto_pop方法进行了异常处理然后调用pop方法出栈)。

58 |

59 | 再视图函数或其他地方需要用到当前请求相关内容时,是从flask导入request。用到session也是从flask导入,如下:

60 | ```python

61 | from flask import session, request

62 | ```

63 | 实际上是从flask框架的globals.py里导入的。这个模块里有如下全局变量:

64 | ```python

65 | # context locals

66 | _request_ctx_stack = LocalStack()

67 | _app_ctx_stack = LocalStack()

68 | current_app = LocalProxy(_find_app)

69 | request = LocalProxy(partial(_lookup_req_object, "request"))

70 | session = LocalProxy(partial(_lookup_req_object, "session"))

71 | g = LocalProxy(partial(_lookup_app_object, "g"))

72 | ```

73 |

74 | 导入request实际上是导入的一个代理对象,对request的操作都是通过这个代理对象去操作的。类似threading.Local(),这个代理对象也实现了线程隔离。

--------------------------------------------------------------------------------

/docs/简历与面经/PreparingForInterview/如果面试官问你“你有什么问题问我吗?”时,你该如何回答.md:

--------------------------------------------------------------------------------

1 | 我还记得当时我去参加面试的时候,几乎每一场面试,特别是HR面和高管面的时候,面试官总是会在结尾问我:“问了你这么多问题了,你有什么问题问我吗?”。这个时候很多人内心就会陷入短暂的纠结中:我该问吗?不问的话面试官会不会对我影响不好?问什么问题?问这个问题会不会让面试官对我的影响不好啊?

2 |

3 |

4 |

5 | ### 这个问题对最终面试结果的影响到底大不大?

6 |

7 | 就技术面试而言,回答这个问题的时候,只要你不是触碰到你所面试的公司的雷区,那么我觉得这对你能不能拿到最终offer来说影响确实是不大的。我说这些并不代表你就可以直接对面试官说:“我没问题了。”,笔主当时面试的时候确实也说过挺多次“没问题要问了。”,最终也没有导致笔主被pass掉(可能是前面表现比较好,哈哈,自恋一下)。我现在回想起来,觉得自己当时做法其实挺不对的。面试本身就是一个双向选择的过程,你对这个问题的回答也会侧面反映出你对这次面试的上心程度,你的问题是否有价值,也影响了你最终的选择与公司是否选择你。

8 |

9 | 面试官在技术面试中主要考察的还是你这样个人到底有没有胜任这个工作的能力以及你是否适合公司未来的发展需要,很多公司还需要你认同它的文化,我觉得你只要不是太笨,应该不会栽在这里。除非你和另外一个人在能力上相同,但是只能在你们两个人中选一个,那么这个问题才对你能不能拿到offer至关重要。有准备总比没准备好,给面试官留一个好的影响总归是没错的。

10 |

11 | 但是,就非技术面试来说,我觉得好好回答这个问题对你最终的结果还是比较重要的。

12 |

13 | 总的来说不管是技术面试还是非技术面试,如果你想赢得公司的青睐和尊重,我觉得我们都应该重视这个问题。

14 |

15 | ### 真诚一点,不要问太 Low 的问题

16 |

17 | 回答这个问题很重要的一点就是你没有必要放低自己的姿态问一些很虚或者故意讨好面试官的问题,也不要把自己从面经上学到的东西照搬下来使用。面试官也不是傻子,特别是那种特别有经验的面试官,你是真心诚意的问问题,还是从别处照搬问题来讨好面试官,人家可能一听就听出来了。总的来说,还是要真诚。除此之外,不要问太 Low 的问题,会显得你整个人格局比较小或者说你根本没有准备(侧面反映你对这家公司不上心,既然你不上心,为什么要要你呢)。举例几个比较 Low 的问题,大家看看自己有没有问过其中的问题:

18 |

19 | - 贵公司的主要业务是什么?(面试之前自己不知道提前网上查一下吗?)

20 | - 贵公司的男女比例如何?(考虑脱单?记住你是来工作的!)

21 | - 贵公司一年搞几次外出旅游?(你是来工作的,这些娱乐活动先别放在心上!)

22 | - ......

23 |

24 | ### 有哪些有价值的问题值得问?

25 |

26 | 针对这个问题。笔主专门找了几个专门做HR工作的小哥哥小姐姐们询问并且查阅了挺多前辈们的回答,然后结合自己的实际经历,我概括了下面几个比较适合问的问题。

27 |

28 | #### 面对HR或者其他Level比较低的面试官时

29 |

30 | 1. **能不能谈谈你作为一个公司老员工对公司的感受?** (这个问题比较容易回答,不会让面试官陷入无话可说的尴尬境地。另外,从面试官的回答中你可以加深对这个公司的了解,让你更加清楚这个公司到底是不是你想的那样或者说你是否能适应这个公司的文化。除此之外,这样的问题在某种程度上还可以拉进你与面试官的距离。)

31 | 2. **能不能问一下,你当时因为什么原因选择加入这家公司的呢或者说这家公司有哪些地方吸引你?有什么地方你觉得还不太好或者可以继续完善吗?** (类似第一个问题,都是问面试官个人对于公司的看法。)

32 | 3. **我觉得我这次表现的不是太好,你有什么建议或者评价给我吗?**(这个是我常问的。我觉得说自己表现不好只是这个语境需要这样来说,这样可以显的你比较谦虚好学上进。)

33 | 4. **接下来我会有一段空档期,有什么值得注意或者建议学习的吗?** (体现出你对工作比较上心,自助学习意识比较强。)

34 | 5. **这个岗位为什么还在招人?** (岗位真实性和价值咨询)

35 | 6. **大概什么时候能给我回复呢?** (终面的时候,如果面试官没有说的话,可以问一下)

36 | 7. ......

37 |

38 |

39 |

40 | #### 面对部门领导

41 |

42 | 1. **部门的主要人员分配以及对应的主要工作能简单介绍一下吗?**

43 | 2. **未来如果我要加入这个团队,你对我的期望是什么?** (部门领导一般情况下是你的直属上级了,你以后和他打交道的机会应该是最多的。你问这个问题,会让他感觉你是一个对他的部门比较上心,比较有团体意识,并且愿意倾听的候选人。)

44 | 3. **公司对新入职的员工的培养机制是什么样的呢?** (正规的公司一般都有培养机制,提前问一下是对你自己的负责也会显的你比较上心)

45 | 4. **以您来看,这个岗位未来在公司内部的发展如何?** (在我看来,问这个问题也是对你自己的负责吧,谁不想发展前景更好的岗位呢?)

46 | 5. **团队现在面临的最大挑战是什么?** (这样的问题不会暴露你对公司的不了解,并且也能让你对未来工作的挑战或困难有一个提前的预期。)

47 |

48 |

49 |

50 | #### 面对Level比较高的(比如总裁,老板)

51 |

52 | 1. **贵公司的发展目标和方向是什么?** (看下公司的发展是否满足自己的期望)

53 | 2. **与同行业的竞争者相比,贵公司的核心竞争优势在什么地方?** (充分了解自己的优势和劣势)

54 | 3. **公司现在面临的最大挑战是什么?**

55 |

56 | ### 来个补充,顺便送个祝福给大家

57 |

58 | 薪酬待遇和相关福利问题一般在终面的时候(最好不要在前面几面的时候就问到这个问题),面试官会提出来或者在面试完之后以邮件的形式告知你。一般来说,如果面试官很愿意为你回答问题,对你的问题也比较上心的话,那他肯定是觉得你就是他们要招的人。

59 |

60 | 大家在面试的时候,可以根据自己对于公司或者岗位的了解程度,对上面提到的问题进行适当修饰或者修改。上面提到的一些问题只是给没有经验的朋友一个参考,如果你还有其他比较好的问题的话,那当然也更好啦!

61 |

62 | 金三银四。过了二月就到了面试高峰期或者说是黄金期。几份惊喜几份愁,愿各位能始终不忘初心!每个人都有每个人的难处。引用一句《阿甘正传》里面的台词:“生活就像一盒巧克力,你永远不知道下一块是什么味道“。

63 |

64 |

--------------------------------------------------------------------------------

/docs/简历与面经/PreparingForInterview/interviewPrepare.md:

--------------------------------------------------------------------------------

1 | 不论是校招还是社招都避免不了各种面试、笔试,如何去准备这些东西就显得格外重要。不论是笔试还是面试都是有章可循的,我这个“有章可循”说的意思只是说应对技术面试是可以提前准备。 我其实特别不喜欢那种临近考试就提前背啊记啊各种题的行为,非常反对!我觉得这种方法特别极端,而且在稍有一点经验的面试官面前是根本没有用的。建议大家还是一步一个脚印踏踏实实地走。

2 |

3 |

4 |

5 | - [1 如何获取大厂面试机会?](#1-如何获取大厂面试机会)

6 | - [2 面试前的准备](#2--面试前的准备)

7 | - [2.1 准备自己的自我介绍](#21-准备自己的自我介绍)

8 | - [2.2 关于着装](#22-关于着装)

9 | - [2.3 随身带上自己的成绩单和简历](#23-随身带上自己的成绩单和简历)

10 | - [2.4 如果需要笔试就提前刷一些笔试题](#24-如果需要笔试就提前刷一些笔试题)

11 | - [2.5 花时间一些逻辑题](#25-花时间一些逻辑题)

12 | - [2.6 准备好自己的项目介绍](#26-准备好自己的项目介绍)

13 | - [2.7 提前准备技术面试](#27-提前准备技术面试)

14 | - [2.7 面试之前做好定向复习](#27-面试之前做好定向复习)

15 | - [3 面试之后复盘](#3-面试之后复盘)

16 |

17 |

18 |

19 | ## 1 如何获取大厂面试机会?

20 |

21 | **在讲如何获取大厂面试机会之前,先来给大家科普/对比一下两个校招非常常见的概念——春招和秋招。**

22 |

23 | 1. **招聘人数** :秋招多于春招 ;

24 | 2. **招聘时间** : 秋招一般7月左右开始,大概一直持续到10月底。但是大厂(如BAT)都会早开始早结束,所以一定要把握好时间。春招最佳时间为3月,次佳时间为4月,进入5月基本就不会再有春招了(金三银四)。

25 | 3. **应聘难度** :秋招略大于春招;

26 | 4. **招聘公司:** 秋招数量多,而春招数量较少,一般为秋招的补充。

27 |

28 | **综上,一般来说,秋招的含金量明显是高于春招的。**

29 |

30 | **下面我就说一下我自己知道的一些方法,不过应该也涵盖了大部分获取面试机会的方法。**

31 |

32 | 1. **关注大厂官网,随时投递简历(走流程的网申);**

33 | 2. **线下参加宣讲会,直接投递简历;**

34 | 3. **找到师兄师姐/认识的人,帮忙内推(能够让你避开网申简历筛选,笔试筛选,还是挺不错的,不过也还是需要你的简历够棒);**

35 | 4. **博客发文被看中/Github优秀开源项目作者,大厂内部人员邀请你面试;**

36 | 5. **求职类网站投递简历(不是太推荐,适合海投);**

37 |

38 |

39 | 除了这些方法,我也遇到过这样的经历:有些大公司的一些部门可能暂时没招够人,然后如果你的亲戚或者朋友刚好在这个公司,而你正好又在寻求offer,那么面试机会基本上是有了,而且这种面试的难度好像一般还普遍比其他正规面试低很多。

40 |

41 | ## 2 面试前的准备

42 |

43 | ### 2.1 准备自己的自我介绍

44 |

45 | 从HR面、技术面到高管面/部门主管面,面试官一般会让你先自我介绍一下,所以好好准备自己的自我介绍真的非常重要。网上一般建议的是准备好两份自我介绍:一份对hr说的,主要讲能突出自己的经历,会的编程技术一语带过;另一份对技术面试官说的,主要讲自己会的技术细节,项目经验,经历那些就一语带过。

46 |

47 | 我这里简单分享一下我自己的自我介绍的一个简单的模板吧:

48 |

49 | > 面试官,您好!我叫某某。大学时间我主要利用课外时间学习某某。在校期间参与过一个某某系统的开发,另外,自己学习过程中也写过很多系统比如某某系统。在学习之余,我比较喜欢通过博客整理分享自己所学知识。我现在是某某社区的认证作者,写过某某很不错的文章。另外,我获得过某某奖,我的Github上开源的某个项目已经有多少Star了。

50 |

51 | ### 2.2 关于着装

52 |

53 | 穿西装、打领带、小皮鞋?NO!NO!NO!这是互联网公司面试又不是去走红毯,所以你只需要穿的简单大方就好,不需要太正式。

54 |

55 | ### 2.3 随身带上自己的成绩单和简历

56 |

57 | 有的公司在面试前都会让你交一份成绩单和简历当做面试中的参考。

58 |

59 | ### 2.4 如果需要笔试就提前刷一些笔试题

60 |

61 | 平时空闲时间多的可以刷一下笔试题目(牛客网上有很多)。但是不要只刷面试题,不动手code,程序员不是为了考试而存在的。

62 |

63 | ### 2.5 花时间一些逻辑题

64 |

65 | 面试中发现有些公司都有逻辑题测试环节,并且都把逻辑笔试成绩作为很重要的一个参考。

66 |

67 | ### 2.6 准备好自己的项目介绍

68 |

69 | 如果有项目的话,技术面试第一步,面试官一般都是让你自己介绍一下你的项目。你可以从下面几个方向来考虑:

70 |

71 | 1. 对项目整体设计的一个感受(面试官可能会让你画系统的架构图)

72 | 2. 在这个项目中你负责了什么、做了什么、担任了什么角色

73 | 3. 从这个项目中你学会了那些东西,使用到了那些技术,学会了那些新技术的使用

74 | 4. 另外项目描述中,最好可以体现自己的综合素质,比如你是如何协调项目组成员协同开发的或者在遇到某一个棘手的问题的时候你是如何解决的又或者说你在这个项目用了什么技术实现了什么功能比如:用redis做缓存提高访问速度和并发量、使用消息队列削峰和降流等等。

75 |

76 | ### 2.7 提前准备技术面试

77 |

78 | 搞清楚自己面试中可能涉及哪些知识点、哪些知识点是重点。面试中哪些问题会被经常问到、自己该如何回答。(强烈不推荐背题,第一:通过背这种方式你能记住多少?能记住多久?第二:背题的方式的学习很难坚持下去!)

79 |

80 | ### 2.7 面试之前做好定向复习

81 |

82 | 所谓定向复习就是专门针对你要面试的公司来复习。比如你在面试之前可以在网上找找有没有你要面试的公司的面经。

83 |

84 | 举个栗子:在我面试 ThoughtWorks 的前几天我就在网上找了一些关于 ThoughtWorks 的技术面的一些文章。然后知道了 ThoughtWorks 的技术面会让我们在之前做的作业的基础上增加一个或两个功能,所以我提前一天就把我之前做的程序重新重构了一下。然后在技术面的时候,简单的改了几行代码之后写个测试就完事了。如果没有提前准备,我觉得 20 分钟我很大几率会完不成这项任务。

85 |

86 | ## 3 面试之后复盘

87 |

88 | 如果失败,不要灰心;如果通过,切勿狂喜。面试和工作实际上是两回事,可能很多面试未通过的人,工作能力比你强的多,反之亦然。我个人觉得面试也像是一场全新的征程,失败和胜利都是平常之事。所以,劝各位不要因为面试失败而灰心、丧失斗志。也不要因为面试通过而沾沾自喜,等待你的将是更美好的未来,继续加油!

89 |

--------------------------------------------------------------------------------

/docs/简历与面经/手把手教你用Markdown写一份高质量的简历.md:

--------------------------------------------------------------------------------

1 | ## Markdown 简历模板样式一览

2 |

3 | **可以看到我把联系方式放在第一位,因为公司一般会与你联系,所以把联系方式放在第一位也是为了方便联系考虑。**

4 |

5 | ## 为什么要用 Markdown 写简历?

6 |

7 | Markdown 语法简单,易于上手。使用正确的 Markdown 语言写出来的简历不论是在排版还是格式上都比较干净,易于阅读。另外,使用 Markdown 写简历也会给面试官一种你比较专业的感觉。

8 |

9 | 除了这些,我觉得使用 Markdown 写简历可以很方便将其与PDF、HTML、PNG格式之间转换。后面我会介绍到转换方法,只需要一条命令你就可以实现 Markdown 到 PDF、HTML 与 PNG之间的无缝切换。

10 |

11 | > 下面的一些内容我在之前的一篇文章中已经提到过,这里再说一遍,最后会分享如何实现Markdown 到 PDF、HTML、PNG格式之间转换。

12 |

13 | ## 为什么说简历很重要?

14 |

15 | 假如你是网申,你的简历必然会经过HR的筛选,一张简历HR可能也就花费10秒钟看一下,然后HR就会决定你这一关是Fail还是Pass。

16 |

17 | 假如你是内推,如果你的简历没有什么优势的话,就算是内推你的人再用心,也无能为力。

18 |

19 | 另外,就算你通过了筛选,后面的面试中,面试官也会根据你的简历来判断你究竟是否值得他花费很多时间去面试。

20 |

21 | ## 写简历的两大法则

22 |

23 | 目前写简历的方式有两种普遍被认可,一种是 STAR, 一种是 FAB。

24 |

25 | **STAR法则(Situation Task Action Result):**

26 |

27 | - **Situation:** 事情是在什么情况下发生;

28 | - **Task::** 你是如何明确你的任务的;

29 | - **Action:** 针对这样的情况分析,你采用了什么行动方式;

30 | - **Result:** 结果怎样,在这样的情况下你学习到了什么。

31 |

32 | **FAB 法则(Feature Advantage Benefit):**

33 |

34 | - **Feature:** 是什么;

35 | - **Advantage:** 比别人好在哪些地方;

36 | - **Benefit:** 如果雇佣你,招聘方会得到什么好处。

37 |

38 | ## 项目经历怎么写?

39 | 简历上有一两个项目经历很正常,但是真正能把项目经历很好的展示给面试官的非常少。对于项目经历大家可以考虑从如下几点来写:

40 |

41 | 1. 对项目整体设计的一个感受

42 | 2. 在这个项目中你负责了什么、做了什么、担任了什么角色

43 | 3. 从这个项目中你学会了那些东西,使用到了那些技术,学会了那些新技术的使用

44 | 4. 另外项目描述中,最好可以体现自己的综合素质,比如你是如何协调项目组成员协同开发的或者在遇到某一个棘手的问题的时候你是如何解决的。

45 |

46 | ## 专业技能该怎么写?

47 | 先问一下你自己会什么,然后看看你意向的公司需要什么。一般HR可能并不太懂技术,所以他在筛选简历的时候可能就盯着你专业技能的关键词来看。对于公司有要求而你不会的技能,你可以花几天时间学习一下,然后在简历上可以写上自己了解这个技能。比如你可以这样写:

48 |

49 | - Dubbo:精通

50 | - Spring:精通

51 | - Docker:掌握

52 | - SOA分布式开发 :掌握

53 | - Spring Cloud:了解

54 |

55 | ## 简历模板分享

56 |

57 | **开源程序员简历模板**: [https://github.com/geekcompany/ResumeSample](https://github.com/geekcompany/ResumeSample)(包括PHP程序员简历模板、iOS程序员简历模板、Android程序员简历模板、Web前端程序员简历模板、Java程序员简历模板、C/C++程序员简历模板、NodeJS程序员简历模板、架构师简历模板以及通用程序员简历模板)

58 |

59 | **上述简历模板的改进版本:** [https://github.com/Snailclimb/Java-Guide/blob/master/面试必备/简历模板.md](https://github.com/Snailclimb/Java-Guide/blob/master/面试必备/简历模板.md)

60 |

61 | ## 其他的一些小tips

62 |

63 | 1. 尽量避免主观表述,少一点语义模糊的形容词,尽量要简洁明了,逻辑结构清晰。

64 | 2. 注意排版(不需要花花绿绿的),尽量使用Markdown语法。

65 | 3. 如果自己有博客或者个人技术栈点的话,写上去会为你加分很多。

66 | 4. 如果自己的Github比较活跃的话,写上去也会为你加分很多。

67 | 5. 注意简历真实性,一定不要写自己不会的东西,或者带有欺骗性的内容

68 | 6. 项目经历建议以时间倒序排序,另外项目经历不在于多,而在于有亮点。

69 | 7. 如果内容过多的话,不需要非把内容压缩到一页,保持排版干净整洁就可以了。

70 | 8. 简历最后最好能加上:“感谢您花时间阅读我的简历,期待能有机会和您共事。”这句话,显的你会很有礼貌。

71 |

72 |

73 | > 我们刚刚讲了很多关于如何写简历的内容并且分享了一份 Markdown 格式的简历文档。下面我们来看看如何实现 Markdown 到 HTML格式、PNG格式之间转换。

74 | ## Markdown 到 HTML格式、PNG格式之间转换

75 |

76 | 网上很难找到一个比较方便并且效果好的转换方法,最后我是通过 Visual Studio Code 的 Markdown PDF 插件完美解决了这个问题!

77 |

78 | ### 安装 Markdown PDF 插件

79 |

80 | **① 打开Visual Studio Code ,按快捷键 F1,选择安装扩展选项**

81 |

82 |

83 |

84 | **② 搜索 “Markdown PDF” 插件并安装 ,然后重启**

85 |

86 |

87 |

88 | ### 使用方法

89 |

90 | 随便打开一份 Markdown 文件 点击F1,然后输入export即可!

91 |

92 |

93 |

94 |

--------------------------------------------------------------------------------

/docs/简历与面经/PreparingForInterview/JavaInterviewLibrary.md:

--------------------------------------------------------------------------------

1 | 昨天我整理了公众号历史所有和面试相关的我觉得还不错的文章:[整理了一些有助于你拿Offer的文章]() 。今天分享一下最近逛Github看到了一些我觉得对于Java面试以及学习有帮助的仓库,这些仓库涉及Java核心知识点整理、Java常见面试题、算法、基础知识点比如网络和操作系统等等。

2 |

3 | ## 知识点相关

4 |

5 | ### 1.JavaGuide

6 |

7 | - Github地址: [https://github.com/Snailclimb/JavaGuide](https://github.com/Snailclimb/JavaGuide)

8 | - star: 64.0k

9 | - 介绍: 【Java学习+面试指南】 一份涵盖大部分Java程序员所需要掌握的核心知识。

10 |

11 | ### 2.CS-Notes

12 |

13 | - Github 地址:

14 | - Star: 68.3k

15 | - 介绍: 技术面试必备基础知识、Leetcode 题解、后端面试、Java 面试、春招、秋招、操作系统、计算机网络、系统设计。

16 |

17 | ### 3. advanced-java

18 |

19 | - Github地址:[https://github.com/doocs/advanced-java](https://github.com/doocs/advanced-java)

20 | - star: 23.4k

21 | - 介绍: 互联网 Java 工程师进阶知识完全扫盲:涵盖高并发、分布式、高可用、微服务等领域知识,后端同学必看,前端同学也可学习。

22 |

23 | ### 4.JCSprout

24 |

25 | - Github地址:[https://github.com/crossoverJie/JCSprout](https://github.com/crossoverJie/JCSprout)

26 | - star: 21.2k

27 | - 介绍: Java Core Sprout:处于萌芽阶段的 Java 核心知识库。

28 |

29 | ### 5.toBeTopJavaer

30 |

31 | - Github地址:[https://github.com/hollischuang/toBeTopJavaer](https://github.com/hollischuang/toBeTopJavaer)

32 | - star: 4.0 k

33 | - 介绍: Java工程师成神之路。

34 |

35 | ### 6.architect-awesome

36 |

37 | - Github地址:[https://github.com/xingshaocheng/architect-awesome](https://github.com/xingshaocheng/architect-awesome)

38 | - star: 34.4 k

39 | - 介绍:后端架构师技术图谱。

40 |

41 | ### 7.technology-talk

42 |

43 | - Github地址: [https://github.com/aalansehaiyang/technology-talk](https://github.com/aalansehaiyang/technology-talk)

44 | - star: 6.1k

45 | - 介绍: 汇总java生态圈常用技术框架、开源中间件,系统架构、项目管理、经典架构案例、数据库、常用三方库、线上运维等知识。

46 |

47 | ### 8.fullstack-tutorial

48 |

49 | - Github地址: [https://github.com/frank-lam/fullstack-tutorial](https://github.com/frank-lam/fullstack-tutorial)

50 | - star: 4.0k

51 | - 介绍: fullstack tutorial 2019,后台技术栈/架构师之路/全栈开发社区,春招/秋招/校招/面试。

52 |

53 | ### 9.3y

54 |

55 | - Github地址:[https://github.com/ZhongFuCheng3y/3y](https://github.com/ZhongFuCheng3y/3y)

56 | - star: 1.9 k

57 | - 介绍: Java 知识整合。

58 |

59 | ### 10.java-bible

60 |

61 | - Github地址:[https://github.com/biezhi/java-bible](https://github.com/biezhi/java-bible)

62 | - star: 2.3k

63 | - 介绍: 这里记录了一些技术摘要,部分文章来自网络,本项目的目的力求分享精品技术干货,以Java为主。

64 |

65 | ### 11.interviews

66 |

67 | - Github地址: [https://github.com/kdn251/interviews/blob/master/README-zh-cn.md](https://github.com/kdn251/interviews/blob/master/README-zh-cn.md)

68 | - star: 35.3k

69 | - 介绍: 软件工程技术面试个人指南(国外的一个项目,虽然有翻译版,但是不太推荐,因为很多内容并不适用于国内)。

70 |

71 | ## 算法相关

72 |

73 | ### 1.LeetCodeAnimation

74 |

75 | - Github 地址:

76 | - Star: 33.4k

77 | - 介绍: Demonstrate all the questions on LeetCode in the form of animation.(用动画的形式呈现解LeetCode题目的思路)。

78 |

79 | ### 2.awesome-java-leetcode

80 |

81 | - Github地址:[https://github.com/Blankj/awesome-java-leetcode](https://github.com/Blankj/awesome-java-leetcode)

82 | - star: 6.1k

83 | - 介绍: LeetCode 上 Facebook 的面试题目。

84 |

85 | ### 3.leetcode

86 |

87 | - Github地址:[https://github.com/azl397985856/leetcode](https://github.com/azl397985856/leetcode)

88 | - star: 12.0k

89 | - 介绍: LeetCode Solutions: A Record of My Problem Solving Journey.( leetcode题解,记录自己的leetcode解题之路。)

--------------------------------------------------------------------------------

/docs/Python/Python进程通信.md:

--------------------------------------------------------------------------------

1 | ## Python进程通信

2 |

3 | 文章整理来源:https://blog.csdn.net/weixin_43790276/article/details/90906683

4 | 文章整理来源:https://www.cnblogs.com/guguobao/p/9398653.html

5 |

6 | ### 1. 第一种:Queue

7 | ```

8 | from multiprocessing import Queue

9 |

10 | Queue([maxsize])

11 |

12 | maxsize:指定队列的长度,即队列中消息的最大数量

13 |

14 | 初始化Queue对象时,若括号中没有指定最大可接收的消息数量,或数量为负值,那么就代表可接受的消息数量没有上限(直到内存的尽头);

15 |

16 | Queue的常用方法:

17 |

18 | 1.qsize():返回当前队列包含的消息数量,即当前队列中有多少条数据

19 |

20 | 2.empty():如果队列为空,返回True,反之False

21 |

22 | 3.full():如果队列满了,返回True,反之False

23 |

24 | 4.get([block[, timeout]]):获取队列中的一条消息,然后将其从列队中移除,block默认值为True

25 |

26 | 如果block使用默认值,且没有设置timeout(单位秒),列队为空,此时程序将被阻塞(停在读取状态),直到从列队读到消息为止。如果设置了timeout,列队为空,则会等待timeout秒,若还没读取到任何消息,抛出"Queue.Empty"异常。

27 |

28 | 如果block值为False,消息列队如果为空,则会立刻抛出"Queue.Empty"异常。

29 |

30 | 5.get_nowait():相当于Queue.get(False)

31 |

32 | 6.Queue.put(item,[block[, timeout]]):将item消息写入队列,block默认值为True

33 |

34 | 如果block使用默认值,且没有设置timeout(单位秒),列队已满,此时程序将被阻塞(停在写入状态),直到列队腾出空间为止,将数据写入。如果设置了timeout,列队已满,则会等待timeout秒,若还没空间,抛出"Queue.Full"异常。

35 |

36 | 如果block值为False,消息列队如果没有空间可写入,则会立刻抛出"Queue.Full"异常。

37 |

38 | 7.Queue.put_nowait(item):相当于Queue.put(item, False)

39 |

40 | ```

41 |

42 | 示例:

43 |

44 | ```

45 | from multiprocessing import Process, Queue

46 | import time

47 |

48 | def put_card(queue):

49 | """往队列中添加数据"""

50 | for card in ['A', 'K', 'Q', 'J', '10']:

51 | print('Put {} to queue...'.format(card))

52 | queue.put(card)

53 | time.sleep(1)

54 |

55 | def get_card(queue):

56 | """从队列中取出数据"""

57 | while True:

58 | if not queue.empty():

59 | card = queue.get(True)

60 | print('Get {} from queue.'.format(card))

61 | time.sleep(1)

62 | else:

63 | break

64 |

65 | if __name__ == "__main__":

66 | q = Queue()

67 | pp = Process(target=put_card, args=(q,))

68 | pg = Process(target=get_card, args=(q,))

69 | pp.start()

70 |

71 | pg.start()

72 | pg.join()

73 | print(pg.is_alive())

74 |

75 | ```

76 |

77 | **进程池中的Queue**

78 |

79 | 如果要使用Pool创建进程,需要使用multiprocessing.Manager()中的Queue()来传递消息。

80 |

81 | ### 2. 第二种:Pipe

82 |

83 | ```

84 | from multiprocessing import Pipe

85 |

86 | pipe = Pipe()

87 |

88 | Pipe常用于两个进程,两个进程分别位于管道的两端

89 | Pipe方法返回(conn1,conn2)代表一个管道的两个端,Pipe方法有duplex参数,默认为True,即全双工模式,若为FALSE,conn1只负责接收信息,conn2负责发送,

90 | send和recv方法分别为发送和接收信息。

91 | ```

92 |

93 | 示例:

94 |

95 | ```

96 | import multiprocessing

97 | import time, random

98 |

99 | # 写数据进程执行的代码

100 | def proc_send(pipe, urls):

101 | # print 'Process is write....'

102 | for url in urls:

103 | print('Process is send :%s' % url)

104 | pipe.send(url)

105 | time.sleep(random.random())

106 |

107 | # 读数据进程的代码

108 | def proc_recv(pipe):

109 | while True:

110 | print('Process rev:%s' % pipe.recv())

111 | time.sleep(random.random())

112 |

113 | if __name__ == '__main__':

114 | # 父进程创建pipe,并传给各个子进程

115 | pipe = multiprocessing.Pipe()

116 | p1 = multiprocessing.Process(target=proc_send, args=(pipe[0], ['url_' + str(i) for i in range(10)]))

117 | p2 = multiprocessing.Process(target=proc_recv, args=(pipe[1],))

118 | # 启动子进程,写入

119 | p1.start()

120 | p2.start()

121 |

122 | p1.join()

123 | p2.terminate()

124 | ```

125 |

126 | ### 3. 第三种:socket

127 |

128 | 见网络编程篇

129 |

130 |

131 |

132 |

133 |

--------------------------------------------------------------------------------

/docs/简历与面经/BATJrealInterviewExperience/5面阿里,终获offer.md:

--------------------------------------------------------------------------------

1 | > 作者:ppxyn。本文来自读者投稿,同时也欢迎各位投稿,**对于不错的原创文章我根据你的选择给予现金(50-200)、付费专栏或者任选书籍进行奖励!所以,快提 pr 或者邮件的方式(邮件地址在主页)给我投稿吧!** 当然,我觉得奖励是次要的,最重要的是你可以从自己整理知识点的过程中学习到很多知识。

2 |

3 | **目录**

4 |

5 |

6 |

7 | - [前言](#前言)

8 | - [一面\(技术面\)](#一面技术面)

9 | - [二面\(技术面\)](#二面技术面)

10 | - [三面\(技术面\)](#三面技术面)

11 | - [四面\(半个技术面\)](#四面半个技术面)

12 | - [五面\(HR面\)](#五面hr面)

13 | - [总结](#总结)

14 |

15 |

16 |

17 | ### 前言

18 |

19 | 在接触 Java 之前我接触的比较多的是硬件方面,用的比较多的语言就是C和C++。到了大三我才正式选择 Java 方向,到目前为止使用Java到现在大概有一年多的时间,所以Java算不上很好。刚开始投递的时候,实习刚辞职,也没准备笔试面试,很多东西都忘记了。所以,刚开始我并没有直接就投递阿里,毕竟心里还是有一点点小害怕的。于是,我就先投递了几个不算大的公司来练手,就是想着刷刷经验而已或者说是练练手(ps:还是挺对不起那些公司的)。面了一个月其他公司后,我找了我实验室的学长内推我,后面就有了这5次面试。

20 |

21 | 下面简单的说一下我的这5次面试:4次技术面+1次HR面,希望我的经历能对你有所帮助。

22 |

23 | ### 一面(技术面)

24 |

25 | 1. 自我介绍(主要讲自己会的技术细节,项目经验,经历那些就一语带过,后面面试官会问你的)。

26 | 2. 聊聊项目(就是一个很普通的分布式商城,自己做了一些改进),让我画了整个项目的架构图,然后针对项目抛了一系列的提高性能的问题,还问了我做项目的过程中遇到了那些问题,如何解决的,差不读就这些吧。

27 | 3. 可能是我前面说了我会数据库优化,然后面试官就开始问索引、事务隔离级别、悲观锁和乐观锁、索引、ACID、MVVC这些问题。

28 | 4. 浏览器输入URL发生了什么? TCP和UDP区别? TCP如何保证传输可靠性?

29 | 5. 讲下跳表怎么实现的?哈夫曼编码是怎么回事?非递归且不用额外空间(不用栈),如何遍历二叉树

30 | 6. 后面又问了很多JVM方面的问题,比如Java内存模型、常见的垃圾回收器、双亲委派模型这些

31 | 7. 你有什么问题要问吗?

32 |

33 | ### 二面(技术面)

34 |

35 | 1. 自我介绍(主要讲自己会的技术细节,项目经验,经历那些就一语带过,后面面试官会问你的)。

36 | 2. 操作系统的内存管理机制

37 | 3. 进程和线程的区别

38 | 4. 说下你对线程安全的理解

39 | 5. volatile 有什么作用 ,sychronized和lock有什么区别

40 | 6. ReentrantLock实现原理

41 | 7. 用过CountDownLatch么?什么场景下用的?

42 | 8. AQS底层原理。

43 | 9. 造成死锁的原因有哪些,如何预防?

44 | 10. 加锁会带来哪些性能问题。如何解决?

45 | 11. HashMap、ConcurrentHashMap源码。HashMap是线程安全的吗?Hashtable呢?ConcurrentHashMap有了解吗?

46 | 12. 是否可以实习?

47 | 13. 你有什么问题要问吗?

48 |

49 | ### 三面(技术面)

50 |

51 | 1. 有没有参加过 ACM 或者他竞赛,有没有拿过什么奖?( 我说我没参加过ACM,本科参加过数学建模竞赛,名次并不好,没拿过什么奖。面试官好像有点失望,然后我又赶紧补充说我和老师一起做过一个项目,目前已经投入使用。面试官还比较感兴趣,后面又和他聊了一下这个项目。)

52 | 2. 研究生期间,做过什么项目,发过论文吗?有什么成果吗?

53 | 3. 你觉得你有什么优点和缺点?你觉得你相比于那些比你更优秀的人欠缺什么?

54 | 4. 有读过什么源码吗?(我说我读过 Java 集合框架和 Netty 的,面试官说 Java 集合前几面一定问的差不多,就不问了,然后就问我 Netty的,我当时很慌啊!)

55 | 5. 介绍一下自己对 Netty 的认识,为什么要用。说说业务中,Netty 的使用场景。什么是TCP 粘包/拆包,解决办法。Netty线程模型。Dubbo 在使用 Netty 作为网络通讯时候是如何避免粘包与半包问题?讲讲Netty的零拷贝?巴拉巴拉问了好多,我记得有好几个我都没回答上来,心里想着凉凉了啊。

56 | 6. 用到了那些开源技术、在开源领域做过贡献吗?

57 | 7. 常见的排序算法及其复杂度,现场写了快排。

58 | 8. 红黑树,B树的一些问题。

59 | 9. 讲讲算法及数据结构在实习项目中的用处。

60 | 10. 自己的未来规划(就简单描述了一下自己未来的设想啊,说的还挺诚恳,面试官好像还挺满意的)

61 | 11. 你有什么问题要问吗?

62 |

63 | ### 四面(半个技术面)

64 |

65 | 三面面完当天,晚上9点接到面试电话,感觉像是部门或者项目主管。 这个和之前的面试不大相同,感觉面试官主要考察的是你解决问题的能力、学习能力和团队协作能力。

66 |

67 | 1. 让我讲一个自己觉得最不错的项目。然后就巴拉巴拉的聊,我记得主要是问了项目是如何进行协作的、遇到问题是如何解决的、与他人发生冲突是如何解决的这些。感觉聊了挺久。

68 | 2. 出现 OOM 后你会怎么排查问题?

69 | 3. 自己平时是如何学习新技术的?除了 Java 还回去了解其他技术吗?

70 | 4. 上一段实习经历的收获。

71 | 5. NginX如何做负载均衡、常见的负载均衡算法有哪些、一致性哈希的一致性是什么意思、一致性哈希是如何做哈希的

72 | 6. 你有什么问题问我吗?

73 | 7. 还有一些其他的,想不起来了,感觉这一面不是偏向技术来问。

74 |

75 | ## 五面(HR面)

76 |

77 | 1. 自我介绍(主要讲能突出自己的经历,会的编程技术一语带过)。

78 | 2. 你觉得你有什么优点和缺点?如何克服这些缺点?

79 | 3. 说一件大学里你自己比较有成就感的一件事情,为此付出了那些努力。

80 | 4. 你前面跟其他面试官讲过一些你做的项目吧?可以给我讲讲吗?你要考虑到我不是一个做技术的人,怎么让我也听得懂。项目中有什么问题,你怎么解决的?你最大的收获是什么?

81 | 5. 你目前有面试过其他公司吗?如果让你选,这些公司和阿里,你选哪个?(送分题,回答不好可能送命)

82 | 6. 你期望的工作地点是哪里?

83 | 7. 你有什么问题吗?

84 |

85 | ### 总结

86 |

87 | 1. 可以看出面试官问我的很多问题都是比较常见的问题,所以记得一定要提前准备,还要深入准备,不要回答的太皮毛。很多时候一个问题可能会牵扯出很多问题,遇到不会的问题不要慌,冷静分析,如果你真的回答不上来,也不要担心自己是不是就要挂了,很可能这个问题本身就比较难。

88 | 2. 表达能力和沟通能力太重要了,一定要提前练一下,我自身就是一个不太会说话的人,所以,面试前我对于自我介绍、项目介绍和一些常见问题都在脑子里练了好久,确保面试的时候能够很清晰和简洁的说出来。

89 | 3. 等待面试的过程和面试的过程真的好熬人,那段时间我压力也比较大,好在我私下找到学长聊了很多,心情也好了很多。

90 | 4. 面试之后及时总结,面的好的话,不要得意,尽快准备下一场面试吧!

91 |

92 | 我觉得我还算是比较幸运的,最后也祝大家都能获得心仪的Offer。

93 |

94 |

95 |

96 |

97 |

--------------------------------------------------------------------------------

/docs/系统设计/data-communication/summary.md:

--------------------------------------------------------------------------------