├── .gitattributes

├── .gitignore

├── .nojekyll

├── README.md

├── _sidebar.md

├── docs

├── distributed

│ ├── 13张图彻底搞懂分布式系统服务注册与发现原理.md

│ ├── 原来10张图就可以搞懂分布式链路追踪系统原理.md

│ └── 用大白话给你解释Zookeeper的选举机制.md

├── it-hot

│ └── 鸿蒙OS尖刀武器之分布式软总线技术.md

├── java

│ ├── annotation

│ │ └── 想自己写框架不会写Java注解可不行.md

│ ├── base

│ │ └── Java基础入门80问.md

│ ├── java8

│ │ ├── Java8函数式接口和Lambda表达式你真的会了吗.md

│ │ ├── 使用Java8 Optional类优雅解决空指针问题.md

│ │ ├── 包学会,教你用Java函数式编程重构烂代码.md

│ │ └── 请避开Stream流式编程常见的坑.md

│ ├── juc

│ │ ├── 倒计时计数CountDownLatch.md

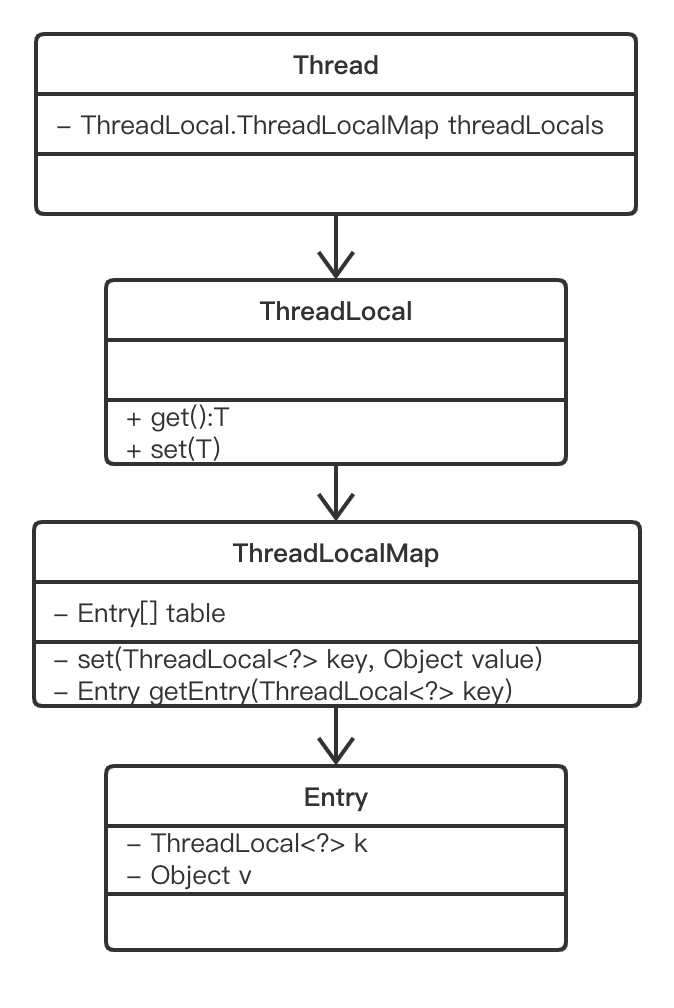

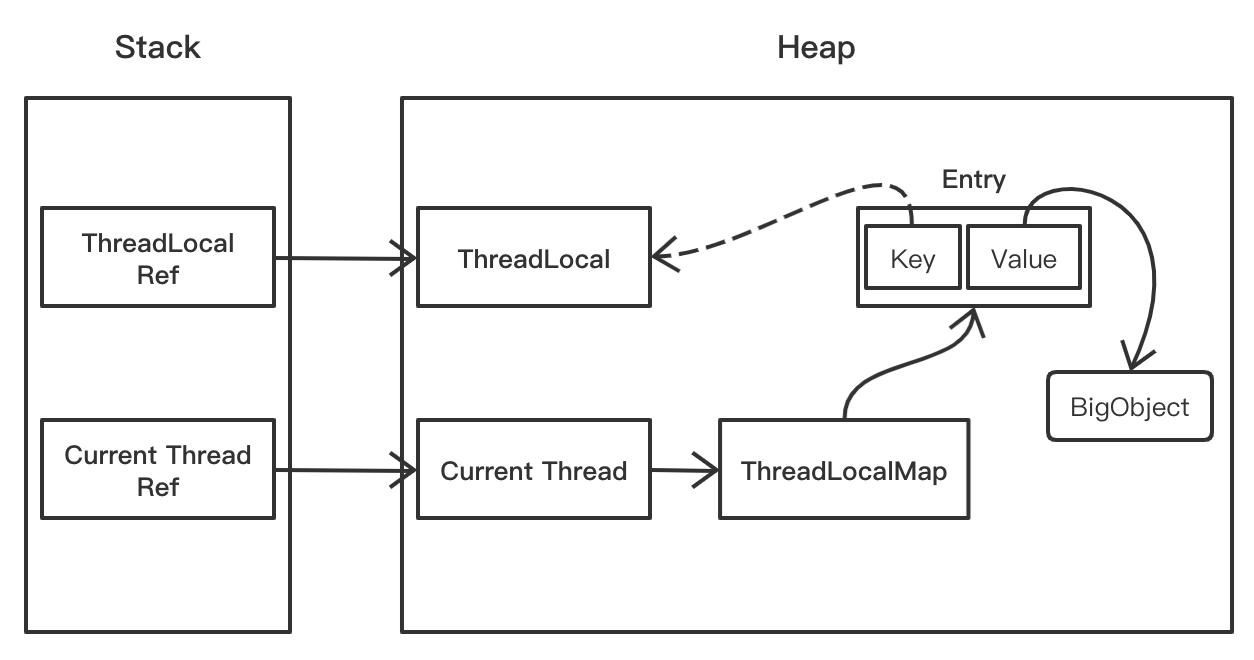

│ │ ├── 内存泄露的原因找到了,罪魁祸首居然是Java TheadLocal.md

│ │ ├── 十张图告诉你多线程那些破事.md

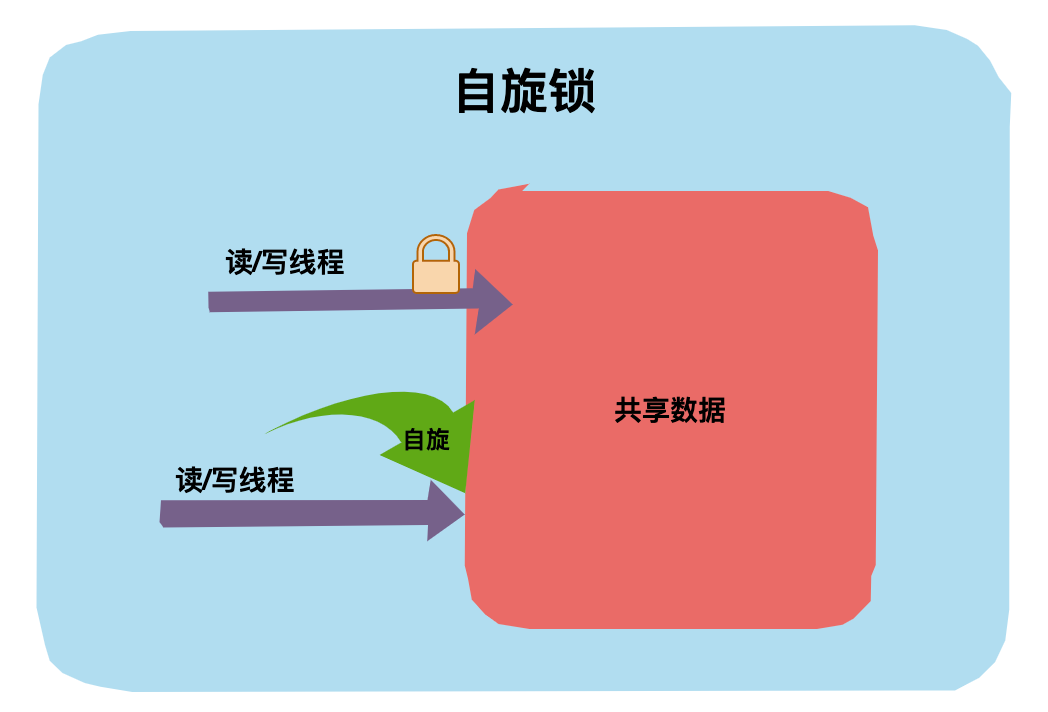

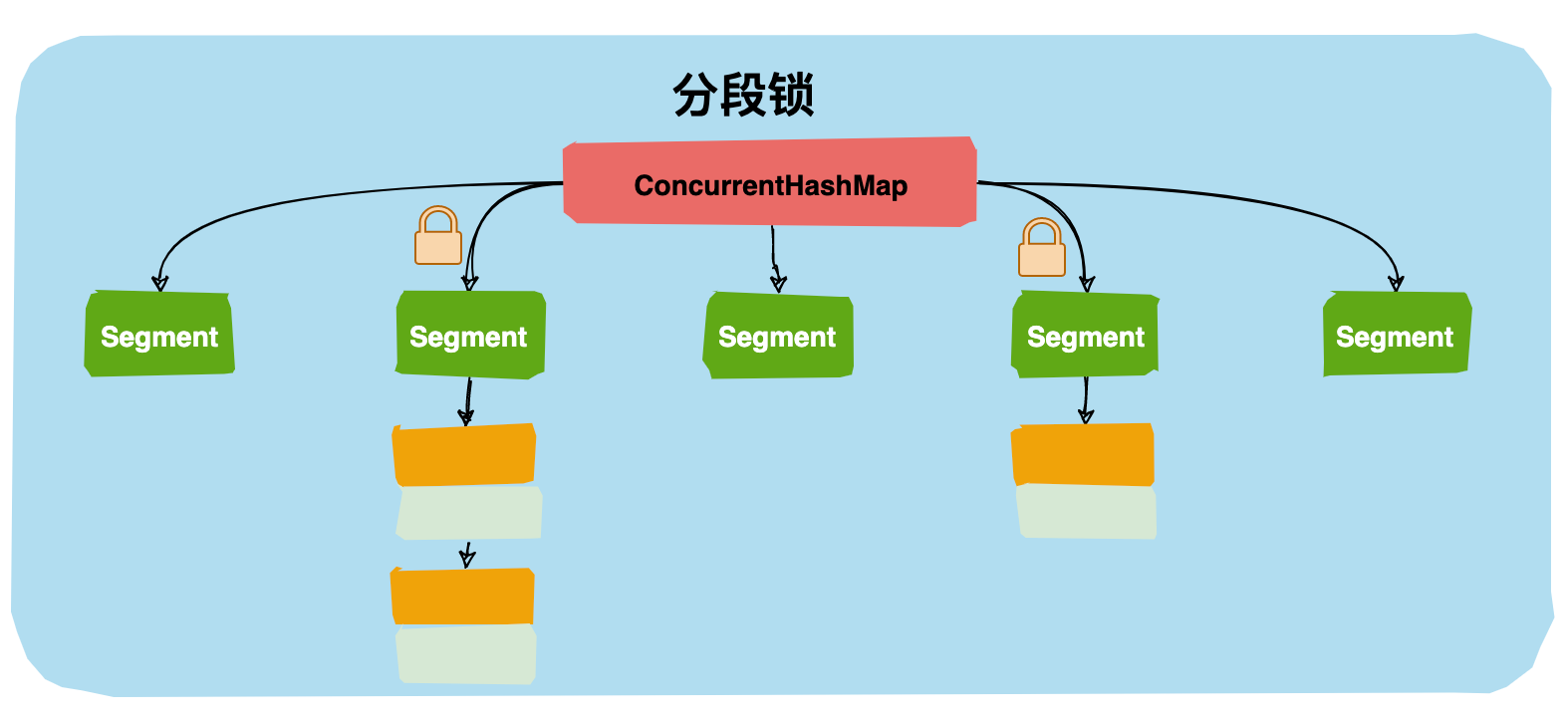

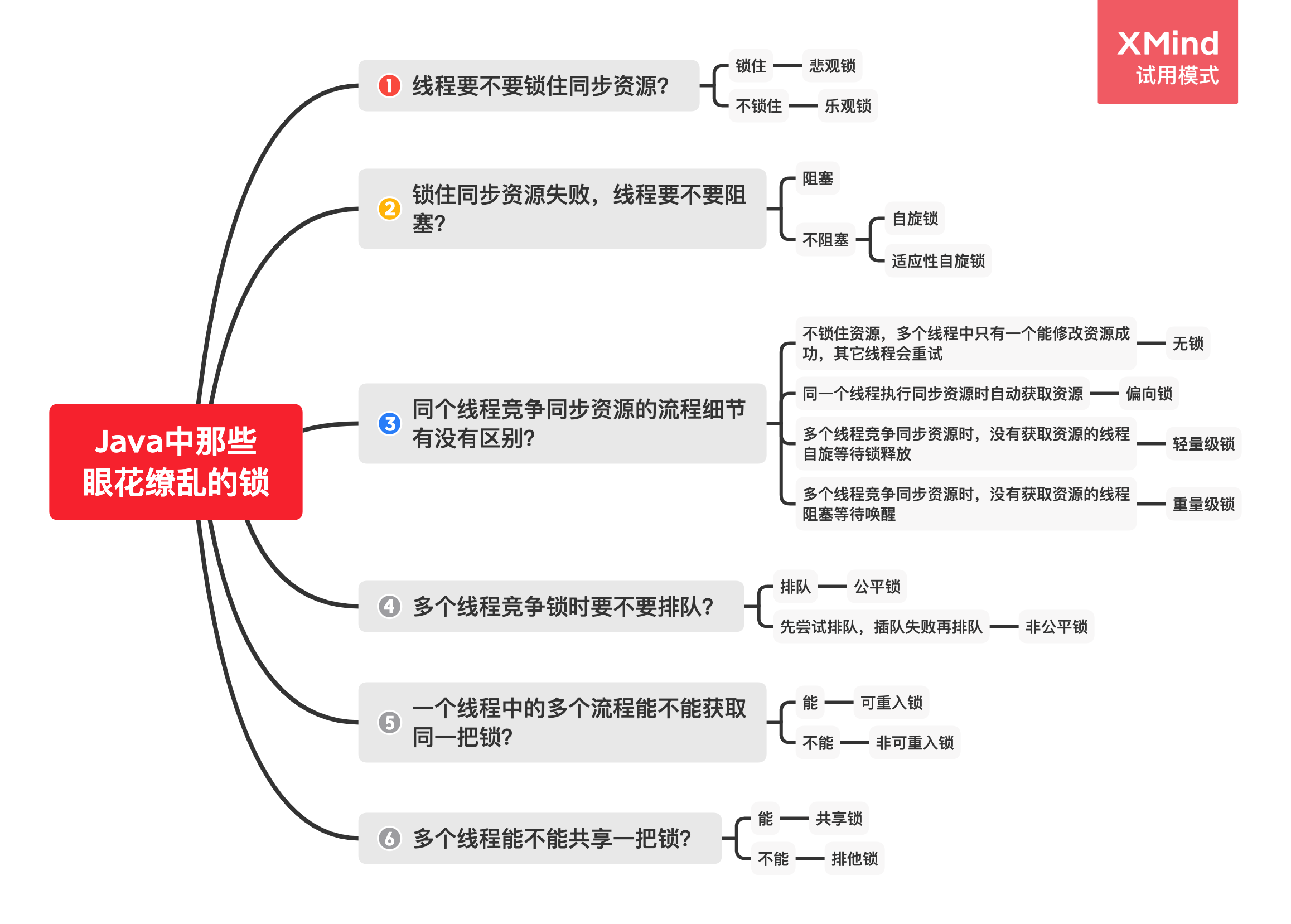

│ │ ├── 图解Java中那18 把锁.md

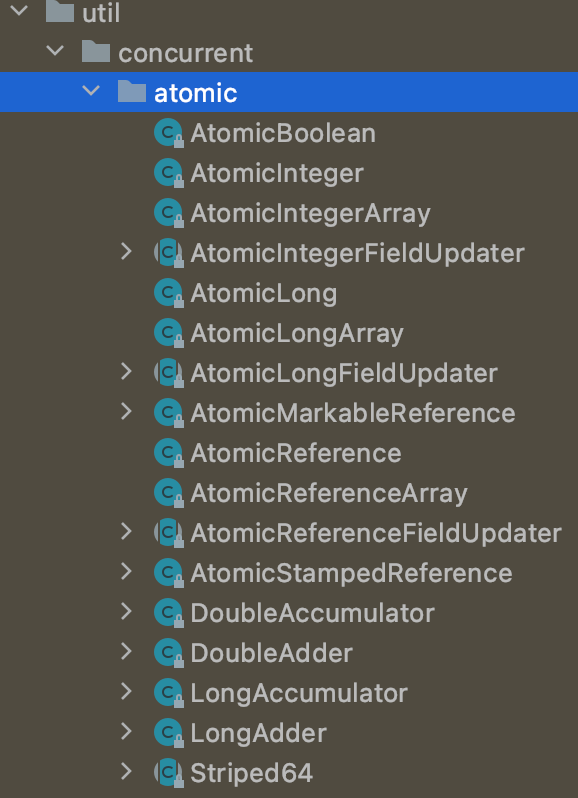

│ │ ├── 面试官:说说Atomic原子类的实现原理.md

│ │ ├── 面试官:说说什么是Java内存模型?.md

│ │ └── 面试必问的CAS原理你会了吗.md

│ └── roadmap

│ │ └── 2021 版最新Java 学习路线图(持续刷新).md

├── mq

│ ├── Kafka支持百万级TPS的秘密都藏在这里.md

│ └── 刨根问底,kafka到底会不会丢消息.md

├── redis

│ ├── Redis 数据结构和常用命令速记.md

│ ├── Redis核心技术知识点全集.md

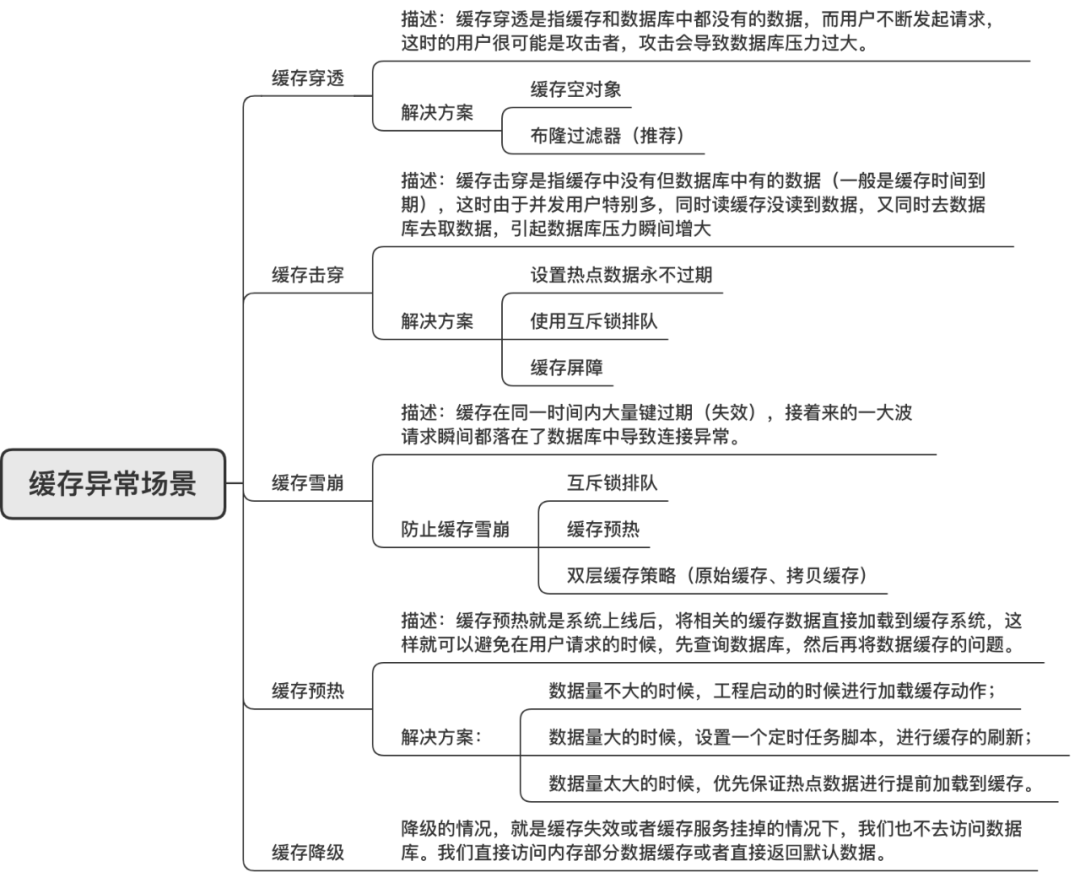

│ ├── 一张图搞懂Redis缓存雪崩、缓存穿透、缓存击穿.md

│ ├── 一次性将Redis RDB持久化和AOF持久化讲透.md

│ ├── 看完这20道Redis面试题,阿里面试可以约起来了.md

│ ├── 经理让我复盘上次Redis缓存雪崩事故.md

│ ├── 记一次由Redis分布式锁造成的重大事故,避免以后踩坑!.md

│ ├── 还在用单机版?教你用Docker+Redis搭建主从复制多实例.md

│ ├── 面试官再问Redis事务把这篇文章扔给他.md

│ └── 高并发场景下,到底先更新缓存还是先更新数据库?.md

└── tools

│ ├── git

│ └── 保姆级Git教程,10000字详解.md

│ ├── 推荐十款精选IntelliJIdea插件.md

│ └── 高效学习资源网站汇总.md

└── index.html

/.gitattributes:

--------------------------------------------------------------------------------

1 | *.js linguist-language=java

2 | *.css linguist-language=java

3 | *.html linguist-language=java

--------------------------------------------------------------------------------

/.gitignore:

--------------------------------------------------------------------------------

1 | .DS_Store

2 |

--------------------------------------------------------------------------------

/.nojekyll:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/CoderLeixiaoshuai/java-eight-part/77620444e663d2bd54fc2286678162f473478d35/.nojekyll

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | :star: 点右上角给一个 `Star`,鼓励技术人输出更多干货,爱了 !

2 |

3 | :gift::gift::gift: 号外号外,学习资料免费下载!

4 | - [进BAT大厂前必读的经典编程书籍,吐血整理共6G一次打包带走](http://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=502841590&idx=1&sn=938f0a4c45d2843aa7545c1f78fcffc6&chksm=0f09beec387e37faede87b50c31e37ee384093f1bd3363304054b7919f9b6266368954b4cbd8#rd)

5 | - [阿里师兄总结的JAVA核心知识点整理(283页,超级详细,高清带目录)](http://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=502841004&idx=1&sn=059dab6b76cbbc50eabd39566ee5ce28&chksm=0f09c0b6387e49a099b9c55d37e112f2049309f2a895a314f0a362e9ce5fb248ad4caafd50e8#rd)

6 |

7 | - [Github 疯传!阿里大佬「LeetCode刷题手册」开放下载了!史上最强悍!](http://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=502841057&idx=1&sn=97576b1a66502b75a6770265515b4a57&chksm=0f09c0fb387e49ed543d3fec9b3ff6ae9da6efbcf8ff52e07c15a05de9d2b90dcee1152a1b28#rd)

8 |

9 |  10 |

11 |

10 |

11 |

12 |

13 |

14 |

15 |

16 |

17 |

18 |

21 |

22 | > 什么是 Java 八股文?Java 面试中经常会问的一些知识点或者套路被大家戏称为『八股文』。希望读完本开源项目可以帮助你熟悉面试套路、拿大厂 offer。

23 | >

24 | > 勘误:如果文章内容有误欢迎[联系我](#iphone-联系我)修改,或者提交 [`PR`](https://github.com/CoderLeixiaoshuai/java-eight-part/pulls) or [`Issue`](https://github.com/CoderLeixiaoshuai/java-eight-part/issues),开源靠大家共同的努力!

25 | >

26 | > 版权说明:所有文章都已首发我的微信公众号,如果需要转载可以[联系我](#iphone-联系我)授权,恶意抄袭我会不惜一切代价维护权益,希望同行一起维护良好的创作环境。

27 |

28 | # :coffee: Java

29 |

30 | [『必看』2021 版最新Java 学习路线图(持续刷新):+1::+1::+1:](docs/java/roadmap/2021%20版最新Java%20学习路线图(持续刷新).md)

31 |

32 | ## Java入门面试题

33 | [Java基础入门80问,适合新手,老鸟直接跳过](docs/java/base/Java基础入门80问.md)

34 |

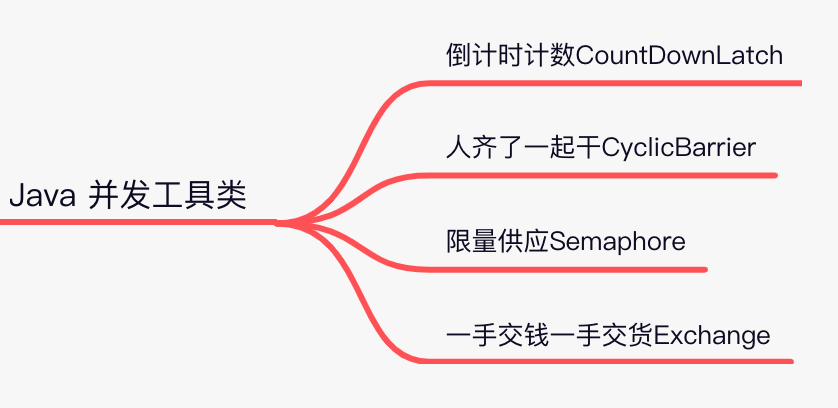

35 | ## Java并发编程(J.U.C) :+1:

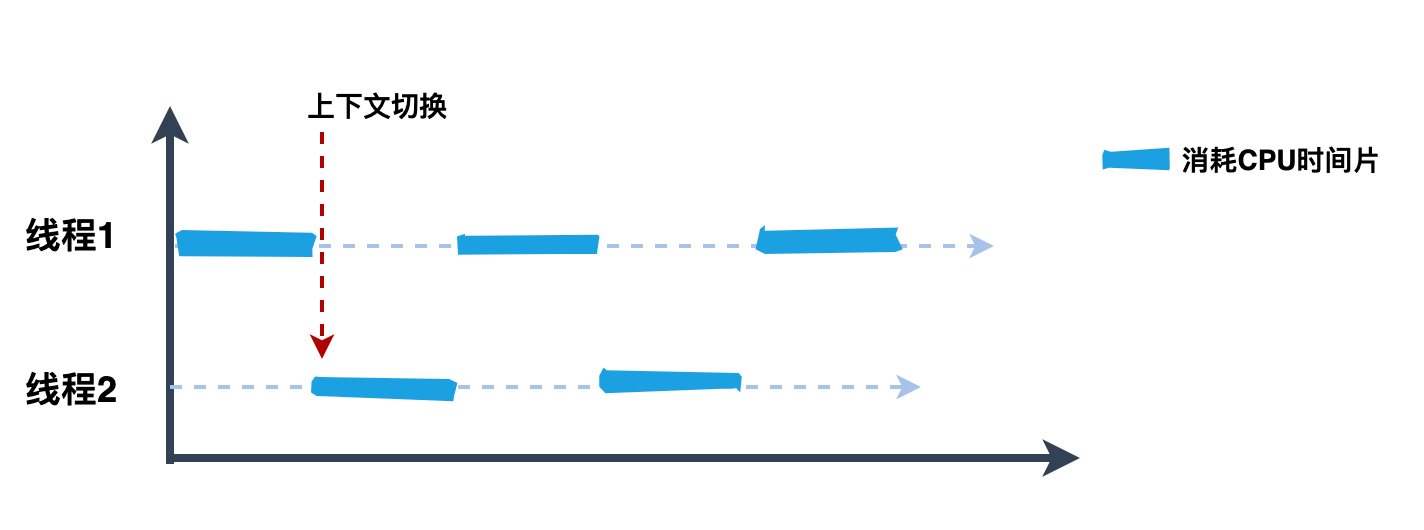

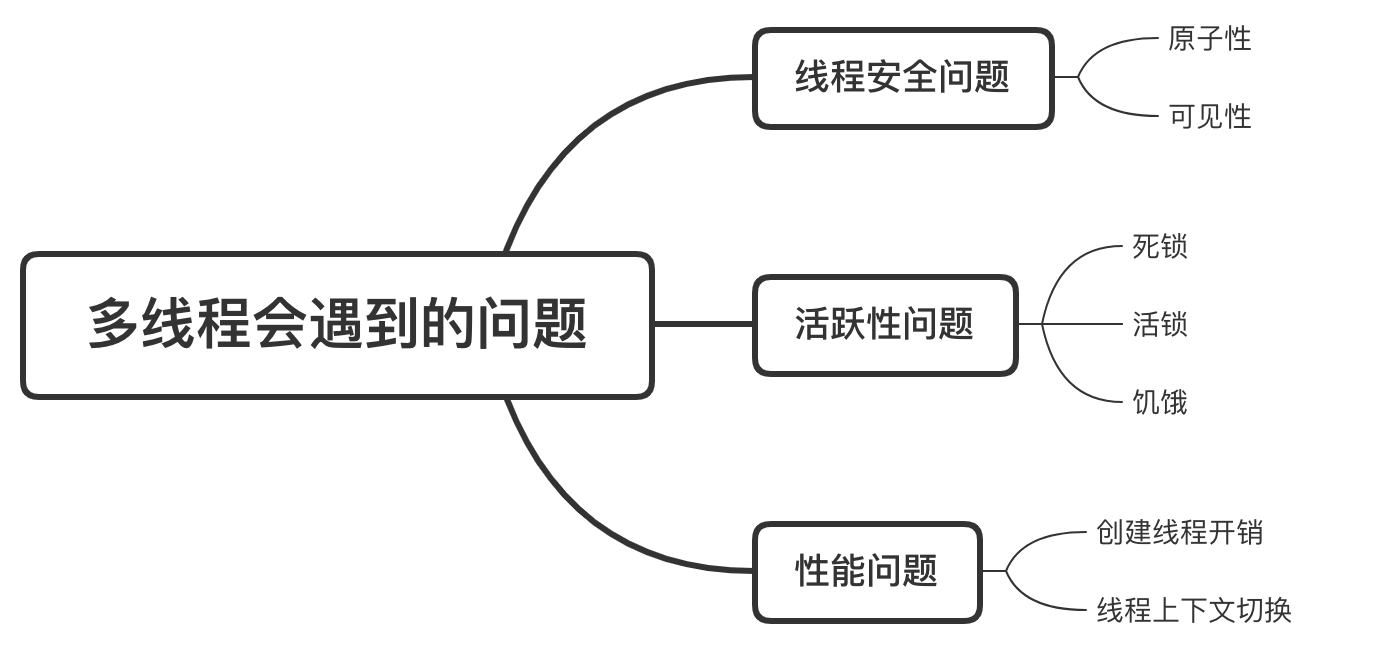

36 | - [『死磕Java并发编程系列』 01 十张图告诉你多线程那些破事](docs/java/juc/十张图告诉你多线程那些破事.md)

37 | - [『死磕Java并发编程系列』 02 面试官:说说什么是Java内存模型?](docs/java/juc/面试官:说说什么是Java内存模型?.md)

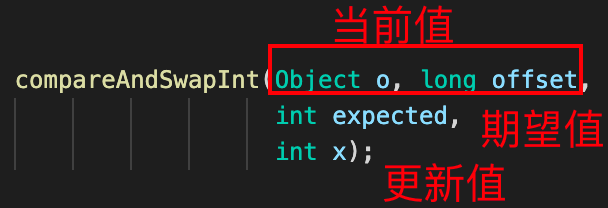

38 | - [『死磕Java并发编程系列』 03 面试必问的CAS原理你会了吗?](docs/java/juc/面试必问的CAS原理你会了吗.md)

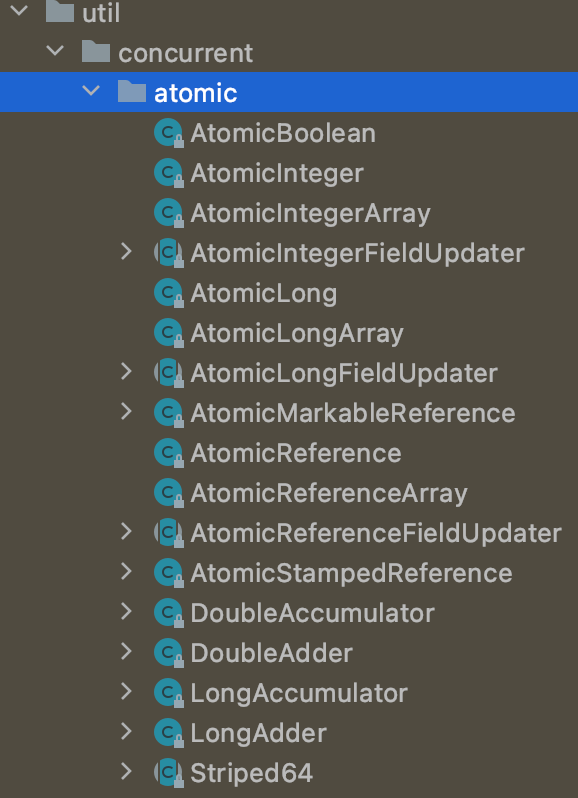

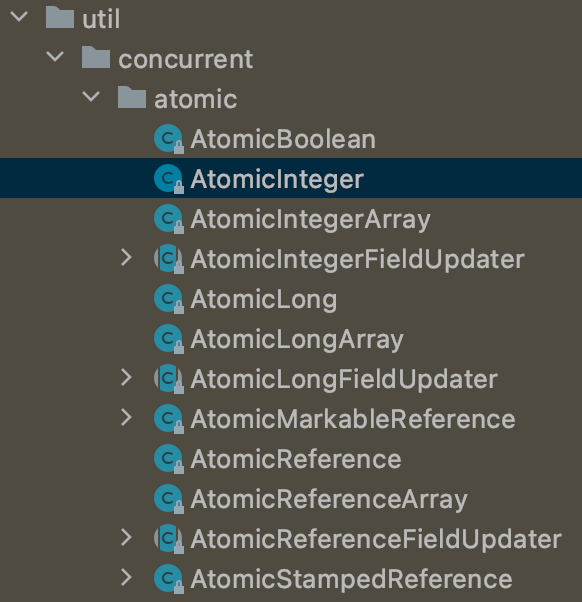

39 | - [『死磕Java并发编程系列』 04 面试官:说说Atomic原子类的实现原理?](docs/java/juc/面试官:说说Atomic原子类的实现原理.md)

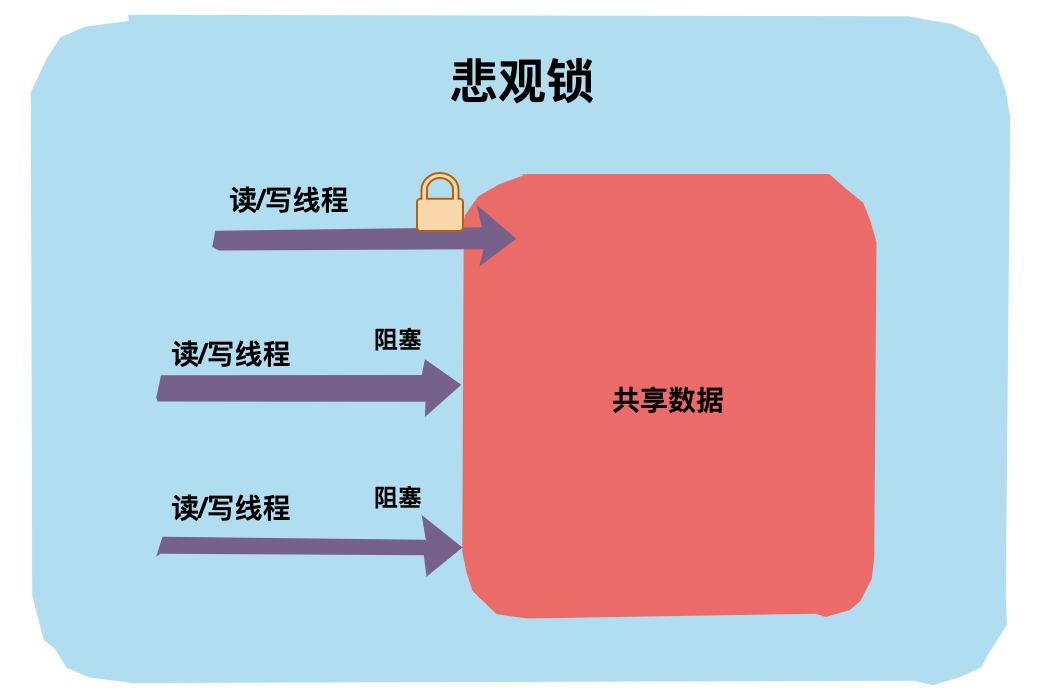

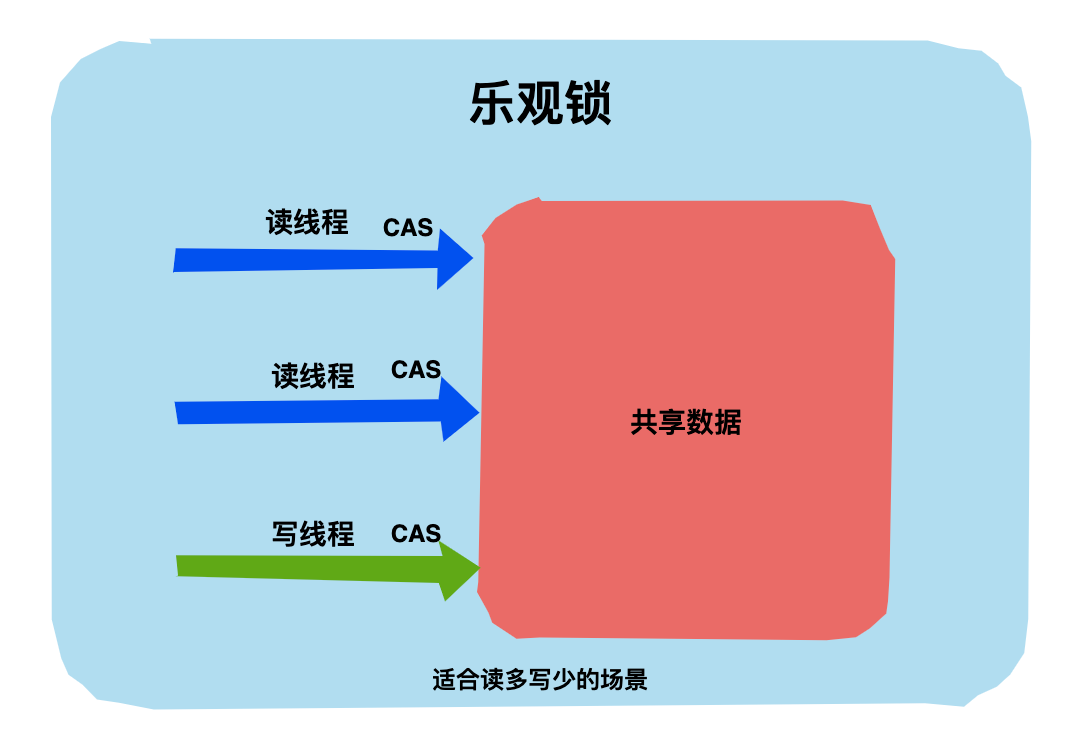

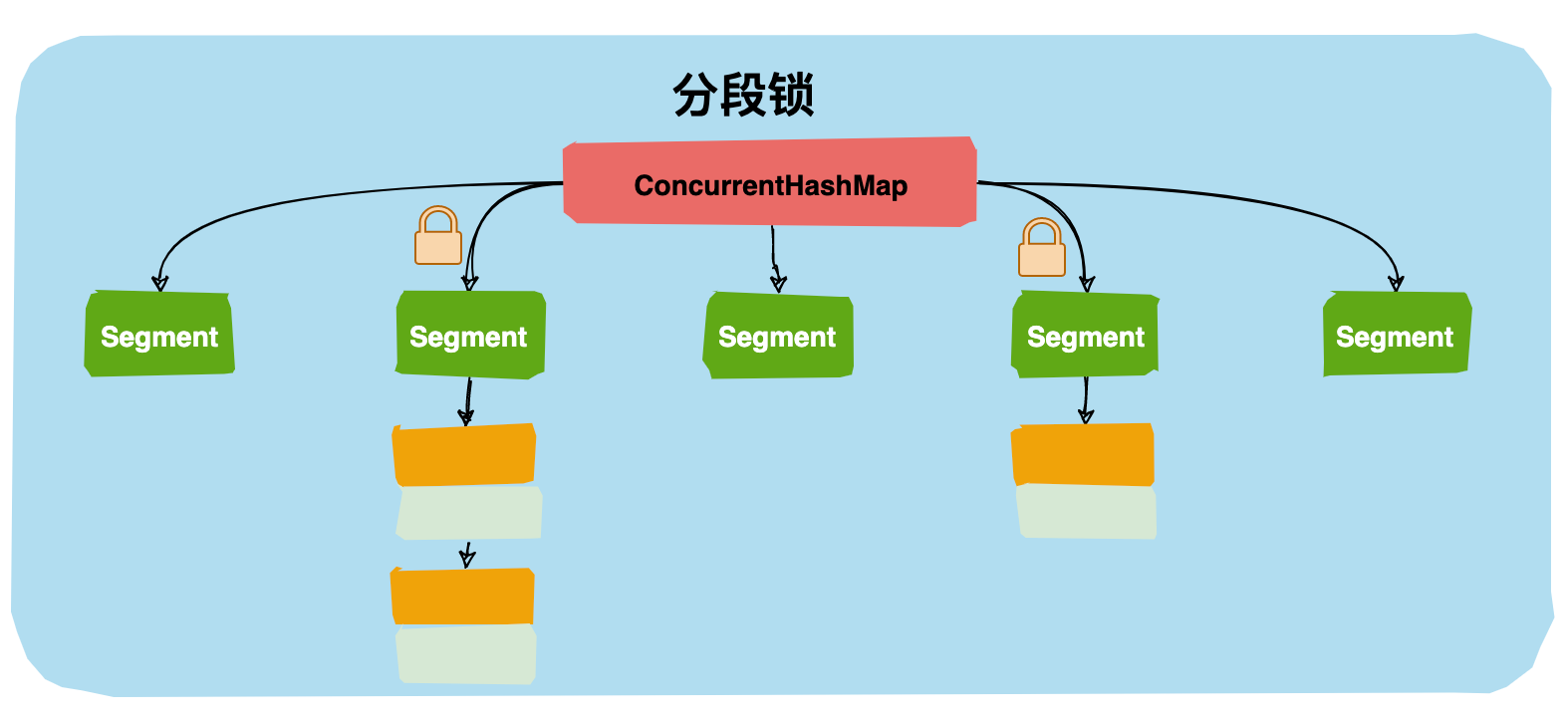

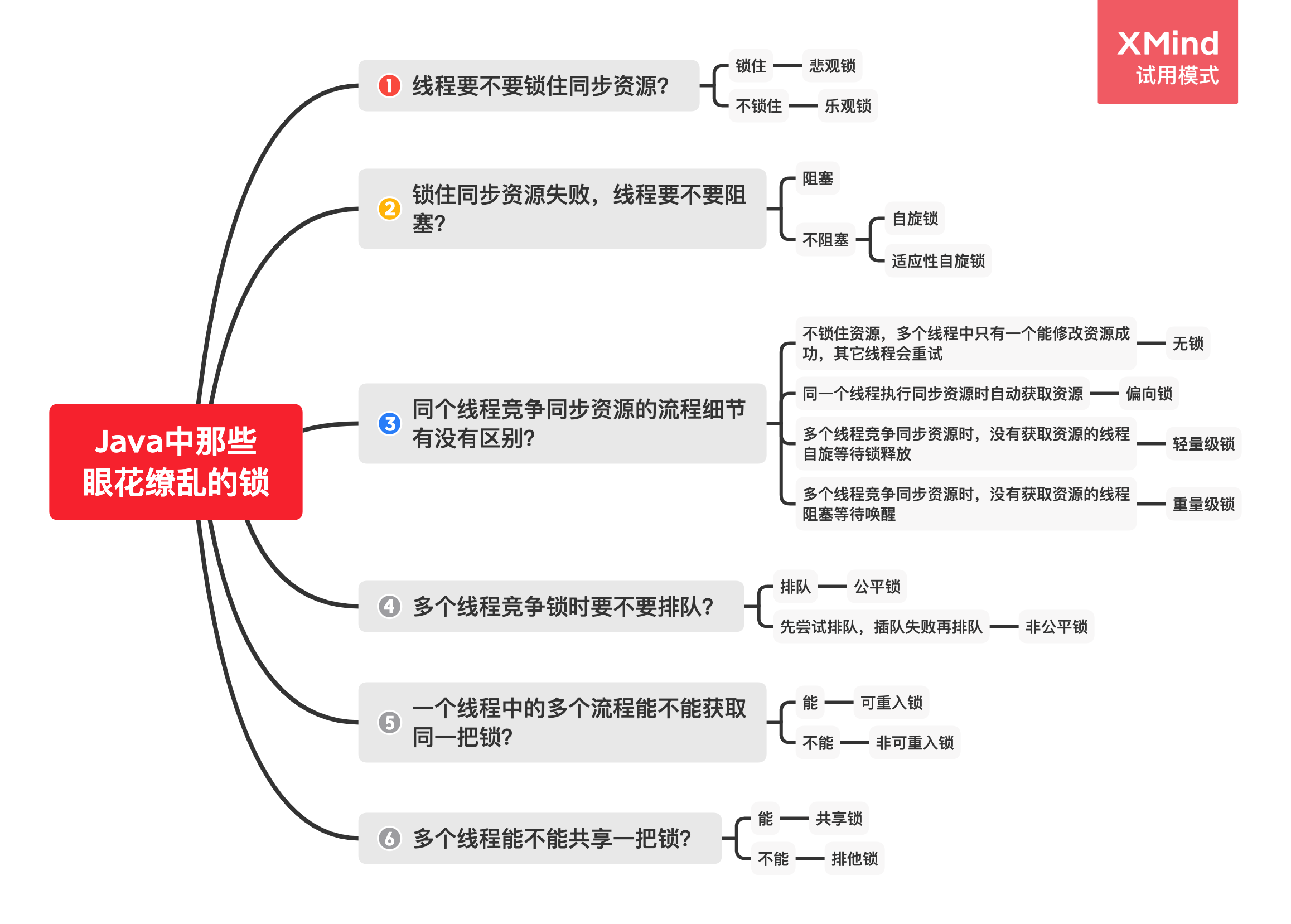

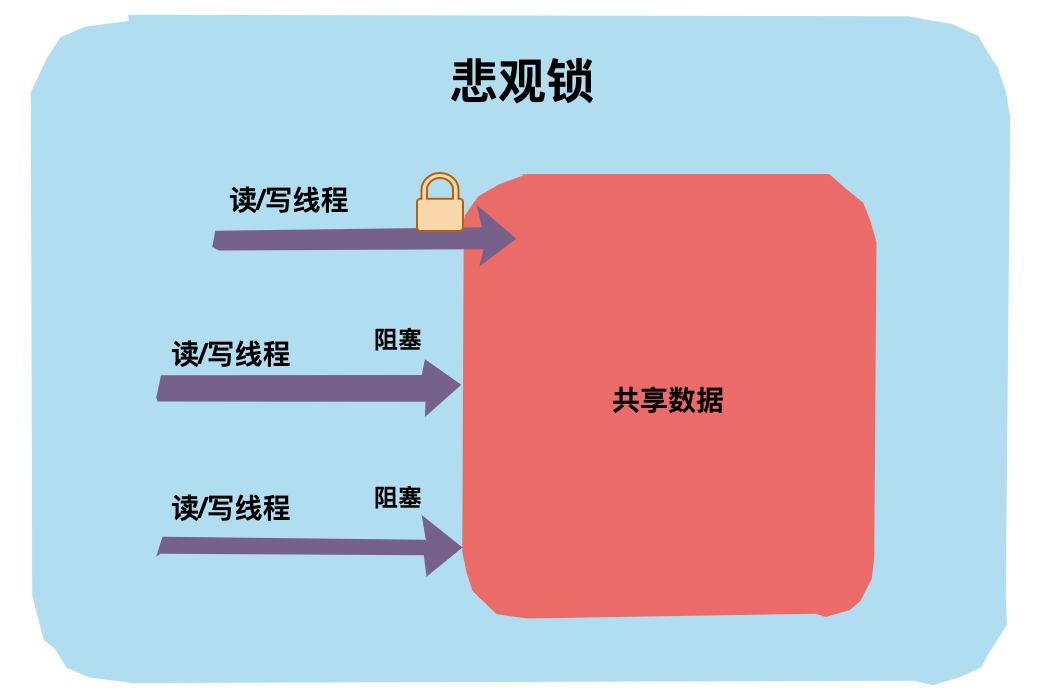

40 | - [『死磕Java并发编程系列』 05 图解Java中那18 把锁.md](docs/java/juc/图解Java中那18%20把锁.md)

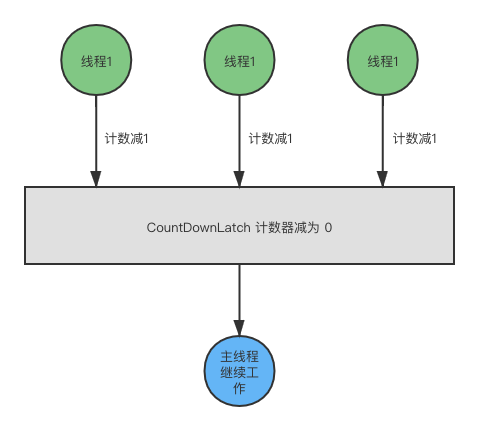

41 | - [『死磕Java并发编程系列』06 倒计时计数CountDownLatch](docs/java/juc/倒计时计数CountDownLatch.md)

42 | - 『死磕Java并发编程系列』07 人齐了一起干CyclicBarrier

43 | - 『死磕Java并发编程系列』08 限量供应Semaphore

44 | - 『死磕Java并发编程系列』09 一手交钱一手交货Exchange

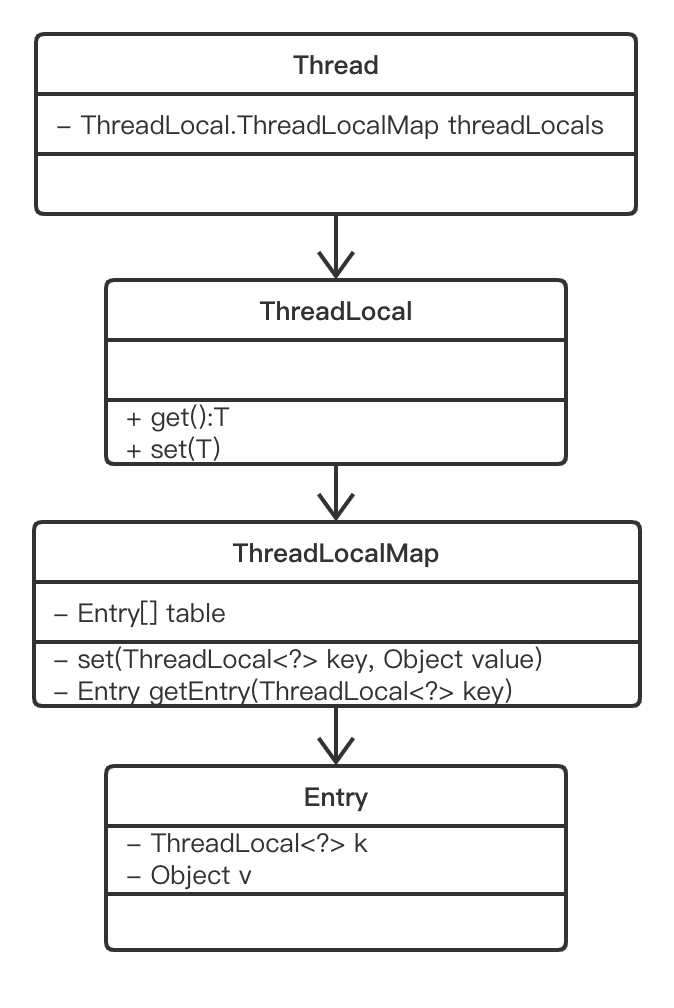

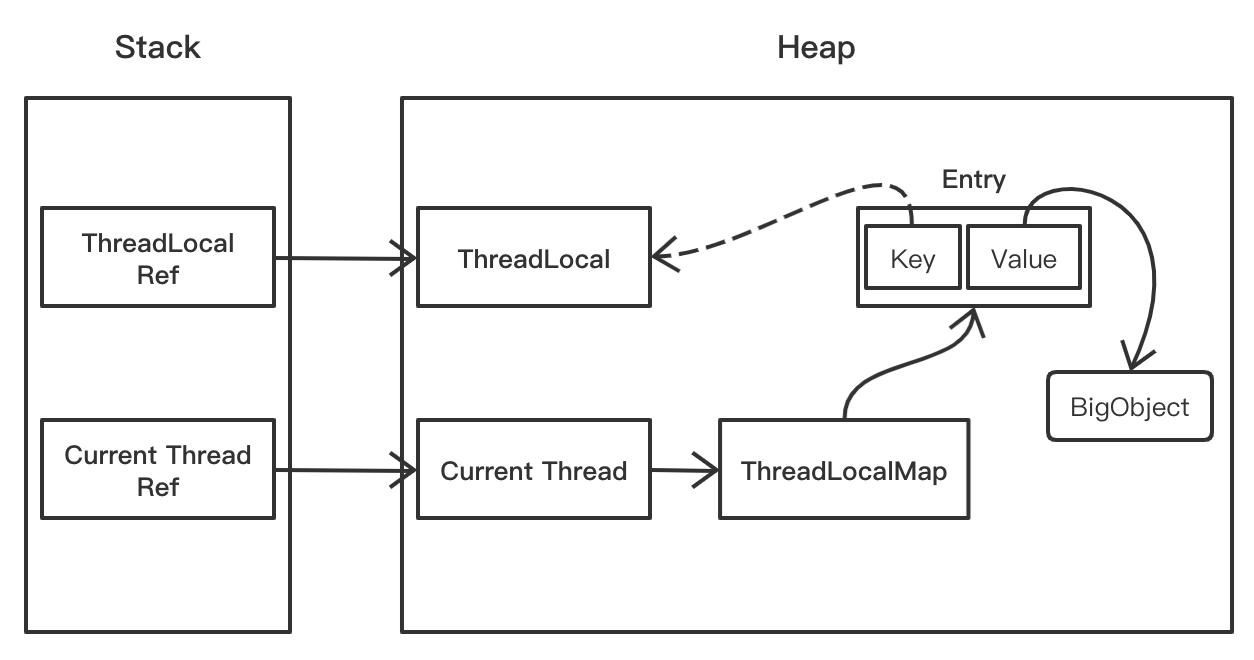

45 | - [内存泄露的原因找到了,罪魁祸首居然是Java TheadLocal](docs/java/juc/内存泄露的原因找到了,罪魁祸首居然是Java%20TheadLocal.md)

46 |

47 | *疯狂更新中……*

48 |

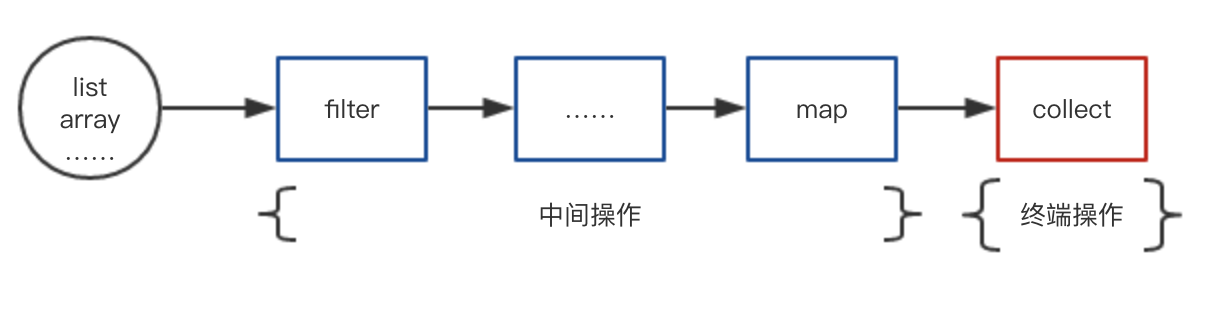

49 | ## Java8实战

50 | - [『Java8实战系列』01 Java8函数式接口和Lambda表达式你真的会了吗?](docs/java/java8/Java8函数式接口和Lambda表达式你真的会了吗.md)

51 | - [『Java8实战系列』02 包学会,教你用Java函数式编程重构烂代码](docs/java/java8/包学会,教你用Java函数式编程重构烂代码.md)

52 | - [『Java8实战系列』03 请避开Stream流式编程常见的坑](docs/java/java8/请避开Stream流式编程常见的坑.md)

53 | - [『Java8实战系列』04 详解Lambda表达式中Predicate Function Consumer Supplier函数式接口](docs/java/java8/%E8%AF%A6%E8%A7%A3Lambda%E8%A1%A8%E8%BE%BE%E5%BC%8F%E4%B8%ADPredicate%20Function%20Consumer%20Supplier%E5%87%BD%E6%95%B0%E5%BC%8F%E6%8E%A5%E5%8F%A3.md)

54 | - [『Java8实战系列』05 使用Java8 Optional类优雅解决空指针问题](docs/java/java8/使用Java8%20Optional类优雅解决空指针问题.md)

55 |

56 | ## Java注解

57 | - [想自己写框架?不会写Java注解可不行!](docs/advanced/java-annotation/想自己写框架不会写Java注解可不行.md)

58 |

59 | # :baby_chick: Redis

60 |

61 | **面试八股文**

62 | - [『玩转Redis面试篇』看完这20道Redis面试题,阿里面试可以约起来了](docs/redis/看完这20道Redis面试题,阿里面试可以约起来了.md)

63 |

64 | **知识点详解**

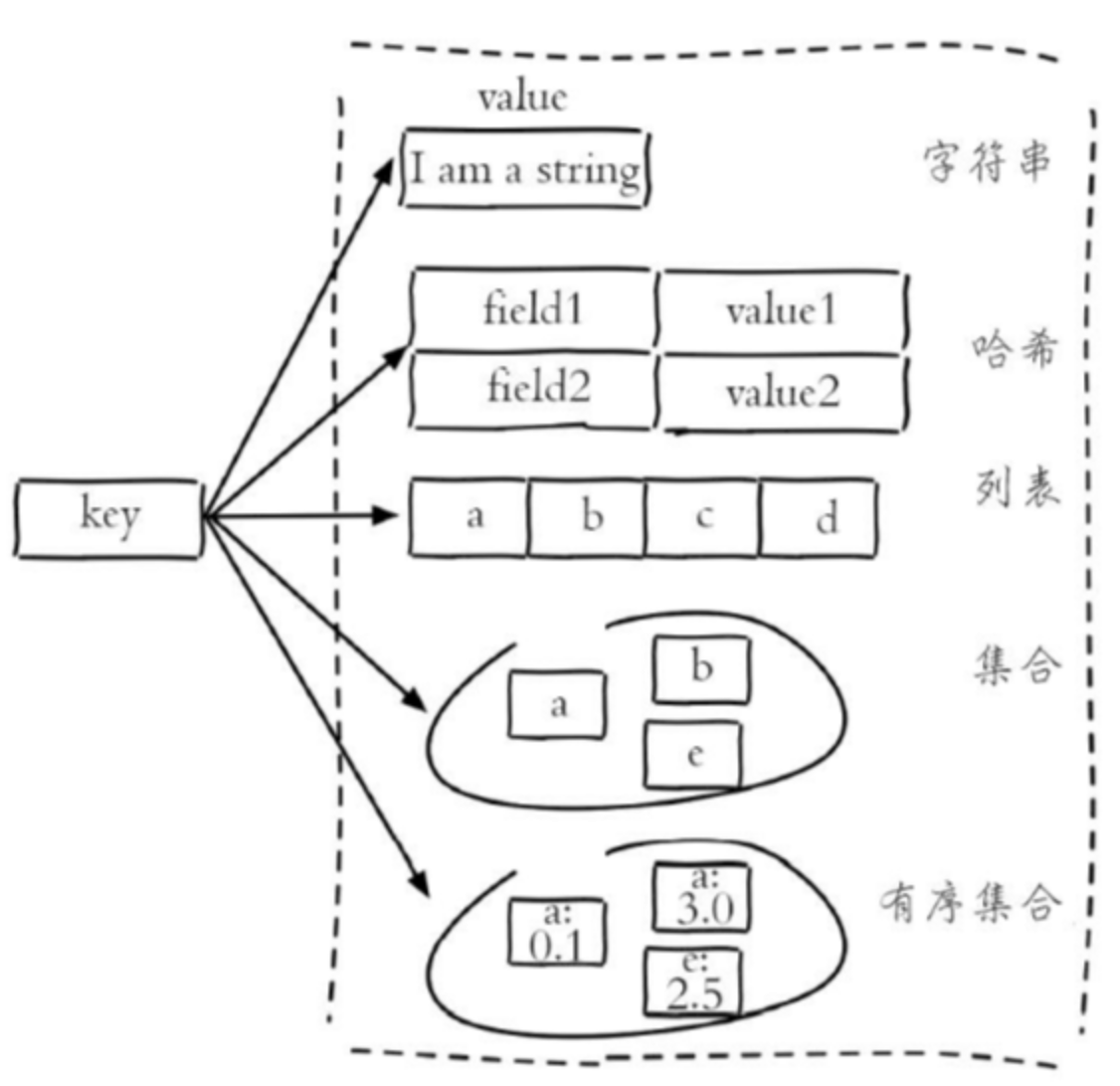

65 | - [『玩转Redis基础篇』Redis数据结构和常用命令速记](docs/redis/Redis%20数据结构和常用命令速记.md)

66 |

67 | - [『玩转Redis基础篇』面试官再问Redis事务把这篇文章扔给他](docs/redis/面试官再问Redis事务把这篇文章扔给他.md)

68 |

69 | - [『玩转Redis基础篇』一次性将Redis RDB持久化和AOF持久化讲透](docs/redis/一次性将Redis%20RDB持久化和AOF持久化讲透.md)

70 |

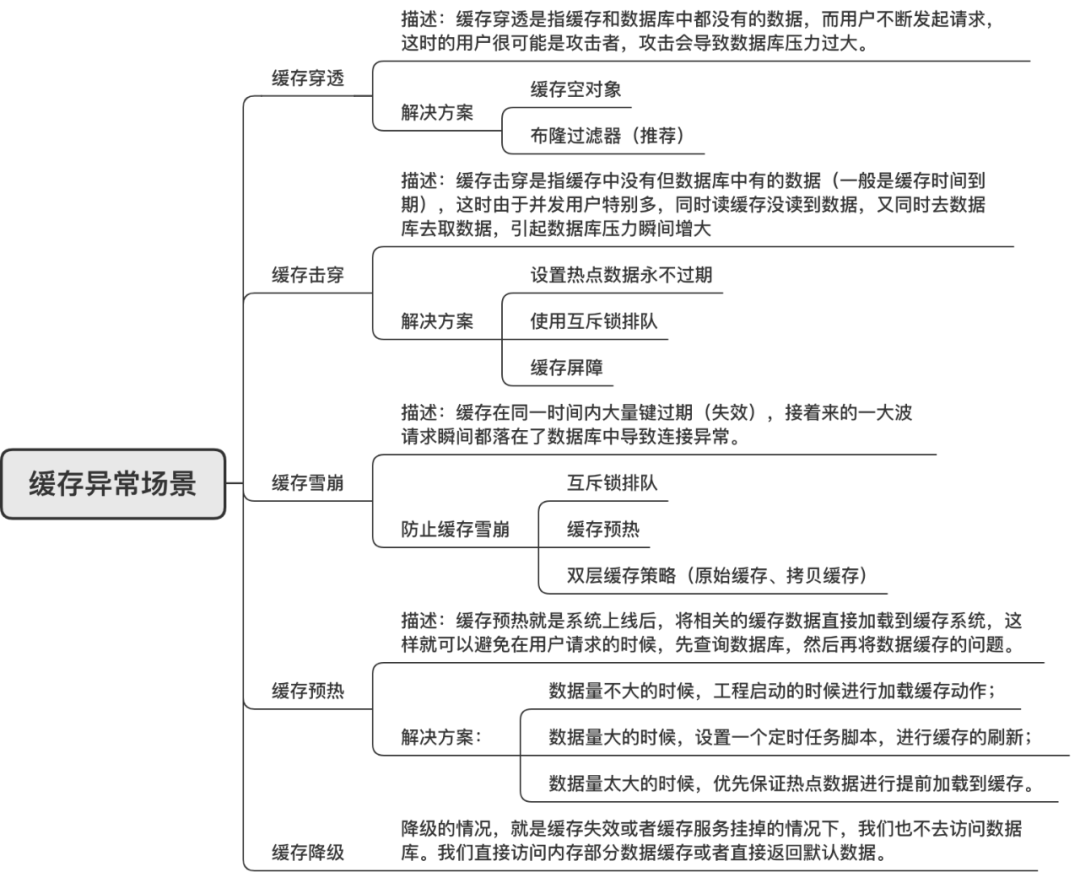

71 | - [『玩转Redis基础篇』一张图搞懂Redis缓存雪崩、缓存穿透、缓存击穿](docs/redis/一张图搞懂Redis缓存雪崩、缓存穿透、缓存击穿.md)

72 |

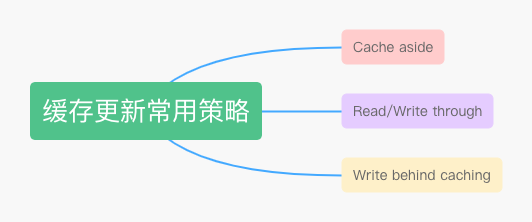

73 | - [『玩转Redis实战篇』高并发场景下,到底先更新缓存还是先更新数据库?:+1::+1:](docs/redis/高并发场景下,到底先更新缓存还是先更新数据库?.md)

74 |

75 | - [『玩转Redis实战篇』经理让我复盘上次Redis缓存雪崩事故](docs/redis/经理让我复盘上次Redis缓存雪崩事故.md)

76 |

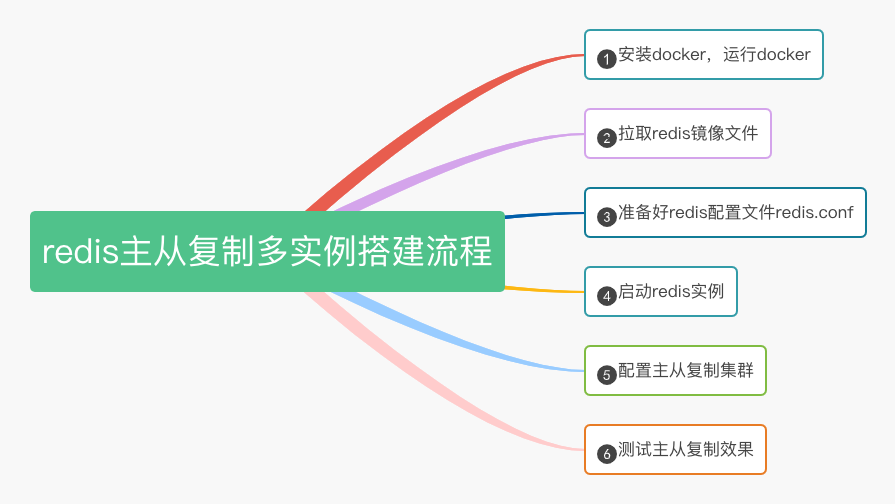

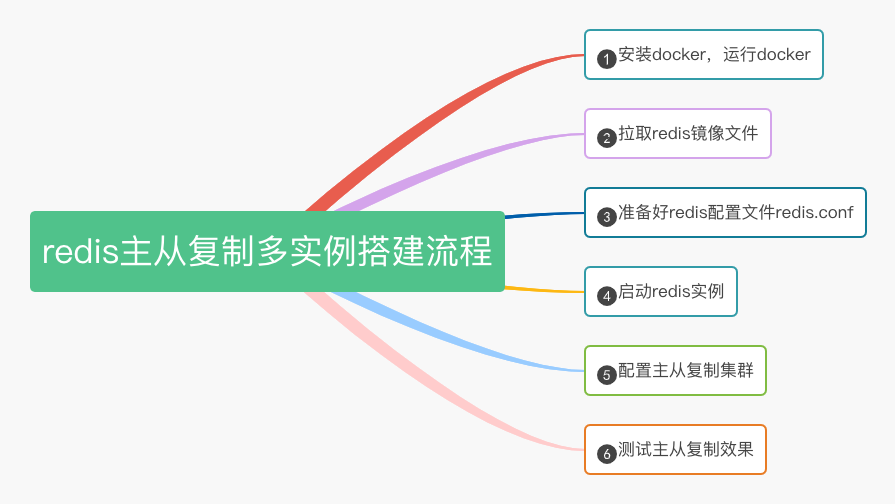

77 | - [『玩转Redis实战篇』还在用单机版?教你用Docker+Redis搭建主从复制多实例](docs/redis/还在用单机版?教你用Docker%2BRedis搭建主从复制多实例.md)

78 |

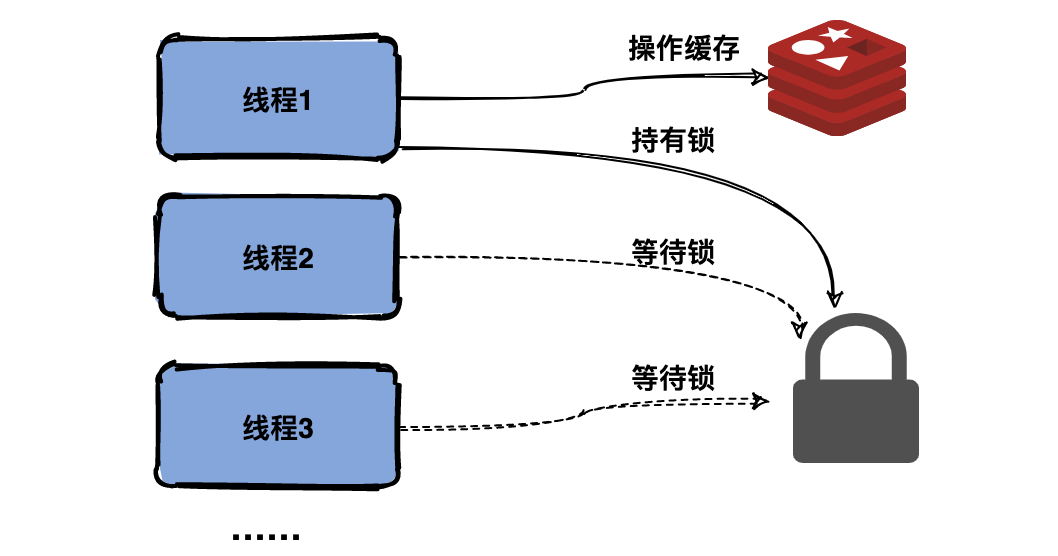

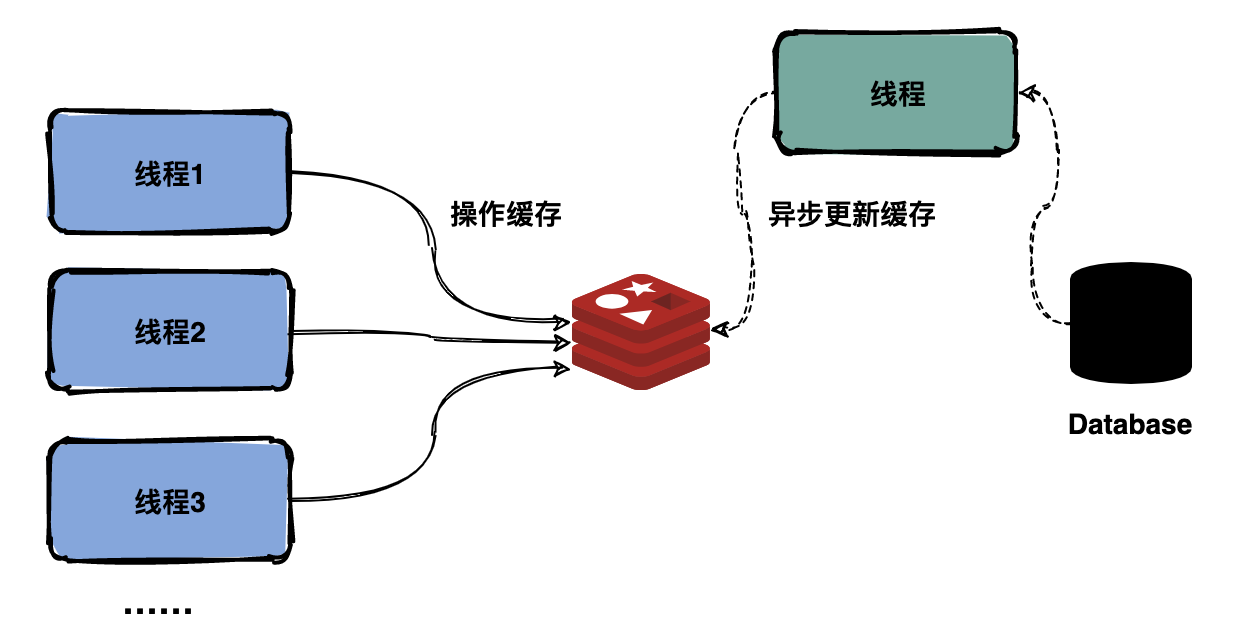

79 | - [『玩转Redis实战篇』记一次由Redis分布式锁造成的重大事故,避免以后踩坑!](docs/redis/记一次由Redis分布式锁造成的重大事故,避免以后踩坑!.md)

80 |

81 |

82 |

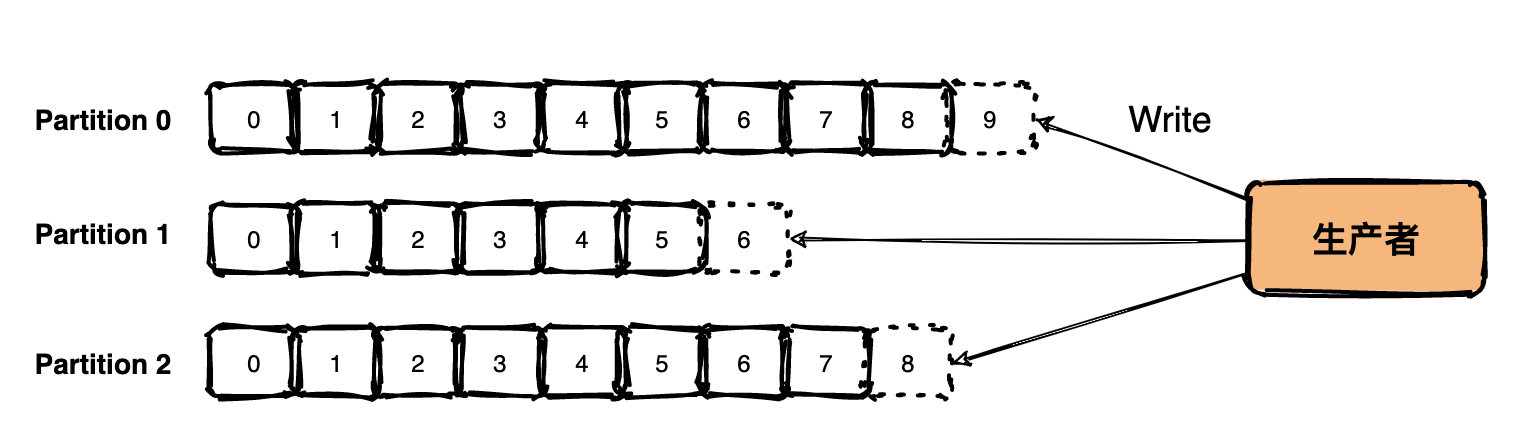

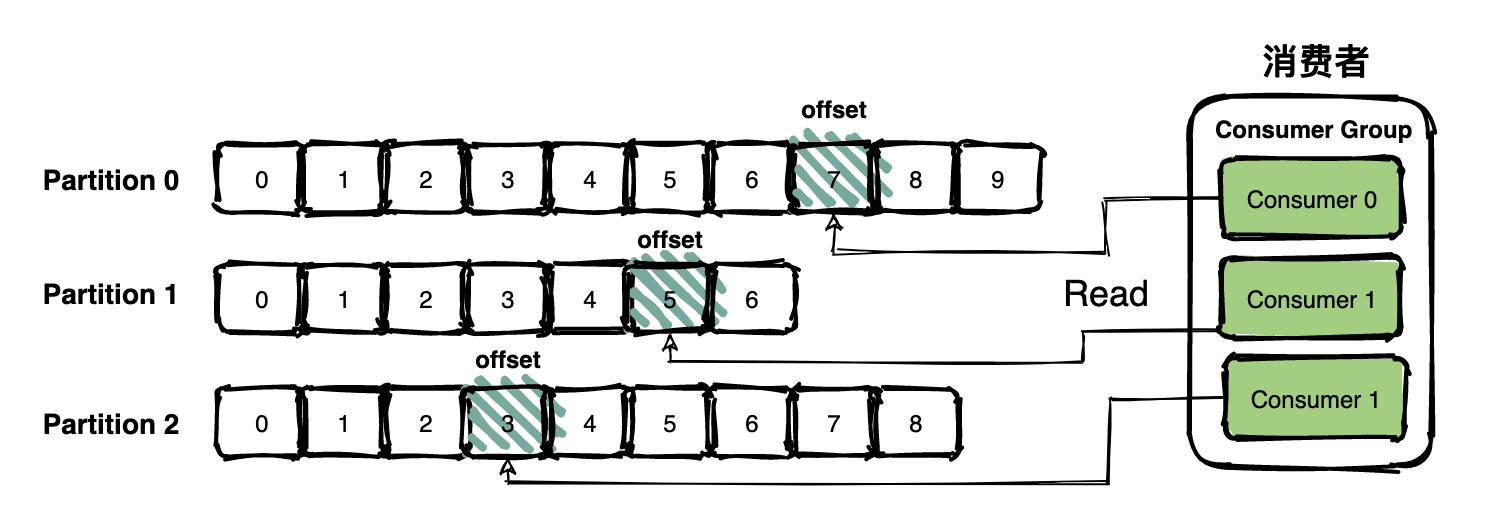

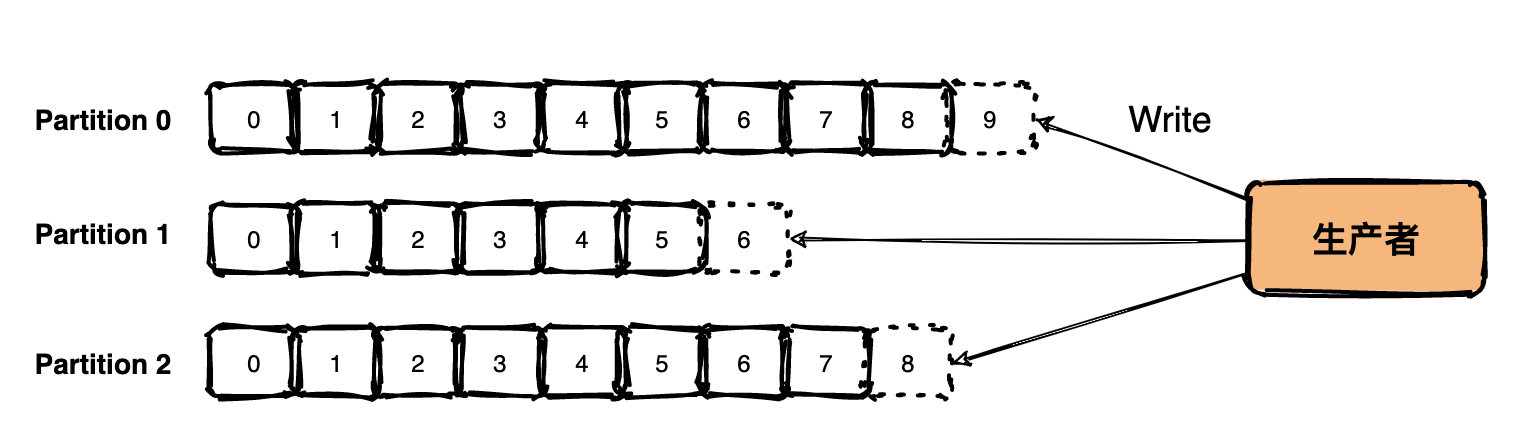

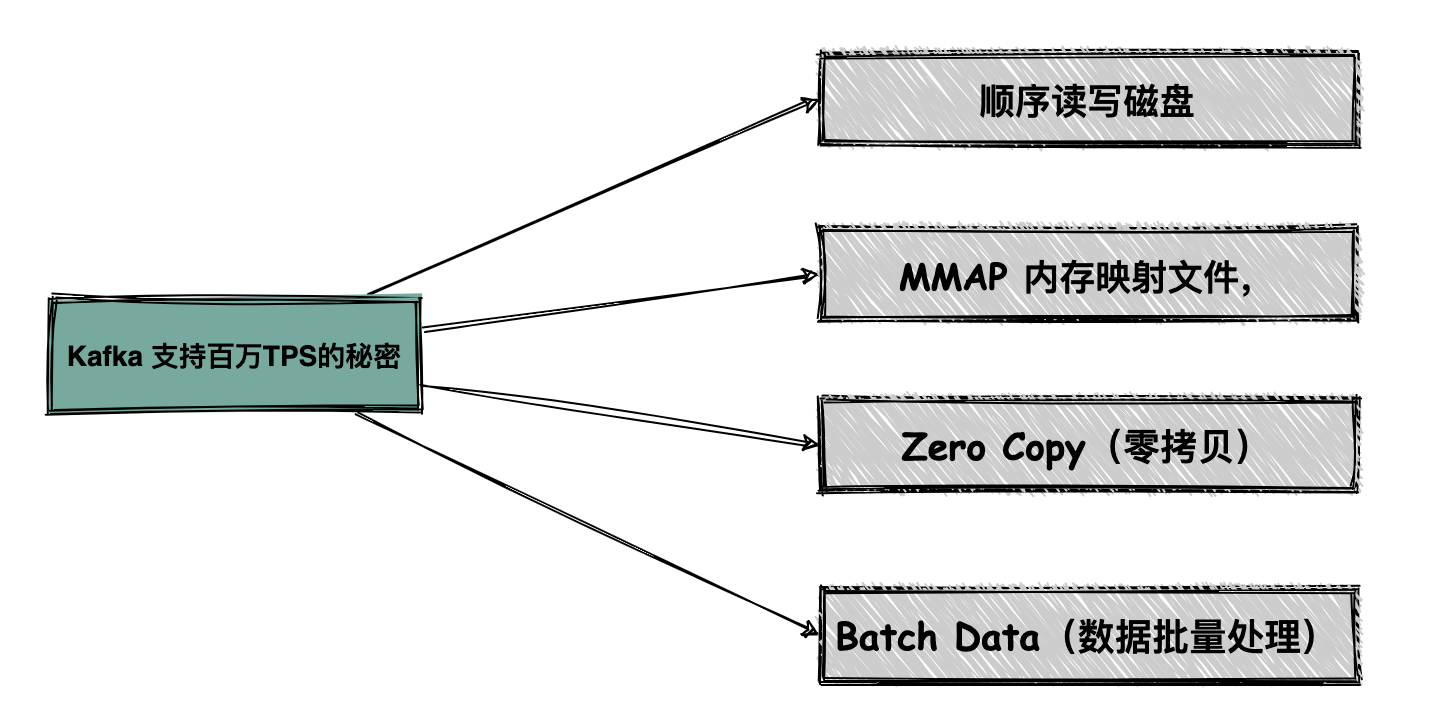

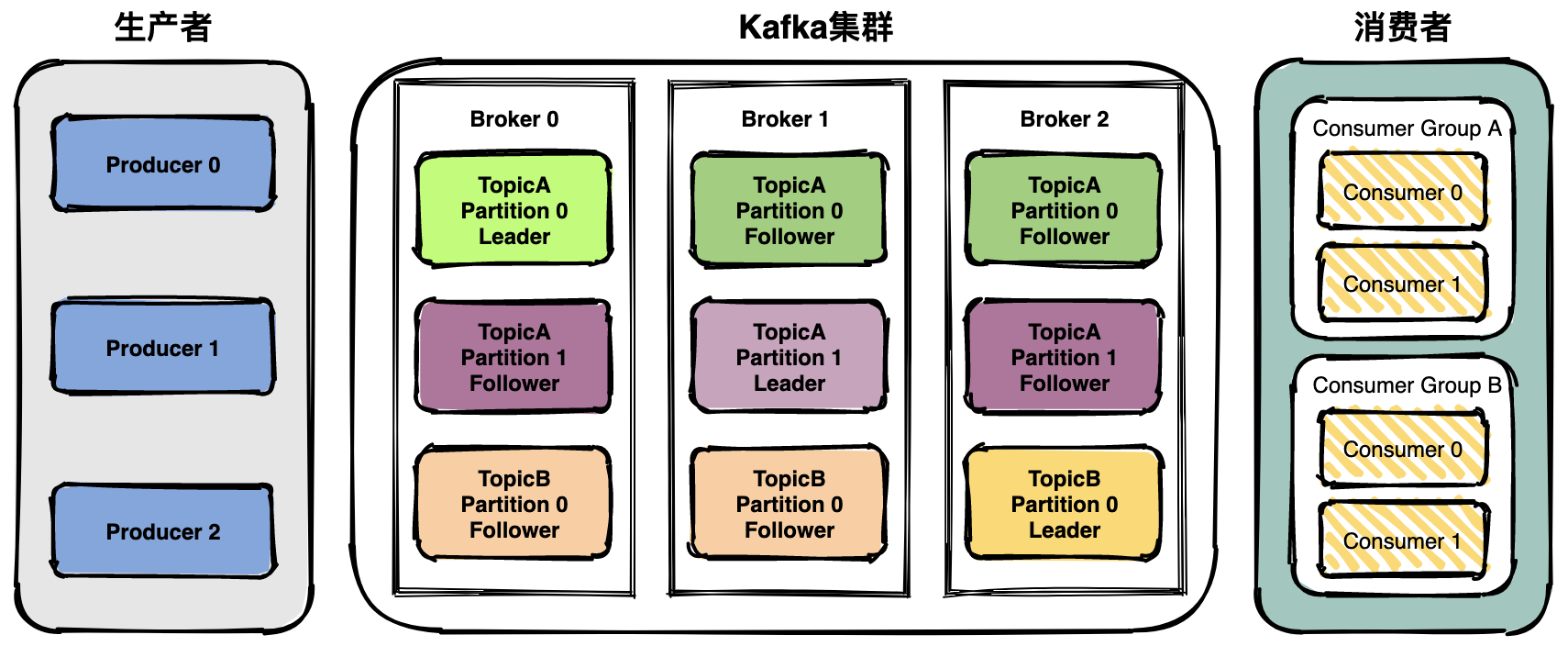

83 | # :tiger: 消息队列(kafka)

84 | - [Kafka支持百万级TPS的秘密都藏在这里:+1::+1::+1:](docs/mq/Kafka支持百万级TPS的秘密都藏在这里.md)

85 | - [刨根问底,kafka到底会不会丢消息:+1::+1::+1:](docs/mq/刨根问底,kafka到底会不会丢消息.md)

86 |

87 | # :cow: 分布式

88 |

89 | - [13张图彻底搞懂分布式系统服务注册与发现原理:+1::+1::+1:](docs/distributed/13张图彻底搞懂分布式系统服务注册与发现原理.md)

90 | - [原来10张图就可以搞懂分布式链路追踪系统原理:+1::+1::+1:](docs/distributed/原来10张图就可以搞懂分布式链路追踪系统原理.md)

91 | - [用大白话给你解释Zookeeper的选举机制:+1::+1:](docs/distributed/用大白话给你解释Zookeeper的选举机制.md)

92 |

93 | # :sheep: 关系数据库

94 |

95 | [我们为什么要分库分表?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322981&idx=1&sn=644537003c300db69934aa7acee80c8c&chksm=8f09c63fb87e4f29b5bebeca1c03e102898fcbd663b6f189a78dba8cec646f875cc01832a221&token=1553501157&lang=zh_CN#rd)

96 |

97 | # :frog: 五分钟入门系列

98 |

99 | - [5分钟带你快速了解ServiceMesh的前世今生](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322518&idx=1&sn=c6e23e98a838e7960e72623326c99360&chksm=8f09c84cb87e415a91f3a898918f45aa32ab17ed784cd68ce07945ecbb3a78b54429a38c9941&token=1553501157&lang=zh_CN#rd)

100 | - [Docker不香吗?为什么还要用k8s](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322467&idx=1&sn=30ab39d4f59135ecf6eb322fb0712189&chksm=8f09c839b87e412fdae1c39072ebdbbdcc3420b46fb66a324f5f81d8ebe621fe0ac3ef003a7d&token=1553501157&lang=zh_CN#rd)

101 |

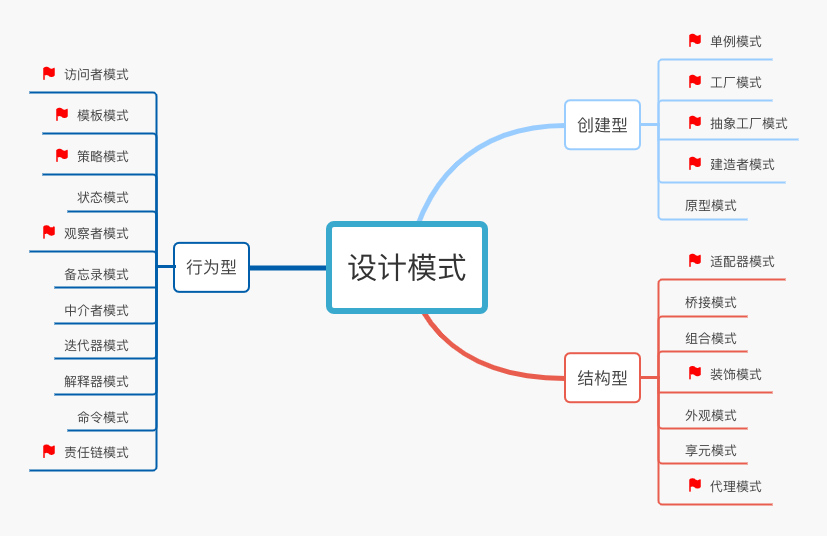

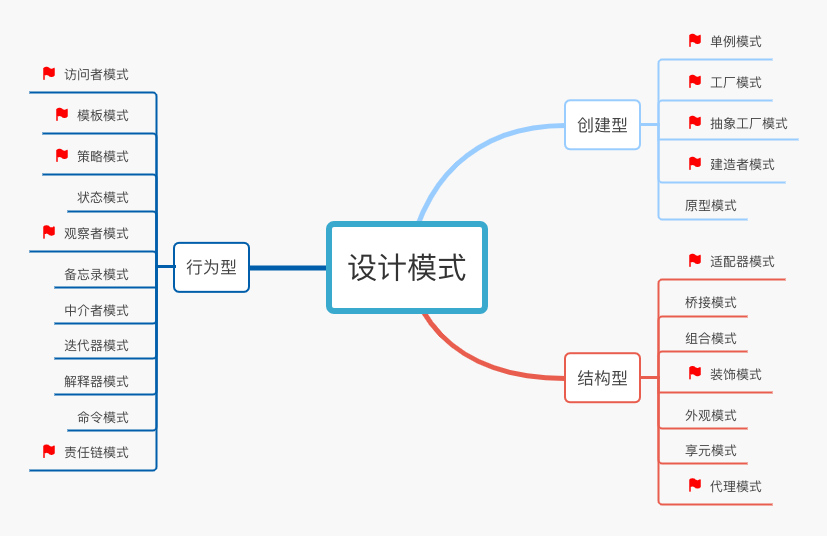

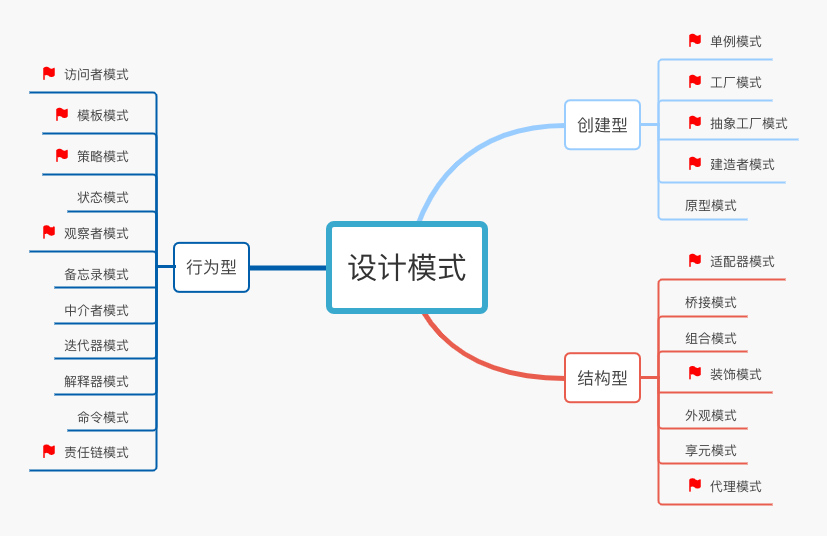

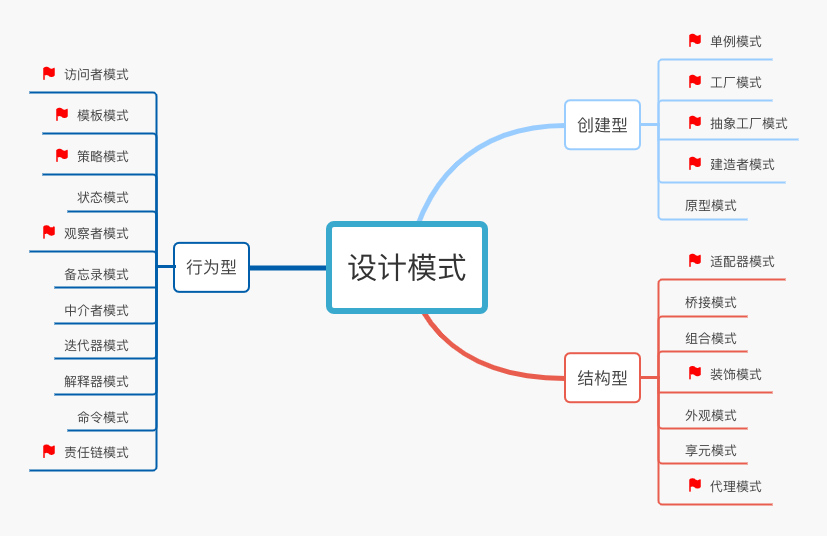

102 | # :horse: 设计模式

103 | [说完观察者和发布订阅模式的区别,面试官不留我吃饭了](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322141&idx=1&sn=ccece65719b5693ecdc6893642caefc3&chksm=8f09cac7b87e43d1efb3fcd2ba4b59159c7fa833b777fbdffaf0e739d3530c6834f80eaffbdd&token=1553501157&lang=zh_CN#rd)

104 |

105 |

106 | # :bulb: 工具&效率提升

107 |

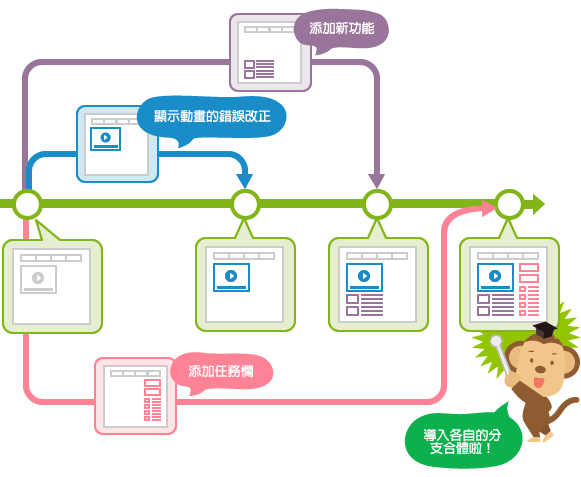

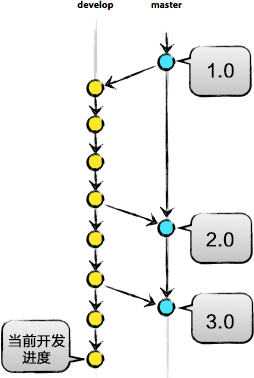

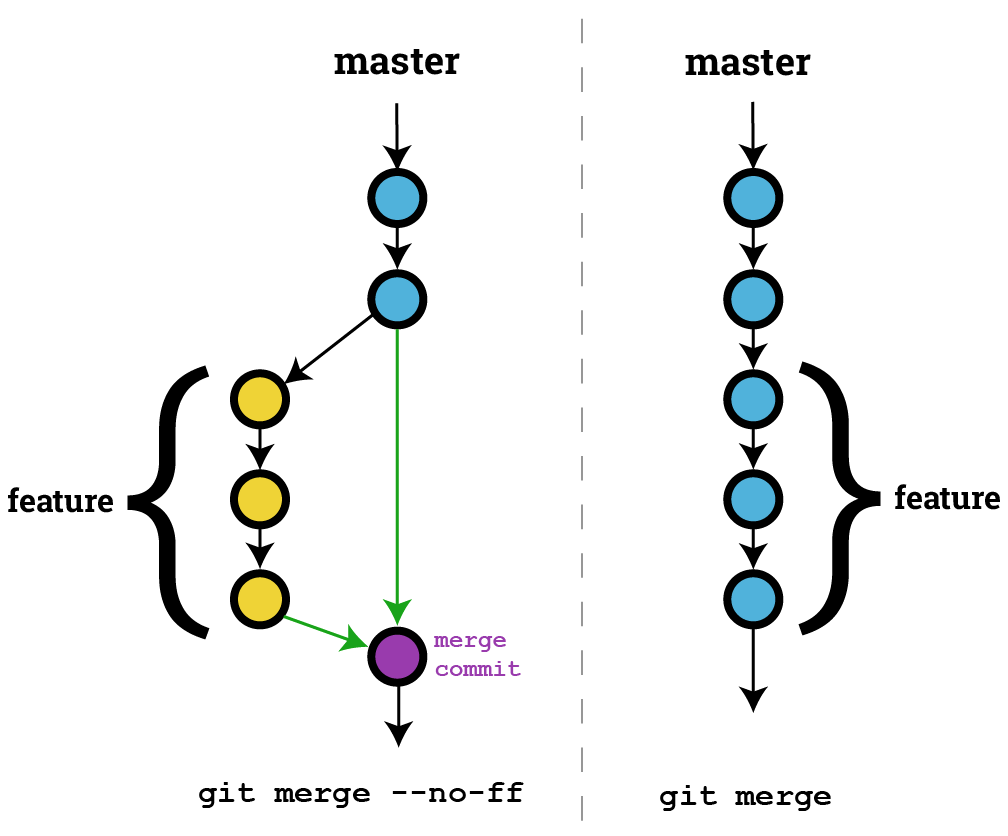

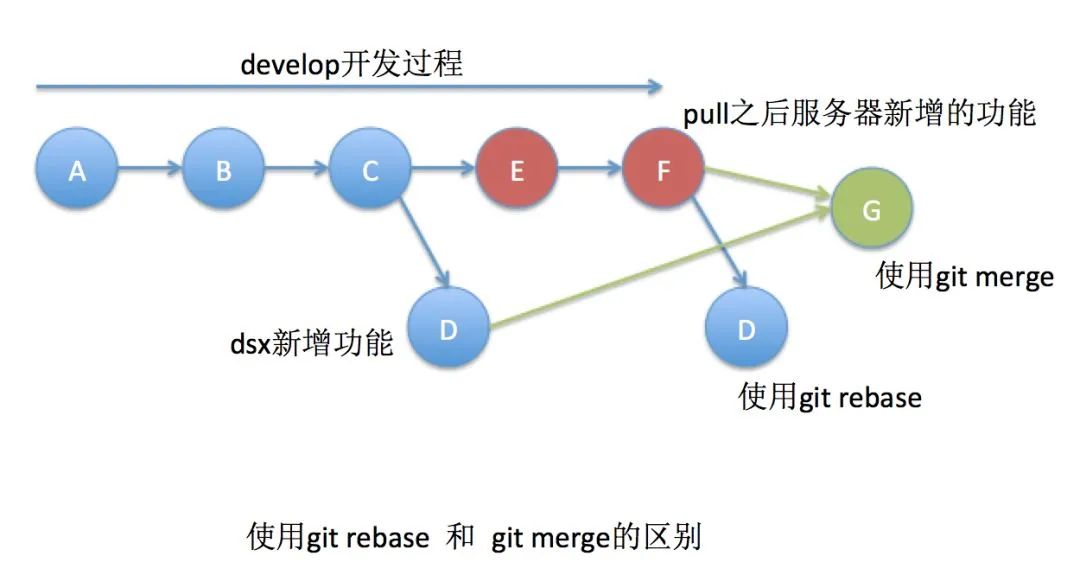

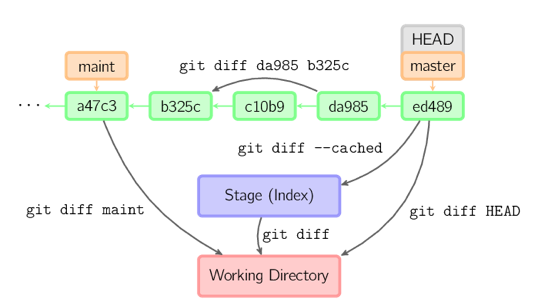

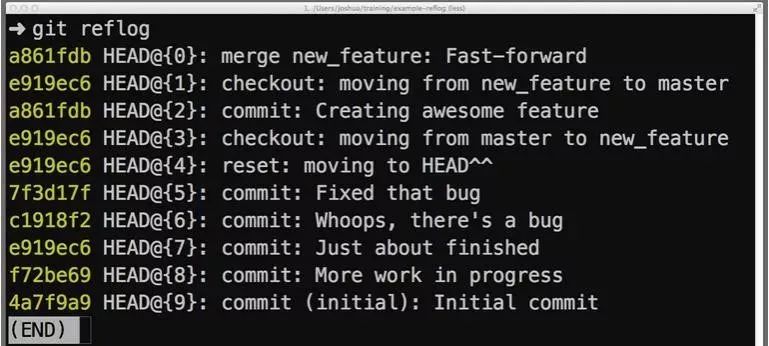

108 | ## Git

109 |

110 | 基础教程:

111 |

112 | - [保姆级Git教程,10000字详解,必看:+1:](docs/tools/git/保姆级Git教程,10000字详解.md)

113 |

114 | 进阶实战:

115 |

116 | - [牛逼!简单的代码提交能玩出这么多花样](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322730&idx=1&sn=6b7593e2cd29747ba424b9ca987ac86c&chksm=8f09c930b87e40269c52f2156d1ed08ce87509f4eca25aeb49f4977e97164622f614d3b93dd0&token=1553501157&lang=zh_CN#rd)

117 | - [吵疯了,Pull Request到底是个啥?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650323040&idx=1&sn=12b5f1342661c7964f8908eb1e14f590&chksm=8f09c67ab87e4f6ce6aa04b9a12ab95700089455b682eea6007e90172ec2d92f705277da34f6&token=1553501157&lang=zh_CN#rd)

118 |

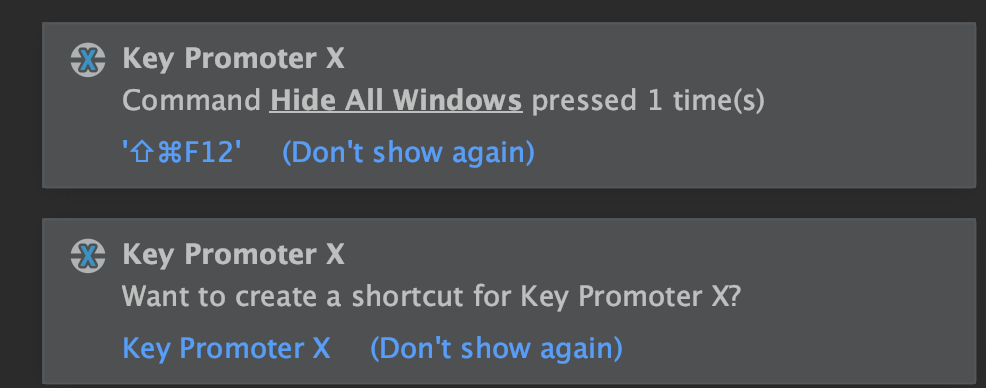

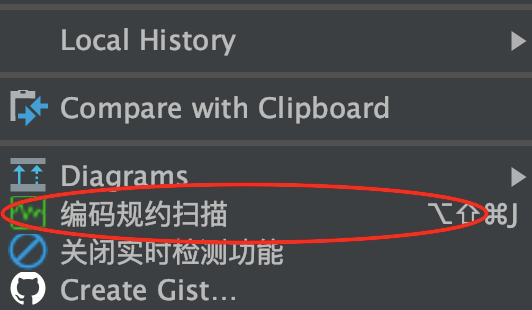

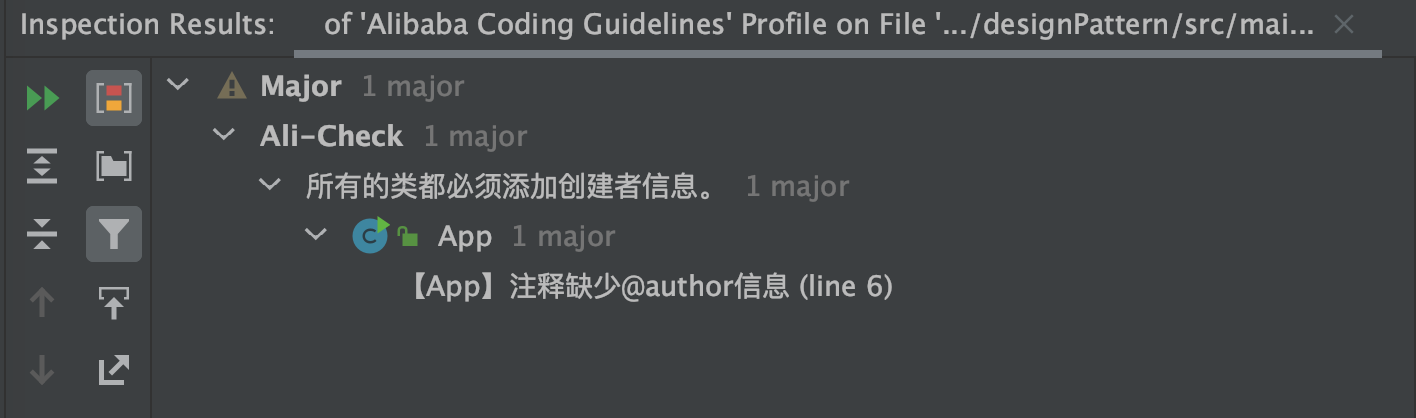

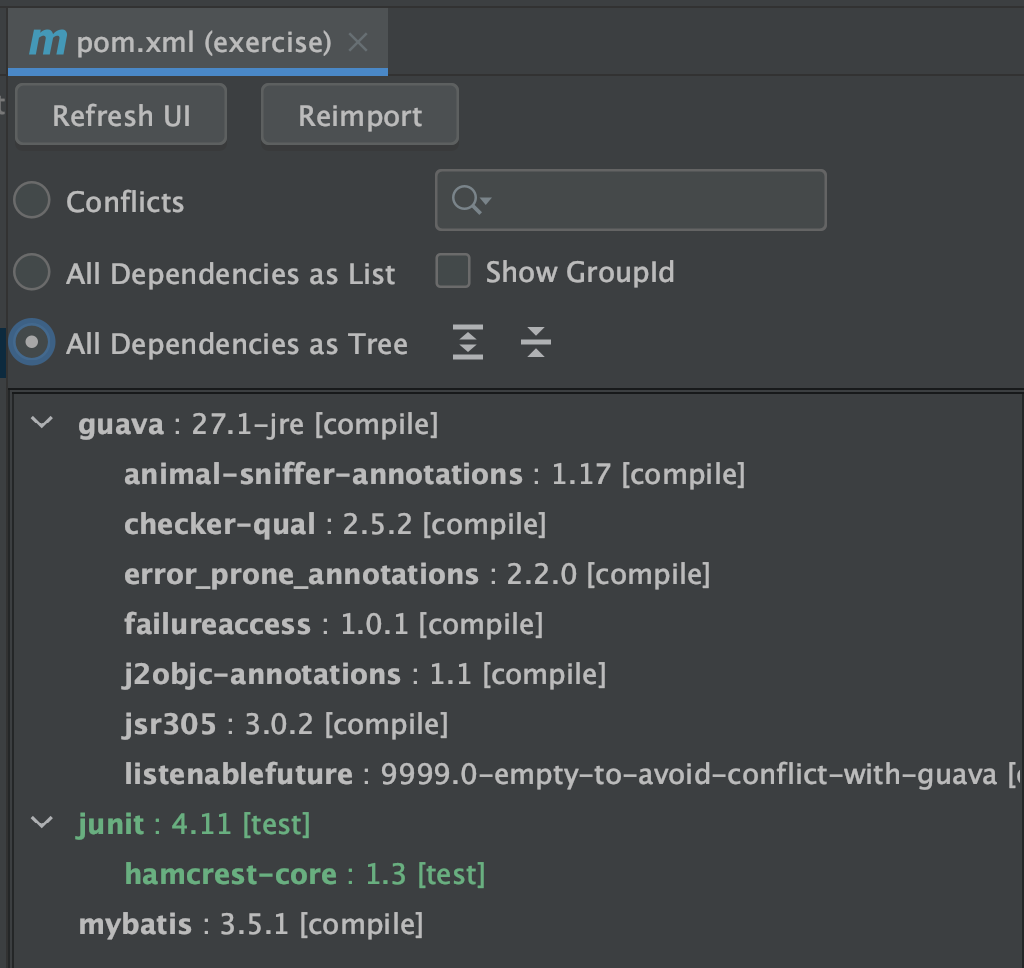

119 | ## IntelliJ IDEA - Java开发利器

120 |

121 | - [开发效率不高?推荐这十款精选IntelliJ Idea插件](docs/tools/推荐十款精选IntelliJIdea插件.md)

122 |

123 | ## 代码重构

124 | - [讲点码德!避免这些代码坏味道,努力做一名优秀的程序员](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322056&idx=1&sn=ab5552ffdc868d3ea004ed0782bd80d3&chksm=8f09ca92b87e4384881ec3ab1d1b20f61c0f77e1185d5f0ad60c7b96d3420cf7f101e88492c6&token=1553501157&lang=zh_CN#rd)

125 |

126 | ## 学习资源

127 | - [高效学习资源网站汇总](docs/tools/高效学习资源网站汇总.md)

128 |

129 |

130 | # :dart: 我要进大厂系列

131 |

132 | - [两年半完成逆袭,室友终于拿到字节跳动的Offer:+1:](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321727&idx=1&sn=2e530651ba6176415cacc91f065d333c&chksm=8f09cd25b87e4433f5a7a248bf91ee64f3e1b025a3096873f543a5cf8f03f31433b6d31c0ddc&token=1941065265&lang=zh_CN#rd)

133 |

134 | - [找工作前这四个坑不要重复踩了](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321540&idx=1&sn=c17e195ec6fa7d40a6327a456f9fd4b2&chksm=8f09cc9eb87e45889fed564e4c1e461cf53863930323c9a5aa86169e94b25092bdd9097c81fc&token=1553501157&lang=zh_CN#rd)

135 |

136 | - [网易面试干货之HR解密网易招聘(上篇)](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321320&idx=1&sn=d0c73f80b6ee92aebc12dbdbcb41d8ec&chksm=8f09cfb2b87e46a4afa541bb198c0bca3acdb9067c269406447587c3c8cfd135bea0ec701bd8&scene=178&cur_album_id=1531431564587417601#rd)

137 | - [网易面试干货之HR解密网易招聘(下篇)](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321320&idx=2&sn=21940f268890e43032434b628fc08819&chksm=8f09cfb2b87e46a4e6c94b8b94667f036be9e8a3e6780e7ca8b714d18b53e0f1b96c67d07781&scene=178&cur_album_id=1531431564587417601#rd)

138 |

139 |

140 |

141 | # :see_no_evil: 程序人生

142 | - [我也是从寒门走出来的:+1::+1::+1: ](https://mp.weixin.qq.com/s/pejkW9F1QsH2toEfoNPe1g)

143 | - [逃离百度](https://mp.weixin.qq.com/s/0Sobo5R4GLE3QmEK_gbksg)

144 | - [寒门难出贵子,我当程序员让爸妈在老家长脸了:+1::+1::+1: ](https://mp.weixin.qq.com/s/GOKberslgcxN7Jl5cTrmyw)

145 | - [摊牌了,这半个月我拍"电影"去了](https://mp.weixin.qq.com/s/ihTIFUqM0z7V1zmgPvT0yA)

146 | - [谈谈拼夕夕事件!为什么我们拼尽全力却还要996](https://mp.weixin.qq.com/s/3WVde2dAKfqKv0DBt5dGLw)

147 | - [IT双职工赢在起跑线,还怕未来吗?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321489&idx=1&sn=c31f56cc06fd21e889be51e189ffed23&chksm=8f09cc4bb87e455d09e5ceda718c27cbf5df113cbe0336faf947b1bce3d28d40cc454ebf872d&token=1553501157&lang=zh_CN#rd)

148 | - [程序员版《我和我的家乡》,拼搏奋斗的IT人是家乡的骄傲!](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321444&idx=1&sn=17f3ce6c05b40afc3c18bdb23ee2f6d7&chksm=8f09cc3eb87e45289fd1e51055a4acb7d9689a8e3d4ffc598fc7fd1ca1e918f1628ee67d55c6&scene=178&cur_album_id=1531431564587417601#rd)

149 | - [女程序员在互联网界到底有没有被歧视?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321297&idx=1&sn=d547a2c54e99e6a69723e39ec955d24e&chksm=8f09cf8bb87e469d560ef47c47e59d814a224a31ccfefe12efe9e62a20abbc0f870e14660648&scene=178&cur_album_id=1531431564587417601#rd)

150 | - [离开华为换种生活,它不香吗?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321143&idx=1&sn=85a794588811541a8e920a60a0edcf4e&chksm=8f09ceedb87e47fb0b9301b6d268b4c68f5a213f47f5a1286fc800a2707b6a9bf57958bd301b&scene=178&cur_album_id=1531431564587417601#rd)

151 | - [如果可以选择,我再也不想在国企当程序员了](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321085&idx=1&sn=12a7cc5c910d547cc696c325826295e1&chksm=8f09cea7b87e47b13256c15a631506fc18fd2d8a25a4546b202f268f84347723f59a9e2e86ac&scene=178&cur_album_id=1531431564587417601#rd)

152 | - [30岁的程序员出路在哪里?](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321044&idx=1&sn=30b10126e477876229f77cd604540b57&chksm=8f09ce8eb87e47981c945363f9601bf8bd524d220fe1b1397f01a18420c8e1cc8f7c76ba94cb&scene=178&cur_album_id=1531431564587417601#rd)

153 |

154 | # :cloud: 侃天侃地侃互联网

155 |

156 | - [求伯君,一个你必须知道的程序员

157 | ](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321596&idx=1&sn=c64858e4f5ed07d53feb00b1aeec2974&chksm=8f09cca6b87e45b09eb7ddc6c35be06d1be7514330e9ac9ef144cd3a5ae61b14e1a6e22bf295&token=1553501157&lang=zh_CN#rd)

158 | - [华为鸿蒙OS尖刀武器之分布式软总线技术全解析](/docs/it-hot/鸿蒙OS尖刀武器之分布式软总线技术.md)

159 | - [汇聚开发者星星之火,华为鸿蒙系统有希望成为国产之光](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321645&idx=1&sn=c263f8db73cdbffee96c2f511ff7ae74&chksm=8f09ccf7b87e45e18eb684d620073d256f95fa25217b8d5c81116600df9a137d33fa93c92961&token=1941065265&lang=zh_CN#rd)

160 |

161 | # :boy: 关于我

162 |

163 | 大家好,我是『雷小帅』,也是微信公众号『爱笑的架构师』的作者。

164 |

165 | - :coffee:读过几年书:华中科技大学硕士毕业;

166 |

167 | - :star2:浪过几个大厂:华为、网易、百度……

168 |

169 | - :kissing:一直坚信技术能改变生活,愿保持初心,加油技术人!

170 |

171 | `我有技术和故事,等你来!`

172 |

173 | **Github 上所有的文章我都会首发在微信公众号『爱笑的架构师』,大家可以关注一下。定时推送技术干货~**

174 |

175 |

176 |

177 |

187 |

188 |

27 |

28 | # 引入服务注册与发现组件的原因

29 |

30 | 先来看一个问题,假如现在我们要做一个商城项目,作为架构师的你应该怎样设计系统的架构?你心里肯定在想:这还不容易直接照搬淘宝的架构不就行了。但在现实的创业环境中一个项目可能是九死一生,如果一开始投入巨大的人力和财力,一旦项目失败损失就很大。

31 |

32 | 作为一位有经验的架构师需要结合公司财力、人力投入预算等现状选择最适合眼下的架构才是王道。大型网站都是从小型网站发展而来,架构也是一样。

33 |

34 | 任何一个大型网站的架构都不是从一开始就一层不变的,而是随着用户量和数据量的不断增加不断迭代演进的结果。

35 |

36 | 在架构不断迭代演进的过程中我们会遇到很多问题,**技术发展的本质就是不断发现问题再解决问题,解决问题又发现问题**。

37 |

38 | ## **单体架构**

39 |

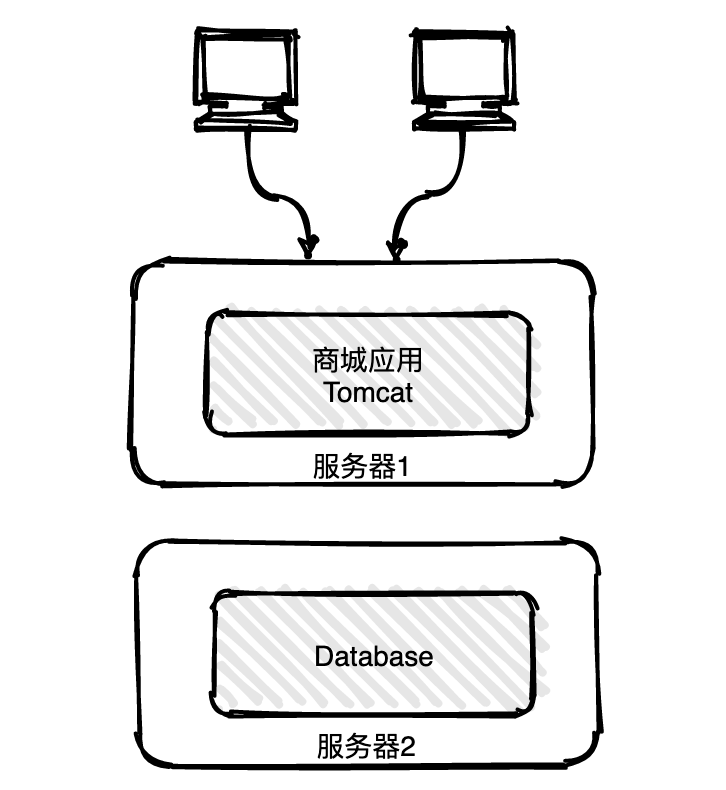

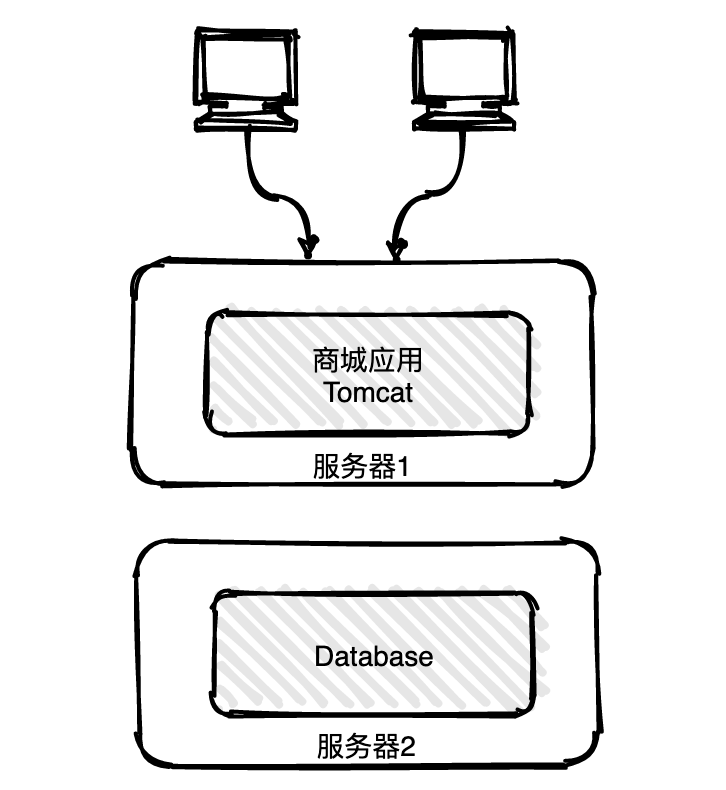

40 | 在系统建立之初可能不会有特别多的用户,将所有的业务打成一个应用包放在tomcat容器中运行,与数据库共用一台服务器,这种架构一般称之为单体架构。

41 |

42 |

27 |

28 | # 引入服务注册与发现组件的原因

29 |

30 | 先来看一个问题,假如现在我们要做一个商城项目,作为架构师的你应该怎样设计系统的架构?你心里肯定在想:这还不容易直接照搬淘宝的架构不就行了。但在现实的创业环境中一个项目可能是九死一生,如果一开始投入巨大的人力和财力,一旦项目失败损失就很大。

31 |

32 | 作为一位有经验的架构师需要结合公司财力、人力投入预算等现状选择最适合眼下的架构才是王道。大型网站都是从小型网站发展而来,架构也是一样。

33 |

34 | 任何一个大型网站的架构都不是从一开始就一层不变的,而是随着用户量和数据量的不断增加不断迭代演进的结果。

35 |

36 | 在架构不断迭代演进的过程中我们会遇到很多问题,**技术发展的本质就是不断发现问题再解决问题,解决问题又发现问题**。

37 |

38 | ## **单体架构**

39 |

40 | 在系统建立之初可能不会有特别多的用户,将所有的业务打成一个应用包放在tomcat容器中运行,与数据库共用一台服务器,这种架构一般称之为单体架构。

41 |

42 | -2021-05-04-23-18-38](https://cdn.jsdelivr.net/gh/CoderLeixiaoshuai/assets/202102/-2021-05-04-23-18-38.png) 43 |

44 | 在初期这种架构的效率非常高,根据用户的反馈可以快速迭代上线。但是随着用户量增加,一台服务的内存和CPU吃紧,很容易造成瓶颈,新的问题来了怎么解决呢?

45 |

46 | ## 应用与数据分离

47 |

48 | 随着用户请求量增加,一台服务器的内存和CPU持续飙升,用户请求响应时间变慢。这时候可以考虑将应用与数据库拆开,各自使用一台服务器,你看问题又解决了吧。

49 |

50 |

43 |

44 | 在初期这种架构的效率非常高,根据用户的反馈可以快速迭代上线。但是随着用户量增加,一台服务的内存和CPU吃紧,很容易造成瓶颈,新的问题来了怎么解决呢?

45 |

46 | ## 应用与数据分离

47 |

48 | 随着用户请求量增加,一台服务器的内存和CPU持续飙升,用户请求响应时间变慢。这时候可以考虑将应用与数据库拆开,各自使用一台服务器,你看问题又解决了吧。

49 |

50 |  51 |

52 |

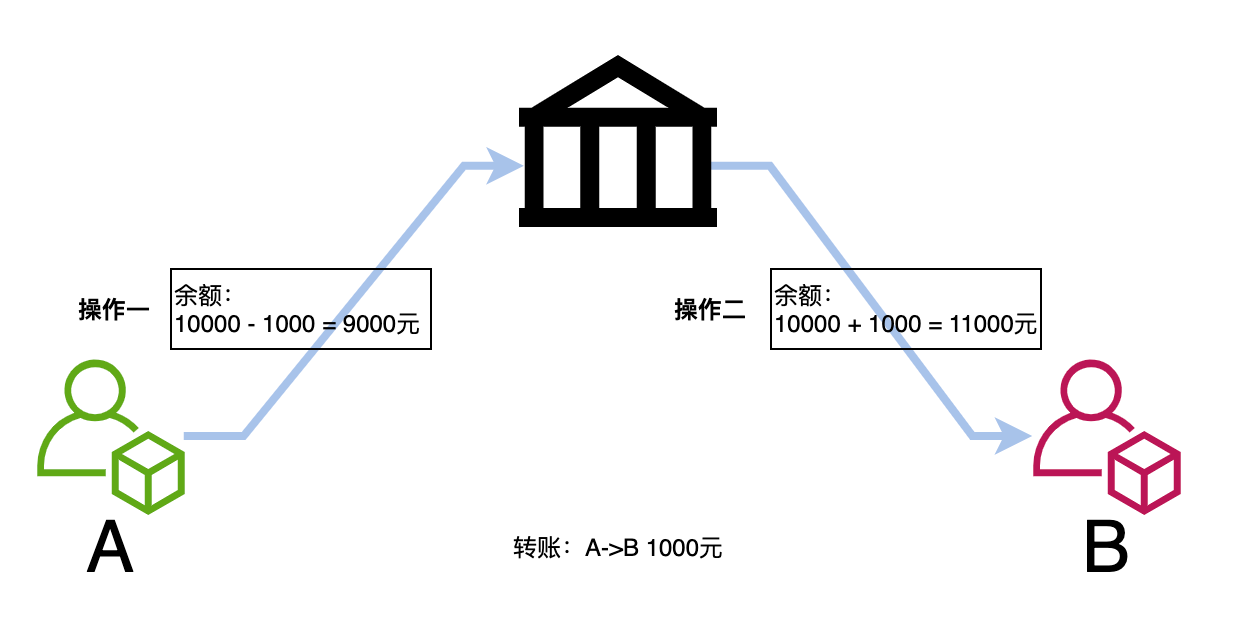

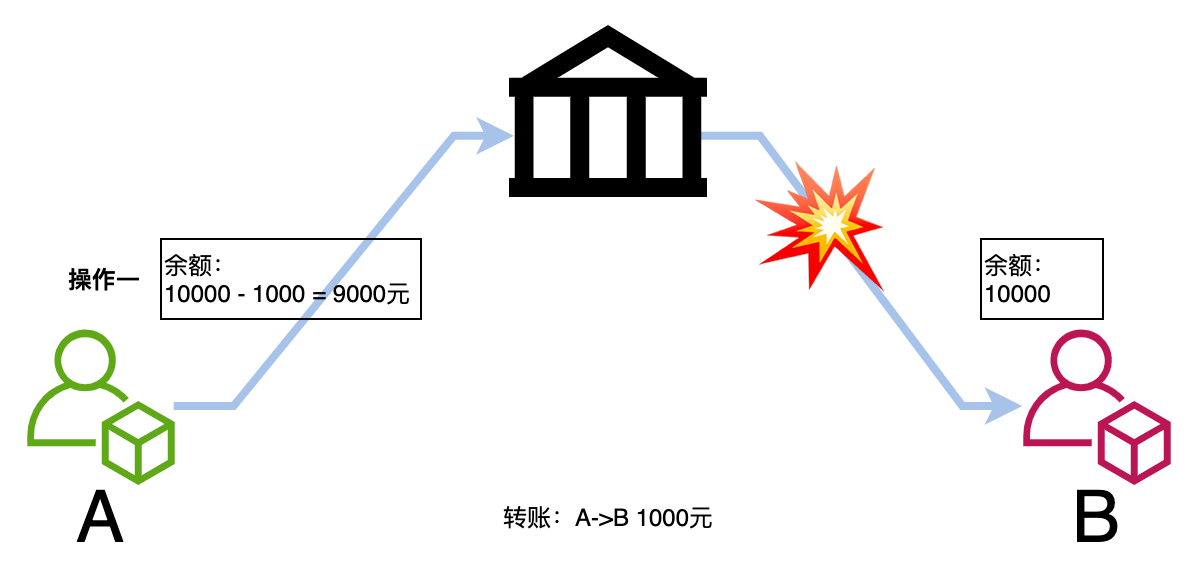

53 | 突然有一天扫地阿姨不小心碰了电线,其中一台服务器掉电了,用户所有的请求都报错,随之而来的是一系列投诉电话。

54 |

55 | ## 集群部署

56 |

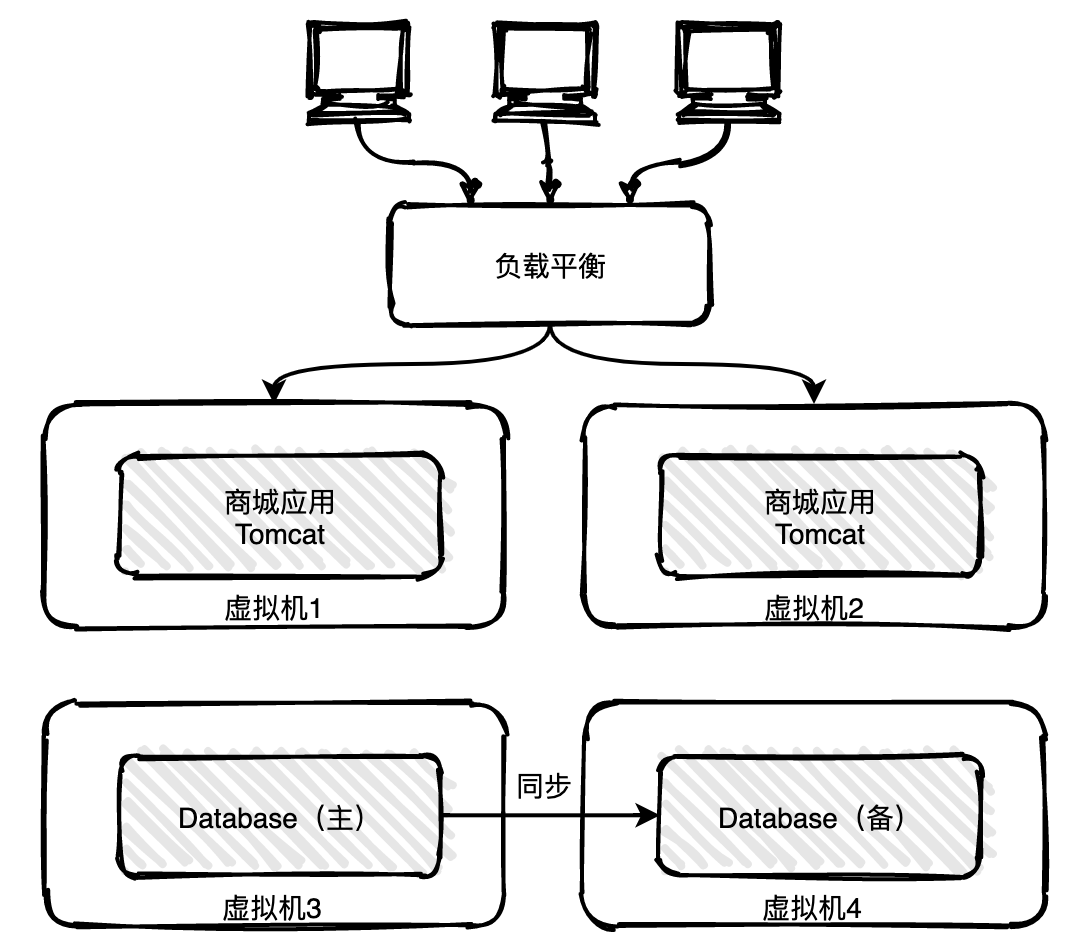

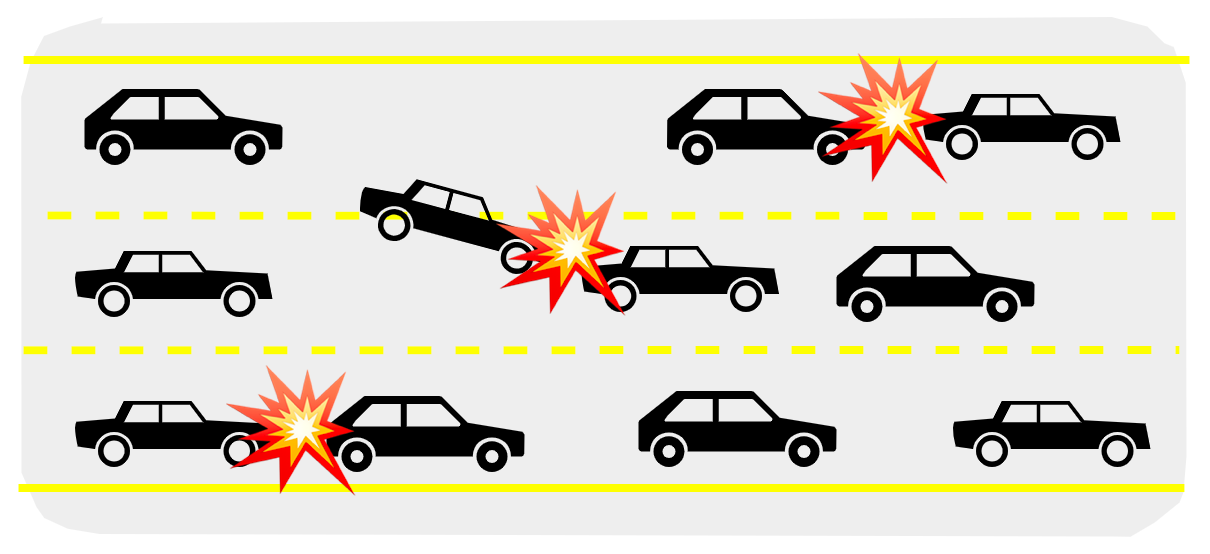

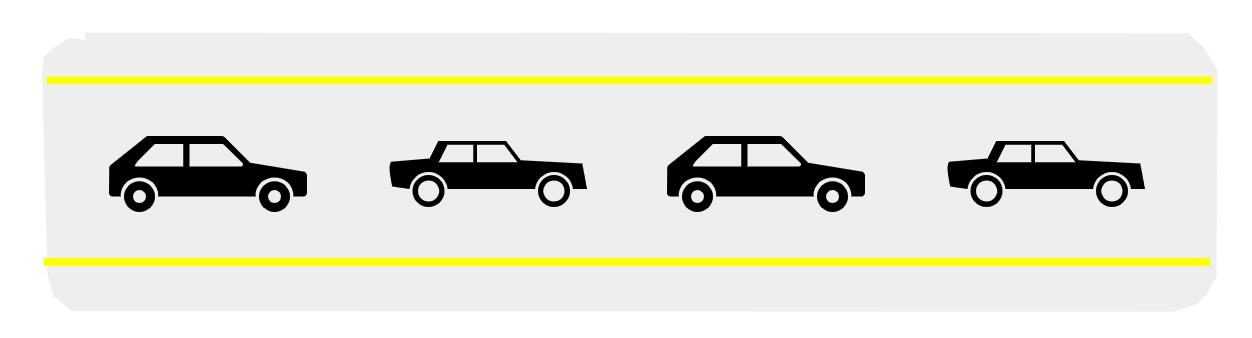

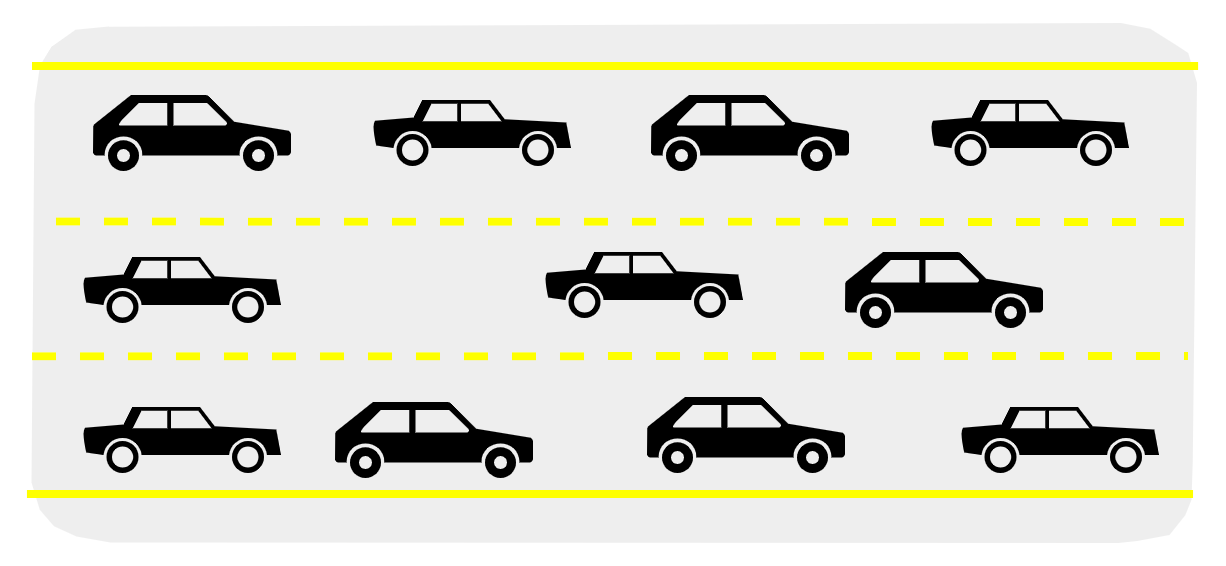

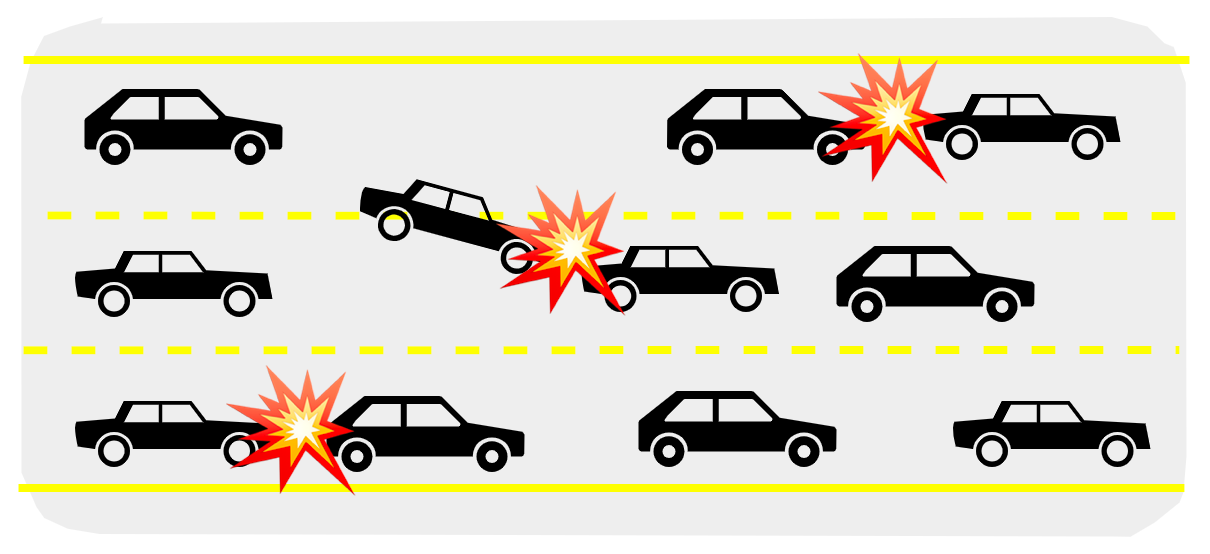

57 | 单实例很容易造成单点问题,比如遇到服务器故障或者服务能力瓶颈,那怎么办?聪明的你肯定想到了,用集群呀。

58 |

59 |

51 |

52 |

53 | 突然有一天扫地阿姨不小心碰了电线,其中一台服务器掉电了,用户所有的请求都报错,随之而来的是一系列投诉电话。

54 |

55 | ## 集群部署

56 |

57 | 单实例很容易造成单点问题,比如遇到服务器故障或者服务能力瓶颈,那怎么办?聪明的你肯定想到了,用集群呀。

58 |

59 |  60 |

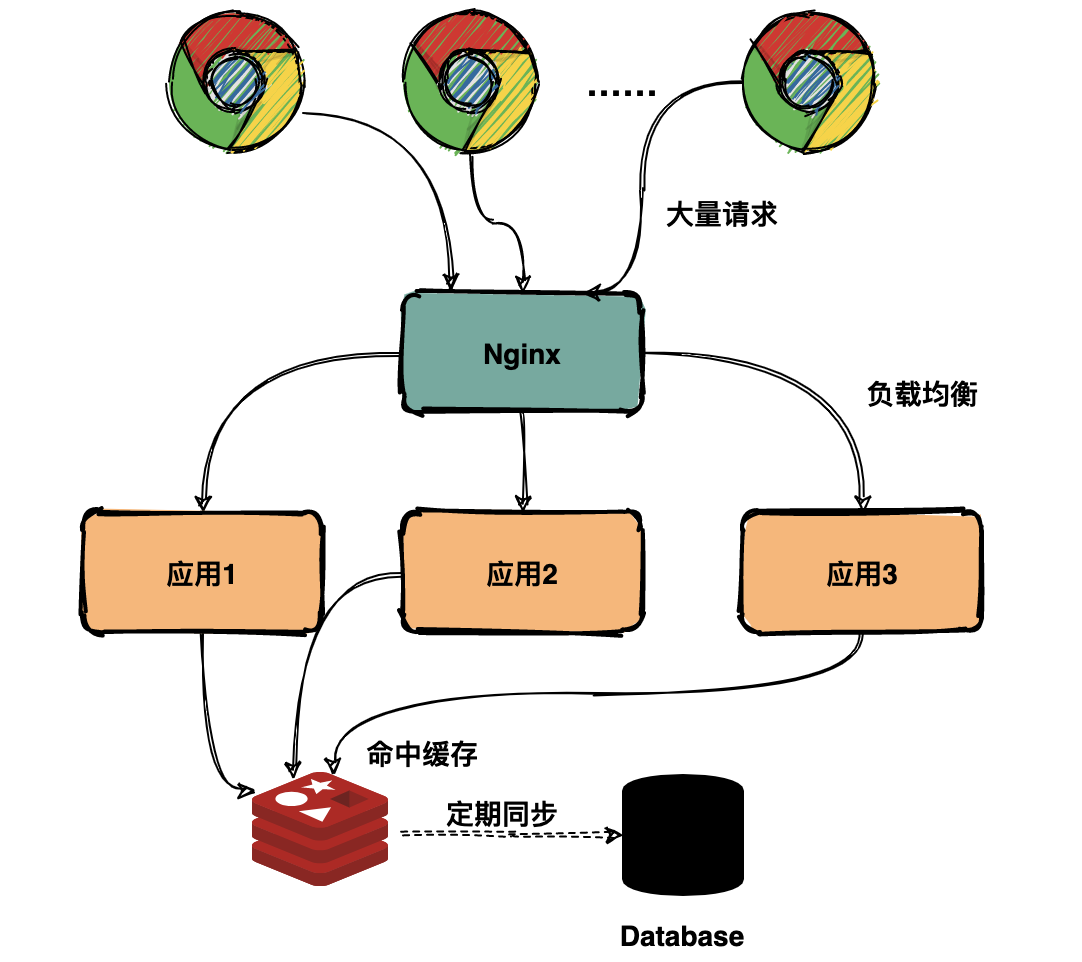

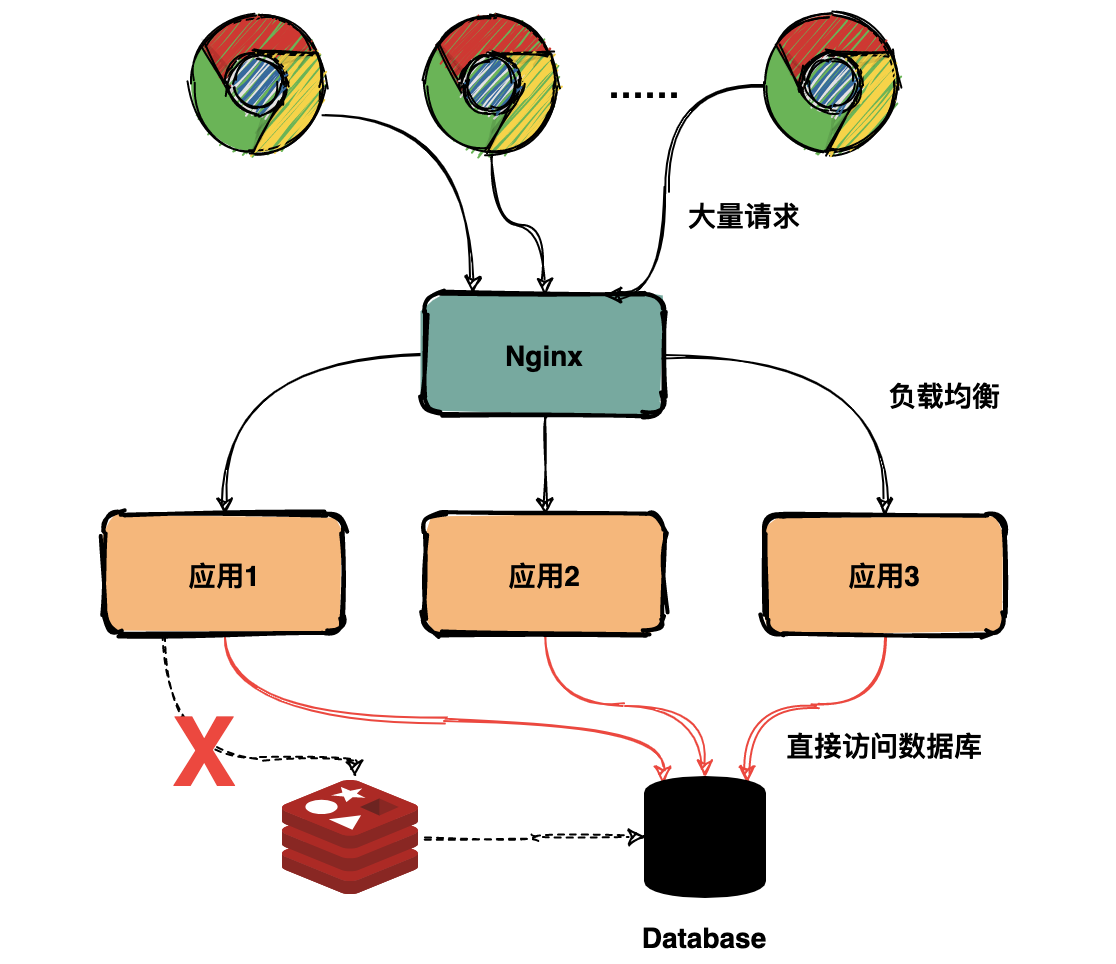

61 | 集群部署是指将应用部署在多个服务器或者虚机上,用户通过服务均衡随机访问其中的一个实例,从而使多个实例的流量均衡,如果一个实例出现故障可以将其下线,其他实例不受影响仍然可以对外提供服务。

62 |

63 | 随着用户数量快速增加,老板决定增加投入扩大团队规模。开发团队壮大后效率并没有得到显著的提高,以前小团队可以一周迭代上线一次,现在至少需要两到三周时间。

64 |

65 | 业务逻辑越来越复杂,代码间耦合很严重,修改一行代码可能引入几个线上问题。架构师意识到需要进行架构重构。

66 |

67 | ## 微服务架构

68 |

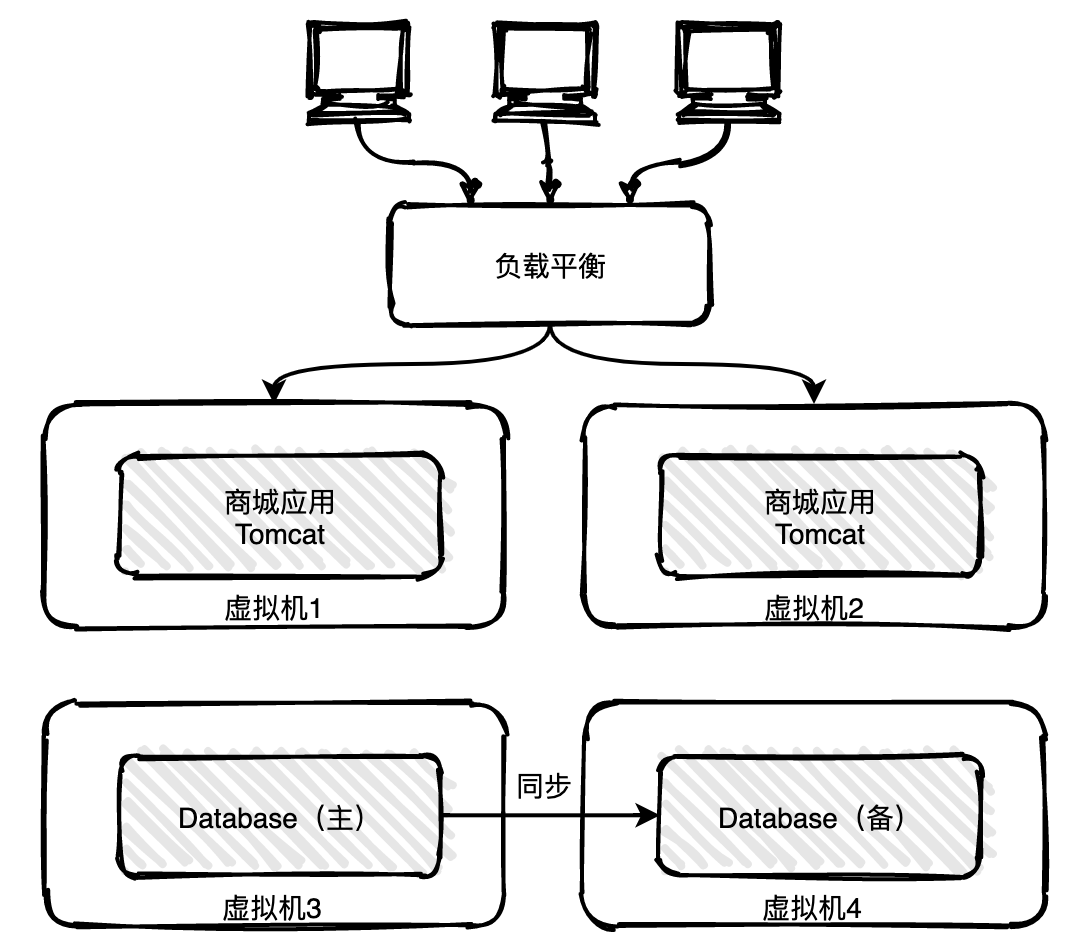

69 | 当单体架构演进到一定阶段后开发测试的复杂性都会成本增加,团队规模的扩大也会使得各自工作耦合性更严重,牵一发而动全身就是这种场景。

70 |

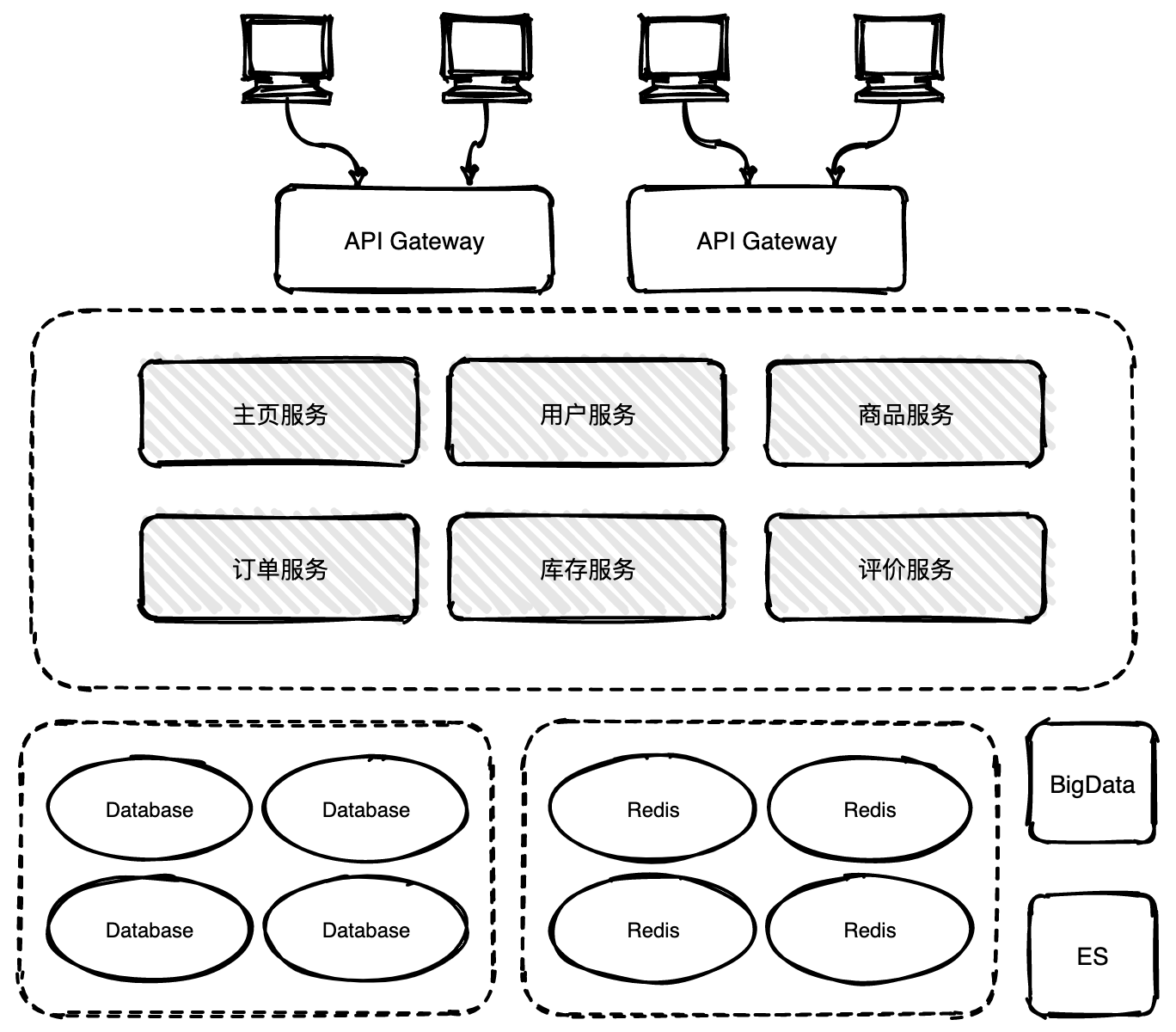

71 | 单体架构遇到瓶颈了,微服务架构就横空出世了。微服务就是将之前的单体服务按照业务维度进行拆分,拆分粒度可大可小,拆分时机可以分节奏进行。最佳实践是先将一些独立的功能从单体中剥离出来抽成一个或多个微服务,这样可以保障业务的连续性和稳定性。

72 |

73 |

60 |

61 | 集群部署是指将应用部署在多个服务器或者虚机上,用户通过服务均衡随机访问其中的一个实例,从而使多个实例的流量均衡,如果一个实例出现故障可以将其下线,其他实例不受影响仍然可以对外提供服务。

62 |

63 | 随着用户数量快速增加,老板决定增加投入扩大团队规模。开发团队壮大后效率并没有得到显著的提高,以前小团队可以一周迭代上线一次,现在至少需要两到三周时间。

64 |

65 | 业务逻辑越来越复杂,代码间耦合很严重,修改一行代码可能引入几个线上问题。架构师意识到需要进行架构重构。

66 |

67 | ## 微服务架构

68 |

69 | 当单体架构演进到一定阶段后开发测试的复杂性都会成本增加,团队规模的扩大也会使得各自工作耦合性更严重,牵一发而动全身就是这种场景。

70 |

71 | 单体架构遇到瓶颈了,微服务架构就横空出世了。微服务就是将之前的单体服务按照业务维度进行拆分,拆分粒度可大可小,拆分时机可以分节奏进行。最佳实践是先将一些独立的功能从单体中剥离出来抽成一个或多个微服务,这样可以保障业务的连续性和稳定性。

72 |

73 |  74 |

75 | 如上图将一个商用应用拆分为六个独立微服务。六个微服务可以使用Docker容器化进行多实例部署。

76 |

77 | 架构演化到这里遇到了一个难题,如果要查询用户所有的订单,用户服务可能会依赖订单服务,用户服务如何与订单服务交互呢?订单服务有多个实例该访问哪一个?

78 |

79 | 通常有几种解决办法:

80 |

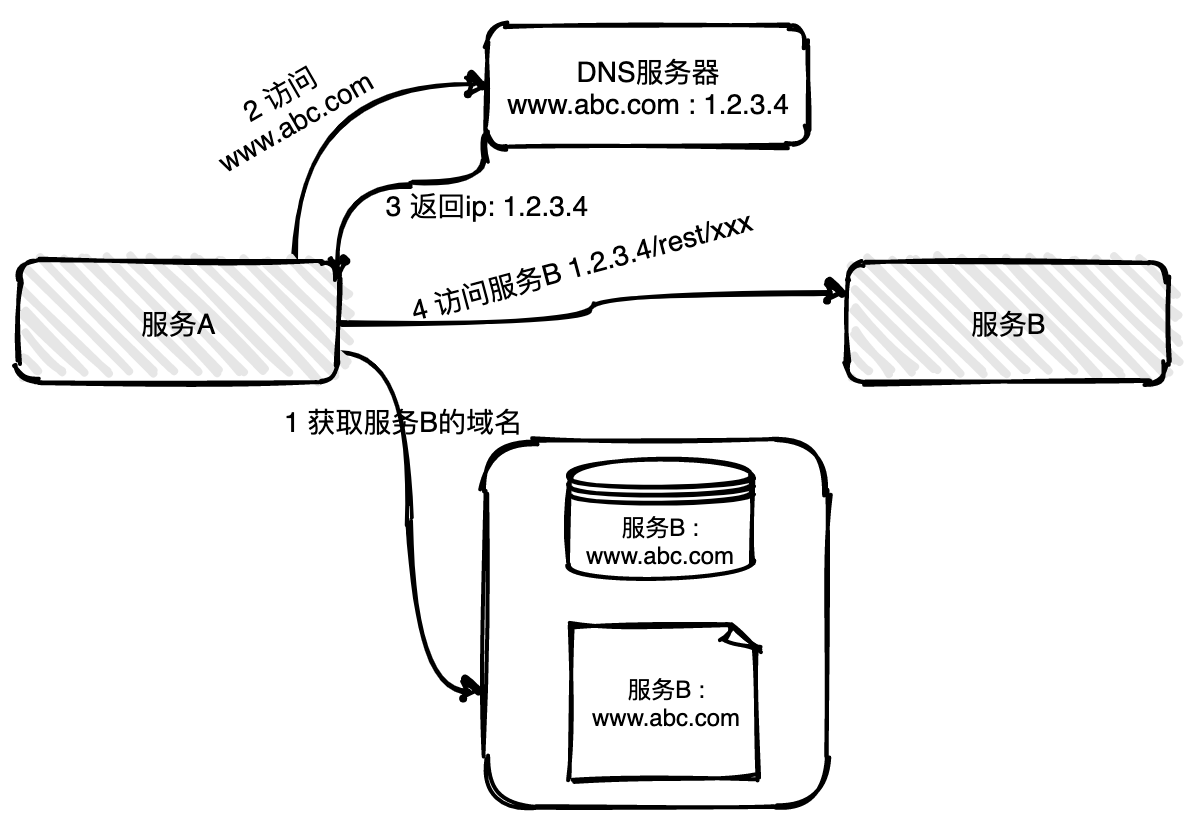

81 | **(1)服务地址硬编码**

82 |

83 | 服务的地址写死在数据库或者配置文件,通过访问DNS域名进行寻址路由。

84 |

85 |

74 |

75 | 如上图将一个商用应用拆分为六个独立微服务。六个微服务可以使用Docker容器化进行多实例部署。

76 |

77 | 架构演化到这里遇到了一个难题,如果要查询用户所有的订单,用户服务可能会依赖订单服务,用户服务如何与订单服务交互呢?订单服务有多个实例该访问哪一个?

78 |

79 | 通常有几种解决办法:

80 |

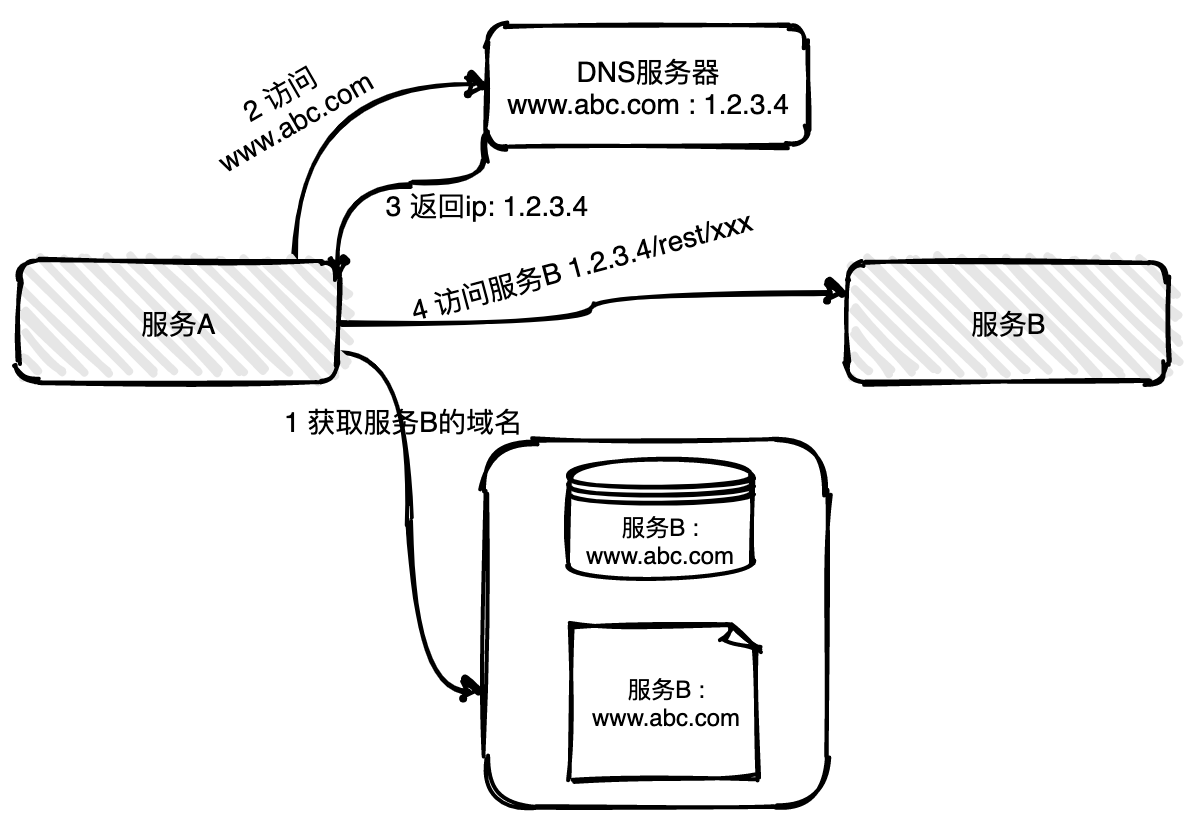

81 | **(1)服务地址硬编码**

82 |

83 | 服务的地址写死在数据库或者配置文件,通过访问DNS域名进行寻址路由。

84 |

85 |  86 |

87 | 服务B的地址硬编码在数据库或者配置文件中,服务A首先需要拿到服务B的地址,然后通过DNS服务器解析获取其中一实例的真实地址,最后可以向服务B发起请求。

88 |

89 | 如果遇到大促活动需要对服务实例扩容,大促完需要对服务实例进行下线,运维人员要做大量的手工操作,非常容易误操作。

90 |

91 | **(2)服务动态注册与发现**

92 |

93 | 服务地址硬编码还有一个非常致命的问题,如果一台实例挂了,运维人员可能不能及时感知到,导致一部分用户的请求会异常。

94 |

95 | 引入服务注册与发现组件可以很好解决上面遇到的问题,避免过多的人工操作。

96 |

97 | ## 架构演进总结

98 |

99 | 在单体架构中一个应用程序就是一个服务包,包内的模块通过函数方法相互调用,模型足够简单,根本没有服务注册和发现一说。

100 |

101 | 在微服务架构中会将一个应用程序拆分为多个微服务,微服务会部署在不同的服务器、不同的容器、甚至多数据中心,微服务间要相互调用,服务注册和发现成为了一个不可或缺的组件。

102 |

103 | # 服务注册与发现基本原理

104 |

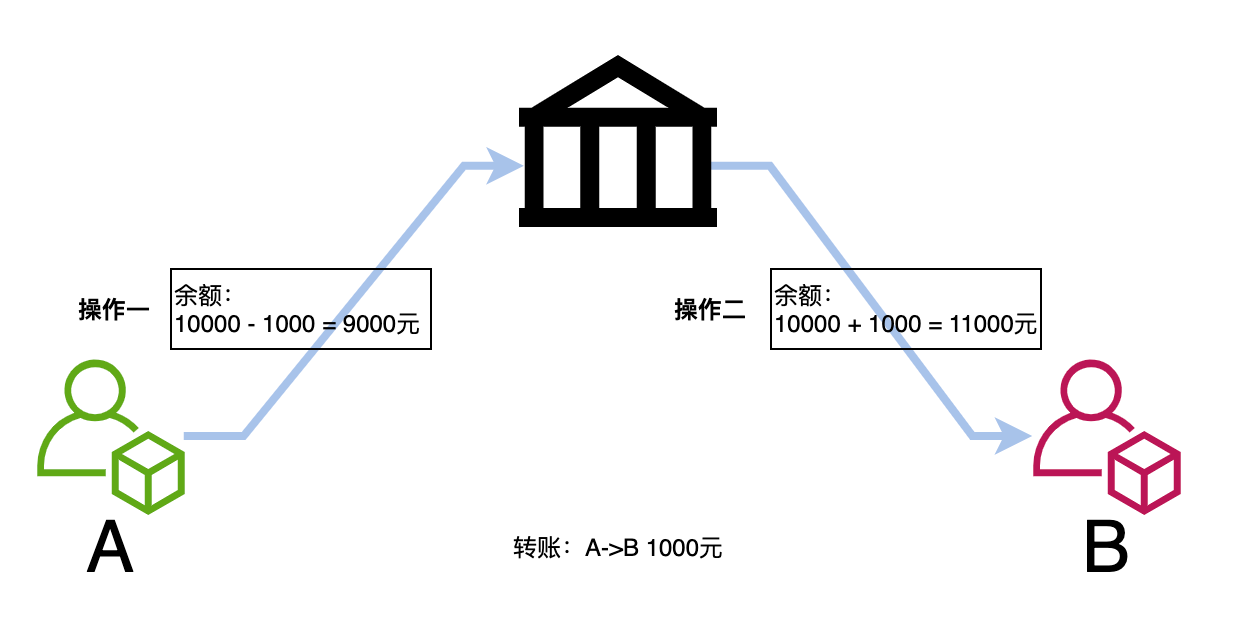

105 | 服务注册与发现是分为注册和发现两个关键的步骤。

106 |

107 | **服务注册**:服务进程在注册中心注册自己的元数据信息。通常包括主机和端口号,有时还有身份验证信息,协议,版本号,以及运行环境的信息。

108 |

109 | **服务发现**:客户端服务进程向注册中心发起查询,来获取服务的信息。服务发现的一个重要作用就是提供给客户端一个可用的服务列表。

110 |

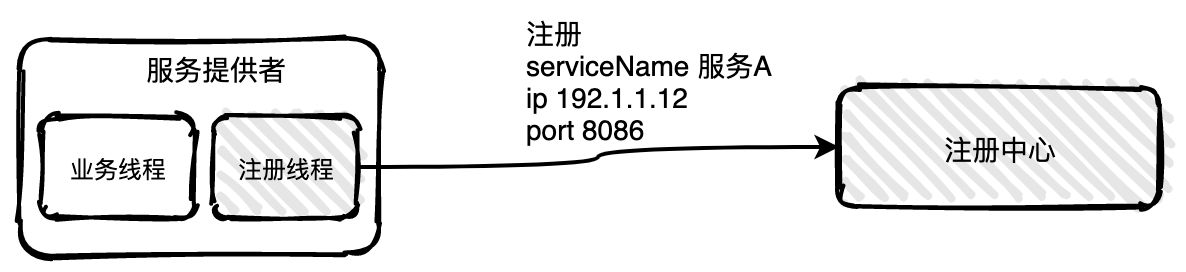

111 | ## 服务注册

112 |

113 | 服务注册有两种形式:客户端注册和代理注册。

114 |

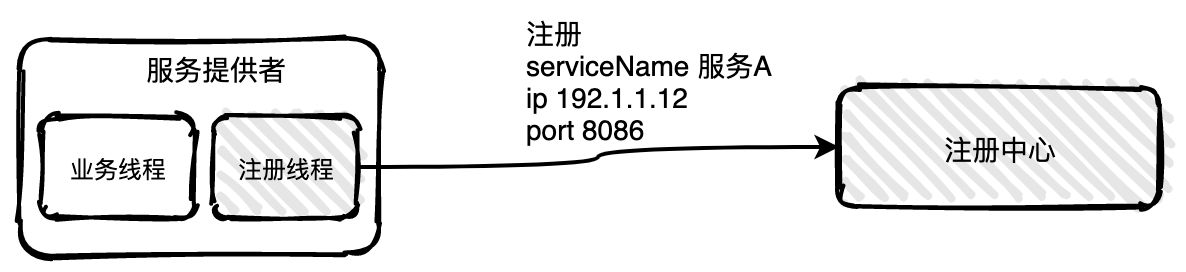

115 | **客户端注册**

116 |

117 | 客户端注册是服务自己要负责注册与注销的工作。当服务启动后注册线程向注册中心注册,当服务下线时注销自己。

118 |

119 |

86 |

87 | 服务B的地址硬编码在数据库或者配置文件中,服务A首先需要拿到服务B的地址,然后通过DNS服务器解析获取其中一实例的真实地址,最后可以向服务B发起请求。

88 |

89 | 如果遇到大促活动需要对服务实例扩容,大促完需要对服务实例进行下线,运维人员要做大量的手工操作,非常容易误操作。

90 |

91 | **(2)服务动态注册与发现**

92 |

93 | 服务地址硬编码还有一个非常致命的问题,如果一台实例挂了,运维人员可能不能及时感知到,导致一部分用户的请求会异常。

94 |

95 | 引入服务注册与发现组件可以很好解决上面遇到的问题,避免过多的人工操作。

96 |

97 | ## 架构演进总结

98 |

99 | 在单体架构中一个应用程序就是一个服务包,包内的模块通过函数方法相互调用,模型足够简单,根本没有服务注册和发现一说。

100 |

101 | 在微服务架构中会将一个应用程序拆分为多个微服务,微服务会部署在不同的服务器、不同的容器、甚至多数据中心,微服务间要相互调用,服务注册和发现成为了一个不可或缺的组件。

102 |

103 | # 服务注册与发现基本原理

104 |

105 | 服务注册与发现是分为注册和发现两个关键的步骤。

106 |

107 | **服务注册**:服务进程在注册中心注册自己的元数据信息。通常包括主机和端口号,有时还有身份验证信息,协议,版本号,以及运行环境的信息。

108 |

109 | **服务发现**:客户端服务进程向注册中心发起查询,来获取服务的信息。服务发现的一个重要作用就是提供给客户端一个可用的服务列表。

110 |

111 | ## 服务注册

112 |

113 | 服务注册有两种形式:客户端注册和代理注册。

114 |

115 | **客户端注册**

116 |

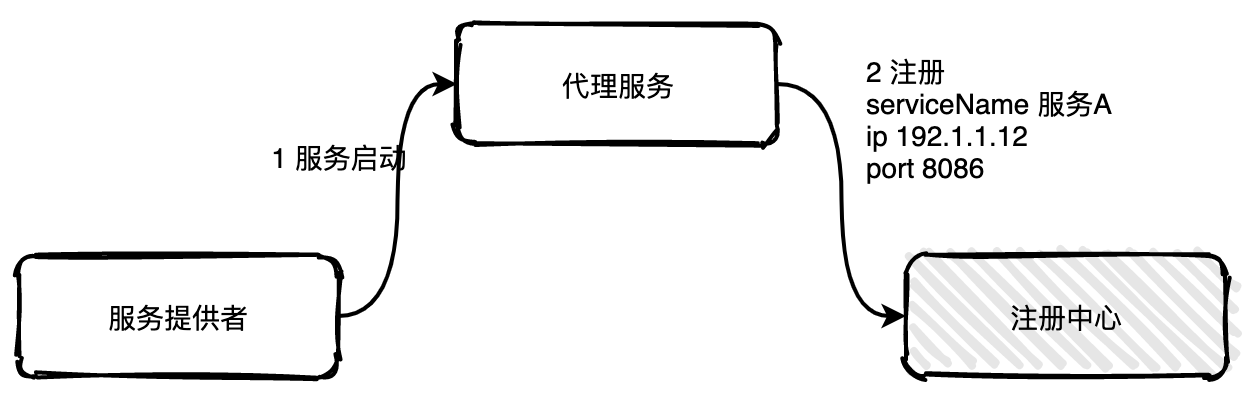

117 | 客户端注册是服务自己要负责注册与注销的工作。当服务启动后注册线程向注册中心注册,当服务下线时注销自己。

118 |

119 |  120 | 这种方式的缺点是注册注销逻辑与服务的业务逻辑耦合在一起,如果服务使用不同语言开发,那需要适配多套服务注册逻辑。

121 |

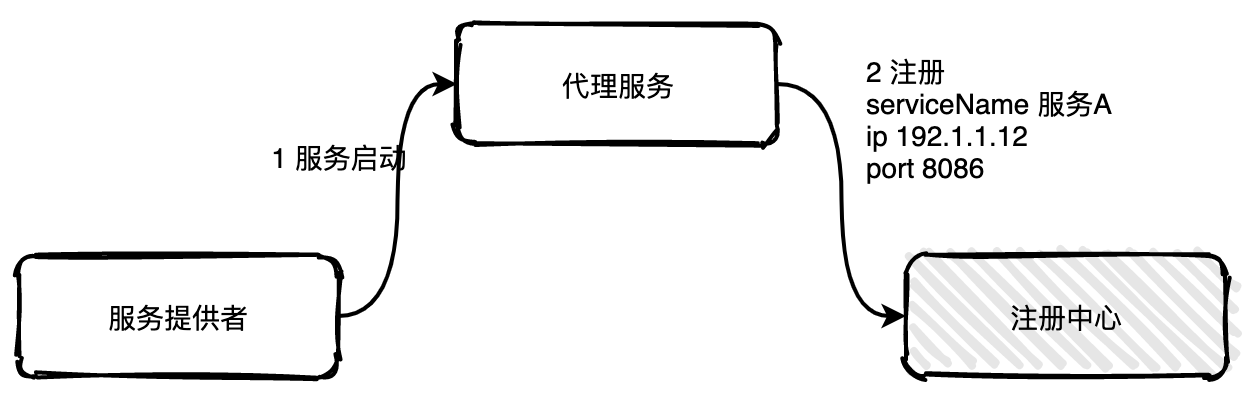

122 | **代理注册**

123 |

124 | 代理注册由一个单独的代理服务负责注册与注销。当服务提供者启动后以某种方式通知代理服务,然后代理服务负责向注册中心发起注册工作。

125 |

126 |

120 | 这种方式的缺点是注册注销逻辑与服务的业务逻辑耦合在一起,如果服务使用不同语言开发,那需要适配多套服务注册逻辑。

121 |

122 | **代理注册**

123 |

124 | 代理注册由一个单独的代理服务负责注册与注销。当服务提供者启动后以某种方式通知代理服务,然后代理服务负责向注册中心发起注册工作。

125 |

126 |  127 |

128 |

129 | 这种方式的缺点是多引用了一个代理服务,并且代理服务要保持高可用状态。

130 |

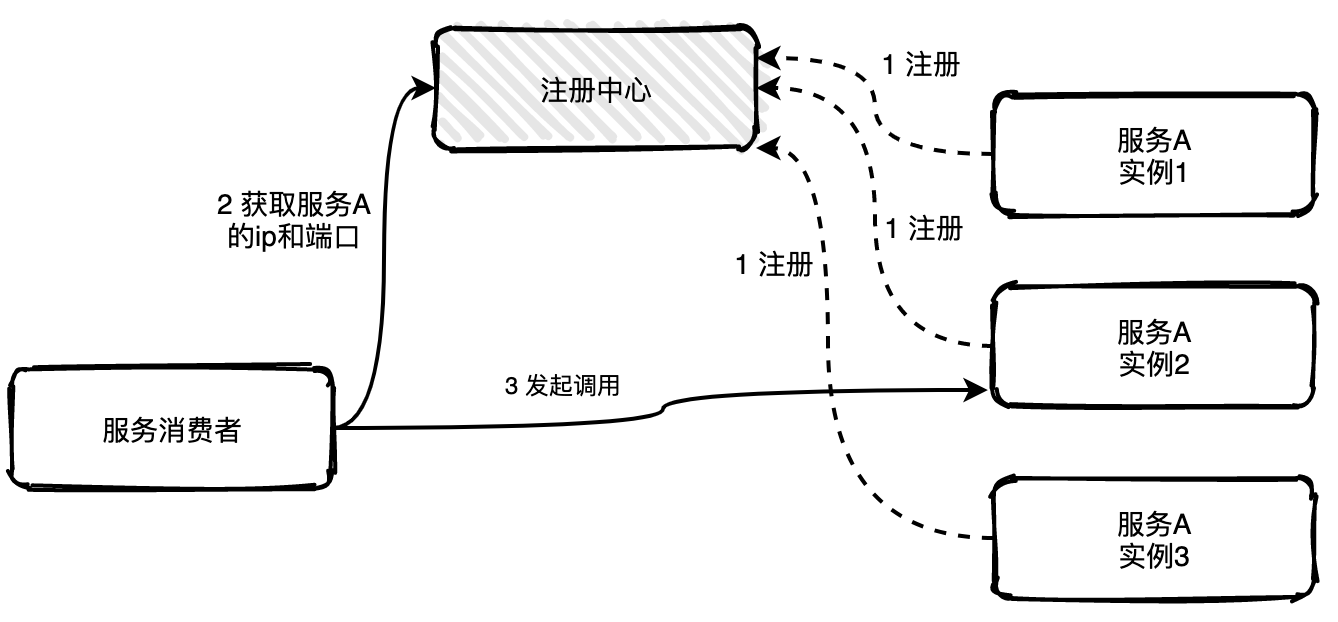

131 | ## 服务发现

132 |

133 | 服务发现也分为客户端发现和代理发现。

134 |

135 | **客户端发现**

136 |

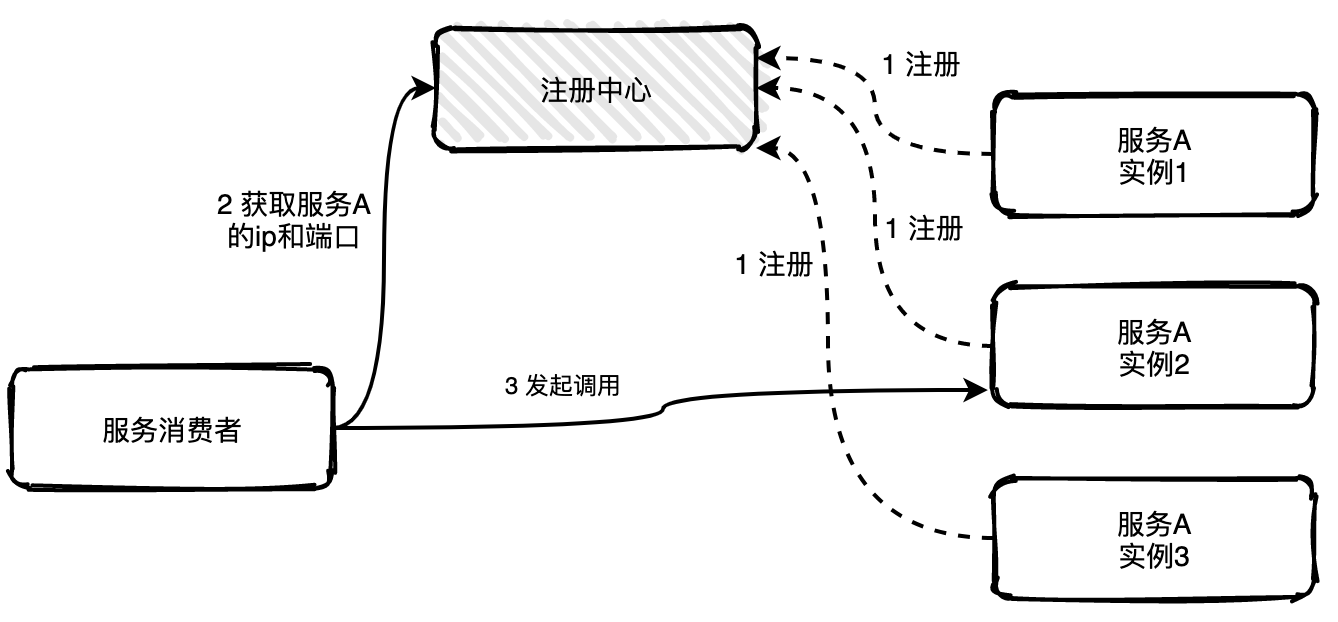

137 | 客户端发现是指客户端负责向注册中心查询可用服务地址,获取到所有的可用实例地址列表后客户端根据负载均衡算法选择一个实例发起请求调用。

138 |

139 |

127 |

128 |

129 | 这种方式的缺点是多引用了一个代理服务,并且代理服务要保持高可用状态。

130 |

131 | ## 服务发现

132 |

133 | 服务发现也分为客户端发现和代理发现。

134 |

135 | **客户端发现**

136 |

137 | 客户端发现是指客户端负责向注册中心查询可用服务地址,获取到所有的可用实例地址列表后客户端根据负载均衡算法选择一个实例发起请求调用。

138 |

139 |  140 |

141 | 这种方式非常直接,客户端可以控制负载均衡算法。但是缺点也很明显,获取实例地址、负载均衡等逻辑与服务的业务逻辑耦合在一起,如果服务发现或者负载平衡有变化,那么所有的服务都要修改重新上线。

142 |

143 | **代理发现**

144 |

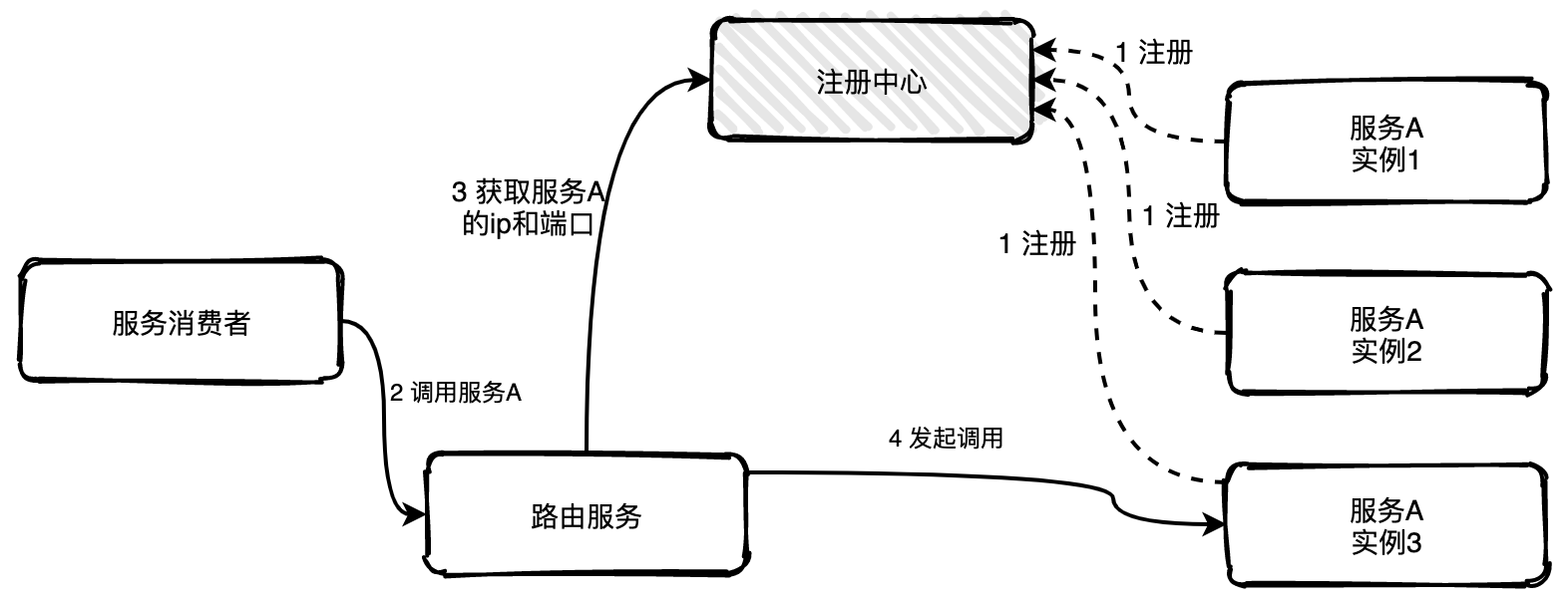

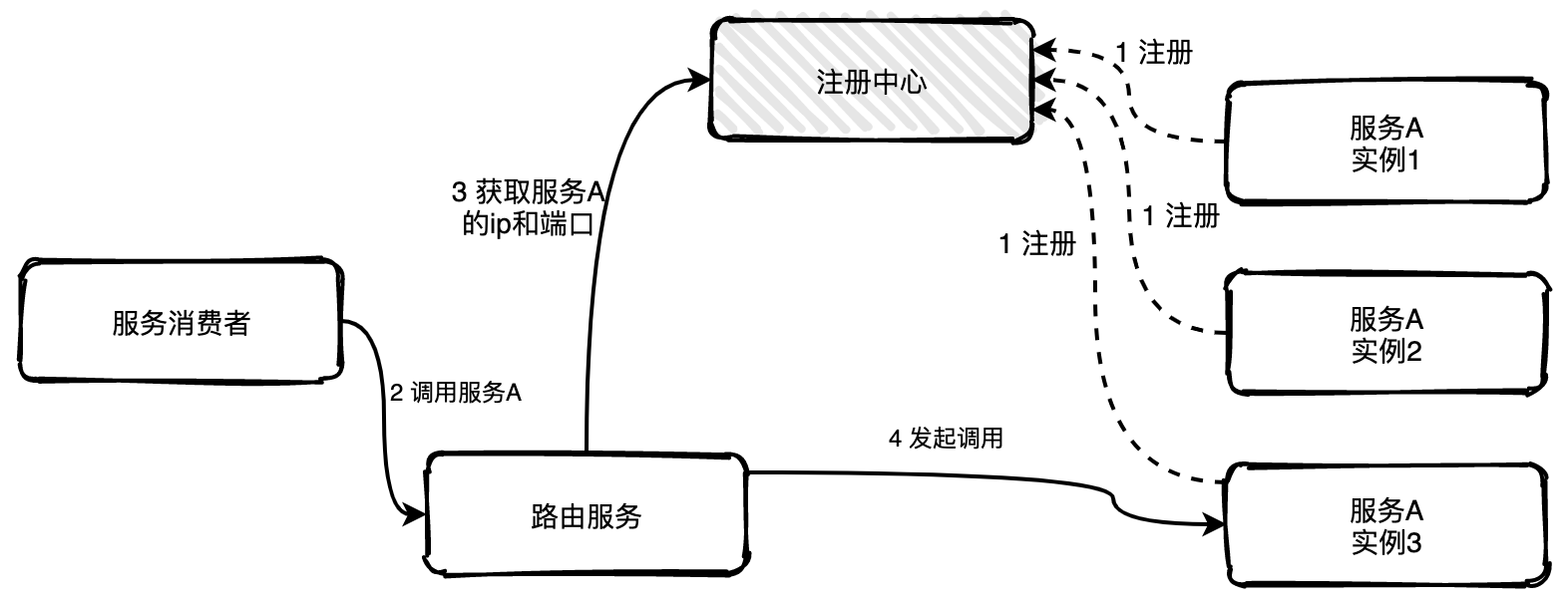

145 | 代理发现是指新增一个路由服务负责服务发现获取可用的实例列表,服务消费者如果需要调用服务A的一个实例可以直接将请求发往路由服务,路由服务根据配置好的负载均衡算法从可用的实例列表中选择一个实例将请求转发过去即可,如果发现实例不可用,路由服务还可以自行重试,服务消费者完全不用感知。

146 |

147 |

140 |

141 | 这种方式非常直接,客户端可以控制负载均衡算法。但是缺点也很明显,获取实例地址、负载均衡等逻辑与服务的业务逻辑耦合在一起,如果服务发现或者负载平衡有变化,那么所有的服务都要修改重新上线。

142 |

143 | **代理发现**

144 |

145 | 代理发现是指新增一个路由服务负责服务发现获取可用的实例列表,服务消费者如果需要调用服务A的一个实例可以直接将请求发往路由服务,路由服务根据配置好的负载均衡算法从可用的实例列表中选择一个实例将请求转发过去即可,如果发现实例不可用,路由服务还可以自行重试,服务消费者完全不用感知。

146 |

147 |  148 |

149 |

150 | ## 心跳机制

151 |

152 | 如果服务有多个实例,其中一个实例出现宕机,注册中心是可以实时感知到,并且将该实例信息从列表中移出,也称为摘机。

153 |

154 | 如何实现摘机?业界比较常用的方式是通过心跳检测的方式实现,心跳检测有**主动**和**被动**两种方式。

155 |

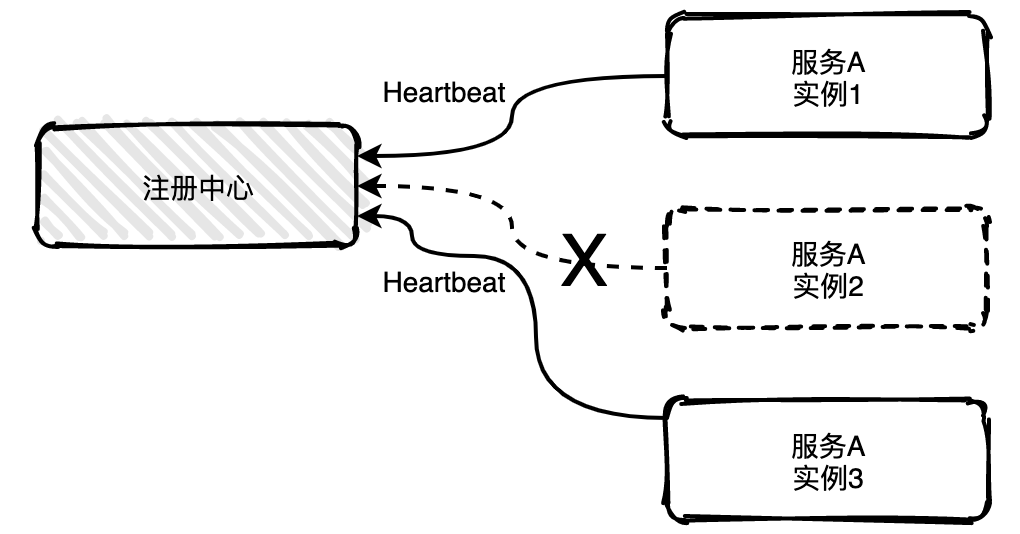

156 | **被动检测**是指服务主动向注册中心发送心跳消息,时间间隔可自定义,比如配置5秒发送一次,注册中心如果在三个周期内比如说15秒内没有收到实例的心跳消息,就会将该实例从列表中移除。

157 |

158 |

148 |

149 |

150 | ## 心跳机制

151 |

152 | 如果服务有多个实例,其中一个实例出现宕机,注册中心是可以实时感知到,并且将该实例信息从列表中移出,也称为摘机。

153 |

154 | 如何实现摘机?业界比较常用的方式是通过心跳检测的方式实现,心跳检测有**主动**和**被动**两种方式。

155 |

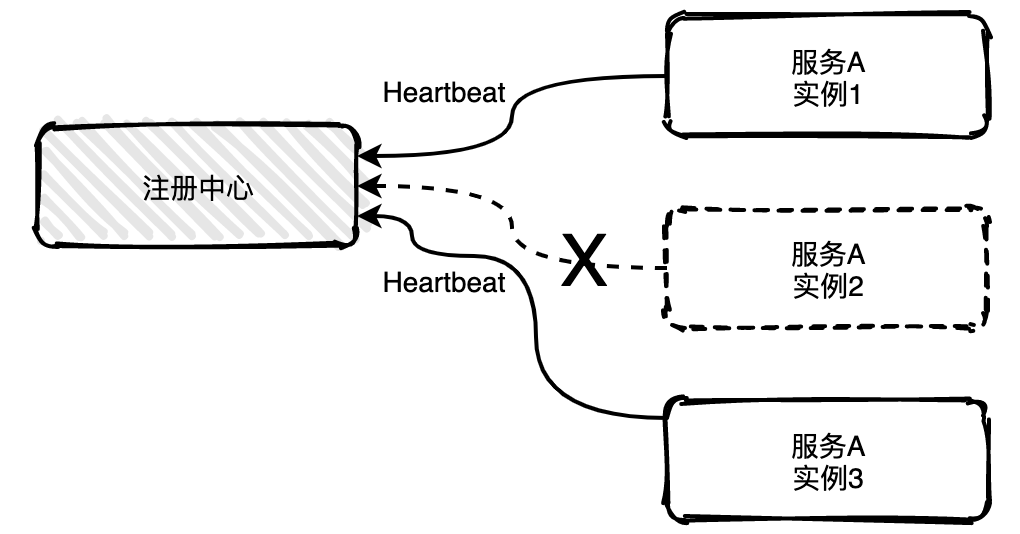

156 | **被动检测**是指服务主动向注册中心发送心跳消息,时间间隔可自定义,比如配置5秒发送一次,注册中心如果在三个周期内比如说15秒内没有收到实例的心跳消息,就会将该实例从列表中移除。

157 |

158 |  159 |

160 | 上图中服务A的实例2已经宕机不能主动给注册中心发送心跳消息,15秒之后注册就会将实例2移除掉。

161 |

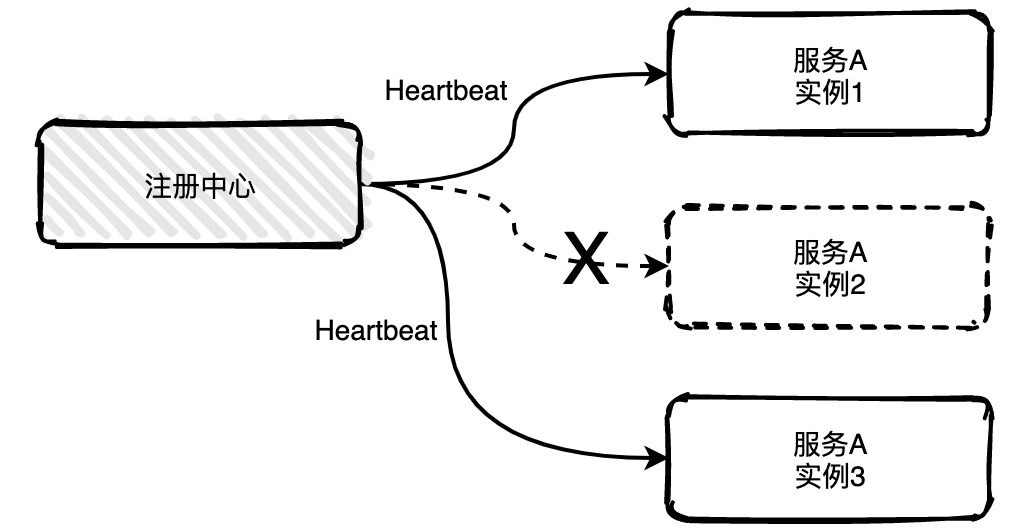

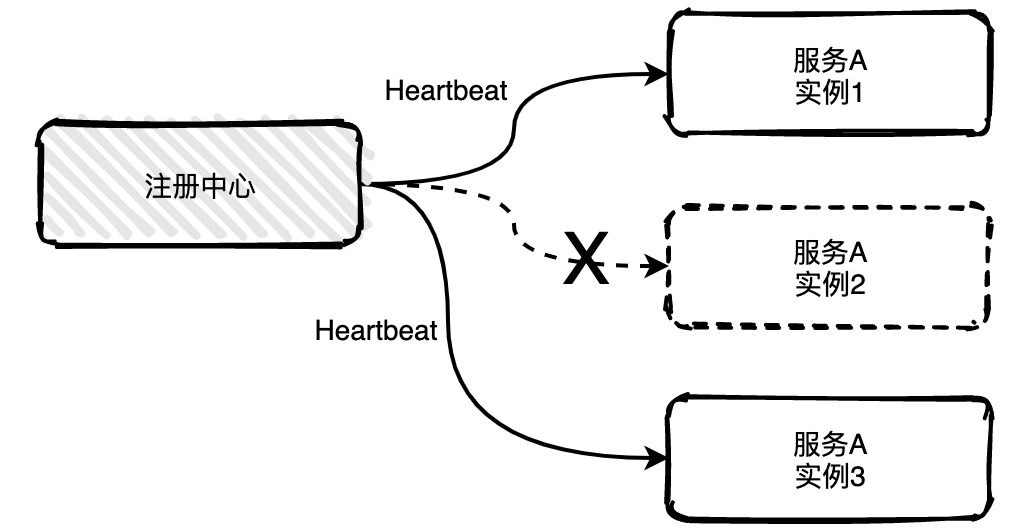

162 | **主动检测**是注册中心主动发起,每隔几秒中会给所有列表中的服务实例发送心跳检测消息,如果多个周期内未发送成功或未收到回复就会主动移除该实例。

163 |

164 |

159 |

160 | 上图中服务A的实例2已经宕机不能主动给注册中心发送心跳消息,15秒之后注册就会将实例2移除掉。

161 |

162 | **主动检测**是注册中心主动发起,每隔几秒中会给所有列表中的服务实例发送心跳检测消息,如果多个周期内未发送成功或未收到回复就会主动移除该实例。

163 |

164 |  165 |

166 |

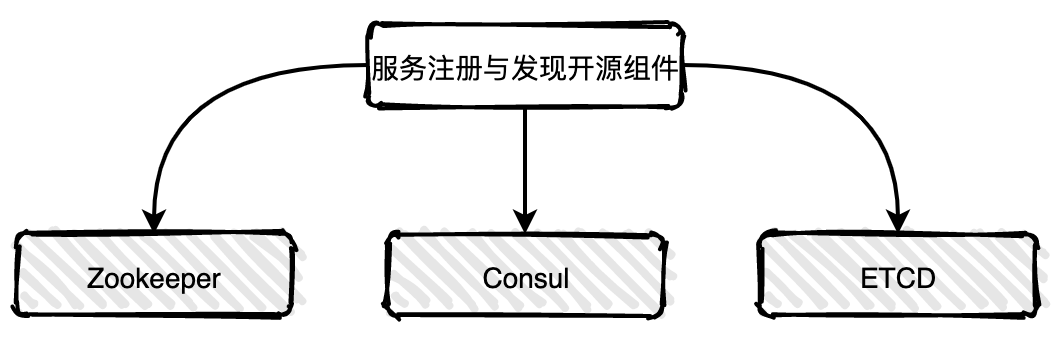

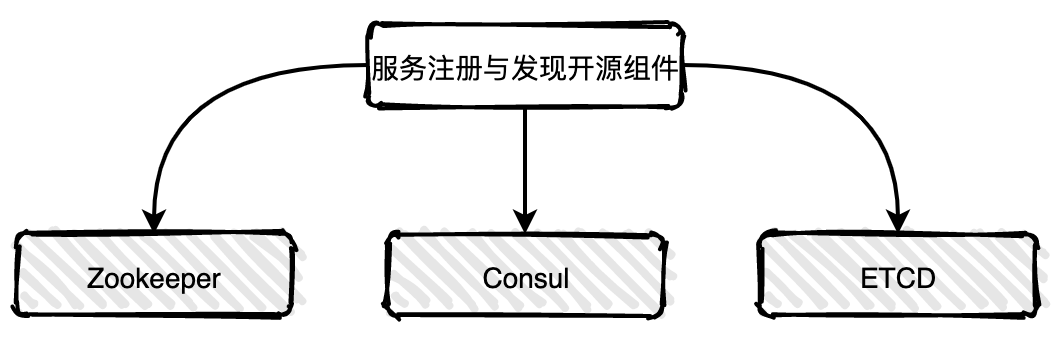

167 | # 业界常用的服务注册与发现组件对比

168 |

169 | 了解服务注册与发现的基本原理后,如果你要在项目中使用服务注册与发现组件,当面对众多的开源组件该如何进行技术选型?

170 |

171 | 在互联网公司里,有研发实力的大公司一般会选择自研或者基于开源组件进行二次开发,但是对于中小型公司来说直接选用一款开源软件会是一个不错的选择。

172 |

173 | 常用的注册与发现组件有eureka,zookeeper,consul,etcd等,由于eureka在2018年已经宣布放弃维护,这里就不再推荐使用了。

174 |

175 |

165 |

166 |

167 | # 业界常用的服务注册与发现组件对比

168 |

169 | 了解服务注册与发现的基本原理后,如果你要在项目中使用服务注册与发现组件,当面对众多的开源组件该如何进行技术选型?

170 |

171 | 在互联网公司里,有研发实力的大公司一般会选择自研或者基于开源组件进行二次开发,但是对于中小型公司来说直接选用一款开源软件会是一个不错的选择。

172 |

173 | 常用的注册与发现组件有eureka,zookeeper,consul,etcd等,由于eureka在2018年已经宣布放弃维护,这里就不再推荐使用了。

174 |

175 |  176 |

177 |

178 | 下面结合各个维度对比一下各组件。

179 |

180 | |**组件**|**优点**|**缺点**|**接口类型**|**一致性算法**|

181 | |:----|:----|:----|:----|:----|:----|:----|

182 | |zookeeper|1.功能强大,不仅仅只是服务发现;

176 |

177 |

178 | 下面结合各个维度对比一下各组件。

179 |

180 | |**组件**|**优点**|**缺点**|**接口类型**|**一致性算法**|

181 | |:----|:----|:----|:----|:----|:----|:----|

182 | |zookeeper|1.功能强大,不仅仅只是服务发现;

2.提供watcher机制可以实时获取服务提供者的状态;

3.广泛使用,dubbo等微服务框架已支持;|1.没有健康检查;

2.需要在服务中引入sdk,集成复杂度高;

3.不支持多数据中心;|sdk|Paxos|

183 | |consul|1.开箱即用,方便集成;

2.带健康检查;

3.支持多数据中心;

4.提供web管理界面;|不能实时获取服务变换通知|restful/dns|Raft|

184 | |etcd|1.开箱即用,方便集成;

2.可配置性强|1.没有健康检查;

2.需配合三方工具完成服务发现功能;

3.不支持多数据中心;|restful|Raft|

185 |

186 | 从整体上看consul的功能更加完备和均衡。接下来以consul为例详细介绍一下。

187 |

188 | # Consul——值得推荐的服务注册与发现开源组件

189 |

190 | ## 简单认识一下Consul

191 |

192 | Consul是HashiCorp公司推出的开源工,使用Go语言开发,具有开箱即可部署方便的特点。Consul是分布式的、高可用的、 可横向扩展的用于实现分布式系统的服务发现与配置。

193 |

194 | ## Consul有哪些优势?

195 |

196 | * 服务注册发现:Consul提供了通过DNS或者restful接口的方式来注册服务和发现服务。服务可根据实际情况自行选择。

197 | * 健康检查:Consul的Client可以提供任意数量的健康检查,既可以与给定的服务相关联,也可以与本地节点相关联。

198 | * 多数据中心:Consul支持多数据中心,这意味着用户不需要担心Consul自身的高可用性问题以及多数据中心带来的扩展接入等问题。

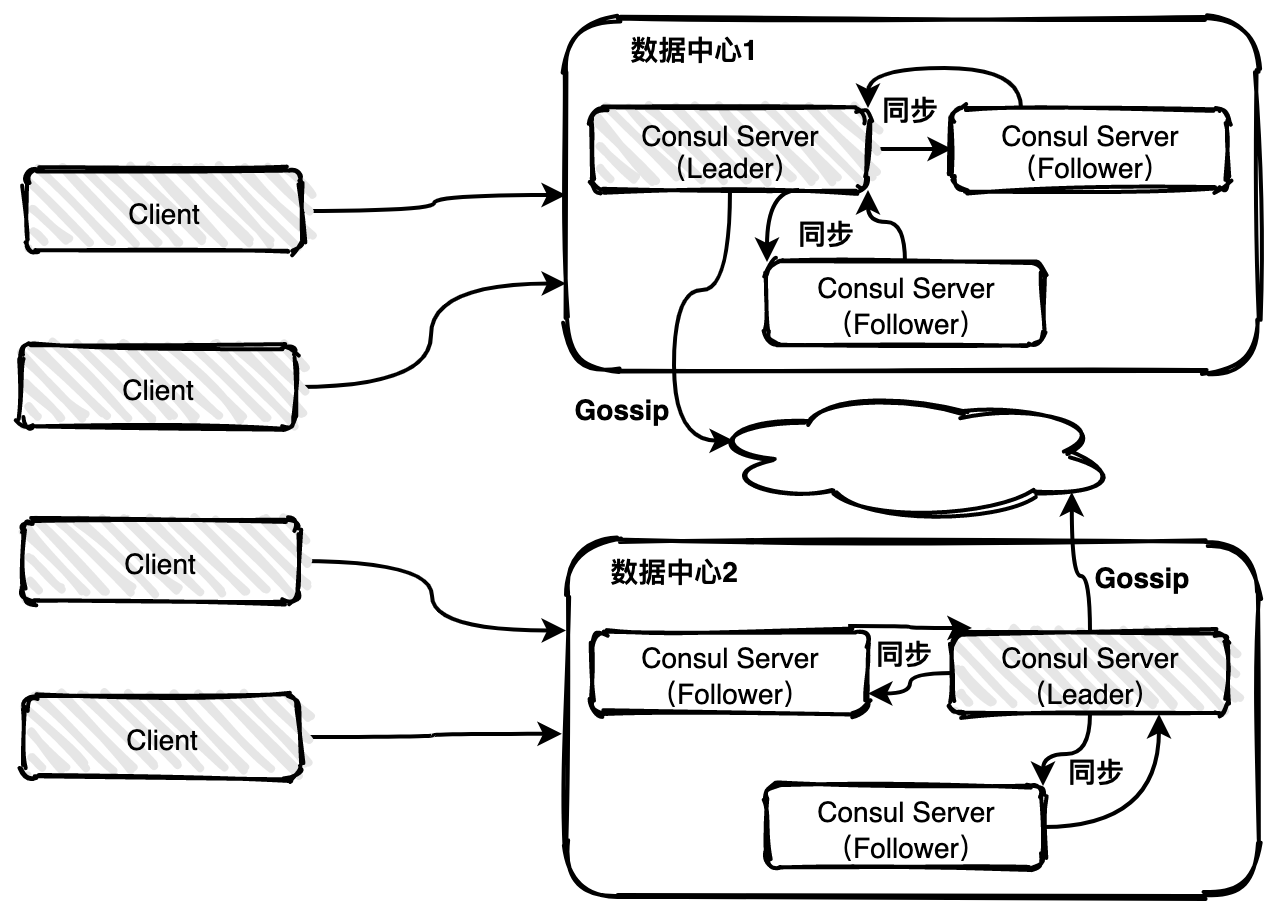

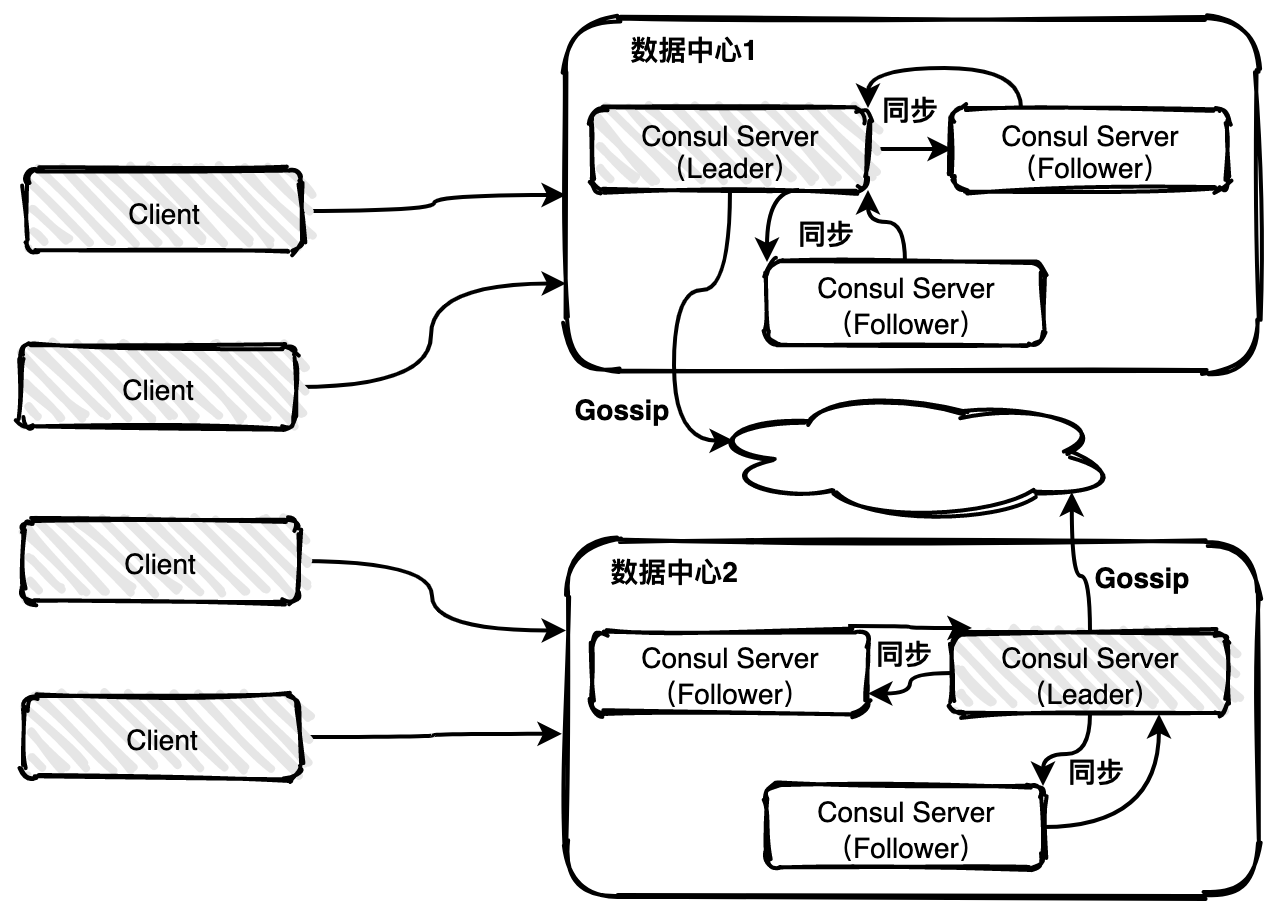

199 | ## Consul的架构图

200 |

201 |  202 |

203 |

204 | Consul 实现多数据中心依赖于gossip protocol协议。这样做的目的:

205 |

206 | * 不需要使用服务器的地址来配置客户端;服务发现是自动完成的。

207 | * 健康检查故障的工作不是放在服务器上,而是分布式的。

208 | ## Consul的使用场景

209 |

210 | Consul的应用场景包括**服务注册发现**、**服务隔离**、**服务配置**等。

211 |

212 | **服务注册发现场景**中consul作为注册中心,服务地址被注册到consul中以后,可以使用consul提供的dns、http接口查询,consul支持health check。

213 |

214 | **服务隔离场景**中consul支持以服务为单位设置访问策略,能同时支持经典的平台和新兴的平台,支持tls证书分发,service-to-service加密。

215 |

216 | **服务配置场景**中consul提供key-value数据存储功能,并且能将变动迅速地通知出去,借助Consul可以实现配置共享,需要读取配置的服务可以从Consul中读取到准确的配置信息。

217 |

218 |

219 |

220 |

--------------------------------------------------------------------------------

/docs/distributed/原来10张图就可以搞懂分布式链路追踪系统原理.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321924&idx=1&sn=d8572df23b47409ab997029cb34c6c07&chksm=8f09ca1eb87e4308d81d322814fdc56acf1e3c4ff9d8655c239ad1468af512719d01b03027c8&token=1553501157&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [分布式系统为什么需要链路追踪?](#分布式系统为什么需要链路追踪)

6 | - [什么是链路追踪?](#什么是链路追踪)

7 | - [链路追踪基本原理](#链路追踪基本原理)

8 | - [Trace](#trace)

9 | - [Span](#span)

10 | - [Annotations](#annotations)

11 | - [带内数据与带外数据](#带内数据与带外数据)

12 | - [采样](#采样)

13 | - [存储](#存储)

14 | - [业界常用链路追踪系统](#业界常用链路追踪系统)

15 | - [分布式链路追踪系统Zipkin实现](#分布式链路追踪系统zipkin实现)

16 | - [**Zipkin基本架构**](#zipkin基本架构)

17 | - [**Zipkin核心组件**](#zipkin核心组件)

18 | - [总结](#总结)

19 |

20 |

21 |

22 |

23 |

202 |

203 |

204 | Consul 实现多数据中心依赖于gossip protocol协议。这样做的目的:

205 |

206 | * 不需要使用服务器的地址来配置客户端;服务发现是自动完成的。

207 | * 健康检查故障的工作不是放在服务器上,而是分布式的。

208 | ## Consul的使用场景

209 |

210 | Consul的应用场景包括**服务注册发现**、**服务隔离**、**服务配置**等。

211 |

212 | **服务注册发现场景**中consul作为注册中心,服务地址被注册到consul中以后,可以使用consul提供的dns、http接口查询,consul支持health check。

213 |

214 | **服务隔离场景**中consul支持以服务为单位设置访问策略,能同时支持经典的平台和新兴的平台,支持tls证书分发,service-to-service加密。

215 |

216 | **服务配置场景**中consul提供key-value数据存储功能,并且能将变动迅速地通知出去,借助Consul可以实现配置共享,需要读取配置的服务可以从Consul中读取到准确的配置信息。

217 |

218 |

219 |

220 |

--------------------------------------------------------------------------------

/docs/distributed/原来10张图就可以搞懂分布式链路追踪系统原理.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321924&idx=1&sn=d8572df23b47409ab997029cb34c6c07&chksm=8f09ca1eb87e4308d81d322814fdc56acf1e3c4ff9d8655c239ad1468af512719d01b03027c8&token=1553501157&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [分布式系统为什么需要链路追踪?](#分布式系统为什么需要链路追踪)

6 | - [什么是链路追踪?](#什么是链路追踪)

7 | - [链路追踪基本原理](#链路追踪基本原理)

8 | - [Trace](#trace)

9 | - [Span](#span)

10 | - [Annotations](#annotations)

11 | - [带内数据与带外数据](#带内数据与带外数据)

12 | - [采样](#采样)

13 | - [存储](#存储)

14 | - [业界常用链路追踪系统](#业界常用链路追踪系统)

15 | - [分布式链路追踪系统Zipkin实现](#分布式链路追踪系统zipkin实现)

16 | - [**Zipkin基本架构**](#zipkin基本架构)

17 | - [**Zipkin核心组件**](#zipkin核心组件)

18 | - [总结](#总结)

19 |

20 |

21 |

22 |

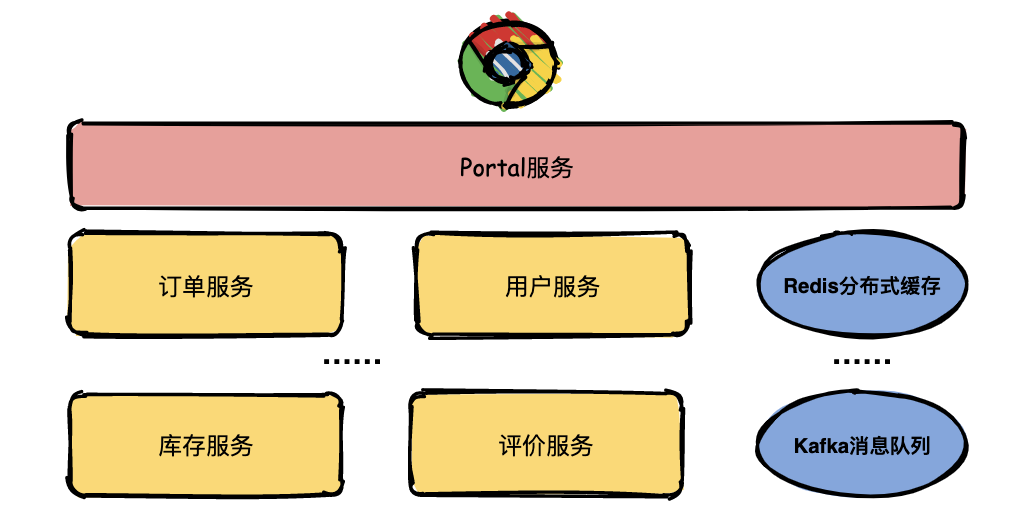

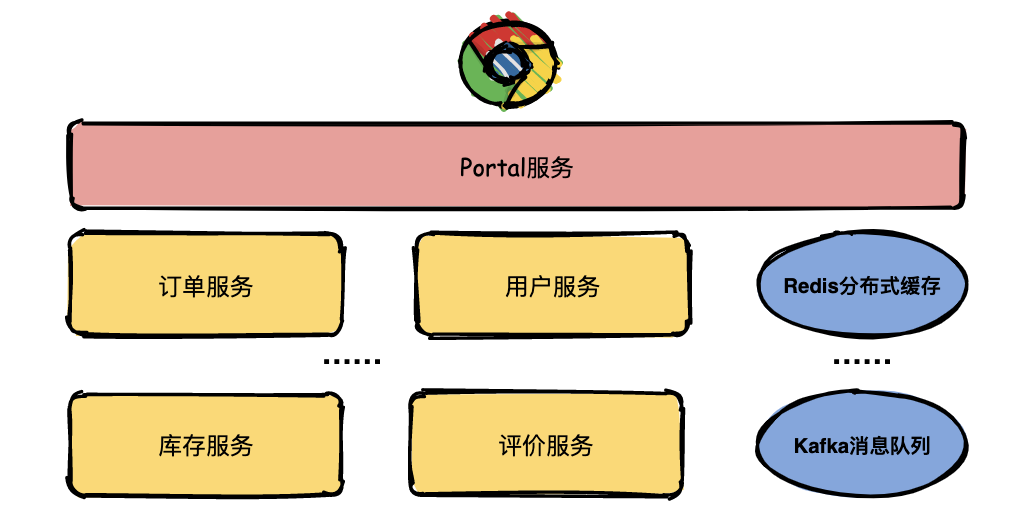

23 |  24 | # 分布式系统为什么需要链路追踪?

25 |

26 | 随着互联网业务快速扩展,软件架构也日益变得复杂,为了适应海量用户高并发请求,系统中越来越多的组件开始走向分布式化,如单体架构拆分为微服务、服务内缓存变为分布式缓存、服务组件通信变为分布式消息,这些组件共同构成了繁杂的分布式网络。

27 |

28 |

24 | # 分布式系统为什么需要链路追踪?

25 |

26 | 随着互联网业务快速扩展,软件架构也日益变得复杂,为了适应海量用户高并发请求,系统中越来越多的组件开始走向分布式化,如单体架构拆分为微服务、服务内缓存变为分布式缓存、服务组件通信变为分布式消息,这些组件共同构成了繁杂的分布式网络。

27 |

28 |  29 |

30 |

31 |

32 | 假如现在有一个系统部署了成千上万个服务,用户通过浏览器在主界面上下单一箱茅台酒,结果系统给用户提示:系统内部错误,相信用户是很崩溃的。

33 |

34 | 运营人员将问题抛给开发人员定位,开发人员只知道有异常,但是这个异常具体是由哪个微服务引起的就需要逐个服务排查了。

35 |

36 |

29 |

30 |

31 |

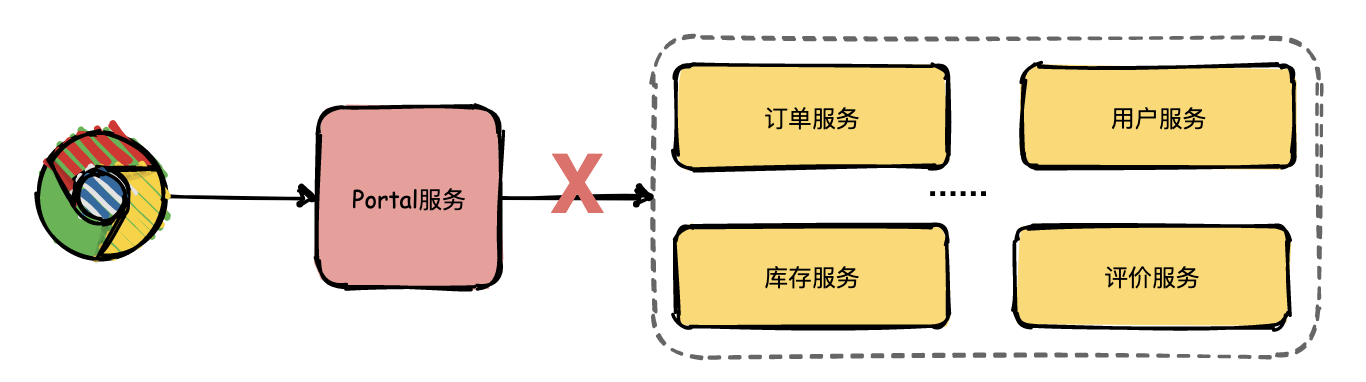

32 | 假如现在有一个系统部署了成千上万个服务,用户通过浏览器在主界面上下单一箱茅台酒,结果系统给用户提示:系统内部错误,相信用户是很崩溃的。

33 |

34 | 运营人员将问题抛给开发人员定位,开发人员只知道有异常,但是这个异常具体是由哪个微服务引起的就需要逐个服务排查了。

35 |

36 |  37 |

38 |

39 | 开发人员借助日志逐个排查的效率是非常低的,那有没有更好的解决方案了?**答案是引入链路追踪系统。**

40 |

41 | # 什么是链路追踪?

42 |

43 | 分布式链路追踪就是将一次分布式请求还原成调用链路,将一次分布式请求的调用情况集中展示,比如各个服务节点上的耗时、请求具体到达哪台机器上、每个服务节点的请求状态等等。

44 |

45 | **链路跟踪主要功能:**

46 |

47 | * **故障快速定位**:可以通过调用链结合业务日志快速定位错误信息。

48 | * **链路性能可视化**:各个阶段链路耗时、服务依赖关系可以通过可视化界面展现出来。

49 | * **链路分析**:通过分析链路耗时、服务依赖关系可以得到用户的行为路径,汇总分析应用在很多业务场景。

50 | # 链路追踪基本原理

51 |

52 | 链路追踪系统(可能)最早是由Goggle公开发布的一篇论文《Dapper, a Large-Scale Distributed Systems Tracing Infrastructure》被大家广泛熟悉,所以各位技术大牛们如果有黑武器不要藏起来赶紧去发表论文吧。

53 |

54 | 在这篇著名的论文中主要讲述了Dapper链路追踪系统的基本原理和关键技术点。接下来挑几个重点的技术点详细给大家介绍一下。

55 |

56 | ## Trace

57 |

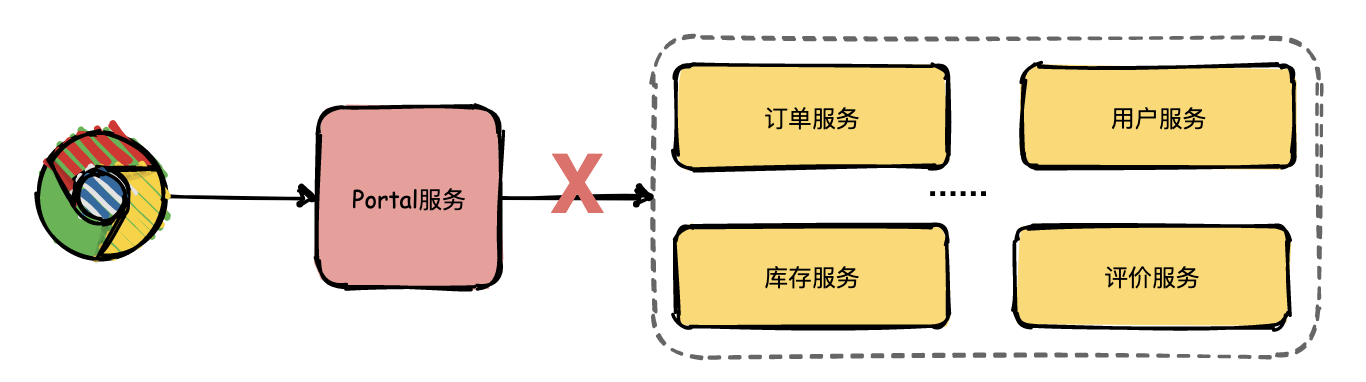

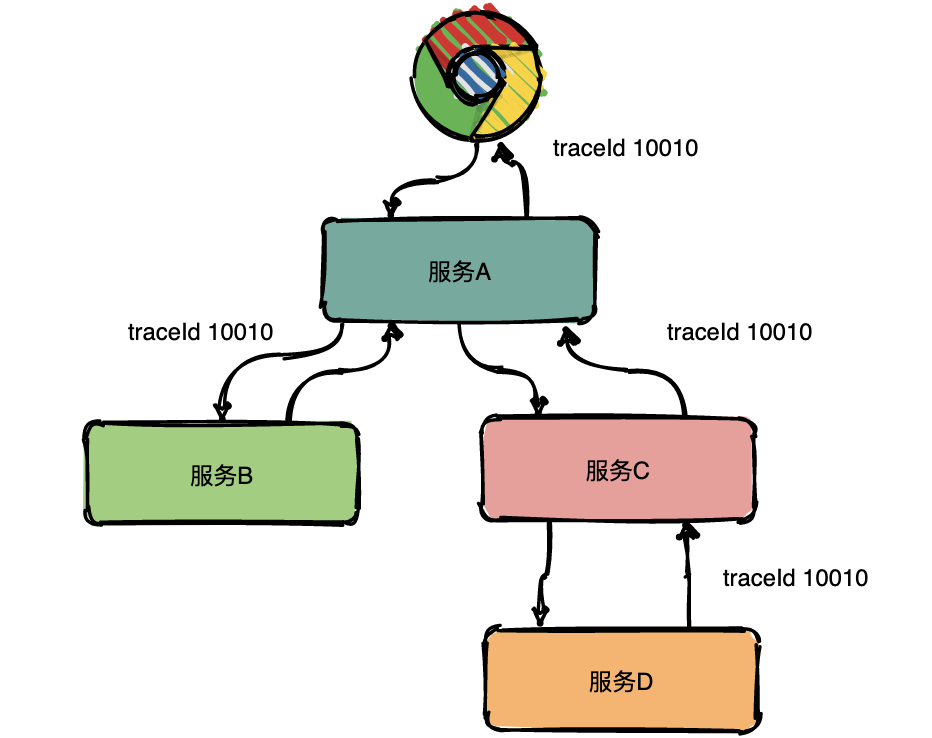

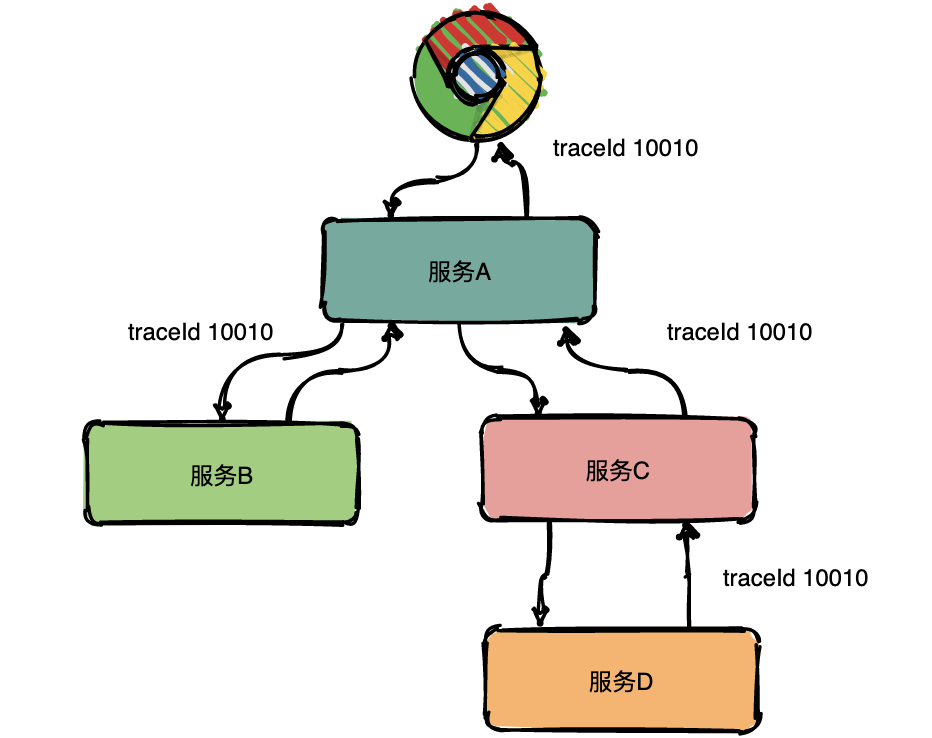

58 | Trace的含义比较直观,就是链路,指一个请求经过所有服务的路径,可以用下面树状的图形表示。

59 |

60 |

37 |

38 |

39 | 开发人员借助日志逐个排查的效率是非常低的,那有没有更好的解决方案了?**答案是引入链路追踪系统。**

40 |

41 | # 什么是链路追踪?

42 |

43 | 分布式链路追踪就是将一次分布式请求还原成调用链路,将一次分布式请求的调用情况集中展示,比如各个服务节点上的耗时、请求具体到达哪台机器上、每个服务节点的请求状态等等。

44 |

45 | **链路跟踪主要功能:**

46 |

47 | * **故障快速定位**:可以通过调用链结合业务日志快速定位错误信息。

48 | * **链路性能可视化**:各个阶段链路耗时、服务依赖关系可以通过可视化界面展现出来。

49 | * **链路分析**:通过分析链路耗时、服务依赖关系可以得到用户的行为路径,汇总分析应用在很多业务场景。

50 | # 链路追踪基本原理

51 |

52 | 链路追踪系统(可能)最早是由Goggle公开发布的一篇论文《Dapper, a Large-Scale Distributed Systems Tracing Infrastructure》被大家广泛熟悉,所以各位技术大牛们如果有黑武器不要藏起来赶紧去发表论文吧。

53 |

54 | 在这篇著名的论文中主要讲述了Dapper链路追踪系统的基本原理和关键技术点。接下来挑几个重点的技术点详细给大家介绍一下。

55 |

56 | ## Trace

57 |

58 | Trace的含义比较直观,就是链路,指一个请求经过所有服务的路径,可以用下面树状的图形表示。

59 |

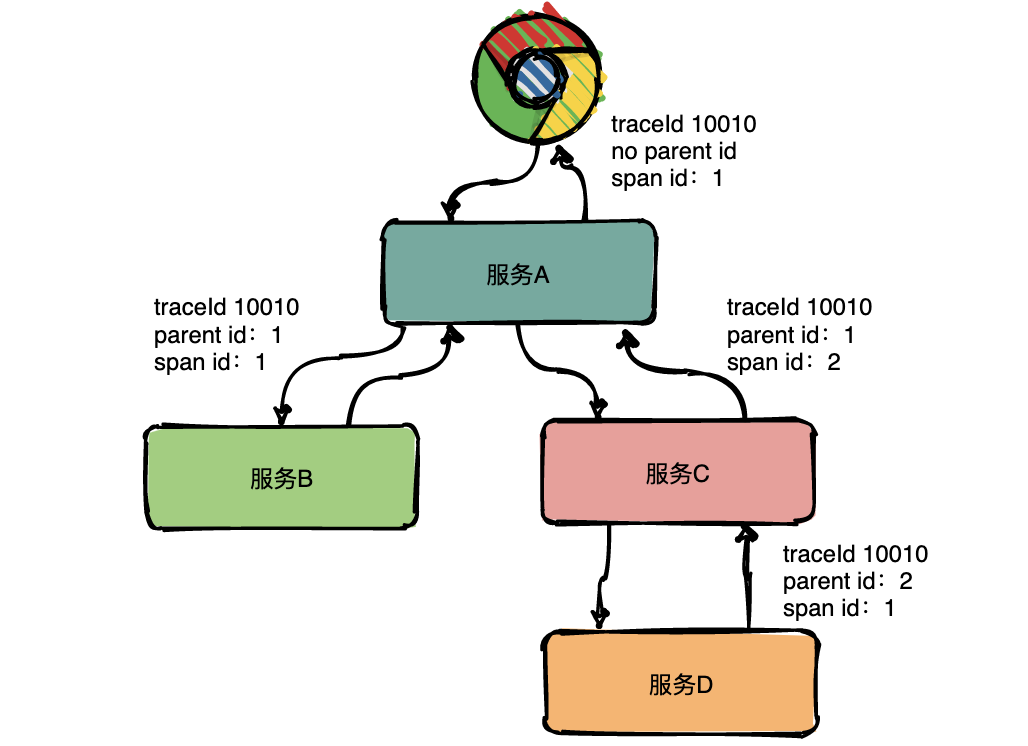

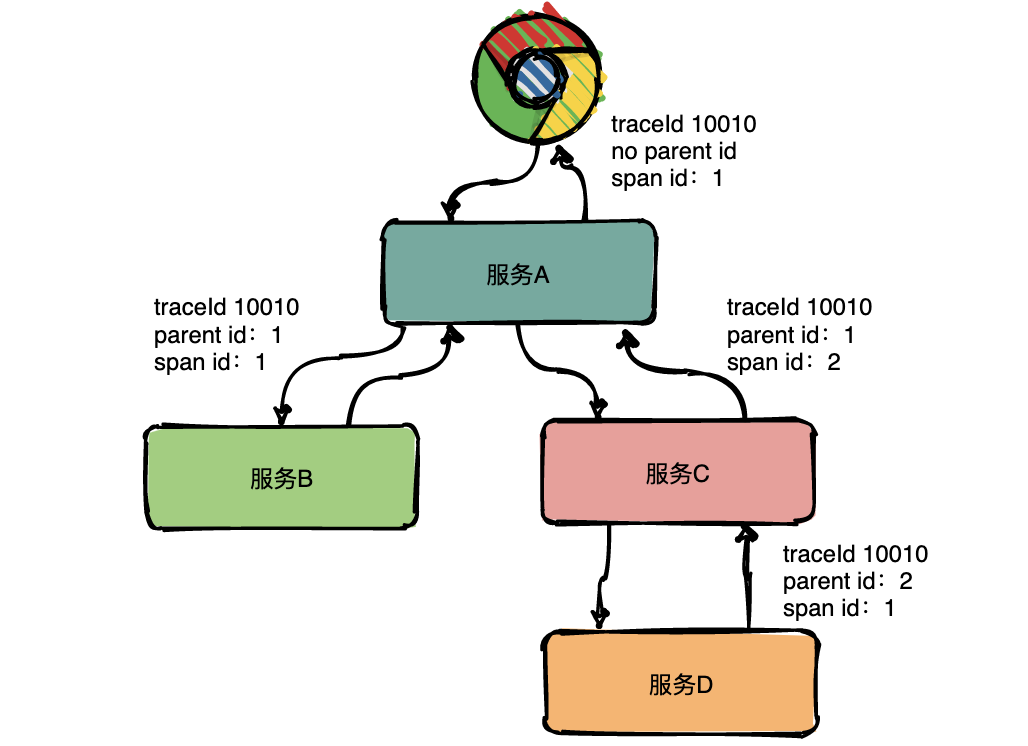

60 |  61 |

62 | 图中一条完整的链路是:chrome -> 服务A -> 服务B -> 服务C -> 服务D -> 服务E -> 服务C -> 服务A -> chrome。服务间经过的局部链路构成了一条完整的链路,其中每一条局部链路都用一个全局唯一的traceid来标识。

63 |

64 | ## Span

65 |

66 | 在上图中可以看出来请求经过了服务A,同时服务A又调用了服务B和服务C,但是先调的服务B还是服务C呢?从图中很难看出来,只有通过查看源码才知道顺序。

67 |

68 | 为了表达这种父子关系引入了Span的概念。

69 |

70 | 同一层级parent id相同,span id不同,span id从小到大表示请求的顺序,从下图中可以很明显看出服务A是先调了服务B然后再调用了C。

71 |

72 | 上下层级代表调用关系,如下图服务C的span id为2,服务D的parent id为2,这就表示服务C和服务D形成了父子关系,很明显是服务C调用了服务D。

73 |

74 |

61 |

62 | 图中一条完整的链路是:chrome -> 服务A -> 服务B -> 服务C -> 服务D -> 服务E -> 服务C -> 服务A -> chrome。服务间经过的局部链路构成了一条完整的链路,其中每一条局部链路都用一个全局唯一的traceid来标识。

63 |

64 | ## Span

65 |

66 | 在上图中可以看出来请求经过了服务A,同时服务A又调用了服务B和服务C,但是先调的服务B还是服务C呢?从图中很难看出来,只有通过查看源码才知道顺序。

67 |

68 | 为了表达这种父子关系引入了Span的概念。

69 |

70 | 同一层级parent id相同,span id不同,span id从小到大表示请求的顺序,从下图中可以很明显看出服务A是先调了服务B然后再调用了C。

71 |

72 | 上下层级代表调用关系,如下图服务C的span id为2,服务D的parent id为2,这就表示服务C和服务D形成了父子关系,很明显是服务C调用了服务D。

73 |

74 |  75 |

76 | **总结:通过事先在日志中埋点,找出相同traceId的日志,再加上parent id和span id就可以将一条完整的请求调用链串联起来。**

77 |

78 | ## Annotations

79 |

80 | Dapper中还定义了annotation的概念,用于用户自定义事件,用来辅助定位问题。

81 |

82 | **通****常****包含四个注解信息**:

83 | cs:Client Start,表示客户端发起请求;

84 | sr:ServerReceived,表示服务端收到请求;

85 | ss: Server Send,表示服务端完成处理,并将结果发送给客户端;

86 | cr:ClientReceived,表示客户端获取到服务端返回信息;

87 |

88 |

75 |

76 | **总结:通过事先在日志中埋点,找出相同traceId的日志,再加上parent id和span id就可以将一条完整的请求调用链串联起来。**

77 |

78 | ## Annotations

79 |

80 | Dapper中还定义了annotation的概念,用于用户自定义事件,用来辅助定位问题。

81 |

82 | **通****常****包含四个注解信息**:

83 | cs:Client Start,表示客户端发起请求;

84 | sr:ServerReceived,表示服务端收到请求;

85 | ss: Server Send,表示服务端完成处理,并将结果发送给客户端;

86 | cr:ClientReceived,表示客户端获取到服务端返回信息;

87 |

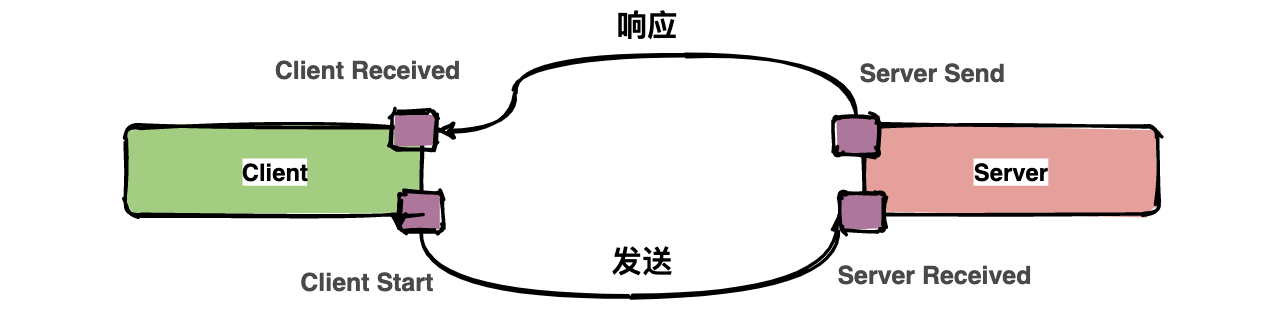

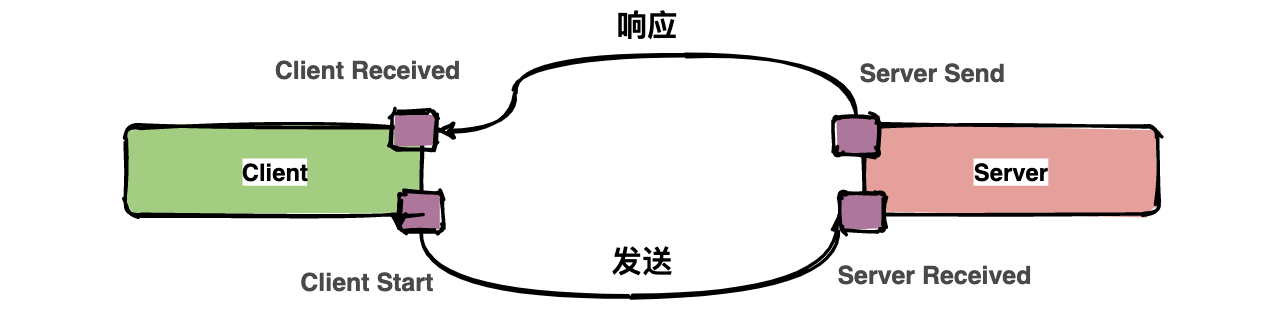

88 |  89 |

90 | 上图中描述了一次请求和响应的过程,四个点也就是对应四个Annotation事件。

91 |

92 | 如下面的图表示从客户端调用服务端的一次完整过程。如果要计算一次调用的耗时,只需要将客户端接收的时间点减去客户端开始的时间点,也就是图中时间线上的T4 - T1。如果要计算客户端发送网络耗时,也就是图中时间线上的T2 - T1,其他类似可计算。

93 |

94 |

89 |

90 | 上图中描述了一次请求和响应的过程,四个点也就是对应四个Annotation事件。

91 |

92 | 如下面的图表示从客户端调用服务端的一次完整过程。如果要计算一次调用的耗时,只需要将客户端接收的时间点减去客户端开始的时间点,也就是图中时间线上的T4 - T1。如果要计算客户端发送网络耗时,也就是图中时间线上的T2 - T1,其他类似可计算。

93 |

94 |  95 |

96 |

97 | ## 带内数据与带外数据

98 |

99 | 链路信息的还原依赖于**带内**和**带外**两种数据。

100 |

101 | 带外数据是各个节点产生的事件,如cs,ss,这些数据可以由节点独立生成,并且需要集中上报到存储端。通过带外数据,可以在存储端分析更多链路的细节。

102 |

103 | 带内数据如traceid,spanid,parentid,用来标识trace,span,以及span在一个trace中的位置,这些数据需要从链路的起点一直传递到终点。 通过带内数据的传递,可以将一个链路的所有过程串起来。

104 |

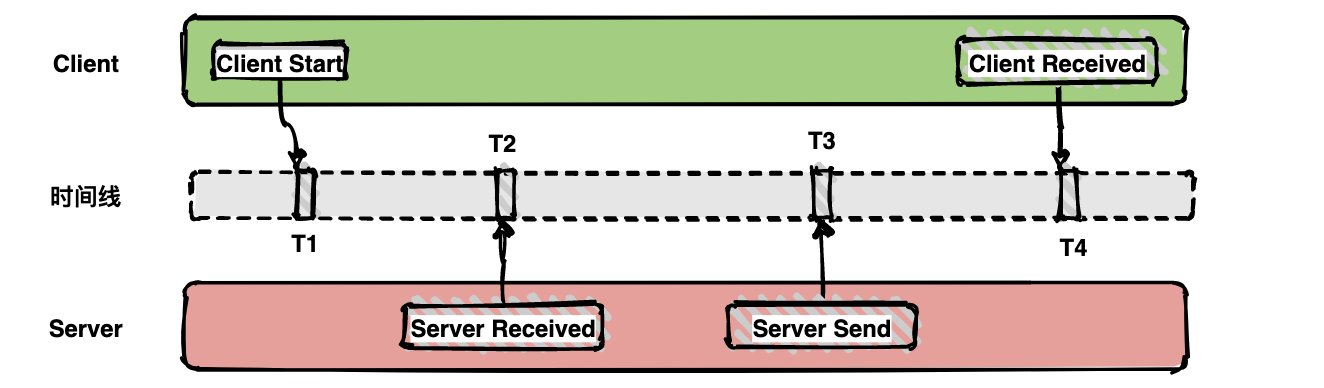

105 | ## 采样

106 |

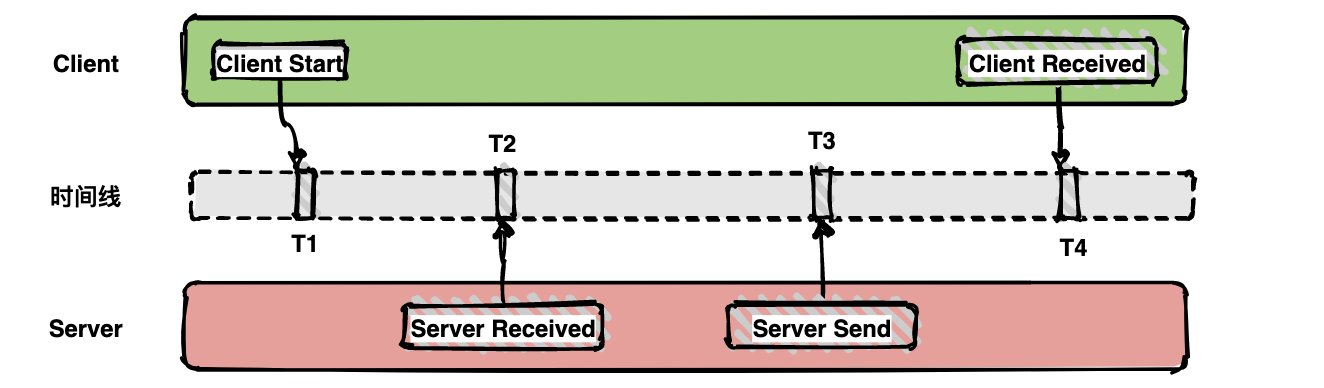

107 | 由于每一个请求都会生成一个链路,为了减少性能消耗,避免存储资源的浪费,dapper并不会上报所有的span数据,而是使用采样的方式。举个例子,每秒有1000个请求访问系统,如果设置采样率为1/1000,那么只会上报一个请求到存储端。

108 |

109 |

95 |

96 |

97 | ## 带内数据与带外数据

98 |

99 | 链路信息的还原依赖于**带内**和**带外**两种数据。

100 |

101 | 带外数据是各个节点产生的事件,如cs,ss,这些数据可以由节点独立生成,并且需要集中上报到存储端。通过带外数据,可以在存储端分析更多链路的细节。

102 |

103 | 带内数据如traceid,spanid,parentid,用来标识trace,span,以及span在一个trace中的位置,这些数据需要从链路的起点一直传递到终点。 通过带内数据的传递,可以将一个链路的所有过程串起来。

104 |

105 | ## 采样

106 |

107 | 由于每一个请求都会生成一个链路,为了减少性能消耗,避免存储资源的浪费,dapper并不会上报所有的span数据,而是使用采样的方式。举个例子,每秒有1000个请求访问系统,如果设置采样率为1/1000,那么只会上报一个请求到存储端。

108 |

109 |  110 |

111 | 通过采集端自适应地调整采样率,控制span上报的数量,可以在发现性能瓶颈的同时,有效减少性能损耗。

112 |

113 | ## 存储

114 |

115 |

110 |

111 | 通过采集端自适应地调整采样率,控制span上报的数量,可以在发现性能瓶颈的同时,有效减少性能损耗。

112 |

113 | ## 存储

114 |

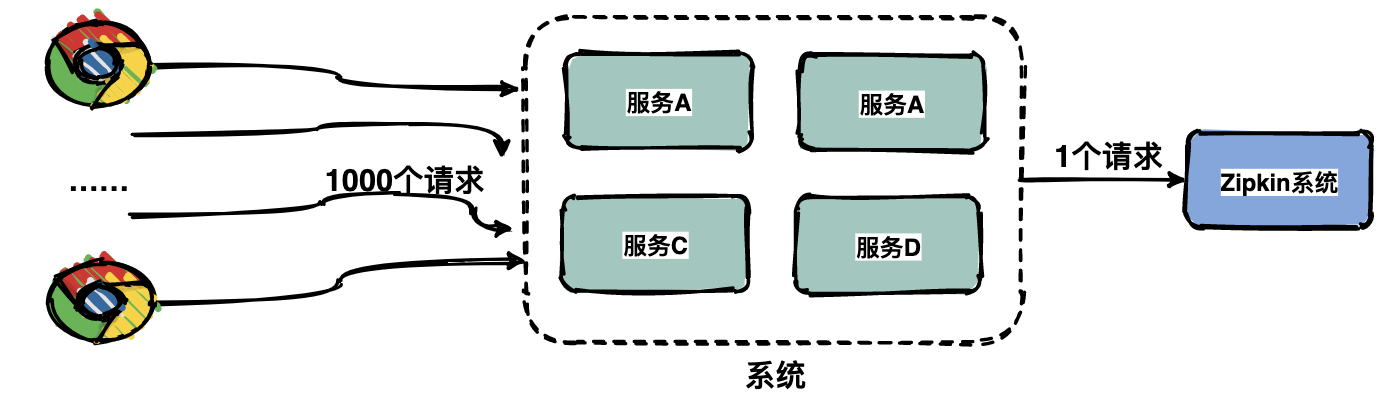

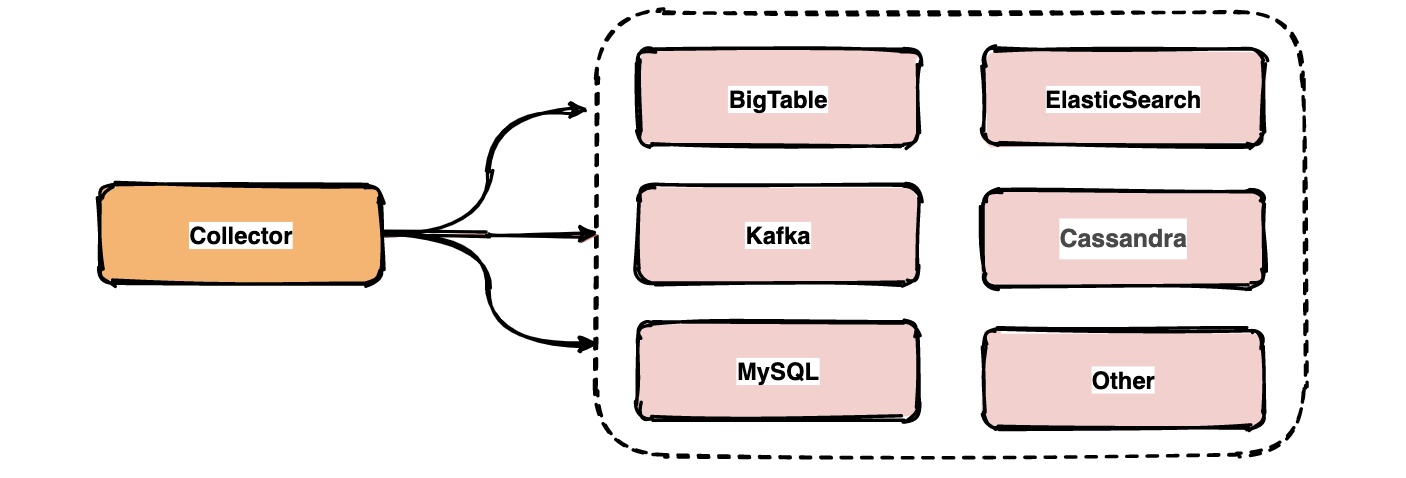

115 |  116 |

117 | 链路中的span数据经过收集和上报后会集中存储在一个地方,Dapper使用了BigTable数据仓库,常用的存储还有ElasticSearch, HBase, In-memory DB等。

118 |

119 | # 业界常用链路追踪系统

120 |

121 | Google Dapper论文发出来之后,很多公司基于链路追踪的基本原理给出了各自的解决方案,如Twitter的Zipkin,Uber的Jaeger,pinpoint,Apache开源的skywalking,还有国产如阿里的鹰眼,美团的Mtrace,滴滴Trace,新浪的Watchman,京东的Hydra,不过国内的这些基本都没有开源。

122 |

123 | 为了便于各系统间能彼此兼容互通,OpenTracing组织制定了一系列标准,旨在让各系统提供统一的接口。

124 |

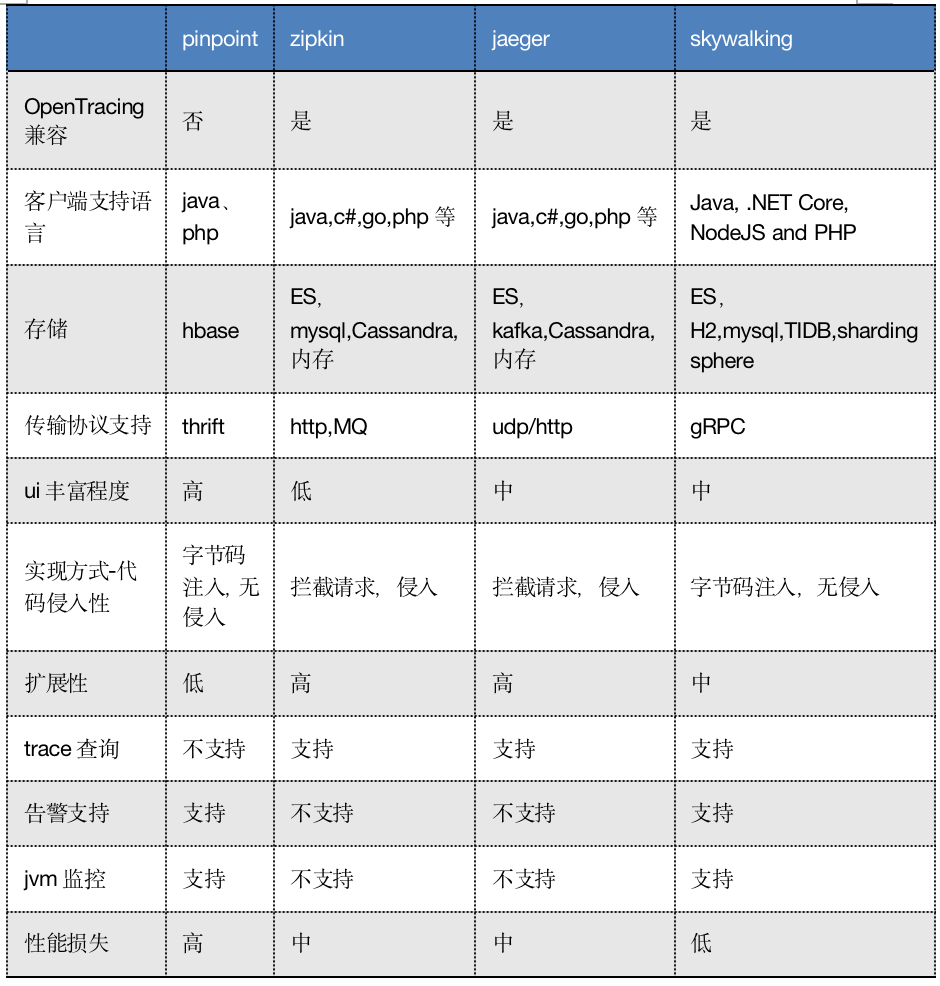

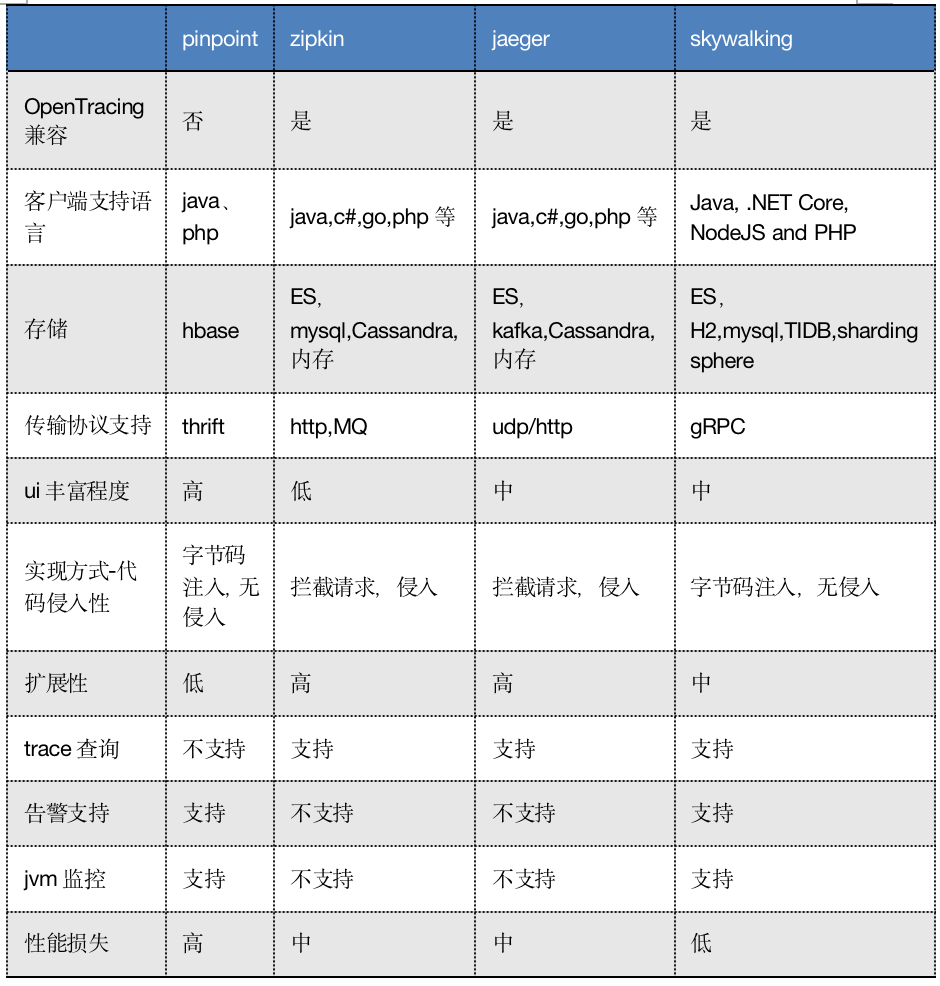

125 | 下面对比一下几个开源组件,方便日后大家做技术选型。

126 |

127 |

116 |

117 | 链路中的span数据经过收集和上报后会集中存储在一个地方,Dapper使用了BigTable数据仓库,常用的存储还有ElasticSearch, HBase, In-memory DB等。

118 |

119 | # 业界常用链路追踪系统

120 |

121 | Google Dapper论文发出来之后,很多公司基于链路追踪的基本原理给出了各自的解决方案,如Twitter的Zipkin,Uber的Jaeger,pinpoint,Apache开源的skywalking,还有国产如阿里的鹰眼,美团的Mtrace,滴滴Trace,新浪的Watchman,京东的Hydra,不过国内的这些基本都没有开源。

122 |

123 | 为了便于各系统间能彼此兼容互通,OpenTracing组织制定了一系列标准,旨在让各系统提供统一的接口。

124 |

125 | 下面对比一下几个开源组件,方便日后大家做技术选型。

126 |

127 |  128 |

129 | 附各大开源组件的地址:

130 |

131 | * zipkin[https://zipkin.io/](https://zipkin.io/?fileGuid=Q8RQjVxpcvdvtC6q)

132 | * Jaeger[www.](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)[jaeger](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)[tracing.io/](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)

133 | * Pinpoint[https://github.com/pinpoint-apm/pinpoint](https://github.com/pinpoint-apm/pinpoint?fileGuid=Q8RQjVxpcvdvtC6q)

134 | * SkyWalking[http://skywalking.apache.org/](http://skywalking.apache.org/?fileGuid=Q8RQjVxpcvdvtC6q)

135 |

136 | 接下来介绍一下Zipkin基本实现。

137 |

138 | # 分布式链路追踪系统Zipkin实现

139 |

140 | Zipkin 是 Twitter 的一个开源项目,它基于 Google Dapper 实现,它致力于收集服务的定时数据,以解决微服务架构中的延迟问题,包括数据的收集、存储、查找和展现。

141 |

142 | ## **Zipkin基本架构**

143 |

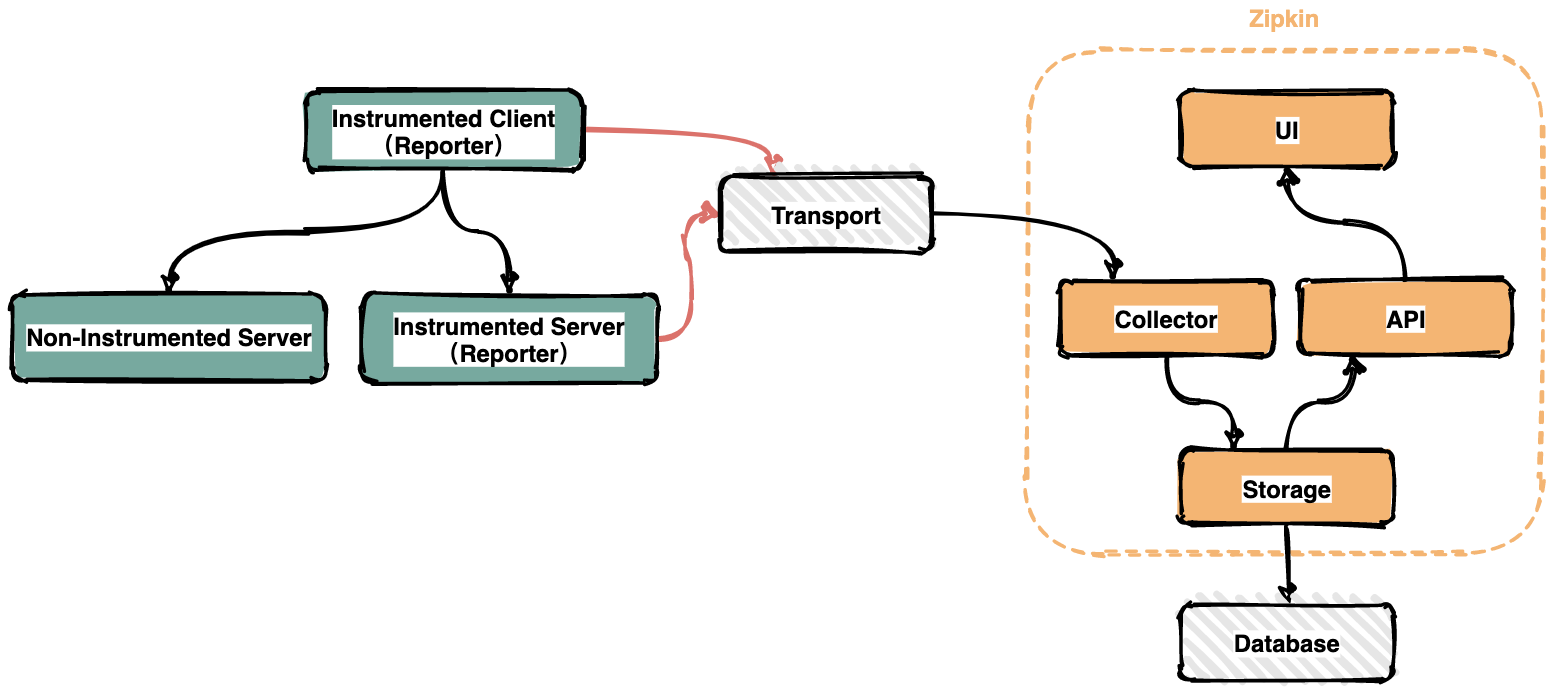

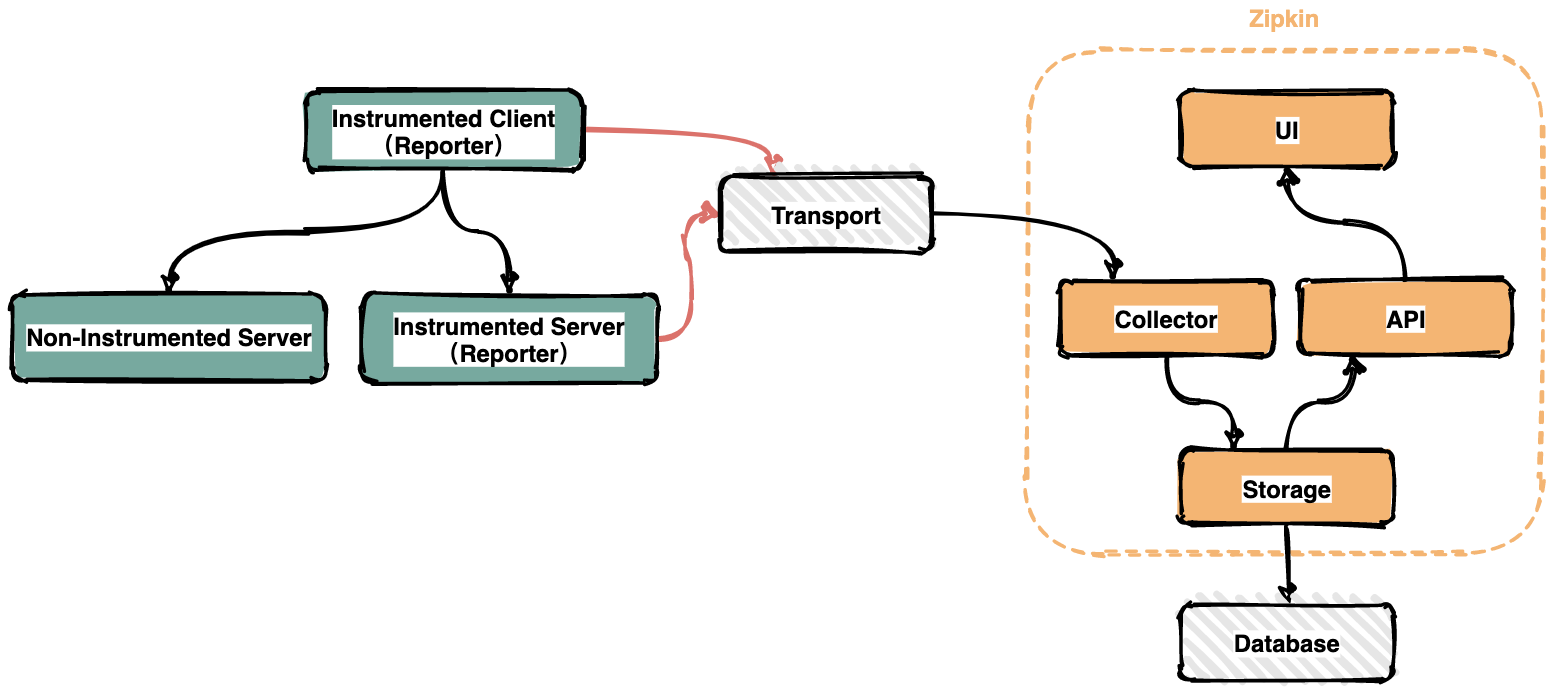

144 |

128 |

129 | 附各大开源组件的地址:

130 |

131 | * zipkin[https://zipkin.io/](https://zipkin.io/?fileGuid=Q8RQjVxpcvdvtC6q)

132 | * Jaeger[www.](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)[jaeger](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)[tracing.io/](http://www.baidu.com/link?url=BktsXcEs4Z1Ci_M7bV8PsKC3PZLoGVDS-omdih46FUB5HP4XXSbzSQRJW-Z0cqps&fileGuid=Q8RQjVxpcvdvtC6q)

133 | * Pinpoint[https://github.com/pinpoint-apm/pinpoint](https://github.com/pinpoint-apm/pinpoint?fileGuid=Q8RQjVxpcvdvtC6q)

134 | * SkyWalking[http://skywalking.apache.org/](http://skywalking.apache.org/?fileGuid=Q8RQjVxpcvdvtC6q)

135 |

136 | 接下来介绍一下Zipkin基本实现。

137 |

138 | # 分布式链路追踪系统Zipkin实现

139 |

140 | Zipkin 是 Twitter 的一个开源项目,它基于 Google Dapper 实现,它致力于收集服务的定时数据,以解决微服务架构中的延迟问题,包括数据的收集、存储、查找和展现。

141 |

142 | ## **Zipkin基本架构**

143 |

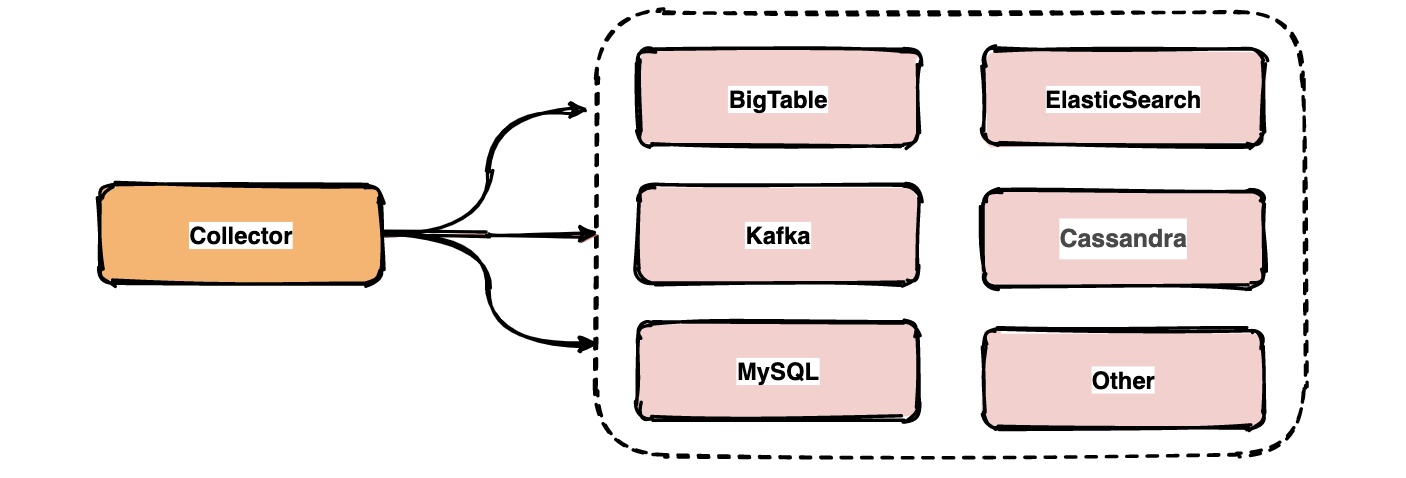

144 |  145 |

146 | 在服务运行的过程中会产生很多链路信息,产生数据的地方可以称之为Reporter。将链路信息通过多种传输方式如HTTP,RPC,kafka消息队列等发送到Zipkin的采集器,Zipkin处理后最终将链路信息保存到存储器中。运维人员通过UI界面调用接口即可查询调用链信息。

147 |

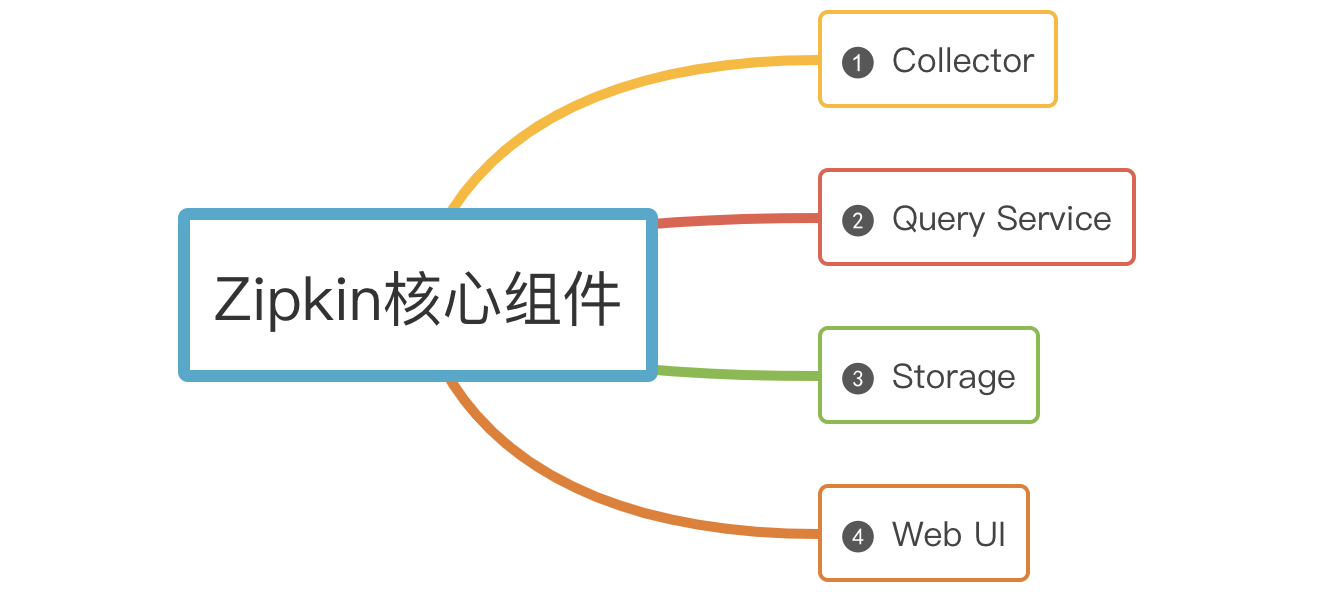

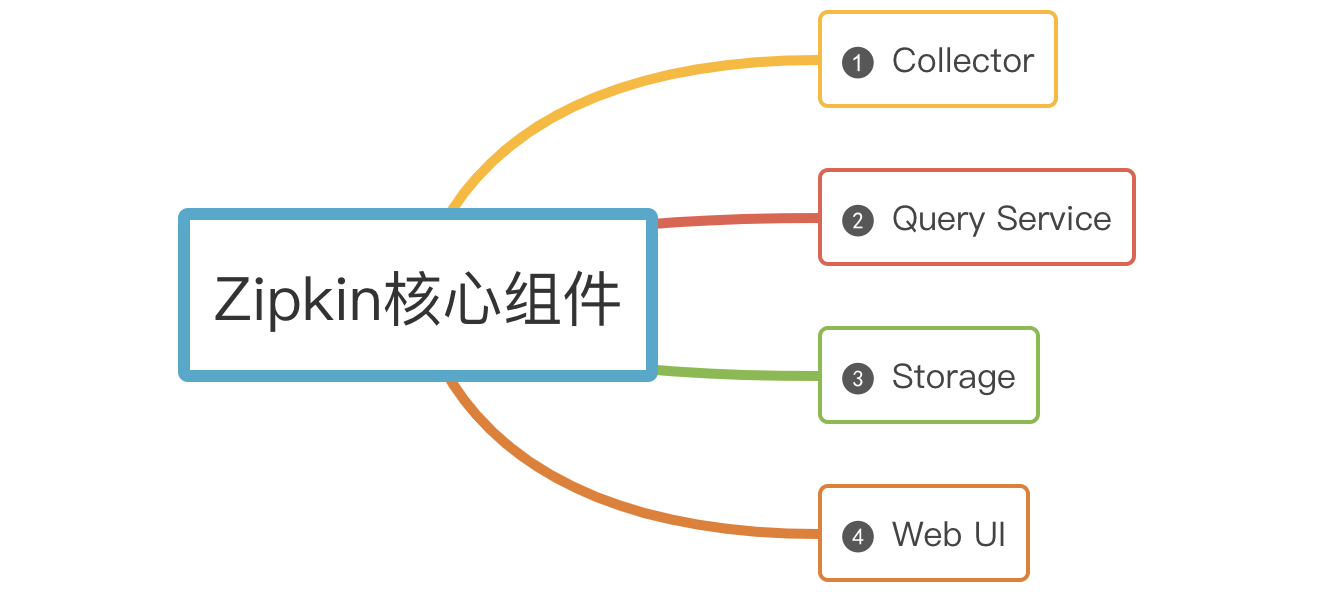

148 | ## **Zipkin核心组件**

149 |

150 | Zipkin有四大核心组件

151 |

152 |

145 |

146 | 在服务运行的过程中会产生很多链路信息,产生数据的地方可以称之为Reporter。将链路信息通过多种传输方式如HTTP,RPC,kafka消息队列等发送到Zipkin的采集器,Zipkin处理后最终将链路信息保存到存储器中。运维人员通过UI界面调用接口即可查询调用链信息。

147 |

148 | ## **Zipkin核心组件**

149 |

150 | Zipkin有四大核心组件

151 |

152 |  153 |

154 | **(1)Collector**

155 |

156 | 一旦Collector采集线程获取到链路追踪数据,Zipkin就会对其进行验证、存储和索引,并调用存储接口保存数据,以便进行查找。

157 |

158 | **(2)Storage**

159 |

160 | Zipkin Storage最初是为了在Cassandra上存储数据而构建的,因为Cassandra是可伸缩的,具有灵活的模式,并且在Twitter中大量使用。除了Cassandra,还支持支持ElasticSearch和MySQL存储,后续可能会提供第三方扩展。

161 |

162 | **(3)Query Service**

163 |

164 | 链路追踪数据被存储和索引之后,webui 可以调用query service查询任意数据帮助运维人员快速定位线上问题。query service提供了简单的json api来查找和检索数据。

165 |

166 | **(4)Web UI**

167 |

168 | Zipkin 提供了基本查询、搜索的web界面,运维人员可以根据具体的调用链信息快速识别线上问题。

169 |

170 | # 总结

171 |

172 | 1. 分布式链路追踪就是将每一次分布式请求还原成调用链路。

173 | 2. 链路追踪的核心概念:Trace、Span、Annotation、带内和带外数据、采样、存储。

174 | 3. 业界常用的开源组件都是基于谷歌Dapper论文演变而来;

175 | 4. Zipkin核心组件有:Collector、Storage、Query Service、Web UI。

176 |

--------------------------------------------------------------------------------

/docs/distributed/用大白话给你解释Zookeeper的选举机制.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322098&idx=1&sn=100089ec2d8c49b85f4acc5ff2af8ca5&chksm=8f09caa8b87e43be0454c4583a914779a5d78d2ae0493e2ec54fd2337d3be9ae99b391a1a35c&token=1553501157&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [人类选举的基本原理](#人类选举的基本原理)

6 | - [Zookeeper选举的基本原理](#zookeeper选举的基本原理)

7 | - [什么场景下 Zookeeper 需要选举?](#什么场景下-zookeeper-需要选举)

8 | - [启动时期的 Leader 选举](#启动时期的-leader-选举)

9 | - [运行时期的Leader选举](#运行时期的leader选举)

10 | - [选举机制中涉及到的核心概念](#选举机制中涉及到的核心概念)

11 | - [总结](#总结)

12 |

13 |

14 |

15 | `Zookeeper` 是一个分布式服务框架,主要是用来解决分布式应用中遇到的一些数据管理问题如:`统一命名服务`、`状态同步服务`、`集群管理`、`分布式应用配置项的管理`等。

16 |

17 | 我们可以简单把 `Zookeeper` 理解为分布式家庭的大管家,那么管家团队是如何选出`Leader`的呢?好奇吗,接下来带领大家一探究竟。

18 |

19 | # 人类选举的基本原理

20 |

21 | 讲解 `Zookeeper` 选举过程前先来介绍一下人类的选举。

22 |

23 | 我们每个人或多或少都经历过几次选举,在投票的过程中可能会遇到这样几种情况:

24 |

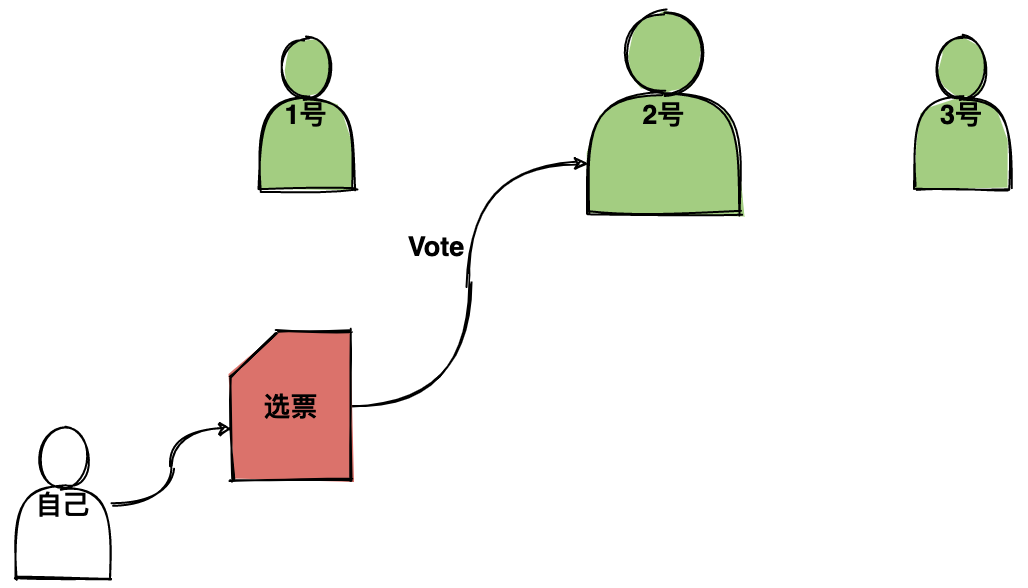

25 | **情况1**:自己与几个候选人都比较熟,你会将票投给你认为`能力比较强的人`;

26 |

27 |

153 |

154 | **(1)Collector**

155 |

156 | 一旦Collector采集线程获取到链路追踪数据,Zipkin就会对其进行验证、存储和索引,并调用存储接口保存数据,以便进行查找。

157 |

158 | **(2)Storage**

159 |

160 | Zipkin Storage最初是为了在Cassandra上存储数据而构建的,因为Cassandra是可伸缩的,具有灵活的模式,并且在Twitter中大量使用。除了Cassandra,还支持支持ElasticSearch和MySQL存储,后续可能会提供第三方扩展。

161 |

162 | **(3)Query Service**

163 |

164 | 链路追踪数据被存储和索引之后,webui 可以调用query service查询任意数据帮助运维人员快速定位线上问题。query service提供了简单的json api来查找和检索数据。

165 |

166 | **(4)Web UI**

167 |

168 | Zipkin 提供了基本查询、搜索的web界面,运维人员可以根据具体的调用链信息快速识别线上问题。

169 |

170 | # 总结

171 |

172 | 1. 分布式链路追踪就是将每一次分布式请求还原成调用链路。

173 | 2. 链路追踪的核心概念:Trace、Span、Annotation、带内和带外数据、采样、存储。

174 | 3. 业界常用的开源组件都是基于谷歌Dapper论文演变而来;

175 | 4. Zipkin核心组件有:Collector、Storage、Query Service、Web UI。

176 |

--------------------------------------------------------------------------------

/docs/distributed/用大白话给你解释Zookeeper的选举机制.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650322098&idx=1&sn=100089ec2d8c49b85f4acc5ff2af8ca5&chksm=8f09caa8b87e43be0454c4583a914779a5d78d2ae0493e2ec54fd2337d3be9ae99b391a1a35c&token=1553501157&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [人类选举的基本原理](#人类选举的基本原理)

6 | - [Zookeeper选举的基本原理](#zookeeper选举的基本原理)

7 | - [什么场景下 Zookeeper 需要选举?](#什么场景下-zookeeper-需要选举)

8 | - [启动时期的 Leader 选举](#启动时期的-leader-选举)

9 | - [运行时期的Leader选举](#运行时期的leader选举)

10 | - [选举机制中涉及到的核心概念](#选举机制中涉及到的核心概念)

11 | - [总结](#总结)

12 |

13 |

14 |

15 | `Zookeeper` 是一个分布式服务框架,主要是用来解决分布式应用中遇到的一些数据管理问题如:`统一命名服务`、`状态同步服务`、`集群管理`、`分布式应用配置项的管理`等。

16 |

17 | 我们可以简单把 `Zookeeper` 理解为分布式家庭的大管家,那么管家团队是如何选出`Leader`的呢?好奇吗,接下来带领大家一探究竟。

18 |

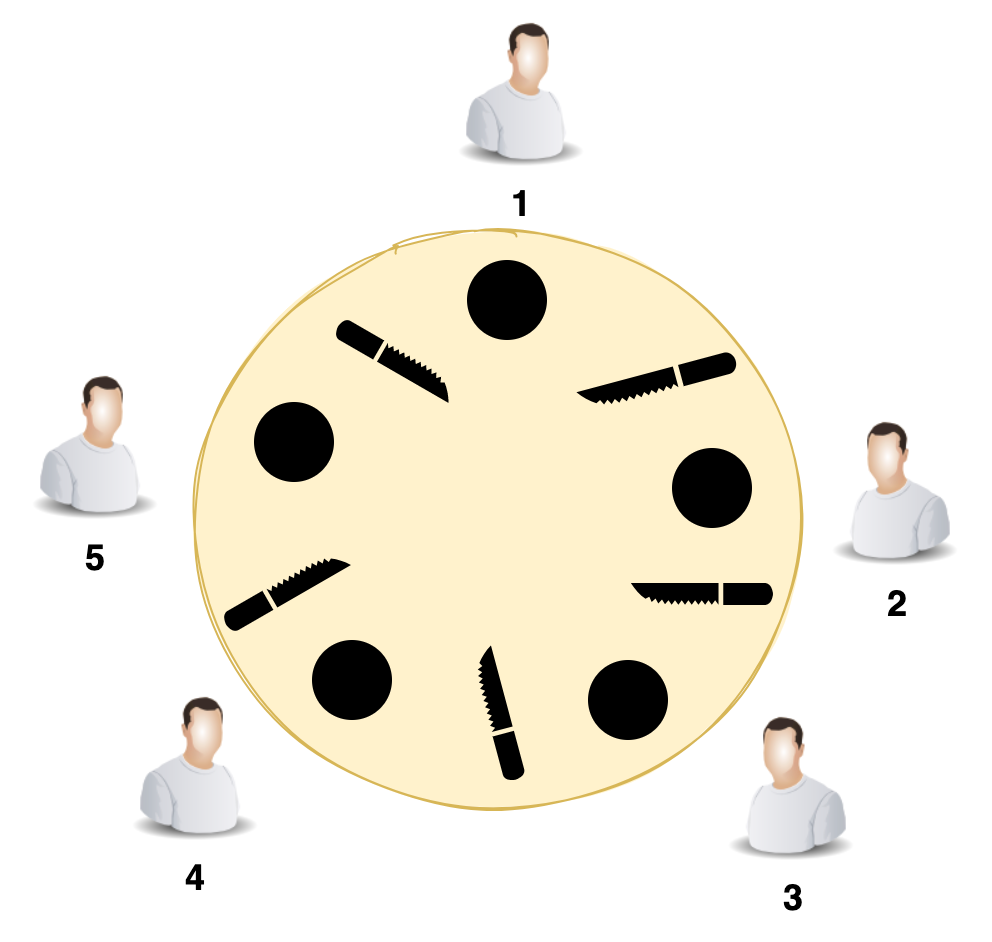

19 | # 人类选举的基本原理

20 |

21 | 讲解 `Zookeeper` 选举过程前先来介绍一下人类的选举。

22 |

23 | 我们每个人或多或少都经历过几次选举,在投票的过程中可能会遇到这样几种情况:

24 |

25 | **情况1**:自己与几个候选人都比较熟,你会将票投给你认为`能力比较强的人`;

26 |

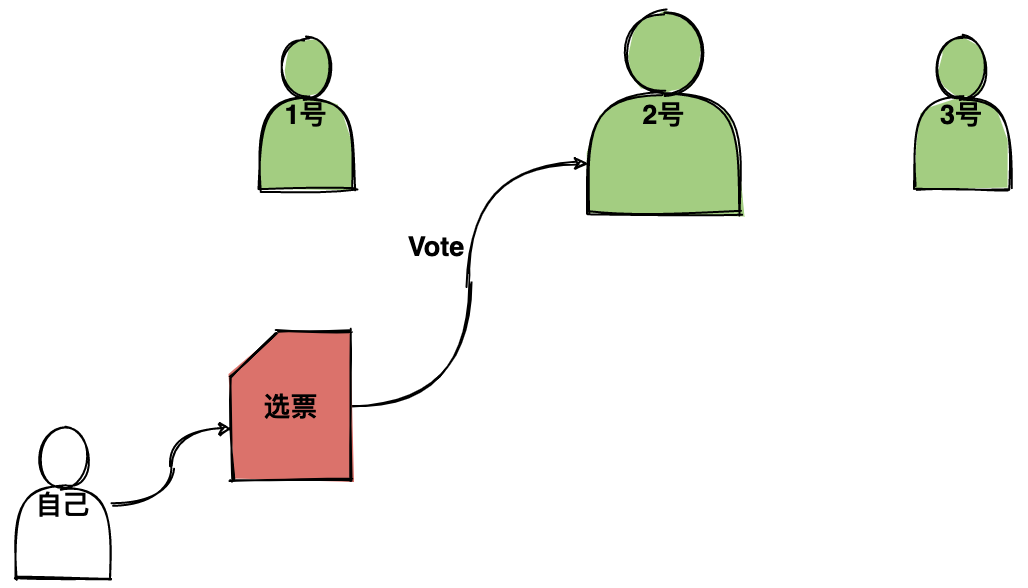

27 |  28 |

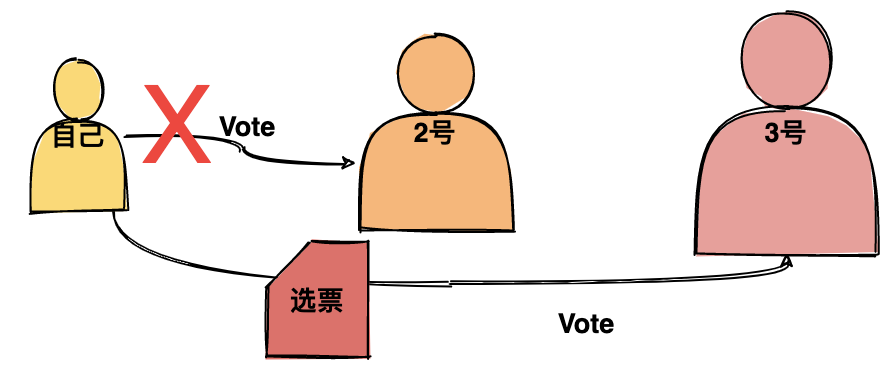

29 | **情况2**:自己也是候选人,并且与其他几个候选人都不熟,这个时候你肯定想着要去拉票,因为觉得自己才是最厉害的人呀,所有人都应该把票投给我。但是遗憾的是在拉票的过程中,你`发现别人比你强`,你开始自卑了,最终还是把票投给了自己认为最强的人。

30 |

31 |

28 |

29 | **情况2**:自己也是候选人,并且与其他几个候选人都不熟,这个时候你肯定想着要去拉票,因为觉得自己才是最厉害的人呀,所有人都应该把票投给我。但是遗憾的是在拉票的过程中,你`发现别人比你强`,你开始自卑了,最终还是把票投给了自己认为最强的人。

30 |

31 |  32 |

33 |

34 | 所有人都投完票之后,最后从投票箱中进行统计,获得票数最多的人当选。

35 |

36 |

32 |

33 |

34 | 所有人都投完票之后,最后从投票箱中进行统计,获得票数最多的人当选。

35 |

36 |  37 |

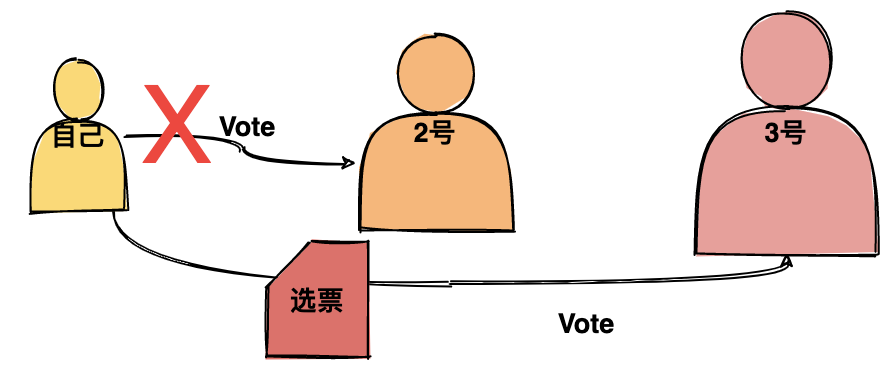

38 | 在整个投票过程中我们可以提炼出四个最核心的概念:

39 |

40 | * `候选人能力`:投票的基本原则是选最强的人。

41 | * `遇强改投`:如果后面发现更强的人可以改投票。

42 | * `投票箱`:所有人的票都会放在投票箱。

43 | * `领导者`:得票最多的人即为领导者。

44 |

45 | 从人类选举的原理我们来简单推导一下Zookeeper的选举原理。

46 |

47 |

48 |

49 | # Zookeeper选举的基本原理

50 |

51 | >注意如果 Zookeeper 是单机部署是不需要选举的,集群模式下才需要选举。

52 |

53 | Zookeeper 的选举原理和人类选举的逻辑类似,套用一下人类选举的四个基本概念详细解释一下Zookeeper。

54 |

55 | * **个人能力**

56 |

57 | 如何衡量 Zookeeper 节点个人能力?答案是靠`数据是否够新`,如果节点的数据越新就代表这个节点的个人能力越强,是不是感觉很奇怪,就是这么定的!

58 |

59 | 在 Zookeeper 中通常是以事务id(后面简称`zxid`)来标识数据的新旧程度(版本),节点最新的zxid越大代表这个节点的数据越新,也就代表这个节点能力越强。

60 |

61 | >zxid 的全称是 `ZooKeeper Transaction Id`,即 Zookeeper 事务id。

62 | * **遇强改投**

63 |

64 | 在集群选举开始时,节点首先认为自己时最强的(即数据是最新的),然后在选票上写上自己的名字(包括`zxid`和`sid`),zxid 是事务id,sid 唯一标识自己。

65 |

66 | 紧接着会将选票传递给其他节点,同时自己也会接收其他节点传过来的选票。每个节点接收到选票后会做比较,这个人是不是比我强(zxid比我大),如果比较强,那我就需要`改票`,明明别人比我强,我也不能厚着脸皮对吧。

67 |

68 | * **投票箱**

69 |

70 | 与人类选举投票箱稍微有点不一样,Zookeeper 集群会在每个节点的内存中维护一个投票箱。节点会将自己的选票以及其他节点的选票都放在这个投票箱中。由于选票时互相传阅的,所以最终每个节点投票箱中的选票会是一样的。

71 |

72 | * **领导者**

73 |

74 | 在投票的过程中会去统计是否有超过一半的选票和自己选择的是同一个节点,即都认为某个节点是最强的。一旦集群中有`超过半数`的节点都认为某个节点最强,那该节点就是领导者了,投票也宣告结束。

75 |

76 | # 什么场景下 Zookeeper 需要选举?

77 |

78 | 当 Zookeeper 集群中的一台服务器出现以下两种情况之一时,需要进入 `Leader 选举`。

79 |

80 | (1)服务器初始化启动。

81 |

82 | (2)服务器运行期间 Leader 故障。

83 |

84 | ## 启动时期的 Leader 选举

85 |

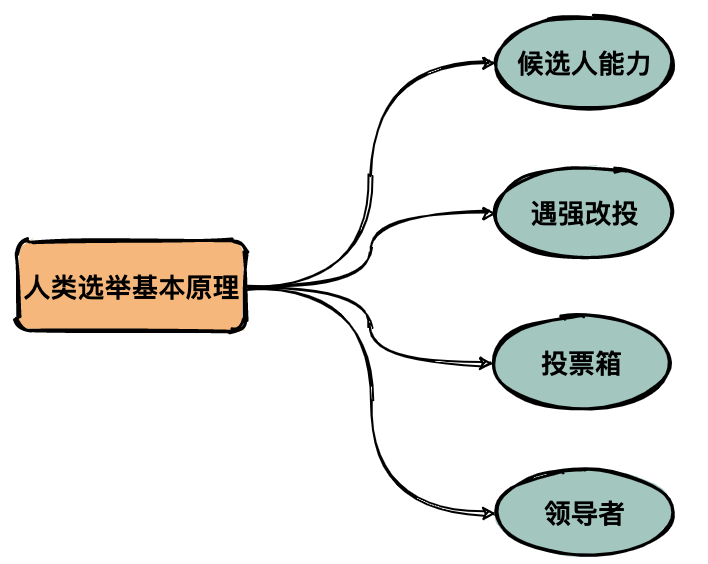

86 | 假设一个 Zookeeper 集群中有5台服务器,id从1到5编号,并且它们都是最新启动的,没有历史数据。

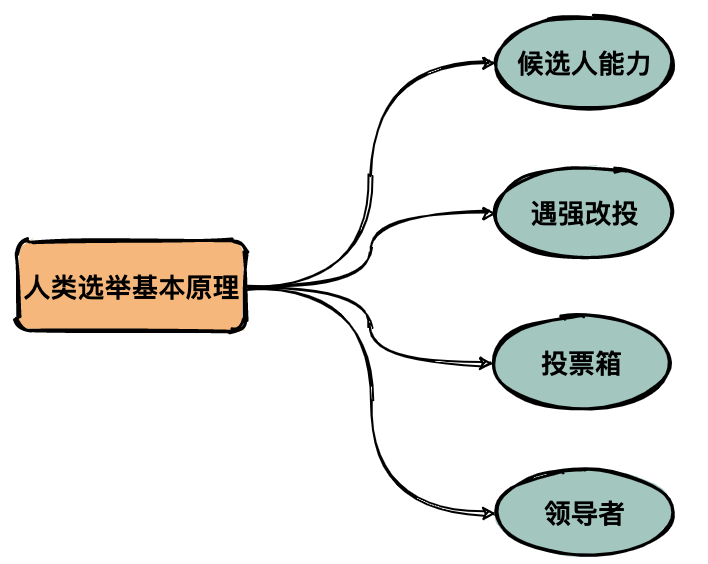

87 |

88 |

37 |

38 | 在整个投票过程中我们可以提炼出四个最核心的概念:

39 |

40 | * `候选人能力`:投票的基本原则是选最强的人。

41 | * `遇强改投`:如果后面发现更强的人可以改投票。

42 | * `投票箱`:所有人的票都会放在投票箱。

43 | * `领导者`:得票最多的人即为领导者。

44 |

45 | 从人类选举的原理我们来简单推导一下Zookeeper的选举原理。

46 |

47 |

48 |

49 | # Zookeeper选举的基本原理

50 |

51 | >注意如果 Zookeeper 是单机部署是不需要选举的,集群模式下才需要选举。

52 |

53 | Zookeeper 的选举原理和人类选举的逻辑类似,套用一下人类选举的四个基本概念详细解释一下Zookeeper。

54 |

55 | * **个人能力**

56 |

57 | 如何衡量 Zookeeper 节点个人能力?答案是靠`数据是否够新`,如果节点的数据越新就代表这个节点的个人能力越强,是不是感觉很奇怪,就是这么定的!

58 |

59 | 在 Zookeeper 中通常是以事务id(后面简称`zxid`)来标识数据的新旧程度(版本),节点最新的zxid越大代表这个节点的数据越新,也就代表这个节点能力越强。

60 |

61 | >zxid 的全称是 `ZooKeeper Transaction Id`,即 Zookeeper 事务id。

62 | * **遇强改投**

63 |

64 | 在集群选举开始时,节点首先认为自己时最强的(即数据是最新的),然后在选票上写上自己的名字(包括`zxid`和`sid`),zxid 是事务id,sid 唯一标识自己。

65 |

66 | 紧接着会将选票传递给其他节点,同时自己也会接收其他节点传过来的选票。每个节点接收到选票后会做比较,这个人是不是比我强(zxid比我大),如果比较强,那我就需要`改票`,明明别人比我强,我也不能厚着脸皮对吧。

67 |

68 | * **投票箱**

69 |

70 | 与人类选举投票箱稍微有点不一样,Zookeeper 集群会在每个节点的内存中维护一个投票箱。节点会将自己的选票以及其他节点的选票都放在这个投票箱中。由于选票时互相传阅的,所以最终每个节点投票箱中的选票会是一样的。

71 |

72 | * **领导者**

73 |

74 | 在投票的过程中会去统计是否有超过一半的选票和自己选择的是同一个节点,即都认为某个节点是最强的。一旦集群中有`超过半数`的节点都认为某个节点最强,那该节点就是领导者了,投票也宣告结束。

75 |

76 | # 什么场景下 Zookeeper 需要选举?

77 |

78 | 当 Zookeeper 集群中的一台服务器出现以下两种情况之一时,需要进入 `Leader 选举`。

79 |

80 | (1)服务器初始化启动。

81 |

82 | (2)服务器运行期间 Leader 故障。

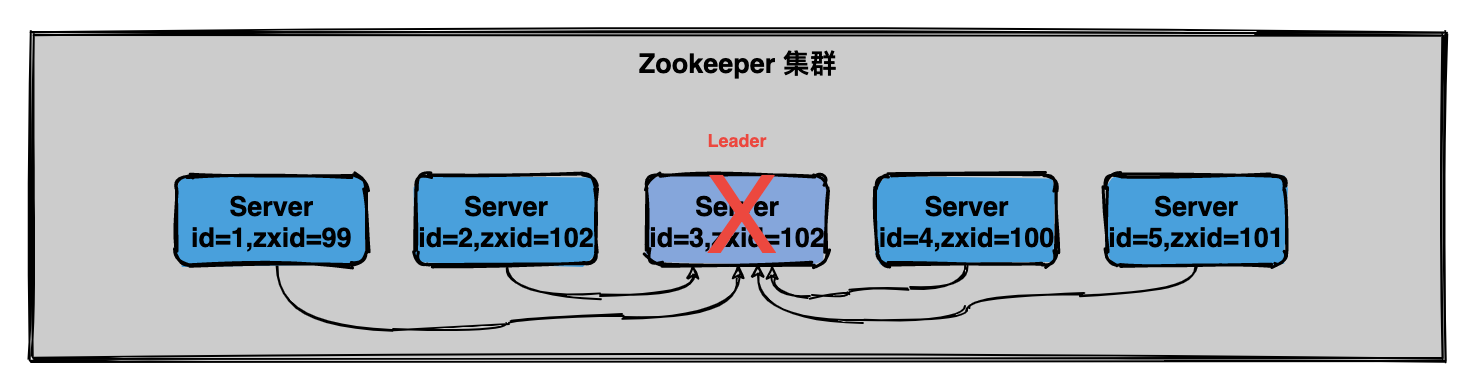

83 |

84 | ## 启动时期的 Leader 选举

85 |

86 | 假设一个 Zookeeper 集群中有5台服务器,id从1到5编号,并且它们都是最新启动的,没有历史数据。

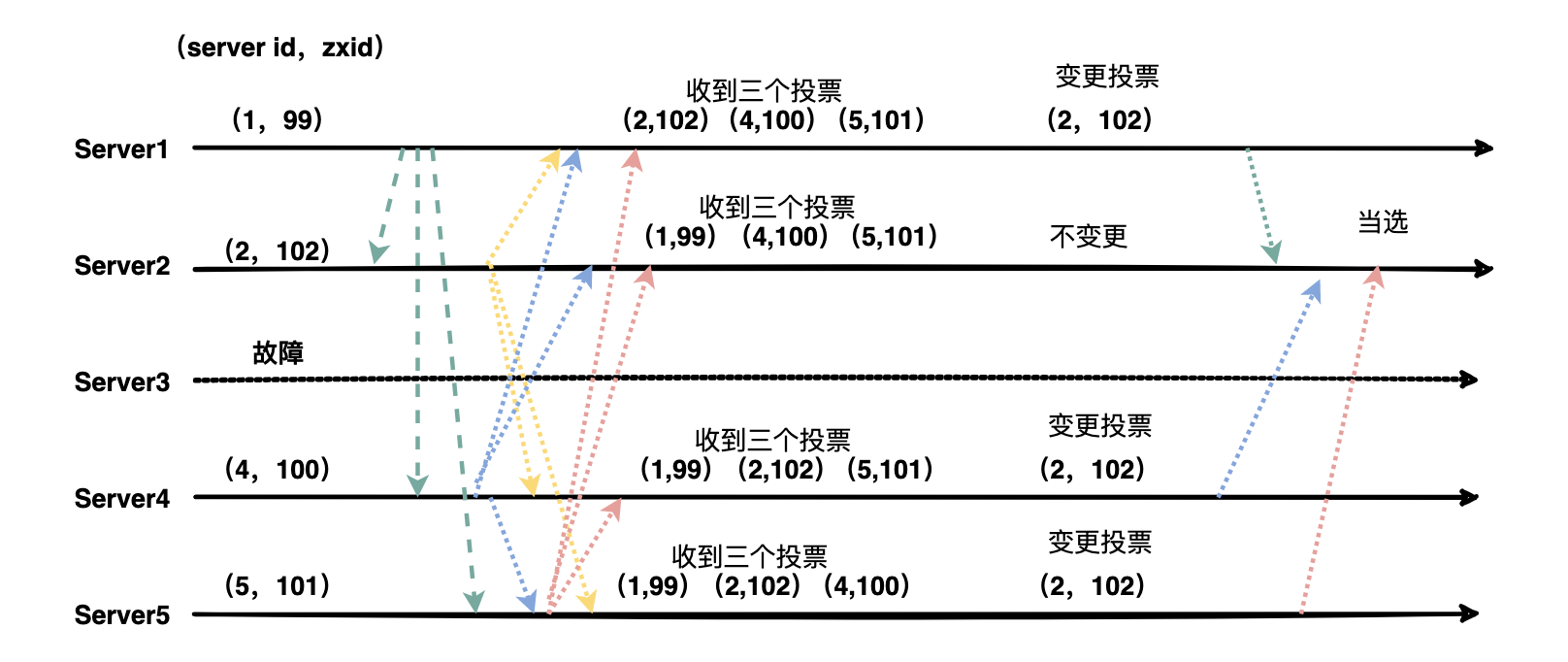

87 |

88 |  89 |

90 | 假设服务器依次启动,我们来分析一下选举过程:

91 |

92 | **(1)服务器1启动**

93 |

94 | 发起一次选举,服务器1投自己一票,此时服务器1票数一票,不够半数以上(3票),选举无法完成。

95 |

96 | 投票结果:服务器1为1票。

97 |

98 | 服务器1状态保持为`LOOKING`。

99 |

100 | **(2)服务器2启动**

101 |

102 | 发起一次选举,服务器1和2分别投自己一票,此时服务器1发现服务器2的id比自己大,更改选票投给服务器2。

103 |

104 | 投票结果:服务器1为0票,服务器2为2票。

105 |

106 | 服务器1,2状态保持`LOOKING`

107 |

108 | **(3)服务器3启动**

109 |

110 | 发起一次选举,服务器1、2、3先投自己一票,然后因为服务器3的id最大,两者更改选票投给为服务器3;

111 |

112 | 投票结果:服务器1为0票,服务器2为0票,服务器3为3票。 此时服务器3的票数已经超过半数(3票),**服务器3当选`Leader`**。

113 |

114 | 服务器1,2更改状态为`FOLLOWING`,服务器3更改状态为`LEADING`。

115 |

116 | **(4)服务器4启动**

117 |

118 | 发起一次选举,此时服务器1,2,3已经不是LOOKING 状态,不会更改选票信息。交换选票信息结果:服务器3为3票,服务器4为1票。此时服务器4服从多数,更改选票信息为服务器3。

119 |

120 | 服务器4并更改状态为`FOLLOWING`。

121 |

122 | **(5)服务器5启动**

123 |

124 | 与服务器4一样投票给3,此时服务器3一共5票,服务器5为0票。

125 |

126 | 服务器5并更改状态为`FOLLOWING`。

127 |

128 | **最终的结果**:

129 |

130 | 服务器3是 `Leader`,状态为 `LEADING`;其余服务器是 `Follower`,状态为 `FOLLOWING`。

131 |

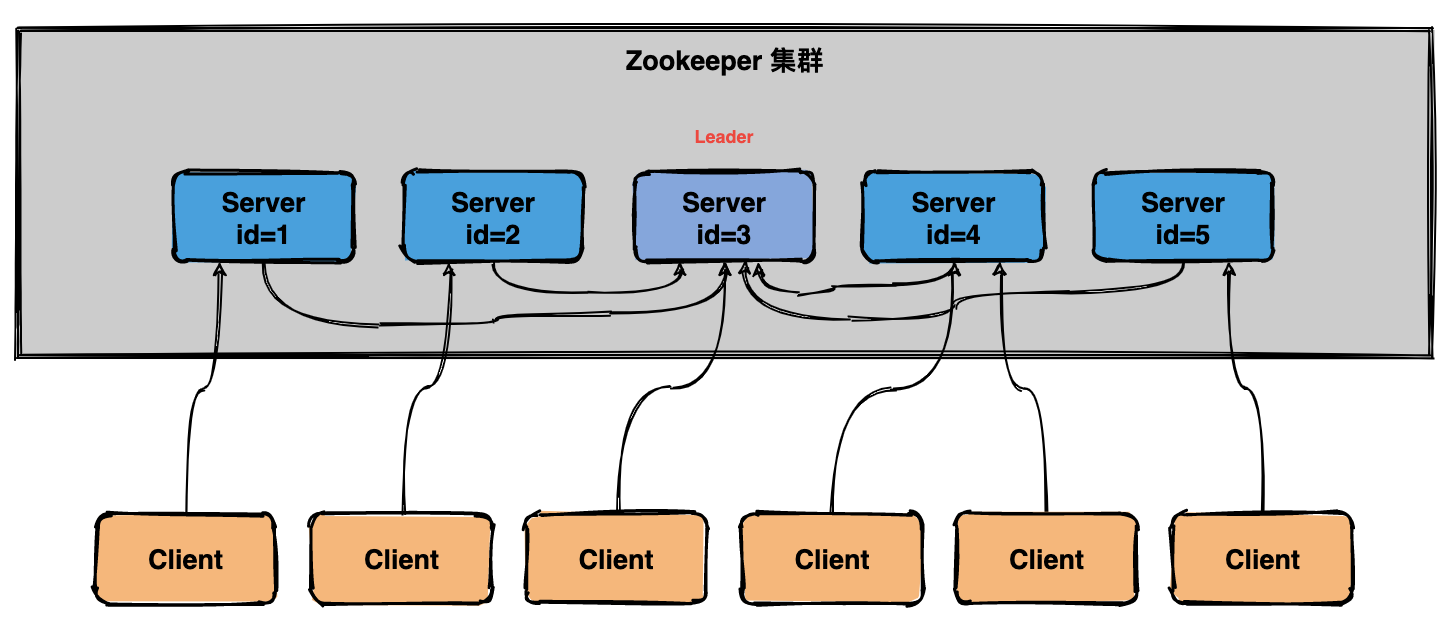

132 | ## 运行时期的Leader选举

133 |

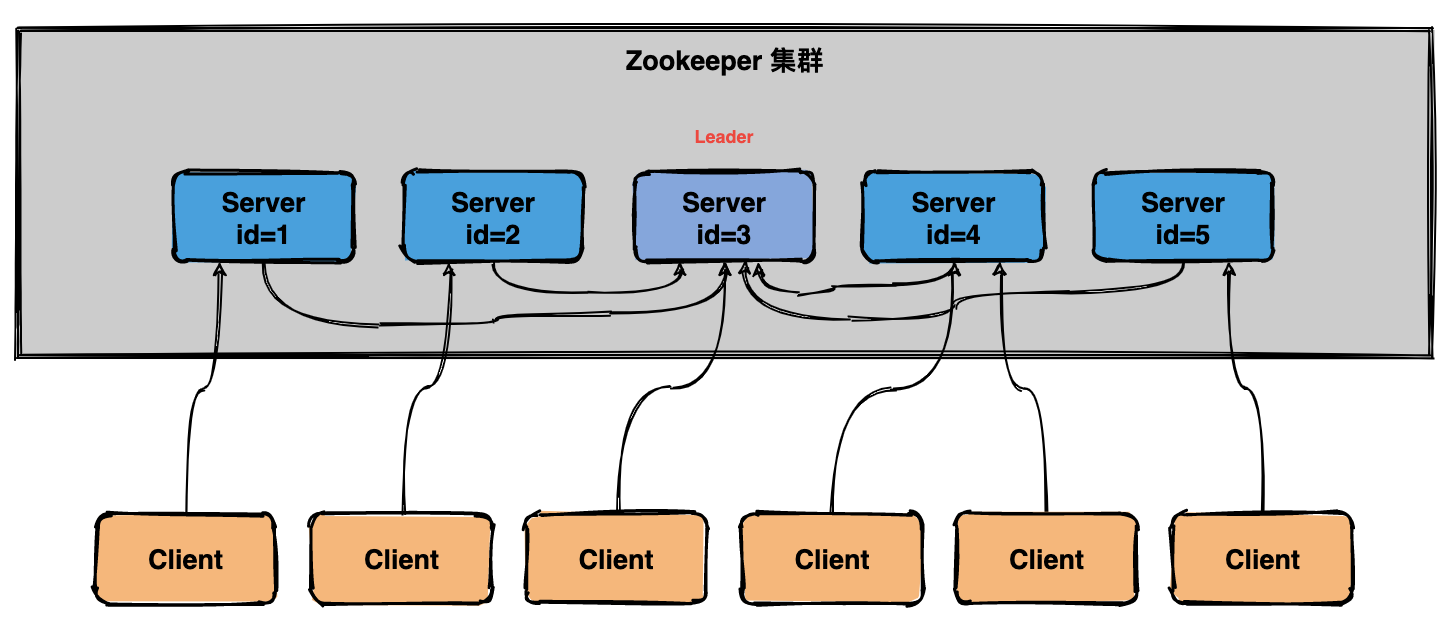

134 | 在 Zookeeper运行期间 `Leader` 和 `非 Leader` 各司其职,当有非 Leader 服务器宕机或加入不会影响 Leader,但是一旦 Leader 服务器挂了,那么整个 Zookeeper 集群将暂停对外服务,会触发新一轮的选举。

135 |

136 | 初始状态下服务器3当选为`Leader`,假设现在服务器3故障宕机了,此时每个服务器上zxid可能都不一样,server1为99,server2为102,server4为100,server5为101

137 |

138 |

89 |

90 | 假设服务器依次启动,我们来分析一下选举过程:

91 |

92 | **(1)服务器1启动**

93 |

94 | 发起一次选举,服务器1投自己一票,此时服务器1票数一票,不够半数以上(3票),选举无法完成。

95 |

96 | 投票结果:服务器1为1票。

97 |

98 | 服务器1状态保持为`LOOKING`。

99 |

100 | **(2)服务器2启动**

101 |

102 | 发起一次选举,服务器1和2分别投自己一票,此时服务器1发现服务器2的id比自己大,更改选票投给服务器2。

103 |

104 | 投票结果:服务器1为0票,服务器2为2票。

105 |

106 | 服务器1,2状态保持`LOOKING`

107 |

108 | **(3)服务器3启动**

109 |

110 | 发起一次选举,服务器1、2、3先投自己一票,然后因为服务器3的id最大,两者更改选票投给为服务器3;

111 |

112 | 投票结果:服务器1为0票,服务器2为0票,服务器3为3票。 此时服务器3的票数已经超过半数(3票),**服务器3当选`Leader`**。

113 |

114 | 服务器1,2更改状态为`FOLLOWING`,服务器3更改状态为`LEADING`。

115 |

116 | **(4)服务器4启动**

117 |

118 | 发起一次选举,此时服务器1,2,3已经不是LOOKING 状态,不会更改选票信息。交换选票信息结果:服务器3为3票,服务器4为1票。此时服务器4服从多数,更改选票信息为服务器3。

119 |

120 | 服务器4并更改状态为`FOLLOWING`。

121 |

122 | **(5)服务器5启动**

123 |

124 | 与服务器4一样投票给3,此时服务器3一共5票,服务器5为0票。

125 |

126 | 服务器5并更改状态为`FOLLOWING`。

127 |

128 | **最终的结果**:

129 |

130 | 服务器3是 `Leader`,状态为 `LEADING`;其余服务器是 `Follower`,状态为 `FOLLOWING`。

131 |

132 | ## 运行时期的Leader选举

133 |

134 | 在 Zookeeper运行期间 `Leader` 和 `非 Leader` 各司其职,当有非 Leader 服务器宕机或加入不会影响 Leader,但是一旦 Leader 服务器挂了,那么整个 Zookeeper 集群将暂停对外服务,会触发新一轮的选举。

135 |

136 | 初始状态下服务器3当选为`Leader`,假设现在服务器3故障宕机了,此时每个服务器上zxid可能都不一样,server1为99,server2为102,server4为100,server5为101

137 |

138 |  139 |

140 | 运行期选举与初始状态投票过程基本类似,大致可以分为以下几个步骤:

141 |

142 | (1)状态变更。Leader 故障后,余下的`非 Observer` 服务器都会将自己的服务器状态变更为`LOOKING`,然后开始进入`Leader选举过程`。

143 |

144 | (2)每个Server会发出投票。

145 |

146 | (3)接收来自各个服务器的投票,如果其他服务器的数据比自己的新会改投票。

147 |

148 | (4)处理和统计投票,没一轮投票结束后都会统计投票,超过半数即可当选。

149 |

150 | (5)改变服务器的状态,宣布当选。

151 |

152 | 话不多说先来一张图:

153 |

154 |

139 |

140 | 运行期选举与初始状态投票过程基本类似,大致可以分为以下几个步骤:

141 |

142 | (1)状态变更。Leader 故障后,余下的`非 Observer` 服务器都会将自己的服务器状态变更为`LOOKING`,然后开始进入`Leader选举过程`。

143 |

144 | (2)每个Server会发出投票。

145 |

146 | (3)接收来自各个服务器的投票,如果其他服务器的数据比自己的新会改投票。

147 |

148 | (4)处理和统计投票,没一轮投票结束后都会统计投票,超过半数即可当选。

149 |

150 | (5)改变服务器的状态,宣布当选。

151 |

152 | 话不多说先来一张图:

153 |

154 |  155 |

156 | (1)第一次投票,每台机器都会将票投给自己。

157 |

158 | (2)接着每台机器都会将自己的投票发给其他机器,如果发现其他机器的zxid比自己大,那么就需要改投票重新投一次。比如server1 收到了三张票,发现server2的xzid为102,pk一下发现自己输了,后面果断改投票选server2为老大。

159 |

160 | # 选举机制中涉及到的核心概念

161 |

162 | 敲黑板了,这些概念是面试必考的。

163 |

164 | **(1)Server id(或sid):服务器ID**

165 |

166 | 比如有三台服务器,编号分别是1,2,3。编号越大在选择算法中的权重越大,比如初始化启动时就是根据服务器ID进行比较。

167 |

168 | **(2)Zxid:事务ID**

169 |

170 | 服务器中存放的数据的事务ID,值越大说明数据越新,在选举算法中数据越新权重越大。

171 |

172 | **(3)Epoch:逻辑时钟**

173 |

174 | 也叫投票的次数,同一轮投票过程中的逻辑时钟值是相同的,每投完一次票这个数据就会增加。

175 |

176 | **(4)Server状态:选举状态**

177 |

178 | `LOOKING`,竞选状态。

179 |

180 | `FOLLOWING`,随从状态,同步leader状态,参与投票。

181 |

182 | `OBSERVING`,观察状态,同步leader状态,不参与投票。

183 |

184 | `LEADING`,领导者状态。

185 |

186 | # 总结

187 |

188 | (1)Zookeeper 选举会发生在服务器初始状态和运行状态下。

189 |

190 | (2)初始状态下会根据服务器sid的编号对比,编号越大权值越大,投票过半数即可选出Leader。

191 |

192 | (3)Leader 故障会触发新一轮选举,`zxid` 代表数据越新,权值也就越大。

193 |

194 | > 没有什么比每天有成长进步更高兴的事情

195 |

--------------------------------------------------------------------------------

/docs/it-hot/鸿蒙OS尖刀武器之分布式软总线技术.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s/AM3C5z1QulG0wEKBFCyH6g)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [1 没有人能够熄灭满天星光](#1-没有人能够熄灭满天星光)

6 | - [2 必须得补的传统总线知识](#2-必须得补的传统总线知识)

7 | - [3 什么是分布式软总线?](#3-什么是分布式软总线)

8 | - [4 分布式软总线功能和原理](#4-分布式软总线功能和原理)

9 | - [4.1 分布式软总线的架构](#41-分布式软总线的架构)

10 | - [4.2 软总线之发现连接:从手动发现,进化成自发现](#42-软总线之发现连接:从手动发现进化成自发现)

11 | - [4.3 软总线组网关键技术-异构网络组网](#43-软总线组网关键技术-异构网络组网)

12 | - [4.4 软总线之传输](#44-软总线之传输)

13 | - [5 畅享未来,鸿蒙系统使能智慧生活](#5-畅享未来鸿蒙系统使能智慧生活)

14 | - [公众号](#公众号)

15 |

16 |

17 |

18 | # 1 没有人能够熄灭满天星光

19 |

20 | 华为开发者大会2020在广东东莞松山湖欧洲小镇举办,在主题演讲环节中,华为消费者业务总裁余承东宣布“鸿蒙”系统升级到2.0版本(HarmonyOS 2.0),余总表示,“鸿蒙”系统将在12月份推出手机版本,明年华为的手机将全面支持“鸿蒙”系统。

21 |

22 | “没有人能够熄灭满天星光,每一位开发者,都是华为要汇聚的星星之火”,华为消费者业务CEO余承东说,华为将全面开放核心技术、软硬件能力,与开发者们共同驱动全场景智慧生态的蓬勃发展。

23 |

24 |

155 |

156 | (1)第一次投票,每台机器都会将票投给自己。

157 |

158 | (2)接着每台机器都会将自己的投票发给其他机器,如果发现其他机器的zxid比自己大,那么就需要改投票重新投一次。比如server1 收到了三张票,发现server2的xzid为102,pk一下发现自己输了,后面果断改投票选server2为老大。

159 |

160 | # 选举机制中涉及到的核心概念

161 |

162 | 敲黑板了,这些概念是面试必考的。

163 |

164 | **(1)Server id(或sid):服务器ID**

165 |

166 | 比如有三台服务器,编号分别是1,2,3。编号越大在选择算法中的权重越大,比如初始化启动时就是根据服务器ID进行比较。

167 |

168 | **(2)Zxid:事务ID**

169 |

170 | 服务器中存放的数据的事务ID,值越大说明数据越新,在选举算法中数据越新权重越大。

171 |

172 | **(3)Epoch:逻辑时钟**

173 |

174 | 也叫投票的次数,同一轮投票过程中的逻辑时钟值是相同的,每投完一次票这个数据就会增加。

175 |

176 | **(4)Server状态:选举状态**

177 |

178 | `LOOKING`,竞选状态。

179 |

180 | `FOLLOWING`,随从状态,同步leader状态,参与投票。

181 |

182 | `OBSERVING`,观察状态,同步leader状态,不参与投票。

183 |

184 | `LEADING`,领导者状态。

185 |

186 | # 总结

187 |

188 | (1)Zookeeper 选举会发生在服务器初始状态和运行状态下。

189 |

190 | (2)初始状态下会根据服务器sid的编号对比,编号越大权值越大,投票过半数即可选出Leader。

191 |

192 | (3)Leader 故障会触发新一轮选举,`zxid` 代表数据越新,权值也就越大。

193 |

194 | > 没有什么比每天有成长进步更高兴的事情

195 |

--------------------------------------------------------------------------------

/docs/it-hot/鸿蒙OS尖刀武器之分布式软总线技术.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s/AM3C5z1QulG0wEKBFCyH6g)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [1 没有人能够熄灭满天星光](#1-没有人能够熄灭满天星光)

6 | - [2 必须得补的传统总线知识](#2-必须得补的传统总线知识)

7 | - [3 什么是分布式软总线?](#3-什么是分布式软总线)

8 | - [4 分布式软总线功能和原理](#4-分布式软总线功能和原理)

9 | - [4.1 分布式软总线的架构](#41-分布式软总线的架构)

10 | - [4.2 软总线之发现连接:从手动发现,进化成自发现](#42-软总线之发现连接:从手动发现进化成自发现)

11 | - [4.3 软总线组网关键技术-异构网络组网](#43-软总线组网关键技术-异构网络组网)

12 | - [4.4 软总线之传输](#44-软总线之传输)

13 | - [5 畅享未来,鸿蒙系统使能智慧生活](#5-畅享未来鸿蒙系统使能智慧生活)

14 | - [公众号](#公众号)

15 |

16 |

17 |

18 | # 1 没有人能够熄灭满天星光

19 |

20 | 华为开发者大会2020在广东东莞松山湖欧洲小镇举办,在主题演讲环节中,华为消费者业务总裁余承东宣布“鸿蒙”系统升级到2.0版本(HarmonyOS 2.0),余总表示,“鸿蒙”系统将在12月份推出手机版本,明年华为的手机将全面支持“鸿蒙”系统。

21 |

22 | “没有人能够熄灭满天星光,每一位开发者,都是华为要汇聚的星星之火”,华为消费者业务CEO余承东说,华为将全面开放核心技术、软硬件能力,与开发者们共同驱动全场景智慧生态的蓬勃发展。

23 |

24 |

25 |

26 |

27 | 在这场发布会上也详细讲解了分布式软总线的概念,下面我们来看一下分布式软总线是不是真的硬核,会给我们以后的生活带来什么影响?

28 |

29 | # 2 必须得补的传统总线知识

30 |

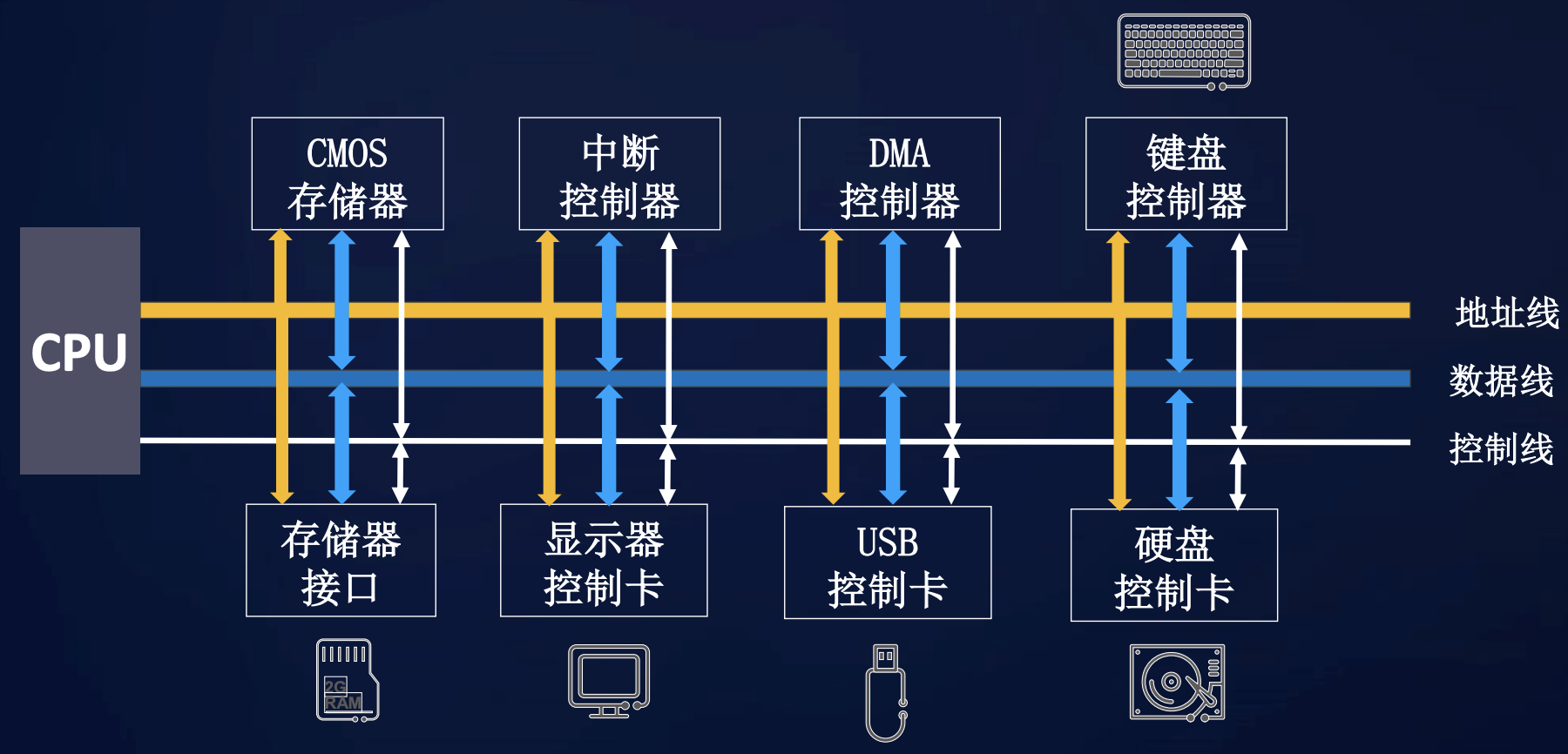

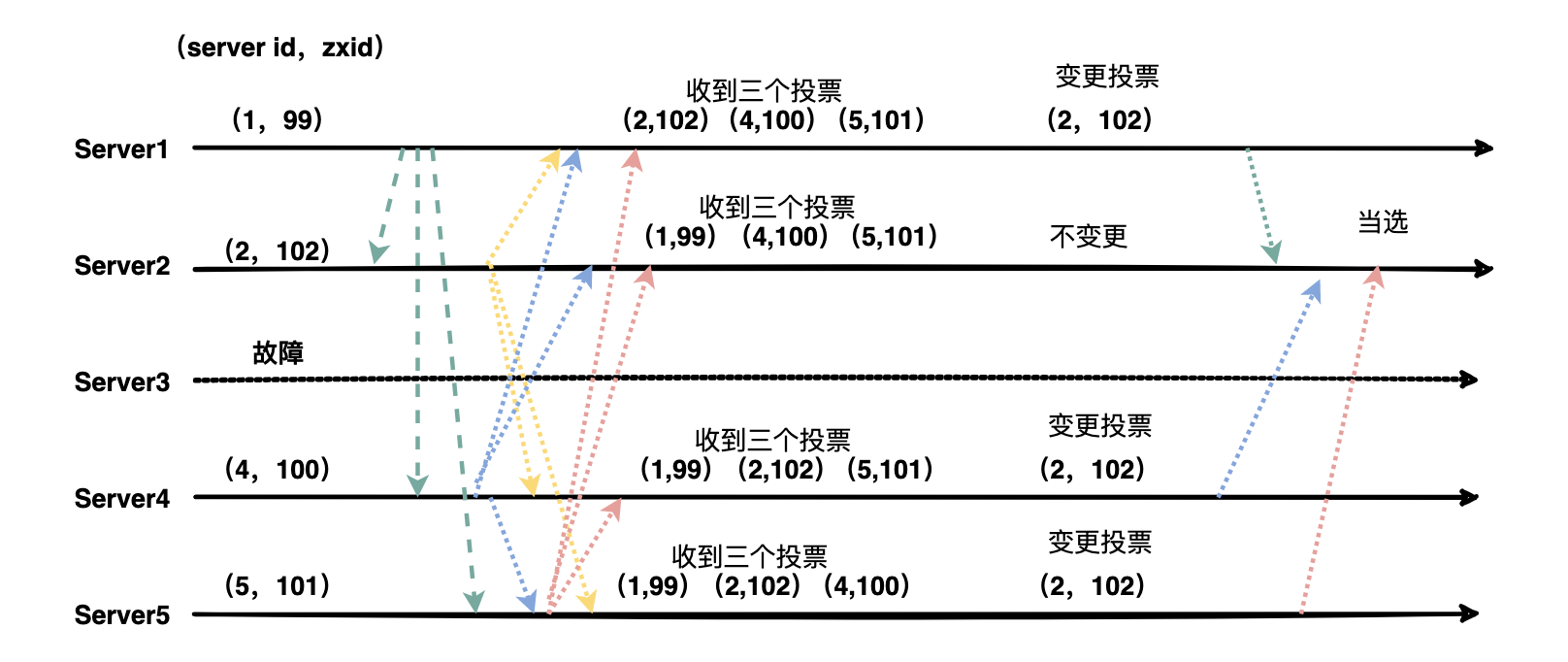

31 | 总线英文名叫Bus,你猜的没错也是公共汽车的意思。总线是一个非常广泛的概念,在传统计算机硬件体系中应用的非常广泛。

32 |

33 | 总线是一种内部结构,它是cpu、内存、输入、输出设备传递信息的公用通道,主机的各个部件通过总线相连接,外部设备通过相应的接口电路再与总线相连接,从而形成了计算机硬件系统。

34 |

35 |

36 |

37 | 在计算机系统中,各个部件之间传送信息的公共通路叫总线,微型计算机是以总线结构来连接各个功能部件的。按照计算机所传输的信息种类,计算机的总线可以划分为数据总线、地址总线和控制总线,分别用来传输数据、数据地址和控制信号。

38 |

39 | 传统总线的典型特征:

40 |

41 | * 即插即用

42 | * 高带宽

43 | * 低时延

44 | * 高可靠

45 | * 标准

46 |

47 |

48 |

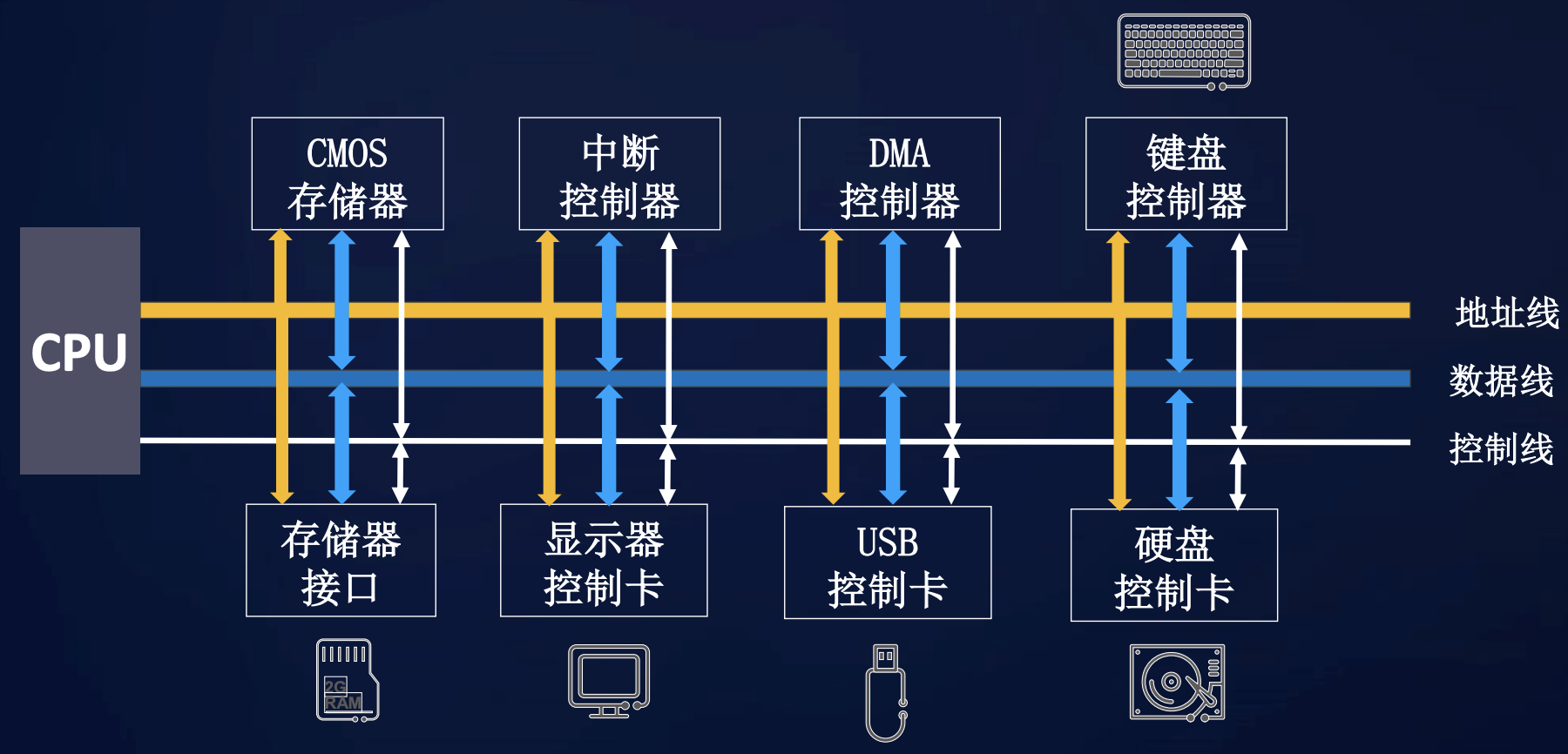

49 | # 3 什么是分布式软总线?

50 |

51 | 分布式软总线技术是基于华为多年的通信技术积累,参考计算机硬件总线,在1+8+N设备间搭建一条“无形”的总线,具备自发现、自组网、高带宽低时延的特点。

52 |

53 | >简单解释一下什么是1+8+N:

54 | >1指的是手机

55 | >8代表车机、音箱、耳机、手表/手环、平板、大屏、PC、AR/VR

56 | >N泛指其他IOT设备

57 |

58 |

59 |

60 | HarmonyOS分布式软总线

61 |

62 | 全场景设备间可以基于软总线完成设备虚拟化、跨设备服务调用、多屏协同、文件分享等分布式业务。

63 |

64 | 分布式软总线的典型特征:

65 |

66 | * 自动发现/即连即用

67 | * 高带宽

68 | * 低时延

69 | * 高可靠

70 | * 开放/标准

71 | # 4 分布式软总线功能和原理

72 |

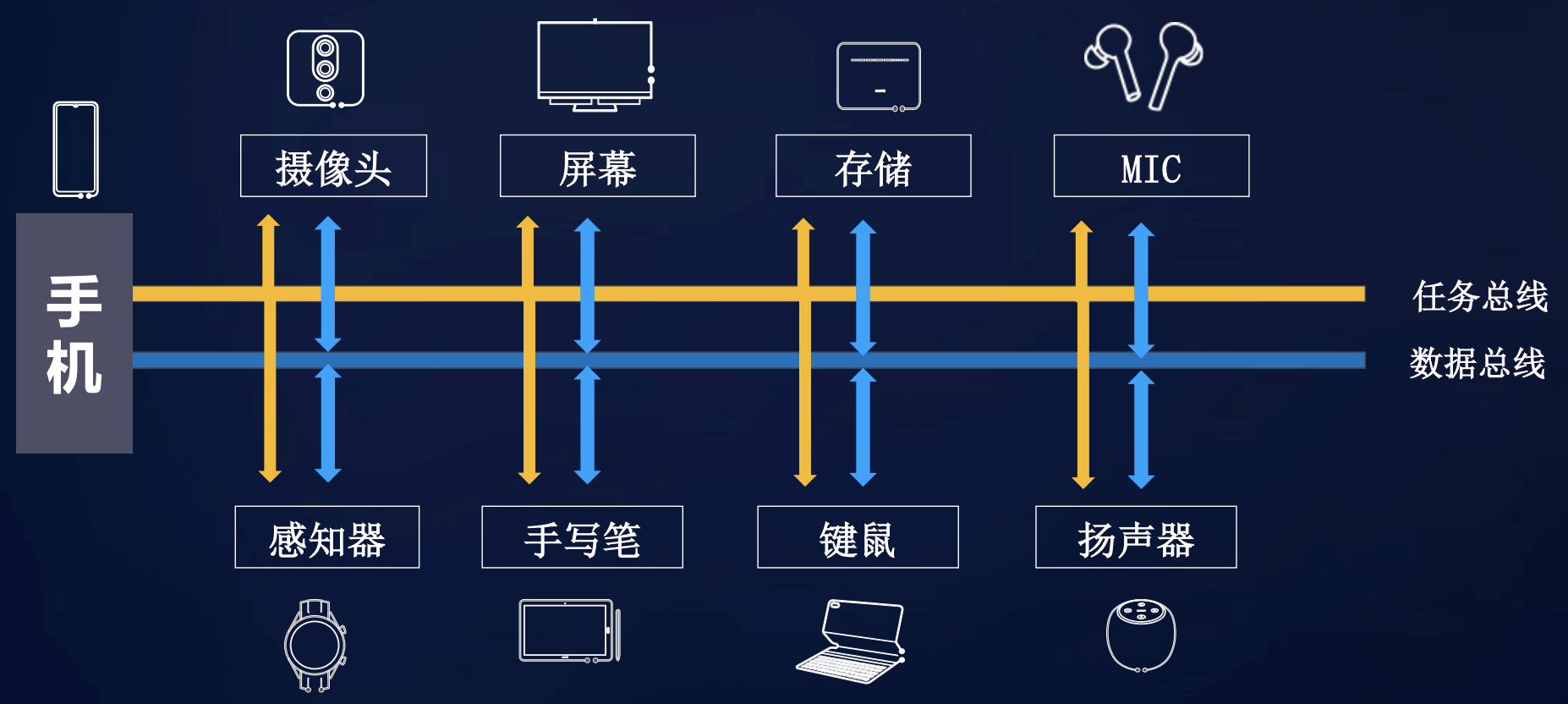

73 | ## 4.1 分布式软总线的架构

74 |

75 |

76 |

77 | 通过协议货架和软硬协同层屏蔽各种设备的协议差别,总线中枢模块负责解析命令完成设备间发现和连接,通过任务和数据两条总线实现设备间文件传输、消息传输等功能。

78 |

79 | 分布式总线的总体目标是实现设备间无感发现,零等待传输。实现这个目标需要解决三个问题:

80 |

81 | (1)设备间如何发现和连接?

82 |

83 | (2)多设备互联后如何组网?

84 |

85 | (3)多设备多协议间如何实现传输?

86 |

87 | 下面带着这三个问题我们一探究竟。

88 |

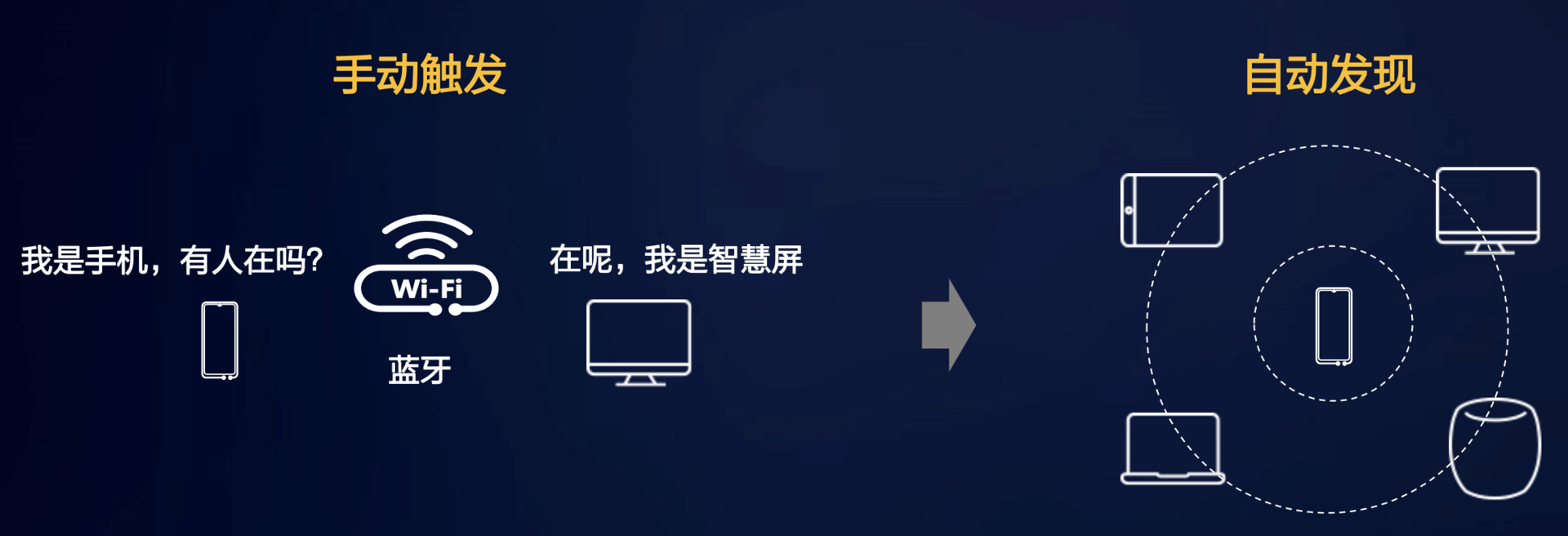

89 | ## 4.2 软总线之发现连接:从手动发现,进化成自发现

90 |

91 | 传统的设备发现是手动的,需要人干预,以生活中常见的一个例子讲解:

92 |

93 | 比如手机上有很多照片需要传到个人PC上,我们可以采用蓝牙传输,首先要打开手机和PC的蓝牙发现功能,手机或者PC点击搜索设备,然后互相配对授权即可连接上,成功连上后就可以肆无忌惮的发送照片啦。

94 |

95 | 在分享照片这个场景中有很多人为的动作:开启蓝牙发现功能、搜索设备、配对授权,这确实有点麻烦,耗费了很多时间,可能会降低分享的意愿。

96 |

97 |

98 |

99 | 软总线提出了自动发现的概念,实现用户零等待的自发现体验,附近同账号的设备自动发现无需等待。

100 |

101 | ## 4.3 软总线组网关键技术-异构网络组网

102 |

103 | 上面的例子中手机传照片是通过蓝牙,假如PC没有蓝牙功能只有WIFI,在传统的场景中这种可能就不能实现分享传输了。

104 |

105 |

106 |

107 | 软总线能否做到手机通过蓝牙传输,PC通过WIFI接收照片呢?

108 |

109 | 答案是:当然可以。软总线提出了异构网络组网可以很好解决设备间不同协议如何交互的问题。

110 |

111 |

112 |

113 | 设备上线后会向网络层注册,同时网络层会与设备建立通道连接,实时检测设备的变换。网络层负责管理设备的上线下线变换,设备间可以监听自己感兴趣的设备,设备上线后可以立即与其建立连接,实现零等待体验。

114 |

115 | 软总线可以自动构建一个逻辑全连接网络,用户或者业务开发者无需关心组网方式与物理协议。

116 |

117 | 对于软件开发者来说软总线异构组网可以大大降低其开发成本。

118 |

119 | 传统开发模式:

120 |

121 | 在传统开发模式中开发者需要适配不同网络协议和标准规范。

122 |

123 | 分布式开发模式:

124 |

125 | 在HarmonyOS分布式开发模式中开发不再需要关心网络协议差异,业务开发与设备组网解耦,业务仅需监听设备上下线,开发成本大大降低。

126 |

127 | ## 4.4 软总线之传输

128 |

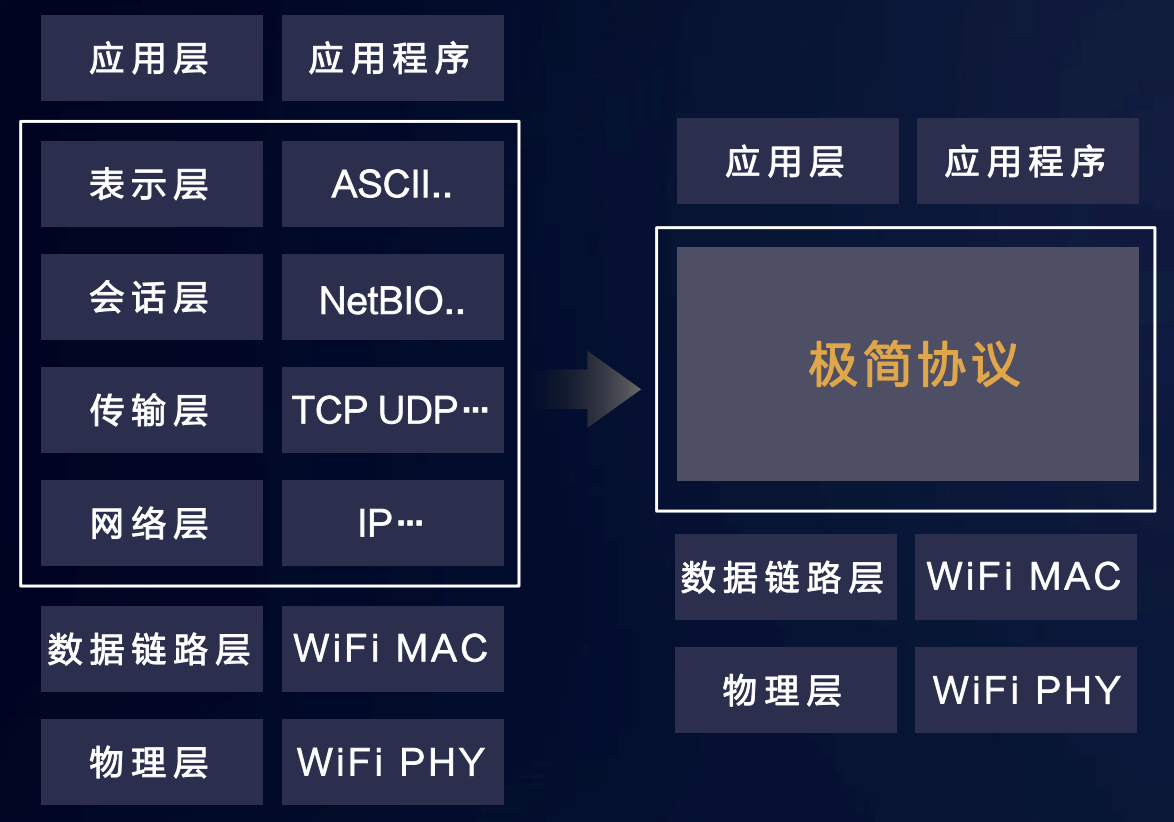

129 | 传统协议的传输速率差异非常大,时延也难以得到保证。

130 |

131 | 软总线传输要实现的目标:

132 |

133 | 高带宽(High Speed)

134 |

135 | 低时延(Low Latency)

136 |

137 | 高可靠(High Reliability)

138 |

139 | 软总线要实现的这三大目标的尖刀武器是:极简协议。

140 |

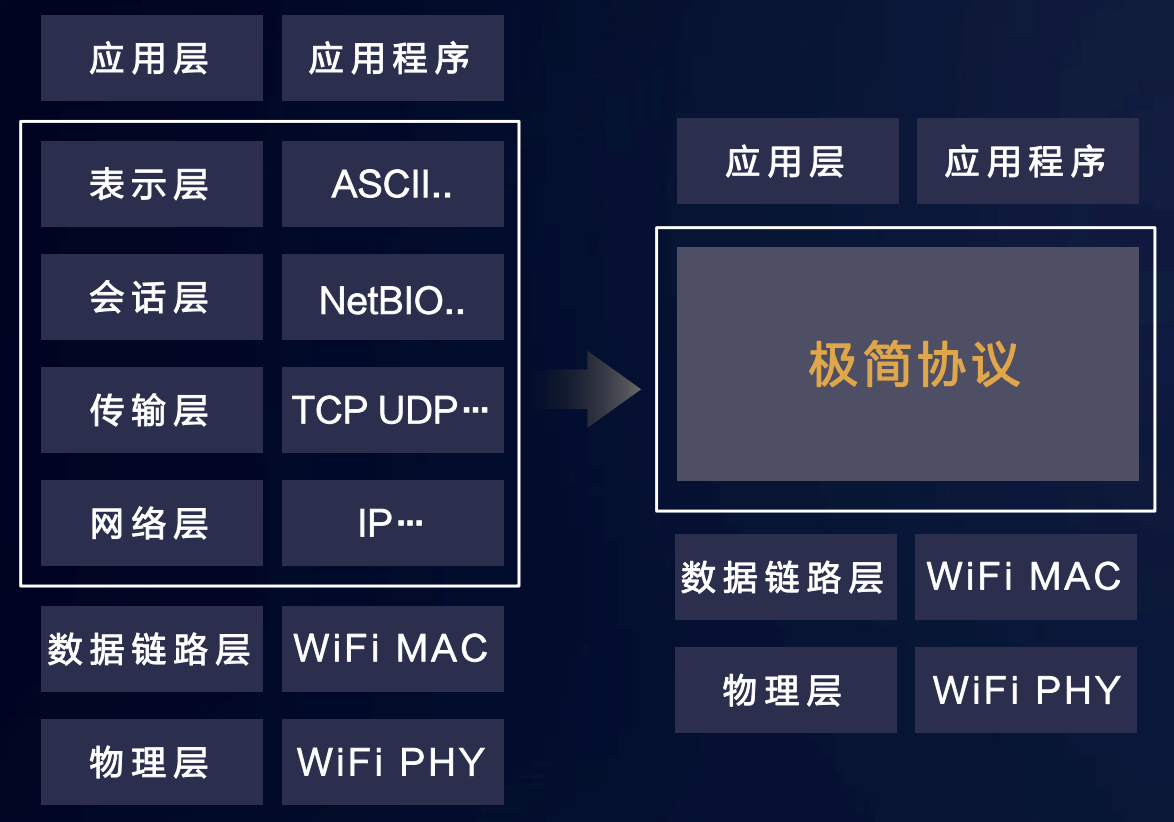

141 |

142 |

143 | 将中间的四层协议栈精简为一层提升有效载荷,有效传输带宽提升20%

144 |

145 | 极简协议在传统网络协议的基础上进行增强:

146 |

147 | * 流式传输:基于UDP实现数据的保序和可靠传输;

148 | * 双轮驱动:颠覆传统TCP每包确认机制;

149 | * 不惧网损:摒弃传统滑动窗口机制,丢包快速恢复,避免阻塞;

150 | * 不惧抖动:智能感知网络变化,自适应流量控制和拥塞控制;

151 | # 5 畅享未来,鸿蒙系统使能智慧生活

152 |

153 | 鸿蒙系统的使命和目标是将不同设备的串联起来,成为设备的“万能语言”,实现万物互联的终极目标。

154 |

155 | **变化一:软件开发从业者的福音**

156 |

157 | 以前开发一款APP不仅需要为手机、手表、平板、电视等不同终端专门设计APP版本,而且还要为同类终端的不同品牌(华为、小米、OV)设计不同的APP版本。

158 |

159 | 而有了鸿蒙分布式系统架构,只需要开发一个版本,鸿蒙可以帮你“翻译”成不同终端的对应版本,真正实现一次开发就能在不同的终端上运行。

160 |

161 |

162 |

163 | 看到这估计很多程序员们会仰天长叹:终于可以早点下班了!

164 |

165 | **变换二:可以活得更懒**

166 |

167 | 鸿蒙系统分布式架构能让你在使用某个APP软件的时候,比如看视频,可以把屏幕随意切换到电视、电脑、手机、平板、投影仪等任何一个设备的界面上。

168 |

169 | 你也不必满桌子找各种遥控器了,一个手表一个手机就可以控制家里的空调、电饭煲、汽车空调、音响、电视、电脑、门口的摄像头以及所有能联网的所有东西。

170 |

171 |

172 |

173 | 这就是鸿蒙所构想的“万物互联”,让一个系统连接起所有上网的智能设备。大家期待吗,让我们拭目以待吧。

174 |

175 | # 公众号

176 |

177 | 公众号比Github早一到两天更新,如果大家想要实时关注我更新的文章以及分享的干货,可以关注我的公众号。

178 |

179 |

--------------------------------------------------------------------------------

/docs/java/annotation/想自己写框架不会写Java注解可不行.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s/JqrJGwyU0oKdWYtHe_W31w)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [用注解一时爽,一直用一直爽](#用注解一时爽一直用一直爽)

6 | - [原来注解不神秘](#原来注解不神秘)

7 | - [造火箭啦,自己动手写一个注解](#造火箭啦自己动手写一个注解)

8 | - [第一步定义一个注解](#第一步定义一个注解)

9 | - [第二步实现注解的业务逻辑](#第二步实现注解的业务逻辑)

10 | - [第三步在业务代码中尽情的使用注解](#第三步在业务代码中尽情的使用注解)

11 | - [公众号](#公众号)

12 |

13 |

14 |

15 |

16 |

17 |

18 | # 用注解一时爽,一直用一直爽

19 |

20 | Java后端开发进入spring全家桶时代后,开发一个微服务提供简单的增删改查接口跟玩泥巴似的非常简单,一顿操作猛如虎,回头一看代码加了一堆注解:@Controller @Autowired @Value,面向注解编程变成了大家不可缺少的操作。

21 |

22 | 想象一下如果没有注解Java程序员可以要哭瞎😭

23 |

24 | 既然注解(annotation)这么重要,用的这么爽,那注解的实现原理你知道么?我猜你只会用注解不会自己写注解(手动滑稽)。

25 |

26 | 好了,下面的内容带大家从零开始写一个注解,揭开注解神秘的面纱。

27 |

28 | # 原来注解不神秘

29 |

30 | 注解用大白话来说就是一个标记或者说是特殊的注释,如果没有解析这些标记的操作那它啥也不是。

31 |

32 | 注解的格式如同类或者方法一样有自己特殊的语法,这个语法下文会详细介绍。

33 |

34 | 那如何去解析注解呢?这就要用到Java强大的反射功能了。反射大家应该都用过,可以通过类对象获取到这个类的各种信息比如成员变量、方法等,那注解标记能不能通过反射获取呢?当然可以了。

35 |

36 | 所以注解的原理其实很简单,本质上是通过反射功能动态获取注解标记,然后按照不同的注解执行不同的操作,比如@Autowired可以注入一个对象给变量赋值。

37 |

38 | 看到这里是不是很躁动啊,来吧自己也撸一个注解。

39 |

40 | # 造火箭啦,自己动手写一个注解

41 |

42 | 便于大家理解,这里先引入一个场景:在线教育火了,经理让我写一个模块实现学生信息管理功能,考虑到分布式并发问题,经理让我务必加上分布式锁。

43 |

44 | 经理问我几天能搞定?我说至少3天。如是脑补了以下代码:

45 |

46 | ```java

47 | /**

48 | * 更新学生信息

49 | * @param student 学生对象

50 | * @return true 更新成功,false 更新失败

51 | */

52 | public boolean updateStudentInfo(Student student) {

53 | // 尝试获取分布式锁

54 | String lockKey = "student:" + student.getId();

55 | if (RedisTool.tryLock(lockKey, 10,

56 | TimeUnit.SECONDS, 5)) {

57 | try {

58 | // 这里写业务逻辑

59 | } finally {

60 | RedisTool.releaseLock(lockKey);

61 | }

62 | }

63 | // 获取锁失败

64 | return false;

65 | }

66 | ```

67 |

68 | 经理走后我在思考,我能不能只花一天时间写完,剩下两天时间用来写博客划水呢?突然灵感来了,我可以把重复的代码逻辑抽出来用注解实现不就节省代码了,哈哈,赶紧写。

69 |

70 | 使用注解之后整个方法清爽了很多,HR小姐姐都夸我写的好呢。

71 | ```java

72 | @EnableRedisLock(lockKey = "student", expireTime = 10, timeUnit = TimeUnit.SECONDS, retryTimes = 5)

73 | public boolean updateStudentInfo(Student student) {

74 | // 这里写业务逻辑

75 | // studentDao.update(student);

76 | return true;

77 | }

78 | ```

79 |

80 | 代码已经写完上库了,现在我在划水写博客呢。是不是很简洁很优雅很牛逼,怎么做到的呢,主要分为三步:1打开冰箱门,2把大象放进去,3把冰箱门关好。好了,扯远了,大家接着往下看。

81 |

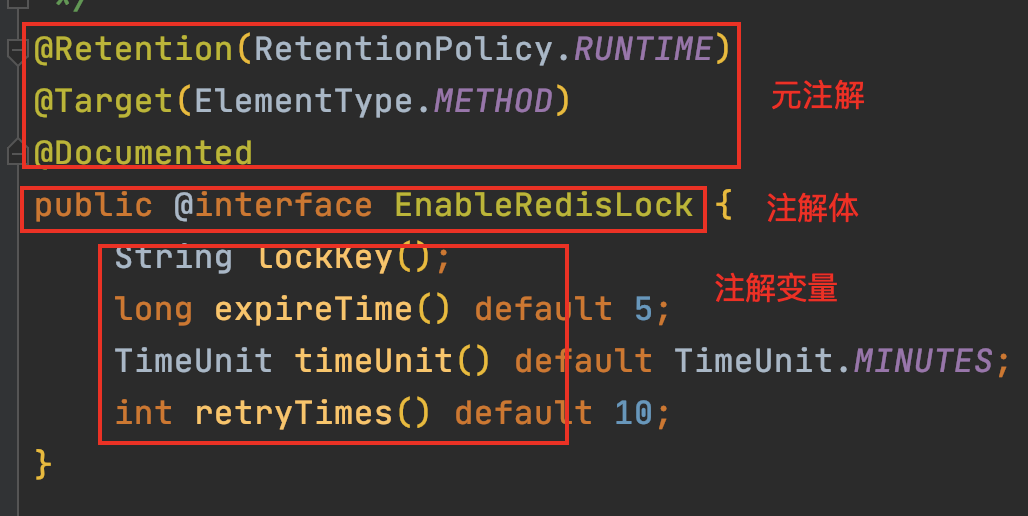

82 | ## 第一步定义一个注解

83 |

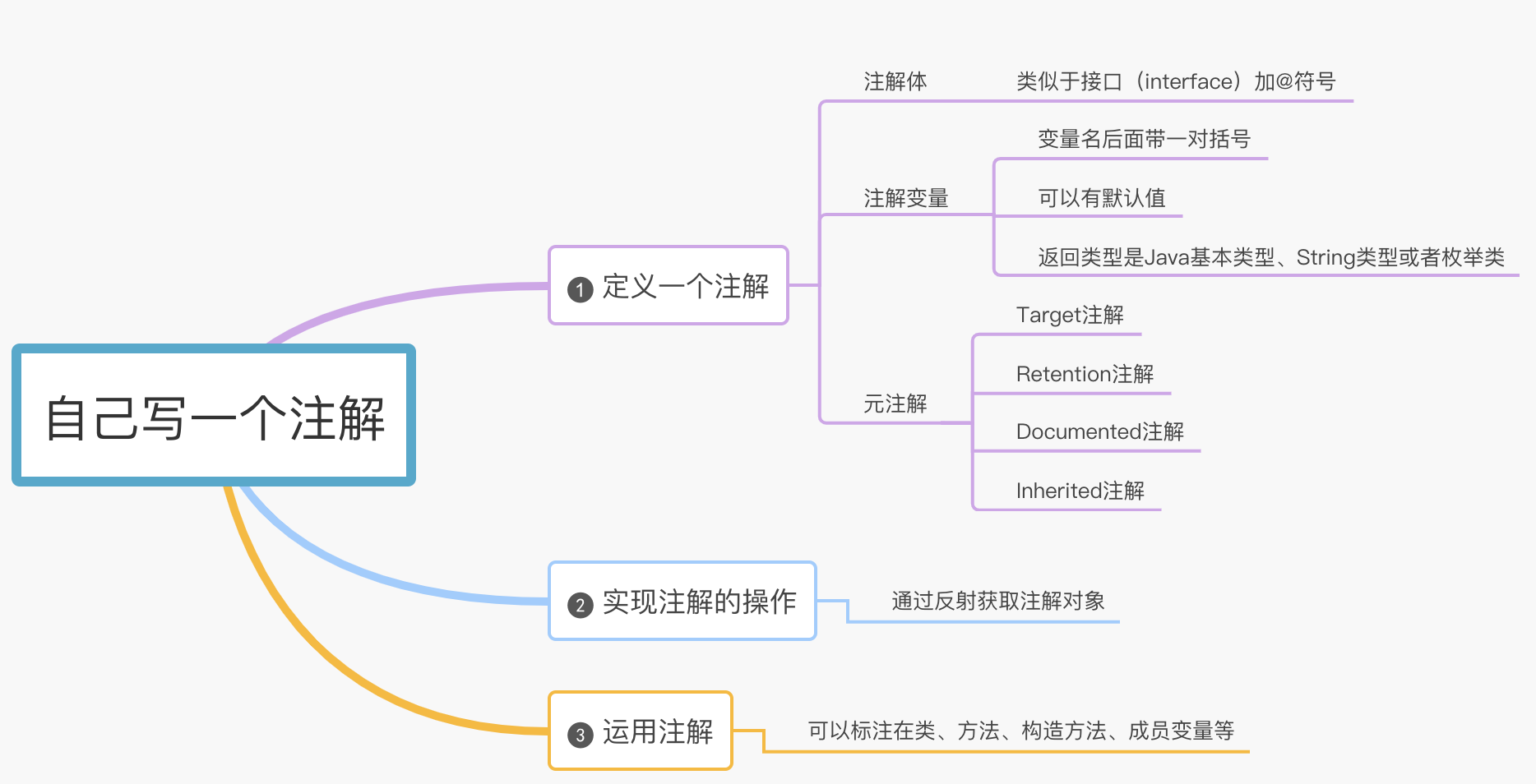

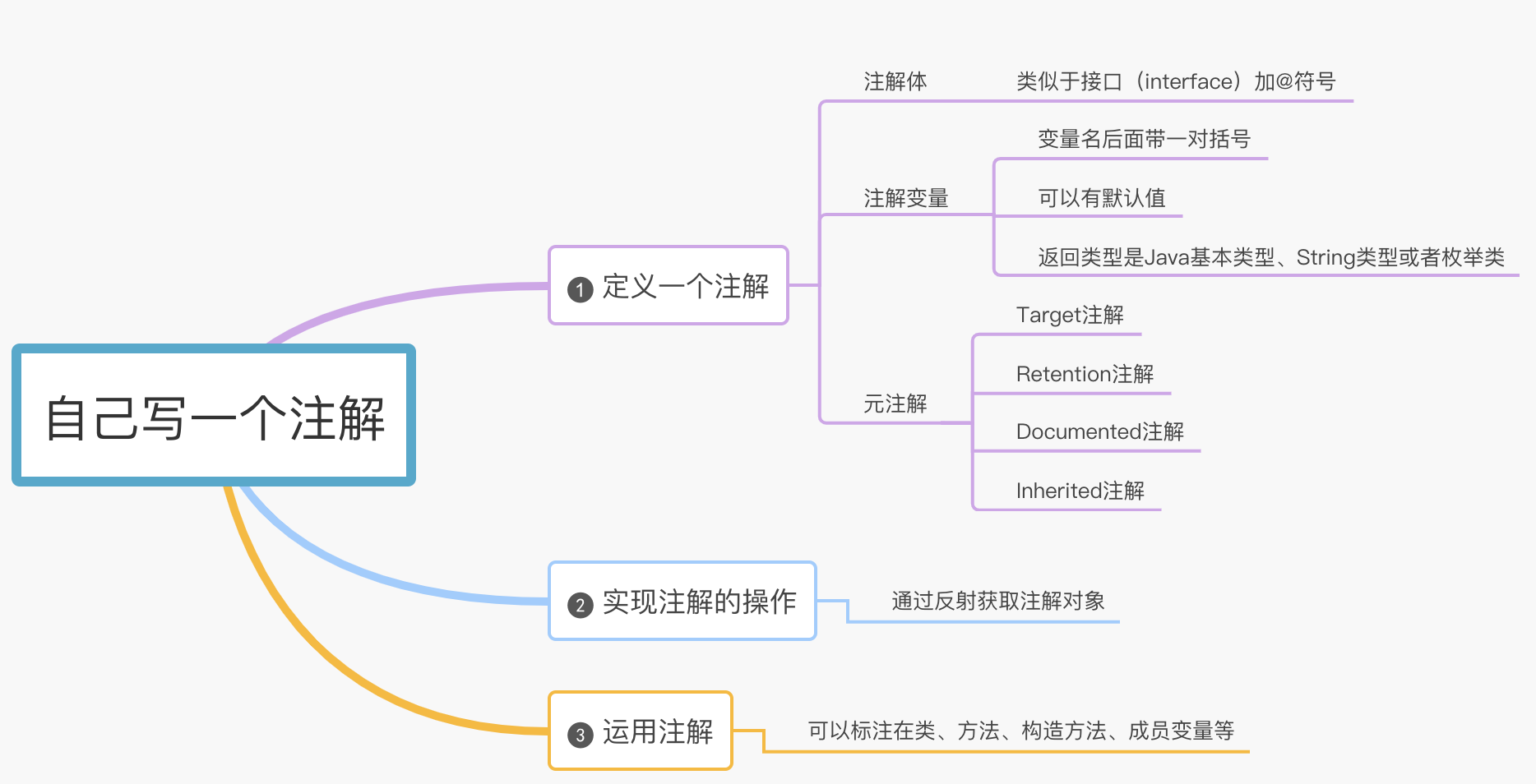

84 |

85 |

86 | 一个注解可以简单拆解为三个部分:

87 |

88 | 第一部分:注解体

89 |

90 | 注解的定义有点类似于接口(interface),只不过前面一个加了一个@符号,这个千万不能省。

91 |

92 | 第二部分:注解变量

93 |

94 | 注解变量的语法有点类似于接口里面定义的方法,变量名后面带一对括号,不同的是注解变量后面可以有默认值。另外返回值只能是Java基本类型、String类型或者枚举类,不可以是对象类型。

95 |

96 | 第三部分:元注解

97 |

98 | 元注解(meta-annotation)说白了就是给注解加注解的注解,是不是有点晕了,这种注解是JDK提前内置好的,可以直接拿来用的。不太懂也没有关系反正数量也不多,总共就4个,我们背下来吧:@Target @Retention @Documented @Inherited

99 |

100 | * Target注解

101 |

102 | 用来描述注解的使用范围,即被修饰的注解可以用在什么地方 。

103 |

104 | 注解可以用于修饰 packages、types(类、接口、枚举、注解类)、类成员(方法、构造方法、成员变量、枚举值)、方法参数和本地变量(如循环变量、catch参数),在定义注解类时使用了@Target 能够更加清晰的知道它能够被用来修饰哪些对象,具体的取值范围定义在ElementType.java 枚举类中。

105 |

106 | 比如上面我们写的Redis锁的注解就只能用于方法上了。

107 |

108 | * Retention注解

109 |

110 | 用来描述注解保留的时间范围,即注解的生命周期。在 RetentionPolicy 枚举类中定义了三个周期:

111 |

112 | ```java

113 | public enum RetentionPolicy {

114 | SOURCE, // 源文件保留

115 | CLASS, // 编译期保留,默认值

116 | RUNTIME // 运行期保留,可通过反射去获取注解信息

117 | }

118 | ```

119 | 像我们熟知的@Override注解就只能保留在源文件中,代码编译后注解就消失了。

120 | 比如上面我们写的Redis锁的注解就保留到了运行期,运行的时候可以通过反射获取信息。

121 |

122 | * Documented注解

123 |

124 | 用来描述在使用 javadoc 工具为类生成帮助文档时是否要保留其注解信息,很简单不多解释了。

125 |

126 | * Inherited注解

127 |

128 | 被Inherited注解修饰的注解具有继承性,如果父类使用了被@Inherited修饰的注解,则其子类将自动继承该注解。

129 |

130 | 好了,这一步我们已经将注解定义好了,但是这个注解如何工作呢?接着看。

131 |

132 | ## 第二步实现注解的业务逻辑

133 |

134 | 在第一步中我们发现定义的注解(@EnableRedisLock)中没有业务逻辑,只有一些变量,别忘了我们的注解是要使能Redis分布式锁的功能,那这个注解到底是怎么实现加锁和释放锁的功能呢?这个就需要我们借助反射的强大功能了。

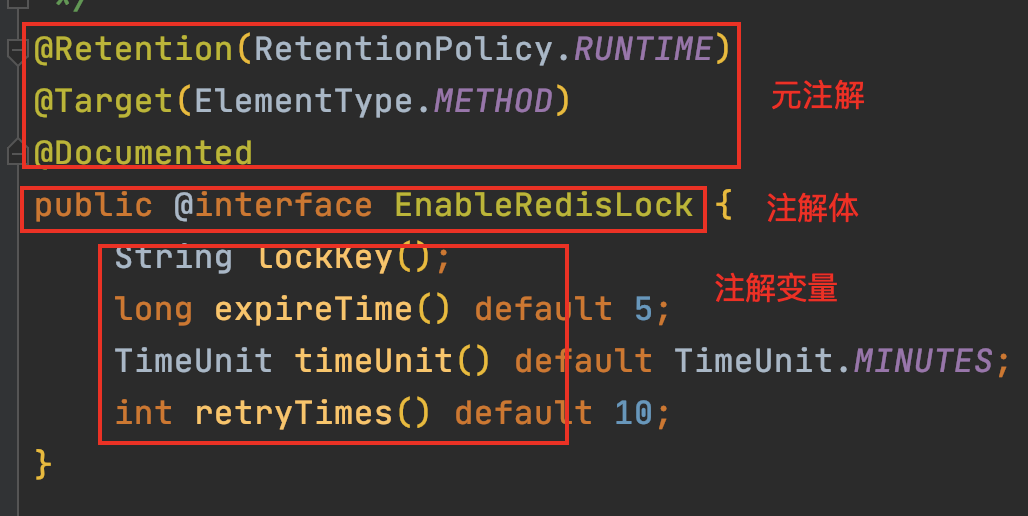

135 | ```java

136 | @Aspect

137 | public class RedisLockAspect {

138 | @Around(value = "@annotation(com.smilelioncoder.EnableRedisLock)")

139 | public void handleRedisLock(ProceedingJoinPoint joinPoint)

140 | throws Throwable {

141 | // 通过反射获取到注解对象,可见反射非常重要的

142 | EnableRedisLock redisLock = ((MethodSignature) joinPoint.getSignature())

143 | .getMethod()

144 | .getAnnotation(EnableRedisLock.class);

145 |

146 | // 获取注解对象的变量值

147 | String lockKey = redisLock.lockKey();

148 | long expireTime = redisLock.expireTime();

149 | TimeUnit timeUnit = redisLock.timeUnit();

150 | int retryTimes = redisLock.retryTimes();

151 |

152 | // 获取锁

153 | if (tryLock(lockKey, expireTime, timeUnit, retryTimes)) {

154 | try {

155 | // 获取锁成功继续执行业务逻辑

156 | joinPoint.proceed();

157 | } finally {

158 | releseLock();

159 | }

160 | }

161 | }

162 | }

163 | ```

164 |

165 | 这里借助了切面的功能,将EnableRedisLock注解作为一个切点,只要方法上标注了这个注解就会自动执行这里的代码逻辑。

166 |

167 | 通过反射机制拿到注解对象后就可以执行加锁解锁的常用逻辑啦。Redis实现分布式锁相信大家已经很熟悉了,这里就不在啰嗦了。

168 |

169 | ## 第三步在业务代码中尽情的使用注解

170 |

171 | ```java

172 | @EnableRedisLock(lockKey = "student", expireTime = 10, timeUnit = TimeUnit.SECONDS, retryTimes = 5)

173 | public void method1(Student student) {

174 | // 这里写业务逻辑

175 | }

176 | ```

177 | 在需要加锁的方法上直接加上注解就可以啦,怎么样是不是很简单呀,赶紧在你的项目中运用起来吧。

178 | 好了,自己写一个注解的内容就介绍到这里了,学会了吗?

179 |

180 | # 公众号

181 | 公众号比Github早一到两天更新,如果大家想要实时关注我更新的文章以及分享的干货,可以关注我的公众号。

182 |

183 |

184 |

--------------------------------------------------------------------------------

/docs/java/java8/Java8函数式接口和Lambda表达式你真的会了吗.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321342&idx=1&sn=2d87b7fe6709a8513eb0abf58b48521d&chksm=8f09cfa4b87e46b29378661f72c832ec5bef782c362eba8cee25527a455c12239e067a80bed9&token=997683041&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 |

6 | - [1. Lambda表达式小试牛刀](#1-lambda表达式小试牛刀)

7 | - [2. Lambda高阶用法](#2-lambda高阶用法)

8 | - [(1)函数式接口](#1函数式接口)

9 | - [(2)函数式接口可以干什么?](#2函数式接口可以干什么)

10 | - [(3)函数描述符](#3函数描述符)

11 | - [(4)常用函数式接口](#4常用函数式接口)

12 | - [(5)将lambda表达式重构为方法引用](#5将lambda表达式重构为方法引用)

13 | - [公众号](#公众号)

14 |

15 |

16 |

17 | >Java8 由Oracle在2014年发布,是继Java5之后最具革命性的版本了。

18 | >Java8吸收其他语言的精髓带来了函数式编程,lambda表达式,Stream流等一系列新特性,学会了这些新特性,可以让你实现高效编码优雅编码。

19 | # 1. Lambda表达式小试牛刀

20 |

21 | Lambada表达式可以理解为:可传递的匿名函数的一种简洁表达方式。Lambda表达式没有名称,同普通方法一样有参数列表、函数主体、返回类型等;

22 |

23 | 下面简单看一个例子,new一个线程打印字符串,采用lambda表达式非常简洁:

24 |

25 | ```java

26 | new Thread(() -> System.out.println("hello java8 lambda")).start()

27 | ```

28 |

29 |

30 | Thread类接受一个Runnable类型实例,查看Jdk源码发现Runnable接口是一个函数式接口,可以直接用lambda表达式替代。

31 |

32 | ```java

33 | @FunctionalInterface

34 | public interface Runnable {

35 | public abstract void run();

36 | }

37 | ```

38 |

39 |

40 | Lambda表达式语法非常简单:

41 |

42 | ```java

43 | () -> System.out.println("hello java8 lambda")

44 | ```

45 |

46 |

47 | * ()括号里面是参数列表,如果只有一个参数还可以写为: a -> System.out.println(a)

48 | * -> 箭头为固定写法;

49 | * System.out.println("hello java8 lambda") 为函数主体,如果有多条语句要用花括号包裹起来, 比如下面这样:

50 | ```java

51 | (a, b) -> {int sum = a + b; return sum;}

52 | ```

53 |

54 |

55 | 综上,Lambda表达式模块可以固化为:

56 |

57 | ```java

58 | (parameter) -> {expression} 或者 (parameter) -> {statements; statements; }

59 | ```

60 |

61 |

62 | 参数只有一个可以省略括号

63 |

64 | 如果不用Lambda表达式,使用匿名内部类的方式,写法就不是那么优雅了。

65 |

66 | ```java

67 | // before Java8

68 | new Thread(new Runnable() {

69 | @Override

70 | public void run() {

71 | System.out.println("hello java8 without lambda");

72 | }

73 | }).start();

74 | ```

75 |

76 |

77 | # 2. Lambda高阶用法

78 |

79 | ## (1)函数式接口

80 |

81 | 函数式接口是只定义了一个抽象方法的接口。注意Java8中允许存在默认方法(default),哪怕有很多默认方法,只要有且仅有一个抽象方法,那么这个接口仍然是函数式接口。

82 |

83 | 函数式接口通常在类上有一个注解@FunctionalInterface,如:

84 |

85 | ```java

86 | @FunctionalInterface

87 | public interface Runnable {

88 | public abstract void run();

89 | }

90 | ```

91 |

92 |

93 | ## (2)函数式接口可以干什么?

94 |

95 | 通常lambda表达式与函数式接口结合一起用,lambda表达式以内联的形式为函数式接口的抽象方法提供实现,把整个表达式作为函数式接口的实例。在没有lambda表达式之前,我们通常会使用匿名内部类的方式实现,详细对比见第一小节的实例代码。

96 |

97 | ## (3)函数描述符

98 |

99 | 函数式接口抽象方法的签名基本上就是lambda表达式的签名,我们可以将这种对应关系称为函数描述符。由一个函数式接口的抽象方法抽象为一个函数描述符,这个过程非常重要,知道了函数描述符去写lambda表达式也就非常容易了。举个例子:

100 |

101 | Runnable接口有一个抽象方法 void run(), 接受空参数返回void,那么函数描述符可以推导为: () -> void

102 |

103 | lambda表达式可以写为 () -> System.out.println("hello java8 lambda")

104 |

105 | ## (4)常用函数式接口

106 |

107 | java8 中常用函数式接口,针对基本类型java还定义了IntPredicate, LongPredicate等类型,详细可以参考jdk源码。

108 |

109 | |函数式接口|函数描述符|

110 | |:----|:----|

111 | |Predicate|T->boolean|

112 | |Consumer|T->void|

113 | |Function|T->R|

114 | |Supplier|() -> T|

115 | |UnaryOperator|T -> T|

116 | |BinaryOperator|(T,T)->T|

117 | |BiPredicate|(L,R)->boolean|

118 | |BiConsumer|(T,U)->void|

119 | |BiFunction|(T,U)->R|

120 |

121 | 至于 Predicate, Consumer, Function这些函数式接口具体作用,在后面的文章中笔者会详细介绍,这里只需有个大体印象即可。

122 |

123 | ## (5)将lambda表达式重构为方法引用

124 |

125 | 方法引用可以看作是lambda表达式的一种快捷写法,它可以调用特性的方法作为参数传递。你也可以将方法引用看作是lambda表达式的语法糖,让lambda表达式写起来更加简介。举个栗子,按学生年龄排序:

126 |

127 | ```java

128 | // before

129 | students.sort((s1, s2) -> s1.getAge.compareTo(s2.getAge()))));

130 | // after 使用方法引用

131 | students.sort(Comparator.comparing(Student::getAge()))));

132 | ```

133 |

134 |

135 | 方法引用主要有三类:

136 |

137 | * **静态方法的方法引用**

138 |

139 | valueOf是String类的静态方法,方法引用写为 String::valueOf, 对应lambda表达式:a -> String.valueOf(a)

140 |

141 | * **任意类型实例方法的方法引用**

142 |

143 | length是String类的实例方法,方法引用写为 String::length,对应lambda表达式: (str) -> str.length()

144 |

145 | * **现有对象的实例方法的方法引用**

146 |

147 | 第三种容易与第二种混淆,现有对象指的是在lambda表达式中调用外部对象(不是入参对象)的实例方法,比如:

148 |

149 | String str = "hello java8";

150 |

151 | () -> str.length();

152 |

153 | 对应方法引用写为 str::length, 注意不是 String::length

154 |

155 | 最后我们将三类方法引用归纳如下:

156 |

157 | |lambda表达式|方法引用| |

158 | |:----|:----|:----|

159 | |(args) -> ClassName.staticMethod(args)|ClassName::staticMethod|静态方法方法引用|

160 | |(arg0, params) -> arg0.instanceMethod(params)|ClassName::instanceMethod|内部实例方法引用|

161 | |arg0

(params) -> arg0.instanceMethod(params)|arg0.instanceMethod|外部实例方法引用|

162 |

163 |

--------------------------------------------------------------------------------

/docs/java/java8/使用Java8 Optional类优雅解决空指针问题.md:

--------------------------------------------------------------------------------

1 | > 本文首发我的微信公众号『[爱笑的架构师](https://mp.weixin.qq.com/s?__biz=MzIwODI1OTk1Nw==&mid=2650321295&idx=1&sn=2fdb1d4c7e44177a7b08393114e55f16&chksm=8f09cf95b87e4683e521502b33319f957a038b5ecc095171de9d287b337411f2ffb2bf1e01d5&token=997683041&lang=zh_CN#rd)』,欢迎大家关注。

2 |

3 |

4 |

5 | - [1. 不受待见的空指针异常](#1-不受待见的空指针异常)

6 | - [2. 糟糕的代码](#2-糟糕的代码)

7 | - [3. 解决空指针的"银弹"](#3-解决空指针的银弹)

8 | - [4. Optional使用入门](#4-optional使用入门)

9 | - [5. 使用Optional重构代码](#5-使用optional重构代码)

10 | - [总结](#总结)

11 | - [公众号](#公众号)

12 |

13 |

14 |

15 | >Java8 由Oracle在2014年发布,是继Java5之后最具革命性的版本。

16 | >Java8吸收其他语言的精髓带来了函数式编程,lambda表达式,Stream流等一系列新特性,学会了这些新特性,可以让你实现高效编码优雅编码。

17 | # 1. 不受待见的空指针异常

18 |

19 | 有个小故事:null引用最早是由英国科学家Tony Hoare提出的,多年后Hoare为自己的这个想法感到后悔莫及,并认为这是"价值百万的重大失误"。可见空指针是多么不受待见。

20 |

21 | NullPointerException是Java开发中最常遇见的异常,遇到这种异常我们通常的解决方法是在调用的地方加一个if判空。

22 |

23 | if判空越多会造成过多的代码分支,后续代码维护也就越来越复杂。

24 |

25 | # 2. 糟糕的代码

26 |

27 | 比如看下面这个例子,使用过多的if判空。

28 |

29 | Person对象里定义了House对象,House对象里定义了Address对象:

30 |

31 | ```java

32 | public class Person {

33 | private String name;

34 | private int age;

35 | private House house;

36 | public House getHouse() {

37 | return house;

38 | }

39 | }

40 | class House {

41 | private long price;

42 | private Address address;

43 | public Address getAddress() {

44 | return address;

45 | }

46 | }

47 | class Address {

48 | private String country;

49 | private String city;

50 | public String getCity() {

51 | return city;

52 | }

53 | }

54 | ```

55 | 现在获取这个人买房的城市,那么通常会这样写:

56 | ```java

57 | public String getCity() {

58 | String city = new Person().getHouse().getAddress().getCity();

59 | return city;

60 | }

61 | ```

62 | 但是这样写容易出现空指针的问题,比如这个人没有房,House对象为null。接着你会改造这段代码,加上很多判断条件:

63 | ```java

64 | public String getCity2(Person person) {

65 | if (person != null) {

66 | House house = person.getHouse();

67 | if (house != null) {

68 | Address address = house.getAddress();

69 | if (address != null) {

70 | String city = address.getCity();

71 | return city;

72 | }

73 | }

74 | }

75 | return "unknown";

76 | }

77 | ```

78 | 为了避免空指针异常,每一层都加上判断,但是这样会造成代码嵌套太深,不易维护。

79 | 你可能想到如何改造上面的代码,比如加上提前判空退出:

80 |

81 | ```java

82 | public String getCity3(Person person) {

83 | String city = "unknown";

84 | if (person == null) {

85 | return city;

86 | }

87 | House house = person.getHouse();

88 | if (house == null) {

89 | return city;

90 | }

91 | Address address = house.getAddress();

92 | if (address == null) {

93 | return city;

94 | }

95 | return address.getCity();

96 | }

97 | ```

98 | 但是这样简单的代码已经加入了三个退出条件,非常不利于后面代码维护。那怎样才能将代码写的优雅一点呢,下面引入今天的主角"Optional"。

99 | # 3. 解决空指针的"银弹"

100 |

101 | 从Java8开始引入了一个新类 java.util.Optional,这是一个对象的容器,意味着可能包含或者没有包含一个非空的值。下面重点看一下Optional的常用方法:

102 |

103 | ```java

104 | public final class Optional {

105 | // 通过指定非空值创建Optional对象

106 | // 如果指定的值为null,会抛空指针异常

107 | public static Optional of(T value) {

108 | return new Optional<>(value);

109 | }

110 | // 通过指定可能为空的值创建Optional对象

111 | public static Optional ofNullable(T value) {

112 | return value == null ? empty() : of(value);

113 | }

114 | // 返回值,不存在抛异常

115 | public T get() {

116 | if (value == null) {

117 | throw new NoSuchElementException("No value present");

118 | }

119 | return value;

120 | }

121 | // 如果值存在,根据consumer实现类消费该值

122 | public void ifPresent(Consumer consumer) {

123 | if (value != null)

124 | consumer.accept(value);

125 | }

126 | // 如果值存在则返回,如果值为空则返回指定的默认值

127 | public T orElse(T other) {

128 | return value != null ? value : other;

129 | }

130 | // map flatmap等方法与Stream使用方法类似,这里不再赘述,读者可以参考之前的Stream系列。

131 | }

132 | ```

133 | 以上就是Optional类常用的方法,使用起来非常简单。

134 | # 4. Optional使用入门

135 |

136 | **(1)创建Optional实例**

137 |

138 | * 创建空的Optional对象。可以通过静态工厂方法Optional.Empty() 创建一个空的对象,例如:

139 | ```java

140 | Optional optionalPerson = Optional.Empty();

141 | ```

142 | * 指定非空值创建Optional对象。

143 | ```java

144 | Person person = new Person();

145 | Optional optionalPerson = Optional.of(person);

146 | ```

147 | * 指定可能为空的值创建Optional对象。

148 | ```java

149 | Person person = null; // 可能为空

150 | Optional optionalPerson = Optional.of(person);

151 | ```

152 | **(2)常用方法**

153 | **ifPresent**

154 |

155 | 如果值存在,则调用consumer实例消费该值,否则什么都不执行。举个栗子:

156 |

157 | ```java

158 | String str = "hello java8";

159 | // output: hello java8

160 | Optional.ofNullable(str).ifPresent(System.out::println);

161 | String str2 = null;

162 | // output: nothing

163 | Optional.ofNullable(str2).ifPresent(System.out::println);

164 | ```

165 | **filter, map, flatMap**

166 | 在三个方法在前面讲Stream的时候已经详细讲解过,读者可以翻看之前写的文章,这里不再赘述。

167 |

168 | **orElse**

169 |

170 | 如果value为空,则返回默认值,举个栗子:

171 |

172 | ```java

173 | public void test(String city) {

174 | String defaultCity = Optional.ofNullable(city).orElse("unknown");

175 | }

176 | ```

177 | **orElseGet**

178 | 如果value为空,则调用Supplier实例返回一个默认值。举个例子:

179 |

180 | ```java

181 | public void test2(String city) {

182 | // 如果city为空,则调用generateDefaultCity方法

183 | String defaultCity = Optional.of(city).orElseGet(this::generateDefaultCity);

184 | }

185 | private String generateDefaultCity() {

186 | return "beijing";

187 | }

188 | ```

189 | **orElseThrow**

190 | 如果value为空,则抛出自定义异常。举个栗子:

191 |

192 | ```java

193 | public void test3(String city) {

194 | // 如果city为空,则抛出空指针异常。

195 | String defaultCity = Optional.of(city).orElseThrow(NullPointerException::new);

196 | }

197 | ```

198 | # 5. 使用Optional重构代码

199 |

200 | **再看一遍重构之前的代码,使用了三个if使代码嵌套层次变得很深。**

201 |

202 | ```java

203 | // before refactor

204 | public String getCity2(Person person) {

205 | if (person != null) {

206 | House house = person.getHouse();

207 | if (house != null) {

208 | Address address = house.getAddress();

209 | if (address != null) {

210 | String city = address.getCity();

211 | return city;

212 | }

213 | }

214 | }

215 | return "unknown";

216 | }

217 | ```

218 | **使用Optional重构**

219 | ```java

220 | public String getCityUsingOptional(Person person) {

221 | String city = Optional.ofNullable(person)

222 | .map(Person::getHouse)

223 | .map(House::getAddress)

224 | .map(Address::getCity).orElse("Unknown city");

225 | return city;

226 | }

227 | ```

228 | 只使用了一行代码就获取到city值,不用再去不断的判断是否为空,这样写代码是不是很优雅呀。

229 | # 总结

230 | 使用optional类可以很优雅的解决项目中空指针的问题,但是optional也不是万能的哦,小伙伴们要适度使用。赶紧用Optional重构之前写的项目吧~**

231 |

--------------------------------------------------------------------------------

/docs/java/java8/包学会,教你用Java函数式编程重构烂代码.md:

--------------------------------------------------------------------------------