├── README.md

├── codes

├── 10_huggingface_example.ipynb

├── 3-2_generating_BERT_embedding.ipynb

├── 3-3_extracting_embeddings_from_all_encoder_layers_of_BERT.ipynb

└── 9-3_BERT라이브러리탐색.ipynb

├── images

├── chap1_1.png

├── chap1_2.png

├── chap5_1.png

├── chap8_probability-of-readmission1.png

├── chap8_probability-of-readmission2.png

├── chap9_multi-modal-transformer.png

├── chap9_table1.png

├── chap9_videobert.png

├── chapter9_BART_architecture.PNG

├── chapter9_BART_comparison.PNG

├── chapter9_BART_fine-tuning.PNG

└── chapter9_BART_noising.PNG

├── order.ipynb

└── summaries

├── chapter01

└── chapter01_eunsik.md

├── chapter02

├── chapter02_BPE.md

└── understanding_BERT_01.md

├── chapter03

├── chapter03_embedding-extraction.md

└── chapter03_finetuning.md

├── chapter04

├── Chapter04_ALBERT_suyeon.pdf

├── Chapter04_ELECTRA.pdf

├── chapter04_SpanBERT.md

└── chapter04_roberta.md

├── chapter05

├── chapter05_DistilBERT.pdf

└── chapter05_TinyBERT.md

├── chapter06

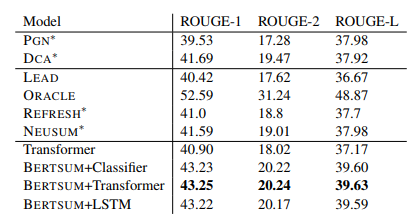

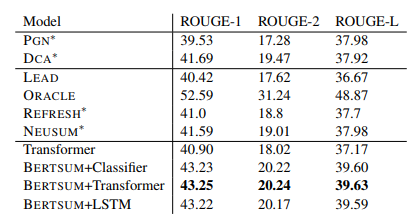

├── chapter06_텍스트_요약을_위한_BERTSUM_탐색_(1).md

└── chapter6_BERTSUM(2)_0hee0.md

├── chapter07

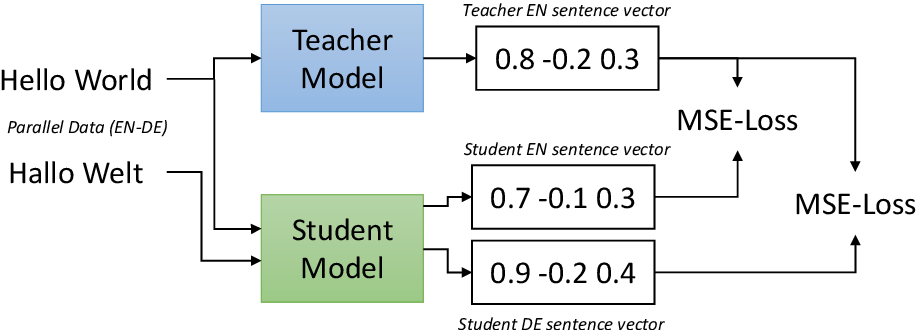

├── chapter07_M-BERT.md

└── chapter07_XLMR_multilingual.md

├── chapter08

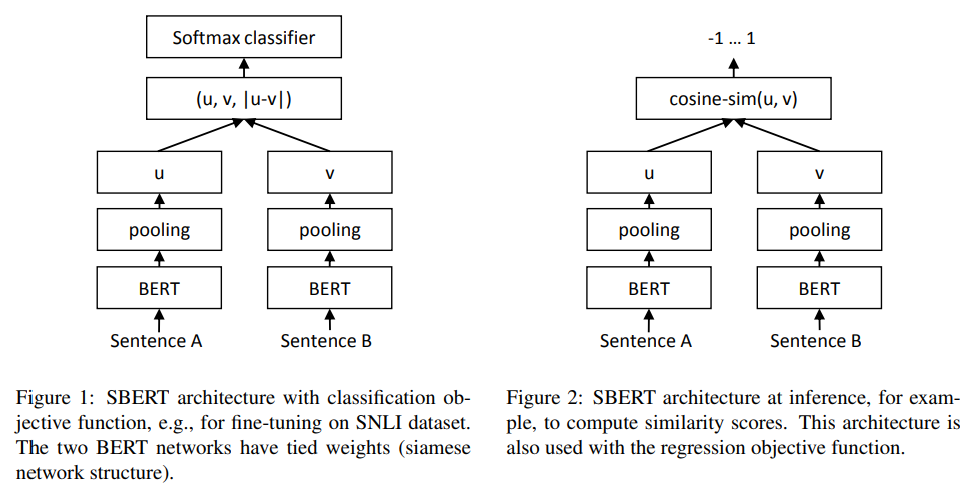

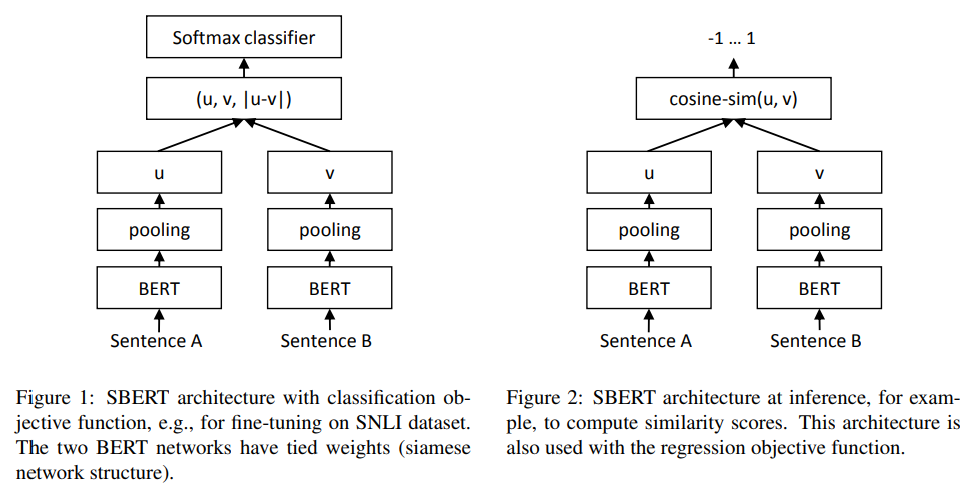

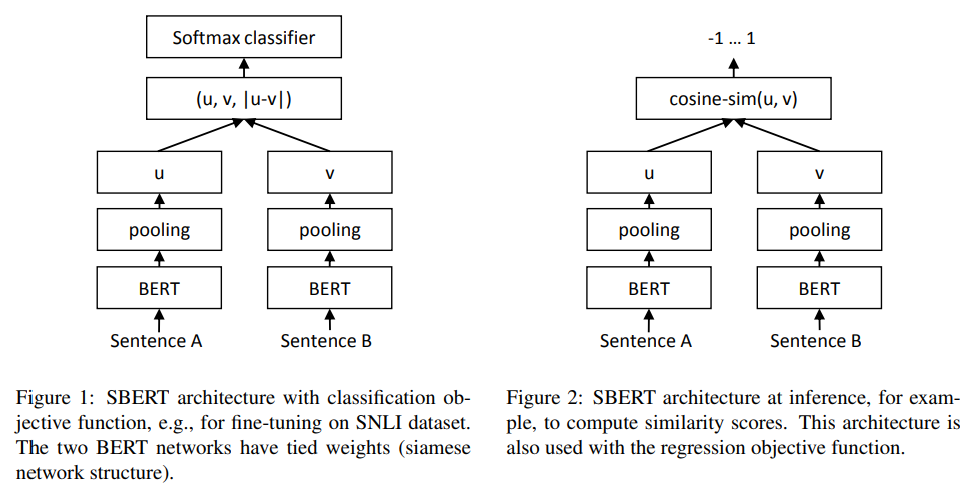

├── S-BERT.md

└── chapter08_domain-BERT.md

├── chapter09

├── chapter09_BART.md

└── chapter09_VideoBERT.md

└── chapter10

└── chapter10_kobert_kogpt2_kobart.md

/README.md:

--------------------------------------------------------------------------------

1 | # 구글 BERT의 정석 스터디

2 | ## Outline

3 | - 원서 제목: Getting Started with Google BERT: Build and train state-of-the-art natural language processing models using BERT

4 | - [도서 링크](https://www.aladin.co.kr/shop/wproduct.aspx?ItemId=281761569)

5 | - 목표

6 | - 구글 BERT의 정석 완독

7 | - 챕터 별 연습문제에 어느 정도 스스로 답할 수 있을 정도의 이해

8 | - BERT 기반의 다른 NLP 논문을 읽을 수 있을 정도의 이해

9 | - 방식:

10 | - 주 1회 1챕터를 2명씩 돌아가면서 발제

11 | - 논문을 참고할 수 있는 챕터는 논문 참고

12 | - 발제하지 않는 스터디원들은 해당 분량을 완독

13 | - Chapter 별로 issue 발행하여 궁금하거나 어려운 부분 스터디일에 공유 및 토의

14 | - 기간: 2022.01.12 ~ 2022.03.23(11주)

15 | - 스터디 일시: 매주 수요일 21:00 ~ 22:00(25+25분 발표 + 10분 토의) (스터디원들과의 협의 하에 사전 조정 가능)

16 | - [Google Meet Link](https://meet.google.com/krj-wqrd-feo)

17 |

18 | ## Presentation Order

19 | 스터디 시작일(220112)을 random seed로 하여 발표 순서를 랜덤으로 배정하였습니다. [Code](./order.ipynb)

20 |

21 | |Chapter| 발제자 |

22 | |-----|----------------|

23 | |1. 트랜스포머 입문| **이은식(fixed)** |

24 | |2. BERT 이해하기| **남수연, 박상일** |

25 | |3. BERT 활용하기| **서희, 이은식** |

26 | |4-1. BERT의 파생모델 1 ALBERT, RoBERTa| **이은식, 남수연** |

27 | |4-2. BERT의 파생모델 1 ELECTRA, SpanBERT| **박상일, 서희** |

28 | |5. BERT의 파생모델 2 지식 증류 기반| **박상일, 이은식** |

29 | |6. 텍스트 요약을 위한 BERTSUM 탐색| **서희, 남수연** |

30 | |7. 다른 언어에 BERT 적용하기| **이은식, 박상일** |

31 | |8. sentence-BERT 및 domain-BERT 살펴보기| **남수연, 서희** |

32 | |9. VideoBERT, BART| **박상일, 서희** |

33 | |10. 한국어 언어 모델 KoBERT, KoGPT2, KoBART| **이은식** |

34 |

35 | ## Repository Structure

36 | ```

37 | # repo 시작 위치를 /로 표기

38 | /summaries # 발제 자료 업로드

39 | /images # 발제 자료 이미지 업로드 (발제 자료에 이미지가 있다면 해당 디렉토리에 업로드해 상대경로로써 이미지 삽입)

40 | /codes # 발제 내용 기반 예시 코드 등 작성 시 해당 디렉토리에 업로드

41 | ```

42 | - 발제 파일 명명 방식: ```chapter01_발제자(e.g. eunsiklee.확장자)```

43 | - 발제 파일 형식: Markdown, ipynb, pdf 등 자유형식

44 | ## Contributors

45 | - 남수연([@mori8](https://github.com/mori8))

46 | - 박상일([@shyram](https://github.com/shyram))

47 | - 서희([@0hee0](https://github.com/0hee0))

48 | - 이은식([@emphasis10](https://github.com/emphasis10))

49 |

50 | ## 그 외의 것들

51 | - 패널티는 따로 정하지 않지만 추후 스터디 운영 상태에 따라 추가될 수 있습니다.

52 |

--------------------------------------------------------------------------------

/codes/10_huggingface_example.ipynb:

--------------------------------------------------------------------------------

1 | {

2 | "cells": [

3 | {

4 | "cell_type": "markdown",

5 | "metadata": {},

6 | "source": [

7 | "# HuggingFace Examples"

8 | ]

9 | },

10 | {

11 | "cell_type": "code",

12 | "execution_count": 1,

13 | "metadata": {},

14 | "outputs": [],

15 | "source": [

16 | "from transformers import AutoTokenizer, PreTrainedTokenizer\n",

17 | "from transformers import AutoModelForSequenceClassification\n",

18 | "from transformers import pipeline"

19 | ]

20 | },

21 | {

22 | "cell_type": "code",

23 | "execution_count": 2,

24 | "metadata": {

25 | "scrolled": true

26 | },

27 | "outputs": [

28 | {

29 | "name": "stderr",

30 | "output_type": "stream",

31 | "text": [

32 | "Some weights of the model checkpoint at monologg/kobigbird-bert-base were not used when initializing BigBirdForMaskedLM: ['cls.seq_relationship.bias', 'cls.seq_relationship.weight']\n",

33 | "- This IS expected if you are initializing BigBirdForMaskedLM from the checkpoint of a model trained on another task or with another architecture (e.g. initializing a BertForSequenceClassification model from a BertForPreTraining model).\n",

34 | "- This IS NOT expected if you are initializing BigBirdForMaskedLM from the checkpoint of a model that you expect to be exactly identical (initializing a BertForSequenceClassification model from a BertForSequenceClassification model).\n"

35 | ]

36 | }

37 | ],

38 | "source": [

39 | "model_name = 'monologg/kobigbird-bert-base'\n",

40 | "fill_mask = pipeline(\n",

41 | " \"fill-mask\",\n",

42 | " model=model_name,\n",

43 | " tokenizer=model_name\n",

44 | ")"

45 | ]

46 | },

47 | {

48 | "cell_type": "code",

49 | "execution_count": 3,

50 | "metadata": {

51 | "scrolled": false

52 | },

53 | "outputs": [

54 | {

55 | "name": "stderr",

56 | "output_type": "stream",

57 | "text": [

58 | "Attention type 'block_sparse' is not possible if sequence_length: 10 <= num global tokens: 2 * config.block_size + min. num sliding tokens: 3 * config.block_size + config.num_random_blocks * config.block_size + additional buffer: config.num_random_blocks * config.block_size = 704 with config.block_size = 64, config.num_random_blocks = 3. Changing attention type to 'original_full'...\n"

59 | ]

60 | },

61 | {

62 | "data": {

63 | "text/plain": [

64 | "[{'score': 0.5767750144004822,\n",

65 | " 'token': 10821,\n",

66 | " 'token_str': '워싱턴',\n",

67 | " 'sequence': '미국의 수도는 워싱턴 이다.'},\n",

68 | " {'score': 0.09579449146986008,\n",

69 | " 'token': 8386,\n",

70 | " 'token_str': '뉴욕',\n",

71 | " 'sequence': '미국의 수도는 뉴욕 이다.'},\n",

72 | " {'score': 0.06737150251865387,\n",

73 | " 'token': 13130,\n",

74 | " 'token_str': 'LA',\n",

75 | " 'sequence': '미국의 수도는 LA 이다.'},\n",

76 | " {'score': 0.05947323143482208,\n",

77 | " 'token': 7581,\n",

78 | " 'token_str': '수도',\n",

79 | " 'sequence': '미국의 수도는 수도 이다.'},\n",

80 | " {'score': 0.03958961367607117,\n",

81 | " 'token': 21661,\n",

82 | " 'token_str': '필라델피아',\n",

83 | " 'sequence': '미국의 수도는 필라델피아 이다.'}]"

84 | ]

85 | },

86 | "execution_count": 3,

87 | "metadata": {},

88 | "output_type": "execute_result"

89 | }

90 | ],

91 | "source": [

92 | "fill_mask(\"미국의 수도는 [MASK]이다.\")"

93 | ]

94 | },

95 | {

96 | "cell_type": "code",

97 | "execution_count": 4,

98 | "metadata": {},

99 | "outputs": [

100 | {

101 | "data": {

102 | "text/plain": [

103 | "[{'score': 0.045219432562589645,\n",

104 | " 'token': 2760,\n",

105 | " 'token_str': '나',\n",

106 | " 'sequence': '나는 나 를 먹는다.'},\n",

107 | " {'score': 0.03540102019906044,\n",

108 | " 'token': 10661,\n",

109 | " 'token_str': '우유',\n",

110 | " 'sequence': '나는 우유 를 먹는다.'},\n",

111 | " {'score': 0.03112361952662468,\n",

112 | " 'token': 8512,\n",

113 | " 'token_str': '고기',\n",

114 | " 'sequence': '나는 고기 를 먹는다.'},\n",

115 | " {'score': 0.026315296068787575,\n",

116 | " 'token': 15610,\n",

117 | " 'token_str': '고구마',\n",

118 | " 'sequence': '나는 고구마 를 먹는다.'},\n",

119 | " {'score': 0.01981933042407036,\n",

120 | " 'token': 14976,\n",

121 | " 'token_str': '쇠고기',\n",

122 | " 'sequence': '나는 쇠고기 를 먹는다.'}]"

123 | ]

124 | },

125 | "execution_count": 4,

126 | "metadata": {},

127 | "output_type": "execute_result"

128 | }

129 | ],

130 | "source": [

131 | "fill_mask(\"나는 [MASK]를 먹는다.\")"

132 | ]

133 | },

134 | {

135 | "cell_type": "code",

136 | "execution_count": 5,

137 | "metadata": {},

138 | "outputs": [

139 | {

140 | "data": {

141 | "text/plain": [

142 | "[{'score': 0.8281315565109253,\n",

143 | " 'token': 7581,\n",

144 | " 'token_str': '수도',\n",

145 | " 'sequence': '한국의 수도 는 인천이다.'},\n",

146 | " {'score': 0.015533183701336384,\n",

147 | " 'token': 6936,\n",

148 | " 'token_str': '도시',\n",

149 | " 'sequence': '한국의 도시 는 인천이다.'},\n",

150 | " {'score': 0.008934497833251953,\n",

151 | " 'token': 9879,\n",

152 | " 'token_str': '고도',\n",

153 | " 'sequence': '한국의 고도 는 인천이다.'},\n",

154 | " {'score': 0.008657638914883137,\n",

155 | " 'token': 12588,\n",

156 | " 'token_str': '중심지',\n",

157 | " 'sequence': '한국의 중심지 는 인천이다.'},\n",

158 | " {'score': 0.005730825942009687,\n",

159 | " 'token': 20365,\n",

160 | " 'token_str': '소재지',\n",

161 | " 'sequence': '한국의 소재지 는 인천이다.'}]"

162 | ]

163 | },

164 | "execution_count": 5,

165 | "metadata": {},

166 | "output_type": "execute_result"

167 | }

168 | ],

169 | "source": [

170 | "fill_mask(\"한국의 [MASK]는 인천이다.\")"

171 | ]

172 | },

173 | {

174 | "cell_type": "code",

175 | "execution_count": 6,

176 | "metadata": {},

177 | "outputs": [

178 | {

179 | "data": {

180 | "text/plain": [

181 | "[{'score': 0.07572885602712631,\n",

182 | " 'token': 7841,\n",

183 | " 'token_str': '소재',\n",

184 | " 'sequence': '인천 소재 대학교'},\n",

185 | " {'score': 0.06376954168081284,\n",

186 | " 'token': 6816,\n",

187 | " 'token_str': '지역',\n",

188 | " 'sequence': '인천 지역 대학교'},\n",

189 | " {'score': 0.053160928189754486,\n",

190 | " 'token': 517,\n",

191 | " 'token_str': '-',\n",

192 | " 'sequence': '인천 - 대학교'},\n",

193 | " {'score': 0.04669084772467613,\n",

194 | " 'token': 7019,\n",

195 | " 'token_str': '국제',\n",

196 | " 'sequence': '인천 국제 대학교'},\n",

197 | " {'score': 0.03119579143822193,\n",

198 | " 'token': 12504,\n",

199 | " 'token_str': '시립',\n",

200 | " 'sequence': '인천 시립 대학교'}]"

201 | ]

202 | },

203 | "execution_count": 6,

204 | "metadata": {},

205 | "output_type": "execute_result"

206 | }

207 | ],

208 | "source": [

209 | "fill_mask(\"인천 [MASK] 대학교\")"

210 | ]

211 | },

212 | {

213 | "cell_type": "markdown",

214 | "metadata": {},

215 | "source": [

216 | "# KoBERT"

217 | ]

218 | },

219 | {

220 | "cell_type": "code",

221 | "execution_count": 1,

222 | "metadata": {},

223 | "outputs": [],

224 | "source": [

225 | "from transformers import AutoTokenizer, PreTrainedTokenizer\n",

226 | "from transformers import AutoModelForSequenceClassification\n",

227 | "from transformers import pipeline"

228 | ]

229 | },

230 | {

231 | "cell_type": "code",

232 | "execution_count": 7,

233 | "metadata": {},

234 | "outputs": [],

235 | "source": [

236 | "tokenizer = AutoTokenizer.from_pretrained('skt/kobert-base-v1', use_fast=False)"

237 | ]

238 | },

239 | {

240 | "cell_type": "code",

241 | "execution_count": 8,

242 | "metadata": {},

243 | "outputs": [

244 | {

245 | "data": {

246 | "text/plain": [

247 | "PreTrainedTokenizer(name_or_path='skt/kobert-base-v1', vocab_size=8002, model_max_len=1000000000000000019884624838656, is_fast=False, padding_side='left', truncation_side='right', special_tokens={'bos_token': '[CLS]', 'eos_token': '[SEP]', 'unk_token': '[UNK]', 'sep_token': '[SEP]', 'pad_token': '[PAD]', 'cls_token': '[CLS]', 'mask_token': AddedToken(\"[MASK]\", rstrip=False, lstrip=True, single_word=False, normalized=True)})"

248 | ]

249 | },

250 | "execution_count": 8,

251 | "metadata": {},

252 | "output_type": "execute_result"

253 | }

254 | ],

255 | "source": [

256 | "tokenizer"

257 | ]

258 | },

259 | {

260 | "cell_type": "code",

261 | "execution_count": 9,

262 | "metadata": {},

263 | "outputs": [

264 | {

265 | "data": {

266 | "text/plain": [

267 | "['▁한국', '어', '▁모델', '을', '▁공유', '합니다', '.']"

268 | ]

269 | },

270 | "execution_count": 9,

271 | "metadata": {},

272 | "output_type": "execute_result"

273 | }

274 | ],

275 | "source": [

276 | "tokenizer.tokenize('한국어 모델을 공유합니다.')"

277 | ]

278 | },

279 | {

280 | "cell_type": "code",

281 | "execution_count": 10,

282 | "metadata": {},

283 | "outputs": [

284 | {

285 | "data": {

286 | "text/plain": [

287 | "[4958, 6855, 2046, 7088, 1050, 7843, 54, 3, 2]"

288 | ]

289 | },

290 | "execution_count": 10,

291 | "metadata": {},

292 | "output_type": "execute_result"

293 | }

294 | ],

295 | "source": [

296 | "tokenizer.encode(\"한국어 모델을 공유합니다.\")"

297 | ]

298 | },

299 | {

300 | "cell_type": "markdown",

301 | "metadata": {},

302 | "source": [

303 | "## Sentiment Analysis using pretrained model(w. klue/bert-base)"

304 | ]

305 | },

306 | {

307 | "cell_type": "markdown",

308 | "metadata": {},

309 | "source": [

310 | "https://huggingface.co/docs/transformers/custom_datasets"

311 | ]

312 | },

313 | {

314 | "cell_type": "code",

315 | "execution_count": 2,

316 | "metadata": {

317 | "scrolled": true

318 | },

319 | "outputs": [

320 | {

321 | "name": "stderr",

322 | "output_type": "stream",

323 | "text": [

324 | "Some weights of the model checkpoint at klue/bert-base were not used when initializing BertForSequenceClassification: ['cls.predictions.decoder.weight', 'cls.predictions.decoder.bias', 'cls.predictions.transform.LayerNorm.weight', 'cls.seq_relationship.bias', 'cls.predictions.transform.dense.bias', 'cls.seq_relationship.weight', 'cls.predictions.transform.LayerNorm.bias', 'cls.predictions.bias', 'cls.predictions.transform.dense.weight']\n",

325 | "- This IS expected if you are initializing BertForSequenceClassification from the checkpoint of a model trained on another task or with another architecture (e.g. initializing a BertForSequenceClassification model from a BertForPreTraining model).\n",

326 | "- This IS NOT expected if you are initializing BertForSequenceClassification from the checkpoint of a model that you expect to be exactly identical (initializing a BertForSequenceClassification model from a BertForSequenceClassification model).\n",

327 | "Some weights of BertForSequenceClassification were not initialized from the model checkpoint at klue/bert-base and are newly initialized: ['classifier.bias', 'classifier.weight']\n",

328 | "You should probably TRAIN this model on a down-stream task to be able to use it for predictions and inference.\n"

329 | ]

330 | }

331 | ],

332 | "source": [

333 | "model = AutoModelForSequenceClassification.from_pretrained('klue/bert-base', num_labels=2)\n",

334 | "tokenizer = AutoTokenizer.from_pretrained('klue/bert-base')"

335 | ]

336 | },

337 | {

338 | "cell_type": "code",

339 | "execution_count": 3,

340 | "metadata": {},

341 | "outputs": [

342 | {

343 | "name": "stdout",

344 | "output_type": "stream",

345 | "text": [

346 | "fatal: destination path 'nsmc' already exists and is not an empty directory.\r\n"

347 | ]

348 | }

349 | ],

350 | "source": [

351 | "!git clone https://github.com/e9t/nsmc.git"

352 | ]

353 | },

354 | {

355 | "cell_type": "code",

356 | "execution_count": 4,

357 | "metadata": {},

358 | "outputs": [],

359 | "source": [

360 | "import json\n",

361 | "import os\n",

362 | "import torch\n",

363 | "\n",

364 | "from collections import Counter\n",

365 | "from datasets import Dataset\n",

366 | "from transformers import Trainer, TrainingArguments"

367 | ]

368 | },

369 | {

370 | "cell_type": "code",

371 | "execution_count": 5,

372 | "metadata": {

373 | "scrolled": false

374 | },

375 | "outputs": [],

376 | "source": [

377 | "raw_paths = [os.path.join('nsmc', 'raw', path) for path in os.listdir('nsmc/raw')]"

378 | ]

379 | },

380 | {

381 | "cell_type": "code",

382 | "execution_count": 38,

383 | "metadata": {},

384 | "outputs": [],

385 | "source": [

386 | "dat = {'text': [], 'label': []}"

387 | ]

388 | },

389 | {

390 | "cell_type": "code",

391 | "execution_count": 39,

392 | "metadata": {},

393 | "outputs": [],

394 | "source": [

395 | "labels = []\n",

396 | "for path in raw_paths:\n",

397 | " with open(path) as f:\n",

398 | " data = json.load(f)\n",

399 | " for i in data:\n",

400 | " if int(i['rating']) >= 9:\n",

401 | " dat['text'].append(i['review'])\n",

402 | " dat['label'].append(1)\n",

403 | " elif int(i['rating']) <= 4:\n",

404 | " dat['text'].append(i['review'])\n",

405 | " dat['label'].append(0)"

406 | ]

407 | },

408 | {

409 | "cell_type": "code",

410 | "execution_count": 40,

411 | "metadata": {},

412 | "outputs": [],

413 | "source": [

414 | "def preprocess_function(examples):\n",

415 | " return tokenizer(examples['text'], truncation=True, padding='max_length', max_length=512)"

416 | ]

417 | },

418 | {

419 | "cell_type": "code",

420 | "execution_count": 41,

421 | "metadata": {},

422 | "outputs": [],

423 | "source": [

424 | "train_dat = {'text': dat['text'][:1000], 'label': dat['label'][:1000]}\n",

425 | "train_dat = Dataset.from_dict(train_dat, split='train')\n",

426 | "train_dataset = train_dat.map(preprocess_function, batched=True, num_proc=7)\n",

427 | "train_dataset = train_dataset.remove_columns('text')"

428 | ]

429 | },

430 | {

431 | "cell_type": "code",

432 | "execution_count": 42,

433 | "metadata": {},

434 | "outputs": [],

435 | "source": [

436 | "valid_dat = {'text': dat['text'][1000:2000], 'label': dat['label'][1000:2000]}\n",

437 | "valid_dat = Dataset.from_dict(valid_dat, split='train')\n",

438 | "valid_dataset = valid_dat.map(preprocess_function, batched=True, num_proc=7)\n",

439 | "valid_dataset = valid_dataset.remove_columns('text')"

440 | ]

441 | },

442 | {

443 | "cell_type": "code",

444 | "execution_count": 43,

445 | "metadata": {},

446 | "outputs": [],

447 | "source": [

448 | "from datasets import load_metric\n",

449 | "import numpy as np\n",

450 | "metric = load_metric('accuracy')\n",

451 | "\n",

452 | "def compute_metrics(eval_pred):\n",

453 | " logits, labels = eval_pred\n",

454 | " predictions = np.argmax(logits, axis=-1)\n",

455 | " return metric.compute(predictions=predictions, references=labels)"

456 | ]

457 | },

458 | {

459 | "cell_type": "code",

460 | "execution_count": 44,

461 | "metadata": {},

462 | "outputs": [

463 | {

464 | "data": {

465 | "text/plain": [

466 | "Dataset({\n",

467 | " features: ['label', 'input_ids', 'token_type_ids', 'attention_mask'],\n",

468 | " num_rows: 1000\n",

469 | "})"

470 | ]

471 | },

472 | "execution_count": 44,

473 | "metadata": {},

474 | "output_type": "execute_result"

475 | }

476 | ],

477 | "source": [

478 | "train_dataset"

479 | ]

480 | },

481 | {

482 | "cell_type": "code",

483 | "execution_count": 45,

484 | "metadata": {},

485 | "outputs": [

486 | {

487 | "data": {

488 | "text/plain": [

489 | "Dataset({\n",

490 | " features: ['text', 'label'],\n",

491 | " num_rows: 1000\n",

492 | "})"

493 | ]

494 | },

495 | "execution_count": 45,

496 | "metadata": {},

497 | "output_type": "execute_result"

498 | }

499 | ],

500 | "source": [

501 | "valid_dataset"

502 | ]

503 | },

504 | {

505 | "cell_type": "code",

506 | "execution_count": 50,

507 | "metadata": {},

508 | "outputs": [

509 | {

510 | "name": "stderr",

511 | "output_type": "stream",

512 | "text": [

513 | "PyTorch: setting up devices\n",

514 | "The default value for the training argument `--report_to` will change in v5 (from all installed integrations to none). In v5, you will need to use `--report_to all` to get the same behavior as now. You should start updating your code and make this info disappear :-).\n"

515 | ]

516 | }

517 | ],

518 | "source": [

519 | "args = TrainingArguments(output_dir='./sentiment',\n",

520 | " per_device_train_batch_size=4,\n",

521 | " logging_steps=100,\n",

522 | " evaluation_strategy='epoch',\n",

523 | " do_eval=True)"

524 | ]

525 | },

526 | {

527 | "cell_type": "code",

528 | "execution_count": 51,

529 | "metadata": {},

530 | "outputs": [],

531 | "source": [

532 | "trainer = Trainer(model=model,\n",

533 | " args=args,\n",

534 | " train_dataset=train_dataset,\n",

535 | " eval_dataset=valid_dataset,\n",

536 | " tokenizer=tokenizer,\n",

537 | " compute_metrics=compute_metrics)"

538 | ]

539 | },

540 | {

541 | "cell_type": "code",

542 | "execution_count": 52,

543 | "metadata": {

544 | "scrolled": false

545 | },

546 | "outputs": [

547 | {

548 | "name": "stderr",

549 | "output_type": "stream",

550 | "text": [

551 | "/usr/local/lib/python3.6/dist-packages/transformers/optimization.py:309: FutureWarning: This implementation of AdamW is deprecated and will be removed in a future version. Use the PyTorch implementation torch.optim.AdamW instead, or set `no_deprecation_warning=True` to disable this warning\n",

552 | " FutureWarning,\n",

553 | "***** Running training *****\n",

554 | " Num examples = 1000\n",

555 | " Num Epochs = 3\n",

556 | " Instantaneous batch size per device = 4\n",

557 | " Total train batch size (w. parallel, distributed & accumulation) = 4\n",

558 | " Gradient Accumulation steps = 1\n",

559 | " Total optimization steps = 750\n"

560 | ]

561 | },

562 | {

563 | "data": {

564 | "text/html": [

565 | "\n",

566 | " \n",

567 | " \n",

568 | "

\n",

569 | " [750/750 03:53, Epoch 3/3]\n",

570 | "

\n",

572 | " \n",

573 | " \n",

574 | " | Epoch | \n",

575 | " Training Loss | \n",

576 | " Validation Loss | \n",

577 | " Accuracy | \n",

578 | "

\n",

579 | " \n",

580 | " \n",

581 | " \n",

582 | " | 1 | \n",

583 | " 0.130500 | \n",

584 | " 1.096880 | \n",

585 | " 0.831000 | \n",

586 | "

\n",

587 | " \n",

588 | " | 2 | \n",

589 | " 0.068400 | \n",

590 | " 0.926864 | \n",

591 | " 0.873000 | \n",

592 | "

\n",

593 | " \n",

594 | " | 3 | \n",

595 | " 0.063500 | \n",

596 | " 0.924929 | \n",

597 | " 0.876000 | \n",

598 | "

\n",

599 | " \n",

600 | "

"

601 | ],

602 | "text/plain": [

603 | ""

604 | ]

605 | },

606 | "metadata": {},

607 | "output_type": "display_data"

608 | },

609 | {

610 | "name": "stderr",

611 | "output_type": "stream",

612 | "text": [

613 | "***** Running Evaluation *****\n",

614 | " Num examples = 1000\n",

615 | " Batch size = 8\n",

616 | "Saving model checkpoint to ./sentiment/checkpoint-500\n",

617 | "Configuration saved in ./sentiment/checkpoint-500/config.json\n",

618 | "Model weights saved in ./sentiment/checkpoint-500/pytorch_model.bin\n",

619 | "tokenizer config file saved in ./sentiment/checkpoint-500/tokenizer_config.json\n",

620 | "Special tokens file saved in ./sentiment/checkpoint-500/special_tokens_map.json\n",

621 | "***** Running Evaluation *****\n",

622 | " Num examples = 1000\n",

623 | " Batch size = 8\n",

624 | "***** Running Evaluation *****\n",

625 | " Num examples = 1000\n",

626 | " Batch size = 8\n",

627 | "\n",

628 | "\n",

629 | "Training completed. Do not forget to share your model on huggingface.co/models =)\n",

630 | "\n",

631 | "\n"

632 | ]

633 | },

634 | {

635 | "data": {

636 | "text/plain": [

637 | "TrainOutput(global_step=750, training_loss=0.0730759978418549, metrics={'train_runtime': 233.4359, 'train_samples_per_second': 12.851, 'train_steps_per_second': 3.213, 'total_flos': 789333166080000.0, 'train_loss': 0.0730759978418549, 'epoch': 3.0})"

638 | ]

639 | },

640 | "execution_count": 52,

641 | "metadata": {},

642 | "output_type": "execute_result"

643 | }

644 | ],

645 | "source": [

646 | "trainer.train()"

647 | ]

648 | },

649 | {

650 | "cell_type": "markdown",

651 | "metadata": {},

652 | "source": [

653 | "# KoGPT2"

654 | ]

655 | },

656 | {

657 | "cell_type": "code",

658 | "execution_count": 53,

659 | "metadata": {},

660 | "outputs": [],

661 | "source": [

662 | "from transformers import GPT2LMHeadModel\n",

663 | "from transformers import PreTrainedTokenizerFast"

664 | ]

665 | },

666 | {

667 | "cell_type": "code",

668 | "execution_count": 54,

669 | "metadata": {

670 | "scrolled": true

671 | },

672 | "outputs": [

673 | {

674 | "name": "stderr",

675 | "output_type": "stream",

676 | "text": [

677 | "loading file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/tokenizer.json from cache at /root/.cache/huggingface/transformers/fd8418e6675550cbca8ad6c102d717aa89372eb7a632ad3168300c7fed43491c.db074bfdd88bec54455de5ee2400efdbc64d4acf449a44d5f314e79c1eadc611\n",

678 | "loading file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/added_tokens.json from cache at None\n",

679 | "loading file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/special_tokens_map.json from cache at None\n",

680 | "loading file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/tokenizer_config.json from cache at None\n",

681 | "loading configuration file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/13bb826cf24517d7849a701e02452715a67c5e560142be3d4735442b2a545809.6b384eec6effdd44287f67715cd55bd0dff2cf846d843b932b43ba7b632b8b1e\n",

682 | "Model config GPT2Config {\n",

683 | " \"_name_or_path\": \"skt/kogpt2-base-v2\",\n",

684 | " \"_num_labels\": 1,\n",

685 | " \"activation_function\": \"gelu_new\",\n",

686 | " \"architectures\": [\n",

687 | " \"GPT2LMHeadModel\"\n",

688 | " ],\n",

689 | " \"attn_pdrop\": 0.1,\n",

690 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

691 | " \"bos_token_id\": 0,\n",

692 | " \"created_date\": \"2021-04-28\",\n",

693 | " \"embd_pdrop\": 0.1,\n",

694 | " \"eos_token_id\": 1,\n",

695 | " \"gradient_checkpointing\": false,\n",

696 | " \"id2label\": {\n",

697 | " \"0\": \"LABEL_0\"\n",

698 | " },\n",

699 | " \"initializer_range\": 0.02,\n",

700 | " \"label2id\": {\n",

701 | " \"LABEL_0\": 0\n",

702 | " },\n",

703 | " \"layer_norm_epsilon\": 1e-05,\n",

704 | " \"license\": \"CC-BY-NC-SA 4.0\",\n",

705 | " \"model_type\": \"gpt2\",\n",

706 | " \"n_ctx\": 1024,\n",

707 | " \"n_embd\": 768,\n",

708 | " \"n_head\": 12,\n",

709 | " \"n_inner\": null,\n",

710 | " \"n_layer\": 12,\n",

711 | " \"n_positions\": 1024,\n",

712 | " \"pad_token_id\": 3,\n",

713 | " \"reorder_and_upcast_attn\": false,\n",

714 | " \"resid_pdrop\": 0.1,\n",

715 | " \"scale_attn_by_inverse_layer_idx\": false,\n",

716 | " \"scale_attn_weights\": true,\n",

717 | " \"summary_activation\": null,\n",

718 | " \"summary_first_dropout\": 0.1,\n",

719 | " \"summary_proj_to_labels\": true,\n",

720 | " \"summary_type\": \"cls_index\",\n",

721 | " \"summary_use_proj\": true,\n",

722 | " \"task_specific_params\": {\n",

723 | " \"text-generation\": {\n",

724 | " \"do_sample\": true,\n",

725 | " \"max_length\": 50\n",

726 | " }\n",

727 | " },\n",

728 | " \"transformers_version\": \"4.17.0\",\n",

729 | " \"use_cache\": true,\n",

730 | " \"vocab_size\": 51200\n",

731 | "}\n",

732 | "\n",

733 | "The tokenizer class you load from this checkpoint is not the same type as the class this function is called from. It may result in unexpected tokenization. \n",

734 | "The tokenizer class you load from this checkpoint is 'GPT2Tokenizer'. \n",

735 | "The class this function is called from is 'PreTrainedTokenizerFast'.\n"

736 | ]

737 | }

738 | ],

739 | "source": [

740 | "tokenizer = PreTrainedTokenizerFast.from_pretrained('skt/kogpt2-base-v2',\n",

741 | " bos_token='',\n",

742 | " eos_token='',\n",

743 | " pad_token='',\n",

744 | " mask_token='')"

745 | ]

746 | },

747 | {

748 | "cell_type": "code",

749 | "execution_count": 55,

750 | "metadata": {},

751 | "outputs": [

752 | {

753 | "data": {

754 | "text/plain": [

755 | "[25906, 8702, 7801, 25856, 34407, 10528, 422, 426, 18258, 14652, 21154]"

756 | ]

757 | },

758 | "execution_count": 55,

759 | "metadata": {},

760 | "output_type": "execute_result"

761 | }

762 | ],

763 | "source": [

764 | "tokenizer.encode(\"안녕하세요. 한국어 GPT-2 모델입니다.\")"

765 | ]

766 | },

767 | {

768 | "cell_type": "code",

769 | "execution_count": 56,

770 | "metadata": {},

771 | "outputs": [],

772 | "source": [

773 | "import torch"

774 | ]

775 | },

776 | {

777 | "cell_type": "code",

778 | "execution_count": 57,

779 | "metadata": {

780 | "scrolled": true

781 | },

782 | "outputs": [

783 | {

784 | "name": "stderr",

785 | "output_type": "stream",

786 | "text": [

787 | "loading configuration file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/13bb826cf24517d7849a701e02452715a67c5e560142be3d4735442b2a545809.6b384eec6effdd44287f67715cd55bd0dff2cf846d843b932b43ba7b632b8b1e\n",

788 | "Model config GPT2Config {\n",

789 | " \"_num_labels\": 1,\n",

790 | " \"activation_function\": \"gelu_new\",\n",

791 | " \"architectures\": [\n",

792 | " \"GPT2LMHeadModel\"\n",

793 | " ],\n",

794 | " \"attn_pdrop\": 0.1,\n",

795 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

796 | " \"bos_token_id\": 0,\n",

797 | " \"created_date\": \"2021-04-28\",\n",

798 | " \"embd_pdrop\": 0.1,\n",

799 | " \"eos_token_id\": 1,\n",

800 | " \"gradient_checkpointing\": false,\n",

801 | " \"id2label\": {\n",

802 | " \"0\": \"LABEL_0\"\n",

803 | " },\n",

804 | " \"initializer_range\": 0.02,\n",

805 | " \"label2id\": {\n",

806 | " \"LABEL_0\": 0\n",

807 | " },\n",

808 | " \"layer_norm_epsilon\": 1e-05,\n",

809 | " \"license\": \"CC-BY-NC-SA 4.0\",\n",

810 | " \"model_type\": \"gpt2\",\n",

811 | " \"n_ctx\": 1024,\n",

812 | " \"n_embd\": 768,\n",

813 | " \"n_head\": 12,\n",

814 | " \"n_inner\": null,\n",

815 | " \"n_layer\": 12,\n",

816 | " \"n_positions\": 1024,\n",

817 | " \"pad_token_id\": 3,\n",

818 | " \"reorder_and_upcast_attn\": false,\n",

819 | " \"resid_pdrop\": 0.1,\n",

820 | " \"scale_attn_by_inverse_layer_idx\": false,\n",

821 | " \"scale_attn_weights\": true,\n",

822 | " \"summary_activation\": null,\n",

823 | " \"summary_first_dropout\": 0.1,\n",

824 | " \"summary_proj_to_labels\": true,\n",

825 | " \"summary_type\": \"cls_index\",\n",

826 | " \"summary_use_proj\": true,\n",

827 | " \"task_specific_params\": {\n",

828 | " \"text-generation\": {\n",

829 | " \"do_sample\": true,\n",

830 | " \"max_length\": 50\n",

831 | " }\n",

832 | " },\n",

833 | " \"transformers_version\": \"4.17.0\",\n",

834 | " \"use_cache\": true,\n",

835 | " \"vocab_size\": 51200\n",

836 | "}\n",

837 | "\n",

838 | "loading weights file https://huggingface.co/skt/kogpt2-base-v2/resolve/main/pytorch_model.bin from cache at /root/.cache/huggingface/transformers/495b405e3742953dbcc56685d1560fa02a2d86fc50b891868990a4471b06c934.4ebf112d34c2c8fc657866680005d92d21859c52c0ef5e941fa640129b2f8f88\n",

839 | "All model checkpoint weights were used when initializing GPT2LMHeadModel.\n",

840 | "\n",

841 | "All the weights of GPT2LMHeadModel were initialized from the model checkpoint at skt/kogpt2-base-v2.\n",

842 | "If your task is similar to the task the model of the checkpoint was trained on, you can already use GPT2LMHeadModel for predictions without further training.\n"

843 | ]

844 | }

845 | ],

846 | "source": [

847 | "text = \"근육이 커지기 위해서는\"\n",

848 | "input_ids = tokenizer.encode(text)\n",

849 | "model = GPT2LMHeadModel.from_pretrained('skt/kogpt2-base-v2')\n",

850 | "gen_ids = model.generate(torch.tensor([input_ids]),\n",

851 | " max_length=128,\n",

852 | " repetition_penalty=2.0,\n",

853 | " pad_token_id=tokenizer.pad_token_id,\n",

854 | " eos_token_id=tokenizer.eos_token_id,\n",

855 | " bos_token_id=tokenizer.bos_token_id,\n",

856 | " use_cache=True)\n",

857 | "generated = tokenizer.decode(gen_ids[0,:].tolist())"

858 | ]

859 | },

860 | {

861 | "cell_type": "code",

862 | "execution_count": 58,

863 | "metadata": {},

864 | "outputs": [

865 | {

866 | "data": {

867 | "text/plain": [

868 | "'근육이 커지기 위해서는 무엇보다 규칙적인 생활습관이 중요하다.\\n특히, 아침식사는 단백질과 비타민이 풍부한 과일과 채소를 많이 섭취하는 것이 좋다.\\n또한 하루 30분 이상 충분한 수면을 취하는 것도 도움이 된다.\\n아침 식사를 거르지 않고 규칙적으로 운동을 하면 혈액순환에 도움을 줄 뿐만 아니라 신진대사를 촉진해 체내 노폐물을 배출하고 혈압을 낮춰준다.\\n운동은 하루에 10분 정도만 하는 게 좋으며 운동 후에는 반드시 스트레칭을 통해 근육량을 늘리고 유연성을 높여야 한다.\\n운동 후 바로 잠자리에 드는 것은 피해야 하며 특히 아침에 일어나면 몸이 피곤해지기 때문에 무리하게 움직이면 오히려 역효과가 날 수도 있다.\\n운동을'"

869 | ]

870 | },

871 | "execution_count": 58,

872 | "metadata": {},

873 | "output_type": "execute_result"

874 | }

875 | ],

876 | "source": [

877 | "generated"

878 | ]

879 | },

880 | {

881 | "cell_type": "markdown",

882 | "metadata": {},

883 | "source": [

884 | "# KoBART"

885 | ]

886 | },

887 | {

888 | "cell_type": "code",

889 | "execution_count": 59,

890 | "metadata": {},

891 | "outputs": [],

892 | "source": [

893 | "model_name = 'gogamza/kobart-base-v2'"

894 | ]

895 | },

896 | {

897 | "cell_type": "code",

898 | "execution_count": 60,

899 | "metadata": {},

900 | "outputs": [

901 | {

902 | "name": "stderr",

903 | "output_type": "stream",

904 | "text": [

905 | "Could not locate the tokenizer configuration file, will try to use the model config instead.\n",

906 | "loading configuration file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/54a37e9385f90886428b084042f151c1a699203416d41765d94aac4cddb5fd5c.d098ef3866c1da94bdfaa5c1f24ecb7c5c16b37423b79263fbd3668d2ae61f91\n",

907 | "Model config BartConfig {\n",

908 | " \"_name_or_path\": \"gogamza/kobart-base-v2\",\n",

909 | " \"activation_dropout\": 0.0,\n",

910 | " \"activation_function\": \"gelu\",\n",

911 | " \"add_bias_logits\": false,\n",

912 | " \"add_final_layer_norm\": false,\n",

913 | " \"architectures\": [\n",

914 | " \"BartModel\"\n",

915 | " ],\n",

916 | " \"attention_dropout\": 0.0,\n",

917 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

918 | " \"bos_token_id\": 1,\n",

919 | " \"classif_dropout\": 0.1,\n",

920 | " \"classifier_dropout\": 0.1,\n",

921 | " \"d_model\": 768,\n",

922 | " \"decoder_attention_heads\": 16,\n",

923 | " \"decoder_ffn_dim\": 3072,\n",

924 | " \"decoder_layerdrop\": 0.0,\n",

925 | " \"decoder_layers\": 6,\n",

926 | " \"decoder_start_token_id\": 1,\n",

927 | " \"do_blenderbot_90_layernorm\": false,\n",

928 | " \"dropout\": 0.1,\n",

929 | " \"encoder_attention_heads\": 16,\n",

930 | " \"encoder_ffn_dim\": 3072,\n",

931 | " \"encoder_layerdrop\": 0.0,\n",

932 | " \"encoder_layers\": 6,\n",

933 | " \"eos_token_id\": 1,\n",

934 | " \"extra_pos_embeddings\": 2,\n",

935 | " \"force_bos_token_to_be_generated\": false,\n",

936 | " \"forced_eos_token_id\": 1,\n",

937 | " \"gradient_checkpointing\": false,\n",

938 | " \"id2label\": {\n",

939 | " \"0\": \"NEGATIVE\",\n",

940 | " \"1\": \"POSITIVE\"\n",

941 | " },\n",

942 | " \"init_std\": 0.02,\n",

943 | " \"is_encoder_decoder\": true,\n",

944 | " \"kobart_version\": 2.0,\n",

945 | " \"label2id\": {\n",

946 | " \"NEGATIVE\": 0,\n",

947 | " \"POSITIVE\": 1\n",

948 | " },\n",

949 | " \"max_position_embeddings\": 1026,\n",

950 | " \"model_type\": \"bart\",\n",

951 | " \"normalize_before\": false,\n",

952 | " \"normalize_embedding\": true,\n",

953 | " \"num_hidden_layers\": 6,\n",

954 | " \"pad_token_id\": 3,\n",

955 | " \"scale_embedding\": false,\n",

956 | " \"static_position_embeddings\": false,\n",

957 | " \"tokenizer_class\": \"PreTrainedTokenizerFast\",\n",

958 | " \"transformers_version\": \"4.17.0\",\n",

959 | " \"use_cache\": true,\n",

960 | " \"vocab_size\": 30000\n",

961 | "}\n",

962 | "\n",

963 | "loading file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/tokenizer.json from cache at /root/.cache/huggingface/transformers/f94202e1dad4fcfcb282aff4c6865b6119e03c87c6fa9e5886abe93835c41ecd.dc2013f8bbecd755468e2c44397f53dc624be5451d0190744397caf61a20383f\n",

964 | "loading file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/added_tokens.json from cache at /root/.cache/huggingface/transformers/7c75331e2f4b5767db997fbb489f1408eb36a3217beb3057ae8d04bd2b3f97ba.04312f398a3bbda664297588800a86e0fda9d4ef4f0749cd9d96f88043daad39\n",

965 | "loading file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/special_tokens_map.json from cache at /root/.cache/huggingface/transformers/a87d2ed77831bb40ce806a97c04126addf5ecc82b3e23ecf916b2a4acdb9c29a.c23d5e62137984cf842a885705037b25b156747d145406702932d5f5d5e7c88e\n",

966 | "loading file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/tokenizer_config.json from cache at None\n",

967 | "loading configuration file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/54a37e9385f90886428b084042f151c1a699203416d41765d94aac4cddb5fd5c.d098ef3866c1da94bdfaa5c1f24ecb7c5c16b37423b79263fbd3668d2ae61f91\n",

968 | "Model config BartConfig {\n",

969 | " \"_name_or_path\": \"gogamza/kobart-base-v2\",\n",

970 | " \"activation_dropout\": 0.0,\n",

971 | " \"activation_function\": \"gelu\",\n",

972 | " \"add_bias_logits\": false,\n",

973 | " \"add_final_layer_norm\": false,\n",

974 | " \"architectures\": [\n",

975 | " \"BartModel\"\n",

976 | " ],\n",

977 | " \"attention_dropout\": 0.0,\n",

978 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

979 | " \"bos_token_id\": 1,\n",

980 | " \"classif_dropout\": 0.1,\n",

981 | " \"classifier_dropout\": 0.1,\n",

982 | " \"d_model\": 768,\n",

983 | " \"decoder_attention_heads\": 16,\n",

984 | " \"decoder_ffn_dim\": 3072,\n",

985 | " \"decoder_layerdrop\": 0.0,\n",

986 | " \"decoder_layers\": 6,\n",

987 | " \"decoder_start_token_id\": 1,\n",

988 | " \"do_blenderbot_90_layernorm\": false,\n",

989 | " \"dropout\": 0.1,\n",

990 | " \"encoder_attention_heads\": 16,\n",

991 | " \"encoder_ffn_dim\": 3072,\n",

992 | " \"encoder_layerdrop\": 0.0,\n",

993 | " \"encoder_layers\": 6,\n",

994 | " \"eos_token_id\": 1,\n",

995 | " \"extra_pos_embeddings\": 2,\n",

996 | " \"force_bos_token_to_be_generated\": false,\n",

997 | " \"forced_eos_token_id\": 1,\n",

998 | " \"gradient_checkpointing\": false,\n",

999 | " \"id2label\": {\n",

1000 | " \"0\": \"NEGATIVE\",\n",

1001 | " \"1\": \"POSITIVE\"\n",

1002 | " },\n",

1003 | " \"init_std\": 0.02,\n",

1004 | " \"is_encoder_decoder\": true,\n",

1005 | " \"kobart_version\": 2.0,\n",

1006 | " \"label2id\": {\n",

1007 | " \"NEGATIVE\": 0,\n",

1008 | " \"POSITIVE\": 1\n",

1009 | " },\n",

1010 | " \"max_position_embeddings\": 1026,\n",

1011 | " \"model_type\": \"bart\",\n",

1012 | " \"normalize_before\": false,\n",

1013 | " \"normalize_embedding\": true,\n",

1014 | " \"num_hidden_layers\": 6,\n",

1015 | " \"pad_token_id\": 3,\n",

1016 | " \"scale_embedding\": false,\n",

1017 | " \"static_position_embeddings\": false,\n",

1018 | " \"tokenizer_class\": \"PreTrainedTokenizerFast\",\n",

1019 | " \"transformers_version\": \"4.17.0\",\n",

1020 | " \"use_cache\": true,\n",

1021 | " \"vocab_size\": 30000\n",

1022 | "}\n",

1023 | "\n"

1024 | ]

1025 | }

1026 | ],

1027 | "source": [

1028 | "tokenizer = AutoTokenizer.from_pretrained(model_name)"

1029 | ]

1030 | },

1031 | {

1032 | "cell_type": "code",

1033 | "execution_count": 61,

1034 | "metadata": {},

1035 | "outputs": [

1036 | {

1037 | "data": {

1038 | "text/plain": [

1039 | "['▁안녕하',\n",

1040 | " '세요.',\n",

1041 | " '▁한국어',\n",

1042 | " '▁B',\n",

1043 | " 'A',\n",

1044 | " 'R',\n",

1045 | " 'T',\n",

1046 | " '입니다.',\n",

1047 | " 'ᄆ',\n",

1048 | " ':)',\n",

1049 | " '▁',\n",

1050 | " 'ᅵ',\n",

1051 | " '^',\n",

1052 | " 'o']"

1053 | ]

1054 | },

1055 | "execution_count": 61,

1056 | "metadata": {},

1057 | "output_type": "execute_result"

1058 | }

1059 | ],

1060 | "source": [

1061 | "tokenizer.tokenize(\"안녕하세요. 한국어 BART입니다.ㅁ:)ㅣ^o\")"

1062 | ]

1063 | },

1064 | {

1065 | "cell_type": "code",

1066 | "execution_count": 62,

1067 | "metadata": {},

1068 | "outputs": [],

1069 | "source": [

1070 | "from transformers import AutoModel"

1071 | ]

1072 | },

1073 | {

1074 | "cell_type": "code",

1075 | "execution_count": 63,

1076 | "metadata": {},

1077 | "outputs": [

1078 | {

1079 | "name": "stderr",

1080 | "output_type": "stream",

1081 | "text": [

1082 | "loading configuration file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/54a37e9385f90886428b084042f151c1a699203416d41765d94aac4cddb5fd5c.d098ef3866c1da94bdfaa5c1f24ecb7c5c16b37423b79263fbd3668d2ae61f91\n",

1083 | "Model config BartConfig {\n",

1084 | " \"_name_or_path\": \"gogamza/kobart-base-v2\",\n",

1085 | " \"activation_dropout\": 0.0,\n",

1086 | " \"activation_function\": \"gelu\",\n",

1087 | " \"add_bias_logits\": false,\n",

1088 | " \"add_final_layer_norm\": false,\n",

1089 | " \"architectures\": [\n",

1090 | " \"BartModel\"\n",

1091 | " ],\n",

1092 | " \"attention_dropout\": 0.0,\n",

1093 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

1094 | " \"bos_token_id\": 1,\n",

1095 | " \"classif_dropout\": 0.1,\n",

1096 | " \"classifier_dropout\": 0.1,\n",

1097 | " \"d_model\": 768,\n",

1098 | " \"decoder_attention_heads\": 16,\n",

1099 | " \"decoder_ffn_dim\": 3072,\n",

1100 | " \"decoder_layerdrop\": 0.0,\n",

1101 | " \"decoder_layers\": 6,\n",

1102 | " \"decoder_start_token_id\": 1,\n",

1103 | " \"do_blenderbot_90_layernorm\": false,\n",

1104 | " \"dropout\": 0.1,\n",

1105 | " \"encoder_attention_heads\": 16,\n",

1106 | " \"encoder_ffn_dim\": 3072,\n",

1107 | " \"encoder_layerdrop\": 0.0,\n",

1108 | " \"encoder_layers\": 6,\n",

1109 | " \"eos_token_id\": 1,\n",

1110 | " \"extra_pos_embeddings\": 2,\n",

1111 | " \"force_bos_token_to_be_generated\": false,\n",

1112 | " \"forced_eos_token_id\": 1,\n",

1113 | " \"gradient_checkpointing\": false,\n",

1114 | " \"id2label\": {\n",

1115 | " \"0\": \"NEGATIVE\",\n",

1116 | " \"1\": \"POSITIVE\"\n",

1117 | " },\n",

1118 | " \"init_std\": 0.02,\n",

1119 | " \"is_encoder_decoder\": true,\n",

1120 | " \"kobart_version\": 2.0,\n",

1121 | " \"label2id\": {\n",

1122 | " \"NEGATIVE\": 0,\n",

1123 | " \"POSITIVE\": 1\n",

1124 | " },\n",

1125 | " \"max_position_embeddings\": 1026,\n",

1126 | " \"model_type\": \"bart\",\n",

1127 | " \"normalize_before\": false,\n",

1128 | " \"normalize_embedding\": true,\n",

1129 | " \"num_hidden_layers\": 6,\n",

1130 | " \"pad_token_id\": 3,\n",

1131 | " \"scale_embedding\": false,\n",

1132 | " \"static_position_embeddings\": false,\n",

1133 | " \"tokenizer_class\": \"PreTrainedTokenizerFast\",\n",

1134 | " \"transformers_version\": \"4.17.0\",\n",

1135 | " \"use_cache\": true,\n",

1136 | " \"vocab_size\": 30000\n",

1137 | "}\n",

1138 | "\n",

1139 | "loading weights file https://huggingface.co/gogamza/kobart-base-v2/resolve/main/pytorch_model.bin from cache at /root/.cache/huggingface/transformers/6a128677efa8d82c5bc9853bbefcff450bf4174bed52765687fc77f1aa7a39c1.ef5977990801f5b7dbc37adda9fe5948ed9829c75ac20e99bf026098743b1978\n",

1140 | "All model checkpoint weights were used when initializing BartModel.\n",

1141 | "\n",

1142 | "All the weights of BartModel were initialized from the model checkpoint at gogamza/kobart-base-v2.\n",

1143 | "If your task is similar to the task the model of the checkpoint was trained on, you can already use BartModel for predictions without further training.\n"

1144 | ]

1145 | }

1146 | ],

1147 | "source": [

1148 | "model = AutoModel.from_pretrained(model_name)"

1149 | ]

1150 | },

1151 | {

1152 | "cell_type": "code",

1153 | "execution_count": 64,

1154 | "metadata": {},

1155 | "outputs": [],

1156 | "source": [

1157 | "inputs = tokenizer(['안녕하세요'], return_tensors='pt')"

1158 | ]

1159 | },

1160 | {

1161 | "cell_type": "code",

1162 | "execution_count": 65,

1163 | "metadata": {},

1164 | "outputs": [

1165 | {

1166 | "data": {

1167 | "text/plain": [

1168 | "{'input_ids': tensor([[22465, 23935]]), 'token_type_ids': tensor([[0, 0]]), 'attention_mask': tensor([[1, 1]])}"

1169 | ]

1170 | },

1171 | "execution_count": 65,

1172 | "metadata": {},

1173 | "output_type": "execute_result"

1174 | }

1175 | ],

1176 | "source": [

1177 | "inputs"

1178 | ]

1179 | },

1180 | {

1181 | "cell_type": "code",

1182 | "execution_count": 66,

1183 | "metadata": {},

1184 | "outputs": [],

1185 | "source": [

1186 | "results = model(inputs['input_ids'])"

1187 | ]

1188 | },

1189 | {

1190 | "cell_type": "code",

1191 | "execution_count": 67,

1192 | "metadata": {},

1193 | "outputs": [

1194 | {

1195 | "data": {

1196 | "text/plain": [

1197 | "odict_keys(['last_hidden_state', 'past_key_values', 'encoder_last_hidden_state'])"

1198 | ]

1199 | },

1200 | "execution_count": 67,

1201 | "metadata": {},

1202 | "output_type": "execute_result"

1203 | }

1204 | ],

1205 | "source": [

1206 | "results.keys()"

1207 | ]

1208 | },

1209 | {

1210 | "cell_type": "code",

1211 | "execution_count": 68,

1212 | "metadata": {},

1213 | "outputs": [

1214 | {

1215 | "data": {

1216 | "text/plain": [

1217 | "torch.Size([1, 2, 768])"

1218 | ]

1219 | },

1220 | "execution_count": 68,

1221 | "metadata": {},

1222 | "output_type": "execute_result"

1223 | }

1224 | ],

1225 | "source": [

1226 | "results['encoder_last_hidden_state'].shape # (batch_size, sequence_length, hidden state dimension)"

1227 | ]

1228 | },

1229 | {

1230 | "cell_type": "code",

1231 | "execution_count": 69,

1232 | "metadata": {},

1233 | "outputs": [

1234 | {

1235 | "data": {

1236 | "text/plain": [

1237 | "torch.Size([1, 2, 768])"

1238 | ]

1239 | },

1240 | "execution_count": 69,

1241 | "metadata": {},

1242 | "output_type": "execute_result"

1243 | }

1244 | ],

1245 | "source": [

1246 | "results['last_hidden_state'].shape"

1247 | ]

1248 | },

1249 | {

1250 | "cell_type": "markdown",

1251 | "metadata": {},

1252 | "source": [

1253 | "## BART for summarization"

1254 | ]

1255 | },

1256 | {

1257 | "cell_type": "code",

1258 | "execution_count": 70,

1259 | "metadata": {},

1260 | "outputs": [],

1261 | "source": [

1262 | "from transformers import PreTrainedTokenizerFast\n",

1263 | "from transformers import BartForConditionalGeneration"

1264 | ]

1265 | },

1266 | {

1267 | "cell_type": "code",

1268 | "execution_count": 71,

1269 | "metadata": {},

1270 | "outputs": [],

1271 | "source": [

1272 | "model_name = 'gogamza/kobart-summarization'"

1273 | ]

1274 | },

1275 | {

1276 | "cell_type": "code",

1277 | "execution_count": 72,

1278 | "metadata": {},

1279 | "outputs": [

1280 | {

1281 | "name": "stderr",

1282 | "output_type": "stream",

1283 | "text": [

1284 | "loading file https://huggingface.co/gogamza/kobart-summarization/resolve/main/tokenizer.json from cache at /root/.cache/huggingface/transformers/4369897f91813214377063544fb9a44ad537ca3a2559c7bdc98eaf9d934d4a89.dc2013f8bbecd755468e2c44397f53dc624be5451d0190744397caf61a20383f\n",

1285 | "loading file https://huggingface.co/gogamza/kobart-summarization/resolve/main/added_tokens.json from cache at /root/.cache/huggingface/transformers/c8171f2310611c5f6994c35b7016633d42194eb424192baa1910c896fdd197f6.04312f398a3bbda664297588800a86e0fda9d4ef4f0749cd9d96f88043daad39\n",

1286 | "loading file https://huggingface.co/gogamza/kobart-summarization/resolve/main/special_tokens_map.json from cache at /root/.cache/huggingface/transformers/aed722871fe9f8d064a1df70dcfe967be2f02797eaaaf6ee28ffd2c59d7514e9.15447ae63ad4a2eba8bc7a5146360711dc32b315b4f1488b4806debf35315e9a\n",

1287 | "loading file https://huggingface.co/gogamza/kobart-summarization/resolve/main/tokenizer_config.json from cache at None\n",

1288 | "loading configuration file https://huggingface.co/gogamza/kobart-summarization/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/1c32baaf6a1067a5e27a0dfbac0a3d23a86d958ab10b092d5ea4150bd451de17.4e52ef6c87e6938c92ba0d19888607d76e30e950e81060a8fa6cb1189c93614d\n",

1289 | "Model config BartConfig {\n",

1290 | " \"_name_or_path\": \"gogamza/kobart-summarization\",\n",

1291 | " \"activation_dropout\": 0.0,\n",

1292 | " \"activation_function\": \"gelu\",\n",

1293 | " \"add_bias_logits\": false,\n",

1294 | " \"add_final_layer_norm\": false,\n",

1295 | " \"architectures\": [\n",

1296 | " \"BartForConditionalGeneration\"\n",

1297 | " ],\n",

1298 | " \"attention_dropout\": 0.0,\n",

1299 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

1300 | " \"bos_token_id\": 0,\n",

1301 | " \"classif_dropout\": 0.1,\n",

1302 | " \"classifier_dropout\": 0.1,\n",

1303 | " \"d_model\": 768,\n",

1304 | " \"decoder_attention_heads\": 16,\n",

1305 | " \"decoder_ffn_dim\": 3072,\n",

1306 | " \"decoder_layerdrop\": 0.0,\n",

1307 | " \"decoder_layers\": 6,\n",

1308 | " \"decoder_start_token_id\": 2,\n",

1309 | " \"do_blenderbot_90_layernorm\": false,\n",

1310 | " \"dropout\": 0.1,\n",

1311 | " \"encoder_attention_heads\": 16,\n",

1312 | " \"encoder_ffn_dim\": 3072,\n",

1313 | " \"encoder_layerdrop\": 0.0,\n",

1314 | " \"encoder_layers\": 6,\n",

1315 | " \"eos_token_id\": 1,\n",

1316 | " \"extra_pos_embeddings\": 2,\n",

1317 | " \"force_bos_token_to_be_generated\": false,\n",

1318 | " \"forced_eos_token_id\": 2,\n",

1319 | " \"id2label\": {\n",

1320 | " \"0\": \"NEGATIVE\",\n",

1321 | " \"1\": \"POSITIVE\"\n",

1322 | " },\n",

1323 | " \"init_std\": 0.02,\n",

1324 | " \"is_encoder_decoder\": true,\n",

1325 | " \"label2id\": {\n",

1326 | " \"NEGATIVE\": 0,\n",

1327 | " \"POSITIVE\": 1\n",

1328 | " },\n",

1329 | " \"max_position_embeddings\": 1026,\n",

1330 | " \"model_type\": \"bart\",\n",

1331 | " \"normalize_before\": false,\n",

1332 | " \"normalize_embedding\": true,\n",

1333 | " \"num_hidden_layers\": 6,\n",

1334 | " \"pad_token_id\": 3,\n",

1335 | " \"scale_embedding\": false,\n",

1336 | " \"static_position_embeddings\": false,\n",

1337 | " \"transformers_version\": \"4.17.0\",\n",

1338 | " \"use_cache\": true,\n",

1339 | " \"vocab_size\": 30000\n",

1340 | "}\n",

1341 | "\n",

1342 | "The tokenizer class you load from this checkpoint is not the same type as the class this function is called from. It may result in unexpected tokenization. \n",

1343 | "The tokenizer class you load from this checkpoint is 'BartTokenizer'. \n",

1344 | "The class this function is called from is 'PreTrainedTokenizerFast'.\n",

1345 | "loading configuration file https://huggingface.co/gogamza/kobart-summarization/resolve/main/config.json from cache at /root/.cache/huggingface/transformers/1c32baaf6a1067a5e27a0dfbac0a3d23a86d958ab10b092d5ea4150bd451de17.4e52ef6c87e6938c92ba0d19888607d76e30e950e81060a8fa6cb1189c93614d\n",

1346 | "Model config BartConfig {\n",

1347 | " \"activation_dropout\": 0.0,\n",

1348 | " \"activation_function\": \"gelu\",\n",

1349 | " \"add_bias_logits\": false,\n",

1350 | " \"add_final_layer_norm\": false,\n",

1351 | " \"architectures\": [\n",

1352 | " \"BartForConditionalGeneration\"\n",

1353 | " ],\n",

1354 | " \"attention_dropout\": 0.0,\n",

1355 | " \"author\": \"Heewon Jeon(madjakarta@gmail.com)\",\n",

1356 | " \"bos_token_id\": 0,\n",

1357 | " \"classif_dropout\": 0.1,\n",

1358 | " \"classifier_dropout\": 0.1,\n",

1359 | " \"d_model\": 768,\n",

1360 | " \"decoder_attention_heads\": 16,\n",

1361 | " \"decoder_ffn_dim\": 3072,\n",

1362 | " \"decoder_layerdrop\": 0.0,\n",

1363 | " \"decoder_layers\": 6,\n",

1364 | " \"decoder_start_token_id\": 2,\n",

1365 | " \"do_blenderbot_90_layernorm\": false,\n",

1366 | " \"dropout\": 0.1,\n",

1367 | " \"encoder_attention_heads\": 16,\n",

1368 | " \"encoder_ffn_dim\": 3072,\n",

1369 | " \"encoder_layerdrop\": 0.0,\n",

1370 | " \"encoder_layers\": 6,\n",

1371 | " \"eos_token_id\": 1,\n",

1372 | " \"extra_pos_embeddings\": 2,\n",

1373 | " \"force_bos_token_to_be_generated\": false,\n",

1374 | " \"forced_eos_token_id\": 2,\n",

1375 | " \"id2label\": {\n",

1376 | " \"0\": \"NEGATIVE\",\n",

1377 | " \"1\": \"POSITIVE\"\n",

1378 | " },\n",

1379 | " \"init_std\": 0.02,\n",

1380 | " \"is_encoder_decoder\": true,\n",

1381 | " \"label2id\": {\n",

1382 | " \"NEGATIVE\": 0,\n",

1383 | " \"POSITIVE\": 1\n",

1384 | " },\n",

1385 | " \"max_position_embeddings\": 1026,\n",

1386 | " \"model_type\": \"bart\",\n",

1387 | " \"normalize_before\": false,\n",

1388 | " \"normalize_embedding\": true,\n",

1389 | " \"num_hidden_layers\": 6,\n",

1390 | " \"pad_token_id\": 3,\n",

1391 | " \"scale_embedding\": false,\n",

1392 | " \"static_position_embeddings\": false,\n",

1393 | " \"transformers_version\": \"4.17.0\",\n",

1394 | " \"use_cache\": true,\n",

1395 | " \"vocab_size\": 30000\n",

1396 | "}\n",

1397 | "\n",

1398 | "loading weights file https://huggingface.co/gogamza/kobart-summarization/resolve/main/pytorch_model.bin from cache at /root/.cache/huggingface/transformers/f30ba9ba60f377194e6a39913246c76f6dcac8158e399598ed56fec262103dba.b063b56b256aaf29f8c7c67e318ed78b83b9381147ac794d0df9ef0399066ea7\n",

1399 | "All model checkpoint weights were used when initializing BartForConditionalGeneration.\n",

1400 | "\n",

1401 | "All the weights of BartForConditionalGeneration were initialized from the model checkpoint at gogamza/kobart-summarization.\n",

1402 | "If your task is similar to the task the model of the checkpoint was trained on, you can already use BartForConditionalGeneration for predictions without further training.\n"

1403 | ]

1404 | }

1405 | ],

1406 | "source": [

1407 | "tokenizer = PreTrainedTokenizerFast.from_pretrained(model_name)\n",

1408 | "model = BartForConditionalGeneration.from_pretrained(model_name)"

1409 | ]

1410 | },

1411 | {

1412 | "cell_type": "code",

1413 | "execution_count": 73,

1414 | "metadata": {},

1415 | "outputs": [

1416 | {

1417 | "name": "stdout",

1418 | "output_type": "stream",

1419 | "text": [

1420 | "과거를 떠올려보자. 방송을 보던 우리의 모습을. 독보적인 매체는 TV였다. 온 가족이 둘러앉아 TV를 봤다. 간혹 가족들끼리 뉴스와 드라마, 예능 프로그램을 둘러싸고 리모컨 쟁탈전이 벌어지기도 했다. 각자 선호하는 프로그램을 '본방'으로 보기 위한 싸움이었다. TV가 한 대인지 두 대인지 여부도 그래서 중요했다. 지금은 어떤가. '안방극장'이라는 말은 옛말이 됐다. TV가 없는 집도 많다. 미디어의 혜택을 누릴 수 있는 방법은 늘어났다. 각자의 방에서 각자의 휴대폰으로, 노트북으로, 태블릿으로 콘텐츠를 즐긴다.\n"

1421 | ]

1422 | }

1423 | ],

1424 | "source": [

1425 | "text = \"과거를 떠올려보자. 방송을 보던 우리의 모습을. 독보적인 매체는 TV였다. 온 가족이 둘러앉아 TV를 봤다. 간혹 가족들끼리 뉴스와 드라마, 예능 프로그램을 둘러싸고 리모컨 쟁탈전이 벌어지기도 했다. 각자 선호하는 프로그램을 '본방'으로 보기 위한 싸움이었다. TV가 한 대인지 두 대인지 여부도 그래서 중요했다. 지금은 어떤가. '안방극장'이라는 말은 옛말이 됐다. TV가 없는 집도 많다. 미디어의 혜택을 누릴 수 있는 방법은 늘어났다. 각자의 방에서 각자의 휴대폰으로, 노트북으로, 태블릿으로 콘텐츠를 즐긴다.\"\n",

1426 | "print(text)"

1427 | ]

1428 | },

1429 | {

1430 | "cell_type": "code",

1431 | "execution_count": 74,

1432 | "metadata": {},

1433 | "outputs": [],

1434 | "source": [

1435 | "raw_input_ids = tokenizer.encode(text)\n",

1436 | "input_ids = [tokenizer.bos_token_id] + raw_input_ids + [tokenizer.eos_token_id]"

1437 | ]

1438 | },

1439 | {

1440 | "cell_type": "code",

1441 | "execution_count": 75,

1442 | "metadata": {},

1443 | "outputs": [],

1444 | "source": [

1445 | "summary_ids = model.generate(torch.tensor([input_ids]))"

1446 | ]

1447 | },

1448 | {

1449 | "cell_type": "code",

1450 | "execution_count": 76,

1451 | "metadata": {},

1452 | "outputs": [

1453 | {

1454 | "data": {

1455 | "text/plain": [

1456 | "'TV가 없는 집도 많고, TV가 없는 집도 많아진 만큼 미디어의 혜택을'"

1457 | ]

1458 | },

1459 | "execution_count": 76,

1460 | "metadata": {},

1461 | "output_type": "execute_result"

1462 | }

1463 | ],

1464 | "source": [

1465 | "tokenizer.decode(summary_ids.squeeze().tolist(), skip_special_tokens=True)"

1466 | ]

1467 | },

1468 | {

1469 | "cell_type": "code",

1470 | "execution_count": 77,

1471 | "metadata": {},

1472 | "outputs": [

1473 | {

1474 | "data": {

1475 | "text/plain": [

1476 | "tensor([[ 2, 16132, 8981, 14426, 14230, 9866, 14178, 14161, 16132, 8981,\n",

1477 | " 14426, 14230, 9866, 16664, 12335, 14933, 17166, 12024, 18477, 2]])"

1478 | ]

1479 | },

1480 | "execution_count": 77,

1481 | "metadata": {},

1482 | "output_type": "execute_result"

1483 | }

1484 | ],

1485 | "source": [

1486 | "summary_ids"

1487 | ]

1488 | },

1489 | {

1490 | "cell_type": "code",

1491 | "execution_count": 78,

1492 | "metadata": {},

1493 | "outputs": [

1494 | {

1495 | "data": {

1496 | "text/plain": [

1497 | "[0,\n",

1498 | " 15320,\n",

1499 | " 10443,\n",

1500 | " 17697,\n",

1501 | " 10313,\n",

1502 | " 10884,\n",

1503 | " 12060,\n",

1504 | " 245,\n",

1505 | " 21801,\n",

1506 | " 14046,\n",

1507 | " 9810,\n",

1508 | " 16433,\n",

1509 | " 15266,\n",

1510 | " 245,\n",

1511 | " 14373,\n",

1512 | " 10884,\n",

1513 | " 14134,\n",

1514 | " 14174,\n",

1515 | " 18610,\n",

1516 | " 16132,\n",

1517 | " 20029,\n",

1518 | " 14488,\n",

1519 | " 22795,\n",

1520 | " 16215,\n",

1521 | " 11700,\n",

1522 | " 11696,\n",

1523 | " 16132,\n",

1524 | " 10443,\n",

1525 | " 16786,\n",

1526 | " 14130,\n",

1527 | " 14313,\n",

1528 | " 13700,\n",

1529 | " 14978,\n",

1530 | " 9993,\n",

1531 | " 19769,\n",

1532 | " 15126,\n",

1533 | " 11863,\n",

1534 | " 15891,\n",

1535 | " 243,\n",

1536 | " 19517,\n",

1537 | " 17624,\n",

1538 | " 25749,\n",

1539 | " 14420,\n",

1540 | " 10607,\n",

1541 | " 12924,\n",

1542 | " 18787,\n",

1543 | " 13128,\n",

1544 | " 16984,\n",

1545 | " 16557,\n",

1546 | " 26499,\n",

1547 | " 19754,\n",

1548 | " 24252,\n",

1549 | " 26046,\n",

1550 | " 17624,\n",

1551 | " 14063,\n",

1552 | " 10888,\n",

1553 | " 10788,\n",

1554 | " 17075,\n",

1555 | " 17238,\n",

1556 | " 14353,\n",

1557 | " 20155,\n",

1558 | " 19249,\n",

1559 | " 16132,\n",

1560 | " 8981,\n",

1561 | " 14036,\n",

1562 | " 14029,\n",

1563 | " 15539,\n",

1564 | " 14196,\n",

1565 | " 14029,\n",

1566 | " 15539,\n",

1567 | " 20771,\n",

1568 | " 9866,\n",

1569 | " 14955,\n",

1570 | " 14610,\n",

1571 | " 15615,\n",

1572 | " 17444,\n",

1573 | " 14593,\n",

1574 | " 8981,\n",

1575 | " 245,\n",

1576 | " 26907,\n",

1577 | " 10788,\n",

1578 | " 29540,\n",

1579 | " 17164,\n",

1580 | " 18220,\n",

1581 | " 16565,\n",

1582 | " 25649,\n",

1583 | " 15097,\n",

1584 | " 14130,\n",

1585 | " 16132,\n",

1586 | " 8981,\n",

1587 | " 14426,\n",

1588 | " 14230,\n",

1589 | " 9866,\n",

1590 | " 14178,\n",

1591 | " 14130,\n",

1592 | " 17166,\n",

1593 | " 12024,\n",

1594 | " 18477,\n",

1595 | " 25689,\n",

1596 | " 14032,\n",

1597 | " 14082,\n",

1598 | " 20913,\n",

1599 | " 29553,\n",

1600 | " 14130,\n",

1601 | " 26667,\n",

1602 | " 14110,\n",

1603 | " 14030,\n",

1604 | " 26667,\n",

1605 | " 19594,\n",

1606 | " 16077,\n",

1607 | " 27476,\n",

1608 | " 16077,\n",

1609 | " 21980,\n",

1610 | " 14027,\n",

1611 | " 23786,\n",

1612 | " 14999,\n",

1613 | " 9267,\n",

1614 | " 14130,\n",

1615 | " 1]"

1616 | ]

1617 | },

1618 | "execution_count": 78,

1619 | "metadata": {},

1620 | "output_type": "execute_result"

1621 | }

1622 | ],

1623 | "source": [

1624 | "input_ids"

1625 | ]

1626 | },

1627 | {

1628 | "cell_type": "code",

1629 | "execution_count": null,

1630 | "metadata": {},

1631 | "outputs": [],

1632 | "source": []

1633 | }

1634 | ],

1635 | "metadata": {

1636 | "kernelspec": {

1637 | "display_name": "Python 3",

1638 | "language": "python",

1639 | "name": "python3"

1640 | },

1641 | "language_info": {

1642 | "codemirror_mode": {

1643 | "name": "ipython",

1644 | "version": 3

1645 | },

1646 | "file_extension": ".py",

1647 | "mimetype": "text/x-python",

1648 | "name": "python",

1649 | "nbconvert_exporter": "python",

1650 | "pygments_lexer": "ipython3",

1651 | "version": "3.6.9"

1652 | }

1653 | },

1654 | "nbformat": 4,

1655 | "nbformat_minor": 2

1656 | }

1657 |

--------------------------------------------------------------------------------

/codes/9-3_BERT라이브러리탐색.ipynb:

--------------------------------------------------------------------------------

1 | {

2 | "cells": [

3 | {

4 | "cell_type": "code",

5 | "execution_count": 2,

6 | "id": "1a5da9b8",

7 | "metadata": {},

8 | "outputs": [

9 | {

10 | "name": "stdout",

11 | "output_type": "stream",

12 | "text": [

13 | "Collecting ktrain\n",

14 | " Downloading ktrain-0.29.3.tar.gz (25.3 MB)\n",

15 | " --------------------------------------- 25.3/25.3 MB 59.9 MB/s eta 0:00:00\n",

16 | " Preparing metadata (setup.py): started\n",

17 | " Preparing metadata (setup.py): finished with status 'done'\n",

18 | "Collecting scikit-learn==0.24.2\n",

19 | " Downloading scikit_learn-0.24.2-cp38-cp38-win_amd64.whl (6.9 MB)\n",

20 | " ---------------------------------------- 6.9/6.9 MB 73.3 MB/s eta 0:00:00\n",

21 | "Requirement already satisfied: matplotlib>=3.0.0 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (3.3.4)\n",

22 | "Requirement already satisfied: pandas>=1.0.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (1.2.4)\n",

23 | "Collecting fastprogress>=0.1.21\n",

24 | " Downloading fastprogress-1.0.2-py3-none-any.whl (12 kB)\n",

25 | "Requirement already satisfied: requests in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (2.25.1)\n",

26 | "Requirement already satisfied: joblib in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (1.0.1)\n",

27 | "Requirement already satisfied: packaging in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (20.9)\n",

28 | "Collecting langdetect\n",

29 | " Downloading langdetect-1.0.9.tar.gz (981 kB)\n",

30 | " ---------------------------------------- 981.5/981.5 KB ? eta 0:00:00\n",

31 | " Preparing metadata (setup.py): started\n",

32 | " Preparing metadata (setup.py): finished with status 'done'\n",

33 | "Collecting jieba\n",

34 | " Downloading jieba-0.42.1.tar.gz (19.2 MB)\n",

35 | " --------------------------------------- 19.2/19.2 MB 73.1 MB/s eta 0:00:00\n",

36 | " Preparing metadata (setup.py): started\n",

37 | " Preparing metadata (setup.py): finished with status 'done'\n",

38 | "Collecting cchardet\n",

39 | " Downloading cchardet-2.1.7-cp38-cp38-win_amd64.whl (115 kB)\n",

40 | " -------------------------------------- 115.2/115.2 KB 6.6 MB/s eta 0:00:00\n",

41 | "Requirement already satisfied: chardet in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from ktrain) (4.0.0)\n",

42 | "Collecting syntok==1.3.3\n",

43 | " Downloading syntok-1.3.3-py3-none-any.whl (22 kB)\n",

44 | "Collecting seqeval==0.0.19\n",

45 | " Downloading seqeval-0.0.19.tar.gz (30 kB)\n",

46 | " Preparing metadata (setup.py): started\n",

47 | " Preparing metadata (setup.py): finished with status 'done'\n",

48 | "Collecting transformers==4.10.3\n",

49 | " Downloading transformers-4.10.3-py3-none-any.whl (2.8 MB)\n",

50 | " ---------------------------------------- 2.8/2.8 MB 88.8 MB/s eta 0:00:00\n",

51 | "Collecting sentencepiece\n",

52 | " Downloading sentencepiece-0.1.96-cp38-cp38-win_amd64.whl (1.1 MB)\n",

53 | " ---------------------------------------- 1.1/1.1 MB 67.6 MB/s eta 0:00:00\n",

54 | "Collecting keras_bert>=0.86.0\n",

55 | " Downloading keras-bert-0.89.0.tar.gz (25 kB)\n",

56 | " Preparing metadata (setup.py): started\n",

57 | " Preparing metadata (setup.py): finished with status 'done'\n",

58 | "Collecting whoosh\n",

59 | " Downloading Whoosh-2.7.4-py2.py3-none-any.whl (468 kB)\n",

60 | " ------------------------------------- 468.8/468.8 KB 30.6 MB/s eta 0:00:00\n",

61 | "Requirement already satisfied: threadpoolctl>=2.0.0 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from scikit-learn==0.24.2->ktrain) (2.1.0)\n",

62 | "Requirement already satisfied: numpy>=1.13.3 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from scikit-learn==0.24.2->ktrain) (1.20.1)\n",

63 | "Requirement already satisfied: scipy>=0.19.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from scikit-learn==0.24.2->ktrain) (1.6.2)\n",

64 | "Requirement already satisfied: Keras>=2.2.4 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from seqeval==0.0.19->ktrain) (2.7.0)\n",

65 | "Requirement already satisfied: regex in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from syntok==1.3.3->ktrain) (2021.4.4)\n",

66 | "Requirement already satisfied: pyyaml>=5.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from transformers==4.10.3->ktrain) (5.4.1)\n",

67 | "Requirement already satisfied: filelock in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from transformers==4.10.3->ktrain) (3.0.12)\n",

68 | "Collecting tokenizers<0.11,>=0.10.1\n",

69 | " Downloading tokenizers-0.10.3-cp38-cp38-win_amd64.whl (2.0 MB)\n",

70 | " ---------------------------------------- 2.0/2.0 MB 64.1 MB/s eta 0:00:00\n",

71 | "Requirement already satisfied: huggingface-hub>=0.0.12 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from transformers==4.10.3->ktrain) (0.4.0)\n",

72 | "Requirement already satisfied: sacremoses in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from transformers==4.10.3->ktrain) (0.0.47)\n",

73 | "Requirement already satisfied: tqdm>=4.27 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from transformers==4.10.3->ktrain) (4.59.0)\n",

74 | "Collecting keras-transformer==0.40.0\n",

75 | " Downloading keras-transformer-0.40.0.tar.gz (9.7 kB)\n",

76 | " Preparing metadata (setup.py): started\n",

77 | " Preparing metadata (setup.py): finished with status 'done'\n",

78 | "Collecting keras-pos-embd==0.13.0\n",

79 | " Downloading keras-pos-embd-0.13.0.tar.gz (5.6 kB)\n",

80 | " Preparing metadata (setup.py): started\n",

81 | " Preparing metadata (setup.py): finished with status 'done'\n",

82 | "Collecting keras-multi-head==0.29.0\n",

83 | " Downloading keras-multi-head-0.29.0.tar.gz (13 kB)\n",

84 | " Preparing metadata (setup.py): started\n",

85 | " Preparing metadata (setup.py): finished with status 'done'\n",

86 | "Collecting keras-layer-normalization==0.16.0\n",

87 | " Downloading keras-layer-normalization-0.16.0.tar.gz (3.9 kB)\n",

88 | " Preparing metadata (setup.py): started\n",

89 | " Preparing metadata (setup.py): finished with status 'done'\n",

90 | "Collecting keras-position-wise-feed-forward==0.8.0\n",

91 | " Downloading keras-position-wise-feed-forward-0.8.0.tar.gz (4.1 kB)\n",

92 | " Preparing metadata (setup.py): started\n",

93 | " Preparing metadata (setup.py): finished with status 'done'\n",

94 | "Collecting keras-embed-sim==0.10.0\n",

95 | " Downloading keras-embed-sim-0.10.0.tar.gz (3.6 kB)\n",

96 | " Preparing metadata (setup.py): started\n",

97 | " Preparing metadata (setup.py): finished with status 'done'\n",

98 | "Collecting keras-self-attention==0.51.0\n",

99 | " Downloading keras-self-attention-0.51.0.tar.gz (11 kB)\n",

100 | " Preparing metadata (setup.py): started\n",

101 | " Preparing metadata (setup.py): finished with status 'done'\n",

102 | "Requirement already satisfied: pyparsing!=2.0.4,!=2.1.2,!=2.1.6,>=2.0.3 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from matplotlib>=3.0.0->ktrain) (2.4.7)\n",

103 | "Requirement already satisfied: kiwisolver>=1.0.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from matplotlib>=3.0.0->ktrain) (1.3.1)\n",

104 | "Requirement already satisfied: pillow>=6.2.0 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from matplotlib>=3.0.0->ktrain) (8.2.0)\n",

105 | "Requirement already satisfied: python-dateutil>=2.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from matplotlib>=3.0.0->ktrain) (2.8.1)\n",

106 | "Requirement already satisfied: cycler>=0.10 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from matplotlib>=3.0.0->ktrain) (0.10.0)\n",

107 | "Requirement already satisfied: pytz>=2017.3 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from pandas>=1.0.1->ktrain) (2021.1)\n",

108 | "Requirement already satisfied: six in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from langdetect->ktrain) (1.15.0)\n",

109 | "Requirement already satisfied: urllib3<1.27,>=1.21.1 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from requests->ktrain) (1.26.4)\n",

110 | "Requirement already satisfied: idna<3,>=2.5 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from requests->ktrain) (2.10)\n",

111 | "Requirement already satisfied: certifi>=2017.4.17 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from requests->ktrain) (2020.12.5)\n",

112 | "Requirement already satisfied: typing-extensions>=3.7.4.3 in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from huggingface-hub>=0.0.12->transformers==4.10.3->ktrain) (3.7.4.3)\n",

113 | "Requirement already satisfied: click in c:\\users\\shyram\\anaconda3\\lib\\site-packages (from sacremoses->transformers==4.10.3->ktrain) (7.1.2)\n",

114 | "Building wheels for collected packages: ktrain, seqeval, keras_bert, keras-transformer, keras-embed-sim, keras-layer-normalization, keras-multi-head, keras-pos-embd, keras-position-wise-feed-forward, keras-self-attention, jieba, langdetect\n",

115 | " Building wheel for ktrain (setup.py): started\n",

116 | " Building wheel for ktrain (setup.py): finished with status 'done'\n",

117 | " Created wheel for ktrain: filename=ktrain-0.29.3-py3-none-any.whl size=25295401 sha256=1455f83b354cef5a321ad1f6b092c4a60df38cfc9958278fed03654b5d3ad991\n",

118 | " Stored in directory: c:\\users\\shyram\\appdata\\local\\pip\\cache\\wheels\\e4\\04\\35\\785e4d64090aa723d2731def6d883294c9e501d605330a34a2\n",

119 | " Building wheel for seqeval (setup.py): started\n",

120 | " Building wheel for seqeval (setup.py): finished with status 'done'\n",

121 | " Created wheel for seqeval: filename=seqeval-0.0.19-py3-none-any.whl size=9918 sha256=46a5f115cfbfbb78870a1cf01600f490346181296e507243b51fc3c7c94daa82\n",

122 | " Stored in directory: c:\\users\\shyram\\appdata\\local\\pip\\cache\\wheels\\58\\e5\\9e\\2f94312239a6753267da6ceafe12d614603b78d308676df5e2\n",

123 | " Building wheel for keras_bert (setup.py): started\n",

124 | " Building wheel for keras_bert (setup.py): finished with status 'done'\n",