├── Markdown笔记

├── Redis设计与实现1-数据结构.md

├── Redis设计与实现10-发布与订阅.md

├── Redis设计与实现11-事务.md

├── Redis设计与实现12-Lua脚本.md

├── Redis设计与实现2-对象.md

├── Redis设计与实现3-数据库基本结构.md

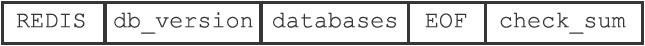

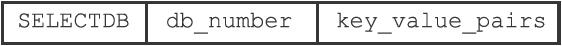

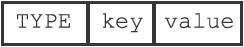

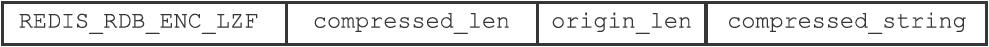

├── Redis设计与实现4-RDB持久化和AOF持久化.md

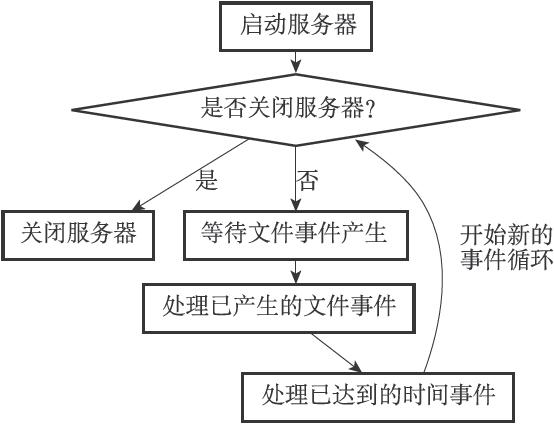

├── Redis设计与实现5-事件.md

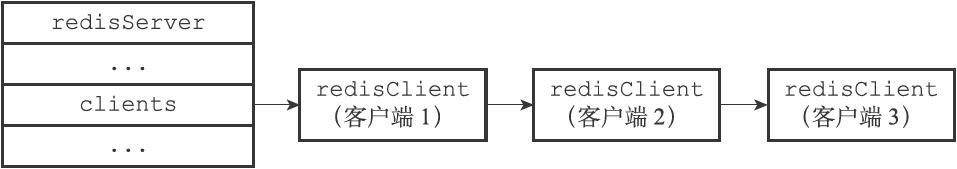

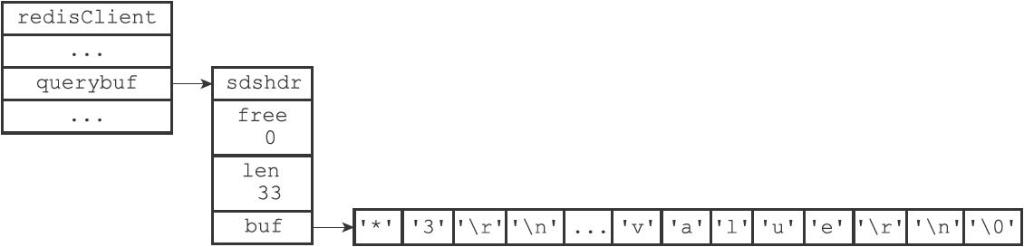

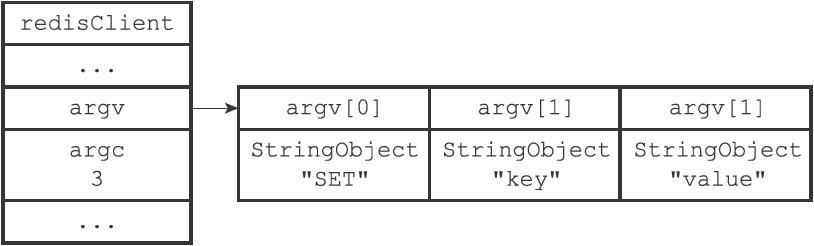

├── Redis设计与实现6-客户端与服务器.md

├── Redis设计与实现7-复制.md

├── Redis设计与实现8-Sentinel.md

└── Redis设计与实现9-集群.md

├── README.md

├── 思维导图

├── Pic

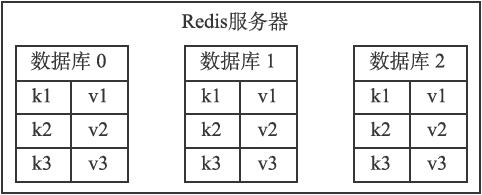

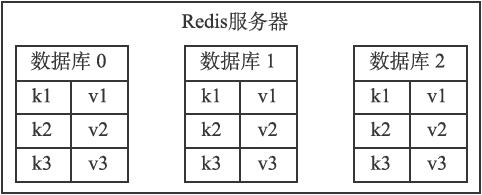

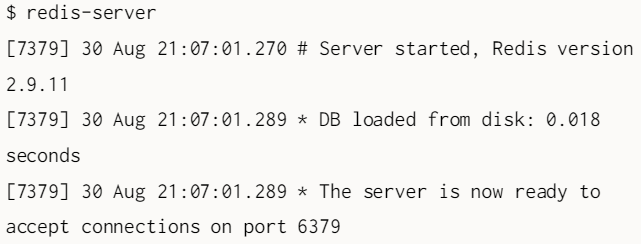

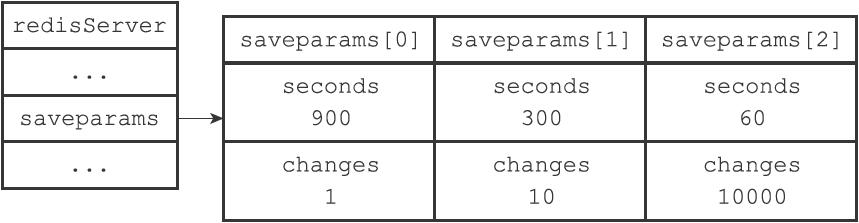

│ ├── 单机数据库.png

│ ├── 多机数据库.png

│ ├── 数据结构与对象.png

│ └── 独立功能的实现.png

└── Xmind

│ ├── 单机数据库.xmind

│ ├── 多机数据库.xmind

│ ├── 数据结构与对象.xmind

│ └── 独立功能的实现.xmind

└── 面试相关

├── Redis的简单应用场景总结.md

└── Redis面试常见基本问题.md

/Markdown笔记/Redis设计与实现1-数据结构.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现1-数据结构

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | - 数据结构

11 | mathjax: true

12 | date: 2020-01-02 10:30:29

13 | ---

14 |

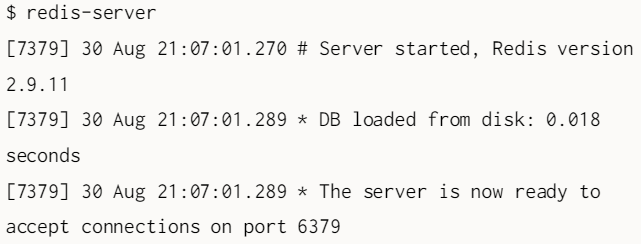

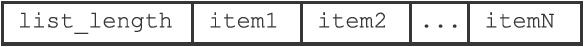

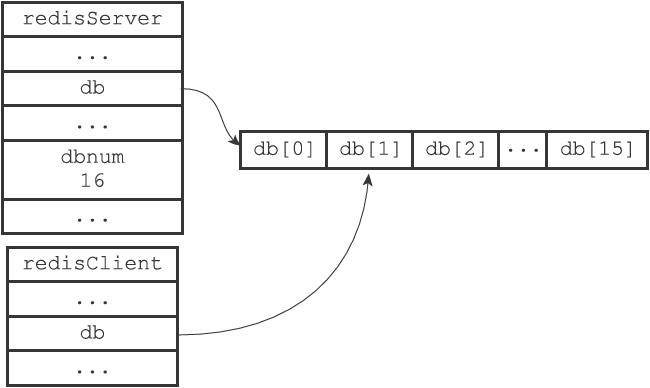

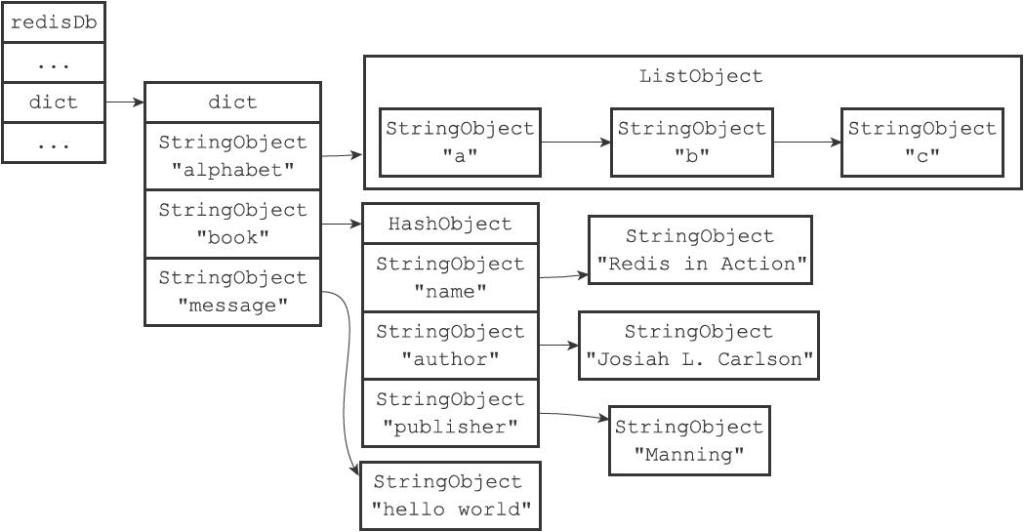

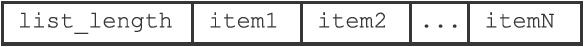

15 | 由于C语言的缺陷,Redis自身创建了许多有用的数据结构,包括:简单动态字符串、链表、字典、跳跃表、整数集合、压缩列表。

16 |

17 | # 1. 简单动态字符串

18 |

19 | 传统C语言的字符串以空字符结尾,而Redis自己重新构建了一种新的字符串结构,命名为简单动态字符串(simple dynamic string, SDS)。

20 |

21 | 在Redis中,**C字符串只会用在一些无须修改的地方**,比如打印常量:

22 |

23 | ```C

24 | redisLog(REDIS_WARNING,"Redis is now ready to exit, bye bye...");

25 | ```

26 |

27 | 如果是需要修改的地方,会使用SDS来表示:

28 |

29 | ```SHELL

30 | redis> RPUSH fruits "apple" "banana" "cherry"

31 | (integer) 3

32 | ```

33 |

34 | Redis 将在数据库中创建一个**新的键值对**,其中:

35 |

36 | - key是一个**字符串对象**,底层保存了一个字符串fruits的SDS。

37 | - value是一个**列表对象**,**列表包含了三个字符串对象**,由SDS实现。

38 |

39 | ## 1.1 SDS的定义

40 |

41 | SDS是一个结构体,定义在`sds.h/sdshdr`中

42 |

43 | ```C

44 | struct sdshdr {

45 | // 记录 buf 数组中已使用字节的数量

46 | // 等于 SDS 所保存字符串的长度

47 | int len;

48 | // 记录 buf 数组中未使用字节的数量

49 | int free;

50 | // 字节数组,用于保存字符串

51 | char buf[];

52 | };

53 | ```

54 |

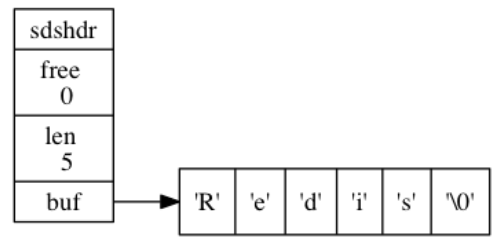

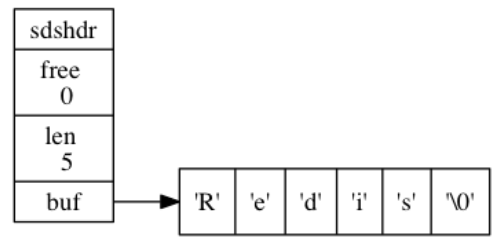

55 | 下面给出了一个示例,free为0代表所有空间都被使用,len长度为5,表示SDS保存的字符串长度为5,buf就是字符串实体。

56 |

57 |  58 |

59 | 保存空字符的1字节空间**不计算在len属性内**。遵循空字符结尾这一惯例的好处是, **SDS 可以直接重用一部分 C 字符串函数库里面的函数。**

60 |

61 | 比如我们不需要对SDS专门设置打印函数。

62 |

63 | ```C

64 | printf("%s",s->buf);

65 | ```

66 |

67 | ## 1.2 SDS 与 C 字符串的区别

68 |

69 | C 语言使用的简单的字符串表示方式, 并不能满足 Redis 对字符串在安全性、效率、以及功能方面的要求。主要有以下几个弊端。

70 |

71 | **(1)C字符串获取长度的能力有限**

72 |

73 | C字符串需要依靠遍历获取长度,时间复杂度$O(N)$,而SDS本身记录了len,所以时间复杂度$O (1)$,**常数时间**。

74 |

75 | **(2)杜绝缓冲区溢出**

76 |

77 | 由于C字符串不记录长度,当我们拼接两个字符串的时候,容器可能**因为空间不足发生溢出**。redis中的`sdscat`将在执行拼接操作前**检查长度是否充足**,若不足则先拓展空间,再拼接。

78 |

79 | **(3)减少修改字符串时带来的内存重分配次数**

80 |

81 | C字符串类似于数组,每次修改大小都会重新分配以此内存。Redis的分配原理类似于`std::vector`,通过**空间预分配**的办法**优化字符串增加**,分配规则如下:

82 |

83 | - 若len比较小(小于1MB),则free是len一样大。如果修改后len为13字节,则free也为13字节,buf实际长度为13+13+1=27字节。

84 | - 若len比较大(大于1MB),则每次free只会有1MB,比如修改后len为30MB,则free为1MB,总长度为30MB+1MB+1byte。

85 |

86 | 此外,使用**惰性空间释放**来**优化字符串缩短**。当缩短时,将释放的空间放入free中保存起来,等待使用。

87 |

88 | **(4)二进制安全**

89 |

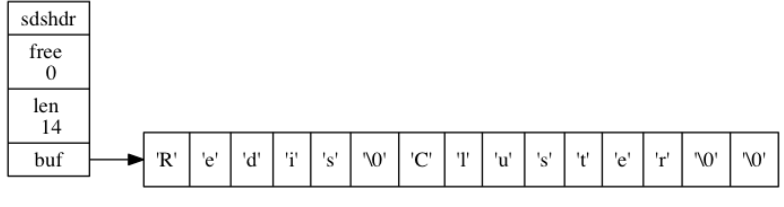

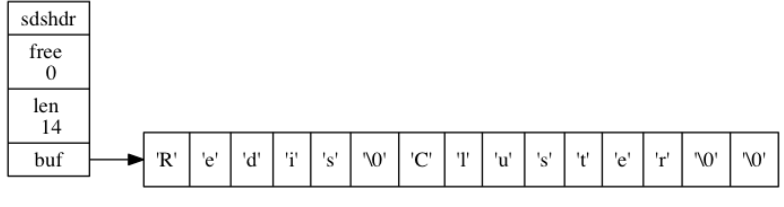

90 | C字符串以空字符`\0`结尾,使得 C 字符串只能保存文本数据, 而不能保存像图片、音频、视频、压缩文件这样的二进制数据。我们希望**有一种使用空字符来分割多个单词的特殊数据格式**。换句话说,**数据写入时什么样,读取时就是什么样**。

91 |

92 | SDS利用len来判断是否结束,而不是空字符`\0`

93 |

94 |

58 |

59 | 保存空字符的1字节空间**不计算在len属性内**。遵循空字符结尾这一惯例的好处是, **SDS 可以直接重用一部分 C 字符串函数库里面的函数。**

60 |

61 | 比如我们不需要对SDS专门设置打印函数。

62 |

63 | ```C

64 | printf("%s",s->buf);

65 | ```

66 |

67 | ## 1.2 SDS 与 C 字符串的区别

68 |

69 | C 语言使用的简单的字符串表示方式, 并不能满足 Redis 对字符串在安全性、效率、以及功能方面的要求。主要有以下几个弊端。

70 |

71 | **(1)C字符串获取长度的能力有限**

72 |

73 | C字符串需要依靠遍历获取长度,时间复杂度$O(N)$,而SDS本身记录了len,所以时间复杂度$O (1)$,**常数时间**。

74 |

75 | **(2)杜绝缓冲区溢出**

76 |

77 | 由于C字符串不记录长度,当我们拼接两个字符串的时候,容器可能**因为空间不足发生溢出**。redis中的`sdscat`将在执行拼接操作前**检查长度是否充足**,若不足则先拓展空间,再拼接。

78 |

79 | **(3)减少修改字符串时带来的内存重分配次数**

80 |

81 | C字符串类似于数组,每次修改大小都会重新分配以此内存。Redis的分配原理类似于`std::vector`,通过**空间预分配**的办法**优化字符串增加**,分配规则如下:

82 |

83 | - 若len比较小(小于1MB),则free是len一样大。如果修改后len为13字节,则free也为13字节,buf实际长度为13+13+1=27字节。

84 | - 若len比较大(大于1MB),则每次free只会有1MB,比如修改后len为30MB,则free为1MB,总长度为30MB+1MB+1byte。

85 |

86 | 此外,使用**惰性空间释放**来**优化字符串缩短**。当缩短时,将释放的空间放入free中保存起来,等待使用。

87 |

88 | **(4)二进制安全**

89 |

90 | C字符串以空字符`\0`结尾,使得 C 字符串只能保存文本数据, 而不能保存像图片、音频、视频、压缩文件这样的二进制数据。我们希望**有一种使用空字符来分割多个单词的特殊数据格式**。换句话说,**数据写入时什么样,读取时就是什么样**。

91 |

92 | SDS利用len来判断是否结束,而不是空字符`\0`

93 |

94 |  95 |

96 | # 2. 链表

97 |

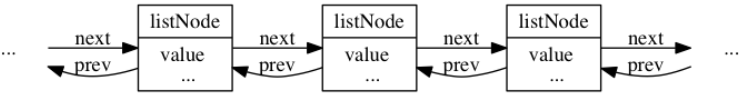

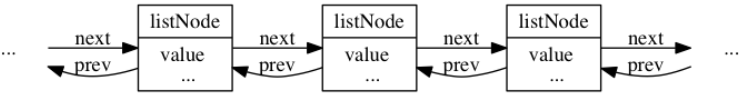

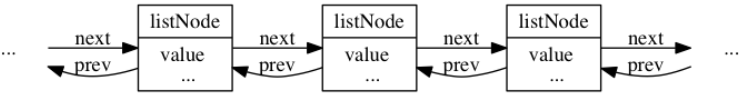

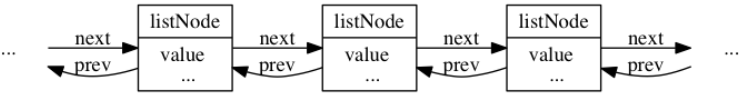

98 | 链表随机读写能力差,但增删和重排能力较强。C语言没有链表结构,所以Redis自制了一个。

99 |

100 | **链表节点**定义在`adlist.h/listNode`,如下:

101 |

102 | ```C

103 | typedef struct listNode {

104 | // 前置节点

105 | struct listNode *prev;

106 | // 后置节点

107 | struct listNode *next;

108 | // 节点的值

109 | void *value;

110 | } listNode;

111 | ```

112 |

113 | 这是一个**双端链表**。

114 |

115 |

116 |

117 | 虽然可以多个Node组成链表,但是为了方便,Redis设计了`adlist.h/list` 来持有链表。

118 |

119 | ```C

120 | typedef struct list {

121 | // 表头节点

122 | listNode *head;

123 | // 表尾节点

124 | listNode *tail;

125 | // 链表所包含的节点数量

126 | unsigned long len;

127 | // 节点值复制函数

128 | void *(*dup)(void *ptr);

129 | // 节点值释放函数

130 | void (*free)(void *ptr);

131 | // 节点值对比函数

132 | int (*match)(void *ptr, void *key);

133 | } list;

134 | ```

135 |

136 | Redis 的链表实现的特性可以总结如下:

137 |

138 | - 双端

139 | - 无环,表头和结尾都指向`NULL`

140 | - 带有表头表位指针,访问$ O (1)$

141 | - 自带链表长度计数器

142 | - **多态**:使用`void*`来保存节点值,有泛型编程内味了。

143 |

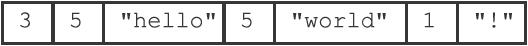

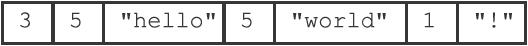

144 | # 3. 字典

145 |

146 | 在字典中, 一个键(key)可以和一个值(value)进行关联(或者说将键映射为值), 这些**关联的键和值就被称为键值对**。字典中的每个键必须保证都是独一无二的。C并没有这样的结构,所以Redis自己实现了。

147 |

148 | ## 3.1 字典的实现

149 |

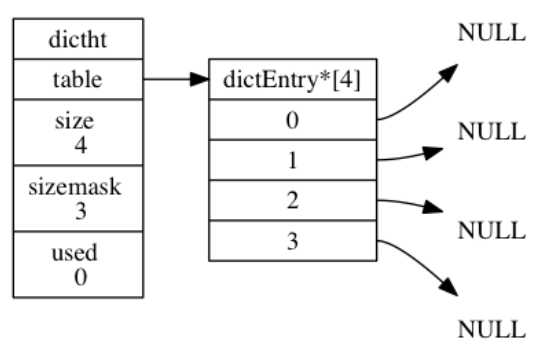

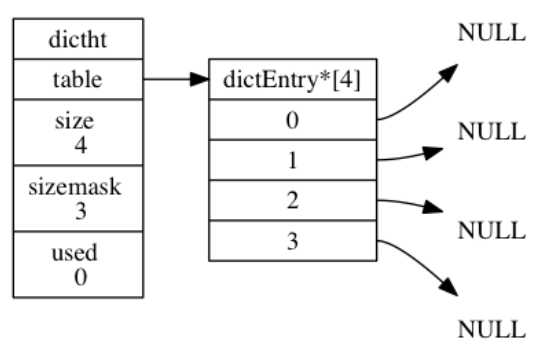

150 | Redis 字典所使用的**哈希表**由 `dict.h/dictht` 结构定义:

151 |

152 | ```C

153 | typedef struct dictht {

154 | // 哈希表数组

155 | dictEntry **table;

156 | // 哈希表大小

157 | unsigned long size;

158 | // 哈希表大小掩码,用于计算索引值

159 | // 总是等于 size - 1

160 | unsigned long sizemask

161 | // 该哈希表已有节点的数量

162 | unsigned long used;

163 | } dictht;

164 | ```

165 |

166 | `table` 是一个数组, 数组中的每个元素都是一个指向 `dict.h/dictEntry` 结构的指针。

167 |

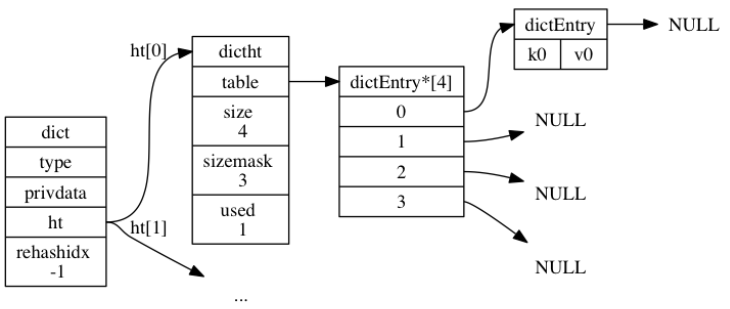

168 |

95 |

96 | # 2. 链表

97 |

98 | 链表随机读写能力差,但增删和重排能力较强。C语言没有链表结构,所以Redis自制了一个。

99 |

100 | **链表节点**定义在`adlist.h/listNode`,如下:

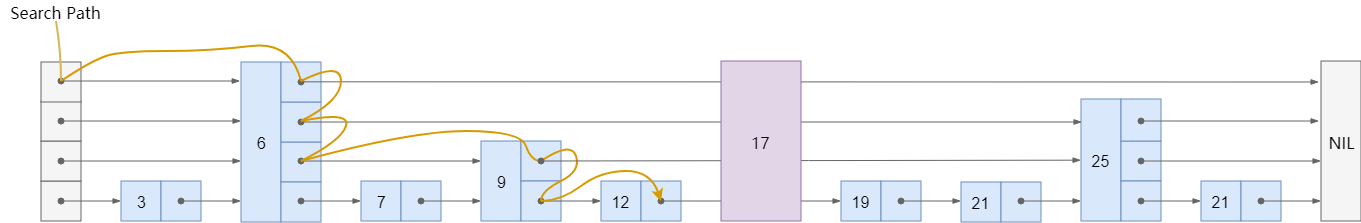

101 |

102 | ```C

103 | typedef struct listNode {

104 | // 前置节点

105 | struct listNode *prev;

106 | // 后置节点

107 | struct listNode *next;

108 | // 节点的值

109 | void *value;

110 | } listNode;

111 | ```

112 |

113 | 这是一个**双端链表**。

114 |

115 |

116 |

117 | 虽然可以多个Node组成链表,但是为了方便,Redis设计了`adlist.h/list` 来持有链表。

118 |

119 | ```C

120 | typedef struct list {

121 | // 表头节点

122 | listNode *head;

123 | // 表尾节点

124 | listNode *tail;

125 | // 链表所包含的节点数量

126 | unsigned long len;

127 | // 节点值复制函数

128 | void *(*dup)(void *ptr);

129 | // 节点值释放函数

130 | void (*free)(void *ptr);

131 | // 节点值对比函数

132 | int (*match)(void *ptr, void *key);

133 | } list;

134 | ```

135 |

136 | Redis 的链表实现的特性可以总结如下:

137 |

138 | - 双端

139 | - 无环,表头和结尾都指向`NULL`

140 | - 带有表头表位指针,访问$ O (1)$

141 | - 自带链表长度计数器

142 | - **多态**:使用`void*`来保存节点值,有泛型编程内味了。

143 |

144 | # 3. 字典

145 |

146 | 在字典中, 一个键(key)可以和一个值(value)进行关联(或者说将键映射为值), 这些**关联的键和值就被称为键值对**。字典中的每个键必须保证都是独一无二的。C并没有这样的结构,所以Redis自己实现了。

147 |

148 | ## 3.1 字典的实现

149 |

150 | Redis 字典所使用的**哈希表**由 `dict.h/dictht` 结构定义:

151 |

152 | ```C

153 | typedef struct dictht {

154 | // 哈希表数组

155 | dictEntry **table;

156 | // 哈希表大小

157 | unsigned long size;

158 | // 哈希表大小掩码,用于计算索引值

159 | // 总是等于 size - 1

160 | unsigned long sizemask

161 | // 该哈希表已有节点的数量

162 | unsigned long used;

163 | } dictht;

164 | ```

165 |

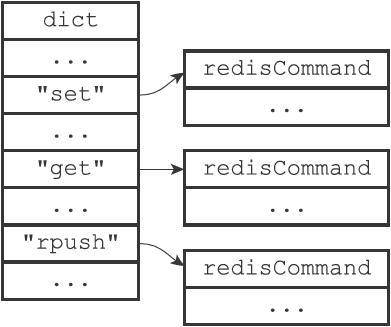

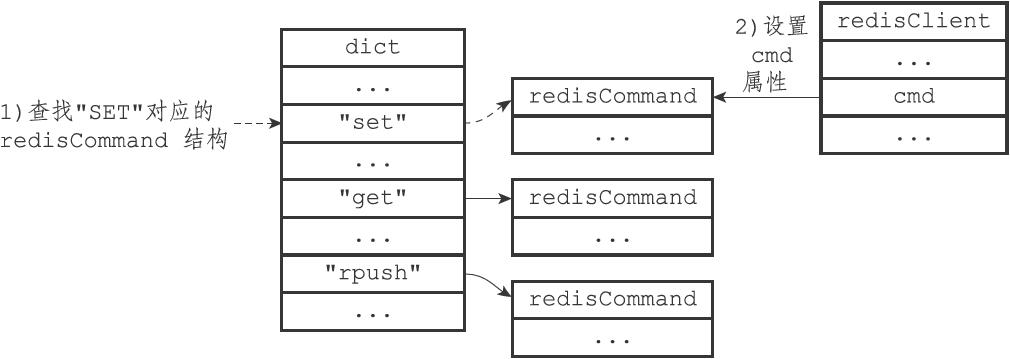

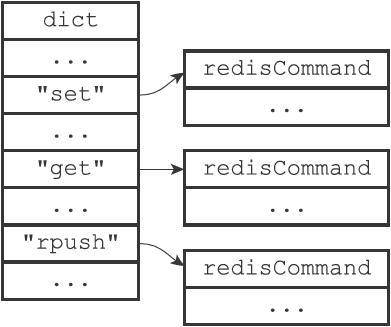

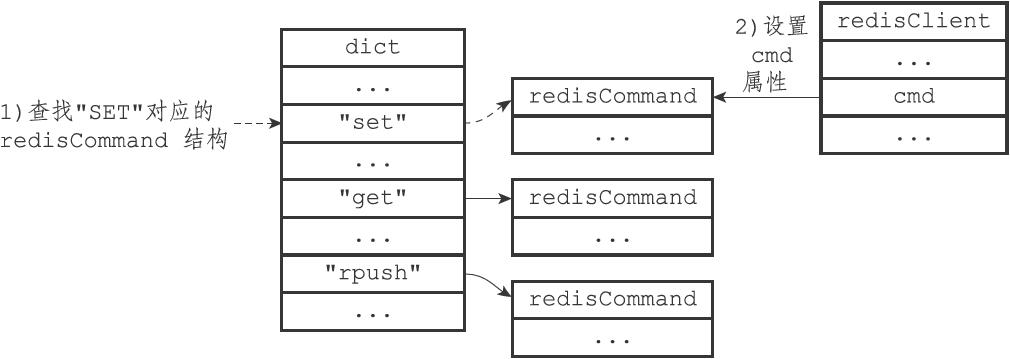

166 | `table` 是一个数组, 数组中的每个元素都是一个指向 `dict.h/dictEntry` 结构的指针。

167 |

168 |  169 |

170 | **哈希表节点**使用 `dictEntry` 结构表示, 每个 `dictEntry` 结构都保存着一个键值对:

171 |

172 | ```C

173 | typedef struct dictEntry {

174 | // 键

175 | void *key;

176 | // 值

177 | union {

178 | void *val;

179 | uint64_t u64;

180 | int64_t s64;

181 | } v;

182 | // 指向下个哈希表节点,形成链表

183 | struct dictEntry *next;

184 | } dictEntry;

185 | ```

186 |

187 | `v` 属性则保存着键值对中的值, 值可以是一个指针, 或者是一个 `uint64_t` 整数, 又或者是一个 `int64_t` 整数。

188 |

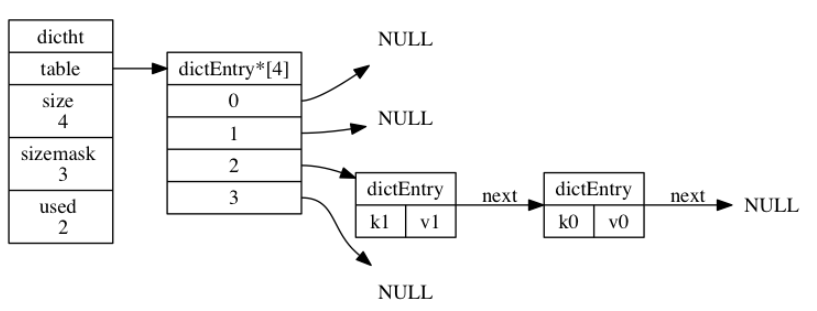

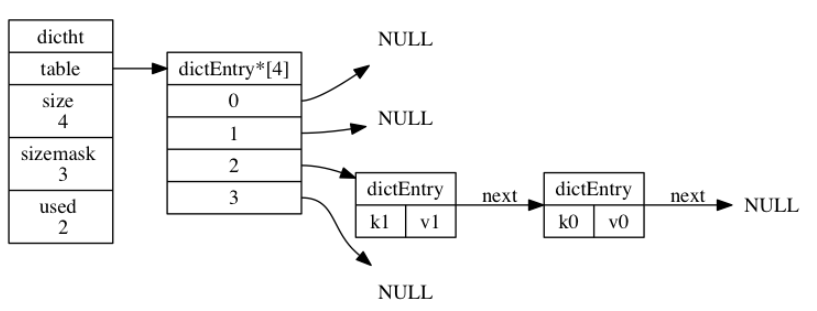

189 | `next` 属性是指向另一个哈希表节点的指针, 这个指针可以将多个哈希值相同的键值对连接在一次, 以此来**解决键冲突(collision)的问题**。

190 |

191 | 下图中,键的索引值都是2,通过链表的形式完成了冲突的规避。

192 |

193 |

169 |

170 | **哈希表节点**使用 `dictEntry` 结构表示, 每个 `dictEntry` 结构都保存着一个键值对:

171 |

172 | ```C

173 | typedef struct dictEntry {

174 | // 键

175 | void *key;

176 | // 值

177 | union {

178 | void *val;

179 | uint64_t u64;

180 | int64_t s64;

181 | } v;

182 | // 指向下个哈希表节点,形成链表

183 | struct dictEntry *next;

184 | } dictEntry;

185 | ```

186 |

187 | `v` 属性则保存着键值对中的值, 值可以是一个指针, 或者是一个 `uint64_t` 整数, 又或者是一个 `int64_t` 整数。

188 |

189 | `next` 属性是指向另一个哈希表节点的指针, 这个指针可以将多个哈希值相同的键值对连接在一次, 以此来**解决键冲突(collision)的问题**。

190 |

191 | 下图中,键的索引值都是2,通过链表的形式完成了冲突的规避。

192 |

193 |  194 |

195 | ---

196 |

197 | 上面提到的是哈希表和哈希表节点的实现,现在来说真正的**字典结构**。Redis 中的字典由 `dict.h/dict` 结构表示:

198 |

199 | ```C

200 | typedef struct dict {

201 | // 类型特定函数

202 | dictType *type;

203 | // 私有数据

204 | void *privdata;

205 | // 哈希表

206 | dictht ht[2];

207 | // rehash 索引

208 | // 当 rehash 不在进行时,值为 -1

209 | int rehashidx; /* rehashing not in progress if rehashidx == -1 */

210 | } dict;

211 | ```

212 |

213 | 其中`type` 属性和 `privdata` 属性是**针对不同类型的键值对, 为创建多态字典而设置的**。

214 |

215 | - `type` 属性是一个指向 `dictType` 结构的指针, 每个 `dictType` 结构保存了一簇用于操作特定类型键值对的函数。

216 | - `privdata` 属性则保存了需要传给那些类型特定函数的可选参数。

217 |

218 | ```C

219 | typedef struct dictType {

220 | // 计算哈希值的函数

221 | unsigned int (*hashFunction)(const void *key);

222 | // 复制键的函数

223 | void *(*keyDup)(void *privdata, const void *key);

224 | // 复制值的函数

225 | void *(*valDup)(void *privdata, const void *obj);

226 | // 对比键的函数

227 | int (*keyCompare)(void *privdata, const void *key1, const void *key2);

228 | // 销毁键的函数

229 | void (*keyDestructor)(void *privdata, void *key);

230 | // 销毁值的函数

231 | void (*valDestructor)(void *privdata, void *obj);

232 | } dictType;

233 | ```

234 |

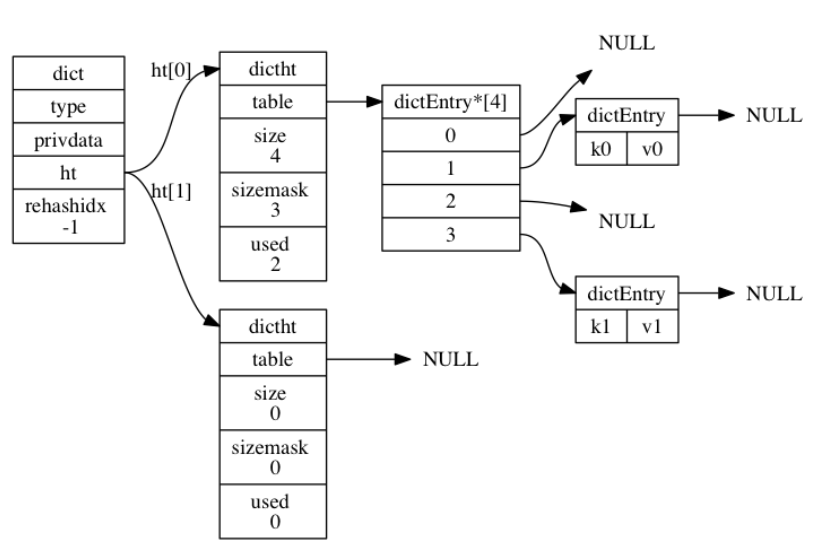

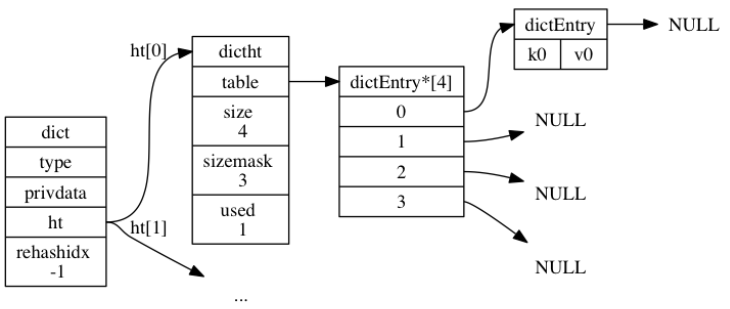

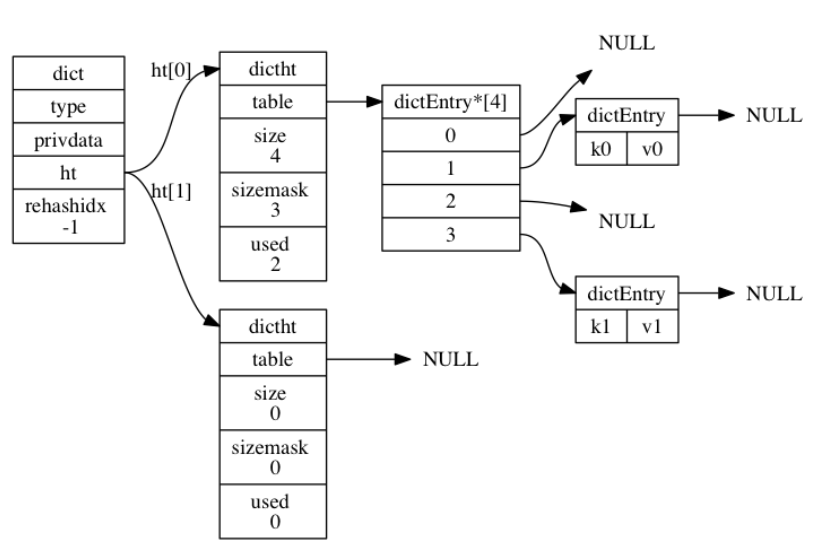

235 | 哈希表数组ht包含了两个元素, 一般情况下, 字典只使用 `ht[0]` 哈希表, `ht[1]` 哈希表只会在对 `ht[0]` 哈希表进行 rehash 时使用。

236 |

237 | 除了 `ht[1]` 之外, 另一个和 rehash 有关的属性就是 `rehashidx` : 它记录了 rehash 目前的进度, 如果目前没有在进行 rehash , 那么它的值为 `-1` 。

238 |

239 | 下图展示了一个普通状态下(没有rehash)的字典

240 |

241 |

194 |

195 | ---

196 |

197 | 上面提到的是哈希表和哈希表节点的实现,现在来说真正的**字典结构**。Redis 中的字典由 `dict.h/dict` 结构表示:

198 |

199 | ```C

200 | typedef struct dict {

201 | // 类型特定函数

202 | dictType *type;

203 | // 私有数据

204 | void *privdata;

205 | // 哈希表

206 | dictht ht[2];

207 | // rehash 索引

208 | // 当 rehash 不在进行时,值为 -1

209 | int rehashidx; /* rehashing not in progress if rehashidx == -1 */

210 | } dict;

211 | ```

212 |

213 | 其中`type` 属性和 `privdata` 属性是**针对不同类型的键值对, 为创建多态字典而设置的**。

214 |

215 | - `type` 属性是一个指向 `dictType` 结构的指针, 每个 `dictType` 结构保存了一簇用于操作特定类型键值对的函数。

216 | - `privdata` 属性则保存了需要传给那些类型特定函数的可选参数。

217 |

218 | ```C

219 | typedef struct dictType {

220 | // 计算哈希值的函数

221 | unsigned int (*hashFunction)(const void *key);

222 | // 复制键的函数

223 | void *(*keyDup)(void *privdata, const void *key);

224 | // 复制值的函数

225 | void *(*valDup)(void *privdata, const void *obj);

226 | // 对比键的函数

227 | int (*keyCompare)(void *privdata, const void *key1, const void *key2);

228 | // 销毁键的函数

229 | void (*keyDestructor)(void *privdata, void *key);

230 | // 销毁值的函数

231 | void (*valDestructor)(void *privdata, void *obj);

232 | } dictType;

233 | ```

234 |

235 | 哈希表数组ht包含了两个元素, 一般情况下, 字典只使用 `ht[0]` 哈希表, `ht[1]` 哈希表只会在对 `ht[0]` 哈希表进行 rehash 时使用。

236 |

237 | 除了 `ht[1]` 之外, 另一个和 rehash 有关的属性就是 `rehashidx` : 它记录了 rehash 目前的进度, 如果目前没有在进行 rehash , 那么它的值为 `-1` 。

238 |

239 | 下图展示了一个普通状态下(没有rehash)的字典

240 |

241 |  242 |

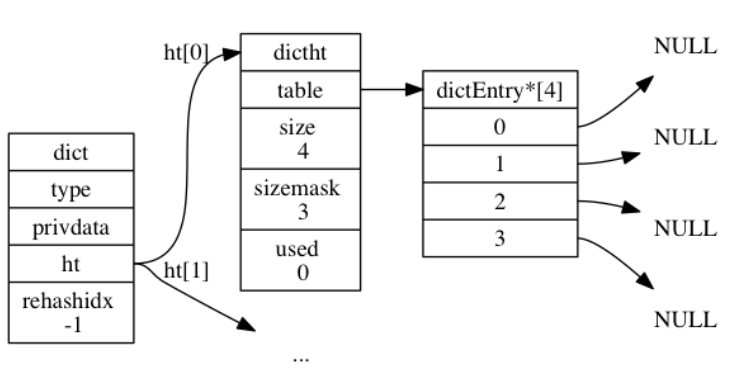

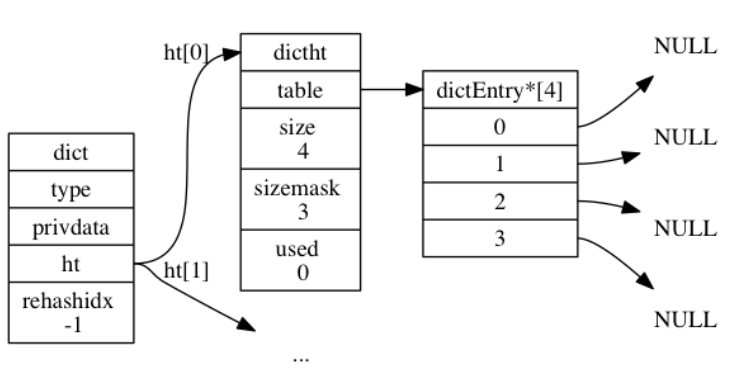

243 | ## 3.2 哈希算法

244 |

245 | 程序需要先根据键值对的键计算出**哈希值和索引值**, 然后再根据索引值, 将包含新键值对的哈希表节点放到哈希表数组的指定索引上面。

246 |

247 | Redis 计算哈希值和索引值的方法如下:

248 |

249 | ```C

250 | // 使用字典设置的哈希函数,计算键 key 的哈希值

251 | hash = dict->type->hashFunction(key);

252 |

253 | // 使用哈希表的 sizemask 属性和哈希值,计算出索引值

254 | // 根据情况不同, ht[x] 可以是 ht[0] 或者 ht[1]

255 | index = hash & dict->ht[x].sizemask;

256 | ```

257 |

258 | 举个例子,假如想要将键值对`k0` 和 `v0` 添加到下面的字典中。

259 |

260 |

242 |

243 | ## 3.2 哈希算法

244 |

245 | 程序需要先根据键值对的键计算出**哈希值和索引值**, 然后再根据索引值, 将包含新键值对的哈希表节点放到哈希表数组的指定索引上面。

246 |

247 | Redis 计算哈希值和索引值的方法如下:

248 |

249 | ```C

250 | // 使用字典设置的哈希函数,计算键 key 的哈希值

251 | hash = dict->type->hashFunction(key);

252 |

253 | // 使用哈希表的 sizemask 属性和哈希值,计算出索引值

254 | // 根据情况不同, ht[x] 可以是 ht[0] 或者 ht[1]

255 | index = hash & dict->ht[x].sizemask;

256 | ```

257 |

258 | 举个例子,假如想要将键值对`k0` 和 `v0` 添加到下面的字典中。

259 |

260 |  261 |

262 | 假设计算出的hash值是8,则index为

263 |

264 | ```c

265 | index = hash & dict->ht[0].sizemask = 8 & 3 = 0;

266 | ```

267 |

268 |

261 |

262 | 假设计算出的hash值是8,则index为

263 |

264 | ```c

265 | index = hash & dict->ht[0].sizemask = 8 & 3 = 0;

266 | ```

267 |

268 |  269 |

270 | 至于Redis的哈希值计算方法,使用的是 MurmurHash2。这种算法的优点在于, 即使输入的键是有规律的, 算法仍能给出一个很好的随机分布性, 并且算法的计算速度也非常快。

271 |

272 | ## 3.3 Rehash

273 |

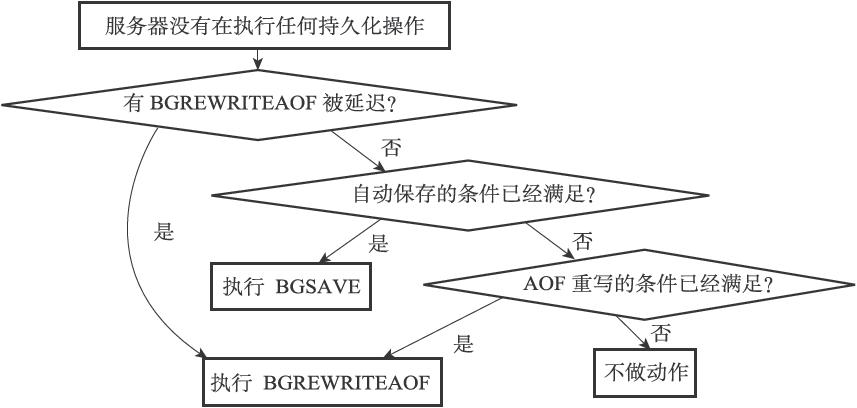

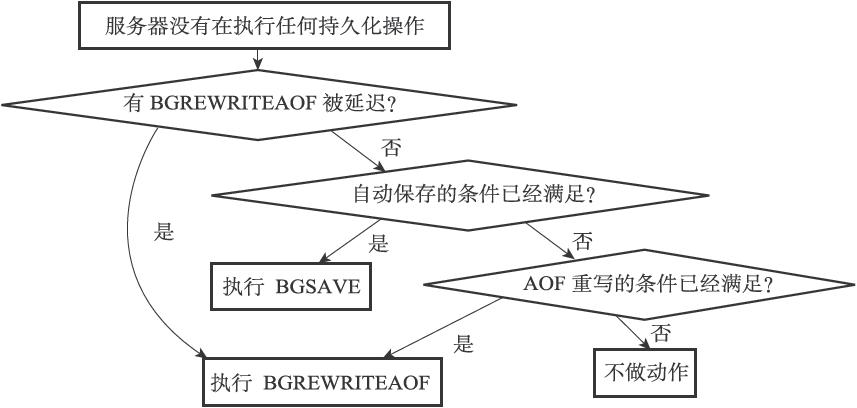

274 | 随着操作的不断执行, 哈希表保存的键值对会逐渐地增多或者减少, 为了让哈希表的**负载因子(load factor)**维持在一个合理的范围之内, **当哈希表保存的键值对数量太多或者太少时, 程序需要对哈希表的大小进行相应的扩展或者收缩。**

275 |

276 | 再哈希的关键在于**重新分配哈希表的大小**,分配的原则如下:

277 |

278 | - 如果执行拓展操作`ht[1]` 的大小为第一个大于等于 `ht[0].used * 2` 的 $2^n$,比如原表大小为4,则 `ht[0].used * 2`结果为8,而8刚好是$2^3$,所以新的大小是8。

279 | - 如果执行的是收缩操作, 那么 `ht[1]` 的大小为第一个大于等于 `ht[0].used` 的$2^ n$

280 |

281 | 完成分配后,将保存在 `ht[0]` 中的所有键值对 **rehash** 到 `ht[1]` 上面,然后 将 `ht[1]` 设置为 `ht[0]` , 并在 `ht[1]` 新创建一个空白哈希表, 为下一次 rehash 做准备。

282 |

283 | 决定是否再Hash的要素来自于负载因子,计算方法如下:

284 |

285 | ```C

286 | //负载因子 = 哈希表已保存节点数量 / 哈希表大小

287 | load_factor = ht[0].used / ht[0].size

288 | ```

289 |

290 | ## 3.4 渐进式Rehash

291 |

292 | 如果键值对很多,则将`ht[0]`重新hash到`ht[1]`上,则会导致服务器在一段时间内停止服务。为了避免这种问题,需要分多次渐进式的慢慢映射。

293 |

294 | 关键点在于维持一个**索引计数器变量** `rehashidx` , 并将它的值设置为 `0` , 表示 rehash 工作正式开始。

295 |

296 | 在 rehash 进行期间, 每次对字典执行增删改查, 程序除了执行指定的操作以外, **还会顺带将 `ht[0]` 哈希表在 `rehashidx` 索引上的所有键值对 rehash 到 `ht[1]`** , 当 rehash 工作完成之后, 程序将 `rehashidx` **属性的值增一**。

297 |

298 | 完成后程序将 `rehashidx` 属性的值设为 `-1` , 表示 rehash 操作已完成。

299 |

300 | 渐进式 rehash 的好处在于它采取分而治之的方式, 将 rehash 键值对所需的计算工作均滩到对字典的每个增删改查上, 从而避免了集中式 rehash 而带来的庞大计算量。

301 |

302 | # 4. 跳跃表

303 |

304 | ## 4.1 什么是跳跃表

305 |

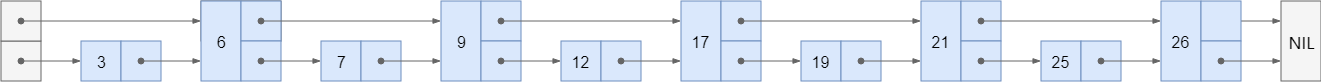

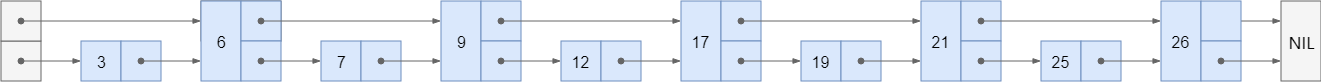

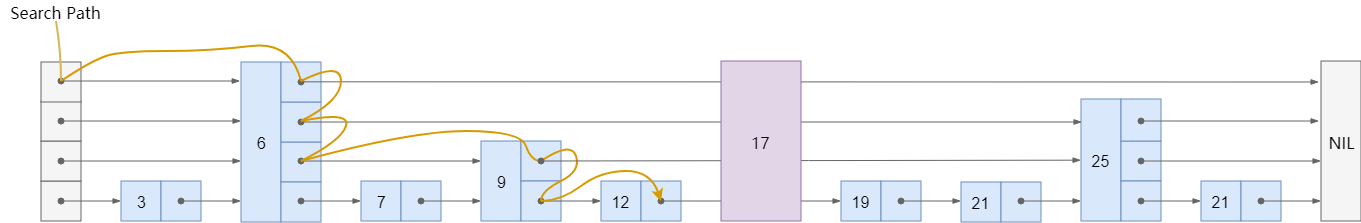

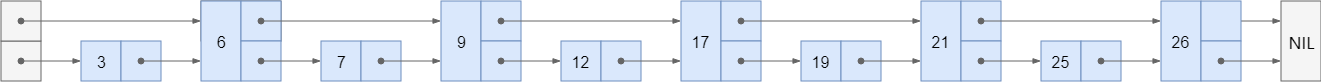

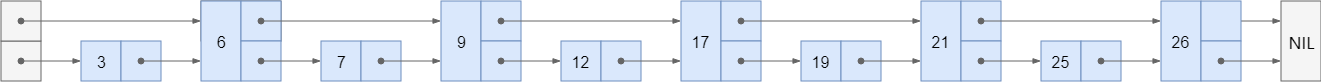

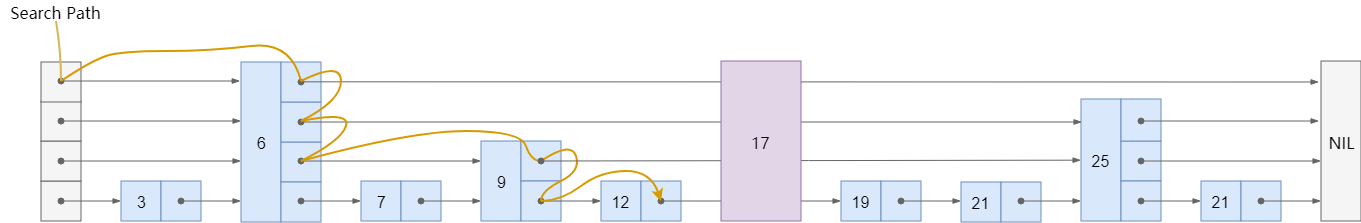

306 | 我们知道链表随机读写的能力很差,当增删改查的时候,如果要找到目标元素就需要遍历链表。假设某个数据结构是有序的,我们就会想到用二分法来快速查找,但**链表是没有索引的**,所以我们需要添加。

307 |

308 |

309 |

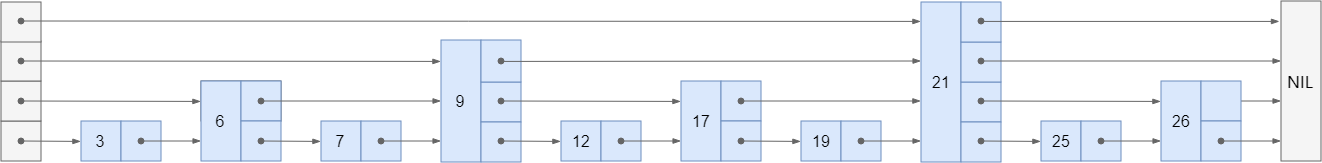

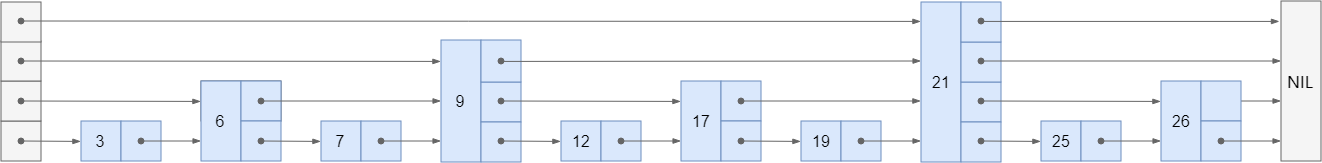

310 | 可以继续向上拓展层数:

311 |

312 |

313 |

314 | 但是我们的链表不是静态的,增加和删除会破坏二分结构,所以我们就不强制要求 `1:2` 了,一个节点要不要被索引,建几层的索引,都在节点插入时由**随机决定**。

315 |

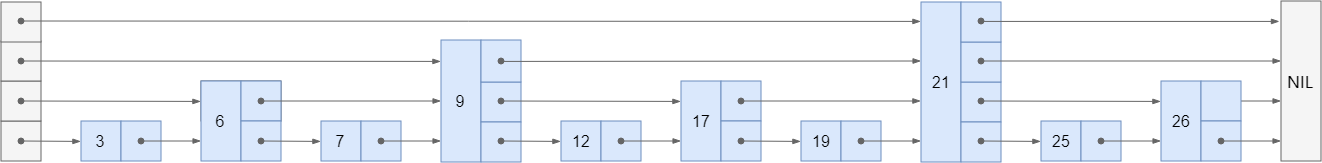

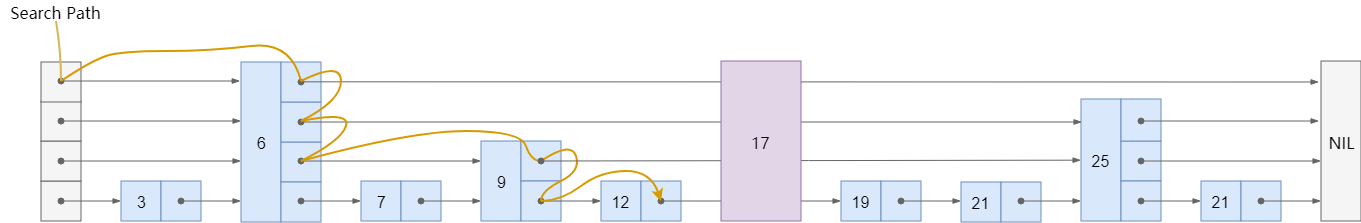

316 | 现在假设节点 `17` 是最后插入的,在插入之前,我们需要搜索得到插入的位置:

317 |

318 |

319 |

320 | ## 4.2 跳跃表的实现

321 |

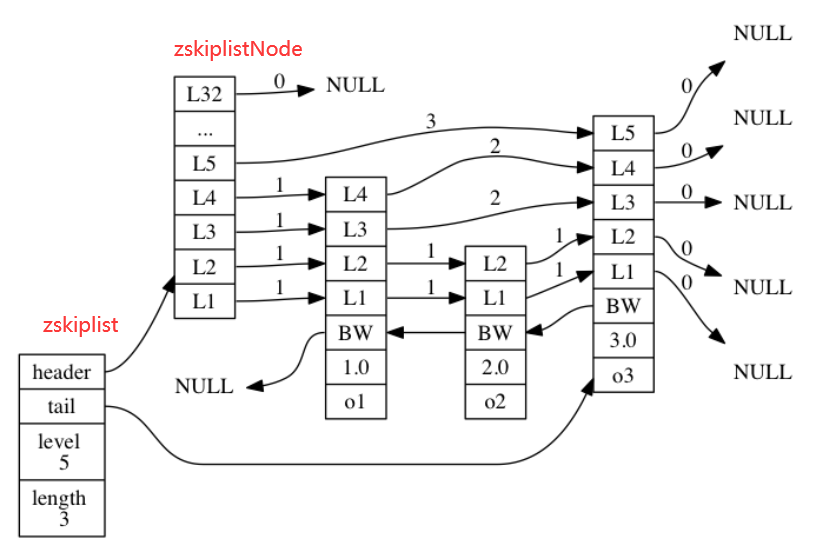

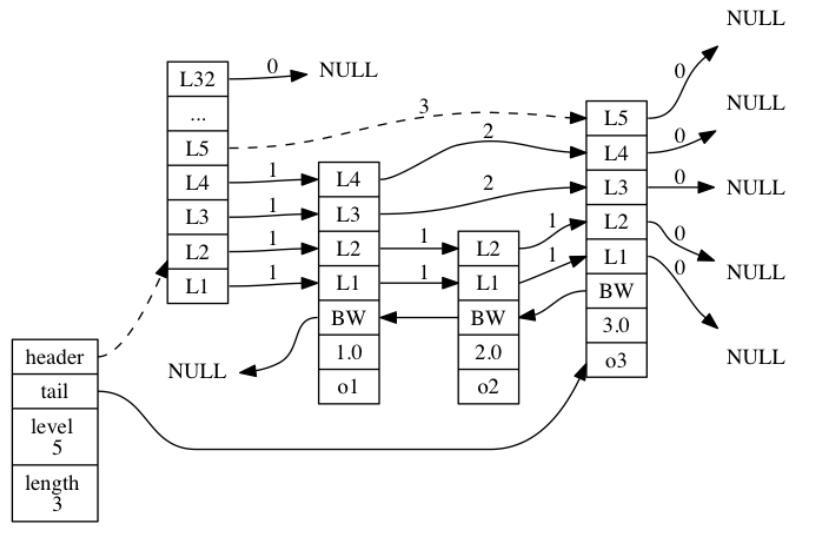

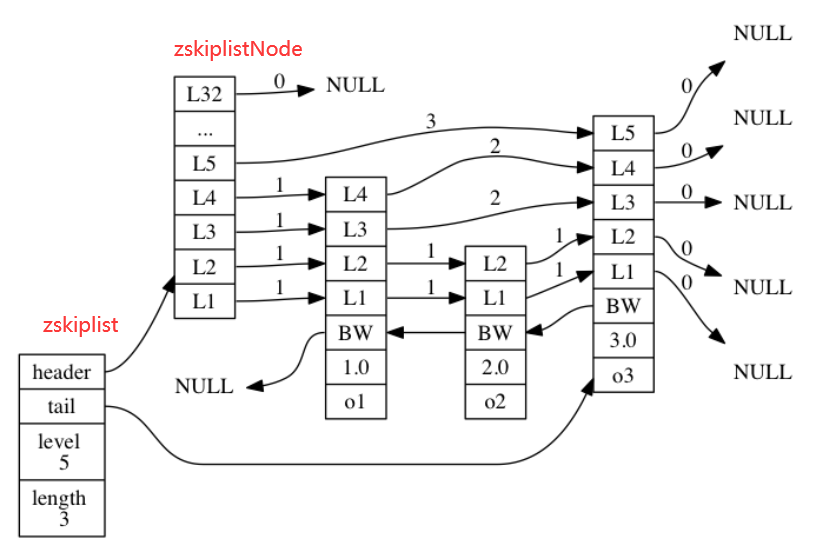

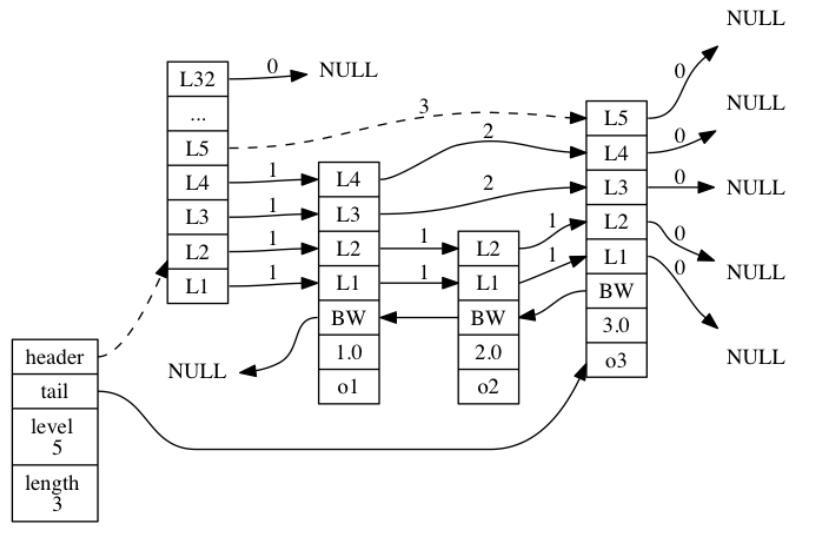

322 | Redis 的跳跃表由 `redis.h/zskiplistNode` 和 `redis.h/zskiplist` 两个结构定义, 其中 `zskiplistNode` 结构用于表示跳跃表**节点**, 而 `zskiplist`结构则用于保存跳跃表节点的相关信息, 比如**节点的数量, 以及指向表头节点和表尾节点的指针**, 等等。

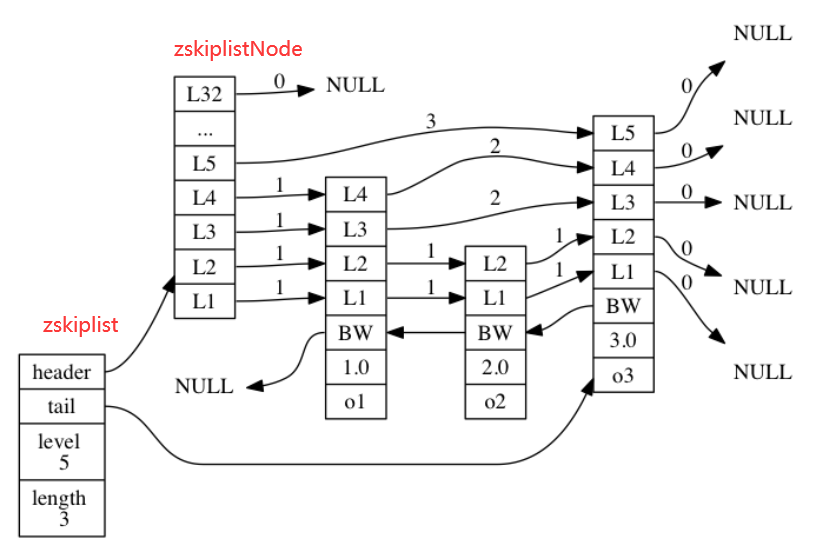

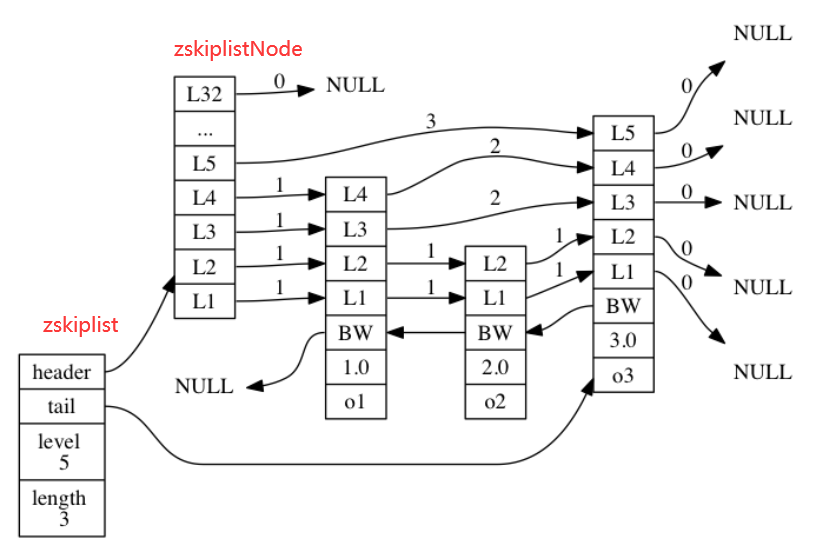

323 |

324 |

325 |

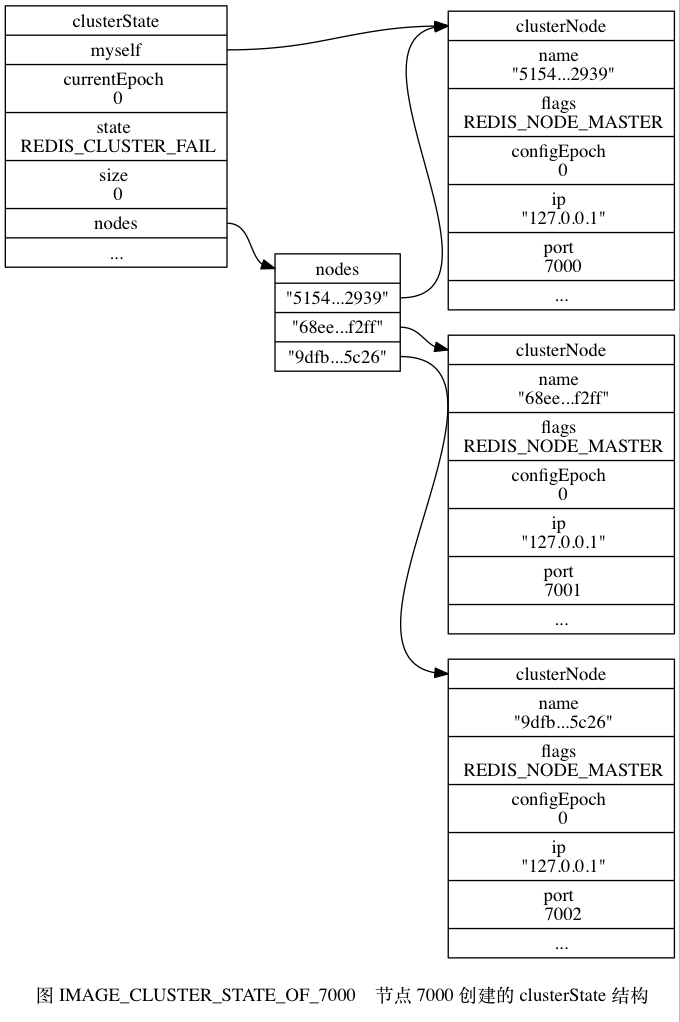

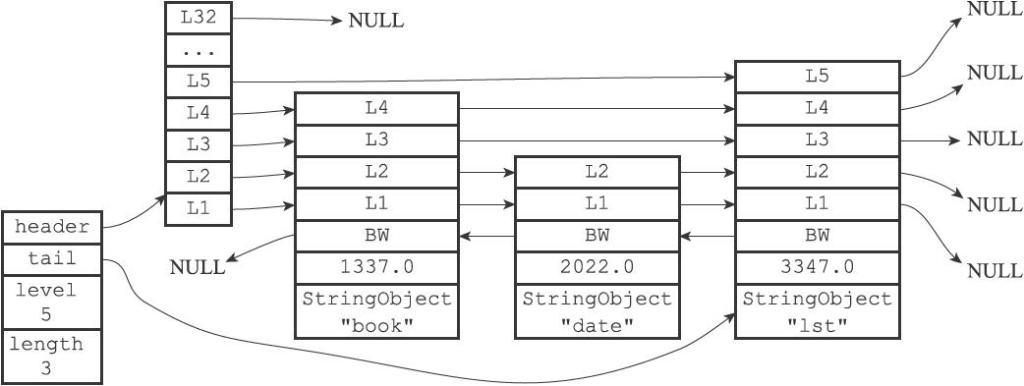

326 | 在`zskiplist`中`level` 记录目前跳跃表内最大层数(表头不算),`length`记录包含的节点数量(表头不算)。

327 |

328 | `zskiplistNode` 结构包含以下属性:

329 |

330 | - 层:每一层有两个属性

331 | - 前进指针用于访问位于表尾方向的其他节点

332 | - 跨度则记录了前进指针所指向节点和当前节点的距离。

333 | - 后退指针(bw):指向位于当前节点的前一个节点。后退指针在程序从表尾向表头遍历时使用。

334 | - 分值(score):各个节点中的 `1.0` 、 `2.0` 和 `3.0` 是节点所保存的分值。用于从小到大排列。**如果分值相同,则成员对象小的排在前面。**

335 | - 成员对象(obj):各个节点中的 `o1` 、 `o2` 和 `o3` 是节点所保存的成员对象。

336 |

337 | ```C

338 | typedef struct zskiplistNode {

339 | // 后退指针

340 | struct zskiplistNode *backward;

341 | // 分值

342 | double score;

343 | // 成员对象

344 | robj *obj;

345 | // 层

346 | struct zskiplistLevel {

347 | // 前进指针

348 | struct zskiplistNode *forward;

349 | // 跨度

350 | unsigned int span;

351 | } level[];

352 | } zskiplistNode;

353 | ```

354 |

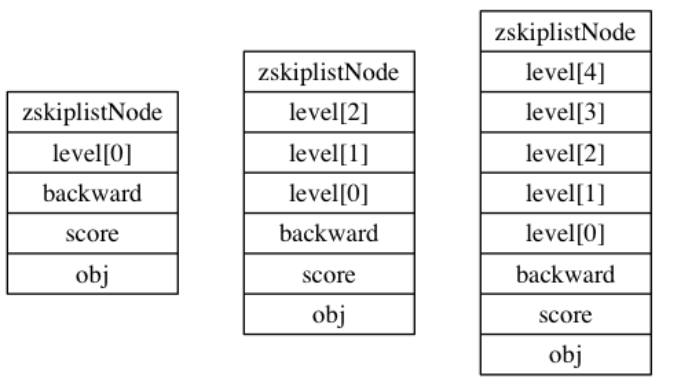

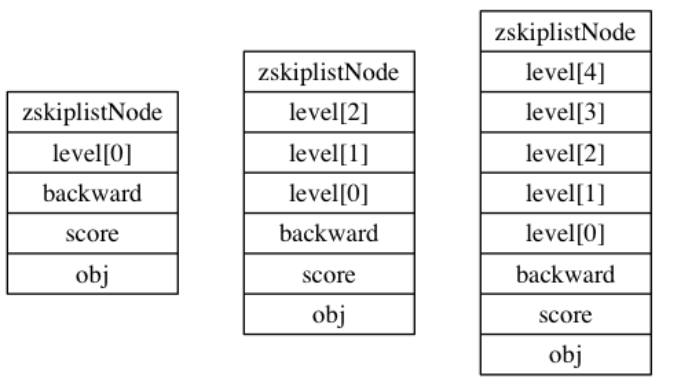

355 | **(1)层**

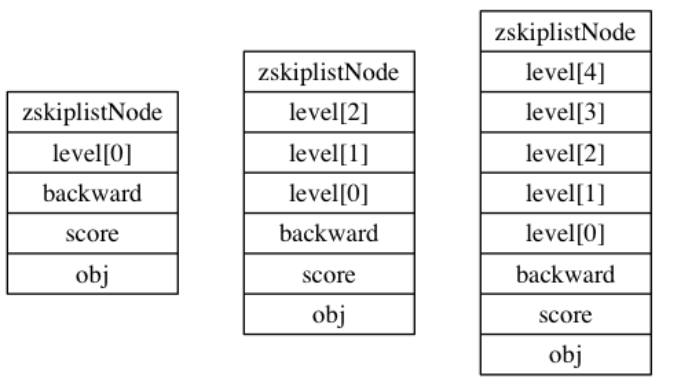

356 |

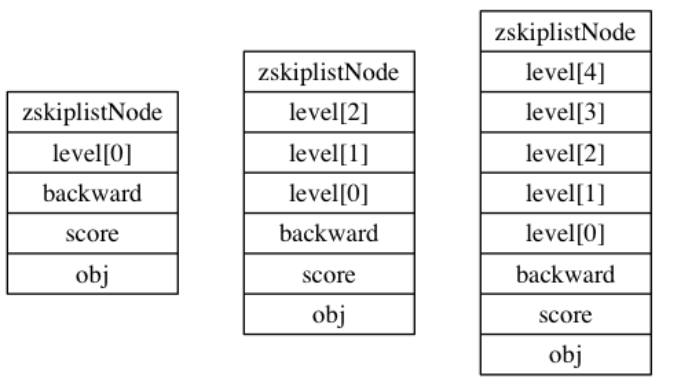

357 | 每次创建一个新跳跃表节点的时候, 程序都根据幂次定律 ([power law](http://en.wikipedia.org/wiki/Power_law),**越大的数出现的概率越小**) **随机**生成一个介于 `1` 和 `32` 之间的值作为 `level` 数组的大小, 这个大小就是层的“高度”。

358 |

359 | 下图展示了三个高度为 `1` 层、 `3` 层和 `5` 层的节点

360 |

361 |

362 |

363 | **(2)前进指针**

364 |

365 | 前进指针分属于不同的层,`level[i].forward`,用于从表头向表尾方向访问节点。

366 |

367 | **(3)跨度**

368 |

369 | 跨度也分属不同的层,指向 `NULL` 的所有前进指针的跨度都为 `0`, 因为它们没有连向任何节点。

370 |

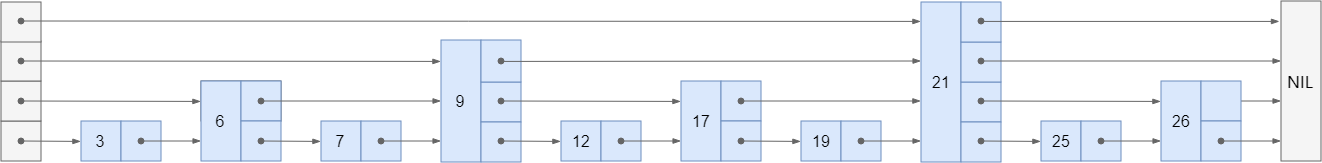

371 | 跨度实际上是用来计算**位次**(rank)的: **将沿途访问过的所有层的跨度累计起来, 得到的结果就是目标节点在跳跃表中的排位。**

372 |

373 | 下图的例子中,查找分值为3.0的节点,由于只经过了一个层,跨度为3,所以跳跃表中的排位为3。

374 |

375 |

269 |

270 | 至于Redis的哈希值计算方法,使用的是 MurmurHash2。这种算法的优点在于, 即使输入的键是有规律的, 算法仍能给出一个很好的随机分布性, 并且算法的计算速度也非常快。

271 |

272 | ## 3.3 Rehash

273 |

274 | 随着操作的不断执行, 哈希表保存的键值对会逐渐地增多或者减少, 为了让哈希表的**负载因子(load factor)**维持在一个合理的范围之内, **当哈希表保存的键值对数量太多或者太少时, 程序需要对哈希表的大小进行相应的扩展或者收缩。**

275 |

276 | 再哈希的关键在于**重新分配哈希表的大小**,分配的原则如下:

277 |

278 | - 如果执行拓展操作`ht[1]` 的大小为第一个大于等于 `ht[0].used * 2` 的 $2^n$,比如原表大小为4,则 `ht[0].used * 2`结果为8,而8刚好是$2^3$,所以新的大小是8。

279 | - 如果执行的是收缩操作, 那么 `ht[1]` 的大小为第一个大于等于 `ht[0].used` 的$2^ n$

280 |

281 | 完成分配后,将保存在 `ht[0]` 中的所有键值对 **rehash** 到 `ht[1]` 上面,然后 将 `ht[1]` 设置为 `ht[0]` , 并在 `ht[1]` 新创建一个空白哈希表, 为下一次 rehash 做准备。

282 |

283 | 决定是否再Hash的要素来自于负载因子,计算方法如下:

284 |

285 | ```C

286 | //负载因子 = 哈希表已保存节点数量 / 哈希表大小

287 | load_factor = ht[0].used / ht[0].size

288 | ```

289 |

290 | ## 3.4 渐进式Rehash

291 |

292 | 如果键值对很多,则将`ht[0]`重新hash到`ht[1]`上,则会导致服务器在一段时间内停止服务。为了避免这种问题,需要分多次渐进式的慢慢映射。

293 |

294 | 关键点在于维持一个**索引计数器变量** `rehashidx` , 并将它的值设置为 `0` , 表示 rehash 工作正式开始。

295 |

296 | 在 rehash 进行期间, 每次对字典执行增删改查, 程序除了执行指定的操作以外, **还会顺带将 `ht[0]` 哈希表在 `rehashidx` 索引上的所有键值对 rehash 到 `ht[1]`** , 当 rehash 工作完成之后, 程序将 `rehashidx` **属性的值增一**。

297 |

298 | 完成后程序将 `rehashidx` 属性的值设为 `-1` , 表示 rehash 操作已完成。

299 |

300 | 渐进式 rehash 的好处在于它采取分而治之的方式, 将 rehash 键值对所需的计算工作均滩到对字典的每个增删改查上, 从而避免了集中式 rehash 而带来的庞大计算量。

301 |

302 | # 4. 跳跃表

303 |

304 | ## 4.1 什么是跳跃表

305 |

306 | 我们知道链表随机读写的能力很差,当增删改查的时候,如果要找到目标元素就需要遍历链表。假设某个数据结构是有序的,我们就会想到用二分法来快速查找,但**链表是没有索引的**,所以我们需要添加。

307 |

308 |

309 |

310 | 可以继续向上拓展层数:

311 |

312 |

313 |

314 | 但是我们的链表不是静态的,增加和删除会破坏二分结构,所以我们就不强制要求 `1:2` 了,一个节点要不要被索引,建几层的索引,都在节点插入时由**随机决定**。

315 |

316 | 现在假设节点 `17` 是最后插入的,在插入之前,我们需要搜索得到插入的位置:

317 |

318 |

319 |

320 | ## 4.2 跳跃表的实现

321 |

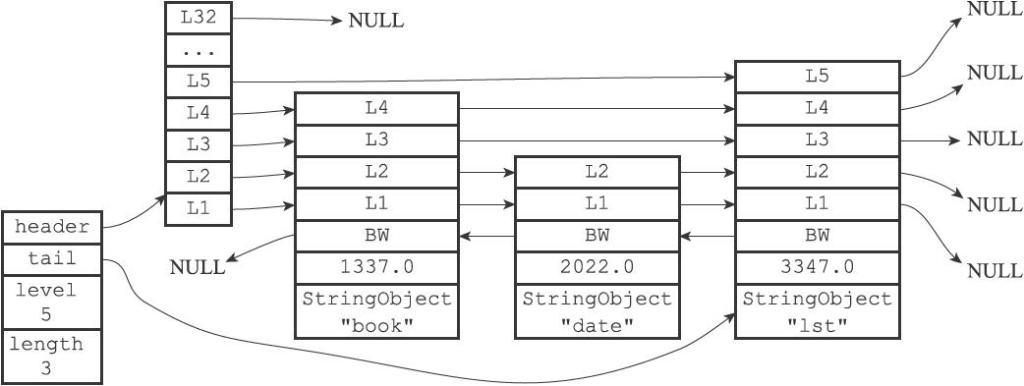

322 | Redis 的跳跃表由 `redis.h/zskiplistNode` 和 `redis.h/zskiplist` 两个结构定义, 其中 `zskiplistNode` 结构用于表示跳跃表**节点**, 而 `zskiplist`结构则用于保存跳跃表节点的相关信息, 比如**节点的数量, 以及指向表头节点和表尾节点的指针**, 等等。

323 |

324 |

325 |

326 | 在`zskiplist`中`level` 记录目前跳跃表内最大层数(表头不算),`length`记录包含的节点数量(表头不算)。

327 |

328 | `zskiplistNode` 结构包含以下属性:

329 |

330 | - 层:每一层有两个属性

331 | - 前进指针用于访问位于表尾方向的其他节点

332 | - 跨度则记录了前进指针所指向节点和当前节点的距离。

333 | - 后退指针(bw):指向位于当前节点的前一个节点。后退指针在程序从表尾向表头遍历时使用。

334 | - 分值(score):各个节点中的 `1.0` 、 `2.0` 和 `3.0` 是节点所保存的分值。用于从小到大排列。**如果分值相同,则成员对象小的排在前面。**

335 | - 成员对象(obj):各个节点中的 `o1` 、 `o2` 和 `o3` 是节点所保存的成员对象。

336 |

337 | ```C

338 | typedef struct zskiplistNode {

339 | // 后退指针

340 | struct zskiplistNode *backward;

341 | // 分值

342 | double score;

343 | // 成员对象

344 | robj *obj;

345 | // 层

346 | struct zskiplistLevel {

347 | // 前进指针

348 | struct zskiplistNode *forward;

349 | // 跨度

350 | unsigned int span;

351 | } level[];

352 | } zskiplistNode;

353 | ```

354 |

355 | **(1)层**

356 |

357 | 每次创建一个新跳跃表节点的时候, 程序都根据幂次定律 ([power law](http://en.wikipedia.org/wiki/Power_law),**越大的数出现的概率越小**) **随机**生成一个介于 `1` 和 `32` 之间的值作为 `level` 数组的大小, 这个大小就是层的“高度”。

358 |

359 | 下图展示了三个高度为 `1` 层、 `3` 层和 `5` 层的节点

360 |

361 |

362 |

363 | **(2)前进指针**

364 |

365 | 前进指针分属于不同的层,`level[i].forward`,用于从表头向表尾方向访问节点。

366 |

367 | **(3)跨度**

368 |

369 | 跨度也分属不同的层,指向 `NULL` 的所有前进指针的跨度都为 `0`, 因为它们没有连向任何节点。

370 |

371 | 跨度实际上是用来计算**位次**(rank)的: **将沿途访问过的所有层的跨度累计起来, 得到的结果就是目标节点在跳跃表中的排位。**

372 |

373 | 下图的例子中,查找分值为3.0的节点,由于只经过了一个层,跨度为3,所以跳跃表中的排位为3。

374 |

375 |  376 |

377 | ---

378 |

379 | 使用一个 `zskiplist` 结构来持有这些节点, 程序可以更方便地对整个跳跃表进行处理。

380 |

381 | ```C

382 | typedef struct zskiplist {

383 | // 表头节点和表尾节点

384 | struct zskiplistNode *header, *tail;

385 | // 表中节点的数量

386 | unsigned long length;

387 | // 表中层数最大的节点的层数

388 | int level;

389 | } zskiplist;

390 | ```

391 |

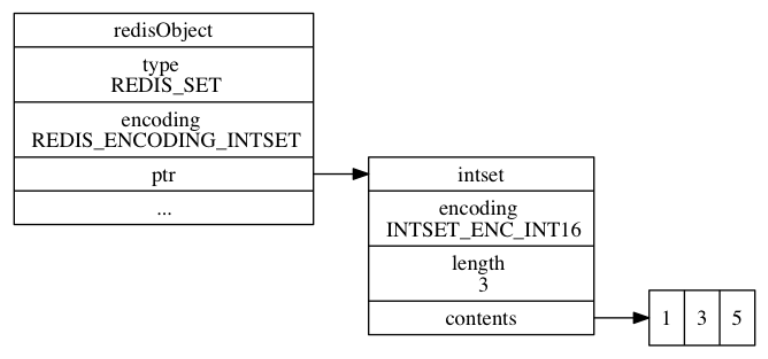

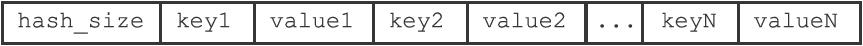

392 | # 5. 整数集合

393 |

394 | 当一个集合中**只包含整数**,并且**元素的个数不是很多**的话,redis 会用**整数集合**作为底层存储,它可以节省很多内存。

395 |

396 | ## 5.1 整数集合的实现

397 |

398 | 整数集合(intset)是 Redis 用于保存整数值的集合抽象数据结构, 它可以保存类型为 `int16_t` 、 `int32_t` 或者 `int64_t` 的整数值, 并且保证集合中不会出现重复元素。

399 |

400 | 每个 `intset.h/intset` 结构表示一个整数集合:

401 |

402 | ```C

403 | typedef struct intset {

404 | // 编码方式

405 | uint32_t encoding;

406 | // 集合包含的元素数量

407 | uint32_t length;

408 | // 保存元素的数组

409 | int8_t contents[];

410 | } intset;

411 | ```

412 |

413 | `contents` 数组是整数集合的底层实现: 整数集合的每个元素都是 `contents` 数组的一个数组项(item), 从小到大有序地排列,不包含任何重复项。

414 |

415 | 虽然 `intset` 结构将 `contents` 属性声明为 `int8_t` 类型的数组, 但实际上 `contents` 数组并不保存任何 `int8_t` 类型的值 —— **`contents` 数组的真正类型取决于 `encoding` 属性的值**:

416 |

417 | - `encoding` 为 `INTSET_ENC_INT16`,`int16_t` 类型的数组,范围$[-2^{16},2^{16}-1]$

418 | - `encoding` `INTSET_ENC_INT32` , 是一个 `int32_t` 类型的数组。

419 | - `encoding` 为 `INTSET_ENC_INT64` , 是一个 `int64_t` 类型的数组

420 |

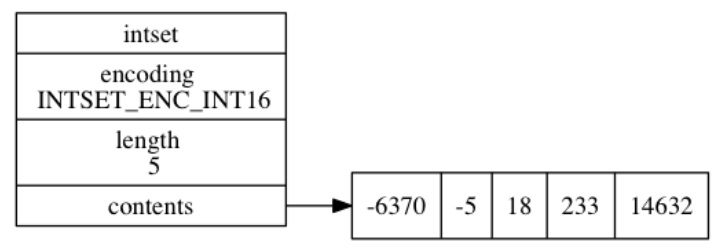

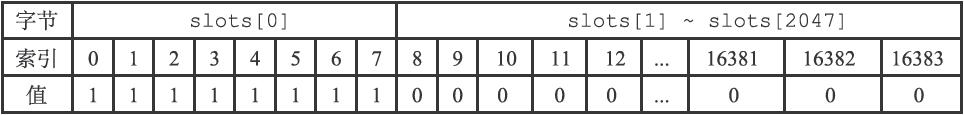

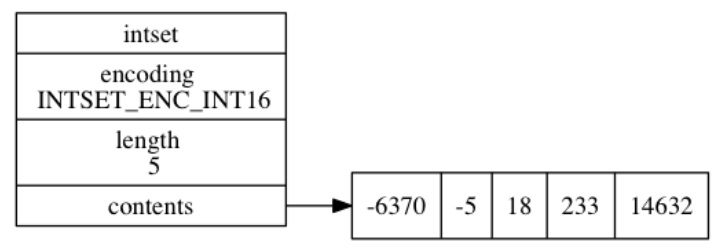

421 | 下图展示了一个示例:

422 |

423 |

376 |

377 | ---

378 |

379 | 使用一个 `zskiplist` 结构来持有这些节点, 程序可以更方便地对整个跳跃表进行处理。

380 |

381 | ```C

382 | typedef struct zskiplist {

383 | // 表头节点和表尾节点

384 | struct zskiplistNode *header, *tail;

385 | // 表中节点的数量

386 | unsigned long length;

387 | // 表中层数最大的节点的层数

388 | int level;

389 | } zskiplist;

390 | ```

391 |

392 | # 5. 整数集合

393 |

394 | 当一个集合中**只包含整数**,并且**元素的个数不是很多**的话,redis 会用**整数集合**作为底层存储,它可以节省很多内存。

395 |

396 | ## 5.1 整数集合的实现

397 |

398 | 整数集合(intset)是 Redis 用于保存整数值的集合抽象数据结构, 它可以保存类型为 `int16_t` 、 `int32_t` 或者 `int64_t` 的整数值, 并且保证集合中不会出现重复元素。

399 |

400 | 每个 `intset.h/intset` 结构表示一个整数集合:

401 |

402 | ```C

403 | typedef struct intset {

404 | // 编码方式

405 | uint32_t encoding;

406 | // 集合包含的元素数量

407 | uint32_t length;

408 | // 保存元素的数组

409 | int8_t contents[];

410 | } intset;

411 | ```

412 |

413 | `contents` 数组是整数集合的底层实现: 整数集合的每个元素都是 `contents` 数组的一个数组项(item), 从小到大有序地排列,不包含任何重复项。

414 |

415 | 虽然 `intset` 结构将 `contents` 属性声明为 `int8_t` 类型的数组, 但实际上 `contents` 数组并不保存任何 `int8_t` 类型的值 —— **`contents` 数组的真正类型取决于 `encoding` 属性的值**:

416 |

417 | - `encoding` 为 `INTSET_ENC_INT16`,`int16_t` 类型的数组,范围$[-2^{16},2^{16}-1]$

418 | - `encoding` `INTSET_ENC_INT32` , 是一个 `int32_t` 类型的数组。

419 | - `encoding` 为 `INTSET_ENC_INT64` , 是一个 `int64_t` 类型的数组

420 |

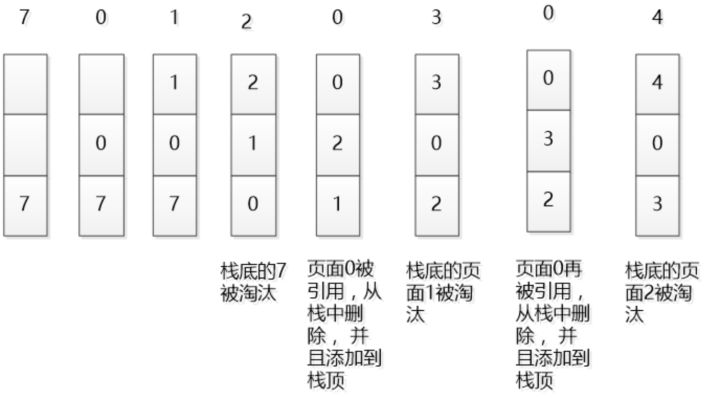

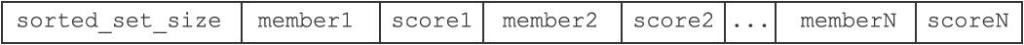

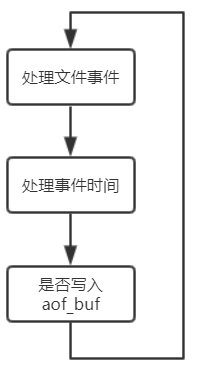

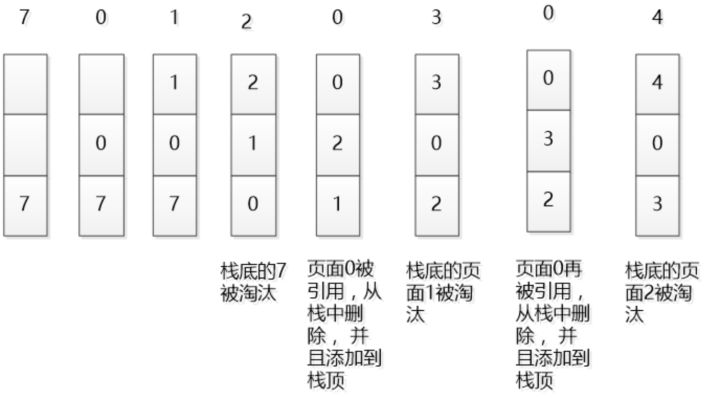

421 | 下图展示了一个示例:

422 |

423 |  424 |

425 | ## 5.2 升级

426 |

427 | 每当我们要将一个新元素添加到整数集合里面, 并且**新元素的类型比整数集合元素的类型长时**, 整数集合需要先进行**升级(upgrade)**, 然后才能将新元素添加到整数集合里面。

428 |

429 | 过程如下:

430 |

431 | 1. 根据新类型,扩展整数集合底层数组的空间大小, 并为新元素分配空间

432 | 2. 将底层数组现有的所有元素都转换成与新元素相同的类型, 并将类型转换后的元素有序放置。

433 | 3. 将新元素添加到底层数组里面。

434 |

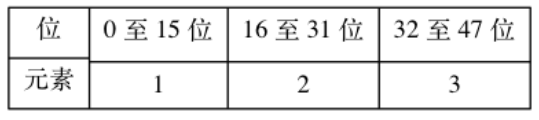

435 | 假设想要在16位编码的intset中插入32位的65535数据,原来的集合是这样的:

436 |

437 |

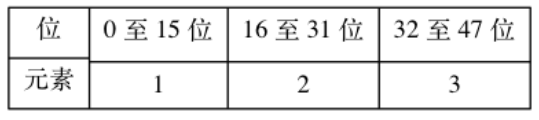

424 |

425 | ## 5.2 升级

426 |

427 | 每当我们要将一个新元素添加到整数集合里面, 并且**新元素的类型比整数集合元素的类型长时**, 整数集合需要先进行**升级(upgrade)**, 然后才能将新元素添加到整数集合里面。

428 |

429 | 过程如下:

430 |

431 | 1. 根据新类型,扩展整数集合底层数组的空间大小, 并为新元素分配空间

432 | 2. 将底层数组现有的所有元素都转换成与新元素相同的类型, 并将类型转换后的元素有序放置。

433 | 3. 将新元素添加到底层数组里面。

434 |

435 | 假设想要在16位编码的intset中插入32位的65535数据,原来的集合是这样的:

436 |

437 |  438 |

439 | 需要扩容为$32\times4=128$位,新intset结构会扩容成这样:

440 |

441 |

438 |

439 | 需要扩容为$32\times4=128$位,新intset结构会扩容成这样:

440 |

441 |  442 |

443 | 剩下就需要对元素重排。

444 |

445 | 先将3移动到新intset结构的索引2的位置上,然后将2移动到索引1的位置,然后将1移动到索引0的位置。最后再讲65535移动到索引3的位置。

446 |

447 | ## 5.3 降级

448 |

449 | 整数集合不支持降级操作, 一旦对数组进行了升级, 编码就会一直保持升级后的状态。

450 |

451 | 即使我们将集合里唯一一个真正需要使用 `int64_t` 类型来保存的元素 `4294967295` 删除了, 整数集合的编码仍然会维持 `INTSET_ENC_INT64`。

452 |

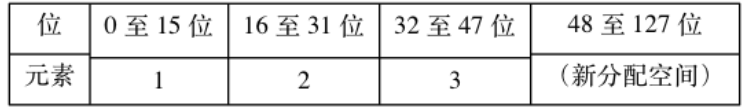

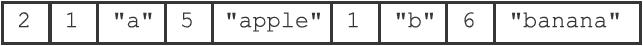

453 | # 6. 压缩列表

454 |

455 | 压缩列表(ziplist)**是列表键和哈希键的底层实现之一。**当一个列表键只包含少量列表项, 并且每个列表项要么就是**小整数值或长度比较短的字符串**, 那么 Redis 就会使用压缩列表来做列表键的底层实现。

456 |

457 | ## 6.1 压缩列表的构成

458 |

459 | 压缩列表是 Redis 为了节约内存而开发的, 由一系列特殊编码的**连续内存块组成的顺序型(sequential)数据结构。**

460 |

461 |

442 |

443 | 剩下就需要对元素重排。

444 |

445 | 先将3移动到新intset结构的索引2的位置上,然后将2移动到索引1的位置,然后将1移动到索引0的位置。最后再讲65535移动到索引3的位置。

446 |

447 | ## 5.3 降级

448 |

449 | 整数集合不支持降级操作, 一旦对数组进行了升级, 编码就会一直保持升级后的状态。

450 |

451 | 即使我们将集合里唯一一个真正需要使用 `int64_t` 类型来保存的元素 `4294967295` 删除了, 整数集合的编码仍然会维持 `INTSET_ENC_INT64`。

452 |

453 | # 6. 压缩列表

454 |

455 | 压缩列表(ziplist)**是列表键和哈希键的底层实现之一。**当一个列表键只包含少量列表项, 并且每个列表项要么就是**小整数值或长度比较短的字符串**, 那么 Redis 就会使用压缩列表来做列表键的底层实现。

456 |

457 | ## 6.1 压缩列表的构成

458 |

459 | 压缩列表是 Redis 为了节约内存而开发的, 由一系列特殊编码的**连续内存块组成的顺序型(sequential)数据结构。**

460 |

461 |  462 |

463 | | 属性 | 类型 | 长度 | 作用 |

464 | | :-----: | :------: | :---: | :------------------------------------: |

465 | | zlbytes | uint32_t | 4字节 | 整个压缩列表占用内存字节数 |

466 | | zltail | uint32_t | 4字节 | 记录表尾节点距离表起始地址有多少个字节 |

467 | | zllen | uint16_t | 2字节 | 记录节点数量 |

468 | | entryX | | 不定 | 节点 |

469 | | zlend | uint8_t | 1字节 | 用于标记末端 |

470 |

471 | 下面展示了一个例子:

472 |

473 |

462 |

463 | | 属性 | 类型 | 长度 | 作用 |

464 | | :-----: | :------: | :---: | :------------------------------------: |

465 | | zlbytes | uint32_t | 4字节 | 整个压缩列表占用内存字节数 |

466 | | zltail | uint32_t | 4字节 | 记录表尾节点距离表起始地址有多少个字节 |

467 | | zllen | uint16_t | 2字节 | 记录节点数量 |

468 | | entryX | | 不定 | 节点 |

469 | | zlend | uint8_t | 1字节 | 用于标记末端 |

470 |

471 | 下面展示了一个例子:

472 |

473 |  474 |

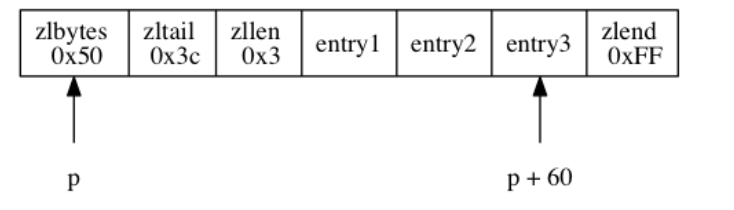

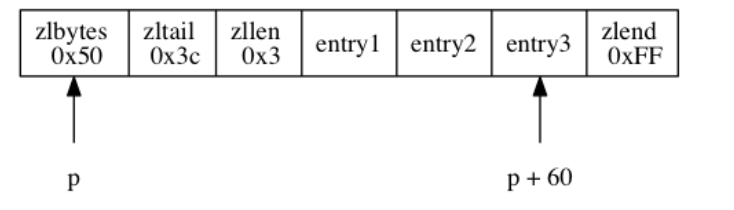

475 | - `zlbytes` 属性的值为 `0x50` (十进制 `80`), 表示压缩列表的总长为 `80` 字节。

476 | - `zltail` 属性的值为 `0x3c` (十进制 `60`),如果一个指向压缩列表起始地址的指针 `p` , 那么只要用指针 `p` 加上偏移量 `60` , 就可以计算出表尾节点 `entry3` 的地址。

477 | - `zllen` 属性的值为 `0x3` (十进制 `3`), 表示压缩列表包含三个节点。

478 |

479 | ## 6.2 压缩列表的节点构成

480 |

481 | 每个压缩列表节点可以保存一个字节数组或者一个整数值, 其中, 字节数组可以是以下三种长度的其中一种:

482 |

483 | 1. 长度小于等于`63`($2^6-1$)字节的字节数组;

484 | 2. 长度小于等于 `16383` ($2^{14}-1$)字节的字节数组;

485 | 3. 长度小于等于 `4294967295` ($2^{32}-1$)字节的字节数组;

486 |

487 | 而整数值则可以是以下六种长度的其中一种:

488 |

489 | 1. `4` 位长,介于 `0` 至 `12` 之间的无符号整数;

490 | 2. `1` 字节长的有符号整数;

491 | 3. `3` 字节长的有符号整数;

492 | 4. `int16_t` 类型整数;

493 | 5. `int32_t` 类型整数;

494 | 6. `int64_t` 类型整数。

495 |

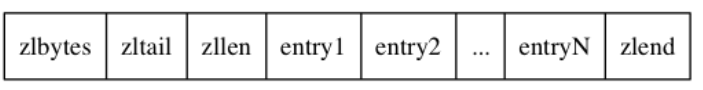

496 | 每个压缩列表节点都由 `previous_entry_length` 、 `encoding` 、 `content` 三个部分组成。

497 |

498 | ---

499 |

500 | **(1)previous_entry_length**

501 |

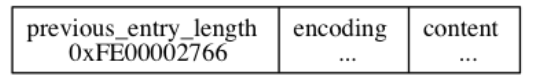

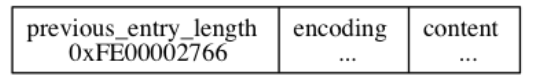

502 | 以字节为单位, 记录了压缩列表中**前一个节点的长度。**这个属性的长度可以是1字节或5字节,如果前一个小于254则使用1字节,反之使用5字节( 其中属性的**第一字节会被设置为 `0xFE`(十进制值 `254`)**, 而之后的四个字节则用于保存前一节点的长度)

503 |

504 |

474 |

475 | - `zlbytes` 属性的值为 `0x50` (十进制 `80`), 表示压缩列表的总长为 `80` 字节。

476 | - `zltail` 属性的值为 `0x3c` (十进制 `60`),如果一个指向压缩列表起始地址的指针 `p` , 那么只要用指针 `p` 加上偏移量 `60` , 就可以计算出表尾节点 `entry3` 的地址。

477 | - `zllen` 属性的值为 `0x3` (十进制 `3`), 表示压缩列表包含三个节点。

478 |

479 | ## 6.2 压缩列表的节点构成

480 |

481 | 每个压缩列表节点可以保存一个字节数组或者一个整数值, 其中, 字节数组可以是以下三种长度的其中一种:

482 |

483 | 1. 长度小于等于`63`($2^6-1$)字节的字节数组;

484 | 2. 长度小于等于 `16383` ($2^{14}-1$)字节的字节数组;

485 | 3. 长度小于等于 `4294967295` ($2^{32}-1$)字节的字节数组;

486 |

487 | 而整数值则可以是以下六种长度的其中一种:

488 |

489 | 1. `4` 位长,介于 `0` 至 `12` 之间的无符号整数;

490 | 2. `1` 字节长的有符号整数;

491 | 3. `3` 字节长的有符号整数;

492 | 4. `int16_t` 类型整数;

493 | 5. `int32_t` 类型整数;

494 | 6. `int64_t` 类型整数。

495 |

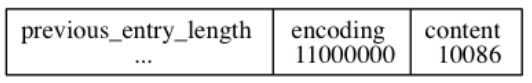

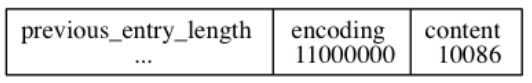

496 | 每个压缩列表节点都由 `previous_entry_length` 、 `encoding` 、 `content` 三个部分组成。

497 |

498 | ---

499 |

500 | **(1)previous_entry_length**

501 |

502 | 以字节为单位, 记录了压缩列表中**前一个节点的长度。**这个属性的长度可以是1字节或5字节,如果前一个小于254则使用1字节,反之使用5字节( 其中属性的**第一字节会被设置为 `0xFE`(十进制值 `254`)**, 而之后的四个字节则用于保存前一节点的长度)

503 |

504 |  505 |

506 | 程序可以通过指针运算, 根据当前节点的起始地址来**计算出前一个节点的起始地址**。进而可以回溯到表头。

507 |

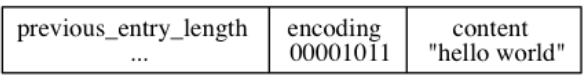

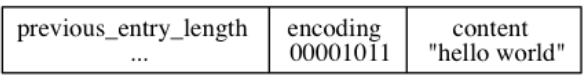

508 | **(2)encoding**

509 |

510 | 节点的 `encoding` 属性记录了节点的 `content` 属性所保存数据的类型以及长度。编码由8位组成。

511 |

512 | **如果是字符类型**,则开头两位`00`,`01`,`10`分别表示1字节,2字节,5字节,后6位表示字符串长度。

513 |

514 | 保存每个元素是1个字节的数组,长度11。

515 |

516 |

505 |

506 | 程序可以通过指针运算, 根据当前节点的起始地址来**计算出前一个节点的起始地址**。进而可以回溯到表头。

507 |

508 | **(2)encoding**

509 |

510 | 节点的 `encoding` 属性记录了节点的 `content` 属性所保存数据的类型以及长度。编码由8位组成。

511 |

512 | **如果是字符类型**,则开头两位`00`,`01`,`10`分别表示1字节,2字节,5字节,后6位表示字符串长度。

513 |

514 | 保存每个元素是1个字节的数组,长度11。

515 |

516 |  517 |

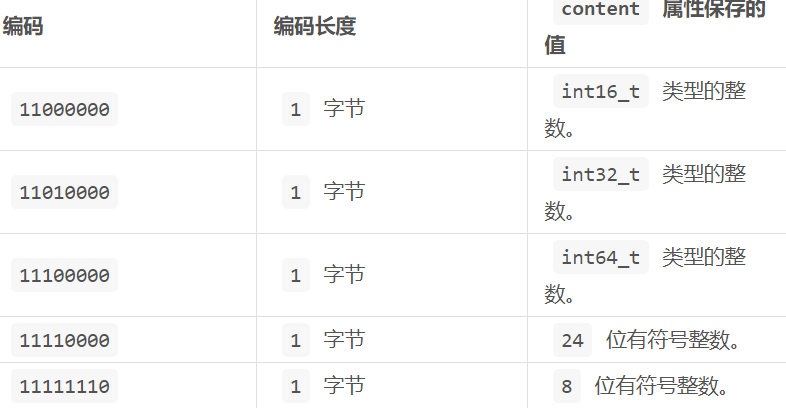

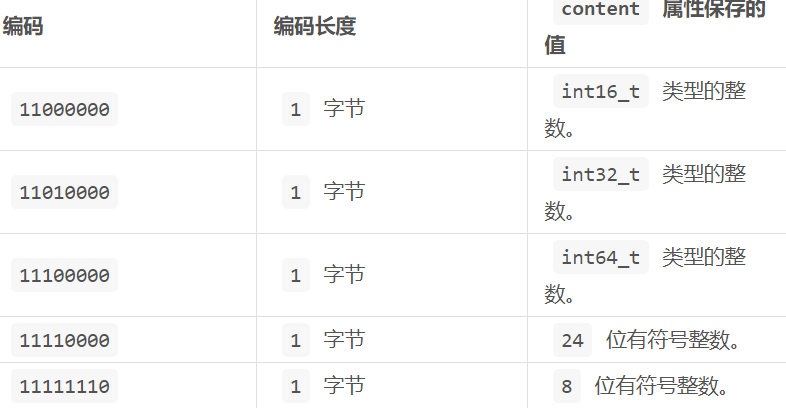

518 | 如果是整数类型,则开头必是11,然后从第6位开始往低位开始计数:

519 |

520 |

517 |

518 | 如果是整数类型,则开头必是11,然后从第6位开始往低位开始计数:

519 |

520 |  521 |

522 | 每个元素`int16_t`,值为10086

523 |

524 |

521 |

522 | 每个元素`int16_t`,值为10086

523 |

524 |  525 |

526 | ## 6.3 连锁更新

527 |

528 | 每个节点的 `previous_entry_length` 属性都记录了前一个节点的长度:

529 |

530 | - 如果前一节点的长度小于 `254` 字节, 那么 `previous_entry_length` 属性需要用 `1` 字节长的空间来保存这个长度值。

531 | - 如果前一节点的长度大于等于 `254` 字节, 那么 `previous_entry_length` 属性需要用 `5` 字节长的空间来保存这个长度值。

532 |

533 | 假设现在有一些长度为252字节的节点,他们在`previous_entry_length`中保存为1字节。现在插入了一个260字节的新节点,`new` 将成为 `e1` 的前置节点。

534 |

535 |

525 |

526 | ## 6.3 连锁更新

527 |

528 | 每个节点的 `previous_entry_length` 属性都记录了前一个节点的长度:

529 |

530 | - 如果前一节点的长度小于 `254` 字节, 那么 `previous_entry_length` 属性需要用 `1` 字节长的空间来保存这个长度值。

531 | - 如果前一节点的长度大于等于 `254` 字节, 那么 `previous_entry_length` 属性需要用 `5` 字节长的空间来保存这个长度值。

532 |

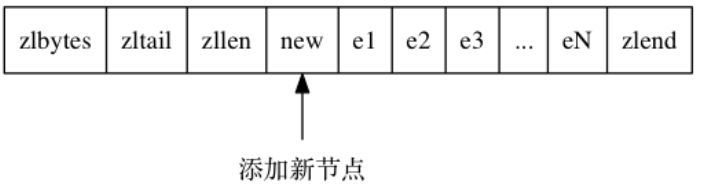

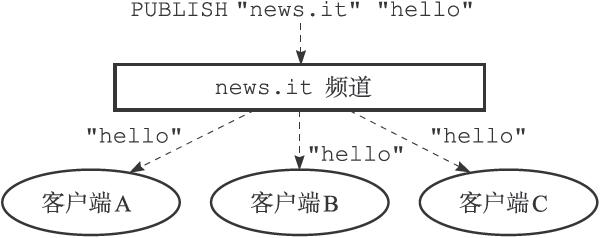

533 | 假设现在有一些长度为252字节的节点,他们在`previous_entry_length`中保存为1字节。现在插入了一个260字节的新节点,`new` 将成为 `e1` 的前置节点。

534 |

535 |  536 |

537 | 因为 `e1` 的 `previous_entry_length` 属性仅长 `1` 字节, 它没办法保存新节点 `new` 的长度, 所以程序将对压缩列表执行空间重分配操作, **并将`e1` 节点的 `previous_entry_length` 属性从原来的 `1` 字节长扩展为 `5` 字节长。**

538 |

539 | 由于`previous_entry_length` 的变化,导致`e1`的长度也发生了变化$252+4=256>254$,所以导致`e2`也必须更新它的`previous_entry_length` 。这就是连锁更新。

540 |

541 | 除了添加节点外,删除节点也会导致连锁更新,若删除一个260字节的节点,则后一个节点长度也会变化。如果很不凑巧,小于254,则又会引起后序效应。

542 |

543 | 连锁更新在最坏情况下需要对压缩列表执行 `N` 次空间重分配操作, 而每次空间重分配的最坏复杂度为$O(N)$ , 所以连锁更新的最坏复杂度为 $O(N^2)$ 。

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现10-发布与订阅.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现10-发布与订阅

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-07 12:46:10

12 | ---

13 |

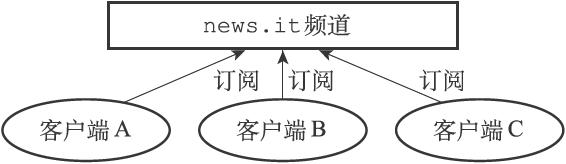

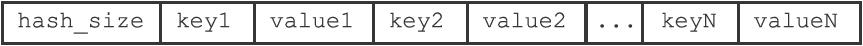

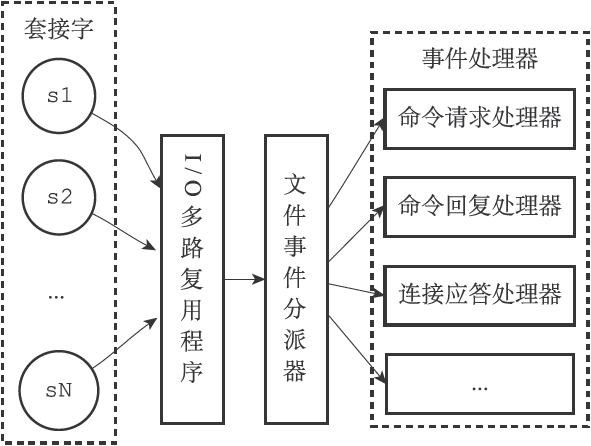

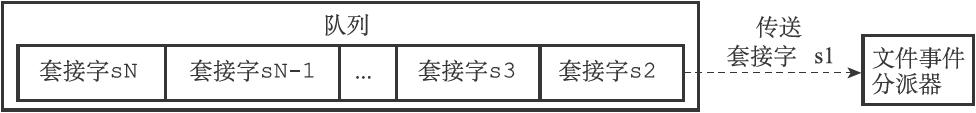

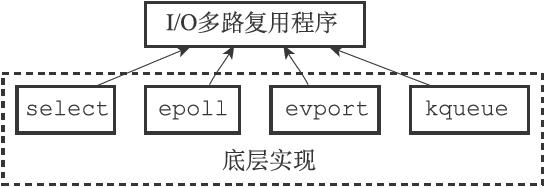

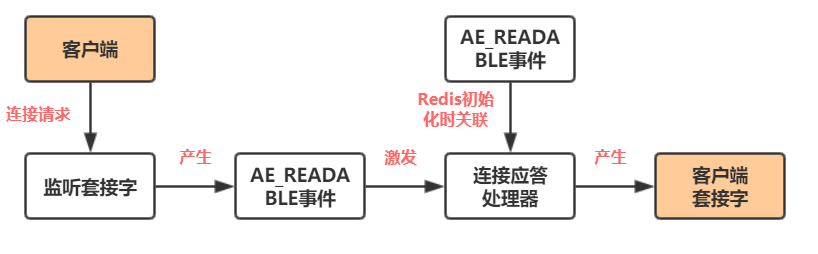

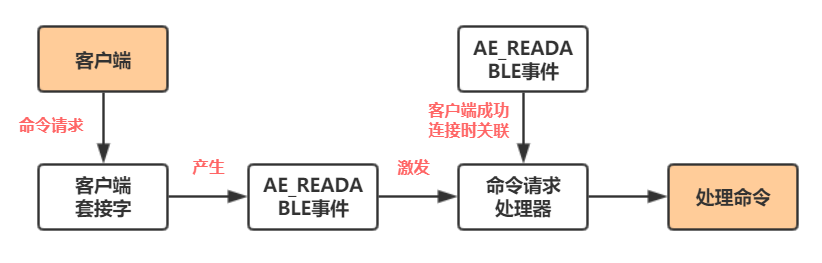

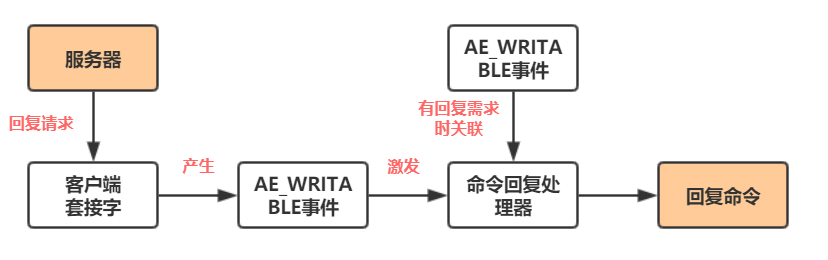

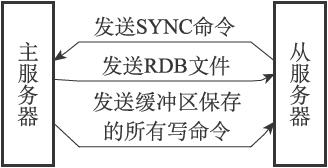

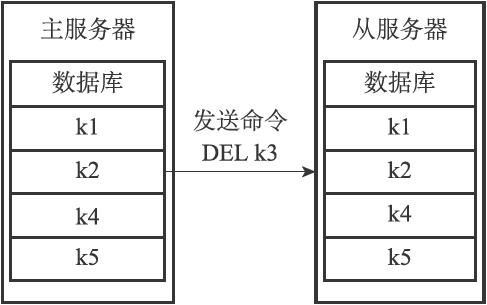

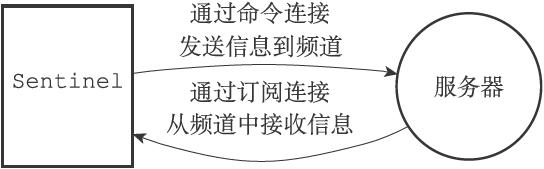

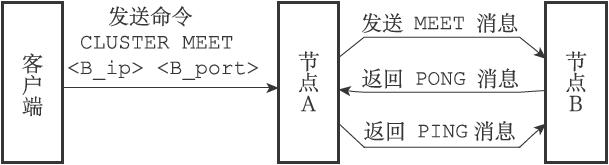

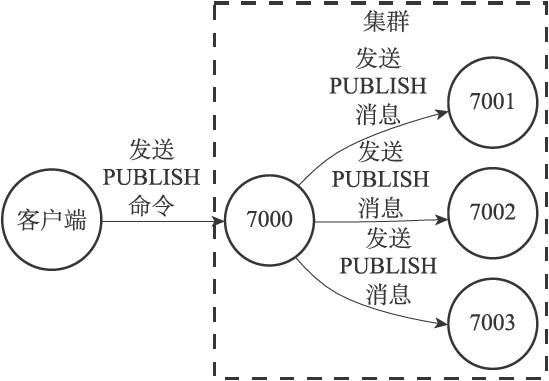

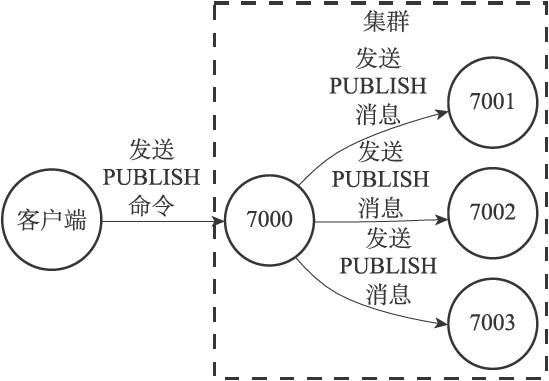

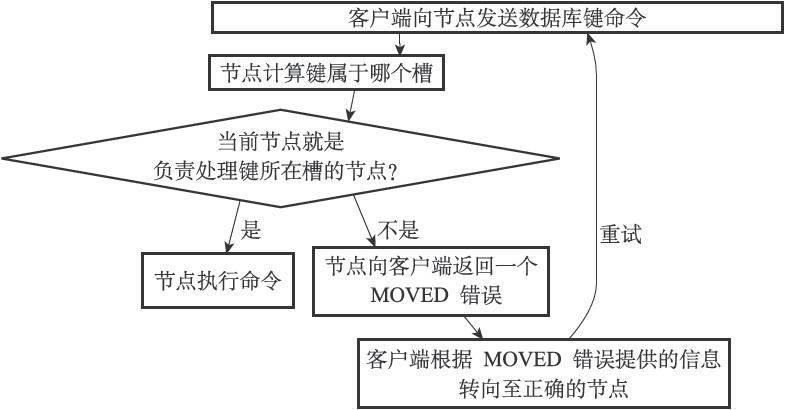

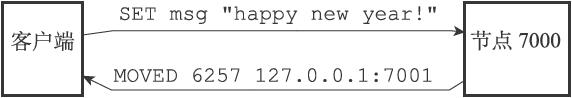

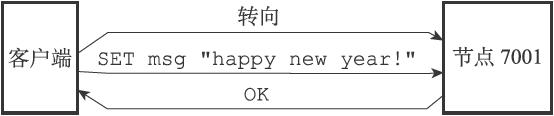

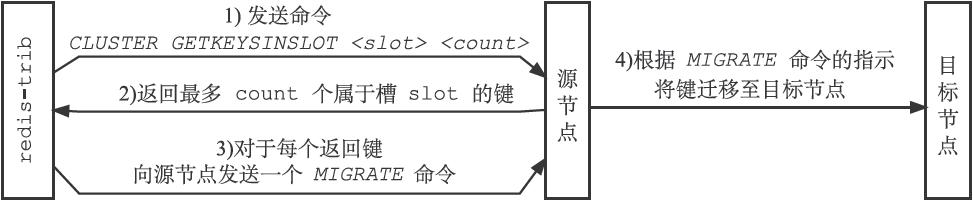

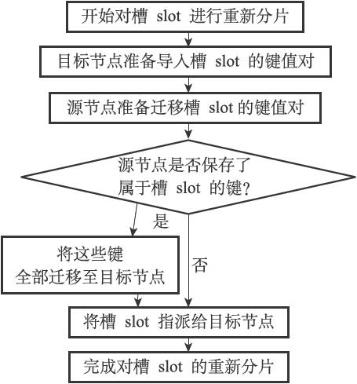

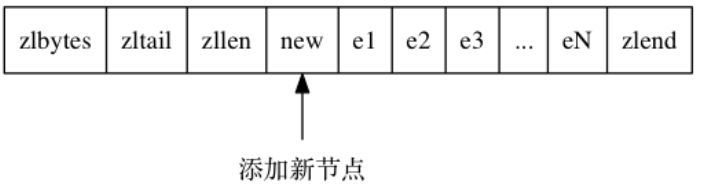

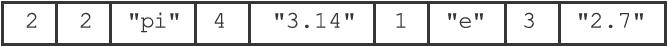

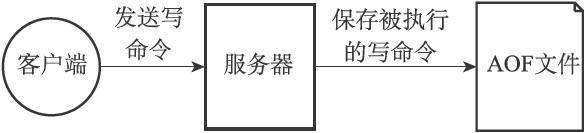

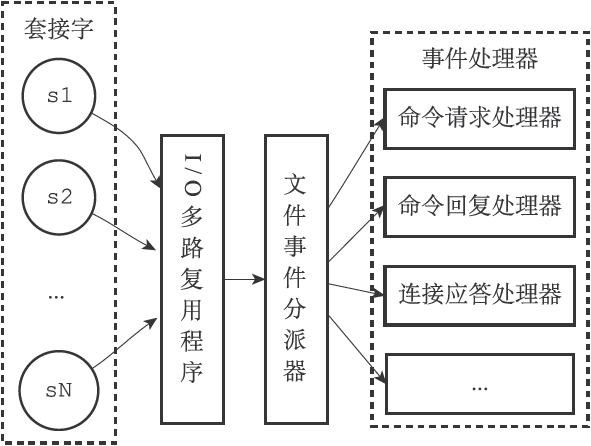

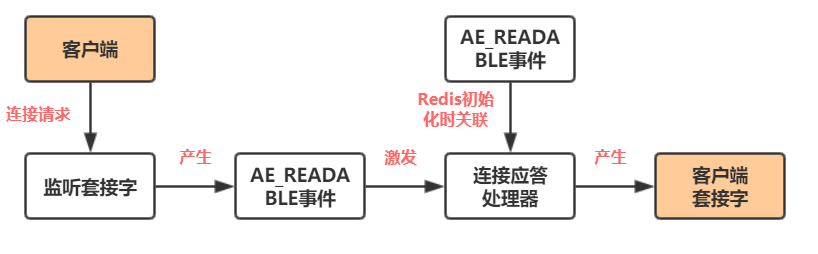

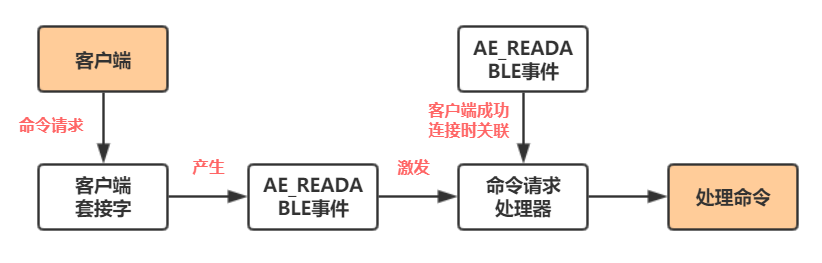

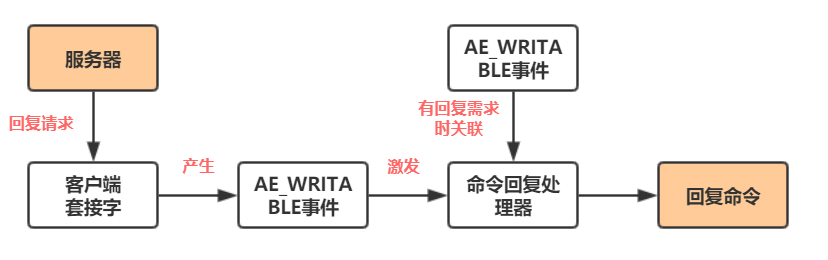

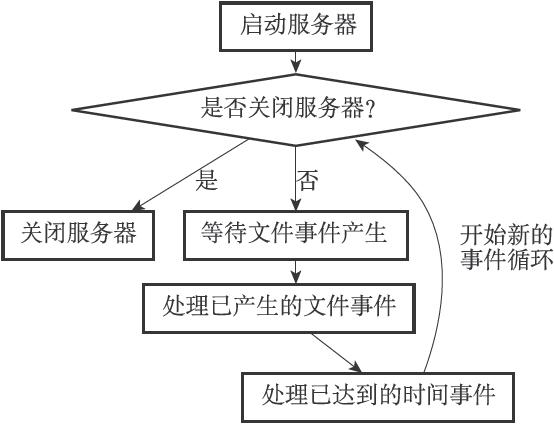

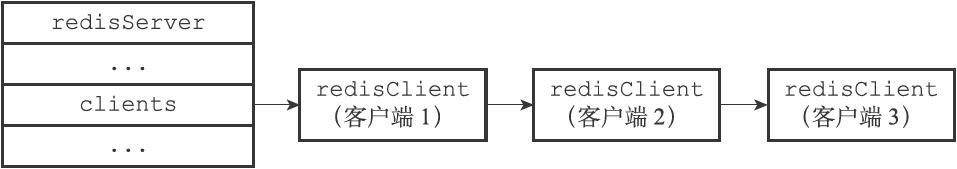

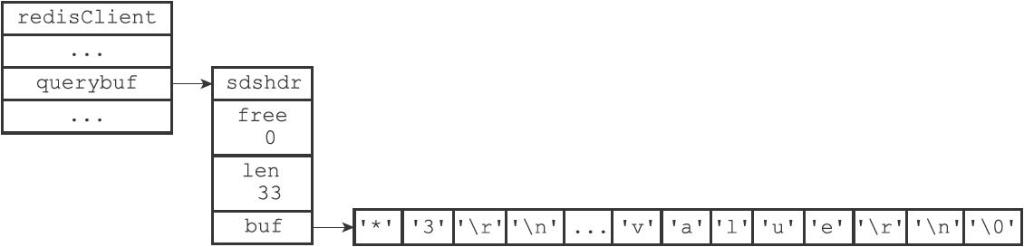

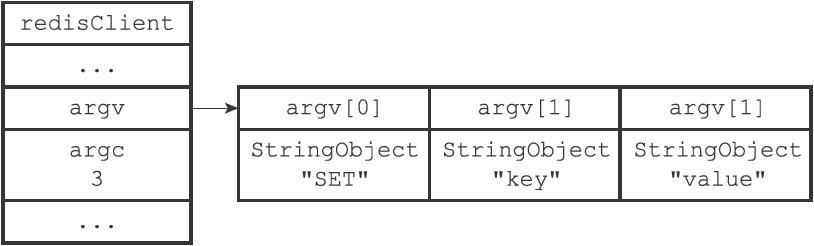

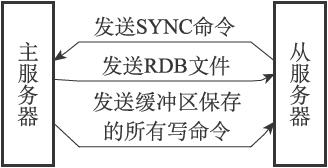

14 | Redis的发布与订阅功能由PUBLISH、SUBSCRIBE、PSUB-SCRIBE等命令组成。本章主要介绍这些命令的实现原理。

15 |

16 | 通过执行SUBSCRIBE命令,客户端可以订阅一个或多个频道,从而成为这些频道的**订阅者**(subscriber):**每当有其他客户端向被订阅的频道发送消息(message)时,频道的所有订阅者都会收到这条消息**。

17 |

18 | 假如ABC三个客户端都执行了:

19 |

20 | ```C

21 | SUBSCRIBE "news.it"

22 | ```

23 |

24 | 那么这三个客户端都成了"news.it"频道的订阅者,

25 |

26 |

536 |

537 | 因为 `e1` 的 `previous_entry_length` 属性仅长 `1` 字节, 它没办法保存新节点 `new` 的长度, 所以程序将对压缩列表执行空间重分配操作, **并将`e1` 节点的 `previous_entry_length` 属性从原来的 `1` 字节长扩展为 `5` 字节长。**

538 |

539 | 由于`previous_entry_length` 的变化,导致`e1`的长度也发生了变化$252+4=256>254$,所以导致`e2`也必须更新它的`previous_entry_length` 。这就是连锁更新。

540 |

541 | 除了添加节点外,删除节点也会导致连锁更新,若删除一个260字节的节点,则后一个节点长度也会变化。如果很不凑巧,小于254,则又会引起后序效应。

542 |

543 | 连锁更新在最坏情况下需要对压缩列表执行 `N` 次空间重分配操作, 而每次空间重分配的最坏复杂度为$O(N)$ , 所以连锁更新的最坏复杂度为 $O(N^2)$ 。

--------------------------------------------------------------------------------

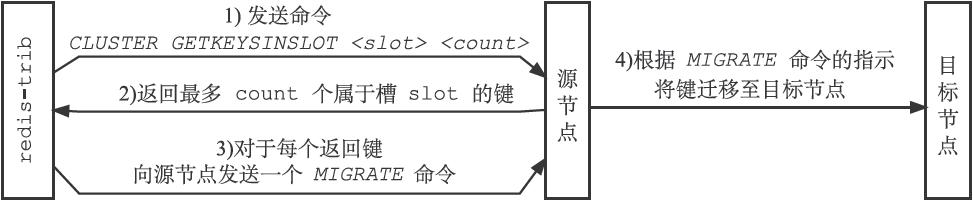

/Markdown笔记/Redis设计与实现10-发布与订阅.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现10-发布与订阅

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-07 12:46:10

12 | ---

13 |

14 | Redis的发布与订阅功能由PUBLISH、SUBSCRIBE、PSUB-SCRIBE等命令组成。本章主要介绍这些命令的实现原理。

15 |

16 | 通过执行SUBSCRIBE命令,客户端可以订阅一个或多个频道,从而成为这些频道的**订阅者**(subscriber):**每当有其他客户端向被订阅的频道发送消息(message)时,频道的所有订阅者都会收到这条消息**。

17 |

18 | 假如ABC三个客户端都执行了:

19 |

20 | ```C

21 | SUBSCRIBE "news.it"

22 | ```

23 |

24 | 那么这三个客户端都成了"news.it"频道的订阅者,

25 |

26 |  27 |

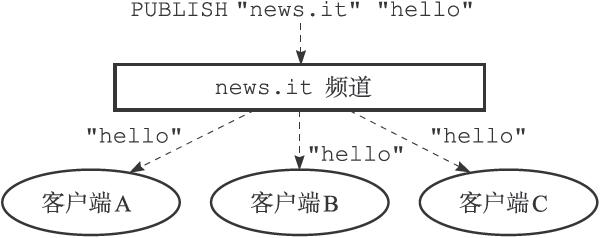

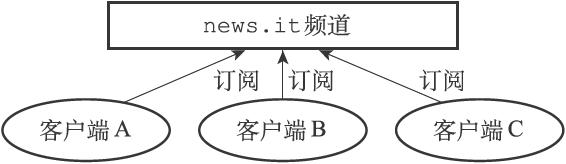

28 | 向"news.it"频道发送消息"hello",那么"news.it"的三个订阅者都将收到这条消息。

29 |

30 |

27 |

28 | 向"news.it"频道发送消息"hello",那么"news.it"的三个订阅者都将收到这条消息。

29 |

30 |  31 |

32 | 除了订阅频道之外,客户端还可以通过执行**PSUBSCRIBE**命令订阅一个或多个**模式**,从而成为这些模式的订阅者:每当有其他客户端向某个频道发送消息时,消息不仅会被发送给这个频道的所有订阅者,**它还会被发送给所有与这个频道相匹配的模式的订阅者。**

33 |

34 |

31 |

32 | 除了订阅频道之外,客户端还可以通过执行**PSUBSCRIBE**命令订阅一个或多个**模式**,从而成为这些模式的订阅者:每当有其他客户端向某个频道发送消息时,消息不仅会被发送给这个频道的所有订阅者,**它还会被发送给所有与这个频道相匹配的模式的订阅者。**

33 |

34 |  35 |

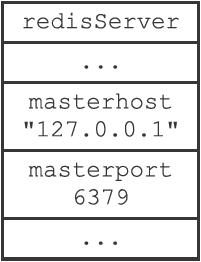

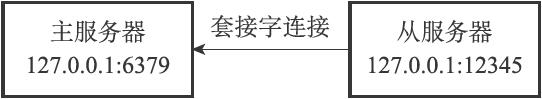

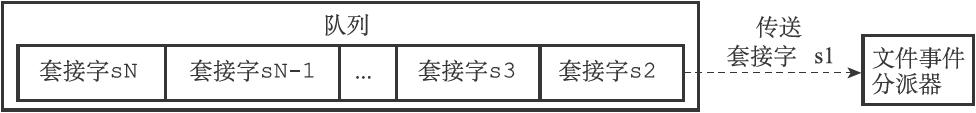

36 | # 1. 订阅与退订

37 |

38 | ## 1.1 频道的订阅与退订

39 |

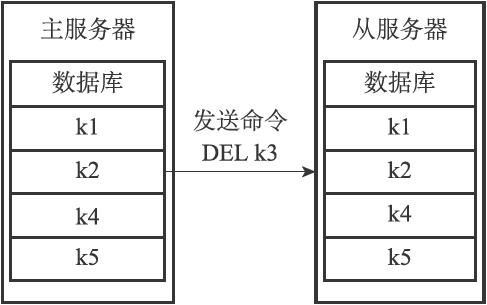

40 | Redis将所有频道的订阅关系都保存在服务器状态的`pubsub_channels`**字典**里面,这个字典的**键是某个被订阅的频道**,而键的**值则是一个链表**,链表里面记录了所有订阅这个频道的客户端。

41 |

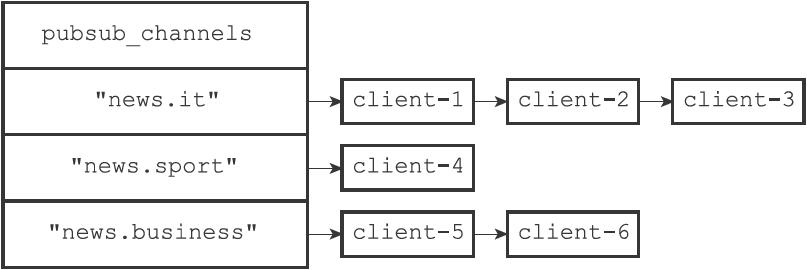

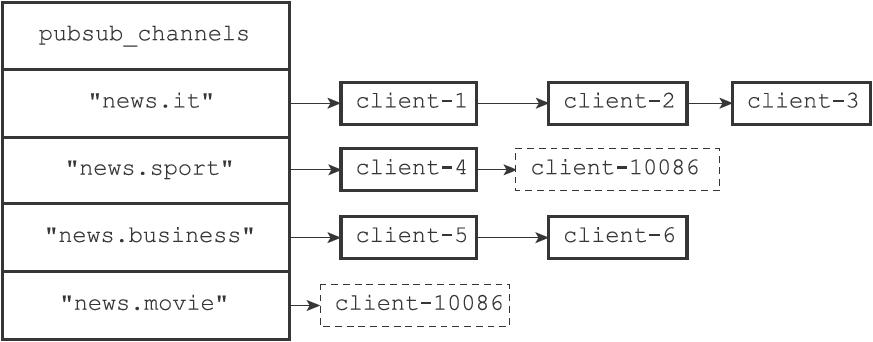

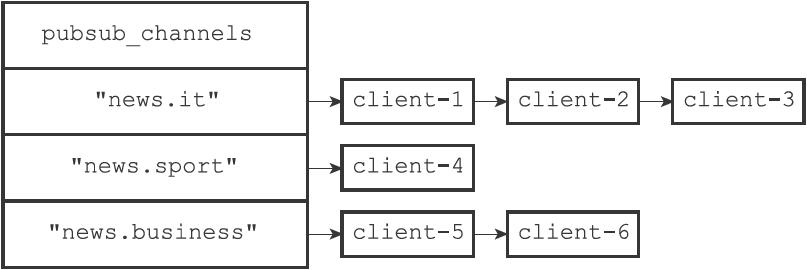

42 | 看下图,不同客户端订阅了不同频道:

43 |

44 |

35 |

36 | # 1. 订阅与退订

37 |

38 | ## 1.1 频道的订阅与退订

39 |

40 | Redis将所有频道的订阅关系都保存在服务器状态的`pubsub_channels`**字典**里面,这个字典的**键是某个被订阅的频道**,而键的**值则是一个链表**,链表里面记录了所有订阅这个频道的客户端。

41 |

42 | 看下图,不同客户端订阅了不同频道:

43 |

44 |  45 |

46 | ---

47 |

48 | 订阅的原理是:**服务器将客户端与被订阅频道在`pubsub_channels`字典中进行关联。**

49 |

50 | 假如客户端10086执行命令:

51 |

52 | ```C

53 | SUBSCRIBE "news.sport" "news.movie"

54 | ```

55 |

56 | 服务器完成两件事:

57 |

58 | - 将10086添加到sport链表后面

59 | - 新增一个键"news.movie"

60 |

61 |

45 |

46 | ---

47 |

48 | 订阅的原理是:**服务器将客户端与被订阅频道在`pubsub_channels`字典中进行关联。**

49 |

50 | 假如客户端10086执行命令:

51 |

52 | ```C

53 | SUBSCRIBE "news.sport" "news.movie"

54 | ```

55 |

56 | 服务器完成两件事:

57 |

58 | - 将10086添加到sport链表后面

59 | - 新增一个键"news.movie"

60 |

61 |  62 |

63 | ---

64 |

65 | 退订就是在链表中删除客户端信息,如果退订后某个键没有任何客户端,则**程序将从pubsub_channels字典中删除频道对应的键。**

66 |

67 | ## 1.2 模式的订阅与退订

68 |

69 | 类似地,服务器也将所有模式的订阅关系都保存在服务器状态的`pubsub_patterns`属性。

70 |

71 | 与频道不同的是,这是一个**链表**,链表中的每个节点都包含着一个`pubsubPattern`结构,这个结构的`pattern`属性记录了被订阅的模式,而`client`属性则记录了订阅模式的客户端:

72 |

73 | ```C

74 | typedef struct pubsub_Pattern

75 | {

76 | // 订阅模式的客户端

77 | redisClient *client;

78 | // 被订阅的模式

79 | robj *pattern;

80 | } pubsubPattern;

81 | ```

82 |

83 | 下面举一个例子:

84 |

85 | - 客户端7正在订阅模式"music.*"

86 | - 客户端8正在订阅模式"book.*"

87 | - 客户端9正在订阅模式"news.*"

88 |

89 |

62 |

63 | ---

64 |

65 | 退订就是在链表中删除客户端信息,如果退订后某个键没有任何客户端,则**程序将从pubsub_channels字典中删除频道对应的键。**

66 |

67 | ## 1.2 模式的订阅与退订

68 |

69 | 类似地,服务器也将所有模式的订阅关系都保存在服务器状态的`pubsub_patterns`属性。

70 |

71 | 与频道不同的是,这是一个**链表**,链表中的每个节点都包含着一个`pubsubPattern`结构,这个结构的`pattern`属性记录了被订阅的模式,而`client`属性则记录了订阅模式的客户端:

72 |

73 | ```C

74 | typedef struct pubsub_Pattern

75 | {

76 | // 订阅模式的客户端

77 | redisClient *client;

78 | // 被订阅的模式

79 | robj *pattern;

80 | } pubsubPattern;

81 | ```

82 |

83 | 下面举一个例子:

84 |

85 | - 客户端7正在订阅模式"music.*"

86 | - 客户端8正在订阅模式"book.*"

87 | - 客户端9正在订阅模式"news.*"

88 |

89 |  90 |

91 | ---

92 |

93 | 订阅模式时,服务器会对每个被订阅的模式执行以下两个操作:

94 |

95 | 1. 新建一个`pubsubPattern`结构,将结构的`pattern`属性设置为被订阅的模式,`client`属性设置为订阅模式的客户端。

96 | 2. 将`pubsubPattern`结构添加到`pubsub_patterns`链表的表尾。

97 |

98 |

90 |

91 | ---

92 |

93 | 订阅模式时,服务器会对每个被订阅的模式执行以下两个操作:

94 |

95 | 1. 新建一个`pubsubPattern`结构,将结构的`pattern`属性设置为被订阅的模式,`client`属性设置为订阅模式的客户端。

96 | 2. 将`pubsubPattern`结构添加到`pubsub_patterns`链表的表尾。

97 |

98 |  99 |

100 | 退订时,在`pubsub_patterns`链表中查找并删除。

101 |

102 | # 2. 发布消息

103 |

104 | 发布消息有两个动作:

105 |

106 | 1. 将消息发送给所有channel的订阅者。

107 | 2. 如果有一个或多个模式与频道channel匹配,则同时将消息发送给模式的订阅者。

108 |

109 | **对于频道订阅者**,首先服务器要在`pubsub_channels`中找到相对应的channel(一个链表),然后顺着这个链表,将消息发送给所有客户端。

110 |

111 | **对于模式订阅者**,服务器会在`pubsub_patterns`链表中找到**与channel频道相匹配的模式**,然后将消息发送给订阅了这些模式的所有客户端。

112 |

113 | # 3. 查看订阅消息

114 |

115 | **PUBSUB**命令是Redis 2.8新增加的命令之一,**客户端可以通过这个命令来查看频道或者模式的相关信息**,比如某个频道目前有多少订阅者,又或者某个模式目前有多少订阅者。本节介绍这个命令的实现方法。

116 |

117 | ## 3.1 PUBSUB CHANNELS

118 |

119 | `PUBSUB CHANNELS[pattern]`子命令用于返回服务器**当前被订阅的频道**,其中`pattern`参数是可选的:

120 |

121 | - 不给定,则返回所有被订阅的所有频道。

122 | - 给定,与pattern模式相匹配的频道。

123 |

124 | 比如:

125 |

126 | ```C

127 | redis> PUBSUB CHANNELS

128 | 1) "news.it"

129 | 2) "news.sport"

130 | 3) "news.business"

131 | 4) "news.movie"

132 |

133 | redis> PUBSUB CHANNELS "news.[is]*"

134 | 1) "news.it"

135 | 2) "news.sport"

136 | ```

137 |

138 | ## 3.2 PUBSUB NUMSUB

139 |

140 | `PUBSUB NUMSUB[channel-1 channel-2...channel-n]`子命令接受任意多个频道作为输入参数,并返回这些**频道的订阅者数量**。

141 |

142 | 这个子命令是通过在`pubsub_channels`字典中找到频道对应的订阅者链表,然后**返回订阅者链表的长度**。

143 |

144 | ## 3.3 PUBSUB NUMPAT

145 |

146 | `PUBSUB NUMPAT`子命令用于返回服务器当前被**订阅模式的数量**。

147 |

148 | 通过返回`pubsub_patterns`链表的长度来实现的。注意一下频道数量的查找逻辑是:**频道字典->频道订阅者链表->数量**;而模式数量的查找逻辑是:**模式链表->数量**。

149 |

150 |

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现11-事务.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现11-事务

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-07 13:54:21

12 | ---

13 |

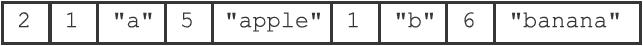

14 | Redis通过MULTI、EXEC、WATCH等命令来实现事务(transaction)功能。事务将**一种将多个命令请求打包,然后一次性、按顺序地执行多个命令的机制**,并且在事务执行期间,**服务器不会中断事务**而改去执行其他客户端的命令请求。

15 |

16 | ```C

17 | redis->MULTI

18 | OK

19 |

20 | redis->SET "name" "hellp"

21 | QUEUED

22 |

23 | redis->GET "name"

24 | QUEUED

25 |

26 | redis->EXEC

27 | 1)OK

28 | 2)"hellp"

29 | ```

30 |

31 | # 1. 事务的实现

32 |

33 | 一个事务从开始到结束会经历三个阶段:

34 |

35 | - 事务开始

36 | - 命令入队

37 | - 事务执行

38 |

39 | **(1)事务开始**

40 |

41 | 通过MULTI命令可以将执行该命令的客户端**从非事务状态切换至事务状态**,这一切换是通过在客户端状态的flags属性中打开REDIS_MULTI标识来完成的。

42 |

43 | 当一个客户端已经处于非事务状态时,这个客户端发送的**命令会被服务器执行**。然而当切换到事务状态后,服务器会根据这个客户端发来的不同命令执行不同的操作:

44 |

45 | - 如果客户端发送EXEC,DISCARD,WATCH,MULTI这四个命令,则立即执行。

46 | - 如果发送的是其他命令,则放到事务队列里面,向客户端返回QUEUED回复。

47 |

48 |

99 |

100 | 退订时,在`pubsub_patterns`链表中查找并删除。

101 |

102 | # 2. 发布消息

103 |

104 | 发布消息有两个动作:

105 |

106 | 1. 将消息发送给所有channel的订阅者。

107 | 2. 如果有一个或多个模式与频道channel匹配,则同时将消息发送给模式的订阅者。

108 |

109 | **对于频道订阅者**,首先服务器要在`pubsub_channels`中找到相对应的channel(一个链表),然后顺着这个链表,将消息发送给所有客户端。

110 |

111 | **对于模式订阅者**,服务器会在`pubsub_patterns`链表中找到**与channel频道相匹配的模式**,然后将消息发送给订阅了这些模式的所有客户端。

112 |

113 | # 3. 查看订阅消息

114 |

115 | **PUBSUB**命令是Redis 2.8新增加的命令之一,**客户端可以通过这个命令来查看频道或者模式的相关信息**,比如某个频道目前有多少订阅者,又或者某个模式目前有多少订阅者。本节介绍这个命令的实现方法。

116 |

117 | ## 3.1 PUBSUB CHANNELS

118 |

119 | `PUBSUB CHANNELS[pattern]`子命令用于返回服务器**当前被订阅的频道**,其中`pattern`参数是可选的:

120 |

121 | - 不给定,则返回所有被订阅的所有频道。

122 | - 给定,与pattern模式相匹配的频道。

123 |

124 | 比如:

125 |

126 | ```C

127 | redis> PUBSUB CHANNELS

128 | 1) "news.it"

129 | 2) "news.sport"

130 | 3) "news.business"

131 | 4) "news.movie"

132 |

133 | redis> PUBSUB CHANNELS "news.[is]*"

134 | 1) "news.it"

135 | 2) "news.sport"

136 | ```

137 |

138 | ## 3.2 PUBSUB NUMSUB

139 |

140 | `PUBSUB NUMSUB[channel-1 channel-2...channel-n]`子命令接受任意多个频道作为输入参数,并返回这些**频道的订阅者数量**。

141 |

142 | 这个子命令是通过在`pubsub_channels`字典中找到频道对应的订阅者链表,然后**返回订阅者链表的长度**。

143 |

144 | ## 3.3 PUBSUB NUMPAT

145 |

146 | `PUBSUB NUMPAT`子命令用于返回服务器当前被**订阅模式的数量**。

147 |

148 | 通过返回`pubsub_patterns`链表的长度来实现的。注意一下频道数量的查找逻辑是:**频道字典->频道订阅者链表->数量**;而模式数量的查找逻辑是:**模式链表->数量**。

149 |

150 |

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现11-事务.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现11-事务

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-07 13:54:21

12 | ---

13 |

14 | Redis通过MULTI、EXEC、WATCH等命令来实现事务(transaction)功能。事务将**一种将多个命令请求打包,然后一次性、按顺序地执行多个命令的机制**,并且在事务执行期间,**服务器不会中断事务**而改去执行其他客户端的命令请求。

15 |

16 | ```C

17 | redis->MULTI

18 | OK

19 |

20 | redis->SET "name" "hellp"

21 | QUEUED

22 |

23 | redis->GET "name"

24 | QUEUED

25 |

26 | redis->EXEC

27 | 1)OK

28 | 2)"hellp"

29 | ```

30 |

31 | # 1. 事务的实现

32 |

33 | 一个事务从开始到结束会经历三个阶段:

34 |

35 | - 事务开始

36 | - 命令入队

37 | - 事务执行

38 |

39 | **(1)事务开始**

40 |

41 | 通过MULTI命令可以将执行该命令的客户端**从非事务状态切换至事务状态**,这一切换是通过在客户端状态的flags属性中打开REDIS_MULTI标识来完成的。

42 |

43 | 当一个客户端已经处于非事务状态时,这个客户端发送的**命令会被服务器执行**。然而当切换到事务状态后,服务器会根据这个客户端发来的不同命令执行不同的操作:

44 |

45 | - 如果客户端发送EXEC,DISCARD,WATCH,MULTI这四个命令,则立即执行。

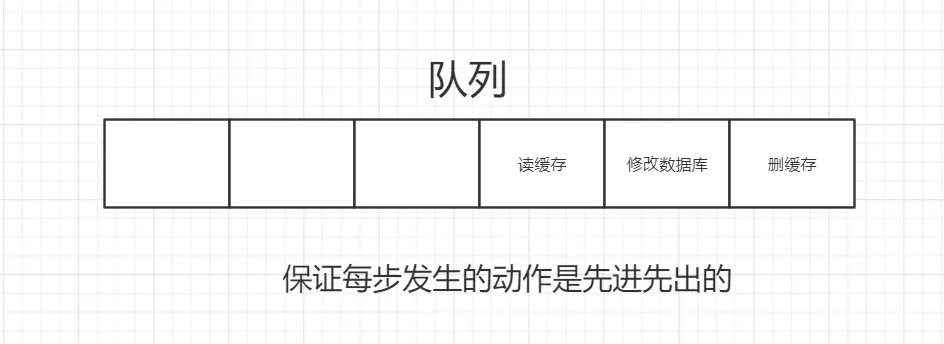

46 | - 如果发送的是其他命令,则放到事务队列里面,向客户端返回QUEUED回复。

47 |

48 |  49 |

50 | **(2)命令入队**

51 |

52 | 事务的关键实现在于**命令入队**,每个Redis客户端都有自己的**事务状态**,这个事务状态保存在客户端状态的mstate属性里面:

53 |

54 | ```C

55 | typedef struct redisClient

56 | {

57 | //...

58 | multiState mstate;

59 | //...

60 | }

61 | ```

62 |

63 | 而**事务状态结构体**又包含了一个**事务队列**,以及一个**已入队命令的计数器**。

64 |

65 | ```C

66 | typedef struct multiState

67 | {

68 | // 事务队列,FIFO顺序

69 | multiCmd *commands;

70 | // 已入队命令计数

71 | int count;

72 | } multiState;

73 | ```

74 |

75 | **事务队列**是一个结构体,实现了队列数据结构,执行FIFO先进先出的策略。真实结构是一个数组。

76 |

77 | ```c

78 | typedef struct multiCmd

79 | {

80 | // 参数

81 | robj **argv;

82 | // 参数数量

83 | int argc;

84 | // 命令指针

85 | struct redisCommand *cmd;

86 | } multiCmd;

87 | ```

88 |

89 | 事务结构具体的包含逻辑是:**客户端->事务状态multiState->事务队列multiCmd->具体命令cmd**

90 |

91 |

49 |

50 | **(2)命令入队**

51 |

52 | 事务的关键实现在于**命令入队**,每个Redis客户端都有自己的**事务状态**,这个事务状态保存在客户端状态的mstate属性里面:

53 |

54 | ```C

55 | typedef struct redisClient

56 | {

57 | //...

58 | multiState mstate;

59 | //...

60 | }

61 | ```

62 |

63 | 而**事务状态结构体**又包含了一个**事务队列**,以及一个**已入队命令的计数器**。

64 |

65 | ```C

66 | typedef struct multiState

67 | {

68 | // 事务队列,FIFO顺序

69 | multiCmd *commands;

70 | // 已入队命令计数

71 | int count;

72 | } multiState;

73 | ```

74 |

75 | **事务队列**是一个结构体,实现了队列数据结构,执行FIFO先进先出的策略。真实结构是一个数组。

76 |

77 | ```c

78 | typedef struct multiCmd

79 | {

80 | // 参数

81 | robj **argv;

82 | // 参数数量

83 | int argc;

84 | // 命令指针

85 | struct redisCommand *cmd;

86 | } multiCmd;

87 | ```

88 |

89 | 事务结构具体的包含逻辑是:**客户端->事务状态multiState->事务队列multiCmd->具体命令cmd**

90 |

91 |  92 |

93 | **(3)执行事务**

94 |

95 | 当一个处于事务状态的客户端向服务器发送EXEC命令时,这个EXEC命令将立即被服务器执行。**服务器会遍历这个客户端的事务队列,执行队列中保存的所有命令,最后将执行命令所得的结果全部返回给客户端。**

96 |

97 | 1. 创建空白回复队列

98 | 2. 抽取一条命令,读取参数、参数个数以及要执行的函数

99 | 3. 执行命令,取得返回值

100 | 4. 将返回值追加到1中的队列末尾,重复步骤2

101 |

102 | 完成所有命令后,将**清除REDIS_MULTI标志**,让客户端变为非事务状态,同时清**零入队命令计数器,并释放事务队列。**

103 |

104 | # 2. WATCH命令的实现

105 |

106 | WATCH可以别翻译为**监视器**。WATCH命令是一个**乐观锁(optimistic locking)**。

107 |

108 | > 悲观锁:有罪推定原则,每次有人操作数据时都会假定他要修改,每次都会上互斥锁。

109 | >

110 | > 乐观锁:无罪推定原则,每次别人拿数据都假定他不修改,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据。

111 |

112 | 它可以**在EXEC命令执行之前**,**监视任意数量的数据库键**,并在EXEC命令执行时,**检查被监视的键是否至少有一个已经被修改过了**,**如果是的话,服务器将拒绝执行事务**,并向客户端返回代表事务执行失败的空回复。

113 |

114 | ```C

115 | redis-> WATCH "name"

116 | OK

117 |

118 | redis-> MULTI

119 | OK

120 |

121 | redis-> SET "name" "peter"

122 | QUEUED

123 |

124 | redis-> EXEC

125 | (nil)

126 | ```

127 |

128 | 上面的例子中,WATCH监视器发现了事务修改了name的值,因此拒绝执行该事务,返回空回复。

129 |

130 | ## 2.1 监视原理

131 |

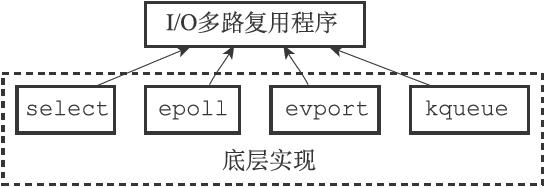

132 | 每个Redis数据库都保存着一个`watched_keys`字典,这个字典的**键是某个被WATCH命令监视的数据库键**,而**字典的值则是一个链表,链表中记录了所有监视相应数据库键的客户端:**

133 |

134 | ```C

135 | typedef struct redisDb

136 | {

137 | // ...

138 | // 正在被WATCH命令监视的键

139 | dict *watched_keys;

140 | // ...

141 | } redisDb;

142 | ```

143 |

144 | 下图说明:c1和c2客户端正在监视键"name",c3客户端正在监视"age"....

145 |

146 |

92 |

93 | **(3)执行事务**

94 |

95 | 当一个处于事务状态的客户端向服务器发送EXEC命令时,这个EXEC命令将立即被服务器执行。**服务器会遍历这个客户端的事务队列,执行队列中保存的所有命令,最后将执行命令所得的结果全部返回给客户端。**

96 |

97 | 1. 创建空白回复队列

98 | 2. 抽取一条命令,读取参数、参数个数以及要执行的函数

99 | 3. 执行命令,取得返回值

100 | 4. 将返回值追加到1中的队列末尾,重复步骤2

101 |

102 | 完成所有命令后,将**清除REDIS_MULTI标志**,让客户端变为非事务状态,同时清**零入队命令计数器,并释放事务队列。**

103 |

104 | # 2. WATCH命令的实现

105 |

106 | WATCH可以别翻译为**监视器**。WATCH命令是一个**乐观锁(optimistic locking)**。

107 |

108 | > 悲观锁:有罪推定原则,每次有人操作数据时都会假定他要修改,每次都会上互斥锁。

109 | >

110 | > 乐观锁:无罪推定原则,每次别人拿数据都假定他不修改,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据。

111 |

112 | 它可以**在EXEC命令执行之前**,**监视任意数量的数据库键**,并在EXEC命令执行时,**检查被监视的键是否至少有一个已经被修改过了**,**如果是的话,服务器将拒绝执行事务**,并向客户端返回代表事务执行失败的空回复。

113 |

114 | ```C

115 | redis-> WATCH "name"

116 | OK

117 |

118 | redis-> MULTI

119 | OK

120 |

121 | redis-> SET "name" "peter"

122 | QUEUED

123 |

124 | redis-> EXEC

125 | (nil)

126 | ```

127 |

128 | 上面的例子中,WATCH监视器发现了事务修改了name的值,因此拒绝执行该事务,返回空回复。

129 |

130 | ## 2.1 监视原理

131 |

132 | 每个Redis数据库都保存着一个`watched_keys`字典,这个字典的**键是某个被WATCH命令监视的数据库键**,而**字典的值则是一个链表,链表中记录了所有监视相应数据库键的客户端:**

133 |

134 | ```C

135 | typedef struct redisDb

136 | {

137 | // ...

138 | // 正在被WATCH命令监视的键

139 | dict *watched_keys;

140 | // ...

141 | } redisDb;

142 | ```

143 |

144 | 下图说明:c1和c2客户端正在监视键"name",c3客户端正在监视"age"....

145 |

146 |  147 |

148 | ## 2.2 监视触发

149 |

150 | 对数据库**执行修改命令**时,比如SET、LPUSH、SADD、ZREM、DEL、FLUSHDB等等,在执行之后都会调用`multi.c/touchWatchKey`函数对`watched_keys`字典进行检查。**查看当前命令修改的键是否在`watched_keys`字典中**,如果有,则客户端的`REDIS_DIRTY_CAS`标识打开**,表示该客户端的事务安全性已经被破坏**。

151 |

152 | ## 2.3 判断事务是否安全

153 |

154 | 当服务器接收到一个客户端发来的EXEC命令时,服务器会根据这个客户端是否打开了`REDIS_DIRTY_CAS`标识来决定是否执行事务。

155 |

156 | - 如果标志被打开,则说明哨兵监视的键中被修改过了,所以当前提交的事务不再安全,拒绝执行客户端提交的事务。

157 | - 反之,是安全的,继续执行。

158 |

159 | # 3. 事务的ACID性质

160 |

161 | 所谓ACID性质是指:**有原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)、耐久性(Durability)。**

162 |

163 | **(1)原子性**

164 |

165 | 所谓原子性就是某个操作不可再分,比如汇编语言里面的`MOV DST,SRC`。事务的定义就是:将多个命令打包成一个实现,**要么全部执行,要么都不执行**。**在命令入队的时候,用WATCH进行检查**,不符合要求就直接返回。

166 |

167 | Redis的事务和传统的关系型数据库事务的最大区别在于,**Redis不支持事务回滚机制(rollback)**。作者认为Redis追求简单高效,回滚机制太复杂。

168 |

169 | > 回滚(rollback)是指当事务中某一条命令执行出错时,意味着前面的命令可能也不安全,这时候就会释放掉前面的操作,恢复到执行事务之前的状态。MySQL数据库支持回滚操作。

170 |

171 | **(2)一致性**

172 |

173 | “**一致”指的是数据符合数据库本身的定义和要求,没有包含非法或者无效的错误数据。**如果数据库在执行事务之前是一致的,那么在事务执行之后,无论事务是否执行成功,数据库也应该仍然是一致的。Redis保证一致性的方法如下:

174 |

175 | - **入队错误**:事务入队时命令格式不正确,则Redis拒绝执行

176 | - **执行错误**:执行时操作不正确,会被服务器识别,并做错误处理,所以这些出错命令不会对数据库做任何修改

177 | - **服务器停机**:停机分三种情况,

178 | - 无持久化:重启后清空,数据总是一致的

179 | - RDB模式:根据RDB恢复数据,还原为一致状态

180 | - AOF模式:根据AOF恢复数据,还原为一致状态

181 |

182 | **(3)隔离性**

183 |

184 | 隔离性也可被理解为**不存在竞争**。即使数据库中有多个事务并发地执行,各个事务之间也不会互相影响。

185 |

186 | 因为Redis使用**单线程**的方式来执行事务(以及事务队列中的命令),并且服务器保证,在执行事务期间**不会对事务进行中断**。这种**串行**的方式保证了事务也总是具有隔离性的。

187 |

188 | **(4)耐久性**

189 |

190 | 事务的耐久性指的是,当一个事务执行完毕时,执行这个事务所得的结果已经**被保存到永久性存储介质**(比如硬盘)里面了,即使服务器在事务执行完毕之后停机,执行事务所得的结果也不会丢失。

191 |

192 | Redis事务只是简答包裹了一组Redis命令,耐久性由持久化实现。前面提到持久化分不同的情况

193 |

194 | - RDB模式下,只有特定条件被满足时才会执行BGSAVE,具有耐久性。

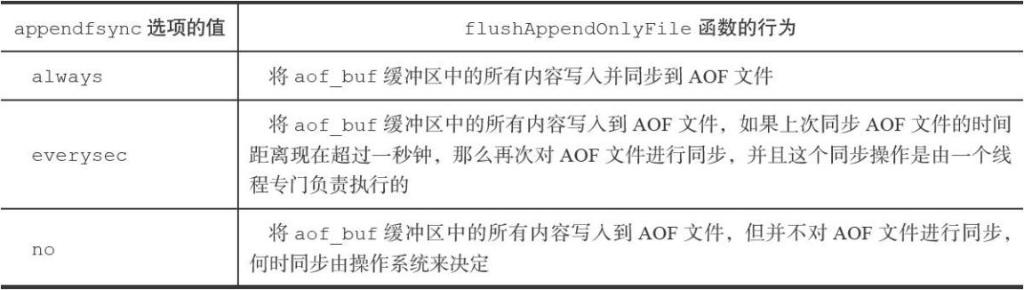

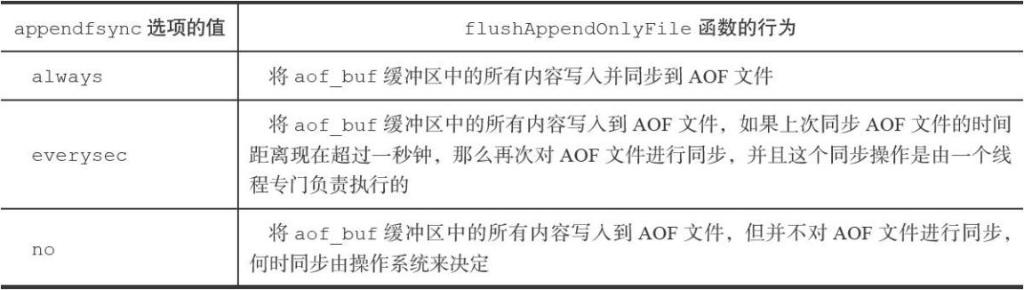

195 | - AOF模式根据appendfsync选项来决定

196 | - always,每次执行命令后都会调用同步函数,具有耐久性。

197 | - everysec,每一秒才会同步到硬盘,不具有耐久性。

198 | - no,程序会交由操作系统来决定何时将命令数据同步到硬盘。不具有耐久性。

199 |

200 | ---

201 |

202 | 总的来说,Redis事务**一定**具有原子性,一致性和隔离性,但**只有在特定条件**下才具有耐久性。

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现12-Lua脚本.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现12-Lua脚本

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-08 11:27:51

12 | ---

13 |

14 | Redis提供了非常丰富的指令集,官网上提供了200多个命令。但是某些特定领域,需要扩充若干指令原子性执行时,仅使用原生命令便无法完成,所以需要Lua脚本进行补充。Redis客户端可以使用Lua脚本,**直接在服务器端原子地执行多个Redis命令。**

15 |

16 | 比如,使用EVAL命令可以对脚本进行求值

17 |

18 | ```C

19 | redis> EVAL "return 1+1" 0

20 | (integer) 2

21 | ```

22 |

23 | 使用Lua的原因主要有:

24 |

25 | - **拓展原生指令集功能**。

26 | - **减少网络开销**。多个指令集同时发出,作为整体执行。

27 | - **原子操作**。对事务功能的一个替代,避免竞争。

28 | - **复用**。发送的脚本会以函数形式保存在Redis中,其他客户端也能使用。

29 |

30 | # 1. Lua环境

31 |

32 | Redis在服务器内嵌了一个Lua环境(environ-ment),并**对这个Lua环境进行了一系列修改**,从而确保这个Lua环境可以满足Redis服务器的需要。

33 |

34 | 步骤如下:

35 |

36 | 1. 创建一个基础的Lua环境

37 | 2. 载入多个函数库到Lua环境里面,让Lua脚本可以使用这些函数库来进行数据操作

38 | 3. 创建**全局表格**redis,这个表格包含了对Redis进行操作的函数。

39 | 4. 使用Redis自制的随机函数来替换Lua原有的带有副作用的随机函数,从而**避免在脚本中引入副作用。**

40 | 5. 创建排序辅助函数,Lua环境使用这个辅佐函数来对一部分Redis命令的结果进行排序,从而**消除这些命令的不确定性**。

41 | 6. 创建redis.pcall函数的错误报告辅助函数,这个函数可以提供更详细的出错信息。

42 | 7. **对Lua环境中的全局环境进行保护**,防止用户在执行Lua脚本的过程中,将额外的全局变量添加到Lua环境中。

43 | 8. 将完成修改的Lua环境保存到服务器状态的lua属性中,等待执行服务器传来的Lua脚本。

44 |

45 | **(1)创建Lua环境**

46 |

47 | 在最开始的这一步,服务器首先调用Lua的C API函数`lua_open`,创建一个新的Lua环境。因为`lua_open`函数创建的**只是一个基本的Lua环境**,为了让这个Lua环境可以满足Redis的操作要求,接下来服务器将对这个Lua环境进行一系列修改。

48 |

49 | **(2)载入函数库**

50 |

51 | Redis修改Lua环境的第一步,就是将以下函数库载入到Lua环境里面:

52 |

53 | - 基础库:包含了Lua核心函数

54 | - 表格库:用于处理表格的通用函数

55 | - 字符串库

56 | - 数学库:标准C语言数学库的接口

57 | - 调试库:钩子函数和取得钩子函数,还包括元数据相关函数

58 | - Lua CJSON库:用于处理UTF-8编码的JSON格式

59 | - Lua cmsgpack库:用于处理MessagePack格式的数据

60 |

61 | **(3)创建redis表格**

62 |

63 | 服务器将在Lua环境中创建一个redis表格(table),**并将它设为全局变量**。这个redis表格包含以下函数:

64 |

65 | - 用于执行Redis命令的`redis.call`和`redis.pcall`函数。

66 | - 用于记录Redis日志(log)的`redis.log`函数

67 | - 用于计算SHA1校验和的`redis.sha1hex`函数。

68 | - 用于返回错误信息的`redis.error_reply`函数和`redis.status_reply`函数。

69 |

70 | **(4)自制随机函数替代Lua原有的随机函数**

71 |

72 | 为了保证相同的脚本可以在不同的机器上产生相同的结果,**Redis要求所有传入服务器的Lua脚本,以及Lua环境中的所有函数,都必须是无副作用(side effect)的纯函数(pure func-tion)。**

73 |

74 | > 副作用是指:函数使用时除了返回值以外还破坏了系统环境,比如全局变量。

75 |

76 | Redis使用自制的函数替换了math库中原有的`math.random`函数和`math.randomseed`函数,替换之后的两个函数有以下特征:

77 |

78 | - 对于相同的seed来说,`math.random`总产生相同的随机数序列

79 | - 除非在脚本中使用`math.randomseed`显式地修改seed,否则每次运行脚本时,Lua环境都使用固定的`math.random-seed(0)`语句来初始化seed。

80 |

81 | **(5)创建排序辅助函数**

82 |

83 | 另一个可能产生不一致数据的地方是**那些带有不确定性质的命令**。比如对于一个集合键来说,因为集合元素的排列是无序的,所以即使两个集合的元素完全相同,它们的输出结果也可能并不相同。

84 |

85 | 为了消除这些命令带来的不确定性,服务器会为Lua环境创建一个排序辅助函数`__redis__compare_helper`,当Lua脚本执行完一个带有不确定性的命令之后,程序会使用`__redis__compare_helper`**作为对比函数自动调用`table.sort`函数对命令的返回值做一次排序,以此来保证相同的数据集总是产生相同的输出。**

86 |

87 | 如果我们在Lua脚本中对fruit集合和anotherfruit集合执行`SMEMBERS`命令,那么两个脚本将得出相同的结果:

88 |

89 | ```C

90 | redis> EVAL "return redis.call('SMEMBERS', KEYS[1])" 1 anotherfruit

91 | 1) "apple"

92 | 2) "banana"

93 | 3) "cherry"

94 |

95 | redis> EVAL "return redis.call('SMEMBERS', KEYS[1])" 1 fruit

96 | 1) "apple"

97 | 2) "banana"

98 | 3) "cherry"

99 | ```

100 |

101 | **(6)创建redis.pcall函数的错误报告辅助函数**

102 |

103 | 服务器将为Lua环境创建一个名为`__redis__err__handler`的错误处理函数,当脚本调用`redis.pcall`函数执行Redis命令,并且被执行的命令出现错误时,`__re-dis__err__handler`就会打印出错代码的来源和发生错误的行数,为程序的调试提供方便。

104 |

105 | **(7)保护Lua的全局环境**

106 |

107 | **确保传入服务器的脚本不会因为忘记使用local关键字而将额外的全局变量添加到Lua环境里面**。

108 |

109 | 如果误操作,程序会报错:

110 |

111 | ```

112 | redis> EVAL "x = 10" 0

113 | (error) ERR Error running script

114 | (call to f_df1ad3745c2d2f078f0f41377a92bb6f8ac79af0):

115 | @enable_strict_lua:7: user_script:1:

116 | Script attempted to create global variable 'x'

117 | ```

118 |

119 | 试图获取一个不存在的全局变量也会引发一个错误

120 |

121 | 不过**Redis并未禁止用户修改已存在的全局变量**,所以在执行Lua脚本的时候,必须非常小心,以免错误地修改了已存在的全局变量。

122 |

123 | ```C

124 | redis> EVAL "redis = 10086; return redis" 0

125 | (integer) 10086

126 | ```

127 |

128 | **(8)将Lua环境保存到服务器状态的lua属性里面**

129 |

130 | 最后的这一步,服务器会将Lua环境和服务器状态的lua属性关联起来

131 |

132 |

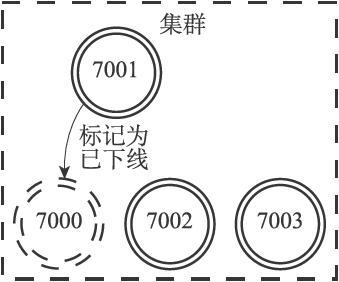

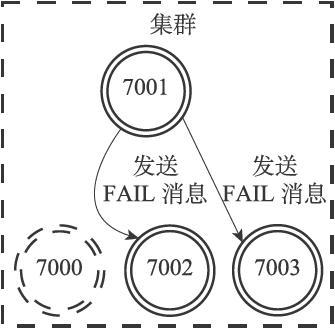

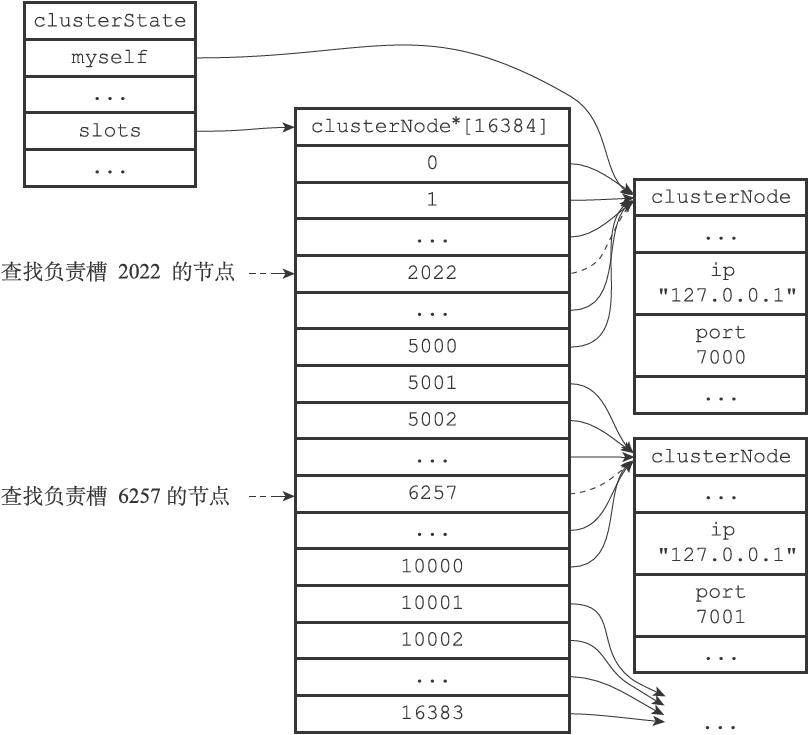

147 |

148 | ## 2.2 监视触发

149 |

150 | 对数据库**执行修改命令**时,比如SET、LPUSH、SADD、ZREM、DEL、FLUSHDB等等,在执行之后都会调用`multi.c/touchWatchKey`函数对`watched_keys`字典进行检查。**查看当前命令修改的键是否在`watched_keys`字典中**,如果有,则客户端的`REDIS_DIRTY_CAS`标识打开**,表示该客户端的事务安全性已经被破坏**。

151 |

152 | ## 2.3 判断事务是否安全

153 |

154 | 当服务器接收到一个客户端发来的EXEC命令时,服务器会根据这个客户端是否打开了`REDIS_DIRTY_CAS`标识来决定是否执行事务。

155 |

156 | - 如果标志被打开,则说明哨兵监视的键中被修改过了,所以当前提交的事务不再安全,拒绝执行客户端提交的事务。

157 | - 反之,是安全的,继续执行。

158 |

159 | # 3. 事务的ACID性质

160 |

161 | 所谓ACID性质是指:**有原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)、耐久性(Durability)。**

162 |

163 | **(1)原子性**

164 |

165 | 所谓原子性就是某个操作不可再分,比如汇编语言里面的`MOV DST,SRC`。事务的定义就是:将多个命令打包成一个实现,**要么全部执行,要么都不执行**。**在命令入队的时候,用WATCH进行检查**,不符合要求就直接返回。

166 |

167 | Redis的事务和传统的关系型数据库事务的最大区别在于,**Redis不支持事务回滚机制(rollback)**。作者认为Redis追求简单高效,回滚机制太复杂。

168 |

169 | > 回滚(rollback)是指当事务中某一条命令执行出错时,意味着前面的命令可能也不安全,这时候就会释放掉前面的操作,恢复到执行事务之前的状态。MySQL数据库支持回滚操作。

170 |

171 | **(2)一致性**

172 |

173 | “**一致”指的是数据符合数据库本身的定义和要求,没有包含非法或者无效的错误数据。**如果数据库在执行事务之前是一致的,那么在事务执行之后,无论事务是否执行成功,数据库也应该仍然是一致的。Redis保证一致性的方法如下:

174 |

175 | - **入队错误**:事务入队时命令格式不正确,则Redis拒绝执行

176 | - **执行错误**:执行时操作不正确,会被服务器识别,并做错误处理,所以这些出错命令不会对数据库做任何修改

177 | - **服务器停机**:停机分三种情况,

178 | - 无持久化:重启后清空,数据总是一致的

179 | - RDB模式:根据RDB恢复数据,还原为一致状态

180 | - AOF模式:根据AOF恢复数据,还原为一致状态

181 |

182 | **(3)隔离性**

183 |

184 | 隔离性也可被理解为**不存在竞争**。即使数据库中有多个事务并发地执行,各个事务之间也不会互相影响。

185 |

186 | 因为Redis使用**单线程**的方式来执行事务(以及事务队列中的命令),并且服务器保证,在执行事务期间**不会对事务进行中断**。这种**串行**的方式保证了事务也总是具有隔离性的。

187 |

188 | **(4)耐久性**

189 |

190 | 事务的耐久性指的是,当一个事务执行完毕时,执行这个事务所得的结果已经**被保存到永久性存储介质**(比如硬盘)里面了,即使服务器在事务执行完毕之后停机,执行事务所得的结果也不会丢失。

191 |

192 | Redis事务只是简答包裹了一组Redis命令,耐久性由持久化实现。前面提到持久化分不同的情况

193 |

194 | - RDB模式下,只有特定条件被满足时才会执行BGSAVE,具有耐久性。

195 | - AOF模式根据appendfsync选项来决定

196 | - always,每次执行命令后都会调用同步函数,具有耐久性。

197 | - everysec,每一秒才会同步到硬盘,不具有耐久性。

198 | - no,程序会交由操作系统来决定何时将命令数据同步到硬盘。不具有耐久性。

199 |

200 | ---

201 |

202 | 总的来说,Redis事务**一定**具有原子性,一致性和隔离性,但**只有在特定条件**下才具有耐久性。

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现12-Lua脚本.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现12-Lua脚本

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-08 11:27:51

12 | ---

13 |

14 | Redis提供了非常丰富的指令集,官网上提供了200多个命令。但是某些特定领域,需要扩充若干指令原子性执行时,仅使用原生命令便无法完成,所以需要Lua脚本进行补充。Redis客户端可以使用Lua脚本,**直接在服务器端原子地执行多个Redis命令。**

15 |

16 | 比如,使用EVAL命令可以对脚本进行求值

17 |

18 | ```C

19 | redis> EVAL "return 1+1" 0

20 | (integer) 2

21 | ```

22 |

23 | 使用Lua的原因主要有:

24 |

25 | - **拓展原生指令集功能**。

26 | - **减少网络开销**。多个指令集同时发出,作为整体执行。

27 | - **原子操作**。对事务功能的一个替代,避免竞争。

28 | - **复用**。发送的脚本会以函数形式保存在Redis中,其他客户端也能使用。

29 |

30 | # 1. Lua环境

31 |

32 | Redis在服务器内嵌了一个Lua环境(environ-ment),并**对这个Lua环境进行了一系列修改**,从而确保这个Lua环境可以满足Redis服务器的需要。

33 |

34 | 步骤如下:

35 |

36 | 1. 创建一个基础的Lua环境

37 | 2. 载入多个函数库到Lua环境里面,让Lua脚本可以使用这些函数库来进行数据操作

38 | 3. 创建**全局表格**redis,这个表格包含了对Redis进行操作的函数。

39 | 4. 使用Redis自制的随机函数来替换Lua原有的带有副作用的随机函数,从而**避免在脚本中引入副作用。**

40 | 5. 创建排序辅助函数,Lua环境使用这个辅佐函数来对一部分Redis命令的结果进行排序,从而**消除这些命令的不确定性**。

41 | 6. 创建redis.pcall函数的错误报告辅助函数,这个函数可以提供更详细的出错信息。

42 | 7. **对Lua环境中的全局环境进行保护**,防止用户在执行Lua脚本的过程中,将额外的全局变量添加到Lua环境中。

43 | 8. 将完成修改的Lua环境保存到服务器状态的lua属性中,等待执行服务器传来的Lua脚本。

44 |

45 | **(1)创建Lua环境**

46 |

47 | 在最开始的这一步,服务器首先调用Lua的C API函数`lua_open`,创建一个新的Lua环境。因为`lua_open`函数创建的**只是一个基本的Lua环境**,为了让这个Lua环境可以满足Redis的操作要求,接下来服务器将对这个Lua环境进行一系列修改。

48 |

49 | **(2)载入函数库**

50 |

51 | Redis修改Lua环境的第一步,就是将以下函数库载入到Lua环境里面:

52 |

53 | - 基础库:包含了Lua核心函数

54 | - 表格库:用于处理表格的通用函数

55 | - 字符串库

56 | - 数学库:标准C语言数学库的接口

57 | - 调试库:钩子函数和取得钩子函数,还包括元数据相关函数

58 | - Lua CJSON库:用于处理UTF-8编码的JSON格式

59 | - Lua cmsgpack库:用于处理MessagePack格式的数据

60 |

61 | **(3)创建redis表格**

62 |

63 | 服务器将在Lua环境中创建一个redis表格(table),**并将它设为全局变量**。这个redis表格包含以下函数:

64 |

65 | - 用于执行Redis命令的`redis.call`和`redis.pcall`函数。

66 | - 用于记录Redis日志(log)的`redis.log`函数

67 | - 用于计算SHA1校验和的`redis.sha1hex`函数。

68 | - 用于返回错误信息的`redis.error_reply`函数和`redis.status_reply`函数。

69 |

70 | **(4)自制随机函数替代Lua原有的随机函数**

71 |

72 | 为了保证相同的脚本可以在不同的机器上产生相同的结果,**Redis要求所有传入服务器的Lua脚本,以及Lua环境中的所有函数,都必须是无副作用(side effect)的纯函数(pure func-tion)。**

73 |

74 | > 副作用是指:函数使用时除了返回值以外还破坏了系统环境,比如全局变量。

75 |

76 | Redis使用自制的函数替换了math库中原有的`math.random`函数和`math.randomseed`函数,替换之后的两个函数有以下特征:

77 |

78 | - 对于相同的seed来说,`math.random`总产生相同的随机数序列

79 | - 除非在脚本中使用`math.randomseed`显式地修改seed,否则每次运行脚本时,Lua环境都使用固定的`math.random-seed(0)`语句来初始化seed。

80 |

81 | **(5)创建排序辅助函数**

82 |

83 | 另一个可能产生不一致数据的地方是**那些带有不确定性质的命令**。比如对于一个集合键来说,因为集合元素的排列是无序的,所以即使两个集合的元素完全相同,它们的输出结果也可能并不相同。

84 |

85 | 为了消除这些命令带来的不确定性,服务器会为Lua环境创建一个排序辅助函数`__redis__compare_helper`,当Lua脚本执行完一个带有不确定性的命令之后,程序会使用`__redis__compare_helper`**作为对比函数自动调用`table.sort`函数对命令的返回值做一次排序,以此来保证相同的数据集总是产生相同的输出。**

86 |

87 | 如果我们在Lua脚本中对fruit集合和anotherfruit集合执行`SMEMBERS`命令,那么两个脚本将得出相同的结果:

88 |

89 | ```C

90 | redis> EVAL "return redis.call('SMEMBERS', KEYS[1])" 1 anotherfruit

91 | 1) "apple"

92 | 2) "banana"

93 | 3) "cherry"

94 |

95 | redis> EVAL "return redis.call('SMEMBERS', KEYS[1])" 1 fruit

96 | 1) "apple"

97 | 2) "banana"

98 | 3) "cherry"

99 | ```

100 |

101 | **(6)创建redis.pcall函数的错误报告辅助函数**

102 |

103 | 服务器将为Lua环境创建一个名为`__redis__err__handler`的错误处理函数,当脚本调用`redis.pcall`函数执行Redis命令,并且被执行的命令出现错误时,`__re-dis__err__handler`就会打印出错代码的来源和发生错误的行数,为程序的调试提供方便。

104 |

105 | **(7)保护Lua的全局环境**

106 |

107 | **确保传入服务器的脚本不会因为忘记使用local关键字而将额外的全局变量添加到Lua环境里面**。

108 |

109 | 如果误操作,程序会报错:

110 |

111 | ```

112 | redis> EVAL "x = 10" 0

113 | (error) ERR Error running script

114 | (call to f_df1ad3745c2d2f078f0f41377a92bb6f8ac79af0):

115 | @enable_strict_lua:7: user_script:1:

116 | Script attempted to create global variable 'x'

117 | ```

118 |

119 | 试图获取一个不存在的全局变量也会引发一个错误

120 |

121 | 不过**Redis并未禁止用户修改已存在的全局变量**,所以在执行Lua脚本的时候,必须非常小心,以免错误地修改了已存在的全局变量。

122 |

123 | ```C

124 | redis> EVAL "redis = 10086; return redis" 0

125 | (integer) 10086

126 | ```

127 |

128 | **(8)将Lua环境保存到服务器状态的lua属性里面**

129 |

130 | 最后的这一步,服务器会将Lua环境和服务器状态的lua属性关联起来

131 |

132 |  133 |

134 | # 2. Lua环境协作组件

135 |

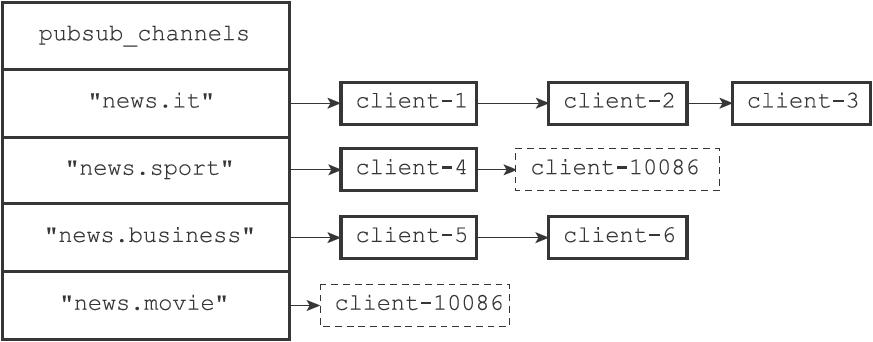

136 | ## 2.1 伪客户端

137 |

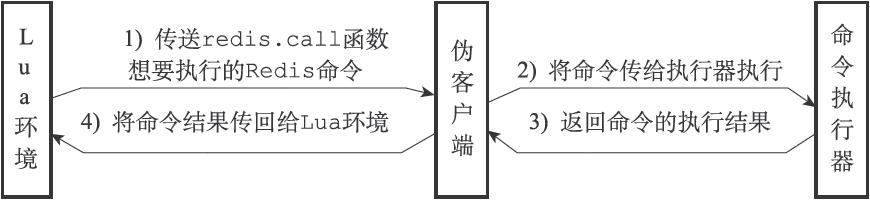

138 | 伪客户端负责处理Lua脚本中包含的所有Redis命令。Lua脚本使用`redis.call`函数或者`redis.pcall`函数执行一个Redis命令,需要完成以下步骤:

139 |

140 | 1. `redis.call`函数或者`redis.pcall`函数想要执行的命令传给伪客户端。

141 | 2. 伪客户端将命令传递给命令执行器

142 | 3. 命令执行器执行,将结果返回给伪客户端

143 | 4. 伪客户端接受结果,返回给Lua环境

144 | 5. Lua环境在接收到命令结果之后,将该结果返回给`redis.call`函数或者`redis.pcall`函数。

145 | 6. 接收到结果的`redis.call`函数或者`redis.pcall`函数会将命令结果作为函数返回值返回给脚本中的调用者。

146 |

147 |

133 |

134 | # 2. Lua环境协作组件

135 |

136 | ## 2.1 伪客户端

137 |

138 | 伪客户端负责处理Lua脚本中包含的所有Redis命令。Lua脚本使用`redis.call`函数或者`redis.pcall`函数执行一个Redis命令,需要完成以下步骤:

139 |

140 | 1. `redis.call`函数或者`redis.pcall`函数想要执行的命令传给伪客户端。

141 | 2. 伪客户端将命令传递给命令执行器

142 | 3. 命令执行器执行,将结果返回给伪客户端

143 | 4. 伪客户端接受结果,返回给Lua环境

144 | 5. Lua环境在接收到命令结果之后,将该结果返回给`redis.call`函数或者`redis.pcall`函数。

145 | 6. 接收到结果的`redis.call`函数或者`redis.pcall`函数会将命令结果作为函数返回值返回给脚本中的调用者。

146 |

147 |  148 |

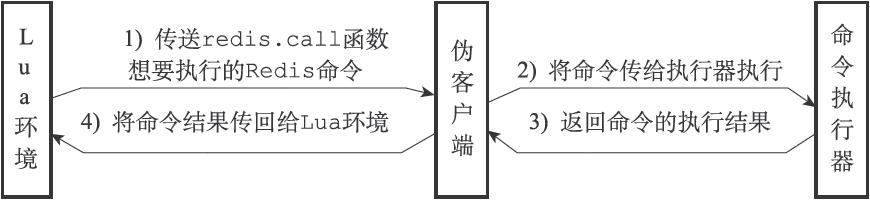

149 | ## 2.2 lua_script字典

150 |

151 | 这个字典的**键**为某个Lua脚本的SHA1校验和(checksum),而字典的**值**则是SHA1校验和对应的Lua脚本:

152 |

153 | ```C

154 | struct redisServer

155 | {

156 | // ...

157 | dict *lua_scripts;

158 | // ...

159 | };

160 | ```

161 |

162 | Redis服务器会**将所有被EVAL命令执行过的Lua脚本,以及所有被`SCRIPT LOAD`命令载入过的Lua脚本都保存到`lua_scripts`字典里面。**

163 |

164 | 如果客户端给服务器发送以下命令:

165 |

166 | ```C

167 | redis> SCRIPT LOAD "return 'hi'"

168 | "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3"

169 |

170 | redis> SCRIPT LOAD "return 1+1"

171 | "a27e7e8a43702b7046d4f6a7ccf5b60cef6b9bd9"

172 |

173 | redis> SCRIPT LOAD "return 2*2"

174 | "4475bfb5919b5ad16424cb50f74d4724ae833e72"

175 | ```

176 |

177 |

148 |

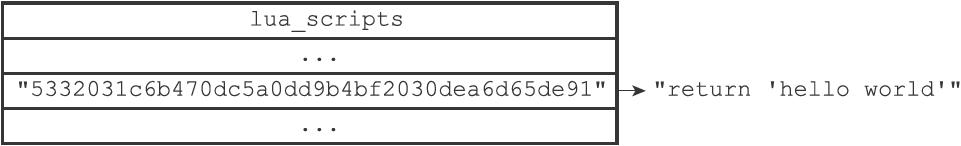

149 | ## 2.2 lua_script字典

150 |

151 | 这个字典的**键**为某个Lua脚本的SHA1校验和(checksum),而字典的**值**则是SHA1校验和对应的Lua脚本:

152 |

153 | ```C

154 | struct redisServer

155 | {

156 | // ...

157 | dict *lua_scripts;

158 | // ...

159 | };

160 | ```

161 |

162 | Redis服务器会**将所有被EVAL命令执行过的Lua脚本,以及所有被`SCRIPT LOAD`命令载入过的Lua脚本都保存到`lua_scripts`字典里面。**

163 |

164 | 如果客户端给服务器发送以下命令:

165 |

166 | ```C

167 | redis> SCRIPT LOAD "return 'hi'"

168 | "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3"

169 |

170 | redis> SCRIPT LOAD "return 1+1"

171 | "a27e7e8a43702b7046d4f6a7ccf5b60cef6b9bd9"

172 |

173 | redis> SCRIPT LOAD "return 2*2"

174 | "4475bfb5919b5ad16424cb50f74d4724ae833e72"

175 | ```

176 |

177 |  178 |

179 | # 3. Lua相关命令的实现

180 |

181 | ## 3.1 EVAL命令

182 |

183 | EVAL命令有三个参数:

184 |

185 | - Lua脚本

186 | - 脚本中使用键的个数

187 | - 键参数和脚本参数

188 |

189 | 比如,下面的例子中,2表示有两个键,名字为Key1和key2,first和second为脚本参数。

190 |

191 | ```lua

192 | -> EVAL "return {KEYS[1],KEYS[2],ARGV[1],ARGV[2]}" 2 key1 key2 first second

193 | 1) "key1"

194 | 2) "key2"

195 | 3) "first"

196 | 4) "second"

197 | ```

198 |

199 | 下面的例子中,比较了两种不同的用法:

200 |

201 | ```lua

202 | -> EVAL "return redis.call('set','foo','bar')" 0

203 | OK

204 |

205 | -> EVAL "return redis.call('set',KEYS[1],'bar')" 1 foo

206 | OK

207 | ```

208 |

209 | EVAL命令实现的过程分三步:

210 |

211 | 1. 根据客户端给定的Lua脚本,在Lua环境中定义一个Lua函数。

212 | 2. 将客户端给定的脚本保存到`lua_scripts`字典

213 | 3. 执行刚刚在Lua环境中定义的函数,以此来执行客户端给定的Lua脚本

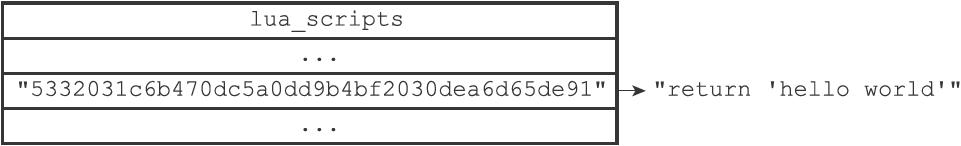

214 |

215 | **(1)定义脚本函数**

216 |

217 | 服务器首先要做的就是在Lua环境中,为传入的脚本**定义一个与这个脚本相对应的Lua函数**。Lua函数的名字为`"_f"+SHA1校验和`,而函数的体(body)则是脚本本身。

218 |

219 | ```lua

220 | function f_5332031c6b470dc5a0dd9b4bf2030dea6d65de91()

221 | return 'hello world'

222 | end

223 | ```

224 |

225 | 使用函数来保存客户端传入的脚本可以**让Lua环境保持清洁**:减少了垃圾回收的工作量,并且避免了使用全局变量。

226 |

227 | **(2)脚本保存到lua_scripts字典**

228 |

229 | 首先服务器向lua_stripts字典中添加一个键值对,键为Lua脚本的SHA1校验和,值为Lua脚本本身(一个字符串)

230 |

231 |

178 |

179 | # 3. Lua相关命令的实现

180 |

181 | ## 3.1 EVAL命令

182 |

183 | EVAL命令有三个参数:

184 |

185 | - Lua脚本

186 | - 脚本中使用键的个数

187 | - 键参数和脚本参数

188 |

189 | 比如,下面的例子中,2表示有两个键,名字为Key1和key2,first和second为脚本参数。

190 |

191 | ```lua

192 | -> EVAL "return {KEYS[1],KEYS[2],ARGV[1],ARGV[2]}" 2 key1 key2 first second

193 | 1) "key1"

194 | 2) "key2"

195 | 3) "first"

196 | 4) "second"

197 | ```

198 |

199 | 下面的例子中,比较了两种不同的用法:

200 |

201 | ```lua

202 | -> EVAL "return redis.call('set','foo','bar')" 0

203 | OK

204 |

205 | -> EVAL "return redis.call('set',KEYS[1],'bar')" 1 foo

206 | OK

207 | ```

208 |

209 | EVAL命令实现的过程分三步:

210 |

211 | 1. 根据客户端给定的Lua脚本,在Lua环境中定义一个Lua函数。

212 | 2. 将客户端给定的脚本保存到`lua_scripts`字典

213 | 3. 执行刚刚在Lua环境中定义的函数,以此来执行客户端给定的Lua脚本

214 |

215 | **(1)定义脚本函数**

216 |

217 | 服务器首先要做的就是在Lua环境中,为传入的脚本**定义一个与这个脚本相对应的Lua函数**。Lua函数的名字为`"_f"+SHA1校验和`,而函数的体(body)则是脚本本身。

218 |

219 | ```lua

220 | function f_5332031c6b470dc5a0dd9b4bf2030dea6d65de91()

221 | return 'hello world'

222 | end

223 | ```

224 |

225 | 使用函数来保存客户端传入的脚本可以**让Lua环境保持清洁**:减少了垃圾回收的工作量,并且避免了使用全局变量。

226 |

227 | **(2)脚本保存到lua_scripts字典**

228 |

229 | 首先服务器向lua_stripts字典中添加一个键值对,键为Lua脚本的SHA1校验和,值为Lua脚本本身(一个字符串)

230 |

231 |  232 |

233 | **(3)执行脚本函数**

234 |

235 | 执行过程如下:

236 |

237 | 1. 将EVAL命令中传入的**键名(key name)参数和脚本参数分别保存到KEYS数组和ARGV数组**,然后将这两个数组作为全局变量传入到Lua环境里面。

238 | 2. 为Lua环境装载**超时处理钩子(hook)**,这个钩子可以在脚本出现超时运行情况时,让客户端通过SCRIPT KILL命令停止脚本,或者通过SHUTDOWN命令直接关闭服务器。

239 | 3. 执行脚本函数

240 | 4. 卸载钩子

241 | 5. 结果保存到客户端状态的输出缓冲区里面,等待服务器将结果返回给客户端。

242 | 6. 对Lua环境执行垃圾回收操作。

243 |

244 | ## 3.2 EVALSHA命令的实现

245 |

246 | 只要脚本对应的函数曾经在Lua环境里面定义过,那么**即使不知道脚本的内容本身,客户端也可以根据脚本的SHA1校验和来调用脚本对应的函数**,从而达到执行脚本的目的,这就是EVALSHA命令的实现原理。

247 |

248 |

232 |

233 | **(3)执行脚本函数**

234 |

235 | 执行过程如下:

236 |

237 | 1. 将EVAL命令中传入的**键名(key name)参数和脚本参数分别保存到KEYS数组和ARGV数组**,然后将这两个数组作为全局变量传入到Lua环境里面。

238 | 2. 为Lua环境装载**超时处理钩子(hook)**,这个钩子可以在脚本出现超时运行情况时,让客户端通过SCRIPT KILL命令停止脚本,或者通过SHUTDOWN命令直接关闭服务器。

239 | 3. 执行脚本函数

240 | 4. 卸载钩子

241 | 5. 结果保存到客户端状态的输出缓冲区里面,等待服务器将结果返回给客户端。

242 | 6. 对Lua环境执行垃圾回收操作。

243 |

244 | ## 3.2 EVALSHA命令的实现

245 |

246 | 只要脚本对应的函数曾经在Lua环境里面定义过,那么**即使不知道脚本的内容本身,客户端也可以根据脚本的SHA1校验和来调用脚本对应的函数**,从而达到执行脚本的目的,这就是EVALSHA命令的实现原理。

247 |

248 |  249 |

250 | 举个例子,当服务器执行完以下EVAL命令之后:

251 |

252 | ```lua

253 | redis> EVAL "return 'hello world'" 0

254 | "hello world"

255 | ```

256 |

257 | 当客户端执行以下EVALSHA命令时:

258 |

259 | ```lua

260 | redis> EVALSHA "5332031c6b470dc5a0dd9b4bf2030dea6d65de91" 0

261 | "hello world"

262 | ```

263 |

264 | ## 3.3 脚本管理命令的实现

265 |

266 | 除了EVAL命令和EVALSHA命令之外,Redis中与Lua脚本有关的命令还有四个,它们分别是**SCRIPT FLUSH命令、SCRIPT EXISTS命令、SCRIPT LOAD命令、以及SCRIPT KILL命令**。

267 |

268 | **(1)SCRIPT FLUSH**

269 |

270 | 释放并重建lua_scripts字典,关闭现有的Lua环境并重新创建一个新的Lua环境。

271 |

272 | **(2)SCRIPT EXISTS**

273 |

274 | 检查校验和对应的脚本是否存在于服务器中

275 |

276 | **(3)SCRIPT LOAD**

277 |

278 | Load和EVAL比较相似,区别在于Load装载后并不执行。

279 |

280 | ```lua

281 | redis> SCRIPT LOAD "return 'hi'"

282 | "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3"

283 | ```

284 |

285 | 执行后,服务器创建此函数,于是我们可以:

286 |

287 | ```lua

288 | redis> EVALSHA "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3" 0

289 | "hi"

290 | ```

291 |

292 | **(4)SCRIPT KILL**

293 |

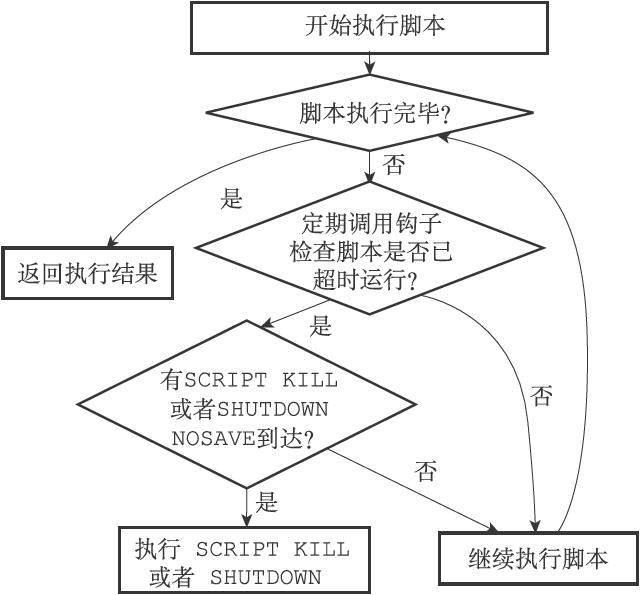

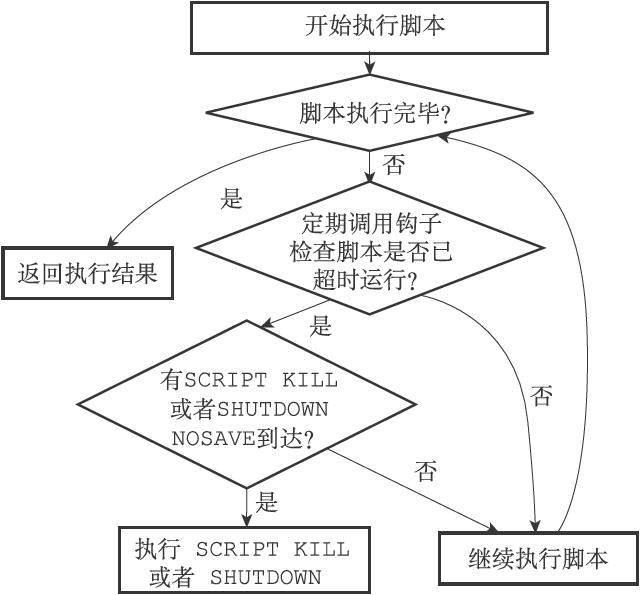

294 | 如果服务器设置了`lua-time-limit`配置选项,那么在每次执行Lua脚本之前,服务器都会在Lua环境里面设置一个超时处理钩子(hook)。

295 |

296 | 一旦钩子发现脚本的运行时间已经超过了lua-time-limit选项设置的时长,**钩子将定期在脚本运行的间隙中,查看是否有SCRIPT KILL命令或者SHUTDOWN命令到达服务器。**达到类似于**中断**的效果。

297 |

298 |

249 |

250 | 举个例子,当服务器执行完以下EVAL命令之后:

251 |

252 | ```lua

253 | redis> EVAL "return 'hello world'" 0

254 | "hello world"

255 | ```

256 |

257 | 当客户端执行以下EVALSHA命令时:

258 |

259 | ```lua

260 | redis> EVALSHA "5332031c6b470dc5a0dd9b4bf2030dea6d65de91" 0

261 | "hello world"

262 | ```

263 |

264 | ## 3.3 脚本管理命令的实现

265 |

266 | 除了EVAL命令和EVALSHA命令之外,Redis中与Lua脚本有关的命令还有四个,它们分别是**SCRIPT FLUSH命令、SCRIPT EXISTS命令、SCRIPT LOAD命令、以及SCRIPT KILL命令**。

267 |

268 | **(1)SCRIPT FLUSH**

269 |

270 | 释放并重建lua_scripts字典,关闭现有的Lua环境并重新创建一个新的Lua环境。

271 |

272 | **(2)SCRIPT EXISTS**

273 |

274 | 检查校验和对应的脚本是否存在于服务器中

275 |

276 | **(3)SCRIPT LOAD**

277 |

278 | Load和EVAL比较相似,区别在于Load装载后并不执行。

279 |

280 | ```lua

281 | redis> SCRIPT LOAD "return 'hi'"

282 | "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3"

283 | ```

284 |

285 | 执行后,服务器创建此函数,于是我们可以:

286 |

287 | ```lua

288 | redis> EVALSHA "2f31ba2bb6d6a0f42cc159d2e2dad55440778de3" 0

289 | "hi"

290 | ```

291 |

292 | **(4)SCRIPT KILL**

293 |

294 | 如果服务器设置了`lua-time-limit`配置选项,那么在每次执行Lua脚本之前,服务器都会在Lua环境里面设置一个超时处理钩子(hook)。

295 |

296 | 一旦钩子发现脚本的运行时间已经超过了lua-time-limit选项设置的时长,**钩子将定期在脚本运行的间隙中,查看是否有SCRIPT KILL命令或者SHUTDOWN命令到达服务器。**达到类似于**中断**的效果。

297 |

298 |  --------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现2-对象.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现2-对象

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-03 11:01:39

12 |

13 | ---

14 |

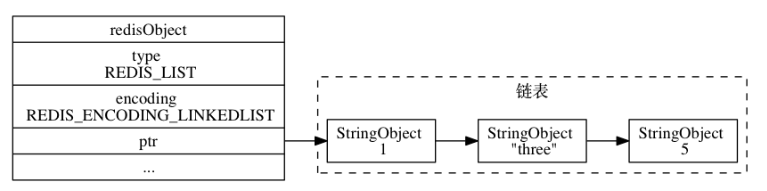

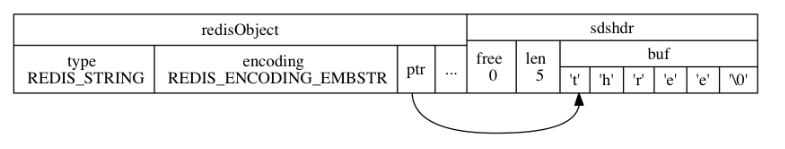

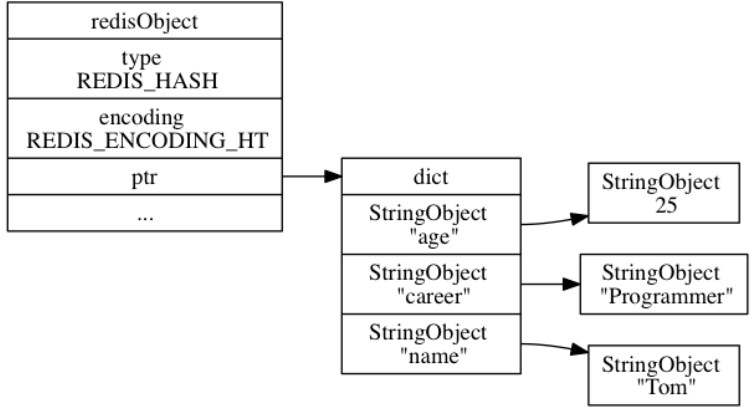

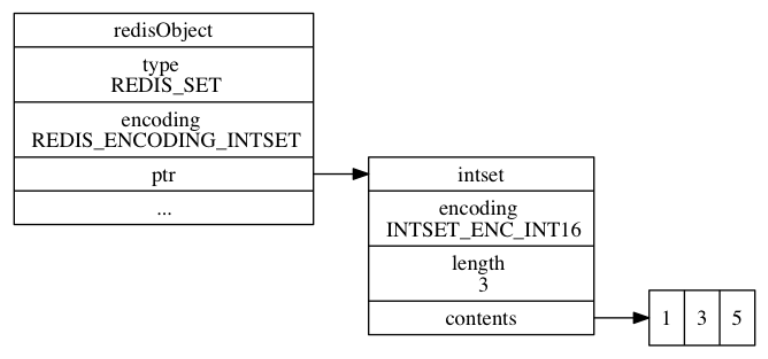

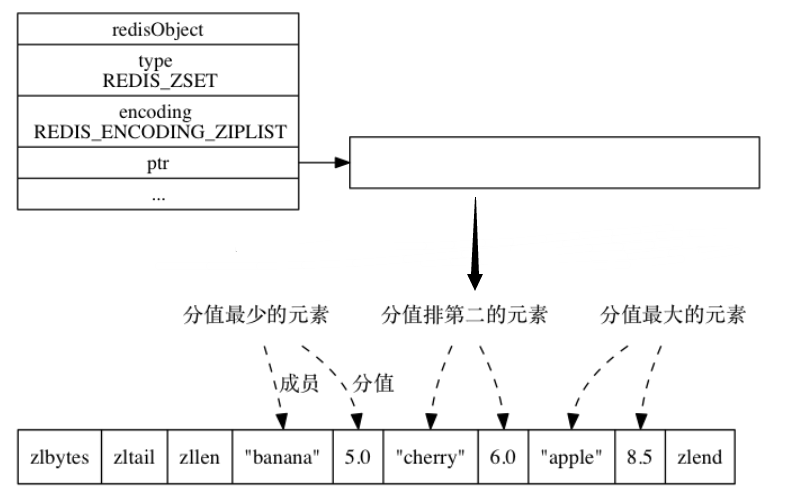

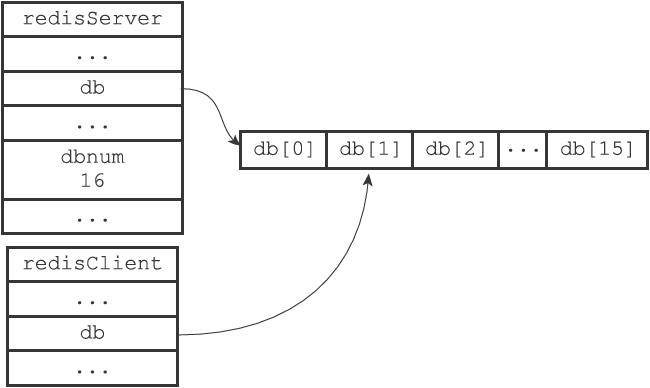

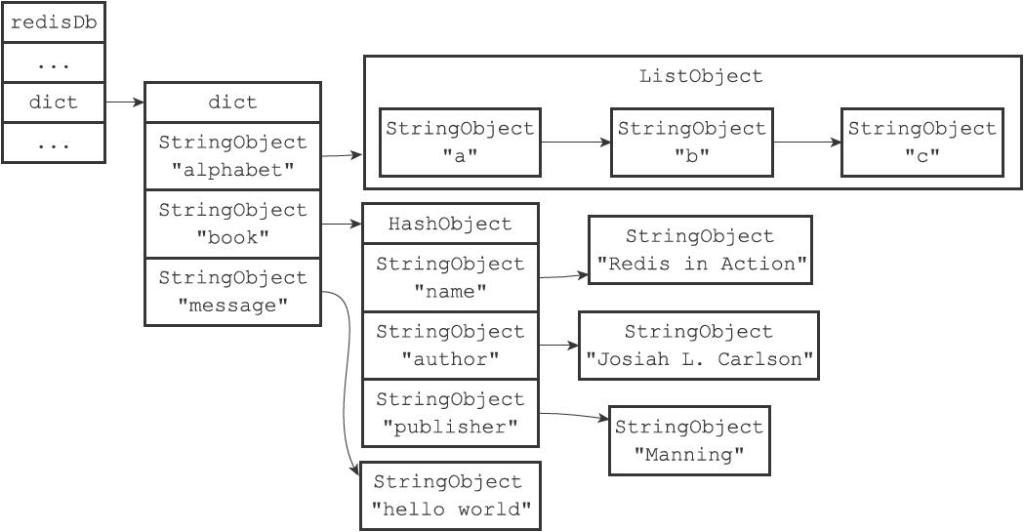

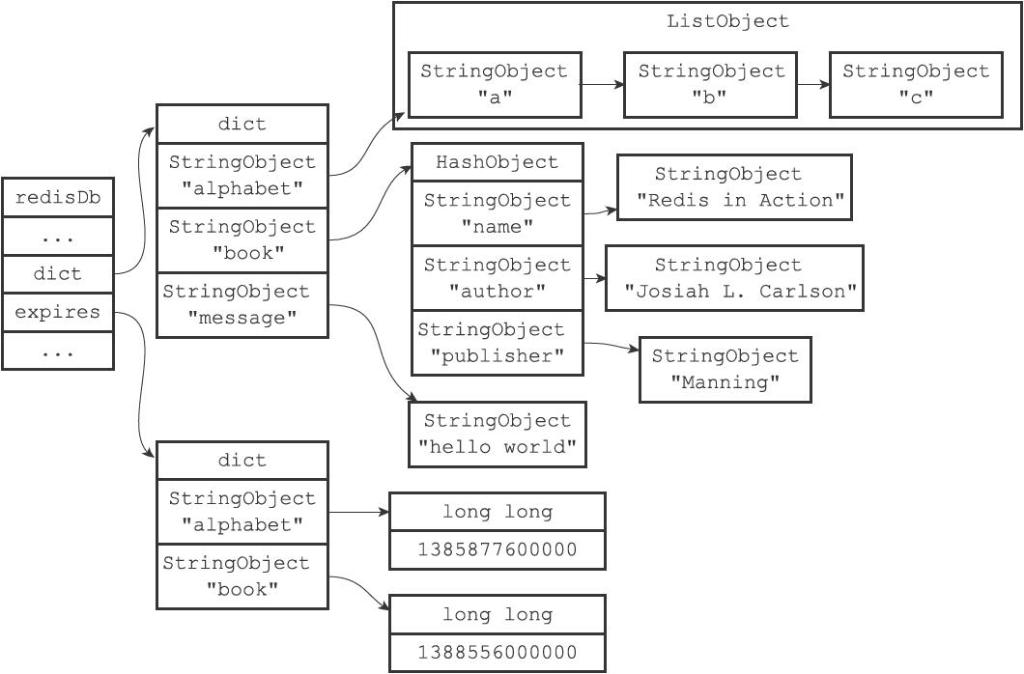

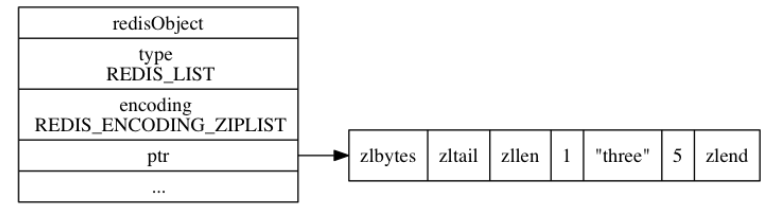

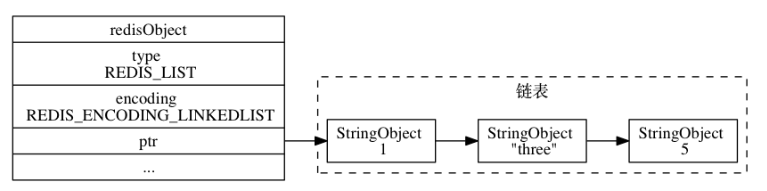

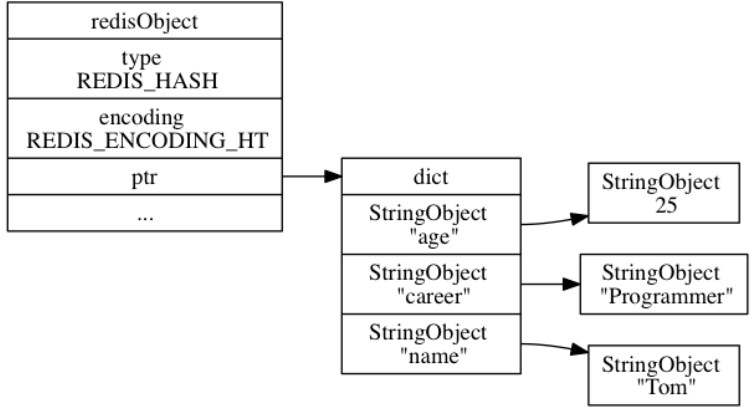

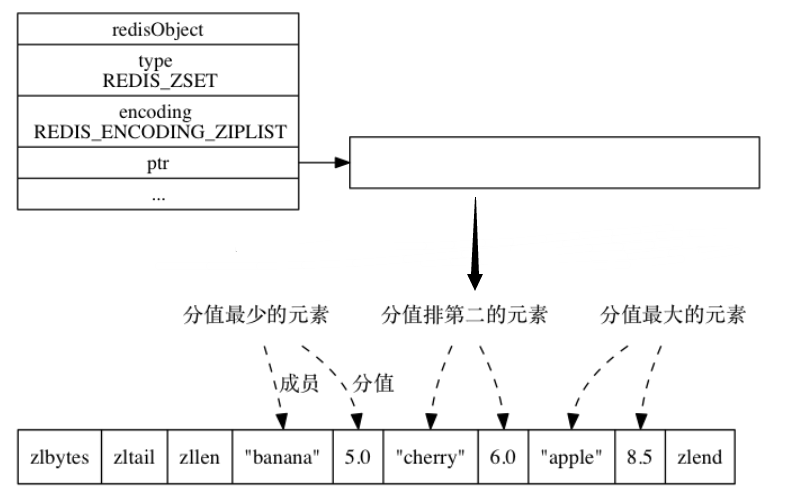

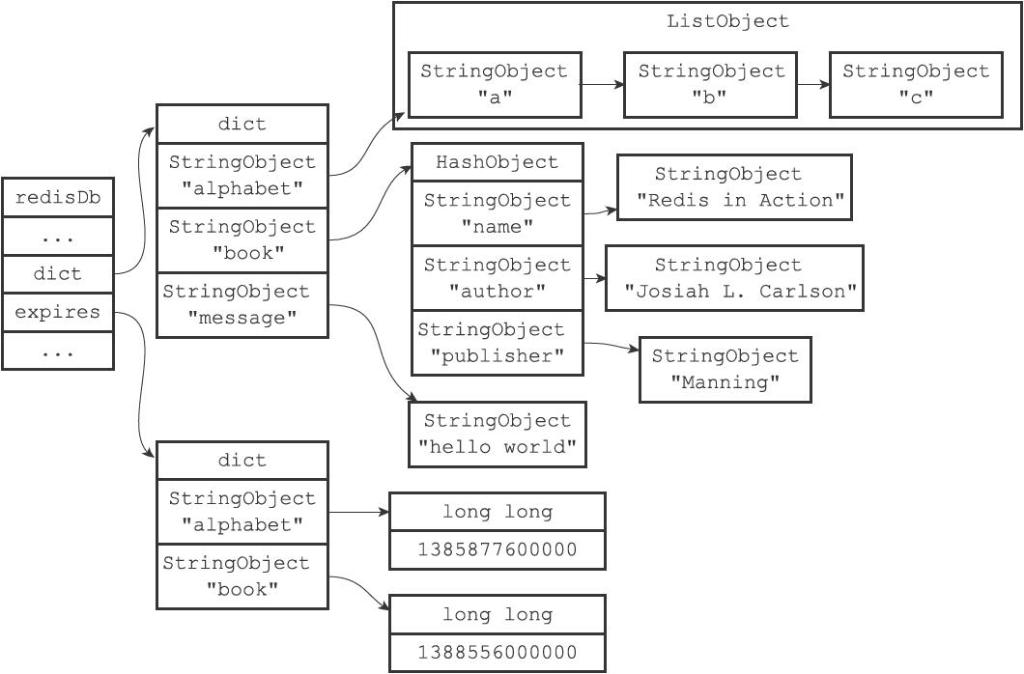

15 | 前一章介绍了Redis的主要数据结构,但Redis并没有直接使用这些数据结构来实现键值对数据库, 而是基于这些数据结构创建了一个对象系统 ,**这个系统包含字符串对象、列表对象、哈希对象、集合对象和有序集合对象**这五种类型的对象。

16 |

17 | 使用对象有两个好处:

18 |

19 | - 执行命令前,根据对象类型来**判断是否可以执行此命令**。

20 | - 针对不同使用场景,为对象**设置多种不同的数据结构实现**,达到优化的目的。

21 |

22 | 此外,对象系统还引入了**引用计数实现内存回收机制**,以及**对象共享**。

23 |

24 | # 1. 对象的类型与编码

25 |

26 | Redis 中的**每个键值对的键和值都是一个对象,每个对象都由一个 `redisObject` 结构表示**, 该结构中和保存数据有关的三个属性分别是 `type` 属性、 `encoding` 属性和 `ptr` 属性:

27 |

28 | ```C

29 | typedef struct redisObject {

30 | // 类型

31 | unsigned type:4;

32 | // 编码

33 | unsigned encoding:4;

34 | // 指向底层实现数据结构的指针

35 | void *ptr;

36 | ...

37 |

38 | } robj;

39 | ```

40 |

41 | > 结构体的冒号表示位域,表示该变量占用的二进制位数

42 |

43 | ---

44 |

45 | 对象的 `type` 属性记录了**对象的类型**,属性的值如下表所示:

46 |

47 | | 类型常量 | 对象的名称 |

48 | | :------------: | :----------: |

49 | | `REDIS_STRING` | 字符串对象 |

50 | | `REDIS_LIST` | 列表对象 |

51 | | `REDIS_HASH` | 哈希对象 |

52 | | `REDIS_SET` | 集合对象 |

53 | | `REDIS_ZSET` | 有序集合对象 |

54 |

55 | 对于 Redis 数据库保存的键值对来说, **键总是一个字符串对象**, 而值则可以是上表中的其中一个。

56 |

57 | 所以,当我们称呼一个数据库键为“字符串键”时, 我们指的是“这个数据库键所对应的**值**为字符串对象”;同理,当我们称呼一个键为“列表键”时, 我们指的是“这个数据库键所对应的**值**为列表对象”。

58 |

59 | ---

60 |

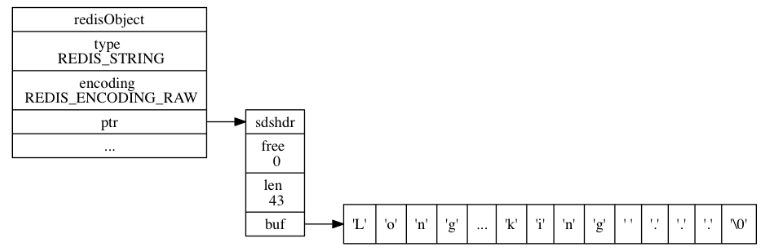

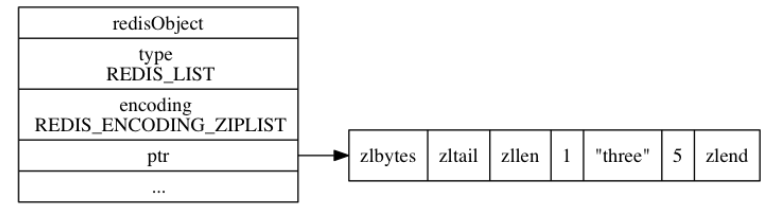

61 | 对象的 `ptr` 指针指向对象的底层实现数据结构, 而这些数据结构由对象的 `encoding` 属性决定。`encoding` 属性如下表所示:

62 |

63 | | 编码常量 | 编码所对应的底层数据结构 |

64 | | :-------------------------: | :---------------------------: |

65 | | `REDIS_ENCODING_INT` | `long` 类型的整数 |

66 | | `REDIS_ENCODING_EMBSTR` | `embstr` 编码的简单动态字符串 |

67 | | `REDIS_ENCODING_RAW` | 简单动态字符串 |

68 | | `REDIS_ENCODING_HT` | 字典 |

69 | | `REDIS_ENCODING_LINKEDLIST` | 双端链表 |

70 | | `REDIS_ENCODING_ZIPLIST` | 压缩列表 |

71 | | `REDIS_ENCODING_INTSET` | 整数集合 |

72 | | `REDIS_ENCODING_SKIPLIST` | 跳跃表和字典 |

73 |

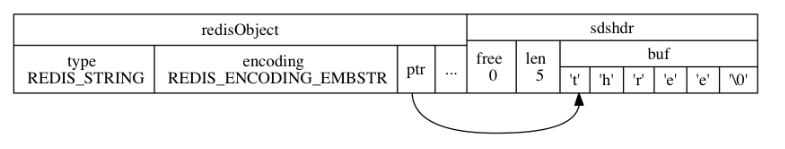

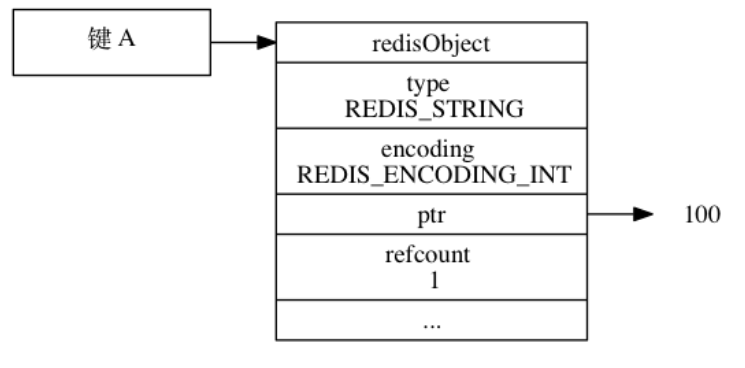

74 | # 2. 字符串对象

75 |

76 | ## 2.1 编码方式

77 |

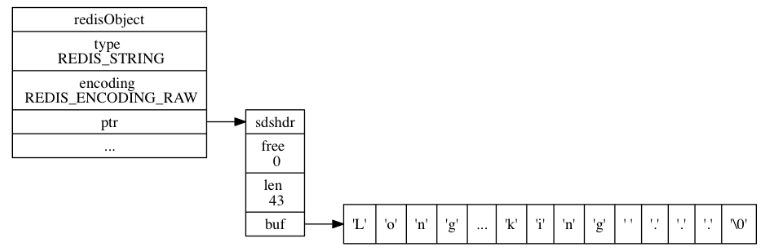

78 | 字符串对象的编码可以是 `int` 、 `raw` 或者 `embstr` 。

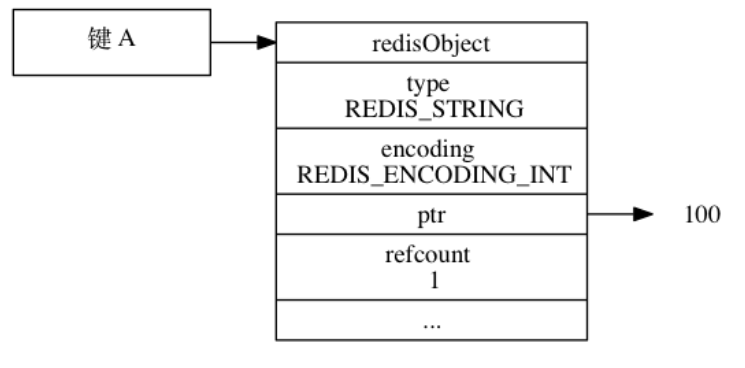

79 |

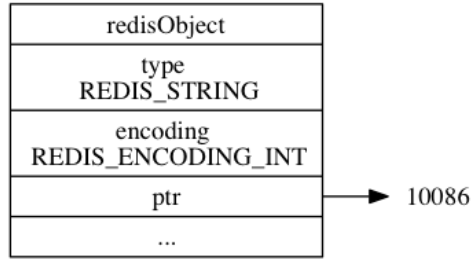

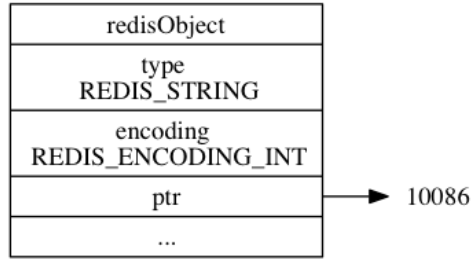

80 | (1)如果一个字符串对象保存的是**整数值**, 并且这个整数值可以用 `long` 类型来表示, 那么字符串对象会**将整数值保存在字符串对象结构的 `ptr`属性里面**(将 `void*` 转换成 `long` ), 并将字符串对象的编码设置为 `int` 。

81 |

82 |

--------------------------------------------------------------------------------

/Markdown笔记/Redis设计与实现2-对象.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: Redis设计与实现2-对象

3 | category:

4 | - 数据库

5 | tags:

6 | - 计算机网络

7 | - 数据库

8 | - Redis

9 | - 读书笔记

10 | mathjax: true

11 | date: 2020-01-03 11:01:39

12 |

13 | ---

14 |

15 | 前一章介绍了Redis的主要数据结构,但Redis并没有直接使用这些数据结构来实现键值对数据库, 而是基于这些数据结构创建了一个对象系统 ,**这个系统包含字符串对象、列表对象、哈希对象、集合对象和有序集合对象**这五种类型的对象。

16 |

17 | 使用对象有两个好处:

18 |

19 | - 执行命令前,根据对象类型来**判断是否可以执行此命令**。

20 | - 针对不同使用场景,为对象**设置多种不同的数据结构实现**,达到优化的目的。

21 |

22 | 此外,对象系统还引入了**引用计数实现内存回收机制**,以及**对象共享**。

23 |

24 | # 1. 对象的类型与编码

25 |

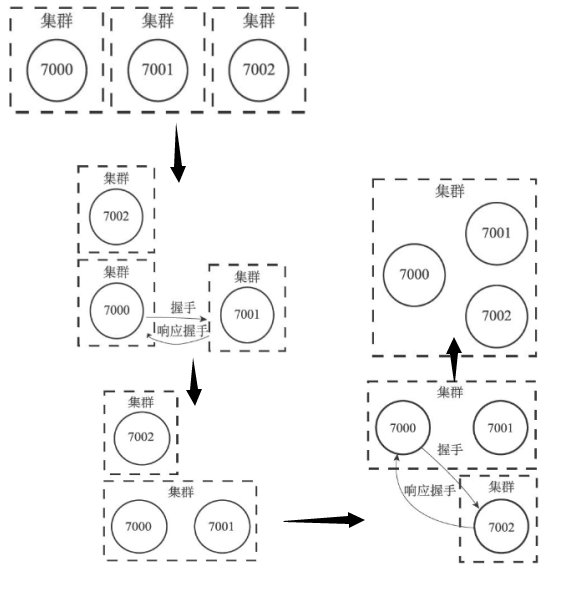

26 | Redis 中的**每个键值对的键和值都是一个对象,每个对象都由一个 `redisObject` 结构表示**, 该结构中和保存数据有关的三个属性分别是 `type` 属性、 `encoding` 属性和 `ptr` 属性: