├── ebpf-guide

├── eBPF基础

│ ├── BPF学习资料.md

│ ├── 为什么你应该关注eBPF.md

│ ├── BPF(eBPF)最初是来源于网络流量过滤的需求.md

│ ├── 计算机领域最有前途基础软件技术eBPF.md

│ ├── eBPF技术背景.md

│ ├── 初识eBPF,eBPF发展现状.md

│ ├── eBPF概念和基本原理.md

│ ├── eBPF的实现原理.md

│ ├── eBPF基本架构及使用.md

│ ├── eBPF解读-基础篇.md

│ └── eBPF完全入门指南.md

├── eBPF实战应用

│ ├── eBPF技术的5G实现思路.md

│ ├── eBPF揭示隐藏的超能力.md

│ ├── eBPF实战.md

│ └── eBPF快速定位网络抖动.md

└── eBPF高级

│ ├── eBPF允许您在内核中编写自定义代码.md

│ ├── eBPF是一个基于寄存器的虚拟机.md

│ ├── eBPF指令集.md

│ ├── 区分三种类型的eBPF重定向.md

│ └── eBPF捕获生产流量的实用指南.md

├── .gitignore

└── README.md

/ebpf-guide/eBPF基础/BPF学习资料.md:

--------------------------------------------------------------------------------

1 | # BPF学习资料

2 |

3 | ### 书籍

4 |

5 | - 《Linux内核观测技术BPF》

6 | - 《BPF之巅:洞悉Linux系统和应用性能》

7 | - 《Systems Performance》

8 | - 《BPF Performance Tools》

9 |

10 | ### Brendan Gregg大神的个人网站

11 |

12 | https://www.brendangregg.com/index.html

13 |

14 | ### Github

15 |

16 | Linux基金会的IO Visor项目:https://github.com/iovisor https://github.com/zoidbergwill/awesome-ebpf

17 |

18 | ### 网站

19 |

20 | Cilium eBPF:https://ebpf.io

21 |

22 | ### BPF原始论文

23 |

24 | https://www.tcpdump.org/papers/bpf-usenix93.pdf

25 |

26 | ### 本文原直播视频

27 |

28 | https://www.bilibili.com/video/BV1LX4y157Gp?share_source=copy_web

--------------------------------------------------------------------------------

/.gitignore:

--------------------------------------------------------------------------------

1 |

2 |

3 | *.idea

4 |

5 |

6 | .DS_Store

7 |

8 |

9 | # Byte-compiled / optimized / DLL files

10 | __pycache__/

11 | *.py[cod]

12 | *$py.class

13 |

14 | # C extensions

15 | *.so

16 | D:\temporary

17 | # Distribution / packaging

18 | .Python

19 | build/

20 | develop-eggs/

21 | dist/

22 | downloads/

23 | eggs/

24 | .eggs/

25 | lib/

26 | lib64/

27 | parts/

28 | sdist/

29 | var/

30 | wheels/

31 | *.egg-info/

32 |

33 | *.egg

34 | MANIFEST

35 | # PyInstaller

36 | # Usually these files are written by a python script from a template

37 | # before PyInstaller builds the exe, so as to inject date/other infos into it.

38 | *.manifest

39 | *.spec

40 |

41 | # Installer logs

42 | pip-log.txt

43 | pip-delete-this-directory.txt

44 |

45 | # Unit test / coverage reports

46 | htmlcov/

47 | .tox/

48 | .coverage

49 | .coverage.*

50 | .cache

51 | nosetests.xml

52 | coverage.xml

53 | *.cover

54 | .hypothesis/

55 | .pytest_cache/

56 |

57 | # Translations

58 | *.mo

59 | *.pot

60 |

61 | # Django stuff:

62 | *.log

63 |

64 |

65 | # Flask stuff:

66 | instance/

67 | .webassets-cache

68 |

69 | # Scrapy stuff:

70 | .scrapy

71 |

72 | # Sphinx documentation

73 | docs/_build/

74 |

75 | # PyBuilder

76 | target/

77 |

78 | # Jupyter Notebook

79 | .ipynb_checkpoints

80 |

81 | # pyenv

82 | .python-version

83 |

84 | # celery beat schedule file

85 | celerybeat-schedule

86 |

87 | # SageMath parsed files

88 | *.sage.py

89 |

90 | # Environments

91 | .env

92 | .venv

93 | env/

94 | venv/

95 | ENV/

96 | env.bak/

97 | venv.bak/

98 |

99 | # Spyder project settings

100 | .spyderproject

101 | .spyproject

102 |

103 | # Rope project settings

104 | .ropeproject

105 |

106 | # mkdocs documentation

107 | /site

108 |

109 | # mypy

110 | .mypy_cache/

111 |

112 | venv/bin/python3

113 | venv/bin/python

114 | venv/bin/activate

115 | *.zip

116 | *.aab

117 | *.apk

118 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # eBPF指南

2 | ### ebpf指南开源文档:

3 | #### eBPF基础

4 | #### eBPF高级

5 | #### eBPF实战应用

6 | ## 指南介绍

7 | - 欢迎Star,Fork,同时也欢迎您的参与

8 | - 更优雅的阅读方式:开源文档github.io[程序员开发指南 Developer Guide for Programmers](https://guide.996station.com/#/)

9 | - 更多更好的内容,请访问[996station技术栈](https://www.996station.com)

10 |

11 | ## 指南目录

12 | - **eBPF指南**

13 | - eBPF基础

14 | - [eBPF完全入门指南](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF完全入门指南.md)

15 | - [BPF学习资料](https://guide.996station.com/#/ebpf-guide/eBPF基础/BPF学习资料.md)

16 | - [eBPF基本架构及使用](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF基本架构及使用.md)

17 | - [eBPF技术背景](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF技术背景.md)

18 | - [eBPF概念和基本原理](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF概念和基本原理.md)

19 | - [eBPF的实现原理](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF的实现原理.md)

20 | - [eBPF解读-基础篇](https://guide.996station.com/#/ebpf-guide/eBPF基础/eBPF解读-基础篇.md)

21 | - [为什么你应该关注eBPF](https://guide.996station.com/#/ebpf-guide/eBPF基础/为什么你应该关注eBPF.md)

22 | - [初识eBPF,eBPF发展现状](https://guide.996station.com/#/ebpf-guide/eBPF基础/初识eBPF,eBPF发展现状.md)

23 | - [计算机领域最有前途基础软件技术eBPF](https://guide.996station.com/#/ebpf-guide/eBPF基础/计算机领域最有前途基础软件技术eBPF.md)

24 | - [BPF(eBPF)最初是来源于网络流量过滤的需求](https://guide.996station.com/#/ebpf-guide/eBPF基础/BPF(eBPF)最初是来源于网络流量过滤的需求.md)

25 | - eBPF高级

26 | - [eBPF捕获生产流量的实用指南](https://guide.996station.com/#/ebpf-guide/eBPF高级/eBPF捕获生产流量的实用指南.md)

27 | - [eBPF指令集](https://guide.996station.com/#/ebpf-guide/eBPF高级/eBPF指令集.md)

28 | - [eBPF允许您在内核中编写自定义代码](https://guide.996station.com/#/ebpf-guide/eBPF高级/eBPF允许您在内核中编写自定义代码.md)

29 | - [eBPF是一个基于寄存器的虚拟机](https://guide.996station.com/#/ebpf-guide/eBPF高级/eBPF是一个基于寄存器的虚拟机.md)

30 | - [区分三种类型的eBPF重定向](https://guide.996station.com/#/ebpf-guide/eBPF高级/区分三种类型的eBPF重定向.md)

31 | - eBPF实战应用

32 | - [eBPF实战](https://guide.996station.com/#/ebpf-guide/eBPF实战应用/eBPF实战.md)

33 | - [eBPF快速定位网络抖动](https://guide.996station.com/#/ebpf-guide/eBPF实战应用/eBPF快速定位网络抖动.md)

34 | - [eBPF技术的5G实现思路](https://guide.996station.com/#/ebpf-guide/eBPF实战应用/eBPF技术的5G实现思路)

35 | - [eBPF揭示隐藏的超能力](https://guide.996station.com/#/ebpf-guide/eBPF实战应用/eBPF揭示隐藏的超能力.md)

36 |

37 |

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/为什么你应该关注eBPF.md:

--------------------------------------------------------------------------------

1 | # 为什么你应该关注eBPF

2 |

3 | [KingSun](https://www.996station.com/author/kingsun) 4小时 前

4 |

5 |

6 |

7 | 虽然它远非主流主题,但我们已经从我们关注的聪明人那里听到了大量关于 eBPF 的讨论。在 RedMonk,当新兴技术引起我们尊重的人的兴趣时,我们学会了注意,因为从历史上看,这种模式往往表明相关性并暗示未来重要性的潜力。事实上,在这种情况下,所讨论的技术与 DTrace 相关的事实只会给我们带来更多的风险。

8 |

9 | 这是一个快速的、不全面的 eBPF 入门读物,适合好奇的人:

10 |

11 | - eBPF[代表什么](https://ebpf.io/what-is-ebpf/)。它曾经是 Extended Berkeley Packet Filter 的首字母缩写词,但根据文档,它“不再是任何东西的首字母缩写词”。

12 | - eBPF 允许您在 Linux 内核中运行事件驱动程序。程序员可以在沙盒内核环境中运行自定义字节码,而无需直接修改内核源代码本身。

13 | - eBPF 被认为比 Linux 可加载内核模块 (LKM) 更安全,因为在代码执行之前必须通过额外的安全检查和验证。

14 | - 事件可以由各种内核挂钩驱动。触发 eBPF 程序的常见内核挂钩包括系统调用、网络事件(如网络包到达)、对内核中特定函数的调用以及被命中的跟踪点。

15 | - 人们通常不会手写字节码,通常它是从 C 或 Rust 编译而来的。eBPF 程序在被触发后被 JIT 编译为机器码。

16 | - eBPF[与 DTrace 相关](https://www.infoq.com/articles/gentle-linux-ebpf-introduction/)。

17 |

18 | *更正*:这篇文章之前说 eBPF 受到 DTrace 的启发,但 Brendan Gregg 在我发表后友善地提供了以下更正。非常感谢他的评论,我在这里分享这些评论是为了向其他人提供此背景信息:

19 |

20 | > eBPF 并没有受到 DTrace 的启发;它起源于软件定义网络(在此之前,BPF 本身是用于数据包过滤的)。早期 eBPF 的共同创建者(Alexei Starovoitov,然后在 SDN 初创公司 PLUMgrid 工作)意识到它不仅可以用于实现 SDN,而且我参与使用 eBPF 重新实现我的 DTrace 工具。我们确实有一个名为 bpftrace 的受 DTrace 启发的前端,但那是几年后才出现的。换句话说,DTrace 可以作为一个 eBPF 程序来实现,但 eBPF 本身要大得多。eBPF 不是跟踪器——它是内核执行环境。

21 |

22 | - eBPF 的主要用例分为三个总体类别:网络、可观察性和安全性。

23 |

24 | eBPF 绝对是一项我们将继续密切关注的技术。特别是随着[Istio Ambient Mesh](https://istio.io/latest/blog/2022/introducing-ambient-mesh/)等技术的引入,eBPF 有望在生态系统中扮演越来越重要的角色。

25 |

26 |

27 |

28 | ## 其他资源:

29 |

30 | - Corey Quinn 对[Liz Rice 进行了精彩的采访,](https://share.transistor.fm/s/cba9541b)讨论了 eBPF 和 Cilium

31 | - [eBPF 文档](https://ebpf.io/what-is-ebpf/)

32 | - 来自 Tigera 的指南:[eBPF 解释](https://www.tigera.io/learn/guides/ebpf/)

33 | - InfoQ:[对 eBPF 的简要介绍](https://www.infoq.com/articles/gentle-linux-ebpf-introduction/)

34 | - [Brendan Gregg 的推文](https://twitter.com/brendangregg),通常充满了 eBPF 优点

35 |

36 | ## 作者

37 |

38 | Rachel Stephens

39 |

40 | ## 原文链接

41 |

42 |

--------------------------------------------------------------------------------

/ebpf-guide/eBPF实战应用/eBPF技术的5G实现思路.md:

--------------------------------------------------------------------------------

1 | # eBPF技术的5G实现思路

2 |

3 | 在讨论利用eBPF程序的具体好处和方法时,很容易直接进入技术兔子洞。该技术非常详细,可用于各种用例。因此,谈话可能会很快围绕细节展开,同时掩盖技术的基本要素。与任何较新的技术一样,设置水平并退后一步讨论基础知识通常很有帮助。这篇文章将用于实现这一目标——提供对eBPF程序基础知识的高级视图,更具体地说,是用于 5G SA 可见性的eBPF程序。

4 |

5 | *eBPF**是关于内核的*

6 |

7 |

8 |

9 | [正如我们在之前的博文中所讨论的那样,](https://www.mantisnet.com/blog/ebpf-v-sidecar-containers-5g-observability) eBPF是一种通过在系统内核级别部署来绑定操作系统原语的方法。

10 |

11 | 右图显示了一个用于监控 5G 资源的示例eBPF程序。请注意,eBPF程序/代理的“插入点”在节点级别,而不是 pod/容器级别(因为其他基于代理的方法,例如 sidecar 容器,依赖于n)。

12 |

13 | eBPF解决方案作为存在于内核空间中的沙盒程序运行,它们不需要对内核进行任何更改。这不是内核模块,而是在用户空间中定义的独立实体,可以将容器环境内省为在内核空间中运行的独立程序。eBPF程序可以通过部署为单个 pod/容器来自省整个节点环境(所有 pod 到 pod 的通信、进程、接口等)。它对内核检测的独特关注是 eBPF 将自己与其他云原生技术区分开来的一种方式。

14 |

15 | eBPF 是关于消息的

16 |

17 |

18 |

19 | eBPF程序非常高效。与 sidecar 容器(和vTAP 、span 端口、服务网格等)不同, eBPF程序在内核级别充当事件处理程序——它们不会搅动环境中的每条信息,而是为非常特定的类型设置挂钩交通。

20 |

21 | **在监控程序的上下文中,可以将其视为关注消息与关注数据包**之间的区别。eBPF程序*可以瞄准并观察*基于 HTTP/2 的环境的核心消息传递。eBPF程序为其正在寻找的特定消息/事件(例如,特定于 5G 的 SBI 消息传递)设置挂钩,并在这些特定挂钩上触发以开始监视通信。

22 |

23 |

24 |

25 | 这种方法与前面提到的方法(vTAPS 、sidecars 等)有很大的不同,后者是非常大量的数据包进程,通常处理环境中的所有数据(而不是为非常具体的消息设置挂钩)。这些传统方法需要计算资源来访问和处理所有这些数据包数据,从而导致生产计算资源承受巨大压力。另一方面, eBPF允许使用一种基本方法,该方法基于以下因素将**资源利用率降低一个数量级**

26 |

27 | : - 它关注消息,而不是数据包

28 | \- 它如何访问数据的目标性质

29 |

30 | *eBPF**占用空间小*

31 |

32 | 将监控解决方案部署到分布式 k8s环境时,最大的考虑因素之一是解决方案本身的实际占用空间。使用eBPF程序,代理被部署为daemonsets ,并与生产资源一起自动扩展。这意味着每个节点将有一 (1) 个代理(无论节点是裸机还是基于 VM 都无关紧要)。这些代理可以查看该节点中存在的 pod 和容器内部和之间的所有活动。请看下面的例子,每个节点有 10 个 pod:

33 |

34 |

35 |

36 | 与替代方法相比,这种方法显着减少了足迹。eBPF 程序的“部署足迹”远小于边车容器方法。如果使用 sidecar 容器,则必须在上面的示例中部署六十 (60) 个代理,而基于 eBPF 的方法只需要六 (6) 个代理。

37 |

38 | *eBPF 与供应商无关*

39 |

40 | 同样,eBPF程序通过在**节点级别**(linux内核)集成到 k8s 集群来访问数据。eBPF程序不访问容器或 pod 级别的信息。

41 |

42 |

43 |

44 | 这导致一个解决方案只需要来自生产系统的一个集成依赖——内核支持 eBPF。实际上,这意味着正在运行的linux内核版本需要是大约在过去 13 年发布的版本(当时eBPF最初 被采用并包含在linux基金会中)。对应用程序层的依赖性为零——这意味着不存在 基于生产环境中存在的供应商的集成依赖性。

45 |

46 | 这在整个云原生环境中非常有益,但在 5G 电信云原生环境中尤其如此,随着时间的推移,服务提供商的趋势是从单一供应商、整体解决方案转向最佳网络功能选择现在有多个供应商出现在 5G 堆栈的各个方面。

47 |

48 |

49 |

50 | ## 作者

51 |

52 | Mike Fecher

53 |

54 | ## 原文链接

55 |

56 | https://www.mantisnet.com/blog/back-to-the-basics-ebpf-fundamentals

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/BPF(eBPF)最初是来源于网络流量过滤的需求.md:

--------------------------------------------------------------------------------

1 | # BPF(eBPF)最初是来源于网络流量过滤的需求

2 |

3 | 一般我们会听到类似这样的说法:BPF/eBPF 最初是来源于网络流量过滤的需求,但它现在已被扩展到一般的内核观测中。那就先来看看,它为何是产生自网络传输领域的。

4 |

5 | ### **怎样快速过滤**

6 |

7 | 现代网络传输有个特点:流量巨大,因此需要快速过滤。那如何才能快速?比如这样一个过滤器:

8 |

9 |

10 |

11 | 如果采用基于传统的 tree 的结构来实现,大致是这样的:

12 |

13 |

14 |

15 | 假设被过滤的 packet 是一个 ARP 包或者 IP 包,那么通过这样一种树形结构来判断是很快的,但如果既不是 ARP 也不是 IP 包呢(也就是 P1 和 P2 这两个条件都为 false),那么 AND1 和 AND2 就是没必要的。

16 |

17 | 而 BPF 采用基于 CFG (Control Flow Graph) 的结构实现:

18 |

19 |

20 |

21 | 判断从顶点的 P1 开始,当条件为 false 时走右路,true 时走左路,直到抵达末端的 false 或者 true。这样,当 P1 和 P2 都为 false 时,就可以直达最后的 false,而不需要再判断 P3 和 P4。

22 |

23 | 好,接下来再来看看它是如何被应用到内核行为的观测中的。

24 |

25 | ### **过滤的输入 - 前端**

26 |

27 | 观测需要数据,准确的说是你感兴趣的那些数据,那它们来自哪里?内核依靠执行一条条的指令运行,所以可以在执行指令的点位抓取数据。

28 |

29 | 说到如何抓取,不管是静态的的 tracepoint 和 ftrace,还是动态的 kprobe,都可以被视作提供了 event source 的一种 hook 行为,而 perf, systemtap 等工具都依赖于这些作为数据输入的「前端」,在 kernel tracing 中发挥作用的 BPF/eBPF 也不例外。

30 |

31 | ### **过滤的输出 - 后端**

32 |

33 | 需要劫持哪些 hook 点,劫持后需要获取哪些数据,以及之后怎样处理这些数据,就是所谓「后端」做的事了。具体而言,比较简便快速的方法是在用户态编写 perf, systemtap 等对应的脚本来指定。

34 |

35 | 在这一点上,BPF/eBPF 可以说和前两者并没有本质上的区别,它支持用 bpftrace (融合了 awk 和 C 的语法)或者 python (比如 bcc-tools)等语言来编写脚本,然后经过 LLVM 的处理,转化为可以在机器上执行的代码。

36 |

37 | ### **为什么需要虚拟机**

38 |

39 | 只不过,针对 BPF/eBPF,是先转换为面向 BPF 虚拟机的 bytecode。为啥需要一个 VM 呢?其中一个原因是前面说到的 BPF 采用的 CFG 结构,这种结构很适合用 bytecode 的形式来表达。

40 |

41 | 既然是 VM,通常就有自己的一套指令集 (ISA) 和寄存器,且由于最终运行在内核,所以应尽量保持和 Linux 的 calling convention 的兼容,这就要求其功能设计上应尽量保持和真实 CPU 在寄存器/指令集上的接近。

42 |

43 |

44 |

45 | 诞生于上世纪 90 年代初的 BPF 只有 2 个 寄存器,随着 CPU 技术的不断迭代,寄存器已普遍步入了 64 位时代,且产生了一些专门面向多核处理器的新指令。正是由于 BPF 虚拟机和底层 CPU 存在的这种关联,这种寄存器和指令都非常有限的设计,已越来越不能利用现代处理器发展带来的红利。

46 |

47 | 这也是 20 年后的 eBPF 选择在这方面进行扩展的原因,其中就寄存器这一块,已经被扩展到了 10 个(包括 R0 到 R9,未将作为只读 frame pointer 的 R10 涵盖在内),基本可以形成和硬件寄存器一对一的映射关系,以 x86-64 体系为例,其对应关系如下:

48 |

49 |

50 |

51 | 经过 eBPF 的改良,多种网络过滤的 benchmark 的结果显示(以 3.15 内核为例),其相较 BPF 在性能有了 1.5 到 4 倍的提升。

52 |

53 | 不过其目前在使用上还是存在一些限制的,比如函数参数不能超过 5 个,只允许 1 个返回值(因为只有 rax 作为存放 return value 的寄存器)等。

54 |

55 |

56 |

57 | 既然是 VM,那么 bytecode 还需要转为主机上真实硬件架构(比如 x86)的汇编指令,这里就要用到 JIT 来作为解释器。下图的蓝色箭头部分就展示了上述的这一过程,即 eBPF 中作为 filter 的程序是如何流转和工作的。

58 |

59 |

60 |

61 | 内核通过探测点获得了数据后,又该如何传递给用户态呢?答案是存储在 eBPF maps 中。这些 maps 采用 key/value 的形式(比如组织为 hash 表),因而可以包含不同类型的数据,这也是 "eBPF" 里这个 "e" 所代表的 extended 的一个体现。

62 |

63 | 上图的红色箭头部分,呈现的正是 eBPF maps 作为用户态和内核态共享数据的方式(当然它也可以作为 eBPF 的内核态程序之间进行数据交互的渠道)。

64 |

65 |

66 |

67 | 这里就要说到 eBPF 的一个优势了。相比于 perf 需要将采集数据存储在 buffer 里,然后传送到用户态解析的方式不同,eBPF 支持在内核态直接处理一些数据(比如生成直方图),这可以减少用户态和内核态的数据拷贝,有利于降低观测工具带来的开销,因而更适合作为生产环境的 performance tool【注-1】。

68 |

69 |

70 |

71 | 其适用于生产环境的另一个重要原因是它的安全性。VM 为 eBPF 程序的运行提供了一个类似 sandbox 的环境,是保障其不会造成内核 crash 的基石之一,但如果希望 eBPF 像 systemtap 那样,可以通过修改函数的返回值来实现 fault injection 的功能,那么很可能就会破坏这一层保障,这也算是 production safe 对 eBPF 适用面扩展的一个掣肘吧。

72 |

73 | 注-1:自 eBPF 出现后,BPF 已被替代,所以目前说到 "BPF",有时就是指 "eBPF"。

74 |

75 | ## 作者

76 |

77 | 术道经纬

78 |

79 | ## 原文链接

80 |

81 | https://mp.weixin.qq.com/s/udpHAaB27DpVPm1ynvUxuA

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/计算机领域最有前途基础软件技术eBPF.md:

--------------------------------------------------------------------------------

1 | # 计算机领域最有前途基础软件技术eBPF

2 |

3 |

4 |

5 |

6 |

7 | 如果非要说当前计算机领域最有前途的两个基础软件技术,那非eBPF和wasm莫属了。

8 |

9 | ------

10 |

11 | ### **什么是eBPF?**

12 |

13 | Linux内核一直是实现监视/可观察性,网络和安全性的理想场所。不幸的是,这通常是不切实际的,因为它需要更改内核源代码或加载内核模块,并导致彼此堆叠的抽象层。eBPF是一项革命性的技术,可以在Linux内核中运行沙盒程序,而无需更改内核源代码或加载内核模块。通过使Linux内核可编程,基础架构软件可以利用现有的层,从而使它们更加智能和功能丰富,而无需继续为系统增加额外的复杂性层。

14 |

15 | eBPF导致了网络,安全性,应用程序配置/跟踪和性能故障排除等领域的新一代工具的开发,这些工具不再依赖现有的内核功能,而是在不影响执行效率或安全性的情况下主动重新编程运行时行为。

16 |

17 |

18 |

19 | 如果直接解释eBPF,有点不明所以。那我们就看看有哪些基于eBPF的工程,这些工程或许你已经知道,或是已经经常使用,也许你会明白eBPF距离我们并不遥远。

20 |

21 | ------

22 |

23 | ### **基于eBPF的项目**

24 |

25 | **1:bcc**

26 |

27 | BCC是用于创建基于eBPF的高效内核跟踪和操作程序的工具包,其中包括一些有用的命令行工具和示例。BCC简化了用C进行内核检测的eBPF程序的编写,包括LLVM的包装器以及Python和Lua的前端。它还提供了用于直接集成到应用程序中的高级库。

28 |

29 | **2:bpftrace**

30 |

31 | bpftrace是Linux eBPF的高级跟踪语言。它的语言受awk和C以及DTrace和SystemTap等以前的跟踪程序的启发。bpftrace使用LLVM作为后端将脚本编译为eBPF字节码,并利用BCC作为与Linux eBPF子系统以及现有Linux跟踪功能和连接点进行交互的库。

32 |

33 | **3:Cilium**

34 |

35 | Cilium是一个开源项目,提供基于eBPF的联网,安全性和可观察性。它是从头开始专门设计的,旨在将eBPF的优势带入Kubernetes的世界,并满足容器工作负载的新可伸缩性,安全性和可见性要求。

36 |

37 | **4:Falco**

38 |

39 | Falco是一种行为活动监视器,旨在检测应用程序中的异常活动。Falco在eBPF的帮助下审核Linux内核层的系统。它使用其他输入流(例如容器运行时度量标准和Kubernetes度量标准)丰富了收集的数据,并允许连续监视和检测容器,应用程序,主机和网络活动。

40 |

41 | **5:Katran**

42 |

43 | Katran是一个C ++库和eBPF程序,用于构建高性能的第4层负载平衡转发平面。Katran利用Linux内核中的XDP基础结构来提供用于快速数据包处理的内核功能。它的性能与NIC接收队列的数量成线性比例,并且使用RSS友好的封装转发到L7负载平衡器。

44 |

45 |

46 |

47 | **6:Sysdig**

48 |

49 | Sysdig是提供深层系统可见性的简单工具,并具有对容器的原生支持。

50 |

51 | 其他基于eBPF技术的项目还有很多,比如kubectl-trace ,ply 等,这里不再赘述。

52 |

53 | ------

54 |

55 | ### **如何编写一个eBPF程序?**

56 |

57 | 在很多情况下,不是直接使用eBPF,而是通过Cilium,bcc或bpftrace等项目间接使用eBPF,这些项目在eBPF之上提供了抽象,并且不需要直接编写程序,而是提供了指定基于意图的定义的功能,然后使用eBPF实施。

58 |

59 | 如果不存在更高级别的抽象,则需要直接编写程序。Linux内核希望eBPF程序以字节码的形式加载。虽然当然可以直接编写字节码,但更常见的开发实践是利用LLVM之类的编译器套件将伪C代码编译为eBPF字节码。

60 |

61 | 在编写eBPF程序之前,需要简单了解几个概念。

62 |

63 | 1)map(映射) :BPF最令人着迷的方面之一是,内核上运行的代码和加载了该代码的程序可以在运行时使用消息传递相互通信。

64 |

65 | BPF映射是驻留在内核中的键/值存储。任何BPF程序都可以访问它们。在用户态中运行的程序也可以使用文件描述符访问这些映射。只要事先正确指定数据大小,就可以在映射中存储任何类型的数据。内核将键和值视为二进制 blobs,它并不关心您在映射中保留的内容。

66 |

67 |

68 |

69 | BPF验证程序包括多种保护措施,以确保您创建和访问映射的方式是安全的。当我们解释如何访问这些映射中的数据时,我们也将解释这些保护措施。

70 |

71 | 当然BPF映射类型有很多,比如哈希表映射,数组映射,Cgroup 数组映射等,分别满足不同的场景。

72 |

73 | 2)验证器:BPF验证程序也是在您的系统上运行的程序,因此,对其进行严格审查是确保其正确执行工作的目标。

74 |

75 | 验证程序执行的第一项检查是对VM即将加载的代码的静态分析。第一次检查的目的是确保程序有预期的结果。为此,验证程序将使用代码创建有向循环图(DAG)。验证程序分析的每个指令将成为图中的一个节点,并且每个节点都链接到下一条指令。验证程序生成此图后,它将执行深度优先搜索(DFS),以确保程序完成并且代码不包含危险路径。这意味着它将遍历图的每个分支,一直到分支的底部,以确保没有递归循环。

76 |

77 | 这些是验证器在第一次检查期间可能拒绝您的代码的情形,要求有以下几个方面:

78 |

79 | - 该程序不包含控制循环。为确保程序不会陷入无限循环,验证程序会拒绝任何类型的控制循环。已经提出了在BPF程序中允许循环的建议,但是截至撰写本文时,没有一个被采用。

80 | - 该程序不会尝试执行超过内核允许的最大指令数的指令。此时,可执行的最大指令数为4,096。此限制是为了防止BPF永远运行。在第3章,我们讨论如何嵌套不同的BPF程序,以安全的方式解决此限制。

81 | - 该程序不包含任何无法访问的指令,例如从未执行过的条件或功能。这样可以防止在VM中加载无效代码,这也会延迟BPF程序的终止。

82 | - 该程序不会尝试越界。

83 |

84 | 验证者执行的第二项检查是BPF程序的空运行。这意味着验证者将尝试分析程序将要执行的每条指令,以确保它不会执行任何无效的指令。此执行还将检查所有内存指针是否均已正确访问和取消引用。最后,空运行向验证程序通知程序中的控制流,以确保无论程序采用哪个控制路径,它都会到达BPF_EXIT指令。为此,验证程序会跟踪堆栈中所有访问过的分支路径,并在采用新路径之前对其进行评估,以确保它不会多次访问特定路径。经过这两项检查后,验证者认为程序可以安全执行。

85 |

86 | \3) hook :由于eBPF是事件驱动的,所以ebpf是作用于具体的hook的。根据不同的作用,常用的有XDP,trace,套接字等。

87 |

88 |

89 |

90 | 4)帮助函数:eBPF程序无法调用任意内核功能。允许这样做会将eBPF程序绑定到特定的内核版本,并使程序的兼容性复杂化。取而代之的是,eBPF程序可以调用帮助函数,该函数是内核提供的众所周知且稳定的API。

91 |

92 | ------

93 |

94 | ### **总结**

95 |

96 | 安全,网络,负载均衡,故障分析,追踪等领域都是eBPF的主战场。

97 |

98 | 对于云原生领域,Cilium 已经使用eBPF 实现了无kube-proxy的容器网络。利用eBPF解决iptables带来的性能问题。

99 |

100 | 整个eBPF生态发展比较好,社区已经提供了诸多工具方便大家编写自己的eBPF程序。

101 |

102 | ------

103 |

104 | ## 作者

105 |

106 | iyacontrol

107 |

108 | ## 原文链接

109 |

110 | https://mp.weixin.qq.com/s/GxjcRzcgPGhzK3Q3shNbLg

--------------------------------------------------------------------------------

/ebpf-guide/eBPF高级/eBPF允许您在内核中编写自定义代码.md:

--------------------------------------------------------------------------------

1 | # eBPF允许您在内核中编写自定义代码

2 |

3 | eBPF 非常强大,因为它在所有魔法发生的地方(Linux 内核)根深蒂固。eBPF 允许您在内核中编写自定义代码。

4 |

5 |

6 |

7 | ## 什么是 eBPF?

8 |

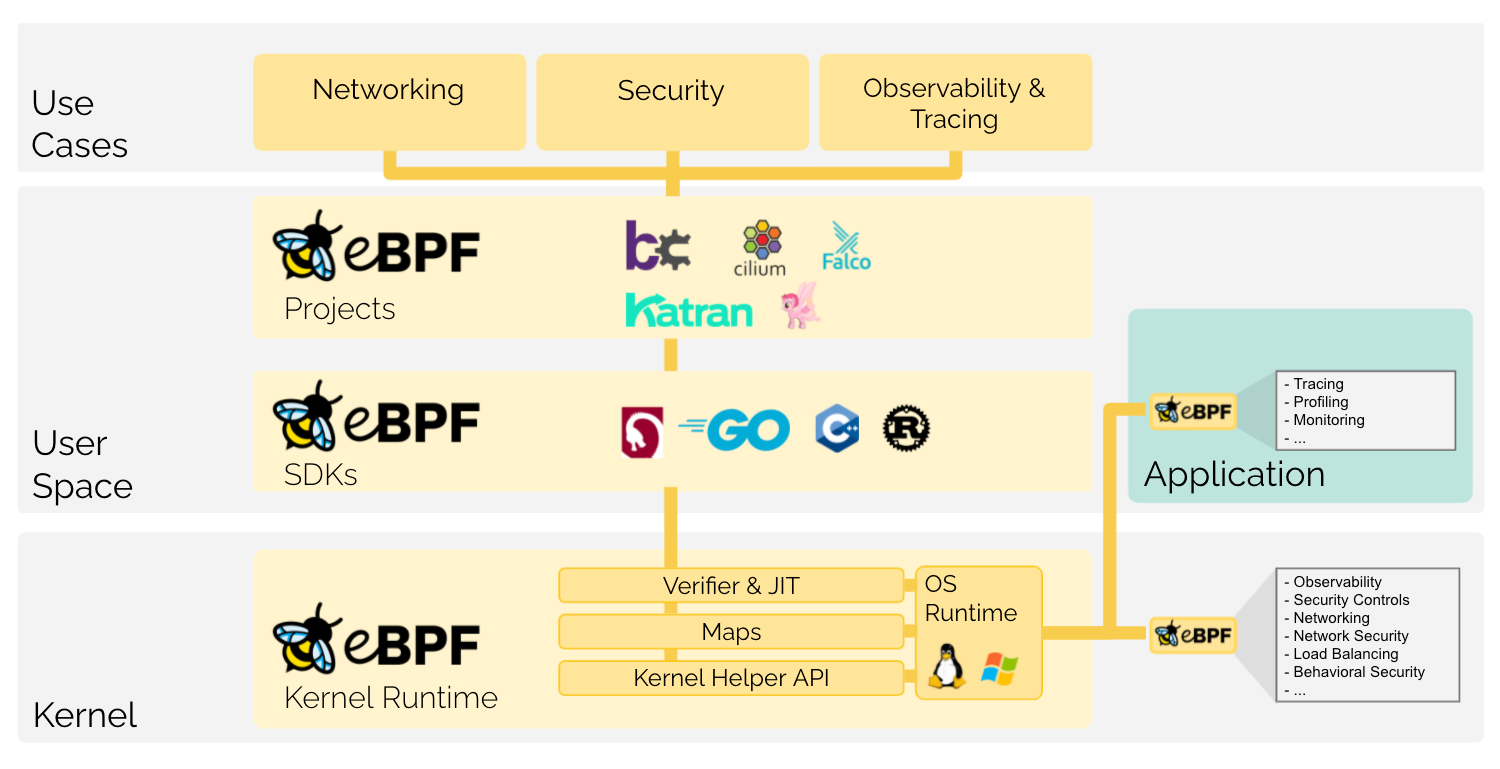

9 | > eBPF(不再是任何东西的缩写)是一项革命性的技术,起源于 Linux 内核,可以在操作系统内核等特权上下文中运行沙盒程序。它用于安全有效地扩展内核的功能,而无需更改内核源代码或加载内核模块。

10 |

11 | ## eBPF 是如何工作的?

12 |

13 | > eBPF 程序是事件驱动的,当内核或应用程序通过某个挂钩点时运行。预定义的挂钩包括系统调用、函数入口/出口、内核跟踪点、网络事件等。

14 |

15 | [](https://ebpf.io/)

16 |

17 | eBPF 概述由[eBPF.io](https://ebpf.io/)根据[Creative Commons Attribution 4.0 International License 提供](https://creativecommons.org/licenses/by/4.0/)。

18 |

19 | 关于 eBPF,您应该立即为两个站点添加书签:

20 |

21 | - [https://ebpf.foundation/(Linux](https://ebpf.foundation/)基金会网站)

22 | - [https://ebpf.io](https://ebpf.io/)(由 Daniel Borkmann 运营)

23 |

24 | 在撰写本文时,这两个网站看起来惊人地相似,但运营它们的人却不同。出于“原因”,该`.foundation`网站决定从该`.io`网站的一个分支开始。是的,我知道有几个 SEO 正在读这篇文章,他们刚刚吐了他们选择的饮料。冷静一下。您的设备可能是防水的¯\_(ツ)_/¯。

25 |

26 | 如果您不熟悉[Isovalent](https://isovalent.com/),它是制作企业级[Cilium](https://cilium.io/)产品(Cilium 容器网络接口 (CNI))的人,我的同事[Liz Rice](https://twitter.com/lizrice)和[Duffie Cooley](https://twitter.com/mauilion)就在这里工作。如果您还记得的话,我今年早些时候与他们坐下[来聊了聊他们在 KubeCon EU 2022 之前的计划](https://chrisshort.net/video/aws-container-days-eu-2022-day-3/#cilium-on-eks-anywhere--liz-rice-chief-open-source-officer-isovalent---duffie-cooley-field-cto-isovalent)。Isovalent 网站上的标语是“基于 eBPF 的网络、安全性和可观察性”。您可以使用 eBPF 做很多艰苦的工作。

27 |

28 |

29 |

30 | 如果您像我一样,在添加和删除模块以优化系统或使独特的硬件工作之前一直深入了解内核,您就会知道这通常会非常具有破坏性或破坏性。eBPF 使您能够以新的和令人兴奋的方式处理内核,而无需运行单个`modprobe`命令甚至重新启动。它们通常也比内核模块更安全。[为了保证eBPF 的安全](https://ebpf.io/what-is-ebpf/#ebpf-safety),我们付出了很多努力。

31 |

32 | 您编写的 eBPF 程序会触发 Linux 内核中的不同事件,或者完全阻止它们发生。因此,eBPF 非常强大,因为它在所有魔法发生的地方(Linux 内核)根深蒂固。eBPF 允许您在内核中编写自定义代码。由于活动发生在内核中,它通常使 eBPF 程序快速高效。例如,您编写的程序甚至可以在访问网络堆栈之前拦截网络访问,或者提供有关由哪些程序进行的调用的详细执行信息以实现可观察性。

33 |

34 |

35 |

36 | 这是很多人的学习路径出现分歧的地方。有些人会想阅读所有的东西。好消息是[BPF 和 XDP 参考指南](https://docs.cilium.io/en/latest/bpf/)以及[HOWTO 与 BPF 子系统的交互](https://www.kernel.org/doc/html/latest/bpf/bpf_devel_QA.html)是*非常棒*的深入研究。其他人希望看到一些实现。如果您想挑选,请查看[awesome-ebpf 存储](https://github.com/zoidbergwill/awesome-ebpf)库。想看一些实现吗?首先,我推荐观看[Liz Rice 在 GOTO 2021 上使用 Go 进行 eBPF 编程的初学者指南](https://youtu.be/uBqRv8bDroc)。另外,[eBPF 到底是什么,为什么 Kubernetes 管理员应该关心?](https://www.groundcover.com/blog/what-is-ebpf)如果您在 Kubernetes 上使用 eBPF,这是一个很好的参考。

37 |

38 | ## eBPF 程序

39 |

40 | 什么样的程序可以利用 eBPF?实际上有很多:

41 |

42 | - [pixie](https://github.com/pixie-io/pixie) : Instant Kubernetes-Native Application Observability (aka FM: F'ing Magic)

43 | - [boopkit](https://github.com/kris-nova/boopkit):基于 TCP 的 Linux eBPF 后门。在先前的特权访问上生成反向 shell,RCE。少本金,多东京。

44 | - [Calico](https://projectcalico.docs.tigera.io/about/about-calico):一个开源网络和网络安全解决方案,适用于容器、虚拟机和基于主机的本地工作负载(他们的[eBPF 页面有漂亮的图片](https://projectcalico.docs.tigera.io/about/about-ebpf))

45 | - [kubectl trace](https://github.com/iovisor/kubectl-trace):kubectl 插件,允许您在 Kubernetes 集群中安排 bpftrace 程序的执行

46 | - [bpftrace](https://bpftrace.org/):Linux 系统的高级跟踪语言

47 | - [Falco](https://falco.org/blog/choosing-a-driver/#ebpf-probe):Falco eBPF 探针在内核模块不受信任或不允许但 eBPF 程序可用的环境中是一个可行的选择

48 | - [SysmonForLinux](https://github.com/Sysinternals/SysmonForLinux) : Sysmon For Linux 是 Windows Sysmon 工具的一个端口,驱动程序被 eBPF 程序替换

49 | - [tracee](https://github.com/aquasecurity/tracee) : 使用 eBPF 的 Linux 运行时安全和取证

50 | - [ebpf-for-windows](https://github.com/microsoft/ebpf-for-windows):在 Windows 之上运行的 eBPF 实现

51 | - [Katran](https://engineering.fb.com/2018/05/22/open-source/open-sourcing-katran-a-scalable-network-load-balancer/):Facebook 创建的网络负载均衡器

52 |

53 | [eBPF Project Landscape](https://ebpf.io/projects)中还有一个可爱的项目列表。

54 |

55 | ## eBPF 值得炒作吗?

56 |

57 | 是的!eBPF 是个好东西,只会随着采用率的提高而改进。我正在等待合适的项目推出上述程序之一,以深入研究性能问题或查看传递给内核的[系统调用。](https://syscall.sh/)

58 |

59 | “任何足够先进的技术都与魔法没有区别”适用于此。但是,eBPF 是一个橡皮锤,你不能用它来解决所有问题。你可以用 eBPF 掩盖很多错误。你可以用它找到附近的任何东西,这是任何人都可以给你的最好的开始。

60 |

61 |

62 |

63 | 如果您想为 eBPF 或 eBPF 开发工具链做出贡献,请随时在[ebpf.io/contribute](https://ebpf.io/contribute)开始您的旅程。感谢 Alexei Starovoitov、Daniel Borkmann 和整个 eBPF 社区创造了如此出色的技术。

64 |

65 | ## 作者

66 |

67 | 克里斯·肖特

68 |

69 | ## 原文链接

70 |

71 | https://chrisshort.net/intro-to-ebpf/

--------------------------------------------------------------------------------

/ebpf-guide/eBPF实战应用/eBPF揭示隐藏的超能力.md:

--------------------------------------------------------------------------------

1 | # eBPF揭示隐藏的超能力

2 |

3 | 如果你是性能工程师/网络工程师甚至是安全工程师,以后接触到eBPF技术的几率是非常大的。eBPF 现在拥有庞大的用户社区,包括像 Meta、Google、Cloudflare 和 Netflix 这样的大公司,他们都在日常运营中使用这项技术。

4 |

5 |

6 |

7 | # 序幕

8 |

9 | 让我以一个真实的故事开始博客。一年前,我的一个朋友打电话给我讨论技术(这是我们之间很常见的事情)。我们分享我们每个人在工作场所或我们的任何同行面临的不同技术挑战,这些讨论导致一些信息丰富和创造性的知识共享会议。在这样的讨论中,他描述了在一家大型云提供商工作的堂兄所面临的具体挑战。挑战在于动态限制某些 IP,因为它们提供诸如 DOS(拒绝服务攻击)之类的威胁,我的应用程序开发人员的大脑冲动地回答说这些应该在防火墙级别处理,或者可以编写中间件来检查数据包的来源并为恶意发件人维护黑名单并忽略请求(是的,我来自 NodeJS 和 Go 背景,所以最初的解决方案作为中间件罢工)。我的朋友耐心地解释了这需要执行的规模和性能,这超出了我的理解范围。经过一个新手的疑惑清理会议后,我们同意他想要的规模只能在内核级别实现。我祝他好运(讽刺地)编写内核补丁并提出 PR,希望操作系统维护者将内核补丁包含在即将发布的内核版本中,并且他可以在发布时使用此功能。作为对我讽刺的回应,他与我分享了一篇文章的链接,该文章详细介绍了名为“eBPF”(扩展的 Berkeley 数据包过滤器)的东西。

10 |

11 | 根据 eBPF,你可以直接将代码注入内核,而无需编写补丁,等待 OS 维护者的批准,

12 |

13 | “直接在操作系统内核中运行您的自定义代码” **— LIZ RICE**

14 |

15 | “Linux 的超能力”。—**布伦丹·格雷格斯**

16 |

17 |

18 |

19 | 注意:我在参考部分添加了一些视频和博客链接,请查看 eBPF 的一些精彩会议和博客。

20 |

21 | # 历史

22 |

23 | eBPF 于 2014 年问世,在 Linux 内核 3.18 中引入,从而解锁了 Linux 内核的上帝模式。任何阅读此博客的人自然会怀疑这个名字。如果这是一个“扩展的伯克利包过滤器”,那么应该有一个 BPF“伯克利包过滤器”。嗯,你是对的。BSD 包过滤器并不是一个新概念。它是从 90 年代开始的。这颗宝石多年来一直隐藏在雷达之下,Xennails 是真正的创新者。BPF 非常基础,它唯一的工作就是在内核级别过滤数据包,因此得名。

24 |

25 | 注意:我添加了 1992 年 12 月 19 日发表的原始 BPF 论文,这是一篇非常有趣的文章。

26 |

27 | eBPF 已经从 BPF 走了很长一段路,BPF 只是一个数据包过滤实用程序,到考虑内核的微服务架构或他们称之为微内核。如今,所有大规模运营的顶级科技公司每天都在使用 eBPF。现在的 CNCF 社区依靠 eBPF 呼吸和生存,如果您是 DevOps 工程师或系统管理员,您会听说过 cilium 和 Falco,它们在 Kubernetes 用户和基于 eBPF 编写的生产工具中都很流行。2018 年 Linux 宣布将在内核中用 eBPF 版本替换其基于 iptable 的实现(用任何解决方案替换 iptable 会更好),回退和使用 iptables 的缺点超出了本文的范围,请转到参考部分并找到一篇关于它的写得很好的文章。Kubernetes 主要将 iptables 用于以下用例

28 |

29 | - Kube-proxy — 通过 DNAT iptables 规则实现服务和负载均衡的组件

30 | - 大多数 CNI 插件都使用 iptables 作为网络策略

31 |

32 | Cilium 通过消除性能下降的 iptable 使其更加高效。你可以参考[这里](https://cilium.io/blog/2018/04/17/why-is-the-kernel-community-replacing-iptables)的细节。

33 |

34 | # 程序执行 Bozo 的指南

35 |

36 | 要解释 eBPF 的重要性,就需要解释一下程序在 Linux 中是如何执行的,我会尝试从 1000ft 的角度为大家解释。

37 |

38 | 注意:Windows 用户?那么你为什么还要阅读这篇文章,你们没有所有这些很酷的功能。

39 |

40 | Linux内存分为两部分

41 |

42 | 1. 内核空间

43 | 2. 用户空间

44 |

45 |

46 |

47 | 图像本身解释了这两者之间的区别。您编写的所有程序都只是作为内核 API 的系统调用的集合。举个例子,通过你最喜欢的编程语言打开一个文件,它只是在内核中转换成一个 fileopen 系统调用。

48 |

49 | 当您的应用程序向内核请求某些东西时,内核空间中的一大块数据经常被复制到用户空间中。我们必须这样做,因为操作系统严格划分内核使用的内存区域,因此不可能简单地向用户空间程序提供指向内核内存某个区域的指针。这被称为“跨越用户/内核边界”,由于复制操作,此类操作可能会对性能产生重大影响。

50 |

51 |

52 |

53 | 虽然系统调用几乎涵盖了所有情况,但有时会出现这还不够的情况,例如当我们需要内核级性能或编写新的驱动程序时,等等。依赖操作系统维护人员为所有这些小用例打补丁是一种浪费时间和一个不可能的过程。这就是 ebpf 发挥作用的地方。

54 |

55 | eBPF 帮助您在用户空间编写程序,这些程序被打包并直接注入内核,这些程序在内核中的 VM 上运行,指令集有限,从而扩展了基本内核模块的功能。

56 |

57 | # eBPF 剖析

58 |

59 | eBPF 是为各种进程运行在内核上运行的自定义代码的规定,例如

60 |

61 | - 可观察性(追踪)

62 | - 调试

63 | - 防火墙

64 | - 负载均衡

65 | - 网络相关活动

66 |

67 | 任何在内核中跟踪过各种程序的人都知道它的难度。Linux 系统中可用的半生不熟的实用程序不足以配置复杂的系统,甚至不足以扩展 perf 工具。

68 |

69 | Ebpf 是事件驱动的,这意味着它会在以下情况下触发

70 |

71 | - 一个系统调用

72 | - 函数入口/出口

73 | - 当数据包进入或离开时

74 | - K 探头或 U 探头

75 |

76 | 这些程序是用一种称为 restricted c 的语言编写的,这种语言具有有限的指令集。BPF 编译器 BCC 将其转换为字节码,并加载到内核中执行。在编译之前运行验证程序以确保没有无限循环或可能导致内核崩溃的永无止境的 I/O 操作。

77 |

78 | # 袖子下的额外技巧

79 |

80 | ebpf 确实是一个您可以随身携带的强大工具。在处理高性能项目时,调整数据包或扩展跟踪功能都可以帮助您更好地观察系统正在发生的事情。尽管现阶段应用开发者遇到ebpf是很无力的,但如果你是性能工程师/网络工程师,甚至是安全工程师,未来遇到ebpf的机率将是千钧一发。

81 |

82 | 在编写 ebpf 程序时有一些注意事项,由于 ebpf 在 sudo 权限下运行,因此已经发生了几次利用 ebpf 的权限升级攻击。在利用内核内存漏洞时,ebpf 程序可以用作强大的辅助工具。Qualys 发现了利用此类漏洞的详细文章,他们有一篇文章,您可以从[此处](https://www.qualys.com/2021/07/20/cve-2021-33909/sequoia-local-privilege-escalation-linux.txt)参考。

83 |

84 | # 结论

85 |

86 | 正如蜘蛛侠电影中所说的“能力越大,责任越大”,当你解锁 Linux 的上帝模式时,你就只能靠自己了,保护你的程序免于破坏整体的守卫现在不可用了。使用 Ebpf 有特定的用例,它不是解决所有性能问题的瑞士刀。社区现在非常庞大,包括像 meta、google、Cloudflare 和 Netflix 这样的大公司每天都在使用这项技术。该技术具有巨大的增长潜力,近年来已经看到了针对 ebpf 爱好者的单独会议。

87 |

88 | 这个博客为不了解这项酷技术的人提供了一个小机会,所以请进行研究。网上有大量关于 ebpf 和基于它构建的开源项目的资源。我将写一篇后续文章,详细介绍如何编写示例 ebpf 程序并执行它。

89 |

90 | # 参考

91 |

92 | - BPF 研究论文链接发表于 1992 年 — https://www.tcpdump.org/papers/bpf-usenix93.pdf

93 | - Brendann Gregg 谈论 eBPF -

94 | - https://www.facebook.com/atscaleevents/videos/1693888610884236/

95 | - https://www.youtube.com/watch?v=w8nFRoFJ6EQ

96 | - iptables 博客上的 Ebpf — https://cilium.io/blog/2018/04/17/why-is-the-kernel-community-replacing-iptables

97 | - Qualys 漏洞 — https://www.qualys.com/2021/07/20/cve-2021-33909/sequoia-local-privilege-escalation-linux.txt

98 |

99 |

100 |

101 |

102 |

103 | ## 原文链接

104 |

105 | https://coffeebeans-brewinginnovations.medium.com/ebpf-divulging-the-hidden-super-power-181f96291ef7

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/eBPF技术背景.md:

--------------------------------------------------------------------------------

1 | # eBPF技术背景

2 |

3 | **发展历史**

4 |

5 | BPF,是类 Unix 系统上数据链路层的一种原始接口,提供原始链路层封包的收发。1992 年,Steven McCanne 和 Van Jacobson 写了一篇名为《The BSD Packet Filter: A New Architecture for User-level Packet Capture[2]》的论文。在文中,作者描述了他们如何在 Unix 内核实现网络数据包过滤,这种新的技术比当时最先进的数据包过滤技术快 20 倍。

6 |

7 |

8 |

9 | BPF 在数据包过滤上引入了两大革新:

10 |

11 | - 一个新的虚拟机 (VM) 设计,可以有效地工作在基于寄存器结构的 CPU 之上

12 | - 应用程序使用缓存只复制与过滤数据包相关的数据,不会复制数据包的所有信息,这样可以最大程度地减少BPF 处理的数据

13 |

14 | 由于这些巨大的改进,所有的 Unix 系统都选择采用 BPF 作为网络数据包过滤技术,直到今天,许多 Unix 内核的派生系统中(包括 Linux 内核)仍使用该实现。tcpdump 的底层采用 BPF 作为底层包过滤技术,我们可以在命令后面增加 -d 来查看 tcpdump 过滤条件的底层汇编指令。

15 |

16 | ```

17 | $ tcpdump -d 'ip and tcp port 8080'

18 | (000) ldh [12]

19 | (001) jeq #0x800 jt 2 jf 12

20 | (002) ldb [23]

21 | (003) jeq #0x6 jt 4 jf 12

22 | (004) ldh [20]

23 | (005) jset #0x1fff jt 12 jf 6

24 | (006) ldxb 4*([14]&0xf)

25 | (007) ldh [x + 14]

26 | (008) jeq #0x1f90 jt 11 jf 9

27 | (009) ldh [x + 16]

28 | (010) jeq #0x1f90 jt 11 jf 12

29 | (011) ret #262144

30 | (012) ret #0

31 | ```

32 |

33 | 2014 年初,Alexei Starovoitov 实现了 eBPF(extended Berkeley Packet Filter)。经过重新设计,eBPF 演进为一个通用执行引擎,可基于此开发性能分析工具、软件定义网络等诸多场景。

34 |

35 | eBPF 最早出现在 3.18 内核中,此后原来的 BPF 就被称为经典 BPF,缩写 cBPF(classic BPF),cBPF 现在已经基本废弃。现在,Linux 内核只运行 eBPF,内核会将加载的 cBPF 字节码透明地转换成 eBPF 再执行。

36 |

37 | **eBPF 与 cBPF**

38 |

39 | eBPF 新的设计针对现代硬件进行了优化,所以 eBPF 生成的指令集比旧的 BPF 解释器生成的机器码执行得更快。扩展版本也增加了虚拟机中的寄存器数量,将原有的 2 个 32 位寄存器增加到 10 个 64 位寄存器。

40 |

41 | 由于寄存器数量和宽度的增加,开发人员可以使用函数参数自由交换更多的信息,编写更复杂的程序。总之,这些改进使 eBPF 版本的速度比原来的 BPF 提高了 4 倍。

42 |

43 | | 维度 | cBPF | eBPF |

44 | | -------------- | ------------------------- | ------------------------------------------------------------ |

45 | | 内核版本 | Linux 2.1.75(1997 年) | Linux 3.18(2014 年)[4.x for kprobe/uprobe/tracepoint/perf-event] |

46 | | 寄存器数目 | 2 个:A,X | 10个:R0–R9,另外 R10 是一个只读的帧指针R0:eBPF 中内核函数的返回值和退出值R1 - R5:eBF 程序在内核中的参数值R6 - R9:内核函数将保存的被调用者callee保存的寄存器R10:一个只读的堆栈帧指针 |

47 | | 寄存器宽度 | 32 位 | 64 位 |

48 | | 存储 | 16 个内存位: M[0–15] | 512 字节堆栈,无限制大小的 map 存储 |

49 | | 限制的内核调用 | 非常有限,仅限于 JIT 特定 | 有限,通过 bpf_call 指令调用 |

50 | | 目标事件 | 数据包、 seccomp-BPF | 数据包、内核函数、用户函数、跟踪点 PMCs 等 |

51 |

52 | 2014 年 6 月,eBPF 扩展到用户空间,这也成为了 BPF 技术的转折点。正如 Alexei 在提交补丁的注释中写到:「这个补丁展示了 eBPF 的潜力」。当前,eBPF 不再局限于网络栈,已经成为内核顶级的子系统。

53 |

54 | **eBPF 与内核模块**

55 |

56 | 对比 Web 的发展,eBPF 与内核的关系有点类似于 JavaScript 与浏览器内核的关系,eBPF 相比于直接修改内核和编写内核模块提供了一种新的内核可编程的选项。eBPF 程序架构强调安全性和稳定性,看上去更像内核模块,但与内核模块不同,eBPF 程序不需要重新编译内核,并且可以确保 eBPF 程序运行完成,而不会造成系统的崩溃。

57 |

58 | | 维度 | Linux 内核模块 | eBPF |

59 | | ------------------- | ------------------------------------ | ---------------------------------------------- |

60 | | kprobes/tracepoints | 支持 | 支持 |

61 | | 安全性 | 可能引入安全漏洞或导致内核 Panic | 通过验证器进行检查,可以保障内核安全 |

62 | | 内核函数 | 可以调用内核函数 | 只能通过 BPF Helper 函数调用 |

63 | | 编译性 | 需要编译内核 | 不需要编译内核,引入头文件即可 |

64 | | 运行 | 基于相同内核运行 | 基于稳定 ABI 的 BPF 程序可以编译一次,各处运行 |

65 | | 与应用程序交互 | 打印日志或文件 | 通过 perf_event 或 map 结构 |

66 | | 数据结构 | 丰富性 | 一般丰富 |

67 | | 入门门槛 | 高 | 低 |

68 | | 升级 | 需要卸载和加载,可能导致处理流程中断 | 原子替换升级,不会造成处理流程中断 |

69 | | 内核内置 | 视情况而定 | 内核内置支持 |

70 |

71 | **eBPF 架构**

72 |

73 | eBPF 分为用户空间程序和内核程序两部分:

74 |

75 | - 用户空间程序负责加载 BPF 字节码至内核,如需要也会负责读取内核回传的统计信息或者事件详情

76 | - 内核中的 BPF 字节码负责在内核中执行特定事件,如需要也会将执行的结果通过 maps 或者 perf-event 事件发送至用户空间

77 | - 其中用户空间程序与内核 BPF 字节码程序可以使用 map 结构实现双向通信,这为内核中运行的 BPF 字节码程序提供了更加灵活的控制

78 |

79 | eBPF 整体结构图如下:

80 |

81 |

82 |

83 | 用户空间程序与内核中的 BPF 字节码交互的流程主要如下:

84 |

85 | 1、使用 LLVM 或者 GCC 工具将编写的 BPF 代码程序编译成 BPF 字节码

86 |

87 | 2、使用加载程序 Loader 将字节码加载至内核

88 |

89 | 3、内核使用验证器(Verfier) 组件保证执行字节码的安全性,以避免对内核造成灾难,在确认字节码安全后将其加载对应的内核模块执行

90 |

91 | 4、内核中运行的 BPF 字节码程序可以使用两种方式将数据回传至用户空间:

92 |

93 | - maps 方式可用于将内核中实现的统计摘要信息(比如测量延迟、堆栈信息)等回传至用户空间;

94 | - perf-event 用于将内核采集的事件实时发送至用户空间,用户空间程序实时读取分析。

95 |

96 | **eBPF 限制**

97 |

98 | eBPF 技术虽然强大,但是为了保证内核的处理安全和及时响应,内核中的 eBPF 技术也给予了诸多限制,当然随着技术的发展和演进,限制也在逐步放宽或者提供了对应的解决方案。

99 |

100 | eBPF 程序不能调用任意的内核参数,只限于内核模块中列出的 BPF Helper 函数,函数支持列表也随着内核的演进在不断增加。

101 |

102 | eBPF 程序不允许包含无法到达的指令,防止加载无效代码,延迟程序的终止。

103 |

104 | eBPF 程序中循环次数限制且必须在有限时间内结束,这主要是用来防止在 kprobes 中插入任意的循环,导致锁住整个系统;解决办法包括展开循环,并为需要循环的常见用途添加辅助函数。Linux 5.3 在 BPF 中包含了对有界循环的支持,它有一个可验证的运行时间上限。

105 |

106 | eBPF 堆栈大小被限制在 MAX_BPF_STACK,截止到内核 Linux 5.8 版本,被设置为 512;参见 include/linux/filter.h[3],这个限制特别是在栈上存储多个字符串缓冲区时:一个char[256]缓冲区会消耗这个栈的一半。目前没有计划增加这个限制,解决方法是改用 bpf 映射存储,它实际上是无限的。

107 |

108 | ```

109 | /* BPF program can access up to 512 bytes of stack space. */

110 | #define MAX_BPF_STACK 512

111 | ```

112 |

113 | eBPF 字节码大小最初被限制为 4096 条指令,截止到内核 Linux 5.8 版本, 当前已将放宽至 100 万指令( BPF_COMPLEXITY_LIMIT_INSNS),参见:include/linux/bpf.h[4],对于无权限的BPF程序,仍然保留4096条限制 ( BPF_MAXINSNS );新版本的 eBPF 也支持了多个 eBPF 程序级联调用,虽然传递信息存在某些限制,但是可以通过组合实现更加强大的功能。

114 |

115 | ```

116 | #define BPF_COMPLEXITY_LIMIT_INSNS 1000000 /* yes. 1M insns */

117 | ```

118 |

119 | ##

120 |

121 |

--------------------------------------------------------------------------------

/ebpf-guide/eBPF实战应用/eBPF实战.md:

--------------------------------------------------------------------------------

1 | # eBPF实战

2 |

3 | 在深入介绍 eBPF 特性之前,让我们 Get Hands Dirty,切切实实的感受 eBPF 程序到底是什么,我们该如何开发 eBPF 程序。随着 eBPF 生态的演进,现在已经有越来越多的工具链用于开发 eBPF 程序,在后文也会详细介绍:

4 |

5 | - 基于 bcc 开发:bcc 提供了对 eBPF 开发,前段提供 Python API,后端 eBPF 程序通过 C 实现。特点是简单易用,但是性能较差。

6 | - 基于 libebpf-bootstrap 开发:libebpf-bootstrap 提供了一个方便的脚手架。

7 | - 基于内核源码开发:内核源码开发门槛较高,但是也更加切合 eBPF 底层原理,所以这里以这个方法作为示例。

8 |

9 | **内核源码编译**

10 |

11 | 系统环境如下,采用腾讯云 CVM,Ubuntu 20.04,内核版本 5.4.0。

12 |

13 | ```

14 | $ uname -a

15 | Linux VM-1-3-ubuntu 5.4.0-42-generic #46-Ubuntu SMP Fri Jul 10 00:24:02 UTC 2020 x86_64 x86_64 x86_64 GNU/Linux

16 | ```

17 |

18 | 首先安装必要依赖:

19 |

20 | ```

21 | sudo apt install -y bison build-essential cmake flex git libedit-dev pkg-config libmnl-dev \

22 | python zlib1g-dev libssl-dev libelf-dev libcap-dev libfl-dev llvm clang pkg-config \

23 | gcc-multilib luajit libluajit-5.1-dev libncurses5-dev libclang-dev clang-tools

24 | ```

25 |

26 | 一般情况下推荐采用 apt 方式的安装源码,安装简单而且只安装当前内核的源码,源码的大小在 200M 左右。

27 |

28 | ```

29 | # apt-cache search linux-source

30 |

31 | # apt install linux-source-5.4.0

32 | ```

33 |

34 | 源码安装至 /usr/src/ 目录下。

35 |

36 | ```

37 | $ ls -hl

38 | total 4.0K

39 | drwxr-xr-x 4 root root 4.0K Nov 9 13:22 linux-source-5.4.0

40 | lrwxrwxrwx 1 root root 45 Oct 15 10:28 linux-source-5.4.0.tar.bz2 -> linux-source-5.4.0/linux-source-5.4.0.tar.bz2

41 | $ tar -jxvf linux-source-5.4.0.tar.bz2

42 | $ cd linux-source-5.4.0

43 |

44 | $ cp -v /boot/config-$(uname -r) .config # make defconfig 或者 make menuconfig

45 | $ make headers_install

46 | $ make modules_prepare

47 | $ make scripts # 可选

48 | $ make M=samples/bpf # 如果配置出错,可以使用 make oldconfig && make prepare 修复

49 | ```

50 |

51 | 编译成功后,可以在 samples/bpf 目录下看到一系列的目标文件和二进制文件。

52 | **Hello World**

53 | 前面说到 eBPF 通常由内核空间程序和用户空间程序两部分组成,现在 samples/bpf 目录下有很多这种程序,内核空间程序以 _kern.c 结尾,用户空间程序以 _user.c 结尾。先不看这些复杂的程序,我们手动写一个 eBPF 程序的 Hello World。

54 | 内核中的程序 hello_kern.c:

55 |

56 | ```

57 | #include

58 | #include "bpf_helpers.h"

59 |

60 | #define SEC(NAME) __attribute__((section(NAME), used))

61 |

62 | SEC("tracepoint/syscalls/sys_enter_execve")

63 | int bpf_prog(void *ctx)

64 | {

65 | char msg[] = "Hello BPF from houmin!\n";

66 | bpf_trace_printk(msg, sizeof(msg));

67 | return 0;

68 | }

69 |

70 | char _license[] SEC("license") = "GPL";

71 | ```

72 |

73 | 函数入口:

74 |

75 | 上述代码和普通的C语言编程有一些区别。

76 |

77 | - 程序的入口通过编译器的 pragama __section("tracepoint/syscalls/sys_enter_execve") 指定的。

78 | - 入口的参数不再是 argc, argv, 它根据不同的 prog type 而有所差别。我们的例子中,prog type 是 BPF_PROG_TYPE_TRACEPOINT, 它的入口参数就是 void *ctx。

79 |

80 | 头文件:

81 |

82 | ```

83 | #include

84 | ```

85 |

86 | 这个头文件的来源是kernel source header file 。它安装在 /usr/include/linux/bpf.h中。

87 |

88 | 它提供了bpf 编程需要的很多symbol。例如:

89 |

90 | - enum bpf_func_id 定义了所有的kerne helper function 的id

91 | - enum bpf_prog_type 定义了内核支持的所有的prog 的类型。

92 | - struct __sk_buff 是bpf 代码中访问内核struct sk_buff的接口。

93 |

94 | 等等

95 |

96 | ```

97 | #include “bpf_helpers.h”

98 | ```

99 |

100 | 来自libbpf ,需要自行安装。我们引用这个头文件是因为调用了bpf_printk()。这是一个kernel helper function。

101 |

102 | 程序解释:

103 |

104 | 这里我们简单解读下内核态的 ebpf 程序,非常简单:

105 |

106 | - bpf_trace_printk 是一个 eBPF helper 函数,用于打印信息到 trace_pipe (/sys/kernel/debug/tracing/trace_pipe),详见这里[5]

107 | - 代码声明了 SEC 宏,并且定义了 GPL 的 License,这是因为加载进内核的 eBPF 程序需要有 License 检查,类似于内核模块

108 |

109 | 加载 BPF 代码:

110 |

111 | 用户态程序 hello_user.c:

112 |

113 | ```

114 | #include

115 | #include "bpf_load.h"

116 |

117 | int main(int argc, char **argv)

118 | {

119 | if(load_bpf_file("hello_kern.o") != 0)

120 | {

121 | printf("The kernel didn't load BPF program\n");

122 | return -1;

123 | }

124 |

125 | read_trace_pipe();

126 | return 0;

127 | }

128 | ```

129 |

130 | 在用户态 ebpf 程序中,解读如下:

131 |

132 | - 通过 load_bpf_file 将编译出的内核态 ebpf 目标文件加载到内核

133 | - 通过 read_trace_pipe 从 trace_pipe 读取 trace 信息,打印到控制台中

134 |

135 | 修改 samples/bpf 目录下的 Makefile 文件,在对应的位置添加以下三行:

136 |

137 | ```

138 | hostprogs-y += hello

139 | hello-objs := bpf_load.o hello_user.o

140 | always += hello_kern.o

141 | ```

142 |

143 | 重新编译,可以看到编译成功的文件:

144 |

145 | ```

146 | $ make M=samples/bpf

147 | $ ls -hl samples/bpf/hello*

148 | -rwxrwxr-x 1 ubuntu ubuntu 404K Mar 30 17:48 samples/bpf/hello

149 | -rw-rw-r-- 1 ubuntu ubuntu 317 Mar 30 17:47 samples/bpf/hello_kern.c

150 | -rw-rw-r-- 1 ubuntu ubuntu 3.8K Mar 30 17:48 samples/bpf/hello_kern.o

151 | -rw-rw-r-- 1 ubuntu ubuntu 246 Mar 30 17:47 samples/bpf/hello_user.c

152 | -rw-rw-r-- 1 ubuntu ubuntu 2.2K Mar 30 17:48 samples/bpf/hello_user.o

153 | ```

154 |

155 | 进入到对应的目录运行 hello 程序,可以看到输出结果如下:

156 |

157 | ```

158 | $ sudo ./hello

159 | <...>-102735 [001] .... 6733.481740: 0: Hello BPF from houmin!

160 |

161 | <...>-102736 [000] .... 6733.482884: 0: Hello BPF from houmin!

162 |

163 | <...>-102737 [002] .... 6733.483074: 0: Hello BPF from houmin!

164 | ```

165 |

166 | **代码解读**

167 |

168 | 前面提到 load_bpf_file 函数将 LLVM 编译出来的 eBPF 字节码加载进内核,这到底是如何实现的呢?

169 |

170 | 经过搜查,可以看到 load_bpf_file 也是在 samples/bpf 目录下实现的,具体的参见 bpf_load.c[6]。

171 |

172 |

173 |

174 | 阅读 load_bpf_file 代码可以看到,它主要是解析 ELF 格式的 eBPF 字节码,然后调用 load_and_attach[7] 函数。

175 |

176 | 在 load_and_attach 函数中,我们可以看到其调用了 bpf_load_program 函数,这是 libbpf 提供的函数。

177 |

178 | 调用的 bpf_load_program 中的 license、kern_version 等参数来自于解析 eBPF ELF 文件,prog_type 来自于 bpf 代码里面 SEC 字段指定的类型。

179 |

180 | ```

181 | static int load_and_attach(const char *event, struct bpf_insn *prog, int size)

182 | {

183 | bool is_socket = strncmp(event, "socket", 6) == 0;

184 | bool is_kprobe = strncmp(event, "kprobe/", 7) == 0;

185 | bool is_kretprobe = strncmp(event, "kretprobe/", 10) == 0;

186 | bool is_tracepoint = strncmp(event, "tracepoint/", 11) == 0;

187 | bool is_raw_tracepoint = strncmp(event, "raw_tracepoint/", 15) == 0;

188 | bool is_xdp = strncmp(event, "xdp", 3) == 0;

189 | bool is_perf_event = strncmp(event, "perf_event", 10) == 0;

190 | bool is_cgroup_skb = strncmp(event, "cgroup/skb", 10) == 0;

191 | bool is_cgroup_sk = strncmp(event, "cgroup/sock", 11) == 0;

192 | bool is_sockops = strncmp(event, "sockops", 7) == 0;

193 | bool is_sk_skb = strncmp(event, "sk_skb", 6) == 0;

194 | bool is_sk_msg = strncmp(event, "sk_msg", 6) == 0;

195 |

196 | //...

197 |

198 | fd = bpf_load_program(prog_type, prog, insns_cnt, license, kern_version,

199 | bpf_log_buf, BPF_LOG_BUF_SIZE);

200 | if (fd < 0) {

201 | printf("bpf_load_program() err=%d\n%s", errno, bpf_log_buf);

202 | return -1;

203 | }

204 | //...

205 | }

206 | ```

207 |

208 | ##

--------------------------------------------------------------------------------

/ebpf-guide/eBPF高级/eBPF是一个基于寄存器的虚拟机.md:

--------------------------------------------------------------------------------

1 | # eBPF是一个基于寄存器的虚拟机

2 |

3 | ## 1. 前言

4 |

5 | **有兴趣了解更多关于 eBPF 技术的底层细节?那么请继续移步,我们将深入研究 eBPF 的底层细节,从其虚拟机机制和工具,到在远程资源受限的嵌入式设备上运行跟踪。**

6 |

7 | 注意:本系列博客文章将集中在 eBPF 技术,因此对于我们来讲,文中 BPF 和 eBPF 等同,可相互使用。BPF 名字/缩写已经没有太大的意义,因为这个项目的发展远远超出了它最初的范围。BPF 和 eBPF 在该系列中会交替使用。

8 |

9 | - **第 1 部分**[1]和**第 2 部分**[2] 为新人或那些希望通过深入了解 eBPF 技术栈的底层技术来进一步了解 eBPF 技术的人提供了深入介绍。

10 | - **第 3 部分**[3]是对用户空间工具的概述,旨在提高生产力,建立在第 1 部分和第 2 部分中介绍的底层虚拟机机制之上。

11 | - **第 4 部分**[4]侧重于在资源有限的嵌入式系统上运行 eBPF 程序,在嵌入式系统中完整的工具链技术栈(BCC/LLVM/python 等)是不可行的。我们将使用占用资源较小的嵌入式工具在 32 位 ARM 上交叉编译和运行 eBPF 程序。只对该部分感兴趣的读者可选择跳过其他部分。

12 | - **第 5 部分**[5]是关于用户空间追踪。到目前为止,我们的努力都集中在内核追踪上,所以是时候我们关注一下用户进程了。

13 |

14 | 如有疑问时,可使用该流程图:

15 |

16 |

17 |

18 | ## 2. eBPF 是什么?

19 |

20 | eBPF 是一个基于寄存器的虚拟机,使用自定义的 64 位 RISC 指令集,能够在 Linux 内核内运行即时本地编译的 "BPF 程序",并能访问内核功能和内存的一个子集。这是一个完整的虚拟机实现,不要与基于内核的虚拟机(KVM)相混淆,后者是一个模块,目的是使 Linux 能够作为其他虚拟机的管理程序。eBPF 也是主线内核的一部分,所以它不像其他框架那样需要任何第三方模块(**LTTng**[6] 或 **SystemTap**[7]),而且几乎所有的 Linux 发行版都默认启用。熟悉 DTrace 的读者可能会发现 **DTrace/BPFtrace 对比**[8]非常有用。

21 |

22 | 在内核内运行一个完整的虚拟机主要是考虑便利和安全。虽然 eBPF 程序所做的操作都可以通过正常的内核模块来处理,但直接的内核编程是一件非常危险的事情 - 这可能会导致系统锁定、内存损坏和进程崩溃,从而导致安全漏洞和其他意外的效果,特别是在生产设备上(eBPF 经常被用来检查生产中的系统),所以通过一个安全的虚拟机运行本地 JIT 编译的快速内核代码对于安全监控和沙盒、网络过滤、程序跟踪、性能分析和调试都是非常有价值的。部分简单的样例可以在这篇优秀的 **eBPF 参考**[9]中找到。

23 |

24 |

25 |

26 | 基于设计,eBPF 虚拟机和其程序有意地设计为**不是**图灵完备的:即不允许有循环(正在进行的工作是支持有界循环【译者注:已经支持有界循环,#pragma unroll 指令】),所以每个 eBPF 程序都需要保证完成而不会被挂起、所有的内存访问都是有界和类型检查的(包括寄存器,一个 MOV 指令可以改变一个寄存器的类型)、不能包含空解引用、一个程序必须最多拥有 BPF_MAXINSNS 指令(默认 4096)、"主"函数需要一个参数(context)等等。当 eBPF 程序被加载到内核中,其指令被验证模块解析为有向环状图,上述的限制使得正确性可以得到简单而快速的验证。

27 |

28 | > 译者注:BPF_MAXINSNS 这个限制已经被放宽至 100 万条指令(BPF_COMPLEXITY_LIMIT_INSNS),但是非特权执行的 BPF 程序这个限制仍然会保留。

29 |

30 | 历史上,eBPF (cBPF) 虚拟机只在内核中可用,用于过滤网络数据包,与用户空间程序没有交互,因此被称为 "伯克利数据包过滤器"【译者注:早期的 BPF 实现被称为经典 cBPF】。从内核 v3.18(2014 年)开始,该虚拟机也通过 **bpf() syscall**[10] 和**uapi/linux/bpf.h**[11] 暴露在用户空间,这导致其指令集在当时被冻结,成为公共 ABI,尽管后来仍然可以(并且已经)添加新指令。

31 |

32 | 因为内核内的 eBPF 实现是根据 GPLv2 授权的,它不能轻易地被非 GPL 用户重新分发,所以也有一个替代的 Apache 授权的用户空间 eBPF 虚拟机实现,称为 "uBPF"。撇开法律条文不谈,基于用户空间的实现对于追踪那些需要避免内核-用户空间上下文切换成本的性能关键型应用很有用。

33 |

34 | ## 3. eBPF 是怎么工作的?

35 |

36 | eBPF 程序在事件触发时由内核运行,所以可以被看作是一种函数挂钩或事件驱动的编程形式。从用户空间运行按需 eBPF 程序的价值较小,因为所有的按需用户调用已经通过正常的非 VM 内核 API 调用("syscalls")来处理,这里 VM 字节码带来的价值很小。事件可由 kprobes/uprobes、tracepoints、dtrace probes、socket 等产生。这允许在内核和用户进程的指令中钩住(hook)和检查任何函数的内存、拦截文件操作、检查特定的网络数据包等等。一个比较好的参考是 **Linux 内核版本对应的 BPF 功能**[12]。

37 |

38 | 如前所述,事件触发了附加的 eBPF 程序的执行,后续可以将信息保存至 map 和环形缓冲区(ringbuffer)或调用一些特定 API 定义的内核函数的子集。一个 eBPF 程序可以链接到多个事件,不同的 eBPF 程序也可以访问相同的 map 以共享数据。一个被称为 "program array" 的特殊读/写 map 存储了对通过 bpf() 系统调用加载的其他 eBPF 程序的引用,在该 map 中成功的查找则会触发一个跳转,而且并不返回到原来的 eBPF 程序。这种 eBPF 嵌套也有限制,以避免无限的递归循环。

39 |

40 | 运行 eBPF 程序的步骤:

41 |

42 | 1. 用户空间将字节码和程序类型一起发送到内核,程序类型决定了可以访问的内核区域【译者注:主要是 BPF 帮助函数的各种子集】。

43 | 2. 内核在字节码上运行验证器,以确保程序可以安全运行(kernel/bpf/verifier.c)。

44 | 3. 内核将字节码编译为本地代码,并将其插入(或附加到)指定的代码位置。【译者注:如果启用了 JIT 功能,字节码编译为本地代码】。

45 | 4. 插入的代码将数据写入环形缓冲区或通用键值 map。

46 | 5. 用户空间从共享 map 或环形缓冲区中读取结果值。

47 |

48 | map 和环形缓冲区结构是由内核管理的(就像管道和 FIFO 一样),独立于挂载的 eBPF 或访问它们的用户程序。对 map 和环形缓冲区结构的访问是异步的,通过文件描述符和引用计数实现,可确保只要有至少一个程序还在访问,结构就能够存在。加载的 JIT 后代码通常在加载其的用户进程终止时被删除,尽管在某些情况下,它仍然可以在加载进程的生命期之后继续存在。

49 |

50 | 为了方便编写 eBPF 程序和避免进行原始的 bpf()系统调用,内核提供了方便的 **libbpf 库**[13],包含系统调用函数包装器,如**bpf_load_program**[14] 和结构定义(如 **bpf_map**[15]),在 LGPL 2.1 和 BSD 2-Clause 下双重许可,可以静态链接或作为 DSO。内核代码也提供了一些使用 libbpf 简洁的例子,位于目录 **samples/bpf/**[16] 中。

51 |

52 | ## 4. 样例学习

53 |

54 | 内核开发者非常可怜,因为内核是一个独立的项目,因而没有用户空间诸如 Glibc、LLVM、JavaScript 和 WebAssembly 诸如此类的好东西! - 这就是为什么内核中 eBPF 例子中会包含原始字节码或通过 libbpf 加载预组装的字节码文件。我们可以在 **sock_example.c**[17] 中看到这一点,这是一个简单的用户空间程序,使用 eBPF 来计算环回接口上统计接收到 TCP、UDP 和 ICMP 协议包的数量。

55 |

56 | 我们跳过微不足道的的 **main**[18] 和 **open_raw_sock**[19] 函数,而专注于神奇的代码 **test_sock**[20]。

57 |

58 | ```

59 | static int test_sock(void)

60 | {

61 | int sock = -1, map_fd, prog_fd, i, key;

62 | long long value = 0, tcp_cnt, udp_cnt, icmp_cnt;

63 |

64 | map_fd = bpf_create_map(BPF_MAP_TYPE_ARRAY, sizeof(key), sizeof(value), 256, 0);

65 | if (map_fd < 0) {printf("failed to create map'%s'\n", strerror(errno));

66 | goto cleanup;

67 | }

68 |

69 | struct bpf_insn prog[] = {BPF_MOV64_REG(BPF_REG_6, BPF_REG_1),

70 | BPF_LD_ABS(BPF_B, ETH_HLEN + offsetof(struct iphdr, protocol) /* R0 = ip->proto */),

71 | BPF_STX_MEM(BPF_W, BPF_REG_10, BPF_REG_0, -4), /* *(u32 *)(fp - 4) = r0 */

72 | BPF_MOV64_REG(BPF_REG_2, BPF_REG_10),

73 | BPF_ALU64_IMM(BPF_ADD, BPF_REG_2, -4), /* r2 = fp - 4 */

74 | BPF_LD_MAP_FD(BPF_REG_1, map_fd),

75 | BPF_RAW_INSN(BPF_JMP | BPF_CALL, 0, 0, 0, BPF_FUNC_map_lookup_elem),

76 | BPF_JMP_IMM(BPF_JEQ, BPF_REG_0, 0, 2),

77 | BPF_MOV64_IMM(BPF_REG_1, 1), /* r1 = 1 */

78 | BPF_RAW_INSN(BPF_STX | BPF_XADD | BPF_DW, BPF_REG_0, BPF_REG_1, 0, 0), /* xadd r0 += r1 */

79 | BPF_MOV64_IMM(BPF_REG_0, 0), /* r0 = 0 */

80 | BPF_EXIT_INSN(),};

81 | size_t insns_cnt = sizeof(prog) / sizeof(struct bpf_insn);

82 |

83 | prog_fd = bpf_load_program(BPF_PROG_TYPE_SOCKET_FILTER, prog, insns_cnt,

84 | "GPL", 0, bpf_log_buf, BPF_LOG_BUF_SIZE);

85 | if (prog_fd < 0) {printf("failed to load prog'%s'\n", strerror(errno));

86 | goto cleanup;

87 | }

88 |

89 | sock = open_raw_sock("lo");

90 |

91 | if (setsockopt(sock, SOL_SOCKET, SO_ATTACH_BPF, &prog_fd, sizeof(prog_fd)) < 0) {printf("setsockopt %s\n", strerror(errno));

92 | goto cleanup;

93 | }

94 | ```

95 |

96 | 首先,通过 libbpf API 创建一个 BPF map,该行为就像一个最大 256 个元素的固定大小的数组。按 **IPROTO_\***[21] 定义的键索引网络协议(2 字节的 word),值代表各自的数据包计数(4 字节大小)。除了数组,eBPF 映射还实现了**其他数据结构类型**[22],如栈或队列。

97 |

98 | 接下来,eBPF 的字节码指令数组使用方便的**内核宏**[23]进行定义。在这里,我们不会讨论字节码的细节(这将在第 2 部分描述机器后进行)。更高的层次上,字节码从数据包缓冲区中读取协议字,在 map 中查找,并增加特定的数据包计数。

99 |

100 |

101 |

102 | 然后 BPF 字节码被加载到内核中,并通过 libbpf 的 bpf_load_program 返回 fd 引用来验证正确/安全。调用指定了 eBPF **程序类型**[24],这决定了它可以访问哪些内核子集。因为样例是一个 SOCKET_FILTER 类型,因此提供了一个指向当前网络包的参数。最后,eBPF 的字节码通过套接字层被附加到一个特定的原始套接字上,之后在原始套接字上接受到的每一个数据包运行 eBPF 字节码,无论协议如何。

103 |

104 | 剩余的工作就是让用户进程开始轮询共享 map 的数据。

105 |

106 | ```

107 | for (i = 0; i < 10; i++) {

108 | key = IPPROTO_TCP;

109 | assert(bpf_map_lookup_elem(map_fd, &key, &tcp_cnt) == 0);

110 |

111 | key = IPPROTO_UDP;

112 | assert(bpf_map_lookup_elem(map_fd, &key, &udp_cnt) == 0);

113 |

114 | key = IPPROTO_ICMP;

115 | assert(bpf_map_lookup_elem(map_fd, &key, &icmp_cnt) == 0);

116 |

117 | printf("TCP %lld UDP %lld ICMP %lld packets\n",

118 | tcp_cnt, udp_cnt, icmp_cnt);

119 | sleep(1);

120 | }

121 | }

122 | ```

123 |

124 | ## 5. 总结

125 |

126 | 第 1 部分介绍了 eBPF 的基础知识,我们通过如何加载字节码和与 eBPF 虚拟机通信的例子进行了讲述。由于篇幅限制,编译和运行例子作为留给读者的练习。我们也有意不去分析具体的 eBPF 字节码指令,因为这将是第 2 部分的重点。在我们研究的例子中,用户空间通过 libbpf 直接用 C 语言从内核虚拟机中读取 eBPF map 值(使用 10 次 1 秒的睡眠!),这很笨重,而且容易出错,而且很快就会变得很复杂,所以在第 3 部分,我们将研究更高级别的工具,通过脚本或特定领域的语言自动与虚拟机交互。

127 |

128 | ## 作者

129 |

130 | 狄卫华

131 |

132 | ## 原文链接

133 |

134 | https://mp.weixin.qq.com/s/-K3GD2xWN5glFcbd8iSesg

--------------------------------------------------------------------------------

/ebpf-guide/eBPF高级/eBPF指令集.md:

--------------------------------------------------------------------------------

1 | # eBPF指令集

2 |

3 | 并不是每个开发 BPF 程序的人都知道存在多个版本的指令集。鉴于有关该主题的文档很少,这并不奇怪。那么让我们来看看不同的 eBPF 指令集,它们存在的原因,以及它们的选择为何重要。

4 |

5 | ### LLVM 的后端选择器

6 |

7 | 如果你一直使用`llc`它来编译你的 BPF 程序,你可能已经注意到一个`-mcpu`参数。帮助输出为我们提供了以下信息:

8 |

9 | ```

10 | $ llc -march=bpf -mcpu=help

11 | Available CPUs for this target:

12 |

13 | generic - Select the generic processor.

14 | probe - Select the probe processor.

15 | v1 - Select the v1 processor.

16 | v2 - Select the v2 processor.

17 | v3 - Select the v3 processor.

18 |

19 | Available features for this target:

20 |

21 | alu32 - Enable ALU32 instructions.

22 | dummy - unused feature.

23 | dwarfris - Disable MCAsmInfo DwarfUsesRelocationsAcrossSections.

24 |

25 | Use +feature to enable a feature, or -feature to disable it.

26 | For example, llc -mcpu=mycpu -mattr=+feature1,-feature2

27 | ```

28 |

29 | 参数使用`-mcpu`如下:

30 |

31 | ```

32 | $ clang -O2 -Wall -target bpf -emit-llvm -c example.c -o example.bc

33 | $ llc example.bc -march=bpf -mcpu=probe -filetype=obj -o example.o

34 | ```

35 |

36 | 该参数允许我们告诉 LLVM 使用哪个 eBPF 指令集。它默认为,最旧指令集 `generic`的别名。将选择您的内核支持的最新指令集。我们将在下面看到,选择较新的版本可以让 LLVM 生成更小、更高效的字节码。`v1``probe`

37 |

38 | ### 先决条件

39 |

40 | 基本指令集的两个扩展(v2 和 v3)添加了对新跳转指令的支持。具体来说,v2 添加了对低于跳跃的支持,而以前只有大于跳跃可用。当然,第一种跳转可以重写为第二种,但这需要额外的寄存器加载:

41 |

42 | ```

43 | // Using mcpu=v1:

44 | 0: r2 = 7

45 | 1: if r2 s> r1 goto pc+1

46 | // Using mcpu=v2's BPF_JSLT:

47 | 0: if r1 s< 7 goto pc+1

48 | ```

49 |

50 | 第二个扩展 v3 添加了现有条件 64 位跳转的 32 位变体。同样,您可以通过清除 32 个最高有效位来解决缺少 32 位条件跳转的问题。但是使用 32 位条件跳转更短:

51 |

52 | ```

53 | 0: call bpf_skb_load_bytes

54 | // Using mcpu=v2's 64-bit jumps:

55 | 1: r0 <<= 32

56 | 2: r0 s>>= 32

57 | 3: if r0 s< 0 goto +1785

58 | // Using mcpu=v3's 32-bit jumps:

59 | 1: if w0 s< 0 goto +1689

60 | ```

61 |

62 | `w0`是 的 32 位子寄存器`r0`。

63 |

64 | 您需要足够新的 Linux 和 LLVM 版本才能使用 v2 和 v3 扩展。下表对其进行了总结。

65 |

66 | | BPF ISA version | New instructions | Linux version | LLVM version |

67 | | --------------- | ---------------------------- | ------------------------------------------------------------ | ------------------------------------------------------------ |

68 | | v1 (generic) | - | [v3.18](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=daedfb22451dd02b35c0549566cbb7cc06bdd53b) | [v3.7](https://reviews.llvm.org/rL227008) |

69 | | v2 | `BPF_J{LT,LE,SLT,SLE}` | [v4.14](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=92b31a9af73b3a3fc801899335d6c47966351830) | [v6.0](https://reviews.llvm.org/rL311522) |

70 | | `mattr=+alu32` | 32-bit calling convention | [v5.0](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=2dc6b100f928aac8d7532bf7112d3f8d3f952bad)[1](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fn:alu32-support) | [v7.0](https://reviews.llvm.org/rL325983) |

71 | | v3 | 32-bit variants of all jumps | [v5.1](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=092ed0968bb648cd18e8a0430cd0a8a71727315c) | [v9.0](https://reviews.llvm.org/rL353384), with `mattr=+alu32` |

72 |

73 | [BPF 常见问题解答](https://github.com/torvalds/linux/blob/28806e4d9b97865b450d72156e9ad229f2067f0b/Documentation/bpf/bpf_design_QA.rst#q-why-bpf-jlt-and-bpf-jle-instructions-were-not-introduced-in-the-beginning)还很好地了解了为什么存在这些指令集扩展:

74 |

75 | > **为什么一开始没有引入BPF_JLT和BPF_JLE指令?**

76 | >

77 | > 答:因为经典 BPF 没有它们,BPF 作者认为编译器变通方案是可以接受的。结果是程序由于缺少这些比较指令而失去了性能,并且添加了它们。这两条指令是新的 BPF 指令的完美示例,可以接受并且可以在将来添加。这两个在本机 CPU 中已经有了等效的指令。不接受与硬件指令没有一对一映射的新指令。

78 |

79 | ### 对程序大小和复杂性的影响

80 |

81 | 为什么这一切很重要?使用默认的 v1 指令集有那么糟糕吗?我们可以设置`mcpu=probe`吗?

82 |

83 | 让我们首先看一下对程序大小的影响。为此,我们可以使用[Cilium 的 BPF 程序](https://github.com/cilium/cilium/tree/master/bpf)。它们是开源的,大小不一,用于生产系统。`check-complexity.sh`Cilium 存储库中的脚本加载内核中的程序并检索各种统计信息。在下文中,我使用的是 LLVM 10.0.0。

84 |

85 | ```

86 | $ git checkout v1.10.0-rc0

87 | $ for v in v1 v2 v3 "v1 -mattr=+alu32" "v2 -mattr=+alu32"; do \

88 | sed -i "s/mcpu=v[1-3].*/mcpu=$v/" bpf/Makefile.bpf && \

89 | make -C bpf KERNEL=netnext && \

90 | sudo ./test/bpf/check-complexity.sh > ${v/ /-}.txt; \

91 | done

92 | ```

93 |

94 |

95 |

96 |

97 |

98 | 正如预期的那样,每个更新的指令集版本都会生成更小的 BPF 程序。由于新指令具有与 x86 指令的一对一映射,我们可以预期对 JIT 编译程序的大小有类似的影响。因此,在大多数情况下,使用较新的指令集时,您可以期望获得较小的性能优势。

99 |

100 | 的影响`mattr=+alu32`更为细微——单击图例以显示它。它有时会增加程序大小,尤其是与 结合使用时`mcpu=v1`,而不是减少它。除非您使用`mcpu=v3`,否则程序的许多部分仍然需要 64 位指令和操作。因此,可能更细微的影响是由于在 32 位和 64 位值之间转换需要额外的指令。

101 |

102 |

103 |

104 | 对于 v5.2 [2](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fn:4k-limit)之前的较大程序和内核,v2 和 v3 指令集还可以让您将程序大小减少到验证程序规定的 4096 条指令限制以下。然而,这并不是验证者施加的唯一限制。大型程序更常见的问题来源是验证器分析的指令数量限制。

105 |

106 | 当验证程序分析通过程序的所有路径时,它会计算已经分析了多少条指令,并在给定限制后停止(例如,Linux 5.2+ 上的 100 万条)。我们将验证者分析的指令数称为BPF 程序的*复杂度。*在最坏的情况下,复杂性会随着程序[3](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fn:state-pruning)中条件的数量呈指数增长。

107 |

108 |

109 |

110 | `check-complexity.sh`还报告了每个加载的 BPF 程序的复杂性。我在 Linux 5.10 上执行它并在下图中报告结果。

111 |

112 |

113 |

114 |

115 |

116 | 通过单击图例隐藏 v3,我们可以注意到 v1 和 v2 非常接近。然而,前两个版本和最后一个版本之间存在显着差异。v3 指令集有时会降低复杂性,有时会加剧复杂性。添加`mattr=+alu32`具有类似的影响。

117 |

118 | 目前尚不清楚为什么较新的指令集在减少指令数量时有时会增加复杂性。鉴于它们没有显着修改控制流,可能是它们降低了[验证者状态修剪](https://pchaigno.github.io/ebpf/2021/04/12/bmc-accelerating-memcached-using-bpf-and-xdp.html#bpfs-complexity-constraint)的效率。

119 |

120 |

121 |

122 | 总而言之,如果您遇到复杂性问题(即达到验证者的阈值),您需要在进行切换之前仔细测试每个指令集的影响。唯一明确的情况是从 v2 + alu32 切换到 v3,而 v3 几乎总是保持较低的复杂性。

123 |

124 | ### 结论

125 |

126 | 我们已经看到,Linux 内核支持的 eBPF 指令集不止一种,而是三种!这些指令集对程序大小和性能有影响,在大多数情况下,您最好设置`mcpu=probe`为使用最新的受支持版本。如果你有非常大的 BPF 程序,版本切换可能会导致内核验证器拒绝,如果你达到了复杂性限制,那么你应该在进行切换之前进行彻底的测试。

127 |

128 | 1. 据我所知,它应该从 v3.19 开始支持[第一次 helper 调用](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=d0003ec01c667b731c139e23de3306a8b328ccf5),但大多数程序在 v5.0 之前中断,因为不[支持 32 位有符号右移](https://git.kernel.org/pub/scm/linux/kernel/git/torvalds/linux.git/commit/?id=2dc6b100f928aac8d7532bf7112d3f8d3f952bad)。 [](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fnref:alu32-support)

129 | 2. Linux 5.2 中为特权用户取消了 4096 条指令对程序大小的限制。 [](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fnref:4k-limit)

130 | 3. 在实践中,验证者使用状态修剪来识别等效路径并减少要分析的指令数。 [](https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html#fnref:state-pruning)

131 |

132 |

133 |

134 | 原文链接

135 |

136 | https://pchaigno.github.io/bpf/2021/10/20/ebpf-instruction-sets.html

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/初识eBPF,eBPF发展现状.md:

--------------------------------------------------------------------------------

1 | # 初识eBPF,eBPF发展现状

2 |

3 |

4 |

5 | > eBPF 作为一颗在基础软件领域冉冉上升的新星,可谓前途大好,越来越多的基于 eBPF 的应用如雨后春笋般蓬勃涌现,这是 eBPF 展现出的惊人力量。本文就将带着大家了解 eBPF。

6 |

7 | ------

8 |

9 | 11月,「DaoCloud 道客」正式加入了 eBPF 基金会 ,是继 8 月 12 日创始成员 Facebook、Google、Isovalent、Microsoft 和 Netflix 之后,**第一家正式获准加入的中国公司**。

10 |

11 |

12 |

13 |

14 |

15 | ## **什么是 eBPF,与 eBPF 基金会?**

16 |

17 | 简单来说,**eBPF 是 Linux 内核中一个非常灵活与高效的类虚拟机 (virtual machine-like) 组件, 能够在许多内核 hook 点安全地执行字节码 (bytecode)。**很多内核子系统都已经使用了 BPF,例如常见的网络、跟踪与安全。

18 |

19 | **eBPF 基金会 (https://ebpf.io) 是一个为 eBPF 技术而创建的非盈利性组织,隶属于 Linux 基金会,其意在推动 eBPF 更好地发展,使其得到更加广泛的运用。**eBPF 基金会每年都会举办 eBPF 峰会,来自社会和各个企业的 eBPF 爱好、技术专家齐聚一堂,深度交流 eBPF 技术热点,分享创新成果。当前,eBPF 技术得到了企业的广泛应用。

20 |

21 |

22 |

23 | eBPF 技术给云原生和现代化应用带来了一些全新的解决方案和巨大的技术红利,包括可观的性能提升、CPU 开销降低。「DaoCloud 道客」作为国内云原生平台的头部供应商,非常重视 eBPF 技术给 Linux 社区、kubernetes 社区带来的技术革命。

24 |

25 | ## **eBPF如何变化演进?**

26 |

27 |

28 |

29 | 此图展示在过去的 Linux 内核版本中,引入的几个 eBPF 代表性能力,截止 Linux5.14 内核版本,已经拥有了 32 种 eBPF 程序类型。

30 |

31 | eBPF 的全称是 extended Berkeley Packet Filter,eBPF 技术的前身称为 BPF (Berkeley Packet Filter),或者 cBPF (classic BPF),在 1992 年 Steven McCanne 和 Van Jacobson 的一篇论文 《The BSD Packet Filter: A New Architecture for User-level Packet Capture》 中被第一次被提及。

32 |

33 |

34 |

35 | 最初的 Berkeley Packet Filter (BPF) 是为捕捉和过滤符合特定规则的网络包而设计的,过滤器为运行在基于寄存器的虚拟机上的程序。

36 |

37 | 在内核中运行用户指定的程序被证明是一种有用的设计,但最初 BPF 设计中的一些特性却并没有得到很好的支持。例如,虚拟机的指令集架构 (ISA) 相对落后,现在处理器已经使用 64 位的寄存器,并为多核系统引入了新的指令,如原子指令 XADD。BPF 提供的一小部分 RISC 指令已经无法在现有的处理器上使用。

38 |

39 | 因此 Alexei Starovoitov 在 eBPF 的设计中介绍了如何利用现代硬件,使 eBPF 虚拟机更接近当代处理器,eBPF 指令更接近硬件的 ISA,便于提升性能。其中**最大的变动之一是使用了 64 位的寄存器,并将寄存器的数量从 2 提升到了 10 个。**现代架构使用的寄存器远远大于 10 个,这样就可以像本机硬件一样将参数通过 eBPF 虚拟机寄存器传递给对应的函数。

40 |

41 | ## **eBPF可以做什么?**

42 |

43 | 一个 eBPF 程序会附加到指定的内核代码路径中,当执行该代码路径时,会执行对应的 eBPF 程序。鉴于它的起源,**eBPF 特别适合编写网络程序**,将该网络程序附加到网络 socket,进行流量过滤、流量分类以及执行网络分类器的动作。eBPF 程序甚至可以修改一个已建链的网络 socket 的配置。XDP 工程会在网络栈的底层运行 eBPF 程序,高性能地处理接收到的报文。从下图可以看到 eBPF 支持的功能:

44 |

45 |

46 |

47 | eBPF 对调试内核和执行性能分析也具有很大的帮助,程序可以附加到跟踪点、kprobes 和 perf 事件。因为 eBPF 可以访问内核数据结构,**开发者可以在不编译内核的前提下编写并测试代码**。对于工作繁忙的工程师,通过该方式可以方便地调试一个在线运行的系统。此外,还可以通过静态定义的追踪点调试用户空间的程序 (即 BCC 调试用户程序,如 Mysql)。

48 |

49 | 使用 eBPF 可以发挥其两大优势:**快速和安全**。为了更好地使用 eBPF,最好是全方位了解它是如何工作的。

50 |

51 | ## **eBPF如何进行工作?**

52 |

53 | **eBPF 程序是在内核中被事件触发的。**在一些特定的指令被执行时,这些事件会在 hook 处被捕获。Hook 被触发就会执行 eBPF 程序,对数据进行捕获和操作。接下来将系统介绍 eBPF 是如何工作的,你将了解到校验器流程、系统调用以及后续工作中所涉及到的程序类型、数据结构和辅助函数等内容。内核的 eBPF 校验器

54 |

55 | **在内核中运行用户空间的代码可能会存在安全和稳定性风险。因此,在加载 eBPF 程序前需要进行大量校验。**

56 |

57 |

58 |

59 | 校验器流程图

60 |

61 | **首先通过对程序控制流的深度优先搜索保证 eBPF 能够正常结束,不会因为任何循环导致内核锁定**。严禁使用无法到达的指令;任何包含无法到达的指令的程序都会导致加载失败。

62 |

63 | **第二个阶段涉及使用校验器模拟执行 eBPF 程序 (每次执行一个指令)**。在每次指令执行前后都需要校验虚拟机的状态,保证寄存器和栈的状态都是有效的。严禁越界 (代码) 跳跃,以及访问越界数据。

64 |

65 |

66 |

67 | 校验器不会检查程序的每条路径,它能够知道程序的当前状态是否是已经检查过的程序的子集。由于前面的所有路径都必须是有效的 (否则程序会加载失败),当前的路径也必须是有效的,因此允许验证器“修剪”当前分支并跳过其模拟阶段。

68 |

69 | 校验器有一个 "安全模式",禁止指针运算。当一个没有 CAP_SYS_ADMIN 特权的用户加载 eBPF 程序时会启用安全模式,确保不会将内核地址泄露给非特权用户,且不会将指针写入内存。如果没有启用安全模式,则仅允许在执行检查之后进行指针运算。例如,所有的指针访问时都会检查类型,对齐和边界冲突。

70 |

71 | 无法读取包含未初始化内容的寄存器,尝试读取这类寄存器中的内容将导致加载失败。R0-R5 的寄存器内容在函数调用期间被标记未不可读状态,可以通过存储一个特殊值来测试任何对未初始化寄存器的读取行为;对于读取堆栈上的变量的行为也进行了类似的检查,确保没有指令会写入只读的帧指针寄存器。

72 |

73 | **最后,校验器会使用 eBPF 程序类型来限制可以从 eBPF 程序调用哪些内核函数,以及访问哪些数据结构**。例如,一些程序类型可以直接访问网络报文。bpf () 系统调用

74 |

75 | 使用 bpf() 系统调用和 BPF_PROG_LOAD 命令加载程序。该系统调用的原型为:

76 |

77 | int bpf(int cmd, union bpf_attr *attr, unsigned int size);

78 |

79 | BPF_PROG_LOAD 加载的命令可以用于创建和修改 eBPF maps,maps 是普通的 key/value 数据结构,用于在 eBPF 程序和内核空间或用户空间之间通信。其他命令允许将 eBPF 程序附加到一个控制组目录或 socket 文件描述符上,迭代所有的 maps 和程序,以及将 eBPF 对象固定到文件,这样在加载 eBPF 程序的进程结束后不会被销毁 (后者由 tc 分类器 / 操作代码使用,因此可以将 eBPF 程序持久化,而不需要加载的进程保持活动状态)。完整的命令可以参考 bpf() 帮助文档。

80 |

81 |

82 |

83 | 虽然可能存在很多不同的命令,但大体可以分为以下几类:**与 eBPF 程序交互的命令、与 eBPF maps 交互的命令,或同时与程序和 maps 交互的命令(统称为对象)**。

84 |

85 | eBPF 程序类型的作用

86 |

87 | 使用 BPF_PROG_LOAD 加载的程序类型确定了四件事:

88 |

89 | 1. 附加程序的位置;

90 | 2. 验证器允许调用的内核辅助函数;

91 | 3. 是否可以直接访问网络数据报文;

92 | 4. 传递给程序的第一个参数对象的类型。

93 |

94 | 实际上,**程序类型本质上定义了一个 API**。创建新的程序类型甚至纯粹是为了区分不同的可调用函数列表 (例如,BPF_PROG_TYPE_CGROUP_SKB 和BPF_PROG_TYPE_SOCKET_FILTER)。

95 |

96 | 随着新程序类型的增加,内核开发人员也会发现需要添加新的数据结构。

97 |

98 | eBPF 数据结构

99 |

100 | **eBPF 使用的主要的数据结构是 eBPF map,这是一个通用的数据结构,用于在内核或内核和用户空间传递数据。**其名称 "map" 也意味着数据的存储和检索需要用到 key。

101 |

102 | 使用 bpf() 系统调用创建和管理 map。当成功创建一个 map 后,会返回与该 map 关联的文件描述符。关闭相应的文件描述符的同时会销毁 map。每个 map 定义了四个值:类型,元素最大数目,数值的字节大小,以及 key 的字节大小。eBPF 提供了不同的 map 类型,不同类型的 map 提供了不同的特性。

103 |

104 | 以下将会列举一下常见的类型:

105 |

106 | ```

107 | BPF_MAP_TYPE_HASH : a hash table「哈希表」

108 | BPF_MAP_TYPE_ARRAY : an array map, optimized for fast lookup speeds, often used for counters「数组映射,已针对快速查找速度进行优化,通常用于计数器」

109 | BPF_MAP_TYPE_PROG_ARRAY : an array of file descriptors corresponding to eBPF programs; used to implement jump tables and sub-programs to handle specific packet protocols「对应 eBPF 程序的文件描述符数组;用于实现跳转表和子程序处理特定的数据包协议」

110 | BPF_MAP_TYPE_PERCPU_ARRAY : a per-CPU array, used to implement histograms of latency「每个 CPU 的阵列,用于实现延迟的直方图」

111 | BPF_MAP_TYPE_PERF_EVENT_ARRAY : stores pointers to struct perf_event, used to read and store perf event counters「存储指向 struct perf_event 的指针,用于读取和存储 perf 事件计数器」

112 | BPF_MAP_TYPE_CGROUP_ARRAY : stores pointers to control groups「存储指向控制组的指针」

113 | BPF_MAP_TYPE_PERCPU_HASH : a per-CPU hash table「每个 CPU 的哈希表」

114 | BPF_MAP_TYPE_LRU_HASH : a hash table that only retains the most recently used items「仅保留最近使用项目的哈希表」

115 | BPF_MAP_TYPE_LRU_PERCPU_HASH : a per-CPU hash table that only retains the most recently used items「每个 CPU 的哈希表,仅保留最近使用的项目」

116 | BPF_MAP_TYPE_LPM_TRIE : a longest-prefix match trie, good for matching IP addresses to a range「最长前缀匹配数,适用于将 IP 地址匹配到某个范围」

117 | BPF_MAP_TYPE_STACK_TRACE : stores stack traces「存储堆栈跟踪」

118 | BPF_MAP_TYPE_ARRAY_OF_MAPS : a map-in-map data structure「map-in-map 数据结构」

119 | BPF_MAP_TYPE_HASH_OF_MAPS : a map-in-map data structure「map-in-map 数据结构」

120 | BPF_MAP_TYPE_DEVICE_MAP : for storing and looking up network device references「用于存储和查找网络设备引用」

121 | BPF_MAP_TYPE_SOCKET_MA : stores and looks up sockets and allows socket redirection with BPF helper functions「存储和查找套接字,并允许使用 BPF 辅助函数进行套接字重定向」

122 | ```

123 |

124 |

125 |

126 | 所有的 map 都可以通过 eBPF 或在用户空间的程序中使用 bpf_map_lookup_elem() 和 bpf_map_update_elem() 函数进行访问。某些map类型,如 socket map,会使用其他执行特殊任务的 eBPF 辅助函数。

127 |

128 | eBPF 的更多细节可以参见官方帮助文档eBPF 辅助函数

129 |

130 | eBPF 程序被触发时,会调用辅助函数。这些特别的函数让 eBPF 能够有访问内存的丰富功能。

131 |

132 | 可以参考官方帮助文档查看 libbpf 库提供的辅助函数。

133 |

134 | 官方文档给出了现有的 eBPF 辅助函数。更多的实例可以参见内核源码的 samples/bpf/ 和 tools/testing/selftests/bpf/ 目录。

135 |

136 | ## **eBPF相关开源项目**

137 |

138 | 使用了 eBPF 的开源项目有近百项,其中包括了如下一些耳熟能详的项目:

139 |

140 | Ciliumkubernetes 平台上一个完全基于 eBPF 实现数据转发的 CNI 网络插件。

141 |

142 | https://github.com/cilium/cilium

143 |

144 | Bcc

145 | 提供了一个基于 python 的 eBPF 编程框架

146 |

147 | https://github.com/iovisor/bcc

148 |

149 | Bpftrace提供了基于 eBPF 的 Linux 内核观测工具

150 |

151 | https://github.com/iovisor/bpftrace

152 |

153 | Falcokubernetes 平台上的一个安全监控项目

154 |

155 | https://github.com/falcosecurity/falco

156 |

157 | Katran

158 |

159 | 一个实现四层负载均衡转发的项目

160 |

161 | https://github.com/facebookincubator/katran

162 |

163 | 本文作为 eBPF 系列的第一篇科普,简单的介绍了 eBPF。eBPF 这项技术是无法简单地用言语来表达出它的魅力,只有切身体验后,才能明白这项技术的神奇。

164 |

165 | ## 作者

166 |

167 | 道客船长

168 |

169 | ## 原文链接

170 |

171 | https://mp.weixin.qq.com/s/IKR64ryK2cn3nr6CJKDgYA

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/eBPF概念和基本原理.md:

--------------------------------------------------------------------------------

1 | # eBPF概念和基本原理

2 |

3 | 大约一年前,有个朋友想要用 Rust 开发一个 EVM Assembler。在他的一再要求之下,我开始帮忙编写单元测试。那时候我还不大了解操作系统的相关知识,只好开始学习一些语法和词法方面的东西。很快这个事情就无以为继了,然而我对操作系统有了一些整体了解。之后他对 eBPF 赞赏有加时,我觉得我的春天又来了。

4 |

5 | eBPF 的门槛有点高,有 500 字的小品,也有 Cilium 铺天盖地的文档。我编写本文的目的,是针对这一新技术读者提供一个全面的入门介绍,用户可以以此为基础,进行进一步的探索。后续可以阅读 Linux Weekly News、Brenden Gregg 的网站 以及 Cilium 文档学习更多相关知识。本文设计的内容包括:

6 |

7 | - eBPF 的用处

8 | - eBPF 的原理

9 | - eBPF 的实例

10 | - 如何开始使用 eBPF

11 |

12 | ## eBPF 的用处

13 |

14 | 有了 eBPF,无需修改内核,也不用加载内核模块,程序员也能在内核中执行自定义的字节码。eBPF 和内核紧密联系,下面先介绍一些相关的基本概念。

15 |

16 | Linux 系统分为内核空间和用户空间。内核空间是操作系统的核心,对所有硬件都具备不受限制的完整的访问能力,例如内存、存储以及 CPU 等。内核既然具备了这样的超级权限,势必需要严加保护,仅允许运行最可靠的代码。而用户空间运行的就是非内核的进程——例如 I/O、文件系统等。这些进程仅能通过内核开放的系统调用,对硬件进行有限的访问。换句话说,用户空间的程序一定要经过内核空间的过滤。

17 |

18 |

19 |

20 | 系统调用接口能够满足绝大多数需要,开发者在面对新的硬件、文件系统、网络协议甚至自定义的系统调用时,还是需要更多的弹性的。在不修改内核源码的情况下,用户代码要直接访问硬件怎么办呢?可以使用 Linux 内核模块(LKM)。用户空间一般是需要通过系统调用来访问内核空间,而 LKM 是直接加载到内核的,是内核的一部分。LKM 最有价值的特点之一,就是可以在运行时加载,不用编译内核也不用重启机器。

21 |

22 |

23 |

24 | LKM 非常有用,但是也引入了很多风险。内核和用户空间不同,要进行不同的安全考量。内核空间是为了操作系统内核这样的特权代码准备的。系统调用连接了内核和用户空间,让用户空间能够对硬件进行合适的操作。换个说法,LKM 是能够让内核崩溃的。模块和内核的紧密关系,使得安全和升级成本直线升高。

25 |

26 | ### eBPF 是什么

27 |

28 | eBPF 是一个用于访问 Linux 内核服务和硬件的新方法。这一新技术已经用于网络、出错、跟踪以及防火墙等方面。

29 |

30 | `dtrace` 是一个 Solaris 和 BSD 操作系统上的动态跟踪工具,eBPF 受到 `dtrace` 的启发,原意是设计一个更好的 Linux 跟踪工具。跟 `dtrace` 不同的是,Linux 无法获取运行中系统的鸟瞰视图,它被系统调用、库调用以及函数所限制。一小撮工程师在 Berkeley Packet Filter(BPF)基础之上,构建一个内核虚拟机级别的包过滤机制,提供了类似 `dtrace` 的功能。2014 年第一个版本适配了 Linux 3.18,提供的功能相对较少。要使用完整的 eBPF,需要 Linux 4.4 或以上。

31 |

32 |

33 |

34 | 上图对 eBPF 架构进行了一个简单的展示。eBPF 程序需要满足一系列的需求,才能被加载到内核。Verifier 中有一万多行代码用来对 eBPF 程序进行检查。Verifier 会遍历对 eBPF 程序在内核中可能的执行路径进行遍历,确保程序能够在不出现导致内核锁定的循环的情况下运行完成。除此之外还有其它必须满足的检查,例如有效的寄存器状态、程序大小以及越界等。安全控制方面,eBPF 和 LKM 是颇有差异的。

35 |

36 | 如果所有的检查都通过了,eBPF 程序被加载并编译到内核中,并监听特定的信号。该信号以事件的形式出现,会被传递给被加载的 eBPF 程序。一旦被触发,字节码就会根据其中的指令执行并收集信息。

37 |

38 |

39 |

40 | 所以 eBPF 到底做了什么?程序员能够在不增加或者修改内核代码的情况下,就能够在 Linux 内核中执行自定义的字节码。虽说还远不能整体取代 LKM,eBPF 程序可以自定义代码来和受保护的硬件资源进行交互,对内核的威胁最小。

41 |

42 | ## eBPF 的机制

43 |

44 | 前面介绍了 eBPF 的基础架构。这些能力是由多个组件协同实现的,每一种都有自己的复杂度。

45 |

46 | ### eBPF 程序剖析

47 |

48 | #### 事件和钩子

49 |

50 | eBPF 程序是在内核中被事件触发的。在一些特定的指令被执行时时,这些事件会在钩子处被捕获。钩子被触发就会执行 eBPF 程序,对数据进行捕获和操作。钩子定位的多样性正是 eBPF 的闪光点之一。例如下面几种:

51 |

52 | - 系统调用:当用户空间程序通过系统调用执行内核功能时。

53 | - 功能的进入和退出:在函数退出之前拦截调用。

54 | - 网络事件:当接收到数据包时。

55 | - kprobe 和 uprobe:挂接到内核或用户函数中。

56 |

57 | #### 辅助函数

58 |

59 | eBPF 程序被触发时,会调用辅助函数。这些特别的函数让 eBPF 能够有访问内存的丰富功能。例如 Helper 能够执行一系列的任务:

60 |

61 | - 在数据表中对键值对进行搜索、更新以及删除。

62 | - 生成伪随机数。

63 | - 搜集和标记隧道元数据。

64 | - 把 eBPF 程序连接起来,这个功能被称为 `tail call`。

65 | - 执行 Socket 相关任务,例如绑定、获取 Cookie、数据包重定向等。

66 |

67 | 这些助手函数必须是内核定义的,换句话说,eBPF 程序的调用能力是受到一个白名单限制的。这个名单很长,并且还在持续增长之中。

68 |

69 | #### Map

70 |

71 | 要在 eBPF 程序和内核以及用户空间之间存储和共享数据,eBPF 需要使用 Map。正如其名,Map 是一种键值对。Map 能够支持多种数据结构,eBPF 程序能够通过辅助函数在 Map 中发送和接收数据。

72 |

73 | ### 执行 eBPF 程序

74 |

75 | #### 加载和校验

76 |

77 | 所有 eBPF 程序都是以字节码的形式执行的,因此需要有办法把高级语言编译成这种字节码。eBPF 使用 LLVM 作为后端,前端可以介入任何语言。因为 eBPF 使用 C 编写的,所以前端使用的是 Clang。但在字节码被 Hook 之前,必须通过一系列的检查。在一个类似虚拟机的环境下用内核 Verifier阻止带有循环、权限不正确或者导致崩溃的程序运行。如果程序通过了所有的检查,字节码会使用 `bpf()` 系统调用被载入到 Hook 上。

78 |

79 | #### JIT 编译器

80 |

81 | 校验结束后,eBPF 字节码会被 JIT 编译器转译成本地机器码。eBPF 是 64 位编码,共有 11 个寄存器,因此 eBPF 和 x86、ARM 以及 arm64 等硬件都能紧密对接。虽然 eBPF 受到 VM 限制,JIT 过程保障了它的运行性能。

82 |

83 |

84 |

85 | ### 总结

86 |

87 | 上面的概念们放在一起,eBPF 程序通过安全检查后插入钩子,被事件触发之后,程序会启动执行,用辅助函数和 Map 来对数据进行存储和操作。下一届我们来研究一下它们的协同方式。

88 |

89 | ## 一个例子

90 |

91 | 在 Gravitational 有一个叫做 Teleport 的开源项目,其中使用了 eBPF 程序进行跟踪和网络操作。有的组织希望知道 SSH 会话中发生了什么,Teleport 提供 SSH 访问途径的同时,加入了对用户行为的记录。可以通过对命令编码、在 Shell 脚本中运行命令的方式来进行混淆,从而阻碍对会话的记录。

92 |

93 | Teleport 4.2 中,我们引入了会话记录,其中用了三个 eBPF 程序来获取 SSH 会话,并将其转化为结构化的事件。

94 |

95 |

96 |

97 | 例如 `echo Y3VybCBodHRwOi8vd3d3LmV4YW1wbGUuY29tCg== | base64 --decode | sh`,我们能够在终端抓取到这个命令,但是这并无意义,用户已经对命令进行了混淆,但是有了 eBPF,我们就能知道,用户试图隐藏的是 `curl`:

98 |

99 | ```

100 | {

101 | "event": "session.command",

102 | "path": "/bin/sh",

103 | "program": "sh",

104 | "argv": [],

105 | "login": "centos",

106 | "user": "jsmith"}

107 | {

108 | "event": "session.command",

109 | "path": "/bin/base64",

110 | "program": "base64",

111 | "argv": [ "--decode"

112 | ],

113 | "login": "centos",

114 | "user": "jsmith"}

115 | {

116 | "event": "session.command",

117 | "path": "/bin/curl",

118 | "argv": [ "http://www.example.com"

119 | ],

120 | "program": "curl",

121 | "return_code": 0,

122 | "login": "centos",

123 | "user": "jsmith"}

124 | {

125 | "event": "session.network",

126 | "program": "curl",

127 | "src_addr": "172.31.43.104",

128 | "dst_addr": "93.184.216.34",

129 | "dst_port": 80,

130 | "login": "centos",

131 | "user": "jsmith",

132 | "version": 4}

133 | ```

134 |

135 | 借助 eBPF 的能力,我们把这种混淆行为转换为事件流,便于导出和分析。Teleport 用 `execsnoop`、`opensnoop` 以及 `tcpconnect` 来恢复这些事件。特别会关注的是 `tcpconnect`,它最终将信息以 JSON 的形式返回来。

136 |

137 |

138 |

139 | `tcpconnect` 会跟踪 TCP 连接。像 Teleport 这样用 SSH 证书管理访问的工具来说,必须要知道 TCP 连接的发起情况。`tcpconnect` 能跟踪 `connect()` 系统调用,该调用会在 Socket 上初始化一个连接。要对这个情况进行跟踪,tcpconnect 在内核中插入了一个 `kprobe`,能够动态进入任何例程:

140 |

141 | ```

142 | # initializeBPF b = BPF(text=bpf_text) b.attach_kprobe(event="tcp_v4_connect", fn_name="trace_connect_entry") b.attach_kretprobe(event="tcp_v4_connect", fn_name="trace_connect_v4_return")

143 | ```

144 |

145 | 程序被触发以后,`tcpconnect` 会开始输出信息,下表展示的就是这样的信息:

146 |

147 | ```

148 | $ ./tcpconnect

149 | PID COMM SADDR DADDR DPORT

150 | -----------------------------------------------------

151 | 2315 curl 172.31.43.104 93.184.216.34 80

152 | ```

153 |

154 | 所有这些数据都是用辅助函数收集而来。如果看看 Python 代码,会发现 `tcpconnect` 试用了来自 bcc 的 BPF 库的辅助函数来对上述输出内容进行格式化。

155 |

156 | ```

157 | ...struct ipv4_data_t data4 = {.pid = pid, .ip = ipver};

158 | data4.saddr = skp->__sk_common.skc_rcv_saddr;

159 | data4.daddr = skp->__sk_common.skc_daddr;

160 | data4.dport = ntohs(dport);

161 | bpf_get_current_comm(&data4.task, sizeof(data4.task));

162 | ...

163 | ```

164 |

165 | ## eBPF 入门

166 |

167 | 行文至此,我希望读者已经对 eBPF 有了一个最基础的了解,知道了他的重要性以及基本原理。是时候浏览更多技术文档和文章了。本文中提供了不少链接,不过这里最推荐的是 Quinten Monnet 的博客。

168 |

169 | 自行编写代码,开发自己的 eBPF 可能有点难。但是很多开源的开发工具链正在涌现,简化了很多 eBPF 的相关场景。下面介绍几个最流行的:

170 |

171 | - BCC:BCC 是一个工具包用于创建高效的内核跟踪和处理程序,并包含了很多有用的工具和示例。BCC 简化了 BPF 程序的开发,内核指令使用 C 指令(包含了 LLVM 的封装),前端使用的是 Python 和 LUA。BCC 有很多用途,例如性能分析和网络流量控制。BCC 还为其它程序提供了 API。

172 | - bpftrace:BPFtrace 是一个高级跟踪语言,用 LLVM 作为后端把脚本编译为 BPF 字节码,并用 BCC 和 Linux BPF 系统进行交互,并支持现有的 Linux 跟踪能力:kprobe、uprobe 以及 `tracepoint`。

173 | - Go、C/C++ 以及 Rust 的通用库。

174 |

175 | ## 结论

176 |

177 | eBPF 还是个很新鲜的技术,让程序员在不修改内核空间的情况下,能够在内核中执行自定义的字节码并从内核函数中获取更多信息。原本这些目标需要通过系统调用或内核模块来完成,eBPF 降低了所需的复杂度和危险性。简单来说,eBPF 的工作流程:

178 |

179 | - 把 eBPF 程序编译成字节码。

180 | - 在载入到 Hook 之前,在虚拟机中对程序进行校验。

181 | - 把程序附加到内核之中,被特定事件触发。

182 | - JIT 编译。

183 | - 在程序被触发时,调用辅助函数处理数据。

184 | - 在用户空间和内核空间之间使用键值对共享数据。

185 |

186 | ## 推荐阅读

187 |

188 | - SCP - Familiar, Simple, Insecure, and Slow

189 | - Greed is Good: Creating Teleport’s Discovery Protocol

190 | - Gracefully Restarting a Go Program Without Downtime

191 |

192 | ## 相关链接

193 |

194 | - **What is eBPF and How Does it Work?**:`https://gravitational.com/blog/what-is-ebpf/`

195 | - **Virag Mody**:`https://www.linkedin.com/in/virag-mody-650974a9`

196 | - **EVM Assembler**:`https://medium.com/mycrypto/the-ethereum-virtual-machine-how-does-it-work-9abac2b7c9e`

197 | - **Cilium**:`https://cilium.io/`

198 | - **Linux Weekly News**:`https://lwn.net/Articles/740157/`

199 | - **Brenden Gregg 的网站**:`http://www.brendangregg.com/index.html`

200 | - **Cilium 文档**:`https://docs.cilium.io/en/stable/bpf/`

201 | - **Linux 内核模块(LKM)**:`https://tldp.org/LDP/lkmpg/2.6/html/lkmpg.html`

202 | - **what is ebpf 1**:`image/what-is-ebpf-1.png`

203 | - **what is ebpf 2**:`images/what-is-ebpf-2.png`

204 | - **Verifier**:`https://github.com/torvalds/linux/blob/master/kernel/bpf/verifier.c`

205 | - **名单**:`https://man7.org/linux/man-pages/man7/bpf-helpers.7.html`

206 | - **LLVM**:`https://llvm.org/`

207 | - **Clang**:`https://clang.llvm.org/`

208 | - **内核 Verifier**:`https://elixir.bootlin.com/linux/latest/source/kernel/bpf/verifier.c`

209 | - **what-is-ebpf-3.png**:`images/what-is-ebpf-3.png`

210 | - **Teleport**:`https://gravitational.com/teleport`

211 | - **Teleport 4.2**:`https://gravitational.com/blog/teleport-release-4-2`

212 | - **what-is-ebpf-4.png**:`images/what-is-ebpf-4.png`

213 | - **Python 代码**:`https://github.com/iovisor/bcc/blob/ec3747ed6b16f9eec36a204dfbe3506d3778dcb4/tools/tcpconnect.py`

214 | - **bcc 的 BPF 库**:`https://github.com/iovisor/bcc/blob/master/src/cc/export/helpers.h`

215 | - **Quinten Monnet**:`https://qmonnet.github.io/whirl-offload/2016/09/01/dive-into-bpf/`

216 | - **BCC**:`https://github.com/iovisor/bcc`

217 | - **bpftrace**:`https://github.com/ajor/bpftrace`

218 | - **Go**:`https://github.com/iovisor/gobpf`

219 | - **C/C++**:`https://github.com/libbpf/libbpf`

220 | - **Rust**:`https://github.com/redsift/redbpf`

221 | - **SCP - Familiar, Simple, Insecure, and Slow**:`https://gravitational.com/blog/scp-familiar-simple-insecure-slow/`

222 | - **Greed is Good: Creating Teleport’s Discovery Protocol**:`https://gravitational.com/blog/teleport-discovery-protocol/`

223 | - **Gracefully Restarting a Go Program Without Downtime**:`https://gravitational.com/blog/golang-ssh-bastion-graceful-restarts/`

224 |

225 | 文章转载自伪架构师。[点击这里阅读原文了解更多](https://mp.weixin.qq.com/s?__biz=MzIxMDY5ODM1OA==&mid=2247485238&idx=1&sn=c4a2be9542210f51506fac520b540c5d&scene=21#wechat_redirect)。

--------------------------------------------------------------------------------

/ebpf-guide/eBPF基础/eBPF的实现原理.md:

--------------------------------------------------------------------------------

1 | # eBPF的实现原理

2 |

3 | 在介绍 eBPF 的实现原理前,我们先来回顾一下 eBPF 的架构图:

4 |

5 |

6 |

7 | 这幅图对理解 eBPF 实现原理有非常大的作用,在分析 eBPF 实现原理时,要经常参照这幅图来进行分析。

8 |

9 | ## eBPF虚拟机

10 |

11 | 其实我不太想介绍 eBPF 虚拟机的,因为一般来说很少会用到 eBPF 汇编来写程序。但是,不介绍 eBPF 虚拟机的话,又不能说清 eBPF 的原理。

12 |

13 | 所以,还是先简单介绍一下 eBPF 虚拟机的原理,这样对分析 eBPF 实现有很大的帮助。

14 |

15 | ### eBPF汇编

16 |

17 | eBPF 本质上是一个虚拟机(Virtual Machine),可以执行 eBPF 字节码。

18 |

19 | 用户可以使用 eBPF 汇编或者 C 语言来编写程序,然后编译成 eBPF 字节码,再由 eBPF 虚拟机执行。

20 |

21 | > **什么是虚拟机?**

22 | >

23 | > 官方的解释是:虚拟机(VM)是一种创建于物理硬件系统(位于外部或内部)、充当虚拟计算机系统的虚拟环境,它模拟出了自己的整套硬件,包括 CPU、内存、网络接口和存储器。通过名为虚拟机监控程序的软件,用户可以将机器的资源与硬件分开并进行适当设置,以供虚拟机使用。

24 | >

25 | > 通俗的解释:虚拟机就是模拟计算机的运行环境,你可以把它当成是一台虚拟出来的计算机。

26 | >

27 | > 计算机的最本质功能就是执行代码,所以 eBPF 虚拟机也一样,可以运行 eBPF 字节码。

28 |

29 | 用户编写的 eBPF 程序最终会被编译成 eBPF 字节码,eBPF 字节码使用 `bpf_insn` 结构来表示,如下:

30 |

31 | ```

32 | struct bpf_insn {

33 | __u8 code; // 操作码

34 | __u8 dst_reg:4; // 目标寄存器

35 | __u8 src_reg:4; // 源寄存器

36 | __s16 off; // 偏移量

37 | __s32 imm; // 立即操作数

38 | };

39 | ```

40 |

41 | 下面介绍一下 `bpf_insn` 结构各个字段的作用:

42 |

43 | 1. `code`:指令操作码,如 mov、add 等。

44 | 2. `dst_reg`:目标寄存器,用于指定要操作哪个寄存器。