├── tutorials

├── gui

│ ├── add_camera

│ │ ├── 4_add_camera.usd

│ │ └── 4_add_camera.md

│ ├── move_simple_robot

│ │ ├── 3_move_robot.usd

│ │ └── 3_move_robot.md

│ ├── create_simple_robot

│ │ ├── 2_create_robot.usd

│ │ └── 2_create_simple_robot.md

│ ├── script_editor

│ │ ├── 5_script_editor_USDAPI.usd

│ │ ├── 5_script_editor_IssacSimCoreAPI.usd

│ │ └── 5_script_editor.md

│ ├── save_custom_usd

│ │ └── 33_save_custom_usd.md

│ ├── cad_importer

│ │ └── 35_cad_importer.md

│ ├── change_object_texture

│ │ └── 34_change_object_texture.md

│ └── intaractive_demos

│ │ └── 37_interactive_demos.md

├── required

│ ├── hello_world

│ │ ├── 8_hello_world.usd

│ │ ├── my_application.py

│ │ └── 8_hellow_world.md

│ ├── isaac_sim_workflow

│ │ ├── 7_issac_sim_workflows.usd

│ │ └── 7_isaac_sim_workflows.md

│ ├── required_interface

│ │ ├── 6_required_interface.usd

│ │ └── 6_required_interface.md

│ ├── adding_controller

│ │ └── 10_adding_controller.md

│ ├── hello_robot

│ │ └── 9_hello_robot.md

│ ├── adding_a_manipulator_robot

│ │ └── 11_adding_a_manipulator_robots.md

│ ├── mutiple_tasks

│ │ └── 13_multiple_tasks.md

│ └── adding_multiple_robots

│ │ └── 12_adding_multiple_robots.md

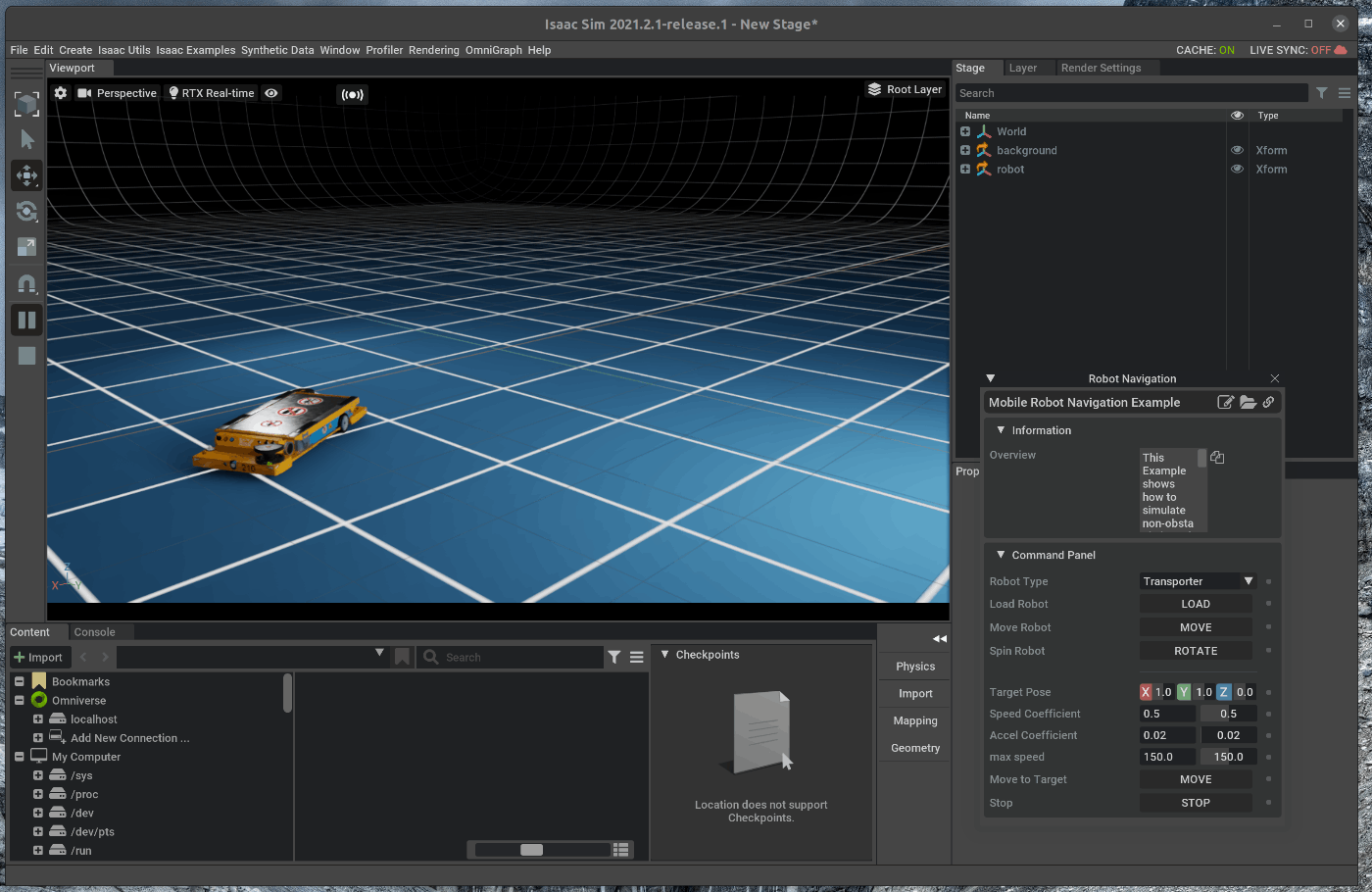

├── ros

│ ├── cameras

│ │ ├── simple_room_apriltag_with_turtlebot3_with_camera.usd

│ │ └── 26_cameras.md

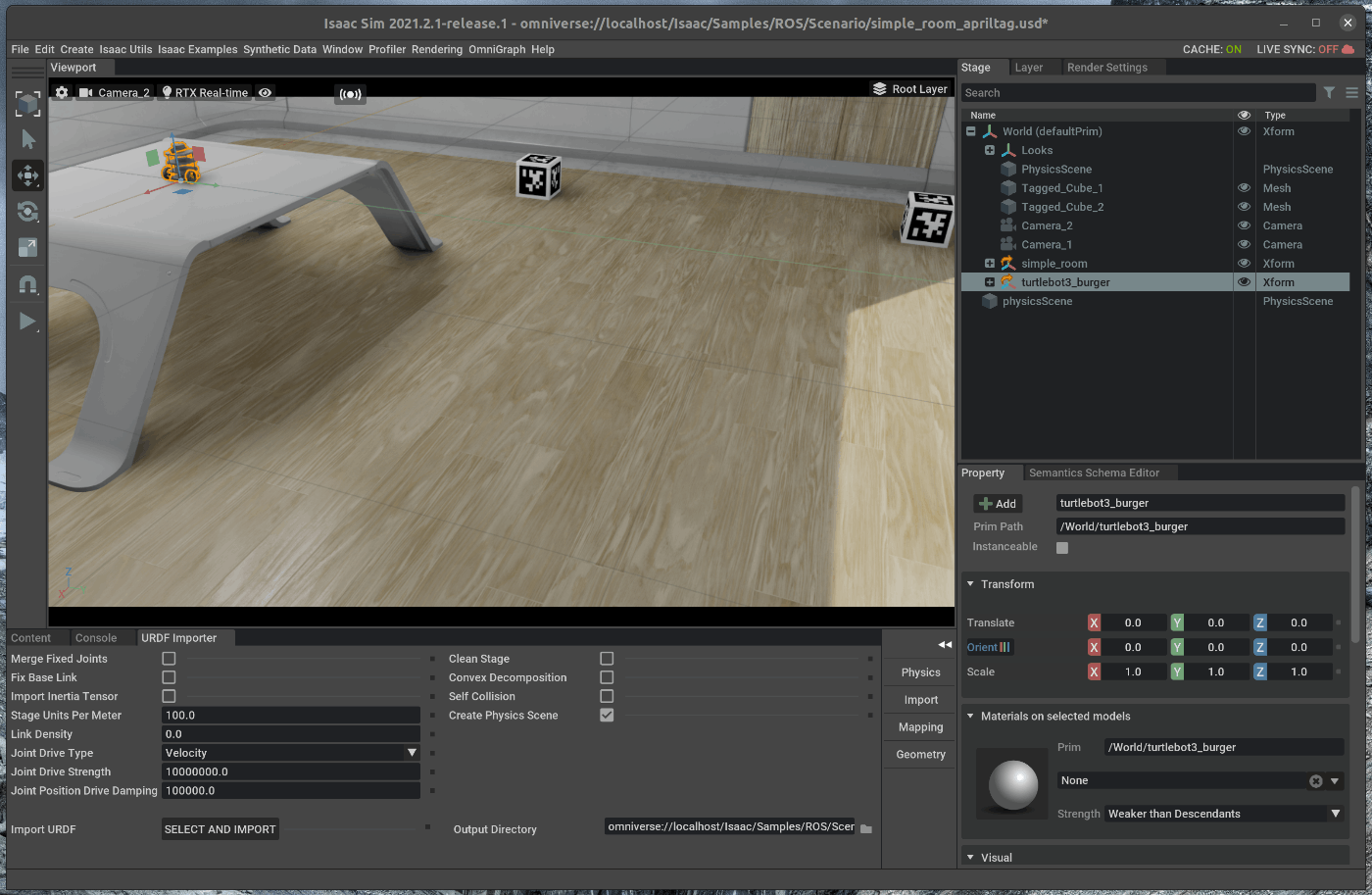

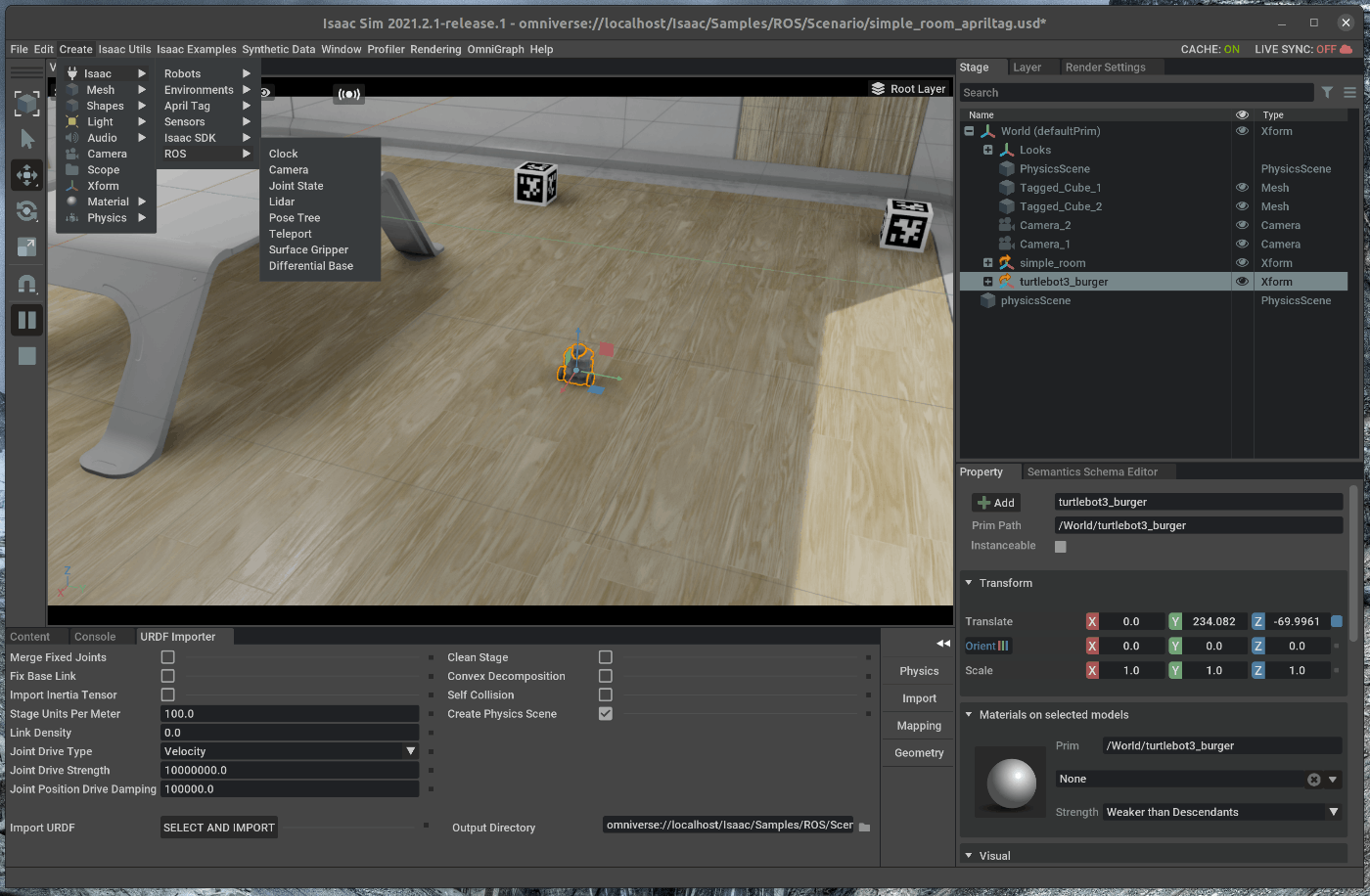

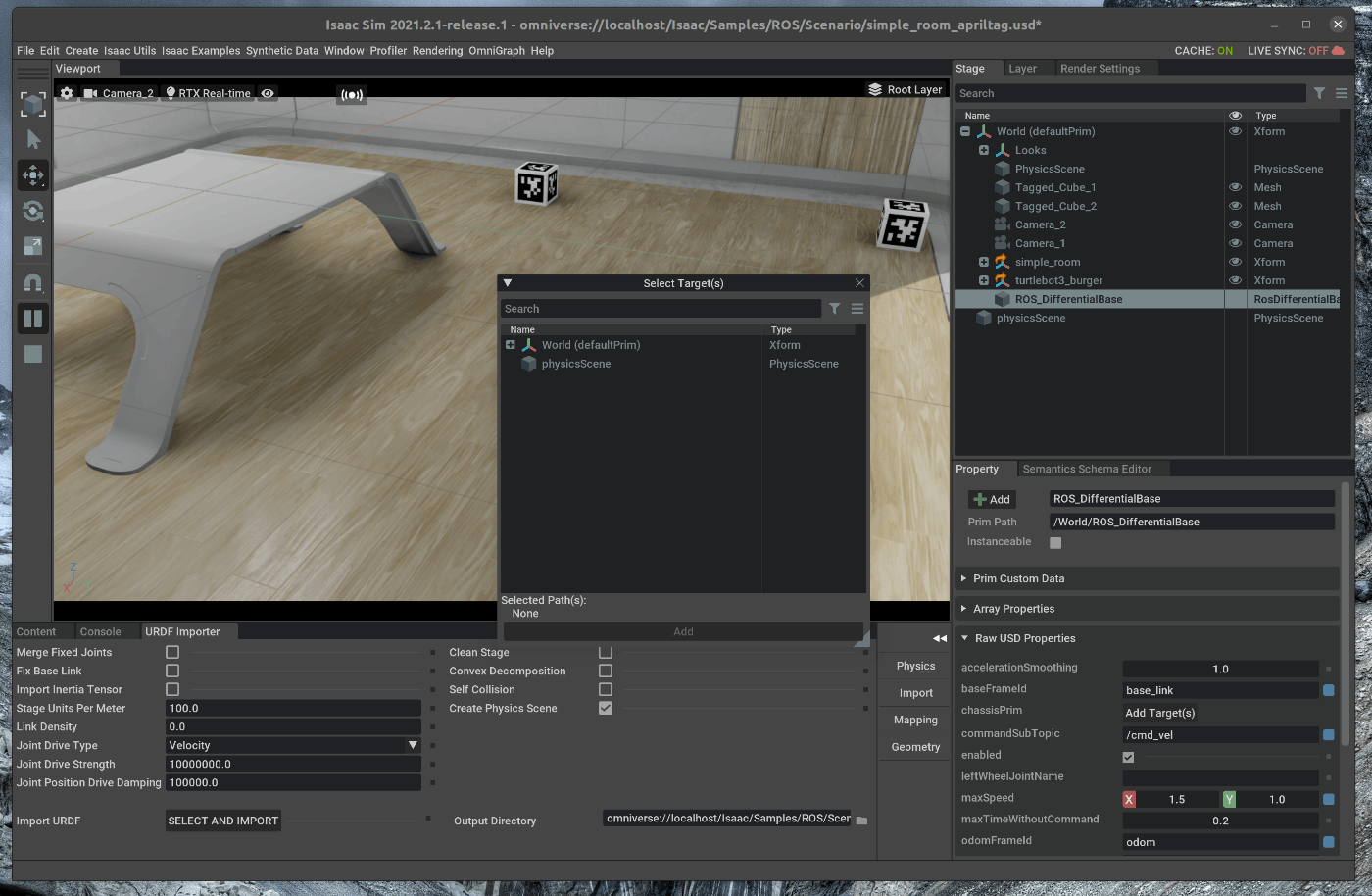

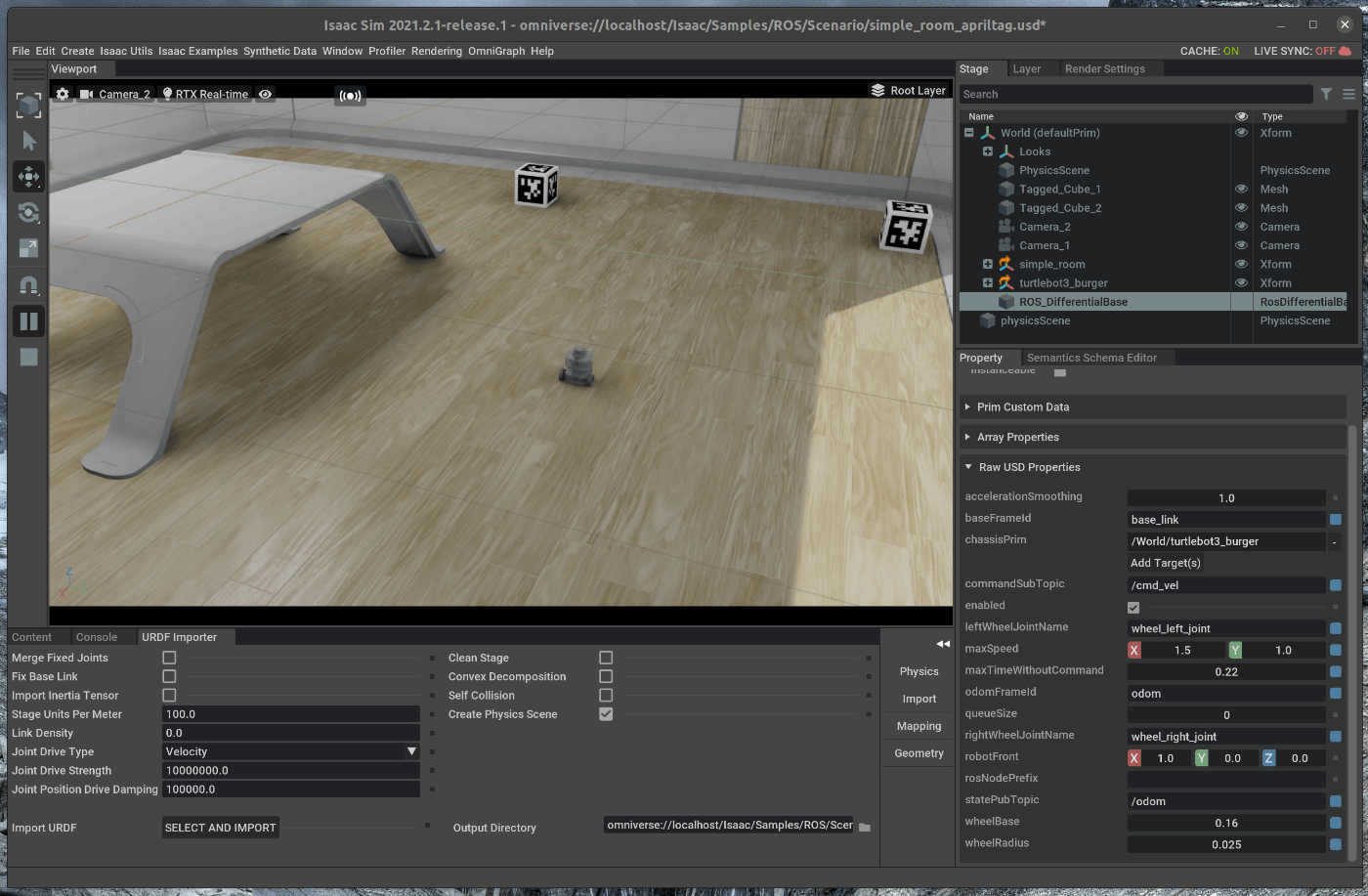

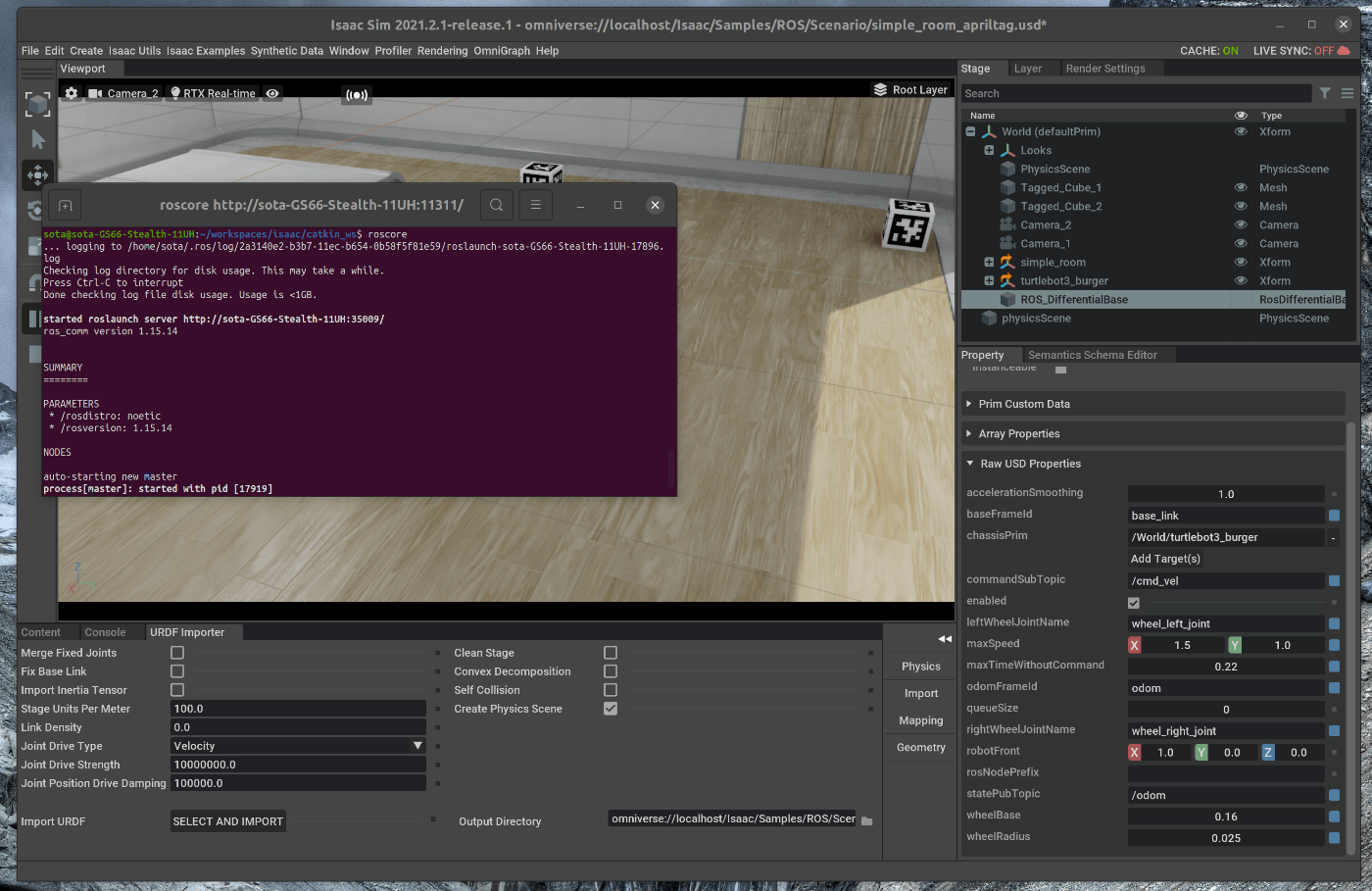

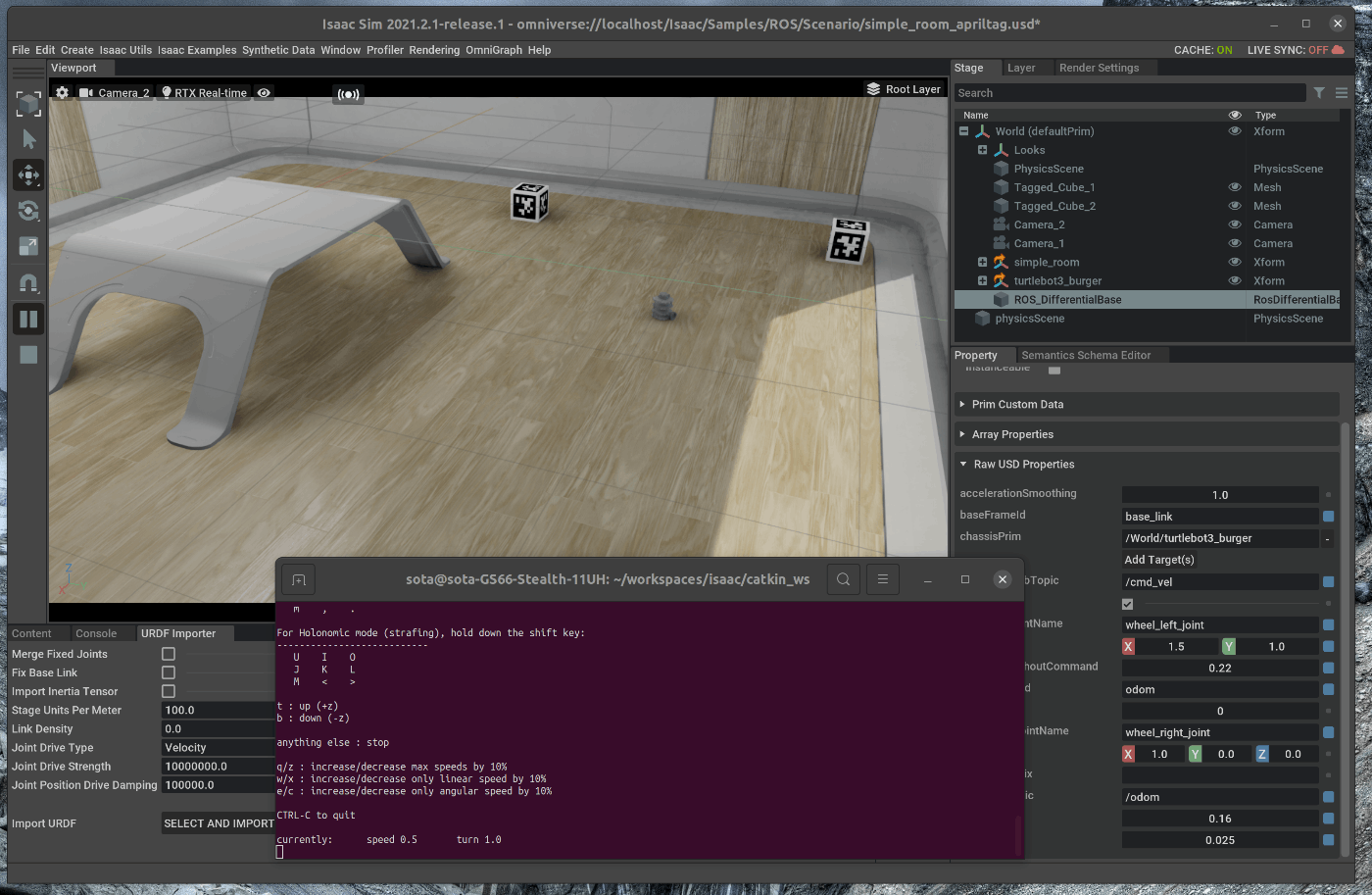

│ ├── import_and_drive_turtlebot3

│ │ ├── simple_room_apriltag_with_turtlebot3.usd

│ │ └── 25_import_and_drive_turtlebot3.md

│ ├── lidar_sensors

│ │ ├── simple_room_apriltag_with_turtlebot3_with_camera_and_lidar.usd

│ │ └── 27_lidar_sensors.md

│ ├── transform_trees

│ │ ├── simple_room_apriltag_with_turtlebot3_with_camera_and_lidar_tf_publisher.usd

│ │ └── 28_transform_trees.md

│ ├── april_tags

│ │ └── 29_april_tags.md

│ ├── moveit_motion_planning_framework

│ │ └── 32_moveit_motion_planning_framework.md

│ ├── ros_navigation

│ │ └── 30_ros_navigation.md

│ └── multiple_robots_ros_navigation

│ │ └── 31_multiple_robots_ros_navigation.md

├── advanced

│ ├── using_input_devices_keyboard

│ │ └── 14_using_input_devices_keyboard.md

│ ├── using_contact_sensor

│ │ └── 36_using_contact_sensor.md

│ ├── occupancy_map_generation

│ │ └── 17_occupacy_map_generation.md

│ ├── using_sensors_generic_range_sensor

│ │ └── 16_using_sensor_generic_range_sensor.md

│ ├── jupyter_notebook

│ │ └── 18_jupyter_notebook.md

│ ├── dynamic_control

│ │ └── 38_dynamic_control.md

│ └── using_sensors_lidar

│ │ └── 15_using_sensor_lidar.md

├── replicator

│ ├── visualize_synthetic_data

│ │ └── 21_visualize_synthetic_data.md

│ ├── offline_dataset_generation

│ │ └── 22_offline_dataset_generation.md

│ ├── recording_synthetic_data

│ │ └── 20_recording_synthetic_data.md

│ ├── applying_and_visualizing_semantic_data

│ │ └── 19_applying_and_visualizing_semantic_data.md

│ ├── replicator_playgroud

│ │ └── 23_replicator_playgroud.md

│ └── replicator_composer

│ │ └── 24_replicator_composer.md

└── install

│ └── 1_install.md

└── README.md

/tutorials/gui/add_camera/4_add_camera.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/gui/add_camera/4_add_camera.usd

--------------------------------------------------------------------------------

/tutorials/gui/move_simple_robot/3_move_robot.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/gui/move_simple_robot/3_move_robot.usd

--------------------------------------------------------------------------------

/tutorials/required/hello_world/8_hello_world.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/required/hello_world/8_hello_world.usd

--------------------------------------------------------------------------------

/tutorials/gui/create_simple_robot/2_create_robot.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/gui/create_simple_robot/2_create_robot.usd

--------------------------------------------------------------------------------

/tutorials/gui/script_editor/5_script_editor_USDAPI.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/gui/script_editor/5_script_editor_USDAPI.usd

--------------------------------------------------------------------------------

/tutorials/gui/script_editor/5_script_editor_IssacSimCoreAPI.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/gui/script_editor/5_script_editor_IssacSimCoreAPI.usd

--------------------------------------------------------------------------------

/tutorials/required/isaac_sim_workflow/7_issac_sim_workflows.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/required/isaac_sim_workflow/7_issac_sim_workflows.usd

--------------------------------------------------------------------------------

/tutorials/required/required_interface/6_required_interface.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/required/required_interface/6_required_interface.usd

--------------------------------------------------------------------------------

/tutorials/ros/cameras/simple_room_apriltag_with_turtlebot3_with_camera.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/ros/cameras/simple_room_apriltag_with_turtlebot3_with_camera.usd

--------------------------------------------------------------------------------

/tutorials/ros/import_and_drive_turtlebot3/simple_room_apriltag_with_turtlebot3.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/ros/import_and_drive_turtlebot3/simple_room_apriltag_with_turtlebot3.usd

--------------------------------------------------------------------------------

/tutorials/ros/lidar_sensors/simple_room_apriltag_with_turtlebot3_with_camera_and_lidar.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/ros/lidar_sensors/simple_room_apriltag_with_turtlebot3_with_camera_and_lidar.usd

--------------------------------------------------------------------------------

/tutorials/ros/transform_trees/simple_room_apriltag_with_turtlebot3_with_camera_and_lidar_tf_publisher.usd:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/SOutaHI/isaac_sim_examples/HEAD/tutorials/ros/transform_trees/simple_room_apriltag_with_turtlebot3_with_camera_and_lidar_tf_publisher.usd

--------------------------------------------------------------------------------

/tutorials/required/hello_world/my_application.py:

--------------------------------------------------------------------------------

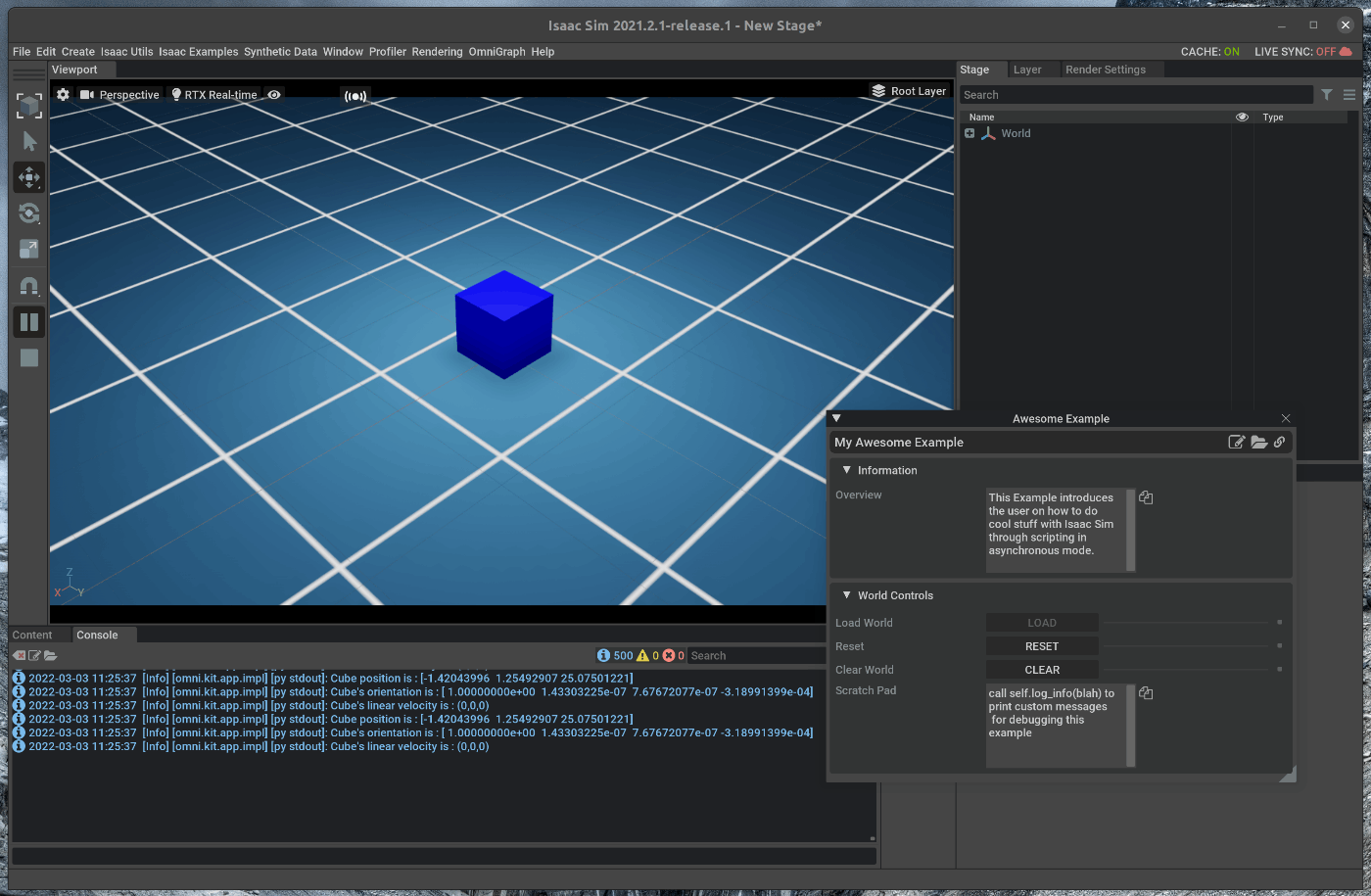

1 | #launch Isaac Sim before any other imports

2 | #default first two lines in any standalone application

3 |

4 | # if exe this script, you have to exe from python.sh

5 | # https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/manual_standalone_python.html

6 |

7 |

8 | from omni.isaac.kit import SimulationApp

9 | simulation_app = SimulationApp({"headless": False}) # we can also run as headless.

10 |

11 | from omni.isaac.core import World

12 | from omni.isaac.core.objects import DynamicCuboid

13 | import numpy as np

14 |

15 | world = World(stage_units_in_meters=0.01)

16 | world.scene.add_default_ground_plane()

17 | fancy_cube = world.scene.add(

18 | DynamicCuboid(

19 | prim_path="/World/random_cube",

20 | name="fancy_cube",

21 | position=np.array([0, 0, 100.0]),

22 | size=np.array([50.15, 50.15, 50.15]),

23 | color=np.array([0, 0, 1.0]),

24 | ))

25 | # Resetting the world needs to be called before querying anything related to an articulation specifically.

26 | # Its recommended to always do a reset after adding your assets, for physics handles to be propagated properly

27 | world.reset()

28 | for i in range(500):

29 | position, orientation = fancy_cube.get_world_pose()

30 | linear_velocity = fancy_cube.get_linear_velocity()

31 | # will be shown on terminal

32 | print("Cube position is : " + str(position))

33 | print("Cube's orientation is : " + str(orientation))

34 | print("Cube's linear velocity is : " + str(linear_velocity))

35 | # we have control over stepping physics and rendering in this workflow

36 | # things run in sync

37 | world.step(render=True) # execute one physics step and one rendering step

38 |

39 | simulation_app.close() # close Isaac Sim

40 |

--------------------------------------------------------------------------------

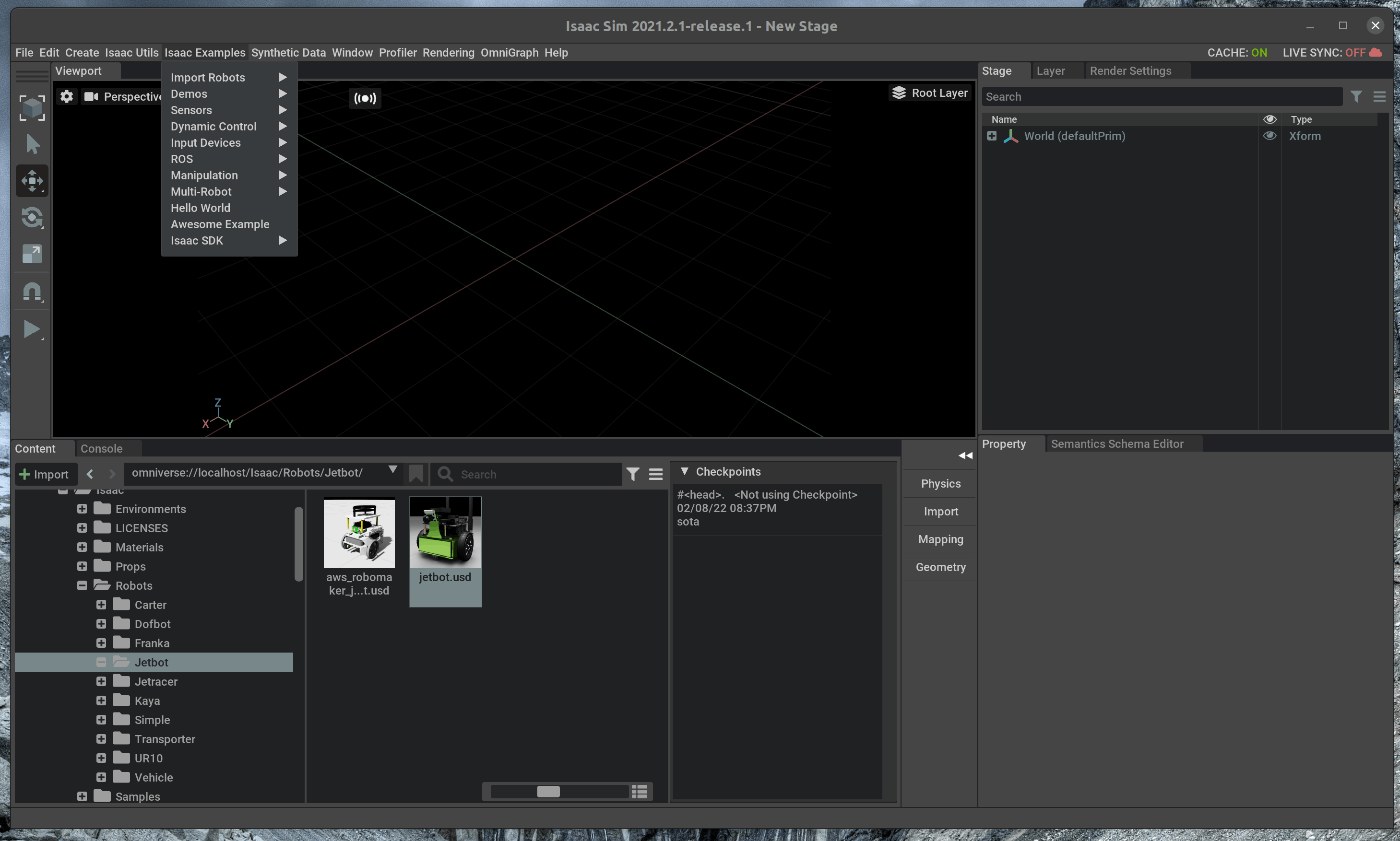

/tutorials/advanced/using_input_devices_keyboard/14_using_input_devices_keyboard.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | keyboardからの入力を、シミュレーション内で使用するExampleを紹介します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_keyboard_control.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 | # 概要

24 |

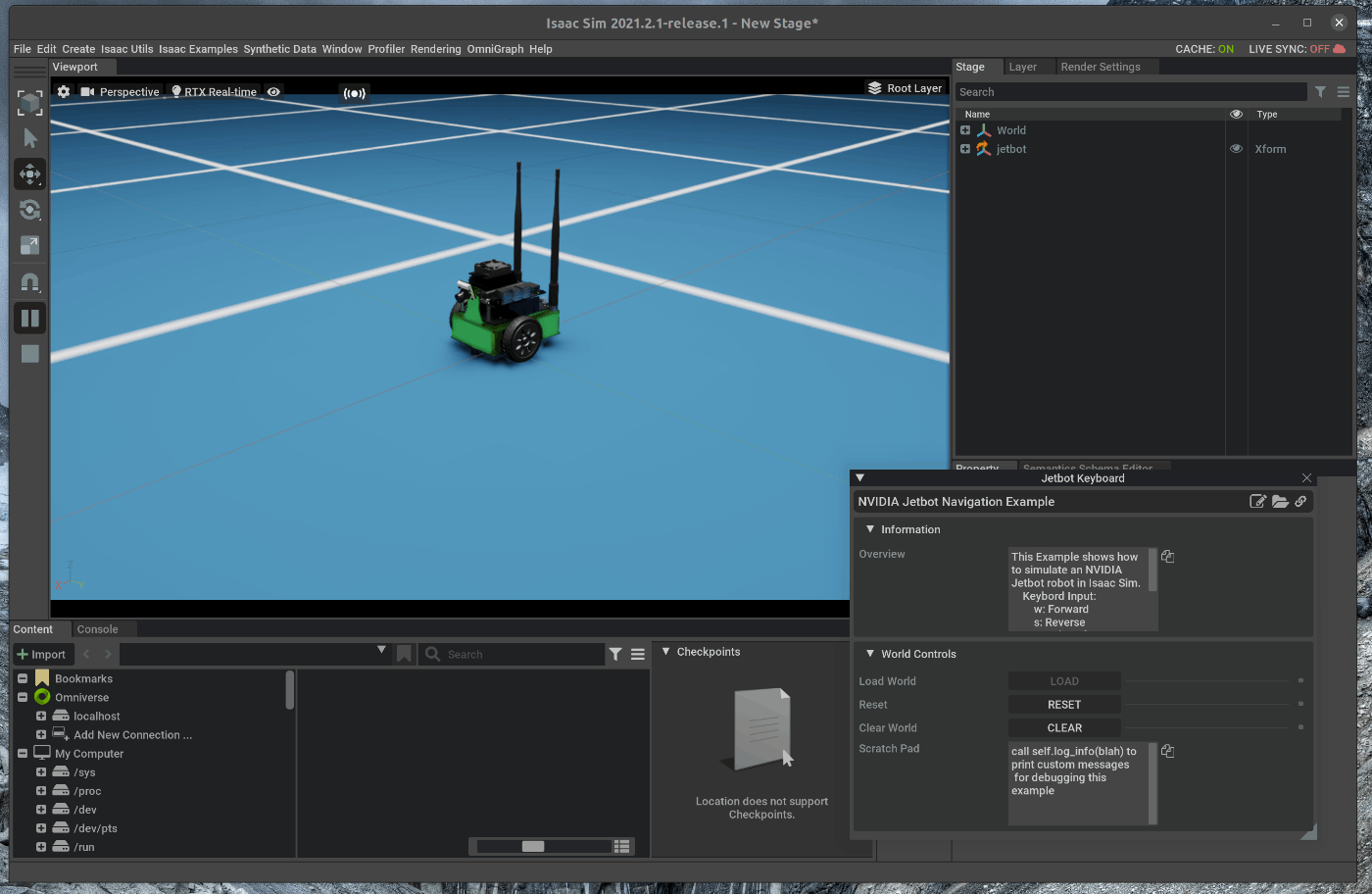

25 | JetbotのExampleとして、キーボードからの入力により、Jetbotの両輪の速度を制御します。

26 |

27 | 1. Jetbot Keyboardを実行する

28 |

29 | ## 1. Jetbot Keyboardを実行する

30 | ### 1.1 OmniverseからIssac Simを起動する

31 |

32 |

33 | ### 1.2 Jetbot Keyboardのソースコードを表示

34 | メニューバーのIsaac Examples > Input Devices > Jetbot Keyboardを選択します。

35 |

36 |

37 | 次に、Jetbot keyboardのウィンドウの右上にある3つのボタンの内、一番左側のOpen Source Codeボタンを選択します。

38 |

39 |

40 | 選択すると、がVScodeが開き、Jetbot keyboardのソースコードが表示されます。

41 |

42 |

43 |

44 | Loadを選択すると、Jetbotが表示されます。

45 |

46 |

47 | この状態で、Viewportの左側のPLAYボタンを押すと、Keyboardからの入力を受け付け、Jetbotが移動します。

48 |

49 | - W: 前進

50 | - S: 停止

51 | - A: 左旋回

52 | - D: 右旋回

53 |

54 |

55 |

56 |

--------------------------------------------------------------------------------

/tutorials/advanced/using_contact_sensor/36_using_contact_sensor.md:

--------------------------------------------------------------------------------

1 |

2 | # 概要

3 | シミュレーション内で接触センサを使用します。

4 |

5 | Issac SimのDocumentationのExtension部分に上記の内容が記載されており、この内容に沿って進めます。

6 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/ext_omni_isaac_contact_sensor.html

7 |

8 | # 実行環境

9 |

10 | - インストール実行環境

11 |

12 | | unit | specification |

13 | |:-----------------:|:------------------:|

14 | | CPU | i9-11900H |

15 | | GPU | GeForce RTX 3080 Laptop|

16 | | RAM | 32GB |

17 | | OS | Ubuntu 20.04.3 LTS |

18 |

19 | - Nvidia Driverバージョン

20 | - 510.39.01

21 | - Issac simバージョン

22 | - 2021.2.1

23 |

24 |

25 | # 手順

26 |

27 | Isaac SimのExampleの中に、接触センサのExampleが存在します。

28 | 今回はこのExamdpleを実行します。

29 |

30 | 1. Exampleシーンのロード

31 | 2. シミュレーションの実行

32 |

33 |

34 | ## 1. Exampleシーンのロード

35 |

36 | ### 1.1 OmniverseからIssac Simを起動する

37 |

38 |

39 | ### 1.2 Exampleシーンをロードする

40 | メニューバーのIsaac Examples > Sensors > Contactを選択します。

41 |

42 |

43 |

44 | ポップアップしたウィンドウにおいて、”Open Source Code”をクリックすると、ExampleのソースコードがVscode上に展開されます。

45 |

46 |

47 | ## 2. シミュレーションの実行

48 | ## 2.1 シミュレーションを実行する

49 | Viewportの左側のPLAYボタンを押すと、シミュレーションが開始されます。

50 | センサ値はロボットの各足部に設定されており、取得されるセンサ値は、Exampleシーンロード時のポップアップウィンドウに表示されます。

51 |

52 |

53 |

54 | センサ値はロボットの各足部に設定されており、取得されるセンサ値は、Exampleシーンロード時のポップアップウィンドウに表示されます。

55 |

56 |

--------------------------------------------------------------------------------

/tutorials/replicator/visualize_synthetic_data/21_visualize_synthetic_data.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | 保存した合成データをVisualizeします。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_visualize_groundtruth.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | 保存した合成データをVisualizeします。

26 |

27 | 1. Exampleコードの実行

28 | 2. 保存したデータの確認

29 |

30 | ## 1. Exampleコードの実行

31 | ### 1.1 Exampleコードを実行する

32 | terminalで次のコマンドを実行します。

33 |

34 | ~~~ bash:shell

35 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1

36 | $ ./python.sh standalone_examples/replicator/visualize_groundtruth.py

37 | ~~~

38 |

39 |

40 |

41 |

42 | visualize_groundtruth.pyでは、Stageの設定及び、画像の取得、Visualizationの処理が記載されています。

43 | 詳細は次のURLにから確認することが可能です(説明は追記予定)。

44 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_visualize_groundtruth.html#the-code

45 |

46 | ## 2.保存したデータの確認

47 | ### 2.1 保存したデータを確認する

48 | 保存されたデータを確認します。

49 | terminalを開き、次のコマンドを入力します。

50 |

51 | ~~~ bash:shell

52 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1

53 | $ nautlius ./ &

54 | ~~~

55 |

56 | 実行すると、保存先ディレクトリが表示されます。

57 | 保存したデータはこのディレクトリ直下に存在します。

58 |

59 |

60 | 該当データを開き、撮影されたデータが存在することを確認します。

61 |

62 |

63 |

--------------------------------------------------------------------------------

/tutorials/replicator/offline_dataset_generation/22_offline_dataset_generation.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Offlineで学習用のデータセットを作成します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_offline_generation.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | ランダムなシーンを作成し、シーンにおける合成データを連続して保存します。

26 |

27 | 1. Exampleコードの実行

28 | 2. 保存したデータの確認

29 |

30 | ## 1. Exampleコードの実行

31 | ### 1.1 Exampleコードを実行する

32 | terminalで次のコマンドを実行します。

33 |

34 | ~~~ bash:shell

35 | $ cd ~/.local/share/ov/pkg/isaac_sim.2021.2.1/

36 | $ ./python.sh standalone_examples/replicator/offline_generation.py --scenario omniverse://localhost/Isaac/Samples/Synthetic_Data/Stage/warehouse_with_sensors.usd --num_frames 10 --max_queue_size 500

37 | ~~~

38 |

39 |

40 | ]

41 |

42 | offline_generation.pyの詳細は次のURLにから確認することが可能です(説明は追記します)。

43 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_offline_generation.html#loading-the-environment

44 |

45 |

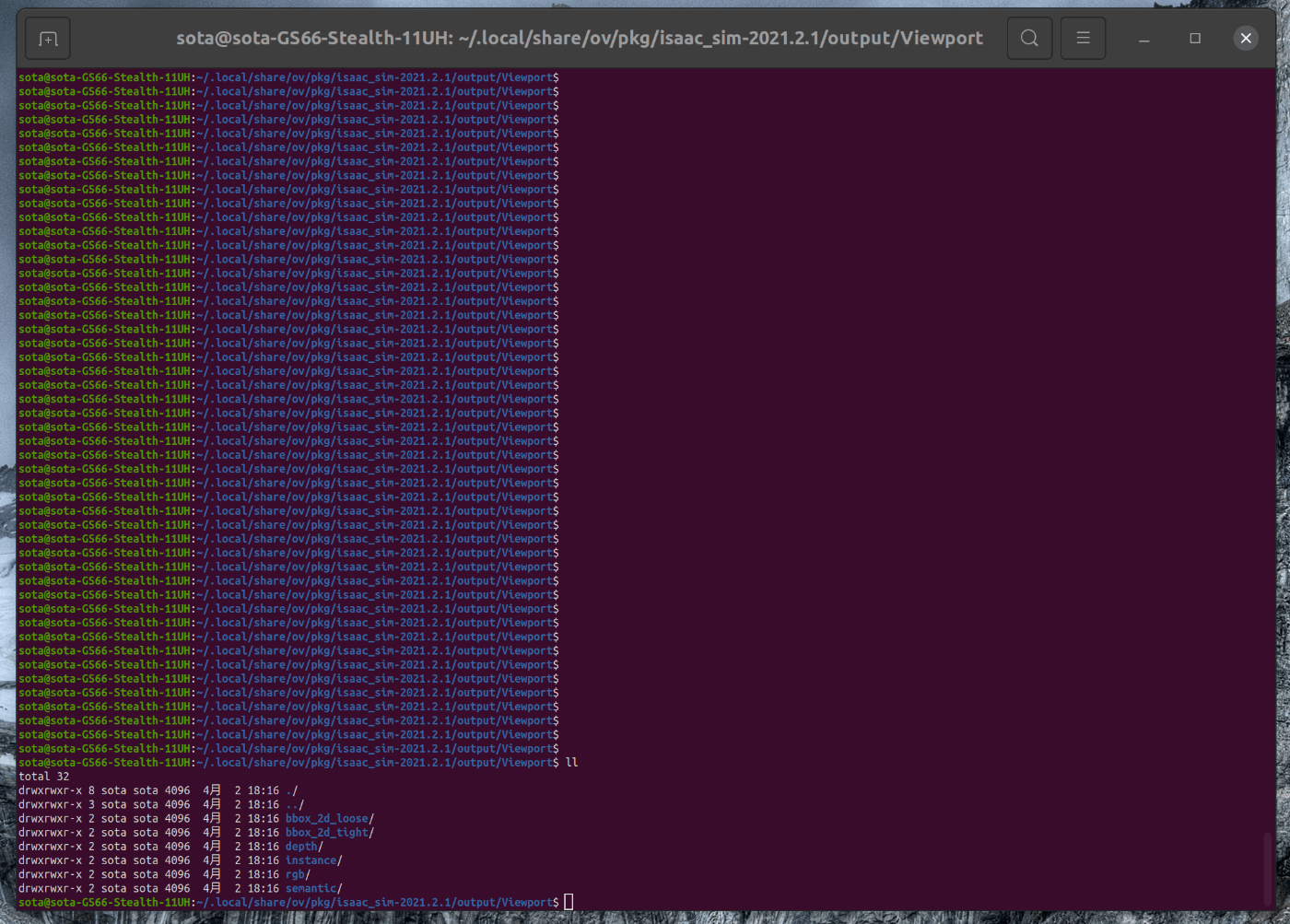

46 | ## 2. 保存したデータの確認

47 | ### 2.1 保存したデータを確認する

48 | 保存されたデータを確認します。

49 | terminalを開き、次のコマンドを入力します。

50 |

51 | ~~~ bash:shell

52 | $ cd /home/"user名"/output/Viewport/

53 | $ nautlius ./ &

54 | ~~~

55 |

56 |

57 | 実行すると、保存先ディレクトリが表示されます。

58 | 各ディレクトリの中のデータを開き、撮影されたデータが存在することを確認します。

59 |

60 |

61 |

62 |

63 |

--------------------------------------------------------------------------------

/tutorials/gui/add_camera/4_add_camera.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Nvidia Issac simのGUIの機能を使用し、簡単な2輪ロボットのモデルにカメラを追加します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_gui_camera_sensors.html#isaac-sim-app-tutorial-gui-camera-sensors

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 |

25 | # 手順

26 |

27 | 大まかな手順は次の通りです。

28 |

29 | 1. シーンにカメラを追加

30 | 2. 2輪ロボットにカメラを追加

31 |

32 | 以下内容のシーンファイルはこちらからダウンロードできます。

33 | ()[]

34 |

35 | ## 1. シーンにカメラを追加

36 | こちらのページに記載してある手順を進めます。

37 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_gui_camera_sensors.html#getting-started

38 |

39 | ### 1.1 OmniverseからIssac Simを起動する

40 |

41 |

42 | ### 1.2 シーンをロードする

43 | 以前作成した2輪のロボットモデルをロードします。

44 | シーンファイルは[こちらからダウンロード]()できます。

45 | メニューバーのFile > Open を選択します。

46 | 該当ファイルを選択し、シーンをロードします。

47 |

48 |

49 | ## 1.3 カメラの追加

50 | シーン内にカメラを追加します。

51 | メニューバーのCreate > Physics > Cameraを選択します。

52 |

53 | 選択後、右側のStageタブの中にCameraが追加されていることを確認します。

54 |

55 |

56 | ## 2. 2輪ロボットにカメラを追加

57 | 右側のStageタブの中でcameraを右クリックし、renameを選択します。

58 | renameにより次の名称に変更します。

59 | - camera > car_camera

60 |

61 | ### 2.1 Viewportの追加

62 | カメラで撮影した画像を映し出すViewportを作成します。

63 | メニューバーのWindow > New Viewport Windowを選択します。

64 |

65 | 選択後、生成したWindowをGUI内でドラッグアンドドロップで移動し、任意の位置に配置します。

66 |

67 | 配置したウィンドウ中のPerspectiveをクリックし、Cameraをcar_cameraにします。

68 |

69 | ### 2.2 2輪ロボットへのアタッチ

70 | 右側のStageタブの中でcar_cameraをドラッグアンドドロップでBodyの下に移動させます。

71 |

72 |

73 | Bodyの下に追加したcar_cameraを選択します。

74 | 選択した状態で、右下にあるPropertyの中から、次の値を変更します。

75 | - transformationのtransformのXを20にする

76 | - transformationのtransformのYを0にする

77 | - transformationのtransformのZを200にする

78 | - transformationのorientationのXを0にする

79 | - transformationのorientationのYを70にする

80 | - transformationのorientationのZを90にする

81 |

82 |

83 | カメラの位置および姿勢の設定が完了すると、ロボットの前のシーンがViewportに写し出されます。

84 |

85 |

86 | この状態で、側のツールバーのシミュレーションPlayボタンを押し、ロボットが進んでいる状態でカメラ画像が変化していることを確認します。

87 |

88 |

--------------------------------------------------------------------------------

/tutorials/ros/transform_trees/28_transform_trees.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac Sim上に配置したCameraのTFをros topicとして発行します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_tf.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

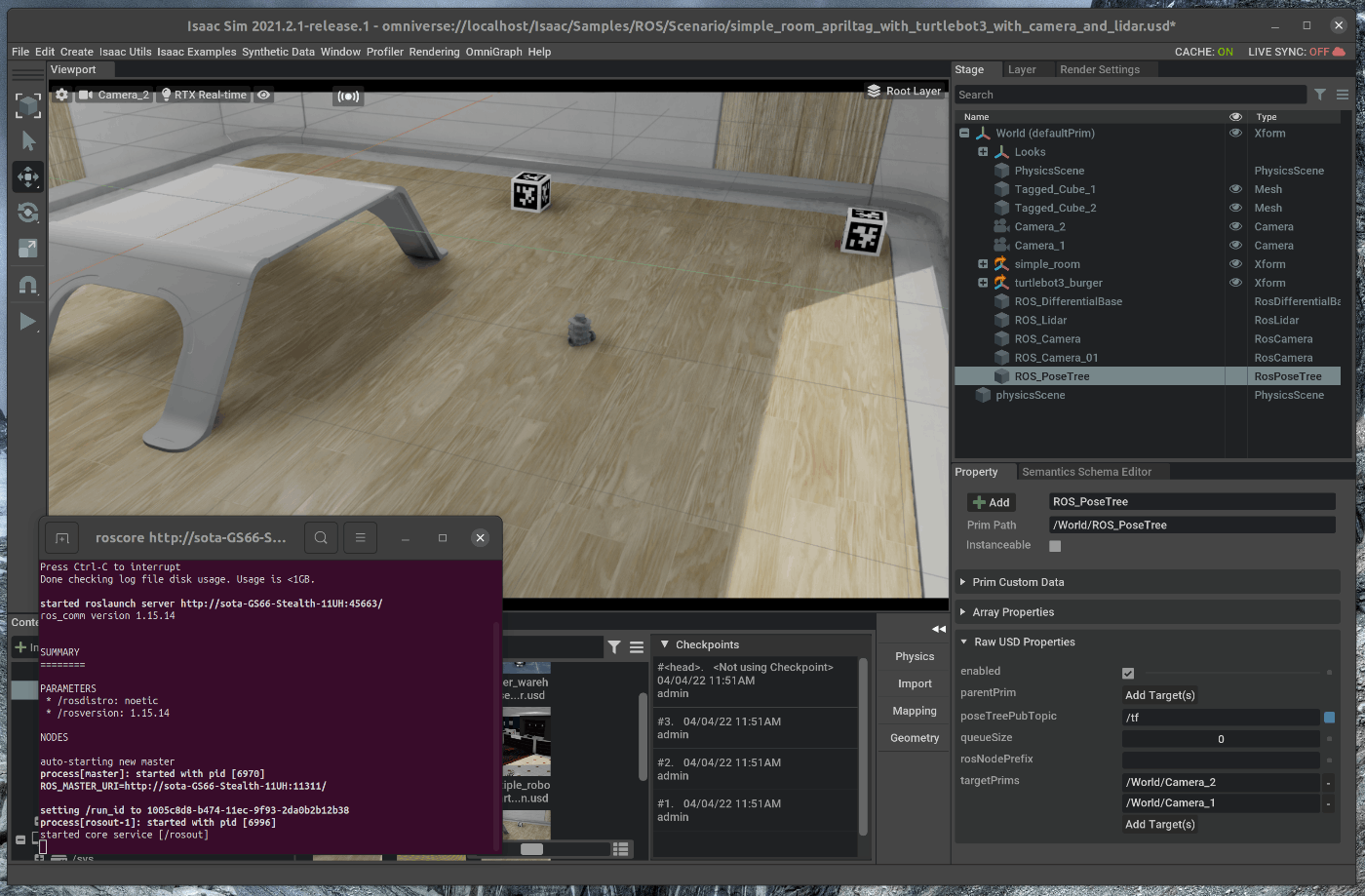

25 | Isaac Sim上に配置したCameraのTFをros topicとして発行します。

26 | シーンファイルとして、Turtlebotを追加したシーンファイルを使用します。

27 | シーンファイルはこちらからダウンロードできます。

28 |

29 | 1. シーンのロード

30 | 2. ROS PoseTreeの追加

31 | 3. Topicの確認

32 |

33 | ## 1. シーンのロード

34 | ### 1.1 OmniverseからIssac Simを起動する

35 |

36 |

37 | ### 1.2 シーンをロードする

38 | Isaac Simの下部にあるContentの中から、”ダウンロードしたディレクトリ” > simple_room_apriltag_with_turtlebot3_with_camera_and_lidar.usdをダブルクリックします。

39 |

40 |

41 |

42 | ## 2. ROS PoseTreeの追加

43 | ### 2.1 ROS PoseTreを追加する

44 | メニューバーのCreate > Isaac > ROS > Pose Treeを選択します。

45 |

46 |

47 | 右側のStageの中で、追加したROS_PoseTreeを選択します。

48 |

49 |

50 | 選択した状態で、Stage下部のpropertyのRaw USD propertiesを開きます。

51 | Raw USD propertiesの中で、 targetPrimsを選択し、Stageの中のCamera_1とCamera_2 を選択します。

52 |

53 |

54 |

55 | ## 3. Topicの確認

56 | 新たにterminalを開き、roscoreを起動します。

57 |

58 |

59 | この状態で、Viewportの左側のPLAYボタンを押すと、各種topicが発行されます。

60 | 新たにterminalを開き、次のコマンドを入力します。

61 |

62 | ~~~ bash:shell

63 | $ rostop list

64 | ~~~

65 |

66 |

67 | TFが発行されていることが確認できます。

68 | rostopic echoを使用すると、Topicの内容を確認できます。

69 |

70 |

71 |

72 |

73 |

74 |

75 |

76 |

77 |

78 |

--------------------------------------------------------------------------------

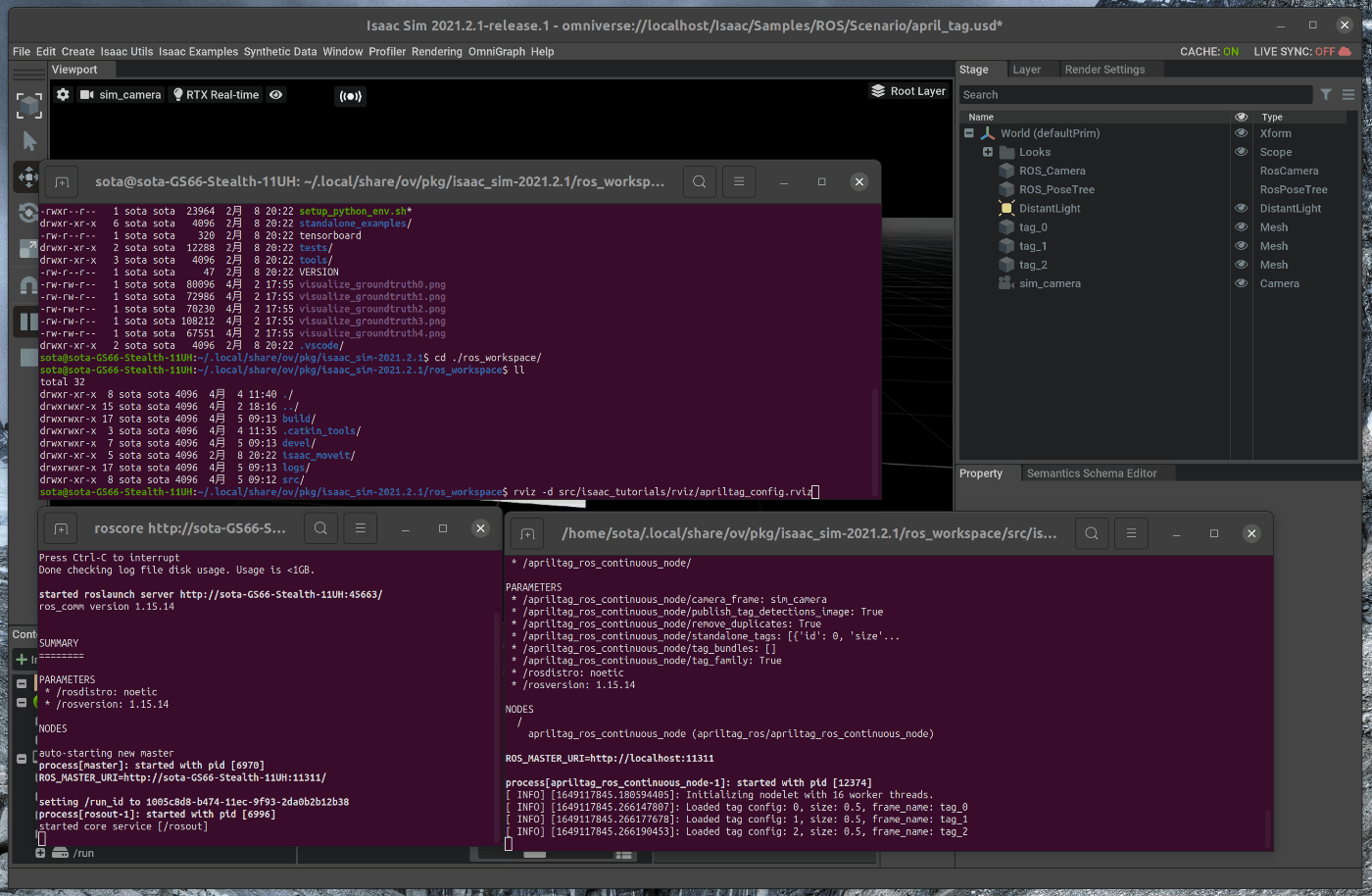

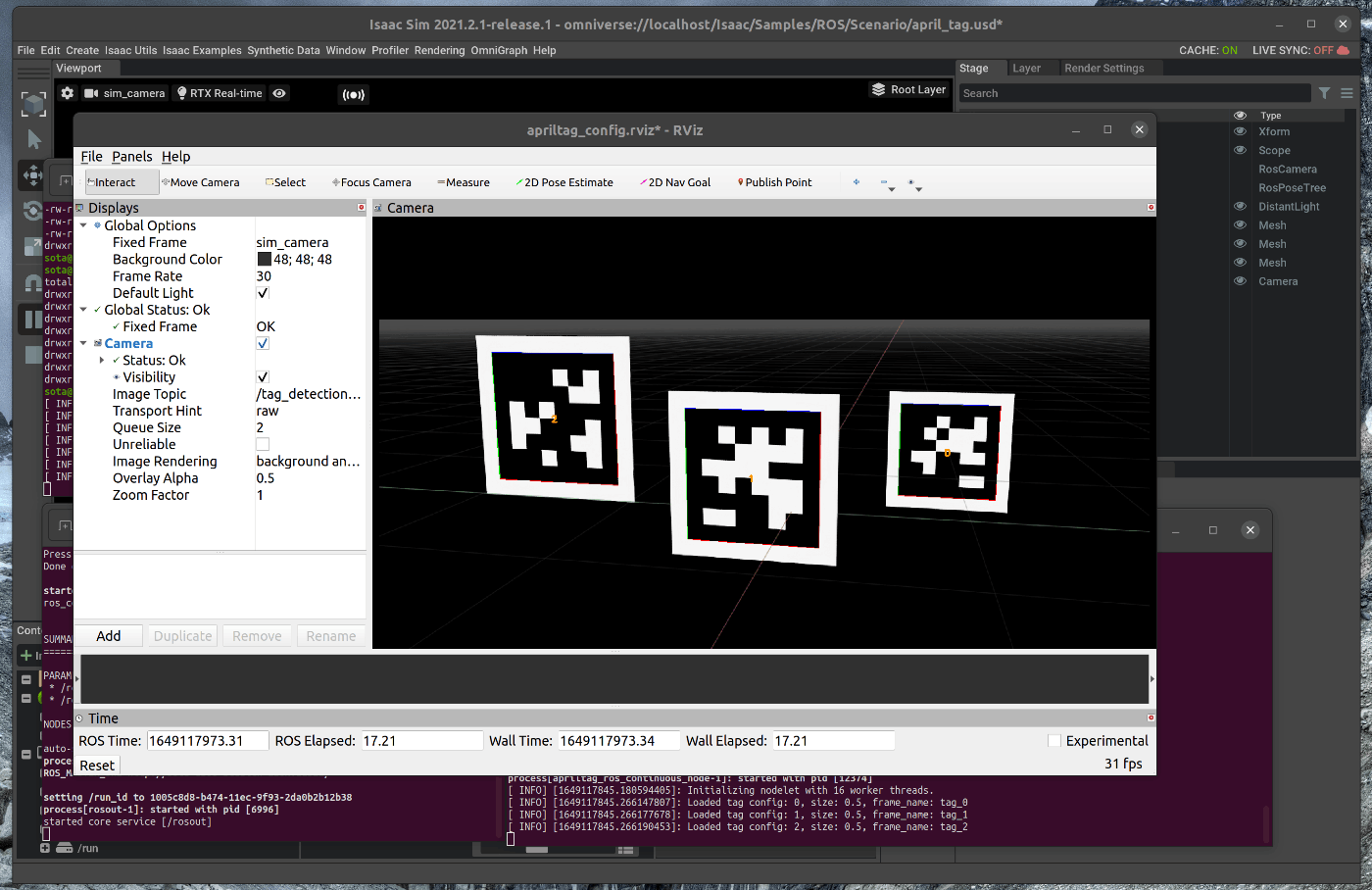

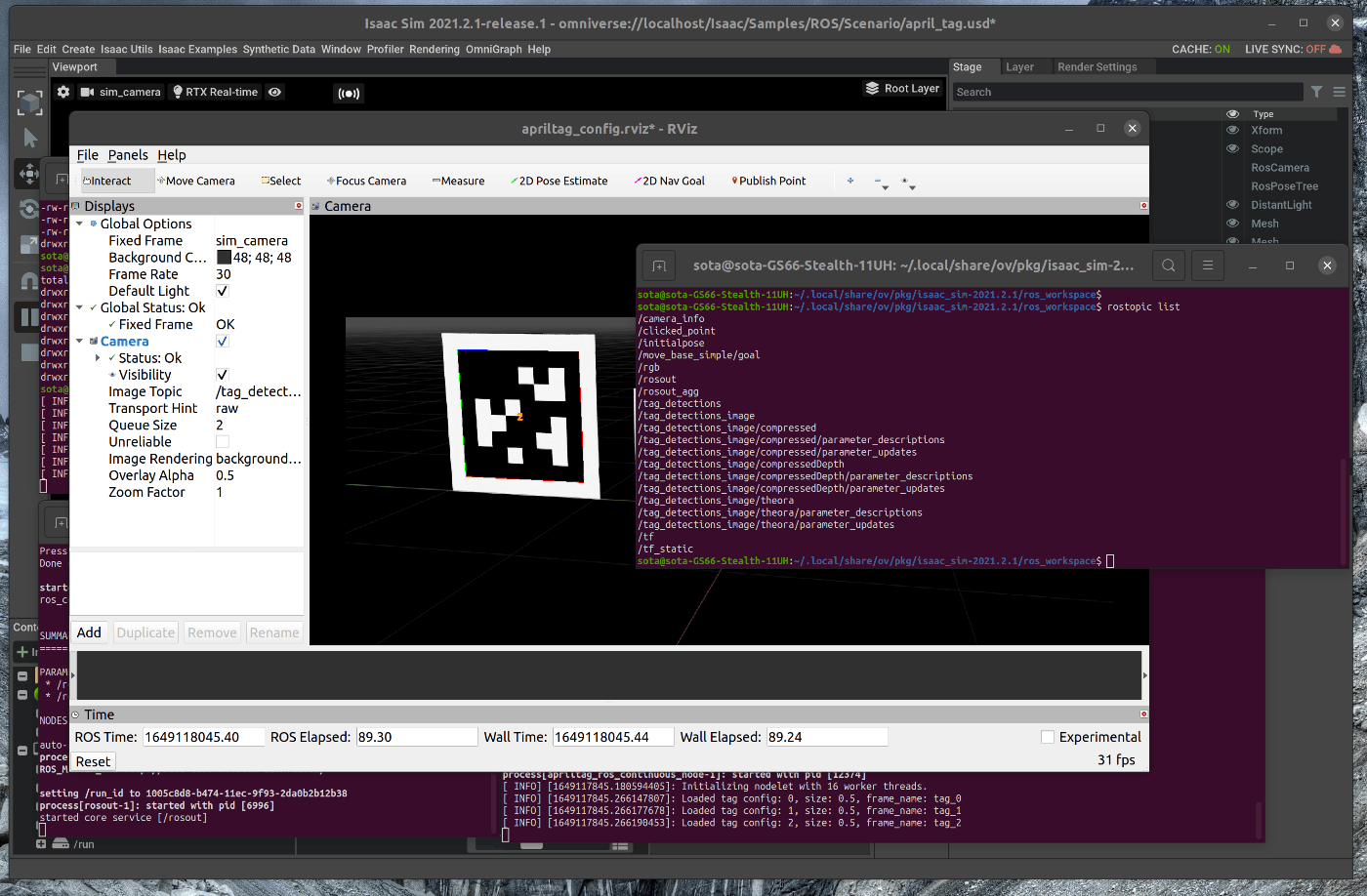

/tutorials/ros/april_tags/29_april_tags.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac Sim上に配置したApril Tagsをros topicとして発行し, detectionの処理を実行します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_apriltag.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | Isaac Sim上に配置したApril Tagsをros topicとして発行し, detectionの処理を実行します。

26 | detectionの処理はros側で実行します。

27 |

28 | 1. シーンのロード

29 | 2. detection処理の実行

30 | 3. Topicの確認

31 |

32 | ## 1. シーンのロード

33 | ### 1.1 OmniverseからIssac Simを起動する

34 |

35 |

36 | ### 1.2 シーンをロードする

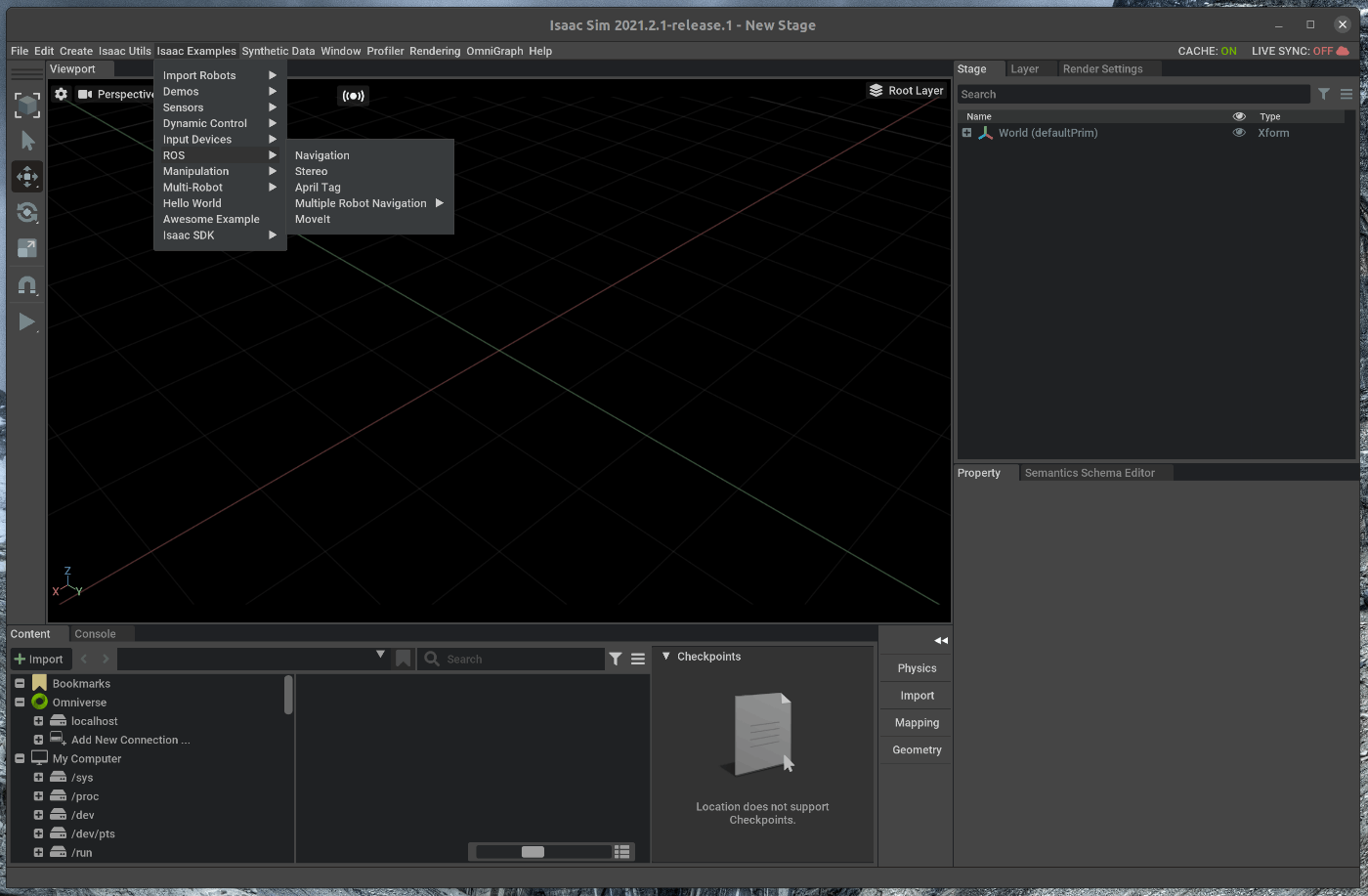

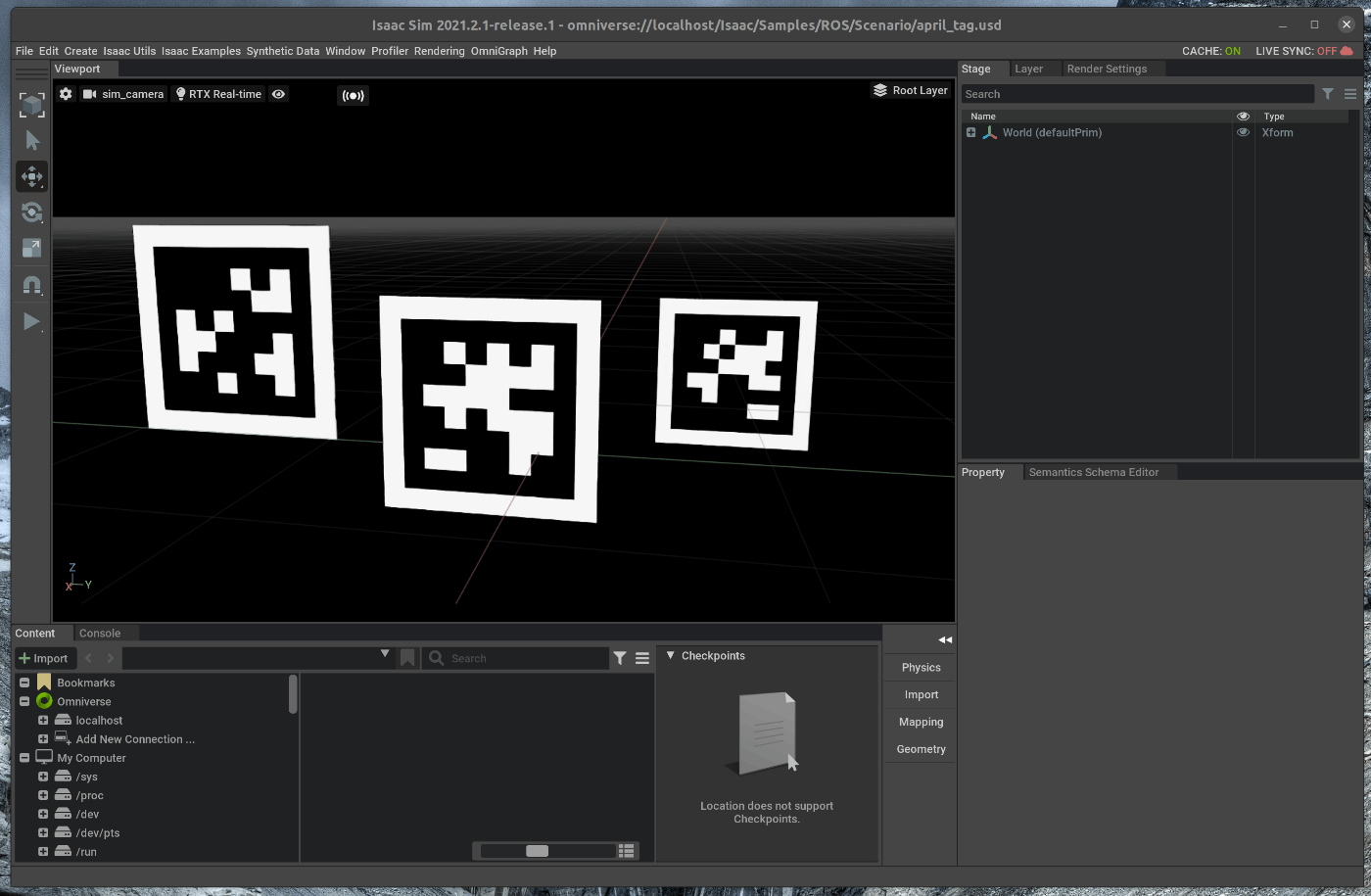

37 | メニューバーのIsaac Examples > ROS > April Tagを選択します。

38 |

39 |

40 |

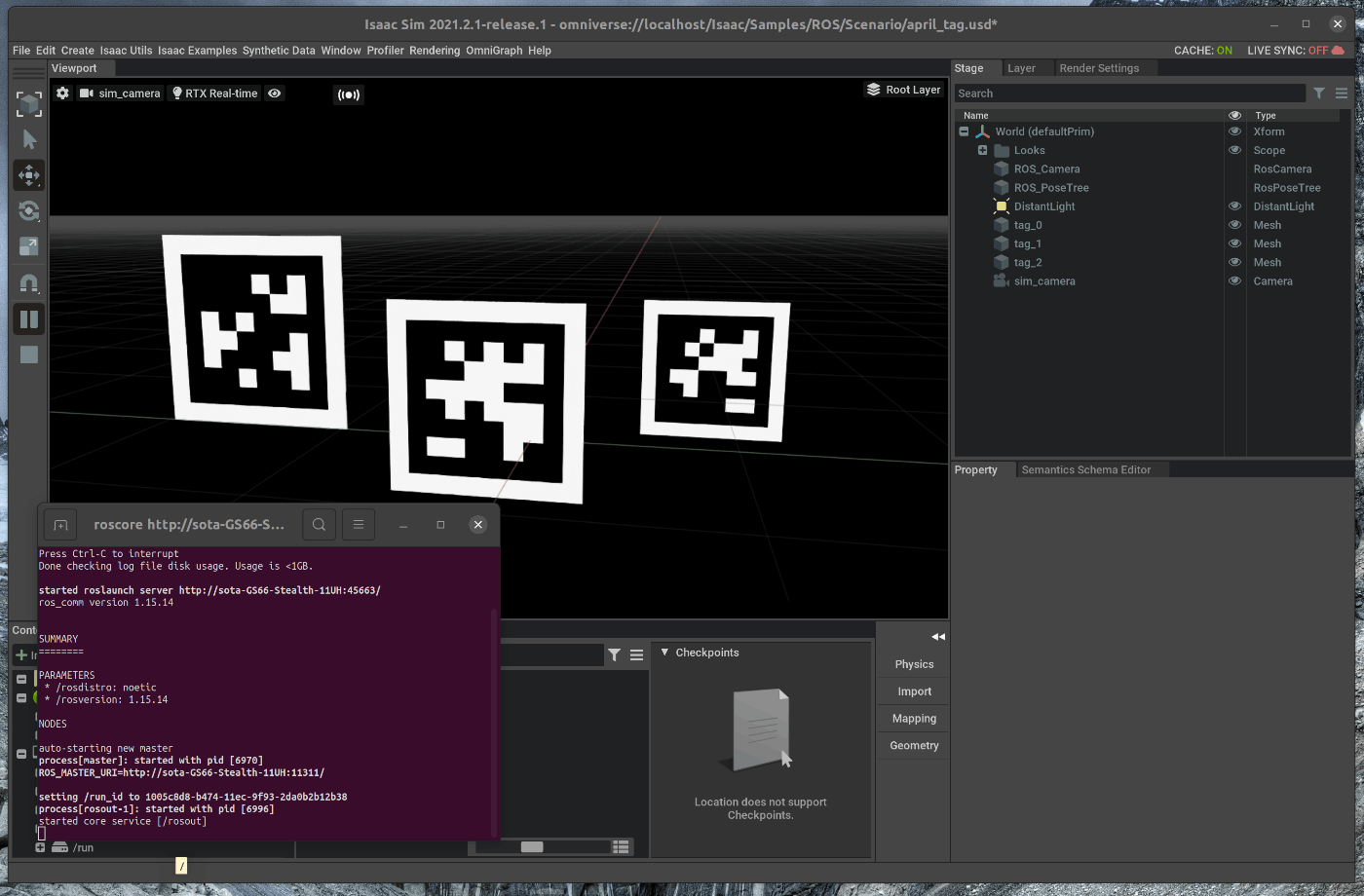

41 | 新たにterminalを開き、roscoreを起動します。

42 |

43 |

44 | この状態で、Viewportの左側のPLAYボタンを押すと、各種topicが発行されます。

45 |

46 | ## 2. detection処理の実行

47 | ### 2.1 detection用のLaunchを実行する

48 |

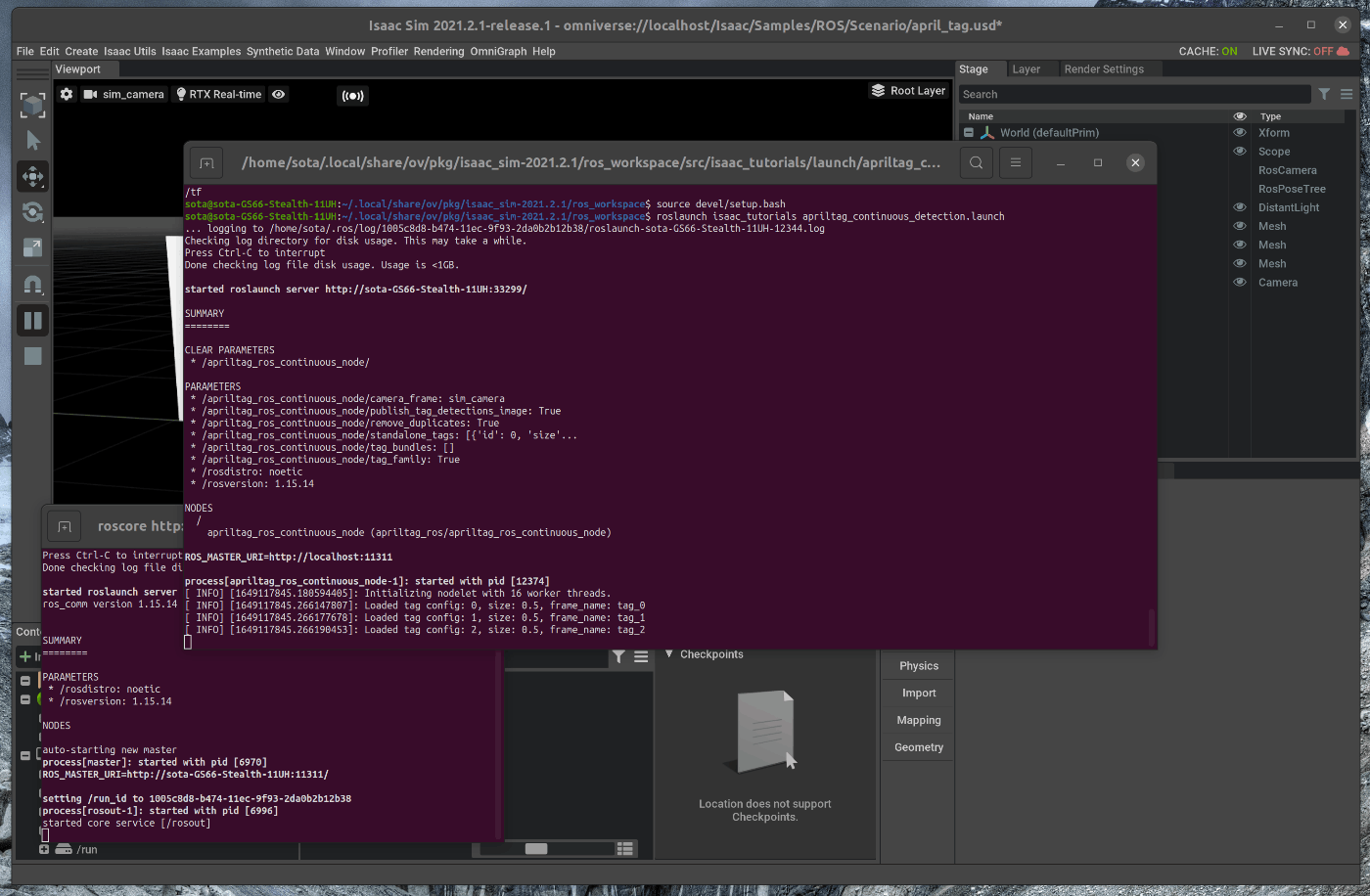

49 | また、新たにterminalを開き、次のコマンドを入力します。

50 |

51 | ~~~ bash:shell

52 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/

53 | $ cd ./src

54 | $ git clone https://github.com/AprilRobotics/apriltag.git

55 | $ git clone https://github.com/AprilRobotics/apriltag_ros.git

56 | $ caktin b

57 | $ source devel/setup.bash

58 | $ roslaunch isaac_tutorials apriltag_continuous_detection.launch

59 | ~~~

60 |

61 |

62 | ## 3. Topicの確認

63 | Detectionの結果をRviz上で確認します。

64 | 新たにterminalを開き、次のコマンドを入力します。

65 |

66 | ~~~ bash:shell

67 | $ cd ~/.local/share/ov/pkg/isaac_sim_2(version)/ros_workspace/

68 | $ rviz -d src/isaac_tutorials/rviz/apriltag_config.rviz

69 | ~~~

70 |

71 |

72 | Detectionされていることが確認できます。

73 |

74 |

75 | 各種Topicも発行されています。

76 |

77 |

78 |

79 |

80 |

81 |

82 |

--------------------------------------------------------------------------------

/tutorials/replicator/recording_synthetic_data/20_recording_synthetic_data.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | 合成データを連続して取得し、保存します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_recorder.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | GUI上での操作で、シーン内のカメラから合成データを連続して取得し、保存します。

26 |

27 | 1. テストシーンのロード

28 | 2. Synthetic Data Recordeの使用

29 |

30 | ## 1. テストシーンのロード

31 | ### 1.1 OmniverseからIssac Simを起動する

32 |

33 |

34 | ### 1.2 テストシーンをロードする

35 | Isaac Simの下部にあるContentの中から、Isaac > Samples > Synthetic_Data > Stage > warehouse_with_sensors.usdをダブルクリックします。

36 |

37 |

38 | ## 2. Synthetic Data Recordeの使用

39 | ### 2.1 Viewportの設定を変更する

40 | Viewportの中の上部にある目のアイコンをクリックします。

41 |

42 |

43 | ”Show By Type”の中で、CemaraとLightのチェックを外します。

44 |

45 |

46 | 次に、Viewportの中の上部にあるカメラのアイコンの表示名が”RandomCamera”になっているか確認します。

47 |

48 | ### 2.2 Synthetic Data Recorderを使用する

49 | メニューバーのSynthetic Data > Synthetic Data Recodarをクリックします。

50 |

51 |

52 | ポップアップした”Synthetic Data Recoder”のWindowをstage下部のPropertyの右隣に追加します。

53 |

54 |

55 | ”Synthetic Data Recoder”の”Viewport: Sensor Settings”の中のすべての欄にチェックを入れます。

56 |

57 |

58 | 左側のツールバーのPLAYボタンを押し、Viewportに表示されるシーンが切り替わることを確認します。

59 |

60 |

61 | この状態で、”Synthetic Data Recoder”の”Start Recording”をクリックします。

62 | 10sec程度経過した後、”Synthetic Data Recoder”の”Stop Recording”をクリックします。

63 |

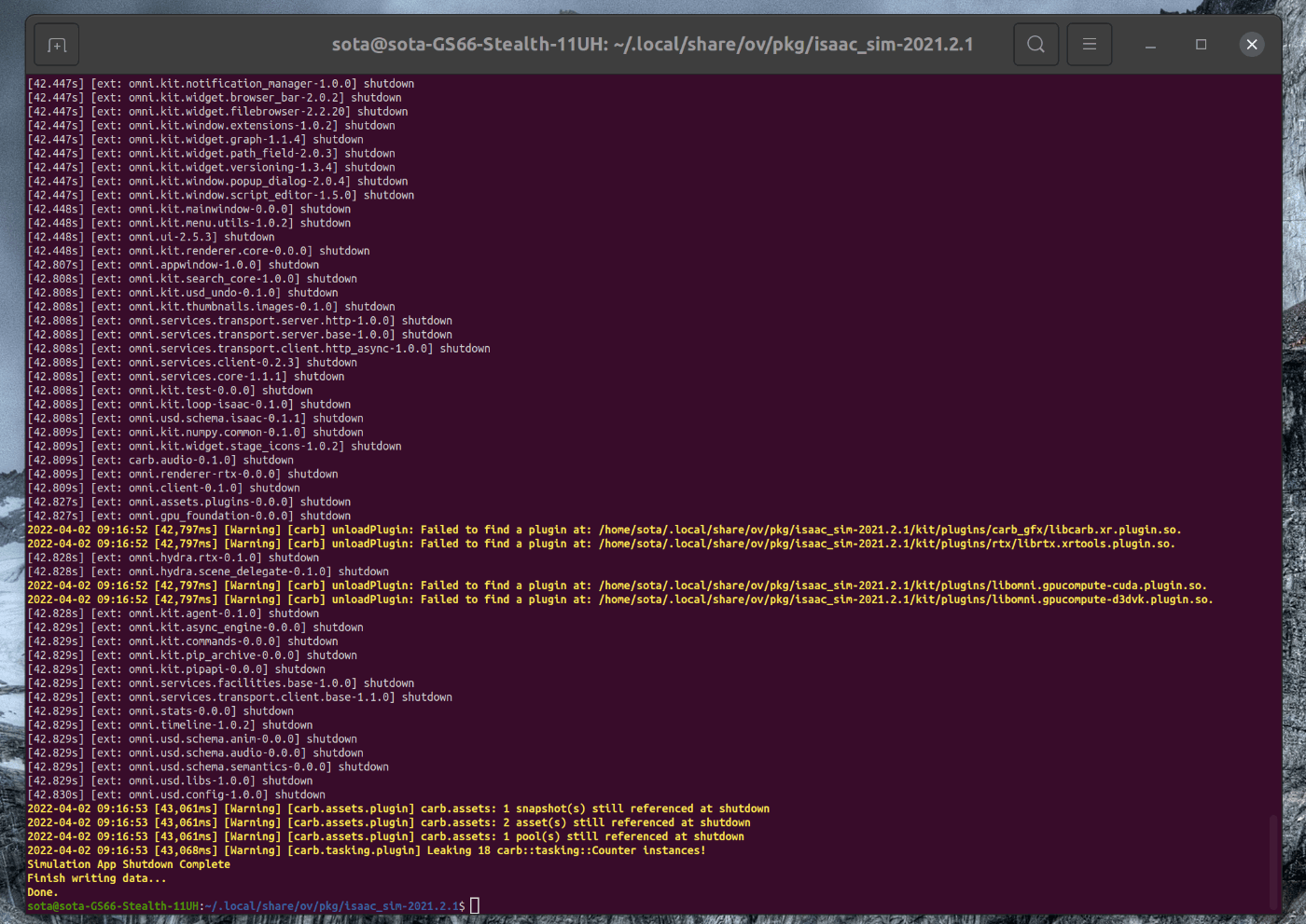

64 | ### 2.3 保存したデータを確認する

65 | 保存されたデータを確認します。

66 | terminalを開き、次のコマンドを入力します。

67 |

68 | ~~~ bash:shell

69 | $ cd /home/"user名"/output/Viewport/

70 | $ nautlius ./ &

71 | ~~~

72 |

73 | 実行すると、保存先ディレクトリが表示されます。

74 |

75 |

76 | 各ディレクトリの中のデータを開き、撮影されたデータが存在することを確認します。

77 |

78 |

79 |

80 |

81 |

82 |

83 |

84 |

--------------------------------------------------------------------------------

/tutorials/gui/save_custom_usd/33_save_custom_usd.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac SimのGUI上でサンプルのオブジェクトを複数まとめて、USDファイルとして保存します。

3 |

4 |

5 | # 実行環境

6 |

7 | - インストール実行環境

8 |

9 | | unit | specification |

10 | |:-----------------:|:------------------:|

11 | | CPU | i9-11900H |

12 | | GPU | GeForce RTX 3080 Laptop|

13 | | RAM | 32GB |

14 | | OS | Ubuntu 20.04.3 LTS |

15 |

16 | - Nvidia Driverバージョン

17 | - 510.39.01

18 | - Issac simバージョン

19 | - 2021.2.1

20 |

21 |

22 | # 手順

23 |

24 | 大まかな手順は次の通りです。

25 |

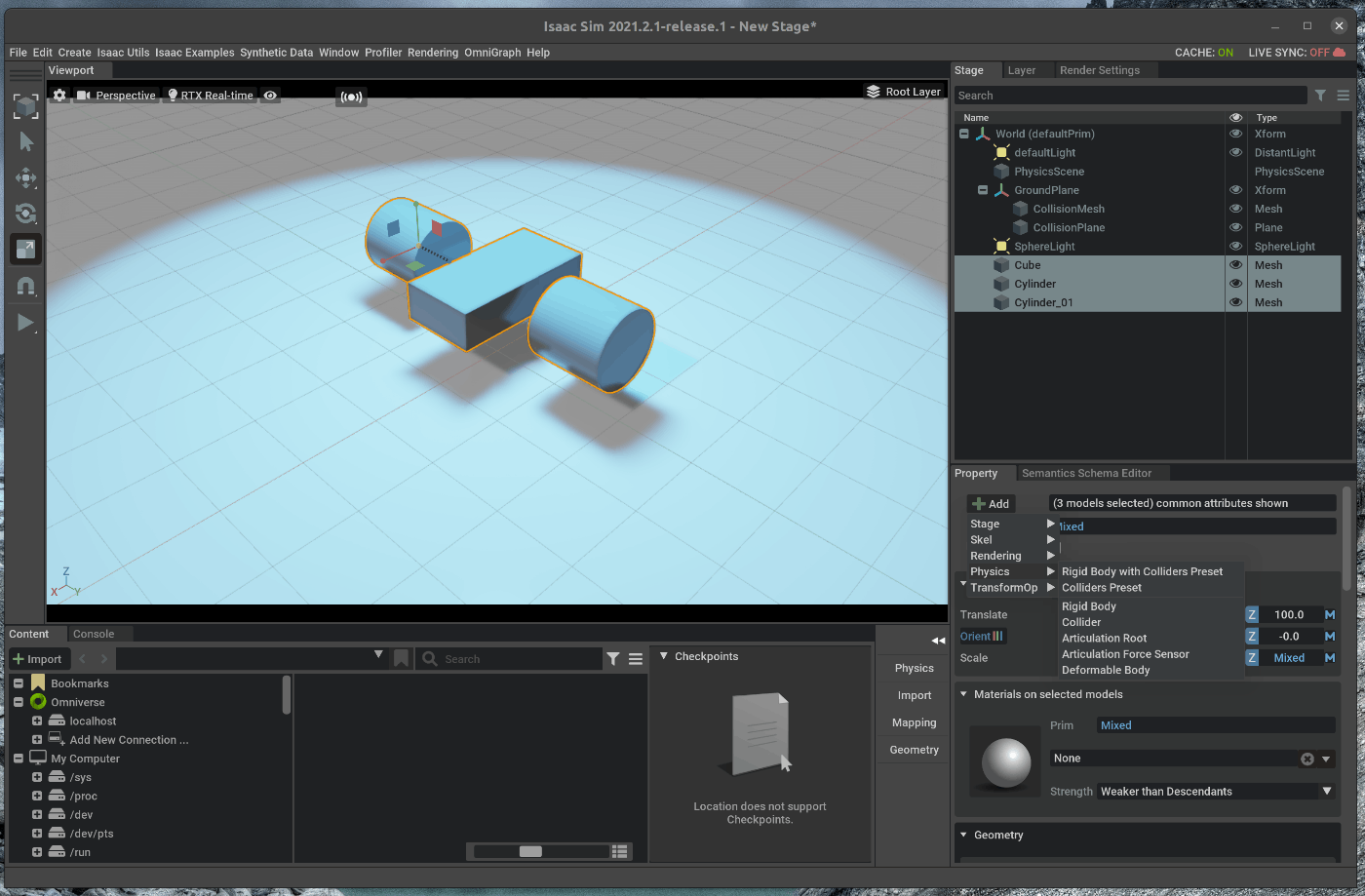

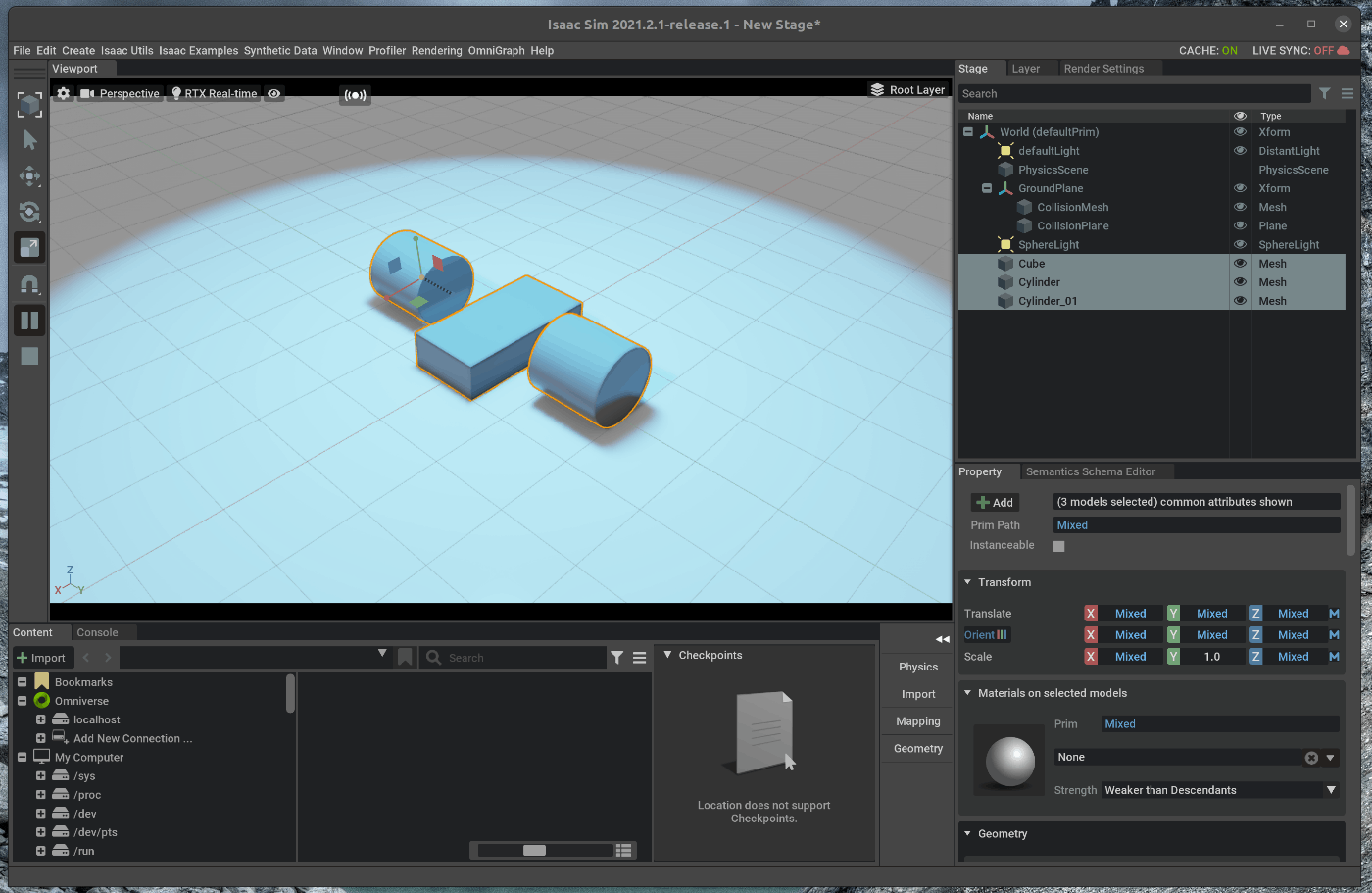

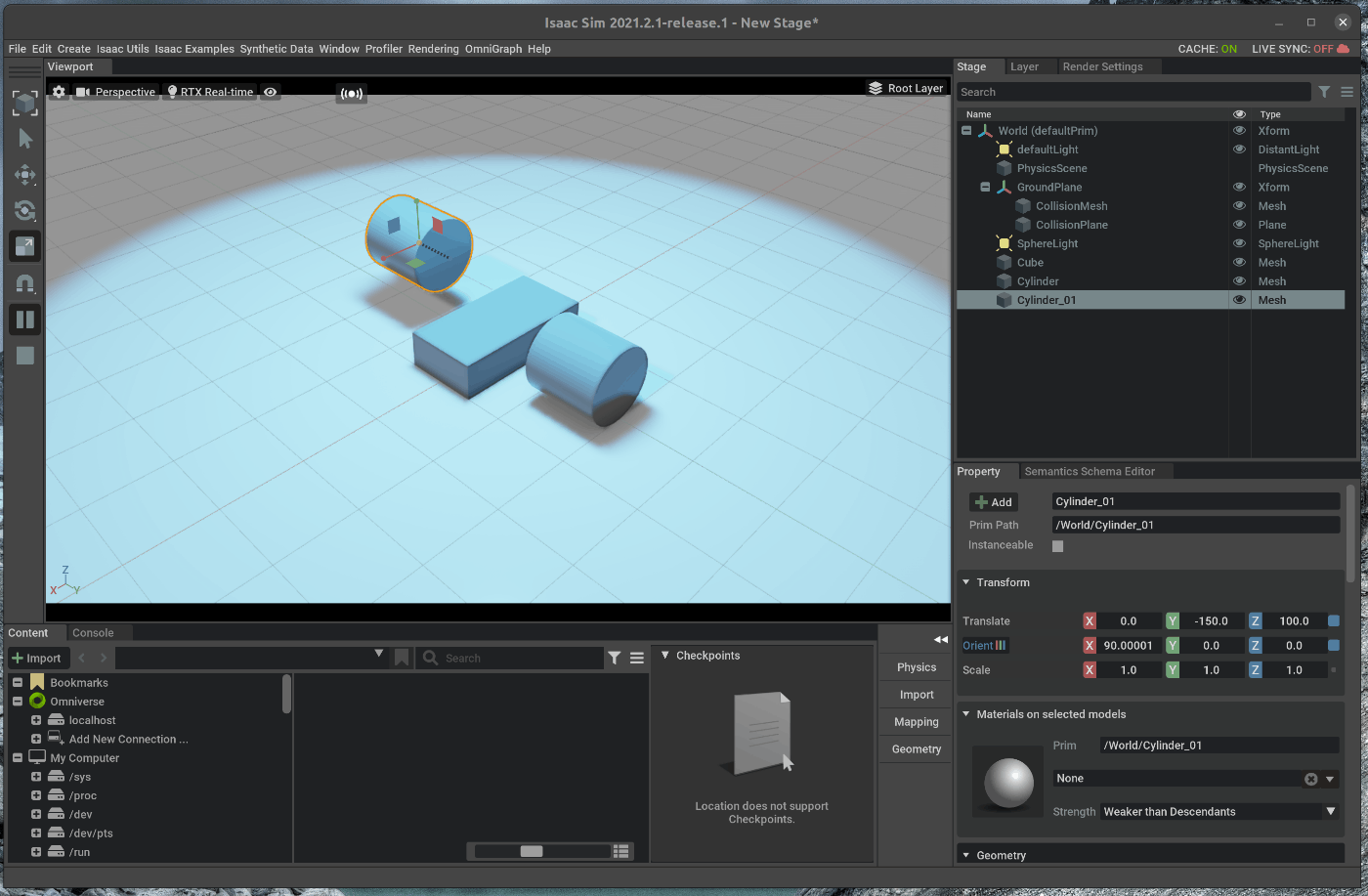

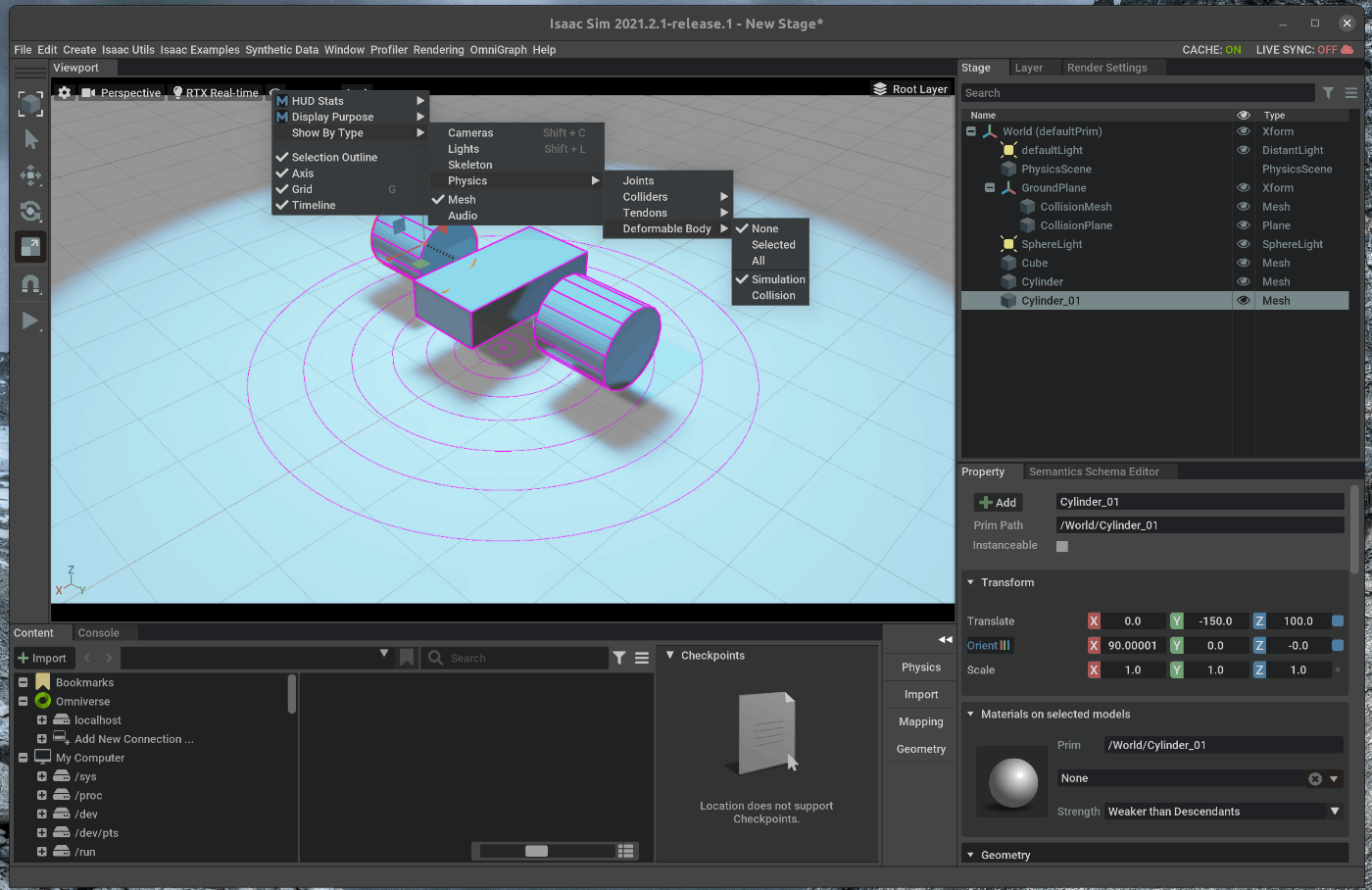

26 | 1. オブジェクトをシーンに追加

27 | 2. Groupにまとめたオブジェクトの保存

28 |

29 | シミュレーション上でロボットを動作させる環境を作成する場合、決まったオブジェクトはある程度まとめて設置したいと思います。

30 | そのような場合には、事前にオブジェクトをまとめたオブジェクト群を1つのUSDファイルとして、保存しておくと便利です。

31 | 実際に、そのオブジェクト群を使用する場合には、1つのUSDファイルのインポートで実現することができます。

32 |

33 | ## 1. オブジェクトをシーンに追加

34 | ### 1.1 OmniverseからIssac Simを起動する

35 |

36 |

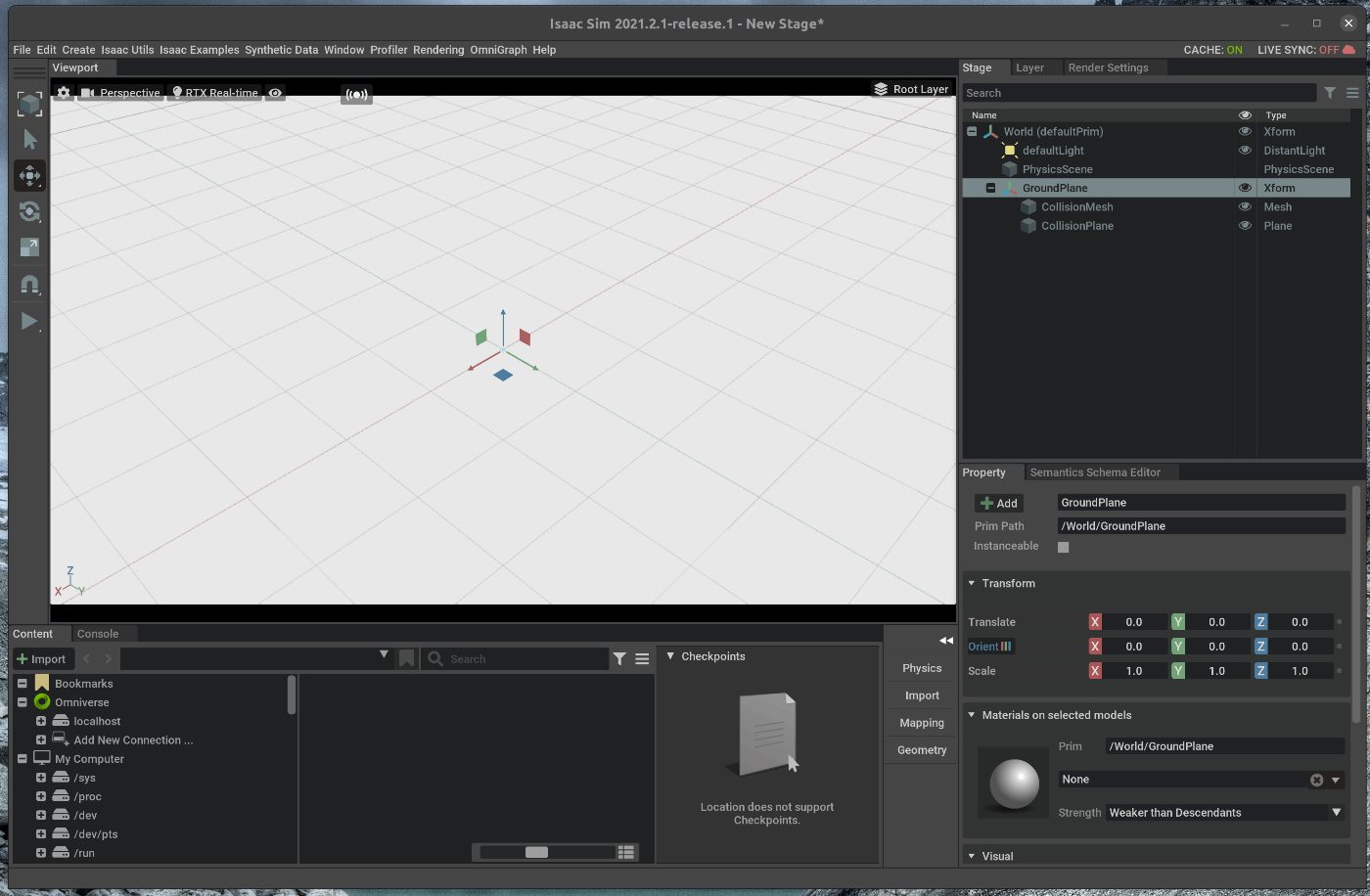

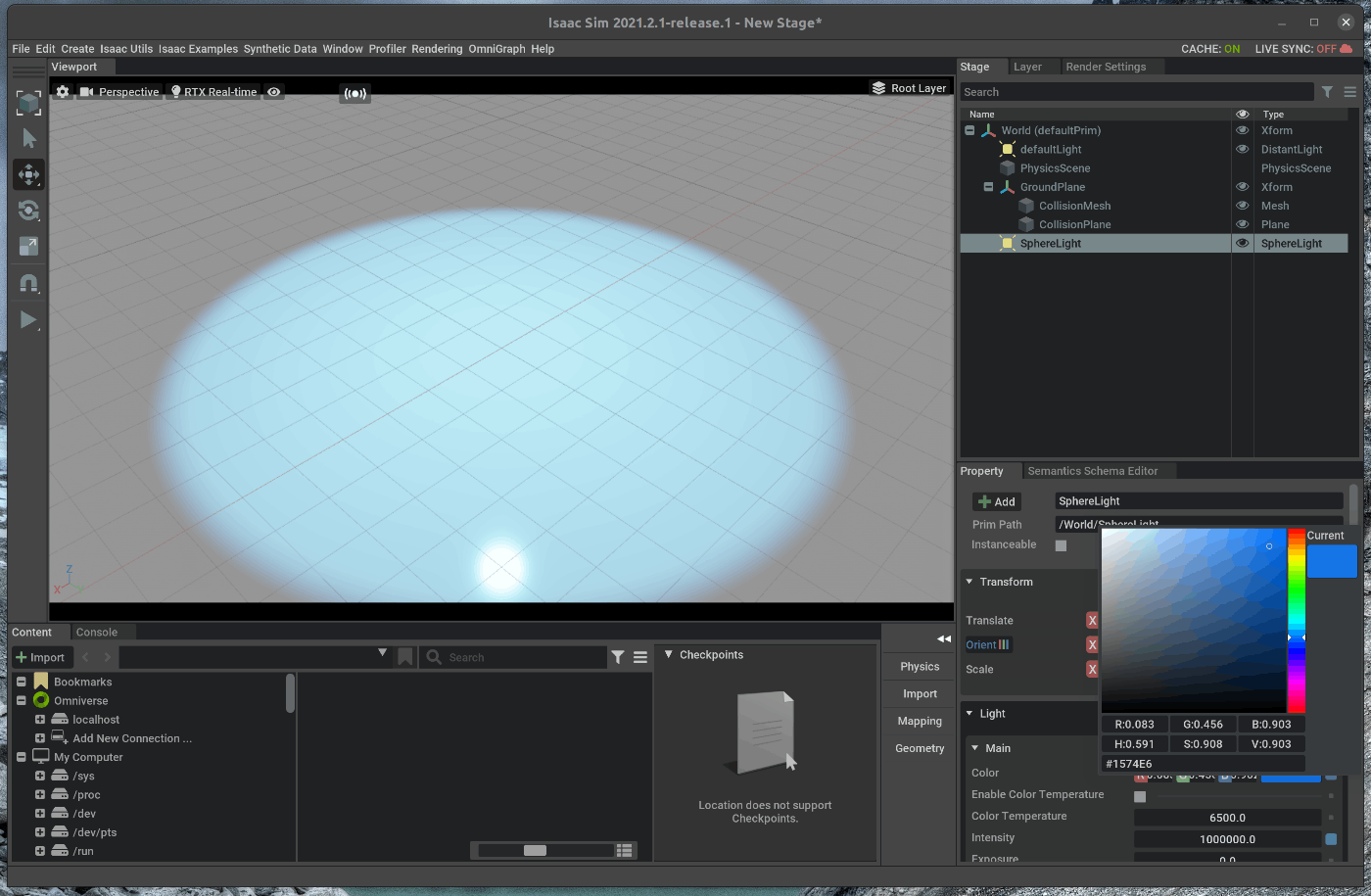

37 | ### 1.2 シーンをロードする

38 | メニューバーのCreate > Physics > Groud Planeを選択します。

39 |

40 |

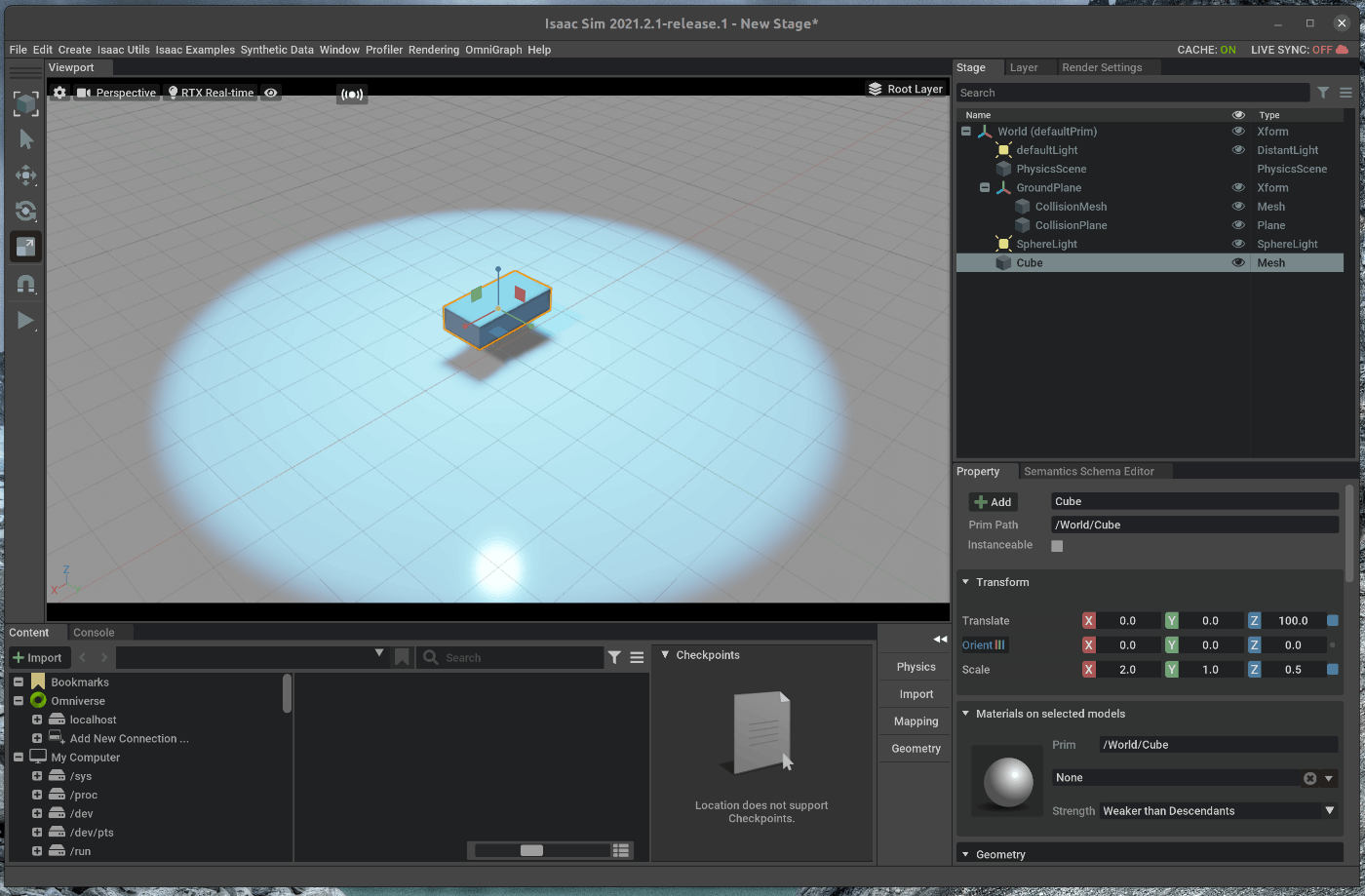

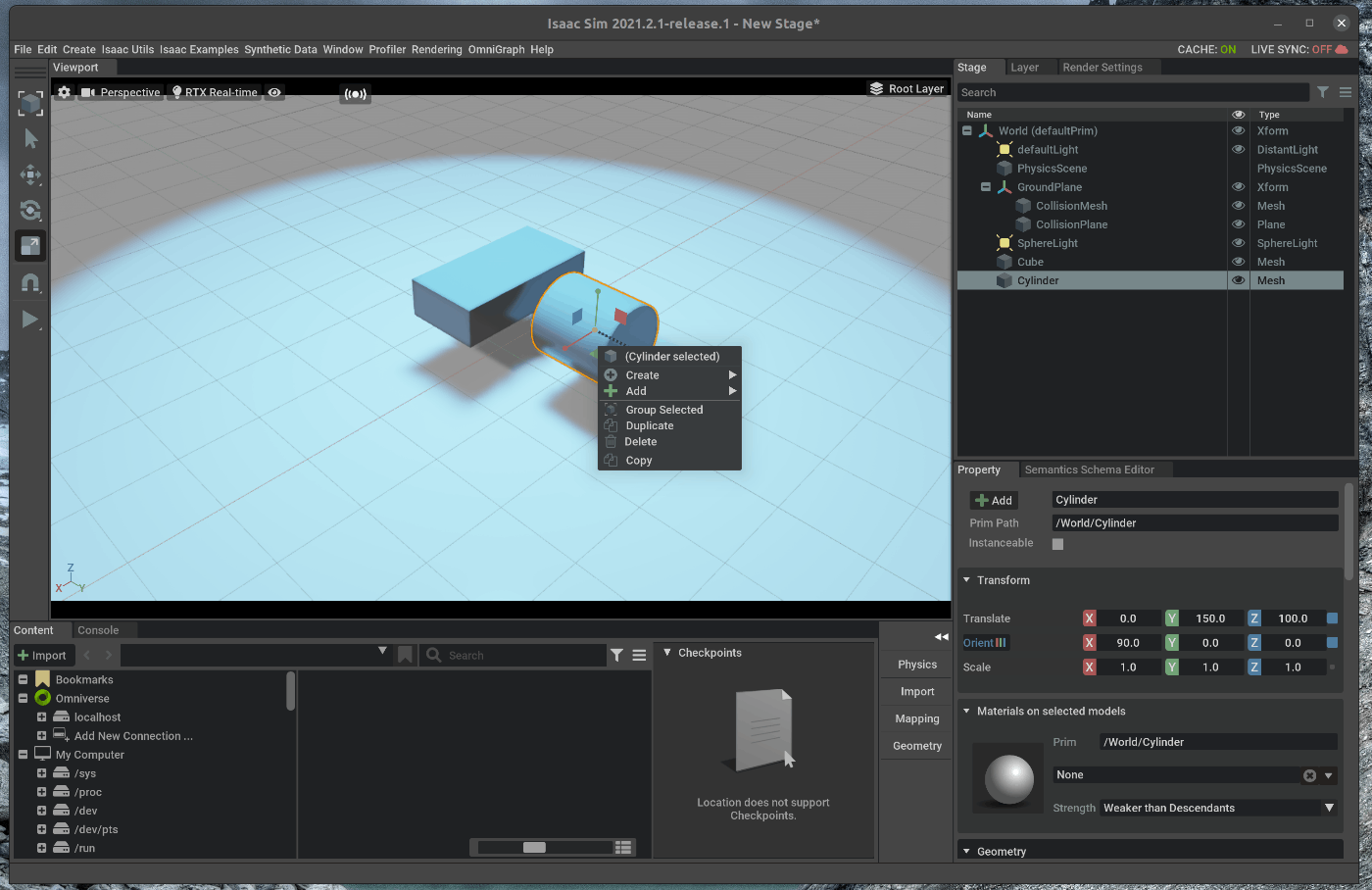

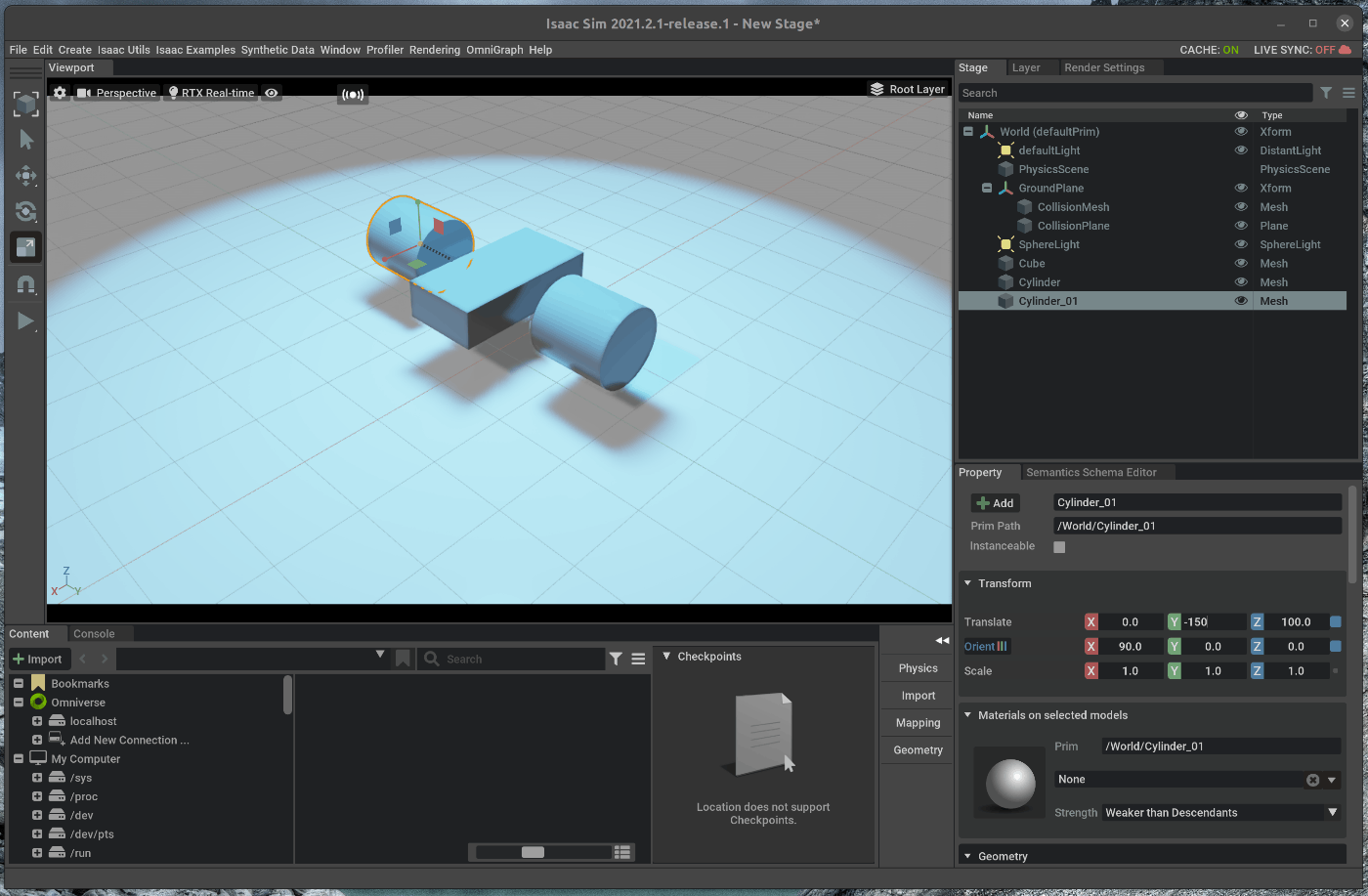

41 | ### 1.3 オブジェクトの追加

42 | シーン内にオブジェクトを追加します。

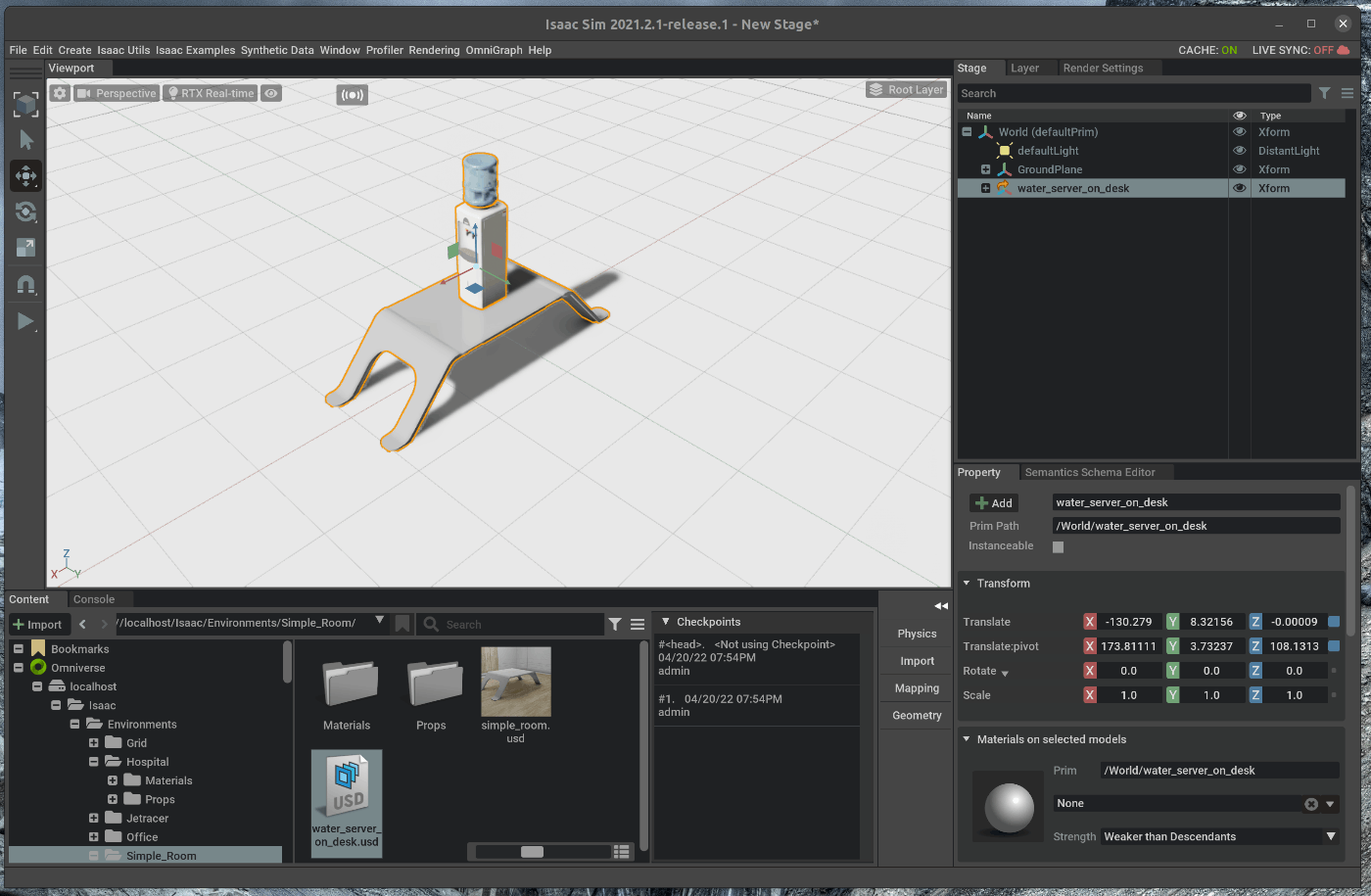

43 | 今回は、ウォーターサーバーと机を追加します。

44 |

45 | Viewportの下にあるContentの中で、omniverse/localhost/Isaac/Enviroments/Hospital/Props/SM_WaterDispenser_01a.usdを選択します。

46 | 選択した状態で、選択したUSDファイルをドラッグアンドドロップでViewport内に移動します。

47 | 移動すると、シーン内にウォーターサーバーが追加されます。

48 |

49 |

50 | 次に、机を追加します。

51 | Viewportの下にあるContentの中で、omniverse/localhost/Isaac/Enviroments/Simple_Room/Props/table_low.usdを選択します。

52 | 選択した状態で、選択したUSDファイルをドラッグアンドドロップでViewport内に移動します。

53 | 移動すると、シーン内に机が追加されます。

54 |

55 |

56 | ### 1.4 オブジェクト間の相対位置を変更する

57 | 追加したウォーターサーバーと机の位置を変更します。

58 | 今回は、机の上にウォーターサーバーを置きます。

59 |

60 | 右側のStageタブの中で、SM_WaterDispenser_01aを選択し、Viewport内の座標系の座標面を選択し、机の上に設置するように移動します。

61 |

62 |

63 |

64 | ## 2. Groupにまとめたオブジェクトの保存

65 | ### 2.1 Groupとしてまとめる

66 |

67 | 右側のStageタブの中で、SM_WaterDispenser_01aとtable_lowを選択します。

68 |

69 |

70 | 選択した状態で、右クリックし、Group Selectedを選択します。

71 |

72 |

73 | ### 2.2 GroupをUSDファイルとしてエクスポートする

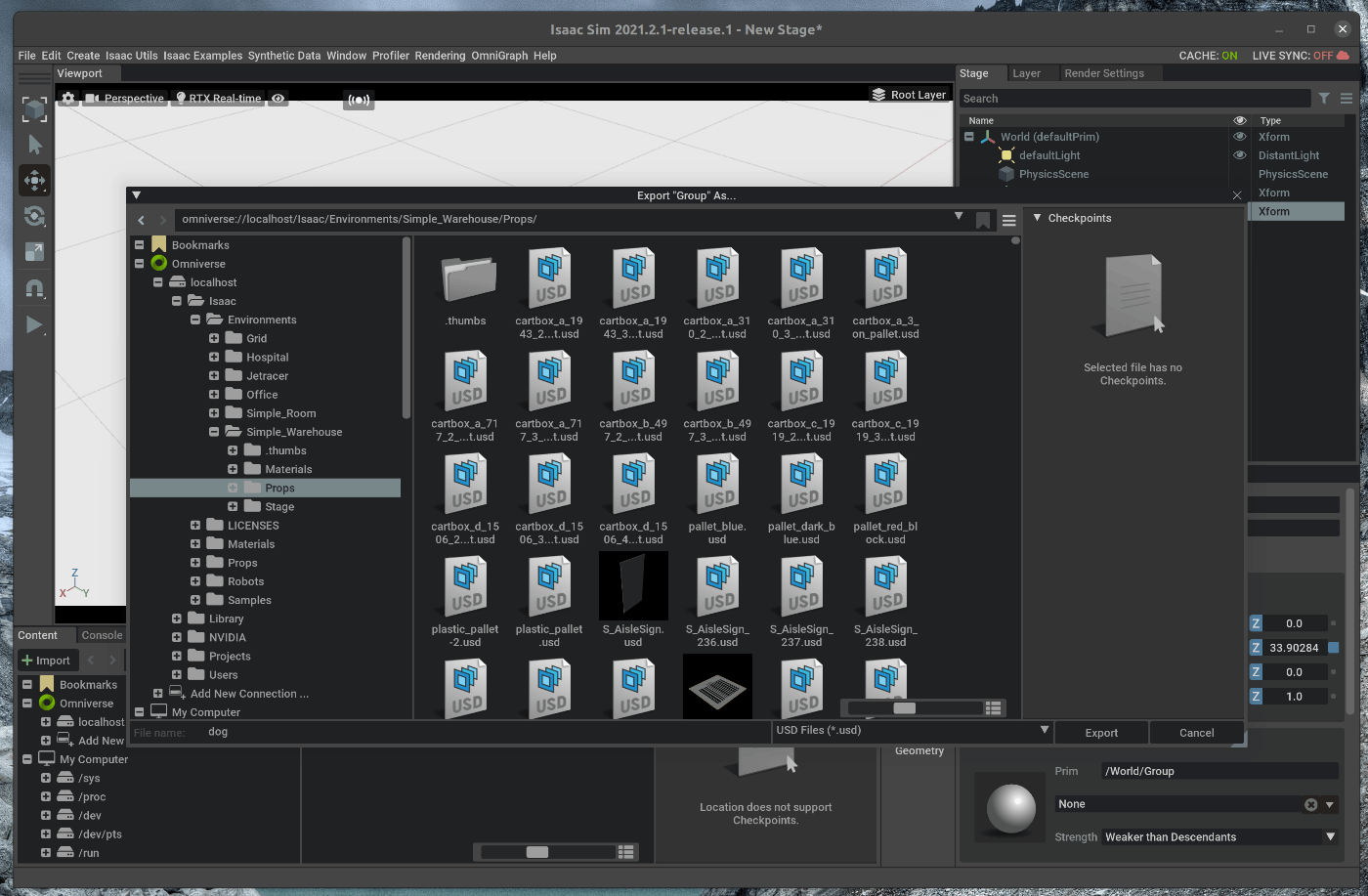

74 |

75 | 右側のStageタブの中で、Groupを選択します。

76 |

77 | 選択した状態で、右クリックし、Export Selectedを選択します。

78 | ポップアップしたウィンドウにて、任意の保存名と保存先を指定します。

79 |

80 |

81 | ### 2.3 保存したUSDファイルをインポートする

82 | 今回はomniverse/localhost/Isaac/Enviroments/Simple_Room/Props/water_server_on_desk.usdとして保存しました。

83 | 1.3の手順と同様にViewport内に該当のUSDファイルをドラッグアンドドロップすると、机の上にウォーターサーバーが設置されているオブジェクトが追加されます。

84 |

85 |

--------------------------------------------------------------------------------

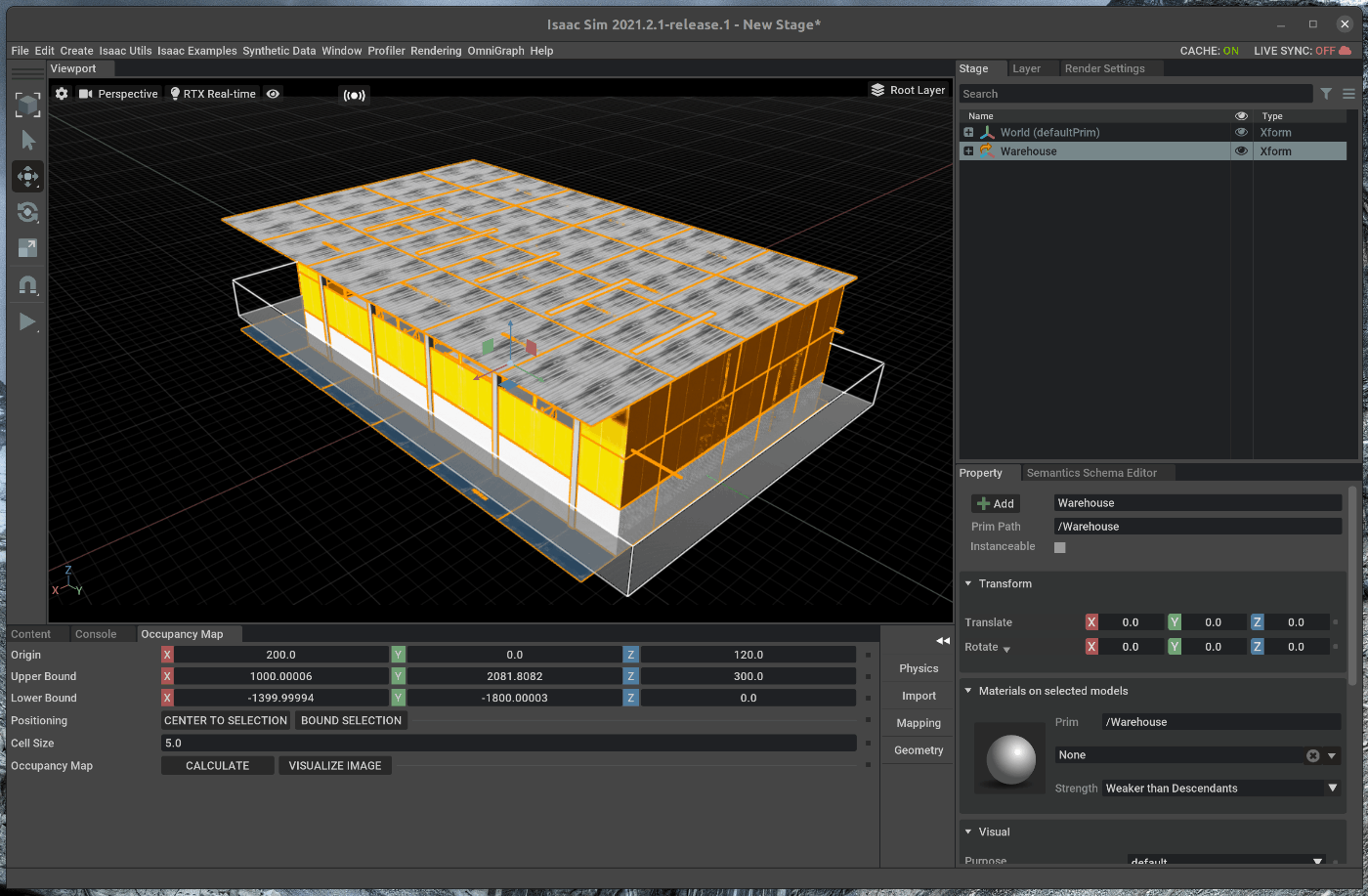

/tutorials/advanced/occupancy_map_generation/17_occupacy_map_generation.md:

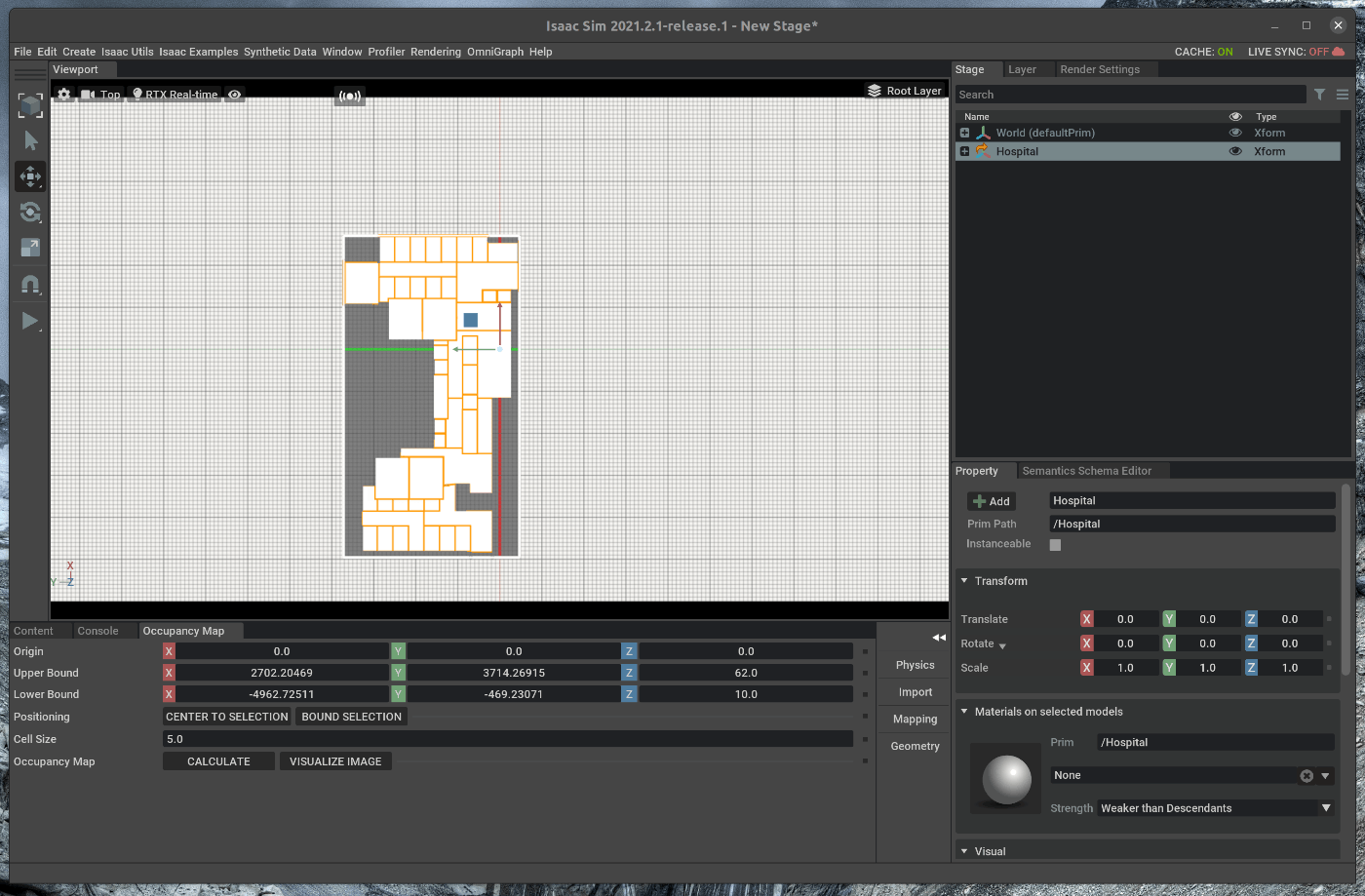

--------------------------------------------------------------------------------

1 | # 概要

2 | シミュレーション内で2DのOccupacy Mapを作成します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_occupancy_map.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 |

26 | GUI上からの操作によって、Occupacy Mapを作成します。

27 | Occupacy Mapは時系列のセンサ情報をもとに事後確率として障害物の存在性を評価する際に使用されます。

28 | [参考:菅沼、魚住、自動車の自律走行のためのOccupacy Grid Mapに基づく全方位障害物検出、2013](https://www.jstage.jst.go.jp/article/jsaeronbun/44/3/44_20134483/_pdf)

29 |

30 | 1. 2D Occupacy Mapの作成(GUI)

31 |

32 | ## 1. 2D Occupacy Mapの作成(GUI)

33 | こちらのページに記載してある手順を進めます。

34 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_range_sensor_lidar.html#getting-started

35 |

36 | ### 1.1 OmniverseからIssac Simを起動する

37 |

38 |

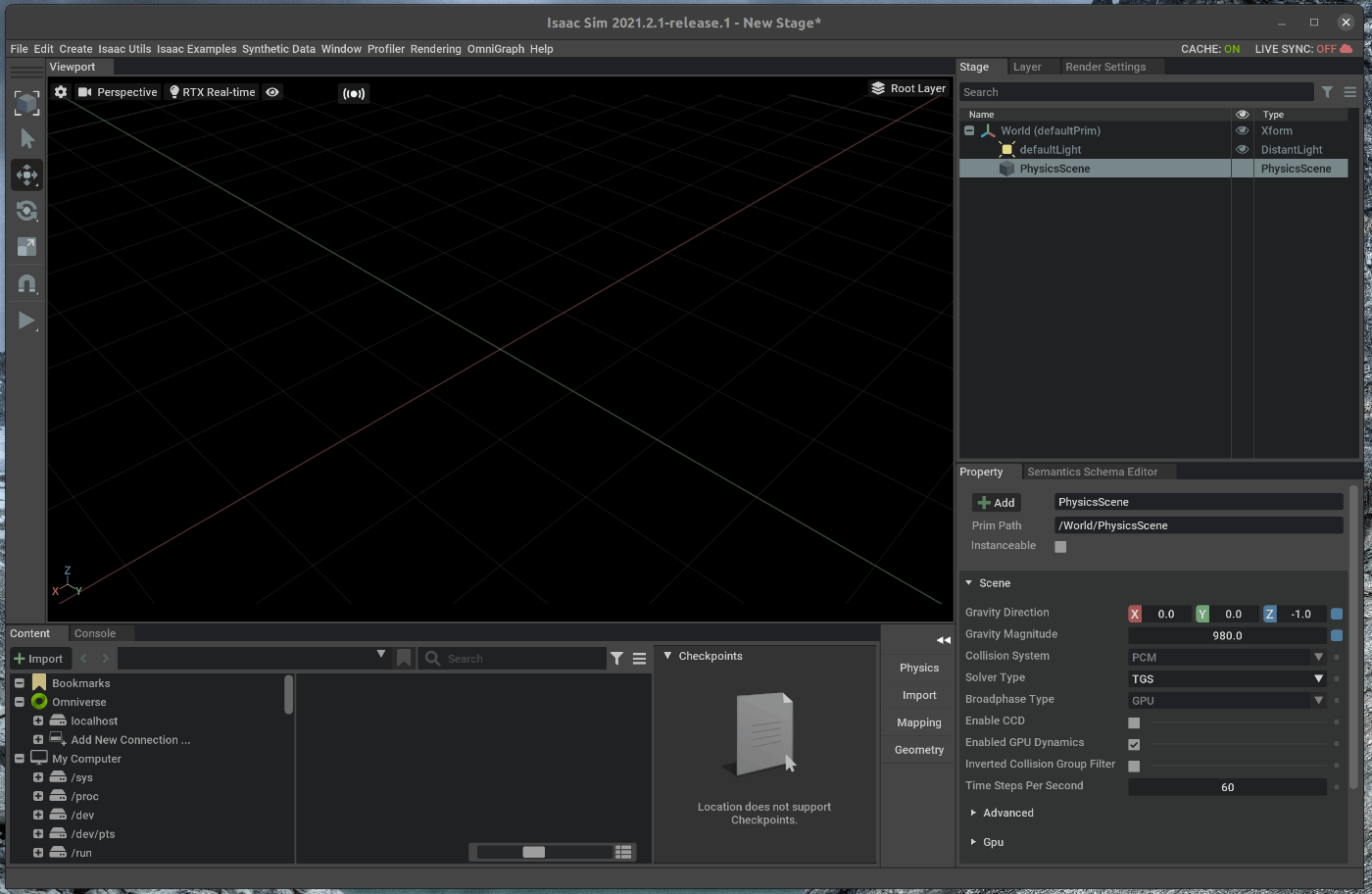

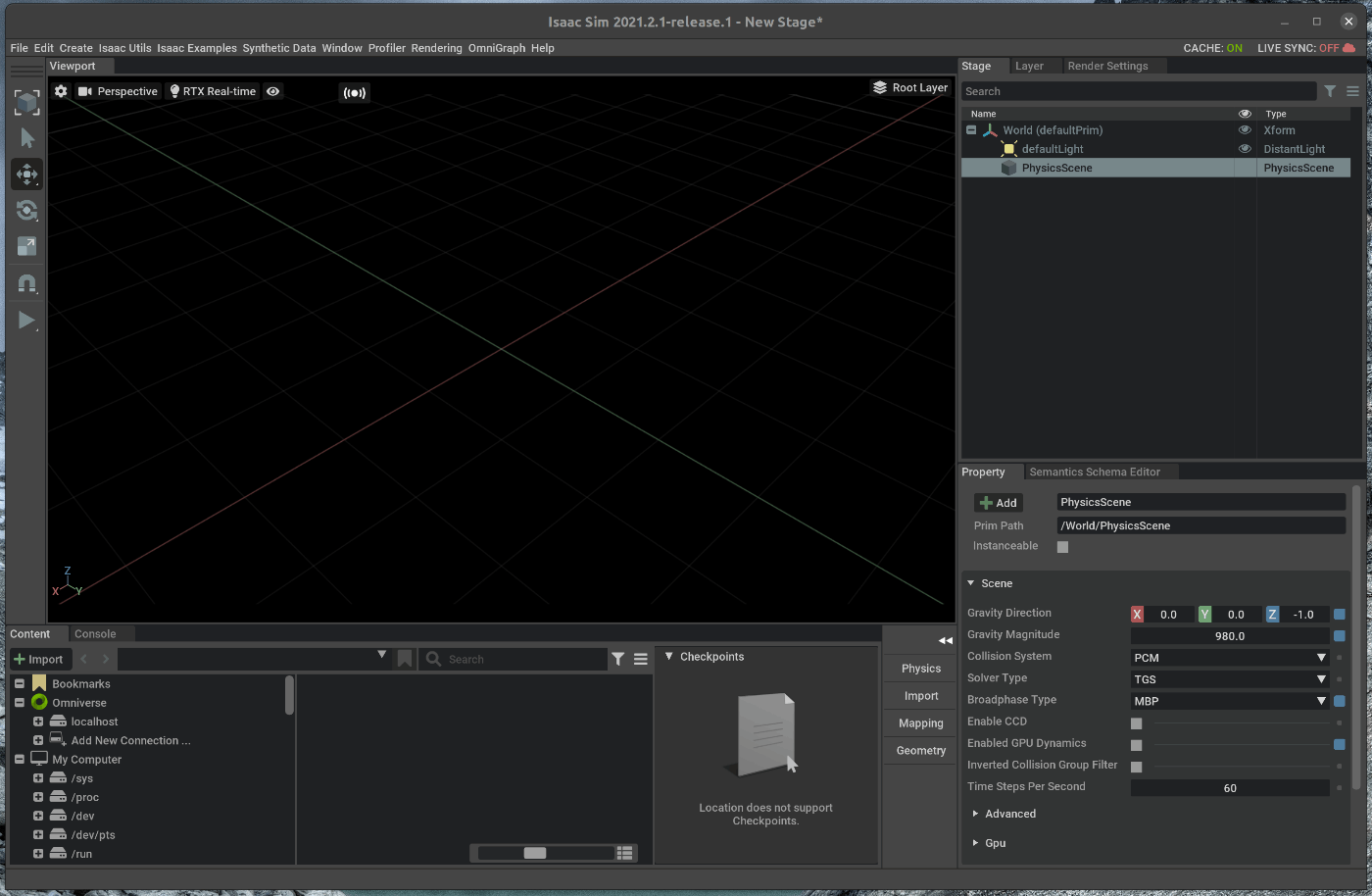

39 | ### 1.2 シーンを作成する

40 | メニューバーのCreate > Physics > Phisics Sceneを選択します。

41 |

42 |

43 |

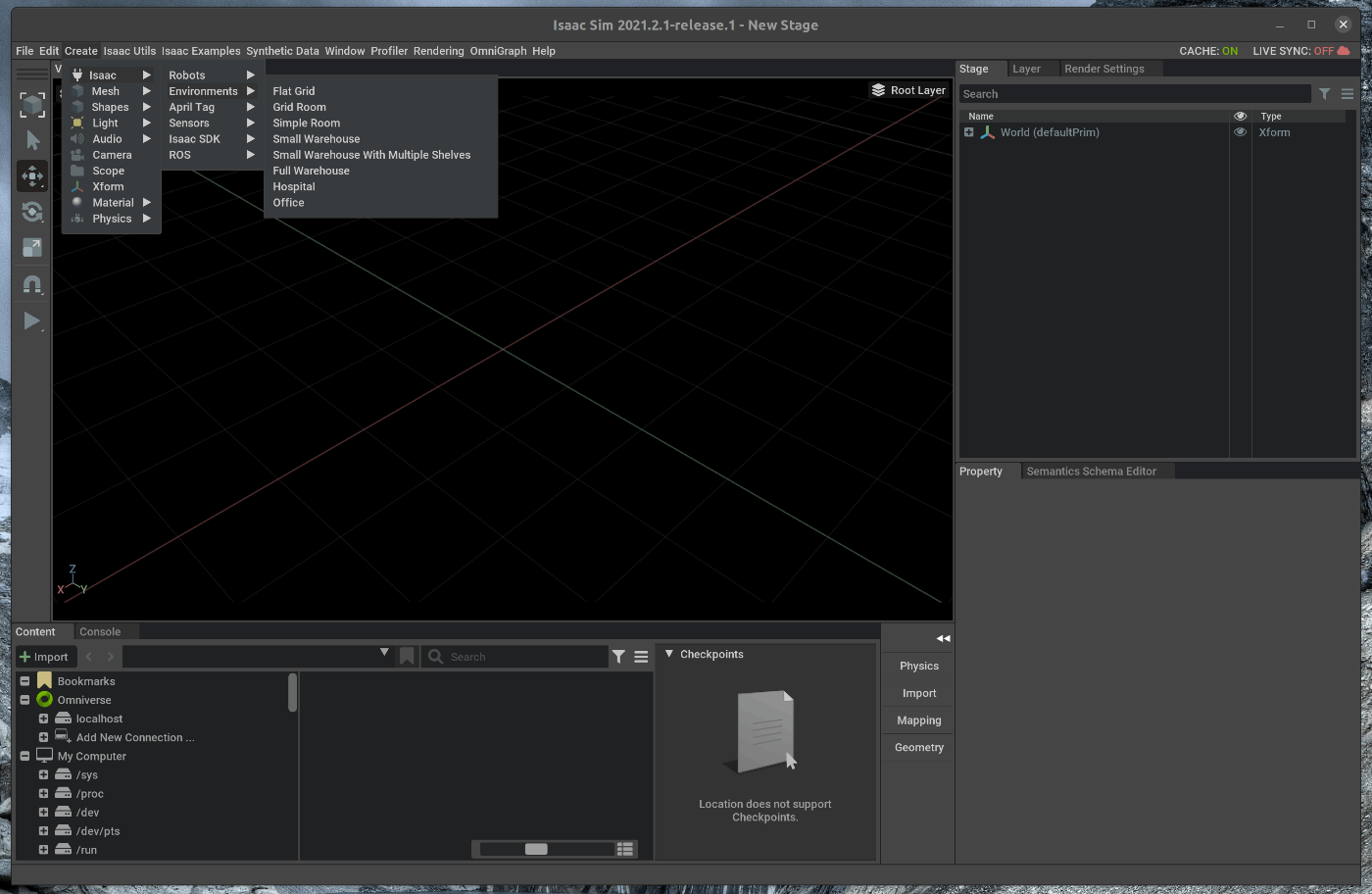

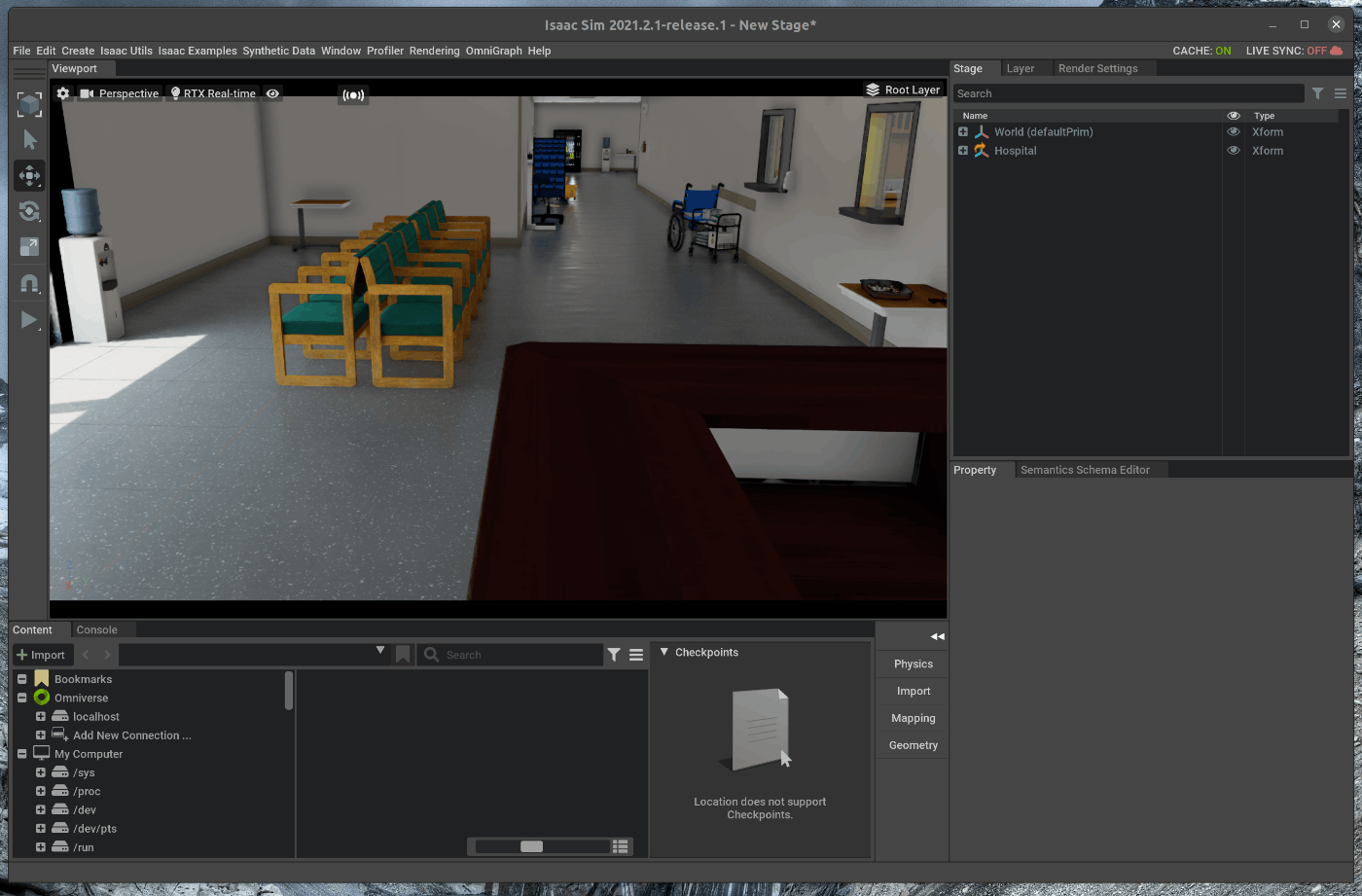

44 | ### 1.3 Warehouse環境のロード

45 | Warehouseの環境をシーン内にロードします。

46 | メニューバーのCreate -> Isaac -> Environments -> Warehouse Multiple Shelvesを選択します。

47 |

48 |

49 |

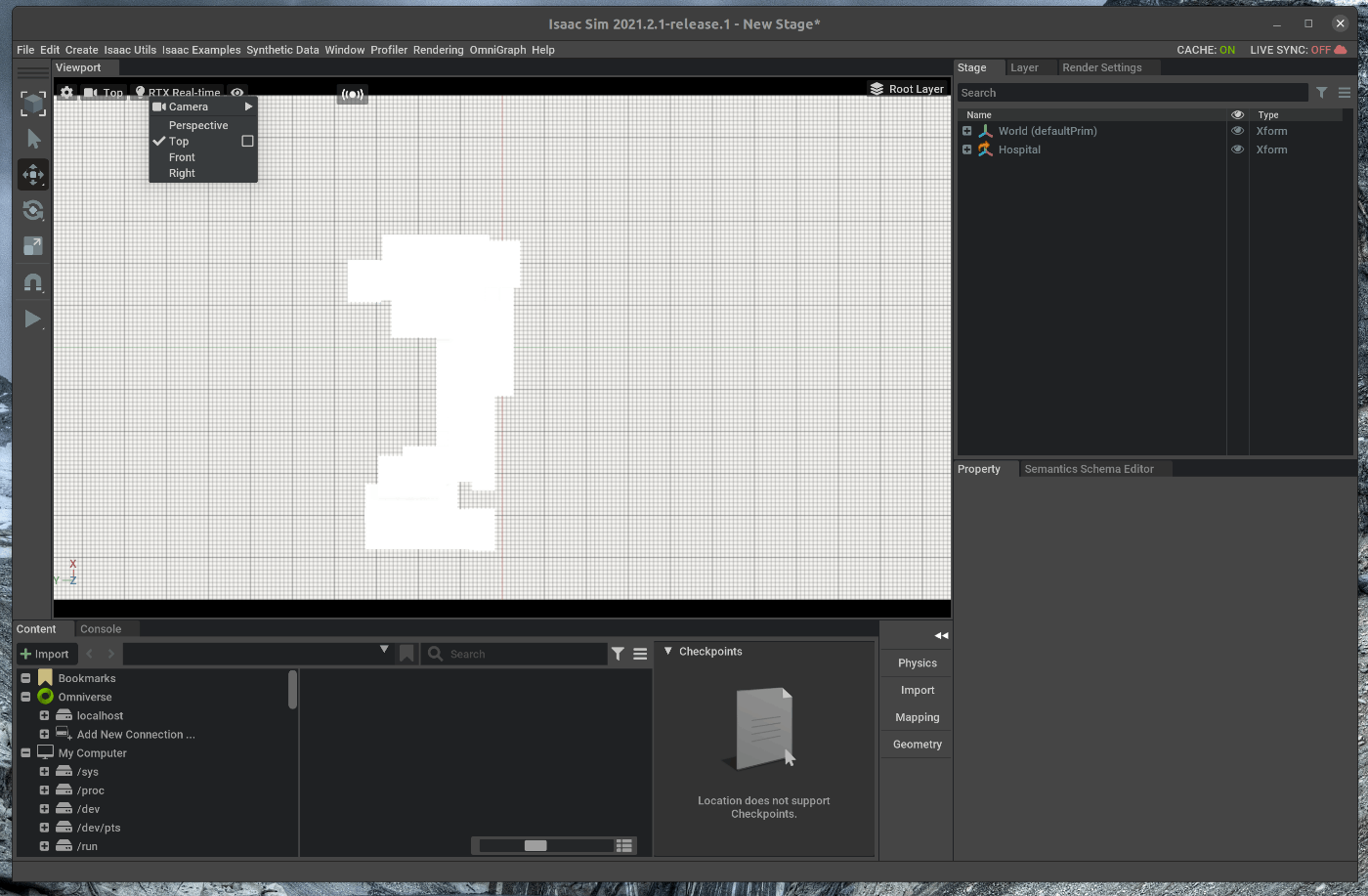

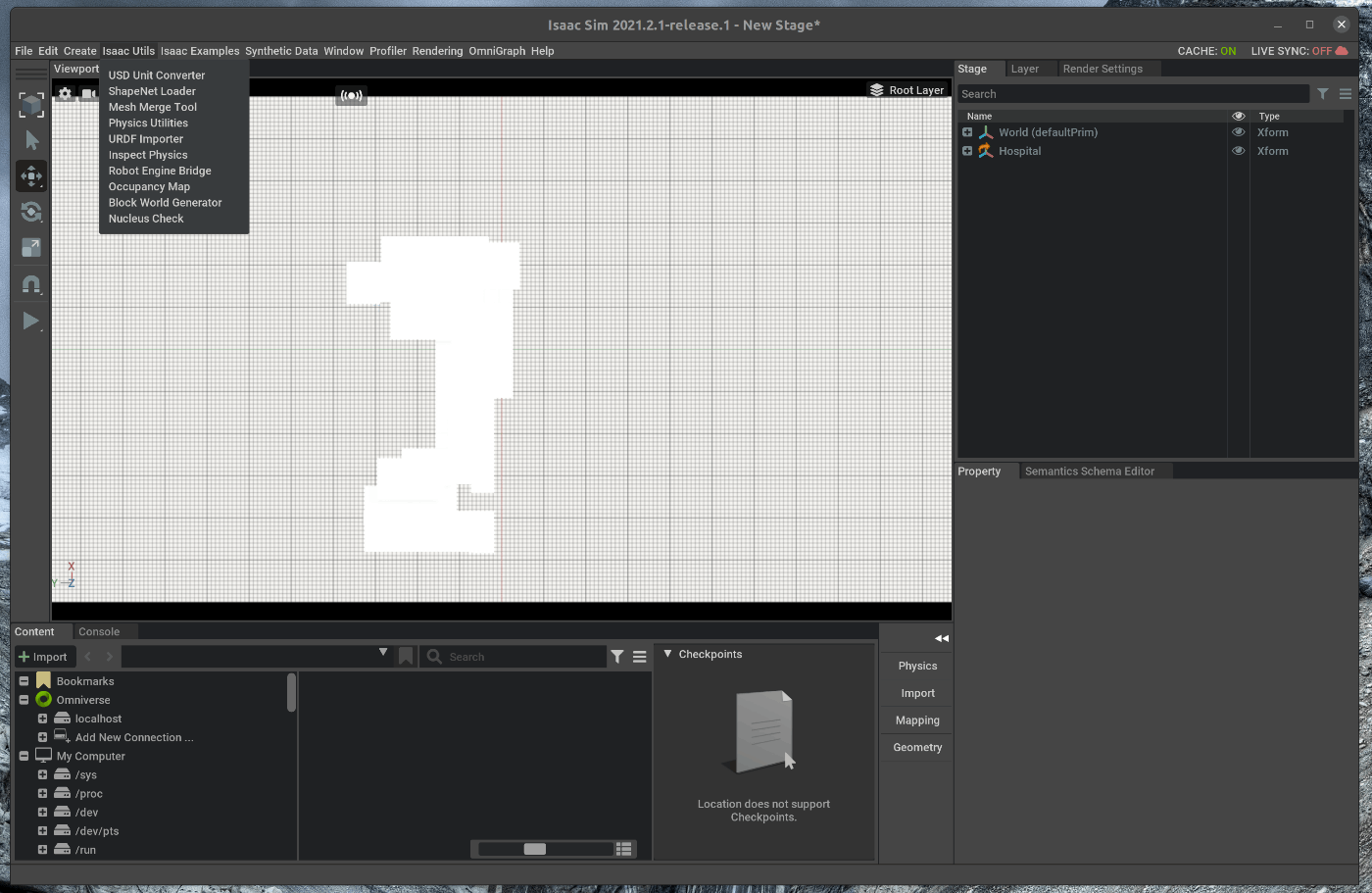

50 | ### 1.3 Occupacy Mapの作成

51 | まず、Occupacy Map Generatorをロードします。

52 | メニューバーのIsaac Utils -> Occupacy Mapを選択します。

53 |

54 |

55 |

56 | Viewportの下にあるOccupacy Map ExtensionのOriginの値を次の値に設定します。

57 |

58 | - OriginのXを200にする

59 | - OriginのYを0にする

60 | - OriginのZを120にする

61 |

62 |

63 | Viwport内に2DのGridが作成されることを確認します。

64 |

65 |

66 | 次に、右側にあるStageの中で、ロードしたWarehouseを選択します。

67 | この状態で、Viewportの下にあるOccupacy Map Extensionの”BOUND SELECTION”を選択します。

68 |

69 |

70 | Viewportの下にあるOccupacy MapのUpper Boundの値を次の値に設定します。

71 |

72 | - Upper BoundのZを300にする

73 |

74 |

75 | Occupacy Map Extensionの”CALCULATE” > "VISUALIZE IMAGE"を選択します。

76 | 選択すると、2DのOccupacy Mapが表示されます。

77 |

78 |

79 |

80 |

81 |

82 |

83 |

84 |

85 |

86 |

87 |

--------------------------------------------------------------------------------

/tutorials/advanced/using_sensors_generic_range_sensor/16_using_sensor_generic_range_sensor.md:

--------------------------------------------------------------------------------

1 |

2 | # 概要

3 | シミュレーション内で投射パターンを自由に変更することが可能なLIDARを使用します。

4 |

5 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

6 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_range_sensor_generic.html#

7 |

8 | # 実行環境

9 |

10 | - インストール実行環境

11 |

12 | | unit | specification |

13 | |:-----------------:|:------------------:|

14 | | CPU | i9-11900H |

15 | | GPU | GeForce RTX 3080 Laptop|

16 | | RAM | 32GB |

17 | | OS | Ubuntu 20.04.3 LTS |

18 |

19 | - Nvidia Driverバージョン

20 | - 510.39.01

21 | - Issac simバージョン

22 | - 2021.2.1

23 |

24 |

25 | # 手順

26 |

27 | GUI上からの操作と、Python APIからシーンにLIDARを追加します。

28 |

29 | 1. Generic Range Sensorの追加(GUI)

30 | 2. Generic Range Sensorの設定を変更する

31 |

32 |

33 | ## 1. Generic Range Sensorの追加(GUI)

34 | こちらのページに記載してある手順を進めます。

35 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_range_sensor_lidar.html#getting-started

36 |

37 | ### 1.1 OmniverseからIssac Simを起動する

38 |

39 |

40 | ### 1.2 シーンを作成する

41 | メニューバーのCreate > Physics > Phisics Sceneを選択します。

42 |

43 |

44 |

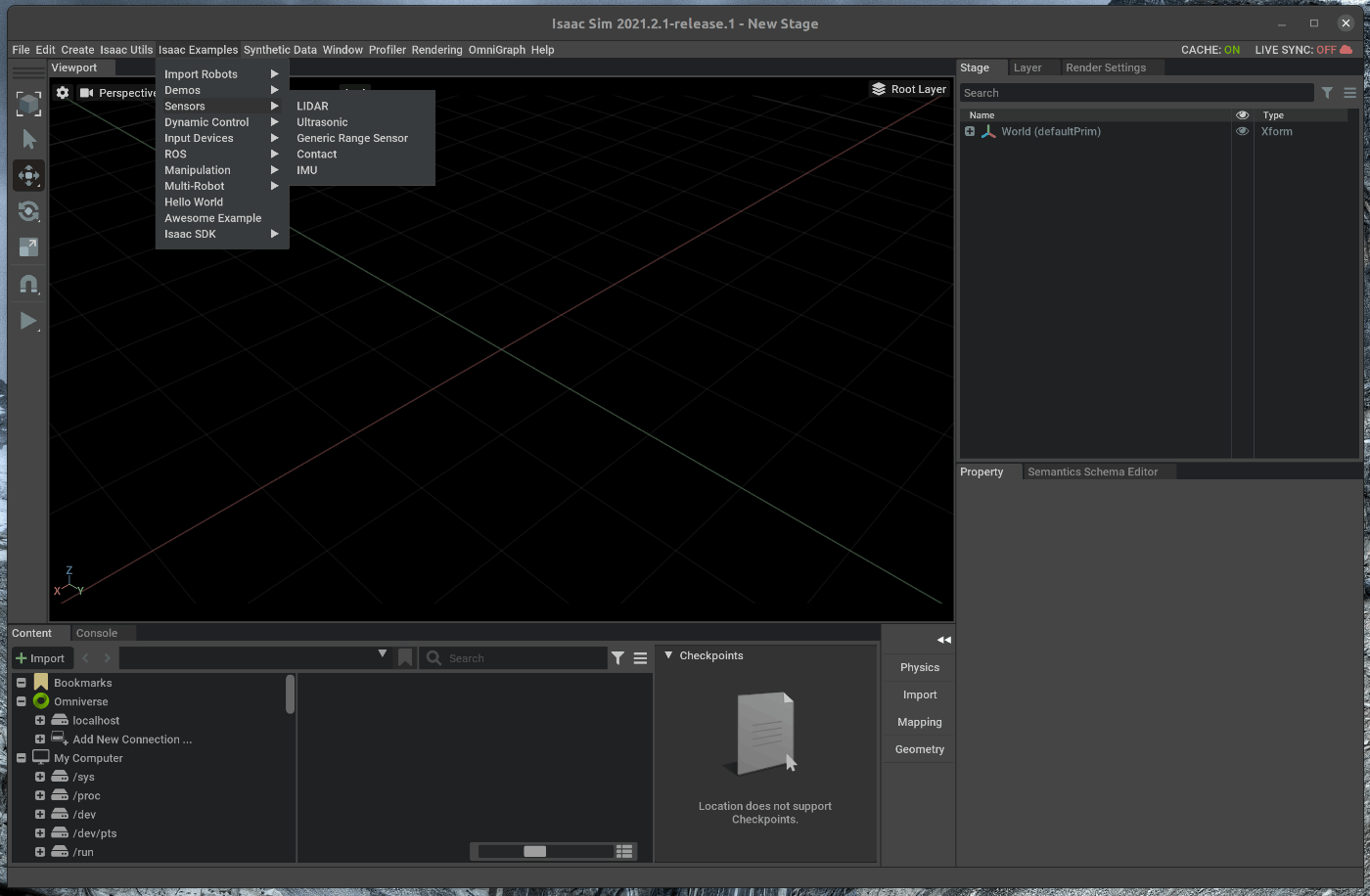

45 | ### 1.3 LIDARの追加

46 | 作成したシーン内に、Generic Range Sensorを追加します。

47 | メニューバーのIsaac Examples > Sensors > Generic Range Sensorを選択します。

48 |

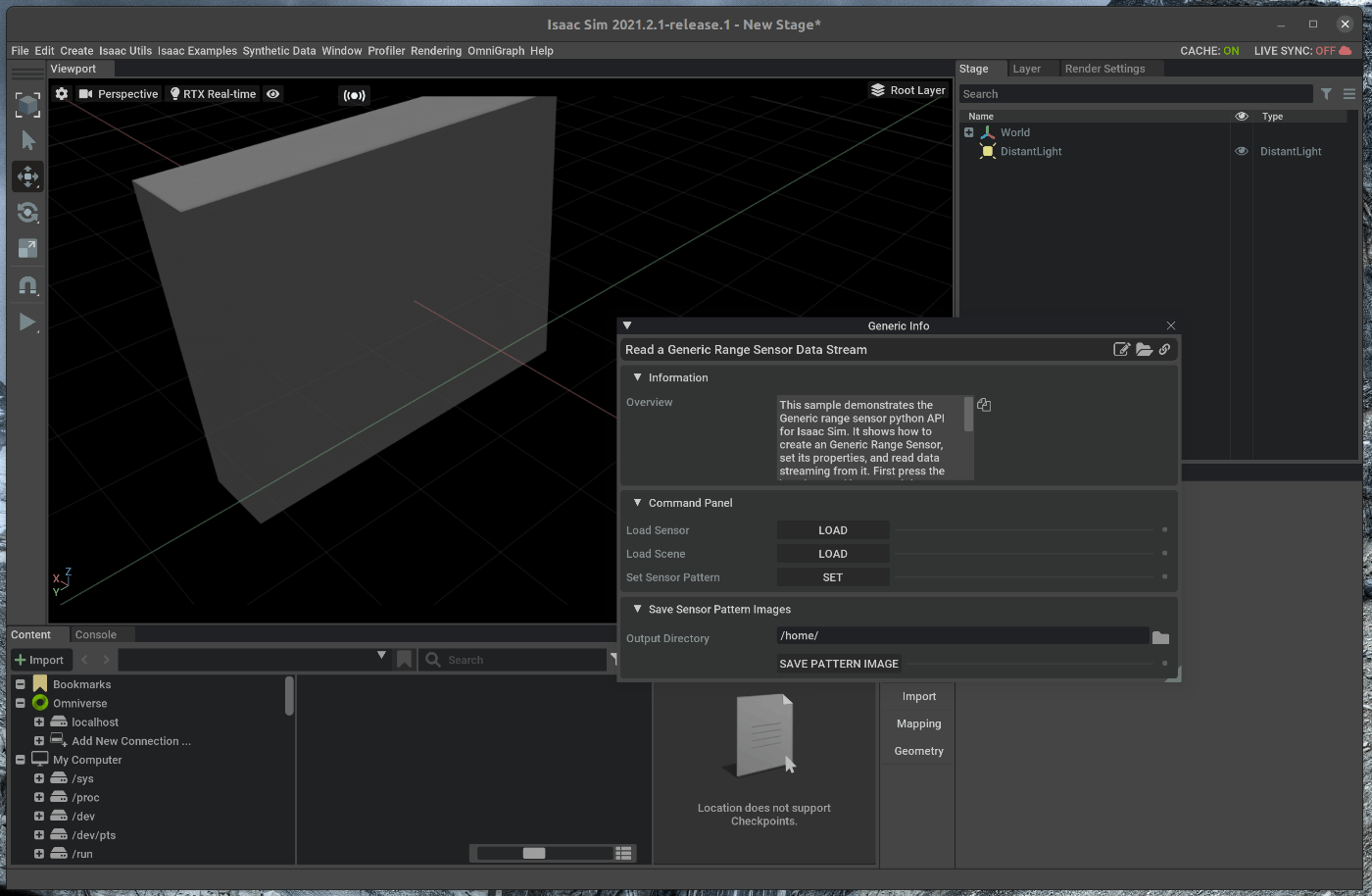

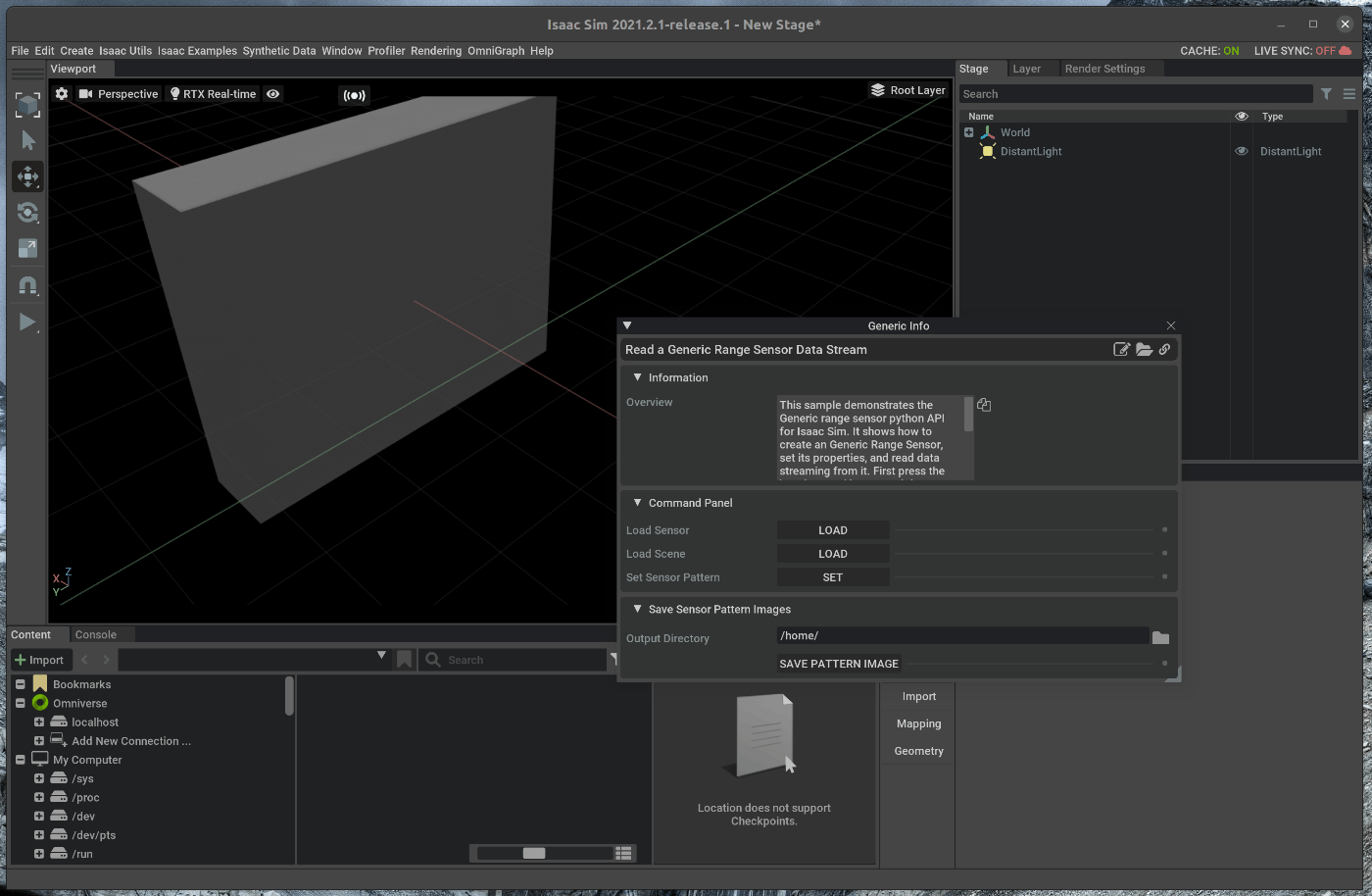

49 |

50 | ポップアップしたWindowにおいて、"Load Sensor"を選択します。

51 |

52 |

53 | 次に、ポップアップしたWindowにおいて、”Load Scene”を選択します。

54 |

55 |

56 | ”Set Sensor Pattern”をすると、ExampleのSensor Patternが読み込まれます。

57 |

58 |

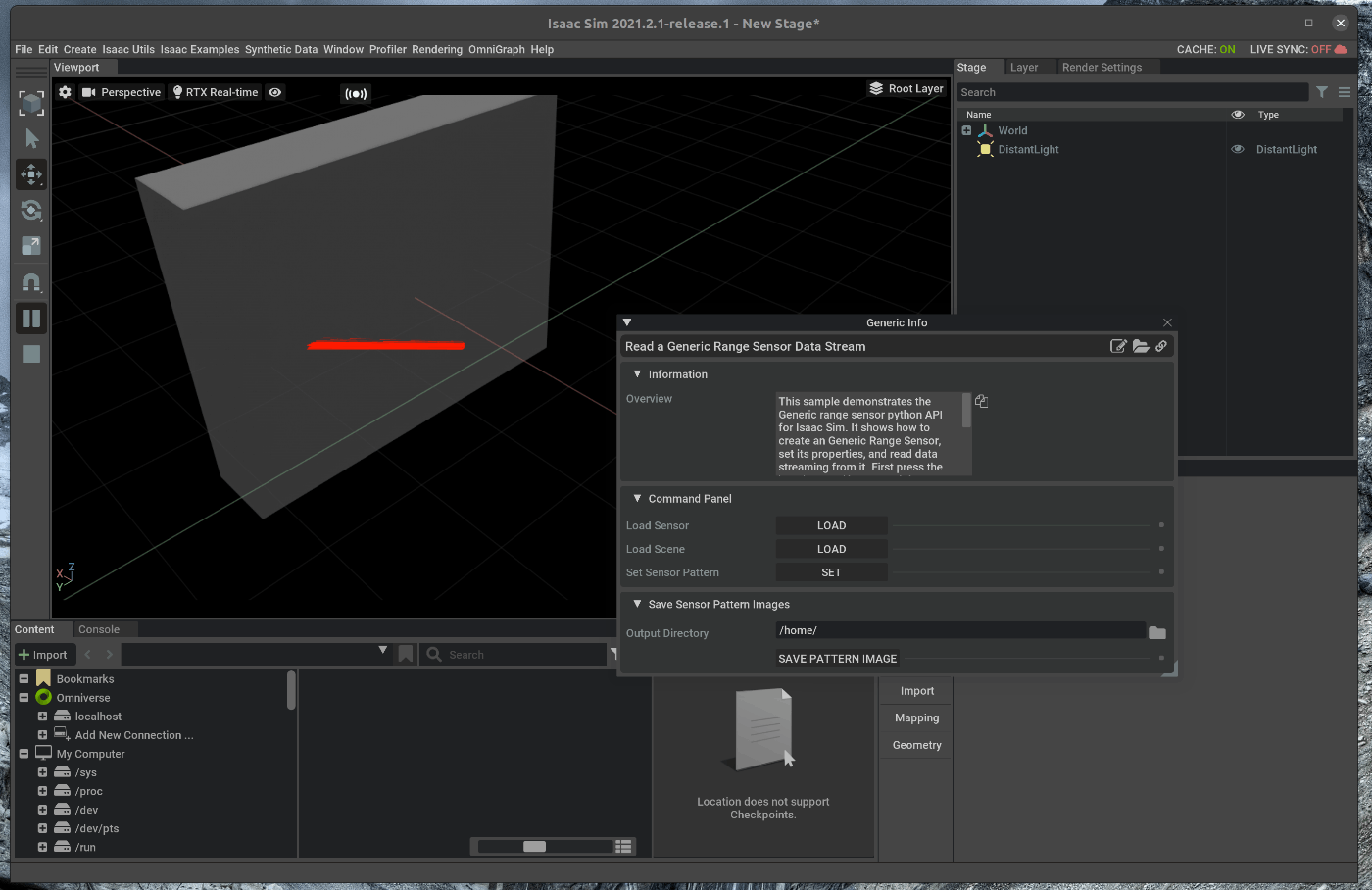

59 | この状態で、Viewportの左側のPLAYボタンを押すと、Exampleのレーザパターンが照射されます。

60 |

61 |

62 | ## 2. Generic Range Sensorの設定を変更する

63 | ## 2.1 Generic Range Sensorのサンプルコードを開く

64 |

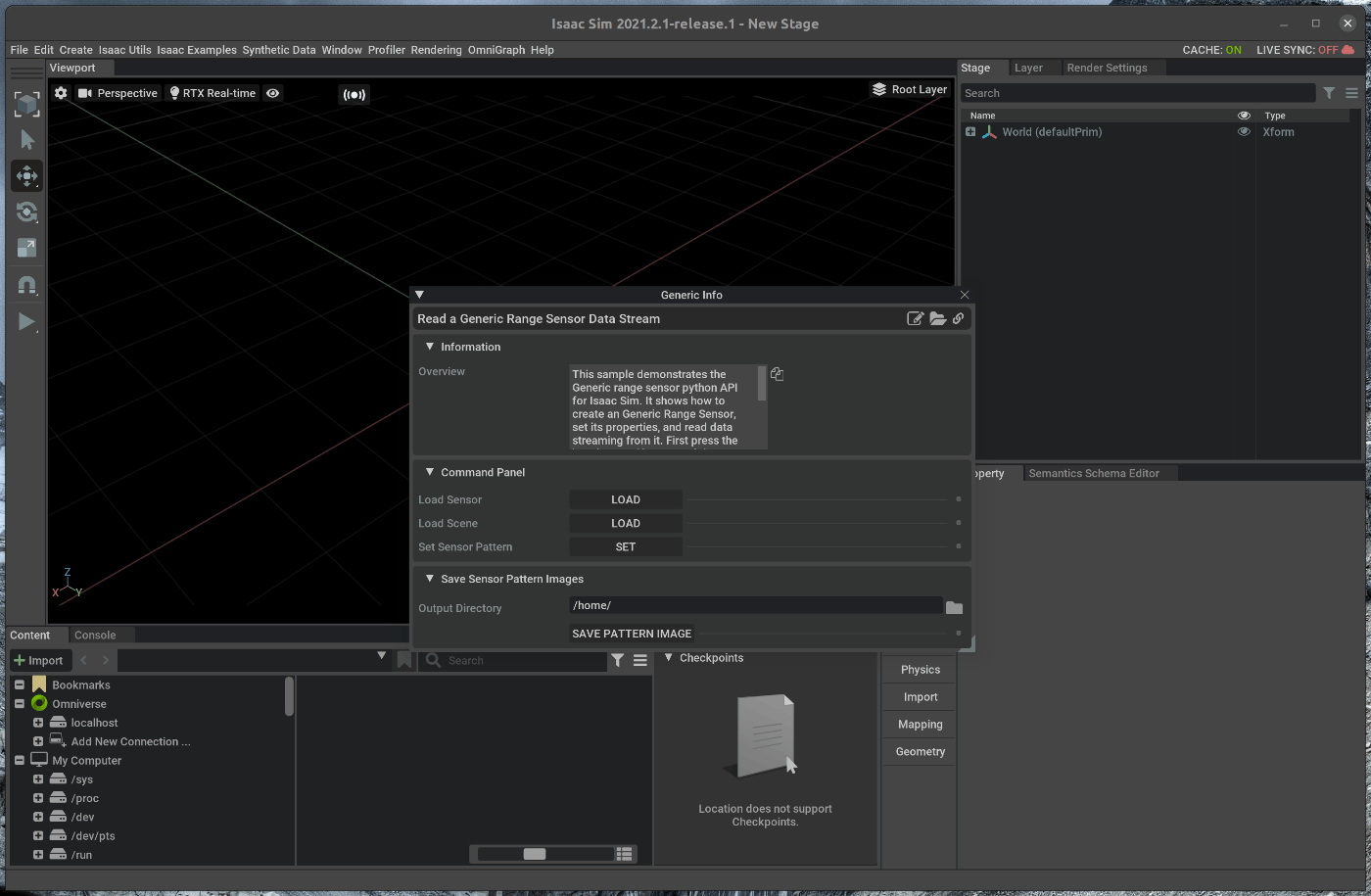

65 | ポップアップしているウィンドウの右上にある3つのボタンの内、一番左側のOpen Source Codeボタンを選択します。

66 |

67 |

68 | 選択すると、がVScodeが開き、Generic Range SensorのExampleのソースコードが表示されます。

69 |

70 |

71 | ## 2.2 Generic Range Sensorの設定を変更する

72 | ソースコードを変更し、レーザの照射レートを変更します。

73 | Exampleの248行目を以下の設定に変更します。

74 |

75 | ~~~ change_prop_generic_range_sensor.py:Python3

76 | frequency = 100

77 | ~~~

78 |

79 | ポップアップしたWindowにおいて、"Load Sensor" > ”Load Scene” > ”Set Sensor Pattern”を順番に選択します。

80 |

81 |

82 | この状態で、Viewportの左側のPLAYボタンを押すと、照射レートが変更されたレーザパターンが照射されます。

83 |

84 |

85 |

--------------------------------------------------------------------------------

/tutorials/gui/cad_importer/35_cad_importer.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac SimにUSDファイル以外のファイル形式の3Dモデルをインポートします。

3 |

4 | Issac SimのExtension部分に上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/prod_extensions/ext_cad-importer.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | 大まかな手順は次の通りです。

26 |

27 | 1. Cad Importerの有効化

28 | 2. オブジェクトのインポート(.stp)

29 | 3. オブジェクトの保存(USDファイル)

30 |

31 | 今回はstpファイルをインポートします。

32 | 他にもobj形式のモデル等もインポート可能です。

33 |

34 | ## 1. Cad Importerの有効化

35 | ### 1.1 OmniverseからIssac Simを起動する

36 |

37 |

38 | ### 1.2 Cad Importerを有効化する

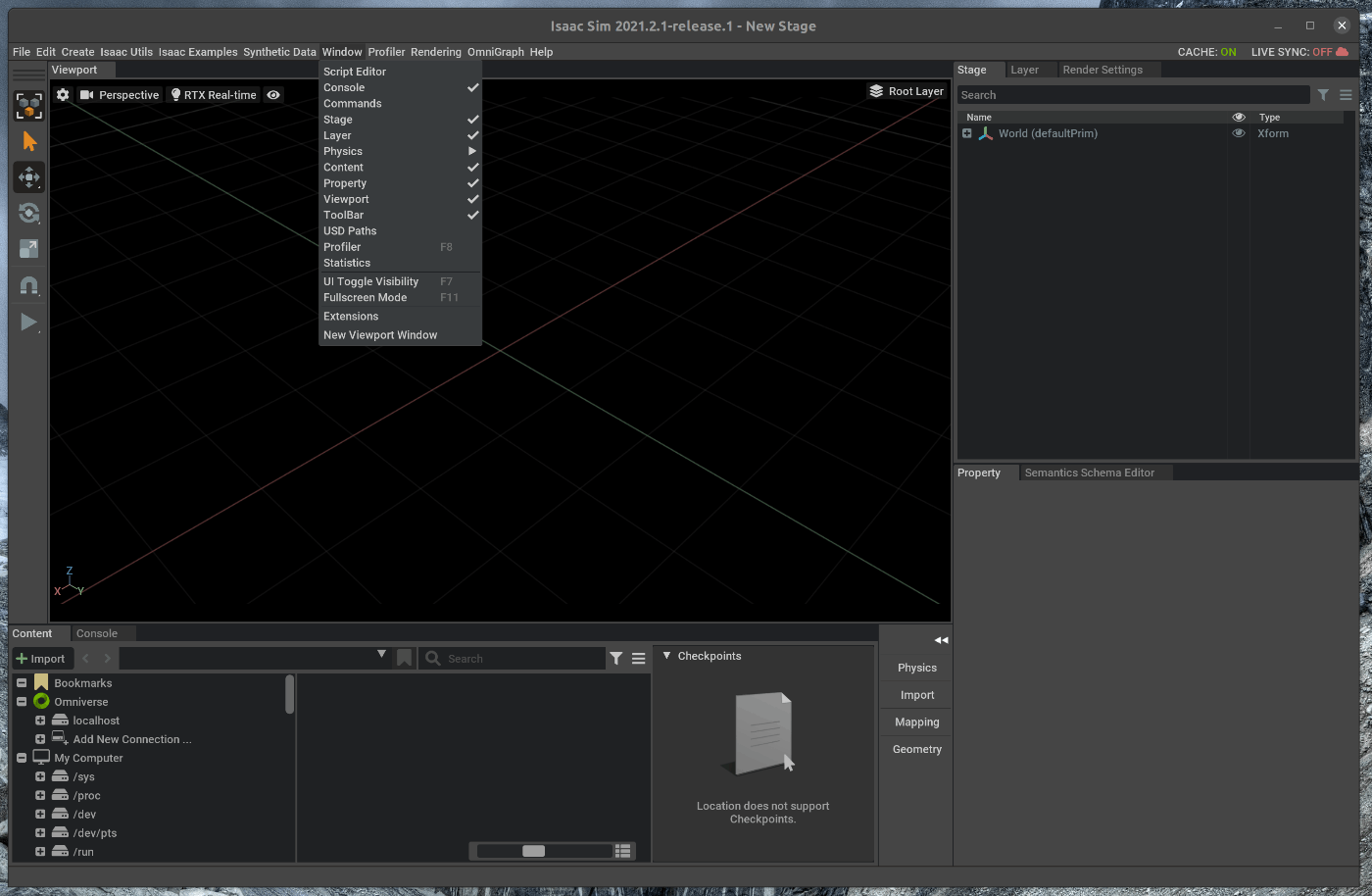

39 | メニューバーのWindow > Extensionsを選択します。

40 |

41 |

42 | ポップアップしたWindowの検索部分に”CAD”と入力します。

43 | 検索結果として、CAD Importerが表示されます。

44 |

45 | ポップアップしたWindowの右上部分にExtensionの有効状態が表示されています。

46 | 緑色で”Enable”と表示されている場合には、有効な状態です。

47 |

48 |

49 | 上記の状態になっていない場合には、トグルスイッチをクリックし、Enable状態にします。

50 |

51 | ## 2. オブジェクトのインポート(.stp)

52 | ### 2.1 シーンをロードする

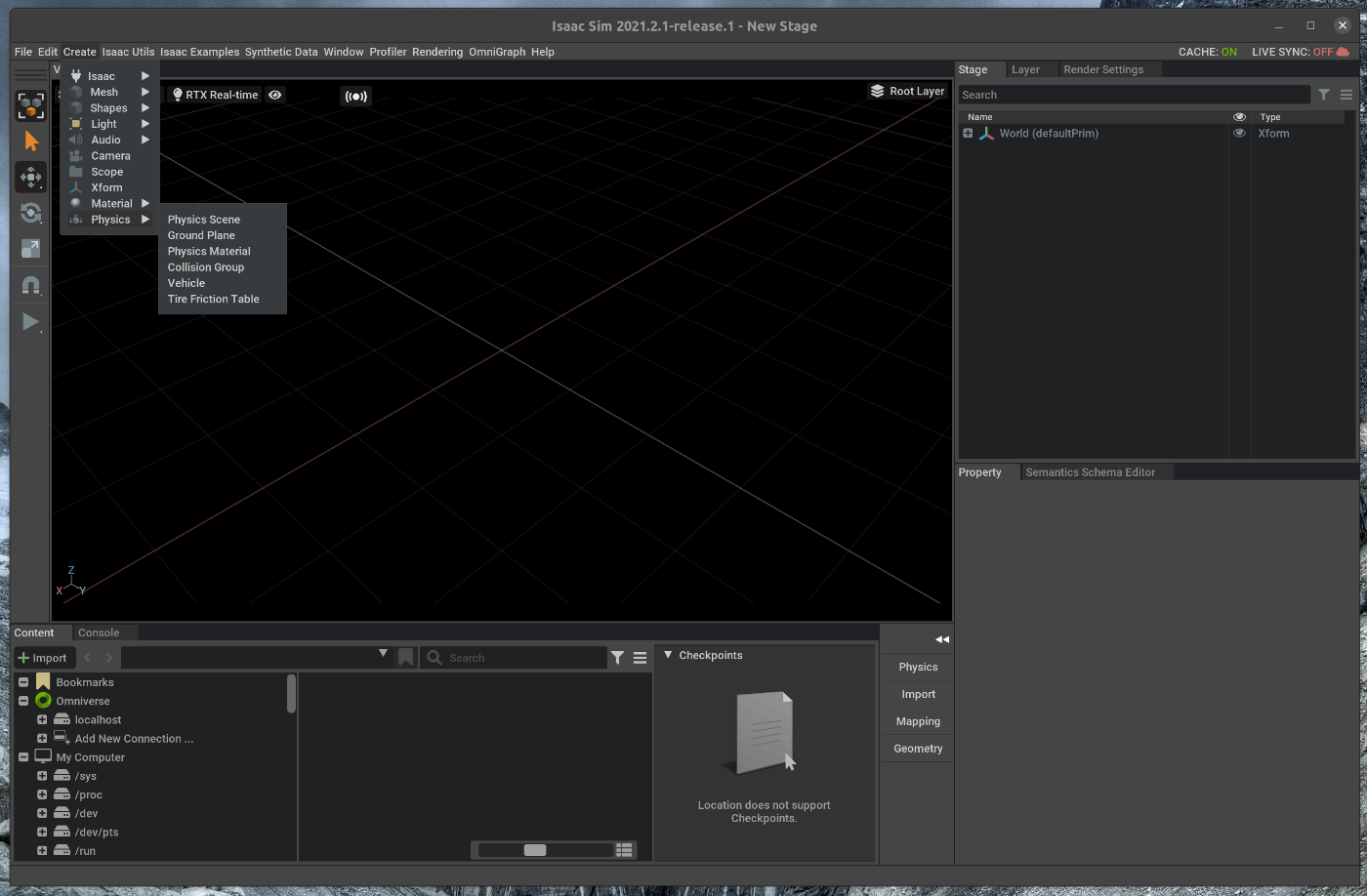

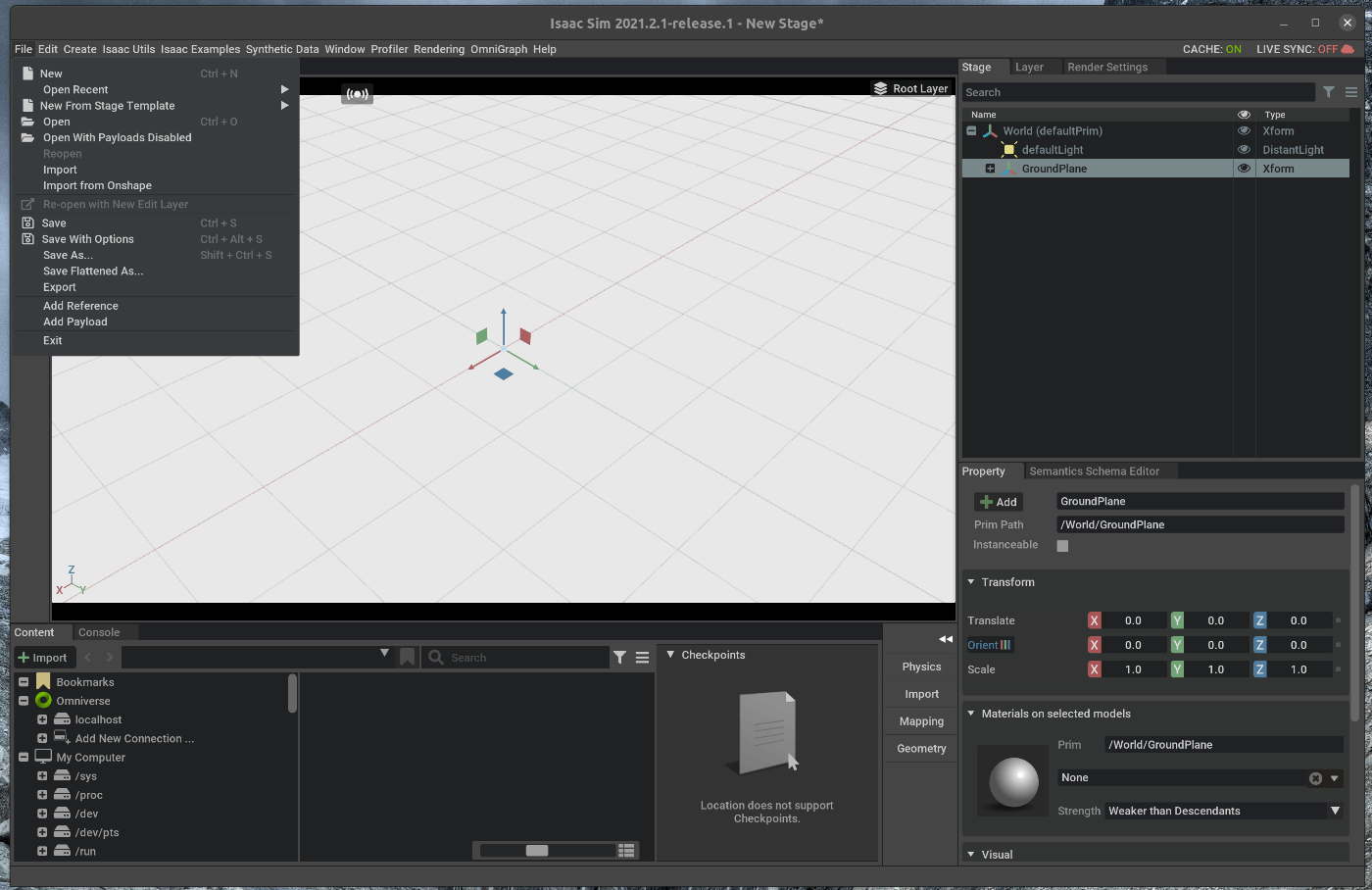

53 | メニューバーのCreate > Physics > Groud Planeを選択します。

54 |

55 |

56 |

57 | ### 2.2 オブジェクトのインポート

58 | シーン内にオブジェクトを追加します。

59 | 今回は、.stpファイルをインポートします。

60 | メニューバーのFile > Importを選択します。

61 |

62 |

63 | ポップアップしたWindowにおいて、任意のstpファイルを選択します。

64 |

65 |

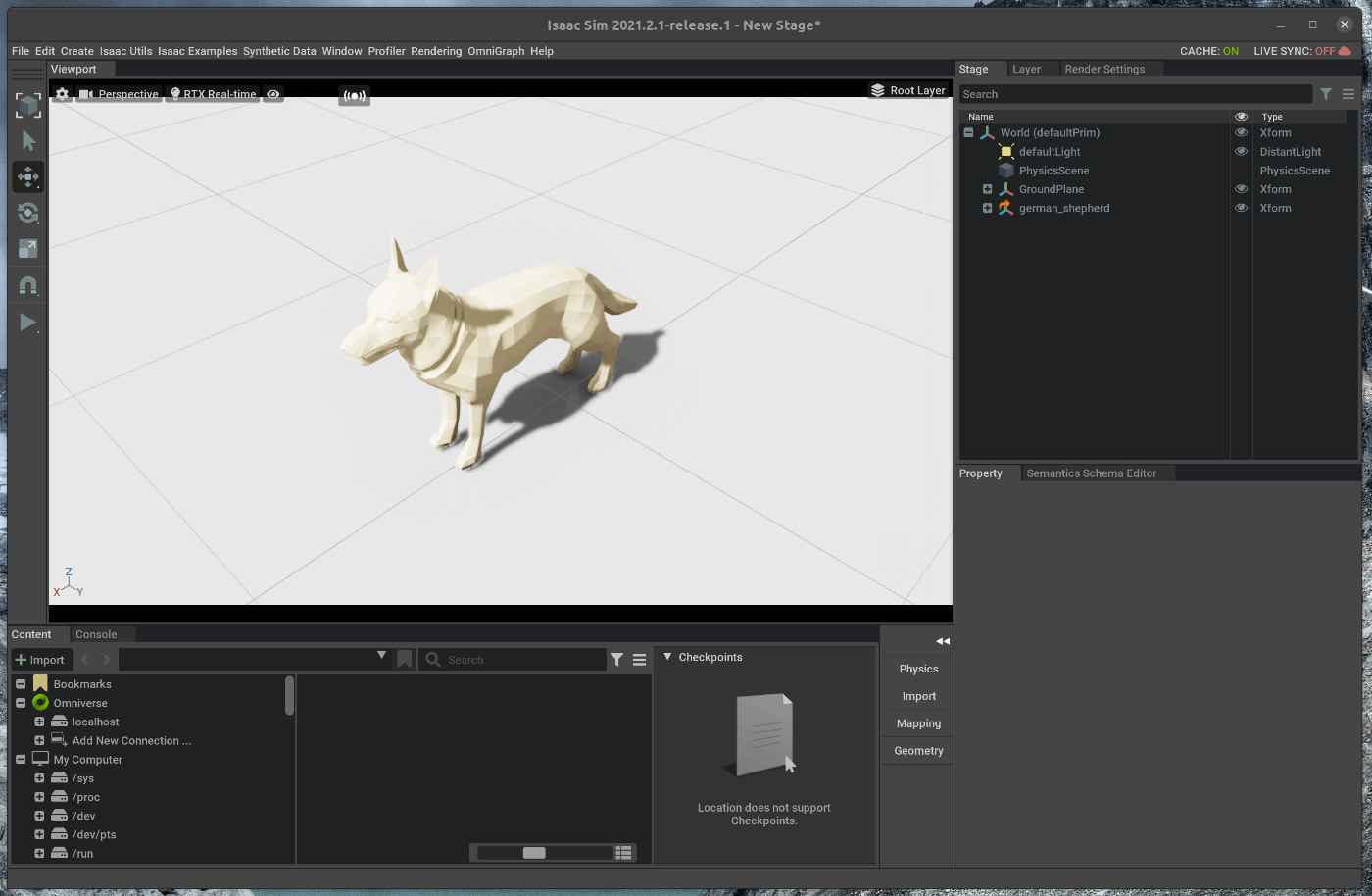

66 | 選択し、Openをクリックすると、Viewport内にstpファイルに記述されているオブジェクトがインポートされます。

67 |

68 |

69 | ## 3. オブジェクトの保存(USDファイル)

70 | ### 3.1 オブジェクトをGropu化する

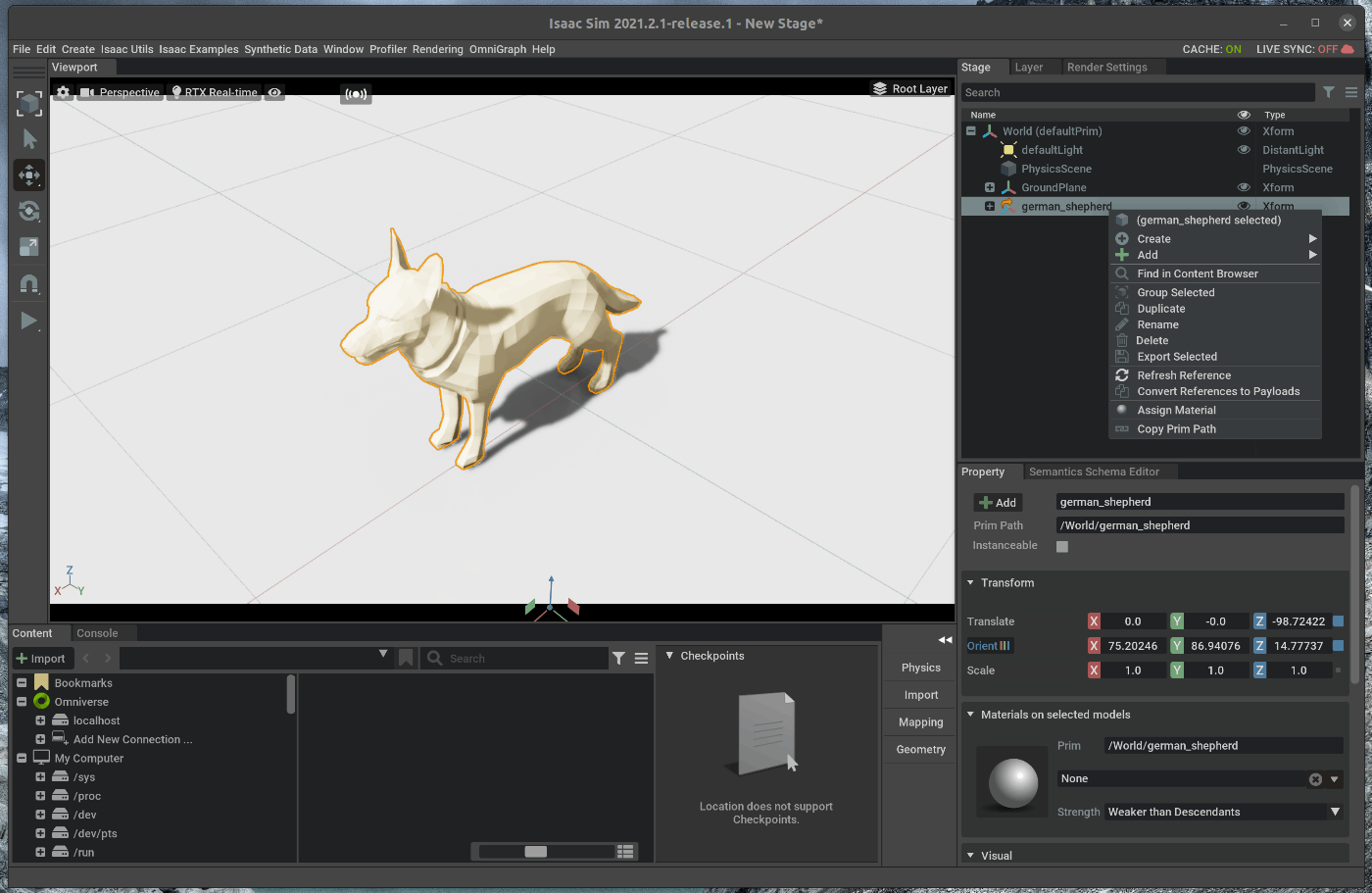

71 | 右側のStageタブの中で、先ほどインポートしたオブジェクトを選択します。

72 | 選択した状態で、右クリックし、Group Selectedを選択します。

73 |

74 |

75 | ### 3.2 GroupをUSDファイルとしてエクスポートする

76 | 右側のStageタブの中で、Groupを選択します。

77 | 選択した状態で、右クリックし、Export Selectedを選択します。

78 |

79 | ポップアップしたウィンドウにて、任意の保存名と保存先を指定します。

80 |

81 |

82 | ### 2.2 保存したUSDファイルをインポートする

83 | 今回はomniverse/localhost/Isaac/Enviroments/Simple_Room/Props/dog.usdとして保存しました。

84 | Viwportの下にあるContentの中から、Viewport内に該当のUSDファイルをドラッグアンドドロップすると、USDファイルとして先ほどインポートしたstpファイルがインポートされます。

85 |

86 |

87 |

--------------------------------------------------------------------------------

/tutorials/replicator/applying_and_visualizing_semantic_data/19_applying_and_visualizing_semantic_data.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | GUI上での操作で、シーン内のカメラから合成データを取得します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_semantics.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | GUI上での操作で、シーン内のカメラから合成データを取得します。

26 |

27 | 1. テストシーンのロード

28 | 2. 個別のオブジェクトのSemantic dataの生成

29 | 3. Stage全体のSemantic dataの生成

30 |

31 | ## 1. テストシーンのロード

32 | ### 1.1 OmniverseからIssac Simを起動する

33 |

34 |

35 | ### 1.2 テストシーンをロードする

36 | Isaac Simの下部にあるContentの中から、Isaac > Environments > Simple_Room > simple_room.usdをダブルクリックします。

37 |

38 |

39 | 次に、メニューバーのSynthetic Data > Sematics Schema Editorを選択します。

40 |

41 |

42 | ポップアップしたSematics Schema EditorのWindowをドラッグし、Stageの下のPropertyの右隣に追加します。

43 |

44 |

45 | ## 2. 個別のオブジェクトのSemantic dataの生成

46 | ### 2.1 個別のオブジェクトのSemantic dataを生成する

47 | Viwportの中で、左上にある目のアイコンの隣のアイコンを選択します。

48 | 表示されたWindowの中で、RGBとSemantic Segmentaitonにチェックを入れます。

49 |

50 |

51 | チェック後に、”Visualize”を選択すると、シーン内のカメラで撮影されたRGB画像が表示されます。

52 |

53 |

54 | 次に、シーン内のテーブルをSemantic Segmentationの結果で認識するように設定を変更します。

55 | Stageの中でRoot > table_low_327 > table_lowを選択します。

56 |

57 | 選択した状態で、Stageの下部にあるPropertyの”Raw USD properties”の中の”semantic:Semantics:params:semanticData”と”semantic:Semantics:params:semanticType”の値を確認します。

58 |

59 | 確認した値を、Semantic Schema Editorの”Apply Semantic data on selected objects”のTableのTypeとDataの値にそれぞれ入力します。

60 |

61 |

62 | 追加後、Viwportの中で、左上にある目のアイコンの隣のアイコンを選択します。

63 | 再度、”Visualize”を選択すると、シーン内のカメラで撮影されたRGB画像とTableが認識されたSemantic Segmentationの結果が表示されます。

64 |

65 |

66 | ## 3. Stage全体のSemantic dataの生成

67 | ### 3.1 Stage全体のSemantic dataを生成する

68 |

69 | Semantic Schema Editorの設定値を次の様に変更します。

70 |

71 | - "Prim types to label"に”Mesh”を入力する

72 | - "Class list"に”table,floor,wall”を入力する

73 |

74 |

75 | 入力後、"Prim types to label"欄の中で、”Generate Labels”を選択します。

76 |

77 | 追加後、Viwportの中で、左上にある目のアイコンの隣のアイコンを選択します。

78 |

79 |

80 | 再度、”Visualize”を選択すると、シーン内のカメラで撮影されたRGB画像とTableが認識されたSemantic Segmentationの結果が表示されます。

81 |

--------------------------------------------------------------------------------

/tutorials/replicator/replicator_playgroud/23_replicator_playgroud.md:

--------------------------------------------------------------------------------

1 | # 手順

2 | 学習用のデータセットを作成し、Replicator Playgroudからモデルの学習を行います。

3 | 今回の例はサンプルとして説明されており、学習したモデルを保存することはできません、、、、

4 | 合成データの作成から学習までGUIの操作で完結しているため、操作の利便性はかなり高いと感じました。

5 |

6 | 1. 合成データの作成

7 | 2. Replicator Playgroudを用いた学習

8 |

9 | ## 1. 合成データの作成

10 | ### 1.1 OmniverseからIssac Simを起動する

11 |

12 |

13 | ### 1.2 シーンをロードする

14 | メニューバーのCreate > Synthetic Data > Replicator playgroudを選択します。

15 |

16 |

17 | ポップアップした”Replicator playgroud”のWindowをViewport下部のConsoleの右隣に追加します。

18 |

19 |

20 | 追加したReplicator playgroudのScene and Randamization > Base Sceneをクリックし、”Simple Room”を選択します。

21 | 選択後、”Base Scene”の下の”LOAD”をクリックすると、”Simple Room”がロードされます。

22 |

23 |

24 | ### 1.3 シーンのColorを変更する

25 |

26 | 追加したReplicator playgroudのScene and Randamization > Select randamzationをクリックし、”Color”を選択します。

27 | 選択後、”Select randamzation”の下の”ADD”をクリックすると、ランダムなカラーが適用されます。

28 | 適用されたカラーは、”ADD”の下にある”Preview”を選択すると、表示されます。

29 |

30 |

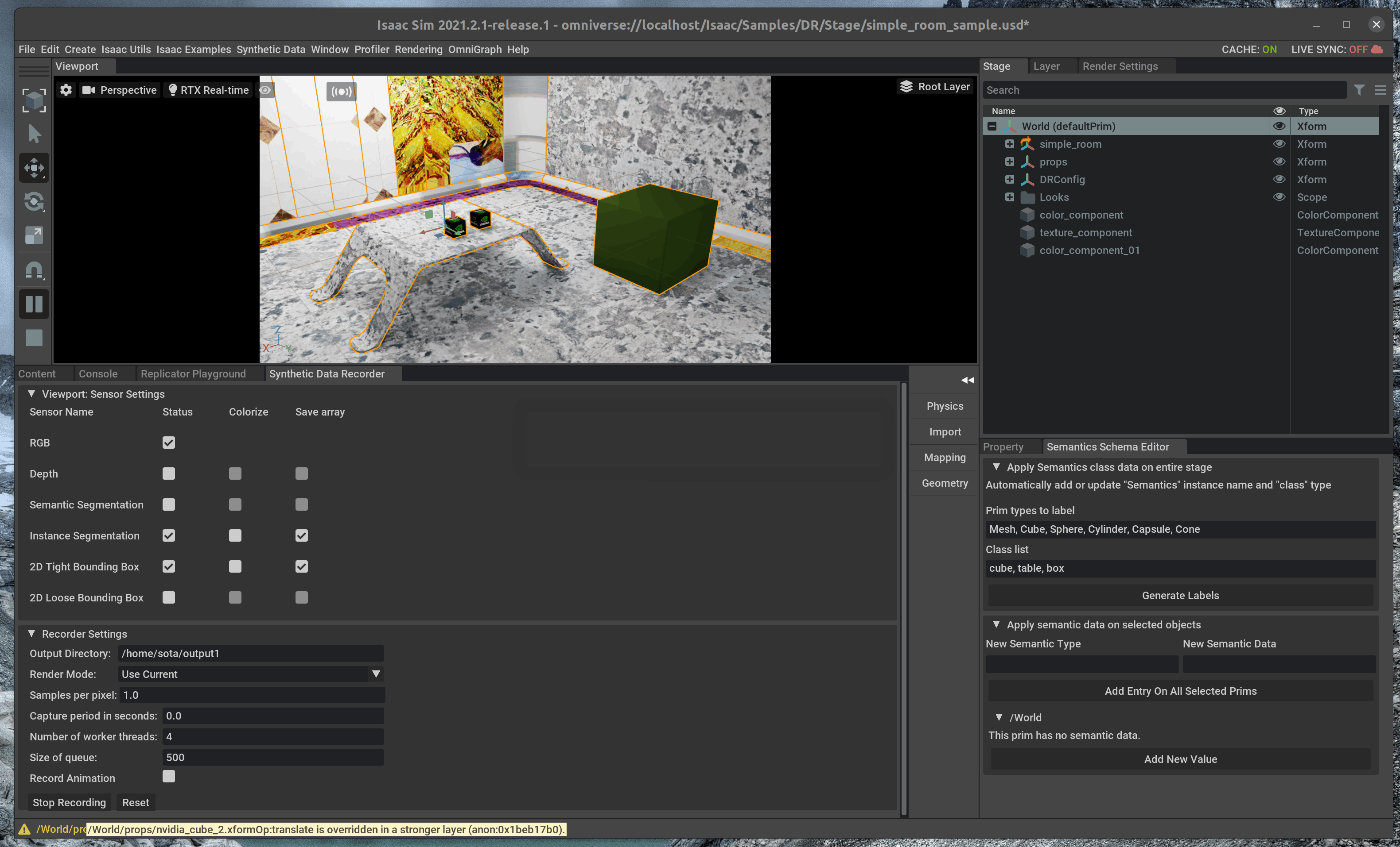

31 | ### 1.4 合成データのデータセットを作成する

32 | メニューバーのCreate > Synthetic Data > Synthetic Data Recodarを選択します。

33 | ポップアップした”Synthetic Data Recoda”のWindowをViewport下部のReplicator playgroudyの右隣に追加します。

34 |

35 |

36 | Synthetic Data Recodar > Sensor Settingの中で、学習に必要なデータにチェックを入れます。

37 | チェックを入れるデータは次の通りです。

38 |

39 | - RGB ( status )

40 | - Instance Segmentation (status, Save array)

41 | - 2D Tight Bounding Box (status, Save array)

42 |

43 | また、学習データの保存先ディレクトリは、Recodar Settingsの”output directory”において指定します。

44 |

45 |

46 | チェック後、シミュレータ左側のツールバーの”PLAY”を押すと、シーンのカラーがランダムに変更されます。

47 |

48 |

49 | Synthetic Data RecodarのRecodar Settingにある”Start Recording”を選択します。

50 |

51 |

52 | 10sec程度経過後、”Stop Recording”を選択します。

53 |

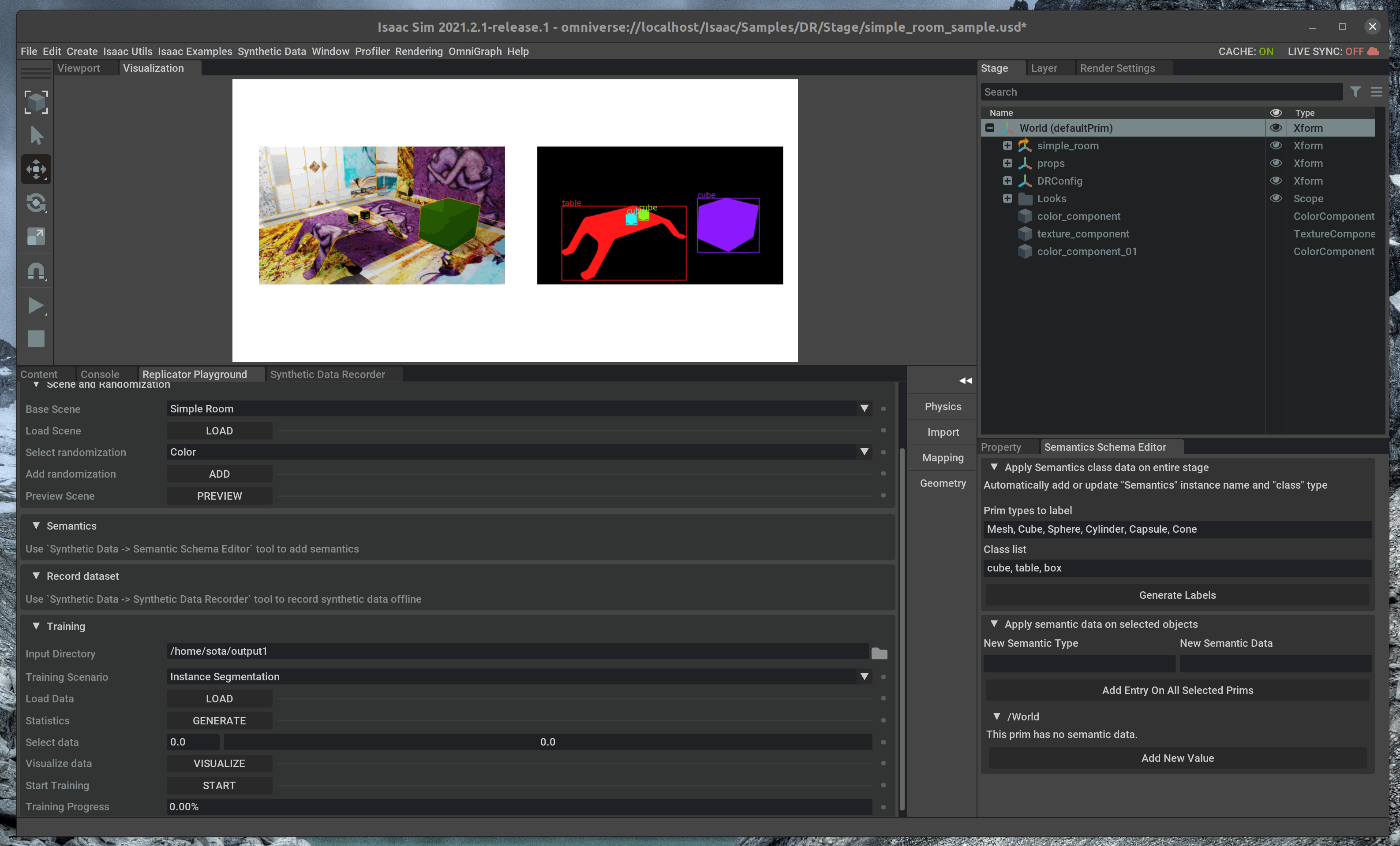

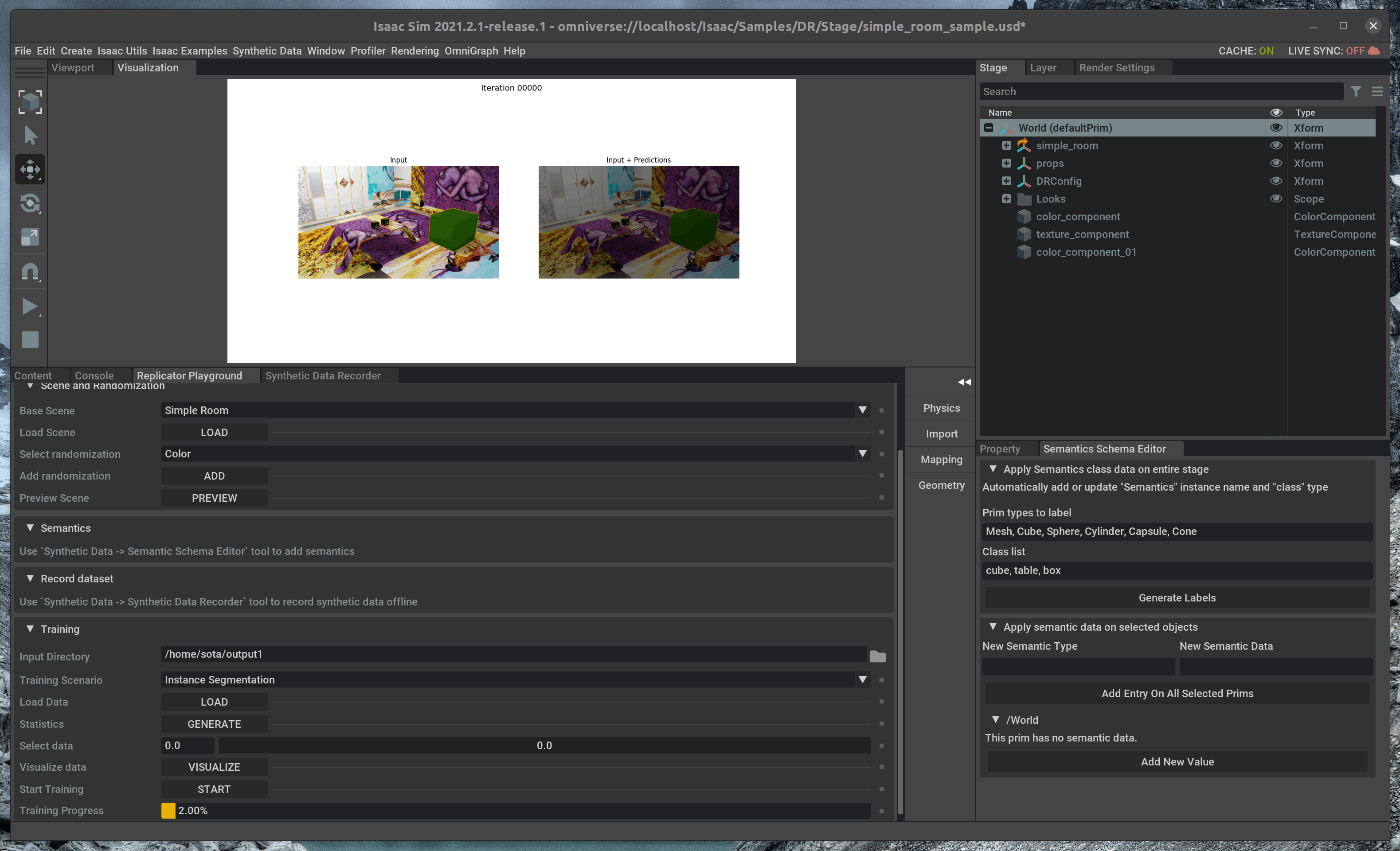

54 | ## 2. Replicator Playgroudを用いた学習

55 |

56 | Replicator playgroudのTrainingの設定値を次の通りに変更します。

57 |

58 | - "input directory"を先ほど学習データを生成したSynthetic Data Recodarの出力先ディレクトリに変更する

59 | - "Training Scenario"を”instance Segmentation”に設定する

60 | - instance segmentationはMaskR-CNNが使用されています。

61 |

62 |

63 |

64 | 設定後、Replicator playgroudのTrainingの”LOAD”を選択します。

65 | Replicator playgroudのTrainingの”GENERATEを選択すると、データセットの統計値のグラフ表示されます。また、”Visualize”を選択すると、学習データを可視化することができます。

66 |

67 |

68 |

69 | 最後に、Replicator playgroudのTrainingの”START"を選択すると、学習が開始されます。

70 |

71 |

72 | 学習が経過するにつれて、学習できていることが確認できます。

73 |

74 |

75 |

--------------------------------------------------------------------------------

/tutorials/required/required_interface/6_required_interface.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | GUI上でExtensionを追加します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_required_interface.html

6 | # 実行環境

7 |

8 | - インストール実行環境

9 |

10 | | unit | specification |

11 | |:-----------------:|:------------------:|

12 | | CPU | i9-11900H |

13 | | GPU | GeForce RTX 3080 Laptop|

14 | | RAM | 32GB |

15 | | OS | Ubuntu 20.04.3 LTS |

16 |

17 | - Nvidia Driverバージョン

18 | - 510.39.01

19 | - Issac simバージョン

20 | - 2021.2.1

21 |

22 | # 概要

23 |

24 | Isaac Sim上では、GUI上からの操作性を向上するExtensionが容易されています。

25 | 今回は、Extensionの使用例として、”TimeSample Editor”を用いて、オブジェクトを操作します。

26 | GUIでの操作はすべてPythonのAPIから操作することが可能です。

27 |

28 | 1. GUI内にObjectを追加

29 | 2. Extensionの追加

30 |

31 |

32 | ## 1. GUI内にObjectを追加

33 | こちらのページに記載してある手順を進めます。

34 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_required_interface.html

35 |

36 | ### 1.1 OmniverseからIssac Simを起動する

37 |

38 |

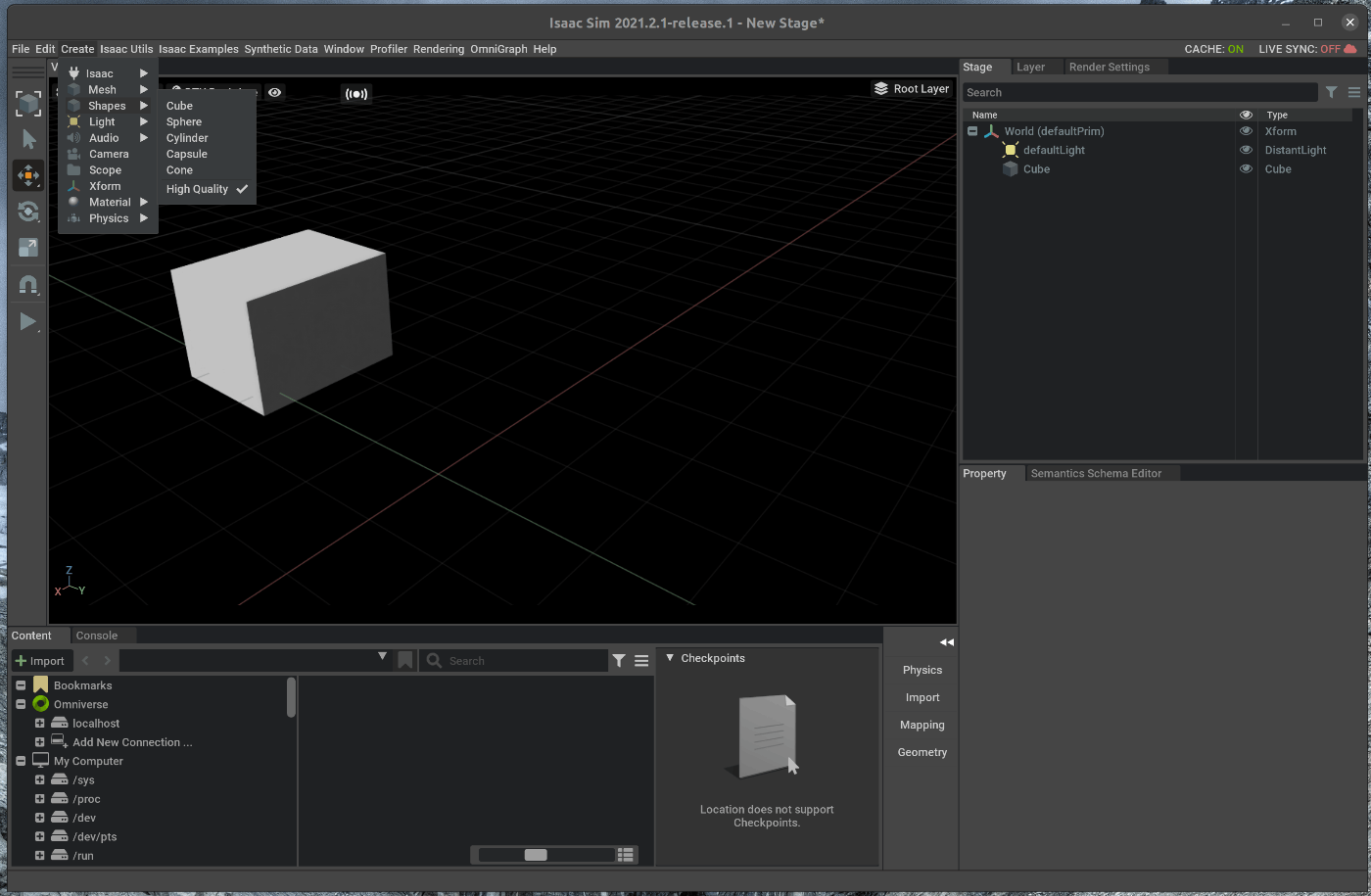

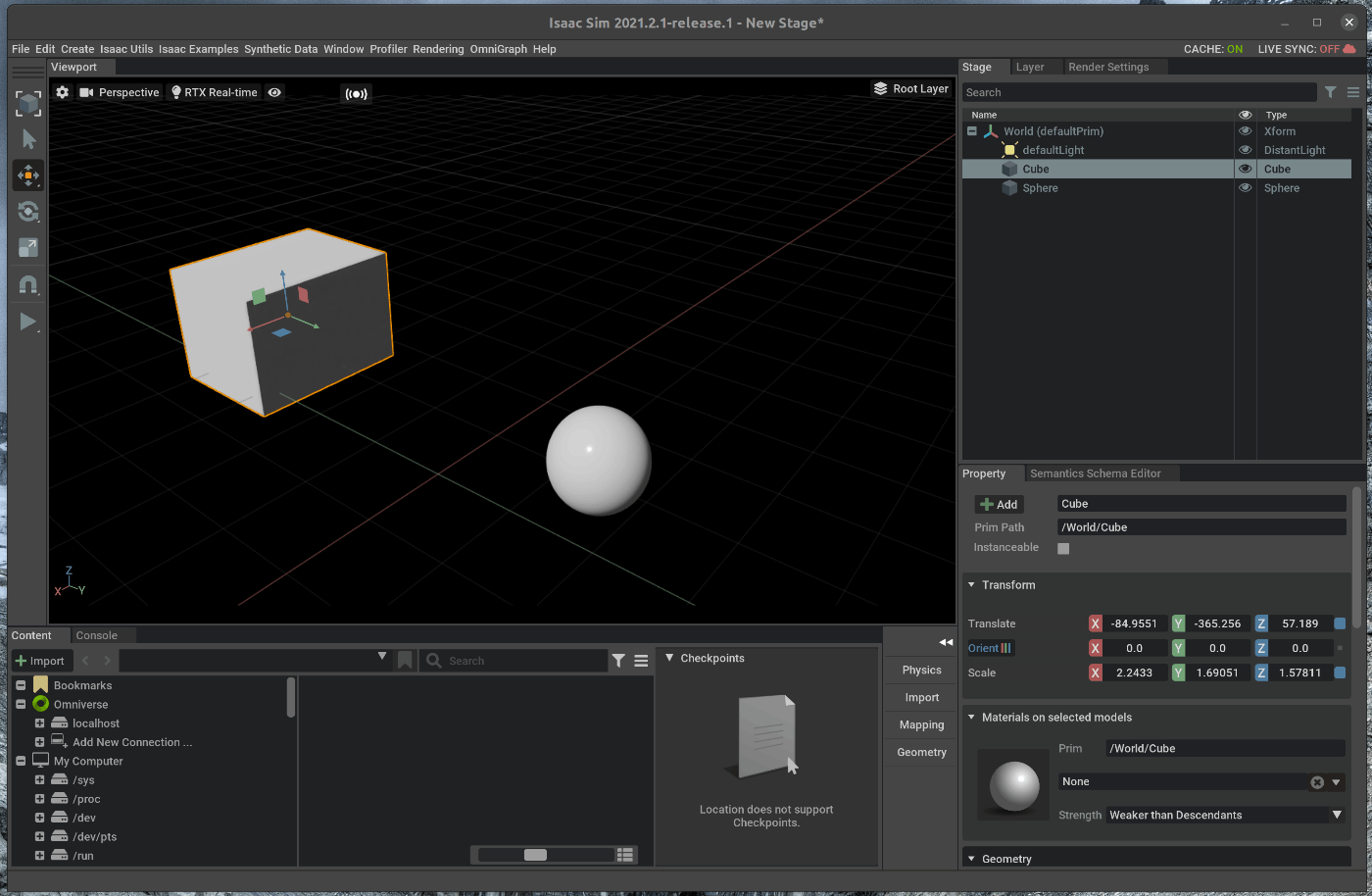

39 | ### 1.2 シーンにObjectを追加

40 | メニューバーのCCreate > Shapes > Cubeを選択します。

41 |

42 |

43 | 次に、球体をシーンに追加します。

44 | メニューバーのCreate > Shapes > Sphereを選択します。

45 |

46 |

47 |

48 |

49 | ### 1.3 Objectの関係

50 | 右側のStageタブの中でCubeをドラッグアンドドロップでSphereの下に移動させます。

51 |

52 | この状態で、Sphereをシーン内で動かすと、CubeもSphereとの相対位置を保ったまま、動きます。

53 |

54 |

55 | CubeとSphereを独立させる場合には、CubeをドラッグアンドドロップでWorldの下に移動させます。

56 |

57 |

58 |

59 |

60 | ## 2. Extensionの追加

61 |

62 | ## 2.1 TimeSample Editorの有効化

63 | シーンにExtensionを追加します。

64 | TimeSample Editorは時間ごとのObjectの動きを記録し、再生するExtensionです。

65 | メニューバーのWindow > Extensionsを選択します。

66 |

67 |

68 |

69 | ポップアップしたウィンドウのSearchの部分に“TimeSample Editor”を入力します。

70 |

71 |

72 | 検索結果の”TimeSample Editor”の右側のトグルボタンをクリックし、Enableにします。

73 | Enableにすると、インストールされます。

74 |

75 |

76 | インストール後、ポップアップされた”TimeSample Editor”のウィンドウを、右側のStageの下にドラッグアンドドロップで移動させます。

77 |

78 |

79 | ## 2.2 TimeSample Editorの設定

80 | 右側のStageの中のSphereを選択します。

81 |

82 |

83 | Stageの下についかしたTimeSample Editorの”xformOp:translate”の”Add key”を選択します。

84 |

85 |

86 | Viewportの中のTimelineを50程度の位置に変更します。

87 | この状態で、Sphereを動かします。

88 | Viewportの中のTimelineを100程度の位置に変更します。

89 | この状態で、Sphereを動かします。

90 |

91 |

92 |

93 | 上記の設定の完了後、'Space'キーを押すと、Animationが開始されます。

94 |

--------------------------------------------------------------------------------

/tutorials/gui/change_object_texture/34_change_object_texture.md:

--------------------------------------------------------------------------------

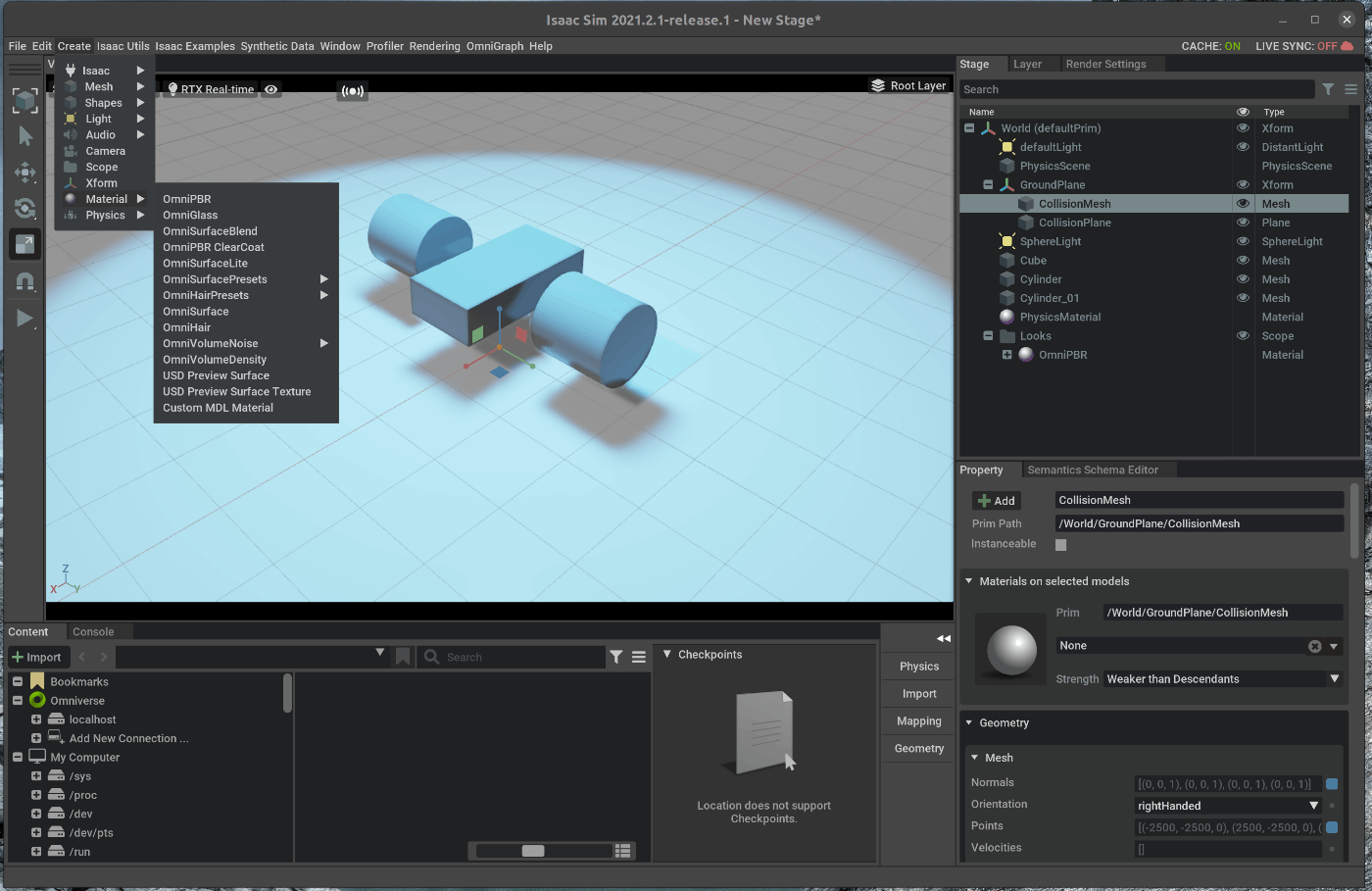

1 | # 概要

2 | Isaac SimのGUI上でオブジェクトのテクスチャを変更します。

3 |

4 |

5 | # 実行環境

6 |

7 | - インストール実行環境

8 |

9 | | unit | specification |

10 | |:-----------------:|:------------------:|

11 | | CPU | i9-11900H |

12 | | GPU | GeForce RTX 3080 Laptop|

13 | | RAM | 32GB |

14 | | OS | Ubuntu 20.04.3 LTS |

15 |

16 | - Nvidia Driverバージョン

17 | - 510.39.01

18 | - Issac simバージョン

19 | - 2021.2.1

20 |

21 |

22 | # 手順

23 | 大まかな手順は次の通りです。

24 |

25 | 1. オブジェクトのテクスチャを変更

26 | 2. テクスチャを変更したオブジェクトの保存

27 |

28 | 物体認識等の学習モデル用の正解データを作成する際に、オブジェクトのテクスチャを変更したいと思います。

29 | このような場合に、GUIから任意のテクスチャに変更する方法を紹介します。

30 |

31 | ## 1. オブジェクトのテクスチャを変更

32 | ### 1.1 OmniverseからIssac Simを起動する

33 |

34 |

35 | ### 1.2 シーンをロードする

36 | メニューバーのCreate > Physics > Groud Planeを選択します。

37 |

38 |

39 | ### 1.3 オブジェクトの追加

40 | シーン内にオブジェクトを追加します。

41 | 今回は、前回作成したウォーターサーバーと机をまとめたオブジェクトを追加します。

42 |

43 | Viewportの下にあるContentの中で、omniverse/localhost/Isaac/Enviroments/Simple_Room/Props/water_server_on_desk.usdを選択します。

44 | 選択した状態で、選択したUSDファイルをドラッグアンドドロップでViewport内に移動します。

45 | 移動すると、シーン内にウォーターサーバーと机をまとめたオブジェクトが追加されます。

46 |

47 |

48 | ### 1.4 オブジェクトのテクスチャを変更する

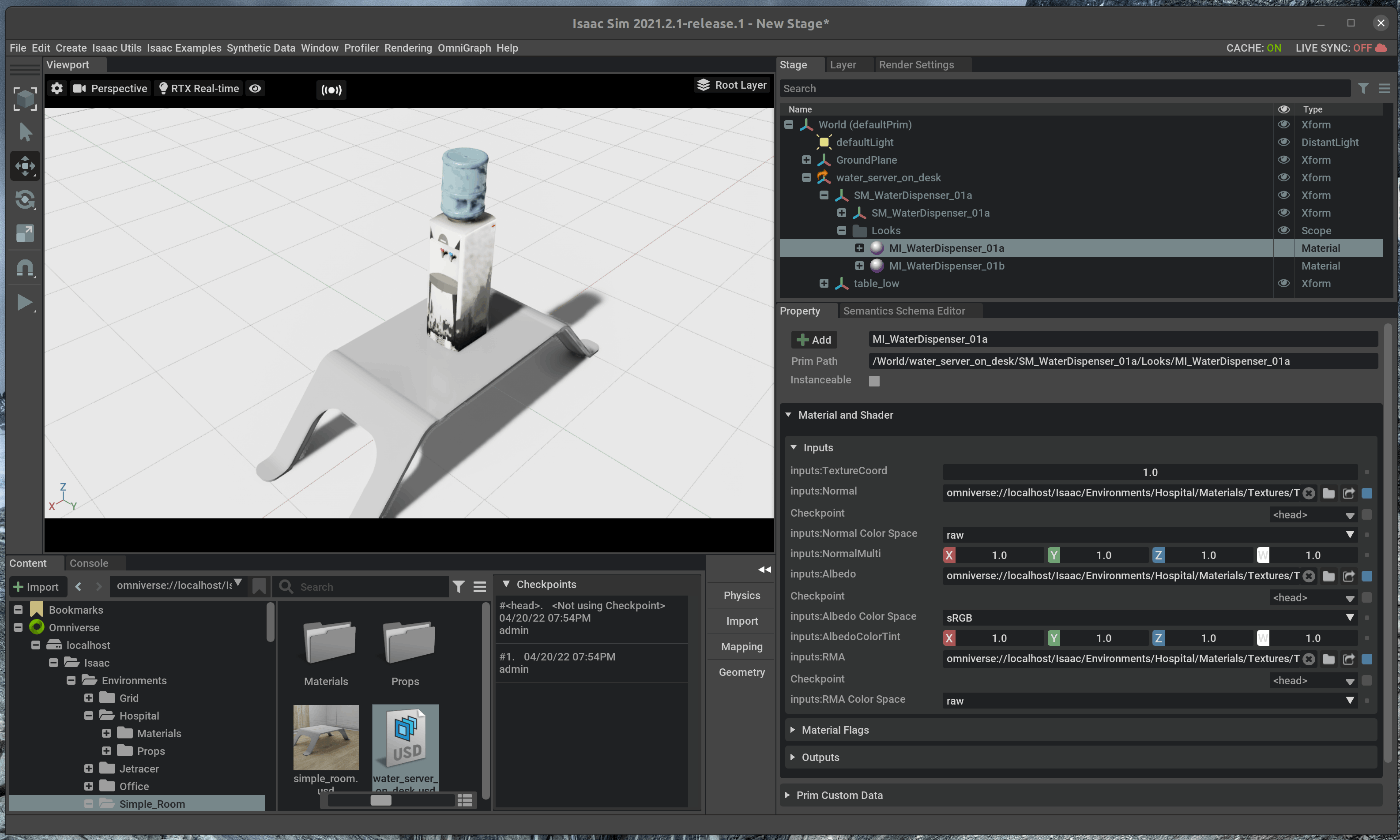

49 | 右側のStageタブの中で、water_server_on_desk > SM_WaterDispenser_01a > MI_WaterDispenser_01aを選択します。

50 | 選択すると、Stageタブ下のPropeertyの中に、Material Shader > Inputsが表示されます。

51 |

52 |

53 |

54 | マテリアルについての詳細な説明は、Omniverseのマニュアルに記載されています。

55 | https://docs.omniverse.nvidia.com/prod_materials-and-rendering/prod_materials-and-rendering/materials.html

56 |

57 | 今回は、Inputs:Normal, Inputs:Albedo, Inputs:RMAをそれぞれ、空の風景のテクスチャに変更します。

58 |

59 | まず、Inputs:Normalを変更します。

60 | Inputs:Normalの横にあるフォルダマークをクリックし、ポップアップしたウィンドウにおいて、T_Sky_Blue.pngを選択します。

61 |

62 |

63 |

64 | 次に、Inputs:Albedoを変更します。

65 | Inputs:Albedoの横にあるフォルダマークをクリックし、ポップアップしたウィンドウにおいて、T_Sky_Blue.pngを選択します。

66 |

67 |

68 |

69 | 最後に、Inputs:RMAを変更します。

70 | Inputs:RMAの横にあるフォルダマークをクリックし、ポップアップしたウィンドウにおいて、T_Sky_Blue.pngを選択します。

71 |

72 |

73 |

74 | ## 2. テクスチャを変更したオブジェクトの保存

75 | ### 2.1 GroupをUSDファイルとしてエクスポートする

76 |

77 | 右側のStageタブの中で、Groupを選択します。

78 | 選択した状態で、右クリックし、Export Selectedを選択します。

79 |

80 |

81 | ポップアップしたウィンドウにて、任意の保存名と保存先を指定します。

82 |

83 |

84 |

85 | ### 2.2 保存したUSDファイルをインポートする

86 | 今回はomniverse/localhost/Isaac/Enviroments/Simple_Room/Props/water_server_with_texture_on_desk.usdとして保存しました。

87 | 1.3の手順と同様にViewport内に該当のUSDファイルをドラッグアンドドロップすると、机の上にウォーターサーバーが設置されているオブジェクトが追加されます。

88 |

89 |

--------------------------------------------------------------------------------

/tutorials/advanced/jupyter_notebook/18_jupyter_notebook.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Jupyter notebook上からソースコードを実行し、Stageをインタラクティブに操作します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_advanced_jupyter.html

6 |

7 |

8 | # 実行環境

9 |

10 | - インストール実行環境

11 |

12 | | unit | specification |

13 | |:-----------------:|:------------------:|

14 | | CPU | i9-11900H |

15 | | GPU | GeForce RTX 3080 Laptop|

16 | | RAM | 32GB |

17 | | OS | Ubuntu 20.04.3 LTS |

18 |

19 | - Nvidia Driverバージョン

20 | - 510.39.01

21 | - Issac simバージョン

22 | - 2021.2.1

23 |

24 |

25 | # 手順

26 | Jupyter notebook上からScriptを実行し、Stageをインタラクティブに操作します。

27 | シミュレーション内のStageを、Jupyter notebookから操作する際には、Stageの設定を変更します。

28 |

29 | 1. Jupyter notebookからシミュレーションを実行する

30 | 2. Jupyter notebookからインタラクティブに操作する

31 |

32 | ## 1. Jupyter notebookからシミュレーションを実行する

33 | こちらのページに記載してある手順を進めます。

34 |

35 | ### 1.1 Jupyter notebookを起動する

36 | terminalで次のコマンドを実行します。

37 |

38 | ~~~ bash:shell

39 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/

40 | $ ./jupyter_notebook.sh standalone_examples/notebooks/scene_generation.ipynb

41 | ~~~

42 |

43 |

44 |

45 |

46 | ./jupyter_notebook.shを実行すると、Jupyter notebookが起動します。

47 |

48 |

49 | ### 1.2 シーンをロードする

50 | Jupyter notebook上で、1つ目のCellを実行します。

51 |

52 | 次に、Isaac Simの下部にあるContentのOmniverse > localhost > Users > "User名" > temp_jupyter_stage.usdをダブルクリックします。

53 |

54 |

55 | ## 1.3 Live SyncをEnableにする

56 | 読み込んだシーンをJupyter notebookから操作できるように、設定を変更します。

57 | Isaac Simの右上にあるLayerタブを選択し、Cloudアイコンをクリックします。

58 |

59 |

60 | クリックすると、Isaac Simの上部に存在するLive Syncのアイコンの色が緑色に変化します。

61 |

62 |

63 | ## 1.4 Jupyter notebookから操作する

64 | Jupyter NootebookのCell 1以外のCellを上から順番に実行します。

65 | 実行する前に、最後のCellに記載されている、SimulaterのShutdownコマンドをコメントアウトします。

66 |

67 | 最後のCellの1つ前のCellを実行すると、シーンに設置したカメラから取得されたRGB画像、Depth画像、Semantic Segmentaitonの結果が表示されます。

68 |

69 |

70 | ## 2. Jupyter notebookからインタラクティブに操作する

71 |

72 | シーン内のオブジェクトをJupyter notebookから操作します。

73 | まず、Viewport内で右クリックし、Create > Mesh > Cone選択します。

74 |

75 |

76 | 次に、SimulaterのShutdownコマンドをコメントアウトしたcellに次のコードを追加します。

77 |

78 | ~~~ add_process:Python3

79 | carter_prim = stage.GetPrimAtPath(stage_path)

80 | print(carter_prim)

81 |

82 | xform_prim = XFormPrim(stage_path)

83 | xform_prim.set_world_pose(position = np.array([0,100,0]))

84 | simulation_world.render()

85 |

86 | simulation_world.step()

87 | cone_prim = stage.GetPrimAtPath('/Cone')

88 | print(cone_prim)

89 | ~~~

90 |

91 |

92 | 追加したコードでは、ロボットの位置を変更し、シーン内に追加したConeのPrimを取得しています。

93 | 追加後、編集したCellを実行します。

94 |

95 | 実行後、最後のCellの1つ前のCellを再実行すると、Coneが追加されたシーンでの撮影結果が表示されます。

96 |

97 |

98 |

99 |

100 |

--------------------------------------------------------------------------------

/tutorials/ros/lidar_sensors/27_lidar_sensors.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac Sim上に配置したLiDARからのlazer_scanをros topicとして発行します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_sensors.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | Isaac Sim上に配置したLiDARからのlazer_scanをros topicとして発行します。

26 | シーンファイルとして、Turtlebotを追加したシーンファイルを使用します。

27 | シーンファイルはこちらからダウンロードできます。

28 |

29 | 1. シーンのロード

30 | 2. ROS LiDARの追加

31 | 3. Topicの確認

32 |

33 | ## 1. シーンのロード

34 | ### 1.1 OmniverseからIssac Simを起動する

35 |

36 |

37 | ### 1.2 シーンをロードする

38 | Isaac Simの下部にあるContentの中から、”ダウンロードしたディレクトリ” > simple_room_apriltag_with_camera.usdをダブルクリックします。

39 |

40 |

41 |

42 | ## 2. ROS LiDARの追加

43 | ### 2.1 LiDARを追加する

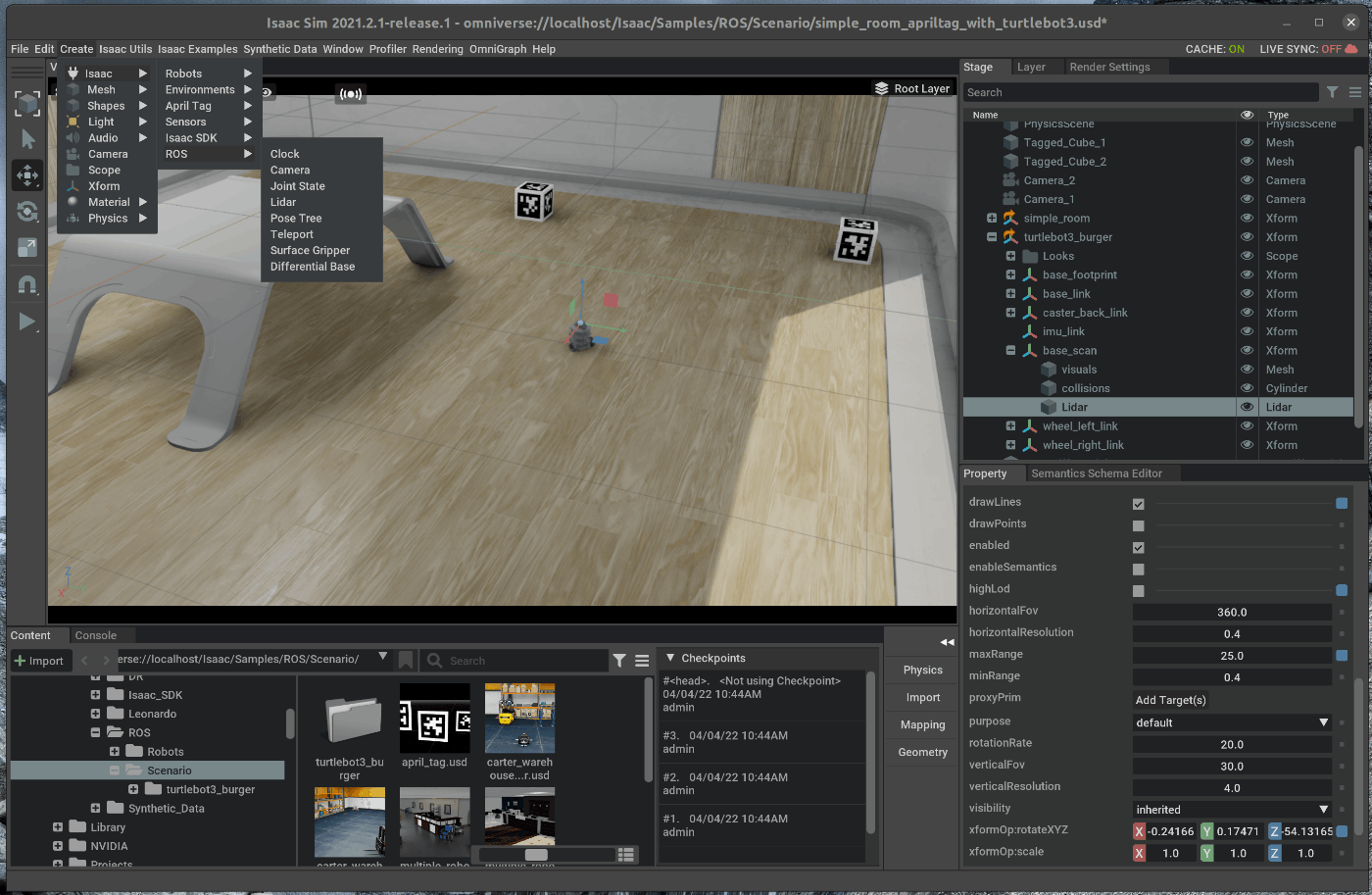

44 | メニューバーのCreate > Isaac > Sensors > Lidar > Rotatingを選択します。

45 |

46 |

47 | 右側のStageの中で追加したLiDARをWorld > turtlebot3_burger > base_scanの下にドラッグアンドドロップします。

48 |

49 |

50 | 右側のStageの中で追加したLiDARを選択します。

51 | Stage下部のTransformの値を次の通りに変更します。

52 |

53 | - translateのXを0.0にする

54 | - translateのYを0.0にする

55 | - translateのZを0.0にする

56 |

57 |

58 | Stage下部のpropertyのRaw USD propertiesを開きます。

59 | 設定値の中で次の値を変更します。

60 |

61 | - maxRangeに25を設定します

62 | - drawLinesにチェックを入れる

63 |

64 |

65 | この状態で、Viewportの左側のPLAYボタンを押すと、LiDARのレーザ光が出力されます。

66 |

67 |

68 | ### 2.2 ROS LiDARを追加する

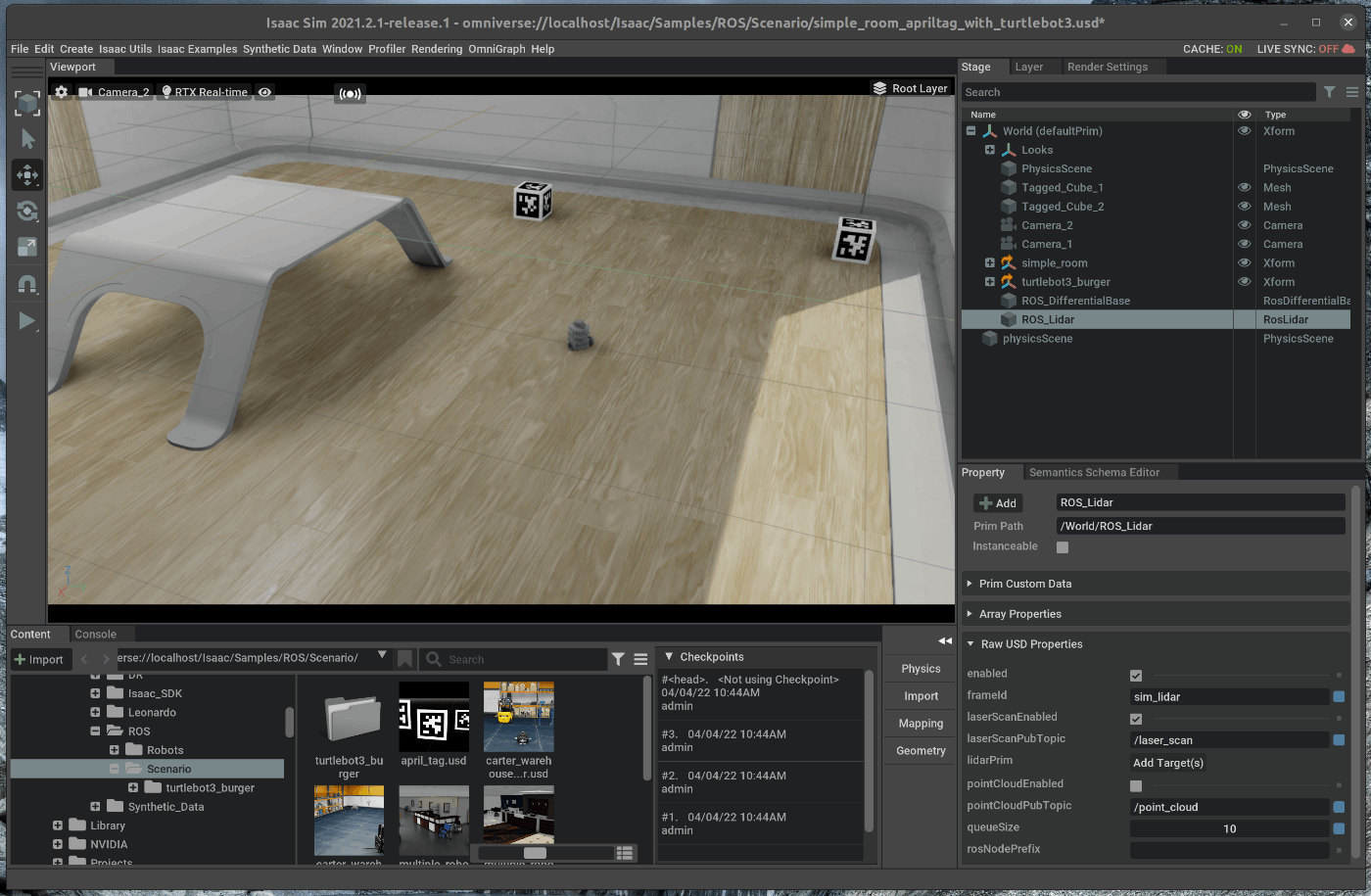

69 | メニューバーのCreate > Isaac > ROS > Lidarを選択します。

70 |

71 |

72 | 右側のStageの中で、追加したROS_LiDARを選択します。

73 |

74 |

75 | 選択した状態で、Stage下部のpropertyのRaw USD propertiesを開きます。

76 | Raw USD propertiesの中で、lidarPrimを選択し、Stageの中の/world/turtlebot3_burger/base_scan/Lidarを選択します。

77 |

78 |

79 | 設定値の中で次の値を変更します。

80 |

81 | - pointCloudEnabledにチェックを入れる

82 | - lazerScanEnabledにチェックを入れる

83 |

84 |

85 | また、ROS Camera、ROS Camera_1, ROS_LIDARのRaw USD propertiessのframeIdを”turtle”に変更します。

86 |

87 | ## 3. Topicの確認

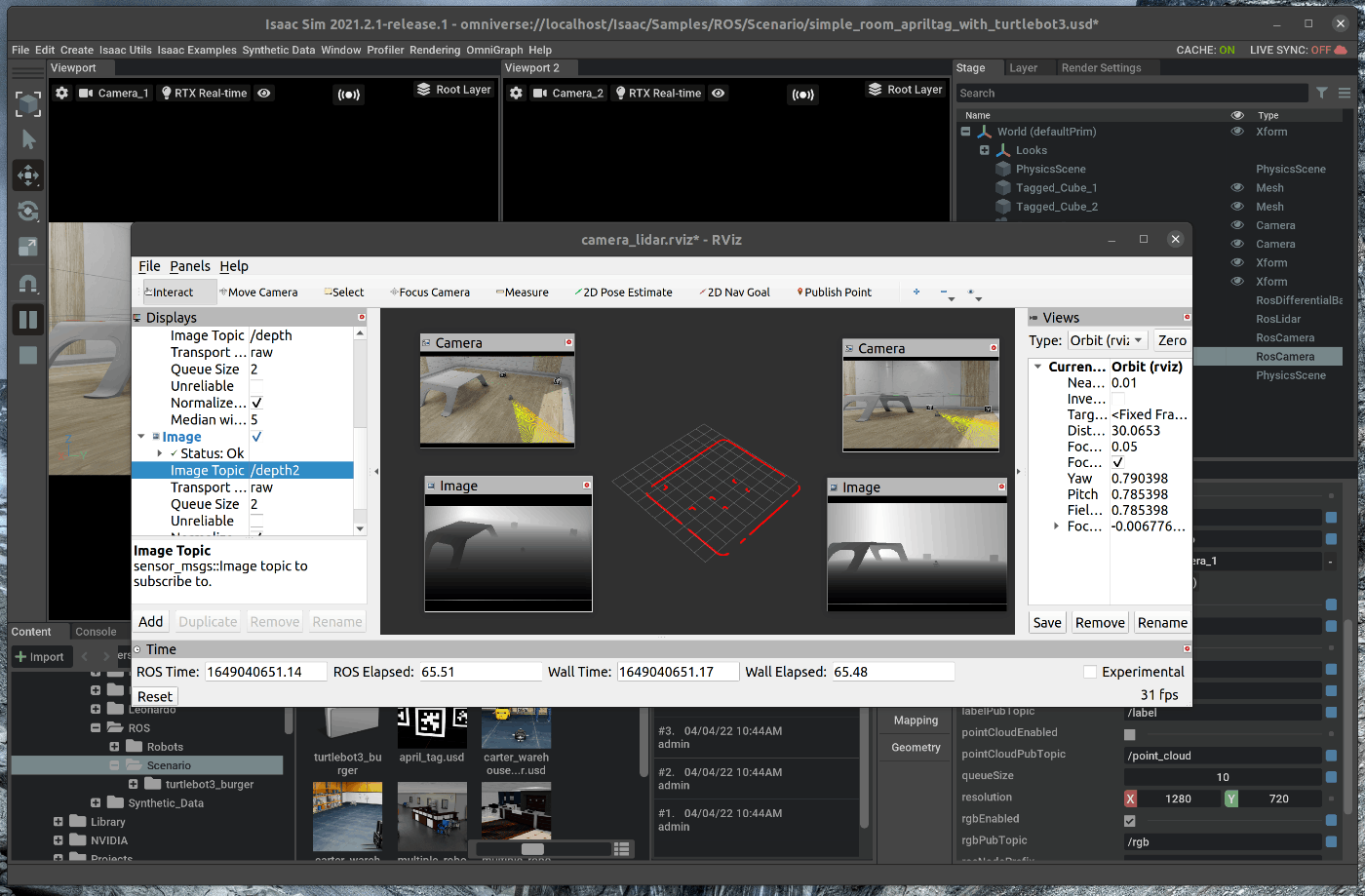

88 | 新たにterminalを開き、roscoreを起動します。

89 |

90 |

91 | この状態で、Viewportの左側のPLAYボタンを押すと、各種topicが発行されます。

92 |

93 |

94 | また、新たにterminalを開き、次のコマンドを入力します。

95 |

96 | ~~~ bash:shell

97 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/

98 | $ rosdep install -i --from-paths ./src/

99 | $ caktin b

100 | $ source devel/setup.bash

101 | $ rviz -d src/isaac_tutorials/rviz/camera_lidar.rviz

102 | ~~~

103 |

104 | rvizにカメラとLiDARから取得できる情報が表示されます。

105 |

106 |

107 |

108 |

109 |

--------------------------------------------------------------------------------

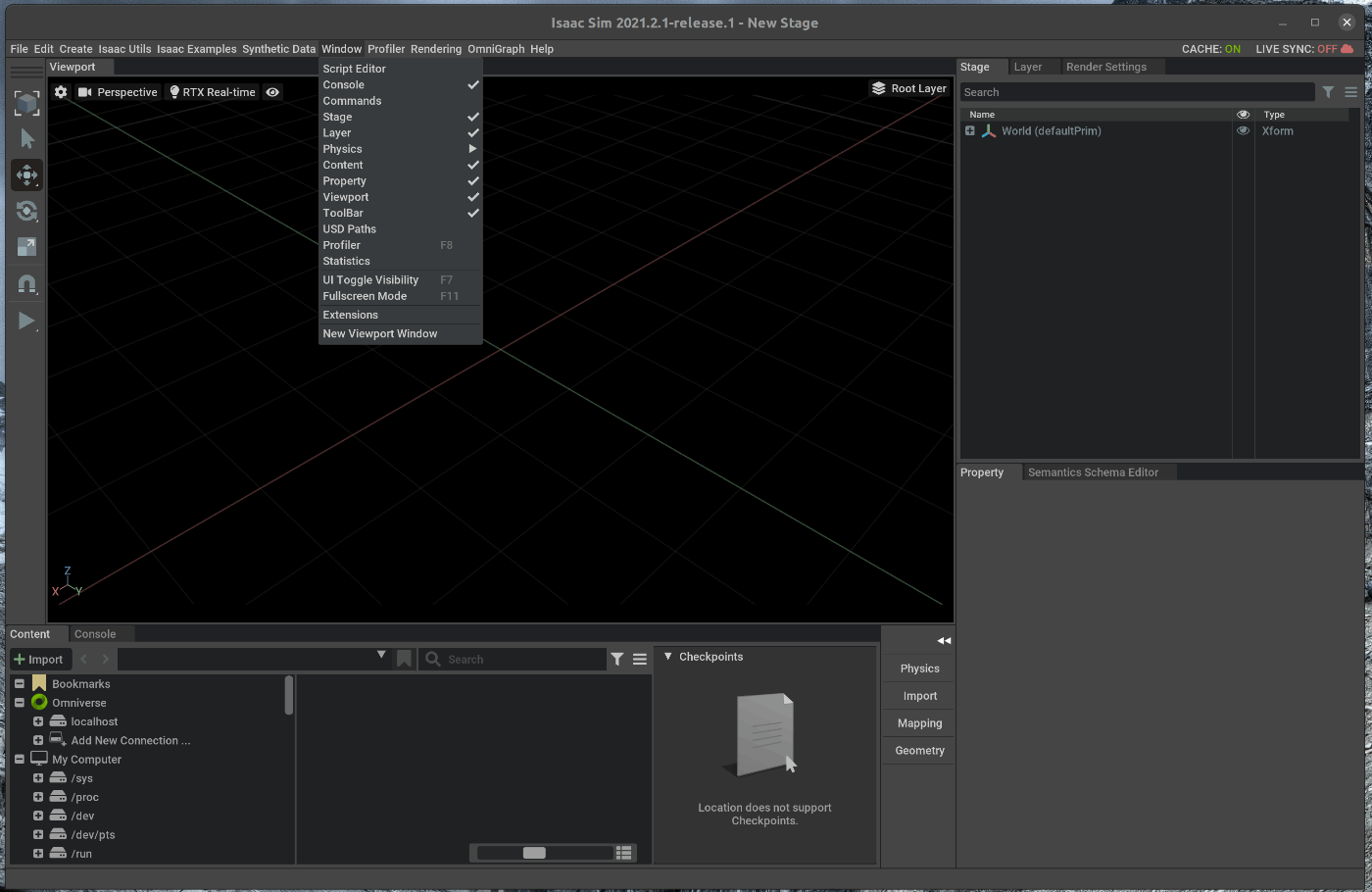

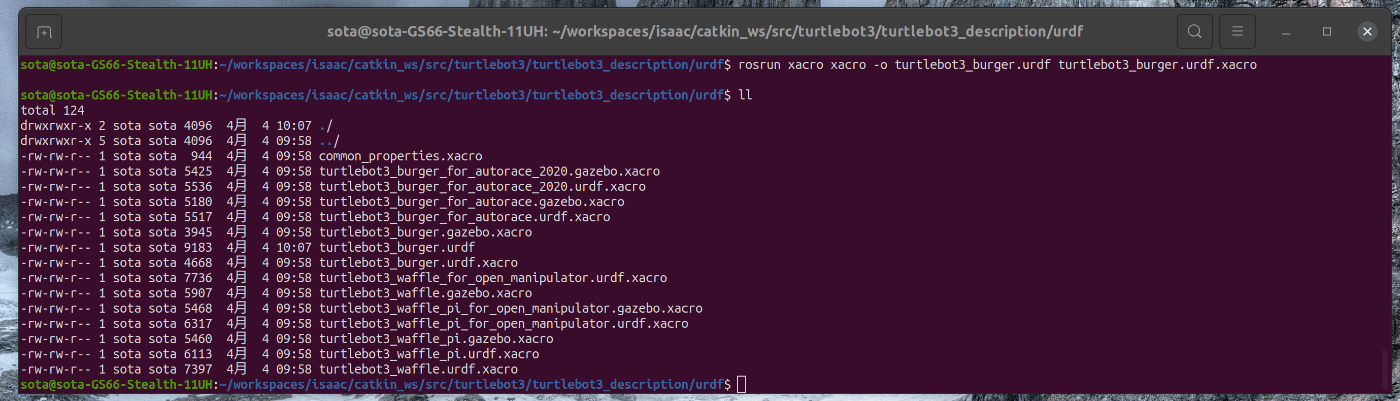

/tutorials/required/isaac_sim_workflow/7_isaac_sim_workflows.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac SimのWorkflowを紹介します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_required_workflows.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 |

25 | # 概要

26 |

27 | Isaac simでは、次の3種類の開発方式が用意されています。

28 |

29 | - Extensionts

30 | - Standalone Applications

31 | - Jupyter Notebook

32 |

33 | 上記の内、ExtensionsとStandalone Applicationについて紹介します。

34 |

35 | 1. Extensionsにおける操作

36 | 2. Standalone Applicationにおける操作

37 |

38 |

39 | ## 1. Extensionsにおける操作

40 |

41 | ExtensionsはOmniverse kitのcore building blockです。

42 | 上記の様に、ExtensionsはOmniverse kitの要素として設計されている為、Issac simに限らず他のOmniverseのApplication内でも使用することが可能です。

43 |

44 | Extensionsでは、Applicationは非同期に実行されるという特徴を持ちます。

45 | これは、タイムステップの制御(例えば、phisics stepやrendering step)を行わないということを意味してます。

46 |

47 | また、もう1つの特徴として、hot reloadingという機能を持っています。

48 | Isaac simでは、Aplicationのソースコードを変更を、Aplicationのreloadによって確認することが可能です。

49 | reloadはGUIの操作から実行することが可能であり、Issac sim自体のシャットダウンやリスタートは必要ありません。

50 |

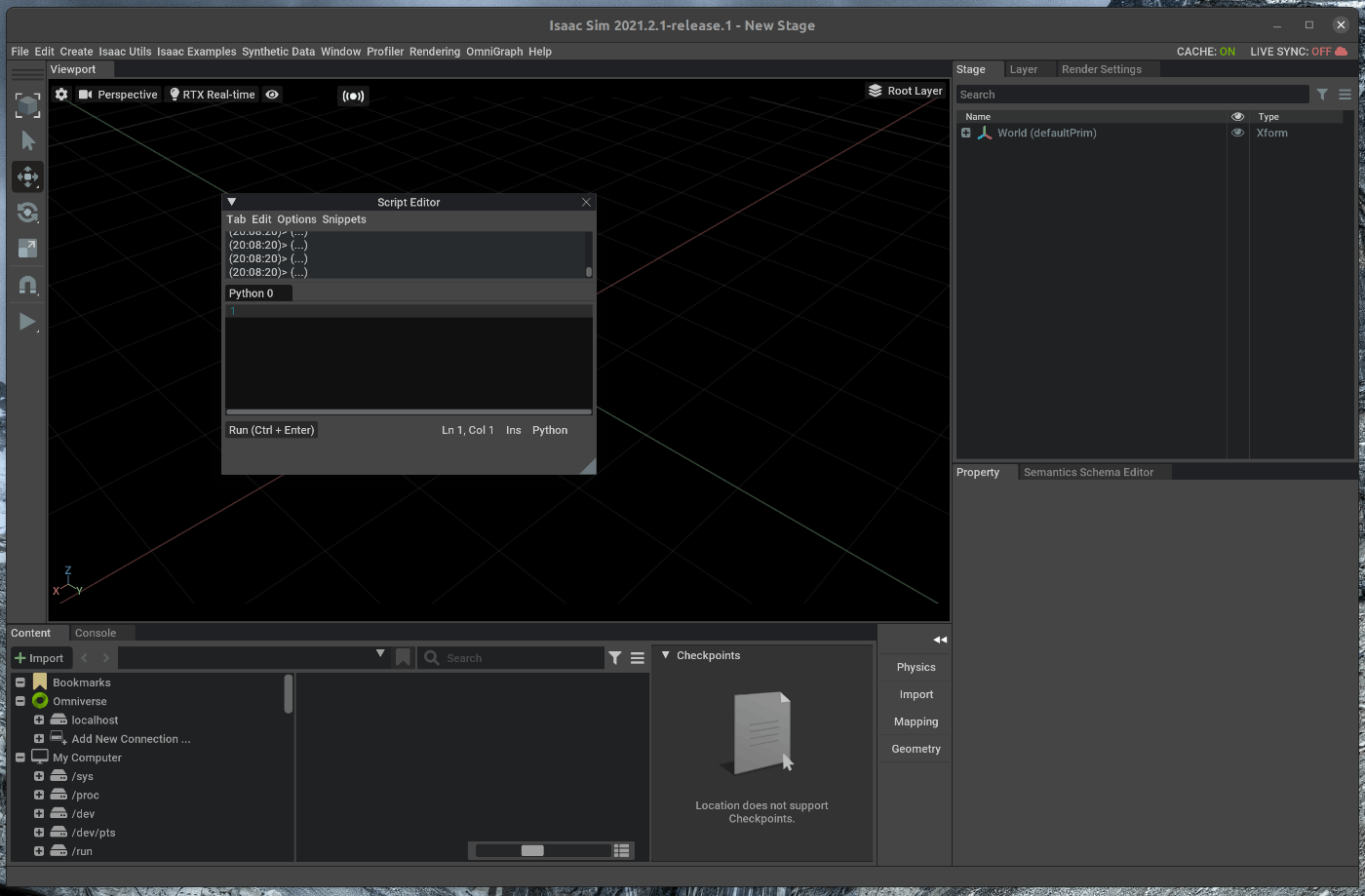

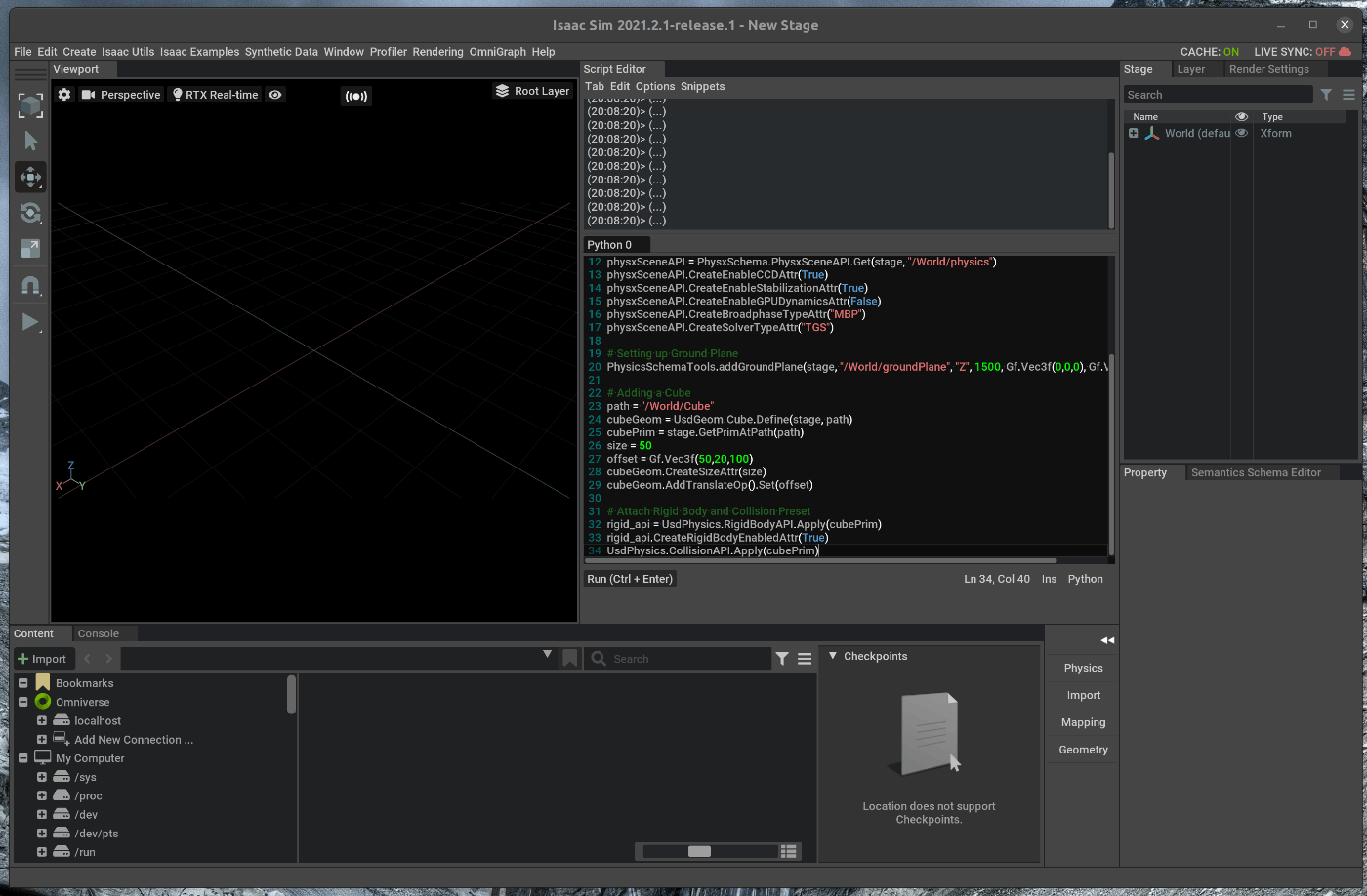

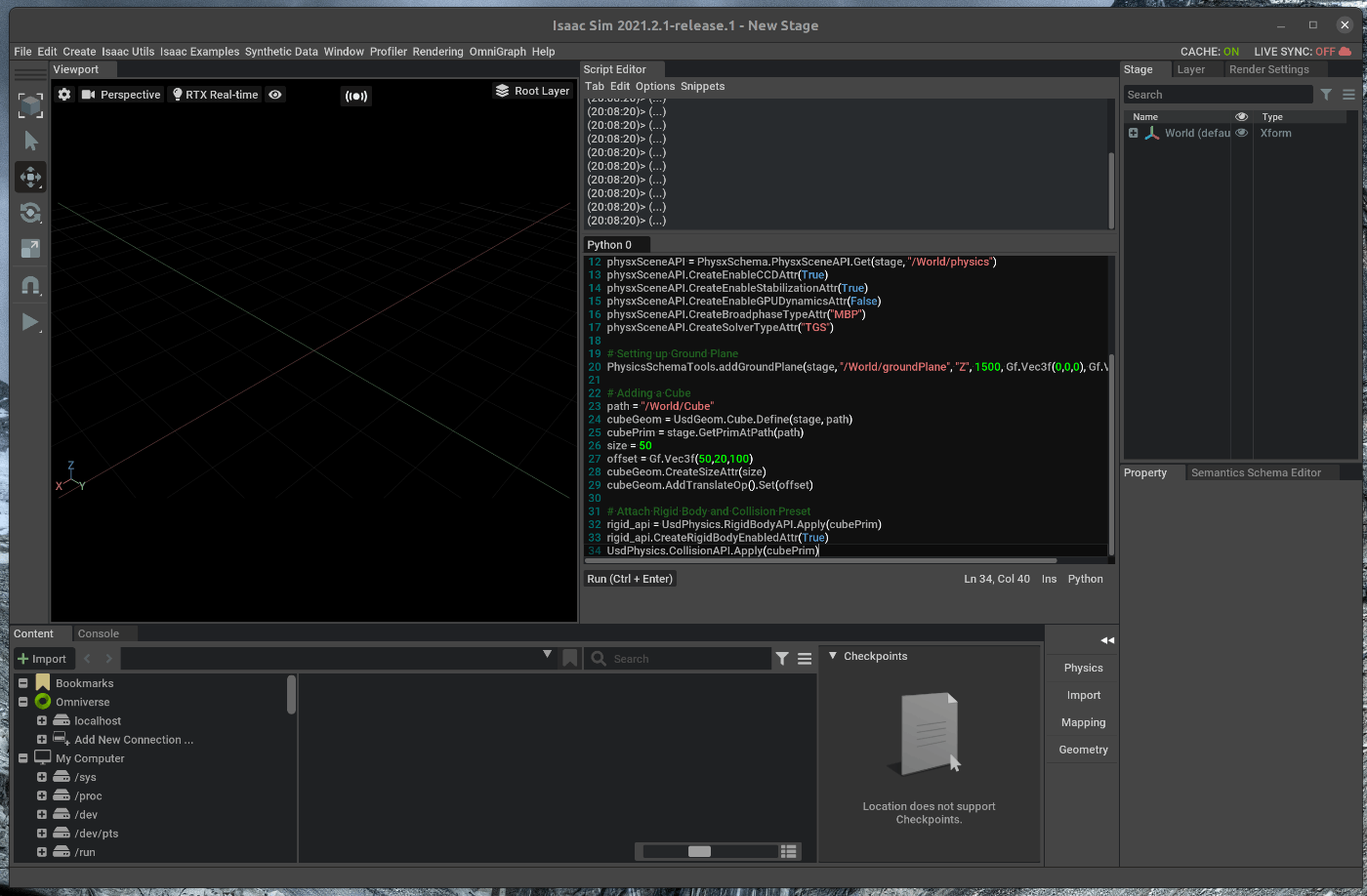

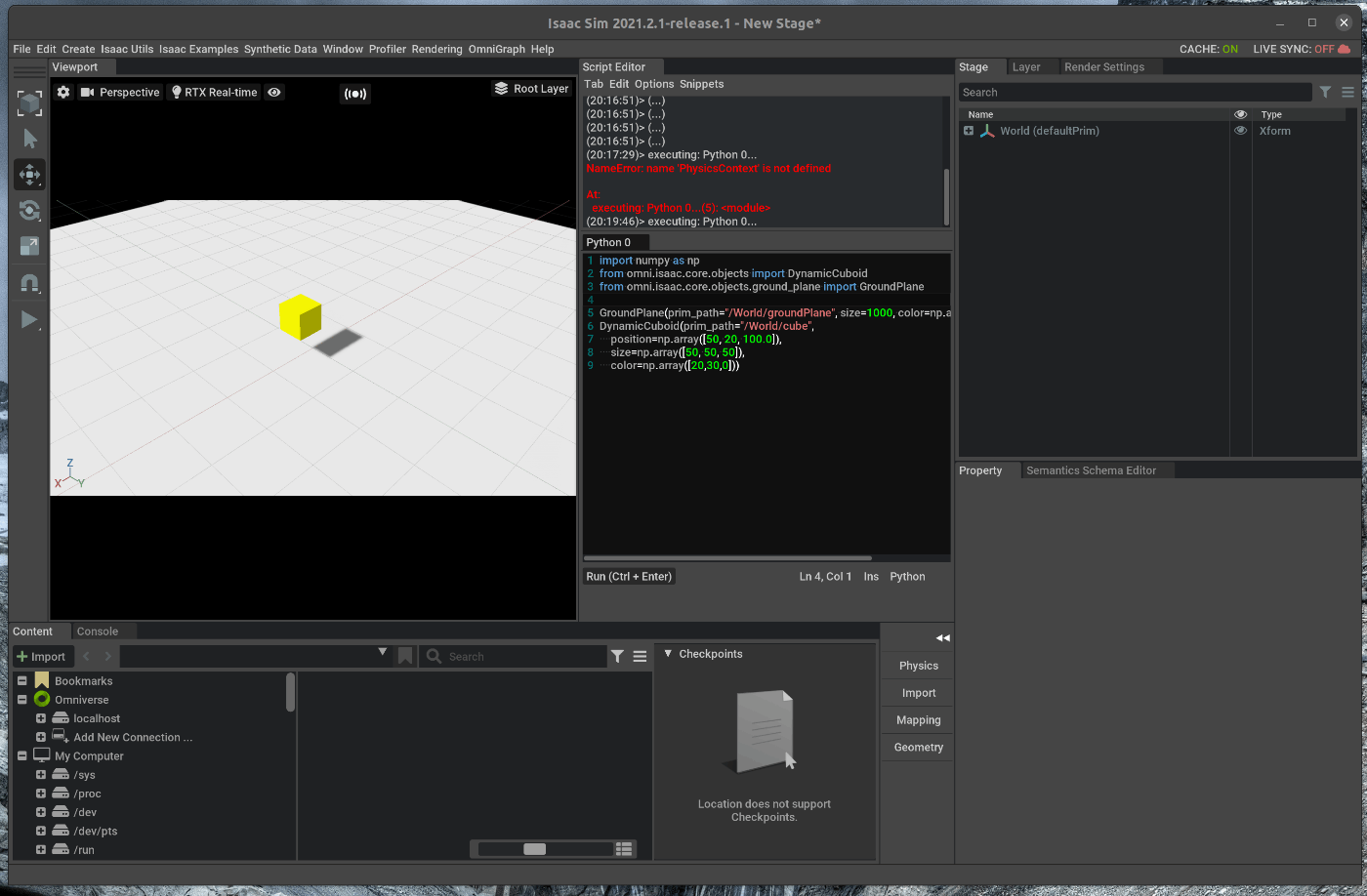

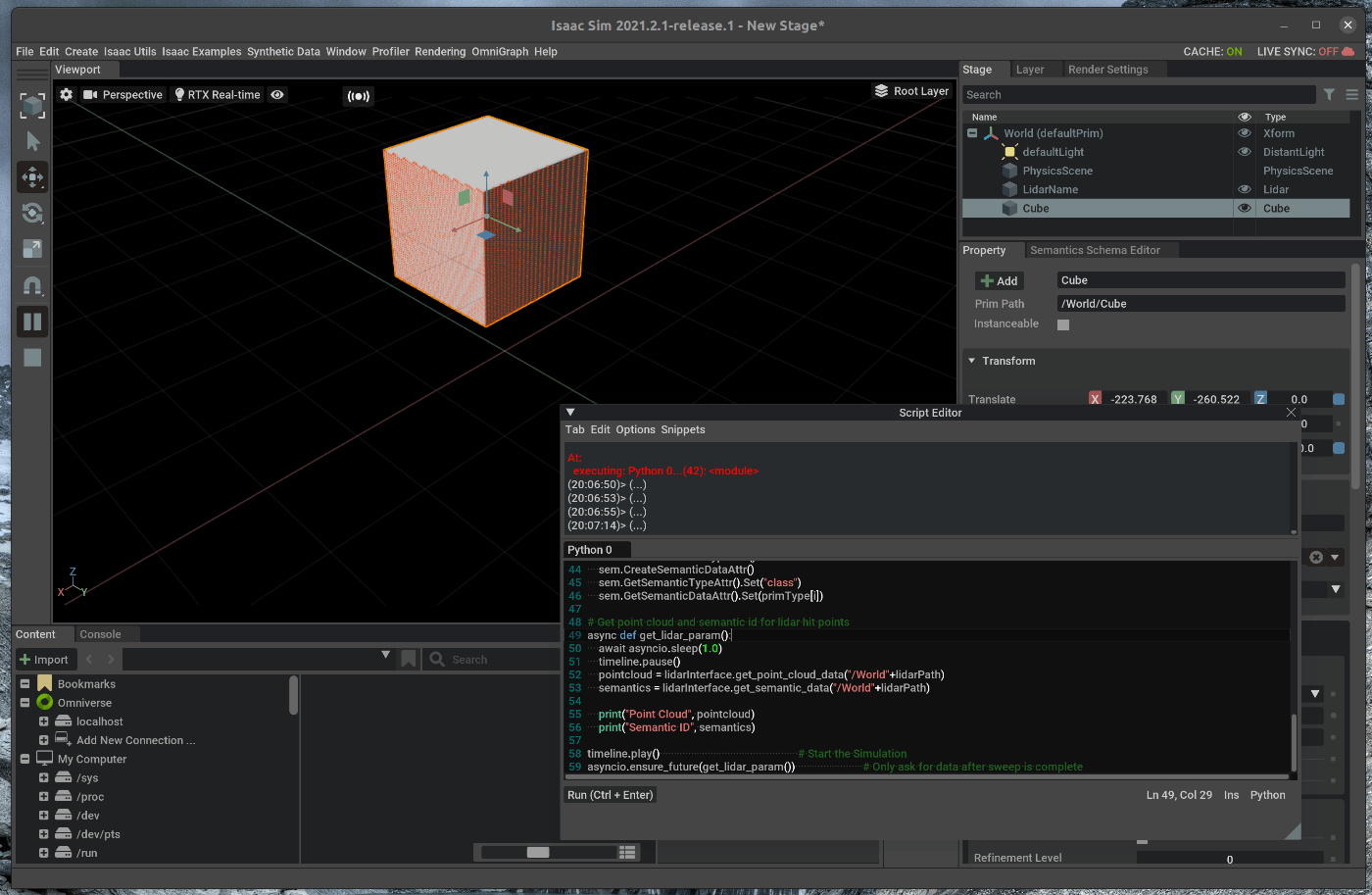

51 | 今回はサンプルシーンをロードし、ロードしたシーン内にScript Editorからオブジェクトを追加します。

52 | その後、サンプルシーンをリロードし、変更点の反映を確認します。

53 |

54 |

55 | ### 1.1 OmniverseからIssac Simを起動する

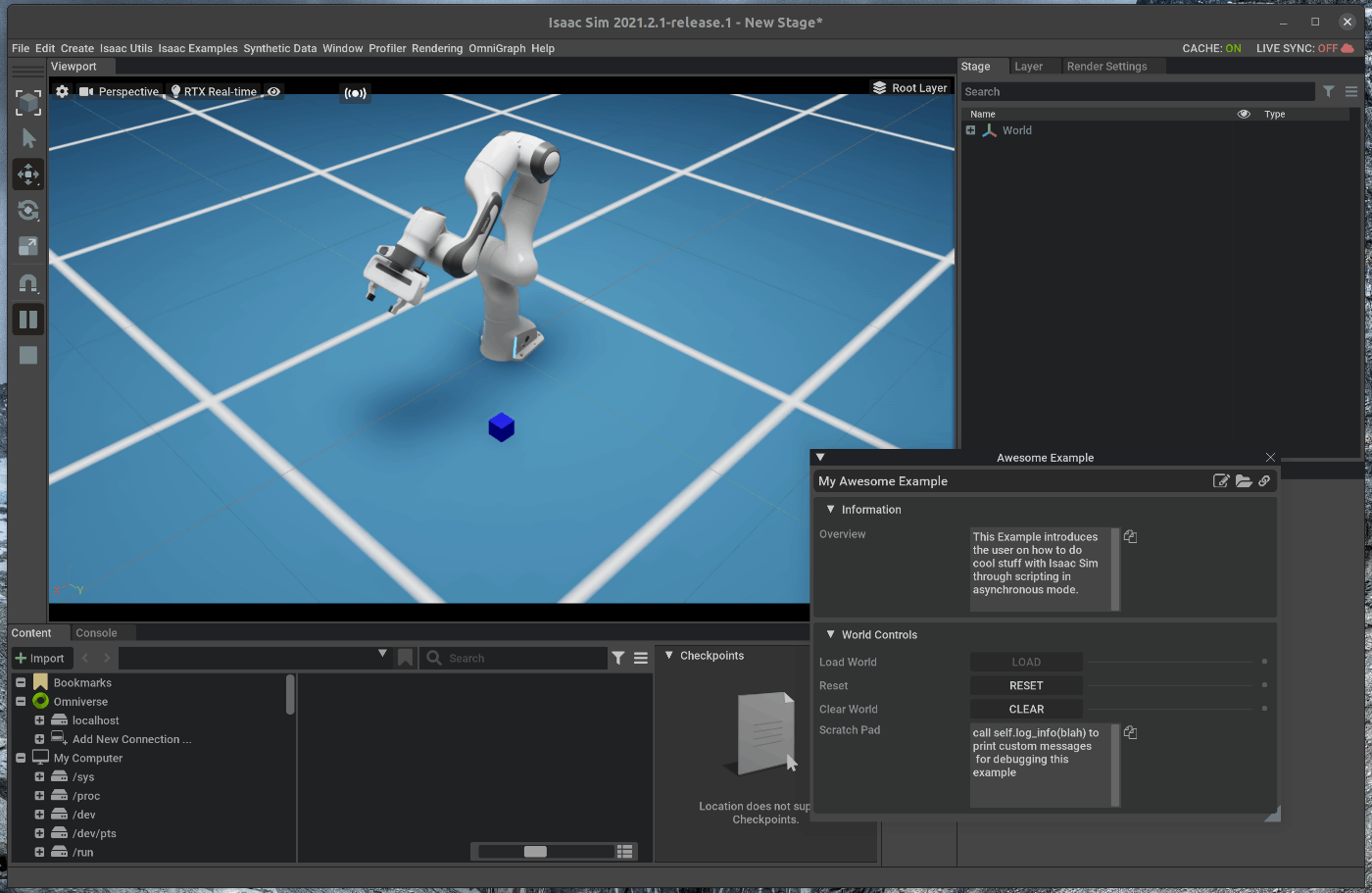

56 |

57 |

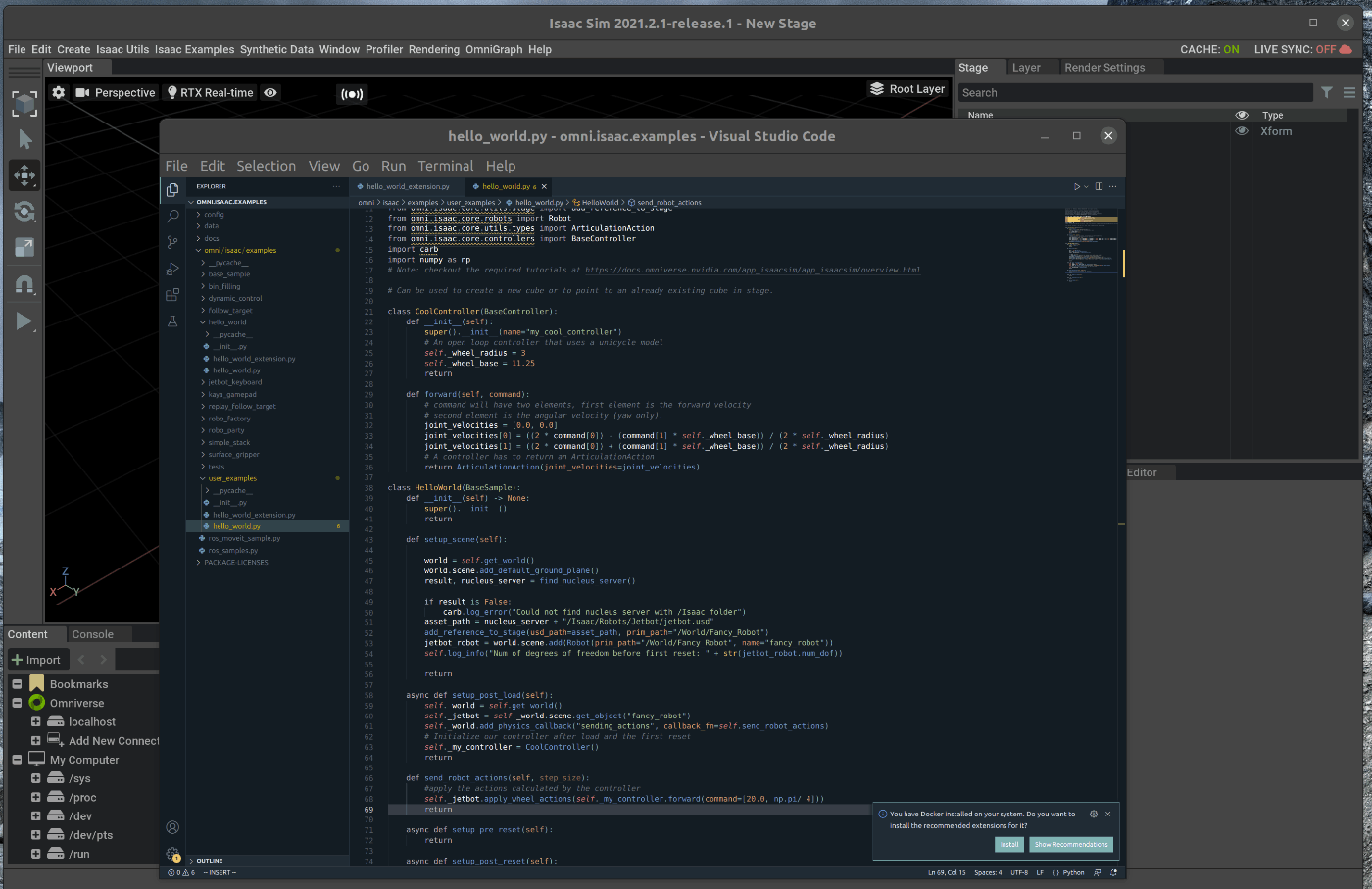

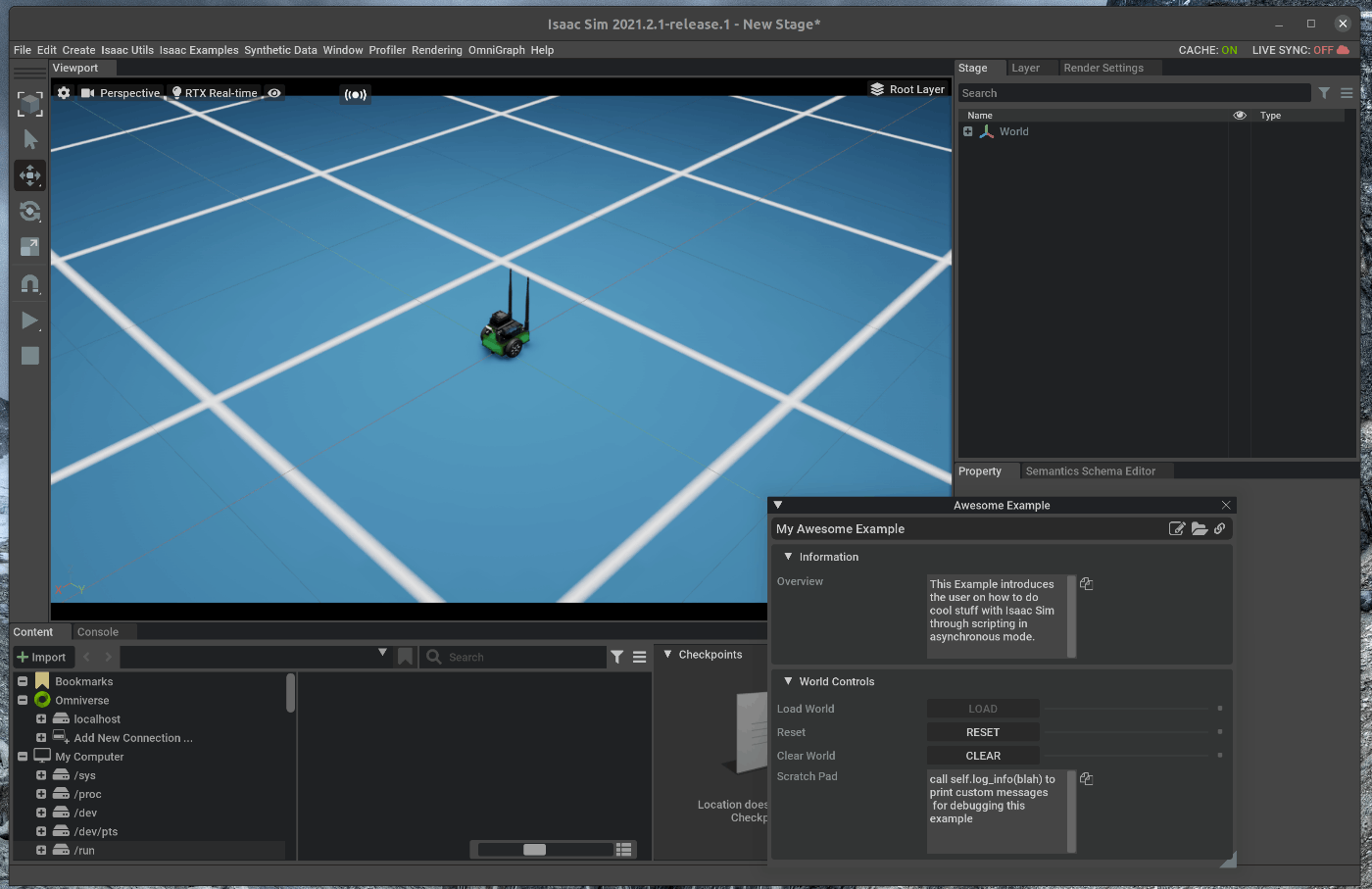

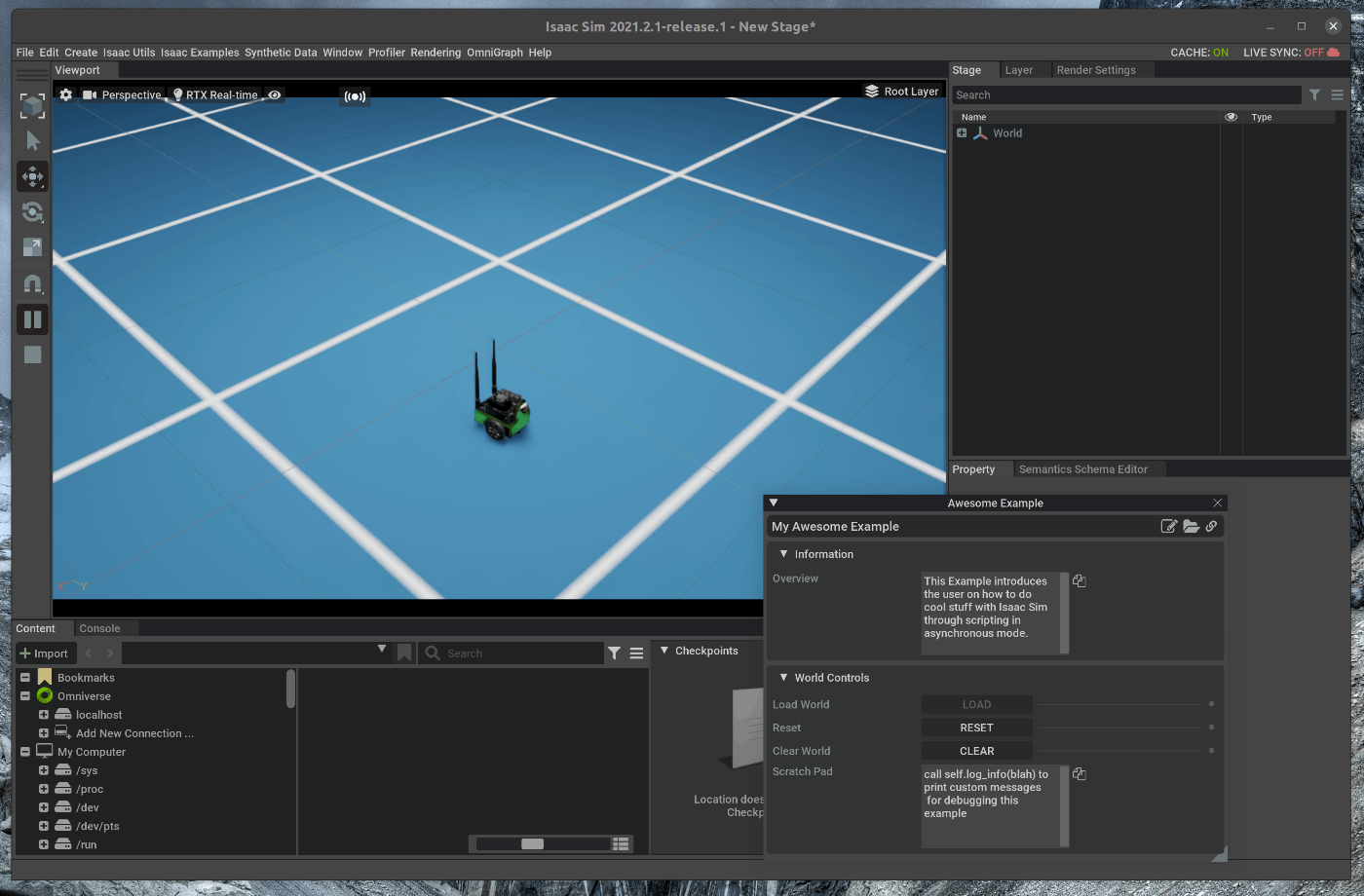

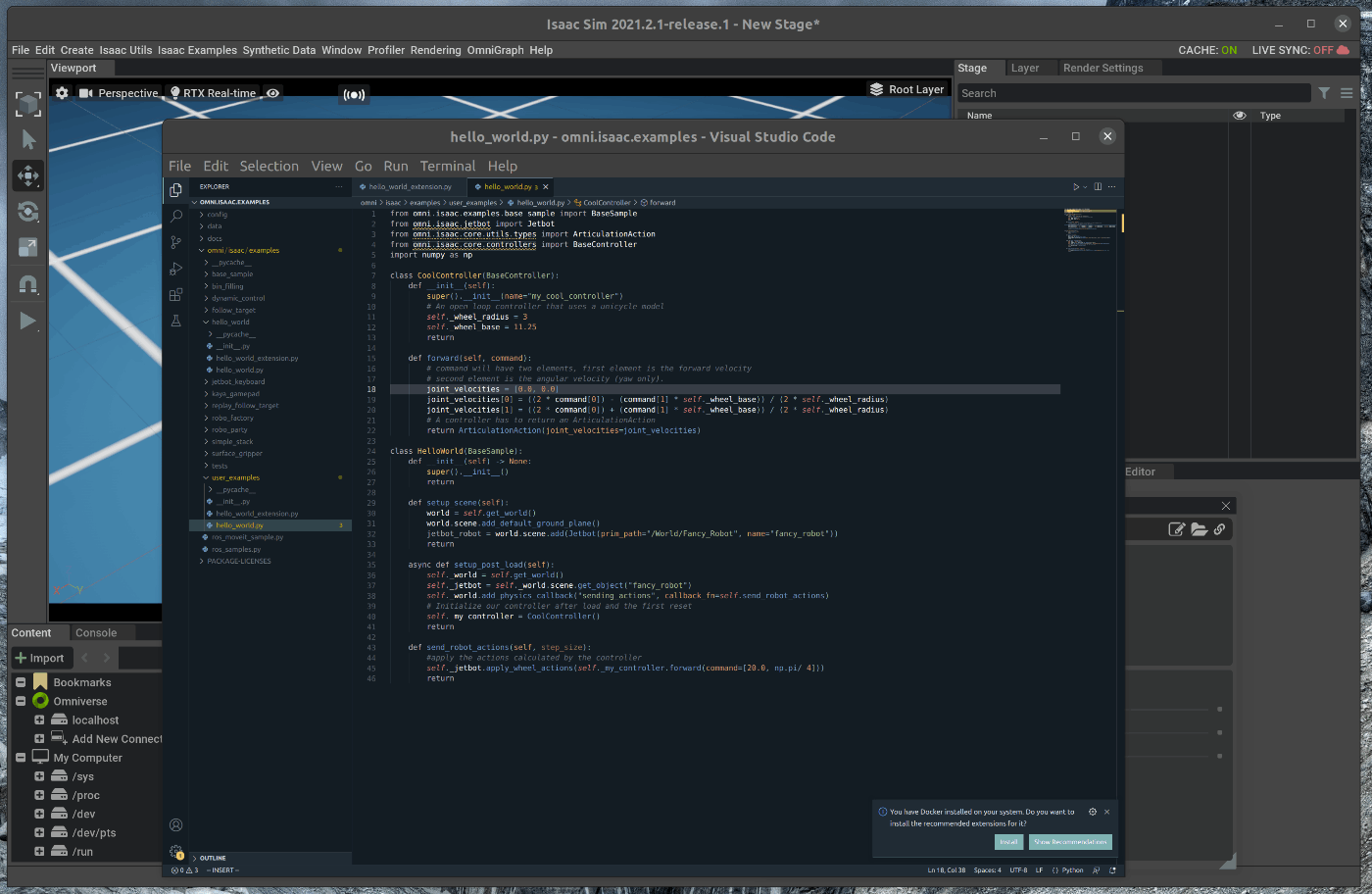

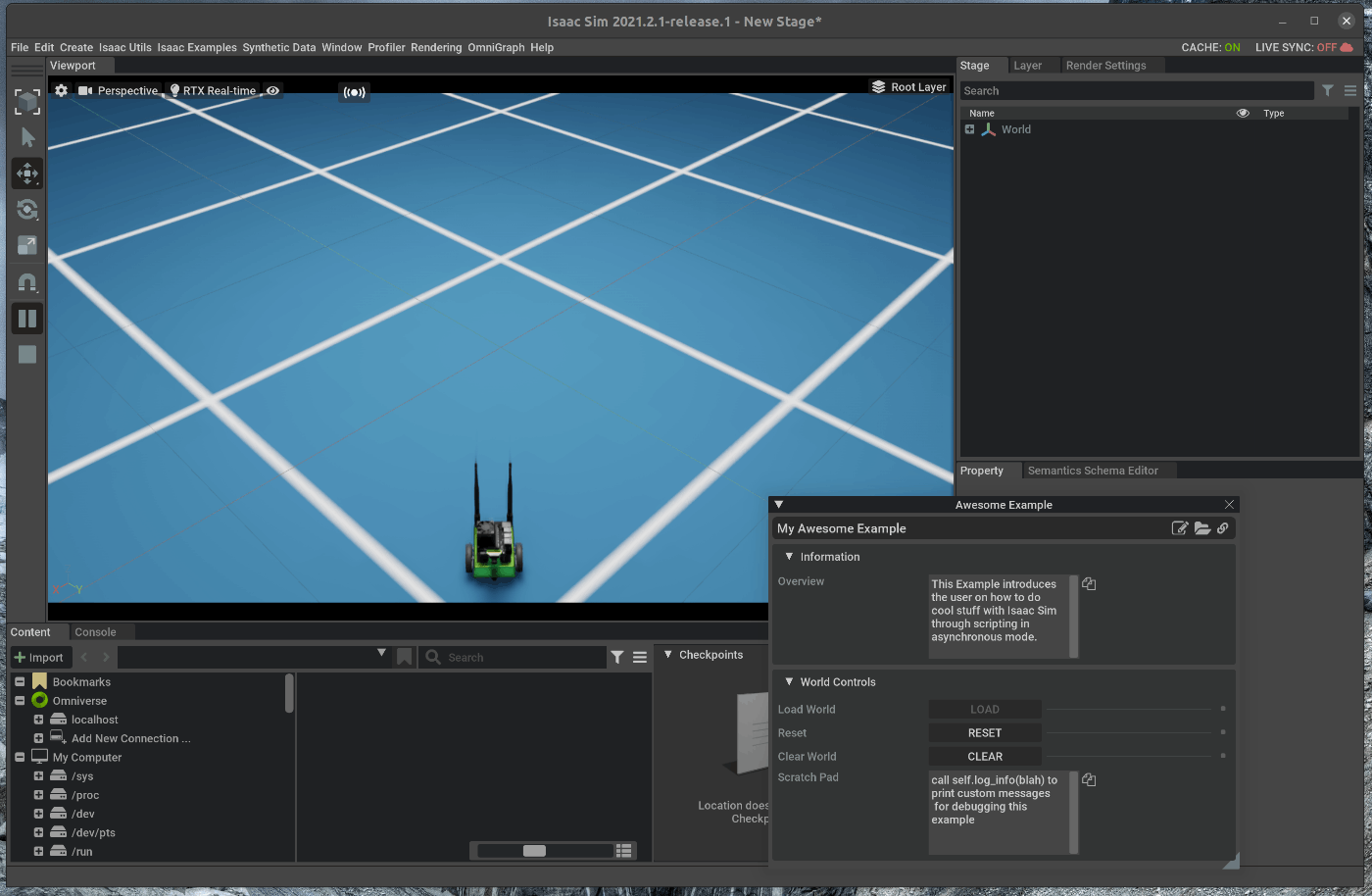

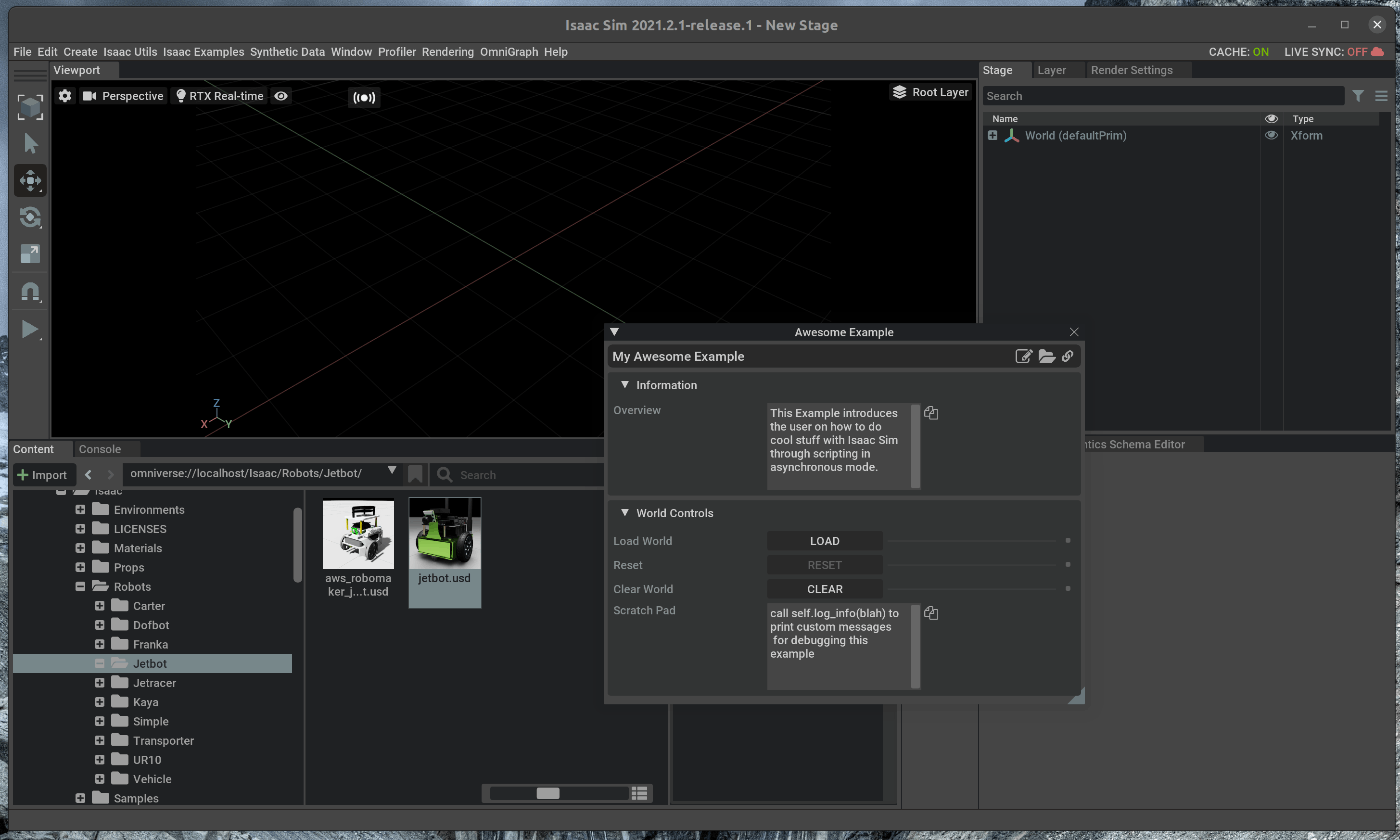

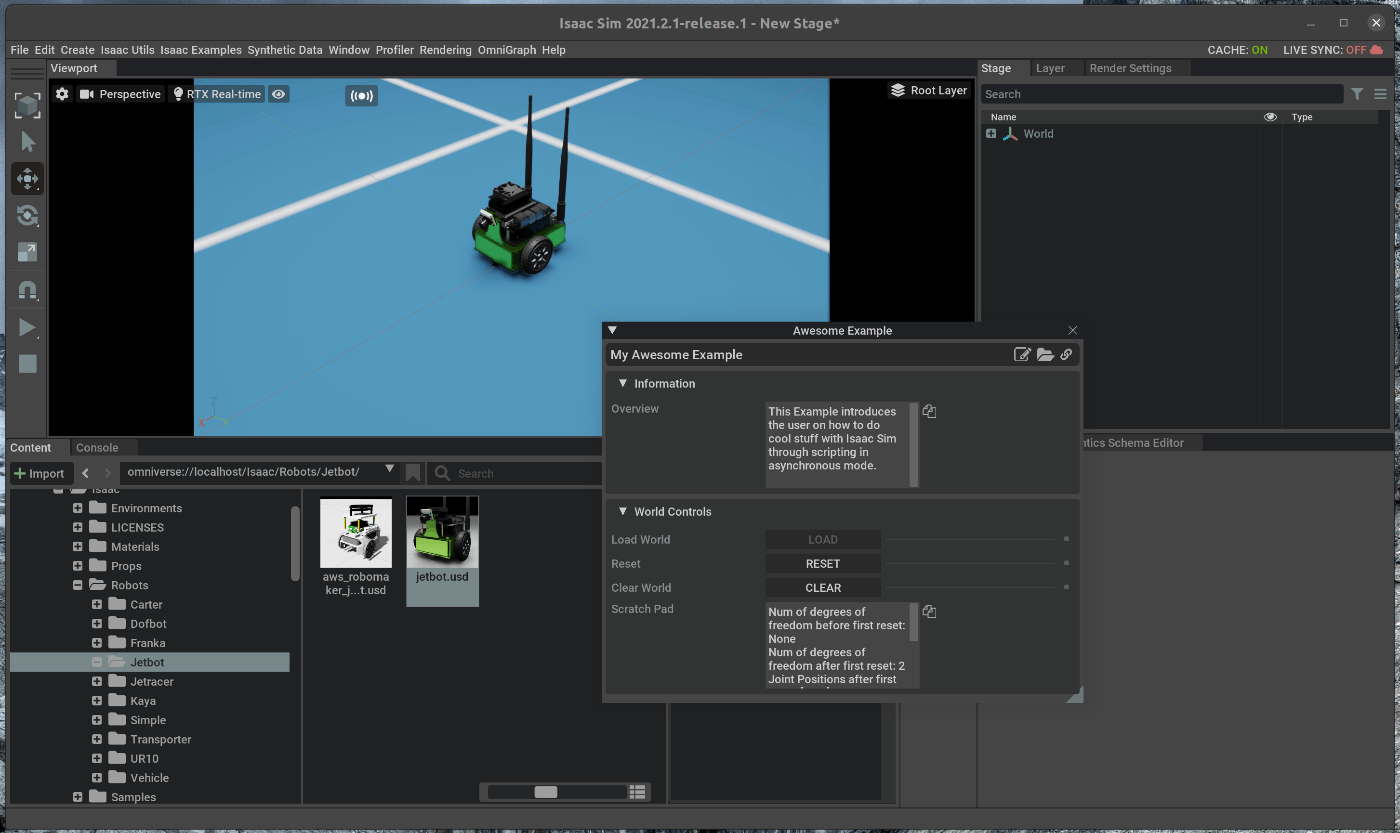

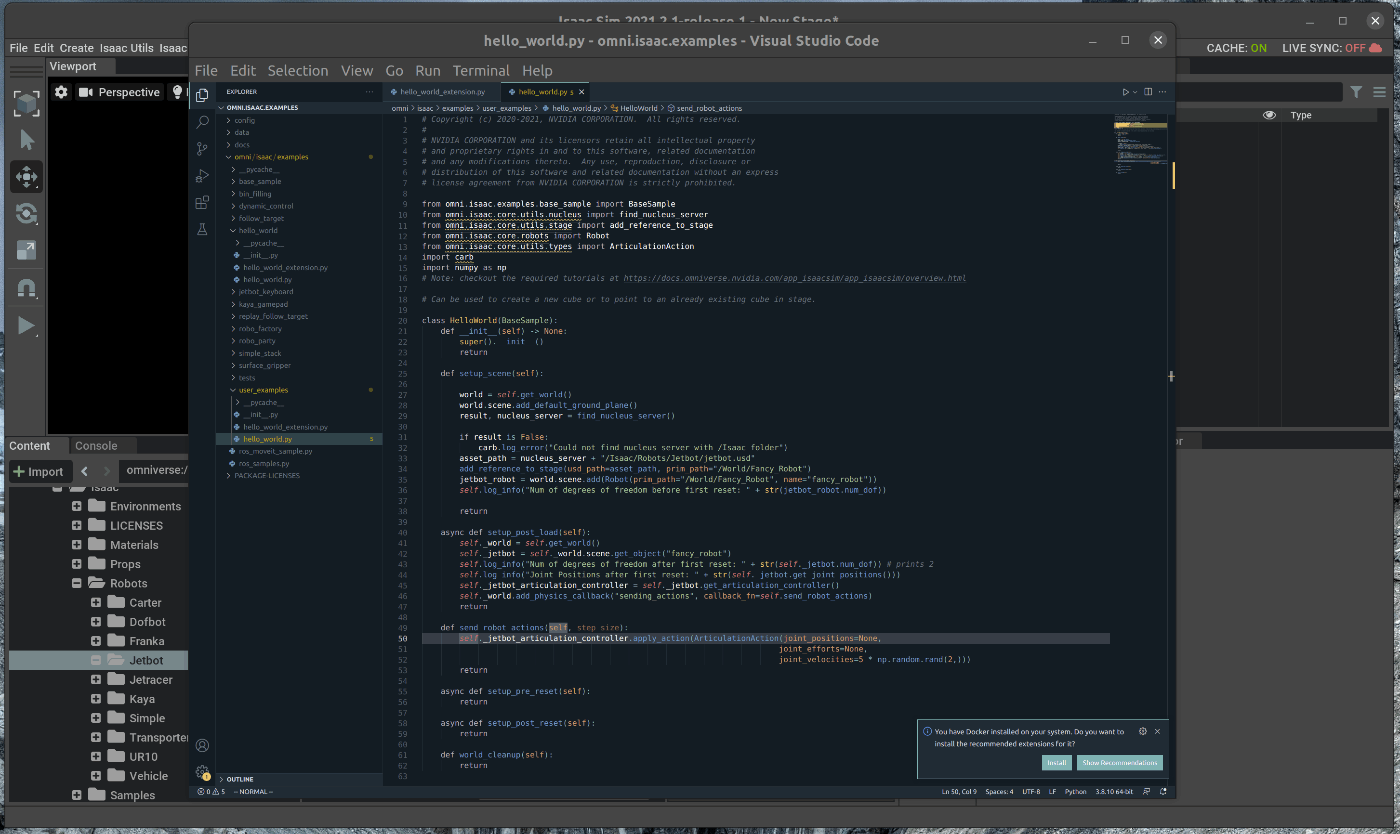

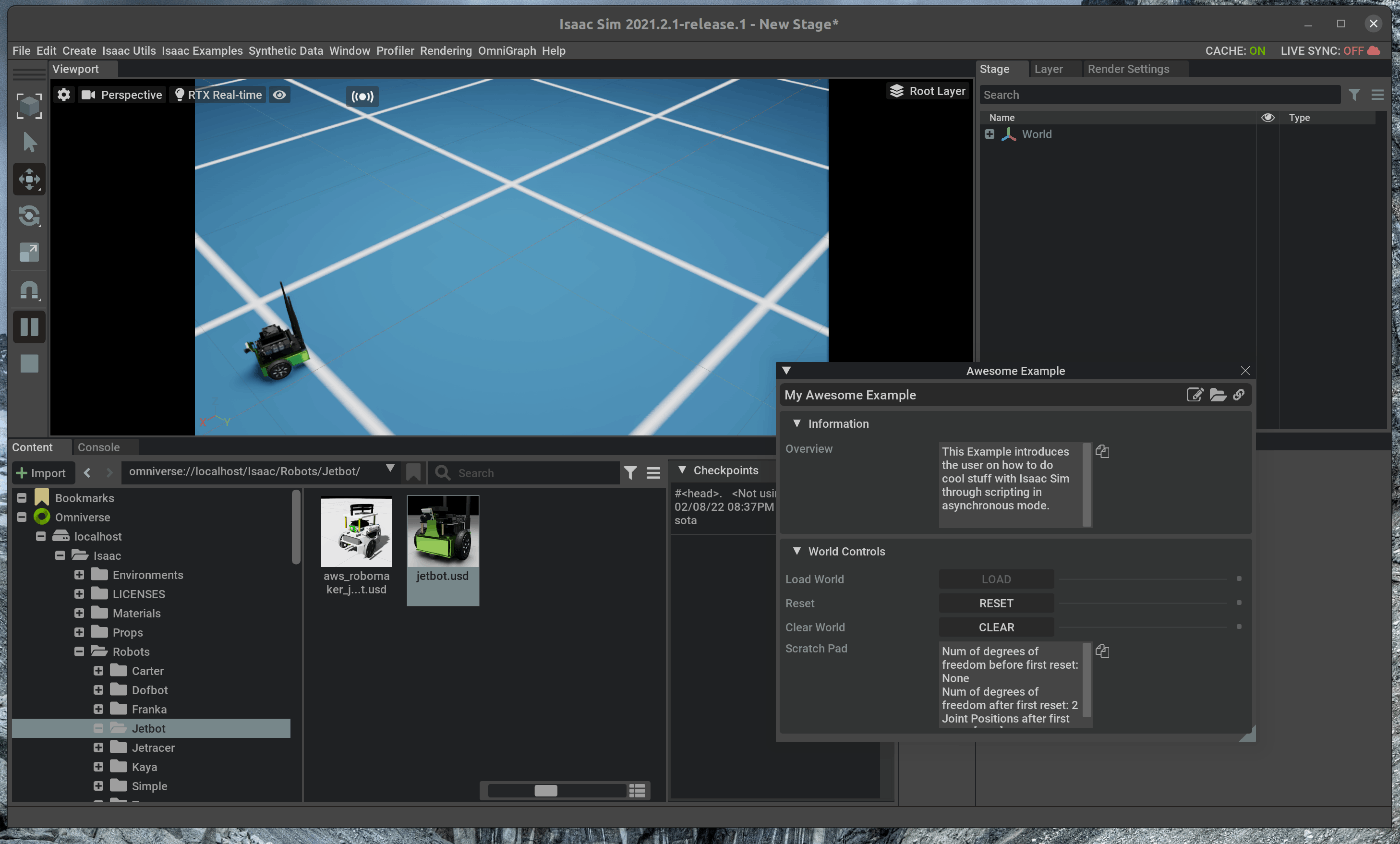

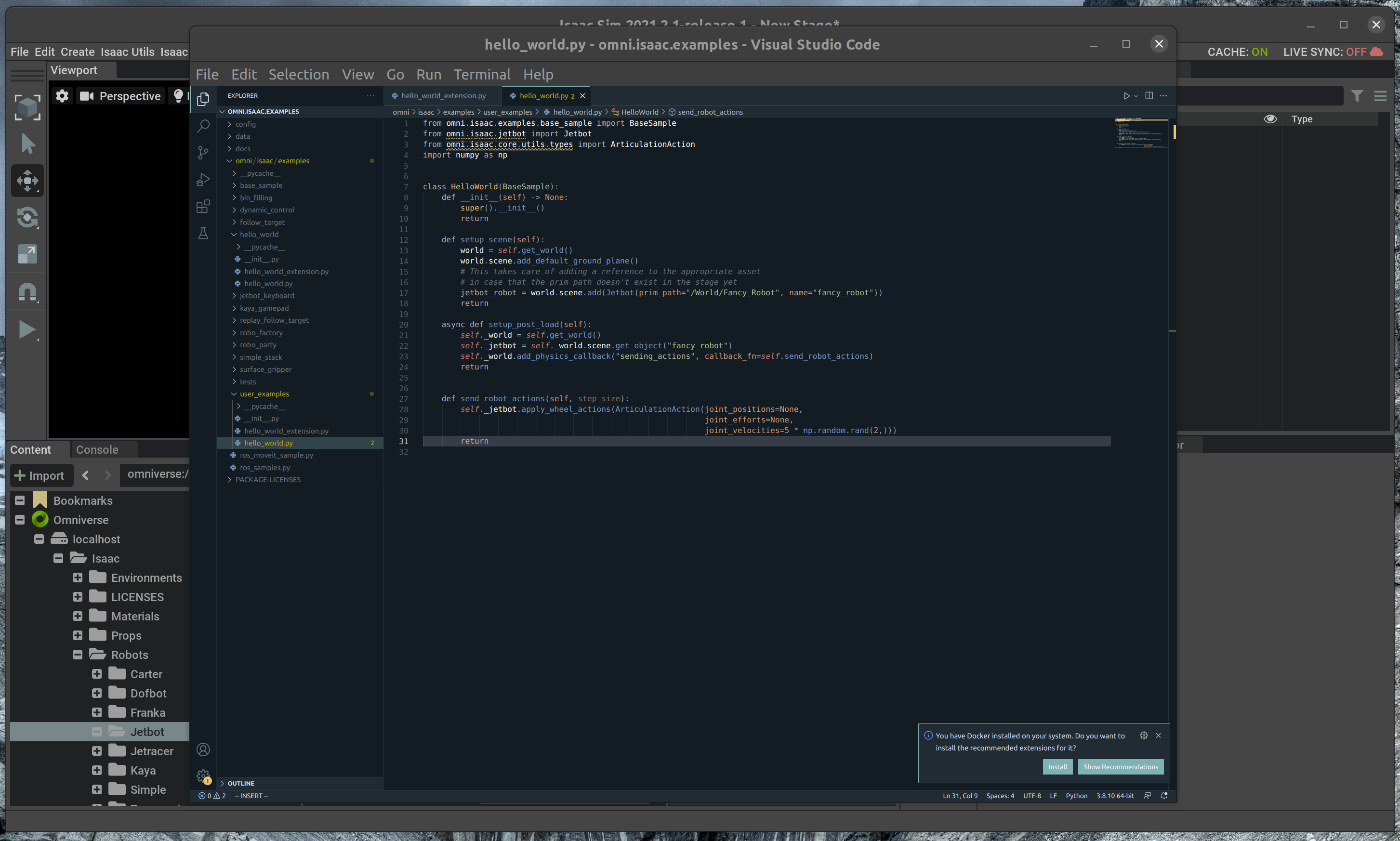

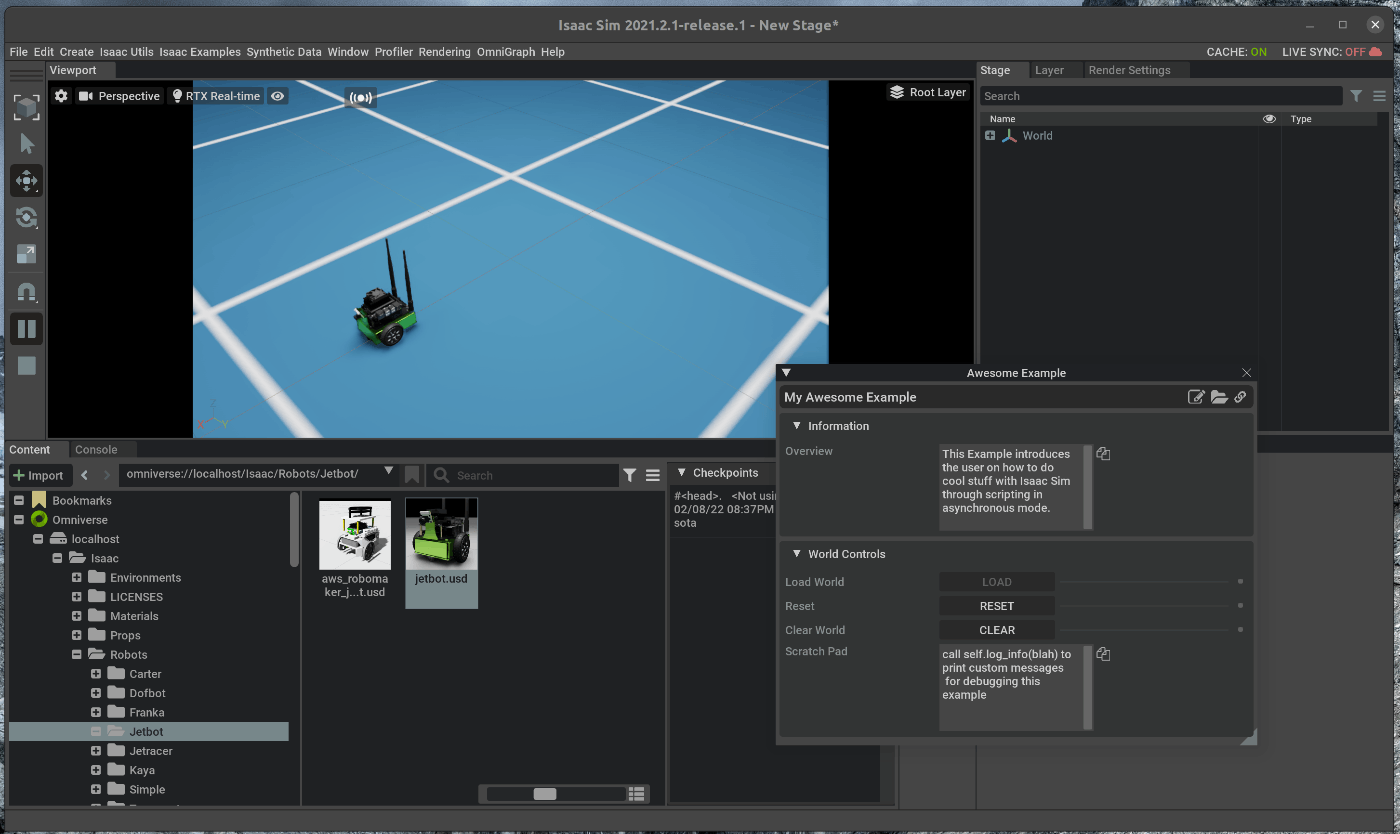

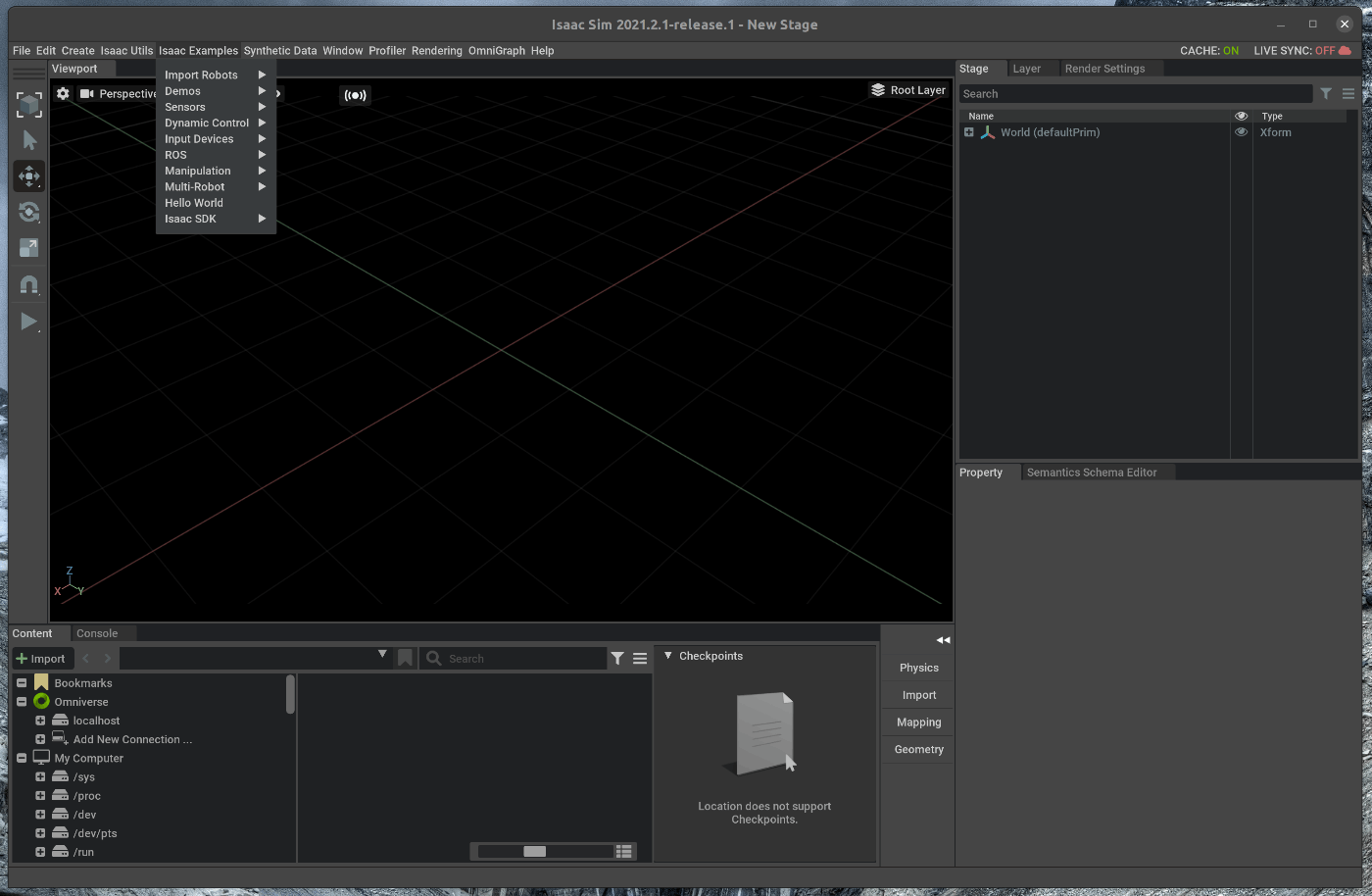

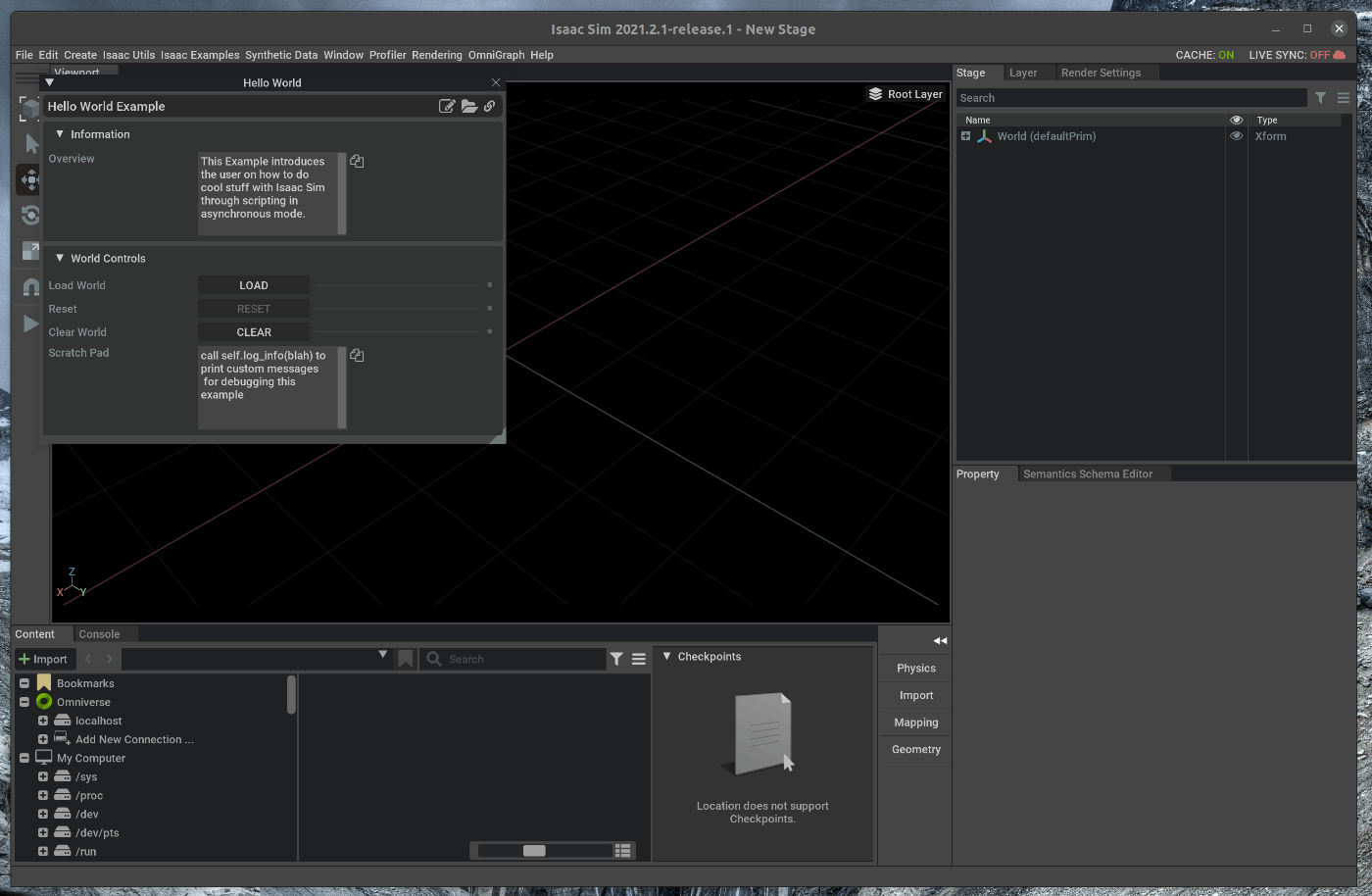

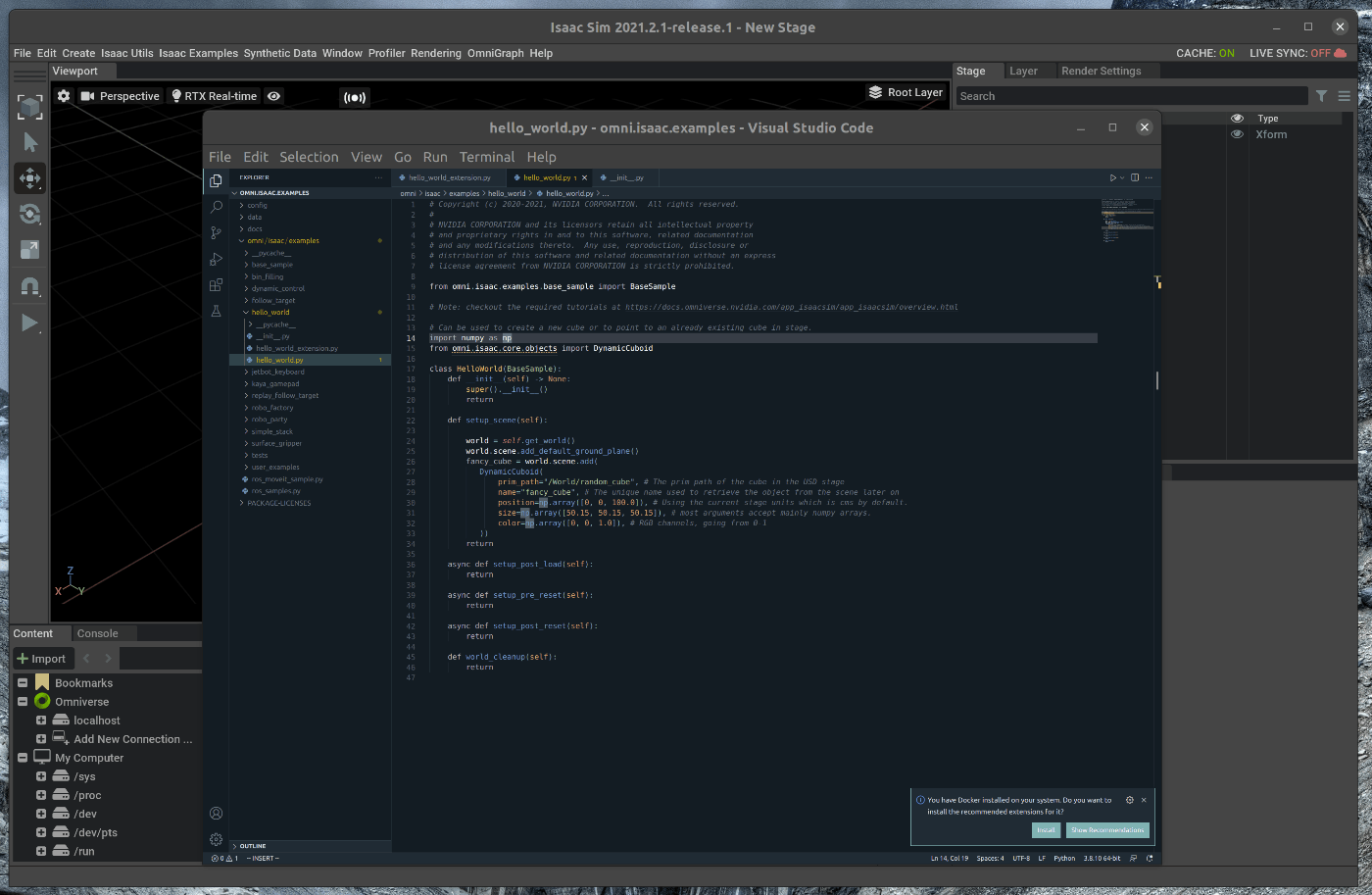

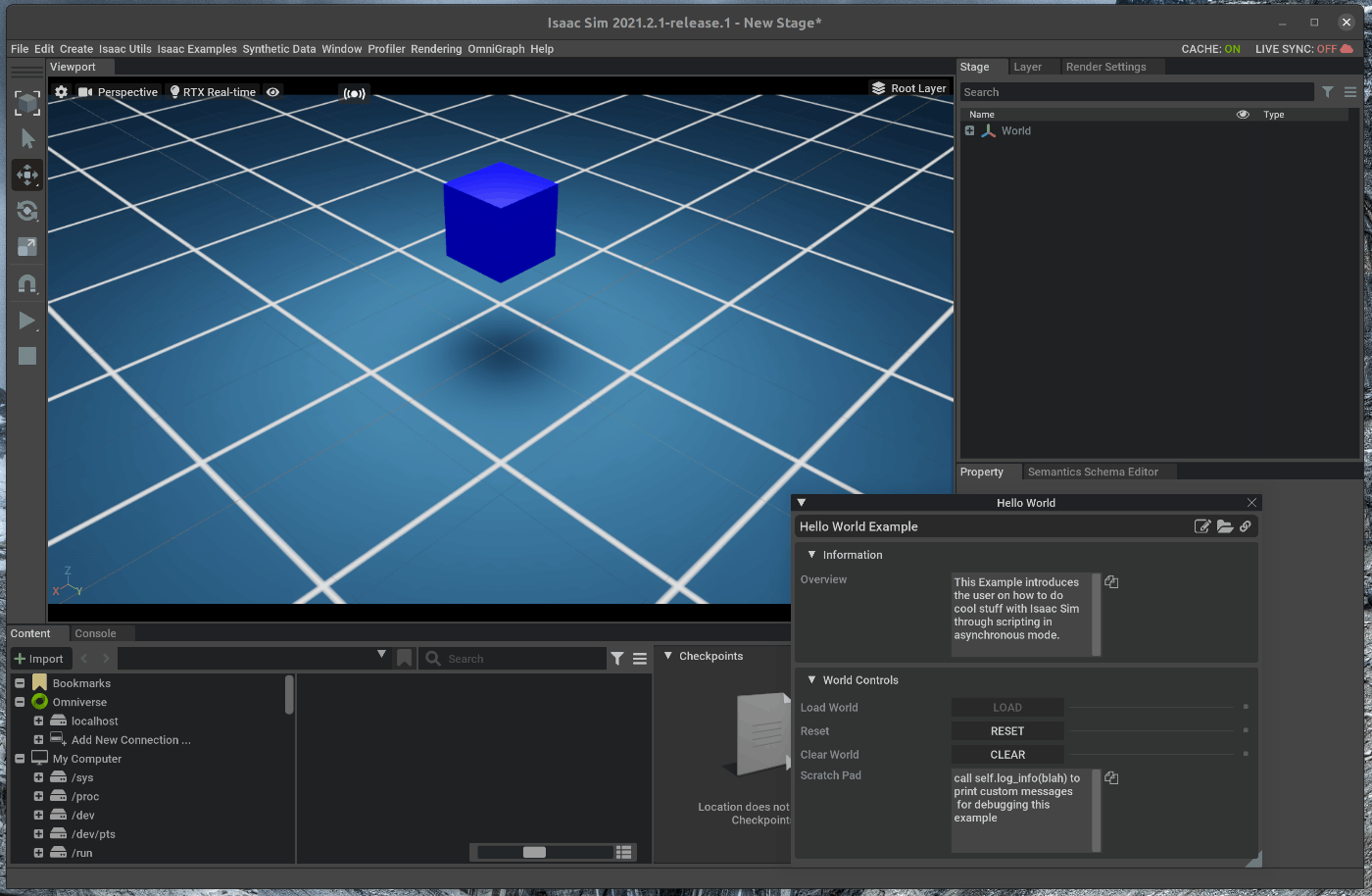

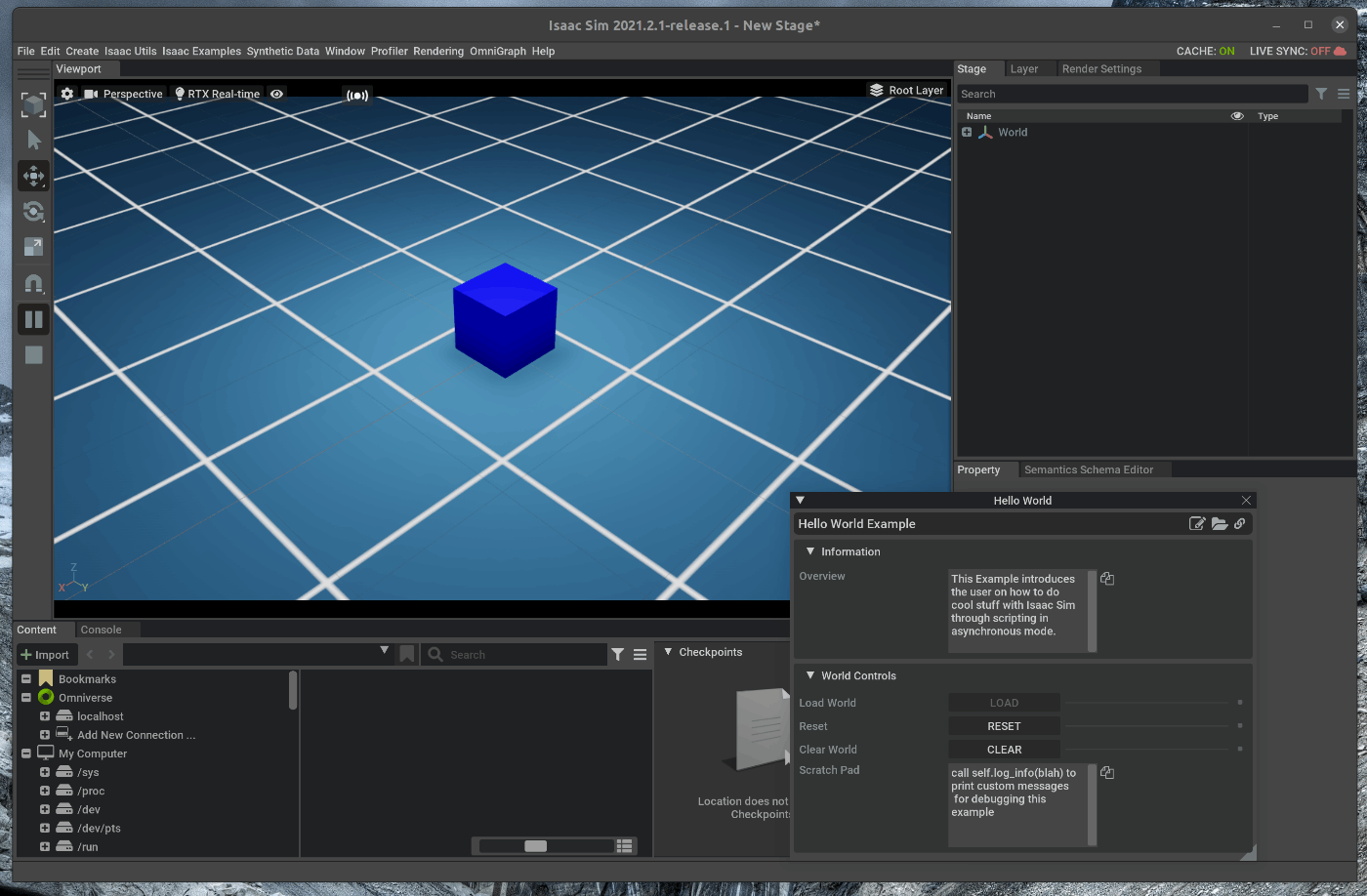

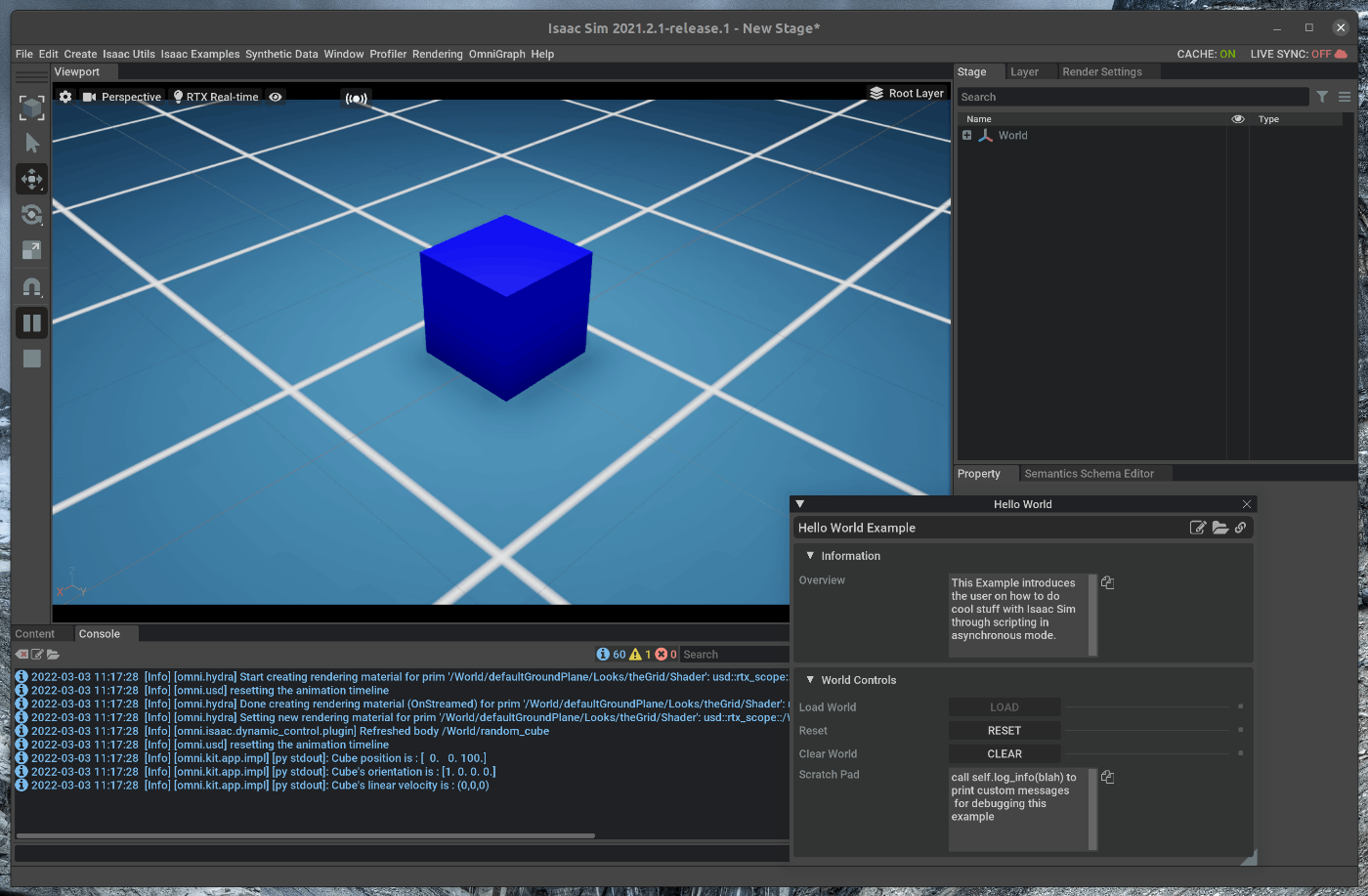

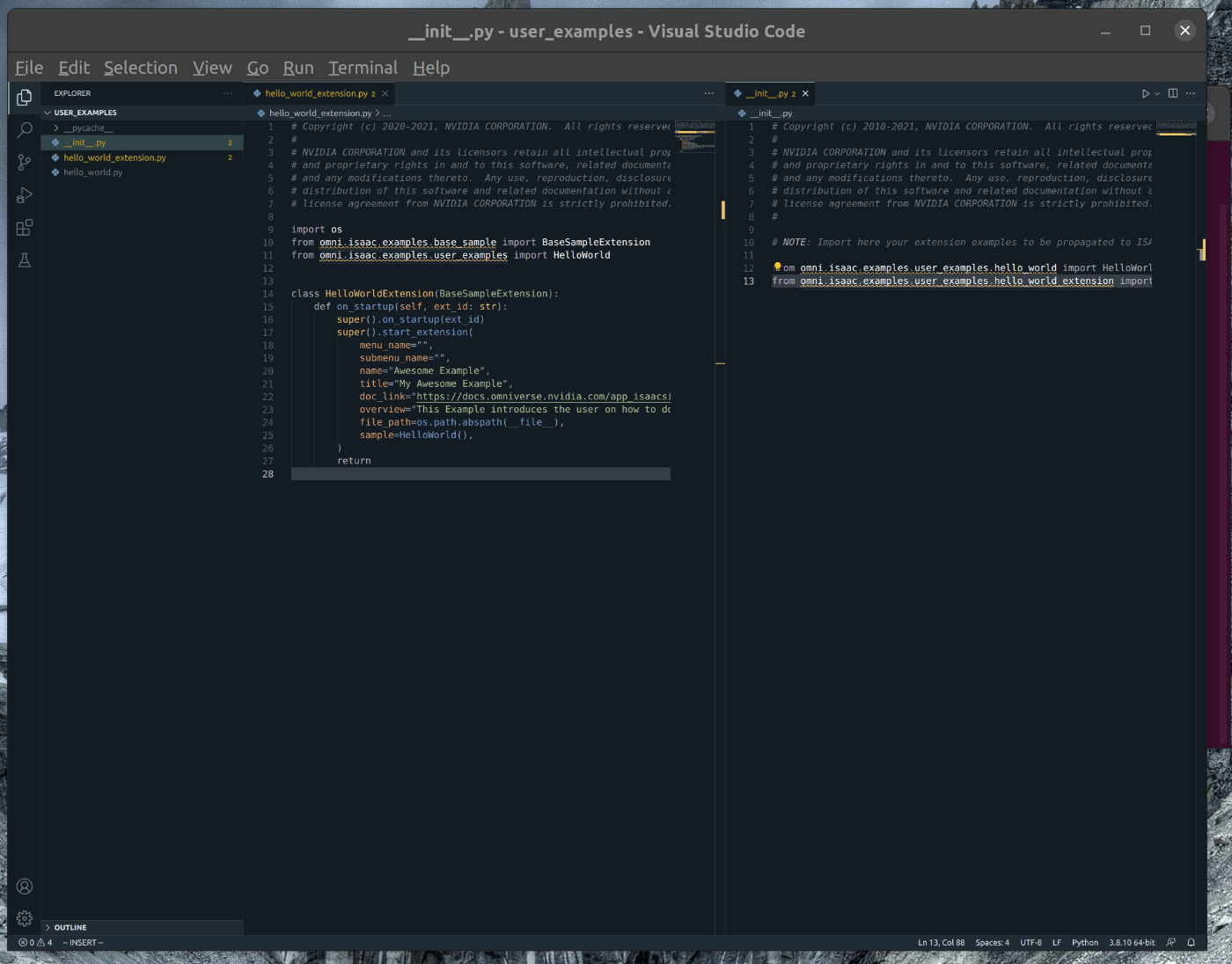

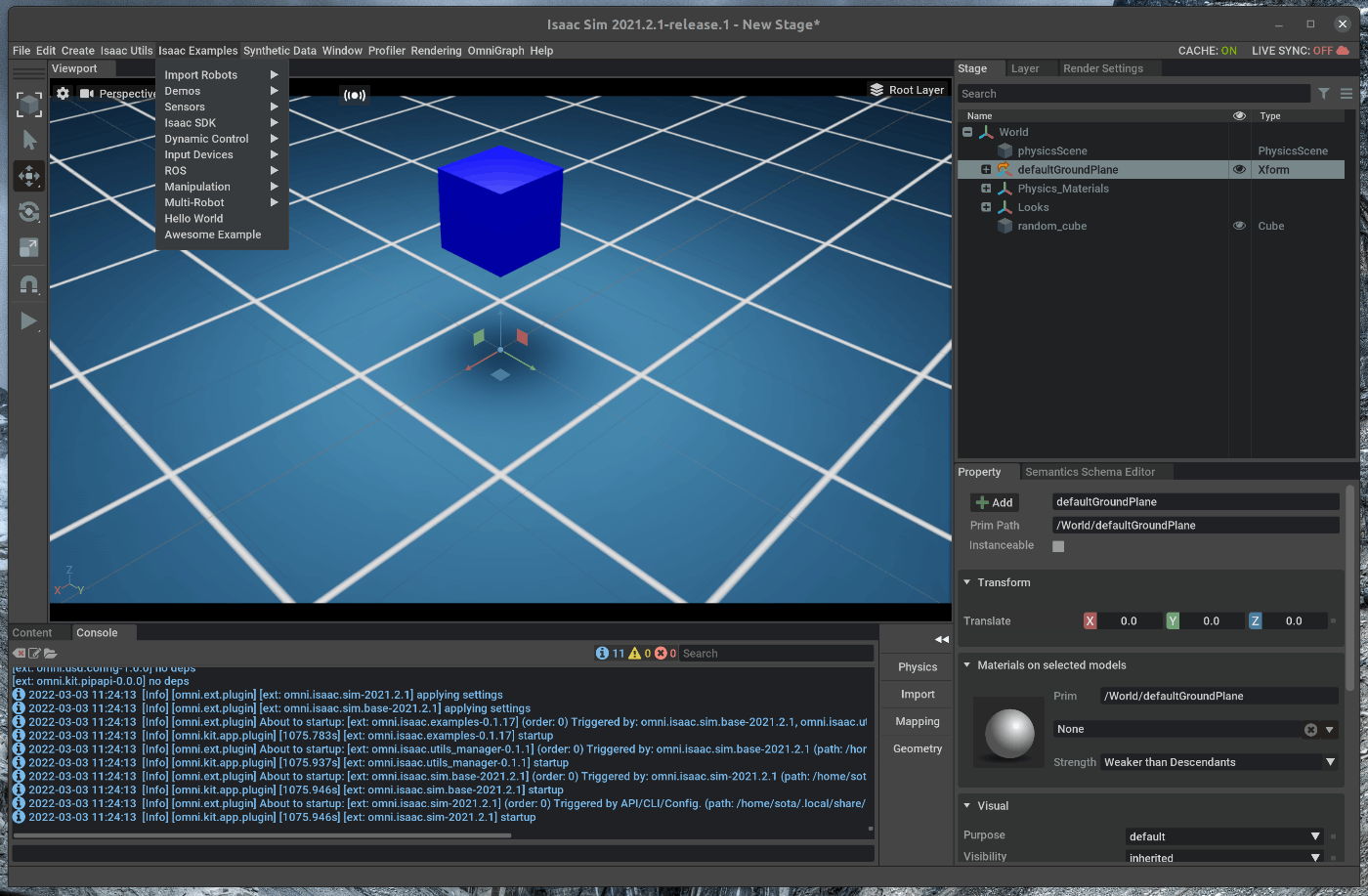

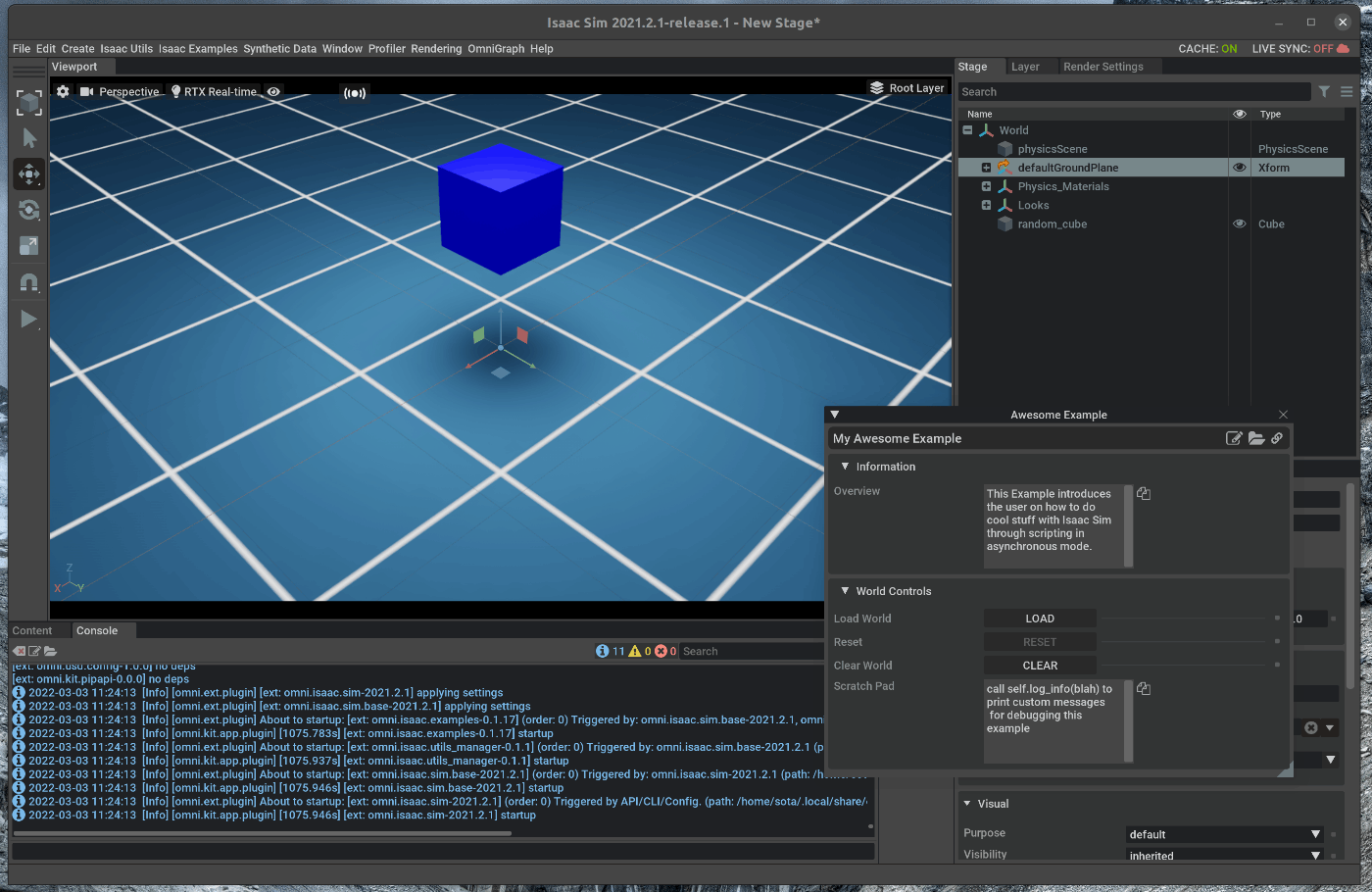

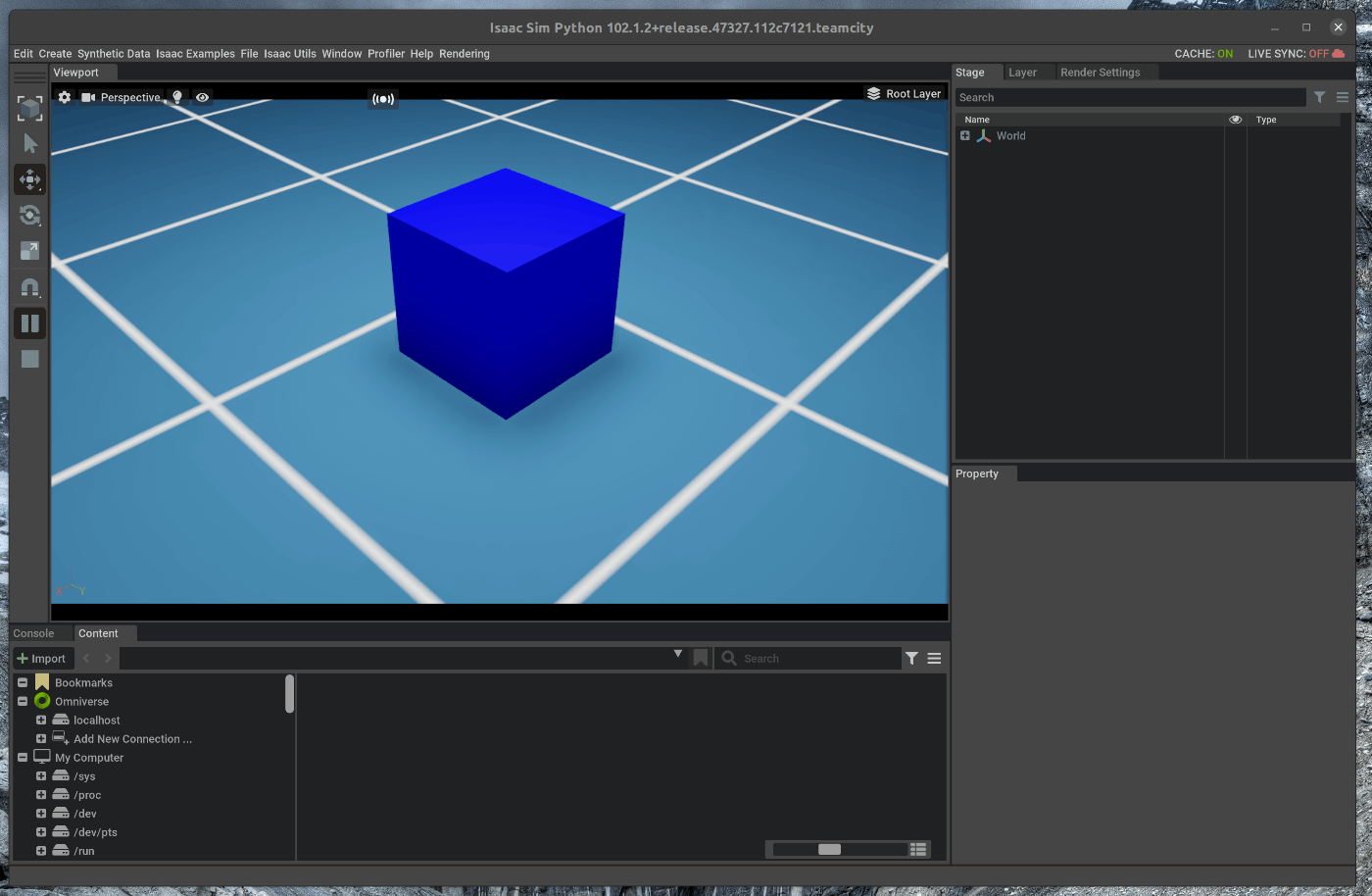

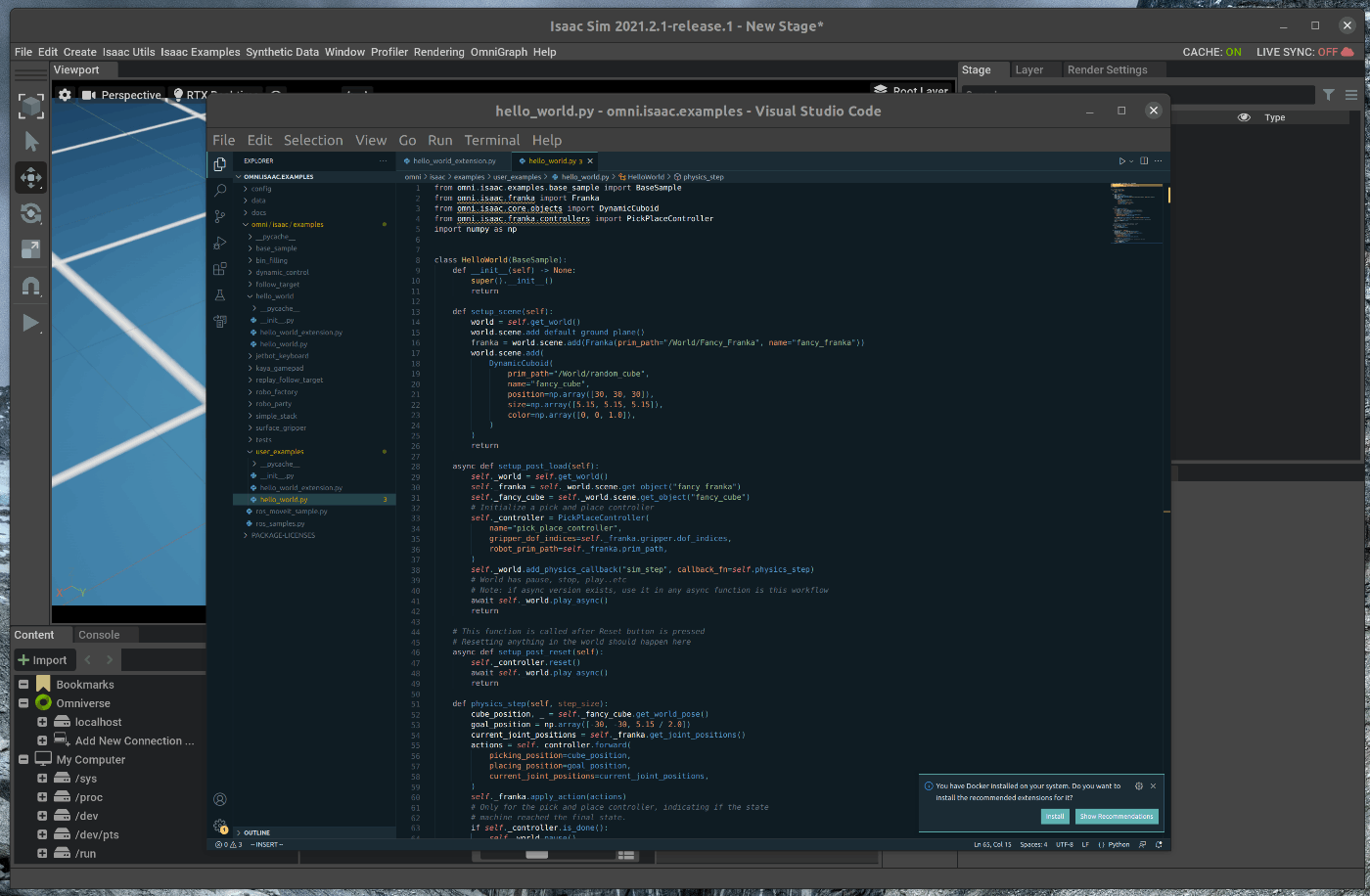

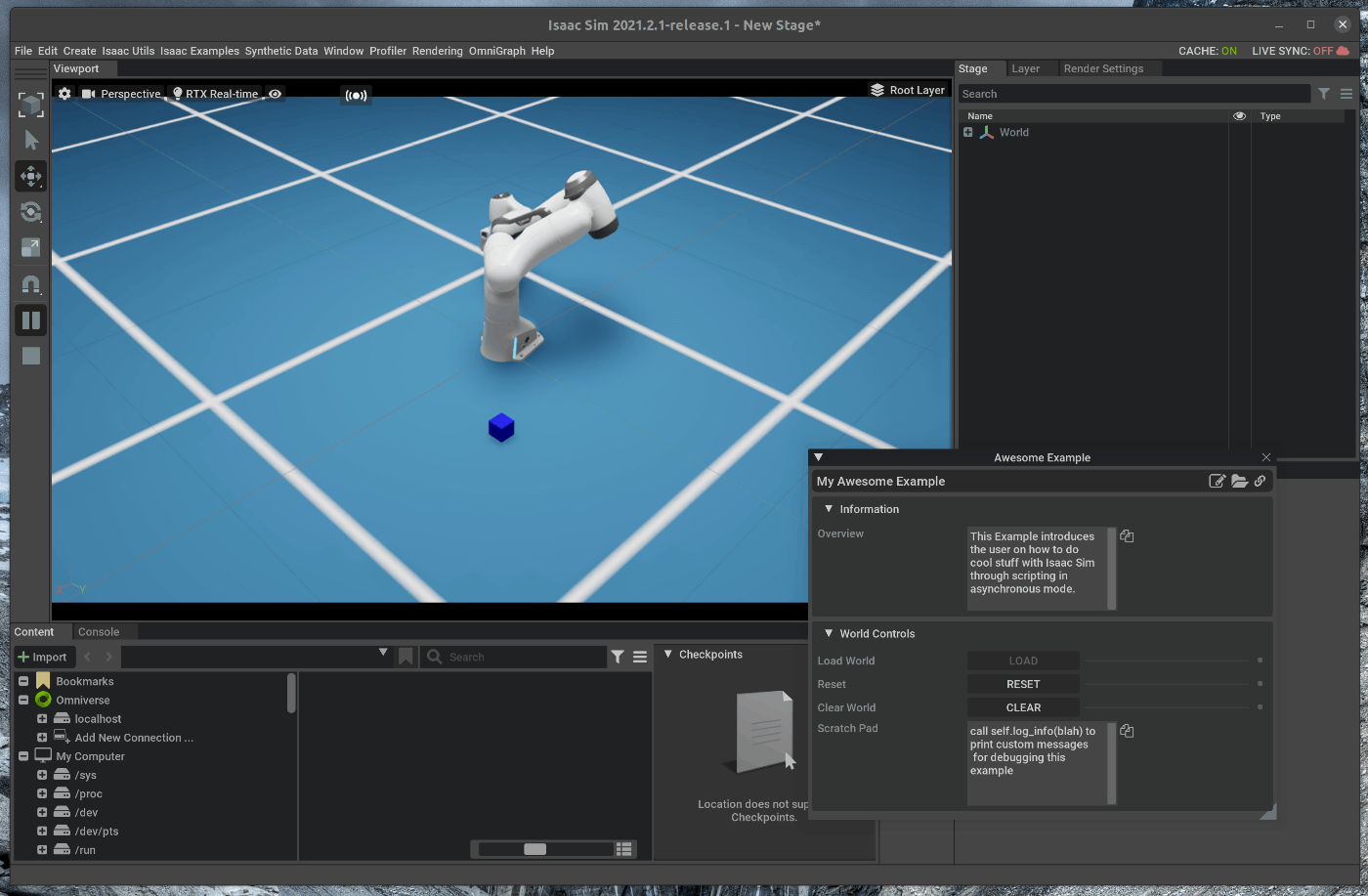

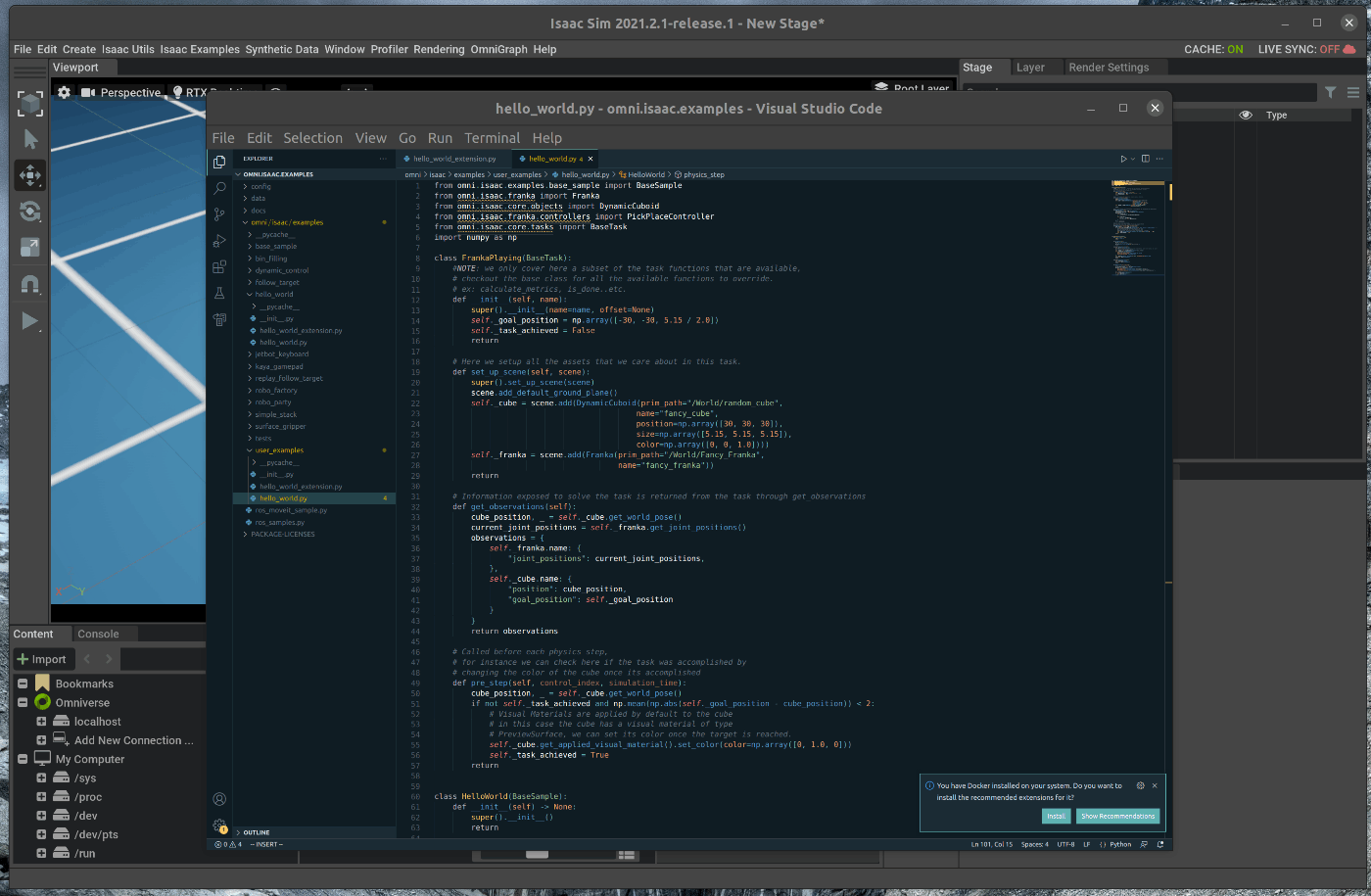

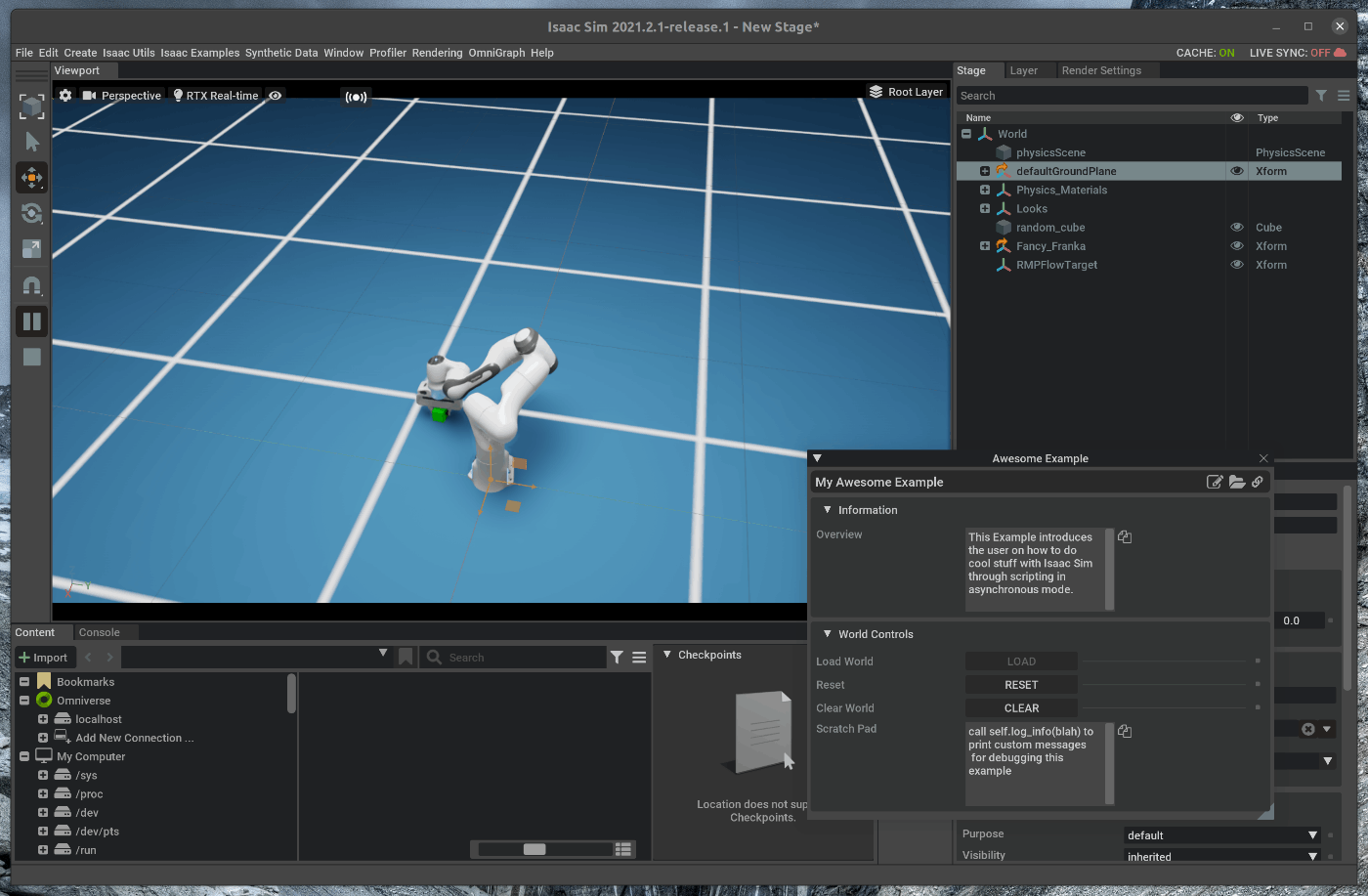

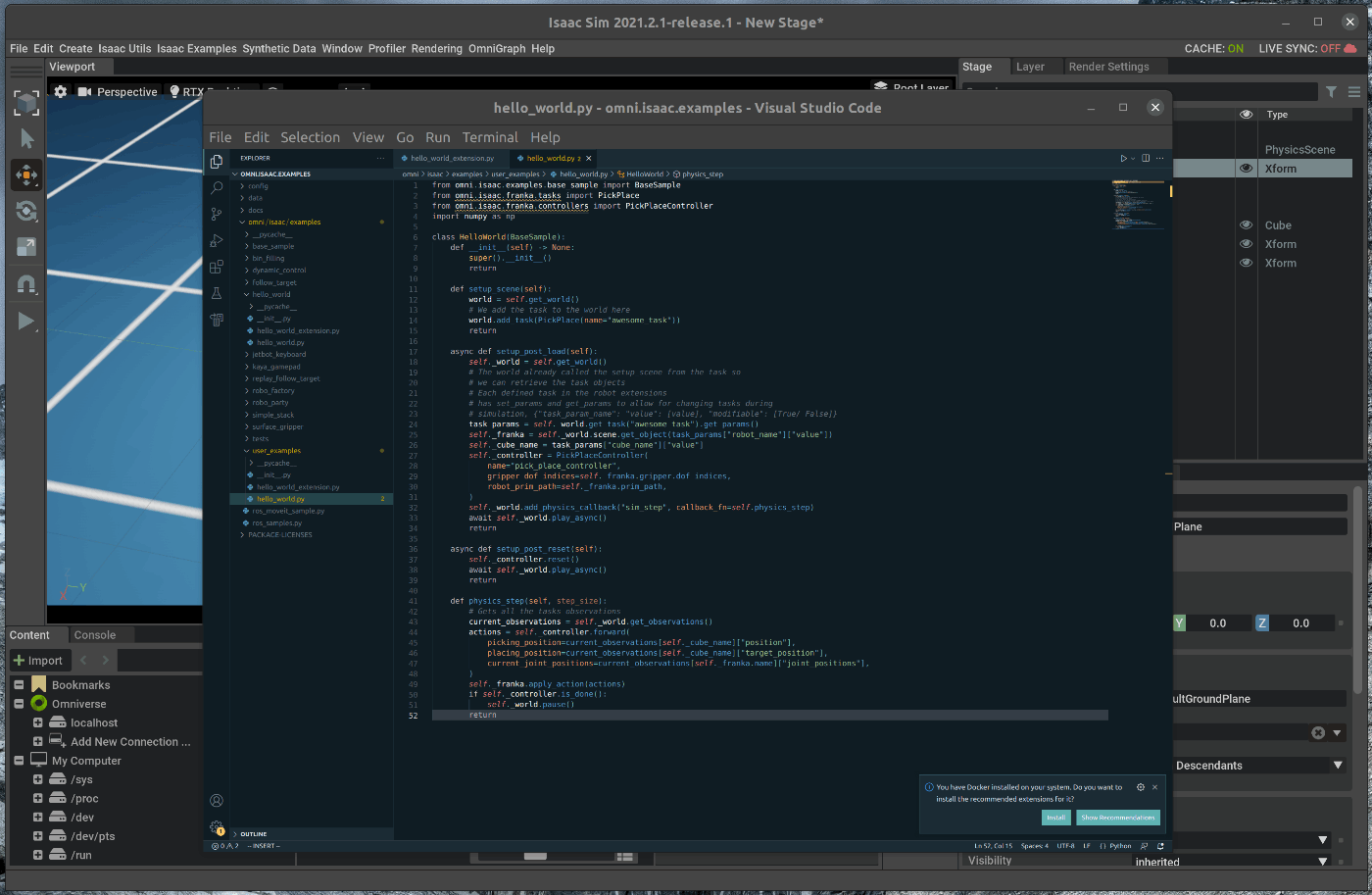

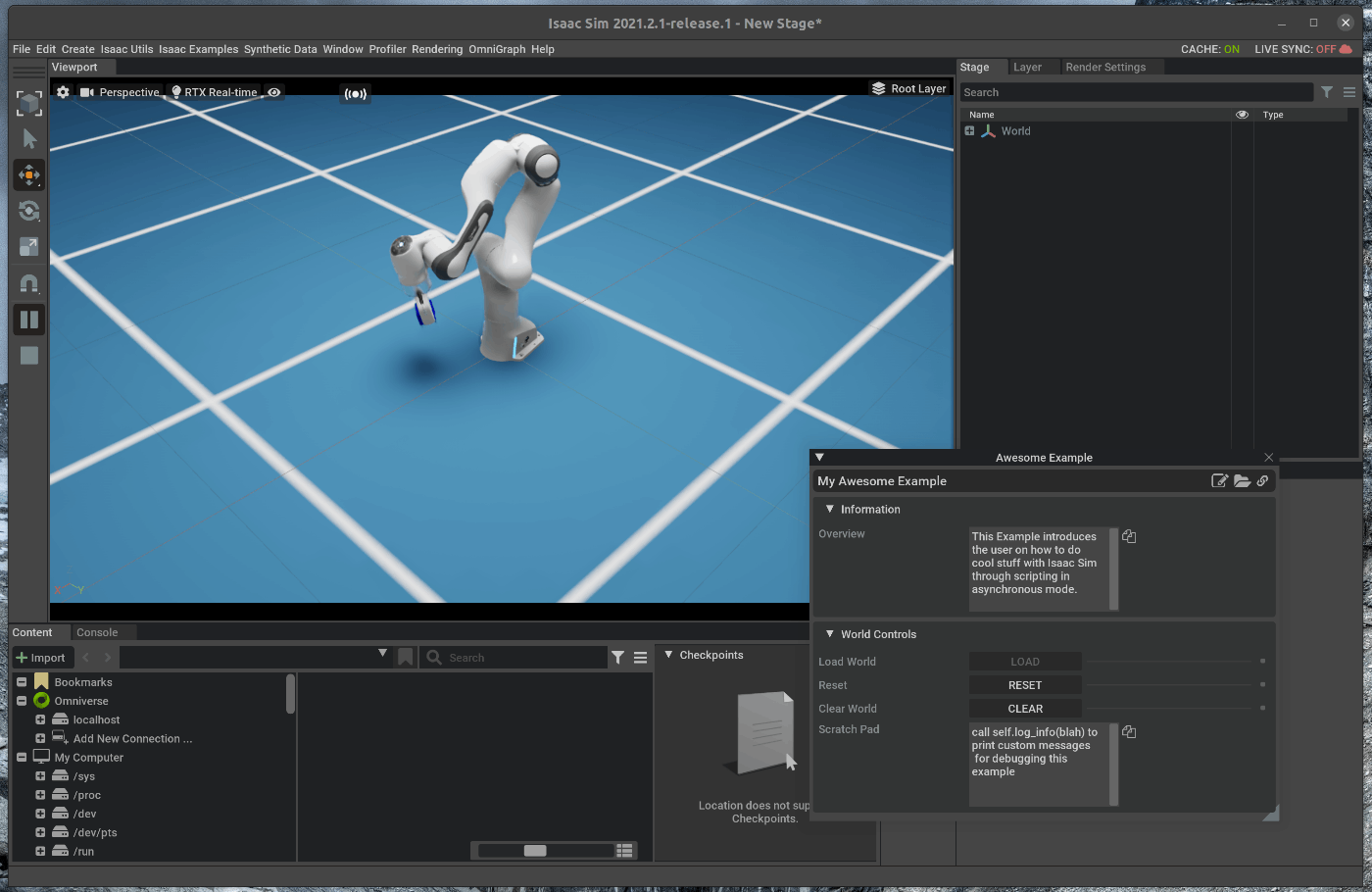

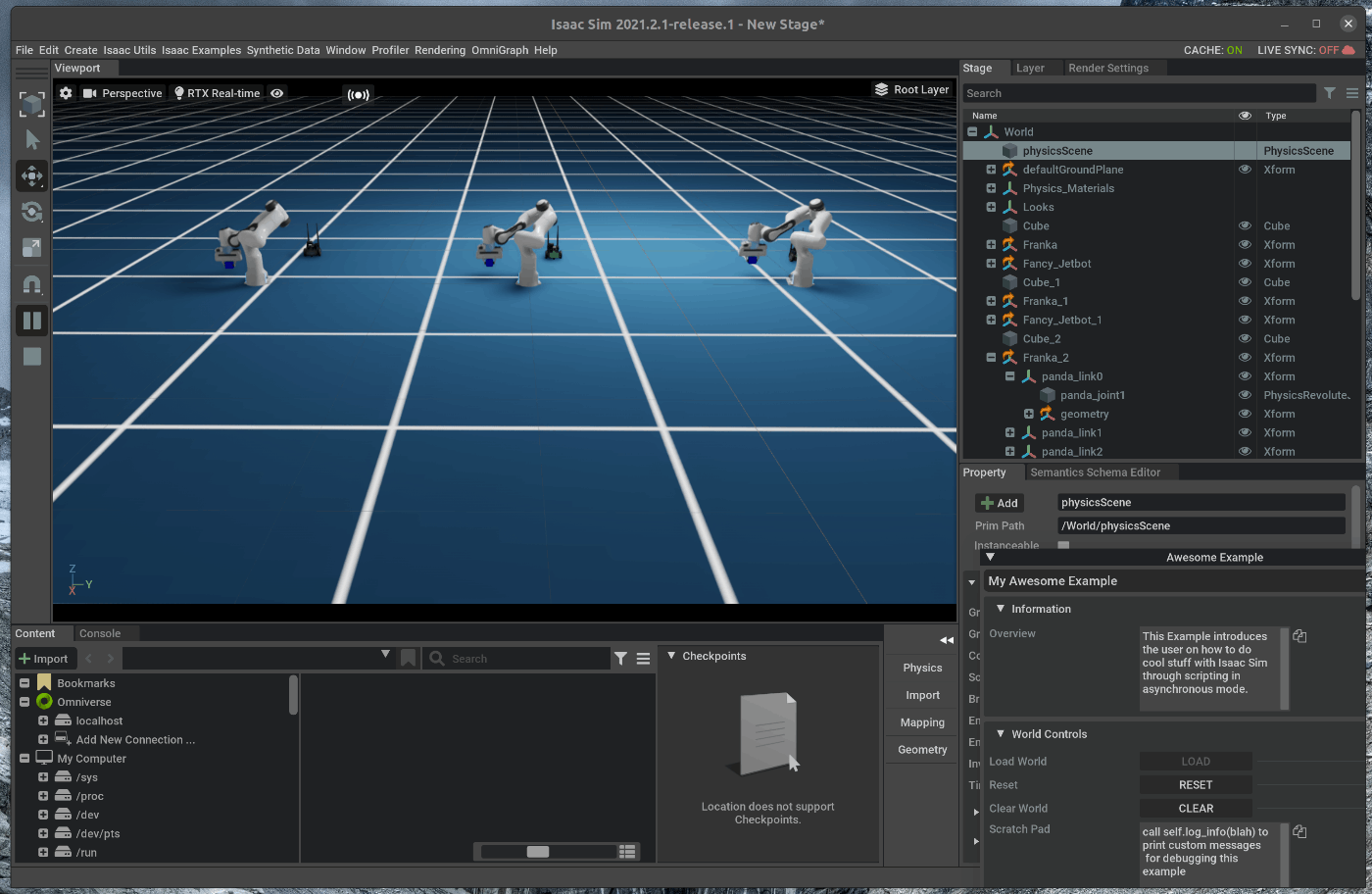

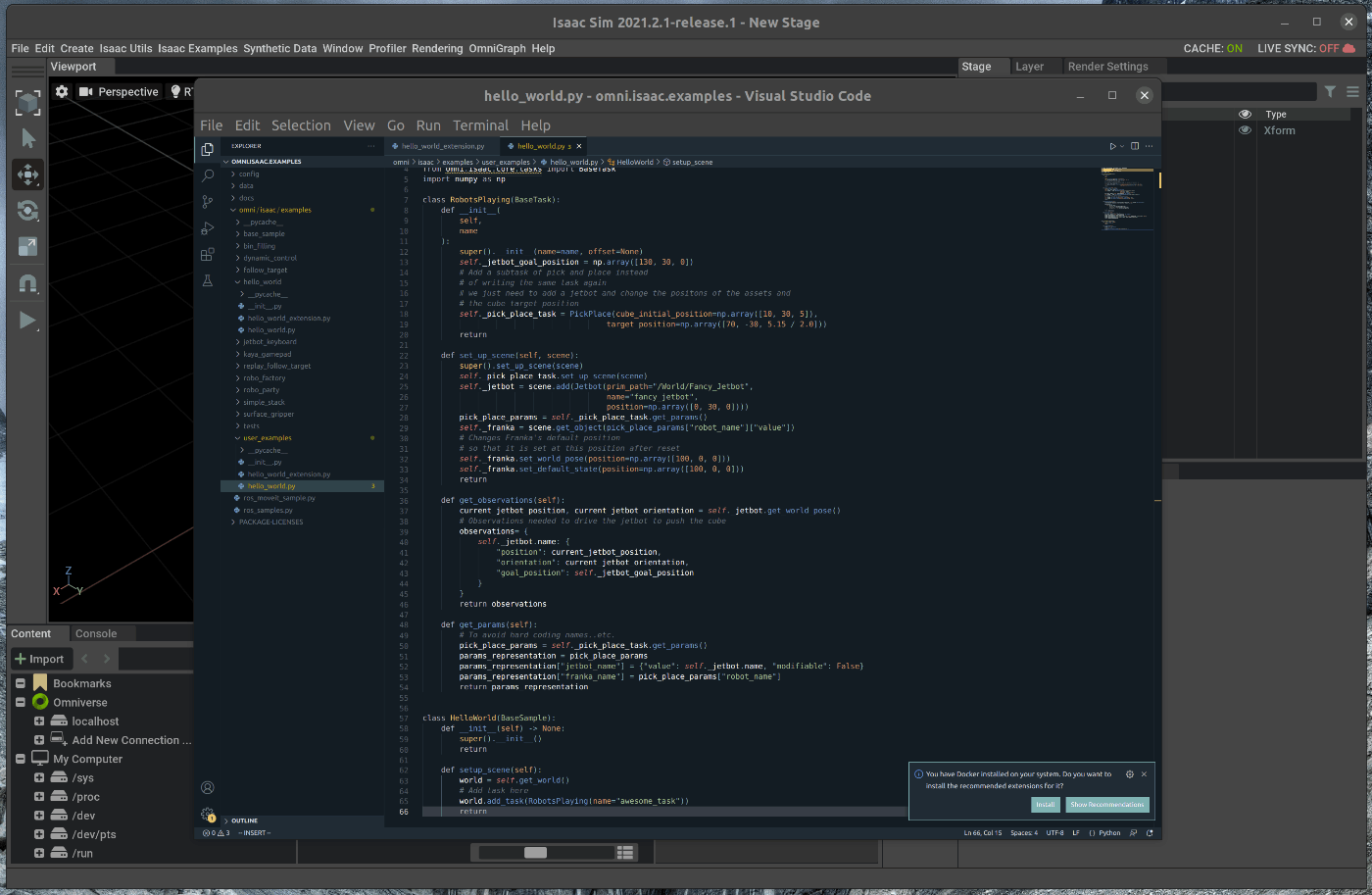

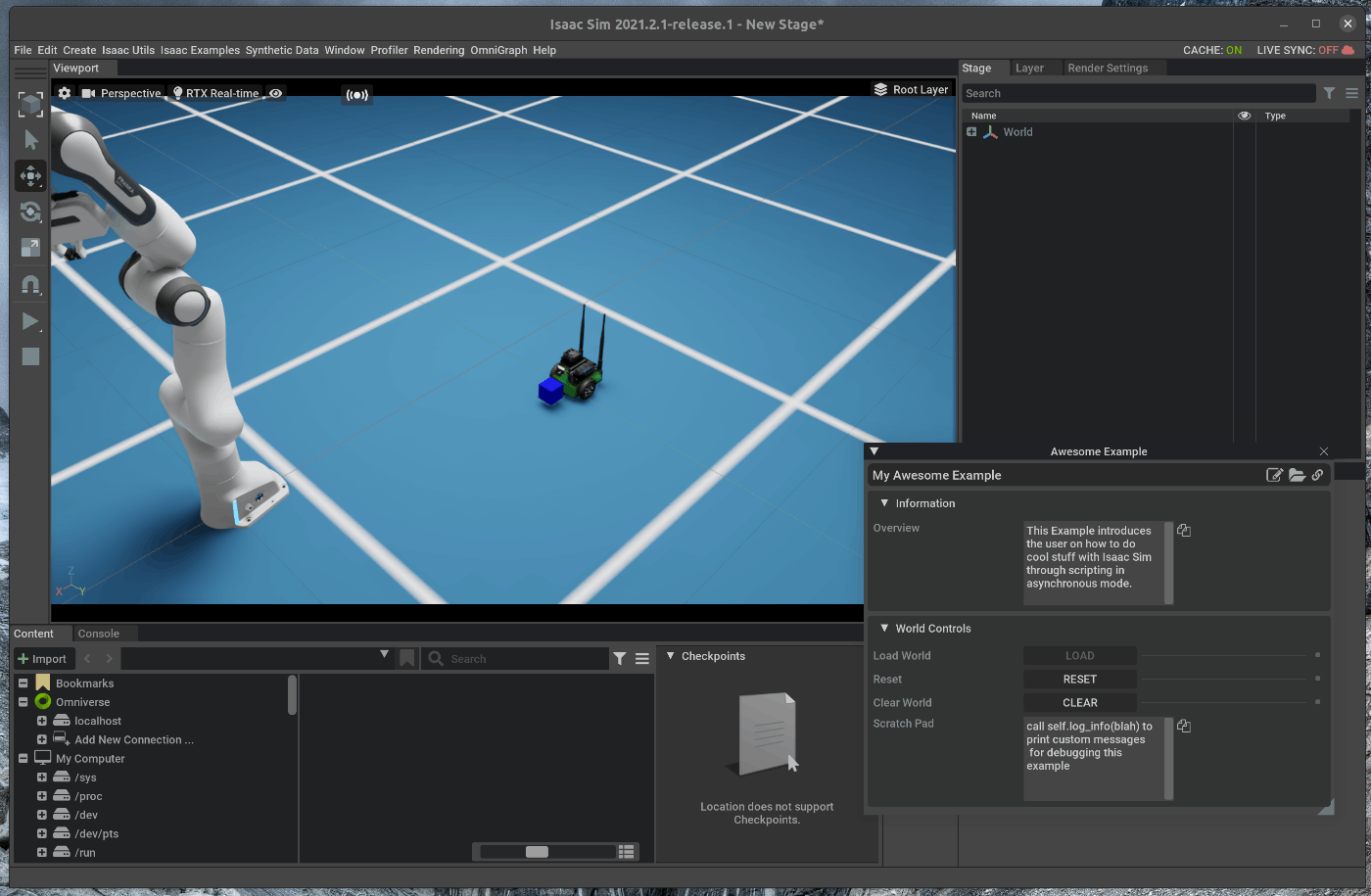

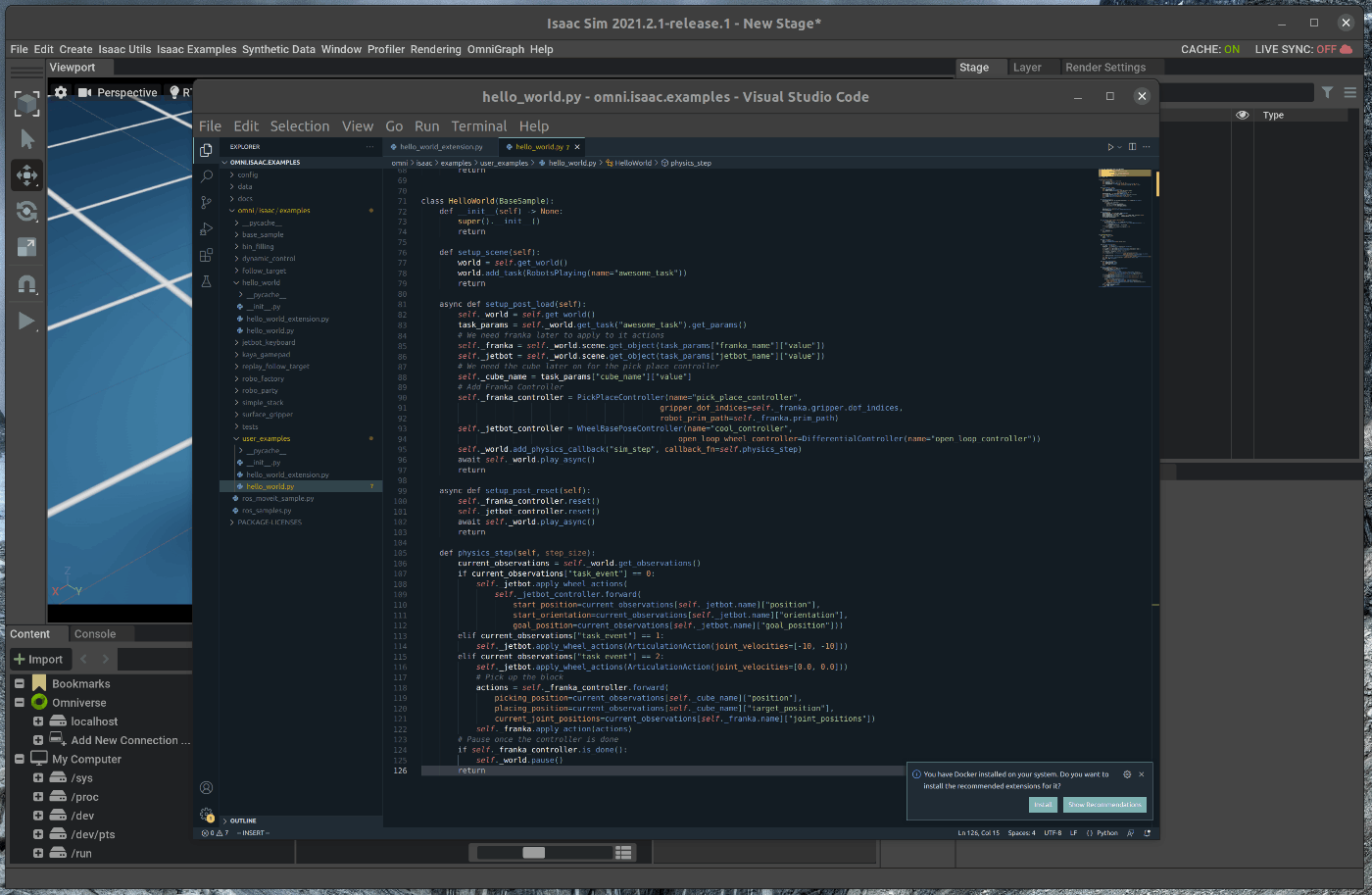

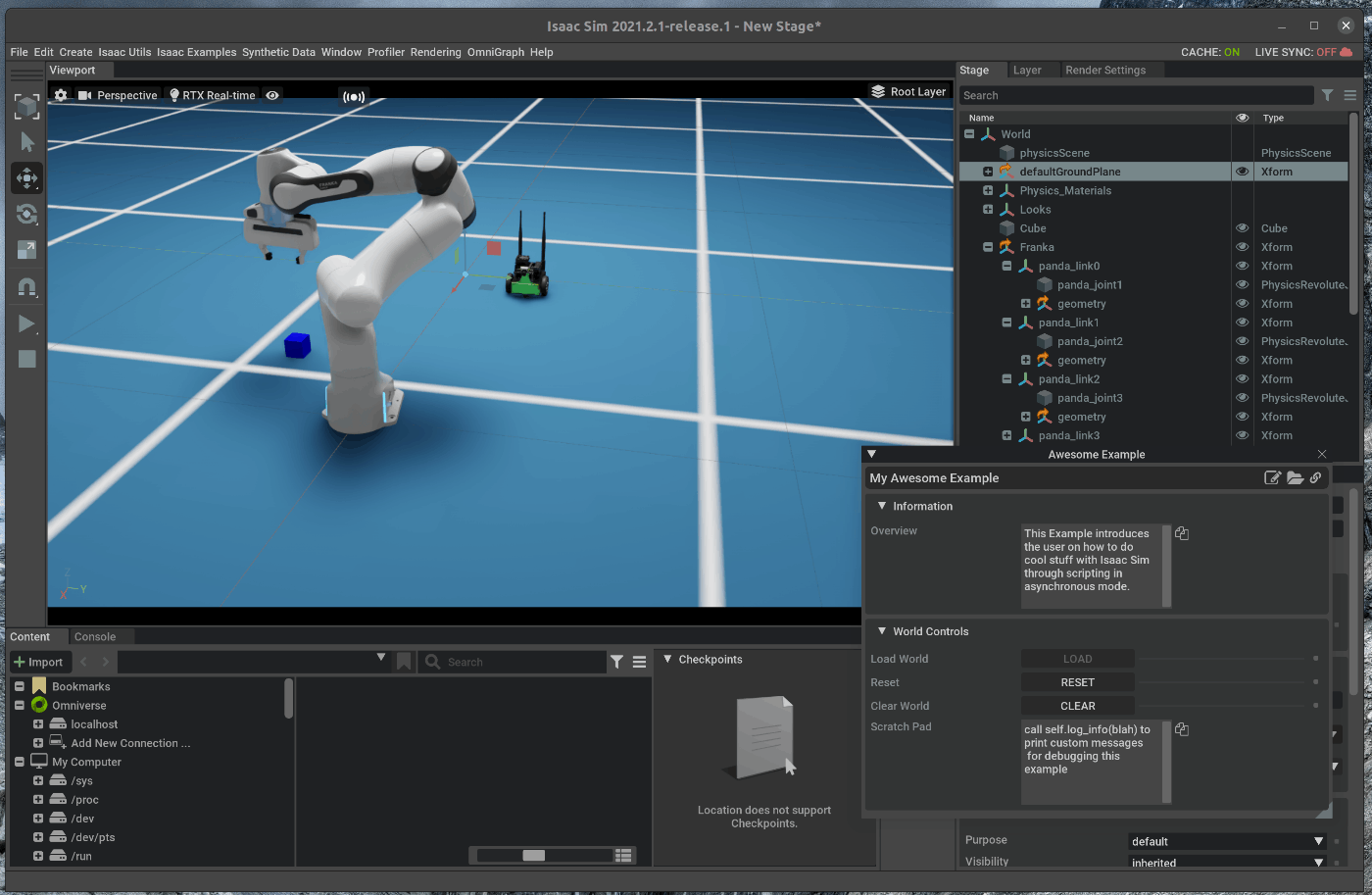

58 | ### 1.2 Hello Worldのロード

59 | メニューバーのIsaac Examples > Hello Worldを選択します。

60 |

61 |

62 |

63 | ポップアップしたHello Worldのウィンドウの中のLoadを選択します。

64 | 選択すると、シーンがロードされます。

65 |

66 |

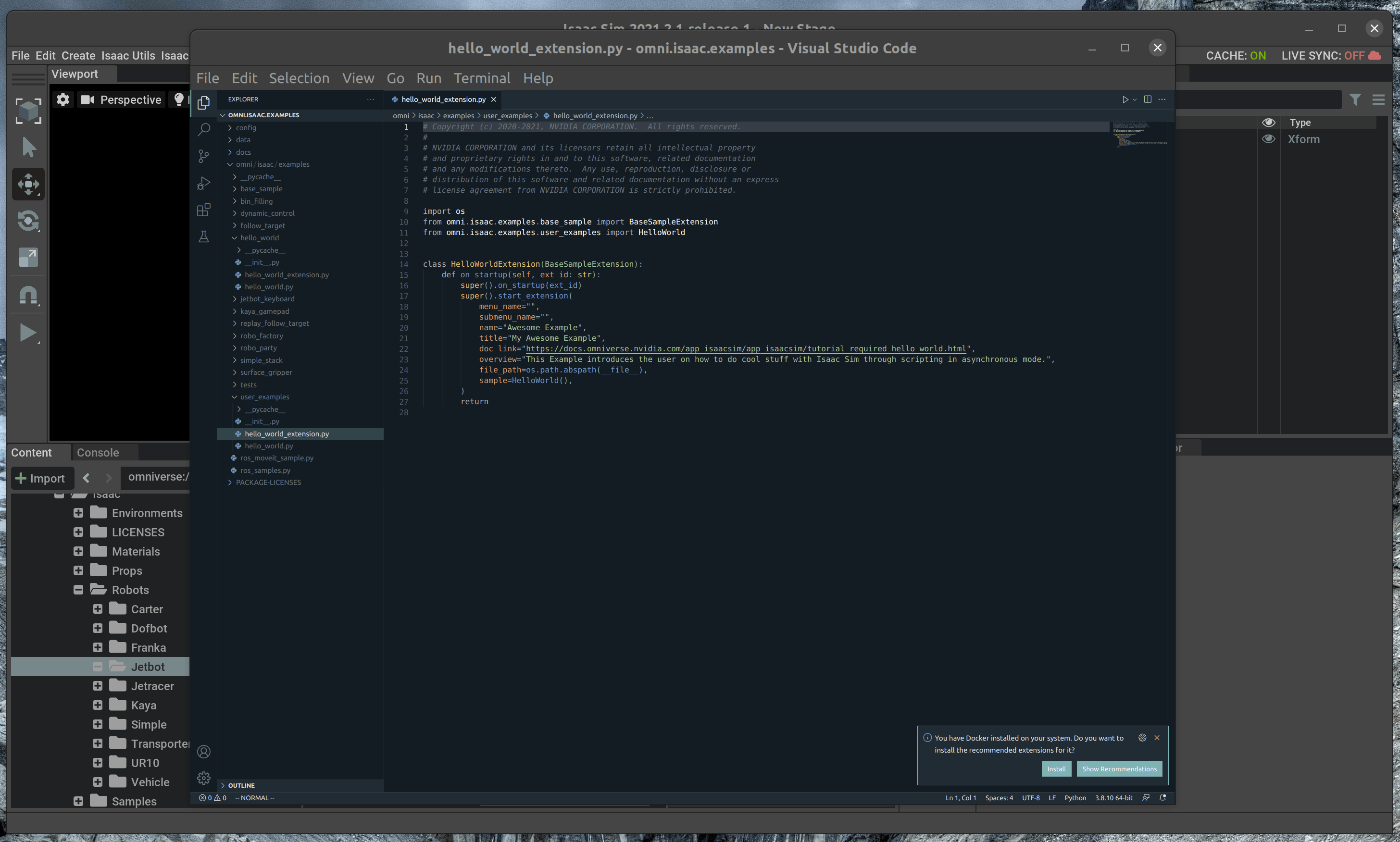

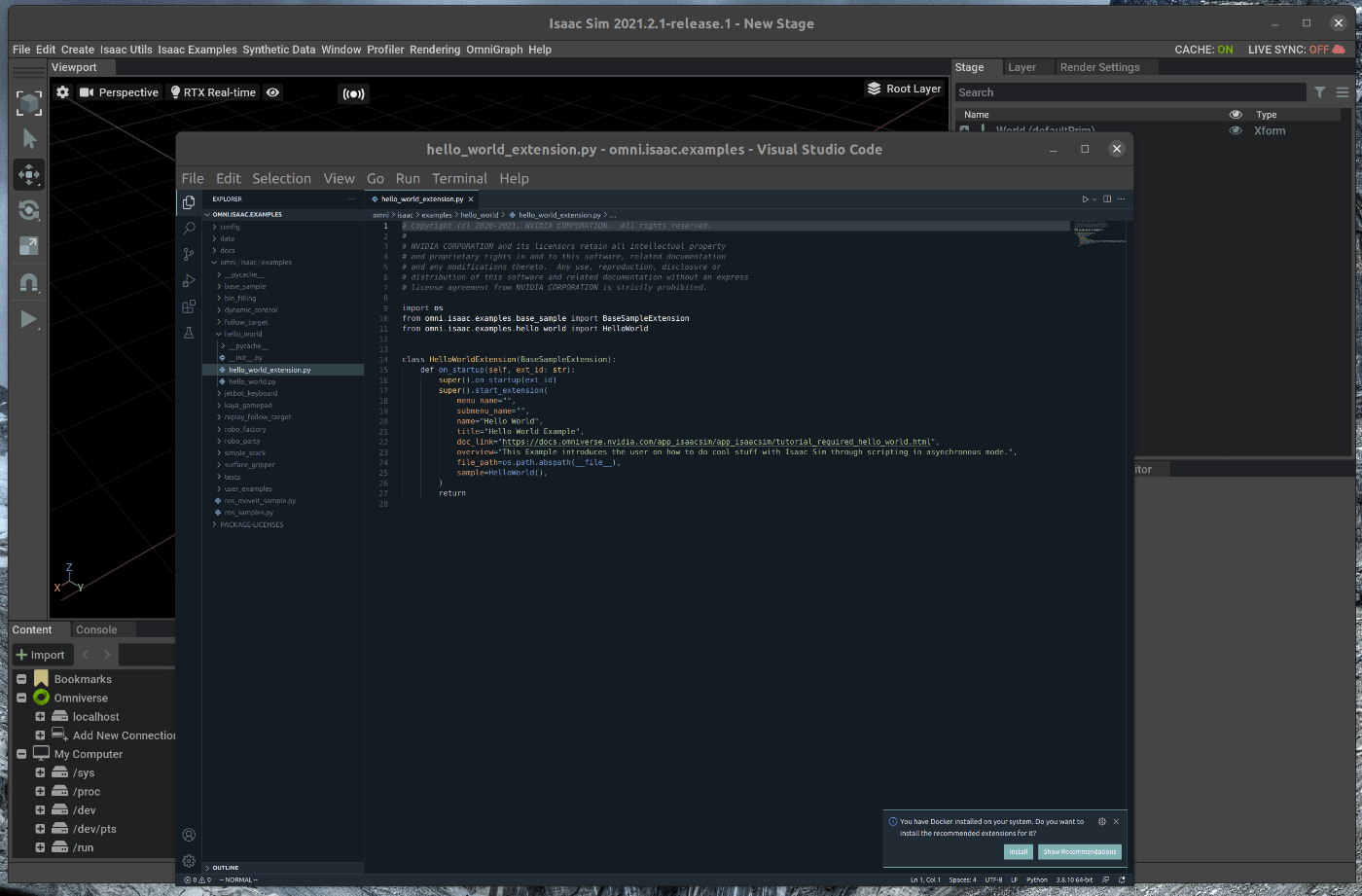

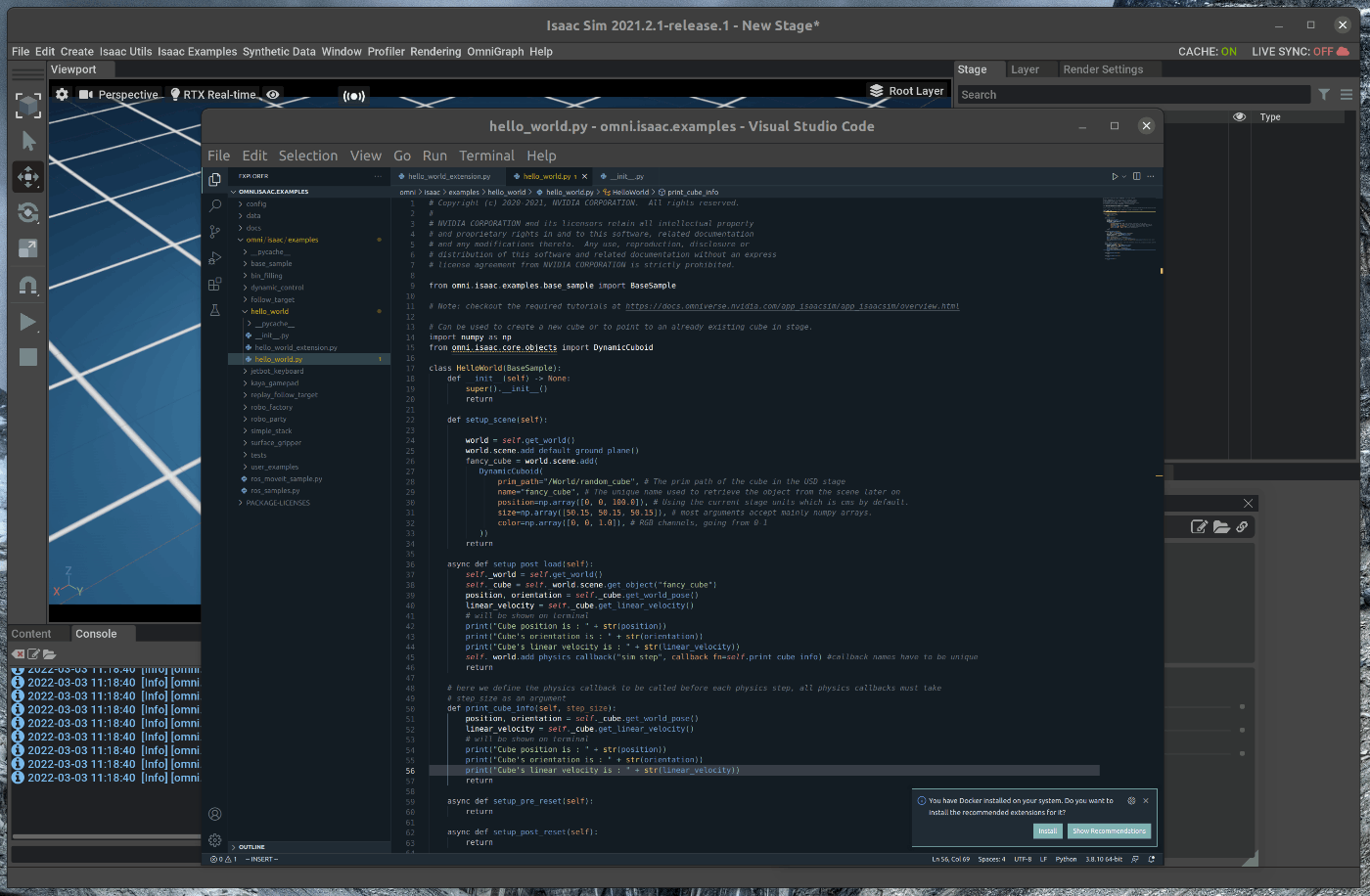

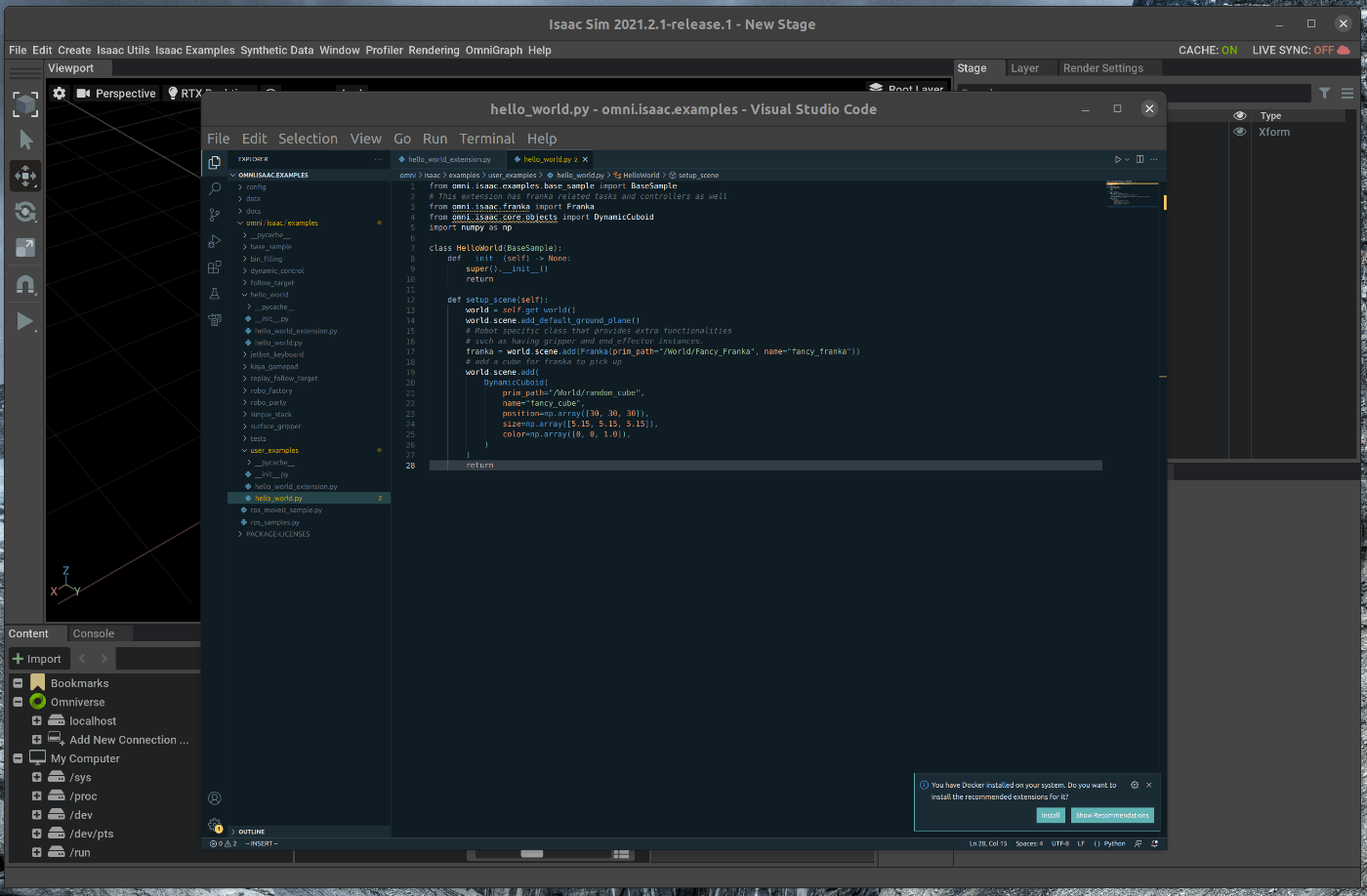

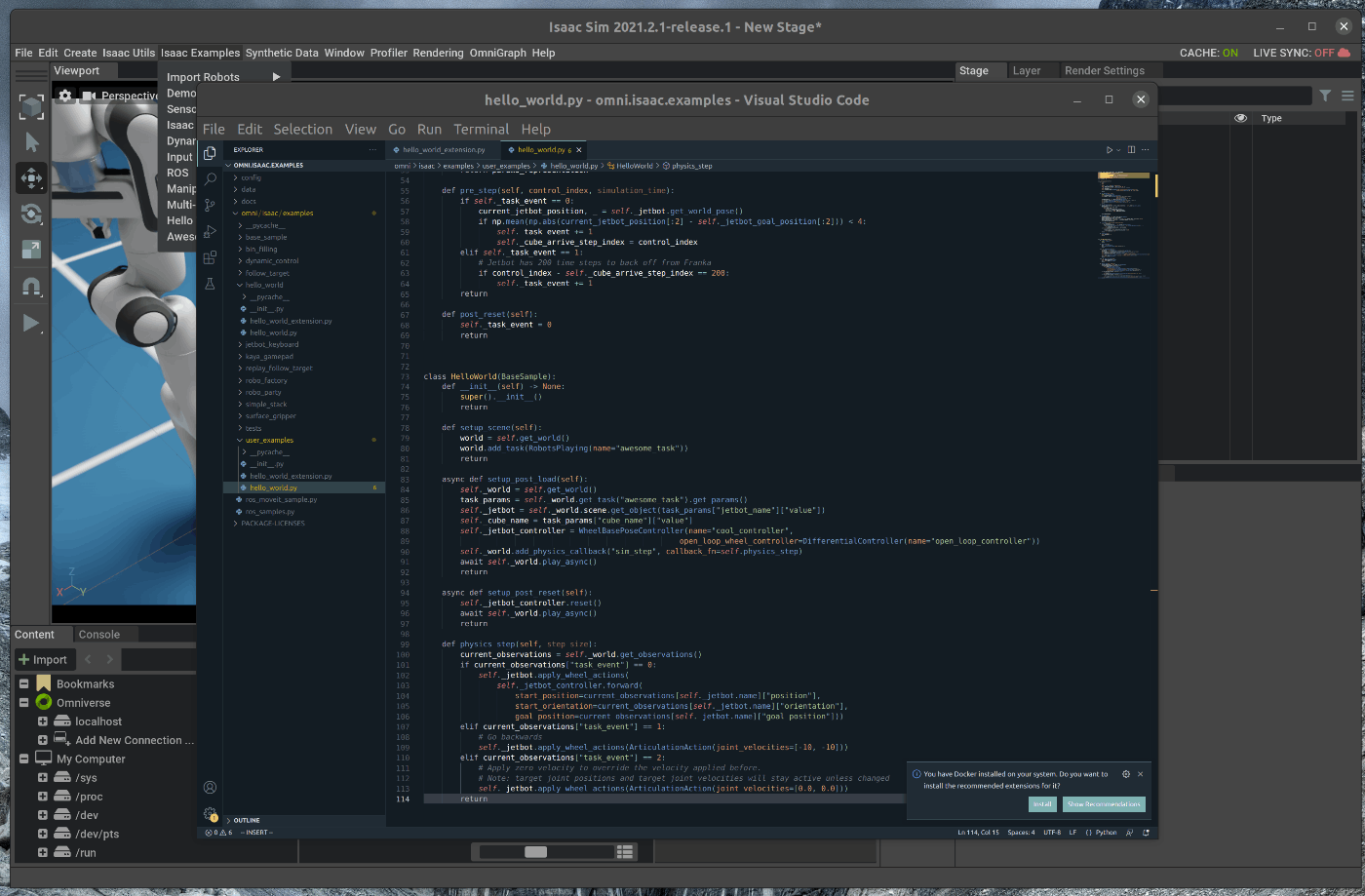

67 | このシーンのソースコードを変更する場合には、Hello Worldのウィンドウの右上にある3つのボタンの内、一番左側のボタンを選択します。

68 | 選択すると、VScodeが開き、Hello Worldのソースコードを編集することができます。

69 |

70 |

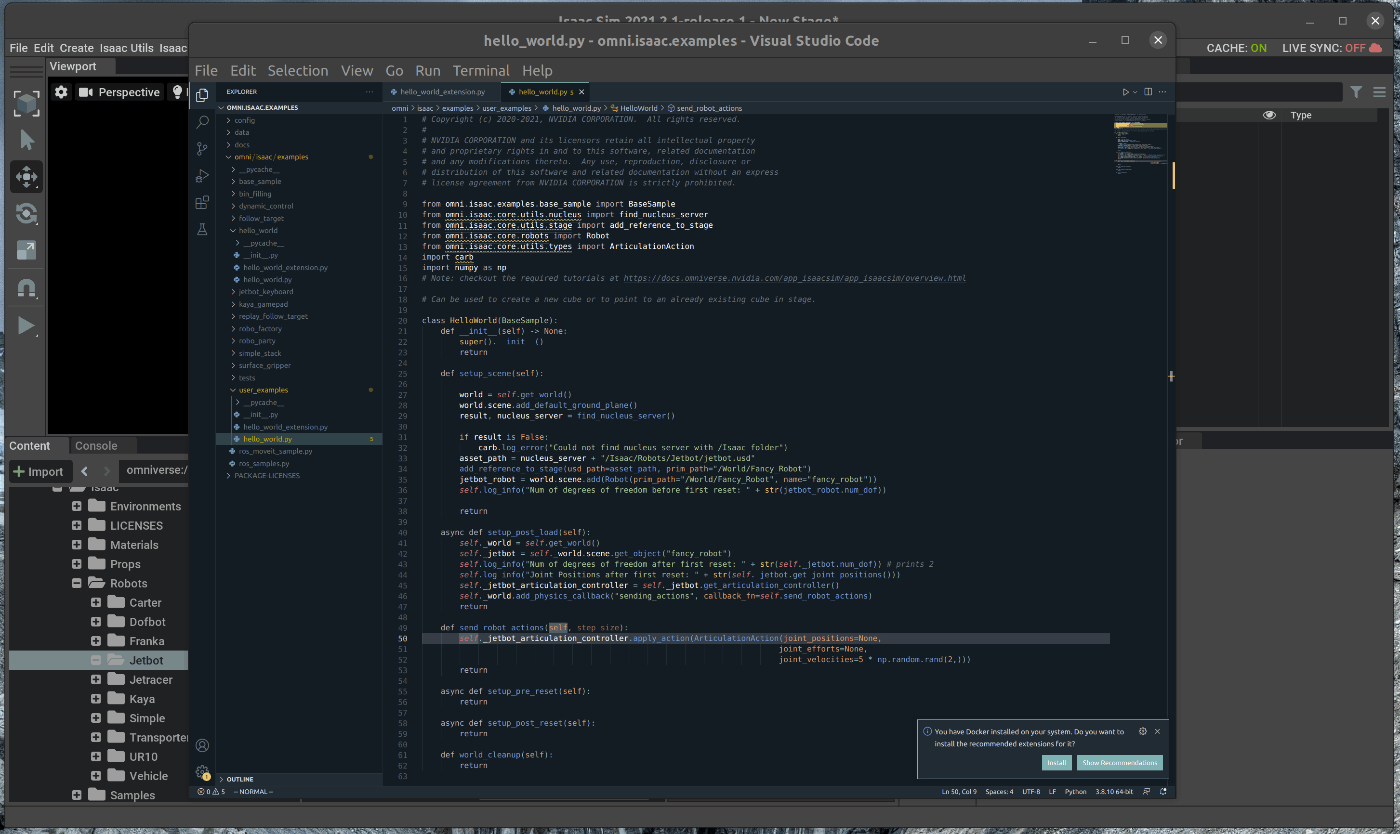

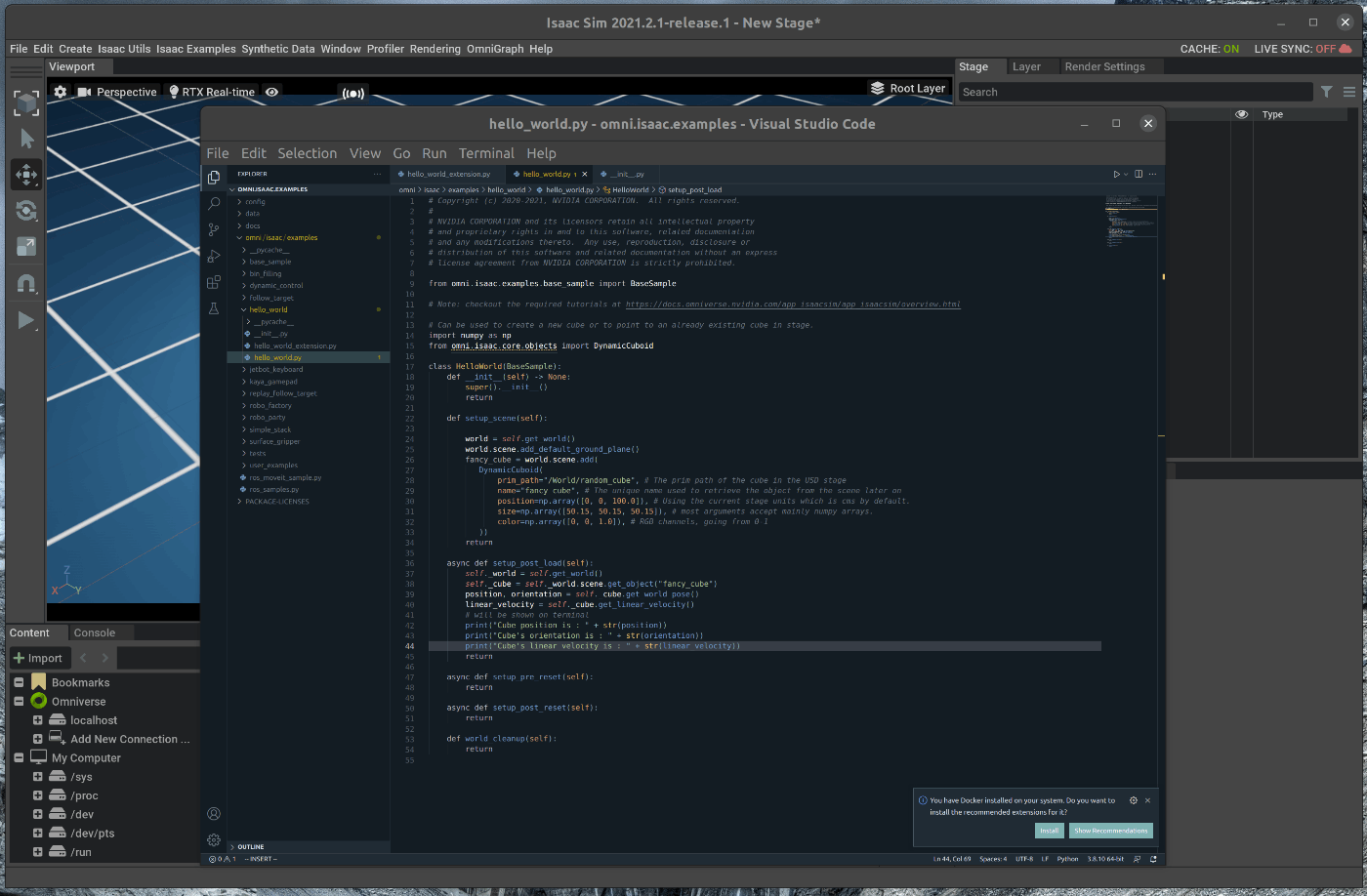

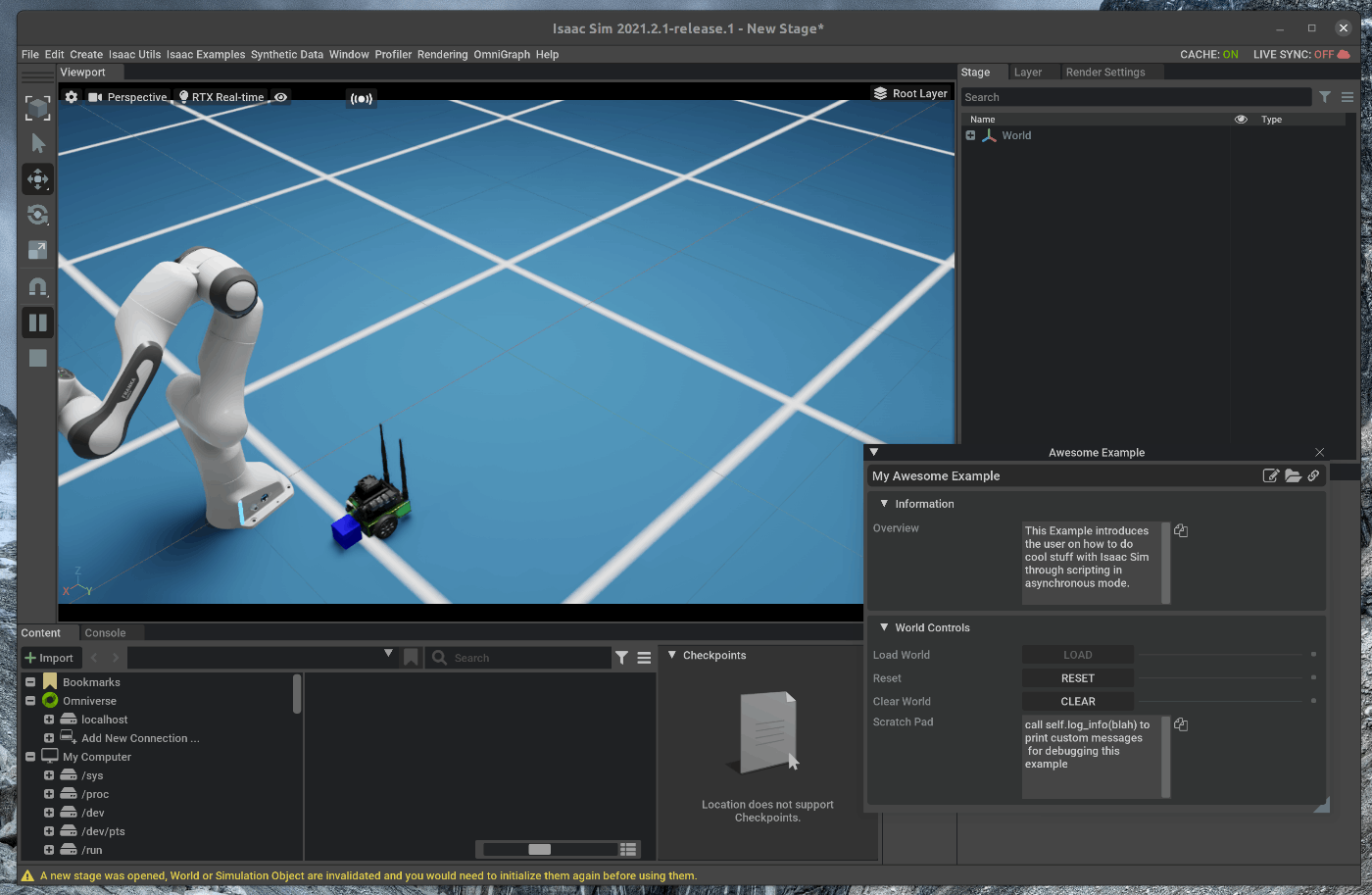

71 | ### 1.3 Script Editorからオブジェクトを追加

72 | ポップアップしたHello WorldのウィンドウはViewportの下にドラッグアンドドロップで移動させます。

73 |

74 |

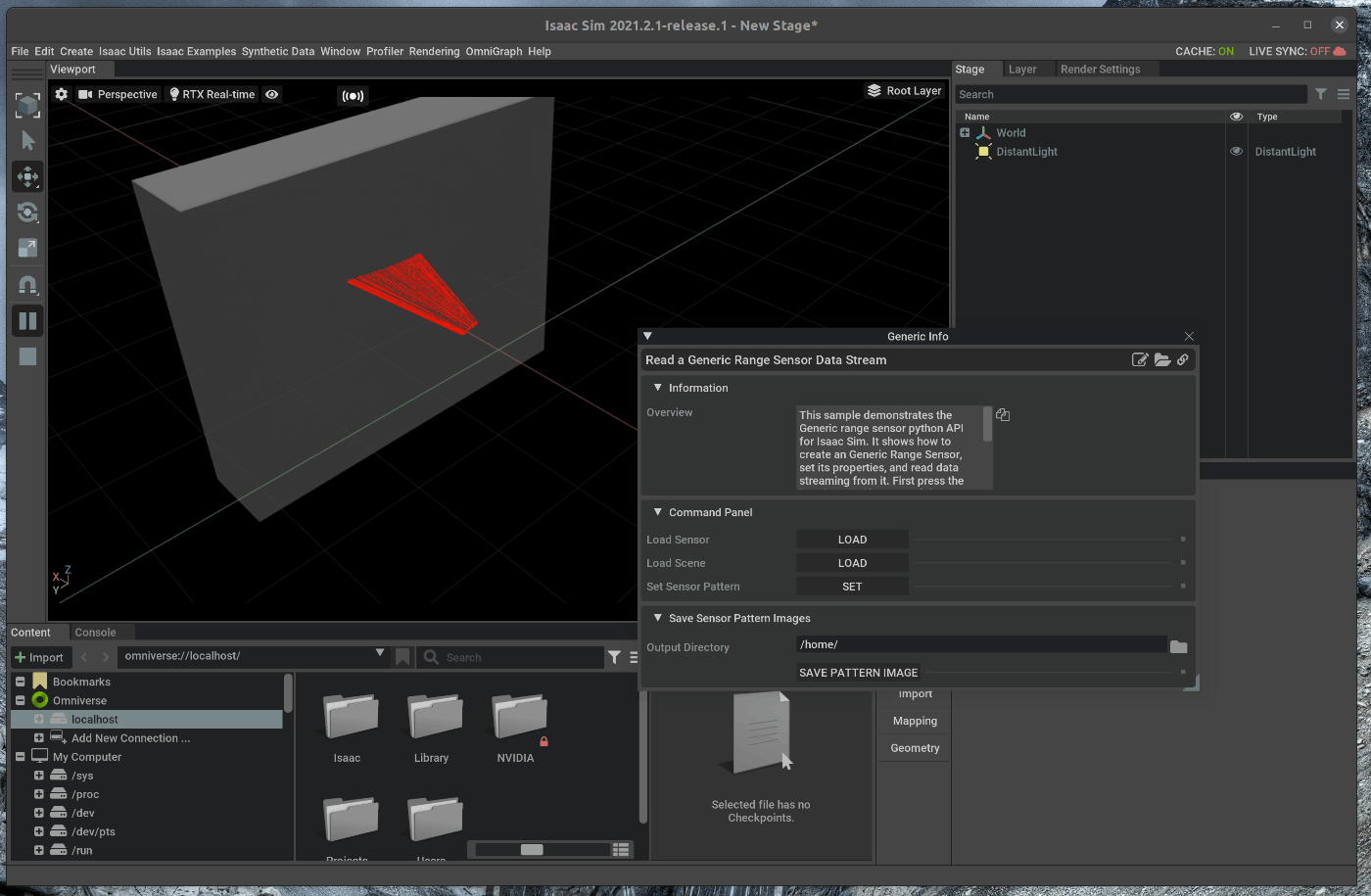

75 | メニューバーのWindow > Script Editorを選択します。

76 |

77 | ポップアップしたScript Editorのウィンドウを、Viewportの下にドラッグアンドドロップで移動させます。

78 |

79 |

80 | Script Editorに次のコードを記述します。

81 |

82 | ~~~ add_object:Python3

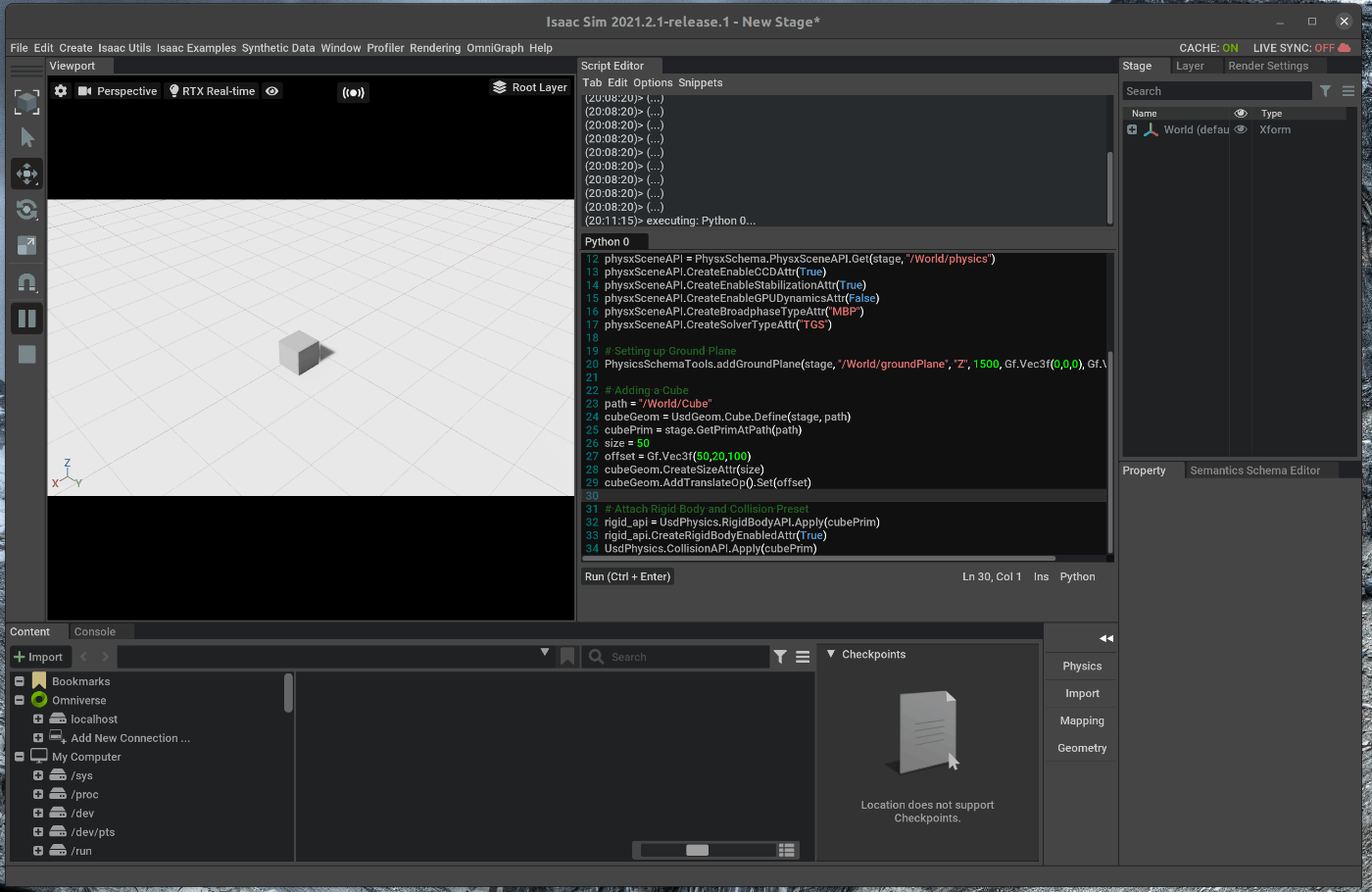

83 |

84 |

85 | ~~~

86 |

87 | 追加後、実行すると、シーン内にCubeが追加されます。

88 | また、Hello Worldのウィンドウにおいて、Resetを選択し、その後loadを選択すると、Cubeが追加されたシーンがロードされます。

89 |

90 |

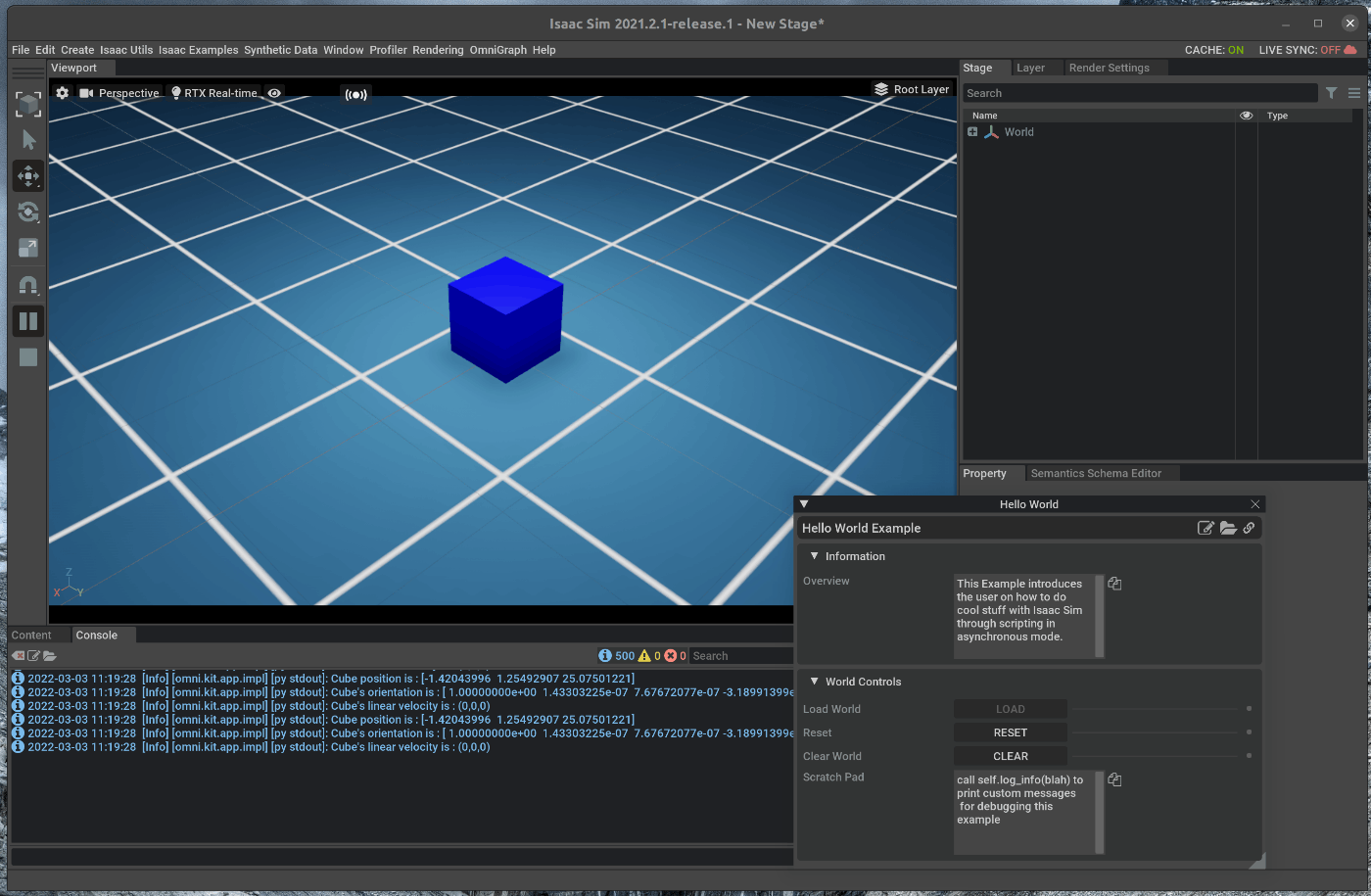

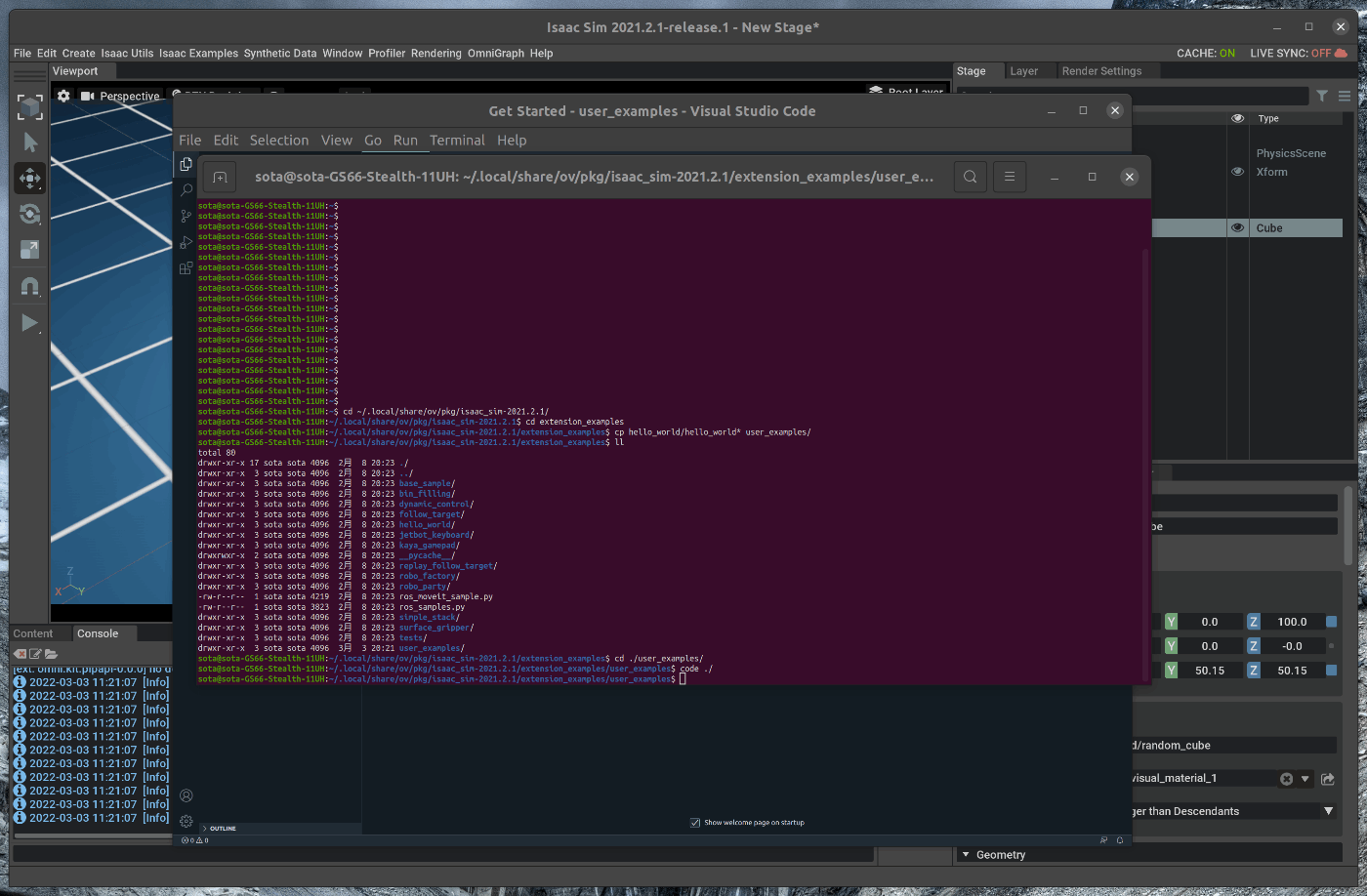

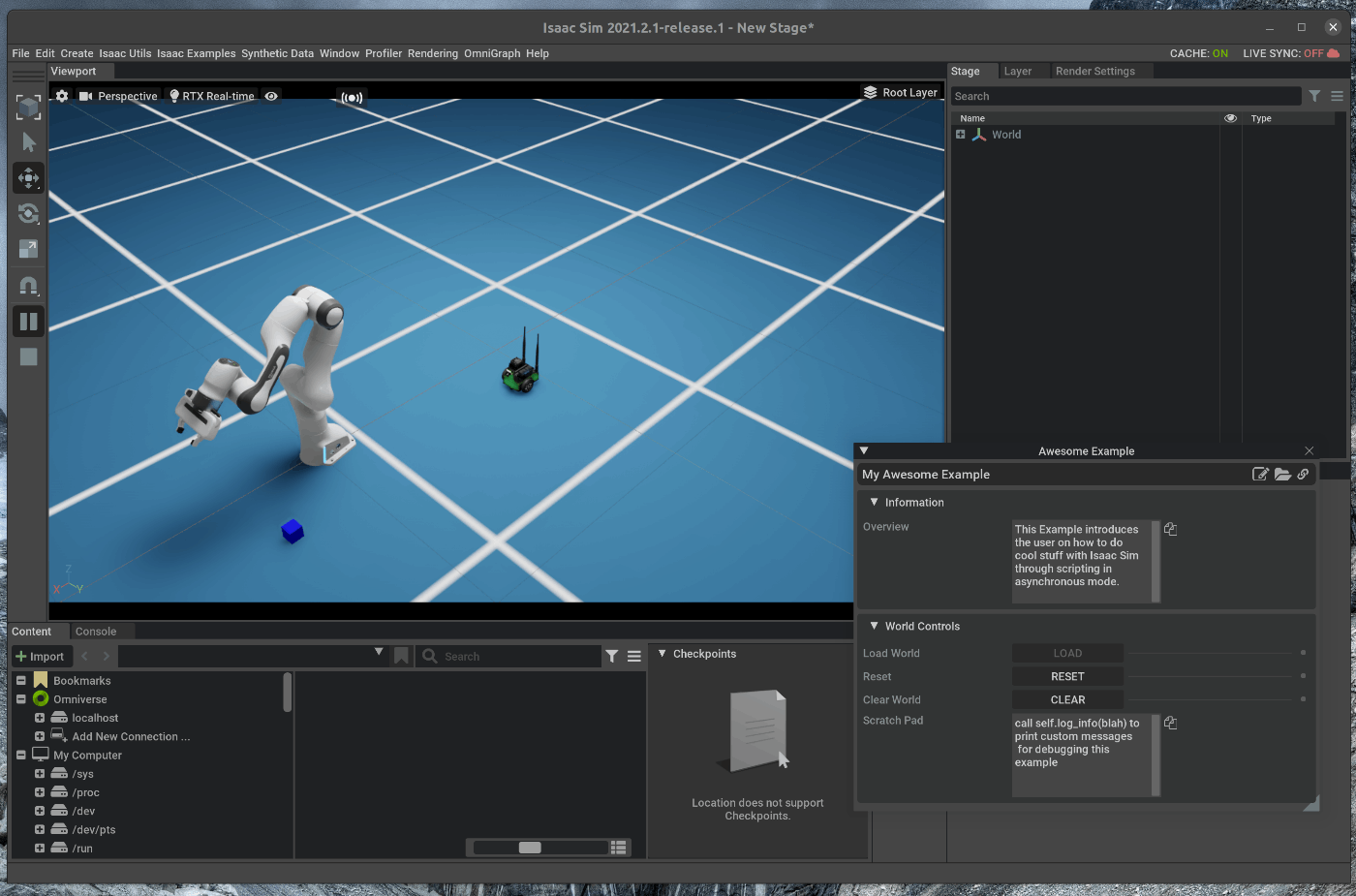

91 | ## 2. Standalone Applicationにおける操作

92 |

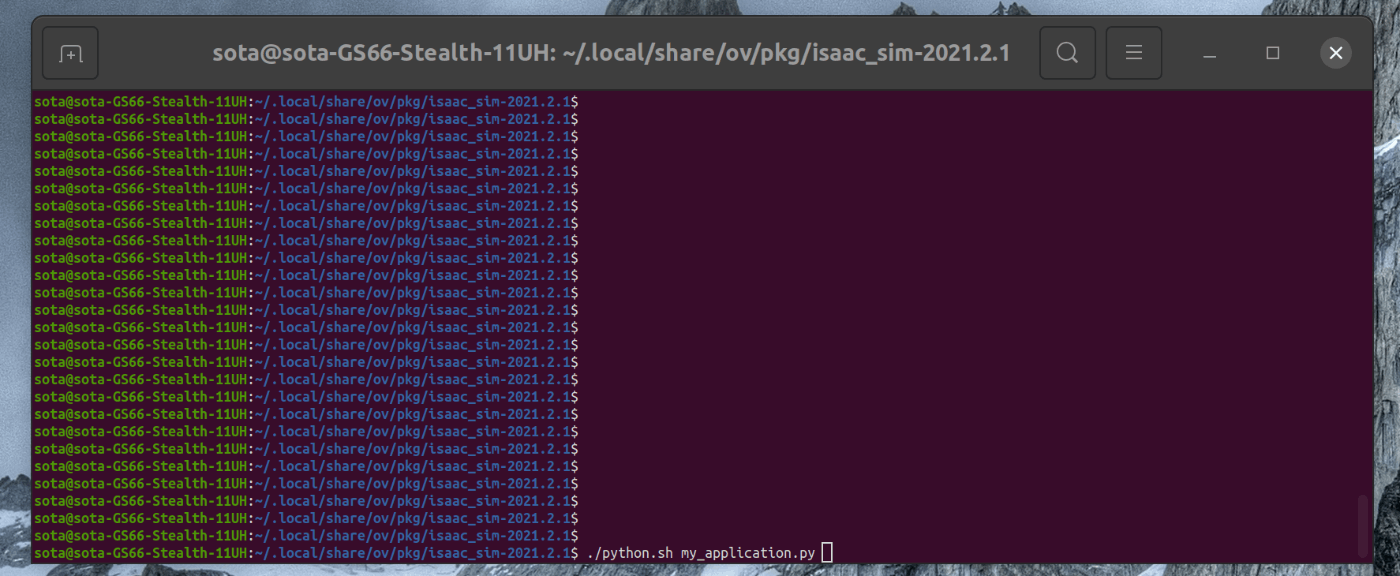

93 | Applicationは、PythonのScriptとしても実行することが可能です。

94 | Standalone Applicationでは、Applicationは同期して実行されます。

95 | Extensionsとは異なり、タイムステップの制御(例えば、phisics stepやrendering step)を行うということを意味してます。

96 |

97 | ターミナルで次のコマンドを実行します。

98 |

99 | ~~~ franka:bash

100 |

101 | cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1

102 | ./python.sh standalone_examples/api/omni.isaac.franka/follow_target.py

103 |

104 | ~~~

105 |

106 |

107 |

108 | 実行すると、Isaac simが立ち上がり、FrankaのExampleシーンがロードされます。

109 | Frankaのグリッパーの中心にあるTargetCubeを動かすと、Cubeの位置に合わせて、Frankaの手先が追従します。

110 |

111 |

112 |

--------------------------------------------------------------------------------

/tutorials/ros/moveit_motion_planning_framework/32_moveit_motion_planning_framework.md:

--------------------------------------------------------------------------------

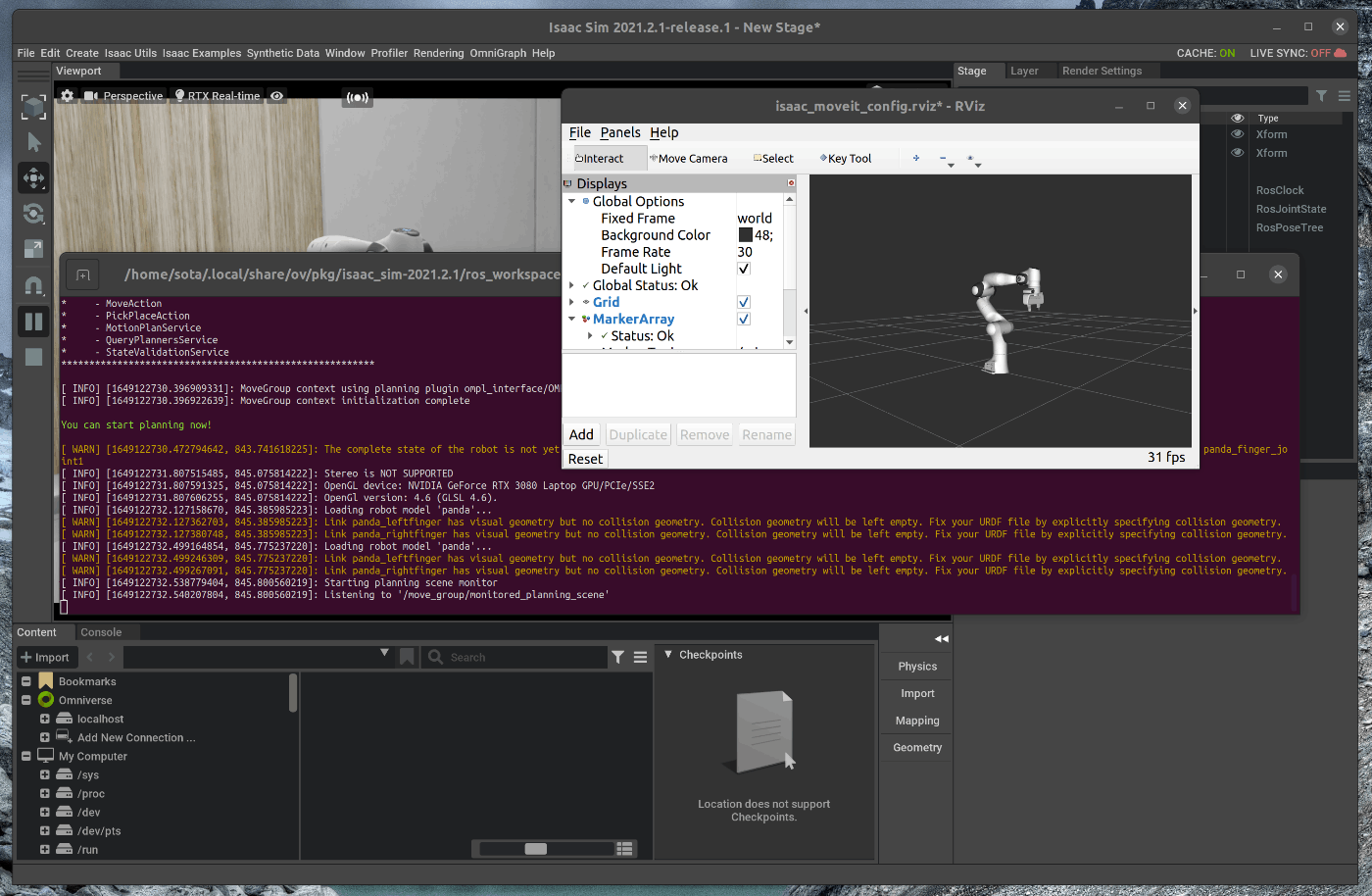

1 | # 概要

2 | Isaac Sim上でFrankaを配置し、Moveitを用いてRobotを動かします。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_moveit.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | Isaac Sim上でFrankaを配置し、Moveitを用いてRobotを動かします。

26 | moveitはros側から実行し、rviz上でmoveitを使用します。

27 |

28 | 1. moveitのインストール

29 | 2. シーンのロード

30 | 3. moveitの実行

31 | 4. トラブルシューティング

32 |

33 | ## 1. moveitのインストール

34 | ### 1.1 moveitをインストールする

35 | terminalで次のコマンドを実行します。

36 |

37 | ~~~ bash:shell

38 | $ sudo apt-get install -y ros-noetic-moveit

39 | ~~~

40 |

41 | ## 2. シーンのロード

42 | ### 2.1 OmniverseからIssac Simを起動する

43 |

44 |

45 | ### 2.2 シーンをロードする

46 | メニューバーのIsaac Examples > ROS > MoveItを選択します。

47 |

48 |

49 | この状態で、Viewportの左側のPLAYボタンを押します。

50 |

51 |

52 | ## 3. moveitの実行

53 |

54 | 新たにterminalを開き、次のコマンドを入力します

55 |

56 | ~~~ bash:shell

57 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/

58 | $ source devel/setup.bash

59 | $ roslaunch isaac_moveit franka_isaac_execution.launch

60 | ~~~

61 |

62 | 最後のコマンドを実行すると、rvizが立ち上がります。

63 |

64 |

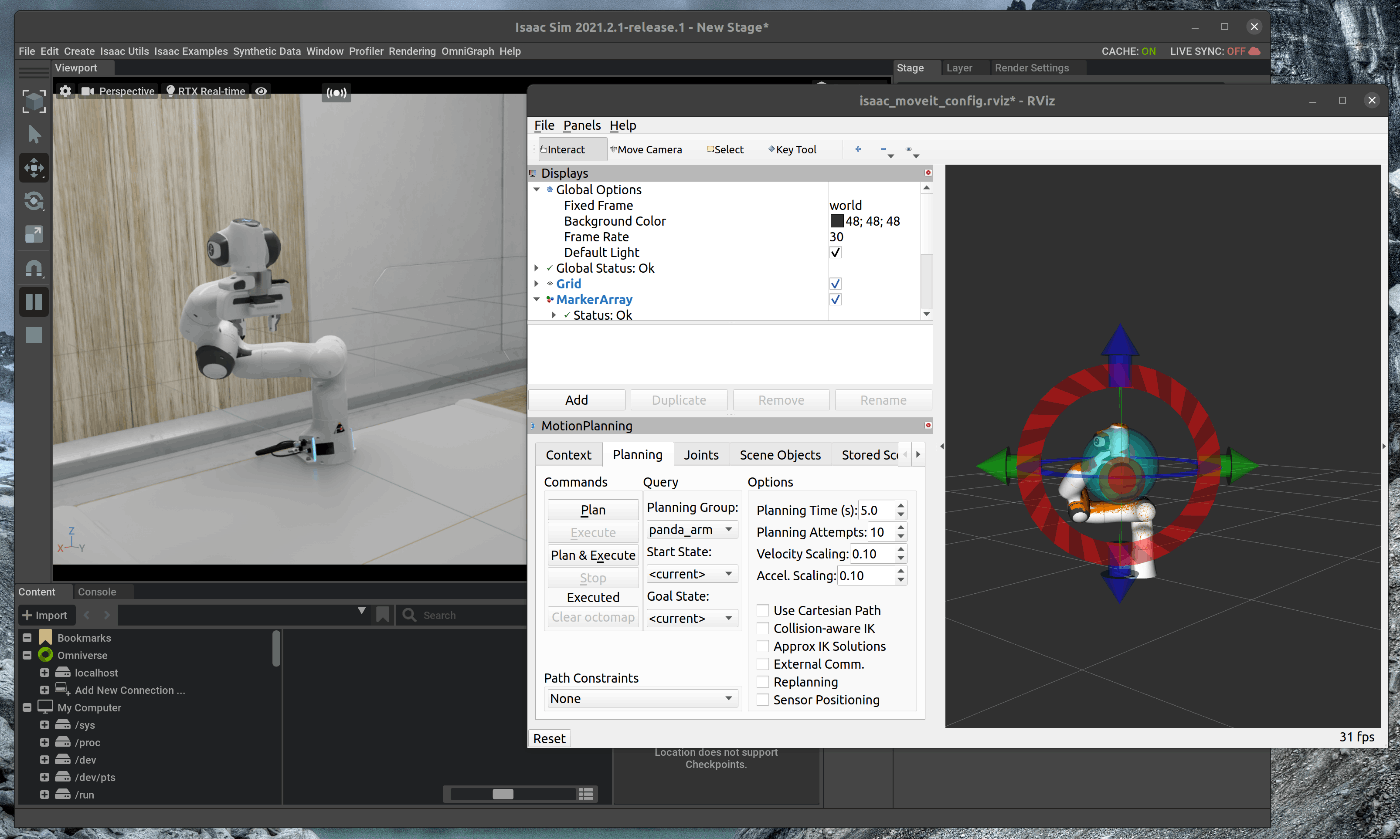

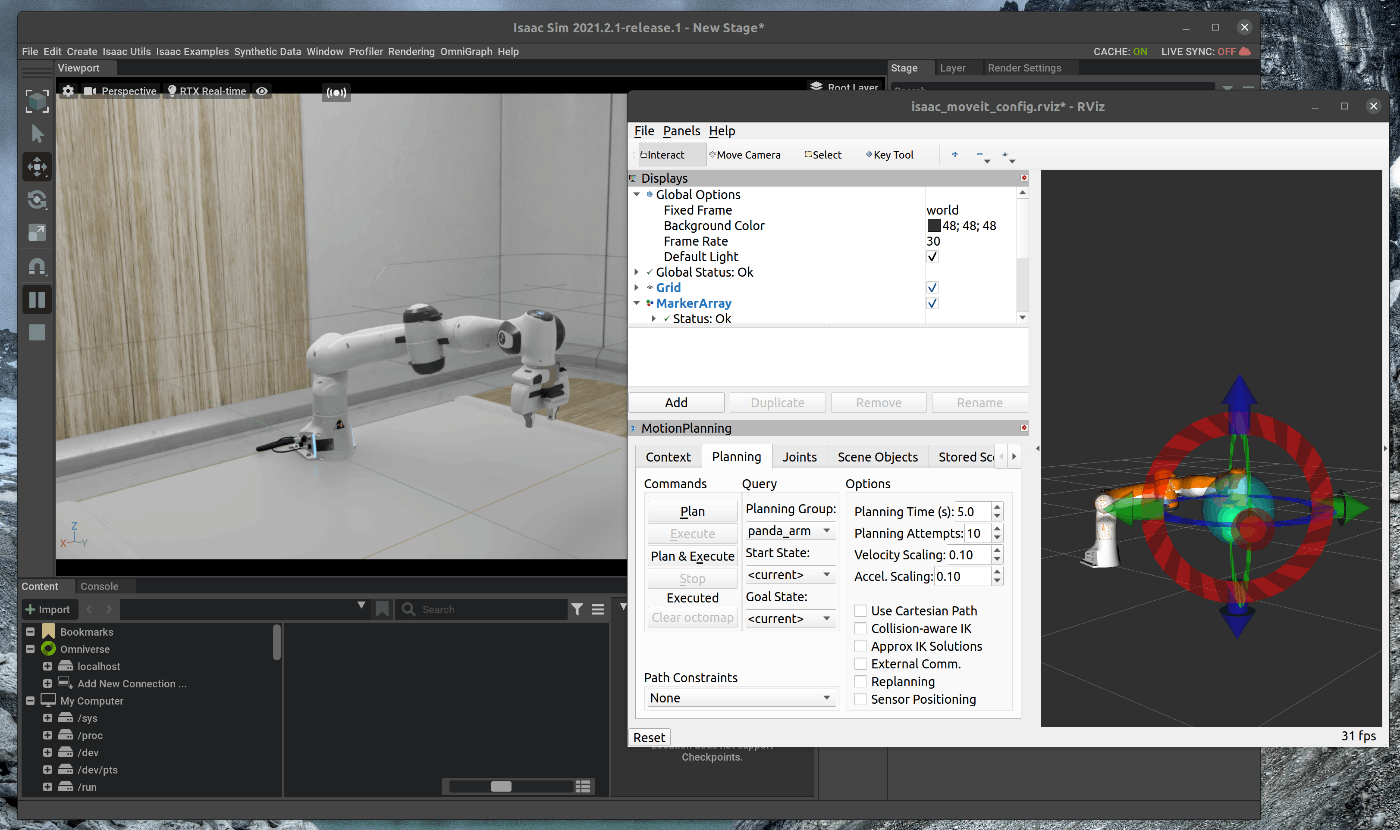

65 | rviz上で、左側にある”ADD”をクリックし、ポップアップしたWindowの中から”MotionPlaning”を選択します。

66 |

67 |

68 | rviz上で、左下にある”MotionPlanning”の”PlanningGroup”を”panda_arm”に変更します。

69 |

70 |

71 | rviz上でArmの姿勢を変更し、”MotionPlanning”のPlan > Executeを選択すると、Isaac Sim上で動作することを確認できます。

72 |

73 |

74 |

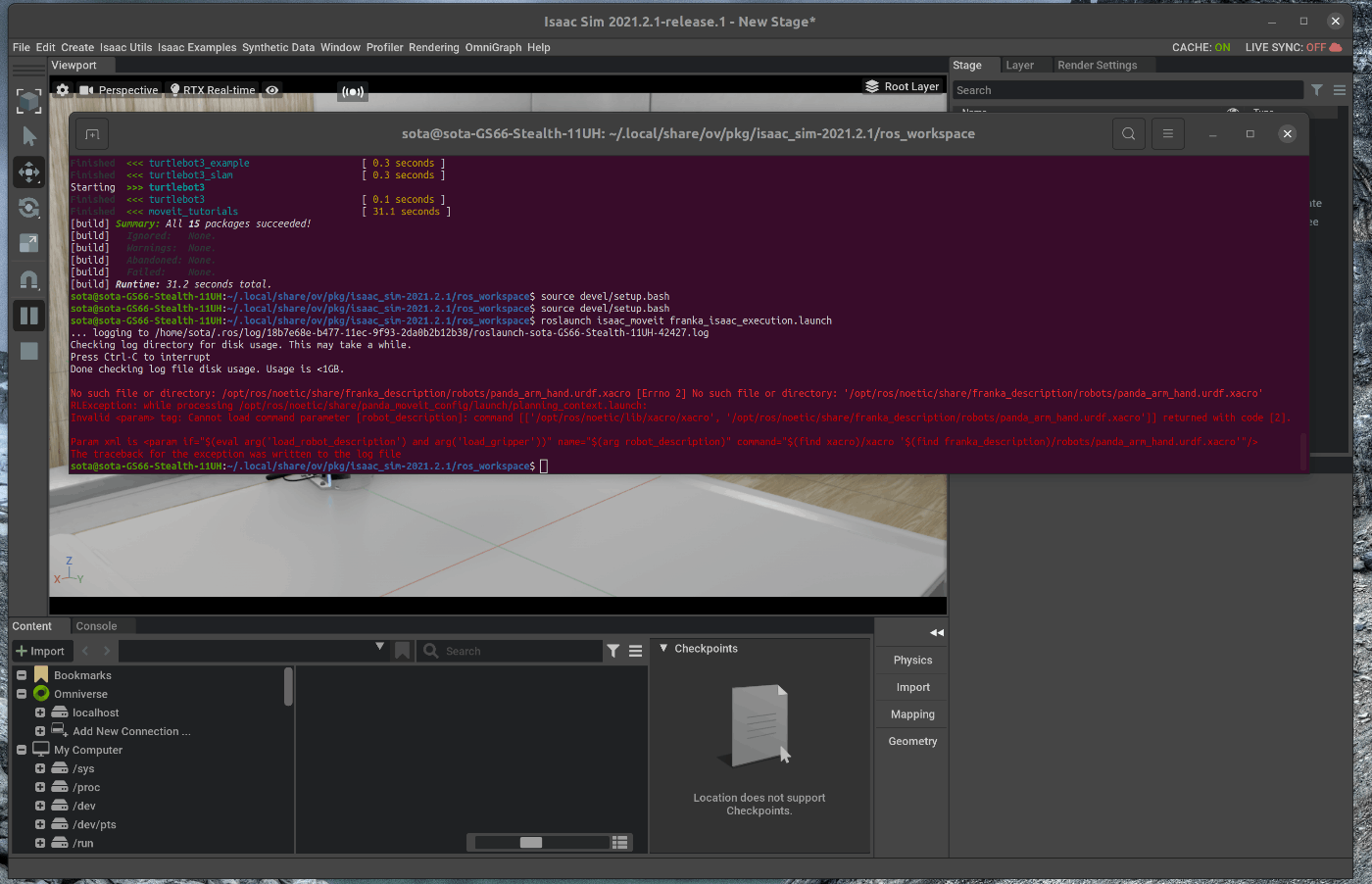

75 | ## トラブルシューティング

76 |

77 | 次のコマンドを実行する際にエラーが発生し、実行できないことがありました。

78 |

79 | ~~~ bash:shell

80 | $ roslaunch isaac_moveit franka_isaac_execution.launch

81 | ~~~

82 |

83 | エラー内容は次の通りです。

84 |

85 |

86 | このエラーはFrankaのPackageに含まれているlaunchのエラーであり、[該当launchファイル(https://answers.ros.org/question/384900/failed-to-lunch-this-command/

87 | https://github.com/ros-planning/panda_moveit_config/blob/noetic-devel/launch/planning_context.launch)のエラー箇所を修正することで解決できました。

88 |

89 | こちらを参考にしました。

90 | https://answers.ros.org/question/384900/failed-to-lunch-this-command/

91 |

92 |

93 | まず、frankaのpackageをクローンします。

94 |

95 | ~~~ bash:shell

96 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/src/

97 | $ git clone git@github.com:ros-planning/panda_moveit_config.git

98 | ~~~

99 |

100 | エディタで該当launchファイルを開き、コードを変更します。

101 | 変更部分は11行目です。元の部分を次の内容に置き換えます。

102 |

103 | ~~~ xml:xml

104 |

105 | ~~~

106 |

107 | buildすると、実行できるようになります。

108 |

109 | ~~~ bash:shell

110 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/

111 | $ catkin b

112 | $ source devel/setup.bash

113 | $ roslaunch isaac_moveit franka_isaac_execution.launch

114 | ~~~

--------------------------------------------------------------------------------

/tutorials/ros/ros_navigation/30_ros_navigation.md:

--------------------------------------------------------------------------------

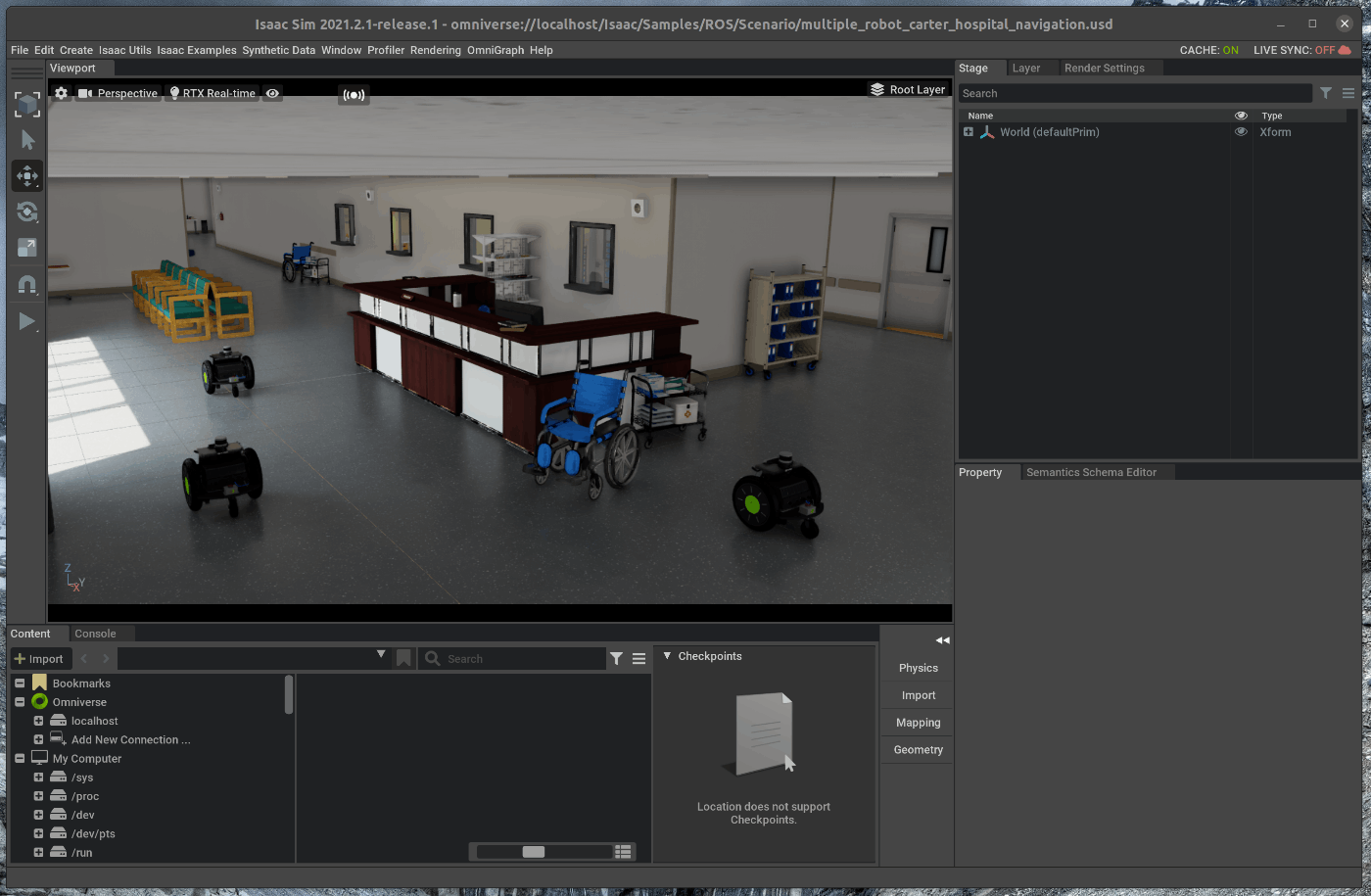

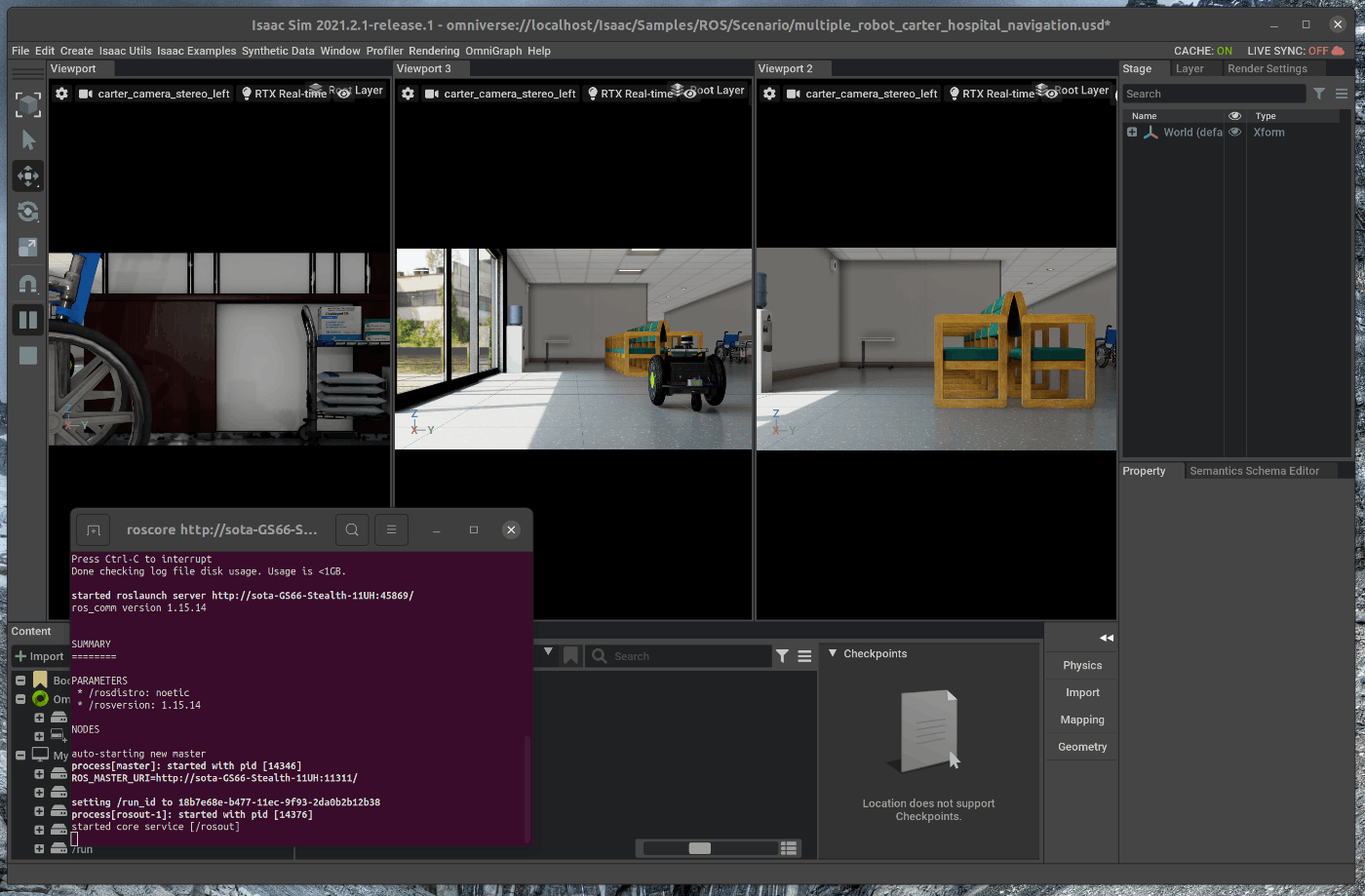

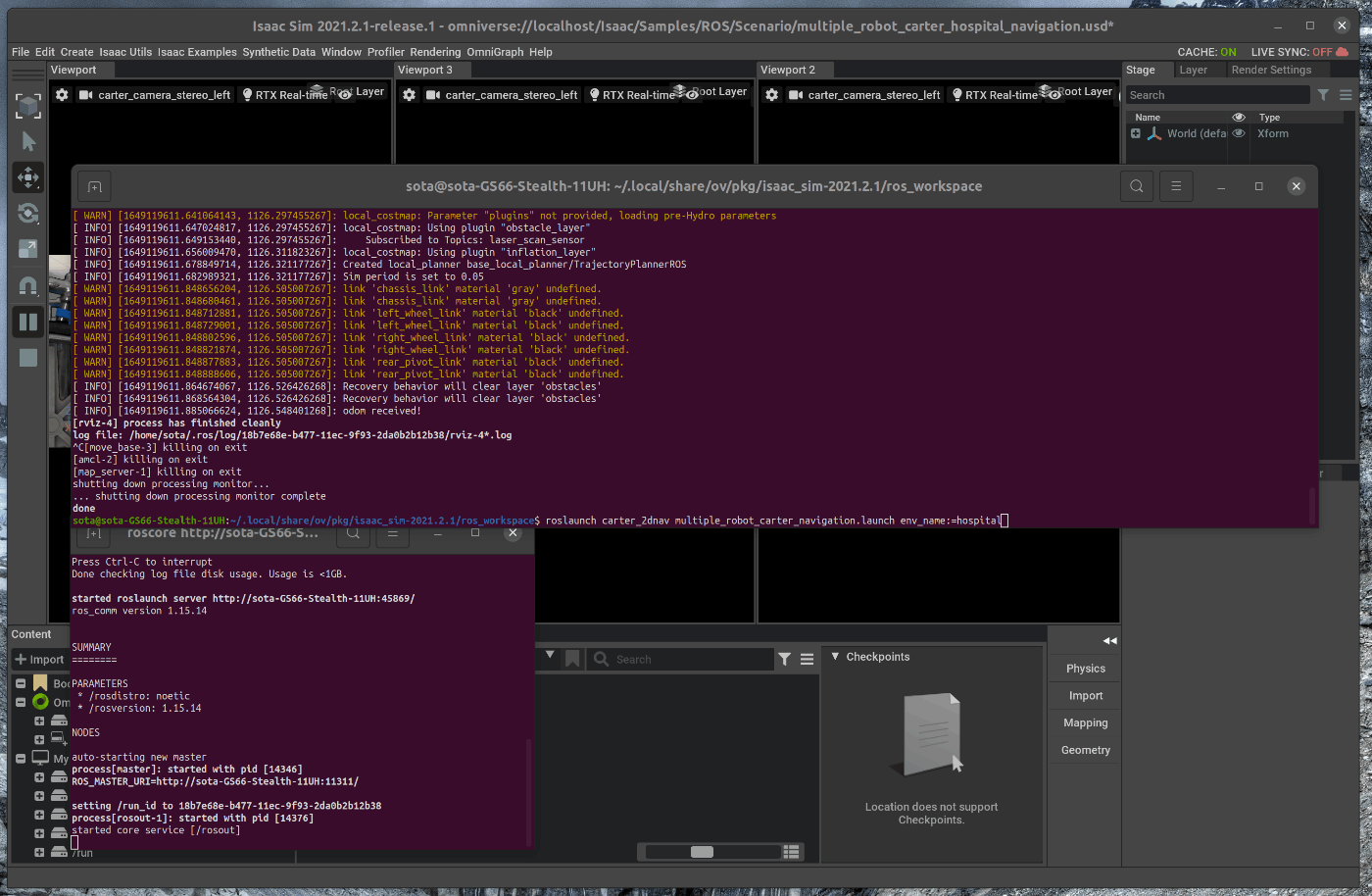

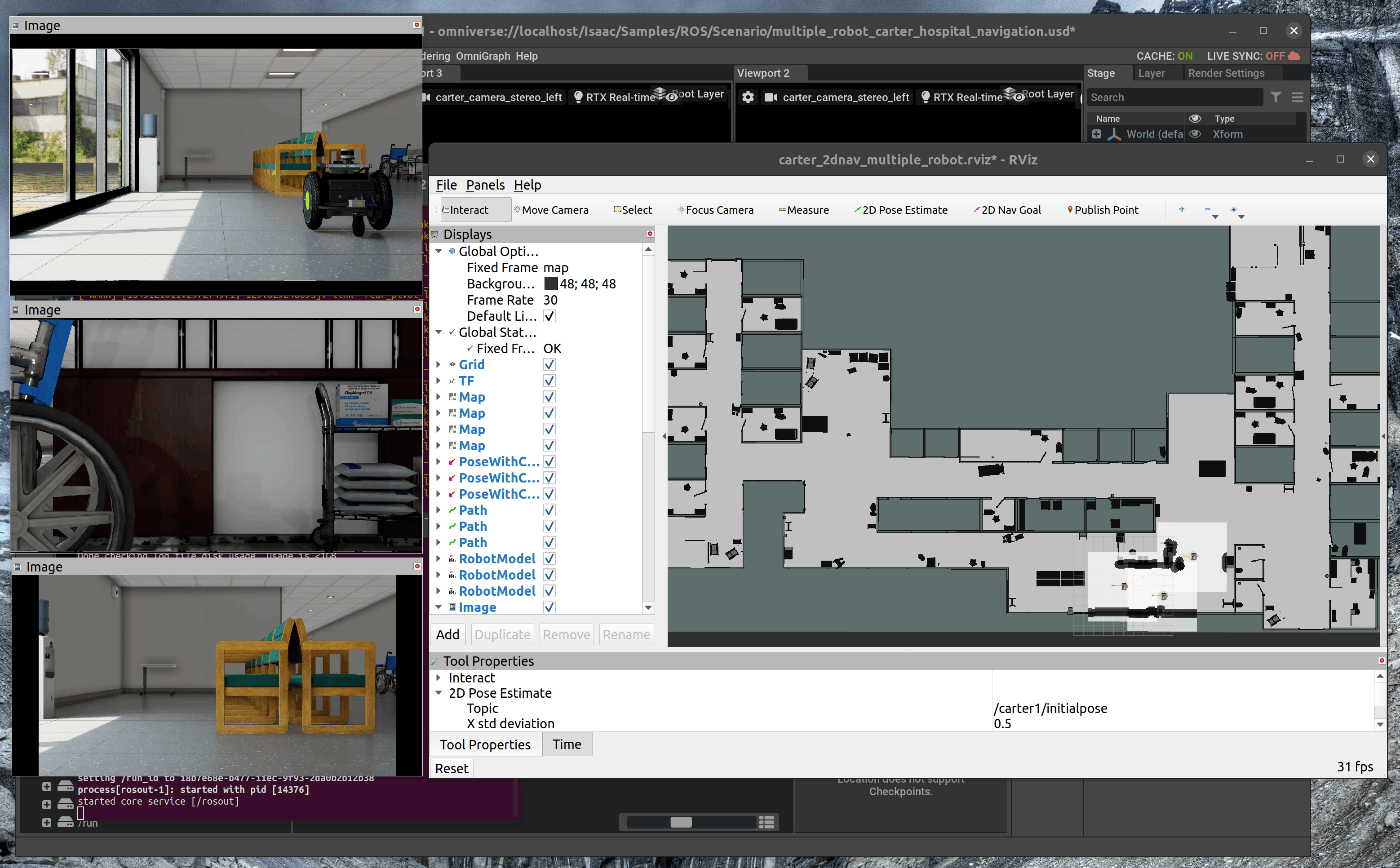

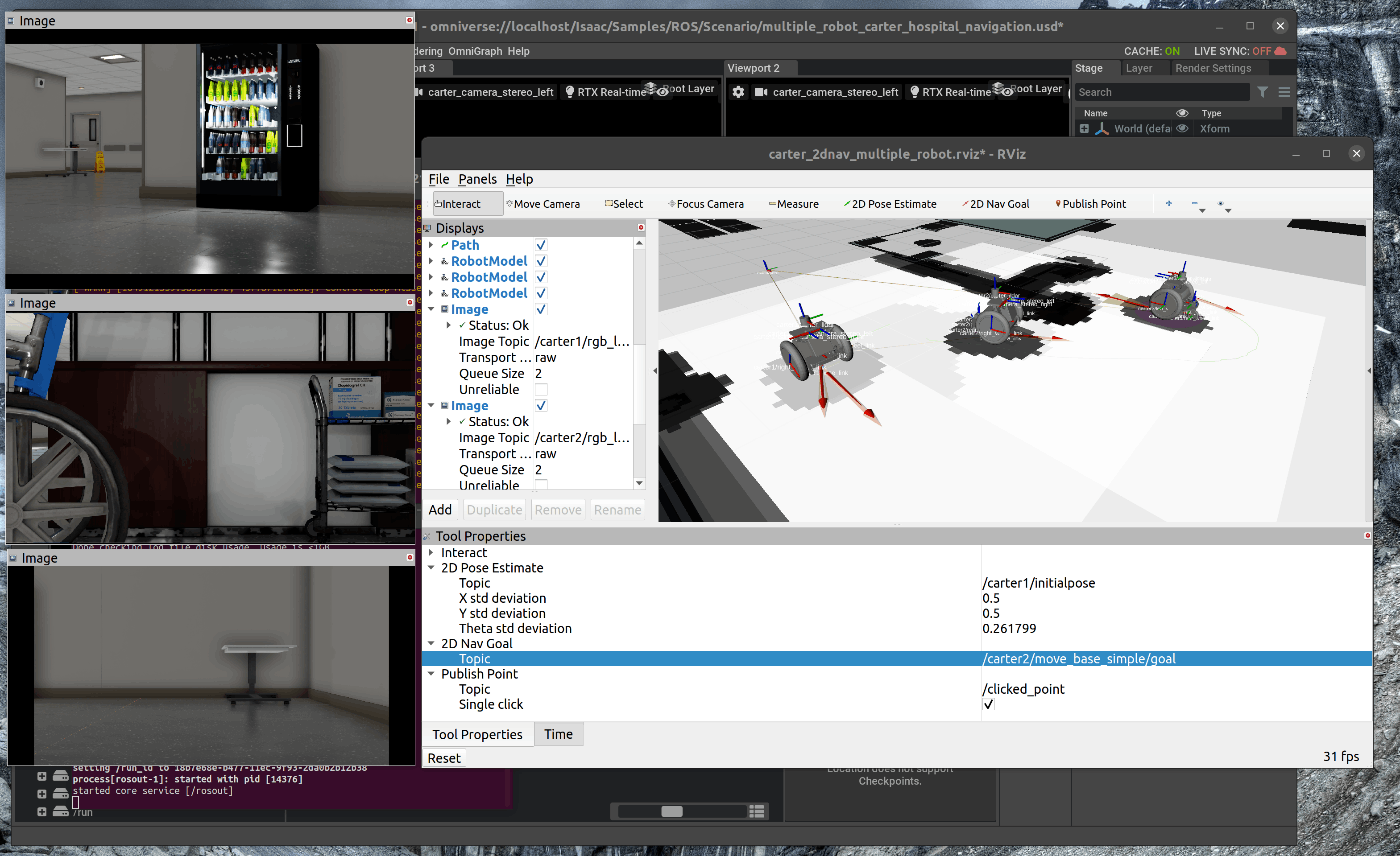

1 | # 概要

2 | Isaac Sim上でSceneとRobotを配置し、ROS Nvigation Stackを用いてRobotを動かします。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_navigation.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

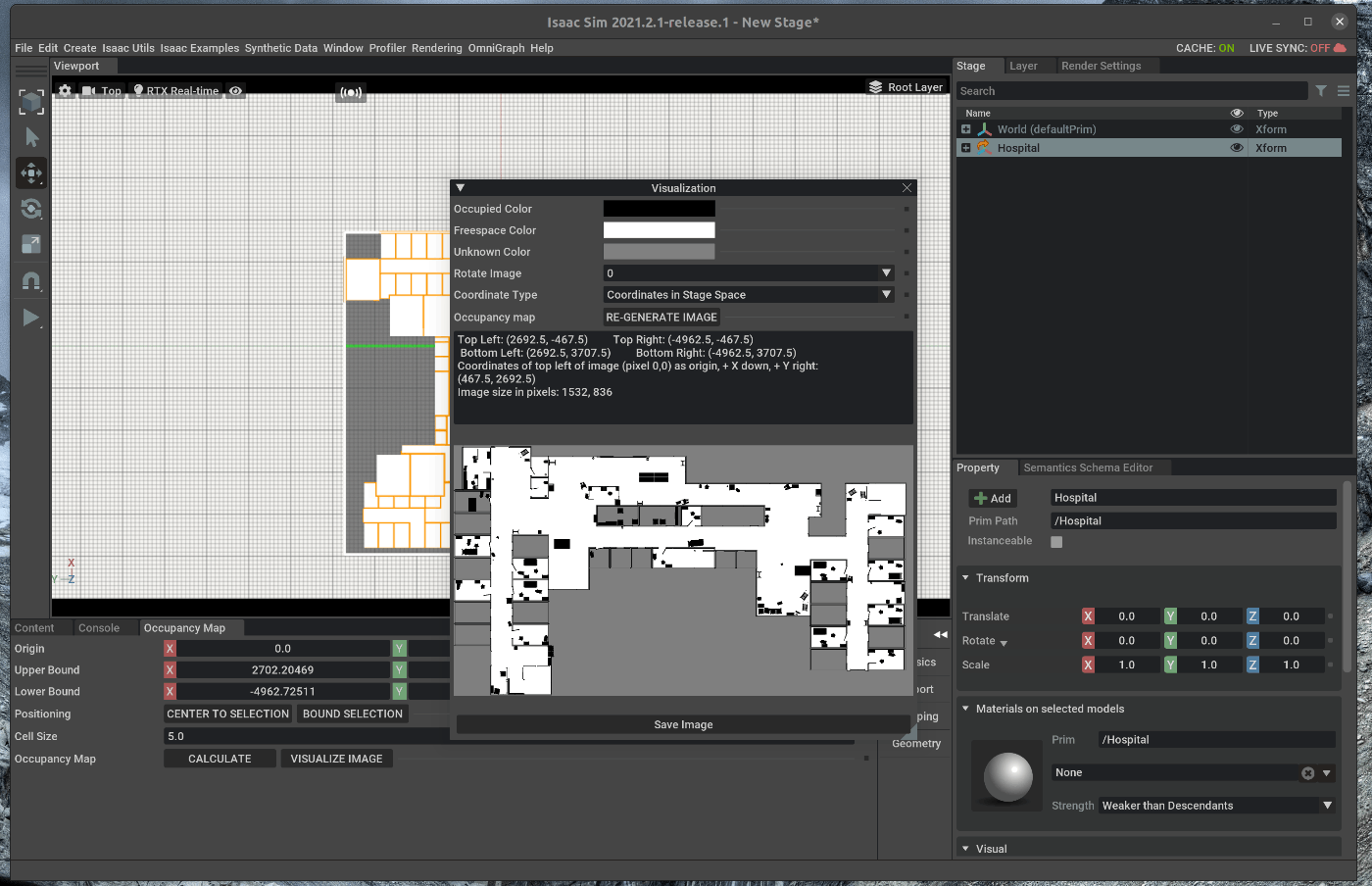

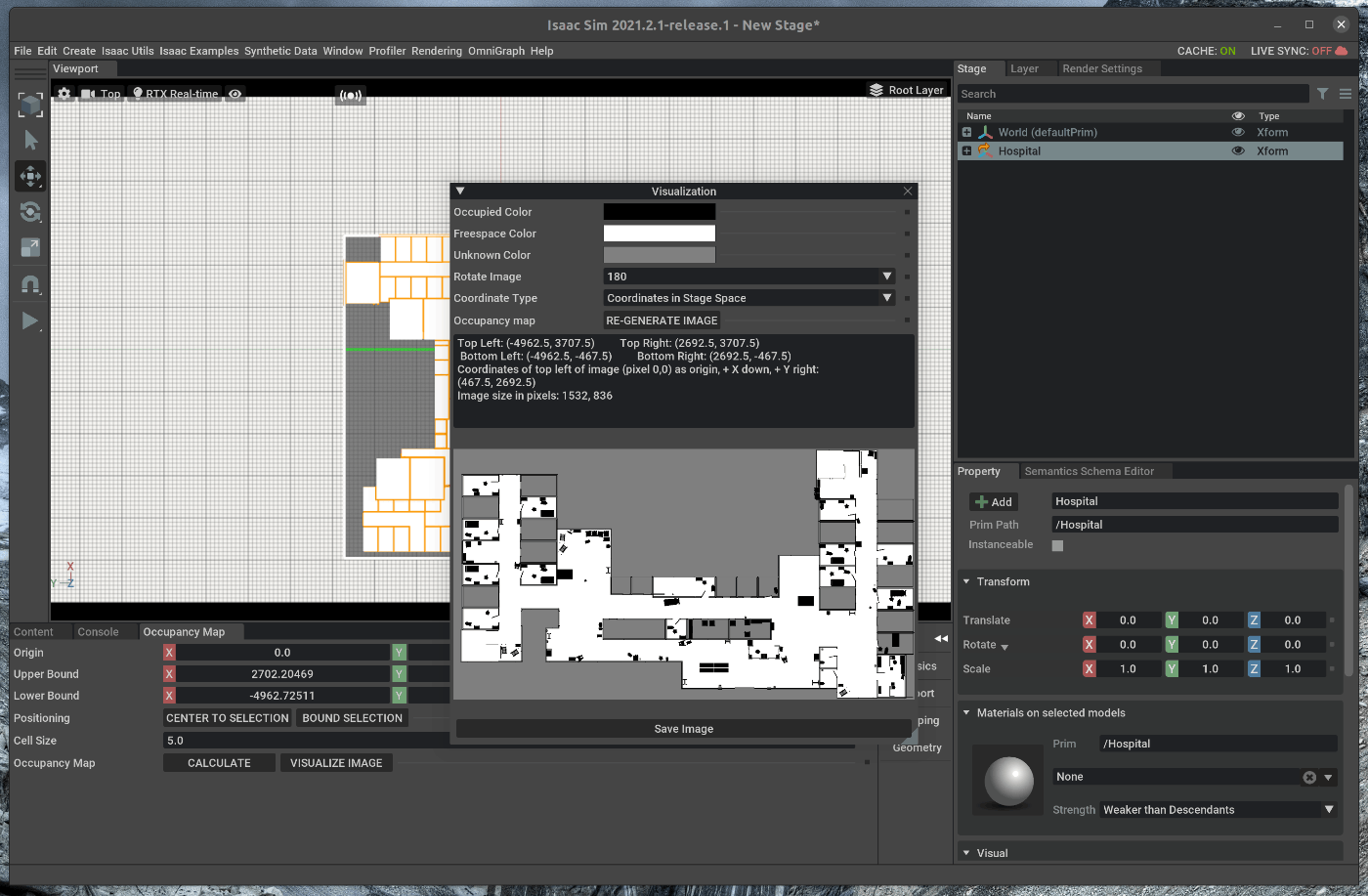

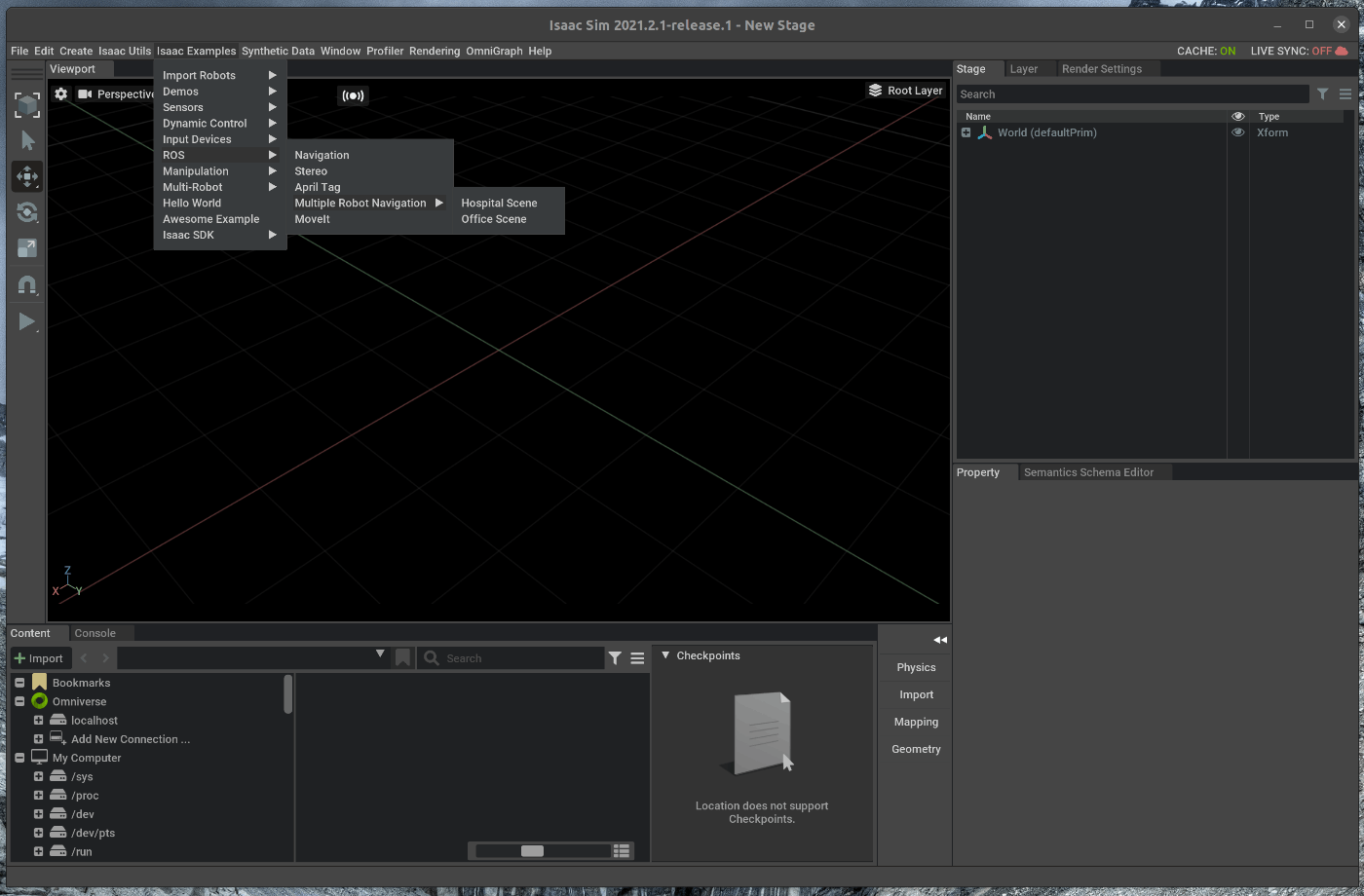

24 | # 手順

25 | Isaac Sim上でSceneとRobotを配置し、ROS Nvigation Stackを用いてRobotを動かします。

26 | まず、ROS Nvigation Stack上で使用するOccupacy MapをIssac Sim上で作成します。

27 | 作成したOccupacy Mapを用いて、Navigationを実行します。

28 |

29 | 1. ROS Navigationのインストール

30 | 2. Occupacy Mapの生成

31 | 3. Navigationの実行

32 |

33 | ## 1. ROS Navigationのインストール

34 | ### 1.1 ROS Navigationをインストールする

35 | terminalで次のコマンドを実行します。

36 |

37 | ~~~ bash:shell

38 | $ sudo apt-get install -y ros-noetic-navigation

39 | ~~~

40 |

41 | ## 2. Occupacy Mapの生成

42 | ### 2.1 OmniverseからIssac Simを起動する

43 |

44 |

45 | ### 2.2 シーンをロードする

46 | メニューバーのIsaac Examples > ROS > Navigation > warehouseを選択します。

47 |

48 |

49 |

50 | この状態で、Viewportの左側のPLAYボタンを押します。

51 |

52 |

53 | viewportのカメラアイコンをクリックし、carter_camera_stereo_leftを選択します。

54 | また、ドロップダウンしたメニューの中から”Top”を選択します。

55 |

56 |

57 | ### 2.3 Occupacy Mapを生成する

58 | メニューバーのIsaac Utils > Occupancy Mapを選択します。

59 | ポップアップしたWindowをViwport下部にあるConsoleの右隣にドラッグし、追加します。

60 |

61 |

62 | Occupacy Mapの設定を次の通りに変更します。

63 |

64 | - originのXを0.0にする

65 | - originのYを0.0にする

66 | - originのZを0.0にする

67 | - Lower BpundのZを10.0にする

68 | - Upprer BoundのZを62.0にする

69 |

70 |

71 |

72 | 右側のStage上で、warehouse_with_forkliftsを選択します。

73 |

74 |

75 | この状態で、Occupacy Mapの”BOUND SELECTION”をクリックします。

76 | クリックすると、map parametersがwarehouse_with_forkliftsに合うようにアップデートされます。

77 |

78 |

79 | 次に、Occupacy Mapの”CALCULATE” > "VISUALIZE IMAG"をクリックします。

80 |

81 |

82 | 表示されたOccupacy MapのWindowの中で次の設定を変更します。

83 |

84 | - rotationを180にする

85 | - Coordinate Typeを”ROS Occupancy Map Parameters File (YAML)”にする

86 |

87 | 設定後、Occupacy Mapの”RE-GENERATE IMAGE”を選択します。

88 |

89 |

90 | 生成したImage(Occupacy Map)を保存します。

91 | Imageの保存名は”carter_warehouse_navigation.png”に設定します。

92 |

93 | この状態で、Viewportの左側のSTOPボタンを押します。

94 |

95 | ## 3. Navigationの実行

96 | ### 3.1 NavigationのLaunchを実行する

97 |

98 | 新たにterminalを開き、次のコマンドを入力します

99 |

100 | ~~~ bash:shell

101 | $ cd ~/.local/share/ov/pkg/isaac_sim-2021.2.1/ros_workspace/

102 | $ source devel/setup.bash

103 | $ roslaunch carter_2dnav carter_navigation.launch

104 | ~~~

105 |

106 |

107 | rviz上で、2D Nav Goalを使用すると、ロボットが動くことが確認できます。

108 |

109 |

110 |

--------------------------------------------------------------------------------

/tutorials/ros/cameras/26_cameras.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Isaac Sim上に配置したカメラにおける画像をros topicとして発行します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_ros_camera.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | Isaac Sim上でTurtlebot3のURDFをロードし、ROSのTopicから車輪の速度指令値を発行し、TurtleBot3を動かします。

26 |

27 | 1. シーンのロード

28 | 2. ROS Cameraの追加

29 | 3. Topicの確認

30 |

31 | ## 1. シーンのロード

32 | ### 1.1 OmniverseからIssac Simを起動する

33 |

34 |

35 | ### 1.2 シーンをロードする

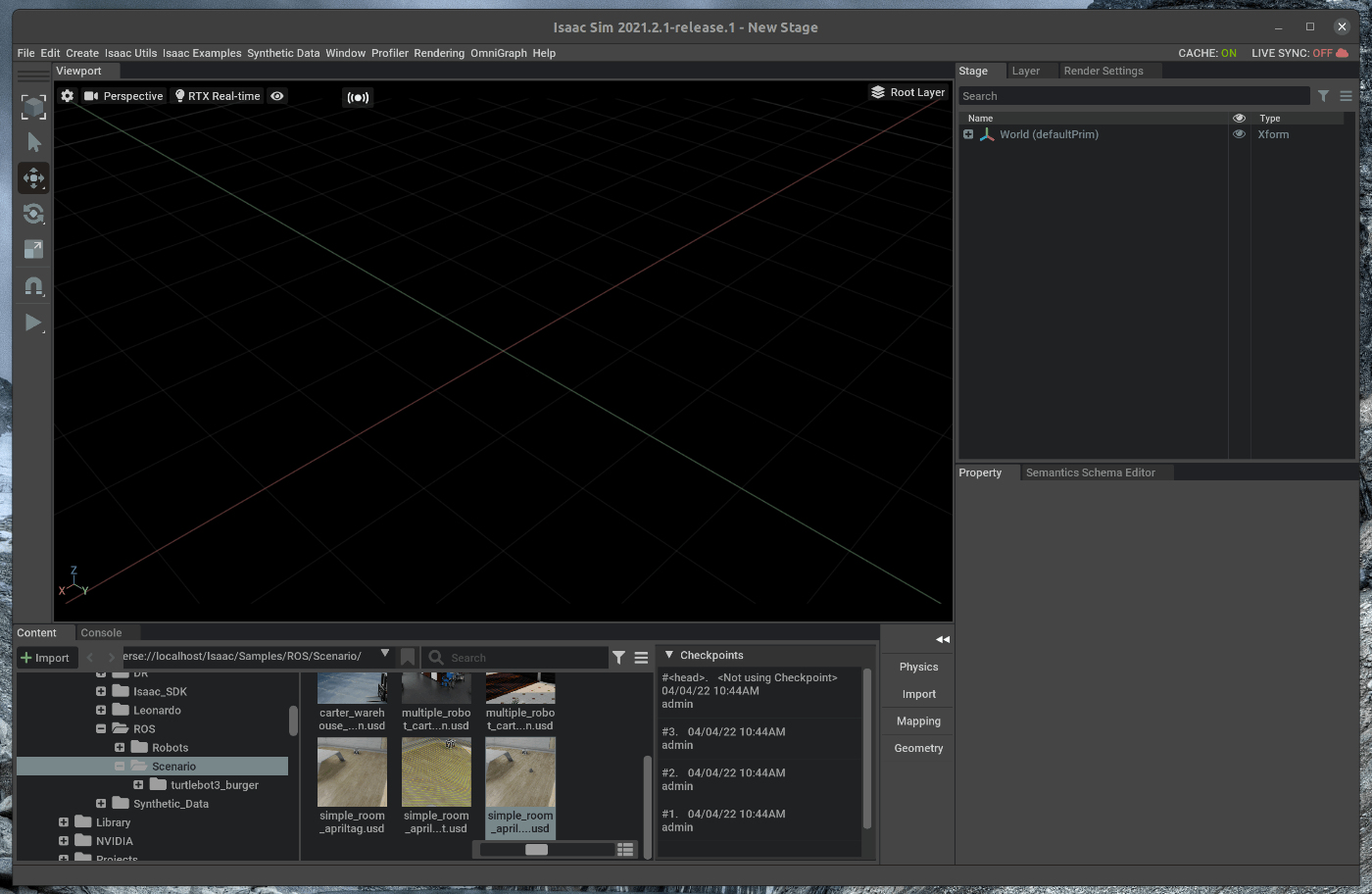

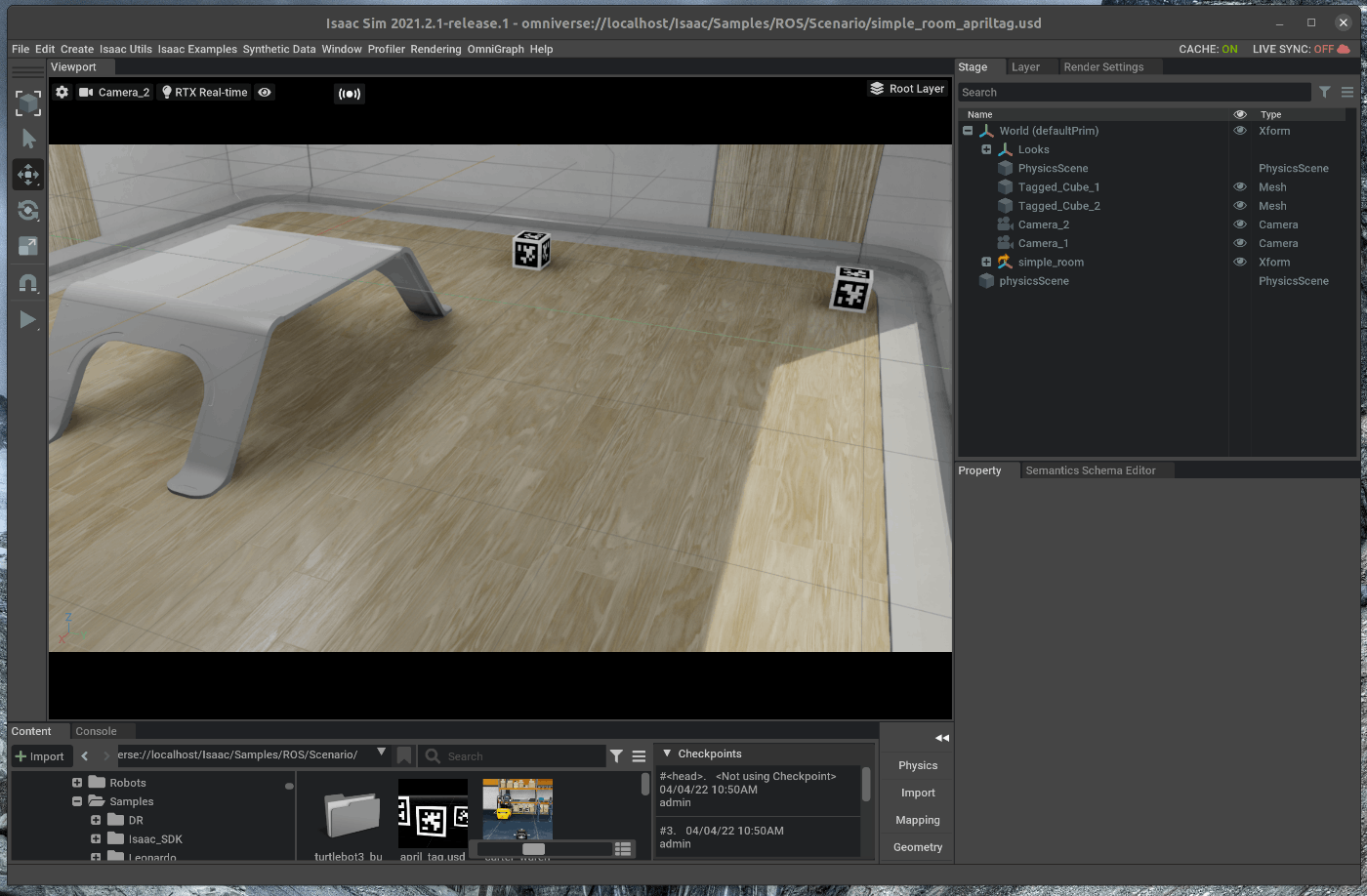

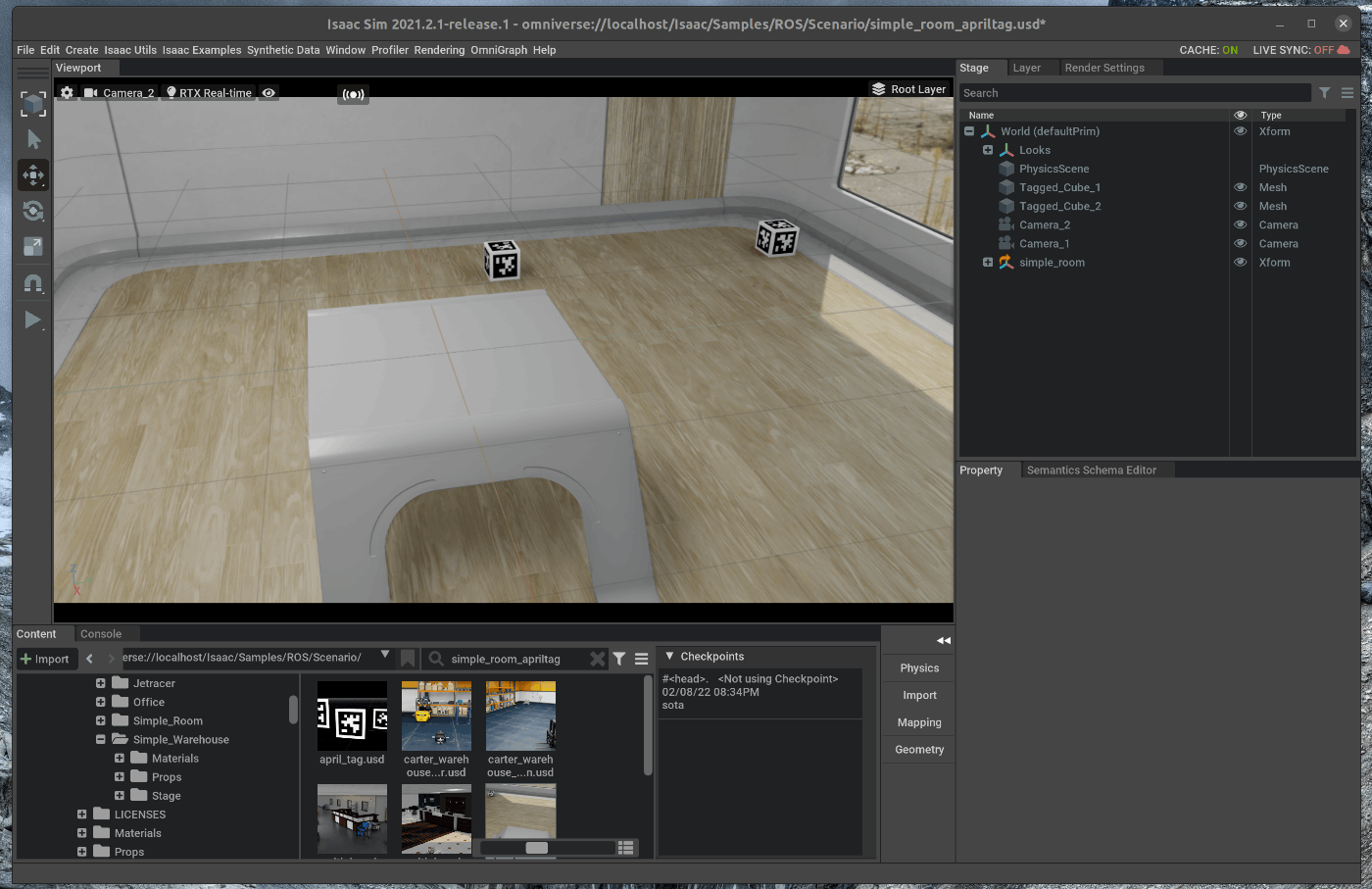

36 | Isaac Simの下部にあるContentの中から、Isaac > Samples > ROS > Scenario > simple_room_apriltag.usd.をダブルクリックします。

37 |

38 |

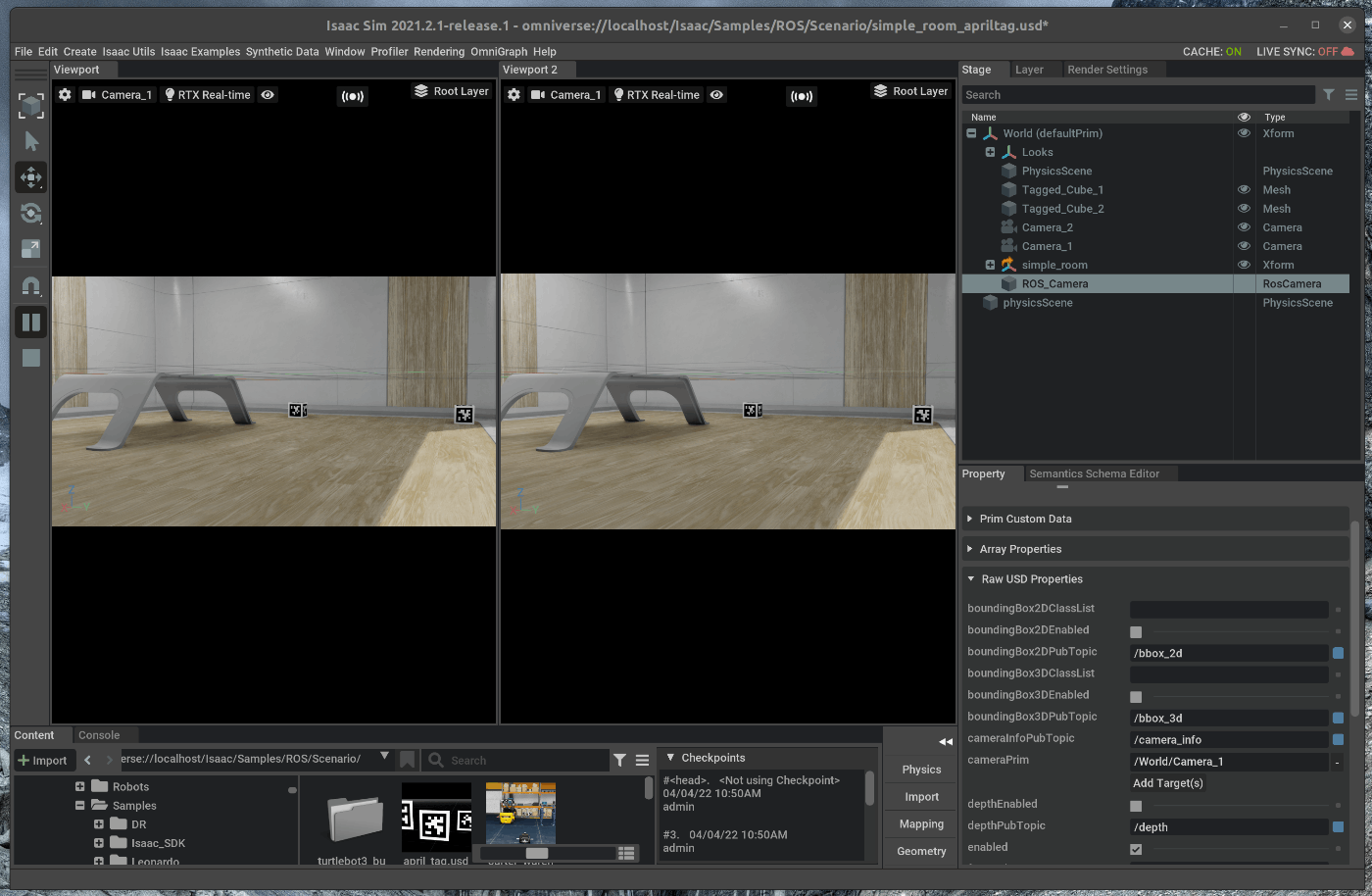

39 | ## 2. ROS Cameraの追加

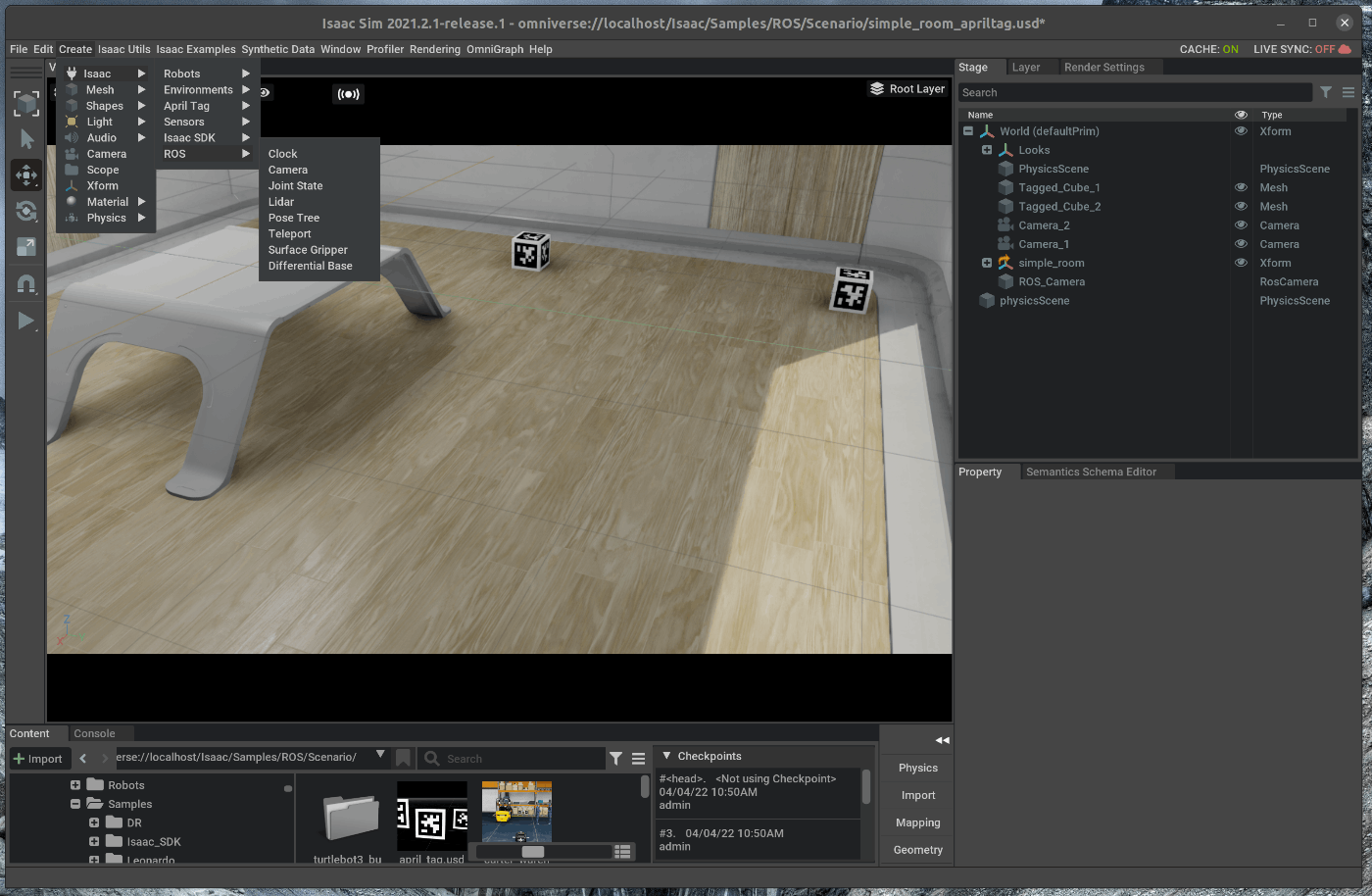

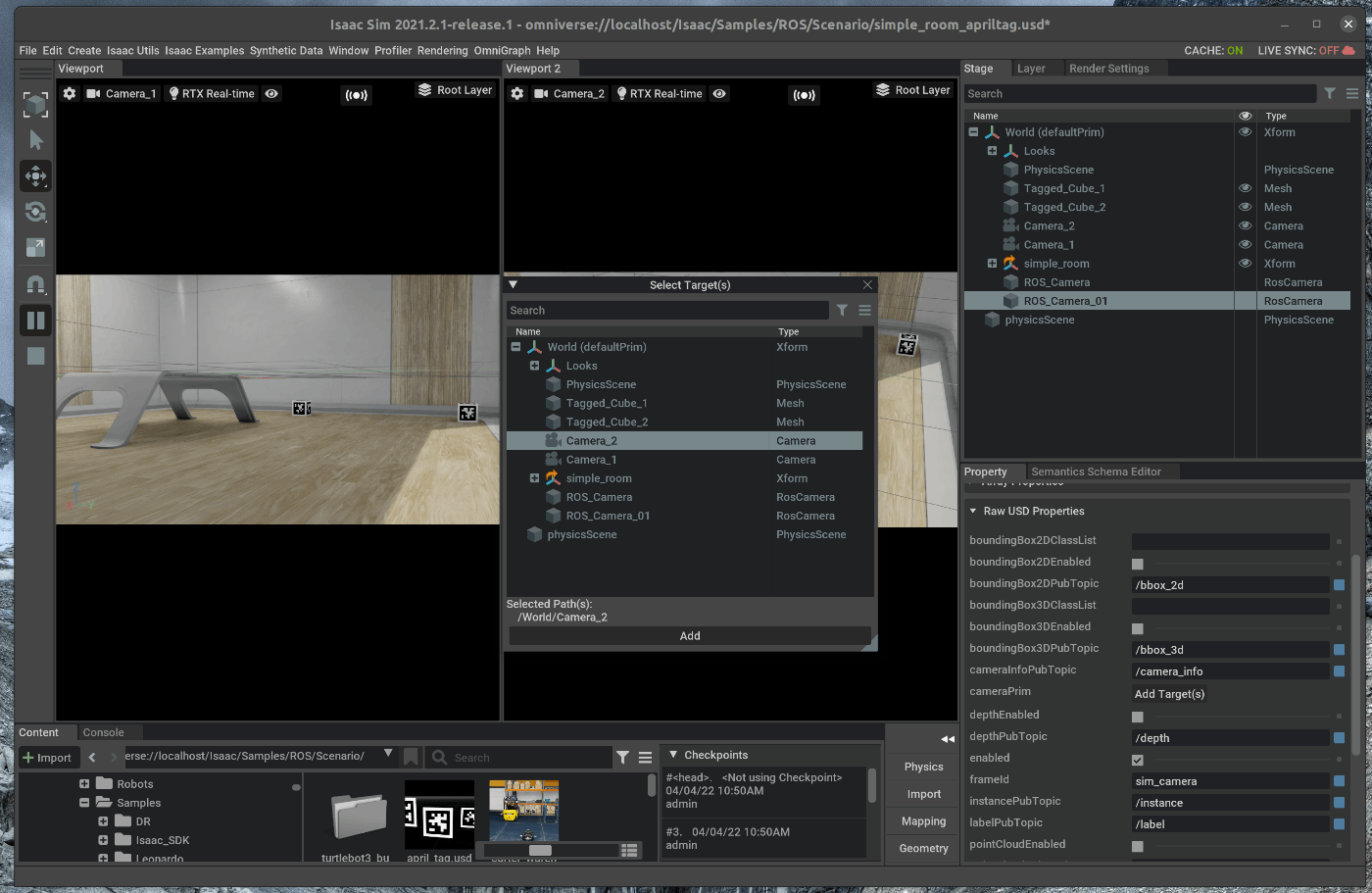

40 | ### 2.1 camera_1用のROS Cameraを追加する

41 | メニューバーのCreate > Isaac > ROS > Cameraを選択します。

42 |

43 |

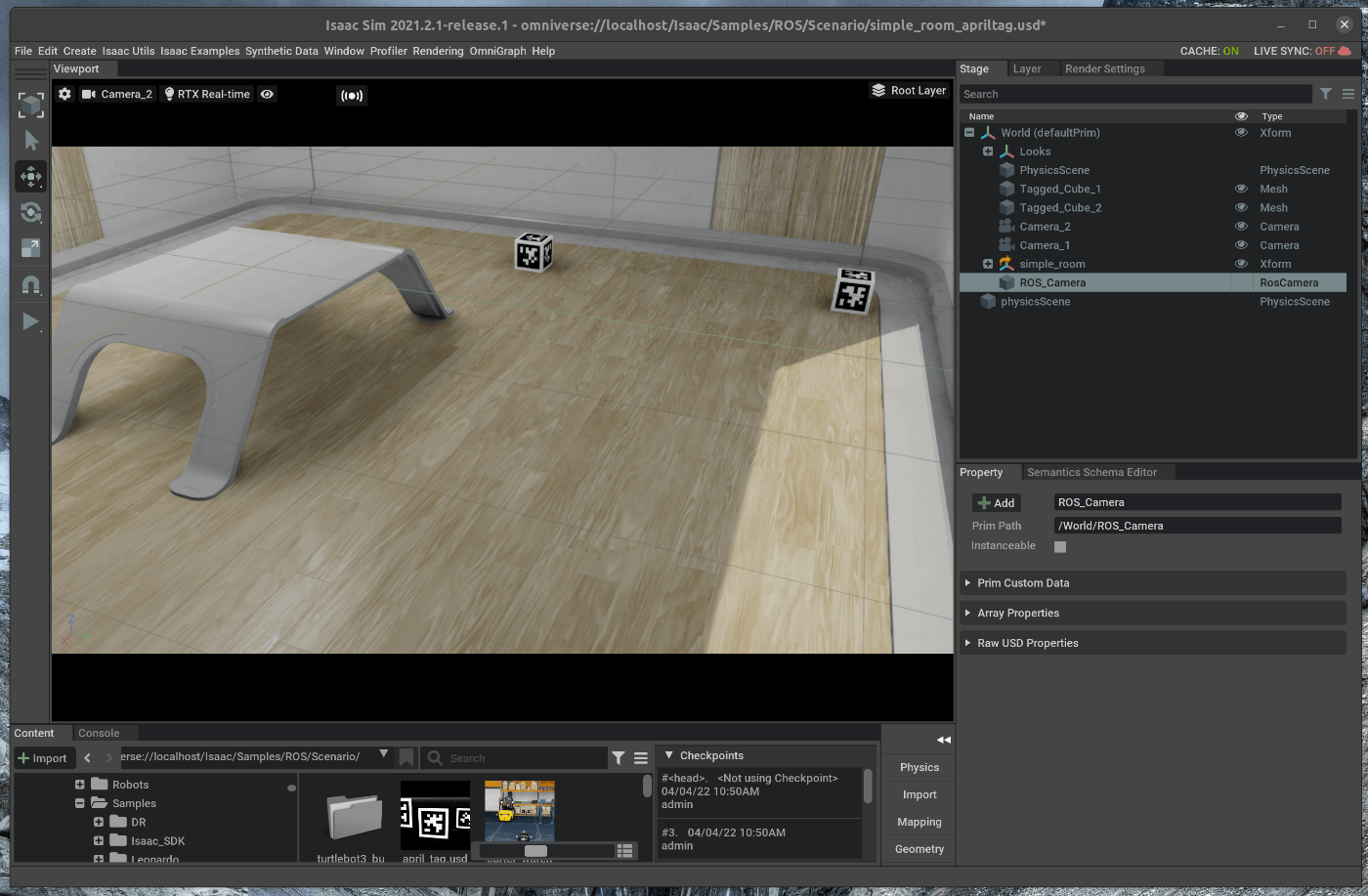

44 | 右側のStageの中で、追加したROS_Cameraを選択します。

45 |

46 |

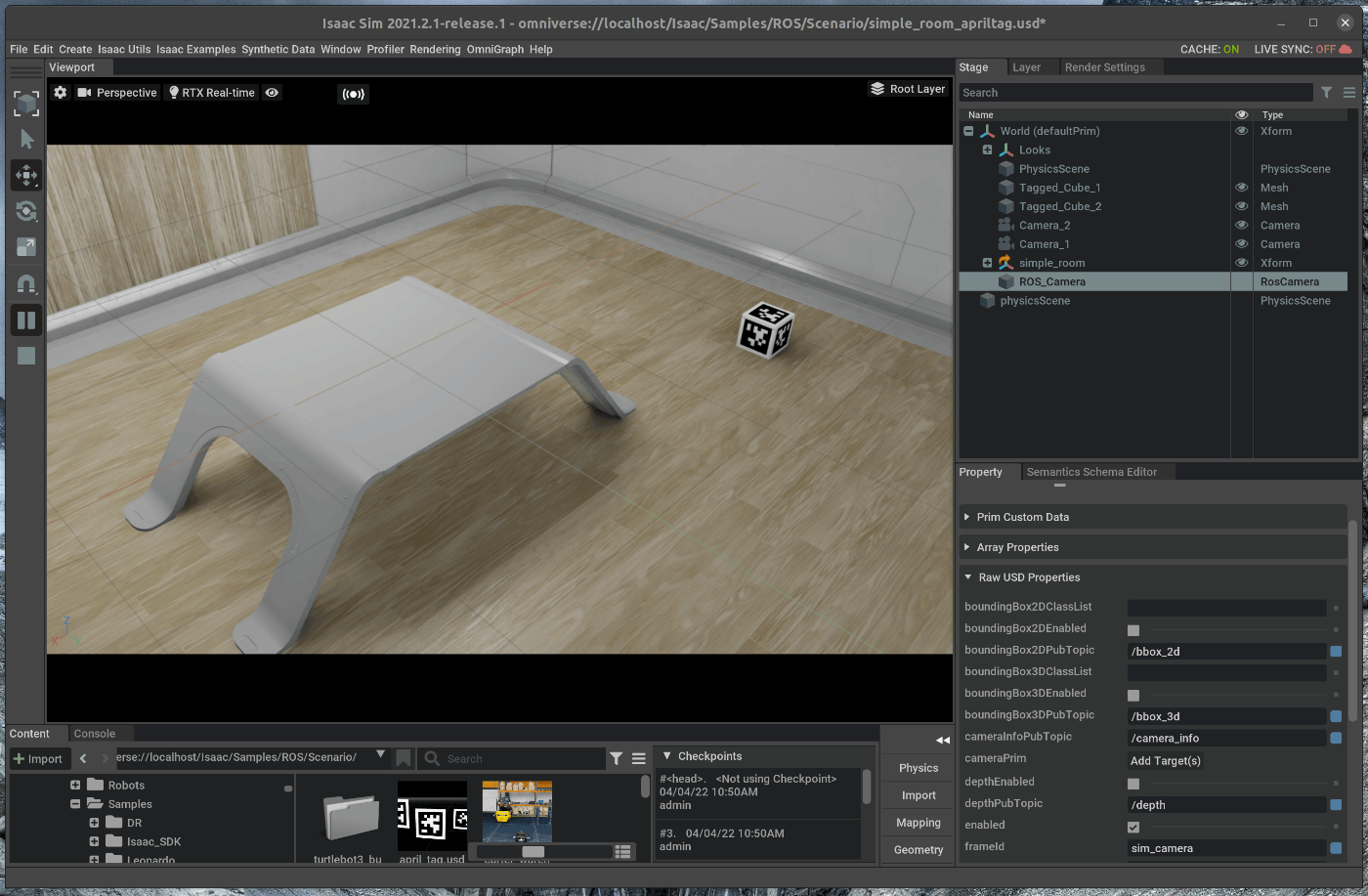

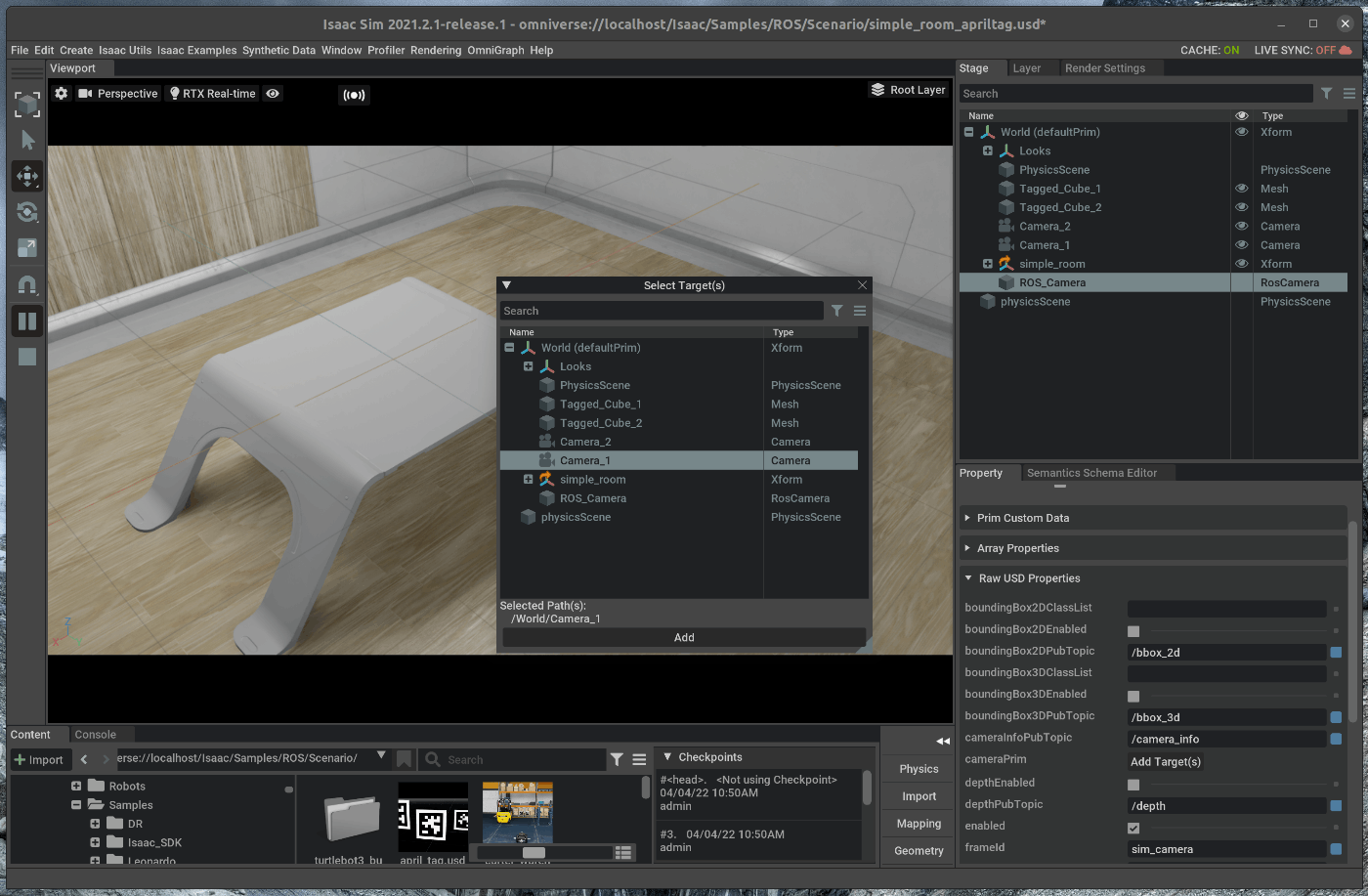

47 | 選択した状態で、Stage下部のpropertyのRaw USD propertiesを開きます。

48 |

49 |

50 | Raw USD propertiesの中で、cameraPrimを選択し、Stageの中の/world/Camera_1を選択します。

51 |

52 |

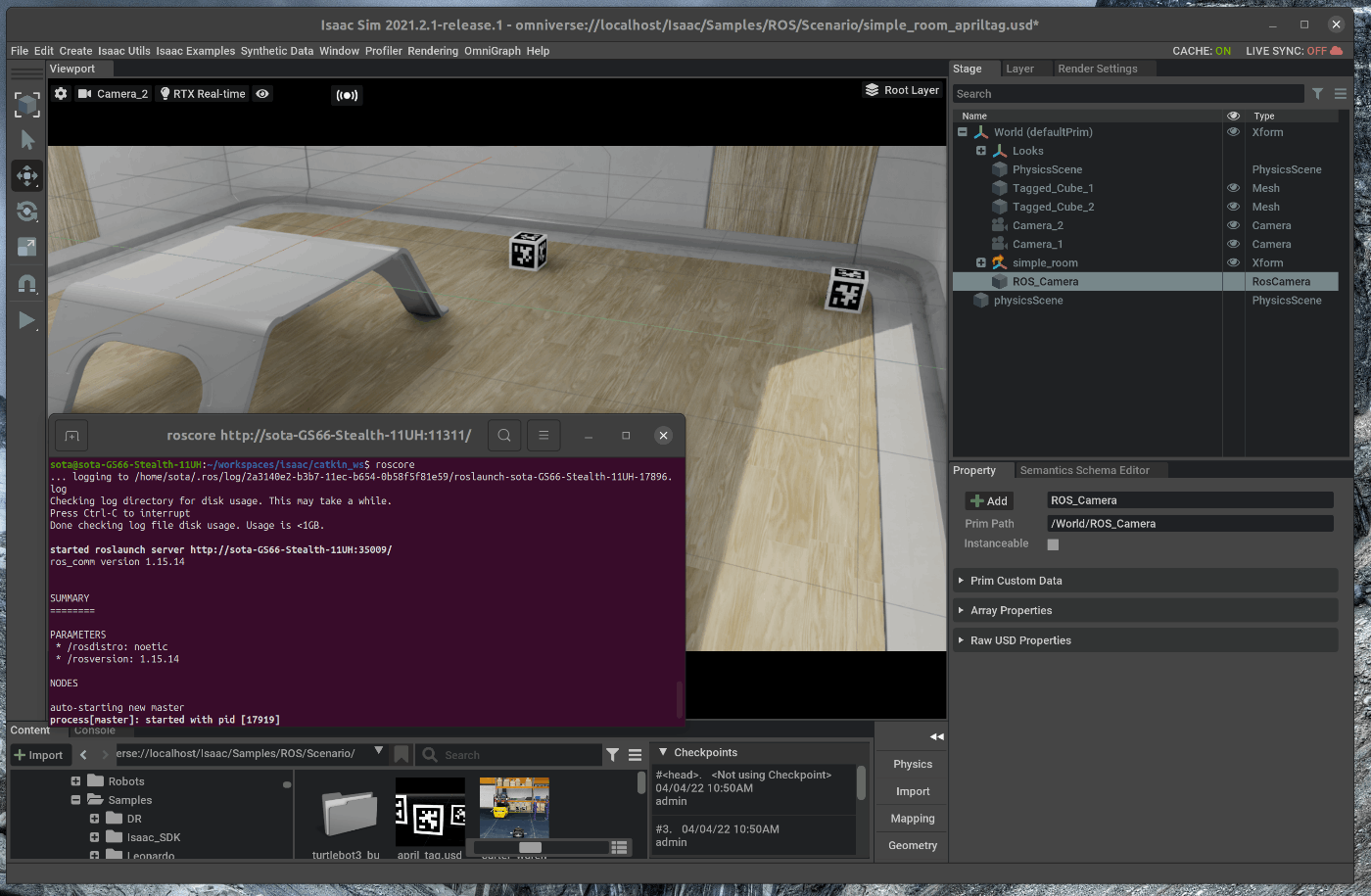

53 | 新たにterminalを開き、roscoreを起動します。

54 |

55 |

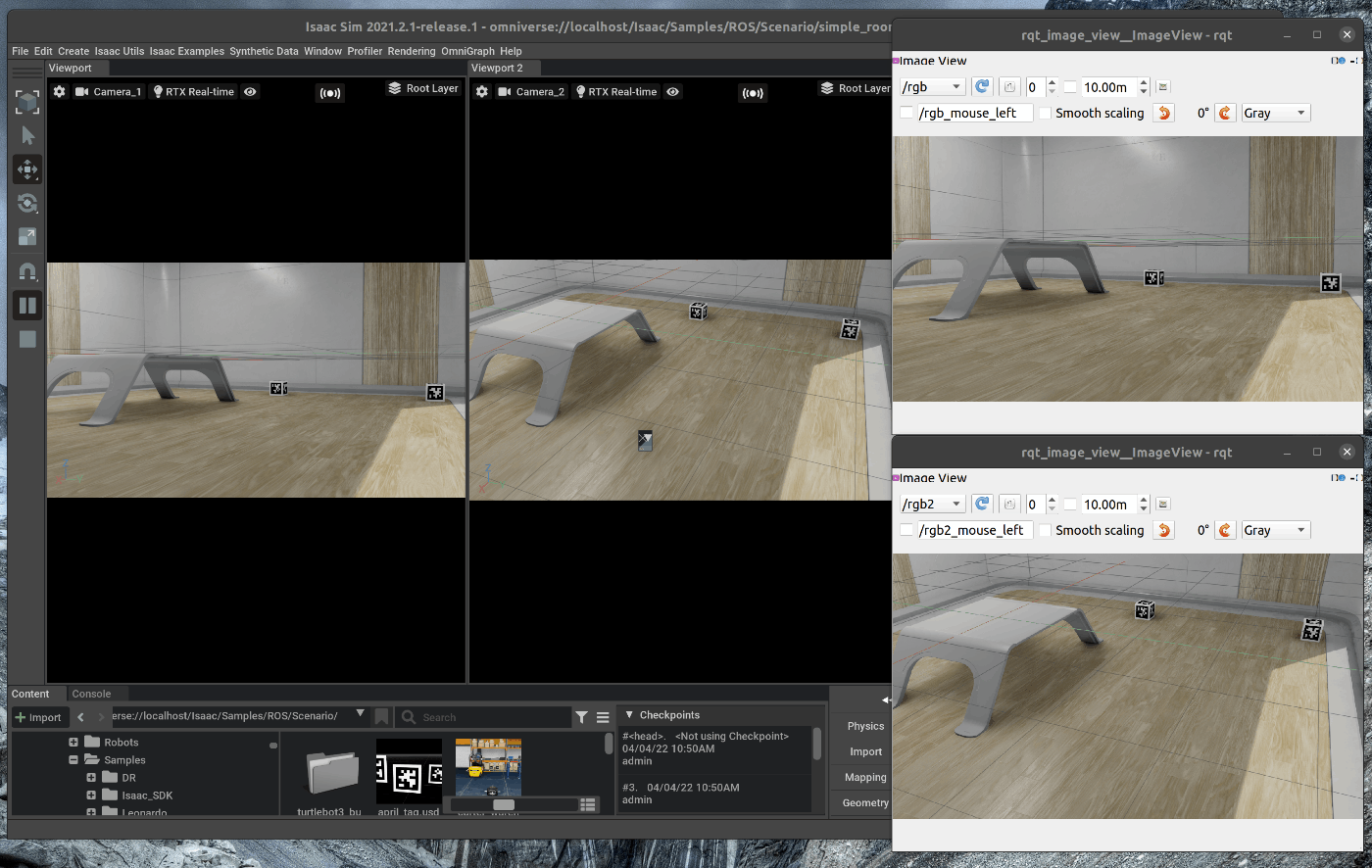

56 | この状態で、Viewportの左側のPLAYボタンを押すと、各種topicが発行されます。

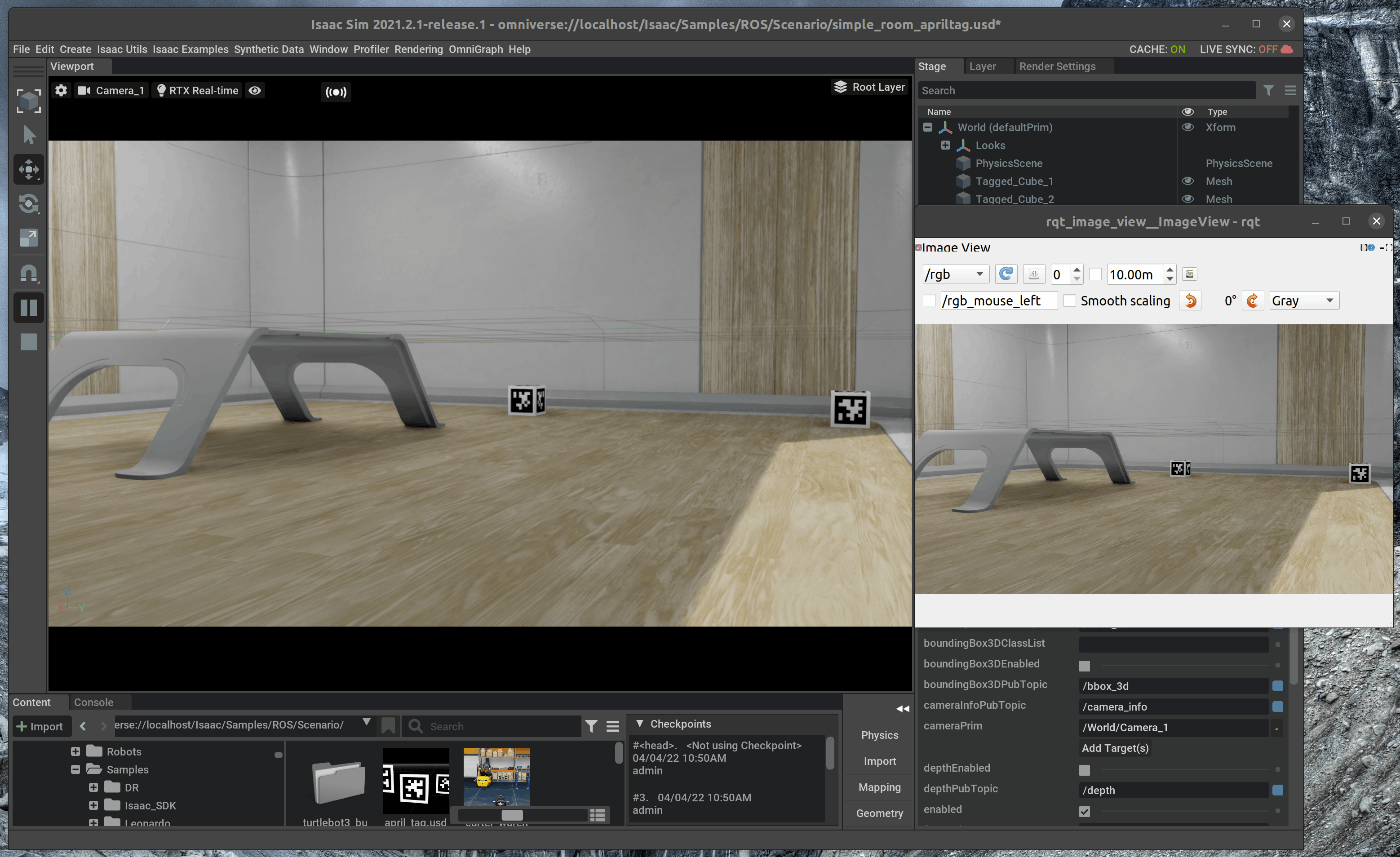

57 | また、新たにterminalを開き、次のコマンドを入力します。

58 |

59 | ~~~ bash:shell

60 | $ rosrun rqt_image_viewer rqt_image_viewer

61 | ~~~

62 | topicに/rgbを選択すると、カメラからの画像を取得することができます。

63 |

64 |

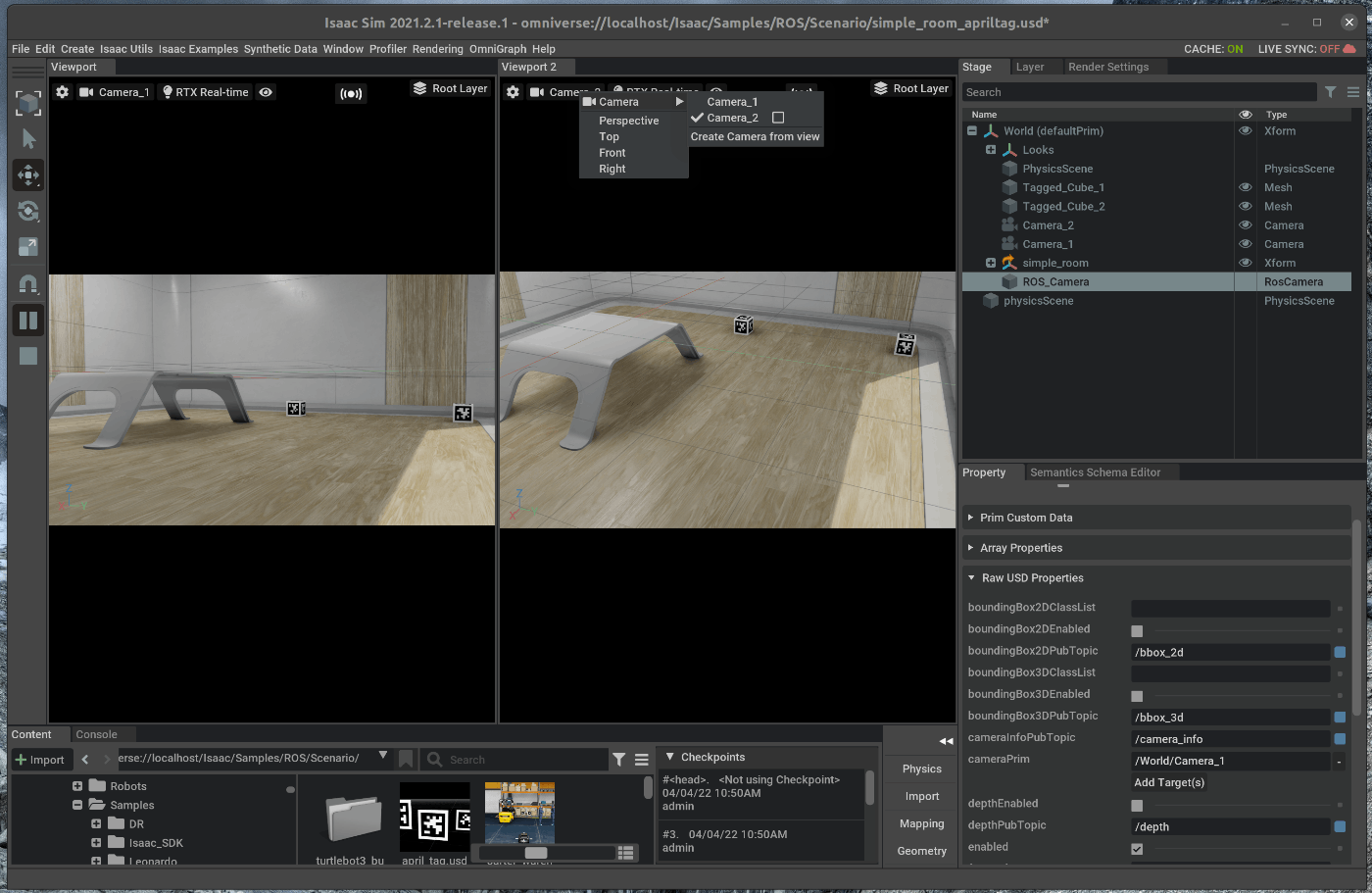

65 | ### 2.2 camera_2用のROS Cameraを追加する

66 | 次に2つ目のカメラのROS Cameraを追加します。

67 | 操作方法は1つ目のカメラと同様です。

68 |

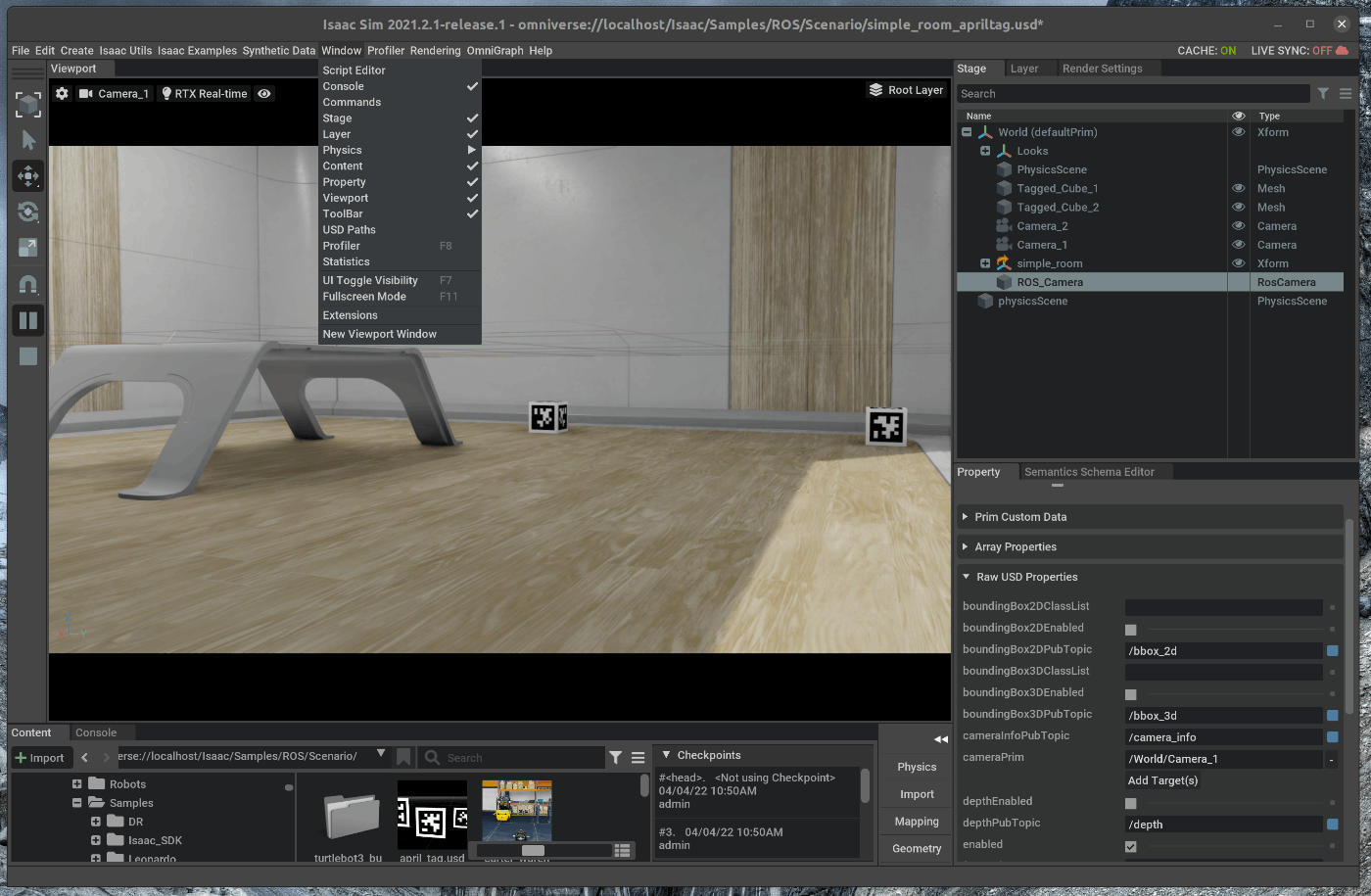

69 | まず、メニューバーのWindow > New Viewport windowを選択します。

70 |

71 |

72 | ポップアップしたWindowを1つ目のViewportの隣に追加します。

73 |

74 |

75 | 追加した2つ目のViewportのカメラアイコンをdクリックし、Camera_2を選択します。

76 |

77 |

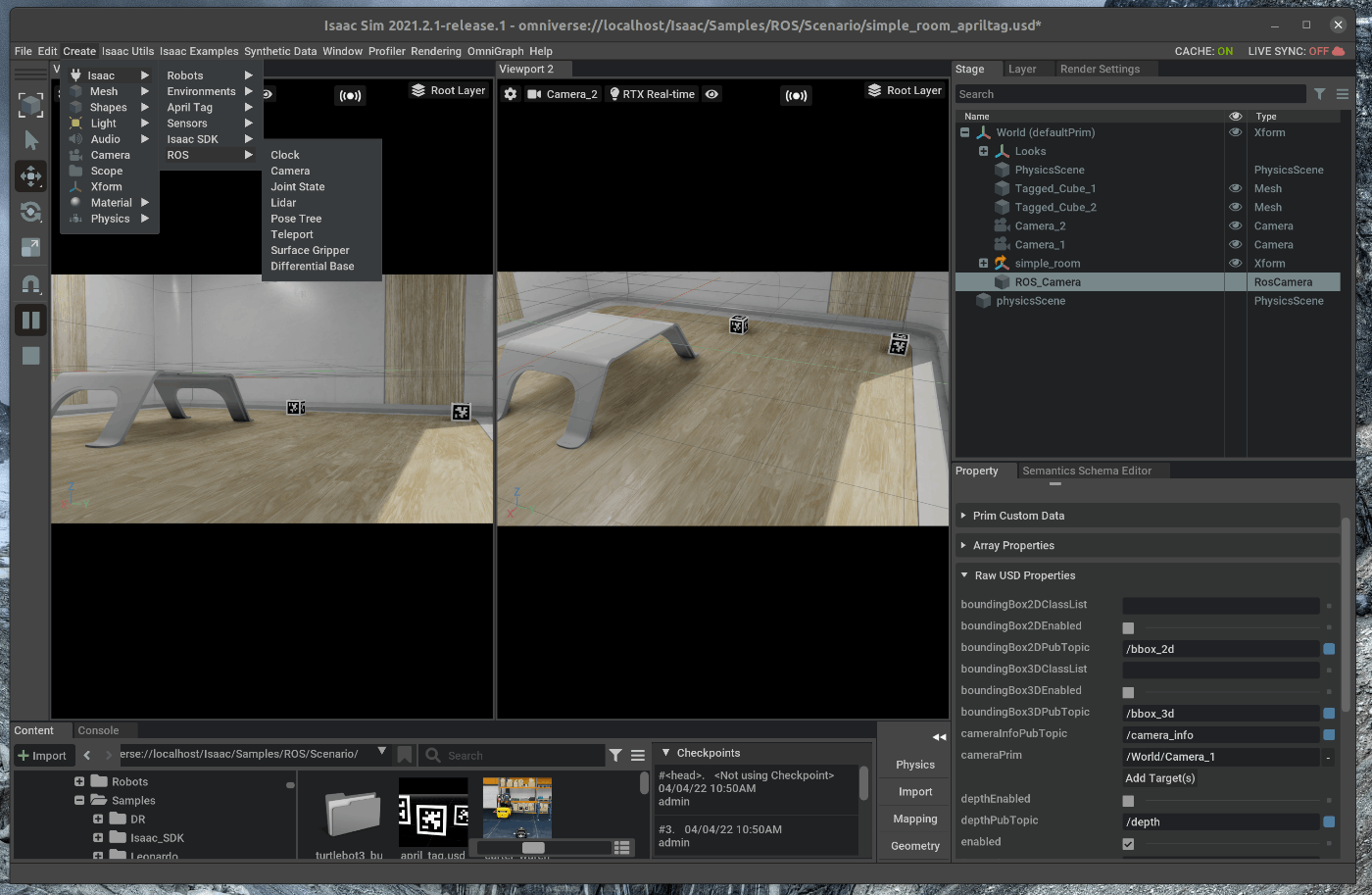

78 | メニューバーのCreate > Isaac > ROS > Cameraを選択します。

79 |

80 |

81 | 右側のStageの中で、追加したROS_Cameraを選択します。

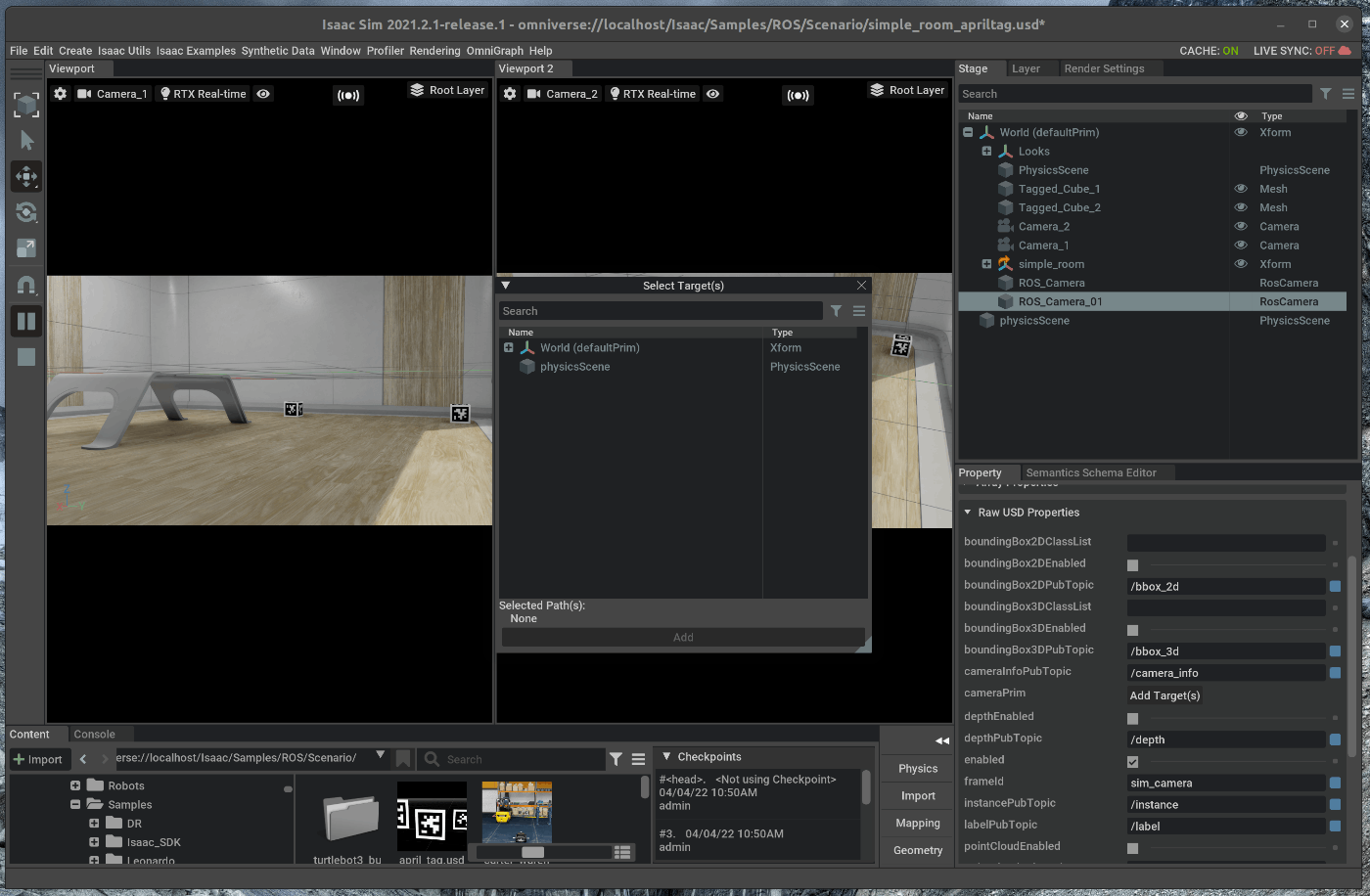

82 | 選択した状態で、Stage下部のpropertyのRaw USD propertiesを開きます。

83 | Raw USD propertiesの中で、cameraPrimを選択し、Stageの中の/world/Camera_2を選択します。

84 |

85 |

86 |

87 | 新たにterminalを開き、次のコマンドを入力します。

88 |

89 | ~~~ bash:shell

90 | $ rosrun rqt_image_viewer rqt_image_viewer

91 | ~~~

92 |

93 | topicに/rgb2を選択すると、カメラからの画像を取得することができます。

94 |

95 |

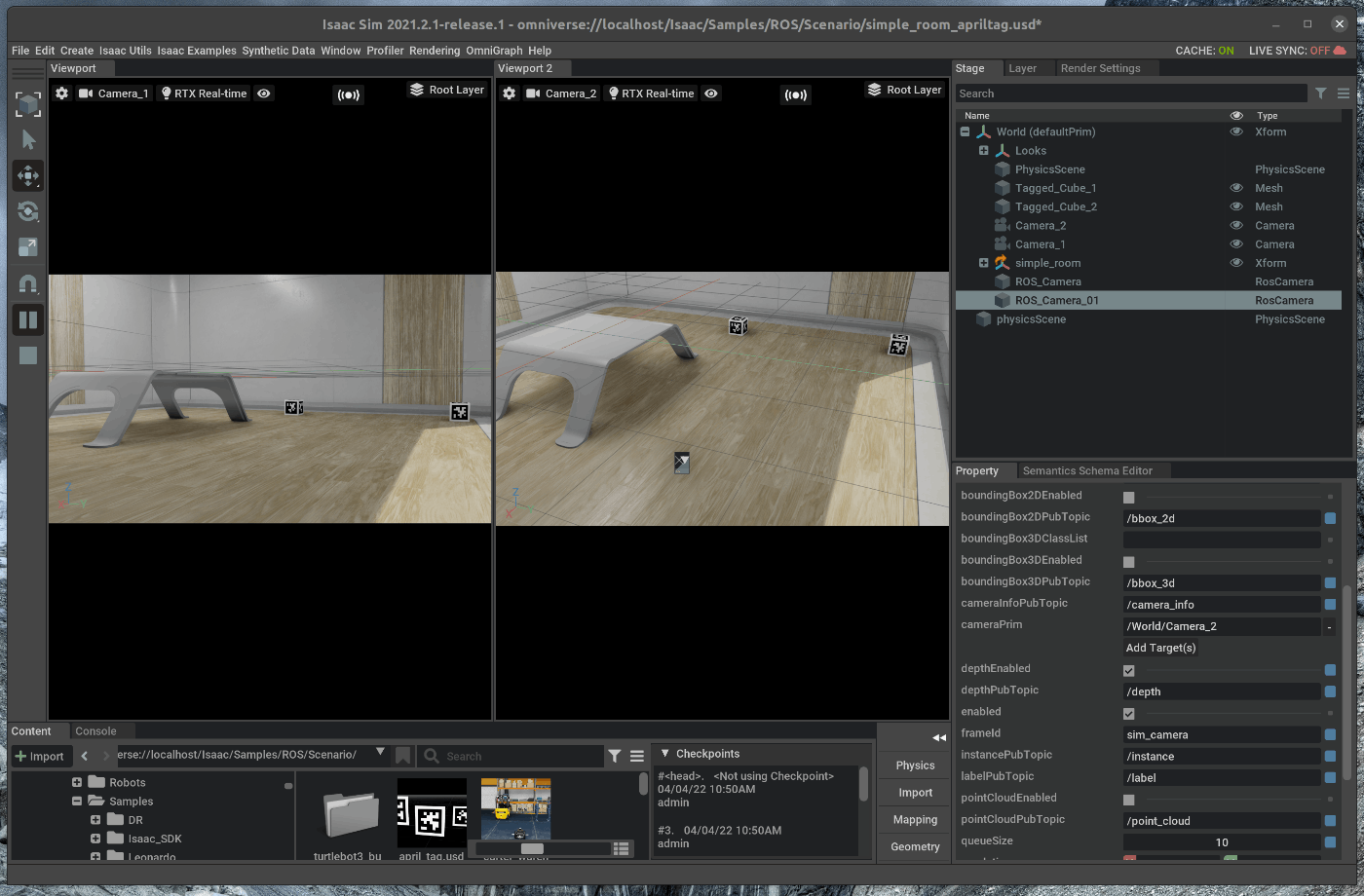

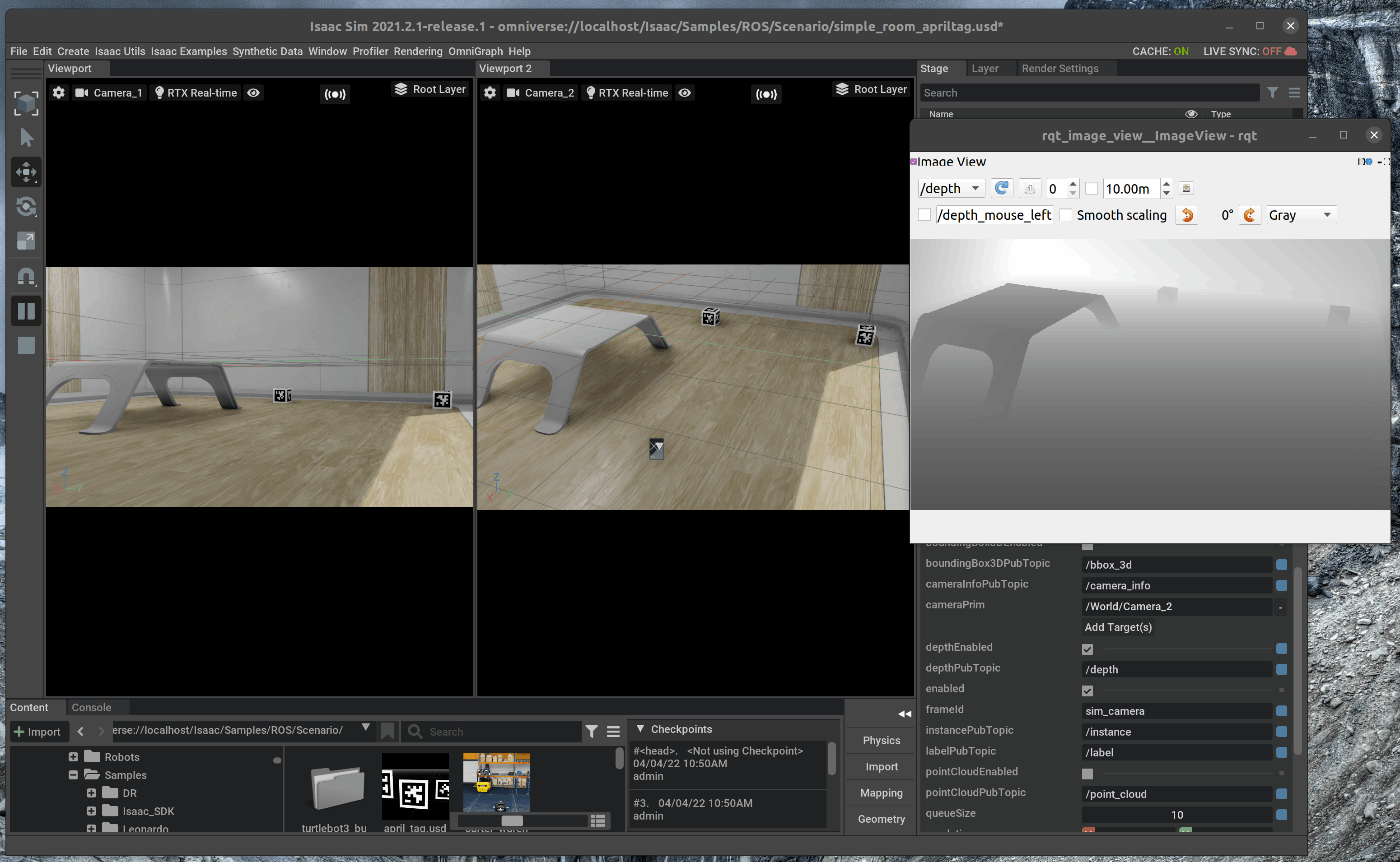

96 | ### 2.3 Depth画像の発行

97 | 右側のStageの中で、ROS_Camera_01を選択します。

98 | 選択した状態で、Stage下部のpropertyのRaw USD propertiesを開きます。

99 |

100 | depthEnabledにチェックを入れます。

101 |

102 |

103 | 新たにterminalを開き、次のコマンドを入力します。

104 |

105 | ~~~ bash:shell

106 | $ rosrun rqt_image_viewer rqt_image_viewer

107 | ~~~

108 |

109 | topicに/depthを選択すると、カメラからのdepth画像を取得することができます。

110 |

111 |

--------------------------------------------------------------------------------

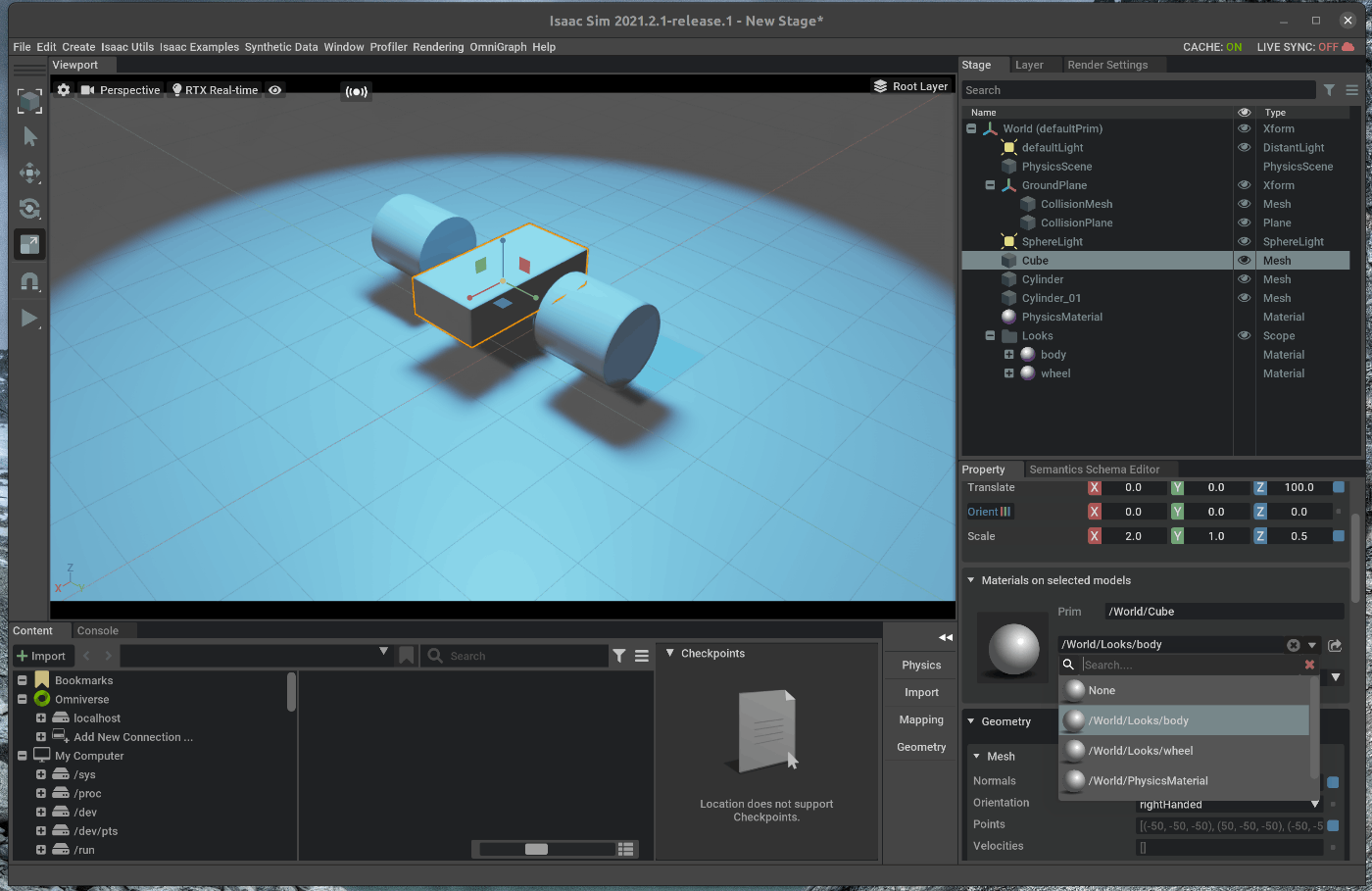

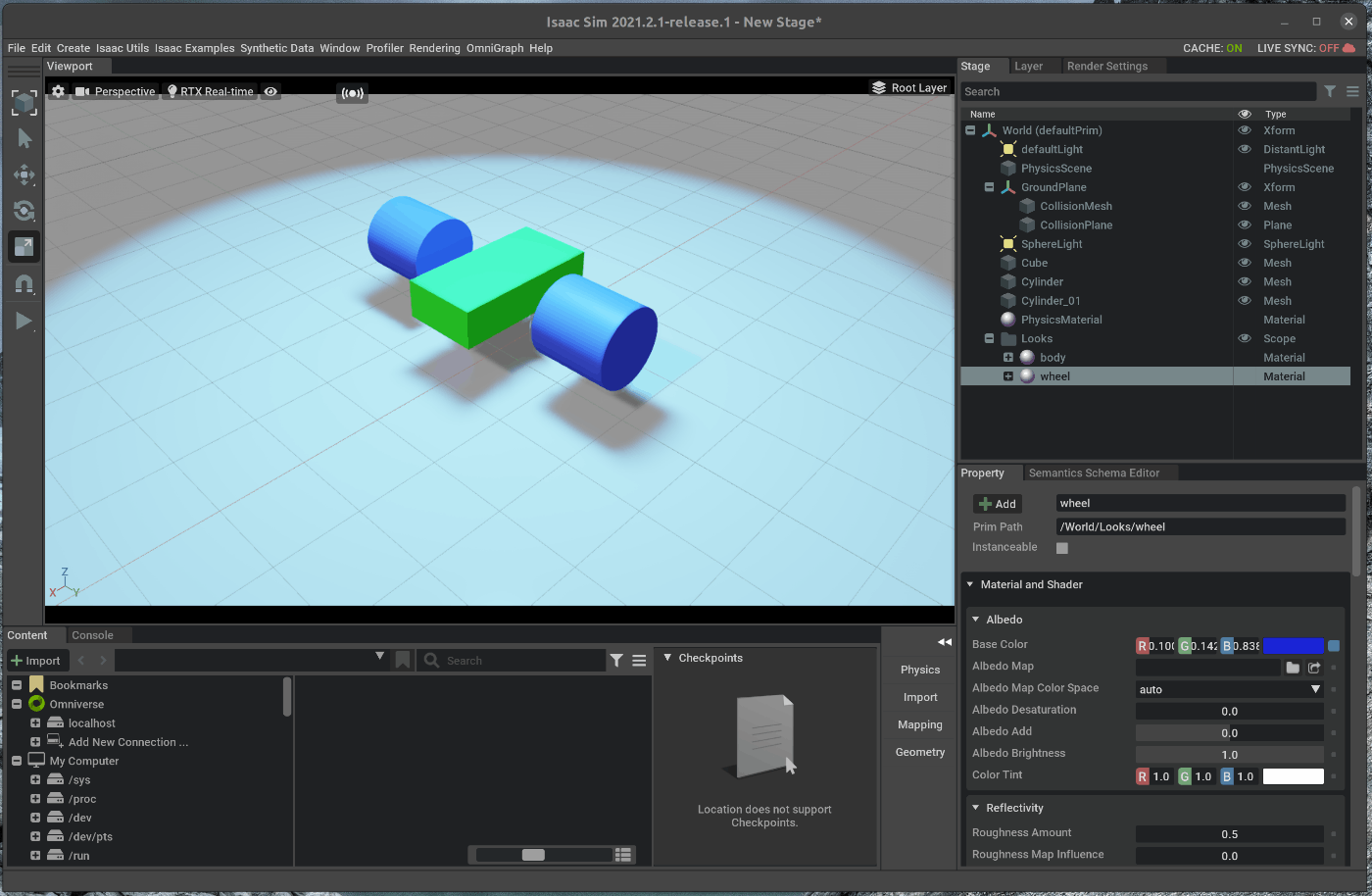

/tutorials/gui/move_simple_robot/3_move_robot.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Nvidia Issac simのGUIの機能を使用し、簡単な2輪ロボットのモデルを動かします。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_gui_simple_robot.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 |

25 | # 手順

26 |

27 | 大まかな手順は次の通りです。

28 |

29 | 1. 2輪ロボットモデルにJoint設定を追加

30 | 2. 2輪ロボットにJointDriveを追加

31 |

32 | 以下内容のシーンファイルはこちらからダウンロードできます。(準備中)

33 |

34 | ## 1. 2輪ロボットモデルにJoint設定を追加

35 | こちらのページに記載してある手順を進めます。

36 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_gui_simple_robot.html#isaac-sim-app-tutorial-gui-simple-robot

37 |

38 | ### 1.1 OmniverseからIssac Simを起動する

39 |

40 |

41 | ### 1.2 シーンをロードする

42 | 以前作成した2輪のロボットモデルをロードします。

43 | シーンファイルは[こちらからダウンロード]()できます。

44 | メニューバーのFile > Open を選択します。

45 | 該当ファイルを選択し、シーンをロードします。

46 |

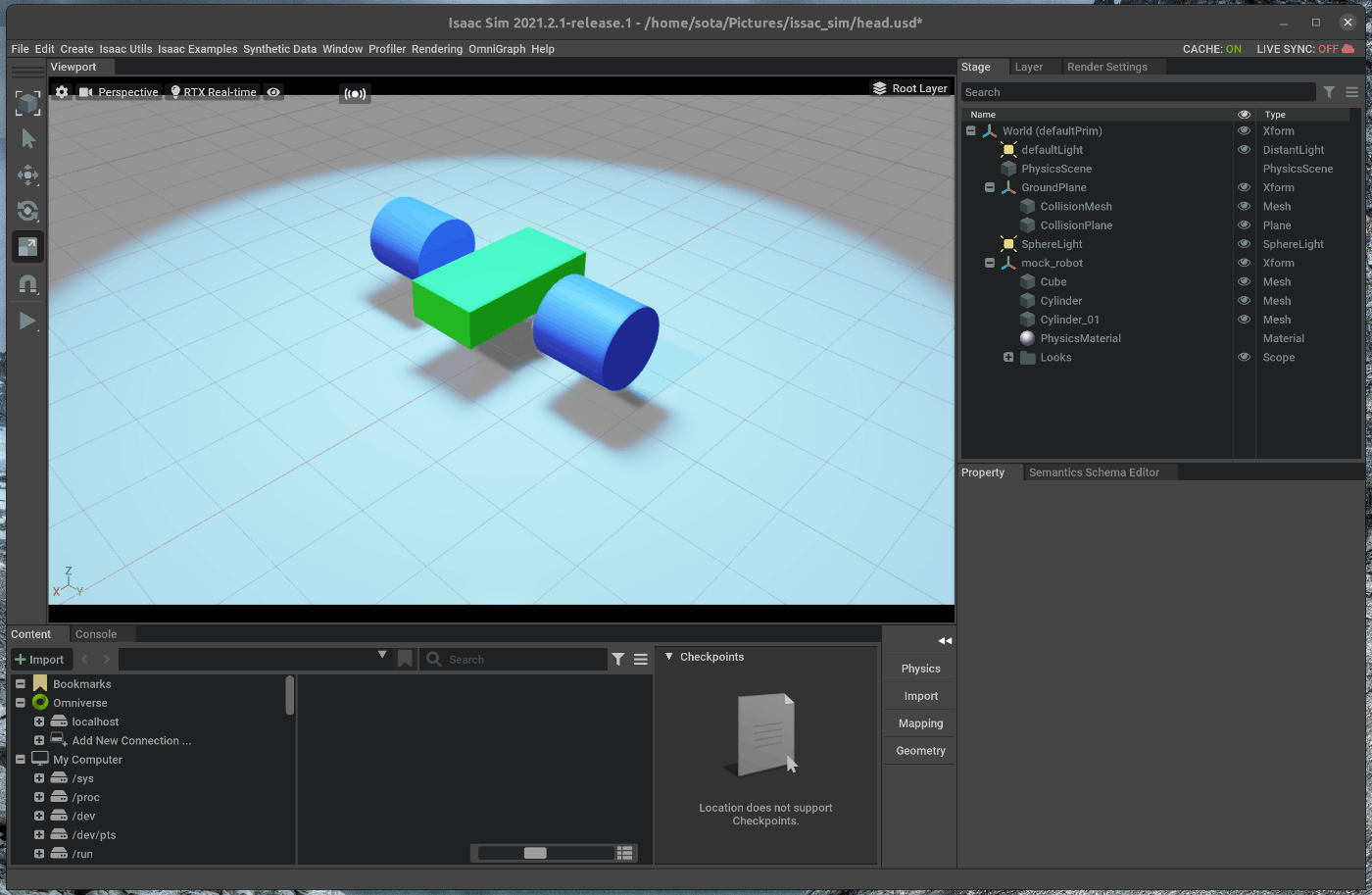

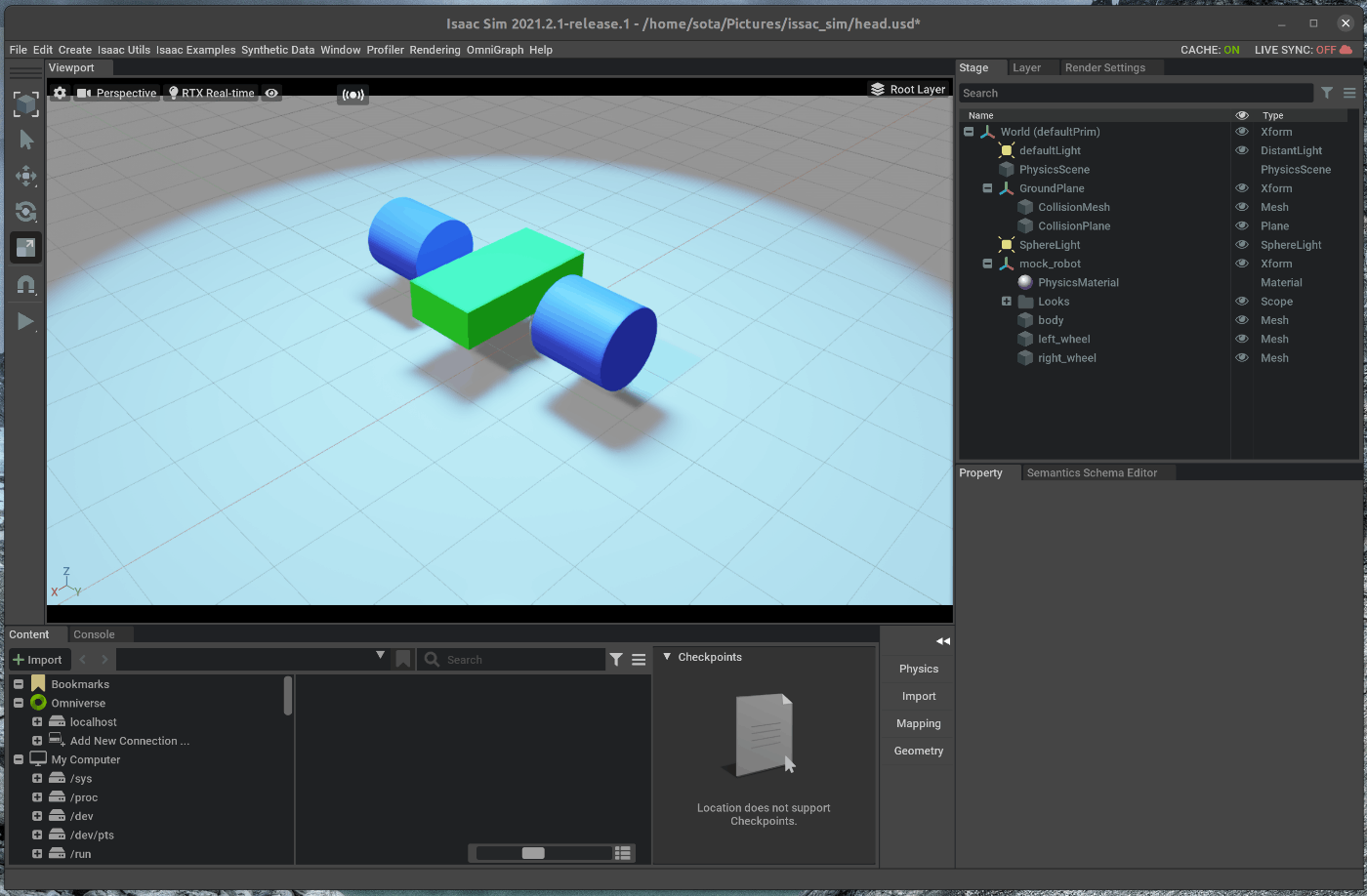

47 | ## 1.3 Primの追加

48 | シーン内にPrimを追加します。Primはコンテナオブジェクトであり、Stageの中に名前空間を作ることができます。

49 | 右側のStageタブの中で右クリックし、Create>Xformを選択します。

50 |

51 |

52 | 追加したXformを右クリックし、Renameを選択します。

53 | 名称は次の名称に変更します。

54 | - mock_robot

55 |

56 | 右側のStageタブの中で、CubeとCylinders, Physics Material, Looksフォルダーを選択し、mock_robotの下にドラッグアンドドロップで移動させます。

57 |

58 |

59 |

60 | 移動後、CubeとCylindersをそれぞれ右クリックし、次の名称にrenameします。

61 | - cube > body

62 | - cylinders > wheel_left

63 | - cylinders_01 > wheel_right

64 |

65 |

66 |

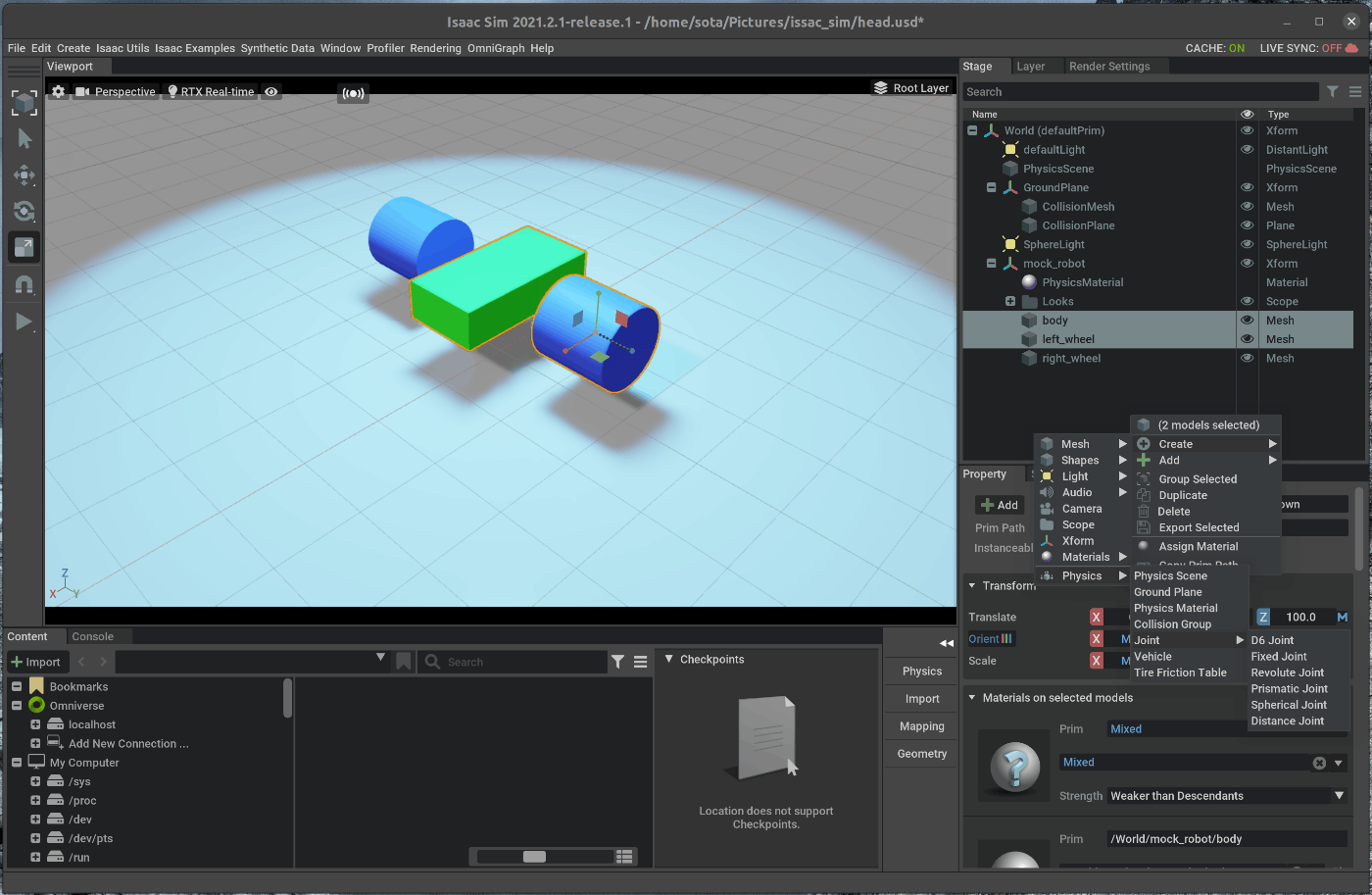

67 | ## 1.4 Jointの追加

68 | BodyとWheel間にJointを追加します。

69 | 右側にあるStageの中で、”wheel_left”を選択します。

70 | 選択した状態で、Ctrl+Shiftを押しながら、bodyを選択します。

71 |

72 | 右側のStageタブの中で右クリックし、Create > Physics > Joints > Revoluteを選択します。

73 |

74 |

75 |

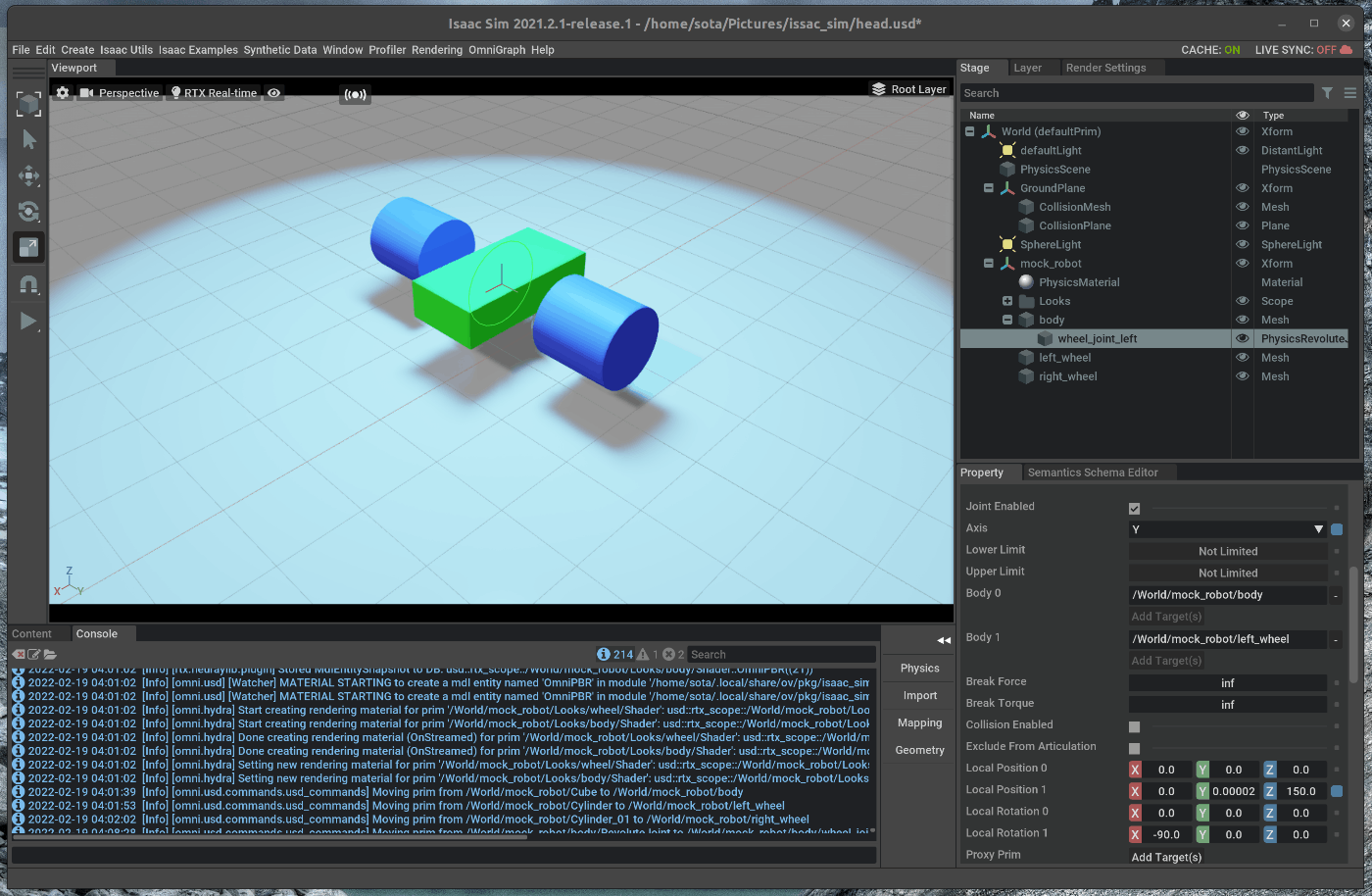

76 | Bodyの下のRevoluteJointを右クリックし、renameします。

77 | - RevoluteJoint > wheel_joint_left

78 |

79 |

80 |

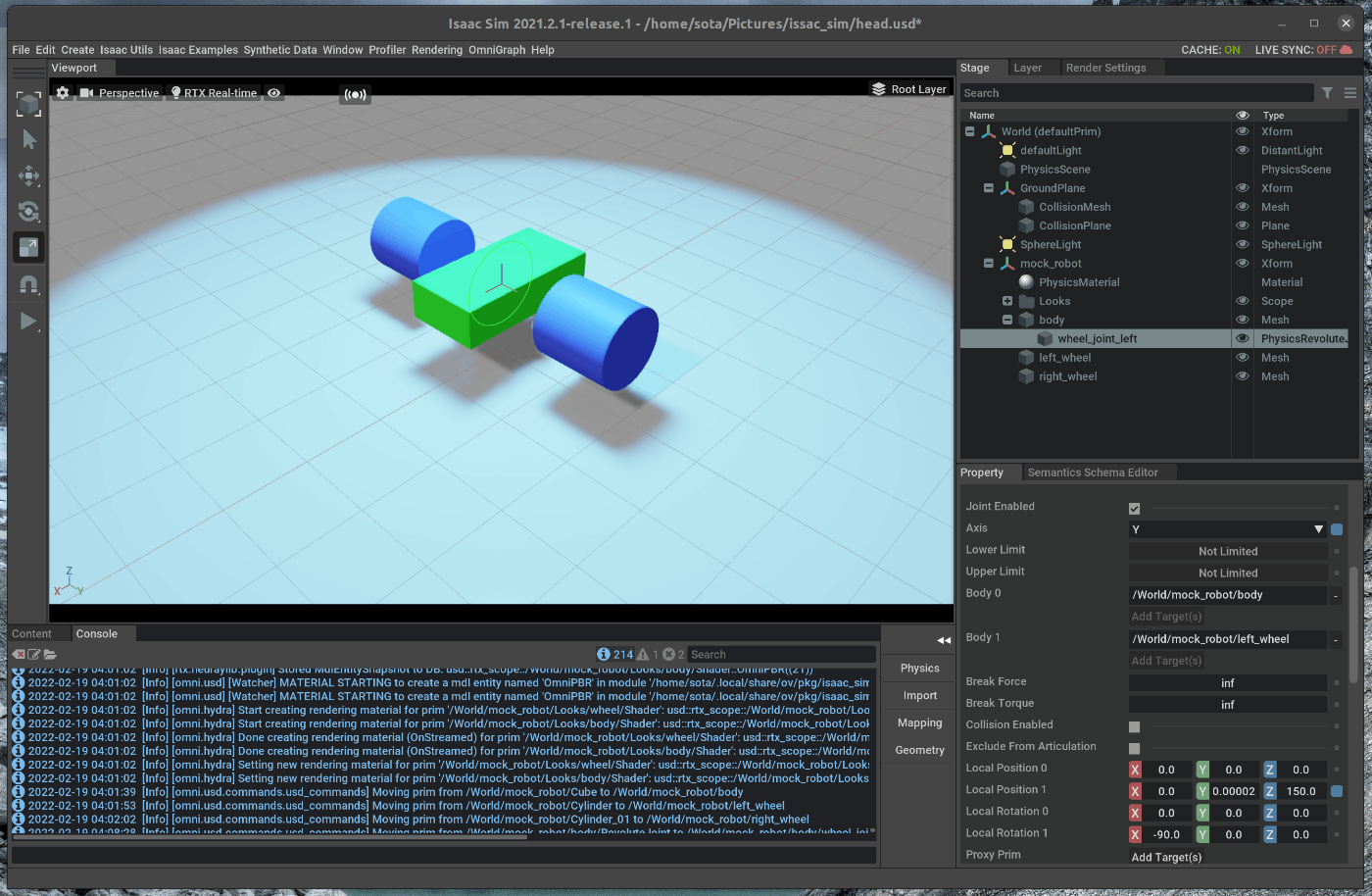

81 | 右側のStageタブの中で、wheel_joint_leftを選択します。

82 | 選択した状態で、右下にあるPropertyの中から、次の値を変更します。

83 | - AxisをYにする

84 | - Local Rotation 1のXを-90にする

85 |

86 |

87 |

88 | 左タイヤに対して行ったJointの設定を右タイヤについても同様に行います。

89 |

90 |

91 |

92 | 各wheelの設定完了後、右側のツールバーのシミュレーションstartボタンを押すと、関節関係が保たれたまま、重力がかかり落下することを確認します。

93 |

94 |

95 |

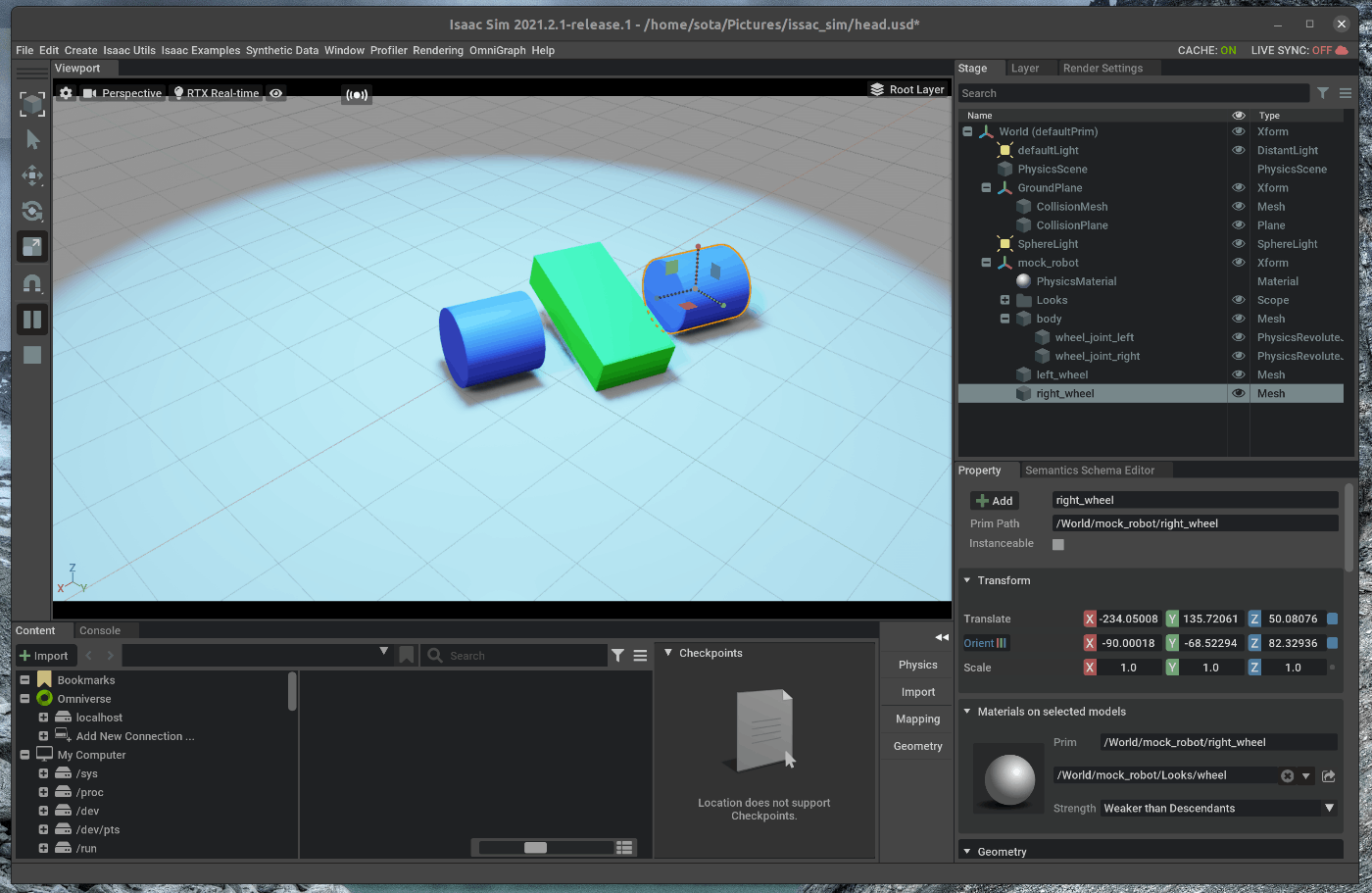

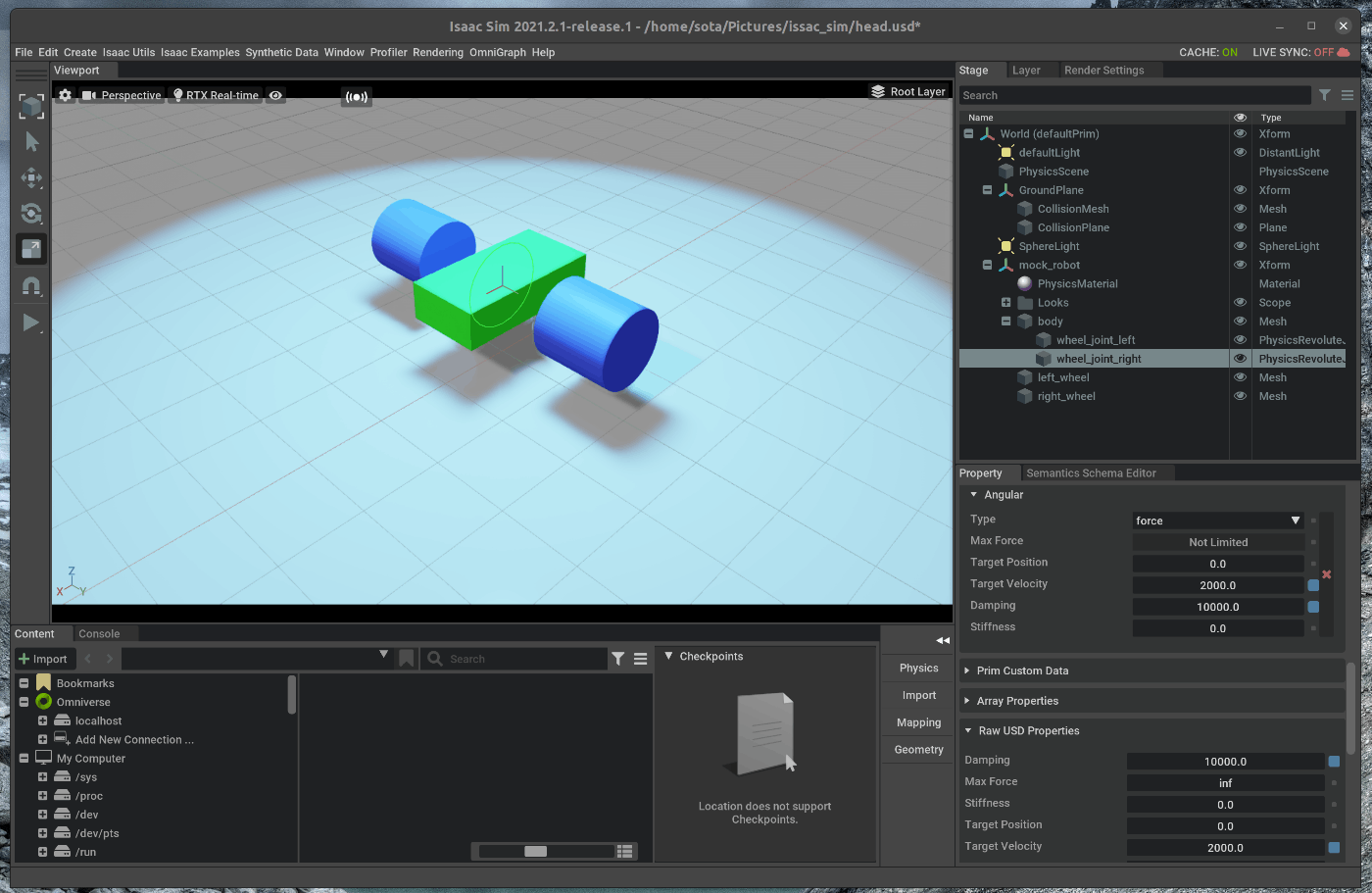

96 | ## 2. Joint Driveの追加

97 | Jointを制御するための設定を追加します。

98 | 右側のStageタブの中で、wheel_joint_leftとwheel_joint_rightを選択します。

99 | 選択した状態で、右下のPropertyの”+Add”をクリックし、Physics > Angular Driveを選択します。

100 |

101 |

102 |

103 | それぞれのJointにおいて、ダンパと指令各速度値を設定します。

104 | 右側のStageタブの中で、wheel_joint_leftを選択します。

105 | 選択した状態で、右下のPropertyの中のDrive >Angularの次の値を変更します。

106 | - Dampingを1e4にする

107 | - Target Velocityを2000にする

108 |

109 |

110 | wheel_joint_rightにおいても同様の手順を行い、ダンパと指令各速度値を設定します。

111 |

112 | 両方のWheelにおいて設定が完了し、左側のツールバーのシミュレーションStartボタンを押すと、ロボットが進むことを確認します。

113 |

114 |

115 |

--------------------------------------------------------------------------------

/tutorials/replicator/replicator_composer/24_replicator_composer.md:

--------------------------------------------------------------------------------

1 | # 概要

2 | Replicator Comporserを用いてデータセットを作成します。

3 |

4 | Issac Simのtutorialに上記の内容が記載されており、この内容に沿って進めます。

5 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/tutorial_replicator_composer.html

6 |

7 | # 実行環境

8 |

9 | - インストール実行環境

10 |

11 | | unit | specification |

12 | |:-----------------:|:------------------:|

13 | | CPU | i9-11900H |

14 | | GPU | GeForce RTX 3080 Laptop|

15 | | RAM | 32GB |

16 | | OS | Ubuntu 20.04.3 LTS |

17 |

18 | - Nvidia Driverバージョン

19 | - 510.39.01

20 | - Issac simバージョン

21 | - 2021.2.1

22 |

23 |

24 | # 手順

25 | Replicator Composerを用いてデータセットを作成します。

26 | Replicator Composerでは、Parameter FileとAsset Fileの2つのファイルからシーンを生成します。

27 | シーンの設定では、Objectの種類や特性、環境の種類や特性をそれぞれ設定するこが可能です。

28 |

29 | 設定値の一覧はこちらのReferenceから確認できます。

30 | https://docs.omniverse.nvidia.com/app_isaacsim/app_isaacsim/manual_replicator_composer_parameter_list.html#isaac-sim-app-manual-replicator-composer-parameter-list

31 |

32 | Replicator ComposerのTutorialとして用意されているParameter FileとAsset Fileを用いてデータセットを作成します。

33 |

34 | また、Tutorialには、Launcherから実行する方法とDocker上で実行する方法が記載されています。

35 | 今回はLauncherから実行する方法によってデータセットを作成します。

36 |

37 | 流れを次に示します。

38 |

39 | 1. Isaac SimのインストールディレクトリでTerminalを開く

40 | 2. データ生成のコマンドの実行

41 |

42 | ## 1. Isaac SimのインストールディレクトリでTerminalを開く

43 | ### 1.1 OmniverseからIsaac Simを起動する

44 | まず、OmniverseのLauncherからIsaac SimのLauncherを起動します。

45 |

46 |

47 | ### 1.2 Isaac SimのインストールディレクトリでTerminalを開く

48 | 次に、Isaac SimのLauncherから”Open in Terminal”を選択します。

49 |

50 |

51 |

52 | ## 2. データ生成のコマンドの実行

53 | ### 2.1 データ保存先ディレクトリを作成する