├── 1 深度学习介绍.md

├── 10 卷积神经网络.md

├── 11 深度卷积网络 实例探究.md

├── 12 目标检测.md

├── 13 特殊应用 人脸识别和神经风格转换.md

├── 14 序列模型.md

├── 15 自然语言处理与词嵌入.md

├── 2 神经网络基础.md

├── 3 浅层神经网络.md

├── 4 深层神经网络.md

├── 5 深度学习的实用层面.md

├── 6 优化算法.md

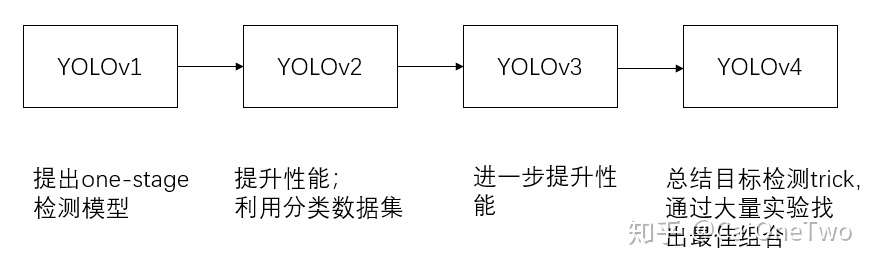

├── 7 超参数的调试,BN和程序框架.md

├── 8 机器学习(ML)策略(1).md

├── 9 机器学习(ML)策略(2).md

└── README.md

/1 深度学习介绍.md:

--------------------------------------------------------------------------------

1 | ## 深度学习基础介绍

2 |

3 | ### 1.简述深度学习

4 |

5 | 深度学习(DL, Deep Learning)是机器学习(ML, Machine Learning)领域中一个新的研究方向,它被引入机器学习使其更接近于最初的目标——人工智能(AI, Artificial Intelligence)。

6 |

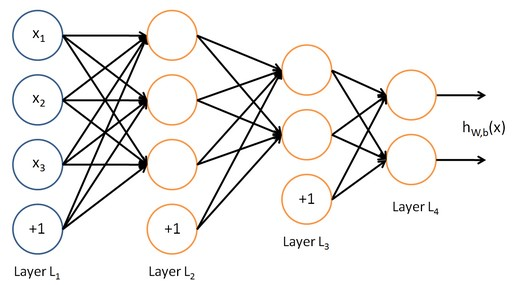

7 | 深度学习就是模仿人脑的“神经网络“建立一个类似的学习策略(如下图),基于大量的数据进行训练和学习,在这个过程中不断修改模型的参数,得到的一个更好的模型,使得这个模型能类似于人一样,识别和处理一些问题,这就是其学习性,并且有些模型的能力甚至能够超越人类的水平。

8 |

9 | 深度学习的最终目标是让机器能够像人一样具有分析学习能力,能够识别文字、图像和声音等数据。

10 |

11 |

12 |

13 | 深度学习最近几年才火起来,看似是比较新的技术,其实其早就在上个世纪被提出了,但当时由于硬件等因素,深度学习并没有引起很多人的关注和研究,如今随着各个领域的发展,深度学习有了其一定的发展前提和基础,就不断地有研究者和从业者投入其中进行研究和应用,在工业以及其他应用场景下,深度学习训练的模型为人们带来了更方便的生活,为企业带来更多的利润以及更多的剩余价值。

14 |

15 | ### 2.为什么深度学习会兴起

16 |

17 | 深度学习和神经网络之前的基础技术理念已经存在大概几十年了,为什么它们现在才突然流行起来呢?

18 |

19 |

20 |

21 | 如上图,横轴为数据量,纵轴为模型的性能,可以看到,它的性能一开始在增加更多数据时会上升,但是一段变化后它的性能就会像一个高原一样。

22 |

23 | 而在过去的几十年里,训练模型的数据集是非常小的,当时的人们难以收集并且构建足够大,有效的数据集,从而导致模型没有充足地得到训练,而随着数字化社会的来临,现在的数据量都非常巨大,制作有效的数据集变得容易得多,模型也就能够得到充足的训练,这也是深度学习兴起的一大重要原因。

24 |

25 | 同时无论是在CPU还是GPU上面的,都在不断得发展,使得高计算量的深度学习模型能够更快的得到训练,以往需要训练两个月的数据量,现在只需要三天就能够完成。尤其是在最近这几年,我们也见证了算法方面的极大创新。许多算法方面的创新,一直是在尝试着使得神经网络运行的更快。

26 |

27 |

28 |

29 |

30 |

31 | ### 3.深度学习和机器学习以及人工智能之间的关系。

32 |

33 |

34 |

35 | ### 3.学习深度学习需要什么前置知识

36 |

37 | 要有比较基础的高数和线性代数的知识

38 |

39 | 编程语言:python

40 |

41 | 最好有机器学习的基础,当然如果没有直接学习也没有什么影响(笔者建议可以有时间可以的看一下)

42 |

43 |

44 |

45 | ## 吴恩达深度学习课程介绍

46 |

47 | ### 1.简介:

48 |

49 | 吴恩达这门课可以说是非常适合新手,或者说对于零基础的人学习的,这几门课程的顺序也是由浅至深的进行,只要按照顺序学习,无需担心看不懂。

50 |

51 | 这些课程中可以学习到深度学习的基础,学会构建神经网络,也会有很多实操项目,帮助学生更好地应用自己学到的深度学习技术,解决真实世界问题。

52 |

53 |

54 |

55 | ### 2.具体结构:

56 |

57 | 吴恩达的课程主要分为五门课,具体内容如下:

58 |

59 | 第一门课程中,将学习如何建立神经网络(包含一个深度神经网络),以及如何在数据上面训练他们。

60 |

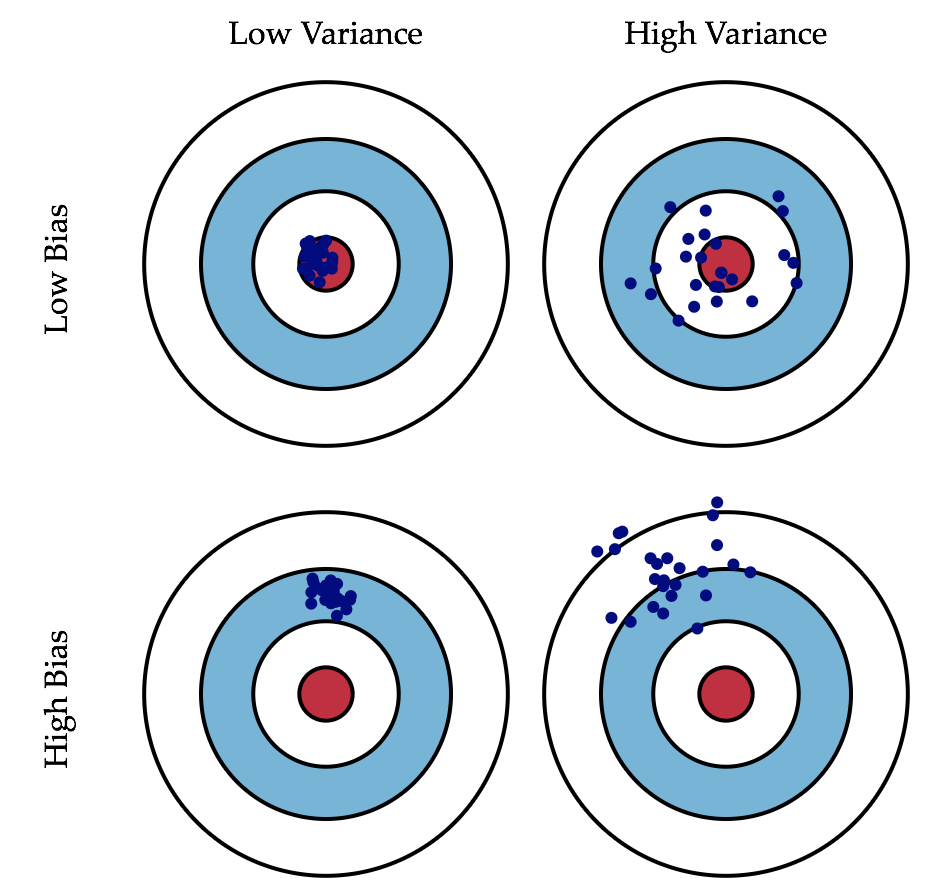

61 | 第二门课中,将进行深度学习方面的实践,学习严密地构建神经网络,如何真正让它表现良好,因此你将要学习超参数调整、正则化、诊断偏差和方差以及一些高级优化算法。以及神经网络的编程知识,了解神经网络的结构,逐步完善算法并思考如何使得神经网络高效地实现。

62 |

63 | 第三门课中,将学习如何结构化机器学习工程。

64 |

65 | 第四门课程中,将会学到如何搭建卷积神经网络(***\*CNN(s)\****)这样的模型。

66 |

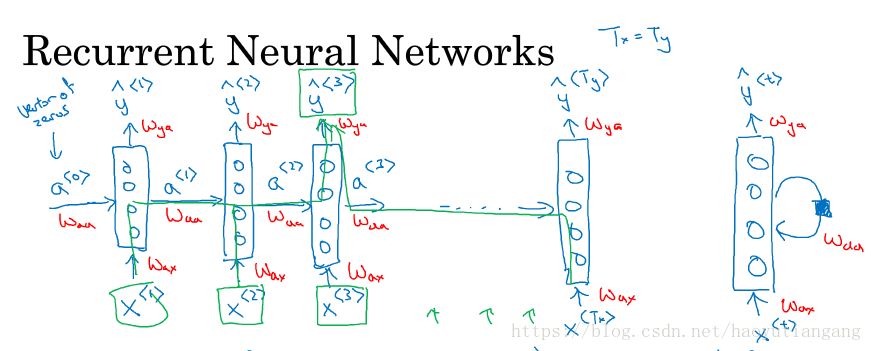

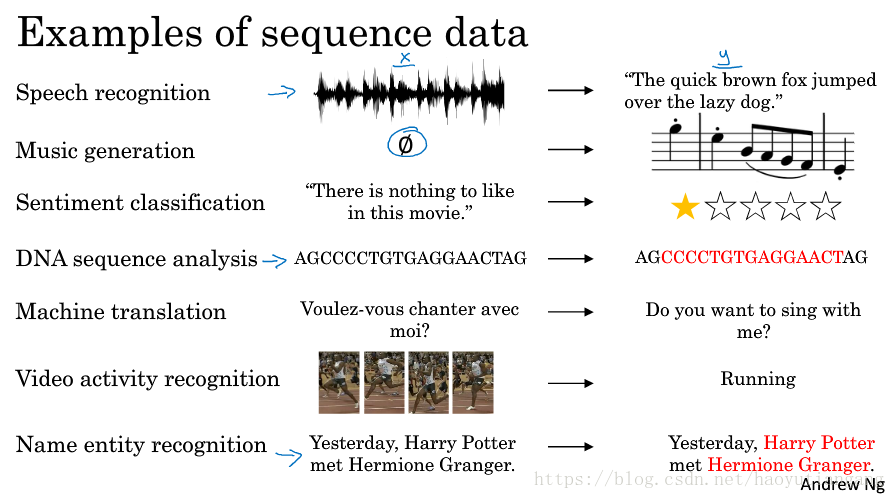

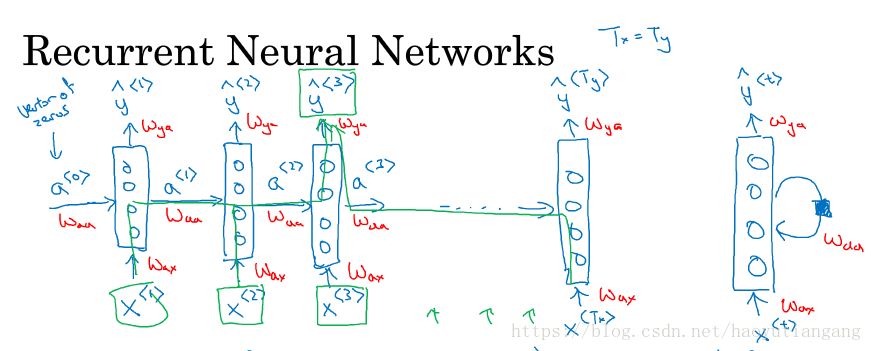

67 | 第五门课中,将会学习到序列模型(循环神经网络(***\*RNN\****)、长短期记忆网络(***\*LSTM\****)),以及如何将它们应用于自然语言处理,以及其它问题。

68 |

69 |

70 |

71 |

72 |

73 | ## 深度学习学习资源

74 |

75 | 1.[吴恩达系列课](https://study.163.com/courses-search?keyword=%E5%90%B4%E6%81%A9%E8%BE%BE)

76 |

77 | 网易云课堂搜索 吴恩达(这个是免费的)

78 |

79 | 2.[吴恩达课后作业以及代码](https://blog.csdn.net/u013733326/article/details/79827273)

80 |

81 | 3.[吴恩达课程内容笔记](https://github.com/fengdu78/deeplearning_ai_books):(这个真的很全,主要有视频文字版,也有涉及的论文清单以及其他的相关的资料和)

82 |

83 | 4.[经典论文清单](https://github.com/terryum/awesome-deep-learning-papers)

84 |

85 | 5.[TensorFlow 2.0入门教程](https://github.com/snowkylin/tensorflow-handbook)(大家找TensorFlow的教程时一定要注意1.0和2.0的版本差别)

86 |

87 | 8.[Keras中文档案](https://keras.io/zh/why-use-keras/)

88 |

89 | 9.[CV进阶](http://cs231n.stanford.edu/):斯坦福的计算机视觉课CS231n(官网只有2017年的,b站有中文版)

90 |

91 | 11. [Deep Learning](https://link.zhihu.com/?target=http%3A//www.deeplearningbook.org/) by Yoshua Bengio, Ian Goodfellow and Aaron Courville

92 |

93 | 深度学习的一本教科书,知识面很全,书籍同时兼顾广度和深度,是很多深度学习系统化学习的参考教材。

94 |

95 | 12. [Neural networks and deep learning](https://link.zhihu.com/?target=http%3A//neuralnetworksanddeeplearning.com/) by Michael Nielsen

96 |

97 | 这是一本免费的在线书籍,主要介绍了神经网络和深度学习背后的核心概念。

98 |

99 | 13. [Deep Learning: Methods and Applications - Microsoft Research](https://link.zhihu.com/?target=https%3A//www.microsoft.com/en-us/research/publication/deep-learning-methods-and-applications/%3Ffrom%3Dhttp%3A%2F%2Fresearch.microsoft.com%2Fpubs%2F209355%2Fdeeplearning-nowpublishing-vol7-sig-039.pdf) Microsoft Research (2013)

100 |

101 | 本书旨在提供一般深度学习方法及其应用于各种信号和信息处理任务的概述,介绍了深度学习在语言、文字处理、信息检索、计算机视觉领域的具体运用。

102 |

103 | 14. [Deep Learning Tutorial](https://link.zhihu.com/?target=http%3A//deeplearning.net/tutorial/deeplearning.pdf) LISA lab, University of Montreal (Jan 6 2015)

104 |

105 | 蒙特利尔大学LISA实验室深度学习的教材,对卷积神经网络和LSTM、RNN等神经网络进行了具体的介绍,教材例子比较多,操作性比较强。

106 |

107 | 15. [An introduction to genetic algorithms](https://link.zhihu.com/?target=https%3A//svn-d1.mpi-inf.mpg.de/AG1/MultiCoreLab/papers/ebook-fuzzy-mitchell-99.pdf)

108 |

109 | 遗传算法简介

110 |

111 | 16. [Artificial Intelligence: A Modern Approach](https://link.zhihu.com/?target=http%3A//aima.cs.berkeley.edu/)

112 |

113 | 目前已经是第三版,是110多个国家超过1300所大学的教材,有免费的在线AI课程。主要是从数学的角度介绍人工智能、问题求解、知识与推理。

114 |

115 | 17. [Deep Learning in Neural Networks: An Overview](https://link.zhihu.com/?target=http%3A//arxiv.org/pdf/1404.7828v4.pdf)

116 |

117 | 本文详细地回顾了监督学习(包括反向传播)、无监督学习、强化学习和进化学习。

118 |

119 |

--------------------------------------------------------------------------------

/10 卷积神经网络.md:

--------------------------------------------------------------------------------

1 | ## 10 卷积神经网络

2 |

3 | ### 10.1 计算机视觉

4 |

5 | 计算机视觉(Computer Vision)是指用计算机实现人的视觉功能——对客观世界的三维场景的感知、识别和理解。它的任务包括:

6 |

7 | 1. 图片分类(图片识别):识别图像物体属于的类别。比如分辨图片中的猫咪。

8 |

9 | 2. 目标检测:用框去标出物体的位置,并给出物体的类别。比如无人驾驶项目中,识别图片中障碍物的位置,再将它们模拟成一个个盒子,并计算距离。

10 |

11 | 3. 风格迁移:如图1所示,两种不同的图片风格,可以利用神经网络将它们融合到一起,描绘出一张新的图片。它的整体轮廓来自于左边,却是右边的风格。

12 |

13 |

14 |

15 | 图1

16 |

17 | 4. 图像语义分割:像素级分类,输出图像与输入图像大小一致,整体效果为图像的每一个区域都会分类。如图

18 |

19 |

20 |

21 |

22 |

23 | 为何难以使用全连接?

24 |

25 | 图片处理的数据量巨大。如果是1000x1000的彩色图片,因为每张图片都有3个颜色通道,那么输入就是300万,进入神经网络后假设第一层有1000个节点,那么$w_1$的参数个数就是30亿,如此大的参数量对内存和计算资源都是一种挑战,面对这个问题需要使用计算机视觉中常用的卷积操作。

26 |

27 |

28 |

29 |

30 | ### 10.2 边缘检测

31 |

32 | #### 10.2.1 卷积神经网络中的卷积运算

33 |

34 | 以一维灰度图像为例,输入是6×6×1的矩阵,构造一个3×3×1的矩阵,如图2所示。在卷积神经网络的术语中,它被称为过滤器(又称卷积核)。

35 |

36 | 对输入矩阵进行卷积,即输入矩阵与卷积核相乘,具体乘法方式为:从输入矩阵左上角开始找到与卷积核相同尺寸的小矩阵,并对应位置相乘求和,得到第一个卷积的结果,继续位移对整个矩阵进行该操作,得到新的矩阵,过程如下:

37 |

38 |

39 |

40 | 图2

41 |

42 | 1. 计算输出矩阵第一个元素:对于4×4输出矩阵最左上角元素,使用3×3的过滤器,将其覆盖在输入图像,如图2所示。然后进行元素乘法运算,即:

43 |

44 | $$

45 | \left[\begin{array}{ccc}

46 | 3 \times 1 & 0 \times 0 & 1 \times(1) \\

47 | 1 \times 1 & 5 \times 0 & 8 \times(-1) \\

48 | 2 \times 1 & 7 \times 0 & 2 \times(-1)

49 | \end{array}\right]=\left[\begin{array}{ccc}

50 | 3 & 0 & -1 \\

51 | 1 & 0 & -8 \\

52 | 2 & 0 & -2

53 | \end{array}\right]

54 | $$

55 |

56 | 然后将该矩阵每个元素相加得到最左上角的元素,即3 + 1 + 2 + 0 + 0 + 0 + (-1) + (-8) + (-2) = -5。

57 |

58 | 2. 计算输出矩阵第二个元素:即图3标注的红框,先把蓝色的方块向右移动一步,再继续做同样的元素乘法,然后相加,所以是0×1 + 5×1 + 7×1 + 1×0 + 8×0 + 2×0 + 2×(-1) + 9×(-1) + 5×(-1) = -4。以此类推,可以计算输出矩阵第一行的值。

59 |

60 |

61 |

62 | 图3

63 |

64 | 3. 得到下一行的元素:把蓝色块下移,到如图4所示位置,重复进行元素乘法,然后加起来。通过这样做得到-10。再将其右移得到-2,接着是2,3。以此类推,这样计算完矩阵中的其他元素。

65 |

66 |

67 |

68 | 图3

69 |

70 | 左边矩阵容易被理解为一张图片,中间的这个被理解为过滤器,右边的图片可以理解为另一张图片。这就是垂直边缘检测器。结果如图所示:

71 |

72 |

73 |

74 | 图4

75 |

76 | #### 10.2.2 垂直边缘检测

77 |

78 | 为了讲清楚,举一个简单的例子。这是一个简单的6×6图像,左边的一半是10,代表亮色,右边一半是0,代表暗色。在中间部分,就被视为一个垂直边缘。

79 |

80 | 使用一个3×3过滤器进行卷积运算,得到图5最右边4×4的输出矩阵,在中间有段亮一点的区域(30),即对应检查到6×6图像中间的垂直边缘。结果为正数(30),代表从左至右来看,原图左半部分较亮。

81 |

82 |

83 | 图5

84 |

85 | #### 10.2.3 水平边缘检测

86 |

87 | 相似的,如图六所示,检测输入图片的水平边缘,左上方和右下方都相对较亮(10)。水平边缘过滤器则是一个3×3的矩阵,但是它的上边相对较亮(1),而下方相对较暗(-1)。

88 |

89 | 卷积后从输出矩阵看出一条水平边缘。其中左半部分为正数(30,10),代表从上至下来看,原图上面部分较亮。右半部分为负数(-10,-30),代表原图下面部分较亮。

90 |

91 |

92 |

93 | 图6

94 |

95 | #### 10.2.4 区分正边和负边

96 |

97 | 假如把输入图片的颜色翻转,变成了左边比较暗,而右边比较亮,使用相同的过滤器进行卷积,最后得到的图中间会是-30,而不是30。表明是由暗向亮过渡,而不是由亮向暗过渡。因此,输出的正负即可代表边缘的过渡情况。

98 |

99 |

100 | 图7

101 |

102 | #### 10.2.5 为什么是3*3的卷积核?

103 |

104 | 1. 3x3是最小的能够捕获像素八邻域信息的尺寸。

105 | 2. 两个3x3的卷积核有限感受野是5x5;三个3x3的卷积核的感受野是7x7,故可以通过小尺寸卷积层的堆叠替代大尺寸卷积层,并且感受野大小不变。

106 | 3. 多个3x3的卷积核比一个大尺寸卷积核有更多的非线性(更多层可以使用更多个非线性函数)。

107 | 4. 多个3x3的卷积层比一个大尺寸卷积核有更少的参数,如三个3x3的卷积层参数个数3x3x3=27;一个7x7的卷积层参数为49。唯一的不足是,在进行反向传播时,中间的卷积层可能会导致占用更多的内存。

108 |

109 |

110 | ### 10.3 更多的边缘检测

111 |

112 | 在历史上,在计算机视觉的文献中,对于这个3×3的过滤器来说,曾公平地争论过怎样的数字组合才是最好的。不同的过滤器可以起到不同的效果,如Sobel过滤器,Scharr过滤器。

113 |

114 | 1. Prewitt过滤器:是一种图像边缘检测的微分算子,其原理是利用特定区域内像素灰度值产生的差分实现边缘检测。实际上也是一种垂直边缘检测。将其翻转90度,就能得到对应水平边缘检测。

115 |

116 | $$

117 | \left[\begin{array}{lll}-1 & 0 & 1 \\-1 & 0 & 1 \\-1 & 0 & 1\end{array}\right]

118 | $$

119 |

120 |

121 | 2. Sobel的过滤器:它的优点在于增加了中间一行元素的权重,这使得结果的鲁棒性会更高一些。

122 |

123 | $$

124 | \left[\begin{array}{lll}

125 | 1 & 0 & -1 \\

126 | 2 & 0 & -2 \\

127 | 1 & 0 & -1

128 | \end{array}\right]

129 | $$

130 |

131 | 3. Scharr过滤器:它和sobel过滤器类似,但结果更为精确。

132 |

133 | $$

134 | \left[\begin{array}{lll}

135 | 3 & 0 & -3 \\

136 | 10 & 0 & -10 \\

137 | 3 & 0 & -3

138 | \end{array}\right]

139 | $$

140 |

141 | 4. 拉普拉斯(Laplacian) 过滤器:是 $n$ 维欧几里德空间中的一个二阶微分算子,常用于图像增强领域和边缘提取。它可以判断中心像素灰度与邻域内其他像素灰度的关系。Laplacian算子分为四邻域和八邻域,四邻域是对邻域中心像素的四个方向求梯度,八邻域是对八个方向求梯度。

142 | 其中,Laplacian算子四邻域模板如下所示:

143 |

144 | $$

145 | \begin{array}{l}

146 | \mathrm{H}=\left[\begin{array}{ccc}

147 | 0 & -1 & 0 \\

148 | -1 & 4 & -1 \\

149 | 0 & -1 & 0

150 | \end{array}\right] \\

151 | \end{array}

152 | $$

153 |

154 | 八邻域模板如下所示:

155 | $$

156 | \begin{array}{l}

157 | \mathrm{H}=\left[\begin{array}{ccc}

158 | -1 & -1 & -1 \\

159 | -1 & 8 & -1 \\

160 | -1 & -1 & -1

161 | \end{array}\right]

162 | \end{array}

163 | $$

164 |

165 | 5. Kirsch过滤器:类似于Sobel过滤器,Sobel过滤器计算出某点两个方向的梯度值$G_x$、$G_y$;但Kirsch过滤器利用8个卷积模板来确定梯度幅度值和梯度的方向,并以最大的卷积值作为该点的灰度值。

166 |

167 |

168 |

169 | 图8

170 |

171 | 将过滤器的所有数字都设置为参数,可以通过反向传播学习,得到的滤波器没有特定的名称,但是可以检测不同的特征,如偏向45度的边缘检测,或者70度78度都可以检测。

172 | 这种将这9个数字当成参数的思想,已经成为计算机视觉中最为有效的思想之一。

173 |

174 | ### 10.4 Padding

175 |

176 | **为什么需要Padding?**

177 |

178 | 如果你用一个 3×3 的过滤器卷积一个 6×6 的图像,你最后会得到一个 4×4 的输出,也就是一个 4×4 矩阵。因为你的 3×3 过滤器在 6×6 矩阵中,只可能有 4×4 种可能的位置。这背后的数学解释是,如果我们有一个𝑛 × 𝑛的图像,用𝑓 × 𝑓的过滤器做卷积,那么输出的维度就是(𝑛 − 𝑓 + 1) × (𝑛 − 𝑓 + 1)。在这个例子里是6 − 3 + 1 = 4,因此得到了一个 4×4 的输出。

179 |

180 |

181 |

182 | 这样的话会有两个缺点。

183 |

184 | 第一个缺点是**输出缩小**。每次做卷积操作,图像就会缩小,从 6×6 缩小到 4×4,你可能做了几次之后,你的图像就会变得很小了,可能会缩小到只有 1×1 的大小。但我们不想让图像在每次识别边缘或其他特征时都缩小。

185 |

186 | 第二个缺点是**丢失了图像边缘的大部分信息**。角落边缘的像素点只被一个输出所触碰或者使用,因为它位于这个 3×3 的区域的一角。但如果是在中间的像素点,就会有许多 3×3 的区域与之重叠。所以那些在角落或者边缘区域的像素点在输出中采用较少,意味着你丢掉了图像边缘位置的许多信息。

187 |

188 | 为了解决这些问题,我们可以进行Padding操作——在卷积操作之前填充这幅图像。

189 |

190 | **Padding**

191 |

192 |

193 |

194 | 例如,我们沿着图像边缘再填充一层像素。那么 6×6 的图像就被你填充成了一个 8×8 的图像。如果你用 3×3 的图像对这个 8×8 的图像卷积,你得到的输出就不是 4×4 的,而是 6×6的图像,你就得到了一个尺寸和原始图像 6×6 的图像。习惯上,你可以用 0 去填充。

195 |

196 | **使用Padding后计算输出图像的大小**

197 |

198 | 如果𝑝是填充的数量,输出就变成(𝑛 + 2𝑝 − 𝑓 + 1) × (𝑛 + 2𝑝 − 𝑓 + 1)。

199 |

200 | 在这个案例中,𝑝 = 1,因为我们在周围都填充了一个像素点,所以就变成了(6 + 2 × 1 − 3 + 1) × (6 + 2 × 1 − 3 + 1) = 6 × 6。

201 |

202 | **Valid卷积**

203 |

204 | 意味着不填充。

205 | $$

206 | (n \times n) \text { * } (f \times f) \rightarrow (n-f+1) \times (n-f+1)

207 | $$

208 | **Same卷积**

209 |

210 | 意味着填充后输出大小和输入大小是一样的。

211 | $$

212 | (n+2 p) \times (n+2 p) \quad * \quad (f \times f) \rightarrow (n+2 p-f+1 ) \times (n+2 p-f+1)

213 | $$

214 | 根据这个公式𝑛 − 𝑓 + 1,当你填充𝑝个像素点,𝑛就变成了𝑛 + 2𝑝,最后公式变为𝑛 + 2𝑝 − 𝑓 + 1。因此如果你有一个𝑛 × 𝑛的图像,用𝑝个像素填充边缘,输出的大小就是这样的(𝑛 + 2𝑝 − 𝑓 + 1) × (𝑛 + 2𝑝 − 𝑓 + 1)。

215 |

216 | 如果你想让**𝑛 + 2𝑝 − 𝑓 + 1 = 𝑛**的话,使得输出和输入大小相等,如果你用这个等式求解𝑝,那么**𝑝 = (𝑓 − 1)/2**。所以当𝑓是一个奇数的时候,只要选择相应的填充尺寸,你就能确保得到和输入相同尺寸的输出。

217 |

218 | 习惯上,计算机视觉中,𝑓通常是奇数。如果𝑓是一个偶数,那么你只能使用一些不对称填充。只有𝑓是奇数的情况下,Same 卷积才会有自然的填充,我们可以以同样的数量填充四周,而不是左边填充多一点,右边填充少一点,这样不对称的填充。其次,当你有一个奇数维过滤器,比如 3×3 或者 5×5 的,它就有一个中心点。有时在计算机视觉里,如果有一个中心像素点会更方便,便于指出过滤器的位置。

219 |

220 | ### 10.5 卷积步长

221 |

222 | 卷积中的步幅是另一个构建卷积神经网络的基本操作,如下例。

223 |

224 |

225 |

226 | 如果你想用 3×3 的过滤器卷积这个 7×7 的图像,和之前不同的是,我们把步幅设置成了2。你还和之前一样取左上方的 3×3 区域的元素的乘积,再加起来,最后结果为 91。

227 |

228 |

229 |

230 | 只是之前我们移动蓝框的步长是 1,现在移动的步长是 2,我们让过滤器跳过 2 个步长,注意一下左上角,这个点移动到其后两格的点,跳过了一个位置。然后你还是将每个元素相乘并求和,你将会得到的结果是 100。

231 |

232 | 现在我们继续,将蓝色框移动两个步长,你将会得到 83 的结果。当你移动到下一行的时候,你也是使用步长 2 而不是步长 1,所以我们将蓝色框移动到这里:

233 |

234 |

235 |

236 | 注意到我们跳过了一个位置,得到 69 的结果,现在你继续移动两个步长,会得到 91,127,最后一行分别是 44,72,74。

237 |

238 |

239 |

240 | 在这个例子中,用 3×3 的矩阵卷积一个 7×7 的矩阵,得到一个 3×3 的输出。输入和输出的维度是由下面的公式决定的。

241 |

242 | 如果你用一个𝑓 × 𝑓的过滤器卷积一个𝑛 × 𝑛的图像,你的 padding为𝑝,步幅为𝑠,在这个例子中𝑠 = 2,你会得到一个输出,因为现在你不是一次移动一个步子,而是一次移动𝑠个步子,输出于是变为

243 | $$

244 | (\frac{n+2 p-f}{s}+1) \times (\frac{n+2 p-f}{s}+1)

245 | $$

246 | 如果商不是一个整数,则**向下取整**。

247 |

248 |  249 |

250 | ⌊ ⌋这是向下取整的符号,这也叫做对𝑧进行地板除(floor),这意味着𝑧向下取整到最近的整数。这个原则实现的方式是,你只在蓝框完全包括在图像或填充完的图像内部时,才对它进行运算。如果有任意一个蓝框移动到了外面,那你就不要进行相乘操作,这是一个惯例。

251 |

252 | 可以选择所有的数使结果是整数是挺不错的,尽管一些时候,你不必这样做,只要向下取整也就可以了。你也可以自己选择一些𝑛,𝑓,𝑝和𝑠的值来验证这个输出尺寸的公式是对的。

253 |

254 | **卷积(concolution)与互相关(cross-correlation)**

255 |

256 | 如果你看的是一本典型的数学教科书,那么卷积的定义是做元素乘积求和,实际上还有一个步骤是你首先要做的,也就是在把这个 6×6 的矩阵和 3×3 的过滤器卷积之前,首先你将 3×3 的过滤器沿水平和垂直轴翻转,所以

257 | $$

258 | \left[\begin{array}{ccc}

259 | 3 & 4 & 5 \\

260 | 1 & 0 & 2 \\

261 | -1 & 9 & 7

262 | \end{array}\right] \text { 变为 }\left[\begin{array}{ccc}

263 | 7 & 2 & 5 \\

264 | 9 & 0 & 4 \\

265 | -1 & 1 & 3

266 | \end{array}\right]

267 | $$

268 | 这相当于将 3×3 的过滤器做了个**镜像**,在水平和垂直轴上。然后再把这个翻转后的矩阵复制到这里(左边的图像矩阵),你要把这个翻转矩阵的元素相乘来计算输出的 4×4 矩阵左上角的元素,如图所示。然后取这 9 个数字,把它们平移一个位置,再平移一格,以此类推。

269 |

270 |

249 |

250 | ⌊ ⌋这是向下取整的符号,这也叫做对𝑧进行地板除(floor),这意味着𝑧向下取整到最近的整数。这个原则实现的方式是,你只在蓝框完全包括在图像或填充完的图像内部时,才对它进行运算。如果有任意一个蓝框移动到了外面,那你就不要进行相乘操作,这是一个惯例。

251 |

252 | 可以选择所有的数使结果是整数是挺不错的,尽管一些时候,你不必这样做,只要向下取整也就可以了。你也可以自己选择一些𝑛,𝑓,𝑝和𝑠的值来验证这个输出尺寸的公式是对的。

253 |

254 | **卷积(concolution)与互相关(cross-correlation)**

255 |

256 | 如果你看的是一本典型的数学教科书,那么卷积的定义是做元素乘积求和,实际上还有一个步骤是你首先要做的,也就是在把这个 6×6 的矩阵和 3×3 的过滤器卷积之前,首先你将 3×3 的过滤器沿水平和垂直轴翻转,所以

257 | $$

258 | \left[\begin{array}{ccc}

259 | 3 & 4 & 5 \\

260 | 1 & 0 & 2 \\

261 | -1 & 9 & 7

262 | \end{array}\right] \text { 变为 }\left[\begin{array}{ccc}

263 | 7 & 2 & 5 \\

264 | 9 & 0 & 4 \\

265 | -1 & 1 & 3

266 | \end{array}\right]

267 | $$

268 | 这相当于将 3×3 的过滤器做了个**镜像**,在水平和垂直轴上。然后再把这个翻转后的矩阵复制到这里(左边的图像矩阵),你要把这个翻转矩阵的元素相乘来计算输出的 4×4 矩阵左上角的元素,如图所示。然后取这 9 个数字,把它们平移一个位置,再平移一格,以此类推。

269 |

270 |  271 |

272 | 但在深度学习文献中,定义卷积运算时跳过了这个镜像操作。前面我们实际上做的,有时被称为互相关而不是卷积。

273 |

274 | 总结来说,按照机器学习的惯例,我们通常不进行翻转操作。从技术上说,这个操作可能叫做互相关更好。但在大部分的深度学习文献中都把它叫做卷积运算。

275 |

276 | ### 10.6 三维卷积

277 |

278 | **三维(RGB图像)上的卷积操作**

279 |

280 | 举例,假如你不仅想检测灰度图像的特征,也想检测 RGB 彩色图像的特征。彩色图像如果6×6×3,这里的第一个 6 代表图像高度,第二个 6 代表宽度,这个3 代表颜色通道的数目。你可以把它想象成三个 6×6图像的堆叠。为了检测图像的边缘或者其他的特征,不是把它跟原来的 3×3 的过滤器做卷积,而是跟一个三维的过滤器,它的维度是 3×3×3,这样这个过滤器也有三层,对应红、绿、蓝三个通道。得到的输出会是一个 4×4 的图像,注意是 4×4×1,最后一个数不是 3 了。

281 |

282 | 为了简化这个 3×3×3过滤器的图像,我们不把它画成 3 个矩阵的堆叠,而画成一个三维的立方体。

283 |

284 |

285 |

286 | **计算过程**:

287 |

288 | 把这个 3×3×3 的过滤器先放到最左上角的位置,这个 3×3×3 的过滤器有 27 个数,27 个参数就是 3 的立方。依次取这 27 个数,然后乘以相应的红绿蓝通道中的数字。先取红色通道的前 9 个数字,然后是绿色通道,然后再是蓝色通道,乘以左边黄色立方体覆盖的对应的 27 个数,然后把这些数都加起来,就得到了输出的第一个数字。如果要计算下一个输出,你把这个立方体滑动一个单位,再与这 27 个数相乘,把它们都加起来,就得到了下一个输出,以此类推。

289 |

290 |

291 |

292 |

293 |

294 | **作用**:

295 |

296 | 举例:

297 |

298 | - 如果你想检测图像红色通道的边缘,那么你可以将第一个过滤器设为$\left[\begin{array}{rrr}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right]$,和之前一样,而绿色通道全为 0,$\left[\begin{array}{lll}0 & 0 & 0 \\ 0 & 0 & 0 \\ 0 & 0 & 0\end{array}\right]$,蓝色也全为 0。如果你把这三个堆叠在一起形成一个3×3×3的过滤器,那么这就是一个检测垂直边界的过滤器,但只对红色通道有用。

299 | - 或者如果你不关心垂直边界在哪个颜色通道里,那么你可以用一个这样的过滤器,$\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right],\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right],\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right]$,所有三个通道都是这样。所以通过设置第二个过滤器参数,你就有了一个边界检测器,3×3×3 的边界检测器,用来检测任意颜色通道里的边界。参数的选择不同,可以得到不同的特征检测器,所有的都是 3×3×3 的过滤器。

300 |

301 | **同时用多个过滤器**

302 |

303 | 有时候我们会想要同时检测垂直边缘和水平边缘,还有 45°倾斜的边缘,还有 70°倾斜的边缘等等,这是就需要使用多个过滤器。

304 |

305 |

306 |

307 | 例如我们让这个 6×6×3 的图像和这个 3×3×3 的过滤器卷积,得到 4×4 的输出。(第一个)这可能是一个垂直边界检测器或者是学习检测其他的特征。第二个过滤器可以用橘色来表示,它可以是一个水平边缘检测器。做完卷积,然后把这两个 4×4 的输出堆叠在一起,这样你就都得到了一个4×4×2 的输出立方体。这里的 2 的来源于我们用了两个不同的过滤器。

308 |

309 | **维度总结**

310 |

311 | 如果你有一个$n \times n \times n_{c}$(通道数)的输入图像,上例中就是 6×6×3,这里的$n_{c}$就是通道数目,然后卷积上一个$f \times f \times n_{c}$,这个例子中是 3×3×3,按照惯例,这个(前一个𝑛𝑐)和这个(后一个𝑛𝑐)必须数值相同。然后你就得到了,$(n-f+1)\times(n-f+1) \times n_{c^{\prime}}$这里$n_{c^{\prime}}$其实就是下一层的通道数,它就是你用的过滤器的个数,在我们的例子中,那就是 4×4×2。我写下这个假设时,用的步幅为 1,并且没有 padding。如果你用了不同的步幅或者 padding,那么这个$𝑛 − 𝑓 + 1$数值会变化。

312 | $$

313 | n \times n \times n_{c} \text { * } f \times f \times n_{c} \rightarrow (n-f+1)\times(n-f+1) \times n_{c^{\prime}}

314 | $$

315 | **思考**:为什么卷积核是3\*3channels而不是3\*3\*1在多个通道之间移动?

316 |

317 | 如果使用3\*3\*1的卷积核在多个通道中移动,那意味着每个通道都用同一个过滤器,而且每个过滤器(卷积核)都忽略了隐藏在通道之间的联系和信息,这无疑会降低卷积网络的效果。

318 |

319 | ### 10.7 单层卷积网络

320 |

321 |

322 |

323 | 相比之前的卷积过程,CNN的单层结构多了激活函数ReLU和偏移量b,与神经网络的单层结构类似,即:

324 |

325 | $Z^{[l]}=W^{[l]} A^{[l-1]}+b$

326 | $A^{[l]}=g^{[l]}\left(Z^{[l]}\right)$

327 |

328 | 其中,卷积运算对应上式中的乘积运算,过滤器组数值对应着权重$W^{[l]}$,激活函数则为ReLU

329 |

330 | 上图中参数$W$的计算:每个过滤器组共有3x3x3=27个参数,两个过滤器组则共包含27x2=54个参数$W$

331 |

332 | 相关符号的总结(设层数为$l$)

333 |

334 | $f^{[l]}=$ filter size

335 | $p^{[l]}=$ padding

336 | $s^{[l]}=$ stride

337 | $n_{c}^{[l]}=$ number of filters

338 | $n_{H}^{[l]}=$ height of input

339 | $n_{W}^{[l]}=$ width of filters

340 |

341 | 输入维度为:

342 |

343 | $n_{H}^{[l-1]} \times n_{W}^{[l-1]} \times n_{c}^{[l-1]}$

344 | 每个滤波器组维度为:

345 |

346 | $f^{[l]} \times f^{[l]} \times n_{c}^{[l-1]}$

347 |

348 | 权重维度为:

349 |

350 | $f^{[l]} \times f^{[l]} \times n_{c}^{[l-1]} \times n_{c}^{[l]}$

351 |

352 | 偏置维度为:

353 |

354 | $ 1 \times 1 \times 1 \times n_{c}^{[l]}$

355 |

356 | 输出维度为 :

357 |

358 | $ n_{H}^{[l]} \times n_{W}^{[l]} \times n_{c}^{[l]}$

359 |

360 | 其中:

361 | $$

362 | \begin{aligned}

363 | n_{H}^{[l]} &=\left\lfloor\frac{n_{H}^{[l-1]}+2 p^{[l]}-f^{[l]}}{s^{[l]}}+1\right\rfloor \\

364 | n_{W}^{[l]} &=\left\lfloor\frac{n_{W}^{[l-1]}+2 p^{[l]}-f^{[l]}}{s^{[l]}}+1\right\rfloor

365 | \end{aligned}

366 | $$

367 | 若有$m$个样本进行向量化运算,则输出的维度为:

368 |

369 | $m \times n_{H}^{[l]} \times n_{W}^{[l]} \times n_{c}^{[l}$

370 |

371 | ### 10.8 简单卷积网络示例

372 |

373 |

374 |

375 | 如上图,是一个简单的CNN模型,且$a^{[3]}$维度为7 x 7 x 40,若将$a^{[3]}$排成1列,则维度为1960 x 1,再与输出层连接,输出层若为1个神经元,则为二元分类;若为多个神经元,则为多元分类。由此得出预测输出$\hat{y}$。

376 |

377 | 当CNN层数增加时,一般$n_{H}^{[l]}$和$n_{W}^{[l]}$会逐渐减小,而$n_{c}^{[l]}$会逐渐增大。

378 |

379 | CNN有以下三种类型的layer:

380 |

381 | - Convolution(CONV)(最为常见)

382 | - Pooling(POOL)

383 | - Fully connected(FC)

384 |

385 | ### 10.9 池化层

386 |

387 | 池化是一种下采样(downsample)手段,是对信息进行抽象的过程。

388 |

389 | 池化并不只有最大池化Max Pooling一种,不过Max Pooling是最广泛使用的一种。

390 |

391 | #### 10.9.1 最大池化 Max Pooling

392 |

393 | 最大池化指的是在采样区间内用区间内的最大值代表这个区间。

394 |

395 |

396 |

397 | 和卷积运算一样,池化也有自己的参数:池化大小、步长和Padding。只不过最常用的是2*2大小、步长为2和Valid Padding。下文如没有说明则都是采用这种最大池化。

398 |

399 | #### 10.9.2 其他池化

400 |

401 | * 平均池化:平均池化和最大池化相对应,用该区间的平均值来代表该区间。

402 | * 全局平均池化:和上述池化有点不同,是将一个通道的信息都用该通道的平均值代替。比如输入4\*4\*channels的特征图,输出一个长度为channels的特征向量。该向量每一个值都是对应通道(4*4=16个值)的平均值。通常用在最后一层卷积层后、softmax前。主要作用是代替全连接,降低参数个数。

403 | * ASPP(空洞卷积空间金字塔池化,Atrous Spatial Pyramid Pooling):和传统的池化操作不同,该池化并不降低分辨率(输出特征图的大小),但是同样可以起到对增加感受野的效果(下文介绍感受野)。

404 |

405 | #### 10.9.3 池化的作用

406 |

407 | 在介绍池化的作用前,先介绍一下感受野。

408 |

409 | **感受野 Receptive Field**

410 |

411 | 感受野表示了一个神经元(输出图的一个像素点)与多少个**原始图像**上的像素点有关联。浅层的感受野小,深层的感受野逐渐增大。对于单个神经元,其值只与其感受野有关,与感受野外无关。下图给出在经过两层3\*3的卷积后的神经元的感受野示例。

412 |

413 |

414 |

415 | 上图还可以发现,两个3\*3的卷积核能够与单个5\*5的卷积核有相同的感受野。但是前者只有2\*3\*3=18个参数,后者有5\*5=25个参数。可见可以通过多层小的卷积核来获得和单个大卷积核的相同效果,同时参数更少。甚至可以在GoogleNet中看到将n\*n拆分为1\*n和n\*1两个卷积核的做法。

416 |

417 | 对于池化层有效的原因之一,在于池化操作可以只用少量的参数大大增加下一层的神经元的感受野。方便起见,下列感受野计算不计算到原始图像那层。如果卷积层之间没有加入池化层,那后一层的神经元的感受野只为3\*3=9(假设是3\*3的卷积核);如果加入了最大池化层,那后一层的神经元的感受野可以增大到3\*3\*4=36,用同样的参数数量直接扩大了4倍。当然,简单地增加卷积核的大小也可以增加感受野,但是这样做增加了计算成本、参数数量、以及过拟合的风险。

418 |

419 | **作用**

420 |

421 | 介绍完感受野,现在开始正式介绍池化的作用:

422 |

423 | * 降低分辨率、降维、压缩特征、可以减少后续的运算量等等。但是在某些需要保持分辨率的任务(图像语义分割)中会变成一种弊端。

424 | * 只用少量参数就可以大大增加后续神经元的感受野。

425 |

426 | ### 10.10 卷积神经网络示例

427 |

428 | #### 10.10.1 LeNet5

429 |

430 | LeNet的[论文连接](https://ieeexplore.ieee.org/document/726791?reload=true&arnumber=726791)。LeNet是一个很简单很小的网络,建立之初是为了手写字识别(0-9)。虽然简单,但是是第一个典型的CNN网络。麻雀虽小,五脏俱全,包含了卷积层、池化层和全连接层。

431 |

432 | 网络结构如下:

433 |

434 |

435 |

436 |

437 |

438 | 该图没有说清楚,网络中所有卷积层的卷积核都是5*5的,以及步长为1,padding为0。图中的subsampling指的是池化,具体来说是最大池化。细心的话还会留意到最后一层用了Gaussian connections。我个人认为已经被淘汰了,感兴趣的可以自行了解。自己实现的时候当成全连接也可以。

439 |

440 | 该论文的典型之处主要在于:

441 |

442 | * 一层卷积一层池化交替出现。

443 | * 最后输出前若干层采用全连接层。

444 | * 全连接层的参数真的很多。卷积网络的参数主要集中在第一层全连接层(16\*5\*5\*120=48000)。

445 |

446 | #### 10.10.2 AlexNet

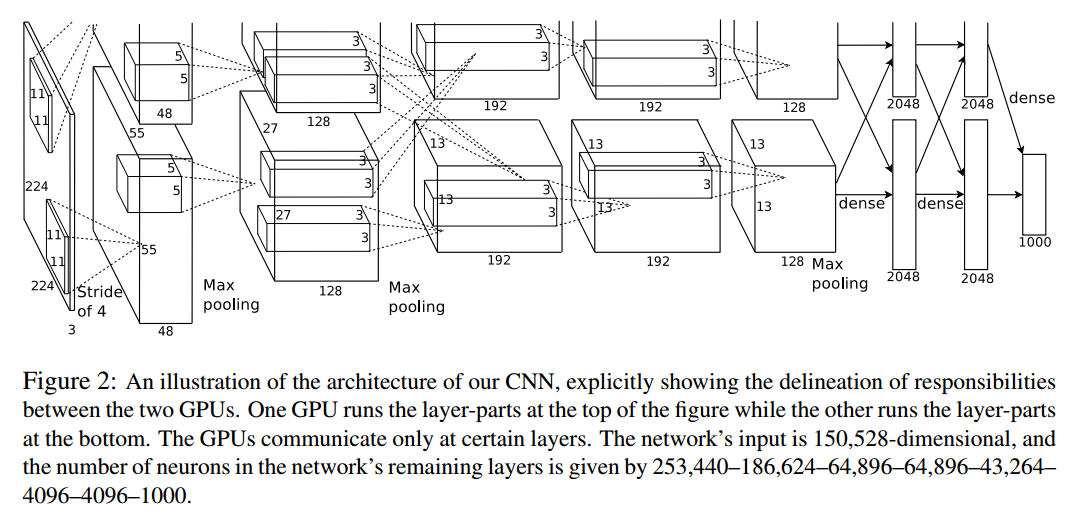

447 |

448 | AlexNet的[论文连接](http://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf)。这是第一个引起大家注意的卷积网络,该模型取得了2012年的ImageNet比赛冠军,而且也正是因为这次比赛而打响了名号。

449 |

450 | 网络结构如下:

451 |

452 |

453 |

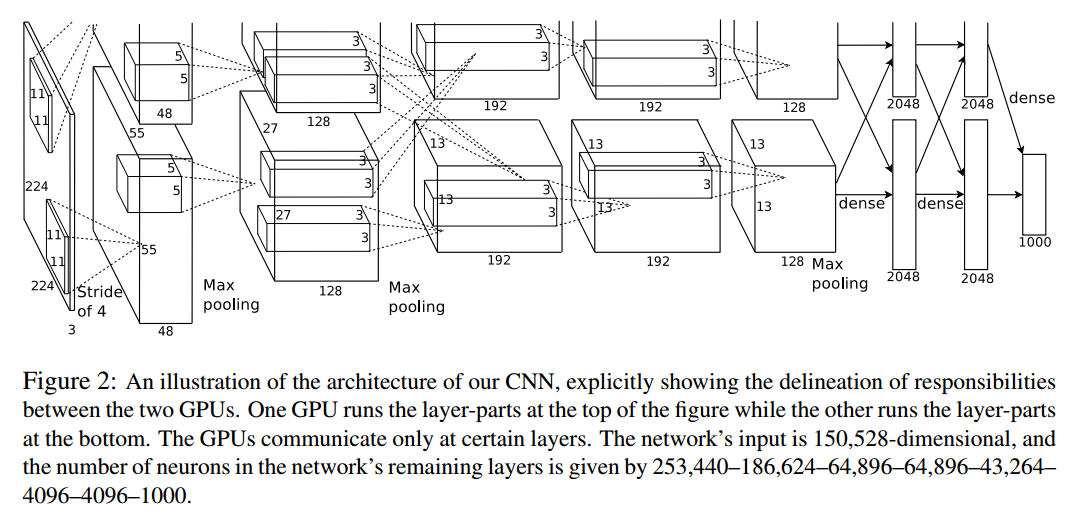

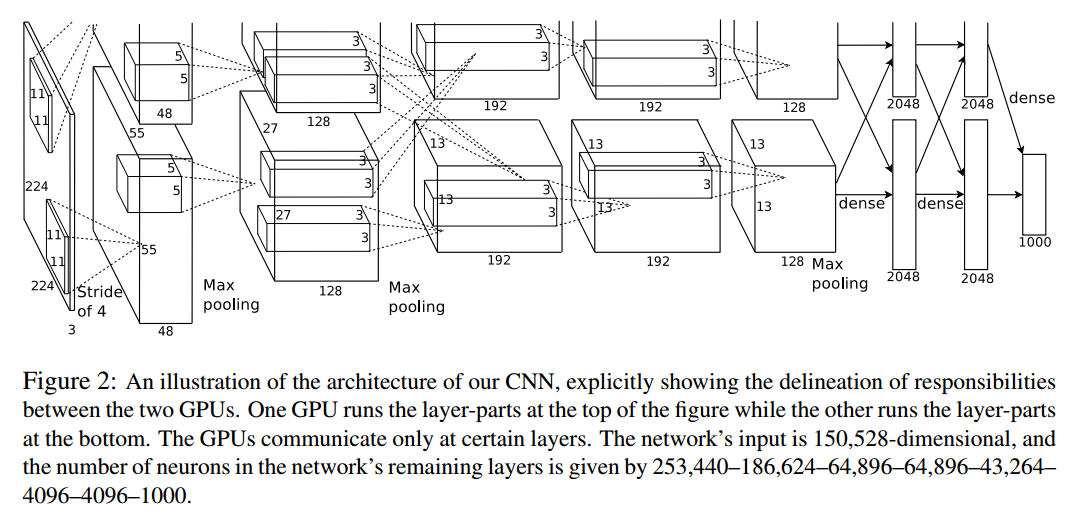

454 | 论文中该图片有误,第一个卷积层的输出应该是54\*54而不是55\*55,这个可以自己计算一下来验证。该网络在前两层就采用了相当大的卷积核,不过后面的层都只用3*3的了。该网络拿下冠军时,以比第二名少20%左右的误差率而取得优胜。

455 |

456 | 个人认为比较值得注意的点是:

457 |

458 | * 并不一定需要每层卷积层后都添加池化层。连续多层卷积层可以视为一层卷积核更大、能拟合更复杂函数的卷积层。

459 | * 对于更大的图片,感受野也需要对应增大。AlexNet的做法是前两层卷积层用了较大的卷积核。

460 |

461 | #### 10.10.3 VGG16

462 |

463 | VGG16的[论文连接](https://arxiv.org/abs/1409.1556)。该网络改进了AlexNet,改进的思路是:用更多层、更小的卷积核代替原来那些比较大的卷积核。最根本的一点是在不减小感受野的前提下增加层数和减少参数量。从结果上来看,这么做确实起到了不错的效果。

464 |

465 | 下图中,卷积层默认步长为1,padding为same。网络结构如下:

466 |

467 |

468 |

469 | 该网络不止是本身很有价值,其来源(论文)也很有价值。该论文通过对比各种网络,来说明卷积网络越深效果越好这一点。VGG16中的16就是指除去池化层,该网络一个有16层。

470 |

471 | 对比AlexNet,该网络的改进如下:

472 |

473 | * 采用多层连续的3*3卷积层代替大卷积层。

474 | * 网络深度更深了。

475 | * 通道数全部用2的幂。更符合计算机的存储规则。

476 | * 两、三层卷积层 + 一层池化。

477 | * 池化后通道数翻倍。

478 | * 每层网络的步长都为1,padding都为same。

479 |

480 | 上述改进也是现在我所看到的大部分网络的构建习惯(趋势)。我想这足以说明这些“规律”有多好用。

481 |

482 | ### 10.11 为什么使用卷积

483 |

484 | #### 10.11.1 减少参数

485 |

486 | 1.10介绍的网络也基本可以看出,卷积网络中全连接层的参数占了绝大一部分。举例LeNet5,各层参数个数分别为:第一层卷积层 5\*5\*1\*6=150、第二层卷积层 5\*5\*6\*16=2400、第一层全连接层 5\*5\*16\*120=48000、第二层全连接层 120\*84=10080,若最后一层视为全连接层则有 84\*10=840。

487 |

488 | 不难发现,第一层全连接层的参数占据了$\frac{48000}{150+2400+48000+10080+840}=0.78=78%$的参数,这已经占据了一半以上的参数。很明显,卷积层对比全连接层来说可以大大减小参数的数量,一方面可以避免过拟合,另一方面减少了对设备的要求。

489 |

490 | 更进一步,卷积操作需要的参数很少的原因在于

491 |

492 | * **权值共享**。一个卷积核的权值可以适用到整个网络,而不是每个神经元独占一个权值。因为一个卷积核的工作可以理解为专门识别某一些特征。而且这个特征应该是通用的,与所处位置无关,即**平移不变性**。同时平移不变性也是网络学习的潜在目标之一。举例垂直边缘检测便可以检索对应区域是否有垂直边界,而不在乎这个边界的具体位置在哪。

493 | * **稀疏连接**。与全连接对应,在全连接中任意一个神经元都要与上一层的所有神经元连接;而卷积则只受感受野内的神经元影响,对于感受野外的并不关心。

494 |

495 | #### 10.11.2 训练卷积网络

496 |

497 | 假设要做一个猫咪检测网络,$x^{(i)}$表示第$i$张图片,$y^{(i)}$表示对应图片的标签。在选定一个网络后,设计好损失函数,对全部样本的损失求平均作为代价函数。随机初始化权重矩阵和偏置。在Python实现时还可以向量化$x^{(i)}$(当然,就我所知大部分架构也会这么做)。用梯度下降来训练网络,而且也可以采用优化器如$RMSProp$或$Adam$。

498 |

499 |

--------------------------------------------------------------------------------

/11 深度卷积网络 实例探究.md:

--------------------------------------------------------------------------------

1 | #第二周 深度卷积网络:实例探究

2 | ## 2.1为什么要实例探究

3 |

4 | 在计算机视觉的研究中,将卷积层、池化层及全连接层进行有有机结合,才能形成有效的卷积神经网络,而更好地去实现这种有机结合可以多多参考他人所构建的框架,而且在计算机视觉中,良好的神经网络框架往往也适用于其他的任务,所以多多参考其他案例有利于我们更好地应用卷积神经网络。在框架学习中,我们也可以多多研读计算机视觉领域相关的论文或相关的研讨内容。

5 |

6 |

7 |

8 | ## 2.2经典网络

9 |

10 | ### 2.2.1LeNet-5网络

11 |

12 |

13 |

14 | 该网络是针对灰度图像训练的,该例用其对手写字体进行识别

15 |

16 | 在池化后选用$sigmoid$函数来进行非线性函数处理

17 |

18 | 其结构为卷积——池化——卷积——池化——全连接——全连接。

19 |

20 | 且采取了平均池化(当时年代的人们更倾向使用平均池化),然而现在会更多的使用最大池化。因没有使用padding或有效卷积,使得每完成一次卷积,图像的高度和宽度都缩小了。

21 |

22 | 最后输出层利用了$softmax$函数来分类输出十种结果。

23 |

24 | 相比于其他更复杂的神经网络,其参数较少,只有约六万个。

25 |

26 | 随着网络层次的加深,图像的高度和宽度都在缩小,信道数量则会增加。

27 |

28 | 其中的“一个或多个卷积层后跟着一个池化层,然后又是若干个卷积层,池化层,然后再是全连接层,最后输出。”这一模式仍被经常使用。

29 |

30 | ### 2.2.2AlexNet网络

31 |

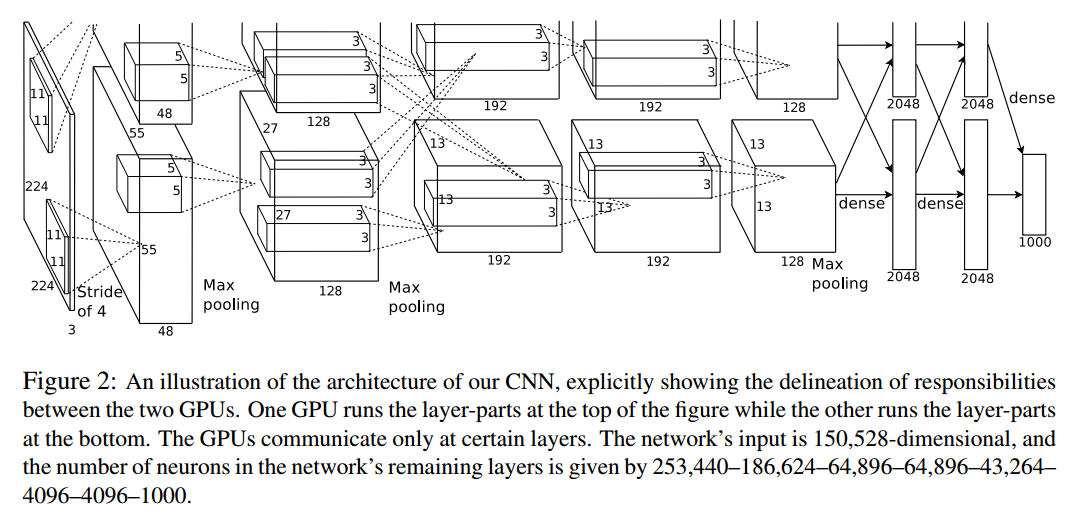

32 |

33 |

34 | 相比于LeNet-5,AlexNet网络要大得多,其有约六千万个参数,但优点在于在用于训练图像和数据集时,它能处理非常相似的基本构造模块,而往往这些模块有着隐藏单元或数据;同时采用了$Relu$函数。

35 |

36 | 在写这篇论文时,GPU的处理速度并不快,所以针对这个模型,采用了两个GPU进行训练,将不同的层拆分到两个GPU中进行训练,并用了一些专门的方法使这两个GPU得以交流。

37 |

38 | ### 2.2.3VGG-16

39 |

40 |

41 |

42 | VGG-16中的“16”代表该网络结构包含16个卷积层和全连接层

43 |

44 | 这是一个极大的网络,约有1.38亿个参数,但其优点是其结构不复杂,一般为卷积层后跟着可压缩图像大小(高度和宽度)的池化层。其过滤器数量变化存在一定规律,变化为64→128→256→512,论文作者可能认为512的信道数量已经足够大了,故没有继续增加。除了VGG-16外,还有VGG-19模型,但VGG-19模型比VGG-16要大得多,但实现的效果并不比VGG-16要好多少,故较少使用VGG-19。

45 |

46 | 随着该网络的加深,图像的高度和宽度在不断缩小,每次池化后缩小一半,而信道数量在不断增加(每次卷积后增加1倍)。即图像缩小的比例和信道增加的比例是有规律的。

47 |

48 |

49 |

50 | ## 2.3残差网络

51 |

52 | 神经网络层数越多,网络越深,越容易受到梯度消失和梯度爆炸的影响。我们可以通过让神经网络某些层跳过下一层神经元的连接,隔层相连,弱化每层之间的强联系来解决该问题。而这样的神经网络即为残差网络(ResNets)

53 |

54 | ### 2.3.1残差块

55 |

56 | 残差网络由多个残差块组成,如下图为残差块组成

57 |

58 |

59 |

60 | 图中红色箭头称为跳远连接,其建立了$a^{[l]}$与$a^{[l+2]}$的隔层联系。具体表达式为:

61 |

62 | $z^{[l+1]}=W^{[l+1]} a^{[l]}+b^{[l+1]}$

63 | $a^{[l+1]}=g\left(z^{[l+1]}\right)$

64 | $z^{[l+2]}=W^{[l+2]} a^{[l+1]}+b^{[l+2]}$

65 | $a^{[l+2]}=g\left(z^{[l+2]}+a^{[l]}\right)$

66 |

67 | 其中$a^{[l]}$与$z^{[l+2]}$共同作用,通过ReLU函数输出$a^{[l+2]}$

68 |

69 | 多个残差块构成了如下图所示的残差网络

70 |

71 |

72 |

73 | ### 2.3.2与Plain Network对比

74 |

75 | 我们将非残差网络称为Plain Network,将其与ResNet对比可发现,残差网络可以有效解决梯度消失和梯度爆炸的问题,睡着网络层数的增加,Plain Network的training error甚至可能变大,而ResNet的training error则一直呈现下降趋势。如下图

76 |

77 | 详细可参考

78 |

79 | [Deep Residual Learning for Image Recognition](extension://ibllepbpahcoppkjjllbabhnigcbffpi/https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf)

80 |

81 |

82 |

83 |

84 | ### 2.4 网络中的网络/1*1卷积

85 |

86 | #### 2.4.1 定义

87 |

88 | 也被称为***\*Network in Network\****,对输入的个不同的位置都应用一个全连接层,全连接层的作用是便在输入层上实施一个非平凡(***\*non-trivial\****)计算。简单点说就是将输入数据的通道数进行压缩,压缩成所使用的过滤器的数量大小。

89 |

90 |

91 |

92 | #### 2.4.2例子一

93 |

94 | 假设这是一个28×28×192的输入层,可以使用池化层压缩它的高度和宽度,这个过程我们很清楚。但如果通道数量很大,该如何把它压缩为28×28×32维度的层呢?你可以用32个大小为1×1的过滤器,严格来讲每个过滤器大小都是1×1×192维,因为过滤器中通道数量必须与输入层中通道的数量保持一致。但是你使用了32个过滤器,输出层为28×28×32,这就是压缩通道数()的方法。

95 |

96 |

97 |

98 |

99 |

100 | #### 2.4.3例子二

101 |

102 | 过滤器为1×1,输入一张6×6×32的图片,然后对它做卷积,遍历这36个单元格,计算左图中32个数字和过滤器中32个数字的元素积之和,然后应用***\*ReLU\****非线性函数。

103 |

104 | 我们以其中一个单元为例,它是这个输入层上的某个切片,用这36个数字乘以这个输入层上1×1切片,得到一个实数,像这样把它画在输出中。

105 |

106 |

107 |

108 |

109 |

110 | 这个1×1×32过滤器中的32个数字可以这样理解,一个神经元的输入是32个数字(输入图片中左下角位置32个通道中的数字),即相同高度和宽度上某一切片上的32个数字,这32个数字具有不同通道,乘以32个权重(将过滤器中的32个数理解为权重),然后应用***\*ReLU\****非线性函数,在这里输出相应的结果。

111 |

112 |

113 |

114 |

115 |

116 | 一般来说,如果过滤器不止一个,而是多个,就好像有多个输入单元,其输入内容为一个切片上所有数字,输出结果是6×6过滤器数量。

117 |

118 |

119 |

120 |

121 |

122 |

123 |

124 |

125 |

126 | 所以1×1卷积可以从根本上理解为对这32个不同的位置都应用一个全连接层,全连接层的作用是输入32个数字(过滤器数量标记为,在这36个单元上重复此过程),输出结果是6×6×#filters(过滤器数量),以便在输入层上实施一个非平凡(***\*non-trivial\****)计算。此时,输入的结果的通道层数取决于过滤器的个数。

127 |

128 |

129 |

130 | #### 2.4.4深度可分离卷积

131 |

132 | **定义**:一个卷积核负责一个通道,一个通道只被一个卷积核卷积

133 |

134 | **引用博客**:https://blog.csdn.net/makefish/article/details/88716534

135 |

136 | 相较于一般卷积,深度可分离卷积有着不同的计算方法:

137 |

138 | 在卷积计算时,先用三个卷积对三个通道分别做卷积,这样在一次卷积后,输出3个数,然后这输出的三个数,再通过一个1x1x3的卷积核(pointwise核),得到一个数。下面进行分步解释;

139 |

140 | 第一步,对三个通道分别做卷积,输出三个通道的属性:

141 |

142 |

143 |

144 |

145 |

146 |

147 |

148 |

149 |

150 | 第二步,用卷积核1x1x3对三个通道再次做卷积,这个时候的输出就和正常卷积一样,是8x8x1:

151 |

152 |

153 |

154 |

155 |

156 | 如果要提取更多的属性,则需要设计更多的1x1x3卷积核心就可以(图片引用自原网站。感觉应该将8x8x256那个立方体绘制成256个8x8x1,因为他们不是一体的,代表了256个属性)::

157 |

158 |

159 |

160 | **深度可分离卷积的优点缺点**:

161 |

162 | 对于需要提取大量属性或者特征的情景下,深度可分离卷积随着要提取的属性越来越多,就能够节省更多的参数。当然如果提取的特征属性不多,普通的卷积效果优于深度可分离卷积。

163 |

164 |

165 |

166 |

167 |

168 | ### 2.5 Inception网络

169 |

170 | #### 2.5.1作用

171 |

172 | 代替人工决定所使用的过滤器的大小,或者确定是否需要创建卷积层或池化层,

173 |

174 | #### 2.5.2 论文链接

175 |

176 | https://arxiv.org/pdf/1409.4842.pdf

177 |

178 | #### 2.5.3主要思想

179 |

180 | 不需要人为决定使用哪个过滤器或者是否需要池化,而是由网络自行确定这些参数,你可以给网络添加这些参数的所有可能值,然后把这些输出连接起来,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

181 |

182 | #### 2.5.4原理

183 |

184 | 利用多种维度的过滤器,分别使用不同的方法,产生大量长宽相等,通道可以不同的输出块,并将这些输出块堆积在一起,产生一个组合了各种类型的参数的输出,从而在后续的训练中,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

185 |

186 |

187 |

188 | 例如,这是你28×28×192维度的输入层,***\*Inception\****网络或***\*Inception\****层的作用就是代替人工来确定卷积层中的过滤器类型,或者确定是否需要创建卷积层或池化层,我们演示一下。

189 |

190 |

191 |

192 |

193 |

194 | 如果使用1×1卷积,输出结果会是28×28×#(某个值),假设输出为28×28×64,并且这里只有一个层。

195 |

196 |

197 |

198 |

199 |

200 | 如果使用3×3的过滤器,那么输出是28×28×128。然后我们把第二个值堆积到第一个值上,为了匹配维度,我们应用***\*same\****卷积,输出维度依然是28×28,和输入维度相同,即高度和宽度相同。

201 |

202 |

203 |

204 |

205 |

206 | 或许你会说,我希望提升网络的表现,用5×5过滤器或许会更好,我们不妨试一下,输出变成28×28×32,我们再次使用***\*same\****卷积,保持维度不变。

207 |

208 |

209 |

210 |

211 |

212 | 或许你不想要卷积层,那就用池化操作,得到一些不同的输出结果,我们把它也堆积起来,这里的池化输出是28×28×32。为了匹配所有维度,我们需要对最大池化使用***\*padding\****,它是一种特殊的池化形式,因为如果输入的高度和宽度为28×28,则输出的相应维度也是28×28。然后再进行池化,***\*padding\****不变,步幅为1。

213 |

214 |

215 |

216 |

217 |

218 | 有了这样的***\*Inception\****模块,你就可以输入某个量,因为它累加了所有数字,这里的最终输出为32+32+128+64=256。***\*Inception\****模块的输入为28×28×192,输出为28×28×256。这就是Inception网络的核心内容。

219 |

220 |

221 |

222 | #### 2.5.5计算成本问题

223 |

224 | 由于进行了多种模型的计算,会造成计算成本会非常的大,如何缩小成本是一个非常重要的一环。

225 |

226 | 下面以5×5过滤器为例计算成本

227 |

228 |

229 |

230 |

231 |

232 | 这是一个28×28×192的输入块,执行一个5×5卷积,它有32个过滤器,输出为28×28×32。我们来计算这个28×28×32输出的计算成本,它有32个过滤器,因为输出有32个通道,每个过滤器大小为5×5×192,输出大小为28×28×32,所以你要计算28×28×32个数字。对于输出中的每个数字来说,你都需要执行5×5×192次乘法运算,所以乘法运算的总次数为每个输出值所需要执行的乘法运算次数(5×5×192)乘以输出值个数(28×28×32),把这些数相乘结果等于1.2亿(120422400)。

233 |

234 |

235 |

236 |

237 |

238 | 为了缩小成本,我们使用1*1卷积对输入进行通道缩小。对于输入层,使用1×1卷积把输入值从192个通道减少到16个通道。然后对这个较小层运行5×5卷积,得到最终输出。请注意,输入和输出的维度依然相同,输入是28×28×192,输出是28×28×32。

239 |

240 | 然后我们进行成本计算应用1×1卷积,过滤器个数为16,每个过滤器大小为1×1×192,这两个维度相匹配(输入通道数与过滤器通道数),28×28×16这个层的计算成本是,输出28×28×192中每个元素都做192次乘法,用1×1×192来表示,相乘结果约等于240万,这是第一个卷积层的计算成本。第二层的输出为28×28×32,对每个输出值应用一个5×5×16维度的过滤器,计算结果为1000万。

241 |

242 | 所以所需要乘法运算的总次数是这两层的计算成本之和,也就是1204万,与上一张幻灯片中的值做比较,计算成本从1.2亿下降到了原来的十分之一,即1204万。

243 |

244 |

245 |

246 | #### 2.5.6 瓶颈层

247 |

248 |

249 |

250 |

251 |

252 |

253 |

254 | 这个被增加的1*1卷积层常被称为瓶颈层,即先缩小网络表示,然后再扩大它。

255 |

256 |

257 |

258 | 需要注意的是,只要合理构建瓶颈层,你既可以显著缩小表示层规模,又不会降低网络性能,从而节省了计算。

259 |

260 |

261 |

262 | #### 2.5.7 Inception Net

263 |

264 | 简述:由多个***\*Inception\*******\*模块所组成的神经网络。\****

265 |

266 | 原理:

267 |

268 | 首先如下图所示,建立前面所说的***\*Inception\****模块。

269 |

270 |

271 |

272 |

273 |

274 | 为了能在最后将这些输出都连接起来,我们会使用***\*same\****类型的***\*padding\****来池化,使得输出的高和宽依然是28×28,这样才能将它与其他输出连接起来。

275 |

276 | 但注意,如果你进行了最大池化,即便用了***\*same padding\****,3×3的过滤器,***\*stride\****为1,其输出将会是28×28×192,其通道数或者说深度与这里的输入(通道数)相同。所以看起来它会有很多通道,我们实际要做的就是再加上一个1×1的卷积层,去进行我们在1×1卷积层的视频里所介绍的操作,将通道的数量缩小,缩小到28×28×32。

277 |

278 |

279 |

280 |

281 |

282 | 最后,将这些方块全都连接起来。在这过程中,把得到的各个层的通道都加起来,最后得到一个28×28×256的输出。通道连接实际就是之前视频中看到过的,把所有方块连接在一起的操作。这就是一个***\*Inception\****模块,而***\*Inception\****网络所做的就是将这些模块都组合到一起。

283 |

284 |

285 |

286 |

287 |

288 | ***\*上图为\*******\*Inception\****网络的图片,并且其由多个***\*Inception\*******\*模块所组成,需要注意的是有一些\*******\*Inception\*******\*模块中间还夹着一个最大池化层,如图中的6和7.\****

289 |

290 |

291 |

292 |

293 |

294 | ***\*在论文原文中,网络里有着一些其他分支,如上图中的1、2、4,其中1是一个\*******\*softmax\****层,用于做出预测,编号2所做的就是通过隐藏层(编号3)来做出预测,所以这其实是一个***\*softmax\****输出(编号2),编号4也包含了一个隐藏层,通过一些全连接层,然后有一个***\*softmax\****来预测,输出结果的标签。 这些分支确保了即便是隐藏单元和中间层(编号5)也参与了特征计算,它们也能预测图片的分类。它在***\*Inception\****网络中,起到一种调整的效果,并且能防止网络发生过拟合。

295 |

296 |

297 |

298 | #### 2.5.8 Inception网络多种类型

299 |

300 | 参考博客:https://www.cnblogs.com/dengshunge/p/10808191.html

301 |

302 | ##### Inception v1

303 |

304 | v1其实就是我们前面所说的使用1*1卷积降低计算量后的Inception网络。

305 |

306 | 提升神经网络的性能是各种方法和算法的目的,当然提升网络的性能的方法有很多,例如增加网络的深度和宽度,但当深度和宽度不断增加时,需要训练的参数也会增加,过多的参数容易发生过拟合,并且会导致计算量增加。所以就有了v1结构来解决此问题,也就是利用1*1卷积降低计算量。

307 |

308 |

309 |

310 | ##### Inception v2

311 |

312 | 在训练时每层输入数据的分布会发生改变,所以需要较低的学习率和精心设置初始化参数。只要网络的前面几层发生微小的改变,那么后面几层就会被累积放大下去。一旦网络某一层的输入数据的分布发生改变,那么这一层网络就需要去适应学习这个新的数据分布,所以如果训练过程中,训练数据的分布一直在发生变化,那么将会影响网络的训练速度。为此,提出了v2版本的Inception网络。

313 |

314 | V2版本网络使用了BN算法,可以设置较大的初始学习率,并且减少对参数初始化的依赖,提高了训练速度,同时也可以能防止网络陷入饱和,即消除梯度弥散。

315 |

316 |

317 |

318 | ##### Inception v3

319 |

320 | Inception v3主要解决的是:inception结构过于复杂,使得我们很难对网络进行修改。

321 |

322 | V3主要思路为:利用小尺度的卷积来代替大尺度的卷积,在减少计算量的同时,保证能够学习到更多的信息。例如提出了使用两个级联的3*3的滤波器来代替一个5*5的滤波器,如下图所示:

323 |

324 |

325 |

326 |

327 |

328 |

329 |

330 | 同时又对3*3卷积进行分解为3*1+1*3,如下图所示,进而进一步降低计算量

331 |

332 |

333 |

334 |

335 |

336 | V3主要遵循下列几条思想

337 |

338 | 1. 避免特征表示瓶颈,尤其是在网络的前面。要避免严重压缩导致的瓶颈。特征表示尺寸应该温和地减少,从输入端到输出端。特征表示的维度只是一个粗浅的信息量表示,它丢掉了一些重要的因素如相关性结构。

339 |

340 | 2. 高维信息更适合在网络的局部处理。在卷积网络中逐步增加非线性激活响应可以解耦合更多的特征,那么网络就会训练的更快。

341 |

342 | 3. 空间聚合可以通过低维嵌入,不会导致网络表示能力的降低。例如在进行大尺寸的卷积(如3*3)之前,我们可以在空间聚合前先对输入信息进行降维处理,如果这些信号是容易压缩的,那么降维甚至可以加快学习速度。

343 |

344 | 4. 平衡好网络的深度和宽度。通过平衡网络每层滤波器的个数和网络的层数可以是网络达到最佳性能。增加网络的宽度和深度都会提升网络的性能,但是两者并行增加获得的性能提升是最大的。所以计算资源应该被合理的分配到网络的宽度和深度。

345 |

346 |

347 |

348 | ##### Inception v4

349 |

350 | V4的提出主要是基于 ”当网络更深更宽时,inception网络能否一样高效”的问题提出的,v4具体的解决方法为,结合TensorFlow,简化训练,不需要将模型进行分割,并且将inception和resnet两者进行融合,进一步改善网络。

351 |

352 |

353 |

354 | 以上对Inception网络的4种模型进行概述,具体解释可参考下列博客 https://www.cnblogs.com/dengshunge/p/10808191.html

355 |

356 |

357 |

358 | ### 2.6使用开源实现方案

359 |

360 | 本节为介绍如何下载开源代码。

361 |

362 | 本节下载的代码网站为:

363 |

364 | ***\*ResNets\****实现的***\*GitHub\****地址:https://github.com/KaimingHe/deep-residual-networks

365 |

366 |

367 |

368 |

369 |

370 |

371 |

372 | ***\*点击Code按钮,并且点击复制按钮复制代码的URL\****

373 |

374 |

375 |

376 |

377 |

378 | 在需要保存代码的目录下打开cmd,使用下列指令进行代码的下载(复制)

379 |

380 | git clone your URL

381 |

382 | git clone https://github.com/KaimingHe/deep-residual-networks.git

383 |

384 |

385 |

386 |

387 |

388 | 使用指令观察目录,说明此时代码已下载完毕。

389 |

390 | 接下来进行打开代码。

391 |

392 |

393 |

394 |

395 |

396 |

397 |

398 | 代码储存在prototxt文件夹中

399 |

400 |

401 |

402 |

403 |

404 | 使用指令打开其中一个文件。

405 |

406 | more 文件名

407 |

408 |

409 |

410 | 当然也可以用ide直接打开来进行修改。

411 | ### 2.7 迁移学习

412 | #### 2.7.1 迁移学习的概念

413 | 迁移学习是从一个或多个源领域中通过训练该模型,得出有用的知识并将其用在新的目标任务上(未标记的同一类有相似特征的物品或者是未标记的不同类物品)本质是知识的迁移再利用。

414 | #### 2.7.2 ImageNet、MS COCO\Pascal数据集的获取

415 | ImageNet数据集的获取:

416 | 所有图像可通过url下载:不需要账号登录即可免费下载,下载链接:http://www.image-net.org/download-imageurls ,在SEARCH框中输入需要下载的synset,如tree,也可按类别下载即WordNet ID,下载链接:http://www.image-net.org/synset?wnid=n02084071 ,其中好像个别url已失效。

417 | MS COCO:

418 |

419 | 数据集官网首页:http://cocodataset.org/#home

420 |

421 | 数据集下载:

422 |

423 | 可用迅雷去下载官方链接,速度也挺快的。也可以去这个高中生搭建的下载站下载:http://bendfunction.f3322.net:666/share/。 他的首页是这样子的:http://bendfunction.f3322.net:666/

424 | https://pjreddie.com/projects/coco-mirror/

425 | #### 2.7.3 迁移学习的分类

426 | 按照迁移学习的定义,可以将迁移学习分为三种类型,分布差异迁移学习,特征差异迁移学习和标签差异迁移学习。分布差异迁移学习之源域和目标域数据的边缘分布或者条件概率分布不同,特征差异迁移学习之源域数据和目标数据特征空间不同,标签差异迁移学习指源域和目标域的数据标记空间不同。

427 | 用香蕉和苹果分类问题为例,源域数据是已有的带标签香蕉和苹果的文本数据,目标域是新来的不带标记的香蕉和苹果的文本数据,源域和目标域的数据来自不同的时间,不同地点,数据分布不同,但标记空间和特征空间是相同的,利用源域中的数据来进行目标域的学习问题就是属于分布差异迁移学习问题。源域数据是带有标记的苹果和香蕉的文本数据,而目标域是不带有 标记的苹果和香蕉的图片数据,源域和目标域一个是文本,一个是图像,属于特征差异迁移学习范围。源域数据是带有标记的香蕉和苹果的文本数据,属于二分类问题,目标域是不带标记的梨子,橘子和橙子的文本数据属于三分类问题,源域和目标域的数据标记空间不同,属于标记差异迁移学习的范围。

428 |

429 | 现已成熟的监督学习模式下,在大样本的已标记的数据量集中训练形成传统的监督学习,但是这种模式在运用到情况更为复杂,更多变的实际环境中往往会出现很大的误差,

430 | 所以迁移学习就是在样本量比较少的情况下,训练分类器,随之把这种模式可以运用到其他很多种情况下。

431 |

432 | ### 2.8 数据增强

433 | #### 2.8.1数据增强的基本操作

434 | 数据增强也叫数据扩增,意思是在不实质性的增加数据的情况下,让有限的数据产生等价于更多数据的价值。

435 | 数据增强的手段包括几何变换类,颜色变换类等。

436 |

437 | (1) 几何变换类

438 |

439 | 几何变换类即对图像进行几何变换,包括翻转,旋转,裁剪,变形,缩放等各类操作,下面展示以上操作。

440 | 图一2 3 4 5

441 | (2) 颜色变换类

442 | 颜色变换类时改变图片的R、G、B的值。

443 | #### 2.8.2数据增强的代码实现

444 | TensorFlow实现图片数据增强:

445 | 参见以下网址https://zhuanlan.zhihu.com/p/57284174

446 | #### 2.8.2数据增强的优缺点

447 | 优点:

448 | 增加训练的数据量,提高模型的泛化能力

449 | 增加噪声数据,提升模型的鲁棒性

450 | ### 2.9 计算机视觉现状

451 | #### 2.9.1计算机视觉现状

452 | 深度学习已经成功地应用于计算机视觉、自然语言处理、语音识别、在线广告、物流还有其他许多问题。

453 | 在计算机视觉的现状下,深度学习应用于计算机视觉应用有一些独特之处。

454 | ####2.9.2 banchmark

455 | Benchmark 基准测试,Benchmark是一个评价方式,在整个计算机领域有着长期的应用。

456 | Benchmark在计算机领域应用最成功的就是性能测试,主要测试负载的执行时间、传输速度、吞吐量、资源占用率等。基准测试同时也可以用来识别某段代码的CPU或者内存效率问题. 许多开发人员会用基准测试来测试不同的并发模式, 或者用基准测试来辅助配置工作池的数量, 以保证能最大化系统的吞吐量.

457 | 关于实战可参考:

458 | https://blog.csdn.net/woniu317/article/details/82560312

459 |

--------------------------------------------------------------------------------

/12 目标检测.md:

--------------------------------------------------------------------------------

1 | ## 12 目标检测

2 |

3 | ### 12.1 目标定位

4 |

5 | #### 12.1.1 定义

6 |

7 | 除了要识别出目标类(例如是否有汽车)以外,算法还需要能够给出目标的位置(例如用红框框出目标的位置),这是一种分类定位问题。分类定位问题可以是只有一个目标对象在图片中,也可以是多个目标对象在图片中的。先从单个目标对象的情况开始。

8 |

9 | #### 12.1.2 实现

10 |

11 | **1. 边界框参数定义**

12 |

13 | 图片分类我们已经比较熟悉了,知道最后通过 *softmax* 激活函数激活来表示该图片属于每一类的概率。相较于单纯的分类问题,目标定位还需要输出4个值:$b_x,b_y,b_h,b_w$。这四个值用于表示边框的位置和大小,具体为

14 | $$

15 | \begin{array}{l}

16 | b_x:边框的中心点的x轴坐标 \\

17 | b_y:边框的中心点的y轴坐标 \\

18 | b_h:边框的高度 \\

19 | b_w:边框的宽度 \\

20 | \end{array}

21 | $$

22 | 以上4个值的取值范围均为[0, 1],表示的是边界框与图片对应的**比例**。

23 |

24 | 关于坐标轴的选取,一般选图片的左上角为原点(0, 0),右下角为(1, 1)。且$x$轴为纵轴正方向向下,$y$轴为横轴正方向向右。

25 |

26 | **2. 标签的定义**

27 |

28 | 在确定需要增加的额外输出之后,也要重新定义目标标签 $y$:

29 | $$

30 | y=\left[\begin{array}{l}

31 | p_{c} \\

32 | b_{x} \\

33 | b_{y} \\

34 | b_{h} \\

35 | b_{w} \\

36 | c_{1} \\

37 | c_{2} \\

38 | c_{3}

39 | \end{array}\right]

40 | $$

41 | 其中额外增加了$p_c$,用于表示是否有对象属于类$c_1、c_2$或$c_3$,若为1则表示有目标类在图片中,为0表示只有背景。在只有背景(无目标类)时,其他输出均无效。

42 |

43 | 举一个具体的例子,如下图:

44 |

45 |

46 |

47 | x 是输入,y 是标签,假设$c_2$表示为车,则最终标签应该如上图所示。当输入中不含任何目标类时,$p_c=0$,其他参数全用“?”表示,即不参与 loss 的计算。

48 |

49 | **3. 边界框参数取值范围**

50 |

51 | 关于边框的4个参数,吴恩达老师给出的取值范围都是[0, 1]的。虽然确实可以这么做,但是背后的原因却没有解释。个人猜测可能是以下原因:

52 |

53 | * 固定取值在[0, 1]之间更容易用激活函数表示,比如sigmoid可以将单个值映射到[0, 1];

54 | * 让标签的所有参数都在一个取值范围,这样在计算loss的时候就不会变相加权了;

55 | * 取值范围在[0, 1]内更容易训练、收敛。

56 |

57 | **4. 损失函数**

58 | $$

59 | L(\hat y,y)=

60 | \begin{cases}

61 | (\hat{y_1}-y_1)^2+(\hat{y_2}-y_2)^2+...+(\hat{y_n}-y_n)^2 & {y_1=1}\\

62 | (\hat{y_1}-y_1)^2 & {y_1=0}

63 | \end{cases}

64 | $$

65 |

66 | * 对于$p_c$可以采用 Logistic 回归的方法,甚至用均方误差$(p_c-\hat{p_c})^2$也可以;

67 | * 对于$b_x,b_y,b_w,b_h$,loss 可以用平方差或类似方法;

68 | * 对于$c_1,c_2,c_3$,是多分类问题,和之前一样用 softmax 即可。

69 |

70 | ### 12.2 特征点检测

71 |

72 | #### 12.2.1 定义

73 |

74 | 以下图为例,检测双眼的眼角位置

75 |

76 |

77 |

78 | 这个就是特征点检测,主要任务是预测对应的特征点的位置,一般会同时预测多个点。

79 |

80 | #### 12.2.2 实现

81 |

82 | 对于单个点,其坐标为$(l_{ix},l_{iy}),i \in [1, m]$,$m$是特征点的个数,$l_{ix},l_{iy} \in [0,1]$。坐标轴的选取和目标定位时一致,以及需要保证每个样本的特征点的顺序是一致的,比如$l_1$都是左眼的左眼角,$l_2$都是左眼的右眼角等。

83 |

84 | 关于最后一层的激活函数,可以对每个坐标的值用 sigmoid 激活。

85 |

86 | ### 12.3 目标检测

87 |

88 | #### 12.3.1 滑动窗口目标检测算法

89 |

90 | 滑动窗口检测是分两步执行的:第一步是从原图中裁剪一部分并根据需求调整大小,第二步是检测裁剪部分有无目标对象。

91 |

92 | 对于第二步,是我们比较熟悉的分类算法,只是训练集需要人为调整到为几乎整张图都是目标对象,如下图:

93 |

94 |

95 |

96 | $x$ 为一张无车的图片或者被车占满的图片,标签 $y$ 为1时有车,为0时无车。

97 |

98 | 对于第一步,滑动窗口用的方法是先选定一个裁剪大小,然后从图片的左上角开始,每隔一定像素(距离)裁剪一次,一直滑动到图片的右下角,然后下一个裁剪大小用相同的方法裁剪。如图,上图为3种裁剪大小,下图为一个滑动流程:

99 |

100 |

101 |

102 |

103 |

104 | #### 12.3.2 滑动窗口缺点——计算成本

105 |

106 | 看到这里不难发现,滑动窗口检测由于需要多个窗口且每个窗口滑动多次而导致运算量会相当巨大,运行时间过慢。而且如果滑动的步幅过大或者裁剪的大小不合适也会导致很难检测到目标。

107 |

108 | ### 12.4 卷积的滑动窗口实现

109 |

110 | #### 12.4.1 把神经网络的全连接层转化成卷积层

111 |

112 |

113 |

114 | - 假设目标检测算法输入一个14×14×3的图像,过滤器大小为5×5,数量是16,14×14×3的图像在过滤器处理之后映射为10×10×16。

115 |

116 | - 然后通过参数为2×2的最大池化操作,图像减小到5×5×16。

117 |

118 | - 添加一个连接400个单元的全连接层,接着再添加一个全连接层。

119 |

120 | - 最后通过softmax单元输出,用4个数字来表示 ,它们分别对应softmax单元所输出的4个分类出现的概率。这4个分类可以是行人、汽车、摩托车和背景或其它对象。

121 |

122 | **全连接层转化为卷积层**

123 |

124 |

125 |

126 | - 前几层和之前的一样。

127 |

128 | - 而对于全连接层,用5×5的过滤器来实现,数量是400个。输入图像大小为5×5×16,用5×5的过滤器对它进行卷积操作,过滤器实际上是5×5×16,因为在卷积过程中,过滤器会遍历这16个通道,所以这两处的通道数量必须保持一致,输出结果为1×1。假设应用400个这样的5×5×16过滤器,输出维度就是1×1×400。它不再是一个含有400个节点的集合,而是一个1×1×400的输出层。从数学角度看,它和全连接层是一样的,因为这400个节点中每个节点都有一个5×5×16维度的过滤器,所以每个值都是上一层这些5×5×16激活值经过某个任意线性函数的输出结果。

129 | - 再添加另外一个卷积层,这里用1×1卷积,假设有400个1×1的过滤器,在这400个过滤器的作用下,下一层的维度是1×1×400,它其实就是上个网络中的这一全连接层。最后经由1×1过滤器的处理,得到一个softmax激活值,通过卷积网络,我们最终得到这个1×1×4的输出层,而不是4个数字。

130 |

131 | 以上就是用卷积层代替全连接层的过程。

132 |

133 | #### 12.4.2 在卷积上应用滑动窗口对象检测算法

134 |

135 |

136 |

137 | 假设向滑动窗口卷积网络输入14×14×3的图片。和前面一样,神经网络最后的输出层,即softmax单元的输出是1×1×4,这里画得比较简单,严格来说,14×14×3应该是一个长方体,第二个10×10×16也是一个长方体,为了方便,这里只画了正面,所以这里显示的都是平面图,而不是3D图像。

138 |

139 |

140 |

141 | 假设输入给卷积网络的图片大小是14×14×3,测试集图片是16×16×3,现在给这个输入图片加上黄色条块,在最初的滑动窗口算法中,你会把这片蓝色区域输入卷积网络(红色笔标记)生成0或1分类。接着滑动窗口,步幅为2个像素,向右滑动2个像素,将这个绿框区域输入给卷积网络,运行整个卷积网络,得到另外一个标签0或1。继续将这个橘色区域输入给卷积网络,卷积后得到另一个标签,最后对右下方的紫色区域进行最后一次卷积操作。我们在这个16×16×3的小图像上滑动窗口,卷积网络运行了4次,于是输出了了4个标签。

142 |

143 |

144 |

145 | 这4次卷积操作中很多计算都是重复的。所以执行滑动窗口的卷积时使得卷积网络在这4次前向传播过程中共享很多计算。

146 |

147 | - 卷积网络运行同样的参数,使得相同的5×5×16过滤器进行卷积操作,得到12×12×16的输出层。

148 |

149 | - 然后执行同样的最大池化,输出结果6×6×16。照旧应用400个5×5的过滤器,得到一个2×2×400的输出层,现在输出层为2×2×400,而不是1×1×400。

150 |

151 | - 应用1×1过滤器得到另一个2×2×400的输出层。

152 |

153 | - 再做一次全连接的操作,最终得到2×2×4的输出层,而不是1×1×4。

154 |

155 | - 最终,在输出层这4个子方块中,蓝色的是图像左上部分14×14的输出(红色箭头标识),右上角方块是图像右上部分(绿色箭头标识)的对应输出,左下角方块是输入层左下角(橘色箭头标识),也就是这个14×14区域经过卷积网络处理后的结果,同样,右下角这个方块是卷积网络处理输入层右下角14×14区域(紫色箭头标识)的结果。

156 |

157 | 该卷积操作的原理是我们不需要把输入图像分割成四个子集,分别执行前向传播,而是把它们作为一张图片输入给卷积网络进行计算,其中的公共区域可以共享很多计算,就像这里我们看到的这个4个14×14的方块一样。

158 |

159 |

160 |

161 | 再看一个更大的图片样本,假如对一个28×28×3的图片应用滑动窗口操作,如果以同样的方式运行前向传播,最后得到8×8×4的结果。跟上一个范例一样,以14×14区域滑动窗口,首先在这个区域应用滑动窗口,其结果对应输出层的左上角部分。接着以大小为2的步幅不断地向右移动窗口,直到第8个单元格,得到输出层的第一行。然后向图片下方移动,最终输出这个8×8×4的结果。因为最大池化参数为2,相当于以大小为2的步幅在原始图片上应用神经网络。

162 |

163 | **滑动窗口的实现过程总结**

164 |

165 |

166 |

167 | 在图片上剪切出一块区域,假设它的大小是14×14,把它输入到卷积网络。继续输入下一块区域,大小同样是14×14,重复操作,直到某个区域识别到汽车。

168 |

169 | 但是我们不用依靠连续的卷积操作来识别图片中的汽车,比如,我们可以对大小为28×28的整张图片进行卷积操作,一次得到所有预测值,如果足够幸运,神经网络便可以识别出汽车的位置。

170 |

171 | ### 12.5 Bounding Box预测

172 |

173 | 滑动窗口法的卷积实现的算法虽然效率更高,但仍然存在问题,不能输出最精准的边界框。

174 |

175 |

271 |

272 | 但在深度学习文献中,定义卷积运算时跳过了这个镜像操作。前面我们实际上做的,有时被称为互相关而不是卷积。

273 |

274 | 总结来说,按照机器学习的惯例,我们通常不进行翻转操作。从技术上说,这个操作可能叫做互相关更好。但在大部分的深度学习文献中都把它叫做卷积运算。

275 |

276 | ### 10.6 三维卷积

277 |

278 | **三维(RGB图像)上的卷积操作**

279 |

280 | 举例,假如你不仅想检测灰度图像的特征,也想检测 RGB 彩色图像的特征。彩色图像如果6×6×3,这里的第一个 6 代表图像高度,第二个 6 代表宽度,这个3 代表颜色通道的数目。你可以把它想象成三个 6×6图像的堆叠。为了检测图像的边缘或者其他的特征,不是把它跟原来的 3×3 的过滤器做卷积,而是跟一个三维的过滤器,它的维度是 3×3×3,这样这个过滤器也有三层,对应红、绿、蓝三个通道。得到的输出会是一个 4×4 的图像,注意是 4×4×1,最后一个数不是 3 了。

281 |

282 | 为了简化这个 3×3×3过滤器的图像,我们不把它画成 3 个矩阵的堆叠,而画成一个三维的立方体。

283 |

284 |

285 |

286 | **计算过程**:

287 |

288 | 把这个 3×3×3 的过滤器先放到最左上角的位置,这个 3×3×3 的过滤器有 27 个数,27 个参数就是 3 的立方。依次取这 27 个数,然后乘以相应的红绿蓝通道中的数字。先取红色通道的前 9 个数字,然后是绿色通道,然后再是蓝色通道,乘以左边黄色立方体覆盖的对应的 27 个数,然后把这些数都加起来,就得到了输出的第一个数字。如果要计算下一个输出,你把这个立方体滑动一个单位,再与这 27 个数相乘,把它们都加起来,就得到了下一个输出,以此类推。

289 |

290 |

291 |

292 |

293 |

294 | **作用**:

295 |

296 | 举例:

297 |

298 | - 如果你想检测图像红色通道的边缘,那么你可以将第一个过滤器设为$\left[\begin{array}{rrr}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right]$,和之前一样,而绿色通道全为 0,$\left[\begin{array}{lll}0 & 0 & 0 \\ 0 & 0 & 0 \\ 0 & 0 & 0\end{array}\right]$,蓝色也全为 0。如果你把这三个堆叠在一起形成一个3×3×3的过滤器,那么这就是一个检测垂直边界的过滤器,但只对红色通道有用。

299 | - 或者如果你不关心垂直边界在哪个颜色通道里,那么你可以用一个这样的过滤器,$\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right],\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right],\left[\begin{array}{ccc}1 & 0 & -1 \\ 1 & 0 & -1 \\ 1 & 0 & -1\end{array}\right]$,所有三个通道都是这样。所以通过设置第二个过滤器参数,你就有了一个边界检测器,3×3×3 的边界检测器,用来检测任意颜色通道里的边界。参数的选择不同,可以得到不同的特征检测器,所有的都是 3×3×3 的过滤器。

300 |

301 | **同时用多个过滤器**

302 |

303 | 有时候我们会想要同时检测垂直边缘和水平边缘,还有 45°倾斜的边缘,还有 70°倾斜的边缘等等,这是就需要使用多个过滤器。

304 |

305 |

306 |

307 | 例如我们让这个 6×6×3 的图像和这个 3×3×3 的过滤器卷积,得到 4×4 的输出。(第一个)这可能是一个垂直边界检测器或者是学习检测其他的特征。第二个过滤器可以用橘色来表示,它可以是一个水平边缘检测器。做完卷积,然后把这两个 4×4 的输出堆叠在一起,这样你就都得到了一个4×4×2 的输出立方体。这里的 2 的来源于我们用了两个不同的过滤器。

308 |

309 | **维度总结**

310 |

311 | 如果你有一个$n \times n \times n_{c}$(通道数)的输入图像,上例中就是 6×6×3,这里的$n_{c}$就是通道数目,然后卷积上一个$f \times f \times n_{c}$,这个例子中是 3×3×3,按照惯例,这个(前一个𝑛𝑐)和这个(后一个𝑛𝑐)必须数值相同。然后你就得到了,$(n-f+1)\times(n-f+1) \times n_{c^{\prime}}$这里$n_{c^{\prime}}$其实就是下一层的通道数,它就是你用的过滤器的个数,在我们的例子中,那就是 4×4×2。我写下这个假设时,用的步幅为 1,并且没有 padding。如果你用了不同的步幅或者 padding,那么这个$𝑛 − 𝑓 + 1$数值会变化。

312 | $$

313 | n \times n \times n_{c} \text { * } f \times f \times n_{c} \rightarrow (n-f+1)\times(n-f+1) \times n_{c^{\prime}}

314 | $$

315 | **思考**:为什么卷积核是3\*3channels而不是3\*3\*1在多个通道之间移动?

316 |

317 | 如果使用3\*3\*1的卷积核在多个通道中移动,那意味着每个通道都用同一个过滤器,而且每个过滤器(卷积核)都忽略了隐藏在通道之间的联系和信息,这无疑会降低卷积网络的效果。

318 |

319 | ### 10.7 单层卷积网络

320 |

321 |

322 |

323 | 相比之前的卷积过程,CNN的单层结构多了激活函数ReLU和偏移量b,与神经网络的单层结构类似,即:

324 |

325 | $Z^{[l]}=W^{[l]} A^{[l-1]}+b$

326 | $A^{[l]}=g^{[l]}\left(Z^{[l]}\right)$

327 |

328 | 其中,卷积运算对应上式中的乘积运算,过滤器组数值对应着权重$W^{[l]}$,激活函数则为ReLU

329 |

330 | 上图中参数$W$的计算:每个过滤器组共有3x3x3=27个参数,两个过滤器组则共包含27x2=54个参数$W$

331 |

332 | 相关符号的总结(设层数为$l$)

333 |

334 | $f^{[l]}=$ filter size

335 | $p^{[l]}=$ padding

336 | $s^{[l]}=$ stride

337 | $n_{c}^{[l]}=$ number of filters

338 | $n_{H}^{[l]}=$ height of input

339 | $n_{W}^{[l]}=$ width of filters

340 |

341 | 输入维度为:

342 |

343 | $n_{H}^{[l-1]} \times n_{W}^{[l-1]} \times n_{c}^{[l-1]}$

344 | 每个滤波器组维度为:

345 |

346 | $f^{[l]} \times f^{[l]} \times n_{c}^{[l-1]}$

347 |

348 | 权重维度为:

349 |

350 | $f^{[l]} \times f^{[l]} \times n_{c}^{[l-1]} \times n_{c}^{[l]}$

351 |

352 | 偏置维度为:

353 |

354 | $ 1 \times 1 \times 1 \times n_{c}^{[l]}$

355 |

356 | 输出维度为 :

357 |

358 | $ n_{H}^{[l]} \times n_{W}^{[l]} \times n_{c}^{[l]}$

359 |

360 | 其中:

361 | $$

362 | \begin{aligned}

363 | n_{H}^{[l]} &=\left\lfloor\frac{n_{H}^{[l-1]}+2 p^{[l]}-f^{[l]}}{s^{[l]}}+1\right\rfloor \\

364 | n_{W}^{[l]} &=\left\lfloor\frac{n_{W}^{[l-1]}+2 p^{[l]}-f^{[l]}}{s^{[l]}}+1\right\rfloor

365 | \end{aligned}

366 | $$

367 | 若有$m$个样本进行向量化运算,则输出的维度为:

368 |

369 | $m \times n_{H}^{[l]} \times n_{W}^{[l]} \times n_{c}^{[l}$

370 |

371 | ### 10.8 简单卷积网络示例

372 |

373 |

374 |

375 | 如上图,是一个简单的CNN模型,且$a^{[3]}$维度为7 x 7 x 40,若将$a^{[3]}$排成1列,则维度为1960 x 1,再与输出层连接,输出层若为1个神经元,则为二元分类;若为多个神经元,则为多元分类。由此得出预测输出$\hat{y}$。

376 |

377 | 当CNN层数增加时,一般$n_{H}^{[l]}$和$n_{W}^{[l]}$会逐渐减小,而$n_{c}^{[l]}$会逐渐增大。

378 |

379 | CNN有以下三种类型的layer:

380 |

381 | - Convolution(CONV)(最为常见)

382 | - Pooling(POOL)

383 | - Fully connected(FC)

384 |

385 | ### 10.9 池化层

386 |

387 | 池化是一种下采样(downsample)手段,是对信息进行抽象的过程。

388 |

389 | 池化并不只有最大池化Max Pooling一种,不过Max Pooling是最广泛使用的一种。

390 |

391 | #### 10.9.1 最大池化 Max Pooling

392 |

393 | 最大池化指的是在采样区间内用区间内的最大值代表这个区间。

394 |

395 |

396 |

397 | 和卷积运算一样,池化也有自己的参数:池化大小、步长和Padding。只不过最常用的是2*2大小、步长为2和Valid Padding。下文如没有说明则都是采用这种最大池化。

398 |

399 | #### 10.9.2 其他池化

400 |

401 | * 平均池化:平均池化和最大池化相对应,用该区间的平均值来代表该区间。

402 | * 全局平均池化:和上述池化有点不同,是将一个通道的信息都用该通道的平均值代替。比如输入4\*4\*channels的特征图,输出一个长度为channels的特征向量。该向量每一个值都是对应通道(4*4=16个值)的平均值。通常用在最后一层卷积层后、softmax前。主要作用是代替全连接,降低参数个数。

403 | * ASPP(空洞卷积空间金字塔池化,Atrous Spatial Pyramid Pooling):和传统的池化操作不同,该池化并不降低分辨率(输出特征图的大小),但是同样可以起到对增加感受野的效果(下文介绍感受野)。

404 |

405 | #### 10.9.3 池化的作用

406 |

407 | 在介绍池化的作用前,先介绍一下感受野。

408 |

409 | **感受野 Receptive Field**

410 |

411 | 感受野表示了一个神经元(输出图的一个像素点)与多少个**原始图像**上的像素点有关联。浅层的感受野小,深层的感受野逐渐增大。对于单个神经元,其值只与其感受野有关,与感受野外无关。下图给出在经过两层3\*3的卷积后的神经元的感受野示例。

412 |

413 |

414 |

415 | 上图还可以发现,两个3\*3的卷积核能够与单个5\*5的卷积核有相同的感受野。但是前者只有2\*3\*3=18个参数,后者有5\*5=25个参数。可见可以通过多层小的卷积核来获得和单个大卷积核的相同效果,同时参数更少。甚至可以在GoogleNet中看到将n\*n拆分为1\*n和n\*1两个卷积核的做法。

416 |

417 | 对于池化层有效的原因之一,在于池化操作可以只用少量的参数大大增加下一层的神经元的感受野。方便起见,下列感受野计算不计算到原始图像那层。如果卷积层之间没有加入池化层,那后一层的神经元的感受野只为3\*3=9(假设是3\*3的卷积核);如果加入了最大池化层,那后一层的神经元的感受野可以增大到3\*3\*4=36,用同样的参数数量直接扩大了4倍。当然,简单地增加卷积核的大小也可以增加感受野,但是这样做增加了计算成本、参数数量、以及过拟合的风险。

418 |

419 | **作用**

420 |

421 | 介绍完感受野,现在开始正式介绍池化的作用:

422 |

423 | * 降低分辨率、降维、压缩特征、可以减少后续的运算量等等。但是在某些需要保持分辨率的任务(图像语义分割)中会变成一种弊端。

424 | * 只用少量参数就可以大大增加后续神经元的感受野。

425 |

426 | ### 10.10 卷积神经网络示例

427 |

428 | #### 10.10.1 LeNet5

429 |

430 | LeNet的[论文连接](https://ieeexplore.ieee.org/document/726791?reload=true&arnumber=726791)。LeNet是一个很简单很小的网络,建立之初是为了手写字识别(0-9)。虽然简单,但是是第一个典型的CNN网络。麻雀虽小,五脏俱全,包含了卷积层、池化层和全连接层。

431 |

432 | 网络结构如下:

433 |

434 |

435 |

436 |

437 |

438 | 该图没有说清楚,网络中所有卷积层的卷积核都是5*5的,以及步长为1,padding为0。图中的subsampling指的是池化,具体来说是最大池化。细心的话还会留意到最后一层用了Gaussian connections。我个人认为已经被淘汰了,感兴趣的可以自行了解。自己实现的时候当成全连接也可以。

439 |

440 | 该论文的典型之处主要在于:

441 |

442 | * 一层卷积一层池化交替出现。

443 | * 最后输出前若干层采用全连接层。

444 | * 全连接层的参数真的很多。卷积网络的参数主要集中在第一层全连接层(16\*5\*5\*120=48000)。

445 |

446 | #### 10.10.2 AlexNet

447 |

448 | AlexNet的[论文连接](http://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf)。这是第一个引起大家注意的卷积网络,该模型取得了2012年的ImageNet比赛冠军,而且也正是因为这次比赛而打响了名号。

449 |

450 | 网络结构如下:

451 |

452 |

453 |

454 | 论文中该图片有误,第一个卷积层的输出应该是54\*54而不是55\*55,这个可以自己计算一下来验证。该网络在前两层就采用了相当大的卷积核,不过后面的层都只用3*3的了。该网络拿下冠军时,以比第二名少20%左右的误差率而取得优胜。

455 |

456 | 个人认为比较值得注意的点是:

457 |

458 | * 并不一定需要每层卷积层后都添加池化层。连续多层卷积层可以视为一层卷积核更大、能拟合更复杂函数的卷积层。

459 | * 对于更大的图片,感受野也需要对应增大。AlexNet的做法是前两层卷积层用了较大的卷积核。

460 |

461 | #### 10.10.3 VGG16

462 |

463 | VGG16的[论文连接](https://arxiv.org/abs/1409.1556)。该网络改进了AlexNet,改进的思路是:用更多层、更小的卷积核代替原来那些比较大的卷积核。最根本的一点是在不减小感受野的前提下增加层数和减少参数量。从结果上来看,这么做确实起到了不错的效果。

464 |

465 | 下图中,卷积层默认步长为1,padding为same。网络结构如下:

466 |

467 |

468 |

469 | 该网络不止是本身很有价值,其来源(论文)也很有价值。该论文通过对比各种网络,来说明卷积网络越深效果越好这一点。VGG16中的16就是指除去池化层,该网络一个有16层。

470 |

471 | 对比AlexNet,该网络的改进如下:

472 |

473 | * 采用多层连续的3*3卷积层代替大卷积层。

474 | * 网络深度更深了。

475 | * 通道数全部用2的幂。更符合计算机的存储规则。

476 | * 两、三层卷积层 + 一层池化。

477 | * 池化后通道数翻倍。

478 | * 每层网络的步长都为1,padding都为same。

479 |

480 | 上述改进也是现在我所看到的大部分网络的构建习惯(趋势)。我想这足以说明这些“规律”有多好用。

481 |

482 | ### 10.11 为什么使用卷积

483 |

484 | #### 10.11.1 减少参数

485 |

486 | 1.10介绍的网络也基本可以看出,卷积网络中全连接层的参数占了绝大一部分。举例LeNet5,各层参数个数分别为:第一层卷积层 5\*5\*1\*6=150、第二层卷积层 5\*5\*6\*16=2400、第一层全连接层 5\*5\*16\*120=48000、第二层全连接层 120\*84=10080,若最后一层视为全连接层则有 84\*10=840。

487 |

488 | 不难发现,第一层全连接层的参数占据了$\frac{48000}{150+2400+48000+10080+840}=0.78=78%$的参数,这已经占据了一半以上的参数。很明显,卷积层对比全连接层来说可以大大减小参数的数量,一方面可以避免过拟合,另一方面减少了对设备的要求。

489 |

490 | 更进一步,卷积操作需要的参数很少的原因在于

491 |

492 | * **权值共享**。一个卷积核的权值可以适用到整个网络,而不是每个神经元独占一个权值。因为一个卷积核的工作可以理解为专门识别某一些特征。而且这个特征应该是通用的,与所处位置无关,即**平移不变性**。同时平移不变性也是网络学习的潜在目标之一。举例垂直边缘检测便可以检索对应区域是否有垂直边界,而不在乎这个边界的具体位置在哪。

493 | * **稀疏连接**。与全连接对应,在全连接中任意一个神经元都要与上一层的所有神经元连接;而卷积则只受感受野内的神经元影响,对于感受野外的并不关心。

494 |

495 | #### 10.11.2 训练卷积网络

496 |

497 | 假设要做一个猫咪检测网络,$x^{(i)}$表示第$i$张图片,$y^{(i)}$表示对应图片的标签。在选定一个网络后,设计好损失函数,对全部样本的损失求平均作为代价函数。随机初始化权重矩阵和偏置。在Python实现时还可以向量化$x^{(i)}$(当然,就我所知大部分架构也会这么做)。用梯度下降来训练网络,而且也可以采用优化器如$RMSProp$或$Adam$。

498 |

499 |

--------------------------------------------------------------------------------

/11 深度卷积网络 实例探究.md:

--------------------------------------------------------------------------------

1 | #第二周 深度卷积网络:实例探究

2 | ## 2.1为什么要实例探究

3 |

4 | 在计算机视觉的研究中,将卷积层、池化层及全连接层进行有有机结合,才能形成有效的卷积神经网络,而更好地去实现这种有机结合可以多多参考他人所构建的框架,而且在计算机视觉中,良好的神经网络框架往往也适用于其他的任务,所以多多参考其他案例有利于我们更好地应用卷积神经网络。在框架学习中,我们也可以多多研读计算机视觉领域相关的论文或相关的研讨内容。

5 |

6 |

7 |

8 | ## 2.2经典网络

9 |

10 | ### 2.2.1LeNet-5网络

11 |

12 |

13 |

14 | 该网络是针对灰度图像训练的,该例用其对手写字体进行识别

15 |

16 | 在池化后选用$sigmoid$函数来进行非线性函数处理

17 |

18 | 其结构为卷积——池化——卷积——池化——全连接——全连接。

19 |

20 | 且采取了平均池化(当时年代的人们更倾向使用平均池化),然而现在会更多的使用最大池化。因没有使用padding或有效卷积,使得每完成一次卷积,图像的高度和宽度都缩小了。

21 |

22 | 最后输出层利用了$softmax$函数来分类输出十种结果。

23 |

24 | 相比于其他更复杂的神经网络,其参数较少,只有约六万个。

25 |

26 | 随着网络层次的加深,图像的高度和宽度都在缩小,信道数量则会增加。

27 |

28 | 其中的“一个或多个卷积层后跟着一个池化层,然后又是若干个卷积层,池化层,然后再是全连接层,最后输出。”这一模式仍被经常使用。

29 |

30 | ### 2.2.2AlexNet网络

31 |

32 |

33 |

34 | 相比于LeNet-5,AlexNet网络要大得多,其有约六千万个参数,但优点在于在用于训练图像和数据集时,它能处理非常相似的基本构造模块,而往往这些模块有着隐藏单元或数据;同时采用了$Relu$函数。

35 |

36 | 在写这篇论文时,GPU的处理速度并不快,所以针对这个模型,采用了两个GPU进行训练,将不同的层拆分到两个GPU中进行训练,并用了一些专门的方法使这两个GPU得以交流。

37 |

38 | ### 2.2.3VGG-16

39 |

40 |

41 |

42 | VGG-16中的“16”代表该网络结构包含16个卷积层和全连接层

43 |

44 | 这是一个极大的网络,约有1.38亿个参数,但其优点是其结构不复杂,一般为卷积层后跟着可压缩图像大小(高度和宽度)的池化层。其过滤器数量变化存在一定规律,变化为64→128→256→512,论文作者可能认为512的信道数量已经足够大了,故没有继续增加。除了VGG-16外,还有VGG-19模型,但VGG-19模型比VGG-16要大得多,但实现的效果并不比VGG-16要好多少,故较少使用VGG-19。

45 |

46 | 随着该网络的加深,图像的高度和宽度在不断缩小,每次池化后缩小一半,而信道数量在不断增加(每次卷积后增加1倍)。即图像缩小的比例和信道增加的比例是有规律的。

47 |

48 |

49 |

50 | ## 2.3残差网络

51 |

52 | 神经网络层数越多,网络越深,越容易受到梯度消失和梯度爆炸的影响。我们可以通过让神经网络某些层跳过下一层神经元的连接,隔层相连,弱化每层之间的强联系来解决该问题。而这样的神经网络即为残差网络(ResNets)

53 |

54 | ### 2.3.1残差块

55 |

56 | 残差网络由多个残差块组成,如下图为残差块组成

57 |

58 |

59 |

60 | 图中红色箭头称为跳远连接,其建立了$a^{[l]}$与$a^{[l+2]}$的隔层联系。具体表达式为:

61 |

62 | $z^{[l+1]}=W^{[l+1]} a^{[l]}+b^{[l+1]}$

63 | $a^{[l+1]}=g\left(z^{[l+1]}\right)$

64 | $z^{[l+2]}=W^{[l+2]} a^{[l+1]}+b^{[l+2]}$

65 | $a^{[l+2]}=g\left(z^{[l+2]}+a^{[l]}\right)$

66 |

67 | 其中$a^{[l]}$与$z^{[l+2]}$共同作用,通过ReLU函数输出$a^{[l+2]}$

68 |

69 | 多个残差块构成了如下图所示的残差网络

70 |

71 |

72 |

73 | ### 2.3.2与Plain Network对比

74 |

75 | 我们将非残差网络称为Plain Network,将其与ResNet对比可发现,残差网络可以有效解决梯度消失和梯度爆炸的问题,睡着网络层数的增加,Plain Network的training error甚至可能变大,而ResNet的training error则一直呈现下降趋势。如下图

76 |

77 | 详细可参考

78 |

79 | [Deep Residual Learning for Image Recognition](extension://ibllepbpahcoppkjjllbabhnigcbffpi/https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf)

80 |

81 |

82 |

83 |

84 | ### 2.4 网络中的网络/1*1卷积

85 |

86 | #### 2.4.1 定义

87 |

88 | 也被称为***\*Network in Network\****,对输入的个不同的位置都应用一个全连接层,全连接层的作用是便在输入层上实施一个非平凡(***\*non-trivial\****)计算。简单点说就是将输入数据的通道数进行压缩,压缩成所使用的过滤器的数量大小。

89 |

90 |

91 |

92 | #### 2.4.2例子一

93 |

94 | 假设这是一个28×28×192的输入层,可以使用池化层压缩它的高度和宽度,这个过程我们很清楚。但如果通道数量很大,该如何把它压缩为28×28×32维度的层呢?你可以用32个大小为1×1的过滤器,严格来讲每个过滤器大小都是1×1×192维,因为过滤器中通道数量必须与输入层中通道的数量保持一致。但是你使用了32个过滤器,输出层为28×28×32,这就是压缩通道数()的方法。

95 |

96 |

97 |

98 |

99 |

100 | #### 2.4.3例子二

101 |

102 | 过滤器为1×1,输入一张6×6×32的图片,然后对它做卷积,遍历这36个单元格,计算左图中32个数字和过滤器中32个数字的元素积之和,然后应用***\*ReLU\****非线性函数。

103 |

104 | 我们以其中一个单元为例,它是这个输入层上的某个切片,用这36个数字乘以这个输入层上1×1切片,得到一个实数,像这样把它画在输出中。

105 |

106 |

107 |

108 |

109 |

110 | 这个1×1×32过滤器中的32个数字可以这样理解,一个神经元的输入是32个数字(输入图片中左下角位置32个通道中的数字),即相同高度和宽度上某一切片上的32个数字,这32个数字具有不同通道,乘以32个权重(将过滤器中的32个数理解为权重),然后应用***\*ReLU\****非线性函数,在这里输出相应的结果。

111 |

112 |

113 |

114 |

115 |

116 | 一般来说,如果过滤器不止一个,而是多个,就好像有多个输入单元,其输入内容为一个切片上所有数字,输出结果是6×6过滤器数量。

117 |

118 |

119 |

120 |

121 |

122 |

123 |

124 |

125 |

126 | 所以1×1卷积可以从根本上理解为对这32个不同的位置都应用一个全连接层,全连接层的作用是输入32个数字(过滤器数量标记为,在这36个单元上重复此过程),输出结果是6×6×#filters(过滤器数量),以便在输入层上实施一个非平凡(***\*non-trivial\****)计算。此时,输入的结果的通道层数取决于过滤器的个数。

127 |

128 |

129 |

130 | #### 2.4.4深度可分离卷积

131 |

132 | **定义**:一个卷积核负责一个通道,一个通道只被一个卷积核卷积

133 |

134 | **引用博客**:https://blog.csdn.net/makefish/article/details/88716534

135 |

136 | 相较于一般卷积,深度可分离卷积有着不同的计算方法:

137 |

138 | 在卷积计算时,先用三个卷积对三个通道分别做卷积,这样在一次卷积后,输出3个数,然后这输出的三个数,再通过一个1x1x3的卷积核(pointwise核),得到一个数。下面进行分步解释;

139 |

140 | 第一步,对三个通道分别做卷积,输出三个通道的属性:

141 |

142 |

143 |

144 |

145 |

146 |

147 |

148 |

149 |

150 | 第二步,用卷积核1x1x3对三个通道再次做卷积,这个时候的输出就和正常卷积一样,是8x8x1:

151 |

152 |

153 |

154 |

155 |

156 | 如果要提取更多的属性,则需要设计更多的1x1x3卷积核心就可以(图片引用自原网站。感觉应该将8x8x256那个立方体绘制成256个8x8x1,因为他们不是一体的,代表了256个属性)::

157 |

158 |

159 |

160 | **深度可分离卷积的优点缺点**:

161 |

162 | 对于需要提取大量属性或者特征的情景下,深度可分离卷积随着要提取的属性越来越多,就能够节省更多的参数。当然如果提取的特征属性不多,普通的卷积效果优于深度可分离卷积。

163 |

164 |

165 |

166 |

167 |

168 | ### 2.5 Inception网络

169 |

170 | #### 2.5.1作用

171 |

172 | 代替人工决定所使用的过滤器的大小,或者确定是否需要创建卷积层或池化层,

173 |

174 | #### 2.5.2 论文链接

175 |

176 | https://arxiv.org/pdf/1409.4842.pdf

177 |

178 | #### 2.5.3主要思想

179 |

180 | 不需要人为决定使用哪个过滤器或者是否需要池化,而是由网络自行确定这些参数,你可以给网络添加这些参数的所有可能值,然后把这些输出连接起来,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

181 |

182 | #### 2.5.4原理

183 |

184 | 利用多种维度的过滤器,分别使用不同的方法,产生大量长宽相等,通道可以不同的输出块,并将这些输出块堆积在一起,产生一个组合了各种类型的参数的输出,从而在后续的训练中,让网络自己学习它需要什么样的参数,采用哪些过滤器组合。

185 |

186 |

187 |

188 | 例如,这是你28×28×192维度的输入层,***\*Inception\****网络或***\*Inception\****层的作用就是代替人工来确定卷积层中的过滤器类型,或者确定是否需要创建卷积层或池化层,我们演示一下。

189 |

190 |

191 |

192 |

193 |

194 | 如果使用1×1卷积,输出结果会是28×28×#(某个值),假设输出为28×28×64,并且这里只有一个层。

195 |

196 |

197 |

198 |

199 |

200 | 如果使用3×3的过滤器,那么输出是28×28×128。然后我们把第二个值堆积到第一个值上,为了匹配维度,我们应用***\*same\****卷积,输出维度依然是28×28,和输入维度相同,即高度和宽度相同。

201 |

202 |

203 |

204 |

205 |

206 | 或许你会说,我希望提升网络的表现,用5×5过滤器或许会更好,我们不妨试一下,输出变成28×28×32,我们再次使用***\*same\****卷积,保持维度不变。

207 |

208 |

209 |

210 |

211 |

212 | 或许你不想要卷积层,那就用池化操作,得到一些不同的输出结果,我们把它也堆积起来,这里的池化输出是28×28×32。为了匹配所有维度,我们需要对最大池化使用***\*padding\****,它是一种特殊的池化形式,因为如果输入的高度和宽度为28×28,则输出的相应维度也是28×28。然后再进行池化,***\*padding\****不变,步幅为1。

213 |

214 |

215 |

216 |

217 |

218 | 有了这样的***\*Inception\****模块,你就可以输入某个量,因为它累加了所有数字,这里的最终输出为32+32+128+64=256。***\*Inception\****模块的输入为28×28×192,输出为28×28×256。这就是Inception网络的核心内容。

219 |

220 |

221 |

222 | #### 2.5.5计算成本问题

223 |

224 | 由于进行了多种模型的计算,会造成计算成本会非常的大,如何缩小成本是一个非常重要的一环。

225 |

226 | 下面以5×5过滤器为例计算成本

227 |

228 |

229 |

230 |

231 |

232 | 这是一个28×28×192的输入块,执行一个5×5卷积,它有32个过滤器,输出为28×28×32。我们来计算这个28×28×32输出的计算成本,它有32个过滤器,因为输出有32个通道,每个过滤器大小为5×5×192,输出大小为28×28×32,所以你要计算28×28×32个数字。对于输出中的每个数字来说,你都需要执行5×5×192次乘法运算,所以乘法运算的总次数为每个输出值所需要执行的乘法运算次数(5×5×192)乘以输出值个数(28×28×32),把这些数相乘结果等于1.2亿(120422400)。

233 |

234 |

235 |

236 |

237 |

238 | 为了缩小成本,我们使用1*1卷积对输入进行通道缩小。对于输入层,使用1×1卷积把输入值从192个通道减少到16个通道。然后对这个较小层运行5×5卷积,得到最终输出。请注意,输入和输出的维度依然相同,输入是28×28×192,输出是28×28×32。

239 |

240 | 然后我们进行成本计算应用1×1卷积,过滤器个数为16,每个过滤器大小为1×1×192,这两个维度相匹配(输入通道数与过滤器通道数),28×28×16这个层的计算成本是,输出28×28×192中每个元素都做192次乘法,用1×1×192来表示,相乘结果约等于240万,这是第一个卷积层的计算成本。第二层的输出为28×28×32,对每个输出值应用一个5×5×16维度的过滤器,计算结果为1000万。

241 |

242 | 所以所需要乘法运算的总次数是这两层的计算成本之和,也就是1204万,与上一张幻灯片中的值做比较,计算成本从1.2亿下降到了原来的十分之一,即1204万。

243 |

244 |

245 |

246 | #### 2.5.6 瓶颈层

247 |

248 |

249 |

250 |

251 |

252 |

253 |

254 | 这个被增加的1*1卷积层常被称为瓶颈层,即先缩小网络表示,然后再扩大它。

255 |

256 |

257 |

258 | 需要注意的是,只要合理构建瓶颈层,你既可以显著缩小表示层规模,又不会降低网络性能,从而节省了计算。

259 |

260 |

261 |

262 | #### 2.5.7 Inception Net

263 |

264 | 简述:由多个***\*Inception\*******\*模块所组成的神经网络。\****

265 |

266 | 原理:

267 |

268 | 首先如下图所示,建立前面所说的***\*Inception\****模块。

269 |

270 |

271 |

272 |

273 |

274 | 为了能在最后将这些输出都连接起来,我们会使用***\*same\****类型的***\*padding\****来池化,使得输出的高和宽依然是28×28,这样才能将它与其他输出连接起来。

275 |

276 | 但注意,如果你进行了最大池化,即便用了***\*same padding\****,3×3的过滤器,***\*stride\****为1,其输出将会是28×28×192,其通道数或者说深度与这里的输入(通道数)相同。所以看起来它会有很多通道,我们实际要做的就是再加上一个1×1的卷积层,去进行我们在1×1卷积层的视频里所介绍的操作,将通道的数量缩小,缩小到28×28×32。

277 |

278 |

279 |

280 |

281 |

282 | 最后,将这些方块全都连接起来。在这过程中,把得到的各个层的通道都加起来,最后得到一个28×28×256的输出。通道连接实际就是之前视频中看到过的,把所有方块连接在一起的操作。这就是一个***\*Inception\****模块,而***\*Inception\****网络所做的就是将这些模块都组合到一起。

283 |

284 |

285 |

286 |

287 |

288 | ***\*上图为\*******\*Inception\****网络的图片,并且其由多个***\*Inception\*******\*模块所组成,需要注意的是有一些\*******\*Inception\*******\*模块中间还夹着一个最大池化层,如图中的6和7.\****

289 |

290 |

291 |

292 |

293 |

294 | ***\*在论文原文中,网络里有着一些其他分支,如上图中的1、2、4,其中1是一个\*******\*softmax\****层,用于做出预测,编号2所做的就是通过隐藏层(编号3)来做出预测,所以这其实是一个***\*softmax\****输出(编号2),编号4也包含了一个隐藏层,通过一些全连接层,然后有一个***\*softmax\****来预测,输出结果的标签。 这些分支确保了即便是隐藏单元和中间层(编号5)也参与了特征计算,它们也能预测图片的分类。它在***\*Inception\****网络中,起到一种调整的效果,并且能防止网络发生过拟合。

295 |

296 |

297 |

298 | #### 2.5.8 Inception网络多种类型

299 |

300 | 参考博客:https://www.cnblogs.com/dengshunge/p/10808191.html

301 |

302 | ##### Inception v1

303 |

304 | v1其实就是我们前面所说的使用1*1卷积降低计算量后的Inception网络。

305 |

306 | 提升神经网络的性能是各种方法和算法的目的,当然提升网络的性能的方法有很多,例如增加网络的深度和宽度,但当深度和宽度不断增加时,需要训练的参数也会增加,过多的参数容易发生过拟合,并且会导致计算量增加。所以就有了v1结构来解决此问题,也就是利用1*1卷积降低计算量。

307 |

308 |

309 |

310 | ##### Inception v2

311 |

312 | 在训练时每层输入数据的分布会发生改变,所以需要较低的学习率和精心设置初始化参数。只要网络的前面几层发生微小的改变,那么后面几层就会被累积放大下去。一旦网络某一层的输入数据的分布发生改变,那么这一层网络就需要去适应学习这个新的数据分布,所以如果训练过程中,训练数据的分布一直在发生变化,那么将会影响网络的训练速度。为此,提出了v2版本的Inception网络。

313 |

314 | V2版本网络使用了BN算法,可以设置较大的初始学习率,并且减少对参数初始化的依赖,提高了训练速度,同时也可以能防止网络陷入饱和,即消除梯度弥散。

315 |

316 |

317 |

318 | ##### Inception v3

319 |

320 | Inception v3主要解决的是:inception结构过于复杂,使得我们很难对网络进行修改。

321 |

322 | V3主要思路为:利用小尺度的卷积来代替大尺度的卷积,在减少计算量的同时,保证能够学习到更多的信息。例如提出了使用两个级联的3*3的滤波器来代替一个5*5的滤波器,如下图所示:

323 |

324 |

325 |

326 |

327 |

328 |

329 |

330 | 同时又对3*3卷积进行分解为3*1+1*3,如下图所示,进而进一步降低计算量

331 |

332 |

333 |

334 |

335 |

336 | V3主要遵循下列几条思想

337 |

338 | 1. 避免特征表示瓶颈,尤其是在网络的前面。要避免严重压缩导致的瓶颈。特征表示尺寸应该温和地减少,从输入端到输出端。特征表示的维度只是一个粗浅的信息量表示,它丢掉了一些重要的因素如相关性结构。

339 |

340 | 2. 高维信息更适合在网络的局部处理。在卷积网络中逐步增加非线性激活响应可以解耦合更多的特征,那么网络就会训练的更快。

341 |

342 | 3. 空间聚合可以通过低维嵌入,不会导致网络表示能力的降低。例如在进行大尺寸的卷积(如3*3)之前,我们可以在空间聚合前先对输入信息进行降维处理,如果这些信号是容易压缩的,那么降维甚至可以加快学习速度。

343 |

344 | 4. 平衡好网络的深度和宽度。通过平衡网络每层滤波器的个数和网络的层数可以是网络达到最佳性能。增加网络的宽度和深度都会提升网络的性能,但是两者并行增加获得的性能提升是最大的。所以计算资源应该被合理的分配到网络的宽度和深度。

345 |

346 |

347 |

348 | ##### Inception v4

349 |

350 | V4的提出主要是基于 ”当网络更深更宽时,inception网络能否一样高效”的问题提出的,v4具体的解决方法为,结合TensorFlow,简化训练,不需要将模型进行分割,并且将inception和resnet两者进行融合,进一步改善网络。

351 |

352 |

353 |

354 | 以上对Inception网络的4种模型进行概述,具体解释可参考下列博客 https://www.cnblogs.com/dengshunge/p/10808191.html

355 |

356 |

357 |

358 | ### 2.6使用开源实现方案

359 |

360 | 本节为介绍如何下载开源代码。

361 |

362 | 本节下载的代码网站为:

363 |

364 | ***\*ResNets\****实现的***\*GitHub\****地址:https://github.com/KaimingHe/deep-residual-networks

365 |

366 |

367 |

368 |

369 |

370 |

371 |

372 | ***\*点击Code按钮,并且点击复制按钮复制代码的URL\****

373 |

374 |

375 |

376 |

377 |

378 | 在需要保存代码的目录下打开cmd,使用下列指令进行代码的下载(复制)

379 |

380 | git clone your URL

381 |

382 | git clone https://github.com/KaimingHe/deep-residual-networks.git

383 |

384 |

385 |

386 |

387 |

388 | 使用指令观察目录,说明此时代码已下载完毕。

389 |

390 | 接下来进行打开代码。

391 |

392 |

393 |

394 |

395 |

396 |

397 |

398 | 代码储存在prototxt文件夹中

399 |

400 |

401 |

402 |

403 |

404 | 使用指令打开其中一个文件。

405 |

406 | more 文件名

407 |

408 |

409 |

410 | 当然也可以用ide直接打开来进行修改。

411 | ### 2.7 迁移学习

412 | #### 2.7.1 迁移学习的概念

413 | 迁移学习是从一个或多个源领域中通过训练该模型,得出有用的知识并将其用在新的目标任务上(未标记的同一类有相似特征的物品或者是未标记的不同类物品)本质是知识的迁移再利用。

414 | #### 2.7.2 ImageNet、MS COCO\Pascal数据集的获取

415 | ImageNet数据集的获取:

416 | 所有图像可通过url下载:不需要账号登录即可免费下载,下载链接:http://www.image-net.org/download-imageurls ,在SEARCH框中输入需要下载的synset,如tree,也可按类别下载即WordNet ID,下载链接:http://www.image-net.org/synset?wnid=n02084071 ,其中好像个别url已失效。

417 | MS COCO:

418 |

419 | 数据集官网首页:http://cocodataset.org/#home

420 |

421 | 数据集下载:

422 |

423 | 可用迅雷去下载官方链接,速度也挺快的。也可以去这个高中生搭建的下载站下载:http://bendfunction.f3322.net:666/share/。 他的首页是这样子的:http://bendfunction.f3322.net:666/

424 | https://pjreddie.com/projects/coco-mirror/

425 | #### 2.7.3 迁移学习的分类

426 | 按照迁移学习的定义,可以将迁移学习分为三种类型,分布差异迁移学习,特征差异迁移学习和标签差异迁移学习。分布差异迁移学习之源域和目标域数据的边缘分布或者条件概率分布不同,特征差异迁移学习之源域数据和目标数据特征空间不同,标签差异迁移学习指源域和目标域的数据标记空间不同。

427 | 用香蕉和苹果分类问题为例,源域数据是已有的带标签香蕉和苹果的文本数据,目标域是新来的不带标记的香蕉和苹果的文本数据,源域和目标域的数据来自不同的时间,不同地点,数据分布不同,但标记空间和特征空间是相同的,利用源域中的数据来进行目标域的学习问题就是属于分布差异迁移学习问题。源域数据是带有标记的苹果和香蕉的文本数据,而目标域是不带有 标记的苹果和香蕉的图片数据,源域和目标域一个是文本,一个是图像,属于特征差异迁移学习范围。源域数据是带有标记的香蕉和苹果的文本数据,属于二分类问题,目标域是不带标记的梨子,橘子和橙子的文本数据属于三分类问题,源域和目标域的数据标记空间不同,属于标记差异迁移学习的范围。

428 |

429 | 现已成熟的监督学习模式下,在大样本的已标记的数据量集中训练形成传统的监督学习,但是这种模式在运用到情况更为复杂,更多变的实际环境中往往会出现很大的误差,

430 | 所以迁移学习就是在样本量比较少的情况下,训练分类器,随之把这种模式可以运用到其他很多种情况下。

431 |

432 | ### 2.8 数据增强

433 | #### 2.8.1数据增强的基本操作

434 | 数据增强也叫数据扩增,意思是在不实质性的增加数据的情况下,让有限的数据产生等价于更多数据的价值。

435 | 数据增强的手段包括几何变换类,颜色变换类等。

436 |

437 | (1) 几何变换类

438 |

439 | 几何变换类即对图像进行几何变换,包括翻转,旋转,裁剪,变形,缩放等各类操作,下面展示以上操作。

440 | 图一2 3 4 5

441 | (2) 颜色变换类

442 | 颜色变换类时改变图片的R、G、B的值。

443 | #### 2.8.2数据增强的代码实现

444 | TensorFlow实现图片数据增强:

445 | 参见以下网址https://zhuanlan.zhihu.com/p/57284174

446 | #### 2.8.2数据增强的优缺点

447 | 优点:

448 | 增加训练的数据量,提高模型的泛化能力

449 | 增加噪声数据,提升模型的鲁棒性

450 | ### 2.9 计算机视觉现状

451 | #### 2.9.1计算机视觉现状

452 | 深度学习已经成功地应用于计算机视觉、自然语言处理、语音识别、在线广告、物流还有其他许多问题。

453 | 在计算机视觉的现状下,深度学习应用于计算机视觉应用有一些独特之处。

454 | ####2.9.2 banchmark

455 | Benchmark 基准测试,Benchmark是一个评价方式,在整个计算机领域有着长期的应用。

456 | Benchmark在计算机领域应用最成功的就是性能测试,主要测试负载的执行时间、传输速度、吞吐量、资源占用率等。基准测试同时也可以用来识别某段代码的CPU或者内存效率问题. 许多开发人员会用基准测试来测试不同的并发模式, 或者用基准测试来辅助配置工作池的数量, 以保证能最大化系统的吞吐量.

457 | 关于实战可参考:

458 | https://blog.csdn.net/woniu317/article/details/82560312

459 |

--------------------------------------------------------------------------------

/12 目标检测.md:

--------------------------------------------------------------------------------

1 | ## 12 目标检测

2 |

3 | ### 12.1 目标定位

4 |

5 | #### 12.1.1 定义

6 |

7 | 除了要识别出目标类(例如是否有汽车)以外,算法还需要能够给出目标的位置(例如用红框框出目标的位置),这是一种分类定位问题。分类定位问题可以是只有一个目标对象在图片中,也可以是多个目标对象在图片中的。先从单个目标对象的情况开始。

8 |

9 | #### 12.1.2 实现

10 |

11 | **1. 边界框参数定义**

12 |

13 | 图片分类我们已经比较熟悉了,知道最后通过 *softmax* 激活函数激活来表示该图片属于每一类的概率。相较于单纯的分类问题,目标定位还需要输出4个值:$b_x,b_y,b_h,b_w$。这四个值用于表示边框的位置和大小,具体为

14 | $$

15 | \begin{array}{l}

16 | b_x:边框的中心点的x轴坐标 \\

17 | b_y:边框的中心点的y轴坐标 \\

18 | b_h:边框的高度 \\

19 | b_w:边框的宽度 \\

20 | \end{array}

21 | $$

22 | 以上4个值的取值范围均为[0, 1],表示的是边界框与图片对应的**比例**。

23 |

24 | 关于坐标轴的选取,一般选图片的左上角为原点(0, 0),右下角为(1, 1)。且$x$轴为纵轴正方向向下,$y$轴为横轴正方向向右。

25 |

26 | **2. 标签的定义**

27 |

28 | 在确定需要增加的额外输出之后,也要重新定义目标标签 $y$:

29 | $$

30 | y=\left[\begin{array}{l}

31 | p_{c} \\

32 | b_{x} \\

33 | b_{y} \\

34 | b_{h} \\

35 | b_{w} \\

36 | c_{1} \\

37 | c_{2} \\

38 | c_{3}

39 | \end{array}\right]

40 | $$

41 | 其中额外增加了$p_c$,用于表示是否有对象属于类$c_1、c_2$或$c_3$,若为1则表示有目标类在图片中,为0表示只有背景。在只有背景(无目标类)时,其他输出均无效。

42 |

43 | 举一个具体的例子,如下图:

44 |

45 |

46 |

47 | x 是输入,y 是标签,假设$c_2$表示为车,则最终标签应该如上图所示。当输入中不含任何目标类时,$p_c=0$,其他参数全用“?”表示,即不参与 loss 的计算。

48 |

49 | **3. 边界框参数取值范围**

50 |

51 | 关于边框的4个参数,吴恩达老师给出的取值范围都是[0, 1]的。虽然确实可以这么做,但是背后的原因却没有解释。个人猜测可能是以下原因:

52 |

53 | * 固定取值在[0, 1]之间更容易用激活函数表示,比如sigmoid可以将单个值映射到[0, 1];

54 | * 让标签的所有参数都在一个取值范围,这样在计算loss的时候就不会变相加权了;

55 | * 取值范围在[0, 1]内更容易训练、收敛。

56 |

57 | **4. 损失函数**

58 | $$

59 | L(\hat y,y)=

60 | \begin{cases}

61 | (\hat{y_1}-y_1)^2+(\hat{y_2}-y_2)^2+...+(\hat{y_n}-y_n)^2 & {y_1=1}\\

62 | (\hat{y_1}-y_1)^2 & {y_1=0}

63 | \end{cases}

64 | $$

65 |

66 | * 对于$p_c$可以采用 Logistic 回归的方法,甚至用均方误差$(p_c-\hat{p_c})^2$也可以;

67 | * 对于$b_x,b_y,b_w,b_h$,loss 可以用平方差或类似方法;

68 | * 对于$c_1,c_2,c_3$,是多分类问题,和之前一样用 softmax 即可。

69 |

70 | ### 12.2 特征点检测

71 |

72 | #### 12.2.1 定义

73 |

74 | 以下图为例,检测双眼的眼角位置

75 |

76 |

77 |

78 | 这个就是特征点检测,主要任务是预测对应的特征点的位置,一般会同时预测多个点。

79 |

80 | #### 12.2.2 实现

81 |

82 | 对于单个点,其坐标为$(l_{ix},l_{iy}),i \in [1, m]$,$m$是特征点的个数,$l_{ix},l_{iy} \in [0,1]$。坐标轴的选取和目标定位时一致,以及需要保证每个样本的特征点的顺序是一致的,比如$l_1$都是左眼的左眼角,$l_2$都是左眼的右眼角等。

83 |

84 | 关于最后一层的激活函数,可以对每个坐标的值用 sigmoid 激活。

85 |

86 | ### 12.3 目标检测

87 |

88 | #### 12.3.1 滑动窗口目标检测算法

89 |

90 | 滑动窗口检测是分两步执行的:第一步是从原图中裁剪一部分并根据需求调整大小,第二步是检测裁剪部分有无目标对象。

91 |

92 | 对于第二步,是我们比较熟悉的分类算法,只是训练集需要人为调整到为几乎整张图都是目标对象,如下图:

93 |

94 |

95 |

96 | $x$ 为一张无车的图片或者被车占满的图片,标签 $y$ 为1时有车,为0时无车。

97 |

98 | 对于第一步,滑动窗口用的方法是先选定一个裁剪大小,然后从图片的左上角开始,每隔一定像素(距离)裁剪一次,一直滑动到图片的右下角,然后下一个裁剪大小用相同的方法裁剪。如图,上图为3种裁剪大小,下图为一个滑动流程:

99 |

100 |

101 |

102 |

103 |

104 | #### 12.3.2 滑动窗口缺点——计算成本

105 |

106 | 看到这里不难发现,滑动窗口检测由于需要多个窗口且每个窗口滑动多次而导致运算量会相当巨大,运行时间过慢。而且如果滑动的步幅过大或者裁剪的大小不合适也会导致很难检测到目标。

107 |

108 | ### 12.4 卷积的滑动窗口实现

109 |

110 | #### 12.4.1 把神经网络的全连接层转化成卷积层

111 |

112 |

113 |

114 | - 假设目标检测算法输入一个14×14×3的图像,过滤器大小为5×5,数量是16,14×14×3的图像在过滤器处理之后映射为10×10×16。

115 |

116 | - 然后通过参数为2×2的最大池化操作,图像减小到5×5×16。

117 |

118 | - 添加一个连接400个单元的全连接层,接着再添加一个全连接层。

119 |

120 | - 最后通过softmax单元输出,用4个数字来表示 ,它们分别对应softmax单元所输出的4个分类出现的概率。这4个分类可以是行人、汽车、摩托车和背景或其它对象。

121 |

122 | **全连接层转化为卷积层**

123 |

124 |

125 |

126 | - 前几层和之前的一样。

127 |

128 | - 而对于全连接层,用5×5的过滤器来实现,数量是400个。输入图像大小为5×5×16,用5×5的过滤器对它进行卷积操作,过滤器实际上是5×5×16,因为在卷积过程中,过滤器会遍历这16个通道,所以这两处的通道数量必须保持一致,输出结果为1×1。假设应用400个这样的5×5×16过滤器,输出维度就是1×1×400。它不再是一个含有400个节点的集合,而是一个1×1×400的输出层。从数学角度看,它和全连接层是一样的,因为这400个节点中每个节点都有一个5×5×16维度的过滤器,所以每个值都是上一层这些5×5×16激活值经过某个任意线性函数的输出结果。

129 | - 再添加另外一个卷积层,这里用1×1卷积,假设有400个1×1的过滤器,在这400个过滤器的作用下,下一层的维度是1×1×400,它其实就是上个网络中的这一全连接层。最后经由1×1过滤器的处理,得到一个softmax激活值,通过卷积网络,我们最终得到这个1×1×4的输出层,而不是4个数字。

130 |

131 | 以上就是用卷积层代替全连接层的过程。

132 |

133 | #### 12.4.2 在卷积上应用滑动窗口对象检测算法

134 |

135 |

136 |

137 | 假设向滑动窗口卷积网络输入14×14×3的图片。和前面一样,神经网络最后的输出层,即softmax单元的输出是1×1×4,这里画得比较简单,严格来说,14×14×3应该是一个长方体,第二个10×10×16也是一个长方体,为了方便,这里只画了正面,所以这里显示的都是平面图,而不是3D图像。

138 |

139 |

140 |

141 | 假设输入给卷积网络的图片大小是14×14×3,测试集图片是16×16×3,现在给这个输入图片加上黄色条块,在最初的滑动窗口算法中,你会把这片蓝色区域输入卷积网络(红色笔标记)生成0或1分类。接着滑动窗口,步幅为2个像素,向右滑动2个像素,将这个绿框区域输入给卷积网络,运行整个卷积网络,得到另外一个标签0或1。继续将这个橘色区域输入给卷积网络,卷积后得到另一个标签,最后对右下方的紫色区域进行最后一次卷积操作。我们在这个16×16×3的小图像上滑动窗口,卷积网络运行了4次,于是输出了了4个标签。

142 |

143 |

144 |

145 | 这4次卷积操作中很多计算都是重复的。所以执行滑动窗口的卷积时使得卷积网络在这4次前向传播过程中共享很多计算。

146 |

147 | - 卷积网络运行同样的参数,使得相同的5×5×16过滤器进行卷积操作,得到12×12×16的输出层。

148 |

149 | - 然后执行同样的最大池化,输出结果6×6×16。照旧应用400个5×5的过滤器,得到一个2×2×400的输出层,现在输出层为2×2×400,而不是1×1×400。

150 |

151 | - 应用1×1过滤器得到另一个2×2×400的输出层。

152 |

153 | - 再做一次全连接的操作,最终得到2×2×4的输出层,而不是1×1×4。

154 |

155 | - 最终,在输出层这4个子方块中,蓝色的是图像左上部分14×14的输出(红色箭头标识),右上角方块是图像右上部分(绿色箭头标识)的对应输出,左下角方块是输入层左下角(橘色箭头标识),也就是这个14×14区域经过卷积网络处理后的结果,同样,右下角这个方块是卷积网络处理输入层右下角14×14区域(紫色箭头标识)的结果。

156 |

157 | 该卷积操作的原理是我们不需要把输入图像分割成四个子集,分别执行前向传播,而是把它们作为一张图片输入给卷积网络进行计算,其中的公共区域可以共享很多计算,就像这里我们看到的这个4个14×14的方块一样。

158 |

159 |

160 |

161 | 再看一个更大的图片样本,假如对一个28×28×3的图片应用滑动窗口操作,如果以同样的方式运行前向传播,最后得到8×8×4的结果。跟上一个范例一样,以14×14区域滑动窗口,首先在这个区域应用滑动窗口,其结果对应输出层的左上角部分。接着以大小为2的步幅不断地向右移动窗口,直到第8个单元格,得到输出层的第一行。然后向图片下方移动,最终输出这个8×8×4的结果。因为最大池化参数为2,相当于以大小为2的步幅在原始图片上应用神经网络。

162 |

163 | **滑动窗口的实现过程总结**

164 |

165 |

166 |

167 | 在图片上剪切出一块区域,假设它的大小是14×14,把它输入到卷积网络。继续输入下一块区域,大小同样是14×14,重复操作,直到某个区域识别到汽车。

168 |

169 | 但是我们不用依靠连续的卷积操作来识别图片中的汽车,比如,我们可以对大小为28×28的整张图片进行卷积操作,一次得到所有预测值,如果足够幸运,神经网络便可以识别出汽车的位置。

170 |

171 | ### 12.5 Bounding Box预测

172 |

173 | 滑动窗口法的卷积实现的算法虽然效率更高,但仍然存在问题,不能输出最精准的边界框。

174 |

175 |  176 |

177 | 在滑动窗口法中,你取这些离散的位置集合,然后在它们上运行分类器,在这种情况下,这些边界框没有一个能完美匹配汽车位置,也许这个框(编号1)是最匹配的了。还有看起来这个真实值,最完美的边界框甚至不是方形,稍微有点长方形(红色方框所示),长宽比有点向水平方向延伸。