├── Linux内核知识体系.png

├── Linux学习笔记.pdf

├── README.md

├── 文章

├── Linux IO 之 IO与网络模型.md

├── Linux操作系统学习——内核初始化.md

├── Linux操作系统学习——内核运行.md

├── Linux操作系统学习——启动.md

├── 任务空间管理.md

├── 你真的理解Linux中断机制嘛.md

├── 内存管理

│ ├── 1.txt

│ ├── Linux中的内存管理机制.md

│ ├── 一文了解,Linux内存管理,malloc、free 实现原理.md

│ ├── 其他工程问题以及调优.md

│ ├── 内存与IO的交换.md

│ ├── 内存的动态申请和释放.md

│ ├── 内存管理之内存映射.md

│ ├── 内存管理之分页.md

│ ├── 多核心Linux内核路径优化的不二法门之-slab与伙伴系统.md

│ ├── 尽情阅读,技术进阶,详解mmap原理.md

│ ├── 浅谈Linux内存管理机制.md

│ ├── 熟读精思,熟读玩味,Linux虚拟内存管理,MMU机制,原来如此也.md

│ ├── 硬件原理 和 分页管理.md

│ └── 进程的内存消耗和泄漏.md

├── 文件系统

│ ├── 1.txt

│ ├── Linux IO 之 块IO流程与IO调度器.md

│ ├── Linux IO 之 文件系统的实现.md

│ ├── Linux IO 之 文件系统的架构.md

│ ├── Linux 操作系统原理-文件系统(1).md

│ ├── Linux 操作系统原理-文件系统(2).md

│ ├── Linux操作系统学习之文件系统.md

│ ├── Linux文件系统详解.md

│ ├── 磁盘IO那些事.md

│ └── 虚拟文件系统.md

├── 浅谈Linux内核之CPU缓存.md

├── 系统调用.md

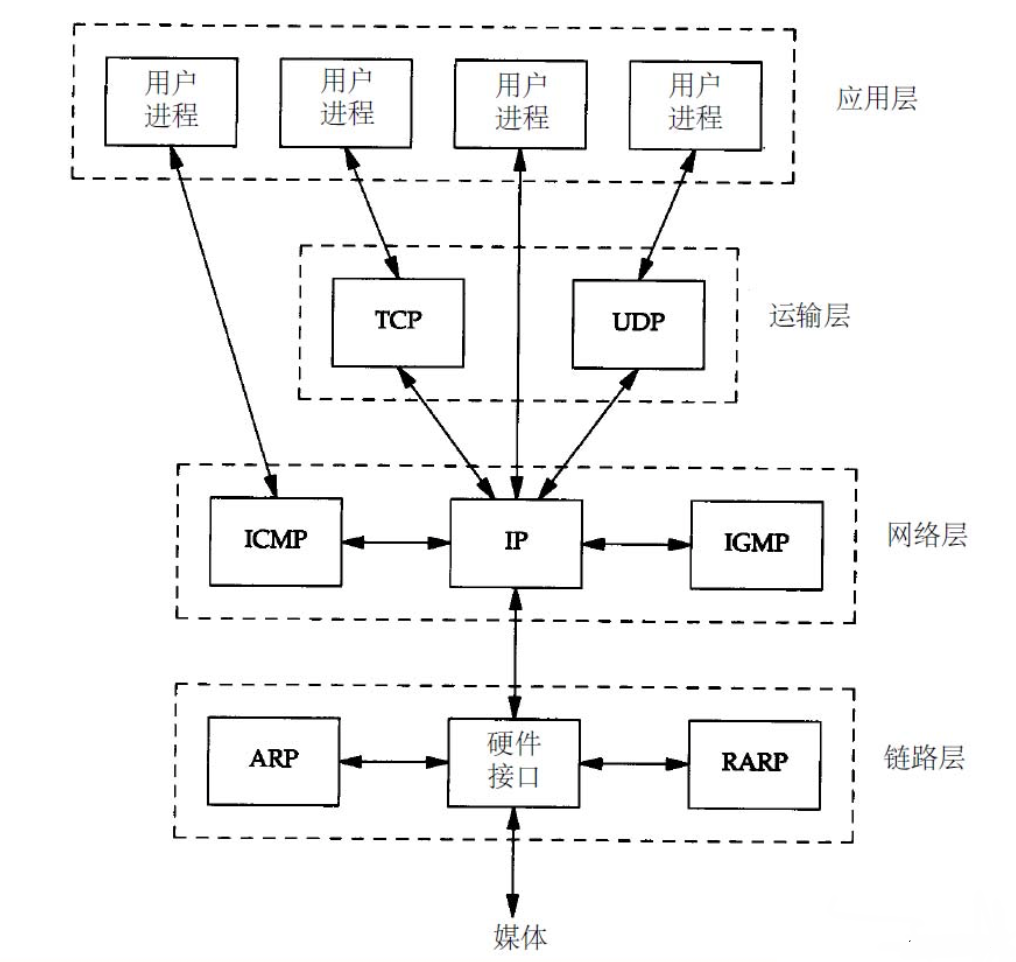

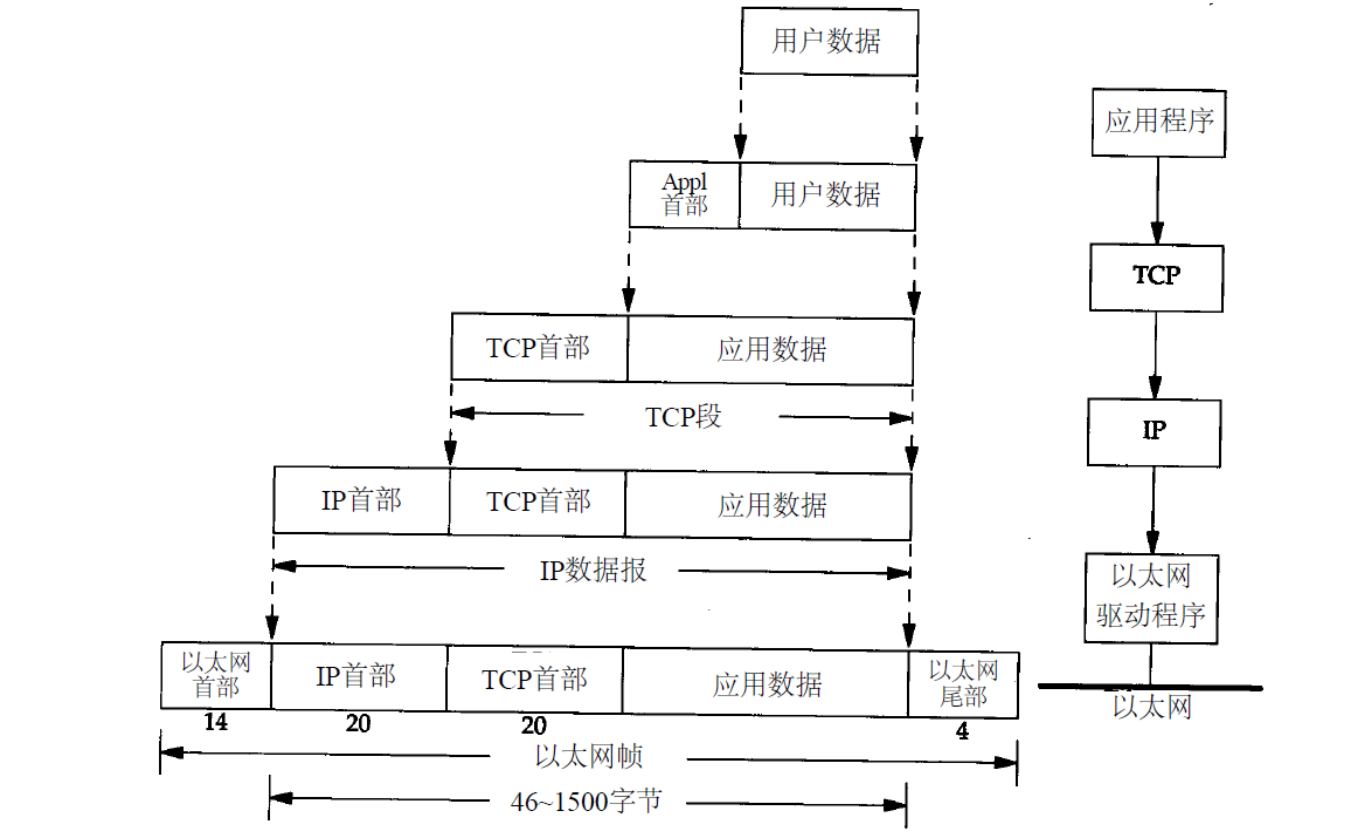

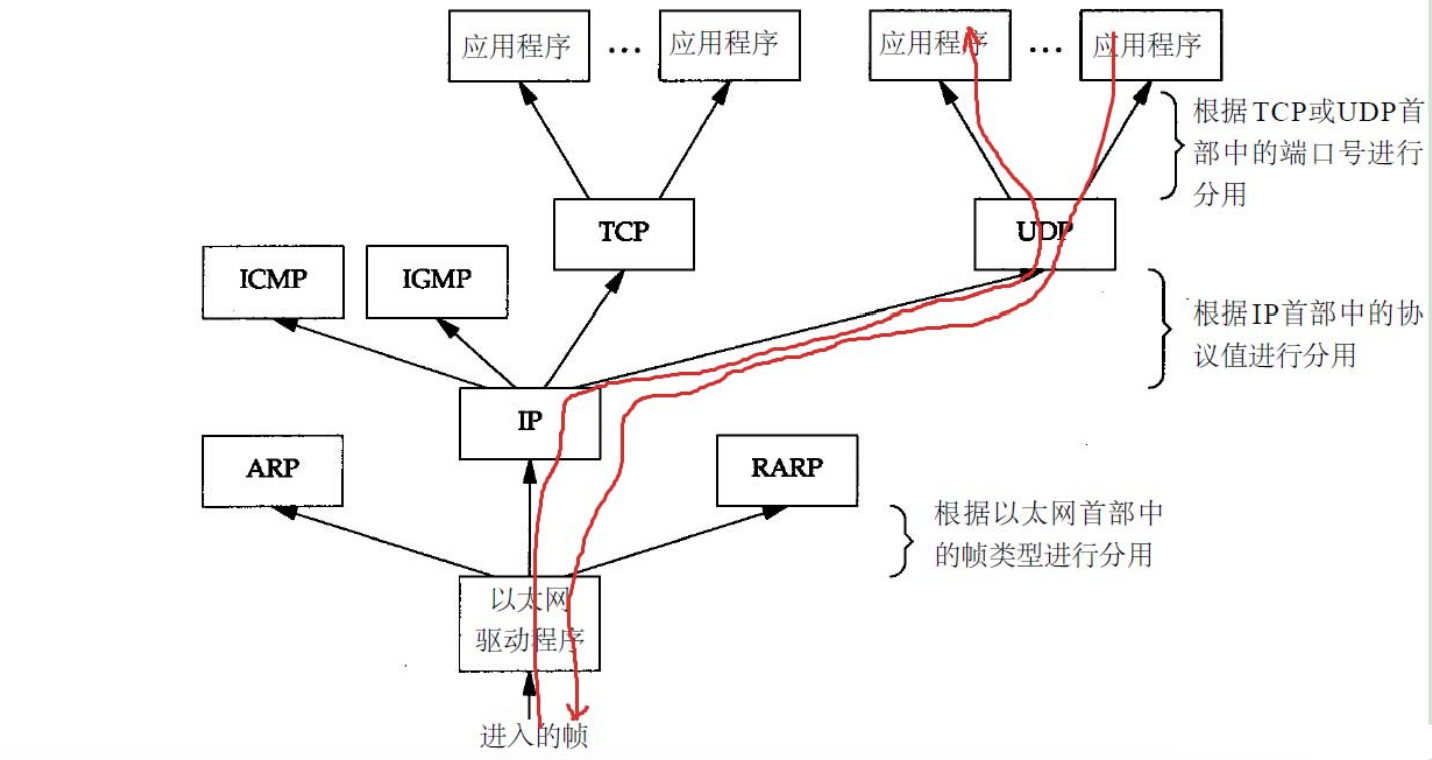

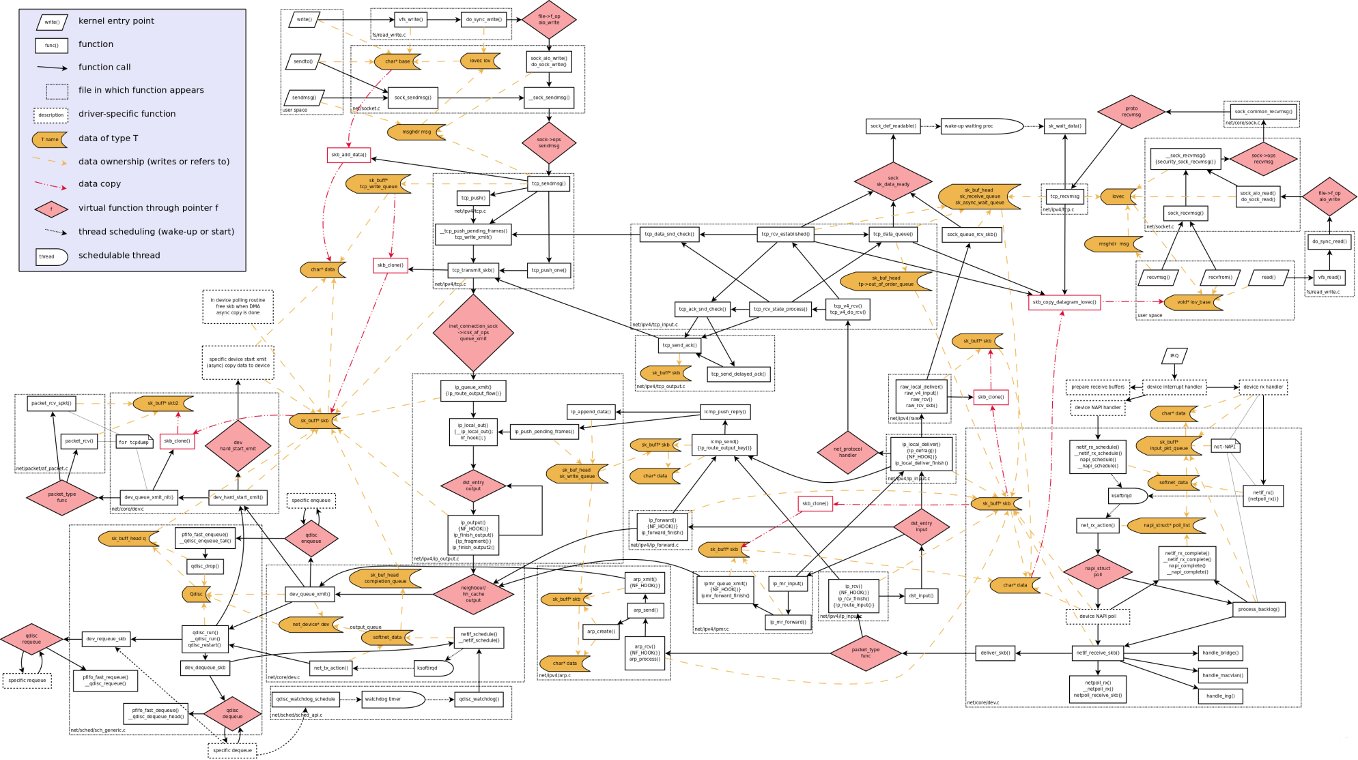

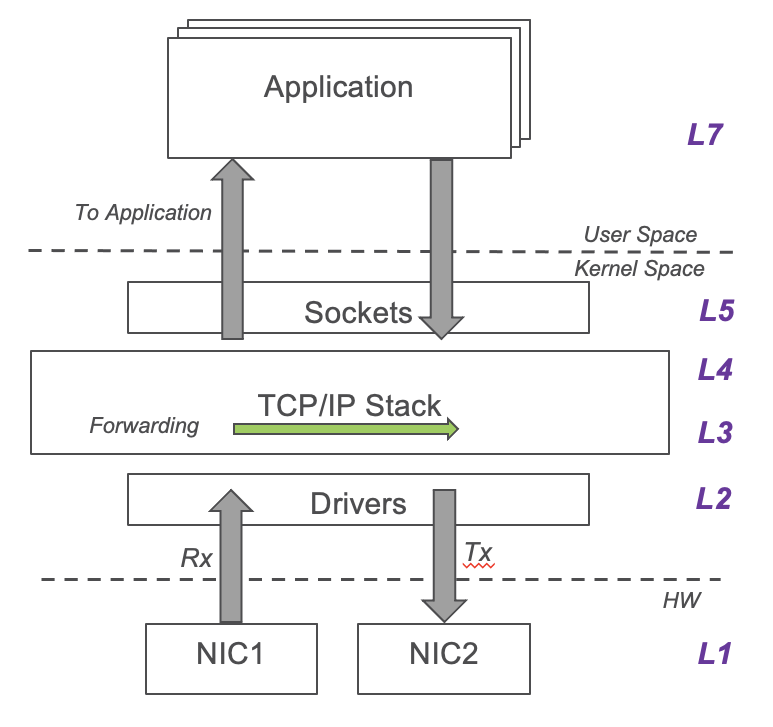

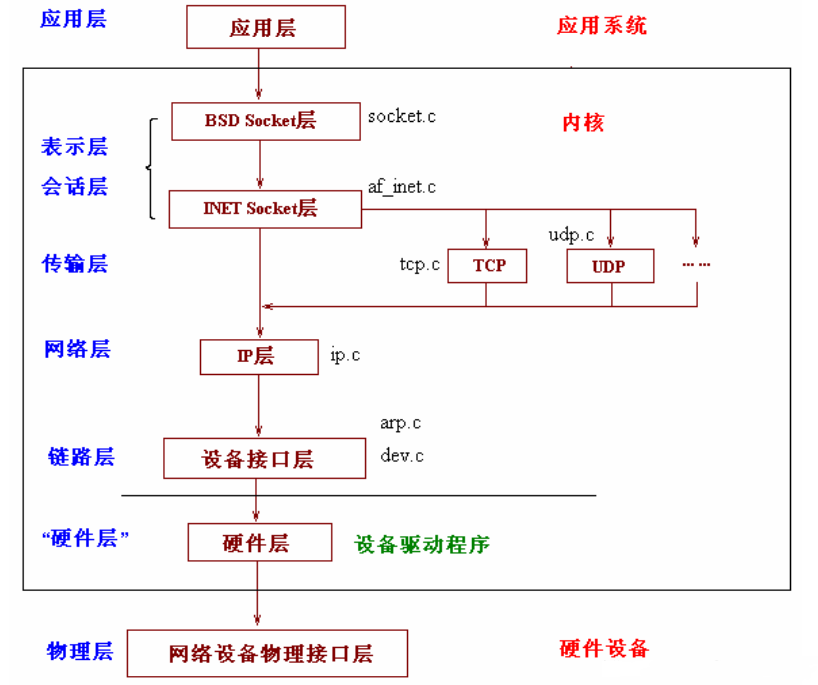

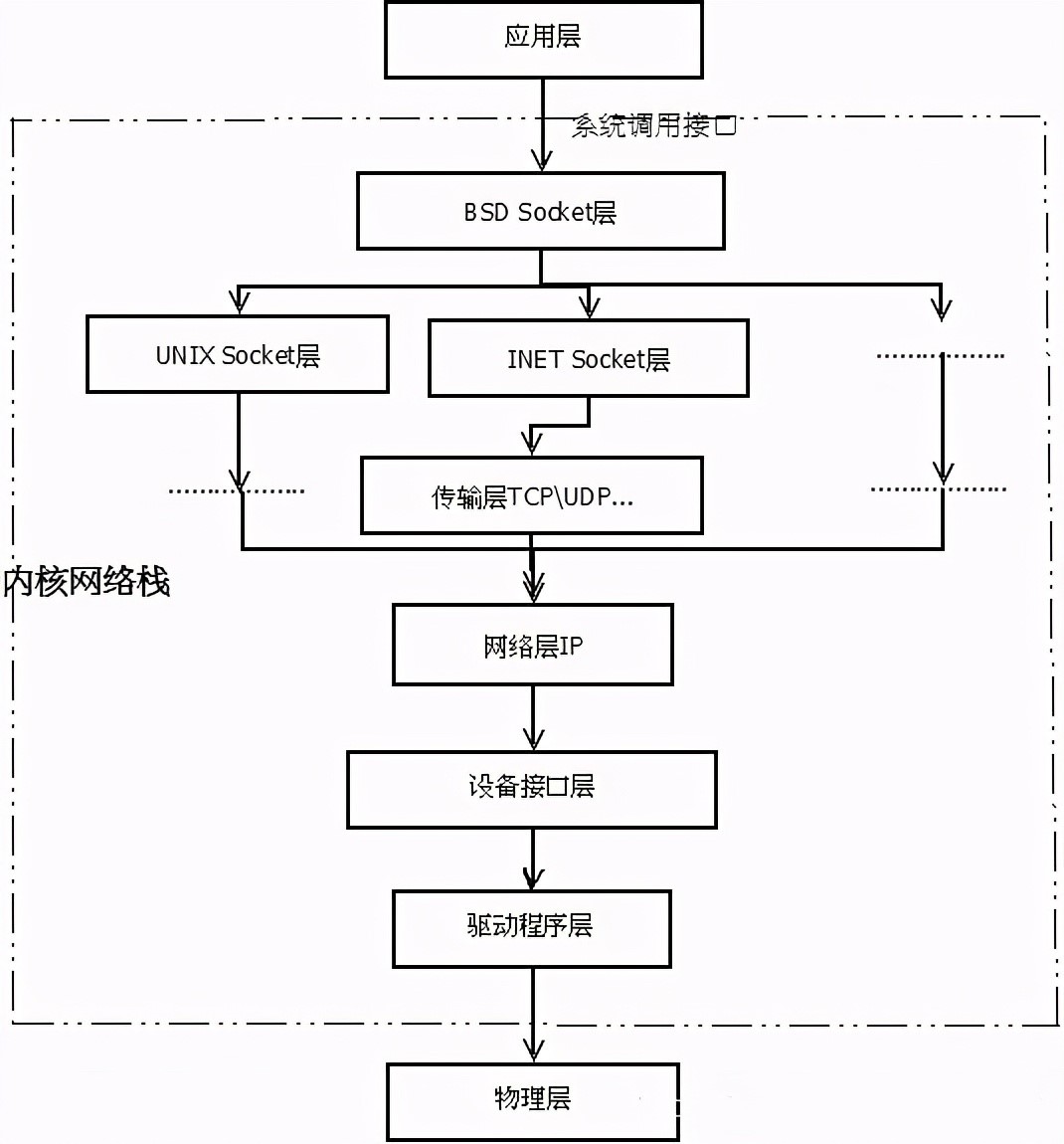

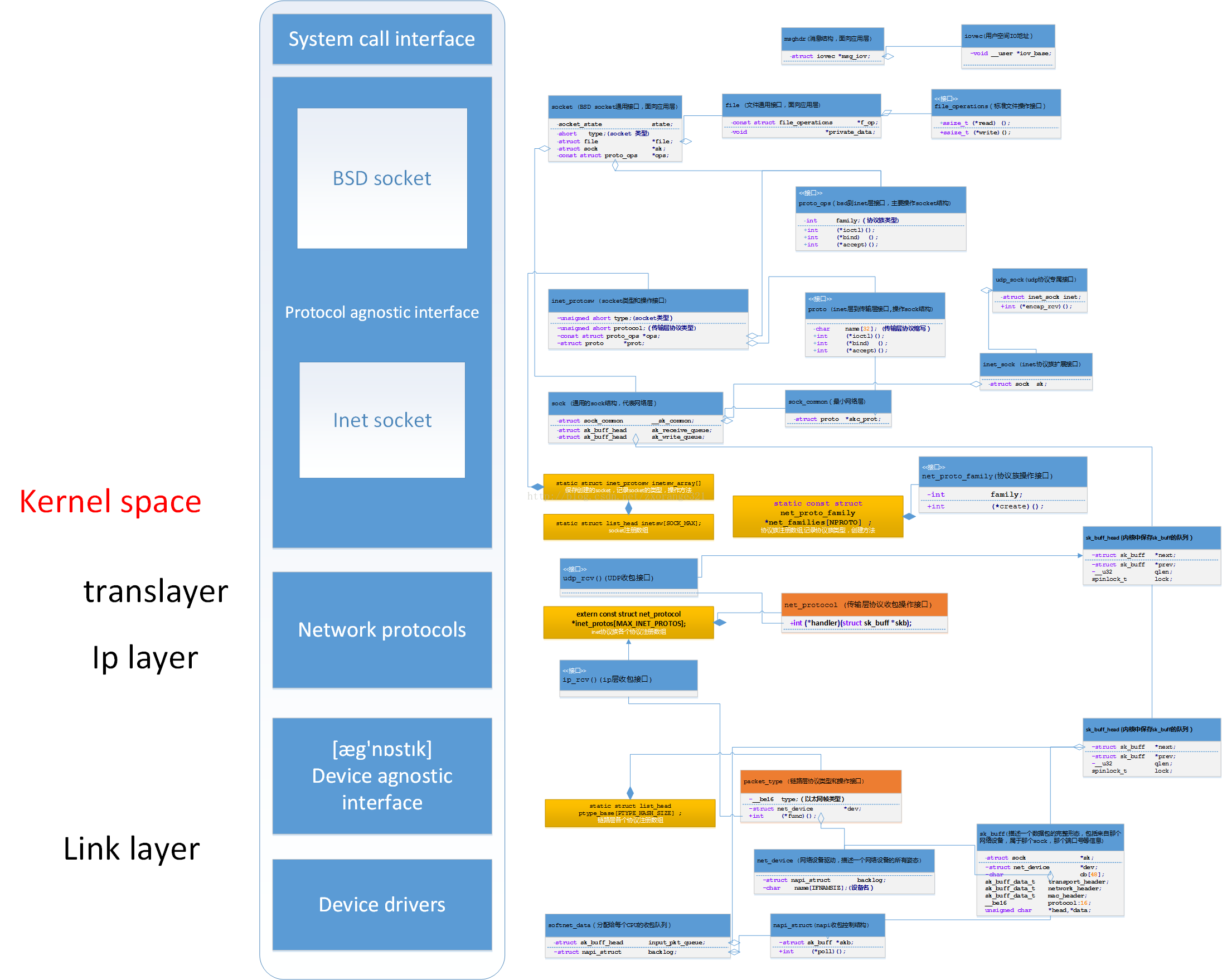

├── 网络协议栈

│ ├── 1.txt

│ ├── Linux 中的五种IO模型.md

│ ├── Linux内核之epoll模型.md

│ ├── Linux内核网络UDP数据包发送(三)—IP协议层分析.md

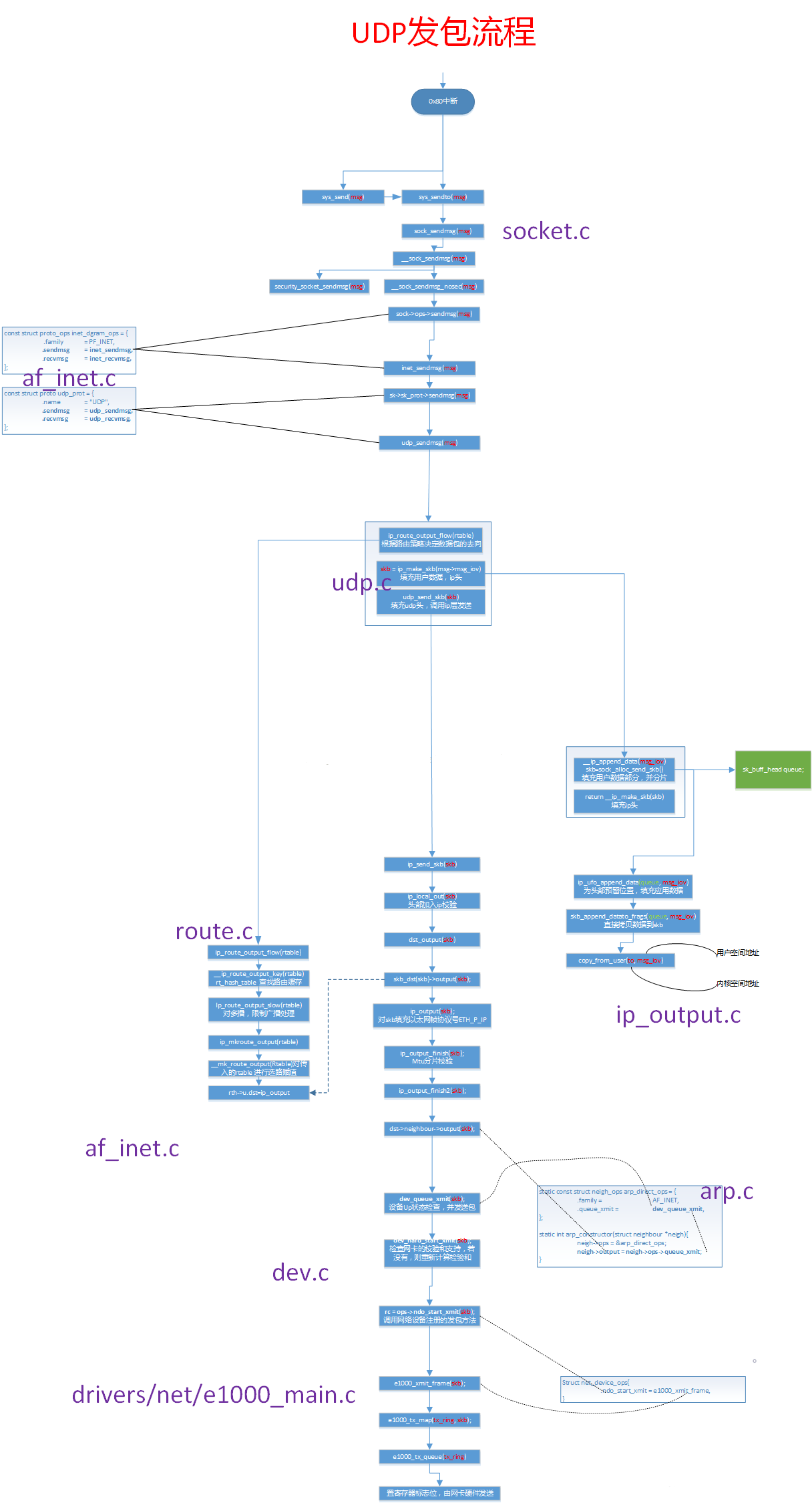

│ ├── Linux内核网络udp数据包发送(一).md

│ ├── Linux内核网络udp数据包发送(二)-UDP协议层分析.md

│ ├── Linux操作系统原理—内核网络协议栈.md

│ ├── Linux网络栈解剖.md

│ ├── Linux网络源代码学习——整体介绍.md

│ ├── 深入分析Linux操作系统对于TCP IP栈的实现原理与具体过程.md

│ ├── 透过现象看本质,从linux源码角度看epoll.md

│ └── 驾驭Linux内部网络实现——关键数据结构 sk_buff.md

├── 设备驱动

│ ├── 1.txt

│ ├── Linux 总线、设备、驱动模型的探究.md

│ ├── Linux 设备和驱动的相遇.md

│ └── Linux操作系统学习之字符设备.md

└── 进程管理

│ ├── 1.txt

│ ├── Linux进程、线程、调度(一).md

│ ├── Linux进程、线程、调度(三).md

│ ├── Linux进程、线程、调度(二).md

│ ├── Linux进程、线程、调度(四).md

│ ├── Linux进程状态总结.md

│ ├── 一文带你,彻底了解,零拷贝Zero-Copy技术.md

│ ├── 任务调度.md

│ ├── 进程、线程的创建和派生.md

│ ├── 进程的核心——task_truct.md

│ ├── 进程间通信之信号.md

│ ├── 进程间通信之共享内存和信号量.md

│ ├── 进程间通信之管道.md

│ └── 进程间通信,管道,socket,XSI(System V).md

├── 源码组织结构.png

├── 电子书籍

├── 1.txt

├── Linux内核完全注释V3.0书签版.pdf

├── Linux命令行大全 - 绍茨 (william E.shotts).pdf

├── Linux命令速查手册.mobi

├── Linux就该这么学.epub

├── Linux性能优化大师.epub

├── Linux环境编程:从应用到内核 (Linux Unix技术丛书).pdf

├── Linux集群和自动化运维 余洪春.pdf

├── Linux驱动程序开发实例(第2版).pdf

├── Linux高级程序设计(第3版).epub

├── 构建高可用Linux服务器(第4版).epub

└── 深入了解Linux内核.pdf

├── 论文

├── 1.txt

├── 《A Novel DDoS Floods Detection and Testing Approaches for Network Traffic based on Linux Techniques》.pdf

├── 《A Permission Check Analysis Framework for Linux Kernel》.pdf

├── 《A dataset of feature additions and feature removals from the Linux kernel》.pdf

├── 《An Evaluation of Adaptive Partitioning of Real-Time Workloads on Linux》.pdf

├── 《Analysis and Study of Security Mechanisms inside Linux Kernel 》.pdf

├── 《Architecture of the Linux kernel》.pdf

├── 《Automated Patch Backporting in Linux》.pdf

├── 《Automated Voxel Placement A Linux-based Suite of Tools for Accurate and Reliable Single Voxel Coregistration》.pdf

├── 《Automatic Rebootless Kernel Updates》.pdf

├── 《Communication on Linux using Socket Programming in ‘C’》.pdf

├── 《Compatibility of Linux Architecture for Diskless Technology System》.pdf

├── 《Concurrency in the Linux kernel》.pdf

├── 《Container-based real-time scheduling in the Linux kernel》.pdf

├── 《Crash Consistency Test Generation for the Linux Kernel》.pdf

├── 《Designing of a Virtual File System》.pdf

├── 《Efficient Formal Verification for the Linux Kernel》.pdf

├── 《Exploiting Uses of Uninitialized Stack Variables in Linux Kernels to Leak Kernel Pointers》.pdf

├── 《Hybrid Fuzzing on the Linux Kernel》.pdf

├── 《In-Process Memory Isolation for Modern Linux Systems》.pdf

├── 《Introduction to the Linux kernel challenges and case studies》.pdf

├── 《Kernel Mode Linux Toward an Operating System Protected by a Type Theory》.pdf

├── 《Linux Kernel Transport Layer Security》.pdf

├── 《Linux Kernel Workshop Hacking the Kernel for Fun and Profit》.pdf

├── 《Linux Kernel development》.pdf

├── 《Linux Network Device Drivers an Overview》.pdf

├── 《Linux Physical Memory Page Allocation》.pdf

├── 《Linux Random Number Generator – A New Approach》.pdf

├── 《Linux kernel vulnerabilities State-of-the-art defenses and open problems》.pdf

├── 《Machine Learning for Load Balancing in the Linux Kernel》.pdf

├── 《Performance of IPv6 Segment Routing in Linux Kernel》.pdf

├── 《Professional Linux® Kernel Architecture》.pdf

├── 《Research of Performance Linux Kernel File Systems》.pdf

├── 《Resource Management for Hardware Accelerated Linux Kernel Network Functions》.pdf

├── 《Rethinking Compiler Optimizations for the Linux Kernel An Explorative Study》.pdf

├── 《Securing the Linux Boot Process From Start to Finish》.pdf

├── 《Security Applications of Extended BPF Under the Linux Kernel》.pdf

├── 《Simple and precise static analysis of untrusted Linux kernel extensions》.pdf

├── 《Speeding Up Linux Disk Encryption》.pdf

├── 《Stateless model checking of the Linux kernel's hierarchical read-copy-update (tree RCU)》.pdf

├── 《Survey Paper on Adding System Call in Linux Kernel 3.2+ & 3.16》.pdf

├── 《TRACING THE WAY OF DATA IN A TCP CONNECTION THROUGH THE LINUX KERNEL》.pdf

├── 《The benefits and costs of writing a POSIX kernel in a high-level language》.pdf

├── 《The real-time Linux kernel a Survey on PREEMPT_RT》.pdf

├── 《Trace-Based Analysis of Locking in the Linux Kernel》.pdf

├── 《Tracing Network Packets in the Linux Kernel using eBPF》.pdf

├── 《Understanding Linux Kernel》.pdf

├── 《Understanding Linux Malware》.pdf

├── 《Using kAFS on Linux for Network Home Directories》.pdf

├── 《Verification of tree-based hierarchical read-copy update in the Linux kernel》.pdf

└── 《XDP test suite for Linux kernel》.pdf

└── 面试题

├── 1.txt

├── 面试题一.md

└── 面试题二.md

/Linux内核知识体系.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ZhongYi-LinuxDriverDev/linux_kernel_wiki/3f6c0f20abec5b11af937f1cbcdd9ca2809befef/Linux内核知识体系.png

--------------------------------------------------------------------------------

/Linux学习笔记.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ZhongYi-LinuxDriverDev/linux_kernel_wiki/3f6c0f20abec5b11af937f1cbcdd9ca2809befef/Linux学习笔记.pdf

--------------------------------------------------------------------------------

/文章/Linux IO 之 IO与网络模型.md:

--------------------------------------------------------------------------------

1 | ## Linux内核针对不同并发场景的工具实现

2 |

3 |

4 |

5 | ### atomic 原子变量

6 |

7 | x86在多核环境下,多核竞争数据总线时,提供Lock指令进行锁总线操作。保证“读-修改-写”的操作在芯片级的原子性。

8 |

9 | ### spinlock 自旋锁

10 |

11 | 自旋锁将当前线程不停地执行循环体,而不改变线程的运行状态,在CPU上实现忙等,以此保证响应速度更快。这种类型的线程数不断增加时,性能明显下降。所以自旋锁保护的临界区必须小,操作过程必须短。

12 |

13 | ### semaphore 信号量

14 |

15 | 信号量用于保护有限数量的临界资源,信号量在获取和释放时,通过自旋锁保护,当有中断会把中断保存到eflags寄存器,最后再恢复中断。

16 |

17 | ### mutex 互斥锁

18 |

19 | 为了控制同一时刻只有一个线程进入临界区,让无法进入临界区的线程休眠。

20 |

21 | ### rw-lock 读写锁

22 |

23 | 读写锁,把读操作和写操作分别进行加锁处理,减小了加锁粒度,优化了读大于写的场景。

24 |

25 | ### preempt 抢占

26 |

27 | * 时间片用完后调用schedule函数。

28 | * 由于IO等原因自己主动调用schedule。

29 | * 其他情况,当前进程被其他进程替换的时候。

30 |

31 | ### per-cpu 变量

32 |

33 | linux为解决cpu 各自使用的L2 cache 数据与内存中的不一致的问题。

34 |

35 | ### RCU机制 (Read, Copy, Update)

36 |

37 | 用于解决多个CPU同时读写共享数据的场景。它允许多个CPU同时进行写操作,不使用锁,并且实现垃圾回收来处理旧数据。

38 |

39 |

40 |

41 | ### 内存屏障 memory-barrier

42 |

43 | 程序运行过程中,对内存访问不一定按照代码编写的顺序来进行。

44 |

45 | * 编译器对代码进行优化。

46 | * 多cpu架构存在指令乱序访问内存的可能。

47 |

48 | ## I/O 与网络模型

49 |

50 | 介绍各种各样的I/O模型,包括以下场景:

51 |

52 | * 阻塞 & 非阻塞

53 | * 多路复用

54 | * Signal IO

55 | * 异步 IO

56 | * libevent

57 |

58 | 现实生活中的场景复杂,Linux CPU和IO行为,他们之间互相等待。例如,阻塞的IO可能会让CPU暂停。

59 |

60 | I/O模型很难说好与坏,只能说在某些场景下,更适合某些IO模型。其中,1、4 更适合块设备,2、3 更适用于字符设备。

61 |

62 | 为什么硬盘没有所谓的 多路复用,libevent,signal IO?

63 |

64 | > 因为select(串口), epoll(socket) 这些都是在监听事件,所以各种各样的IO模型,更多是描述字符设备和网络socket的问题。但硬盘的文件,只有读写,没有 epoll这些。

65 | > 这些IO模型更多是在字符设备,网络socket的场景。

66 |

67 | ### 为什么程序要选择正确的IO模型?

68 |

69 | 蓝色代表:cpu,红色代表:io

70 |

71 |

72 |

73 | 如上图,某个应用打开一个图片文件,先需要100ms初始化,接下来100ms读这个图片。那打开这个图片就需要200ms。

74 |

75 | 但是 是否可以开两个线程,同时做这两件事?

76 |

77 |

78 |

79 | 如上图,网络收发程序,如果串行执行,CPU和IO会需要互相等待。

80 | 为什么CPU和IO可以并行?因为一般硬件,IO通过DMA,cpu消耗比较小,在硬件上操作的时间更长。CPU和硬盘是两个不同的硬件。

81 |

82 | 再比如开机加速中systemd使用的readahead功能:

83 | 第一次启动过程,读的文件,会通过Linux inotify监控linux内核文件被操作的情况,记录下来。第二次启动,后台有进程直接读这些文件,而不是等到需要的时候再读。

84 |

85 |

86 |

87 | I/O模型会深刻影响应用的最终性能,阻塞 & 非阻塞 、异步 IO 是针对硬盘, 多路复用、signal io、libevent 是针对字符设备和 socket。

88 |

89 | ### 简单的IO模型

90 |

91 |

92 |

93 | 当一个进程需要读 键盘、触屏、鼠标时,进程会阻塞。但对于大量并发的场景,阻塞IO无法搞定,也可能会被信号打断。

94 |

95 | 内核程序等待IO,gobal fifo read不到

96 |

97 | 一般情况select返回,会调用 if signal_pending,进程会返回 ERESTARTSYS;此时,进程的read 返回由singal决定。有可能返回(EINTR),也有可能不返回。

98 |

99 | #### demo:

100 |

101 | ```c

102 | #include

103 | #include

104 | #include

105 | #include

106 | #include

107 | #include

108 | #include

109 |

110 | static void sig_handler(int signum)

111 | {

112 | printf("int handler %d\n", signum);

113 | }

114 |

115 | int main(int argc, char **argv)

116 | {

117 | char buf[100];

118 | ssize_t ret;

119 | struct sigaction oldact;

120 | struct sigaction act;

121 |

122 | act.sa_handler = sig_handler;

123 | act.sa_flags = 0;

124 | // act.sa_flags |= SA_RESTART;

125 | sigemptyset(&act.sa_mask);

126 | if (-1 == sigaction(SIGUSR1, &act, &oldact)) {

127 | printf("sigaction failed!/n");

128 | return -1;

129 | }

130 |

131 | bzero(buf, 100);

132 | do {

133 | ret = read(STDIN_FILENO, buf, 10);

134 | if ((ret == -1) && (errno == EINTR))

135 | printf("retry after eintr\n");

136 | } while((ret == -1) && (errno == EINTR));

137 |

138 | if (ret > 0)

139 | printf("read %d bytes, content is %s\n", ret, buf);

140 | return 0;

141 | }

142 | ```

143 |

144 |

145 |

146 | 一个阻塞的IO,在睡眠等IO时Ready,但中途被信号打断,linux响应信号,read/write请求阻塞。

147 | 配置信号时,在SA_FLAG是不是加“自动”,SA_RESTART指定 被阻塞的IO请求是否重发,并且应用中可以捕捉。加了SA_RESTART重发,就不会返回出错码EINTR。

148 | 没有加SA_RESTART重发,就会返回出错码(EINTR),这样可以检测read被信号打断时的返回。

149 |

150 | 但Linux中有一些系统调用,即便你加了自动重发,也不能自动重发。man signal.

151 |

152 |

153 |

154 | 当使用阻塞IO时,要小心这部分。

155 |

156 |

157 |

158 | ### 多进程、多线程模型

159 |

160 | 当有多个socket消息需要处理,阻塞IO搞不定,有一种可能是多个进程/线程,每当有一个连接建立(accept socket),都会启动一个线程去处理新建立的连接。但是,这种模型性能不太好,创建多进程、多线程时会有开销。

161 |

162 | 经典的C10K问题,意思是 在一台服务器上维护1w个连接,需要建立1w个进程或者线程。那么如果维护1亿用户在线,则需要1w台服务器。

163 |

164 | IO多路复用,则是解决以上问题的场景。

165 |

166 | 总结:多进程、多线程模型企图把每一个fd放到不同的线程/进程处理,避免阻塞的问题,从而引入了进程创建\撤销,调度的开销。能否在一个线程内搞定所有IO? -- 这就是多路复用的作用。

167 |

168 | ### 多路复用

169 |

170 |

171 |

172 | #### select

173 |

174 | select:效率低,性能不太好。不能解决大量并发请求的问题。

175 |

176 | 它把1000个fd加入到fd_set(文件描述符集合),通过select监控fd_set里的fd是否有变化。如果有一个fd满足读写事件,就会依次查看每个文件描述符,那些发生变化的描述符在fd_set对应位设为1,表示socket可读或者可写。

177 |

178 | Select通过轮询的方式监听,对监听的FD数量 t通过FD_SETSIZE限制。

179 |

180 | 两个问题:

181 |

182 | 1、select初始化时,要告诉内核,关注1000个fd, 每次初始化都需要重新关注1000个fd。前期准备阶段长。

183 | 2、select返回之后,要扫描1000个fd。 后期扫描维护成本大,CPU开销大。

184 |

185 | #### epoll

186 |

187 | epoll :在内核中的实现不是通过轮询的方式,而是通过注册callback函数的方式。当某个文件描述符发现变化,就主动通知。成功解决了select的两个问题,“epoll 被称为解决 C10K 问题的利器。”

188 |

189 | 1、select的“健忘症”,一返回就不记得关注了多少fd。api 把告诉内核等哪些文件,和最终监听哪些文件,都是同一个api。而epoll,告诉内核等哪些文件 和具体等哪些文件分开成两个api,epoll的“等”返回后,还是知道关注了哪些fd。

190 | 2、select在返回后的维护开销很大,而epoll就可以直接知道需要等fd。

191 |

192 |

193 |

194 |

195 |

196 | epoll获取事件的时候,无须遍历整个被侦听的描述符集,只要遍历那些被内核I/O事件异步唤醒而加入就绪队列的描述符集合。

197 |

198 | epoll_create: 创建epoll池子。

199 | epoll_ctl:向epoll注册事件。告诉内核epoll关心哪些文件,让内核没有健忘症。

200 | epoll_wait:等待就绪事件的到来。专门等哪些文件,第2个参数 是输出参数,包含满足的fd,不需要再遍历所有的fd文件。

201 |

202 |

203 |

204 | 如上图,epoll在CPU的消耗上,远低于select,这样就可以在一个线程内监控更多的IO。

205 |

206 | ```c

207 | #include

208 | #include

209 | #include

210 | #include

211 | #include

212 | #include

213 |

214 | static void call_epoll(void)

215 | {

216 | int epfd, fifofd, pipefd;

217 | struct epoll_event ev, events[2];

218 | int ret;

219 |

220 | epfd = epoll_create(2);

221 | if (epfd < 0) {

222 | perror("epoll_create()");

223 | return;

224 | }

225 |

226 | ev.events = EPOLLIN|EPOLLET;

227 |

228 | fifofd = open("/dev/globalfifo", O_RDONLY, S_IRUSR);

229 | printf("fifo fd:%d\n", fifofd);

230 | ev.data.fd = fifofd;

231 | ret = epoll_ctl(epfd, EPOLL_CTL_ADD, fifofd, &ev);

232 |

233 | pipefd = open("pipe", O_RDONLY|O_NONBLOCK, S_IRUSR);

234 | printf("pipe fd:%d\n", pipefd);

235 | ev.data.fd = pipefd;

236 | ret = epoll_ctl(epfd, EPOLL_CTL_ADD, pipefd, &ev);

237 |

238 | while(1) {

239 | ret = epoll_wait(epfd, events, 2, 50000);

240 | if (ret < 0) {

241 | perror("epoll_wait()");

242 | } else if (ret == 0) {

243 | printf("No data within 50 seconds.\n");

244 | } else {

245 | int i;

246 | for(i=0;i

36 | 2、收回刚刚结束使用寿命的程序所占内存空间。

37 | 3、让内核代码占据内存物理地址最开始的、天然的、有利的位置。

38 |

39 | 此时,重要角色要登场了,他们就是中断描述符表IDT和全局描述符表GDT。

40 |

41 | * GDT(Global Descriptor Table,全局描述符表),在系统中唯一的存放段寄存器内容(段描述符)的数组,配合程序进行保护模式下的段寻址。它在操作系统的进程切换中具有重要意义,可理解为所有进程的总目录表,其中存放每一个任务(task)局部描述符表(LDT, Local Descriptor Table)地址和任务状态段(TSS, Task Structure Segment)地址,完成进程中各段的寻址、现场保护与现场恢复。GDTR是GDT基地址寄存器,当程序通过段寄存器引用一个段描述符时,需要取得GDT的入口,GDTR标识的即为此入口。在操作系统对GDT的初始化完成后,可以用LGDT(Load GDT)指令将GDT基地址加载至GDTR。

42 | * IDT(Interrupt Descriptor Table,中断描述符表),保存保护模式下所有中断服务程序的入口地址,类似于实模式下的中断向量表。IDTR(IDT基地址寄存器),保存IDT的起始地址。

43 |

44 | 32位的中断机制和16位的中断机制,在原理上有比较大的差别。最明显的是16位的中断机制用的是中断向量表,中断向量表的起始位置在0x00000处,这个位置是固定的;32位的中断机制用的是中断描述符表(IDT),位置是不固定的,可以由操作系统的设计者根据设计要求灵活安排,由IDTR来锁定其位置。GDT是保护模式下管理段描述符的数据结构,对操作系统自身的运行以及管理、调度进程有重大意义。

45 |

46 | 此时此刻内核尚未真正运行起来,还没有进程,所以现在创建的GDT第一项为空,第二项为内核代码段描述符,第三项为内核数据段描述符,其余项皆为空。IDT虽然已经设置,实为一张空表,原因是目前已关中断,无需调用中断服务程序。此处反映的是数据“够用即得”的思想。

47 |

48 | 创建这两个表的过程可理解为是分两步进行的:

49 |

50 | 1、在设计内核代码时,已经将两个表写好,并且把需要的数据也写好。此处的数据区域是在内核源代码中设定、编译并直接加载至内存形成的一块数据区域。专用寄存器的指向由程序中的lidt和lgdt指令完成

51 | 2、将专用寄存器(IDTR、GDTR)指向表。

52 |

53 | ## 三. A20

54 |

55 | A20启用是一个标志性的动作,由上文提到的lzma_decompress.img 调用 real_to_prot启动。打开A20,意味着CPU可以进行32位寻址,最大寻址空间为4 GB。注意图1-19中内存条范围的变化:从5个F扩展到8个F,即0xFFFFFFFF(4 GB)。

56 |

57 | 实模式下,当程序寻址超过0xFFFFF时,CPU将“回滚”至内存地址起始处寻址(注意,在只有20根地址线的条件下,0xFFFFF+1=0x00000,最高位溢出)。例如,系统的段寄存器(如CS)的最大允许地址为0xFFFF,指令指针(IP)的最大允许段内偏移也为0xFFFF,两者确定的最大绝对地址为0x10FFEF,这将意味着程序中可产生的实模式下的寻址范围比1 MB多出将近64 KB(一些特殊寻址要求的程序就利用了这个特点)。这样,此处对A20地址线的启用相当于关闭CPU在实模式下寻址的“回滚”机制。如下所示为利用此特点来验证A20地址线是否确实已经打开。注意此处代码并不在此时运行,而是在后续head运行过程中为了检测是否处于保护模式中使用。

58 |

59 | #boot/head.s

60 | ……

61 | xorl %eax,%eax

62 | 1:incl%eax#check that A20 really IS enabled

63 | movl %eax,0x000000#loop forever if it isn't

64 | cmpl %eax,0x100000

65 | je 1b

66 | ……

67 |

68 | A20如果没打开,则计算机处于20位的寻址模式,超过0xFFFFF寻址必然“回滚”。一个特例是0x100000会回滚到0x000000,也就是说,地址0x100000处存储的值必然和地址0x000000处存储的值完全相同。通过在内存0x000000位置写入一个数据,然后比较此处和1 MB(0x100000,注意,已超过实模式寻址范围)处数据是否一致,就可以检验A20地址线是否已打开。

69 |

70 | ## 四. 进入main函数

71 |

72 | 这里涉及到一个硬件知识:在X86体系中,采用的终端控制芯片名为8259A,此芯片,是可以用程序控制的中断控制器。单个的8259A能管理8级向量优先级中断,在不增加其他电路的情况下,最多可以级联成64级的向量优先级中断系统。CPU在保护模式下,int 0x00~int 0x1F被Intel保留作为内部(不可屏蔽)中断和异常中断。如果不对8259A进行重新编程,int 0x00~int 0x1F中断将被覆盖。例如,IRQ0(时钟中断)为8号(int 0x08)中断,但在保护模式下此中断号是Intel保留的“Double Fault”(双重故障)。因此,必须通过8259A编程将原来的IRQ0x00~IRQ0x0F对应的中断号重新分布,即在保护模式下,IRQ0x00~IRQ0x0F的中断号是int 0x20~int 0x2F。

73 |

74 | setup程序通过下面代码将CPU工作方式设为保护模式。这里涉及到一个CR0寄存器:0号32位控制寄存器,放系统控制标志。第0位为PE(Protected Mode Enable,保护模式使能)标志,置1时CPU工作在保护模式下,置0时为实模式。将CR0寄存器第0位(PE)置1,即设定处理器工作方式为保护模式。CPU工作方式转变为保护模式,一个重要的特征就是要根据GDT决定后续执行哪里的程序。前文提到GDT初始时已写好了数据,这些将用来完成从setup程序到head程序的跳转。

75 |

76 | #boot/setup.s

77 | mov ax,#0x0001!protected mode(PE)bit

78 | lmsw ax!This is it!

79 | jmpi 0,8!jmp offset 0 of segment 8(cs)

80 |

81 | head程序是进入main之前的最后一步了。head在空间创建了内核分页机制,即在0x000000的位置创建了页目录表、页表、缓冲区、GDT、IDT,并将head程序已经执行过的代码所占内存空间覆盖。这意味着head程序自己将自己废弃,main函数即将开始执行。具体的分页机制因为较为复杂,所以打算放在后续介绍内存管理的部分再单独介绍。

82 |

83 | head构造IDT,使中断机制的整体架构先搭建起来(实际的中断服务程序挂接则在main函数中完成),并使所有中断服务程序指向同一段只显示一行提示信息就返回的服务程序。从编程技术上讲,这种初始化操作,既可以防止无意中覆盖代码或数据而引起的逻辑混乱,也可以对开发过程中的误操作给出及时的提示。IDT有256个表项,实际只使用了几十个,对于误用未使用的中断描述符,这样的提示信息可以提醒开发人员注意错误。

84 |

85 | 除此之外,head程序要废除已有的GDT,并在内核中的新位置重新创建GDT。原来GDT所在的位置是设计代码时在setup.s里面设置的数据,将来这个setup模块所在的内存位置会在设计缓冲区时被覆盖。如果不改变位置,将来GDT的内容肯定会被缓冲区覆盖掉,从而影响系统的运行。这样一来,将来整个内存中唯一安全的地方就是现在head.s所在的位置了。

86 |

87 | 下来步骤主要包括

88 |

89 | 1、初始化段寄存器和堆栈

90 |

91 | 2、主要包括将DS和ES寄存器指向相同的地址,并将DS和CS设置为相同的值。

92 |

93 | 3、清零eflag寄存器以及内核未初始化数据区

94 |

95 | 4、调用decompress_kernel()解压内核映像并跳转至0X00100000处。

96 |

97 | 5、段寄存器初始化为最终值并填充BSS字段为0

98 |

99 | 初始化临时内核页表

100 |

101 | 最终完成了分页机制初始化后,PG(Paging) 标志位将会置1,表示地址映射模式采取分页机制,最终跳转至main函数,内核开始初始化工作。

102 |

103 | ## 五. 内核初始化

104 |

105 | 注意,至此为止,我们尚未打开中断,而必须通过main函数完成一系列的初始化后才会打开新的中断,从而使内核正式运行起来。该部分主要包括:

106 |

107 | 1、为进程0建立内核态堆栈

108 |

109 | 2、清零eflags寄存器

110 |

111 | 3、调用setup_idt()用空的中断处理程序填充IDT

112 |

113 | 4、把BIOS中获得的参数传递给第一个页框

114 |

115 | 5、用GDT和IDT表填充寄存器

116 |

117 | 完成这些之后,内核就正式运行,开始创建0号进程了。

118 |

119 | ## 六. 总结

120 |

121 | 本文介绍了实模式到保护模式的整个切换过程,完成了内核的加载并开始正式准备创建0号进程。后续将继续分析启动内核创建0号、1号、2号进程的整个过程。本文介绍过程中忽略了很多汇编代码以及一些虽然很重要但是不属于基本流程的知识,有兴趣了解的可以根据文中链接、文末的源码和参考资料进行更深入的学习研究。

122 |

--------------------------------------------------------------------------------

/文章/Linux操作系统学习——启动.md:

--------------------------------------------------------------------------------

1 | ## 一. 前言

2 |

3 | Linux操作系统内核是服务端学习的根基,也是提高编程能力、源码阅读能力和进阶知识学习能力的重要部分,本文开始将记录Linux操作系统中的各个部分源码学习历程。

4 |

5 | 关于如何学习源码,个人觉得可以从以下角度入手,有效地提高阅读和学习的效率。(学习语言就不说了,这是基本功。学习IDE推荐Source Insight或者Visual Studio,网站源码阅读推荐woboq)

6 |

7 | * 理解代码的组织结构。 以Linux源码举例,首先你得知道操作系统分为哪几个部分,他们单独做了什么功能,如何进行配合完成更为具体的功能。建立整体的印象有助于后续深入学习的时候方便理解,毕竟代码是用的不是看的,理解他的作用有利于理解为什么要这么做。

8 |

9 | * 深入各个模块学习

10 | * 模块接口: 这里推荐微软的画图工具visio或者思维导图xmind,用其画图可以将各个模块的接口列出,并绘制各个模块之间的关系,通过了解接口可以清楚各个模块之间的关系,即绘制模块组织图

11 | * 工作流程:通过上面一步得到各模块间的关系,然后实际用断点或log等方式看一看整体的工作流程,在模块组织图的基础上绘制程序流程图

12 | * 模块粘合层:我们的代码有很多都是用来粘合代码的,比如中间件(middleware)、Promises 模式、回调(Callback)、代理委托、依赖注入等。这些代码模块间的粘合技术是非常重要的,因为它们会把本来平铺直述的代码给分裂开来,让你不容易看明白它们的关系。这些可以作为程序流程图的补充,让其中本来无法顺畅衔接的地方变得通畅无阻。

13 | * 模块具体实现 :这是最难得地方,涉及到大量具体源码的学习。深入细节容易迷失在细节的海洋里,因此需要有一些重点去关注,将非重点的内容省略。通过学习绘制模块具体架构图和模块的算法时序图,可以帮助你更好的掌握源码的精髓。

14 |

15 | * 需要关注的包括

16 | * 代码逻辑。代码有两种逻辑,一种是业务逻辑,这种逻辑是真正的业务处理逻辑;另一种是控制逻辑,这种逻辑只是用控制程序流转的,不是业务逻辑。比如:flag 之类的控制变量,多线程处理的代码,异步控制的代码,远程通讯的代码,对象序列化反序列化的代码等。这两种逻辑你要分开,很多代码之所以混乱就是把这两种逻辑混在一起了。

17 | * 重要的算法。一般来说,我们的代码里会有很多重要的算法,我说的并不一定是什么排序或是搜索算法,可能会是一些其它的核心算法,比如一些索引表的算法,全局唯一 ID 的算法、信息推荐的算法、统计算法、通读算法(如 Gossip)等。这些比较核心的算法可能会非常难读,但它们往往是最有技术含量的部分。

18 | * 底层交互。有一些代码是和底层系统的交互,一般来说是和操作系统或是 JVM 的交互。因此,读这些代码通常需要一定的底层技术知识,不然,很难读懂。

19 |

20 | * 可以忽略的包括

21 | * 出错处理。根据二八原则,20% 的代码是正常的逻辑,80% 的代码是在处理各种错误,所以,你在读代码的时候,完全可以把处理错误的代码全部删除掉,这样就会留下比较干净和简单的正常逻辑的代码。排除干扰因素,可以更高效地读代码。

22 | * 数据处理。只要你认真观察,就会发现,我们好多代码就是在那里倒腾数据。比如 DAO、DTO,比如 JSON、XML,这些代码冗长无聊,不是主要逻辑,可以不理。

23 |

24 | * 忽略过多的实现细节。在第一遍阅读源码时,已弄懂整体流程为主,至于具体的实现细节先简单的理清处过一遍,不用过于纠结。当梳理清楚全部的框架逻辑后,第二遍再深入的学习研究各个模块的实现,此时应该解决第一遍中的疑惑。第三遍可以跳出代码的实现,来看Linux的设计思路、编程艺术和演进之路。

25 |

26 | * 重在实践。Linux的代码都是可以调试的,看很多遍也许不如跟着调试走一遍,然后再自己修改修改做一些小测试。

27 |

28 | * 传授知识。当你能将知识讲述给别人听,并让别人听懂时,你已经可以自豪的说洞悉了这些知识。所以不妨从一个小的例子开始自说自话,看能不能自圆其说,甚至写成博客、做成PPT给大家讲解。

29 |

30 | 说了一大堆的废话,下面就正式开始操作系统的深入学习记录之旅了。

31 |

32 | ## 二. 混沌初开

33 |

34 | 本文分析从按下电源键到加载BIOS以及后续bootloader的整个过程。犹如盘古开天辟地一般,该过程将混沌的操作系统世界分为清晰的内核态和用户态,并经历从实模式到保护模式的变化。这里先简单介绍一下名词,便于后续理解。

35 |

36 | * 实模式(Real Mode):又名 Real Address Mode,在此模式下地址访问的是真实地内存地址所在位置。在此模式下,可以使用20位(1MB)的地址空间,软件可以不受限制的操作所有地址的空间和IO设备。

37 | * 保护模式(Protected Mode):又名 Protected Virtual Address Mode,采用虚拟内存、页等机制对内存进行了保护,比起实模式更为安全可靠,同时也增加了灵活性和扩展性。

38 |

39 | ### 2.1 从启动电源到BIOS

40 |

41 | 当我们按下电源键,主板会发向电源组发出信号,接收到信号后,电源会提供合适的电压给计算机。当主板收到电源正常启动的信号后,主板会启动CPU。CPU重置所有寄存器数据,并设置初始化数据,这个初始化数据在X86架构里如下所示:

42 |

43 | IP 0xfff0

44 | CS selector 0xf000

45 | CS base 0xffff0000

46 | IP/EIP (Instruction Pointer) : 指令指针寄存器,记录将要执行的指令在代码段内的偏移地址

47 | CS(Code Segment Register):代码段寄存器,指向CPU当前执行代码在内存中的区域(定义了存放代码的存储器的起始地址)

48 |

49 | 实模式采取内存段来管理 0 - 0xFFFFF的这1M内存空间,但是由于只有16位寄存器,所以最大地址只能表示为0xFFFFF(64KB),因此不得不采取将内存按段划分为64KB的方式来充分利用1M空间。也就是上所示的,采取段选择子 + 偏移量的表示法。这种方法在保护模式中对于页的设计上也沿用了下来,可谓祖传的智慧了。具体的计算公式如下所示:

50 |

51 | PhysicalAddress = Segment Selector * 16 + Offset

52 |

53 | 该部分由硬件完成,通过计算访问0XFFFF0,如果该位置没有可执行代码则计算机无法启动。如果有,则执行该部分代码,这里也就是我们故事的开始,BIOS程序了。

54 |

55 | ### 2.2 BIOS到BootLoader

56 |

57 | BIOS执行程序存储在ROM中,起始位置为0XFFFF0,当CS:IP指向该位置时,BIOS开始执行。BIOS主要包括以下内存映射:

58 |

59 | 0x00000000 - 0x000003FF - Real Mode Interrupt Vector Table

60 | 0x00000400 - 0x000004FF - BIOS Data Area

61 | 0x00000500 - 0x00007BFF - Unused

62 | 0x00007C00 - 0x00007DFF - Our Bootloader

63 | 0x00007E00 - 0x0009FFFF - Unused

64 | 0x000A0000 - 0x000BFFFF - Video RAM (VRAM) Memory

65 | 0x000B0000 - 0x000B7777 - Monochrome Video Memory

66 | 0x000B8000 - 0x000BFFFF - Color Video Memory

67 | 0x000C0000 - 0x000C7FFF - Video ROM BIOS

68 | 0x000C8000 - 0x000EFFFF - BIOS Shadow Area

69 | 0x000F0000 - 0x000FFFFF - System BIOS

70 |

71 | 其中最重要的莫过于中断向量表和中断服务程序。BIOS程序在内存最开始的位置(0x00000)用1 KB的内存空间(0x00000~0x003FF)构建中断向量表,在紧挨着它的位置用256字节的内存空间构建BIOS数据区(0x00400~0x004FF),并在大约57 KB以后的位置(0x0E05B)加载了8 KB左右的与中断向量表相应的若干中断服务程序。中断向量表中有256个中断向量,每个中断向量占4字节,其中两个字节是CS的值,两个字节是IP的值。每个中断向量都指向一个具体的中断服务程序。

72 |

73 | BIOS程序会选择一个启动设备,并将控制权转交给启动扇区中的代码。主要工作即使用中断向量和中断服务程序完成BootLoader的加载,最终将boot.img加载至0X7C00的位置启动。Linux内核通过Boot Protocol定义如何实现该引导程序,有如GRUB 2和syslinux等具体实现方式,这里仅介绍GRUB2。

74 |

75 | ### 2.3 BootLoader的工作

76 |

77 | boot.img由boot.S编译而成,512字节,安装在启动盘的第一个扇区,即MBR。由于空间有限,其代码十分简单,仅仅是起到一个引导的作用,指向后续的核心镜像文件,即core.img。core.img包括很多重要的部分,如lzma_decompress.img、diskboot.img、kernel.img等,结构如下图。

78 |

79 |

80 |

81 | 整个加载流程如下:

82 |

83 | 1、boot.img加载core.img的第一个扇区,即diskboot.img,对应代码为diskboot.S

84 | 2、diskboot.img加载core.img的其他部分模块,先是解压缩程序 lzma_decompress.img,再往下是 kernel.img,最后是各个模块 module 对应的映像。这里需要注意,它不是 Linux 的内核,而是 grub 的内核。注意,lzma_decompress.img 对应的代码是 startup_raw.S,本来 kernel.img 是压缩过的,现在执行的时候,需要解压缩。

85 | 3、加载完core之后,启动grub_main函数。

86 | 4、grub_main函数初始化控制台,计算模块基地址,设置 root 设备,读取 grub 配置文件,加载模块。最后,将 GRUB 置于 normal 模式,在这个模式中,grub_normal_execute (from grub-core/normal/main.c) 将被调用以完成最后的准备工作,然后显示一个菜单列出所用可用的操作系统。当某个操作系统被选择之后,grub_menu_execute_entry 开始执行,它将调用 GRUB 的 boot 命令,来引导被选中的操作系统。

87 |

88 | 在这之前,我们所有遇到过的程序都非常非常小,完全可以在实模式下运行,但是随着我们加载的东西越来越大,实模式这 1M 的地址空间实在放不下了,所以在真正的解压缩之前,lzma_decompress.img 做了一个重要的决定,就是调用 real_to_prot,切换到保护模式,这样就能在更大的寻址空间里面,加载更多的东西。

89 |

90 | 开机时的16位实模式与内核启动的main函数执行需要的32位保护模式之间有很大的差距,这个差距谁来填补?head.S做的就是这项工作。就像 kernel boot protocol 所描述的,引导程序必须填充 kernel setup header (位于 kernel setup code 偏移 0x01f1 处) 的必要字段,这些均在head.S中定义。在这期间,head程序打开A20,打开pe、pg,废弃旧的、16位的中断响应机制,建立新的32位的IDT……这些工作都做完了,计算机已经处在32位的保护模式状态了,调用32位内核的一切条件已经准备完毕,这时顺理成章地调用main函数。后面的操作就可以用32位编译的main函数完成,从而正式启动内核,进入波澜壮阔的Linux内核操作系统之中。

91 |

92 | ## 三. 总结

93 |

94 | 本文介绍了从按下电源开关至加载完毕BootLoader的整个过程,后续将继续分析从实模式进入保护模式,从而启动内核创建0号、1号、2号进程的整个过程。本文介绍过程中忽略了很多汇编代码以及一些虽然很重要但是不属于基本流程的知识,有兴趣了解的可以根据文中链接、文末的源码和参考资料进行更深入的学习研究。

95 |

96 |

97 |

98 |

99 |

100 |

101 |

102 |

103 |

104 |

105 |

106 |

107 |

108 |

109 |

110 |

111 |

112 |

113 |

114 |

115 |

116 |

117 |

118 |

119 |

--------------------------------------------------------------------------------

/文章/你真的理解Linux中断机制嘛.md:

--------------------------------------------------------------------------------

1 | Linux中断是指在CPU正常运行期间,由于内外部事件或由程序预先安排的事件引起的CPU暂时停止正在运行的程序,转而为该内部或外部事件或预先安排的事件服务的程序中去,服务完毕后再返回去继续运行被暂时中断的程序。

2 |

3 | 进程的不可中断状态是系统的一种保护机制,可以保证硬件的交互过程不被意外打断。所以,短时间的不可中断状态是很正常的。但是,当进程长时间都处于不可中断状态时,你就需要提起注意力确认下是不是磁盘I/O存在问题,相关的进程和磁盘设备是否工作正常。

4 |

5 | 今天我们详细了解一下中断的机制,进而对其中的软中断进行一个剖析。

6 |

7 | ## 概念解释

8 |

9 | (1)中断:是一种异步的事件处理机制,可以提高系统的并发处理能力。

10 |

11 | (2)如何解决中断处理程序执行过长和中断丢失的问题:

12 | Linux 将中断处理过程分成了两个阶段,也就是上半部和下半部。

13 | 上半部用来快速处理中断,它在中断禁止模式下运行,主要处理跟硬件紧密相关的或时间敏感的工作。也就是我们常说的硬中断,特点是快速执行。

14 | 下半部用来延迟处理上半部未完成的工作,通常以内核线程的方式运行。也就是我们常说的软中断,特点是延迟执行。

15 |

16 | (3)proc 文件系统:是一种内核空间和用户空间进行通信的机制,可以用来查看内核的数据结构,或者用来动态修改内核的配置。

17 | /proc/softirqs 提供了软中断的运行情况;

18 | /proc/interrupts 提供了硬中断的运行情况。

19 |

20 | (4)硬中断:硬中断是由硬件产生的,比如,像磁盘,网卡,键盘,时钟等。每个设备或设备集都有它自己的IRQ(中断请求)。基于IRQ,CPU可以将相应的请求分发到对应的硬件驱动上。硬中断可以直接中断CPU,引起内核中相关的代码被触发。

21 |

22 | (5)软中断:软中断仅与内核相关,由当前正在运行的进程所产生。 通常,软中断是一些对I/O的请求,这些请求会调用内核中可以调度I/O发生的程序。 软中断并不会直接中断CPU,也只有当前正在运行的代码(或进程)才会产生软中断。这种中断是一种需要内核为正在运行的进程去做一些事情(通常为I/O)的请求。

23 | 除了iowait(等待I/O的CPU使用率)升高,软中断(softirq)CPU使用率升高也是最常见的一种性能问题。

24 |

25 | ## 查看软中断和内核线程

26 |

27 | 小伙伴们肯定好奇该怎么查看系统里有哪些软中断?接下来将教给大家方法。

28 | 前面有提到过proc文件系统,它是一种内核空间和用户空间进行通信的机制, 可以用来查看内核的数据结构,或者用来动态修改内核的配置。

29 |

30 | * /proc/softirqs 提供了软中断的运行情况;

31 | * /proc/interrupts 提供了硬中断的运行情况。

32 |

33 | (1)如何查看各种类型软中断在不同 CPU上的累积运行次数:

34 |

35 | ```

36 | $ cat /proc/softirqs

37 | CPU0 CPU1 CPU2 CPU3

38 | HI: 276180 286764 2509097 254357

39 | TIMER: 1550133 1285854 1440533 1812909

40 | NET_TX: 102895 16 15 57

41 | NET_RX: 155 178 115 1619192

42 | BLOCK: 1713 15048 251826 1082

43 | IRQ_POLL: 0 0 0 0

44 | TASKLET: 9 63 6 2830

45 | SCHED: 1484942 1207449 1310735 1724911

46 | HRTIMER: 0 0 0 0

47 | RCU: 690954 685825 787447 878963

48 |

49 | ```

50 |

51 | 软中断的类型:对应第1列,包含了10个类别,分别对应不同的工作类型。比如说NET_RX 表示网络接收中断,而 NET_TX 表示网络发送中 断。

52 |

53 | 同一种软中断类型在不同CPU上的分布情况:对应每一行,正常情况下,同一种中断类型在不同CPU上的累计次数基本在同一个数量级。但是也有例外,比如TASKLET

54 |

55 | 拓展:什么是TASKLET?

56 | * TASKLET是最常用的软中断实现机制,每个TASKLET只会运行一次就会结束,并且只在调用它的函数所在的CPU上运行,不能并行而只能串行执行。

57 | * 多个不同类型的TASKLET可以并行在多个CPU上。

58 | * 软中断是静态,只能支持有限的几种软中断类型,一旦内核编译好之后就不能改变;而TASKLET灵活很多,可以通过添加内核模块的方式在运行时修改。

59 |

60 |

61 | (2)如何查看软中断内核线程的运行状况?

62 | 软中断是以内核线程的方式运行的,每个CPU都会对应一个软中断内核线程,查看的方式如下:

63 |

64 | ```

65 | $ ps -ef|grep softirq

66 | root 7 2 0 Nov04 ? 00:00:53 [ksoftirqd/0]

67 | root 16 2 0 Nov04 ? 00:00:51 [ksoftirqd/1]

68 | root 22 2 0 Nov04 ? 00:00:53 [ksoftirqd/2]

69 | root 28 2 0 Nov04 ? 00:00:53 [ksoftirqd/3]

70 | ```

71 |

72 | 这些线程的名字外面都有中括号,这说明 ps 无法获取它们的命令行参数 (cmline)。

73 |

74 | 一般来说,ps 的输出中,名字括在中括号里的,一般都是内核线程。

75 |

76 | (3)如何查看硬中断运行情况

77 |

78 | ```

79 | $ cat /proc/interrupts

80 | CPU0 CPU1 CPU2 CPU3

81 | 0: 33 0 0 0 IO-APIC-edge timer

82 | 1: 10 0 0 0 IO-APIC-edge i8042

83 | 4: 325 0 0 0 IO-APIC-edge serial

84 | 8: 1 0 0 0 IO-APIC-edge rtc0

85 | 9: 0 0 0 0 IO-APIC-fasteoi acpi

86 | 10: 0 0 0 0 IO-APIC-fasteoi virtio3

87 | 40: 0 0 0 0 PCI-MSI-edge virtio1-config

88 | 41: 16669006 0 0 0 PCI-MSI-edge virtio1-requests

89 | 42: 0 0 0 0 PCI-MSI-edge virtio2-config

90 | 43: 59166530 0 0 0 PCI-MSI-edge virtio2-requests

91 | 44: 0 0 0 0 PCI-MSI-edge virtio0-config

92 | 45: 6689988 0 0 0 PCI-MSI-edge virtio0-input.0

93 | 46: 0 0 0 0 PCI-MSI-edge virtio0-output.0

94 | 47: 2093616484 0 0 0 PCI-MSI-edge peth1-TxRx-0

95 | 48: 5 2045859720 0 0 PCI-MSI-edge peth1-TxRx-1

96 | 49: 81 0 0 0 PCI-MSI-edge peth1

97 | NMI: 0 0 0 0 Non-maskable interrupts

98 | LOC: 2936184495 965056330 1641503935 1442909354 Local timer interrupts

99 | SPU: 0 0 0 0 Spurious interrupts

100 | PMI: 0 0 0 0 Performance monitoring interrupts

101 | IWI: 53775871 47387196 47737572 44243915 IRQ work interrupts

102 | RTR: 0 0 0 0 APIC ICR read retries

103 | RES: 1198594562 964481221 966552350 902484234 Rescheduling interrupts

104 | CAL: 4294967071 4438 430547422 419910155 Function call interrupts

105 | TLB: 1206563963 65932469 1378887038 1028081848 TLB shootdowns

106 | TRM: 0 0 0 0 Thermal event interrupts

107 | THR: 0 0 0 0 Threshold APIC interrupts

108 | MCE: 0 0 0 0 Machine check exceptions

109 | MCP: 65623 65623 65623 65623 Machine check polls

110 | ERR: 0

111 | ```

112 |

113 | ## 工具与技巧

114 |

115 |

116 |

117 |

118 | (1)sar 是一个系统活动报告工具,既可以实时查看系统的当前活动,又可以配置保存和报告历史统计数据。

119 | 命令:sar -n DEV 1

120 | 含义:-n DEV 1 表示显示网络收发的报告,间隔1秒输出一组数据

121 |

122 | ```

123 | $ sar -n DEV 1

124 | 16:01:21 IFACE rxpck/s txpck/s rxkB/s txkB/s rxcmp/s txcmp/s rxmcst/s %ifutil

125 | 16:01:22 eth0 12605.00 6304.00 664.86 358.11 0.00 0.00 0.00 0.01

126 | 16:01:22 docker0 6302.00 12604.00 270.79 664.66 0.00 0.00 0.00 0.00

127 | 16:01:22 lo 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

128 | 16:01:22 veth9f6bbcd 6302.00 12604.00 356.95 664.66 0.00 0.00 0.00 0.05

129 | ```

130 |

131 | 第1列:表示报告的时间

132 |

133 | 第2列:IFACE 表示网卡

134 |

135 | 第3,4列:rxpck/s 和 txpck/s 分别表示每秒接收、发送的网络帧数,也就是 PPS

136 |

137 | 第5,6列:rxkB/s 和 txkB/s 分别表示每秒接收、发送的千字节数,也就是 BPS。

138 |

139 | (2)tcpdump 是一个常用的网络抓包工具,常用来分析各种网络问题。

140 |

141 | 命令:tcpdump -i eth0 -n tcp port 80

142 | 含义:-i eth0 只抓取eth0网卡,-n不解析协议名和主机名

143 | tcp port 80表示只抓取tcp协议并且端口号为80的网络帧

144 |

145 |

--------------------------------------------------------------------------------

/文章/内存管理/1.txt:

--------------------------------------------------------------------------------

1 |

2 |

--------------------------------------------------------------------------------

/文章/内存管理/Linux中的内存管理机制.md:

--------------------------------------------------------------------------------

1 | 程序在运行时所有的数据结构的分配都是在堆和栈上进行的,而堆和栈都是建立在内存之上。内存作为现代计算机运行的核心,CPU可以直接访问的通用存储只有内存和处理器内置的寄存器,所有的代码都需要装载到内存之后才能让CPU通过指令寄存器找到相应的地址进行访问。

2 |

3 | ## 地址空间和MMU

4 |

5 | 内存管理单元(MMU)是硬件提供的最底层的内存管理机制,是CPU的一部分,用来管理内存的控制线路,提供把虚拟地址映射为物理地址的能力。

6 |

7 | 在x86体系结构下,CPU对内存的寻址都是通过分段方式进行的。其工作流程为:CPU生成逻辑地址并交给分段单元。分段单元为每个逻辑地址生成一个线性地址。然后线性地址交给分页单元,以生成内存的物理地址。因此也就是分段和分页单元组成了内存管理单元(MMU)。

8 |

9 |

10 |

11 | 其中: + 虚拟地址:在段中的偏移地址 + 线性地址:在某个段中“基地址+偏移地址”得出的地址 + 物理地址:在x86中,MMU还提供了分页机制,假如没有开启分页机制,那么线性地址就等于物理地址;否则还需要经过分页机制换算后线性地址才能转换成物理地址。 一个段是由“基地址+段界限(该段长度)+类型”组成,主要确定了段的起始地址,段的界限长度和确定段的属性如是否可读、可写、段的基本粒度单位、表述该段是数据段还是代码段等。 分段允许进程的物理地址空间是非连续的,分页则是提供这一优势的另外一种内存管理方案,并且**分页避免了外部碎片和紧缩,分段却不可以**。在x86体系中MMU支持多级的分页模型,主要分为以下三种情况: 1. 32为系统分为2级分页模型 2. 32位系统开启了物理地址扩展模式(PAE),则分为3级分页模型 3. 64位系统分为4级分页模型 80x86的分页机制由CR0中的PG位开启,若PG=0则禁用分页机制,也就是直接将线性地址作为物理地址。32位的线性地址主要分为三个部分:

12 |

13 |

14 |

15 | * 22-31位指向页目录表中的某一项,页目录表中的每一项存有4子节地址指向页表。所以页表目录大小为4 * 210 = 4K

16 | * 12-21位指向页表中的某一项,页表大小与页目录表相同为4K

17 | * 一个物理页为4K,刚好0-11位指向页表中的偏移,一个页表刚好4K(212)

18 |

19 | 页表和页目录表可以存放在内存的任何地方,当分页机制开启后,需要让CR3寄存器指向页目录表的起始地址。

20 |

21 | > CR0-CR4这五个寄存器为系统内的控制寄存器,与分页机制密切相关。

22 | > CR0控制寄存器是一些特殊的寄存器,可以控制CPU的一些重要特性;

23 | > CR1是未定义的控制寄存器,供将来使用;

24 | > CR2是页故障线性地址寄存器,保存最后一次出现页故障的全32位线性地址;

25 | > CR3是页目录基址寄存器,保存页目录表的物理地址(页目录表总是放在4k为单位的存储器边界上,因此其低12位总为0不起作用,即使写上内容也不会被理会)

26 | > CR4在Pentium系列(包括486后期版本)处理器中才出现,处理事务包括何时启用虚拟8086模式等。

27 |

28 | ### Linux中的分段与分页

29 |

30 | MMU在保护模式下分段数据主要定义在GDT中。

31 |

32 | ```c

33 | //arch/x86/kernel/cpu/common.c

34 |

35 | DEFINE_PER_CPU_PAGE_ALIGNED(struct gdt_page, gdt_page) = { .gdt = {

36 | ...

37 | [GDT_ENTRY_KERNEL_CS] = GDT_ENTRY_INIT(0xc09a, 0, 0xfffff), //代码段

38 | [GDT_ENTRY_KERNEL_DS] = GDT_ENTRY_INIT(0xc092, 0, 0xfffff), //数据段

39 | [GDT_ENTRY_DEFAULT_USER_CS] = GDT_ENTRY_INIT(0xc0fa, 0, 0xfffff),

40 | [GDT_ENTRY_DEFAULT_USER_DS] = GDT_ENTRY_INIT(0xc0f2, 0, 0xfffff),

41 | ...

42 | } };

43 | EXPORT_PER_CPU_SYMBOL_GPL(gdt_page);

44 | ```

45 |

46 | 通过代码可知道这些段的基地址都是0,界限为4G。说明Linux只定义了一个段,并没有真正利用分段机制。

47 |

48 | Linux中只用了一个段,而且基地址从0开始,那么在程序中使用的虚地址就是线性地址了。Linux为了兼容64位、32位及其PAE扩展情况,在代码中通过4级分页机制来做兼容。

49 |

50 | ## Linux的内存分配与管理

51 |

52 | 在32位的x86设备中,Linux为每个进程分配的虚拟地址空间都是0-4GB,其中

53 |

54 | * 0-3GB用于用户态使用

55 | * 3GB-3GB+896MB映射到物理地址的0-896MB处,作为内核态地址空间

56 | * 3GB+896MB-4GB之间的128MB空间用于vmalloc保留区域,该区域用于kmalloc、kmap固定地址映射等功能,可以让内核访问高端物理地址空间

57 |

58 |

59 |

60 | Linux中进程的地址空间由mm_struct来描述,一个进程只会有一个mm_struct。系统中的内核态是共享的,不会发生缺页中断或者访问用户进程空间,所以内核线程的task_struct->mm为NULL。

61 |

62 | 页表的分配分为两个部分:

63 |

64 | 1、内核页表,也就是在系统启动中,最后会在paging_init函数中,把ZONE_DMA和ZONE_NORMAL区域的物理页面与虚拟地址空间的3GB-3GB+896MB进行直接映射

65 | 2、内核高端地址和用户态地址,都是通过MMU机制修改线性地址(虚拟地址)和物理地址的映射关系,然后刷新页表缓存来达到的

66 |

67 | > 物理内存中ZONE_DMA的范围是0-16MB,该区域的物理页面专门供IO设备的DMA使用,之所以要单独管理DMA的物理页面,是因为DMA使用物理地址访问内存不经过MMU,并且需要连续的缓冲区。为了能够提供物理上的连续缓冲区,必须从物理地址专门划分出一段区域用于DMA。 ZONE_NORMAL的范围是16MB-896MB,该区域的物理页面是内核能够直接使用的。 ZONE_HIGHMEM的范围是896MB-结束,该区域即高端内存,内核不能直接使用。

68 |

69 | ### 伙伴系统

70 | 对于物理内存经过频繁地申请和释放后会产生外部碎片,Linux通过伙伴系统来解决外部碎片的问题。

71 |

72 | 满足:

73 | 1.具有相同的大小;

74 | 2.物理地址连续条件的两个块为伙伴。主要实现思路位伙伴系统在申请内存的时候让最小的块满足申请的需求,在归还的时候,尽量让连续的小块内存伙伴合并成大块,降低外部碎片出现的可能性。

75 |

76 | 在Linux系统中伙伴系统维护了11个块链表,每个块链表分别包含了大小为20-211个连续的物理页。对1024个页的最大请求对应着4MB大小的连续RAM块。每个快的第一个页框的物理地址就是该块大小的整数倍。如大小为16个页框的块,其起始地址为16×212(212=4KB这是一个页的大小)的倍数。

77 |

78 | 系统在初始化的时候把内各节点各区域都释放到伙伴系统中,每个区域还维护了per-cpu高速缓存来处理单页的分配,各个区域都通过伙伴算法进行物理内存的分配。

79 |

80 | ### slab分配器

81 |

82 | Linux系统通过伙伴算法解决了外部碎片的问题,此外还提供了slab分配器来处理内部碎片的问题。slab分配器也是一种内存预分配机制,是一种空间换时间的做法,并且其假定从slab分配器中获得的内存都是比页还小的小内存块。

83 |

84 |

85 |

86 | slab的设计思想就是把若干的页框合在一起形成一大存储块——slab,并在这个slab中只存储同一类数据,这样就可以在这个slab内部打破页的界限,以该类型数据的大小来定义分配粒度,存放多个数据,这样就可以尽可能地减少页内碎片了。在Linux中,多个存储同类数据的slab的集合叫做一类对象的缓冲区——cache。注意,这不是硬件的那个cache,只是借用这个名词而已。

87 |

88 | Linux中slab的可分为以下三种状态:

89 |

90 | 1、slabs_full:该链表中slab已经完全分配出去

91 | 2、slabs_free:该链表中的slab都是空闲可分配状态

92 | 3、labs_partial:该链表中的slab部分已经被分配出去了

93 |

94 | 其中slab代表物理地址连续的内存块,由1-N个物理页面组成,在一个slab中可以分配多个object对象。

95 |

96 | slab的优点:

97 |

98 | * 内核通常依赖于对小对象的分配,它们会在系统生命周期内进行无数次分配。slab 缓存分配器通过对类似大小的对象进行缓存而提供这种功能,从而避免了常见的碎片问题;

99 | * slab 分配器还支持通用对象的初始化,从而避免了为同一目的而对一个对象重复进行初始化;

100 | * slab 分配器还可以支持硬件缓存对齐和着色,这允许不同缓存中的对象占用相同的缓存行,从而提高缓存的利用率并获得更好的性能。

101 |

102 | slab的缺点:

103 |

104 | * 较多复杂的队列管理。在slab分配器中存在众多的队列,例如针对处理器的本地缓存队列,slab中空闲队列,每个slab处于一个特定状态的队列之中。

105 | * slab管理数据和队列的存储开销比较大。每个slab需要一个struct slab数据结构和一个管理者kmem_bufctl_t型的数组。当对象体积较小时,该数组将造成较大的开销(比如对象大小为32字节时,将浪费1/8空间)。同时,缓冲区针对节点和处理器的队列也会浪费不少内存。

106 | * 缓冲区回收、性能调试调优比较复杂。

107 |

108 |

109 | ### 内核态内存管理

110 |

111 | 根据之前的的Linux的内存管理机制,即伙伴系统和slab分配器。对于内核态的内存分配主要通过函数kmalloc和vmalloc完成。

112 |

113 |

114 |

115 | 其中kmalloc函数可以为内核申请连续物理地址的内存空间,由于kmalloc是基于slab分配器实现的,所以比较适合较小块的内存申请。kmalloc函数的调用过程为:`kmalloc->__kmalloc->__do_kmalloc`,其中`__do_kmalloc`的实现主要分为两步:

116 |

117 | 1、通过`kmalloc_slab`找到一个合适的`kmem_cache`缓存

118 | 2、通过`slab_alloc`向slab分配器申请对象内存空间

119 |

120 | Linux提供的vmalloc函数可以获得连续的虚拟空间,但是其物理内存不一定连续。vmalloc函数的调用过程为:`vmalloc->__vmalloc_node_flags->__vmalloc_node->__vmalloc_node_range`。其中`__vmalloc_node_range`函数也分为两步:

121 |

122 | 1、通过`__get_vm_area_node`分配一个可用的虚拟地址空间

123 | 2、`__vmalloc_node_range`通过`alloc_pages`一页一页申请物理内存,再为刚才申请的虚拟地址空间分配物理页表映射

124 |

125 |

126 |

--------------------------------------------------------------------------------

/文章/内存管理/一文了解,Linux内存管理,malloc、free 实现原理.md:

--------------------------------------------------------------------------------

1 | ## malloc / free 简介

2 |

3 | ```c

4 | void *malloc(size_t size)

5 | void free(void *ptr)

6 | ```

7 | `malloc` 分配指定大小的内存空间,返回一个指向该空间的指针。大小以字节为单位。返回 `void*` 指针,需要强制类型转换后才能引用其中的值。

8 | `free` 释放一个由 `malloc` 所分配的内存空间。`ptr` 指向一个要释放内存的内存块,该指针应当是之前调用 `malloc` 的返回值。

9 |

10 | 使用示例:

11 |

12 | ```c

13 | int* ptr;

14 | ptr = (int*)malloc(10 * sizeof(int)); /* 进行强制类型转换 */

15 | free(ptr);

16 | ```

17 |

18 | ## 动态内存分配的系统调用:`brk / sbrk`

19 |

20 | 动态分配的内存都在堆中,堆从低地址向高地址增长:

21 |

22 |

23 |

24 | Linux 提供了两个系统调用 `brk` 和 `sbrk`:

25 |

26 | ```c

27 | int brk(void *addr);

28 | void *sbrk(intptr_t increment);

29 | ```

30 |

31 | `brk` 用于返回堆的顶部地址;`sbrk` 用于扩展堆,通过参数 `increment` 指定要增加的大小,如果扩展成功,返回 `brk` 的旧值。如果 `increment` 为零,返回 `brk` 的当前值。

32 |

33 | 我们不会直接通过 `brk` 或 `sbrk` 来分配堆内存,而是先通过 `sbrk` 扩展堆,将这部分空闲内存空间作为缓冲池,然后通过 `malloc / free` 管理缓冲池中的内存。这是一种池化思想,能够避免频繁的系统调用,提高程序性能。

34 |

35 | ## malloc / free 实现思路

36 |

37 | `malloc` 使用空闲链表组织堆中的空闲区块,空闲链表有时也用双向链表实现。每个空闲区块都有一个相同的首部,称为“内存控制块” `mem_control_block`,其中记录了空闲区块的元信息,比如指向下一个分配块的指针、当前分配块的长度、或者当前区块是否已经被分配出去。这个首部对于程序是不可见的,`malloc `返回的是紧跟在首部后面的地址,即可用空间的起始地址。

38 |

39 | `malloc` 分配时会搜索空闲链表,根据匹配原则,找到一个大于等于所需空间的空闲区块,然后将其分配出去,返回这部分空间的指针。如果没有这样的内存块,则向操作系统申请扩展堆内存。注意,返回的指针是从可用空间开始的,而不是从首部开始的:

40 |

41 |

42 |

43 | malloc 所实际使用的内存匹配算法有很多,执行时间和内存消耗各有不同。到底使用哪个匹配算法,取决于实现。常见的内存匹配算法有:

44 |

45 | * 最佳适应法

46 | * 最差适应法

47 | * 首次适应法

48 | * 下一个适应法

49 |

50 | free 会将区块重新插入到空闲链表中。free 只接受一个指针,却可以释放恰当大小的内存,这是因为在分配的区域的首部保存了该区域的大小。

51 |

52 | ## malloc 的实现方式一:显式空闲链表 + 整块分配

53 |

54 | malloc 的实现方式有很多种。最简单的方法是使用一个链表来管理所有已分配和未分配的内存块,在每个内存块的首部记录当前块的大小、当前区块是否已经被分配出去。首部对应这样的结构体:

55 |

56 | ```c

57 | struct mem_control_block {

58 | int is_available; // 是否可用(如果还没被分配出去,就是 1)

59 | int size; // 实际空间的大小

60 | };

61 | ```

62 |

63 | 使用首次适应法进行分配:遍历整个链表,找到第一个未被分配、大小合适的内存块;如果没有这样的内存块,则向操作系统申请扩展堆内存。

64 |

65 | 下面是这种实现方式的代码:

66 |

67 | ```c

68 | int has_initialized = 0; // 初始化标志

69 | void *managed_memory_start; // 指向堆底(内存块起始位置)

70 | void *last_valid_address; // 指向堆顶

71 |

72 | void malloc_init() {

73 | // 这里不向操作系统申请堆空间,只是为了获取堆的起始地址

74 | last_valid_address = sbrk(0);

75 | managed_memory_start = last_valid_address;

76 | has_initialized = 1;

77 | }

78 |

79 | void *malloc(long numbytes) {

80 | void *current_location; // 当前访问的内存位置

81 | struct mem_control_block *current_location_mcb; // 只是作了一个强制类型转换

82 | void *memory_location; // 这是要返回的内存位置。初始时设为

83 | // 0,表示没有找到合适的位置

84 | if (!has_initialized) {

85 | malloc_init();

86 | }

87 | // 要查找的内存必须包含内存控制块,所以需要调整 numbytes 的大小

88 | numbytes = numbytes + sizeof(struct mem_control_block);

89 | // 初始时设为 0,表示没有找到合适的位置

90 | memory_location = 0;

91 | /* Begin searching at the start of managed memory */

92 | // 从被管理内存的起始位置开始搜索

93 | // managed_memory_start 是在 malloc_init 中通过 sbrk() 函数设置的

94 | current_location = managed_memory_start;

95 | while (current_location != last_valid_address) {

96 | // current_location 是一个 void 指针,用来计算地址;

97 | // current_location_mcb 是一个具体的结构体类型

98 | // 这两个实际上是一个含义

99 | current_location_mcb = (struct mem_control_block *)current_location;

100 | if (current_location_mcb->is_available) {

101 | if (current_location_mcb->size >= numbytes) {

102 | // 找到一个可用、大小适合的内存块

103 | current_location_mcb->is_available = 0; // 设为不可用

104 | memory_location = current_location; // 设置内存地址

105 | break;

106 | }

107 | }

108 | // 否则,当前内存块不可用或过小,移动到下一个内存块

109 | current_location = current_location + current_location_mcb->size;

110 | }

111 | // 循环结束,没有找到合适的位置,需要向操作系统申请更多内存

112 | if (!memory_location) {

113 | // 扩展堆

114 | sbrk(numbytes);

115 | // 新的内存的起始位置就是 last_valid_address 的旧值

116 | memory_location = last_valid_address;

117 | // 将 last_valid_address 后移 numbytes,移动到整个内存的最右边界

118 | last_valid_address = last_valid_address + numbytes;

119 | // 初始化内存控制块 mem_control_block

120 | current_location_mcb = memory_location;

121 | current_location_mcb->is_available = 0;

122 | current_location_mcb->size = numbytes;

123 | }

124 | // 最终,memory_location 保存了大小为 numbyte的内存空间,

125 | // 并且在空间的开始处包含了一个内存控制块,记录了元信息

126 | // 内存控制块对于用户而言应该是透明的,因此返回指针前,跳过内存分配块

127 | memory_location = memory_location + sizeof(struct mem_control_block);

128 | // 返回内存块的指针

129 | return memory_location;

130 | }

131 | ```

132 |

133 | 对应的free实现:

134 |

135 | ```c

136 | void free(void *ptr) { // ptr 是要回收的空间

137 | struct mem_control_block *free;

138 | free = ptr - sizeof(struct mem_control_block); // 找到该内存块的控制信息的地址

139 | free->is_available = 1; // 该空间置为可用

140 | return;

141 | }

142 | ```

143 |

144 | 这种方法的缺点是:

145 |

146 | 1、已分配和未分配的内存块位于同一个链表中,每次分配都需要从头到尾遍历

147 | 2、采用首次适应法,内存块会被整体分配,容易产生较多内部碎片

148 |

149 | ## malloc 的实现方式二:显式空闲链表 + 按需分配

150 |

151 | 这种实现方式维护一个空闲块链表,只包含未分配的内存块。malloc 分配时会搜索空闲链表,找到第一个大于等于所需空间的空闲区块,然后从该区块的尾部取出所需要的空间,剩余空间还是存在空闲链表中;如果该区块的剩余部分不足以放下首部信息,则直接将其从空闲链表摘除。最后返回这部分空间的指针。

152 | 下面是这种实现方式的几个示例:

153 |

154 |

155 |

156 |

157 |

158 |

159 |

160 | 通过 free 释放内存时,会将内存块加入到空闲链表中,并将前后相邻的空闲内存合并,这时使用双向链表管理空闲链表就很有用了。

161 |

162 | 和第一种方式相比,这种方式的优点主要是:

163 | * 空闲链表中只包含未被分配的内存块,节省遍历开销

164 | * 只分配必须大小的空间,避免内存浪费

165 |

166 | 这种方式的缺点是:多次调用 malloc 后,空闲内存被切成很多的小内存片段,产生较多外部碎片,会导致用户在申请内存使用时,找不到足够大的内存空间。这时需要进行内存整理,将连续的空闲内存合并,但是这会降低函数性能。

167 |

168 | 注意:内存紧凑在这里一般是不可用的,因为这会改变之前 malloc 返回的空间的地址。

169 |

170 | ## malloc 的实现方式三:分离的空闲链表

171 |

172 | 上面的两种分配方法,分配时间都和空闲块的数量成线性关系。

173 |

174 | 另一种实现方式是分离存储,即维护多个空闲链表,其中每个链表中的块有大致相等或者相同的大小。一般常见的是根据 2 的幂来划分块大小。分配时,可以直接在某个空闲链表里搜索合适的块。如果没有找到合适的块与之匹配,就搜索下一个链表,以此类推。

175 |

176 | ### 简单分离存储

177 |

178 | 每个大小类的空闲链表包含大小相等的块。分配时,从某个空闲链表取下一块,或者向操作系统请求内存片并分割成大小相等的块,形成新的链表。释放时,只需要简单的将块插入到相应空闲链表的前面。

179 |

180 | 优点一是分配和释放只需要在链表头进行操作,都是常数时间,二是因为每个块大小都是固定的,所以只需要一个 next 指针,不需要额外的控制信息,节省空间。缺点是容易造成内部碎片和外部碎片。内部碎片显而易见,因为每个块都是整体分配的,不会被分割。外部碎片在这样的模式下很容易产生:应用频繁地申请和释放较小大小的内存块,由于这些内存块不会合并,所以系统维护了大量小内存块形成的空闲链表,而没有多余空间来分配大内存块,导致产生外部碎片。

181 |

182 | ### 分离适配

183 | 这种方法同样维护了多个空闲链表,只不过每个链表中的块是大致相等的大小,比如每个链表中的块大小范围可能是:

184 |

185 | * 1

186 | * 2

187 | * 3~4

188 | * 5~8

189 | * …

190 | * 1025~2048

191 | * 2049~4096

192 | * 4097~∞

193 |

194 | 在分配的时候,需要先根据申请内存的大小选择适当的空闲链表,然后遍历该链表,根据匹配算法(如首次适应)寻找合适的块。如果找到一个块,将其分割(可选),并将剩余部分插入到适当的空闲链表中。如果找不到合适的块,则查找下一个更大的大小类的空闲链表,以此类推,直到找到或者向操作系统申请额外的堆内存。在释放一个块时,合并前后相邻的空闲块,并将结果放到相应的空闲链表中。

195 |

196 | 分离适配方法是一种常见的选择,C 标准库中提供的 GNU malloc 包就是采用的这种方法。这种方法既快速,对内存的使用也很有效率。由于搜索被限制在堆的某个部分而不是整个堆,所以搜索时间减少了。内存利用率也得到了改善,避免大量内部碎片和外部碎片。

197 |

198 | ### 伙伴系统

199 |

200 | 伙伴系统是分离适配的一种特例。它的每个大小类的空闲链表包含大小相等的块,并且大小都是 2 的幂。最开始时,全局只有一个大小为 2m2m 字的空闲块,2m2m 是堆的大小。

201 |

202 | 假设分配的块的大小都是 2 的幂,为了分配一个大小为 2k2k 的块,需要找到大小恰好是 2k2k 的空闲块。如果找到,则整体分配。如果没有找到,则将刚好比它大的块分割成两块,每个剩下的半块(也叫做伙伴)被放置在相应的空闲链表中,以此类推,直到得到大小恰好是 2k2k 的空闲块。释放一个大小为 2k2k 的块时,将其与空闲的伙伴合并,得到新的更大的块,以此类推,直到伙伴已分配时停止合并。

203 |

204 | 伙伴系统分配器的主要优点是它的快速搜索和快速合并。主要缺点是要求块大小为 2 的幂可能导致显著的内部碎片。因此,伙伴系统分配器不适合通用目的的工作负载。然而,对于某些特定应用的工作负载,其中块大小预先知道是 2 的幂,伙伴系统分配器就很有吸引力了。

205 |

206 | ### tcmalloc

207 |

208 | tcmalloc 是 Google 开发的内存分配器,全称 Thread-Caching Malloc,即线程缓存的 malloc,实现了高效的多线程内存管理。

209 |

210 | tcmalloc 主要利用了池化思想来管理内存分配。对于每个线程,都有自己的私有缓存池,内部包含若干个不同大小的内存块。对于一些小容量的内存申请,可以使用线程的私有缓存;私有缓存不足或大容量内存申请时再从全局缓存中进行申请。在线程内分配时不需要加锁,因此在多线程的情况下可以大大提高分配效率。

211 |

212 | ## 总结

213 | malloc 使用链表管理内存块。malloc 有多种实现方式,在不同场景下可能会使用不同的匹配算法。

214 |

215 | malloc 分配的空间中包含一个首部来记录控制信息,因此它分配的空间要比实际需要的空间大一些。这个首部对用户而言是透明的,malloc 返回的是紧跟在首部后面的地址,即可用空间的起始地址。

216 |

217 | malloc 分配的函数应该是字对齐的。在 32 位模式中,malloc 返回的块总是 8 的倍数。在 64 位模式中,该地址总是 16 的倍数。最简单的方式是先让堆的起始位置字对齐,然后始终分配字大小倍数的内存。

218 |

219 | malloc 只分配几种固定大小的内存块,可以减少外部碎片,简化对齐实现,降低管理成本。

220 |

221 | free 只需要传递一个指针就可以释放内存,空间大小可以从首部读取。

222 |

223 |

224 |

225 |

226 |

227 |

228 |

229 |

--------------------------------------------------------------------------------

/文章/内存管理/其他工程问题以及调优.md:

--------------------------------------------------------------------------------

1 | ## 其他工程问题以及调优

2 | * DMA和cache一致性

3 | * 内存的cgroup

4 | * memcg子系统分析

5 | * 性能方面的调优: page in/out, swap in/out

6 | * Dirty ratio的一些设置

7 | * swappiness

8 |

9 | ### DMA和cache一致性

10 |

11 |

12 |

13 | 工程中,DMA可以直接在内存和外设进行数据搬移,而CPU访问内存时要经过MMU。DMA访问不到CPU内部的cache,所以会出现cache不一致的问题。因为CPU读写内存时,如果在cache中命中,就不会再访问内存。

14 |

15 | 当CPU 写memory时,cache有两种算法:write_back ,write_through。一般都采用write_back。cache的硬件,使用LRU算法,把cache中的数据替换到磁盘。

16 |

17 |

18 |

19 | cache一致性问题,主要靠以上两类api来解决这个问题。一致性DMA缓冲区api,和流式DMA映射api。CPU通过MMU访问DMA区域,在页表项中可以配置这片区域是否带cache。

20 |

21 | 现代的SoC,DMA引擎可以自动维护cache的同步。

22 |

23 | ### 内存的cgroup

24 | 进程分group,内存也分group。

25 |

26 | 进程调度时,把一组进程加到一个cgroup,控制这一组进程的CPU权重和最大CPU占用率。在/sys/fs/cgroup/memory创建一个目录,把进程放到这个group。可以限制某个group下的进程不用swap,每个group的swapiness都可以配置。

27 |

28 | 比如,当你把某个group下的swapiness设置为0,那么这个group下进程的匿名页就不允许交换了。

29 | /proc/sys/vm/swapiness是控制全局的swap特性,不影响加到group中的进程。

30 |

31 | 也可以控制每个group的最大内存消耗为200M,当这个group下进程使用的内存达到200M,就oom。

32 |

33 | demo: 演示用memory cgroup来限制进程group内存资源消耗的方法

34 |

35 | ```

36 | swapoff -a

37 | echo 1 > /proc/sys/vm/overcommit_memory # 进程申请多少资源,内核都允许

38 |

39 | root@whale:/sys/fs/cgroup/memory# mkdir A

40 | root@whale:/sys/fs/cgroup/memory# cd A

41 | root@whale:/sys/fs/cgroup/memory/A# echo $((200*1024*1024)) > memory.limit_in_bytes

42 |

43 | cgexec -g memory:A ./a.out

44 |

45 |

46 | [ 560.618666] Memory cgroup out of memory: Kill process 5062 (a.out) score 977 or sacrifice child

47 | [ 560.618817] Killed process 5062 (a.out) total-vm:2052084kB, anon-rss:204636kB, file-rss:1240kB

48 | ```

49 |

50 | ### memory cgroup子系统分析

51 | memcg v1的参数有25个, 通过数据结构 res_counter 来计算。

52 |

53 | ```

54 | ~~~

55 | /* * The core object. the cgroup that wishes to account for some

56 | * resource may include this counter into its structures and use

57 | * the helpers described beyond */

58 |

59 | struct res_counter {

60 | unsigned long long usage; /* * 目前资源消费的级别 */

61 | unsigned long long max_usage; /* *从counter创建的最大使用值 */

62 | unsigned long long limit; /* * 不能超过的使用限制 */

63 | unsigned long long soft_limit; /* * 可以超过使用的限制 */

64 | unsigned long long failcnt; /* * 尝试消费资源的失败数 */

65 | spinlock_t lock; /* * the lock to protect all of the above.

66 | * the routines below consider this to be IRQ-safe */

67 | struct res_counter *parent; /* * Parent counter, used for hierarchial resource accounting */

68 | };

69 | ```

70 | 内存的使用量 mem_cgroup_usage 通过递归RSS和page cache之和来计算。

71 |

72 | struct mem_cgroup是负责内存 cgroup 的结构

73 |

74 | ```c

75 | struct mem_cgroup {

76 | struct cgroup_subsys_state css; // 通过css关联cgroup.

77 | struct res_counter res; // mem统计变量

78 | res_counter memsw; // mem+sw的和

79 | struct res_counter kmem; // 内核内存统计量 ...

80 | }

81 | ```

82 | 这些参数的入口都在mm/memcontrol.c下,比如说memory.usage_in_bytes的读取调用的是mem_cgroup_read函数, 统计的入口是mem_cgroup_charge_common(),如果统计值超过限制就会在cgroup内进行回收。调用者分别是缺页时调用的mem_cgroup_newpage_charge和 page cache相关的mem_cgroup_cache_charge。

83 |

84 | 当进程进入缺页异常的时候就会分配具体的物理内存,当物理内存使用超过高水平线以后,换页daemon(kswapd)就会被唤醒用于把内存交换到交换空间以腾出内存,当内存恢复至高水平线以后换页daemon进入睡眠。

85 |

86 | 缺页异常的入口是 __do_fault,

87 |

88 | RSS在page_fault的时候记录,page cache是插入到inode的radix-tree中才记录的。

89 | RSS在完全unmap的时候减少计数,page cache的page在离开inode的radix-tree才减少计数。

90 | 即使RSS完全unmap,也就是被kswapd给换出,可能作为SwapCache存留在系统中,除非不作为SwapCache,不然还是会被计数。

91 | 一个换入的page不会马上计数,只有被map的时候才会,当进行换页的时候,会预读一些不属于当前进程的page,而不是通过page fault,所以不在换入的时候计数。

92 |

93 | ### 脏页写回的“时空”控制

94 |

95 |

96 |

97 | “脏页”:当进程修改了高速缓存里的数据时,该页就被内核标记为脏页,内核将会在合适的时间把脏页的数据写到磁盘中去,以保持高速缓存中的数据和磁盘中的数据是一致的。

98 |

99 | 通过时间(dirty_expire_centisecs)和比例,控制Linux脏页返回。

100 |

101 | dirty_expire_centisecs:当Linux中脏页的时间到达dirty_expire_centisecs,无论脏页的数量多少,必须立即写回。通过在后台启动进程,进行脏页写回。

102 | 默认时间设置为30s。

103 |

104 | dirty_ratio,dirty_background_ratio 基于空间的脏页写回控制。

105 | 不能让内存中存在太多空间的脏页。如果一个进程在循环调用write,当达到dirty_background_ratio后,后台进程就开始写回脏页。默认值5%。当达到第2个阈值dirty_ratio时,应用进程被阻塞。当内存中的脏页在两个阈值之间时,应用程序是不会阻塞。

106 |

107 | ### 内存何时回收:水位控制

108 | 脏页写回不是 内存回收。

109 |

110 | 脏页写回:是保证在内存不在磁盘的数据不要太多。

111 | 水位控制:是指内存何时开始回收。

112 |

113 |

114 |

115 | 由/pro/sys/vm/min_free_kbytes 控制,根据内存大小算出来的平方根。

116 | pf_mem_alloc,允许内存达到低水位以下,还可以继续申请。内存的回收,在最低水位以上就开始回收。

117 |

118 |

119 |

120 | 每个Zone都有自己的三个水位,最小的水位是根据min_free_kbytes控制。5/4min_free_kbytes =low 3/2min_free_kbytes =high ,

121 | Zone的最小内存达到5/4的low 水位,Linux开始后台回收内存。直到达到6/4的high水位,开始不回收。

122 | 当Zone的最小内存达到min水位,应用程序的写会直接阻塞。

123 |

124 | 实时操作系统,

125 |

126 |

127 |

128 | 当你要开始回收内存时,回收比例通过swappiness越大,越倾向于回收匿名页;swappiness越小,越倾向于回收file-backed的页面。

129 | 当把cgroup中的swapiness设置为0,就不回收匿名页了。

130 | 当你的应用会经常去访问数据malloc的内存,需要把swapiness设置小。dirty的设置,水位的设置都没有一个标准,要看应用使用内存的情况而定。

131 |

132 | getdelays工具:用来评估应用等待CPU,内存,IO,的时间。

133 | linux/Documents/accounting

134 |

135 |

136 |

137 | CONFIG_TASK_DELAY_ACCT=y

138 | CONFIG_TASKSTATS=y

139 |

140 | vmstat 可以展现给定时间间隔的服务器的状态值,包括Linux的CPU使用率,内存使用,虚拟内存交换情况,IO读写情况。

141 | ```

142 | vmstat 1

143 | ```

144 | Documents/sysctl/vm.txt 中有所有参数最细节的描述。

145 |

146 |

--------------------------------------------------------------------------------

/文章/内存管理/内存与IO的交换.md:

--------------------------------------------------------------------------------

1 | ## 内存与I/O的交换

2 | 堆、栈、代码段是否常驻内存?本文主要介绍两类不同的页面,以及这两类页面如何在内存和磁盘间进行交换?以及内存和磁盘的颠簸行为- swaping,和硬盘的swap分区。

3 |

4 | ### page cache

5 |

6 | **file-backed的页面**:(有文件背景的页面,比如代码段、比如read/write方法读写的文件、比如mmap读写的文件;他们有对应的硬盘文件,因此如果要交换,可以直接和硬盘对应的文件进行交换),此部分页面进page cache。

7 |

8 | **匿名页**:匿名页,如stack,heap,CoW后的数据段等;他们没有对应的硬盘文件,因此如果要交换,只能交换到虚拟内存-swapfile或者Linux的swap硬盘分区),此部分页面,如果系统内存不充分,可以被swap到swapfile或者硬盘的swap分区。

9 |

10 |

11 |

12 | 内核通过两种方式打开硬盘的文件,**任何时候打开文件,Linux会申请一个page cache,然后把文件读到page cache里。**page cache 是内存针对硬盘的缓存。

13 |

14 | Linux读写文件有两种方式:read/write 和 mmap

15 |

16 | 1)read/write: read会把内核空间的page cache,往用户空间的buffer拷贝。

17 | 参数 fd, buffer, size ,write只是把用户空间的buffer拷贝到内核空间的page cache。

18 |

19 | 2)mmap:可以避免内核空间到用户空间拷贝的过程,直接把文件映射成一个虚拟地址指针,指向linux内核申请的page cache。也就知道page cache和硬盘里文件的对应关系。

20 |

21 | 参数 fd,

22 |

23 | 文件对于应用程序,只是一部分内存。Linux使用write写文件,只是把文件写进内存,并没有sync。而内存的数据和硬盘交换的功能去完成。

24 |

25 | ELF可执行程序的头部会记录,从xxx到xxx是代码段。把代码段映射到虚拟地址,0~3 G, 权限是RX。这段地址映射到内核空间的page cache, 这段page cache又映射到可执行程序。

26 |

27 | page cache,会根据LRU算法(最近最少使用)进行替换。

28 |

29 | demo演示 page cache会多大程度影响程序执行时间。

30 |

31 | ```

32 | echo 3 > /proc/sys/vm/drop_caches

33 | time python hello.py

34 | \time -v python hello.py

35 |

36 | root@whale:/home/gzzhangyi2015# \time -v python hello.py

37 | Hello World! Love, Python

38 | Command being timed: "python hello.py"

39 | User time (seconds): 0.01

40 | System time (seconds): 0.00

41 | Percent of CPU this job got: 40%

42 | Elapsed (wall clock) time (h:mm:ss or m:ss): 0:00.03

43 | Average shared text size (kbytes): 0

44 | Average unshared data size (kbytes): 0

45 | Average stack size (kbytes): 0

46 | Average total size (kbytes): 0

47 | Maximum resident set size (kbytes): 6544

48 | Average resident set size (kbytes): 0

49 | Major (requiring I/O) page faults: 10

50 | Minor (reclaiming a frame) page faults: 778

51 | Voluntary context switches: 54

52 | Involuntary context switches: 9

53 | Swaps: 0

54 | File system inputs: 6528

55 | File system outputs: 0

56 | Socket messages sent: 0

57 | Socket messages received: 0

58 | Signals delivered: 0

59 | Page size (bytes): 4096

60 | Exit status: 0

61 |

62 | root@whale:/home/gzzhangyi2015# \time -v python hello.py

63 | Hello World! Love, Python

64 | Command being timed: "python hello.py"

65 | User time (seconds): 0.01

66 | System time (seconds): 0.00

67 | Percent of CPU this job got: 84%

68 | Elapsed (wall clock) time (h:mm:ss or m:ss): 0:00.01

69 | Average shared text size (kbytes): 0

70 | Average unshared data size (kbytes): 0

71 | Average stack size (kbytes): 0

72 | Average total size (kbytes): 0

73 | Maximum resident set size (kbytes): 6624

74 | Average resident set size (kbytes): 0

75 | Major (requiring I/O) page faults: 0

76 | Minor (reclaiming a frame) page faults: 770

77 | Voluntary context switches: 1

78 | Involuntary context switches: 4

79 | Swaps: 0

80 | File system inputs: 0

81 | File system outputs: 0

82 | Socket messages sent: 0

83 | Socket messages received: 0

84 | Signals delivered: 0

85 | Page size (bytes): 4096

86 | Exit status: 0

87 | ```

88 |

89 | 总结:Linux有两种方式读取文件,不管以何种方式读文件,都会产生page cache 。

90 |

91 | ### free命令的详细解释

92 |

93 | ```

94 | total used free shared buffers cached

95 | Mem: 49537244 1667532 47869712 146808 21652 421268

96 | -/+ buffers/cache: 1224612 48312632

97 | Swap: 4194300 0 4194300

98 | ```

99 |

100 |

101 |

102 | buffers/cache都是文件系统的缓存,当访问ext3/ext4,fat等文件系统中的文件,产生cache。当直接访问裸分区(/dev/sdax)时,产生buffer。

103 |

104 | 访问裸分区的用户,主要是应用程序直接打开 or 文件系统本身。dd命令 or 硬盘备份 or sd卡,会访问裸分区,产生的缓存就是buffer。而ext4文件系统把硬盘当作裸分区。

105 |

106 | buffer和cache没有本质的区别,只是背景的区别。

107 |

108 | -/+ buffer/cache 的公式

109 | used buffers/cache = used - buffers - cached

110 | free buffers/cache = free + buffers + cached

111 |

112 | 新版free

113 | available参数:评估出有多少空闲内存给应用程序使用,free + 可回收的。

114 |

115 |

116 |

117 | ### File-backed和Anonymous page

118 |

119 | * File-backed映射把进程的虚拟地址空间映射到files

120 | * 比如 代码段

121 | * 比如 mmap一个字体文件

122 |

123 | * Anonymous映射是进程的虚拟地址空间没有映射到任何file

124 | * Stack

125 | * Heap

126 | * CoW pages

127 |

128 | anonymous pages(没有任何文件背景)分配一个swapfile文件或者一个swap分区,来进行交换到磁盘的动作。

129 |

130 | read/write和 mmap 本质上都是有文件背景的映射,把进程的虚拟地址空间映射到files。在内存中的副本,只是一个page cache。是page cache就有可能被踢出内存。CPU 内部的cache,当访问新的内存时,也会被踢出cache。

131 |

132 | demo:演示进程的代码段是如何被踢出去的?

133 |

134 | ```

135 | pidof firefox

136 | cat /proc//smaps

137 |

138 | 运行 oom.c

139 |

140 | ```

141 | ### swap以及zRAM

142 |

143 | 数据段,在未写过时,有文件背景。在写过之后,变成没有文件背景,就被当作匿名页。linux把swap分区,当作匿名页的文件背景。

144 | ```

145 | swap(v.),内存和硬盘之间的颠簸行为。

146 | swap(n.),swap分区和swap文件,当作内存中匿名页的交换背景。在windows内,被称作虚拟内存。pagefile.sys

147 | ```

148 | ### 页面回收和LRU

149 |

150 |

151 |

152 | 回收匿名页和 回收有文件背景的页面。

153 | 后台慢慢回收:通过kswapd进程,回收到高水位(high)时,才停止回收。从low -> high

154 | 直接回收:当水位达到min水位,会在两种页面同时进行回收,回收比例通过swappiness越大,越倾向于回收匿名页;swappiness越小,越倾向于回收file-backed的页面。当然,它们的回收方法都是一样的LRU算法。

155 |

156 | ### Linux Page Replacement

157 |

158 | 用LRU算法来进行swap和page cache的页面替换。

159 |

160 |

161 |

162 | ```

163 | 现在cache的大小是4页,前四次,1,2,3,4文件被一次使用,注意第七次,5文件被使用,系统评估最近最少被使用的文件是3,那么不好意思,3被swap出去,5加载进来,依次类推。

164 |

165 | 所以LRU可能会触发page cache或者anonymous页与对应文件的数据交换。

166 | ```

167 |

168 | ### 嵌入式系统的zRAM

169 |

170 |

171 |

172 | zRAM: 用内存来做swap分区。从内存中开辟一小段出来,模拟成硬盘分区,做交换分区,交换匿名页,自带透明压缩功能。当应用程序往zRAM写数据时,会自动把匿名页进行压缩。当应用程序访问匿名页时,内存页表里不命中,发生page fault(major)。从zRAM中把匿名页透明解压出来,还到内存。

173 |

174 |

175 |

176 |

177 |

178 |

179 |

180 |

181 |

182 |

183 |

184 |

185 |

186 |

--------------------------------------------------------------------------------

/文章/内存管理/内存的动态申请和释放.md:

--------------------------------------------------------------------------------

1 | ## 内存的动态申请和释放

2 |

3 | 内核空间 和用户空间申请的内存最终和buddy怎么交互?以及在页表映射上的区别?虚拟地址到物理地址,什么时候开始映射?

4 |

5 | ### Buddy的问题

6 | 分配的粒度太大

7 | buddy算法把空闲页面分成1,2,4页,buddy算法会明确知道哪一页内存空闲还是被占用?

8 |

9 | 4k,8k,16k

10 |

11 | 无论是在应用还是内核,都需要申请很小的内存。

12 |

13 | 从buddy要到的内存,会进行slab切割。

14 |

15 | ### slab原理:

16 | 比如在内核中申请8字节的内存,buddy分配4K,分成很多个小的8个字节,每个都是一个object。

17 |

18 | slab,slub,slob 是slab机制的三种不同实现算法。

19 |

20 | Linux 会针对一些常规的小的内存申请,数据结构,会做slab申请。

21 |

22 | cat /proc/slabinfo 可以看到内核空间小块内存的申请情况,也是slab分配的情况。

23 |

24 | :每个slab一共可以分出多少个obj,

25 | :还可以分配多少个obj,

26 | < pagesperslab>:每个slab对应多少个pages,

27 | < objperslab>:每个slab可以分出多少个object,

28 | < objsize>:每个obj多大,

29 |

30 | slab主要分为两类:

31 |

32 | 一、常用数据结构像 nfsd_drc, UDPv6,TCPv6 ,这些经常申请和释放的数据结构。比如,存在TCPv6的slab,之后申请 TCPv6 数据结构时,会通过这个slab来申请。

33 |

34 |

35 |

36 | 二、常规的小内存申请,做的slab。例如 kmalloc-32,kmalloc-64, kmalloc-96, kmalloc-128

37 |

38 |

39 |

40 |

41 |

42 | 注意,slab申请和分配的都是只针对内核空间,与用户空间申请分配内存无关。用户空间的malloc和free调用的是libc。

43 |

44 | slab和buddy的关系?

45 | 1、slab的内存来自于buddy。slab相当于二级管理器。

46 | 2、slab和buddy在算法上,级别是对等的。

47 |

48 | 两者都是内存分配器,buddy是把内存条分成多个Zone来管理分配,slab是把从buddy拿到的内存,进行管理分配。

49 |

50 | 同理,malloc 和free也不找buddy拿内存。 malloc 和free不是系统调用,只是c库中的函数。

51 |

52 | ### mallopt

53 | 在C库中有一个api是mallopt,可以控制一系列的选项。

54 |

55 |

56 |

57 | M_TRIM_THRESHOLD:控制c库把内存还给内核的阈值。

58 | -1UL 代表最大的正整数。

59 |

60 | 此处代表应用程序把内存还给c库后,c库并不把内存还给内核。

61 |

62 | <\do your RT-thing>

63 | 程序在此处申请内存,都不需要再和内核交互了,此时程序的实时性比较高。

64 |

65 | ### kmalloc vs. vmalloc/ioremap

66 |

67 | 内存空间: 内存+寄存器

68 |

69 | register --> LDR/STR

70 |

71 | 所有内存空间的东西,CPU去访问,都要通过虚拟地址。

72 | CPU --> virt --> mmu --> phys

73 |

74 | cpu请求虚拟地址,mmu根据cpu请求的虚拟地址,查页表得物理地址。

75 |

76 | buddy算法,管理这一页的使用情况。

77 |

78 | 两个虚拟地址可以映射到同一个物理地址。

79 |

80 |

81 |

82 | 页表 -> 数组,

83 |

84 | 任何一个虚拟地址,都可以用地址的高20位,作为页表的行号去读对应的页表项。而低12位,是指页内偏移。(由于一页是4K,2^12 足够描述)

85 |

86 | kmalloc 和 vmalloc 申请的内存,有什么区别?

87 | 答:申请之后,是否还要去改页表。一般情况,kmalloc申请内存,不需要再去改页表。同一张页表,几个虚拟地址可以同时映射到同一个物理地址。

88 |

89 | 寄存器,通过ioremap往vmalloc区域,进行映射。然后改进程的虚拟地址页表。

90 |

91 | 总结:所有的页,最底层都是用buddy算法进行管理,用虚拟地址找物理地址。理解内存分配和映射的区别,无论是lowmem还是highmem 都可以被vmalloc拿走,也可能被用户拿走,只不过拿走之后,还要把虚拟地址往物理地址再映射一遍。但如果是被kmalloc拿走,一般指低端内存,就不需要再改进程的页表。因为这部分低端内存,已经做好了虚实映射。

92 | ```

93 | cat /proc/vmallocinfo |grep ioremap

94 | ```

95 | 可以看到寄存器中的哪个区域,被映射到哪个虚拟地址。

96 |

97 | vmalloc区域主要用来,vmalloc申请的内存从这里找虚拟地址 和 寄存器的ioremap映射。

98 |

99 | ### Linux内存分配的lazy行为

100 |

101 | Linux总是以最lazy的方式,给应用程序分配内存。

102 |

103 |

104 |

105 | malloc 100M内存成功时,其实并没有真实拿到。只有当100M内存中的任何一页,被写一次的时候,才成功。

106 |

107 | vss:虚拟地址空间。 rss:常驻内存空间

108 |

109 | malloc 100M内存成功时,Linux把100M内存全部以只读的形式,映射到一个全部清0的页面。

110 |

111 | 当应用程序写100M中每一页任意字节时,会发出page fault。 linux 内核收到缺页中断后,从硬件寄存器中读取到,包括缺页中断发生的原因和虚拟地址。Linux从内存条申请一页内存,执行cow,把页面重新拷贝到新申请的页表,再把进程页表中的虚拟地址,指向一个新的物理地址,权限也被改成R+W。

112 |

113 | 调用brk 把8k变成 16k。

114 |

115 | 针对应用程序的堆、代码、栈、等,会使用lazy分配机制,只有当写内存页时,才会真实请求内存分配页表。但,当内核使用kmalloc申请内存时,就真实的分配相应的内存,不使用lazy机制。

116 |

117 | ### 内存OOM

118 |

119 | 当真实去写内存时,应用程序并不能拿到真实的内存时。Linux启动OOM,linux在运行时,会对每一个进程进行out-of-memory打分。打分主要基于,耗费的内存。耗费的内存越多,打分越高。

120 |

121 | ```

122 | cat /proc//oom_score

123 | ```

124 |

125 | demo:

126 |

127 | ```c

128 | #include

129 | #include

130 | #include

131 | int main(int argc, char **argv)

132 | {

133 | int max = -1;

134 | int mb = 0;

135 | char *buffer;

136 | int i;

137 | #define SIZE 2000

138 | unsigned int *p = malloc(1024 * 1024 * SIZE);

139 | printf("malloc buffer: %p\n", p);

140 | for (i = 0; i < 1024 * 1024 * (SIZE/sizeof(int)); i++) {

141 | p[i] = 123;

142 | if ((i & 0xFFFFF) == 0) {

143 | printf("%dMB written\n", i >> 18);

144 | usleep(100000);

145 | }

146 | }

147 | pause();

148 | return 0;

149 | }

150 | ```

151 |

152 | 设定条件:

153 |

154 | 总内存1G

155 | 1、swapoff -a 关掉swap交换

156 | 2、echo 1 > /proc/sys/vm/overcommit_memory

157 | 3、内核不去评估系统还有多少空闲内存

158 |

159 | Linux进行OOM打分,主要是看耗费内存情况,此外还会参考用户权限,比如root权限,打分会减少30分。

160 |

161 | 还有OOM打分因子:/proc/pid/oom_score_adj (加减)和 /proc/pid/oom_adj (乘除)。

162 |

163 |

164 |

165 | ### 总结:

166 | 1、slab的作用,针对在内核空间小内存分配,和常用数据结构的申请。

167 | 2、同样的二次分配器,在用户空间是C库。malloc和free的时候,内存不一定从buddy分配和还给buddy。

168 | 3、kmalloc,vmalloc 和malloc的区别

169 |

170 | * kmalloc:申请内存,一般在低端内存区。申请到时,内存已经映射过了,不需要再去改进程的页表。所以,申请到的物理页是连续的。

171 | * vmalloc:申请内存,申请到就拿到内存,并且已经修改了进程页表的虚拟地址到物理地址的映射。vmalloc()申请的内存并不保证物理地址的连续。

172 | * 用户空间的malloc:申请内存,申请到并没有拿到,写的时候才去拿到。拿到之后,才去改页表。申请成功,页表只读,只有到写时,发生page fault,才去buddy拿内存。

173 | * kmalloc和vmalloc针对内核空间,malloc针对用户空间。这些内存,可以来自任何一个Zone。

174 | * 无论是kmalloc,vmalloc还是用户空间的malloc,都可以使用内存条的不同Zone,无论是highmem zone、lowmem zone 和 DMA zone。

175 |

176 | 4、如果在从buddy拿不到内存时,会触发Linux对所有进程进行OOM打分。当Linux出现内存耗尽,就kill一个oom score 最高的那个进程。oom_score,可以根据 oom_adj (-17~25)。

177 |

178 | 安卓的程序,不停的调整前台和后台进程oom_score,当被切换到后台时,oom_score会被调整的比较大。以保证前台的进程不容易因为oom而kill掉。

179 |

180 |

--------------------------------------------------------------------------------

/文章/内存管理/多核心Linux内核路径优化的不二法门之-slab与伙伴系统.md:

--------------------------------------------------------------------------------

1 | Linux内核的slab来自一种很简单的思想,即事先准备好一些会频繁分配,释放的数据结构。然而标准的slab实现太复杂且维护开销巨大,因此便分化 出了更加小巧的slub,因此本文讨论的就是slub,后面所有提到slab的地方,指的都是slub。另外又由于本文主要描述内核优化方面的内容,并不 是基本原理介绍,因此想了解slab细节以及代码实现的请自行百度或者看源码。

2 |

3 | ## 单CPU上单纯的slab

4 |

5 | 下图给出了单CPU上slab在分配和释放对象时的情景序列:

6 |

7 |

8 |

9 | 可以看出,非常之简单,而且完全达到了slab设计之初的目标。

10 |

11 | ## 扩展到多核心CPU

12 |

13 | 现在我们简单的将上面的模型扩展到多核心CPU,同样差不多的分配序列如下图所示:

14 |

15 |

16 |

17 | 我们看到,在只有单一slab的时候,如果多个CPU同时分配对象,冲突是不可避免的,解决冲突的几乎是唯一的办法就是加锁排队,然而这将大大增加延迟,我们看到,申请单一对象的整个时延从T0开始,到T4结束,这太久了。

18 |

19 | 多CPU无锁化并行化操作的直接思路-复制给每个CPU一套相同的数据结构。

20 |

21 | 不二法门就是增加“每CPU变量”。对于slab而言,可以扩展成下面的样子:

22 |

23 |

24 |

25 | 如果以为这么简单就结束了,那这就太没有意义了。

26 |

27 | ## 问题

28 |

29 | 首先,我们来看一个简单的问题,如果单独的某个CPU的slab缓存没有对象可分配了,但是其它CPU的slab缓存仍有大量空闲对象的情况,如下图所示:

30 |

31 |

32 |

33 | 这 是可能的,因为对单独一种slab的需求是和该CPU上执行的进程/线程紧密相关的,比如如果CPU0只处理网络,那么它就会对skb等数据结构有大量的 需求,对于上图最后引出的问题,如果我们选择从伙伴系统中分配一个新的page(或者pages,取决于对象大小以及slab cache的order),那么久而久之就会造成slab在CPU间分布的不均衡,更可能会因此吃掉大量的物理内存,这都是不希望看到的。

34 |

35 | 在继续之前,首先要明确的是,我们需要在CPU间均衡slab,并且这些必须靠slab内部的机制自行完成,这个和进程在CPU间负载均衡是完全不同的, 对进程而言,拥有一个核心调度机制,比如基于时间片,或者虚拟时钟的步进速率等,但是对于slab,完全取决于使用者自身,只要对象仍然在使用,就不能剥 夺使用者继续使用的权利,除非使用者自己释放。因此slab的负载均衡必须设计成合作型的,而不是抢占式的。

36 |

37 | 好了。现在我们知道,从伙伴系统重新分配一个page(s)并不是一个好主意,它应该是最终的决定,在执行它之前,首先要试一下别的路线。

38 |

39 | 现在,我们引出第二个问题,如下图所示:

40 |

41 |

42 |

43 | 谁也不能保证分配slab对象的CPU和释放slab对象的CPU是同一个CPU,谁也不能保证一个CPU在一个slab对象的生命周期内没有分配新的 page(s),这期间的复杂操作谁也没有规定。这些问题该怎么解决呢?事实上,理解了这些问题是怎么解决的,一个slab框架就彻底理解了。

44 |

45 | ## 问题的解决-分层slab cache

46 |

47 | 无级变速总是让人向往。

48 |

49 | 如果一个CPU的slab缓存满了,直接去抢同级别的别的CPU的slab缓存被认为是一种鲁莽且不道义的做法。那么为何不设置另外一个slab缓存,获 取它里面的对象不像直接获取CPU的slab缓存那么简单且直接,但是难度却又不大,只是稍微增加一点消耗,这不是很好吗?事实上,CPU的 L1,L2,L3 cache不就是这个方案设计的吗?这事实上已经成为cache设计的不二法门。这个设计思想同样作用于slab,就是Linux内核的slub实现。

50 | 现在可以给出概念和解释了。

51 |

52 | * Linux kernel slab cache:一个分为3层的对象cache模型。

53 | * Level 1 slab cache:一个空闲对象链表,每个CPU一个的独享cache,分配释放对象无需加锁。

54 | * Level 2 slab cache:一个空闲对象链表,每个CPU一个的共享page(s) cache,分配释放对象时仅需要锁住该page(s),与Level 1 slab cache互斥,不互相包容。

55 | * Level 3 slab cache:一个page(s)链表,每个NUMA NODE的所有CPU共享的cache,单位为page(s),获取后被提升到对应CPU的Level 1 slab cache,同时该page(s)作为Level 2的共享page(s)存在。

56 | * 共享page(s):该page(s)被一个或者多个CPU占 有,每一个CPU在该page(s)上都可以拥有互相不充图的空闲对象链表,该page(s)拥有一个唯一的Level 2 slab cache空闲链表,该链表与上述一个或多个Level 1 slab cache空闲链表亦不冲突,多个CPU获取该Level 2 slab cache时必须争抢,获取后可以将该链表提升成自己的Level 1 slab cache。

57 |

58 | 该slab cache的图示如下:

59 |

60 |

61 |

62 | 其行为如下图所示:

63 |

64 |

65 |

66 | ## 2个场景

67 |

68 | 对于常规的对象分配过程,下图展示了其细节:

69 |

70 |

71 |

72 | 事实上,对于多个CPU共享一个page(s)的情况,还可以有另一种玩法,如下图所示:

73 |

74 |

75 |

76 | ## 伙伴系统

77 |

78 | 前面我们简短的体会了Linux内核的slab设计,不宜过长,太长了不易理解.但是最后,如果Level 3也没有获取page(s),那么最终会落到终极的伙伴系统。

79 |

80 | 伙伴系统是为了防内存分配碎片化的,所以它尽可能地做两件事:

81 |

82 | **1).尽量分配尽可能大的内存**

83 | **2).尽量合并连续的小块内存成一块大内存**

84 |

85 | 我们可以通过下面的图解来理解上面的原则:

86 |

87 |

88 |

89 | 注意,本文是关于优化的,不是伙伴系统的科普,所以我假设大家已经理解了伙伴系统。

90 |

91 | 鉴于slab缓存对象大多数都是不超过1个页面的小结构(不仅仅slab系统,超过1个页面的内存需求相比1个页面的内存需求,很少),因此会有大量的针 对1个页面的内存分配需求。从伙伴系统的分配原理可知,如果持续大量分配单一页面,会有大量的order大于0的页面分裂成单一页面,在单核心CPU上, 这不是问题,但是在多核心CPU上,由于每一个CPU都会进行此类分配,而伙伴系统的分裂,合并操作会涉及大量的链表操作,这个锁开销是巨大的,因此需要 优化!

92 |

93 | Linux内核对伙伴系统针对单一页面的分配需求采取的批量分配“每CPU单一页面缓存”的方式!

94 |

95 | 每一个CPU拥有一个单一页面缓存池,需要单一页面的时候,可以无需加锁从当前CPU对应的页面池中获取页面。而当池中页面不足时,系统会批量从伙伴系统中拉取一堆页面到池中,反过来,在单一页面释放的时候,会择优将其释放到每CPU的单一页面缓存中。

96 |

97 | 为了维持“每CPU单一页面缓存”中页面的数量不会太多或太少(太多会影响伙伴系统,太少会影响CPU的需求),系统保持了两个值,当缓存页面数量低于 low值的时候,便从伙伴系统中批量获取页面到池中,而当缓存页面数量大于high的时候,便会释放一些页面到伙伴系统中。

98 |

99 | ## 小结

100 |

101 | 多 CPU操作系统内核中,关键的开销就是锁的开销。我认为这是一开始的设计导致的,因为一开始,多核CPU并没有出现,单核CPU上的共享保护几乎都是可以 用“禁中断”,“禁抢占”来简单实现的,到了多核时代,操作系统同样简单平移到了新的平台,因此同步操作是在单核的基础上后来添加的。简单来讲,目前的主 流操作系统都是在单核年代创造出来的,因此它们都是顺应单核环境的,对于多核环境,可能它们一开始的设计就有问题。

102 |

103 | 不管怎么说,优化操作的不二法门就是禁止或者尽量减少锁的操作。随之而来的思路就是为共享的关键数据结构创建"每CPU的缓存“,而这类缓存分为两种类型:

104 |

105 | 1).数据通路缓存。

106 | 比如路由表之类的数据结构,你可以用RCU锁来保护,当然如果为每一个CPU都创建一个本地路由表缓存,也是不错的,现在的问题是何时更新它们,因为所有的缓存都是平级的,因此一种批量同步的机制是必须的。

107 | 2).管理机制缓存。

108 | 比 如slab对象缓存这类,其生命周期完全取决于使用者,因此不存在同步问题,然而却存在管理问题。采用分级cache的思想是好的,这个非常类似于CPU 的L1/L2/L3缓存,采用这种平滑的开销逐渐增大,容量逐渐增大的机制,并配合以设计良好的换入/换出等算法,效果是非常明显的。

109 |

--------------------------------------------------------------------------------

/文章/内存管理/尽情阅读,技术进阶,详解mmap原理.md:

--------------------------------------------------------------------------------

1 | ## 1. 一句话概括mmap

2 |

3 | mmap的作用,在应用这一层,是让你把文件的某一段,当作内存一样来访问。将文件映射到物理内存,将进程虚拟空间映射到那块内存。

4 |

5 | 这样,进程不仅能像访问内存一样读写文件,多个进程映射同一文件,还能保证虚拟空间映射到同一块物理内存,达到内存共享的作用。

6 |

7 | ## 2. 虚拟内存?虚拟空间?

8 |

9 | 其实是一个概念,前一篇对于这个词没有确切的定义,现在定义一下:

10 |

11 | 虚拟空间就是进程看到的所有地址组成的空间,虚拟空间是某个进程对分配给它的所有物理地址(已经分配的和将会分配的)的重新映射。

12 |

13 | 而虚拟内存,为啥叫虚拟内存,是因为它就不是真正的内存,是假的,因为它是由地址组成的空间,所以在这里,使用虚拟空间这个词更加确切和易懂。(不过虚拟内存这个词也不算错)

14 |

15 | ### 2.1 虚拟空间原理

16 |

17 | #### 2.1.1物理内存

18 |

19 | 首先,物理地址实际上也不是连续的,通常是包含作为主存的DRAM和IO寄存器

20 |

21 |

22 |

23 | 以前的CPU(如X86)是为IO划分单独的地址空间,所以不能用直接访问内存的方式(如指针)IO,只能用专门的方法(in/read/out/write)诸如此类。

24 |

25 | 现在的CPU利用PCI总线将IO寄存器映射到物理内存,所以出现了基于内存访问的IO。

26 |

27 | 还有一点补充的,就如同进程空间有一块内核空间一样,物理内存也会有极小一部分是不能访问的,为内核所用。

28 |

29 | ### 2.1.2三个总线

30 |

31 | 这里再补充下三个总线的知识,即:地址总线、数据总线、控制总线

32 | * 地址总线,用来传输地址

33 | * 数据总线,用来传输数据

34 | * 控制总线,用来传输命令

35 |

36 | 比如CPU通过控制总线发送读取命令,同时用地址总线发送要读取的数据虚地址,经过MMU后到内存

37 |

38 | 内存通过数据总线将数据传输给CPU。

39 |

40 | 虚拟地址的空间和指令集的地址长度有关,不一定和物理地址长度一致,比如现在的64位处理器,从VA角度看来,可以访问64位的地址,但地址总线长度只有48位,所以你可以访问一个位于2^52这个位置的地址。

41 |

42 | #### 2.1.3虚拟内存地址转换(虚地址转实地址)

43 |

44 | 上面已经明确了虚拟内存是虚拟空间,即地址的集合这一概念。基于此,来说说原理。

45 |

46 | 如果还记得操作系统课程里面提到的虚地址,那么这个虚地址就是虚拟空间的地址了,虚地址通过转换得到实地址,转换方式课程内也讲得很清楚,虚地址头部包含了页号(段地址和段大小,看存储模式:页存储、段存储,段页式),剩下部分是偏移量,经过MMU转换成实地址。

47 |

48 |

49 |

50 | 存储方式

51 |

52 |

53 |

54 | 如图则是页式存储动态地址变换的方式

55 |

56 | 虚拟地址头部为页号通过查询页表得到物理页号,假设一页时1K,那么页号*偏移量就得到物理地址

57 |

58 |

59 |

60 | 如图所示,段式存储

61 |

62 | 虚拟地址头部为段号,段表中找到段基地址加上偏移量得到实地址

63 |

64 |

65 |

66 | 段页式结合两者,如图所示。

67 |

68 | ## 3. mmap映射

69 |

70 | 至此,如果对虚拟空间已经了解了,那么接下来,作为coder,应该自动把虚拟空间无视掉,因为Linux的目的也是要让更多额进程能享用内存,又不让进程做麻烦的事情,是将虚拟空间和MMU都透明化,让进程(和coder)只需要管对内存怎样使用。

71 |

72 | 所以现在开始不再强调虚拟空间了。

73 |

74 | mmap就是将文件映射到内存上,进程直接对内存进行读写,然后就会反映到磁盘上。

75 |

76 |

77 |

78 | * 虚拟空间获取到一段连续的地址

79 | * 在没有读写的时候,这个地址指向不存在的地方(所以,上图中起始地址和终止地址是还没分配给进程的)

80 | * 好了,根据偏移量,进程要读文件数据了,数据占在两个页当中(物理内存着色部分)

81 | * 这时,进程开始使用内存了,所以OS给这两个页分配了内存(即缺页异常)(其余部分还是没有分配)

82 | * 然后刚分配的页内是空的,所以再将相同偏移量的文件数据拷贝到物理内存对应页上。

83 |

--------------------------------------------------------------------------------

/文章/内存管理/浅谈Linux内存管理机制.md:

--------------------------------------------------------------------------------

1 | ## 活学活用

2 |

3 | OOM Killer 在 Linux 系统里如果内存不足时,会杀死一个正在运行的进程来释放一些内存。

4 |

5 | Linux 里的程序都是调用 malloc() 来申请内存,如果内存不足,直接 malloc() 返回失败就可以,为什么还要去杀死正在运行的进程呢?Linux允许进程申请超过实际物理内存上限的内存。因为 malloc() 申请的是内存的虚拟地址,系统只是给了程序一个地址范围,由于没有写入数据,所以程序并没有得到真正的物理内存。物理内存只有程序真的往这个地址写入数据的时候,才会分配给程序。

6 |

7 |

8 |

9 | ## 内存管理

10 |

11 | 对于内存的访问,用户态的进程使用虚拟地址,内核的也基本都是使用虚拟地址

12 |

13 | ## 物理内存空间布局

14 |

15 |

16 |

17 | ## 虚拟内存与物理内存的映射

18 |

19 |

20 |

21 | ## 进程“独占”虚拟内存及虚拟内存划分

22 |

23 | 为了保证操作系统的稳定性和安全性。用户程序不可以直接访问硬件资源,如果用户程序需要访问硬件资源,必须调用操作系统提供的接口,这个调用接口的过程也就是系统调用。每一次系统调用都会存在两个内存空间之间的相互切换,通常的网络传输也是一次系统调用,通过网络传输的数据先是从内核空间接收到远程主机的数据,然后再从内核空间复制到用户空间,供用户程序使用。这种从内核空间到用户空间的数据复制很费时,虽然保住了程序运行的安全性和稳定性,但是牺牲了一部分的效率。

24 |

25 | 如何分配用户空间和内核空间的比例也是一个问题,是更多地分配给用户空间供用户程序使用,还是首先保住内核有足够的空间来运行。在当前的Windows 32位操作系统中,默认用户空间:内核空间的比例是1:1,而在32位Linux系统中的默认比例是3:1(3GB用户空间、1GB内核空间)(这里只是地址空间,映射到物理地址,可没有某个物理地址的内存只能存储内核态数据或用户态数据的说法)。

26 |

27 |

28 |

29 |

30 |

31 | 左右两侧均表示虚拟地址空间,左侧以描述内核空间为主,右侧以描述用户空间为主。

32 |

33 |

34 |

35 | 在内核里面也会有内核的代码,同样有 Text Segment、Data Segment 和 BSS Segment,别忘了内核代码也是 ELF 格式的。

36 |

37 | **在代码上的体现**

38 |

39 | ```c

40 | // 持有task_struct 便可以访问进程在内存中的所有数据

41 | struct task_struct {

42 | ...

43 | struct mm_struct *mm;

44 | struct mm_struct *active_mm;

45 | ...

46 | void *stack; // 指向内核栈的指针

47 | }

48 | ```

49 |

50 | 内核使用内存描述符mm_struct来表示进程的地址空间,该描述符表示着进程所有地址空间的信息

51 |

52 |

53 |

54 | 在用户态,进程觉着整个空间是它独占的,没有其他进程存在。但是到了内核里面,无论是从哪个进程进来的,看到的都是同一个内核空间,看到的都是同一个进程列表。虽然内核栈是各用个的,但是如果想知道的话,还是能够知道每个进程的内核栈在哪里的。所以,如果要访问一些公共的数据结构,需要进行锁保护。

55 |

56 |

57 |

58 | ## 地址空间内的栈

59 |

60 | 栈是主要用途就是支持函数调用。

61 |

62 | 大多数的处理器架构,都有实现硬件栈。有专门的栈指针寄存器,以及特定的硬件指令来完成 入栈/出栈 的操作。

63 |

64 | ### 用户栈和内核栈的切换

65 |

66 | 内核在创建进程的时候,在创建task_struct的同时,会为进程创建相应的堆栈。每个进程会有两个栈,一个用户栈,存在于用户空间,一个内核栈,存在于内核空间。当进程在用户空间运行时,cpu堆栈指针寄存器里面的内容是用户堆栈地址,使用用户栈;当进程在内核空间时,cpu堆栈指针寄存器里面的内容是内核栈空间地址,使用内核栈。

67 |

68 | 当进程因为中断或者系统调用而陷入内核态之行时,进程所使用的堆栈也要从用户栈转到内核栈。

69 |

70 | 如何相互切换呢?

71 |

72 | 进程陷入内核态后,先把用户态堆栈的地址保存在内核栈之中,然后设置堆栈指针寄存器的内容为内核栈的地址,这样就完成了用户栈向内核栈的转换;当进程从内核态恢复到用户态执行时,在内核态执行的最后,将保存在内核栈里面的用户栈的地址恢复到堆栈指针寄存器即可。这样就实现了内核栈和用户栈的互转。

73 |

74 | 那么,我们知道从内核转到用户态时用户栈的地址是在陷入内核的时候保存在内核栈里面的,但是在陷入内核的时候,我们是如何知道内核栈的地址的呢?

75 |

76 | 关键在进程从用户态转到内核态的时候,进程的内核栈总是空的。这是因为,一旦进程从内核态返回到用户态后,内核栈中保存的信息无效,会全部恢复。因此,每次进程从用户态陷入内核的时候得到的内核栈都是空的,直接把内核栈的栈顶地址给堆栈指针寄存器就可以了。

77 |

78 | ### 为什么需要单独的进程内核栈?

79 |

80 | 内核地址空间所有进程空闲,但内核栈却不共享。为什么需要单独的进程内核栈?因为同时可能会有多个进程在内核运行。

81 |

82 | 所有进程运行的时候,都可能通过系统调用陷入内核态继续执行。假设第一个进程 A 陷入内核态执行的时候,需要等待读取网卡的数据,主动调用 schedule() 让出 CPU;此时调度器唤醒了另一个进程 B,碰巧进程 B 也需要系统调用进入内核态。那问题就来了,如果内核栈只有一个,那进程 B 进入内核态的时候产生的压栈操作,必然会破坏掉进程 A 已有的内核栈数据;一但进程 A 的内核栈数据被破坏,很可能导致进程 A 的内核态无法正确返回到对应的用户态了。

83 |

84 | 进程内核栈在进程创建的时候,通过 slab 分配器从 thread_info_cache 缓存池中分配出来,其大小为 THREAD_SIZE,一般来说是一个页大小 4K;

85 |

86 | ### 进程切换带来的用户栈切换和内核栈切换

87 |

88 | ```c

89 | // 持有task_struct 便可以访问进程在内存中的所有数据

90 | struct task_struct {

91 | ...

92 | struct mm_struct *mm;

93 | struct mm_struct *active_mm;

94 | ...

95 | void *stack; // 指向内核栈的指针

96 | }

97 | ```

98 |

99 | 从进程 A 切换到进程 B,用户栈要不要切换呢?当然要,在切换内存空间的时候就切换了,每个进程的用户栈都是独立的,都在内存空间里面。

100 |

101 | 那内核栈呢?已经在 __switch_to 里面切换了,也就是将 current_task 指向当前的 task_struct。里面的 void *stack 指针,指向的就是当前的内核栈。

102 |

103 | 内核栈的栈顶指针呢?在 __switch_to_asm 里面已经切换了栈顶指针,并且将栈顶指针在 __switch_to加载到了 TSS 里面。

104 |

105 | 用户栈的栈顶指针呢?如果当前在内核里面的话,它当然是在内核栈顶部的 pt_regs 结构里面呀。当从内核返回用户态运行的时候,pt_regs 里面有所有当时在用户态的时候运行的上下文信息,就可以开始运行了。

106 |

107 | 主线程的用户栈和一般现成的线程栈

108 |

109 |

110 |

111 | 对应着jvm 一个线程一个栈

112 |

113 | ### 中断栈

114 |

115 | 中断有点类似于我们经常说的事件驱动编程,而这个事件通知机制是怎么实现的呢,硬件中断的实现通过一个导线和 CPU 相连来传输中断信号,软件上会有特定的指令,例如执行系统调用创建线程的指令,而 CPU 每执行完一个指令,就会检查中断寄存器中是否有中断,如果有就取出然后执行该中断对应的处理程序。

116 |

117 | 当系统收到中断事件后,进行中断处理的时候,也需要中断栈来支持函数调用。由于系统中断的时候,系统当然是处于内核态的,所以中断栈是可以和内核栈共享的。但是具体是否共享,这和具体处理架构密切相关。ARM 架构就没有独立的中断栈。

118 |

119 | ## 内存管理的进程和硬件背景

120 |

121 | ### 页表的位置

122 |

123 | 每个进程都有独立的地址空间,为了这个进程独立完成映射,每个进程都有独立的进程页表,这个页表的最顶级的 pgd 存放在 task_struct 中的 mm_struct 的 pgd 变量里面。

124 |

125 | 在一个进程新创建的时候,会调用 fork,对于内存的部分会调用 copy_mm,里面调用 dup_mm。

126 |

127 | ```c

128 | // Allocate a new mm structure and copy contents from the mm structure of the passed in task structure.

129 | static struct mm_struct *dup_mm(struct task_struct *tsk){

130 | struct mm_struct *mm, *oldmm = current->mm;

131 | mm = allocate_mm();

132 | memcpy(mm, oldmm, sizeof(*mm));

133 | if (!mm_init(mm, tsk, mm->user_ns))

134 | goto fail_nomem;

135 | err = dup_mmap(mm, oldmm);

136 | return mm;

137 | }

138 | ```

139 |

140 | 除了创建一个新的 mm_struct,并且通过memcpy将它和父进程的弄成一模一样之外,我们还需要调用 mm_init 进行初始化。接下来,mm_init 调用 mm_alloc_pgd,分配全局页目录项,赋值给mm_struct 的 pdg 成员变量。

141 |

142 | ```c

143 | static inline int mm_alloc_pgd(struct mm_struct *mm){

144 | mm->pgd = pgd_alloc(mm);

145 | return 0;

146 | }

147 | ```

148 |

149 | 一个进程的虚拟地址空间包含用户态和内核态两部分。为了从虚拟地址空间映射到物理页面,页表也分为用户地址空间的页表和内核页表。在内核里面,映射靠内核页表,这里内核页表会拷贝一份到进程的页表

150 |

151 | 如果是用户态进程页表,会有 mm_struct 指向进程顶级目录 pgd,对于内核来讲,也定义了一个 mm_struct,指向 swapper_pg_dir(指向内核最顶级的目录 pgd)。

152 |

153 | ```c

154 | struct mm_struct init_mm = {

155 | .mm_rb = RB_ROOT,

156 | // pgd 页表最顶级目录

157 | .pgd = swapper_pg_dir,

158 | .mm_users = ATOMIC_INIT(2),