├── CPU.md

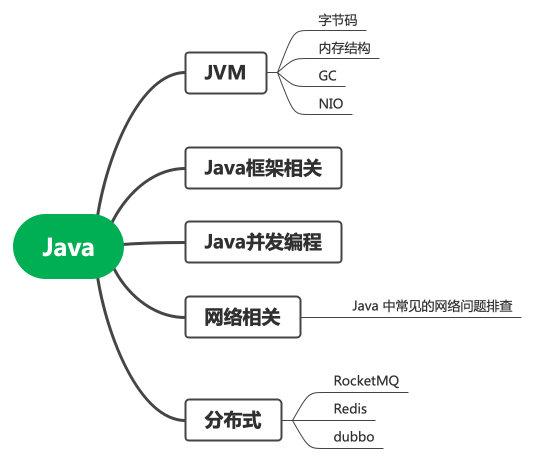

├── Java

├── dubbo.md

├── 一次使用多线程所引发的惨案.md

├── 我是一个线程池.md

├── 一个故事看懂对象的创建过程.md

├── 为什么线程崩溃不会导致JVM崩溃.md

├── Java线程模型.md

├── ConrrentHashMap是强一致性的吗.md

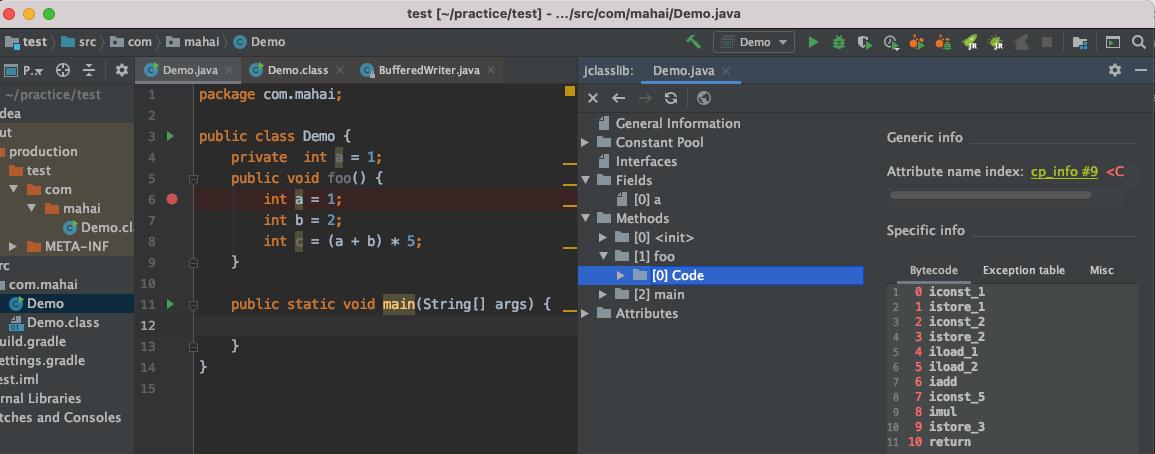

├── 字节码剖析.md

└── 多线程使用不当引发的惨案.md

├── 学习指南

├── 美团2017-2020年技术文章.md

└── 谷歌师兄刷题笔记.md

├── 程序人生

├── 我创业啦!!!.md

├── 我是如何晋升专家岗的.md

├── 面试了十几位前端有感.md

├── 与一位全职转行做滴滴司机的前程序员对话引发的思考.md

├── 谈谈一些学习心得.md

└── 优秀的程序员应该具备哪些能力.md

├── 工程师效率

├── Gradlebuild慢?可能是你使用的姿势不对.md

└── Alfred有多强悍,我写了个一键上传图片的workflow来告诉你.md

├── README.md

├── 系统设计

├── 震惊!线上四台机器同一时间全部OOM,到底发生了什么?.md

├── 优秀程序员必备的四项能力.md

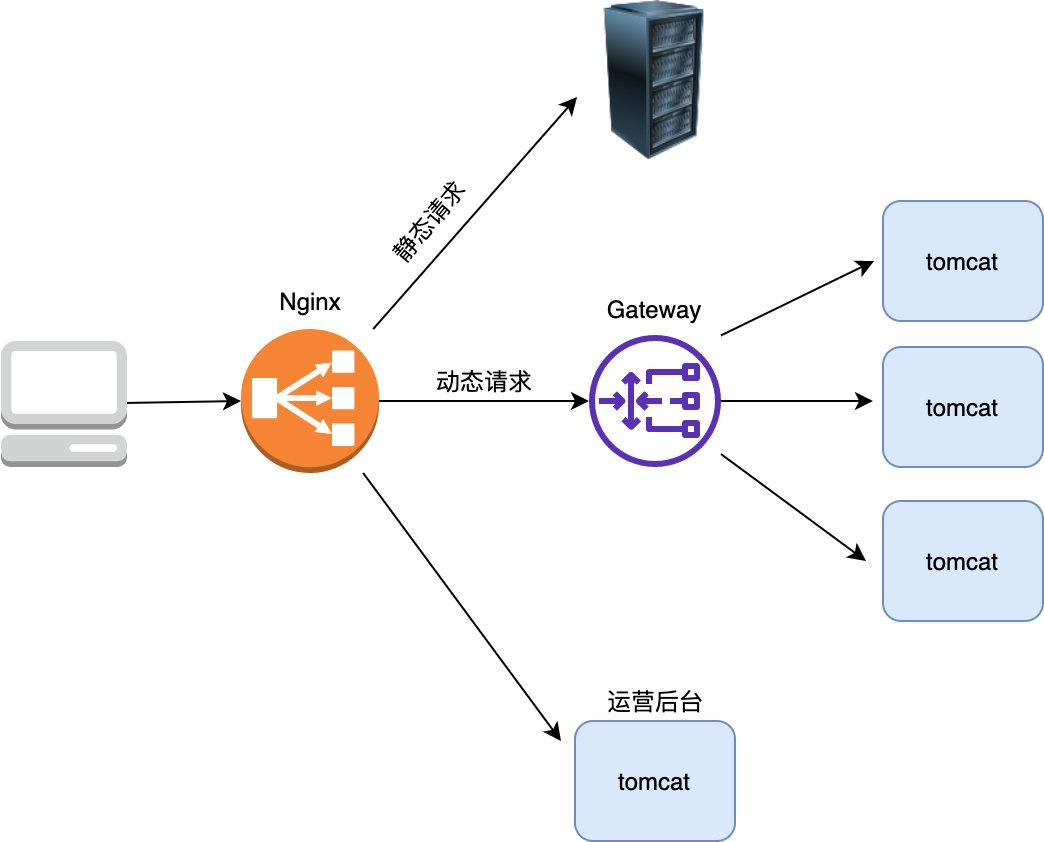

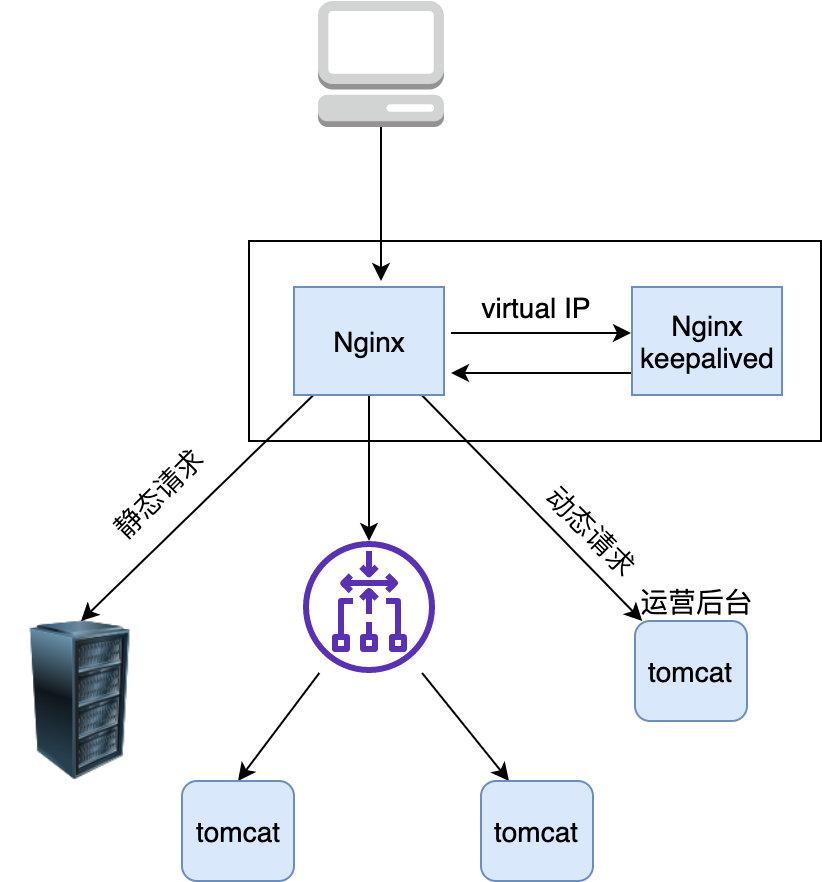

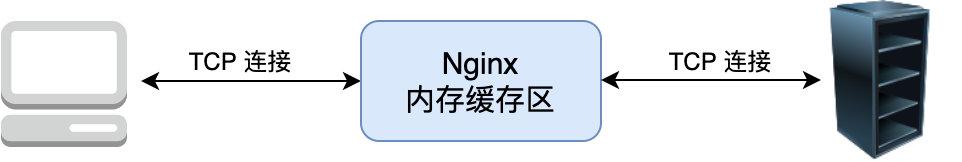

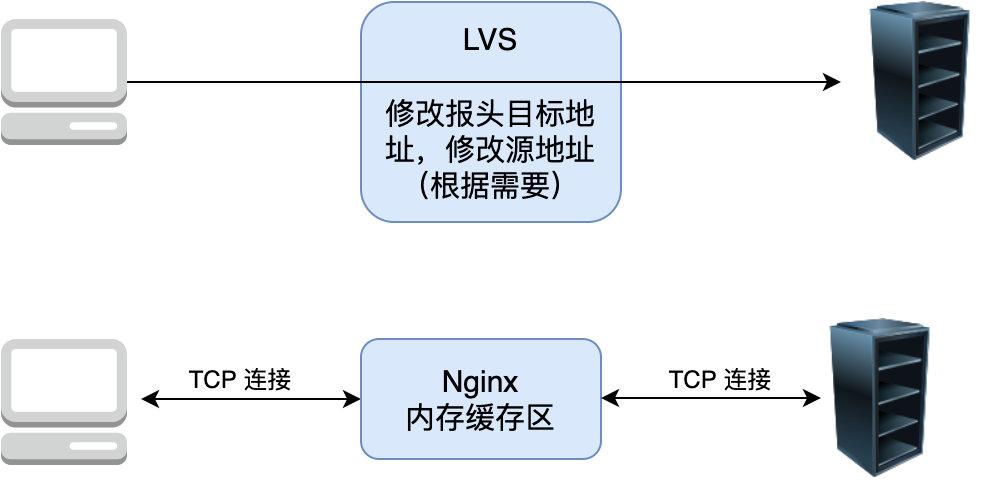

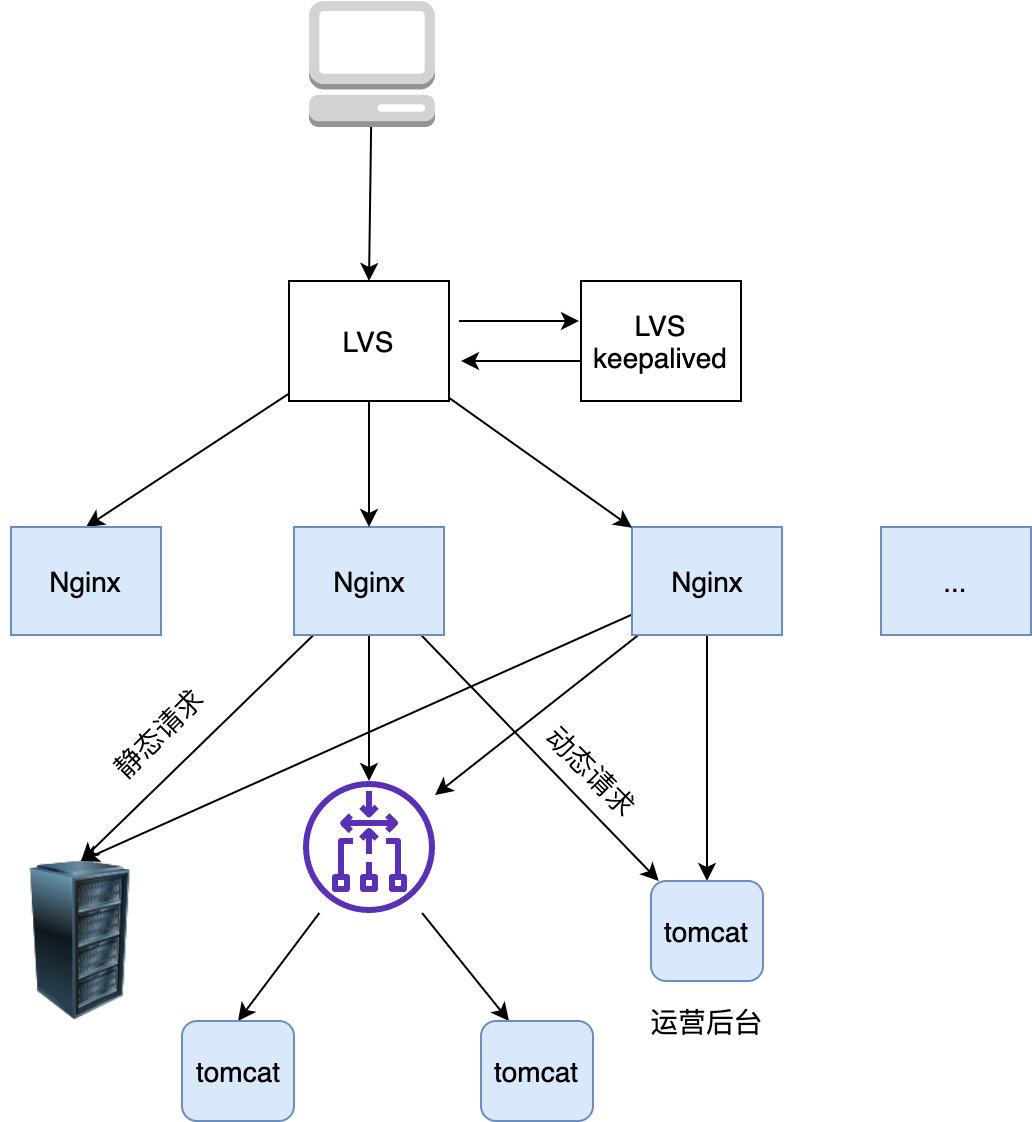

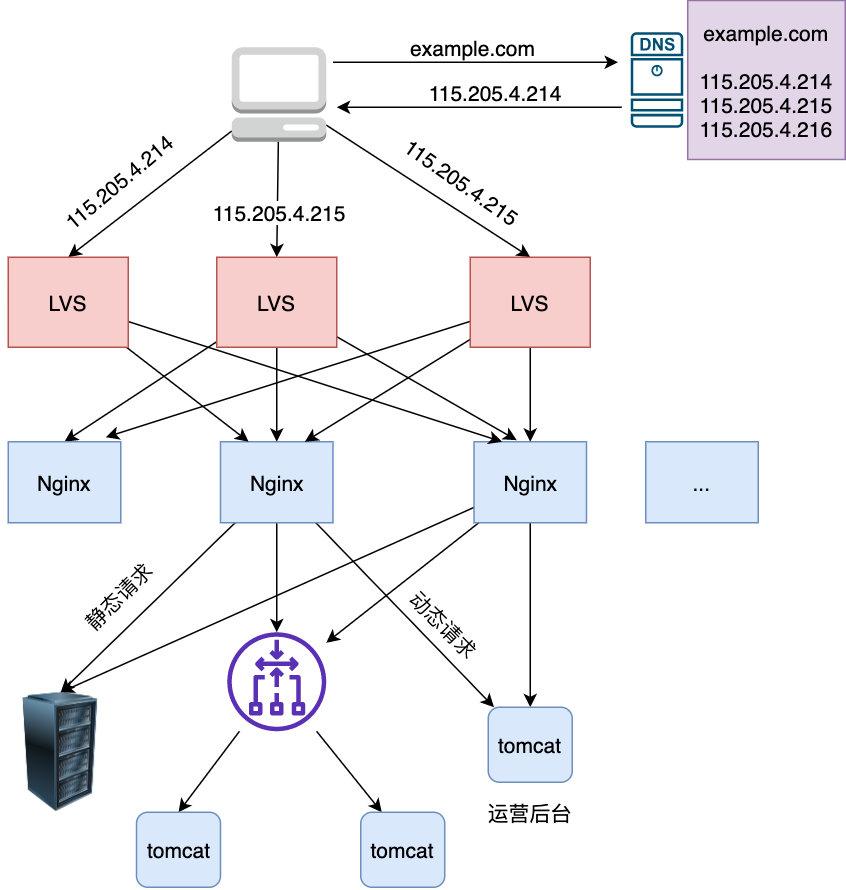

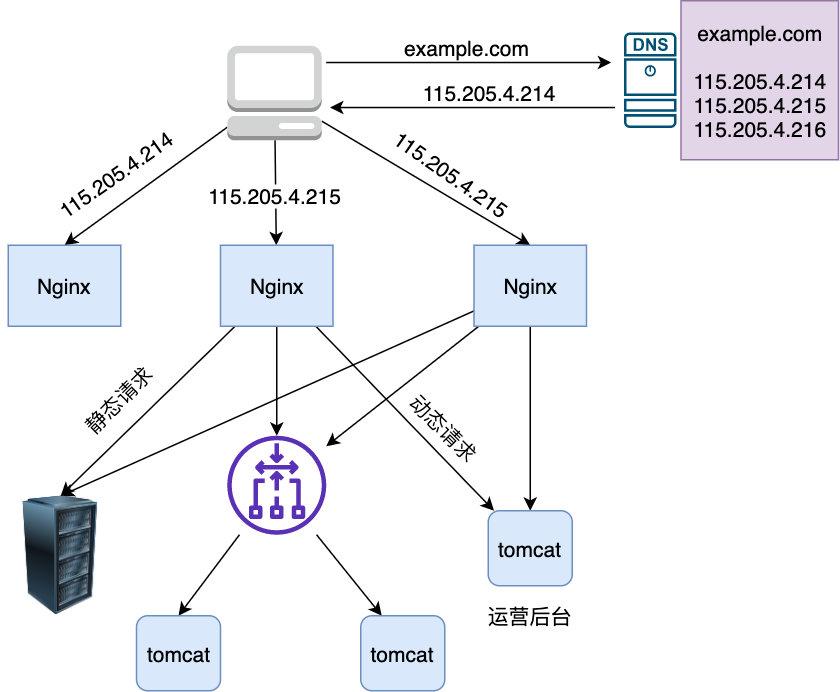

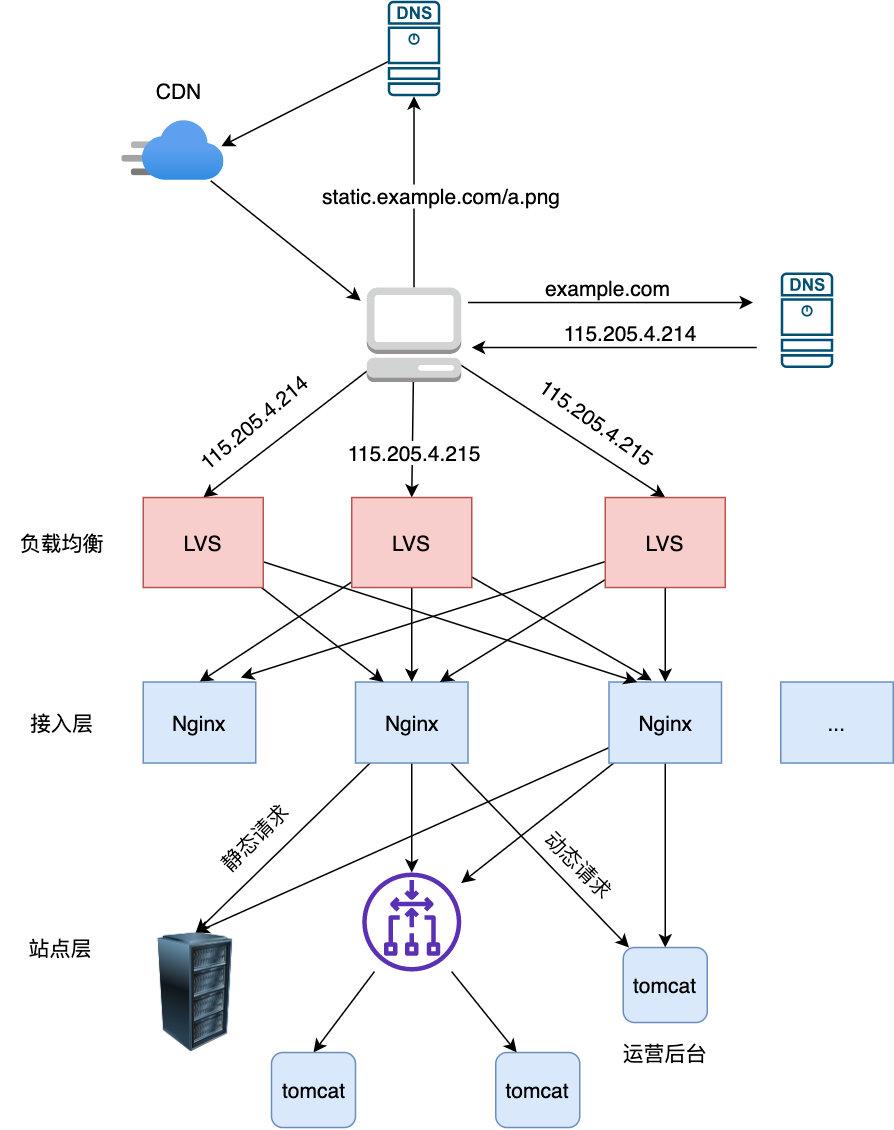

├── 你管这破玩意儿叫负载均衡.md

├── 金融监控实战.md

├── 从应用层到网络层排查Dubbo接口超时全记录.md

├── 高性能短链设计.md

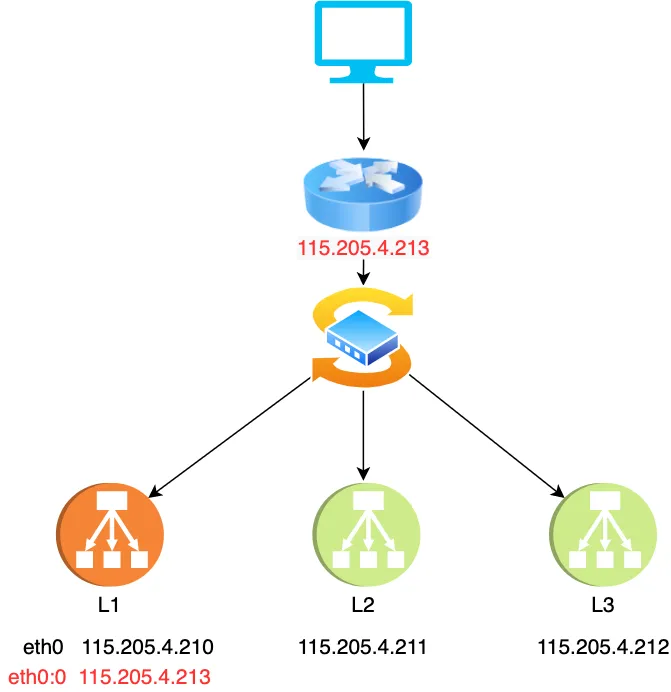

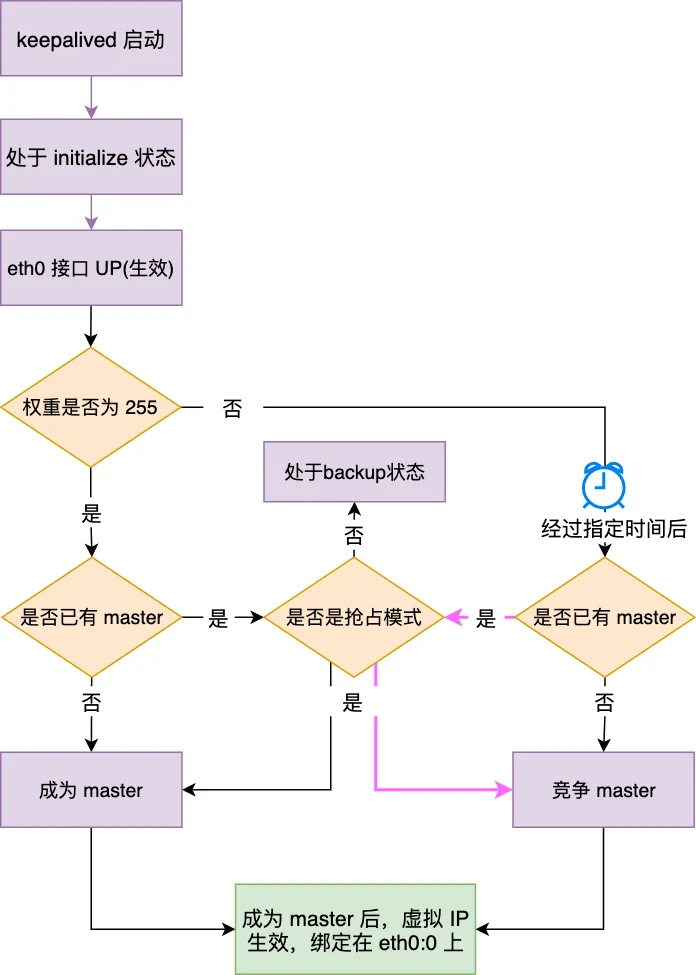

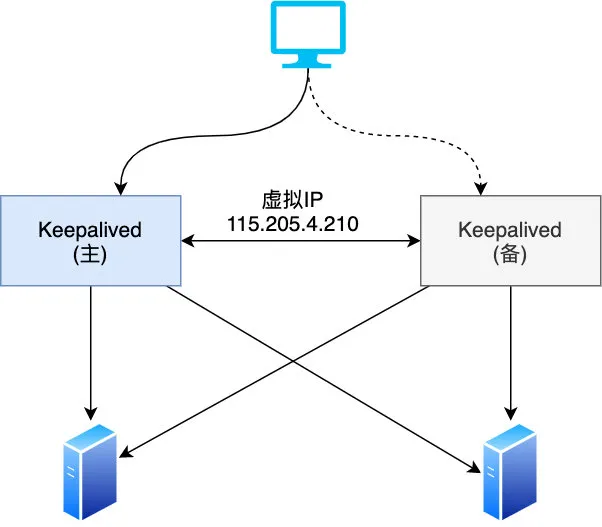

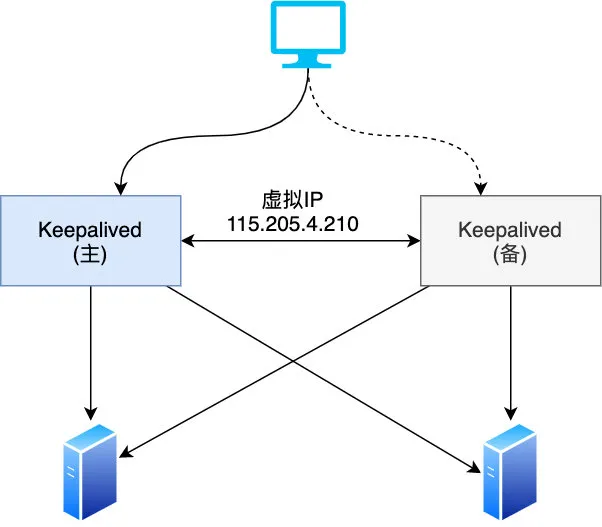

├── keepalived工作原理.md

└── 高性能网关设计实践.md

├── ChatGPT

└── AI地图实践.md

├── 网络

├── 这个下载文件的问题困住了我至少三位同事.md

├── TCP:一个悲伤的故事.md

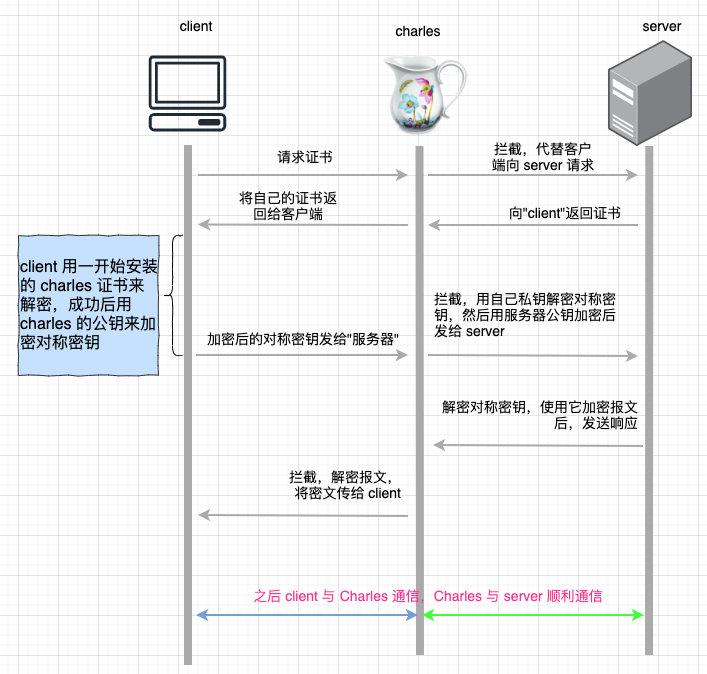

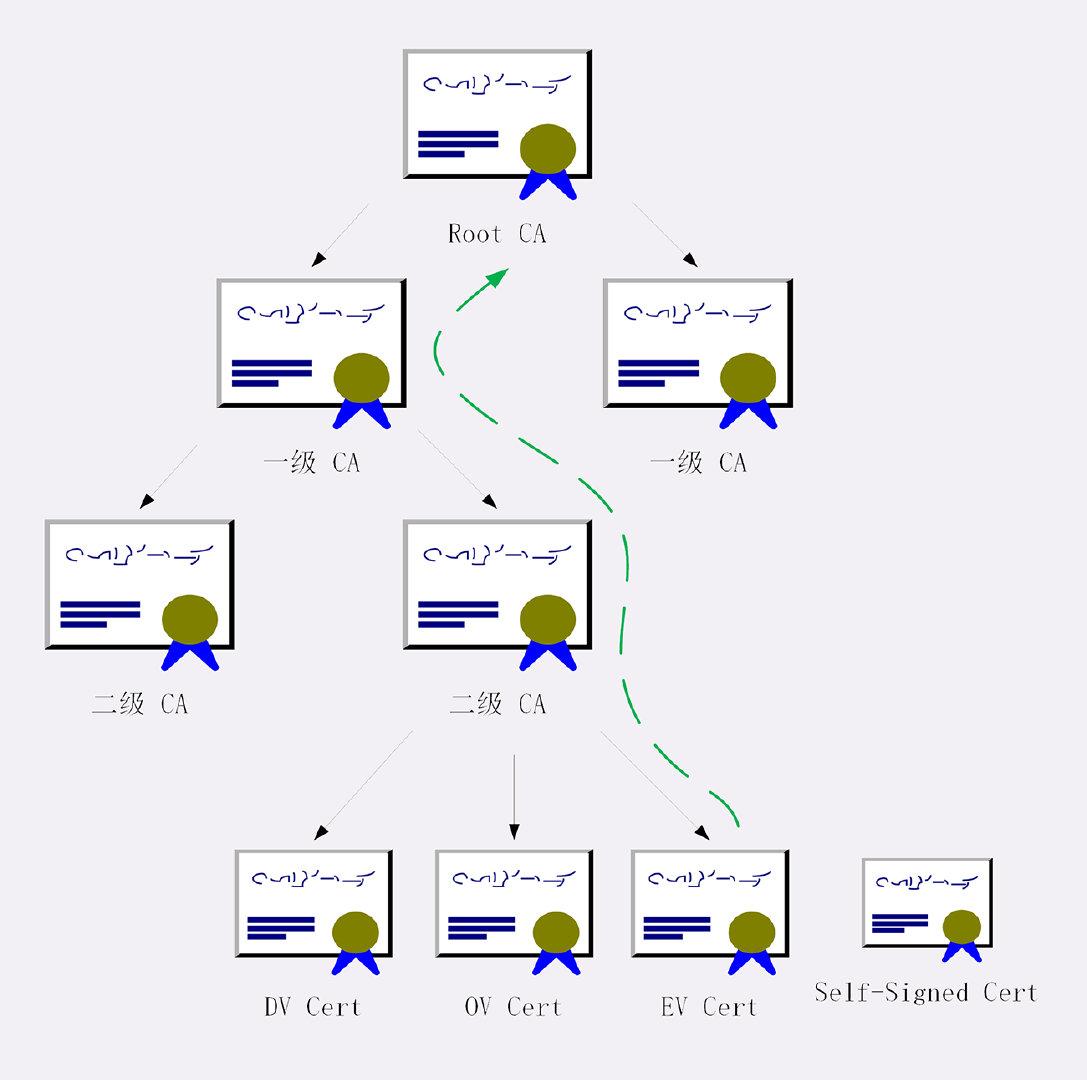

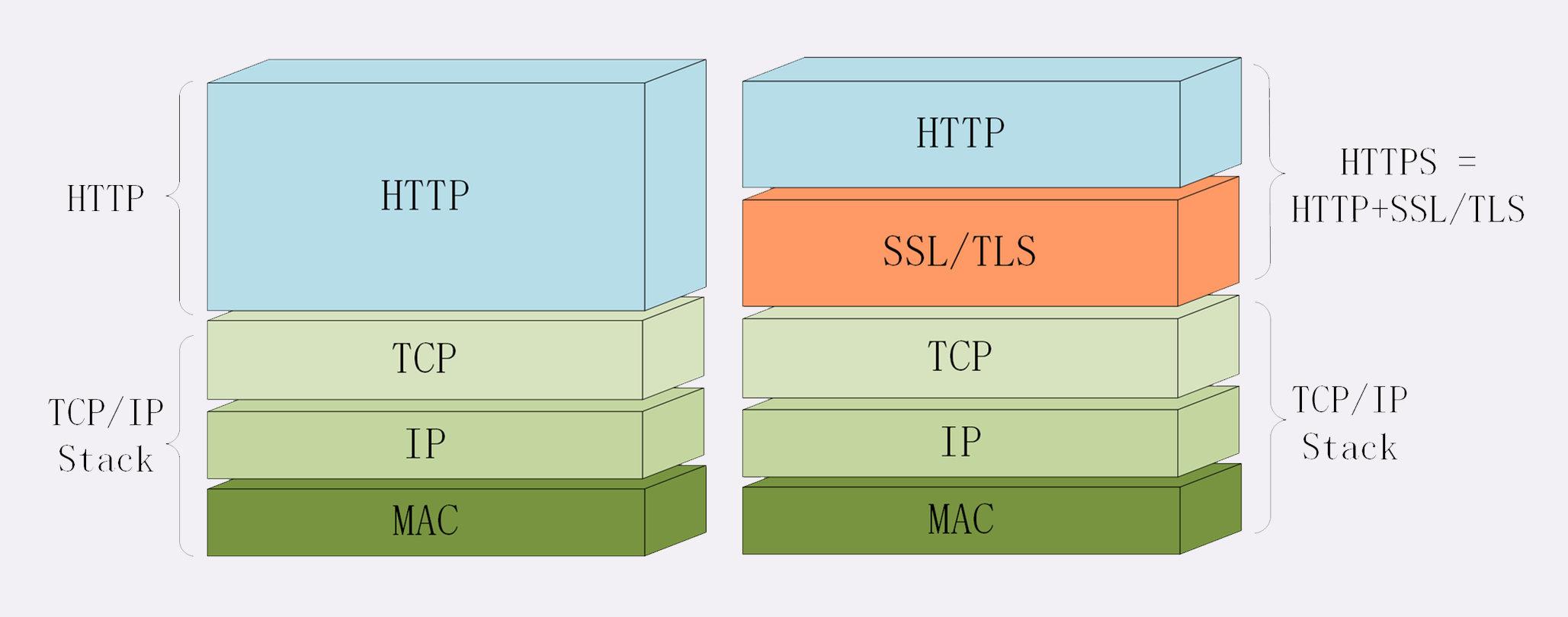

├── 20张图让你彻底弄懂HTTPS原理.md

└── 你管这破玩意儿叫token.md

├── 个人感悟

└── 随想.md

├── 算法

├── Trie树的妙用.md

├── 拜托,别再问我什么是B+树了.md

└── 提升逼格利器-位运算.md

├── MySQL

└── 深入浅出索引原理.md

└── 架构

└── 高可用.md

/CPU.md:

--------------------------------------------------------------------------------

1 |

--------------------------------------------------------------------------------

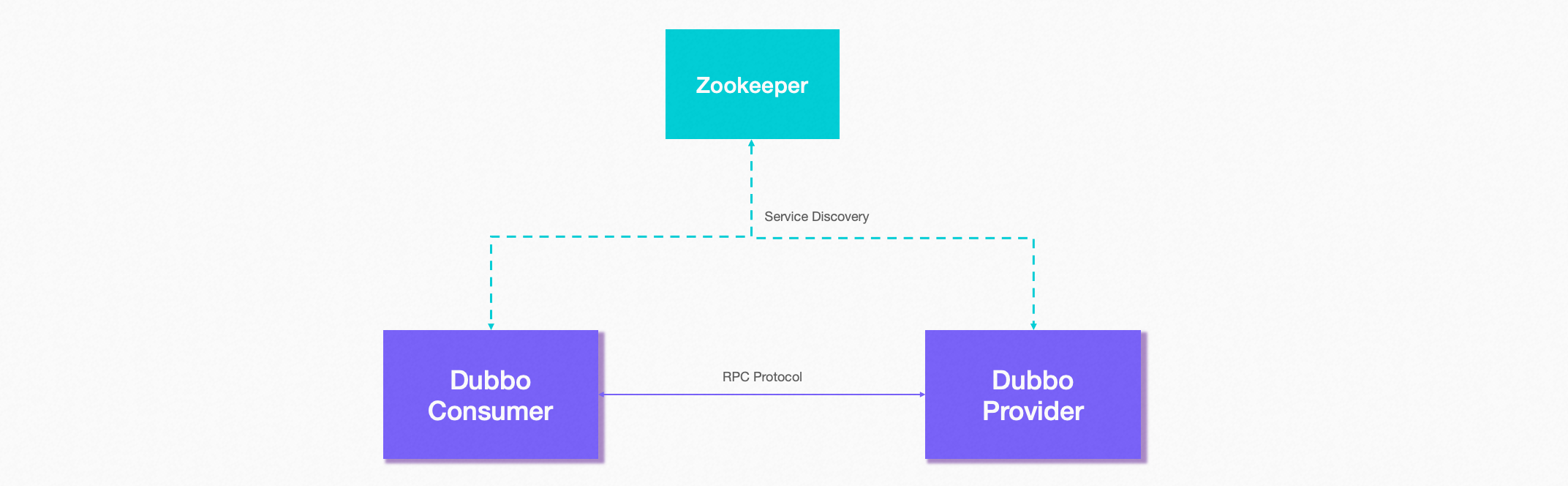

/Java/dubbo.md:

--------------------------------------------------------------------------------

1 |

--------------------------------------------------------------------------------

/学习指南/美团2017-2020年技术文章.md:

--------------------------------------------------------------------------------

1 | 给大家送一份很不错的资料,是美团技术团队送给技术人的年货,我过年期间看了几篇,确实是很扎实的年货。

2 | 美团 2017-2020 年发布的技术文章合集,我也给大家收集并汇总到一起了。

3 |

4 |

5 |

6 |

7 |

8 | 美团文章质量真的是很高,如果你也想看,可以扫一扫关注「码海」,回复关键字【java】,即可获得下载链接。

9 |

10 |

--------------------------------------------------------------------------------

/学习指南/谷歌师兄刷题笔记.md:

--------------------------------------------------------------------------------

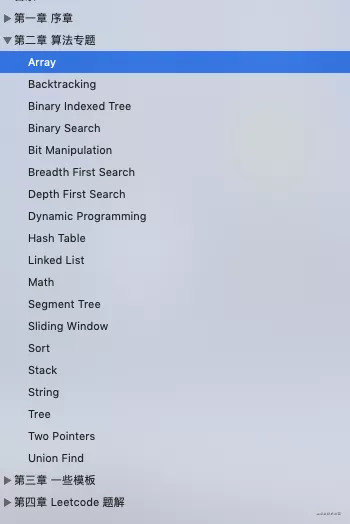

1 | 对于刷题相关的文章,在之前我也推荐过不少,今天在给大家推荐一份谷歌师兄的算法刷题笔记,这份笔记与以往的刷题有所区别,作者把 Leetcode 一千多道题都进行了系统的整理,并且对于每一道题的代码,都要求 beat 100%。

2 |

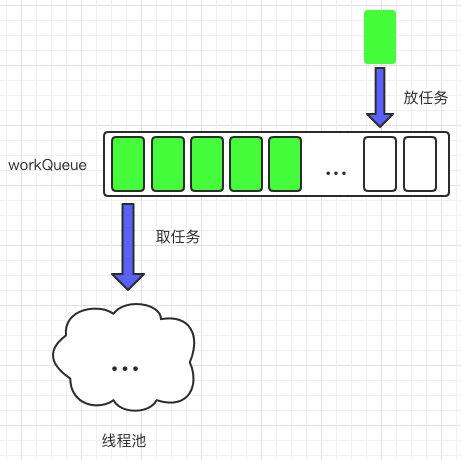

3 | 作者把所有题型分成了 13 个类别,截个图给大家看一下

4 |

5 |

6 |

7 | 无论是为了面试,为了打比赛还是入门学习一些算法,我还是挺建议前期按照各类题型逐个击破,这份刷题笔记,或许可以给大家带来一些帮忙。

8 |

9 | 我简单看了一下每一个道题的解答,每个题并没有给出多种答案,基本都是直接给出最优解,代码写的挺简洁,所以呢,我觉得这份刷题笔记,大家还是可以收藏一份放在电脑里,时不时拿大神的代码出来参考一下。截几个图给大家看看

10 |

11 |

12 |

13 |

14 |

15 | 就算你现在不学算法,那么这份笔记也值得你收藏,万一有人问你 Leetcode 某道题解,或者有大神在讨论题解,咱打开这份笔记,不管三七二十一,直接把最优解扔给他,然后退出群聊

16 |

17 | 如何获取呢?

18 |

19 | 大家可以关注下面这个微信公众号「码海」回复「**刷题**」即可获取。

20 |

21 |

22 |

23 | 另外大家可以star一下这个github地址: [easy-cs](https://github.com/allentofight/easy-cs),会持续更新文档哦

--------------------------------------------------------------------------------

/Java/一次使用多线程所引发的惨案.md:

--------------------------------------------------------------------------------

1 | 你好,我是坤哥

2 |

3 |

4 |

5 | 今天和大家分享一下前几天出现的一次使用多线程导致的线上故障,挺有代表性的,这个错误估计比较资深的程序员也会犯错,特此分享出来,相信大家看了肯定收获

6 |

7 |

8 |

9 | ### 问题背景

10 |

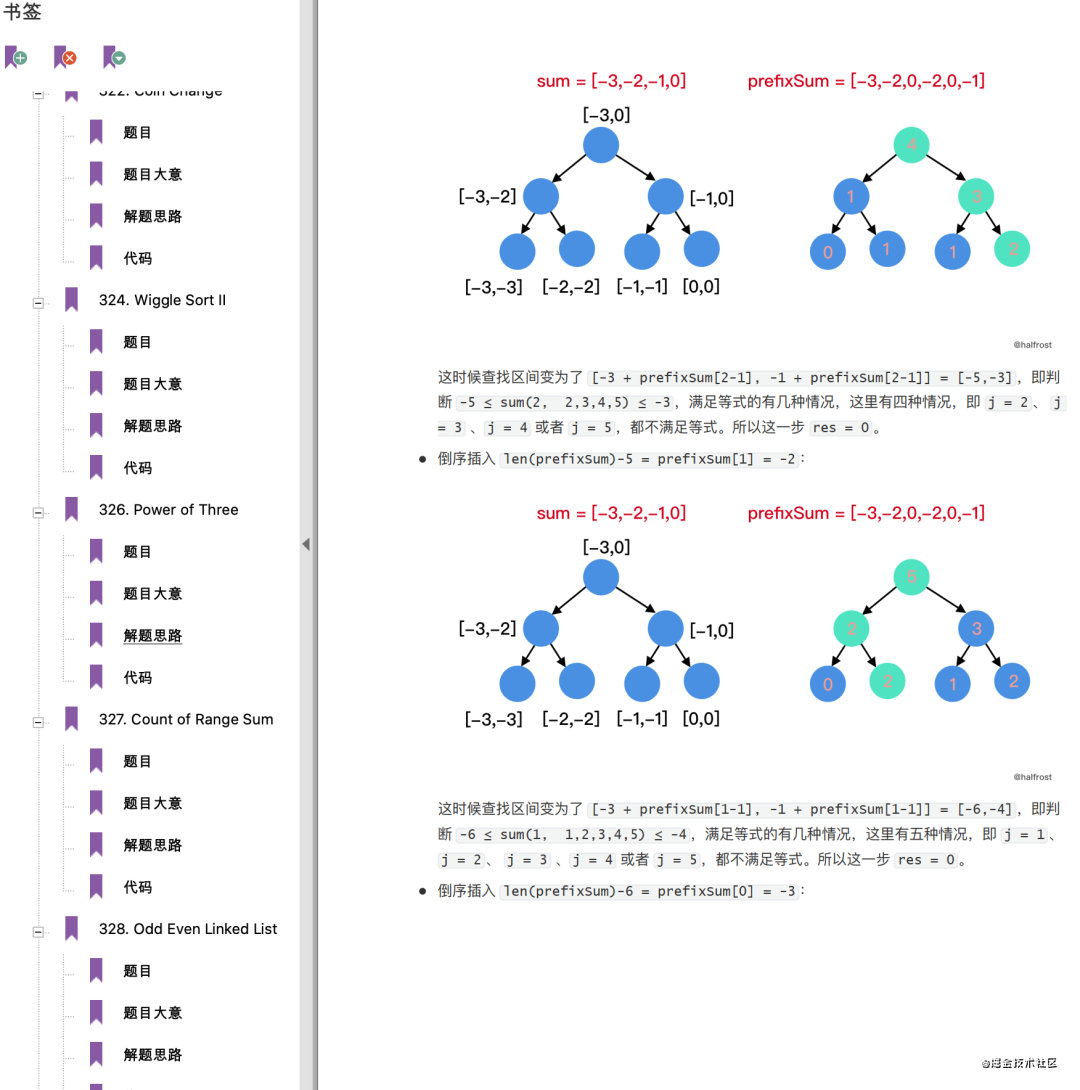

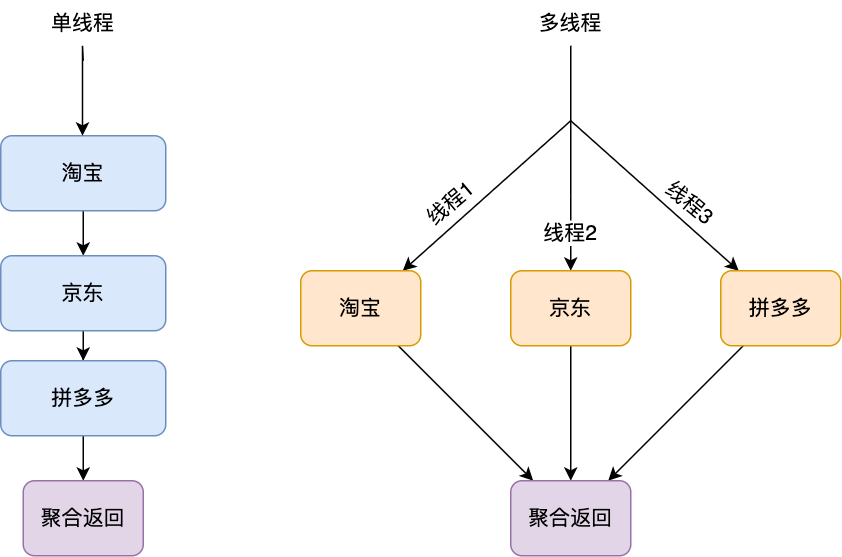

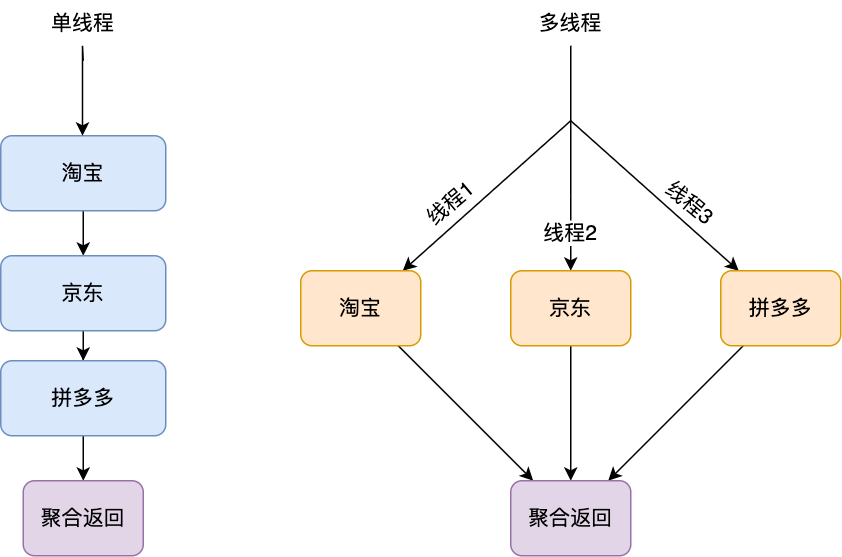

11 | 先简单介绍下此次使用多线程改造的业务背景,我们的平台是是返利平台,有一个搜索场景是用户在 app 上输入商品名称,传给 server 后 server 会根据此商品名称来查找其在各个平台(如淘宝,京东,拼多多)上对应的商品列表再返回给 app 进行展示,由于是单线程,显然 server 的处理时间和平台的数量成简单的线性关系(平台越多,server 的处理时间越多),由于各个平台的搜索接口是独立的,所以显然单线程是可以改成多线程的,如下

12 |

13 |

14 |

15 |

16 |

17 | 改成用多线程后,server 的处理时间只取决于商品搜索接口耗时最长的那一个平台了,显然效率得到了极大的提升,看起来这是一次完美的改造,不过这只是灾难的开始,上线后有大量用户反馈搜索接口不能用,经过定位后发现是因为 app 的版本号(version)无法获取,所以搜索接口会触发引导用户去升级 app 的提示,伪代码如下

18 |

19 | ```java

20 | static String getAppVersion() {

21 | String version = getVersion();

22 | if (StringUtils.isEmpty(version)) {

23 | throw new Exception("获取 version 失败,请升级");

24 | }

25 | return version;

26 | }

27 | ```

28 |

29 | 好了,原因找到了,那么问题来了,好好的 version 怎么突然间就找不到了呢,我们可以先思考一下这个 version 应该存在哪里比较合适

30 |

31 |

32 |

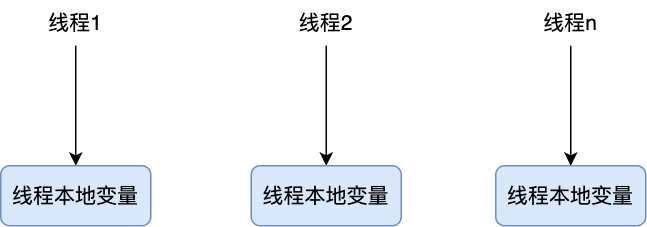

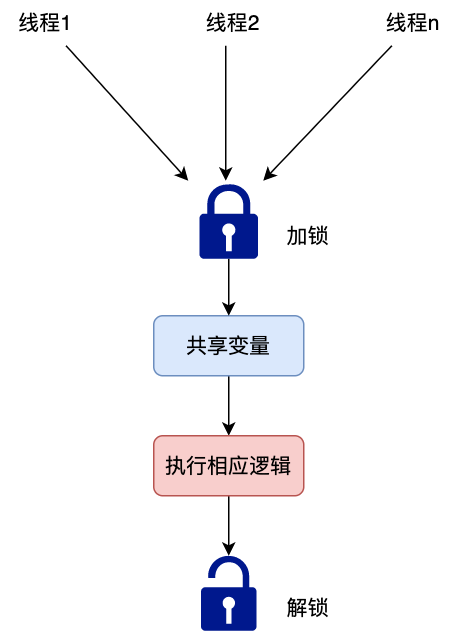

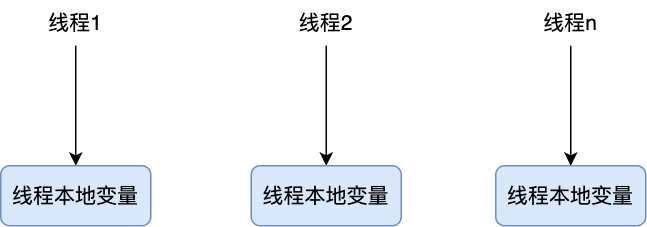

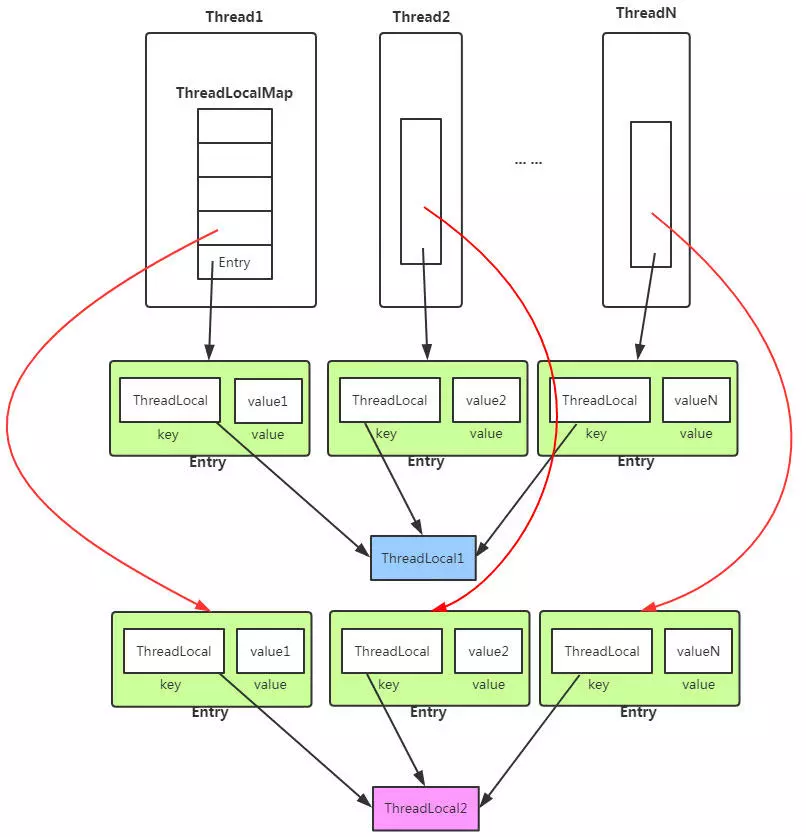

33 | ### threadlocal 简介

34 |

35 |

36 |

37 |

38 |

39 | 主要是为了提高性能将单线程改成多线程

--------------------------------------------------------------------------------

/程序人生/我创业啦!!!.md:

--------------------------------------------------------------------------------

1 | 大家好,我是坤哥。

2 |

3 | 今天要宣布一件大事,我要创业了!确切地说是我们部门要拆分成一个独立的公司,盈亏自负。

4 |

5 | 自从去年 leader 和我说部门要拆分之后就一直很期待,熟悉我的读者都知道去年我是从金融部门转向了返利业务,原因嘛其实很简单,金融受监管影响较大,在增长上遇到了较大瓶颈,而返利业务发展还不错,有奔头,本来属于无心插柳的试水业务,没想到发展比较迅猛,成了公司的扛把子部门!有很高的想象力。

6 |

7 | 为啥我对部门独立成公司这么期待,leader 让我选择后我毫不犹豫得就答应了呢?

8 |

9 | 主要有以下三个原因

10 |

11 | ### 1、 市场巨大,想象空间高

12 |

13 | 给大家看一下网上找到的一张图

14 |

15 |

16 |

17 | 2019年淘宝联盟(阿里妈妈)全年支出淘客佣金 500 亿,官方的目标是希望在未来几年佣金能达到 1000 亿的规模!想象空间巨大,这是其一。其二,当前阿里,拼多多,京东等巨头厮杀激烈,必然在获客上会下大功夫,可以预见必然会大力扶持淘客,所以在可预见的未来对淘客而言都是很大的利好!

18 |

19 | ### 2、 团队现金流稳定

20 |

21 | 正向的现金流太重要了,多少创业公司死于缺钱这两字,这个问题在我们这不存在,我们已能实现正向的现金流,而且投资人看好,已融了一大笔钱(具体数额不便透露),第二轮融资也基本敲定,估值上亿,所以未来几年我们都不用为钱的事发愁,可以尝试一些方向。

22 |

23 | ### 3、 团队靠谱

24 |

25 | 团队成员太重要了,事在人为,投资人投你一方面是业务方向,另一方面毫无疑问是人,公司挺多人都觉得我们是最具创业精神的团队,而且我们产品总监(未来新公司的 CEO)连续两次把公司的试水业务做成了公司的战略级产品,眼光,产品思维确实让人佩服!团队可以说是我选择出去干的最重要原因了。

26 |

27 | ## 因为相信,所以看见

28 |

29 | 我想简单谈下我对创业的一点点想法,背靠大集团,确实安全感提升很多,可以旱涝保收,不过既然有机会实现 10 倍速的财富增长,为啥不去做呢,像字节,快手等早期员工有多少人因为选择的时机而实现了财富自由,而且基于对上述我说的几个理由的判断,不得不对新团队有这样高的期待! 我非常喜欢那句话「因为相信,所以看见」,因为基于对未来的判断,所以我们看见了这条路是可以走下去的,梦想总是要有的,万一实现了呢?

30 |

31 | 当然了,创业有风险,大家之后在选择创业公司时一定要擦亮眼睛,可以试试上文我所说的判断逻辑,从业务前景,现金流,团队人员配置这三项来判断,相信你能避开不少坑。

32 |

33 | ## 最后: 招人

34 |

35 | 目前新公司人员已经到位,不过独缺**前端**,如果你是前端开发人员,欢迎投简历给我,另外第二轮融资我们也基本敲定,到时可能会扩招后端等人员,欢迎大家扫一扫关注公号「码海」,添加我的微信:geekoftaste,我会第一时间把招聘消息发到朋友圈里,希望我们能共事

36 |

37 |

38 |

39 |

--------------------------------------------------------------------------------

/工程师效率/Gradlebuild慢?可能是你使用的姿势不对.md:

--------------------------------------------------------------------------------

1 | 之前我司每个 Java 应用部署到预发都要等待漫长的编译打包时间,非常地痛苦!大项目编译时间常常达到接近 10 分钟,生命短暂啊,人生有多少个 10 分钟可以等待,于是我的效能团队针对编译作了一些优化,提速非常明显,对某个应用的测试来看,编译时间从 160 s 缩短到了 50 s 左右,提升近 70%,大家纷纷点赞,那么效能团队做了哪些措施来让编译速度提升这么明显呢?

2 |

3 | 首先要说的是我们用的 Gradle 来作为我们的构建工具,所以主要是针对 Gradle 的命令来作了一些优化

4 |

5 | ## 1、修改 gradle build 的参数

6 |

7 | * 使用 --build-cache

8 |

9 | 什么是 build cache(构建缓存),在 Gradle 中,每一个待编译的工程叫 Project,每一个 Project 在构建时都包含一系列的 task

10 |

11 |

12 |

13 | 每个 task 的输入都可以作为下一个 task 的输出,build cache 做的事就是把可以缓存(注:并不是所有的 task 输出都能缓存)的 task 输出都缓存住,这样在构建过程中,如果发现这个 task 的输入不变,就没必要重新执行任务了,直接从 task ouput 缓存里拿即可,如下图示,Build 2 的构建输入直接从 Build Cache 中拿,这样 Build 1 就不用构建了。

14 |

15 |

16 |

17 | 效果怎么样呢,看下图,下面图分别显示了 Gradle 持续集成时使用构建缓存和不使用构建缓存两种情况下的聚合的构建时间,可以看到使用了 cache 的 Gradle 构建速度明显快于不使用 cache 的情况

18 |

19 |

20 |

21 |

22 | 更骚的是这个 Buiid Cache 支持分布式的,可以统一把这些 cache 丢到一台机器上,本地机器要编译时统一去这台机器拉 cache,这样如果我们切换分支时执行构建也能用 Build Cache 来加快构建速度

23 |

24 | --build-cache 的具有使用需要注意一些事项,比如得 Gradle 4.3 以上才有效,建议大家直接去官网查查看

25 |

26 | * 增加 --parallel 参数

27 |

28 | 并行执行在多项目编译的项目中能有效提升编译的速度,但是并行执行的前提是每个项目已经被模块化,每个项目之间没有耦合。

29 |

30 |

31 | * 移除 --refresh-dependencies 参数

32 |

33 | 原来 gradle build 有加这个参数,这个参数会忽略缓存,强制重新下载,显然是编译的瓶颈

34 |

35 | ## 2、任务并行

36 |

37 | 原来 Jenkins 中执行 Gradle 编译任务,每个 Task 是串行执行的,总编译耗时是每个任务执行时间的总和。

38 |

39 |

40 |

41 | 现在把它改成了并行的

42 |

43 |

44 | 显然并行执行会快得多

45 |

46 | ## 3、将大项目工程中的常用代码抽成 jar 包

47 |

48 | 对于业务方来说,采用这种方式也是提升编译速度的有效手段 ,将大量代码抽成 jar 包,意味着它们本身就是字段码了,在 gradle build 时就不用编译啦。

49 |

50 | 希望本文对你有帮助,记得点个在看哦 ^_^

51 |

52 | 欢迎关注公号,共同交流学习

53 |

54 |

--------------------------------------------------------------------------------

/程序人生/我是如何晋升专家岗的.md:

--------------------------------------------------------------------------------

1 | 大家好,我是坤哥。

2 |

3 | 近期收至少不少读者私信咨询,最普通的困惑是「每天都在 CRUD。没啥竞争力,该怎么办」,我觉得这是一个很普遍的问题,也应该是很多人的困惑,我想讲讲我的经历,希望对大家能有所启发。

4 |

5 | 目前我虽然做的从事的是 Java 后端,不过其实我一开始做的是 iOS 客户端,16 年我司在移动端业务发展迅猛,业务都高歌猛进,随之而来的是 iOS APP 工程的急速膨胀,于是一个大问题就出现了:由于工程庞大,打包时间急遽上升,经常需要一小时以上,更恼人的是打包经常失败,这样的话从提测,到提交到 appstore 发布等流程都受到了严重影响,甚至影响到了整体的业务迭代流程。这事还惊动了我们的副总裁,问我们是否是 Mac mini 性能太差所致,是否可以换个高配的机器来解决。

6 |

7 | 当时我刚加入集团不久,做的也是某业务的负责人,其实做的也是 CRUD 的工作,听到这个消息,**立马意识到这是个巨大的机会**,解决好了不仅能让集团的业务迭代速度大大提升,更是能成为第二年的晋升的重要加成,于是就在业余时间着手调研解决方案,当时我们正在实行 iOS 的组件化方案,简单地说就是把一个工程拆分一个个以业务,功能划分的组件,这样的话组件之间的开发互不影响,能极大地提升业务的迭代速度。

8 |

9 |

10 |

11 | **如图示:组件化示意图,有点类似于微服务架构中的服务拆分,只不过与微服务不同的是这些组件共同组成了一个 app,这些组件编译归档后会生成 ipa,也就是运行在大家手中的 app。**

12 |

13 | 经过观察不难发现从工程打包生成 ipa 99% 的耗时就在组件编译生成静态库这一步,所以解决方案很简单,提前将组件打包成静态库不就行了,这样 app 工程就由一个个组件的静态库组成,省去了编译这一步

14 |

15 |

16 |

17 | 当然组件打包生成静态库这一步还要有工具来实现,调研了一下发现有现成的第三方库可用,于是将一整套方案整理成文档第一时间在 iOS 团队进行了分享,之后各个组件负责人一起加班加点地把这件事落实了下来。

18 |

19 | 效果也是很明显的,整个打包时间从一个多小时降低到了 3 分钟以内,生产力得到了巨大的提升,后续所有 iOS 打包方案也是用的这套方案,可以说彻底解决了打包的问题,第二年晋升我也将此项写到了我的述职报告中,并得到了评委的认可,当然能晋升还有其他的一些要素,但打包方案的提出可以说是一个重大加成。

20 |

21 | 仔细看打包的解决方案,你会发现,其实没啥技术含量,但我把握住了,而且发现痛点后第一时间调研提出解决方案,也取得了显著效果。

22 |

23 | 所以虽然说很多人都在担心一直在 CRUD,但我们其实能做很多来提升我们的技术,提升我们的影响力,我们可以及时发现痛点并解决它,关键是要**有心**,当时我司 iOS 开发人员有十几个,结果是我主动调研并第一时间先提出了解决方案,我觉得我自己的积极主动有很大的关系。

24 |

25 | 这件事对我们的启发是我觉得要**要争取成为解决方案的提出者**,提出者贡献最大,执行虽然重要,但没有方案,便无从下手,这就好比没有建筑图纸,如何施工。

26 |

27 | 所以我觉得虽然很多人都在 CRUD,但只要我们**有心**,一样可以提升自己的技术能力,就比如你做 CRUD,关心过接口性能吗,是否还有优化的空间(比如提升 20%等),上次我看到安琪拉在阿里做的事就颇多感慨,他把接口性能优化的耗时,从三十几毫秒下降到五毫秒,类似的接口还有十几个,都是核心接口,还有SQL性能的优化等等,如下是他优化后的效果:

28 |

29 |

30 |

31 | 这样的话你做的每一个优化日积月累必然会给你带来出其不意的回报!

32 |

33 | 另一方面,我学得稍微大点的团队都会有技术分享,可以多去旁听下其他团队的解决方案,痛点以便看下是否能引入自己的团队中。

34 |

35 | 最后我想再说的是千万不要觉得 CRUD 就不能提高技术了,关键还在于你是否有心。

36 |

37 | 最后欢迎大家加我好友,一起交流,共同进步^_^

38 |

39 |

40 |

--------------------------------------------------------------------------------

/程序人生/面试了十几位前端有感.md:

--------------------------------------------------------------------------------

1 | 创业后一直没招到合适的前端,一直都是后端干着前端的活,当然对技术尤其是创业公司而言,其实没必要分前后端这么细,但我们还是希望能招到一位比较有经验的前端,一是团队的人员配置更加合理,二是有一位有经验的前端可以给我们团队带来很大的帮助,提升我们的前端的整体 level,比如有时页面需要用一些复杂的交互动画或者碰到一些疑难杂症如果招一位有经验的前端能让问题更快速的解决。

2 |

3 |

4 |

5 | 基于以上的这些想法 ,我们打算招一位有经验的前端,由于之前委托过别人招聘过一位不合格的前端,所以这次招聘我们决定自己上阵,当然要求其实不会很高,能干活,有潜力,完整地参与过商业项目的开发即可,毕竟创业公司压力比较大(我们大小周),而且总的 package 确实不如大厂,如果再按大厂的要求来招聘那估计招不到多少人。

6 |

7 |

8 |

9 | 在面试中我发现一些共性的问题,这里简单总结下,最近正值金九银十,有不少读者让我帮忙看看简历或者说说面试中注意的事项,也顺带借此简单说下

10 |

11 | ### 1.简历的书写问题

12 |

13 | 这一块我发现主要有以下问题

14 |

15 | #### 简单罗列项目,未突出重点

16 |

17 | 不少人简历大段大段地介绍项目的功能,确实写了一些对应的技术栈,但面试官最关心的比如技术难点和自己承担的角色却只字未提,这样的简历其实是要打折扣的,面试官其实更关心的此项目的含金量,在我看来主要有以下两点

18 |

19 | * **项目中的难点与改进**: 这一点**尤其关键**,最好能有可量化的指标,比如说通过采用 xxx 等手段,让页面的加载速度提升了xxx s,通过对 xxx 开源项目的改造,解决了 xxx 的痛点等

20 | * **自己在项目中承担的角色**: 这一点也很重要,同样一个项目,承担的是核心还是边缘角色,这对个人的评价至关重要,如果是核心开发角色并承担了主要技术的攻关,无疑能让简历的份量大大提升,反之会逊色不少,但如果你承担的就是边缘角色呢,该怎么办,我觉得个人也得主要去了解整个项目的脉络,各个功能模块的实现原理,尤其是那些技术实现难点,最好也能把它们都摸透,这样能把项目的难点等说透在逻辑也能自洽

21 |

22 |

23 |

24 | ### 2. 简历上写的与自身能力不匹配

25 |

26 | 这一点是大忌,在面试中发现好几位有这样的问题,比如有一位说使用代理服务解决跨域问题,结果一问部署步骤说不出所以然,再问什么是跨域,也说不上来,再比如有一位说熟悉 TCP 协议,结果一问为什么需要三次握手,也说不出个所以然,这些都是比较忌讳的,面试官只能通过简历来了解你,如果简历上写的点与实际不符,他可能会很怀疑你简历你的真实性,或者认为你个人不够严谨,这样最后的结果往往不理想,不熟悉的就不要写,写上了就一定要了解掌握这些技术点的原理,至少要让你的能力与简历上的相符

27 |

28 |

29 |

30 | 接下来再来谈谈简历中的加分项,在我看来以下两点无疑会大大加分

31 |

32 | #### 主动解决问题的意识

33 |

34 | 项目中存在问题,如果自己能主动推进解决,这样的简历毫无疑问会大大加分,比如我之前就曾在[我是如何晋升专家岗](https://mp.weixin.qq.com/s/zElQzjft_cBoamb_5-GxfA)里提到主动去优化技术方案将打包时间从一个多小时降低到 3 分钟以内,这些没有人让你做,属于「无中生有」,如果能解决好这些问题那你的简历其实是非常亮眼的,可能有人说这样的机遇可遇而不可求,其实我觉得还是要看自己是否**有心**,比如我面过一个两年工作经验的前端,问到代码规范的问题,他说组内主要看个人的意识,这显然是有问题的,也不利于团队协作,最佳方式应该是靠工具的形式来约束,比如使用 VSCode + eslint 插件自动修复或者指出你的代码问题,光这样还不够,如果有些人不修复,写了一大堆 console.log 提交了怎么办?所以你还需要利用 git commit 的 pre hook 来校验代码规范,如果校验不通过那就不让提交,通过这样的方式就有力推进了代码规范,你看这就是一个很好的优化点,如果你能推进这方面工具化的落地,那说明你有一定的技术追求与代码规范和工具化意识,这在简历上无疑是一个比较大的亮点。

35 |

36 |

37 |

38 | 再比如一些候选人所在的公司在外包公司或者其他的一些小厂,一些发布流程不是那么自动化(碰到几个手动需要手动打包后再交给运维部署的), 那能否想办法把这个流程自动化呢(比如很多大厂里的发布流程都是一键点击自动化的),这样的话省去了人力之苦,而且也对项目是怎么跑起来的有一个清晰的认识,如果我们在项目中碰到这些不那么高效的活能把它自动化掉,那对团队的效率提升无疑是很大的,也能为你的履历添砖加瓦。

39 |

40 |

41 |

42 | #### 线上部署可演示的项目

43 |

44 | 这一点对于工作经验不足的开发者尤其有帮助,比如我发现其中一位候选人就做得很好,让我印象深刻,他业余时间自己做了一个如下皮卡丘的动画项目

45 |

46 |

47 |

48 | 在线上可演示效果,并且还有代码滚动展示,这种意识确实非常棒,让人感觉更真实,收到的挺多简历都写着做过 xxx 系统,如果这些能在线上让面试官体验一下,确实是一个很大的亮点。

49 |

50 |

51 |

52 | 再比如秒杀系统在后端面试中经常出现,那我们能否去做一套这样的系统并部署上去呢,如果能让面试官体验一下,用户体验上无疑会好很多,怎么从 0 开始做秒杀项目呢,这里推荐几个我看过的质量很高的专栏和文章,可能对大家有帮助

53 |

54 | 1. 极客时间的《手把手带你搭建秒杀系统》从 0 到 1 带你打造一个百万 QPS 的秒杀项目,关于秒杀理论讲解得很到位,实践性也很强

55 | 2. github 上的 2.2w star 的秒杀项目:https://github.com/qiurunze123/miaosha

56 | 3. [秒杀系统实战总结](https://mp.weixin.qq.com/s/yWn_2OQV31zn5wJKKejGug),一位技术总监关于秒杀的总结,根据他们公司的秒杀项目估的总结,可以应付大部分的场景

57 |

58 |

59 |

60 | 部署一个完整的上线项目,一来可以让你对项目如何是跑起来的会有非常感性的认识,二来面试官线上可以有直观的体验,而且也能看到你的代码书写规范等,好处很多,挺多人说自己没有高并发经验,那就手动实践一下部署上去让面试官见证一下,这些经验不就有了吗,好处这么多,何乐而不为呢。

61 |

62 |

63 |

64 | 另外不少人抱怨说面试官喜欢问很多八股文,其实我想说的是如果项目经验足够硬核,技术含量足够高,没有人喜欢也没必要问那些八股文,直接顺着项目经验问你在项目中掌握的技术点就足以给你定级了。

65 |

66 |

--------------------------------------------------------------------------------

/程序人生/与一位全职转行做滴滴司机的前程序员对话引发的思考.md:

--------------------------------------------------------------------------------

1 | 昨天晚上由于没赶上班车,所以打开了滴滴叫了一辆快车,上车后看这司机小伙子挺斯文的,简单聊了几句,没想到居然是位前程序员,一开始还以为是兼职,结果聊完之后才知道是全职,确实是大吃一惊,仔细一问原委才知道,原来是去年因为疫情原因被裁,但是之后一直没找到工作,但生活总得继续吧,最终选择了全职转行做滴滴这条路。由于我司到地铁只有几分钟的车程,很快就到站了,没法再继续细聊下去,但是听完之后,不胜唏嘘。

2 |

3 | 每个人都有自己的选择,旁人确实不好评价,可能在当时的情况下转行做滴滴是他作出的最利于摆脱当前困境的最佳选择,就像前段时间很热门有三位程序员相约考公成功上岸这事一样,在我们看来,他们放弃了程序员的高薪,可能难以理解,但对他们而言,他们摆脱了 996,每天准点下班,发季线低了,也能常和老婆孩子热炕头,这样的生活别提有多惬意了,都云作者痴, 谁解其中味?

4 |

5 | 虽然理解他们的选择,职业也并无贵贱之分,但肯定有好坏之别,那么什么样的职业是好,什么样的职业是坏呢?

6 |

7 | ## 好职业与坏职业

8 |

9 | 我觉得好工作应该是**上限高,有想象力的**,坏工作则是有上限,自己的未来一眼就能看穿,看得到头的,什么意思?

10 |

11 | 比如说吧以滴滴司机为例,每天的收入与你跑的单数成正比,可能每天都非常努力地跑单,拼死拼活一天能赚个一千多,但**当你停止接单时,你的收入也就停止了**,清洁工,餐饮里跑腿的也是一样,这一类工作只要你停止劳动了,你的收入也就戛然而止了,而且这类工作需要付出极大的体力消耗,每天劳累了一天,根本没有时间思考人生,第二天开始又**重复机械**地劳作,**可替代性极高**,而我们知道职场的收入与你的不可替代性是成正比的,所以这类工作我认为并不是好工作。

12 |

13 | 那么好工作又有哪些特性呢,我觉得有两点,一是能持续打造自己的稀缺性,比如程序员行业,随着你技能的不断精进,你的待遇,不可替代性自然会越来越强,二是想象空间足够高,比如说自媒体,可能你写的文章没人看,但也有可能写出 10w+ 的爆文,而且做自媒体长尾效应明显,只要你的文章/视频等足够好,在很长的时间内你都可以借此不断获得关注,长尾效应明显,在当今时代,流量就是钱啊,所以你用心写好文章,就可以借此获得源源不断地关注,认可,也就是说**当你停止写作时,你过去的作品还在不断地吸引很多人关注你,为你创造价值**,这就是为啥我一直坚持写作,也鼓励大家写作的原因,从这个角度来看,自媒体确实是一个好职业!

14 |

15 | ## 工程师如何抵御风险

16 |

17 | 为了避免别人觉得我在说教,我先简单亮一下自己的成绩,目前的被动收入(副业+理财等)已能 cover 包括房贷等在内的生活开支,老婆的一个投资项目每年也能稳定收益 20 w 左右,生活上只要不出现特别大的变故,可以说没有任何问题,所以我说的一些经验可能对大家有些借鉴意义,希望能给大家带来一些启发。

18 |

19 | 首先当然是把自己的本职工作做好,技术越强,职位越高,你的竞争力也就越强,现在虽然是寒冬时期,招聘标准越来越高,但从全局来看,技术优秀的候选者去头条,拼多多这样的大厂呆个十年运气好挣个千万依然不是什么大问题问题,但不得不承认的是,90% 的工程师想要拿到百万年薪确实很难,我司之前一位总裁就说过,P8 以下我们认为都是可以培养的,P8及以上看天赋,升职除了能力之外,可能多少也掺杂着些运气。

20 |

21 | 所以我们应该怎么办,之前有提过,这里再搬出之前 linkedln 和 paypal 的联合创始人ReidHoffman 提出的 ABZ 理论吧。

22 |

23 | A: 是你正在从事的工作,也是能长期从事下去的工作,值得你持续投入,并可以获得安全感,并且这份工作,你个人还很满意。

24 |

25 | B: 是除去 A 计划外,业余时间你给自己其他能力的培训,或者兴趣爱好或梦想,可以认为是副业,这样的话万一主业出现问题,哪天被机器人替代了,由于你有自己的副业,可以立马转为 A,可以让你从容应对。

26 |

27 | Z: 即个人资产,是你的保障,也是你的退路。假设有一天你的 AB 计划全部落空失败,你的 Z 计划,可以保证你在未来某一段时间内,可以继续保持现有的生活品质,能给你一次从头再来的机会。我的理解就是理财,比如基金,定投,股票,房产投资等,

28 |

29 | 在 IT 界并不是每个人都是人中龙凤,达到百万年薪并不是那么容易,那么我们是否可以考虑做斜杠青年呢,可能我们在某种能力上并不突出,但可以在沟通,写作,影响力上多向发展构建自己的 IP 矩阵,这些能力的关系可能是「能力 1 x 能力 2 x 能力 n」这样的乘法关系,无形中会让我们的竞争力大大提高,IT 人可能大部分人听过侯捷,翻译了很多畅销书,我记得业内有位大牛评论侯捷老师时说,单论技术能力算中上,离顶尖有距离,但他翻译的书非常好,基本都是畅销书,就就构建了强大的影响力,这就像现在技术公号领域最知名的博主 stormzhang 一样,技术并非顶尖,但通过投资,写作等构建了坚实的护城河,他们未必有顶尖的技术,但为读者提供了一流的服务,进而构建了自己影响力。

30 |

31 | 需要注意的是在斜杠青年的尝试中,这些能力最好是对主业有促进作用的,比如写作,通过写作你巩固了对知识点的理解,厘清了各个模糊的概念,由点及面构建了自己的知识体系,也锻炼了自己的写作,表达能力等,这对主业就有极大的促进作用,千万慎重考虑由程序员转行做滴滴这样的事,因为这是两个完全不同的行业,一旦转行,你之前行业的积累就没有,相当于从头开始,而且就我们以上的分析来看,滴滴这样的职业上限有限,一眼望得到头,不是一份好职业。

32 |

33 | 我最近做了淘客,一些朋友看来有点「不务正业」,但其实一来我的业务从之前负责的金融转到返利来了,从事淘客有助于我对本身的业务有更深的理解,二来淘客其实也是一个长尾效应很明显的行业,回报也是比较丰厚的(我看到最夸张的案例一个月躺赚 30w,你没有看错,是一个月 30w!),而且要做好淘客,你要懂得些拉新,精细化运营等思路,这样来看又锻炼了你的产品和运营思维,不管怎么看,都对你的主业有很大的促进作用!有这么多好处,为啥不做。

34 |

35 | 说了这么多最重要的我觉得是**不要给自己设限**,在保证自己主业的前提下多去尝试,尽量构建自己的能力矩阵。

36 |

37 | 再说投资,一般人可能想得到的投资就是股票,理财,还有房子,不过其实还有一种投资回报也很丰厚,比如投资「密室逃脱」这种新兴项目,上文我说的老婆投资每年能躺赚 20w 的项目就是这个,前期投资,后斯回本后躺赚的这种,当然这种投资需要有眼光,更需要勇气,我建议是不要超过家庭总收入的四分之一,这样万一失败也不至于影响到正常的家庭生活水平。

38 |

39 | ## 最后

40 |

41 | 希望本文对你有所启发,另外前几天在朋友圈分享了做淘客的一点心得,没想到这么多人感兴趣,本周将会在我的另一个号「程序员坤哥」上分享出来,希望对想做淘客的朋友一定会有帮助!如果想看的可以关注这个号哦。

42 |

43 | 另外欢迎大家扫描以下二维码,关注公众号「码海」共同进步

44 |

45 |

46 |

47 |

--------------------------------------------------------------------------------

/Java/我是一个线程池.md:

--------------------------------------------------------------------------------

1 | ## 线程池的自我介绍

2 | 我是一个线程池(ThreadPoolExecutor),我的主要工作是管理在我这的多个线程(Thread),让他们能并发地执行多个任务的同时,又不会造成很大的的系统开销,有人不明白,创建线程有啥开销呢,不是只要 new 一个 Thread 出来让它跑就行了吗,这里我要简单解释下:

3 |

4 | 1. 其实 Java 中的中的线程模型是基于操作系统原生线程模型实现的,也就是说 Java 中的线程其实是基于内核线程实现的,线程的创建,析构与同步都需要进行系统调用,而系统调用需要在用户态与内核中来回切换,代价相对较高,线程的生命周期包括「线程创建时间」,「线程执行任务时间」,「线程销毁时间」,创建和销毁都需要导致系统调用。

5 |

6 | 2. 每个 Thread 都需要有一个内核线程的支持,也就意味着每个 Thread 都需要消耗一定的内核资源(如内核线程的栈空间),因为能创建的 Thread 是有限的,默认一个线程的线程栈大小是 1 M,如果每来一个任务就创建线程的话,1024 个任务就占用了 1 G 内存,很容易就系统崩溃了。

7 |

8 |

9 | ## corePoolSize

10 | 所以我的主要作用就是减少线程的**创建时间**和**销毁时间**,线程创建后不让它马上销毁,而是常驻在我这,随叫随到,我把这些常驻的线程叫做核心线程,核心线程数也不宜过多,所以我指定了它们的数量(corePoolSize),假定为 3 吧。

11 |

12 | 「线程池,这是我的一个任务,帮我执行一下吧」,主线程丢给我任务后立马返回,于是我赶紧调用 execute 方法来处理丢给我的这个任务(Runnable)

13 |

14 | ```java

15 | public interface Executor {

16 | void execute(Runnable command);

17 | }

18 | ```

19 | 由于我诞生后还没有执行过任务,核心线程一直为 0,于是在这个方法里我创建了一个线程作为核心线程。

20 |

21 | 「线程池,任务又来了,帮我执行一下吧」,又来任务了!于是我再次调用 了 execute,又创建了一个核心线程,此时核心线程数为 2。

22 |

23 | 过了一段时间,第一个核心线程已经执行完任务,空闲出来了,此时任务又来了。。。

24 |

25 | 「线程池,这是我的一个任务,帮我执行一下吧」主线程摞下一句话后又走了,此时是 1 个核心线程在忙碌,一个核心线程空闲,可能很多人误以为这里既然有一个核心线程在空闲,那就把任务交给这个线程处理即可,不用再创建核心线程了,但实际上只要**当前核心线程数少于当初设置的 corePoolSize,不管当前核心线程是否空闲,我依然会再创建一个核心线程**,主要是为了保证核心线程尽快达到我们设置的数量,这样如果之后有很多任务涌进来,这些已创建好的核心线程就可以马上准备好处理这些任务了,不需要再经过创建线程这种耗时的操作了。

26 |

27 | 经过上面的一番操作,核心线程数来到了最开始设置的数量 3 了。

28 |

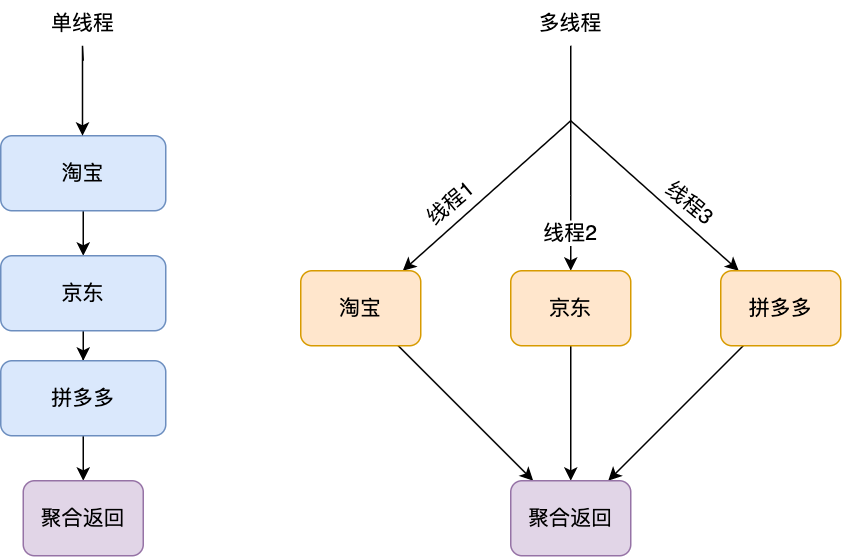

29 | ## workQueue

30 |

31 | 「线程池,任务又来了,帮我执行一下吧」,熟悉的声音又来了,此时核心线程已经达到了我们设置的数量 3 个了,再创建线程当然可以,但又要造成一个系统调用,开销比较大,其实核心线程可能经过很短的时间又能马上空闲出来了,不如把任务放到放到一个队列里,让这些核心线程自己去取。

32 |

33 |

34 |

35 | 聪明的你一定发现了,这就是典型的生产者-消费者模型,线程池中的线程只要不断循环去 workQueue 队列获取任务即可,为了避免 workQueue 为空线程一直轮询导致的 CPU 资源被占用的问题,这里的 workQueue 采用了阻塞队列,所谓阻塞是指,如果 workQueue 为空,则获取元素的线程会等待队列变为非空,一旦有新的任务入队列,会唤醒等待中的线程。

36 | **画外音:线程等待是指调用 LockSupport.park 将线程从运行态变为阻塞态,此时线程就不占用 CPU 资源了**

37 |

38 | 可是好景不长, JVM 老大向我反馈出现 OOM 问题了,一看问题我就明白了,原来是哪个新手程序员在创建我的时候,声明使用了**无界队列**,导致核心线程无法及时处理任务,而任务又源源不断地添加进了 workQueue 中(即生产任务速度远大于消费任务速度),导致 workQueue 越来越大,最终产生了 OOM!

39 |

40 |

41 | 解决方式很简单,**使用有界队列即可**,这样当 workQueue 满时就无法添加任务了,不会导致 workQueue 无限增大导致 OOM。

42 | **画外音:所谓有界队列是指设定了固定大小的队列,当队列里的元素超过这个大小后就再也不能往这个队列里塞任务了,而无界队列由于没有设置固定大小 ,可以直接入队,直到溢出,容易造成 OOM,所以创建线程池时应该尽量使用有界队列**

43 |

44 | ## maximumPoolSize

45 |

46 | 将 workQueue 改用有界队列后,再也没出现过 OOM 了,不过由于主线程又源源不断地丢了一些耗时的任务过来,核心线程依然处理不过来,workQueue 很快又满了,这时我想起了另一个参数 maximumPoolSize,这个参数定义了我能创建的最大线程数,当其它线程要往队列塞任务,但发现 workQueue 满时,由于当前在我这的线程还未到达 maximumPoolSize(假设起初指定为 5),所以我又创建了线程来处理这个任务。

47 |

48 | **画外音: 在 workQueue 已满的条件下,如果当前线程池的线程数量 >= corePoolSize 且 <= maximumPoolSize,后续如果一直有其它线程丢任务进来,会一直创建线程,直到 maximumPoolSize。**

49 |

50 | ## RejectedExecutionHandler

51 | 某天,往我这丢任务的某个线程反馈收到异常了,我一看,我靠,workQueue 满了,线程数也达到了 maximumPoolSize,但此时依然有任务不断往 workQueue 中插,但这种情况下已经超出了我的处理能力了,只好执行默认的拒绝策略,抛出 RejectedExecutionException 异常让其他线程(往我这丢任务的线程)自己处理。

52 | **画外音:线程池提供了 AbortPolicy,DiscardPolicy,DiscardOldestPolicy,CallerRunsPolicy,自定义这五种拒绝策略,默认是 AbortPolicy**

53 |

54 | ## keepAliveTime

55 | 在线程们的努力之下,workQueue 队列中的任务很快被清空了,很长一段时间都没有任务进来了,线程们很快就无事可做,放着又占用资源,该怎么处理呢?此时我这有核心线程 3(corePoolSize = 3), 额外线程 2 (maximumPoolSize 为 5),

56 |

57 | 我是这么处理的,如果当前线程总数超过了 corePoolSize,在 keepAliveTime 这个时间内,如果池子里的线程一直空闲,就把这个线程给干掉,哪个线程空闲时间先到达 keepAliveTime,就干掉哪个,直到线程数减少到 corePoolSize。

58 |

59 | **画外音:线程池里没有核心线程和额外线程之分,只是为了讲述方便人为划分了一下,但其实线程池里的线程都是平等的,任何一个线程都可以被干掉**

60 |

61 | ## 总结

62 | 通过上文的自我介绍,我相信你已经对我的工作机制有了较为深入的了解,但这还不够,本周请看主人对我的另一篇深度剖析文,<<万字长文深度剖析线程池>>,敬请期待!

63 |

64 | 欢迎关注公号一起交流,共同进步

65 |

66 |

67 |

68 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

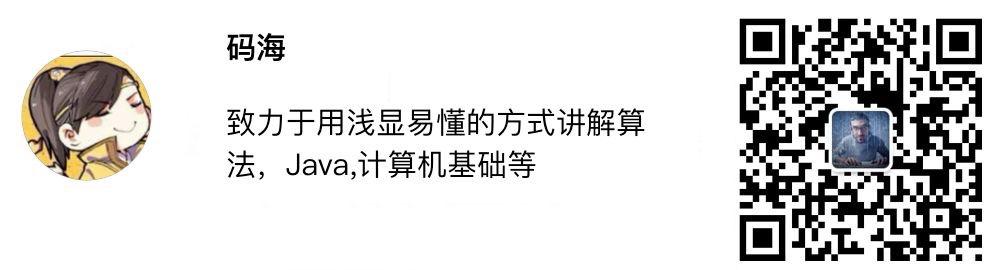

1 | 大家好,我是坤哥,公众号「坤哥漫谈IT」号主,本人双非一本,非科班出身,目前就任某独角兽技术专家职位,相信很多人都和我一样有普通的出身,但希望能在计算机这个领域有所建树,希望我的一些学习经验能帮助到你。

2 |

3 | 不少读者反馈公号搜索文章不方便,所以响应大家号召,把文章整到了 github 上以方便大家查阅,仓库地址就叫 easy-cs 吧,致力于让天下没有难学的计算机,哈哈。

4 |

5 | 这些文章平均被转载 20 次以上,得到很多人的认可,相信看完之后无论是面试还是工作对你都会有很大的帮助,绝对精品!希望大家给个 **star** 支持一下,这是笔者持续更文的动力!目录如下

6 |

7 | * 学习指南PDF

8 | * [谷歌师兄刷题笔记](学习指南/谷歌师兄刷题笔记.md)

9 | * [美团2017-2020年技术文章](学习指南/美团2017-2020年技术文章.md)

10 | * 计算机基础

11 | * [从进入内核态看内存管理](计算机基础/从进入内核态看内存管理.md)

12 |

13 | * 网络

14 | * [20 张图让你彻底弄懂 HTTPS 原理!](网络/20张图让你彻底弄懂HTTPS原理.md)

15 | * [51 张图带你彻底弄懂HTTP](网络/51张图带你彻底弄懂HTTP.md)

16 | * [TCP:一个悲伤的故事](网络/TCP:一个悲伤的故事.md)

17 | * [你管这破玩意儿叫token](网络/你管这破玩意儿叫token.md)

18 | * [这个下载文件的问题困住了我至少三位同事](网络/这个下载文件的问题困住了我至少三位同事.md)

19 | * [一个数据包的互联网之旅](网络/一个数据包的互联网之旅.md)

20 | * [51 张图带你彻底弄懂HTTP](网络/51张图带你彻底弄懂HTTP.md)

21 | * 算法

22 | * [一文学会递归解题](算法/一文学会递归解题.md)

23 | * [一文学会动态规划解题技巧](算法/一文学会动态规划解题技巧.md)

24 | * [一文学会链表解题](算法/一文学会链表解题.md)

25 | * [一文看懂排列组合算法](算法/一文看懂排列组合算法.md)

26 | * [一文学会回溯算法解题技巧](算法/一文学会回溯算法解题技巧.md)

27 | * [红黑树杀人事件始末](算法/红黑树杀人事件始末.md)

28 | * [Trie树的妙用](算法/Trie树的妙用.md)

29 | * [图文详解bfs,dfs](算法/图文详解bfs,dfs.md)

30 | * [提升逼格利器-位运算](算法/提升逼格利器-位运算.md)

31 | * [拜托,别再问我什么是 B+ 树了](算法/拜托,别再问我什么是B+树了.md)

32 | * 系统设计

33 | * [震惊!线上四台机器同一时间全部 OOM,到底发生了什么?](系统设计/震惊!线上四台机器同一时间全部OOM,到底发生了什么?.md)

34 | * [ELK 性能优化实战](系统设计/ELK性能优化实战.md)

35 | * [keepalived工作原理](系统设计/keepalived工作原理.md)

36 | * [优秀程序员必备的四项能力](系统设计/优秀程序员必备的四项能力.md)

37 | * [金融监控实战](系统设计/金融监控实战.md)

38 | * [高性能短链设计](系统设计/高性能短链设计.md)

39 | * [高性能网关设计实践](系统设计/高性能网关设计实践.md)

40 | * [simhash实现机制](系统设计/simhash实现机制.md)

41 | * [从应用层到网络层排查Dubbo接口超时全记录.md](系统设计/从应用层到网络层排查Dubbo接口超时全记录.md)

42 | * [你管这破玩意儿叫负载均衡](系统设计/你管这破玩意儿叫负载均衡.md)

43 | * Java

44 | * [我是一个线程池](Java/我是一个线程池.md)

45 | * [2w字长文深度解析线程池](Java/2w字长文深度解析线程池.md)

46 | * [1.5w字,30图带你彻底掌握 AQS!](Java/1.5w字,30图带你彻底掌握AQS!.md)

47 | * [看完这篇垃圾回收,和面试官扯皮没问题了](Java/看完这篇垃圾回收,和面试官扯皮没问题了.md)

48 | * [垃圾回收-实战篇](Java/垃圾回收-实战篇.md)

49 | * [一文学会注解的正确使用姿势](Java/一文学会注解的正确使用姿势.md)

50 | * [Netty 架构与原理初探](Java/Netty架构与原理初探.md)

51 | * [Netty 源码剖析](Java/Netty源码剖析.md)

52 | * [Netty 应用篇](Java/Netty应用篇.md)

53 | * [Sharding-JDBC 的基本用法和基本原理](Java/Sharding-JDBC的基本用法和基本原理.md)

54 | * [aop造火箭事件始末](Java/aop造火箭事件始末.md)

55 | * [一个故事看懂对象的创建过程.md](Java/一个故事看懂对象的创建过程.md)

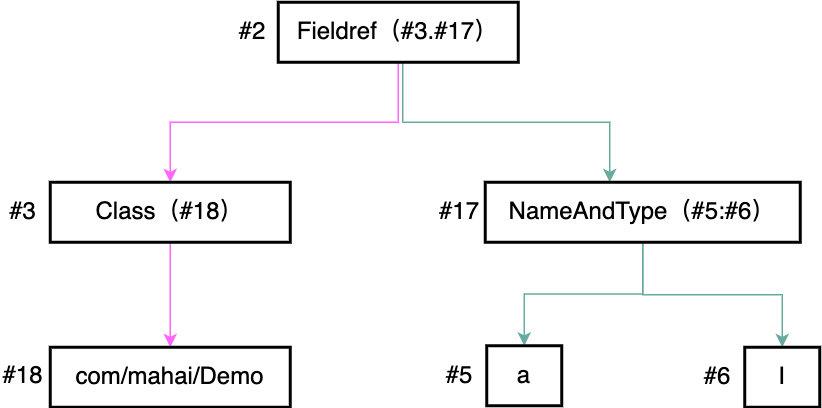

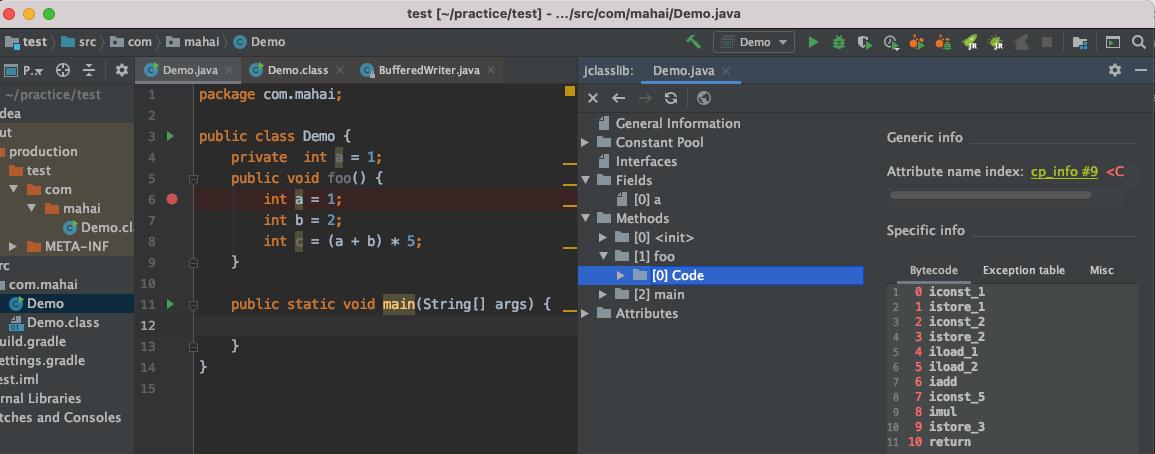

56 | * [字节码剖析.md](Java/字节码剖析.md)

57 | * [类加载机制.md](Java/类加载机制.md)

58 | * [为什么线程崩溃不会导致 JVM 崩溃](Java/为什么线程崩溃不会导致JVM崩溃.md)

59 | * [Java线程模型](Java/Java线程模型.md)

60 | * MySQL

61 | * [SQL 进阶使用技巧](MySQL/SQL进阶使用技巧.md)

62 | * [执行一条 SQL 后 MySQL 做了哪些事情](MySQL/执行一条SQL后MySQL做了哪些事情.md)

63 | * [深入浅出索引原理](MySQL/深入浅出索引原理.md)

64 | * 分布式

65 | * [分布式事务,看这篇真的够了!](分布式/分布式事务,看这篇真的够了!.md)

66 | * [40张图看懂分布式追踪系统原理及实践](分布式/40张图看懂分布式追踪系统原理及实践.md)

67 | * 工程师效率

68 | * [Alfred 有多强悍,我写了个一键上传图片的 workflow 来告诉你](工程师效率/Alfred有多强悍,我写了个一键上传图片的workflow来告诉你.md)

69 | * [Gradle build 慢?可能是你使用的姿势不对](工程师效率/Gradlebuild慢?可能是你使用的姿势不对.md)

70 | * 架构

71 | * [什么是高可用](架构/高可用.md)

72 | * 中间件

73 | * [深入浅出消息队列](中间件/MQ基本概念.md)

74 | * 设计模式

75 | * [我用 DCL 写出了单例模式,结果阿里面试官不满意!](设计模式/我用DCL写出了单例模式,结果阿里面试官不满意!.md)

76 | * 程序人生

77 | * [一位全职转行做滴滴司机的前程序员对话引发的思考](程序人生/一位全职转行做滴滴司机的前程序员对话引发的思考.md)

78 | * [谈谈一些学习心得](程序人生/谈谈一些学习心得.md)

79 | * [优秀的程序员应该具备哪些能力](程序人生/优秀的程序员应该具备哪些能力.md)

80 | * [我创业啦!!!](程序人生/我创业啦!!!.md)

81 | * [我是如何晋升专家岗的](程序人生/我是如何晋升专家岗的.md)

82 | * [面试了十几位前端有感](程序人生/面试了十几位前端有感.md)

83 | * 个人随想

84 | * [随想](个人感悟/随想.md)

85 |

86 | 更多精品文章,欢迎大家扫码关注「坤哥漫谈IT」

87 |

88 |

89 |

90 | 也欢迎大家扫一扫加我好友(备注:github),拉你进学习交流群,里面有各位 BAT 大佬,可以提问,内推等,一起抱团取暖^_^

91 |

92 |

93 |

--------------------------------------------------------------------------------

/系统设计/震惊!线上四台机器同一时间全部OOM,到底发生了什么?.md:

--------------------------------------------------------------------------------

1 |

2 |

3 | ### 案发现场

4 | 昨天晚上突然短信收到 APM (即 Application Performance Management 的简称,我们内部自己搭建了这样一套系统来对应用的性能、可靠性进行线上的监控和预警的一种机制)大量告警

5 |

6 | (画外音: 监控是一种非常重要的发现问题的手段,没有的话一定要及时建立哦)

7 |

8 | 紧接着运维打来电话告知线上部署的四台机器全部 OOM (out of memory, 内存不足),服务全部不可用,赶紧查看问题!

9 |

10 | ### 问题排查

11 | 首先运维先重启了机器,保证线上服务可用,然后再仔细地看了下线上的日志,确实是因为 OOM 导致服务不可用

12 |

13 |

14 | 第一时间想到 dump 当时的内存状态,但由于为了让线上尽快恢复服务,运维重启了机器,导致无法 dump 出事发时的内存。所以我又看了下我们 APM 中对 JVM 的监控图表

15 |

16 | 画外音: 一种方式不行,尝试另外的角度切入!再次强调,监控非常重要!完善的监控能还原当时的事发现场,方便定位问题。

17 |

18 |

19 |

20 |

21 |

22 |

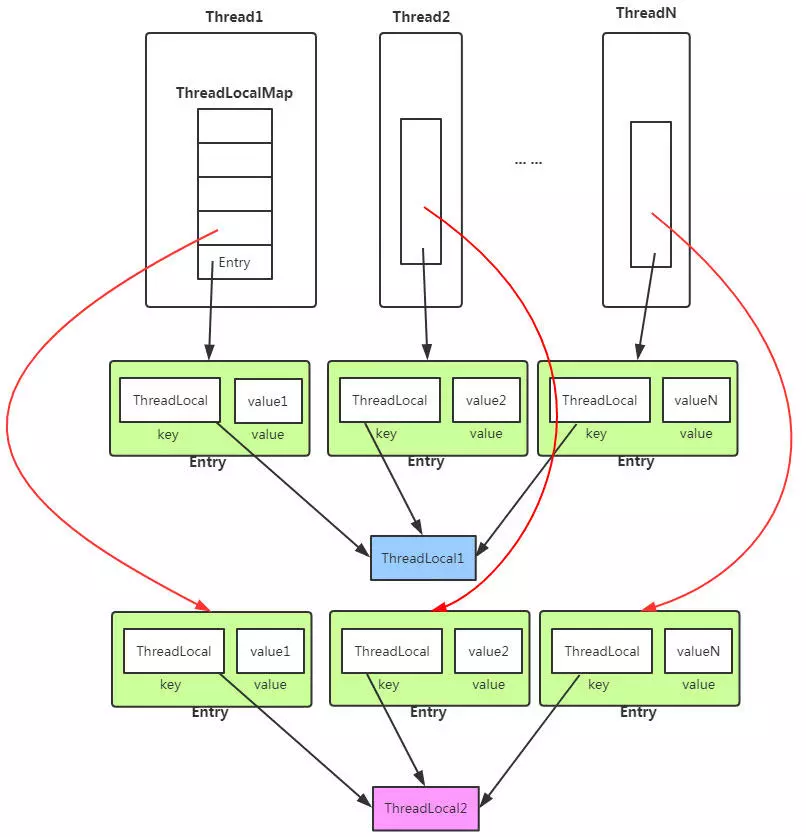

23 | 不看不知道,一看吓一跳,从 16:00 开始应用中创建的线程居然每时每刻都在上升,一直到 3w 左右,重启后(蓝色箭头),线程也一直在不断增长),正常情况下的线程数是多少呢,600!问题找到了,应该是在下午 16:00 左右发了一段有问题的代码,导致线程一直在创建,且创建的线程一直未消亡!查看发布记录,发现发布记录只有这么一段可疑的代码 diff:在 HttpClient 初始化的时候额外加了一个 **evictExpiredConnections** 配置

24 |

25 |

26 |

27 | 问题定位了,应该是就是这个配置导致的!(线程上升的时间点和发布时间点完全吻合!),于是先把这个新加的配置给干掉上线,上线之后线程数果然恢复正常了。那 **evictExpiredConnections** 做了什么导致线程数每时每刻在上升呢?这个配置又是为了解决什么问题而加上的呢?于是找到了相关同事来了解加这个配置的前因后果

28 |

29 | ### 还原事发经过

30 |

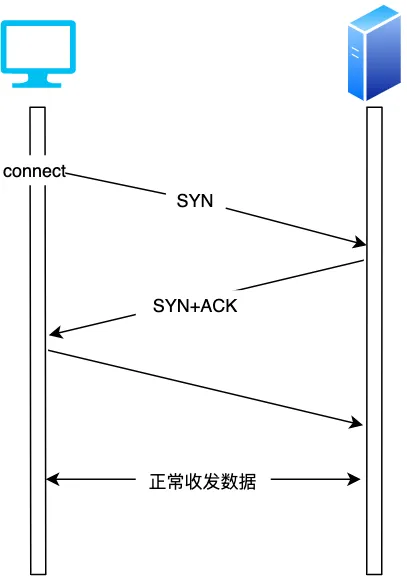

31 | 最近线上出现不少 **NoHttpResponseException** 的异常,那是什么导致了这个异常呢?

32 |

33 | 在说这个问题之前我们得先了解一下 http 的 keep-alive 机制。

34 |

35 | 先看下正常的一个 TCP 连接的生命周期

36 |

37 |

38 | 可以看到每个 TCP 连接都要经过**三次握手**建立连接后才能发送数据,要经过**四次挥手**才能断开连接,如果每个 TCP 连接在 server 返回 response 后都立马断开,则发起多个 HTTP 请求就要多次创建断开 TCP, 这在 **Http 请求很多**的情况下无疑是很耗性能的, 如果在 server 返回 response 不立即断开 TCP 链接,而是**复用**这条链接进行下一次的 Http 请求,则无形中省略了很多创建 / 断开 TCP 的开销,性能上无疑会有很大提升。

39 |

40 | 如下图示,左图是不复用 TCP 发起多个 HTTP 请求的情况,右图是复用 TCP 的情况,可以看到发起三次 HTTP 请求,复用 TCP 的话可以省去两次建立 / 断开 TCP 的开销,理论上发起 一个应用只要启一个 TCP 连接即可,其他 HTTP 请求都可以复用这个 TCP 连接,这样 n 次 HTTP 请求可以省去 n-1 次创建 / 断开 TCP 的开销。这对性能的提升无疑是有巨大的帮助。

41 |

42 |

43 |

44 | 回过头来看 keep-alive (又称持久连接,连接复用)做的就是复用连接, 保证连接持久有效。

45 |

46 | (画外音: Http 1.1 之后 keep-alive 才默认支持并开启,不过目前大部分网站都用了 http 1.1 了,也就是说大部分都默认支持链接复用了)

47 |

48 | **天下没有免费的午餐** ,虽然 keep-alive 省去了很多不必要的握手/挥手操作,但由于连接长期保活,如果一直没有 http 请求的话,这条连接也就长期闲着了,会占用系统资源,有时反而会比复用连接带来更大的性能消耗。 所以我们一般会为 keep-alive 设置一个 timeout, 这样如果连接在设置的 timeout 时间内一直处于空闲状态(未发生任何数据传输),经过 timeout 时间后,连接就会释放,就能节省系统开销。

49 |

50 | 看起来给 keep-alive 加 timeout 是完美了,但是又引入了新的问题(一波已平,一波又起!),考虑如下情况:

51 |

52 | 如果服务端关闭连接,发送 FIN 包(注:在设置的 timeout 时间内服务端如果一直未收到客户端的请求,服务端会主动发起带 Fin 标志的请求以断开连接释放资源),在这个 FIN 包发送但是还未到达客户端期间,客户端如果继续复用这个 TCP 连接发送 HTTP 请求报文的话,服务端会因为在四次挥手期间不接收报文而发送 RST 报文给客户端,客户端收到 RST 报文就会提示异常 (即 **NoHttpResponseException**)

53 |

54 |

55 | 我们再用流程图仔细梳理一下上述这种产生 **NoHttpResponseException** 的原因,这样能看得更明白一些

56 |

57 |

58 |

59 | 费了这么大的功夫,我们终于知道了产生 ** **NoHttpResponseException**** 的原因,那该怎么解决呢,有两种策略

60 |

61 | 1. 重试,收到异常后,重试一两次,由于重试后客户端会用有效的连接去请求,所以可以避免这种情况,不过一次要注意重试次数,避免引起雪崩!

62 | 2. 设置一个定时线程,定时清理上述的闲置连接,可以将这个定时时间设置为 keep alive timeout 时间的一半以保证超时前回收。

63 |

64 | **evictExpiredConnections** 就是用的上述第二种策略,来看下官方用法使用说明

65 |

66 | ```java

67 | Makes this instance of HttpClient proactively evict idle connections from the

68 | connection pool using a background thread.

69 | ```

70 |

71 | 调用这个方法只会产生一个定时线程,那为啥应用中线程会一直增加呢,因为我们对每一个请求都创建了一个 HttpClient! 这样由于每一个 HttpClient 实例都会调用 **evictExpiredConnections** ,导致有多少请求都会创建多少个 定时线程!

72 |

73 | 还有一个问题,为啥线上四台机器几乎同一时间点全挂呢?

74 | 因为由于负载均衡,这四台机器的权重是一样的,硬件配置也一样,收到的请求其实也可以认为是差不多的,这样这四台机器由于创建 HttpClient 而生成的后台线程也在同一时间达到最高点,然后同时 OOM。

75 |

76 | ### 解决问题

77 | 所以针对以上提到的问题,我们首先把 HttpClient 改成了单例,这样保证服务启动后只会有一个定时清理线程,另外我们也让运维针对应用的线程数做了监控,如果超过某个阈值直接告警,这样能在应用 OOM 前及时发现处理。

78 | 画外音:再次强调,监控相当重要,能把问题扼杀在摇篮里!

79 |

80 |

81 | ### 总结

82 | 本文通过线上四台机器同时 OOM 的现象,来详细剖析产定位了产生问题的原因,可以看到我们在应用某个库时首先要对这个库要有充分的了了解(上述 HttpClient 的创建不用单例显然是个问题),其次必要的网络知识还是需要的,所以要成为一个合格的程序员,不关对语言本身有所了解,还要对网络,数据库等也要有所涉猎,这些对排查问题以及性能调优等会有非常大的帮助,再次,完善的监控非常重要,通过触发某个阈值提前告警,可以将问题扼杀在摇篮里!

83 |

84 |

85 |

86 |

--------------------------------------------------------------------------------

/ChatGPT/AI地图实践.md:

--------------------------------------------------------------------------------

1 |

2 | 大家好,我是坤哥

3 |

4 |

5 |

6 | AI 时代已至!在工作中我大量使用 ChatGPT 来提升工作效率,得到了很好的效果

7 |

8 | 今天我就给大家分享一个案例,来看一下我在工作中是利用 AI 把原本半天的工作量压缩到不到半小时的。希望能对职场人士尤其是程序员群体有所启发

9 |

10 |

11 |

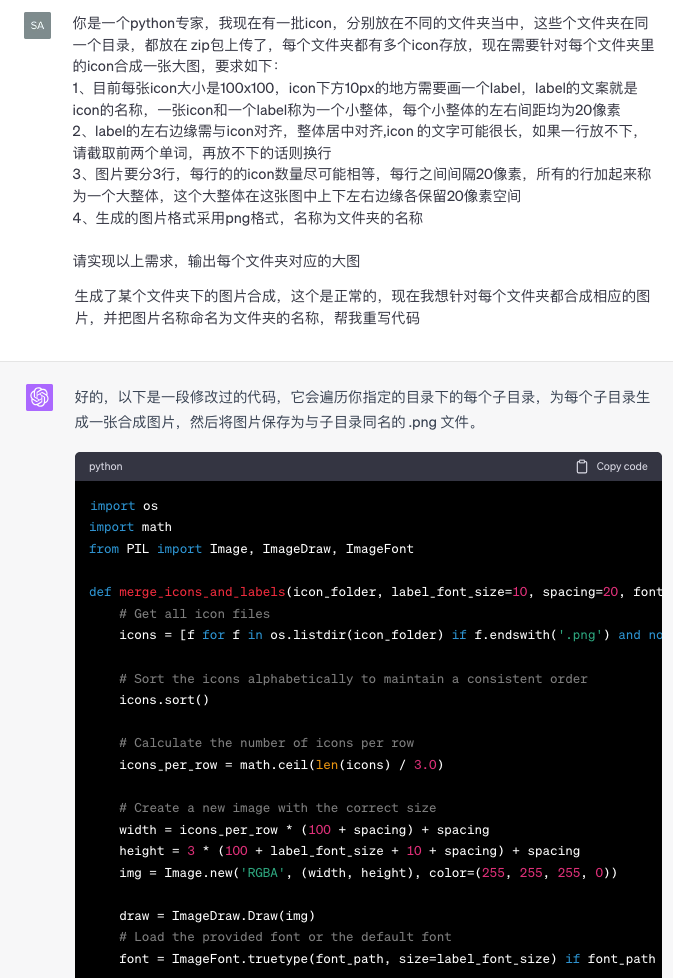

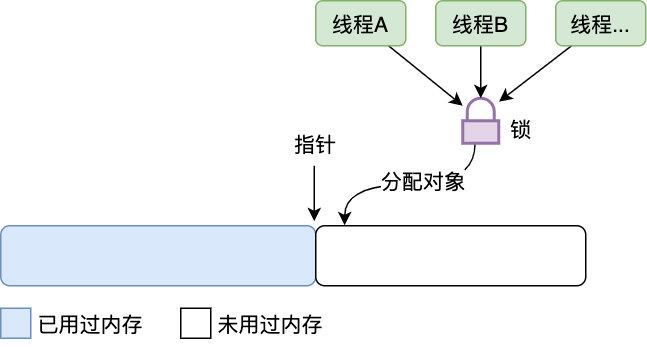

12 | 最近我司要做一个 AI 工具地图,效果如下

13 |

14 |

15 |

16 |

17 |

18 |

19 |

20 | 需求是把每个 AI 产品的图标分门别类地先合成一个小图,再把所有小图整合成一个 AI 大地图,注意每个图标下面的文字都是其对应的产品名哦,放大看某一类AI产品的效果如下:

21 |

22 |

23 |

24 |

25 |

26 |

27 |

28 |

29 |

30 |

31 |

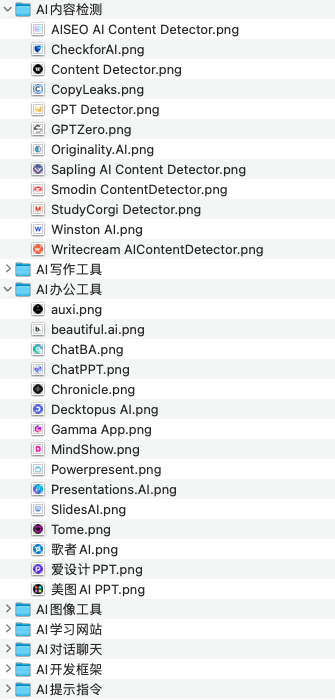

32 | 如果把所有的工作如包括下载图标,合成每个类别的 AI 产品,再到合成最后的大图都交给 UI,可想而知这样的工作量是非常巨大的,所以我们就想能不能尽可能地减轻 UI 的工作量,用技术的手段至少能先做到分门别类地合成小图,这样 UI 所要做的事就比较简单了,只要把小图拼成大图就行了

33 |

34 |

35 |

36 |

37 |

38 |

39 |

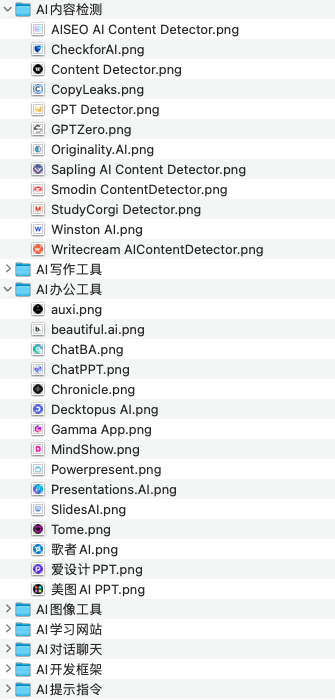

40 | 首先我们需要找到这样 AI 图标,毫无疑问 AI 导航网站最合适不过了,这些导航网站基本上分门别类地给你整理好了这些AI产品的图标,我们决定使用 https://ai-bot.cn/ 这个导航网站里的图标,它的首页截图如下

41 |

42 |

43 |

44 |

45 |

46 |

47 |

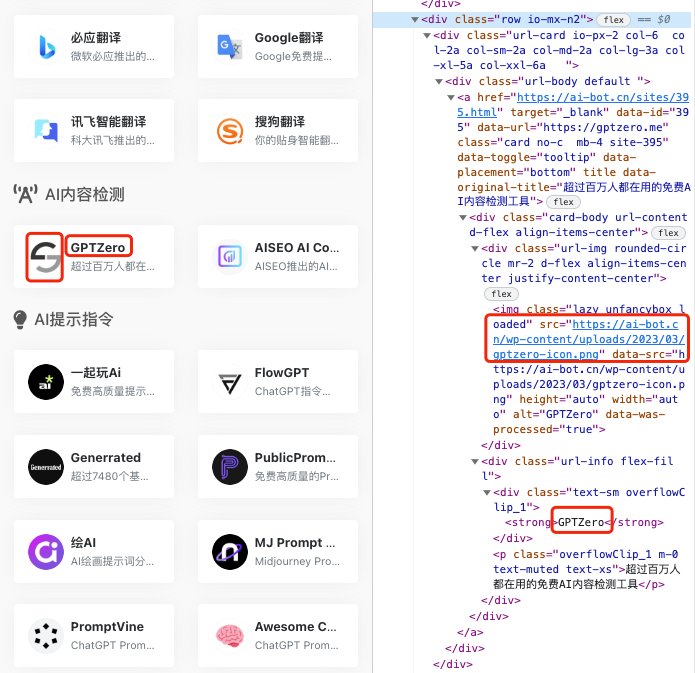

48 | 好了再来明确我们的需求,首先需要获取每一类 AI 产品下的图标,并将图标命名为此 AI 对应的产品名,然后将这属于同一类AI产品的图标置于同一个文件夹下,如下

49 |

50 |

51 |

52 |

53 |

54 |

55 |

56 |

57 |

58 |

59 |

60 | 图标有几百个,如果人工一个个下载图标并命名,工作量巨大不说,还很容易出错,最容易想到的当然是用脚本如 Js 或 Python 来爬取网页中的图标和文案,但是如果人工去写脚本,也挺费时的,而且很难一次性写对所有的代码, 需要花很多时间 来 debug,所以写脚本这样的重活最好让 ChatGPT 来帮我们写,又快又好,只要我们把需求写清楚,ChatGPT 基本一次性就能把脚本给我们写好。

61 |

62 |

63 |

64 |

65 |

66 |

67 |

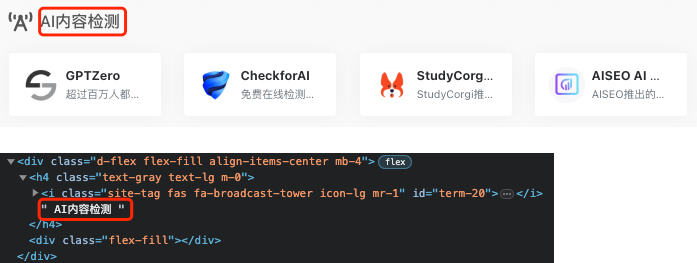

68 | 我们首先观察网站的结构,注意到网站的结构很相似,基本都是 「AI 类别标题 + AI 类别图标集合」这样的组合结构,我们就取一个来观察

69 |

70 |

71 |

72 | 下图中绿框为AI 类别标题对应相应的 div,红框为标题下的图标集合对应相应的 div

73 |

74 |

75 |

76 | [外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-oYadyg7z-1691679560090)(/Users/ronaldo/Library/Application Support/typora-user-images/image-20230720103226947.png)]

77 |

78 |

79 |

80 |

81 |

82 |

83 |

84 | 继续观察,每一个类别的标题对应着 class 为 d-flex 的 `div > h4 > i` 中的文字

85 |

86 |

87 |

88 |

89 |

90 |

91 |

92 |

93 |

94 |

95 |

96 |

97 |

98 |

99 |

100 | 而每个 AI 图标的 url 和名称在 html 中的元素如下

101 |

102 |

103 |

104 |

105 |

106 |

107 |

108 | `注意`:有一些AI产品分类如热门工具等不是这样的结构,不过结构都非常类似,用 Visual Studio 来将它们调整成以上的结构即可

109 |

110 |

111 |

112 |

113 |

114 |

115 |

116 | 了解了我们要提取的 html 结构后,我们就可以给 ChatGPT 下指令来让其为我们生成脚本来提取每一类 AI 产品下的图标并在下载后将其命名为相应的 AI 产品名了,指令如下(test.html 即网页的 html):

117 |

118 |

119 |

120 |

121 |

122 |

123 |

124 | 最终它会给我生成类似以下的 Python 代码:

125 |

126 |

127 |

128 |

129 |

130 |

131 |

132 | 放在本地,下载对应的依赖后一键执行即可按要求提取每个分类下的AI图标,如下

133 |

134 |

135 |

136 |

137 |

138 |

139 |

140 | 做到这一步还不够, 为了进一步减轻 UI 的工作量我们希望帮 UI 把每一个 AI 类别的图标合成一张大图,如下:

141 |

142 |

143 |

144 |

145 |

146 |

147 |

148 | 合成图片这种工作 Python 也能做,指令如下:

149 |

150 |

151 |

152 |

153 |

154 |

155 |

156 |

157 |

158 |

159 |

160 |

161 |

162 |

163 |

164 | 执行代码后效果如下:

165 |

166 |

167 |

168 |

169 |

170 |

171 |

172 | 可以看到,每一类的图标都合成了一个大图

173 |

174 |

175 |

176 | 这样的话交付给UI的就是一些合成好的每个 AI 类别的小图了,他们拿到后再将其拼成一张大图就相对容易多了

177 |

178 |

179 |

180 |

181 |

182 | ### 总结

183 |

184 |

185 |

186 | 本文给大家展示了一个典型地利用 AI 来提效的案例,这只是其中之一,实际上在工作中我大量使用了 AI 来编码,以网站的后端代码为例上,90%的代码都是 AI 写的,当然指令还是我的下的,有人说 ChatGPT 的出现可能会替代程序员,但就我的大量实践经验来看,暂时还没达到这种程度,比如我一开始让它写后端,但它没给我处理跨域这种情况,这就需要程序员本人有相关的经验指引它补全,再比如我希望后端的很多接口都需要有用户身份的验证后才能进入具体的代码逻辑,但又不想每个接口都写重复的校验代码,那就需要指示 GPT 帮我封装校验逻辑,使用类似`export default withMiddleware(handler, cors, authenticate)`这样的责任链的方式来重用代码以提高代码的可扩展性,所以事在人为,对于程序员来说,你越资深,掌握的知识越多,就越能指示 ChatGPT 最大程序地发挥其功效, AI 能够帮我们处理那些重复的,不需要怎么动脑的工作,但更高层次的抽象还是需要程序员来指示它来完成。未来 AI 可能会进化,但至少当下我们能做的还是提升我们的功力以进一步利用释放 AI 的潜能

187 |

188 |

189 |

190 | 我建了一个 [AI 导航网站](https://ainavtech.com/),欢迎大家体验

191 |

--------------------------------------------------------------------------------

/程序人生/谈谈一些学习心得.md:

--------------------------------------------------------------------------------

1 | 最近不少读者加我探讨了一些算法,Java 或如何看书等学习方面的困惑,我觉得这些都挺有共性的,所以就想着结合自己的经历来谈谈有关学习的一些话题,希望能给读者一些启发。

2 |

3 | ## 提升自己的起点

4 | 先简单介绍我自己,我大学是双非普通一本,非科班出身,目前在某独角兽公司担任技术专家职位,相信大多数人的出身和我一样,普通院线毕业,想渴望着能一步步走上技术专家乃至更高级别的职位,那既然是普通院校毕业,与那些 985 院校科班出身的同学相比本身就有天然的劣势,所以我们就更要提升自己的起点了。

5 |

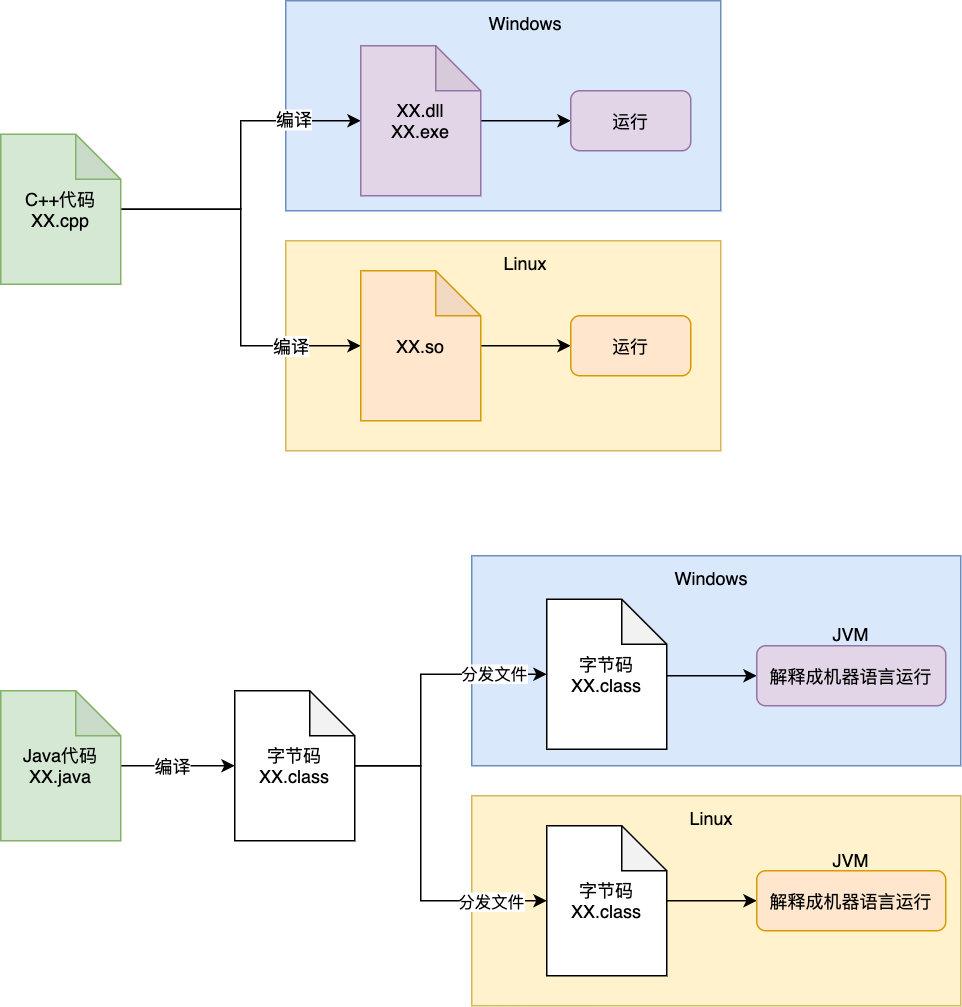

6 | 何谓提升自己的起点,比如对于技术人员来说搜索资料就应该用 Google, 而不是百度,查不到就去 Stackoverflow 提问,大部分资料用英文都能搜到,日积月累,你的英文水平就算再蹩脚也能完成华丽蜕变,为什么要强调英文水平呢,现在移动互联网时代,各大主流平台 iOS, Android,甚至一些领先的框架如 Flutter 等全是国外出的,第一手资料全是英文的,所以如何用英文查资料,无压力读取英文官方文档这是技术人的基本素质,再者就算是翻译难免也有瑕疵,所以一定要持续提升自己的英文水平,坚决用 Google!

7 |

8 | 再比如大多数人学习可能主要通过各种博客来学,这样确实可以学到不少东西,但是博客的问题是**各种知识点比较散**,而且多数是作者对知识的提炼和总结总结,总结的过程中可能省略了很多知识点,也漏掉了书中的一些精华,所以如果要提升自己,系统地构建自己的知识体系,一定要**看书**!看书确实是一件很费力地事,但长期来看,对你知识体系的构建大有裨益!看书一定要看好书,怎么去找好书呢,推荐大家看看图灵社区(https://www.ituring.com.cn/ ) 很多书都很经典,也可以去豆瓣上搜搜那些高分书籍,看看底下的评论到底好在哪,买东西我们都会货比三家,更何况一本好书对你的成长大有裨益,所以值得你多花点心思来挑本好书!另外值得一提的是一开始很多人入门可能摸不着门道,这时候看视频快速入门是没问题的,但后期一定要回归到书本的学习中来!看书是实现知识技能充分必要条件!

9 |

10 | 再举个我自己的例子吧,目前我一直在运营着公号,坚持原创!一周至少发一篇精品文章,其实我也可以多多转载下别人的文章多吸点粉,但我没有这样做,转载只需要五分钟,确实方便,但对我个人写作能力地提升没有任何帮助!所以我一直坚持着原创,努力地写文章,这样虽然很苦,但对自己写作能力的提升,逻辑思维的构建长远来看帮助很大!这就叫提升自己的起点。

11 |

12 | 提升自己的起点会带来什么效果,这里给大家介绍一下复利曲线

13 |

14 |

15 |

16 | 前期的增长势头非常慢,但日积月累,到达某个拐点之后,增长就如火箭上升一般,势不可挡,就像我另一个做公号的朋友 cxuan 一样,前面几十篇文章无人问津,最近写得几篇文章带来的粉丝量突然爆发,其实也是因为之前的几十篇文章给他带来了足够强的写作能力,奠定了强大的写作基础,所以现在就像上面的后期的复利曲线一样,势不可挡。所以坚持提升自己的起点长期来看一定能给自己带来足够强的复利!

17 |

18 | ## 底层能力很重要

19 |

20 | 什么是底层能力,算法,数据结构,操作系统这些就属于底层能力,这些为什么重要,这些是上层语言,工具的根基!这些属于心法,内功,学好之后对你后期势能的爆发大有裨益!内功很重要,**工具不重要**!不少人误把工具用得熟练程序当作自己资本,甚至在 V 站上看到一个人对刚入职的同事不会用 git 而大加吐嘈,这是大错特错的,工具为什么不重要,想想杨过在武功大成后用玄铁重剑和木剑对他来说差别大吗,对于一个内功深厚的人来说,工具的掌握只要稍微看下文档,Google 一下即可掌握,信手拈来!内功决定程序员的上限,而工具的掌握甚至连下限都不算,内功最重要。

21 |

22 | 再举一个和大家工作息息相关的例子,曾经一个人来我司面试,我面了之后觉得不错,但上司面试之后觉得人不够聪明,所谓不够聪明指的是给出一道相关设计题,在多方引导下仍然没有思路,所以最后没拿到 offer,所以大厂为什么喜欢考虑算法,我在之前的[文章](https://mp.weixin.qq.com/s/DA4zHIPFP6ISzVeobdgdew)里也说过了,其实就是考你的构建模型,修改模型的能力,这样是判断一个人是否聪明的重要标准,所以掌握算法这些底层能力十分重要,算法的学习很枯燥。学习算法最好先掌握理论,掌握之后再去 leetcode 上多刷下题,学习算法理论建议大家可以学学极客时间上王争老师的「数据结构与算法」教程,对每个点讲得都很透彻!再结合吴师兄的动画题解与自己的多加练习,相信大家掌握算法不成问题。

23 |

24 | ## 多读源码

25 | 要掌握好一个框架,学习它的底层原理,读源码是必不可少的,这样才能在面对多个框架的选型时根据框架的优劣性做出取舍,同时多读框架的源码你还会对它底层的思想有更深刻的理解,能够做到知其然,更能知其所以然,举个简单地例子,在 Java 中有一个 **Arrays.sort** 的方法可以对数组进行排序,一开始我以为是个简单地快排,读它的源码之后才发现它虽然是用的快排,不过它用的是 dual-pivot 快排,这就让我产生了深厚的兴趣, 后来了解到这个 dual-pivot 快排比经典快排节省了 12% 的元素扫描,扫描元素的个数这种新的算法把内存的流量的因素考虑进去,比较适应新时代。看到一种框架可以不断地引出新的知识点,深挖这些新知识点,这样框架的优劣性也就吃透了。

26 |

27 | 曾经做 iOS 的时候国内优酷就有一个大神 ibireme 通读各类框架源码然后设计了 YYKit 等框架,引起轰动!甚至引来 Facebook 挖角,所以通读框架源码对于提升自己的能力非常有效!那怎么读一个框架源码呢,这又是一个大的话题,后面我会结合 HttpClient 的源码阅读来谈谈我的一些心得体会

28 |

29 | ## 以教为学

30 |

31 | 学完了某些知识点,怎么确定自己就掌握它了呢,可以试着把这些知识点写成博客,在写博客的过程中要反复思考这些知识点怎么让小白也看得懂,如果写出来之后小白也看懂了,那么基本可以肯定这些知识点可以算掌握了,同时在写博客的过程中,如果有问题,读者说不定也会帮你指出来,这样对自己知识的盲点是个很好的补充,写博客最好的时间是十年前,其次是现在!强烈建议读者现在都开始写博客,一方面是对自己知识体系的一个梳理,另一方面也能与读者探讨,一举两得!

32 |

33 | ## 再谈 Java 学习

34 | 由于我的主业是 Java ,所以也有不少人来和我交流 Java 的学习,这里推荐几本书吧

35 |

36 | **新手必备**

37 | 1、《Java 核心技术:卷 1 基础知识》

38 | 对于新手来说非常友好的一本技术书,也是 Sun 公司的官方用书,对 Java 的基础有深入剖析,初学者必读!

39 | 2、《Head first Java》

40 | Head first 公司出品的书都非常耐读, 这本书对 Java 的各种基本概念的讲解非常到位,清晰易懂!推荐阅读英文版哦,如果你英文不好,更要阅读这本书了,还记得我们上文提得:请提升自己的起点吗,刚好可以通过读取这本书要慢慢地养成读取英文书的习惯,技术书籍其实英文并不是很难,要多读读,养成读取英文版书籍的习惯

41 |

42 | **进阶**

43 | 1、《深入理解 Java 虚拟机》

44 | 要进阶一定要对垃圾回收原理, JVM 调优,字节码,Java 线程模型有较清晰地认识,这本书可以说是这些补齐这些知识点的不二之选!精典书籍,谁看谁知道!

45 | 2、《Effective Java》

46 | 这样书对如何写好 Java 总结了很多有用的知识点,也是精典书籍了,必看

47 | 3、 《Java编程思想》

48 | 这本书可以说是 Java 编程的圣经了,要学好 Java 就绕不开本书,豆瓣评分 9.1 分,也是必看书籍,不过不推荐小白一开始就看这本书,建议还是先看完上述所说的新手必备书籍后并且阅读一些框架的源码或工作过一段时间后再看,对里面的知识点体会会更深

49 |

50 | 暂时就推荐这么多吧,其还有一些像《Java并发编程实战》,netty 等书籍等进阶到一定阶段后其实也可以看看,不过这些都是后话了,大家啃完上面的几本书对于再去学其他书问题不大。

51 |

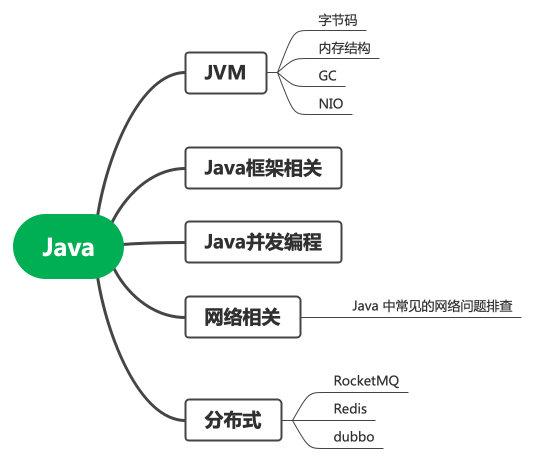

52 | 身为 Java 后端开发,只了解 Java 就够了吗, 至少你要对网络知识,MySql 这些也要做一定的了解吧,所以 《TCP/IP 详解》《高性能 Mysql》也是你进阶的不二书籍,至少要对 TCP 的慢启动,拥塞机制有所了解,要对索引,如何优化 Mysql 性能有一定的了解吧。可以先对后端工程师应该具备哪些能力画出一个技能树(如下图),然后再对这个技能树上的每个点再各个击破!

53 |

54 |

55 |

56 | ## 再谈学习

57 |

58 | 前面说了多次看书的好处,这里也推荐大家学习一下极客时间的教程,我基本上每出一个教程必买,有人会说,你看得过来吗,其实我们都陷入了一个误区,买这些教程一定要看完吗,其实只要它的的某个知识点能帮助到你,你就赚了!能完整地看完当然更好,但如果暂时没时间,可以利用碎片化时间选择对自己有帮助的点先学习啊,只要某个点对你有启发,你就赚了!很多面不都是由这些点一个个组成的吗,将这些点串联起来,这样就能逐步构建自己的知识体系和学习框架。

59 |

60 |

61 |

62 | ## 最后

63 | 前面谈了很多学习方面的一些个人体会,这只是我个人的一些学习感悟,欢迎大家扫码关注我公号回复「学习路线」,可以拿到相关的学习路线中的电子书

64 |

65 |

--------------------------------------------------------------------------------

/Java/一个故事看懂对象的创建过程.md:

--------------------------------------------------------------------------------

1 | Java 帝国发生了一场危机,各个线程正在闹罢工。。。

2 |

3 | 「发生了什么事,听说各个线程最近正在闹罢工」国王老虚说道

4 |

5 | 「报告国王,最近各个线程反应创建对象太难了,要求王国进行变革」线程大臣启奏道

6 |

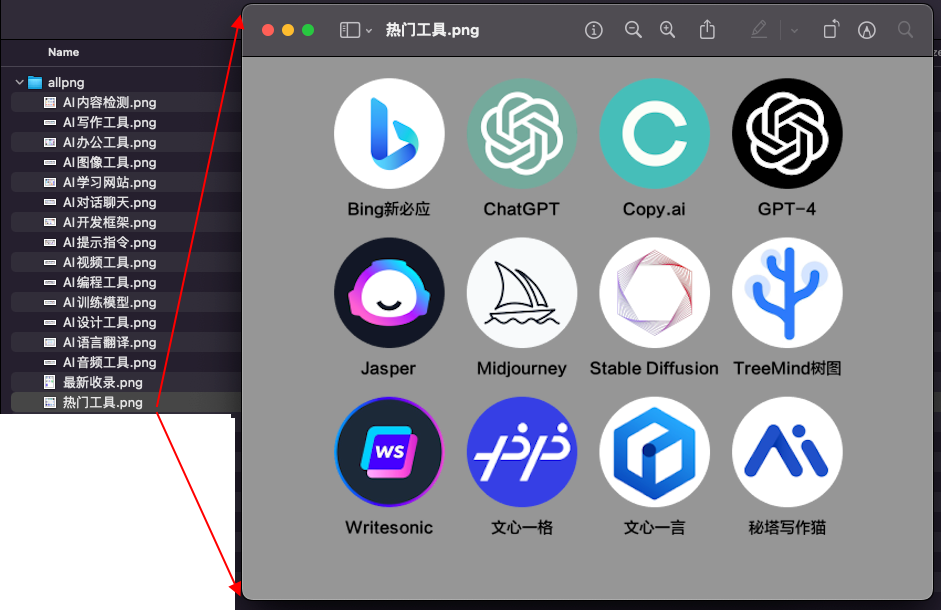

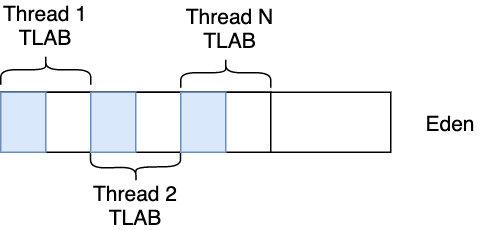

7 | 「创建对象有什么难的,我们不是用了 bump the pointer 机制吗,new 一下对象不就创建了吗」老虚大惑不解,「我们知道对象一般来说都是先分配在堆上的 Eden 区的,那么在堆上怎样才能快速地给对象分配空间呢?假设堆是内存是绝对规整的,用过的放一边,空闲的放另一边,中间放一个指针作为分界点,那么在分配对象时只需要将指针移动到与对象大小相等的距离即可,这样创建对象只要不断地移动指针就行啦。这就是我们所说说的 bump the pointer(指针碰撞)」老虚边说边画出了以下图示

8 |

9 |

10 |

11 | 「指针碰撞我们当然知道,如果是单线程这样轻轻移动指针分配对象的方式当然很快,但如果是多线程呢,会产生严重的锁竞争呀」

12 |

13 |

14 |

15 | 「这确实是个问题,锁在多线程下确实会产生比较严重的问题,虽然这里用的是 CAS 乐观锁,但在多线程对象分配上由于锁竞争关系也会有较严重的性能问题」老虚沉思道

16 |

17 | ### TLAB

18 |

19 | 「能否这样,我们知道对象一般是在 Eden 区分配的,为每个线程创建一块单独的区域,每个线程分配对象时只在自己的区域里分配,在自己的区域分配时也采用 bump the pointer 的方式来分配,这样既可以用 bump the pointer 的方式来加速了对象的创建,又避免了创建对象时的锁竞争,可谓一举双得!」线程大臣说道

20 |

21 | 「妙啊,我们给这块区域取个名字吧,就叫它 Thread Local Allocation Buffer(即线程本地分配缓存区),这块是线程专用的内存分配区域」老虚道

22 |

23 |

24 |

25 | 「还有一个问题,这块区域该分配多大呢,如果分配太大,可能一个线程根本就没有分配对象的需求或者分配对象很少,造成了空间的浪费,如果分配太小,则可能某些线程比较活跃,分配的对象比较多,那么就要重新分配一个 TLAB,或者直接在 Eden 上分配,这样频繁分配 TLAB 或者在 Eden 分配会造成资源与性能的浪费」不愧是国王,一眼看出问题的本质

26 |

27 | 「是的,TLAB 大小主要和两个因素有关:每个 gc 内需要对象分配的线程个数以及线程每次 gc 分配的内存,这两项指标显然也与历史值有关,所以我们需要根据历史值来算出当前应该分配的 TLAB 大小,有一种算法指数平均数算法(EMA)可以干这事」线程大臣也不赖,一眼就抓住了问题的关键

28 |

29 | 「如果 TLAB 满了咋办」老虚困惑道

30 |

31 | 「满了就针对此线程创建一个 TLAB,或者直接丢到 Eden 区呗,另外需要说明的是 TLAB 比较适用于小对象的分配,大对象一般直接分配到 Eden 区哦」线程大臣解释道

32 |

33 | ### 逃逸分析与标量替换

34 |

35 | 老虚采纳了线程大臣的建议实现了 TLAB,由于采用了 TLAB 机制,各个线程的工作效率瞬间提升,老虚笑开了花,可是好景不长,新的问题又出现了。。。

36 |

37 | 「老虚啊,我发现采用 TLAB 之后线程的工作效率确实提升了很多,但一些线程反映由于 GC 时的 STW(stop the word),导致他们啥也干不了,这个问题自 Java 帝国诞生起就出现了,能否解决一下」

38 |

39 | 「这没办法,STW 是必须的,总不能一边清理垃圾一边扔垃圾吧,那垃圾还怎么收拾地干净」

40 |

41 | 「STW 确实不能避免,但能否减少 GC 次数呢,GC 次数少了,STW 自然也少了,GC 发生在堆中,那只要对象不分配在堆中,GC 次数不就自然而然少了吗」线臣大臣说到

42 |

43 | 「难不成要把它分配在栈上?」老虚一听能减少 GC 次数,顿时来了精神

44 |

45 | 「没错,就是要把它分配在栈上!这样线程在调用栈销毁后对象也就销毁了」线程大臣看起来胸有成竹「但它首先必须满足一个条件:逃逸分析」

46 |

47 | 「什么是逃逸分析」老虚x疑惑道

48 |

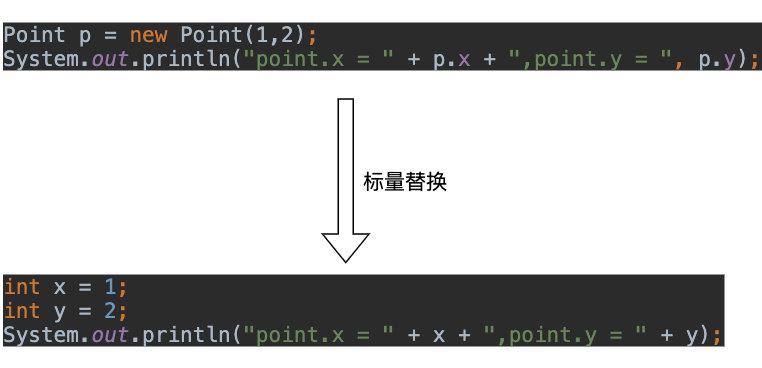

49 | > 逃逸分析是指分析指针动态范围的方法,分析在程序的哪些地方可以访问到指针。当一个变量(或对象)在子程序中被分配时,一个指向变量的指针可能逃逸到其它执行线程中,或是返回到调用者子程序。我们就说这个对象「逃逸」了,否则就说对象未逃逸,未逃逸的对象是可以分配在堆栈上的(采用标量替换的形式)的。

50 |

51 | 「Talk is cheap, show me your code,举几个例子来吧」老虚道

52 |

53 | ```

54 | public class EscapeTest {

55 |

56 | public static Object globalVariableObject;

57 |

58 | public Object instanceObject;

59 |

60 | public void globalVariableEscape(){

61 | globalVariableObject = new Object(); // 1.静态变量,外部线程可见,发生逃逸

62 | }

63 |

64 | public void instanceObjectEscape(){

65 | instanceObject = new Object(); // 2.赋值给堆中实例字段,外部线程可见,发生逃逸

66 | }

67 |

68 | public Object returnObjectEscape(){

69 | return new Object(); // 3.返回实例,外部线程可见,发生逃逸

70 | }

71 |

72 | public void noEscape(){

73 | //仅创建线程可见,对象无逃逸

74 | Object noEscape = new Object(); //4. 仅创建线程可见,对象无逃逸

75 | }

76 |

77 | }

78 | ```

79 |

80 | 我们可以看到,当对象符合以下两种条件时我们就说它逃逸了

81 |

82 | 1. 被赋值给了对象的字段或类的变量,因为很显然对象分配在堆中,是线程共享的,其他线程可能对其进行修改

83 |

84 |

85 |

86 | 2. 对象被传进了不确定的代码中去运行,比如返回给上一个调用栈赋值给其他对象的属性等

87 |

88 | 只有那种满足条件 4 的仅创建线程可见的对象,才能被判断为无逃逸,才能将对象分配到堆上

89 |

90 | 「未逃逸的对象怎样才能被分配在栈上呢?」老虚还是有点困惑

91 |

92 | 「我们先了解两个名词:**标量**和**聚合量**,标量就是不可进一步分解的量,像 Java 的基本类型如 int 等基本类型以及 reference 类型就是标量,聚合量就简单了,就是各个标量的组合,对象其实就是聚合量,所以让对象分配在栈上其实很简单,将其替换为各个标量即可」线程大臣顿了顿,给出了标量替换的 demo

93 |

94 |

95 |

96 | 「妙啊,通过将对象打散为多个标量,由于标量是直接在栈上分配的,就避免了对象在堆中的分配」这个思路确实给力!老虚立即下令实行

97 |

98 | ### 锁消除

99 |

100 | 「老虚啊,我无意中发现未逃逸的对象还有锁消除功能」线程大臣兴奋地说

101 |

102 | 「啥是锁消除」老虚挺兴奋的

103 |

104 | 我们先来看看 StringBuffer 的 append 方法:

105 |

106 | ```

107 | @Override

108 | public synchronized StringBuffer append(Object obj) {

109 | toStringCache = null;

110 | super.append(String.valueOf(obj));

111 | return this;

112 | }

113 | ```

114 |

115 | 你看看是不是有个 synchronized 锁,那如果 StringBuffer 不是逃逸对象,比如下面这样

116 |

117 | ```

118 | public void test() {

119 | StringBuffer sb = new StringBuffer()

120 | sb.append(s1).append(s2)

121 | return sb.toString();

122 | }

123 | ```

124 |

125 | 那 append 方法的 Synchronized 锁就可以消除了对不对

126 |

127 | 「可以可以」老虚兴奋极了,完成之后 JVM 帝国的生产力又提升了一个新台阶。。。

--------------------------------------------------------------------------------

/网络/这个下载文件的问题困住了我至少三位同事.md:

--------------------------------------------------------------------------------

1 | 大家好,我是坤哥

2 |

3 | 今天给大家分享两个比较有用的浏览器行为与预期不一致的现象,这两个问题其实并不是什么难题,但在工作中发现不少人被难住了,在我的印象中至少有三位同事在群里问这样的问题,上周又有同事被此现象困住了,所以我觉得这应该是个共性问题,在这里分享给大家,希望对大家有帮助

4 |

5 | ### 现象一、点击按钮无法实现文件下载

6 |

7 | 前端同事反馈在浏览器里点击实现好的「下载商品图片」按钮却无法下载(预期应该下载 zip 文件)

8 |

9 |

10 |

11 | 但如果你在浏览器的地址栏里输入此下载地址却又能直接从浏览器里下载,这是为何?

12 |

13 | 我们可以打开调试工具「网络部分」,然后点击一下上面的「下载商品图片」,首先看一下网络请求是否正常。

14 |

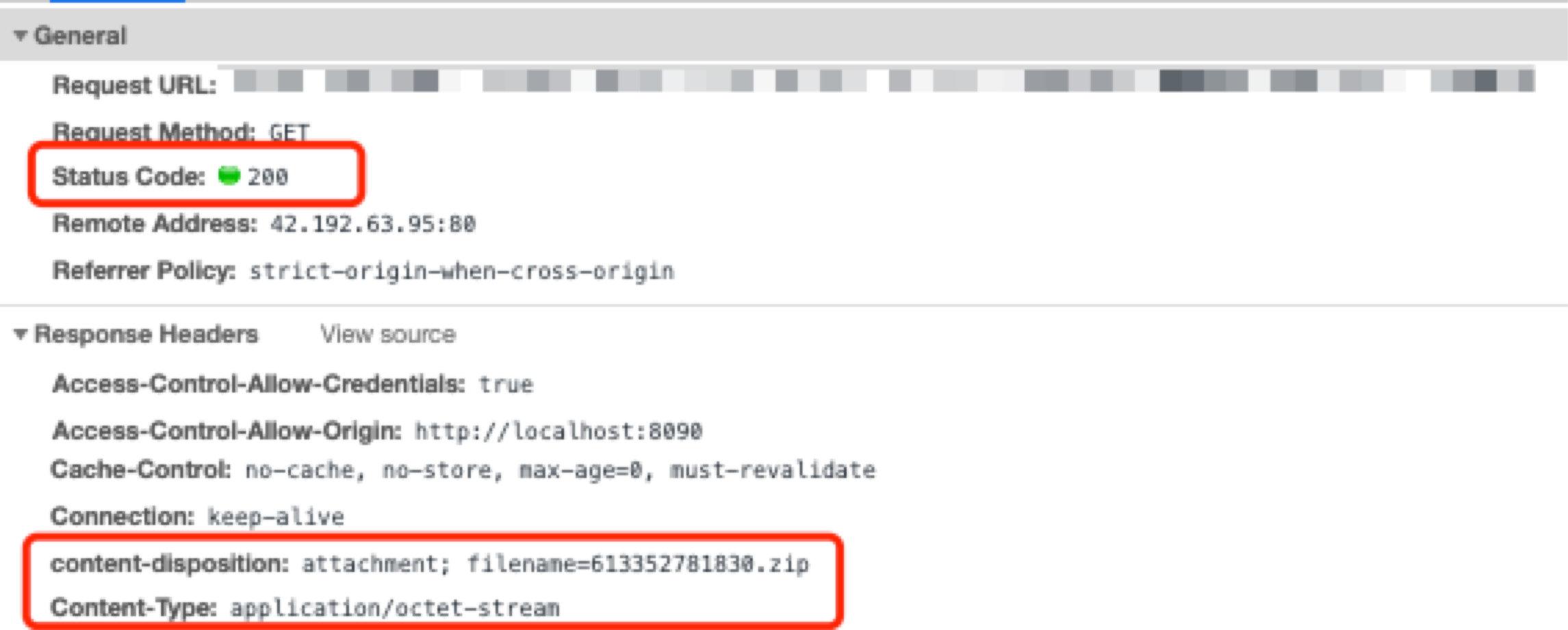

15 | 1、 首先看请求头,可以看出状态码是 200,另外还有 content-disposition 与 Content-Type 这两个 response header

16 |

17 |

18 | 画外音:`Content-Type: application/octet-stream` 告诉客户端这是一个二进制文件,`content-disposition` 告诉客户端这是一个需要下载的附件并告诉浏览器该附件默认的文件名。

19 |

20 |

21 | 2、再看此请求的 response body,是否和步骤一的 **application/octet-stream** 相符:

22 |

23 |

24 |

25 | 可以看到 response 就是一堆乱码,即文件的二进制流表现形式,所以从请求来看其实是没有问题的,文件是正常的返回的,但为啥文件却没有下载下来,下载下来的文件去哪里了呢,注意看上图的另一个红框 **XHR **,它的全称是 XMLHttpRequest,是 ajax 请求的一种表现形式。

26 |

27 | ajax 本身无法触发浏览器的下载功能, 它的 response 会交由 JavaScript 处理,使用 ajax 下载完成后,response 以字符串的形式存储在内存中,那使用 ajax 就没法下载了吗?不是的,我们看下浏览器为啥能下载

28 |

29 | 我们发现使用浏览器的 GET 请求(主要以 frame 加载, a 标签点击触发)或 POST请求(以 form 的形式存在)是可以下载文件的,因为这是浏览器的内置事件,下载的 response 会交由浏览器自己处理,浏览器如果识别到是二进制流数据则下载,如果识别到是可以打开的文件,如 xml, image 等则不会下载,会以预览的样式存在。

30 |

31 | 那么为啥 ajax 不能默认实现文件下载呢,这是浏览器的安全策略限制的,试想如果 ajax 可以下载文件,那就意味着 ajax 可以直接与磁盘交互,这会存在严重的安全隐患。

32 |

33 |

34 | 根据以上分析,要使用 ajax 下载文件我们也就有思路了,既然使用 a 标签(或 frame)的点击事件可以触发浏览器的内置下载行为,那我们在用 ajax 下载拿到 response 后,可以用 js 新建一个隐藏的 a 标签(标签的 href 指向文件的链接),执行它的 click 事件,这样就触发了浏览器的内置下载事件,就可以下载文件了,不过需要注意的事,创建的 a 标签中要添加一个 download 属性,如 下载。

35 |

36 | 这个 download 属性有啥用呢,对于浏览器能打开得文件,例如 html,xml 等,如果你不加 download,点击 a 标签就不是下载了,而是打开,(注意 download 属性目前只被火狐和谷歌兼容)

37 |

38 | 使用 ajax 来执行下载文件的代码示例如下:

39 |

40 | ```javascript

41 | const filename = response.headers['content-disposition'].match(

42 | /filename=(.*)/

43 | )[1]

44 | // 首先要创建一个 Blob 对象(表示不可变、原始数据的类文件对象)

45 | const blob = new Blob([response.data], {type: 'application/zip'});

46 | if (typeof window.navigator.msSaveBlob !== 'undefined') {

47 | // 兼容IE,window.navigator.msSaveBlob:以本地方式保存文件

48 | window.navigator.msSaveBlob(blob, decodeURI(filename))

49 | } else {

50 | let elink = document.createElement("a"); // 创建一个标签

51 | elink.style.display = "none"; // 隐藏标签

52 | elink.href = window.URL.createObjectURL(blob); // 配置href,指向本地文件的内存地址

53 | elink.download = filename;

54 | elink.click();

55 | URL.revokeObjectURL(elink.href); // 释放URL 对象

56 | document.body.removeChild(elink); // 移除标签

57 | }

58 | ```

59 |

60 |

61 | ### 现象二、在浏览器输入图片链接想预览,结果却变成了下载图片

62 |

63 | 这个问题其实经由上文分析,相信你不难猜出是咋回事,我们先抓包看一下:

64 |

65 |

66 |

67 | 可以看到返回的 Content-Type 为 `octet-stream`,上文我们提到,它指任意类型的二进制流数据,一般下载文件返回的是这种类型,浏览器由于无法识别打开流数据,所以会下载,那为啥大多数图片在浏览器上是可以预览的呢,因为它返回的 Content-Type 是 image/png 或 image/jpeg 等浏览器可以直接识别打开的文件,这样就不会执行下载事件

68 |

69 | ### 总结

70 |

71 | 以上两个问题需要我们对浏览器的工作机制与 HTTP 协议有一定的了解,所以基础真的很重要啊,不然很可能你排查半天也无从下手,但如果你知道了这些原理,抓个包分析一下它们的 Content-Type,瞬间就豁然开朗了!另外对一些疑难杂症,了解 HTTP 协议与浏览器的工作机制也有助于帮助你快速定位解决问题。

72 |

73 | 比如上图的解决方案中我们通过 content-disposition 来获取文件的名称

74 |

75 | ```javascript

76 | const filename = response.headers['content-disposition'].match(

77 | /filename=(.*)/

78 | )[1]

79 | ```

80 | 但在最开始发现这段代码有问题,打印日志发现 response.headers['content-disposition'] 居然为空,可是打开浏览器的 network 会发现, content-disposition 明明存在啊

81 |

82 |

83 |

84 | 那为啥在 reponse 的 header 里拿不到 content-disposition 呢?

85 |

86 | 一查发现原来还是 HTTP 协议的问题

87 |

88 | 默认情况下,header 只有七种 simple response headers (简单响应首部)可以暴露给外部:

89 |

90 | ```shell

91 | Cache-Control

92 | Content-Language

93 | Content-Length

94 | Content-Type

95 | Expires

96 | Last-Modified

97 | Pragma

98 | ```

99 |

100 | 这里的暴露给外部,意思是让客户端(比如 Chrome)可以访问得到,既可以在 Network 里看到,也可以在代码里获取到他们的值。

101 |

102 | 而 content-disposition 不在其中,所以即使服务器在协议回包里加了该字段,如下

103 |

104 | ```java

105 | response.setHeader("content-disposition", "attachment; filename=" + filename);

106 | ```

107 |

108 | 但因没“暴露”给外部,客户端就「看得到,吃不到」。

109 |

110 | 而响应首部 Access-Control-Expose-Headers 就是控制“暴露”的开关,它列出了哪些首部可以作为响应的一部分暴露给外部。

111 |

112 | 所以如果想要让客户端可以访问到其他的首部信息,服务器不仅要在 header 里加入该首部,还要将它们在 Access-Control-Expose-Headers 里面列出来,如下:

113 |

114 | ```java

115 | response.setHeader("Access-Control-Expose-Headers", "Content-Disposition");

116 | response.setHeader("content-disposition", "attachment; filename=" + filename);

117 | ```

118 |

119 | 这样的话 JS 的 response header 里就有 content-disposition 的值啦。

120 |

121 |

122 | 更多精品文章,欢迎大家扫码关注「码海」

123 |

124 |

--------------------------------------------------------------------------------

/个人感悟/随想.md:

--------------------------------------------------------------------------------

1 | 大家好,我是坤哥

2 |

3 | 不少读者私下对我说我的朋友圈对他们的帮助很大,所以想了一下把一些有价值的思考提炼出来分享出来,希望对大家有帮助,也欢迎大家扫码加我好友,围观朋友圈,共同进步^_^

4 |

5 |

6 |

7 | ### 编程思维

8 |

9 | * 「分析源码第一步,先看一下单元测试用例。因为,一般单元测试中,每一个用例就是测试代码中的一个局部或者说是一个小流程。那对于一些比较完善的开源软件,它们的单元测试覆盖率都非常高,很容易找到我们关心的那个流程所对应的测试用例。我们的源码分析,就可以从这些测试用例入手,一步一步跟踪其方法调用链路,理清实现过程。」摘自极客时间,说得不错/:handclap

10 |

11 | * JAVA 网络,看到一个比喻挺不错的(有一些瑕疵,不过不影响整体理解),分享给大家:

12 | 例子:有一个养鸡的农场,里面养着来自各个农户(Thread)的鸡(Socket),每家农户都在农场中建立了自己的鸡舍(SocketChannel)

13 | 1、BIO:Block IO,每个农户盯着自己的鸡舍,一旦有鸡下蛋,就去做捡蛋处理;

14 | 2、NIO:No-Block IO-单Selector,农户们花钱请了一个饲养员(Selector),并告诉饲养员(register)如果哪家的鸡有任何情况(下蛋)均要向这家农户报告(select keys);

15 | 3、NIO:No-Block IO-多Selector,当农场中的鸡舍逐渐增多时,一个饲养员巡视(轮询)一次所需时间就会不断地加长,这样农户知道自己家的鸡有下蛋的情况就会发生较大的延迟。怎么解决呢?没错,多请几个饲养员(多Selector),每个饲养员分配管理鸡舍,这样就可以减轻一个饲养员的工作量,同时农户们可以更快的知晓自己家的鸡是否下蛋了;

16 | 4、Epoll模式:如果采用Epoll方式,农场问题应该如何改进呢?其实就是饲养员不需要再巡视鸡舍,而是听到哪间鸡舍的鸡打鸣了(活跃连接),就知道哪家农户的鸡下蛋了;

17 | 5、AIO:Asynchronous I/O, 鸡下蛋后,以前的NIO方式要求饲养员通知农户去取蛋,AIO模式出现以后,事情变得更加简单了,取蛋工作由饲养员自己负责,然后取完后,直接通知农户来拿即可,而不需要农户自己到鸡舍去取蛋。

18 |

19 | * 在看 ConcurrentHashMap 源码,看到 helpTransfer 的方法时,被一个地方卡住了,联系上下文,想了半天,总感觉这里有问题

20 |

21 |

22 |

23 | 于是打开 https://bugs.java.com/bugdatabase/view_bug.do 搜了一下,果然是 bug!比较坑爹的是这个 bug 在 JDK 12 才解决,顺便感叹一句,搜了不少靠前的文章,都讲到这一段,但都没有发现这是 bug,怀疑还是很重要的,即便这是 Doug Lea 写的。源码要看,但要细看,指不定你哪天也在这上面提一下 bug,简历上可以增添一句:我是给 bugs.java.com 提过 bug 的男人,简历瞬间熠熠生辉😃

24 |

25 | * 看了一篇被誉为是"程序员史诗般必读文章"的论文,同时也是 Kafka 的起源论文,大受震憾,中文版:https://www.kancloud.cn/kancloud/log-real-time-datas-unifying/58711

26 |

27 | * 接手了一个很复杂的 PHP 转 Java 的工作,评估了一下工作量,如果硬转,估计一天都搞不定,这个功能其实用的很少,于是想到 Java 可以执行 shell,这样直接在 Java 里调用执行 php 脚本的命令(php xxx.php)就可拿到结果,处理后,10 分钟搞定,先思考再动手,结果会大不一样[Smirk]

28 |

29 | * 极客时间李智慧的《高并发架构实战课》确实给力!不管是秒杀还是短链设计虽然我之前我都写过,但这门课在这两节中依然给出了让我眼前一亮的思路,每一章节信息量都很大,比如短链设计中提到居然可以将 144 亿条 86.4GB 的短链提前生成保存在一个 HDFS 文件中!短链过期后还可以重复利用(过个一两年其实这些短链也就过期了),而我们之前短链的设计是连续递增,使用openrestry 等方案来实现高性能,看完这门课之后最大的感叹是原来高性能还可以用这些相对简单的技术来实现,设计思路都挺巧妙的/::,@

30 |

31 | * 美团的这篇垃圾回收写得太棒了!不过文章略长,2万多字,记笔记都记了好久,慢用/:,@P https://tech.meituan.com/2020/11/12/java-9-cms-gc.html

32 |

33 | * 发现一本神作《Inside Java Virtual Machine》,虽然是2000年出版的,但关于JVM的知识点讲得很细,不少东西依然不过时,是对《深入理解Java虚拟机》很好的补充

34 |

35 | * 非常好的一篇线上问题复盘文章,信息量很大,GET 到很多新技能,比如

36 |

37 | 1. 可以使用 OQL(类 SQL)来查找容量大于 xx 的对象

38 | 2. 在 FullGC 后新老年代都占用 700 M 的空间下,JVM 却依然持续进行 full GC,原因居然是 Vector 扩容引起的

39 |

40 | 最后的解决方案也是挺巧妙的,推荐看看

41 |

42 | https://tech.ebayinc.com/engineering/sre-case-study-triage-a-non-heap-jvm-out-of-memory-issue/

43 |

44 | * 最近看了一些秒杀方面的东西,收获颇丰,推荐几个很有技术含量的秒杀项目或文章,希望对大家有帮助

45 |

46 | 1. 极客时间的《手把手带你搭建秒杀系统》从 0 到 1 带你打造一个百万 QPS 的秒杀项目,关于秒杀理论讲解得很到位

47 | 2. 秒杀系统实战总结:https://mp.weixin.qq.com/s/yWn_2OQV31zn5wJKKejGug,一位技术总监关于秒杀的总结,实战性非常强

48 | 3. github 上的 2.2w 秒杀项目:https://github.com/qiurunze123/miaosha

49 |

50 | * 最近面试了不少前端,其中一位让我印象深刻,他在简历上写了一个可以演示的项目(计时展示一个皮卡丘的绘制过程,并且源码滚动展示),整体聊下来感觉非常好,其实说实话谁也不想问那些枯燥的八股文,如果有项目经验,顺着项目问相关知识点最舒服,如果可以演示就更棒了/:handclap

51 |

52 | * 提起IO多路复用,我们第一感觉是复用一个线程去处理大量的 Socket 连接,今天看到一个观点很受启发,复用更多的是指系统调用的复用,「因为在非阻塞 IO 时,就已经可以实现一个线程处理多个网络连接了,这个是由于其非阻塞而决定的(下图为非阻塞IO)多路复用主要复用的是通过有限次的系统调用来实现管理多个网络连接。最简单来说,我目前有 10 个连接,我可以通过一次系统调用将这 10 个连接都丢给内核,让内核告诉我,哪些连接上面数据准备好了,然后我再去读取每个就绪的连接上的数据。因此,IO 多路复用,复用的是系统调用。通过有限次系统调用判断海量连接是否数据准备好了」

53 |

54 |

55 |

56 | * 推荐一门比较系统的计算机科学概览课程,在油管上非常火爆的计算机科学入门课程,累积千万播放,能够帮助我们在脑海中建立完整的计算机学科体系

57 |

58 | 很贴心的是,这个课程被一些计算机博主看到了之后,自发的组织起来,翻译了中文字幕,并将视频上传到了 B 站上,也建立了相应的 Github 项目,目前在 B 站的播放也有百万量级了。

59 |

60 | Github:https://github.com/1c7/Crash-Course-Computer-Science-Chinese

61 |

62 | Bilibili:https://www.bilibili.com/video/av21376839

63 |

64 | 每天在地铁上看几集,进步一点点[Smirk]

65 |

66 | * 网上不少博客说 disruptor 的 ringbuffer 满了之后会阻塞业务线程,差点我就信了,但转念一想 log4j2 用的也是 ringbuffer,它又是个如此常见的日志组件,这样的话岂不是打日志都得悠着点,看了一下源码,发现它有个 AsyncQueueFullPolicy 的选项,可以选择 discard 模式,这个 discard 模式用的是 disruptor 的 tryPublishEvent 的方法,用这个方法投递的话在 ringbuffer 满了之后并不会阻塞,而是会直接返回 false,而用 publishEvent 来投递的话则在 ringbuffer 满时会发生阻塞 1 纳秒现象。尽信书不如无书,确实要多探索一下,多读下源码,毕竟:源码之下无秘密!

67 |

68 | * 前端迟迟未招到合适的人,小程序的需求又特别多,于是这两周客串了一把前端,主要时间其实是花在界面的调整上,今天看需求准备开始搭页面时突然想到我们的 UI 稿是用 sketch 标的 html 页面,每个元素都有 css 等样式,是否可以写个脚本把这些 html 页面转成小程序代码,一搜居然还真有,阿里的 imgcook已经实现了,可以导出多端代码,试用了一下非常给力!导出的 css 还原度 100%!开发在导出的代码里稍作修改即可,大大减少了开发量和视觉走查成本,多思考,减少重复无效的工作,生活会更美好/:,@P,顺便说一句,阿里牛逼/::>

69 |

70 |

71 |

72 |

73 |

74 | ### 商业思维

75 |

76 | 1. 近期看到几例创业卖房或者抵押房子最后失败的案例,实在让人唏嘘,余世维曾经说过一句话我觉得每一个创业者都应该谨记:我在外面打拼不管结局如何,但我始终不会动用留给家里的这栋房产。这就是底线思维,创业者应该要做最坏的打算,留有最基本的底线(不影响冢人体面的生活),当然说来容易做来难,毕竟公司就像自己的孩子一样,很难接受它半路胎死腹中,所以说大部分人都不适合创业,要承受极高的压力和极有可能一无所有的窘境,别没事想着创业,做一夜暴富的美梦,如果一定要创业,建议做轻资产创业,比如做自媒体等,这样成本就只有一台电脑还有个人时间,后果也可以承受

77 |

78 | 2. 晚上打车回家,1.2 公里等了 15 分钟,本来挺恼火的,上车一问为什么这么久,司机说他注册了好多个平台,没留意到接单通知,并且补充说现在每天的接单收入都不及油钱,主要是因为疫情,大家都不敢出来消费了,而且现在出现大量的工厂倒闭潮,大量的服装厂,做外贸的等倒闭了,大家都不好过,他因为有不少人脉,帮了不少老板介绍了工作,所以比较了解这这些,他自己则准备再干一周也转行。想起王兴 2019 年所说的那句话:今年是未来十年最好的一年,现在仔细一想,确实有先见之明,时刻准备着过冬

79 |

80 | 3. 年初亦仁说今天应该全力发力抖音,深以为然,这两个月我们在抖音直播带货取得了挺大的突破,这个月预计可以提前完成单品牌单月百万 GMV 的目标,为什么很多商家现在都布局抖音了呢,因为阿里电商遭遇了比较大的挑战,和我们合作的某 TOP 3 品牌也反馈他们在淘宝,天猫的销量下滑了30%~40%,而抖音的电商数据一直在稳步增长,抖音毫无疑问是个不容忽视的巨大的金矿!

81 | 4. 好几位读者反应公司在裁员中,最近确实是裁员滚滚,资本趋冷,加入有稳定现金流的公司太重要了,存量博杀的时代,活着才是王道

82 | 5. 上个月为某品牌带货卖了两万多,品牌方觉得有点少,于是他们自己播了一场,结果只卖了 80,终于明白了我们的直播相对专业,于是毫无保留的把最新款式等他们觉得比较有用的款式以及其他一些商品信息同步给了我们/:,@P,这一方面说明了把一些看似简单的事情做到极致也是很强的竞争力,另一方面我觉得更重要得是让客户觉得我们做这事是专业,有壁垒的/::,@

83 |

84 | ### 其他

85 |

86 | * 今日的乌克兰与当年的国民政府何其相似,民众都处在悲惨的境地,都沦为大国博弈的棋子,都有一个将自己命运寄托于其他大国的“领袖”,如此焉能不败!天幸中国有润之!

87 |

88 | * 磁盘空间满了,准备删些文件,发现 QQ 居然占了好几个 G,于是手起刀落,直接卸载,这玩意貌似一年多没用了,以后估计也不会再怎么用了,重要的人和事都保存在微信里,这就够了。顺便推荐一款清理 mac 很好用的工具 omniDiskSweeper,使用 GUI 的形式能帮你按容量大小列出本机上的所有文件并删除,体验很不错

89 |

90 | * 晚上第一次看话剧,《最后晚餐》,确实精彩,两个演员撑起了一场一个半小时的戏,很有感染力,听到现场挺多人的啜泣声,记得有一篇文章说看一个演员的水平高低没有什么统一的标准,但如果长时间经历过话剧表演的演员表演功力一般很深厚,原因很简单,话剧是现场表演,到某段台词需要哭,那你就得立马哭,不像电影那样可以后期剪辑或者使用催泪剂来达成效果,建议大家有机会看看话剧,感受下现场表演的魅力/:,@P

91 |

92 |

--------------------------------------------------------------------------------

/系统设计/优秀程序员必备的四项能力.md:

--------------------------------------------------------------------------------

1 | ## 前言

2 | 一个优秀的程序员需要具备挺多特质的,比如好奇心,学习能力等,但在我看来一个优秀的程序员必须具备四项核心能力,哪四 项,先卖个关子,程序员最喜欢说的话是「Talk is Cheap, show me your code」,那我们先来看一道很常见的面试题

3 |

4 | > 如何快速定位IP对应的省份地址?

5 |

6 | 我们知道,每个省市都分配了一个 ip 段,如下

7 |

8 | ```shell

9 | [202.102.133.0, 202.102.133.255] 山东东营市

10 | [202.102.135.0, 202.102.136.255] 山东烟台

11 | [202.102.156.34, 202.102.157.255] 山东青岛

12 | [202.102.48.0, 202.102.48.255] 江苏宿迁

13 | [202.102.49.15, 202.102.51.251] 江苏泰州

14 | [202.102.56.0, 202.102.56.255] 江苏连云港

15 | ```

16 | 输入一个 ip 地址怎么做到秒级定位此 ip 所在的省市呢?

17 |

18 |

19 |

20 | **如图示:在百度上输入一个 ip 地址,能做到秒级展示其所属地,怎么做到的呢,背后用到了什么原理**

21 |

22 | 这就引入了我们要谈的程序员需要具备的第一项能力: **抽象问题**或者说**数据建模**的能力

23 |

24 | ## 抽象问题的能力

25 | 所谓抽象问题或者说数据建模的能力,即能把一个问题抽象或归类为某种方案来解决,比如要实现负载均衡, 会想到一致性哈希算法,要实现最短路径,想到使用动态规划, 微服务下要保证服务可用引入降级机制等等,一句话就是把具体的问题抽象成到解决此问题背后的方法论,进而用相关的技术方案得以解决。

26 |

27 | 回归到如何快速定位 IP 对应的省份地址这道题来看,如果我们不具备抽象问题的能力,硬着头皮从头到尾把输入的ip 与所有区间段的 ip 都遍历对比一遍,然后判断它落到哪个区间,那么 ip 地址有 32 位,共有 2^32 个,约有 42.9 亿个,用暴力遍历法每查找一个 ip 最坏情况下要遍历约 42 亿次,这种方法显然是不可行的。

28 |

29 | 所以我们必须得把这个问题抽象为另一种可行的方法,即: **二分查找**, ip 地址查找怎么就跟二分查找扯上关系了,背后的逻辑是什么,我们一起来看看。

30 |

31 | ip 地址不容易比较,那我们首先把 ip 地址转成整数,于是每个省市对应的 ip 地址区间就变成了整数区间,假设为如下区间

32 |

33 | ```shell

34 | [1, 5]

35 | [11, 15]

36 | [16, 20]

37 | [6, 10]

38 | ....

39 | ```

40 |

41 | 再以每个整数区间的起始数字对这些区间进行排序,排序后的区间如下

42 |

43 | ```shell

44 | [1, 5]

45 | [6, 10]

46 | [11, 15]

47 | [16, 20]

48 | ...

49 | ```

50 | 看到这些排序后的区间,想到了啥,二分查找就是在一组有序的数字中进行查找!是不是找到相似点了?

51 |

52 | 这里给没听过二分查找的读者简单普及下啥是二分查找,小时候可能我们都玩过猜字游戏,在纸面上写一个 1 到 100 的数字,比如 70,让对方猜,怎样猜才能猜最快。

53 |

54 | 1. 首先猜 1 和 100 的**中间数字** (1+ 100) / 2 = 50(取整)

55 | 2. 50 < 70, 于是我们继续猜 50 和 100 的**中间数字** (50+100) / 2 = 75

56 | 3. 75 > 70,于是我们继续猜 50 和 75 的**中间数字** (50+75) / 2 = 62

57 | 4. 依次持续类似以上的步骤,不断地缩小范围,直至找到 70

58 |

59 |

60 |

61 |

62 | 总共只猜了 7 次,比起我们从 1 猜到 100 效率高了十几倍,如果被猜字的范围从一扩大到成百上千万,提升的效率是指数级的!二分查找也叫折半查找(注意上文中加粗的**中间数字**),每查找一次,问题规模缩小一半,整体时间复杂度是O(logn),即使我们要在 42 亿的数字中查找数字,最多也只要查 32 次,所以采用二分查找对查找性能的提升无疑是巨大的!

63 |

64 | 二分查找是要在一堆有序的数字中精准地查找所要查找的数**是否存在**,而回过头来看已经排序好的以下 ip 段

65 |

66 | ```shell

67 | [1, 5]

68 | [6, 10]

69 | [11, 15]

70 | [16, 20]

71 | ...

72 | ```

73 |

74 | 我们要查找的是某个整数是否在一个有序数组的相邻两个数字的区间里,例如:取这些 ip 区间的起始地址组成一个数组 (1,6,11,16,....)(有序数组),如果我们要找的 ip 对应的整型为 14, 由于它在 [11,16) (11是闭区间,16是开区间) 之间,所以这个 ip 就落在 [11, 15] 这个 ip 区间,这样就找到了这个 ip 对应的省市了。

75 |

76 | 所以就由二分查找某个值是否存在转变成了查找某个值是否在有序数组中相邻的两个值之间了,这就引入了程序员要具备的第二层能力:举一反三或者说修改模型的能力

77 |

78 | ## 修改模型的能力

79 | 就像机器学习,现在其实有很多现成的模型可用,比如识别物的模型等等,我们需要的话可以直接拿来用,但是现有模型的准确率可能不是那么理想(比如只有80%),如果我们需要进一步地提升识别准确率,可能就需要对其参数进行进一步的调优,以进一步地优化模型,达到我们预期的值。

80 |

81 | 再比如当当网基于 Dubbo 的扩展版本开发的 Dubbox 也是由于原来的 Dubbo 功能不满足其团队需求而在其基础上修改扩展的。

82 |

83 | 回过头来看以上说的原来二分查找只是查找某个值是否存在,而我们现在要解决的问题是查找某个值是否在相邻的两个值之间,这本质是也是对模型的调优或修改,以进一步满足我们的要求。于是我们写下了如下代码

84 |

85 | ```java

86 | public static int bsearch(int[] a, int length, int value) {

87 | int low = 0;

88 | int high = length - 1;

89 | while (low <= high) {

90 | int mid = (low + high) / 2;

91 | if (a[mid] > value) {

92 | if (mid == 0) {

93 | return -1;

94 | }

95 | if (a[mid-1] <= value) {

96 | return mid-1;

97 | } else {

98 | high = mid-1;

99 | }

100 | }else {

101 | low = mid + 1;

102 | }

103 | }

104 | return -1;

105 | }

106 | ```

107 | 那这段代码有啥问题吗,或者说有哪些可以优化的空间,这就引入了程序员需要具备的第三项能力: 代码要有足够的健壮性

108 |

109 | ## 代码要有足够的健壮性

110 | 仔细看上文的代码,有两个地方有潜在隐患,一个是 length 可能是负数,而显然数组的长度不可能是负数,也就是说对这种异常数据应该**抛异常**。另外 **(low + higth) / 2** 这段代码中的 low+high 如果在数组很大的情况下比较容易造成溢出,所以可以改造成 low + (high - low) / 2, 另外为了提升性能可以把除以 2 改成位运算,即 **low + ((high - low) >> 1)**,于是代码变成了

111 |

112 | ```java

113 | public static int bsearch(int[] a, int length, int value) throws Exception {

114 |

115 | if (length < 0) {

116 | // 实际应该抛出一个继续自Exception的异常,这里为了方便直接抛出Exception

117 | throw new Exception("数据长度不合法");

118 | }

119 |

120 | int low = 0;

121 | int high = length - 1;

122 | while (low <= high) {

123 | int mid = low + ((high - low) >> 1);

124 | if (a[mid] > value) {

125 | if (mid == 0) {

126 | return -1;

127 | }

128 | if (a[mid-1] <= value) {

129 | return mid-1;

130 | } else {

131 | high = mid-1;

132 | }

133 | }else {

134 | low = mid + 1;

135 | }

136 | }

137 | return -1;

138 | }

139 | ```

140 | 有人可能觉得判断数组长度小于 0 过于严苛了,但是是人就会犯错误,这里也是为了强调我们对异常情况的处理要到位,说到代码的健壮性,这里再多说几句,在创业初期我司主要用的是 php,主要是创业团队追求快,用 PHP 这种弱类型语言开发确实效率高,不过不安全,线上多次出现因为变量可以随意赋值造成的多次线上故障,而 Java 这种强类型语言虽然开发效率上比 PHP 慢了不少,但强类型语言的特征保证了它的稳定,**足够安全**,所以后期随着人员的扩充,为了保证线上足够安全,我司去年把大部分的服务都 Java 化了,近年来有不少人唱衰 Java,但 Java 的安全,稳定性以及强大的生态能力注定了它的长久生命力。

141 |

142 | 代码写成这样看起来确实完美了,还能再优化吗,注意上文中的代码只适用于 int 的数组,如果我们想针对 short 或 long 型等类型的数组进行查找就无能为力了,所以这就引入了程序员需要具备的第四项能力: 代码要有足够的可扩展性

143 |

144 | ## 代码要有足够的可扩展性

145 | 怎么让 bsearch 这个二分查找也支持 long 型或 short 型数组呢,这里引入 Java 语言中的泛型,于是我们代码改造如下

146 |

147 | ```java

148 | public static int bsearch(T[] a, int length, T value) throws Exception {

149 | if (length < 0) {

150 | // 实际应该抛出一个继承自Exception的异常,这里为了方便直接抛出Exception

151 | throw new Exception("数据长度不合法");

152 | }

153 | int low = 0;

154 | int high = length - 1;

155 | while (low <= high) {

156 | int mid = low + ((high - low) >> 1);

157 | if (a[mid].compareTo(value) > 0) {

158 | if (mid == 0) {

159 | return -1;

160 | }

161 | if (a[mid-1].compareTo(value) <= 0) {

162 | return mid-1;

163 | } else {

164 | high = mid-1;

165 | }

166 | }else {

167 | low = mid + 1;

168 | }

169 | }

170 | return -1;

171 | }

172 | ```

173 |

174 | 写成这样,可以说我们的代码具有足够的健壮性与可扩展性了。

175 |

176 | ## 总结

177 | 本文通过一个常见的面试题来详细阐述了优秀程序员必须具备的四项核心能力: 抽象问题,修改模型,写出健壮性,可扩展性的代码!所以为什么面试中大厂喜欢考算法,主要是想详细地了解你是否具备解决此算法题背后的思想,即**抽象问题**的能力,面试官还喜欢对相应算法题进行各种变形,其实也是为了考察你是否具有**修改模型**的能力(比如一个翻转链表,可以引申出顺序每 k 个一组翻转,逆序每 k 个一组翻转),所以为了同时具备这两项能力,我们需要提前掌握大量的理论知识,做大量的刻意练习。共勉!

--------------------------------------------------------------------------------

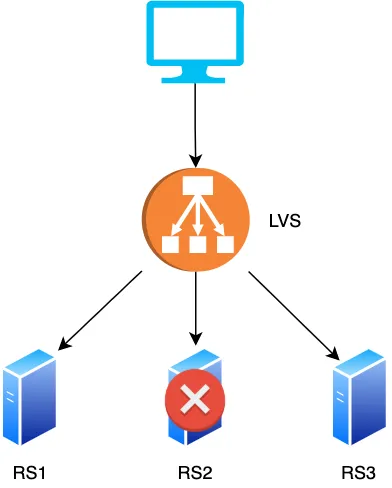

/系统设计/你管这破玩意儿叫负载均衡.md:

--------------------------------------------------------------------------------

1 | 相信大家都听过这样的一道经典面试题:「请说出在淘宝网输入一个关键词到最终展示网页的整个流程,越详细越好」

2 |

3 | 这个问题其实很难,涉及到 HTTP,TCP,网关,LVS 等一系列相关的概念及工作机制,如果你能掌握到这其中的每个知识点,那将极大地点亮你的技能树,你对于网络是如何运作也会了然于胸,即便不能完全掌握,但知道流量怎么流转的对你排查定位问题会大有帮助,我之前就利用这些知识定位到不少问题,为了弄清楚整个流程,我查阅了很多资料也请教了不少人,相信应该可以把这个问题讲明白,不过写着写着发现篇幅实在太长,所以分为上下两篇来分别介绍一下,本篇先介绍流量在后端的的整体架构图,下一篇会深入剖析细节点,如 LVS 的工作细节,这其中会涉及到交换机,路由器的工作机制等

4 |

5 |

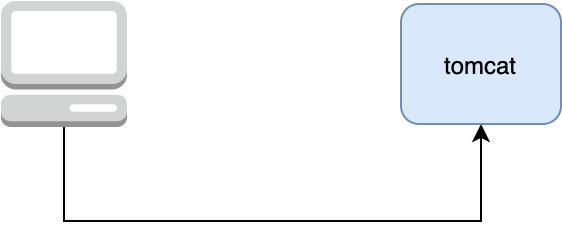

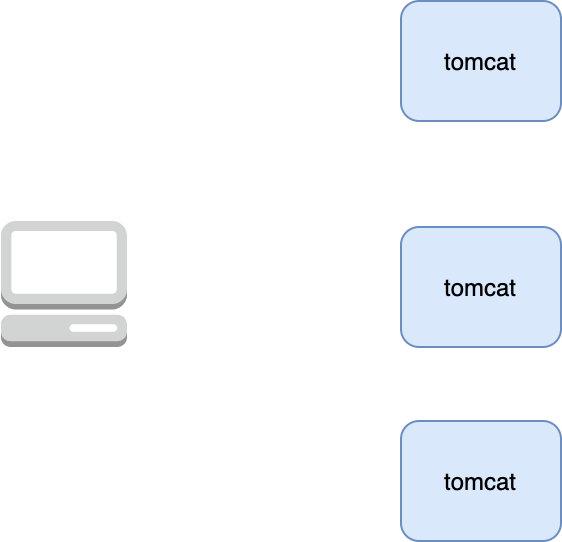

6 | 李大牛创业了,由于前期没啥流量,所以他只部署了一台 tomcat server,让客户端将请求直接打到这台 server 上

7 |

8 |

9 |

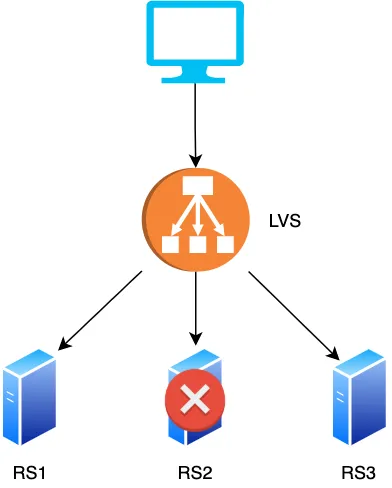

10 | 这样部署一开始也没啥问题,因为业务量不是很大,单机足以扛住,但后来李大牛的业务踩中了风口,业务迅猛发展,于是单机的性能逐渐遇到了瓶颈,而且由于只部署了一台机器,这台机器挂掉了业务也就跌零了,这可不行,所以为了避免单机性能瓶颈与解决单点故障的隐患,李大牛决定多部署几台机器(假设为三台),这样可以让 client 随机打向其中的一台机器,这样就算其中一台机器挂了,另外的机器还存活,让 client 打向其它没有宕机的机器即可

11 |

12 |

13 |

14 |

15 |

16 |

17 |

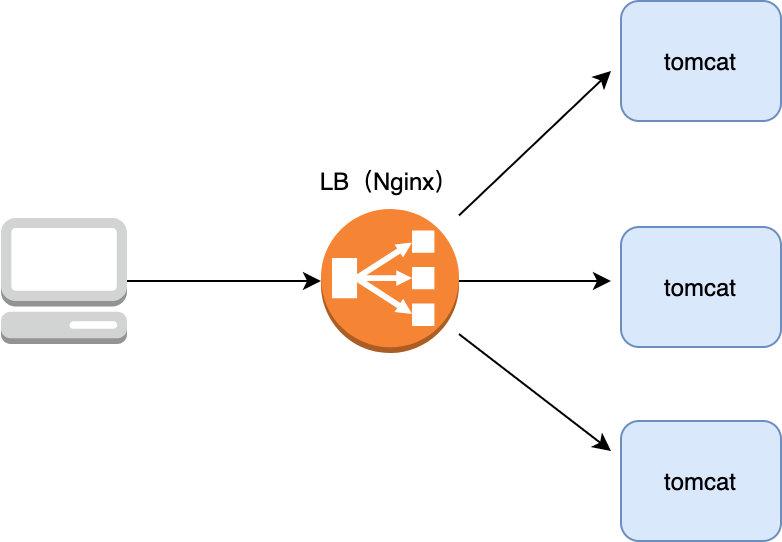

18 | 现在问题来了,client 到底该打向这三台机器的哪一台呢,如果让 client 来选择肯定不合适,因为如果让 client 来选择具体的 server,那么它必须知道有哪几台 server,然后再用轮询等方式随机连接其中一台机器,但如果其中某台 server 宕机了,client 是无法提前感知到的,那么很可能 client 会连接到这台挂掉的 server 上,所以选择哪台机器来连接的工作最好放在 server 中,具体怎么做呢,在架构设计中有个经典的共识:没有什么是加一层解决不了的,如果有那就再加一层,所以我们在 server 端再加一层,将其命名为 LB(Load Balance,负载均衡),由 LB 统一接收 client 的请求,然后再由它来决定具体与哪一个 server 通信,一般业界普遍使用 Nginx 作为 LB

19 |

20 |

21 |

22 |

23 |

24 |

25 |

26 |

27 |

28 |

29 |

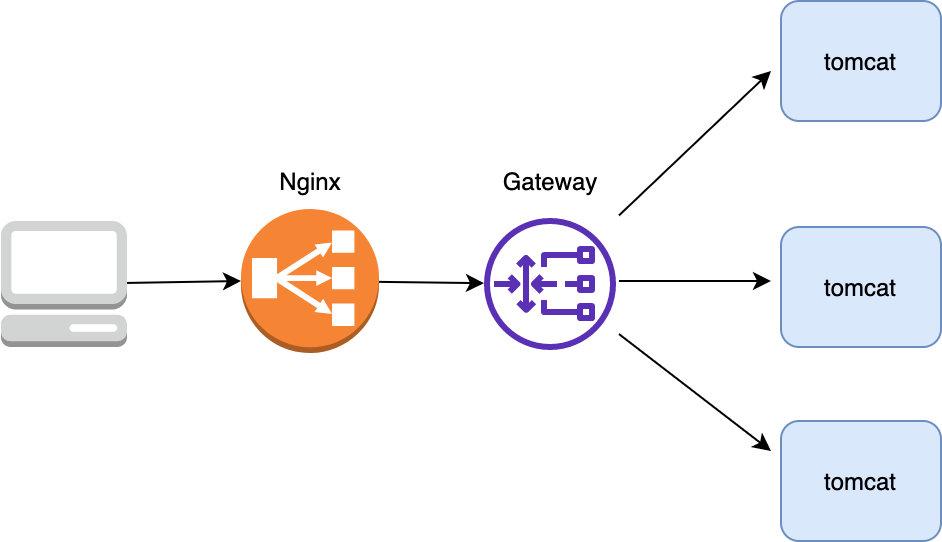

30 | 采用这样的架构设计总算支撑了业务的快速增长,但随后不久李大牛发现这样的架构有点问题:所有的流量都能打到 server 上,这显然是有问题的,不太安全,那能不能在流量打到 server 前再做一层鉴权操作呢,鉴权通过了我们才让它打到 server 上,我们把这一层叫做网关(为了避免单点故障,网关也要以集群的形式存在)

31 |

32 |

33 |

34 |

35 |

36 |

37 |

38 | 这样的话所有的流量在打到 server 前都要经过网关这一层,鉴权通过后才把流量转发到 server 中,否则就向 client 返回报错信息,除了鉴权外,网关还起到风控(防止羊毛党),协议转换(比如将 HTTP 转换成 Dubbo),流量控制等功能,以最大程度地保证转发给 server 的流量是安全的,可控的。

39 |

40 |

41 |

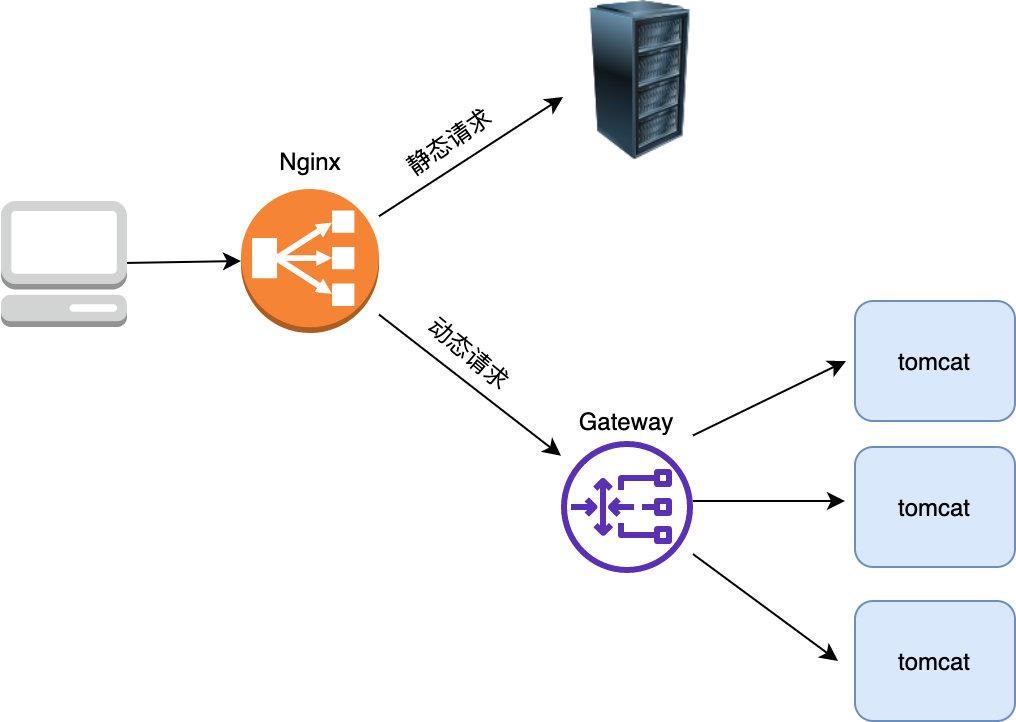

42 | 这样的设计持续了很长一段时间,但是后来李大牛发现这样的设计其实还是有问题,不管是动态请求,还是静态资源(如 js,css文件)请求都打到 tomcat 了,这样在流量大时会造成 tomcat 承受极大的压力,其实对于静态资源的处理 tomcat 不如 Nginx,tomcat 每次都要从磁盘加载文件比较影响性能,而 Nginx 有 proxy cache 等功能可以极大提升对静态资源的处理能力。

43 |

44 | **画外音:所谓的 proxy cache 是指 nginx 从静态资源服务器上获取资源后会缓存在本地的内存+磁盘中,下次请求如果命中缓存就从 Nginx 本机的 Cache 中直接返回了**

45 |

46 |

47 |

48 | 所以李大牛又作了如下优化:如果是动态请求,则经过 gateway 打到 tomcat,如果是静态请求,则打到静态资源服务器上

49 |

50 |

51 |

52 | 这就是我们所说的**动静分离**,将静态请求与动态请求分开,这样 tomcat 就可以专注于处理其擅长的动态请求,而静态资源由于利用到了 Nginx 的 proxy cache 等功能,后端的处理能力又上了一个台阶。

53 |

54 |

55 |

56 | 另外需要注意的是并不是所有的动态请求都需要经过网关,像我们的运营中心后台由于是内部员工使用的,所以它的鉴权与网关的 api 鉴权并不相同,所以我们直接部署了两台运营中心的 server ,直接让 Nginx 将运营中心的请求打到了这两台 server 上,绕过了网关。

57 |

58 |

59 |

60 |

61 |

62 | 当然为了避免单点故障 Nginx 也需要部署至少两台机器,于是我们的架构变成了下面这样,Nginx 部署两台,以主备的形式存在,备 Nginx 会通过 keepalived 机制(发送心跳包) 来及时感知到主 Nginx 的存活,发现宕机自己就顶上充当主 Nginx 的角色

63 |

64 |

65 |

66 |

67 |

68 |

69 |

70 | 看起来这样的架构确实不错,但要注意的是 Nginx 是七层(即应用 层)负载均衡器 ,这意味着如果它要转发流量首先得和 client 建立一个 TCP 连接,并且转发的时候也要与转发到的上游 server 建立一个 TCP 连接,而我们知道建立 TCP 连接其实是需要耗费内存(TCP Socket,接收/发送缓存区等需要占用内存)的,客户端和上游服务器要发送数据都需要先发送暂存到到 Nginx 再经由另一端的 TCP 连接传给对方。

71 |

72 |

73 |

74 |

75 |

76 |

77 |

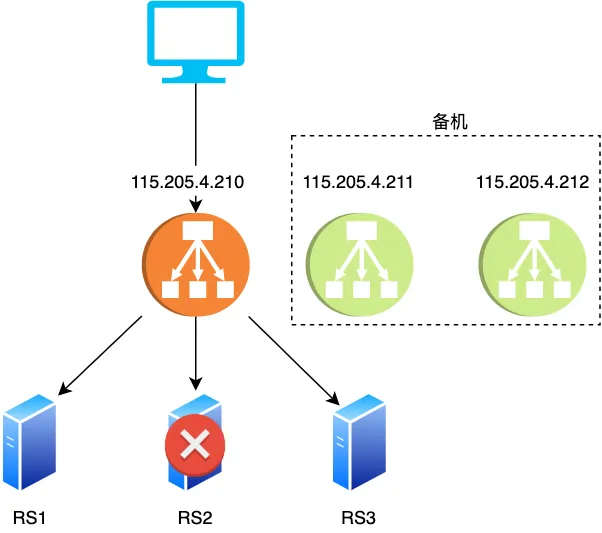

78 | 所以 Nginx 的负载能力受限于机器I/O,CPU内存等一系列配置,一旦连接很多(比如达到百万)的话,Nginx 抗负载能力就会急遽下降。

79 |

80 |

81 |

82 | 经过分析可知 Nginx 的负载能力较差主要是因为它是七层负载均衡器必须要在上下游分别建立两个 TCP 所致,那么是否能设计一个类似路由器那样的只负载转发包但不需要建立连接的负载均衡器呢,这样由于不需要建立连接,只负责转发包,不需要维护额外的 TCP 连接,它的负载能力必然大大提升,于是四层负载均衡器 LVS 就诞生了,简单对比下两者的区别

83 |

84 |

85 |

86 |

87 |

88 | 可以看到 LVS 只是单纯地转发包,不需要和上下游建立连接即可转发包,相比于 Nginx 它的抗负载能力强、*性能*高,能达到 F5 硬件的 60%;对内存和cpu资源消耗比较低

89 |

90 |

91 |

92 | > 那么四层负载均衡器是如何工作的呢

93 |

94 |

95 |

96 | 负载均衡设备在接收到第一个来自客户端的SYN 请求时,即通过负载均衡算法选择一个最佳的服务器,并对报文中目标IP地址进行修改(改为后端服务器 IP ),直接转发给该服务器。TCP 的连接建立,即三次握手是客户端和服务器直接建立的,负载均衡设备只是起到一个类似路由器的转发动作。在某些部署情况下,为保证服务器回包可以正确返回给负载均衡设备,在转发报文的同时可能还会对报文原来的源地址进行修改。

97 |

98 |

99 |

100 | 综上所述,我们在 Nginx 上再加了一层 LVS,以让它来承接我们的所有流量,当然为了保证 LVS 的可用性,我们也采用主备的方式部署 LVS,另外采用这种架构如果 Nginx 容量不够我们可以很方便地进行水平扩容,于是我们的架构改进如下:

101 |

102 |

103 |

104 |

105 |

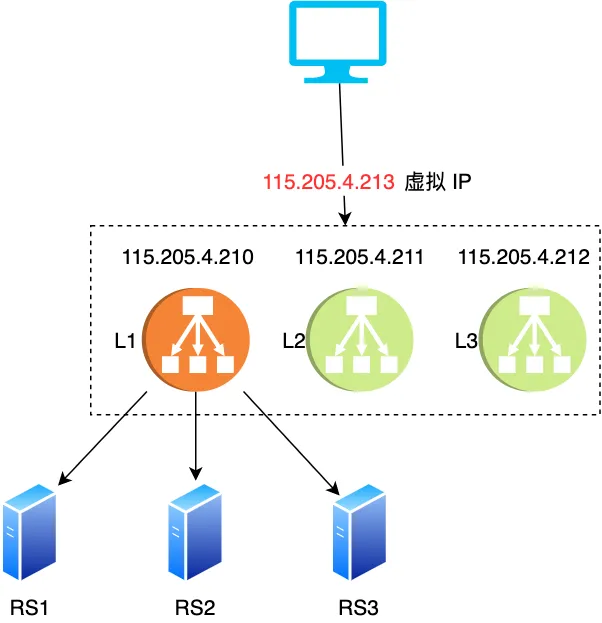

106 |

107 |

108 | 当然只有一台 LVS 的话在流量很大的情况下也是找不住的,怎么办,多加几台啊,使用 DNS 负载均衡在解析域名的时候随机打到其中一台不就行了

109 |

110 |

111 |

112 |

113 |

114 |

115 |

116 | 通过这样的方式终于可以让流量稳定流转了,有个点可能一些朋友会有疑问,下面我们一起来看看

117 |

118 |

119 |

120 | > 既然 LVS 可以采用部署多台的形式来避免单点故障,那 Nginx 也可以啊,而且 Nginx 在 1.9 之后也开始支持*四层负载*均衡了,所以貌似 LVS 不是很有必要?

121 |

122 | 如果不用 LVS 则架构图是这样的

123 |

124 |

125 |

126 | 通过部署多台 Nginx 的方式在流量不是那么大的时候确实是可行,但 LVS 是 Linux 的内核模块,工作在内核态,而 Nginx 工作在用户态,也相对比较重,所以在性能和稳定性上 Nginx 是不如 LVS 的,这就是为什么我们要采用 LVS + Nginx 的部署方式。

127 |

128 |

129 |

130 | 另外相信大家也注意到了,如果流量很大时,静态资源应该部署在 CDN 上, CDN 会自动选择离用户最近的节点返回给用户,所以我们最终的架构改进如下

131 |

132 |

133 |

134 |

135 |

136 | ### 总结

137 |

138 | 架构一定要结合业务的实际情况来设计,脱离业务谈架构其实是耍流氓,可以看到上文每一个架构的衍化都与我们的业务发展息息相关,对于中小型流量没有那么大的公司,其实用 Nginx 作为负载均衡足够,在流量迅猛增长后则考虑使用 lvs+nginx,当然像美团这样的巨量流量(数十 Gbps的流量、上千万的并发连接),lvs 也不管用了(实测虽然使用了 lvs 但依然出现了不少丢包的现象)所以它们开发出了自己的一套四层负载均衡器 MGW

139 |

140 | 另外看了本文相信大家对分层的概念应该有更透彻的理解,没有什么是分层解决不了的事,如果有,那就再多加一层,分层使每个模块各司其职,功能解藕,而且方便扩展,大家很熟悉的 TCP/IP 就是个很好的例子,每层只管负责自己的事,至于下层是什么实现的上层是不 care 的

141 |

142 | 以上就是本文的全部内容,希望大家看了有收获^_^,下一篇我们再继续深入探究一个请求的往返链路,会深入剖析 LVS,交换机,路由器等的工作原理,敬请期待 ^_^

143 |

144 |

145 | 更多精品文章,欢迎大家扫码关注「码海」

146 |

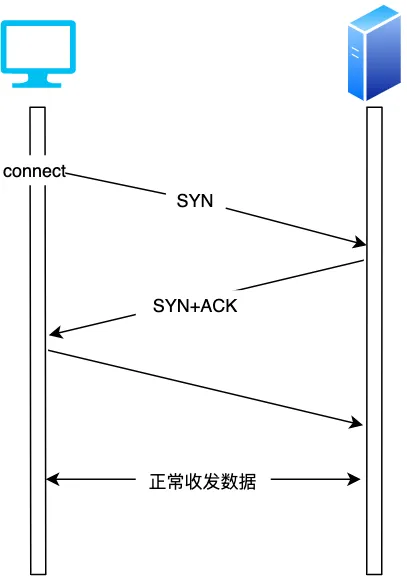

147 |

--------------------------------------------------------------------------------

/程序人生/优秀的程序员应该具备哪些能力.md:

--------------------------------------------------------------------------------

1 |

2 | 我认为以下特性是一个优秀程序员的必备素质。

3 | 1. 抽象问题或者说数据建模的问题:将复杂的问题转化为相应的方法论来解决,比如说打的时显示的导航按最短距离,最短用时等展示给用户,所用的解决方式就是用图论的方式来建模

4 | 2. 修改模型的能力:即对现成的模型进行修改以更好地满足业务需求,比如说对开源库进行修改以更好地适应业务的需求

5 | 3. 举一反三的能力:比如说你写了几年的 PHP,突然丢给你一个 Java 的项目,你能否在较短的时间内熟悉 Java 语法 ,快速上手,这项能力可以看出程序员的底层功底是否扎实,因为语言只是表现形式,只是工具,内功才是区分工程师是否优秀的重要特性,想想看杨过神功大成后,使用木剑还是使用玄铁重剑对他来说区别大吗。

6 | 4. 写出的代码要有足够的健壮性,可扩展性:比如你写个功能模块,是否考虑异常等场景,再比如产品需求变了,你的代码是否能够做到几乎不改动,因为我们知道代码越写隐藏的 bug 越多,所以如果可扩展性好的话极大避免了给队友埋坑的可能

7 |

8 | 说了这么多我相信大家还是觉得太理论化了,好,那我们就来看一道题来演练一下工程师的能力模型

9 |

10 | > 题目:如何快速定位IP对应的省份地址?

11 |

12 | 我们知道,每个省市都分配了一个 ip 段,如下

13 |

14 | ```shell

15 | [202.102.133.0, 202.102.133.255] 山东东营市

16 | [202.102.135.0, 202.102.136.255] 山东烟台

17 | [202.102.156.34, 202.102.157.255] 山东青岛

18 | [202.102.48.0, 202.102.48.255] 江苏宿迁

19 | [202.102.49.15, 202.102.51.251] 江苏泰州

20 | [202.102.56.0, 202.102.56.255] 江苏连云港

21 | ```

22 | 输入一个 ip 地址怎么做到秒级定位此 ip 所在的省市呢?

23 |

24 |

25 |

26 | **如图示:在百度上输入一个 ip 地址,能做到秒级展示其所属地,怎么做到的呢,背后用到了什么原理**

27 |

28 | 这就引入了我们要谈的程序员需要具备的第一项能力: **抽象问题**或者说**数据建模**的能力

29 |

30 | ## 抽象问题的能力

31 | 所谓抽象问题或者说数据建模的能力,即能把一个问题抽象或归类为某种方案来解决,比如要实现负载均衡, 会想到一致性哈希算法,要实现最短路径,想到使用动态规划, 微服务下要保证服务可用引入降级机制等等,一句话就是把具体的问题抽象成到解决此问题背后的方法论,进而用相关的技术方案得以解决。

32 |

33 | 回归到如何快速定位 IP 对应的省份地址这道题来看,如果我们不具备抽象问题的能力,硬着头皮从头到尾把输入的ip 与所有区间段的 ip 都遍历对比一遍,然后判断它落到哪个区间,那么 ip 地址有 32 位,共有 2^32 个,约有 42.9 亿个,用暴力遍历法每查找一个 ip 最坏情况下要遍历约 42 亿次,这种方法显然是不可行的。

34 |

35 | 所以我们必须得把这个问题抽象为另一种可行的方法,即: **二分查找**, ip 地址查找怎么就跟二分查找扯上关系了,背后的逻辑是什么,我们一起来看看。

36 |

37 | ip 地址不容易比较,那我们首先把 ip 地址转成整数,于是每个省市对应的 ip 地址区间就变成了整数区间,假设为如下区间

38 |

39 | ```shell

40 | [1, 5]

41 | [11, 15]

42 | [16, 20]

43 | [6, 10]

44 | ....

45 | ```

46 |

47 | 再以每个整数区间的起始数字对这些区间进行排序,排序后的区间如下

48 |

49 | ```shell

50 | [1, 5]

51 | [6, 10]

52 | [11, 15]

53 | [16, 20]

54 | ...

55 | ```

56 | 看到这些排序后的区间,想到了啥,二分查找就是在一组有序的数字中进行查找!是不是找到相似点了?

57 |

58 | 这里给没听过二分查找的读者简单普及下啥是二分查找,小时候可能我们都玩过猜字游戏,在纸面上写一个 1 到 100 的数字,比如 70,让对方猜,怎样猜才能猜最快。

59 |

60 | 1. 首先猜 1 和 100 的**中间数字** (1+ 100) / 2 = 50(取整)

61 | 2. 50 < 70, 于是我们继续猜 50 和 100 的**中间数字** (50+100) / 2 = 75

62 | 3. 75 > 70,于是我们继续猜 50 和 75 的**中间数字** (50+75) / 2 = 62

63 | 4. 依次持续类似以上的步骤,不断地缩小范围,直至找到 70

64 |

65 |

66 |

67 |

68 | 总共只猜了 7 次,比起我们从 1 猜到 100 效率高了十几倍,如果被猜字的范围从一扩大到成百上千万,提升的效率是指数级的!二分查找也叫折半查找(注意上文中加粗的**中间数字**),每查找一次,问题规模缩小一半,整体时间复杂度是O(logn),即使我们要在 42 亿的数字中查找数字,最多也只要查 32 次,所以采用二分查找对查找性能的提升无疑是巨大的!

69 |

70 | 二分查找是要在一堆有序的数字中精准地查找所要查找的数**是否存在**,而回过头来看已经排序好的以下 ip 段

71 |

72 | ```shell

73 | [1, 5]

74 | [6, 10]

75 | [11, 15]

76 | [16, 20]

77 | ...

78 | ```

79 |

80 | 我们要查找的是某个整数是否在一个有序数组的相邻两个数字的区间里,例如:取这些 ip 区间的起始地址组成一个数组 (1,6,11,16,....)(有序数组),如果我们要找的 ip 对应的整型为 14, 由于它在 [11,16) (11是闭区间,16是开区间) 之间,所以这个 ip 就落在 [11, 15] 这个 ip 区间,这样就找到了这个 ip 对应的省市了。

81 |

82 | 所以就由二分查找某个值是否存在转变成了查找某个值是否在有序数组中相邻的两个值之间了,这就引入了程序员要具备的第二层能力:举一反三或者说修改模型的能力

83 |

84 | ## 修改模型的能力

85 | 就像机器学习,现在其实有很多现成的模型可用,比如识别物的模型等等,我们需要的话可以直接拿来用,但是现有模型的准确率可能不是那么理想(比如只有80%),如果我们需要进一步地提升识别准确率,可能就需要对其参数进行进一步的调优,以进一步地优化模型,达到我们预期的值。

86 |

87 | 再比如当当网基于 Dubbo 的扩展版本开发的 Dubbox 也是由于原来的 Dubbo 功能不满足其团队需求而在其基础上修改扩展的。

88 |

89 | 回过头来看以上说的原来二分查找只是查找某个值是否存在,而我们现在要解决的问题是查找某个值是否在相邻的两个值之间,这本质是也是对模型的调优或修改,以进一步满足我们的要求。于是我们写下了如下代码

90 |

91 | ```java

92 | public static int bsearch(int[] a, int length, int value) {

93 | int low = 0;

94 | int high = length - 1;

95 | while (low <= high) {

96 | int mid = (low + high) / 2;

97 | if (a[mid] > value) {

98 | if (mid == 0) {

99 | return -1;

100 | }

101 | if (a[mid-1] <= value) {

102 | return mid-1;

103 | } else {

104 | high = mid-1;

105 | }

106 | }else {

107 | low = mid + 1;

108 | }

109 | }

110 | return -1;

111 | }

112 | ```

113 | 那这段代码有啥问题吗,或者说有哪些可以优化的空间,这就引入了程序员需要具备的第三项能力: 代码要有足够的健壮性

114 |

115 | ## 代码要有足够的健壮性

116 | 仔细看上文的代码,有两个地方有潜在隐患,一个是 length 可能是负数,而显然数组的长度不可能是负数,也就是说对这种异常数据应该**抛异常**。另外 **(low + higth) / 2** 这段代码中的 low+high 如果在数组很大的情况下比较容易造成溢出,所以可以改造成 low + (high - low) / 2, 另外为了提升性能可以把除以 2 改成位运算,即 **low + ((high - low) >> 1)**,于是代码变成了

117 |

118 | ```java

119 | public static int bsearch(int[] a, int length, int value) throws Exception {

120 |

121 | if (length < 0) {

122 | // 实际应该抛出一个继续自Exception的异常,这里为了方便直接抛出Exception

123 | throw new Exception("数据长度不合法");

124 | }

125 |

126 | int low = 0;

127 | int high = length - 1;

128 | while (low <= high) {

129 | int mid = low + ((high - low) >> 1);

130 | if (a[mid] > value) {

131 | if (mid == 0) {

132 | return -1;

133 | }

134 | if (a[mid-1] <= value) {

135 | return mid-1;

136 | } else {

137 | high = mid-1;

138 | }

139 | }else {

140 | low = mid + 1;

141 | }

142 | }

143 | return -1;

144 | }

145 | ```

146 | 有人可能觉得判断数组长度小于 0 过于严苛了,但是是人就会犯错误,这里也是为了强调我们对异常情况的处理要到位,说到代码的健壮性,这里再多说几句,在创业初期我司主要用的是 php,主要是创业团队追求快,用 PHP 这种弱类型语言开发确实效率高,不过不安全,线上多次出现因为变量可以随意赋值造成的多次线上故障,而 Java 这种强类型语言虽然开发效率上比 PHP 慢了不少,但强类型语言的特征保证了它的稳定,**足够安全**,所以后期随着人员的扩充,为了保证线上足够安全,我司去年把大部分的服务都 Java 化了,近年来有不少人唱衰 Java,但 Java 的安全,稳定性以及强大的生态能力注定了它的长久生命力。

147 |

148 | 代码写成这样看起来确实完美了,还能再优化吗,注意上文中的代码只适用于 int 的数组,如果我们想针对 short 或 long 型等类型的数组进行查找就无能为力了,所以这就引入了程序员需要具备的第四项能力: 代码要有足够的可扩展性

149 |

150 | ## 代码要有足够的可扩展性

151 | 怎么让 bsearch 这个二分查找也支持 long 型或 short 型数组呢,这里引入 Java 语言中的泛型,于是我们代码改造如下

152 |

153 | ```java

154 | public static int bsearch(T[] a, int length, T value) throws Exception {

155 | if (length < 0) {

156 | // 实际应该抛出一个继承自Exception的异常,这里为了方便直接抛出Exception

157 | throw new Exception("数据长度不合法");

158 | }

159 | int low = 0;

160 | int high = length - 1;

161 | while (low <= high) {

162 | int mid = low + ((high - low) >> 1);

163 | if (a[mid].compareTo(value) > 0) {

164 | if (mid == 0) {

165 | return -1;

166 | }

167 | if (a[mid-1].compareTo(value) <= 0) {

168 | return mid-1;

169 | } else {

170 | high = mid-1;

171 | }

172 | }else {

173 | low = mid + 1;

174 | }

175 | }

176 | return -1;

177 | }

178 | ```

179 |

180 | 写成这样,可以说我们的代码具有足够的健壮性与可扩展性了。

181 |

182 |

183 | 如果大家觉得不错,希望能点个赞支持一下,感谢!也欢迎关注我的微信公众号:「码海」,共同进步

--------------------------------------------------------------------------------

/系统设计/金融监控实战.md:

--------------------------------------------------------------------------------

1 | ## 前言

2 | 从电商转金融 2 年多了,由于两者商业模式,流量的不同,期间踩了很多坑,尤其是在监控这一块,我们吃过不少苦头,前期由于监控缺失,造成了多起线上事故,经过一番摸索,我们实现了一些相对可行的监控方法,有效地保证了大盘及业务的稳定,在此总结出来分享给大家,希望能为大家提供一些金融场景下的监控思路,如果大家如有更好的思路,也欢迎共同探讨。

3 |

4 | 本文主要从以下几个方面来阐述:

5 |

6 | 1. 电商场景下的常用监控方式

7 | 2. 金融监控的难点

8 | 3. 金融场景下监控的几种可靠手段

9 |

10 | ## 电商场景下的常用监控方式

11 |

12 | 电商场景下的监控主要有两种,一种是流量监控(接口请求),一种是关键节点(如注册,下单)的监控

13 |

14 | 对于这两者监控来说,我们常用的手法就是打点,接口每请求一次或关键节点每生成一次打个点,这样我们就可以通过比较今天和昨天的打点数据来监控,以下为我们针对某一关键事件的打点数据

15 |

16 |

17 |

18 | **如图示:绿色代表今天打点数据,黄色代表昨天**

19 |

20 | 有了昨天和今天的打点数据我们要做监控就很简单了,可以对比同一时间段两者的打点数据,如果今天的打点数据相对于昨天下跌超过比如 50%,那么这个关键节点的路径可能是有问题的,就可以触发告警,如下图示

21 |

22 |

23 |

24 | 这两种监控之所以在电商场景下可行主要有两个原因:

25 |

26 | 一是因为电商场景下的流量比较大,流量大,那么每分钟的打点数据就比较大, 这样通过下跌百分比来触发告警误差相对较小,所以可行,另外流量大所以意味着有任何的风吹草动,比如因为页面不可用造成的投诉短时间内会暴增,或打点数据短时间的急剧下降,都能在较短的时候内提早预警,让我们及时发现问题所在。

27 |

28 | 二是因为电商下的关键节点相对比较少,主要无非就是「添加购物车」与「下单」等关键节点,关键节点少意味着只要关键节点出了问题了,通过上文所述的下跌百分比告警排查关键节点的路径是否出问题即可,由于关键节点少,整个需要关注的核心链路相对比较短,所以排查起来相对比较容易一些。

29 |

30 | ## 金融监控的难点

31 |

32 | 上节介绍的电商场景下的两种方案在金融场景上都不适用,原因主要是因为金融是一个低频操作,且电商场景下的日活通常能达到几十上百万,但金融场景下的日活要少个几十倍,这就意味着每个关键节点的打点每小时可能只有几十不到,可能在长达几十分钟内关键节点对应的打点都为 0,所以也就无法用这种下跌百分比的形式进行告警。为了更好地向大家介绍金融业务监控的痛点,还是先简单介绍一下金融业务。

33 |

34 | ### 金融业务简介

35 |

36 | 目前我们主要从事的是现金贷业务,属于助贷业务,所谓助贷,即平台方并不直接发放贷款,只是平台方利用自身的获客,贷后管理等优势为借款人撮合匹配资金方,以实现资金的融通,平台方收取相当的手续费。主要业务流程如下

37 |

38 |

39 |

40 | 我们平台会为每一个用户挑选其中与之匹配的资金方进行授信,这些资金方的风控策略不同,所以授信通过率,借款通过率这些核心指标自然有较大的差异,像一些头部资金方如马上消金或 360 借钱等通过率比较高,我们会给予更多的流量,而一些不太知名的资金方这些关键指标表现不太如人意,给之分配的流量自然较少。

41 |

42 | 为每一个用户匹配申请资金方后,通常都要经历以下周期:

43 |

44 |

45 |

46 | 1. 贷前:授信环节,资金方要给你额度,你总要提供身份证以及相关的学历等个人信息吧,这样资金方通过这些信息就可以评估你的信用,决定是否给你额度

47 | 2. 贷中:即借款环节,授信通过之后,用户就可以借款了

48 | 3. 贷后:即还款环节

49 |

50 | 可以看到对于每一步,尤其是贷前和贷中,核心流程的关键节点都非常多,关键节点多就意味着漏斗大,用户的转化就越低,关键节点的打点(如提交授信,提交借款)可能一天只有几千,平均到每分钟也就几次甚至没有,而且由于金融本身是个非常低频的操作,用户的行为具有很大的不确定性,可能今天 8~9 点提交授信人数有 50,但第二天 8~9 点提交授信人数又降到个位数了,这些在电商里肯定会触发告警的现象在金融里却再正常不过,所以初期常常出现这样一种现象:我们在监控图表上发现两天同一时间段某些资金方关键节点的打点(如提交授信,放款成功单数)相差巨大,但排查后发现链路却没有问题,搞得我们焦头烂额。

51 |

52 | 通过以上简介,相信大家不难理解电商场景下的监控不能照搬到金融场景中,我们必须要结合金融场景**低频**的特点来设计一套相应的监控体系。

53 |

54 |

55 | ## 金融场景下监控的几种可靠手段

56 |

57 | ### 1、针对每个资金方每个流程(贷前贷中贷后)成功数或成功率进行监控

58 |

59 | 针对以上所述金融低频的特点,我们设计了一套相对有效的监控系统,思路如下:虽然贷前,贷中,贷后每个流程的关键节点都很多,但其实我们没必要对所有的关键节点都进行监控,我们只需要对**每个资金方**的关键流程的成功结果(授信成功,借款成功,授信通过率,借款通过率)进行打点监控,因为如果授信或借款成功了,说明贷前和贷中的流程都没有问题了

60 |

61 |

62 |

63 |

64 | 注意我们需要分别对**每个资金方**的授信成功和借款成功都进行打点监控,因为统计总数成功没有意义,每个资金的风控策略和流量分配是不一样的,以成功总数来判断流程是否正常很可能导致一些资金方某天风控策略调整(或其他 bug)导致授信或借款全部失败而未被发现。

65 |

66 | 当然上文也说了,每个资金方授信成功或借款成功的总数很可能在几十分钟内都为 0,那我们可以以小时的成功总数来告警。 我们记录下每天每小时的成功总数,每半小时比较今天和过去一周同一时间段(平均值)近 X 小时内的成功数,如果低于过去一周平均成功数的一半,说明可能链接出问题了,就告警,这个 X 怎么选择呢,如果最近一小时成功总数小于 20(这个阈值需要根据实际情况选取),那我们就选今天和过去一周同一时间段最近两小时的成功总数进行比较,如果还是小于 20 ,那就选最近三小时的成功总数进行比较。。。,直到最近 X 小时的成功总数达到 20,这样误差就比较小了,通过这种方式的告警有效率目前为止 100%! 也发现了线上多起问题,钉钉告警展示如下:

67 |

68 |

69 |

70 | 优质资金方由于通过率高,分配的流量大,所以对应的每小时的成功数相对来说比较多,用这种与过去一周同一时间段平均值比较的方式来进行告警确实可行,但对于那些通过率较差的资金方呢,这些资金方可能一天总共才有几个成功数,用上面的告警方式误差较大,那我们就拉长一下时间线,统计近 8 个小时此资金方的成功数,如果为 0 ,说明可能有问题:

71 |

72 |

73 |

74 | 通过这种方式我们也发现了多起因为资金方风控调整导致授信/放款成功数降低导致的问题,及时通知资金方解决了问题。

75 |

76 | ### 2、巧用切面及时发现解决资金方异常

77 |

78 | 迄今为止,我们总共接入了二十几家资金方,每个资金方都有自己的一套接口规范,每个资金方的接口都不一样,总共可能接入了几百上千个接口,这就带来了一些隐患,如果由于我们代码的 bug 或资金方内部问题导致接口请求失败(通常是接口返回的状态码为失败的状态码),我们很难发现,有人说这不简单吗,如果接口返回的是失败的状态码,针对此时的请求错误告警不就行了。

79 |

80 | 这里有两个问题:

81 |

82 | 一是这种告警代码应该写在哪里,有人说就写在每个资金方的请求底层啊,如果是这样的话,监控代码与业务代码紧藕合,而且我们接入了二十几家资金方,每一家的底层请求对应的文件里都要一个个的写告警代码,工作量巨大,且之后如果新接资金方很容易忘记把告警代码给加上。

83 |