├── .DS_Store

├── .gitignore

├── README.md

├── SUMMARY.md

├── beats

├── README.md

├── file.md

├── metric.md

├── packet.md

└── winlog.md

├── contributors.md

├── cover.jpg

├── diff-hdfs.md

├── donors.md

├── elasticsearch

├── README.md

├── alias.md

├── api

│ ├── CRUD.md

│ ├── reindex.md

│ ├── script.md

│ └── search.md

├── auth

│ ├── searchguard-2.md

│ ├── searchguard.md

│ └── shield.md

├── hadoop

│ └── spark-streaming.md

├── ingest.md

├── monitor

│ ├── README.md

│ ├── api

│ │ ├── cat-cmd.md

│ │ ├── health.md

│ │ ├── index-stats.md

│ │ ├── node-stats.md

│ │ └── tasks-management.md

│ ├── bigdesk-banner.png

│ ├── bigdesk-indexing.png

│ ├── bigdesk-jvm.png

│ ├── bigdesk.md

│ ├── cerebro.md

│ ├── logging.md

│ ├── marvel-1.jpg

│ ├── marvel-2.jpg

│ ├── marvel-3.jpg

│ ├── marvel-4.jpg

│ ├── marvel-5.jpg

│ ├── marvel-6.jpg

│ ├── marvel.md

│ └── zabbix.md

├── other

│ ├── README.md

│ ├── elastalert.md

│ ├── grafana.md

│ ├── images

│ │ ├── grafana-1.png

│ │ ├── grafana-10.png

│ │ ├── grafana-11.png

│ │ ├── grafana-12.png

│ │ ├── grafana-13.png

│ │ ├── grafana-14.png

│ │ ├── grafana-15.png

│ │ ├── grafana-16.png

│ │ ├── grafana-17.png

│ │ ├── grafana-18.png

│ │ ├── grafana-19.png

│ │ ├── grafana-2.png

│ │ ├── grafana-20.png

│ │ ├── grafana-21.png

│ │ ├── grafana-3.png

│ │ ├── grafana-4.png

│ │ ├── grafana-5.png

│ │ ├── grafana-6.png

│ │ ├── grafana-7.png

│ │ ├── grafana-8.png

│ │ └── grafana-9.png

│ ├── juttle-viz.png

│ ├── juttle.md

│ ├── kale.md

│ ├── percolator.md

│ ├── rrd.md

│ └── watcher.md

├── performance

│ ├── bulk.md

│ ├── cache.md

│ ├── cluster-state.md

│ ├── curator.md

│ ├── fielddata.md

│ ├── gateway.md

│ └── profile.md

├── principle

│ ├── README.md

│ ├── auto-discovery.md

│ ├── indexing-performance.md

│ ├── realtime.md

│ ├── route-and-replica.md

│ └── shard-allocate.md

├── puppet.md

├── rollover.md

├── snapshot.md

├── template.md

├── testing.md

├── tribe.md

└── upgrade.md

├── kibana

├── README.md

├── difference.md

├── phantomjs.md

├── v3

│ ├── README.md

│ ├── advanced

│ │ ├── schema.md

│ │ ├── scripted.md

│ │ └── template.md

│ ├── aggs.md

│ ├── auth

│ │ ├── mojo-auth.md

│ │ ├── nginx.md

│ │ └── nodejs-cas.md

│ ├── configuration.md

│ ├── dashboard

│ │ ├── README.md

│ │ ├── queries-and-filters.md

│ │ └── rows-and-panels.md

│ ├── facet.md

│ ├── img

│ │ ├── alipay.png

│ │ ├── bettermap-gaode.png

│ │ ├── bettermap-heap.png

│ │ ├── class-cast-exception.jpg

│ │ ├── column-panel.png

│ │ ├── column.png

│ │ ├── cors.jpg

│ │ ├── hist-general.png

│ │ ├── hist-grid.png

│ │ ├── hist-mb.png

│ │ ├── hist-panel-mean.png

│ │ ├── hist-panel-percent.png

│ │ ├── hist-panel-queries.png

│ │ ├── hist-panel-style.png

│ │ ├── hist-panel.png

│ │ ├── hist-percent.png

│ │ ├── hist-queries.png

│ │ ├── hist-setting.png

│ │ ├── hist-stack.png

│ │ ├── hist-total-ps.png

│ │ ├── hist-total-scale.png

│ │ ├── hist-uniq-conf.png

│ │ ├── hist-uniq.png

│ │ ├── hist-view.png

│ │ ├── map-cn.png

│ │ ├── map-setting.png

│ │ ├── map-world.png

│ │ ├── query-topn.png

│ │ ├── sparklines-panel.png

│ │ ├── table-fields.png

│ │ ├── table-highlight.png

│ │ ├── table-micropanel.png

│ │ ├── table-paging.png

│ │ ├── table-panel-setting.png

│ │ ├── table-sorting.png

│ │ ├── table-trim.png

│ │ ├── terms-bar.png

│ │ ├── terms-donut.png

│ │ ├── terms-panel.png

│ │ ├── terms-pie-no-other.png

│ │ ├── terms-pie.png

│ │ ├── terms-stat-map.png

│ │ ├── terms-table.png

│ │ ├── topn-histogram.png

│ │ ├── topn-sparklines.png

│ │ ├── trends-panel.png

│ │ └── trends.png

│ ├── panels

│ │ ├── README.md

│ │ ├── bettermap.md

│ │ ├── column.md

│ │ ├── goal.md

│ │ ├── histogram.md

│ │ ├── hits.md

│ │ ├── map.md

│ │ ├── query.md

│ │ ├── sparklines.md

│ │ ├── stats.md

│ │ ├── table.md

│ │ ├── terms.md

│ │ ├── text.md

│ │ └── trends.md

│ ├── saving-and-loading.md

│ ├── simple.md

│ └── source-code-analysis

│ │ ├── README.md

│ │ ├── controller-and-service.md

│ │ ├── directives.md

│ │ ├── panel.md

│ │ ├── require.md

│ │ └── tree.md

└── v5

│ ├── README.md

│ ├── console.md

│ ├── dashboard.md

│ ├── discover.md

│ ├── examples

│ ├── README.md

│ ├── datehistogram_topn.png

│ ├── function-stack.md

│ ├── function_stack.png

│ ├── histogram-filters.md

│ ├── histogram_filters.png

│ ├── percentile-datehistogram.md

│ ├── percentile_datehistogram.png

│ ├── terms-split.md

│ ├── terms_split.png

│ ├── topn-datehistogram.md

│ └── topn_datehistogram.png

│ ├── plugin

│ ├── README.md

│ ├── app.md

│ ├── server-develop.md

│ └── vis-develop.md

│ ├── production.md

│ ├── settings.md

│ ├── setup.md

│ ├── source-code-analysis

│ ├── README.md

│ ├── dashboard.md

│ ├── discover.md

│ ├── indexjs.md

│ ├── kbnindex.md

│ └── visualize.md

│ ├── timelion.md

│ └── visualize

│ ├── README.md

│ ├── area.md

│ ├── bar.md

│ ├── lines.md

│ ├── map.md

│ ├── markdown.md

│ ├── metric.md

│ ├── pie.md

│ └── table.md

├── logstash

├── README.md

├── develop

│ ├── README.md

│ └── utmp.md

├── examples

│ ├── README.md

│ ├── java.md

│ ├── mysql-slow.md

│ ├── nginx-access.md

│ ├── nginx-error.md

│ ├── ossec.md

│ ├── postfix.md

│ └── windows.md

├── get-start

│ ├── README.md

│ ├── daemon.md

│ ├── full-config.md

│ ├── hello-world.md

│ ├── install-plugins.md

│ └── install.md

├── images

│ ├── logstash-arch.jpg

│ └── nxlog.png

├── performance

│ ├── README.md

│ ├── generator.md

│ └── monitor

│ │ ├── api.md

│ │ ├── heartbeat.md

│ │ ├── jconsole.png

│ │ └── jmx.md

├── plugins

│ ├── codec

│ │ ├── README.md

│ │ ├── collectd.md

│ │ ├── json.md

│ │ ├── multiline.md

│ │ └── netflow.md

│ ├── filter

│ │ ├── README.md

│ │ ├── date.md

│ │ ├── dissect.md

│ │ ├── elapsed.md

│ │ ├── geoip.md

│ │ ├── grok.md

│ │ ├── json.md

│ │ ├── kv.md

│ │ ├── metrics.md

│ │ ├── mutate.md

│ │ ├── ruby.md

│ │ └── split.md

│ ├── input

│ │ ├── README.md

│ │ ├── file.md

│ │ ├── stdin.md

│ │ ├── syslog.md

│ │ └── tcp.md

│ └── output

│ │ ├── elasticsearch.md

│ │ ├── email.md

│ │ ├── exec.md

│ │ ├── file.md

│ │ ├── hdfs.md

│ │ ├── nagios.md

│ │ ├── statsd.md

│ │ ├── stdout.md

│ │ └── tcp.md

├── scale

│ ├── README.md

│ ├── fluent.md

│ ├── heka.md

│ ├── kafka.md

│ ├── logstash-forwarder-java.md

│ ├── message-passing.md

│ ├── nxlog.md

│ ├── redis.md

│ └── rsyslog.md

└── source-code-analysis

│ ├── README.md

│ ├── event.md

│ └── pipeline.md

└── see-also.md

/.DS_Store:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/.DS_Store

--------------------------------------------------------------------------------

/.gitignore:

--------------------------------------------------------------------------------

1 | # Node rules:

2 | ## Grunt intermediate storage (http://gruntjs.com/creating-plugins#storing-task-files)

3 | .grunt

4 |

5 | ## Dependency directory

6 | ## Commenting this out is preferred by some people, see

7 | ## https://docs.npmjs.com/misc/faq#should-i-check-my-node_modules-folder-into-git

8 | node_modules

9 |

10 | # Book build output

11 | _book

12 |

13 | # eBook build output

14 | *.epub

15 | *.mobi

16 | *.pdf

17 |

18 | count.sh

19 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # 前言

2 |

3 | Elastic Stack 是 原 ELK Stack 在 5.0 版本加入 Beats 套件后的新称呼。

4 |

5 | Elastic Stack 在最近两年迅速崛起,成为机器数据分析,或者说实时日志处理领域,开源界的第一选择。和传统的日志处理方案相比,Elastic Stack 具有如下几个优点:

6 |

7 | * 处理方式灵活。Elasticsearch 是实时全文索引,不需要像 storm 那样预先编程才能使用;

8 | * 配置简易上手。Elasticsearch 全部采用 JSON 接口,Logstash 是 Ruby DSL 设计,都是目前业界最通用的配置语法设计;

9 | * 检索性能高效。虽然每次查询都是实时计算,但是优秀的设计和实现基本可以达到全天数据查询的秒级响应;

10 | * 集群线性扩展。不管是 Elasticsearch 集群还是 Logstash 集群都是可以线性扩展的;

11 | * 前端操作炫丽。Kibana 界面上,只需要点击鼠标,就可以完成搜索、聚合功能,生成炫丽的仪表板。

12 |

13 | 当然,Elastic Stack 也并不是实时数据分析界的灵丹妙药。在不恰当的场景,反而会事倍功半。我自 2014 年初开 QQ 群交流 Elastic Stack,发现网友们对 Elastic Stack 的原理概念,常有误解误用;对实现的效果,又多有不能理解或者过多期望而失望之处。更令我惊奇的是,网友们广泛分布在传统企业和互联网公司、开发和运维领域、Linux 和 Windows 平台,大家对非专精领域的知识,一般都缺乏了解,这也成为使用 Elastic Stack 时的一个障碍。

14 |

15 | 为此,写一本 Elastic Stack 技术指南,帮助大家厘清技术细节,分享一些实战案例,成为我近半年一大心愿。本书大体完工之后,幸得机械工业出版社华章公司青睐,以《ELK Stack 权威指南》之名重修完善并出版,有意收藏者欢迎[购买](http://search.jd.com/Search?keyword=elkstack%E6%9D%83%E5%A8%81%E6%8C%87%E5%8D%97&enc=utf-8)。

16 |

17 | 本人于 Elastic Stack,虽然接触较早,但本身专于 web 和 app 应用数据方面,动笔以来,得到诸多朋友的帮助,详细贡献名单见[合作名单](./contributors.md)。此外,还要特别感谢曾勇(medcl)同学,完成 ES 在国内的启蒙式分享,并主办 ES 中国用户大会;吴晓刚(wood)同学,积极帮助新用户们,并最早分享了携程的 Elastic Stack 日亿级规模的实例。

18 |

19 | 欢迎加入 Elastic Stack 交流 QQ 群:315428175。

20 |  21 |

22 | *欢迎捐赠,作者支付宝账号:*

23 |

24 |

25 |

26 | # Version

27 |

28 | 2016-10-27 发布了 Elastic Stack 5.0 版。由于变动较大,本书 Git 仓库将 master 分支统一调整为基于 5.0 的状态。

29 |

30 | 想要查阅过去 k3、k4、logstash-2.x 等不同老版本资料的读者,请下载 ELK release:

31 |

32 | # TODO

33 |

34 | 限于个人经验、时间和场景,有部分 Elastic Stack 社区比较常见的用法介绍未完成,期待各位同好出手。罗列如下:

35 |

36 | * es-hadoop 用例

37 | * beats 开发

38 | * codec/netflow 的详解

39 | * filter/elapsed 的用例

40 | * zeppelin 的 es 用例

41 | * kibana的filter交互用法

42 | * painless的date对象用法:同比环比图

43 | * significant_text aggs用例

44 | * cat nodeattrs接口

45 | * timelion保存成panel的用法

46 | * regionmap用法

47 | * Time Series Visual Builder用法

48 | * Viewing Document Context用法

49 | * Dead Letter Queues讲解

50 | * elastalert 新版说明

51 |

52 |

--------------------------------------------------------------------------------

/beats/winlog.md:

--------------------------------------------------------------------------------

1 | # winlogbeat

2 |

3 | winlogbeat 通过标准的 windows API 获取 windows 系统日志,常见的有 application,hardware,security 和 system 四类。winlogbeat 示例配置如下:

4 |

5 | ```

6 | winlogbeat.event_logs:

7 | - name: Application

8 | provider:

9 | - Application Error

10 | - Application Hang

11 | - Windows Error Reporting

12 | - EMET

13 | - name: Security

14 | level: critical, error, warning

15 | event_id: 4624, 4625, 4700-4800, -4735

16 | - name: System

17 | ignore_older: 168h

18 | - name: Microsoft-Windows-Windows Defender/Operational

19 | include_xml: true

20 |

21 | output.elasticsearch:

22 | hosts:

23 | - localhost:9200

24 | pipeline: "windows-pipeline-id"

25 |

26 | logging.to_files: true

27 | logging.files:

28 | path: C:/ProgramData/winlogbeat/Logs

29 | logging.level: info

30 | ```

31 |

32 | 和其他 beat 一样,这里示例的配置不都是必填项。事实上只有 `event_logs.name` 是必须的。而 winlogbeat 的输出字段中,除了 beats 家族的通用内容外,还包括一下特有字段:

33 |

34 |

35 | * activity\_id

36 | * computer\_name:如果运行在 Windows 事件转发模式,这个值会和 beat.hostname 不一样。

37 | * event\_data

38 | * event\_id

39 | * keywords

40 | * log\_name

41 | * level:可选值包括 Success, Information, Warning, Error, Audit Success, and Audit Failure.

42 | * message

43 | * message\_error

44 | * record\_number

45 | * related\_activity\_id

46 | * opcode

47 | * provider\_guid

48 | * process\_id

49 | * source\_name

50 | * task

51 | * thread\_id

52 | * user\_data

53 | * user.identifier

54 | * user.name

55 | * user.domain

56 | * user.type

57 | * version

58 | * xml

59 |

--------------------------------------------------------------------------------

/contributors.md:

--------------------------------------------------------------------------------

1 | 致谢

2 | =============

3 |

4 | * 感谢 crazw 完成 collectd 插件介绍章节。

5 | * 感谢 松涛 完成 nxlog 场景介绍章节。

6 | * 感谢 LeiTu 完成 logstash-forwarder 介绍章节。

7 | * 感谢 jingbli 完成 kafka 插件介绍章节。

8 | * 感谢 林鹏 完成 ossec 场景介绍章节。

9 | * 感谢 cameluo 完成 shield 介绍章节。

10 | * 感谢 tuxknight 指出 hdfs 章节笔误。

11 | * 感谢 lemontree 完成 marvel 介绍章节。

12 | * 感谢 NERO 完成 utmp 插件开发介绍章节。

13 | * 感谢 childe 完成 kibana-auth-CAS 介绍, elasticsearch 读写分离和别名等章节。

14 | * 感谢 gnuhpc 完善 elasticsearch 插件 index 配置细节,logstash-fowarder-java 部署细节。

15 | * 感谢 东南 指出两处代码示例笔误。

16 | * 感谢 陆一鸣 指出 openjdk 的 rpm 名错误。

17 | * 感谢 elain 完成 search-guard 章节。

18 | * 感谢 wdh 完成 search-guard v2 版章节。

19 | * 感谢 李宏旭 完成 hdfs 快照备份 章节。

20 | * 感谢 abcfy2 完成 grafana 章节。

21 |

--------------------------------------------------------------------------------

/cover.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/cover.jpg

--------------------------------------------------------------------------------

/diff-hdfs.md:

--------------------------------------------------------------------------------

1 | # Elastic Stack 与 Hadoop 体系的区别

2 |

3 | Kibana 因其丰富的图表类型和漂亮的前端界面,被很多人理解成一个统计工具。而我个人认为,ELK 这一套体系,不应该和 Hadoop 体系同质化。定期的离线报表,不是 Elasticsearch 专长所在(多花费分词、打分这些步骤在高负载压力环境上太奢侈了),也不应该由 Kibana 来完成(每次刷新都是重新计算)。Kibana 的使用场景,应该集中在两方面:

4 |

5 | * 实时监控

6 |

7 | 通过 histogram 面板,配合不同条件的多个 queries 可以对一个事件走很多个维度组合出不同的时间序列走势。时间序列数据是最常见的监控报警了。

8 |

9 | * 问题分析

10 |

11 | 通过 Kibana 的交互式界面可以很快的将异常时间或者事件范围缩小到秒级别或者个位数。期望一个完美的系统可以给你自动找到问题原因并且解决是不现实的,能够让你三两下就从 TB 级的数据里看到关键数据以便做出判断就很棒了。这时候,一些非 histogram 的其他面板还可能会体现出你意想不到的价值。全局状态下看似很普通的结果,可能在你锁定某个范围的时候发生剧烈的反方向的变化,这时候你就能从这个维度去重点排查。而表格面板则最直观的显示出你最关心的字段,加上排序等功能。入库前字段切分好,对于排错分析真的至关重要。

12 |

13 | ## Splunk 场景参考

14 |

15 | 关于 elk 的用途,我想还可以参照其对应的商业产品 splunk 的场景:

16 |

17 | > 使用 Splunk 的意义在于使信息收集和处理智能化。而其操作智能化表现在:

18 | >

19 | > 1. 搜索,通过下钻数据排查问题,通过分析根本原因来解决问题;

20 | > 2. 实时可见性,可以将对系统的检测和警报结合在一起,便> 于跟踪 SLA 和性能问题;

21 | > 3. 历史分析,可以从中找出趋势和历史模式,行为基线和阈值,生成一致性报告。

22 |

23 | -- Peter Zadrozny, Raghu Kodali 著/唐宏,陈健译《Splunk大数据分析》

24 |

--------------------------------------------------------------------------------

/elasticsearch/README.md:

--------------------------------------------------------------------------------

1 | Elasticsearch 来源于作者 Shay Banon 的第一个开源项目 Compass 库,而这个 Java 库最初的目的只是为了给 Shay 当时正在学厨师的妻子做一个菜谱的搜索引擎。2010 年,Elasticsearch 正式发布。至今已经成为 GitHub 上最流行的 Java 项目,不过 Shay 承诺给妻子的菜谱搜索依然没有面世……

2 |

3 | 2015 年初,Elasticsearch 公司召开了第一次全球用户大会 Elastic{ON}15。诸多 IT 巨头纷纷赞助,参会,演讲。会后,Elasticsearch 公司宣布改名 Elastic,公司官网也变成 。这意味着 Elasticsearch 的发展方向,不再限于搜索业务,也就是说,Elastic Stack 等机器数据和 IT 服务领域成为官方更加注意的方向。随后几个月,专注监控报警的 Watcher 发布 beta 版,社区有名的网络抓包工具 Packetbeat、多年专注于基于机器学习的异常探测 Prelert 等 ITOA 周边产品纷纷被 Elastic 公司收购。

4 |

--------------------------------------------------------------------------------

/elasticsearch/alias.md:

--------------------------------------------------------------------------------

1 | alias的几点应用

2 | ==================

3 |

4 | *本节作者:childe*

5 |

6 | # 索引更改名字时, 无缝过渡

7 |

8 | ## 情景1

9 |

10 | 用Logstash采集当前的所有nginx日志, 放入ES, 索引名叫nginx-YYYY.MM.DD.

11 |

12 | 后来又增加了apache日志, 希望能放在同一个索引里面,统一叫web-YYYY.MM.DD.

13 |

14 | 我们只要把Logstash配置更改一下,然后重启, 数据就会写入新的索引名字下. 但是同一天的索引就会被分成了2个, kibana上面就不好配置了.

15 |

16 | ### 如此实现

17 |

18 | 1. 今天是2015.07.28. 我们为nginx-2015.07.28建一个alias叫做web-2015.07.28, 之前的所有nginx日志也如此照做.

19 | 2. kibana中把dashboard配置的索引名改成web-YYYY.MM.DD

20 | 3. 将logstash里面的elasticsearch的配置改成web-YYYY.MM.DD, 重启.

21 | 4. 无缝切换实现.

22 |

23 | ## 情景2

24 |

25 | 用Logstash采集当前的所有nginx日志, 放入ES, 索引名叫nginx-YYYY.MM.DD.

26 |

27 | 某天(2015.07.28)希望能够按月建立索引, 索引名改成nginx-YYYY.MM.

28 |

29 | **[注意]** 像情景1中那样新建一个叫nginx-2015.07的alias, 并指向本月的其他的索引是不行的. 因为一个alias指向了多个索引, 写这个alias的时候, ES不可能知道写入哪个真正的索引.

30 |

31 | ### 如此实现

32 |

33 | 1. 新建索引nginx-2015.07, 以及他的alias: nginx-2015.07.29, nginx-2015.07.30 ... 等.

34 | 新建索引nginx-2015.08, 以及他的alias: nginx-2015.08.01, nginx-2015.08.02 ... 等.

35 | 2. 等到第二天, 将logstash配置更改为nginx-YYYY.MM, 重启.

36 | 3. 如果索引只保留10天(一般来说, 不可能永久保存), 在10天之后的某天, 将kibana配置更改为 `[nginx-]YYYY.MM`

37 |

38 | ### 缺点

39 |

40 | 第二步, 第三步需要记得手工操作, 或者写一个crontab定时任务.

41 |

42 | ### 另外一种思路

43 |

44 | 1. 新建一个叫nginx-2015.07的alias, 并指向本月的其他的索引.

45 | 这个时候不能马上更改logstash配置写入nginx-2015.07. 因为一个alias指向了多个索引, 写这个alias的时候, ES不可能知道写入哪个真正的索引.

46 | 2. 新建索引nginx-2015.08, 以及他的alias: nginx-2015.08.01, nginx-2015.08.02 ... 等.

47 | 3. 把kibana配置改为 `[nginx-]YYYY.MM`.

48 | 4. 到2015.08.01这天, 或者之后的某天, 更改logstash配置, 把elasticsearch的配置更改为nginx-YYYY.MM. 重启.

49 |

50 | ### 缺点

51 |

52 | 1. 7月份的索引还是按天建立.

53 | 2. 第四步需要记得手工操作.

54 |

55 | 情景2的操作有些麻烦, 这些都是为了"无缝"这个大前提. 我们不希望用户(kibana的使用者)感觉到任何变化, 更不能让使用者感受到数据有缺失.

56 |

57 | 如果用户愿意妥协, 那ELK的管理者就可以马上简单粗暴的把数据写到nginx-2015.07, 并把kibana配置改过去. 这样一来, 用户可能就不能方便的看到之前的数据了.

58 |

59 | # 按域名配置kibana的dashboard

60 |

61 | nginx日志中有个字段是domain, 各个业务部门在Kibana中需要看且只看自己域名下的日志.

62 |

63 | 可以在logstash中按域名切分索引,但ES的metadata会成倍的增长,带来极大的负担.

64 |

65 | 也可以放在nginx-YYYY.MM.DD一个索引中, 在kibana加一个filter过滤. 但这个关键的filter和其它所有filter排在一起,是很容易很不小心清掉的.

66 |

67 | 我们可以在template中配置, 对每一个域名做一个alias.

68 |

69 | ```

70 | "aliases" : {

71 | "{index}-www.corp.com" : {

72 | "filter" : {

73 | "term" : {

74 | "domain" : "www.corp.com"

75 | }

76 | }

77 | },

78 | "{index}-abc.corp.com" : {

79 | "filter" : {

80 | "term" : {

81 | "domain" : "abc.corp.com"

82 | }

83 | }

84 | }

85 | }

86 | ```

87 |

88 | 当新的索引nginx-2015.07.28生成的时候, 会有nginx-2015.07.28-www.corp.com和nginx-2015.07.28-abc.corp.com等alias指向nginx-2015.07.28.

89 |

90 | 在kibana配置dashboard的时候, 就可以直接用alias做配置了.

91 |

92 | 在实际使用中, 可能还需要一个crontab定时的查询是否有新的域名加入, 自动对新域名做当天的alias, 并把它加入template.

93 |

--------------------------------------------------------------------------------

/elasticsearch/api/CRUD.md:

--------------------------------------------------------------------------------

1 | # 增删改查

2 |

3 | 增删改查是数据库的基础操作方法。ES 虽然不是数据库,但是很多场合下,都被人们当做一个文档型 NoSQL 数据库在使用,原因自然是因为在接口和分布式架构层面的相似性。虽然在 Elastic Stack 场景下,数据的写入和查询,分别由 Logstash 和 Kibana 代劳,作为测试、调研和排错时的基本功,还是需要了解一下 ES 的增删改查用法的。

4 |

5 | ## 数据写入

6 |

7 | ES 的一大特点,就是全 RESTful 接口处理 JSON 请求。所以,数据写入非常简单:

8 |

9 | ```

10 | # curl -XPOST http://127.0.0.1:9200/logstash-2015.06.21/testlog -d '{

11 | "date" : "1434966686000",

12 | "user" : "chenlin7",

13 | "mesg" : "first message into Elasticsearch"

14 | }'

15 | ```

16 |

17 | 命令返回响应结果为:

18 |

19 | ```

20 | {"_index":"logstash-2015.06.21","_type":"testlog","_id":"AU4ew3h2nBE6n0qcyVJK","_version":1,"created":true}

21 | ```

22 |

23 | ## 数据获取

24 |

25 | 可以看到,在数据写入的时候,会返回该数据的 `_id`。这就是后续用来获取数据的关键:

26 |

27 | ```

28 | # curl -XGET http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK

29 | ```

30 |

31 | 命令返回响应结果为:

32 |

33 | ```

34 | {"_index":"logstash-2015.06.21","_type":"testlog","_id":"AU4ew3h2nBE6n0qcyVJK","_version":1,"found":true,"_source":{

35 | "date" : "1434966686000",

36 | "user" : "chenlin7",

37 | "mesg" : "first message into Elasticsearch"

38 | }}

39 | ```

40 |

41 | 这个 `_source` 里的内容,正是之前写入的数据。

42 |

43 | 如果觉得这个返回看起来有点太过麻烦,可以使用 `curl -XGET http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK/_source` 来指明只获取源数据部分。

44 |

45 | 更进一步的,如果你只想看数据中的一部分字段内容,可以使用 `curl -XGET http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK?fields=user,mesg` 来指明获取字段,结果如下:

46 |

47 | ```

48 | {"_index":"logstash-2015.06.21","_type":"testlog","_id":"AU4ew3h2nBE6n0qcyVJK","_version":1,"found":true,"fields":{"user":["chenlin7"],"mesg":["first message into Elasticsearch"]}}

49 | ```

50 |

51 | ## 数据删除

52 |

53 | 要删除数据,修改发送的 HTTP 请求方法为 DELETE 即可:

54 |

55 | ```

56 | # curl -XDELETE http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK

57 | ```

58 |

59 | 删除不单针对单条数据,还可以删除整个整个索引。甚至可以用通配符。

60 |

61 | ```

62 | # curl -XDELETE http://127.0.0.1:9200/logstash-2015.06.0*

63 | ```

64 |

65 | 在 Elasticsearch 2.x 之前,可以通过查询语句删除,也可以删除某个 `_type` 内的数据。现在都已经不再内置支持,改为 `Delete by Query` 插件。因为这种方式本身对性能影响较大!

66 |

67 | ## 数据更新

68 |

69 | 已经写过的数据,同样还是可以修改的。有两种办法,一种是全量提交,即指明 `_id` 再发送一次写入请求。

70 |

71 | ```

72 | # curl -XPOST http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK -d '{

73 | "date" : "1434966686000",

74 | "user" : "chenlin7",

75 | "mesg" " "first message into Elasticsearch but version 2"

76 | }'

77 | ```

78 |

79 | 另一种是局部更新,使用 `/_update` 接口:

80 |

81 | ```

82 | # curl -XPOST 'http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK/_update' -d '{

83 | "doc" : {

84 | "user" : "someone"

85 | }

86 | }'

87 | ```

88 |

89 | 或者

90 |

91 | ```

92 | # curl -XPOST 'http://127.0.0.1:9200/logstash-2015.06.21/testlog/AU4ew3h2nBE6n0qcyVJK/_update' -d '{

93 | "script" : "ctx._source.user = \"someone\""

94 | }'

95 | ```

96 |

--------------------------------------------------------------------------------

/elasticsearch/api/reindex.md:

--------------------------------------------------------------------------------

1 | # reindex

2 |

3 | Elasticsearch 本身不提供对索引的 rename,mapping 的 alter 等操作。所以,如果有需要对全索引数据进行导出,或者修改某个已有字段的 mapping 设置等情况下,我们只能通过 scroll API 导出全部数据,然后重新做一次索引写入。这个过程,叫做 reindex。

4 |

5 | 之前完成这个过程只能自己写程序或者用 logstash。5.0 中,Elasticsearch 将这个过程内置为 reindex API,但是要注意:这个接口并没有什么黑科技,其本质仅仅是将这段相同逻辑的代码预置分发而已。如果有复杂的数据变更操作等细节需求,依然需要自己编程完成。

6 |

7 | 下面分别给出这三种方法的示例:

8 |

9 | ## Perl 客户端

10 |

11 | Elastic 官方提供各种语言的客户端库,其中,Perl 库提供了对 reindex 比较方便的写法和示例。通过 `cpanm Search::Elasticsearch` 命令安装库完毕后,使用以下程序即可:

12 |

13 | ```

14 | use Search::Elasticsearch;

15 |

16 | my $es = Search::Elasticsearch->new(

17 | nodes => ['192.168.0.2:9200']

18 | );

19 | my $bulk = $es->bulk_helper(

20 | index => 'new_index',

21 | );

22 |

23 | $bulk->reindex(

24 | source => {

25 | index => 'old_index',

26 | size => 500, # default

27 | search_type => 'scan' # default

28 | }

29 | );

30 | ```

31 |

32 | ## Logstash 做 reindex

33 |

34 | 在最新版的 Logstash 中,对 logstash-input-elasticsearch 插件做了一定的修改,使得通过 logstash 完成 reindex 成为可能。

35 |

36 | reindex 操作的 logstash 配置如下:

37 |

38 | ```

39 | input {

40 | elasticsearch {

41 | hosts => [ "192.168.0.2" ]

42 | index => "old_index"

43 | size => 500

44 | scroll => "5m"

45 | docinfo => true

46 | }

47 | }

48 | output {

49 | elasticsearch {

50 | hosts => [ "192.168.0.3" ]

51 | index => "%{[@metadata][_index]}"

52 | document_type => "%{[@metadata][_type]}"

53 | document_id => "%{[@metadata][_id]}"

54 | }

55 | }

56 | ```

57 |

58 | 如果你做 reindex 的源索引并不是 logstash 记录的内容,也就是没有 `@timestamp`, `@version` 这两个 logstash 字段,那么可以在上面配置中添加一段 filter 配置,确保前后索引字段完全一致:

59 |

60 | ```

61 | filter {

62 | mutate {

63 | remove_field => [ "@timestamp", "@version" ]

64 | }

65 | }

66 | ```

67 |

68 | ## reindex API

69 |

70 | 简单的 reindex,可以很容易的完成:

71 |

72 | ```

73 | curl -XPOST http://localhost:9200/_reindex -d '

74 | {

75 | "source": {

76 | "index": "logstash-2016.10.29"

77 | },

78 | "dest": {

79 | "index": "logstash-new-2016.10.29"

80 | }

81 | }'

82 | ```

83 |

84 | 复杂需求,也能通过配合其他 API,比如 script、pipeline 等来满足一些,下面举一个复杂的示例:

85 |

86 | ```

87 | curl -XPOST http://localhost:9200/_reindex?requests_per_second=10000 -d '

88 | {

89 | "source": {

90 | "remote": {

91 | "host": "http://192.168.0.2:9200",

92 | },

93 | "index": "metricbeat-*",

94 | "query": {

95 | "match": {

96 | "host": "webserver"

97 | }

98 | }

99 | },

100 | "dest": {

101 | "index": "metricbeat",

102 | "pipeline": "ingest-rule-1"

103 | },

104 | "script": {

105 | "lang": "painless",

106 | "inline": "ctx._index = 'metricbeat-' + (ctx._index.substring('metricbeat-'.length(), ctx._index.length())) + '-1'"

107 | }

108 | }'

109 | ```

110 |

111 | 上面这个请求的作用,是将来自 192.168.0.2 集群的 metricbeat-2016.10.29 索引中,有关 `host:webserver` 的数据,读取出来以后,经过 localhost 集群的 `ingest-rule-1` 规则处理,在写入 localhost 集群的 metricbeat-2016.10.29-1 索引中。

112 |

113 | 注意:读取远端集群数据需要先配置对应的 `reindex.remote.whitelist:192.168.0.2:9200` 到 elasticsearch.yml 的白名单里。

114 |

115 | 通过 reindex 接口运行的任务可以通过同样是 5.0 新引入的任务管理接口进行取消、修改等操作。详细介绍见后续任务管理章节。

116 |

--------------------------------------------------------------------------------

/elasticsearch/api/script.md:

--------------------------------------------------------------------------------

1 | # script

2 |

3 | Elasticsearch 中,可以使用自定义脚本扩展功能。包括评分、过滤函数和聚合字段等方面。内置脚本引擎历经 MVEL、Groovy、Lucene expression 的变换后,Elastic.co 最终决定实现一个自己专用的 Painless 脚本语言,并在 5.0 版正式发布。

4 |

5 | 作为 Elastic Stack 场景,我们只介绍在聚合字段方面使用 script 的方式。

6 |

7 | ## 动态提交

8 |

9 | 最简单易用的方式,就是在正常的请求体中,把 `field` 换成 `script` 提交。比如一个标准的 terms agg 改成 script 方式,写法如下:

10 |

11 | ```

12 | # curl 127.0.0.1:9200/logstash-2015.06.29/_search -d '{

13 | "aggs" : {

14 | "clientip_top10" : {

15 | "terms" : {

16 | "script" : {

17 | "lang" : "painless",

18 | "inline" : "doc['clientip'].value"

19 | }

20 | }

21 | }

22 | }

23 | }'

24 | ```

25 |

26 | 在 script 中,有三种方式引用数据:`doc['clientip'].value`、`_field['clientip'].value` 和 `_source.clientip`。其区别在于:

27 |

28 | * `doc[].value` 读取 doc value 内的数据;

29 | * `_field[]` 读取 field 设置 `"store":true` 的存储内容;

30 | * `_source.obj.attr` 读取 `_source` 的 JSON 内容。

31 |

32 | 这也意味着,前者必须读取的是最终的词元字段数据,而后者可以返回任意的数据结构。

33 |

34 | **注意**:如果有分词,且未禁用 fielddata 的话,`doc[].value` 读取到的是分词后的数据。所以请注意使用 `doc['clientip.keyword'].value` 写法。

35 |

36 | ## 固定文件

37 |

38 | 为了和动态提交的语法有区别,调用固定文件的写法如下:

39 |

40 | ```

41 | # curl 127.0.0.1:9200/logstash-2015.06.29/_search -d '{

42 | "aggs" : {

43 | "clientip_subnet_top10" : {

44 | "terms" : {

45 | "script" : {

46 | "file" : "getvalue",

47 | "lang" : "groovy",

48 | "params" : {

49 | "fieldname": "clientip.keyword",

50 | "pattern": "^((?:\d{1,3}\.?){3})\.\d{1,3}$"

51 | }

52 | }

53 | }

54 | }

55 | }

56 | }'

57 | ```

58 |

59 | 上例要求在 ES 集群的所有数据节点上,都保存有一个 `/etc/elasticsearch/scripts/getvalue.groovy` 文件,并且该脚本文件可以接收 `fieldname` 和 `pattern` 两个变量。试举例如下:

60 |

61 | ```

62 | #!/usr/bin/env groovy

63 | matcher = ( doc[fieldname].value =~ /${pattern}/ )

64 | if (matcher.matches()) {

65 | matcher[0][1]

66 | }

67 | ```

68 |

69 | **注意**:ES 进程默认每分钟扫描一次 `/etc/elasticsearch/scripts/` 目录,并尝试加载该目录下所有文件作为 script。所以,不要在该目录内做文件编辑等工作,不要分发 .svn 等目录到生成环境,这些临时或者隐藏文件都会被 ES 进程加载然后报错。

70 |

71 | ## 其他语言

72 |

73 | ES 支持通过插件方式,扩展脚本语言的支持,目前默认自带的语言包括:

74 |

75 | * painless

76 | * lucene expression

77 | * groovy

78 | * mustache

79 |

80 | 而 github 上目前已有以下语言插件支持,基本覆盖了所有 JVM 上的可用语言:

81 |

82 | *

83 | *

84 | *

85 | *

86 | *

87 | *

88 |

--------------------------------------------------------------------------------

/elasticsearch/hadoop/spark-streaming.md:

--------------------------------------------------------------------------------

1 | # spark streaming 交互

2 |

3 | Apache Spark 是一个高性能集群计算框架,其中 Spark Streaming 作为实时批处理组件,因为其简单易上手的特性深受喜爱。在 es-hadoop 2.1.0 版本之后,也新增了对 Spark 的支持,使得结合 ES 和 Spark 成为可能。

4 |

5 | 目前最新版本的 es-hadoop 是 2.1.0-Beta4。安装如下:

6 |

7 | ```

8 | wget http://d3kbcqa49mib13.cloudfront.net/spark-1.0.2-bin-cdh4.tgz

9 | wget http://download.elasticsearch.org/hadoop/elasticsearch-hadoop-2.1.0.Beta4.zip

10 | ```

11 |

12 | 然后通过 `ADD_JARS=../elasticsearch-hadoop-2.1.0.Beta4/dist/elasticsearch-spark_2.10-2.1.0.Beta4.jar` 环境变量,把对应的 jar 包加入 Spark 的 jar 环境中。

13 |

14 | 下面是一段使用 spark streaming 接收 kafka 消息队列,然后写入 ES 的配置:

15 |

16 | ```

17 | import org.apache.spark._

18 | import org.apache.spark.streaming.kafka.KafkaUtils

19 | import org.apache.spark.streaming._

20 | import org.apache.spark.streaming.StreamingContext._

21 | import org.apache.spark.SparkContext

22 | import org.apache.spark.SparkContext._

23 | import org.apache.spark.SparkConf

24 | import org.apache.spark.sql._

25 | import org.elasticsearch.spark.sql._

26 | import org.apache.spark.storage.StorageLevel

27 | import org.apache.spark.Logging

28 | import org.apache.log4j.{Level, Logger}

29 |

30 | object Elastic {

31 | def main(args: Array[String]) {

32 | val numThreads = 1

33 | val zookeeperQuorum = "localhost:2181"

34 | val groupId = "test"

35 | val topic = Array("test").map((_, numThreads)).toMap

36 | val elasticResource = "apps/blog"

37 |

38 | val sc = new SparkConf()

39 | .setMaster("local[*]")

40 | .setAppName("Elastic Search Indexer App")

41 |

42 | sc.set("es.index.auto.create", "true")

43 | val ssc = new StreamingContext(sc, Seconds(10))

44 | ssc.checkpoint("checkpoint")

45 | val logs = KafkaUtils.createStream(ssc,

46 | zookeeperQuorum,

47 | groupId,

48 | topic,

49 | StorageLevel.MEMORY_AND_DISK_SER)

50 | .map(_._2)

51 |

52 | logs.foreachRDD { rdd =>

53 | val sc = rdd.context

54 | val sqlContext = new SQLContext(sc)

55 | val log = sqlContext.jsonRDD(rdd)

56 | log.saveToEs(elasticResource)

57 | }

58 |

59 | ssc.start()

60 | ssc.awaitTermination()

61 |

62 | }

63 | }

64 | ```

65 |

66 | 注意,代码中使用了 spark SQL 提供的 `jsonRDD()` 方法,如果在对应的 kafka topic 里的数据,本身并不是已经处理好了的 JSON 数据的话,这里还需要自己写一写额外的处理函数,利用 `cast class` 来规范数据。

67 |

--------------------------------------------------------------------------------

/elasticsearch/ingest.md:

--------------------------------------------------------------------------------

1 | # Ingest 节点

2 |

3 | Ingest 节点是 Elasticsearch 5.0 新增的节点类型和功能。其开启方式为:在 `elasticsearch.yml` 中定义:

4 |

5 | ```

6 | node.ingest: true

7 | ```

8 |

9 | Ingest 节点的基础原理,是:节点接收到数据之后,根据请求参数中指定的管道流 id,找到对应的已注册管道流,对数据进行处理,然后将处理过后的数据,按照 Elasticsearch 标准的 indexing 流程继续运行。

10 |

11 | ## 创建管道流

12 |

13 | ```

14 | curl -XPUT http://localhost:9200/_ingest/pipeline/my-pipeline-id -d '

15 | {

16 | "description" : "describe pipeline",

17 | "processors" : [

18 | {

19 | "convert" : {

20 | "field": "foo",

21 | "type": "integer"

22 | }

23 | }

24 | ]

25 | }'

26 | ```

27 |

28 | 然后发送端带着这个 `my-pipeline-id` 发请求就好了。示例见本书 beats 章节的介绍。

29 |

30 | ## 测试管道流

31 |

32 | 想知道自己的 ingest 配置是否正确,可以通过仿真接口测试验证一下:

33 |

34 | ```

35 | curl -XPUT http://localhost:9200/_ingest/pipeline/_simulate -d '

36 | {

37 | "pipeline" : {

38 | "description" : "describe pipeline",

39 | "processors" : [

40 | {

41 | "set" : {

42 | "field": "foo",

43 | "value": "bar"

44 | }

45 | }

46 | ]

47 | },

48 | "docs" : [

49 | {

50 | "_index": "index",

51 | "_type": "type",

52 | "_id": "id",

53 | "_source": {

54 | "foo" : "bar"

55 | }

56 | }

57 | ]

58 | }'

59 | ```

60 |

61 | ## 处理器

62 |

63 | Ingest 节点的处理器,相当于 Logstash 的 filter 插件。事实上其主要处理器就是直接移植了 Logstash 的 filter 代码成 Java 版本。目前最重要的几个处理器分别是:

64 |

65 | ### convert

66 |

67 | ```

68 | {

69 | "convert": {

70 | "field" : "foo",

71 | "type": "integer"

72 | }

73 | }

74 | ```

75 |

76 | ### grok

77 |

78 | ```

79 | {

80 | "grok": {

81 | "field": "message",

82 | "patterns": ["my %{FAVORITE_DOG:dog} is colored %{RGB:color}"]

83 | "pattern_definitions" : {

84 | "FAVORITE_DOG" : "beagle",

85 | "RGB" : "RED|GREEN|BLUE"

86 | }

87 | }

88 | }

89 | ```

90 |

91 | ### gsub

92 |

93 | ```

94 | {

95 | "gsub": {

96 | "field": "field1",

97 | "pattern": "\.",

98 | "replacement": "-"

99 | }

100 | }

101 | ```

102 |

103 | ### date

104 |

105 | ```

106 | {

107 | "date" : {

108 | "field" : "initial_date",

109 | "target_field" : "timestamp",

110 | "formats" : ["dd/MM/yyyy hh:mm:ss"],

111 | "timezone" : "Europe/Amsterdam"

112 | }

113 | }

114 | ```

115 |

116 | ### 其他处理器插件

117 |

118 | 除了内置的处理器之外,还有 3 个处理器,官方选择了以插件性质单独发布,它们是 attachement,geoip 和 user-agent 。原因应该是这 3 个处理器需要额外数据模块,而且处理性能一般,担心拖累 ES 集群。

119 |

120 | 它们可以和其他普通 ES 插件一样安装:

121 |

122 | ```

123 | sudo bin/elasticsearch-plugin install ingest-geoip

124 | ```

125 |

126 | 使用方式和其他处理器一样:

127 |

128 | ```

129 | curl -XPUT http://localhost:9200/_ingest/pipeline/my-pipeline-id-2 -d '

130 | {

131 | "description" : "Add geoip info",

132 | "processors" : [

133 | {

134 | "geoip" : {

135 | "field" : "ip",

136 | "target_field" : "geo",

137 | "database_file" : "GeoLite2-Country.mmdb.gz"

138 | }

139 | }

140 | ]

141 | }

142 | ```

143 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/README.md:

--------------------------------------------------------------------------------

1 | # 监控方案

2 |

3 | Elasticsearch 作为一个分布式系统,监控自然是重中之重。Elasticsearch 本身提供了非常完善的,由浅及深的各种性能数据接口。和数据读写检索接口一样,采用 RESTful 风格。我们可以直接使用 curl 来获取数据,编写监控程序,也可以使用一些现成的监控方案。通常这些方案也是通过接口读取数据,解析 JSON,渲染界面。

4 |

5 | 本章会先介绍一些常用的监控接口,以及其响应数据的含义。然后再介绍几种常用的开源和商业 Elasticsearch 监控产品。

6 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/api/index-stats.md:

--------------------------------------------------------------------------------

1 | # 索引状态监控接口

2 |

3 | 索引状态监控接口的输出信息和节点状态监控接口非常类似。一般情况下,这个接口单独监控起来的意义并不大。

4 |

5 | 不过在 ES 1.6 版开始,加入了对索引分片级别的 commit id 功能。

6 |

7 | 回忆一下之前原理章节的内容,commit 是在分片内部,对每个 segment 做的。而数据在主分片和副本分片上,是由各自节点自行做 segment merge 操作,所以副本分片和主分片的 segment 的 commit id 是不一致的。这导致 ES 副本恢复时,跟主分片比对 commit id,基本上每个 segment 都不一样,所以才需要从主分片完整重传一份数据。

8 |

9 | 新加入分片级别的 commit id 后,副本恢复时,先比对跟主分片的分片级 commit id,如果一致,直接本地恢复副本分片内容即可。

10 |

11 | 查看分片级别 commit id 的命令如下:

12 |

13 | ```

14 | # curl 'http://127.0.0.1:9200/logstash-mweibo-2015.06.15/_stats/commit?level=shards&pretty'

15 | ...

16 | "indices" : {

17 | "logstash-2015.06.15" : {

18 | "primaries" : { },

19 | "total" : { },

20 | "shards" : {

21 | "0" : [ {

22 | "routing" : {

23 | "state" : "STARTED",

24 | "primary" : true,

25 | "node" : "AqaYWFQJRIK0ZydvVgASEw",

26 | "relocating_node" : null

27 | },

28 | "commit" : {

29 | "generation" : 726,

30 | "user_data" : {

31 | "translog_id" : "1434297603053",

32 | "sync_id" : "AU4LEh6wnBE6n0qcEXs5"

33 | },

34 | "num_docs" : 36792652

35 | }

36 | } ],

37 | ...

38 | ```

39 |

40 | 注意:为了节约频繁变更的资源消耗,ES 并不会实时更新分片级 commit id。只有连续 5 分钟没有新数据写入的索引,才会触发给索引各分片更新 commit id 的操作。如果你查看的是一个还在新写入数据的索引,看到的内容应该是下面这样:

41 |

42 | ```

43 | "commit" : {

44 | "generation" : 590,

45 | "user_data" : {

46 | "translog_id" : "1434038402801"

47 | },

48 | "num_docs" : 29051938

49 | }

50 | ```

51 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/bigdesk-banner.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/bigdesk-banner.png

--------------------------------------------------------------------------------

/elasticsearch/monitor/bigdesk-indexing.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/bigdesk-indexing.png

--------------------------------------------------------------------------------

/elasticsearch/monitor/bigdesk-jvm.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/bigdesk-jvm.png

--------------------------------------------------------------------------------

/elasticsearch/monitor/bigdesk.md:

--------------------------------------------------------------------------------

1 | # bigdesk

2 |

3 | 要想最快的了解 ES 各节点的性能细节,推荐使用 bigdesk 插件,其原作者为 lukas-vlcek。但是从 Elasticsearch 1.4 版本开始就不再更新了。国内有用户 fork 出来继续维护到支持 5.0 版本,GitHub 地址见:

4 |

5 | bigdesk 通过浏览器直连 ES 节点,发起 RESTful 请求,并渲染结果成图。所以其安装部署极其简单:

6 |

7 | ```

8 | # git clone https://github.com/hlstudio/bigdesk

9 | # cd bigdesk/_site

10 | # python -mSimpleHTTPServer

11 | Serving HTTP on 0.0.0.0 port 8000 ...

12 | ```

13 |

14 | 浏览器打开 `http://localhost:8000` 即可看到 bigdesk 页面。在 **endpoint** 输入框内填写要连接的 ES 节点地址,选择 refresh 间隔和 keep 时长,点击 **connect**,完成。

15 |

16 |

17 |

18 | 注意:设置 refresh 间隔请考虑 Elastic Stack 使用的 template 里实际的 `refresh_interval` 是多少。否则你可能看到波动太大的数据,不足以说明情况。

19 |

20 | 点选某个节点后,就可以看到该节点性能的实时走势。一般重点关注 JVM 性能和索引性能。

21 |

22 | 有关 JVM 部分截图如下:

23 |

24 |

25 |

26 | 有关数据读写性能部分截图如下:

27 |

28 |

29 |

30 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/cerebro.md:

--------------------------------------------------------------------------------

1 | # cerebro

2 |

3 | cerebro 这个名字大家可能觉得很陌生,其实它就是过去的 kopf 插件!因为 Elasticsearch 5.0 不再支持 site plugin,所以 kopf 作者放弃了原项目,另起炉灶搞了 cerebro,以独立的单页应用形式,继续支持新版本下 Elasticsearch 的管理工作。

4 |

5 | 项目地址:

6 |

7 | ## 安装部署

8 |

9 | 单页应用的安装方式都非常简单,下载打开即可:

10 |

11 | ```

12 | # git clone https://github.com/lmenezes/cerebro

13 | # cd cerebro

14 | # ./bin/cerebro

15 | ```

16 |

17 | 然后浏览器打开 `http://localhost:9000` 即可。

18 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/logging.md:

--------------------------------------------------------------------------------

1 | # 日志记录

2 |

3 | Elasticsearch 作为一个服务,本身也会记录很多日志信息。默认情况下,日志都放在 `$ES_HOME/logs/` 目录里。

4 |

5 | 日志配置在 Elasticsearch 5.0 中改成了使用 `log4j2.properties` 文件配置,包括日志滚动的方式、命名等,都和标准的 log4j2 一样。唯一的特点是:Elasticsearch 导出了一个变量叫 `${sys:es.logs}`,指向你在 `elasticsearch.yml` 中配置的 `path.logs` 地址:

6 |

7 | ```

8 | appender.index_search_slowlog_rolling.filePattern = ${sys:es.logs}_index_search_slowlog-%d{yyyy-MM-dd}.log

9 | ```

10 |

11 | 具体的级别等级也可以通过 `/_cluster/settings` 接口动态调整。比如说,如果你的节点一直无法正确的加入集群,你可以将集群自动发现方面的日志级别修改成 DEBUG,来关注这方面的问题:

12 |

13 | ```

14 | # curl -XPUT http://127.0.0.1:9200/_cluster/settings -d'

15 | {

16 | "transient" : {

17 | "logger.org.elasticsearch.indices.recovery" : "DEBUG"

18 | }

19 | }'

20 | ```

21 |

22 | ## 性能日志

23 |

24 | 除了进程状态的日志输出,ES 还支持跟性能相关的日志输出。针对数据写入,检索,读取三个阶段,都可以设置具体的慢查询阈值,以及不同的输出等级。

25 |

26 | 此外,慢查询日志是针对索引级别的设置。除了通过 `/_cluster/settings` 接口配置一组集群各索引共用的参数以外,还可以针对每个索引设置不同的参数。

27 |

28 | *注:过去的版本,还可以在 `elasticsearch.yml` 中设置,5.0 版禁止在配置文件中添加索引级别的设置!*

29 |

30 | 比如说,我们可以先设置集群共同的参数:

31 |

32 | ```

33 | # curl -XPUT http://127.0.0.1:9200/_cluster/settings -d'

34 | {

35 | "transient" : {

36 | "logger.index.search.slowlog" : "DEBUG",

37 | "logger.index.indexing.slowlog" : "WARN",

38 | "index.search.slowlog.threshold.query.debug" : "10s",

39 | "index.search.slowlog.threshold.fetch.debug": "500ms",

40 | "index.indexing.slowlog.threshold.index.warn": "5s"

41 | }

42 | }'

43 | ```

44 |

45 | 然后针对某个比较大的索引,调高设置:

46 |

47 | ```

48 | # curl -XPUT http://127.0.0.1:9200/logstash-wwwlog-2015.06.21/_settings -d'

49 | {

50 | "index.search.slowlog.threshold.query.warn" : "10s",

51 | "index.search.slowlog.threshold.fetch.debug": "500ms",

52 | "index.indexing.slowlog.threshold.index.info": "10s"

53 | }

54 | ```

55 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-1.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-2.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-3.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-4.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-5.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel-6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/monitor/marvel-6.jpg

--------------------------------------------------------------------------------

/elasticsearch/monitor/marvel.md:

--------------------------------------------------------------------------------

1 | # marvel

2 |

3 | *本节作者:lemontree*

4 |

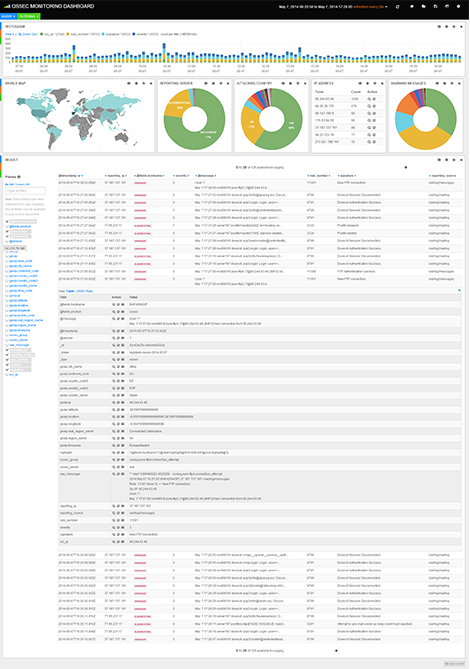

5 | marvel 是 Elastic.co 公司推出的商业监控方案,也是用来监控 Elasticsearch 集群实时、历史状态的有力用具,便于性能优化以及故障诊断。监控主要分为六个层面,分别是集群层、节点层、索引层、分片层、事件层、Sense。

6 |

7 | * 集群层:主要对集群健康情况进行汇总,包括集群名称、集群状态、节点数量、索引个数、分片数、总数据量、集群版本等信息。同时,对节点、索引整体情况分别展示。

8 | * 节点层:主要对每个节点的 CPU 、内存、负载、索引相关的性能数据等信息进行统计,并进行图形化展示。

9 | * 索引层:展示的信息与节点层类似,主要从索引的角度展示。

10 | * 分片层:从索引、节点两个角度展示分片的分布情况,并提供 playback 功能演示分片分配的历史过程。

11 | * 事件层:展示集群相关事件,如节点脱离、加入,Master 选举、索引创建、Shard 分配等。

12 | * Sense:轻量级的开发界面,主要用于通过 API 查询数据,管理集群。

13 |

14 | Elastic.co 公司的收费标准是:

15 |

16 | * 开发模式免费

17 | * 生产环境前 5 个节点,每年 1000 美元

18 | * 之后每增加 5 个节点,每年加收 250 美元

19 |

20 | ## 安装和卸载

21 |

22 | marvel 是以 elasticsearch 的插件形式存在的,可以直接通过插件安装:

23 |

24 | ```

25 | # ./bin/plugin -i elasticsearch/marvel/latest

26 | ```

27 |

28 | 如果你是从官网下载的安装包,则运行:

29 |

30 | ```

31 | # ./bin/plugin -i marvel -u file:///path/to/marvel-latest.zip

32 | ```

33 |

34 | 各节点都安装完毕后,可以通过下行命令来查看节点上的插件列表,检查列表中是否含有 marvel:

35 |

36 | ```

37 | # curl http://127.0.0.1:9200/_nodes/_local/plugins

38 | ```

39 |

40 | 安装之后,插件自动运行,并将定期获取到的集群状态数据,存储在 `.marvel-YYYY.MM.DD` 索引中,以单台 ES 计算,该索引的大小在 500MB 左右。所以,如果在小规模环境下运行,首先请注意,不要让你宝贵的内存都花在 marvel 的数据索引上了。

41 |

42 | 如果不打算使用 marvel,在各节点上通过下行命令下载:

43 |

44 | ```

45 | # ./bin/plugin -r marvel

46 | ```

47 |

48 | ## 配置

49 |

50 | 如果不想让 marvel 数据索引影响到生产环境 ES 的运行,可以搭建单独的 marvel 数据集群,而生产数据集群上通过主动汇报的方式把数据发送过去。

51 |

52 | 在两个集群都安装好 marvel 插件后,生产集群的 `elasticsearch.yml` 上添加如下配置:

53 |

54 | ```

55 | marvel.agent.exporter.es.hosts: ["marvel-cluster-ip:9200"]

56 | ```

57 |

58 | 和大多数 cluster 设置一样,marvel 设置也是可以动态变更的:

59 |

60 | ```

61 | # curl –XPUT 127.0.0.1:9200/_cluster/settings -d '{

62 | "transient" : {

63 | "marvel.agent.exporter.es.hosts": [ "192.168.0.2:9200", "192.168.0.3:9200" ]

64 | }

65 | }'

66 | ```

67 |

68 | 数据接收端的 marvel 集群(即上一行写的 marvel-cluster-ip 代表的主机)则添加如下配置:

69 |

70 | ```

71 | marvel.agent.enabled: false

72 | ```

73 |

74 | 即本身不启用 marvel,以免数据有混淆。

75 |

76 | ## 访问

77 |

78 | 既然是 ES 插件,访问地址自然是插件式的:`http://marvel-cluster-ip:9200/_plugin/marvel/index.html`

79 |

80 | marvel 的监控页面是在 Kibana3 基础上稍有改造。如下图所示,其顶部菜单栏设计了一个下拉选择框,可以切换几个不同纬度的仪表板:

81 |

82 |

83 |

84 | ## 面板定制

85 |

86 | Marvel的信息展示能够以Panel为单元进行个性化定制。每个Panel定制的过程比较类似。这里举例定制一个DOCUMENT COUNT文档数Panel,配置过程如下:

87 |

88 | 1. 点击红色椭圆部分,添加一个Panel:

89 |

90 | 2. 输入Panel的名字DOCUMENT COUNT:

91 |

92 | 3. 输入Panel Y 轴显示的值 "Primaries.docx.count":

93 |

94 | 4. 选择展示风格

95 |

96 | 5. 选择查看的集合,这里选择 *all*:

97 |

98 | 6. 一个Document Count Panel就完成了:

99 |

100 |

--------------------------------------------------------------------------------

/elasticsearch/monitor/zabbix.md:

--------------------------------------------------------------------------------

1 | # zabbix

2 |

3 | 之前提到的都是 Elasticsearch 的 sites 类型插件,其实质是实时从浏览器读取 cluster stats 接口数据并渲染页面。这种方式直观,但不适合生产环境的自动化监控和报警处理。要达到这个目标,还是需要使用诸如 nagios、zabbix、ganglia、collectd 这类监控系统。

4 |

5 | 本节以 zabbix 为例,介绍如何使用监控系统完成 Elasticsearch 的监控报警。

6 |

7 | github 上有好几个版本的 ESZabbix 仓库,都源自 Elastic 公司员工 untergeek 最早的贡献。但是当时 Elasticsearch 还没有官方 python 客户端,所以监控程序都是用的是 pyes 库。对于最新版的 ES 来说,已经不推荐使用了。

8 |

9 | 这里推荐一个修改使用了官方 `elasticsearch.py` 库的衍生版。GitHub 地址见:。

10 |

11 | ## 安装配置

12 |

13 | 仓库中包括三个文件:

14 |

15 | 1. ESzabbix.py

16 | 2. ESzabbix.userparm

17 | 3. ESzabbix_templates.xml

18 |

19 | 其中,前两个文件需要分发到每个 ES 节点上。如果节点上运行的是 yum 安装的 zabbix,二者的默认位置应该分别是:

20 |

21 | 1. `/etc/zabbix/zabbix_externalscripts/ESzabbix.py`

22 | 2. `/etc/zabbix/agent_include/ESzabbix.userparm`

23 |

24 | 然后在各节点安装运行 ESzabbix.py 所需的 python 库依赖:

25 |

26 | ```

27 | # yum install -y python-pbr python-pip python-urllib3 python-unittest2

28 | # pip install elasticsearch

29 | ```

30 |

31 | 安装成功后,你可以试运行下面这行命令,看看命令输出是否正常:

32 |

33 | ```

34 | # /etc/zabbix/zabbix_externalscripts/ESzabbix.py cluster status

35 | ```

36 |

37 | 最后一个文件是 zabbix server 上的模板文件,不过在导入模板之前,还需要先创建一个数值映射,因为在模板中,设置了集群状态的触发报警,没有映射的话,报警短信只有 0, 1, 2 数字不是很易懂。

38 |

39 | 创建数值映射,在浏览器登录 zabbix-web,菜单栏的 **Zabbix Administration** 中选择 **General** 子菜单,然后在右侧下拉框中点击 **Value Maping**。

40 |

41 | 选择 **create**, 新建表单中填写:

42 |

43 | > name: ES Cluster State

44 | > 0 ⇒ Green

45 | > 1 ⇒ Yellow

46 | > 2 ⇒ Red

47 |

48 | 完成以后,即可在 **Templates** 页中通过 **import** 功能完成导入 `ESzabbix_templates.xml`。

49 |

50 | 在给 ES 各节点应用新模板之前,需要给每个节点定义一个 `{$NODENAME}` 宏,具体值为该节点 `elasticsearch.yml` 中的 `node.name` 值。从统一配管的角度,建议大家都设置为 ip 地址。

51 |

52 | ## 模板应用

53 |

54 | 导入完成后,zabbix 里多出来三个可用模板:

55 |

56 | 1. Elasticsearch Node & Cache

57 | 其中包括两个 Application:ES Cache 和 ES Node。分别有 Node Field Cache Size, Node Filter Cache Size 和 Node Storage Size, Records indexed per second 共计 4 个 item 监控项。在完成上面说的宏定义后,就可以把这个模板应用到各节点(即监控主机)上了。

58 | 2. Elasticsearch Service

59 | 只有一个监控项 Elasticsearch service status,做进程监控的,也应用到各节点上。

60 | 3. Elasticsearch Cluster

61 | 包括 11 个监控项,如下列所示。其中,**ElasticSearch Cluster Status** 这个监控项连带有报警的触发器,并对应之前创建的那个 Value Map。

62 | * Cluster-wide records indexed per second

63 | * Cluster-wide storage size

64 | * ElasticSearch Cluster Status

65 | * Number of active primary shards

66 | * Number of active shards

67 | * Number of data nodes

68 | * Number of initializing shards

69 | * Number of nodes

70 | * Number of relocating shards

71 | * Number of unassigned shards

72 | * Total number of records

73 | 这个模板下都是集群总体情况的监控项,所以,运用在一台有 ES 集群读取权限的主机上即可,比如 zabbix server。

74 |

75 | ## 其他

76 |

77 | untergeek 最近刚更新了他的仓库,重构了一个 es_stats_zabbix 模块用于 Zabbix 监控,有兴趣的读者可以参考:

78 |

--------------------------------------------------------------------------------

/elasticsearch/other/README.md:

--------------------------------------------------------------------------------

1 | # Elasticsearch 在运维领域的其他运用

2 |

3 | 目前 Elasticsearch 虽然以 Elastic Stack 作为主打产品,但其优秀的分布式设计,灵活的搜索评分函数和强大简洁的检索聚合功能,在运维领域也衍生出不少其他有趣的应用方式。

4 |

5 | 对于 Elastic 公司来说,这些周边应用,也随时可能成为他们的后续目标产品。就在本书第一版编写期间,packetbeat 就被 Elastic 公司收购,并且可能作为未来数据采集端的标准应用。所以,Elastic Stack 用户提前了解其他方面的多种可能,也是非常有意义的。

6 |

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-1.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-1.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-10.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-10.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-11.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-11.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-12.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-12.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-13.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-13.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-14.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-14.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-15.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-15.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-16.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-16.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-17.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-17.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-18.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-18.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-19.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-19.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-2.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-2.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-20.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-20.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-21.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-21.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-3.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-3.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-4.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-4.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-5.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-5.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-6.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-6.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-7.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-7.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-8.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-8.png

--------------------------------------------------------------------------------

/elasticsearch/other/images/grafana-9.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/images/grafana-9.png

--------------------------------------------------------------------------------

/elasticsearch/other/juttle-viz.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/chenryn/ELKstack-guide-cn/a30092eb98bae2148782f3d851039f327c2de2f7/elasticsearch/other/juttle-viz.png

--------------------------------------------------------------------------------

/elasticsearch/other/kale.md:

--------------------------------------------------------------------------------

1 | # Kale 系统

2 |

3 | Kale 系统是 Etsy 公司开源的一个监控分析系统。Kale 分为两个部分:skyline 和 oculus。skyline 负责对时序数据进行概率分布校验,对校验失败率超过阈值的时序数据发报警;oculus 负责给被报警的时序,找出趋势相似的其他时序作为关联性参考。

4 |

5 | 看到“相似”两个字,你一定想到了。没错,oculus 组件,就是利用了 Elasticsearch 的相似度打分。

6 |

7 | oculus 中,为 Elasticsearch 的 `org.elasticsearch.script.ExecutableScript` 扩展了 `DTW` 和 `Euclidian` 两种 NativeScript。可以在界面上选择用其中某一种算法来做相似度打分:

8 |

9 |

10 |

11 | 然后相似度最高的几个时序图就依次排列出来了。

12 |

13 | Euclidian 即欧几里得距离,是时序相似度计算里最基础的方式。

14 |

15 | DWT 即动态时间规整(Dynamic Time Warping),也是时序相似度计算的常用方式,它和欧几里得距离的差别在于,欧几里得距离要求比对的时序数据是一一对应的,而动态时间规整计算的时序数据并不要求长度相等。在运维监控来说,也就是延后一定时间发生的相近趋势也可以以很高的打分项排名靠前。

16 |

17 | 不过,oculus 插件仅更新到支持 Elasticsearch-0.90.3 版本为止。Etsy 性能优化团队在 Oreilly 2015 大会上透露,他们内部已经根据 Kale 的经验教训,重新开发了 Kale 2.0 版。会在年内开源放出来。大家一起期待吧!

18 |

19 | ## 参考阅读

20 |

21 |

22 |

--------------------------------------------------------------------------------

/elasticsearch/other/rrd.md:

--------------------------------------------------------------------------------

1 | # 时序数据

2 |

3 | 之前已经介绍过,ES 默认存储数据时,是有索引数据、*_all* 全文索引数据、*_source* JSON 字符串三份的。其中,索引数据由于倒排索引的结构,压缩比非常高。因此,在某些特定环境和需求下,可以只保留索引数据,以极小的容量代价,换取 ES 灵活的数据结构和聚合统计功能。

4 |

5 | 在监控系统中,对监控项和监控数据的设计一般是这样:

6 |

7 | > metric_path value timestamp (Graphite 设计)

8 | > { "host": "Host name 1", "key": "item_key", "value": "33", "clock": 1381482894 } (Zabbix 设计)

9 |

10 | 这些设计有个共同点,数据是二维平面的。以最简单的访问请求状态监控为例,一次请求,可能转换出来的 `metric_path` 或者说 `key` 就有:**{city,isp,host,upstream}.{urlpath...}.{status,rt,ut,size,speed}** 这么多种。假设 urlpath 有 1000 个,就是 20000 个组合。意味着需要发送 20000 条数据,做 20000 次存储。

11 |

12 | 而在 ES 里,这就是实实在在 1000 条日志。而且在多条日志的时候,因为词元的相对固定,压缩比还会更高。所以,使用 ES 来做时序监控数据的存储和查询,是完全可行的办法。

13 |

14 | 对时序数据,关键就是定义缩减数据重复。template 示例如下:

15 |

16 | ```

17 | {

18 | "order" : 2,

19 | "template" : "logstash-monit-*",

20 | "settings" : {

21 | },

22 | "mappings" : {

23 | "_default_" : {

24 | "_source" : {

25 | "enabled" : false

26 | },

27 | "_all" : {

28 | "enabled" : false

29 | }

30 | }

31 | },

32 | "aliases" : { }

33 | }

34 | ```

35 |

36 | 如果有些字段,是完全不用 Query ,只参加 Aggregation 的,还可以设置:

37 |

38 | ```

39 | "properties" : {

40 | "sid" : {

41 | "index" : "no",

42 | "type" : "keyword"

43 | }

44 | },

45 | ```

46 |

47 | 关于 Elasticsearch 用作 rrd 用途,与 MongoDB 等其他工具的性能测试与对比,可以阅读腾讯工程师写的系列文章:

48 |

--------------------------------------------------------------------------------

/elasticsearch/performance/bulk.md:

--------------------------------------------------------------------------------

1 | # 批量提交

2 |

3 | 在 CRUD 章节,我们已经知道 ES 的数据写入是如何操作的了。喜欢自己动手的读者可能已经迫不及待的自己写了程序开始往 ES 里写数据做测试。这时候大家会发现:程序的运行速度非常一般,即使 ES 服务运行在本机,一秒钟大概也就能写入几百条数据。

4 |

5 | 这种速度显然不是 ES 的极限。事实上,每条数据经过一次完整的 HTTP POST 请求和 ES indexing 是一种极大的性能浪费,为此,ES 设计了批量提交方式。在数据读取方面,叫 mget 接口,在数据变更方面,叫 bulk 接口。mget 一般常用于搜索时 ES 节点之间批量获取中间结果集,对于 Elastic Stack 用户,更常见到的是 bulk 接口。

6 |

7 | bulk 接口采用一种比较简朴的数据积累格式,示例如下:

8 |

9 | ```

10 | # curl -XPOST http://127.0.0.1:9200/_bulk -d'

11 | { "create" : { "_index" : "test", "_type" : "type1" } }

12 | { "field1" : "value1" }

13 | { "delete" : { "_index" : "test", "_type" : "type1" } }

14 | { "index" : { "_index" : "test", "_type" : "type1", "_id" : "1" } }

15 | { "field1" : "value2" }

16 | { "update" : {"_id" : "1", "_type" : "type1", "_index" : "test"} }

17 | { "doc" : {"field2" : "value2"} }

18 | '

19 | ```

20 |

21 | 格式是,每条 JSON 数据的上面,加一行描述性的元 JSON,指明下一行数据的操作类型,归属索引信息等。

22 |

23 | 采用这种格式,而不是一般的 JSON 数组格式,是因为接收到 bulk 请求的 ES 节点,就可以不需要做完整的 JSON 数组解析处理,直接按行处理简短的元 JSON,就可以确定下一行数据 JSON 转发给哪个数据节点了。这样,一个固定内存大小的 network buffer 空间,就可以反复使用,又节省了大量 JVM 的 GC。

24 |

25 | 事实上,产品级的 logstash、rsyslog、spark 都是默认采用 bulk 接口进行数据写入的。对于打算自己写程序的读者,建议采用 Perl 的 `Search::Elasticsearch::Bulk` 或者 Python 的 `elasticsearch.helpers.*` 库。

26 |

27 | ## bulk size

28 |

29 | 在配置 bulk 数据的时候,一般需要注意的就是请求体大小(bulk size)。

30 |

31 | 这里有一点细节上的矛盾,我们知道,HTTP 请求,是可以通过 HTTP 状态码 *100 Continue* 来持续发送数据的。但对于 ES 节点接收 HTTP 请求体的 *Content-Length* 来说,是按照整个大小来计算的。所以,首先,要确保 bulk 数据不要超过 `http.max_content_length` 设置。

32 |

33 | 那么,是不是尽量让 bulk size 接近这个数值呢?当然不是。

34 |

35 | 依然是请求体的问题,因为请求体需要全部加载到内存,而 JVM Heap 一共就那么多(按 31GB 算),过大的请求体,会挤占其他线程池的空间,反而导致写入性能的下降。

36 |

37 | 再考虑网卡流量,磁盘转速的问题,所以一般来说,建议 bulk 请求体的大小,在 15MB 左右,通过实际测试继续向上探索最合适的设置。

38 |

39 | 注意:这里说的 15MB 是请求体的字节数,而不是程序里里设置的 bulk size。bulk size 一般指数据的条目数。不要忘了,bulk 请求体中,每条数据还会额外带上一行元 JSON。

40 |

41 | 以 logstash 默认的 `bulk_size => 5000` 为例,假设单条数据平均大小 200B ,一次 bulk 请求体的大小就是 1.5MB。那么我们可以尝试 `bulk_size => 50000`;而如果单条数据平均大小是 20KB,一次 bulk 大小就是 100MB,显然超标了,需要尝试下调至 `bulk_size => 500`。

42 |

43 |

--------------------------------------------------------------------------------

/elasticsearch/performance/curator.md:

--------------------------------------------------------------------------------

1 | # curator

2 |

3 | 如果经过之前章节的一系列优化之后,数据确实超过了集群能承载的能力,除了拆分集群以外,最后就只剩下一个办法了:清除废旧索引。

4 |

5 | 为了更加方便的做清除数据,合并 segment,备份恢复等管理任务,Elasticsearch 在提供相关 API 的同时,另外准备了一个命令行工具,叫 curator 。curator 是 Python 程序,可以直接通过 pypi 库安装:

6 |

7 | ```

8 | pip install elasticsearch-curator

9 | ```

10 |

11 | *注意,是 elasticsearch-curator 不是 curator。PyPi 原先就有另一个项目叫这个名字*

12 |

13 | ## 参数介绍

14 |

15 | 和 Elastic Stack 里其他组件一样,curator 也是被 Elastic.co 收购的原开源社区周边。收编之后同样进行了一次重构,命令行参数从单字母风格改成了长单词风格。新版本的 curator 命令可用参数如下:

16 |

17 | > Usage: curator [OPTIONS] COMMAND [ARGS]...

18 |

19 | Options 包括:

20 |

21 | --host TEXT Elasticsearch host.

22 | --url_prefix TEXT Elasticsearch http url prefix.

23 | --port INTEGER Elasticsearch port.

24 | --use_ssl Connect to Elasticsearch through SSL.

25 | --http_auth TEXT Use Basic Authentication ex: user:pass

26 | --timeout INTEGER Connection timeout in seconds.

27 | --master-only Only operate on elected master node.

28 | --dry-run Do not perform any changes.

29 | --debug Debug mode

30 | --loglevel TEXT Log level

31 | --logfile TEXT log file

32 | --logformat TEXT Log output format [default|logstash].

33 | --version Show the version and exit.

34 | --help Show this message and exit.

35 |

36 | Commands 包括:

37 | alias Index Aliasing

38 | allocation Index Allocation

39 | bloom Disable bloom filter cache

40 | close Close indices

41 | delete Delete indices or snapshots

42 | open Open indices

43 | optimize Optimize Indices

44 | replicas Replica Count Per-shard

45 | show Show indices or snapshots

46 | snapshot Take snapshots of indices (Backup)

47 |

48 | 针对具体的 Command,还可以继续使用 `--help` 查看该子命令的帮助。比如查看 *close* 子命令的帮助,输入 `curator close --help`,结果如下:

49 |

50 | ```

51 | Usage: curator close [OPTIONS] COMMAND [ARGS]...

52 |

53 | Close indices

54 |

55 | Options:

56 | --help Show this message and exit.

57 |

58 | Commands:

59 | indices Index selection.

60 | ```

61 |

62 | ## 常用示例

63 |

64 | 在使用 1.4.0 以上版本的 Elasticsearch 前提下,curator 曾经主要的一个子命令 `bloom` 已经不再需要使用。所以,目前最常用的三个子命令,分别是 `close`, `delete` 和 `optimize`,示例如下:

65 |

66 | ```

67 | curator --timeout 36000 --host 10.0.0.100 delete indices --older-than 5 --time-unit days --timestring '%Y.%m.%d' --prefix logstash-mweibo-nginx-

68 | curator --timeout 36000 --host 10.0.0.100 delete indices --older-than 10 --time-unit days --timestring '%Y.%m.%d' --prefix logstash-mweibo-client- --exclude 'logstash-mweibo-client-2015.05.11'

69 | curator --timeout 36000 --host 10.0.0.100 delete indices --older-than 30 --time-unit days --timestring '%Y.%m.%d' --regex '^logstash-mweibo-\d+'

70 | curator --timeout 36000 --host 10.0.0.100 close indices --older-than 7 --time-unit days --timestring '%Y.%m.%d' --prefix logstash-

71 | curator --timeout 36000 --host 10.0.0.100 optimize --max_num_segments 1 indices --older-than 1 --newer-than 7 --time-unit days --timestring '%Y.%m.%d' --prefix logstash-

72 | ```

73 |

74 | 这一顿任务,结果是:

75 |

76 | *logstash-mweibo-nginx-yyyy.mm.dd* 索引保存最近 5 天,*logstash-mweibo-client-yyyy.mm.dd* 保存最近 10 天,*logstash-mweibo-yyyy.mm.dd* 索引保存最近 30 天;且所有七天前的 *logstash-\** 索引都暂时关闭不用;最后对所有非当日日志做 segment 合并优化。

77 |

--------------------------------------------------------------------------------

/elasticsearch/performance/gateway.md:

--------------------------------------------------------------------------------

1 | # gateway

2 |

3 | gateway 是 ES 设计用来长期存储索引数据的接口。一般来说,大家都是用本地磁盘来存储索引数据,即 `gateway.type` 为 `local`。

4 |

5 | 数据恢复中,有很多策略调整我们已经在之前分片控制小节讲过。除开分片级别的控制以外,gateway 级别也还有一些可优化的地方:

6 |

7 | * gateway.recover_after_nodes

8 | 该参数控制集群在达到多少个节点的规模后,才开始数据恢复任务。这样可以避免集群自动发现的初期,分片不全的问题。

9 |

10 | * gateway.recover_after_time

11 | 该参数控制集群在达到上条配置设置的节点规模后,再等待多久才开始数据恢复任务。

12 |

13 | * gateway.expected_nodes

14 | 该参数设置集群的预期节点总数。在达到这个总数后,即认为集群节点已经完全加载,即可开始数据恢复,不用再等待上条设置的时间。

15 |

16 | 注意:gateway 中说的节点,仅包括主节点和数据节点,纯粹的 client 节点是不算在内的。如果你有更明确的选择,也可以按需求写:

17 |

18 | * gateway.recover_after_data_nodes

19 | * gateway.recover_after_master_nodes

20 | * gateway.expected_data_nodes

21 | * gateway.expected_master_nodes

22 |

23 | ## 共享存储上的影子副本

24 |

25 | 虽然 ES 对 gateway 使用 NFS,iscsi 等共享存储的方式极力反对,但是对于较大量级的索引的副本数据,ES 从 1.5 版本开始,还是提供了一种节约成本又不特别影响性能的方式:影子副本(shadow replica)。

26 |

27 | 首先,需要在集群各节点的 `elasticsearch.yml` 中开启选项:

28 |

29 | ```

30 | node.enable_custom_paths: true

31 | ```

32 |

33 | 同时,确保各节点使用相同的路径挂载了共享存储,且目录权限为 Elasticsearch 进程用户可读可写。

34 |

35 | 然后,创建索引:

36 |

37 | ```

38 | # curl -XPUT 'http://127.0.0.1:9200/my_index' -d '

39 | {

40 | "index" : {

41 | "number_of_shards" : 1,

42 | "number_of_replicas" : 4,

43 | "data_path": "/var/data/my_index",

44 | "shadow_replicas": true

45 | }

46 | }'

47 | ```

48 |

49 | 针对 shadow replicas ,ES 节点不会做实际的索引操作,而是单纯的每次 flush 时,把 segment 内容 fsync 到共享存储磁盘上。然后 refresh 让其他节点能够搜索该 segment 内容。

50 |

51 | 如果你已经决定把数据放到共享存储上了,采用 shadow replicas 还是有一些好处的:

52 |

53 | 1. 可以帮助你节省一部分不必要的多副本分片的数据写入压力;

54 | 2. 在节点出现异常,需要在其他节点上恢复副本数据的时候,可以避免不必要的网络数据拷贝。

55 |

56 | 但是请注意:主分片节点还是要承担一个副本的写入过程,并不像 Lucene 的 FileReplicator 那样通过复制文件完成,所以达不到完全节省 CPU 的效果。

57 |

58 | shadow replicas 只是一个在某些特定环境下有用的方式。在资源允许的情况下,还是应该使用 local gateway。而另外采用 snapshot 接口来完成数据长期备份到 HDFS 或其他共享存储的需要。

59 |

--------------------------------------------------------------------------------

/elasticsearch/performance/profile.md:

--------------------------------------------------------------------------------

1 | # profiler

2 |

3 | profiler 是 Elasticsearch 5.0 的一个新接口。通过这个功能,可以看到一个搜索聚合请求,是如何拆分成底层的 Lucene 请求,并且显示每部分的耗时情况。

4 |

5 | 启用 profiler 的方式很简单,直接在请求里加一行即可:

6 |

7 | ```

8 | curl -XPOST 'http://localhost:9200/_search' -d '{

9 | "profile": true,

10 | "query": { ... },

11 | "aggs": { ... }

12 | }'

13 | ```

14 |

15 | 可以看到其中对 query 和 aggs 部分的返回是不太一样的。

16 |

17 | ## query

18 |

19 | query 部分包括 collectors、rewrite 和 query 部分。对复杂 query,profiler 会拆分 query 成多个基础的 TermQuery,然后每个 TermQuery 再显示各自的分阶段耗时如下:

20 |

21 | ```

22 | "breakdown": {

23 | "score": 51306,

24 | "score_count": 4,

25 | "build_scorer": 2935582,

26 | "build_scorer_count": 1,

27 | "match": 0,

28 | "match_count": 0,

29 | "create_weight": 919297,

30 | "create_weight_count": 1,

31 | "next_doc": 53876,

32 | "next_doc_count": 5,

33 | "advance": 0,

34 | "advance_count": 0

35 | }

36 | ```

37 |

38 |

39 |

40 | ## aggs

41 |

42 | ```

43 | "time": "1124.864392ms",

44 | "breakdown": {

45 | "reduce": 0,

46 | "reduce_count": 0,

47 | "build_aggregation": 1394,

48 | "build_aggregation_count": 150,

49 | "initialise": 2883,

50 | "initialize_count": 150,

51 | "collect": 1124860115,

52 | "collect_count": 900

53 | }

54 | ```

55 |

56 | 我们可以很明显的看到聚合统计在初始化阶段、收集阶段、构建阶段、汇总阶段分别花了多少时间,遍历了多少数据。

57 |

58 | *注意其中 reduce 阶段还没实现完毕,所有都是 0。因为目前 profiler 只能在 shard 级别上做统计。*

59 |

60 | collect 阶段的耗时,有助于我们调整对应 aggs 的 `collect_mode` 参数选择。目前 Elasticsearch 支持 `breadth_first` 和 `depth_first` 两种方式。

61 |

62 | initialise 阶段的耗时,有助于我们调整对应 aggs 的 `execution_hint` 参数选择。目前 Elasticsearch 支持 `map`、`global_ordinals_low_cardinality`、`global_ordinals` 和 `global_ordinals_hash` 四种选择。在计算离散度比较大的字段统计值时,适当调整该参数,有益于节省内存和提高计算速度。

63 |

64 | *对高离散度字段值统计性能很关注的读者,可以关注 这条记录的进展。*

65 |

--------------------------------------------------------------------------------

/elasticsearch/principle/README.md:

--------------------------------------------------------------------------------

1 | # 架构原理

2 |

3 | 本书作为 Elastic Stack 指南,关注于 Elasticsearch 在日志和数据分析场景的应用,并不打算对底层的 Lucene 原理或者 Java 编程做详细的介绍,但是 Elasticsearch 层面上的一些架构设计,对我们做性能调优,故障处理,具有非常重要的影响。

4 |

5 | 所以,作为 ES 部分的起始章节,先从数据流向和分布的层面,介绍一下 ES 的工作原理,以及相关的可控项。各位读者可以跳过这节先行阅读后面的运维操作部分,但作为性能调优的基础知识,依然建议大家抽时间返回来了解。

6 |

--------------------------------------------------------------------------------

/elasticsearch/principle/auto-discovery.md:

--------------------------------------------------------------------------------

1 | # 集群自动发现

2 |

3 | ES 是一个 P2P 类型(使用 gossip 协议)的分布式系统,除了集群状态管理以外,其他所有的请求都可以发送到集群内任意一台节点上,这个节点可以自己找到需要转发给哪些节点,并且直接跟这些节点通信。

4 |

5 | 所以,从网络架构及服务配置上来说,构建集群所需要的配置极其简单。在 Elasticsearch 2.0 之前,无阻碍的网络下,所有配置了相同 `cluster.name` 的节点都自动归属到一个集群中。

6 |

7 | 2.0 版本之后,基于安全的考虑,Elasticsearch 稍作了调整,避免开发环境过于随便造成的麻烦。

8 |

9 | ## unicast 方式

10 |

11 | ES 从 2.0 版本开始,默认的自动发现方式改为了单播(unicast)方式。配置里提供几台节点的地址,ES 将其视作 gossip router 角色,借以完成集群的发现。由于这只是 ES 内一个很小的功能,所以 gossip router 角色并不需要单独配置,每个 ES 节点都可以担任。所以,采用单播方式的集群,各节点都配置相同的几个节点列表作为 router 即可。

12 |

13 | 此外,考虑到节点有时候因为高负载,慢 GC 等原因可能会有偶尔没及时响应 ping 包的可能,一般建议稍微加大 Fault Detection 的超时时间。

14 |

15 | 同样基于安全考虑做的变更还有监听的主机名。现在默认只监听本地 lo 网卡上。所以正式环境上需要修改配置为监听具体的网卡。

16 |

17 | ```

18 | network.host: "192.168.0.2"

19 | discovery.zen.minimum_master_nodes: 3

20 | discovery.zen.ping_timeout: 100s

21 | discovery.zen.fd.ping_timeout: 100s

22 | discovery.zen.ping.unicast.hosts: ["10.19.0.97","10.19.0.98","10.19.0.99","10.19.0.100"]

23 | ```

24 |

25 | 上面的配置中,两个 timeout 可能会让人有所迷惑。这里的 **fd** 是 fault detection 的缩写。也就是说:

26 |

27 | * discovery.zen.ping_timeout 参数仅在加入或者选举 master 主节点的时候才起作用;

28 | * discovery.zen.fd.ping\_timeout 参数则在稳定运行的集群中,master 检测所有节点,以及节点检测 master 是否畅通时长期有用。

29 |

30 | 既然是长期有用,自然还有运行间隔和重试的配置,也可以根据实际情况调整:

31 |

32 | ```

33 | discovery.zen.fd.ping_interval: 10s

34 | discovery.zen.fd.ping_retries: 10

35 | ```

36 |

--------------------------------------------------------------------------------

/elasticsearch/principle/indexing-performance.md:

--------------------------------------------------------------------------------

1 | # segment merge对写入性能的影响

2 |

3 | 通过上节内容,我们知道了数据怎么进入 ES 并且如何才能让数据更快的被检索使用。其中用一句话概括了 Lucene 的设计思路就是"开新文件"。从另一个方面看,开新文件也会给服务器带来负载压力。因为默认每 1 秒,都会有一个新文件产生,每个文件都需要有文件句柄,内存,CPU 使用等各种资源。一天有 86400 秒,设想一下,每次请求要扫描一遍 86400 个文件,这个响应性能绝对好不了!

4 |

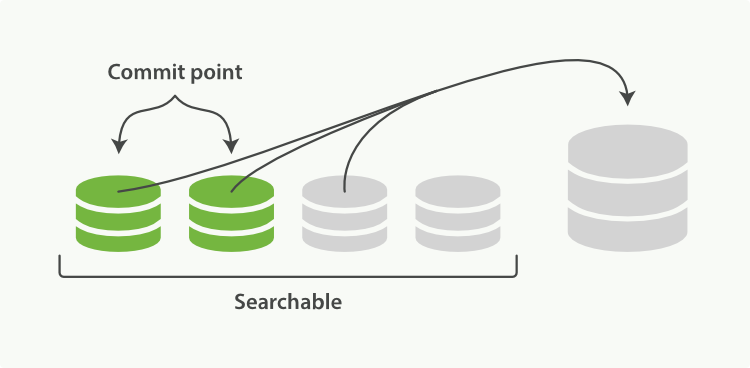

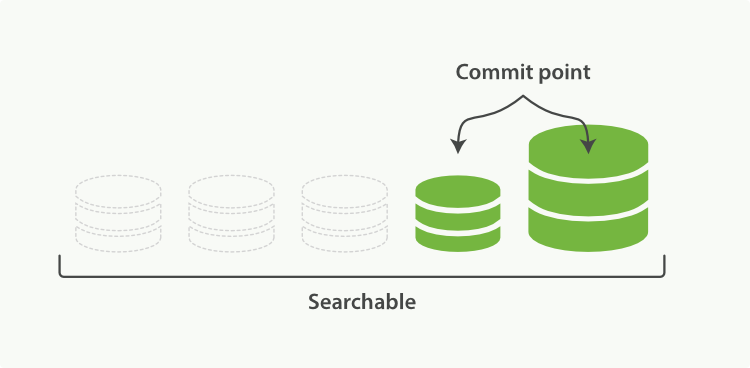

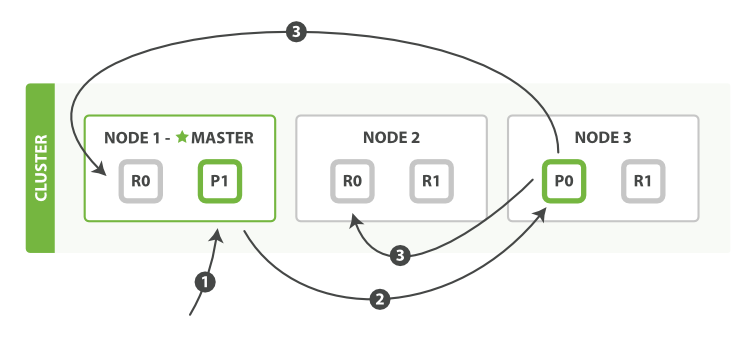

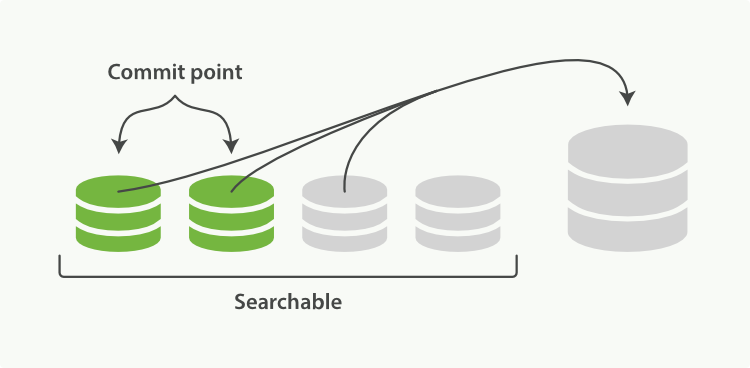

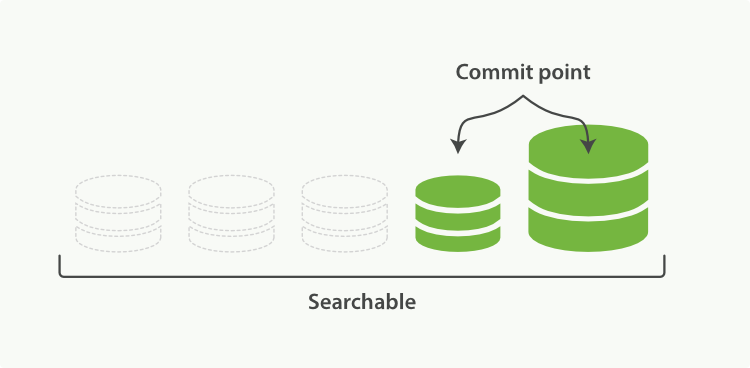

5 | 为了解决这个问题,ES 会不断在后台运行任务,主动将这些零散的 segment 做数据归并,尽量让索引内只保有少量的,每个都比较大的,segment 文件。这个过程是有独立的线程来进行的,并不影响新 segment 的产生。归并过程中,索引状态如图 2-7,尚未完成的较大的 segment 是被排除在检索可见范围之外的:

6 |

7 |

8 | 图 2-7

9 |