├── README.md

├── data

├── javabase

│ ├── collection

│ │ ├── ArrayList delete.jpg

│ │ ├── ArrayList delete2.jpg

│ │ ├── ArrayList insert.jpg

│ │ ├── ArrayList insert2.jpg

│ │ ├── LinkedList.jpg

│ │ ├── jmm.jpg

│ │ ├── linkedlist 删除.jpg

│ │ └── linkedlist 插入.jpg

│ ├── image

│ └── thread

│ │ └── jmm.jpg

├── network

│ ├── format.png

│ ├── http无状态.png

│ ├── osi.png

│ ├── tcp-udp.png

│ ├── 三次握手.png

│ ├── 三次握手示意图.png

│ ├── 四次挥手.png

│ └── 状态码.png

└── 公众号.jpg

└── doc

├── db

├── mongodb

│ ├── MongoDB聚合.md

│ ├── MongoDB面试题.md

│ ├── MongonDB索引.md

│ ├── SpringDataMongoDB详细的操作手册.md

│ ├── 复制集(ReplicaSet)应用部署.md

│ └── 复制集(replication).md

└── redis

│ ├── RedisRDB持久化与AOF持久化.md

│ ├── Redis常用的五种数据类型底层结构.md

│ └── Redis的ExpireKey(过期键).md

├── javabase

├── Java对象的浅克隆和深克隆.md

├── StringBuilder在高性能场景下的正确用法.md

├── base

│ └── javabase.md

├── collection

│ ├── ArrayList 源码分析.md

│ ├── ArrayList&Linkedist面试.md

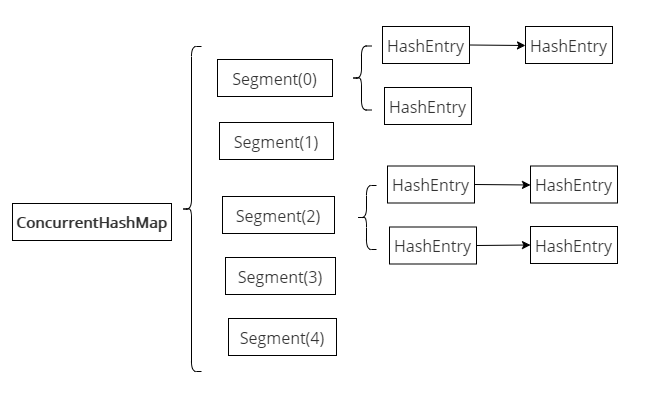

│ ├── ConcurrentHashMap源码和面试题一.md

│ ├── ConcurrentHashMap源码和面试题二.md

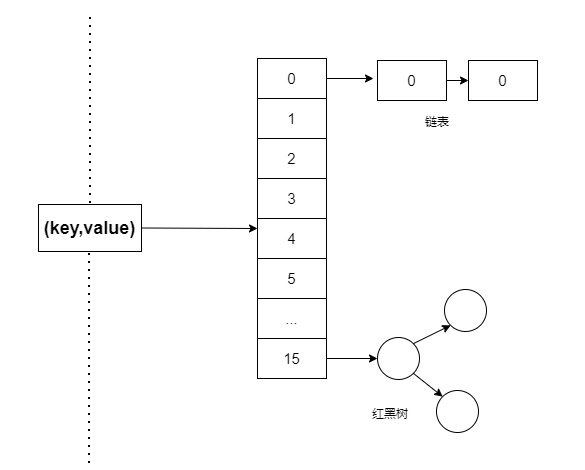

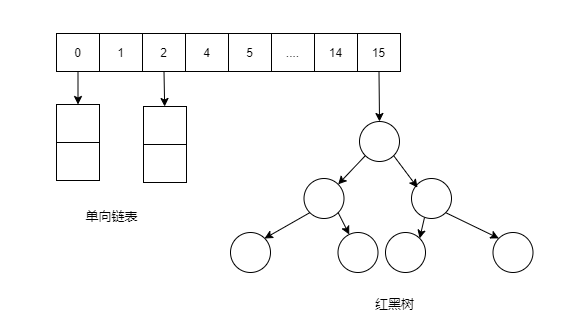

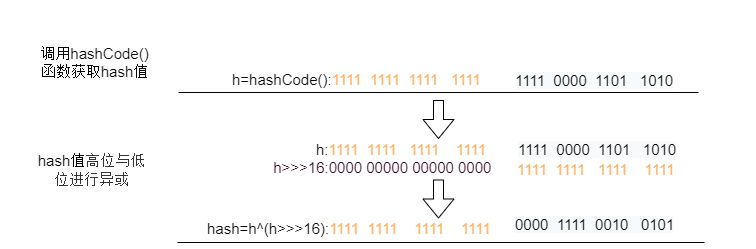

│ ├── HashMap 源码详细分析.md

│ ├── HashMap原理和面试题(图解版一).md

│ ├── LinkedHashMap 源码详细分析.md

│ ├── LinkedList.md

│ ├── TreeMap源码分析.md

│ └── collectionbase.md

├── designMode.md

├── jdk版本特性.md

├── jvm

│ ├── ClassLoad.md

│ └── jvmbase.md

├── orm

│ ├── MyBatis常见面试题.md

│ ├── MyBatis架构以及核心内容.md

│ └── Mybatis执行过程.md

├── sql

│ └── mysql

│ │ ├── mysql事务.md

│ │ └── mysql索引.md

├── thread

│ ├── Java多线程与并发之ThreadLocal.md

│ ├── ReentrantLock原理.md

│ ├── Synchronized.md

│ ├── ThreadLocal的内存泄露的原因分析以及如何避免.md

│ ├── Volatile与Synchronized.md

│ ├── threadbase.md

│ └── 并发CAS.md

├── 一篇文章让你彻底了解Java内部类.md

├── 你可能不知道的Java.Integer的缓存策略.md

├── 单例模式.md

├── 必须理解的Java 类的实例化顺序.md

└── 深入浅出Java注解.md

└── network

└── network.md

/README.md:

--------------------------------------------------------------------------------

1 | # JavaCommunity(后端开发必备,技术知识应有尽有)

2 |

3 | > **JavaCommunity开源社区的文章收集来源网络各个平台,如果有侵犯到各位博主,请联系我,我马上删除,谢谢哈,最后请大家多多支持,Star一个!!**

4 |

5 | >欢迎关注:【**JavaCodeHub**】,一起学习

6 | >《提升能力,涨薪可待》

7 | >《面试知识,工作可待》

8 | >《实战演练,拒绝996》

9 | >也欢迎关注微信公众号[【**终端研发部**】](#公众号),id:codeGoogler,原创技术文章第一时间推出

10 | >如果学习社区对你有帮助、喜欢的话,那就点个star呗!

11 |

12 | ## 前言

13 |

14 | >是不是感觉在工作上难于晋升了呢?

15 | >是不是感觉找工作面试是那么难呢?

16 | >是不是感觉自己每天都在996加班呢?

17 | >在工作上必须保持学习的能力,这样才能在工作得到更好的晋升,涨薪指日可待,欢迎一起学习

18 | >在找工作面试应在学习的基础进行总结面试知识点,找工作也指日可待,欢迎一起学习

19 | >最后,理论知识到准备充足,是不是该躬行起来呢?欢迎一起学习

20 |

21 | ## 目录

22 | + [java基础](#Java基础知识)

23 | + [Spring全家桶](#Spring精选面试题)

24 | + [数据库](#SQL数据库)

25 | + [ORM框架](#ORM框架)

26 | + [消息队列](#消息队列)

27 | + [缓存](#缓存)

28 | + [服务调用](#服务调用)

29 | + [注册中心](#注册中心)

30 | + [配置中心](#配置中心)

31 | + [分布式系统](#分布式系统)

32 | + [代码优化](#代码优化)

33 | + [SpringBoot集成](#SpringBoot集成)

34 | + [SpringCloud微服务](#SpringCloud微服务)

35 | + [项目](#项目)

36 | + [服务器](#服务器)

37 | + [Linux](#Linux)

38 | + [计算机网络](#计算机网络)

39 | + [数据结构与算法](#算法)

40 | + [开发工具](#开发工具)

41 | + [面试技巧](#面试技巧)

42 |

43 |

44 |

45 |

46 | ### Java基础

47 |

48 | #### Java基础知识

49 | + [jdk版本特性](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/jdk版本特性.md)

50 | + [Java对象的浅克隆和深克隆](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/Java对象的浅克隆和深克隆.md)

51 | + [StringBuilder在高性能场景下的正确用法](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/StringBuilder在高性能场景下的正确用法.md)

52 | + [深入浅出Java注解](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/深入浅出Java注解.md)

53 | + [一篇文章让你彻底了解Java内部类](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/一篇文章让你彻底了解Java内部类.md)

54 | + [你可能不知道的Java Integer的缓存策略](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/你可能不知道的Java.Integer的缓存策略.md)

55 | + [面试:Java基础知识点(涉及范围广)]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/base/javabase.md )

56 | #### Java集合

57 | + [TreeMap源码分析](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/TreeMap%E6%BA%90%E7%A0%81%E5%88%86%E6%9E%90.md)

58 | + [HashMap 源码详细分析(jdk 1.8)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/HashMap%20%E6%BA%90%E7%A0%81%E8%AF%A6%E7%BB%86%E5%88%86%E6%9E%90.md)

59 | + [LinkedHashMap 源码详细分析(jdk 1.8)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/LinkedHashMap%20%E6%BA%90%E7%A0%81%E8%AF%A6%E7%BB%86%E5%88%86%E6%9E%90.md)

60 | + [ArrayList 源码分析](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/ArrayList%20%E6%BA%90%E7%A0%81%E5%88%86%E6%9E%90.md)

61 | + [LinkedHashMap 源码详细分析](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/LinkedHashMap%20%E6%BA%90%E7%A0%81%E8%AF%A6%E7%BB%86%E5%88%86%E6%9E%90.md)

62 | + [面试-集合基础》](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/collectionbase.md )

63 | + [面试:在面试中关于List(ArrayList、LinkedList)集合会怎么问呢?你该如何回答呢?](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/ArrayList&Linkedist面试.md)

64 | + [面试:为了进阿里,必须掌握HashMap原理和面试题(图解版一)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/HashMap原理和面试题(图解版一).md)

65 | + [面试:为了进阿里,死磕了ConcurrentHashMap源码和面试题(一)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/ConcurrentHashMap源码和面试题一.md)

66 | + [面试:为了进阿里,死磕了ConcurrentHashMap源码和面试题(二)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/collection/ConcurrentHashMap源码和面试题二.md)

67 |

68 | #### Java多线程与并发

69 | + [面试:多线程与并发基础](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/threadbase.md)

70 | + [面试:为了进阿里,又把并发CAS(Compare and Swap)实现重新精读一遍](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/并发CAS.md)

71 | + [面试:Java并发之Synchronized](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/Synchronized.md)

72 | + [面试:Volatile与Synchronized分析](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/Volatile与Synchronized.md)

73 | + [面试:Java多线程与并发之ThreadLocal](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/Java多线程与并发之ThreadLocal.md)

74 | + [面试:ThreadLocal内存泄露分析以及如何避免](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/ThreadLocal的内存泄露的原因分析以及如何避免.md)

75 | + [面试:为了进阿里,需要深入理解ReentrantLock原理](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/thread/ReentrantLock原理.md)

76 |

77 | #### JVM虚拟机

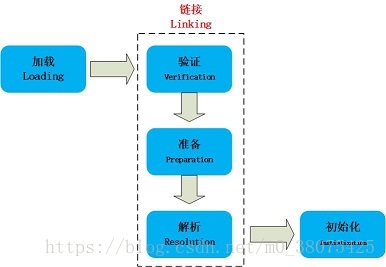

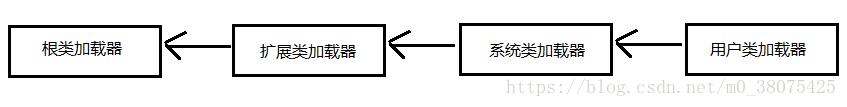

78 | + [《面试知识,工作可待篇-JVM内存篇》]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/jvm/jvmbase.md )

79 | + [《面试知识,工作可待篇-JVM类加载篇》]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/jvm/ClassLoad.md )

80 |

81 | #### 设计模式

82 |

83 | + [《面试知识-设计模式篇》]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/designMode.md )

84 | + [面试:对于单例模式面试官会怎样提问呢?你又该如何回答呢?]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/单例模式.md )

85 |

86 | ### ORM框架

87 |

88 | #### Mybatis

89 |

90 | + [MyBatis常见面试题](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/orm/MyBatis常见面试题.md)

91 | + [MyBatis面试题分析导读-架构以及核心内容](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/orm/MyBatis架构以及核心内容.md)

92 | + [面试:面试官有没有在Mybatis执行过程上为过难你呢?看完就不再怂(图文解析)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/orm/Mybatis执行过程.md)

93 |

94 |

95 | ### 数据库

96 | #### SQL数据库

97 | + [理解完这些基本上能解决面试中MySql的事务问题](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/javabase/sql/mysql/mysql事务.md)

98 | + [MySQL查询性能优化前,必须先掌握MySQL索引理论]()

99 | 面试:谈谈你对分库分表的理解

100 | + 面试:MySQL经典的面试题

101 |

102 |

103 | #### NoSQL数据库

104 | ##### redis

105 | + [面试:原来Redis常用的五种数据类型底层结构是这样的]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/redis/Redis常用的五种数据类型底层结构.md )

106 | + [当遇到美女面试官之如何理解Redis的Expire Key(过期键)](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/redis/Redis的ExpireKey(过期键).md)

107 | + [面试:简明的图解Redis RDB持久化、AOF持久化](https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/redis/RedisRDB持久化与AOF持久化.md)

108 | ##### mongodb

109 | + [面试:快2020年了,赶紧收藏起MongoDB面试题轻松面对BAT灵魂式的拷问]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/MongoDB面试题.md )

110 | + [MongoDB--Spring Data MongoDB详细的操作手册(增删改查)]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/SpringDataMongoDB详细的操作手册.md )

111 | + [MongoDB系列--深入理解MongoDB聚合(Aggregation )]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/MongoDB聚合.md )

112 | + [MongoDB系列--轻松应对面试中遇到的MongonDB索引(index)问题]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/MongonDB索引.md )

113 | + [MongoDB系列-在复制集(replication)以及分片(Shard)中创建索引]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/复制集(replication).md )

114 | + [MongoDB系列-复制集(Replica Set)应用部署(生产、测试、开发环境)]( https://github.com/Ccww-lx/Ccww-lx.github.io/blob/master/doc/db/mongodb/复制集(ReplicaSet)应用部署.md )

115 | ### Spring全家桶

116 |

117 | #### Spring

118 |

119 | + 《面试知识,工作可待篇-Spring篇》

120 |

121 | #### SpringMVC精选面试题

122 |

123 | + 《面试知识,工作可待篇-Spring MVC篇》

124 |

125 | #### SpringBoot精选面试题

126 |

127 | + 《面试知识,工作可待篇-Spring Boot篇》

128 |

129 | #### SpringCloud精选面试题

130 |

131 | + 《面试知识,工作可待篇-SpringCloud篇》

132 |

133 |

134 |

135 | ### 消息队列

136 |

137 | + 《面试知识,工作可待篇-消息队列知识篇》

138 | + 《面试知识,工作可待篇-RocketMQ篇》

139 | + 《面试知识,工作可待篇-Kafka篇》

140 | + 《面试知识,工作可待篇-RabbitMQ篇》

141 |

142 | ### 缓存

143 |

144 | + 《面试知识,工作可待篇-缓存篇》

145 |

146 | ### 服务调用

147 |

148 | #### Fegin

149 |

150 | + 《面试知识,工作可待篇-SpringCloud Fegin篇》

151 |

152 | #### Dubbo

153 |

154 | + 《面试知识,工作可待篇-Dubbo篇》

155 |

156 | ### 注册中心

157 |

158 | #### Eureka

159 |

160 | + 《面试知识,工作可待篇-Eureka篇》

161 |

162 | #### Zookeeper

163 |

164 | + 《面试知识,工作可待篇-Zookeeper篇》

165 |

166 | ### 配置中心

167 |

168 | #### Apollo

169 |

170 | + 《面试知识,工作可待篇-Apollo篇

171 |

172 | #### SpringCloud Config

173 |

174 | + 《面试知识,工作可待篇-SpringCloud Config篇》

175 |

176 | ### 服务器

177 |

178 | #### Tomcat

179 |

180 | + 《面试知识,工作可待篇-Tomcat篇》

181 |

182 | #### Netty

183 |

184 | + 《面试知识,工作可待篇-Netty篇》

185 |

186 | #### Nginx

187 |

188 | + 《面试知识,工作可待篇-Nginx篇》

189 |

190 | ### Linux

191 |

192 | + 《面试知识,工作可待篇-Linux篇》

193 |

194 | ### 计算机网络

195 |

196 | + [《面试知识,工作可待篇-计算机网络基础篇》](https://github.com/Ccww-lx/JavaCommunity/blob/master/doc/network/network.md )

197 |

198 |

199 | ### 数据结构与算法

200 |

201 | - 《面试知识,工作可待篇-算法面试篇》

202 |

203 | ### 分布式系统

204 |

205 | ### 代码优化

206 |

207 | ### SpringBoot集成

208 |

209 | ### SpringCloud微服务

210 |

211 | ### 工具

212 |

213 | ### 项目

214 |

215 | ### 开发工具

216 |

217 | + 《面试知识,工作可待篇-Maven篇》

218 |

219 | + 《面试知识,工作可待篇-Git篇》

220 |

221 | ### 面试技巧

222 |

223 | + 《面试知识,工作可待篇-面试技巧篇》

224 |

225 |

226 |

227 |

228 |

229 | ## 公众号

230 |

231 | 欢迎关注微信公众号[【**终端研发部**】](https://upload-images.jianshu.io/upload_images/14371339-8bc3926bc154fda1.jpg),原创技术文章第一时间推出 ,并且获取更多资料和视频

232 |

233 |

--------------------------------------------------------------------------------

/data/javabase/collection/ArrayList delete.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/ArrayList delete.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/ArrayList delete2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/ArrayList delete2.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/ArrayList insert.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/ArrayList insert.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/ArrayList insert2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/ArrayList insert2.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/LinkedList.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/LinkedList.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/jmm.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/jmm.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/linkedlist 删除.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/linkedlist 删除.jpg

--------------------------------------------------------------------------------

/data/javabase/collection/linkedlist 插入.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/collection/linkedlist 插入.jpg

--------------------------------------------------------------------------------

/data/javabase/image:

--------------------------------------------------------------------------------

1 |

2 |

--------------------------------------------------------------------------------

/data/javabase/thread/jmm.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/javabase/thread/jmm.jpg

--------------------------------------------------------------------------------

/data/network/format.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/format.png

--------------------------------------------------------------------------------

/data/network/http无状态.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/http无状态.png

--------------------------------------------------------------------------------

/data/network/osi.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/osi.png

--------------------------------------------------------------------------------

/data/network/tcp-udp.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/tcp-udp.png

--------------------------------------------------------------------------------

/data/network/三次握手.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/三次握手.png

--------------------------------------------------------------------------------

/data/network/三次握手示意图.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/三次握手示意图.png

--------------------------------------------------------------------------------

/data/network/四次挥手.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/四次挥手.png

--------------------------------------------------------------------------------

/data/network/状态码.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/network/状态码.png

--------------------------------------------------------------------------------

/data/公众号.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/codeGoogler/JavaCodeHub/45a8287cc8cb6f6a6be374c902d62d40765148c1/data/公众号.jpg

--------------------------------------------------------------------------------

/doc/db/mongodb/MongoDB聚合.md:

--------------------------------------------------------------------------------

1 | **MongoDB中聚合(aggregate)** 操作将来自多个document的value组合在一起,并通过对分组数据进行各种操作处理,并返回计算后的数据结果,主要用于处理数据(诸如统计平均值,求和等)。MongoDB提供三种方式去执行聚合操作:**聚合管道(aggregation pipeline)**、**Map-Reduce函数**以及**单一的聚合命令(count、distinct、group)**。

2 |

3 | ## 1. 聚合管道(aggregation pipeline)

4 | ### 1.1聚合管道

5 | 聚合管道是由aggregation framework将文档进入一个由多个阶段(stage)组成的管道,可以对每个阶段的管道进行分组、过滤等功能,然后经过一系列的处理,输出相应的聚合结果。如图所示:

6 |

7 |

8 |

9 | **聚合管道操作:**

10 |

11 | db.orders.aggregate([

12 | { $match: { status: "A" } },

13 | { $group: { _id: "$cust_id", total: { $sum: "$amount" } } }

14 | ])

15 |

16 | + **\$match阶段:通过status字段过滤出符合条件的Document(即是Status等于“A”的Document);**

17 | + ** \$group 阶段:按cust_id字段对Document进行分组,以计算每个唯一cust_id的金额总和。**

18 |

19 | ### 1.2 管道

20 | 管道在Unix和Linux中一般用于将当前命令的输出结果作为下一个命令的参数,MongoDB的聚合管道将MongoDB文档在一个管道处理完毕后将结果传递给下一个管道处理。管道操作是可以重复的。

21 | 最基本的管道功能提供**过滤器filter**,其操作类似于查询和文档转换,可以修改输出文档的形式。

22 | 其他管道操作提供了按特定字段或字段对文档进行分组和排序的工具,以及用于聚合数组内容(包括文档数组)的工具。 此外,管道阶段可以使用运算符执行任务,例如计算平均值或连接字符串。总结如下:

23 |

24 | **管道操作符**

25 | 常用管道|解析

26 | :-|:-|

27 | $group|将collection中的document分组,可用于统计结果

28 | $match|过滤数据,只输出符合结果的文档

29 | $project|修改输入文档的结构(例如重命名,增加、删除字段,创建结算结果等)

30 | $sort|将结果进行排序后输出

31 | $limit|限制管道输出的结果个数

32 | $skip|跳过制定数量的结果,并且返回剩下的结果

33 | $unwind|将数组类型的字段进行拆分

34 |

35 | **表达式操作符**

36 | 常用表达式|含义

37 | :-|:-|

38 | $sum|计算总和,{\$sum: 1}表示返回总和×1的值(即总和的数量),使用{\$sum: '\$制定字段'}也能直接获取制定字段的值的总和

39 | $avg|求平均值

40 | $min|求min值

41 | $max|求max值

42 | $push|将结果文档中插入值到一个数组中

43 | $first|根据文档的排序获取第一个文档数据

44 | $last|同理,获取最后一个数据

45 |

46 | **为了便于理解,将常见的mongo的聚合操作和MySql的查询做类比:**

47 | MongoDB聚合操作|MySql操作/函数

48 | :-|:-|

49 | $match|where

50 | $group|group by

51 | $match|having

52 | $project|select

53 | $sort|order by

54 | $limit|limit

55 | $sum|sum()

56 | $lookup |join

57 |

58 |

59 | ### 1.3 Aggregation Pipeline 优化

60 |

61 | + **聚合管道可以确定它是否仅需要文档中的字段的子集来获得结果。 如果是这样,管道将只使用那些必需的字段,减少通过管道的数据量**

62 | + **管道序列优化化**

63 |

64 |

65 | **管道序列优化化:**

66 | **1).使用\$projector/\$addFields+\$match 序列优化:当Aggregation Pipeline中有多个\$projectior/\$addFields阶段和\$match 阶段时,会先执行有依赖的\$projector/\$addFields阶段,然后会新创建的$match阶段执行,如下,**

67 |

68 | { $addFields: {

69 | maxTime: { $max: "$times" },

70 | minTime: { $min: "$times" }

71 | } },

72 | { $project: {

73 | _id: 1, name: 1, times: 1, maxTime: 1, minTime: 1,

74 | avgTime: { $avg: ["$maxTime", "$minTime"] }

75 | } },

76 | { $match: {

77 | name: "Joe Schmoe",

78 | maxTime: { $lt: 20 },

79 | minTime: { $gt: 5 },

80 | avgTime: { $gt: 7 }

81 | } }

82 | **优化执行:**

83 |

84 | { $match: { name: "Joe Schmoe" } },

85 | { $addFields: {

86 | maxTime: { $max: "$times" },

87 | minTime: { $min: "$times" }

88 | } },

89 | { $match: { maxTime: { $lt: 20 }, minTime: { $gt: 5 } } },

90 | { $project: {

91 | _id: 1, name: 1, times: 1, maxTime: 1, minTime: 1,

92 | avgTime: { $avg: ["$maxTime", "$minTime"] }

93 | } },

94 | { $match: { avgTime: { $gt: 7 } } }

95 | **2). \$sort + \$match 以及\$project + \$skip,当\$sort/\$project跟在\$match/\$skip之后时,会先执行\$match/\$skip后再执行\$sort/\$project,\$sort以达到最小化需排列的对象数,\$skip约束,如下:**

96 |

97 | { $sort: { age : -1 } },

98 | { $match: { score: 'A' } }

99 | { $project: { status: 1, name: 1 } },

100 | { $skip: 5 }

101 | **优化执行:**

102 |

103 | { $match: { score: 'A' } },

104 | { $sort: { age : -1 } }

105 | { $skip: 5 },

106 | { $project: { status: 1, name: 1 } }

107 | **3). \$redact+\$match序列优化,当\$redact后有\$match时,可能会新创一个\$match阶段进行优化,如下,**

108 |

109 | { $redact: { $cond: { if: { $eq: [ "$level", 5 ] }, then: "?PRUNE", else: "?DESCEND" } } },

110 | { $match: { year: 2014, category: { $ne: "Z" } } }

111 | **优化执行:**

112 |

113 | { $match: { year: 2014 } },

114 | { $redact: { $cond: { if: { $eq: [ "$level", 5 ] }, then: "?PRUNE", else: "?DESCEND" } } },

115 | { $match: { year: 2014, category: { $ne: "Z" } } }

116 |

117 | 还有很多管道序列优化可以查看《[官方文档-Aggregation Pipeline Optimization](https://docs.mongodb.com/manual/core/aggregation-pipeline-optimization/)》。

118 |

119 | ### 1.4 Aggregation Pipeline以及分片(Sharded)collections

120 | 如果管道以\$match精确分片 key开始的后,所有管道会在匹配的分片上进行。对于需运行在多分片中的聚合(aggregation)操作,如果不不需要在主分片进行的,这些操作后的结果会路由到随机分片中进行合并结果,避免重载该主分片的数据库。\$out和\$look阶段必须在主分片数据库运行。

121 |

122 |

123 | ## 2. Map-Reduce函数

124 | MongoDB还提供map-reduce操作来执行聚合。 通常,**map-reduce操作有两个阶段**:**一个map阶段**,它处理每个文档并为每个输入文档发出一个或多个对象,以及**reduce阶段**组合map操作的输出。 可选地,map-reduce可以具有最终化阶段以对结果进行最终修改。 与其他聚合操作一样,map-reduce可以指定查询条件以选择输入文档以及排序和限制结果。

125 |

126 | Map-reduce使用自定义JavaScript函数来执行映射和减少操作,以及可选的finalize操作。 虽然自定义JavaScript与聚合管道相比提供了极大的灵活性,但通常,map-reduce比聚合管道效率更低,更复杂。模式如下:

127 |

128 |

129 |

130 |

131 | ## 3. 单一的聚合命令

132 | MongoDB还提供了,db.collection.estimatedDocumentCount(),db.collection.count()和db.collection.distinct()

133 | 所有这些单一的聚合命令。 虽然这些操作提供了对常见聚合过程的简单访问操作,但它们缺乏聚合管道和map-reduce的灵活性和功能。模型如下

134 |

135 |

136 |

137 | ## 总结

138 | 可使用MongoDB中聚合操作用于数据处理,可以适应于一些数据分析等,聚合的典型应用包括销售数据的业务报表,比如将各地区的数据分组后计算销售总和、财务报表等。最后想要更加深入理解还需要自己去实践。

139 |

140 | **最后可关注公众号,一起学习,每天会分享干货,还有学习视频干货领取!**

141 |

142 |

143 |

144 |

--------------------------------------------------------------------------------

/doc/db/mongodb/MongoDB面试题.md:

--------------------------------------------------------------------------------

1 |

2 | `MongoDB`是基于分布式文件存储的数据库,由`C++`语言编写。旨在为`WEB`应用提供可扩展的高性能数据存储解决方案,且`MongodDB`是一个介于关系数据库与非关系数据库之间的产品,是非关系型数据库中功能最丰富,最像关系数据库。

3 |

4 | 由于`MongoDB`的特性以及功能,使得其在企业使用频率很大,所以很多面试都会MongoDB的相关知识,基于网上以及自己阅读官网文档总结2019-2020年`MongoDB`的面试题。具体如下:

5 |

6 |

7 |

8 | ### **1Q:`MongoDB`的优势有哪些?**

9 |

10 | * 面向集合(`Collection`)和文档(`document`)的存储,以JSON格式的文档保存数据。

11 |

12 | * 高性能,支持`Document`中嵌入`Document`减少了数据库系统上的I/O操作以及具有完整的索引支持,支持快速查询

13 | * 高效的传统存储方式:支持二进制数据及大型对象

14 | * 高可用性,数据复制集,MongoDB 数据库支持服务器之间的数据复制来提供自动故障转移(`automatic failover`)

15 |

16 | * 高可扩展性,分片(`sharding`)将数据分布在多个数据中心,MongoDB支持基于分片键创建数据区域.

17 |

18 | * 丰富的查询功能, 聚合管道(`Aggregation Pipeline`)、全文搜索(`Text Search`)以及地理空间查询(`Geospatial Queries`)

19 | * 支持多个存储引擎,WiredTiger存储引、In-Memory存储引擎

20 |

21 | ### **2Q:`MongoDB` 支持哪些数据类型?**

22 |

23 | **java类似数据类型:**

24 | |类型|解析|

25 | |:-|:-|

26 | |`String`|字符串。存储数据常用的数据类型。在 `MongoDB` 中,`UTF-8` 编码的字符串才是合法的|

27 | | `Integer`|整型数值。用于存储数值。根据你所采用的服务器,可分为 32 位或 64 位|

28 | |`Double`|双精度浮点值。用于存储浮点值|

29 | |`Boolean`|布尔值。用于存储布尔值(真/假)|

30 | |`Arrays`|用于将数组或列表或多个值存储为一个键|

31 | |`Datetime`|记录文档修改或添加的具体时间|

32 |

33 | **MongoDB特有数据类型:**

34 | |类型|解析|

35 | |:-|:-|

36 | |`ObjectId`|用于存储文档 `id`,`ObjectId`是基于分布式主键的实现`MongoDB`分片也可继续使用|

37 | |`Min/Max Keys`|将一个值与 BSON(二进制的 JSON)元素的最低值和最高值相对比|

38 | |`Code`|用于在文档中存储 `JavaScript`代码|

39 | | `Regular Expression`|用于在文档中存储正则表达式|

40 | |`Binary Data`|二进制数据。用于存储二进制数据|

41 | |`Null`|用于创建空值|

42 | |`Object`|用于内嵌文档|

43 |

44 | ### **3Q:什么是集合`Collection`、文档`Document`,以及与关系型数据库术语类比。**

45 |

46 | * 集合`Collection`位于单独的一个数据库MongoDB 文档`Document`集合,它类似关系型数据库(RDBMS)中的表`Table`。一个集合`Collection`内的多个文档`Document`可以有多个不同的字段。通常情况下,集合`Collection`中的文档`Document`有着相同含义。

47 | * 文档`Document`由key-value构成。文档`Document`是动态模式,这说明同一集合里的文档不需要有相同的字段和结构。类似于关系型数据库中table中的每一条记录。

48 | * 与关系型数据库术语类比

49 |

50 | |mongodb|关系型数据库|

51 | |:---|---|

52 | |Database|Database|

53 | |Collection|Table|

54 | |Document|Record/Row|

55 | |Filed|Column|

56 | |Embedded Documents| Table join|

57 |

58 |

59 | ### **4Q:什么是”`Mongod`“,以及`MongoDB`命令。**

60 |

61 | `mongod`是处理`MongoDB`系统的主要进程。它处理数据请求,管理数据存储,和执行后台管理操作。当我们运行`mongod`命令意味着正在启动`MongoDB`进程,并且在后台运行。

62 |

63 | `MongoDB`命令:

64 |

65 | |命令|说明|

66 | |---|----|

67 | |use database_name|切换数据库|

68 | |db.myCollection.find().pretty()|格式化打印结果|

69 | |db.getCollection(collectionName).find()|修改Collection名称|

70 |

71 |

72 | ### **5Q:"`Mongod`"默认参数有?**

73 | * 传递数据库存储路径,默认是`"/data/db"`

74 | * 端口号 默认是 "27017"

75 |

76 | ### **6Q:`MySQL`和`mongodb`的区别**

77 |

78 | |形式|MongoDB|MySQL|

79 | |---|----|----|

80 | |数据库模型|非关系型|关系型|

81 | |存储方式||虚拟内存+持久化|不同的引擎有不同的存储方式|

82 | |查询语句|独特的MongoDB查询方式|传统SQL语句|

83 | |架构特点|副本集以及分片|常见单点、M-S、MHA、MMM等架构方式|

84 | |数据处理方式|基于内存,将热数据存在物理内存中,从而达到高速读写|不同的引擎拥有自己的特点|

85 | |使用场景|事件的记录,内容管理或者博客平台等数据大且非结构化数据的场景|适用于数据量少且很多结构化数据|

86 |

87 |

88 | ### 7Q:问`mongodb`和`redis`区别以及选择原因

89 |

90 | |形式|MongoDB|redis|

91 | |---|---|----|

92 | |内存管理机制|MongoDB 数据存在内存,由 linux系统 mmap 实现,当内存不够时,只将热点数据放入内存,其他数据存在磁盘|Redis 数据全部存在内存,定期写入磁盘,当内存不够时,可以选择指定的 LRU 算法删除数据|

93 | |支持的数据结构|MongoDB 数据结构比较单一,但是支持丰富的数据表达,索引|Redis 支持的数据结构丰富,包括hash、set、list等|

94 | |性能|mongodb依赖内存,TPS较高|Redis依赖内存,TPS非常高。性能上Redis优于MongoDB|

95 | |可靠性|支持持久化以及复制集增加可靠性|Redis依赖快照进行持久化;AOF增强可靠性;增强可靠性的同时,影响访问性能|

96 | |数据分析|mongodb内置数据分析功能(mapreduce)|Redis不支持|

97 | |事务支持情况|只支持单文档事务,需要复杂事务支持的场景暂时不适合|Redis 事务支持比较弱,只能保证事务中的每个操作连续执行|

98 | |集群|MongoDB 集群技术比较成熟|Redis从3.0开始支持集群|

99 | **选择原因:**

100 | * 架构简单

101 |

102 | * 没有复杂的连接

103 |

104 | * 深度查询能力,`MongoDB`支持动态查询。

105 |

106 | * 容易调试

107 |

108 | * 容易扩展

109 |

110 | * 不需要转化/映射应用对象到数据库对象

111 |

112 | * 使用内部内存作为存储工作区,以便更快的存取数据。

113 |

114 |

115 | ### **8Q:如何执行事务/加锁?**

116 |

117 | `mongodb`没有使用传统的锁或者复杂的带回滚的事务,因为它设计的宗旨是轻量,快速以及可预计的高性能.可以把它类比成`mysql mylsam`的自动提交模式.通过精简对事务的支持,性能得到了提升,特别是在一个可能会穿过多个服务器的系统里.

118 |

119 | ### **9Q:更新操作会立刻fsync到磁盘?**

120 |

121 | 不会,磁盘写操作默认是延迟执行的.写操作可能在两三秒(默认在60秒内)后到达磁盘,通过 `syncPeriodSecs` 启动参数,可以进行配置.例如,如果一秒内数据库收到一千个对一个对象递增的操作,仅刷新磁盘一次.

122 |

123 | ### MongoDB索引

124 | **10Q: 索引类型有哪些?**

125 | + 单字段索引(`Single Field Indexes`)

126 | + 复合索引(`Compound Indexes`)

127 | + 多键索引(`Multikey Indexes`)

128 | + 全文索引(`text Indexes`)

129 | + Hash 索引(`Hash Indexes`)

130 | + 通配符索引(`Wildcard Index`)

131 | + 2dsphere索引(`2dsphere Indexes`)

132 |

133 | **11Q:`MongoDB`在A:{B,C}上建立索引,查询A:{B,C}和A:{C,B}都会使用索引吗?**

134 |

135 | 由于`MongoDB`索引使用`B-tree`树原理,只会在A:{B,C}上使用索引

136 |

137 |

138 | **`MongoDB`索引详情可看文章**[【**`MongoDB`系列--轻松应对面试中遇到的MongonDB索引(index)问题**】](https://juejin.im/post/6844903905441103880),**其中包括很多索引的问题:**

139 | + **创建索引,需要考虑的问题**

140 | + **索引限制问题**

141 | + **索引类型详细解析**

142 | + **索引的种类问题**

143 |

144 | ### **12Q:什么是聚合**

145 |

146 | 聚合操作能够处理数据记录并返回计算结果。聚合操作能将多个文档中的值组合起来,对成组数据执行各种操作,返回单一的结果。它相当于 `SQ`L 中的 `count(*)` 组合 `group by`。对于 `MongoDB` 中的聚合操作,应该使用`aggregate()`方法。

147 |

148 | **详情可查看文章**[【**MongoDB系列--深入理解MongoDB聚合(Aggregation)**】](https://juejin.im/post/6844903903000002574),**其中包括很多聚合的问题:**

149 | + **聚合管道(`aggregation pipeline`)的问题**

150 | + **`Aggregation Pipeline` 优化等问题**

151 | + **Map-Reduce函数的问题**

152 |

153 | ### MongoDB分片

154 | **13Q:`monogodb` 中的分片`sharding`**

155 |

156 | 分片`sharding`是将数据水平切分到不同的物理节点。当应用数据越来越大的时候,数据量也会越来越大。当数据量增长

157 | 时,单台机器有可能无法存储数据或可接受的读取写入吞吐量。利用分片技术可以添加更多的机器来应对数据量增加

158 | 以及读写操作的要求。

159 |

160 | **14Q:分片(`Shard`)和复制(`replication`)是怎样工作的?**

161 |

162 | 每一个分片(`shard`)是一个分区数据的逻辑集合。分片可能由单一服务器或者集群组成,我们推荐为每一个分片(`shard`)使用集群。

163 |

164 | **15Q:如果块移动操作(`moveChunk`)失败了,我需要手动清除部分转移的文档吗?**

165 |

166 | 不需要,移动操作是一致(`consistent`)并且是确定性的(`deterministic`)。

167 | + 一次失败后,移动操作会不断重试。

168 | + 当完成后,数据只会出现在新的分片里(shard)

169 |

170 | **16Q:数据在什么时候才会扩展到多个分片(`Shard`)里?**

171 |

172 | `MongoDB` 分片是基于区域(`range`)的。所以一个集合(`collection`)中的所有的对象都被存放到一个块(`chunk`)中,默认块的大小是 64Mb。当数据容量超过64 Mb,才有可能实施一个迁移,只有当存在不止一个块的时候,才会有多个分片获取数据的选项。

173 |

174 | **17Q:更新一个正在被迁移的块(Chunk)上的文档时会发生什么?**

175 |

176 | 更新操作会立即发生在旧的块(Chunk)上,然后更改才会在所有权转移前复制到新的分片上。

177 |

178 | **18Q:如果一个分片(Shard)停止或很慢的时候,发起一个查询会怎样?**

179 |

180 | 如果一个分片停止了,除非查询设置了 “`Partial`” 选项,否则查询会返回一个错误。如果一个分片响应很慢,`MongoDB` 会等待它的响应。

181 |

182 | ### MongoDB复制集

183 | **19Q:`MongoDB`副本集实现高可用的原理**

184 |

185 | `MongoDB` 使用了其复制(`Replica Set`)方案,实现自动容错机制为高可用提供了基础。目前,`MongoDB` 支持两种复制模式:

186 | + `Master` / `Slave` ,主从复制,角色包括 `Master` 和 `Slave` 。

187 | + `Replica Set` ,复制集复制,角色包括 `Primary` 和 `Secondary` 以及 `Arbiter` 。(**生产环境必选**)

188 |

189 | **20Q:什么是`master`或`primary`?**

190 |

191 | 副本集只能有一个主节点能够确认写入操作来接收所有写操作,并记录其操作日志中的数据集的所有更改(记录在oplog中)。在集群中,当主节点(`master`)失效,Secondary节点会变为`master`

192 |

193 | **21Q:什么是`Slave`或`Secondary`?**

194 |

195 | 复制主节点的oplog并将oplog记录的操作应用于其数据集,如果主节点宕机了,将从符合条件的从节点选举选出新的主节点。

196 |

197 | **22Q:什么是`Arbiter`?**

198 |

199 | 仲裁节点不维护数据集。 仲裁节点的目的是通过响应其他副本集节点的心跳和选举请求来维护副本集中的仲裁

200 |

201 | **23Q:复制集节点类型有哪些?**

202 | + 优先级0型(`Priority 0`)节点

203 | + 隐藏型(`Hidden`)节点

204 | + 延迟型(`Delayed`)节点

205 | + 投票型(`Vote`)节点以及不可投票节点

206 |

207 | **24Q:启用备份故障恢复需要多久?**

208 |

209 | 从备份数据库声明主数据库宕机到选出一个备份数据库作为新的主数据库将花费10到30秒时间.这期间在主数据库上的操作将会失败–包括写入和强一致性读取(`strong consistent read`)操作.然而,你还能在第二数据库上执行最终一致性查询(`eventually consistent query`)(在`slaveok`模式下),即使在这段时间里.

210 |

211 | **`MongoDB`复制详解分析可查看文章**[【**MongoDB系列-解决面试中可能遇到的MongoDB复制集(replica set)问题**】](https://juejin.im/post/6844903919659778055)

212 |

213 | ### 25Q:`raft`选举过程,投票规则?

214 |

215 | **选举过程:**

216 |

217 | 当系统启动好之后,初始选举后系统由1个`Leader`和若干个`Follower`角色组成。然后突然由于某个异常原因,`Leader`服务出现了异常,导致`Follower`角色检测到和`Leader`的上次RPC更新时间超过给定阈值时间时。此时`Followe`r会认为`Leader`服务已出现异常,然后它将会发起一次新的`Leader`选举行为,同时将自身的状态从`Follower`切换为`Candidate`身份。随后请求其它`Follower`投票选择自己。

218 |

219 | **投票规则:**

220 | + 当一个候选人获得了同一个任期号内的大多数选票,就成为领导人。

221 | + 每个节点最多在一个任期内投出一张选票。并且按照先来先服务的原则。

222 | + 一旦候选人赢得选举,立刻成为领导,并发送心跳维持权威,同时阻止新领导人的诞生

223 |

224 | **可查看文章**[【**通俗易懂的Paxos算法-基于消息传递的一致性算法**】](https://juejin.im/post/6844903874587787277)

225 |

226 |

227 | ### **26Q:在哪些场景使用`MongoDB`?**

228 |

229 | **规则:** 如果业务中存在大量复杂的事务逻辑操作,则不要用`MongoDB`数据库;在处理非结构化 / 半结构化的大数据使用`MongoDB`,操作的数据类型为动态时也使用`MongoDB`,比如:

230 | * 内容管理系统,切面数据、日志记录

231 | * 移动端`Apps`:`O2O`送快递骑手、快递商家的信息(包含位置信息)

232 | * 数据管理,监控数据

233 |

234 |

235 |

236 |

237 | > 各位看官还可以吗?喜欢的话,动动手指点个💗,点个关注呗!!谢谢支持!

238 | >

239 | > 欢迎关注公众号【**Ccww技术博客**】,原创技术文章第一时间推出

240 |

241 |

242 |

243 |

244 |

--------------------------------------------------------------------------------

/doc/db/mongodb/SpringDataMongoDB详细的操作手册.md:

--------------------------------------------------------------------------------

1 |

2 | `MongoDB`是基于分布式文件存储的数据库,由`C++`语言编写。旨在为`WEB`应用提供可扩展的高性能数据存储解决方案,且`MongodDB`是一个介于关系数据库与非关系数据库之间的产品,是非关系型数据库中功能最丰富,最像关系数据库。

3 |

4 | 由于`MongoDB`的特性以及功能,使得其在企业使用频率很大,所以很多面试都会MongoDB的相关知识,基于网上以及自己阅读官网文档总结2019-2020年`MongoDB`的面试题。具体如下:

5 |

6 |

7 |

8 | ### **1Q:`MongoDB`的优势有哪些?**

9 |

10 | * 面向集合(`Collection`)和文档(`document`)的存储,以JSON格式的文档保存数据。

11 |

12 | * 高性能,支持`Document`中嵌入`Document`减少了数据库系统上的I/O操作以及具有完整的索引支持,支持快速查询

13 | * 高效的传统存储方式:支持二进制数据及大型对象

14 | * 高可用性,数据复制集,MongoDB 数据库支持服务器之间的数据复制来提供自动故障转移(`automatic failover`)

15 |

16 | * 高可扩展性,分片(`sharding`)将数据分布在多个数据中心,MongoDB支持基于分片键创建数据区域.

17 |

18 | * 丰富的查询功能, 聚合管道(`Aggregation Pipeline`)、全文搜索(`Text Search`)以及地理空间查询(`Geospatial Queries`)

19 | * 支持多个存储引擎,WiredTiger存储引、In-Memory存储引擎

20 |

21 | ### **2Q:`MongoDB` 支持哪些数据类型?**

22 |

23 | **java类似数据类型:**

24 | |类型|解析|

25 | |:-|:-|

26 | |`String`|字符串。存储数据常用的数据类型。在 `MongoDB` 中,`UTF-8` 编码的字符串才是合法的|

27 | | `Integer`|整型数值。用于存储数值。根据你所采用的服务器,可分为 32 位或 64 位|

28 | |`Double`|双精度浮点值。用于存储浮点值|

29 | |`Boolean`|布尔值。用于存储布尔值(真/假)|

30 | |`Arrays`|用于将数组或列表或多个值存储为一个键|

31 | |`Datetime`|记录文档修改或添加的具体时间|

32 |

33 | **MongoDB特有数据类型:**

34 | |类型|解析|

35 | |:-|:-|

36 | |`ObjectId`|用于存储文档 `id`,`ObjectId`是基于分布式主键的实现`MongoDB`分片也可继续使用|

37 | |`Min/Max Keys`|将一个值与 BSON(二进制的 JSON)元素的最低值和最高值相对比|

38 | |`Code`|用于在文档中存储 `JavaScript`代码|

39 | | `Regular Expression`|用于在文档中存储正则表达式|

40 | |`Binary Data`|二进制数据。用于存储二进制数据|

41 | |`Null`|用于创建空值|

42 | |`Object`|用于内嵌文档|

43 |

44 | ### **3Q:什么是集合`Collection`、文档`Document`,以及与关系型数据库术语类比。**

45 |

46 | * 集合`Collection`位于单独的一个数据库MongoDB 文档`Document`集合,它类似关系型数据库(RDBMS)中的表`Table`。一个集合`Collection`内的多个文档`Document`可以有多个不同的字段。通常情况下,集合`Collection`中的文档`Document`有着相同含义。

47 | * 文档`Document`由key-value构成。文档`Document`是动态模式,这说明同一集合里的文档不需要有相同的字段和结构。类似于关系型数据库中table中的每一条记录。

48 | * 与关系型数据库术语类比

49 |

50 | |mongodb|关系型数据库|

51 | |:---|---|

52 | |Database|Database|

53 | |Collection|Table|

54 | |Document|Record/Row|

55 | |Filed|Column|

56 | |Embedded Documents| Table join|

57 |

58 |

59 | ### **4Q:什么是”`Mongod`“,以及`MongoDB`命令。**

60 |

61 | `mongod`是处理`MongoDB`系统的主要进程。它处理数据请求,管理数据存储,和执行后台管理操作。当我们运行`mongod`命令意味着正在启动`MongoDB`进程,并且在后台运行。

62 |

63 | `MongoDB`命令:

64 |

65 | |命令|说明|

66 | |---|----|

67 | |use database_name|切换数据库|

68 | |db.myCollection.find().pretty()|格式化打印结果|

69 | |db.getCollection(collectionName).find()|修改Collection名称|

70 |

71 |

72 | ### **5Q:"`Mongod`"默认参数有?**

73 | * 传递数据库存储路径,默认是`"/data/db"`

74 | * 端口号 默认是 "27017"

75 |

76 | ### **6Q:`MySQL`和`mongodb`的区别**

77 |

78 | |形式|MongoDB|MySQL|

79 | |---|----|----|

80 | |数据库模型|非关系型|关系型|

81 | |存储方式||虚拟内存+持久化|不同的引擎有不同的存储方式|

82 | |查询语句|独特的MongoDB查询方式|传统SQL语句|

83 | |架构特点|副本集以及分片|常见单点、M-S、MHA、MMM等架构方式|

84 | |数据处理方式|基于内存,将热数据存在物理内存中,从而达到高速读写|不同的引擎拥有自己的特点|

85 | |使用场景|事件的记录,内容管理或者博客平台等数据大且非结构化数据的场景|适用于数据量少且很多结构化数据|

86 |

87 |

88 | ### 7Q:问`mongodb`和`redis`区别以及选择原因

89 |

90 | |形式|MongoDB|redis|

91 | |---|---|----|

92 | |内存管理机制|MongoDB 数据存在内存,由 linux系统 mmap 实现,当内存不够时,只将热点数据放入内存,其他数据存在磁盘|Redis 数据全部存在内存,定期写入磁盘,当内存不够时,可以选择指定的 LRU 算法删除数据|

93 | |支持的数据结构|MongoDB 数据结构比较单一,但是支持丰富的数据表达,索引|Redis 支持的数据结构丰富,包括hash、set、list等|

94 | |性能|mongodb依赖内存,TPS较高|Redis依赖内存,TPS非常高。性能上Redis优于MongoDB|

95 | |可靠性|支持持久化以及复制集增加可靠性|Redis依赖快照进行持久化;AOF增强可靠性;增强可靠性的同时,影响访问性能|

96 | |数据分析|mongodb内置数据分析功能(mapreduce)|Redis不支持|

97 | |事务支持情况|只支持单文档事务,需要复杂事务支持的场景暂时不适合|Redis 事务支持比较弱,只能保证事务中的每个操作连续执行|

98 | |集群|MongoDB 集群技术比较成熟|Redis从3.0开始支持集群|

99 | **选择原因:**

100 | * 架构简单

101 |

102 | * 没有复杂的连接

103 |

104 | * 深度查询能力,`MongoDB`支持动态查询。

105 |

106 | * 容易调试

107 |

108 | * 容易扩展

109 |

110 | * 不需要转化/映射应用对象到数据库对象

111 |

112 | * 使用内部内存作为存储工作区,以便更快的存取数据。

113 |

114 |

115 | ### **8Q:如何执行事务/加锁?**

116 |

117 | `mongodb`没有使用传统的锁或者复杂的带回滚的事务,因为它设计的宗旨是轻量,快速以及可预计的高性能.可以把它类比成`mysql mylsam`的自动提交模式.通过精简对事务的支持,性能得到了提升,特别是在一个可能会穿过多个服务器的系统里.

118 |

119 | ### **9Q:更新操作会立刻fsync到磁盘?**

120 |

121 | 不会,磁盘写操作默认是延迟执行的.写操作可能在两三秒(默认在60秒内)后到达磁盘,通过 `syncPeriodSecs` 启动参数,可以进行配置.例如,如果一秒内数据库收到一千个对一个对象递增的操作,仅刷新磁盘一次.

122 |

123 | ### MongoDB索引

124 | **10Q: 索引类型有哪些?**

125 | + 单字段索引(`Single Field Indexes`)

126 | + 复合索引(`Compound Indexes`)

127 | + 多键索引(`Multikey Indexes`)

128 | + 全文索引(`text Indexes`)

129 | + Hash 索引(`Hash Indexes`)

130 | + 通配符索引(`Wildcard Index`)

131 | + 2dsphere索引(`2dsphere Indexes`)

132 |

133 | **11Q:`MongoDB`在A:{B,C}上建立索引,查询A:{B,C}和A:{C,B}都会使用索引吗?**

134 |

135 | 由于`MongoDB`索引使用`B-tree`树原理,只会在A:{B,C}上使用索引

136 |

137 |

138 | **`MongoDB`索引详情可看文章**[【**`MongoDB`系列--轻松应对面试中遇到的MongonDB索引(index)问题**】](https://juejin.im/post/6844903905441103880),**其中包括很多索引的问题:**

139 | + **创建索引,需要考虑的问题**

140 | + **索引限制问题**

141 | + **索引类型详细解析**

142 | + **索引的种类问题**

143 |

144 | ### **12Q:什么是聚合**

145 |

146 | 聚合操作能够处理数据记录并返回计算结果。聚合操作能将多个文档中的值组合起来,对成组数据执行各种操作,返回单一的结果。它相当于 `SQ`L 中的 `count(*)` 组合 `group by`。对于 `MongoDB` 中的聚合操作,应该使用`aggregate()`方法。

147 |

148 | **详情可查看文章**[【**MongoDB系列--深入理解MongoDB聚合(Aggregation)**】](https://juejin.im/post/6844903903000002574),**其中包括很多聚合的问题:**

149 | + **聚合管道(`aggregation pipeline`)的问题**

150 | + **`Aggregation Pipeline` 优化等问题**

151 | + **Map-Reduce函数的问题**

152 |

153 | ### MongoDB分片

154 | **13Q:`monogodb` 中的分片`sharding`**

155 |

156 | 分片`sharding`是将数据水平切分到不同的物理节点。当应用数据越来越大的时候,数据量也会越来越大。当数据量增长

157 | 时,单台机器有可能无法存储数据或可接受的读取写入吞吐量。利用分片技术可以添加更多的机器来应对数据量增加

158 | 以及读写操作的要求。

159 |

160 | **14Q:分片(`Shard`)和复制(`replication`)是怎样工作的?**

161 |

162 | 每一个分片(`shard`)是一个分区数据的逻辑集合。分片可能由单一服务器或者集群组成,我们推荐为每一个分片(`shard`)使用集群。

163 |

164 | **15Q:如果块移动操作(`moveChunk`)失败了,我需要手动清除部分转移的文档吗?**

165 |

166 | 不需要,移动操作是一致(`consistent`)并且是确定性的(`deterministic`)。

167 | + 一次失败后,移动操作会不断重试。

168 | + 当完成后,数据只会出现在新的分片里(shard)

169 |

170 | **16Q:数据在什么时候才会扩展到多个分片(`Shard`)里?**

171 |

172 | `MongoDB` 分片是基于区域(`range`)的。所以一个集合(`collection`)中的所有的对象都被存放到一个块(`chunk`)中,默认块的大小是 64Mb。当数据容量超过64 Mb,才有可能实施一个迁移,只有当存在不止一个块的时候,才会有多个分片获取数据的选项。

173 |

174 | **17Q:更新一个正在被迁移的块(Chunk)上的文档时会发生什么?**

175 |

176 | 更新操作会立即发生在旧的块(Chunk)上,然后更改才会在所有权转移前复制到新的分片上。

177 |

178 | **18Q:如果一个分片(Shard)停止或很慢的时候,发起一个查询会怎样?**

179 |

180 | 如果一个分片停止了,除非查询设置了 “`Partial`” 选项,否则查询会返回一个错误。如果一个分片响应很慢,`MongoDB` 会等待它的响应。

181 |

182 | ### MongoDB复制集

183 | **19Q:`MongoDB`副本集实现高可用的原理**

184 |

185 | `MongoDB` 使用了其复制(`Replica Set`)方案,实现自动容错机制为高可用提供了基础。目前,`MongoDB` 支持两种复制模式:

186 | + `Master` / `Slave` ,主从复制,角色包括 `Master` 和 `Slave` 。

187 | + `Replica Set` ,复制集复制,角色包括 `Primary` 和 `Secondary` 以及 `Arbiter` 。(**生产环境必选**)

188 |

189 | **20Q:什么是`master`或`primary`?**

190 |

191 | 副本集只能有一个主节点能够确认写入操作来接收所有写操作,并记录其操作日志中的数据集的所有更改(记录在oplog中)。在集群中,当主节点(`master`)失效,Secondary节点会变为`master`

192 |

193 | **21Q:什么是`Slave`或`Secondary`?**

194 |

195 | 复制主节点的oplog并将oplog记录的操作应用于其数据集,如果主节点宕机了,将从符合条件的从节点选举选出新的主节点。

196 |

197 | **22Q:什么是`Arbiter`?**

198 |

199 | 仲裁节点不维护数据集。 仲裁节点的目的是通过响应其他副本集节点的心跳和选举请求来维护副本集中的仲裁

200 |

201 | **23Q:复制集节点类型有哪些?**

202 | + 优先级0型(`Priority 0`)节点

203 | + 隐藏型(`Hidden`)节点

204 | + 延迟型(`Delayed`)节点

205 | + 投票型(`Vote`)节点以及不可投票节点

206 |

207 | **24Q:启用备份故障恢复需要多久?**

208 |

209 | 从备份数据库声明主数据库宕机到选出一个备份数据库作为新的主数据库将花费10到30秒时间.这期间在主数据库上的操作将会失败–包括写入和强一致性读取(`strong consistent read`)操作.然而,你还能在第二数据库上执行最终一致性查询(`eventually consistent query`)(在`slaveok`模式下),即使在这段时间里.

210 |

211 | **`MongoDB`复制详解分析可查看文章**[【**MongoDB系列-解决面试中可能遇到的MongoDB复制集(replica set)问题**】](https://juejin.im/post/6844903919659778055)

212 |

213 | ### 25Q:`raft`选举过程,投票规则?

214 |

215 | **选举过程:**

216 |

217 | 当系统启动好之后,初始选举后系统由1个`Leader`和若干个`Follower`角色组成。然后突然由于某个异常原因,`Leader`服务出现了异常,导致`Follower`角色检测到和`Leader`的上次RPC更新时间超过给定阈值时间时。此时`Followe`r会认为`Leader`服务已出现异常,然后它将会发起一次新的`Leader`选举行为,同时将自身的状态从`Follower`切换为`Candidate`身份。随后请求其它`Follower`投票选择自己。

218 |

219 | **投票规则:**

220 | + 当一个候选人获得了同一个任期号内的大多数选票,就成为领导人。

221 | + 每个节点最多在一个任期内投出一张选票。并且按照先来先服务的原则。

222 | + 一旦候选人赢得选举,立刻成为领导,并发送心跳维持权威,同时阻止新领导人的诞生

223 |

224 | **可查看文章**[【**通俗易懂的Paxos算法-基于消息传递的一致性算法**】](https://juejin.im/post/6844903874587787277)

225 |

226 |

227 | ### **26Q:在哪些场景使用`MongoDB`?**

228 |

229 | **规则:** 如果业务中存在大量复杂的事务逻辑操作,则不要用`MongoDB`数据库;在处理非结构化 / 半结构化的大数据使用`MongoDB`,操作的数据类型为动态时也使用`MongoDB`,比如:

230 | * 内容管理系统,切面数据、日志记录

231 | * 移动端`Apps`:`O2O`送快递骑手、快递商家的信息(包含位置信息)

232 | * 数据管理,监控数据

233 |

234 |

235 |

236 |

237 | > 各位看官还可以吗?喜欢的话,动动手指点个💗,点个关注呗!!谢谢支持!

238 | >

239 | > 欢迎关注公众号【**Ccww技术博客**】,原创技术文章第一时间推出

240 |

241 |

242 |

243 |

244 |

--------------------------------------------------------------------------------

/doc/db/mongodb/复制集(replication).md:

--------------------------------------------------------------------------------

1 | 在使用MongoDB时,在创建索引会涉及到在复制集(replication)以及分片(Shard)中创建,为了最大限度地减少构建索引的影响,在副本和分片中创建索引,使用滚动索引构建过程。如果不使用滚动索引构建过程:

2 | + **主服务器上的前台索引构建需要数据库锁定。它复制为副本集辅助节点上的前台索引构建,并且复制工作程序采用全局数据库锁定,该锁定将读取和写入排序到索引服务器上的所有数据库。**

3 | + **主要的后台索引构建复制为后台索引构建在辅助节点上。复制工作程序不会进行全局数据库锁定,并且辅助读取不会受到影响。**

4 | + **对于主服务器上的前台和后台索引构建,副本集辅助节点上的索引操作在主节点完成构建索引之后开始。**

5 | + **在辅助节点上构建索引所需的时间必须在oplog的窗口内,以便辅助节点可以赶上主节点。

6 | 那么该如何创建呢?具体步骤呢?请看接下来的具体过程。**

7 |

8 |

9 |

10 | ## 1. 在副本集创建索引

11 | ### 准备

12 | **必须在索引构建期间停止对集合的所有写入,否则可能会在副本集成员中获得不一致的数据。**

13 | ### 具体过程

14 | **在副本集中以滚动方式构建唯一索引包括以下过程:**

15 |

16 | 1. **停止一个Secondary节点(从节点)并以单机模式重新启动,可以使用配置文件更新配置以单机模式重新启动:**

17 | + **注释掉replication.replSetName选项。**

18 | + **将net.port更改为其他端口。将原始端口设置注释掉。**

19 | + **在setParameter部分中将参数disableLogicalSessionCacheRefresh设置为true。**

20 |

21 | **例如:**

22 |

23 | //修改配置

24 | net:

25 | bindIp: localhost,

26 | port: 27217

27 | #port: 27017

28 | #replication:

29 | #replSetName: myRepl

30 | setParameter:

31 | disableLogicalSessionCacheRefresh: true

32 | //重新启动

33 | mongod --config

34 | 2. **创建索引:在单机模式下进行索引创建**

35 | 3. **重新开启Replica Set 模式:索引构建完成后,关闭mongod实例。撤消作为独立启动时所做的配置更改,以返回其原始配置并作为副本集的成员重新启动。**

36 |

37 | //回退原来的配置:net:

38 | bindIp: localhost,

39 | port: 27017

40 | replication:

41 | replSetName: myRepl

42 | //重新启动:

43 | mongod --config

44 |

45 | 4. **在其他从节点中重复1、2、3步骤的过程操作。**

46 | 5. **主节点创建索引,当所有从节点都有新索引时,降低主节点,使用上述过程作为单机模式重新启动它,并在原主节点上构建索引:**

47 | + **使用mongo shell中的rs.stepDown()方法来降低主节点为从节点,**

48 | + **成功降级后,当前主节点成为从节点,副本集成员选择新主节点,并进行从节点创建方式进行创建索引。**

49 |

50 | ## 2. 分片集群创建唯一索引

51 | ### 准备

52 | **创建唯一索引,必须在索引构建期间停止对集合的所有写入。 否则,您可能会在副本集成员中获得不一致的数据。如果无法停止对集合的所有写入,请不要使用以下过程来创建唯一索引。**

53 | ### 具体过程

54 |

55 | 1. **停止Balancer:将mongo shell连接到分片群集中的mongos实例,然后运行sh.stopBalancer()以禁用Balancer。如果正在进行迁移,系统将在停止平衡器之前完成正在进行的迁移。**

56 | 2. **确定Collection的分布:刷新该mongos的缓存路由表,以避免返回该Collection旧的分发信息。刷新后,对要构建索引的集合运行db.collection.getShardDistribution()。**

57 |

58 | 例如:在test数据库中的records字段中创建上升排序的索引

59 |

60 | db.adminCommand( { flushRouterConfig: "test.records" } );

61 | db.records.getShardDistribution();

62 |

63 | 例如,考虑一个带有3个分片shardA,shardB和shardC的分片集群,db.collection.getShardDistribution()返回以下内容

64 |

65 | Shard shardA at shardA/s1-mongo1.example.net:27018,s1-mongo2.example.net:27018,s1-mongo3.example.net:27018

66 | data : 1KiB docs : 50 chunks : 1

67 | estimated data per chunk : 1KiB

68 | estimated docs per chunk : 50 Shard shardC at shardC/s3-mongo1.example.net:27018,s3-mongo2.example.net:27018,s3-mongo3.example.net:27018

69 | data : 1KiB docs : 50 chunks : 1

70 | estimated data per chunk : 1KiB

71 | estimated docs per chunk : 50

72 | Totals data : 3KiB docs : 100 chunks : 2

73 | Shard shardA contains 50% data, 50% docs in cluster, avg obj size on shard : 40B

74 | Shard shardC contains 50% data, 50% docs in cluster, avg obj size on shard : 40B

75 | 从输出中,您只在shardA和shardC上为test.records构建索引。

76 |

77 | 3. **在包含集合Chunks的分片创建索引**

78 | + **C1.停止从节点,并以单机模式重新启动:对于受影响的分片,停止从节点与其中一个分区相关联的mongod进程,进行配置文件/命令模式更新后重新启动。**

79 |

80 | **配置文件:**

81 | + **将net.port更改为其他端口。 注释到原始端口设置。**

82 | + **注释掉replication.replSetName选项。**

83 | + **注释掉sharding.clusterRole选项。**

84 | + **在setParameter部分中将参数skipShardingConfigurationChecks设置为true。**

85 | + **在setParameter部分中将参数disableLogicalSessionCacheRefresh设置为true。**

86 |

87 | net:

88 | bindIp: localhost,

89 | port: 27218

90 | # port: 27018

91 | #replication:

92 | # replSetName: shardA

93 | #sharding:

94 | # clusterRole: shardsvr

95 | setParameter:

96 | skipShardingConfigurationChecks: true

97 | disableLogicalSessionCacheRefresh: true

98 | //重启:

99 | mongod --config

100 | + **C2.创建索引:直接连接到在新端口上作为独立运行的mongod实例,并为此实例创建新索引。**

101 |

102 | //例如:在record Collection的username创建索引

103 | db.records.createIndex( { username: 1 } )

104 |

105 | + **C3.恢复C1的配置,并作为 Replica Set成员启动:索引构建完成后,关闭mongod实例。 撤消作为单机模式时所做的配置更改,以返回其原始配置并重新启动。**

106 |

107 | **配置文件模式:**

108 | + **恢复为原始端口号。**

109 | + **取消注释replication.replSetName。**

110 | + **取消注释sharding.clusterRole。**

111 | + **删除setParameter部分中的参数skipShardingConfigurationChecks。**

112 | + **在setParameter部分中删除参数disableLogicalSessionCacheRefresh。**

113 |

114 | net:

115 | bindIp: localhost,

116 | port: 27018

117 | replication:

118 | replSetName: shardA

119 | sharding:

120 | clusterRole: shardsvr

121 | 重启:mongod --config

122 | + **C4.其他从节点分片重复C1、C2、C3过程创建索引。**

123 | + **C5.主节点创建索引:当所有从节点都有新索引时,降低主节点,使用上述过程作为单机模式重新启动它,并在原主节点上构建索引

124 | 使用mongo shell中的rs.stepDown()方法来降低主节点为从节点,成功降级后,当前主节点成为从节点,副本集成员选择新主节点,并进行从节点创建方式进行创建索引。**

125 | 4. **在其他受影响的分片重复C步骤;**

126 | 5. **重启Balancer,一旦全部分片创建完索引,重启Balancer:sh.startBalancer()。**

127 |

128 | ## 总结

129 | **后续还有关于实践中复制集以及分片的搭建过程,复制集成员节点增加删除等一系列实战操作。**

130 |

131 |

132 |

133 | **最后可关注公众号,一起学习,每天会分享干货,还有学习视频领取!**

134 |

135 |

--------------------------------------------------------------------------------

/doc/db/redis/RedisRDB持久化与AOF持久化.md:

--------------------------------------------------------------------------------

1 | ## 1.持久化

2 | ### 1.1 持久化简介

3 | 持久化(Persistence),持久化是将程序数据在持久状态和瞬时状态间转换的机制,即把数据(如内存中的对象)保存到可永久保存的存储设备中(如磁盘)。

4 |

5 |

6 |

7 |

8 | ### 1.2 redis持久化

9 | redis为内存数据库,为了防止服务器宕机以及服务器进程退出后,服务器数据丢失,Redis提供了持久化功能,即将Redis中内存数据持久化到磁盘中。Redis 提供了不同级别的持久化方式:

10 | + RDB持久化方式:可以在指定的时间间隔能对数据进行快照存储.

11 | + AOF持久化方式:记录每次对服务器写的操作,当服务器重启的时候会重新执行这些命令来恢复原始的数据,AOF命令以redis协议追加保存每次写的操作到文件末尾.Redis还能对AOF文件进行后台重写,使得AOF文件的体积不至于过大.

12 |

13 | 如果服务器开启了AOF持久化功能。服务器会优先使用AOF文件还原数据。只有关闭了AOF持久化功能,服务器才会使用RDB文件还原数据

14 |

15 |

16 |

17 |

18 | ## 2. RDB持久化

19 | ### 2.1 RDB文件格式

20 | RDB文件是一个经过压缩的二进制文件(默认的文件名:dump.rdb),由多个部分组成,RDB格式:

21 |

22 |

23 | ### 2.2 RDB文件持久化创建与载入

24 | 在 Redis持久化时, RDB 程序将当前内存中的数据库状态保存到磁盘文件中, 在 Redis 重启动时, RDB 程序可以通过载入 RDB 文件来还原数据库的状态。

25 |

26 |

27 |

28 |

29 | ### 2.3 工作方式

30 | 当 Redis 需要保存 dump.rdb 文件时, 服务器执行以下操作:

31 |

32 | + Redis 调用forks。同时拥有父进程和子进程。

33 | + 子进程将数据集写入到一个临时 RDB 文件中。

34 | + 当子进程完成对新 RDB 文件的写入时,Redis 用新 RDB 文件替换原来的 RDB 文件,并删除旧的 RDB 文件。

35 |

36 | 这种工作方式使得 Redis 可以从写时复制(copy-on-write)机制中获益。

37 |

38 | ### 2.4 创建方式

39 |

40 | **SAVE**

41 |

42 | 同步操作,在执行该命令时,服务器会被阻塞,拒绝客户端发送的命令请求

43 |

44 | redis> save

45 |

46 |

47 | **BGSAVE**

48 |

49 | 异步操作,在执行该命令时,子进程执行保存工作,服务器还可以继续让主线程处理客户端发送的命令请求

50 |

51 | redis>bgsave

52 |

53 |

54 |

55 | **自动创建**

56 |

57 | 由于BGSAVE命令可不阻塞服务器进程下执行,可以让用户自定义save属性,让服务器每个一段时间自动执行一次BGSAVE命令(即通过配置文件对 Redis 进行设置, 让它在“ N 秒内数据集至少有 M 个改动”这一条件被满足时, 自动进行数据集保存操作)。

58 |

59 | 比如:

60 | /*服务器在900秒之内,对数据库进行了至少1次修改*/

61 | Save 900 1

62 | /*服务器在300秒之内,对数据库进行了至少10次修改*/

63 | Save 300 10

64 | /*服务器在60秒之内,对数据库进行了至少10000次修改*/

65 | Save 60 10000

66 | 只要满足其中一个条件就会执行BGSAVE命令

67 |

68 |

69 |

70 |

71 |

72 |

73 |

74 | ### 2.5 RDB 默认配置

75 | ################################ SNAPSHOTTING ################################

76 | #

77 | # Save the DB on disk:

78 | #在给定的秒数和给定的对数据库的写操作数下,自动持久化操作。

79 | # save

80 | #

81 | save 900 1

82 | save 300 10

83 | save 60 10000

84 |

85 | #bgsave发生错误时是否停止写入,一般为yes

86 | stop-writes-on-bgsave-error yes

87 |

88 | #持久化时是否使用LZF压缩字符串对象?

89 | rdbcompression yes

90 |

91 | #是否对rdb文件进行校验和检验,通常为yes

92 | rdbchecksum yes

93 |

94 | # RDB持久化文件名

95 | dbfilename dump.rdb

96 |

97 | #持久化文件存储目录

98 | dir ./

99 |

100 |

101 |

102 | ## 3. AOF持久化

103 | ### 3.1 AOF持久化简介

104 | AOF持久化是通过保存Redis服务器所执行的写命令来记录数据库状态

105 |

106 |

107 |

108 |

109 |

110 |

111 |

112 | **AOF持久化功能实现:**

113 |

114 | 1. append命令追加:当AOF持久化功能处于打开状态时,服务器执行完一个写命令会协议格式被执行的命令追加服务器状态的aof_buf缓冲区的末尾。

115 |

116 | reids>SET KET VAULE

117 | //协议格式

118 | \r\n$3\r\nSET\r\n$3\r\nKEY\r\n$5\r\nVAULE\r\n

119 |

120 | 2. 文件写入和同步sync:Redis的服务器进程是一个事件循环,这个文件事件负责接收客户端的命令请求以及向客户端发送命令回复。当执行了append命令追加后,服务器会调用flushAppendOnlyFile函数是否需要将AOF缓冲区的内容写入和保存到AOF文件

121 |

122 |

123 | redis> SET msg "Ccww"

124 | redis> SADD persistence "rdb" "aof"

125 | redis> RPUSH size 128 256 512

126 |

127 |

128 |

129 |

130 |

131 |

132 |

133 |

134 | ### 3.2 AOF持久化策略

135 | AOF持久化策略(即缓冲区内容写入和同步sync到AOF中),可以通过配置appendfsync属性来选择AOF持久化策略:

136 | + always:将aof_buf缓冲区中的所有内容写入并同步到AOF文件,每次有新命令追加到 AOF 文件时就执行一次 fsync。

137 | + everysec(默认):如果上次同步AOF的时间距离现在超过一秒,先将aof_buf缓冲区中的所有内容写入到AOF文件,再次对AOF文件进行同步,且同步操作由一个专门线程负责执行。

138 | + no:将aof_buf缓冲区中的所有内容写入到AOF文件,但并不对AOF文件进行同步,何时同步由操作系统(OS)决定。

139 |

140 |

141 |

142 | AOF持久化策略的效率与安全性:

143 | + Always:效率最慢的,但安全性是最安全的,即使出现故障宕机,持久化也只会丢失一个事件 循环的命令数据

144 | + everysec:兼顾速度和安全性,出现宕机也只是丢失一秒钟的命令数据

145 | + No:写入最快,但综合起来单次同步是时间是最长的,且出现宕机时会丢失上传同步AOF文件之后的所有命令数据。

146 |

147 |

148 |

149 |

150 | ### 3.3 AOF重写

151 |

152 | 由于AOF持久化会把执行的写命令追加到AOF文件中,所以随着时间写入命令会不断增加, AOF文件的体积也会变得越来越大。AOF文件体积大对Reids服务器,甚至宿主服务器造成影响。

153 |

154 | 为了解决AOF文件体积膨胀的问题,Redis提供了AOF文件重写(rewrite)功能:

155 |

156 | + 生成一个不保存任何浪费空间的冗余命令新的AOF文件,且新旧AOF文件保存数据库状态一样的

157 | + 新的AOF文件是通过读取数据库中的键值对来实现的,程序无须对现有的AOF文件进行读入,分析,或者写入操作。

158 | + 为防止缓冲区溢出,重写处理list,hash,set以及Zset时,超过设置常量数量时会多条相同命令记录一个集合。

159 | + Redis 2.4 可以通过配置自动触发 AOF 重写,触发参数 **`auto-aof-rewrite-percentage`(触发AOF文件执行重写的增长率)** 以及 **`auto-aof-rewrite-min-size`(触发AOF文件执行重写的最小尺寸)**

160 |

161 | **AOF重写的作用:**

162 |

163 | + 减少磁盘占用量

164 | + 加速数据恢复

165 |

166 |

167 |

168 |

169 | Redis服务器使用单个线程来处理命令请求,服务器大量调用aof_rewrite函数,在AOF重写期间,则无法处理client发来的命令请求,所以AOF重写程序放在子进程执行,好处:

170 | 1. 子进程进行AOF重写期间,服务器进程可以继续处理命令请求

171 | 2. 子进程带有服务器进程的数据副本,保证了数据的安全性。

172 |

173 | AOF重写使用子进程会造成数据库与重写后的AOF保存的数据不一致,为了解决这种数据不一致,redis使用了AOF重写缓冲区

174 | 实现:

175 |

176 |

177 | BGREWRITEAOF命令实现原理(只有信号处理函数执行时才对服务器进程造成阻塞):

178 | + 执行命令,同时将命令追加到AOF缓冲区和AOF重写缓冲区

179 | + 当AOF子进程重写完成后,发送一个信号给父进程,父进程将执行AOF重写缓冲区中的所有内容写入到新AOF文件中,新AOF文件保存的数据库状态将和服务器当前的数据库状态一致。

180 | + 对新的AOF文件进行改名,原子性地覆盖现有AOF文件,完成新旧两个AOF文件替换处理完成。

181 |

182 |

183 |

184 |

185 |

186 |

187 | ### 3.4 AOF持久化默认参数

188 |

189 | ############################## APPEND ONLY MODE ###############################

190 |

191 | #开启AOF持久化方式

192 | appendonly no

193 |

194 | #AOF持久化文件名

195 | appendfilename "appendonly.aof"

196 | #每秒把缓冲区的数据fsync到磁盘

197 | appendfsync everysec

198 | # appendfsync no

199 | #是否在执行重写时不同步数据到AOF文件

200 | no-appendfsync-on-rewrite no

201 |

202 | # 触发AOF文件执行重写的增长率

203 | auto-aof-rewrite-percentage 100

204 | #触发AOF文件执行重写的最小size

205 | auto-aof-rewrite-min-size 64mb

206 |

207 | #redis在恢复时,会忽略最后一条可能存在问题的指令

208 | aof-load-truncated yes

209 |

210 | #是否打开混合开关

211 | aof-use-rdb-preamble yes

212 |

213 | ## 4 持久化方式总结与抉择

214 | ### 4.1 RDB优缺点

215 | **RDB的优点**

216 |

217 | + RDB是一个非常紧凑的文件,它保存了某个时间点得数据集,非常适用于数据集的备份,比如你可以在每个小时报保存一下过去24小时内的数据,同时每天保存过去30天的数据,这样即使出了问题你也可以根据需求恢复到不同版本的数据集.

218 | + 基于RDB文件紧凑性,便于复制数据到一个远端数据中心,非常适用于灾难恢复.

219 | + RDB在保存RDB文件时父进程唯一需要做的就是fork出一个子进程,接下来的工作全部由子进程来做,父进程不需要再做其他IO操作,所以RDB持久化方式可以最大化redis的性能.

220 | + 与AOF相比,在恢复大的数据集的时候,RDB方式会更快一些.

221 |

222 | **RDB的缺点**

223 |

224 | + 如果你希望在redis意外停止工作(例如电源中断)的情况下丢失的数据最少的话,那么RDB不适合你.虽然你可以配置不同的save时间点(例如每隔5分钟并且对数据集有100个写的操作),是Redis要完整的保存整个数据集是一个比较繁重的工作,你通常会每隔5分钟或者更久做一次完整的保存,万一在Redis意外宕机,你可能会丢失几分钟的数据.

225 | + RDB 需要经常fork子进程来保存数据集到硬盘上,当数据集比较大的时候,fork的过程是非常耗时的,可能会导致Redis在一些毫秒级内不能响应客户端的请求.如果数据集巨大并且CPU性能不是很好的情况下,这种情况会持续1秒,AOF也需要fork,但是你可以调节重写日志文件的频率来提高数据集的耐久度.

226 |

227 | ### 4.2 AOF的优缺点

228 |

229 | **AOF的优点:**

230 | + 使用AOF 会让你的Redis更加耐久:使用不同的fsync策略:无fsync,每秒fsync,每次写的时候fsync.使用默认的每秒fsync策略,Redis的性能依然很好(fsync是由后台线程进行处理的,主线程会尽力处理客户端请求),一旦出现故障,你最多丢失1秒的数据.

231 | + AOF文件是一个只进行追加的日志文件,所以不需要写入seek,即使由于某些原因(磁盘空间已满,写的过程中宕机等等)未执行完整的写入命令,你也可使用redis-check-aof工具修复问题.

232 | + Redis可以在AOF文件体积变得过大时,自动对 AOF 进行重写: 重写后的新 AOF 文件包含了恢复当前数据集所需的最小命令集合。 整个重写操作是绝对安全的,因为 Redis 在创建新 AOF 文件的过程中,会继续将命令追加到现有的 AOF 文件里面,即使重写过程中发生停机,现有的 AOF 文件也不会丢失。 而一旦新 AOF 文件创建完毕,Redis 就会从旧 AOF 文件切换到新 AOF 文件,并开始对新 AOF 文件进行追加操作。

233 | + AOF 文件有序地保存了对数据库执行的所有写入操作, 这些写入操作以 Redis 协议的格式保存, 因此 AOF 文件的内容非常容易被人读懂, 对文件进行分析(parse)也很轻松。 导出(export) AOF 文件也非常简单(例如, 如果你不小心执行了 FLUSHALL 命令, 但只要 AOF 文件未被重写, 那么只要停止服务器, 移除 AOF 文件末尾的 FLUSHALL 命令, 并重启 Redis , 就可以将数据集恢复到 FLUSHALL 执行之前的状态)。

234 |

235 | **AOF 缺点:**

236 | + 对于相同的数据集来说,AOF 文件的体积通常要大于 RDB 文件的体积。

237 | + 根据所使用的 fsync 策略,AOF 的速度可能会慢于 RDB 。 在一般情况下, 每秒 fsync 的性能依然非常高, 而关闭 fsync 可以让 AOF 的速度和 RDB 一样快, 即使在高负荷之下也是如此。 不过在处理巨大的写入载入时,RDB 可以提供更有保证的最大延迟时间(latency)。

238 |

239 | ### 4.3 如何选择使用哪种持久化方式?

240 | 一般来说, 如果想达到足以媲美 PostgreSQL 的数据安全性, 你应该同时使用两种持久化功能。

241 |

242 | 如果你非常关心你的数据, 但仍然可以承受数分钟以内的数据丢失, 那么你可以只使用 RDB 持久化。

243 |

244 | 有很多用户都只使用 AOF 持久化, 但我们并不推荐这种方式: 因为定时生成 RDB 快照(snapshot)非常便于进行数据库备份, 并且 RDB 恢复数据集的速度也要比 AOF 恢复的速度要快, 除此之外, 使用 RDB 还可以避免之前提到的 AOF 程序的 bug 。

245 |

246 |

247 | > 各位看官还可以吗?喜欢的话,动动手指点个💗,点个关注呗!!谢谢支持!

248 | >

249 | > 欢迎关注公众号【**Ccww技术博客**】,原创技术文章第一时间推出

250 |

251 |

252 |

253 |

254 |

--------------------------------------------------------------------------------

/doc/db/redis/Redis常用的五种数据类型底层结构.md:

--------------------------------------------------------------------------------

1 |

2 | 在Redis中会涉及很多数据结构,比如SDS,双向链表、字典、压缩列表、整数集合等等。Redis会基于这些数据结构自定义一个对象系统,而且自定义的对象系统有很多好处。

3 |

4 | 通过对以下的Redis对象系统的学习,可以了解Redis设计原理以及初衷,为了我们在使用Redis的时候,更加能够理解到其原理和定位问题。

5 |

6 | ## Redis 对象

7 | Redis基于上述的数据结构自定义一个Object 系统,Object结构:

8 |

9 | redisObject结构:

10 | typedef struct redisObject{

11 | //类型

12 | unsigned type:4;

13 | //编码

14 | unsigned encoding:4;

15 | //指向底层实现数据结构的指针

16 | void *ptr;

17 | …..

18 | }

19 |

20 |

21 | Object 系统包含五种Object:

22 |

23 | + String:字符串对象

24 | + List:列表对象

25 | + Hash:哈希对象

26 | + Set:集合对象

27 | + ZSet:有序集合

28 |

29 | Redis使用对象来表示数据库中的键和值,即每新建一个键值对,至少创建有两个对象,而且使用对象的具有以下好处:

30 | 1. redis可以在执行命令前会根据对象的类型判断一个对象是否可以执行给定的命令

31 | 2. 针对不同的使用场景,为对象设置不同的数据结构实现,从而优化对象的不同场景夏的使用效率

32 | 3. 对象系统还可以基于引用计数计数的内存回收机制,自动释放对象所占用的内存,或者还可以让多个数据库键共享同一个对象来节约内存。

33 | 4. redis对象带有访问时间记录信息,使用该信息可以进行优化空转时长较大的key,进行删除!

34 |

35 |

36 |

37 | 对象的ptr指针指向对象的底层现实数据结构,而这些数据结构由对象的encoding属性决定,对应关系:

38 |

39 | |编码常量|编码对应的底层数据结构|

40 | |-------|---------|

41 | |REDIS_ENCODING_INT|long类型的整数|

42 | |REDIS_ENCODING_EMBSTR|embstr编码的简单动态字符串|

43 | |REDIS_ENCODING_RAW|简单动态字符串|

44 | |REDIS_ENCODING_HT|字典|

45 | |REDIS_ENCODING_LINKEDLIST|双向链表|

46 | |REDIS_ENCODING_ZIPLIST|压缩列表|

47 | |REDIS_ENCODING_INTSET|整数集合|

48 | |REDIS_ENCODING_SKIPLIST|跳跃表和字典|

49 |

50 |

51 | 每种Object对象至少有两种不同的编码,对应关系:

52 |

53 | |类型| 编码| 对象|

54 | |-------|---------|--------|

55 | |String| int| 整数值实现|

56 | |String| embstr| sds实现 <=39 字节|

57 | |String |raw| sds实现 > 39字节|

58 | |List| ziplist |压缩列表实现|

59 | |List| linkedlist| 双端链表实现|

60 | |Set| intset |整数集合使用|

61 | |Set| hashtable |字典实现|

62 | |Hash| ziplist |压缩列表实现|

63 | |Hash |hashtable| 字典使用|

64 | |Sorted set| ziplist |压缩列表实现|

65 | |Sorted set |skiplist| 跳跃表和字典|

66 |

67 |

68 |

69 |

70 | ## String 对象

71 |

72 | 字符串对象编码可以int 、raw或者embstr,如果保存的值为整数值且这个值可以用long类型表示,使用int编码,其他编码类似。

73 |

74 | 比如:int编码的String Object

75 |

76 | redis> set number 520

77 | ok

78 | redis> OBJECT ENCODING number

79 | "int"

80 | String Object结构:

81 |

82 |

83 |

84 |

85 | ### String 对象之间的编码转换

86 | int编码的字符串对象和embstr编码的字符串对象在条件满足的情况下,会被转换为raw编码的字符串对象。

87 |

88 | 比如:对int编码的字符串对象进行append命令时,就会使得原来是int变为raw编码字符串

89 |

90 |

91 |

92 | ## List对象

93 |

94 | list对象可以为ziplist或者为linkedlist,对应底层实现ziplist为压缩列表,linkedlist为双向列表。

95 |

96 | Redis>RPUSH numbers “Ccww” 520 1

97 |

98 | 用ziplist编码的List对象结构:

99 |

100 |

101 | 用linkedlist编码的List对象结构:

102 |

103 |

104 |

105 |

106 | ### List对象的编码转换:

107 | 当list对象可以同时满足以下两个条件时,list对象使用的是ziplist编码:

108 | 1. list对象保存的所有字符串元素的长度都小于64字节

109 | 2. list对象保存的元素数量小于512个,

110 | 不能满足这两个条件的list对象需要使用linkedlist编码。

111 |

112 |

113 |

114 |

115 | ## Hash对象

116 | Hash对象的编码可以是ziplist或者hashtable

117 | 其中,ziplist底层使用压缩列表实现:

118 | + 保存同一键值对的两个节点紧靠相邻,键key在前,值vaule在后

119 | + 先保存的键值对在压缩列表的表头方向,后来在表尾方向

120 |

121 | hashtable底层使用字典实现,Hash对象种的每个键值对都使用一个字典键值对保存:

122 | + 字典的键为字符串对象,保存键key

123 | + 字典的值也为字符串对象,保存键值对的值

124 |

125 | 比如:HSET命令

126 |

127 | redis>HSET author name "Ccww"

128 | (integer)

129 |

130 | redis>HSET author age 18

131 | (integer)

132 |

133 | redis>HSET author sex "male"

134 | (integer)

135 | ziplist的底层结构:

136 |

137 |

138 |

139 |

140 | hashtable底层结构:

141 |

142 |

143 |

144 |

145 | ### Hash对象的编码转换:

146 | 当list对象可以同时满足以下两个条件时,list对象使用的是ziplist编码:

147 | 1. list对象保存的所有字符串元素的长度都小于64字节

148 | 2. list对象保存的元素数量小于512个,

149 | 不能满足这两个条件的hash对象需要使用hashtable编码

150 |

151 | **Note**:这两个条件的上限值是可以修改的,可查看配置文件hash-max-zaiplist-value和hash-max-ziplist-entries

152 |

153 |

154 |

155 |

156 |

157 | ## Set对象:

158 | Set对象的编码可以为intset或者hashtable

159 | + intset编码:使用整数集合作为底层实现,set对象包含的所有元素都被保存在intset整数集合里面

160 | + hashtable编码:使用字典作为底层实现,字典键key包含一个set元素,而字典的值则都为null

161 |

162 | inset编码Set对象结构:

163 |

164 | redis> SAD number 1 3 5

165 |

166 |

167 |

168 | hashtable编码Set对象结构:

169 |

170 | redis> SAD Dfruits “apple” "banana" " cherry"

171 |

172 |

173 |

174 |

175 | ### Set对象的编码转换:

176 | 使用intset编码:

177 | 1. set对象保存的所有元素都是整数值

178 | 2. set对象保存的元素数量不超过512个

179 | 不能满足这两个条件的Set对象使用hashtable编码

180 |

181 |

182 |

183 |

184 |

185 |

186 | ## ZSet对象

187 | ZSet对象的编码 可以为ziplist或者skiplist

188 | ziplist编码,每个集合元素使用相邻的两个压缩列表节点保存,一个保存元素成员,一个保存元素的分值,然后根据分数进行从小到大排序。

189 |

190 | ziplist编码的ZSet对象结构:

191 |

192 | Redis>ZADD price 8.5 apple 5.0 banana 6.0 cherry

193 |

194 |

195 |

196 | skiplist编码的ZSet对象使用了zset结构,包含一个字典和一个跳跃表

197 |

198 | Type struct zset{

199 |

200 | Zskiplist *zsl;

201 | dict *dict;

202 | ...

203 | }

204 |

205 | skiplist编码的ZSet对象结构

206 |

207 |

208 |

209 |

210 | ### ZSet对象的编码转换

211 |

212 | 当ZSet对象同时满足以下两个条件时,对象使用ziplist编码

213 | 1. 有序集合保存的元素数量小于128个

214 | 2. 有序集合保存的所有元素的长度都小于64字节

215 | 不能满足以上两个条件的有序集合对象将使用skiplist编码。

216 |

217 | **Note:** 可以通过配置文件中zset-max-ziplist-entries和zset-max-ziplist-vaule

218 |

219 | > 各位看官还可以吗?喜欢的话,动动手指点个💗,点个关注呗!!谢谢支持!

220 | >

221 | > 欢迎关注公众号【**Ccww技术博客**】,原创技术文章第一时间推出

222 |

223 |

224 |

225 |

226 |

--------------------------------------------------------------------------------

/doc/db/redis/Redis的ExpireKey(过期键).md:

--------------------------------------------------------------------------------

1 | 在面试中遇到美女面试官时,我们以为面试会比较容易过,也能好好表现自己技术的时候了。然而却出现以下这一幕,当美女面试官听说你使用过Redis时,那么问题来了。

2 |

3 | **👩面试官**:**Q1,你知道Redis设置key过期时间的命令吗?**

4 |

5 | **👧你**:你毫不犹豫的巴拉巴拉说了一堆命令,以及用法,比如expire 等等命令

6 |

7 | (🎈这时候你想问得那么简单?但真的那么简单吗?美女面试官停顿了一下,接着问)

8 |

9 | **👩面试官**:**Q2,那你说说Redis是怎么实现过期时间设置呢?以及怎么判断键过期的呢?**

10 | **👧你**:(这时候想这还难不倒我),然后又巴拉巴拉的说一通,Redis的数据库服务器中redisDb数据结构以及过期时间的判定

11 |

12 | (🎈你又在想应该不会问了吧,换个Redis的话题了吧,那你就错了)

13 |

14 | **👩面试官**:**(抬头笑着看了看你)Q3,那你说说过期键的删除策略以及Redis过期键的删除策略以及实现?**

15 | **🤦️你**:这时你回答的就不那么流畅了,有时头脑还阻塞了。

16 |

17 | (🎈这是你可能就有点蒙了,或者只知道一些过期键的删除策略,但具体怎么实现不知道呀,你以为面试官的提问这样就完了吗?)

18 |

19 | **👩面试官**:**Q4,那你再说说其他环节中是怎么处理过期键的呢(比如AOF、RDB)?**

20 | **🤦🤦你**:...........

21 |

22 | (🎈这更加尴尬了,知道的不全,也可能不知道,本来想好好表现,也想着面试比较简单,没想到会经历这些)

23 |

24 | **为了避免这尴尬的场景出现,那现在需要你记录下以下的内容,这样就可以在美女面试官面前好好表现了。**

25 |

26 | ## 1. Redis Expire Key基础

27 | redis数据库在数据库服务器中使用了`redisDb`数据结构,结构如下:

28 |

29 | typedef struct redisDb {

30 | dict *dict; /* 键空间 key space */

31 | dict *expires; /* 过期字典 */

32 | dict *blocking_keys; /* Keys with clients waiting for data (BLPOP) */

33 | dict *ready_keys; /* Blocked keys that received a PUSH */

34 | dict *watched_keys; /* WATCHED keys for MULTI/EXEC CAS */

35 | struct evictionPoolEntry *eviction_pool; /* Eviction pool of keys */

36 | int id; /* Database ID */

37 | long long avg_ttl; /* Average TTL, just for stats */

38 | } redisDb;

39 | 其中,

40 | + **键空间(`key space`):dict字典用来保存数据库中的所有键值对**

41 | + **过期字典(`expires`):保存数据库中所有键的过期时间,过期时间用`UNIX`时间戳表示,且值为`long long`整数**

42 |

43 |

44 |

45 |

46 | ### 1.1 设置过期时间命令

47 | + **`EXPIRE \ \`**:命令用于将键key的过期时间设置为ttl秒之后

48 | + **`PEXPIRE \ \`**:命令用于将键key的过期时间设置为ttl毫秒之后

49 | + **`EXPIREAT \ \`**:命令用于将key的过期时间设置为timrestamp所指定的秒数时间戳

50 | + **`PEXPIREAT \ \`**:命令用于将key的过期时间设置为timrestamp所指定的毫秒数时间戳

51 |

52 | **设置过期时间:**

53 |

54 | redis> set Ccww 5 2 0

55 | ok

56 | redis> expire Ccww 5

57 | ok

58 | **使用redisDb结构存储数据图表示:**

59 |

60 | ### 1.2过期时间保存以及判定

61 | 过期键的判定,其实通过**过期字典**进行判定,步骤:

62 | 1. 检查给定键是否存在于过期字典,如果存在,取出键的过期时间

63 | 2. 通过判断当前UNIX时间戳是否大于键的过期时间,是的话,键已过期,相反则键未过期。

64 |

65 |

66 |

67 |

68 |

69 |

70 |

71 | ## 2. 过期键删除策略

72 | ### 2.1 三种不同删除策略

73 | 1. **定时删除**:在设置键的过期时间的同时,创建一个定时任务,当键达到过期时间时,立即执行对键的删除操作

74 | 2. **惰性删除**:放任键过期不管,但在每次从键空间获取键时,都检查取得的键是否过期,如果过期的话,就删除该键,如果没有过期,就返回该键

75 | 3. **定期删除**:每隔一点时间,程序就对数据库进行一次检查,删除里面的过期键,至于要删除多少过期键,以及要检查多少个数据库,则由算法决定。

76 |

77 | ### 2.2 三种删除策略的优缺点

78 | #### 2.2.1 定时删除

79 | + **优点:** 对内存友好,定时删除策略可以保证过期键会尽可能快地被删除,并释放国期间所占用的内存

80 | + **缺点:** 对cpu时间不友好,在过期键比较多时,删除任务会占用很大一部分cpu时间,在内存不紧张但cpu时间紧张的情况下,将cpu时间用在删除和当前任务无关的过期键上,影响服务器的响应时间和吞吐量

81 |

82 | #### 2.2.2 惰性删除

83 | + **优点:** 对cpu时间友好,在每次从键空间获取键时进行过期键检查并是否删除,删除目标也仅限当前处理的键,这个策略不会在其他无关的删除任务上花费任何cpu时间。

84 | + **缺点:** 对内存不友好,过期键过期也可能不会被删除,导致所占的内存也不会释放。甚至可能会出现内存泄露的现象,当存在很多过期键,而这些过期键又没有被访问到,这会可能导致它们会一直保存在内存中,造成内存泄露。

85 |

86 | #### 2.2.4 定期删除

87 | 由于定时删除会占用太多cpu时间,影响服务器的响应时间和吞吐量以及惰性删除浪费太多内存,有内存泄露的危险,所以出现一种整合和折中这两种策略的定期删除策略。

88 | 1. 定期删除策略每隔一段时间执行一次删除过期键操作,并通过限制删除操作执行的时长和频率来减少删除操作对CPU时间的影响。

89 | 2. 定时删除策略有效地减少了因为过期键带来的内存浪费。

90 |

91 |

92 | **定时删除策略难点就是确定删除操作执行的时长和频率:**

93 |

94 | 删除操作执行得太频繁。或者执行时间太长,定期删除策略就会退化成为定时删除策略,以至于将cpu时间过多地消耗在删除过期键上。相反,则惰性删除策略一样,出现浪费内存的情况。

95 | 所以使用定期删除策略,需要根据服务器的情况合理地设置删除操作的执行时长和执行频率。

96 |

97 | ## 3. Redis的过期键删除策略

98 | Redis服务器结合惰性删除和定期删除两种策略一起使用,通过这两种策略之间的配合使用,使得服务器可以在合理使用CPU时间和浪费内存空间取得平衡点。

99 |

100 | ### 3.1 惰性删除策略的实现

101 | Redis在执行任何读写命令时都会先找到这个key,惰性删除就作为一个切入点放在查找key之前,如果key过期了就删除这个key。

102 |

103 |

104 |

105 | robj *lookupKeyRead(redisDb *db, robj *key) {

106 | robj *val;

107 | expireIfNeeded(db,key); // 切入点

108 | val = lookupKey(db,key);

109 | if (val == NULL)

110 | server.stat_keyspace_misses++;

111 | else

112 | server.stat_keyspace_hits++;

113 | return val;

114 | }

115 |

116 | **通过`expireIfNeeded`函数对输入键进行检查是否删除**

117 |

118 | int expireIfNeeded(redisDb *db, robj *key) {

119 | /* 取出键的过期时间 */

120 | mstime_t when = getExpire(db,key);

121 | mstime_t now;

122 |

123 | /* 没有过期时间返回0*/

124 | if (when < 0) return 0; /* No expire for this key */

125 |

126 | /* 服务器loading时*/

127 | if (server.loading) return 0;

128 |

129 | /* 根据一定规则获取当前时间*/

130 | now = server.lua_caller ? server.lua_time_start : mstime();

131 | /* 如果当前的是从(Slave)服务器

132 | * 0 认为key为无效

133 | * 1 if we think the key is expired at this time.

134 | * */

135 | if (server.masterhost != NULL) return now > when;

136 |

137 | /* key未过期,返回 0 */

138 | if (now <= when) return 0;

139 |

140 | /* 删除键 */

141 | server.stat_expiredkeys++;

142 | propagateExpire(db,key,server.lazyfree_lazy_expire);

143 | notifyKeyspaceEvent(NOTIFY_EXPIRED,

144 | "expired",key,db->id);

145 | return server.lazyfree_lazy_expire ? dbAsyncDelete(db,key) :

146 | dbSyncDelete(db,key);

147 | }

148 |

149 | ### 3.2 定期删除策略的实现

150 | key的定期删除会在Redis的周期性执行任务(`serverCron`,默认每100ms执行一次)中进行,而且是发生Redis的`master`节点,因为`slave`节点会通过主节点的DEL命令同步过来达到删除key的目的。

151 |

152 | for (j = 0; j < dbs_per_call; j++) {

153 | int expired;

154 | redisDb *db = server.db+(current_db % server.dbnum);

155 |

156 | current_db++;

157 |

158 | /* 超过25%的key已过期,则继续. */

159 | do {

160 | unsigned long num, slots;

161 | long long now, ttl_sum;

162 | int ttl_samples;

163 |

164 | /* 如果该db没有设置过期key,则继续看下个db*/

165 | if ((num = dictSize(db->expires)) == 0) {

166 | db->avg_ttl = 0;

167 | break;

168 | }

169 | slots = dictSlots(db->expires);

170 | now = mstime();

171 |

172 | /*但少于1%时,需要调整字典大小*/

173 | if (num && slots > DICT_HT_INITIAL_SIZE &&

174 | (num*100/slots < 1)) break;

175 |

176 | expired = 0;

177 | ttl_sum = 0;

178 | ttl_samples = 0;

179 |

180 | if (num > ACTIVE_EXPIRE_CYCLE_LOOKUPS_PER_LOOP)

181 | num = ACTIVE_EXPIRE_CYCLE_LOOKUPS_PER_LOOP;// 20

182 |

183 | while (num--) {

184 | dictEntry *de;

185 | long long ttl;

186 |

187 | if ((de = dictGetRandomKey(db->expires)) == NULL) break;

188 | ttl = dictGetSignedIntegerVal(de)-now;

189 | if (activeExpireCycleTryExpire(db,de,now)) expired++;

190 | if (ttl > 0) {

191 | /* We want the average TTL of keys yet not expired. */

192 | ttl_sum += ttl;

193 | ttl_samples++;

194 | }

195 | }

196 |

197 | /* Update the average TTL stats for this database. */

198 | if (ttl_samples) {

199 | long long avg_ttl = ttl_sum/ttl_samples;

200 |

201 | /样本获取移动平均值 */

202 | if (db->avg_ttl == 0) db->avg_ttl = avg_ttl;

203 | db->avg_ttl = (db->avg_ttl/50)*49 + (avg_ttl/50);

204 | }

205 | iteration++;

206 | if ((iteration & 0xf) == 0) { /* 每迭代16次检查一次 */

207 | long long elapsed = ustime()-start;

208 |

209 | latencyAddSampleIfNeeded("expire-cycle",elapsed/1000);

210 | if (elapsed > timelimit) timelimit_exit = 1;

211 | }

212 | /* 超过时间限制则退出*/

213 | if (timelimit_exit) return;

214 | /* 在当前db中,如果少于25%的key过期,则停止继续删除过期key */

215 | } while (expired > ACTIVE_EXPIRE_CYCLE_LOOKUPS_PER_LOOP/4);

216 | }

217 | 依次遍历每个db(默认配置数是16),针对每个db,每次循环随机选择20个(`ACTIVE_EXPIRE_CYCLE_LOOKUPS_PER_LOOP`)key判断是否过期,如果一轮所选的key少于25%过期,则终止迭次,此外在迭代过程中如果超过了一定的时间限制则终止过期删除这一过程。

218 |

219 | ## 4. AOF、RDB和复制功能对过期键的处理

220 | ### 4.1 RDB

221 | **生成RDB文件**

222 | 程序会数据库中的键进行检查,已过期的键不会保存到新创建的RDB文件中

223 |

224 | **载入RDB文件**

225 | 1. 主服务载入RDB文件,会对文件中保存的键进行检查会忽略过期键加载未过期键

226 | 2. 从服务器载入RDB文件,会加载文件所保存的所有键(过期和未过期的),但从主服务器同步数据同时会清空从服务器的数据库。

227 |

228 | ### 4.2 AOF

229 | + AOF文件写入:当过期键被删除后,会在AOF文件增加一条DEL命令,来显式地记录该键已被删除。

230 | + AOF重写:已过期的键不会保存到重写的AOF文件中

231 |

232 | ### 4.3 复制

233 | 当服务器运行在复制模式下时,从服务器的过期键删除动作由主服务器控制的,这样的好处主要为了保持主从服务器数据一致性:

234 | 1. 主服务器在删除一个过期键之后,会显式地向所有的从服务器发送一个DEL命令,告知从服务器删除这个过期键

235 | 2. 从服务器在执行客户端发送的读取命令时,即使碰到过期键也不会将过期键删除,不作任何处理。

236 | 3. 只有接收到主服务器 DEL命令后,从服务器进行删除处理。

237 |

238 |

239 | > 各位看官还可以吗?喜欢的话,动动手指点个💗,点个关注呗!!谢谢支持!

240 | >

241 | > 欢迎关注公众号【**Ccww技术博客**】,原创技术文章第一时间推出

242 |

243 |

244 |

245 |

246 |

--------------------------------------------------------------------------------

/doc/javabase/Java对象的浅克隆和深克隆.md:

--------------------------------------------------------------------------------

1 | ## Java对象的浅克隆和深克隆

2 |

3 | ### 为什么需要克隆

4 | 在实际编程过程中,我们常常要遇到这种情况:有一个对象A,在某一时刻A中已经包含了一些有效值,此时可能会需要一个和A完全相同新对象B,并且此后对B任何改动都不会影响到A中的值,也就是说,A与B是两个独立的对象,但B的初始值是由A对象确定的。在Java语言中,用简单的赋值语句是不能满足这种需求的,要满足这种需求有很多途径。

5 |

6 | ### 克隆的实现方式

7 | ### 一、浅度克隆

8 | 浅度克隆对于要克隆的对象,对于其基本数据类型的属性,复制一份给新产生的对象,对于非基本数据类型的属性,仅仅复制一份引用给新产生的对象,即新产生的对象和原始对象中的非基本数据类型的属性都指向的是同一个对象。

9 |

10 | **浅度克隆步骤:**

11 | 1. 实现java.lang.Cloneable接口

12 | 要clone的类为什么还要实现Cloneable接口呢?Cloneable接口是一个标识接口,不包含任何方法的!这个标识仅仅是针对Object类中clone()方法的,如果clone类没有实现Cloneable接口,并调用了Object的 clone()方法(也就是调用了super.Clone()方法),那么Object的clone()方法就会抛出 CloneNotSupportedException异常。

13 | 2. 重写java.lang.Object.clone()方法

14 | JDK API的说明文档解释这个方法将返回Object对象的一个拷贝。要说明的有两点:一是拷贝对象返回的是一个新对象,而不是一个引用。二是拷贝对象与用new操作符返回的新对象的区别就是这个拷贝已经包含了一些原来对象的信息,而不是对象的初始信息。

15 |

16 | 观察一下Object类的clone()方法是一个native方法,native方法的效率一般来说都是远高于java中的非native方法。这也解释了为什么要用Object中clone()方法而不是先new一个类,然后把原始对象中的信息赋到新对象中,虽然这也实现了clone功能。Object类中的clone()还是一个protected属性的方法,重写之后要把clone()方法的属性设置为public。

17 |

18 | Object类中clone()方法产生的效果是:先在内存中开辟一块和原始对象一样的空间,然后原样拷贝原始对象中的内容。对基本数据类型,这样的操作是没有问题的,但对非基本类型变量,我们知道它们保存的仅仅是对象的引用,这也导致clone后的非基本类型变量和原始对象中相应的变量指向的是同一个对象。

19 |

20 | **Java代码实例:**

21 |

22 | public class Product implements Cloneable {

23 | private String name;

24 |

25 | public Object clone() {

26 | try {

27 | return super.clone();

28 | } catch (CloneNotSupportedException e) {

29 | return null;

30 | }

31 | }

32 | }

33 |

34 | ### 二、深度克隆

35 | 在浅度克隆的基础上,对于要克隆的对象中的非基本数据类型的属性对应的类,也实现克隆,这样对于非基本数据类型的属性,复制的不是一份引用,即新产生的对象和原始对象中的非基本数据类型的属性指向的不是同一个对象

36 |

37 | **深度克隆步骤:**

38 | 要克隆的类和类中所有非基本数据类型的属性对应的类

39 | 1. 都实现java.lang.Cloneable接口

40 | 2. 都重写java.lang.Object.clone()方法

41 |

42 | **Java代码实例:**

43 |

44 | public class Attribute implements Cloneable {

45 | private String no;

46 |

47 | public Object clone() {

48 | try {

49 | return super.clone();

50 | } catch (CloneNotSupportedException e) {

51 | return null;

52 | }

53 | }

54 | }

55 |

56 | public class Product implements Cloneable {

57 | private String name;

58 |

59 | private Attribute attribute;

60 |

61 | public Object clone() {

62 | try {

63 | return super.clone();

64 | } catch (CloneNotSupportedException e) {

65 | return null;

66 | }

67 | }

68 | }

69 |

70 |

71 | ### 三、使用对象序列化和反序列化实现深度克隆

72 | **所谓对象序列化就是将对象的状态转换成字节流,以后可以通过这些值再生成相同状态的对象。**

73 |

74 | 对象的序列化还有另一个容易被大家忽略的功能就是对象复制(Clone),Java中通过Clone机制可以复制大部分的对象,但是众所周知,Clone有深度Clone和浅度Clone,如果你的对象非常非常复杂,并且想实现深层 Clone,如果使用序列化,不会超过10行代码就可以解决。

75 |

76 | 虽然Java的序列化非常简单、强大,但是要用好,还有很多地方需要注意。比如曾经序列化了一个对象,可由于某种原因,该类做了一点点改动,然后重新被编译,那么这时反序列化刚才的对象,将会出现异常。 你可以通过添加serialVersionUID属性来解决这个问题。如果你的类是个单例(Singleton)类,虽然我们多线程下的并发问题来控制单例,但是,是否允许用户通过序列化机制或者克隆来复制该类,如果不允许你需要谨慎对待该类的实现(让此类不用实现Serializable接口或Externalizable接口和Cloneable接口就行了)。

77 |

78 | **Java代码实例:**

79 | public class Attribute {

80 | private String no;

81 | }

82 |

83 | public class Product {

84 | private String name;

85 |

86 | private Attribute attribute;

87 |

88 | public Product clone() {

89 | ByteArrayOutputStream byteOut = null;

90 | ObjectOutputStream objOut = null;

91 | ByteArrayInputStream byteIn = null;

92 | ObjectInputStream objIn = null;

93 |

94 | try {

95 | // 将该对象序列化成流,因为写在流里的是对象的一个拷贝,而原对象仍然存在于JVM里面。所以利用这个特性可以实现对象的深拷贝

96 | byteOut = new ByteArrayOutputStream();

97 | objOut = new ObjectOutputStream(byteOut);

98 | objOut.writeObject(this);

99 | // 将流序列化成对象

100 | byteIn = new ByteArrayInputStream(byteOut.toByteArray());

101 | objIn = new ObjectInputStream(byteIn);

102 |

103 | return (ContretePrototype) objIn.readObject();