├── README.md

├── WebRTC 零基础开发者教程(中文).pdf

├── article

├── 001-WebRTC 发送方码率预估实现解析.md

├── 002-码率控制基本概念.md

├── 003-Speex回声消除代码分析.md

├── 004-房间声学原理与Schroeder混响算法实现.md

├── 005-H264系列--压缩编码技术.md

├── 006-RTSP 媒体协议流的录制方案及其覆盖策略详解.md

├── 007-webrtc建立连接之ICE框架.md

├── 008-流媒体协议介绍.md

├── 009-音视频同步原理及实现.md

├── 010-直播概念和流程框架.md

├── 011-CDN在直播中的运用.md

├── 012-常见音视频编码格式.md

├── 013-H.264官方软件JM源代码分析-编码器lencod.md

├── 014-H.264官方软件JM源代码分析-解码器ldecod.md

├── 015-Android 音视频技术.md

├── 016-Web前端WebRTC攻略-媒体协商与SDP简析.md

├── 017-基于FFmpeg的AVfilter的例子-纯净版.md

├── 018-WebRTC 传输安全机制第二话:深入显出 SRTP 协议.md

├── 019-WebRTC能给我带来什么?.md

├── 020-视音频数据处理:RGB、YUV像素数据处理.md

├── 021-视音频数据处理:PCM音频采样数据处理.md

├── 022-视音频数据处理:H.264视频码流解析.md

├── 023-视音频数据处理:AAC音频码流解析.md

├── 024-视音频数据处理:FLV封装格式解析.md

├── 025-视音频数据处理:UDP-RTP协议解析.md

├── 026-如何生成mp4文件.md

├── 027-ffmpeg滤镜的基本使用.md

├── 028-webRTC是如何实现音视频的录制.md

├── 029-音视频同步算法.md

├── 030-房间声学原理与Schroeder混响算法实现.md

├── 031-一个频域语音降噪算法实现及改进方法.md

├── 032-HEVC官方软件HM源代码分析-编码器TAppEncoder.md

├── 033-HEVC官方软件HM源代码分析-解码器TAppDecoder.md

├── 034-音视频编解码常用知识点.md

├── 035-微信小程序集成实时音视频通话功能.md

├── 036-视音频编解码技术零基础学习方法.md

├── 037-RTSP协议学习.md

├── 038-HEVC码流分析.md

├── 039-H.264简单码流分析.md

├── 040-MPEG2简单码流分析.md

├── 041-视频码流分析工具.md

├── 042-H.264分析器.md

├── 043-FFmpeg架构之IO模块分析.md

├── 044-[Video and Audio Data Processing] UDP-RTP协议解析.md

├── 045-RTSP协议实例分析.md

├── 046-RTSP协议之TCP或UDP问题.md

├── 047-ffplay工具命令使用技巧.md

├── 048-VLC RTSP网络串流播放失败.md

├── 049-RTMP协议详解.md

└── 050-STUN 原理理解.md

├── books

├── 002-视频图像处理与性能优化.pdf

├── 003-数字图像与视频处理.pdf

├── 005-音视频开发进阶指南:基于Android与iOS平台的实践.pdf

├── 006-Real-Time Communication with WebRTC.pdf

├── 007-FFMPEG - From Zero to Hero.pdf

├── 008-Learning WebRTC.pdf

├── 010-FFmpeg Basics 2012.pdf

└── README.md

├── case_interview

├── 001-README.md

└── 002-README.md

├── paper

├── README.md

├── ffmpeg

│ ├── H264

│ │ ├── 01594776.pdf

│ │ ├── 10.1.1.669.484.pdf

│ │ ├── 133112608024.pdf

│ │ ├── 2013-ole-h264.pdf

│ │ ├── 8116ijma03.pdf

│ │ ├── A2126065115.pdf

│ │ ├── AVC_overview_1.pdf

│ │ ├── H.264-vs-H.265.pdf

│ │ ├── H_264_Video_Frame_Size_prediction.pdf

│ │ ├── JRTIP-2014-Real-time H264-AVCEncoderBasedOnEnhancedFrameLevelParallelismForSmartMulticoreDSPCamera.pdf

│ │ ├── MMCN09-QoE.pdf

│ │ ├── README.md

│ │ ├── Tutorial_H264_MPEG4.pdf

│ │ ├── cr1077.pdf

│ │ ├── h264-AVC-Standard.pdf

│ │ ├── nenciIROS14.pdf

│ │ ├── parallel_scalability_of_h264.pdf

│ │ ├── spie04-h264OverviewPaper.pdf

│ │ └── swseo-samos09.pdf

│ ├── README.md

│ ├── Research on Audio-Video Codec Based on Android.PDF

│ ├── aac

│ │ ├── RANDOL AAC Pumpcell Paper.pdf

│ │ ├── README.md

│ │ └── chi2020_talkingboogie_paper.pdf

│ ├── cloud-computing-quicksync-video-ffmpeg-white-paper.pdf

│ ├── ffplay

│ │ ├── 1709.pdf

│ │ ├── 97_Andrew_Weaver_SP.pdf

│ │ ├── README.md

│ │ ├── iPres2019_paper_97.pdf

│ │ ├── j-kaneda18mastersthesis-FunctionReallocationMec.pdf

│ │ └── nsdi18-fouladi.pdf

│ ├── fuzzeval.pdf

│ ├── gg-paper.pdf

│ ├── iPres2019_paper_97.pdf

│ ├── mm19-miniview-comp.pdf

│ └── sec20fall_jiang_prepub.pdf

└── streaming_media

│ ├── HLS

│ ├── 1524_a_survey_and_evaluation_of_fpga_highlevel_synthesis_tools.pdf

│ ├── Centrifuge_ICCAD.pdf

│ ├── FPGA2021.pdf

│ ├── README.md

│ └── mantovani_cicc20.pdf

│ ├── README.md

│ ├── RTSP

│ ├── 10.1.1.124.9084.pdf

│ ├── 11647.pdf

│ ├── 2014-Q2SWinet-Offload-Perf-Evaluation-Migault.pdf

│ ├── 2019-07.pdf

│ ├── 2b14328e0c0a65c14b2a307459f69a8c.DREAM A Data Streaming Application Using RTP RTSP in a Local Area Network.pdf

│ ├── A201111-706_1322795059.pdf

│ ├── FinalPaperA Survey on open Source Protocols SIP, RTP, RTCP, RTSP, H.264 for Video Conferencing System191361.pdf

│ ├── MSE2002.pdf

│ ├── PROMS2000.pdf

│ ├── README.md

│ ├── RTSP-live-streaming.pdf

│ ├── cache.pdf

│ ├── rossi06eurongi.pdf

│ ├── rtp.pdf

│ ├── rtsp.pdf

│ ├── wp529-som-benchmarks.pdf

│ └── wu01streaming.pdf

│ └── rtmp

│ ├── 2011-AES.pdf

│ ├── 22-1.pdf

│ ├── 32-_Fauzan_Masykur.pdf

│ ├── 360_video_IFIP.pdf

│ ├── 76533338.pdf

│ ├── Cloud-Ingest-of-Live-Video-An-open-approach-to-RIST-SRT-and-retransmission-protocols.pdf

│ ├── E3_Management_of_Traffic_During_Construction_v1.3.pdf

│ ├── README.md

│ ├── cired2005_0127.pdf

│ ├── hockxyu-44.pdf

│ ├── hotnets17-final39.pdf

│ ├── imc2018.pdf

│ ├── periscope-imc16.pdf

│ └── symmetry-12-01491.pdf

├── practice_project

├── README.md

├── project_02.md

├── project_03.md

└── project_04.md

├── protocol

├── Connection-rfc1242.txt.pdf

├── Gopher-rfc4266.txt.pdf

├── HTTP-rfc2068.txt.pdf

├── HTTP-rfc2069.txt.pdf

├── HTTP-rfc2227.txt.pdf

├── HTTP-rfc2518.txt.pdf

├── HTTP-rfc2585.txt.pdf

├── HTTP-rfc2817.txt.pdf

├── README.md

├── RTCP-rfc1889.txt.pdf

├── RTCP-rfc3556.txt.pdf

├── RTCP-rfc3605.txt.pdf

├── RTCP-rfc3611.txt.pdf

├── RTCP-rfc4571.txt.pdf

├── RTCP-rfc4585.txt.pdf

├── RTCP-rfc4588.txt.pdf

├── RTCP-rfc5124.txt.pdf

├── RTCP-rfc5506.txt.pdf

├── RTCP-rfc5725.txt.pdf

├── RTCP-rfc5760.txt.pdf

├── RTCP-rfc5764.txt.pdf

├── RTCP-rfc6035.txt.pdf

├── RTCP-rfc6051.txt.pdf

├── RTCP-rfc6128.txt.pdf

├── RTCP-rfc6222.txt.pdf

├── RTCP-rfc6263.txt.pdf

├── RTCP-rfc6332.txt.pdf

├── RTCP-rfc6642.txt.pdf

├── RTP-rfc1889.txt.pdf

├── RTP-rfc1890.txt.pdf

├── RTP-rfc2029.txt.pdf

├── RTP-rfc2035.txt.pdf

├── RTP-rfc2038.txt.pdf

├── RTP-rfc2198.txt.pdf

├── RTP-rfc2250.txt.pdf

├── RTP-rfc2429.txt.pdf

├── RTP-rfc2431.txt.pdf

├── RTP-rfc2435.txt.pdf

├── RTP-rfc2508.txt.pdf

├── RTP-rfc2733.txt.pdf

├── RTP-rfc2793.txt.pdf

├── RTP-rfc2833.txt.pdf

├── RTP-rfc2862.txt.pdf

├── RTP-rfc3016.txt.pdf

├── RTP-rfc3047.txt.pdf

├── RTSP-rfc2326.txt.pdf

├── RTSP-rfc4567.txt.pdf

├── RTSP-rfc7825.txt.pdf

├── RTSP-rfc7826.txt.pdf

├── RTSP-rfc8866.pdf

├── SDP-rfc2327.txt.pdf

├── SDP-rfc2848.txt.pdf

├── SDP-rfc3107.txt.pdf

├── SDP-rfc3264.txt.pdf

├── SDP-rfc3266.txt.pdf

├── SDP-rfc3388.txt.pdf

├── SDP-rfc3407.txt.pdf

├── SDP-rfc3485.txt.pdf

├── SDP-rfc3524.txt.pdf

├── SDP-rfc3556.txt.pdf

├── SDP-rfc3611.txt.pdf

├── SDP-rfc3890.txt.pdf

├── SDP-rfc4091.txt.pdf

├── SDP-rfc4145.txt.pdf

├── SDP-rfc4298.txt.pdf

├── SDP-rfc4566.txt.pdf

├── SDP-rfc4567.txt.pdf

├── TCP-rfc1001.txt.pdf

├── TCP-rfc1002.txt.pdf

├── TCP-rfc793.txt.pdf

├── UDP-rfc1001.txt.pdf

├── UDP-rfc1002.txt.pdf

├── UDP-rfc2013.txt.pdf

├── UDP-rfc2147.txt.pdf

├── UDP-rfc2508.txt.pdf

├── UDP-rfc3489.txt.pdf

├── UDP-rfc3519.txt.pdf

├── UDP-rfc3828.txt.pdf

├── UDP-rfc3948.txt.pdf

├── UDP-rfc4019.txt.pdf

├── UDP-rfc4113.txt.pdf

└── UDP-rfc768.txt.pdf

├── video

└── README.md

└── 音视频流媒体开发知识归纳导图.png

/WebRTC 零基础开发者教程(中文).pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ddc7451/git-github.com-0voice-audio_video_streaming/e80c94419c06636c16e5bbfcec32f1d1343e70c3/WebRTC 零基础开发者教程(中文).pdf

--------------------------------------------------------------------------------

/article/001-WebRTC 发送方码率预估实现解析.md:

--------------------------------------------------------------------------------

1 | # WebRTC 发送方码率预估实现解析

2 |

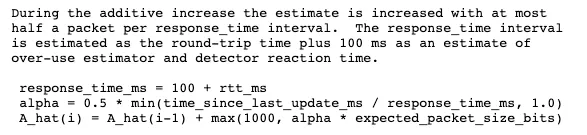

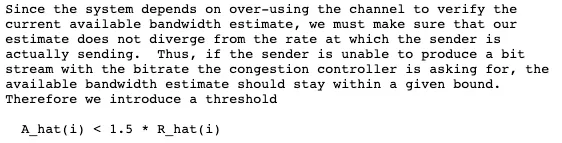

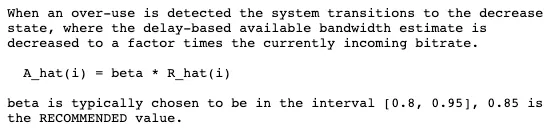

3 | WebRTC使用的是Google Congestion Control (简称GCC)拥塞控制,目前有两种实现:

4 | * 旧的实现是接收方根据收到的音视频RTP报文, 预估码率,并使用REMB RTCP报文反馈回发送方。

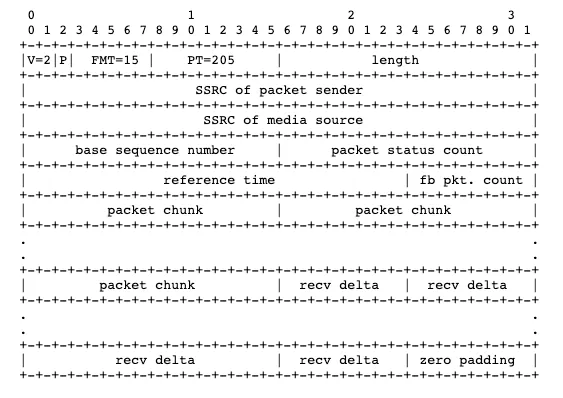

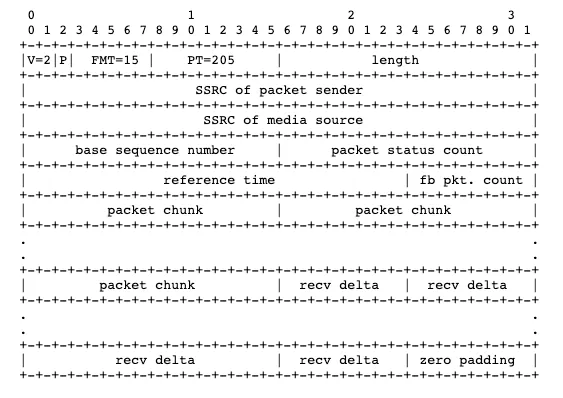

5 | * 新的实现是在发送方根据接收方反馈的TransportFeedback RTCP报文,预估码率。

6 |

7 | ## 基于延迟的拥塞控制原理

8 |

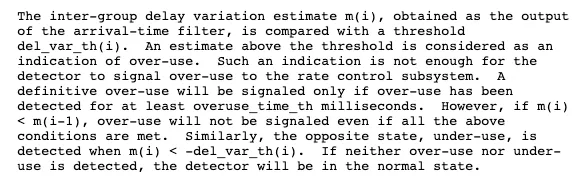

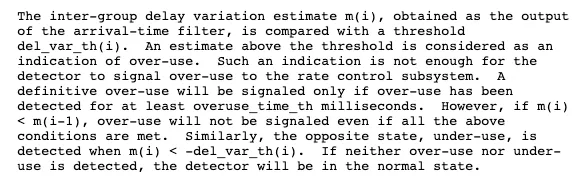

9 | 先来看下Google Congestion Control(GCC)的标准草案:https://tools.ietf.org/html/draft-ietf-rmcat-gcc-02

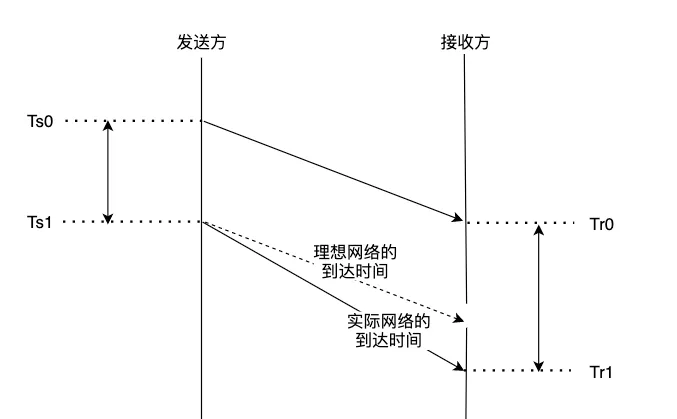

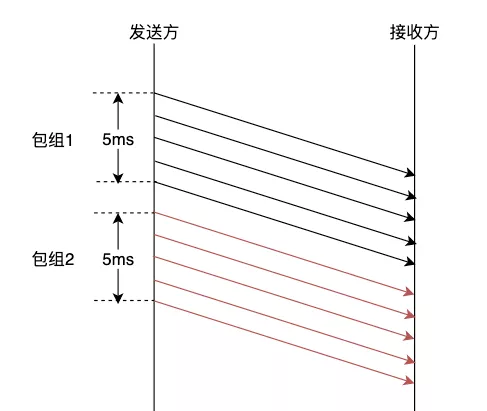

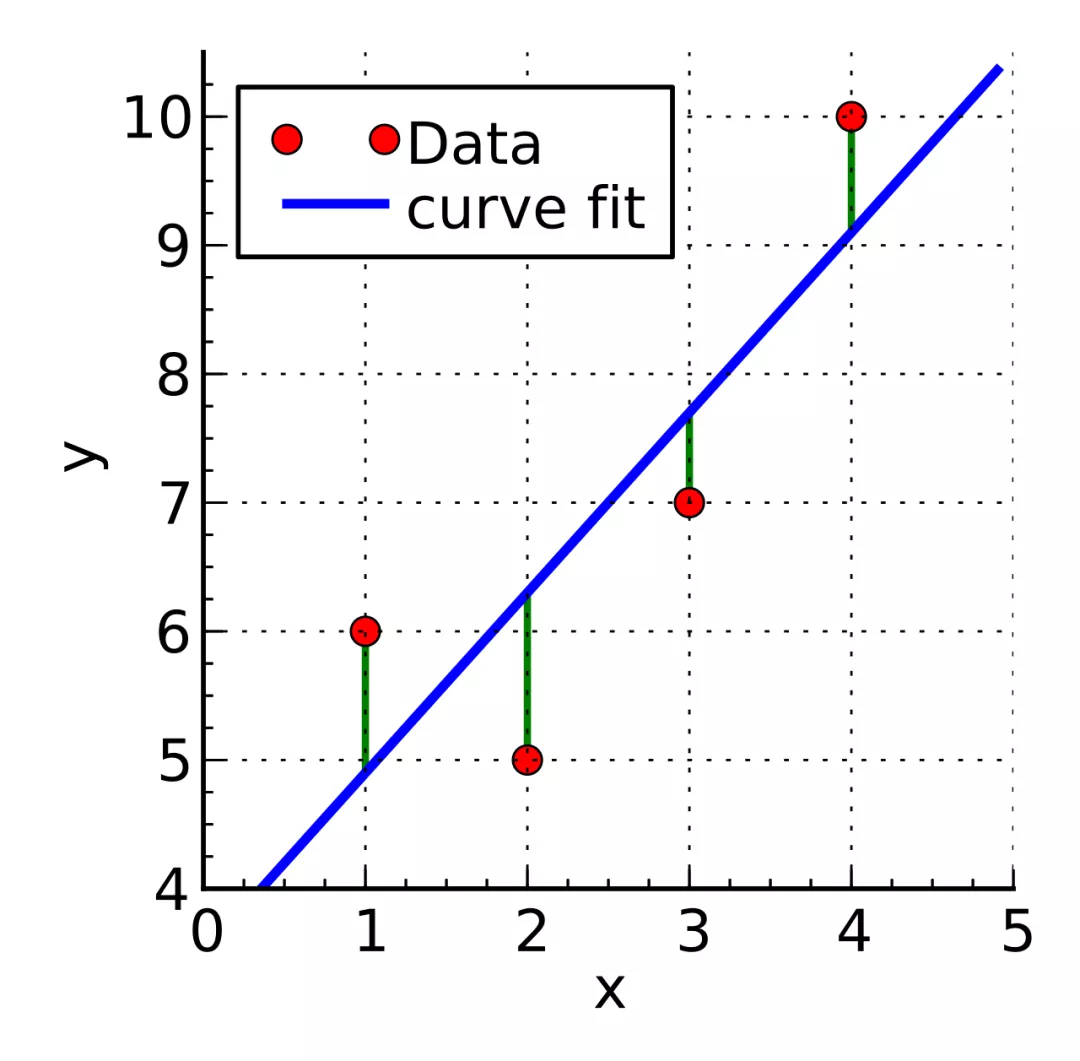

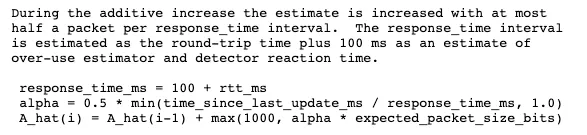

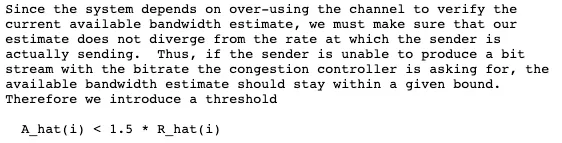

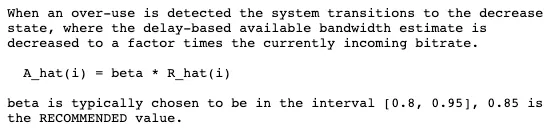

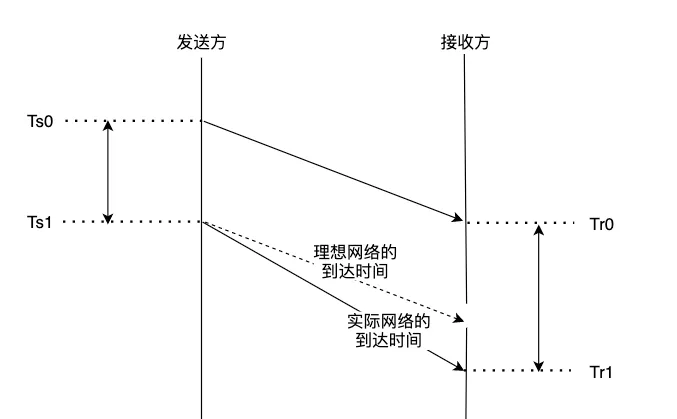

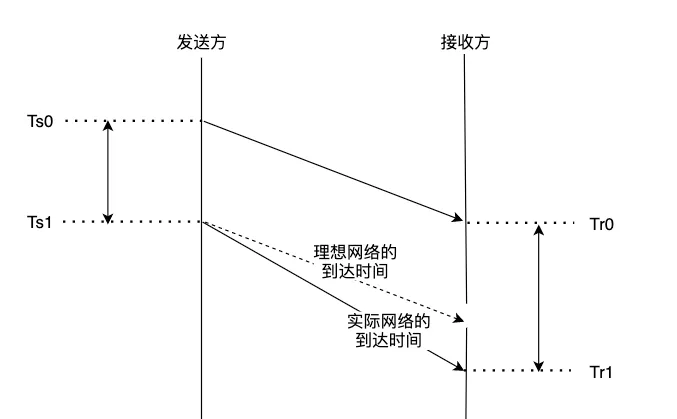

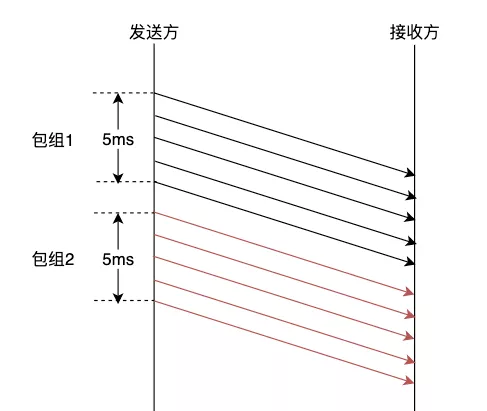

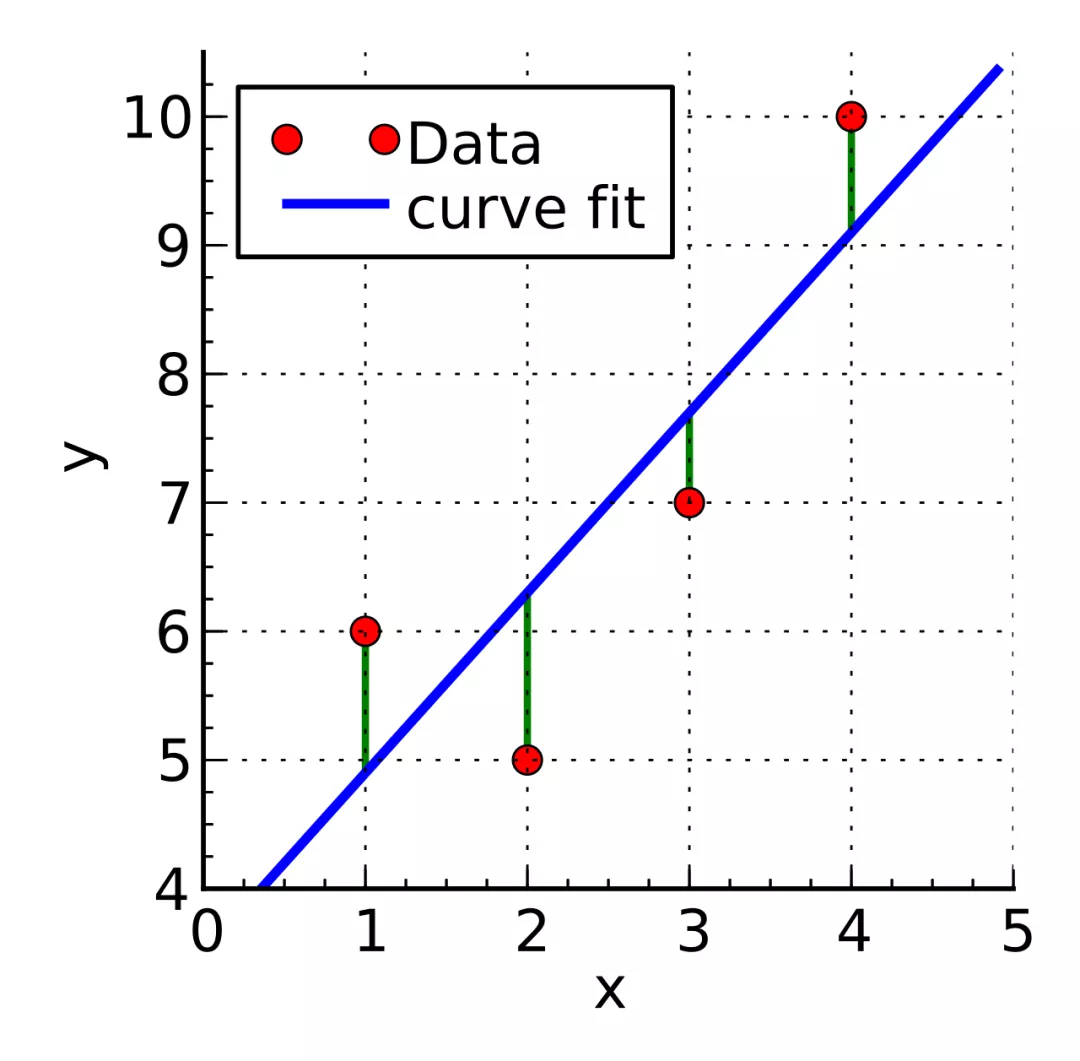

10 | 结合草案,可以得知GCC是基于网络延迟梯度的拥塞控制算法,判断的依据如下图:

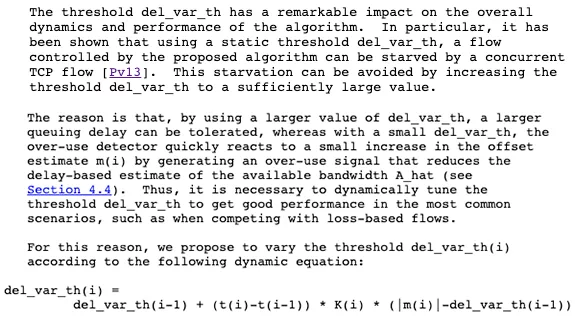

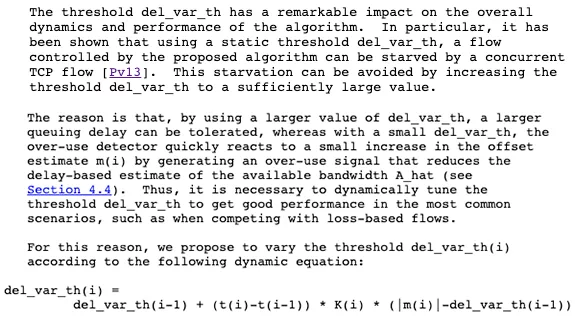

11 |

12 |

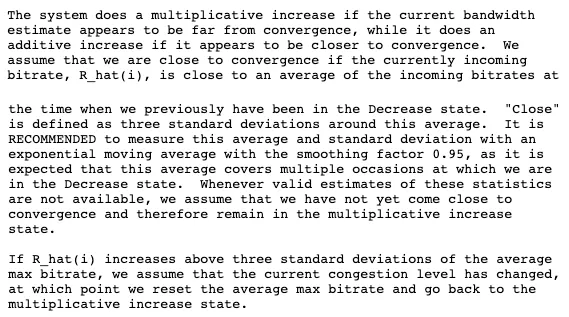

13 |

14 |

15 |

43 |

44 |

45 |

46 |

56 |

57 |

58 |

59 |

77 |

78 |

79 |

80 |

96 |

97 |

98 |

99 |

109 |

110 |

111 |

112 |

123 |

124 |

125 |

126 |

141 |

142 |

143 |

144 |

155 |

156 |

157 |

158 |

167 |

168 |

169 |

170 |

178 |

179 |

180 |

181 |

189 |

190 |

191 |

192 |

233 | WebRTC研究:包组时间差计算-InterArrival: https://blog.jianchihu.net/webrtc-research-interarrival.html

234 |

235 | WebRTC研究:Trendline滤波器-TrendlineEstimator: https://blog.jianchihu.net/webrtc-research-trendlineestimator.html

236 |

237 | 袁荣喜的一个GCC C语言的实现: https://github.com/yuanrongxi/razor

238 |

239 |

240 |

241 |

242 |

243 |

244 |

245 |

246 |

247 |

248 |

249 |

250 |

251 |

252 |

253 |

254 | 文章原作者:腾讯云音视频

255 |

--------------------------------------------------------------------------------

/article/002-码率控制基本概念.md:

--------------------------------------------------------------------------------

1 | # 码率控制基本概念

2 |

3 | 码率控制是指视频编码中决定输出码率的过程。首先介绍一下 X264 中使用到的与码率控制相关的几个概念:

4 |

5 | CQP(Constant QP) 恒 定QP(Quantization Parameter),追求量化失真的恒定,瞬时码率会随场景 复杂度而波动,该模式基本被淘汰(被 CRF 取代),只有用”-pq 0”来进行无损编码还有价值。

6 |

7 | CRF(Constant Rate Factor),恒定质量因子,与恒定 QP 类似,但追求主观感知到的质量恒定,瞬时码率也 会随场景复杂度波动。对于快速运动或细节丰富的场景会适当增大量化失真(因为人眼不易注意到),反之 对于静止或平坦区域则减少量化失真。

8 |

9 | ABR(Average Bitrate),平均码率,追求整个文件的码率平均达到指定值(对于流媒体有何特殊之处?)。瞬时码率也会随着场景复杂度波动,但最终要受平均值的约束。

10 |

11 | CBR(Constant Bitrate),恒定码率。前面几个模式都属于可变码率(瞬时码率在波动),即VBR(Variable Bitrate);恒定码率与之相对,即码率保持不变。

12 |

13 | x264 并没有直接提供 CBR 这种模式,但可以通过在 VBR 模式的基础上做进一步限制来达到恒定码率的目标。CRF 和 ABR 模式都能通过--vbv-maxrate --vbv-bufsize来限制码率波动。

14 |

15 | >关于这几个概念的参考如下:

16 |

17 | + 1.Waht are CBR,VBV and CPB?

18 | + 2.FFmpeg and H.264 Encoding Guide

19 | + 3.CRF Guide(Constant Rate Factor in X264 and X265)

20 | + 4.MeGUI/x264 setting

21 |

22 | ## X264 中码率控制

23 |

24 | X264 中对于码率控制方法有三种:X264_RC_CQP、X264_RC_CRF、X264_RC_ABR。默认情况是选择 CRF 方法,设置是在 x264_param_default函数里设置的

25 |

26 | ```C++

27 | param->rc.i_rc_method = X264_RC_CRF;

28 | param->rc.f_rf_constant = 23;

29 | ```

30 |

31 | 关于这三种方法,网上有提到优先级是ABR>CQP>CRF的,但分析 X264 的源码,并没有看出有优先级顺序,关于码率控制方法的设置代码如下:

32 |

33 | ```C++

34 | OPT("bitrate")

35 | {

36 | p->rc.i_bitrate = atoi(value);

37 | p->rc.i_rc_method = X264_RC_ABR;

38 | }

39 | OPT2("qp", "qp_constant")

40 | {

41 | p->rc.i_qp_constant = atoi(value);

42 | p->rc.i_rc_method = X264_RC_CQP;

43 | }

44 | OPT("crf")

45 | {

46 | p->rc.f_rf_constant = atof(value);

47 | p->rc.i_rc_method = X264_RC_CRF;

48 | }

49 | ```

50 |

51 | ## X264 中关于 QP设置

52 | 首先看一段 X264 中关于 QP 值的代码,该段代码在x264_ratecontrol_new:

53 |

54 | ```C++

55 | rc->ip_offset = 6.0 * log2f(h->param.rc.f_ip_factor);

56 | rc->pb_offset = 6.0 * log2f(h->param.rc.f_pb_factor);

57 | rc->qp_constant[SLICE_TYPE_P] = h->param.rc.i_qp_constant;

58 | rc->qp_constant[SLICE_TYPE_I] = x264_clip3(h->param.rc.i_qp_constant - rc->ip_offset + 0.5, 0, QP_MAX);

59 | rc->qp_constant[SLICE_TYPE_B] = x264_clip3(h->param.rc.i_qp_constant + rc->pb_offset + 0.5, 0, QP_MAX);

60 | ```

61 |

62 | 从上面的代码可以看出,默认的i_qp_constant或者通过命令行传入的qp qp_constant实际设置的是 P 帧的 QP。I 帧和 B 帧的 QP 设置是根据f_ip_factor f_pb_factor计算得到。

63 |

64 | 在研究编码算法的时候,一般会选用 CQP 方法,设定 QP 为 24、28、32、36、40等(一般选 4 个 QP 值),然后比较算法优劣。在 X264 中,关于QPmin、QPmax、QPstep的默认设置如下:

65 |

66 | ```C++

67 | param->rc.i_qp_min = 0;

68 | param->rc.i_qp_max = QP_MAX;

69 | param->rc.i_qp_step = 4;

70 | ```

71 |

72 | QPmin,默认值:

0. 定义 X264 可以使用的最小量化值,量化值越小,输出视频质量越好。当 QP 小于某一个值后, 编码输出的宏块质量与原始块极为相近,此时没必要继续降低 QP。如果开启了自适应量化器(默认开启),不建议 提高 QPmin 的值,因为这会降低平滑背景区域的视觉质量。

73 |

74 | QPmax,默认值:

51. 定义 X264 可以使用的最大量化值。默认值 51 是 H.264 规格中可供使用的最大量化值。如果 想要控制 X264 输出的最低品质,可以将此值设置的小一些。QPmin 和 QPmax 在CRF,ABR方法下是有效的,过低的设置 QPmax,可能造成 ABR 码率控制失败。不建议调整该参数。

75 |

76 | QPstep,默认值:

4.设置两帧间量化值的最大变化幅度。

77 |

78 | . 比较三种码率控制方式如下:

79 |

80 | 码率控制方法| 视觉质量稳定性 | 即时输出码率 | 输出文件大小

81 | :--|:--|:--|:--

82 | CBR |不稳定| 恒定| 可控

83 | VBR |稳定 |变化 |不可控

84 | ABR |基本稳定| 变化| 可控

85 |

86 | 帧间 QP 变化,帧内宏块 QP 不变,输出码率未知,各帧输出视觉质量有变化(高 QP 低码率的情况下会更明显)。

87 |

88 |

89 |

90 |

91 |

92 |

93 |

94 |

95 |

96 |

97 |

98 |

99 | 文章原作者: 音视频开发训练营

100 |

101 |

102 |

103 |

--------------------------------------------------------------------------------

/article/003-Speex回声消除代码分析.md:

--------------------------------------------------------------------------------

1 | # Speex回声消除代码分析

2 |

3 | 首先说明,这里的代码流程是修改过的Speex流程,但与Speex代码差异不大,应该不影响阅读。

4 |

5 | 1. 用RemoveDCoffset函数进行去直流

6 | 2. 远端信号预加重后放入x[i+frame_size],近端信号预加重后放入input缓冲区

7 | 3. 前M-1帧的远端频域信号移位,为当前帧频域信号腾出空间

8 | 4. 用spx_fft函数进行FFT变换,变换后的系数存在X中

9 | 5. 计算当前远端信号当前帧的方差Sxx。(去直流操作后,意味着均值可以视为零)

10 | 6. 当前远端时域信号移位,x[i] = x[i+frame_size],50%交叠处理

11 | 7. 先用前景滤波器进行滤波

12 | 8. 将滤器后的输出进行反变换

13 | 9. 再用近端信号(麦克风语音)减去滤波输出得到前景滤波器的语差信号

14 | 10. 再用mdf_inner_prod计算前景滤后器的时域误差总功率

15 | 11. 使用mdf_adjust_prop计算背景滤波器各段(每个)相同频率的系数幅度,存放在prop( 这里进行了归一化处理)。

16 | 12. 用weighted_spectral_mul_conj函数计算背景滤波器频域系数需要调整多少量,(其思想为LMS:步长乘以W*E)

17 |

18 | >power_1 最优步长因子,具体可以参考Mader算法,与prop相乘得到最化步长

19 | >prop 为归一化后的背景滤波器各频率的系数幅度。与power_1相乘

20 | >X 为转换到频域后的远端信号

21 | >E 为转换到频域后的误差信号

22 | >PHI 输出结果:背景滤波器频域系数需要调整的量

23 |

24 | 13. 背景滤波器频域系数调整:W[j*N+i] = W[j*N+i]+ PHI[i]

25 | 14. 防止循环卷积处理(重叠保留法变循环卷积为线性卷积,把相关块的FFT系数中的后半部分置为零)

26 | 15. 根据调整后的背景滤波器对远端信号再进行频域滤波处理

27 | 16. 滤波后的输出进行反变换,存到y

28 | 17. 在时域计算两次滤波之间的误差及两次滤波之间误差的功率Dbf

29 | 18. 在时域计算背景滤波器滤波后的误差和背景滤波器滤波后误差的方差See。至此我们得到:

30 |

31 | >Sff 前景滤波后的方差

32 | >See 背景滤波后的方差

33 | >Dbf 前景滤波与背景滤波之间方差

34 |

35 | 19. 利用Sff、See、Dbf来计算是否需要更新前景滤波器(总的来说,当Dbf值比较大时需要更新前景滤波器系数)

36 | 20. 如果需要更新前景滤波器系数则把背景滤波器系数给前景滤波器,并平滑背景滤波后的时域误差(前景滤波时域语差加上背景滤波器的时域输出),得到总误差,存在e[i+frame_size],这里的总误差,就是总的远端信号回声。

37 | 21. 根据总的远端信号回声,计算回声消除后的语音信号,并进行预加重处理,存在out输出缓冲区中(这个步骤是我自己调的)

38 | 22. 误差缓冲区移动,为下一帧处理做好准备

39 | 23. 计算背景滤波器输出与误差的互相关Sey、背景滤波器的自相关Syy

40 | 24. 再把语差信号与输出信号(前面都置为0)都是变换到频域

41 | 25. 再计算变换后的E、Y、X的功率谱,对应的分别是Rf、Xf、Xf

42 | 26. 通过Xf平滑得到远端信号功率谱power

43 |

44 | >power[j] = (ss_1*power[j]) + 1 + (ss*Xf[j]);

45 |

46 | 27. 当(前一帧的)泄露系数小于一个阀值(0.5)时,重新估算远端信号功率谱power

47 | 28. 计算ey协方差,得到e和y的相关系数 Pey,标准差 Pyy。(Pey为相关系数:ey协方差/y标准差)

48 | 29. 计算远端信号泄露系数

49 |

50 | 参考论文:On Adjusting the Learning Rate in Frequency Domain Echo Cancellation With Double-Talk

51 |

52 | >先计算递归平均系数:

53 | > alpha = beta0*Syy/See; 这里beta0为泄露估计的学习速率

54 | > alpha_1 = 1-alpha;

55 | >再递归计算相关系数Pey和标准差Pyy

56 | >最后得到泄露系数:leak_estimate = Pey/Pyy

57 |

58 | 30. 计算残余回声与误差的比率,并做上下限处理。

59 |

60 | >RER = (0.0001*Sxx + 3.0f*leak_estimate*Syy) / See;

61 | >下限:Sey*Sey/(1+See*Syy)

62 | >上限:0.5

63 |

64 | 31. 判断收敛条件:sum_adapt > M 且leak_estimate > 0.03

65 |

66 | >如果滤波器收敛:

67 | > r = 0.7*leak_estimate*Yf + 0.3*RER*(RF+1) // 计算残余回声的功率

68 | > // 计算最优步长因子,具体可以参考Mader算法,或者到本文作者那里寻求帮助

69 | > power_1[i] = r / (e*(power[i]+10));

70 | >如果没有收敛

71 | > 当Sxx > N*1000时,按如下计算adapt,否则adapt_rate值为0

72 | > adapt_rate = 0.25f*Sxx/See;

73 | > sum_adapt += adapt_rate

74 |

75 | 32. 把残余回声保存在last_y,这是为了语音增强时去掉回声的影响

76 |

77 |

78 |

79 |

80 |

81 |

82 |

83 |

84 |

85 |

86 |

87 | 原文作者:icoolmedia

88 |

--------------------------------------------------------------------------------

/article/004-房间声学原理与Schroeder混响算法实现.md:

--------------------------------------------------------------------------------

1 | # 房间声学原理与Schroeder混响算法实现

2 |

3 | 因原文公式较多,因此直接贴上图片。

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

12 |

13 |

14 |

15 |

16 | 原文作者:icoolmedia

17 |

--------------------------------------------------------------------------------

/article/005-H264系列--压缩编码技术.md:

--------------------------------------------------------------------------------

1 | # H264系列--压缩编码技术

2 |

3 | ## 概述

4 | H264 无疑是目前应用最广泛的编码技术。一些比较优秀的开源库x264/openh264, ffmpeg等让人们处理h264编解码变得相对容易。为了能更好地理解和处理h264问题,还是有必要了解相关的原理

5 |

6 | H264压缩技术主要采用了以下几种方法对视频数据进行压缩:

7 |

8 | * 帧内预测压缩,解决的是空域数据冗余问题。

9 | * 帧间预测压缩(运动估计与补偿),解决的是时域数据冗徐问题。

10 | * 整数离散余弦变换(DCT),将空间上的相关性变为频域上无关的数据然后进行量化。

11 | * CABAC熵编码, 对量化后的系数进一步的压缩

12 |

13 | 经过压缩后的帧分为:I帧,P帧和B帧:

14 |

15 | * I帧:关键帧,采用帧内压缩技术。

16 | * P帧:向前参考帧,在压缩时,只参考前面已经处理的帧。采用帧音压缩技术。

17 | * B帧:双向参考帧,在压缩时,它即参考前而的帧,又参考它后面的帧。采用帧间压缩技术。

18 |

19 | 两个I帧间的图像序列就称为GOP

20 |

21 |

22 |

23 | Tip:对目前比较流行的直播和短视频来说,短视频的数据I帧会比较少,因为I帧数据比较大。而直播的话I帧比较多,因为客户端需要一进入直播间就能马上播放,一般是2s左右一个I帧

24 |

25 | ## 宏块

26 |

27 | 宏块是编码标准的基本处理单元,通常它的大小也为16x16像素。16X16 的宏块上可以划分出更小的子块。子块的大小可以是 8X16、 16X8、 8X8、 4X8、 8X4、 4X4。这主要看图像细节的丰富程度。比如下面的图片

28 |

29 |

30 |

31 | 宏块划分好后,就可以对H264编码器缓存中的所有图片进行分组了

32 |

33 | ## 帧分组(即GOP)

34 |

35 | 对于视频数据主要有两类数据冗余,一类是时间上的数据冗余,另一类是空间上的数据冗余。其中时间上的数据冗余是最大的。下面我们就先来说说视频数据时间上的冗余问题。

36 |

37 | 为什么说时间上的冗余是最大的呢?假设摄像头每秒抓取30帧,这30帧的数据大部分情况下都是相关联的。也有可能不止30帧的的数据,可能几十帧,上百帧的数据都是关联特别密切的。

38 |

39 | 对于这些关联特别密切的帧,其实我们只需要保存一帧的数据,其它帧都可以通过这一帧再按某种规则预测出来,所以说视频数据在时间上的冗余是最多的。

40 |

41 | 下面是捕获的一组运动的台球的视频帧,台球从右上角滚到了左下角。

42 |

43 |

44 |

45 |

46 |

47 | 通过宏块扫描与宏块搜索可以发现这两个帧的关联度是非常高的。进而发现这一组帧的关联度都是非常高的。因此,上面这几帧就可以划分为一组。其算法是:在相邻几幅图像画面中,一般有差别的像素只有10%以内的点,亮度差值变化不超过2%,而色度差值的变化只有1%以内,我们认为这样的图可以分到一组。

48 |

49 | 在这样一组帧中,经过编码后,我们只保留第一帖的完整数据,其它帧都通过参考上一帧计算出来。我们称第一帧为IDR/I帧,其它帧我们称为P/B帧,这样编码后的数据帧组我们称为GOP

50 |

51 | 所以如果场景一直没什么变化,则一系列视频帧中I帧的数量会很少。如果场景变换很复杂,一直在场景变换大的场景切换时就会有I帧出现。

52 |

53 | ## 运动估计与运动补偿

54 |

55 | 在H264编码器中将帧分组后,就要计算帧组内物体的运动矢量了。还以上面运动的台球视频帧为例,我们来看一下它是如何计算运动矢量的。

56 |

57 | H264编码器首先按顺序从缓冲区头部取出两帧视频数据,然后进行宏块扫描。当发现其中一幅图片中有物体时,就在另一幅图的邻近位置(搜索窗口中)进行搜索。如果此时在另一幅图中找到该物体,那么就可以计算出物体的运动矢量了

58 |

59 |

60 |

61 | 运动矢量计算出来后,将相同部分(也就是绿色部分)减去,就得到了补偿数据。我们最终只需要将补偿数据进行压缩保存,以后在解码时就可以恢复原图了。压缩补偿后的数据只需要记录很少的一点数据。如下所示:

62 |

63 |

64 |

65 | 现在在电视和投影上经常看到运动补偿(MEMC)的广告,其实并不是什么高深的技术,比如在上面的例子中,就是根据运动矢量,在帧与帧间插入新运动矢量,使得整个GOP中矢量变化更加平滑。

66 |

67 | ## 帧内压缩(这部分也看不懂,后面补充)

68 |

69 | 计算残差数据 --->DCT ---> CABAC

70 |

71 | ## 帧内预测,计数残差值

72 |

73 | H264的帧内压缩与JPEG很相似。一幅图像被划分好宏块后,对每个宏块可以进行 9 种模式的预测。找出与原图最接近的一种预测模式。

74 |

75 | 然后,将原始图像与帧内预测后的图像相减得残差值。

76 |

77 | 再将我们之前得到的预测模式信息一起保存起来,这样我们就可以在解码时恢复原图了

78 |

79 | ## 对残差数据进行DCT

80 |

81 | ## CABAC

82 |

83 | 上面的帧内压缩是属于有损压缩技术。也就是说图像被压缩后,无法完全复原。而CABAC属于无损压缩技术

84 |

85 |

86 |

87 |

88 |

89 |

90 |

91 |

92 |

93 |

94 | 原文作者: 简单程序员

95 |

--------------------------------------------------------------------------------

/article/006-RTSP 媒体协议流的录制方案及其覆盖策略详解.md:

--------------------------------------------------------------------------------

1 | # RTSP 媒体协议流的录制方案及其覆盖策略详解

2 |

3 | ## 前言

4 |

5 | 在安防和监控领域,RTSP 媒体协议流有很广泛的使用。本文将介绍一种针对 RTSP 媒体流的录制方案及其相应的覆盖策略。据我所知,声网的实时录制功能支持三种模式,分别是云端录制、本地服务端录制和页面录制,今天我们介绍的录制方案和声网的云端录制类似。

6 |

7 | ## 正文

8 |

9 | 本文将从录制视频格式的调研、录制方案的选择、异常状况的处理、覆盖策略的执行四个大方面进行介绍。

10 |

11 | ### 1. 录制视频格式调研

12 | 如果想要实现 RTSP 媒体流的录制功能,就需要考虑录制目标文件的格式,也就是把媒体流录制成哪种格式的视频文件。起初我们预设了三种方案,经过一系列调研后,最终选择了 m3u8。接下来,我们简单介绍一下这个选择过程。

13 |

14 | ### 1.1 为什么不用 mp4 格式

15 | mp4 是点播视频中最为常见的视频格式,综合分析下来并不符合我们的使用场景。一般情况下,一个电影视频的最大时长也就两到三个小时左右,保存成一个 mp4 文件就够用了,但是在安防和监控场景下,一个摄像头对应的录制视频文件的长度可能是十几个小时,甚至是十几天。所以,对比下来,mp4 格式更适用于电影网站。

16 |

17 | 这就引出了 mp4 格式的一个缺点,如果录制存储为一个 mp4 格式,那文件体积可能会非常大。那么,存储的时候就会面临一系列问题,比如磁盘空间不足、大文件分片等状况的处理,特别是录制过程中数据流异常中断可能会导致已经录制的 mp4 文件不可用,这是其一。

18 |

19 |

20 |

21 | 我们知道 mp4 文件是由许多 Box 和 FullBox 组成的,可以参考上图的 Box 树形图,其中,FullBox 是 Box 的扩展,每个 Box 又包含 Header 和 Data 两部分,moov Box 记录了整个 mp4 文件的音视频媒体信息。而 moov Box 一般是在 mp4 文件写完时才在文件尾部添加。因此,又引出了另外一个缺点,如果 mp4 文件特别大,那么在播放的时候,播放器需要加载全部的视频文件到内存中,如果视频文件特别大,这几乎是不现实的。因此,我们在录制结束保存 mp4 的时候,需要把 moov Box 调整到文件头部来避免这个问题。

22 |

23 | ### 1.2 为什么不用 mpd 格式

24 | mpd 格式类似于 m3u8 格式,但是它采用的是 XML 的组织形式。我们不选择它的原因也有两个,其一,mpd 格式在现有产品线上没有类似使用场景,我们使用更多的是 m3u8,换句话说就是技术储备不足。

25 |

26 | 其二,播放器方案的通用性上存在问题,如果使用 mpd 格式,那么我们的播放器方案需要调整,能够支持 mpd 格式媒体的播放,这样一来会给播放器带来一定的工作量和隐含的问题。

27 |

28 | 最后,给出一个 mpd 的文件示例,让大家对其有一个更加直观的了解。

29 |

30 | ```HTML

31 |

32 |

33 |

34 |

35 |

36 |

37 |

38 | tears_audio_eng.mp4

39 |

40 |

41 |

42 |

43 |

44 |

45 |

46 | tears_h264_baseline_240p_800.mp4

47 |

48 |

49 |

50 |

51 |

52 | tears_h264_main_480p_2000.mp4

53 |

54 |

55 |

56 |

57 |

58 | tears_h264_main_720p_8000.mp4

59 |

60 |

61 |

62 |

63 |

64 | tears_h264_high_1080p_20000.mp4

65 |

66 |

67 |

68 |

69 |

70 |

71 |

72 | ```

73 |

74 | 通过上述文件,我们可以知道这个 mpd 文件包含了一路音频流,同时支持三种不同分辨率和码率的视频流。不同的媒体类型是用 AdaptationSet 标签表示的,内部还可以使用 Representation 标签标记不同分辨率和码率的媒体流。

75 |

76 | ### 1.3 为什么最终选择 m3u8 格式

77 | 选择 m3u8 的话,优势就会更加明显,除了规避上述方案的问题外,还有一些自身的优势,具体表现如下:

78 |

79 | 1. 本身就是 ts 分片存储形式,不需要再单独考虑大文件的切片问题。

80 | 2. 现有播放器方案支持 m3u8 格式,不需要再单独进行适配。

81 | 3. 具有一定的技术储备,开发上手快,开发周期可控。

82 | 4. 相应的覆盖策略执行起来会更加方便。

83 |

84 | 最后,给出一个 m3u8 的文件示例,让大家对其有一个更加直观的了解。

85 |

86 | ```C++

87 | #EXTM3U

88 | #EXT-X-VERSION:3

89 | #EXT-X-TARGETDURATION:17

90 | #EXT-X-MEDIA-SEQUENCE:0

91 | #EXTINF:11.933333,

92 | index_0000.ts

93 | #EXTINF:3.866667,

94 | index_0001.ts

95 | #EXTINF:7.333333,

96 | index_0002.ts

97 | #EXTINF:16.666667,

98 | index_0003.ts

99 | #EXTINF:4.133333,

100 | index_0004.ts

101 | #EXT-X-ENDLIST

102 | ```

103 |

104 | 通过上述文件,我们可以知道这个 m3u8 文件包含了 5 个 ts 分片,以及它们各自的时长信息。文件以 #EXTM3U 标签开始,并以 #EXT-X-ENDLIST 标签结束。这里有一点需要注意,如果是直播使用的 m3u8 文件,它是没有 #EXT-X-ENDLIST 标签的。

105 |

106 | ## 2. 录制方案选择

107 | 既然已经确定了目标文件的格式,那么我们就要考虑怎么实现了。目前有两个方案可以考虑,一个是 Golang 纯原生方案,另一个是利用 ffmpeg 实现,接下来分别介绍。

108 |

109 | ### 2.1 Go 原生

110 | 利用纯原生的 Golang 实现,其实,Golang 处理音视频数据还是有一定优势的,通过解封装 RTSP 媒体流,得到音频数据和视频数据,然后创建对应的解码器,得到对应的原始音频 PCM 数据和原始视频 YUV 数据,再分别编码成 AAC 的音频和 H264 的视频,最后保存成 m3u8 格式的录制文件。整个过程可以参考下图:

111 |

112 |

113 |

114 | 这种方案,编码的工作量会稍微大一些,同时有很多音视频数据处理的细节问题,负载度和难易程度上不如 ffmpeg 方案。

115 |

116 | ### 2.2 ffmpeg

117 | 利用 ffmpeg 工具库,通过启用 ffmpeg 进程来完成对应的 RTSP 流数据接收和 m3u8 文件录制保存工作,这样会更加简单,我们只需要管理好进程的创建、释放和异常处理工作。

118 |

119 | ## 3. 异常处理

120 |

121 | 录制过程中会遇到各种各样的问题,接下会分别介绍。有一点是相同的,所有的异常状况都会通知到录制调度服务,由调度服务进行统一分析和管理,同时支持热备机制,我们通过 Nacos 的服务发现机制监测录制调度服务的运行状态,具体关系可以参考下图:

122 |

123 |

124 |

125 | ### 3.1 CPU、磁盘

126 |

127 | CPU 负载过高和磁盘空间不足是最为常见的两种录制时的异常状况,大致的处理逻辑也是较为相似的。

128 |

129 | CPU 过高的处理逻辑,可以参考下图:

130 |

131 |

132 |

133 | 当前机器接收到任务后,进行自检操作,发现 CPU 负载过高会停止当前录制任务的执行,同时上报调度服务,重新分配别的机器执行该录制任务。

134 |

135 | 当前机器正在执行录制任务,突然发现 CPU 负载超过阈值,会持续观察一段时间,假定观察周期为 10 秒,如果 CPU 负载连续 10 秒钟超高,那么会停止当前录制任务,同时上报调度服务,请求别的机器继续执行该录制任务,最后将两台机器上的录制文件进行逻辑关联保存到数据库中。如果 CPU 负载在 10 秒内恢复到正常值,我们将继续执行当前录制任务。

136 |

137 | 磁盘空间不足的处理逻辑和 CPU 负载过高有类似的处理逻辑,具体可以参考下图:

138 |

139 |

140 |

141 | 通过流程图,我们也可以知道磁盘空间不足的处理逻辑和 CPU 负载过高时类似,上图已经展示的非常明确了,这里就不过多赘述了。

142 |

143 | ### 3.2 异常处理

144 |

145 | 一些其他的异常处理情况,比如崩溃,整体流程可以参考下图:

146 |

147 |

148 |

149 | 异常发生时,如果是一般异常,我们只需要将状态通知调度服务即可,调度服务记录相关日志,综合分析整个录制服务的状态。如果 60%的录制机器触发了相同的异常,调度服务就要采取相应的策略。如果是崩溃等重大异常,就需要重启机器或者调度新的机器继续执行录制任务。

150 |

151 | ### 3.3 录制超时

152 |

153 | 如果发生了录制超时,比如我们想录制 24 个小时的视频,现在时长已经录够了,接下来应该怎么做呢?一般有两种处理方法,第一种是直接停止当前录制,上报通知调度服务即可,这种处理方式比较简单粗暴,但是在安防和监控领域是不合适的。第二种是执行特定规则的覆盖策略,实现循环覆盖,始终保留最近 24 小时之内的视频画面内容。

154 |

155 |

156 |

157 | 对比上述两种处理方式,当发生录制超时时,第二种方式是最符合安防和监控领域的通用做法。那么覆盖策略又是怎么实现的呢,这就引出了下面的内容——覆盖策略。

158 |

159 | ## 4. 覆盖策略

160 |

161 | 覆盖策略在原理上理解起来很简单,但是具体执行时,就不那么简单了。首先,我们也先通过一个流程图对覆盖策略的处理逻辑有一个整体上的认识。

162 |

163 |

164 |

165 |

166 | ### 4.1 一级定时器

167 |

168 | 当录制任务启动时,我们同时启动一个定时器(一级定时器),定时器的时长就是录制任务的目标时长,这个非常好理解。但是,这个定时器只生效一次或者一次都不生效。只有一级定时器生效后,才会启动二级定时器。如果一级定时器没有启动,那么二级定时器也不会启动。

169 |

170 | 我们可以这样理解,只有一级定时器触发,录制服务才会执行对应的覆盖策略。当覆盖策略启动后,一级定时器销毁,二级定时器生效。

171 |

172 | ### 4.2 二级定时器

173 |

174 | 当文件时长达到了预设的最大时长时,我们将启动二级定时器。其实,二级定时器控制的是覆盖策略的删除频率,每次时间到了,就删除早些时候到录制文件分片。

175 |

176 | ### 4.3 执行覆盖

177 |

178 | 具体覆盖的执行逻辑是,根据 ts 分片的时长和二级定时器的时间周期,计算需要删除的 ts 分片个数,同时更新 m3u8 中的索引列表,然后循环执行该策略,最终实现动态循环的录制覆盖策略。

179 |

180 |

181 |

182 | 覆盖策略的执行过程如上图所示,相信通过上文的解释,大家理解起来还是非常容易的。需要特别说明的是,由于二级定时器执行周期 t 的限制,录制文件的实际时长在最大录制时长 T 和(T+t)之间。

183 |

184 | ## 结尾

185 |

186 | 好了,现在关于 RTSP 媒体流的录制方案和覆盖策略就介绍完了,相信大家对云端录制方案也有了一定认识,有自己想法和感兴趣的小伙伴,欢迎评论留言。关注我,分享更多音视频和流媒体服务器内容。

187 |

188 |

189 |

190 |

191 |

192 |

193 |

194 |

195 |

196 | 原文作者: 刘振

197 |

--------------------------------------------------------------------------------

/article/007-webrtc建立连接之ICE框架.md:

--------------------------------------------------------------------------------

1 | # webrtc建立连接之ICE框架

2 |

3 | ## ICE介绍

4 |

5 | ICE全称Interactive Connectivity Establishment,即交互式连通建立方式,它是根据RFC5245实现,是一组基于Offer/Answer模式解决NAT穿越打洞的协议集合

6 |

7 | ## ICE架构

8 |

9 |

10 |

11 | ICE框架如上图所示,Peer A和Peer B通过STUN/TURN,建立连接的过程,它是后续P2P媒体流通讯的基础。

12 |

13 | ## ICE基本功能

14 |

15 | 在了解ICE基本功能前,先了解ICE一些基本概念,

16 |

17 | * Candidate:媒体传播的候选地址,组成pair做连通性检查,确定传输路径

18 | * Candidate pair :由本地和远端candidate组成的pair

19 | * Checklist:由candidate pair生成的按优先级排序的链表,用于连通性检查

20 | * Validlist:连通性间检查成功的condidate pair按优先级排序生成链表,用于ICE提名和选择最佳路径

21 |

22 | ### ICE基本功能:

23 |

24 | 第一、收集所有的通路

25 | 第二、对通路进行连通性检查(先对pair进行排序,然后提名并选择最佳路径)

26 |

27 | ### 收集所有通路

28 |

29 |

30 |

31 | 如上图所示,candidate类型有三种

32 |

33 | * 主机候选者(Local Address)

34 | * 反射候选者(Reflexive Address)

35 | * 中继候选者(Relayed Address)

36 |

37 | 拿到上面的三类候选者之后,要通过SDP交换数据。

38 | 一方收集到上面的所有三类候选者后,通过SDP信令传给对方。

39 | 同样另一方收集到候选者后,也做收集工作。

40 | 当双方拿到全部列表后,将候选者形成candidate pair

41 |

42 | ### 连通性检查

43 |

44 | 1. 对候选对进行优先级排序

45 | 2. 对每个候选对进行发送检查

46 | 3. 对每个候选对进行接收检查

47 |

48 | 第一个要进行排序,要把哪一些优先级高的先排队最先进行检测,这样可以节省时间。那在检测的时候呢,首先是要进行发送检测,那发送是OK的时候,然后再测试接收,其实在实际过程中为了这个节省时间是发送跟接收是同时进行的,所以如果我发送出去之后,然后再能收回我自己发送的信息,那么说明整个通路就是通过了,这其实在实现时还是非常简单的,这么说起来呢,就是要分为发送检测和接收检测。

49 |

50 |

51 |

52 |

53 |

54 |

55 |

56 |

57 |

58 |

59 | 原文作者: webrtc菜鸟笔记

60 |

--------------------------------------------------------------------------------

/article/008-流媒体协议介绍.md:

--------------------------------------------------------------------------------

1 | # 流媒体协议介绍(rtp/rtcp/rtsp/rtmp/mms/hls)

2 |

3 | ## RTP

4 | 参考文档 RFC3550/RFC3551

5 |

6 | Real-time Transport Protocol)是用于Internet上针对多媒体数据流的一种传输层协议。RTP协议详细说明了在互联网上传递音频和视频的标准数据包格式。RTP协议常用于流媒体系统(配合RTCP协议),视频会议和一键通(Push to Talk)系统(配合H.323或SIP),使它成为IP电话产业的技术基础。RTP协议和RTP控制协议RTCP一起使用,而且它是建立在UDP协议上的。

7 |

8 | RTP 本身并没有提供按时发送机制或其它服务质量(QoS)保证,它依赖于低层服务去实现这一过程。 RTP 并不保证传送或防止无序传送,也不确定底层网络的可靠性。 RTP 实行有序传送, RTP 中的序列号允许接收方重组发送方的包序列,同时序列号也能用于决定适当的包位置,例如:在视频解码中,就不需要顺序解码。

9 |

10 | RTP 由两个紧密链接部分组成: RTP ― 传送具有实时属性的数据;RTP 控制协议(RTCP) ― 监控服务质量并传送正在进行的会话参与者的相关信息。

11 |

12 | ## RTCP

13 | 实时传输控制协议(Real-time Transport Control Protocol或RTP Control Protocol或简写RTCP)是实时传输协议(RTP)的一个姐妹协议。RTCP为RTP媒体流提供信道外(out-of-band)控制。RTCP本身并不传输数据,但和RTP一起协作将多媒体数据打包和发送。RTCP定期在流多媒体会话参加者之间传输控制数据。RTCP的主要功能是为RTP所提供的服务质量(Quality of Service)提供反馈。

14 |

15 | RTCP收集相关媒体连接的统计信息,例如:传输字节数,传输分组数,丢失分组数,jitter,单向和双向网络延迟等等。网络应用程序可以利用RTCP所提供的信息试图提高服务质量,比如限制信息流量或改用压缩比较小的编解码器。RTCP本身不提供数据加密或身份认证。SRTCP可以用于此类用途。

16 |

17 | ## SRTP & SRTCP

18 | 参考文档 RFC3711

19 |

20 | 安全实时传输协议(Secure Real-time Transport Protocol或SRTP)是在实时传输协议(Real-time Transport Protocol或RTP)基础上所定义的一个协议,旨在为单播和多播应用程序中的实时传输协议的数据提供加密、消息认证、完整性保证和重放保护。它是由David Oran(思科)和Rolf Blom(爱立信)开发的,并最早由IETF于2004年3月作为RFC3711发布。

21 |

22 | 由于实时传输协议和可以被用来控制实时传输协议的会话的实时传输控制协议(RTP Control Protocol或RTCP)有着紧密的联系,安全实时传输协议同样也有一个伴生协议,它被称为安全实时传输控制协议(Secure RTCP或SRTCP);安全实时传输控制协议为实时传输控制协议提供类似的与安全有关的特性,就像安全实时传输协议为实时传输协议提供的那些一样。

23 |

24 | 在使用实时传输协议或实时传输控制协议时,使不使用安全实时传输协议或安全实时传输控制协议是可选的;但即使使用了安全实时传输协议或安全实时传输控制协议,所有它们提供的特性(如加密和认证)也都是可选的,这些特性可以被独立地使用或禁用。唯一的例外是在使用安全实时传输控制协议时,必须要用到其消息认证特性。

25 |

26 | ## RTSP

27 |

28 | 参考文档 RFC2326

29 |

30 | 是由Real Networks和Netscape共同提出的。该协议定义了一对多应用程序如何有效地通过IP网络传送多媒体数据。RTSP提供了一个可扩展框架,使实时数据,如音频与视频的受控、点播成为可能。数据源包括现场数据与存储在剪辑中的数据。该协议目的在于控制多个数据发送连接,为选择发送通道,如UDP、多播UDP与TCP提供途径,并为选择基于RTP上发送机制提供方法。

31 |

32 | RTSP(Real Time Streaming Protocol)是用来控制声音或影像的多媒体串流协议,并允许同时多个串流需求控制,传输时所用的网络通讯协定并不在其定义的范围内,服务器端可以自行选择使用TCP或UDP来传送串流内容,它的语法和运作跟HTTP 1.1类似,但并不特别强调时间同步,所以比较能容忍网络延迟。而前面提到的允许同时多个串流需求控制(Multicast),除了可以降低服务器端的网络用量,更进而支持多方视讯会议(Video Conference)。 因为与HTTP1.1的运作方式相似,所以代理服务器《Proxy》的快取功能《Cache》也同样适用于RTSP,并因RTSP具有重新导向功能,可视实际负载情况来转换提供服务的服务器,以避免过大的负载集中于同一服务器而造成延迟。

33 |

34 | ## RTSP 和RTP的关系

35 |

36 | RTP不象http和ftp可完整的下载整个影视文件,它是以固定的数据率在网络上发送数据,客户端也是按照这种速度观看影视文件,当影视画面播放过后,就不可以再重复播放,除非重新向服务器端要求数据。

37 |

38 | RTSP与RTP最大的区别在于:RTSP是一种双向实时数据传输协议,它允许客户端向服务器端发送请求,如回放、快进、倒退等操作。当然,RTSP可基于RTP来传送数据,还可以选择TCP、UDP、组播UDP等通道来发送数据,具有很好的扩展性。它时一种类似与http协议的网络应用层协议。目前碰到的一个应用:服务器端实时采集、编码并发送两路视频,客户端接收并显示两路视频。由于客户端不必对视频数据做任何回放、倒退等操作,可直接采用UDP+RTP+组播实现。

39 |

40 |

41 |

42 | RTP:实时传输协议(Real-time Transport Protocol)

43 | RTP/RTCP是实际传输数据的协议

44 | RTP传输音频/视频数据,如果是PLAY,Server发送到Client端,如果是RECORD,可以由Client发送到Server

45 | 整个RTP协议由两个密切相关的部分组成:RTP数据协议和RTP控制协议(即RTCP)

46 | RTSP:实时流协议(Real Time Streaming Protocol,RTSP)

47 | RTSP的请求主要有DESCRIBE,SETUP,PLAY,PAUSE,TEARDOWN,OPTIONS等,顾名思义可以知道起对话和控制作用

48 | RTSP的对话过程中SETUP可以确定RTP/RTCP使用的端口,PLAY/PAUSE/TEARDOWN可以开始或者停止RTP的发送,等等

49 | RTCP:

50 | RTP/RTCP是实际传输数据的协议

51 | RTCP包括Sender Report和Receiver Report,用来进行音频/视频的同步以及其他用途,是一种控制协议

52 |

53 | ## SDP

54 | 会话描述协议(SDP)为会话通知、会话邀请和其它形式的多媒体会话初始化等目的提供了多媒体会话描述。

55 | 会话目录用于协助多媒体会议的通告,并为会话参与者传送相关设置信息。SDP 即用于将这种信息传输到接收端。SDP 完全是一种会话描述格式 ― 它不属于传输协议 ― 它只使用不同的适当的传输协议,包括会话通知协议(SAP)、会话初始协议(SIP)、实时流协议(RTSP)、MIME 扩展协议的电子邮件以及超文本传输协议(HTTP)。

56 |

57 | SDP 的设计宗旨是通用性,它可以应用于大范围的网络环境和应用程序,而不仅仅局限于组播会话目录,但 SDP 不支持会话内容或媒体编码的协商。

58 | 在因特网组播骨干网(Mbone)中,会话目录工具被用于通告多媒体会议,并为参与者传送会议地址和参与者所需的会议特定工具信息,这由 SDP 完成。SDP 连接好会话后,传送足够的信息给会话参与者。SDP 信息发送利用了会话通知协议(SAP),它周期性地组播通知数据包到已知组播地址和端口处。这些信息是 UDP 数据包,其中包含 SAP 协议头和文本有效载荷(text payload)。这里文本有效载荷指的是 SDP 会话描述。此外信息也可以通过电子邮件或 WWW (World Wide Web) 进行发送。

59 |

60 | SDP 文本信息包括:

61 |

62 | >* 会话名称和意图;

63 | >* 会话持续时间;

64 | >* 构成会话的媒体;

65 | >* 有关接收媒体的信息(地址等)

66 | >* 协议结构

67 |

68 | SDP 信息是文本信息,采用 UTF-8 编 码中的 ISO 10646 字符集。SDP 会话描述如下:(标注 * 符号的表示可选字段):

69 | >v = (协议版本)

70 | >o = (所有者/创建者和会话标识符)

71 | >s = (会话名称)

72 | >i = * (会话信息)

73 | >u = * (URI 描述)

74 | >e = * (Email 地址)

75 | >p = * (电话号码)

76 | >c = * (连接信息 ― 如果包含在所有媒体中,则不需要该字段)

77 | >b = * (带宽信息)

78 |

79 | 一个或更多时间描述(如下所示):

80 | >z = * (时间区域调整)

81 | >k = * (加密密钥)

82 | >a = * (0 个或多个会话属性行)

83 | >0个或多个媒体描述(如下所示)

84 |

85 | 时间描述

86 | >t = (会话活动时间)

87 | >r = * (0或多次重复次数)

88 |

89 | 媒体描述

90 |

91 | >m = (媒体名称和传输地址)

92 | >i = * (媒体标题)

93 | >c = * (连接信息 — 如果包含在会话层则该字段可选)

94 | >b = * (带宽信息)

95 | >k = * (加密密钥)

96 | >a = * (0 个或多个会话属性行)

97 |

98 | ## RTMP/RTMPS

99 | RTMP(Real Time Messaging Protocol)实时消息传送协议是Adobe Systems公司为Flash播放器和服务器之间音频、视频和数据传输 开发的开放协议。

100 | 它有三种变种:

101 | >1. 工作在TCP之上的明文协议,使用端口1935;

102 | >2. RTMPT封装在HTTP请求之中,可穿越防火墙;

103 | >3. RTMPS类似RTMPT,但使用的是HTTPS连接;

104 |

105 | RTMP协议(Real Time Messaging Protocol)是被Flash用于对象,视频,音频的传输.这个协议建立在TCP协议或者轮询HTTP协议之上.

106 | RTMP协议就像一个用来装数据包的容器,这些数据既可以是AMF格式的数据,也可以是FLV中的视/音频数据.一个单一的连接可以通过不同的通道传输多路网络流.这些通道中的包都是按照固定大小的包传输的.

107 |

108 | ## mms

109 |

110 | MMS (Microsoft Media Server Protocol),中文“微软媒体服务器协议”,用来访问并流式接收 Windows Media 服务器中 .asf 文件的一种协议。MMS 协议用于访问 Windows Media 发布点上的单播内容。MMS 是连接 Windows Media 单播服务的默认方法。若观众在 Windows Media Player 中键入一个 URL 以连接内容,而不是通过超级链接访问内容,则他们必须使用MMS 协议引用该流。MMS的预设埠(端口)是1755

111 |

112 | 当使用 MMS 协议连接到发布点时,使用协议翻转以获得最佳连接。“协议翻转”始于试图通过 MMSU 连接客户端。 MMSU 是 MMS 协议结合 UDP 数据传送。如果 MMSU 连接不成功,则服务器试图使用 MMST。MMST 是 MMS 协议结合 TCP 数据传送。

113 | 如果连接到编入索引的 .asf 文件,想要快进、后退、暂停、开始和停止流,则必须使用 MMS。不能用 UNC 路径快进或后退。若您从独立的 Windows Media Player 连接到发布点,则必须指定单播内容的 URL。若内容在主发布点点播发布,则 URL 由服务器名和 .asf 文件名组成。例如:mms://windows_media_server/sample.asf。其中 windows_media_server 是 Windows Media 服务器名,sample.asf 是您想要使之转化为流的 .asf 文件名。

114 | 若您有实时内容要通过广播单播发布,则该 URL 由服务器名和发布点别名组成。例如:mms://windows_media_server/LiveEvents。这里 windows_media_server 是 Windows Media 服务器名,而 LiveEvents 是发布点名

115 |

116 | ## HLS

117 |

118 | HTTP Live Streaming(HLS)是苹果公司(Apple Inc.)实现的基于HTTP的流媒体传输协议,可实现流媒体的直播和点播,主要应用在iOS系统,为iOS设备(如iPhone、iPad)提供音视频直播和点播方案。HLS点播,基本上就是常见的分段HTTP点播,不同在于,它的分段非常小。

119 |

120 | 相对于常见的流媒体直播协议,例如RTMP协议、RTSP协议、MMS协议等,HLS直播最大的不同在于,直播客户端获取到的,并不是一个完整的数据流。HLS协议在服务器端将直播数据流存储为连续的、很短时长的媒体文件(MPEG-TS格式),而客户端则不断的下载并播放这些小文件,因为服务器端总是会将最新的直播数据生成新的小文件,这样客户端只要不停的按顺序播放从服务器获取到的文件,就实现了直播。由此可见,基本上可以认为,HLS是以点播的技术方式来实现直播。由于数据通过HTTP协议传输,所以完全不用考虑防火墙或者代理的问题,而且分段文件的时长很短,客户端可以很快的选择和切换码率,以适应不同带宽条件下的播放。不过HLS的这种技术特点,决定了它的延迟一般总是会高于普通的流媒体直播协议。

121 |

122 |

123 | 根据以上的了解要实现HTTP Live Streaming直播,需要研究并实现以下技术关键点

124 | >* 采集视频源和音频源的数据

125 | >* 对原始数据进行H264编码和AAC编码

126 | >* 视频和音频数据封装为MPEG-TS包

127 | >* HLS分段生成策略及m3u8索引文件

128 | >* HTTP传输协议

129 |

130 |

131 |

132 |

133 |

134 |

135 |

136 |

137 | 原文作者: 雪影

138 |

--------------------------------------------------------------------------------

/article/011-CDN在直播中的运用.md:

--------------------------------------------------------------------------------

1 | # CDN在直播中的运用

2 |

3 | ## CDN技术原理

4 |

5 | CDN的全称为Content Delivery Network,即内容分发网络,是一个策略性部署的整体系统,主要用来解决由于网络带宽小、用户访问量大、网点分布不均匀等导致用户访问网站速度慢的问题。这中间就有了很多的CDN节点,简单一点理解就相当于我们开始学习计算机选择网络。具体实现是通过在现有的网络中,增加一层新的网络架构,将网站的内容发布到离用户最近的网络节点上,这样用户可以就近获取所需的内容,解决之前网络拥塞、访问延迟高的问题,提高用户体验。

6 |

7 |

8 |

9 |

10 | 上图中,不同的流媒体走的节点和协议做了区分,网络拥塞减少,访问延迟降低,带宽得到良好的控制等等。 CDN直播中常用的流媒体协议包括RTMP,HLS,HTTP FLV等。

11 |

12 | RTMP(Real Time Messaging Protocol)是基于TCP的,由Adobe公司为Flash播放器和服务器之间音频、视频传输开发的开放协议。 HLS(HTTP Live Streaming)是基于HTTP的,是Apple公司开放的音视频传输协议。 HTTP FLV则是将RTMP封装在HTTP协议之上的,可以更好的穿透防火墙等。

13 |

14 | ## CDN的常用架构

15 |

16 | CDN架构设计比较复杂。不同的CDN厂商,也在对其架构进行不断的优化,所以架构不能统一而论。这里只是对一些基本的架构进行简单的剖析。

17 | CDN主要包含:源站、缓存服务器、智能DNS、客户端等几个主要组成部分。

18 | 源站:是指发布内容的原始站点。添加、删除和更改网站的文件,都是在源站上进行的;另外缓存服务器所抓取的对象也全部来自于源站。对于直播来说,源站为主播客户端。

19 | 缓存服务器:是直接提供给用户访问的站点资源,由一台或数台服务器组成;当用户发起访问时,他的访问请求被智能DNS定位到离他较近的缓存服务器。如果用户所请求的内容刚好在缓存里面,则直接把内容返还给用户;如果访问所需的内容没有被缓存,则缓存服务器向邻近的缓存服务器或直接向源站抓取内容,然后再返还给用户。

20 | 智能DNS:是整个CDN技术的核心,它主要根据用户的来源,以及当前缓存服务器的负载情况等,将其访问请求指向离用户比较近且负载较小的缓存服务器。通过智能DNS解析,让用户访问同服务商下、负载较小的服务器,可以消除网络访问慢的问题,达到加速作用。

21 | 客户端:即发起访问的普通用户。对于直播来说,就是观众客户端,例如手机客户端,PC客户端。

22 | 用图表示如下:

23 |

24 |

25 |

26 | 整个流程描述如下:

27 |

28 | 主播开始进行直播,向智能DNS发送解析请求; 智能DNS返回最优CDN节点IP地址; 主播端采集音视频数据,发送给CDN节点,CDN节点进行缓存等处理; 观众端要观看此主播的视频,向智能DNS发送解析请求; 智能DNS返回最优CDN节点IP地址; 观众端向CDN节点请求音视频数据; CDN节点同步其他节点的音视频数据; CDN节点将音视频数据发送给观众端;

29 |

30 | ## 采用CDN的缺点

31 | 大概了解了CDN的技术原理后,我们在做直播选型时,还需要了解一个方案优缺点。接下来,我们来分析一下CDN的短板。

32 | 总结一下主要有如下短板:

33 |

34 | ### 播放延时(网络延时)

35 |

36 | 网络延时这里指的是从主播端采集,到观众端播放,这之间的时间差。这里不考虑主播段采集对视频进行编码的时间,以及观众端观看对视频进行解码的时间,仅考虑网络传输中的延时。例如说下图中的网络延时:

37 |

38 |

39 | ### 网络抖动

40 |

41 | 网络抖动,是指数据包的到达顺序、间隔和发出时不一致。比如说,发送100个数据包,每个包间隔1s发出。结果第27个包在传输过程中遇到网络拥塞,造成包27不是紧跟着26到达的,而是延迟到87后面才达。在直播中,这种抖动的效果实际上跟丢包是一样的。因为你不能依照接收顺序把内容播放出来,否则会造成失真。网络抖动,会造成播放延时对应增大。如果网络中抖动较大,会造成播放卡顿等现象。这个之前在云计算上都不是什么难事。

42 |

43 |

44 |

45 | ### 网络丢包

46 | CDN直播中用到的RTMP、HLS、HTTP FLV等协议都是在TCP的基础之上。TCP一个很重要的特性是可靠性,即不会发生数据丢失的问题。为了保证可靠性,TCP在传输过程中有3次握手,见下图。首先客户端会向服务端发送连接请求,服务端同意后,客户端会确认这次连接。这就是3次握手。接着,客户端就开始发送数据,每次发送一批数据,得到服务端的“收到“确认后,继续发送下一批。TCP为了保证传到,会有自动重传机制。如果传输中发生了丢包,没有收到对端发出的“收到”信号,那么就会自动重传丢失的包,一直到超时。

47 | 由于互联网的网络状况是变化的,以及主播端的网络状况是无法控制的。所以当网络中丢包率开始升高时,重传会导致延时会不断增大,甚至导致不断尝试重连等情况,这样不能有效的缓存,严重情况下会导致观众端视频无法观看。

48 |

49 |

50 |

51 |

52 |

53 |

54 |

55 |

56 |

57 |

58 |

59 |

60 | 原文作者: HugoforAndroid

61 |

--------------------------------------------------------------------------------

/article/012-常见音视频编码格式.md:

--------------------------------------------------------------------------------

1 | # 常见音视频编码格式

2 |

3 | ## 常见的音频编码格式

4 |

5 | ### MP3

6 | >这种压缩方式的全称叫MPEG Audio Layer3,MP3是利用MPEG Audio Layer 3的技术,将音乐以1:10甚至1:12 的压缩率,压缩成容量较小的file,换句话说,能够在音质丢失很小的情况下把文件压缩到更小的程度。>而且还非常好的保持了原来的音质。

7 | >* 压缩率:10~12倍

8 | >* 优点:压缩比高,适合用于互联网上的传播

9 | >* 缺点: MP3 在 128KBitrate 及以下时,会出现明显的高频丢失

10 |

11 | ### AAC高级音频编码

12 | >Advanced Audio Coding。一种专为声音数据设计的文件压缩格式,与MP3不同,它采用了全新的算法进行编码,更加高效,具有更高的“性价比”。利用AAC格式,可使人感觉声音质量没有明显降低aac标志的前提下,更加小巧。AAC属于有损压缩的格式,与时下流行的APE、FLAC等无损格式相比音质存在“本质上”的差距。加之,传输速度更快的USB3.0和16G以上大容量MP3正在加速普及,也使得AAC头上“小巧”的光环不复存在了。

13 | >* 优点:支持多种音频声道组合,提供优质的音质。

14 |

15 | ### WMA

16 |

17 | >WMA的全称是Windows Media Audio,是微软力推的一种音频格式。WMA格式是以减少数据流量但保持音质的方法来达到更高的压缩率目的,其压缩率一般可以达到1:18,生成的文件大小只有相应MP3文件的一半。

18 | >* 压缩率:10~12倍

19 | >* 缺点:在高比率的渲染能力低下,同音源的一个320KBPS的MP3与比较192KBPS的WMA相比,音质和渲染力很容易分别出是前者较优。因为:

20 | >* 当 Bitrate 小于 128K 时, WMA 最为出色且编码后得到的音频文件很小。

21 | >* 当 Bitrate 大于 128K 时, WMA 音质损失过大。

22 | >* 优点:WMA还可以通过DRM(Digital Rights Management)方案加入防止拷贝,或者加入限制播放时间和播放次数,甚至是播放机器的限制,可有力地防止盗版。

23 |

24 | ### WAV

25 | > WAV是录音时用的标准的windows文件格式,文件的扩展名为“.wav”,WAVE文件作为最经典的Windows多媒体音频格式,应用非常广泛。声道有单声道和立体声之分,采样频率一般有11kHz、22kHz和44kHz三种。

26 | > WAVE文件所占容量=(采样频率×采样位数×声道)×时间/8(1字节=8bit)。

27 |

28 | ### ATRAC

29 | >ATRAC压缩技术主要是利用了人耳的蔽遮效应,在心理声学原理上,在进行音频录入的同时,有许多外部的频段同时也会被录入,当人耳同时听到两个不同频率、不同音量的声音时,音量较小的低频及音量较小的高频连同不为人耳所察觉的频段信号都会被自动减弱或忽略不予记录,因此又可以称为适应性变换声码技术,由于近年來编码压缩技术(ATRAC的版本)越來越成熟,所以经过编码解码过程后的声音仍直逼CD,

30 | >ATRAC将16比特44.1KHz的数字信号以频率响应轴分成52个区段(在低频时分割较细而在高频时分割较粗),根据声音心理学的原理,将声音信号中人耳听不到和对人的听力影响不大的信息给剔除出去而达到缩小声音文件的目的。利用这种原理,ATRAC可以将录音的资料量压缩为原来的五分之一(即压缩比为1:5)。

31 | >* 压缩率:5倍

32 | >* 特点:自动减弱或者忽略外部频段的杂音

33 |

34 | ### PLAC

35 | >FLAC与MP3不同,MP3是音频压缩编码,但FLAC是无损压缩,也就是说音频以FLAC编码压缩后不会丢失任何信息,将FLAC文件还原为WAV文件后,与压缩前的WAV文件内容相同OGG

36 |

37 | ### OGG

38 | >OGG格式的全称应该是OGG Vobis。它是一种新的音频压缩格式,类似于MP3等现有的音乐格式。但有一点不同的是,它是完全免费、开放和没有专利限制的。OGG Vobis有一个很出众的特点,就是支持多声道,

39 | >OGG Vobis在压缩技术上比MP3好,而且它的多声道,免费,开源这些特点,使它很有可能成为一个流行的趋势,这也正是一些MP3播放器对其支持的原因

40 |

41 | >可以对所有的声道进行编码,而不是MP3只能编码2个声道。多声道音乐的兴起,给音乐欣赏带来了革命性的变化,尤其在欣赏交响时,会带来更多临场感。这场革命性的变化是MP3无法适应的。在以后的播放技术>不断提高以后,而且人们对音质要求不断提高,Ogg的优势将更加明显。

42 | >* 优点:完全免费。开放没有专利限制。支持多声道

43 |

44 | ### APE

45 | >APE的本质,其实它是一种无损压缩音频格式。庞大的WAV音频文件可以通过Monkey”s Audio这个软件进行“瘦身”压缩为APE。有时候它被用做网络音频文件传输,因为被压缩后的APE文件容量要比WAV源文件小一半多,可以节约传输所用的时间。更重要的是,通过Monkey”s Audio解压缩还原以后得到的WAV文件可以做到与压缩前的源文件完全一致,.。所以APE被誉为“无损音频压缩格式”

46 | >* 无损压缩

47 |

48 | ### 各种编码比较

49 | >* 1.压缩比比较:

50 | >aac>ogg>mp3(wma)>ape>flac>wav(同一音源条件下)

51 | >mp3和wma以192kbps为分界线,192kbps以上mp3好,192kbps以下wma好。

52 | >WMA(10~12),,APE(无损压缩,但庞大的WAV可以瘦身为APE),,

53 | >ATRAC(1:5),,MP3(10~12),,AAC(18~20),,OGG(),,

54 | >FLAC(1:2)

55 |

56 | >* 2.2.音质比较:

57 | >wav=flac=ape>aac>ogg>mp3>wma

58 |

59 | >* 3.3.硬件支持比较:

60 | >MP3播放器:mp3>wma>wav>flac>ape aac ogg

61 | >手机:mp3>wma>aac wav>flac ogg>ape

62 |

63 | ### 各种编码比较

64 |

65 | 种类| 压缩比 |支持声道数| 优点| 缺点

66 | :---|:---|:---|:---|:---

67 | MP3| 10~12| 2个声道| 压缩比高,适合用于互联网上的传播| 在 128KBitrate 及以下时,会出现明显的高频丢失

68 | WMA| 10~12| |当 Bitrate 小于 128K 时, WMA 最为出色且编码后得到的音频文件很小。| 当 Bitrate 大于 128K 时, WMA 音质损失过大。

69 | OGG| |支持多声道 |OGG Vobis在压缩技术上比MP3好,而且它的多声道 |

70 | AAC| 18~20|支持多声道| 支持多种音频声道组合,提供优质的音质| 与时下流行的APE、FLAC等无损格式相比音质存在“本质上”的差距。加之,传输速度更快的USB3.0和16G以上大容量MP3正在加速普及,也使得AAC头上“小巧”的光环不复存在了。

71 | APE| 无损压缩| |用做网络音频文件传输,因为被压缩后的APE文件容量要比WAV源文件小一半多,可以节约传输所用的时间。 |

72 | FLAC| 2 | |

73 | WAV |无损压缩 |单声道和立体声| WAVE文件作为最经典的Windows多媒体音频格式 |

74 |

75 | ## 常见的视频编码格式

76 |

77 | 所谓视频编码方式就是指通过特定的压缩技术,将某个视频格式的文件转换成另 一种视频格式文件的方式。

78 |

79 | ### 视频传输中的编码标准

80 | 1. 国际电联的H.264

81 | 2. 国际标准化组织运动图像专家 组的MPEG系列标准

82 | 3. 微软公司的WMV

83 | 4. Apple公司的 QuickTime

84 | 5. google力推的WebM格式

85 |

86 | ### 视频编码格式

87 |

88 | 高清视频的编码格式有五种,即H.264、MPEG-4、MPEG-2、WMA-HD以及VC-1。

89 |

90 | ### H.264

91 | >H.264是由国际电信联盟(iTU-T)所制定的新一代的视频压缩格式。H.264的数据压缩比能比当前DVD系统中使用的 MPEG-2高2~3倍,比MPEG-4高1.5~2倍。正因为如此,经过H.264压缩的视频数据,在网络传输过程中所需要的带宽更少,也更加经济.

92 |

93 | ##### 缺点:

94 | 1. 与MPEG-4一样,经过H.264压缩的视频文件一般也是采用avi 作为其后缀名,同样不容易辨认,只能通过解码器来自己识别。

95 | 2. H.264编码的影片在播放的时候对硬件系统也提出了非常高的要求。

96 | 据相关资料显示,H.264的影片在编码的过程中复杂度是MPEG2的10倍,解码的复杂度是MPEG2的3倍,这对于CPU来说是很沉重的负担,而显卡芯片如果要整合硬件解码模块,其难度也随之加大。

97 | ##### 优点:

98 | 1. H.264 使图像压缩技术上升到了一个更高的阶段,能够在较低带宽上提供高质量的图像传输,该优点非常适合国内运营商用户量大、接入网/骨干网带宽相对有限的状况。

99 | ##### 特点:

100 |

101 | 1. 更高的编码效率

102 | 2. 高质量的视频画面

103 | 3. 提高网络适应能力:H.264可以工作在实时通信应用(如视频会议)低延时模式下,也可以工作在没有延时的视频存储或视频流服务器中。

104 | 4. 采用混合编码结构

105 | 5. 错误恢复功能:H.264提供了解决网络传输包丢失的问题的工具,适用于在高误码率传输的无线网络中传输视频数据。

106 | 6. 较高的复杂度:264性能的改进是以增加复杂性为代价而获得的。据估计,H.264编码的计算复杂度大约相当于H.263的3倍,解码复杂度大约相当于H.263的2倍。

107 |

108 | ##### MPEG4

109 | 由于MPEG4只处理图像帧与帧之间有差异的元素,而舍弃相同的元素,因此大大减少了合成多媒体文件的体积。应用MPEG4技术的影音文件最显著特点就是 压缩率高且成像清晰,一般来说,一小时的影像可以被压缩为350M左右的数据,而一部高清晰度的DVD电影, 可以压缩成两张甚至一张650M CD光碟来存储。

110 |

111 | ### MPEG-4

112 | >MPEG-4不仅可提供高压缩率,同时也可实现更好的多媒体内容互动性及全方位的存取性,它采用开放的编码系统,可随时加入新的编码算法模块,同时也可根据不同应用需求现场配置解码器,以支持多种多媒体应用。

113 | >优点:

114 | >1.具有很好的兼容性;

115 | >2.MPEG-4比其他算法提供更好的压缩比,最高达200:1;

116 | >3.MPEG-4在提供高压缩比的同时,对数据的损失很小。所以,mpeg-4的应用能大 幅度的降低录像存储容量,获得较高的录像清晰度,特别适用于长时间实时录像的需求,同时具备在低带宽上优良的网络传输能力。

117 | >4.采用开放的编码系统,可以加入新的编码算法模块.

118 |

119 | ### VC-1

120 |

121 | >VC-1是软件巨头微软力推的一种视频编码的格式

122 | >总的来说,从压缩比上来看,H.264的压缩比率更高一些,也就是同样的视频,通过H.264编码算法压出来的视频容量要比VC-1的更小,但是VC-1 格式的视频在解码计算方面则更小一些,一般通过高性能的CPU就可以很流畅的观看高清视频。(H.264对硬件的要求比较高)

123 |

124 | VC-1目前的气势依然弱于H.264,也弱于MPEG-4,一方面是VC-1在技术层面上的实际表现与H.264无太大差异,VC-1同样以MPEG-4为基础,但并没有特别的突出点或优越性,运营商从技术角度考虑没有必要非选择VC-1。

125 | 另外,从授权角度来看VC-1是否有优势呢?答案是三者中最不利的,碍于Microsoft一贯的推行策略,VC-1的授权来源仅只一家,授权价格与方式调整,以及后续版本的改进方向,都由微软一手掌握,无人能左右,眼前为与MPGE-4、H.264等竞争,VC-1授权自然不敢过高,但运营商依然对未来是否会涨价表示担心。

126 |

127 | ### MPEG-2

128 |

129 | >目前的MPEG-2的视频在蓝光时代一样是得到了重用,MPEG-2不是MPEG -1的简单升级,MPEG-2在系统和传送方面作了更加详细的规定和进一步的完善。MPEG-2特别适用于广播级的数字电视的编码和传送,被认定为SDTV和HDTV的编码标准。DVD影碟就是采用MPEG-2压缩标准。

130 |

131 | ### 各种视频编码格式性能比较

132 |

133 | 性能| MPEG2| MPEG4| H264| VC-1

134 | :--- | :--- | :--- | :--- | :---

135 | 压缩比(MPEG2为1)| 100%| 50%~60% |25%~40% |30%~40%

136 | 对硬件的要求| 最低| 较低| 最高 | 较高

137 | 授权成本| 最低| 较高| 最低 | 较低

138 | 画面质量| 一般| 较好| 最好| 最好

139 | 适用场景| 适用于广播级的数字电视的编码和传送,被认定为SDTV和HDTV的编码标准。DVD影碟就是采用MPEG-2压缩标准。| MPEG-4在提供高压缩比的同时,对数据的损失很小。所以,mpeg-4的应用能大 幅度的降低录像存储容量,获得较高的录像清晰度,特别适用于长时间实时录像的需求 | H.264可以工作在实时通信应用(如视频会议)低延时模式下,也可以工作在没有延时的视频存储或视频流服务器中。| 高压缩比,画面质量好但是对硬件要求没有H264高的场景

140 |

141 |

142 |

143 |

144 |

145 |

146 |

147 |

148 |

149 | 原文作者: xixihaha331

150 |

--------------------------------------------------------------------------------

/article/013-H.264官方软件JM源代码分析-编码器lencod.md:

--------------------------------------------------------------------------------

1 | # H.264官方软件JM源代码分析-编码器lencod

2 |

3 | ## 函数调用关系图

4 |

5 | JM中的H.264视频编码器lencod的函数调用关系图如下所示。

6 |

7 |

8 |

9 | ### 下面解释一下图中关键标记的含义。

10 |

11 | >函数背景色

12 | >函数在图中以方框的形式表现出来。不同的背景色标志了该函数不同的作用:

13 | >* 白色背景的函数:不加区分的普通内部函数。

14 | >* 黄色背景函数:滤波函数(Filter)。用于环路滤波,半像素插值,SSIM/PSNR的计算。

15 | >* 绿色背景的函数:宏块编码函数(Encode)。通过对残差的DCT变换、量化等方式对宏块进行编码。

16 | >* 紫色背景的函数:熵编码函数(Entropy Coding)。对宏块编码后的数据进行CABAC或者CAVLC熵编码。

17 | >* 浅蓝色背景函数:码率控制函数(Rate Control)。对码率进行控制的函数。

18 |

19 | >箭头线

20 | >箭头线标志了函数的调用关系:

21 | >* 黑色箭头线:不加区别的调用关系。

22 | >* 黄色的箭头线:滤波函数(Filter)之间的调用关系。

23 | >* 绿色箭头线:宏块编码函数(Encode)之间的调用关系。

24 | >* 紫色箭头线:熵编码函数(Entropy Coding)之间的调用关系。

25 |

26 | >函数所在的文件

27 | >每个函数标识了它所在的文件路径。

28 |

29 | ### 下文记录结构图中几个关键的部分。

30 |

31 | ## 普通内部函数

32 |

33 | 普通内部函数指的是lencod中还没有进行分类的函数。例如:

34 | * 码器的main()函数中调用的参数配置函数Configure()、初始化编码器函数init_encoder()、编码函数encode_sequence()、释放编码器函数free_encoder()等。

35 | * 编码器主要编码函数encode_one_frame()逐层调用的函数perform_encode_frame()、frame_picture()、code_a_picture()、code_a_plane()等。

36 |

37 | ## 宏块编码函数

38 | 宏块编码函数通过运动估计、DCT变换、量化等步骤对图像数据进行编码。编码的工作都是在Slice结构体中的encode_one_macroblock()中完成的。encode_one_macroblock()调用PartitionMotionSearch()完成帧间宏块运动估计的工作;调用mode_decision_for_I8x8_MB()、mode_decision_for_I4x4_MB()完成帧内宏块的模式选择;调用Slice结构体的luma_residual_coding()完成了残差编码的工作。

39 |

40 | PartitionMotionSearch()调用了BlockMotionSearch()。BlockMotionSearch()调用了Macroblock结构体中的IntPelME()完成整像素的运动估计,又调用了SubPelME()完成了亚像素的运动估计。整像素的运动估计可以使用下面的方法:

41 |

42 | >EPZS_motion_estimation():EPZS算法;

43 | >full_search_motion_estimation():全搜索算法;

44 | >UMHEXIntegerPelBlockMotionSearch():UMHEX算法;

45 |

46 | 亚像素的运动估计可以使用下面的方法:

47 | >EPZS_sub_pel_motion_estimation():EPZS算法;

48 | >full_sub_pel_motion_estimation():全搜索算法;

49 | >UMHEXSubPelBlockME():UMHEX算法;

50 |

51 | ## 熵编码函数

52 |

53 | 熵编码函数使用CAVLC或者CABAC的方式对宏块编码后的数据进行熵编码。熵编码的工作都是在write_macroblock()中完成的。write_macroblock()调用了Slice结构体中的write_MB_layer()方法,根据Slice类型的不同,write_MB_layer()可以指向下面方法:

54 | >write_i_slice_MB_layer():I Slice宏块熵编码;

55 | >write_p_slice_MB_layer():P Slice宏块熵编码;

56 | >write_b_slice_MB_layer():B Slice宏块熵编码;

57 |

58 | ## 环路滤波函数

59 |

60 | 环路滤波函数对重建帧数据进行滤波,去除方块效应。去块效应滤波是在DeblockPicture()中完成的。DeblockPicture()调用了DeblockMb()。而DeblockMb()中调用GetStrengthVer()、GetStrengthHor()函数获取滤波强度;调用EdgeLoopLumaVer()、EdgeLoopLumaHor()进行滤波。

61 |

62 | ## 码率控制函数

63 |

64 | 码率控制模块函数分布在lencod源代码不同的地方,包括rc_init_seq()、rc_init_GOP()、rc_init_frame()、rc_handle_mb()等。

65 |

66 |

67 |

68 |

69 |

70 |

71 |

72 |

73 |

74 |

75 | 原文作者: 雷霄骅

76 |

--------------------------------------------------------------------------------

/article/014-H.264官方软件JM源代码分析-解码器ldecod.md:

--------------------------------------------------------------------------------

1 | # H.264官方软件JM源代码分析-解码器ldecod

2 |

3 | ## 函数调用关系图

4 |

5 | JM中的H.264视频解码器ldecod的函数调用关系图如下所示。

6 |

7 |

8 |

9 | 下面解释一下图中关键标记的含义。

10 |

11 | >函数背景色

12 | >函数在图中以方框的形式表现出来。不同的背景色标志了该函数不同的作用:

13 | >* 白色背景的函数:普通内部函数。

14 | >* 粉红色背景函数:解析函数(Parser)。这些函数用于解析SPS、PPS等信息。

15 | >* 紫色背景的函数:熵解码函数(Entropy Decoding)。这些函数读取码流数据并且进行CABAC或者CAVLC熵解码。

16 | >* 绿色背景的函数:解码函数(Decode)。这些函数通过帧内预测、帧间预测、DCT反变换等方法解码压缩数据。

17 | >* 黄色背景的函数:环路滤波函数(Loop Filter)。这些函数对解码后的数据进行滤波,去除方块效应。

18 |

19 | >箭头线

20 | >箭头线标志了函数的调用关系:

21 | >* 黑色箭头线:不加区别的调用关系。

22 | >* 粉红色的箭头线:解析函数(Parser)之间的调用关系。

23 | >* 紫色箭头线:熵解码函数(Entropy Decoding)之间的调用关系。

24 | >* 绿色箭头线:解码函数(Decode)之间的调用关系。

25 | >* 黄色箭头线:环路滤波函数(Loop Filter)之间的调用关系。

26 |

27 | >函数所在的文件

28 | >每个函数标识了它所在的文件路径。

29 |

30 | 下文记录结构图中的几个关键部分。

31 |

32 | ### 普通内部函数

33 | 普通内部函数指的是ldecod中还没有进行分类的函数。例如:

34 | * 解码器的main()函数中调用的参数配置函数Configure()、打开解码器函数OpenDecoder()、解码函数DecodeOneFrame()、输出函数WriteOneFrame()、关闭解码器函数CloseDecoder()等。

35 | * 解码器主要解码函数DecodeOneFrame()逐层调用的函数decode_one_frame()、decode_slice()、decode_one_slice()等。

36 |

37 | ### 解析函数(Parser)

38 | 解析函数(Parser)用于解析H.264码流中的一些信息(例如SPS、PPS、Slice Header等)。在read_new_slice()中都调用这些解析函数完成了解析。下面举几个解析函数的例子。

39 | >* read_next_nalu():解析NALU。这个函数是后几个解析函数的前提。

40 | >* ProcessPPS():解析Slice Header。其中调用了InterpretPPS()用于解析PPS。

41 | >* ProcessSPS():解析SEI。其中调用了InterpretSPS()用于解析SPS。

42 |

43 | 其中read_next_nalu()调用了下面几个函数:

44 | >* get_annex_b_NALU():读取annexb格式的NALU。

45 | >* GetRTPNALU():读取RTP格式的NALU。

46 | >* NALUtoRBSP():将NALU处理为RBSP格式。

47 | >* (PS:annexb和RTP是H.264码流的2种格式)

48 |

49 | ### 熵解码函数(Entropy Decoding)

50 | 熵解码函数(Entropy Decoding)读取码流数据并且进行CABAC或者CAVLC熵解码。熵解码工作是在Slice结构体的read_one_macroblock()函数中完成的。该函数根据宏块类型的不同,会调用不同的熵解码函数。CAVLC对应的解码函数是:

51 |

52 | >* read_one_macroblock_p_slice_cavlc():解码P宏块。

53 | >* read_one_macroblock_b_slice_cavlc():解码B宏块。

54 | >* read_one_macroblock_i_slice_cavlc():解码I宏块。

55 |

56 | CABAC对应的解码函数是:

57 | >* read_one_macroblock_p_slice_cabac():解码P宏块。

58 | >* read_one_macroblock_b_slice_cabac():解码B宏块。

59 | >* read_one_macroblock_i_slice_cabac():解码I宏块。

60 |

61 | ### 解码函数(Decode)

62 |

63 | 解码函数(Decode)通过帧内预测、帧间预测等方法解码宏块压缩数据。解码工作都是在decode_one_macroblock()中完成的。decode_one_macroblock()调用了Slice结构体中的decode_one_component()解码一个亮度分量。decode_one_component()根据宏块所在的Slice的不同,会调用不同的处理函数:

64 |

65 | >* decode_one_component_i_slice():解码I Slice中的宏块。

66 | >* decode_one_component_p_slice():解码P Slice中的宏块。

67 | >* decode_one_component_b_slice():解码B Slice中的宏块。

68 |

69 | I Slice中只包含Intra类型的宏块。因此decode_one_component_i_slice()调用下面函数对Intra类型宏块进行解码:

70 |

71 | >* mb_pred_intra16x16():帧内预测16x16宏块

72 | >* mb_pred_intra4x4():帧内预测4x4宏块

73 | >* mb_pred_intra8x8():帧内预测8x8宏块

74 |

75 | P Slice中包含Intra类型和Inter类型(单向)的宏块。因此decode_one_component_p_slice()调用下面函数对Intra类型宏块进行解码:

76 |

77 | >* mb_pred_intra16x16():同上

78 | >* mb_pred_intra4x4():同上

79 | >* mb_pred_intra8x8():同上

80 | >* mb_pred_p_inter16x16():单向帧间预测16x16宏块

81 | >* mb_pred_p_inter16x8():单向帧间预测16x8宏块

82 | >* mb_pred_p_inter8x16():单向帧间预测8x16宏块

83 | >* mb_pred_p_inter8x8():单向帧间预测8x8宏块

84 |

85 | B Slice中包含Intra类型和Inter类型(双向)的宏块。因此decode_one_component_b_slice()调用的函数和P Slice中的宏块是类似的,唯一的不同在于它增加了对B宏块的处理。

86 | 对于逐行扫描的Intra16x16宏块,具体的预测函数是intra_pred_16x16_normal(),其中根据帧内预测类型的不同,调用不同的函数进行处理:

87 |

88 | >* intra16x16_vert_pred():垂直模式

89 | >* intra16x16_hor_pred():水平模式

90 | >* intra16x16_dc_pred():DC模式

91 | >* intra16x16_plane_pred():Plane模式

92 |

93 | 对于逐行扫描的Inter16x16的P类型宏块,具体的预测函数是mb_pred_p_inter16x16(),其中会调用perform_mc()完成运动补偿。对于单向运动补偿,perform_mc()会调用perform_mc_single();对于双向运动补偿,perform_mc()会调用perform_mc_bi()。运动补偿的过程中,会调用get_block_luma()完成四分之一像素的插值工作。

94 | 无论Inter类型宏块还是Intra类型的宏块,最后都会调用iMBtrans4x4()完成DCT反变换和残差叠加的工作。其中DCT反变换在inverse4x4()中完成,而残差叠加在sample_reconstruct()中完成。

95 |

96 | 环路滤波函数(Loop Filter)

97 | 环路滤波函数(Loop Filter)对解码后的数据进行滤波,去除方块效应。去块效应滤波是在DeblockPicture()中完成的。DeblockPicture()调用了DeblockMb()。而DeblockMb()中调用GetStrengthVer()、GetStrengthHor()函数获取滤波强度;调用EdgeLoopLumaVer()、EdgeLoopLumaHor()进行滤波。

98 |

99 |

100 |

101 |

102 |

103 |

104 |

105 |

106 |

107 |

108 |

109 | 原文作者: 雷霄骅

110 |

--------------------------------------------------------------------------------

/article/015-Android 音视频技术.md:

--------------------------------------------------------------------------------

1 | # Android 音视频技术

2 |

3 | ## 1. 整体流程

4 |

5 | 以手机直播为例,其整体流程如下:

6 |

7 |

8 |

9 | ## 2. 数据采集

10 |

11 | ### 2.1. 音频采集

12 |

13 | 音频采集涉及到以下几点:

14 |

15 | 检测麦克风是否可以使用;

16 | 需要检测手机对某个音频采样率的支持;

17 | 在一些情况下需要对音频进行回声消除处理;

18 | 音频采集时设置正确的缓冲区大小。

19 |

20 | 在 Android 系统中,一般使用 AudioRecord 或者 MediaRecord 来采集音频。AudioRecord 是一个比较偏底层的 API,它可以获取到一帧帧 PCM 数据,之后可以对这些数据进行处理。而 MediaRecorder 是基于 AudioRecorder 的 API (最终还是会创建AudioRecord 用来与 AudioFlinger 进行交互) ,它可以直接将采集到的音频数据转化为执行的编码格式,并保存。

21 |

22 | ### 2.2 视频采集

23 |

24 | 视频采集涉及到以下几点:

25 |

26 | 检测摄像头是否可以使用;

27 | 摄像头采集到的图像是横向的,需要对采集到的图像进行一定的旋转后再进行显示;

28 | 摄像头采集时有一系列的图像大小可以选择,当采集的图像大小和手机屏幕大小比例不一致时,需要进行特殊处理;

29 | Android 手机摄像头有一系列的状态,需要在正确的状态下才能对摄像头进行相应的操作。

30 | Android 手机摄像头的很多参数存在兼容性问题,需要较好地处理这些兼容性的问题。

31 |

32 | 在 Android 系统下有两套 API 可以进行视频采集,它们是 Camera 和 Camera2 。Camera是以前老的 API ,从 Android 5.0(21) 之后就已经放弃了。和音频一样,也有高层和低层的 API,高层就是 Camera 和 MediaRecorder,可以快速实现编码,低层就是直接使用 Camera,然后将采集的数据进行滤镜、降噪等前处理,处理完成后由 MediaCodec 进行硬件编码,最后采用 MediaMuxer 生成最终的视频文件。

33 |

34 | ## 3. 数据处理

35 |

36 | ### 3.1 音频处理

37 |

38 | 可以对音频的原始流做处理,如降噪、回音、以及各种 filter 效果。

39 |

40 | ### 3.2 视频处理

41 | 现在抖音、美图秀秀等,在拍摄,视频处理方面,都提供了很多视频滤镜,而且还有各种贴纸、场景、人脸识别、特效、添加水印等。

42 |

43 | 其实对视频进行美颜和添加特效都是通过 OpenGL 进行处理的。Android 中有 GLSurfaceView,这个类似于 SurfaceView,不过可以利用 Renderer 对其进行渲染。通过 OpenGL 可以生成纹理,通过纹理的 Id 可以生成 SurfaceTexture,而 SurfaceTexture 可以交给 Camera,最后通过纹理就将摄像头预览画面和 OpenGL 建立了联系,从而可以通过 OpenGL 进行一系列的操作。

44 |

45 | 美颜的整个过程无非是根据 Camera 预览的纹理通过 OpenGL 中 FBO 技术生成一个新的纹理,然后在 Renderer 中的onDrawFrame() 使用新的纹理进行绘制。添加水印也就是先将一张图片转换为纹理,然后利用 OpenGL 进行绘制。添加动态挂件特效则比较复杂,先要根据当前的预览图片进行算法分析识别人脸部相应部位,然后在各个相应部位上绘制相应的图像,整个过程的实现有一定的难度,人脸识别技术目前有 OpenCV、Dlib、MTCNN 等。

46 |

47 | ## 4. 数据编码

48 |

49 | ### 4.1 音频编码

50 |

51 | Android 中利用 AudioRecord 可以录制声音,录制出来的声音是 PCM 声音,使用三个参数来表示声音,它们是:声道数、采样位数和采样频率。如果音频全部用 PCM 的格式进行传输,则占用带宽比较大,因此在传输之前需要对音频进行编码。

52 |

53 | 现在已经有一些广泛使用的声音格式,如:WAV、MIDI、MP3、WMA、AAC、Ogg 等等。相比于 PCM 格式而言,这些格式对声音数据进行了压缩处理,可以降低传输带宽。对音频进行编码也可以分为软编和硬编两种。软编则下载相应的编码库,写好相应的 JNI,然后传入数据进行编码。硬编则是使用 Android 自身提供的 MediaCodec。

54 |

55 | >硬编码和软编码的区别是:软编码可以在运行时确定、修改;而硬编码是不能够改变的。

56 |

57 | ### 4.2 视频编码

58 |

59 | 在 Android 平台上实现视频的编码有两种实现方式:一种是软编,一种是硬编。软编的话,往往是依托于 cpu,利用 cpu 的计算能力去进行编码。比如我们可以下载 x264 编码库,写好相关的 JNI 接口,然后传入相应的图像数据。经过 x264 库的处理以后就将原始的图像转换成为 h264 格式的视频。

60 |

61 | 硬编则是采用 Android 自身提供的 MediaCodec,使用 MediaCodec 需要传入相应的数据,这些数据可以是 YUV 的图像信息,也可以是一个 Surface,一般推荐使用 Surface,这样的话效率更高。Surface 直接使用本地视频数据缓存,而没有映射或复制它们到 ByteBuffers;因此,这种方式会更加高效。在使用 Surface 的时候,通常不能直接访问原始视频数据,但是可以使用ImageReader 类来访问不可靠的解码后 (或原始) 的视频帧。这可能仍然比使用 ByteBuffers 更加高效,因为一些本地缓存可以被映射到 direct ByteBuffers。当使用 ByteBuffer 模式,可以利用 Image 类和 getInput/OutputImage(int) 方法来访问到原始视频数据帧。

62 |

63 | ## 5. 音视频混合

64 |

65 | 下面我盗了一张图,画图实在太费时间:

66 |

67 |

68 |

69 | 以合成 MP4 视频为例:

70 | 1. 整体来看,合成的 MP4 文件,视频部分为 H.264 编码格式的数据,音频部分为 AAC 编码格式的数据。

71 | 2. 通过 MediaMuxer 提供的接口-writeSampleData(),将 H.264 和 AAC 数据分别同时写入到 MP4 文件。

72 |

73 | ## 6. 数据传输

74 |

75 | 目前比较主流的视频推流协议有 RTMP 协议、RTSP 协议。

76 |

77 | ### 7. 需要用到的技术

78 |

79 | 涉及到如下技术,我将从图像、音频、视频的顺序来罗列:

80 | * Camera、Camera2。

81 | * SurfaceView、TextureView、SurfaceTexture、GLSurfaceView。

82 | * OpenGL ES。

83 | * OpenCV、DLIB。

84 | * YUV、PCM、H.264、H.265、ACC。

85 | * AudioRecord、AudioTrack。

86 | * MediaRecorder。

87 | * MediaCodec。

88 | * MediaExtractor、MediaMuxer。

89 | * ffmpeg、ijkplayer。

90 | * RTMP、RTSP。

91 |

92 |

93 |

94 |

95 |

96 |

97 |

98 |

99 |

100 |

101 |

102 |

103 | 原文作者: 况众文

104 |

--------------------------------------------------------------------------------

/article/016-Web前端WebRTC攻略-媒体协商与SDP简析.md:

--------------------------------------------------------------------------------

1 | # Web前端WebRTC攻略-媒体协商与SDP简析

2 |

3 | ## 1. 媒体协商

4 |

5 | 在音视频通讯场景中,由于两端之间所支持的音视频编解码、传输协议、传输的速率,都需要进行彼此通知对方。

6 |

7 |

8 |

9 | 我们把一个 1 对 1 的音视频通讯,比喻成双方互送快递包裹的过程。

10 |

11 |

12 |

13 | 首先这里有很多问题,双方要彼此告知对方后,才能寄送包裹。

14 | 比如:

15 |

16 | * 我不知道包裹要寄给谁?(我要和谁建立通讯)

17 | * 对方能否使用我的包裹?(我的媒体格式对方是否支持)

18 | * 对方在哪里,地址是什么?(对方所处网络的位置在哪)

19 | * 走那条路线寄送最快?(走哪种网络传输最效率)

20 |

21 |

22 |

23 | 实际场景中,我们要打电话互相告诉对方一些信息。而在音视频通讯中,也需要这个“打电话”步骤,形式上一般是通过建立“信令通道”来传送信令。对于 Web 前端来说最常见以 WebSocket 来作为信令通道,通过它来交换信令并进行协商。真正的媒体数据,则是通过 RTCPeerConnection 进行传输。

24 |

25 |

26 |

27 | 比如包含什么媒体流/轨,或者是我的编码是否被对方的解码器所支持等等这些问题,则通过 SDP 作为载体告诉给对方。

28 |

29 | ### 1.1 什么是媒体协商?

30 |

31 | 在没有建立 WebRTC 连接传输数据前,首先需要让本地端和远端确认彼此共同支持的媒体能力。如:音视频编解码器、使用的传输协议、IP 端口和传输速率等等。而这些信息需要通过前文所说的 SDP 来互换,这个过程称之为媒体协商。

32 |

33 | ### 1.2 媒体协商的流程

34 | 这里以在两个前端浏览器建立通讯来进行说明,我们暂且称“发起端”和“应答端”。

35 |

36 |

37 |

38 | 1. 首先双方连接信令通道,(一般由业务决定如何实现),并能交换信令。

39 | 2. 发起端调用 RTCPeerConnection.createOffer 创建一个offer,并调用 setLocalDescription 设置本地的 SDP。

40 | 3. 然后通过信令服务器 将含有 SDP 的 offer 设置给应答端。

41 | 4. 应答端拿到此 offer 以后调用 setRemoteDescription 将此 SDP 信息保存。

42 | 5. 应答端调用 RTCPeerConnection.createAnswer 创建一个 answer,并调用 setLocalDescription 设置本地的 SDP。

43 | 6. 通过信令服务器将含有 SDP 的 answer 发送给发起端。

44 | 7. 发起端调用 setRemoteDescription 将此 SDP 信息保存。

45 |

46 | 简单概括就是:发起端和应答端通过 creatOffer 和 createAnswer 创建 offer/answerSDP,然后通过信令服务互换,最后调用 setLocalDescription/setRemoteDescription 进行设置本地和远端的 SDP 以完成协商。

47 |

48 | 在双方都创建 RTCPeerConnection 之后,它们就可以开始进行媒体协商了。

49 |

50 | ### 1.3 媒体协商的前端代码实现

51 |

52 | ##### 1.3.1 呼叫方创建&发送 Offer

53 |

54 | ```C++

55 | //local

56 | var pc_local = new RTCPeerConnection(otps1);

57 |

58 | pc_local.createOffer((offer)=>{

59 | pc_local.setLocalDescription(offer);

60 | singalChannel.send(offer)

61 | }, handleError);

62 | ```

63 | ##### 1.3.2 应答方收到 Offer

64 | ```C++

65 | //remote

66 | var pc_remote = new RTCPeerConnection(otps2);

67 |

68 | signalChannel.on('message', (message)=>{

69 | if(message.type === 'offer'){

70 | pc_remote.setRemoteDescription(

71 | new RTCSessionDescription(message)

72 | )

73 | }

74 | })

75 | ```

76 |

77 | ##### 1.3.3 应答方创建&发送 Answer

78 | ```C++

79 | //remote

80 | pc_remote.createAnswer((answer)=>{

81 | pc_remote.setLocalDescription(answer);

82 | singalChannel.send(answer);

83 | }, handleError );

84 | ```

85 |

86 | ##### 1.3.4 呼叫方收到 Answer

87 | ```C++

88 | //local

89 | signalChannel.on('message',(message)=>{

90 | if(message.type==='answer'){

91 | pc_local.setRemoteDescription(

92 | new RTCSessionDescription(message)

93 | )

94 | }

95 | })

96 | ```

97 |

98 | ## 2 SDP

99 | ### 2.1 什么是SDP?

100 | SDP 全称 SessionDescription Protocal,直译就是通用会话描述协议。

101 |

102 | 光看直面意思可能不太好理解,其实就是描述双方的会话信息,以及各端所具备能力的通用协议。

103 |

104 | 在 WebRTC 中 SDP 所描述的信息主要有:

105 | 1. 各端所支持音视频编解码器

106 | 2. 编解码所设定的参数

107 | 3. 所使用的的传输协议

108 | 4. ICE 连接候选项等

109 |

110 | ### 2.2 标准SDP规范

111 | 要注意的是 SDP 并不是 WebRTC 独有规范,关于标准的 SDP 规范可以查阅:IETFRFC4556规范。

112 | 标准 SDP 规范主要包括 SDP 描述格式和 SDP 结构,而 SDP 结构由会话描述和媒体信息描述两个部分组成。

113 |

114 |

115 |

116 | ### 2.3 SDP的格式

117 |

118 | SDP 是由多个 = 这样的表达式组成的。

119 |

120 | ```C++

121 | v=0

122 | o=- 7017624586836067756 2 IN IP4 127.0.0.1

123 | s=-

124 | t=0 0...

125 | ```

126 | * type 只能为一个字符,代表属性。

127 | * value 为结构化文本,UTF-8 编码,代表属性值。

128 | * = 两边不能有空格。

129 |

130 | SDPLine 没有统一的 Schema 描述,也就是没有一个固定的规则能解析所有 Line,SDPGrammer 只是描述了 SDP 相关的属性,具体每个属性的表达需要根据属性定义 IETFRFC4556。

131 | 而 SDP 的结构有一个会话描述和零至多个媒体信息描述组成。

132 |

133 | ##### 2.3.1 会话描述

134 |

135 | 常见属性:

136 |

137 | v=SDP 协议版本

138 | ```C++

139 | v=0

140 | ```

141 |

142 | o=会话发起者描述

143 | ```C++

144 | o=

145 | ```

146 | >username:用户名

147 | >sess-id:会话id,在整个会话中是唯一的,建议使用NTP时间戳。

148 | >sess-version:会话版本,每次会话数据修改后,该版本值会递增。

149 | >nettype:网络类型,一般为“IN”。

150 | >addrtype:地址类型,一般为IP4。

151 | >address:IP地址。

152 |

153 | s=会话名

154 | ```C++

155 | s=

156 | ```

157 | >不关注时可为-

158 |

159 | t=会话活动时间

160 | ```C++

161 | t=

162 | ```

163 | >start-time:会话开始时间

164 | >stop-time:结束时间

165 | >均为NTP时间,单位是秒,均为0时表示持久会话。

166 |

167 | c=连接信息

168 | ```C++

169 | c=

170 | ```

171 | >nettype:网路类型

172 | >addrtype:地址类型

173 | >connection-address:连接地址

174 |

175 | ##### 2.3.2 媒体描述

176 |

177 | 会话级别描述完成后,后面就是零到多个媒体级别描述,比如:

178 |

179 | 常见属性:

180 |

181 | m=媒体描述

182 | ```C++

183 | m=

184 | ```

185 | >media:媒体类型(audio / video)

186 | >port:端口号

187 | >transport:传输协议 RTP/AVP(RTP/SAVP)或 UDP

188 | >fmt-list:媒体格式,表述 RTP 的数据负载类型(PayloadType)的列表,可以包含多个。分别代表音频和视频的编码格式,后面会跟着 rtpmap、rtcp-fb、fmtp 这些属性来做进一步的详细的描述。

189 | >RTP类型参考:RTPPayload

190 |

191 | a=附加描述

192 | 有以下两种格式:

193 | >a=

194 | >a=:

195 |

196 | SDP 解析时,每个 SDPLine 都是以 key=... 形式,解析出 key 是 a 后,可能有两种方式,可参考 RFC4566:

197 | >在 m= 之前,为会话附加描述;

198 | >在 m= 之后,为媒体附加描述。

199 | >其中可以关注 rtpmap 和 fmtp。

200 |

201 | a=rtpmap RTP参数映射表

202 | ```C++

203 | a=rtpmap://

204 | ```

205 | >playload-type:数据负载类型

206 | >encoding-name:编码名称

207 | >sample-rate:采样率

208 | >encodingparameters:编码参数

209 |

210 | a=fmtp 格式参数

211 | ```C++

212 | a=fmtp:

213 | ```

214 | >playload-type:数据负载类型

215 | >specific-parameters:编码参数

216 |

217 | ### 2.4 SDP剖析的示例结构与说明

218 |

219 |

220 | https://webrtchacks.com/sdp-anatomy/ 这个站点给我们展示了一个详细的 SDP 例子。左侧为 SDP 文本,可以明显看出 SDP 的格式与结构,右侧则对每一行描述进行了说明。如果你不想看冗长的规范文档,这个例子是一个不错的学习材料。

221 |

222 | ### 2.5 WebRTC 的 SDP 总结

223 |

224 | 在 WebRTC 中的 SDP 相对于标准 SDP 规范中有点不一样,它对于 SDP 划分了更多部分,详情可以看下图:

225 |

226 |

227 | WebRTC 按功能将 SDP 划分成了五部分,即会话元数据、网络描述、流描述、安全描述以及服务质量描述。WebRTCSDP 中的会话元数据(SessionMetadata)其实就是 SDP 标准规范中的会话层描述;流描述、网络描述与 SDP 标准规范中的媒体层描述是一致的;而安全描述与服务质量描述都是新增的一些属性描述。SDP 作为 WebRTC 的核心部分,是你深入学习 WebRTC 前所要必须掌握的基础内容。

228 |

229 | ## 3 参考文章

230 |

231 | * SDP: Session Description Protocol

232 | * https://webrtchacks.com/

233 |

234 |

235 |

236 |

237 |

238 |

239 |

240 |

241 |

242 |

243 |

244 | 原文作者: 腾讯IMWeb前端团队

245 |

--------------------------------------------------------------------------------

/article/017-基于FFmpeg的AVfilter的例子-纯净版.md:

--------------------------------------------------------------------------------

1 | # 基于FFmpeg的AVfilter的例子-纯净版

2 |

3 | ## 流程图

4 |

5 | 该程序的流程图如下所示。AVFilter的初始化比较复杂,而使用起来比较简单。初始化的时候需要调用avfilter_register_all()到avfilter_graph_config()一系列函数。而使用的时候只有两个函数:av_buffersrc_add_frame()用于向FilterGraph中加入一个AVFrame,而av_buffersink_get_frame()用于从FilterGraph中取出一个AVFrame。

6 |

7 |

8 |

9 | 流程中的关键函数如下所示:

10 |

11 | >avfilter_register_all():注册所有AVFilter。

12 | >avfilter_graph_alloc():为FilterGraph分配内存。

13 | >avfilter_graph_create_filter():创建并向FilterGraph中添加一个Filter。

14 | >avfilter_graph_parse_ptr():将一串通过字符串描述的Graph添加到FilterGraph中。

15 | >avfilter_graph_config():检查FilterGraph的配置。

16 | >av_buffersrc_add_frame():向FilterGraph中加入一个AVFrame。

17 | >av_buffersink_get_frame():从FilterGraph中取出一个AVFrame。

18 |

19 | ## 代码

20 |

21 | ```C++

22 | /**

23 | * 本程序使用FFmpeg的AVfilter实现了YUV像素数据的滤镜处理功能。

24 | * 可以给YUV数据添加各种特效功能。

25 | * 是最简单的FFmpeg的AVFilter方面的教程。

26 | * 适合FFmpeg的初学者。

27 | *

28 | * This software uses FFmpeg's AVFilter to process YUV raw data.

29 | * It can add many excellent effect to YUV data.

30 | * It's the simplest example based on FFmpeg's AVFilter.

31 | * Suitable for beginner of FFmpeg

32 | *

33 | */

34 | #include

35 |

36 | #define __STDC_CONSTANT_MACROS

37 |

38 | #ifdef _WIN32

39 | #define snprintf _snprintf

40 | //Windows

41 | extern "C"

42 | {

43 | #include "libavfilter/avfiltergraph.h"

44 | #include "libavfilter/buffersink.h"

45 | #include "libavfilter/buffersrc.h"

46 | #include "libavutil/avutil.h"

47 | #include "libavutil/imgutils.h"

48 | };

49 | #else

50 | //Linux...

51 | #ifdef __cplusplus

52 | extern "C"

53 | {

54 | #endif

55 | #include

56 | #include

57 | #include

58 | #include

59 | #include

60 | #ifdef __cplusplus

61 | };

62 | #endif

63 | #endif

64 |

65 |

66 |

67 |

68 | int main(int argc, char* argv[])

69 | {

70 | int ret;

71 | AVFrame *frame_in;

72 | AVFrame *frame_out;

73 | unsigned char *frame_buffer_in;

74 | unsigned char *frame_buffer_out;

75 |

76 | AVFilterContext *buffersink_ctx;

77 | AVFilterContext *buffersrc_ctx;

78 | AVFilterGraph *filter_graph;

79 | static int video_stream_index = -1;

80 |

81 | //Input YUV

82 | FILE *fp_in=fopen("sintel_480x272_yuv420p.yuv","rb+");

83 | if(fp_in==NULL){

84 | printf("Error open input file.\n");

85 | return -1;

86 | }

87 | int in_width=480;

88 | int in_height=272;

89 |

90 | //Output YUV

91 | FILE *fp_out=fopen("output.yuv","wb+");

92 | if(fp_out==NULL){

93 | printf("Error open output file.\n");

94 | return -1;

95 | }

96 |

97 | //const char *filter_descr = "lutyuv='u=128:v=128'";

98 | const char *filter_descr = "boxblur";

99 | //const char *filter_descr = "hflip";

100 | //const char *filter_descr = "hue='h=60:s=-3'";

101 | //const char *filter_descr = "crop=2/3*in_w:2/3*in_h";

102 | //const char *filter_descr = "drawbox=x=100:y=100:w=100:h=100:color=pink@0.5";

103 | //const char *filter_descr = "drawtext=fontfile=arial.ttf:fontcolor=green:fontsize=30:text='Lei Xiaohua'";

104 |

105 | avfilter_register_all();

106 |

107 | char args[512];

108 | AVFilter *buffersrc = avfilter_get_by_name("buffer");

109 | AVFilter *buffersink = avfilter_get_by_name("ffbuffersink");

110 | AVFilterInOut *outputs = avfilter_inout_alloc();

111 | AVFilterInOut *inputs = avfilter_inout_alloc();

112 | enum PixelFormat pix_fmts[] = { AV_PIX_FMT_YUV420P, PIX_FMT_NONE };

113 | AVBufferSinkParams *buffersink_params;

114 |

115 | filter_graph = avfilter_graph_alloc();

116 |

117 | /* buffer video source: the decoded frames from the decoder will be inserted here. */

118 | snprintf(args, sizeof(args),

119 | "video_size=%dx%d:pix_fmt=%d:time_base=%d/%d:pixel_aspect=%d/%d",

120 | in_width,in_height,AV_PIX_FMT_YUV420P,

121 | 1, 25,1,1);

122 |

123 | ret = avfilter_graph_create_filter(&buffersrc_ctx, buffersrc, "in",

124 | args, NULL, filter_graph);

125 | if (ret < 0) {

126 | printf("Cannot create buffer source\n");

127 | return ret;

128 | }

129 |

130 | /* buffer video sink: to terminate the filter chain. */

131 | buffersink_params = av_buffersink_params_alloc();

132 | buffersink_params->pixel_fmts = pix_fmts;

133 | ret = avfilter_graph_create_filter(&buffersink_ctx, buffersink, "out",

134 | NULL, buffersink_params, filter_graph);

135 | av_free(buffersink_params);

136 | if (ret < 0) {

137 | printf("Cannot create buffer sink\n");

138 | return ret;

139 | }

140 |

141 | /* Endpoints for the filter graph. */

142 | outputs->name = av_strdup("in");

143 | outputs->filter_ctx = buffersrc_ctx;

144 | outputs->pad_idx = 0;

145 | outputs->next = NULL;

146 |

147 | inputs->name = av_strdup("out");

148 | inputs->filter_ctx = buffersink_ctx;

149 | inputs->pad_idx = 0;

150 | inputs->next = NULL;

151 |

152 | if ((ret = avfilter_graph_parse_ptr(filter_graph, filter_descr,

153 | &inputs, &outputs, NULL)) < 0)

154 | return ret;

155 |

156 | if ((ret = avfilter_graph_config(filter_graph, NULL)) < 0)

157 | return ret;

158 |

159 | frame_in=av_frame_alloc();

160 | frame_buffer_in=(unsigned char *)av_malloc(av_image_get_buffer_size(AV_PIX_FMT_YUV420P, in_width,in_height,1));

161 | av_image_fill_arrays(frame_in->data, frame_in->linesize,frame_buffer_in,

162 | AV_PIX_FMT_YUV420P,in_width, in_height,1);

163 |

164 | frame_out=av_frame_alloc();

165 | frame_buffer_out=(unsigned char *)av_malloc(av_image_get_buffer_size(AV_PIX_FMT_YUV420P, in_width,in_height,1));

166 | av_image_fill_arrays(frame_out->data, frame_out->linesize,frame_buffer_out,

167 | AV_PIX_FMT_YUV420P,in_width, in_height,1);

168 |

169 | frame_in->width=in_width;

170 | frame_in->height=in_height;

171 | frame_in->format=AV_PIX_FMT_YUV420P;

172 |

173 | while (1) {

174 |

175 | if(fread(frame_buffer_in, 1, in_width*in_height*3/2, fp_in)!= in_width*in_height*3/2){

176 | break;

177 | }

178 | //input Y,U,V

179 | frame_in->data[0]=frame_buffer_in;

180 | frame_in->data[1]=frame_buffer_in+in_width*in_height;

181 | frame_in->data[2]=frame_buffer_in+in_width*in_height*5/4;

182 |

183 | if (av_buffersrc_add_frame(buffersrc_ctx, frame_in) < 0) {

184 | printf( "Error while add frame.\n");

185 | break;

186 | }

187 |

188 | /* pull filtered pictures from the filtergraph */

189 | ret = av_buffersink_get_frame(buffersink_ctx, frame_out);

190 | if (ret < 0)

191 | break;

192 |

193 | //output Y,U,V

194 | if(frame_out->format==AV_PIX_FMT_YUV420P){

195 | for(int i=0;iheight;i++){

196 | fwrite(frame_out->data[0]+frame_out->linesize[0]*i,1,frame_out->width,fp_out);

197 | }

198 | for(int i=0;iheight/2;i++){

199 | fwrite(frame_out->data[1]+frame_out->linesize[1]*i,1,frame_out->width/2,fp_out);

200 | }

201 | for(int i=0;iheight/2;i++){

202 | fwrite(frame_out->data[2]+frame_out->linesize[2]*i,1,frame_out->width/2,fp_out);

203 | }

204 | }

205 | printf("Process 1 frame!\n");

206 | av_frame_unref(frame_out);

207 | }

208 |

209 | fclose(fp_in);

210 | fclose(fp_out);

211 |

212 | av_frame_free(&frame_in);

213 | av_frame_free(&frame_out);

214 | avfilter_graph_free(&filter_graph);

215 |

216 | return 0;

217 | }

218 | ```

219 |

220 | ## 结果

221 |

222 | 本程序输入为一个名称为“sintel_480x272_yuv420p.yuv”的YUV420P视频数据,输出为一个名称为“output.yuv” 的YUV420P视频数据。输入的视频数据的内容如下所示。

223 |

224 |

225 |

226 | 程序中提供了几种特效:

227 | >* lutyuv='u=128:v=128'

228 | >* boxblur

229 | >* hflip

230 | >* hue='h=60:s=-3'

231 | >* crop=2/3*in_w:2/3*in_h

232 | >* drawbox=x=100:y=100:w=100:h=100:color=pink@0.5

233 | >* drawtext=fontfile=arial.ttf:fontcolor=green:fontsize=30:text='Lei Xiaohua'

234 |

235 | 可以通过修改程序中的filter_descr字符串实现上述几种特效。下面展示几种特效的效果图。

236 |

237 | #### lutyuv='u=128:v=128'

238 |

239 |

240 |

241 | #### boxblur

242 |

243 |

244 |

245 | #### hflip

246 |

247 |

248 |

249 | #### hue='h=60:s=-3'

250 |

251 |

252 |

253 | #### crop=2/3*in_w:2/3*in_h

254 |

255 |

256 |

257 | #### drawbox=x=100:y=100:w=100:h=100:color=pink@0.5

258 |

259 |

260 |

261 | #### drawtext=fontfile=arial.ttf:fontcolor=green:fontsize=30:text='Lei Xiaohua'

262 |

263 |

264 |

265 | ## 下载

266 |

267 | Github:https://github.com/leixiaohua1020/simplest_ffmpeg_video_filter

268 |

269 | 本程序使用包含下面两个项目:

270 | * simplest_ffmpeg_video_filter:可以将一张PNG图片作为水印叠加到视频上,结合使用了libavfilter,libavcodec等类库。

271 | * simplest_ffmpeg_video_filter_pure:可以给YUV像素数据加特效,只用了libavfilter库。

272 |

273 |

274 |

275 |

276 |

277 |

278 |

279 |

280 |

281 |

282 |

283 |

284 | 原文作者: 雷霄骅

285 |

--------------------------------------------------------------------------------

/article/019-WebRTC能给我带来什么?.md:

--------------------------------------------------------------------------------

1 | # WebRTC能给我带来什么?

2 |

3 | WebRTC现在已经成为了W3C的正式标准,提供具有NAT遍历功能的次秒级的点对点视频和音频流。次秒级延迟已经被广泛应用于视频会议之中,也一直是视频流公司的焦点,如Millicast和Limelight(仅举两个例子),这些公司旨在将这种点对点技术交付给成千上万的人。在不到一秒钟的时间内便实现了交互式视频、游戏流、拍卖和超低延迟的体育运动。

4 |

5 | 针对直接使用其他流媒体协议的用户,Pion的创建者肖恩•杜布瓦(Sean DuBois)在SF Video Tech上谈到了WebRTC带来的RTMP、SRT和RIST等协议。它的核心是WebRTC(如SRT和RIST)创建一个连接,通过它可以发送各种数据。虽然我们期望媒体被发送,但是实际上,文件传输可以很容易地被实现——让我们不要忘记整个SRT是建立在UDT之上的,而UDT是一个专门用于文件传输的实用程序。在可以实现文件传输的地方,实时数据和元数据传输也可以实现。

6 |

7 | Sean很快将WebRTC概括为(典型)浏览器之间的协议,这是一种点对点的安全连接,多个音频和视频流可以在其连接上流动。与RIST和其他最新的协议一样,它基于许多已有的协议:SRTP、DTLS、ICE和SDP等技术来提供信令、连接管理、加密和通信。

8 |

17 |

18 | 对于RTMP非常长的改进列表,它们都在视频中被简明扼要地展现出来了,所以我们在这里只突出几个要点。重要的是,低延迟是其中的关键。RTMP在当时是属于低延迟的,但并不是以今天的低延迟标准。Sean解释说,谷歌的Stadia可以为按键提供125毫秒的视频延迟。DTLS和SRTP对于安全性来说是必不可少的,但是它们是众所周知便于理解和可靠的保护数据的方法。DTLS与TLS几乎完全相同,TLS保护您的银行转账,只是将其改为UDP而不是TCP中。但是,WebRTC可以通过交换“指纹”(DTLS-SRTP)而不是支持web上TLS的完全可信的证书基础结构来工作。只要您有信心可以提前安全地交换指纹,那么取消对证书的要求对于灵活性和敏捷性是一个很大的提升。

19 |

20 | NAT遍历也是一大福音,即使两个端点都在防火墙后面,端点也总能找到通信的方法,尽管这确实意味着需要ICE服务器来促进连接。然而,在广播中,你更有可能控制一端,这样就不太需要这样做了。Sean强调了使用WebRTC的“同步广播”功能在同一流中发送多个质量级别的能力。

21 |

22 | 之后Sean着眼于SRT和RIST。这两种协议都是低延迟流协议,它们都可以提供次秒级的流传输,以实现RTT相对较低的良好连接。Sean强调了SRT和RIST在协商使用中的编解码器及其可选安全性方面的不足。由于更注重提供贡献源,它们往往具有更静态的配置,通常是在测试程序之后创建的,以确保其质量能够被广播商/流媒体提供商所接受。

23 |

24 | 最后,Sean重点介绍了WebRTC的一系列有趣的创新用途,从非正式的群组流媒体到无人机、共享在线游戏到文件传输等等。

25 |

--------------------------------------------------------------------------------

/article/022-视音频数据处理:H.264视频码流解析.md:

--------------------------------------------------------------------------------

1 | # 视音频数据处理:H.264视频码流解析

2 |

3 | 本文介绍视音频码流的处理程序。本文介绍的程序是视频码流处理程序。视频码流在视频播放器中的位置如下所示。

4 |

5 |

6 |

7 | 本文中的程序是一个H.264码流解析程序。该程序可以从H.264码流中分析得到它的基本单元NALU,并且可以简单解析NALU首部的字段。通过修改该程序可以实现不同的H.264码流处理功能。

8 |

9 | ## 原理

10 |

11 | H.264原始码流(又称为“裸流”)是由一个一个的NALU组成的。他们的结构如下图所示。

12 |

13 |

14 |

15 | 其中每个NALU之间通过startcode(起始码)进行分隔,起始码分成两种:0x000001(3Byte)或者0x00000001(4Byte)。如果NALU对应的Slice为一帧的开始就用0x00000001,否则就用0x000001。

16 | H.264码流解析的步骤就是首先从码流中搜索0x000001和0x00000001,分离出NALU;然后再分析NALU的各个字段。本文的程序即实现了上述的两个步骤。

17 |

18 | ## 代码

19 |

20 | 整个程序位于simplest_h264_parser()函数中,如下所示。

21 |

22 | ```C++

23 | /**

24 | *