├── guias

└── Perceptron

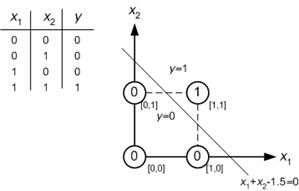

│ ├── and.jpg

│ ├── Perceptron.py

│ ├── README.md

│ └── iris_data.csv

├── dados

├── IMG_20190927_105514.jpg

├── ODB2013originalcorrigido.csv

├── avaliacoes_tripadvisor_paprica.csv

├── horas_estudos_x_notas.csv

├── antihorario004.txt

├── crescimento_populacional.csv

├── altura_x_peso.csv

├── horario004.csv

├── antihorario003.txt

├── pop_brasil.csv

├── horario003.csv

├── Distancias_Pessoas.csv

├── antihorario002.txt

├── horario002.csv

├── ultrassom_simples_radar_1_reduzida.csv

├── salario_x_experiencia.csv

├── compra_casa_didatico.csv

├── xor_3.csv

├── preco_casas.csv

├── serie_historica_ibge_empregos_sp

│ ├── README.md

│ ├── series_historicas_sp.xls

│ ├── series_historicas_sp_v2.tsv

│ └── series_historicas_sp_v3.tsv

├── Salary_Data.csv

├── PWMxVelocidade.csv

├── didatico_dados_pessoas_e_notas.csv

├── obitos_covid.csv

├── README.md

├── DataBaseLopDescription.txt

├── Banco de Dados 22.csv

├── perfil_politico.csv

├── perfil_notas_sem_identificacao.txt

├── alunos_didatico.csv

├── milsa.csv

├── perfil_politico2019.csv

├── 50_Startups.csv

├── pib_regioes_brasil.csv

├── ultrassom_simples_radar_1.csv

├── Resultados_Strava_2_CSV2020_2023.csv

├── zoo.csv

├── Mall_Customers.csv

├── Iris.csv

└── limpo1.csv

├── atividades

└── 2019.2

│ ├── MLP

│ ├── Leandro_Tobias.pdf

│ ├── Relatório MLP - Vilson.pdf

│ ├── Relatorio_Igor_Rony_Thati_MLP

│ ├── Relatorio I - MLP (Luis Fernando Tavares).docx

│ ├── modelo_de_relatorio.md

│ ├── relatorioLOP_Severino_e_Jorge.md

│ ├── Relatório_Michel.md

│ ├── Relatorio_Alysson_Lima_MLP.md

│ ├── relatorio_sistema-LOP_Lucas-Gualberto.md

│ └── relatorioMLP - JoaoMarcos.md

│ ├── SOM

│ ├── Vilson - Rede SOM.pdf

│ ├── SOM_Leandro_Tobias.pdf

│ ├── RelatórioSOMAprovacaoLOP.pdf

│ ├── Relatório_SOM_Alysson_Lima.pdf

│ ├── Relatório III - SOM (Luís Fernando Tavares).docx

│ ├── modelo_de_relatorio.md

│ ├── SOM_Lucas_Gualberto.md

│ ├── Análise_do_perfil_ de_aprovacao_com_SOM-Lucas_Gualberto.md

│ ├── Relatorio_Michel.md

│ ├── Relat_Jorge_e_Severino.md

│ └── som_bruno_guedes_spinelli.md

│ ├── SVM

│ ├── Leandro_Tobias2.pdf

│ ├── Relatorio_SVM_Alysson_Lima

│ ├── Relatório SVM - Vilson.pdf

│ ├── Relatório - SVM_Igor_Rony_Thatiana.pdf

│ ├── Relatorio II - SVM (Luis Fernando Tavares).docx

│ ├── modelo_de_relatorio.md

│ ├── MacielBarbosa.md

│ ├── relatorio_pose_estimation_Lucas-Gualberto.md

│ ├── Relatório_Michel_SVM.md

│ ├── Lucas_e_Luis2.md

│ └── relatorioSVM-JoaoMarcos.md

│ ├── CharRec

│ ├── Relatrio4-Vilson.pdf

│ ├── Deep Learning_Leandro_Tobias.pdf

│ ├── Relatorio IV - CharRec (Luis Fernando Tavares).docx

│ ├── Relatorio_Reconhecimento_de_Caracteres_Igor_Rony_Thatiana.pdf

│ ├── modelo_de_relatorio.md

│ ├── maciel_barbosa.md

│ ├── Identificação de letras usando Multilayer Perceptron - Lucas Gualberto.md

│ └── Relatorio_Jorge_e_Severino.md

│ └── trabalhos_finais

│ ├── Lucas e Vanin.pdf

│ ├── TCC__Hardcode (2) (1).pdf

│ ├── Babycry-Leandro_Tobias.pdf

│ ├── Vilson-Perfis-de-Reprovacao.pdf

│ ├── Detecção de objetos_Igor_Rony_Thatiana.pdf

│ ├── Relatório_Projeto_NLP_Twitter_Alysson_Lima.pdf

│ ├── reconhecimento_facial_(bruno_guedes_spinelli).pdf

│ ├── README.md

│ ├── Relatorio - Teacher Sensor (Luis Fernando Tavares).pdf

│ └── Identificacao_de_movimentos_com_SOM_SVM.md

├── README.md

├── noticiais.md

├── entrega_trabalho_final_2020.md

├── modelo_de_relatorio.md

├── roteiro_trabalho_final.md

├── aulas

├── arvore_decisao.md

├── cnn.md

├── introducao.md

├── svm.md

├── som.md

├── k_means.md

├── nlp.md

├── mlp.md

├── deep_learning.md

└── regressao.md

├── relatorio_ml_vc.md

├── relatorio_ml.md

├── cronograma_2020_2.md

├── cursos_online.md

├── outras_referencias.md

├── atividades_2018_2.md

├── 2020_1.md

├── 2019_2.md

└── 2024_2.md

/guias/Perceptron/and.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/guias/Perceptron/and.jpg

--------------------------------------------------------------------------------

/dados/IMG_20190927_105514.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/dados/IMG_20190927_105514.jpg

--------------------------------------------------------------------------------

/dados/ODB2013originalcorrigido.csv:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/dados/ODB2013originalcorrigido.csv

--------------------------------------------------------------------------------

/atividades/2019.2/MLP/Leandro_Tobias.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/MLP/Leandro_Tobias.pdf

--------------------------------------------------------------------------------

/dados/avaliacoes_tripadvisor_paprica.csv:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/dados/avaliacoes_tripadvisor_paprica.csv

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/Vilson - Rede SOM.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SOM/Vilson - Rede SOM.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/Leandro_Tobias2.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SVM/Leandro_Tobias2.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/SOM_Leandro_Tobias.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SOM/SOM_Leandro_Tobias.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/Relatrio4-Vilson.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/CharRec/Relatrio4-Vilson.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/MLP/Relatório MLP - Vilson.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/MLP/Relatório MLP - Vilson.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/Relatorio_SVM_Alysson_Lima:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SVM/Relatorio_SVM_Alysson_Lima

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/Relatório SVM - Vilson.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SVM/Relatório SVM - Vilson.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/RelatórioSOMAprovacaoLOP.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SOM/RelatórioSOMAprovacaoLOP.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/MLP/Relatorio_Igor_Rony_Thati_MLP:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/MLP/Relatorio_Igor_Rony_Thati_MLP

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/Relatório_SOM_Alysson_Lima.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SOM/Relatório_SOM_Alysson_Lima.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Lucas e Vanin.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Lucas e Vanin.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/Deep Learning_Leandro_Tobias.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/CharRec/Deep Learning_Leandro_Tobias.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/Relatório - SVM_Igor_Rony_Thatiana.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SVM/Relatório - SVM_Igor_Rony_Thatiana.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/TCC__Hardcode (2) (1).pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/TCC__Hardcode (2) (1).pdf

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Babycry-Leandro_Tobias.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Babycry-Leandro_Tobias.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/MLP/Relatorio I - MLP (Luis Fernando Tavares).docx:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/MLP/Relatorio I - MLP (Luis Fernando Tavares).docx

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Vilson-Perfis-de-Reprovacao.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Vilson-Perfis-de-Reprovacao.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/Relatório III - SOM (Luís Fernando Tavares).docx:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SOM/Relatório III - SOM (Luís Fernando Tavares).docx

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/Relatorio II - SVM (Luis Fernando Tavares).docx:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/SVM/Relatorio II - SVM (Luis Fernando Tavares).docx

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/Relatorio IV - CharRec (Luis Fernando Tavares).docx:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/CharRec/Relatorio IV - CharRec (Luis Fernando Tavares).docx

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Detecção de objetos_Igor_Rony_Thatiana.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Detecção de objetos_Igor_Rony_Thatiana.pdf

--------------------------------------------------------------------------------

/dados/horas_estudos_x_notas.csv:

--------------------------------------------------------------------------------

1 | Discente,Horas de estudo,Nota do discente

2 | 1,1,53

3 | 2,5,74

4 | 3,7,59

5 | 4,8,43

6 | 5,10,56

7 | 6,11,84

8 | 7,14,96

9 | 8,15,69

10 | 9,15,84

11 | 10,19,83

12 |

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Relatório_Projeto_NLP_Twitter_Alysson_Lima.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Relatório_Projeto_NLP_Twitter_Alysson_Lima.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/reconhecimento_facial_(bruno_guedes_spinelli).pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/reconhecimento_facial_(bruno_guedes_spinelli).pdf

--------------------------------------------------------------------------------

/dados/antihorario004.txt:

--------------------------------------------------------------------------------

1 | 0.5, 132

2 | 0.54, 143

3 | 0.58, 149

4 | 0.62, 154

5 | 0.66, 159

6 | 0.7, 162

7 | 0.74, 166

8 | 0.78, 169

9 | 0.82, 173

10 | 0.86, 175

11 | 0.9, 178

12 | 0.94, 182

13 | 0.98, 184

14 |

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/Relatorio_Reconhecimento_de_Caracteres_Igor_Rony_Thatiana.pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/CharRec/Relatorio_Reconhecimento_de_Caracteres_Igor_Rony_Thatiana.pdf

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/README.md:

--------------------------------------------------------------------------------

1 | # Trabalho Final

2 |

3 | * Entrega do relatório final

4 | * Entrega do código

5 |

6 | Obs.: Apresentar no relatório o link para o código ou explicações para o código.

7 |

--------------------------------------------------------------------------------

/dados/crescimento_populacional.csv:

--------------------------------------------------------------------------------

1 | ano,populacao

2 | 1872,9.9

3 | 1890,14.3

4 | 1900,17.4

5 | 1920,30.6

6 | 1940,41.2

7 | 1950,51.9

8 | 1960,70.2

9 | 1970,93.1

10 | 1980,119.0

11 | 1991,146.2

12 | 1996,157.1

13 |

--------------------------------------------------------------------------------

/atividades/2019.2/trabalhos_finais/Relatorio - Teacher Sensor (Luis Fernando Tavares).pdf:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/ect-comp/ml/HEAD/atividades/2019.2/trabalhos_finais/Relatorio - Teacher Sensor (Luis Fernando Tavares).pdf

--------------------------------------------------------------------------------

/dados/altura_x_peso.csv:

--------------------------------------------------------------------------------

1 | Indivíduo,Altura (cm),Peso (Kg)

2 | 1,167,56

3 | 2,187,"89,2"

4 | 3,188,"90,6"

5 | 4,189,"93,6"

6 | 5,178,"60,5"

7 | 6,189,"91,4"

8 | 7,190,"95,8"

9 | 8,176,"62,4"

10 | 9,194,95

11 | 10,195,99

12 |

--------------------------------------------------------------------------------

/dados/horario004.csv:

--------------------------------------------------------------------------------

1 | pwm, pulses

2 | 0.5, 134

3 | 0.54, 139

4 | 0.58, 145

5 | 0.62, 150

6 | 0.66, 155

7 | 0.7, 158

8 | 0.74, 162

9 | 0.78, 163

10 | 0.82, 167

11 | 0.86, 171

12 | 0.9, 173

13 | 0.94, 176

14 | 0.98, 178

15 |

--------------------------------------------------------------------------------

/dados/antihorario003.txt:

--------------------------------------------------------------------------------

1 | 0.5, 133

2 | 0.53, 142

3 | 0.56, 146

4 | 0.59, 151

5 | 0.62, 155

6 | 0.65, 158

7 | 0.68, 161

8 | 0.71, 164

9 | 0.74, 167

10 | 0.77, 169

11 | 0.8, 171

12 | 0.83, 174

13 | 0.86, 176

14 | 0.89, 178

15 | 0.92, 180

16 | 0.95, 183

17 | 0.98, 185

18 |

--------------------------------------------------------------------------------

/dados/pop_brasil.csv:

--------------------------------------------------------------------------------

1 | ano,população

2 | 1872,9930478

3 | 1890,14333915

4 | 1900,17438434

5 | 1920,30635605

6 | 1940,41236315

7 | 1950,51944397

8 | 1960,70992343

9 | 1970,94508583

10 | 1980,121150573

11 | 1991,146917459

12 | 2000,169590693

13 | 2010,190755799

--------------------------------------------------------------------------------

/dados/horario003.csv:

--------------------------------------------------------------------------------

1 | pwm, pulses

2 | 0.5, 125

3 | 0.53, 135

4 | 0.56, 140

5 | 0.59, 144

6 | 0.62, 148

7 | 0.65, 152

8 | 0.68, 155

9 | 0.71, 158

10 | 0.74, 160

11 | 0.77, 163

12 | 0.8, 164

13 | 0.83, 166

14 | 0.86, 170

15 | 0.89, 173

16 | 0.92, 173

17 | 0.95, 176

18 | 0.98, 179

19 |

--------------------------------------------------------------------------------

/dados/Distancias_Pessoas.csv:

--------------------------------------------------------------------------------

1 | ID,Sexo,Distancia,Tamanho passo,Altura

2 | 1,F,6.0625,0.60625,1.49

3 | 2,M,6.5,0.65,1.71

4 | 3,F,6.705,0.6705,1.55

5 | 4,F,6.96,0.696,1.615

6 | 5,F,7.38,0.738,1.595

7 | 6,M,8.305,0.8305,1.73

8 | 7,M,7.895,0.7895,1.85

9 | 8,F,5.6075,0.56075,1.5

10 | 9,F,6.095,0.6095,1.54

11 | 10,M,6.3525,0.63525,1.64

12 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # Semestres

2 |

3 | * [2024.2](https://github.com/ect-info/ml/blob/master/2024_2.md)

4 | * [2023.1](https://github.com/ect-info/ml/blob/master/2023_1.md)

5 | * [2020.2](https://github.com/ect-info/ml/blob/master/2020_2.md)

6 | * [2020.1](https://github.com/ect-info/ml/blob/master/2020_1.md)

7 | * [2019.2](https://github.com/ect-info/ml/blob/master/2019_2.md)

8 |

--------------------------------------------------------------------------------

/dados/antihorario002.txt:

--------------------------------------------------------------------------------

1 | 0.5, 131

2 | 0.52, 139

3 | 0.54, 143

4 | 0.56, 147

5 | 0.58, 150

6 | 0.6, 152

7 | 0.62, 154

8 | 0.64, 157

9 | 0.66, 159

10 | 0.68, 161

11 | 0.7, 163

12 | 0.72, 165

13 | 0.74, 167

14 | 0.76, 168

15 | 0.78, 170

16 | 0.8, 171

17 | 0.82, 174

18 | 0.84, 175

19 | 0.86, 176

20 | 0.88, 177

21 | 0.9, 179

22 | 0.92, 180

23 | 0.94, 181

24 | 0.96, 183

25 | 0.98, 185

26 |

--------------------------------------------------------------------------------

/dados/horario002.csv:

--------------------------------------------------------------------------------

1 | pwm, pulses

2 | 0.5, 127

3 | 0.52, 133

4 | 0.54, 137

5 | 0.56, 140

6 | 0.58, 143

7 | 0.6, 146

8 | 0.62, 148

9 | 0.64, 150

10 | 0.66, 153

11 | 0.68, 156

12 | 0.7, 158

13 | 0.72, 159

14 | 0.74, 161

15 | 0.76, 163

16 | 0.78, 164

17 | 0.8, 166

18 | 0.82, 168

19 | 0.84, 170

20 | 0.86, 172

21 | 0.88, 173

22 | 0.9, 173

23 | 0.92, 174

24 | 0.94, 176

25 | 0.96, 177

26 | 0.98, 179

27 |

--------------------------------------------------------------------------------

/dados/ultrassom_simples_radar_1_reduzida.csv:

--------------------------------------------------------------------------------

1 | a20,a40,a60,a80,a100,a120,a140,a160,comando

2 | 51,51,51,51,51,14,16,51,d

3 | 51,51,51,51,51,24,21,37,d

4 | 51,51,51,51,51,51,28,28,d

5 | 23,21,51,51,51,51,51,51,e

6 | 51,16,51,51,51,51,51,51,e

7 | 51,36,34,51,31,51,51,51,e

8 | 51,51,51,16,13,51,51,51,f

9 | 51,51,51,51,27,51,51,51,f

10 | 51,51,51,23,51,51,51,51,f

11 | 51,51,51,51,51,51,51,51,f

12 |

--------------------------------------------------------------------------------

/dados/salario_x_experiencia.csv:

--------------------------------------------------------------------------------

1 | Salário,Experiência

2 | 19307,0

3 | 31769,17

4 | 22769,8

5 | 31307,15

6 | 27769,9

7 | 30923,15

8 | 26538,8

9 | 22230,5

10 | 28538,13

11 | 32307,20

12 | 28230,11

13 | 19076,1

14 | 25384,6

15 | 25692,7

16 | 42230,23

17 | 40923,20

18 | 36000,18

19 | 47076,27

20 | 31461,11

21 | 29923,10

22 | 47461,29

23 | 41153,23

24 | 23615,4

25 | 40923,22

26 | 45076,25

27 | 29076,9

28 | 44846,25

29 |

--------------------------------------------------------------------------------

/dados/compra_casa_didatico.csv:

--------------------------------------------------------------------------------

1 | Idade,Renda (mil reais),Estado civil,Filhos,Região,Compra

2 | 25,50,Solteiro,0,Sudeste,Não

3 | 32,80,Casado,2,Nordeste,Sim

4 | 40,120,Casado,1,Sudeste,Sim

5 | 50,200,Divorciado,3,Centro-Oeste,Sim

6 | 60,150,Viúvo,0,Sul,Não

7 | 35,60,Solteiro,0,Nordeste,Não

8 | 45,100,Casado,2,Sudeste,Não

9 | 55,180,Divorciado,1,Centro-Oeste,Sim

10 | 28,70,Solteiro,1,Sudeste,Não

11 | 38,90,Casado,2,Nordeste,Não

12 |

--------------------------------------------------------------------------------

/dados/xor_3.csv:

--------------------------------------------------------------------------------

1 | a,b,xor

2 | -1,-0.6,0

3 | -1,0.2,1

4 | -1,1,1

5 | -0.8,-0.4,0

6 | -0.8,0.4,1

7 | -0.6,0,0

8 | -0.6,-0.2,1

9 | -0.6,0.6,1

10 | -0.4,-0.8,0

11 | -0.4,0,1

12 | -0.4,0.8,1

13 | -0.2,-0.6,1

14 | -0.2,0.2,1

15 | -0.2,1,1

16 | 0,-0.4,1

17 | 0,0.4,1

18 | 0.2,-1,1

19 | 0.2,-0.2,1

20 | 0.2,0.6,1

21 | 0.4,-0.8,1

22 | 0.4,0,1

23 | 0.4,0.8,0

24 | 0.6,-0.6,1

25 | 0.6,0.2,1

26 | 0.6,1,0

27 | 0.8,-0.4,1

28 | 0.8,0.4,0

29 | 1,-1,1

30 | 1,-0.2,1

31 | 1,0.6,0

32 |

--------------------------------------------------------------------------------

/dados/preco_casas.csv:

--------------------------------------------------------------------------------

1 | Área (m²),Preço (R$)

2 | 50,100000

3 | 70,150000

4 | 100,200000

5 | 120,220000

6 | 150,250000

7 | 80,160000

8 | 90,180000

9 | 110,210000

10 | 130,230000

11 | 160,260000

12 | 75,155000

13 | 85,170000

14 | 95,185000

15 | 105,195000

16 | 115,205000

17 | 125,215000

18 | 135,225000

19 | 120,235000

20 | 141,240000

21 | 135,255000

22 | 161,265000

23 | 150,270000

24 | 179,275000

25 | 160,280000

26 | 182,285000

27 | 190,290000

28 | 181,295000

29 | 200,300000

30 | 201,305000

31 | 203,310000

32 |

--------------------------------------------------------------------------------

/dados/serie_historica_ibge_empregos_sp/README.md:

--------------------------------------------------------------------------------

1 | # Base de Dado do IBGE

2 | Pessoas economicamente ativas ocupadas por anos de estudo no estado de São Paulo - Brasil. Essa base de dados contem medições mensais começando em março de 2002 e finalizando em fevereiro de 2016.

3 |

4 | Descrição de cada linha da base de dados:

5 | * Sem instrução ou menos de 1 ano

6 | * 1 a 3 anos

7 | * 4 a 7 anos

8 | * 8 a 10 anos

9 | * 11 anos ou mais

10 |

11 | Fonte: https://seriesestatisticas.ibge.gov.br/series.aspx?no=1&op=2&vcodigo=PE54&t=pessoas-economicamente-ativas-ocupadas-anos-estudo

--------------------------------------------------------------------------------

/dados/Salary_Data.csv:

--------------------------------------------------------------------------------

1 | YearsExperience,Salary

2 | 1.1,39343.00

3 | 1.3,46205.00

4 | 1.5,37731.00

5 | 2.0,43525.00

6 | 2.2,39891.00

7 | 2.9,56642.00

8 | 3.0,60150.00

9 | 3.2,54445.00

10 | 3.2,64445.00

11 | 3.7,57189.00

12 | 3.9,63218.00

13 | 4.0,55794.00

14 | 4.0,56957.00

15 | 4.1,57081.00

16 | 4.5,61111.00

17 | 4.9,67938.00

18 | 5.1,66029.00

19 | 5.3,83088.00

20 | 5.9,81363.00

21 | 6.0,93940.00

22 | 6.8,91738.00

23 | 7.1,98273.00

24 | 7.9,101302.00

25 | 8.2,113812.00

26 | 8.7,109431.00

27 | 9.0,105582.00

28 | 9.5,116969.00

29 | 9.6,112635.00

30 | 10.3,122391.00

31 | 10.5,121872.00

32 |

--------------------------------------------------------------------------------

/noticiais.md:

--------------------------------------------------------------------------------

1 | # Notícias

2 |

3 | ## Ano 2020

4 | 1. [IA oferece à TI uma vantagem na melhoria da experiência do cliente](https://cio.com.br/ia-oferece-a-ti-uma-vantagem-na-melhoria-da-experiencia-do-cliente)

5 | 1. [Startup de inteligência artificial recebe aporte de R$ 40 mi e mira Brasil](https://exame.com/tecnologia/startup-de-inteligencia-artificial-recebe-aporte-de-r-40-mi-e-mira-brasil/)

6 | 1. [Inteligência Artificial e RPA: por que é fundamental que essas tecnologias caminhem juntas? - 29/09/2020](https://cio.com.br/tendencias/inteligencia-artificial-e-rpa-por-que-e-fundamental-que-essas-tecnologias-caminhem-juntas)

7 |

--------------------------------------------------------------------------------

/entrega_trabalho_final_2020.md:

--------------------------------------------------------------------------------

1 | # Trabalho Final

2 | * Procedimento para entrega

3 | * Entrega via atividade no SIGAA

4 |

5 | ## Relatório

6 | * Escrever o relatório de acordo com o modelo: [ver este link](https://github.com/ect-info/ml/blob/master/relatorio_ml_vc.md)

7 |

8 | ## Código

9 | * Gerar um link para o código e colocar em sua respectiva seção no relatório

10 |

11 | ## Vídeo

12 | * Apresentação com duração de 5 a 15 minutos (uma sugestão)

13 | * Explicar rapidamente:

14 | * O problema

15 | * A base de dados

16 | * Explicar como o conhecimento visto na(s) disciplina(s) foi aplicado

17 | * Discutir os resultados

18 |

--------------------------------------------------------------------------------

/modelo_de_relatorio.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | * Apresentar os membros da equipe.

6 | * Descrever o problema.

7 | * Descrever a base de dados.

8 |

9 | ## Metodologia

10 |

11 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

12 | * Explicar as etapas do treinamento e teste.

13 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

14 |

15 | ## Códigos

16 |

17 | * Mostrar trechos de códigos mais importantes e explicações.

18 |

19 | ## Experimentos

20 |

21 | * Descrever em detalhes os tipos de testes executados.

22 | * Descrever os parâmentros avaliados.

23 | * Explicar os resultados.

24 |

--------------------------------------------------------------------------------

/roteiro_trabalho_final.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 | * Explicar o problema

5 | * Explicar os objetivos

6 | * Descrever a base de dados.

7 |

8 | ## Metodologia

9 | * Explicar brevemente a técnica de _machine learning_ escolhida

10 | * Explicar as etapas de treinamento e teste

11 |

12 | ## Códigos

13 | * Mostrar e explicar os trechos de códigos mais importantes

14 | * Informar o link para acessar o código.

15 |

16 | ## Experimentos

17 | * Descrever em detalhes os tipos de testes executados

18 | * Descrever os parâmetros avaliados

19 | * Explicar os resultados

20 |

21 | ## Conclusão

22 | * O trabalho atingiu os objetivos?

23 | * O que precisa ser melhorado?

24 |

--------------------------------------------------------------------------------

/dados/PWMxVelocidade.csv:

--------------------------------------------------------------------------------

1 | PWM,Velocidade

2 | 80,12.82

3 | 80,13.03

4 | 90,16.02

5 | 100,18.37

6 | 110,20.93

7 | 110,21.15

8 | 100,18.8

9 | 100,19.01

10 | 90,16.24

11 | 120,22.64

12 | 120,23.07

13 | 120,23.28

14 | 130,24.35

15 | 130,24.99

16 | 130,24.78

17 | 140,25.85

18 | 140,26.7

19 | 140,26.49

20 | 140,26.28

21 | 140,26.06

22 | 150,27.34

23 | 150,27.56

24 | 150,27.77

25 | 160,28.41

26 | 160,29.05

27 | 160,28.63

28 | 170,29.91

29 | 170,29.69

30 | 190,31.62

31 | 190,31.4

32 | 210,33.33

33 | 210,33.26

34 | 210,32.47

35 | 210,32.9

36 | 230,32.9

37 | 230,32.68

38 | 230,32.9

39 | 230,33.1

40 | 250,32.68

41 | 250,33.11

42 | 250,32.47

43 | 250,33.54

44 | 250,34.18

45 |

--------------------------------------------------------------------------------

/atividades/2019.2/MLP/modelo_de_relatorio.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | * Apresentar os membros da equipe.

6 | * Descrever o problema.

7 | * Descrever a base de dados.

8 |

9 | ## Metodologia

10 |

11 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

12 | * Explicar as etapas do treinamento e teste.

13 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

14 |

15 | ## Códigos

16 |

17 | * Mostrar trechos de códigos mais importantes e explicações.

18 |

19 | ## Experimentos

20 |

21 | * Descrever em detalhes os tipos de testes executados.

22 | * Descrever os parâmentros avaliados.

23 | * Explicar os resultados.

24 |

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/modelo_de_relatorio.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | * Apresentar os membros da equipe.

6 | * Descrever o problema.

7 | * Descrever a base de dados.

8 |

9 | ## Metodologia

10 |

11 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

12 | * Explicar as etapas do treinamento e teste.

13 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

14 |

15 | ## Códigos

16 |

17 | * Mostrar trechos de códigos mais importantes e explicações.

18 |

19 | ## Experimentos

20 |

21 | * Descrever em detalhes os tipos de testes executados.

22 | * Descrever os parâmentros avaliados.

23 | * Explicar os resultados.

24 |

--------------------------------------------------------------------------------

/atividades/2019.2/SVM/modelo_de_relatorio.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | * Apresentar os membros da equipe.

6 | * Descrever o problema.

7 | * Descrever a base de dados.

8 |

9 | ## Metodologia

10 |

11 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

12 | * Explicar as etapas do treinamento e teste.

13 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

14 |

15 | ## Códigos

16 |

17 | * Mostrar trechos de códigos mais importantes e explicações.

18 |

19 | ## Experimentos

20 |

21 | * Descrever em detalhes os tipos de testes executados.

22 | * Descrever os parâmentros avaliados.

23 | * Explicar os resultados.

24 |

--------------------------------------------------------------------------------

/dados/didatico_dados_pessoas_e_notas.csv:

--------------------------------------------------------------------------------

1 | Nome,Nota do aluno,Sexo,Idade,Peso,Altura

2 | Otavio,1,Masculino,18,98,1.780

3 | Sandra,2,Feminino,19,66,1.680

4 | Ana,2,Feminino,18,102,1.570

5 | Francisco,3,Masculino,22,76,1.590

6 | Rafael,3,Masculino,18,90,1.630

7 | Maria,4,Feminino,19,91,1.780

8 | Leda ,4,Feminino,23,72,1.770

9 | Antonio,5,Masculino,25,87,1.750

10 | Roberto ,5,Masculino,29,87,1.540

11 | Ivan,5,Masculino,22,77,1.880

12 | Carla ,6,Feminino,36,102,1.900

13 | Luiz,6,Masculino,51,84,1.770

14 | David,6,Masculino,22,99,1.760

15 | Edson,6,Masculino,29,71,1.760

16 | Rachel,6,Feminino,27,71,1.800

17 | Ângela,7,Feminino,26,80,1.770

18 | Paulo,7,Masculino,19,98,1.760

19 | Nicole,7,Feminino,24,66,1.550

20 | Lika,7,Feminino,22,98,1.880

21 | Matheus,9,Masculino,25,100,1.900

22 |

--------------------------------------------------------------------------------

/aulas/arvore_decisao.md:

--------------------------------------------------------------------------------

1 | # Árvore de Decisão

2 | * [Slides](https://docs.google.com/presentation/d/1IOQGZS21VcNK8GHDCT5IoaeOPbEBEtSYGcZr-Lm7AxQ/edit?usp=sharing)

3 | * [Vídeo: introdução conceitual sobre árvore de decisão](https://youtu.be/UktH9kZm-w0)

4 | * Código:

5 | * [Tem diabetes?](https://colab.research.google.com/drive/1ISIObTt9PCeW950jotNgRWkjmdhdMfcN?usp=sharing)

6 |

7 | Material Complementar:

8 | * Problema, predição de compra de um produto:

9 | * [Vídeo - trinando uma árvore de decisão](https://youtu.be/NWqdl3vw5YE)

10 | * [Código](https://colab.research.google.com/drive/1YVy68Eo9Mf5r5qijp7orxFxjUNTsc6Q3?usp=sharing)

11 |

12 |

13 | Atividade avaliativa:

14 | * Treinar uma árvore de decisão para classificar as espécies da flor de iris, [acesse a base de dados aqui.](https://raw.githubusercontent.com/ect-info/ml/master/dados/Iris.csv)

15 |

--------------------------------------------------------------------------------

/relatorio_ml_vc.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | ### Identificação

6 | * Apresentar os membros da equipe (nome e mátricula)

7 | * Colocar o link para o vídeo da apresentação do trabalho

8 |

9 | ### Informações Gerais

10 | * Descrever o problema

11 | * Descrever a base de dados

12 |

13 | ## Metodologia

14 | * Explicar quais técnicas de visão computacional foram usadas e como (Se for o caso).

15 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

16 | * Explicar as etapas do treinamento e teste.

17 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

18 |

19 | ## Códigos

20 | * Mostrar trechos de códigos mais importantes e explicações.

21 | * Informar o link para acessar o código

22 |

23 | ## Experimentos

24 | * Descrever em detalhes os tipos de testes executados.

25 | * Descrever os parâmentros avaliados.

26 | * Explicar os resultados.

27 |

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/modelo_de_relatorio.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | * Apresentar os membros da equipe.

6 | * Descrever o problema.

7 | * Descrever a base de dados.

8 |

9 | ## Metodologia

10 |

11 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

12 | * Explicar as etapas do treinamento e teste.

13 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

14 |

15 | ## Códigos

16 |

17 | * Mostrar trechos de códigos mais importantes e explicações.

18 |

19 | ## Experimentos

20 |

21 | * Descrever em detalhes os tipos de testes executados.

22 | * Descrever os parâmentros avaliados.

23 | * Explicar os resultados.

24 | ### Base de dados

25 | * Dígitos escritos a mão, https://drive.google.com/open?id=1MQ799fvtrs6pXNI3aDB2otEpdg9N-E7H

26 | * Caracteres escritos a mão, https://drive.google.com/open?id=1B4fy3Nqy9AoEnC2MuuPaCstcrJ-FZstW

27 |

28 |

--------------------------------------------------------------------------------

/dados/obitos_covid.csv:

--------------------------------------------------------------------------------

1 | SEXO,IDADE

2 | 0,96

3 | 0,94

4 | 0,93

5 | 1,93

6 | 0,93

7 | 0,92

8 | 1,92

9 | 1,92

10 | 0,91

11 | 0,91

12 | 0,90

13 | 0,89

14 | 0,88

15 | 1,88

16 | 1,87

17 | 0,87

18 | 0,86

19 | 1,86

20 | 0,86

21 | 0,85

22 | 1,85

23 | 0,84

24 | 1,84

25 | 0,84

26 | 0,83

27 | 0,83

28 | 1,83

29 | 1,82

30 | 0,82

31 | 1,82

32 | 0,82

33 | 0,82

34 | 1,82

35 | 0,81

36 | 0,81

37 | 1,81

38 | 0,81

39 | 0,81

40 | 0,81

41 | 0,81

42 | 0,81

43 | 0,80

44 | 0,80

45 | 1,79

46 | 0,78

47 | 0,77

48 | 1,76

49 | 1,76

50 | 1,75

51 | 1,75

52 | 1,75

53 | 0,73

54 | 1,72

55 | 0,71

56 | 1,71

57 | 0,69

58 | 0,69

59 | 0,68

60 | 1,67

61 | 0,66

62 | 0,66

63 | 1,66

64 | 1,65

65 | 1,65

66 | 1,64

67 | 1,64

68 | 1,62

69 | 0,62

70 | 1,62

71 | 1,61

72 | 0,61

73 | 1,61

74 | 1,61

75 | 1,58

76 | 1,58

77 | 1,57

78 | 0,56

79 | 0,56

80 | 1,52

81 | 1,52

82 | 1,52

83 | 0,49

84 | 1,45

85 | 1,45

86 | 1,44

87 | 1,40

88 | 1,39

89 | 0,35

90 | 0,32

91 | 1,31

--------------------------------------------------------------------------------

/relatorio_ml.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | ### Identificação

6 | * Apresentar os membros da equipe (nome e mátricula).

7 | * Colocar o link para o vídeo da apresentação do trabalho (para quem não for apresentar presencialmente).

8 |

9 | ### Informações Gerais

10 | * Descrever o problema.

11 | * Descrever brevemente os algoritmos usados.

12 | * Descrever os objetivos.

13 | * Descrever a base de dados.

14 |

15 | ## Metodologia

16 | * Explicar em detalhes quais técnicas de _machine learning_ (ML) foram aplicadas neste trabalhando.

17 | * Explicar as etapas do treinamento e teste.

18 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

19 |

20 | ## Códigos

21 | * Mostrar trechos de códigos mais importantes e explicações.

22 | * Informar o link para acessar o código.

23 |

24 | ## Experimentos

25 | * Descrever em detalhes os tipos de testes executados.

26 | * Descrever os parâmentros avaliados.

27 | * Explicar os resultados.

28 |

29 | ## Conclusão

30 | * O trabalho atendeu aos objetivos?

31 |

--------------------------------------------------------------------------------

/aulas/cnn.md:

--------------------------------------------------------------------------------

1 | # Rede Neural Convolucional

2 | * [Slides](https://docs.google.com/presentation/d/1KTPsi2Y4U63cuNUoCh32sd3VJfyYf6MA7NT3fHucboM/edit?usp=drivesdk)

3 | * Códigos:

4 | * [Código: reconhecimento de números escritos à mão](https://colab.research.google.com/drive/1gd9aB82vSHAEb_nHV0wJJZU4-gSfPbHN?usp=sharing)

5 |

6 | Material de Apoio

7 | * [Vídeos e Form](https://docs.google.com/forms/d/e/1FAIpQLSev6WOXJcQj9cIDlHYPIfsbPvpkDVsl2rqI4g7J6flD-03LOg/viewform?usp=sf_link)

8 |

9 | Extras:

10 | * [Vídeo: The Convolutional Neural Network (Animated Introduction)](https://www.youtube.com/watch?v=H1ZC9COwtMs)

11 | * [Treinando um modelo de "Machine Learning" na web com a ferramenta "Teachable Machine" do Google](https://www.youtube.com/watch?v=Qkop0rB-v1A)

12 |

13 | Sugestão de exercício:

14 | * Treinar uma Rede CNN para a base de dados "Fashion MNIST"

15 | * Exemplo de código: https://colab.research.google.com/drive/15DMm3Qf3IcN-syiNIvy_O04N5k9bBZV6?usp=sharing

16 |

17 | Material complementar:

18 | * [Vídeo: Prática com Redes Convolucionais](https://youtu.be/pCHKzOtLWOs)

19 |

--------------------------------------------------------------------------------

/dados/README.md:

--------------------------------------------------------------------------------

1 | # Base de dados

2 | * [OpenDataSUS: Sistema de Informação sobre Mortalidade](https://opendatasus.saude.gov.br/dataset/sim-2020-2021/resource/9dc15b23-70bc-46d8-b080-bb98fbeb0f27?inner_span=True)

3 | * [Consumidor comprar um determinado produto](https://raw.githubusercontent.com/ect-info/ml/master/dados/Social_Network_Ads.csv)

4 | * [Diabetes](https://www.kaggle.com/saurabh00007/diabetescsv)

5 | * [Visual Imagination with MEG](https://www.kaggle.com/emanuele/visual-imagination-with-meg)

6 | * [Avaliações restaurante Páprica no TripAdvisor](https://github.com/ect-info/ml/blob/master/dados/avaliacoes_tripadvisor_paprica.csv)

7 | * Para carregar use: `dados = pd.read_csv("avaliacoes_tripadvisor_paprica.csv",sep=';',encoding = "ISO-8859-1")`

8 | * [Este é um conjunto de dados de tweets para à análise de sentimento em português](https://www.kaggle.com/code/leandrodoze/sentiment-analysis-in-portuguese/input)

9 |

10 | # Referências

11 |

12 | * UC Irvine Machine Learning Repository, https://archive.ics.uci.edu/ml/index.php

13 | * Kaggle, https://www.kaggle.com/datasets

14 |

--------------------------------------------------------------------------------

/dados/DataBaseLopDescription.txt:

--------------------------------------------------------------------------------

1 | qsemana == Quantidade de dias diferentes que houve submissão

2 | submeteu == quantidade de questões submetidas pelo aluno por semana

3 | subListaLab == quantidade de submissões na lista de lab a cada 2 semanas

4 | subListaExer == quantidade de submissões na lista de exer a cada 2 semanas

5 | subDistintasLab == quantidade de dias em que submeteu a cada 2 semanas nas listas de lab

6 | subDistintasExer == quantidade de dias em que submeteu a cada 2 semanas nas listas de exer

7 | diferentesLabSemanas == quantidade de questões diferentes submetidas nas listas de lab a cada 2 semanas

8 | diferentesExerSemanas == quantidade de questões diferentes submetidas nas listas de lab a cada 2 semanas

9 | situacao == indica se o aluno foi aprovado (1) ou reprovado (0)

10 | qsub == quantidade de submissões das listas correspondente (seja lab ou exercicio)

11 | qsubp == quantidade de questões submetidas para a prova 1 (L1,L2,L3) ou da prova 2 (L4,L5)

12 | totalsub == total de submissões feitas pelo aluno

13 | igualACem == quantidade de submissões em que o aluno acertou 100%, seja nas L123 ou L45

14 |

--------------------------------------------------------------------------------

/aulas/introducao.md:

--------------------------------------------------------------------------------

1 | # Introdução ao Aprendizado de Máquina

2 | * [Apresentação e Planejamento](https://docs.google.com/presentation/d/1dqH0Jwx3zzp5YQnQVOHnU7QthYB5SPcimitccRj3niA/edit?usp=sharing)

3 | * [Slides: Conceitos](https://docs.google.com/presentation/d/1p0ZDtjHuog-ENMHVbMX6LiabMXlTjYIV8t1DA2iBqIY/edit?usp=sharing)

4 |

5 | Prátrica 1

6 | * Abrir o site https://teachablemachine.withgoogle.com/. Criar grupos. Treinar um modelo para reconhecer pessoas pelo rosto.

7 |

8 | Prática 2

9 | * Conhecer um Arquivo CSV

10 | * Abrir um _DataFrame_ com Pandas

11 | * Visualizar alguns dados

12 |

13 | Material de apoio:

14 | * [Vídeos e Form: Introdução ao Aprendizado de Máquina](https://docs.google.com/forms/d/e/1FAIpQLScN2CzUWUSDjj4hCN-Xd8yDJQ75ks00c6eNqE6dFDg-mSnYRw/viewform?usp=sf_link)

15 | * [Vídeos e Form: Aprendizado de Máquina - Exemplos](https://docs.google.com/forms/d/e/1FAIpQLSf2tVmAS_Ovy_Fja5TVktUUWTo3AmnchAtTluMme7kOIIjchA/viewform?usp=sf_link)

16 | * [Vídeos e Form: Introdução ML - Principais Conceitos](https://docs.google.com/forms/d/e/1FAIpQLScqCw62IcRiKWNJx1qyqZPanjeCzPaAjB1Qg3diORDmyxY_OQ/viewform?usp=sf_link)

17 |

--------------------------------------------------------------------------------

/dados/Banco de Dados 22.csv:

--------------------------------------------------------------------------------

1 | Sujeito,Genero,Grau_de_Instruçao,N_Filhos,Idade,Altura,Salario

2 | 1,M,Superior,1,31,160,"4,1"

3 | 2,F,Superior,0,25,160,"2,65"

4 | 3,M,Superior,0,33,157,"4,7"

5 | 4,M,Ens Fundamental,0,20,163,"1,45"

6 | 5,F,Ensino Médio,0,23,163,"1,85"

7 | 6,F,Superior,2,37,155,"2,2"

8 | 7,M,Ens Fundamental,0,38,165,"2,35"

9 | 8,M,Superior,0,37,168,"2,7"

10 | 9,M,Superior,1,34,163,"2,9"

11 | 10,M,Ensino Médio,2,40,170,"1,6"

12 | 11,F,Superior,0,41,170,3

13 | 12,F,Ensino Médio,3,46,157,"3,45"

14 | 13,F,Ensino Médio,0,26,165,1

15 | 14,F,Ensino Médio,0,41,160,"1,7"

16 | 15,F,Ensino Médio,1,43,173,"1,85"

17 | 16,M,Superior,1,27,175,"2,1"

18 | 17,M,Superior,0,26,145,"3,2"

19 | 18,M,Superior,0,42,165,"5,8"

20 | 19,F,Ensino Médio,2,43,157,"4,3"

21 | 20,M,Ensino Médio,2,30,163,"2,75"

22 | 21,M,Ens Fundamental,2,35,168,"3,4"

23 | 22,F,Ens Fundamental,0,33,183,"2,05"

24 | 23,F,Ensino Médio,0,30,175,"2,3"

25 | 24,F,Superior,2,32,185,"3,3"

26 | 25,M,Ensino Médio,4,29,173,"3,65"

27 | 26,F,Ens Fundamental,1,40,173,"3,65"

28 | 27,F,Superior,1,36,191,"4,15"

29 | 28,M,Ens Fundamental,0,34,188,"1,9"

30 | 29,M,Superior,0,31,193,"3,1"

31 | 30,F,Superior,1,35,170,4

32 |

--------------------------------------------------------------------------------

/dados/perfil_politico.csv:

--------------------------------------------------------------------------------

1 | Apoia privatizações das empresas brasileiras?,Lula deve ser solto,O impeachment de Dilma foi um golpe?,Legalização do aborto,Políticas de ações afirmativas (cotas),A favor da reforma agrária,Todos os brasileiro devem alcançar suas conquistas através da meritocracia,Apoia a legalização do porte de armas,Apoia a redução da maioridade penal,Apoia a laicidade do Estado,Apoia a diminuição do Estado,As Universidades são um gasto público?,A favor do foro privilegiado?,A favor de uma reforma política?,A favor de uma diminuição de regalias para os políticos?

2 | 1,0,0,0.5,1,1,0.5,0.5,1,1,1,0,0,1,1

3 | 0.5,1,1,0.5,1,0.5,1,0,1,1,0.5,0,0,1,1

4 | 1,0,0,1,0.5,0.5,1,1,1,1,1,0,0,0,1

5 | 1,0,1,0,1,1,1,0,0,1,1,0,1,1,1

6 | 0,0,1,0,0,0,1,1,1,1,0,0,0,1,1

7 | 0,1,1,1,1,1,0.5,0,0,1,0,0,0.5,1,1

8 | 0,0.5,1,1,1,0,0,0,0.5,1,0,0,1,1,1

9 | 0.5,1,1,1,0.5,1,1,0.5,1,1,1,0,0,1,0

10 | 0.5,0,1,0,0.5,0.5,0,0,0,1,1,0,0,1,1

11 | 1,0,0,1,0,1,1,1,1,1,1,1,0,1,1

12 | 1,0,1,1,1,1,0,0,0,1,1,1,0,1,1

13 | 0.5,0,0.5,0,0.5,0,1,0,1,0.5,1,0,0,1,1

14 | 0.5,0.5,1,1,0.5,0,1,0,0.5,1,0.5,0,0,1,1

15 | 0.5,0.5,1,0,1,0.5,0,0,0,1,0,0,0,1,1

16 | 0,1,1,1,1,1,1,0,0,1,1,0,0,1,1

17 |

--------------------------------------------------------------------------------

/dados/perfil_notas_sem_identificacao.txt:

--------------------------------------------------------------------------------

1 | 'Unid. 1',

2 | 'Unid. 2',

3 | 'Unid. 3',

4 | 'Resultado',

5 | 'Sit.',

6 | 'Qual o seu conhecimento nos tópicos abaixo: [Operadores aritméticos]',

7 | 'Qual o seu conhecimento nos tópicos abaixo: [Estruturas condicionais (if, else, etc.) ]',

8 | 'Qual o seu conhecimento nos tópicos abaixo: [Operadores lógicos]',

9 | 'Qual o seu conhecimento nos tópicos abaixo: [Estruturas de repetição (while, for )]',

10 | 'Qual o seu conhecimento nos tópicos abaixo: [Vetores (Arrays) ]',

11 | 'Qual o seu conhecimento nos tópicos abaixo: [Desenvolvimento de Jogos]',

12 | 'Qual o seu conhecimento nos tópicos abaixo: [HTML]',

13 | 'Qual o seu conhecimento nos tópicos abaixo: [CSS]',

14 | 'Qual o seu conhecimento nos tópicos abaixo: [P5js ]',

15 | 'Qual a sua experiencia em: [C/C++]',

16 | 'Qual a sua experiencia em: [Java]',

17 | 'Qual a sua experiencia em: [JavaScript]',

18 | 'Qual a sua experiencia em: [Python]',

19 | 'Você tem acesso regular a um ambiente computacional no qual possa programar durante a disciplina?',

20 | 'Quanto tempo você disponível para estudar para disciplina por semana? (Em horas) ',

21 | 'Qual a intensidade do seu interesse pela disciplina de Lógica de Programação? ',

22 | 'Qual o tipo de escola você cursou no ensino médio?'

23 |

--------------------------------------------------------------------------------

/dados/alunos_didatico.csv:

--------------------------------------------------------------------------------

1 | Nome,Nota do aluno,,Sexo,Idade,Peso,Altura,IMC,Contagem

2 | Sandra,2,4,Feminino,19,100,1.68,35.4308390022676,Obesidade

3 | Ana,2,4,Feminino,18,92,1.57,37.3240293723883,Obesidade

4 | Maria,4,16,Feminino,19,92,1.78,29.0367377856331,Sobrepeso

5 | Leda ,4,16,Feminino,23,66,1.77,21.0667432730058,Normal

6 | Carla ,6,36,Feminino,36,84,1.9,23.2686980609418,Normal

7 | Rachel,6,36,Feminino,27,67,1.8,20.679012345679,Normal

8 | Ângela,7,49,Feminino,26,66,1.77,21.0667432730058,Normal

9 | Nicole,7,49,Feminino,24,76,1.55,31.633714880333,Obesidade

10 | Lika,7,49,Feminino,22,77,1.88,21.7858759619737,Normal

11 | Otavio,1,1,Masculino,18,66,1.78,20.8307031940412,Normal

12 | Francisco,3,9,Masculino,22,69,1.59,27.2932241604367,Sobrepeso

13 | Rafael,3,9,Masculino,18,104,1.63,39.1433625653958,Obesidade

14 | Antonio,5,25,Masculino,25,93,1.75,30.3673469387755,Obesidade

15 | Roberto ,5,25,Masculino,29,92,1.54,38.7923764547141,Obesidade

16 | Ivan,5,25,Masculino,22,85,1.88,24.0493435943866,Normal

17 | Luiz,6,36,Masculino,51,105,1.77,33.5152733888729,Obesidade

18 | David,6,36,Masculino,22,91,1.76,29.3775826446281,Sobrepeso

19 | Edson,6,36,Masculino,29,104,1.76,33.5743801652893,Obesidade

20 | Paulo,7,49,Masculino,19,81,1.76,26.1492768595041,Sobrepeso

21 | Matheus,9,81,Masculino,25,87,1.9,24.0997229916898,Normal

22 |

--------------------------------------------------------------------------------

/aulas/svm.md:

--------------------------------------------------------------------------------

1 | # Suport Vector Machine (SVM)

2 | * [Slides](https://docs.google.com/presentation/d/19mAI5sjOWURpzuKpoFjbjmCkjUXUysU_kysfbksmVAg/edit?usp=sharing)

3 | * Código:

4 | * [Compra de um produto](https://colab.research.google.com/drive/1gwdc-7YAUDq12wE5TNjuoJ7q1onHET7J?usp=sharing)

5 |

6 | Prática

7 | * Treinar o modelo SVM linear e o modelo SVM RBF com [base de dados de diabetes](https://raw.githubusercontent.com/ect-info/ml/master/dados/diabetes.csv)

8 | * Consultar a documentação https://scikit-learn.org/stable/modules/svm.html#svm

9 | * Mais dados https://www.kaggle.com/datasets

10 |

11 | Material de apoio:

12 | * [Vídeos e Form: SVM](https://docs.google.com/forms/d/e/1FAIpQLSdS3YCo4v5NDzMuHzWKDyX-hb-nf6Pz2XLEM8RXknV6pmjssQ/viewform?usp=sf_link)

13 |

14 | Atividade Avaliativa:

15 | * Treinar o modelo SVM para classificação com a base de dados Titanic. O objetivo é realizar uma predição de quais pessoas sobreviveram ou não a este acidente. Link para a base de dados: https://www.kaggle.com/c/titanic/data

16 |

17 | Material complementar:

18 | * [Vídeo: prática sobre classificação usando SVM](https://youtu.be/R3T4KnYg-tE)

19 | * Códigos:

20 | * [Exempo 1: SVM - compra de um produto](https://colab.research.google.com/drive/1w7Tt9UFngIkEjThnNlYj8Tki6EwVWxeP?usp=sharing)

21 | * [Exempo 2: SVM - compra de um produto](https://colab.research.google.com/drive/1VYmZBcf2FHmz_gwPRxllxwoy0nTaU8X9?usp=sharing)

22 |

23 |

24 |

25 |

--------------------------------------------------------------------------------

/aulas/som.md:

--------------------------------------------------------------------------------

1 | # Rede SOM

2 |

3 | * [Slides](https://docs.google.com/presentation/d/1vGS--E6VbtohvVkUo23GM-0MsL-EMTnxAXKcSHiomLI/edit?usp=sharing)

4 | * Código:

5 | * [SOM - Perfil dos alunos da ECT](https://colab.research.google.com/drive/1_Mo6uSpbQrkRegrR5GeodGeQ5ePUxpak?usp=sharing)

6 |

7 | Material de apoio:

8 | * [Vídeos e Form: Rede SOM](https://docs.google.com/forms/d/e/1FAIpQLSdTb_IhVEJW7LksxXYTBkf-rslxQ_zdywV4AT3bCkJdB1wxjw/viewform?usp=sf_link)

9 |

10 |

11 | Material complementar:

12 | * [Aula prática: introdução à rede SOM - Visualização de Dados](https://youtu.be/-mEn7puBD84)

13 | * [Código](https://colab.research.google.com/drive/1S-aMgBqFe9OgGdjURrWs86l7LaHLRuRJ?usp=sharing)

14 | * [Vídeo: Análise de perfis e desempenho em LoP](https://youtu.be/RFi62fy17tY)

15 | * [Código: Análise de perfis e desempenho em LoP](https://colab.research.google.com/drive/1lVfiGPf1yyDx7Zv_AUrS4o3bgO0E0EzH?usp=sharing)

16 | * [Exemplo de código: visualizar os perfis de alunos da Escola de Ciência e Tecnologia da UFRN](https://colab.research.google.com/drive/1PX9YlNGx_pjgesMsnhyjrXI-nsuJOdWI?usp=sharing)

17 | * Atividade:

18 | * Visualizar os dados de perfis de clientes com uma rede SOM. Exemplo de dados: [Clientes de um supermercado no Kaggle](https://www.kaggle.com/datasets/dev0914sharma/customer-clustering?resource=download&select=segmentation+data.csv) ou [acesso direto](https://raw.githubusercontent.com/ect-info/ml/master/dados/segmentation%20data.csv)

19 |

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/maciel_barbosa.md:

--------------------------------------------------------------------------------

1 | # Reconhecimento de Letras com CNN

2 | ## Introdução

3 |

4 | A equipe é composta apenas por mim.

5 | O objetivo é identificar a letra presente em uma imagem. Para isso foi utilizada uma base de dados composta por 127

6 | exemplos de cada letra, totalizando 3302 imagens.

7 |

8 | ## Metodologia

9 |

10 | O desevolvimento da atividade pode ser dividida em 3 etapas: preparação dos dados, treinamento e teste. Na preparação,

11 | a base de dados é convertida para um formato adequado para o treinamento. No treinamento é definida a configuração da CNN e feita

12 | a compilação do modelo.

13 | No teste é verificado a saída de alguns exemplos.

14 |

15 | ## Códigos

16 |

17 | Definição do modelo:

18 | ```

19 | model = Sequential()

20 | model.add(Conv2D(32, (5,5), input_shape=(28,32,1), activation='relu'))

21 | model.add(MaxPooling2D(pool_size=(2,2)))

22 | model.add(Conv2D(64,(3,3), activation='relu'))

23 | model.add(MaxPooling2D(pool_size=(2,2)))

24 | model.add(Dropout(0.2))

25 | model.add(Flatten())

26 | model.add(Dense(500, activation='relu'))

27 | model.add(Dense(num_classes, activation='softmax'))

28 | model.compile(Adam(lr=0.01), loss='categorical_crossentropy', metrics=['accuracy'])

29 | ```

30 |

31 | ## Experimentos

32 |

33 | Os resultados dos testes não foram satisfatórios. Acredito que seria mais bem sucedido caso houvesse uma melhor distribuição dos

34 | datasets de validação para cada tipo de letra.

35 | ### Base de dados

36 | * Caracteres escritos a mão, https://drive.google.com/open?id=1B4fy3Nqy9AoEnC2MuuPaCstcrJ-FZstW

37 |

38 |

--------------------------------------------------------------------------------

/atividades/2019.2/SOM/SOM_Lucas_Gualberto.md:

--------------------------------------------------------------------------------

1 | # Título do Trabalho

2 |

3 | ## Introdução

4 |

5 | O sistema LOP dispõe de dados de submissões semanais de atividades no sistema por alunos e é em cima dessas submissões

6 | que foi criada a base de dados para essa atividade. O objetivo principal do trabalho com essa base de dados é criar um perfil de aprovação dos alunos por submissão de exercícios, desse forma estimando a porcentagem de aprovação dele de acordo com suas submissões de atividades semanais.

7 |

8 | ## Metodologia

9 |

10 | O modelo de machine learning utilizado para a clusterização dos dados de submissões foi a SOM, self-organizing map. Consiste de uma rede neural não supervisionada que é responsável por criar um mapa dimensionado que descretiza a base de dados e a organiza de forma adequada. A SOM conta com um treinamento a partir de valores de entrada escritos na base de dados. Após o processo de treinamento, ele passará por uma fase de mapeamento, a qual sera responsável por classificar de forma automática a base de dados em neurônios, organizando esses neurônios de forma automática.

11 |

12 | * Explicar o modelo de _machine learning_ (ML) que você está trabalhando.

13 | * Explicar as etapas do treinamento e teste.

14 | * Caso tenha selecionado atributos, explicar a motivação para a seleção de tais atributos.

15 |

16 | ## Códigos

17 |

18 | * Mostrar trechos de códigos mais importantes e explicações.

19 |

20 | ## Experimentos

21 |

22 | * Descrever em detalhes os tipos de testes executados.

23 | * Descrever os parâmentros avaliados.

24 | * Explicar os resultados.

25 |

--------------------------------------------------------------------------------

/dados/milsa.csv:

--------------------------------------------------------------------------------

1 | Funcionario,Est.civil,Inst,Filhos,Salario,Anos,Meses,Regiao

2 | 1,solteiro,1o Grau,NA,4,26,3,interior

3 | 2,casado,1o Grau,1,4.56,32,10,capital

4 | 3,casado,1o Grau,2,5.25,36,5,capital

5 | 4,solteiro,2o Grau,NA,5.73,20,10,outro

6 | 5,solteiro,1o Grau,NA,6.26,40,7,outro

7 | 6,casado,1o Grau,0,6.66,28,0,interior

8 | 7,solteiro,1o Grau,NA,6.86,41,0,interior

9 | 8,solteiro,1o Grau,NA,7.39,43,4,capital

10 | 9,casado,2o Grau,1,7.59,34,10,capital

11 | 10,solteiro,2o Grau,NA,7.44,23,6,outro

12 | 11,casado,2o Grau,2,8.12,33,6,interior

13 | 12,solteiro,1o Grau,NA,8.46,27,11,capital

14 | 13,solteiro,2o Grau,NA,8.74,37,5,outro

15 | 14,casado,1o Grau,3,8.95,44,2,outro

16 | 15,casado,2o Grau,0,9.13,30,5,interior

17 | 16,solteiro,2o Grau,NA,9.35,38,8,outro

18 | 17,casado,2o Grau,1,9.77,31,7,capital

19 | 18,casado,1o Grau,2,9.8,39,7,outro

20 | 19,solteiro,Superior,NA,10.53,25,8,interior

21 | 20,solteiro,2o Grau,NA,10.76,37,4,interior

22 | 21,casado,2o Grau,1,11.06,30,9,outro

23 | 22,solteiro,2o Grau,NA,11.59,34,2,capital

24 | 23,solteiro,1o Grau,NA,12,41,0,outro

25 | 24,casado,Superior,0,12.79,26,1,outro

26 | 25,casado,2o Grau,2,13.23,32,5,interior

27 | 26,casado,2o Grau,2,13.6,35,0,outro

28 | 27,solteiro,1o Grau,NA,13.85,46,7,outro

29 | 28,casado,2o Grau,0,14.69,29,8,interior

30 | 29,casado,2o Grau,5,14.71,40,6,interior

31 | 30,casado,2o Grau,2,15.99,35,10,capital

32 | 31,solteiro,Superior,NA,16.22,31,5,outro

33 | 32,casado,2o Grau,1,16.61,36,4,interior

34 | 33,casado,Superior,3,17.26,43,7,capital

35 | 34,solteiro,Superior,NA,18.75,33,7,capital

36 | 35,casado,2o Grau,2,19.4,48,11,capital

37 | 36,casado,Superior,3,23.3,42,2,interior

38 |

--------------------------------------------------------------------------------

/dados/perfil_politico2019.csv:

--------------------------------------------------------------------------------

1 | Apoia privatizações das empresas brasileiras?,Lula deve ser solto,O impeachment de Dilma foi um golpe?,Legalização do aborto,Políticas de ações afirmativas (cotas),A favor da reforma agrária,Todos os brasileiro devem alcançar suas conquistas através da meritocracia,Apoia a legalização do porte de armas,Apoia a redução da maioridade penal,Apoia a laicidade do Estado,Apoia a diminuição do Estado,As Universidades são um gasto público?,A favor do foro privilegiado?,A favor de uma reforma política?,A favor de uma diminuição de regalias para os políticos?

2 | 1,0,0,0.5,1,1,0.5,0.5,1,1,1,0,0,1,1

3 | 0.5,1,1,0.5,1,0.5,1,0,1,1,0.5,0,0,1,1

4 | 1,0,0,1,0.5,0.5,1,1,1,1,1,0,0,0,1

5 | 1,0,1,0,1,1,1,0,0,1,1,0,1,1,1

6 | 0,0,1,0,0,0,1,1,1,1,0,0,0,1,1

7 | 0,1,1,1,1,1,0.5,0,0,1,0,0,0.5,1,1

8 | 0,0.5,1,1,1,0,0,0,0.5,1,0,0,1,1,1

9 | 0.5,1,1,1,0.5,1,1,0.5,1,1,1,0,0,1,0

10 | 0.5,0,1,0,0.5,0.5,0,0,0,1,1,0,0,1,1

11 | 1,0,0,1,0,1,1,1,1,1,1,1,0,1,1

12 | 1,0,1,1,1,1,0,0,0,1,1,1,0,1,1

13 | 0.5,0,0.5,0,0.5,0,1,0,1,0.5,1,0,0,1,1

14 | 0.5,0.5,1,1,0.5,0,1,0,0.5,1,0.5,0,0,1,1

15 | 0.5,0.5,1,0,1,0.5,0,0,0,1,0,0,0,1,1

16 | 0,1,1,1,1,1,1,0,0,1,1,0,0,1,1

17 | 1,0,0,0,0.5,0.5,0.5,1,1,0.5,1,1,0,1,1

18 | 0.5,0,0,1,0,1,1,0,1,1,0.5,0,0,1,1

19 | 0.5,0,0,0.5,0.5,0.5,0.5,0,0,1,0.5,0,0,1,1

20 | 0,0.5,1,1,0.5,1,0,0,1,1,0.5,0.5,0,1,1

21 | 1,0.5,0.5,1,0,1,1,0,1,0,1,0.5,0.5,1,1

22 | 0.5,0.5,1,0.5,1,1,1,0,0,0.5,0.5,0,0,1,1

23 | 1,0,0,0,0,0,0.5,1,1,1,1,1,0,1,1

24 | 0.5,0.5,1,1,1,0.5,0.5,0,0,1,0.5,0,0,1,1

25 | 0.5,0.5,1,0,1,1,1,0,0,1,0.5,0,0,1,1

26 | 0.5,0,0.5,0,1,0.5,1,0.5,0.5,1,0.5,0,0,1,1

27 | 0.5,0.5,1,1,1,1,0,0.5,0,1,0.5,0,0,1,1

28 | 0.5,0,1,1,0,0,1,0.5,1,1,1,0,0,1,1

29 | 0.5,0,0.5,0.5,1,0.5,0,0,0,1,1,0,0,1,1

30 | 0,1,1,1,1,1,0,0,0,1,0.5,1,0,1,1

31 | 0,0,0,0,1,1,1,0,0,1,1,0,1,1,0

32 | 0.5,1,1,1,1,0.5,0.5,0,1,1,0.5,0.5,0,0.5,0.5

33 | 1,1,1,1,1,1,0,1,1,1,1,1,0,1,1

34 |

--------------------------------------------------------------------------------

/aulas/k_means.md:

--------------------------------------------------------------------------------

1 | # K-Means

2 | * [Slides](https://docs.google.com/presentation/d/1hzeAFwgHNZ7pr_POzd4_2lXUgOz_vrVfuhjxl6tbBCs/edit?usp=sharing)

3 | * Código:

4 | * [Exemplo de código: perfil de clientes de uma loja](https://colab.research.google.com/drive/1kyYG9ojYsTvCKj5X9hn4o6mve4RJjBv5?usp=sharing)

5 |

6 | Material de Apoio:

7 | * [Vídeos e Form: K-Means](https://docs.google.com/forms/d/e/1FAIpQLSfyv1LTd_h0bkniJdy5Zq4Y4oFkqTVQrRVY0MZo8PsvcUzhhQ/viewform?usp=sf_link)

8 |

9 | Exemplo de código com PCA

10 | * [Visualização de metricas do LoP em duas dimensões](https://colab.research.google.com/drive/15uTd1w8uIxpUgQYYGLmaIL33eum6Yjez?usp=sharing)

11 |

12 | Material complementar

13 | * [Aula prática: introdução ao K-Means - Agrupamento](https://youtu.be/t_107z0RHF8)

14 | * [Exemplo de código: perfil de clientes de uma loja](https://colab.research.google.com/drive/15Q-gTih7v2f5pYc64xQa2ytzX2gisX0q?usp=sharing)

15 | * [Código](https://colab.research.google.com/drive/1nc5RD1wMHvROPILgdJVT2GSzwbscLLsw?usp=sharing)

16 |

17 | Atividade Avaliativa

18 | * Analisar os perfis dos estudantes em relação aos atributos de uma lista de exercícios de Lógica de Programação. Baixar a base de dados com as métricas dos alunos [aqui](https://raw.githubusercontent.com/ect-comp/ml/refs/heads/master/dados/metricas_lop.csv).

19 |

20 | Exercícios:

21 | * Escolher uma base de dados para agrupamentos, usar o k-means, e analizar os valores dos centroids

22 | * Sugestões de base de dados:

23 | * [Customer Segmentation: Clustering](https://www.kaggle.com/code/karnikakapoor/customer-segmentation-clustering/input)

24 | * [Customer Clustering](https://www.kaggle.com/datasets/dev0914sharma/customer-clustering?resource=download&select=segmentation+data.csv)

25 | * [Customer segmentation data](https://raw.githubusercontent.com/ect-info/ml/master/dados/customer%20segmentation%20data.csv)

26 |

27 |

28 |

--------------------------------------------------------------------------------

/aulas/nlp.md:

--------------------------------------------------------------------------------

1 | # Processamento de Linguagem Natural (NLP)

2 |

3 | * [Slides](https://docs.google.com/presentation/d/1yFBohFjlsk-O7Rw7YthMVi3nji1zFHYwLQRUZfLv31c/edit?usp=sharing)

4 | * Código:

5 | * [Classificação de texto](https://colab.research.google.com/drive/1kr7KWB_AKYmNT3Pm7IDbzqNcVKGTAFiX?usp=sharing)

6 | * [Introdução a análise de sentimentos](https://colab.research.google.com/drive/19lgWm2qyeX03VIBz4iQzzuUDZstNNTEy?usp=sharing)

7 | * Exercícios

8 | * [Classificação de texto](https://colab.research.google.com/drive/1I4Dhj-EislPdN-ZgvZwjAEclkRFtHdg-?usp=sharing)

9 | * [Introdução a análise de sentimentos.](https://colab.research.google.com/drive/19cDYZi77FHbpiNnedccFlgOsxgxMo14M?usp=sharing)

10 |

11 | Material de apoio:

12 | * [Form e vídeos](https://docs.google.com/forms/d/e/1FAIpQLSc6vVpLZgcoxq-zaJ12TJI1_6OkzCDhzVQAhoI3_5oioIfDPw/viewform?usp=sf_link)

13 |

14 | Material complementar

15 | * [Aula prática - parte 1: Introdução à Processamento de Linguagem Natural](https://youtu.be/ZnGC0tQLjNM)

16 | * [Código](https://colab.research.google.com/drive/1otpdkZhfhBwJrU6jD8pvtQAzzsrn-lGo?usp=sharing)

17 | * [Aula prática - parte 2: Introdução à Processamento de Linguagem Natural](https://youtu.be/gcbeEvpwCZ0)

18 | * [Código](https://colab.research.google.com/drive/1eJRivNcV_ZdqJqEoX9WhcnusV2-sRKm1?usp=sharing)

19 | * [Introdução de Processamento de Linguagem Natural e Análise de Sentimentos](https://youtu.be/-ZsiDKXGk84)

20 | * [Código para avaliações de restaurantes](https://colab.research.google.com/drive/1n80Us6FJZ74XyYIyl8iiqbSyIBapk9Yj?usp=sharing)

21 | * [Código para análise de opiniões no site da amazon](https://colab.research.google.com/drive/1Mx9KAPHeDC3jWJaJbdRYmXtsUFmzlvHS?usp=sharing)

22 | * [Código sobre treinamento de um classificador de texto usando "Embeddings"](https://colab.research.google.com/github/google/generative-ai-docs/blob/main/site/en/gemini-api/tutorials/text_classifier_embeddings.ipynb)

23 |

--------------------------------------------------------------------------------

/cronograma_2020_2.md:

--------------------------------------------------------------------------------

1 | # Cronograma 2020.2

2 |

3 | | Data | Semana | Aula | Conteúdo |

4 | |---| --- |---|---|

5 | | 19/01 | Sem 1 | Aula 1 | Apresentação e Planejamento |

6 | | 21/01 | Sem 1 | Aula 2 | Introdução à _Machine Learning_ e AM - Supervisionados |

7 | | 21/01 | Sem 1 | Aula 3 | Regressão linear |

8 | | 26/01 | Sem 2 | Aula 4 | Atividade 1: Prever o lucro de uma startup |

9 | | 28/01 | Sem 2 | Aula 5 | MultiLayer Perceptron |

10 | | 02/02 | Sem 3 | Aula 6 | Atividade 2: Previsão de compra de um produto |

11 | | 04/02 | Sem 3 | Aula 7 | SVM |

12 | | 09/02 | Sem 4 | Aula 8 | Atividade 2: Previsão de compra de um produto |

13 | | 11/02 | Sem 4 | Aula 9 | Deep Learning |

14 | | 16/02 | Sem 5 | Aula 10 | *Carnaval* |

15 | | 18/02 | Sem 5 | Aula 11 | AM - Não supervisionados |

16 | | 23/02 | Sem 6 | Aula 12 | Atividade 3: Reconhecimento de dígitos escritos a mão |

17 | | 25/02 | Sem 6 | Aula 13 | K-Means |

18 | | 02/03 | Sem 7 | Aula 14 | Atividade 4: Perfil de clientes de uma loja |

19 | | 04/03 | Sem 7 | Aula 15 | SOM |

20 | | 09/03 | Sem 8 | Aula 16 | Atividade 5: Análise de perfil de estudantes |

21 | | 11/03 | Sem 8 | Aula 17 | SOM |

22 | | 16/03 | Sem 9 | Aula 18 | Atividade 5: Análise de perfil de estudantes |

23 | | 18/03 | Sem 9 | Aula 19 | Rede Convolucional |

24 | | 23/03 | Sem 10 | Aula 20 | Atividade 6: Reconhecimento de faces |

25 | | 25/03 | Sem 10 | Aula 21 | Rede Convolucional |

26 | | 30/03 | Sem 11 | Aula 22 | Atividade 6: Reconhecimento de faces |

27 | | 01/04 | Sem 11 | Aula 23 | Processamento de Linguagem Natural |

28 | | 06/04 | Sem 12 | Aula 24 | Atividade 7: Sistema de perguntas e respostas |

29 | | 08/04 | Sem 12 | Aula 25 | Processamento de Linguagem Natural |

30 | | 13/04 | Sem 13 | Aula 26 | Atividade 7: Sistema de perguntas e respostas |

31 | | 15/04 | Sem 13 | Aula 27 | Projeto Final |

32 | | 20/04 | Sem 14 | Aula 28 | Projeto Final |

33 | | 22/04 | Sem 14 | Aula 29 | Projeto Final |

34 | | 27/04 | Sem 15 | Aula 30 | Projeto Final |

35 | | 29/04 | Sem 15 | Aula 31 | Projeto Final |

36 |

37 |

--------------------------------------------------------------------------------

/aulas/mlp.md:

--------------------------------------------------------------------------------

1 | # Multilayer Perceptron (MLP)

2 | * [Slides: MLP](https://docs.google.com/presentation/d/1oIzH-SNbJ3_4vYZdt_IZQi3537BUJKsvio_oV8c8Bnc/edit?usp=sharing)

3 | * Exercício

4 | * [Código com Perceptron de Sklearn - Dígitos](https://colab.research.google.com/drive/1eppuqhaH3qa09_I_IiYbz2ftpAMbQKn5?usp=sharing)

5 | * [Código com MLP - Íris](https://colab.research.google.com/drive/1y0tUhGB3cwWMdMOO9Z5_5OG0gGXNJHq1?usp=sharing)

6 |

7 | * Base de dados:

8 | * [Flor de íris](https://raw.githubusercontent.com/ect-info/ml/master/dados/Iris.csv)

9 |

10 | Exercício de demonstração:

11 | * [Exemplo MLP - Compra de um produto](https://colab.research.google.com/drive/1wR1xoQGDrgDUysDqWkhVdvNj-qluo2pk?usp=sharing)

12 | * Mais dados https://www.kaggle.com/datasets

13 |

14 | Material de apoio:

15 | * [Vídeos e Form: MLP parte 1](https://docs.google.com/forms/d/e/1FAIpQLSc_kQ1w4tnsrRjPsS56jOKZ7Bb1ZwN0bOAEwVRW0pKBWtyZkQ/viewform?usp=sf_link)

16 | * [Vídeos e Form: MLP Parte 2](https://docs.google.com/forms/d/e/1FAIpQLSdFS64t1TlAq9mYtgx6JAi_-XoplMcY0Hj2xc1dub8riXWFTA/viewform?usp=sf_link)

17 | * [Vídeo: Construindo e treinando uma rede MLP simples com keras e tensorflow](https://youtu.be/qyMO5UHLgs4)

18 |

19 | Material complementar:

20 | * Vídeos:

21 | * [RNA - Construindo um Perceptron](https://youtu.be/uTi0O3tjdSM)

22 | * [Classificação dados com aprendizado de máquina](https://youtu.be/_p8Mbe75ZLk)

23 | * [Exemplo comparando a resposta de um modelo linear e outro não-linear](https://youtu.be/YFkVERllgAQ)

24 |

25 | * Códigos:

26 | * [Exemplo de perceptron](https://colab.research.google.com/drive/1jbFCvifaAou19mlu2pI3Rso8DoMow_zl?usp=sharing)

27 |

28 | Exercício extra:

29 | * Treinar uma rede MLP para a [base de dados de diabetes](https://raw.githubusercontent.com/ect-info/ml/master/dados/diabetes.csv)

30 |

31 | Atividade avaliativa:

32 | * Treinar uma rede MLP com a [base de dados para predição de doença cardíaca da UCI](https://raw.githubusercontent.com/ect-comp/ml/refs/heads/master/dados/heart_disease_uci.csv). Nesta tarefa o estudante está livre para escolher a arquitetura da rede MLP, mas a sugestão é escolher uma arquitetura mais simples, pois esta base de dados é muito pequena. Os atributos podem ser escolhido conforme o critério do estudante.

33 |

34 |

--------------------------------------------------------------------------------

/atividades/2019.2/CharRec/Identificação de letras usando Multilayer Perceptron - Lucas Gualberto.md:

--------------------------------------------------------------------------------

1 | # Identificação de letras usando Multilayer Perceptron (MLP)

2 |

3 | ## Introdução

4 |

5 | A base de dados utilizada para esse trabalho é composta de 117 imagens de cada letra do alfabeto da língua portuguesa.

6 | O objetivo principal de utilização dessa base de dados é identificar, dada uma letra qualquer, que letra do alfabeto

7 | a imagem fornecida contém.

8 |

9 | ## Metodologia

10 |