/bin$:./sample_mnist

83 |

84 | ---------------------------

85 | @@@@@@@@@@@@@@@@@@@@@@@@@@@@

86 | @@@@@@@@@@@@@@%.-@@@@@@@@@@@

87 | @@@@@@@@@@@*- %@@@@@@@@@@

88 | @@@@@@@@@@= .-. *@@@@@@@@@@

89 | @@@@@@@@@= +@@@ *@@@@@@@@@@

90 | @@@@@@@@* =@@@@ %@@@@@@@@@@

91 | @@@@@@@@..@@@@% @@@@@@@@@@@

92 | @@@@@@@# *@@@@- @@@@@@@@@@@

93 | @@@@@@@: @@@@% @@@@@@@@@@@

94 | @@@@@@@: @@@@- @@@@@@@@@@@

95 | @@@@@@@: =+*= +: *@@@@@@@@@@

96 | @@@@@@@*. +@: *@@@@@@@@@@

97 | @@@@@@@@%#**#@@: *@@@@@@@@@@

98 | @@@@@@@@@@@@@@@: -@@@@@@@@@@

99 | @@@@@@@@@@@@@@@+ :@@@@@@@@@@

100 | @@@@@@@@@@@@@@@* @@@@@@@@@@

101 | @@@@@@@@@@@@@@@@ %@@@@@@@@@

102 | @@@@@@@@@@@@@@@@ #@@@@@@@@@

103 | @@@@@@@@@@@@@@@@: +@@@@@@@@@

104 | @@@@@@@@@@@@@@@@- +@@@@@@@@@

105 | @@@@@@@@@@@@@@@@*:%@@@@@@@@@

106 | 0:

107 | 1:

108 | 2:

109 | 3:

110 | 4:

111 | 5:

112 | 6:

113 | 7:

114 | 8:

115 | 9: **********

116 | ```

117 |

118 | 注: 如果 download_pgms.py 下载数据失败,手动下载完成后,修改 download_pgms.py 将原有np.fromstring为np.fromfile,相应的 urllib.request.urlopen() 改为 open(' ', 'rb')。

119 |

120 | 若输出与上述一致, 则证明安装成功。

121 |

122 |

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/8.3.2 TensorRT加速原理.md:

--------------------------------------------------------------------------------

1 | # TensorRT加速原理

2 |

3 | ## 一、加速的必要性

4 |

5 |

6 |

7 |

图1. Training VS Inference

9 |

10 | 如上图所示,训练(training)是双向运算,而推理(inference)为单向运算。为了提高训练速度,会使用多GPU分布式训练;而部署推理时,为了降低成本,往往使用单个GPU机器或嵌入式平台(比如 NVIDIA Jetson)进行部署;在实际项目中,一个项目可能会使用多个模型,而模型使用的框架也不能确保统一化。

11 |

12 | **使用TensorRT加速最直接的效果如下:**

13 |

14 | - 加快推理速度,降低延迟。

15 | - 推理框架统一化,方便部署。

16 |

17 | ## 二、优化原理

18 |

19 |

20 |

21 |

图2. 优化原理

23 |

24 | TensorRT优化方法主要有以上5种方法,接下来重点介绍前两种:

25 |

26 | ### (一)层间融合或张量融合(Layer & Tensor Fusion)

27 |

28 |

29 |

30 |

图3. GoogLeNetInception

32 |

33 | 上图是GoogLeNetInception模块的计算图,首先input后会有多个卷积,卷积完后有Bias和ReLU,结束后将结果concat(连接拼接)到一起,得到下一个input。

34 |

35 |

36 |

37 |

图4. 层间融合

39 |

40 | **优化内容:**

41 |

42 | - 纵向合并:首先是convolution, Bias和ReLU这三个操作可以合并成CBR,只占用一个CUDA核心,依次合并得到图1,其中包含四个1×1的CBR,一个3×3的CBR和一个5×5的CBR。

43 | - 横向合并:合并三个相连的1×1的CBR为一个大的1×1的CBR,也只占用一个CUDA核心,得到图2。

44 | - 消除concat层:直接连接到下一层的next input,减少传输吞吐,得到图3。

45 | - 并发(Concurrency:如下图左半部分(max pool和1×1 CBR)与右半部分(大的1×1 CBR,3×3 CBR和5×5 CBR)彼此之间是相互独立的两条路径,本质上是不相关的,可以在GPU上通过并发来做,来达到的优化的目标。

46 |

47 | ### (二)数据精度校准(Weight &Activation Precision Calibration)

48 |

49 | PyTorch、TensorFlow 、MxNet等现有的深度学习框架,训练时多采用 Float 32(简称 FP32)的精度来表示权值、偏置、激活值等;由于部署推理不需要反向传播,可以适当降低数据精度,如降为FP16或INT8的精度, 以此来减少计算量以及提升推理速度,同时压缩模型体积。

50 |

51 | 由于INT8只有256个不同的数值,使用INT8来表示 FP32精度的数值会丢失信息,造成性能下降。为此,TensorRT提供自动化校准(Calibration ),以最好的匹配性能将FP32精度的数据降低为INT8精度,最小化性能损失。具体流程如下:

52 |

53 |

54 |

55 |

图5. 数据精度校准步骤

57 |

58 | **下表为不同精度的动态范围:**

59 |

60 |

61 |

62 |

图6. 动态范围

64 |

65 | 由上图对比可以看出,INT8 和 FP32 表示范围相差很大。需要最小化该转换过程的信息损失,TensorRT 采用是简单有效的线性量化的转换方式,表示为:

66 |

67 | **Tensor Values = FP32 scale factor * int8 array + FP32 bias**

68 |

69 | Nvidia 研究证明偏置项可以去掉,即:

70 |

71 | **Tensor Values = FP32 scale factor * int8 array**

72 |

73 |

74 |

75 |

图7. 偏置项截断

77 |

78 | 如何确定**scale factor**的值 ?

79 |

80 | 最简单的方式如上图左,将**FP32 tensor**值中的 **–|max|** 和 **|max|**映射为 **INT8** 对应的**-127 和 127**,中间值按照线性关系进行映射,该方法也被称为**不饱和(No saturation)映射**。但实验表明,该方法精度损失很大。

81 |

82 | 因此,产生了**饱和 (saturate) 映射**的方式(上图右):

83 |

84 | 相对于非饱和映射,不直接将两端的 ±|max|值映射到±127,而是选取一个阈值|T|, 将 ±|T| 映射为±127,其中 |T| < |max|。在 [ -|T|, |T| ] 区间外的值直接映射为 ±127,如上图右直接将三个红色 x 点映射为 -127, 而在 [ -|T|, |T| ] 区间内的按照线性映射的方式。

85 |

86 | **TensorRT 开发者通过实验表明,权重 ( weights ) 采用非饱和映射,激活值采用饱和映射的方式相对全使用饱和映射效果会更好。**

87 |

88 | **Why?Why?**

89 |

90 |

91 |

92 |

图8. resnet-152 网络模型中间层的激活值统计

94 |

95 | 首先来看上图左,该图是 resnet-152 网络模型中间层的激活值统计,横坐标是激活值,纵坐标是统计数量的归一化表示。

96 |

97 | 可以看到,白线左边的激活值分布比较集中,白线(该线对应的就是阈值 T 线)右边的激活值比较分散,这部分激活值在整个层中所占的比例比较少,因此这部分可以不考虑到映射关系中。非饱和映射使有效值硬合并,降低了表达效果。

98 |

99 | T 值需要满足 FP32 到 INT8 转换信息损失最小化,即 KL 散度(也叫做相对熵)最小化:

100 |

101 |

102 |

103 |

图9. KL 散度

105 |

106 | 其中 P,Q 分别表示 FP32 和 INT8 模式下的分布,每一层 tensor 对应的 T 值都是不同的,而确定 T 值的过程被称为校准(Calibration)。

107 |

108 | ## 三、计算过程

109 |

110 |

111 |

112 |

125 |

126 |

图11. 准确率

128 |

129 |

130 |

131 |

图12. 速度

133 |

134 | 如上图Accuracy所示,经过校准的 INT8 推理相对于 FP32 推理,准确率(Accuracy)有略微的损失,部分情况下INT8 推理相比 FP32 推理准确率有略微提升(图中绿色所示)。Performance表明,一定范围内,Batch Size 越大,加速效果越好。

135 |

136 |

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.1.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.1.1.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.1.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.10.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.10.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.11.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.11.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.12.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.12.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.2.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.3.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.4.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.5.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.6.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.7.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.7.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.8.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.8.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.9.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.2.9.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.1.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.2.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.3.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.4.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.3 TensorRT加速/imgs/7.3.3.5.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.3 TensorRT加速/readme.md:

--------------------------------------------------------------------------------

1 | # 7.3 TensorRT加速

2 |

3 | TensorRT是一个高性能的深度学习推理(Inference)优化器,可以为深度学习应用提供低延迟、高吞吐率的部署推理。TensorRT可用于对超大规模数据中心、嵌入式平台或自动驾驶平台进行推理加速。TensorRT现已能支持TensorFlow、Caffe、Mxnet、Pytorch等几乎所有的深度学习框架,将TensorRT和NVIDIA的GPU结合起来,能在几乎所有的框架中进行快速和高效的部署推理。

4 |

5 | TensorRT 是一个C++库,从 TensorRT 3 开始提供C++ API和Python API,主要用来针对 NVIDIA GPU进行 高性能推理(Inference)加速。

--------------------------------------------------------------------------------

/ch08_工具/8.4 SNPE/8.4.1 Snapdragon NPE Runtime.md:

--------------------------------------------------------------------------------

1 | # **Snapdragon NPE Runtime**

2 |

3 | **Overview**

4 |

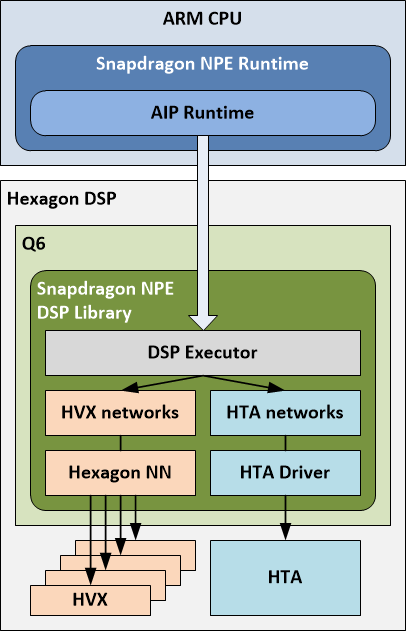

5 | 以下是SNPE软硬件架构的总览图,图中详细介绍了SNPE运行时涉及到的软件和硬件层,包括Runtime Library和常用后端,以及一些简单的硬件实现。

6 |

7 |

8 |

9 | 软件层功能主要包括 :

10 |

11 | **DL Container Loader :** 主要涉及从训练框架到DLC目标格式的转换器,该转换器部分由python实现,可以修改模型转换的逻辑;

12 |

13 | **Model Validation :** 校验模型是否支持,具体可以查看 [SNPE Layer 支持列表](https://developer.qualcomm.com/sites/default/files/docs/snpe/network_layers.html#network_layers),该列表在某些版本中与转换器的支持列表有出入,可以查看python代码确认;

14 |

15 | **Runtime Engine :** 推理引擎,其中内置了Profiling功能,可以在网络初始化时打开,输出的报告可以通过自带的解析器进行解析;UDL或UDO功能,是官方提供的扩展SNPE推理支持的方式,类似于TensorRT中Plugin的概念,可以基于Hexagon SDK进行开发;

16 |

17 | **Partitioning Logic :** 这是一个比较复杂的逻辑,可以简单将它理解为一个“回退”机制:在网络初始化阶段,SNPE允许输入一个backend列表,按照列表中的优先级顺序从高到低地选择网络跑在哪一个后端,当第一优先级后端对网络中某个层不支持的时候,SNPE会尝试将这个层回退到更低优先级的后端。这种做法增加了网络的支持范围,但引入了性能的损耗;

18 |

19 | 硬件层或硬件后端主要包括:

20 |

21 | **CPU Runtime**: 使网络运行在骁龙CPU上,支持FP32/INT8精度模式;

22 |

23 | **GPU Runtime**: 使网络运行在Adreno GPU上,支持FP32/FP16以及a32w16的混合精度模式;

24 |

25 | **DSP Runtime**: 使网络运行在Hexagon DSP上,支持INT8精度模式;图中的Q6是一个软件概念,对应DSP上的神经网络实现,HVX对应硬件的向量计算单元;

26 |

27 | **AIP Runtime**: 使网络运行在Hexagon DSP和CPU的混合模式上,官方称为HTA,支持INT8或a16w8精度模式,需要注意的是,HTA仅在特定硬件上存在,例如:SP855/SP865/XR2。

--------------------------------------------------------------------------------

/ch08_工具/8.4 SNPE/8.4.2 AIP Runtime.md:

--------------------------------------------------------------------------------

1 | # **AIP Runtime**

2 |

3 |

4 |

5 | **概述**

6 |

7 | AIP (AI Processor) Runtime 是 Q6、HVX 和 HTA 的软件抽象,用于跨这三个处理器执行模型。用户将模型加载到 Snapdragon NPE 并选择 AIP Runtime 作为目标后,将在 HTA 和 HVX 上运行模型的部分,由 Q6 进行协调。**注意**:要在 HTA 上执行模型的部分,需要对模型进行离线分析,并将相关部分的二进制文件嵌入 DLC 中。有关详细信息,请参见[添加 HTA 部分](https://developer.qualcomm.com/sites/default/files/docs/snpe/hta_support.html)。

8 |

9 | Snapdragon NPE 在 DSP 上加载一个库,该库与 AIP Runtime 通信。该 DSP 库包含一个执行器(管理 HTA 和 HVX 上的模型执行),用于在 HTA 上运行子网的 HTA 驱动程序以及用于使用 HVX 运行子网的 Hexagon NN。

10 |

11 | 执行器使用模型描述,其中还包含分区信息-描述模型的哪些部分将在 HTA 上运行,哪些部分将在 HVX 上运行。下面称分区的部分为"子网"。

12 |

13 | DSP 执行器在各自的核心上执行子网,并根据需要协调缓冲区交换和格式转换以返回适当的输出到运行在 ARM CPU 上的 Snapdragon 运行时(包括必须的dequantization)。

14 |

15 | # 在 AIP Runtime 上执行模型

16 |

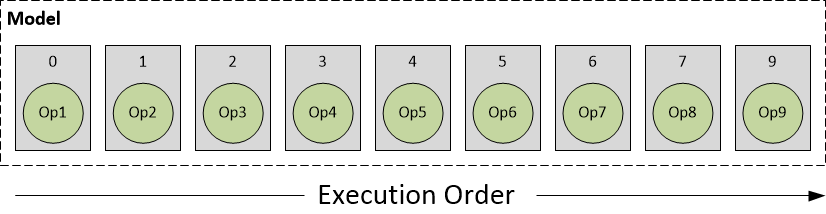

17 | 让我们使用以下模型的说明性示例,该模型嵌入在由 Snapdragon NPE snpe-*framework*-to-dlc 转换工具之一创建的 DL Container 中。

18 |

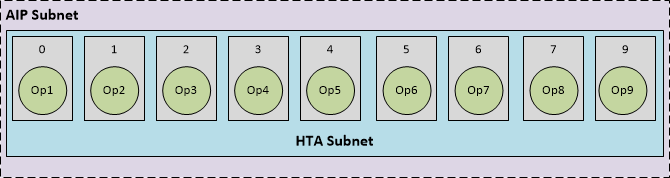

19 | - 圆圈表示模型中的操作

20 | - 矩形表示包含和实现这些操作的层

21 |

22 |

23 |

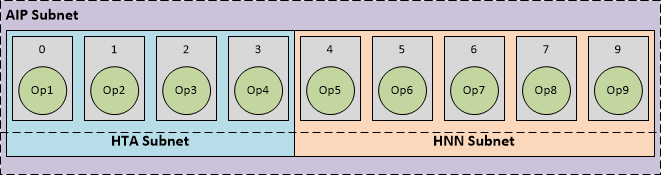

24 | 顶层 Snapdragon NPE 运行时根据层亲和性将模型的执行分解为在不同核心上运行的子网。

25 |

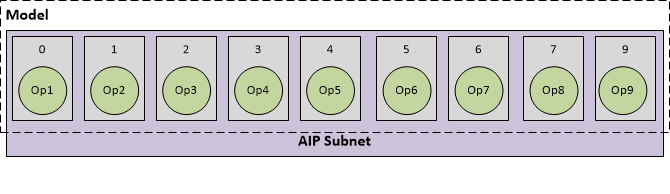

26 | 其中一个情况可能是整个网络都使用 AIP 运行时一起执行,如下所示:

27 |

28 |

29 |

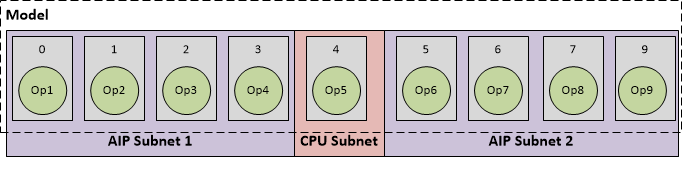

30 | 或者,Snapdragon NPE 运行时可能会创建多个分区-其中几个分区在 AIP 运行时上执行,其余分区则回退到 CPU 运行时,如下所示:

31 |

32 |

33 |

34 | Snapdragon NPE 运行时将自动添加 CPU 运行时以执行其余部分被识别为回退到 CPU 的部分。

35 |

36 | 让我们使用上面的示例更仔细地检查 AIP 运行时的执行,其中整个模型都使用 AIP 作为参考进行执行。

37 |

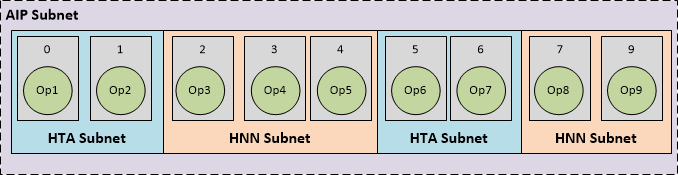

38 | AIP Runtime 进一步将 AIP 子网分解为以下内容:

39 |

40 | - HTA 子网:由 HTA 编译器编译的子网的部分,其 HTA 编译器生成的元数据出现在 DLC 的 HTA 部分中。

41 | - HNN 子网:其余可以使用 Hexagon NN 库在 DSP 上运行子网的子网,其元数据出现在 DLC 的 HVX 部分中。

42 |

43 | 在 AIP 运行时进行分区可能会产生几种可能的组合。下面是一些代表性的情况:

44 |

45 | **A. AIP 子网可以完全在 HTA 上运行**

46 |

47 |

48 |

49 | 在这种情况下,整个 AIP 子网与 HTA 兼容。将 DLC 加载到 Snapdragon NPE 并选择 AIP 运行时后,运行时识别到有一个 HTA 部分,其中包含一个等于整个 AIP 子网的单个 HTA 子网。

50 |

51 | **B. AIP 子网的部分可以在 HTA 上运行,其余部分可以在 HNN 上运行**

52 |

53 |

54 |

55 | 在某些情况下,整个 AIP 子网可能无法在 HTA 上处理。在这种情况下,HTA 编译器仅为网络中的较小一部分层生成 HTA 部分。或者,用户可能希望通过向 snpe-dlc-quantize 工具提供其他选项来手动分区网络,以选择他们希望在 HTA 上处理的子网(了解有关将网络分区为 HTA 的信息,请参见**[添加 HTA 部分](https://developer.qualcomm.com/sites/default/files/docs/snpe/hta_support.html)**)。在这两种情况下,HTA 编译器成功处理了较小的 HTA 子网,并嵌入了 DLC 中的相应 HTA 部分。将 DLC 加载到 Snapdragon NPE 并选择 AIP 运行时后,运行时识别到有一个 HTA 部分,其中包含一个仅覆盖 AIP 子网的一部分的单个 HTA 子网,以及其余部分可以使用 Hexagon NN 运行。

56 |

57 | **C. AIP 子网被分成多个分区**

58 |

59 |

60 |

61 | 作为前面情况的扩展,可能会发现离线 HTA 编译器只能处理已识别的 AIP 子网的某些部分,从而使其余部分由多个 HNN 子网覆盖,如上所示。或者,用户可能希望通过向 snpe-dlc-quantize 工具提供其他选项来手动分区网络,以将网络分成多个 HTA 子网(了解有关将网络分区为 HTA 的信息,请参见[添加 HTA 部分](https://developer.qualcomm.com/sites/default/files/docs/snpe/hta_support.html))。

--------------------------------------------------------------------------------

/ch08_工具/8.4 SNPE/imgs/7.4.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/8.4 SNPE/imgs/7.4.1.jpg

--------------------------------------------------------------------------------

/ch08_工具/8.4 SNPE/readme.md:

--------------------------------------------------------------------------------

1 | # 特性介绍

2 |

3 | SNPE(Snapdragon Neural Processing Engine),是一个在高通骁龙系列芯片上进行神经网络推理的框架,SNPE toolkit包含的主要功能或特性有:

4 |

5 | - 端侧网络推理,支持的后端包括骁龙CPU,Adreno GPU以及Hexagon DSP;

6 | - x86 Ubuntu Linux主机端调试,仅支持CPU;

7 | - 多种训练框架格式转换到SNPE DLC(Deep Learning Container)格式用于模型推理,支持Caffe,Caffe2,ONNX,TensorFlow和PyTorch;

8 | - 模型定点量化功能,主要用于Hexagon DSP相关后端的推理;

9 | - 针对模型推理阶段的分析和调试工具;

10 | - 可通过C++/Java接口,将神经网络推理功能集成到可执行程序或Android APP中。

11 |

12 | 下图展示了基于SNPE部署网络的workflow:

13 |

14 |

15 |

16 |

图1. SNPE workflow

18 |

19 | 该workflow可以简单概括为以下步骤:首先,选择一个SNPE支持转换模型的框架,经过训练/测试等步骤后,输出待部署的模型;然后,将该模型转换到SNPE推理所需的DLC模式,如果需要在DSP/AIP后端硬件上进行推理,则需要额外对模型进行一次量化,或在推理阶段选择在线量化;最后,在运行时指定预设的后端,给模型输入数据,进行网络推理。

20 |

21 | 以下是针对SNPE/AIP更详细的介绍:

22 |

23 | [Snapdragon NPE Runtime](./7.4.1%20Snapdragon%20NPE%20Runtime.md)

24 |

25 | [AIP Runtime](./7.4.2%20AIP%20Runtime.md)

--------------------------------------------------------------------------------

/ch08_工具/modify_log.txt:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch08_工具/modify_log.txt

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/9.1.1 路径以及运动规划算法.md:

--------------------------------------------------------------------------------

1 | # 路径以及运动规划算法

2 |

3 | 有关路径规划介绍请参考[这里](../../ch05_%E7%AD%96%E7%95%A5%E8%A7%84%E5%88%92/),简单来说,场景越复杂,路径以及运动规划更难,当前很多智能驾驶的使用场景基本都在高速环路等半封闭的场景。

4 |

5 | 此次特斯拉AI DAY分享了自动驾驶最难的场景之一,也是最考验路径规划的场景---拥堵十字路口,前方道路有行人横穿和行车占道通行的情况下,路径以及运动规划如何进行安全舒适的无保护左转,场景如下图1所示:

6 |

7 |

8 |

9 |

10 |

11 |

12 | 图1. 拥堵十字路口

13 |

14 | 遇到上图1所示场景,一般处理的方式有:

15 |

16 | - 坚持自己的路径,让其他车辆,行人等交通参与者让自己。

17 | - 在行人和汽车等交通参与者中间找到空隙行驶。

18 | - 礼让汽车和行人,等他们走了,再走。

19 |

20 | 相对应的运算步骤如下:

21 |

22 | (1)对当前场景下所有交通参与者进行运动轨迹预测;

23 |

24 | (2)基于各个轨迹的成本以及约束进行计算;

25 |

26 | (3)让本车以及其他交通参与者的运动轨迹进行交互。

27 |

28 | 特斯拉表示这个运算过程大概耗时10ms,一般一个拥堵的十字路口左转场景,会有超过20个交互相关的交通参与者,有超过100种交互相关组合,那么目标路径规划时间大概是50ms。

29 |

30 | **特斯拉FSD交互搜索算法(Interaction Search)**

31 |

32 |

33 |

34 |

图2. 交互相关组合

36 |

37 | 该算法主要分为五步:

38 |

39 | (1)视觉环境识别

40 |

41 | 采用稀疏抽取的方法抽取潜在特征来识别车道,障碍物,移动物体等交通参与者。

42 |

43 | (2)选定目标候选人

44 |

45 | 确定车道线,非结构化区域来形成可通行的空间信息。

46 |

47 | (3)产生可能的轨迹

48 |

49 | 通过轨迹优化,神经元规划生成运动轨迹。

50 |

51 | (4)产生运动方案

52 |

53 | 例如到底是强行插入交通还是等待行人通行。

54 |

55 | (5)确定轨迹和时间,速度

56 |

57 | 当确定好运动方案时候,还需要考虑运动轨迹下的其他车辆通行情况,多种考虑之后才能输出运动规划。

58 |

59 | 特斯拉表示第5步,是最难的,因为随着每一步约束的增加,每一种新的轨迹生成运算都需要1-5ms,那么你想想这种情况下大约有一百多种方案,那么显然都快需要0.5s的时间用来运算了。

60 |

61 | 特斯拉想到的方案是lightweight queryable networks轻量化可查询的神经元算法,这种算法是去查找基于其人类驾驶方法场景库以及线下虚拟仿真运算出的结论,也就是查找库已有方案,看他的运动轨迹会怎么做,这样可以在大约100us,也就是0.1ms内来生成一种轨迹。

62 |

63 |

64 |

65 |

图3. 交互搜索算法框架

67 |

68 | 有了多种轨迹和运动规划之后,接下来还需要选择一种,这个时候特斯拉算法采取对碰撞检查,控制舒适性,需要介入的可能性,是否拟人化等多项要求,进行打分来确定,选定最终轨迹和运动规划。

69 |

70 | 以上就是特斯拉利用其路径规划算法,在解决交通繁忙条件下无保护左转采用的交互搜寻算法,寻找最优的结果的流程。这里一个比较妙的方法是特斯拉有一个人类驾驶行为和仿真参考库提供检索。

71 |

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/9.1.2 环境感知算法.md:

--------------------------------------------------------------------------------

1 | # 环境感知算法

2 | 有关感知的介绍请参考[这里](./../../ch03_感知/), 环境感知是智能驾驶获得外部信息的源头,与大多数厂商不同的是特斯拉环境感知主要依赖视觉,而视觉存在天生缺少深度信息问题。特斯拉本次介绍了其Occupancy Networks 算法用来探索可运动3D空间, 本文接下来将对其提出的Occupancy Networks 算法进行研究分析。

3 |

4 | ## 一、Occupancy Network

5 |

6 | ### (一)算法介绍

7 |

8 | Occupancy Network 算法是特斯拉近几年一直在开发的算法,主要是通过特斯拉外部的8个摄像头视频流,去构建基于几何体积块的环绕汽车的3D空间,并持续去识别全貌即使短时间内有遮挡物,能够识别标注Occupancy的物体,例如马路牙子、汽车、行人等。此外算法还能识别物理的流动,来预测一些偶然的流体运动,如长巴士(拖挂车)的甩尾,Occupancy Network 算法可以高效识别感兴趣的点。特斯拉表示其Occupancy Network算法在算力和内存之间取得很好的效率,大概10ms就可建模完成,目前此算法已经运行在所有FSD的特斯拉上,如下图1所示。

9 |

10 |

11 |

12 |

13 |

14 |

15 | 图1. 构建环绕汽车的3D空间

16 |

17 | ### (二)算法架构

18 |

19 |

20 |

21 |

图2. Occupancy Network算法架构

23 |

24 | 如上图2所示,Occupancy Network算法工作流大概分以下七个步骤:

25 |

26 | **1. Image Input**

27 |

28 | 8个摄像头依据摄像头标定矫正后直接输入给算法,视觉输入不使用ISP(以人为本的图像处理); 由于摄像头的原始数据是4 位颜色16倍的动态范围给到算法,可以减少输入的延迟。

29 |

30 | * 注: ISP模块会将Sensor采集到的数据进行插值和特效处理,例如:如果一个感光点感应的颜色是R,那么,ISP模块就会根据这个感光点周围的G、B感光点的数值来计算出此点的G、B值,那么,这一点的RGB值就被还原了,然后在编码成601或656的格式传送给Host。经过彩色插值就变成RGB。RGB 每个像素都有三种颜色,每一个的值在0~255之间, 即8位颜色。

31 |

32 | **2. Image Featurizers**

33 |

34 | 使用预训练的深度神经网络模型对图像进行提取特征, 输入给下一步。特斯拉采用RegNet和BiFPNs算法来提取特征,特征化基本就是识别物体了。

35 |

36 | **3. Spatial Attention**

37 |

38 | 是卷积神经网络中用于空间注意的模块。它利用特征的空间关系生成空间注意力图,也就是构建空间信息。将 Mlticam Qurey Emdedding(多摄像头查询)和 Spatial Query(空间查询)的输出,输入入注意力Attention模块来构建空间。

39 |

40 | **4. Temporal Alignment**

41 |

42 | 分为两个部分,一个部分是自己车辆的轨迹对齐,另外一个将各个识别特征物对齐,初步形成了时空特征。

43 |

44 | **5. Deconvolutions**

45 |

46 | 去卷积也就是把浓缩的特征反向成物体。路面地理信息(如上下坡度)一直普通视觉算法的难点,特斯拉表示其算法能够识别路面的地理特征。

47 |

48 | **6. Volume Outputs**

49 |

50 | 去卷积之后的反向物体,将从空间上能代表物体大小,被放置在时空中,而且此类空间占据还根据路面的情况自动匹配,这里特斯拉讲到一个算法NeRF state,能够表示具有复杂遮挡的详细场景几何,这样可以让时空更加真实。

51 |

52 | **7. Queryable Outputs**

53 |

54 | 去卷积之后的反向物体有些可能不能完全代表真实的物体的大小,所以特斯拉算法采用查询法去数据库中查询真实世界的结果,进行位置和大小的矫正再进行空间放置。

55 |

56 | Occupancy Networks 算法可以通过摄像头获取数据,然后利用NeRFs算法构建真实世界的精准映射,即虚拟世界。当然特斯拉当前的虚拟构建并未把摄像头色彩完全投影进来,特斯拉目前主要任务是通过车辆获取数据来构建可支持自动驾驶所需关键信息的虚拟3D世界。

57 |

58 |

59 |

60 |

61 |

62 |

63 | 图3. 虚拟3D世界

64 |

65 | 特斯拉表示其Occupancy Networks 算法都是自动标注算法训练而成的,与 BEV(Bird's-eye view 鸟瞰图)相比,Occupancy Networks 算法可以让自动驾驶对可行驶空间有了进一步的理解,对后续决策更加友好。

66 |

67 | ## 二、新车道识别算法

68 |

69 |

70 |

71 |

图4. 基于2D的车道识别

73 |

74 | 特斯拉老版本车道识别算法是基于2D平面的RegNet分割算法,在高速以及清晰高度结构化的场景应用的比较好,目前基本上国内车型应该都采用此类算法,当然国内的道路结构化都比较好,但在国外那种路面国内车型都是挑战,毕竟国外的设施都没有国内新。

75 |

76 | 当然车道清晰等也不是特斯拉老算法的主要问题,特斯拉在国外训练的算法对于清晰度应该也不是问题,问题是城市应用场景中,简单转弯分隔的结构化车道,繁忙交通中交汇口前车遮挡等无法采集到足够的数据的时候,此类问题是经典车道识别算法无法解决。

77 |

78 | 当然国内依赖高精地图的智能驾驶方案,此类问题基本可以解决,这就是为什么现在的城市领航辅助迟迟没上。高精地图,一需要测绘,二需要有关部门批准。所以不使用高精地图仅仅依靠视觉算法的特斯拉给出的答案是:用神经元算法预测,生成全套车道实例及其相互连接。

79 |

80 | ## 三、FSD新车道算法三个组件

81 |

82 |

83 |

84 |

图5. FSD新车道算法三个组件

86 |

87 | ### (一)视觉组件

88 |

89 | 车辆上八个摄像头的视频流输入卷积层、注意层和其他神经网络层进行编码,或许丰富的环境信息,然后生成带有粗略路线图的表示。

90 |

91 | ### (二)地图组件

92 |

93 | 额外的神经网络层编码的道路级地图数据,特斯拉称之为车道引导,这张地图不是高清地图,但它提供了许多关于交叉口的有用提示,车道内的拓扑结构,交叉路口的车道数,以及一组其他属性。

94 |

95 | 这里的前两个组成部分产生了一个密集张量世界,可以对世界进行编码,但特斯拉真正想做的是转换这个稠密的张量为智能驾驶车道的连通集合。

96 |

97 | ### (三)语言组件

98 |

99 |

100 |

101 |

图6. FSD新车道算法语言组件

103 |

104 | 特斯拉将这个任务看成一个图像转字幕的语言任务,这个任务的输入是这个稠密的张量,输出的特殊的文本语音用来预测车道连通。用这种车道语言单词和符号对车道进行编码,这些单词和符号就是3D中的车道位置,在单词符号中引入修饰语,对连接词进行编码通过将任务建模为语言问题,我们可以利用语言人工智能算法的最新技术来处理道路的多重连通集合。

105 |

106 | 用最先进的语言建模和机器学习算法来解决计算机视觉问题,语言算法应该在人工智能算法中属于比较先进发展较快的一个分支,主要原因应该是语言数据更易得和数据量小,便于学习训练,此次特斯拉发布的车道线识别算法的亮点就是这个。

107 |

108 |

109 |

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/9.1.3 训练算法、设施、软件.md:

--------------------------------------------------------------------------------

1 | # 训练算法、设施、软件

2 |

3 |

4 |

5 |

图1. 特斯拉算力

7 |

8 | ## 一、算力及数据

9 |

10 | ### (一)算力

11 |

12 | 特斯拉目前有3个超算中心,采用了1.4万个GPU,其中4000个用于自动标注数据,其中10000个用于训练算法。

13 |

14 | ### (二)数据

15 |

16 | **1. 图像数据:**

17 |

18 | 特斯拉表示需要训练Occupancy Networks算法,特斯拉目前已经从采集视频中提取出14.4亿张图片;训练这些数据,需要GPU温度达到90度高温的情况下,10万个GPU满负荷计算一小时。

19 |

20 | **2. 视频数据:**

21 |

22 | 目前有30PB分布式视频缓存,1PB=1048576GB你想想30PB多大。其中抽取了1600亿张图片。而且这些数据不是静态的,是动态流转的,每天50万个视频轮流缓存更替,每秒40万个视频转化。

23 |

24 | 所以显然,特斯拉当前这数据中心按照正常的方法肯定行不通,同时可想而知特斯拉对于GPU超算的饥渴程度,另外特斯拉还想加速他的计算能力,这样决定了特斯拉必须自己搞芯片。

25 |

26 | ## 二、数据流优化

27 |

28 | 特斯拉从数据的存储,到数据的加载,最后处理,形成一个倒漏洞的形状,最大限度的压榨计算资源。

29 |

30 |

31 |

32 |

图2. 数据流优化

34 |

35 | 要实现这些,必须考虑数据量的分配,数据流的带宽,CPU,内容,机器学习的框架,而多台GPU同步运算你要考虑延迟,考虑GPU之间的带宽是非常复杂的。

36 |

37 | 首先视频是动态和复杂的,不是简单的图片机器学习,特斯拉的视频到图片再到学习处理过程是动态,所以第一步加速视频库可以增加30%的训练速度。

38 |

39 |

40 |

41 |

图3. 视频压缩

43 |

44 | 特斯拉采用Pytorch进行视频压缩类的工作,加速视频库,如上图3,图中I 帧(帧内编码图片)是完整的图像,例如JPG或BMP图像文件。P帧(预测图片)仅保存图像与前一帧相比的变化。例如,在汽车穿过静止背景的场景中,只需要对汽车的运动进行编码。编码器不需要在 P 帧中存储不变的背景像素,从而节省空间。P 帧也称为增量帧。

45 |

46 |

47 |

48 |

图4. 数据优化指标

50 |

51 | 如上图4所示,通过这种方式特斯拉实现了2.3倍的训练速度增加,现在特斯拉用1024块GPU可以实现几天内从头开始聚合这些数据。

52 |

53 | ## 三、算法编译器以及推理优化

54 |

55 | 上一节讲了对数据链路进行了优化,训练速度提升明显,接下来的优化点放在芯片级上,具体提到算法编译器compiler以及reference推理。

56 |

57 |

58 |

59 |

60 |

图5. 算法编译器以及推理优化

62 |

63 | 算法编译器compiler,将AI算法模型映射到高效的指令集和数据流。执行复杂的优化,例如层融合、指令调度和尽可能重用片上内存。特斯拉的人工智能算法代码运行会并行,重复以及回滚,那么特斯拉想要解决的问题是,如何高效的让代码运行在芯片上面,例如不重复计算,计算之间编排紧凑不空闲不堵塞,这样可以减少延迟,降低功耗。为此,特斯拉设计了一个Arc Max 以及一个中央操作来将稀疏(例如车道的空间位置)编码到首页,然后选择学习算法过程链接到首页。然后在静态内存SRAM中构建一个查询表格,把重复算法存入缓存,这样就不需要重复计算,只需要查询调用。

64 |

65 | 特斯拉表示在FSD车道识别算法中,这项编码提升了其算法9.6ms的延迟,能耗大概只有8w。这种编码的思维贯穿到整个特斯拉FSD算法中,特斯拉构建了一个新的算法编译器用来编译超过1000多个算法信号。通过编译器和推理的优化,确保优算力,低功耗,低延迟的AI计算,即“不拼算力,拼算法软件”。

66 |

67 |

68 |

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/9.1.4 数据标注、采集、虚拟化.md:

--------------------------------------------------------------------------------

1 | # 数据标注、采集、虚拟化

2 |

3 | 现阶段,人工智能的实现多数基于数据标注;广义上,数据喂的越多,算法效果越精准。所以海量数据是精准算法的基础,而海量数据的前提是这些数据带标签,即标注信息。

4 |

5 | 数据标注有两种方法,一种是人工标注,依靠人给数据打标签,非常消耗人力物力,更重要的是时间。一种是自动标注,比如采用聚类的方式,自动标注显然是省时省力的事情,下文将分析特斯拉自动标注方法。

6 |

7 | 特斯拉认为他要实现十字路口车道算法,大概需要几千万个驾驶旅程,经过大概百万个十字路口。特斯拉目前大概每天有50万个旅程,但是要把这些旅程转化成可训练的数据是非常难的课题,特斯拉表示尝试了各种人工和自动标注方法,显然不太可能。为此,特斯拉开发了新自动标注算法耗时12个小时对1万个驾驶旅程,相当于500万小时的人工标注。

8 |

9 | ## 一、自动标注步骤

10 |

11 | 特斯拉表示其车道算法的自动标注,主要采用以下三个步骤来实施:

12 |

13 |

14 |

15 |

图1. 车道的自动标注

17 |

18 | ### (一)高精轨迹获取

19 |

20 | >特斯拉每天可以获取50万个旅程,这些旅程的采集信息为车辆的视频,车辆运动IMU陀螺仪,速度作为原始信号输入,之后在车上的2个CPU线程(所有开通FSD的车辆产生这些信息)去跟踪优化,特征提取输出车辆6个自由度100hz的运动轨迹以及3D结构的道路细节。

21 |

22 | ### (二)多旅程重构

23 |

24 | >由于获取的数据来自不同车辆,所以还需要得到每辆车的高精轨迹信息,进行旅程的道路信息的匹配、重构、接缝优化、包面优化,最后人工分析师进行验证,形成多重旅程的轨迹信息。

25 |

26 | ### (三)自动标注旅程

27 |

28 | >自动标注只会去标注新添加的旅程,而不是去重构所有的片段,相比于几小时的人工标注,自动标注仅需半个小时就可以完成一段旅程的标注。

29 |

30 |

31 |

32 |

33 |

34 |

35 | 图2. 自动标注过程

36 |

37 | 自动标注方式极其容易规模化,只需要有计算单元以及驾驶旅程信息,如上图2所示,此片段时间内,自动标注系统标注了来自53台车的50组数据。自动标注的方法应用于特斯拉算法的各个方面。

38 |

39 | ## 二、构建3D虚拟场景

40 |

41 | 现实的数据获取困难同时很难去标注,但传统的3D场景重构缓慢,所以特斯拉在虚拟验证方面,应用新的方法5分钟就能够构建3D虚拟场景。

42 |

43 | ### (一)介绍

44 |

45 | 特斯拉的建模是首先把场景的真值(Ground truth)输入3D建模软件Houdini,先开始构建道路的边缘,在构建路面地理特征,之后将车道信息投影进入路面,接下来使用道路中间的边缘形成绿化岛。这样基本的主要特征形成,那么道路两边的树以及建筑物都可以随机构建。

46 |

47 |

48 |

49 |

图3. 车道线投影建模

51 |

52 | 车道信息基础上可以引入地图交通信息,如红绿灯、行人、道路名等信息,形成了场景的基础;当然还有天气、光线等形成模拟场景。特斯拉更进一步去改变道路的真值形成新的场景,例如十字路口车道线场景,可以改变里面的车道信息,创建更多基于真实场景的变种场景,来帮助算法训练,而不是只能通过现实采集。在构建虚拟数据后,可以快速的进行各种场景的虚拟测试去优化算法,而省去实际测试费时费力的时间。

53 |

54 | ### (二)场景构建架构

55 |

56 |

57 |

58 |

图4. 场景构建架构

60 |

61 | 构建过程如上图4所示,先有道路交通真值信息,然后元素创造者将交通信息标签转换成元素,例如上文将到的车道线,马路牙子,建筑物等都属于元素。再通过元素提取工具将这些信息分成几何信息和交通实例元素放到150平米Geohash中,并给他命名ID 方便使用加载调用。

62 |

63 | 这样建模信息更加简洁,更容易加载和渲染,然后使用元素加载器工具,特斯拉可以使用Geohash ID编码去加载任意数量的缓存切片,一般虚拟的时间就加载感兴趣的地点以及周边。最后是虚拟引擎生成场景。

64 |

65 | ### (三)场景构建流程

66 |

67 |

68 |

69 |

图5. 场景构建流程

71 |

72 | 基于以上流程,工程师2周就可以生成旧金山的街道虚拟世界,而非几个月甚至年来做单位。相同的技术可以拓展到城市和国家,或者更新原有的虚拟世界,确保数据依据现实动态发展。

73 |

74 | ### (四)现实数据采集器

75 |

76 |

77 |

78 |

79 |

80 |

81 | 图6. Corner Case极端场景

82 |

83 | 特斯拉的仿真能力虽然很强,但很多corner case 极端的场景依然需要真实场景数据。如上图6所示,特斯拉的FSD正在进入弯路口,通过这里的时候,看到旁边有一个车子,现有算法下的特斯拉会认为有车子在等待通行,所以特斯拉自动驾驶车子会减速,但现实这是一个没有人在里面的奇怪停车。

84 |

85 | 此类场景估计任何脑洞大开的虚拟验证都不会想到,必须要有实际场景来识别这类corner case极端场景,所以自动驾驶真实场景数据的收割必须要有,而且还是动态发展的,不同时间,不同城市,不同文化的数据都会不一样。

86 | 所以特斯拉构建了一个工具去识别错误的判断并去纠正标签,并把这个片段归类为需要重新评估的系列。这个场景特斯拉把它诊断为挑战性的在转弯处有停车的场景,目前特斯拉识别了126个这样的场景,挖掘以及促进训练了1.39万视频数据,来提升预测准确性。

87 |

88 | ### (五)数据引擎

89 |

90 |

91 |

92 |

图7. 数据引擎

94 |

95 | 特斯拉解决这类场景需要成千上万这种场景,而特斯拉利用数据采集车辆(客户的车或试验车),以及设备去采集和更正标签来解决这种琐碎的场景。把这种数据引擎框架实施到所有算法的持续优化中,数据引擎是一个完整的从实验车型,虚拟验证,终端用户的流。特斯拉能够大规模使用数据引擎的基础设施为算法提供数据食物,得益于其庞大的车队(终端用户汽车影子模式传输客户使用FSD时候的介入信息以及实验车队的再确认数据)。

96 |

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/README.md:

--------------------------------------------------------------------------------

1 |

2 |

3 |

图1. FSD2022 更新解析

5 |

6 | 2022年的特斯拉 AI Day分为三大主题:AI机器人-Optimus、AI智能驾驶FSD、AI超算芯片技术。本文针对只介绍FSD智能驾驶,该部分主要介绍特斯拉底层人工智能算法技术,也是其汽车,机器人共用的底层算法。

7 |

8 | **一、特斯拉自动驾驶FSD现状**

9 |

10 |

11 |

12 |

图2. 特斯拉自动驾驶FSD现状

14 |

15 | 目前特斯拉自动驾驶软件FSD的使用客户已经从2021年的2千人上升到现在的16万人。仅去年就通过480万段数据训练了超过75000个算法模块,其中交付给车辆281个算法模块,完成了35次版本的发布。

16 |

17 | 关于特斯拉的FSD的算法技术部分,此次特斯拉2022 AI Day把其FSD背后的技术,按照从终端客户使用感觉到的使用问题开始,然后一步一步深入背后的算法创新优化,算法背后的数据训练等串起来讲。本文将其总结为如下四个部分:

18 |

19 | **二、特斯拉自动驾驶FSD算法优化情况**

20 |

21 |

22 |

23 |

图3. 特斯拉自动驾驶FSD算法优化情况

25 |

26 | (1) 路径以及运动规划算法:

27 | 当算法植入到终端(车或者机器人),终端通过算法感知环境,规划路径,确保安全,平顺前进。

28 |

29 | (2) 环境感知算法:

30 | - Occupancy 算法,也就是可活动空间探测

31 | - Lane & Objects 车道以及物体算法,交通中的信息语义层也就是车道线,物体识别以及运动信息。

32 |

33 | (3) 训练算法设施以及软件:

34 | - 训练数据的设施,超算中心用来支持数据处理,算法训练。

35 | - 人工智能算法的编译器以及推理,就是训练算法的框架以及软件方法。

36 |

37 | (4) 数据标注,采集和虚拟:

38 | - 自动标注算法,训练环境感知算法必须需要已经具有标签的数据,自动标注算法就是标注数据,训练环境感知算法识别这类场景或者物体。

39 | - 环境虚拟,合成制造虚拟场景。

40 | - 数据引擎,现实场景车辆,测试软件获取真实场景环境数据,闭环数据引擎,更正标签等。

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.1.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.1.gif

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.2.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.3.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.1.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.1.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.1.gif

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.2.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.3.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.3.gif

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.4.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.5.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.6.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.2.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.1.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.2.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.3.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.4.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.5.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.6.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.3.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.1.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.2.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.2.gif

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.3.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.4.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.5.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.6.gif:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.6.gif

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.7.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/imgs/8.1.4.7.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.1 特斯拉 AI Day2022/modify_log.txt:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.1 特斯拉 AI Day2022/modify_log.txt

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.1.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.10.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.10.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.11.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.11.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.12.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.12.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.2.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.3.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.4.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.4.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.5.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.5.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.6.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.6.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.7.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.7.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.8.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.8.jpg

--------------------------------------------------------------------------------

/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.9.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/ch09_厂商方案/9.2 百度阿波罗apollo/imgs/8.2.9.jpg

--------------------------------------------------------------------------------

/imgs/1.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/imgs/1.jpg

--------------------------------------------------------------------------------

/imgs/2.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/imgs/2.jpg

--------------------------------------------------------------------------------

/imgs/3.jpg:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/gotonote/Autopilot-Notes/04e38c8f5cdd29b8fd77440784f4b9d0018490b5/imgs/3.jpg

--------------------------------------------------------------------------------

/文章撰写规范.md:

--------------------------------------------------------------------------------

1 | # 文章撰写规范

2 |

3 | ## 一、文章序号用法说明

4 | .

5 |

6 | |ch01

7 |

8 | |-- 1.1、1.2、1.3

9 |

10 | |---- 1.1.1、1.1.2、1.1.3

11 |

12 | |------- 1.1.1.1、1.1.1.2、1.1.1.3

13 |

14 | |--------- 章节名称 ---------------------- '#'

15 |

16 | |--------- 一、二、三 -------------------- '##'

17 |

18 | |----------- (一)、(二)、(三) ---- '###'

19 |

20 | |--------------- 1.、2.、3. -------------- '** **'

21 |

22 | |------------------ (1)、(2)、(3)---- '* *'

23 |

24 | |--------------------- • ------------------ '*'

25 |

26 | |--------- 注解 -------------------------- '##'

27 |

28 | |--------- 参考文献 ---------------------- '##'

29 |

30 |

31 |

32 | ## 二、图片插入

33 |

34 |

35 |

36 |

37 |

图1.样例

39 |

40 |

41 |

42 | ## 三、注解

43 |

44 | ### 1. annotate

45 |

46 | * 使用方法:[A](#1-annotate)

47 |

48 |

49 | ## 四、参考文献章内索引

50 |

51 | 索引[1](#refer-anchor)

52 |

53 |

54 |

55 | ## 参考文献

56 |

57 | [1] autopilot updating notes

58 |

59 |

60 |

--------------------------------------------------------------------------------

5 |

5 |  5 |

5 |  157 |

157 |  201 |

201 |  5 |

5 |  5 |

5 |  13 |

13 |  20 |

20 |  27 |

27 |  55 |

55 |  69 |

69 |  76 |

76 |  89 |

89 |  96 |

96 |  103 |

103 |  112 |

112 |  152 |

152 |  25 |

25 |  31 |

31 |  45 |

45 |  72 |

72 |  82 |

82 |  92 |

92 |  6 |

6 |  9 |

9 |  46 |

46 |  55 |

55 |  64 |

64 |  73 |

73 |  104 |

104 |  5 |

5 |  22 |

22 |  30 |

30 |  41 |

41 |  50 |

50 |  63 |

63 |  77 |

77 |  86 |

86 |  94 |

94 |  117 |

117 |  132 |

132 |  5 |

5 |  20 |

20 |  36 |

36 |  5 |

5 |  18 |

18 |  27 |

27 |  35 |

35 |  84 |

84 |  93 |

93 |  102 |

102 |  111 |

111 |  120 |

120 |  5 |

5 |  22 |

22 |  61 |

61 |  70 |

70 |  5 |

5 |  18 |

18 |  29 |

29 |  42 |

42 |  49 |

49 |  4 |

4 |  61 |

61 |  71 |

71 |  80 |

80 |  5 |

5 |  11 |

11 |  34 |

34 |  43 |

43 |  52 |

52 |  13 |

13 |  36 |

36 |  47 |

47 |  3 |

3 |  17 |

17 |  68 |

68 |  13 |

13 |  34 |

34 |  9 |

9 |  20 |

20 |  29 |

29 |  38 |

38 |  45 |

45 |  54 |

54 |  63 |

63 |  10 |

10 |  18 |

18 |  11 |

11 |  22 |

22 |  29 |

29 |  38 |

38 |  45 |

45 |  56 |

56 |  63 |

63 |  72 |

72 |  15 |

15 |  24 |

24 |  33 |

33 |  42 |

42 |  53 |

53 |  11 |

11 |  18 |

18 |  27 |

27 |  34 |

34 |  41 |

41 |  50 |

50 |  59 |

59 |  8 |

8 |  15 |

15 |  22 |

22 |  9 |

9 |  16 |

16 |  23 |

23 |  30 |

30 |  37 |

37 |  11 |

11 |  19 |

19 |  18 |

18 |  5 |

5 |  10 |

10 |  4 |

4 |  11 |

11 |  7 |

7 |  7 |

7 |  21 |

21 |  30 |

30 |  37 |

37 |  55 |

55 |  62 |

62 |  75 |

75 |  92 |

92 |  103 |

103 |  112 |

112 |  126 |

126 |  131 |

131 |  16 |

16 |  34 |

34 |  65 |

65 |  21 |

21 |  71 |

71 |  84 |

84 |  101 |

101 |  5 |

5 |  32 |

32 |  41 |

41 |  48 |

48 |  60 |

60 |  15 |

15 |  49 |

49 |  58 |

58 |  69 |

69 |  92 |

92 |  3 |

3 |  12 |

12 |  23 |

23 |  37 |

37 |