31 |

--------------------------------------------------------------------------------

/_posts/2015-11-28-elasticsearch-ve-gelistirme-araclari-part-1.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Elasticsearch ve Geliştirme Araçları - Part 1

4 | categories:

5 | - blog

6 | summary: Elasticsearch nedir? Nasıl hızlıca nasıl giriş yapabilirsiniz? Plugin nedir? Başlangıç için hangi plugin'leri kullanabilirsiniz? Geliştirme ortamı için neler gerekli?

7 | ---

8 |

9 | Elasticsearch'e yeni başlayanlar için hızlı ve rahat bir başlangıç yapmalarını

10 | sağlayacak araçlardan biraz bahsetmek istiyorum ve bu arada da kısaca

11 | Elasticsearch (ES kısaltması ile devam edeceğim) hakkında bilgi vermeye

12 | çalışacağım.

13 |

14 | [Elasticsearch](https://en.wikipedia.org/wiki/Elasticsearch) wikipedia'da

15 | bahsedildiği üzere [Lucene](https://lucene.apache.org/core/) tabanlı bir arama

16 | sunucusudur. Genel bilinmesi gerekenler:

17 |

18 | - Full-text arama yapabilmenizi sağlar

19 | - Java ile geliştirilmiştir.

20 | - Apache Lisansı ile yayınlanmıştır.

21 | - Apache Solr'dan sonra gelen ikinci en populer arama motorudur.

22 | [1](http://db-engines.com/en/ranking/search+engine)

23 |

24 | Elasticsearch kurulumu ve çalıştırılması hakkında

25 | [buradan](https://www.elastic.co/downloads/elasticsearch) bilgi alabilirsiniz.

26 | Ben genel olarak kurulumdan bahsetmeyeceğim. Elimden geldiğince ES'i daha

27 | hızlı nasıl öğrenirsiniz ve çalışma ortamınızı nasıl hızlıca kurabilirsiniz

28 | bundan bahsedeceğim.

29 |

30 | Elasticsearch'de verilerin tutulduğu [index](https://www.elastic.co/blog/what-is-an-elasticsearch-index)'ler

31 | vardır. Bunları ilişkili bir veritabanındaki `database`ler gibi düşünebilirsiniz.

32 | Indexler içerisinde farklı tipteki verileri tutabilmeniz için `type` kavramı

33 | vardır bunu da tablolar gibi düşünebilirsiniz. Aralarındaki ilişkiyi daha rahat

34 | anlamak için aşağıdaki açıklamaya bakabilirsiniz.

35 |

36 | ```

37 | MySQL => Databases => Tables => Columns/Rows

38 | Elasticsearch => Indices => Types => Documents with Properties

39 | ```

40 |

41 | Şimdi ES'i [şu](https://www.elastic.co/downloads/elasticsearch) adresteki

42 | açıklamalar ışığında kuralım ve çalıştıralım. Burada ES'in default ayarlarını

43 | kullanabilirsiniz. Normalde production sunucusuna kurulum yapmıyorsanız default

44 | ayarlarda kullanmanız bir sakınca yaratmaz. İlerleyen yazılarımızda ES'i daha verimli

45 | nasıl kullanırsınız ve yüksek erişilebilir hale nasıl getirirsiniz ya da ileri seviye

46 | ayarlamaları konfigürasyonları nelerdir bunlardan bahsedeceğiz. Şimdi, ilk olarak

47 | çalışma ortamını ayarlamak için bir iki eklenti ve bir de Chrome Plugin'i

48 | kuracağız.

49 |

50 | Eklentilerden başlayacak olursak, [head](https://github.com/mobz/elasticsearch-head)

51 | eklentisi Elasticsearch'ün API arayüzüne rahatça kullanabilmenizi sağlar. Bu

52 | eklenti ile index'leri type'ları rahatça görebilirsiniz. MySQL'in PhpMyAdmin'i

53 | ile aynı görevi görüyor diyebiliriz. Bu eklenti ile index'lerinizi rahatça

54 | yönetebilirsiniz.

55 |

56 | İkinci eklentimiz olan [inquisitor](https://github.com/polyfractal/elasticsearch-inquisitor)

57 | eklentisi ile sorgularınızı debug edebilir ve anlamaya çalışabilirsiniz. Bu

58 | eklenti ile oluşturmuş olduğunuz analyzer'larınızı kolayca debug edebilirsiniz

59 | ve nasıl çalıştığını görebilirsiniz. Burada doğal olarak analyzer ne sorusu

60 | geliyordur aklınıza. [Analyzer](https://www.elastic.co/guide/en/elasticsearch/reference/1.4/analysis-analyzers.html)'lar

61 | [Tokenizer](https://www.elastic.co/guide/en/elasticsearch/reference/1.4/analysis-tokenizers.html)

62 | ve [TokenFilter](https://www.elastic.co/guide/en/elasticsearch/reference/1.4/analysis-tokenfilters.html)'lardan

63 | oluşurlar. Tokenizer kavramını kısaca anlatacak olursak, verilen bir string'i daha

64 | küçük parçalara ayırma işlemini yaparlar. TokenFilter'lar ise bu parçaları bir

65 | filtreden geçirirler. Böylelikle Analyzer'lar ile ES'de tuttuğunuz verileriniz

66 | bir takım işlemlerden geçirerek arama yapılabilir bir halde hazırda bekletiyor

67 | olacaksınız. Bu konuya daha ilerde ayrı bir yazıda bahsetmeyi düşünüyorum. Şimdilik

68 | böyle bir şeyin olduğunu ve ileride kullanacağınızı bilmeniz yeterli.

69 |

70 | Bunlar dışında bir çok eklenti mevcut. Hepsinden bahsedemeyeceğim ama zamanı

71 | geldikçe eklentiler hakkında kısaca bilgi vermeye çalışacağım.

72 |

73 | Şimdi development ortamımızı şenlendirecek Chrome Eklentimize.

74 | [Sense](https://www.elastic.co/blog/found-sense-a-cool-json-aware-interface-to-elasticsearch)

75 | eklentisi ile ES sorgularını hızlı ve rahat bir şekilde çalıştırabilirsiniz.

76 | Aşağıda bir dizi komut yazacağım ve Sense eklentisi ile hızlıca deneyebileceksiniz.

77 | Sense ile sorgu çalıştırmak için aşağıdaki formatta bir sorgu yapmamız gerekiyor.

78 |

79 | ```json

80 | METHOD /es/paths

81 | {

82 | "JSON" : "DATA"

83 | }

84 | ```

85 |

86 | Bu sorgu formatında METHOD isteğin metodunu belirlemektedir. GET, POST, DELETE, ...

87 | gibi methodlar ile ES'e sorgu atabileceğiz. `/es/paths` kısmı ise ES'de sorgu

88 | yapacağınız index, type'ı belirlemek için kullanılan bir URL. Geri kalan kısmı ise

89 | veri kısmı. Bundan sonraki yazılarımızda sorguları bu formatta yazacağımız için

90 | çabuk ısınacağınıza inanıyorum.

91 |

92 | Aşağıda Sense ile çalıştırabileceğiniz bir kaç komut dizisi oluşturdum. Bunlar

93 | üzerinden giderek kısaca başlangıç yapabilirsiniz.

94 |

95 | Yeni bir index oluşturmak.

96 |

97 | ```

98 | POST /test-index

99 | ```

100 |

101 | Yeni bir döküman oluşturmak.

102 |

103 | ```json

104 | POST /test-index/test/1

105 | {

106 | "id": 1,

107 | "name": "haydar külekci"

108 | }

109 | ```

110 |

111 | Yeni bir döküman oluşturmak

112 |

113 | ```json

114 | POST /test-index/test/2

115 | {

116 | "id": 1,

117 | "name": "Test Name"

118 | }

119 | ```

120 |

121 | Type Mapping Bilgilerini Getirmek

122 |

123 | ```

124 | GET /test-index/test/_mapping

125 | ```

126 |

127 | Oluşturulmuş bir dökümanı getirmek

128 |

129 | ```

130 | GET /test-index/test/1

131 | ```

132 |

133 | Arama yapmak:

134 |

135 | ```json

136 | GET /test-index/test/_search

137 | {

138 | "query": {

139 | "match_all": {}

140 | }

141 | }

142 | ```

143 |

144 |

145 |

146 | Bağlantılar

147 |

148 | - [https://www.elastic.co/blog/what-is-an-elasticsearch-index](https://www.elastic.co/blog/what-is-an-elasticsearch-index)

149 | - [https://lucene.apache.org/core/](https://lucene.apache.org/core/)

150 | - [https://en.wikipedia.org/wiki/Elasticsearch](https://en.wikipedia.org/wiki/Elasticsearch)

151 |

152 | Diğer Bazı Eklentiler

153 |

154 | - [ICU Analysis plugin for Elasticsearch](https://github.com/elastic/elasticsearch-analysis-icu)

155 | - [ElasticSearch analysis plugin providing Turkish stemming functionality](https://github.com/skroutz/elasticsearch-analysis-turkishstemmer/)

156 | - [Web admin interface for elasticsearch](https://github.com/lmenezes/elasticsearch-kopf)

157 |

--------------------------------------------------------------------------------

/_posts/2015-11-29-elasticsearch-index-olusturmak.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Elasticsearch Index Oluşturmak

4 | categories:

5 | - blog

6 | summary: Elasticsearch'de index nedir ve nasıl oluşturulur? Index `settings` nedir ve nasıl kullanılır? `Analyzer` nedir, nasıl oluşturulur.

7 | ---

8 |

9 | Elasticsearch arama motoru hakkında bir önceki yazımda kullanabileceğiniz

10 | araçlar, eklentiler ve kullanımları hakkında kısa bir önbilgi vermiştim. Bu

11 | yazımda ise nasıl index oluşturacağız, mapping nedir ve nasıl oluşturabiliriz,

12 | bir index'in ne gibi özellikleri vardır, gibi sorulara cevap vermeye çalışacağım.

13 |

14 | Index daha önceki yazımda da bahsettiğim gibi verilerin tutulduğu

15 | veritabanlarıdır. Index'leri iki şekilde oluşturabilirsiniz. Birincisi otomatik

16 | oluşturma yöntemi diğeri ise manuel index oluşturma yöntemidir. Bu

17 | yöntemleri sırayla örneklemeye çalışayım.

18 |

19 | Elasticsearch API arayüzünde `create` işlemleri için `POST` metodu kullanılır.

20 | Bir index oluşturmak için de `POST` metodunu kullanıyoruz. Aşağıdaki gibi

21 | bir komut ile Sense arayüzünden `users` adında test bir index oluşturalım.

22 |

23 | ```

24 | POST /users

25 | ```

26 |

27 | Bu yöntem 1. yöntem olsun. Index oluşturmak için çeşitli yollar vardır.

28 | Örneğin siz veri oluşturmak için aşağıdaki sorguyu çalıştırdığınızda da bir

29 | `users` index'i oluşacaktır.

30 |

31 | ```json

32 | POST /users/user/1

33 | {

34 | "name":"Haydar"

35 | }

36 | ```

37 |

38 | Bu yönteme de 2. yöntem diyelim. Bu yöntem ile index oluşturulduğunda

39 | aynı zamanda bir kullanıcı da oluşacaktır ve sonuç olarak aşağıdaki gibi bir

40 | cevap dönecektir.

41 |

42 | ```json

43 | {

44 | "_index": "users",

45 | "_type": "user",

46 | "_id": "1",

47 | "_version": 1,

48 | "created": true

49 | }

50 | ```

51 | Burada iki yöntemde de index oluşacaktır. Ancak ikinci yöntem diğerine göre

52 | biraz daha sakıncalı bir yöntemdir. Bunun sakıncalarına daha ilerde

53 | değineceğiz. Şimdi oluşturduğumuz index'e bir göz atalım.

54 |

55 | ```

56 | GET /users

57 | ```

58 |

59 | Bu komutu Sense arayüzünden çalıştırdığımda eğer index'i birinci yöntem ile

60 | oluşturursam `mappings` alanı boş gelecektir. Ancak eğer ikinci yöntem ile

61 | kullanılmış olsaydı aşağıdaki gibi olacaktı. Burada ikinci yöntemde aslında biz

62 | bir veri oluşturmaya çalışıyoruz. Eğer index yok ise ES o index'i otomatik

63 | oluşturuyor. Bu sırada veri oluşturma işinide yaptığımız için index'in ve

64 | mapping'i (yani veriyi tutma şeklinide) otomatik oluşturmuş oluyoruz. Mapping

65 | mapping verinin yapısını belirler. Eğer biz bunu kendimiz belirlemez ise ES

66 | otomatik yapacaktır.

67 |

68 | ```json

69 | {

70 | "index-name": {

71 | "aliases": {},

72 | "mappings": {

73 | "user": {

74 | "properties": {

75 | "name": {

76 | "type": "string"

77 | }

78 | }

79 | }

80 | },

81 | "settings": {

82 | "index": {

83 | "creation_date": "1447004861339",

84 | "uuid": "KzZW7zJyTPavy4n1TTeNkg",

85 | "number_of_replicas": "1",

86 | "number_of_shards": "5",

87 | "version": {

88 | "created": "1070399"

89 | }

90 | }

91 | },

92 | "warmers": {}

93 | }

94 | }

95 | ```

96 |

97 | Bu yanıttan anlaşılacağı üzere index'leri oluşturan şeyler `mappings`,

98 | `settings`, `warmers` ve `aliases`lardan oluşur. Bunların hepsinden bu yazımda

99 | tabiki bahsedemeyeceğim. Ancak sadece kısaca ne işe yaradıklarından

100 | bahsedeceğim.

101 |

102 | `aliases` kısmında index'inize verdiğiniz takma isimler listelenmektedir. Bu

103 | isimlendirme yöntemi sizi uygulama katmanındaki index'e erişiminiz çok

104 | kolaylaştıracak bir özelliktir. Bu konu hakkında ayrı bir yazıda özellikle

105 | değineceğim. Uygulamanın kesinti yaşamadan index değiştirebilmesi için

106 | çok güzel bir özelliktir.

107 |

108 | `mappings` kısmında ise index'in içerisinde saklanacak verinin yapısı

109 | tutulmaktadır. Ben bunu tabloların yapılarına benzetiyorum. Tabiki aklınızdan

110 | NoSQL veritabanında yapıya ne gerek var. Zaten JSON tutulmuyor mu diye

111 | düşünebilirsiniz. Ancak performans açısından bazı verilerin belirli bir yapıda

112 | kaydedilmesi daha hızlı sonuç dönebilmenize olanak sağlamaktadır. Özellikle

113 | üzerinde arama yapacağınız alanların ell belirlenmesi çok daha iyi sonuçlar

114 | doğuracaktır. Arama yapmayacağınız alanları ise arama yapmayacağım diye

115 | belirtmeniz aramalarınız hızlandıracaktır.

116 |

117 | `settings` kısmında ise index ile ilgili olarak ayarlamalar tutulmaktadır. Örneğin

118 | bu index kaç shard olacaktır ve replica sayısı ne olacaktır. Bunlar dışında

119 | `analyzer` bilgileri de index'lerin `settings`leri içerisinde tutulmaktadır.

120 |

121 | Genel olarak index'lerin yapısını inceledik. Şimdi farklı şekillerde index'ler

122 | oluşturarak daha iyi pekiştirmeye çalışalım. Örneğin aşağıda 2 shard ve

123 | 2 replica ile bir index oluşturalım.

124 |

125 | ```json

126 | POST /index-name

127 | {

128 | "settings": {

129 | "index": {

130 | "number_of_replicas": "2",

131 | "number_of_shards": "2"

132 | }

133 | }

134 | }

135 | ```

136 |

137 | Yukarıdaki sorguyu Sense ile çalıştırdığınızda index oluşacaktır ve bu index'deki

138 | veriler 2 shard ile bölünecektir. Aynı zamanda 2 makinede replica'ları oluşacaktır.

139 | Burada tabiki iki makineniz var ise. Eğer bu ayarları vermez iseniz Elasticsearch

140 | varsayılan ayarları kullanacaktır ve 5 shard 1 replica ile bir index oluşturacaktır.

141 |

142 | Varsayılan ayarlarınızı elasticsearch'ün config klasöründeki `yaml` dosyalarından

143 | değiştirebilirsiniz. Elasticsearch dizininde `config` klasörü altında `elasticsearch.yml`

144 | ve `logging.yml` dosyaları bulunmaktadır. Adlarından da anlaşılacağı gibi

145 | loglama ayarları için `logging.yml` dosyasını Elasticsearch'in genel ayarları için

146 | `elasticsearch.yml` dosyasını kullanabilirsiniz. Ayarlar klasörü için yine ayrı bir

147 | yazımda değineceğim. Ayarların tümüne zaten bir yazıda değinmek çok yetersiz

148 | olur. Buradaki ayarlamalar ile çok daha performanslı bir yapı kurabilirsiniz ya da

149 | yanlış kullanım nedeniyle performansınızı tamamen kaybedebilirsiniz.

150 |

151 | Sağlıcakla.

152 |

--------------------------------------------------------------------------------

/_posts/2015-12-04-elasticsearch-type-and-mapping.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Elasticsearch Type ve Mapping

4 | categories:

5 | - blog

6 | summary: Elasticsearch'de `type`ın ne olduğunu ve nasıl oluşturabilsiniz? `Type`ı ne için kullanabilirsiniz? `Type Mapping` nedir ve ne için kullanılır?

7 | ---

8 |

9 | Elasticsearch'te `type` benzer dökümanlar sınıfıdır. Örneğin `users` adında bir index'iniz

10 | var. Bu index içerisinde `user` diye bir `type` oluşturabilirsiniz. Ya da kullanıcı role'lerine

11 | göre `type`'lar oluşturabilirsiniz. `admin`, `user`, `staff` gibi.

12 |

13 | Elasticsearch `mapping` kavramı daha önceden de belirttiğim üzere verinin yapısıdır.

14 | Veritabanı şeması gibi düşünün. Verilerinizin hangi alanlardan oluştuğunu ve bu

15 | alanların tiplerinin ve özelliklerinin neler olduğunu belirtirler. Hangi alanların `index`e

16 | alınacağı ya da hangi alanların Lucene'de tutulacağını belirler.

17 |

18 | Elasticsearch daha önceden belirttiğimiz üzere Lucene tabanlıdır. Peki Lucene

19 | Elasticsearch üzerinden gönderdiğimiz dökümanları nasıl görür ve nasıl saklar.

20 |

21 | Lucene'de bir döküman basit `field-value` (`alan-değer`) çiftlerini içerir. Bir alanın en az

22 | bir değeri ya da birden fazla değeri olmalıdır. Bazen, tek bir `string` değer analiz

23 | işlemleri sonunda birden fazla değere dönüşebilir. Bazen de uzun bir `string` değeri

24 | analizler sonucunda kısa bir string değerine dönüşebilir. Bunu örneklemek gerekirse

25 |

26 | ```json

27 | {

28 | "title": "Örnek bir başlık"

29 | }

30 | ```

31 |

32 | değeri bazı analizler sonunda aşağıdak gibi

33 |

34 | ```json

35 | {

36 | "title": {

37 | "original": "Örnek bir başlık",

38 | "filtered": "Ornek bir baslik"

39 | }

40 | }

41 | ```

42 |

43 | bir hal almış olabilir. Lucene değerin `string` ya da sayı ya da tarih formatında olmasını

44 | önemsemez. Tüm değerler `opaque bytes` olarak kabul edilir.

45 |

46 | Lucene'de biz bir dökümanı `index`lediğimizde her bir alan (field) için değerler (values) ilgili

47 | alan için `inverted index`e eklenir. İsteğe bağlı olarak, orjinal değerler sonradan ulaşılabilir

48 | olması için değişmeden de saklanabilir.

49 |

50 | Lucene'de şimdiye kadar her seferinde `field-value` tutulur diye konuştuk ve `type`dan hiç

51 | bahsetmedik. Peki, `Lucene`de bütün veriler `field-value` tutulurken Elasticsearch'deki

52 | `type` kavramı nasıl uygulanır? `Type`ların Lucene tarafında direk olarak bir karşılığı

53 | yoktur. Elasticsearch tarafında ise bir `index`te birden fazla `type` ve bunların her birinin

54 | kendi yapıları (mapping) vardır. Lucene tarafında bu veriler her bir dokümanın

55 | `meta data`sında `_type` diye bir alanında tutulur. Biz özel bir type'a göre bir arama

56 | yaptığımızda Lucene tarafında `_type` alanında bir filtreleme yapar.

57 |

58 | Lucene'de aynı zamanda `mapping` diye bir kavramda yoktur. `Mapping`ler Elasticsearch'ün

59 | karışık JSON dökümanlarını Lucene'in beklediği bir yapıya sokmak için kullandığı bir ara

60 | katmandır.

61 |

62 | Burada dikkat edilmesi gereken konu şudur. Biz Elasticsearch'de verileri `type`lara ayırdık

63 | gibi düşünsekte temelde o veriler Lucene'de aynı yerde tutulmaktadır. Bu da aynı index

64 | içerisinde aynı alan (field) adı ile farklı türde ya da farklı analiz edilmiş veriler tutmak

65 | ileride başımızı ağrıtabilir.

66 |

67 | Burana çıkacak sorunları [azaltmak](https://www.elastic.co/guide/en/elasticsearch/guide/current/mapping.html#_avoiding_type_gotchas)

68 | için bu tür verileri farklı alan isimleri ile ya da farklı indexlerde tanımlayarak sorunları

69 | çözebilirsiniz.

70 |

71 | Örneğin, kullanıcı ve şirket bilgileri tuttuğunuz bir Elasticsearch node'unuz olsun. Burada

72 | bilgileri bir index altında `type`lar ile tutabilirsiniz.

73 |

74 | ```json

75 | POST /core/user/_mapping

76 | {

77 | "properties": {

78 | "id": {

79 | "type": "integer"

80 | },

81 | "name": {

82 | "type": "string"

83 | }

84 | }

85 | }

86 |

87 | POST /core/company/_mapping

88 | {

89 | "properties": {

90 | "id": {

91 | "type": "integer"

92 | },

93 | "name": {

94 | "type": "string"

95 | },

96 | "description": {

97 | "type": "string"

98 | }

99 | }

100 | }

101 | ```

102 |

103 | Gördüğünüz gibi `name` ve `id` alanları aynı. Eğer index'imiz bu şekilde olacaksa bir sorun ile

104 | karşılaşmayabilirsiniz. Ancak ileride şirket isimleri için bir analiz işlemi uygulayarak aramalarda

105 | data doğru sonuç vermesini isteyebilirsiniz. Bu durumda bir `type`da bir analiz işlemi çalışırken

106 | diğerinde başka bir analiz işlemi çalışacaktır. Aramalarda bir karmaşa oluşacaktır. Bu iki `type`ı

107 | ayrı index'ler olarak ayırmak daha mantıklı olacaktır. Ya da name alanlarını `user_name` ve

108 | `company_name` olarak değiştirmekte bir çözüm olacaktır. Böylelikle filtreleme yaparken

109 | bu alanlarda karışıklık olmayacaktır.

110 |

111 | #### Kaynakça

112 |

113 | - [Elasticsearch - Mapping](https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping.html)

114 | - [Elasticsearch - Mapping Intro](https://www.elastic.co/guide/en/elasticsearch/guide/current/mapping-intro.html)

115 | - [Types and Mappings](https://www.elastic.co/guide/en/elasticsearch/guide/current/mapping.html)

116 |

--------------------------------------------------------------------------------

/_posts/2015-12-06-mapping-nedir.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Mapping Nedir?

4 | categories:

5 | - blog

6 | summary: Mapping nedir? Nasıl oluşturulur? Nasıl değiştirilir? Nasıl çalışır?

7 | ---

8 |

9 | Bir önceki yazımda daha çok `Type` kavramından bahsetmiştim. `Mapping` hakkında da

10 | kısa bir kaç cümle söylemiştim. Elasticsearch'de `mapping` verilerin index'lerde nasıl

11 | tutulacağını belirleyen yapılarıdır. Normalde Lucene'de `mapping` yapısı yoktur. Lucene'de

12 | veriler `field-value` olarak tutulur ve değerlerin sayı, `string` ya da tarih mi olduğunu

13 | önemsemez. Tüm değerler `opaque byte`lar halinde tutulur.

14 |

15 | Elasticsearch'ün en güzel özelliklerinden birisi hızlıca verilerini oluşturabilrmenizi ve

16 | erişebilmenizi sağlar. Bir dökümanı index'lemek için bir index oluşturmanıza ya da bir

17 | `mapping type` belirlemenize, alanlarınızı tanımlamanıza gerek yoktur.

18 |

19 | ```json

20 | PUT core_index/user/1

21 | {

22 | "name": "Haydar KULEKCI",

23 | "age" : 1

24 | }

25 | ```

26 |

27 | ES otomatik olarak anlayacaktır ve bir index bir `type` ve alanlarınız otomatik olarak

28 | tiplerinize göre oluşturacaktır. Yukarıdaki sorguyu çalıştırdığınızda aşağıdaki gibi bir

29 | mapping otomatik olarak oluşacaktır.

30 |

31 | ```json

32 | {

33 | "core_index": {

34 | "mappings": {

35 | "user": {

36 | "properties": {

37 | "age": {

38 | "type": "long"

39 | },

40 | "name": {

41 | "type": "string"

42 | }

43 | }

44 | }

45 | }

46 | }

47 | }

48 | ```

49 |

50 | Gördüğünüz gbi `name` alanı `string` olarak `age` alanı da `long` olarak tanımlandı.

51 | ES'de yeni bir veriyi içeri almak aslında bu kadar kolay. İşler her zaman ub kadar da

52 | kolay olmayabiliyor. Bazı veriler sayı gelse dahi string olarak tutmamız gerekebilir.

53 | Ya da ilk değer sayı denk gelen bir index oluşturmuş olabiliriz. Ilk olarak `long` olarak

54 | otomatik oluşturulmuş alana daha sonrasında `string` geldiğinde sıkıntı yaşayabiliriz.

55 |

56 | Her bir index'te bir veya daha fazla `type` vardır. Bu `type`lar index'leri belirli gruplara

57 | böler. Her bir `type`'daki dökümanlarda dökümanı ilişkilendirmek için kullanılan

58 | `_index`, `_type`, `_id` ve `_source` gibi `meta` alanlar(field) vardır. Bunlar dışında

59 | kendi belirleyeceğiniz alanlarınız yani `properties`ler vardır.

60 |

61 | Daha iyi anlamak için bir örnek belirleyelim ve bunun üzerinden devam edelim. Aşağıda

62 | aynı index içerisinde iki `type` tanımlayalım ve bunların `mapping` bilgilerini yani index'te

63 | verilerin nasıl tutulacağını biz belirleyelim.

64 |

65 | ```json

66 | POST core_index

67 | {

68 | "index": {

69 | "number_of_replicas": "1",

70 | "number_of_shards": "2"

71 | },

72 | "mappings": {

73 | "user": {

74 | "_all": {

75 | "enabled": false

76 | },

77 | "properties": {

78 | "title": {

79 | "type": "string"

80 | },

81 | "name": {

82 | "type": "string"

83 | },

84 | "age": {

85 | "type": "integer"

86 | }

87 | }

88 | },

89 | "post": {

90 | "properties": {

91 | "title": {

92 | "type": "string"

93 | },

94 | "body": {

95 | "type": "string"

96 | },

97 | "user_id": {

98 | "type": "string",

99 | "index": "not_analyzed"

100 | },

101 | "created": {

102 | "type": "date"

103 | }

104 | }

105 | }

106 | }

107 | }

108 | ```

109 |

110 | Yukarıdaki index'i oluştururken görüldüğü üzere `user` ve `post` adında iki tane `type`

111 | oluşturuyoruz ve `mapping` bilgilerini yazıyoruz. `Type`larda alanları `properties` alanı

112 | altında belirtiyoruz. `Properties` altındaki yapı aşağıdaki gibidir:

113 |

114 | ```

115 | "field-name": {

116 | "type": "type-name",

117 | "other-attribute-name": "value"

118 | },

119 | ```

120 |

121 | `field-name` kısmını siz alana vereceğiniz ismi yazıyorsunuz ve `type-name` kısmına da o

122 | alanın tipini yazıyorsunuz. Yukarıda göreceğiniz gibi `user` `type`'ı için `title`, `name`, `age`

123 | alanları var ve sırasıyla `string`, `string` ve `integer` tipinde. Aynı index'teki `post` `type`ınde

124 | ise `title`, `body`, `user_id` ve `created` alanları bulunuyor ve bu alanlar sırasıyla `string`,

125 | `string`, `string` ve `date` tipindedir.

126 |

127 | Elasticsearch'te `string`, `date`, `long`, `double`, `boolean` ve `ip` basit tipleri mevcuttur.

128 | Bunlar dışında `object` ve `nested` tipleri bulunmaktadır. Daha özelleşmiş olan `geo_point`,

129 | `geo_shape`, ve `completion` tipleri de bulunmaktadır. Tİpleri ilerleyen zamanlarda

130 | kullandıkça açıklayacağız. Yine de erkenden bilgi sahibi olmak isterseniz

131 | [buradan](https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping-types.html)

132 | bilgi alabilirsiniz.

133 |

134 | Yukarıdaki örnekte göreceğiniz `post` type'ındaki `user_id` alanında `index` diye ayrı bir

135 | özellikte mevcut. Bu özellik alandaki değerin nasıl index'e alınacağını belirler. Eğer bu alan

136 | hiç yazılmaz ise `standart analyzer` ile analiz edilerek index'e alınır. Buraya kendi

137 | oluşturduğunuz `analyzer`ları ya da varsayılanları kullanabilirsiniz.

138 |

139 | #### Kaynakça

140 |

141 | - [Elasticsearch - Mapping](https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping.html)

142 | - [Elasticsearch - Mapping Intro](https://www.elastic.co/guide/en/elasticsearch/guide/current/mapping-intro.html)

143 | - [Types and Mappings](https://www.elastic.co/guide/en/elasticsearch/guide/current/mapping.html)

144 |

--------------------------------------------------------------------------------

/_posts/2016-01-10-elasticsearch-references-2-x-ye-gecmeden-bir-goz-atin.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Elasticsearch References 2.x'ye Geçmeden Bir Göz Atın

4 | categories:

5 | - blog

6 | summary: Elasticsearch 2.x ile birlikte neler gidiyor, neler değişiyor. 2.x sürümüne taşınmadan önce hızlıca göz atabileceğiniz bir döküman.

7 | ---

8 |

9 | Elasticsearch 2.0 ile birlikte silinen ya da ismi değişen özellikleri bir

10 | dökümanda toplayayım dedim baya uzun bir liste çıktı. Genel bilgi olması

11 | açısından sırasıyla başlıklar ve kısa açıklamaları aşağıdaki gibi.

12 |

13 | ### Nodes shutdown

14 | `_shutdown` API silindi. Bunun yerine Elasticsearch'ü işletim sisteminizde

15 | `service` olarak çalıştırabilirsiniz ya da `-p` komut satırı özelliğini

16 | kullanarak PID'i bir dosyaya yazdırabilirsiniz.

17 |

18 | ### Bulk UDP API

19 | Bulk UDP servisi silindi. Bunun yerine [`Bulk API`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/docs-bulk.html)'ı

20 | kullanabilirsiniz.

21 |

22 | ### Mapping Silmek

23 | Bir `type` için mapping'i silme özelliği artık olmayacak. Bunun yerine index'i

24 | silip yeni bir mapping ile oluşturabilirsiniz. Burada bir index'de zor durumda

25 | kalmadıkça birden fazla type barındırmamak gerekiyor gibi.

26 |

27 | ### Index Status

28 | `_status` API [Indices Stats](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/indices-stats.html)

29 | ve [Indices Recovery API](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/indices-recovery.html)

30 | ile değiştirildi.

31 |

32 | ### `_analyzer`

33 | Type Mapping'deki `_analyzer` alanı artık desteklenmeyecek ve 2.x ile birlikte

34 | mapping'den otomatik olarak silinecek.

35 |

36 | ### `_boost`

37 | Type Mapping'deki `_boost` alanı artık desteklenmeyecek ve 2.x ile birlikte

38 | mapping'den otomatik olarak silinecek.

39 |

40 | ### Config mappings

41 | `config` klasöründe özel mapping'ler artık kullanılmayacak. Mapping oluşturma

42 | artık aşağıdaki API arayüzleri ile olabilecek:

43 |

44 | - [Create Index](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/indices-create-index.html)

45 | - [Put Mapping](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/indices-put-mapping.html)

46 | - [Index Templates](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/indices-templates.html)

47 |

48 | ### memcached

49 | `memcached` transport artık desteklenmeyecek. Bunun yerine HTTP veya Java API

50 | üzerinden REST arayüzünü kullanın.

51 |

52 | ### Thrift

53 | `thrift` transport artık desteklenmeyecek. Bunun yerine HTTP veya Java API

54 | üzerinden REST arayüzünü kullanın.

55 |

56 | ### Queries, Filters

57 | Query'ler ve Filter'lar birleştirildi. Herhangi bir `query` deyimi artık

58 | `query context` içerisinde `query` olarak, `filter context` içeriside `filter`

59 | olarak kullanılabilecek. (Daha fazla bilgi için [`Query DSL`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl.html))

60 |

61 |

62 | | Silinen Filter'lar | Kullanılabilecek Query Hali |

63 | | ------------------------- | --------------------------- |

64 | | And | [And Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-and-query.html) |

65 | | Or | [Or Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-or-query.html) |

66 | | Not | [Not Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-not-query.html) |

67 | | Bool | [Bool Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-bool-query.html) |

68 | | Exists | [Exists Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-exists-query.html) |

69 | | Missing | [Missing Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-missing-query.html) |

70 | | geo_bounding_box | [Geo Bounding Box Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geo-bounding-box-query.html) |

71 | | geo_distance | [Geo Distance Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geo-distance-query.html) |

72 | | geo_distance_range | [Geo Distance Range Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geo-distance-range-query.html) |

73 | | geo_polygon | [Geo Polygon Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geo-polygon-query.html) |

74 | | geo_shape | [GeoShape Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geo-shape-query.html) |

75 | | geohash_cell | [Geohash Cell Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-geohash-cell-query.html) |

76 | | has_child | [Has Child Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-has-child-query.html) |

77 | | has_parent | [Has Parent Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-has-parent-query.html) |

78 | | ids | [Ids Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-ids-query.html) |

79 | | indices | [Indices Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-indices-query.html) |

80 | | limit | [Limit Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-limit-query.html) |

81 | | match_all | [Match All Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-match-all-query.html) |

82 | | nested | [Nested Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-nested-query.html) |

83 | | prefix | [Prefix Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-prefix-query.html) |

84 | | query | - |

85 | | range | [Range Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-range-query.html) |

86 | | regexp | [Regexp Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-regexp-query.html) |

87 | | script | [Script Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-script-query.html) |

88 | | term | [Term Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-term-query.html) |

89 | | terms | [Terms Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-terms-query.html) |

90 | | type | [Type Query](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-type-query.html) |

91 | | fuzzy_like_this veya flt | [fuzziness](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-match-query.html#query-dsl-match-query-fuzziness) parametresini `match` query ile kullanın veya [`More Like This Query`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-mlt-query.html) kullanın. |

92 | | fuzzy_like_this_field veya flt_field | [fuzziness](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-match-query.html#query-dsl-match-query-fuzziness) parametresini `match` query ile kullanın veya [`More Like This Query`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-mlt-query.html) kullanın. |

93 |

94 | Bakınız: [Query DSL](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl.html)

95 |

96 | ### Top Children Query

97 | `top_children` query silindi. Bunun yerine [`Has Child Query`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-has-child-query.html) kullanın.

98 |

99 | ### More Like This API

100 | `More Like This API` silindi. Bunun yerine [`More Like This Query`](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/query-dsl-mlt-query.html) kullanın.

101 |

102 | ### Facet'ler siliniyor `Aggregation`lar geliyor

103 | `Facet`ler büyük veri kümelerinde özel bilgiler çıkarmak için çok güzel bir

104 | araçtır. Elasticsearch 1.0 ile birlikte `facet`lar `aggregation` olarak

105 | değişmiştir. `Aggregation`lar `facet`ların üst kümesidir.

106 |

107 | Aşağıda genel bir liste oluşturmaya çalıştım:

108 |

109 | | Silinen `Facet`lar | `Aggregation`lar |

110 | | ------------------------- | ------------------------- |

111 | | Filter veya Query Facet | [filter aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-filter-aggregation.html) [filters aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-filters-aggregation.html) |

112 | | Geo Distance Facet | [geo_distance aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-geodistance-aggregation.html) |

113 | | Histogram Facet | [histogram aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-histogram-aggregation.html) |

114 | | Date Histogram Facet | [date_histogram aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-datehistogram-aggregation.html) |

115 | | Range Facet | [range aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-range-aggregation.html) |

116 | | Terms Facet | [terms aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-terms-aggregation.html) |

117 | | Terms Stats Facet | [terms aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-bucket-terms-aggregation.html) [stats aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-metrics-stats-aggregation.html) [extended_stats aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-metrics-extendedstats-aggregation.html) |

118 | | Statistical Facet | [stats aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-metrics-stats-aggregation.html) [extended_stats aggregation](https://www.elastic.co/guide/en/elasticsearch/reference/2.x/search-aggregations-metrics-extendedstats-aggregation.html) |

119 |

120 |

121 | ### Shard request cache

122 | `shard query cache`in ismi `Shard request cache` olarak değişti.

123 |

124 | ### Query cache

125 | `filter cache`, `Node Query Cache` olarak değişti.

126 |

127 | ### `Nested tipi

128 | The docs for the nested field datatype have moved to Nested datatype.

129 |

130 |

131 | #### Kaynakça

132 |

133 | - [Breaking changes in 2.0](https://www.elastic.co/guide/en/elasticsearch/reference/current/breaking-changes-2.0.html)

134 | - [WHAT'S NEW IN ELASTICSEARCH 2.0](http://david.pilato.fr/presentations/what-s-new-in-elasticsearch-20.html)

135 |

--------------------------------------------------------------------------------

/_posts/2016-02-09-bazi-kavramlar--index-inverted-index-shard-segment.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Bazı Kavramlar (index, inverted index, shard, segment)

4 | categories:

5 | - blog

6 | summary: Elasticsearch'de bazı kavramlar anlaması zor olabiliyor. `index` tam olarak ne demek, `inverted index` nedir? `shard`, `segment` nedir? gibi soruları kısaca açıklamalarını bulabileceğiniz bir döküman.

7 | ---

8 |

9 | "index" kelimesi Elasticsearch'de biraz istismar edilmiş. Anlamak için kısaca bakalım:

10 |

11 | #### index

12 |

13 | Elasticsearch'de bir `index` ilişkili bir veritabanındaki veritabanları gibidir.

14 | Verileri sakladığınız yerlerdir. Ama gerçekte, bu sadece senin uygulamanın gördüğüdür.

15 | Temelde, bir `index` bir veya daha fazla `shard`ı temsil eden mantıksal bir alan adıdır.

16 |

17 | Ayrıca, "to index" (index'lemek) kavramıda veriyi Elasticsearch'e koymak/yüklemek

18 | anlamına gelmektedir. Verinizin geri istenebilecek şekilde saklandığını ve arama

19 | yapılabileceğini ifade eder.

20 |

21 |

22 | #### inverted index

23 |

24 | `inverted index` Lucene'in verileri aranabilir yapmak için kullandığı bir veri yapısıdır.

25 | Bu işlemde dökümanın içerdiği verilerden `token`lar ve tekil terimler ortaya çıkarılır.

26 | Bu konu hakkında daha fazla bilgi almak için [buraya](https://en.wikipedia.org/wiki/Inverted_index)

27 | bakabilirsiniz.

28 |

29 | #### shard

30 |

31 | `shard` bir Lucene instance'ıdır. Kendi başına tamamen işlevsel bir arama motorudur. Bir

32 | `index` tek başına bir `shard`dan oluşabilir, ama genellikle `index` in büyüyebilmesi

33 | ve bir kaç `node` üzerinde dağıtılabilmesi için bir kaç `shard`dan oluşmaktadır.

34 |

35 | `primary shard` bir döküman için ev sahipliği yapmaktadır. Bir `replica shard` ise

36 | `primary shard` bir kopyasıdır ve (1) `primary` bir şekilde hata verdiğinde ya da

37 | düştüğünde, (2) okuma çok arttığında, kullanılmaktadır.

38 |

39 |

40 | #### segment

41 |

42 | Her `shard` birden fazla `segment` içermektedir ve bu `segment`ler bir `inverted index`tir.

43 | Bir `shard` üzerindeki bir arama sırayla her bir `segment`'de aranacaktır ve sonra

44 | sonuçlar bu `shard` için son bir sonuçlar kümesinde toplanacaktır.

45 |

46 | Siz bir dökümanı `index`lerken(indexing), Elasticsearch onları bellekte(memory)

47 | toplayacaktır (ve güvenlik için `transaction log`'da), sonra her saniye veya daha fazla

48 | zamanda bir bunu yapar, disk'e yeni bir `segment` oluşturur, ve aramaları `refresh` eder.

49 |

50 | Bu veriyi yeni bir `segment` içerisinde aranabilir yapar, ama bu `segment` diske

51 | `fsync` edilmemiş haldedir. (Bende aynı soruyu kendime sordum. `fsync` nedir?) Veri halen

52 | kaybolma riskine sahiptir.

53 |

54 | Elasticsearch, sık sık `fsync` anlamına gelen `flush` işlemini yapar, (şimdi veri

55 | işlenmiştir.) ve artık gereksiz hale gelen `transaction log`u temizler. Çünkü biz artık

56 | biliyoruz ki veri diske yazılmıştır.

57 |

58 | Ne kadar çok `segment` varsa aramalar o kadar uzun sürer. Yani Elasticsearch arkaplanda

59 | çalışan birleştirici işlemler (merge process) ile benzer büyüklükteki bir kaç `segment`i

60 | daha büyük bir `segment`e birleştirecektir. Yeni oluşan daha büyük `segment` diske

61 | yazıldıktan sonra eskileri silinecektir. Bu işlem bir çok aynı büyüklükte `segment`

62 | olduğu sürece tekrar eder.

63 |

64 | `Segment`ler değişmezdir. Bir döküman update edildiğinde, eski döküman silindi olarak

65 | işaretlenir, ve yeni bir döküman eklenir. Birleştirme işlemleri aynı zamanda silinen

66 | dökümanlarıda çıkarır.

67 |

68 | #### Kaynakça

69 |

70 | - [Basics about segments in elasticsearch](http://stackoverflow.com/a/15429578/721600)

71 | - [Basic Concepts](https://www.elastic.co/guide/en/elasticsearch/reference/current/_basic_concepts.html)

72 |

--------------------------------------------------------------------------------

/_posts/2016-03-26-inverted-index-nedir.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Inverted Index Nedir?

4 | categories:

5 | - blog

6 | summary: Inverted Index ne demektir ve terim bazlı aramalarınızın nasıl çalıştığını ve nasıl daha hızlı çalıştığına bir gözün atın.

7 | ---

8 |

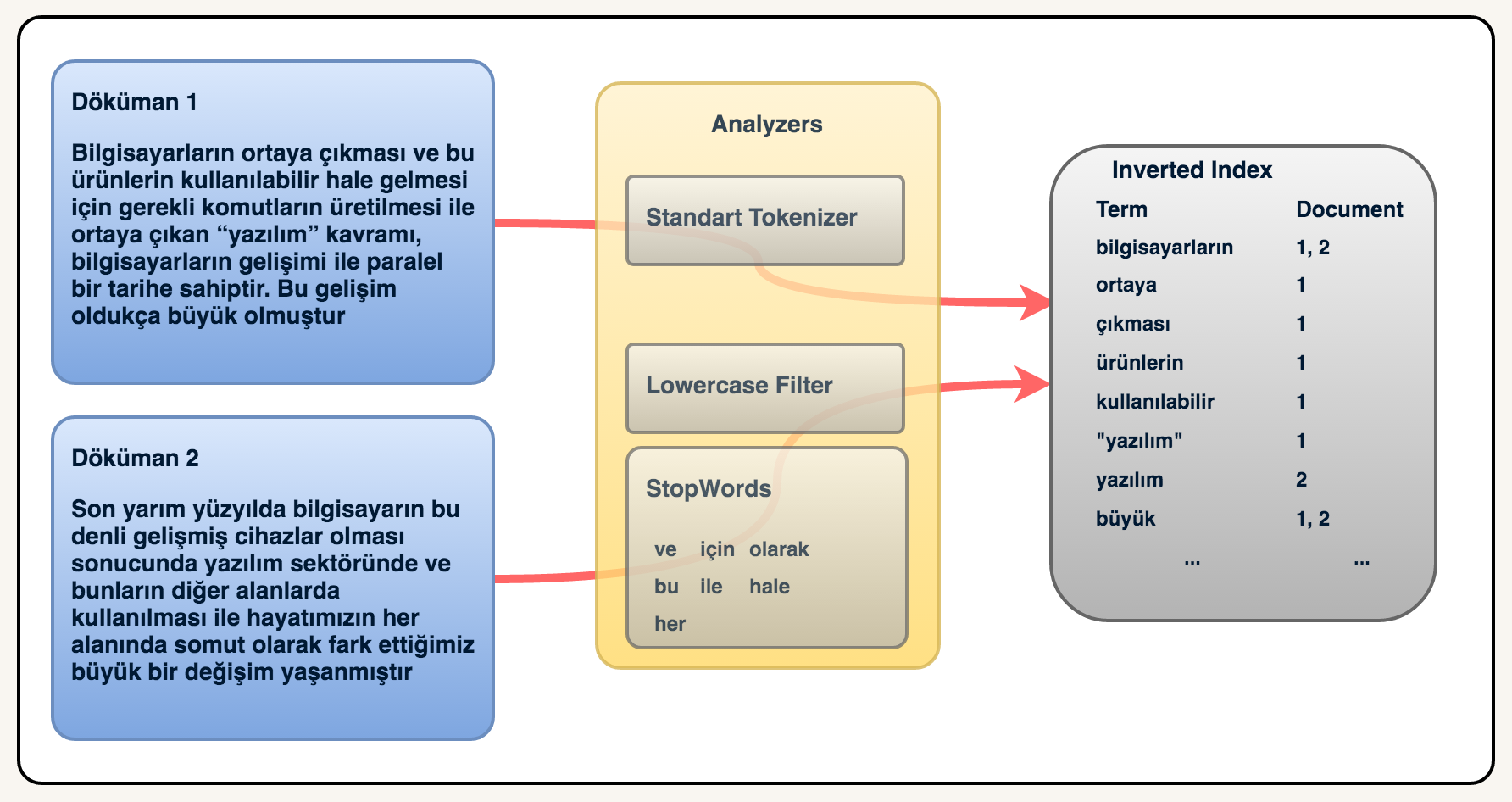

9 | Text tabanlı bir döküman kümeniz olduğunu düşünün. Bu dökümanlar içerisindeki terimlerinizi

10 | bu terimlerin hangi dökümanlar ile ilişkili olduğunu dökümanın bilgisini bir yerde

11 | tuttuğunuzu düşünün. Bu terimler içerisinde bir arama yaptığınızda terimlere karşılık

12 | gelen dökümanları hızlıca bulabileceksiniz. Yani siz dökümanlarınıza terimler üzerinden

13 | ulaşıyor olacaksınız. İşte buna inverted(ters) index denir.

14 |

15 | Aşağıdaki örnekte inverted index kavramını görsel olarak daha iyi anlayabilirsiniz.

16 | Burada dikkat edilmesi gereken bir diğer önemli kısımda `analyzers` kısmıdır. Burada

17 | bizim metnimizi bir takım `tokenizer` ve `filter`lardan geçirerek inverted index olarak

18 | kaydediyoruz. Aşağıdaki örnekte veriler sırasıyla `Standart Tokenizer`, `Lowercase Filter`

19 | ve `Stopwords Filter`'dan geçirilmektedir. Daha sonrada inverted index olarak

20 | kaydedilmektedir.

21 |

22 |

23 |

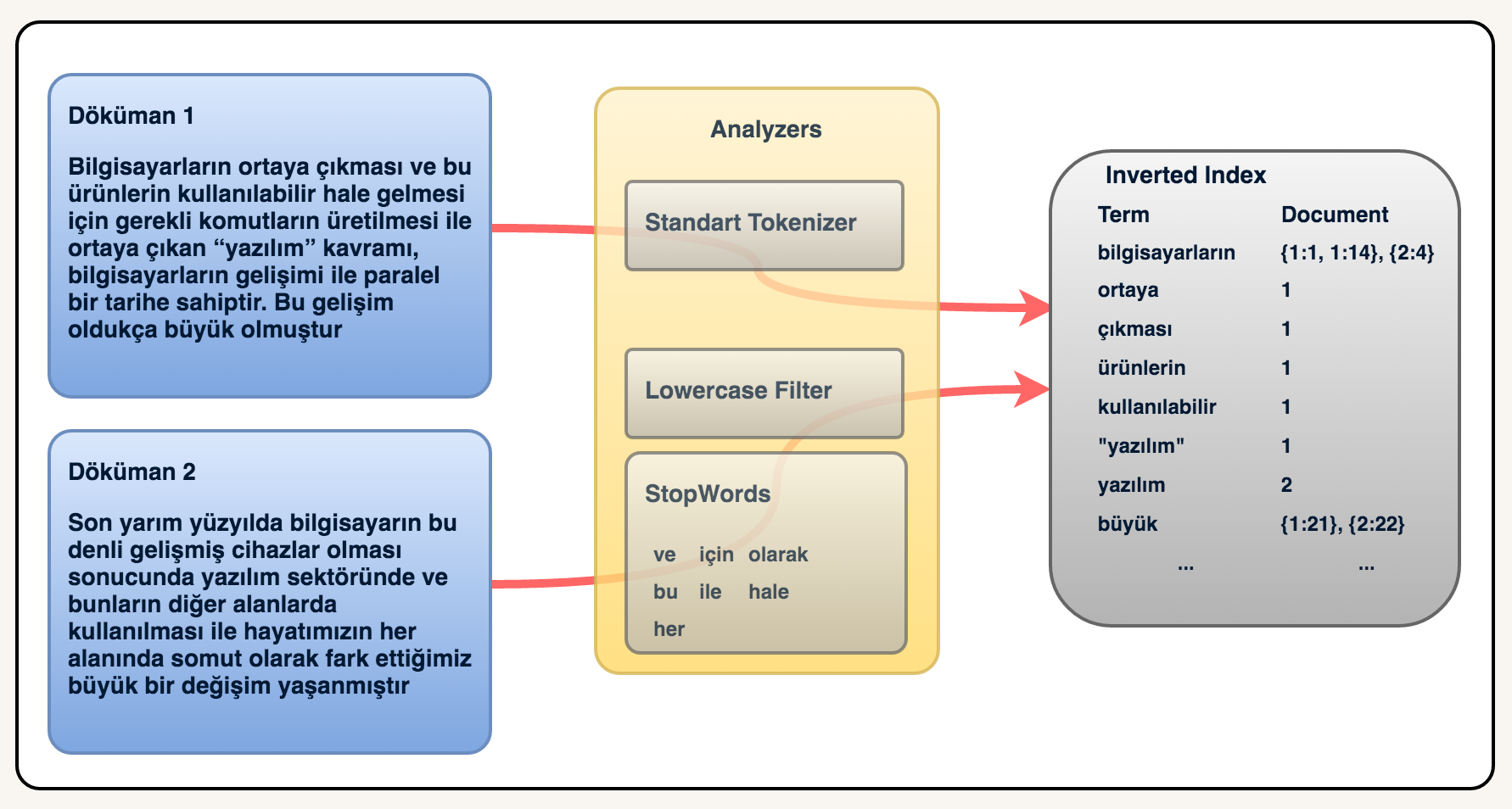

24 | Burada ekstra olarak bir terimin döküman içerisindeki pozisyonunu da kaydettiğinizi

25 | düşünürsek kolayca terim için her döküman karşılık bir puan da çıkarabilirsiniz ve

26 | aramalarda bunu sonuçları sıralamak için kullanabilirsiniz.

27 |

28 | Aşağıdaki örnekte ise aynı dökümanı inverted index'e kaydederken dökümandaki terimlerin

29 | döküman içerisindeki pozisyonları ile birlikte kaydettik. Mesela "bilgisayarın" terimi

30 | 1. döküman içerisinde 2 yerde geçmektedir ve sırasıyla 1. ve 14. sıradadırlar.

31 |

32 |

33 |

34 | Bir arama yaparken ise inverted index'ler üzerinde hızlıca dökümanlara ulaşabiliriz.

35 | Örneğin, `bilgisayarın` kelimesi ile bir arama yaptığımızda hem birinci döküman hem de

36 | ikinci döküman gelecektir. Eğer bir score mekanizmamız olsaydı birinci döküman daha önce gelecektir. Çünkü birinci dökümanda aynı terim 2 kez geçmektedir.

37 |

38 | Bir diğer terim olan `yazılım` teriminde arama yapsaydık sadece 2. döküman gelecekti.

39 | Belki aklınıza 1. döküman neden gelmedi sorusu gelebilir. Burada dikkat etmeniz gereken inverted index'e nasıl kaydedildiği olmalıdır. `"yazılım"` terimi ile `yazılım` terimi

40 | aynı değildir. Bu yüzden biz `yazılım` diye arattığımızda `"yazılım"` terimi geçen

41 | dökümanlar gelmeyecektir.

42 |

43 | #### Kaynakça:

44 |

45 | - [Inverted Index](https://www.elastic.co/guide/en/elasticsearch/guide/current/inverted-index.html)

46 | - [Elasticsearch from the Bottom Up, Part 1](https://www.elastic.co/blog/found-elasticsearch-from-the-bottom-up)

47 | - [What Is Relevance?](https://www.elastic.co/guide/en/elasticsearch/guide/current/relevance-intro.html)

48 |

--------------------------------------------------------------------------------

/_posts/2016-04-22-nginx-ile-elasticsearch-icin-koruma-olusturun.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Nginx ile Elasticsearch için Koruma Oluşturun

4 | categories:

5 | - blog

6 | summary: Nginx ile elasticsearch sorgularını şifre koruması altında yapabilirsiniz ve nginx logları ile elasticsearch sunucularınıza gelen yükü görebilir ve hatalarınızı ayıklayabilirsiniz.

7 | ---

8 |

9 | Elasticsearch HTTP API arayüzü üzerinden çalıştığı için bir sunucu üzerinde çalıştırdığınızda

10 | dış dünya tarafından ulaşılabilir halde çalışıyor olacaktır. Burada Elasticsearch erişimini dış

11 | dünyaya yani sizin uygulamanız dışındaki kişilere erişimini kapatmak için bir kaç yol

12 | bulunmakta. Bunlardan birisi de "Basic Authentication". Yani bir kullanıcı adı şifre ile

13 | koruma yöntemi. Bu yöntem sizin sunucularınızı tabiki tamamen koruyamayabilir. Önerim

14 | firewall seviyesinde ya da network seviyesinde erişimin kısıtlanmasıdır. Ancak bu kısıtlama

15 | iç ağdan birilerinin de elasticsearch içerisinde rahatça işlem yapmalarını engelleyemez.

16 | Bunun için kullanıcı adı ve şifre ile koruyarak buradaki erişimi iç ağ üzerinde de kısıtlamaya

17 | çalışacağız.

18 |

19 | Bunu nasıl yapacağız şimdi kısaca buna değinelim. Gerekli araç ve gereçler :

20 |

21 | - Nginx

22 | - Elasticsearch

23 |

24 | Hepsi bu kadar. Ben şimdilik Elasticsearch'ün varsayılan port'u üzerinden örnekleyeceğim.

25 | İlk olarak bir Elasticsearch makinesini çalıştırıyoruz ve [http://127.0.0.1:9200/](http://127.0.0.1:9200/)

26 | adresinden çalıştığını görüyoruz.

27 |

28 | Daha sonra Nginx üzerinden aşağıdaki gibi bir server oluşturuyoruz.

29 |

30 | ```

31 | server {

32 | listen 80;

33 | server_name elastic.local;

34 |

35 | location / {

36 | proxy_pass http://127.0.0.1:9200;

37 | proxy_set_header Host $host;

38 | proxy_set_header X-Real-IP $remote_addr;

39 |

40 | auth_basic "Restricted Content";

41 | auth_basic_user_file /usr/local/etc/nginx/.htpasswd;

42 | }

43 | }

44 | ```

45 |

46 | Burada dikkat ettiyseniz `127.0.0.1:9200` adresi üzerinden çalışan Elasticsearch için

47 | `elastic.local` domain'inde ve 80. porttan çalışacak şekilde bir server oluşturduk. Daha sonra

48 | bu adrese gelecek bütün istekleri `proxy_pass http://127.0.0.1:9200;` ile Elasticsearch

49 | adresimize yönlendirdik. Böylelikle uygulamamız içerisinden Elasticsearch'e erişmek için

50 | `elastic.local` yazmamız yeterli olacaktır. Bunun yanında firewall üzerinden 9200 portuna

51 | ulaşımı engelliyoruz ki 9200 portu üzerinden API arayüzü kullanılmaya devam etmesin

52 | sadece nginx'in olduğu sunucu üzerinden erişilebilir olsun. Bu örnekte ben kendi

53 | bilgisayarımda bu işlemi yaptığım için 9200 portu üzerinden erişim konusunu gözardı ettim.

54 | Domain yönlendirmesi için bilgisayarımdaki `/etc/hosts` dosyasına aşağıdaki gibi bir

55 | tanımlama yaptım. Eğer siz bunu sunucu düzeyinde yapmak istiyorsanız DNS tanımlamalarınızı

56 | yapmanız gerekmektedir. Ya da burada server_name olarak bir IP adresi kullanabilirsiniz.

57 |

58 | ```

59 | # Host Dosyası tanımlaması

60 | 127.0.0.1 elastic.local

61 | ```

62 |

63 | Şimdi bunları yaptık ancak koruma nerede. Koruma kısmıda yukarıdaki script'in devamında.

64 |

65 | ```

66 | auth_basic "Restricted Content";

67 | auth_basic_user_file /usr/local/etc/nginx/.htpasswd;

68 | ```

69 |

70 | Bu kısımda da sayfamıza bir koruma ekledik ve Nginx'e `/usr/local/etc/nginx/.htpasswd` bu

71 | dosyada yazan bilgilere göre bu alana gelen istekleri koru dedik. Bu dosyada da aşağıdaki

72 | gibi Nginx'in anlayacağı dilde şifremizi oluşturduk. Kaynaklar arasında benim online da test

73 | için kullandığım bir şifre oluşturma sitesi vardı. Ancak tabiki dışarıdaki bir aracı şifre oluşturmak

74 | için önermiyorum. Ben bu örnekte de şifrem olan `123456` için bu siteden kodu oluşturdum.

75 | Dosyanın içeriğide aşağıdaki gibi :

76 |

77 | ```

78 | hkulekci:$apr1$0DffSiqd$IX9t3AE92RfD.zZc0E97t/

79 | ```

80 |

81 | Şimdi son olarak Nginx'i yeniden başlatalım.

82 |

83 | ```

84 | sudo nginx -s reload

85 | ```

86 |

87 | Artık Elasticsearch'e `elastic.local` adresi üzerinden erişebileceksiniz. İlk denememizi yapalım.

88 |

89 | ```

90 | ➜ ~ curl -XGET "http://elastic.local"

91 |

92 | 401 Authorization Required

93 |

94 |

401 Authorization Required

95 |

nginx/1.8.0

96 |

97 |

98 | ```

99 |

100 | Gördüğünüz gibi elasticsearch erişimini kısıtladık, ve erişmeye çalıştığımızda bize kullanıcı adı ve

101 | şifre soruyor. Şimdi elasticsearch için oluşturduğumuz şifre ile erişmeye çalışalım.

102 |

103 | ```json

104 | ➜ ~ curl --user hkulekci:123456 -XGET "http://elastic.local"

105 | {

106 | "name" : "Black Jack Tarr",

107 | "cluster_name" : "elasticsearch",

108 | "version" : {

109 | "number" : "2.3.1",

110 | "build_hash" : "bd980929010aef404e7cb0843e61d0665269fc39",

111 | "build_timestamp" : "2016-04-04T12:25:05Z",

112 | "build_snapshot" : false,

113 | "lucene_version" : "5.5.0"

114 | },

115 | "tagline" : "You Know, for Search"

116 | }

117 | ```

118 |

119 | Bu işlem sonrasında elasticsearh'ü nginx arkasına aldık ve kullanıcı adı ve şifre ile koruduk. Bu

120 | korumanın yanı sıra nginx `access.log` ve `error.log` ile elasticsearch sorgularınız hakkında

121 | analizler de yapabileceksiniz. Benim örnek loglarım aşağıdaki gibi :

122 |

123 | ```

124 | 127.0.0.1 - hkulekci [23/Apr/2016:07:14:59 +0300] "GET / HTTP/1.1" 200 340 "http://elastic.local/_plugin/head/" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.110 Safari/537.36"

125 | 127.0.0.1 - hkulekci [23/Apr/2016:07:15:00 +0300] "GET /_cluster/state HTTP/1.1" 200 97713 "http://elastic.local/_plugin/head/" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.110 Safari/537.36"

126 | 127.0.0.1 - hkulekci [23/Apr/2016:07:15:00 +0300] "GET /_status HTTP/1.1" 200 12427 "http://elastic.local/_plugin/head/" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.110 Safari/537.36"

127 | 127.0.0.1 - hkulekci [23/Apr/2016:07:15:00 +0300] "GET /_nodes HTTP/1.1" 200 3650 "http://elastic.local/_plugin/head/" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.110 Safari/537.36"

128 | ```

129 |

130 | Teşekkürler.

131 |

132 |

133 | ### Kaynaklar :

134 | - https://www.digitalocean.com/community/tutorials/understanding-nginx-http-proxying-load-balancing-buffering-and-caching

135 | - https://www.nginx.com/resources/admin-guide/reverse-proxy/

136 | - https://gist.github.com/soheilhy/8b94347ff8336d971ad0

137 | - http://www.htaccesstools.com/htpasswd-generator/

--------------------------------------------------------------------------------

/_posts/2016-05-06-index-adi-olarak-alias-kullanmak-ve-reindex-api.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Index adı olarak `Alias` Kullanmak ve Reindex API

4 | categories:

5 | - blog

6 | summary: Index isimleri olarak alias kullanarak index değişikliklerinde veya verileri taşımak zorunda kaldığınızda uygulama katmanınızı değiştirmeden verileriniz taşıyın.

7 | ---

8 |

9 | Elasticsearch API arayüzü `index` isimleri üzerinden çalışmaktadır ve bir cluster içerisinde

10 | çoğu zaman bir çok `index`iniz bulunmaktadır. Index Alias API arayüzü ile `index` isimlerinize

11 | takma isimler verebilirsiniz. Bunun önemini bir örnek üzerinden açıklamaya çalışayım.

12 |

13 | Bir kullanıcıların verilerini tuttuğunuz `index`iniz var ve yapısı aşağıdaki gibi:

14 |

15 | ```json

16 | GET users/user/_mapping

17 | {

18 | "users": {

19 | "mappings": {

20 | "user": {

21 | "properties": {

22 | "id": {

23 | "type": "string"

24 | },

25 | "name": {

26 | "type": "string"

27 | },

28 | "tags": {

29 | "type": "string",

30 | "index": "not_analyzed"

31 | }

32 | }

33 | }

34 | }

35 | }

36 | }

37 | ```

38 |

39 | Bir takım verileriniz birikti ve sonradan farkettiniz ki `id` alanını integer yerine string olarak

40 | kaydetmişsiniz. Hemen değiştirmek için bir mapping update sorgusu hazırladınız:

41 |

42 | ```json

43 | PUT users/user/_mapping

44 | {

45 | "properties": {

46 | "id": {

47 | "type": "integer"

48 | }

49 | }

50 | }

51 | ```

52 |

53 | Ancak hali hazırda olan bir alanın veri tipini değiştirmeye çalıştığınızda Elasticsearch

54 | bundan pek hoşlanmayacaktır ve aşağıdaki gibi bir hata verecektir:

55 |

56 | ```json

57 | {

58 | "error": {

59 | "root_cause": [

60 | {

61 | "type": "illegal_argument_exception",

62 | "reason": "mapper [id] of different type, current_type [string], merged_type [integer]"

63 | }

64 | ],

65 | "type": "illegal_argument_exception",

66 | "reason": "mapper [id] of different type, current_type [string], merged_type [integer]"

67 | },

68 | "status": 400

69 | }

70 | ```

71 |

72 | Uygulamanız hali hazırda kullanılıyor olduğu için index'i silip tekrar oluşturamazsınız. Uygulama

73 | içerisinde de bir çok yerde index ismini kullandığınız için farklı bir isimle index oluşturmanız

74 | da sizin için zor olacak. Bu durumlarda `alias`lar hayat kurtarıcı olabiliyor. Hemen kısaca

75 | açıklayalım.

76 |

77 | İlk olarak yeni bir index oluşturup yeni yapımız ile `type`ı oluşturuyoruz.

78 |

79 | ```json

80 | POST users_20160506

81 |

82 | POST users_20160506/user/_mapping

83 | {

84 | "properties": {

85 | "id": {

86 | "type": "integer"

87 | },

88 | "name": {

89 | "type": "string"

90 | },

91 | "tags": {

92 | "type": "string",

93 | "index": "not_analyzed"

94 | }

95 | }

96 | }

97 | ```

98 |

99 | Daha sonrasında verilerimizi yeni index'imize taşıyoruz. Bunun için Elasticsearch 2.3.1 ile gelen

100 | yeni özelliği `_reindex` API arayüzü kullanabilirsiniz.

101 |

102 | ```json

103 | POST /_reindex

104 | {

105 | "source": {

106 | "index": "users"

107 | },

108 | "dest": {

109 | "index": "users_20160506"

110 | }

111 | }

112 | ```

113 | Buradaki örneğimizde tabiki `id` alanımız integer tipine rahatça çevrilebilecek bir alan olduğu

114 | için rahatça bunu yapabildik. Burada eğer bir alan üzerinde ekstra işlem yaparak taşımak isteseydik

115 | nasıl olacaktı. Bunun için de script kullanabilirsiniz:

116 |

117 | ```json

118 | POST /_reindex

119 | {

120 | "source": {

121 | "index": "users"

122 | },

123 | "dest": {

124 | "index": "users_20160506"

125 | },

126 | "script":{

127 | "inline": "if (ctx._source.foo == 'bar') { ctx._source.id = parseInt(ctx._source.id) }"

128 | }

129 | }

130 | ```

131 | Şimdi verimizi taşıdık. Şimdi sıra geldi takma isim kısmına. Şimdi yeni verdiğimiz index için bir

132 | takma isim vereceğiz ve eski index'imizi sileceğiz ya da takma ismini kaldıracağız. Bizim

133 | senaryomuzda `users` adında bir index'imiz vardı ve biz bu index'deki verileri yeni bir index'e

134 | taşıdık. Bu durumda eski index'imizi kaldırmamız ya da silmemiz gerekmekte. Eğer alias olarak

135 | eski index'imizin adını vereceksek ve index'imizi silmeden bu işlemi yapmaya çalışırsak

136 | Elasticsearch alias oluşturma sırasında bize hata verecektir. Bu ismi kullanan bir `index` var

137 | diyecektir. Şimdi bizim adımlarımızı şöyle yapalım. Verilerimizi yeni index'imize taşıdığımıza

138 | göre eski index'imize ihtiyaç kalmadı. Bunun için o index'i silelim ve yeni oluşturduğumuz

139 | index'e `users` takma adını verelim.

140 |

141 | ```json

142 | DELETE users

143 |

144 | POST _aliases

145 | {

146 | "actions" : [

147 | { "add" : { "index" : "users_20160506", "alias" : "users" } }

148 | ]

149 | }

150 | ```

151 |

152 | Bu işlemleri tamamladıktan sonra halen `/users/user/_search` sorgusu yaptığınızda verilerinizi

153 | görebilirsiniz.

154 |

155 | ```json

156 | {

157 | "took": 9,

158 | "timed_out": false,

159 | "_shards": {

160 | "total": 5,

161 | "successful": 5,

162 | "failed": 0

163 | },

164 | "hits": {

165 | "total": 4,

166 | "max_score": 1,

167 | "hits": [

168 | {

169 | "_index": "users_20160506",

170 | "_type": "user",

171 | "_id": "AVSB74LRHQRC9fPqMzsA",

172 | "_score": 1,

173 | "_source": {

174 | "tags": [

175 | "php",

176 | "python",

177 | "html"

178 | ],

179 | "name": "Haydar"

180 | }

181 | },

182 | ...

183 | ]

184 | }

185 | }

186 | ```

187 |

188 | Peki olan bir takma ismi bir index'den diğerine taşımak için ne yapmalısını.z Bunun için

189 | tek bir komut çalıştırmanız yeterli. İki komut birden çalıştırmanız gerekmez. Bir örnek ile

190 | anlatmaya çalışayım. Gün geldi bu yazımızda oluşturduğumuz `users_20160506` index'ini

191 | yine değiştirmeniz ve taşımanız gerekti. Verileriniz `users_20160720` index'ine taşıdınız ve

192 | şimdi `users` takma adınızı taşımak istiyorsunuz. İşiniz gayet basit:

193 |

194 | ```json

195 | POST /_aliases

196 | {

197 | "actions" : [

198 | { "remove" : { "index" : "users_20160506", "alias" : "users" } },

199 | { "add" : { "index" : "users_20160720", "alias" : "users" } }

200 | ]

201 | }

202 | ```

203 |

204 | Sonuç olarak takma isimler (`_aliases`) ve 2.3.1 versiyonu ile gelen `_reindex` API arayüzü

205 | işlerinizi ve hayatınızı baya kolaylaştırabilir. Bu API arayüzlerini kullanarak verinizi uygulama

206 | katmanından ayırarak kolay yönetebilir ve rahatlıkla taşıyabilirsiniz.

--------------------------------------------------------------------------------

/_posts/2016-06-20-takma-isim-alias-kullanarak-verileri-filtrelemek.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Takma isim (Alias) kullanarak verileri filtrelemek

4 | categories:

5 | - blog

6 | summary: Takma isimler kullanarak verilerinizi kolayca filtrelenmiş halleriyle sorgulayabilirsiniz.

7 | ---

8 |

9 | Bir önceki yazımda `index` için takma isim oluşturmayı ve bu takma ismi kullanmayı

10 | görmüştük. Elasticsearch'ün yeni sürümü (2.x) ile birlikte takma isimler ile birlikte

11 | index üzerinde filtreleme de yapabiliyorsunuz. Bir örnek ile açıklamaya çalışalım.

12 |

13 | `id`, `type`, `keywords` alanlarından oluşan bir index ve tipimiz var. Aşağıdakine

14 | benzer verilerin olduğunu düşünün.

15 |

16 | ```

17 | {

18 | "id": 1,

19 | "type": "search",

20 | "keywords": ["elasticsearch", "elastic", "framework"]

21 | },

22 | {

23 | "id": 4,

24 | "type": "client",

25 | "keywords": ["golang", "elasticsearch"]

26 | }

27 | ```

28 |

29 | Örnek veri için bir gist hazırladım.

30 | Göz atabilirsiniz: [https://gist.github.com/hkulekci/2146c1da124e42cd02ed3c4635934f62](https://gist.github.com/hkulekci/2146c1da124e42cd02ed3c4635934f62)

31 |

32 | Bu verilerimiz bir için bir takma isim oluşturacağız ve ayrıca bu takma isim

33 | üzerinden yaptığımız bütün aramalarıda `type` alanı `client` olanları filtrelemesini

34 | isteyeceğiz. Böylelikle bu alias aslında `index`imizin sadece bazı kısımlarını

35 | temsil etmiş olacak.

36 |

37 | Peki bunu nasıl yapacağız. Bunun için önceki yazımızda gördüğünüz takma isim

38 | oluşturma yönteminde olduğu gibi `_aliases` arayüzünü kullanacağız ancak bu arayüze

39 | verimizi gönderirken ekstra olarak `filter` diye bir parametre daha göndereceğiz.

40 |

41 | Hemen bir örnek yapalım:

42 |

43 | ```

44 | POST /_aliases

45 | {

46 | "actions": [

47 | {

48 | "add": {

49 | "index": "test",

50 | "alias": "test_client",

51 | "filter": {

52 | "term": {

53 | "type": "search"

54 | }

55 | }

56 | }

57 | }

58 | ]

59 | }

60 | ```

61 |

62 | Yukarıdaki örnekte `test` index'i için bir filtreleme oluşturdum ve bu takma ismi

63 | kullandığım zaman sadece `type` alanı `search` olan verileri kullanmak istediğimi

64 | belirtmiş oldum.

65 |

66 | Şimdi gidip `/test_client/_search` aramasını yaptığımda bana sadece `type` alanı

67 | `search` değerinde olan verileri geri döndürecektir. Diğer veriler sanki bu

68 | index'te yok gibi davranacaktır.

69 |

70 | Bu özelliği bir çok şey için rahatça kullanabiliriz. Örneğin kendimize büyük

71 | filtrelemeler sonucu hazırladığımız sorgularımızı bir alias olarak tanımlayarak

72 | sanki SQL'deki view'lar gibi ya da `procedure`ler gibi kullanabiliriz.

73 |

--------------------------------------------------------------------------------

/_posts/2016-07-13-panama_belgelerini_analiz_etmek_için_elastic_graph_ve_kibana_kullanmak_ceviri.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Panama Belgelerini Analiz Etmek için Elastic Graph ve Kibana Kullanmak (Çeviri)

4 | categories:

5 | - blog

6 | summary: Elasticsearch'ün eklentisi Graph ile Panama Belgelerini inceleyeceğiz ve Graph Kibana eklentisi ile de bu verileri görselleştireceğiz.

7 | ---

8 |

9 | Yeni Elastic Graph'ın yetenekleri veri içerisindeki bağlantıları daha kolay

10 | analiz etmemizi sağlar. Eğer işiniz Panama Belgelerindeki yabancı ülkelerin

11 | içinden çıkılmayacak finansal düzenlemelerini veya revaçtaki bir e-ticaret

12 | sitesinin yüksek seviye tıklama davranışlarını takip etmek ise, Graph

13 | teknolojisi bu ilişkileri size sağlamakta yardımcı olabilir.

14 |

15 | Graph'ın yetenekleri Elastic Stack için ticari X-Pack eklentisinin bir parçası

16 | olarak gelmektedir. Paket bir Kibana uygulaması ve yeni bir Elasticsearch API

17 | uçnoktası içermektedir. Bu ilk Graph yazımızca biz API'ın ve Kibana arayüzünün

18 | bize ne sundukları ile ilgili kısa bir göz atacağız.

19 |

20 | ### Forensic Analiz: Panama Papers

21 |

22 | Panama Belgeleri, Off-shore hukuk firması Mossack Fonseca tarafından

23 | [Mali ve Yasal kayıtların yayınlanması](https://panamapapers.icij.org/) 2016'nın

24 | en çok tepki toplayan haberlerinden birisidir. Kayıtlar bir çok politikacı,

25 | kraliyet üyesi, zengin ve onların ailelerinin deniz aşırı vergi rejimlerini

26 | kullanmak için kurulan petrol şirketlerini açığa çıkardı. Gazeteciler ve finans

27 | kuruluşları dikkatli bir şekilde bu veriler üzerinde odaklandılar(çalıştılar)

28 | ama bağlantıları ortaya çıkarmak gerçekten çok zor oldu ve de zaman aldı ama

29 | Kibana Graph uygulaması bunu herkes için kolay hale getirdi:

30 |

31 |

32 |

33 | Yukarıda Viladimir Putin'in yakın arkadaşı

34 | [Sergei Roldugin](http://www.theguardian.com/news/2016/apr/03/panama-papers-money-hidden-offshore)'in,

35 | şirketler ve bireysel kişiler ile ilişkilerini görüyorsunuz. Bu resim Graph ile

36 | bir kaç basit adım ile oluşturulabilir:

37 |

38 | ### Veri kaynağını seçmek

39 |

40 | Başlangıçta indis listemizden "panama"yı seçiyoruz ve sonra içerisinde diagramda

41 | göstermek istediğimiz veriler bulunan bir kaç alan(field) seçiyoruz (Varsayılan

42 | olarak tek bir alan(field) seçimine izin veriliyor ancak sağ üssteki tuşlarda

43 | "Advanced Mode"a tıkladığınızda daha fazla alan seçebiliyor olacaksınız).

44 | Diagramda görünen "düğüm"ler için her bir alanı temsil eden bir ikon ve renk

45 | verilir.

46 |

47 |

48 |

49 | ### Arama Yapmak

50 |

51 | Şimdi Putin'in arkadaşının adını "Roldugin" içeren dökümanlara ulaşmak için bir

52 | normal bir metin araması çalıştıralım.

53 |

54 |

55 |

56 | Döküman içerisinde eşleşen terimler bir ağ olarak gösterildi - her bir çizgi

57 | terimler ile eşleşen bir veya daha fazla dökümanı göstermektedir.

58 |

59 | ICIJ'deki veriyi çıkaran gazeteciler belgelere eklenmiş her bir dökümanın

60 | referans verdiği gerçek hayattaki her bir birim/varlık için (person/company/

61 | address) tekil bir ID vermeyi denediler. Ne yazık ki, insan isimleri ve adresler

62 | eşleşmeler için uygun olmayabilir - gazeteciler 3 dökümanda ilişkili halde

63 | bulunan 12180773 kimlik numaralı Person varlığı belirlediler ama bu kişi ile

64 | benzer isimde iki kişi daha olduğunu rahatça görebiliriz ve bu kişiler farklı

65 | bir kimliğe sahipler. Gelecekteki bir yazımızda da, otomatik varlık çözümleme

66 | (Automated Entity Resolution) için Graph API'ın kullanımı hakkında konuşacağız.

67 | Şimdilik bunu elle (gruplama aracı ile) düzenleyelim.

68 |

69 |

70 | ### Düğümleri Gruplama

71 |

72 | Gelişmiş mod aracını kullanarak seçebiliriz(Sağdaki "Selections" kutusunu),

73 | sonra düğümleri birleştirmek için `group` düğmesine basın. Bu bize daha temiz

74 | bir resim verecektir. (Bir düğüme tıklayın ve daha sonra "linked" tuşuna

75 | tıklayarak bağlantılı diğer düğümleri seçin. Sonrasında bazılarının seçimini

76 | kaldırmak istiyorsanız listelenen düğümlerin ikonlarına tıklayarak

77 | kaldırabilirsiniz.)

78 |

79 |

80 |

81 | Eğer istiyorsak, gruplanmışları da ayrıca gruplayabiliriz. Örn, farklı

82 | kimliklere sahip kişilerin bir düğümde toplanması ve sonra bunları şirket

83 | düğümünde birleştirme.

84 |

85 | ### "Spidering out"

86 |

87 | Graph en ilişkili bağlantıları gösterecektir. Ancak siz farzedelim varlıklarla

88 | bağlantılı diğer varlıklarıda (entities) görmek istiyoruz? Araç çubuğundaki "+"

89 | düğmesini kullanarak varlıklar ile ilişkili diğer bağlantıları keşfetmeye devam

90 | edebiliriz.

91 |

92 |

93 |

94 | "+" tuşuna tekrar tekrar basarak resmi genişletebiliriz ve grafiğin belirli bir

95 | alanına odaklananabiliriz. "undo" ve "redo" tuşları ilgisiz sonuçlardan geri

96 | dönmek için önemli tuşlardır. Ek olarak, "delete" ve "blacklist" tuşları ile

97 | düğümlerin tamamen sonuçlardan çıkarılmasını ya da sadece karalisteye alınmasını

98 | sağlayabilirsiniz. Seçilen düğümlerin örnek dökümanlarıda "Show example docs"

99 | tuşu ile ayrıca görüntüleyebilirsiniz.

100 |

101 | Eğer Panama Belgelerini kendiniz görüntülemek istiyorsanız.

102 | [Elasticsearch](https://www.elastic.co/downloads/elasticsearch),

103 | [Kibana](https://www.elastic.co/downloads/kibana),

104 | ve [Graph plugin](https://www.elastic.co/downloads/graph) eklentisinin birer

105 | kopyasını edinin ve [bit.ly/espanama](bit.ly/espanama) şuradaki kurulum

106 | adımlarını izleyin.

107 |

108 | ### Wisdom of crowds

109 |

110 | Panama Belgeleri her tekil dökümanın önemli bağlantılarının olduğu "forensic" tipinde

111 | bir soruşturma örneğidir.

112 |

113 | Ama, Elastic Graph kullanıcı tıklama günlüklerinin bulunduğu verilerin

114 | davranışlarının özetlenmesi için de rahatça kullanılabilir. Analizin bu formunu

115 | tanımlamak için kullanılan genel ifadeler "collective intellegence" veya "wisdom

116 | of crowds"dur. Bu senaryoda, her bir dökümanın kendisi ilgili değildir ama bir

117 | çok kullanıcının davranışları bir desen oluşturabilir ve onlar öneri sisteminde

118 | kullanılabilir. Örn; "X ürününü satın alan kullanıcılar Y ürününü almak

119 | isteyebilir.". Bu senaryoda bizim sahte bağlantılar oluşturan tek seferlik

120 | dökümanların bağlantılarını ve zaten bilinen bağlantıları önlememiz gerekir

121 | (Örneğin X ürünü alan insanlar zaten süt almak zorunda ise). Bu düşüncede

122 | varsayılan ayarlar sadece en önemli bağlantıları tanımlamak için ayarlanmıştır.

123 |

124 | Öneri kullanımı için [LastFM dataset](http://mtg.upf.edu/node/1671) veri setine

125 | bir bakalım. Eğer, her bir dökümanında her bir dinleyici için sevdiği

126 | şarkıcıları bir dizi içerisinde tutan kullanıcı merkezli bir index oluşturursak,

127 | bu index içerisinde insanların "Chopin"i aradığımızda bu şarkıcıyı sevenlerin

128 | başka kimleri sevdiğine ulaşabiliriz.

129 |

130 |

131 |

132 | Birbiri ile ilişkili klasik müzik sanatçıları dönecektir. Bu sanatçılar

133 | arasıdaki çizgilere tıkladığımızda ne kadar dinleyicinin ilgili olduğunu

134 | görebilirsiniz. Neredeyse tüm Mendelssohn dinleyicilerinin yarısı ayrıca Chopin

135 | dinlemektedirler.

136 |

137 | Graph API sadece _önemli ilişkileri_ tanımladı. Bu diğer Graph arama

138 | teknolojilerinden önemli bir ayrımdır.

139 |

140 | ### Popüler != Önemli

141 |

142 | Ayalar sekmesine geçip "sadece önemli bağlantılar" özelliğini kasten kapatıp

143 | neler olduğunu bir görelim.

144 |

145 |

146 |

147 | "significant links" kutusu seçili değilken Chopin dinleyenler aramasını tekrar

148 | çalıştıralım ve farkı görelim.

149 |

150 |

151 |

152 | Radiohead ve Coldplay gibi (dünyada) popüler sanatçılar şimdi sonuçlara

153 | sızmıştır kesin. 5,721 Cohip severin 1,843 tanesi Beatles'da sevmektedir. Biz

154 | bunu süt satın alan kişiler gibi

155 | ["commonly common"](http://www.infoq.com/presentations/elasticsearch-revealing-uncommonly-common)

156 | olarak tanımlıyoruz. "Significant links" düğmesini açtığımızda "uncommonly

157 | common" olarak cağırdığımız gürültülere dikkat etmeden direk konumuza

158 | odaklanıyor olacağız. Aslında yıllardır arama motorlarına güç veren TF-IDF

159 | algoritması da aynı ilkelere dayanmaktadır.

160 |

161 | _By reusing these relevance ranking techniques we can stay "on topic" when exploring connections in data. This is an important distinction from graph databases which have no concept of relevance ranking and are typically forced to employ a strategy of just deleting popular items (see the problem of "supernodes")._

162 |

163 | _Note: When performing detailed forensic work such as exploring the Panama Papers, it can help to keep "significant links" turned on to try avoid the super-popular companies but the "certainty" setting should be lowered from its default value of three to one. For wisdom-of-crowds type scenarios we want at least three documents to assert a link before we trust it whereas in forensics every document is potentially interesting._

164 |

165 | ### Özet

166 |

167 | Umarız bu yazı Graph'ın iki ana modun kullanımı için hızlı bir girişi olmuştur:

168 |

169 | - Forensics: Her döküman potansiyel olarak ilgi çekicidir. Arama bireysel

170 | kayıt ve aktörlere odaklanır.

171 | - Wisdom of crowds: Büyük ölçekli davranışların "büyük resmine" odaklanır.

172 | Bir çok gürültü yaratacak bağlantı mevcuttur ancak verideki sadece gerçekten

173 | önemli olan bağlantılara odaklanır.

174 |

175 | Gelecekteki yazılarımızda diğer özel kullanım alanlarına ve Kibana

176 | uygulamasının arka planda kullandığı Elasticsearch API'ını nasıl kullandığına

177 | daha derin bakıyor olacağız.

178 |

179 | Bizi takip edin...

180 |

181 |

182 | Kaynak : [https://www.elastic.co/blog/using-elastic-graph-and-kibana-to-analyze-panama-papers](https://www.elastic.co/blog/using-elastic-graph-and-kibana-to-analyze-panama-papers)

--------------------------------------------------------------------------------

/_posts/2016-07-17-eszamanlilik-kontrolu.md:

--------------------------------------------------------------------------------

1 | ---

2 | layout: post

3 | title: Eşzamanlılık Kontrolü

4 | categories:

5 | - blog

6 | summary: Elasticsearch dağıtık bir yapıya sahiptir ve bu dağıtık yapıda eşzamanlı işlemlerimizde verilerimizi kaybetmeden nasıl sürümleriz ve sürümleri yönetiriz.

7 | ---

8 |

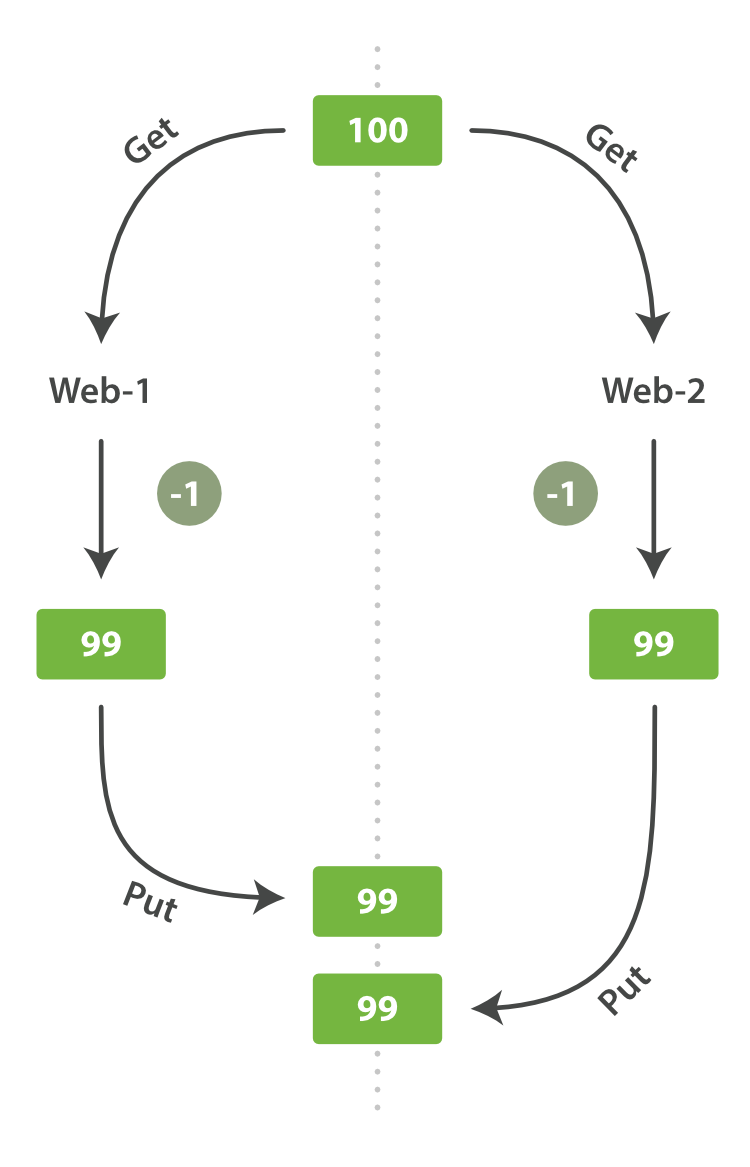

9 | Eğer Dağıtık çalışan bir uygulamanız varsa ve uygulamanızda dökümanları

10 | güncelleyen silen ya da oluşturan bir mekanizmanızda varsa ki vardır; Genellikle

11 | dökümanlar üzerindeki işlemlerde çakışmalar olur ve bu çakışmalar yüzünden veri

12 | kayıpları meydana gelir. Örnek olarak aşağıdaki grafige bir göz atabilirsiniz.

13 |

14 |

15 |

16 | Örnekte görüldüğü üzere `web-1` ve `web-2` paralel işleyen iki web sunucusu

17 | ve aynı döküman üzerinden işlem yapıyorlar ve bu dökümandaki `stock_count`

18 | alanının ilk değeri 100 iken ikiside aynı anda dökümanı çekiyor ve sonra

19 | dökümanın değerini güncelleyip tekrar yazıyorlar. Sonuç itibariyle

20 | dökümanın son değeri 98 olması gerekirken 99 olarak kalıyor. Veritabanı

21 | dünyasında buna sıklıkla rastlanır ve 2 genel yaklaşım vardır.

22 |

23 | - Pessimistic concurrency control (Kötümser eşzamanlılık kontrolü)

24 | İlişkili veritabanı sistemlerinde kullanılan satır ya da tablo bazında

25 | erişimi engelleyerek veri kaybını önleme yönetmidir.

26 | - Optimistic concurrency control (İyimser eşzamanlılık kontrolü)

27 | Elasticsearch tarafından kullanılan yöntemdir ve işlemi engellemez ancak

28 | güncelleme sırasında hata fırlatır ve çakışmayı çözme kararını uygulama

29 | bırakır.

30 |

31 | Elasticsearch dağıtıktır. Döküman oluşturulduğunda, güncellendiğinde ya da

32 | silindiğinde dökümanın yeni sürümü diğer `node`lara ya da yansılar ile

33 | paylaşılır. Elasticsearch aynı zamanda asenkron ve eşzamanlı çalışır,

34 | bunun anlamı replikasyon işlemi isteklerini paralelde göndermesidir.

35 | Elasticsearch eski sürüm bir dökümanın yeni sürüm bir döküman üzerine

36 | yazılmaması için bir yola ihtiyaç duyarmaktadır.

37 |

38 | Daha öncede bahsettiğimiz üzere döküman için çekildiğinde ya da silindiğinde

39 | her bir dökümana ait bir `_version` alanında bir numarası bulunmaktadır. Bu

40 | numara döküman her değiştiğinde artmaktadır. Elasticsearch bu numarayı

41 | değişiklikleri düzgün sırayla onaylamak için kullanmaktadır. Eğer eski

42 | sürüm yeni bir sürümden sonra ulaşırsa sessizce göz ardı eder.

43 |

44 | Biz `_version` numarasını kullanarak veri kaybı yaşamadan değişiklikleri

45 | uygulama içerisinde uygulayabiliriz. Değiştirmeyi düşündüğümüz döküman için

46 | özel bir sürüm numarası vererek bunu yapabiliriz. Eğer bu sürüm şimdi sürüm