├── .github

└── workflows

│ └── main.yml

├── .gitignore

├── .nojekyll

├── CNAME

├── README.md

├── _coverpage.md

├── _navbar.md

├── _sidebar.md

├── docs

├── 0.少儿编程

│ ├── README.md

│ ├── 免费的Scratch学习资源梳理(持续更新ing)_2024-07-31.md

│ ├── 全网爆火的免费少儿编程网站!一文揭开code.org的神秘面纱_2024-07-31.md

│ ├── 公众号排版器.md

│ ├── 在家带娃学编程?附路线规划图_2024-07-31.md

│ ├── 娃适合学编程么?不妨陪ta从零开始_2024-07-31.md

│ ├── 少儿编程考级怎么选?你想要了解的一切都在这里_2024-07-31.md

│ └── 少儿编程都有哪些比赛?全网鼓吹的信奥赛NOI到底有多难?.md

├── 1.Linux笔记

│ ├── AI 本地环境配置:一文梳理 Nvidia驱动_CUDA_CUDNN_PyTorch_Paddle 版本兼容&安装问题(持续更新).md

│ ├── Docker 国内镜像站全部失效?试试这个方法,亲测有效.md

│ ├── README.md

│ ├── 【保姆级教程】Linux系统下如何玩转Docker.md

│ ├── 【保姆级教程】Windows 远程登录 Ubuntu桌面环境.md

│ ├── 【保姆级教程】Windows 远程登陆 Linux 服务器的两种方式:SSH + VS Code,开发必备.md

│ ├── 【保姆级教程】Windows上安装Linux子系统,搞台虚拟机玩玩.md

│ ├── 【保姆级教程】如何在 Windows 上实现和 Linux 子系统的端口映射.md

│ ├── 【保姆级教程】实操 Linux 磁盘管理:硬盘选型 & 分区挂载.md

│ ├── 报错解决ImportError_ libcrypto.so.10_ cannot open shared object file_ No such file or directory.md

│ └── 报错解决ImportError_ libnvinfer.so.7_ cannot open shared object file_ No such file or directory.md

├── 2.玩转云服务

│ ├── 86K Star!又一款内网穿透利器,开源免费+小白友好.md

│ ├── README.md

│ ├── Untitled.md

│ ├── 【保姆级教程】免费内网穿透,手把手搭建,三步搞定.md

│ ├── 【保姆级教程】免费域名注册 & Cloudflare 域名解析 & Ngnix端口转发.md

│ ├── 【保姆级教程】白嫖 Cloudflare 之 5 分钟搭建个人静态网站.md

│ ├── 【白嫖 Cloudflare】之 免费内网穿透,让本地AI服务,触达全球.md

│ ├── 【白嫖 Cloudflare】之免费 AI 服务,从API调用到应用搭建.md

│ ├── 【白嫖 Cloudflare】之免费图床搭建:PicGo + Cloudflare R2,手把手教.md

│ ├── 两款 GPU 云服务器,助力小白上手 AI.md

│ ├── 从0搭建你的免费图床(PicGo + Oracle cloud 甲骨文云对象存储).md

│ ├── 你的服务器管家,不仅免费开源,还贼简洁好用.md

│ ├── 我花了一天时间,搭了个专属知识库,部署上线了,手把手教,不信你学不会.md

│ ├── 玩转云服务:Google Cloud谷歌云永久免费云服务器「白嫖」 指南.md

│ ├── 玩转云服务:Oracle Cloud甲骨文永久免费云主机配置指南(续).md

│ ├── 玩转云服务:Oracle Cloud甲骨文永久免费云服务器注册及配置指南.md

│ ├── 玩转云服务:手把手带你薅一台腾讯云服务器.md

│ └── 谁偷偷看了你的网站?这两款统计工具告诉你!小白易上手.md

├── 3.AI笔记

│ ├── 15.9K Star!知识库RAG还能这么玩?基于 GraphRag 打造知识图谱增强的 LLM - 以解读《红楼梦》为例.md

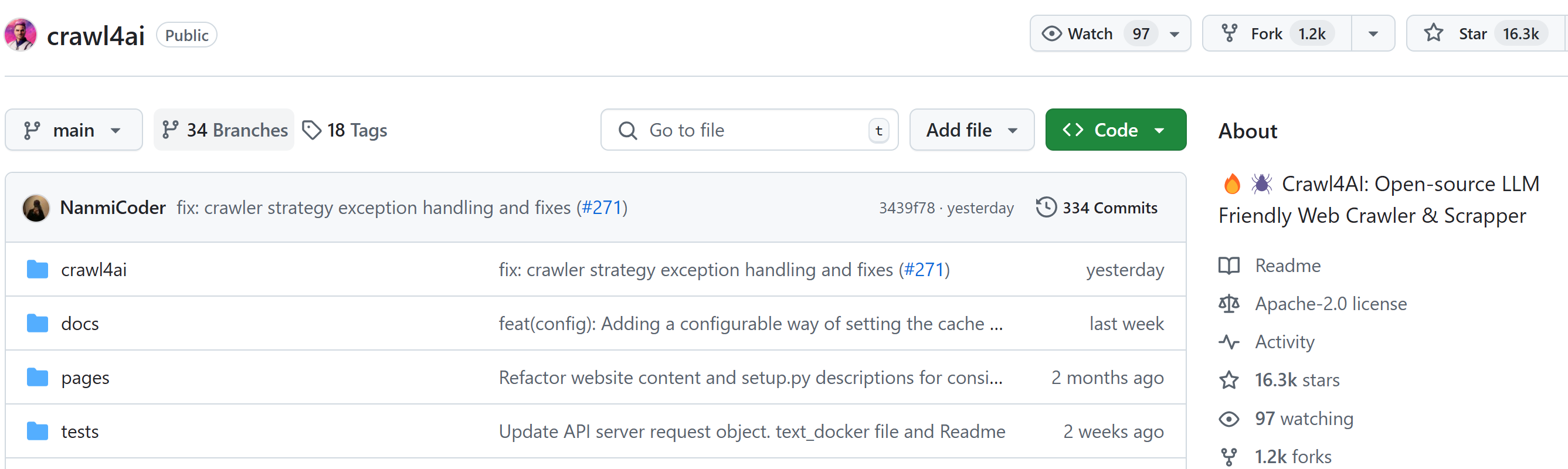

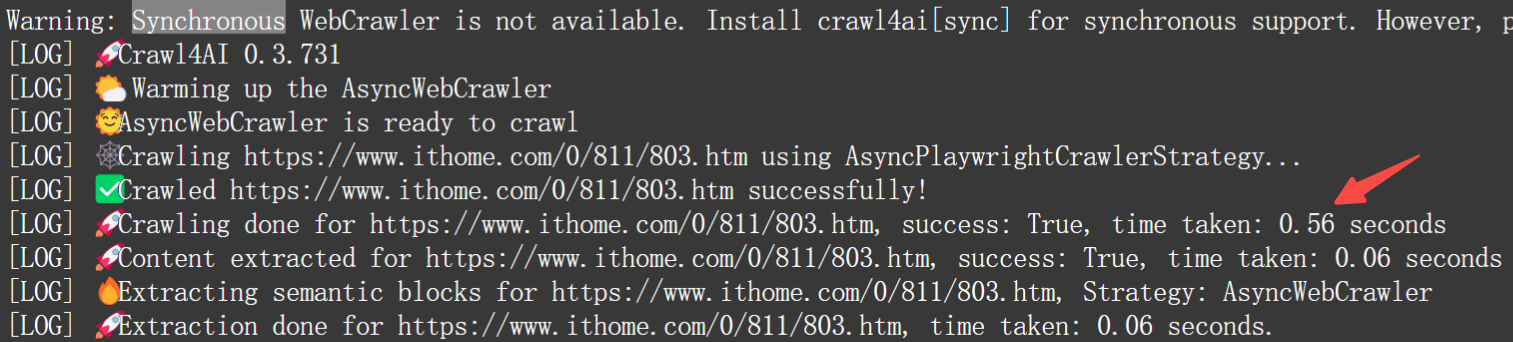

│ ├── 16.3K Star!AI 驱动的的开源爬虫工具.md

│ ├── 17k star!开源最快语音克隆方案,FishSpeech 焕新升级,本地部署实测.md

│ ├── 20K Star! 开源最强 AI 换脸,助力数字人自由.md

│ ├── 37K 下载!开源图像背景去除项目,精确到发丝,数字人福音.md

│ ├── 4.9K Star!开源 AI 搜索引擎本地搭建,全程免费,邀你围观体验.md

│ ├── 4k star!升级版OneAPI,助力 Dify 兼容 OpenAI 格式.md

│ ├── 5分钟,打造你的海报生成器!定制化、批量化、自动化.md

│ ├── AI全栈利器开源!带你用Ollama+Qwen2.5-Code跑bolt.new.md

│ ├── AI全栈开发利器:字节 Trae 初体验,最强 Claude 3.5 _ GPT 4o 无限免费用.md

│ ├── AI全栈开发利器:弃坑 Cursor 拥抱 Google IDX,代码生成+云端部署.md

│ ├── AI加持下,如何从0到1做一个AI服务网站.md

│ ├── B站大模型指令微调入门实战(完整代码),一键打造你的数字分身.md

│ ├── CogVideo 实测,智谱「清影」AI视频生成,全民免费,连 API 都开放了!.md

│ ├── CosyVoice 实测,阿里开源语音合成模型,3s极速语音克隆,5分钟带你部署实战.md

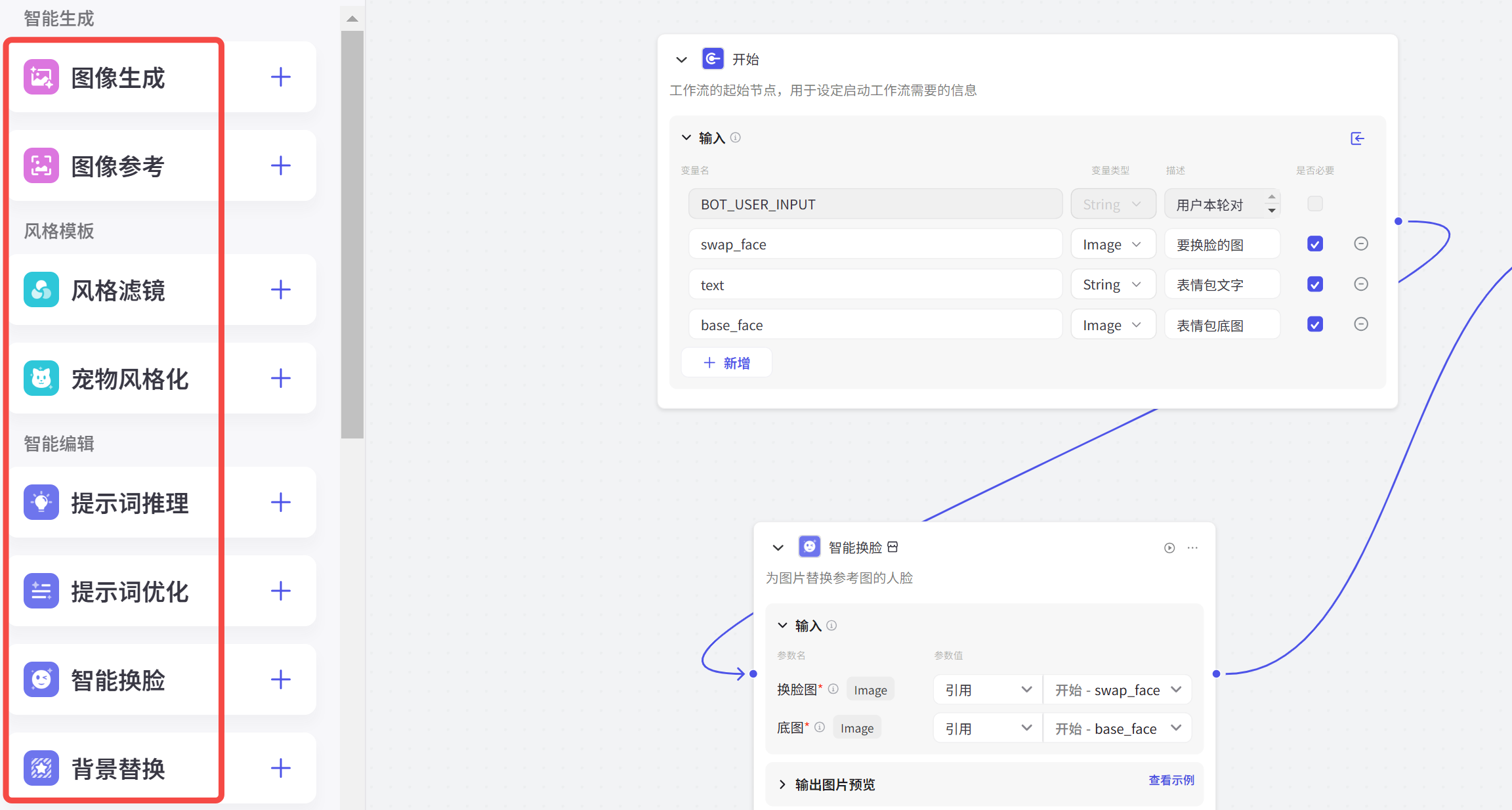

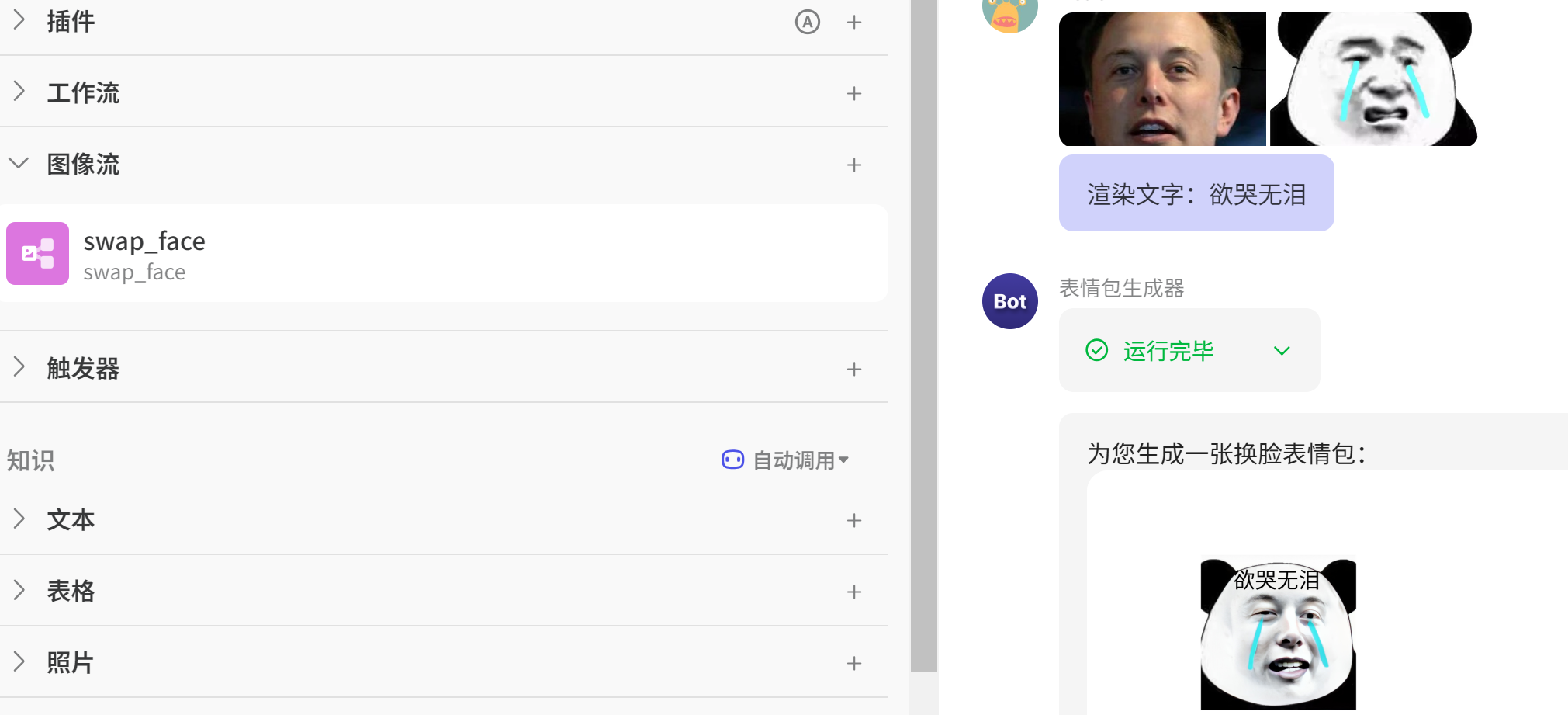

│ ├── Coze 智能体之:零代码打造换脸表情包生成器.md

│ ├── Dify 保姆级教程之:零代码打造 AI 搜索引擎.md

│ ├── Dify 保姆级教程之:零代码打造个性化记忆助手.md

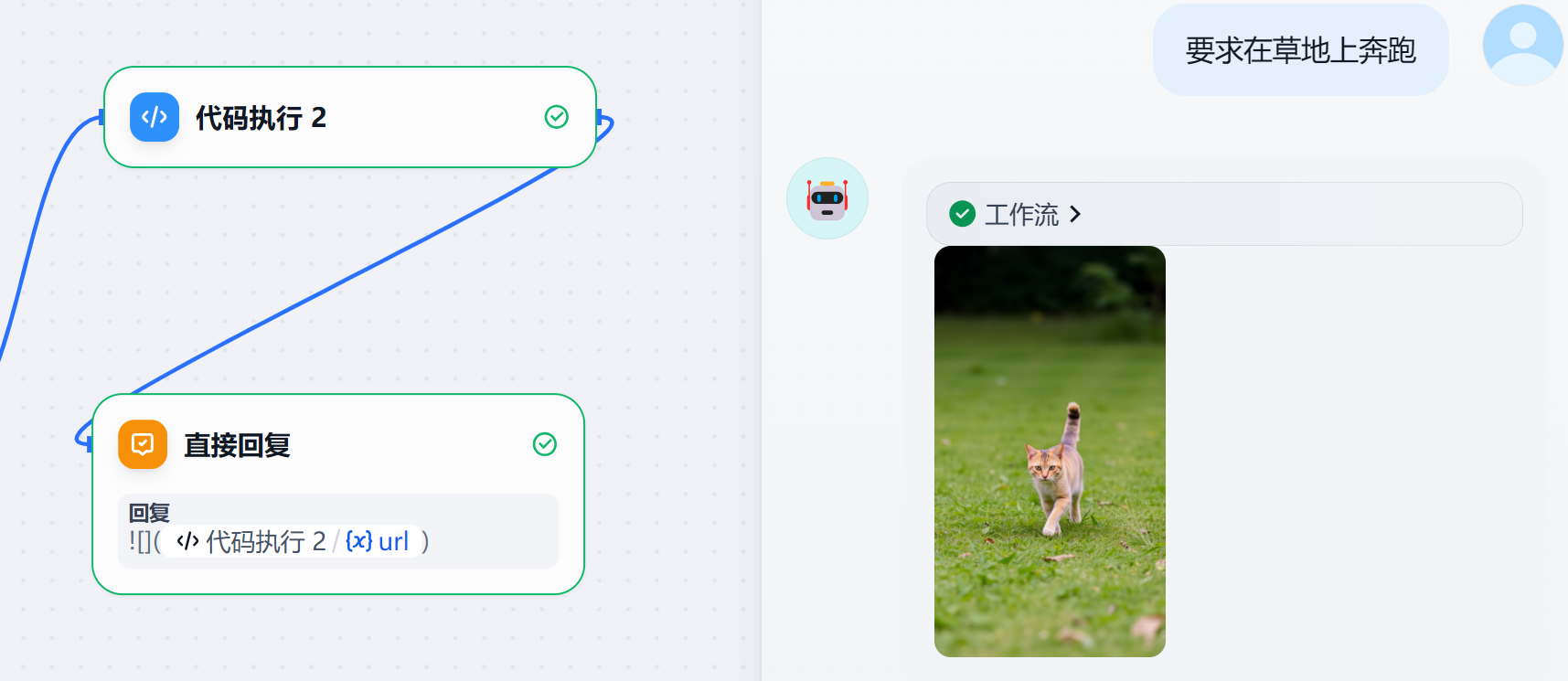

│ ├── Dify 保姆级教程之:零代码打造图像生成专家(上).md

│ ├── Dify 保姆级教程之:零代码打造图像生成专家(下).md

│ ├── Dify 保姆级教程之:零代码打造票据识别专家.md

│ ├── EasyAnimate-v3 实测,阿里开源视频生成模型,5 分钟带你部署体验,支持高分辨率超长视频.md

│ ├── FLUX.1 实测,堪比 Midjourney 的开源 AI 绘画模型,无需本地显卡,带你免费实战.md

│ ├── FastGPT:给 GPT 插上知识库的翅膀!0基础搭建本地私有知识库,有手就行.md

│ ├── FishSpeech 实测,免费语音克隆神器,5分钟部署实战,让川普给你来段中文绕口令?.md

│ ├── Jetson 超频刷机教程!解锁端侧AI推理怪兽的算力极限,附实测对比.md

│ ├── NGCBot-打造基于Hook机制的微信机器人,Windows本地部署.md

│ ├── Nginx 助力 DeepSeek 本地部署,实现高可用、负载均衡的大模型应用.md

│ ├── Ollama 更新!本地跑 LLama3.2,轻量级+视觉能力,能媲美GPT-4o?.md

│ ├── OneAPI - 接口管理和分发系统部署和实战,帮你把大模型封装成OpenAI协议.md

│ ├── README.md

│ ├── SenseVoice 实测,阿里开源语音大模型,识别效果和效率优于 Whisper,居然还能检测掌声、笑声!5分钟带你部署体验.md

│ ├── 「AI数学老师」,一个前后端分离的小项目.md

│ ├── 【AI工具+变现】老照片上色,图像高清化。。。一个网站全搞定.md

│ ├── 【YOLOv8实战】手把手带你入门YOLOv8,你也能训练自己的检测器,以SAR目标检测为例(源码+数据集+Gradio界面).md

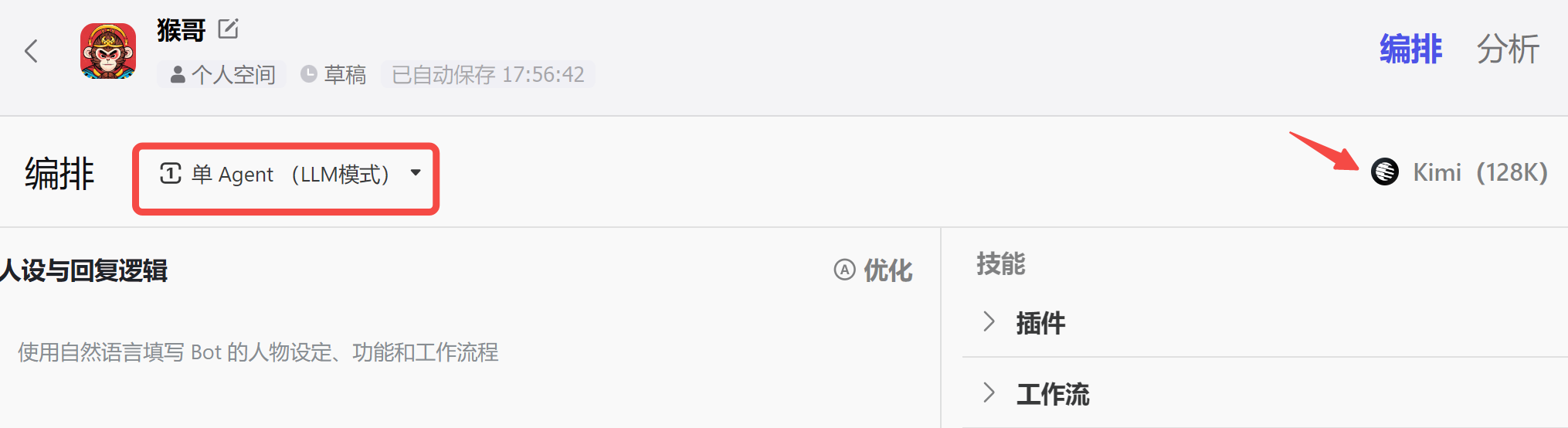

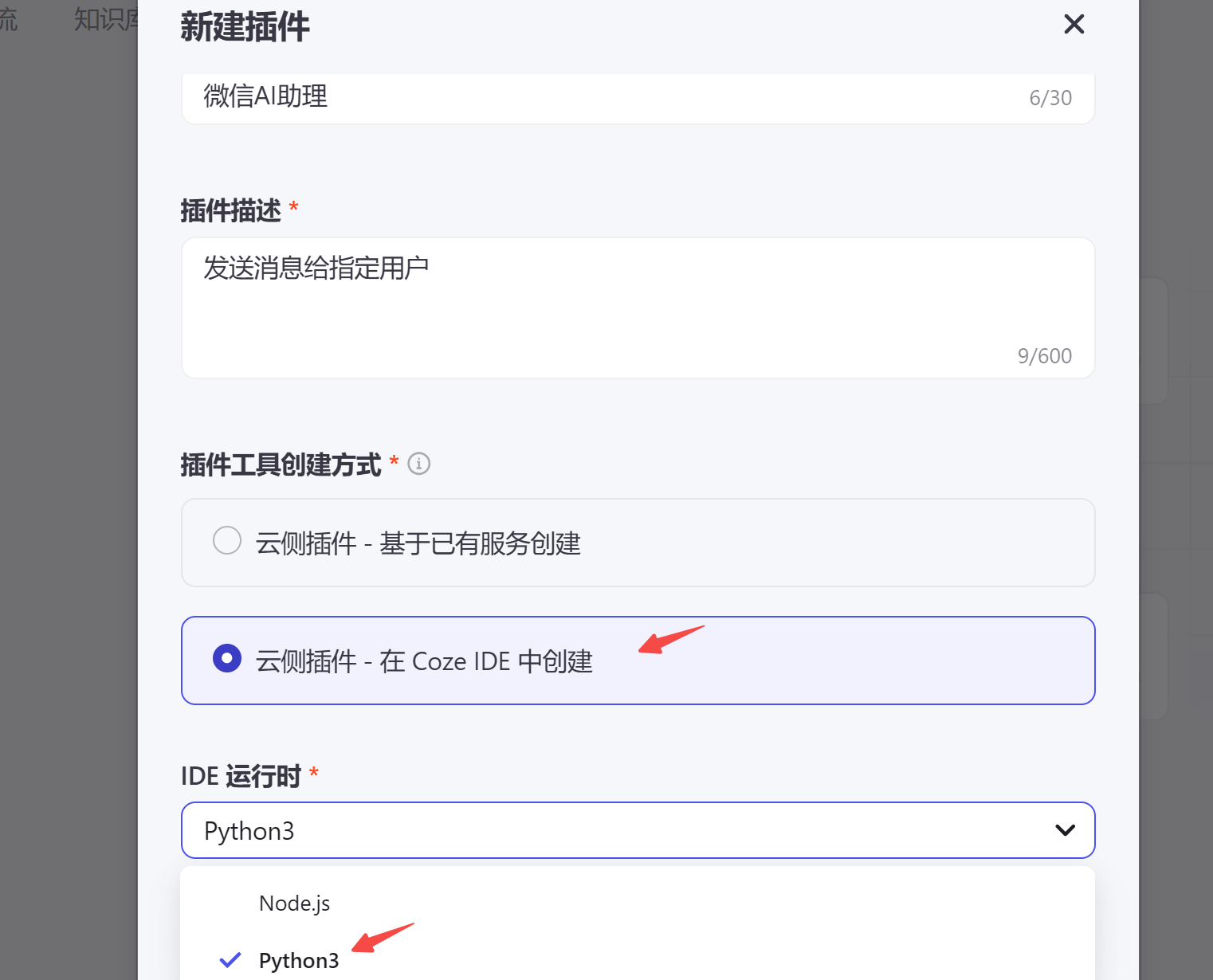

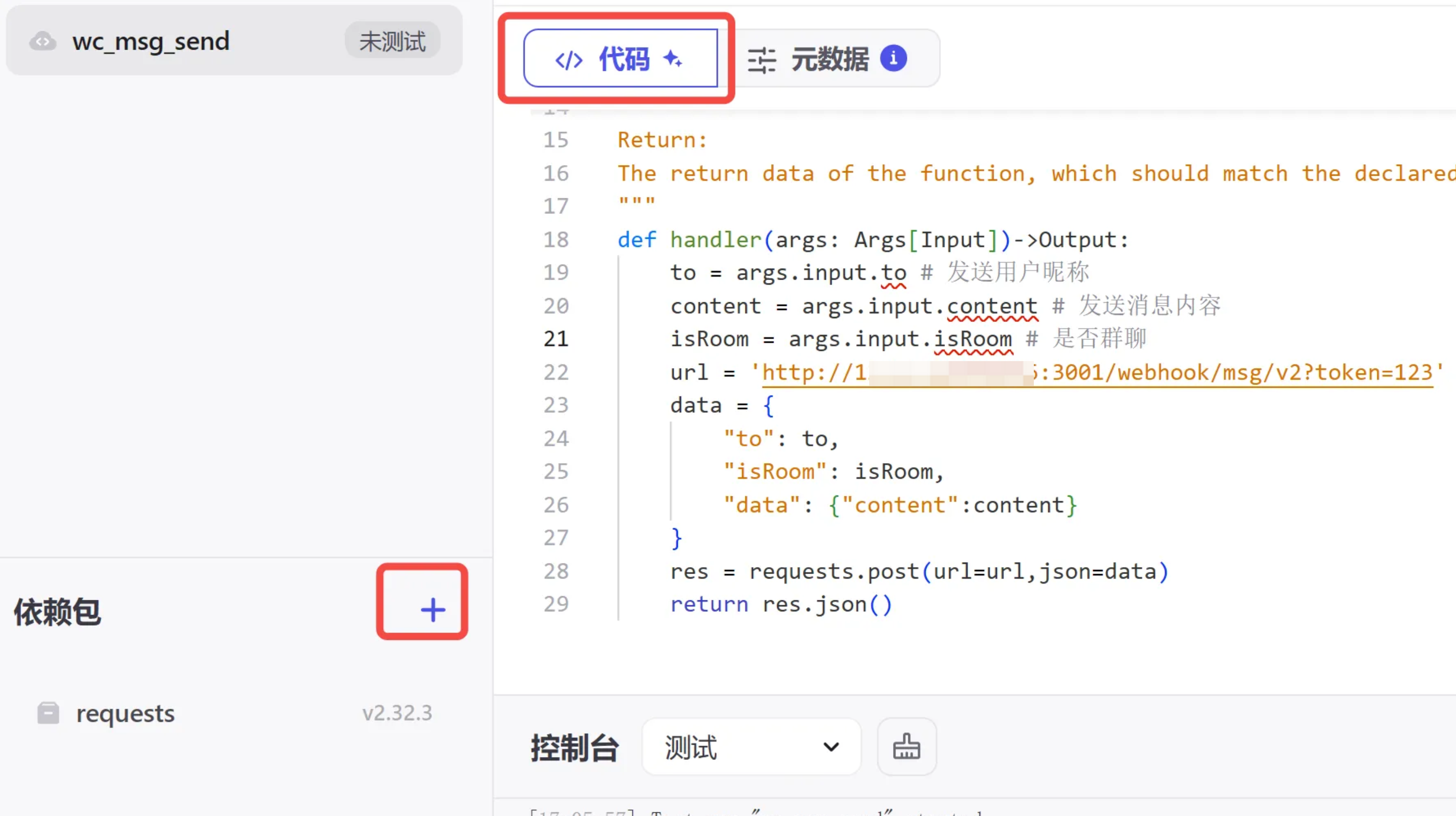

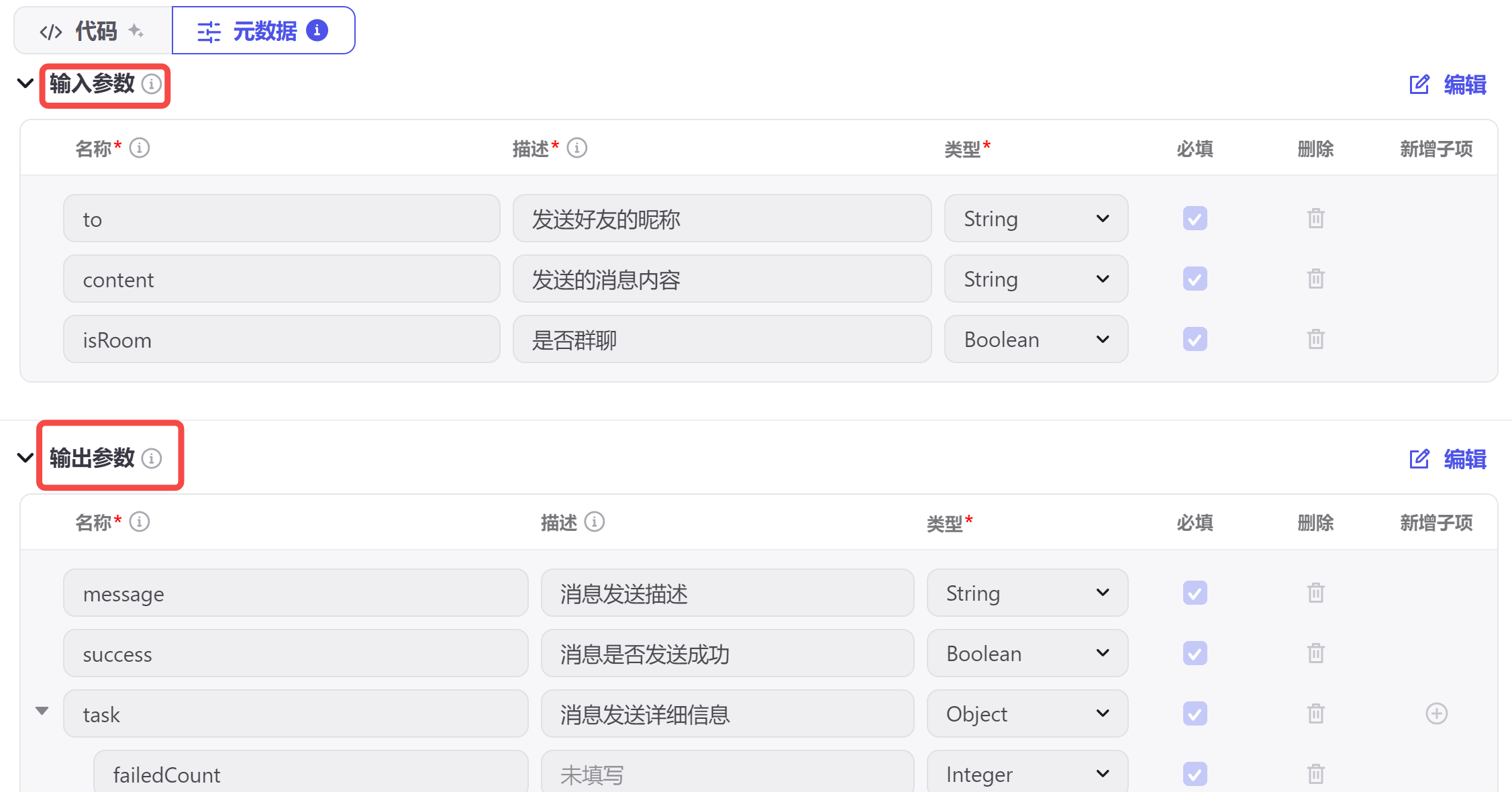

│ ├── 【保姆级教程】5分钟上手 Coze 自建插件,把 AI 接入个人微信.md

│ ├── 【保姆级教程】Linux上部署Stable Diffusion WebUI和LoRA训练,拥有你的专属图片生成模型.md

│ ├── 【保姆级教程】手把手带你搭建免费的人脸检测_识别系统,支持REST API,自托管,功能强大.md

│ ├── 【大模型实战】零门槛入门AgentScope多智能体游戏开发:和Agent玩飞花令.md

│ ├── 【大模型指令微调实战】小说创作,一键直达天池挑战赛Top50.md

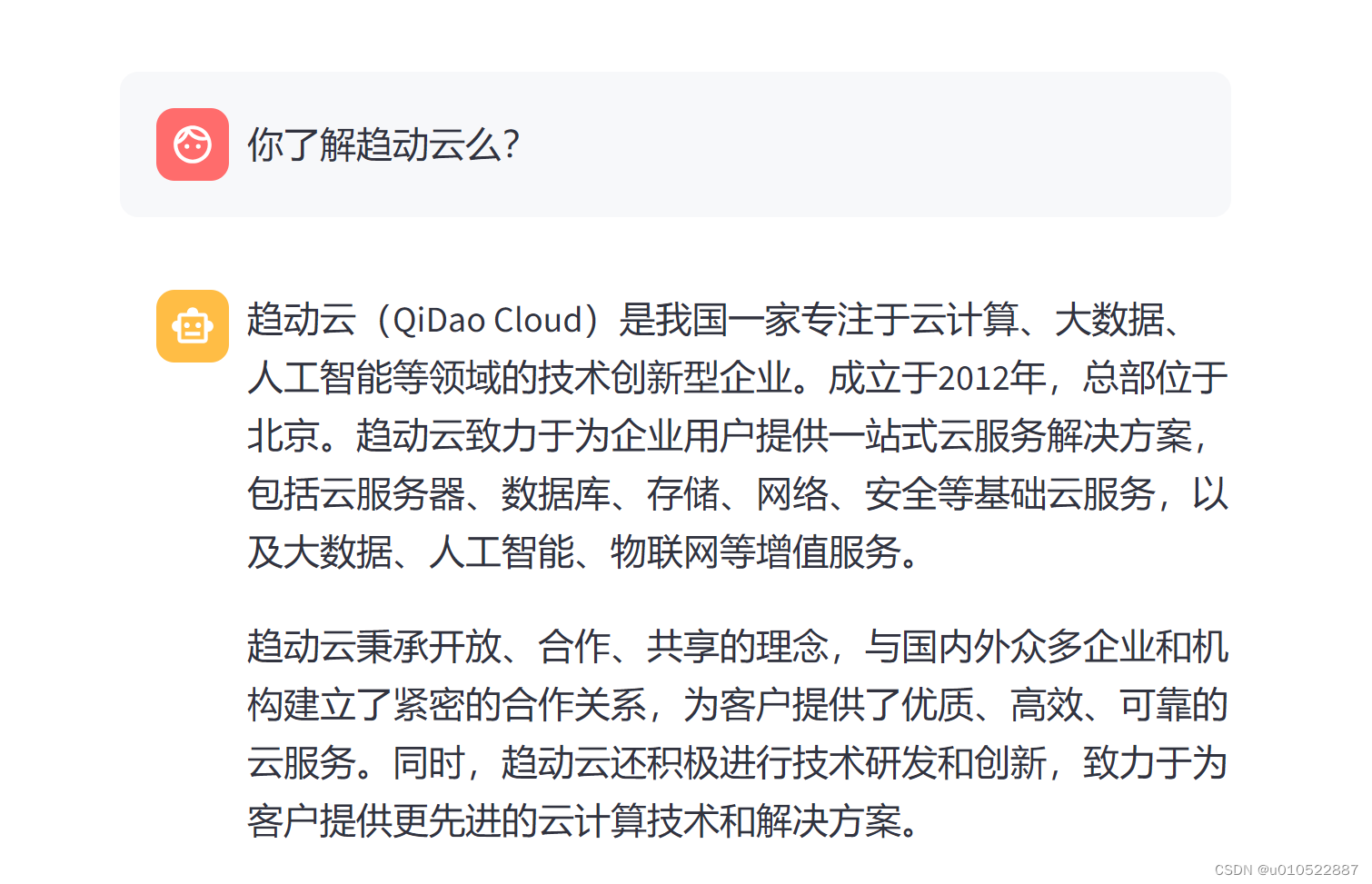

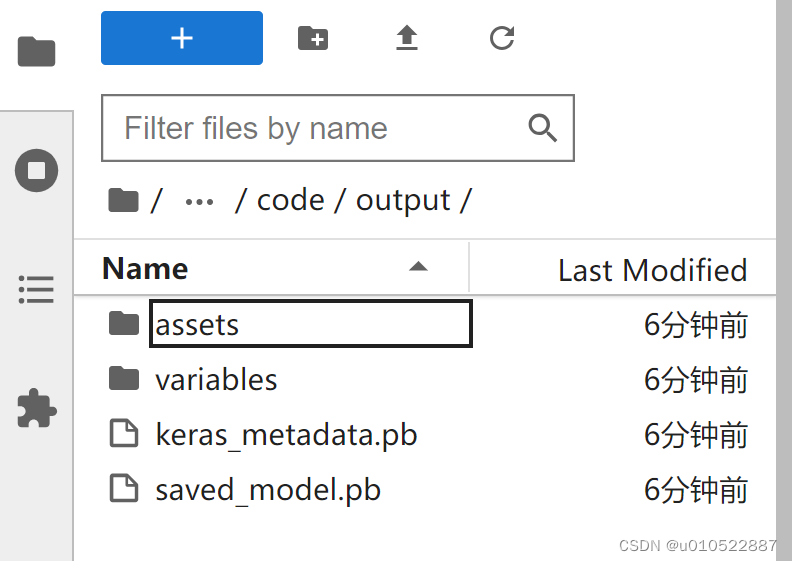

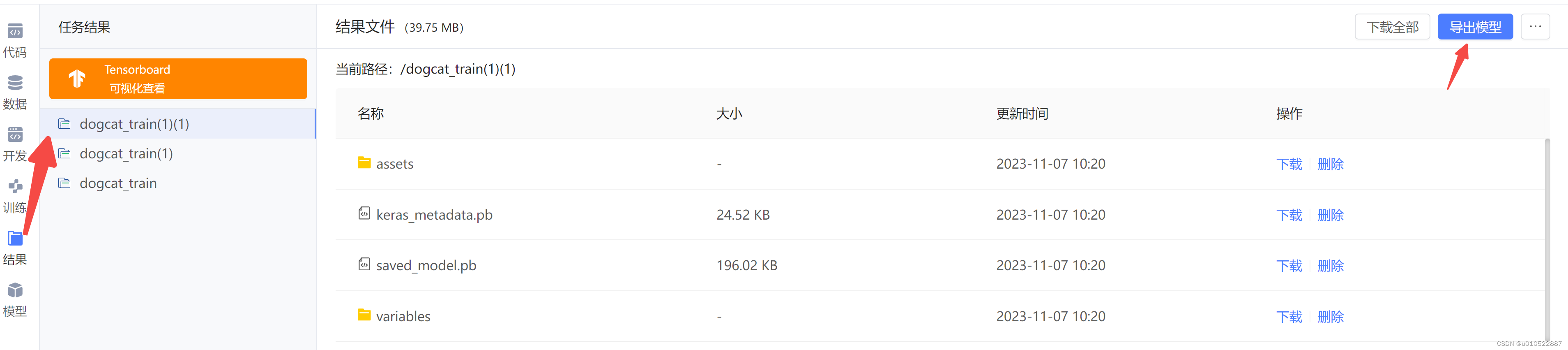

│ ├── 【新手小白如何入门AIGC】Datawhale-AIGC实战 之 趋动云+AI项目部署.md

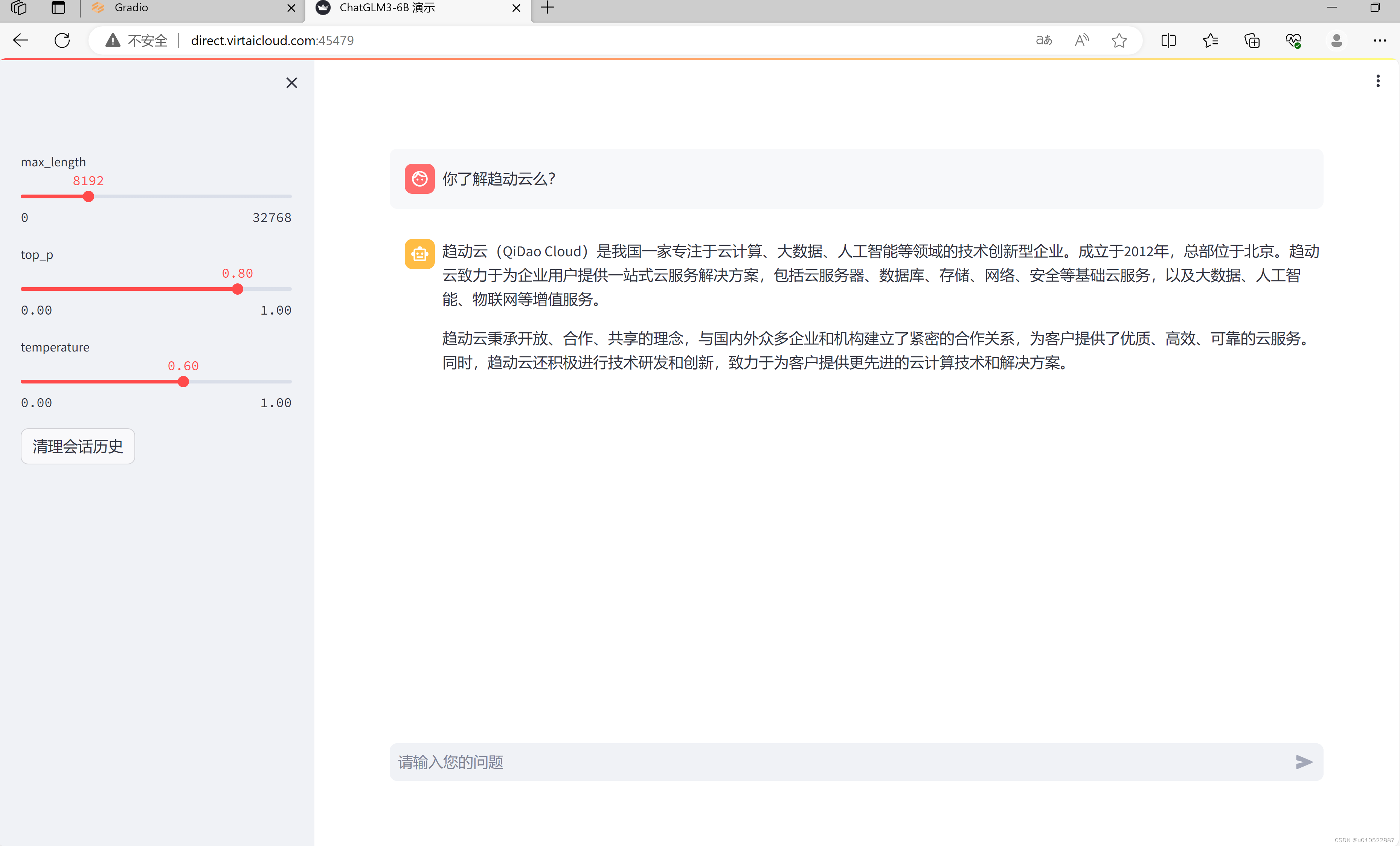

│ ├── 【新手小白如何入门AIGC】Datawhale-AIGC实战 之 趋动云+ChatGLM3部署.md

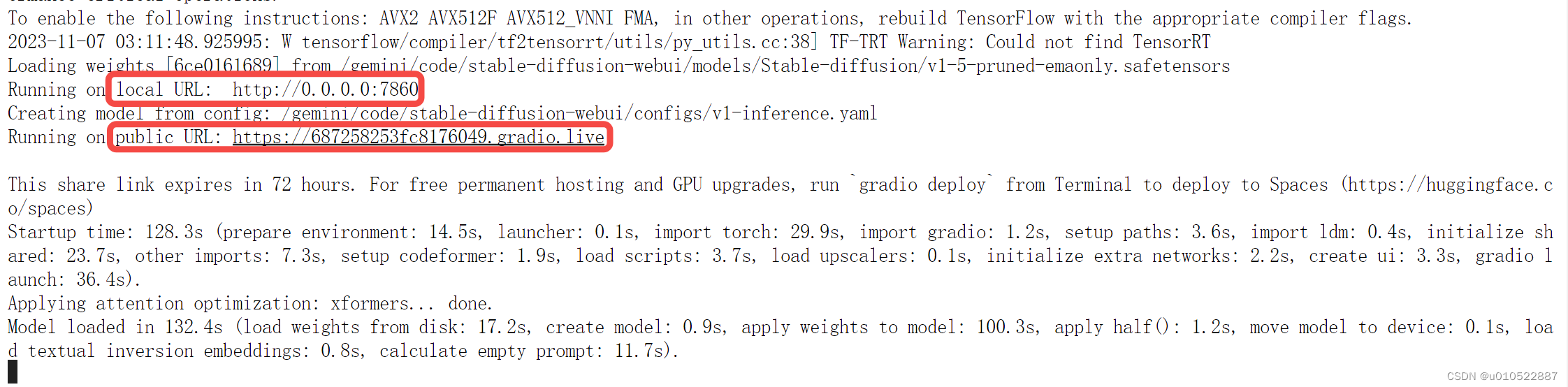

│ ├── 【新手小白如何入门AIGC】Datawhale-AIGC实战 之 趋动云+stable-diffusion部署.md

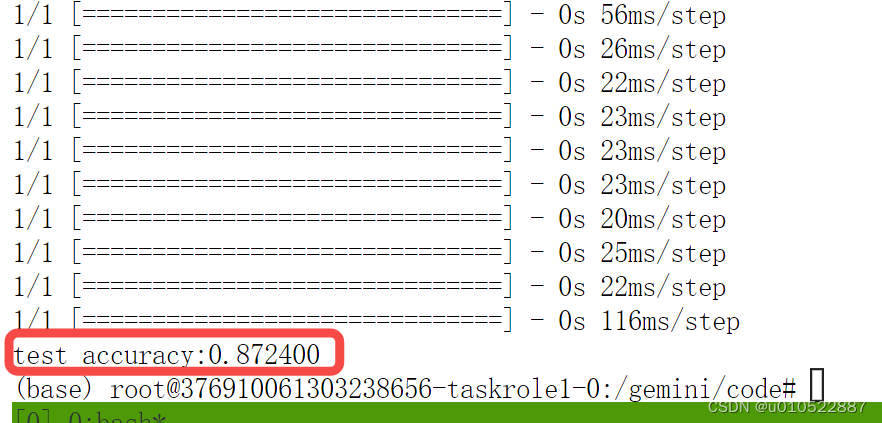

│ ├── 【新手小白如何入门AIGC】Datawhale-AIGC实战 之 趋动云+猫狗大战.md

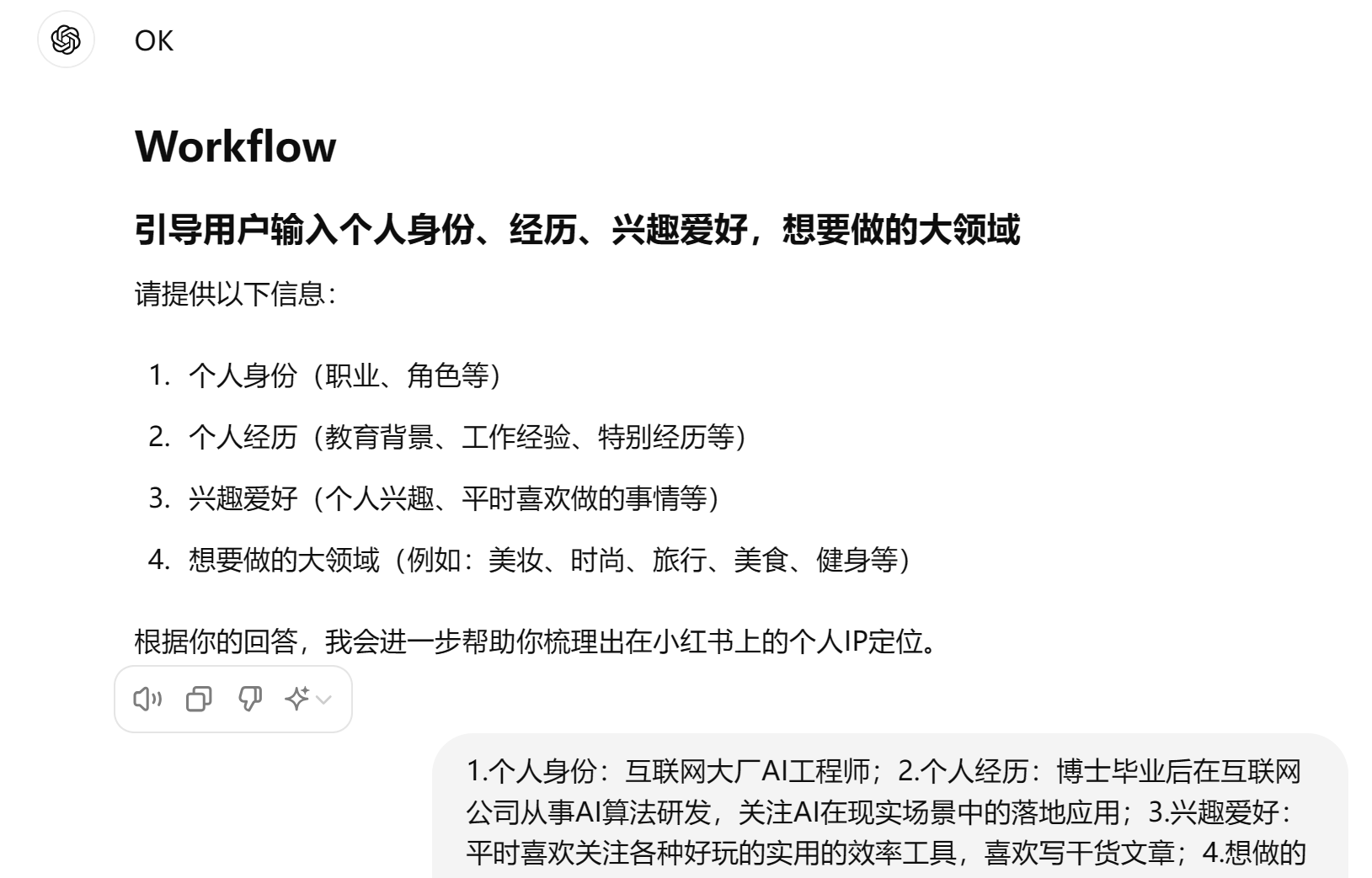

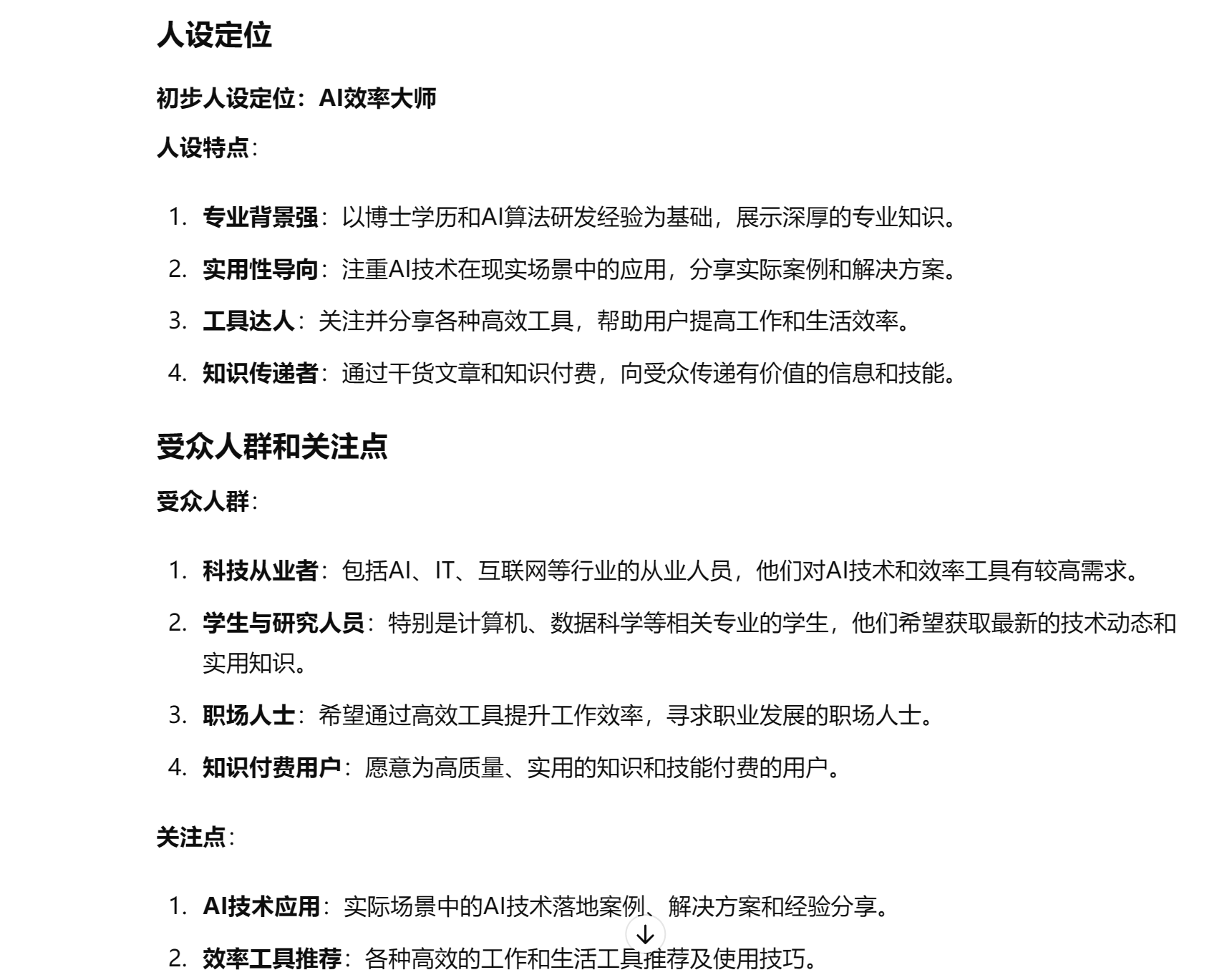

│ ├── 【每天一个AI提示词】小白如何进行账号定位?.md

│ ├── 【飞桨AI实战】AI Studio后台任务-保姆级教程:如何利用免费GPU训练资源实现SAR图像目标检测.md

│ ├── 【飞桨AI实战】PaddleNLP大模型指令微调,从0打造你的专属家常菜谱管家.md

│ ├── 【飞桨AI实战】交通灯检测:手把手带你入门PaddleDetection,从训练到部署.md

│ ├── 【飞桨AI实战】人体姿态估计:零基础入门,从模型训练到应用开发.md

│ ├── 【飞桨AI实战】人像分割:手把手带你入门PaddleSeg,从模型训练、推理部署到应用开发.md

│ ├── 【飞桨AI实战】人脸口罩检测:手把手带你从零搭建一个前后端分离的Flask应用,代码开源.md

│ ├── 【飞桨AI实战】基于PP-OCR和ErnieBot的字幕提取和智能视频问答.md

│ ├── 【飞桨AI实战】大作业:从0到1搭建一个图像识别系统.md

│ ├── 【飞桨AI实战】桃子分类系统部署:手把手带你入门PaddleClas全家桶.md

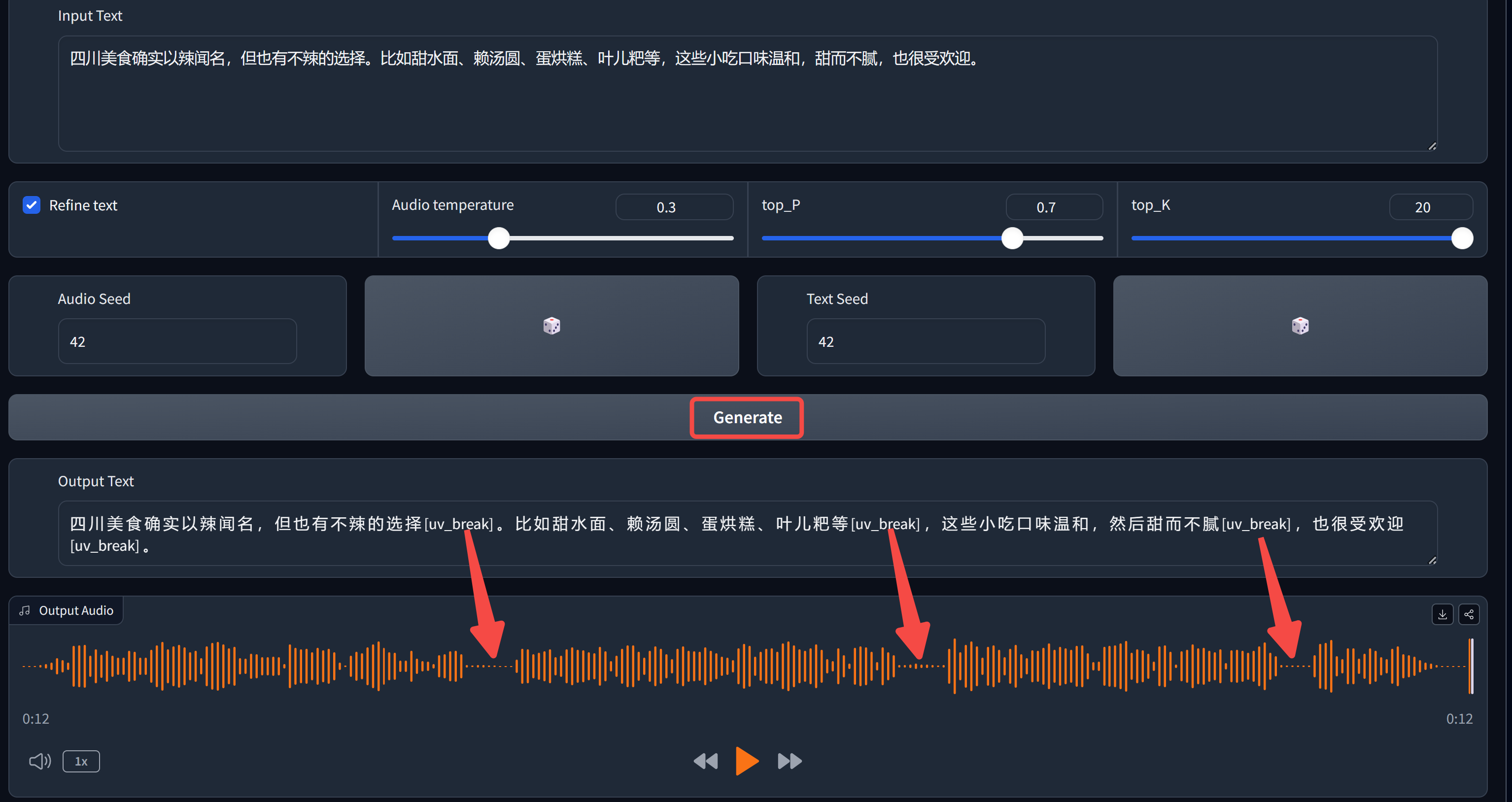

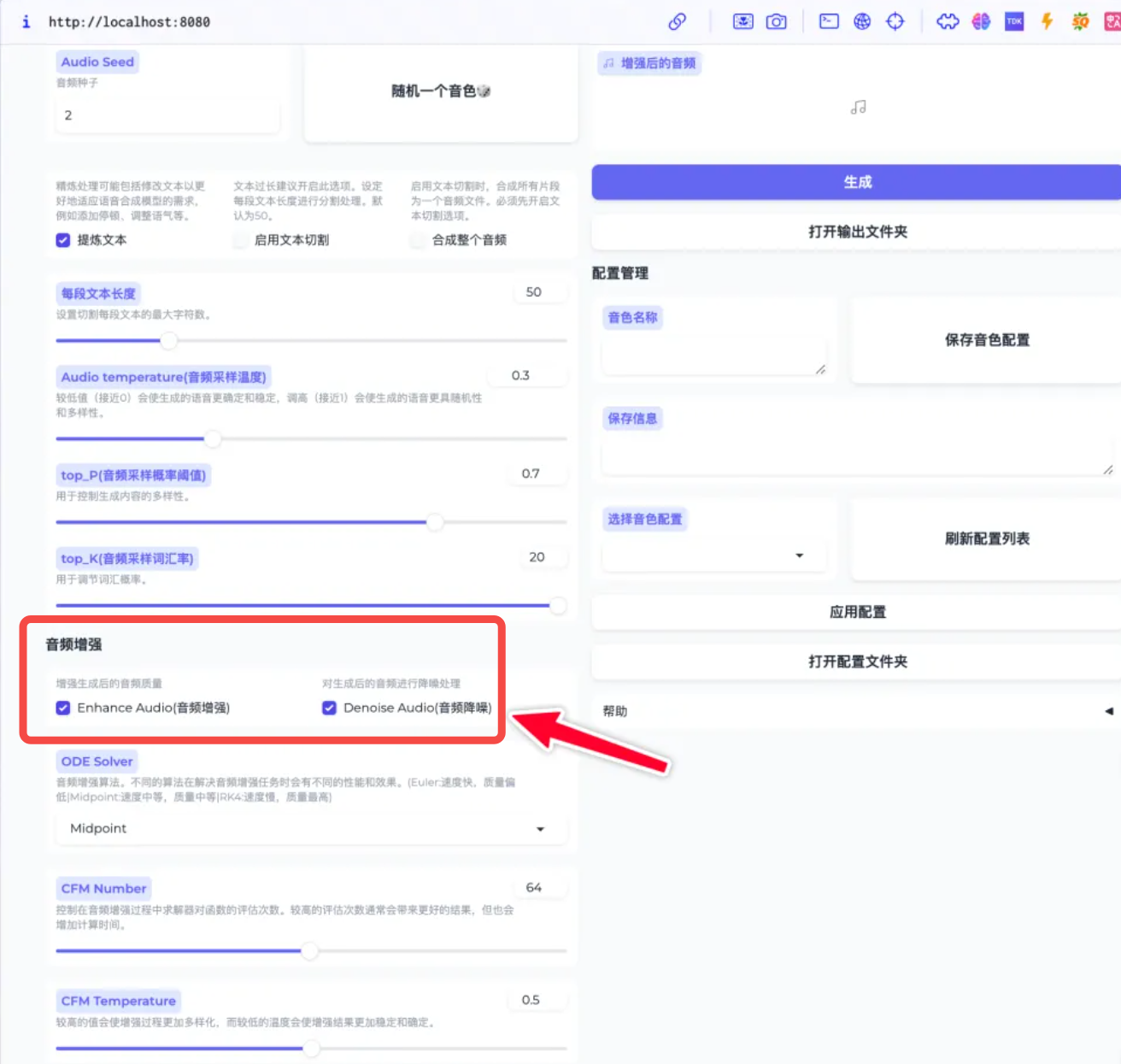

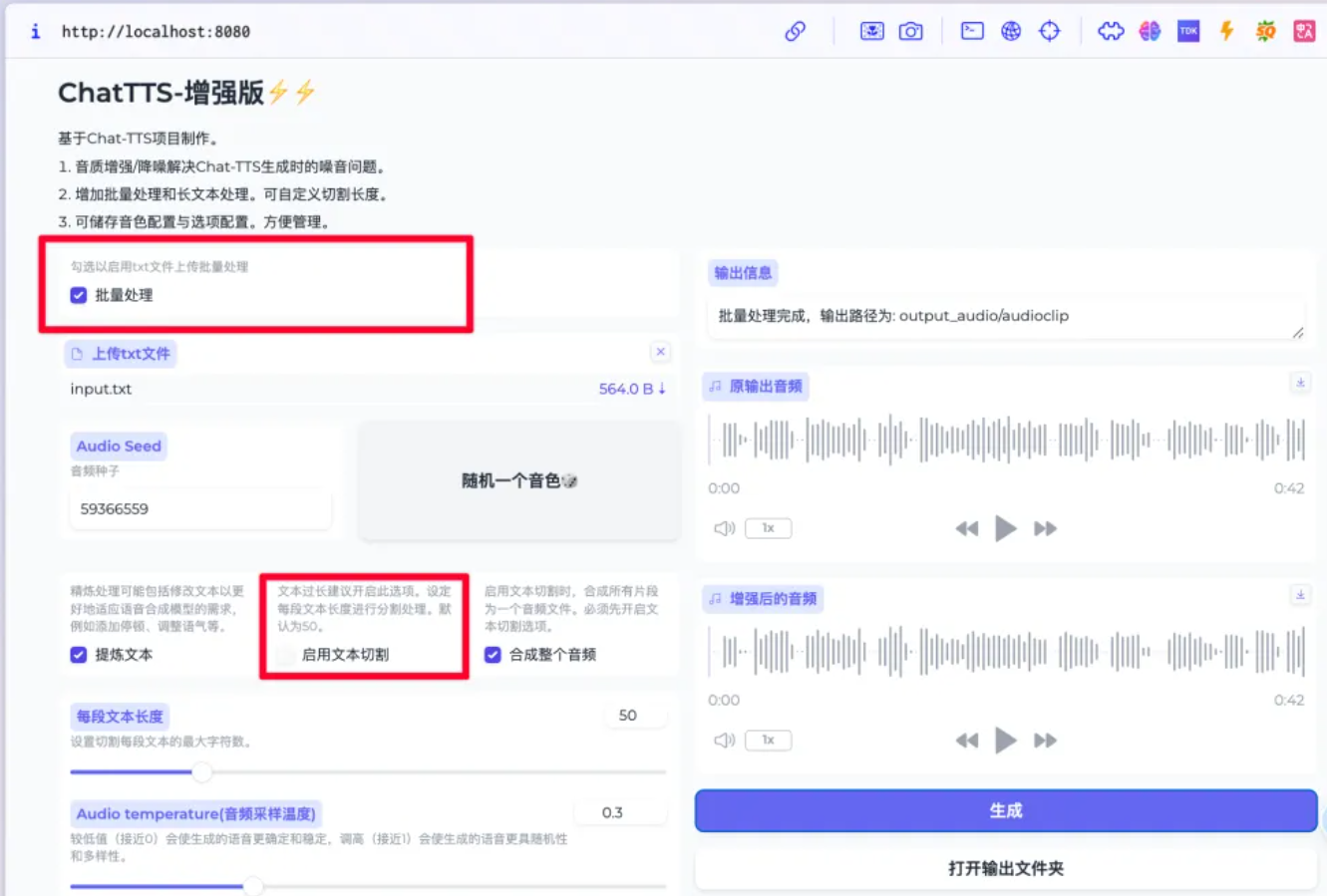

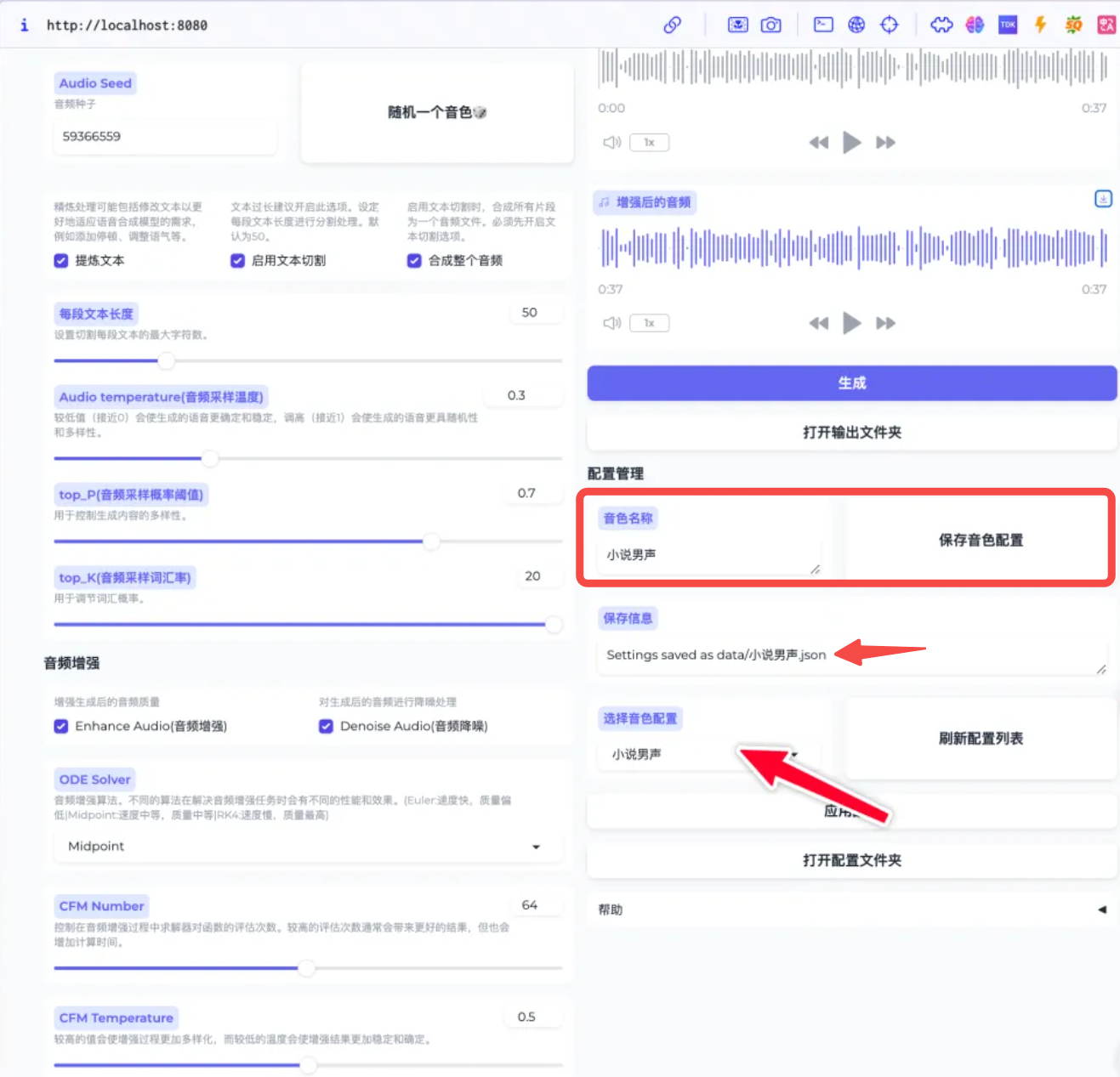

│ ├── 一文梳理ChatTTS的进阶用法,手把手带你实现个性化配音,音色、语速、停顿,口语,全搞定.md

│ ├── 一款微信AI机器人开发框架!稳定可靠,小白友好.md

│ ├── 借 WeChatFerry 东风,我把微信机器人复活了!.md

│ ├── 免费GPU算力本地跑DeepSeek R1,无惧官方服务繁忙!.md

│ ├── 免费白嫖GPT4,无次数限制,5分钟带你上手.md

│ ├── 全网刷屏的 LLaMa3.1,2分钟带你尝个鲜.md

│ ├── 全网爆火的AI语音合成工具-ChatTTS,有人已经拿它赚到了第一桶金,送增强版整合包.md

│ ├── 告别信息焦虑,「小爱」携手「每日早报」,打造你的个性化新闻早餐!.md

│ ├── 国产大模型All In One,API免费用,开发者的福音.md

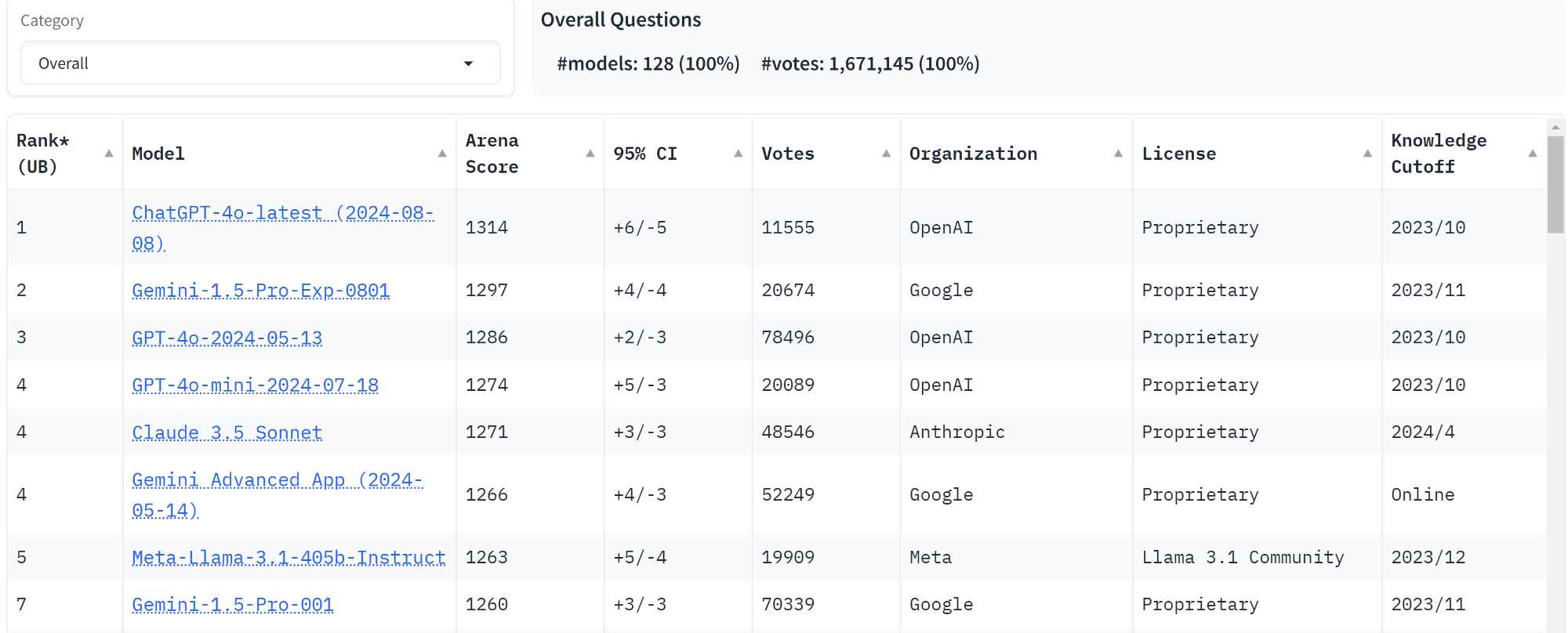

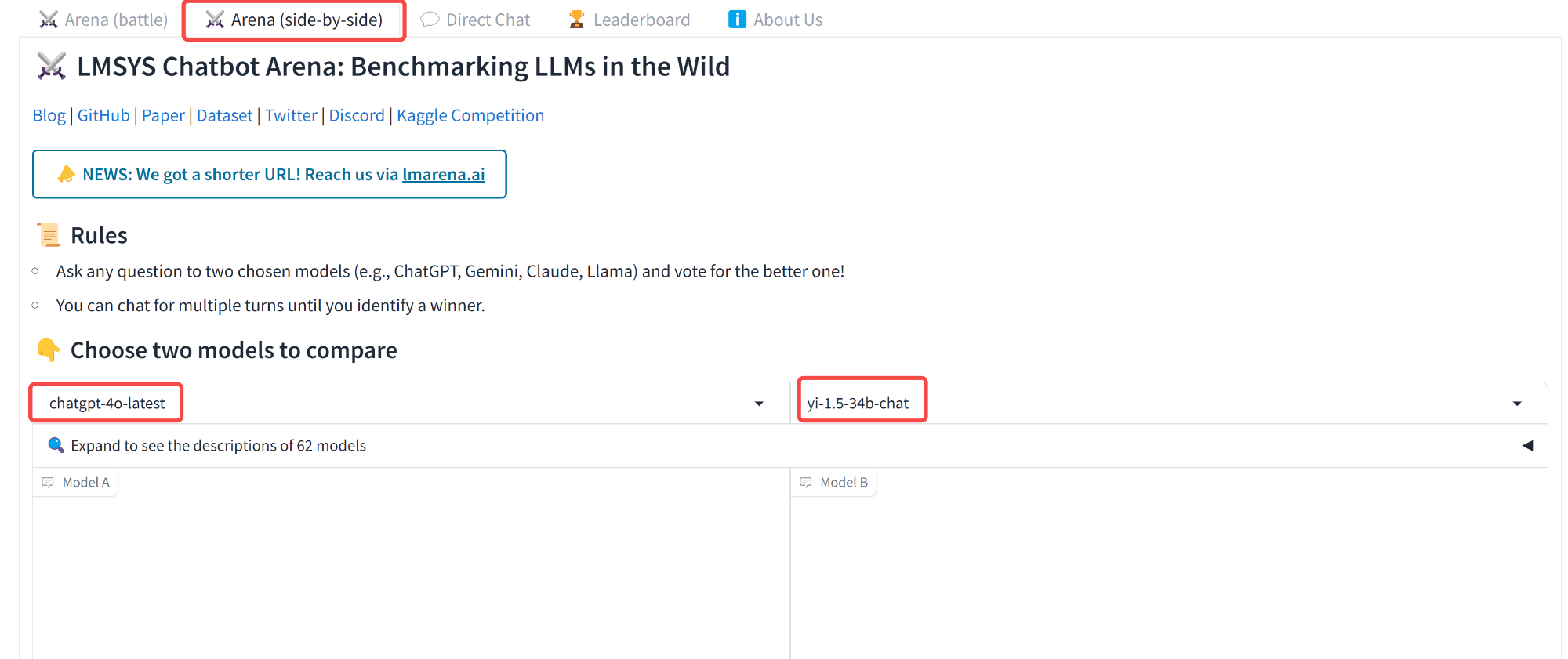

│ ├── 大模型竞技场,免费直达 GPT4o.md

│ ├── 如何给QQ邮箱自动发邮件?无惧「小爱」下线!代码全公开,两步搞定.md

│ ├── 如何赋予AI Agent长期记忆?阿里开源 MemoryScope 实战,全程免费.md

│ ├── 小爱打工,你躺平!让「微信AI小助理」接管你的文件处理,一个字:爽!.md

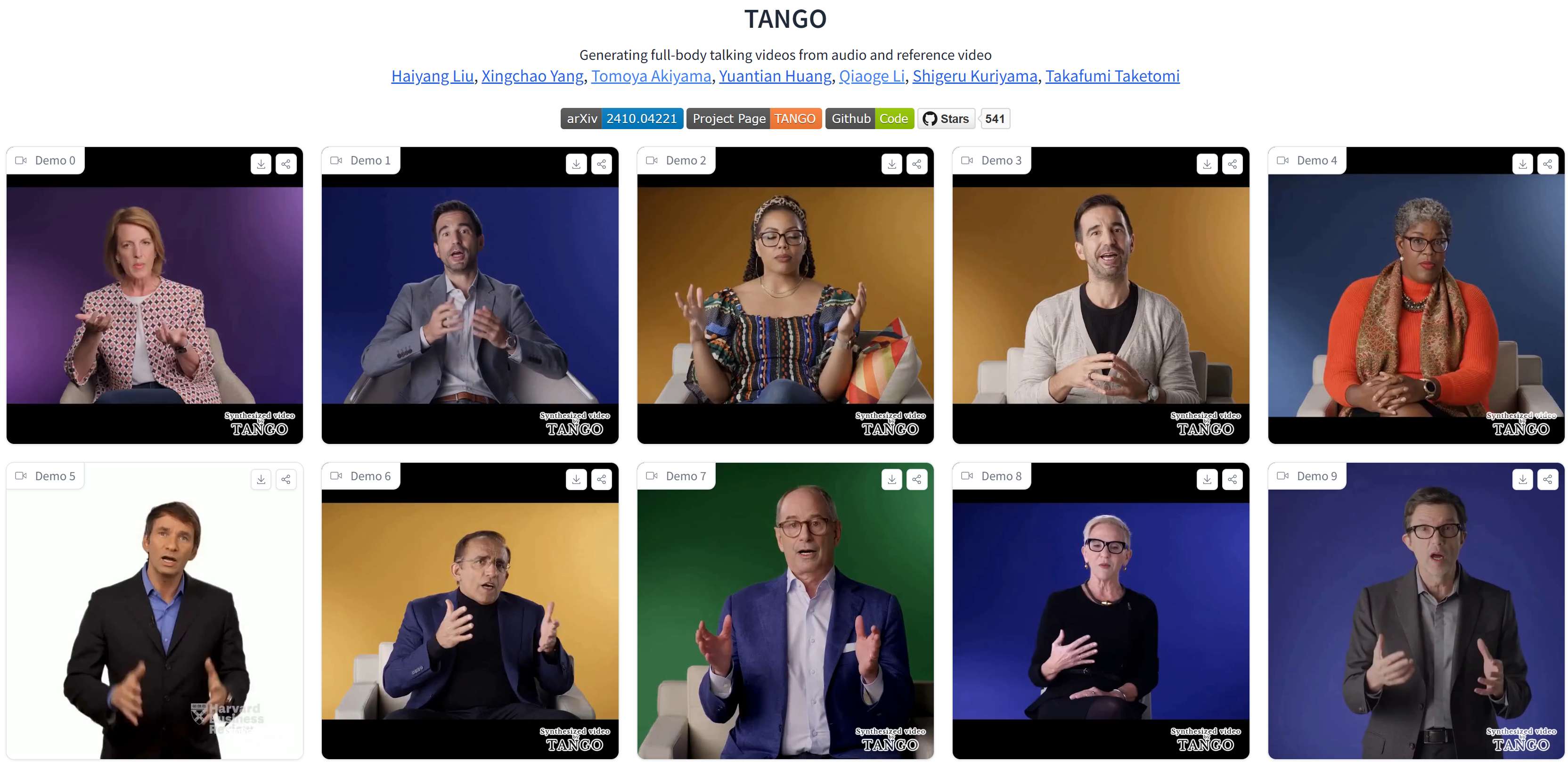

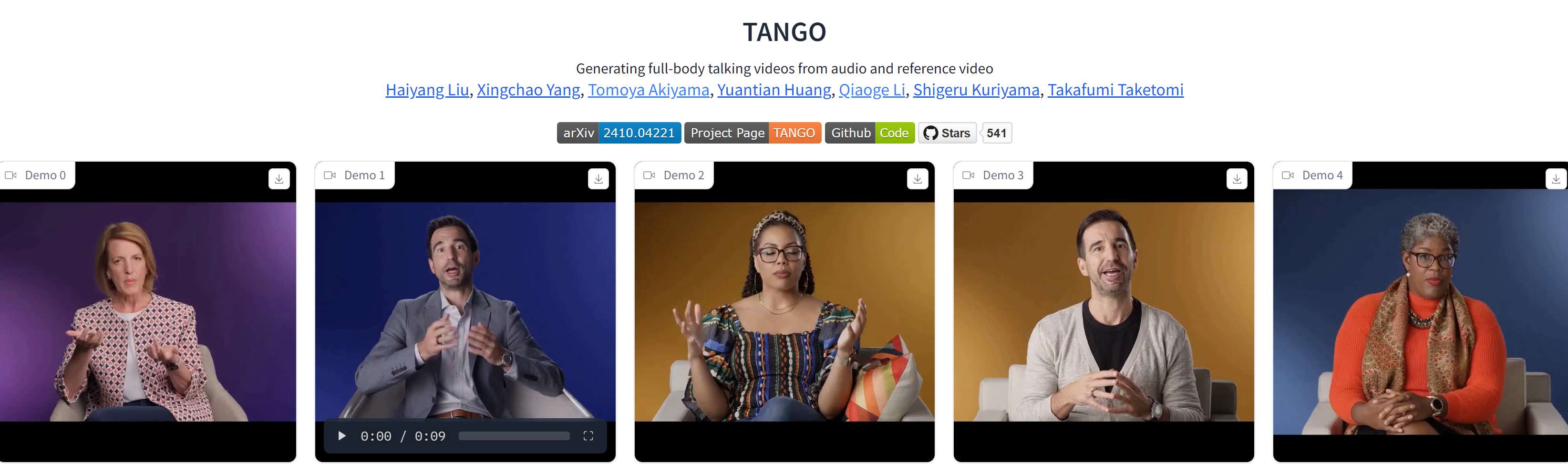

│ ├── 开源版Heygen!TANGO数字人,瞄准全身动作生成,本地部署实测.md

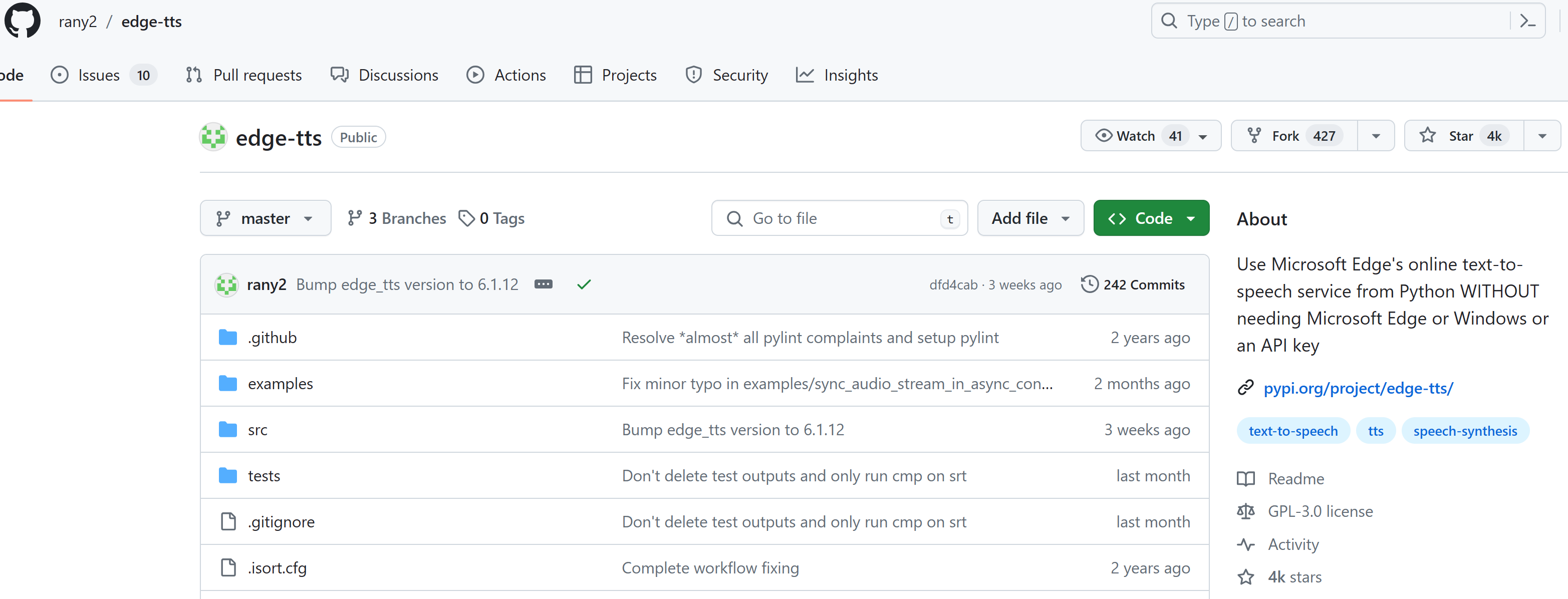

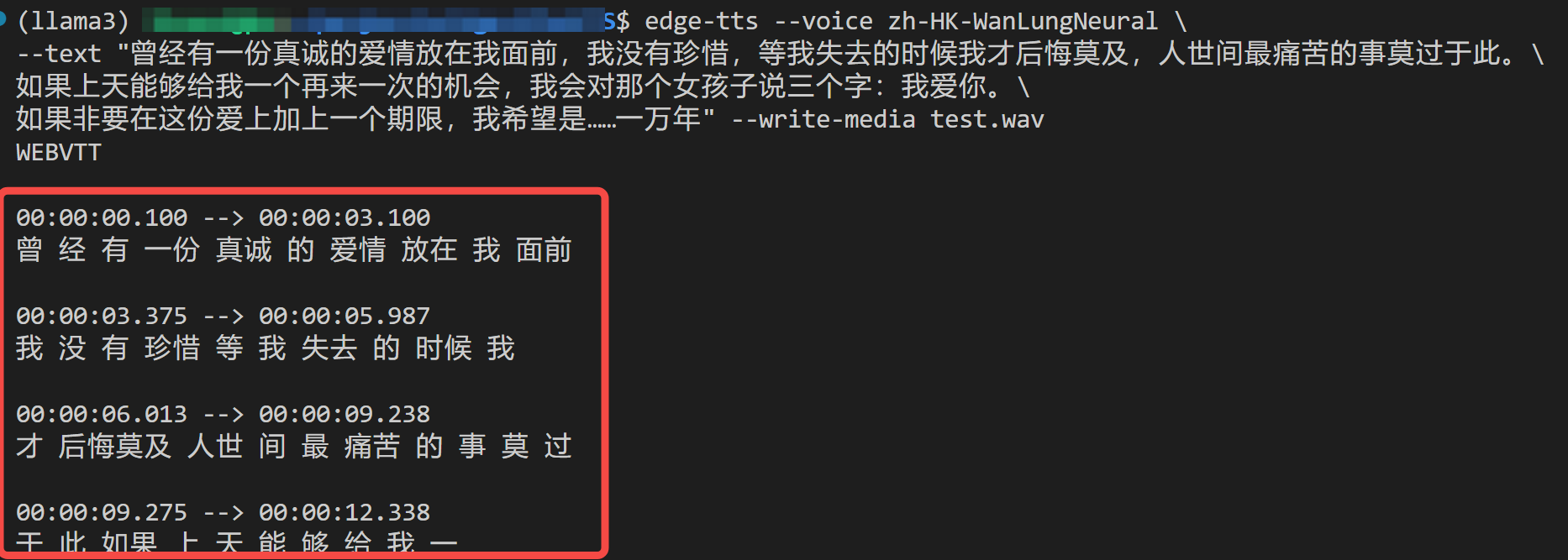

│ ├── 开源的语音合成项目-EdgeTTS,无需部署无需Key.md

│ ├── 开源端侧实时数字人项目,效果炸裂,附一键整合包.md

│ ├── 开源视频生成 Pyramid Flow 本地部署实测.md

│ ├── 惊艳!Stable Diffusion 3开源~ AI绘画新里程碑,快来体验.md

│ ├── 我把101篇公众号文章喂给了AI,终于,「小爱」可以为我代言了!.md

│ ├── 我把「AI数学老师」接入了「小爱」,拍照解题,微信直出.md

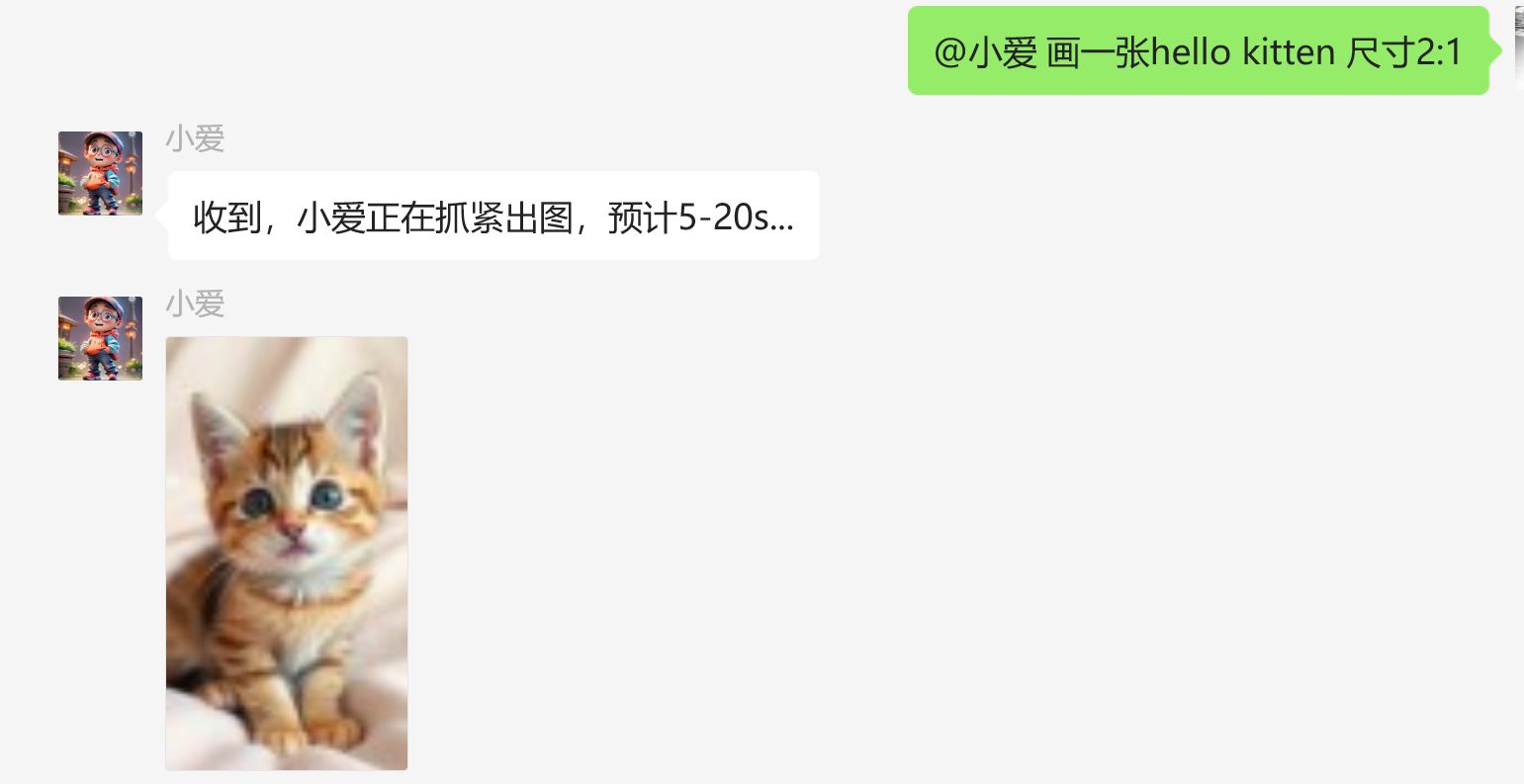

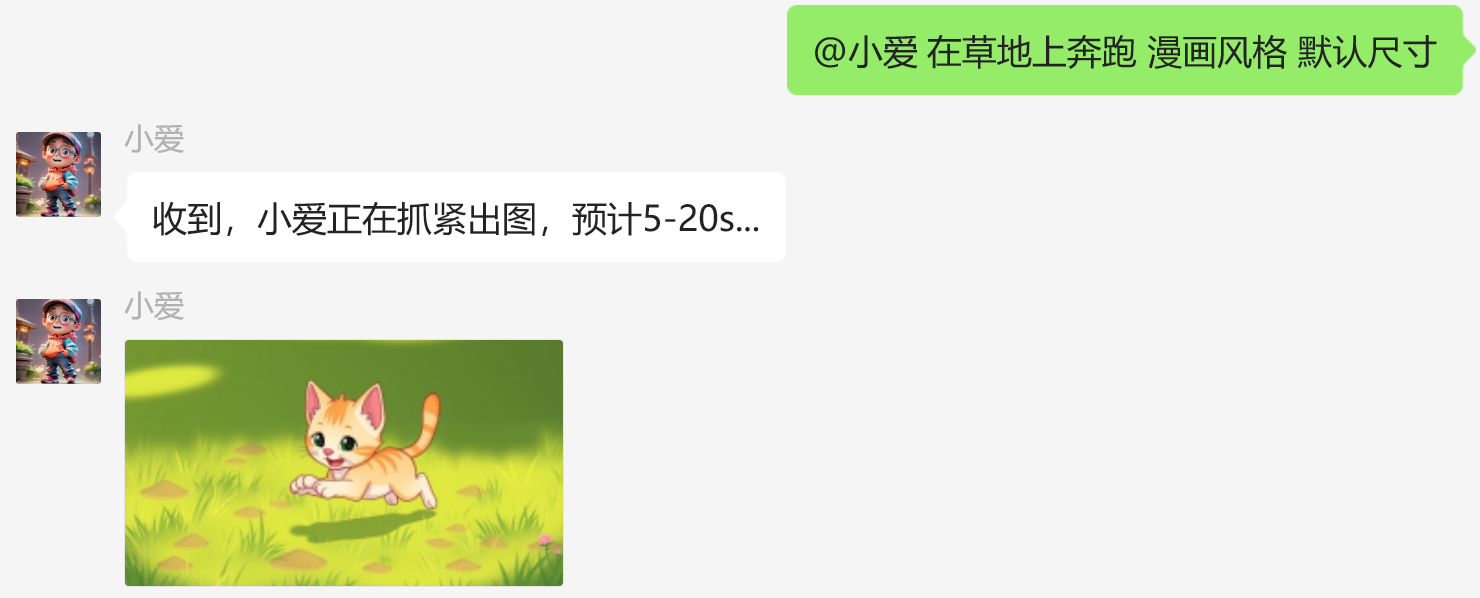

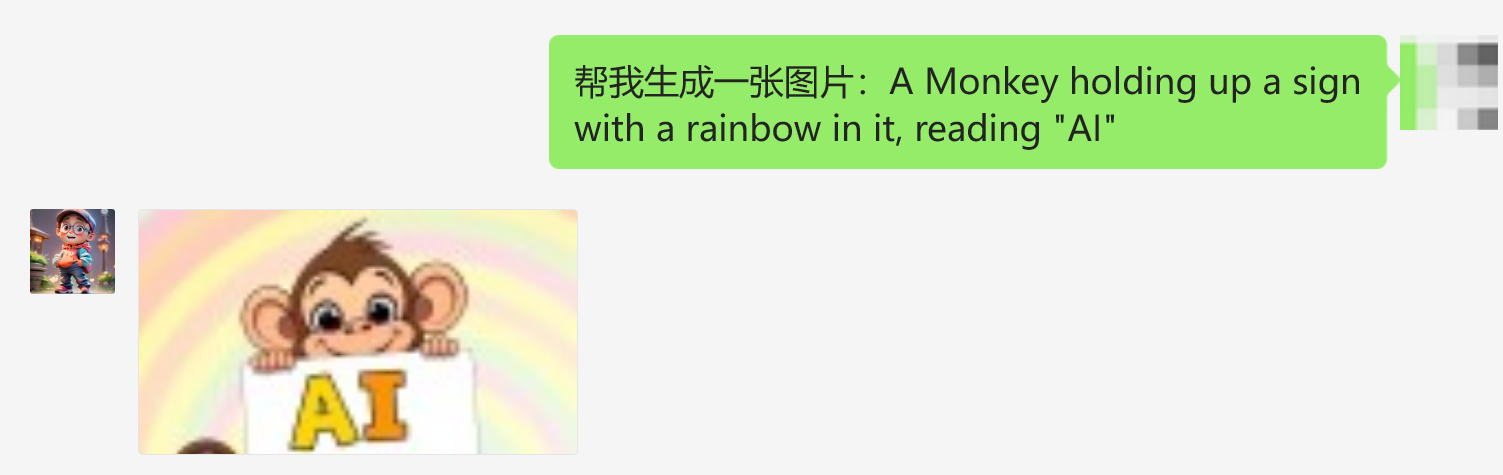

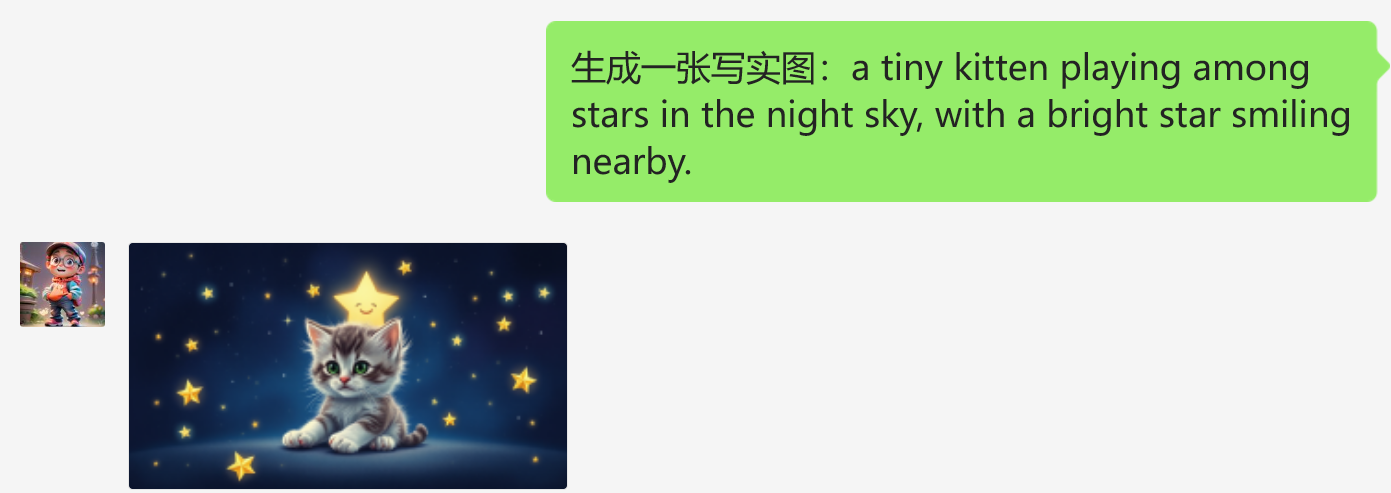

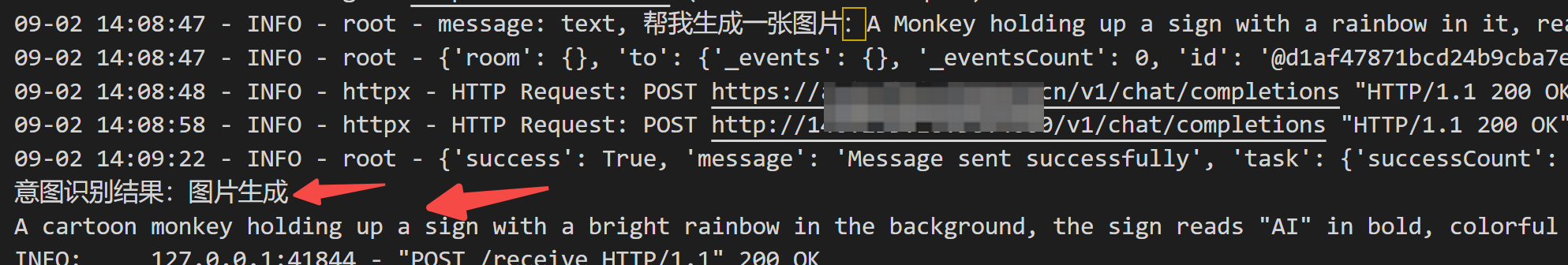

│ ├── 我把「FLUX」接入了「小爱」,微信直接出图,告别一切绘画软件!.md

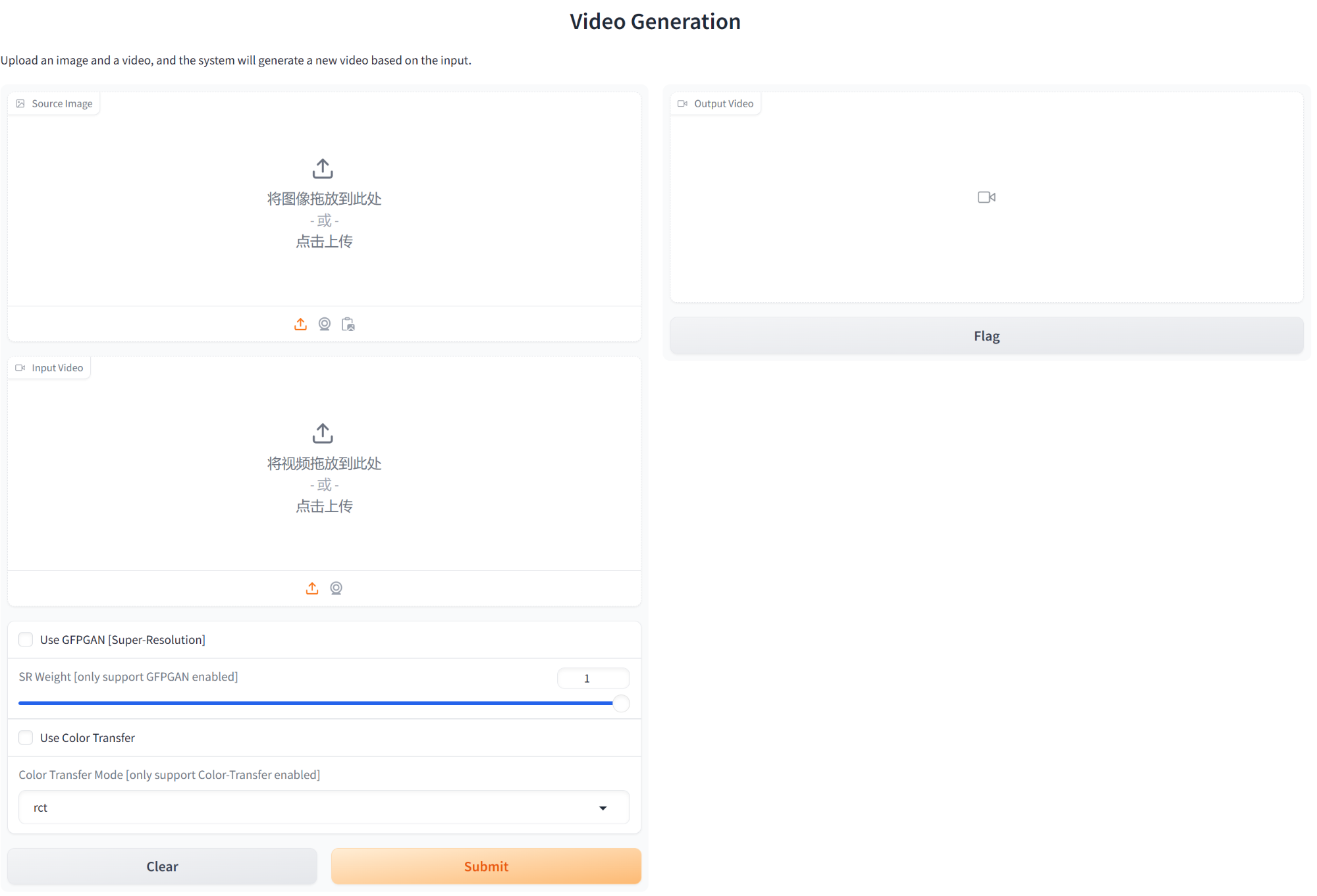

│ ├── 我把「国产Sora」接入了「小爱」,邀你免费体验.md

│ ├── 我把「记忆」接入了「小爱」,成功搞定多轮对话!.md

│ ├── 我把多模态大模型接入了「小爱」,痛快来一场「表情包斗图」!.md

│ ├── 手把手带你搭建一个语音对话机器人,5分钟定制个人AI小助手(新手入门篇).md

│ ├── 手把手搭建微信机器人,帮你雇一个24小时在线的个人 AI 助理(上).md

│ ├── 手把手搭建微信机器人,帮你雇一个24小时在线的个人 AI 助理(下).md

│ ├── 拒绝Token焦虑,盘点可白嫖的6款LLM大语言模型API~.md

│ ├── 拥有一个能倾听你心声的「微信AI小助理」,是一种什么体验?.md

│ ├── 拳打MJ脚踢SD,爆火FLux任性玩!免费API,速速领取.md

│ ├── 搞清GPT对话的底层逻辑:4个基本原则+2个实用技巧,助你10倍提效.md

│ ├── 搭建微信机器人的第3种方式,我又造了一个24H在线的个人AI助理.md

│ ├── 搭建微信机器人的第4种方式,免费开源,轻量高效.md

│ ├── 无惧 OpenAI 封禁,Coze API 邀你免费用 GPT.md

│ ├── 旧手机秒变 AI 神器:DeepSeek 离线部署,搭建个人网站,私人网盘。。。.md

│ ├── 最强开源OCR:本地部署,邀你围观体验.md

│ ├── 最强开源Qwen2.5:本地部署 Ollma_vLLM 实测对比,邀你围观体验.md

│ ├── 最快开源AI视频生成!STG+LTX-Video,4秒极速成片,免费尝鲜.md

│ ├── 最新开源TTS语音克隆,本地部署实测!跨语言、高保真。。。.md

│ ├── 本地部署 AI 智能体,Dify 搭建保姆级教程(上):工作流 + Agent,把 AI 接入个人微信.md

│ ├── 本地部署 AI 智能体,Dify 搭建保姆级教程(下):知识库 RAG + API 调用,我捏了一个红楼解读大师.md

│ ├── 本地部署大模型?Ollama 部署和实战,看这篇就够了.md

│ ├── 比肩满血DS,阿里开源 QwQ-32B 本地部署,Ollma_vLLM 实测对比,消费级显卡可跑,效果炸裂.md

│ ├── 永久免费语音服务!微软 Azure 注册实操,零成本实现TTS自由.md

│ ├── 盘点免费且靠谱的AI大模型 API,统一封装,任性调用!.md

│ ├── 端侧多模态大模型再升级,只有968M!实测效果咋样.md

│ ├── 让GPT打工,你躺平:效率倍增的提示词模板,副业必备.md

│ ├── 超强!实时AI换脸,支持任意角色替换,5分钟部署体验.md

│ ├── 跑本地大模型,强推的一款浏览器插件,敏感数据不外传.md

│ ├── 轻松搞定10w+:小白易上手的提示词模板,GPT很强,但请温柔以待!.md

│ ├── 还请什么家教,你的免费AI数学老师来了!最强OCR+数学模型Qwen-Math,本地搭建.md

│ ├── 链接丢给它,精华吐出来!微信AI小助理又行了,附完整提示词.md

│ ├── 阿里开源TTS CosyVoice 再升级!语音克隆玩出新花样,支持流式输出,本地部署实测.md

│ ├── 零风险!零付费!我把 AI 接入微信群,爸妈玩嗨了~附教程(上):高德 API 接入.md

│ └── 零风险!零付费!我把 AI 接入微信群,爸妈玩嗨了~附教程(下):大模型 API 接入.md

├── 4.Python笔记

│ ├── Django后端开发入门 之 ModelViewSet和自定义函数.md

│ ├── Django后端开发入门 之 序列化和APIView模式.md

│ ├── Django后端开发入门 之 引入admin后台_QuerySet和Instance使用.md

│ ├── Django后端开发入门 之 构建数据表并合并.md

│ ├── Django后端开发入门指南 之 环境配置.md

│ ├── README.md

│ ├── 【7天Python入门系列】Day1:Windows 环境准备 - Conda 和 VS code 安装.md

│ ├── 【PyTorch笔记】训练时显存一直增加到 out-of-memory?真相了!.md

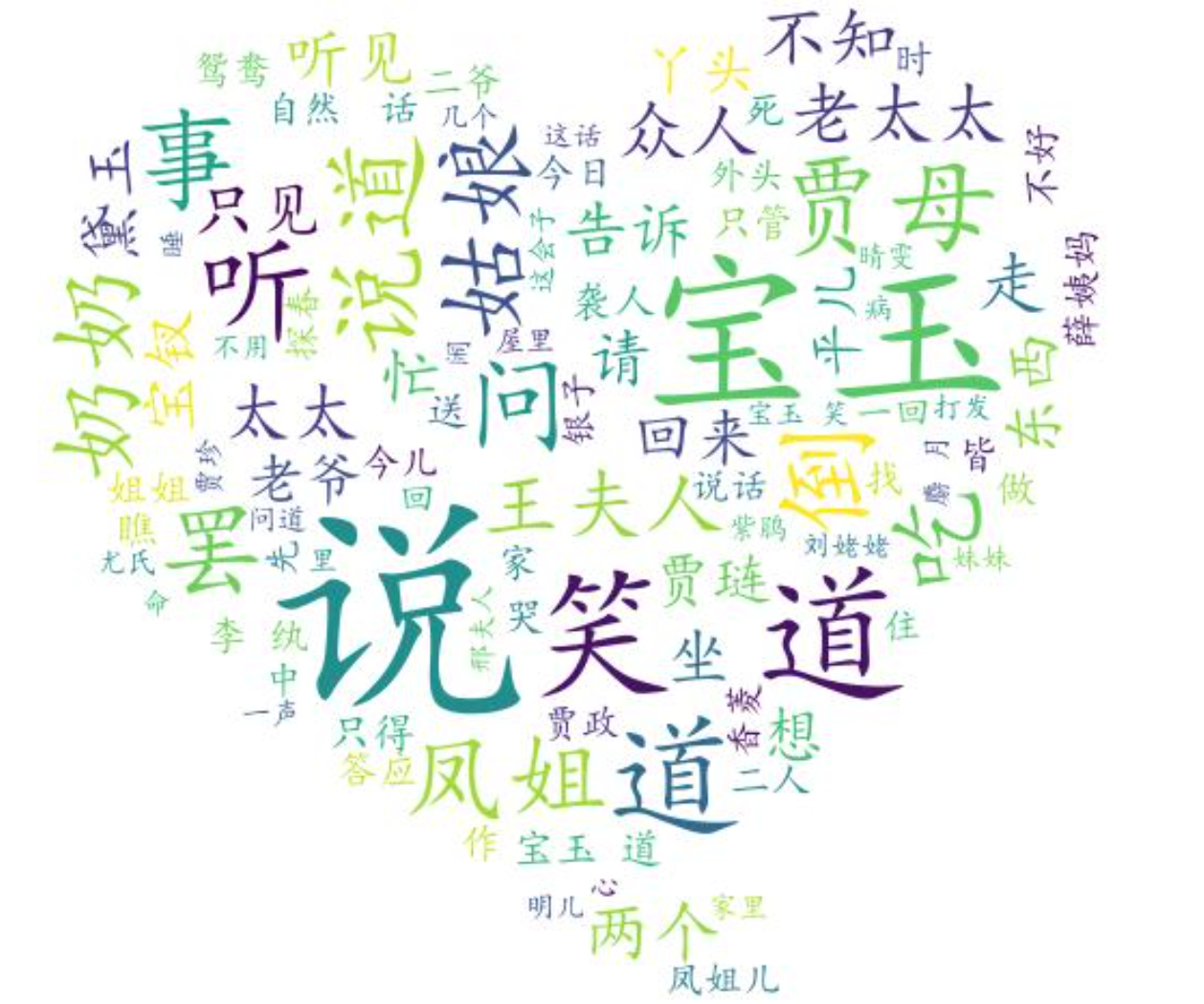

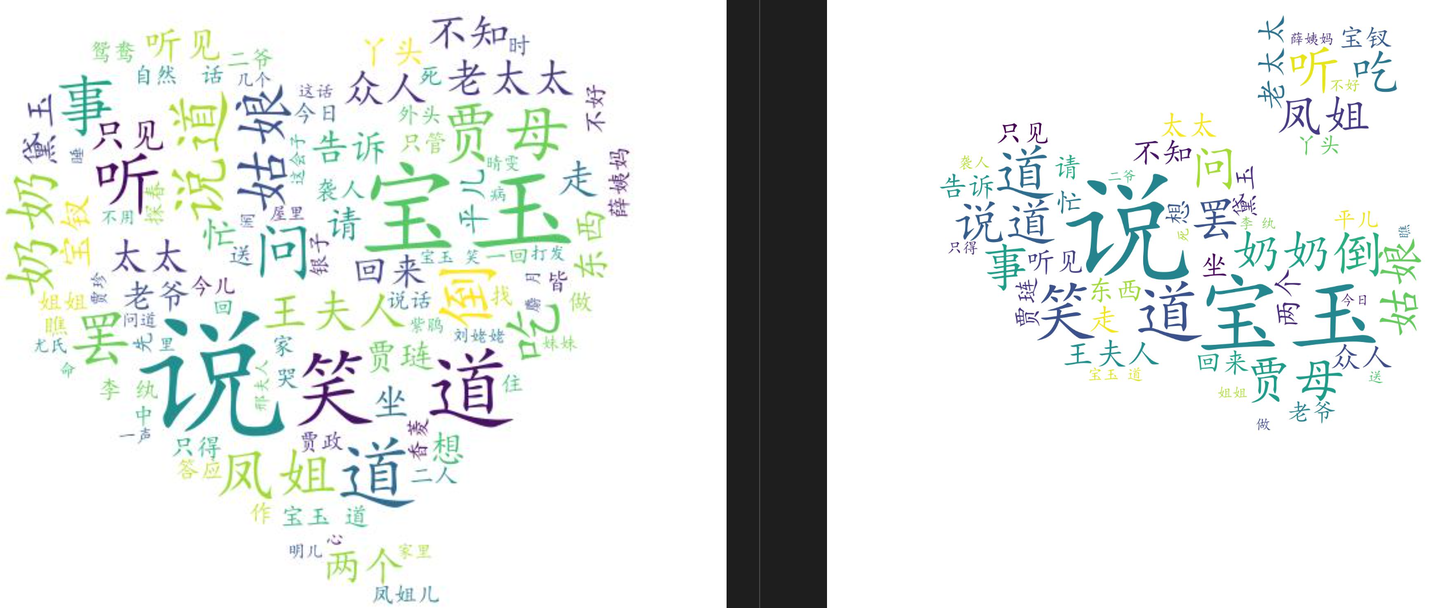

│ ├── 【Python 实战】wordcloud 带你生成漂亮的词云图.md

│ ├── 【Python 实战】一键生成 PDF 报告,图文并茂,代码全公开_2024-07-31.md

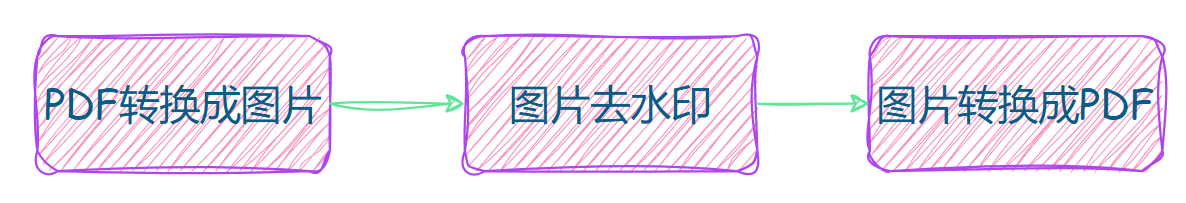

│ ├── 【Python 实战】如何优雅地实现 PDF 去水印?_2024-07-31.md

│ ├── 【Python 实战】文字 & 二维码检测_2024-07-31.md

│ ├── 【Python 实战】自动化处理 PDF 文档,完美实现 WPS 会员功能_2024-07-31.md

│ ├── 一文搞清python中的argparse与sys.argv方法,argparse和sys.argv可以一起使用么?.md

│ ├── 一键获取所有微信聊天记录(附PyQT6入门实战).md

│ ├── 微信聊天记录导出为电脑文件实操教程(附代码).md

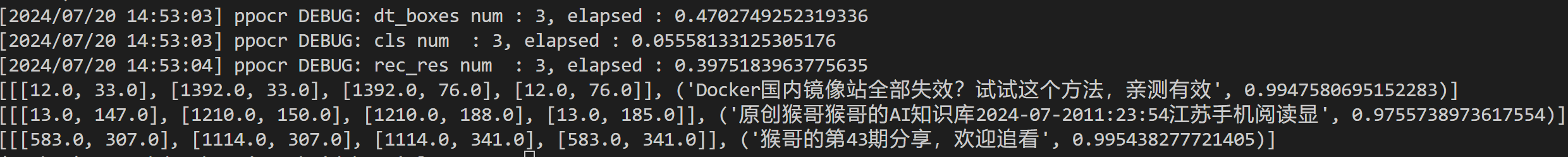

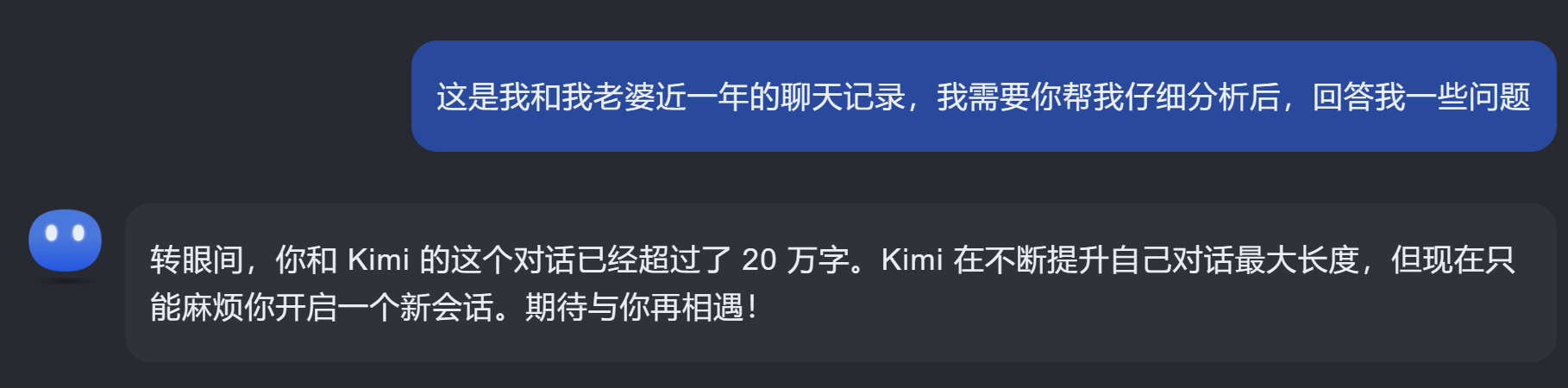

│ ├── 我把和老婆近一年的聊天记录发给Kimi,它的回答亮了....md

│ ├── 用Python爬取公众号历史所有文章,看这篇就够了.md

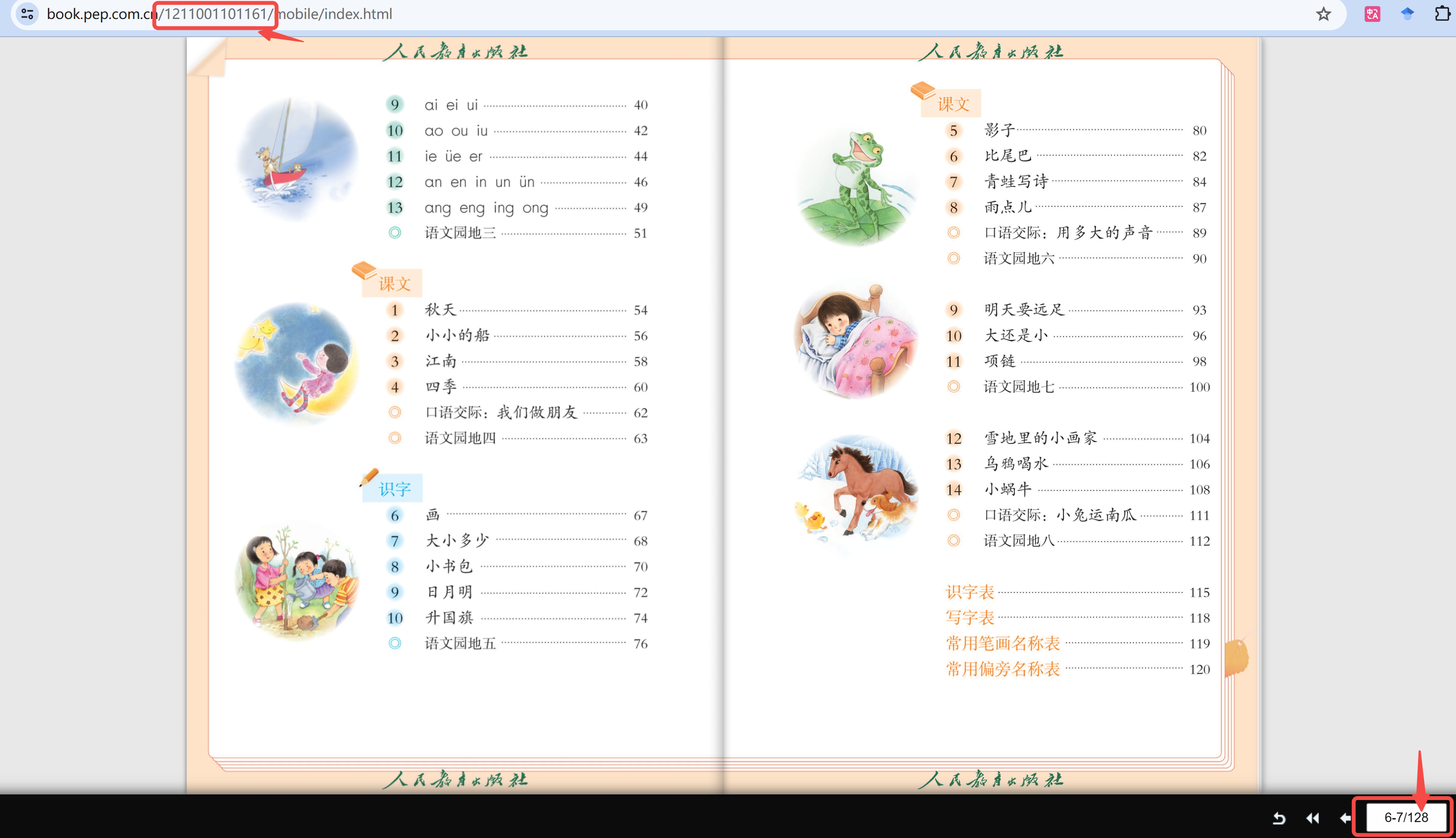

│ └── 自制神器!家长小朋友的福音~.md

├── 5.效率工具

│ ├── README.md

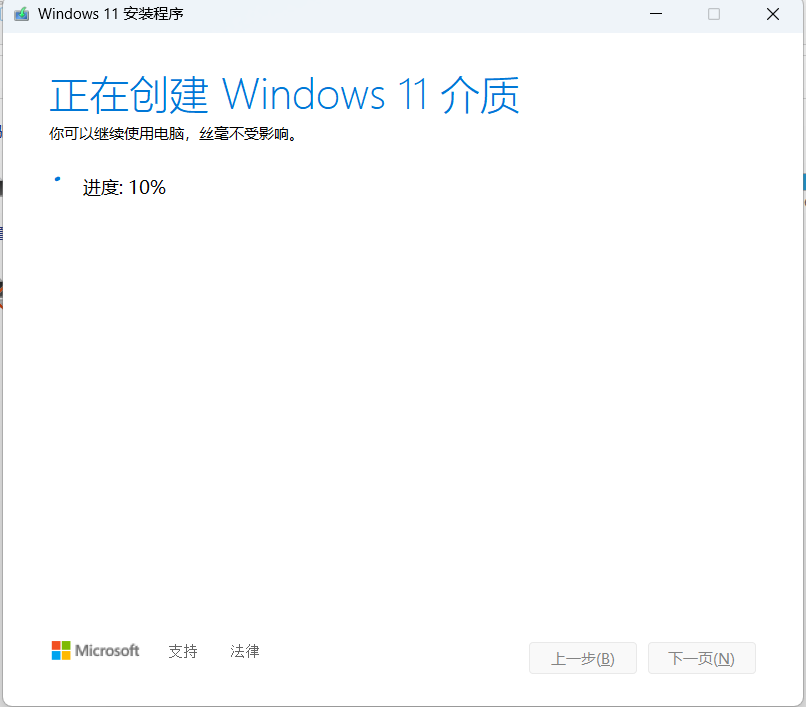

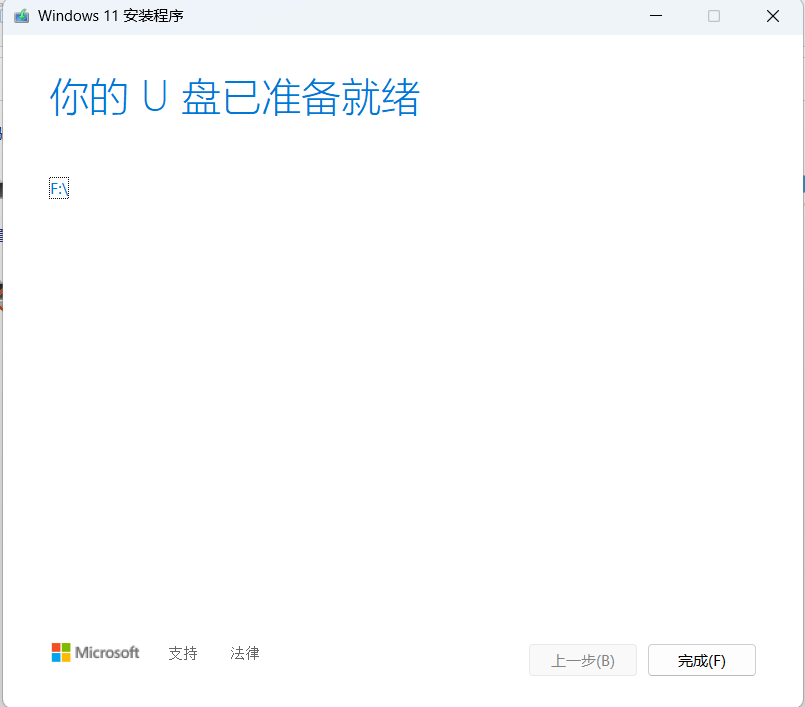

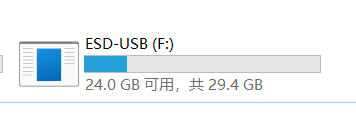

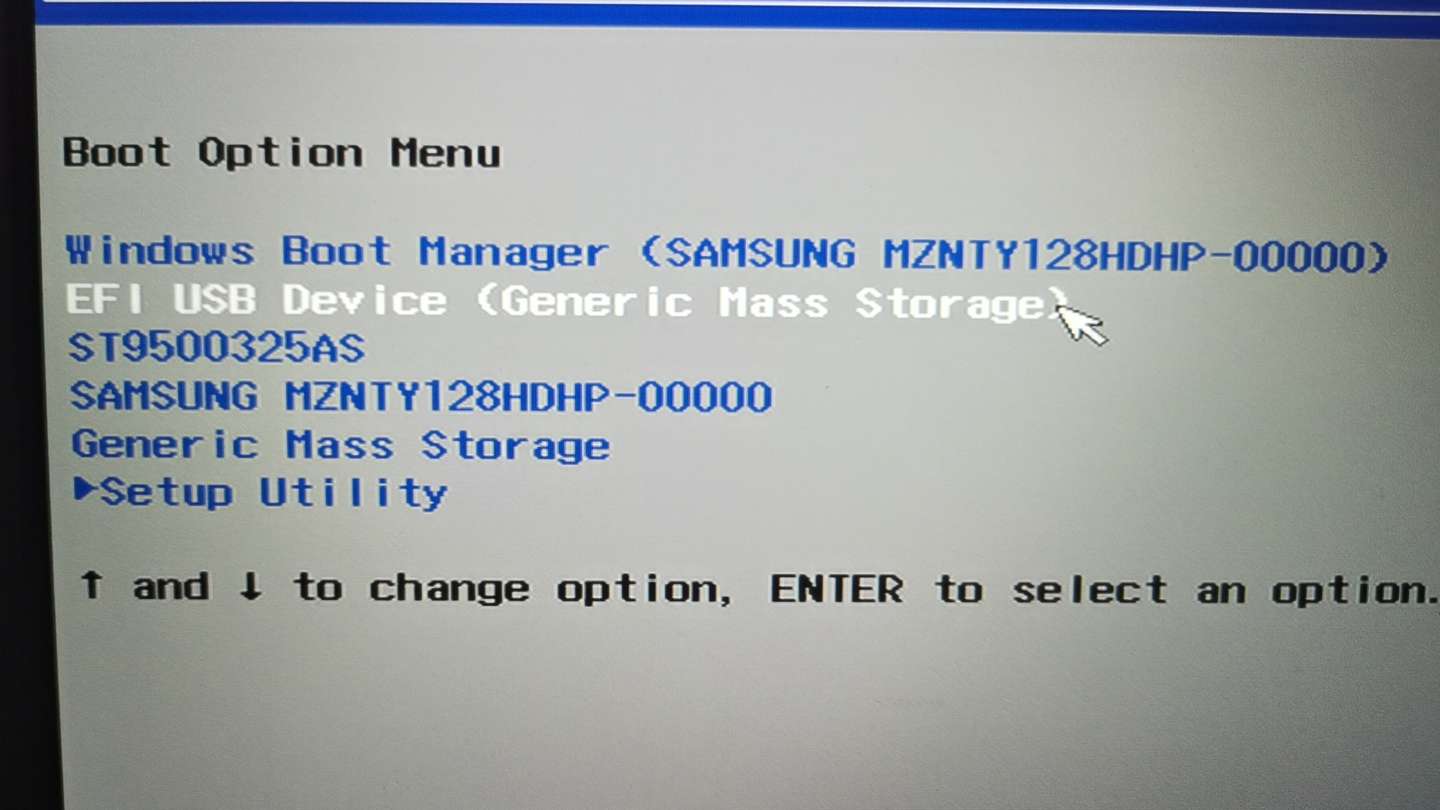

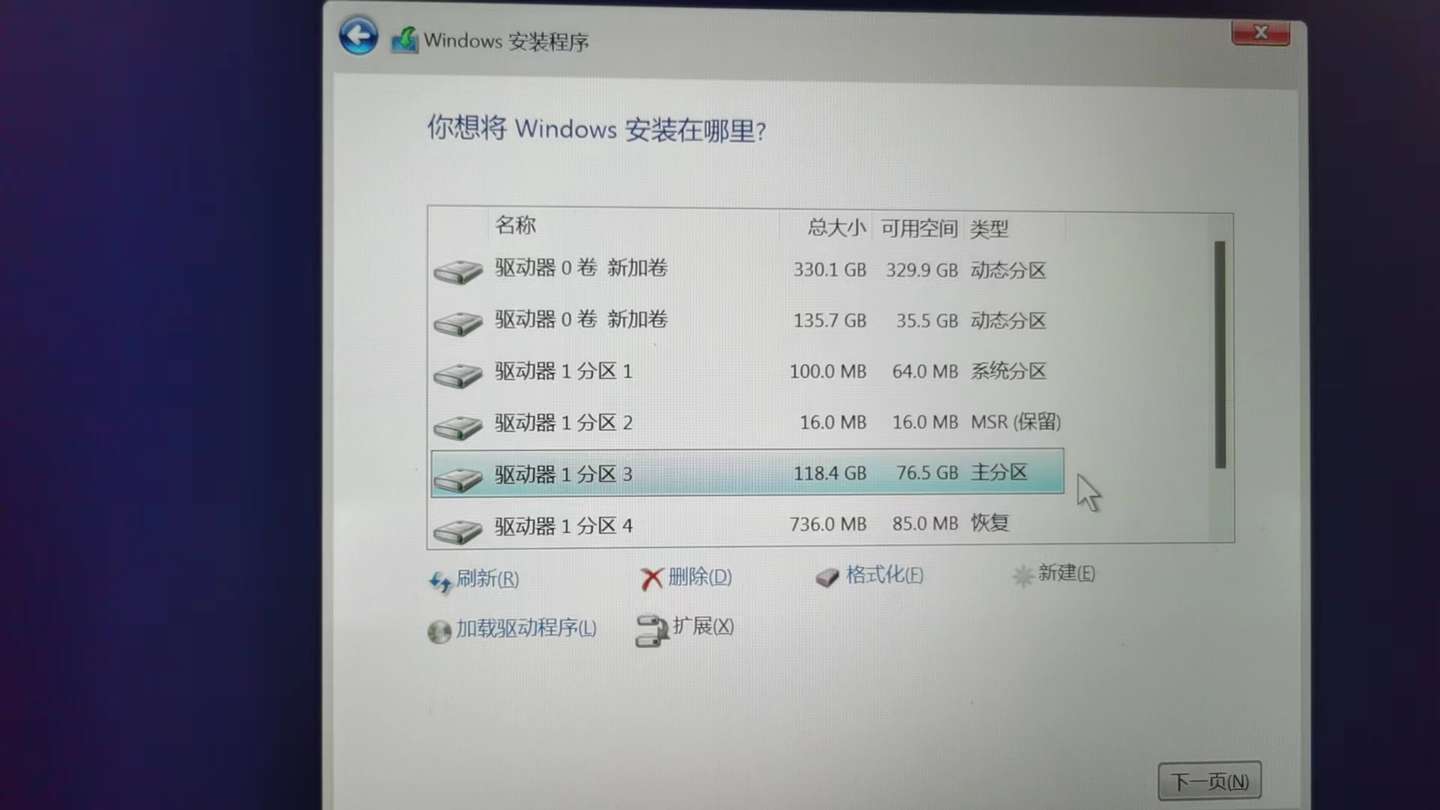

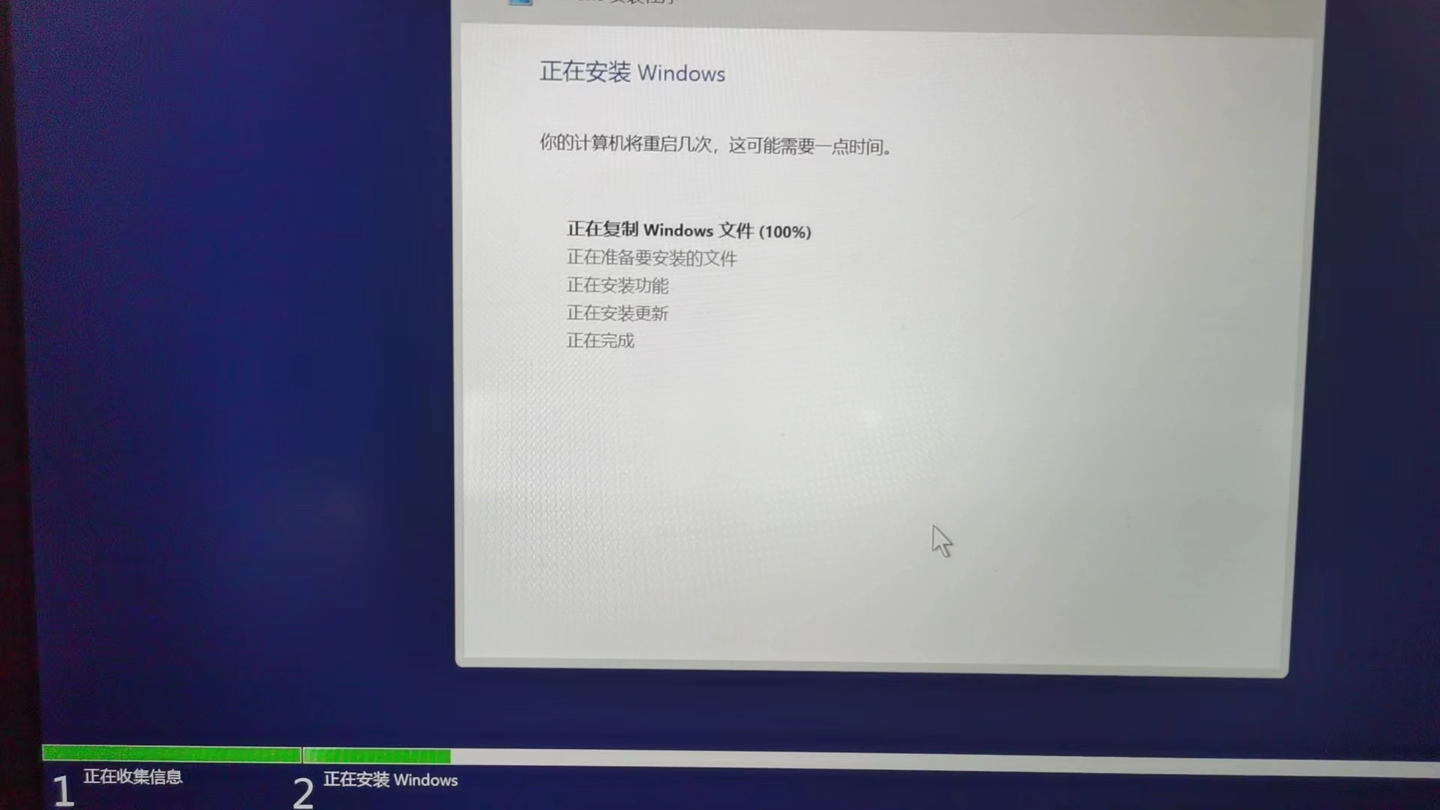

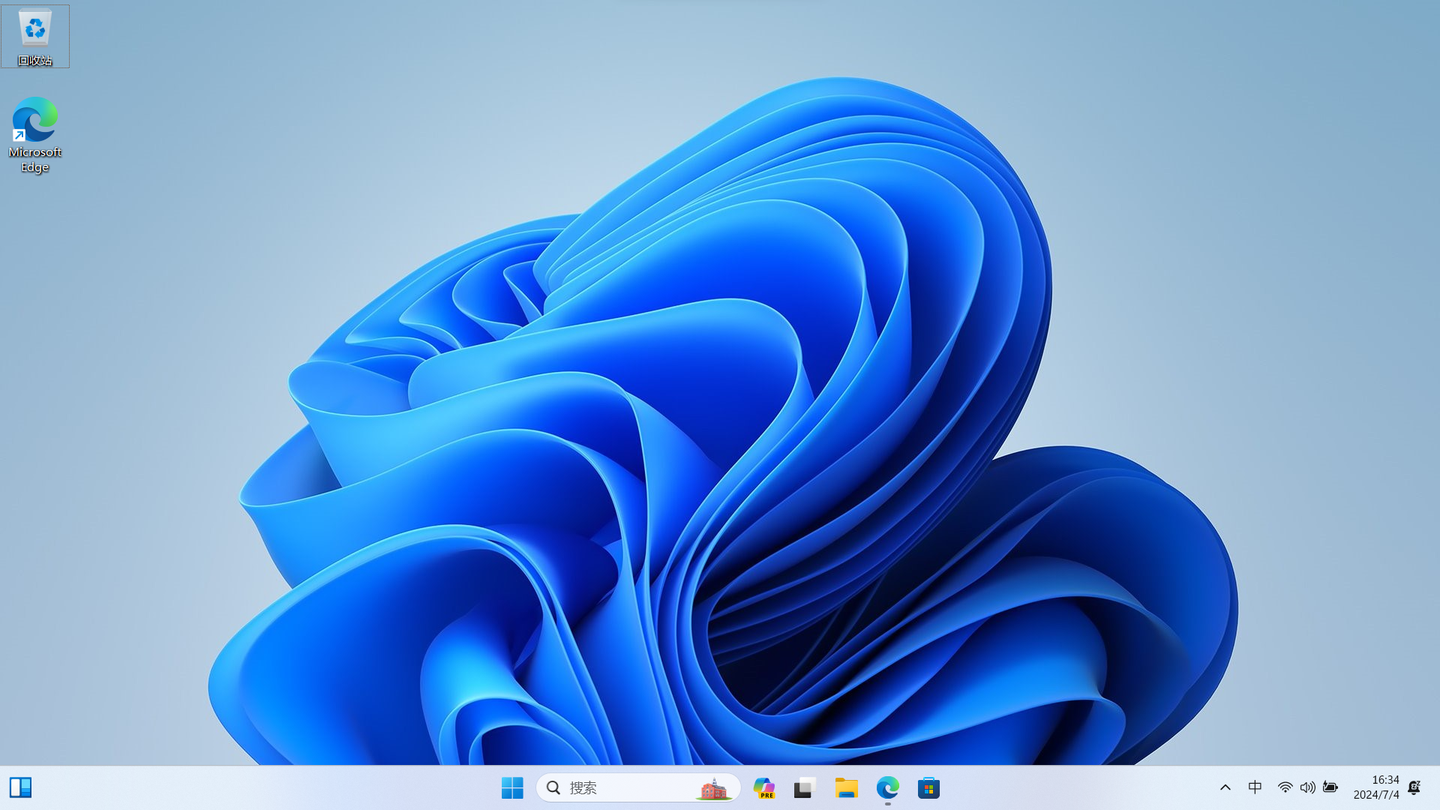

│ ├── Windows11系统安装简明教程,只需3步.md

│ ├── 一行命令实现 Github 国内下载加速.md

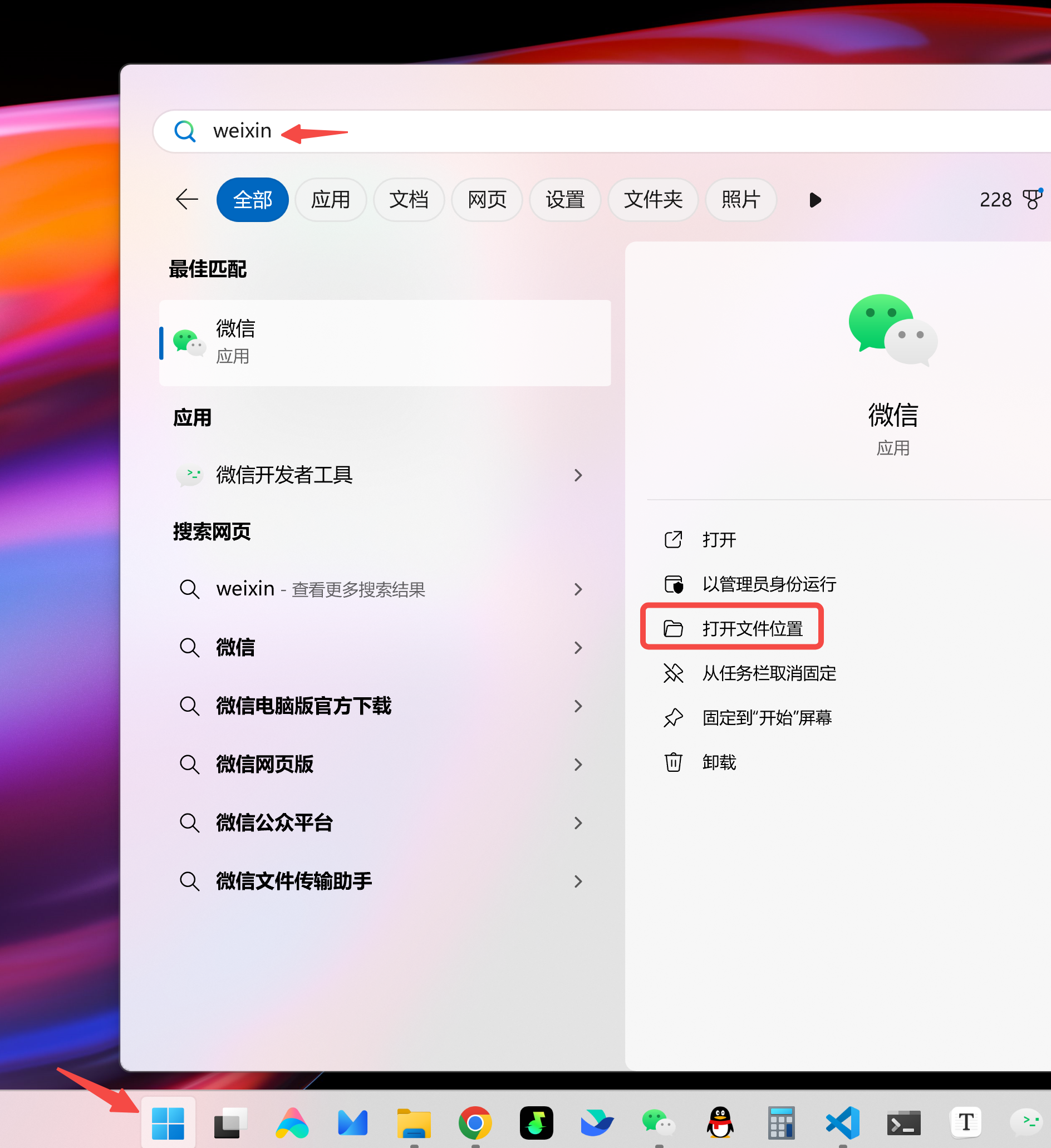

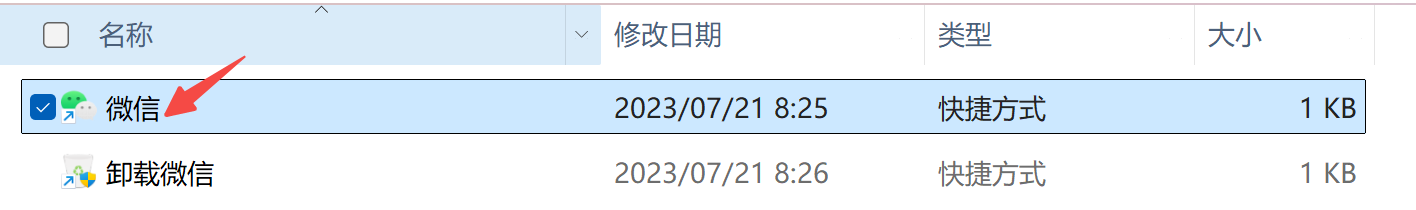

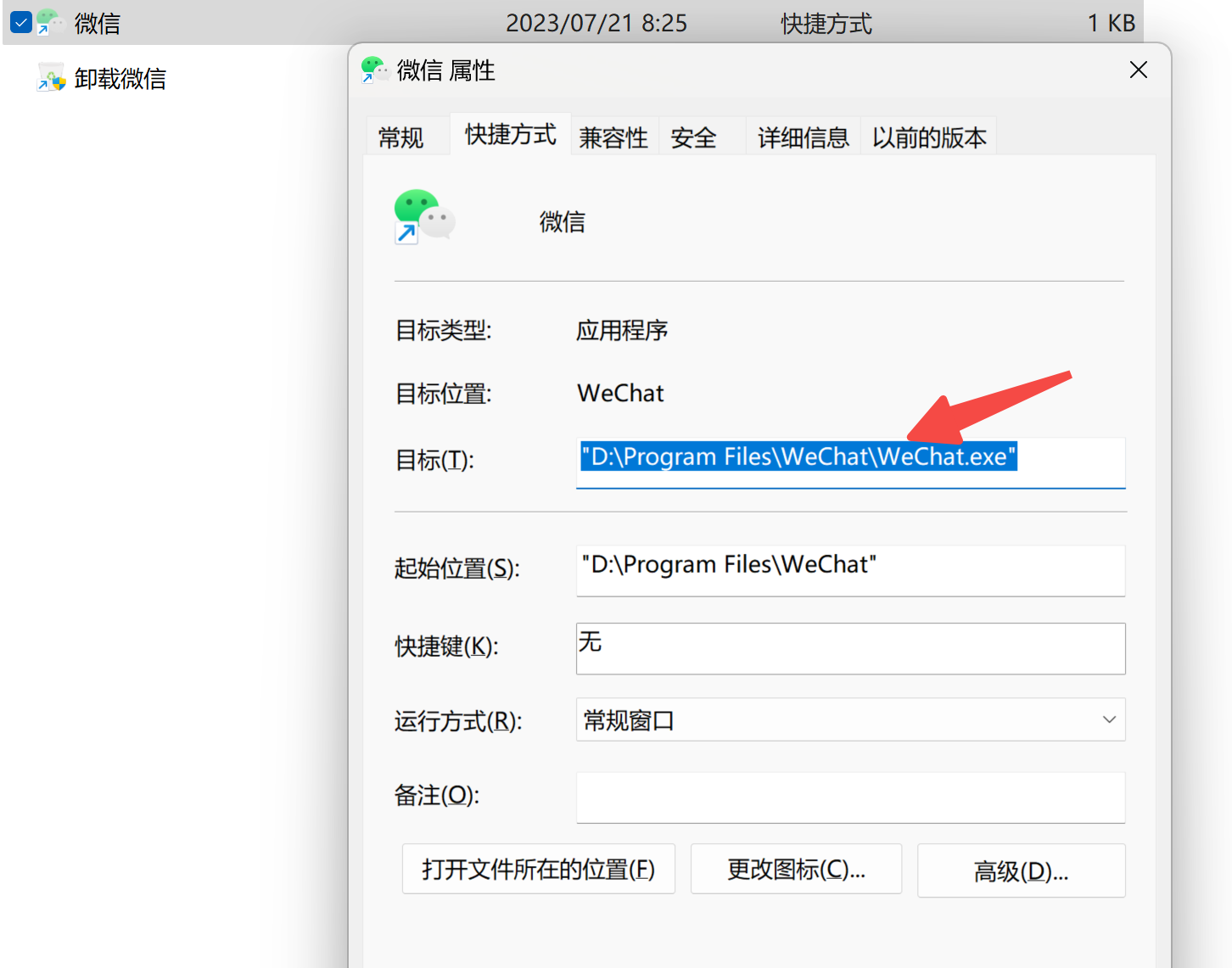

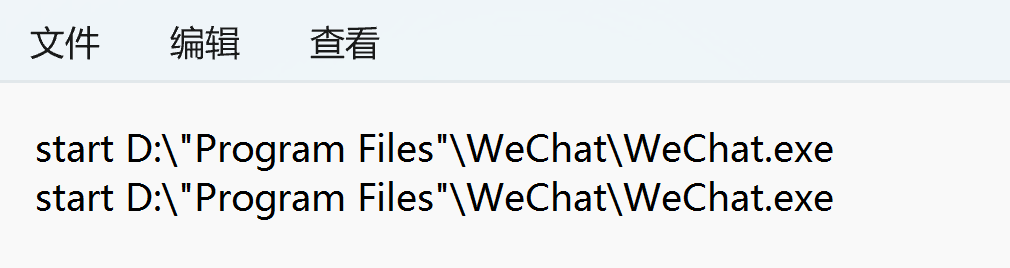

│ ├── 两种方法,实现电脑端微信优雅双开.md

│ ├── 盘点3款AI编程助手,开发效率翻倍.md

│ ├── 盘点简洁好用的8款静态网站搭建框架,小白易上手.md

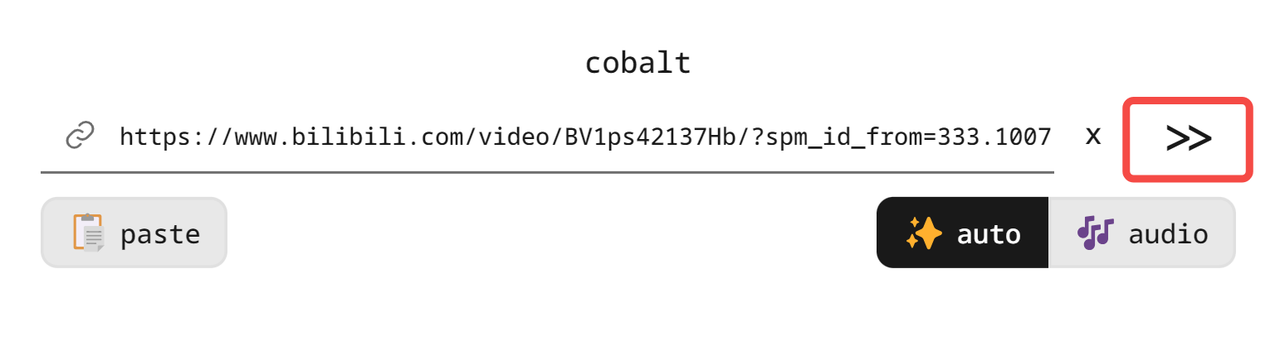

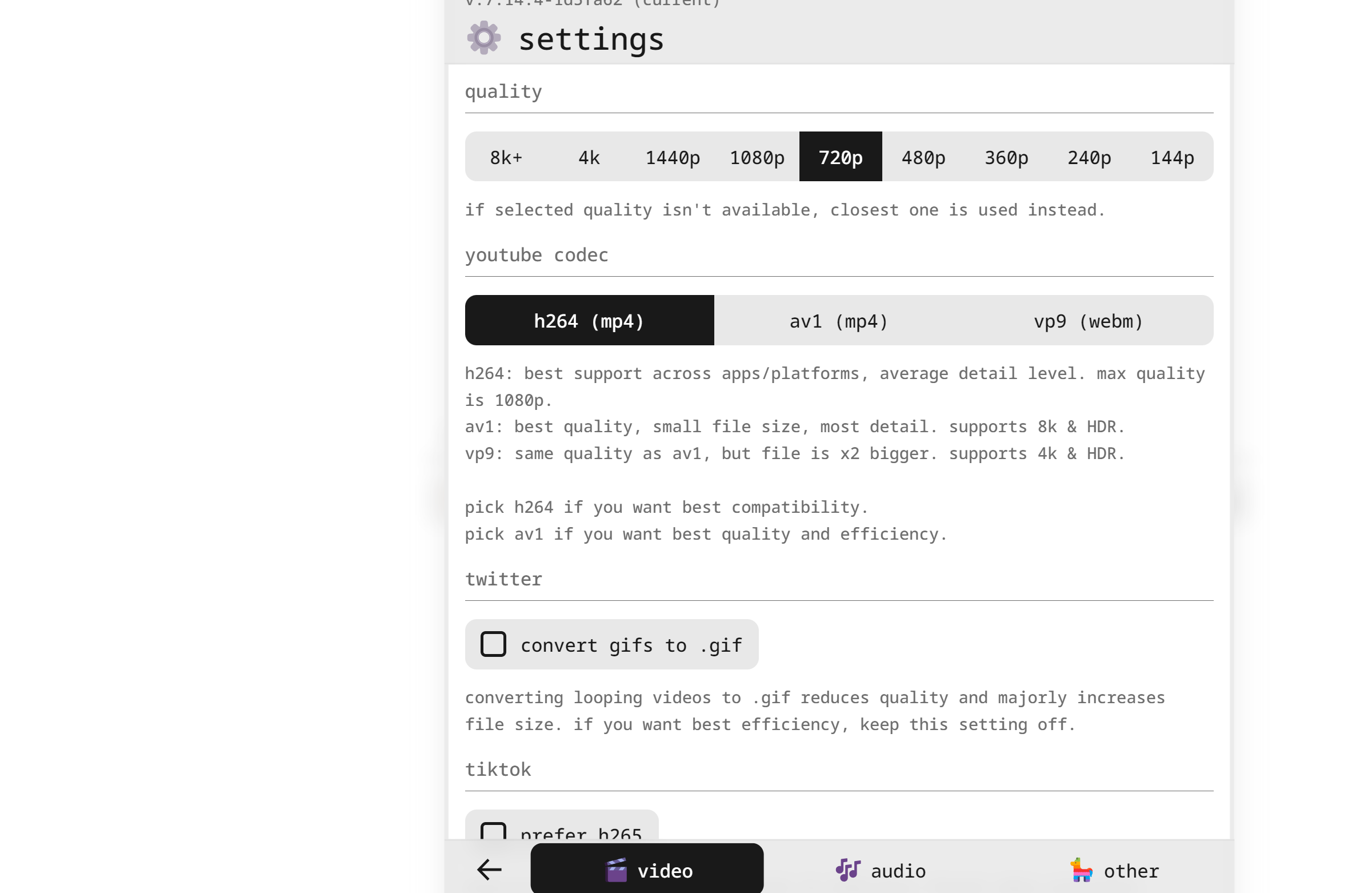

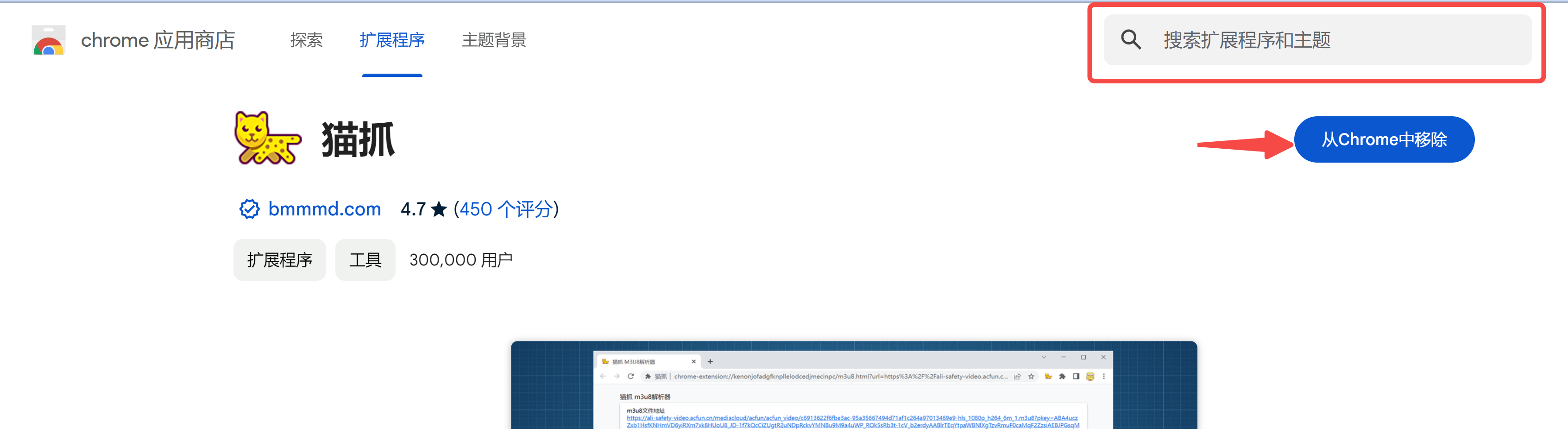

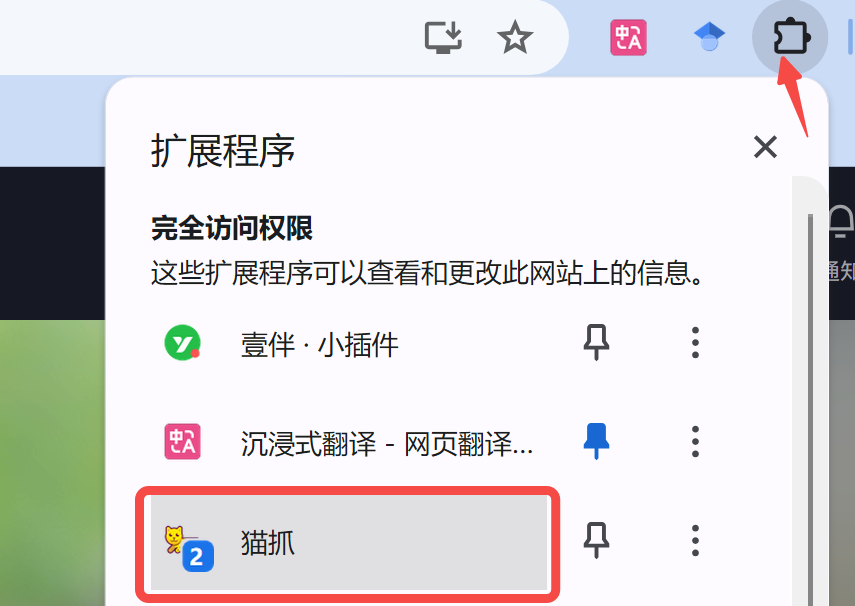

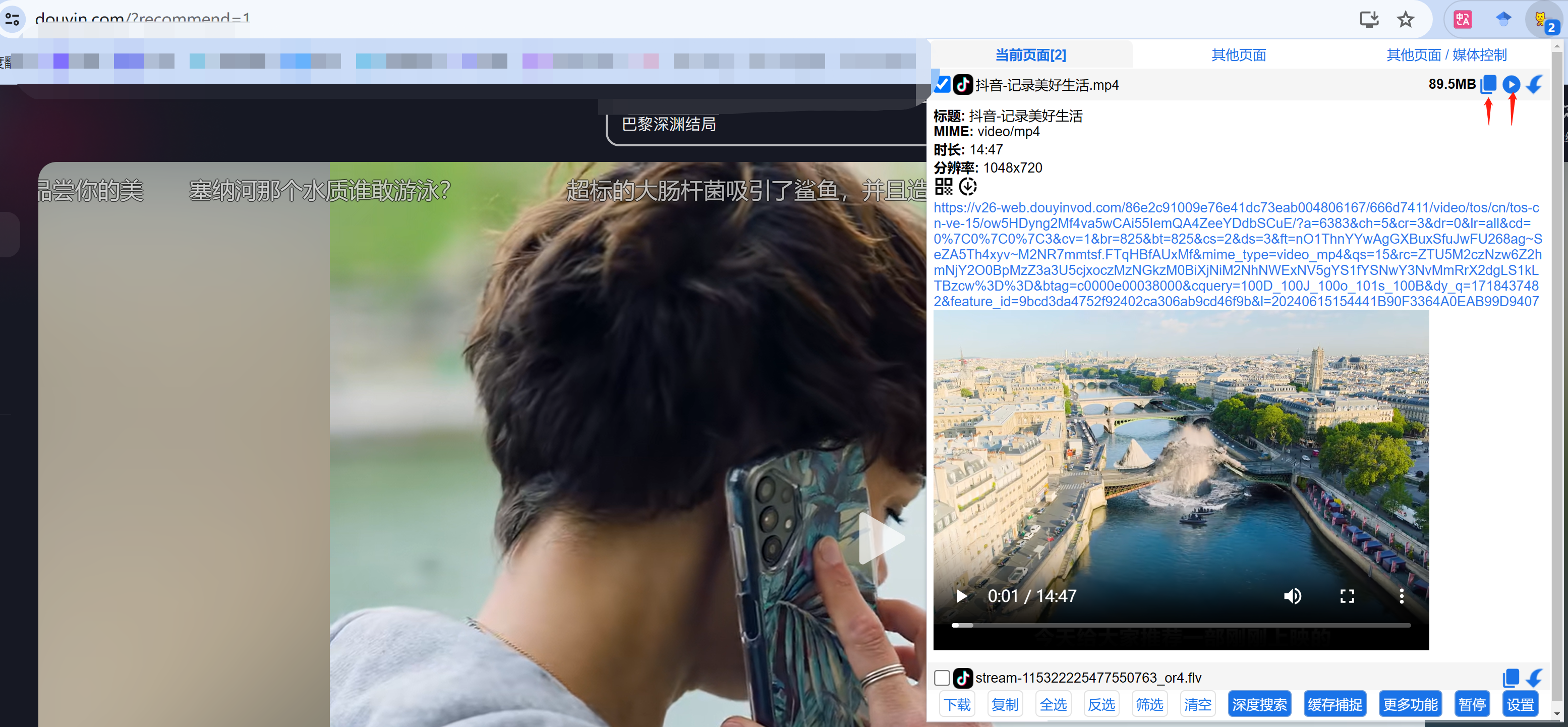

│ └── 视频下载神器!抖音B站YouTube全搞定,免费无广告,亲测好用.md

└── 6.AIoT笔记

│ ├── AIoT应用开发:如何给板子装上'耳朵',实现音频录制.md

│ ├── AIoT应用开发:如何远程查看摄像头,RTSP_RTMP 推流了解下?.md

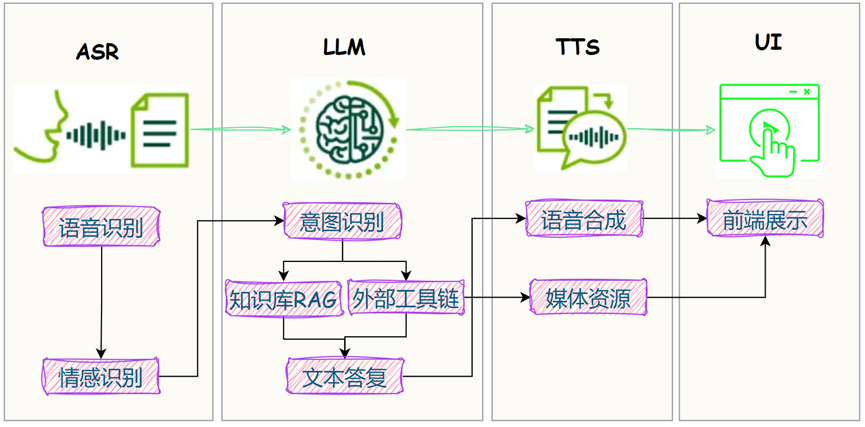

│ ├── AIoT应用开发:搞定语音对话机器人=ASR+LLM+TTS.md

│ ├── AIoT应用开发:本地搭建 AI 口语老师,一对一免费陪练!.md

│ ├── AIoT应用开发:给机器人接入'记忆',完美解决「和谁对话&多轮对话」!附 SQLite 入门实战.md

│ ├── AIoT应用开发:给机器人装上'眼睛',接入CV能力,实现人脸识别.md

│ ├── AIoT应用开发:给板子装上'嘴巴',实现音频播放.md

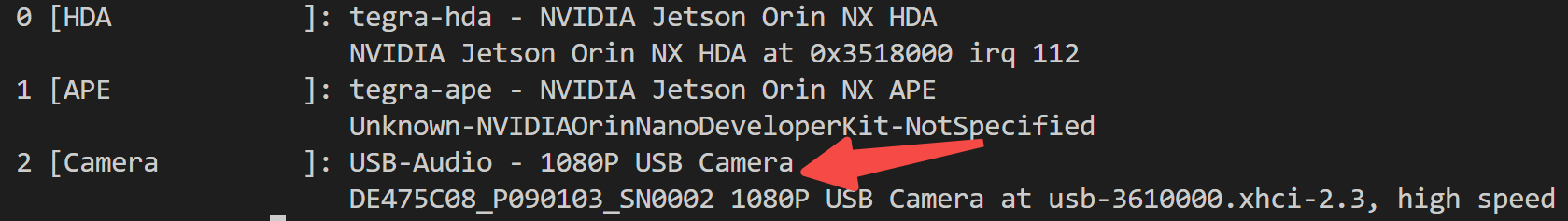

│ ├── Jetson 开发系列:Linux 下如何管理音频设备?.md

│ ├── Jetson 开发系列:Orin Nano 开箱!一款强大的嵌入式&物联网开发板.md

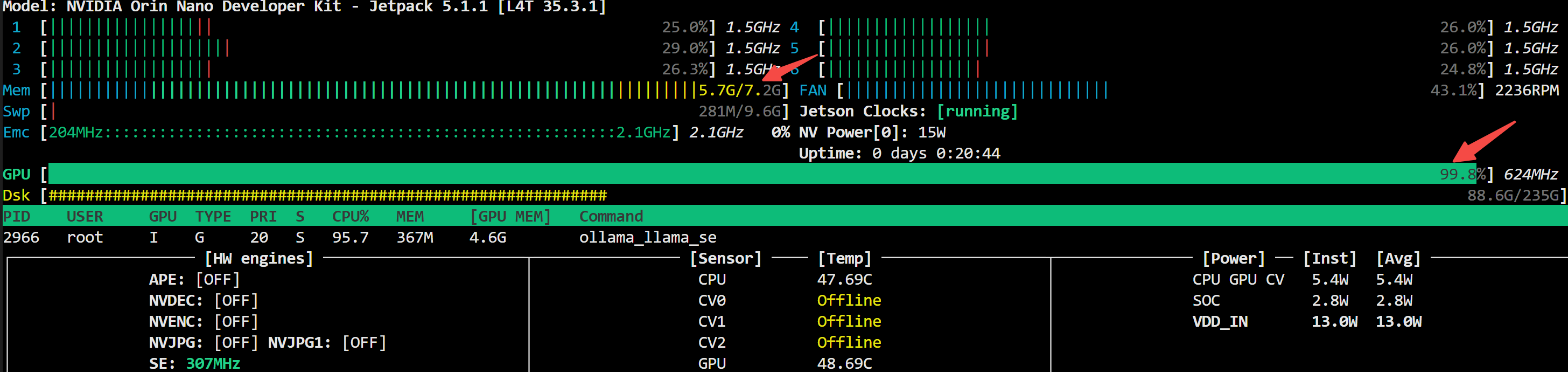

│ ├── Jetson 开发系列:如何用GPU跑本地大模型?.md

│ ├── Jetson 开发系列:离线低延迟的人脸识别方案.md

│ ├── Jetson 开发系列:离线低延迟的语音解决方案.md

│ ├── README.md

│ ├── 从0打造本地聊天机器人:如何实现大模型流式输出?OpenAI+Ollama 实战.md

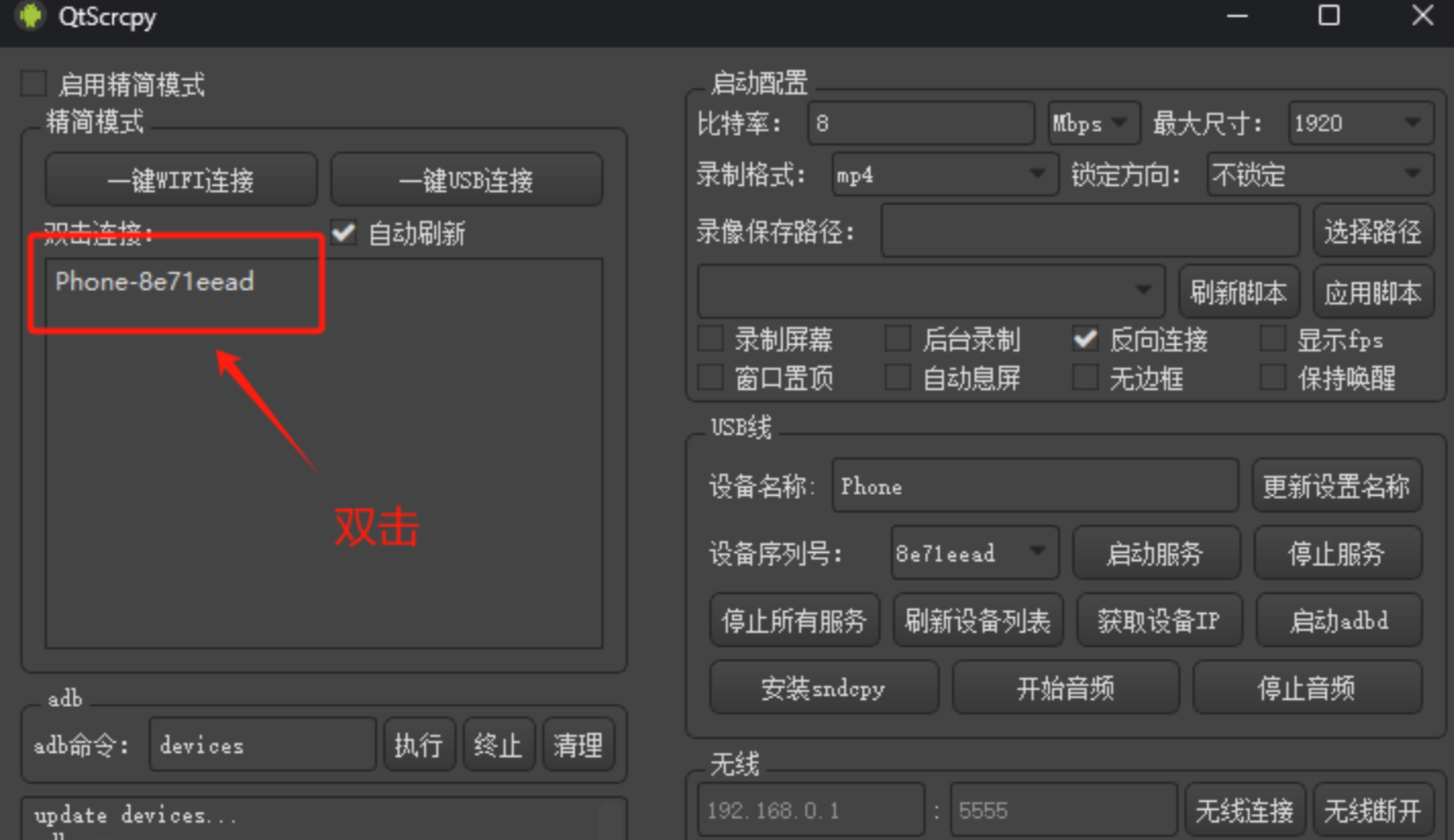

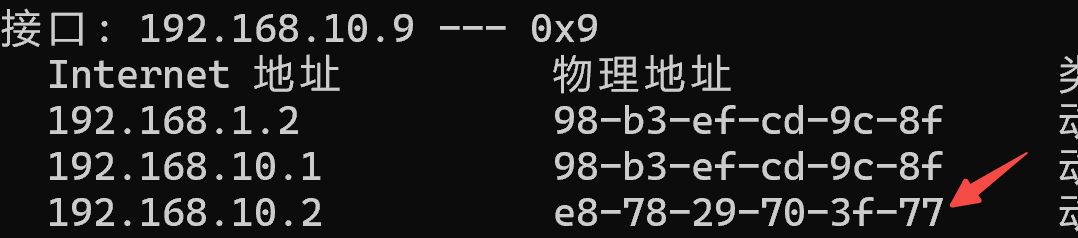

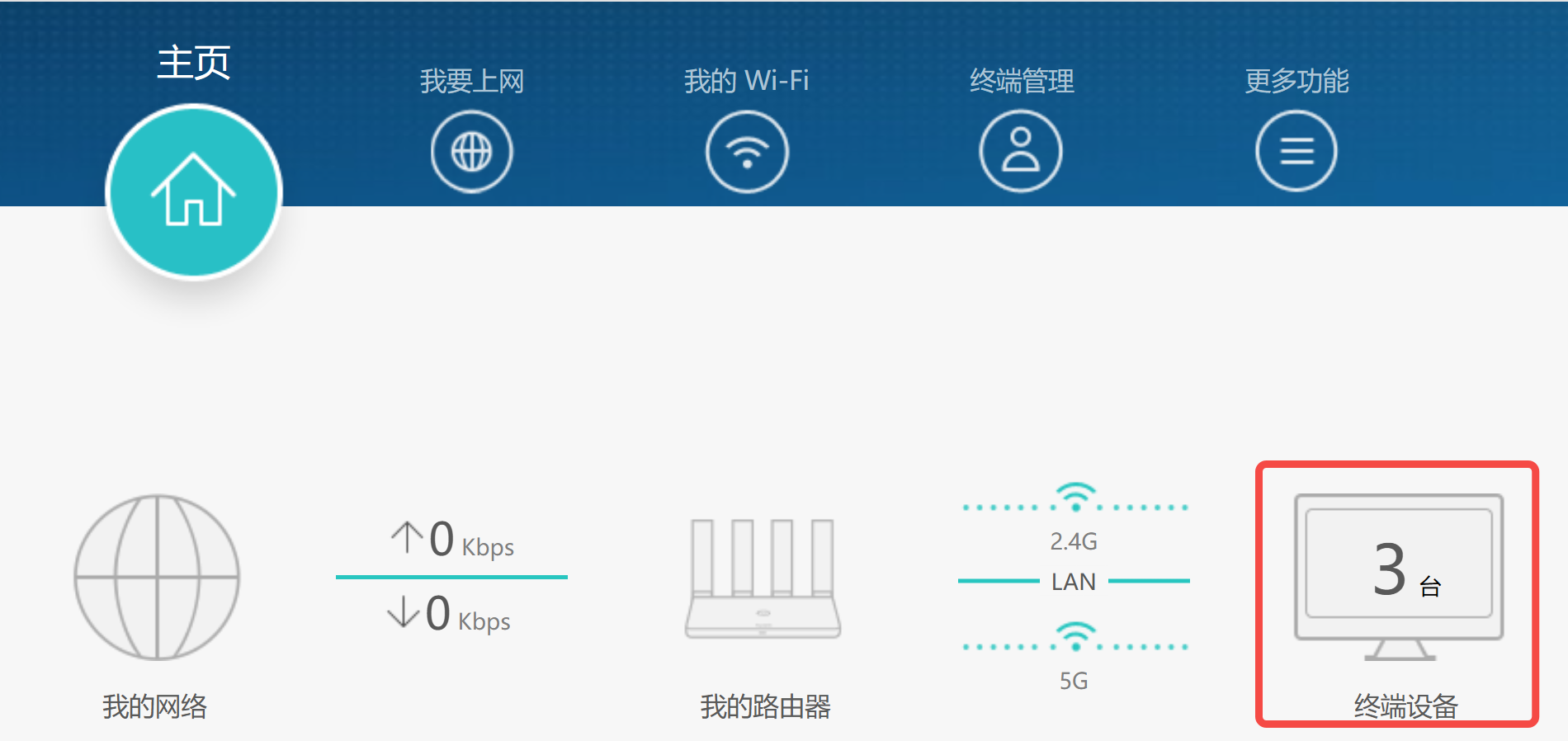

│ ├── 如何在手机端跑大模型?.md

│ ├── 安卓连接 WIFI 但无法上网?盘点我踩过的那些坑.md

│ ├── 成本不到50的AI对话机器人,如何自建服务端?自定义角色+语音克隆,个人隐私不外传.md

│ └── 手机端跑大模型:Ollma_llama.cpp_vLLM 实测对比.md

├── index.html

├── main.py

└── media

├── icon.svg

└── logo_thumbnail.png

/.github/workflows/main.yml:

--------------------------------------------------------------------------------

1 | name: Deploy to GitHub Pages

2 |

3 | on:

4 | push:

5 | branches:

6 | - master # 或者你使用的其他分支

7 |

8 | jobs:

9 | deploy:

10 | runs-on: ubuntu-latest

11 |

12 | steps:

13 | - name: Checkout code

14 | uses: actions/checkout@v4

15 |

16 | - name: Deploy

17 | uses: peaceiris/actions-gh-pages@v3

18 | with:

19 | github_token: ${{ secrets.GITHUB_TOKEN }}

20 | publish_dir: ./ # 使用根目录,或替换为你的 HTML 文件所在目录

21 |

--------------------------------------------------------------------------------

/.gitignore:

--------------------------------------------------------------------------------

1 | **/assets/

2 | main.py

3 | docs/待整理.md

--------------------------------------------------------------------------------

/.nojekyll:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/hougeai/knowledgebase/6cfce85587ecb4903f05af30f3cb5c447c4af868/.nojekyll

--------------------------------------------------------------------------------

/CNAME:

--------------------------------------------------------------------------------

1 | kb.houge.us.kg

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # 猴哥的AI知识库

2 |

3 | > 真诚利他,分享AI学习资料、工具、经验、教程,帮助零基础编程小白快速入门AI。用心做内容,不辜负每一份关注。

4 |

5 | [知识库总览](README.md)

6 |

7 | - [1.Linux笔记](docs/1.Linux笔记/README.md)

8 | - [2.玩转云服务](docs/2.玩转云服务/README.md)

9 | - [3.AI笔记](docs/3.AI笔记/README.md)

10 | - [4.Python笔记](docs/4.Python笔记/README.md)

11 | - [5.效率工具](docs/5.效率工具/README.md)

12 | - [6.少儿编程](docs/6.少儿编程/README.md)

13 |

14 | *截至今日,知识库累计更新原创文章**165**篇*

15 |

16 |

17 |

18 |

19 |

--------------------------------------------------------------------------------

/_coverpage.md:

--------------------------------------------------------------------------------

1 |

2 |

3 |

4 |

5 | # 猴哥的AI知识库 2024

6 |

7 | > 用心做内容,不辜负每一份关注。

8 |

9 | 适合人群:

10 |

11 | - AI 爱好者

12 | - AI 小白

13 | - AI 自媒体变现

14 |

15 | [公众号:猴哥的AI知识库](https://axcvs2xtkbpq.objectstorage.ap-singapore-1.oci.customer-oci.com/n/axcvs2xtkbpq/b/bucket-20240802-0845/o/v2-ffa263db3791634adecf4fcb101e38fa_1440w.png)

16 |

17 | [知乎:AI布道师](https://www.zhihu.com/people/houge-ai)

18 |

19 | [CSDN:AI码上来](https://blog.csdn.net/u010522887)

20 |

21 | [Github](https://github.com/hougeai/knowledgebase)[Get Started](README.md)

22 |

--------------------------------------------------------------------------------

/_navbar.md:

--------------------------------------------------------------------------------

1 |

2 | - [1.Linux笔记](docs/1.Linux笔记/README.md)

3 | - [2.玩转云服务](docs/2.玩转云服务/README.md)

4 | - [3.AI笔记](docs/3.AI笔记/README.md)

5 | - [4.Python笔记](docs/4.Python笔记/README.md)

6 | - [5.效率工具](docs/5.效率工具/README.md)

7 | - [6.少儿编程](docs/6.少儿编程/README.md)

--------------------------------------------------------------------------------

/docs/0.少儿编程/README.md:

--------------------------------------------------------------------------------

1 | # 0.少儿编程

2 |

3 | - [免费的Scratch学习资源梳理(持续更新ing)_2024-07-31](docs/0.少儿编程/免费的Scratch学习资源梳理(持续更新ing)_2024-07-31.md)

4 | - [全网爆火的免费少儿编程网站!一文揭开code.org的神秘面纱_2024-07-31](docs/0.少儿编程/全网爆火的免费少儿编程网站!一文揭开code.org的神秘面纱_2024-07-31.md)

5 | - [公众号排版器](docs/0.少儿编程/公众号排版器.md)

6 | - [在家带娃学编程?附路线规划图_2024-07-31](docs/0.少儿编程/在家带娃学编程?附路线规划图_2024-07-31.md)

7 | - [娃适合学编程么?不妨陪ta从零开始_2024-07-31](docs/0.少儿编程/娃适合学编程么?不妨陪ta从零开始_2024-07-31.md)

8 | - [少儿编程考级怎么选?你想要了解的一切都在这里_2024-07-31](docs/0.少儿编程/少儿编程考级怎么选?你想要了解的一切都在这里_2024-07-31.md)

9 | - [少儿编程都有哪些比赛?全网鼓吹的信奥赛NOI到底有多难?](docs/0.少儿编程/少儿编程都有哪些比赛?全网鼓吹的信奥赛NOI到底有多难?.md)

10 |

11 |

12 |

13 | *本系列共更新**7**篇文章*

14 |

15 |

16 |

17 | [🔙返回首页](/)

18 |

--------------------------------------------------------------------------------

/docs/0.少儿编程/免费的Scratch学习资源梳理(持续更新ing)_2024-07-31.md:

--------------------------------------------------------------------------------

1 | > 我是大力,5年互联网从业经历,目前深耕少儿编程领域,致力于打造全网优质的**免费**少儿编程知识库,致力于打破家长朋友们和机构之间的信息差。

2 | # Scratch是什么

3 | Scratch是由麻省理工学院(MIT)设计开发的少儿编程语言,它将程序设计语言的基本概念,如变量、函数、逻辑、条件语句等,通过积木的方式呈现,使孩子可以轻松地学习和创作。Scratch 适用于 6 岁以上的儿童和初学者,它不仅可以帮助孩子学习编程知识,还可以培养创造力、逻辑思维和解决问题的能力。

4 | 几乎所有的孩子都会一眼喜欢上这个软件,使用它编写各种有趣的故事、动画和游戏。

5 |

6 | # Scratch如何使用

7 | Scratch自2007年发布以来,一共经历了三个版本的迭代,官方团队在2010年推出了2.0版本,2019年推出了3.0版本。Scratch3.0相比之前版本最主要的特点:增加更多拓展功能的模块,甚至可以和Micro:bit、ev3和wedo2.0等硬件进行连接,因此创作的可想象空间更大。

8 | 目前等级考试和学科竞赛采用的都是3.0版本,故建议大家使用3.0版本进行学习和创作。

9 |

10 | 因为Scratch官网部署在国外,国内很难访问Scratch官网,不过这并不影响大家使用Scratch的热情。目前使用Scratch有两种方式,大家可以根据自己的情况选用:

11 | - 离线安装包:安装在本地电脑,不需要电脑联网即可使用

12 | - 在线编程环境:无需本地安装,只要电脑能联互联网就可以使用(**更推荐**)

13 | ## 离线安装包

14 | 为了让广大Scratch爱好者可以使用Scratch软件,我把Scratch3.0安装包放在了云端网盘。

15 | 下载链接:[Scratch3.0.zip](https://pan.quark.cn/s/5c4e88e3e8ee)

16 | ## 在线编程环境

17 | 如果你的电脑存储空间有限,推荐你直接使用在线编程环境。

18 | 相比离线安装包,在线编程环境在功能上没有任何区别,且优势非常明显:

19 | - 只需要一个账号,所有改动都实时保存在线上,在不同电脑和手机上都可以实时无缝查看

20 | - 方便用户将作品分享到社区,在和其他小朋友的互动中获得满满成就感

21 |

22 | 那么都有哪些免费的在线编程环境呢?这里主要推荐以下四种:

23 | - scratch之家:https://scratchers.cn/s/index(推荐指数:⭐️)

24 | - 蒸汽工坊:https://www.steamcollection.com/(推荐指数:⭐️⭐️)

25 | - 蓝桥杯模拟器:https://scratch.stem86.com/ (推荐指数:⭐️⭐️)

26 | - Code Lab:https://create.codelab.club/ (推荐指数:⭐️⭐️⭐️)

27 |

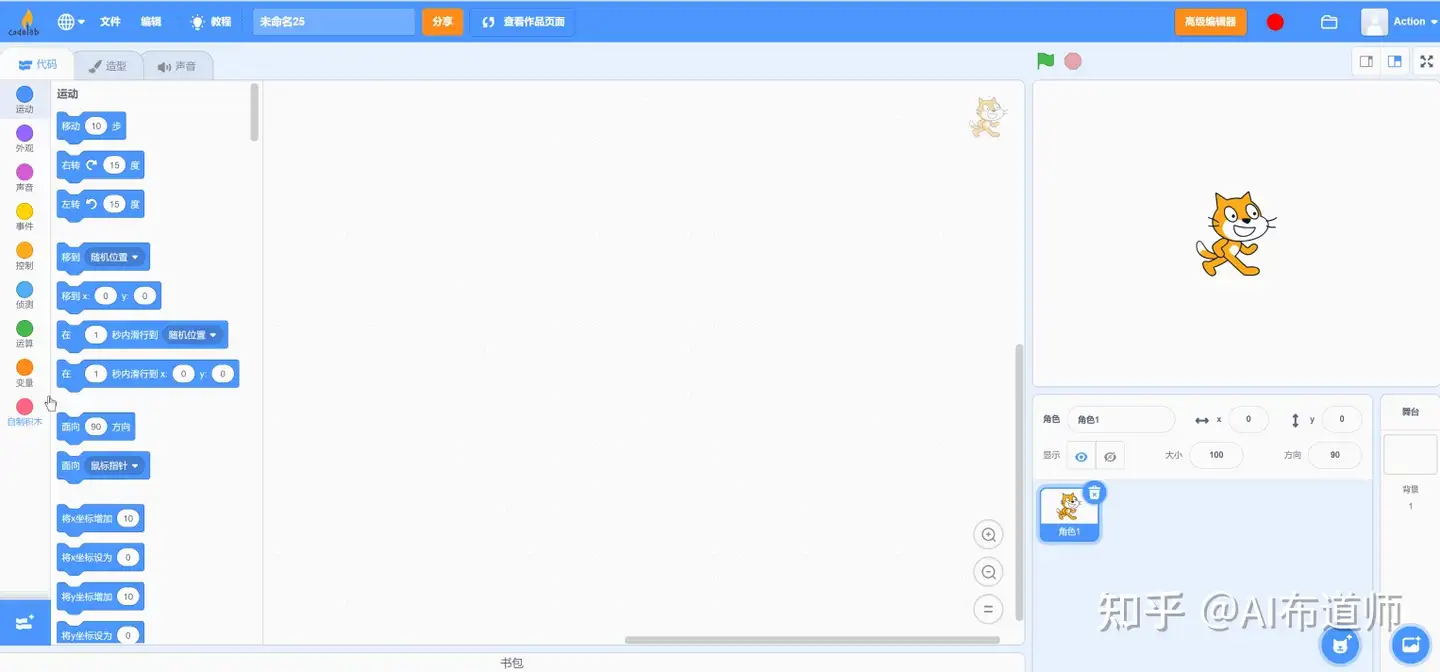

28 | 由于Scratch3.0最主要的特点就是增加了更多扩展功能,上述在线编程环境在使用上没有任何区别,唯一的不同在于扩展功能的数量,为此我更推荐code lab的模拟器。如下图所示,点击左下角的图标,可以看到并搜索使用内置的拓展功能。

29 |

30 |

31 |

32 | # 免费电子书籍

33 | 对于家长小朋友零基础入门,有哪些推荐的书籍呢?

34 |

35 | 我会将搜集到的优质书籍梳理在这个版块,大家有更好的书籍也欢迎多多推荐。

36 |

37 | 1.《零基础scratch 3.0 小学生趣味编程》

38 | - 推荐指数:⭐️⭐️⭐️

39 | - 推荐理由:这是我目前看到的最值得推荐的一本Scratch入门书籍。图文并茂,实操性非常强,采用PBL项目制教学,通过做项目的方式带领大家掌握Scratch的核心基本概念。

40 | - 下载链接:[零基础scratch 3.0 小学生趣味编程.pdf](https://pan.quark.cn/s/b633f7e60d44)

41 |

42 | # 免费优质课程

43 | 网上有大量的Scratch教学课程,这里将系统梳理适合在家自学的优质课程,大家有更好的课程也欢迎多多推荐。

44 | ## scratch创意编程

45 | - 推荐指数:⭐️⭐️⭐️

46 | - 推荐理由:借鉴了哈弗大学scratch创意计算课程,采用PBL项目制教学,内容不是很多,非常适合在家自学。

47 | - 课程简介:第 1-2 单元探索编程工具和社区,并尝试创作两个项目,了解编程的可能性。第 3-8 单元围绕动画、故事、游戏这三大主题进行创作。第 9-10 单元进行深入拓展,并总结之前所学知识

48 | - 课程介绍:https://www.codelab.club/blog/2021/01/19/creativecodingcourse/

49 | - B站视频:https://www.bilibili.com/video/BV1jT4y1K7iA/

50 | ## Scratch入门教程

51 | - 推荐指数:⭐️⭐️

52 | - 推荐理由:内容比较丰富,可在上一门课程学完之后进行深入学习

53 | - B站视频:https://www.bilibili.com/video/BV1bF41187VX?p=1&vd_source=cc29c4ba51b0e6b0472256fe6a96da6d

54 |

55 | > 未完结!后续会持续维护更新这篇文档。如果觉得对你有帮助,欢迎点赞收藏关注~

56 |

--------------------------------------------------------------------------------

/docs/0.少儿编程/全网爆火的免费少儿编程网站!一文揭开code.org的神秘面纱_2024-07-31.md:

--------------------------------------------------------------------------------

1 | > 说起少儿编程网站,是不是只想到Scratch?全网爆火的免费少儿编程网站code.org又是啥?既然免费,新人如何食用?今天一文给你讲明白!

2 |

3 | # code.org是啥?

4 |

5 | code.org是一家提供学习计算机科学机会的非盈利性组织,网站有非常丰富的学习资源。

6 | 孩子在玩Code.org时不需要事先学习编程语言,通过玩游戏的方式,就可以进行逻辑思维训练。在浏览器导航栏中输入code.org,就可以进入网站首页。点击课程,就可以看到所有课程目录了。

7 |

8 |

9 | # code.org的课程如何选择?

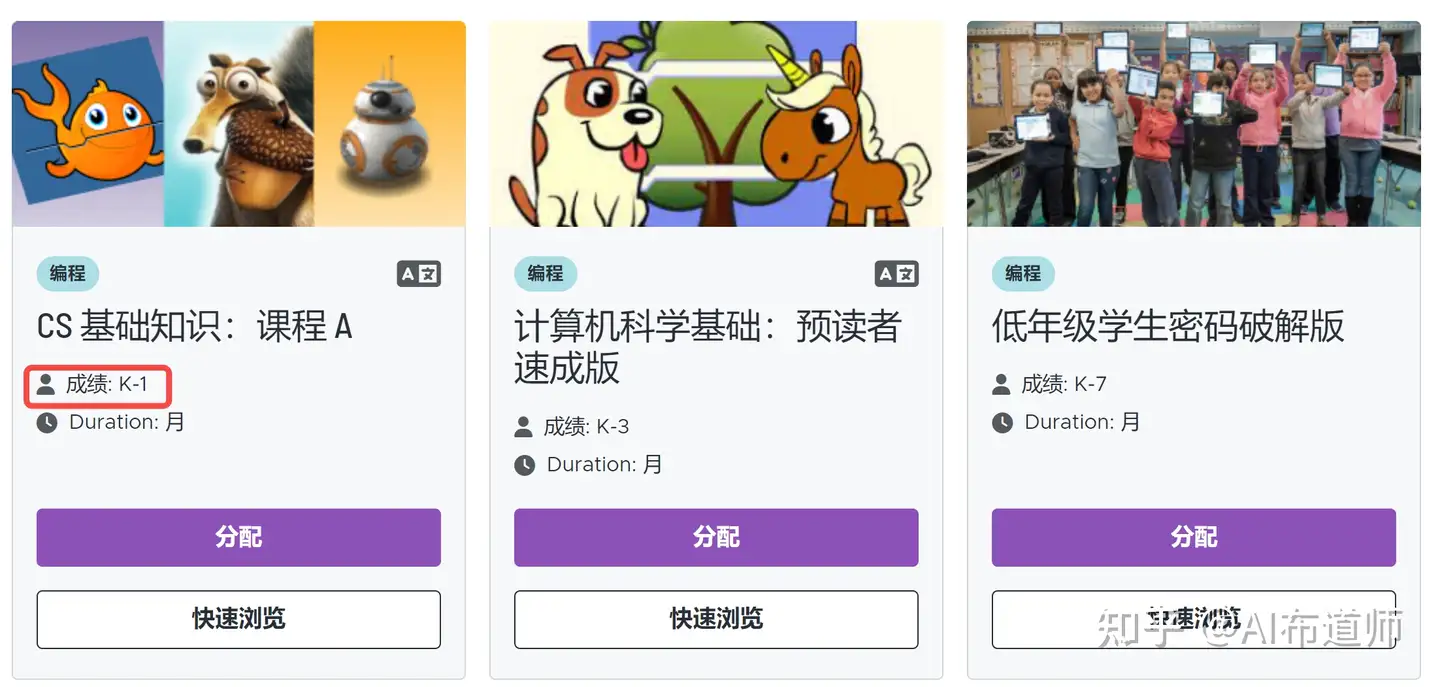

10 | code.org中提供的学习资源非常丰富,但是大部分课程中的内容差别并不是特别大,对于孩子的编程启蒙而言,其实只需要选择其中的一门课程就够了,通过筛选依据-年级,就可以筛选出适合孩子年龄阶段的课程了。每门课程都指定了适合的年龄阶段,比如K-1就是说明适合幼儿园到一年级的小朋友。

11 |

12 | 为了帮助大家更好地理解不同课程之间的联系,减少大家的选择焦虑,大力已经系统梳理了code.org中的所有课程,这些课程大体可以分为如下三类:

13 |

14 | ## 快速课程

15 | [快速计算机科学课程介绍](https://studio.code.org/s/20-hour?section_id=5224695&user_id) 共计20小时的课程,介绍核心计算机科学和编程的概念。每一节都是按照1h设定的,分解为计算思维的四个步骤:分解,模式定位,抽象,算法;后面的概念视频包括:方格纸编程 算法 函数 条件语句 抽象化 编程接力 互联网,每个下面都会一个练习,目前来看整体价值不是特别大,因为覆盖面广,所以针对性不够。

16 | ## 自定义进度课程

17 | 该系列课程下包含了两个速成课程,可以理解为是下面阶段课程的浓缩版,小朋友可以按照自己的节奏尝试以下课程来学习计算机科学!学习创建计算机程序,制作游戏和创意项目。

18 | - [速成课程-预读者快报](https://studio.code.org/s/pre-express-2021?section_id=5224695):适合幼儿园到一年级的小朋友,主要涉及以下3个概念。

19 | - 序列:拖放 斯奎特(冰河世纪) 迷宫编程(愤怒的小鸟) BB8编程 与收割者编程

20 | - 循环:斯奎特 收集器中的循环 艺术家的循环(绘线) 用循环来画花园

21 | - 事件:游戏实验室中的事件:两个小项目-狗乔治 皇室战争

22 | - [速成课程-快速课程](https://studio.code.org/s/express-2021?section_id=5224695):适合2-5年级的小朋友,涉及到了如下编程的概念。

23 | - 序列:迷宫编程 迷宫调试 收集器中编程 艺术家里的编程

24 | - 事件:动作精灵图 虚拟宠物 舞蹈派对

25 | - 循环:涉及嵌套循环(涉及到了角度的概念,嵌套循环时有难度,会越来越难)

26 | - 条件语句:迷宫里的循环 收割者里的条件和循环

27 | - 函数:我的世界中的函数 艺术家之家的功能 收割者中的函数

28 | - 变量:文字和提示 艺术家与变量 蜜蜂与变量

29 | - 计数循环:蜜蜂里的计数循环 艺术家里的计数循环

30 | ### 阶段课程(推荐)

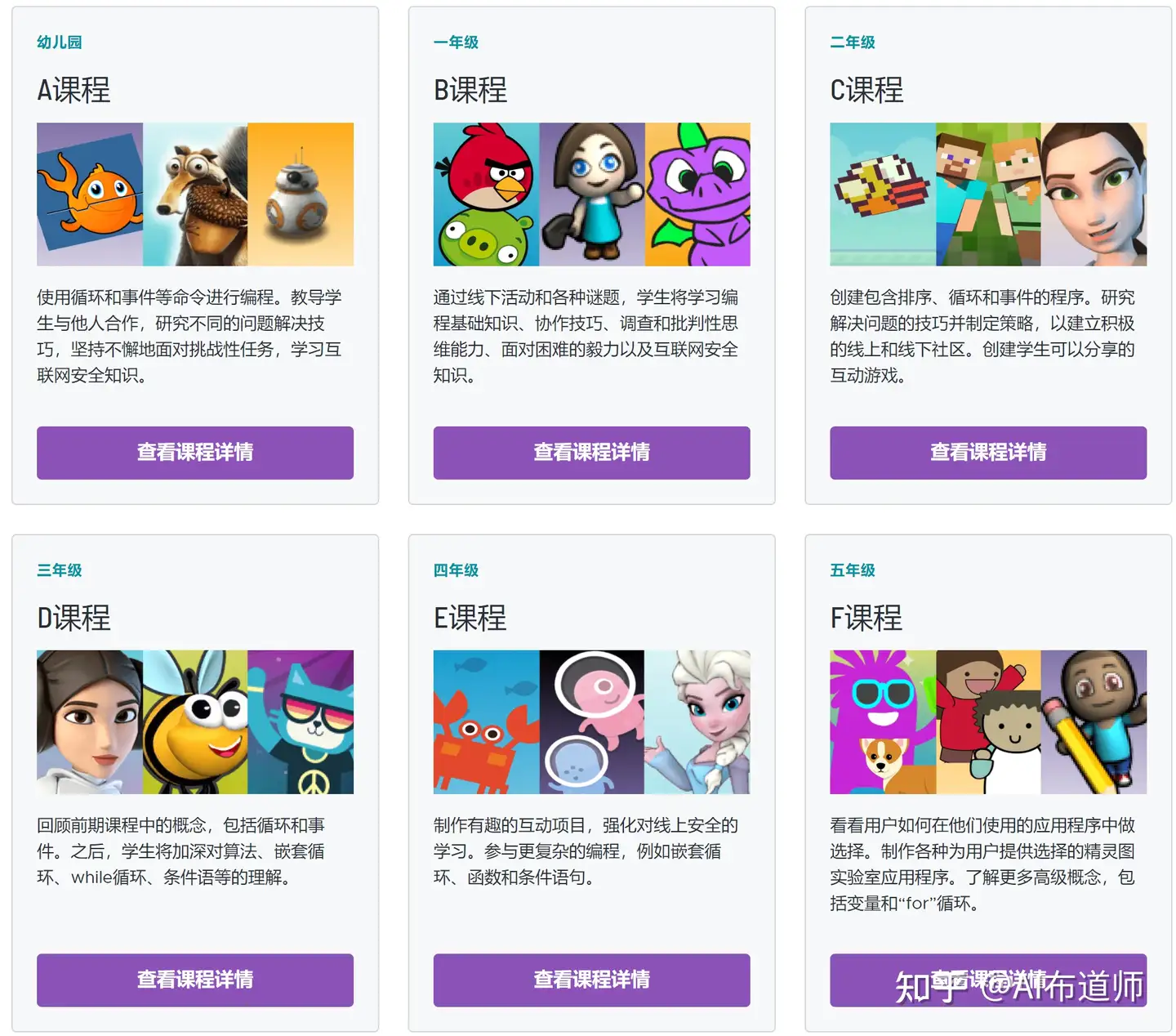

31 | 阶段课程共分为课程A-F,分别对应4-9岁的小朋友,推荐使用2021版。2019年以前,阶段课程只有1-4,现在改版后,针对性更强,家长和小朋友可以根据年龄或者年级来选择对应的课程,完整学完一门课程后就可以基本掌握编程的基本概念了,应该说已经达到了入门的条件,这时候再转到Scratch的学习就会非常顺滑,而不会出现面对一堆组件一脸茫然的尴尬场面了。

32 | 阶段课程的特色有:

33 | - 课程A B中加入了故事来讲述概念,非常适合低年龄阶段的小朋友

34 | - 课程E F的最后引入了课程结束项目(剧本实验室 小艺术家),PBL教学方式,非常适合激发高年龄阶段小朋友的兴趣。

35 |

36 | 需要注意的是,课程编号A-F对应着课程难度不断提高,所以匹配选择对应年龄阶段的课程,学习效果最佳。

37 | - 课程A:幼儿园

38 | - 课程B:一年级,增加了概念的深度。

39 | - 课程C:二年级,学生将创建可以分享的互动游戏。

40 | - 课程D:三年级,首先回顾了早期课程中的概念,包括循环和事件。之后,学生将加深对算法、嵌套循环以及循环、条件等的理解。

41 | - 课程E:四年级。学生将学会制作有趣的互动项目,将学习嵌套循环、函数和条件。

42 | - 课程F:五年级,将学习更高级的概念,包括变量和 “for” 循环。

43 |

44 | # 课程食用的最佳方式?

45 | 阶段课程都可以在这个网址`https://code.org/educate/csf`找到,选择合适的课程点击进入学习即可。

46 |

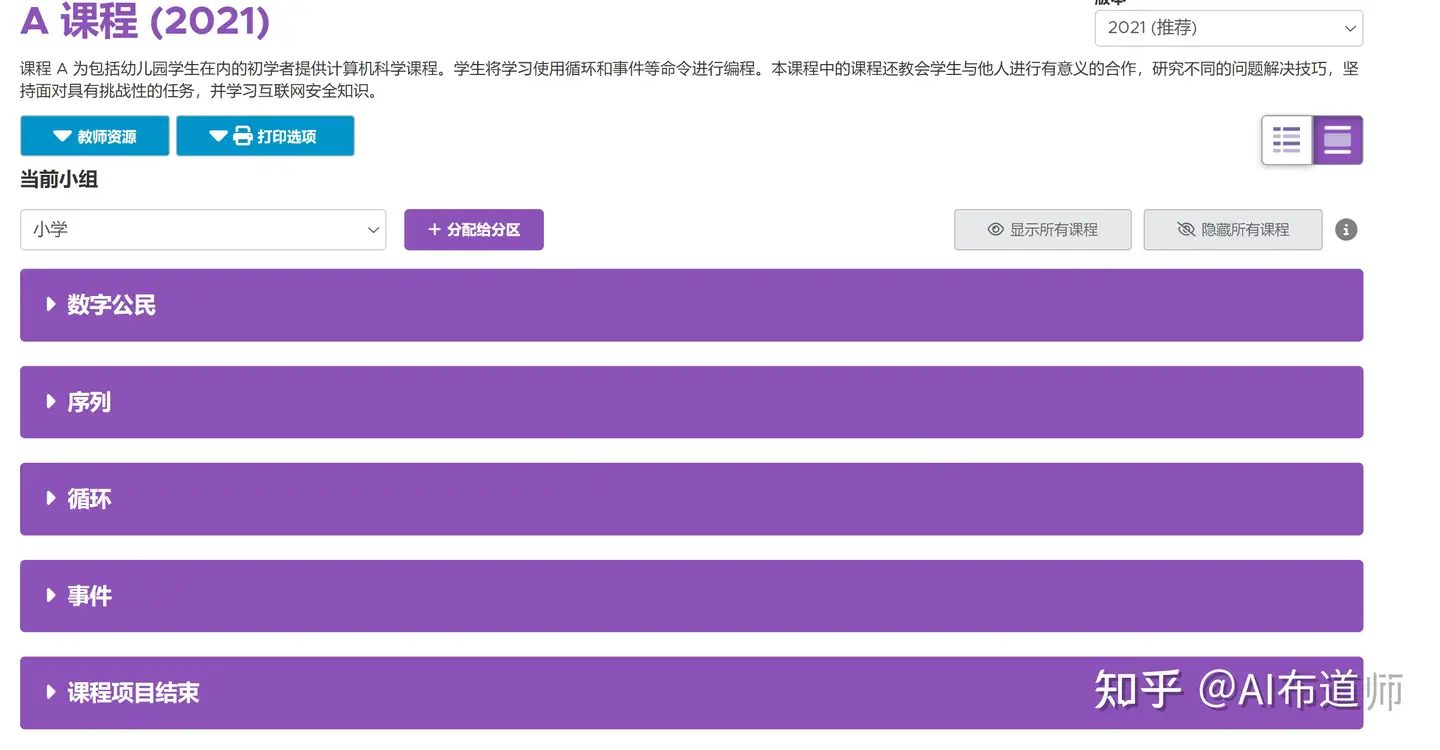

47 | 以课程A为例,进入后,会发现分成了5个单元,每个单元又是由不同关卡组成,难度逐渐加大,因此强烈推荐家长陪着小朋友循序渐进完成所有关卡的学习内容。

48 |

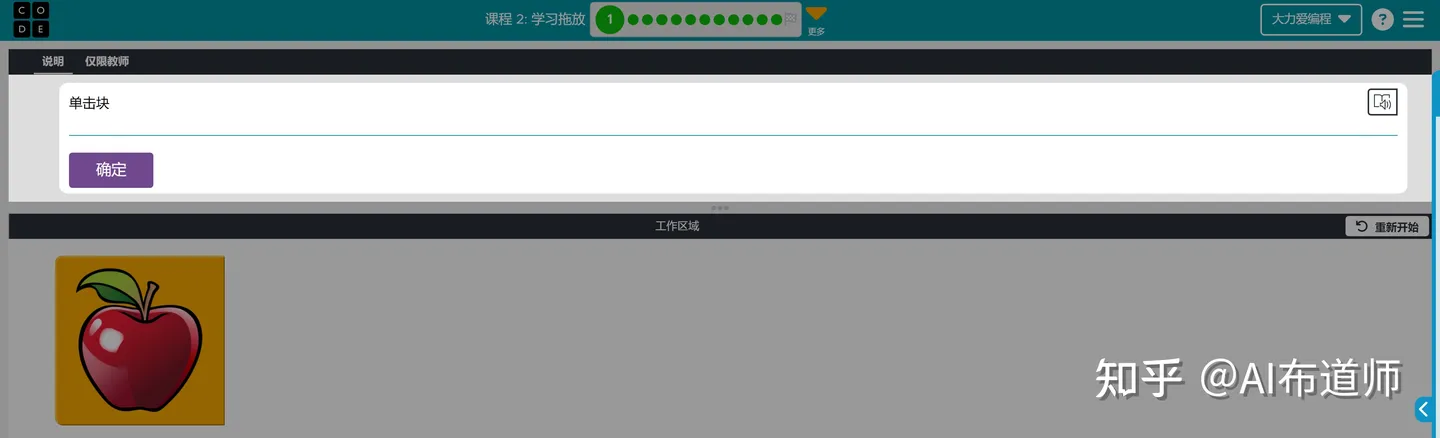

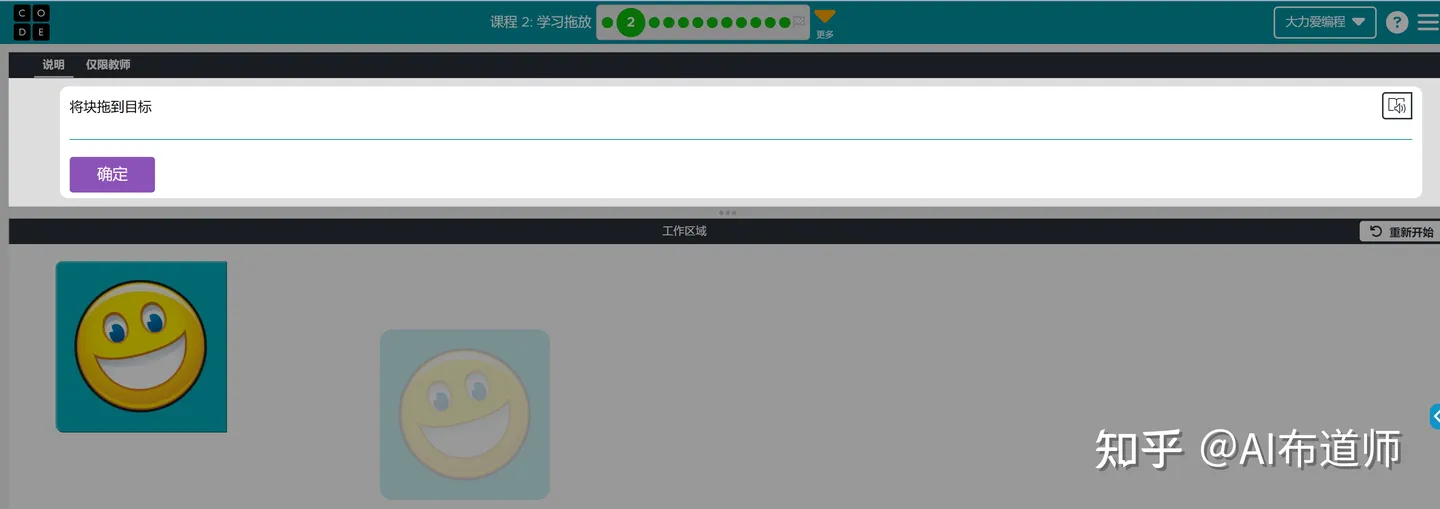

49 | 最初的课程会教孩子最简单的鼠标操作,如点击和拖拽,帮助孩子熟练最基本的电脑操作,而这恰恰是孩子入门编程的最基本条件了。

50 |

51 |

52 |

53 | 通过多个关卡的训练,孩子就能掌握点击 拖拽等基本操作了,接下来会接触到编程中的第一个核心概念`序列`,这时需要孩子们多次拖拽不同的积木来实现更复杂的功能;当孩子们发现多次拖拽同一个板块很麻烦时,这时候就很自然地引入编程中的第二个核心概念`循环`。

54 |

55 | 是的,code.org就是这样带着孩子循序渐进地掌握编程中的基本概念的,一切都是水到渠成,充分实践了皮亚杰的建构主义儿童认知发展理论。

56 |

57 | 如果你认同code.org的编程理念,不妨带着孩子前往code.org一探究竟吧!

58 |

59 |

60 |

61 |

--------------------------------------------------------------------------------

/docs/0.少儿编程/在家带娃学编程?附路线规划图_2024-07-31.md:

--------------------------------------------------------------------------------

1 | > 我是大力,5年互联网教育从业经历,深耕少儿编程领域,致力于打造全网最全的免费少儿编程知识库,致力于打破家长朋友们和机构之间的信息差。

2 | ## 写在前面:

3 | - 上一篇文章([娃适合学编程么?不妨陪ta从零开始](https://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247483663&idx=1&sn=354c18fc9cd6644a62f9589bf797b81a&chksm=c2485c87f53fd591feb677b3673247f8f04e063900a6014b4e694858288b71de1d1320e9a298#rd))大力已经系统回答了`少儿编程是什么`以及`如何开始`的问题

4 | - 这一篇文章将重点回答`如何给娃做好编程的学习规划`。

5 |

6 | 我碰到的大部分家长其实并不分得太清各种编程语言是什么,往往是在培训机构的安利下给孩子报了一个甚至多个阶段的课程,然而培训机构的课程往往需要照顾到所有孩子,因而课程设置无法真正做到”因材施教“。

7 |

8 | 如果你也有这样的疑惑,不妨先点赞收藏,相信看完这篇文章,不仅会帮你省下一大笔少儿编程培训费,更会帮娃省下宝贵的学习时间。

9 | # 关于编程语言

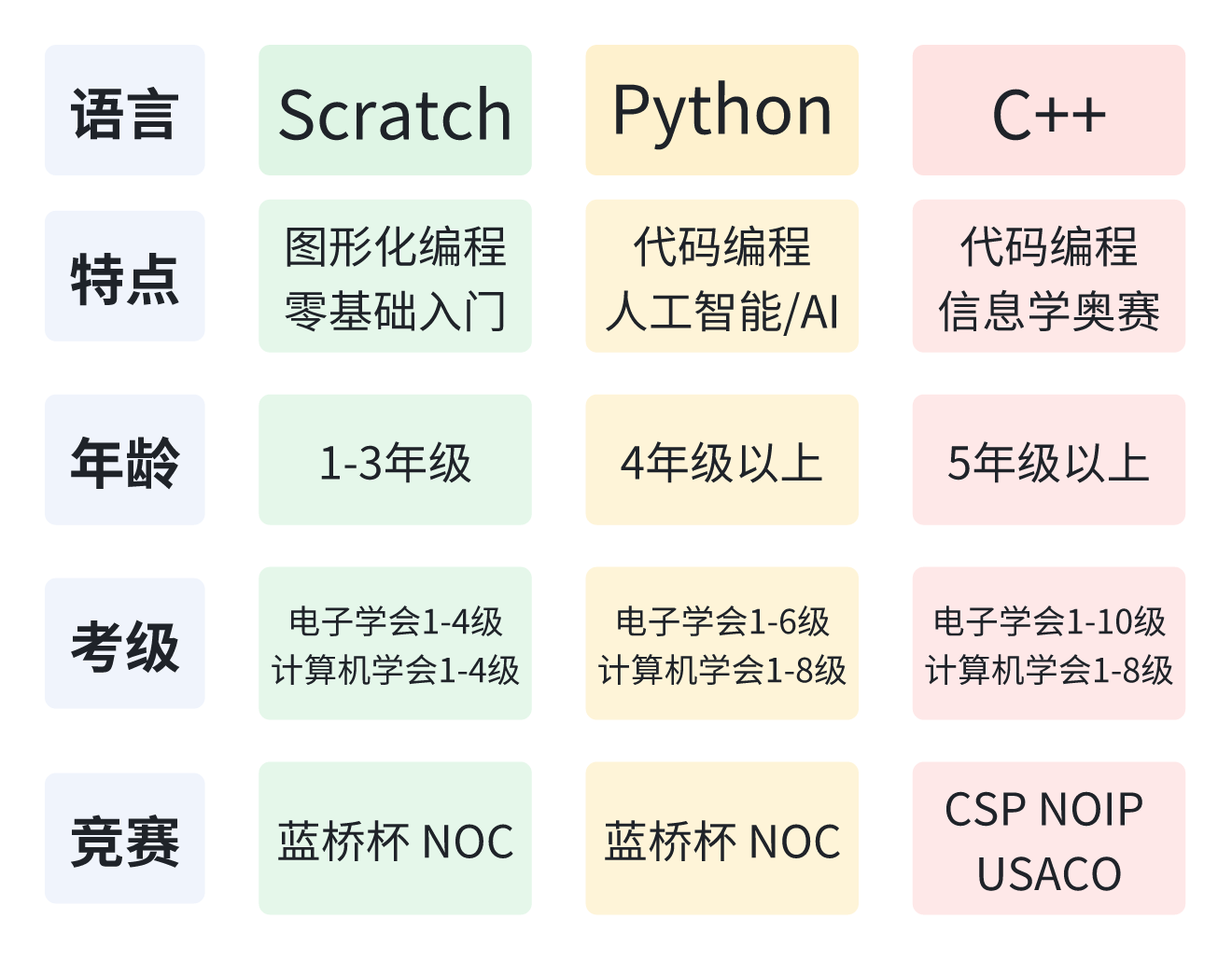

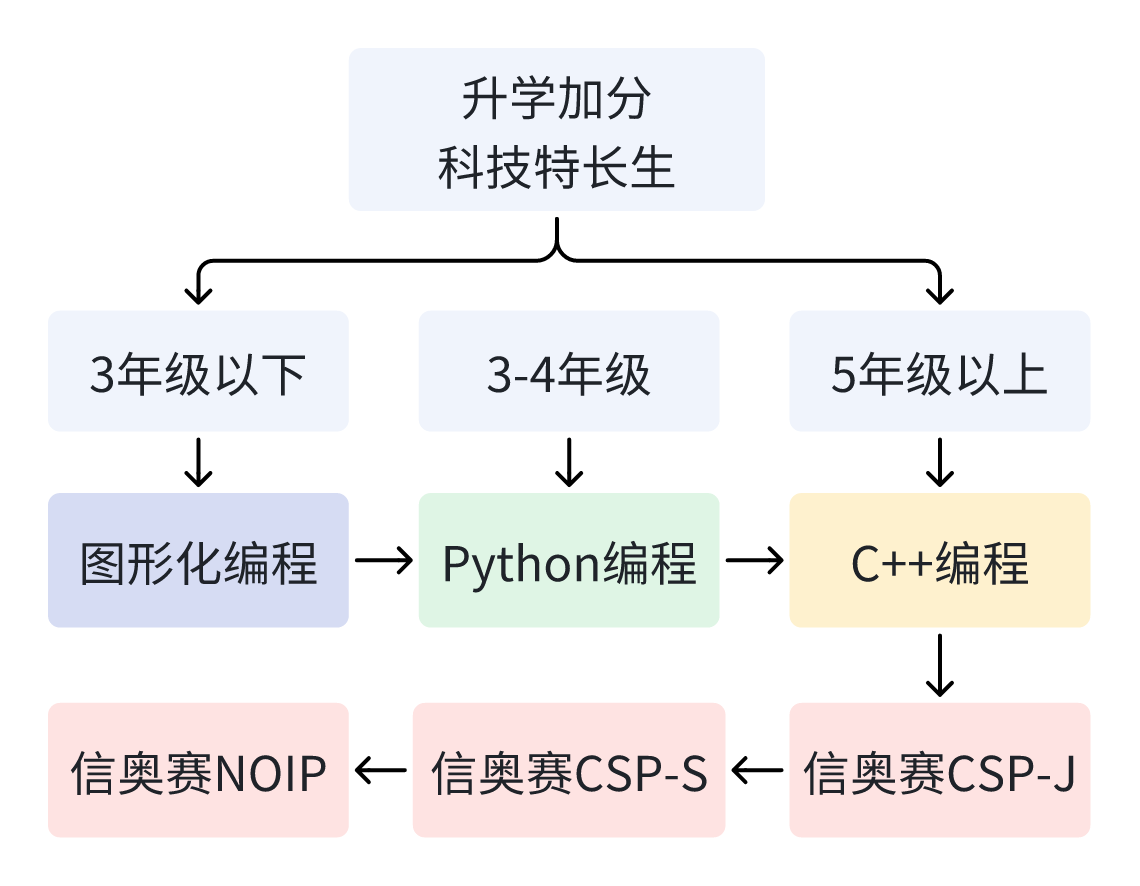

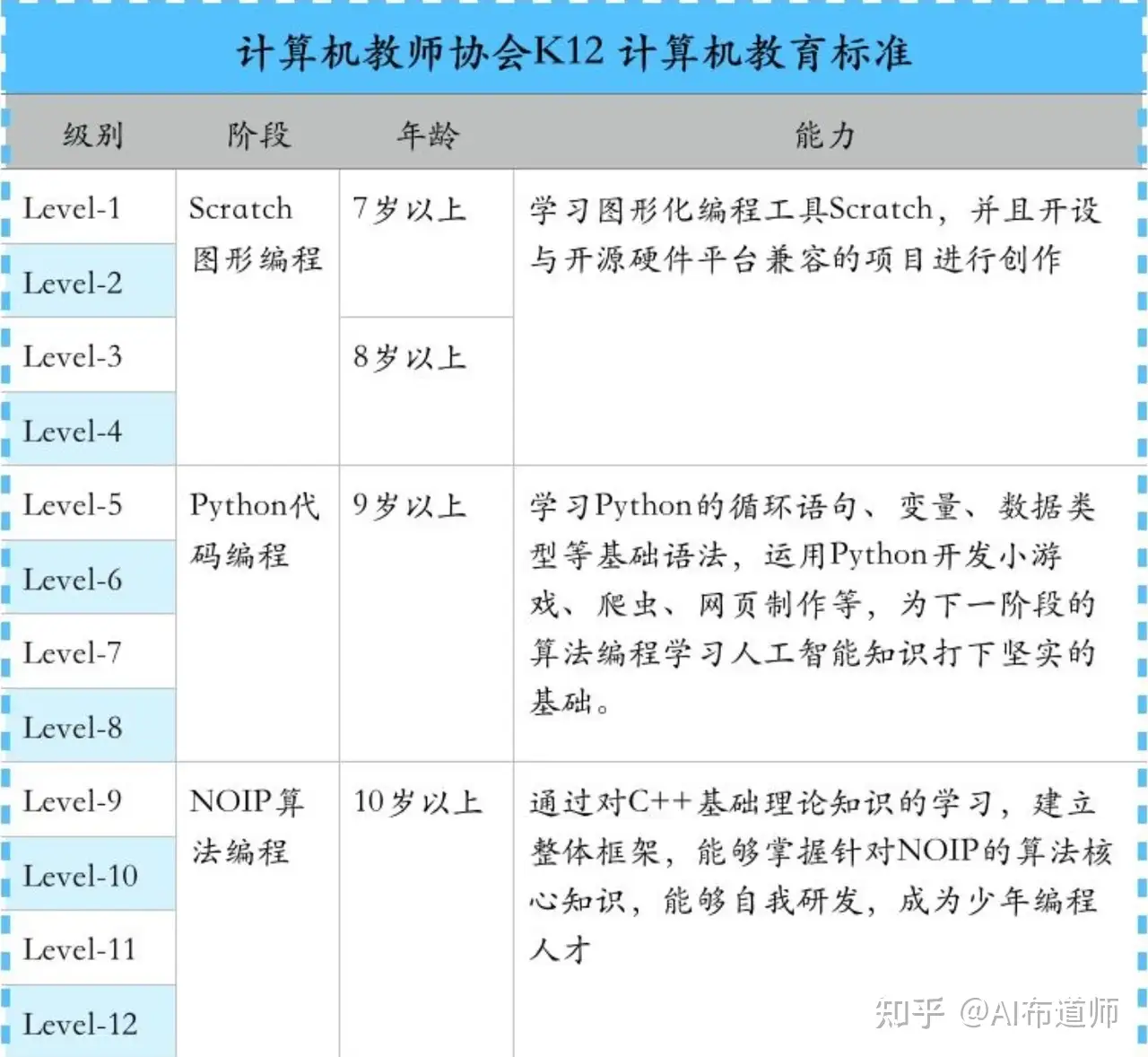

10 | 根据美国计算机教师协会推出的K12计算机教育标准,少儿编程课程中主要涉及到三种编程语言:Scratch、Python、C++。不管选用哪一种语言,语言都只是一种工具,重点是学会利用工具解决问题的能力。

11 |

12 | 下图系统梳理了不同编程语言的特点、适合的年龄阶段,以及可以参加的等级考试和竞赛。考级是为了阶段性地验证孩子的掌握程度,而竞赛则主要是选拔目的,可以为将来的小升初乃至高考加分,走科技特长生路线。

13 |

14 | 关于考级和竞赛的更多内容,我准备单独梳理两篇文章,汇聚全网最全的免费学习资料,供有需要的家长朋友们参考。

15 |

16 | # 如何规划

17 | 每个孩子的天赋和能力不同,因此没有任何一条学习路线是适合所有孩子的。

18 | 大部分孩子经过了编程启蒙阶段后,很多家长都会有一个困惑,是先学Python还是先学C++?

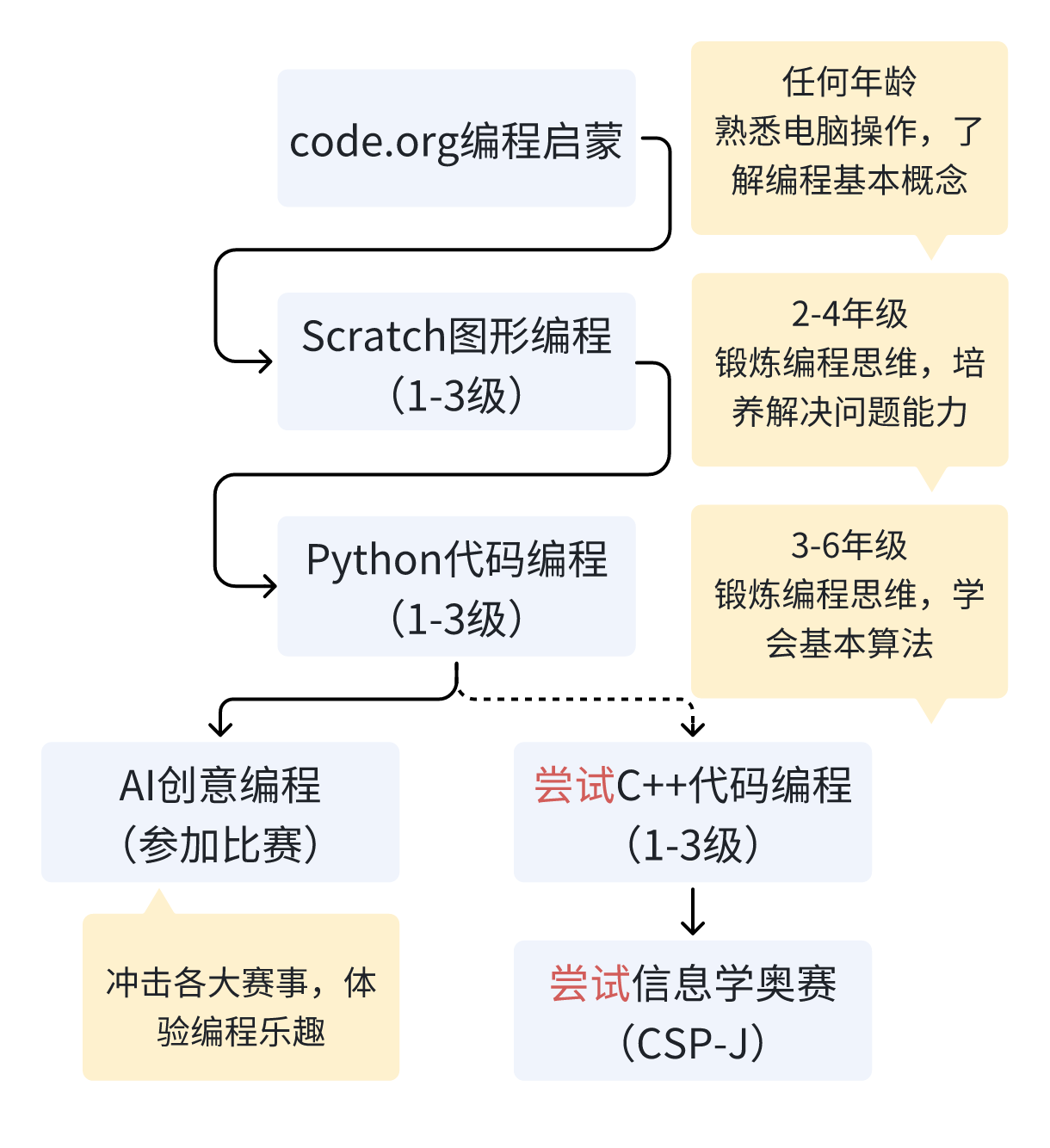

19 | 这里主要根据家长朋友们的需求不同,大力将主要分享两条路线供大家参考,我把他们简称为`佛系路线`和`功利路线` 。

20 | ## 佛系路线

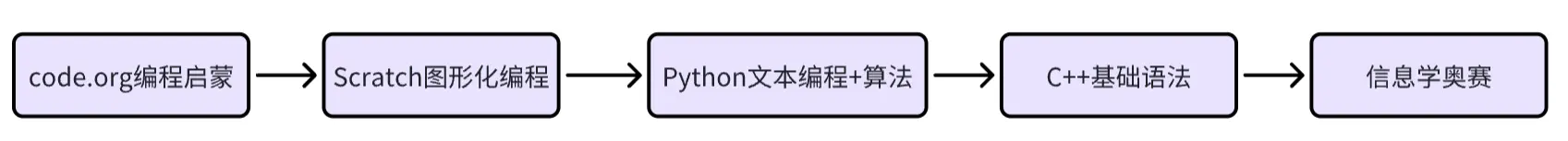

21 | 如果你的目标是培养孩子的计算思维和逻辑思维,那么掌握一门编程语言就够了,而这门语言以Python为最佳选择,因为语法非常简单,而Python的上限却非常高,小到制作游戏,大到可以进行AI创意编程,基于Python甚至可以帮助孩子接触到计算机科学的全貌。

22 |

23 |

24 | - 不论从哪个年龄阶段,都建议从code.org开始编程启蒙,关于code.org如何食用,我在这篇文章(全网爆火的免费少儿编程网站!一文揭开code.org的神秘面纱)中做了系统梳理。通常只需学完一个课程,就可以过渡到Scratch图形化编程的学习了。

25 | - 如果孩子到了2-4年级,不妨通过Scratch来锻炼编程思维,优先培养解决问题的能力。

26 | - 如果孩子到了3-6年级,这个阶段的孩子已经具备了一定的抽象思维能力。在经过Scratch编程启蒙的前提下,可以过渡到Python代码编程,锻炼计算思维,学会基本算法

27 | - 如果孩子对算法有浓厚的兴趣,不妨尝试C++代码编程,先学习基础语法,进而尝试学习更复杂的算法,冲击信奥赛奖项;

28 | - 如果孩子对学习算法有点吃力,但是对代码编程感兴趣,可以尝试通过参加各种创意编程竞赛,体验编程乐趣,毕竟孩子的兴趣是驱使其获得未来更多可能性的源动力。

29 | ## 功利路线

30 | 如果你的目标是升学加分走科技特长生路线,那么学习C++就是必须,因为C++是信奥赛官方唯一指定语言,而大部分升学加分的政策都只认可信息学奥林匹克竞赛(简称信奥赛)。为此,孩子的目标终点就是信奥赛获奖。这时就要看孩子的年龄了。

31 |

32 |

33 |

34 | - 如果孩子的年龄还小,比如3年级以下,那么完全按照佛系路线中的规划来学习,也就是可以从图形化编程开始,做好编程启蒙,培养孩子对编程的兴趣,毕竟兴趣是最好的老师。

35 | - 如果孩子的年龄不大,比如3-4年级,可以先学Python,因为孩子的抽象思维能力刚刚萌芽,抽象的C++语法会抹杀孩子的编程兴趣,而python相对更简单。作为一门过渡语言,帮助孩子巩固Scratch阶段学到的编程核心概念,Python再合适不过了,通过小半年的Python学习,大部分孩子都可以很自然地过渡到C++的学习。

36 | - 如果孩子已经5-6年级,这个阶段的孩子已经具备了较强的抽象思维能力,为了能更快地进入算法阶段的学习,就没必要学习python,可以直接进入C++的语法学习了。需要重点强调的是,信奥赛重点考察的是算法能力,因此不必在C++基础语法阶段学习大量时间。

37 |

38 | # 总结

39 | 本篇文章系统梳理了在家陪娃学编程该如何规划,主要分为两条路线供大家参考食用,如果觉得对你有帮助,不妨收藏转发给身边的朋友,你的真诚点赞是我持续分享的动力!如果你对在家教娃编程如何规划还有疑问,欢迎评论区留言。

--------------------------------------------------------------------------------

/docs/0.少儿编程/娃适合学编程么?不妨陪ta从零开始_2024-07-31.md:

--------------------------------------------------------------------------------

1 | 最近关于少儿编程的信息和资料铺天盖地,害怕家里娃跟不上时代节奏,又担心被收割智商税?

2 | !!不妨陪娃先自学一段时间试试呢!!

3 |

4 | # 少儿编程是什么?

5 | 大白话就是通过寓教于乐的方式让3-18岁青少儿学习程序语言,从而锻炼计算思维和逻辑思维,如果说外语是一门和外国人打交道的语言,那么程序语言就是和计算机打交道的语言。

6 |

7 | # 少儿编程的课程主要有什么?

8 | 目前,培训机构中的少儿编程课程主要可以分为两大类:软件编程、硬件编程。

9 |

10 | 1)软件编程:基于Scratch、Python、C++等编程语言给学生搭建可视化和代码编程学习平台,通过游戏、动画、音乐等载体来学习编程语言。

11 |

12 | 2)硬件编程:通过机器人套件或者Arduino等开源硬件平台,结合电子元件和传感器来学习编程语言。因为需要硬件平台支持,所以成本更高。

13 | 如果家中娃从未接触过编程,不妨从软件编程开始起步,视兴趣再决定是否要接触硬件编程,因为软件几乎零成本,只需自备一台普通的家用电脑就可以了(台式机笔记本均可)。

14 |

15 | # 软件编程的课程如何选择?

16 | 美国计算机教师协会推出的K12计算机教育标准可以帮我们做一个很好的参考。

17 |

18 |

19 | 按照“图形-代码-算法”的阶段式编程体系,需要根据娃的不同年龄阶段匹配不同的学习内容,不同阶段所学的编程语言特点如下:

20 | - Scratch:图形编程语言,适合7岁以上的娃,因为相关数学知识差不多了汉字也有一定基础,思维也能跟上,这个阶段可以陪娃学习和编程相关的汉字,熟悉电脑的基本操作,比如鼠标键盘以及电脑开关机。

21 | - Python:代码编程语言,适合9岁以上的娃,因为孩子的抽象思维能力有了一定提升,且词汇量也有了进一步提升,可以尝试让娃学习一门代码编程语言,而Python则因为简单易学,非常适合初学者学习。这个阶段可以陪娃练习键盘打字了,这是学习代码编程语言的必备条件。

22 | - C++:代码编程语言,适合10岁以上的娃,到了这一阶段,可以尝试让娃学习更多的算法知识,甚至尝试参加一些算法竞赛,比如现在各个机构鼓吹的信奥赛CSP/NOIP,不过信奥赛更多的是选拨性质,如果到了这一阶段,孩子依然有兴趣,可以陪娃学习C++基本的语法知识以及一些简单的算法知识,想要冲击NOIP奖项就需要找专业的教练进行学习了,不是每个机构的老师都能教的。

23 |

24 | # 你最关心的编程启蒙从哪开始?

25 | 也许大部分机构老师都会推荐娃学习Scratch,尽管是一门图形编程语言,Scratch的上限也是非常高的,基本涵盖了编程几乎所有的逻辑训练和算法。网上有关Scratch的学习资料非常多,我会把搜集到的比较不错的资料整理到知识库中,有关Scratch如何入门我会专门出一篇文章来详聊。

26 | 不过如果是在家陪娃学习,我推荐的编程学习路径是:

27 |

28 |

29 | 1. code.org 关卡制,先通过解决问题来学习基本概念,在过五关斩六将中体验乐趣

30 | 2. Scratch 项目制,通过开发制作游戏动画等项目来建立计算思维和逻辑思维,在项目开发中体验成就感

31 | 3. Python 项目制,熟悉文本编程语言并开始接触部分算法知识

32 | 4. C++ 算法竞赛,在校内知识学有余力的情况下,走科技特长生路线,体验编程和算法的乐趣

33 | 所以不管娃是什么年龄,都强烈推荐从code.org开始启蒙,通过解决问题先学会基本概念。code.org的课程体系非常完整,从认识鼠标、到拖拽、到循环等概念,循序渐进带领孩子掌握编程知识,不妨先进去体验一番!不过code.org近两年也进行了改版,更有利于不同年龄段的孩子学习,有关code.org的课程如何选择,我会在下期文章中详细聊聊。

34 |

35 | 经过几年的学习,我陪娃已经快快乐乐度过了编程启蒙阶段,最近想把自己找到的资料以及心得体会系统化梳理下,变成一个知识库,希望能够给更多的宝爸宝妈带来帮助!感兴趣的家长欢迎评论区留言,我们一起为孩子们打造一个编程乐园。

--------------------------------------------------------------------------------

/docs/0.少儿编程/少儿编程考级怎么选?你想要了解的一切都在这里_2024-07-31.md:

--------------------------------------------------------------------------------

1 | # 写在前面:

2 | 在上一篇[娃是否适合学编程?不妨陪ta从这里开始](https://zhuanlan.zhihu.com/p/686105069),我们系统梳理的在家陪娃学编程应该怎么规划。不管我们学什么,兴趣都是最原始的源动力。如果在学习过程中,能够不断获得一些持续正反馈,势必会让孩子走的更远。在少儿编程的学习之路上,等级考试和编程比赛就是给孩子提供正反馈的两种手段。

3 |

4 | 本篇我们将回答有关等级考试的两个问题:

5 | - 等级考试是什么?

6 | - 如何通过等级考试?

7 |

8 | 有关`编程比赛`的相关内容,大力会再专门出一篇笔记进行整理。

9 |

10 | # 等级考试是什么?

11 | 少儿编程等级考试,是考查学生编程能力水平的一种测试,和书法、乐趣等艺术特长的等级考试类似,通过不同的等级来衡量在某一领域的专业水平。因此是检验孩子编程掌握程度的一种非常行之有效的手段,同时也是孩子的一项技能认证。通过对应等级考试后,可以获得对应的等级证书,这不仅是对孩子学习过程的认可,也可以作为孩子简历上重要的一项成绩。

12 |

13 | 那么都有哪些等级考试呢?近年来,随着少儿编程概念的火热,市面上出现了不少少儿编程相关的等级考试,琳琅满目,鱼龙混杂,一不小心就会步入机构的圈套。

14 |

15 | 一句话概括等级考试如何避坑:优先选择国内一级学会主办的等级考试。

16 | 所以大力推荐的等级考试只有两个:

17 | - 中国电子学会(CIE)主办的青少年软件编程等级考试

18 | - 推荐指数:⭐️

19 | - 中国计算机学会(CCF)主办的编程能力等级认证(GESP)

20 | - 推荐指数:⭐️⭐️

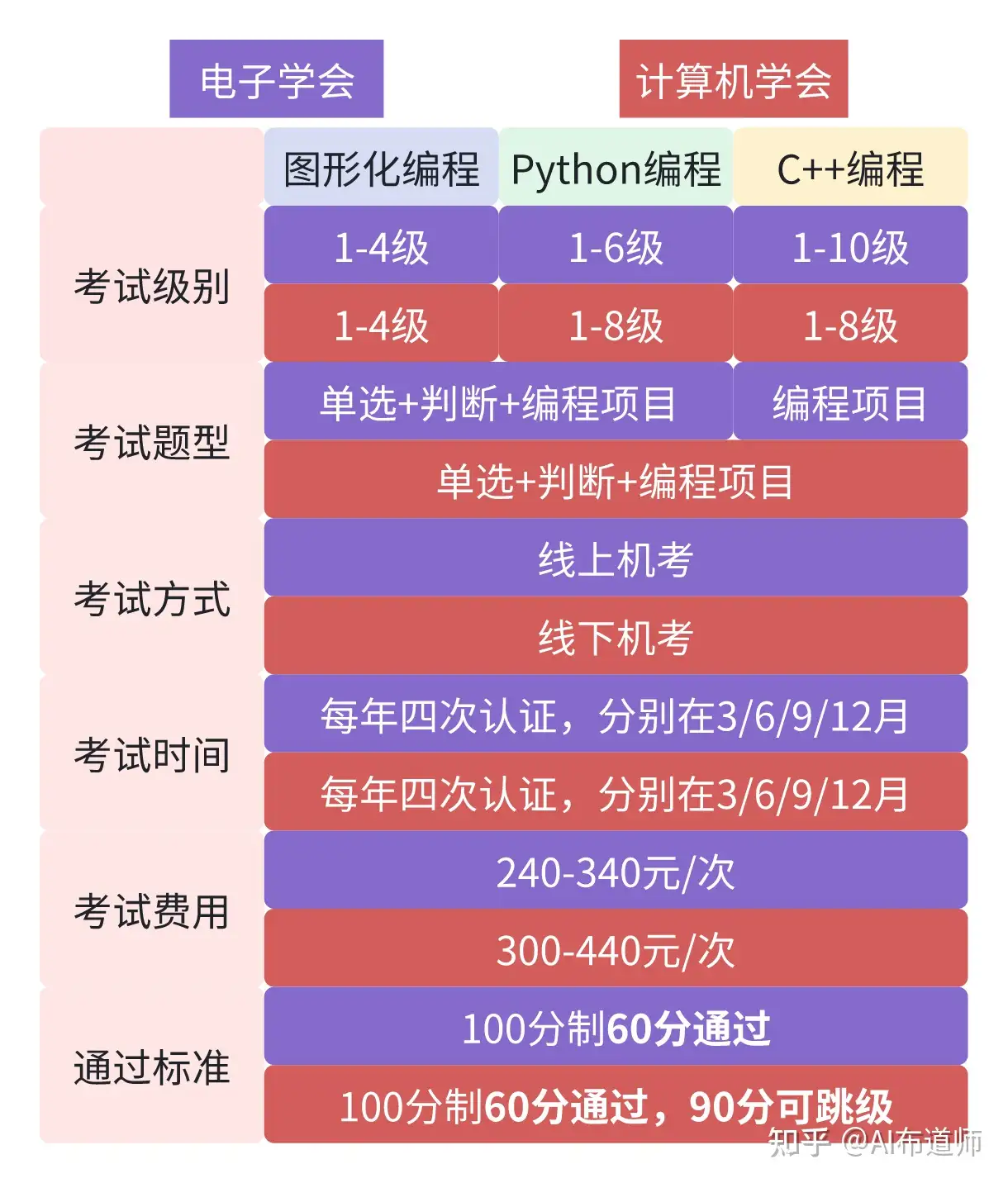

21 | ## 电子学会-青少年软件编程等级考试

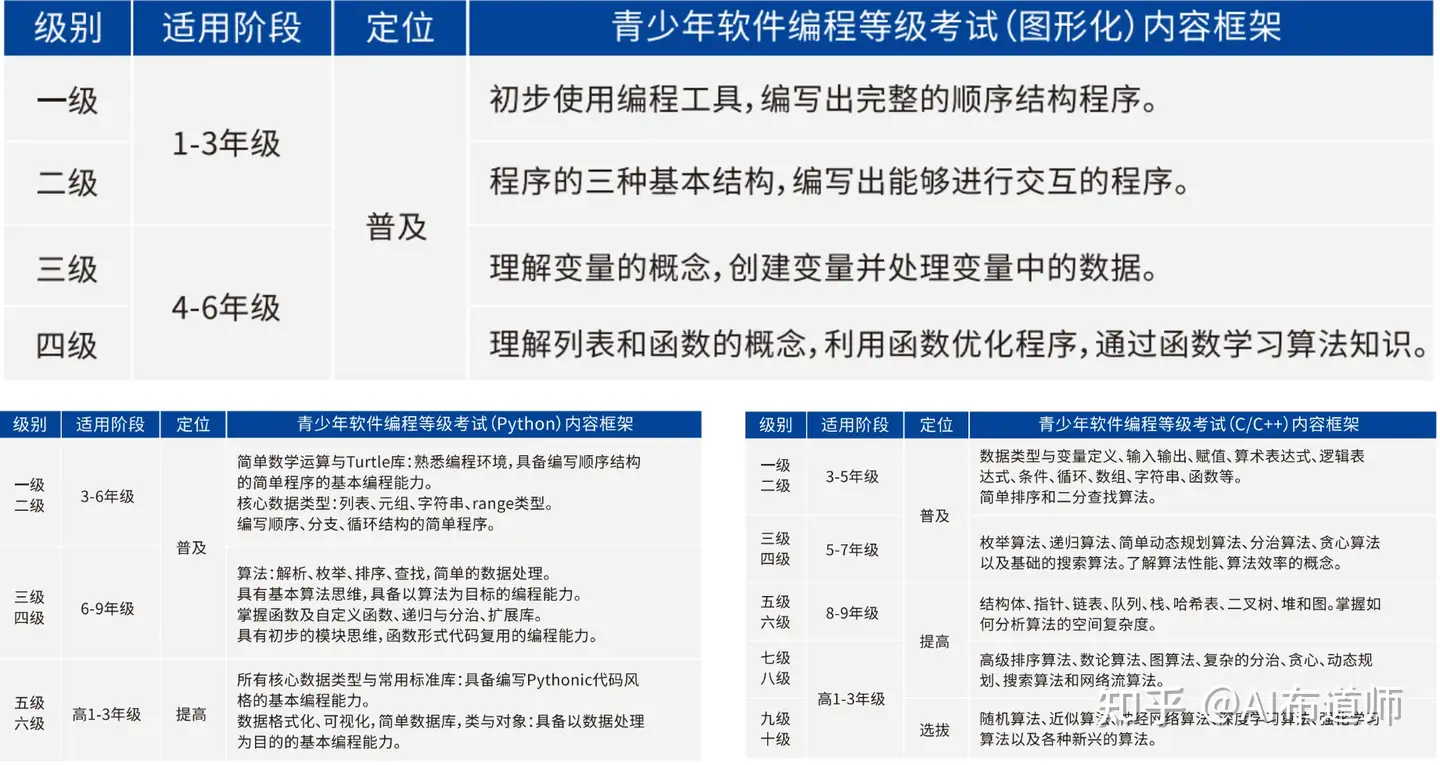

22 | 中国电子学会于2018年启动的面向青少年软件编程能力水平开展的社会化评价项目,全面考察青少年的软件编程水平和实践能力,其考察内容覆盖了Scratch、Python和C++。

23 | - 考试级别:

24 | - Scratch 1-4级

25 | - Python 1-6级

26 | - C++ 1-10级

27 | - 以上考试均为1级必考,可以跳级,100分制60分通过

28 | - 考试内容:

29 | - Scratch和Python:单选题、判断题、编程项目题;

30 | - C++:编程项目题

31 | - 年龄要求:

32 | - Scratch 6-15周岁

33 | - Python和C++ 8-18周岁

34 | - 考试时间:每年四次认证,分别在3/6/9/12月

35 | - 考试方式:线上机考

36 | - 报名费用:240-340/次

37 | - 考试大纲:

38 | - Scratch:www.qceit.org.cn

39 | - Python:www.qceit.org.cn

40 |

41 | 下面三张图分别给出了Scratch、Python和C++三种语言对应的等级考试的各个级别对应的考试内容,供大家参考。

42 |

43 |

44 | ## 计算机学会-编程能力等级认证(GESP)

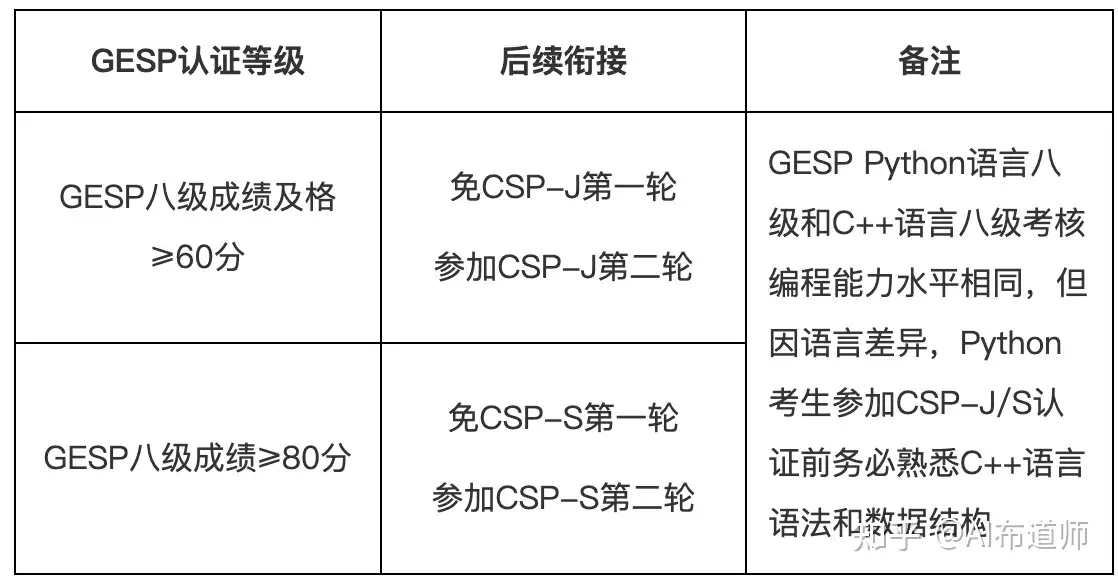

45 | 中国计算机学会主办,为青少年计算机和编程学习者提供学业能力验证的平台。GESP旨在提升青少年计算机和编程教育水平,推广和普及青少年计算机和编程教育。GESP覆盖中小学全学段,符合条件的青少年均可参加认证。其考察内容同样覆盖了Scratch、Python和C++。相比电子学会的认证而言,GESP在2023年3月份才开启第一次认证。

46 | - 考试级别:

47 | - Scratch 1-4级

48 | - Python&C++ 1-8级

49 |

50 | 注:以上考试均为1级必考,100分制60分通过,90分(含90分)以上可跳一级参加认证;不同编程语言同一个级别对应的编程能力基本相同,最高两级考纲贴合CSP-J/S认证大纲,1-4级更倾向于验证能力,5-8级更倾向于选拔高手。

51 | - 考试内容:

52 | - 15道选择题+10道判断题+2道编程题

53 | - 总分100分 90分钟内完成

54 | - 考试时间:每年四次认证,分别在3/6/9/12月

55 | - 考试方式:全国统一线下机考

56 | - 报名费用:300-440/次

57 | - 考试大纲:

58 | - Scratch https://gesp.ccf.org.cn/101/attach/1579692243025952.pdf

59 | - Python&C++ https://gesp.ccf.org.cn/101/attach/1579675000242208.pdf

60 |

61 | # 如何通过等级考试

62 | ## 选择一个等级考试

63 | 关于少儿编程的学习该如何规划,大力在[娃是否适合学编程?不妨陪ta从这里开始](https://zhuanlan.zhihu.com/p/686105069)这篇笔记中已经做了详细梳理,一般来讲Scratch和Python考完1-3级,孩子的编程基础就没有问题了,这时就可以去冲击一些编程赛事或者去挑战学习C++的内容,关于少儿编程都有哪些比赛,大力会再专门出一篇笔记进行整理。

64 |

65 | 大力优先推荐计算机学会的GESP,为什么?一张图给梳理明白。

66 |

67 | 根据上表的汇总分析,大力更推荐计算机学会的GESP认证,主要原因是:

68 | - **等级划分更加合理**:在GESP中,Python和C++都是1-8级,而且不同编程语言同一个级别对应的编程能力基本相同,为此Scratch和Python的考级可以无缝衔接到C++中。

69 | - **考试题型更加统一**:在GESP中,所有等级考试的提醒都是15道选择题+10道判断题+2道编程题,这样孩子在学习过程中适应不同题型的成本更低

70 | - **跳级规则更加明确**:在GESP中,每级考试>90分均可在下一次认证时进行跳级认证,对学习能力和接受能力更强的孩子更加友好。

71 | - **最后且最重要的优势**:GESP的等级考试可以无缝衔接到信奥赛CSP-J和CSP-S,方便孩子进行自我能力评估,发现是否有编程方面的特长,进而早日规划走科技特长生的道路。具体的衔接规则,官网也做了详细说明。

72 | - 不过孩子在通过Python3-4级后,就可以尝试学习C++,进而尝试信奥赛CSP-J了,然后C++的等级考试可以同步进行。

73 | - 关于信奥赛是什么,大力会再专门出一篇笔记进行整理。

74 |

75 |

76 |

77 |

78 | 所以等级考试怎么选,结论是:

79 | - 如果孩子已经参加了等级考试,那么沿着之前选择的继续参加即可

80 | - 如果还没有参加等级考试,那么优先推荐计算机学会的GESP

81 |

82 | ## 对标大纲进行课程学习

83 | 大纲为孩子们的编程学习指明了路径和方向,而且基本也是符合孩子的认知规律的,GESP官网也已经公开了三种语言的大纲:

84 | - Scratch https://gesp.ccf.org.cn/101/attach/1579692243025952.pdf

85 | - Python&C++ https://gesp.ccf.org.cn/101/attach/1579675000242208.pdf

86 |

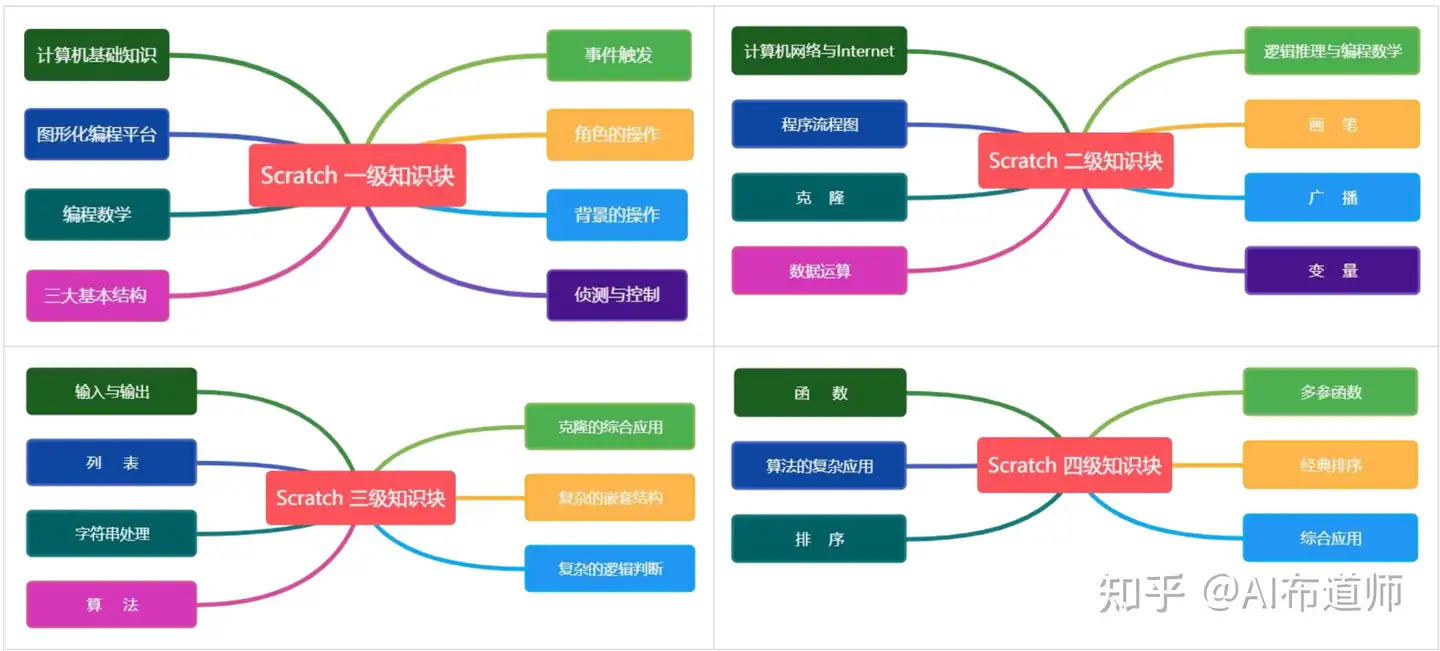

87 | 以scratch1-4级的考察内容为例,可以通过如下思维导图很清晰get到:

88 |

89 |

90 |

91 |

92 | *针对计算机学会GESP等级考试的系统学习,大力准备出一期完备的课程,在编程学习之路上助大家一臂之力,敬请关注!*具体计划安排和优先级如下:

93 | - P0 Scratch 1-3级

94 | - P1 Python 1-4级

95 | - P2 C++ 1-8级

96 |

97 | ## 真题演练

98 | 官网每次认证都会放出真题,这里系统整理下历年的GESP考试真题,供大家备考前进行实战演练。

99 | - 2023-3认证:真题:https://gesp.ccf.org.cn/101/1010/10068.html

100 | - 2023-6认证:真题:https://gesp.ccf.org.cn/101/1010/10092.html

101 | - 2023-9认证:真题:https://gesp.ccf.org.cn/101/1010/10105.html

102 | - 2023-12认证:真题:https://gesp.ccf.org.cn/101/1010/10119.html

103 | - 2023-四次认证的真题解析汇总:https://gesp.ccf.org.cn/101/1010/10100.html

104 |

105 | # 更多资源梳理

106 | > 未完待续!后续会在这部分整理更多关于等级考试的免费学习资源。

107 |

108 | 如果觉得对你有帮助,欢迎点赞收藏关注~

--------------------------------------------------------------------------------

/docs/1.Linux笔记/Docker 国内镜像站全部失效?试试这个方法,亲测有效.md:

--------------------------------------------------------------------------------

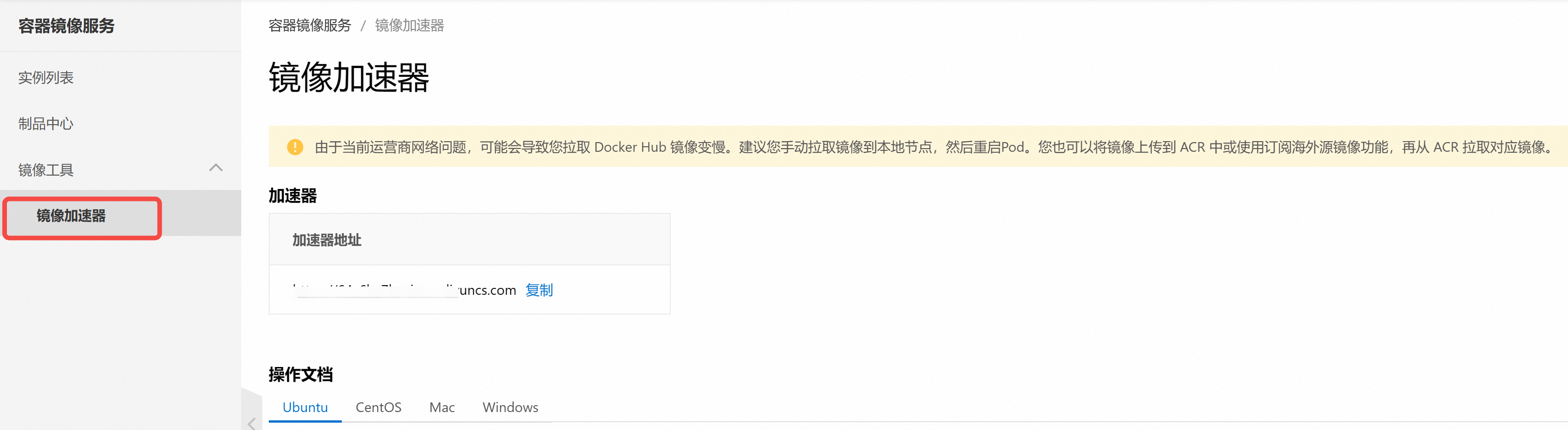

1 | 最近,很多朋友发现 Docker 镜像拉取不下来了~

2 | > PS:还不了解 Docker 的小伙伴,可以看这篇:[【保姆级教程】Linux系统如何玩转Docker](https://blog.csdn.net/u010522887/article/details/137206719)

3 |

4 | 罪魁祸首是:国内的大部分镜像站都停止服务了,包括:sjtu、ustc、百度、腾讯。。。

5 |

6 | 不过还好,阿里云的镜像还不受影响。

7 |

8 | 怎么搞?

9 |

10 | **第 1 步: 阿里云注册账号**

11 | > 传送门:[https://www.aliyun.com/](https://www.aliyun.com/)

12 |

13 | 支付宝扫码即可登录。

14 |

15 | **第 2 步: 搜索容器镜像服务**

16 |

17 | 点击立即开通。

18 |

19 |

20 |

21 | **第 3 步: 找到镜像加速器**

22 |

23 |

24 |

25 | **第 4 步: 配置镜像加速器**

26 |

27 | 参考不同操作系统的配置文档,比如在我的 Linux 服务器上:

28 |

29 | 通过修改 daemon 配置文件,就可以使用加速器。

30 |

31 | 首先,新建文件夹:

32 | ```

33 | sudo mkdir -p /etc/docker

34 | ```

35 | 然后,写入第 3 步的加速器地址:

36 |

37 | ```

38 | sudo tee /etc/docker/daemon.json <<-'EOF'

39 | {

40 | "registry-mirrors": ["https://xxx.mirror.aliyuncs.com"]

41 | }

42 | EOF

43 | ```

44 |

45 | 最后,重启 docker:

46 |

47 | ```

48 | sudo systemctl daemon-reload

49 | sudo systemctl restart docker

50 | ```

51 |

52 | 快去试试,镜像下载,有没有快到飞起~

53 |

54 | 如果本文对你有帮助,欢迎**点赞收藏**备用。

55 |

56 |

57 |

58 |

59 |

60 |

61 |

62 |

63 |

64 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/README.md:

--------------------------------------------------------------------------------

1 | # 1.Linux笔记

2 |

3 | - [AI 本地环境配置:一文梳理 Nvidia驱动_CUDA_CUDNN_PyTorch_Paddle 版本兼容&安装问题(持续更新)](docs/1.Linux笔记/AI%20本地环境配置:一文梳理%20Nvidia驱动_CUDA_CUDNN_PyTorch_Paddle%20版本兼容&安装问题(持续更新).md)

4 | - [Docker 国内镜像站全部失效?试试这个方法,亲测有效](docs/1.Linux笔记/Docker%20国内镜像站全部失效?试试这个方法,亲测有效.md)

5 | - [【保姆级教程】Linux系统下如何玩转Docker](docs/1.Linux笔记/【保姆级教程】Linux系统下如何玩转Docker.md)

6 | - [【保姆级教程】Windows 远程登录 Ubuntu桌面环境](docs/1.Linux笔记/【保姆级教程】Windows%20远程登录%20Ubuntu桌面环境.md)

7 | - [【保姆级教程】Windows 远程登陆 Linux 服务器的两种方式:SSH + VS Code,开发必备](docs/1.Linux笔记/【保姆级教程】Windows%20远程登陆%20Linux%20服务器的两种方式:SSH%20+%20VS%20Code,开发必备.md)

8 | - [【保姆级教程】Windows上安装Linux子系统,搞台虚拟机玩玩](docs/1.Linux笔记/【保姆级教程】Windows上安装Linux子系统,搞台虚拟机玩玩.md)

9 | - [【保姆级教程】如何在 Windows 上实现和 Linux 子系统的端口映射](docs/1.Linux笔记/【保姆级教程】如何在%20Windows%20上实现和%20Linux%20子系统的端口映射.md)

10 | - [【保姆级教程】实操 Linux 磁盘管理:硬盘选型 & 分区挂载](docs/1.Linux笔记/【保姆级教程】实操%20Linux%20磁盘管理:硬盘选型%20&%20分区挂载.md)

11 | - [报错解决ImportError_ libcrypto.so.10_ cannot open shared object file_ No such file or directory](docs/1.Linux笔记/报错解决ImportError_%20libcrypto.so.10_%20cannot%20open%20shared%20object%20file_%20No%20such%20file%20or%20directory.md)

12 | - [报错解决ImportError_ libnvinfer.so.7_ cannot open shared object file_ No such file or directory](docs/1.Linux笔记/报错解决ImportError_%20libnvinfer.so.7_%20cannot%20open%20shared%20object%20file_%20No%20such%20file%20or%20directory.md)

13 |

14 |

15 |

16 | *本系列共更新**10**篇文章*

17 |

18 |

19 |

20 | [🔙返回首页](/)

21 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/【保姆级教程】Windows 远程登录 Ubuntu桌面环境.md:

--------------------------------------------------------------------------------

1 | # 前言

2 | 在Windows下远程访问Linux服务器的桌面,有几种常见的方法:

3 |

4 | - xrdp(X Remote Desktop Protocol):xrdp允许Windows使用RDP(Remote Desktop Protocol)来连接到Linux服务器的桌面。这种方式相对简便,因为它使用Windows自带的远程桌面客户端。

5 |

6 | - VNC(Virtual Network Computing):VNC是一种基于图形界面的远程桌面协议,它允许用户远程访问Linux桌面。

7 |

8 | - SSH(Secure Shell):SSH是一种网络协议,用于加密方式远程登录到服务器。虽然SSH本身不提供图形界面访问,但可以通过X11转发功能在Windows上显示Linux的图形应用程序。

9 |

10 | 原本打算通过 VNC 实现远程连接,不过灰屏的问题一直无法解决,考虑到登陆远程桌面的需求并不多,主要是需要登陆浏览器实现校园网登陆,所以退而求其次采用 xrdp 来实现远程登陆。

11 | # RDP连接Ubuntu桌面具体步骤

12 | 要通过远程桌面协议(RDP)连接运行Xfce4桌面环境的Ubuntu系统,大致可以按照以下步骤操作:

13 | ## 1. 安装 RDP 服务器:

14 | 在Ubuntu系统上,您需要安装一个RDP服务器,如xrdp。使用以下命令安装:

15 |

16 | ```bash

17 | sudo apt-get update

18 | sudo apt-get install xrdp

19 | ```

20 |

21 | ## 2. 配置 Xfce4 桌面:

22 | xrdp默认使用Xfce4作为桌面环境。确保Xfce4已经安装在您的系统上。如果没有,您可以使用以下命令安装:

23 |

24 | ```bash

25 | sudo apt-get install xfce4

26 | ```

27 | xrdp 使用VNC 作为其显示协议,因此您还需要安装一个VNC服务器,不过 xrdp 安装过程中通常会同时安装 Xvnc。

28 | ## 3. 配置 xrdp

29 | 安装完成后,您可能需要配置xrdp以使用Xfce4。这通常涉及到编辑.xsession文件,确保它指向Xfce4。这里使用文本编辑器 Vim 编辑 ~/.xsession 文件,并添加以下行:

30 |

31 | ```bash

32 | xfce4-session

33 | ```

34 | ## 4. 启动 xrdp 服务:

35 | 安装和配置完成后,启动 xrdp 服务:

36 |

37 | ```bash

38 | sudo systemctl enable xrdp

39 | sudo systemctl start xrdp

40 | ```

41 | 如果要退出 xrdp 服务:

42 |

43 | ```bash

44 | sudo systemctl stop xrdp

45 | ```

46 | ## 5. 允许通过防火墙(可选)

47 | 这一步非必须,如果能连接到 RDP 服务器,则不需要执行这一步。否则,需要确保 RDP 端口 3389 在您的防火墙中是开放的。如果您使用的是ufw,可以使用以下命令:

48 |

49 | ```bash

50 | sudo ufw allow 3389/tcp

51 | ```

52 | ## 6. 连接到RDP服务器

53 | 在Windows机器上,打开`远程桌面连接`应用程序,并输入Ubuntu服务器的IP地址。您应该会看到登录界面,输入Ubuntu的用户名和密码后,您就可以通过RDP访问Xfce4桌面了。

54 |

55 |

56 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/【保姆级教程】Windows 远程登陆 Linux 服务器的两种方式:SSH + VS Code,开发必备.md:

--------------------------------------------------------------------------------

1 | # 0. 前言

2 | 很多情况下代码开发需要依赖 Linux 系统,远程连接 Linux 服务器进行开发和维护已成为一种常态。对于使用Windows系统的开发者来说,掌握如何通过 SSH 安全地连接到 Linux 服务器,并利用 VS Code 编辑器进行开发,是一项必备的技能。对于没有服务器的同学,可以参考笔者之前的文章 [Windows上安装Linux子系统,搞台虚拟机玩玩](https://blog.csdn.net/u010522887/article/details/137632509) 准备一个 Linux 环境。

3 |

4 | 本文将详细介绍两种在 Windows 下远程登陆 Linux 服务器的方法:SSH 命令行和 VS Code 远程开发。

5 |

6 | # 1. 远程登陆的两种方式

7 | ## 1.1 SSH远程连接Linux服务器

8 | SSH(Secure Shell)是一种网络协议,用于加密方式远程登录到服务器。以下是通过SSH连接Linux服务器的基本步骤:

9 |

10 | 1. **安装SSH客户端**:Windows 10及以上版本自带了OpenSSH客户端

11 | 2. **安装SSH服务端**:在服务器端安装 OpenSSH,需要在服务器终端进行。

12 |

13 | ```bash

14 | # 安装 ssh

15 | sudo apt install openssh-server

16 | # 安装完成后一般会自动启动,通过如下命令检查 ssh 是否已经启动

17 | sudo systemctl status ssh

18 | # 如果没有启动,需要启动 ssh 服务

19 | sudo systemctl start ssh

20 | # 如果要停止 ssh 服务

21 | sudo systemctl stop ssh

22 | ```

23 | 3. **通过SSH登陆服务器**:ssh 登陆服务器一般有两种方式:

24 | - 使用密钥认证:参考笔者之前的文章 [Windows上安装Linux子系统,搞台虚拟机玩玩](https://blog.csdn.net/u010522887/article/details/137632509) 中对密钥认证步骤的分享,简言之,主要分为以下两步:

25 | **首先,Windows 本地生成SSH密钥对**。下载并安装Git for Windows,然后打开Git Bash终端:在终端中执行命令 `ssh-keygen` ,这时会在本地 .ssh 文件夹中生成了密钥文件, .ssh 文件夹一般保存在 C 盘,比如我的是` C:\Users\12243\.ssh`,文件夹下 id_rsa 是私钥,id_rsa.pub 是公钥。

26 | **然后,复制公钥到 Linux 服务器**。将id_rsa.pub中的内容复制到 Linux 的你的用户根目录 `~/.ssh/authorized_keys` 文件中。

27 |

28 | ```bash

29 | mkdir ~/.ssh

30 | cd ~/.ssh

31 | echo xxx_in_your_id_rsa_pub >> authorized_keys

32 | ```

33 |

34 | - 使用密码认证:这种方式比较简单,唯一的缺点就是每次登陆都需要输入你的账号密码。

35 | 不管采用以上哪种方式,都可以参考如下命令在终端执行登陆,唯一的区别是第一种方式不需要输入密码:

36 | ```bash

37 | ssh your_user_name@172.17.4.63

38 | ```

39 |

40 | ## 1.2 使用VS Code进行远程开发

41 | VS Code(Visual Studio Code)是一个功能强大的编辑器,支持远程开发。以下是使用VS Code连接Linux服务器的步骤:

42 | ### 1.2.1 安装VS Code

43 | 首先需要在本地 Windows 电脑上下载并安装最新版的 VS Code,下载地址见 [官网](https://code.visualstudio.com/)。安装流程可以参考笔者之前的文章[Windows 环境准备 - Conda 和 VS code 安装](https://blog.csdn.net/u010522887/article/details/136969406)

44 | ### 1.2.2 远程登陆

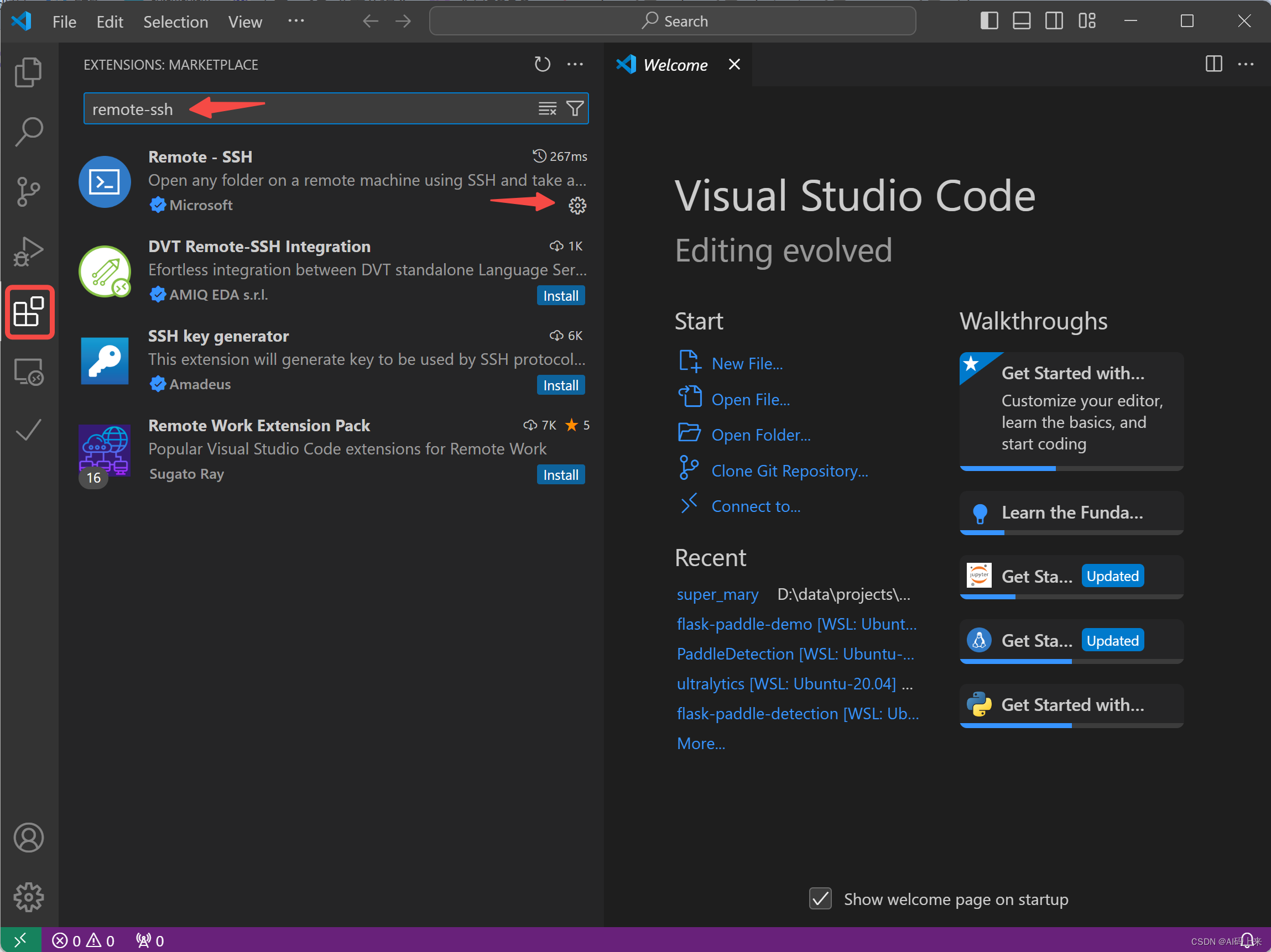

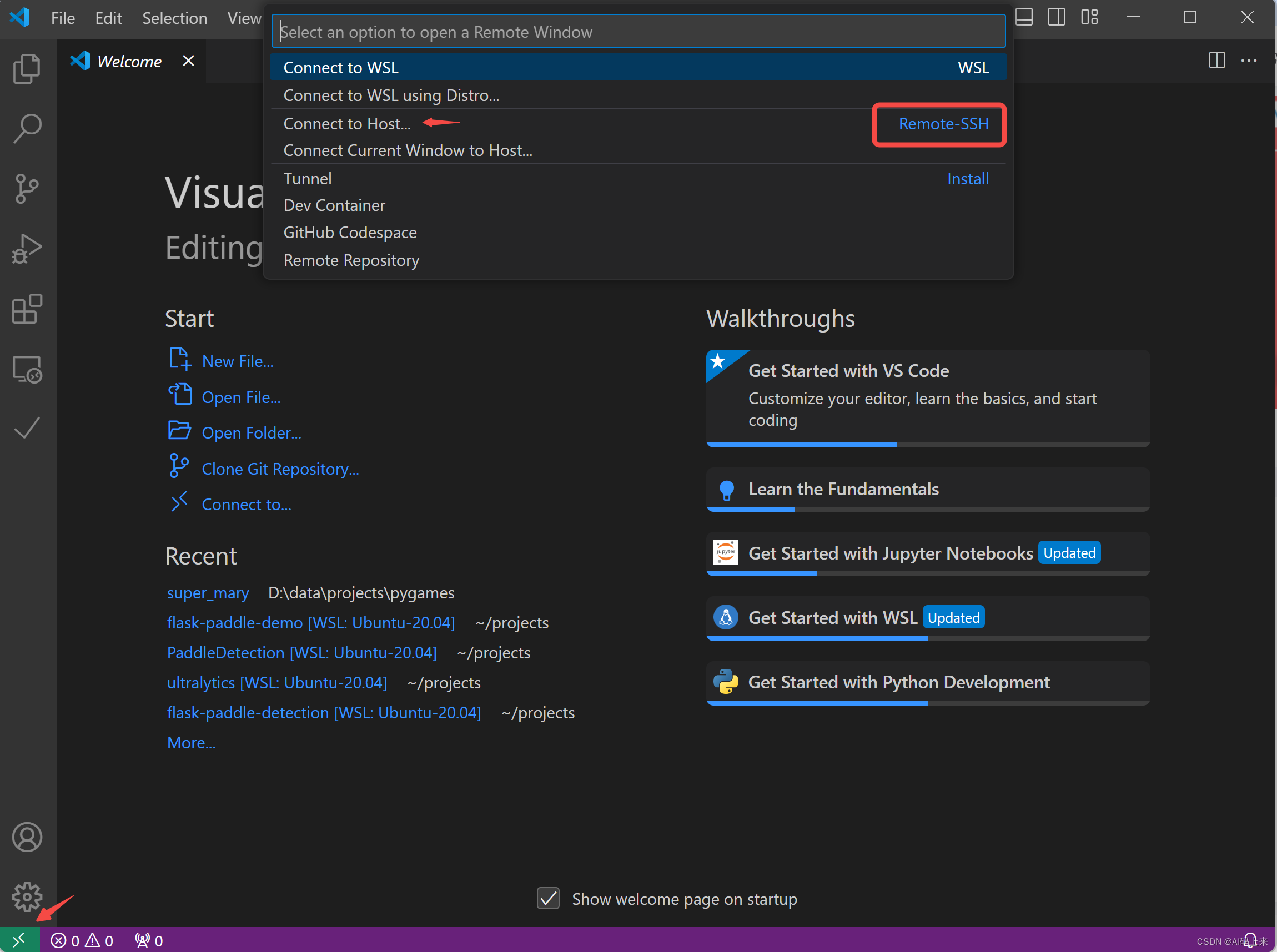

45 | VS Code 访问服务器需要在本地进行一番配置后,然后执行 ssh 登陆,具体而言,可以分为以下几个步骤:

46 | - **Step 1**: 安装 Remote-SSH 插件。第一次使用VS Code 需要在左侧插件栏搜索 Remote-SSH 并安装。

47 |

48 | - **Step 2**: 左下角 Open a remote window 然后选择 Connect to Host。

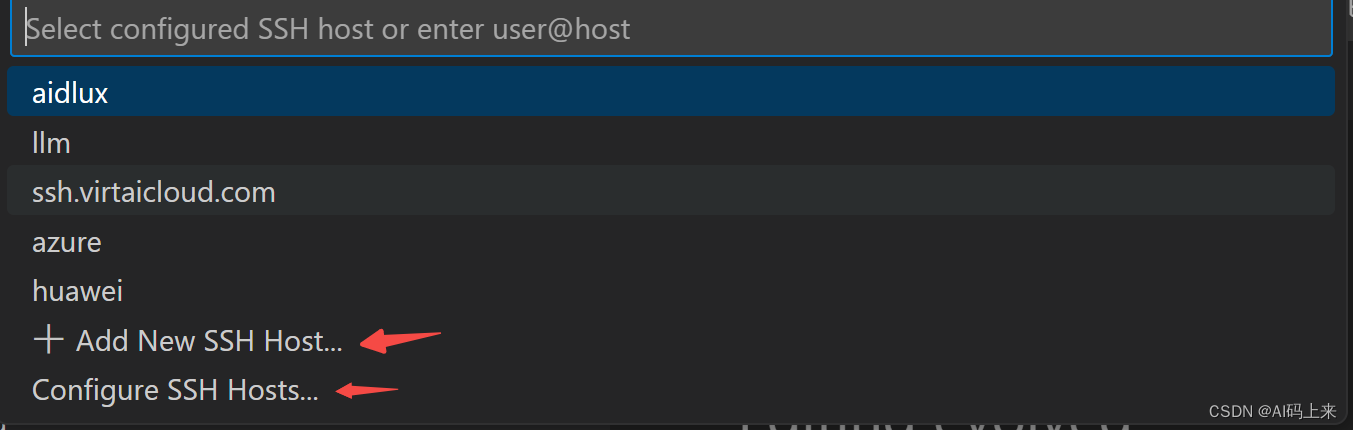

49 |

50 | - **Step 3**: 执行 ssh 登陆。 如下图所示,这里有两种选择:

51 |

52 | - Add New SSH Host,也就是新建一个 Host :如果只是偶尔登陆这个 host ,可以选择这种方式

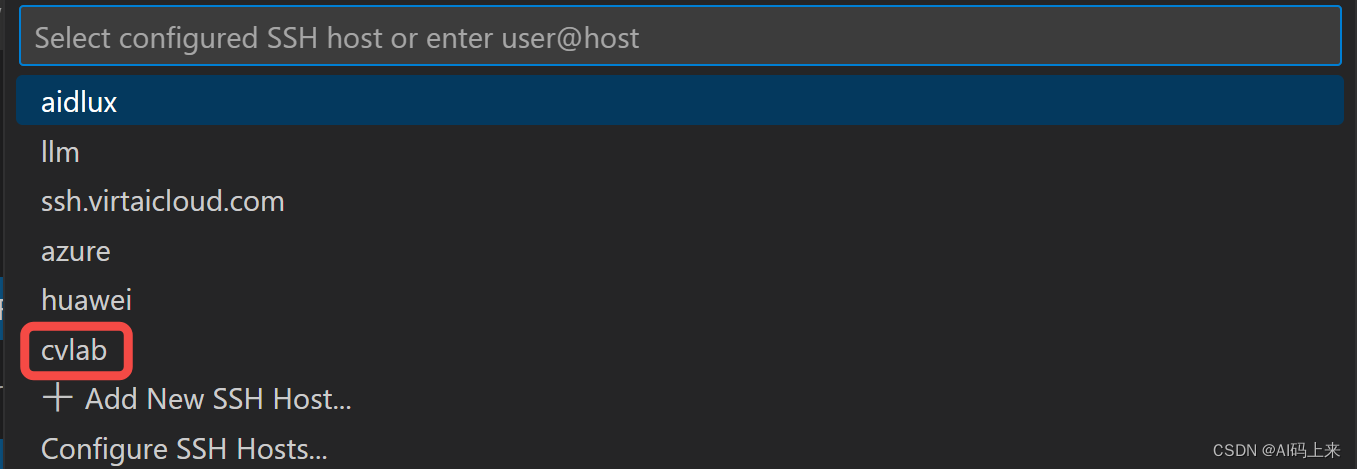

53 | - Configure SSH Hosts,也就是配置一个 Host:如果需要经常登陆,可以新建一个配置文件,这样每次登陆直接选择对应的 Host 名称就可以了,这里的配置文件一般在 C 盘用户目录下,比如我的就在 `C:\Users\12243\.ssh\config`。在config 文件中填入如下信息:Host 就是后续登陆使用的名称,HostName是服务器的 IP 地址,一般 SSH 对应的端口号 Port 是22 ,User 是你在服务器上注册的用户名。

54 | > Host 配置好后,再执行 SSH 登陆时,只需要终端输入Host 名称即可,比如我这里的就是`ssh cvlab` ,等同于之前的 `ssh your_user_name@172.17.4.63`。

55 |

56 | ```bash

57 | Host cvlab

58 | HostName 10.18.32.170

59 | Port 22

60 | User xxx

61 | ```

62 |

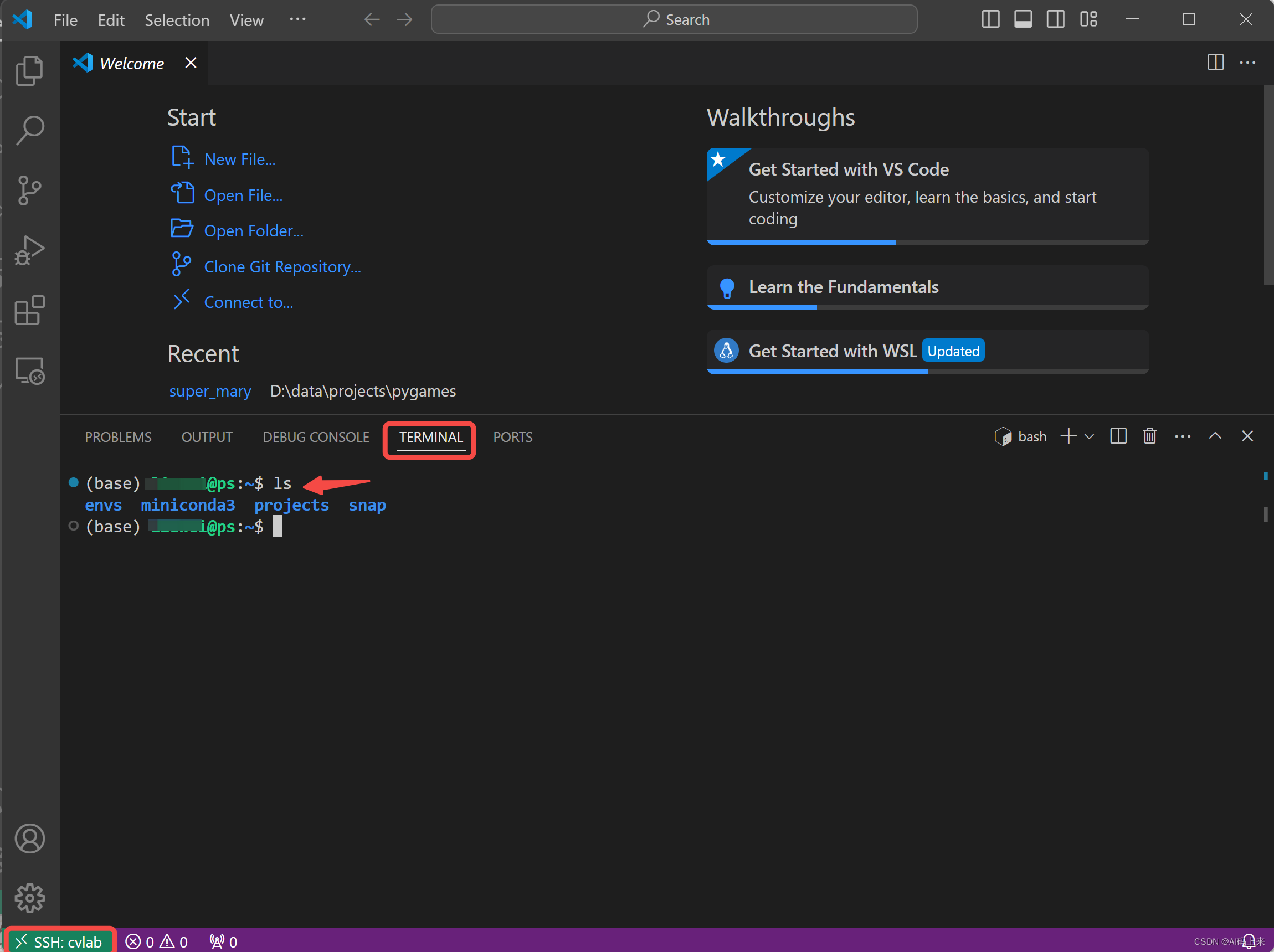

63 | - **Step 3**: 配置好后再重新按照 Step 1 进行登陆,发现登陆名称中多了刚才新建的 cvlab ,点击进去,首先需要选择远程服务器的类型-Linux,然后输入你的账号密码。注:如果你之前应该采用了**密钥认证**,那么这一步就不需要输入密码了。

64 |

65 | - **Step 4**:首次登陆会自动在服务器端安装 VS Code server,如果账号密码都没问题的话,就可以登陆成功了,按 `Ctrl + ~ `键打开终端,可以发现现在已经进入服务器的环境了,接下来的操作就和你在本地机器上一样。

66 |

67 |

68 | ## 1.3 方法对比

69 | - **SSH命令行**:适合需要执行命令行操作的场景,对于脚本编写和快速命令执行非常有效。

70 | - **VS Code远程开发**:适合需要图形界面和复杂编辑功能的场景,尤其是代码编辑、调试和版本控制。

71 |

72 | ## 结语

73 | 无论是通过SSH命令行还是VS Code,都能实现Windows系统下对Linux服务器的远程连接和开发。选择哪种方法取决于你的具体需求和偏好。至此,Windows 连接 Linux服务器的教程就结束了,实践是掌握技能的最好方式,不妨现在就开始尝试连接你的Linux服务器吧!

74 |

75 | 如果对你有帮助的话,不妨 **关注 点赞** 支持一下啊~ 带你了解更多 **Linux + AI** 开发的干货~

76 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/【保姆级教程】如何在 Windows 上实现和 Linux 子系统的端口映射.md:

--------------------------------------------------------------------------------

1 | # 写在前面

2 | 上次分享[【保姆级教程】Windows上安装Linux子系统,搞台虚拟机玩玩](https://zhuanlan.zhihu.com/p/689560472),向大家介绍了什么是虚拟机以及如何在Windows上安装Linux虚拟机。对于开发同学而言,经常遇到的一个问题是:很多情况下代码开发需要依赖 Linux 系统,而在 Linux 子系统上搭建的服务,是无法通过 localhost 在本地浏览器打开的,这时就需要 `端口映射`了,将 Linux 子系统上的端口映射到本地 Windows 机器上。

3 |

4 | 本篇分享将手把手带领大家完成这一功能需求。整个流程需要分为如下几步:

5 |

6 | - 查看 IP

7 | - 查看端口

8 | - 端口映射

9 |

10 | # 1 查看 IP

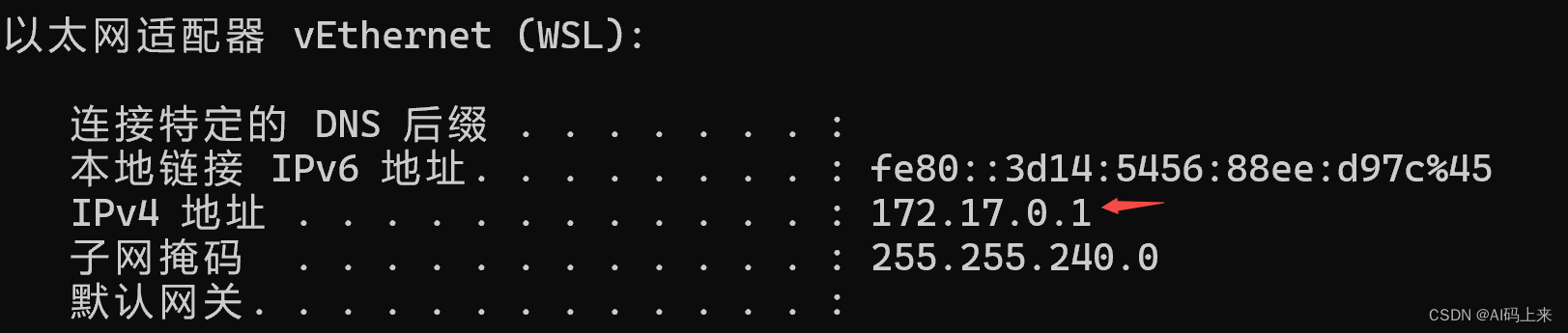

11 | windows 和 linux 系统中查看 IP 地址的命令是不一样的,具体而言。

12 | ## Windows 下查看 IP

13 | 直接打开一个终端,输入 `ipconfig`,可以看到本地的 IPv4 地址。

14 |

15 | ## Linux 下查看 IP

16 | Linux 下查看 IP 地址,有如下三种方式:

17 |

18 | ```bash

19 | ifconfig # 需要 sudo apt install net-tools

20 | hostname -I

21 | ip addr show eth0

22 | ```

23 | 如果是通过 wsl 方式在 windows 上安装的虚拟机,还可以在windows的终端,通过如下命令查看 Linux 子系统的 IP:

24 |

25 | ```bash

26 | wsl -- ifconfig eth0

27 | ```

28 | # 2 查看端口

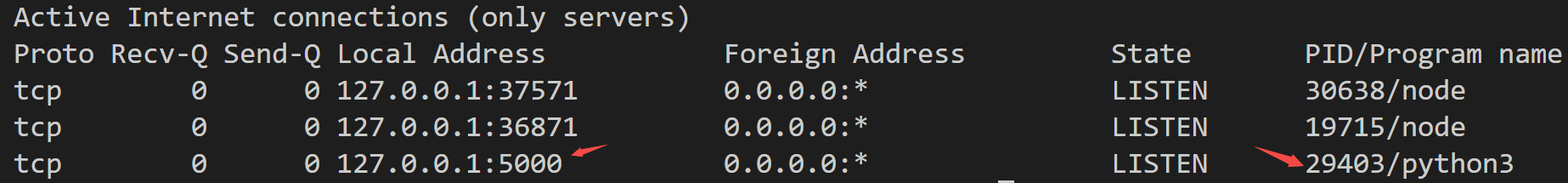

29 | Linux 系统中如果服务启动后,可以通过如下命令查看都有哪些端口已经被占用了:

30 | ```bash

31 | netstat -ntlp

32 | ```

33 | 如果发现有的端口已经被占用了,还可以根据进程号 kill 掉对应进程。

34 |

35 |

36 | 在其中找到需要映射出来的端口号,进入下一步。

37 | # 3 端口映射

38 | Windows 下以管理员身份运行shell,然后运行如下命令实现端口映射:

39 |

40 | ```bash

41 | netsh interface portproxy add v4tov4 listenport=8000 listenaddress=0.0.0.0 connectport=8000 connectaddress=172.17.0.37 # 注意这里是0.0.0.0而非127.0.0.1

42 | netsh interface portproxy add v4tov4 listenport=5000 listenaddress=0.0.0.0 connectport=5000 connectaddress=172.17.0.37

43 | ```

44 | 其中 connectaddress 就是 Linux 子系统的 IP,注意如果你的服务中有两个端口,需要将两个端口都映射出来。

45 |

46 | 查看是否添加成功:

47 |

48 | ```bash

49 | netsh interface portproxy show all

50 | ```

51 | 调试结束后,可以删除端口映射:

52 |

53 | ```bash

54 | netsh interface portproxy delete v4tov4 listenport=8000 listenaddress=0.0.0.0

55 | ```

56 |

57 |

58 |

59 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/报错解决ImportError_ libcrypto.so.10_ cannot open shared object file_ No such file or directory.md:

--------------------------------------------------------------------------------

1 | # 原因分析

2 | 这是因为linux系统中ssl版本的问题,比如程序需要的是1.0版本,而系统中可能是1.1版本,所以需要重新安装open-ssl。

3 |

4 | # 怎么解决

5 | ## 找到libcrypto所在位置

6 | ```bash

7 | find /usr/ -name "libcrypto*" #比如我们这里发现是1.1版本

8 | ```

9 | ## 新建lib文件夹

10 |

11 | ```bash

12 | mkdir ~/lib # 用户根目录下创建lib,用于存放依赖库,如果没有sudo权限,系统根目录下无法保存

13 | cd ~/lib

14 | ```

15 | ## 下载源码包

16 | 这里下载所需要的1.0版本

17 | ```bash

18 | wget https://www.openssl.org/source/old/1.0.2/openssl-1.0.2k.tar.gz

19 | tar -xzf openssl-1.0.2k.tar.gz

20 | cd openssl-1.0.2k

21 | ```

22 | ## 编译安装

23 |

24 | > make 和 make install的区别:

25 | > - ./config 或者 /configure:配置环境,建立Makefile文件

26 | > - make:编译,就是把源码包编译成二进制可执行文件

27 | > - make install:安装

28 |

29 | ```bash

30 | ./config -d shared --prefix=/home/aistudio/lib/ #配置环境,安装到指定目录

31 | make # 编译

32 | echo $? # 检测是否编译成功,输出0说明成功

33 | make install # 安装

34 | echo $? # 检测是否安装成功,输出0说明成功

35 | ```

36 | ## 生成软链接

37 |

38 | ```bash

39 | cd /home/aistudio/lib/ # 回到lib目录下

40 | ln -s lib/libcrypto.so.1.0.0 libcrypto.so.10

41 | ln -s lib/libssl.so.1.0.0 libssl.so.10

42 | export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/aistudio/lib/

43 | ```

44 | 至此,再重新运行你的程序,应该就没有报错了,继续愉快玩耍吧!

45 |

--------------------------------------------------------------------------------

/docs/1.Linux笔记/报错解决ImportError_ libnvinfer.so.7_ cannot open shared object file_ No such file or directory.md:

--------------------------------------------------------------------------------

1 | # 原因分析

2 | 这是因为linux系统中没有安装tensorrt。

3 | ## 什么是tensorrt

4 | - 一句话:TensorRT是用于NVIDIA各种GPU的一个模型推理框架,支持C++和Python。Pytorch或者Paddle框架训好的模型,可以转为TensorRT的格式,再用TensorRT去运行,可以提升NVIDIA-GPU上的运行速度。

5 | - CUDA,CUDNN 和 TensoRT 之间的关系

6 | - cuda 是 NVIDIA-GPU 进行并行计算的框架

7 | - cudnn 是 NVIDIA-GPU 进行神经网络训练和推理的加速库,cudnn 会将神经网络的计算进行优化,再通过 cuda 调用 gpu 进行运算

8 | - tensorrt 和 cudnn 类似,不过只支持模型推理

9 |

10 | # 怎么解决

11 | ## 方式一

12 | > 查看cuda cudnn版本并到官网下载对应tensorrt版本

13 |

14 | ```bash

15 | # 查看cuda cudnn版本

16 | nvcc -V

17 | ls -l /usr/local/ | grep cuda

18 | dpkg -l | grep libcudnn

19 | find /usr/ -name "cudnn*" # 找到cudnn.h的位置

20 | cat /usr/include/cudnn_version.h | grep CUDNN_MAJOR -A 2 # 打印cudnn版本

21 | #define CUDNN_MAJOR 8

22 | #define CUDNN_MINOR 9

23 | #define CUDNN_PATCHLEVEL 6

24 |

25 | # 综上,我的cuda版本是11.8,cudnn版本是8.9.6

26 | # 官网下载对应的tensorrt版本并安装

27 | https://developer.nvidia.cn/tensorrt

28 | ```

29 | ## 方式二(推荐)

30 | > 直接pip安装

31 |

32 | ```bash

33 | pip install tensorrt # 默认会安装8.6.1,所以还是找不到libnvinfer.so.7。目前pip安装已找不到版本7

34 |

35 | # 找到你的python环境安装包位置,并cd进去

36 | # 为了让程序能找到libnvinfer.so.8,这里新建了软链接,并在环境变量中新增安装位置

37 | cd /home/aistudio/envs/py38/lib/python3.8/site-packages/tensorrt_libs

38 | ln -s libnvinfer.so.8 libnvinfer.so.7

39 | ln -s libnvinfer_plugin.so.8 libnvinfer_plugin.so.7

40 | export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/home/aistudio/envs/py38/lib/python3.8/site-packages/tensorrt_libs

41 | ```

42 |

43 |

--------------------------------------------------------------------------------

/docs/2.玩转云服务/86K Star!又一款内网穿透利器,开源免费+小白友好.md:

--------------------------------------------------------------------------------

1 | 如果你想让本地 AI 服务,触达全球,那么一定得了解下内网穿透。

2 |

3 | 前段时间和大家分享过两款内网穿透方案:

4 |

5 | - [Cloudflare:免费内网穿透,让本地AI服务,触达全球](https://zhuanlan.zhihu.com/p/716891964)

6 | - [LanProxy:免费内网穿透,手把手搭建,三步搞定](https://zhuanlan.zhihu.com/p/711445796)

7 |

8 | 有一说一:

9 | - Cloudflare 的内网穿透服务还是很香的,无需自己购买服务器中转。唯一的缺点就是不太稳定,经常出现 Tunnels 无法建立隧道的问题。

10 | - LanProxy 需要拥有一台具有公网 IP 的机器作为中转,最近发现访问量大了之后也不稳定。

11 |

12 | 今日分享,继续带来一款强大的内网穿透方案 - frp,github上已有86.4k star,且项目一直在持续迭代中。

13 |

14 | ## 1. 什么是内网穿透

15 |

16 | 一句话:把只能内网访问的服务,暴露到公网。

17 |

18 | 关于内网穿透的基本原理,可以翻看之前的教程:[免费内网穿透,手把手搭建,三步搞定](https://zhuanlan.zhihu.com/p/711445796),这里就不赘述了。

19 |

20 | ## 1. frp 简介

21 | > 项目地址:[https://github.com/fatedier/frp](https://github.com/fatedier/frp)

22 |

23 | frp 采用 Golang 编写,支持跨平台,你仅需下载对应平台的二进制文件即可,无需任何依赖,堪称小白利器。

24 |

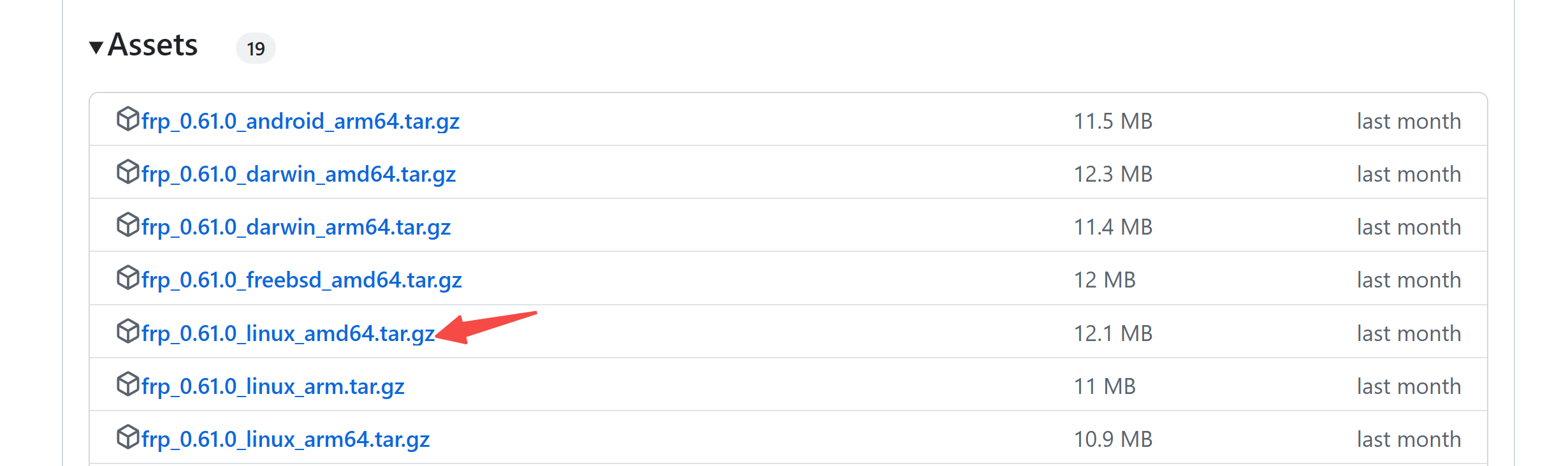

25 | 目前最新版本为 0.61.0,前往官方 releases 页面下载即可。

26 |

27 | > [https://github.com/fatedier/frp/releases](https://github.com/fatedier/frp/releases)

28 |

29 |

30 |

31 | frp 专注于内网穿透,支持 TCP、UDP、HTTP、HTTPS 等多种协议,可将内网服务通过具有公网 IP 的机器中转,暴露到公网。

32 |

33 | 所以,首先要准备一台有公网 IP 的机器,笔者之前已分享过多篇相关内容,可以翻看。

34 |

35 | 接下来,我们上实操。

36 |

37 |

38 | ## 2. frp 实现内网穿透

39 |

40 | ### 2.1 frp 安装

41 | 不像 ngrok 需要编译,frp 安装的非常简单,只需前往上方官方 releases 页面下载对应系统的安装包,解压出来就能用。

42 |

43 | 以 Linux 操作系统为例:

44 |

45 | ```

46 | #下载

47 | wget https://github.com/fatedier/frp/releases/download/v0.61.0/frp_0.61.0_linux_amd64.tar.gz

48 | #解压

49 | tar -zxvf frp_0.61.0_linux_amd64.tar.gz

50 | #进入目录

51 | cd frp_0.61.0_linux_amd64/

52 | ```

53 |

54 | 文件夹中,有两个二进制文件frpc(c代表client)和frps(s代表server),分别是客户端程序和服务端程序。

55 |

56 |

57 | ```

58 | frp_0.61.0_linux_amd64$ ls

59 | frpc frpc.toml frps frps.toml LICENSE

60 | ```

61 |

62 | 因此,客户端(即内网服务器)和服务端(即公网服务器),需要准备好对应文件。

63 |

64 |

65 | ### 2.2 服务端配置和启动

66 |

67 | 首先,修改服务端配置文件`frps.toml`:

68 |

69 | ```

70 | # 服务端配置

71 | bindPort = 7000

72 | webServer.addr = "0.0.0.0"

73 | webServer.port = 7500

74 | ```

75 |

76 | 其中,`bindPort` 用于监听客户端,`webServer.port` 是服务端的管理界面。

77 |

78 | 然后,采用如下命令一键启动:

79 |

80 | ```

81 | nohup ./frps -c frps.toml > server.log 2>&1 &

82 | ```

83 |

84 | 注:frp 默认采用 IPv6,不过会同时监听IPv4和IPv6地址,但你用 netstat 只看到 IPv6 被监听,实际上是通过了 IPv4-Mapped IPv6 Address 同时兼听了IPv4地址。

85 |

86 | 所以,如果你发现端口不通的时候,**一定记得去看看端口防火墙有没打开**。

87 |

88 | 看看端口能否连接?

89 |

90 | ```

91 | sudo apt install telnet

92 | telnet server_ip 7000

93 | ```

94 |

95 | 查看并打开端口防火墙:

96 |

97 | ```

98 | sudo ufw status

99 | sudo ufw allow 7500

100 | sudo ufw allow 7000

101 | # sudo ufw delete allow 7000

102 | ```

103 |

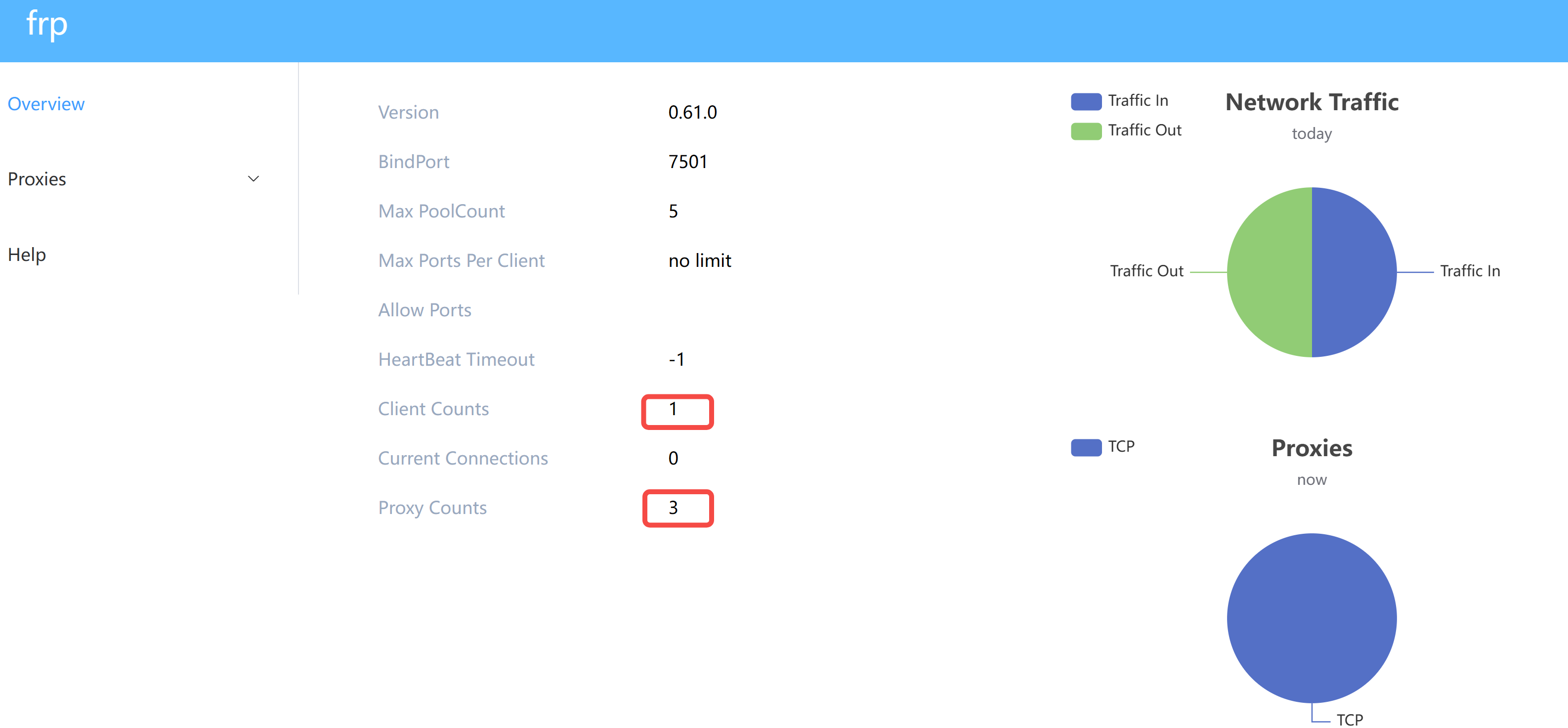

104 | 最后,浏览器输入 `server_ip:7500`,即可看到管理界面:

105 |

106 |

107 |

108 | 这里我有一个客户端已经接入,并映射了3个端口。

109 |

110 | 接下来,我们就来完成客户端配置。

111 |

112 |

113 | ### 2.3 客户端配置和启动

114 |

115 | 首先,修改服务端配置文件`frps.toml`:

116 |

117 | ```

118 | serverAddr = "serve_ip"

119 | serverPort = 7000

120 |

121 | [[proxies]]

122 | name = "ollama"

123 | type = "tcp"

124 | localIP = "127.0.0.1"

125 | localPort = 3002

126 | remotePort = 3002

127 | ```

128 |

129 | 其中,`serverPort` 要对应 服务端的 `bindPort`。我们以`把 ollama 映射到公网可访问` 为例,新增配置如上方代码块:`localPort`和`remotePort`分别是本地服务的端口,和要映射到服务端端口。

130 |

131 | 注:如果有多个端口要映射,只需把`ollama`的复制一份,指定不同端口即可。

132 |

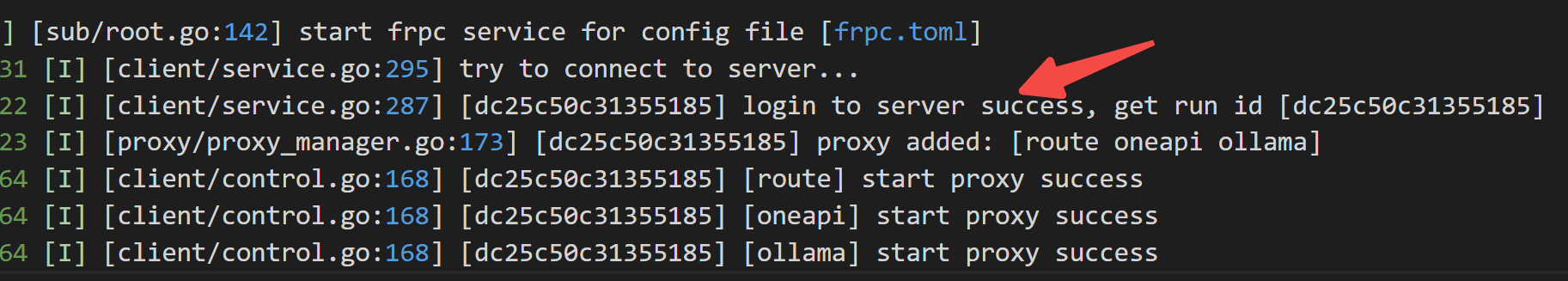

133 | 然后,采用如下命令一键启动:

134 |

135 | ```

136 | nohup ./frpc -c frpc.toml > client.log 2>&1 &

137 | ```

138 |

139 | 日志如下:

140 |

141 |

142 |

143 | 至此,frp 内网穿透服务搭建完毕。

144 |

145 | 以上通过一个简单案例,带大家快速跑通流程。更多配置,可参考官方文档:[https://gofrp.org/zh-cn/docs/](https://gofrp.org/zh-cn/docs/)

146 |

147 | ## 写在最后

148 |

149 | 本文实操带大家走完了`frp搭建内网穿透`的全部流程。

150 |

151 | 作为一款开源免费的服务,frp 配置简单,非常适合小白上手。

152 |

153 | 如果对你有帮助,不妨**点赞收藏**备用。

154 |

155 | ---

156 |

157 | 为方便大家交流,新建了一个 `AI 交流群`,欢迎感兴趣的小伙伴加入。

158 |

159 | 最近搭建的微信机器人`小爱(AI)`也在群里,公众号后台「联系我」,拉你进群。

160 |

161 |

--------------------------------------------------------------------------------

/docs/2.玩转云服务/README.md:

--------------------------------------------------------------------------------

1 | # 2.玩转云服务

2 |

3 | - [86K Star!又一款内网穿透利器,开源免费+小白友好](docs/2.玩转云服务/86K%20Star!又一款内网穿透利器,开源免费+小白友好.md)

4 | - [Untitled](docs/2.玩转云服务/Untitled.md)

5 | - [【保姆级教程】免费内网穿透,手把手搭建,三步搞定](docs/2.玩转云服务/【保姆级教程】免费内网穿透,手把手搭建,三步搞定.md)

6 | - [【保姆级教程】免费域名注册 & Cloudflare 域名解析 & Ngnix端口转发](docs/2.玩转云服务/【保姆级教程】免费域名注册%20&%20Cloudflare%20域名解析%20&%20Ngnix端口转发.md)

7 | - [【保姆级教程】白嫖 Cloudflare 之 5 分钟搭建个人静态网站](docs/2.玩转云服务/【保姆级教程】白嫖%20Cloudflare%20之%205%20分钟搭建个人静态网站.md)

8 | - [【白嫖 Cloudflare】之 免费内网穿透,让本地AI服务,触达全球](docs/2.玩转云服务/【白嫖%20Cloudflare】之%20免费内网穿透,让本地AI服务,触达全球.md)

9 | - [【白嫖 Cloudflare】之免费 AI 服务,从API调用到应用搭建](docs/2.玩转云服务/【白嫖%20Cloudflare】之免费%20AI%20服务,从API调用到应用搭建.md)

10 | - [【白嫖 Cloudflare】之免费图床搭建:PicGo + Cloudflare R2,手把手教](docs/2.玩转云服务/【白嫖%20Cloudflare】之免费图床搭建:PicGo%20+%20Cloudflare%20R2,手把手教.md)

11 | - [两款 GPU 云服务器,助力小白上手 AI](docs/2.玩转云服务/两款%20GPU%20云服务器,助力小白上手%20AI.md)

12 | - [从0搭建你的免费图床(PicGo + Oracle cloud 甲骨文云对象存储)](docs/2.玩转云服务/从0搭建你的免费图床(PicGo%20+%20Oracle%20cloud%20甲骨文云对象存储).md)

13 | - [你的服务器管家,不仅免费开源,还贼简洁好用](docs/2.玩转云服务/你的服务器管家,不仅免费开源,还贼简洁好用.md)

14 | - [我花了一天时间,搭了个专属知识库,部署上线了,手把手教,不信你学不会](docs/2.玩转云服务/我花了一天时间,搭了个专属知识库,部署上线了,手把手教,不信你学不会.md)

15 | - [玩转云服务:Google Cloud谷歌云永久免费云服务器「白嫖」 指南](docs/2.玩转云服务/玩转云服务:Google%20Cloud谷歌云永久免费云服务器「白嫖」%20指南.md)

16 | - [玩转云服务:Oracle Cloud甲骨文永久免费云主机配置指南(续)](docs/2.玩转云服务/玩转云服务:Oracle%20Cloud甲骨文永久免费云主机配置指南(续).md)

17 | - [玩转云服务:Oracle Cloud甲骨文永久免费云服务器注册及配置指南](docs/2.玩转云服务/玩转云服务:Oracle%20Cloud甲骨文永久免费云服务器注册及配置指南.md)

18 | - [玩转云服务:手把手带你薅一台腾讯云服务器](docs/2.玩转云服务/玩转云服务:手把手带你薅一台腾讯云服务器.md)

19 | - [谁偷偷看了你的网站?这两款统计工具告诉你!小白易上手](docs/2.玩转云服务/谁偷偷看了你的网站?这两款统计工具告诉你!小白易上手.md)

20 |

21 |

22 |

23 | *本系列共更新**17**篇文章*

24 |

25 |

26 |

27 | [🔙返回首页](/)

28 |

--------------------------------------------------------------------------------

/docs/2.玩转云服务/Untitled.md:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/hougeai/knowledgebase/6cfce85587ecb4903f05af30f3cb5c447c4af868/docs/2.玩转云服务/Untitled.md

--------------------------------------------------------------------------------

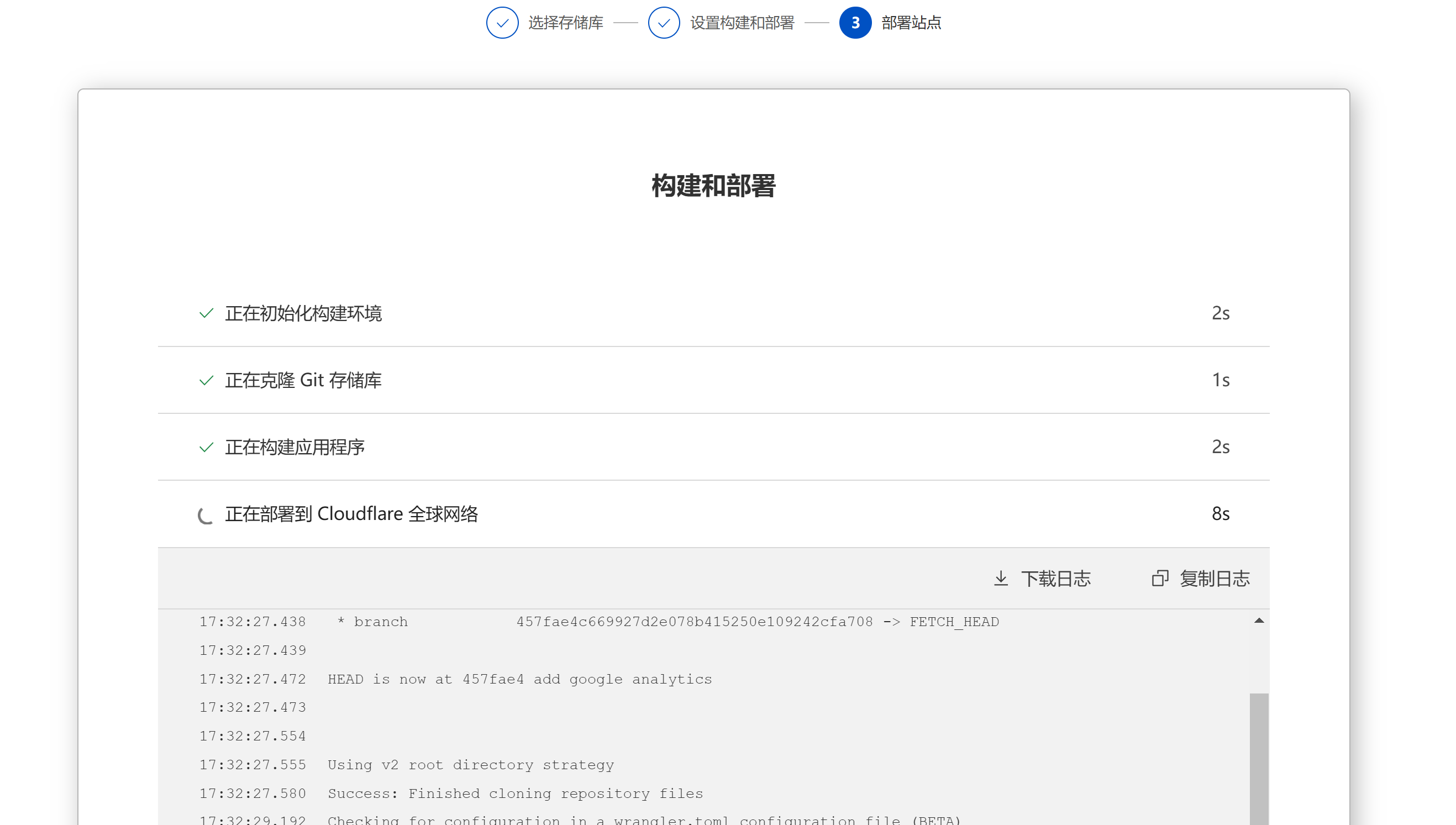

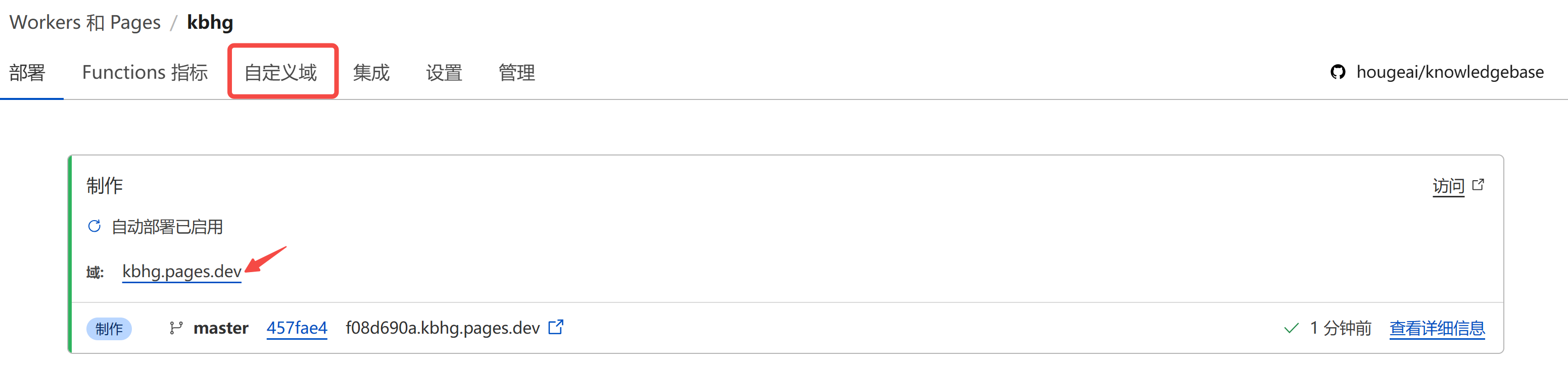

/docs/2.玩转云服务/【保姆级教程】白嫖 Cloudflare 之 5 分钟搭建个人静态网站.md:

--------------------------------------------------------------------------------

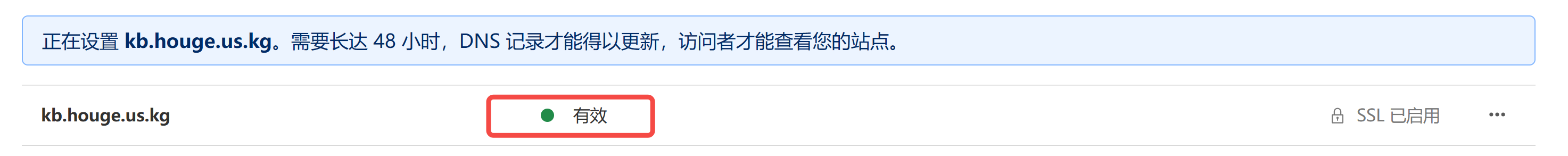

1 | 前端时间,搭了个个人知识库,并部署到 GitHub Pages 上:

2 | [一天时间,搭了个专属知识库,部署上线了,手把手教,不信你学不会](https://blog.csdn.net/u010522887/article/details/140919939)

3 |

4 | 免费使用的 GitHub Pages 优势非常明显,唯一的缺点是:

5 | - 对于大型网站或高流量网站可能存在访问速度较慢的问题。

6 |

7 | 本文将再介绍一款静态网站托管工具:`Cloudflare Pages` ,由 Cloudflare 提供,利用 Cloudflare 的全球性 CDN 进行加速,而且功能更加丰富:

8 | - 支持主流的前端构建工具和框架,如 React、Vue 等;

9 | - 提供更丰富的缓存策略和性能优化选项;

10 | - 支持 Github/GitLab 仓库,和 Github Pages 类似。

11 |

12 | 之前我们网站的域名解析也是用的 Cloudflare 家的服务,感兴趣的小伙伴可参考:[【保姆级教程】免费域名注册 & Cloudflare 域名解析 & Ngnix端口转发](https://blog.csdn.net/u010522887/article/details/140786338)。

13 |

14 | 下面我们开始实操演示:如何利用 `Cloudflare Pages` 部署一个网站。

15 |

16 | ## 1. 网站部署

17 |

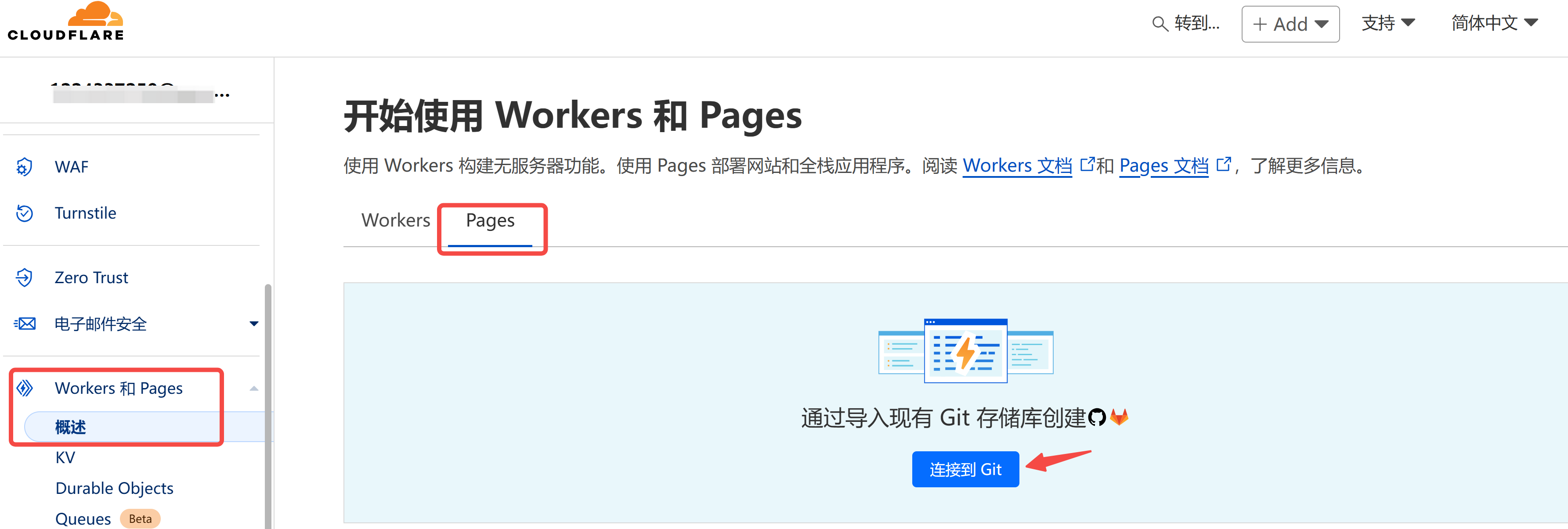

18 | 注册登录后,进入 Cloudflare 控制台,点击按图示进入 `Workers 和 Pages` 面板,选择 Pages。

19 | > 多一嘴:区别于 Pages,Workers 是一个可以运行 Javascript 的无服务器平台。

20 |

21 |

22 |

23 |

24 | `Cloudflare Pages` 支持 Github/GitLab 仓库,这一点和 `Netlify` 是一致的。

25 |

26 |

27 |

28 |

29 | 选择 Github 账号授权后,你可以选择授权所有项目给 Cloudflare,或者选择授权指定的项目仓库。

30 |

31 | 我这里选择全部授权,授权之后,选择一个你要部署的项目,点击 “开始设置”。

32 |

33 | 静态页面,一般设置部署分支、构建命令、构建输出目录就可以。点击“保存并部署”,等待几分钟即可部署完成。

34 |

35 |

36 |

37 |

38 | 部署完成后可看到 Cloudflare 给我们的域名 `xx.pages.dev`,刚部署完成,需要稍等 2 分钟,点击即可直接公网访问。

39 |

40 |

41 |

42 |

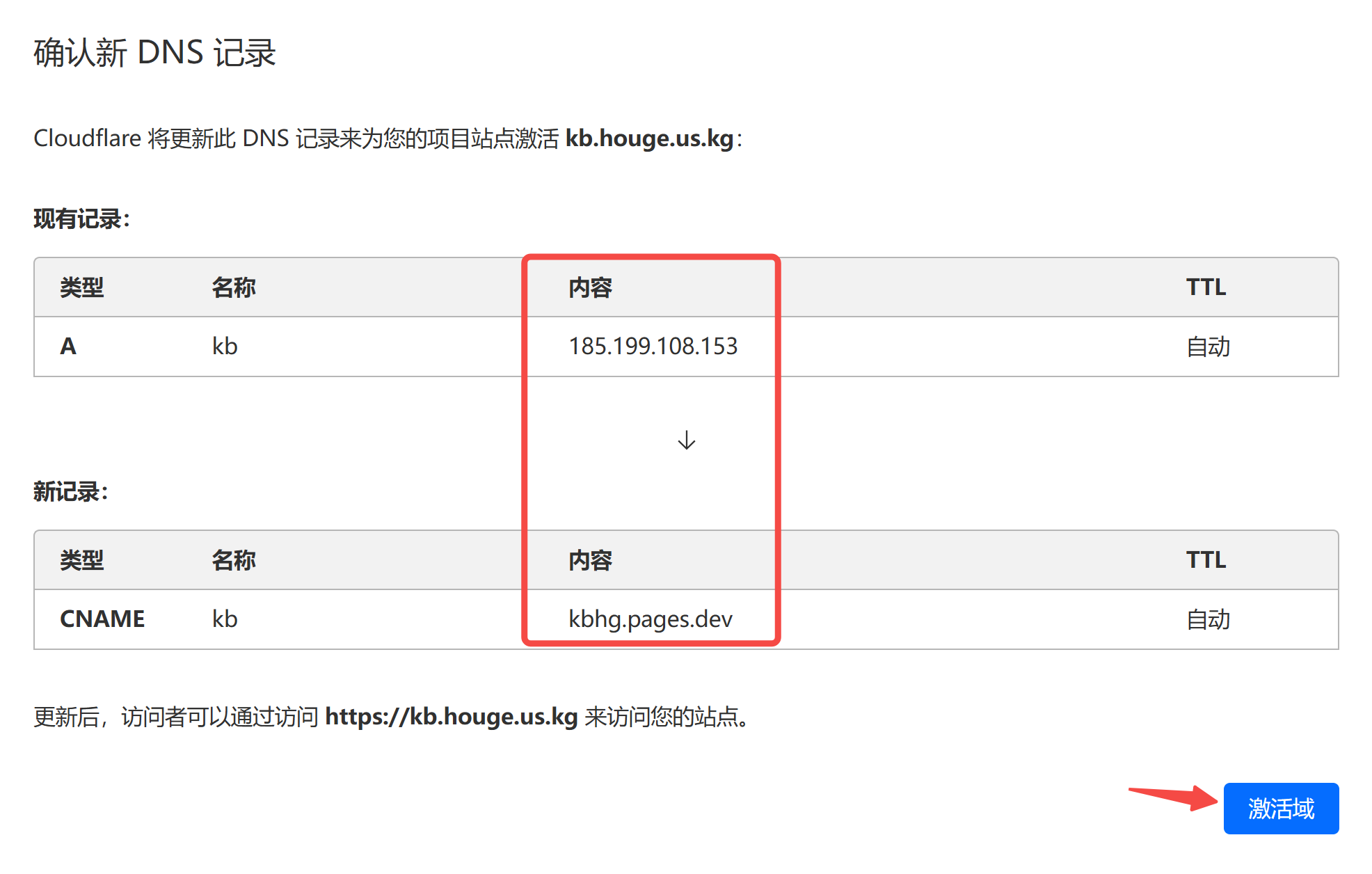

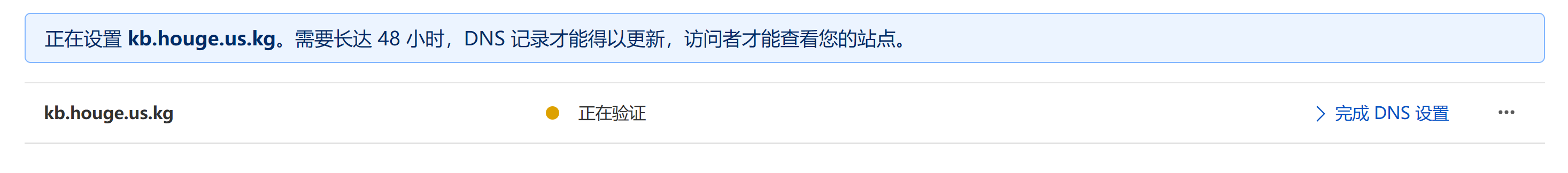

43 | 如果你有自己的域名,并在 Cloudflare 上进行了域名解析,也可以进入项目主页,选择自定义域。

44 |

45 | ## 2. 自定义域名

46 | 进入项目,点击 “自定义域”。

47 |

48 | 注:这里填入的域名一定要在 Cloudflare 上进行了域名解析。

49 |

50 |

51 |

52 | 接入完成之后,Cloudflare 会自动帮你更新 DNS 记录。比如,我这里会自动将原来 github pages 上面的 IP 替换为 `Cloudflare Pages` 上的域名。点击“激活域”,完成更新。

53 |

54 |

55 |

56 |

57 |

58 |

59 |

60 |

61 | 域名验证成功后,你的网站就可以通过自定义域名正式上线了!

62 |

63 | ## 3. 更多部署方案?

64 |

65 | 相信看到这里的你,一定有个疑问:除了 `Cloudflare Pages`,还有哪些平替?

66 |

67 | 今天,趁机给大家做一个盘点~

68 |

69 | 静态网站部署,大致可以分为以下两类:

70 |

71 | ### 3.1 云部署平台

72 | 和 `Cloudflare Pages` 类似的云部署平台还有:

73 |

74 | - Vercel:和全栈开发框架 next.js 同属一家公司,生态非常完善,缺点就是太贵。

75 | - Netlify:Vercel的直接竞争对手,每月 100 GB 免费访问流量。

76 | - Railway:优势是支持 Docker 容器,包括 Dockerfile 和公开的 docker 镜像进行部署,但不支持docker-compose。

77 | - Zeabur:国内公司开发,直接对标 Railway,也支持 Docker 容器。

78 | - Render:另一个流行的云部署平台,和 Vercel 类似。

79 | - Firebase:Google 提供的一个平台,可用于部署和托管 web 应用。

80 |

81 | ### 3.2 开源的部署方案

82 | 社区也有很多开源项目,旨在成为 Vercel 和 Netlify 等云平台的自托管替代方案,可以部署在自己的服务器上:

83 |

84 | - [Coolify](https://github.com/coollabsio/coolify)(27.8k star)

85 | - [Dokku](https://github.com/dokku/dokku)(26.5k star):一个轻量级的开源 PaaS(平台即服务)。

86 | - [SST](https://github.com/sst/sst)(21.2k star):专注于无服务器架构和AWS生态系统。

87 | - [Dokploy](https://github.com/Dokploy/dokploy)(5.3k star):直接叫板 Vercel, Netlify and Heroku 的开源替代方案。

88 |

89 | 我还没尝试过,有机会实操后再来跟大家分享。

90 |

91 |

92 | ## 写在最后

93 | 本文通过一个简单的例子,带大家完成在 `Cloudflare Pages` 上部署网站,其生成的域名,亲测在国内可以直接访问~

94 |

95 | 对于免费账户而言,每天限制访问 10W 次。对于个人网站而言,完全足够。

96 |

97 | 江湖人称`赛博菩萨`的 `Cloudflare`,还有很多常用的网站管理服务,绝大部分都有免费额度。

98 |

99 | 我还没探索完,等用到了再陆续给大家分享。

100 |

101 | 如果本文有帮助,不妨点个**免费的赞**和**收藏**备用。

102 |

103 |

104 |

105 |

--------------------------------------------------------------------------------

/docs/2.玩转云服务/两款 GPU 云服务器,助力小白上手 AI.md:

--------------------------------------------------------------------------------

1 | 最近更新了很多开源 AI 大模型的文章,目前已收录:

2 |

3 | - [CogVideo 实测,智谱「清影」AI视频生成,全民免费,连 API 都开放了!](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247485591&idx=1&sn=38d5c4de97094186578ac0f718ea71b2&chksm=c248551ff53fdc09f08c68fbe5c33bbfac3babb6154cc034ee46068709d3fc55e6beab75f075&scene=21#wechat_redirect)

4 | - [全网刷屏的 LLaMa3.1,2分钟带你尝个鲜](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247485560&idx=1&sn=58aaff0740eb5a0cb995cdb400b91dbf&chksm=c24855f0f53fdce6c485d50319d7a2595a48439232f66ab010c56eb95460445efc1837341d9b&scene=21#wechat_redirect)

5 | - [SenseVoice 实测,阿里开源语音大模型,识别效果和效率优于 Whisper](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247485469&idx=1&sn=87f0223cc59ebb19c86f1f825b64a8f3&chksm=c2485595f53fdc834487b87e63446974e700ae191fc843d1e6ee67ee7b6d65e3560b0a06dcc9&scene=21#wechat_redirect)

6 | - [EasyAnimate-v3 实测,阿里开源视频生成模型,5 分钟带你部署体验,支持高分辨率超长视频](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247485449&idx=1&sn=a3a23259d889f5305b82fd61117b374e&chksm=c2485581f53fdc97834708624b646ad545bff9c961acc5e261a44c5e8dcd6b42d5636e3cf522&scene=21#wechat_redirect)

7 | - [一文梳理ChatTTS的进阶用法,手把手带你实现个性化配音](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247484666&idx=1&sn=95d4983ec16b47b8db6d05d41b208cf9&chksm=c2485972f53fd0641ba175af0d3fb33d77afeaea31fcd41c8c2602676ab8fca275856146a5d1&scene=21#wechat_redirect)

8 | - [开源版 Midjourney 来了,无需本地显卡,5 分钟带你玩转 AI 绘画模型](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247486018&idx=1&sn=aea2048a1afa7bb3ec848b7d6dfc3182&chksm=c24857caf53fdedc4f2b4ac881c1e7c6984756e3ada7b70f36c3f9addac8b576bb4b301a9bfa&scene=21#wechat_redirect)

9 | - [人人有嘴替:免费开源语音合成,3s极速语音克隆](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247486051&idx=1&sn=a87046364773ab42629c5352f9fb63a4&chksm=c24857ebf53fdefde080642e670b4d609f388ed1c0606d27803fe0f8d8a1d29c192c650220ab&scene=21#wechat_redirect)

10 | - [免费语音克隆神器,让川普来段中文绕口令?FishSpeech 5 分钟部署实战](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247486167&idx=1&sn=6828505ed90a4fa808dd2f688d73b0a9&chksm=c248575ff53fde4925259324118df2439a599cb9a2062df6e2b99a5effef5be013ef08a8a5c7&scene=21#wechat_redirect)

11 |

12 | 很多小伙伴发现,本地电脑根本带不动这些大模型,今天给大家推荐两款 GPU 云服务器,助力小白快速上手 AI。

13 |

14 | 大家有其它好的推荐,欢迎留言。

15 |

16 | **推荐1:趋动云**

17 |

18 | https://platform.virtaicloud.com/gemini_web/auth/register?inviteCode=b702f65cfe99e8cf10900a650fdc00c6

19 |

20 | 优缺点:

21 |

22 | - 选择更多,价格相对实惠;远程连接稳定;新人注册送 100 点算力。

23 |

24 | **推荐2:AutoDL**

25 |

26 | https://www.autodl.com/home

27 |

28 | 优缺点:

29 |

30 | - 新人注册送 30 天会员,会员租用价格享受 95 折;支持本地 GPU 集群部署上云。

31 | - 最低配置显存 11 G,价格稍贵。

32 |

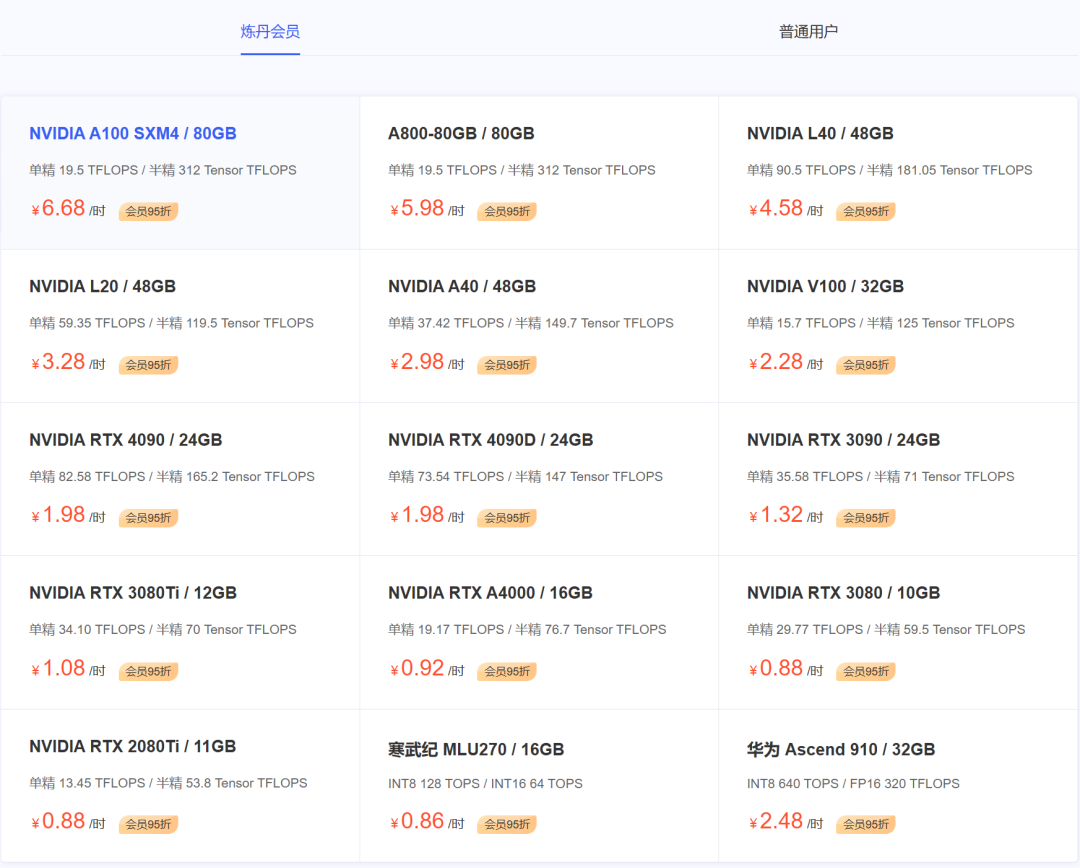

33 | ## **1. 趋动云**

34 |

35 | 新人注册福利打满:

36 |

37 |

38 |

39 | 价格怎么样?

40 |

41 | 最低配置 6 G 显存,低至 0.49 点算力/小时,运行一天 = 0.49 * 24 = 12 元。运行 AI 绘画 / AI 语音模型,完全足够。

42 |

43 | 即便是 24 G 显存,也只有 1.99。运行 13B 以下大语言模型完全足够。

44 |

45 | 不知道如何使用的小伙伴,可以参考我之前在 `趋动云` 上跑模型的两篇教程:

46 |

47 | - [人人有嘴替:免费开源语音合成,3s极速语音克隆](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247486051&idx=1&sn=a87046364773ab42629c5352f9fb63a4&chksm=c24857ebf53fdefde080642e670b4d609f388ed1c0606d27803fe0f8d8a1d29c192c650220ab&scene=21#wechat_redirect)

48 | - [免费语音克隆神器,让川普来段中文绕口令?FishSpeech 5 分钟部署实战](http://mp.weixin.qq.com/s?__biz=MzkzMzY2MTkyNw==&mid=2247486167&idx=1&sn=6828505ed90a4fa808dd2f688d73b0a9&chksm=c248575ff53fde4925259324118df2439a599cb9a2062df6e2b99a5effef5be013ef08a8a5c7&scene=21#wechat_redirect)

49 |

50 |

51 |

52 | 还没注册的小伙伴赶紧去薅羊毛:https://platform.virtaicloud.com/gemini_web/auth/register?inviteCode=b702f65cfe99e8cf10900a650fdc00c6

53 |

54 | ## **2. AutoDL**

55 |

56 | AutoDL 对学生更友好一些,新人注册送 30 天会员,会员租用价格享受 95 折。

57 |

58 |

59 |

60 | 最低配置是 RTX 2080Ti 11 G 显存,会员价格 0.88/小时。

61 |

62 |

63 |

64 | 当然如果你有本地 GPU 服务器, AutoDL 私有云提供了一套解决方案,让本地GPU服务器集群也可以高效管理与使用,免费、安全且不绑定服务器销售厂家。

65 |

66 | ## **写在最后**

67 |

68 | 如果你没有 GPU 机器,又想快速上手 AI,可以使用上述 GPU 云服务器,不过上面两款提供的实例都是 Docker 容器,主打一个性价比!

69 |

70 | 如果本文对你有帮助,不妨点个**免费的赞**和**收藏**备用。你的支持是我创作的最大动力。

--------------------------------------------------------------------------------

/docs/2.玩转云服务/你的服务器管家,不仅免费开源,还贼简洁好用.md:

--------------------------------------------------------------------------------

1 |

2 | 在「玩转云服务」系列中,带着大家申请了几台云服务器。

3 | - [玩转云服务:手把手带你薅一台腾讯云服务器](https://blog.csdn.net/u010522887/article/details/140091900)

4 | - [玩转云服务:Oracle Cloud甲骨文永久免费云服务器注册及配置指南](https://blog.csdn.net/u010522887/article/details/140223094)

5 | - [玩转云服务:Google Cloud谷歌云永久免费云服务器「白嫖」 指南](https://blog.csdn.net/u010522887/article/details/140817919)

6 |

7 | 问题来了:怎么监管这些服务器的运行状态呢?

8 |

9 | 因此,一个简约轻量的监控工具就显得尤为重要。

10 |

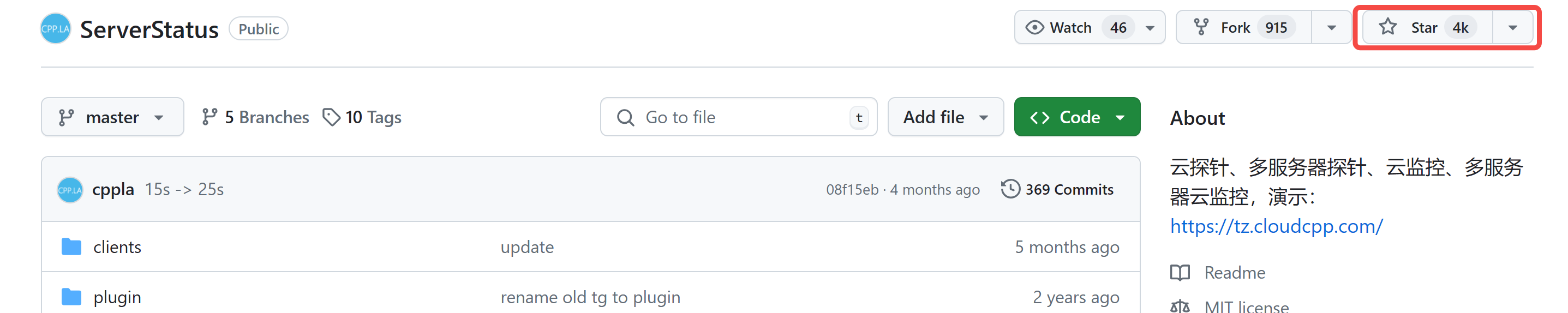

11 | 今日分享 GitHub 上的一款开源项目 - ServerStatus,完美解决多台服务器监管的难题,亲测好用。

12 |

13 | > 项目传送门:[https://github.com/cppla/ServerStatus/](https://github.com/cppla/ServerStatus/)

14 |

15 | 目前该项目已经斩获 4K Star~

16 |

17 |

18 |

19 | ## 1.项目简介

20 |

21 | `ServerStatus` 一个超级贴心的免费开源监控工具,它就像是你服务器的私人保镖+贴身医生,24小时不间断守护。

22 |

23 | 想知道你的服务器 CPU 有没有在拼命工作?内存是不是又在暴饮暴食?网络流量是不是又在疯狂飙车?别担心,ServerStatus都看得一清二楚!

24 |

25 | 而且,不管你家的服务器是VPS、虚拟机还是物理机,它都能照顾得妥妥的。

26 |

27 |

28 |

29 | ## 2. 安装部署

30 |

31 | 整个部署过程包括两个部分:

32 | - 服务端:用于监控多台客户端服务器

33 | - 客户端:一键运行,和服务端建立连接

34 |

35 | ### 2.1 服务端部署

36 |

37 | 如果你本着`拿来即用`,不需要进行二次开发的话,推荐直接 Docker 安装~

38 |

39 | 首先,把项目 clone 下来:

40 |

41 | ```

42 | git clone https://github.com/cppla/ServerStatus.git

43 | ```

44 |

45 | 然后,我们可以简单看下`docker-compose.yml`配置文件,其中有一段:

46 |

47 | ```

48 | networks:

49 | serverstatus-network:

50 | ipv4_address: 172.23.0.2

51 | ```

52 |

53 | 有小伙伴可能有疑惑:这里的 IP 要不要修改?

54 |

55 | 答:**不需要**!因为在 Docker 容器中,ipv4_address 是在自定义网络内部使用的,与服务器的 IP 地址不是一回事,因此你完全不用管它。

56 |

57 | 最后,docker 一键安装:

58 |

59 | ```

60 | cd ServerStatus

61 | docker-compose up -d

62 | ```

63 | 需要稍等片刻,等待编译安装~

64 |

65 | 安装成功后,在宝塔面板中可以看到容器已经启动:

66 |

67 |

68 |

69 | 别忘了打开 8080 端口的防火墙,这是服务端监控界面的端口号。

70 |

71 |

72 | ### 2.2 客户端安装

73 |

74 | 客户端的安装就更简单了。

75 |

76 | 首先,下载客户端运行的 Python 脚本:

77 |

78 | ```

79 | wget --no-check-certificate -qO client-linux.py 'https://raw.githubusercontent.com/cppla/ServerStatus/master/clients/client-linux.py'

80 | ```

81 |

82 | 然后,你只需指定你**服务端的 IP 地址**和**客户端的用户名**,

83 |

84 | 把程序丢到后台去跑吧~

85 |

86 | ```

87 | nohup python3 client-linux.py SERVER=xx.xx.xx.xx USER=s01 PASSWORD=s01 >/dev/null 2>&1 &

88 | ```

89 |

90 | 你想监控几台服务器,分别把上面的程序放上去就行~

91 |

92 | ### 2.3 服务端监控

93 |

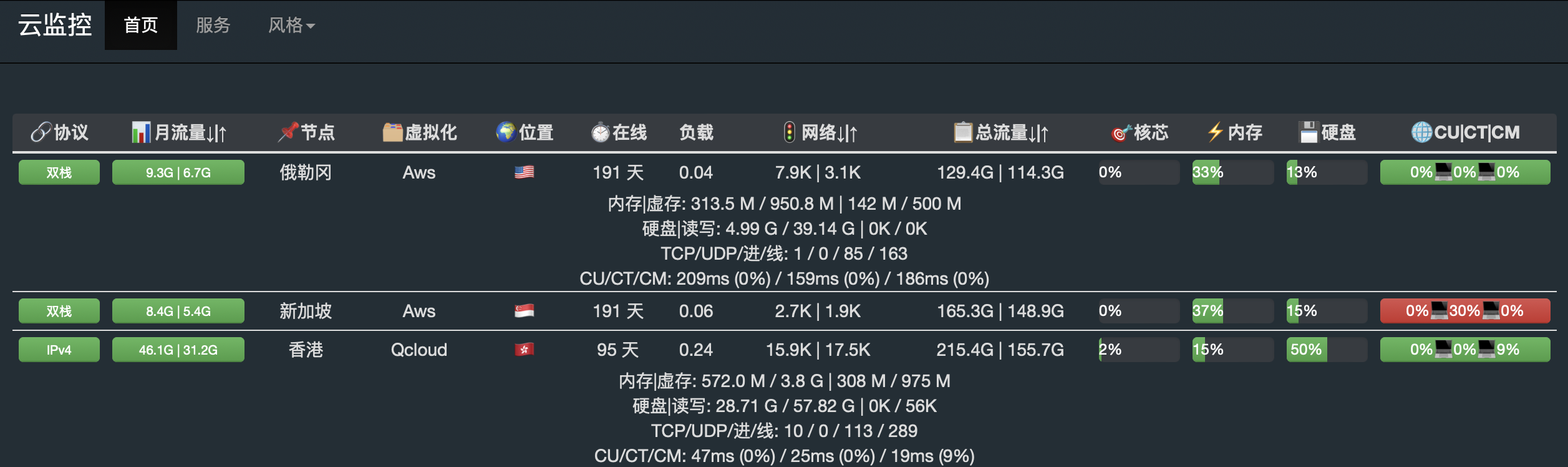

94 | 客户端启动成功后,去打开服务端的监控界面看看吧~

95 |

96 | 地址:http://your_server_ip:8080

97 |

98 | 我这里起了两个客户端作为演示:

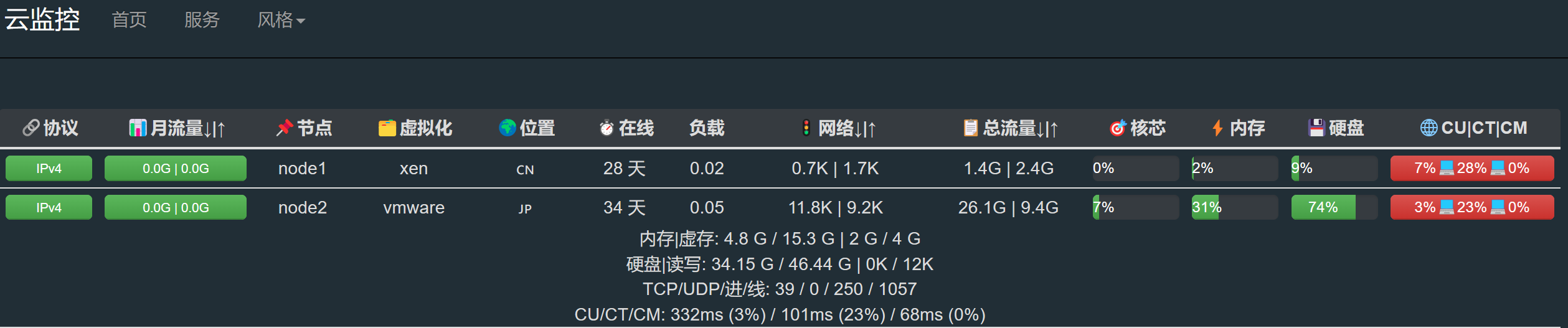

99 |

100 |

101 |

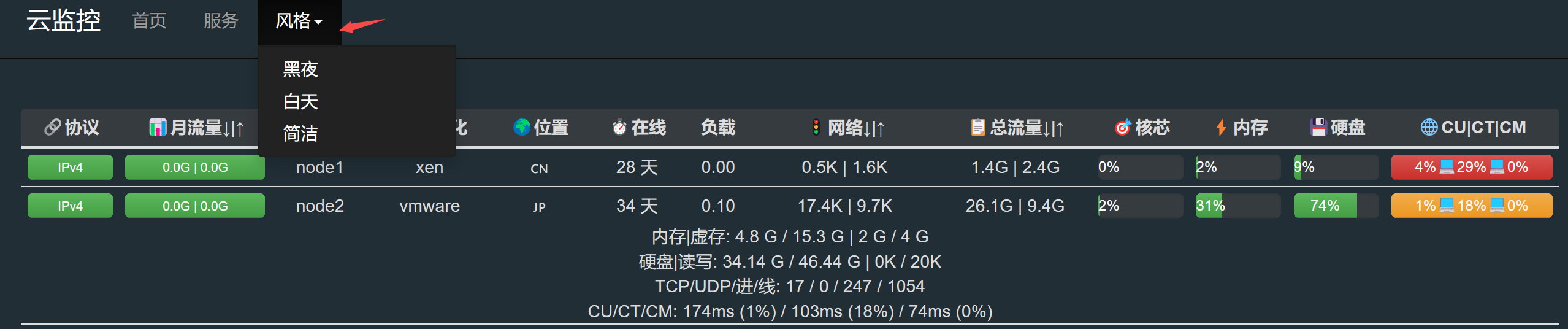

102 | 界面是不是特别简洁美观?支持三种风格切换~

103 |

104 |

105 |

106 |

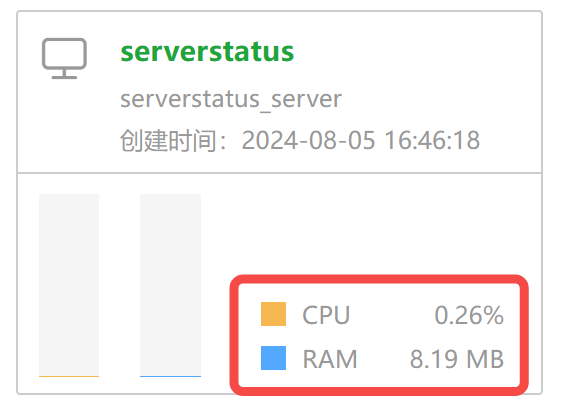

107 | 关键是,你看,这个小东西不过只占了你 8M 的内存,毫无压力~

108 |

109 |

110 |

111 | 太简单了?还想展示更多信息?有一定开发能力的小伙伴,可以基于这个项目进行二开~

112 |

113 | ## 写在最后

114 | `ServerStatus` 这个小家伙不仅免费开源,还贼简洁好用。

115 |

116 | 玩转云服务,ServerStatus,你值得拥有的服务器管家!

117 |

118 | 如果本文对你有帮助,不妨点个**免费的赞**和**收藏**备用。

119 |

120 |

121 |

--------------------------------------------------------------------------------

/docs/2.玩转云服务/谁偷偷看了你的网站?这两款统计工具告诉你!小白易上手.md:

--------------------------------------------------------------------------------

1 | 前两天,上线了一个知识库网站:[花了一天时间,搭了个专属知识库,终于上线了,手把手教,不信你学不会](https://blog.csdn.net/u010522887/article/details/140919939)。

2 |

3 | 想知道这个网站的流量如何,怎么搞?

4 |

5 | 网站流量统计分析工具,了解下?

6 |

7 | 市面上都有哪些分析工具,为什么要选择 Google Analytics?

8 |

9 | [百度统计](https://tongji.baidu.com/)在国内用的较多,不过需要你的网站域名完成备案,会相对麻烦一点。

10 |

11 | 如果你只是想搞了玩玩,强烈推荐对岸的`谷歌分析工具(Google Analytics)`,谷歌官方发布的一款网站流量统计分析工具。

12 |

13 | 当然,海外还有很多类似的产品,但不得不承认,`Google Analytics`是同类型工具中功能最强大的一个,对小白上手零门槛,好用且免费。

14 |

15 | 本篇教程,手把手带大家用 Google Analytics,掌握自己网站的流量来源。

16 |

17 | ## 1. 如何开通 Google Analytics

18 |

19 | 要使用谷歌分析,你必须先注册一个谷歌 Gmail 邮箱账号,这个账号是一号通用的,后续无论是使用 Google Ads、Google Docs、Google Cloud 等任何 Google 的产品,都需要使用这个邮箱账号登录。

20 |

21 | 来到 Google Analytics ,用你的 Gmail 邮箱账号登录。

22 | > 登录地址:[https://analytics.google.com/analytics/web/provision/#/provision](https://analytics.google.com/analytics/web/provision/#/provision)

23 |

24 | 点击上方`开始衡量`,开始注册账号:

25 |

26 |

27 |

28 | `帐号数据共享设置`这里,为实现与其他 Google 产品和服务共享 Google Analytics的数据,默认全选即可,点击最下方的“下一步”。

29 |

30 |

31 |

32 | 然后,填写媒体资源信息,也就意味着同一个账号下可以有多个媒体资源:

33 |

34 |

35 |

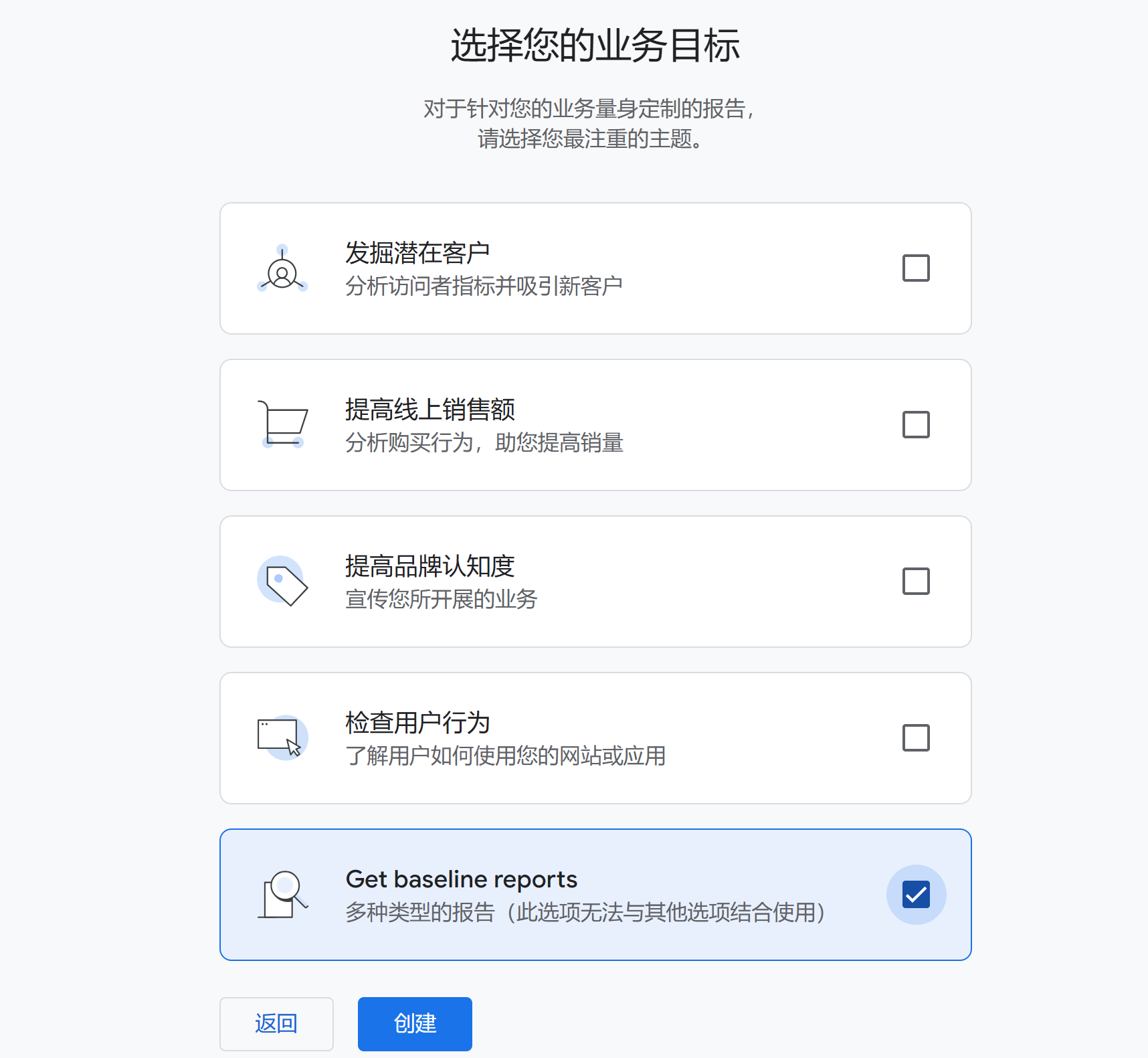

36 | 选择业务目标,根据自己是需求,我这里选择最后的`多种类型报告`:

37 |

38 |

39 |

40 | 进入到最后步骤了:开始收集数据,我们这里只需要统计网站,这里的选择决定了后续在你的应用中插入的代码。

41 |

42 |

43 |

44 |

45 | 网站数据流这里,注意你的是 http 还是 https,否则后期统计不到数据;填写你的域名后,点击右上方 `创建` 按钮。

46 |

47 |

48 |

49 |

50 | ## 2. 如何使用 Google Analytics

51 |

52 | 创建需要稍等片刻,它会弹出你需要插入到你网页 html 中的跟踪代码。

53 |

54 |

55 |

56 | 点击 下一步,看到如下页面,账号和媒体资源已经创建成功了。

57 |

58 |

59 |

60 | 接下来你需要插入跟踪代码,最后将网站重新部署上线。

61 |

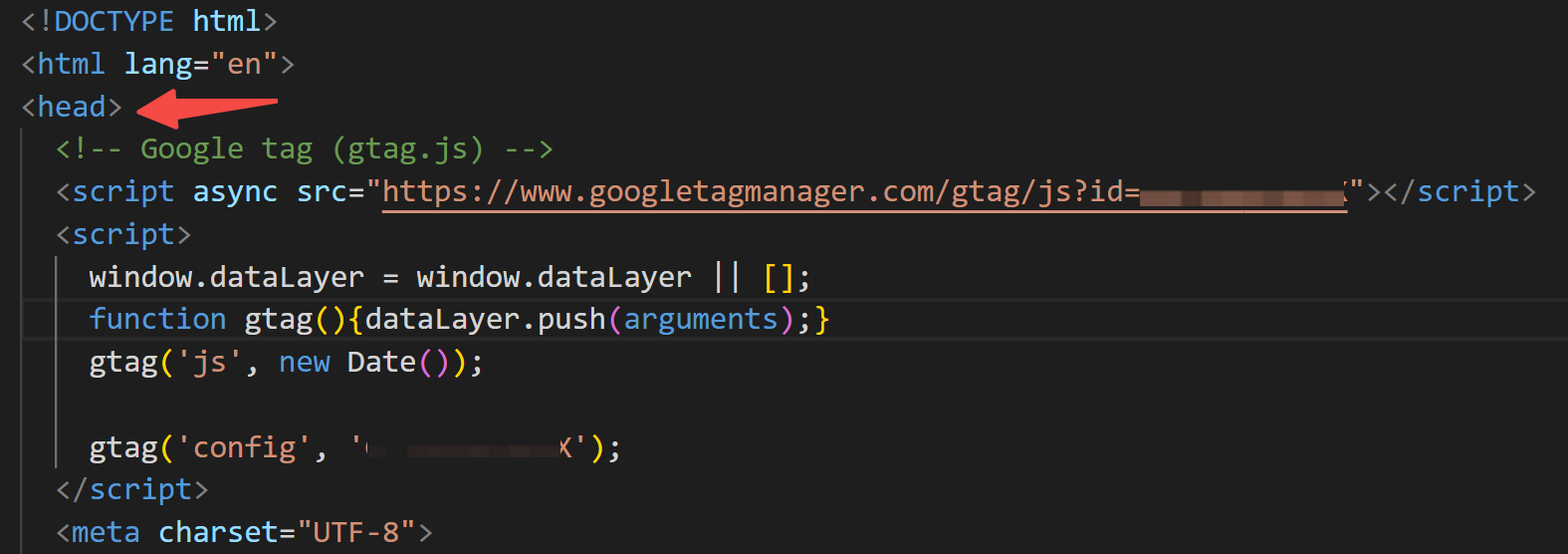

62 | 下面我们以知识库网站为例,你只需要找到根目录下的`index.html`,在 ``元素中,插入刚刚复制的代码即可:

63 |

64 |

65 |

66 |

67 | 如果网站已经重新部署成功,回到你的账号页面,可以看到数据采集已经启动:

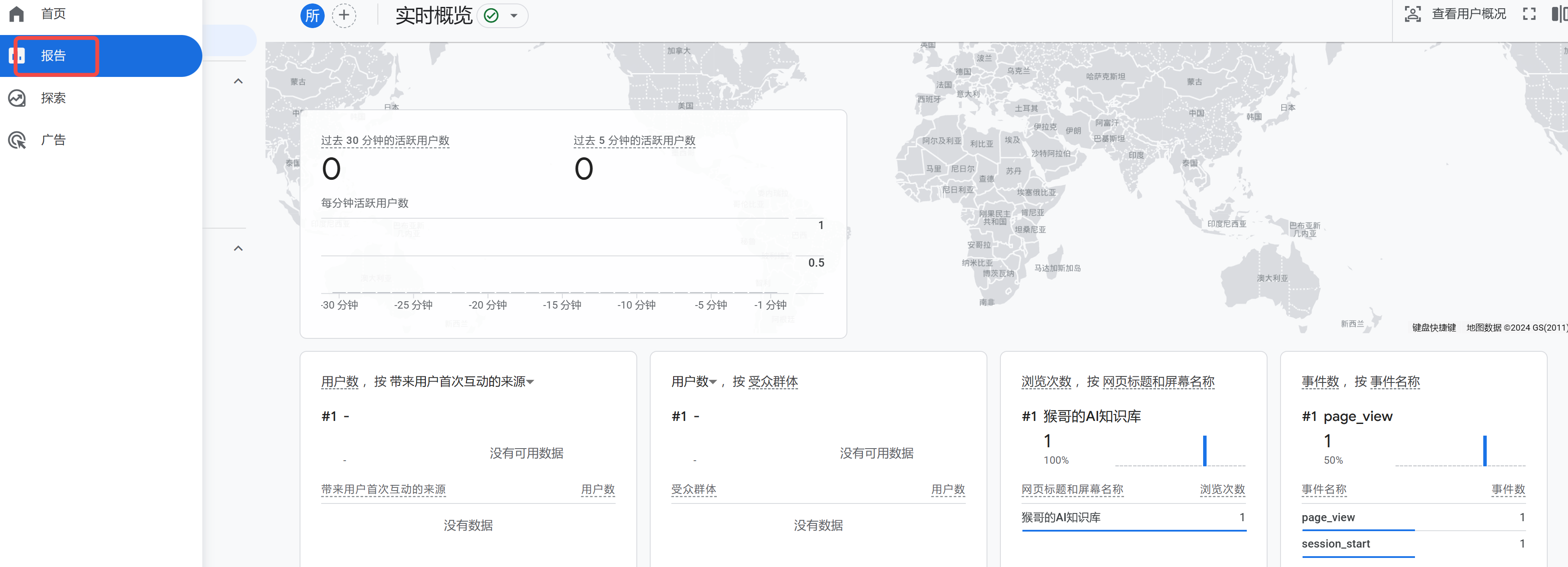

68 |

69 |

70 |

71 | 因为它是实时更新的,所以回到控制台,点击侧边栏的 `报告`,你就可以看到网站的浏览数据了。

72 | > 传送门:[https://analytics.google.com/analytics/web/](https://analytics.google.com/analytics/web/)

73 |

74 |

75 |

76 | 以上仅仅是 Google Analytics 的冰山一角,更多功能使用,还有待小伙伴们根据自己的需求去挖掘~

77 |

78 | 当然,如果你仅仅是想统计一下网站的浏览量,有没有更简单的方法?

79 |

80 | 接着往下看👇

81 |

82 | ## 3. 更简单的平替?

83 |

84 | 要在你的网站上添加类似的访客统计功能,还有许多在线服务提供访客计数功能。比如:StatCounter、FreeCounter 等等。

85 |

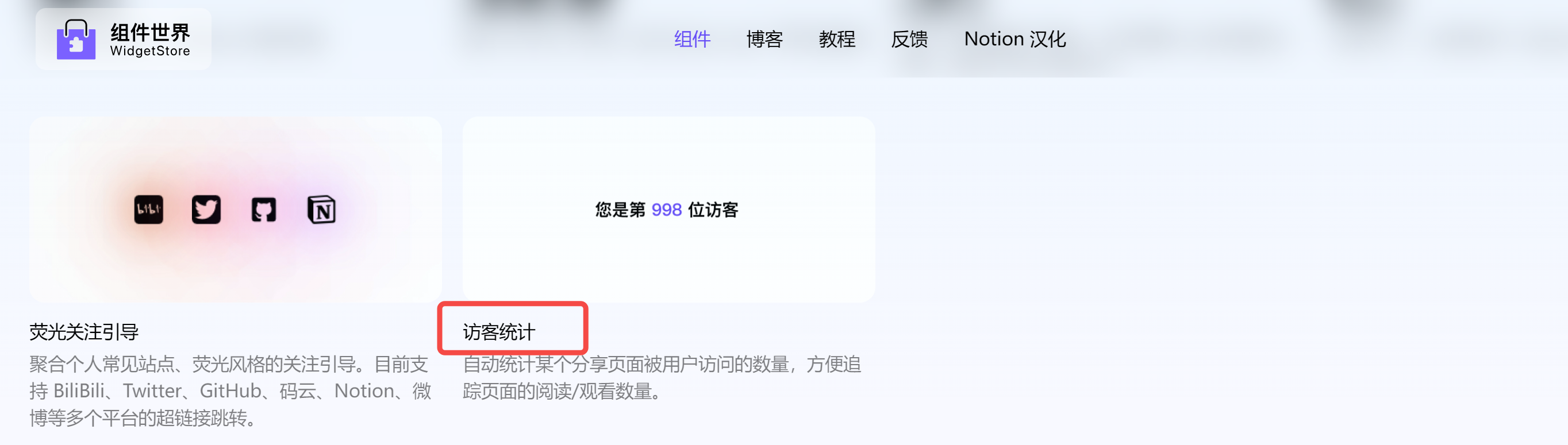

86 | 这里,再给大家推荐一个亲测好用的国产组件库- NotionPet,个人可以免费创建 2 个组件。

87 | > 传送门:[https://cn.widgetstore.net/](https://cn.widgetstore.net/)

88 |

89 | 进入首页后,点击创建组件,拉到最下面,有一个`访客统计`的组件:

90 |

91 |

92 |

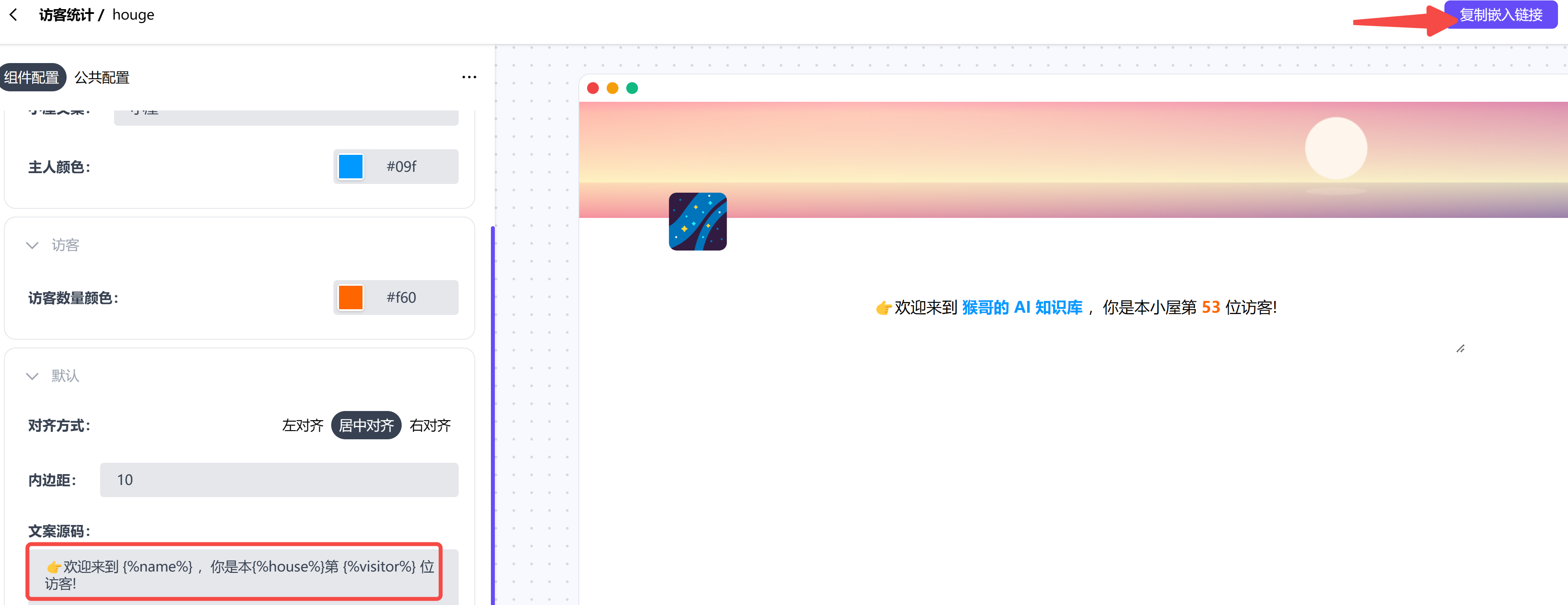

93 | 点击创建,在最下方有可以编辑的文案模板,其他配置也非常简单。

94 |

95 |

96 |

97 | 配置完成后,在右上方,点击 `复制嵌入链接`,会生成一个你的组件专属的 url,类似这个:

98 | `https://cn.widgetstore.net/view/index.html?q=5b049cc8622189440f31d6307d40e568.9bf3df1366b024e705ac9c7046a46b8e`

99 |

100 | 接下来,你只需要在 markdown 文件中,按照如下方式插入:

101 |

102 | ```

103 |

104 | ```

105 |

106 | docsify 会自动将 markdown 文件渲染成 html 文件,刷新一下你的网站,就可以看到效果了:

107 |

108 |

109 |

110 | ## 写在最后

111 |

112 | 想知道你的网站有多受欢迎?

113 |

114 | 本文带你玩转 Google Analytics 和 NotionPet 流量统计工具,让你轻松掌握网站流量的秘密!

115 |

116 | 感兴趣的小伙伴,快去试试,窥探一下你的网站魅力指数吧~

117 |

118 | 如果本文对你有帮助,不妨点个**免费的赞**和**收藏**备用。你的支持是我创作的最大动力。

--------------------------------------------------------------------------------

/docs/3.AI笔记/16.3K Star!AI 驱动的的开源爬虫工具.md:

--------------------------------------------------------------------------------

1 |

2 | 前段时间,给微信机器人-`小爱(AI)`新增了一个 `AI日报`的功能。

3 |

4 |

5 |

6 | 有朋友问怎么做的?

7 |

8 | 其实,这里只用了最简单的爬虫,然后通过定时任务发送。

9 |

10 | 今天,看到一个**更加简单易用、功能强大**爬虫工具 - `Crawl4AI`,几行代码,就能实现高效的网页爬取,分享给大家。

11 |

12 | > 项目地址:[https://github.com/unclecode/crawl4ai](https://github.com/unclecode/crawl4ai)

13 |

14 |

15 | ## 1. Crawl4AI 简介

16 |

17 |

18 |

19 | Crawl4AI 是一个开源免费的自动化数据提取工具,曾荣登 GitHub Trending 榜一!

20 |

21 | 老规矩,简单介绍下项目亮点:

22 | - **AI 驱动**:利用大型语言模型(LLM)智能识别和解析网页数据。

23 | - **结构化输出**:将数据转换为 JSON、Markdown 等格式,便于分析和AI模型训练。

24 | - **高度定制化**:允许自定义认证、请求头、页面修改、用户代理和执行JavaScript。

25 |

26 |

27 | ## 2. 安装

28 |

29 | 推荐两种安装方式。

30 |

31 | ### 2.1 使用 pip 安装

32 |

33 | ```

34 | pip install crawl4ai

35 | ```

36 |

37 | 默认情况下,这将安装异步版本 Crawl4AI,并使用 Playwright 进行网页爬取。

38 |

39 | 👉 注意:安装脚本会自动安装并设置 Playwright。如果遇到与 Playwright 相关的报错,可使用以下方法手动安装:

40 |

41 | ```

42 | playwright install

43 | ```

44 |

45 | ### 2.2 使用 docker 安装

46 |

47 | 直接拉取官方镜像,跑一个容器:

48 |

49 | ```

50 | docker pull unclecode/crawl4ai:basic # Basic crawling features

51 | # 或者

52 | docker pull unclecode/crawl4ai:all # Full installation (ML, LLM support)

53 | # 或者

54 | docker pull unclecode/crawl4ai:gpu # GPU-enabled version

55 |

56 | # Run the container

57 | docker run -p 11235:11235 unclecode/crawl4ai:basic # Replace 'basic' with your chosen version

58 | ```

59 |

60 | 如果镜像拉取失败,也可以拉取官方仓库,自己构建镜像:

61 |

62 | ```

63 | git clone https://github.com/unclecode/crawl4ai.git

64 | cd crawl4ai

65 |

66 | # Build the image

67 | docker build -t crawl4ai:local \

68 | --build-arg INSTALL_TYPE=basic \ # Options: basic, all

69 | .

70 |

71 | # Run your local build

72 | docker run -p 11235:11235 crawl4ai:local

73 | ```

74 |

75 |

76 |

77 | ## 3. 使用

78 |

79 | ### 3.1 本地pip包

80 |

81 | 如果是本地 pip 安装,使用非常简单,采用异步函数实现,示例如下:

82 |

83 | ```

84 | import asyncio

85 | from crawl4ai import AsyncWebCrawler

86 |

87 | async def main():

88 | async with AsyncWebCrawler(verbose=True) as crawler:

89 | result = await crawler.arun(url="https://www.nbcnews.com/business")

90 | print(result.markdown)

91 |

92 | if __name__ == "__main__":

93 | asyncio.run(main())

94 | ```

95 |

96 | 如果要抓取外网内容,需要加上代理:

97 |

98 | ```

99 | import asyncio

100 | from crawl4ai import AsyncWebCrawler

101 |

102 | async def main():

103 | async with AsyncWebCrawler(verbose=True, proxy="http://127.0.0.1:7890") as crawler:

104 | result = await crawler.arun(

105 | url="https://www.nbcnews.com/business",

106 | bypass_cache=True

107 | )

108 | print(result.markdown)

109 |

110 | if __name__ == "__main__":

111 | asyncio.run(main())

112 | ```

113 | ### 3.2 docker 容器

114 | 如果是 docker 镜像安装的,调用需分两步。

115 |

116 | 因为是异步服务,所以:

117 | - 第一步请求会拿到 task_id,

118 | - 第二步基于 task_id 轮询获取结果。

119 |

120 | ```

121 | import requests

122 |

123 | # Submit a crawl job

124 | response = requests.post(

125 | "http://localhost:11235/crawl",

126 | json={"urls": "https://example.com", "priority": 10}

127 | )

128 | task_id = response.json()["task_id"]

129 |

130 | # Get results

131 | result = requests.get(f"http://localhost:11235/task/{task_id}")

132 | ```

133 |

134 |

135 | ## 4. 效果展示

136 |

137 | 下面,以抓取一个 html 页面,并输出为 markdown 格式,给大家展现下效果。

138 |

139 | **速度超快:**

140 |

141 |

142 |

143 | **首页内容:**

144 |

145 |

146 |

147 |

148 |

149 |

150 | **页面底部:**

151 |

152 |

153 |

154 |

155 | **侧边栏:**

156 |

157 |

158 |

159 |

160 |

161 | 怎么样?

162 |

163 | 更多高级策略使用,可参考官方仓库:[https://github.com/unclecode/crawl4ai](https://github.com/unclecode/crawl4ai)

164 |

165 | ## 写在最后

166 |

167 | Crawl4AI,一款功能强大且简单易用的网页爬虫工具,而且速度超快,有需要的朋友,可以去试试了。

168 |

169 | 如果对你有帮助,欢迎**点赞收藏**备用。

170 |

--------------------------------------------------------------------------------

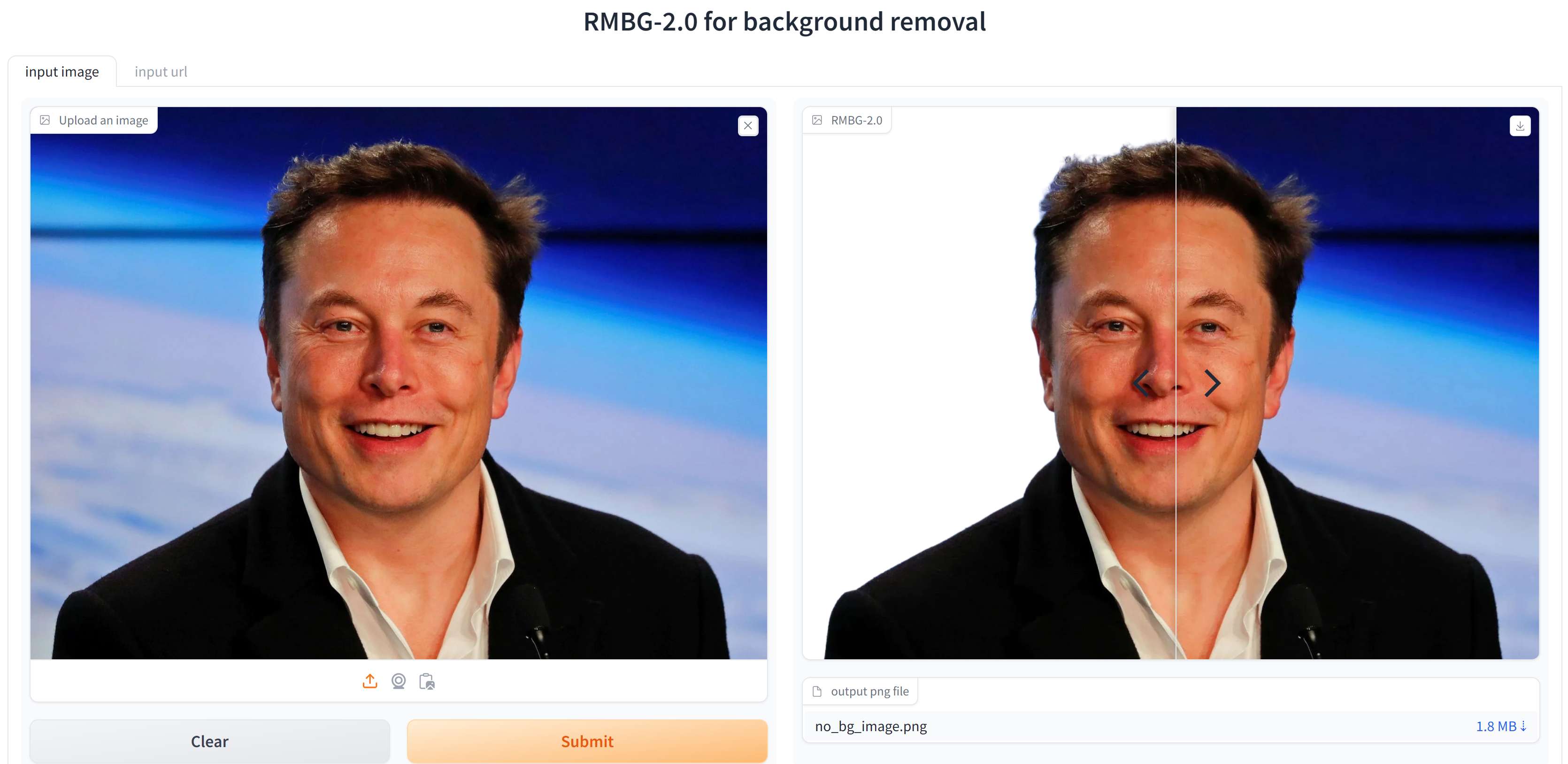

/docs/3.AI笔记/37K 下载!开源图像背景去除项目,精确到发丝,数字人福音.md:

--------------------------------------------------------------------------------

1 |

2 | 最近 AI 数字人领域进展迅速,多款开源方案,效果炸裂,直逼付费方案-HeyGen!

3 |

4 | 我们在各大短视频平台刷到的数字人,背后的制作流程大致包括:

5 | - 底模数字人视频生成

6 | - AI 换脸(FaceFusion 等)

7 | - **背景去除**

8 | - 背景合成

9 |

10 |

11 | 作为数字人背后的关键技术--**背景去除**,很大程度上决定了最终生成视频的真实度。

12 |

13 | 今天,我们不讲数字人,分享一款**开源免费、轻量高效**的背景去除方案 - `RMBG-2.0`,并带大家本地部署实操。

14 |

15 | > 项目地址:[https://github.com/ai-anchorite/BRIA-RMBG-2.0](https://github.com/ai-anchorite/BRIA-RMBG-2.0)

16 |

17 |

18 | ## 1.RMBG-2.0 亮点

19 |

20 | 老规矩,简单介绍下项目亮点:

21 | - **高精度背景移除**:能够精确识别并移除复杂图像中的背景,提供边缘清晰、自然度高的专业级图像质量。

22 | - **丰富多样的训练数据**:该模型在超过 15,000 张涵盖多种领域的高质量图像上进行训练,确保了其准确性和广泛的适用性。

23 | - **高效的处理速度**:单张 1024x1024 图像,GPU推理耗时约 0.15s。

24 |

25 | 先看下官方测试效果:

26 |

27 |

28 |

29 | 感兴趣的朋友,可前往官方体验地址:[https://huggingface.co/spaces/briaai/BRIA-RMBG-2.0](https://huggingface.co/spaces/briaai/BRIA-RMBG-2.0)

30 |

31 | 测试效果如下:

32 |

33 |

34 |

35 | ## 2. 本地部署

36 |

37 | 项目开源了模型权重,为此,可下载到本地自行部署,使用也非常简单,几行代码搞定!

38 |

39 | ### 2.1 依赖安装

40 |

41 | 项目依赖以下仓库:

42 |

43 | ```

44 | torch

45 | torchvision

46 | pillow

47 | kornia

48 | transformers

49 | ```

50 |

51 | 可选择新建 requirents.txt,填入上述依赖库,一键安装。

52 |

53 | ```

54 | pip install -r requirents.txt

55 | ```

56 | ### 2.2 权重下载

57 | 模型权重托管在 huggingface 上:

58 | > 模型下载:[https://huggingface.co/briaai/RMBG-2.0](https://huggingface.co/briaai/RMBG-2.0)

59 |

60 | 考虑到国内访问 huggingface 比较麻烦,推荐大家从 ModelScope 下载:

61 |

62 | ```

63 | git lfs install

64 | git clone https://www.modelscope.cn/AI-ModelScope/RMBG-2.0.git

65 | ```

66 |

67 |

68 | ### 2.2 本地推理

69 |

70 | 推理示例代码:

71 |

72 | ```

73 | from PIL import Image

74 | import torch

75 | from torchvision import transforms

76 | from transformers import AutoModelForImageSegmentation

77 |

78 | model = AutoModelForImageSegmentation.from_pretrained('RMBG-2.0', trust_remote_code=True)

79 | torch.set_float32_matmul_precision(['high', 'highest'][0])

80 | model.to('cuda')

81 | model.eval()

82 | # Data settings

83 | transform_image = transforms.Compose([

84 | transforms.Resize((1024, 1024)),

85 | transforms.ToTensor(),

86 | transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

87 | ])

88 | image = Image.open('elon-musk.jpg')

89 | input_images = transform_image(image).unsqueeze(0).to('cuda')

90 |

91 | # Prediction

92 | with torch.no_grad():

93 | for i in range(10):

94 | preds = model(input_images)[-1].sigmoid().cpu()

95 | pred = preds[0].squeeze()

96 | pred_pil = transforms.ToPILImage()(pred)

97 | mask = pred_pil.resize(image.size)

98 | image.putalpha(mask)

99 |

100 | image.save("elon-musk_no_bg_image.png")

101 | ```

102 |

103 | 模型预设 1024x1024 输入,在单张 4080 显卡上耗时统计如下,基本稳定在 **0.15s/img**:

104 |

105 | ```

106 | Inference time: 0.147s

107 | Inference time: 0.147s

108 | Inference time: 0.150s

109 | Inference time: 0.147s

110 | Inference time: 0.147s

111 | ```

112 |

113 |

114 | 显存占用如何?

115 |

116 | ```

117 | 1 NVIDIA GeForce RTX 4080 On | 00000000:3B:00.0 Off | N/A |

118 | | 38% 28C P2 86W / 320W | 4667MiB / 16376MiB | 0% Default

119 | ```

120 | 推理需占用约 **5G** 显存。

121 |

122 | 实测效果如下,精确到发丝!

123 |

124 |

125 |

126 | ## 写在最后

127 |

128 | 本文介绍了一款强大且易用的背景去除工具- RMBG v2.0,本地部署,方便调用。

129 |

130 | 如果对你有帮助,欢迎**点赞收藏**备用。

131 |

132 | 当然,如果只要 web 端使用,给诸位分享一款免费工具:

133 |

134 | [https://www.remove.bg/zh](https://www.remove.bg/zh)

135 |

136 | ---

137 |

138 | 为方便大家交流,新建了一个 `AI 交流群`,欢迎感兴趣的小伙伴加入,公众号后台「联系我」,拉你进群。

139 |

--------------------------------------------------------------------------------

/docs/3.AI笔记/4k star!升级版OneAPI,助力 Dify 兼容 OpenAI 格式.md:

--------------------------------------------------------------------------------

1 | 最近用 dify 搭建了不少智能体,不过 dify 有一个缺陷。

2 |

3 | 相信用过的朋友会有同样的感受:**它的 API 和 Open AI 不兼容**!

4 |

5 | 这就导致一个应用中,用到 dify 的地方,还必须重新写一套 LLM 的调用逻辑。

6 |

7 | 很是麻烦,怎么搞?

8 |

9 | 前段时间,和大家分享过大模型分发和管理神器 OneAPI:

10 |

11 | [所有大模型一键封装成OpenAI协议](https://zhuanlan.zhihu.com/p/707769192)

12 |

13 | 并接入了多款大模型 API:

14 |

15 | [盘点 9 家免费且靠谱的AI大模型 API,统一封装,任性调用!](https://zhuanlan.zhihu.com/p/717498590)

16 |

17 | 实现一个接口聚合不同的大模型,再统一转换为 OpenAI 的 API,**遗憾的是不支持 Dify 接入**。

18 |

19 | 最近看到一款开源项目 **NewAPI**:对 OneAPI 进行了二次开发,实现了对 Dify 的支持。终于,Dify API 也可以通过 OpenAI 统一分发了!

20 |

21 | 话不多说,上实操!

22 |

23 | ## 1. 服务部署

24 | > 项目:[https://github.com/Calcium-Ion/new-api](https://github.com/Calcium-Ion/new-api)

25 |

26 | 推荐使用 docker 部署:

27 |

28 | **数据库使用 SQLite 的部署命令**:

29 |

30 | ```

31 | docker run -d --name newapi --restart always -p 3007:3000 -e TZ=Asia/Shanghai -v ./data:/data calciumion/new-api:latest

32 | ```

33 |

34 | 当然,也支持 Docker Compose 的方式:

35 |

36 | ```

37 | # 先下载项目到本地

38 | git clone https://github.com/Calcium-Ion/new-api.git

39 | # 然后修改 docker-compose.yml 文件

40 | # 最后启动

41 | docker-compose up -d

42 | ```

43 |

44 | ## 2. NewAPI 使用

45 | ### 2.1 登录

46 | 本地浏览器通过 IP + 端口的形式进行访问,初始账号密码:root 123456。

47 |

48 |

49 |

50 | ### 2.2 渠道

51 | 相信用过 OneAPI 的朋友,应该不陌生:`渠道`用于添加不同厂商的大模型。

52 |

53 | 点击「控制台-渠道-添加渠道」,在支持的渠道里选择 Dify:

54 |

55 |

56 |

57 |

58 |

59 |

60 | 然后,在`代理`这里:需填入 dify 的 IP地址+端口号。

61 |

62 |

63 |