├── .gitignore

├── Makefile

├── README.md

├── babel.config.js

├── codeblock

├── cni

│ └── ptp.json

├── containerization

│ ├── alpine-tz.dockerfile

│ ├── centos-tz.dockerfile

│ ├── maven-jar-pom.xml

│ ├── mount-tz.yaml

│ ├── tz-env.yaml

│ └── ubuntu-tz.dockerfile

├── graceful

│ └── update-strategy.yaml

├── handle-sigterm

│ ├── sigterm.go

│ ├── sigterm.java

│ ├── sigterm.js

│ ├── sigterm.py

│ └── sigterm.sh

├── hello.go

├── home-network

│ ├── 10-router.conf

│ ├── alist.yaml

│ ├── aria2.yaml

│ ├── clean.sh

│ ├── ddns.yaml

│ ├── dnsmasq.conf

│ ├── dnsmasq.yaml

│ ├── filebrowser.yaml

│ ├── home-assistant.yaml

│ ├── homepage.yaml

│ ├── ikev2.yaml

│ ├── jellyfin.yaml

│ ├── netplan-config-bypass-route.yaml

│ ├── netplan-config-main-route.yaml

│ ├── nfs.yaml

│ ├── nftables-firewall.conf

│ ├── nftables-tproxy.conf

│ ├── nftables.yaml

│ ├── nginx.yaml

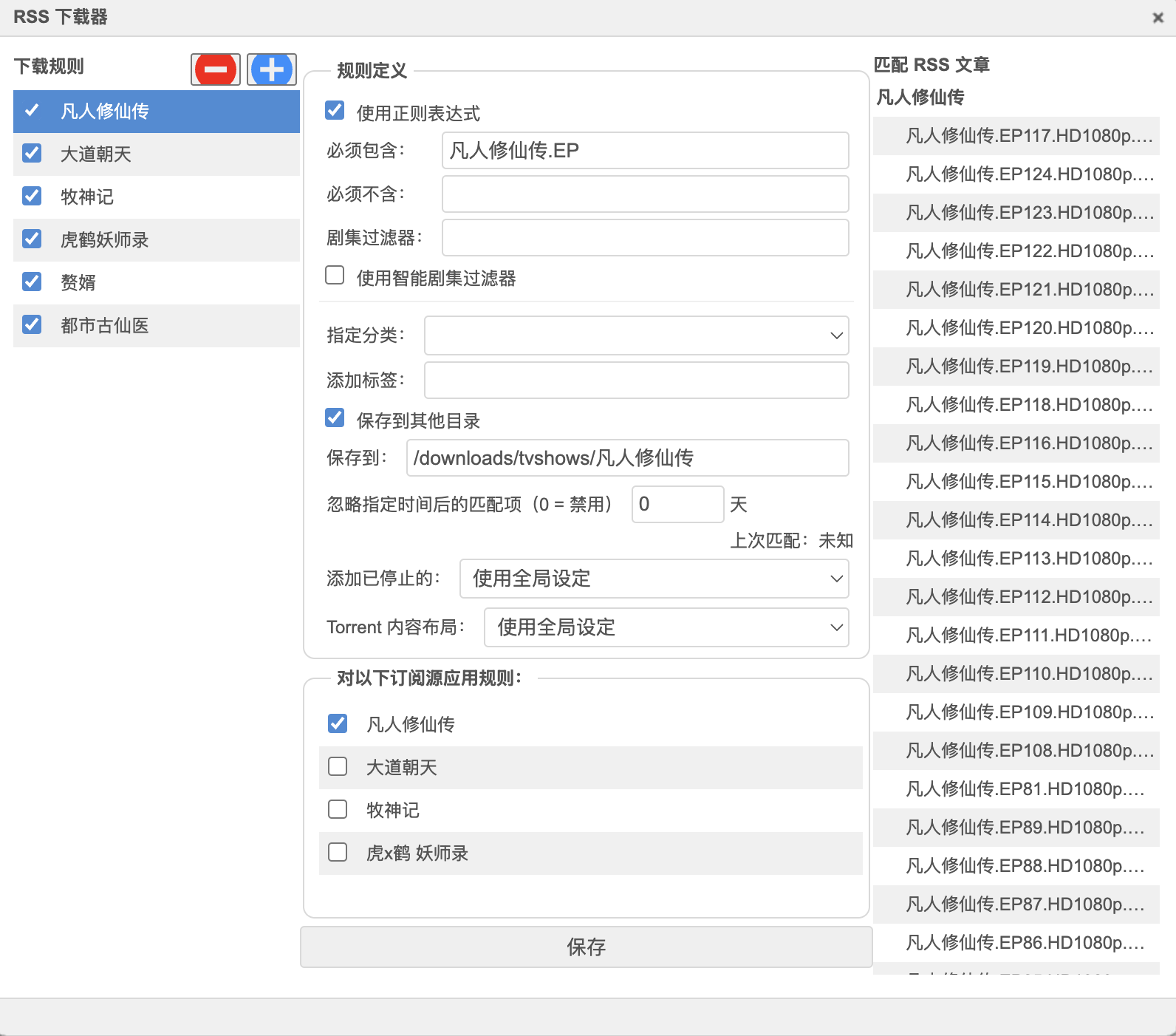

│ ├── qbittorrent.yaml

│ ├── radvd.conf

│ ├── radvd.yaml

│ ├── router.json

│ ├── samba.yaml

│ ├── set-rules.sh

│ ├── setup-pppoe.sh

│ └── vpn.env

├── llama

│ ├── download-llama3-8b.yaml

│ ├── llama3-cpu-8b.yaml

│ ├── llama3-gpu-70b.yaml

│ ├── ollama-nodeselector.yaml

│ ├── ollama.yaml

│ └── open-webui.yaml

├── prometheus

│ ├── kubernetes-pods.yaml

│ └── kubernetes-service-endpoints.yaml

├── rbac

│ ├── cluster-admin.yaml

│ ├── limit-sa.yaml

│ ├── readonly-all.yaml

│ ├── readonly-exclude-secret.yaml

│ ├── secret-reader-for-manager-group.yaml

│ └── test-admin-istio-system-readonly.yaml

├── sysctl

│ ├── set=sysctl-init-containers.yaml

│ └── set=sysctl-security-context.yaml

├── test

│ ├── ab.yaml

│ ├── hey.yaml

│ ├── httpbin.yaml

│ ├── nginx.yaml

│ └── wrk.yaml

└── webhook

│ ├── check-annotation.yaml

│ └── object-selector.yaml

├── content

├── README.md

├── appendix

│ ├── faq

│ │ ├── ipvs-conn-reuse-mode.md

│ │ └── why-enable-bridge-nf-call-iptables.md

│ ├── kubectl

│ │ ├── build.md

│ │ ├── get-raw.md

│ │ ├── node.md

│ │ └── pod.md

│ ├── terraform

│ │ ├── tke-serverless.md

│ │ └── tke-vpc-cni.md

│ └── yaml

│ │ ├── rbac.md

│ │ └── test.md

├── apps

│ └── set-sysctl.md

├── basics

│ └── README.md

├── best-practices

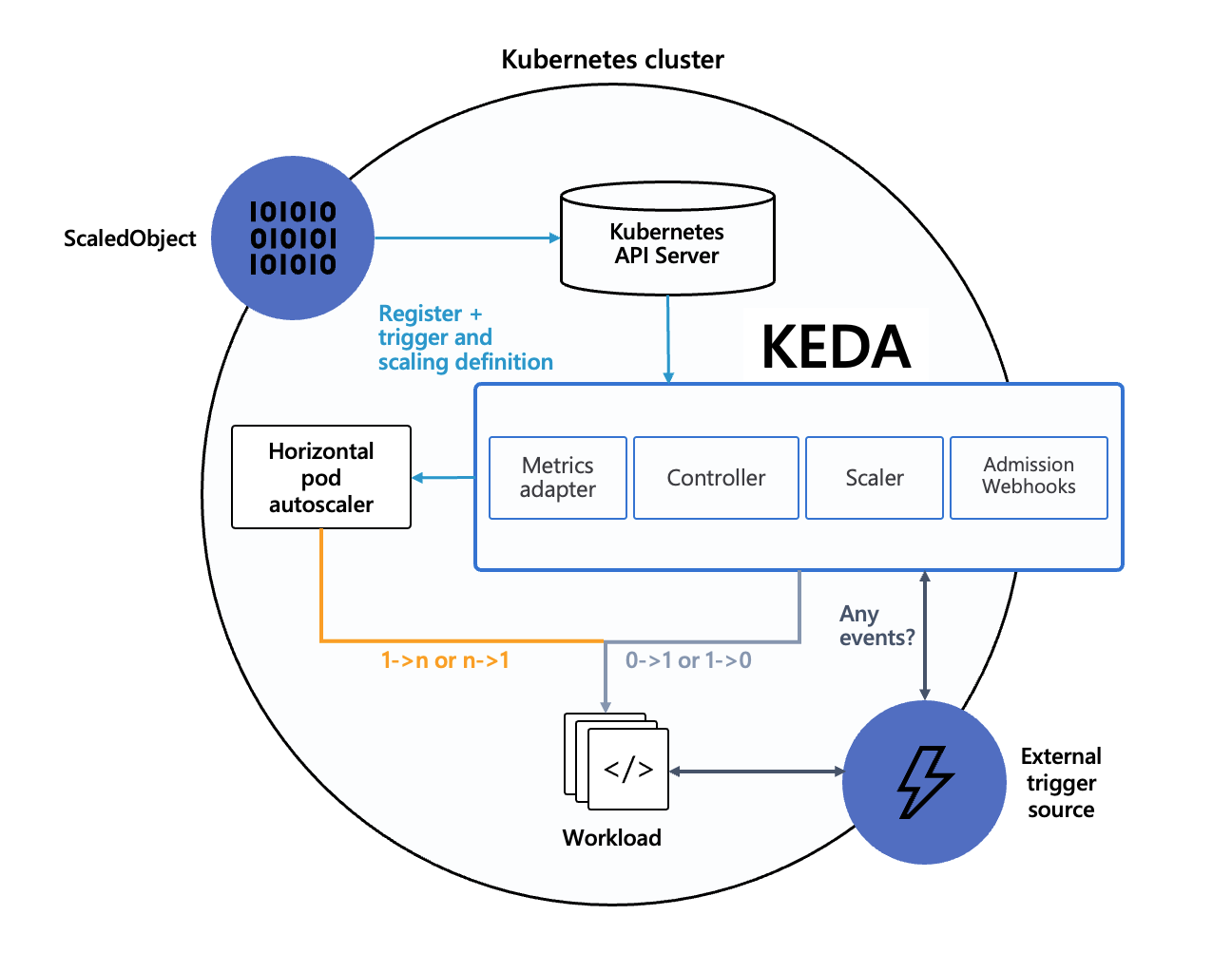

│ ├── autoscaling

│ │ ├── hpa-velocity.md

│ │ ├── hpa-with-custom-metrics

│ │ │ ├── keda.md

│ │ │ └── prometheus-adapter.md

│ │ └── keda

│ │ │ ├── cron.md

│ │ │ ├── install.md

│ │ │ ├── overview.md

│ │ │ ├── prometheus.md

│ │ │ └── workload.md

│ ├── configure-healthcheck.md

│ ├── containerization

│ │ ├── crontab.md

│ │ ├── golang.md

│ │ ├── java.md

│ │ ├── logrotate.md

│ │ ├── systemd.md

│ │ ├── thin-image.md

│ │ └── timezone.md

│ ├── dns

│ │ ├── customize-dns-resolution.md

│ │ └── optimize-coredns-performance.md

│ ├── graceful-shutdown

│ │ ├── intro.md

│ │ ├── lb-to-pod-directly.md

│ │ ├── long-connection.md

│ │ ├── pod-termination-proccess.md

│ │ ├── prestop.md

│ │ ├── sigterm.md

│ │ └── update-strategy.md

│ ├── ha

│ │ ├── pod-split-up-scheduling.md

│ │ └── smooth-upgrade.md

│ ├── logging.md

│ ├── long-connection.md

│ ├── ops

│ │ ├── batch-operate-node-with-ansible.md

│ │ ├── etcd-optimization.md

│ │ ├── large-scale-cluster-optimization.md

│ │ ├── securely-maintain-or-offline-node.md

│ │ └── securely-modify-container-root-dir.md

│ ├── performance-optimization

│ │ ├── cpu.md

│ │ └── network.md

│ └── request-limit.md

├── cases

│ ├── devcontainer

│ │ ├── deploy.md

│ │ ├── dind.md

│ │ ├── dockerfile.md

│ │ ├── host.md

│ │ ├── lang.md

│ │ ├── other.md

│ │ ├── overview.md

│ │ ├── packages.md

│ │ ├── ssh.md

│ │ └── sync-config.md

│ ├── home-network

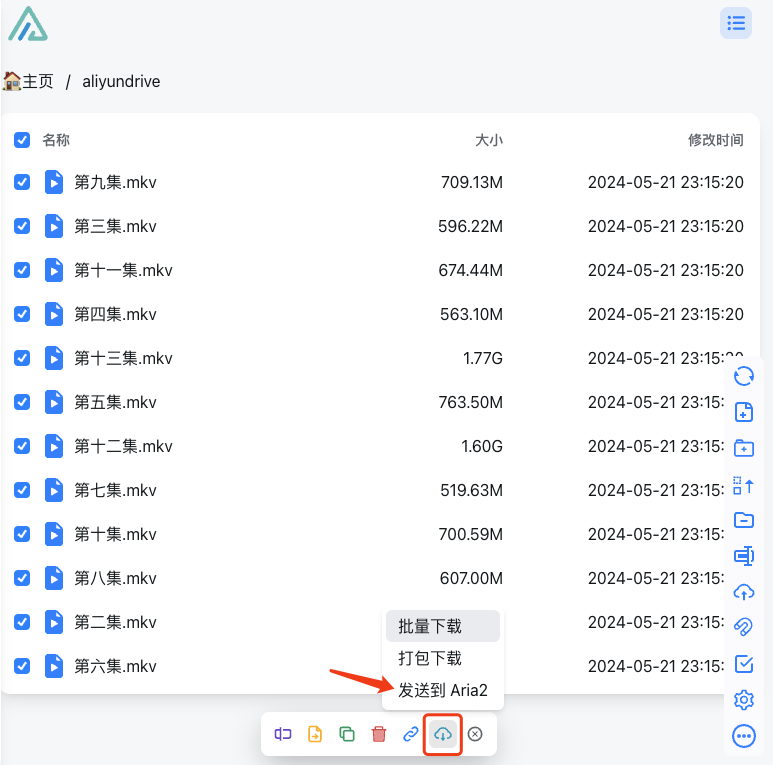

│ │ ├── alist.md

│ │ ├── aria2.md

│ │ ├── containerized-nftables.md

│ │ ├── ddns.md

│ │ ├── dnsmasq.md

│ │ ├── filebrowser.md

│ │ ├── gitops.md

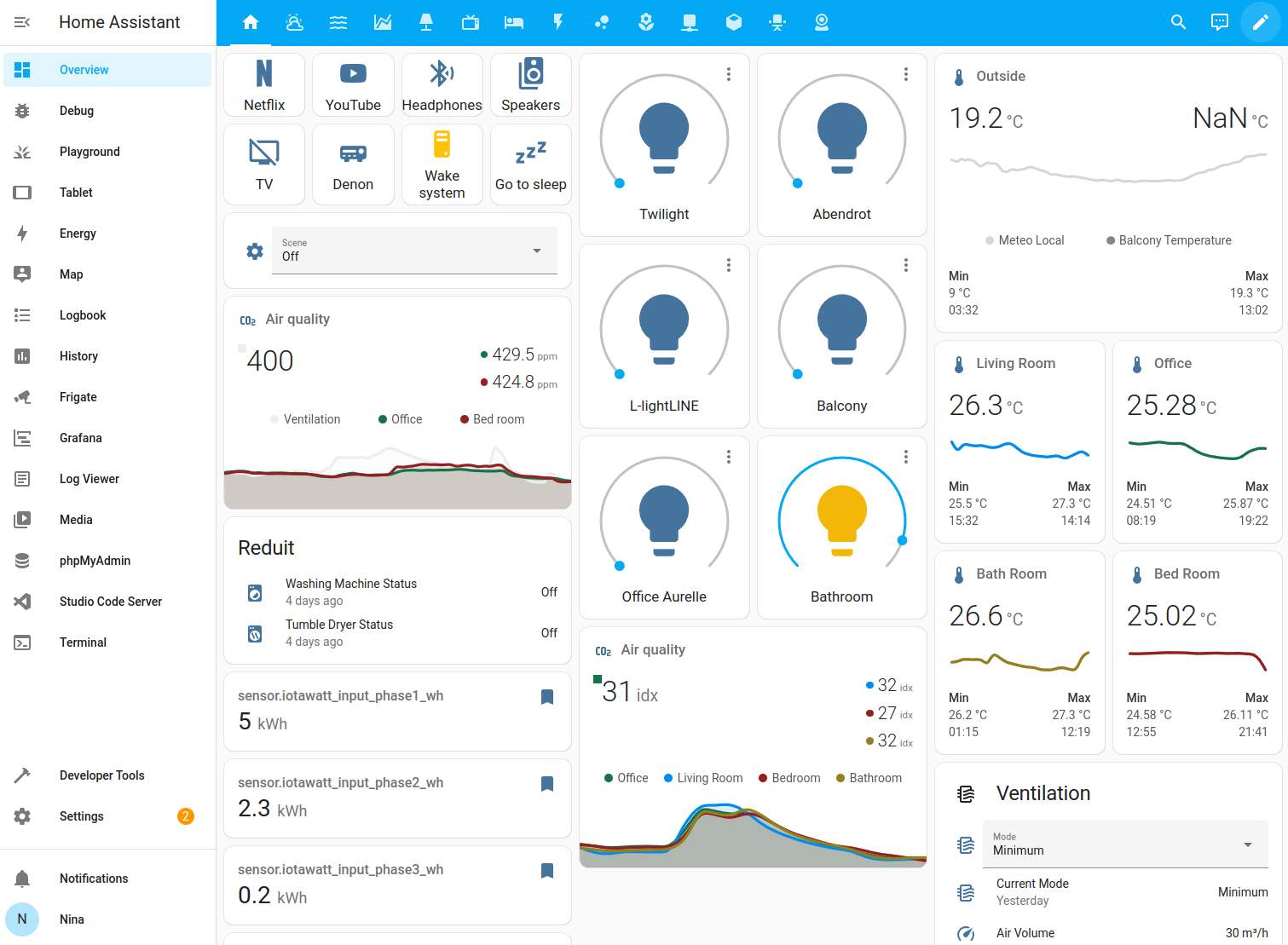

│ │ ├── home-assistant.md

│ │ ├── homepage.md

│ │ ├── ikev2.md

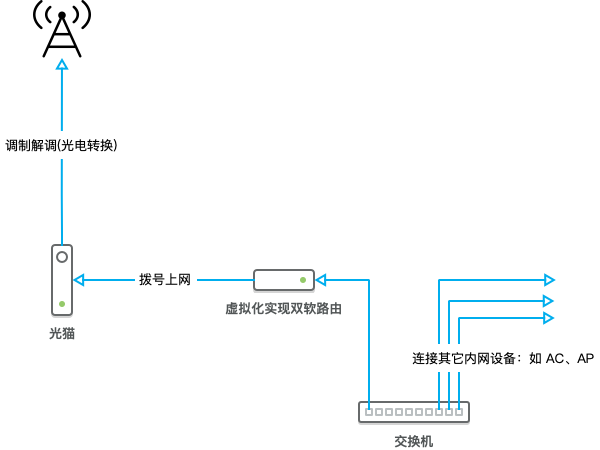

│ │ ├── intro.md

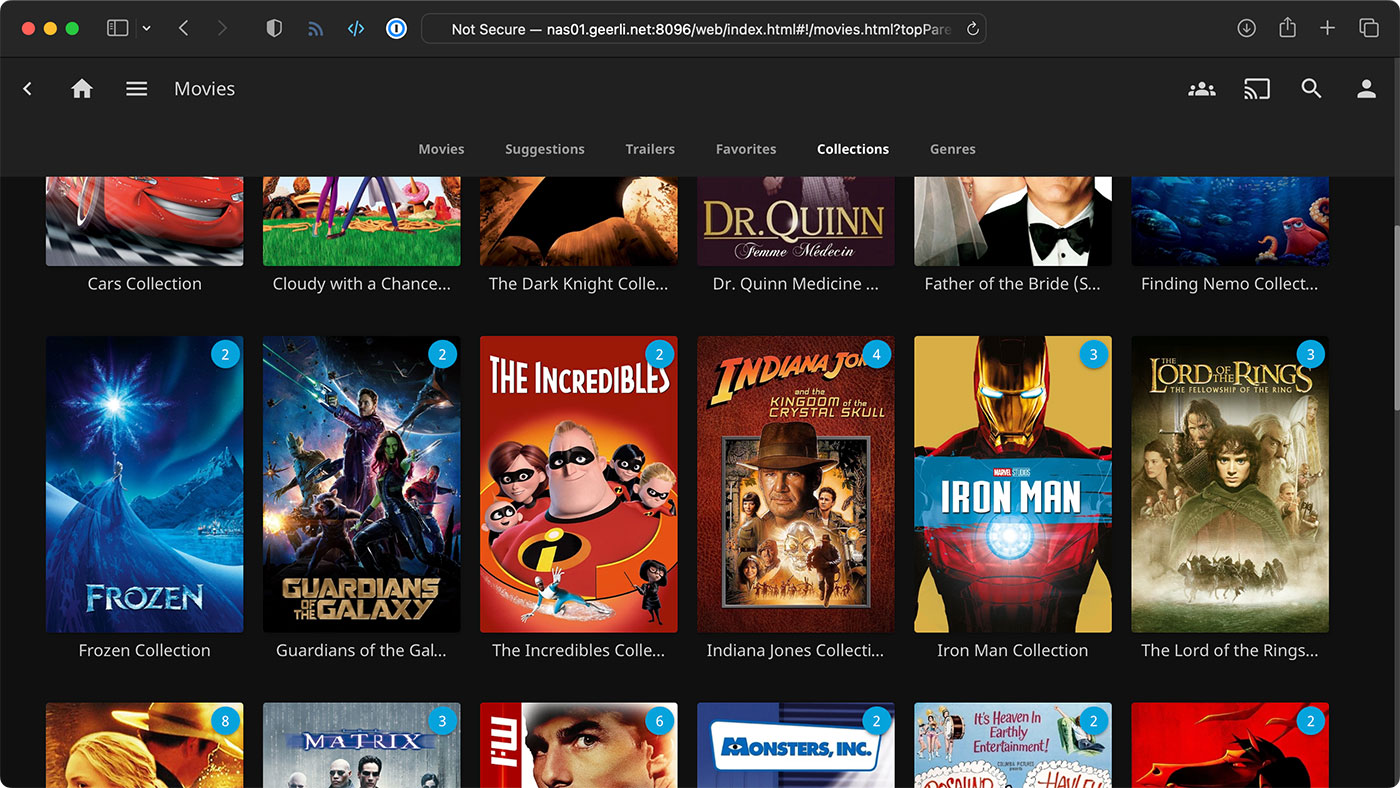

│ │ ├── jellyfin.md

│ │ ├── monitoring.md

│ │ ├── network-config.md

│ │ ├── nfs.md

│ │ ├── prepare.md

│ │ ├── qbittorrent.md

│ │ ├── radvd.md

│ │ ├── samba.md

│ │ └── tproxy.md

│ ├── llama3.md

│ └── nextcloud.md

├── certs

│ ├── sign-certs-with-cfssl.md

│ ├── sign-free-certs-for-dnspod.md

│ └── sign-free-certs-with-cert-manager.md

├── deploy

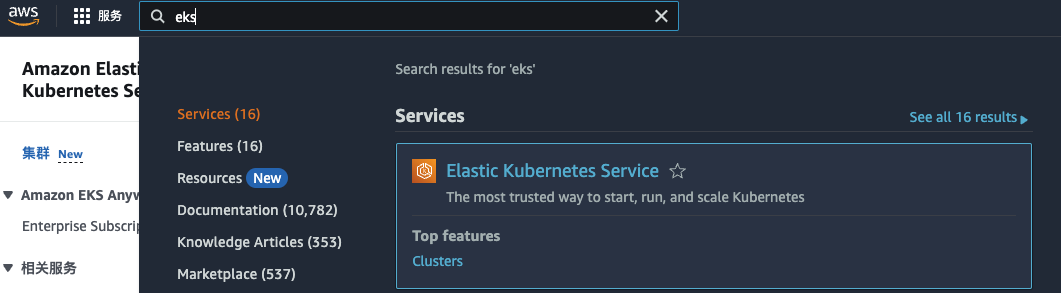

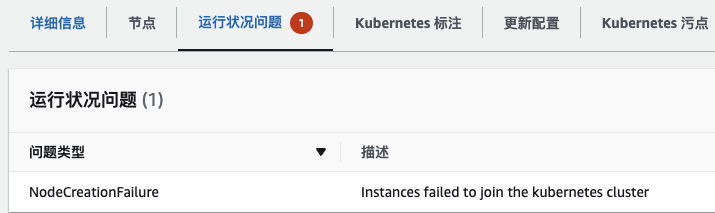

│ ├── aws

│ │ ├── aws-load-balancer-controller.md

│ │ └── eks.md

│ ├── k3s

│ │ ├── install.md

│ │ └── offline.md

│ ├── kubespray

│ │ ├── install.md

│ │ └── offline.md

│ └── terraform.md

├── dev

│ └── kubebuilder

│ │ ├── init-before-start.md

│ │ ├── multi-version.md

│ │ ├── quickstart.md

│ │ ├── reconcile-trigger.md

│ │ ├── reconcile.md

│ │ ├── remove-api.md

│ │ └── webhook.md

├── gitops

│ └── argocd

│ │ ├── cluster-and-repo.md

│ │ ├── install.md

│ │ └── project.md

├── images

│ ├── podman.md

│ └── sync-images-with-skopeo.md

├── kubectl

│ ├── build.md

│ ├── kubectl-aliases.md

│ ├── kubie.md

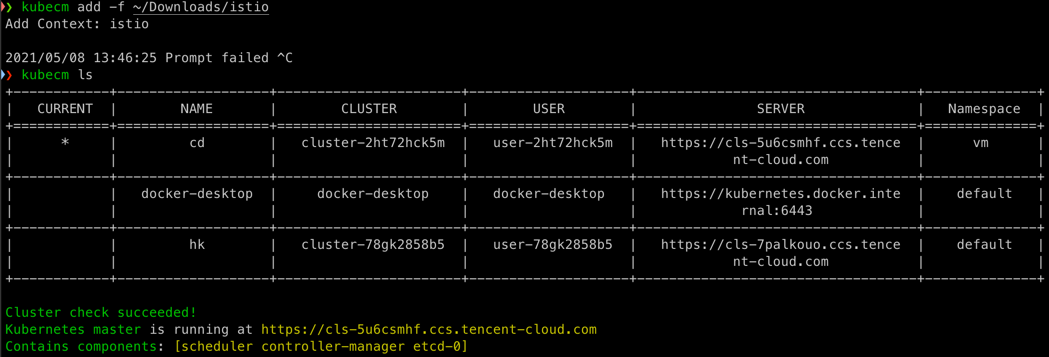

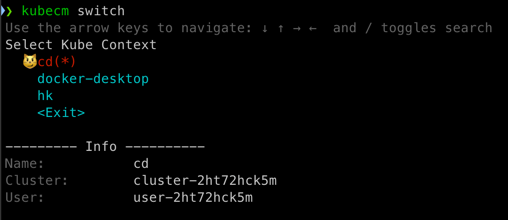

│ ├── merge-kubeconfig-with-kubecm.md

│ └── quick-switch-with-kubectx.md

├── monitoring

│ ├── dcgm-exporter.md

│ ├── grafana

│ │ └── ha.md

│ ├── prometheus

│ │ └── annotation-discovery.md

│ └── victoriametrics

│ │ └── install-with-operator.md

├── rbac

│ └── create-user-using-csr-api.md

└── sidebars.ts

├── coscli.log

├── docusaurus.config.ts

├── giscus.json

├── package-lock.json

├── package.json

├── src

├── components

│ ├── Comment.tsx

│ └── FileBlock.tsx

├── css

│ └── custom.scss

├── theme

│ ├── DocCategoryGeneratedIndexPage

│ │ └── index.tsx

│ ├── DocItem

│ │ └── Layout

│ │ │ └── index.tsx

│ └── MDXComponents.tsx

└── utils

│ └── prismDark.ts

├── static

├── img

│ └── logo.svg

├── js

│ └── BigPicture.min.js

└── manifest.json

└── tsconfig.json

/.gitignore:

--------------------------------------------------------------------------------

1 | # Dependencies

2 | /node_modules

3 |

4 | # Production

5 | /build

6 |

7 | # Generated files

8 | .docusaurus

9 | .cache-loader

10 |

11 | # Misc

12 | .DS_Store

13 | .env.local

14 | .env.development.local

15 | .env.test.local

16 | .env.production.local

17 |

18 | npm-debug.log*

19 | yarn-debug.log*

20 | yarn-error.log*

21 |

--------------------------------------------------------------------------------

/Makefile:

--------------------------------------------------------------------------------

1 | SHELL := /bin/bash

2 |

3 | start:

4 | npm run start

5 | install:

6 | npm install

7 | outdated:

8 | npm outdated

9 | init: install

10 | git clone --depth=1 git@gitee.com:imroc/kubernetes-guide.git build

11 | gen:

12 | npx docusaurus build --out-dir=./build/out

13 | push:

14 | cd build && git add -A && git commit -m update && git push

15 | update: install gen push

16 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # Kubernetes 实践指南

2 |

3 | 本书将介绍 Kubernetes 相关实战经验与总结,助你成为一名云原生老司机 😎。

4 |

5 | ## 关于本书

6 |

7 | 本书为电子书形式,内容为本人多年的云原生与 Kubernetes 实战经验进行系统性整理的结果,不废话,纯干货。

8 |

9 | ## 在线阅读

10 |

11 | 地址:https://imroc.cc/kubernetes

12 |

13 | ## 评论与互动

14 |

15 | 本书已集成 [giscus](https://giscus.app/zh-CN) 评论系统,欢迎对感兴趣的文章进行评论与交流。

16 |

17 | ## 贡献

18 |

19 | 本书使用 [docusaurus](https://docusaurus.io/) 构建,已集成自动构建和发布,欢迎 Fork 并 PR 来贡献干货内容 (点击左下角 `编辑此页` 按钮可快速修改文章)。

20 |

21 | ## 许可证

22 |

23 | 您可以使用 [署名 - 非商业性使用 - 相同方式共享 4.0 (CC BY-NC-SA 4.0)](https://creativecommons.org/licenses/by-nc-sa/4.0/deed.zh) 协议共享。

24 |

--------------------------------------------------------------------------------

/babel.config.js:

--------------------------------------------------------------------------------

1 | module.exports = {

2 | presets: [require.resolve('@docusaurus/core/lib/babel/preset')],

3 | };

4 |

--------------------------------------------------------------------------------

/codeblock/cni/ptp.json:

--------------------------------------------------------------------------------

1 | {

2 | "cniVersion": "0.3.1",

3 | "name": "ptp",

4 | "plugins": [

5 | {

6 | "ipMasq": false,

7 | "ipam": {

8 | "dataDir": "/run/cni-ipam-state",

9 | "ranges": [

10 | [

11 | {

12 | "subnet": "10.244.2.0/24"

13 | }

14 | ]

15 | ],

16 | "routes": [

17 | {

18 | "dst": "0.0.0.0/0"

19 | }

20 | ],

21 | "type": "host-local"

22 | },

23 | "mtu": 1500,

24 | "type": "ptp"

25 | },

26 | {

27 | "capabilities": {

28 | "portMappings": true

29 | },

30 | "snat": false,

31 | "externalSetMarkChain": "KUBE-MARK-MASQ",

32 | "type": "portmap"

33 | }

34 | ]

35 | }

36 |

--------------------------------------------------------------------------------

/codeblock/containerization/alpine-tz.dockerfile:

--------------------------------------------------------------------------------

1 | FROM alpine:latest

2 |

3 | # 安装 tzdata,复制里面的时区文件后删除 tzdata,保持精简

4 | RUN apk add --no-cache tzdata && \

5 | cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime && \

6 | apk del tzdata && \

7 | echo "Asia/Shanghai" > /etc/timezone

8 |

--------------------------------------------------------------------------------

/codeblock/containerization/centos-tz.dockerfile:

--------------------------------------------------------------------------------

1 | FROM centos:latest

2 |

3 | RUN rm -f /etc/localtime \

4 | && ln -sv /usr/share/zoneinfo/Asia/Shanghai /etc/localtime \

5 | && echo "Asia/Shanghai" > /etc/timezone

6 |

--------------------------------------------------------------------------------

/codeblock/containerization/maven-jar-pom.xml:

--------------------------------------------------------------------------------

1 |

2 |

5 | 4.0.0

6 |

7 | org.example

8 | http

9 | 1.0-SNAPSHOT

10 |

11 |

12 |

13 | 11

14 | 11

15 |

16 |

17 |

18 |

19 | app

20 |

21 |

22 |

23 | org.apache.maven.plugins

24 | maven-jar-plugin

25 |

26 |

27 |

28 |

29 | org.example.http.HttpTest

30 |

31 | true

32 |

33 | ./lib/

34 |

35 | false

36 |

37 |

38 |

39 |

40 |

41 |

42 | org.apache.maven.plugins

43 | maven-dependency-plugin

44 |

45 |

46 | copy

47 | package

48 |

49 | copy-dependencies

50 |

51 |

52 | ${project.build.directory}/lib

53 |

54 |

55 |

56 |

57 |

58 |

59 |

60 |

61 |

62 | org.apache.httpcomponents.client5

63 | httpclient5

64 | 5.1.3

65 |

66 |

67 |

68 |

69 |

70 |

--------------------------------------------------------------------------------

/codeblock/containerization/mount-tz.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: Deployment

3 | metadata:

4 | name: app

5 | spec:

6 | replicas: 1

7 | selector:

8 | matchLabels:

9 | app: app

10 | template:

11 | metadata:

12 | labels:

13 | app: app

14 | spec:

15 | containers:

16 | - name: app

17 | image: app

18 | volumeMounts:

19 | # highlight-start

20 | - name: tz

21 | mountPath: /etc/localtime

22 | # highlight-end

23 | volumes:

24 | # highlight-start

25 | - name: tz

26 | hostPath:

27 | path: /etc/localtime

28 | # highlight-end

29 |

--------------------------------------------------------------------------------

/codeblock/containerization/tz-env.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: Deployment

3 | metadata:

4 | name: app

5 | spec:

6 | replicas: 1

7 | selector:

8 | matchLabels:

9 | app: app

10 | template:

11 | metadata:

12 | labels:

13 | app: app

14 | spec:

15 | containers:

16 | - name: app

17 | image: app

18 | env:

19 | # highlight-start

20 | - name: TZ

21 | value: Asia/Shanghai

22 | # highlight-end

23 |

--------------------------------------------------------------------------------

/codeblock/containerization/ubuntu-tz.dockerfile:

--------------------------------------------------------------------------------

1 | FROM ubuntu:latest

2 |

3 | RUN apt update -y && \

4 | DEBIAN_FRONTEND="noninteractive" apt -y install tzdata

5 | RUN ln -fs /usr/share/zoneinfo/Asia/Shanghai /etc/localtime && \

6 | dpkg-reconfigure -f noninteractive tzdata

7 |

--------------------------------------------------------------------------------

/codeblock/graceful/update-strategy.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: Deployment

3 | metadata:

4 | name: nginx

5 | spec:

6 | replicas: 1

7 | selector:

8 | matchLabels:

9 | app: nginx

10 | strategy:

11 | # highlight-start

12 | type: RollingUpdate

13 | rollingUpdate: # 单个串行升级,等新副本 ready 后才开始销毁旧副本

14 | maxUnavailable: 0

15 | maxSurge: 1

16 | # highlight-end

17 | template:

18 | metadata:

19 | labels:

20 | app: nginx

21 | spec:

22 | containers:

23 | - name: nginx

24 | image: nginx:latest

25 | startupProbe:

26 | httpGet:

27 | path: /

28 | port: 80

29 | # highlight-next-line

30 | successThreshold: 5 # 新副本启动时,连续探测成功多次后才交给 readinessProbe 探测

31 | periodSeconds: 5

32 | readinessProbe:

33 | httpGet:

34 | path: /

35 | port: 80

36 | # highlight-next-line

37 | successThreshold: 1 # 运行过程中探测 1 次成功就认为 ready,可在抖动导致异常后快速恢复服务

38 | periodSeconds: 5

39 |

--------------------------------------------------------------------------------

/codeblock/handle-sigterm/sigterm.go:

--------------------------------------------------------------------------------

1 | package main

2 |

3 | import (

4 | "fmt"

5 | "os"

6 | "os/signal"

7 | "syscall"

8 | )

9 |

10 | func main() {

11 | sigs := make(chan os.Signal, 1)

12 | done := make(chan bool, 1)

13 | // registers the channel

14 | signal.Notify(sigs, syscall.SIGTERM)

15 |

16 | go func() {

17 | sig := <-sigs

18 | fmt.Println("Caught SIGTERM, shutting down")

19 | // Finish any outstanding requests, then...

20 | done <- true

21 | }()

22 |

23 | fmt.Println("Starting application")

24 | // Main logic goes here

25 | <-done

26 | fmt.Println("exiting")

27 | }

28 |

--------------------------------------------------------------------------------

/codeblock/handle-sigterm/sigterm.java:

--------------------------------------------------------------------------------

1 | import sun.misc.Signal;

2 | import sun.misc.SignalHandler;

3 |

4 | public class ExampleSignalHandler {

5 | public static void main(String... args) throws InterruptedException {

6 | final long start = System.nanoTime();

7 | Signal.handle(new Signal("TERM"), new SignalHandler() {

8 | public void handle(Signal sig) {

9 | System.out.format("\nProgram execution took %f seconds\n", (System.nanoTime() - start) / 1e9f);

10 | System.exit(0);

11 | }

12 | });

13 | int counter = 0;

14 | while(true) {

15 | System.out.println(counter++);

16 | Thread.sleep(500);

17 | }

18 | }

19 | }

20 |

21 |

--------------------------------------------------------------------------------

/codeblock/handle-sigterm/sigterm.js:

--------------------------------------------------------------------------------

1 | process.on('SIGTERM', () => {

2 | console.log('The service is about to shut down!');

3 |

4 | // Finish any outstanding requests, then...

5 | process.exit(0);

6 | });

7 |

8 |

--------------------------------------------------------------------------------

/codeblock/handle-sigterm/sigterm.py:

--------------------------------------------------------------------------------

1 | import signal, time, os

2 |

3 | def shutdown(signum, frame):

4 | print('Caught SIGTERM, shutting down')

5 | # Finish any outstanding requests, then...

6 | exit(0)

7 |

8 | if __name__ == '__main__':

9 | # Register handler

10 | signal.signal(signal.SIGTERM, shutdown)

11 | # Main logic goes here

12 |

13 |

--------------------------------------------------------------------------------

/codeblock/handle-sigterm/sigterm.sh:

--------------------------------------------------------------------------------

1 | #!/bin/sh

2 |

3 | ## Redirecting Filehanders

4 | ln -sf /proc/$$/fd/1 /log/stdout.log

5 | ln -sf /proc/$$/fd/2 /log/stderr.log

6 |

7 | ## Pre execution handler

8 | pre_execution_handler() {

9 | ## Pre Execution

10 | # TODO: put your pre execution steps here

11 | : # delete this nop

12 | }

13 |

14 | ## Post execution handler

15 | post_execution_handler() {

16 | ## Post Execution

17 | # TODO: put your post execution steps here

18 | : # delete this nop

19 | }

20 |

21 | ## Sigterm Handler

22 | sigterm_handler() {

23 | if [ $pid -ne 0 ]; then

24 | # the above if statement is important because it ensures

25 | # that the application has already started. without it you

26 | # could attempt cleanup steps if the application failed to

27 | # start, causing errors.

28 | kill -15 "$pid"

29 | wait "$pid"

30 | post_execution_handler

31 | fi

32 | exit 143 # 128 + 15 -- SIGTERM

33 | }

34 |

35 | ## Setup signal trap

36 | # on callback execute the specified handler

37 | trap 'sigterm_handler' SIGTERM

38 |

39 | ## Initialization

40 | pre_execution_handler

41 |

42 | ## Start Process

43 | # run process in background and record PID

44 | "$@" >/log/stdout.log 2>/log/stderr.log &

45 | pid="$!"

46 | # Application can log to stdout/stderr, /log/stdout.log or /log/stderr.log

47 |

48 | ## Wait forever until app dies

49 | wait "$pid"

50 | return_code="$?"

51 |

52 | ## Cleanup

53 | post_execution_handler

54 | # echo the return code of the application

55 | exit $return_code

56 |

--------------------------------------------------------------------------------

/codeblock/hello.go:

--------------------------------------------------------------------------------

1 | package main

2 |

3 | import (

4 | "fmt"

5 | )

6 |

7 | func main() {

8 | for i := 0; i < 10; i++ {

9 | fmt.Println("hello world", i)

10 | }

11 | }

12 |

--------------------------------------------------------------------------------

/codeblock/home-network/10-router.conf:

--------------------------------------------------------------------------------

1 |

2 | # 作为路由器,启用 ip 转发 (ipv6默认关闭)

3 | net.ipv4.ip_forward=1

4 | net.ipv6.conf.all.forwarding=1

5 | net.ipv6.conf.default.forwarding=1

6 |

7 | # 接收来自运营商(ISP) 的 ipv6 RA (路由通告),以获取公网 ipv6 地址

8 | #net.ipv6.conf.all.accept_ra=2

9 | #net.ipv6.conf.enp1s0.accept_ra=2

10 | #net.ipv6.conf.default.accept_ra=2

11 | #net.ipv6.conf.all.accept_ra_rt_info_max_plen=128

12 | #net.ipv6.conf.default.accept_ra_rt_info_max_plen=128

13 | #net.ipv6.conf.enp1s0.accept_ra_rt_info_max_plen=128

14 |

15 | # 禁用ipv6

16 | net.ipv6.conf.all.accept_ra=0

17 | net.ipv6.conf.enp1s0.accept_ra=0

18 | net.ipv6.conf.default.accept_ra=0

19 | net.ipv6.conf.all.accept_ra_rt_info_max_plen=0

20 | net.ipv6.conf.default.accept_ra_rt_info_max_plen=0

21 | net.ipv6.conf.enp1s0.accept_ra_rt_info_max_plen=0

22 |

23 | # 可选。暂时没发现什么场景一定要禁用 rp_filter,以防万一,先禁用

24 | net.ipv4.conf.all.rp_filter=0

25 | net.ipv4.conf.default.rp_filter=0

26 |

27 | # 允许容器ns的流量被拦截

28 | net.bridge.bridge-nf-call-iptables=0

29 | net.bridge.bridge-nf-call-ip6tables=0

--------------------------------------------------------------------------------

/codeblock/home-network/alist.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: alist

6 | name: alist

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: alist

12 | template:

13 | metadata:

14 | labels:

15 | app: alist

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | hostAliases:

19 | - hostnames:

20 | - api-cf.nn.ci

21 | ip: 104.21.30.209

22 | containers:

23 | - image: docker.io/xhofe/alist:v3.32.0

24 | imagePullPolicy: IfNotPresent

25 | name: alist

26 | env:

27 | - name: PUID

28 | value: "0"

29 | - name: PGID

30 | value: "0"

31 | - name: UMASK

32 | value: "022"

33 | volumeMounts:

34 | - mountPath: /opt/alist/data

35 | name: data

36 | dnsPolicy: Default

37 | hostNetwork: true

38 | restartPolicy: Always

39 | volumes:

40 | - name: data

41 | hostPath:

42 | path: /data/alist

43 | type: DirectoryOrCreate

44 | updateStrategy:

45 | rollingUpdate:

46 | maxSurge: 0

47 | maxUnavailable: 1

48 | type: RollingUpdate

49 |

--------------------------------------------------------------------------------

/codeblock/home-network/aria2.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: aria2

6 | name: aria2

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: aria2

12 | template:

13 | metadata:

14 | labels:

15 | app: aria2

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: docker.io/p3terx/aria2-pro:202209060423

20 | imagePullPolicy: IfNotPresent

21 | name: aria2

22 | env:

23 | - name: LISTEN_PORT

24 | value: "16881"

25 | - name: RPC_PORT

26 | value: "6800"

27 | - name: RPC_SECRET

28 | value: "111111"

29 | - name: PUID

30 | value: "0"

31 | - name: PGID

32 | value: "0"

33 | - name: IPV6_MODE

34 | value: "true"

35 | - name: TZ

36 | value: "Asia/Shanghai"

37 | - name: SPECIAL_MODE

38 | value: "move"

39 | volumeMounts:

40 | - mountPath: /config

41 | name: config

42 | - mountPath: /downloads

43 | name: media

44 | - image: docker.io/p3terx/ariang:latest

45 | imagePullPolicy: IfNotPresent

46 | name: ariang

47 | dnsPolicy: Default

48 | hostNetwork: true

49 | restartPolicy: Always

50 | volumes:

51 | - name: config

52 | hostPath:

53 | path: /data/aria2/config

54 | type: DirectoryOrCreate

55 | - name: media

56 | hostPath:

57 | path: /data/media/downloads

58 | type: DirectoryOrCreate

59 | updateStrategy:

60 | rollingUpdate:

61 | maxSurge: 0

62 | maxUnavailable: 1

63 | type: RollingUpdate

64 |

--------------------------------------------------------------------------------

/codeblock/home-network/clean.sh:

--------------------------------------------------------------------------------

1 | #!/bin/bash

2 |

3 | set -x

4 |

5 | nft delete table inet proxy # 关闭时清理 nftables,避免拉不了镜像

6 | ip rule delete fwmark 0x1 table 100

7 | ip route delete local 0.0.0.0/0 dev lo table 100

8 | ip -6 rule delete fwmark 0x1 table 100

9 | ip -6 route delete local ::/0 dev lo table 100

10 |

11 | exit 0

12 |

--------------------------------------------------------------------------------

/codeblock/home-network/ddns.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: ddns

6 | name: ddns

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: ddns

12 | template:

13 | metadata:

14 | labels:

15 | app: ddns

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: newfuture/ddns:v2.13.3

20 | imagePullPolicy: IfNotPresent

21 | name: ddns

22 | securityContext:

23 | privileged: true

24 | volumeMounts:

25 | - mountPath: /config.json

26 | subPath: config.json

27 | name: config

28 | dnsPolicy: Default

29 | hostNetwork: true

30 | restartPolicy: Always

31 | volumes:

32 | - configMap:

33 | name: ddns-config

34 | name: config

35 | updateStrategy:

36 | rollingUpdate:

37 | maxSurge: 0

38 | maxUnavailable: 1

39 | type: RollingUpdate

40 |

41 |

--------------------------------------------------------------------------------

/codeblock/home-network/dnsmasq.conf:

--------------------------------------------------------------------------------

1 | log-queries=extra

2 | no-resolv

3 | no-poll

4 | server=61.139.2.69

5 | strict-order

6 | log-dhcp

7 | cache-size=2000

8 | dhcp-range=10.10.10.15,10.10.10.254,255.255.255.0,12h

9 | dhcp-authoritative

10 | dhcp-leasefile=/var/lib/dnsmasq/dnsmasq.leases

11 | dhcp-option=option:router,10.10.10.2

12 | dhcp-option=option:dns-server,61.139.2.69,218.6.200.139

13 |

--------------------------------------------------------------------------------

/codeblock/home-network/dnsmasq.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: dnsmasq

6 | name: dnsmasq

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: dnsmasq

12 | template:

13 | metadata:

14 | labels:

15 | app: dnsmasq

16 | spec:

17 | terminationGracePeriodSeconds: 3

18 | containers:

19 | - image: imroc/dnsmasq:2.90

20 | imagePullPolicy: IfNotPresent

21 | name: dnsmasq

22 | securityContext:

23 | privileged: true

24 | volumeMounts:

25 | - mountPath: /etc/dnsmasq.conf

26 | name: dnsmasq-config

27 | subPath: dnsmasq.conf

28 | - mountPath: /var/lib/dnsmasq

29 | name: lease

30 | hostNetwork: true

31 | restartPolicy: Always

32 | volumes:

33 | - configMap:

34 | name: dnsmasq-config

35 | name: dnsmasq-config

36 | - name: lease

37 | hostPath:

38 | path: /data/lease

39 | type: DirectoryOrCreate

40 | updateStrategy:

41 | rollingUpdate:

42 | maxSurge: 0

43 | maxUnavailable: 1

44 | type: RollingUpdate

45 |

46 |

--------------------------------------------------------------------------------

/codeblock/home-network/filebrowser.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: filebrowser

6 | name: filebrowser

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: filebrowser

12 | template:

13 | metadata:

14 | labels:

15 | app: filebrowser

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: filebrowser/filebrowser:v2.27.0

20 | args:

21 | - "-p"

22 | - "8567"

23 | - "-r"

24 | - "/data"

25 | - "--username=roc"

26 | - "--password=$2a$10$q/0NjHYLYvP/rcB1VdRBxeVg/AnaPILgMJYyrEnOpw6mhimhsgjeG" # 111111

27 | imagePullPolicy: IfNotPresent

28 | name: filebrowser

29 | volumeMounts:

30 | - mountPath: /data

31 | name: data

32 | dnsPolicy: Default

33 | hostNetwork: true

34 | restartPolicy: Always

35 | volumes:

36 | - name: data

37 | hostPath:

38 | path: /data

39 | type: DirectoryOrCreate

40 | updateStrategy:

41 | rollingUpdate:

42 | maxSurge: 0

43 | maxUnavailable: 1

44 | type: RollingUpdate

45 |

--------------------------------------------------------------------------------

/codeblock/home-network/home-assistant.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: home-assistant

6 | name: home-assistant

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: home-assistant

12 | template:

13 | metadata:

14 | labels:

15 | app: home-assistant

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: homeassistant/home-assistant:stable

20 | imagePullPolicy: IfNotPresent

21 | name: home-assistant

22 | ports:

23 | - containerPort: 8123

24 | name: web

25 | env:

26 | - name: TZ

27 | value: Asia/Shanghai

28 | volumeMounts:

29 | - mountPath: /config

30 | name: config

31 | - mountPath: /run/dbus

32 | name: dbus

33 | readOnly: true

34 | dnsPolicy: Default

35 | hostNetwork: true

36 | restartPolicy: Always

37 | volumes:

38 | - name: config

39 | hostPath:

40 | path: /data/home-assistant/config

41 | type: DirectoryOrCreate

42 | - name: dbus

43 | hostPath:

44 | path: /run/dbus

45 | updateStrategy:

46 | rollingUpdate:

47 | maxSurge: 0

48 | maxUnavailable: 1

49 | type: RollingUpdate

50 |

--------------------------------------------------------------------------------

/codeblock/home-network/homepage.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: homepage

6 | name: homepage

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: homepage

12 | template:

13 | metadata:

14 | labels:

15 | app: homepage

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: docker.io/imroc/homepage:v0.8.8

20 | imagePullPolicy: IfNotPresent

21 | name: homepage

22 | env:

23 | - name: PORT

24 | value: "80"

25 | volumeMounts:

26 | - mountPath: /app/config/services.yaml

27 | name: config

28 | subPath: services.yaml

29 | - mountPath: /app/config/settings.yaml

30 | name: config

31 | subPath: settings.yaml

32 | - mountPath: /app/config/widgets.yaml

33 | name: config

34 | subPath: widgets.yaml

35 | - mountPath: /app/config/bookmarks.yaml

36 | name: config

37 | subPath: bookmarks.yaml

38 | dnsPolicy: Default

39 | hostNetwork: true

40 | restartPolicy: Always

41 | volumes:

42 | - name: config

43 | configMap:

44 | name: homepage-config

45 | updateStrategy:

46 | rollingUpdate:

47 | maxSurge: 0

48 | maxUnavailable: 1

49 | type: RollingUpdate

50 |

--------------------------------------------------------------------------------

/codeblock/home-network/ikev2.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: ikev2

6 | name: ikev2

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: ikev2

12 | template:

13 | metadata:

14 | labels:

15 | app: ikev2

16 | spec:

17 | containers:

18 | - image: imroc/ipsec-vpn-server:4.12

19 | imagePullPolicy: IfNotPresent

20 | name: ikev2

21 | ports:

22 | - containerPort: 500

23 | protocol: UDP

24 | hostPort: 500

25 | - containerPort: 4500

26 | protocol: UDP

27 | hostPort: 4500

28 | envFrom:

29 | - secretRef:

30 | name: ikev2-secret

31 | securityContext:

32 | privileged: true

33 | volumeMounts:

34 | - mountPath: /etc/ipsec.d

35 | name: ikev2-vpn-data

36 | - mountPath: /lib/modules

37 | name: mod

38 | readOnly: true

39 | dnsPolicy: Default

40 | restartPolicy: Always

41 | volumes:

42 | - hostPath:

43 | path: /lib/modules

44 | type: Directory

45 | name: mod

46 | - secret:

47 | secretName: ikev2-vpn-data

48 | name: ikev2-vpn-data

49 | updateStrategy:

50 | rollingUpdate:

51 | maxSurge: 0

52 | maxUnavailable: 1

53 | type: RollingUpdate

54 |

--------------------------------------------------------------------------------

/codeblock/home-network/jellyfin.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: jellyfin

6 | name: jellyfin

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: jellyfin

12 | template:

13 | metadata:

14 | labels:

15 | app: jellyfin

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: jellyfin/jellyfin:latest

20 | imagePullPolicy: IfNotPresent

21 | name: jellyfin

22 | resources:

23 | limits:

24 | cpu: "1"

25 | memory: 1Gi

26 | requests:

27 | cpu: 1m

28 | memory: 16Mi

29 | env:

30 | - name: TZ

31 | value: Asia/Shanghai

32 | securityContext:

33 | runAsUser: 0

34 | runAsGroup: 0

35 | privileged: true

36 | volumeMounts:

37 | - mountPath: /dev/dri

38 | name: dri

39 | - mountPath: /data/media

40 | name: media

41 | - mountPath: /config

42 | name: config

43 | - mountPath: /cache

44 | name: cache

45 | dnsPolicy: Default

46 | hostNetwork: true

47 | restartPolicy: Always

48 | volumes:

49 | - name: dri

50 | hostPath:

51 | path: /dev/dri

52 | - name: config

53 | hostPath:

54 | path: /data/jellyfin/config

55 | type: DirectoryOrCreate

56 | - name: cache

57 | hostPath:

58 | path: /data/jellyfin/cache

59 | type: DirectoryOrCreate

60 | - name: media

61 | hostPath:

62 | path: /data/media

63 | type: DirectoryOrCreate

64 | updateStrategy:

65 | rollingUpdate:

66 | maxSurge: 0

67 | maxUnavailable: 1

68 | type: RollingUpdate

69 |

--------------------------------------------------------------------------------

/codeblock/home-network/netplan-config-bypass-route.yaml:

--------------------------------------------------------------------------------

1 | network:

2 | version: 2

3 | renderer: networkd

4 | ethernets:

5 | enp1s0: # 主网口,默认路由指向主路由 IP

6 | optional: true

7 | accept-ra: false

8 | dhcp4: no

9 | dhcp6: no

10 | addresses:

11 | - 10.10.10.2/24

12 | - fddd:dddd:dddd:dddd::2/64

13 | routes:

14 | - to: default

15 | via: 10.10.10.14

16 | enp6s0: # 预留的管理网口,极端情况下用网线连管理网口登录 ssh

17 | optional: true

18 | accept-ra: false

19 | dhcp4: no

20 | dhcp6: no

21 | addresses:

22 | - 10.10.11.1/24

23 |

--------------------------------------------------------------------------------

/codeblock/home-network/netplan-config-main-route.yaml:

--------------------------------------------------------------------------------

1 | network:

2 | version: 2

3 | renderer: networkd

4 | ethernets:

5 | enp1s0: # 拨号网口

6 | optional: true

7 | accept-ra: false

8 | dhcp4: no

9 | dhcp6: no

10 | addresses:

11 | - 192.168.11.1/24

12 | routes: # k3s 需要默认路由,不然会报错,导致 dhcp 服务起不来,从而导致局域网连不上,这里随便设置一个(启动会被pppoe拨号覆盖,这里设置用于没有拨号的情况下也连上机器)

13 | - to: default

14 | via: 192.168.11.1

15 | enp2s0:

16 | optional: true

17 | accept-ra: false

18 | dhcp4: no

19 | dhcp6: no

20 | addresses: # 固定网卡所拥有的内网IP地址段

21 | - 10.10.10.2/24

22 | - fddd:dddd:dddd:dddd::2/64

23 | enp6s0: # 预留的管理网口,极端情况下用网线连管理网口登录 ssh

24 | optional: true

25 | accept-ra: false

26 | dhcp4: no

27 | dhcp6: no

28 | addresses:

29 | - 10.10.11.1/24

30 |

--------------------------------------------------------------------------------

/codeblock/home-network/nfs.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: nfs

6 | name: nfs

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: nfs

12 | template:

13 | metadata:

14 | labels:

15 | app: nfs

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: docker.io/erichough/nfs-server:2.2.1

20 | imagePullPolicy: IfNotPresent

21 | name: nfs

22 | securityContext:

23 | privileged: true

24 | volumeMounts:

25 | - mountPath: /data/media

26 | name: media

27 | - mountPath: /lib/modules

28 | name: mod

29 | readOnly: true

30 | - mountPath: /etc/exports

31 | name: exports

32 | subPath: exports

33 | dnsPolicy: Default

34 | hostNetwork: true

35 | restartPolicy: Always

36 | volumes:

37 | - name: media

38 | hostPath:

39 | path: /data/media

40 | type: DirectoryOrCreate

41 | - name: mod

42 | hostPath:

43 | path: /lib/modules

44 | - name: exports

45 | configMap:

46 | name: nfs-exports

47 | updateStrategy:

48 | rollingUpdate:

49 | maxSurge: 0

50 | maxUnavailable: 1

51 | type: RollingUpdate

52 |

--------------------------------------------------------------------------------

/codeblock/home-network/nftables-tproxy.conf:

--------------------------------------------------------------------------------

1 | #!/usr/sbin/nft -f

2 |

3 | table inet proxy

4 | delete table inet proxy

5 |

6 | table inet proxy {

7 |

8 | # 保留网段,参考:https://zh.wikipedia.org/zh-sg/%E4%BF%9D%E7%95%99IP%E5%9C%B0%E5%9D%80

9 | set byp4 {

10 | typeof ip daddr

11 | flags interval

12 | elements = {

13 | 0.0.0.0/8,

14 | 10.0.0.0/8,

15 | 100.64.0.0/10,

16 | 127.0.0.0/8,

17 | 169.254.0.0/16,

18 | 172.16.0.0/12,

19 | 192.0.0.0/24,

20 | 192.0.2.0/24,

21 | 192.88.99.0/24,

22 | 192.168.0.0/16,

23 | 198.18.0.0/15,

24 | 198.51.100.0/24,

25 | 203.0.113.0/24,

26 | 224.0.0.0/4,

27 | 240.0.0.0/4

28 | }

29 | }

30 | set byp6 {

31 | typeof ip6 daddr

32 | flags interval

33 | elements = {

34 | ::,

35 | ::1,

36 | ::ffff:0:0:0/96,

37 | 100::/64,

38 | 64:ff9b::/96,

39 | 2001::/32,

40 | 2001:10::/28,

41 | 2001:20::/28,

42 | 2001:db8::/32,

43 | 2002::/16,

44 | fc00::/7,

45 | fe80::/10,

46 | ff00::/8

47 | }

48 | }

49 |

50 | chain prerouting {

51 | type filter hook prerouting priority filter; policy accept;

52 |

53 | # 只拦截内网部分设备(10.10.10.0/28 用于拦截内网部分指定设备的流量,10.42.0.0/16 用于拦截容器网络流量)

54 | fib saddr type != local ip saddr != { 10.10.10.0/28, 10.42.0.0/16 } counter return

55 |

56 | # 放行发往 local 的。如果连接已被 tproxy 拦截,后续流量会被认为是 local 的(代理会在本机监听目标地址),流量可以直接转发给代理进程,无需拦截,直接 return 避免再次被 tproxy 拦截

57 | fib daddr type local counter return

58 |

59 | # 放行 reply 方向的

60 | ct direction reply counter return

61 |

62 | # 将局域网设备访问公网的流量标记为需要拦截

63 | meta l4proto {tcp,udp} ct mark != 1 ct state new,related counter jump do_proxy

64 |

65 | # 拦截已经标记要拦截的流量(连接的第一个包在这里被 tproxy 到代理进程,然后代理进程会监听目标地址,后续的包无需拦截就可以被转发给代理进程)

66 | meta l4proto {tcp,udp} ct mark 1 tproxy to :12345 meta mark set 1 counter

67 | }

68 |

69 | chain do_proxy {

70 |

71 | # 放行内网

72 | ip daddr @byp4 counter return

73 | ip6 daddr @byp6 counter return

74 |

75 | # 其余全部打上 mark,标记流量需要拦截

76 | ct mark set 1 counter

77 | }

78 |

79 | chain output {

80 | type route hook output priority filter; policy accept;

81 |

82 | # 放行发往 local 的

83 | fib daddr type local counter return

84 |

85 | # 放行 reply 方向的

86 | ct direction reply counter return

87 |

88 | # 放行代理发出的包。

89 | meta skgid eq 23333 counter return

90 |

91 | # 尝试给需要拦截的连接进行 mark

92 | meta l4proto {tcp,udp} ct state new,related counter jump do_proxy

93 |

94 | # 让报文走策略路由重新进入 PREROUTING,以便被代理。

95 | ct mark 1 meta mark set 1 counter

96 | }

97 | }

98 |

--------------------------------------------------------------------------------

/codeblock/home-network/nftables.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: nftables

6 | name: nftables

7 | spec:

8 | selector:

9 | matchLabels:

10 | app: nftables

11 | template:

12 | metadata:

13 | labels:

14 | app: nftables

15 | spec:

16 | terminationGracePeriodSeconds: 3

17 | containers:

18 | - image: imroc/nftables:ubuntu-24.04

19 | imagePullPolicy: IfNotPresent

20 | name: nftables

21 | securityContext:

22 | privileged: true

23 | command: ["/script/entrypoint.sh"]

24 | volumeMounts:

25 | - mountPath: /etc/nftables

26 | name: nftables-config

27 | - mountPath: /script

28 | name: nftables-script

29 | hostNetwork: true

30 | volumes:

31 | - configMap:

32 | name: nftables-config

33 | name: nftables-config

34 | - configMap:

35 | name: nftables-script

36 | defaultMode: 0755

37 | name: nftables-script

38 | updateStrategy:

39 | rollingUpdate:

40 | maxSurge: 0

41 | maxUnavailable: 1

42 | type: RollingUpdate

43 |

--------------------------------------------------------------------------------

/codeblock/home-network/nginx.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: nginx

6 | name: nginx

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: nginx

12 | template:

13 | metadata:

14 | labels:

15 | app: nginx

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: nginx:latest

20 | imagePullPolicy: IfNotPresent

21 | name: nginx

22 | securityContext:

23 | privileged: true

24 | volumeMounts:

25 | - mountPath: /etc/nginx

26 | name: config

27 | dnsPolicy: Default

28 | hostNetwork: true

29 | restartPolicy: Always

30 | volumes:

31 | - configMap:

32 | name: nginx-config

33 | name: config

34 | updateStrategy:

35 | rollingUpdate:

36 | maxSurge: 0

37 | maxUnavailable: 1

38 | type: RollingUpdate

39 |

--------------------------------------------------------------------------------

/codeblock/home-network/qbittorrent.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: qbittorrent

6 | name: qbittorrent

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: qbittorrent

12 | template:

13 | metadata:

14 | labels:

15 | app: qbittorrent

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: docker.io/linuxserver/qbittorrent:5.0.0

20 | imagePullPolicy: IfNotPresent

21 | name: qbittorrent

22 | env:

23 | - name: PUID

24 | value: "0"

25 | - name: PGID

26 | value: "0"

27 | - name: TZ

28 | value: "Asia/Shanghai"

29 | - name: WEBUI_PORT

30 | value: "9367"

31 | - name: TORRENTING_PORT

32 | value: "16991"

33 | volumeMounts:

34 | - mountPath: /config

35 | name: config

36 | - mountPath: /downloads

37 | name: media

38 | dnsPolicy: Default

39 | hostNetwork: true

40 | restartPolicy: Always

41 | volumes:

42 | - name: config

43 | hostPath:

44 | path: /data/qbittorrent/config

45 | type: DirectoryOrCreate

46 | - name: media

47 | hostPath:

48 | path: /data/media

49 | type: DirectoryOrCreate

50 | updateStrategy:

51 | rollingUpdate:

52 | maxSurge: 0

53 | maxUnavailable: 1

54 | type: RollingUpdate

55 |

--------------------------------------------------------------------------------

/codeblock/home-network/radvd.conf:

--------------------------------------------------------------------------------

1 | interface enp2s0 {

2 | # 网卡启用路由通告(RA)

3 | AdvSendAdvert on;

4 | # 启用 Home Agent(iOS、macOS等移动设备加入网络时发送Home Agent请求获取ipv6信息)

5 | AdvHomeAgentFlag on;

6 | AdvHomeAgentInfo on;

7 | MinRtrAdvInterval 10;

8 | MaxRtrAdvInterval 60;

9 | prefix fddd:dddd:dddd:dddd::2/64 {

10 | AdvOnLink on;

11 | AdvAutonomous on;

12 | AdvRouterAddr on;

13 | };

14 | route fddd:dddd:dddd:dddd::2/64 {

15 | AdvRoutePreference high;

16 | AdvRouteLifetime 3600;

17 | RemoveRoute off;

18 | };

19 | };

20 |

--------------------------------------------------------------------------------

/codeblock/home-network/radvd.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: radvd

6 | name: radvd

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: radvd

12 | template:

13 | metadata:

14 | labels:

15 | app: radvd

16 | spec:

17 | initContainers:

18 | - image: imroc/radvd:2.18

19 | imagePullPolicy: IfNotPresent

20 | name: sysctl

21 | securityContext:

22 | privileged: true

23 | command:

24 | - sh

25 | - -c

26 | - |

27 | sysctl -w net.ipv6.conf.all.accept_ra_rt_info_max_plen=128

28 | sysctl -w net.ipv6.conf.default.accept_ra_rt_info_max_plen=128

29 | sysctl -w net.ipv6.conf.all.forwarding=1

30 | sysctl -w net.ipv6.conf.default.forwarding=1

31 | containers:

32 | - image: imroc/radvd:2.18

33 | imagePullPolicy: IfNotPresent

34 | name: radvd

35 | securityContext:

36 | privileged: true

37 | args: ["--debug", "5"]

38 | volumeMounts:

39 | - mountPath: /etc/radvd.d

40 | name: radvd-config

41 | hostNetwork: true

42 | restartPolicy: Always

43 | volumes:

44 | - configMap:

45 | name: radvd-config

46 | name: radvd-config

47 | updateStrategy:

48 | rollingUpdate:

49 | maxSurge: 0

50 | maxUnavailable: 1

51 | type: RollingUpdate

52 |

--------------------------------------------------------------------------------

/codeblock/home-network/samba.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: DaemonSet

3 | metadata:

4 | labels:

5 | app: samba

6 | name: samba

7 | namespace: default

8 | spec:

9 | selector:

10 | matchLabels:

11 | app: samba

12 | template:

13 | metadata:

14 | labels:

15 | app: samba

16 | spec:

17 | terminationGracePeriodSeconds: 1

18 | containers:

19 | - image: docker.io/dperson/samba:latest

20 | args:

21 | - "-u"

22 | - "roc;111111"

23 | - "-s"

24 | - "data;/data/;yes;no;yes;all;all;all"

25 | - "-w"

26 | - "WORKGROUP"

27 | - "-g"

28 | - "force user=roc"

29 | - "-g"

30 | - "guest account=roc"

31 | - "-S"

32 | imagePullPolicy: IfNotPresent

33 | name: samba

34 | securityContext:

35 | privileged: true

36 | volumeMounts:

37 | - mountPath: /data

38 | name: data

39 | dnsPolicy: Default

40 | hostNetwork: true

41 | restartPolicy: Always

42 | volumes:

43 | - name: data

44 | hostPath:

45 | path: /data

46 | type: DirectoryOrCreate

47 | updateStrategy:

48 | rollingUpdate:

49 | maxSurge: 0

50 | maxUnavailable: 1

51 | type: RollingUpdate

52 |

--------------------------------------------------------------------------------

/codeblock/home-network/set-rules.sh:

--------------------------------------------------------------------------------

1 | #!/bin/bash

2 |

3 | set -x

4 |

5 | while :; do

6 | export https_proxy=http://127.0.0.1:10809 # 假设代理会启动 10809 端口的 HTTP 代理

7 | code=$(curl -I -o /dev/null -m 5 -s -w %{http_code} https://www.google.com | xargs) # 通过代理探测目标地址是否正常响应

8 | if [[ "${code}" == "200" ]]; then # 探测成功就退出探测循环,准备设置策略路由

9 | break

10 | fi

11 | echo "bad code:${code};" >/tmp/error.log

12 | sleep 5s

13 | done

14 |

15 | echo "proxy is ready, set up rules"

16 | ip rule list | grep "from all fwmark 0x1 lookup 100"

17 | if [ $? -ne 0 ]; then

18 | echo "add rule and route"

19 | ip rule add fwmark 0x1 table 100

20 | ip route add local 0.0.0.0/0 dev lo table 100

21 | ip -6 rule add fwmark 0x1 table 100

22 | ip -6 route add local ::/0 dev lo table 100

23 | fi

24 |

25 | nft -f /etc/nftables/nftables.conf # 设置 nftables 规则

26 | exit 0

27 |

28 |

--------------------------------------------------------------------------------

/codeblock/home-network/setup-pppoe.sh:

--------------------------------------------------------------------------------

1 | #!/bin/env sh

2 |

3 | # interface to pppoe workload

4 | INTERFACE=enp1s0

5 |

6 | if [ "${IFACE}" = "${INTERFACE}" ] ; then

7 | echo "running pon ${INTERFACE}..."

8 | pon dsl-provider

9 | fi

--------------------------------------------------------------------------------

/codeblock/home-network/vpn.env:

--------------------------------------------------------------------------------

1 | # 定义 VPN 配置文件的密码,以及登录 VPN 的用户名和密

2 | VPN_IPSEC_PSK=123456

3 | VPN_USER=roc

4 | VPN_PASSWORD=123456

5 |

6 | # Define additional VPN users

7 | # - DO NOT put "" or '' around values, or add space around =

8 | # - DO NOT use these special characters within values: \ " '

9 | # - Usernames and passwords must be separated by spaces

10 | # VPN_ADDL_USERS=additional_username_1 additional_username_2

11 | # VPN_ADDL_PASSWORDS=additional_password_1 additional_password_2

12 |

13 | # 改成家里公网 IP 对应的域名

14 | VPN_DNS_NAME=home.yourdomain.com

15 |

16 | # Specify a name for the first IKEv2 client

17 | # - Use one word only, no special characters except '-' and '_'

18 | # - The default is 'vpnclient' if not specified

19 | VPN_CLIENT_NAME=roc

20 |

21 | # 可以改成家里宽带使用的 DNS 地址

22 | VPN_DNS_SRV1=61.139.2.69

23 | VPN_DNS_SRV2=218.6.200.139

24 |

25 | # Protect IKEv2 client config files using a password

26 | # - By default, no password is required when importing IKEv2 client configuration

27 | # - Uncomment if you want to protect these files using a random password

28 | VPN_PROTECT_CONFIG=yes

29 |

30 |

--------------------------------------------------------------------------------

/codeblock/llama/download-llama3-8b.yaml:

--------------------------------------------------------------------------------

1 | initContainers:

2 | - name: pull

3 | image: ollama/ollama:latest

4 | tty: true

5 | stdin: true

6 | command:

7 | - bash

8 | - -c

9 | - |

10 | # highlight-next-line

11 | model="llama3:8b" # 替换需要使用的模型,模型库列表: https://ollama.com/library/llama3

12 | ollama serve &

13 | sleep 5 # 等待 ollama server 就绪,就绪后才能执行 ollama cli 工具的命令

14 | result=`ollama list | grep $model`

15 | if [ "$result" == "" ]; then

16 | echo "downloading model $model"

17 | ollama pull $model

18 | else

19 | echo "model $model already been downloaded"

20 | fi

21 | volumeMounts:

22 | - name: ollama-volume

23 | mountPath: /root/.ollama

24 |

--------------------------------------------------------------------------------

/codeblock/llama/llama3-cpu-8b.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: StatefulSet

3 | metadata:

4 | name: ollama

5 | namespace: llama

6 | spec:

7 | serviceName: "ollama"

8 | replicas: 1

9 | selector:

10 | matchLabels:

11 | app: ollama

12 | template:

13 | metadata:

14 | labels:

15 | app: ollama

16 | spec:

17 | # highlight-start

18 | initContainers:

19 | - name: pull

20 | image: ollama/ollama:latest

21 | tty: true

22 | stdin: true

23 | command:

24 | - bash

25 | - -c

26 | - |

27 | # highlight-next-line

28 | model="llama3:8b" # 替换需要使用的模型,模型库列表: https://ollama.com/library/llama3

29 | ollama serve &

30 | sleep 5 # 等待 ollama server 就绪,就绪后才能执行 ollama cli 工具的命令

31 | result=`ollama list | grep $model`

32 | if [ "$result" == "" ]; then

33 | echo "downloading model $model"

34 | ollama pull $model

35 | else

36 | echo "model $model already been downloaded"

37 | fi

38 | volumeMounts:

39 | - name: ollama-volume

40 | mountPath: /root/.ollama

41 | # highlight-end

42 | containers:

43 | - name: ollama

44 | image: ollama/ollama:latest

45 | ports:

46 | - containerPort: 11434

47 | resources:

48 | requests:

49 | cpu: "2000m"

50 | memory: "2Gi"

51 | nvidia.com/gpu: "0" # 如果要用 Nvidia GPU,这里声明下 GPU 卡

52 | limits:

53 | cpu: "4000m"

54 | memory: "4Gi"

55 | volumeMounts:

56 | - name: ollama-volume

57 | mountPath: /root/.ollama

58 | tty: true

59 | volumeClaimTemplates:

60 | - metadata:

61 | name: ollama-volume

62 | spec:

63 | accessModes: ["ReadWriteOnce"]

64 | resources:

65 | requests:

66 | storage: 200Gi # 注意要确保磁盘容量能够容纳得下模型的体积

67 | ---

68 | apiVersion: v1

69 | kind: Service

70 | metadata:

71 | name: ollama

72 | namespace: llama

73 | labels:

74 | app: ollama

75 | spec:

76 | type: ClusterIP

77 | ports:

78 | - port: 11434

79 | protocol: TCP

80 | targetPort: 11434

81 | selector:

82 | app: ollama

83 |

--------------------------------------------------------------------------------

/codeblock/llama/llama3-gpu-70b.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: StatefulSet

3 | metadata:

4 | name: ollama

5 | namespace: llama

6 | spec:

7 | serviceName: "ollama"

8 | replicas: 1

9 | selector:

10 | matchLabels:

11 | app: ollama

12 | template:

13 | metadata:

14 | labels:

15 | app: ollama

16 | spec:

17 | initContainers:

18 | - name: pull

19 | image: ollama/ollama:latest

20 | tty: true

21 | stdin: true

22 | command:

23 | - bash

24 | - -c

25 | - |

26 | # highlight-next-line

27 | model="llama3:70b" # 替换需要使用的模型,模型库列表: https://ollama.com/library/llama3

28 | ollama serve &

29 | sleep 5 # 等待 ollama server 就绪,就绪后才能执行 ollama cli 工具的命令

30 | result=`ollama list | grep $model`

31 | if [ "$result" == "" ]; then

32 | echo "downloading model $model"

33 | ollama pull $model

34 | else

35 | echo "model $model already been downloaded"

36 | fi

37 | volumeMounts:

38 | - name: ollama-volume

39 | mountPath: /root/.ollama

40 | containers:

41 | - name: ollama

42 | image: ollama/ollama:latest

43 | ports:

44 | - containerPort: 11434

45 | resources:

46 | requests:

47 | cpu: "2000m"

48 | memory: "2Gi"

49 | # highlight-next-line

50 | nvidia.com/gpu: "1" # 声明使用一张 N 卡

51 | limits:

52 | cpu: "4000m"

53 | memory: "4Gi"

54 | volumeMounts:

55 | - name: ollama-volume

56 | mountPath: /root/.ollama

57 | tty: true

58 | volumeClaimTemplates:

59 | - metadata:

60 | name: ollama-volume

61 | spec:

62 | accessModes: ["ReadWriteOnce"]

63 | resources:

64 | requests:

65 | # highlight-next-line

66 | storage: 200Gi # 注意要确保磁盘容量能够容纳得下模型的体积

67 | ---

68 | apiVersion: v1

69 | kind: Service

70 | metadata:

71 | name: ollama

72 | namespace: llama

73 | labels:

74 | app: ollama

75 | spec:

76 | type: ClusterIP

77 | ports:

78 | - port: 11434

79 | protocol: TCP

80 | targetPort: 11434

81 | selector:

82 | app: ollama

83 |

--------------------------------------------------------------------------------

/codeblock/llama/ollama-nodeselector.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: StatefulSet

3 | metadata:

4 | name: ollama

5 | namespace: llama

6 | spec:

7 | serviceName: "ollama"

8 | replicas: 1

9 | selector:

10 | matchLabels:

11 | app: ollama

12 | template:

13 | metadata:

14 | labels:

15 | app: ollama

16 | spec:

17 | # highlight-start

18 | nodeSelector:

19 | gpu: v100

20 | # highlight-end

21 | containers:

22 | - name: ollama

23 | image: ollama/ollama:latest

24 | ports:

25 | - containerPort: 11434

26 | resources:

27 | requests:

28 | cpu: "2000m"

29 | memory: "2Gi"

30 | nvidia.com/gpu: "4"

31 | limits:

32 | cpu: "4000m"

33 | memory: "4Gi"

34 | volumeMounts:

35 | - name: ollama-volume

36 | mountPath: /root/.ollama

37 | tty: true

38 | volumeClaimTemplates:

39 | - metadata:

40 | name: ollama-volume

41 | spec:

42 | accessModes: ["ReadWriteOnce"]

43 | resources:

44 | requests:

45 | storage: 200Gi

46 |

--------------------------------------------------------------------------------

/codeblock/llama/ollama.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: apps/v1

2 | kind: StatefulSet

3 | metadata:

4 | name: ollama

5 | namespace: llama

6 | spec:

7 | serviceName: "ollama"

8 | replicas: 1

9 | selector:

10 | matchLabels:

11 | app: ollama

12 | template:

13 | metadata:

14 | labels:

15 | app: ollama

16 | spec:

17 | containers:

18 | - name: ollama

19 | image: ollama/ollama:latest

20 | ports:

21 | - containerPort: 11434

22 | resources:

23 | requests:

24 | cpu: "2000m"

25 | memory: "2Gi"

26 | # highlight-next-line

27 | nvidia.com/gpu: "0" # 如果要用 Nvidia GPU,这里声明下 GPU 卡

28 | limits:

29 | cpu: "4000m"

30 | memory: "4Gi"

31 | volumeMounts:

32 | - name: ollama-volume

33 | mountPath: /root/.ollama

34 | tty: true

35 | volumeClaimTemplates:

36 | - metadata:

37 | name: ollama-volume

38 | spec:

39 | accessModes: ["ReadWriteOnce"]

40 | resources:

41 | requests:

42 | # highlight-next-line

43 | storage: 200Gi # 注意要确保磁盘容量能够容纳得下模型的体积

44 | ---

45 | apiVersion: v1

46 | kind: Service

47 | metadata:

48 | name: ollama

49 | namespace: llama

50 | labels:

51 | app: ollama

52 | spec:

53 | type: ClusterIP

54 | ports:

55 | - port: 11434

56 | protocol: TCP

57 | targetPort: 11434

58 | selector:

59 | app: ollama

60 |

--------------------------------------------------------------------------------

/codeblock/llama/open-webui.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: v1

2 | kind: PersistentVolumeClaim

3 | metadata:

4 | name: webui-pvc

5 | namespace: llama

6 | labels:

7 | app: webui

8 | spec:

9 | accessModes: ["ReadWriteOnce"]

10 | resources:

11 | requests:

12 | storage: 2Gi

13 |

14 | ---

15 | apiVersion: apps/v1

16 | kind: Deployment

17 | metadata:

18 | name: webui

19 | namespace: llama

20 | spec:

21 | replicas: 1

22 | selector:

23 | matchLabels:

24 | app: webui

25 | template:

26 | metadata:

27 | labels:

28 | app: webui

29 | spec:

30 | containers:

31 | - name: webui

32 | # highlight-next-line

33 | image: imroc/open-webui:main # docker hub 中的 mirror 镜像,长期自动同步,可放心使用

34 | env:

35 | - name: OLLAMA_BASE_URL

36 | # highlight-next-line

37 | value: http://ollama:11434 # ollama 的地址

38 | tty: true

39 | ports:

40 | - containerPort: 8080

41 | resources:

42 | requests:

43 | cpu: "500m"

44 | memory: "500Mi"

45 | limits:

46 | cpu: "1000m"

47 | memory: "1Gi"

48 | volumeMounts:

49 | - name: webui-volume

50 | mountPath: /app/backend/data

51 | volumes:

52 | - name: webui-volume

53 | persistentVolumeClaim:

54 | claimName: webui-pvc

55 |

56 | ---

57 | apiVersion: v1

58 | kind: Service

59 | metadata:

60 | name: webui

61 | namespace: llama

62 | labels:

63 | app: webui

64 | spec:

65 | type: ClusterIP

66 | ports:

67 | - port: 8080

68 | protocol: TCP

69 | targetPort: 8080

70 | selector:

71 | app: webui

72 |

--------------------------------------------------------------------------------

/codeblock/prometheus/kubernetes-pods.yaml:

--------------------------------------------------------------------------------

1 | - job_name: "kubernetes-pods"

2 |

3 | kubernetes_sd_configs:

4 | - role: pod

5 |

6 | relabel_configs:

7 | # prometheus relabel to scrape only pods that have

8 | # `prometheus.io/scrape: "true"` annotation.

9 | - source_labels:

10 | - __meta_kubernetes_pod_annotation_prometheus_io_scrape

11 | action: keep

12 | regex: true

13 |

14 | # prometheus relabel to customize metric path based on pod

15 | # `prometheus.io/path: ` annotation.

16 | - source_labels:

17 | - __meta_kubernetes_pod_annotation_prometheus_io_path

18 | action: replace

19 | target_label: __metrics_path__

20 | regex: (.+)

21 |

22 | # prometheus relabel to scrape only single, desired port for the pod

23 | # based on pod `prometheus.io/port: ` annotation.

24 | - source_labels:

25 | - __address__

26 | - __meta_kubernetes_pod_annotation_prometheus_io_port

27 | action: replace

28 | regex: ([^:]+)(?::\d+)?;(\d+)

29 | replacement: $1:$2

30 | target_label: __address__

31 | - action: labelmap

32 | regex: __meta_kubernetes_pod_label_(.+)

33 | - source_labels: [__meta_kubernetes_namespace]

34 | action: replace

35 | target_label: namespace

36 | - source_labels: [__meta_kubernetes_pod_name]

37 | action: replace

38 | target_label: pod

39 |

--------------------------------------------------------------------------------

/codeblock/prometheus/kubernetes-service-endpoints.yaml:

--------------------------------------------------------------------------------

1 | - job_name: "kubernetes-service-endpoints"

2 |

3 | kubernetes_sd_configs:

4 | - role: endpoints

5 |

6 | relabel_configs:

7 | # prometheus relabel to scrape only endpoints that have

8 | # `prometheus.io/scrape: "true"` annotation.

9 | - source_labels:

10 | - __meta_kubernetes_service_annotation_prometheus_io_scrape

11 | action: keep

12 | regex: true

13 |

14 | # prometheus relabel to customize metric path based on endpoints

15 | # `prometheus.io/path: ` annotation.

16 | - source_labels:

17 | - __meta_kubernetes_service_annotation_prometheus_io_path

18 | action: replace

19 | target_label: __metrics_path__

20 | regex: (.+)

21 |

22 | # prometheus relabel to scrape only single, desired port for the service based

23 | # on endpoints `prometheus.io/port: ` annotation.

24 | - source_labels:

25 | - __address__

26 | - __meta_kubernetes_service_annotation_prometheus_io_port

27 | action: replace

28 | regex: ([^:]+)(?::\d+)?;(\d+)

29 | replacement: $1:$2

30 | target_label: __address__

31 |

32 | # prometheus relabel to configure scrape scheme for all service scrape targets

33 | # based on endpoints `prometheus.io/scheme: ` annotation.

34 | - source_labels:

35 | - __meta_kubernetes_service_annotation_prometheus_io_scheme

36 | action: replace

37 | target_label: __scheme__

38 | regex: (https?)

39 | - action: labelmap

40 | regex: __meta_kubernetes_service_label_(.+)

41 | - source_labels: [__meta_kubernetes_namespace]

42 | action: replace

43 | target_label: namespace

44 | - source_labels: [__meta_kubernetes_service_name]

45 | action: replace

46 | target_label: service

47 |

--------------------------------------------------------------------------------

/codeblock/rbac/cluster-admin.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: v1

2 | kind: ServiceAccount

3 | metadata:

4 | name: cluster-admin

5 | namespace: kube-system

6 |

7 | ---

8 | apiVersion: rbac.authorization.k8s.io/v1

9 | kind: ClusterRole

10 | metadata:

11 | name: cluster-admin

12 | rules:

13 | - apiGroups: ["*"]

14 | resources: ["*"]

15 | verbs: ["*"]

16 |

17 | ---

18 | apiVersion: rbac.authorization.k8s.io/v1

19 | kind: ClusterRoleBinding

20 | metadata:

21 | name: cluster-admin

22 | subjects:

23 | - kind: ServiceAccount

24 | name: cluster-admin

25 | namespace: kube-system

26 | roleRef:

27 | kind: ClusterRole

28 | name: cluster-admin

29 | apiGroup: rbac.authorization.k8s.io

30 |

--------------------------------------------------------------------------------

/codeblock/rbac/limit-sa.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: v1

2 | kind: ServiceAccount

3 | metadata:

4 | name: build-robot

5 | namespace: build

6 |

7 | ---

8 | apiVersion: rbac.authorization.k8s.io/v1

9 | kind: Role

10 | metadata:

11 | namespace: build

12 | name: pod-reader

13 | rules:

14 | - apiGroups: [""]

15 | resources: ["pods", "pods/log"]

16 | verbs: ["get", "list"]

17 |

18 | ---

19 | apiVersion: rbac.authorization.k8s.io/v1

20 | kind: RoleBinding

21 | metadata:

22 | name: read-pods

23 | namespace: build

24 | subjects:

25 | - kind: ServiceAccount

26 | name: build-robot

27 | namespace: build

28 | roleRef:

29 | kind: Role

30 | name: pod-reader

31 | apiGroup: rbac.authorization.k8s.io

32 |

--------------------------------------------------------------------------------

/codeblock/rbac/readonly-all.yaml:

--------------------------------------------------------------------------------

1 | kind: ClusterRole

2 | apiVersion: rbac.authorization.k8s.io/v1

3 | metadata:

4 | name: readonly

5 | rules:

6 | - apiGroups: ["*"]

7 | resources: ["*"]

8 | verbs: ["get", "watch", "list"]

9 |

10 | ---

11 | kind: ClusterRoleBinding

12 | apiVersion: rbac.authorization.k8s.io/v1

13 | metadata:

14 | name: readonly-to-roc

15 | subjects:

16 | - kind: User

17 | name: roc

18 | apiGroup: rbac.authorization.k8s.io

19 | roleRef:

20 | kind: ClusterRole

21 | name: readonly

22 | apiGroup: rbac.authorization.k8s.io

23 |

--------------------------------------------------------------------------------

/codeblock/rbac/readonly-exclude-secret.yaml:

--------------------------------------------------------------------------------

1 | kind: ClusterRole

2 | apiVersion: rbac.authorization.k8s.io/v1

3 | metadata:

4 | name: readonly

5 | rules:

6 | - apiGroups: [""]

7 | resources:

8 | - bindings

9 | - componentstatuses

10 | - configmaps

11 | - endpoints

12 | - events

13 | - limitranges

14 | - namespaces

15 | - nodes

16 | - persistentvolumeclaims

17 | - persistentvolumes

18 | - pods

19 | - podtemplates

20 | - replicationcontrollers

21 | - resourcequotas

22 | - serviceaccounts

23 | - services

24 | verbs: ["get", "list"]

25 | - apiGroups:

26 | - cert-manager.io

27 | - admissionregistration.k8s.io

28 | - apiextensions.k8s.io

29 | - apiregistration.k8s.io

30 | - apps

31 | - authentication.k8s.io

32 | - autoscaling

33 | - batch

34 | - certificaterequests.cert-manager.io

35 | - certificates.cert-manager.io

36 | - certificates.k8s.io

37 | - cloud.tencent.com

38 | - coordination.k8s.io

39 | - discovery.k8s.io

40 | - events.k8s.io

41 | - extensions

42 | - install.istio.io

43 | - metrics.k8s.io

44 | - monitoring.coreos.com

45 | - networking.istio.io

46 | - node.k8s.io

47 | - policy

48 | - rbac.authorization.k8s.io

49 | - scheduling.k8s.io

50 | - security.istio.io

51 | - storage.k8s.io

52 | resources: ["*"]

53 | verbs: ["get", "list"]

54 |

55 | ---

56 | apiVersion: rbac.authorization.k8s.io/v1

57 | kind: ClusterRoleBinding

58 | metadata:

59 | name: roc

60 | roleRef:

61 | apiGroup: rbac.authorization.k8s.io

62 | kind: ClusterRole

63 | name: readonly

64 | subjects:

65 | - apiGroup: rbac.authorization.k8s.io

66 | kind: User

67 | name: roc

68 |

--------------------------------------------------------------------------------

/codeblock/rbac/secret-reader-for-manager-group.yaml:

--------------------------------------------------------------------------------

1 | apiVersion: rbac.authorization.k8s.io/v1

2 | kind: ClusterRole

3 | metadata:

4 | name: secret-reader

5 | rules:

6 | - apiGroups: [""]

7 | resources: ["secrets"]

8 | verbs: ["get", "watch", "list"]

9 | ---

10 | apiVersion: rbac.authorization.k8s.io/v1

11 | kind: ClusterRoleBinding

12 | metadata:

13 | name: read-secrets-global

14 | subjects:

15 | - kind: Group

16 | name: manager

17 | apiGroup: rbac.authorization.k8s.io

18 | roleRef:

19 | kind: ClusterRole

20 | name: secret-reader

21 | apiGroup: rbac.authorization.k8s.io

22 |

--------------------------------------------------------------------------------

/codeblock/rbac/test-admin-istio-system-readonly.yaml:

--------------------------------------------------------------------------------

1 | kind: Role

2 | apiVersion: rbac.authorization.k8s.io/v1

3 | metadata:

4 | name: admin

5 | namespace: test

6 | rules:

7 | - apiGroups: ["*"]

8 | resources: ["*"]

9 | verbs: ["*"]

10 |

11 | ---

12 | kind: RoleBinding

13 | apiVersion: rbac.authorization.k8s.io/v1

14 | metadata:

15 | name: admin-to-roc

16 | namespace: test

17 | subjects:

18 | - kind: User

19 | name: roc

20 | apiGroup: rbac.authorization.k8s.io

21 | roleRef:

22 | kind: Role

23 | name: admin

24 | apiGroup: rbac.authorization.k8s.io

25 |

26 | ---

27 | kind: Role

28 | apiVersion: rbac.authorization.k8s.io/v1

29 | metadata:

30 | name: readonly

31 | namespace: istio-system

32 | rules:

33 | - apiGroups: ["*"]

34 | resources: ["*"]

35 | verbs: ["get", "watch", "list"]

36 |

37 | ---

38 | kind: RoleBinding

39 | apiVersion: rbac.authorization.k8s.io/v1

40 | metadata: