├── .gitignore

├── Java

├── README.md

├── Tomcat

│ ├── image_tomcat_config.png

│ ├── image_tomcat_issue_1.png

│ ├── Misc.md

│ └── Deploy.md

├── Eclipse.md

├── Annotation.md

├── logback

│ ├── README.md

│ ├── logback-spring.xml

│ └── logback.xml

├── Spring

│ ├── Filter_Interceptor.md

│ ├── Profile.md

│ ├── PropertyFile.md

│ ├── Environment.md

│ └── ApplicationContext.md

├── UseSystemVariables.md

└── Sping-cloud

│ ├── Hystrix.md

│ └── Feign.md

├── etc

├── README.md

├── yum.md

├── UniqueIDs.md

├── equity.md

└── fast_del.md

├── linux

├── README.md

├── systemtap.md

├── systemcmd

│ ├── iptables.md

│ ├── chattr.md

│ ├── selinux.md

│ └── nologin.md

├── openssh.md

├── OOM.md

└── drop_caches.md

├── clickhouse

├── Engines

│ ├── Null.md

│ ├── Log.md

│ ├── Set.md

│ ├── Join.md

│ ├── TinyLog.md

│ ├── Memory.md

│ ├── ReplacingMergeTree.md

│ ├── Merge.md

│ ├── SummingMergeTree.md

│ ├── CollapsingMergeTree.md

│ ├── External.md

│ ├── Buffer.md

│ ├── AggregatingMergeTree.md

│ └── MergeTree.md

├── Client.md

└── install.md

├── consul

├── server

│ ├── systemd

│ │ ├── consul

│ │ └── consul.service

│ └── consul.d

│ │ └── config.json

├── client

│ ├── consul.d

│ │ └── client

│ │ │ └── config.json

│ └── start.sh

├── install.md

├── README.md

└── QuickCmd.md

├── testing

└── README.md

├── druidio

└── script

│ ├── env.sh

│ └── druid.sh

├── README.md

├── SQLite

└── README.md

├── web

├── gulp.md

├── README.md

└── named_css.md

├── logrotate

└── nginx

├── FreeSWITCH

├── FusionPBX

│ └── install.md

├── pgsql.md

└── README.md

├── PostgreSQL

├── QuickCmd.md

├── scripts

│ ├── pg_backup.sh

│ ├── jsonb_ext.sql

│ └── random_string.c

├── compile

├── install.md

├── AccessControl.md

├── docker

│ └── docker-compose.yml

├── Replication.md

├── postgres.conf

├── xact_Isolation.md

└── show_bloat.sql

├── PulsarIO

├── README.md

├── DataFlow.md

├── Pulsar_Real_time_Analytics_at_Scale

│ ├── concluding.md

│ ├── part1-introduction.md

│ └── README.md

├── Processor.md

├── Structure.md

├── Management.md

└── Startup.md

├── nginx

├── README.md

├── nginx_force_redirect.conf

├── auth.md

├── compile.md

├── source

│ └── 配置模块.md

└── nginx_sample.conf

├── python

├── code

│ ├── process_bar.py

│ ├── tar_untar.py

│ ├── zip_unzip.py

│ └── blockedpool.py

├── logging.md

├── README.md

├── data_science.md

├── tornado.md

└── install.md

├── supervisord

└── script

│ ├── supervisor.service

│ ├── conf.d

│ ├── superset.ini

│ └── airflow.ini

│ └── supervisor_init_script.sh

├── etcd

└── README.md

├── claude

├── sample.md

├── claude.md

├── command

│ └── brief.md

└── readme.md

├── pentaho

└── kettle.md

├── nodejs

├── README.md

└── npm_config.md

├── R-Server

├── install_package.md

└── README.md

├── chrome

└── pull_tag.md

├── ZooKeeper

├── scripts

│ └── zookeeper.init

├── deploy.md

├── file_format.md

└── README.md

├── Jenkins

├── ansible

│ ├── sample_nginx.yaml

│ ├── do.build.nginx.yaml

│ ├── do.deploy.nginx.yaml

│ ├── sample_web.yaml

│ ├── sample.yaml

│ └── sample_vars.yaml

└── consul_api.sh

├── Airflow

├── script

│ └── hive_create.sh

└── DAG

│ └── hive_create_partition.py

├── Mac

├── lldb.md

└── rw_ntfs.md

├── kafka

├── Consumer.md

├── kafka4.0_Cmd.md

├── monitor.md

└── docker-compose.yml

├── mattermost

├── deploy_docker.md

├── env.sample

└── docker-compose.yml

├── pulsar

└── QuickCmd.md

├── mysql

└── docker-compose.yml

├── ELK

├── elastic

│ ├── Filter.md

│ └── INSTALL.md

└── logstash

│ └── config.md

├── Flex-Bison

└── Flex_Basic.md

├── ldap

└── README.md

├── php

├── install_php_pgsql.sh

└── install.md

├── CPP

├── gcc

│ └── install.md

└── guard.h

├── oracle

└── sqlplus.md

├── spark

└── README.md

├── docker

└── README.md

├── init_scripts

├── zookeeper.init

├── redis-sentinel.init

├── kafka-manager.init

├── elasticsearch.init

├── kafka.init

├── jenkins.init

└── redis.init

├── zabbix

└── install.md

├── starrocks

└── install.md

├── DNS

└── README.md

└── apisix

├── 介绍.md

└── introduce.md

/.gitignore:

--------------------------------------------------------------------------------

1 | .DS_Store

2 |

--------------------------------------------------------------------------------

/Java/README.md:

--------------------------------------------------------------------------------

1 | # Java

2 |

3 | 记录Java的一些入门姿势。

4 |

--------------------------------------------------------------------------------

/etc/README.md:

--------------------------------------------------------------------------------

1 | etc

2 | ========

3 |

4 | Variable RPM Website: http://rpm.pbone.net/

5 |

6 |

--------------------------------------------------------------------------------

/linux/README.md:

--------------------------------------------------------------------------------

1 | # Linux

2 |

3 | # Misc

4 | [Linux工具快速教程](http://linuxtools-rst.readthedocs.org/zh_CN/latest/)

5 |

--------------------------------------------------------------------------------

/clickhouse/Engines/Null.md:

--------------------------------------------------------------------------------

1 | # Null

2 |

3 | 写入空表时,将忽略数据。从空表读取时,内容为空。

4 |

5 | 但是,您可以在Null表上建立物化视图,写入表的数据会被view(视图)收到

6 |

--------------------------------------------------------------------------------

/Java/Tomcat/image_tomcat_config.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/jaiminpan/awesome-memo/HEAD/Java/Tomcat/image_tomcat_config.png

--------------------------------------------------------------------------------

/Java/Tomcat/image_tomcat_issue_1.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/jaiminpan/awesome-memo/HEAD/Java/Tomcat/image_tomcat_issue_1.png

--------------------------------------------------------------------------------

/consul/server/systemd/consul:

--------------------------------------------------------------------------------

1 | # vi /etc/sysconfig/consul

2 |

3 | CONSUL_OPTIONS="-config-dir=/etc/consul.d -pid-file=/run/consul/consul.pid"

4 |

--------------------------------------------------------------------------------

/testing/README.md:

--------------------------------------------------------------------------------

1 | # Testing

2 |

3 | ## Misc

4 |

5 | [How Google Tests Software](http://www.cnblogs.com/oscarxie/archive/2011/02/17/1956968.html)

6 |

--------------------------------------------------------------------------------

/Java/Eclipse.md:

--------------------------------------------------------------------------------

1 | # Eclipse

2 |

3 |

4 | ## Misc

5 | [怎样用eclipse进行远程debug][1]

6 |

7 |

8 | [1]: http://jingyan.baidu.com/article/148a192199c7a24d71c3b103.html

9 |

--------------------------------------------------------------------------------

/druidio/script/env.sh:

--------------------------------------------------------------------------------

1 |

2 | export DRUID_CONF_DIR=/etc/druid/conf/druid

3 |

4 | export DRUID_LOG_DIR=/data/applogs/druid

5 |

6 | export DRUID_PID_DIR=/data/appdata/druid/pids

7 |

8 | # export LIB_DIR=

9 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # Awesome Memo []()

2 |

3 |

4 | Just For My Record

5 | Deprecated stuff in [Wiki](https://github.com/jaiminpan/MYWIKI/wiki) page

6 |

--------------------------------------------------------------------------------

/SQLite/README.md:

--------------------------------------------------------------------------------

1 | # SQLite

2 |

3 | ## Python

4 |

5 | [SQLite - Python](http://www.runoob.com/sqlite/sqlite-python.html)

6 |

7 | ## Performace

8 |

9 | [提升SQLite数据插入效率低、速度慢的方法](http://blog.csdn.net/chenguanzhou123/article/details/9376537)

10 |

--------------------------------------------------------------------------------

/web/gulp.md:

--------------------------------------------------------------------------------

1 | # gulp

2 |

3 |

4 | ## Misc

5 |

6 | * http://www.w3ctrain.com/2015/12/22/gulp-for-beginners/

7 | * https://ruby-china.org/topics/25477

8 | * http://www.ido321.com/1622.html

9 | * http://www.cnblogs.com/fengyuqing/p/5332112.html

10 |

--------------------------------------------------------------------------------

/Java/Annotation.md:

--------------------------------------------------------------------------------

1 | # Annotation

2 |

3 |

4 | ## Misc

5 | * [Java 注解Annotation使用解析][1]

6 | * [Java基础之理解Annotation][2]

7 |

8 |

9 |

10 | [1]: http://www.sunnyang.com/413.html

11 | [2]: http://www.cnblogs.com/mandroid/archive/2011/07/18/2109829.html

12 |

--------------------------------------------------------------------------------

/clickhouse/Client.md:

--------------------------------------------------------------------------------

1 | # Client

2 |

3 | ## import data

4 | ```sh

5 | # CSV FORMAT

6 | cat qv_stock.csv | clickhouse-client --query="INSERT INTO stock FORMAT CSV";

7 |

8 | # CSV FORMAT WITH HEADER

9 | cat qv_stock.csv | clickhouse-client --query="INSERT INTO stock FORMAT CSVWithNames";

10 | ```

11 |

--------------------------------------------------------------------------------

/clickhouse/Engines/Log.md:

--------------------------------------------------------------------------------

1 | # Log

2 |

3 |

4 | 日志与TinyLog 的不同之处在于,列文件中存在一个'marks'小文件。

5 |

6 | 这些marks(标记)写入每个数据块,并包含偏移量—从何处开始读取文件,以便跳过指定的行数。这使得可以在多个线程中读取表数据。

7 |

8 | 对于并发数据访问,读操作可以同时执行,而写操作互相阻塞并阻塞读操作。

9 |

10 | Log引擎不支持索引。

11 |

12 | 同样,如果对表的写入操作失败,表就会损坏,从表中读数据也会错误误。

13 |

14 | Log引擎适用于临时数据、一次写入表以及测试或演示目的。

15 |

--------------------------------------------------------------------------------

/logrotate/nginx:

--------------------------------------------------------------------------------

1 | /var/log/nginx/*log {

2 | daily

3 | rotate 10

4 | missingok

5 | notifempty

6 | dateext

7 | compress

8 | delaycompress

9 | sharedscripts

10 | postrotate

11 | [ -f /var/run/nginx.pid ] && kill -USR1 `cat /var/run/nginx.pid`

12 | endscript

13 | }

14 |

--------------------------------------------------------------------------------

/clickhouse/Engines/Set.md:

--------------------------------------------------------------------------------

1 | # Set

2 |

3 | 始终位于RAM中的数据集。它用于IN运算符的右侧(请参见“IN operators”一节)。

4 |

5 | 可以使用INSERT在表中插入数据。新元素将添加到数据集,而重复元素将被忽略。

6 | 但不能从表中执行SELECT。检索数据的唯一方法是在IN运算符的右半部分使用它。

7 |

8 | 数据始终位于RAM中。对于插入,插入的数据块也写入磁盘上的表目录。启动服务器时,此数据将加载到RAM中。换句话说,在重新启动之后,数据保持在原位。

9 |

10 | 对于粗暴的服务器重启,磁盘上的数据块可能丢失或损坏。在后一种情况下,可能需要手动删除数据已损坏的文件。

11 |

12 |

--------------------------------------------------------------------------------

/FreeSWITCH/FusionPBX/install.md:

--------------------------------------------------------------------------------

1 | # FusionPBX

2 |

3 |

4 | [github](https://github.com/fusionpbx/fusionpbx)

5 |

6 | [官方安装指南](https://www.fusionpbx.com/download)

7 |

8 | ## Install

9 | #### Prepare

10 | 1. 提前安装好

11 | * nginx

12 | * php-frm

13 | * PostgreSQL (OR SQLite)

14 |

15 | 参考 https://github.com/fusionpbx/fusionpbx-install.sh.git

16 |

--------------------------------------------------------------------------------

/PostgreSQL/QuickCmd.md:

--------------------------------------------------------------------------------

1 | # Quick Cmd

2 |

3 |

4 | ### 导入

5 | `

6 | # 编码转换

7 | iconv -f UTF16LE -t UTF8 -o file_utf.csv file.csv

8 | # 去掉boom

9 | sed -i '1s/^\xEF\xBB\xBF//' file_utf.csv

10 |

11 | # 导入tab分割、无指定quote的文件

12 | copy test_table from program 'sed ''s/\\/\\\\/g'' < /var/lib/pgsql/file_utf.csv' with (format csv, delimiter E'\t', quote '\');

13 | `

--------------------------------------------------------------------------------

/linux/systemtap.md:

--------------------------------------------------------------------------------

1 | # SystemTap

2 |

3 | 图示

4 |

5 |

6 |

7 | ## Reference

8 | * https://www.ibm.com/developerworks/cn/linux/l-systemtap/

9 | * http://blog.csdn.net/zhangskd/article/details/25708441

10 |

--------------------------------------------------------------------------------

/PulsarIO/README.md:

--------------------------------------------------------------------------------

1 | # PulsarIO

2 |

3 | * [jetstream](https://github.com/pulsarIO/jetstream):

4 | PulsarIO的核心,提供大部分基础包,和运行框架

5 | * [jetstream-esper](https://github.com/pulsarIO/jetstream-esper):

6 | 把 esper 做了一层封装,使其能在jetstream框架中使用

7 | * [realtime-analytics](https://github.com/pulsarIO/realtime-analytics):

8 | 使用 jetstream 和 jetstream-esper 的一个简单例子

9 |

10 |

--------------------------------------------------------------------------------

/Java/logback/README.md:

--------------------------------------------------------------------------------

1 | # logback

2 |

3 |

4 | #### Reference

5 | * https://logback.qos.ch/manual/

6 | * https://docs.spring.io/spring-boot/docs/current/reference/html/howto-logging.html

7 | * https://www.cnblogs.com/DeepLearing/p/5663178.html

8 | * https://lankydanblog.com/2017/08/31/configuring-logback-with-spring-boot/

9 | * http://www.leftso.com/blog/132.html

10 |

--------------------------------------------------------------------------------

/PostgreSQL/scripts/pg_backup.sh:

--------------------------------------------------------------------------------

1 | #!/bin/env bash

2 |

3 | TARGET_DAY=`date -d '0 days' +%Y%m%d`

4 |

5 |

6 | TARGET_DIR=/data/appdatas/pg_base/base_${TARGET_DAY}

7 | LOG_DIR=/data/applogs/pg_base/${TARGET_DAY}.log

8 |

9 | if [ ! -d "${TARGET_DIR}" ]; then

10 | mkdir "${TARGET_DIR}" && pg_basebackup -D "${TARGET_DIR}" -Ft -Xf -v -P -h 10.81.5.1 -p 15432 >> $LOG_DIR 2>&1

11 | fi

12 |

--------------------------------------------------------------------------------

/PulsarIO/DataFlow.md:

--------------------------------------------------------------------------------

1 | # DataFlow

2 |

3 | 位于com.ebay.jetstream.application.dataflows包下

4 |

5 | ## 介绍

6 | 这个部分,主要是用来显示相关bean所处理的数据流。

7 |

8 | * DataFlows: 继承了Spring的BeanFactoryAware, 从源头类InboundChannel开始,获取相关的EventSource,形成数据流数据,保存起来

9 | * VisualDataFlow: 通过DataFlows得到数据流,然后使用外部接口 http://yuml.me/ 生成对应的图片。

10 | * VisualServlet: 把VisualDataFlow用servlet暴露出去。

11 | * DirectedGraph: 辅助类,保存图数据

12 |

13 |

--------------------------------------------------------------------------------

/PostgreSQL/compile:

--------------------------------------------------------------------------------

1 | ./configure \

2 | --prefix=/usr/local/pgsql \

3 | --with-pgport=1999 \

4 | --with-perl \

5 | --with-tcl \

6 | --with-python \

7 | --with-openssl \

8 | --with-pam \

9 | --without-ldap \

10 | --with-libxml \

11 | --with-libxslt \

12 | --enable-thread-safety \

13 | --with-wal-blocksize=16 \

14 | --with-blocksize=16 \

15 | --enable-dtrace \

16 | --enable-debug \

17 | --enable-cassert

18 |

--------------------------------------------------------------------------------

/nginx/README.md:

--------------------------------------------------------------------------------

1 | Nginx Reference

2 | =================

3 |

4 | Offical Website: http://nginx.org/

5 |

6 | Packages: http://nginx.org/packages/

7 |

8 | Third Party Module: https://www.nginx.com/resources/wiki/modules/

9 |

10 | ## Optimized

11 |

12 | [How to Configure Nginx for Optimized Performance][1]

13 |

14 | [1]: https://www.linode.com/docs/websites/nginx/configure-nginx-for-optimized-performance

15 |

--------------------------------------------------------------------------------

/python/code/process_bar.py:

--------------------------------------------------------------------------------

1 | # -*- coding: utf-8 -*-

2 |

3 | import sys

4 | import time

5 |

6 | def processbar():

7 |

8 | for num in range(1000):

9 | nowtime = time.strftime('%Y-%m-%d %H:%M:%S', time.localtime(time.time()))

10 | sys.stdout.write('\r%s progress (% 10d)' % (nowtime, num))

11 | sys.stdout.flush()

12 | time.sleep(1)

13 |

14 | if __name__ == '__main__':

15 | processbar()

16 |

--------------------------------------------------------------------------------

/consul/client/consul.d/client/config.json:

--------------------------------------------------------------------------------

1 | {

2 | "datacenter": "sz-dc",

3 | "data_dir": "/home/java/consul/data",

4 | "log_level": "INFO",

5 | "addresses": {

6 | "http": "0.0.0.0"

7 | },

8 | "retry_join": [

9 | "10.81.xx.xxx2",

10 | "10.81.xx.xxx3"

11 | ],

12 | "retry_interval": "10s",

13 | "skip_leave_on_interrupt": true,

14 | "leave_on_terminate": false,

15 | "rejoin_after_leave": true

16 | }

17 |

--------------------------------------------------------------------------------

/supervisord/script/supervisor.service:

--------------------------------------------------------------------------------

1 | [Unit]

2 | Description=supervisor

3 | After=network.target

4 |

5 | [Service]

6 | Type=forking

7 | ExecStart=/usr/bin/supervisord -c /etc/supervisor/supervisord.conf

8 | ExecStop=/usr/bin/supervisorctl $OPTIONS shutdown

9 | ExecReload=/usr/bin/supervisorctl $OPTIONS reload

10 | KillMode=process

11 | Restart=on-failure

12 | RestartSec=42s

13 |

14 | [Install]

15 | WantedBy=multi-user.target

16 |

--------------------------------------------------------------------------------

/PulsarIO/Pulsar_Real_time_Analytics_at_Scale/concluding.md:

--------------------------------------------------------------------------------

1 | 总结

2 | ================================

3 | 在这篇文章中,我们讲述了用于解决实时用户行为分析问题的数据和处理模型。

4 | 我们讲述了Pulsar在一些设计上的考虑,Pulsar已经在eBay云环境运行了一年多,我们每秒处理十万事件并达到99.9%的数据精确度。

5 | 我们管道端对端的延迟在95%都小于100毫秒,我们管道在99.99%的时间里顺利运行,一些eBay的团队使用我们成功地构建一些解决方案,如in-session的个性化推荐、互联网广告营销、记账、业务监控等等。

6 |

7 | 虽然我们主要场景是用户行为分析,但我们可以想象Pulsar可以使用很多其他的实时处理场景。

8 |

9 | -----------------

10 |

11 | [« 首页](README.md)

12 |

--------------------------------------------------------------------------------

/linux/systemcmd/iptables.md:

--------------------------------------------------------------------------------

1 |

2 | cmd `iptables`

3 | ```

4 | # Enable access on IP ranges from 172.16.1.1 to 172.16.1.10 for Port 11211 ##

5 | iptables -A INPUT -p tcp --destination-port 11211 -m state --state NEW -m iprange --src-range 172.16.1.1-172.16.1.10 -j ACCEPT

6 | iptables -A INPUT -p udp --destination-port 11211 -m state --state NEW -m iprange --src-range 172.16.1.1-172.16.1.10 -j ACCEPT

7 |

8 | service iptables restart

9 | ```

10 |

--------------------------------------------------------------------------------

/clickhouse/Engines/Join.md:

--------------------------------------------------------------------------------

1 | # Join

2 |

3 | 为JOIN 预处理的数据结构,始终位于RAM中。

4 |

5 | ```

6 | Join(ANY|ALL, LEFT|INNER, k1[, k2, ...])

7 | ```

8 |

9 | 引擎参数:

10 | * ANY | ALL : 方式

11 | * LEFT | INNER: join类型

12 |

13 | 这些参数设置为不带引号,并且必须与表将用于的JOIN 相匹配。k1,k2,…是将在其上进行连接的USING子句中的关键列。

14 |

15 | 表不能用于GLOBAL JOINs。

16 |

17 | 可以使用INSERT向表中添加数据,类似于Set引擎。对于ANY,将忽略重复键的数据。对于ALL,这将被计算在内。

18 |

19 | 不能直接从表中执行SELECT。检索数据的唯一方法是将其用作JOIN的“右侧”表。

20 |

21 | 在磁盘上存储数据与在Set engine中存储数据相同

22 |

--------------------------------------------------------------------------------

/PostgreSQL/install.md:

--------------------------------------------------------------------------------

1 | # PostgreSQL Install

2 |

3 |

4 | ## CentOS

5 |

6 | #### A

7 | ```

8 | yum install https://download.postgresql.org/pub/repos/yum/9.6/redhat/rhel-6.8-x86_64/pgdg-centos96-9.6-3.noarch.rpm

9 |

10 | yum install postgresql95-server postgresql95-contrib

11 | ```

12 |

13 |

14 | #### B

15 | Reference https://www.postgresql.org/download/linux/redhat/

16 |

17 |

18 | #### C

19 | Direct Download RPM

20 | Click https://yum.postgresql.org/rpmchart.php

21 |

--------------------------------------------------------------------------------

/clickhouse/Engines/TinyLog.md:

--------------------------------------------------------------------------------

1 | # TinyLog

2 |

3 | 最简单的表引擎,用于在磁盘上存储数据。

4 | 每个列都存储在单独的压缩文件中。写入时,数据会附加到文件末尾。

5 |

6 | 并发数据访问不受任何限制:

7 | * 如果您同时对表做读取和写入操作,则读取操作会报错。

8 | * 如果您同时在多个查询做写入操作,则数据将会损坏。

9 |

10 | 使用此表的典型方法是一次写入:首先只写入一次数据,然后根据需要多次读取。读取操作是在单个流中执行的。

11 | 换句话说,此引擎用于相对较小的表(建议最多使用1百万行)。如果您有许多小表,使用此表引擎是有意义的,因为它比Log 引擎简单(需要打开的文件更少)。

12 | 当您拥有大量的小表时,这种情况被证明是有较差的效率,但在使用其他DBMS时可能已经在这样用了,那么您可能会发现切换到使用TinyLog类型的表会很容易。

13 |

14 | 此引擎不支持索引。

15 |

16 | 在Yandex.Metrica、TinyLog 表使用在作为小批量处理的中间数据。

17 |

--------------------------------------------------------------------------------

/supervisord/script/conf.d/superset.ini:

--------------------------------------------------------------------------------

1 | ;vi /usr/lib/python2.7/site-packages/superset/config.py

2 | ;- DATA_DIR = os.path.join(os.path.expanduser('~'), '.superset')

3 | ;+ DATA_DIR = os.getcwd()

4 |

5 | [program:superset]

6 | command=superset runserver

7 | user=superset

8 | redirect_stderr=true

9 | stdout_logfile=/data/applogs/superset/superset.log

10 | autostart=true

11 | autorestart=false

12 | startsecs=5

13 | priority=1

14 | stopasgroup=true

15 | killasgroup=true

16 | directory=/data/appdata/superset

17 |

--------------------------------------------------------------------------------

/etcd/README.md:

--------------------------------------------------------------------------------

1 | # etcd

2 |

3 | etcd is a distributed, consistent key-value store for shared configuration and service discovery, with a focus on being:

4 |

5 | * Simple: well-defined, user-facing API (gRPC)

6 | * Secure: automatic TLS with optional client cert authentication

7 | * Fast: benchmarked 10,000 writes/sec

8 | * Reliable: properly distributed using Raft

9 |

10 | https://github.com/coreos/etcd

11 |

12 |

13 | #### Misc

14 | http://dockone.io/article/667

15 | https://my.oschina.net/u/2362111/blog/714503

16 |

--------------------------------------------------------------------------------

/python/logging.md:

--------------------------------------------------------------------------------

1 | # Logging

2 |

3 | Refference:

4 | https://docs.python.org/2/howto/logging.html

5 | https://docs.python.org/2/howto/logging-cookbook.html

6 | https://docs.python.org/2/library/logging.html

7 |

8 | #### Example

9 | ```

10 | FORMAT = '%(asctime)-15s %(clientip)s %(user)-8s %(message)s'

11 | logging.basicConfig(format=FORMAT)

12 | d = {'clientip': '192.168.0.1', 'user': 'fbloggs'}

13 | logger = logging.getLogger('tcpserver')

14 | logger.warning('Protocol problem: %s', 'connection reset', extra=d)

15 | ```

16 |

--------------------------------------------------------------------------------

/claude/sample.md:

--------------------------------------------------------------------------------

1 | markdown### 🗺️ 关键文档模式

2 | **总是把重要的文档加在这里!** 当你创建或发现:

3 | - **架构**: `/docs/OVERALL_ARCHITECTURE.md` 🐳

4 | - **数据库架构**: `/docs/DATABASE_ARCHITECTURE.md`

5 | - **密码真相**: `/docs/PASSWORD_TRUTH.md` 🚨 先读这个!

6 | - **JWT 认证**: `/docs/JWT_AUTHENTICATION_ARCHITECTURE.md` 🔐

7 | - **安全检查清单**: `/docs/SECURITY_CHECKLIST.md` 🚨

8 | - **功能请求**: `/docs/enhancements/README.md`

9 | - **健康监测 V2**: `/docs/enhancements/HEALTH_MONITORING_V2.md` 🆕

10 |

11 |

12 | > /start 然后请阅读 Brief,并根据 Brief 进行修复,我们上一次会议调查了,记录了我们发现的内容,以便您可以在本次会议上进行修复,开始吧!

13 |

--------------------------------------------------------------------------------

/clickhouse/Engines/Memory.md:

--------------------------------------------------------------------------------

1 | # Memory

2 |

3 |

4 | Memory引擎以未压缩形式将数据存储在RAM中。

5 |

6 | #### 特点

7 | * 数据的存储形式与读取时接收的形式完全相同。

8 | 换句话说,从这个表中读取是完全自由的。并发数据访问是同步过的(synchronized)。

9 |

10 | * 锁很短:读和写操作不会相互阻塞。

11 | * 不支持索引。

12 | * 读取是可以并发的。由于没有从磁盘读取、解压缩或反序列化数据,因此在简单查询上可以达到最高的生产效率(超过 10GB/sec)。

13 | (我们应该注意到,在许多情况下,MergeTree 引擎的生产率几乎一样高。)

14 |

15 | * 重新启动服务器时,数据丢失,表变为空。

16 |

17 | * 通常,使用此表引擎是不合理的。但是,它可以用于测试,也可以用于在相对较少的行(最多约一亿行)上要求最大速度的任务。

18 |

19 | PS:

20 | Memory引擎在系统内用于作为进行查询外部数据的临时表(请参阅“External data for processing a query”章节)和实现全局IN(请参阅“IN operators”章节)。

21 |

--------------------------------------------------------------------------------

/nginx/nginx_force_redirect.conf:

--------------------------------------------------------------------------------

1 |

2 | # 1. enforce https

3 | server {

4 | listen 80;

5 | listen [::]:80;

6 | server_name xxx.xxx.com;

7 |

8 | # return 301 https://$server_name$request_uri;

9 | return 307 https://$server_name$request_uri;

10 | }

11 |

12 | # 2. enforce https

13 | server {

14 | listen 80;

15 | server_name xxx.xxx.com;

16 | location / {

17 | rewrite ^/(.*) https://$server_name/$1 permanent;

18 | break;

19 | }

20 | error_page 497 https://$host:$server_port$request_uri;

21 | }

22 |

--------------------------------------------------------------------------------

/pentaho/kettle.md:

--------------------------------------------------------------------------------

1 | # Kettle

2 |

3 | ## Install

4 | ## Download

5 | http://community.pentaho.com/projects/data-integration/

6 | https://sourceforge.net/projects/pentaho

7 |

8 | #### Prepare

9 | yum install webkitgtk

10 |

11 | #### Running

12 | ./spoon.sh

13 |

14 | #### Other Problem:

15 | Q. undefined symbol: soup_message_set_first_party

16 | A. yum install libsoup

17 |

18 |

19 | ## Usage

20 | http://itroadmap.sinaapp.com/2014/12/10/%E5%BC%80%E6%BA%90etl%E5%B7%A5%E5%85%B7-kettle%EF%BC%88kettle-5-2-0%EF%BC%89%E7%9A%84%E4%BD%BF%E7%94%A8%E4%B9%8Bhello-world/

21 |

--------------------------------------------------------------------------------

/python/code/tar_untar.py:

--------------------------------------------------------------------------------

1 |

2 | import os

3 | import tarfile

4 |

5 | def tar_file(target_name, src_dir):

6 | #创建压缩包名

7 | tar = tarfile.open(target_name,"w:gz")

8 |

9 | #创建压缩包

10 | for root,dir,files in os.walk(src_dir):

11 | for filename in files:

12 | fullpath = os.path.join(root, filename)

13 | tar.add(fullpath)

14 | tar.close()

15 |

16 | def untar_file(target_name, dest):

17 | tar = tarfile.open(target_name)

18 | for filename in tar.getnames():

19 | tar.extract(filename, path=dest)

20 | tar.close()

21 |

--------------------------------------------------------------------------------

/claude/claude.md:

--------------------------------------------------------------------------------

1 | 全局配置

2 | - 技术问题优先中文回复, 代码和代码的注释必须用英文

3 | - 优先使用成熟开源方案,避免造轮子

4 | - 保持数据流与依赖清晰

5 | - 性能优化必须有benchmark数据

6 | - 数据库操作需考虑并发安全

7 |

8 | 工具策略

9 | - 绿灯区:Git、文件读写、pytest、npm install(自动允许)

10 | - 黄灯区:系统命令、网络请求(需确认)

11 | - 红灯区:删除操作、系统配置(禁止自动执行)

12 |

13 | 技术决策

14 | - 单一职责,避免过早抽象

15 | - 易于测试

16 | - 符合现有代码模式

17 |

18 | 开发流程

19 | - 规划:在 WORKING_PLAN.md 记录目标/标准/状态,完成后删除

20 | - 开发:理解 → 实现(绿灯)→ 重构

21 |

22 | 遇阻处理(尝试≤3次):

23 | - 记录尝试+错误+原因

24 | - 寻找 2–3 个替代方案

25 | - 停止盲目尝试,重新评估

26 |

27 | 行为准则

28 | - 禁止:--no-verify 跳过钩子、禁测提交、提交不可编译代码、无验证假设

29 | - 必须:逐步提交可运行代码、更新计划、复用实现、三次失败即停

30 |

--------------------------------------------------------------------------------

/clickhouse/Engines/ReplacingMergeTree.md:

--------------------------------------------------------------------------------

1 | # ReplacingMergeTree

2 |

3 | 此引擎与MergeTree 的不同之处在于,它可以在合并时按主键消除重复数据。

4 |

5 | 对于ReplacingMergeTree模式,最后一个参数是作为'version(版本)'的列(可选)。

6 |

7 | 合并时,对于具有相同主键的所有行,只选取一行(如果没有指定版本列,选择最后一行,如果指定了版本,选择版本号最大的最后一行。)

8 |

9 | version列的类型必须是`UInt`系列或`Date`或`DateTime`其中一种。

10 |

11 | ```

12 | ReplacingMergeTree(EventDate, (OrderID, EventDate, BannerID, ...), 8192, ver)

13 | ```

14 |

15 | 请注意,只有在合并过程中才会对数据进行重复数据消除。合并在后台处理。未指定合并的确切时间,您无法依赖它。部分数据根本无法合并。

16 | 虽然您可以使用OPTIMIZE查询触发额外合并,但不建议这样做,因为OPTIMIZE将读取和写入大量数据。

17 | 此表引擎适用于重复数据的后台删除,以节省空间,但不适于保证重复数据消除。

18 |

19 | *专为特殊目的开发*

20 |

--------------------------------------------------------------------------------

/PostgreSQL/scripts/jsonb_ext.sql:

--------------------------------------------------------------------------------

1 |

2 | -- jsonb de-duplicate json array

3 | CREATE OR REPLACE FUNCTION jsonb_usedef_dedup(arg JSONB) RETURNS JSONB AS

4 | $$

5 | DECLARE

6 | res JSONB;

7 | begin

8 | with in_test as

9 | (

10 | select distinct(jsonb_array_elements(arg)) as jsobj

11 | )

12 |

13 | select jsonb_agg(jsobj) into res from in_test;

14 | return res;

15 | end;

16 | $$ LANGUAGE plpgsql immutable SECURITY DEFINER

17 |

18 | -- jsonb aggregate concat

19 | CREATE AGGREGATE jsonb_object_agg(jsonb) (

20 | SFUNC = 'jsonb_concat',

21 | STYPE = jsonb,

22 | PARALLEL = SAFE

23 | );

24 |

--------------------------------------------------------------------------------

/nodejs/README.md:

--------------------------------------------------------------------------------

1 | # Node

2 |

3 |

4 |

5 | ## Install

6 | 目前,最推荐的使用nvm进行node版本管理及对应版本的npm安装。具体安装步骤如下:

7 |

8 | ```sh

9 | curl -o- https://raw.githubusercontent.com/creationix/nvm/v0.33.8/install.sh | bash

10 | nvm --version

11 | ```

12 |

13 | #### Mirror

14 | ```sh

15 | export NVM_NODEJS_ORG_MIRROR=https://npm.taobao.org/mirrors/node npm --registry=https://registry.npm.taobao.org

16 | ```

17 |

18 | #### Quick-cmd

19 | ```sh

20 | # 查看node版本

21 | nvm ls-remote

22 | # 查看本地安装的node版本

23 | nvm list

24 |

25 | nvm install [node版本号]

26 | nvm uninstall [node 版本]

27 |

28 | # 选定node版本作为开发环境

29 | nvm use [node 版本]

30 | ```

--------------------------------------------------------------------------------

/R-Server/install_package.md:

--------------------------------------------------------------------------------

1 | # install package

2 |

3 | #### Sample

4 |

5 | Install `RPostgreSQL` package in default foler.

6 | ```

7 | [root@localhost]# R

8 |

9 | > install.packages("RPostgreSQL")

10 | ```

11 |

12 | Install `RPostgreSQL` in to `/lib64/R/library/` folder

13 | ```

14 | [root@localhost]# R

15 |

16 | > install.packages("RPostgreSQL", "/lib64/R/library/")

17 | ```

18 |

19 | ## trouble shoot

20 |

21 | if file missing for include or library. Please use

22 | ```

23 | # sample as pgsql

24 | ln -s /usr/pgsql/include /usr/local/include/pgsql

25 | # and

26 | ln -s /usr/pgsql/lib /usr/local/lib/pgsql

27 |

28 | ```

29 |

--------------------------------------------------------------------------------

/chrome/pull_tag.md:

--------------------------------------------------------------------------------

1 | Chromium 的每个版本都会打 tag,可以通过 git fetch origin tag [tag-name] 或取指定版本,减少拉取的时间,拉取完之后需要重新同步相关依赖,具体命令如下:

2 |

3 |

4 |

5 | 1. 拉取指定版本的 tag

6 |

7 | ```bash

8 | git fetch origin tag [tag-name]

9 | # git fetch origin --tags

10 | ```

11 |

12 | 1. 切换到拉取的 tag

13 |

14 | ```bash

15 | git checkout tags/[tag-name]

16 | ```

17 |

18 | 1. 同步依赖

19 |

20 | ```bash

21 | gclient sync

22 | ```

23 |

24 | 1. (可选)有时候可能会需要移除一些在当前版本没有用的依赖

25 |

26 | ```bash

27 | gclient sync -D

28 | ```

29 |

30 | 1. 重新编译,这个步骤可能会报错,重试一遍即可

31 |

32 | ```bash

33 | autoninja -C out\Default chrome

34 | ```

35 |

36 | 1. 生成最小的安装包

37 |

38 | ```bash

39 | ninja -C out/Default mini_installer

40 | ```

41 |

--------------------------------------------------------------------------------

/PostgreSQL/AccessControl.md:

--------------------------------------------------------------------------------

1 | # AccessControl

2 |

3 |

4 | ```sh

5 | Revoke ALL ON DATABASE xxx from public;

6 | Revoke ALL ON SCHEMA public from public;

7 |

8 | # OPTION

9 | CREATE SCHEMA sss;

10 | ALTER DATABASE XXX SET search_path TO sss;

11 |

12 | CREATE USER xxx password 'XXX' with role xxx;

13 |

14 | # GRANT

15 | GRANT CONNECT ON DATABASE XXX TO XXX;

16 | GRANT USAGE ON SCHEMA SSS TO XXXUSER;

17 |

18 | ALTER DEFAULT PRIVILEGES IN SCHEMA SSS grant select, insert, update, delete, references on tables to XXXUSER;

19 | ALTER DEFAULT PRIVILEGES IN SCHEMA SSS grant all on SEQUENCES TO XXXUSER;

20 | ALTER DEFAULT PRIVILEGES IN SCHEMA SSS grant EXECUTE on FUNCTIONS TO XXXUSER;

21 |

22 | ```

23 |

--------------------------------------------------------------------------------

/consul/server/systemd/consul.service:

--------------------------------------------------------------------------------

1 | # vi /etc/systemd/system/consul.service

2 |

3 | [Unit]

4 | Description=Consul service discovery agent

5 | Requires=network-online.target

6 | After=network-online.target

7 |

8 | [Service]

9 | User=consul

10 | Group=consul

11 | Type=simple

12 | EnvironmentFile=/etc/sysconfig/consul

13 | Environment=GOMAXPROCS=2

14 | ExecStartPre=[ -f "/run/consul/consul.pid" ] && /usr/bin/rm -f /run/consul/consul.pid

15 | ExecStartPre=/usr/local/bin/consul validate /etc/consul.d

16 | ExecStart=/usr/local/bin/consul agent $CONSUL_OPTIONS

17 | ExecReload=/bin/kill -HUP $MAINPID

18 | KillSignal=SIGTERM

19 | Restart=on-failure

20 | TimeoutStopSec=5

21 |

22 | [Install]

23 | WantedBy=multi-user.target

--------------------------------------------------------------------------------

/nodejs/npm_config.md:

--------------------------------------------------------------------------------

1 | # npm

2 |

3 | npm 是node.js 环境下的包管理器,非常强大智能.

4 |

5 | 生活这这片神奇的土地上,各种奇葩手段屡见不鲜啊.

6 |

7 | 为什么要换源? npm 官方站点 http://www.npmjs.org/ 并没有被墙,但是下载第三方依赖包的速度让人着急啊!

8 |

9 | 就拿阿里云环境来说,有时npm 一个包也需要耐心等待......等待过去也许是原地踏步,也许就是安装失败.

10 |

11 | 幸运的是,国内有几个镜像站点可以供我们使用,本人在使用 http://www.cnpmjs.org/

12 |

13 | ## 给npm换源

14 |

15 | (1)通过 config 配置指向国内镜像源

16 | ```bash

17 | npm config set registry http://registry.cnpmjs.org //配置指向源

18 | npm info express //下载安装第三方包

19 | ```

20 |

21 | (2)通过 npm 命令指定下载源

22 | ```

23 | npm --registry http://registry.cnpmjs.org info express

24 | ```

25 |

26 | (3)在配置文件 ~/.npmrc 文件写入源地址

27 | ```bash

28 | nano ~/.npmrc //打开配置文件

29 |

30 | registry =https://registry.npm.taobao.org //写入配置文件

31 | ```

32 |

33 |

--------------------------------------------------------------------------------

/ZooKeeper/scripts/zookeeper.init:

--------------------------------------------------------------------------------

1 | #!/bin/sh

2 | #

3 | # chkconfig: 2345 20 90

4 | # description: zookeeper

5 | # processname: zookeeper

6 |

7 | ZOOKEEPER_HOME=/data/appsoft/zookeeper

8 | ZK_USER=zookeeper

9 |

10 | SU=su

11 |

12 | start()

13 | {

14 | $SU -l $ZK_USER -c "$ZOOKEEPER_HOME/bin/zkServer.sh start"

15 | }

16 |

17 | stop()

18 | {

19 | $SU -l $ZK_USER -c "$ZOOKEEPER_HOME/bin/zkServer.sh stop"

20 | }

21 |

22 | status()

23 | {

24 | $SU -l $ZK_USER -c "$ZOOKEEPER_HOME/bin/zkServer.sh status"

25 | }

26 |

27 | restart()

28 | {

29 | $SU -l $ZK_USER -c "$ZOOKEEPER_HOME/bin/zkServer.sh restart"

30 | }

31 |

32 | case $1 in

33 | start|stop|status|restart)

34 | $1

35 | ;;

36 | *)

37 | echo "require start|stop|status|restart" ;;

38 | esac

39 |

--------------------------------------------------------------------------------

/Jenkins/ansible/sample_nginx.yaml:

--------------------------------------------------------------------------------

1 | ---

2 | # ansible-playbook sample

3 |

4 | # usage: ansible-playbook deploy.yaml --

5 | # example: in jenkins | ansible-playbook /etc/ansible/www-sre/deploy.nginx.yaml --extra-vars "work_space=${WORKSPACE}"

6 |

7 | - hosts: www-lbhost1-java

8 | vars: #定义变量

9 | work_space: /data/home/jenkins/.jenkins/workspace/www-job-name

10 | become: yes

11 | become_user: root

12 |

13 | tasks:

14 |

15 | - name: sync nginx conf

16 | synchronize:

17 | src: "{{work_space}}/nginx/"

18 | dest: /data/appdatas/nginx/

19 | delete: yes

20 |

21 | - name: nginx check

22 | shell: nginx -t

23 |

24 | - name: nginx reload

25 | # shell: service nginx reload

26 | service: name=nginx state=reloaded

27 |

--------------------------------------------------------------------------------

/consul/server/consul.d/config.json:

--------------------------------------------------------------------------------

1 | {

2 | "datacenter": "sz-dc",

3 | "data_dir": "/data/appdatas/consul",

4 | "log_level": "INFO",

5 | "enable_syslog": true,

6 | "syslog_facility": "local0",

7 | "node_name": "mynode",

8 | "server": true,

9 | # only one can be on boostrap, others be commented

10 | "bootstrap_expect": 1,

11 | "bind_addr": "10.81.xxx.xxx1",

12 | "addresses": {

13 | "http": "0.0.0.0"

14 | },

15 | "ports": {

16 | "http": 8500

17 | },

18 | "ui": true,

19 | "performance": {

20 | "raft_multiplier": 1

21 | },

22 | "retry_join": [

23 | "10.81.xx.xxx2",

24 | "10.81.xx.xxx3"

25 | ],

26 | "retry_interval": "10s",

27 | "skip_leave_on_interrupt": true,

28 | "leave_on_terminate": false,

29 | "rejoin_after_leave": true

30 | }

31 |

--------------------------------------------------------------------------------

/PostgreSQL/scripts/random_string.c:

--------------------------------------------------------------------------------

1 | PG_FUNCTION_INFO_V1(random_string);

2 |

3 | Datum

4 | random_string(PG_FUNCTION_ARGS)

5 | {

6 | int32 length = PG_GETARG_INT32(0);

7 | int32 i;

8 | const char chars[] = "0123456789ABCDEFGHIJKLMNOPQRSTUVWXYZabcdefghijklmnopqrstuvwxyz";

9 | const int chars_len;

10 | char *result;

11 |

12 | if (length < 0)

13 | PG_RETURN_NULL();

14 |

15 | if (length == 0)

16 | PG_RETURN_TEXT_P(cstring_to_text(""));

17 |

18 | result = palloc(length + 1);

19 | if (result == NULL)

20 | ereport(ERROR,

21 | (errcode(ERRCODE_OUT_OF_MEMORY),

22 | errmsg("out of memory")));

23 |

24 | chars_len = sizeof(chars) - 1;

25 | for (i = 0; i < length; i++)

26 | {

27 | result[i] = chars[random() % chars_len];

28 | }

29 | result[length] = '\0';

30 |

31 | PG_RETURN_TEXT_P(cstring_to_text(result));

32 | }

33 |

--------------------------------------------------------------------------------

/python/code/zip_unzip.py:

--------------------------------------------------------------------------------

1 | import zipfile

2 |

3 | #解压zip文件

4 | def unzip(package_path, dest):

5 | myzip=zipfile.ZipFile(package_path, 'r')

6 | for name in myzip.namelist():

7 | myzip.extract(name, dest)

8 | f_handle=open(dest+name,"wb")

9 | f_handle.write(myzip.read(name))

10 | f_handle.close()

11 | myzip.close()

12 |

13 | #添加文件到已有的zip包中

14 | def addzip(package_path, src):

15 | f = zipfile.ZipFile(package_path,'w',zipfile.ZIP_DEFLATED)

16 | f.write(src)

17 | f.close()

18 |

19 | #把整个文件夹内的文件打包

20 | def adddirfile(package_path, src):

21 | f = zipfile.ZipFile(package_path,'w',zipfile.ZIP_DEFLATED)

22 | for dirpath, dirnames, filenames in os.walk(src):

23 | for filename in filenames:

24 | f.write(os.path.join(dirpath,filename))

25 | f.close()

26 |

--------------------------------------------------------------------------------

/Java/Spring/Filter_Interceptor.md:

--------------------------------------------------------------------------------

1 | ## Filter

2 |

3 | 依赖于servlet容器。在实现上基于函数回调,可以对几乎所有请求进行过滤,但是缺点是一个过滤器实例只能在容器初始化时调用一次。

4 | 使用过滤器的目的是用来做一些过滤操作,获取我们想要获取的数据,

5 |

6 | 比如:在过滤器中修改字符编码;在过滤器中修改HttpServletRequest的一些参数,包括:过滤低俗文字、危险字符等

7 |

8 | ## Interceptor

9 | 依赖于web框架,在SpringMVC中就是依赖于SpringMVC框架。

10 | 在实现上基于Java的反射机制,属于面向切面编程(AOP)的一种运用。

11 | 由于拦截器是基于web框架的调用,因此可以使用Spring的依赖注入(DI)进行一些业务操作,同时一个拦截器实例在一个controller生命周期之内可以多次调用。

12 | 但是缺点是只能对controller请求进行拦截,对其他的一些比如直接访问静态资源的请求则没办法进行拦截处理

13 |

14 |

15 |

16 | ## Define Interceptor

17 | ```

18 | public class XXX implements HandlerInterceptor { ... }

19 | ```

20 | ```

21 | public class XXX implements HandlerInterceptorAdapter { ... }

22 | ```

23 | ```

24 | public class XXX implements WebRequestInterceptor { ... }

25 | ```

26 |

--------------------------------------------------------------------------------

/linux/systemcmd/chattr.md:

--------------------------------------------------------------------------------

1 | chattr命令

2 | -----------

3 | 文件权限属性设置 chattr命令用来改变文件属性。

4 |

5 | 这项指令可改变存放在ext2文件系统上的文件或目录属性,这些属性共有以下8种模式:

6 | ```

7 | a:让文件或目录仅供附加用途;

8 | b:不更新文件或目录的最后存取时间;

9 | c:将文件或目录压缩后存放;

10 | d:将文件或目录排除在倾倒操作之外;

11 | i:不得任意更动文件或目录;

12 | s:保密性删除文件或目录;

13 | S:即时更新文件或目录;

14 | u:预防意外删除。

15 | ```

16 |

17 | ### 语法

18 | ```

19 | chattr(选项)

20 | ```

21 |

22 | ### 选项

23 | ```

24 | -R:递归处理,将指令目录下的所有文件及子目录一并处理;

25 | -v<版本编号>:设置文件或目录版本;

26 | -V:显示指令执行过程;

27 | +<属性>:开启文件或目录的该项属性;

28 | -<属性>:关闭文件或目录的该项属性;

29 | =<属性>:指定文件或目录的该项属性。

30 | ```

31 |

32 | ### 实例

33 | 用chattr命令防止系统中某个关键文件被修改:

34 | ```

35 | chattr +i /etc/fstab

36 | ```

37 | 然后试一下rm、mv、rename等命令操作于该文件,都是得到Operation not permitted的结果。

38 |

39 |

40 | 让某个文件只能往里面追加内容,不能删除,一些日志文件适用于这种操作:

41 | ```

42 | chattr +a /data1/user_act.log

43 | ```

44 |

45 | 来自: http://man.linuxde.net/chattr

46 |

--------------------------------------------------------------------------------

/web/README.md:

--------------------------------------------------------------------------------

1 |

2 |

3 | ## 基本页面格式

4 | 样式位于开头,内容在中间,脚本位于最后

5 | ```

6 |

7 |

8 | Source Example

9 |

10 |

11 |

12 | Hello world!

13 |

14 |

15 |

16 |

17 |

18 |

19 |

20 | ```

21 | 详细参考:[JavaScript 的性能优化:加载和执行](http://www.ibm.com/developerworks/cn/web/1308_caiys_jsload/)

22 |

23 | ## Misc

24 | [学习JavaScript - 我的经验与建议(译)](http://blog.xiayf.cn/2013/03/25/learning-js/)

25 |

26 | ## Books

27 | JavaScript DOM编程艺术 第2版

28 | [JavaScript语言精粹_修订版](http://shop.oreilly.com/product/9780596517748.do)

29 |

--------------------------------------------------------------------------------

/Airflow/script/hive_create.sh:

--------------------------------------------------------------------------------

1 | #!/bin/bash

2 |

3 | TEMPFILE=`mktemp`

4 | echo $TEMPFILE

5 |

6 | TARGET=$1

7 |

8 | CURID=$RANDOM

9 | YEAR=`date -d '1 days ago' +%Y`

10 | MONTH=`date -d '1 days ago' +%m`

11 | DAY=`date -d '1 days ago' +%d`

12 |

13 |

14 | CMDDATA="alter table content_r1 add partition (y='$YEAR', m='$MONTH', d='$DAY') location 'hdfs://mwa/mw/data/tracking/v4/C/$YEAR/$MONTH/$DAY'; alter table request_r1 add partition (y='$YEAR', m='$MONTH', d='$DAY') location 'hdfs://mwa/mw/data/tracking/v4/I/$YEAR/$MONTH/$DAY';

15 | "

16 |

17 |

18 | #CMDDATA="alter table test_txt add partition (y='$YEAR', m='$MONTH', d='$MIN') location 'hdfs://mwa/mw/data/test/C/$YEAR/$MONTH/$MIN';"

19 |

20 |

21 | echo $CMDDATA > $TEMPFILE

22 |

23 | scp -r $TEMPFILE hive@$TARGET:/tmp/airflow_job.$CURID.sh

24 |

25 | ssh hive@$TARGET "hive -f /tmp/airflow_job.$CURID.sh"

26 |

27 | exit $?

28 |

--------------------------------------------------------------------------------

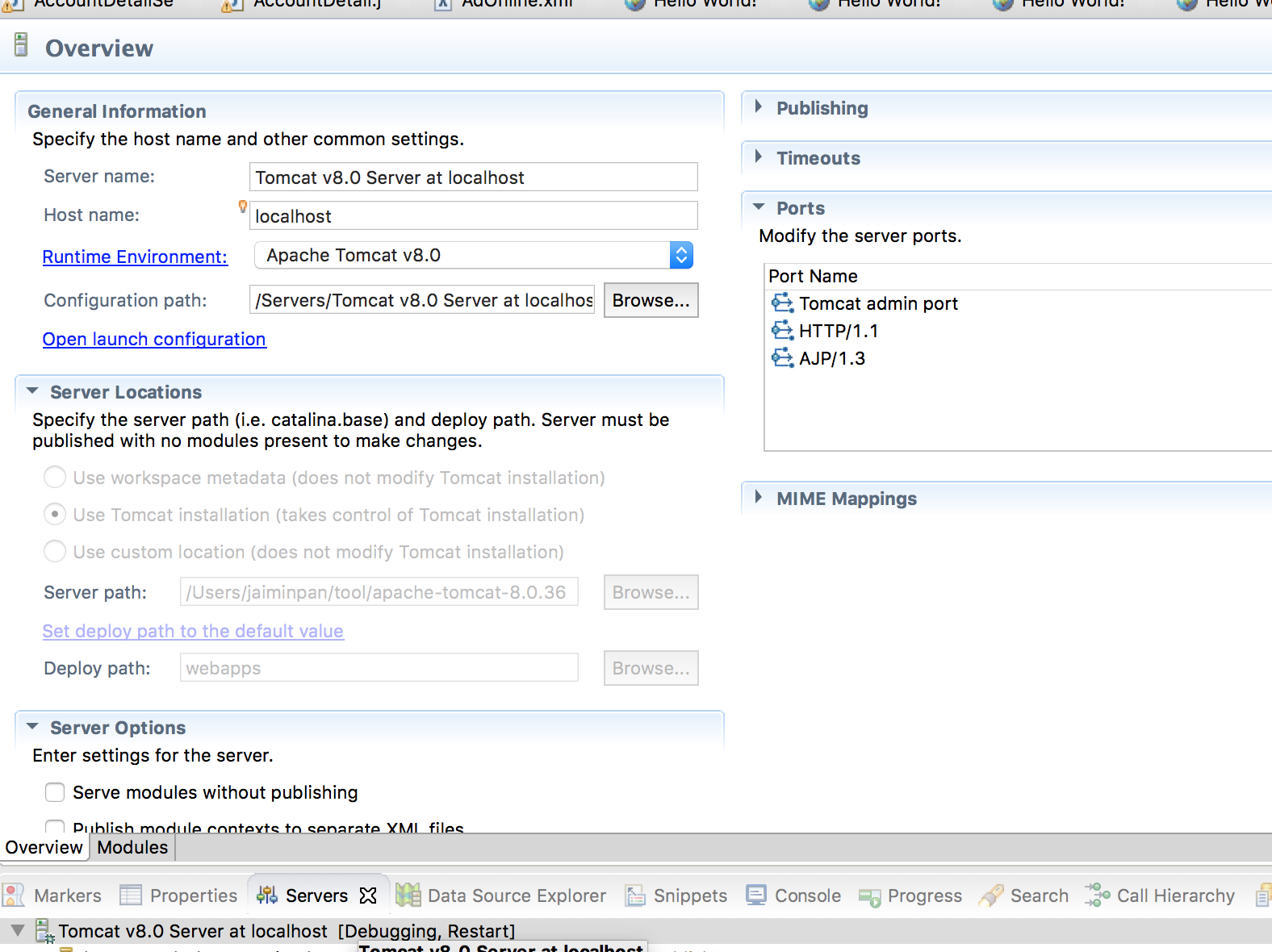

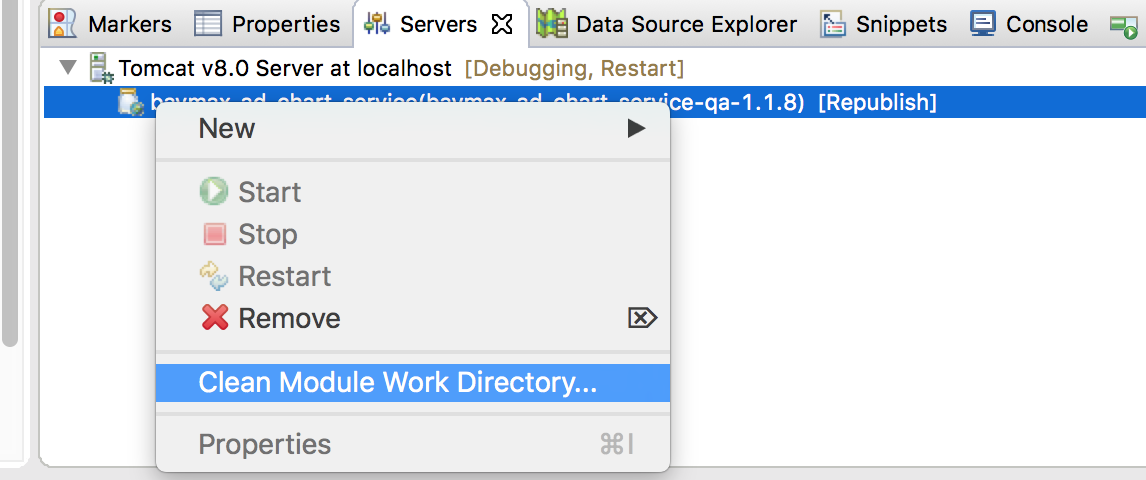

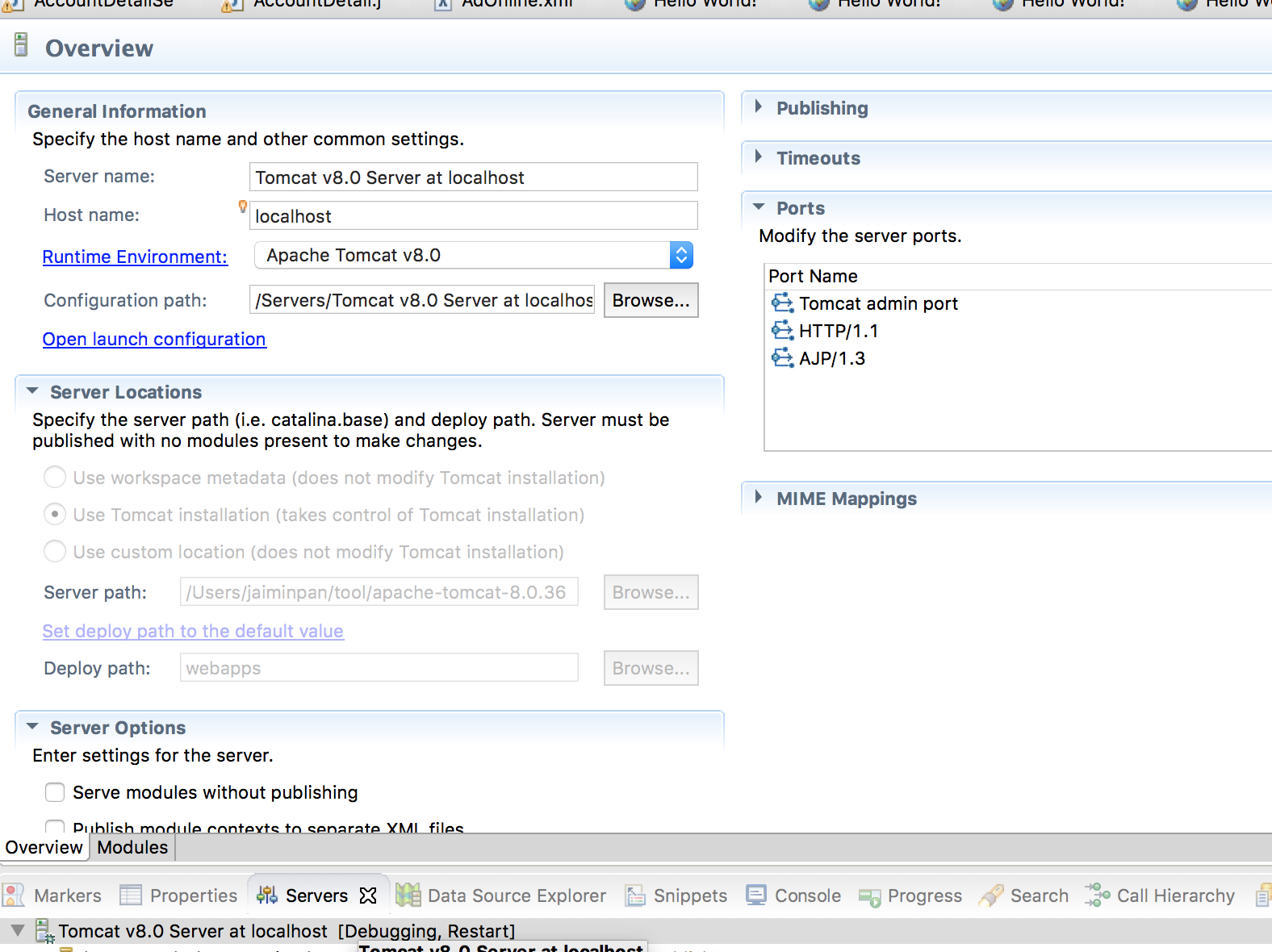

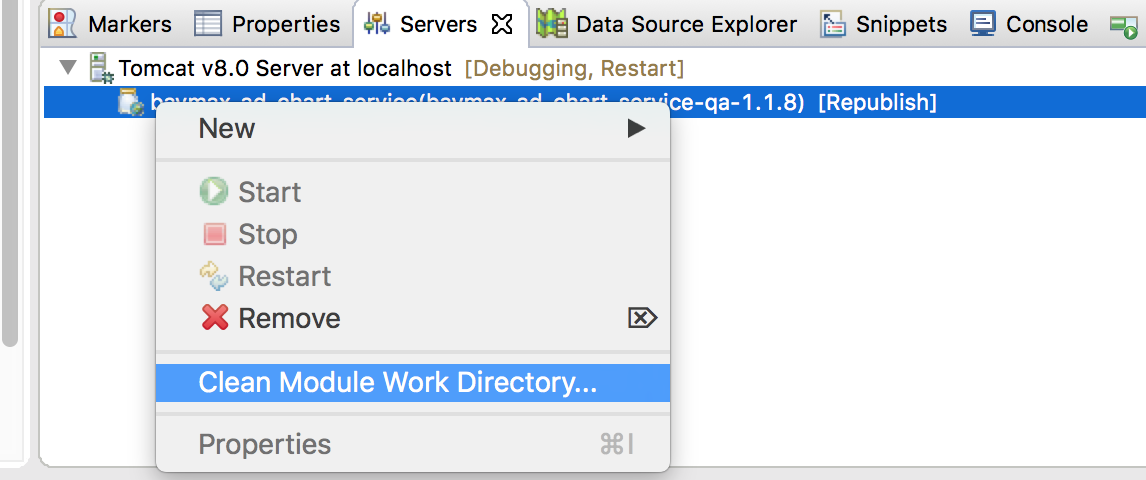

/Java/Tomcat/Misc.md:

--------------------------------------------------------------------------------

1 | # Misc

2 |

3 | ## Configure

4 | I am using `maven + eclipse + tomcat` as java develop environment.

5 |

6 | Configure standalone tomcat server please reference [here][2] and following image.

7 |

8 |  9 |

10 |

11 | #### Issue

12 |

13 | [maven + eclipse + tomcat : class not found exception][1]

14 |

15 | When `mvn compile` is every thing OK, but deploy to Tomcat without .class file

16 | Please try following action in image.

17 |

18 |

9 |

10 |

11 | #### Issue

12 |

13 | [maven + eclipse + tomcat : class not found exception][1]

14 |

15 | When `mvn compile` is every thing OK, but deploy to Tomcat without .class file

16 | Please try following action in image.

17 |

18 |  19 |

20 |

21 |

22 | [1]: http://stackoverflow.com/questions/21222978/maven-eclipse-tomcat-class-not-found-exception

23 | [2]: http://jingyan.baidu.com/article/ca2d939dd90183eb6d31ce79.html

24 |

--------------------------------------------------------------------------------

/Mac/lldb.md:

--------------------------------------------------------------------------------

1 | # lldb

2 |

3 | Since Xcode itself now uses LLDB instead of GDB, this can be a more convenient alternative for Mac users. It integrated much easier in Eclipse than GDB.

4 |

5 | ## lldb on Eclipse CDT

6 | CDT has experimental support for LLDB starting from CDT 9.1. The minimum recommended version for LLDB is 3.8.

7 |

8 | #### How do I install the LLDB debugger integration?

9 |

10 | + Go to Help > Install new Software

11 | + Select the CDT update site (9.1 or greater)

12 | + Under CDT Optional Features, select C/C++ LLDB Debugger Integration

13 |

14 | #### How do I debug with LLDB?

15 | Only local debug (new process) and local attach are supported right now.

16 | First, create a debug configuration just like you would when debugging with GDB. Then you need to set the launcher to **LLDB-MI Debug Process Launcher**.

17 |

18 | ## Reference

19 | https://wiki.eclipse.org/CDT/User/FAQ#How_do_I_get_the_LLDB_debugger.3F

--------------------------------------------------------------------------------

/Java/Spring/Profile.md:

--------------------------------------------------------------------------------

1 | # Profile

2 |

3 | #### Profile in springboot

4 |

5 |

6 | #### Profile in spring tomcat

7 |

8 | In `Spring-applicationContext.xml`

9 | ```

10 |

11 |

15 |

16 |

17 |

21 |

22 | ```

23 |

24 | In `web.xml`

25 | ```

26 |

27 | spring.profiles.default

28 | dev

29 |

30 |

31 | profileEnable

32 | true

33 |

34 | ```

35 |

--------------------------------------------------------------------------------

/linux/systemcmd/selinux.md:

--------------------------------------------------------------------------------

1 | SELinux

2 | ==========

3 |

4 | 关于linux权限控制目前碰到有三种:

5 | * 文件系统权限 lsattr chattr

6 | * 用户组 user:group:other

7 | * SELiunx

8 |

9 | 一般情况下我们只会和用户组权限打交道,一般用chmod chown这两个命令做权限控制,这个也叫 DAC (Discretionary Access Control)”任意式读取控制”。

10 | (DAC权限方式,我的理解就是静态的权限控制,对比于SELinux 我看作动态的权限控制)。

11 |

12 | 如果你已经获取root权限,也无法修改删除响应的文件时,考虑用lsattr查看对应的文件,并用chattr修改。

13 | 这种方式是文件系统对权限进行了限制,只有一部分文件系统支持,如ext3,ext4等。系统被黑了以后才知道的,说多了都是泪。

14 |

15 | SELinux是后期的Linux系统才有的权限控制方式,在同一个用户下面,通过不同的进程拥有不同标签组,才有权限访问对应的标签组的文件。

16 | 也叫 MAC (Mandatory Access Control)“强制性读取控制”。

17 | 通过ps –Z 和 ls –Z查看对应的标签组,用chcon -u|-r|-t 修改对应的用户、角色、类型。

18 |

19 | 简单用法

20 | ```

21 | setenforce 0/1 0 表示允许;1 表示强制

22 | getenforce 查看当前SElinux的状态

23 | ```

24 |

25 | 详见下面链接

26 | http://blog.chinaunix.net/uid-21266384-id-186394.html

27 | http://vbird.dic.ksu.edu.tw/linux_basic/0440processcontrol_5.php

28 | https://wiki.centos.org/zh/HowTos/SELinux

29 |

--------------------------------------------------------------------------------

/consul/install.md:

--------------------------------------------------------------------------------

1 | # Consul install

2 |

3 | ## Install Sample

4 | Example As `consul_1.4.1_linux_amd64.zip`

5 |

6 | ### Download

7 | Download From [Office Website](https://www.consul.io/downloads.html)

8 | #### OR

9 | Compile with [Github](https://github.com/hashicorp/consul)

10 |

11 | ### Install Binary

12 | ```sh

13 |

14 | unzip consul_1.4.1_linux_amd64.zip # Extract to consul

15 |

16 | mv consul /usr/local/bin

17 |

18 | ```

19 |

20 | ### Config Dir

21 | Config location is `/etc/consul.d/config.json` OR `/data/etc/consul.d/config.json`

22 | Reference `consul.d/config.json`

23 |

24 | ## Start

25 | consul agent -config-dir=/data/etc/consul.d

26 |

27 | ## Web Visit

28 | http://ip:port/

29 | http://127.0.0.1:8500/

30 |

31 |

32 | ## Other Config Guide

33 | https://www.consul.io/docs/agent/options.html#command-line-options

34 | https://my.oschina.net/guol/blog/353391

35 | https://www.cnblogs.com/sunsky303/p/9209024.html

36 |

--------------------------------------------------------------------------------

/Java/Spring/PropertyFile.md:

--------------------------------------------------------------------------------

1 | # SpringBoot Application Property Files

2 |

3 | [Application Property Files](https://docs.spring.io/spring-boot/docs/current-SNAPSHOT/reference/htmlsingle/#boot-features-external-config-application-property-files)

4 |

5 |

6 | SpringApplication loads properties from application.properties files in the following locations and adds them to the Spring Environment:

7 | * A /config subdirectory of the current directory

8 | * The current directory

9 | * A classpath /config package

10 | * The classpath root

11 | The list is ordered by precedence (properties defined in locations higher in the list override those defined in lower locations).

12 |

13 | Summary is

14 | * `file:./config/`

15 | * `file:./`

16 | * `classpath:/config/`

17 | * `classpath:/`

18 |

19 | ### Use --spring.config.location

20 | ```

21 | $ java -jar myproject.jar --spring.config.location=classpath:/default.properties,classpath:/override.properties

22 | ```

23 |

--------------------------------------------------------------------------------

/kafka/Consumer.md:

--------------------------------------------------------------------------------

1 | # Kafka Consumer

2 |

3 | [原文](http://m.blog.csdn.net/article/details?id=69554569)

4 |

5 | Kafka从0.7版本到现在的0.10版本, 经历了巨大的变化; 而其中, 首当其冲的是Consumer的机制.

6 |

7 | Kafka最早设计Consumer的时候, 大方向比较明确, 就是同时支持Subscribe功能和Message Queue功能. 语义设计上很清晰,但是实现之后, 发现有一些问题. 主要问题集中在:

8 | * 用户希望自己能够控制Offset的保存和读取;

9 | 0.8.0 SimpleConsumer Example

10 | * Offset保存在Zookeeper中对Zookeeper带来压力较大, 需要脱离的ZK的依赖;

11 | * Committing and fetching consumer offsets in Kafka

12 | * Offset Management

13 | * https://issues.apache.org/jira/browse/KAFKA-657

14 | * 用户希望能获得Offset并且自行决定保存的位置;

15 | * 用户自己控制Offset时, 却会陷入复杂的异常处理逻辑;

16 | * 老的Consumer会有惊群效应和脑裂问题;

17 |

18 | #### Consumer Client Re-Design

19 | Consumer的改进直到0.9版本, 终于有了一个接近完美的版本; 但是由于向前兼容的需要, 以前的Consumer方式正在被使用, 并没有彻底移除. 由于Consumer的多版本存在, 并且个版本的Consumer变化很大, 这些影响又是对上层可见的, 所以对使用者造成了很大的混淆和困惑.

20 | 所以我想在这篇Blog中整理分析一下各Consumer的特点和区别, 让大家有一个纵观历史的认识.

21 |

22 |

23 |

--------------------------------------------------------------------------------

/linux/systemcmd/nologin.md:

--------------------------------------------------------------------------------

1 | nologin命令

2 | -------------

3 |

4 |

5 | **nologin命令**可以实现礼貌地拒绝用户登录系统,同时给出信息。

6 | 如果尝试以这类用户登录,就在log里添加记录,然后在终端输出This account is currently not available信息,就是这样。

7 | 一般设置这样的帐号是给启动服务的账号所用的,这只是让服务启动起来,但是不能登录系统。

8 |

9 | #### 语法

10 | ```sh

11 | nologin

12 | ```

13 |

14 | #### 实例

15 | Linux禁止用户登录: 禁止用户登录后,用户不能登录系统,但可以登录ftp、SAMBA等。

16 |

17 | 我们在Linux下做系统维护的时候,希望个别用户或者所有用户不能登录系统,保证系统在维护期间正常运行。

18 |

19 | 这个时候我们就要禁止用户登录。

20 |

21 | 1、禁止个别用户登录,比如禁止lynn用户登录。

22 |

23 | ```sh

24 | passwd -l lynn

25 | ```

26 | 这就话的意思是锁定lynn用户,这样该用户就不能登录了。

27 | ```sh

28 | passwd -u lynn

29 | ```

30 | 上面是对锁定的用户lynn进行解锁,用户可登录了。

31 |

32 | 2、我们通过修改`/etc/passwd`文件中用户登录的shell

33 |

34 | ```sh

35 | vi /etc/passwd

36 | ```

37 | 更改为:

38 | ```sh

39 | lynn:x:500:500::/home/lynn:/sbin/nologin

40 | ```

41 |

42 | 该用户就无法登录了。

43 | 3、禁止所有用户登录。

44 |

45 | ```sh

46 | touch /etc/nologin

47 | ```

48 | 除root以外的用户不能登录了。

49 |

50 |

51 | 来自: http://man.linuxde.net/nologin

52 |

--------------------------------------------------------------------------------

/kafka/kafka4.0_Cmd.md:

--------------------------------------------------------------------------------

1 | kafka4.0 Cmd

2 |

3 | # 查看

4 | ./kafka-consumer-groups.sh --bootstrap-server localhost:9092 --describe --group game_detail

5 |

6 | # 列出所有 Consumer Groups(User Groups)

7 | bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --list

8 |

9 |

10 | ```

11 | bin/kafka-consumer-groups.sh \

12 | --bootstrap-server \

13 | --group \

14 | --reset-offsets \

15 | --topic \

16 | --to-earliest | --to-latest | --to-offset | --shift-by \

17 | --execute

18 | ```

19 |

20 | # 重置到最新(跳过未消费消息)

21 | bin/kafka-consumer-groups.sh \

22 | --bootstrap-server localhost:9092 \

23 | --group my-consumer-group \

24 | --topic my-topic \

25 | --reset-offsets \

26 | --to-latest \

27 | --execute

28 |

29 | bin/kafka-consumer-groups.sh \

30 | --bootstrap-server localhost:9092 \

31 | --group game_detail \

32 | --topic admin_game_detail \

33 | --reset-offsets \

34 | --to-latest \

35 | --execute

36 |

--------------------------------------------------------------------------------

/linux/openssh.md:

--------------------------------------------------------------------------------

1 |

2 |

3 | ## 背景介绍

4 | 很多公司都使用静态密码+动态密码的方式登陆跳板机,某些还会强制一个动态密码只能登陆一次,于是我们面临着等一分钟才能登陆一次跳板机,很不方便。本文介绍一种在本机的设置,免除每次输入密码的方法。

5 |

6 | ## 实现方法

7 | 此功能是利用SSH的ControlPersist特性,SSH版本必须是5.6或以上版本才可使用ControlPersist特性。升级SSH可参考CentOS6下升级OpenSSH至7.1一文。

8 |

9 |

10 | ```sh

11 | # vi ~/.ssh/config

12 |

13 | Host *

14 | ControlMaster auto

15 | ControlPersist 4h

16 | # ControlPersist yes

17 | ControlPath ~/.ssh/sessions/ctrl:%h:%p:%r

18 | # Compression yes

19 |

20 |

21 | ```

22 |

23 | ```

24 | # Check

25 | ssh -O check HostName

26 |

27 | # Exit

28 | ssh -O exit HostName

29 | ```

30 |

31 |

32 | ### Other Config

33 |

34 | ```sh

35 | # vi ~/.ssh/config, mod 600

36 |

37 | Host jpserver

38 | User testa

39 | Hostname 10.100.3.80

40 | PreferredAuthentications publickey

41 | IdentityFile /Users/xxx/.ssh/abc.pem

42 |

43 | Host fileserver

44 | User centos

45 | Port 22

46 | Hostname 10.81.23.81

47 | #ProxyCommand ssh nixcraft@gateway.uk.cyberciti.biz nc %h %p 2> /dev/null

48 | ```

--------------------------------------------------------------------------------

/etc/yum.md:

--------------------------------------------------------------------------------

1 | YUM

2 | ===========

3 |

4 | yum是基于Red Hat的系统(如CentOS、Fedora、RHEl)上的默认包管理器。使用yum,你可以安装或者更新一个RPM包,并且他会自动解决包依赖关系。

5 |

6 |

7 | #### 如何只从Red Hat 的标准仓库中下载一个RPM包,而不进行安装

8 |

9 | yum命令本身就可以用来下载一个RPM包,标准的yum命令提供了--downloadonly(只下载)的选项来达到这个目的。

10 | ```sh

11 | $ sudo yum install --downloadonly

12 | ```

13 | 默认情况下,一个下载的RPM包会保存在下面的目录中:

14 | ```sh

15 | /var/cache/yum//[centos/fedora-version]/[repository]/packages

16 | ```

17 | 以上的[repository]表示下载包的来源仓库的名称(例如:base、fedora、updates)

18 |

19 | 如果你想要将一个包下载到一个指定的目录(如/tmp):

20 | ```sh

21 | $ sudo yum install --downloadonly --downloaddir=/tmp

22 | ```

23 | 注意,如果下载的包包含了任何没有满足的依赖关系,yum将会把所有的依赖关系包下载,但是都不会被安装。

24 |

25 | PS:

26 | 另外一个重要的事情是,在CentOS/RHEL 6或更早期的版本中,你需要安装一个单独yum插件(名称为 yum-plugin-downloadonly)才能使用--downloadonly命令选项:

27 | ```sh

28 | $ sudo yum install yum-plugin-downloadonly

29 | ```

30 | 或者update yum也同样可以解决问题

31 |

32 | 如果没有该插件,你会在使用yum时得到以下错误:

33 | ```sh

34 | Command line error: no such option: --downloadonly

35 | ```

36 |

--------------------------------------------------------------------------------

/R-Server/README.md:

--------------------------------------------------------------------------------

1 | # Install

2 |

3 | Reference: http://www.rstudio.com/products/rstudio/download-server/

4 |

5 | ## Step On CentOS 7

6 |

7 | #### Install

8 | ```sh

9 | $ sudo yum -y install R

10 |

11 | $ wget https://download2.rstudio.org/rstudio-server-rhel-1.0.143-x86_64.rpm

12 | $ sudo yum install --nogpgcheck rstudio-server-rhel-1.0.143-x86_64.rpm

13 | ```

14 |

15 | Now visit http://:8787

16 |

17 | #### Post config Firewall (option)

18 | ```

19 | vi /etc/sysconfig/iptables

20 | -A INPUT -m state --state NEW -m tcp -p tcp --dport 22 -j ACCEPT

21 | + -A INPUT-m state --state NEW -m tcp -p tcp --dport 8787 -j ACCEPT

22 | ```

23 |

24 | ## Login

25 |

26 | change config

27 | ```

28 | vi /etc/rstudio/rserver.conf

29 | auth-required-user-group=rstudio_users

30 | ```

31 |

32 | Add user

33 | ```

34 | useradd ruser

35 | passwd ruser

36 |

37 | usermod -a -G rstudio_users ruser

38 | ```

39 |

40 | Now you can login using the user in groups rstudio_users by http://:8787

41 |

42 |

43 |

44 |

--------------------------------------------------------------------------------

/Java/Spring/Environment.md:

--------------------------------------------------------------------------------

1 | # Environment

2 |

3 |

4 | ## Custom Env

5 | ```java

6 | // configname = "application-uat.properties";

7 | private Environment customEnv(String configname) throws Exception {

8 | Resource resource = new ClassPathResource(configname);

9 | Properties props = PropertiesLoaderUtils.loadProperties(resource);

10 |

11 | StandardEnvironment stdenv = new StandardEnvironment();

12 | stdenv.getPropertySources().addLast(new PropertiesPropertySource(configname, props));

13 | return stdenv;

14 | }

15 | ```

16 |

17 | ## Without Spring Env

18 | ```java

19 | public static void initialization(String path) throws IOException {

20 |

21 | Properties properties = new Properties()

22 |

23 | try (InputStream resourceAsStream = getPropertyStream(path); //

24 | InputStreamReader inputstreamreader = new InputStreamReader(resourceAsStream, charset);) {

25 | properties.load(inputstreamreader);

26 | }

27 |

28 | properties.forEach((k, v) -> {

29 | LOGGER.info(k + "=" + v);

30 | });

31 | }

32 | ```

33 |

--------------------------------------------------------------------------------

/mattermost/deploy_docker.md:

--------------------------------------------------------------------------------

1 | # Deploy Mattermost on Docker

2 |

3 | https://docs.mattermost.com/deploy/server/deploy-containers.html

4 |

5 |

6 | 1. In a terminal window, clone the repository and enter the directory.

7 |

8 | git clone https://github.com/mattermost/docker

9 | cd docker

10 | Create your .env file by copying and adjusting the env.example file.

11 |

12 | cp env.example .env

13 | Important

14 |

15 | At a minimum, you must edit the DOMAIN value in the .env file to correspond to the domain for your Mattermost server.

16 |

17 | We recommend configuring the Support Email via MM_SUPPORTSETTINGS_SUPPORTEMAIL. This is the email address your users will contact when they need help.

18 |

19 | 2. Create the required directories and set their permissions.

20 |

21 | mkdir -p ./volumes/app/mattermost/{config,data,logs,plugins,client/plugins,bleve-indexes}

22 | sudo chown -R 2000:2000 ./volumes/app/mattermost

23 | (Optional) Configure TLS for NGINX. If you’re not using the included NGINX reverse proxy, you can skip this step.

24 |

25 |

26 |

--------------------------------------------------------------------------------

/PulsarIO/Pulsar_Real_time_Analytics_at_Scale/part1-introduction.md:

--------------------------------------------------------------------------------

1 | 第一部分:简介

2 | =========================================

3 | 用户行为事包含了结构化的信息就像user-agent或者本地应用标识(IP地址)。应用能够通过相关的事件类型来扩展它的内部属性,这些事件被本地或Web应用收集以用于实时或离线分析。在eBay,我们每秒收集成百上千的事件,增长速度是用户增长的5倍。BOTs 伪装成人们的Bots产生一些有意义的事件。BOT来源于有效(例如,搜索引擎爬虫)和没价值的(抓取在分页信息)。另外一个例子,我们需要通过检测他们来保护我们的下游系统,然后隔离这些事件或者根据不通的服务级别进行处理。BOT很重要的一点是能够准确地判断这个马甲还是在购物!

4 |

5 | 另一类的用户行为事件是非结构化数据,就像地理位置,设备标识,人口统计数据和许多需要越早越好需要数据通道传输到集中式处理的反范式的数据。其他场景,就像风险检测和欺诈分析,实时用户行为模式经过某些周期或者年需要垂直扩展摘要信息,这种场景系统需要高吞吐因此不能用关系型数据库。

6 |

7 | 会话化数据是关键数据结构,这种结构允许事件在一个数据容器里计算直到用户会话完成,通常基于固定的一段时间。许多业务指标包括根据用户会话的转化率,这种也是最好在数据通道做一次早期处理。

8 |

9 | 在业务监控领域,为了探索性可视化和可选维度的告警,就需要可实时聚合的时序指标数据。这种场景特别需要更高的查询性能,也不能使用关系型数据库。指标数据实时聚合带来了挑战,就像由于大量的不同维度和大量的维度基数导致爆炸性的计数器操作。

10 |

11 | 为了让态系统接入数据流, 原始流中的部分视图(过滤器,直充,转换)对于需要低成本处理下游系统至关重要。

12 |

13 | 在这篇论文中,我们打算设计一个数据通道:构建一个用于我们大部分的计算、实时处理,基于CEP引擎构高可用的分布式的计算系统。我们的目的是把事件流看作是一个数据库表,类SQL查询能够处理在实时流来创建聚合,就像用数据库表。接下来我们会描述我们怎么做到直充,过滤,转换和创建不同的事件流视图。

14 |

15 | -----------------

16 |

17 | [« 概述](README.md) [第二部分:数据和处理模型»](part2-data-model.md)

18 |

--------------------------------------------------------------------------------

/pulsar/QuickCmd.md:

--------------------------------------------------------------------------------

1 |

2 | # QuickCmd

3 |

4 | ## Basic

5 | ```

6 |

7 | ```

8 |

9 | ## Topics

10 |

11 | ```sh

12 |

13 | bin/pulsar-admin namespaces get-backlog-quotas test-tenant/standalone/test-ns

14 |

15 |

16 | bin/pulsar-admin namespaces set-backlog-quota test-tenant/standalone/test-ns --limit 1k --policy producer_exception

17 | ```

18 |

19 | ## Producer & Consumer

20 |

21 | ```sh

22 | ### comsumer subscriptions

23 | bin/pulsar-admin --admin-url http://10.0.xx.xx:8080/ topics subscriptions topic_name

24 |

25 | ### comsumer unsubscribe

26 | bin/pulsar-admin --admin-url http://10.0.xx.xx:8080/ topics unsubscribe -s my_comsumer_name topic_name

27 |

28 | ```

29 |

30 |

31 | ## Lession & learn

32 |

33 | Q: Found Log

34 | ```

35 | pulsar write failed

36 | org.apache.pulsar.client.api.PulsarClientException$TimeoutException: Could not send message to broker within given timeout

37 | ```

38 | after Restart

39 | ```

40 | Found Exception: Cannot create producer on topic with backlog quota exceeded

41 | ```

42 | A: Delete Unused consumer which block the message dead.

--------------------------------------------------------------------------------

/clickhouse/Engines/Merge.md:

--------------------------------------------------------------------------------

1 | # Merge

2 |

3 | Merge引擎(不要与Mergetree混淆)本身不存储数据,但允许同时读取任意数量的其他表。读取将自动并行化。不支援写入表。

4 | 读取时,使用实际正在读取的表的索引(如果存在)。合并引擎接受参数:数据库名称和表的正则表达式。范例:

5 | ```

6 | Merge(hits, '^WatchLog')

7 | ```

8 |

9 | * 将使用hits中,所有匹配正则`^WatchLog`的表中读取数据。

10 |

11 | 您可以使用传回字串的常数表达式,而不是数据库字符串名。例如,`currentDatabase()`。

12 |

13 | 正则表达式是re2 (类似于PCRE),区分大小写。请参阅“匹配”部分中有关在正则表达式中转义符号的注释。

14 |

15 | 选择要读取的表时,Merge 表本身将不会被选择,即使它与regex匹配。

16 | 这是为了避免循环。比如可以创建两个合并表,它们将无休止地尝试读取彼此的数据。但不要这样做。

17 |

18 | 使用Merge 引擎的典型方法是,把大量的TinyLog表,用起来像使用单个表一样。

19 |

20 | ## Virtual columns

21 |

22 | 虚拟列是由表引擎提供的列,与表定义无关。换句话说,`CREATE TABLE`中未指定这些列,但可以用SELECT访问这些列。

23 |

24 | 虚拟列与普通列的不同之处如下:

25 | * 表定义中未指定它们。

26 | * 无法使用`INSERT`将数据添加到其中。

27 | * 在不指定列列表的情况下使用`INSERT`时,将忽略虚拟列。

28 | * `SELECT *`时,不会选择它们。

29 | * `SHOW CREATE TABLE`和`DESC TABLE`查询中不显示虚拟列。

30 |

31 | Merge 表包含String类型的虚拟列**_table**。(如果表中已有`_table`列,则虚拟列名为`_table1`,如果已有`_table1`,则名为`_table2`,依此类推)。

32 | 它包含读取数据的表的名称。

33 |

34 | 如果WHERE或PREWHERE子句包含不依赖于其他表列的`_table`列的条件(作为连接元素之一或作为整个表达式),则这些条件将用作索引。

35 | 对要从中读取数据的表名数据集执行条件,并且将仅从触发条件的那些表执行读取操作。

36 |

37 |

38 |

--------------------------------------------------------------------------------

/clickhouse/install.md:

--------------------------------------------------------------------------------

1 | # Install

2 |

3 | ## Download

4 |

5 | [Location](https://packagecloud.io/altinity/clickhouse)

6 |

7 | Sample as version 1.1.54318-3 on CentOS7

8 | * clickhouse-server-common-1.1.54318-3.el7.x86_64.rpm

9 | * clickhouse-server-1.1.54318-3.el7.x86_64.rpm

10 | * clickhouse-debuginfo-1.1.54318-3.el7.x86_64.rpm

11 | * clickhouse-compressor-1.1.54318-3.el7.x86_64.rpm

12 | * clickhouse-client-1.1.54318-3.el7.x86_64.rpm

13 |

14 | ## RPM install

15 | * rpm -ivh clickhouse-server-common-1.1.54318-3.el7.x86_64.rpm

16 | * rpm -ivh clickhouse-server-1.1.54318-3.el7.x86_64.rpm

17 | * rpm -ivh clickhouse-client-1.1.54318-3.el7.x86_64.rpm

18 | * rpm -ivh clickhouse-compressor-1.1.54318-3.el7.x86_64.rpm

19 |

20 | ## Config Dir

21 | /etc/clickhouse-server/

22 |

23 | ## Start

24 | 1. service clickhouse-server start

25 | 2. clickhouse-server --daemon --config-file=/etc/clickhouse-server/config.xml

26 |

27 | ## Client

28 | ```sh

29 | clickhouse-client --host=xx.xx.xx.xx --port=9001

30 | :) show tables;

31 | :) select now();

32 | :) select 1;

33 |

34 | ```

35 |

--------------------------------------------------------------------------------

/Jenkins/ansible/do.build.nginx.yaml:

--------------------------------------------------------------------------------

1 | ---

2 |

3 | - name: do package etc stuff

4 | hosts: www-saasfront-web

5 | vars: #定义变量

6 | # work_space: /data/home/jenkins/.jenkins/workspace/www-job-name

7 | timestamp_vary: "{{ lookup('pipe', 'date +%Y%m%d%H%M%S') }}"

8 | # pack_dir_name:

9 | pack_dir_base: /data/appdatas/jenkins_pack

10 |

11 | # become: yes

12 | # become_user: root

13 |

14 | tasks:

15 | - shell: 'date +%Y%m%d%H%M%S'

16 | register: current_run_timestamp

17 |

18 | - name: set facts

19 | set_fact:

20 | timestamp: "{{current_run_timestamp.stdout}}"

21 |

22 | - name: tar file

23 | local_action: shell cd {{work_space}} && tar -cvzf dist.tar.gz dist

24 |

25 | - name: tar file

26 | local_action: shell cd {{work_space}} && mkdir -p {{pack_dir_base}}/{{pack_dir_name}} && mv dist.tar.gz {{pack_dir_base}}/{{pack_dir_name}}/dist_{{timestamp}}.tar.gz

27 |

28 | - name: keep latest 5 then clean other

29 | local_action: shell cd {{pack_dir_base}}/{{pack_dir_name}} && ls -t .| grep ".tar.gz" | awk "{if(NR>5){print $1}}" | xargs rm -rf

30 |

31 |

32 |

--------------------------------------------------------------------------------

/PulsarIO/Processor.md:

--------------------------------------------------------------------------------

1 | # Process

2 |

3 | ## EventSource接口

4 | 定义了添加删除sink的接口

5 | * addEventSink

6 | * getEventSinks

7 | * removeEventSink

8 | * setEventSinks

9 |

10 | ## EventSink接口

11 | * sendEvent

12 |

13 | ## AbstractEventSource

14 |

15 | 简单实现EventSource 接口

16 | * 对sink进行pause/resume

17 | * fireSendEvent(): 实现了把消息发送给子sink对象

18 | * 实现 error接口,注册erro,取error等

19 |

20 | **主要是对子sink的控制**

21 |

22 | ## AbstractEventProcessor

23 |

24 | 继承抽象类AbstractEventSource,并实现EventProcessor接口,

25 | EventProcessor接口主要是组合EventSource,EventSink,Monitorable, MonitorableStatCollector四个接口

26 |

27 | Monitorable, MonitorableStatCollector两个接口主要和监控统计相关

28 | 此类大部分代码是和监控有关,还有用PipelineFlowControl控制process的能力,包括此process的pause/resume状态变更

29 |

30 | **主要是对process本身的控制和信息统计**

31 |

32 | ## AbstractQueuedEventProcessor

33 | 真正实现 sendEvent 的抽象类,在sendEvent中调用queueEvent方法, 默认实现queueEvent方法为:把事件放入RequestQueueProcessor(一个util类,此类实现了一个ringbuffer的工作线程池)线程池并配置真正处理的EventProcessRequest工作类,在工作线程处理

34 |

35 | 子类可以重载 queueEvent方法,并必须实现 getProcessEventRequest,来决定真正的处理工作方式。在EventProcessRequest 中留有接口processEvent方法来处理,如在EsperProcessor的实现中,新增了ProcessEventRequest来让epl处理真正的工作。

36 |

37 |

--------------------------------------------------------------------------------

/mysql/docker-compose.yml:

--------------------------------------------------------------------------------

1 | version: '3.8'

2 |

3 | services:

4 | db:

5 | image: swr.cn-north-4.myhuaweicloud.com/ddn-k8s/docker.io/mysql/mysql-server:8.0

6 | container_name: mysql_container

7 | restart: unless-stopped

8 | environment:

9 | MYSQL_ROOT_PASSWORD: 123456

10 | ports:

11 | - "0.0.0.0:3306:3306"

12 | volumes:

13 | - C:\work\docker_data\mysql\db_data:/var/lib/mysql

14 |

15 | services:

16 | mysql:

17 | image: mysql:8.0.42

18 | container_name: mysql8

19 | restart: always

20 | ports:

21 | - "3306:3306"

22 | environment:

23 | MYSQL_ROOT_PASSWORD: root1234 # root 密码

24 | MYSQL_DATABASE: mysql # 初始数据库

25 | MYSQL_USER: test # 初始用户

26 | MYSQL_PASSWORD: test # 用户密码

27 | volumes:

28 | - /Users/jaiminpan/.data/appdatas/mysql/mysql_84:/var/lib/mysql # 数据持久化

29 | - ./init:/docker-entrypoint-initdb.d # 初始 SQL 脚本(可选)

30 | command:

31 | --default-authentication-plugin=mysql_native_password

32 | --character-set-server=utf8mb4

33 | --collation-server=utf8mb4_unicode_ci

--------------------------------------------------------------------------------

/python/README.md:

--------------------------------------------------------------------------------

1 | Python

2 | -----------

3 |

4 | ## Website

5 | [Python 官网](https://www.python.org/)