├── Markdown

├── Artificial Neural Networks.md

├── Associate Rule Mining.md

├── Cluster Analysis.md

├── Data Mining.md

├── Data Preprocessing.md

├── Data Warehouse.md

├── Decision Tree.md

├── Naive Bayes Analysis.md

├── Regression.md

└── Unclassified.md

├── PDF

├── Artificial Neural Networks.pdf

├── Associate Rule Mining.pdf

├── Cluster Analysis.pdf

├── Data Mining.pdf

├── Data Preprocessing.pdf

├── Data Warehouse.pdf

├── Decision Tree.pdf

├── Naive Bayes Analysis.pdf

├── Regression.pdf

└── Unclassified.pdf

├── README.md

└── python_tool

├── .gitignore

├── debug.py

├── example.py

├── main.py

└── tool.py

/Markdown/Artificial Neural Networks.md:

--------------------------------------------------------------------------------

1 | # Artificial Neural Networks (人工神經網路)

2 |

3 | > Reference:

4 | >

5 | > 1. Artificial Neural Networks - Dr. Tun-Wen Pai

6 | > 2. [Neural Networks Pt. 1: Inside the Black Box](https://www.youtube.com/watch?v=CqOfi41LfDw)

7 | > 3. [Neural Networks Pt. 2: Backpropagation Main Ideas](https://www.youtube.com/watch?v=IN2XmBhILt4)

8 | > 4. [Backpropagation Details Pt. 1: Optimizing 3 parameters simultaneously.](https://www.youtube.com/watch?v=iyn2zdALii8)

9 | > 5. [Backpropagation Details Pt. 2: Going bonkers with The Chain Rule](https://www.youtube.com/watch?v=GKZoOHXGcLo)

10 |

11 |

12 |

13 | ## 概述

14 |

15 | 人工神經網路(ANN)使用了**一種曲線**,能夠近乎完美的符合資料集。

16 |

17 | 使用的曲線為激勵函數,利用參數、權重等等來製作,藉由神經元來構造曲線,進而符合資料集。

18 |

19 | 本篇所講述的人工神經網路均屬於前饋神經網路(前饋神經網路)。

20 |

21 |

22 |

23 | 我們可以把他想成將一個參數放入 input 神經元後。

24 |

25 | 這個 input 神經元會隨著箭頭進入到 Hidden layer 的神經元,通常是一個激勵函數。

26 |

27 | 箭頭會逐漸塑造激勵函數,直到 output 神經元將曲線輸出。

28 |

29 |

30 |

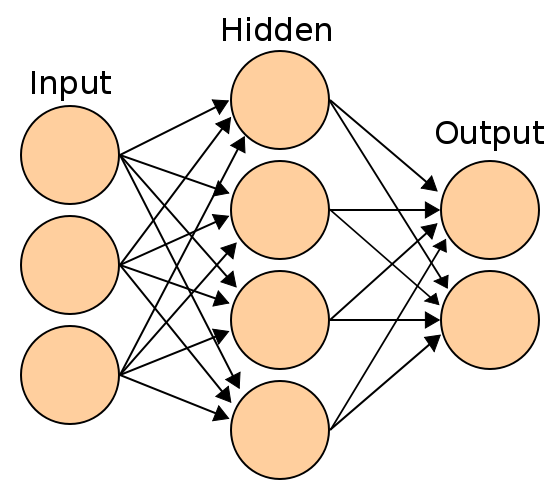

31 | 下圖是一個簡單的 ANN,我們將藍色圈圈稱為 input,綠色圈圈稱為 hidden,粉紅色圈圈稱為 output

32 |

33 | $w_1, w_2, w_3, w_4$ 為 weight,$b_1, b_2, b_3$ 為 bias,而 $af_1, af_2$ 為[激勵函數](#激勵函數)。

34 |

35 |  36 |

37 | 而實際上可能會這麼複雜:

38 |

39 | > Artificial neural network.svg - 維基百科,自由嘅百科全書

40 |

41 |

36 |

37 | 而實際上可能會這麼複雜:

38 |

39 | > Artificial neural network.svg - 維基百科,自由嘅百科全書

40 |

41 |  42 |

43 |

44 |

45 | ## 激勵函數

46 |

47 | 激勵函數在塑造曲線的時候扮演了重要的角色,主要分成四種:

48 |

49 | 1. Tanh:$f(x) = \tan x = \dfrac{e^x-e^{-x}}{e^x+e^{-x}}$

50 | 2. Sigmoid / Logistic:$f(x) = \dfrac{1}{1+e^{-x}}$

51 | 3. ReLu:$f(x) = x^{+} = \max(0, x)$

52 | 4. Softplus:$f(x) = \ln(1+e^x)$

53 |

54 |

55 |

56 | 所謂的激勵函數本質上就是函數,可以想像成把參數放入激勵函數後,可以使激勵函數最後塑造出我們想要的曲線。

57 |

58 |

59 |

60 | ## 建構簡單 ANN

61 |

62 |

63 |

64 | ### 建立概述

65 |

66 | 我們以簡單的例子來說明,以下圖為例。

67 |

68 |

42 |

43 |

44 |

45 | ## 激勵函數

46 |

47 | 激勵函數在塑造曲線的時候扮演了重要的角色,主要分成四種:

48 |

49 | 1. Tanh:$f(x) = \tan x = \dfrac{e^x-e^{-x}}{e^x+e^{-x}}$

50 | 2. Sigmoid / Logistic:$f(x) = \dfrac{1}{1+e^{-x}}$

51 | 3. ReLu:$f(x) = x^{+} = \max(0, x)$

52 | 4. Softplus:$f(x) = \ln(1+e^x)$

53 |

54 |

55 |

56 | 所謂的激勵函數本質上就是函數,可以想像成把參數放入激勵函數後,可以使激勵函數最後塑造出我們想要的曲線。

57 |

58 |

59 |

60 | ## 建構簡單 ANN

61 |

62 |

63 |

64 | ### 建立概述

65 |

66 | 我們以簡單的例子來說明,以下圖為例。

67 |

68 |  69 |

70 | 我們有一個*簡單的資料集*,分成三類,值域界於 $0$ 到 $1$:

71 |

72 | 1. 服用少數量 ntut-xuan 筆記的人 → 考不好 (0)

73 | 2. 服用中等數量 ntut-xuan 筆記的人 → 考得好 (1)

74 | 3. 服用多數量 ntut-xuan 筆記的人 → 考不好 (0)

75 |

76 | 可以得到左圖。

77 |

78 | 此時我們可能會想要用一條直線來分割這些資料,但這條直線可能不存在,因為不管怎麼畫都沒有辦法概括完全的資料。

79 |

80 | 如果這時候有一條*神奇的函數*來讓這些資料 match 就好,就像右圖。

81 |

82 | | | |

83 | | ------------------------------------------------------------ | ------------------------------------------------------------ |

84 | |

69 |

70 | 我們有一個*簡單的資料集*,分成三類,值域界於 $0$ 到 $1$:

71 |

72 | 1. 服用少數量 ntut-xuan 筆記的人 → 考不好 (0)

73 | 2. 服用中等數量 ntut-xuan 筆記的人 → 考得好 (1)

74 | 3. 服用多數量 ntut-xuan 筆記的人 → 考不好 (0)

75 |

76 | 可以得到左圖。

77 |

78 | 此時我們可能會想要用一條直線來分割這些資料,但這條直線可能不存在,因為不管怎麼畫都沒有辦法概括完全的資料。

79 |

80 | 如果這時候有一條*神奇的函數*來讓這些資料 match 就好,就像右圖。

81 |

82 | | | |

83 | | ------------------------------------------------------------ | ------------------------------------------------------------ |

84 | |  |

|  |

85 |

86 | 我們假設已經優化了類神經網路的 $w_1, w_2, b_1, b_2, w_3, w_4, b_3$ 參數,我們可以這樣建構我們的類神經網路。

87 |

88 | 假設我們使用的激勵函數 $af_1, af_2$ 為 Softplus:$f(x) = \ln(1+e^x)$

89 |

90 |

|

85 |

86 | 我們假設已經優化了類神經網路的 $w_1, w_2, b_1, b_2, w_3, w_4, b_3$ 參數,我們可以這樣建構我們的類神經網路。

87 |

88 | 假設我們使用的激勵函數 $af_1, af_2$ 為 Softplus:$f(x) = \ln(1+e^x)$

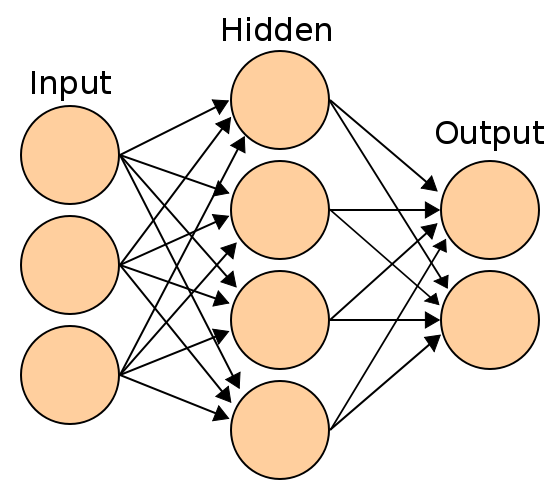

89 |

90 |  91 |

92 | 我們可以由我們建構的類神經網路,往上走建構出一條曲線,往下走建構出另一條曲線,如下圖:

93 |

94 | | 往上走 | 往下走 |

95 | | :----------------------------------------------------------: | :----------------------------------------------------------: |

96 | | $f\left(x\right)=-0.18\ln\left(1+e^{\left(-32.4x+18.34\right)}\right)$ | $g\left(x\right)=2.28\ln\left(1+e^{\left(-1.72x+2.55\right)}\right)$ |

97 | |

91 |

92 | 我們可以由我們建構的類神經網路,往上走建構出一條曲線,往下走建構出另一條曲線,如下圖:

93 |

94 | | 往上走 | 往下走 |

95 | | :----------------------------------------------------------: | :----------------------------------------------------------: |

96 | | $f\left(x\right)=-0.18\ln\left(1+e^{\left(-32.4x+18.34\right)}\right)$ | $g\left(x\right)=2.28\ln\left(1+e^{\left(-1.72x+2.55\right)}\right)$ |

97 | |  |

|  |

98 |

99 |

100 |

101 | 最後將兩個曲線加起來,並減去 $2.88$,得到以下的曲線,就能夠得到我們幾乎亂畫出來的曲線了!

102 |

103 | | $h(x)=-0.18\ln\left(1+e^{\left(-32.4x+18.34\right)}\right)+2.28\ln\left(1+e^{\left(-1.72x+2.55\right)}\right)-2.88$ | 我亂畫的 |

104 | | :----------------------------------------------------------: | :----------------------------------------------------------: |

105 | |  |

|

98 |

99 |

100 |

101 | 最後將兩個曲線加起來,並減去 $2.88$,得到以下的曲線,就能夠得到我們幾乎亂畫出來的曲線了!

102 |

103 | | $h(x)=-0.18\ln\left(1+e^{\left(-32.4x+18.34\right)}\right)+2.28\ln\left(1+e^{\left(-1.72x+2.55\right)}\right)-2.88$ | 我亂畫的 |

104 | | :----------------------------------------------------------: | :----------------------------------------------------------: |

105 | |  |  |

106 |

107 | 這時候我們就可以用這條曲線來判別我們特定資料集所出現的結果,所以人工神經網路*理論上*能夠成功分類所有的資料。

108 |

109 | **問題在於如何找出參數,來建構我們想要的曲線**。

110 |

111 |

112 |

113 | ### 簡單 ANN 的參數優化 (Backward Propagation)

114 |

115 | 對於找出參數,我們可以先給定一個初始值,然後進行參數優化。

116 |

117 | 對於 weight 的部分,我們的初始值可以先給定為**標準常態分布**的隨機一個值,而 bias 可以先預設為 $0$

118 |

119 |

|

106 |

107 | 這時候我們就可以用這條曲線來判別我們特定資料集所出現的結果,所以人工神經網路*理論上*能夠成功分類所有的資料。

108 |

109 | **問題在於如何找出參數,來建構我們想要的曲線**。

110 |

111 |

112 |

113 | ### 簡單 ANN 的參數優化 (Backward Propagation)

114 |

115 | 對於找出參數,我們可以先給定一個初始值,然後進行參數優化。

116 |

117 | 對於 weight 的部分,我們的初始值可以先給定為**標準常態分布**的隨機一個值,而 bias 可以先預設為 $0$

118 |

119 |  120 |

121 |

122 |

123 | 若要使曲線越來越擬合我們的資料集,我們得要先考慮是否能夠限縮 $\text{SSR}$,使他越小,讓曲線 $f(x_i)$ 越能擬合資料集。

124 |

125 | $\text{SSR}$ 即為殘差平方和,即為對於在 $x=i$ 上的資料集,其所有資料 $(y_i - f(x_i))^2$ 的和,可以定義為 $\text{SSR} = \displaystyle \sum^{n}_{i=1} (y_i - f(x_i))^2$

126 |

127 | 若我們想要優化參數,可以找出參數對 $\text{SSR}$ 的導函數,接著使用梯度下降法來同步優化所有參數

128 |

129 |

130 |

131 | 同樣以下圖為例:

132 |

133 |

120 |

121 |

122 |

123 | 若要使曲線越來越擬合我們的資料集,我們得要先考慮是否能夠限縮 $\text{SSR}$,使他越小,讓曲線 $f(x_i)$ 越能擬合資料集。

124 |

125 | $\text{SSR}$ 即為殘差平方和,即為對於在 $x=i$ 上的資料集,其所有資料 $(y_i - f(x_i))^2$ 的和,可以定義為 $\text{SSR} = \displaystyle \sum^{n}_{i=1} (y_i - f(x_i))^2$

126 |

127 | 若我們想要優化參數,可以找出參數對 $\text{SSR}$ 的導函數,接著使用梯度下降法來同步優化所有參數

128 |

129 |

130 |

131 | 同樣以下圖為例:

132 |

133 |  134 |

135 | 我們令 $af_1(x_i)$ 運算出的結果叫做 $y_{1,i}$,$af_2(x_i)$ 運算出的結果叫做 $y_{2,i}$

136 |

137 | 可以得到 $f(x_i) = w_3 \times y_{1, i} + w_4 \times y_{2, i} + b_3$

138 |

139 | 又 $y_{1, i} = \ln(1+e^{x_{1,i}}), y_{2, i} = \ln(1+e^{x_{2, i}}), x_{1,i}=x_i \times w_1+b_1, x_{2,i} = x_i \times w_2+b_2$,以 Softplus 為例。

140 |

141 |

142 |

143 | 找出導函數,可以使用鎖鏈法則來尋找。

144 |

145 | $\dfrac{d\text{SSR}}{db_3} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{db_3} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times 1$

146 |

147 | $\dfrac{d\text{SSR}}{dw_3} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dw_3} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times y_{1, i}$

148 |

149 | $\dfrac{d\text{SSR}}{dw_4} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dw_4} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times y_{2, i}$

150 |

151 | $\dfrac{d\text{SSR}}{db_1} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_1} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{db_1} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_3 \times \dfrac{e^{x_{1, i}}}{1+e^{x_{1, i}}}\times 1$

152 |

153 | $\dfrac{d\text{SSR}}{dw_1} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_1} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_1} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_3 \times \dfrac{e^{x_{1, i}}}{1+e^{x_{1, i}}}\times x_{1i}$

154 |

155 | $\dfrac{d\text{SSR}}{db_2} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_2} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{db_2} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_4 \times \dfrac{e^{x_{2, i}}}{1+e^{x_{2, i}}}\times 1$

156 |

157 | $\dfrac{d\text{SSR}}{dw_2} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_2} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_2} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_4 \times \dfrac{e^{x_{2, i}}}{1+e^{x_{2, i}}}\times x_{2i}$

158 |

159 | 接著使用梯度下降

160 |

161 | $\text{Step size} = \text{Derivative} \times \text{Learning Rate}$

162 |

163 | $\text{New value} = \text{Old value} - \text{Step size}$

164 |

165 | 不斷更新直到值變小到無法再小,或者步驟完成。

166 |

167 |

168 |

169 | ## 建構 2-input ANN

170 |

171 | ### 建立概述

172 |

173 | 我們以複雜的例子來說明,以下圖為例。

174 |

175 |

134 |

135 | 我們令 $af_1(x_i)$ 運算出的結果叫做 $y_{1,i}$,$af_2(x_i)$ 運算出的結果叫做 $y_{2,i}$

136 |

137 | 可以得到 $f(x_i) = w_3 \times y_{1, i} + w_4 \times y_{2, i} + b_3$

138 |

139 | 又 $y_{1, i} = \ln(1+e^{x_{1,i}}), y_{2, i} = \ln(1+e^{x_{2, i}}), x_{1,i}=x_i \times w_1+b_1, x_{2,i} = x_i \times w_2+b_2$,以 Softplus 為例。

140 |

141 |

142 |

143 | 找出導函數,可以使用鎖鏈法則來尋找。

144 |

145 | $\dfrac{d\text{SSR}}{db_3} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{db_3} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times 1$

146 |

147 | $\dfrac{d\text{SSR}}{dw_3} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dw_3} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times y_{1, i}$

148 |

149 | $\dfrac{d\text{SSR}}{dw_4} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dw_4} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times y_{2, i}$

150 |

151 | $\dfrac{d\text{SSR}}{db_1} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_1} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{db_1} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_3 \times \dfrac{e^{x_{1, i}}}{1+e^{x_{1, i}}}\times 1$

152 |

153 | $\dfrac{d\text{SSR}}{dw_1} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_1} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_1} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_3 \times \dfrac{e^{x_{1, i}}}{1+e^{x_{1, i}}}\times x_{1i}$

154 |

155 | $\dfrac{d\text{SSR}}{db_2} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_2} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{db_2} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_4 \times \dfrac{e^{x_{2, i}}}{1+e^{x_{2, i}}}\times 1$

156 |

157 | $\dfrac{d\text{SSR}}{dw_2} = \dfrac{dSSR}{df(x_i)} \times \dfrac{df(x_i)}{dy_2} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_2} = \displaystyle \sum^{n}_{i=1} -2(y_i-f(x_i)) \times w_4 \times \dfrac{e^{x_{2, i}}}{1+e^{x_{2, i}}}\times x_{2i}$

158 |

159 | 接著使用梯度下降

160 |

161 | $\text{Step size} = \text{Derivative} \times \text{Learning Rate}$

162 |

163 | $\text{New value} = \text{Old value} - \text{Step size}$

164 |

165 | 不斷更新直到值變小到無法再小,或者步驟完成。

166 |

167 |

168 |

169 | ## 建構 2-input ANN

170 |

171 | ### 建立概述

172 |

173 | 我們以複雜的例子來說明,以下圖為例。

174 |

175 |  176 |

177 |

178 |

179 | 對於 weight 的部分,我們的初始值可以先給定為**標準常態分布**的隨機一個值,而 bias 可以先預設為 $0$

180 |

181 |

176 |

177 |

178 |

179 | 對於 weight 的部分,我們的初始值可以先給定為**標準常態分布**的隨機一個值,而 bias 可以先預設為 $0$

180 |

181 |  182 |

183 |

184 |

185 | ### 2-input ANN 的參數優化 (Backward Propagation)

186 |

187 | 若要使曲線越來越擬合我們的資料集,我們得要先考慮是否能夠限縮 $\text{SSR}$,使他越小,讓曲線 $f(x_i)$ 越能擬合資料集。

188 |

189 | $\text{SSR}$ 即為殘差平方和,即為對於在 $(x_1, x_2) = (i, j)$ 上的資料集,其所有資料 $(y(x_1, x_2) - f(x_1, x_2))^2$ 的和

190 |

191 | 可以定義為 $\text{SSR} = \displaystyle \sum^{}_{(x_1, x_2) \in S} (y(x_1, x_2) - f(x_1, x_2))^2$

192 |

193 | 若我們想要優化參數,可以找出參數對 $\text{SSR}$ 的導函數,接著使用梯度下降法來同步優化所有參數。

194 |

195 |

196 |

197 | 我們令 $af_1(x_{1i}, x_{2i})$ 運算出的結果叫做 $y_1(x_{1i}, x_{2i})$,$af_2(x_{1i}, x_{2i})$ 運算出的結果叫做 $y_2(x_{1i}, x_{2i})$

198 |

199 | 可以得到 $f(x_{1i}, x_{2i}) = w_5 \times y_1 + w_6 \times y_2 + b_3$

200 |

201 | 又 $y_1 = \ln(1+e^{x_{1}}), y_2 = \ln(1+e^{x_{2}})$,以 Softplus 為例。

202 |

203 | $x_{1}(x_{1i}, x_{2i})= x_{1i} \times w_1 + x_{2i} \times w_3$,$x_2(x_{1i}, x_{2i}) = x_{1i} \times w_2 + x_{2i} \times w_4$

204 |

205 |

206 |

207 | 找出導函數,可以使用鎖鏈法則來尋找。

208 |

209 |

210 |

211 | $\dfrac{d\text{SSR}}{db_3} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \dfrac{df(x_1, x_2)}{db_3} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times 1$

212 |

213 | $\dfrac{d\text{SSR}}{dw_5} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dw_5} = \displaystyle\sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times y_{1}$

214 |

215 | $\dfrac{d\text{SSR}}{dw_6} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dw_6} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times y_{2}$

216 |

217 | $\dfrac{d\text{SSR}}{db_1} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{db_1} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times 1$

218 |

219 | $\dfrac{d\text{SSR}}{db_2} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{db_2} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times 1$

220 |

221 | $\dfrac{d\text{SSR}}{dw_1} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_1} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times x_{1i}$

222 |

223 | $\dfrac{d\text{SSR}}{dw_2} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_2} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times x_{1i}$

224 |

225 | $\dfrac{d\text{SSR}}{dw_3} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_3} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times x_{2i}$

226 |

227 | $\dfrac{d\text{SSR}}{dw_4} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_4} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times x_{2i}$

228 |

229 | 接著使用梯度下降

230 |

231 | $\text{Step size} = \text{Derivative} \times \text{Learning Rate}$

232 |

233 | $\text{New value} = \text{Old value} - \text{Step size}$

234 |

235 | 不斷更新直到值變小到無法再小,或者步驟完成。

236 |

237 |

238 |

239 | ## ANN 的優缺點

240 |

241 | - 優點:

242 | 1. 準確度高

243 | 2. 可以處理很多種類的問題

244 | 3. 可以包含很多種類的資料(數值、名目...)

245 | 4. 可以得到非常好的 R-Score,只要訓練充足就可以

246 | - 缺點

247 | 1. 可能永遠訓練不完

248 | 2. 黑箱,所以很難向別人描述這個原理

249 | 3. 需要很大量的資料來訓練,才有準確度

250 | 4. 對於多變量來說可能會讓訓練過程變得非常長

--------------------------------------------------------------------------------

/Markdown/Associate Rule Mining.md:

--------------------------------------------------------------------------------

1 | # RS -- Associate Rule Mining(推薦系統 ─ 關聯規則探勘)

2 |

3 | > Reference:

4 | >

5 | > 1. Recommendation System -- Associate Rule Mining by Dr. Tun-Wen Pai

6 | > 2. [矩陣分解(Matrix Factorization): 交替最小平方法(Alternating least squares, ALS)和加權交替最小平方法(Alternating-least-squares with weighted-λ -regularization, ALS-WR)](https://chih-sheng-huang821.medium.com/%E7%9F%A9%E9%99%A3%E5%88%86%E8%A7%A3-matrix-factorization-%E4%BA%A4%E6%9B%BF%E6%9C%80%E5%B0%8F%E5%B9%B3%E6%96%B9%E6%B3%95-alternating-least-squares-2a71fd1393f7)

7 | > 3. [Day 07:初探推薦系統(Recommendation System)](https://ithelp.ithome.com.tw/articles/10219033)

8 |

9 |

10 |

11 | ## 推薦系統

12 |

13 | 啤酒對應到尿布是一個著名的關聯規則探勘例子,透過大量的銷售資料集探勘出了啤酒跟尿布同時購買的頻率很高。

14 |

15 | 在這份筆記,我們最主要會去探討要怎麼從大量的資料找到頻繁樣式,也就是找出哪種商品的購買組合頻率最高。

16 |

17 | 從大數據來說,找到東西的關聯是非常重要的。

18 |

19 | 推薦系統支持了我們找出頻繁樣式,進而從大量的資料分析出特定的組合,就能夠找出推薦的組合,稱為推薦系統。

20 |

21 |

22 |

23 | 主要有以下幾種不同的工具可以幫我們建立推薦系統。

24 |

25 | - Association Rule Mining(ARM),關聯規則探勘。

26 | - 我們可以用 Frequent pattern(頻繁樣式)來找出資料集的發生頻率。

27 | - Alternating Least Square(ALS),交替最小平方法。

28 | - 對一個隱含資料(Implicit Data)使用協同過濾演算法,例如 Matrix Factorization 來建立關聯。

29 | - Content Based Filtering

30 | - 以內容為基礎的過濾,比較商品的屬性,找出最相似的商品。

31 |

32 |

33 |

34 | ## 關聯規則探勘

35 |

36 | 關聯規則探勘 (Association Rule Mining),一種非監督式學習技巧,

37 |

38 | 利用大量的資料所產生的資料集來找出頻繁樣式、關聯、相關性、因果結構等等。

39 |

40 | 其中,Association Rule Mining 使用的是類別資料(Categorical Variable)。

41 |

42 |

43 |

44 | 若我們有 $N$ 個物品 $I_i$ 組成的物品集 $I$,對於一個輸入 Association Rule Mining 的資料集,

45 |

46 | 每筆資料 $T$ 都是資料集的子集合,稱為物品集,也就是 $T \subseteq I$。

47 |

48 |

49 |

50 | 例如我們有 6 個物品所組成的 $\{A, B, C, D, E, F\}$,我們有一個資料集:

51 |

52 | | ID | Item Set |

53 | | :--: | :------: |

54 | | 1 | A, B, C |

55 | | 2 | B, D, E |

56 | | 3 | D, E, F |

57 | | 4 | A, C, E |

58 | | 5 | B, E, F |

59 |

60 | 我們就能夠從這個資料集找出頻繁樣式。

61 |

62 |

63 |

64 | ### Support, Confidence and Lift

65 |

66 | 從大量的資料集,我們希望能夠量化出現頻率,來找到頻繁樣式,所以在 ARM 中將每個組合量化出了三種數值。

67 |

68 | 對於先發生事件 $A$ 再發生事件 $C$,我們可以量化出三種數值:

69 |

70 | - Support:$P(A \cap C)$,量化這個組合發生的機率。

71 | - Confidence:$P(C|A)$,量化這個組合發生 A 再發生 C 的機率。

72 | - Lift:$P(C|A)/P(C)$,用於量化這個組合的效力,通常大於 1 就代表這個組合是有效的。

73 |

74 |

75 |

76 | 那麼使用者可以設定一個門檻,用來採納這個頻繁組合該不該適用。

77 |

78 | 若使用者設定 Support > 40%,且 Confidence > 60%,使用者就可以接受這個組合為頻繁組合。

79 |

80 |

81 |

82 | ## 先驗演算法

83 |

84 | 對於一個很大的資料庫來說,我們可能同時會有很多個不同的頻繁組合。

85 |

86 | 我們希望可以制定頻繁組合必須要至少 Support 大於 k,來淘汰掉一些不太適用的組合。

87 |

88 |

89 |

90 | 先驗演算法的一些原則:

91 |

92 | 1. 一個組合的任意子集都在資料庫內,例如組合為 {a, b, c},則 {a}, {b}, {c}, {ab}, {ac}, {bc}, {abc} 都應發生在資料庫內。

93 |

94 | 2. Apriori pruning principle:當我們用任意兩種組合產生出另一個新組合,則這個新組合

95 |

96 | 也應該要符合第一點的原則,否則不該產生。

97 |

98 | 例如:透過 {a, c, e} 與 {a, e, f} 產生出了 {a, c, e, f} 這個組合,

99 |

100 | 但若 {c, e, f} 這個組合並沒有發生在資料庫內,則 {a, c, e, f} 這個組合無效。

101 |

102 |

103 |

104 | 下圖為演算法的產生過程。

105 |

106 | 1. 從原先的資料庫產生出了 1-item-set 的組合,並且刪去只有 support = 1 的組合(因為我們要求 min_support = 2)

107 |

108 | 2. 從 1-item-set 的任意兩種組合聯集,產生出了 **2**-item-set 的組合,並且刪去只有 support = 1 的組合

109 | 3. 從 i-item-set 產生出了 **(i+1)**-item-set 的組合...,直到能夠被分到只有一個。

110 |

111 |

182 |

183 |

184 |

185 | ### 2-input ANN 的參數優化 (Backward Propagation)

186 |

187 | 若要使曲線越來越擬合我們的資料集,我們得要先考慮是否能夠限縮 $\text{SSR}$,使他越小,讓曲線 $f(x_i)$ 越能擬合資料集。

188 |

189 | $\text{SSR}$ 即為殘差平方和,即為對於在 $(x_1, x_2) = (i, j)$ 上的資料集,其所有資料 $(y(x_1, x_2) - f(x_1, x_2))^2$ 的和

190 |

191 | 可以定義為 $\text{SSR} = \displaystyle \sum^{}_{(x_1, x_2) \in S} (y(x_1, x_2) - f(x_1, x_2))^2$

192 |

193 | 若我們想要優化參數,可以找出參數對 $\text{SSR}$ 的導函數,接著使用梯度下降法來同步優化所有參數。

194 |

195 |

196 |

197 | 我們令 $af_1(x_{1i}, x_{2i})$ 運算出的結果叫做 $y_1(x_{1i}, x_{2i})$,$af_2(x_{1i}, x_{2i})$ 運算出的結果叫做 $y_2(x_{1i}, x_{2i})$

198 |

199 | 可以得到 $f(x_{1i}, x_{2i}) = w_5 \times y_1 + w_6 \times y_2 + b_3$

200 |

201 | 又 $y_1 = \ln(1+e^{x_{1}}), y_2 = \ln(1+e^{x_{2}})$,以 Softplus 為例。

202 |

203 | $x_{1}(x_{1i}, x_{2i})= x_{1i} \times w_1 + x_{2i} \times w_3$,$x_2(x_{1i}, x_{2i}) = x_{1i} \times w_2 + x_{2i} \times w_4$

204 |

205 |

206 |

207 | 找出導函數,可以使用鎖鏈法則來尋找。

208 |

209 |

210 |

211 | $\dfrac{d\text{SSR}}{db_3} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \dfrac{df(x_1, x_2)}{db_3} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times 1$

212 |

213 | $\dfrac{d\text{SSR}}{dw_5} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dw_5} = \displaystyle\sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times y_{1}$

214 |

215 | $\dfrac{d\text{SSR}}{dw_6} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dw_6} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times y_{2}$

216 |

217 | $\dfrac{d\text{SSR}}{db_1} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{db_1} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times 1$

218 |

219 | $\dfrac{d\text{SSR}}{db_2} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{db_2} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times 1$

220 |

221 | $\dfrac{d\text{SSR}}{dw_1} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_1} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times x_{1i}$

222 |

223 | $\dfrac{d\text{SSR}}{dw_2} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_2} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times x_{1i}$

224 |

225 | $\dfrac{d\text{SSR}}{dw_3} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{1}} \times \dfrac{dy_1}{dx_1} \times \dfrac{dx_1}{dw_3} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_5 \times \dfrac{e^{x_1}}{1+e^{x_1}} \times x_{2i}$

226 |

227 | $\dfrac{d\text{SSR}}{dw_4} = \dfrac{d\text{SSR}}{df(x_1, x_2)} \times \dfrac{df(x_1, x_2)}{dy_{2}} \times \dfrac{dy_2}{dx_2} \times \dfrac{dx_2}{dw_4} = \displaystyle \sum_{(x_1, x_2) \in S} -2(y(x_1, x_2) - f(x_1, x_2)) \times w_6 \times \dfrac{e^{x_2}}{1+e^{x_2}} \times x_{2i}$

228 |

229 | 接著使用梯度下降

230 |

231 | $\text{Step size} = \text{Derivative} \times \text{Learning Rate}$

232 |

233 | $\text{New value} = \text{Old value} - \text{Step size}$

234 |

235 | 不斷更新直到值變小到無法再小,或者步驟完成。

236 |

237 |

238 |

239 | ## ANN 的優缺點

240 |

241 | - 優點:

242 | 1. 準確度高

243 | 2. 可以處理很多種類的問題

244 | 3. 可以包含很多種類的資料(數值、名目...)

245 | 4. 可以得到非常好的 R-Score,只要訓練充足就可以

246 | - 缺點

247 | 1. 可能永遠訓練不完

248 | 2. 黑箱,所以很難向別人描述這個原理

249 | 3. 需要很大量的資料來訓練,才有準確度

250 | 4. 對於多變量來說可能會讓訓練過程變得非常長

--------------------------------------------------------------------------------

/Markdown/Associate Rule Mining.md:

--------------------------------------------------------------------------------

1 | # RS -- Associate Rule Mining(推薦系統 ─ 關聯規則探勘)

2 |

3 | > Reference:

4 | >

5 | > 1. Recommendation System -- Associate Rule Mining by Dr. Tun-Wen Pai

6 | > 2. [矩陣分解(Matrix Factorization): 交替最小平方法(Alternating least squares, ALS)和加權交替最小平方法(Alternating-least-squares with weighted-λ -regularization, ALS-WR)](https://chih-sheng-huang821.medium.com/%E7%9F%A9%E9%99%A3%E5%88%86%E8%A7%A3-matrix-factorization-%E4%BA%A4%E6%9B%BF%E6%9C%80%E5%B0%8F%E5%B9%B3%E6%96%B9%E6%B3%95-alternating-least-squares-2a71fd1393f7)

7 | > 3. [Day 07:初探推薦系統(Recommendation System)](https://ithelp.ithome.com.tw/articles/10219033)

8 |

9 |

10 |

11 | ## 推薦系統

12 |

13 | 啤酒對應到尿布是一個著名的關聯規則探勘例子,透過大量的銷售資料集探勘出了啤酒跟尿布同時購買的頻率很高。

14 |

15 | 在這份筆記,我們最主要會去探討要怎麼從大量的資料找到頻繁樣式,也就是找出哪種商品的購買組合頻率最高。

16 |

17 | 從大數據來說,找到東西的關聯是非常重要的。

18 |

19 | 推薦系統支持了我們找出頻繁樣式,進而從大量的資料分析出特定的組合,就能夠找出推薦的組合,稱為推薦系統。

20 |

21 |

22 |

23 | 主要有以下幾種不同的工具可以幫我們建立推薦系統。

24 |

25 | - Association Rule Mining(ARM),關聯規則探勘。

26 | - 我們可以用 Frequent pattern(頻繁樣式)來找出資料集的發生頻率。

27 | - Alternating Least Square(ALS),交替最小平方法。

28 | - 對一個隱含資料(Implicit Data)使用協同過濾演算法,例如 Matrix Factorization 來建立關聯。

29 | - Content Based Filtering

30 | - 以內容為基礎的過濾,比較商品的屬性,找出最相似的商品。

31 |

32 |

33 |

34 | ## 關聯規則探勘

35 |

36 | 關聯規則探勘 (Association Rule Mining),一種非監督式學習技巧,

37 |

38 | 利用大量的資料所產生的資料集來找出頻繁樣式、關聯、相關性、因果結構等等。

39 |

40 | 其中,Association Rule Mining 使用的是類別資料(Categorical Variable)。

41 |

42 |

43 |

44 | 若我們有 $N$ 個物品 $I_i$ 組成的物品集 $I$,對於一個輸入 Association Rule Mining 的資料集,

45 |

46 | 每筆資料 $T$ 都是資料集的子集合,稱為物品集,也就是 $T \subseteq I$。

47 |

48 |

49 |

50 | 例如我們有 6 個物品所組成的 $\{A, B, C, D, E, F\}$,我們有一個資料集:

51 |

52 | | ID | Item Set |

53 | | :--: | :------: |

54 | | 1 | A, B, C |

55 | | 2 | B, D, E |

56 | | 3 | D, E, F |

57 | | 4 | A, C, E |

58 | | 5 | B, E, F |

59 |

60 | 我們就能夠從這個資料集找出頻繁樣式。

61 |

62 |

63 |

64 | ### Support, Confidence and Lift

65 |

66 | 從大量的資料集,我們希望能夠量化出現頻率,來找到頻繁樣式,所以在 ARM 中將每個組合量化出了三種數值。

67 |

68 | 對於先發生事件 $A$ 再發生事件 $C$,我們可以量化出三種數值:

69 |

70 | - Support:$P(A \cap C)$,量化這個組合發生的機率。

71 | - Confidence:$P(C|A)$,量化這個組合發生 A 再發生 C 的機率。

72 | - Lift:$P(C|A)/P(C)$,用於量化這個組合的效力,通常大於 1 就代表這個組合是有效的。

73 |

74 |

75 |

76 | 那麼使用者可以設定一個門檻,用來採納這個頻繁組合該不該適用。

77 |

78 | 若使用者設定 Support > 40%,且 Confidence > 60%,使用者就可以接受這個組合為頻繁組合。

79 |

80 |

81 |

82 | ## 先驗演算法

83 |

84 | 對於一個很大的資料庫來說,我們可能同時會有很多個不同的頻繁組合。

85 |

86 | 我們希望可以制定頻繁組合必須要至少 Support 大於 k,來淘汰掉一些不太適用的組合。

87 |

88 |

89 |

90 | 先驗演算法的一些原則:

91 |

92 | 1. 一個組合的任意子集都在資料庫內,例如組合為 {a, b, c},則 {a}, {b}, {c}, {ab}, {ac}, {bc}, {abc} 都應發生在資料庫內。

93 |

94 | 2. Apriori pruning principle:當我們用任意兩種組合產生出另一個新組合,則這個新組合

95 |

96 | 也應該要符合第一點的原則,否則不該產生。

97 |

98 | 例如:透過 {a, c, e} 與 {a, e, f} 產生出了 {a, c, e, f} 這個組合,

99 |

100 | 但若 {c, e, f} 這個組合並沒有發生在資料庫內,則 {a, c, e, f} 這個組合無效。

101 |

102 |

103 |

104 | 下圖為演算法的產生過程。

105 |

106 | 1. 從原先的資料庫產生出了 1-item-set 的組合,並且刪去只有 support = 1 的組合(因為我們要求 min_support = 2)

107 |

108 | 2. 從 1-item-set 的任意兩種組合聯集,產生出了 **2**-item-set 的組合,並且刪去只有 support = 1 的組合

109 | 3. 從 i-item-set 產生出了 **(i+1)**-item-set 的組合...,直到能夠被分到只有一個。

110 |

111 |  112 |

113 |

114 |

115 |

116 |

117 | ### 先驗演算法的缺點

118 |

119 | 對於大資料集來說,**為了產生候選組合,時間與效能耗費過大**。

120 |

121 |

122 |

123 |

124 |

125 | ## FP-Tree

126 |

127 | 樹狀結構很讚,能夠高效的處理大量資料。

128 |

129 |

112 |

113 |

114 |

115 |

116 |

117 | ### 先驗演算法的缺點

118 |

119 | 對於大資料集來說,**為了產生候選組合,時間與效能耗費過大**。

120 |

121 |

122 |

123 |

124 |

125 | ## FP-Tree

126 |

127 | 樹狀結構很讚,能夠高效的處理大量資料。

128 |

129 |  130 |

131 |

132 |

133 | FP-Tree 可以幫助我們建立出頻繁樣式,雖然高壓縮但頻繁樣式完整。

134 |

135 |

136 |

137 | ### frequent item table

138 |

139 | 若我們有左邊的資料表,由上至下的 ID 為 1、2、3、4、5。

140 |

141 | 首先我們應先設定一個 support 為門檻,淘汰掉不需要的資料。

142 |

143 |

144 |

145 | 以左邊為例,我們設定 min_support = 3。

146 |

147 | 經過淘汰掉不在門檻上的資料,得到右邊的 frequent item table。

148 |

149 | | Database | Frequent item table (unordered) |

150 | | :---------------------------------------------------------: | :---------------------------------------------------------: |

151 | |  |  |

152 |

153 | 我們需要對這個 table 做排序,根據物品出現的頻率由多至少排序,左圖呈現物品次數所建構的次數表,右圖呈現排序過後的表格。

154 |

155 | | Header Table | Frequent item table (ordered) |

156 | | :---------------------------------------------------------: | :---------------------------------------------------------: |

157 | |  |  |

158 |

159 | 接著只需要使用 Frequent item table,對於每一項逐一建樹即可。

160 |

161 | | Data1 | Data2 | Data3 |

162 | | :---------------------------------------------------------: | :----------------------------------------------------------: | :----------------------------------------------------------: |

163 | |  |  |

130 |

131 |

132 |

133 | FP-Tree 可以幫助我們建立出頻繁樣式,雖然高壓縮但頻繁樣式完整。

134 |

135 |

136 |

137 | ### frequent item table

138 |

139 | 若我們有左邊的資料表,由上至下的 ID 為 1、2、3、4、5。

140 |

141 | 首先我們應先設定一個 support 為門檻,淘汰掉不需要的資料。

142 |

143 |

144 |

145 | 以左邊為例,我們設定 min_support = 3。

146 |

147 | 經過淘汰掉不在門檻上的資料,得到右邊的 frequent item table。

148 |

149 | | Database | Frequent item table (unordered) |

150 | | :---------------------------------------------------------: | :---------------------------------------------------------: |

151 | |  |  |

152 |

153 | 我們需要對這個 table 做排序,根據物品出現的頻率由多至少排序,左圖呈現物品次數所建構的次數表,右圖呈現排序過後的表格。

154 |

155 | | Header Table | Frequent item table (ordered) |

156 | | :---------------------------------------------------------: | :---------------------------------------------------------: |

157 | |  |  |

158 |

159 | 接著只需要使用 Frequent item table,對於每一項逐一建樹即可。

160 |

161 | | Data1 | Data2 | Data3 |

162 | | :---------------------------------------------------------: | :----------------------------------------------------------: | :----------------------------------------------------------: |

163 | |  |  |  |

164 | | **Data 4** | **Data 5** | |

165 | |  |

|

164 | | **Data 4** | **Data 5** | |

165 | |  |  | |

166 |

167 | 藉此我們就能建構完整的 FP-Tree。

168 |

169 |

170 |

171 | ### conditional pattern base

172 |

173 | 對於一棵 FP-Tree,我們可以非常快速的查詢到樣式發生的次數。

174 |

175 | 以下圖為例,我們可以根據 Header Table 來逐一查詢。

176 |

177 | | Header Table | Frequent item table |

178 | | :---------------------------------------------------------: | :----------------------------------------------------------: |

179 | |  |

| |

166 |

167 | 藉此我們就能建構完整的 FP-Tree。

168 |

169 |

170 |

171 | ### conditional pattern base

172 |

173 | 對於一棵 FP-Tree,我們可以非常快速的查詢到樣式發生的次數。

174 |

175 | 以下圖為例,我們可以根據 Header Table 來逐一查詢。

176 |

177 | | Header Table | Frequent item table |

178 | | :---------------------------------------------------------: | :----------------------------------------------------------: |

179 | |  |  |

180 |

181 | 由於具有 BFS 的特性,所以我們可以很快速的查詢到相對的樣式。

182 |

183 | 我們會從 Header Table 第二項到第六項開始做向上尋訪(紅色節點)即可得到 Conditional Pattern Base

184 |

185 | 發生次數即為紫色節點的數字。

186 |

187 | | Item | Image | Conditional Pattern base |

188 | | :--: | :----------------------------------------------------------: | :----------------------: |

189 | | c |

|

180 |

181 | 由於具有 BFS 的特性,所以我們可以很快速的查詢到相對的樣式。

182 |

183 | 我們會從 Header Table 第二項到第六項開始做向上尋訪(紅色節點)即可得到 Conditional Pattern Base

184 |

185 | 發生次數即為紫色節點的數字。

186 |

187 | | Item | Image | Conditional Pattern base |

188 | | :--: | :----------------------------------------------------------: | :----------------------: |

189 | | c |  | f:3 |

190 | | a |

| f:3 |

190 | | a |  | fc:3 |

191 | | b |

| fc:3 |

191 | | b |  | fca: 1

| fca: 1

f:1

c:1 |

192 | | m |  | fca:2

| fca:2

fcab:1 |

193 | | p |  | fcam:2

| fcam:2

cb:1 |

194 |

195 |

196 |

197 | ### conditional FP-Tree

198 |

199 | 從前面的 conditional pattern base 之後,我們可以根據某一物品 $i$ 的所有 conditional pattern base 所建立出的分支取交集。

200 |

201 | 以 m 為例,我們已知 `fca:2, fcam:1`,即為兩個不同分支,我們可以將這些分支取交集合併,得到一個新的 conditional FP-Tree。

202 |

203 | | FP-Tree when item=m | conditional FP-Tree |

204 | | :----------------------------------------------------------: | :---------------------------------------------------------: |

205 | |  |  |

206 |

207 | 我們就能根據這個 conditional FP-Tree 窮舉出所有含有 m 的樣式,也就是`m, fm, cm, am, fcm, fam, cam, fcam`

208 |

209 | 我們還能根據 conditional FP-Tree 以遞迴的形式找出 am, cm, cam... 的 conditional FP-Tree,與上述同理。

210 |

211 |

212 |

213 | ## Collaborative Filtering

214 |

215 | 我們可以使用 Collaborative Filtering 來找出兩個相似的人或事物,分成以 User-Based 為主與以 Item-Based 為主。

216 |

217 | 我們會根據使用者或物品的 rating 來評估推薦

218 |

219 | 但也因此會有 cold start 的問題,也就是新東西或新的人進來之後會不知道要推薦什麼,因為沒有任何的評分紀錄。

220 |

221 |

222 |

223 | 要找出相似的人事物,我們需要算出相似度:

224 |

225 | - Jaccard similarity measure $\text{sim}(x, y) = \dfrac{|r_x \cap r_y|}{|r_x|+|r_y|-|r_x\cap r_y|}$,其中 $v_x, v_y$ 為 User rating set。

226 | - Cosine similarity:$\text{sim}(x, y) = \dfrac{r_x\cdot r_y}{||r_x||\cdot||r_y||}$

227 | - Pearson correlation coefficient:$\text{sim}(x,y)=\dfrac{\displaystyle \sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})(r_{ys}-\overline{r_y})}{\sqrt{\sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})^2} \sqrt{\sum_{s\in s_{xy}} (r_{ys}-\overline{r_y})^2}}$,$s_{xy}$ 為 x 與 y 對某物的評價。

228 |

229 |

230 |

231 | ### User-based collaborative filtering

232 |

233 | 我們可以使用 user-item rating matrix,找出 user 與 user 之間的關聯性。

234 |

235 | 只要找出兩個 user 有高相似度,就能把類似的行為推薦給 user。

236 |

237 |

238 |

239 | ### Item-based collaborative filtering

240 |

241 | 我們可以使用 user-item rating matrix,找出 item 與 item 之間的關聯性。

242 |

243 | 只要找出兩個 item 有高相似度,就能把類似的行為推薦給 user。

244 |

245 |

246 |

247 |

248 |

249 | ### Jaccard similarity measure

250 |

251 | 第一個提到的相似度計算即為 Jaccard similarity measure。

252 |

253 | Jaccard similarity measure 不管評分,只管該 index 有沒有評分,以下面的例子為例。

254 |

255 | | | 1 | 2 | 3 | 4 | 5 |

256 | | :--: | :--: | :--: | :--: | :--: | :--: |

257 | | x | 1 | | | 1 | 3 |

258 | | y | 1 | | 2 | 2 | |

259 |

260 | 我們可以得到 User rating set $r_x = \{1, 4, 5\}$,$r_y = \{1, 3, 4\}$,因為 $x$ 只有在 1、4、5 做評分,$y$ 只有在 1、3、4 做評分。

261 |

262 | 由於 $r_x$ 與 $r_y$ 有交集的數量只有 $2$,聯集則是 $4$,故 $\text{sim}(x, y) = \dfrac{2}{4} = 0.5$

263 |

264 |

265 |

266 | 缺點則是評分上是有意義的,故這樣做會忽略掉評分的意義。

267 |

268 |

269 |

270 | ### Cosine similarity

271 |

272 | 第二個提到的相似度計算即為 Cosine similarity。

273 |

274 | 以下面的例子為例。

275 |

276 | | | 1 | 2 | 3 | 4 | 5 |

277 | | :--: | :--: | :--: | :--: | :--: | :--: |

278 | | x | 1 | | | 1 | 3 |

279 | | y | 1 | | 2 | 2 | |

280 |

281 | 我們可以將 $r_x, r_y$ 視為點,則可以得到

282 | $$

283 | r_x = <1, 0, 0, 1, 3> \\

284 | r_y = <1, 0, 2, 2, 0>

285 | $$

286 | 故其 Cosine similarity 為 $\dfrac{1+0+0+2+0}{\sqrt{1^2+1^2+3^2}\sqrt{1^2+2^2+2^2}} \approx 30.2\%$

287 |

288 |

289 |

290 | ### Pearson correlation coefficient

291 |

292 | 定義上為 $\text{sim}(x,y)=\dfrac{\displaystyle \sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})(r_{ys}-\overline{r_y})}{\sqrt{\sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})^2} \sqrt{\sum_{s\in s_{xy}} (r_{ys}-\overline{r_y})^2}}$,$s_{xy}$ 為 x 與 y 對某物的評價。

293 |

294 | 雖然定義上是這樣,但,其實你只要算出列/行的平均,行/列存在的元素全部減去平均後砸 Cosine Similarity 也能做出來

295 |

296 | ~~安了我的算式恐懼症,這麼可怕的式子是啥鬼嗚嗚~~

297 |

298 |

299 |

300 | 以下面的例子為例。

301 |

302 | | | 1 | 2 | 3 | 4 | 5 |

303 | | :--: | :--: | :--: | :--: | :--: | :--: |

304 | | x | 2 | | | 1 | 3 |

305 | | y | 2 | | 2 | 2 | |

306 |

307 | 我們可以將 $r_x, r_y$ 視為點,則可以得到

308 | $$

309 | r_x = <1, 0, 0, 1, 3> \\

310 | r_y = <1, 0, 2, 2, 0>

311 | $$

312 | 平均 $\mu_x = 2$,$\mu_y = 2$,則

313 | $$

314 | r_x' = <-1, 0, 0, -1, 1> \\

315 | r_y' = <-1, 0, 0, 0, 0>

316 | $$

317 | 我們可以算出 Pearson correlation coefficient

318 | $$

319 | \text{sim}(x, y) = \dfrac{1}{((-1)^2+(-1)^2+1^2)((-1)^2)} = \dfrac{1}{3} \approx 0.333

320 | $$

321 |

322 |

323 | ### Prediction Function

324 |

325 | 若我們有一個物件與其他 $N$ 個物件相似,則我們可以用以下的式子來表達其預測值

326 | $$

327 | r_{xi} = \dfrac{\displaystyle \sum_{j\in N(i; x)} s_{ij} \cdot r_{xj}}{\displaystyle \sum_{j\in N(i; x)} s_{ij}}

328 | $$

329 | 見以下範例。

330 |

331 |

332 |

333 | ### Item-Item Collaborative Filtering

334 |

335 | 假設我們有一筆這樣的資料,欄為 User 且列為 Movie,表格上每個數字為 User 對 Movie 的評價

336 |

337 | | | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

338 | | :--: | :--: | :--: | :--: | :--: | :----: | :--: | :--: | :--: | :--: | :--: | :--: | :--: |

339 | | 1 | 1 | | 3 | | **?** | 5 | | | 5 | | 4 | |

340 | | 2 | | | 5 | 4 | | | 4 | | | 2 | 1 | 3 |

341 | | 3 | 2 | 4 | | 1 | 2 | | 3 | | 4 | 3 | 5 | |

342 | | 4 | | 2 | 4 | | 5 | | | 4 | | | 2 | |

343 | | 5 | | | 4 | 3 | 4 | 2 | | | | | 2 | |

344 | | 6 | 1 | | 3 | | 3 | | | 2 | | | 4 | |

345 |

346 | 可以看到 $D(1, 5)$ 的資料是問號,即為我們想要推演的資料。

347 |

348 | 我們使用 Pearson correlation coefficient 來**計算電影的相似度**,先算出每個電影的平均值,以及該列減去平均值的向量。

349 |

350 | $\mu_1 = (1+3+5+5+4)/5 = 3.6$,$v'_1 = <-2.6, 0, -0.6, 0, 0, 1.4, 0, 0, 1.4, 0, 0.4, 0>$

351 |

352 | $\mu_2 = (5+4+4+2+1+3)/6=3.167$,$v'_2 = <0, 0, 1.83, 0.83, 0, 0, 0.83, 0, 0, -1.17, -2.17, -0.17>$

353 |

354 | $\mu_3 = (2+4+1+2+3+4+3+5)/8=3$,$v'_3 = <-1, 1, 0, -2, -1, 0, 0, 0, 1, 0, 2, 0>$

355 |

356 | $\mu_4 = (2+4+5+4+2)/5=3.4$,$v'_4 = <0, -1.4, 0.6, 0, 1.6, 0, 0, 0.6, 0, 0, -1.4, 0>$

357 |

358 | $\mu_5 = (4+3+4+2+2)/5=3$,$v'_5 = <0, 0, 1, 0, 1, -1, 0, 0, 0, 0, -1, 0>$

359 |

360 | $\mu_6 = (1+3+3+2+4)/5=2.6$,$v'_6 = <-1.6, 0, 0.4, 0, 0.4, 0, 0, -0.6, 0, 0, 1.4. 0>$

361 |

362 | 我們可以算出 Pearson correlation coefficient,得到

363 |

364 | $\text{sim}(1, 2) = -0.17$,$\text{sim}(1, 3) = 0.41$,$\text{sim}(1, 4) = -0.1$,$\text{sim}(1, 5) = -0.36$,$\text{sim}(1, 6) = 0.59$

365 |

366 | 故我們選擇電影 3、6 與電影 1 有較高的關聯性。

367 |

368 |

369 |

370 | 因此我們可以套用預測函數,得到:

371 | $$

372 | \dfrac{0.41\times 2 + 0.59\times 3}{0.41+0.59} = 2.6

373 | $$

374 | 故 $D(1, 5)$ 可以被預測成 2.6 分。

375 |

376 |

377 |

378 | ### User-User Collaborative Filtering

379 |

380 | 與 [Item-Item Collaborative Filtering](#Item-Item Collaborative Filtering) 同理,跳過。

381 |

382 |

383 |

384 | ## Content-based Filtering

385 |

386 | 使用內容來進行評估,因為使用內容,所以不會有 cold start 的問題。

387 |

388 |

389 |

390 | ### TF-IDF

391 |

392 | TF-IDF (Term Frequency - Inverse Document Frequency),用來量化詞彙的重要性,但會隨著詞彙出現的頻率高而出現反比影響。

393 |

394 | 其定義為:

395 | $$

396 | TF_{ij} = \dfrac{n_{ij}}{\sum_{k} n_{kj}} \\

397 | IDF_{i} = \log(\dfrac{N}{n_i}) \\

398 | \text{TF-IDF}_{ij} = TF_{ij} \times IDF_{i}

399 | $$

400 | 其中 TF 的 $n_{ij}$ 為該詞彙在文件中的次數,分母則是在所有文件中該詞彙出現的次數,$N$ 為文件的總詞彙量。

401 |

402 |

--------------------------------------------------------------------------------

/Markdown/Cluster Analysis.md:

--------------------------------------------------------------------------------

1 | # 群聚分析(Cluster Analysis)

2 |

3 | > Reference:

4 | >

5 | > 1. Cluster Analysis - Dr. Tun-Wen Pai

6 |

7 | ## 群聚分析

8 |

9 | 主要分成兩種不同的群聚分析:

10 |

11 | 1. 分層式群聚:分成由上至下(top-down)或由下至上(bottom-up)演算法,層層迭代運算。

12 | 2. 分割式群聚:一次把所有的分群結果納入考慮。

13 |

14 |

15 |

16 | ## 分割式群聚

17 |

18 | 這邊舉一個最經典的例子:K-Mean。

19 |

20 |

21 |

22 | ### 簡單的步驟舉例

23 |

24 | 舉個例子,我們有個資料集。

25 |

26 |

|  |

206 |

207 | 我們就能根據這個 conditional FP-Tree 窮舉出所有含有 m 的樣式,也就是`m, fm, cm, am, fcm, fam, cam, fcam`

208 |

209 | 我們還能根據 conditional FP-Tree 以遞迴的形式找出 am, cm, cam... 的 conditional FP-Tree,與上述同理。

210 |

211 |

212 |

213 | ## Collaborative Filtering

214 |

215 | 我們可以使用 Collaborative Filtering 來找出兩個相似的人或事物,分成以 User-Based 為主與以 Item-Based 為主。

216 |

217 | 我們會根據使用者或物品的 rating 來評估推薦

218 |

219 | 但也因此會有 cold start 的問題,也就是新東西或新的人進來之後會不知道要推薦什麼,因為沒有任何的評分紀錄。

220 |

221 |

222 |

223 | 要找出相似的人事物,我們需要算出相似度:

224 |

225 | - Jaccard similarity measure $\text{sim}(x, y) = \dfrac{|r_x \cap r_y|}{|r_x|+|r_y|-|r_x\cap r_y|}$,其中 $v_x, v_y$ 為 User rating set。

226 | - Cosine similarity:$\text{sim}(x, y) = \dfrac{r_x\cdot r_y}{||r_x||\cdot||r_y||}$

227 | - Pearson correlation coefficient:$\text{sim}(x,y)=\dfrac{\displaystyle \sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})(r_{ys}-\overline{r_y})}{\sqrt{\sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})^2} \sqrt{\sum_{s\in s_{xy}} (r_{ys}-\overline{r_y})^2}}$,$s_{xy}$ 為 x 與 y 對某物的評價。

228 |

229 |

230 |

231 | ### User-based collaborative filtering

232 |

233 | 我們可以使用 user-item rating matrix,找出 user 與 user 之間的關聯性。

234 |

235 | 只要找出兩個 user 有高相似度,就能把類似的行為推薦給 user。

236 |

237 |

238 |

239 | ### Item-based collaborative filtering

240 |

241 | 我們可以使用 user-item rating matrix,找出 item 與 item 之間的關聯性。

242 |

243 | 只要找出兩個 item 有高相似度,就能把類似的行為推薦給 user。

244 |

245 |

246 |

247 |

248 |

249 | ### Jaccard similarity measure

250 |

251 | 第一個提到的相似度計算即為 Jaccard similarity measure。

252 |

253 | Jaccard similarity measure 不管評分,只管該 index 有沒有評分,以下面的例子為例。

254 |

255 | | | 1 | 2 | 3 | 4 | 5 |

256 | | :--: | :--: | :--: | :--: | :--: | :--: |

257 | | x | 1 | | | 1 | 3 |

258 | | y | 1 | | 2 | 2 | |

259 |

260 | 我們可以得到 User rating set $r_x = \{1, 4, 5\}$,$r_y = \{1, 3, 4\}$,因為 $x$ 只有在 1、4、5 做評分,$y$ 只有在 1、3、4 做評分。

261 |

262 | 由於 $r_x$ 與 $r_y$ 有交集的數量只有 $2$,聯集則是 $4$,故 $\text{sim}(x, y) = \dfrac{2}{4} = 0.5$

263 |

264 |

265 |

266 | 缺點則是評分上是有意義的,故這樣做會忽略掉評分的意義。

267 |

268 |

269 |

270 | ### Cosine similarity

271 |

272 | 第二個提到的相似度計算即為 Cosine similarity。

273 |

274 | 以下面的例子為例。

275 |

276 | | | 1 | 2 | 3 | 4 | 5 |

277 | | :--: | :--: | :--: | :--: | :--: | :--: |

278 | | x | 1 | | | 1 | 3 |

279 | | y | 1 | | 2 | 2 | |

280 |

281 | 我們可以將 $r_x, r_y$ 視為點,則可以得到

282 | $$

283 | r_x = <1, 0, 0, 1, 3> \\

284 | r_y = <1, 0, 2, 2, 0>

285 | $$

286 | 故其 Cosine similarity 為 $\dfrac{1+0+0+2+0}{\sqrt{1^2+1^2+3^2}\sqrt{1^2+2^2+2^2}} \approx 30.2\%$

287 |

288 |

289 |

290 | ### Pearson correlation coefficient

291 |

292 | 定義上為 $\text{sim}(x,y)=\dfrac{\displaystyle \sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})(r_{ys}-\overline{r_y})}{\sqrt{\sum_{s\in s_{xy}} (r_{xs}-\overline{r_x})^2} \sqrt{\sum_{s\in s_{xy}} (r_{ys}-\overline{r_y})^2}}$,$s_{xy}$ 為 x 與 y 對某物的評價。

293 |

294 | 雖然定義上是這樣,但,其實你只要算出列/行的平均,行/列存在的元素全部減去平均後砸 Cosine Similarity 也能做出來

295 |

296 | ~~安了我的算式恐懼症,這麼可怕的式子是啥鬼嗚嗚~~

297 |

298 |

299 |

300 | 以下面的例子為例。

301 |

302 | | | 1 | 2 | 3 | 4 | 5 |

303 | | :--: | :--: | :--: | :--: | :--: | :--: |

304 | | x | 2 | | | 1 | 3 |

305 | | y | 2 | | 2 | 2 | |

306 |

307 | 我們可以將 $r_x, r_y$ 視為點,則可以得到

308 | $$

309 | r_x = <1, 0, 0, 1, 3> \\

310 | r_y = <1, 0, 2, 2, 0>

311 | $$

312 | 平均 $\mu_x = 2$,$\mu_y = 2$,則

313 | $$

314 | r_x' = <-1, 0, 0, -1, 1> \\

315 | r_y' = <-1, 0, 0, 0, 0>

316 | $$

317 | 我們可以算出 Pearson correlation coefficient

318 | $$

319 | \text{sim}(x, y) = \dfrac{1}{((-1)^2+(-1)^2+1^2)((-1)^2)} = \dfrac{1}{3} \approx 0.333

320 | $$

321 |

322 |

323 | ### Prediction Function

324 |

325 | 若我們有一個物件與其他 $N$ 個物件相似,則我們可以用以下的式子來表達其預測值

326 | $$

327 | r_{xi} = \dfrac{\displaystyle \sum_{j\in N(i; x)} s_{ij} \cdot r_{xj}}{\displaystyle \sum_{j\in N(i; x)} s_{ij}}

328 | $$

329 | 見以下範例。

330 |

331 |

332 |

333 | ### Item-Item Collaborative Filtering

334 |

335 | 假設我們有一筆這樣的資料,欄為 User 且列為 Movie,表格上每個數字為 User 對 Movie 的評價

336 |

337 | | | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

338 | | :--: | :--: | :--: | :--: | :--: | :----: | :--: | :--: | :--: | :--: | :--: | :--: | :--: |

339 | | 1 | 1 | | 3 | | **?** | 5 | | | 5 | | 4 | |

340 | | 2 | | | 5 | 4 | | | 4 | | | 2 | 1 | 3 |

341 | | 3 | 2 | 4 | | 1 | 2 | | 3 | | 4 | 3 | 5 | |

342 | | 4 | | 2 | 4 | | 5 | | | 4 | | | 2 | |

343 | | 5 | | | 4 | 3 | 4 | 2 | | | | | 2 | |

344 | | 6 | 1 | | 3 | | 3 | | | 2 | | | 4 | |

345 |

346 | 可以看到 $D(1, 5)$ 的資料是問號,即為我們想要推演的資料。

347 |

348 | 我們使用 Pearson correlation coefficient 來**計算電影的相似度**,先算出每個電影的平均值,以及該列減去平均值的向量。

349 |

350 | $\mu_1 = (1+3+5+5+4)/5 = 3.6$,$v'_1 = <-2.6, 0, -0.6, 0, 0, 1.4, 0, 0, 1.4, 0, 0.4, 0>$

351 |

352 | $\mu_2 = (5+4+4+2+1+3)/6=3.167$,$v'_2 = <0, 0, 1.83, 0.83, 0, 0, 0.83, 0, 0, -1.17, -2.17, -0.17>$

353 |

354 | $\mu_3 = (2+4+1+2+3+4+3+5)/8=3$,$v'_3 = <-1, 1, 0, -2, -1, 0, 0, 0, 1, 0, 2, 0>$

355 |

356 | $\mu_4 = (2+4+5+4+2)/5=3.4$,$v'_4 = <0, -1.4, 0.6, 0, 1.6, 0, 0, 0.6, 0, 0, -1.4, 0>$

357 |

358 | $\mu_5 = (4+3+4+2+2)/5=3$,$v'_5 = <0, 0, 1, 0, 1, -1, 0, 0, 0, 0, -1, 0>$

359 |

360 | $\mu_6 = (1+3+3+2+4)/5=2.6$,$v'_6 = <-1.6, 0, 0.4, 0, 0.4, 0, 0, -0.6, 0, 0, 1.4. 0>$

361 |

362 | 我們可以算出 Pearson correlation coefficient,得到

363 |

364 | $\text{sim}(1, 2) = -0.17$,$\text{sim}(1, 3) = 0.41$,$\text{sim}(1, 4) = -0.1$,$\text{sim}(1, 5) = -0.36$,$\text{sim}(1, 6) = 0.59$

365 |

366 | 故我們選擇電影 3、6 與電影 1 有較高的關聯性。

367 |

368 |

369 |

370 | 因此我們可以套用預測函數,得到:

371 | $$

372 | \dfrac{0.41\times 2 + 0.59\times 3}{0.41+0.59} = 2.6

373 | $$

374 | 故 $D(1, 5)$ 可以被預測成 2.6 分。

375 |

376 |

377 |

378 | ### User-User Collaborative Filtering

379 |

380 | 與 [Item-Item Collaborative Filtering](#Item-Item Collaborative Filtering) 同理,跳過。

381 |

382 |

383 |

384 | ## Content-based Filtering

385 |

386 | 使用內容來進行評估,因為使用內容,所以不會有 cold start 的問題。

387 |

388 |

389 |

390 | ### TF-IDF

391 |

392 | TF-IDF (Term Frequency - Inverse Document Frequency),用來量化詞彙的重要性,但會隨著詞彙出現的頻率高而出現反比影響。

393 |

394 | 其定義為:

395 | $$

396 | TF_{ij} = \dfrac{n_{ij}}{\sum_{k} n_{kj}} \\

397 | IDF_{i} = \log(\dfrac{N}{n_i}) \\

398 | \text{TF-IDF}_{ij} = TF_{ij} \times IDF_{i}

399 | $$

400 | 其中 TF 的 $n_{ij}$ 為該詞彙在文件中的次數,分母則是在所有文件中該詞彙出現的次數,$N$ 為文件的總詞彙量。

401 |

402 |

--------------------------------------------------------------------------------

/Markdown/Cluster Analysis.md:

--------------------------------------------------------------------------------

1 | # 群聚分析(Cluster Analysis)

2 |

3 | > Reference:

4 | >

5 | > 1. Cluster Analysis - Dr. Tun-Wen Pai

6 |

7 | ## 群聚分析

8 |

9 | 主要分成兩種不同的群聚分析:

10 |

11 | 1. 分層式群聚:分成由上至下(top-down)或由下至上(bottom-up)演算法,層層迭代運算。

12 | 2. 分割式群聚:一次把所有的分群結果納入考慮。

13 |

14 |

15 |

16 | ## 分割式群聚

17 |

18 | 這邊舉一個最經典的例子:K-Mean。

19 |

20 |

21 |

22 | ### 簡單的步驟舉例

23 |

24 | 舉個例子,我們有個資料集。

25 |

26 |  27 |

28 | 既然要分群,我們先***雖然說是隨機,但是為了做黑魔法所以不隨機的***挑選兩個群心。

29 |

30 |

27 |

28 | 既然要分群,我們先***雖然說是隨機,但是為了做黑魔法所以不隨機的***挑選兩個群心。

29 |

30 |  31 |

32 | 接下來我們開始迭代每個點,來知道距離哪個群心比較近,就屬於那個群心。

33 |

34 | 根據上圖來說,我們用眼睛可以看出這個分類結果,為了方便辨識群心在哪,我將群心用空心圓代替。

35 |

36 |

31 |

32 | 接下來我們開始迭代每個點,來知道距離哪個群心比較近,就屬於那個群心。

33 |

34 | 根據上圖來說,我們用眼睛可以看出這個分類結果,為了方便辨識群心在哪,我將群心用空心圓代替。

35 |

36 |  37 |

38 |

39 |

40 | 此時我們可以更新群心,利用每個向度 $x$, $y$ 的平均。

41 |

42 |

37 |

38 |

39 |

40 | 此時我們可以更新群心,利用每個向度 $x$, $y$ 的平均。

41 |

42 |  43 |

44 | 經過多次迭代之後就可以找到一個穩定的分群。

45 |

46 |

47 |

48 | ### 問題探討

49 |

50 | 顯然,我們用***雖然說是隨機,但是為了做黑魔法所以不隨機的***方式挑選群心是一個很大的問題。

51 |

52 | 因為隨機挑選群心可能會挑出一個完全不同的結果,舉個例子:

53 |

54 |

43 |

44 | 經過多次迭代之後就可以找到一個穩定的分群。

45 |

46 |

47 |

48 | ### 問題探討

49 |

50 | 顯然,我們用***雖然說是隨機,但是為了做黑魔法所以不隨機的***方式挑選群心是一個很大的問題。

51 |

52 | 因為隨機挑選群心可能會挑出一個完全不同的結果,舉個例子:

53 |

54 |  55 |

56 | 群心這樣挑選會得到這樣的結果。

57 |

58 |

55 |

56 | 群心這樣挑選會得到這樣的結果。

57 |

58 |  59 |

60 | 跟前面的結果幾乎完全不一樣,所以挑選適當的群心是非常重要的。

61 |

62 |

63 |

64 | ## 分層式群聚

65 |

66 | ### 簡介

67 |

68 | 分層式群聚可以將群聚的步驟畫成一樹枝狀圖。

69 |

70 | > Image source:[Hierarchical Clustering for Large Data Sets](https://www.researchgate.net/publication/278706094_Hierarchical_Clustering_for_Large_Data_Sets)

71 |

72 |

59 |

60 | 跟前面的結果幾乎完全不一樣,所以挑選適當的群心是非常重要的。

61 |

62 |

63 |

64 | ## 分層式群聚

65 |

66 | ### 簡介

67 |

68 | 分層式群聚可以將群聚的步驟畫成一樹枝狀圖。

69 |

70 | > Image source:[Hierarchical Clustering for Large Data Sets](https://www.researchgate.net/publication/278706094_Hierarchical_Clustering_for_Large_Data_Sets)

71 |

72 |  73 |

74 | 在這份筆記會介紹四種不同的分層式群聚。

75 |

76 | 令 $A$ 為某個群集的點,$B$ 為某個群集的點,以下是群集表格。

77 |

78 | | 分群演算法 | 群聚概念 | 演算表達式 |

79 | | :--------------: | :----------------------: | :----------------------------------------------------------: |

80 | | Single Linkage | 以兩個群聚的最近點 | $\text{min}\{d(a,b): a \in A, b \in B\}$ |

81 | | Complete Linkage | 以兩個群聚的最遠點 | $\text{max}\{d(a,b): a \in A, b \in B\}$ |

82 | | UPGMA | 以兩群的平均距離 | $\displaystyle \dfrac{1}{|A|+|B|}\sum_{a\in A}\sum_{b\in B}d(a,b)$ |

83 | | WPGMA | 以某點至兩群和的平均距離 | $d(i\cup j, k)=\dfrac{d(i, k)+d(j, k)}{2}$ |

84 |

85 |

86 |

87 | ### 群集步驟

88 |

89 | 以上的演算法其實都大同小異,只有差別在演算法更新「群集距離表」的方式不同。

90 |

91 | 群集距離表即為每個群集到其他群集的距離,與自己的群集距離為 0。

92 |

93 | 例如下方表格即為群集距離表。

94 |

95 | 以圖上來說,群集 A 至群集 B 的距離為 25,群集 B 至群集 C 的距離為 25,群集 A 至群集 C 的距離為 15。

96 |

97 | | | A | B | C |

98 | | :--: | :--: | :--: | :--: |

99 | | A | 0 | 25 | 15 |

100 | | B | 25 | 0 | 25 |

101 | | C | 15 | 25 | 0 |

102 |

103 |

104 |

105 | 這張流程圖是我自製的,用來解釋群集分析的流程。

106 |

107 |

73 |

74 | 在這份筆記會介紹四種不同的分層式群聚。

75 |

76 | 令 $A$ 為某個群集的點,$B$ 為某個群集的點,以下是群集表格。

77 |

78 | | 分群演算法 | 群聚概念 | 演算表達式 |

79 | | :--------------: | :----------------------: | :----------------------------------------------------------: |

80 | | Single Linkage | 以兩個群聚的最近點 | $\text{min}\{d(a,b): a \in A, b \in B\}$ |

81 | | Complete Linkage | 以兩個群聚的最遠點 | $\text{max}\{d(a,b): a \in A, b \in B\}$ |

82 | | UPGMA | 以兩群的平均距離 | $\displaystyle \dfrac{1}{|A|+|B|}\sum_{a\in A}\sum_{b\in B}d(a,b)$ |

83 | | WPGMA | 以某點至兩群和的平均距離 | $d(i\cup j, k)=\dfrac{d(i, k)+d(j, k)}{2}$ |

84 |

85 |

86 |

87 | ### 群集步驟

88 |

89 | 以上的演算法其實都大同小異,只有差別在演算法更新「群集距離表」的方式不同。

90 |

91 | 群集距離表即為每個群集到其他群集的距離,與自己的群集距離為 0。

92 |

93 | 例如下方表格即為群集距離表。

94 |

95 | 以圖上來說,群集 A 至群集 B 的距離為 25,群集 B 至群集 C 的距離為 25,群集 A 至群集 C 的距離為 15。

96 |

97 | | | A | B | C |

98 | | :--: | :--: | :--: | :--: |

99 | | A | 0 | 25 | 15 |

100 | | B | 25 | 0 | 25 |

101 | | C | 15 | 25 | 0 |

102 |

103 |

104 |

105 | 這張流程圖是我自製的,用來解釋群集分析的流程。

106 |

107 |  108 |

109 |

110 |

111 |

112 |

113 | ### 利用演算法更新群集距離表

114 |

115 | 基本上群聚的方法只差在利用演算法來合併群集與更新群聚分析表,也就是更新除了合併群集以外群集距離。

116 |

117 | | | A | B | C | D |

118 | | :--: | :--: | :--: | :--: | :--: |

119 | | A | 0 | 25 | 15 | 18 |

120 | | B | 25 | 0 | 25 | 35 |

121 | | C | 15 | 25 | 0 | 45 |

122 | | D | 18 | 35 | 45 | 0 |

123 |

124 | 以上方這個表格為例,要尋找最小距離進行合併,該合併的兩個群集即為 **A 與 C**。

125 |

126 |

127 |

128 | **請注意,$A$ 與 $C$ 非常重要。**

129 |

130 | 例如當你欲合併的結果為 $(B, C)$ 與 $D$ 得到 $(B, C, D)$ 時,你應該要在更新時使用 $(B, C)$ 欄的值與 $D$ 欄的值。

131 |

132 | 否則你可能會用 $B$ 與 $(C, D)$ 的值,但表格上 $(C, D)$ 的值並不存在,所以記住什麼與什麼合併是非常重要。

133 |

134 | | | (A, C) | B | D |

135 | | :----: | :----: | :--: | :--: |

136 | | (A, C) | 0 | ? | ? |

137 | | B | ? | 0 | 35 |

138 | | D | ? | 35 | 0 |

139 |

140 | 合併完成之後,此時我們想要知道群集 $(A, C)$ 與 $B$ 的距離,此時我們根據演算法的定義:$\dfrac{d(i, k) + d(j, k)}{2}$

141 |

142 | $d(i, k) = d(A, B) = 25$,$d(j, k) = d(C, B) = 25$,可以得到距離為 $d((A, C), B) = \dfrac{25+25}{2} = 25$。

143 |

144 | 故$d((A, C), B) = 25$

145 |

146 | 同理我們可以算出 $d((A, C), D) = \dfrac{d(A, D)+d(C, D)}{2} = \dfrac{18+45}{2} = \dfrac{63}{2} = 31.5$

147 |

148 | | | (A, C) | B | D |

149 | | :----: | :----: | :--: | :--: |

150 | | (A, C) | 0 | 25 | 31.5 |

151 | | B | 25 | 0 | 35 |

152 | | D | 31.5 | 35 | 0 |

153 |

154 | 且我們可以得到 branch length = $\dfrac{15}{2} = 7.5$,也就是我們合併時使用的最短距離除以 2。

155 |

156 | 通常來說會越來越大,就能在樹枝狀圖上畫出 branch length(或者你可以說他是 thoushold)。

157 |

158 |

159 |

160 | ### 舉例其他演算法更新群集距離表

161 |

162 | 此時就能完成表格更新的步驟,其餘的合併方法只差在演算法的不同,照著做就行。

163 |

164 | 以其他三種不同的演算法來說:

165 |

166 | 1. Single Linkage:更新其他群集距離的方式為,取合併群集與該群集的**最短距離**。

167 |

168 | 2. Complete Linkage:更新其他群集距離的方式為,取合併群集與該群集的**最長距離**。

169 |

170 | 3. UPGMA:更新其他群集距離的方式為,若合併群集為 $A$ 與 $B$ 的合併,且欲合併的群集為 $C$。

171 |

172 | 則距離更新方式為 $d((A, C), B) = \dfrac{|A| \times d(A, C) + |B| \times d(B, C)}{|A| + |B|}$,其中 $|A|$ 與 $|B|$ 為該群集的點數量。

173 |

174 | 4. WPGMA:更新其他群集距離的方式為,若合併群集為 $A$ 與 $B$ 的合併,且欲合併的群集為 $C$。

175 |

176 | 則距離更新方式為 $d((A, C), B) = \dfrac{d(A, C)+d(B, C)}{2}$

177 |

178 |

179 |

180 | ## 優化分群結果

181 |

182 | - 什麼樣的分群結果是好的?

183 | - 我們可以將不同的 $K$ 值進行計算 total variation,並且找出拐點。

--------------------------------------------------------------------------------

/Markdown/Data Mining.md:

--------------------------------------------------------------------------------

1 | # 資料探勘(Data Mining)

2 |

3 | > 參考資料:

4 | >

5 | > 資料探勘(Data Mining)Dr. Tun-Wen Pai

6 | >

7 | > Business Intelligence and Data Mining Anil K. Maheshwari, Ph.D.

8 |

9 |

10 |

11 | ## 資料探勘的介紹

12 |

13 | 資料探勘是一種技術,為了探索大量經過組織的資料中,得到有利的資訊、見解與模式。

14 |

15 | 資料探勘利用了統計學、人工智慧領域、機器學習的知識,挖掘資料中未知的資訊,例如發現資料的類別與結構、分類資料等等。

16 |

17 |

18 |

19 | ## 資料蒐集與資料選擇

20 |

21 | 從大量支離破碎的資料中很難探勘出有用的資訊,所以我們需要先做資料蒐集與資料選擇。

22 |

23 |

24 |

25 | 資料從大量的資料來源中被蒐集,此時資料是支離破碎的,所以我們需要經過一系列的處理(例如資料倉儲的 ETL)

26 |

27 | 在建立資料倉儲之前,我們可以使用企業模式的資料模型(Enterprise Data Model, EDM),為這些資料打造一個統一的框架。

28 |

29 | 經過資料倉儲一系列的處理之後得到組織過的資料,再從這些資料進行探勘。

30 |

31 |

32 |

33 | 這也是為什麼資料倉儲被用來幫助資料探勘,因為資料探勘需要整理過的資料,此時即完成了資料蒐集與資料選擇。

34 |

35 |

36 |

37 | ## 資料淨化

38 |

39 | 資料的品質會嚴重影響到資料探勘,所以我們會希望資料都是高品質的,也因此我們需要把資料淨化。

40 |

41 |

42 |

43 | 我們可以利用一些手段進行資料淨化,例如:填充遺失的欄位、處理異常值、劃分連續型變數等等。

44 |

45 | 經過資料淨化,就可以確保資料都是高品質,確保不會造成 Garbage in Garbage out 的問題。

46 |

47 |

48 |

49 | 以下列舉一些資料淨化的手段:

50 |

51 | 1. 重複的資料需要被移除,從各方資料來源蒐集資料可能會導致出現重複的資料,所以需要被移除。

52 |

53 | 2. 欄位若遺失值則需要被填上去,如果不該被填上去,則這個欄位應該被移除。

54 |

55 | 3. 資料元素從單一單位轉換成另一個單位。

56 |

57 | 例如透過總病人數量與總花費較難得到有利的資訊,但如果資料是病人與花費的對應關係,那麼我們可以從這邊得到更有利的資訊。

58 |

59 | 4. 連續型變數可以被劃分以利於資料探勘更佳。

60 |

61 | 例如工作經驗可以被劃分成低、中、高。

62 |

63 | 5. 資料元素可能需要經過調整,讓他能夠隨著時間的推移產生可比性。

64 |

65 | 例如大量不同的貨幣可以被調整成通用貨幣,用來評估通膨的情況。

66 |

67 | 6. 極值需要被移除。

68 |

69 | 7. 偏差數值需要經過矯正,來確保分析結果是正常的。

70 |

71 | 8. 資料應該保持同樣的顆粒度(Granularity),來讓資料能夠比較。

72 |

73 | 例如:櫃台銷售所產生的資料通常都是以日為單位,而銷售員的資料通常都是以月為單位。

74 |

75 | 為此我們應該將櫃台銷售調整成月為單位,兩個資料才做比較。

76 |

77 | 9. 資料需要足夠密集。

78 |

79 |

80 |

81 | ## Confusion Matrix

82 |

83 | Confusion Matrix 可用來監督學習、可以確定在機器學習中是否將兩個不同類型的資料混淆了。

84 |

85 |

86 |

87 | 以採檢病人是否為陽性反應為例,我們可以獲得以下的表格。

88 |

89 |

108 |

109 |

110 |

111 |

112 |

113 | ### 利用演算法更新群集距離表

114 |

115 | 基本上群聚的方法只差在利用演算法來合併群集與更新群聚分析表,也就是更新除了合併群集以外群集距離。

116 |

117 | | | A | B | C | D |

118 | | :--: | :--: | :--: | :--: | :--: |

119 | | A | 0 | 25 | 15 | 18 |

120 | | B | 25 | 0 | 25 | 35 |

121 | | C | 15 | 25 | 0 | 45 |

122 | | D | 18 | 35 | 45 | 0 |

123 |

124 | 以上方這個表格為例,要尋找最小距離進行合併,該合併的兩個群集即為 **A 與 C**。

125 |

126 |

127 |

128 | **請注意,$A$ 與 $C$ 非常重要。**

129 |

130 | 例如當你欲合併的結果為 $(B, C)$ 與 $D$ 得到 $(B, C, D)$ 時,你應該要在更新時使用 $(B, C)$ 欄的值與 $D$ 欄的值。

131 |

132 | 否則你可能會用 $B$ 與 $(C, D)$ 的值,但表格上 $(C, D)$ 的值並不存在,所以記住什麼與什麼合併是非常重要。

133 |

134 | | | (A, C) | B | D |

135 | | :----: | :----: | :--: | :--: |

136 | | (A, C) | 0 | ? | ? |

137 | | B | ? | 0 | 35 |

138 | | D | ? | 35 | 0 |

139 |

140 | 合併完成之後,此時我們想要知道群集 $(A, C)$ 與 $B$ 的距離,此時我們根據演算法的定義:$\dfrac{d(i, k) + d(j, k)}{2}$

141 |

142 | $d(i, k) = d(A, B) = 25$,$d(j, k) = d(C, B) = 25$,可以得到距離為 $d((A, C), B) = \dfrac{25+25}{2} = 25$。

143 |

144 | 故$d((A, C), B) = 25$

145 |

146 | 同理我們可以算出 $d((A, C), D) = \dfrac{d(A, D)+d(C, D)}{2} = \dfrac{18+45}{2} = \dfrac{63}{2} = 31.5$

147 |

148 | | | (A, C) | B | D |

149 | | :----: | :----: | :--: | :--: |

150 | | (A, C) | 0 | 25 | 31.5 |

151 | | B | 25 | 0 | 35 |

152 | | D | 31.5 | 35 | 0 |

153 |

154 | 且我們可以得到 branch length = $\dfrac{15}{2} = 7.5$,也就是我們合併時使用的最短距離除以 2。

155 |

156 | 通常來說會越來越大,就能在樹枝狀圖上畫出 branch length(或者你可以說他是 thoushold)。

157 |

158 |

159 |

160 | ### 舉例其他演算法更新群集距離表

161 |

162 | 此時就能完成表格更新的步驟,其餘的合併方法只差在演算法的不同,照著做就行。

163 |

164 | 以其他三種不同的演算法來說:

165 |

166 | 1. Single Linkage:更新其他群集距離的方式為,取合併群集與該群集的**最短距離**。

167 |

168 | 2. Complete Linkage:更新其他群集距離的方式為,取合併群集與該群集的**最長距離**。

169 |

170 | 3. UPGMA:更新其他群集距離的方式為,若合併群集為 $A$ 與 $B$ 的合併,且欲合併的群集為 $C$。

171 |

172 | 則距離更新方式為 $d((A, C), B) = \dfrac{|A| \times d(A, C) + |B| \times d(B, C)}{|A| + |B|}$,其中 $|A|$ 與 $|B|$ 為該群集的點數量。

173 |

174 | 4. WPGMA:更新其他群集距離的方式為,若合併群集為 $A$ 與 $B$ 的合併,且欲合併的群集為 $C$。

175 |

176 | 則距離更新方式為 $d((A, C), B) = \dfrac{d(A, C)+d(B, C)}{2}$

177 |

178 |

179 |

180 | ## 優化分群結果

181 |

182 | - 什麼樣的分群結果是好的?

183 | - 我們可以將不同的 $K$ 值進行計算 total variation,並且找出拐點。

--------------------------------------------------------------------------------

/Markdown/Data Mining.md:

--------------------------------------------------------------------------------

1 | # 資料探勘(Data Mining)

2 |

3 | > 參考資料:

4 | >

5 | > 資料探勘(Data Mining)Dr. Tun-Wen Pai

6 | >

7 | > Business Intelligence and Data Mining Anil K. Maheshwari, Ph.D.

8 |

9 |

10 |

11 | ## 資料探勘的介紹

12 |

13 | 資料探勘是一種技術,為了探索大量經過組織的資料中,得到有利的資訊、見解與模式。

14 |

15 | 資料探勘利用了統計學、人工智慧領域、機器學習的知識,挖掘資料中未知的資訊,例如發現資料的類別與結構、分類資料等等。

16 |

17 |

18 |

19 | ## 資料蒐集與資料選擇

20 |

21 | 從大量支離破碎的資料中很難探勘出有用的資訊,所以我們需要先做資料蒐集與資料選擇。

22 |

23 |

24 |

25 | 資料從大量的資料來源中被蒐集,此時資料是支離破碎的,所以我們需要經過一系列的處理(例如資料倉儲的 ETL)

26 |

27 | 在建立資料倉儲之前,我們可以使用企業模式的資料模型(Enterprise Data Model, EDM),為這些資料打造一個統一的框架。

28 |

29 | 經過資料倉儲一系列的處理之後得到組織過的資料,再從這些資料進行探勘。

30 |

31 |

32 |

33 | 這也是為什麼資料倉儲被用來幫助資料探勘,因為資料探勘需要整理過的資料,此時即完成了資料蒐集與資料選擇。

34 |

35 |

36 |

37 | ## 資料淨化

38 |

39 | 資料的品質會嚴重影響到資料探勘,所以我們會希望資料都是高品質的,也因此我們需要把資料淨化。

40 |

41 |

42 |

43 | 我們可以利用一些手段進行資料淨化,例如:填充遺失的欄位、處理異常值、劃分連續型變數等等。

44 |

45 | 經過資料淨化,就可以確保資料都是高品質,確保不會造成 Garbage in Garbage out 的問題。

46 |

47 |

48 |

49 | 以下列舉一些資料淨化的手段:

50 |

51 | 1. 重複的資料需要被移除,從各方資料來源蒐集資料可能會導致出現重複的資料,所以需要被移除。

52 |

53 | 2. 欄位若遺失值則需要被填上去,如果不該被填上去,則這個欄位應該被移除。

54 |

55 | 3. 資料元素從單一單位轉換成另一個單位。

56 |

57 | 例如透過總病人數量與總花費較難得到有利的資訊,但如果資料是病人與花費的對應關係,那麼我們可以從這邊得到更有利的資訊。

58 |

59 | 4. 連續型變數可以被劃分以利於資料探勘更佳。

60 |

61 | 例如工作經驗可以被劃分成低、中、高。

62 |

63 | 5. 資料元素可能需要經過調整,讓他能夠隨著時間的推移產生可比性。

64 |

65 | 例如大量不同的貨幣可以被調整成通用貨幣,用來評估通膨的情況。

66 |

67 | 6. 極值需要被移除。

68 |

69 | 7. 偏差數值需要經過矯正,來確保分析結果是正常的。

70 |

71 | 8. 資料應該保持同樣的顆粒度(Granularity),來讓資料能夠比較。

72 |

73 | 例如:櫃台銷售所產生的資料通常都是以日為單位,而銷售員的資料通常都是以月為單位。

74 |

75 | 為此我們應該將櫃台銷售調整成月為單位,兩個資料才做比較。

76 |

77 | 9. 資料需要足夠密集。

78 |

79 |

80 |

81 | ## Confusion Matrix

82 |

83 | Confusion Matrix 可用來監督學習、可以確定在機器學習中是否將兩個不同類型的資料混淆了。

84 |

85 |

86 |

87 | 以採檢病人是否為陽性反應為例,我們可以獲得以下的表格。

88 |

89 |  90 |

91 | 以理想的情況來說,採檢試劑要能夠分辨出陽性(True Positive)與陰性(True Negative)。

92 |

93 | 但必定會出現偽陰(False Negative)與偽陽(False Positive)的情況出現。

94 |

95 | 將這些數值填入表格,即可得到一個 Confusion Matrix。

96 |

97 |

98 |

99 | 我們可以擴展表格,得到更多的資訊。

100 |

101 |

102 |

103 |

104 |

105 | 將同樣的概念,可以套用到機器分類數字、機器分類花...等情況,所以可以適用於績效評估機器學習。

106 |

107 |

108 |

109 | ## AUC - ROC Curve

110 |

111 | 我們可以使用 AUC - ROC Curve 來進行機器學習的績效評估。

112 |

113 | 對於上面表格,我們可以設定特定的閥值,用來得到在這個閥值中的真陽、真陰、偽陽、偽陰數量,進而劃出由兩個曲線組成的圖片。

114 |

115 |

116 |

117 | 例如我們預期在 TPR 閥值低於 0.5 時則為陰性,在閥值高於 0.5 時則為陽性。

118 |

119 | 此時我們可以預期沒有任何偽陰、偽陽的情況,所以可以得到以下這張圖。

120 |

121 |

90 |

91 | 以理想的情況來說,採檢試劑要能夠分辨出陽性(True Positive)與陰性(True Negative)。

92 |

93 | 但必定會出現偽陰(False Negative)與偽陽(False Positive)的情況出現。

94 |

95 | 將這些數值填入表格,即可得到一個 Confusion Matrix。

96 |

97 |

98 |

99 | 我們可以擴展表格,得到更多的資訊。

100 |

101 |

102 |

103 |

104 |

105 | 將同樣的概念,可以套用到機器分類數字、機器分類花...等情況,所以可以適用於績效評估機器學習。

106 |

107 |

108 |

109 | ## AUC - ROC Curve

110 |

111 | 我們可以使用 AUC - ROC Curve 來進行機器學習的績效評估。

112 |

113 | 對於上面表格,我們可以設定特定的閥值,用來得到在這個閥值中的真陽、真陰、偽陽、偽陰數量,進而劃出由兩個曲線組成的圖片。

114 |

115 |

116 |

117 | 例如我們預期在 TPR 閥值低於 0.5 時則為陰性,在閥值高於 0.5 時則為陽性。

118 |

119 | 此時我們可以預期沒有任何偽陰、偽陽的情況,所以可以得到以下這張圖。

120 |

121 |  122 |

123 | 這時無論到哪點都不會出現偽陽性,故 ROC 曲線呈現直角,幾乎是完美分類。

124 |

125 |

126 |

127 | 另一個例子,若我們期望 TPR 閥值低於 0.5 時為陰性,高於 0.5 時則陽性。

128 |

129 | 然而結果不如預期,得到了以下這張圖。

130 |

131 |

122 |

123 | 這時無論到哪點都不會出現偽陽性,故 ROC 曲線呈現直角,幾乎是完美分類。

124 |

125 |

126 |

127 | 另一個例子,若我們期望 TPR 閥值低於 0.5 時為陰性,高於 0.5 時則陽性。

128 |

129 | 然而結果不如預期,得到了以下這張圖。

130 |

131 |  132 |

133 | 這時我們只需要反預測即可校正回上例。

134 |

135 |

136 |

137 | 換另一個不理想的例子,若可能出現偽陰偽陽的情況,

138 |

139 | 例如閥值是 0.46 時,陰性與陽性都出現,這時就會出真陽、偽陽的情況,得到以下這張圖。

140 |

141 | 可以發現,在出現 FPR 時,TPR 的數值稍微下跌,而在之後幾乎回到 1 的位置。

142 |

143 |

132 |

133 | 這時我們只需要反預測即可校正回上例。

134 |

135 |

136 |

137 | 換另一個不理想的例子,若可能出現偽陰偽陽的情況,

138 |

139 | 例如閥值是 0.46 時,陰性與陽性都出現,這時就會出真陽、偽陽的情況,得到以下這張圖。

140 |

141 | 可以發現,在出現 FPR 時,TPR 的數值稍微下跌,而在之後幾乎回到 1 的位置。

142 |

143 |  144 |

145 |

146 |

147 | 另一個例子,若無論在任何閥值出現的情況,真陰、真陽的人數都一樣,

148 |

149 | 則這個模型視同無效,因為檢驗一個人是否偽陰偽陽的機率相等於隨機。

150 |

151 |

144 |

145 |

146 |

147 | 另一個例子,若無論在任何閥值出現的情況,真陰、真陽的人數都一樣,

148 |

149 | 則這個模型視同無效,因為檢驗一個人是否偽陰偽陽的機率相等於隨機。

150 |

151 |  152 |

153 |

154 |

155 | 我們可以透過描點的方式畫出 ROC 曲線,就可以從 ROC 曲線中得出 AUC 值,若 AUC 值越大則模型越好。

156 |

157 |

158 |

159 | ## 機器學習的種類

160 |

161 | 1. 學習問題

162 | 1. 監督式學習:所有資料都被標註,給機器去學習與分類,通常來說對機器最簡單,對人類來說最累。

163 | 2. 非監督式學習:所有資料都沒有被標註,透過機器去尋找特徵的學習分式,對機器最困難,誤差較大。

164 | 3. 強化式學習:不標註任何資料,但告訴機器哪步正確,哪步錯誤,讓機器逐步自我修正。

165 | 2. 混合學習問題

166 | 1. 半監督式學習:對少部分資料進行標註,機器透過有標註的資料找出特徵並進行分類,能使非監督式學習的準確率提升。

167 | 2. 自我監督式學習:從一堆沒有 label 標註的資料,訓練出一個監督式模型,然後造出更多 label。

168 | 3. 多實例學習:輸入許多「包」,這些包都含有許多實例,若所有實例都是負例時則包即為負包,若有至少一個實例為正例時,包即為正包。

169 | 3. 推論統計學

170 | 1. 歸納學習:用來辨識汽車的知識可以用來提升辨識卡車的能力,以現有問題的解決模型利用在其他不同但相關的問題上。

171 | 2. 演繹學習:利用廣泛的前提去推論較具體的結論,通常依賴前提是否正確。

172 | 3. 轉導學習:通過觀察特定的訓練樣本,來預測特定測試樣本的方法。

173 | 4. 學習技術

174 | 1. 多任務學習:利用單一一個模型,解決多個問題

175 | 2. 主動學習:從每輪學習迭代中,尋找出一個最不確定的一個或一組樣本,來讓外部反饋者給予回饋。

176 | 3. 線上學習:利用當前的資料來直接更新模型,進而在預測前根據先前的資料給予預測。

177 | 4. 遷移學習:一個模型先訓練一個例子,接著所有模型用這個模型的訓練例子當成起始點,訓練其他的例子。

178 | 5. 集成學習:集成兩個以上合適的模型,接著從這個集成的模型上訓練。。

179 | 6. 聯盟式學習:從各式各樣的自訓練模型中,在不用給自己數據的情況下,也可以進行訓練得到模型。

180 |

181 |

182 |

183 | > Reference Website:

184 | >

185 | > 1. Marketing. (n.d.). *你知道機器學習(Machine Learning),有幾種學習方式嗎?* 伊雲谷eCloudvalley. Retrieved April 5, 2022, from https://www.ecloudvalley.com/zh-hant/machine-learning/

186 | > 2. *自監督學習 self-supervised learning 介紹*. (2021, June 11). 藏字閣. https://jigfopsda.com/zh/posts/2021/self_supervised_learning/

187 | > 3. *多實例學習*. (2021, August 31). 維基百科,自由的百科全書. https://zh.wikipedia.org/wiki/%E5%A4%9A%E7%A4%BA%E4%BE%8B%E5%AD%A6%E4%B9%A0

188 | > 4. *遷移學習*. (2020, September 19). 維基百科,自由的百科全書. https://zh.wikipedia.org/wiki/%E8%BF%81%E7%A7%BB%E5%AD%A6%E4%B9%A0

189 | > 5. *簡要介紹Active Learning(主動學習)思想框架,以及從IF(isolation forest)衍生出來的演算法:FBIF(Feedback-Guided Anomaly Discovery)*. (n.d.). IT人. Retrieved April 5, 2022, from https://iter01.com/420911.html

190 | > 6. Su, S. (2021, December 13). *聯盟式學習 (Federated Learning) - Sherry.AI*. Medium. https://medium.com/sherry-ai/%E8%81%AF%E7%9B%9F%E5%BC%8F%E5%AD%B8%E7%BF%92-federated-learning-b4cc5af7a9c0

--------------------------------------------------------------------------------

/Markdown/Data Preprocessing.md:

--------------------------------------------------------------------------------

1 | # 資料預處理(Data Preprocessing)

2 |

3 | > Reference:

4 | >

5 | > 1. Data Preprocessing by Dr. Tun-Wen Pai

6 |

7 | ## 資料預處理

8 |

9 | 對於一個資料集來說,若數值偏大或偏小的情況下,我們很難去做資料視覺化,甚至資料過大時會讓自然指數過大導致 overflow。

10 |

11 | 故我們希望可以把資料集的值域縮小,有以下幾種方法:

12 |

13 | 1. Z-score normalization

14 | 2. MinMaxScaler

15 | 3. MaxAbsScaler

16 | 4. Robust Scaling

17 | 5. QuantileTrasformation

18 |

19 |

20 |

21 | ### Z-score normalization

22 |

23 | 對於每個資料,我們利用常態分佈將他標準化(Standardization),定義為

24 | $$

25 | x'=\dfrac{x-\overline{x}}{\sigma}

26 | $$

27 | 用這樣的方式就能夠將其值域限縮至 $[-1, 1]$ 之間。

28 |

29 |

30 |

31 | ### MinMaxScaler

32 |

33 | 對於每個資料,我們使用最大與最小值的區間來限縮值域,定義如下:

34 | $$

35 | x' = \dfrac{x-\min(x)}{\max(x)-\min(x)}

36 | $$

37 | 用這樣的方式就能夠將其值域限縮至 $[0, 1]$ 之間。

38 |

39 |

40 |

41 | ### MaxAbsScaler

42 |

43 | 對於每個資料,我們單純使用最大與最小值的區間來限縮值域,定義如下:

44 | $$

45 | x' = \dfrac{x}{\max\{|x|\}}

46 | $$

47 |

48 |

49 | 用這樣的方式就能夠將其值域限縮至 $[-1, 1]$ 之間。

50 |

51 |

52 |

53 | ### Robust Scaling

54 |

55 | Robust Scaling 是一種非線性的限縮方式,使用第三分位與第一分位來進行限縮。

56 |

57 | 前面的方法,以最大值來說,若最大值過大則限縮資料會變小。

58 |

59 | Robust Scaling 優化了這個部分,他沒有特定的值域限縮範圍,但可以對極值有良好的抗噪性,定義如下:

60 | $$

61 | x' = \dfrac{x-Q_2}{(Q_3-Q_1)}

62 | $$

63 |

64 |

65 |

--------------------------------------------------------------------------------

/Markdown/Data Warehouse.md:

--------------------------------------------------------------------------------

1 | # Data Warehouse(資料倉儲)

2 |

3 | >主要的資料來源:

4 | >

5 | >Essentials of Database Management Jeffrey A. Hoffer, Heikki Topi, V. Ramesh

6 | >

7 | >資料倉儲(Data Warehouse, DW) Dr. Tun-Wen Pai

8 |

9 |

10 |

11 | ## 關於資料倉儲

12 |

13 | 資料倉儲具有主題式、經過整合、分析具有時變性、資料不會流失的優勢,用來支援商業智慧,例如分析。

14 |

15 |

16 |

17 | ## 關於資料超市

18 |

19 | 由資料倉儲的資料,分離出一個更具主題式的資料集,稱為資料超市。

20 |

21 |

22 |

23 | ## 資料倉儲的需求

24 |

25 | 從各方蒐集出來的資料通常來說都是支離破碎的(例如:包含編碼、形式不同、格式不一等等)。

26 |

27 | 所以通常一個企業需要的是從這堆支離破碎的資料中經過整合,提供出一個企業想要的簡潔有力的資訊。

28 |

29 | 因此資料倉儲主要就是蒐集這些破碎的資料,然後提供給企業一個高質量的資料。

30 |

31 |

32 |

33 | ## 資料倉儲的開發考慮

34 |

35 | 1. 主題式:僅對特定主題感興趣

36 | 2. 整合性:各式各樣的資料進入資料倉儲都會經過整合成統一格式的資料

37 | 3. 時變性:分析具有時變性,根據不同時間具有不同的分析結果

38 | 4. 穩定性:進入資料倉儲的資料並不會變動。

39 | 5. 摘要整理:進入的資料會盡可能地最佳化資料欄位與維度。

40 | 6. 非標準化:Data Warehouse 使用星狀綱要,因此不是標準化成一個表格做查詢。

41 | 7. 後設資料:可以衍伸出其他的資料變數。

42 | 8. 即時/合適的時間

43 |

44 |

45 |

46 | ## Operational System 與 Informational System

47 |

48 | Operational System 主要負責即時的商業活動運行,例如:訂單整合、預訂系統...

49 |

50 | Operational System 會將這個活動的資料完整的保存下來,但這些資料都是支離破碎的,會需要經過整合。

51 |

52 |

53 |

54 | Informational System 主要被設計來從資料倉儲的資料提供出對於特定時間的快照資料,以利於支援資料探勘、分析等等。

55 |

56 |

57 |

58 | 總歸來說,Operational System 與 Informational System 可以利用以下的表格來比較。

59 |

60 | | | Operational System | Informational System |

61 | | :----------: | :--------------------------------------------: | :------------------------------------: |

62 | | 主要用途 | 即時的商業活動運行 | 支援決策、分析等等 |

63 | | 資料型態 | 進行商業活動得到的數據(客戶、銷售商品...) | 特定時間的快照資料與預測 |

64 | | 給哪些人使用 | 銷售者 | 管理層級的人員、商業分析、客戶... |

65 | | 使用範圍 | 狹窄、易於更新與查詢 | 非常廣、特設、在詢問與分析上非常複雜 |

66 | | 設計目標 | 能夠被存取、能夠完整 | 易於使用與存取 |

67 | | 資料大小 | 在更新與存取時,得到的只有帶有幾列的表格資料 | 定期更新、詢問,通常需要非常大量的資料 |

68 |

69 |

70 |

71 | ## 資料倉儲的資料處理

72 |

73 | 一般遵循 `ETL` 的方式處理,也就是 Extract(萃取)、Transform(轉換)、Load(讀入)。

74 |

75 | 通常來說,會從各式資料源萃取資料,將資料進行整合(轉換)、接著讀入 Data Mart 或 Data Warehouse。

76 |

77 |

78 |

79 | ## 資料倉儲的開發方法

80 |

81 | 主要分成兩種:Top-Down、Buttom-Up。

82 |

83 |

84 |

85 | ### Bill Inmon – Top-down

86 |

87 | 先從各方提取資料,接著經過 `ETL` 後,放入 Data Warehouse。

88 |

89 | 接著從 Data Warehouse 再經過 `ETL` 後,轉成各式各樣的 Data Mart。

90 |

91 |

92 |

93 |

152 |

153 |

154 |

155 | 我們可以透過描點的方式畫出 ROC 曲線,就可以從 ROC 曲線中得出 AUC 值,若 AUC 值越大則模型越好。

156 |

157 |

158 |

159 | ## 機器學習的種類

160 |

161 | 1. 學習問題

162 | 1. 監督式學習:所有資料都被標註,給機器去學習與分類,通常來說對機器最簡單,對人類來說最累。

163 | 2. 非監督式學習:所有資料都沒有被標註,透過機器去尋找特徵的學習分式,對機器最困難,誤差較大。

164 | 3. 強化式學習:不標註任何資料,但告訴機器哪步正確,哪步錯誤,讓機器逐步自我修正。

165 | 2. 混合學習問題

166 | 1. 半監督式學習:對少部分資料進行標註,機器透過有標註的資料找出特徵並進行分類,能使非監督式學習的準確率提升。

167 | 2. 自我監督式學習:從一堆沒有 label 標註的資料,訓練出一個監督式模型,然後造出更多 label。

168 | 3. 多實例學習:輸入許多「包」,這些包都含有許多實例,若所有實例都是負例時則包即為負包,若有至少一個實例為正例時,包即為正包。

169 | 3. 推論統計學

170 | 1. 歸納學習:用來辨識汽車的知識可以用來提升辨識卡車的能力,以現有問題的解決模型利用在其他不同但相關的問題上。

171 | 2. 演繹學習:利用廣泛的前提去推論較具體的結論,通常依賴前提是否正確。

172 | 3. 轉導學習:通過觀察特定的訓練樣本,來預測特定測試樣本的方法。

173 | 4. 學習技術

174 | 1. 多任務學習:利用單一一個模型,解決多個問題

175 | 2. 主動學習:從每輪學習迭代中,尋找出一個最不確定的一個或一組樣本,來讓外部反饋者給予回饋。

176 | 3. 線上學習:利用當前的資料來直接更新模型,進而在預測前根據先前的資料給予預測。

177 | 4. 遷移學習:一個模型先訓練一個例子,接著所有模型用這個模型的訓練例子當成起始點,訓練其他的例子。

178 | 5. 集成學習:集成兩個以上合適的模型,接著從這個集成的模型上訓練。。

179 | 6. 聯盟式學習:從各式各樣的自訓練模型中,在不用給自己數據的情況下,也可以進行訓練得到模型。

180 |

181 |

182 |

183 | > Reference Website:

184 | >

185 | > 1. Marketing. (n.d.). *你知道機器學習(Machine Learning),有幾種學習方式嗎?* 伊雲谷eCloudvalley. Retrieved April 5, 2022, from https://www.ecloudvalley.com/zh-hant/machine-learning/

186 | > 2. *自監督學習 self-supervised learning 介紹*. (2021, June 11). 藏字閣. https://jigfopsda.com/zh/posts/2021/self_supervised_learning/

187 | > 3. *多實例學習*. (2021, August 31). 維基百科,自由的百科全書. https://zh.wikipedia.org/wiki/%E5%A4%9A%E7%A4%BA%E4%BE%8B%E5%AD%A6%E4%B9%A0

188 | > 4. *遷移學習*. (2020, September 19). 維基百科,自由的百科全書. https://zh.wikipedia.org/wiki/%E8%BF%81%E7%A7%BB%E5%AD%A6%E4%B9%A0

189 | > 5. *簡要介紹Active Learning(主動學習)思想框架,以及從IF(isolation forest)衍生出來的演算法:FBIF(Feedback-Guided Anomaly Discovery)*. (n.d.). IT人. Retrieved April 5, 2022, from https://iter01.com/420911.html

190 | > 6. Su, S. (2021, December 13). *聯盟式學習 (Federated Learning) - Sherry.AI*. Medium. https://medium.com/sherry-ai/%E8%81%AF%E7%9B%9F%E5%BC%8F%E5%AD%B8%E7%BF%92-federated-learning-b4cc5af7a9c0

--------------------------------------------------------------------------------

/Markdown/Data Preprocessing.md:

--------------------------------------------------------------------------------

1 | # 資料預處理(Data Preprocessing)

2 |

3 | > Reference:

4 | >

5 | > 1. Data Preprocessing by Dr. Tun-Wen Pai

6 |

7 | ## 資料預處理

8 |

9 | 對於一個資料集來說,若數值偏大或偏小的情況下,我們很難去做資料視覺化,甚至資料過大時會讓自然指數過大導致 overflow。

10 |

11 | 故我們希望可以把資料集的值域縮小,有以下幾種方法:

12 |

13 | 1. Z-score normalization

14 | 2. MinMaxScaler

15 | 3. MaxAbsScaler

16 | 4. Robust Scaling

17 | 5. QuantileTrasformation

18 |

19 |

20 |

21 | ### Z-score normalization

22 |

23 | 對於每個資料,我們利用常態分佈將他標準化(Standardization),定義為

24 | $$

25 | x'=\dfrac{x-\overline{x}}{\sigma}

26 | $$

27 | 用這樣的方式就能夠將其值域限縮至 $[-1, 1]$ 之間。

28 |

29 |

30 |

31 | ### MinMaxScaler

32 |

33 | 對於每個資料,我們使用最大與最小值的區間來限縮值域,定義如下:

34 | $$

35 | x' = \dfrac{x-\min(x)}{\max(x)-\min(x)}

36 | $$

37 | 用這樣的方式就能夠將其值域限縮至 $[0, 1]$ 之間。

38 |

39 |

40 |

41 | ### MaxAbsScaler

42 |

43 | 對於每個資料,我們單純使用最大與最小值的區間來限縮值域,定義如下:

44 | $$

45 | x' = \dfrac{x}{\max\{|x|\}}

46 | $$

47 |

48 |

49 | 用這樣的方式就能夠將其值域限縮至 $[-1, 1]$ 之間。

50 |

51 |

52 |

53 | ### Robust Scaling

54 |

55 | Robust Scaling 是一種非線性的限縮方式,使用第三分位與第一分位來進行限縮。

56 |

57 | 前面的方法,以最大值來說,若最大值過大則限縮資料會變小。

58 |

59 | Robust Scaling 優化了這個部分,他沒有特定的值域限縮範圍,但可以對極值有良好的抗噪性,定義如下:

60 | $$

61 | x' = \dfrac{x-Q_2}{(Q_3-Q_1)}

62 | $$

63 |

64 |

65 |