├── Journey

├── Day07

│ ├── translation_cache.json

│ ├── translated_samples.json

│ └── Day07.md

├── Day06

│ └── Day06.md

├── Day03

│ ├── __pycache__

│ │ └── packed_dataset.cpython-310.pyc

│ ├── Day03.md

│ └── Day03.ipynb

├── Day10

│ ├── Attachments

│ │ └── Capture-2024-09-16-235351.png

│ └── Day10.md

├── Day11

│ ├── single_model_inference.py

│ ├── multi_model_inference.py

│ ├── generate_dpo_data.py

│ ├── Day11.md

│ ├── service.py

│ └── Day11.ipynb

├── Day08

│ ├── Day08.md

│ └── Day08.ipynb

├── Day13

│ ├── dpo_train.py

│ ├── Day13.md

│ └── Day13.ipynb

├── Day12

│ ├── Day12.md

│ └── Day12.ipynb

├── Day01

│ └── Day01.md

├── Day02

│ └── Day02.md

├── Day_Final

│ └── Day_final.md

├── Day09

│ ├── Day09.md

│ └── Day09.ipynb

├── Day05

│ ├── Day05.md

│ └── Day05.ipynb

└── Day04

│ ├── Day04.md

│ └── Day04.ipynb

├── .gitignore

├── .gitmodules

├── Experiments

└── configs

│ └── microstories

│ ├── config.json

│ ├── sft.yaml

│ └── pretrain.yaml

└── README.md

/Journey/Day07/translation_cache.json:

--------------------------------------------------------------------------------

1 | {}

2 |

--------------------------------------------------------------------------------

/.gitignore:

--------------------------------------------------------------------------------

1 | **/.DS_Store

2 | **/.ipynb_checkpoints

3 | **/__pycache__

4 |

--------------------------------------------------------------------------------

/Journey/Day06/Day06.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀 Day06

2 |

3 | 这几天比较忙,没来得及肝代码,所以梳理了一下之前的内容上传了`github`。

4 |

5 | 详情可以参见[这里](https://github.com/puppyapple/Chinese_LLM_From_Scratch)。

--------------------------------------------------------------------------------

/Journey/Day03/__pycache__/packed_dataset.cpython-310.pyc:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/puppyapple/Chinese_LLM_From_Scratch/HEAD/Journey/Day03/__pycache__/packed_dataset.cpython-310.pyc

--------------------------------------------------------------------------------

/Journey/Day10/Attachments/Capture-2024-09-16-235351.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/puppyapple/Chinese_LLM_From_Scratch/HEAD/Journey/Day10/Attachments/Capture-2024-09-16-235351.png

--------------------------------------------------------------------------------

/.gitmodules:

--------------------------------------------------------------------------------

1 | [submodule "References/nano-llama31"]

2 | path = References/nano-llama31

3 | url = https://github.com/karpathy/nano-llama31.git

4 | [submodule "References/baby-llama2-chinese"]

5 | path = References/baby-llama2-chinese

6 | url = https://github.com/DLLXW/baby-llama2-chinese.git

7 | [submodule "Data/TinyStoriesChinese"]

8 | path = Data/TinyStoriesChinese

9 | url = https://huggingface.co/datasets/adam89/TinyStoriesChinese

10 |

--------------------------------------------------------------------------------

/Experiments/configs/microstories/config.json:

--------------------------------------------------------------------------------

1 | {

2 | "architectures": ["LlamaForCausalLM"],

3 | "bos_token_id": 1,

4 | "eos_token_id": 2,

5 | "initializer_range": 0.02,

6 | "aux_loss_alpha": 0.01,

7 | "hidden_act": "silu",

8 | "tie_word_embeddings": true,

9 | "dropout": 0.0,

10 | "flash_attn": true,

11 | "hidden_size": 768,

12 | "intermediate_size": 2048,

13 | "model_type": "llama",

14 | "multiple_of": 512,

15 | "num_attention_heads": 16,

16 | "num_key_value_heads": 4,

17 | "num_hidden_layers": 16,

18 | "max_position_embeddings": 512,

19 | "n_routed_experts": 4,

20 | "n_shared_experts": true,

21 | "rms_norm_eps": 1e-5,

22 | "norm_topk_prob": true,

23 | "num_experts_per_tok": 2,

24 | "scoring_func": "softmax",

25 | "seq_aux": true,

26 | "torch_dtype": "float32",

27 | "transformers_version": "4.44.0",

28 | "use_moe": false,

29 | "vocab_size": 6400

30 | }

31 |

--------------------------------------------------------------------------------

/Journey/Day11/single_model_inference.py:

--------------------------------------------------------------------------------

1 | import json

2 | import hashlib

3 | from litgpt import LLM

4 | from tqdm import tqdm

5 | from litgpt.prompts import MicroStories

6 |

7 |

8 | def hash_prompt(prompt):

9 | return hashlib.md5(prompt.encode()).hexdigest()

10 |

11 |

12 | ms = MicroStories()

13 | llm = LLM.load(model="../../Experiments/Output/sft/microstories/mask_prompt_5e-4/final")

14 |

15 | sft_data = json.load(

16 | open("../../Data/TinyStoriesInstruct/sft_data_v2.json", "r", encoding="utf-8")

17 | )

18 |

19 | try:

20 | with open("dpo_cache.json", "r", encoding="utf-8") as f:

21 | cache = json.load(f)

22 | except FileNotFoundError:

23 | cache = {}

24 |

25 | try:

26 | for case in tqdm(sft_data):

27 | prompt = ms.apply(prompt=case["instruction"], input=case["input"])

28 | hash_key = hash_prompt(prompt)

29 | if hash_key in cache:

30 | continue

31 | else:

32 | generated = llm.generate(prompt=prompt, max_new_tokens=350)

33 | dpo_sample = {

34 | "prompt": prompt,

35 | "rejected": generated,

36 | "chosen": case["output"],

37 | }

38 | cache[hash_key] = dpo_sample

39 |

40 | except Exception as e:

41 | print(repr(e))

42 | with open("dpo_cache.json", "w", encoding="utf-8") as f:

43 | json.dump(cache, f, ensure_ascii=False)

44 |

--------------------------------------------------------------------------------

/Journey/Day07/translated_samples.json:

--------------------------------------------------------------------------------

1 | {

2 | "-3480331710719636664": "特点:对话 \n摘要:蒂米和妈妈一起去商店,对商店里所有的玩具和糖果感到惊讶。他请求触摸一个玩具,妈妈允许他,这让他非常开心。 \n词汇:触摸、商店、宽敞 \n故事:很久以前,有一个小男孩名叫蒂米。蒂米喜欢在外面玩耍和探索。 \n一天,蒂米和妈妈一起去商店。商店非常大,宽敞。蒂米对他看到的玩具和糖果真是太多了,感到惊讶。 \n突然,蒂米看到一个他非常想触摸的玩具。“妈妈,我可以触摸那个玩具吗?”他问。 \n“当然可以啊,蒂米,”妈妈说。蒂米非常开心,他轻轻摸了摸玩具。摸起来软软的,特别有弹性。 \n离开商店后,蒂米对妈妈说他有多喜欢和她一起逛商店。“我玩得可开心了,摸玩具真有意思,”他说。妈妈微笑着把他抱住了。",

3 | "-845848373090745693": "特征:对话 \n单词:靠近,彩虹,不高兴 \n故事:从前有个小女孩,叫莉莉。一天,莉莉在天空中看到了美丽的彩虹。她非常高兴,想把它展示给她的朋友蒂米。 \n莉莉去了蒂米的家,敲了敲门。蒂米开门问:“怎么了,莉莉?你看起来不高兴。” \n莉莉回答:“我没有不高兴!快看外面,有一条漂亮的彩虹!” \n蒂米看向窗外,说:“哇,太棒了!我们去外面,试着靠近一点。” \n于是,莉莉和蒂米走到外面,朝彩虹跑去。他们无法靠近到可以触摸它,但能看到它就已经很开心了。他们在雨中跳舞、欢笑,直到该回家了。从那天起,每当莉莉和蒂米看到天空中的彩虹时,他们都会特别兴奋,虽然他们试着靠近,但其实只要能看到就已经很开心了。 \n总结:莉莉和蒂米每次看到彩虹时都会特别兴奋,虽然他们试着靠近,但其实只要能看到就已经很开心了。",

4 | "1082711273807971183": "摘要:莉莉不喜欢妈妈的辣番茄汤,决定把它卖给邻居史密斯太太,她喜欢吃辣。她成功地把汤卖给了邻居,邻居非常开心。 \n特点:冲突 \n词汇:卖,汤,平静 \n故事:从前,有一个小女孩叫莉莉。她喜欢吃汤,尤其是番茄汤。一天,她的妈妈给她做了一碗汤当午餐。但是当莉莉尝了一口时,她不喜欢。她觉得这汤太辣了。她哭着说:“我不想要这个汤。太热了。” \n她妈妈试图让她平静下来,说:“别担心,莉莉。我明天会给你做另一种汤。”但莉莉不想等。她现在就想喝汤。于是,她有了一个主意。她决定把汤卖给邻居史密斯太太,她喜欢吃辣。 \n莉莉去了史密斯太太的家,说:“你想买我的汤吗?它很辣,但很好。”史密斯太太尝了一口汤,立刻喜欢上了。她给了莉莉一些钱,说:“谢谢你,莉莉。这汤真好吃!”莉莉很高兴能卖掉汤,还让别人开心。她回到家,告诉妈妈这一切。妈妈为她感到骄傲地说:“你真聪明,莉莉。”他们幸福地生活在一起,过着快乐的生活。",

5 | "-1358704974736508821": "词汇:开车,野餐,差 \n总结:莉莉和家人一起去野餐,了解到找到一个好地方和在不对劲的时候要敢于表达自己的重要性。 \n特点:对话,道德价值 \n故事:从前有个小女孩,叫莉莉。她想和家人一起去野餐。她问妈妈:“我们今天可以去野餐吗?”妈妈说:“可以,今天我们就去野餐吧。” \n他们打包了食物,开车去了公园。当他们到达时,发现了一个不太好的地方。莉莉说:“这个地方不太好。我们找一个更好的地方。”他们四处寻找,找到了一个大树下的好地方。 \n莉莉了解到,找到一个好的野餐地点很重要。她还学会了在不对劲时发声是好的。他们在野餐时玩得很开心,开车回家的路上,心里满是快乐的回忆。"

6 | }

7 |

--------------------------------------------------------------------------------

/Journey/Day11/multi_model_inference.py:

--------------------------------------------------------------------------------

1 | import json

2 | import multiprocessing

3 | from functools import partial

4 | from litgpt import LLM

5 | from litgpt.prompts import MicroStories

6 | import click

7 | import torch

8 |

9 | # 设置多进程启动方法为'spawn'

10 | multiprocessing.set_start_method("spawn", force=True)

11 |

12 |

13 | def init_model():

14 | model = LLM.load(

15 | model="../../Experiments/Output/sft/microstories/mask_prompt_5e-4/final"

16 | )

17 | return model

18 |

19 |

20 | def process_chunk(model, chunk):

21 | ms = MicroStories()

22 | results = []

23 | for case in chunk:

24 | prompt = ms.apply(prompt=case["instruction"], input=case["input"])

25 | with torch.no_grad():

26 | response = model.generate(prompt=prompt, max_new_tokens=350)

27 | results.append(

28 | {"prompt": prompt, "rejected": response, "chosen": case["output"]}

29 | )

30 | return results

31 |

32 |

33 | @click.command()

34 | @click.option("-n", "--num_processes", default=4, help="并发进程数")

35 | @click.option("--test", is_flag=True, help="测试模式,只处理前100条数据")

36 | def main(num_processes, test):

37 | # 加载SFT数据

38 | with open(

39 | "../../Data/TinyStoriesInstruct/sft_data_v2.json", "r", encoding="utf-8"

40 | ) as f:

41 | sft_data = json.load(f)

42 |

43 | if test:

44 | sft_data = sft_data[:100]

45 |

46 | # 确定进程数量

47 | n_processes = min(multiprocessing.cpu_count(), num_processes)

48 |

49 | # 初始化模型

50 | model = init_model()

51 |

52 | # 使用partial创建一个新的函数,将model作为第一个参数

53 | process_chunk_with_model = partial(process_chunk, model)

54 |

55 | # 将数据分成n_processes份

56 | chunk_size = len(sft_data) // n_processes

57 | chunks = [sft_data[i : i + chunk_size] for i in range(0, len(sft_data), chunk_size)]

58 |

59 | # 使用进程池并行处理数据

60 | with multiprocessing.Pool(n_processes) as pool:

61 | results = pool.map(process_chunk_with_model, chunks)

62 |

63 | # 合并结果

64 | dpo_samples = [item for sublist in results for item in sublist]

65 |

66 | # 保存结果

67 | output_file = "dpo_samples_test.json" if test else "dpo_samples.json"

68 | with open(output_file, "w", encoding="utf-8") as f:

69 | json.dump(dpo_samples, f, ensure_ascii=False, indent=2)

70 |

71 | print(f"处理完成,结果已保存到 {output_file}")

72 |

73 |

74 | if __name__ == "__main__":

75 | main()

76 |

--------------------------------------------------------------------------------

/Journey/Day08/Day08.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀 Day08

2 |

3 | 上一期介绍了`SFT`的数据准备流程,但是在正式开启`SFT`之前,我打算熟悉了解一些`SFT`的知识点。

4 |

5 | 以下大多数都是来自[互联网上资料](https://zhuanlan.zhihu.com/p/682604566)的收集整理,给自己留个记录,便于复习和回顾。

6 |

7 | 所以这期的内容算是一个**笔记**,也希望能够帮助到有需要的朋友。

8 |

9 | > 另外最近也确实比较忙,这篇总结分享也算是给自己一个缓冲来继续后面的实践。

10 |

11 |

12 | ## 什么是SFT?

13 |

14 | `SFT`是`Supervised Fine-Tuning`的缩写,中文翻译为**有监督微调**。

15 |

16 | 指的是在已经预训练好的模型基础上,使用**有标签的数据**进行微调,以适应特定的任务。

17 |

18 | 在预训练模型中,由于数据量和场景的限制,模型可能无法很好地处理某些特定任务。

19 |

20 | 通过有监督微调,我们可以使模型更好地适应特定场景,提高模型在特定任务上的性能。

21 |

22 | 在大模型领域,我们提到`SFT`,通常指的是它一种特殊形式,即`Instruction Tuning`。

23 |

24 | 接下来的内容都是基于`Instruction Tuning`来展开。

25 |

26 | ## 训练方式

27 |

28 | 在进行指令微调的时候,会将`Instruction`(指令) 以及对应的`Response`(回答)拼接成文本(具体有很多`prompt style`可以参考),然后依然以预训练时的**自回归**方式进行训练。

29 |

30 | 但和预训练不同的是,在`loss`计算的时候只考虑`Response`部分,而不考虑`Instruction`部分(通过`ignore_index`来隐去)。

31 |

32 | ## 训练数据

33 |

34 | `Meta`在论文[LIMA: Less Is More for Alignment](https://arxiv.org/abs/2305.11206)中详细地论述了一个结论:数据集的质量对微调的重要性远大于数据集的数量(即便1万的高质量数据集也能取得很好的效果,胜过10万低质量数据集)。

35 |

36 | 因此我们应该花更多的时间去提升样本质量,而不是追求样本的数量。

37 |

38 | 在大规模的`SFT`上(区别于我这个故事生成的`toy model`),各类指令数据的配比是一个非常重要的参数,但很可惜,各大家开放的报告里对这部分内容的细节描述非常少。

39 |

40 | 找到一篇关于[SFT数据集的配比的调研](https://zhuanlan.zhihu.com/p/703825827),里面搜集整理了一些干货,感兴趣的朋友可以移步去看看。

41 |

42 |

43 |

44 | ## 微调技巧

45 |

46 | ### 训练模式

47 |

48 | 1. base model + domain SFT

49 | 2. base model + domain continue pre-train + domain SFT

50 | 3. base model + common SFT + domain SFT

51 |

52 | 上述的`base model`也都可以换成`chat model`。

53 |

54 | 除了主流的这几种模式,其实还可以有其他的组合方式,例如将`SFT`数据混合到`pretrain`中等等,这里就不穷举了,我自己也没有太多的经验,所以大家按照自己的实际情况调研测试是最好的。

55 |

56 | #### `base model` vs `chat model`

57 | - `base model`质量够好的时候,在base模型基础进行领域数据的SFT与在chat模型上进行SFT,效果上差异不大

58 | - `chat model`接`SFT`时候出现灾难性遗忘的概率比较大

59 | - 如果既追求领域任务的性能,又希望尽量保留通用能力,则可以考虑`base model`

60 | - 如果只追求领域任务的性能,则可以考虑`chat model`

61 |

62 | #### 是否`continue pre-train`

63 | - 如果领域任务数据集和通用数据集差异较大,则务必`continue pre-train`

64 | - 领域任务数据集较大且不在意通用能力而只关注领域任务,则也建议进行`continue pre-train`

65 | - 其他情况可以考虑不进行`continue pre-train`

66 |

67 | ### 关于炼丹

68 |

69 | 1. `SFT`数据集的量级如果不是特别大,建议选择较小学习率,一般设置为`pre-train`阶段学习率的10%左右。

70 |

71 | 例如在`pre-train`阶段的学习率为`1e-5`,则`SFT`阶段的学习率设置为`1e-6`。

72 |

73 | 2. `SFT`阶段建议使用比`pre-train`阶段更小的`warmup steps`,这是因为`SFT`阶段的数据量级远小于`pre-train`阶段,较小的`warmup steps`有助于模型更好地收敛。

74 | 3. `Epoch`数量的设置和`SFT`数据的量级成反比,`SFT`数据量级越大,可以将`Epoch`数量设置越小。

75 |

76 |

77 | ## 说明

78 |

79 | 以上内容是我花了半天的时间简单整理的内容,可能会有不准确的地方,欢迎大家指正。

80 |

81 | `SFT`的细节内容还有很多,例如`SFT`的`loss`计算方式等,这些展开来讲内容会非常多,所以这里就不再赘述了。

82 |

83 | 在后面的实践过程中我再根据自己遇到的问题来补充分享给大家吧。

84 |

85 |

86 |

87 |

--------------------------------------------------------------------------------

/Journey/Day13/dpo_train.py:

--------------------------------------------------------------------------------

1 | import os

2 | import click

3 |

4 | os.environ["CUDA_VISIBLE_DEVICES"] = "0"

5 |

6 | import torch

7 | from peft import get_peft_model, LoraConfig, TaskType

8 | from transformers import TrainingArguments, AutoModelForCausalLM, AutoTokenizer

9 | from trl import DPOTrainer

10 | from trl import DPOConfig

11 | from datasets import load_dataset

12 | from litgpt.utils import num_parameters

13 |

14 |

15 | def find_all_linear_names(model):

16 | cls = torch.nn.Linear

17 | lora_module_names = set()

18 | for name, module in model.named_modules():

19 | if isinstance(module, cls):

20 | names = name.split(".")

21 | lora_module_names.add(names[0] if len(names) == 1 else names[-1])

22 |

23 | if "lm_head" in lora_module_names:

24 | lora_module_names.remove("lm_head")

25 | return list(lora_module_names)

26 |

27 |

28 | def init_model(model_name_or_path, device="cuda:0"):

29 | model = AutoModelForCausalLM.from_pretrained(

30 | model_name_or_path,

31 | # local_files_only=True,

32 | # state_dict=torch.load(f"{model_name_or_path}/pytorch_model.bin"),

33 | )

34 | tokenizer = AutoTokenizer.from_pretrained(model_name_or_path)

35 | tokenizer.pad_token = tokenizer.eos_token

36 | print(f"Total parameters: {num_parameters(model):,}")

37 | model = model.to(device)

38 | return model, tokenizer

39 |

40 |

41 | @click.command()

42 | @click.option("--model_name_or_path", type=str)

43 | def main(model_name_or_path):

44 | model, tokenizer = init_model(model_name_or_path)

45 | dpo_config = DPOConfig(

46 | output_dir="../../Experiments/Output/dpo/microstories_lora_v2",

47 | per_device_train_batch_size=16,

48 | remove_unused_columns=False,

49 | num_train_epochs=2,

50 | learning_rate=1e-5,

51 | do_eval=True,

52 | eval_strategy="steps",

53 | eval_steps=200,

54 | save_steps=200,

55 | logging_steps=10,

56 | )

57 |

58 | data_files = {

59 | "train": "../../Data/TinyStoriesInstruct/dpo_data_train.json",

60 | "eval": "../../Data/TinyStoriesInstruct/dpo_data_eval.json",

61 | }

62 | dataset_dpo = load_dataset("json", data_files=data_files)

63 |

64 | dpo_trainer = DPOTrainer(

65 | model,

66 | ref_model=None,

67 | args=dpo_config,

68 | beta=0.1,

69 | train_dataset=dataset_dpo["train"],

70 | eval_dataset=dataset_dpo["eval"],

71 | tokenizer=tokenizer,

72 | max_length=512,

73 | max_prompt_length=512,

74 | )

75 | dpo_trainer.train()

76 |

77 |

78 | if __name__ == "__main__":

79 | main()

80 |

--------------------------------------------------------------------------------

/Journey/Day12/Day12.md:

--------------------------------------------------------------------------------

1 | 之前说准备好`DPO`数据就着手开始自己`DIY`一下训练的实现了(因为`litgpt`库暂时还没有集成相关实现)。

2 | 虽说是`DIY`但是纯从零手撸的成本还是有点高的,因此还是打算参考已有的实现来弄,比如:

3 | - [eric-mitchell/direct-preference-optimization: Reference implementation for DPO (Direct Preference Optimization)](https://github.com/eric-mitchell/direct-preference-optimization)

4 | - [huggingface的trl库里的实现](https://github.com/huggingface/trl/blob/main/trl/trainer/dpo_trainer.py)

5 |

6 | `transformers`库毕竟是大主流,因此还是优先考虑基于`transformers`库的`API`来实现。

7 |

8 | 那么面临的第一个问题就是需要将`litgpt`框架训练的模型转换为`huggingface`库的模型格式。

9 |

10 | 而在这个过程中我遇到了一个**意想不到的坑**,直接给我整**破防**了。

11 |

12 | 大家听我慢慢道来。

13 |

14 |

15 |

16 | ## litgpt模型转换到huggingface format

17 | `litgpt`框架本身考虑得很周全,它从简化模型实现的角度完全基于`torch`实现的[model.py](https://github.com/Lightning-AI/litgpt/blob/main/litgpt/model.py)

18 |

19 | 同时也提供了将`checkpoint`转换为`huggingface`模型格式的`API`:

20 |

21 |

22 | ```python

23 | # ! litgpt convert_from_litgpt input_checkpoint_dir output_dir

24 | ```

25 |

26 | 这里会得到一个`model.pth`文件,为了后续加载方便,大家可以直接改名为`pytorch_model.bin`。

27 |

28 | 另外需要注意的是`transformers`库依赖`config.json`文件,如果大家的模型架构选择的是使用`litgpt`框架已经支持的`huggingface`上的模型,那么可以直接去下载;但如果是自己定义的模型架构,那么就需要大家自己动手来写这个`config.json`文件了。

29 |

30 | > 后面我会写一个简单的脚本,基于`litgpt`框架的`config.yaml`文件来生成`config.json`文件,可能在一些场景下能具备通用性。

31 |

32 |

33 | ## transformers库模型加载

34 |

35 | 模型的转换还是比较简单且顺利的,但是按照[litgpt的convert文档](https://github.com/Lightning-AI/litgpt/blob/main/tutorials/convert_lit_models.md),通过`transformers`库加载转换后的模型文件的时候,问题来了。

36 |

37 | 我的到了一个意想不到的报错,追溯到的是`transformers`库里对模型参数尺寸检查的这段代码:

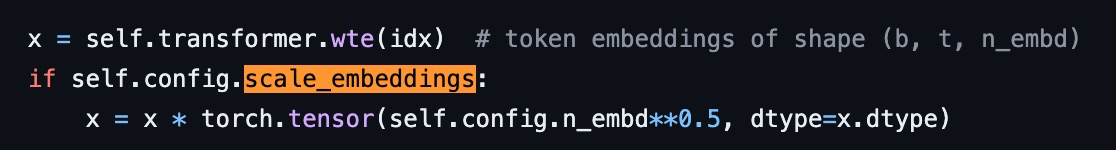

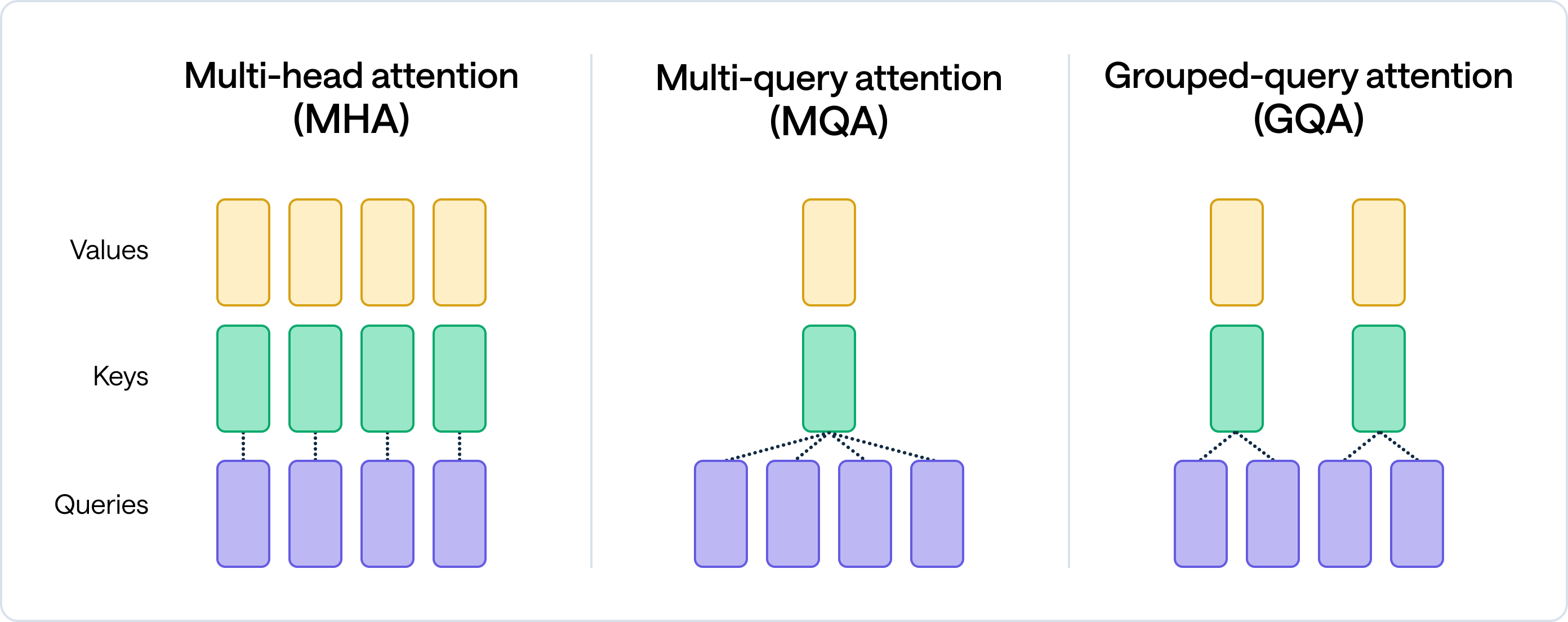

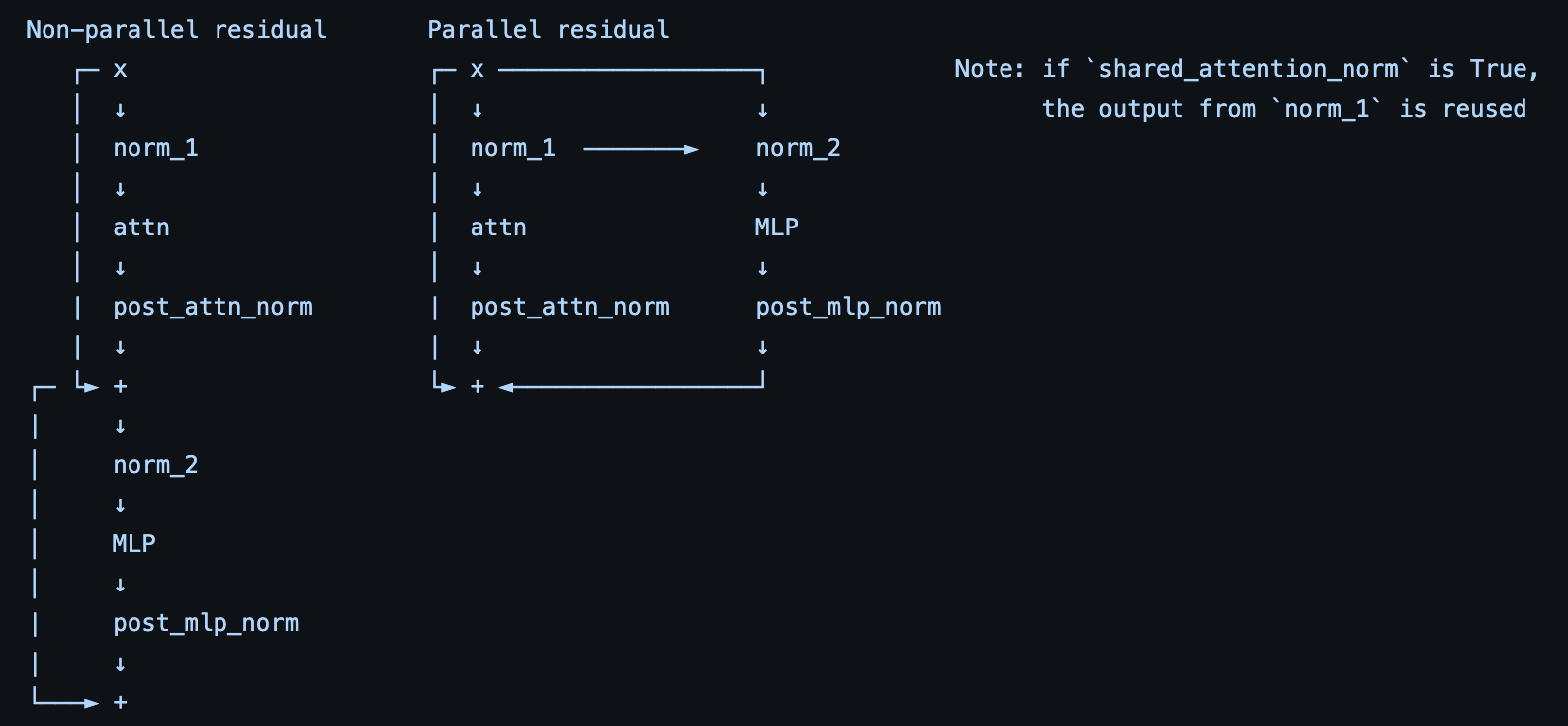

38 |

39 |

40 |

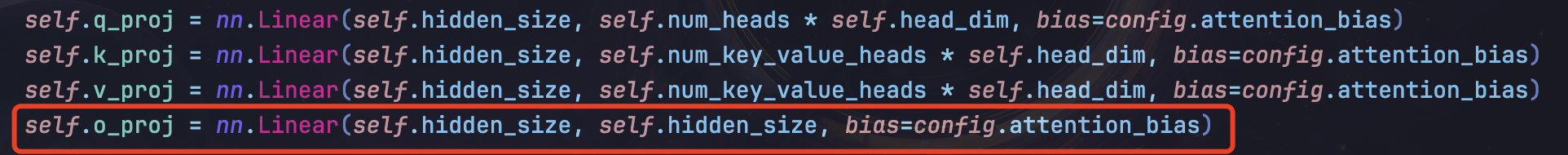

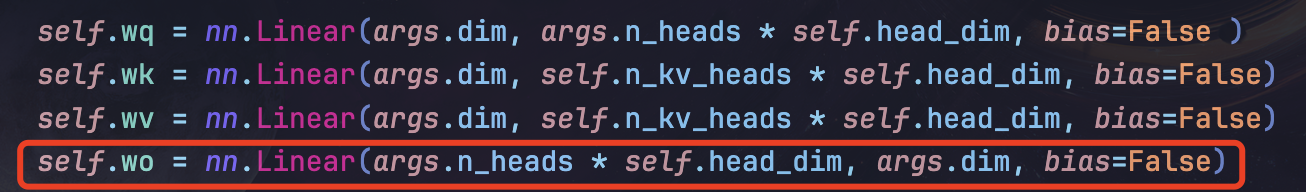

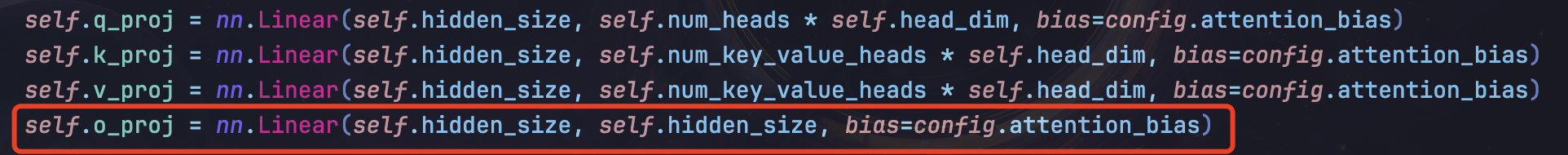

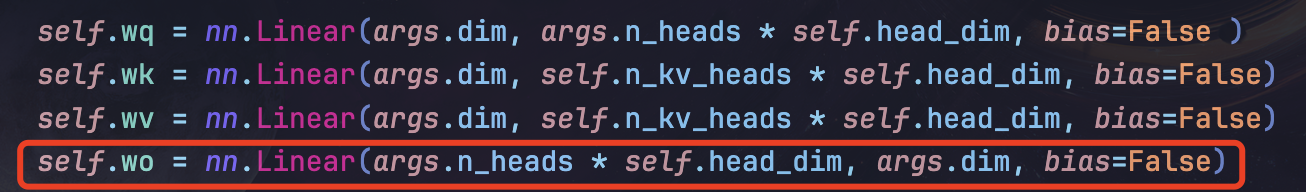

41 | **它强制要求了`embedding`的向量尺寸必须正好等于注意力头数`n_heads`和注意力头尺寸`head_size`的乘积**。

42 |

43 | 原因是他们不知出于什么考虑,在对`attention`的`kqv`转换矩阵实现的时候,做了一个简化,大家看下图里我用红框标出的地方。

44 |

45 |

46 |

47 |

48 | 如果不理解的话,再对比看下面这张图应当就能理解了,是`Karpathy`大神的`nanoGPT`里同样模块的实现。

49 |

50 |

51 |

52 | 但凡看过原始论文里的公式推导就会知道,`hidden_size = n_heads * head_size`这个要求是**完全没有必要**的。

53 |

54 | `W_k/W_q/W_v`矩阵理论上可以将`hidden_size`投影到任何维度上去,只要最后再通过`W_o`的线性层映射回`hidden_size`即可。

55 |

56 | 而`transformers`库的实现里将这个任何维度简化为了`n_heads * head_size`,这对我这种需要从自定义的模型架构转换过来的场景造成了**毁灭性打击**🤦♂️。

57 |

58 | 因为我当时**拍脑袋**定的`0.044b`参数模型里,`embedding`维度选的`768`,`n_heads`是`6`,而`head_size`定了个`48`,导致这里没有办法加载了。

59 |

60 | 我当然可以通过改源码的方式来弥补这个问题,但是如果我希望我的模型能够被更多使用`transformers`库的人使用,这个方式就不合适了。

61 |

62 | 最保险的方式是按照它这个**不合理的**要求来调整我的模型架构,从而得到一个满足`hidden_size = n_heads * head_size`的模型。

63 |

64 | ## 教训总结

65 |

66 |

67 | 没办法,我最终选择了重新预训练我的故事模型;坑虽然踩了,但是也得到了一些收获。

68 |

69 | 大部分人一般情况下主要是基于`huggingface`上已有的模型架构来训练,我这类**自定义模型架构**的情况相对少见,因此踩坑踩得有点狠。

70 |

71 | 即便是`transformers`库这样的大主流,也难免会有一些设计不合理的地方。

72 |

73 | 也提醒我,对开源库的使用,如果时间精力允许,还是要**多花点功夫看看源码**,理解其背后的设计思想,这样在遇到问题的时候才能从更本质的地方找到解决方案。

74 |

75 |

76 | > 一个更让我欲哭无泪的事实:

77 | >

78 | > 就在我的新架构模型快完成预训练的时候,

79 | > 我发现这个不合理的逻辑其实在[这个PR](https://github.com/huggingface/transformers/pull/32857)里得到了修复。

80 | >

81 | > 在`transformers`库的最新版本里已经没有这个问题了。

82 | >

83 | > 合着是我更新库不够积极呗?🤷♂️

84 |

85 |

86 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型计划

2 |

3 | ## 项目简介

4 |

5 | 心血来潮想要走一遍大模型训练的流程,于是有了这个项目。

6 |

7 | 由于我自己只有一张`3090`,也不好用单位的显卡,所以训练只能选很小的模型。

8 |

9 | 其实我自己对`SLM`是很感兴趣的,感觉现在也有越来越多地研究开始关注**小尺寸大模型的性能**以及**如何把大模型做小**。

10 |

11 | 如果是希望学习大规模并行训练相关的内容(例如`DeepSpeed`,`Megatron`),这个项目可能不太适合你。

12 |

13 | 另外个人经历和精力有限,所以可能很多地方做的不是很好,请大家多多包涵。也欢迎大家提出意见和建议。

14 |

15 | 最后给自己的自媒体号打个广告,欢迎大家关注一波~(**公众号/B站/小红书/抖音:喵懂AI**)

16 |

17 |

18 |

19 | ## 最近更新

20 |

21 | 2024-09-25

22 | 上传了Day12 - Day13的内容:

23 |

24 | - `Day12`: `litgpt`模型转换到`huggingface`格式

25 | - `Day13`: `DPO`训练

26 |

27 |

28 |

29 | 2024-09-20

30 | 上传了Day10 - Day11的内容:

31 |

32 | - `Day10`: 中秋特刊,自己关于大模型的一些思考

33 | - `Day11`: `DPO`数据构建

34 |

35 |

36 |

37 | 2024-09-12

38 | 上传了Day07 - Day09的内容:

39 |

40 | - `Day07`: `SFT`数据构建

41 | - `Day08`: `SFT`训练相关知识点调研

42 | - `Day09`: `SFT`训练及效果测试

43 |

44 |

45 |

46 | 2024-09-02

47 | 上传了Day01 - Day05的内容:

48 |

49 | - `Day01`: 项目调研

50 | - `Day02`: `Tokenizer`分词

51 | - `Day03`: 数据预处理

52 | - `Day04`: 模型搭建和预训练启动

53 | - `Day05`: 预训练效果测试

54 |

55 |

56 | ## 计划执行

57 | 在一个垂直领域的小数据集上完成:

58 | - [x] 一个小尺寸模型的预训练(能在单卡上跑)

59 | - [x] 在上面的基础上完成指令微调

60 | - [x] 在上面的基础上完成`DPO`

61 | - [ ] 其他待定

62 |

63 | **Journey**文件夹下有每次任务的详细记录。

64 | 下载相应的文件(`chatglm`的`tokenizer`,`TinyStoriesChinese`的数据集)之后,可以跟着`Journey`中的步骤一步步来。

65 | 理论上可以复现已经放出的结果(`GPU`如果比我还小的,需要自己调整下`batch_size`)。

66 |

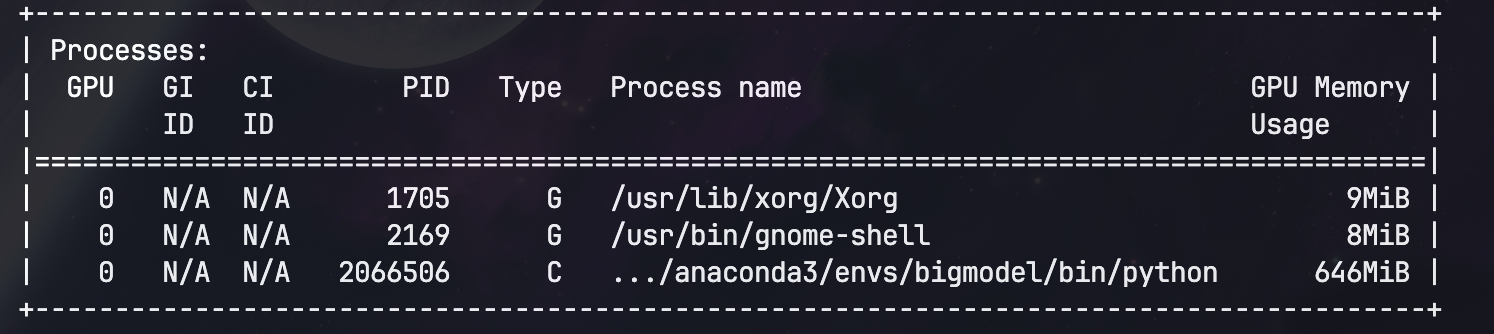

67 | ## 训练信息

68 | 机器配置:

69 | ```bash

70 | OS: Ubuntu 22.04.3 LTS x86_64

71 | Kernel: 6.5.0-35-generic

72 | Uptime: 60 days, 4 hours, 55 mins

73 | Packages: 2719 (dpkg), 17 (snap)

74 | Shell: fish 3.6.1

75 | Terminal: WezTerm

76 | CPU: AMD Ryzen 9 5950X (32) @ 3.400G

77 | GPU: NVIDIA 09:00.0 NVIDIA Corporati

78 | Memory: 9347MiB / 64195MiB

79 | ```

80 | ### 预训练

81 | 详细参数请参考 [pretrain.yaml](./Experiments/configs/microstories/pretrain.yaml)。

82 |

83 |

84 | ### 指令微调

85 | 详细参数请参考 [sft.yaml](./Experiments/configs/microstories/sft.yaml)。

86 |

87 |

88 | ### DPO

89 | 训练脚本参考[dpo_train.py](./Journey/Day13/dpo_train.py)

90 |

91 |

92 |

93 | ## 目录结构

94 |

95 | ```

96 | Chinese_LLM_From_Scratch

97 | ├── Data

98 | │ └── TinyStoriesChinese

99 | │ ├── processed_data

100 | │ └── raw_data

101 | ├── Experiments

102 | │ ├── configs

103 | │ │ ├── debug.yaml

104 | │ │ ├── microstories.yaml

105 | │ │ └── ...

106 | │ └── Output

107 | │ └── pretrain

108 | │ ├── debug

109 | │ └── microstories

110 | ├── References

111 | │ ├── chatglm3-6b

112 | │ └── ...

113 | ├── Journey

114 | │ ├── Day01

115 | │ ├── Day02

116 | │ ├── Day03

117 | │ ├── Day04

118 | │ └── ...

119 | ```

120 |

--------------------------------------------------------------------------------

/Journey/Day08/Day08.ipynb:

--------------------------------------------------------------------------------

1 | {

2 | "cells": [

3 | {

4 | "cell_type": "markdown",

5 | "metadata": {},

6 | "source": [

7 | "# 从零手搓中文大模型|🚀 Day08"

8 | ]

9 | },

10 | {

11 | "cell_type": "markdown",

12 | "metadata": {},

13 | "source": [

14 | "上一期介绍了`SFT`的数据准备流程,但是在正式开启`SFT`之前,我打算熟悉了解一些`SFT`的细节。\n",

15 | "\n",

16 | "大多数都是来自[互联网上资料](https://zhuanlan.zhihu.com/p/682604566)的收集整理,算是给自己留个记录,便于复习和回顾。\n",

17 | "\n",

18 | "也希望能够帮助到有需要的人。\n"

19 | ]

20 | },

21 | {

22 | "cell_type": "markdown",

23 | "metadata": {},

24 | "source": [

25 | "## 什么是SFT?\n",

26 | "\n",

27 | "`SFT`是`Supervised Fine-Tuning`的缩写,中文翻译为`有监督微调`。\n",

28 | "\n",

29 | "指的是在已经预训练好的模型基础上,使用有标签的数据进行微调,以适应特定的任务。\n",

30 | "\n",

31 | "在预训练模型中,由于数据量和场景的限制,模型可能无法很好地处理某些特定任务。\n",

32 | "\n",

33 | "通过有监督微调,我们可以使模型更好地适应特定场景,提高模型在特定任务上的性能。\n",

34 | "\n",

35 | "在大模型领域,我们提到`SFT`,通常指的是它一种特殊形式,即`Instruction Tuning`。\n",

36 | "\n",

37 | "接下来的内容都是基于`Instruction Tuning`来展开。"

38 | ]

39 | },

40 | {

41 | "cell_type": "markdown",

42 | "metadata": {},

43 | "source": [

44 | "## 训练方式\n",

45 | "\n",

46 | "在进行指令微调的时候,会将`Instruction`(指令) 以及对应的`Response`(回答)拼接成文本(具体有很多`prompt style`可以参考),然后依然以预训练时的**自回归**方式进行训练。\n",

47 | "\n",

48 | "但和预训练不同的是,在`loss`计算的时候只考虑`Response`部分,而不考虑`Instruction`部分(通过`ignore_index`来隐去)。"

49 | ]

50 | },

51 | {

52 | "cell_type": "markdown",

53 | "metadata": {},

54 | "source": [

55 | "## 训练数据\n",

56 | "\n",

57 | "`Meta`在论文[LIMA: Less Is More for Alignment](https://arxiv.org/abs/2305.11206)中详细地论述了一个结论:数据集的质量对微调的重要性远大于数据集的数量(即便1万的高质量数据集也能取得很好的效果,胜过10万低质量数据集)。\n",

58 | "\n",

59 | "因此我们应该花更多的时间去提升样本质量,而不是追求样本的数量。"

60 | ]

61 | },

62 | {

63 | "cell_type": "markdown",

64 | "metadata": {},

65 | "source": [

66 | "## 微调技巧"

67 | ]

68 | },

69 | {

70 | "cell_type": "markdown",

71 | "metadata": {},

72 | "source": [

73 | "### 训练模式\n",

74 | "\n",

75 | "1. base model + domain SFT\n",

76 | "2. base model + domain continue pre-train + domain SFT\n",

77 | "3. base model + common SFT + domain SFT\n",

78 | " \n",

79 | "上述的`base model`也都可以换成`chat model`。\n",

80 | "\n",

81 | "#### `base model` vs `chat model`\n",

82 | "- `base model`质量够好的时候,在base模型基础进行领域数据的SFT与在chat模型上进行SFT,效果上差异不大\n",

83 | "- `chat model`接`SFT`时候出现灾难性遗忘的概率比较大\n",

84 | "- 如果既追求领域任务的性能,又希望尽量保留通用能力,则可以考虑`base model`\n",

85 | "- 如果只追求领域任务的性能,则可以考虑`chat model`\n",

86 | "\n",

87 | "#### 是否`continue pre-train`\n",

88 | "- 如果领域任务数据集和通用数据集差异较大,则务必`continue pre-train`\n",

89 | "- 领域任务数据集较大且不在意通用能力而只关注领域任务,则也建议进行`continue pre-train`\n",

90 | "- 其他情况可以考虑不进行`continue pre-train`\n",

91 | "\n",

92 | "### 关于炼丹\n",

93 | "\n",

94 | "1. `SFT`数据集的量级如果不是特别大,建议选择较小学习率,一般设置为`pre-train`阶段学习率的10%左右。\n",

95 | " \n",

96 | " 例如在`pre-train`阶段的学习率为`1e-5`,则`SFT`阶段的学习率设置为`1e-6`。\n",

97 | "\n",

98 | "2. `SFT`阶段建议使用比`pre-train`阶段更小的`warmup steps`,这是因为`SFT`阶段的数据量级远小于`pre-train`阶段,较小的`warmup steps`有助于模型更好地收敛。\n",

99 | "3. `Epoch`数量的设置和`SFT`数据的量级成反比,`SFT`数据量级越大,可以将`Epoch`数量设置越小。"

100 | ]

101 | }

102 | ],

103 | "metadata": {

104 | "kernelspec": {

105 | "display_name": "bigmodel",

106 | "language": "python",

107 | "name": "python3"

108 | },

109 | "language_info": {

110 | "name": "python",

111 | "version": "3.10.10"

112 | }

113 | },

114 | "nbformat": 4,

115 | "nbformat_minor": 2

116 | }

117 |

--------------------------------------------------------------------------------

/Experiments/configs/microstories/sft.yaml:

--------------------------------------------------------------------------------

1 |

2 | # The path to the base model's checkpoint directory to load for finetuning. (type: , default: checkpoints/stabilityai/stablelm-base-alpha-3b)

3 | checkpoint_dir: Chinese_LLM_From_Scratch/Experiments/Output/pretrain/microstories/latest

4 |

5 | # Directory in which to save checkpoints and logs. (type: , default: out/lora)

6 | out_dir: Chinese_LLM_From_Scratch/Experiments/Output/sft/microstories/mask_prompt_5e-4

7 |

8 | # The precision to use for finetuning. Possible choices: "bf16-true", "bf16-mixed", "32-true". (type: Optional[str], default: null)

9 | precision: bf16-true

10 |

11 | # How many devices/GPUs to use. (type: Union[int, str], default: 1)

12 | devices: 1

13 |

14 | # How many nodes to use. (type: int, default: 1)

15 | num_nodes: 1

16 |

17 | # Data-related arguments. If not provided, the default is ``litgpt.data.Alpaca``.

18 | data:

19 | class_path: litgpt.data.JSON

20 | init_args:

21 | json_path: Chinese_LLM_From_Scratch/Data/TinyStoriesInstruct/sft_data.json

22 | mask_prompt: true

23 | val_split_fraction: 0.01

24 | prompt_style: microstories

25 | ignore_index: -100

26 | seed: 42

27 | num_workers: 8

28 |

29 | resume: false

30 |

31 | # Training-related arguments. See ``litgpt.args.TrainArgs`` for details

32 | train:

33 |

34 | # Number of optimizer steps between saving checkpoints (type: Optional[int], default: 1000)

35 | save_interval: 500

36 |

37 | # Number of iterations between logging calls (type: int, default: 1)

38 | log_interval: 1

39 |

40 | # Number of samples between optimizer steps across data-parallel ranks (type: int, default: 128)

41 | global_batch_size: 32

42 |

43 | # Number of samples per data-parallel rank (type: int, default: 4)

44 | micro_batch_size: 32

45 |

46 | # Number of iterations with learning rate warmup active (type: int, default: 100)

47 | lr_warmup_steps: 100

48 |

49 | # Number of epochs to train on (type: Optional[int], default: 5)

50 | epochs: 3

51 |

52 | # Total number of tokens to train on (type: Optional[int], default: null)

53 | max_tokens:

54 |

55 | # Limits the number of optimizer steps to run. (type: Optional[int], default: null)

56 | max_steps:

57 |

58 | # Limits the length of samples. Off by default (type: Optional[int], default: null)

59 | max_seq_length: 512

60 |

61 | # Whether to tie the embedding weights with the language modeling head weights. (type: Optional[bool], default: null)

62 | tie_embeddings:

63 |

64 | # (type: Optional[float], default: null)

65 | max_norm:

66 |

67 | # (type: float, default: 6e-05)

68 | min_lr: 0.0

69 |

70 | # Evaluation-related arguments. See ``litgpt.args.EvalArgs`` for details

71 | eval:

72 |

73 | # Number of optimizer steps between evaluation calls (type: int, default: 100)

74 | interval: 300

75 |

76 | # Number of tokens to generate (type: Optional[int], default: 100)

77 | max_new_tokens: 400

78 |

79 | # Number of iterations (type: int, default: 100)

80 | max_iters: 10

81 |

82 | # Whether to evaluate on the validation set at the beginning of the training

83 | initial_validation: true

84 |

85 | # Whether to evaluate on the validation set at the end the training

86 | final_validation: true

87 |

88 | # The name of the logger to send metrics to. (type: Literal['wandb', 'tensorboard', 'csv'], default: csv)

89 | logger_name: wandb

90 |

91 | # The random seed to use for reproducibility. (type: int, default: 1337)

92 | seed: 1337

93 |

94 | # Optimizer-related arguments

95 | optimizer:

96 |

97 | class_path: torch.optim.AdamW

98 |

99 | init_args:

100 |

101 | # (type: float, default: 0.001)

102 | lr: 0.0005

103 |

104 | # (type: float, default: 0.01)

105 | weight_decay: 0.0

106 |

107 | # (type: tuple, default: (0.9,0.999))

108 | betas:

109 | - 0.9

110 | - 0.95

--------------------------------------------------------------------------------

/Journey/Day11/generate_dpo_data.py:

--------------------------------------------------------------------------------

1 | import asyncio

2 | import aiohttp

3 | import json

4 | import argparse

5 | import hashlib

6 | import time

7 | import atexit

8 | from tqdm import tqdm

9 | from litgpt.prompts import MicroStories

10 | from loguru import logger

11 |

12 |

13 | def hash_prompt(prompt):

14 | return hashlib.md5(prompt.encode()).hexdigest()

15 |

16 |

17 | cache = {}

18 | error_cache = {}

19 |

20 |

21 | def save_caches():

22 | with open("dpo_cache.json", "w", encoding="utf-8") as f:

23 | json.dump(cache, f, ensure_ascii=False, indent=2)

24 | with open("error_cache.json", "w", encoding="utf-8") as f:

25 | json.dump(error_cache, f, ensure_ascii=False, indent=2)

26 | logger.info("缓存已保存")

27 |

28 |

29 | atexit.register(save_caches)

30 |

31 |

32 | async def generate_response(session, prompt, semaphore):

33 | prompt_hash = hash_prompt(prompt)

34 | if prompt_hash in cache:

35 | return cache[prompt_hash]

36 |

37 | async with semaphore:

38 | try:

39 | async with session.post(

40 | "http://127.0.0.1:8000/predict", json={"prompt": prompt}

41 | ) as response:

42 | result = await response.json()

43 | cache[prompt_hash] = result

44 | return result

45 | except Exception as e:

46 | error_msg = f"生成响应时出错: {str(e)}"

47 | logger.error(error_msg)

48 | error_cache[prompt_hash] = error_msg

49 | return None

50 |

51 |

52 | async def main(concurrency, test_mode):

53 | global cache, error_cache

54 | ms = MicroStories()

55 |

56 | with open(

57 | "../../Data/TinyStoriesInstruct/sft_data_v2.json", "r", encoding="utf-8"

58 | ) as f:

59 | sft_data = json.load(f)

60 |

61 | if test_mode:

62 | sft_data = sft_data[:100]

63 |

64 | # 读取缓存

65 | try:

66 | with open("dpo_cache.json", "r", encoding="utf-8") as f:

67 | cache = json.load(f)

68 | logger.info(f"加载缓存: {len(cache)}条")

69 | except FileNotFoundError:

70 | cache = {}

71 |

72 | try:

73 | with open("error_cache.json", "r", encoding="utf-8") as f:

74 | error_cache = json.load(f)

75 | except FileNotFoundError:

76 | error_cache = {}

77 |

78 | semaphore = asyncio.Semaphore(concurrency)

79 |

80 | async with aiohttp.ClientSession() as session:

81 | tasks = []

82 | for i, case in enumerate(tqdm(sft_data, desc="生成DPO数据")):

83 | prompt = ms.apply(prompt=case["instruction"], input=case["input"])

84 | task = asyncio.create_task(generate_response(session, prompt, semaphore))

85 | tasks.append(task)

86 |

87 | # 每处理100个样本保存一次缓存

88 | if (i + 1) % 100 == 0:

89 | save_caches()

90 |

91 | responses = await asyncio.gather(*tasks)

92 |

93 | dpo_data = []

94 | for case, response in zip(sft_data, responses):

95 | prompt = ms.apply(prompt=case["instruction"], input=case["input"])

96 | dpo_sample = {

97 | "prompt": prompt,

98 | "rejected": response.get("output") or response.get("rejected"),

99 | "chosen": case["output"],

100 | }

101 | dpo_data.append(dpo_sample)

102 |

103 | # 保存错误缓存

104 | save_caches() # 最后再保存一次缓存

105 |

106 | output_file = "dpo_data_test.json" if test_mode else "dpo_data.json"

107 | with open(output_file, "w", encoding="utf-8") as f:

108 | json.dump(dpo_data, f, ensure_ascii=False, indent=2)

109 |

110 | logger.info(f"DPO数据已生成并保存到 {output_file}")

111 | logger.info(f"缓存已更新并保存到 dpo_cache.json")

112 | logger.info(f"错误缓存已保存到 error_cache.json")

113 |

114 | end_time = time.time()

115 | execution_time = end_time - start_time

116 | logger.info(f"总执行时间: {execution_time:.2f} 秒")

117 |

118 |

119 | if __name__ == "__main__":

120 | parser = argparse.ArgumentParser(description="生成DPO数据")

121 | parser.add_argument("--concurrency", type=int, default=10, help="并发数量")

122 | parser.add_argument("--test", action="store_true", help="测试模式")

123 | args = parser.parse_args()

124 |

125 | logger.add("generate_dpo_data.log", rotation="500 MB")

126 | start_time = time.time()

127 | asyncio.run(main(args.concurrency, args.test))

128 |

--------------------------------------------------------------------------------

/Journey/Day12/Day12.ipynb:

--------------------------------------------------------------------------------

1 | {

2 | "cells": [

3 | {

4 | "cell_type": "markdown",

5 | "metadata": {},

6 | "source": [

7 | "之前说准备好`DPO`数据就着手开始自己`DIY`一下训练的实现了(因为`litgpt`库暂时还没有集成相关实现)。\n",

8 | "虽说是`DIY`但是纯从零手撸的成本还是有点高的,因此还是打算参考已有的实现来弄,比如:\n",

9 | "- [eric-mitchell/direct-preference-optimization: Reference implementation for DPO (Direct Preference Optimization)](https://github.com/eric-mitchell/direct-preference-optimization)\n",

10 | "- [huggingface的trl库里的实现](https://github.com/huggingface/trl/blob/main/trl/trainer/dpo_trainer.py)\n",

11 | "\n",

12 | "`transformers`库毕竟是大主流,因此还是优先考虑基于`transformers`库的`API`来实现。\n",

13 | "\n",

14 | "那么面临的第一个问题就是需要将`litgpt`框架训练的模型转换为`huggingface`库的模型格式。\n",

15 | "\n",

16 | "而在这个过程中我遇到了一个**意想不到的坑**,直接给我整**破防**了。\n",

17 | "\n",

18 | "大家听我慢慢道来。\n",

19 | "\n"

20 | ]

21 | },

22 | {

23 | "cell_type": "markdown",

24 | "metadata": {},

25 | "source": [

26 | "## litgpt模型转换到huggingface format\n",

27 | "`litgpt`框架本身考虑得很周全,它从简化模型实现的角度完全基于`torch`实现的[model.py](https://github.com/Lightning-AI/litgpt/blob/main/litgpt/model.py)\n",

28 | "\n",

29 | "同时也提供了将`checkpoint`转换为`huggingface`模型格式的`API`:"

30 | ]

31 | },

32 | {

33 | "cell_type": "code",

34 | "execution_count": 2,

35 | "metadata": {},

36 | "outputs": [],

37 | "source": [

38 | "# ! litgpt convert_from_litgpt input_checkpoint_dir output_dir"

39 | ]

40 | },

41 | {

42 | "cell_type": "markdown",

43 | "metadata": {},

44 | "source": [

45 | "这里会得到一个`model.pth`文件,为了后续加载方便,大家可以直接改名为`pytorch_model.bin`。\n",

46 | "\n",

47 | "另外需要注意的是`transformers`库依赖`config.json`文件,如果大家的模型架构选择的是使用`litgpt`框架已经支持的`huggingface`上的模型,那么可以直接去下载;但如果是自己定义的模型架构,那么就需要大家自己动手来写这个`config.json`文件了。\n",

48 | "\n",

49 | "> 后面我会写一个简单的脚本,基于`litgpt`框架的`config.yaml`文件来生成`config.json`文件,可能在一些场景下能具备通用性。\n",

50 | "\n",

51 | "\n",

52 | "## transformers库模型加载\n",

53 | " \n",

54 | "模型的转换还是比较简单且顺利的,但是按照[litgpt的convert文档](https://github.com/Lightning-AI/litgpt/blob/main/tutorials/convert_lit_models.md),通过`transformers`库加载转换后的模型文件的时候,问题来了。\n",

55 | "\n",

56 | "我的到了一个意想不到的报错,追溯到的是`transformers`库里对模型参数尺寸检查的这段代码:\n",

57 | "\n",

58 | "\n",

59 | "\n",

60 | "**它强制要求了`embedding`的向量尺寸必须正好等于注意力头数`n_heads`和注意力头尺寸`head_size`的乘积**。\n",

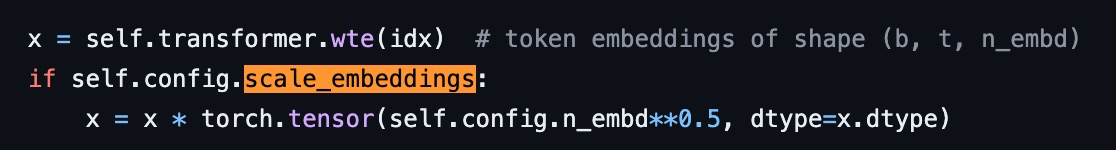

61 | "\n",

62 | "原因是他们不知出于什么考虑,在对`attention`的`kqv`转换矩阵实现的时候,做了一个简化,大家看下图里我用红框标出的地方。\n",

63 | "\n",

64 | "\n",

65 | "\n",

66 | "\n",

67 | "如果不理解的话,再对比看下面这张图应当就能理解了,是`Karpathy`大神的`nanoGPT`里同样模块的实现。\n",

68 | "\n",

69 | "\n",

70 | "\n",

71 | "但凡看过原始论文里的公式推导就会知道,`hidden_size = n_heads * head_size`这个要求是**完全没有必要**的。\n",

72 | "\n",

73 | "`W_k/W_q/W_v`矩阵理论上可以将`hidden_size`投影到任何维度上去,只要最后再通过`W_o`的线性层映射回`hidden_size`即可。\n",

74 | "\n",

75 | "而`transformers`库的实现里将这个任何维度简化为了`n_heads * head_size`,这对我这种需要从自定义的模型架构转换过来的场景造成了**毁灭性打击**🤦♂️。\n",

76 | "\n",

77 | "因为我当时**拍脑袋**定的`0.044b`参数模型里,`embedding`维度选的`768`,`n_heads`是`6`,而`head_size`定了个`48`,导致这里没有办法加载了。\n",

78 | "\n",

79 | "我当然可以通过改源码的方式来弥补这个问题,但是如果我希望我的模型能够被更多使用`transformers`库的人使用,这个方式就不合适了。\n",

80 | "\n",

81 | "最保险的方式是按照它这个**不合理的**要求来调整我的模型架构,从而得到一个满足`hidden_size = n_heads * head_size`的模型。\n",

82 | "\n",

83 | "## 教训总结\n",

84 | "\n",

85 | "\n",

86 | "没办法,我最终选择了重新预训练我的故事模型;坑虽然踩了,但是也得到了一些收获。\n",

87 | "\n",

88 | "大部分人一般情况下主要是基于`huggingface`上已有的模型架构来训练,我这类**自定义模型架构**的情况相对少见,因此踩坑踩得有点狠。\n",

89 | "\n",

90 | "即便是`transformers`库这样的大主流,也难免会有一些设计不合理的地方。\n",

91 | "\n",

92 | "也提醒我,对开源库的使用,如果时间精力允许,还是要**多花点功夫看看源码**,理解其背后的设计思想,这样在遇到问题的时候才能从更本质的地方找到解决方案。\n"

93 | ]

94 | },

95 | {

96 | "cell_type": "markdown",

97 | "metadata": {},

98 | "source": [

99 | "> 一个更让我欲哭无泪的事实:\n",

100 | "> \n",

101 | "> 就在我的新架构模型快完成预训练的时候,\n",

102 | "> 我发现这个不合理的逻辑其实在[这个PR](https://github.com/huggingface/transformers/pull/32857)里得到了修复。\n",

103 | "> \n",

104 | "> 在`transformers`库的最新版本里已经没有这个问题了。\n",

105 | "> \n",

106 | "> 合着是我更新库不够积极呗?🤷♂️"

107 | ]

108 | },

109 | {

110 | "cell_type": "markdown",

111 | "metadata": {},

112 | "source": []

113 | }

114 | ],

115 | "metadata": {

116 | "kernelspec": {

117 | "display_name": "bigmodel",

118 | "language": "python",

119 | "name": "python3"

120 | },

121 | "language_info": {

122 | "codemirror_mode": {

123 | "name": "ipython",

124 | "version": 3

125 | },

126 | "file_extension": ".py",

127 | "mimetype": "text/x-python",

128 | "name": "python",

129 | "nbconvert_exporter": "python",

130 | "pygments_lexer": "ipython3",

131 | "version": "3.10.10"

132 | }

133 | },

134 | "nbformat": 4,

135 | "nbformat_minor": 2

136 | }

137 |

--------------------------------------------------------------------------------

/Journey/Day10/Day10.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀 Day10

2 |

3 | 中秋节到啦,假期不太有机会跑代码,打算码码字来讲一讲自己对**大模型**以及**人工智能**的一些拙见。

4 |

5 | 可能有些零碎或者发散,但都是自己平时工作或者学习过程中**反复在思考**的事情,一方面做个记录,一方面希望能抛砖引玉吧。

6 |

7 |

8 |

9 | ## 自回归模型的这一波AI崛起和以往有什么不同

10 |

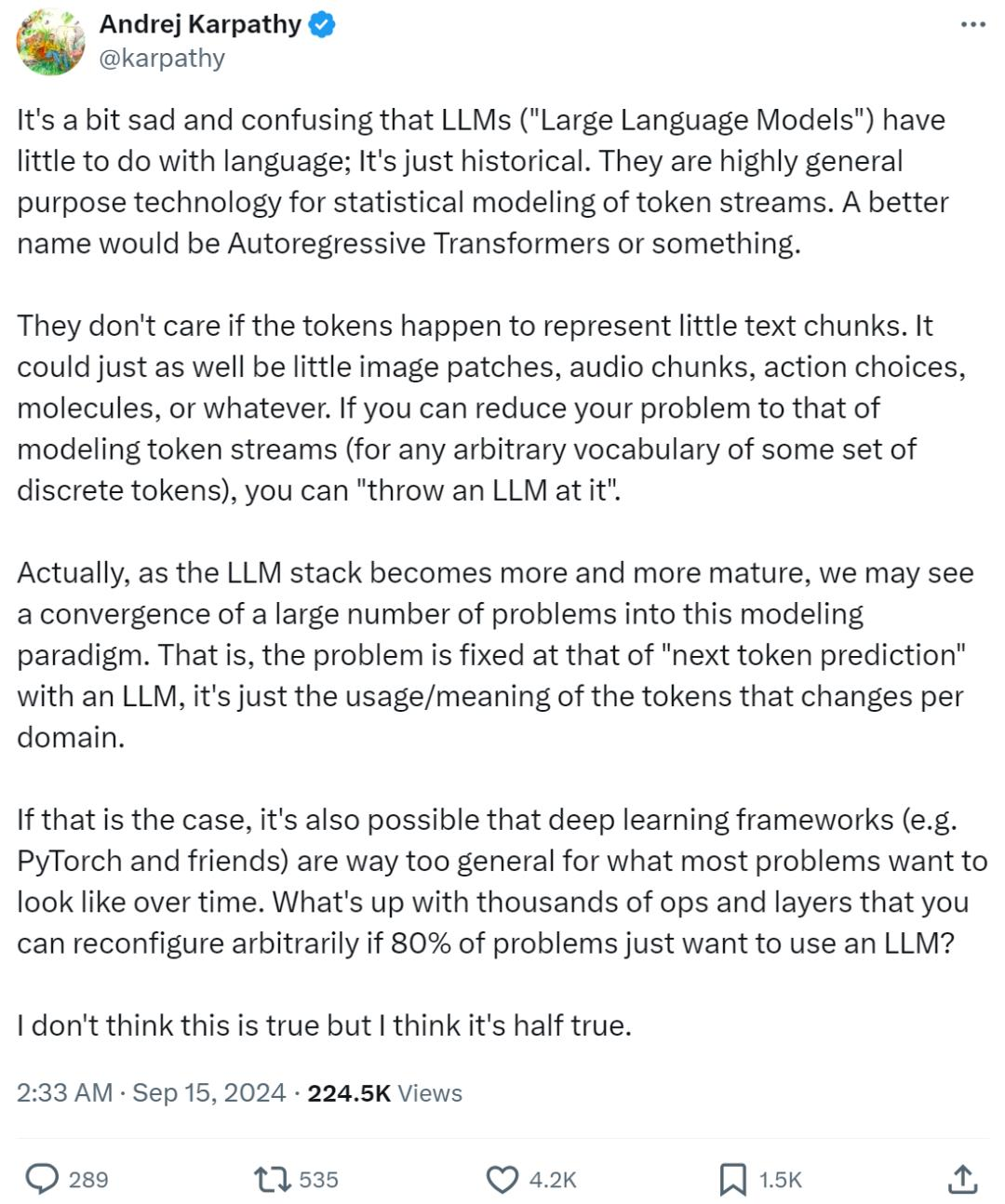

11 | 这里特地用了**自回归模型**而没有用**大(语言)模型**,是因为这两天看到网上`Karpathy`大神关于「**大语言模型**应该纠正命名」这一引发热议的观点(详见下面的动态原文👇)。

12 |

13 |

14 |

15 | 大意如下:

16 |

17 | >「大型语言模型(`LLM`)名字虽然带有语言二字,但它们其实与语言关系并不大,这只是命名的历史遗留问题,更确切的名字应该是**自回归 Transformers** (`Autoregressive Transformers`)或者其他类似的表达。

18 | >

19 | >大家现在口中提到的`LLM` 更多是一种通用的统计建模技术:通过自回归的`Transformer`结构来模拟预测`token`流,而这些 `token`可以理论上可以是文本、图片、音频、动作、甚至是分子等任何东西。

20 | >

21 | >换句话说,只要能将实际问题转化为对一系列离散`token`的模拟,理论上都可以应用当下被称为`LLM`的技术路径来解决。

22 |

23 | K神的这个观点我个人赞成**一半**。

24 |

25 | 从**纯粹的底层技术路径**角度来看,这个说法没有一点问题。

26 |

27 | 正如`Elon Musk`也同时发声所指出的:`Multimodal LLM(多模态大语言模型)`这种叫法实在很愚蠢,完全是自相矛盾的。

28 |

29 | 当下对于**大规模参数模型**+**大规模训练数据**结合`Next Token Prediction`进行预训练并且跟随后续的`SFT`/`RLHF`这一完整技术范式的应用,已经不仅仅限于文本数据了,而`LLM`里的`Language`这个词却很容易限制甚至说误导人们的思维在**文本**层面。

30 |

31 | 然而,尽管`Language`的概念应当且已经被从文本扩展到了图片、音频等更宽泛的范畴,这次以`ChatGPT`为引爆点的大模型革命之所以如此成功,很重要的一个不该被忽视的点在于,它在**应用层**让「语言」(这里我指的就是狭义的人类语言——文本或者语音)作为**交互的接口**成为了可能。

32 |

33 | 现在最主流的方向诸如`ChatGPT`以及其他类似的`AI Assistant`,又或是`Text2Image`、`Text2Video`等生成式应用,在其应用阶段甚至应用内部模块的构建阶段,我们都绕不开需要要通过人类的语言和它们底层的模型进行**交流**。

34 |

35 | 无论在大模型黑盒的内部是否建立了**自己的语言**,甚至说产生了**自己的意识**,只要我们还需要或者说还能掌控他们,那么**人类语言**在模型运转机制中的嵌入/耦合就是一个绕不开的必要条件。从这个角度讲,强调`LLM`中的人类`Language`在我看来依然有必要的。

36 |

37 | 扯得有点远哈,再稍微说回**人类语言作为交互接口**这个事儿,这是我个人认为这次「AI革命」中最为颠覆的一个点。

38 |

39 | 最末端的应用侧我就不多说了,用过`GPT4`、`Claude`或者玩过`Midjourney`、`Sora`的应该都深有体会:**人工智障**忽然能听懂人话了,尽管还不是那么利索那么聪明,但是显然已经不能用**智障**来形容人家了。

40 |

41 | 从应用的开发侧来讲,事情也发生了一些变化。

42 |

43 | 人工智能领域中纠缠了多年的**符号主义**、**联结主义**、**行为主义**,撇开其中抽象而复杂的底层逻辑,单看各个路径或者多个路径结合所构建出来的人工智能系统级应用(这里更多地是指类似`Bot`、`Agent`一类的产品形态),交互的**生硬**、**死板**是任何非专业人士也能一眼指出的致命缺陷。

44 |

45 | 私以为其中的一个原因:无论是大量规则构建的**专家系统**还是**(判别式)深度学习模型**为基础模块的**神经网络**系统,都在其内在的某个层面上,难以避免需要以严格的**符号表达或者说结构化数据**来实现通信,说人话就是整个系统需要依赖**类编程语言**这样的「接口」给串联起来。

46 |

47 | > 可以说**符号主义**从来就没有真正消亡,它只是被削减了话语权,退居幕后隐藏得更深了。

48 |

49 | 而**大语言模型**为代表的**生成式模型**的异军突起,给这个问题提供了一个此前想都不敢想的可能性:那就是人类的自然语言也可以作为「接口」了。

50 |

51 | 为`Agent`系统做过`Prompt Engineering`,或者给大模型做过`SFT`之类的`Finetuning`的朋友,或许能感受到这些开发和以往的一些不同。

52 |

53 | 说来挺有意思,人类语言本质也是一种**符号**,但又天然具备了**模糊性**。

54 |

55 | 如果将纯`Symbolic`的东西比做**冰**,`Neural`的东西比做**水**,那么人类语言就好像是**冰水混合物**般的存在,能更加自然地在两者间来回转换。

56 |

57 | 在这个前提下,开发工作的重心之一变成了如何**更自如、更精确地引导这个双向转换的过程**。

58 |

59 | 我不敢也没有资格断言这个方式就一定能解决此前人工智能系统里的所有问题,但至少让大家看到了一种非常不一样的前景。

60 |

61 | 表达和比喻或许都有些抽象,但意思就是这么个意思,要是没看懂或者觉得我在胡说八道,大家权当一乐,不必太较真。

62 |

63 |

64 |

65 | ## 对我们的工作生活到底能有多大影响

66 |

67 | 有很多唱衰大模型这一波的,认为应用还是很难落地,我觉得得更具体地看对**落地**的定义。

68 |

69 | 如果说以`AGI`或者零门槛的「傻瓜式」应用为标准,那么的确现在的应用落地情况还远远达不到。

70 |

71 | 目前基于大模型技术的能带来真正增益的应用(所谓**新质生产力**)都多少有一定的门槛:

72 |

73 | ### 第一道槛是认知门槛

74 |

75 | `Cursor`代码辑器这阵子很火,起初我以为是来了一波营销做得好,试用之后发现和两年前体验时确实不可同日而语,很增效、很智能,于是果断氪金入了坑。

76 |

77 | 作为`AI`从业者,我身边不乏高级程序员,但是像这样能极大提升工作效率的工具,我发现身边并没有太多人在使用。

78 |

79 | 他们或许有所耳闻,但对于它的`AI`能做到什么程度一无所知。

80 |

81 | 这还是我们这群每天在进行人工智能研发的群体里的情况。

82 |

83 | 再比如此前一度红得发紫的`Kimi`,可以说目前也只在一部分白领阶层有一定的知名度,对于更广大的普通老百姓而言,可能顶多就是在短视频平台上能刷到一些展示和`GPT`如何聊天的展示或者`AI`生成的逼真的图片/视频。

84 |

85 | 他们依然会觉得这个东西一定是离自己遥远的高端科技产品,自己不会有机会接触得到或者用得上。

86 |

87 | 他们自然也不会知道即使自己从没学过英语,也可以下一个免费的`APP`,通过不算太复杂的方式让一个`AI`助手辅导自己上小学的孩子的英语听说读写,效果不会逊色几千块的学习机多少。

88 |

89 | 从这个方面来讲,我觉得`AI`技术的**科普**是一件非常**迫在眉睫**的事情。

90 |

91 | 对一个`AI`应用而言,更庞大的、长尾的应用群体可以成为非常重要的发展助力。

92 |

93 | 而对个人而言,等到`AI`工具的使用已经和曾经的`Office`套件一样成为**基础技能**的时候才意识到需要学起来、用起来,可能已经落后了一大步了。

94 |

95 | ### 第二道槛才是技术门槛

96 |

97 | 这里的**技术**并非是编程这类具备专业门槛的技术,而是目前的`AI`应用的使用方式层面的技巧。

98 |

99 | 那些需要「**魔法**」/「**梯子**」的情况我就不多说了,大家懂的都懂。

100 |

101 | 可即便是国内可以接触到的面向C端的`AI Assistant`产品,能真正会用并且用好的人恐怕比例不大。

102 |

103 | 更别提那些完全免费但需要有**硬件支持和部署能力**的开源大模型了,否则像李某舟这样**锋利的镰刀**就不会出现了。

104 |

105 | 光是写`Prompt`这件看似只要会说人话就能干的事儿,其实不但需要对大模型的**技术和概念**有一定的了解,还需要大量**科学的实验和总结**。

106 |

107 | 所以,这两道门槛的存在导致了当下大模型为基础的`AI`应用现状是**割裂**的:头部的**早鸟**们要么已经在挖掘人工智能提效个人生产力的路上一路狂飞,要么已经开始利用信息差**割起了韭菜**;而绝大多数人还没有意识到变革已经在悄悄发生。

108 |

109 |

110 |

111 | ## 大模型出现后,AGI(通用人工智能)还有多远

112 |

113 | 我个人的工作算是`AGI`方向的,尽管我前面对于大模型的应用前景持乐观态度,但对于「**大模型是否带领我们走向AGI**」这件事儿还是存疑的。

114 |

115 | 首先,目前以大模型为基座的`Agent`系统还是在解决一些被动输入的任务,缺乏一个**内在的动力系统**提供自驱力。

116 |

117 | 即使推理能力强如`GPT-o1`,在没有任何外界指令的时候整个系统是静止的,简单来说不具备真正意义上的主动思考的能力。

118 |

119 | 这个问题的解决路径或许不在大模型的技术栈范畴。国内外也有一些前沿的研究在关注这块的内容,例如给机器构建类似人类的**价值体系**来让它具备自我驱动的可能,大家感兴趣的话可以去了解一下。

120 |

121 | 其次,性能是大模型的一个**硬伤**。

122 |

123 | 虽然**力大砖飞**的`Scaling Law`的的确确让大家看到了**大力出奇迹**的可能性,但是我们也不要忘了另一句话:「**天下武功,唯快不破**」。

124 |

125 | 但这反而也给我们提供了更多的想象空间:量变引发质变,其实「**速变**」也可以,这在计算机技术的发展历史上也得到过很多次的证明。

126 |

127 | 我们设想一下,如果能力最强的大模型在推理速度方面有了量级上的突破,那么一个以此为基础的多`Agent`系统能求解的问题复杂度可能要远超我们的想象。

128 |

129 | 最后是**硬件层面的门槛**,这可能已经上升到国家战略层面的博弈了。

130 |

131 | 这个问题和上面的**性能问题**有一定的关联,我个人对硬件技术一窍不通,只能从其他的角度来思考可能的解决途径。

132 |

133 | 于是我对于`SLM`(**小语言模型**)的相关研究产生了兴趣,其实`GPT2`的出现就已经一定程度地证明了**小尺寸的语言模型**也是具备很大的潜力的。

134 |

135 | 如果没有「**速度超快的最强大模型**」作为通用基座来构建系统,那么许多个**能力单一但卓越的小模型**是否能成为无限接近的平替呢?性能和硬件的问题同时得到了解决。

136 |

137 |

138 |

139 | ## 写在最后

140 |

141 | 不知不觉瞎扯的有点多了。

142 |

143 | 还是强调一下,个人水平有限,以上纯属自己个人的胡思乱想,可能有很多异想天开甚至错误的地方。

144 |

145 | 尽管历史证明,每一次人工智能的热潮都将逐渐降温和退去,但每次都将下一次的起点拉高了。

146 |

147 | 因此我对人工智能的未来还是十分乐观的,也很庆幸能在整个领域工作。

148 |

149 | 最后祝大家**中秋快乐**!

150 |

--------------------------------------------------------------------------------

/Experiments/configs/microstories/pretrain.yaml:

--------------------------------------------------------------------------------

1 | # The name of the model to pretrain. Choose from names in ``litgpt.config``. Mutually exclusive with

2 | # ``model_config``. (type: Optional[str], default: null)

3 | model_name: microstories

4 |

5 | # A ``litgpt.Config`` object to define the model architecture. Mutually exclusive with

6 | # ``model_config``. (type: Optional[Config], default: null)

7 | model_config:

8 | name: microstories

9 | hf_config: {}

10 | scale_embeddings: false

11 | block_size: 512

12 | padded_vocab_size: 65024

13 | vocab_size: 64798

14 | n_layer: 6

15 | n_head: 6

16 | n_query_groups: 6

17 | n_embd: 512

18 | head_size: 48

19 | rotary_percentage: 1.0

20 | parallel_residual: false

21 | bias: false

22 | norm_class_name: RMSNorm

23 | mlp_class_name: LLaMAMLP

24 | intermediate_size: 768

25 |

26 | # Directory in which to save checkpoints and logs. If running in a Lightning Studio Job, look for it in

27 | # /teamspace/jobs//share. (type: , default: out/pretrain)

28 | out_dir: Chinese_LLM_From_Scratch/Experiments/Output/pretrain/microstories

29 |

30 | # The precision to use for pretraining. Possible choices: "bf16-true", "bf16-mixed", "32-true". (type: Optional[str], default: null)

31 | precision: bf16-mixed

32 |

33 | # Optional path to a checkpoint directory to initialize the model from.

34 | # Useful for continued pretraining. Mutually exclusive with ``resume``. (type: Optional[Path], default: null)

35 | initial_checkpoint_dir:

36 |

37 | # Path to a checkpoint directory to resume from in case training was interrupted, or ``True`` to resume

38 | # from the latest checkpoint in ``out_dir``. An error will be raised if no checkpoint is found. Passing

39 | # ``'auto'`` will resume from the latest checkpoint but not error if no checkpoint exists.

40 | # (type: Union[bool, Literal["auto"], Path], default: False)

41 | resume: True

42 |

43 | # Data-related arguments. If not provided, the default is ``litgpt.data.TinyLlama``.

44 | data:

45 | # TinyStories

46 | class_path: litgpt.data.LitData

47 | init_args:

48 | data_path: Chinese_LLM_From_Scratch/Data/TinyStoriesChinese/processed_data

49 | split_names:

50 | - train

51 | - val

52 |

53 | # Training-related arguments. See ``litgpt.args.TrainArgs`` for details

54 | train:

55 | # Number of optimizer steps between saving checkpoints (type: Optional[int], default: 1000)

56 | save_interval: 1000

57 |

58 | # Number of iterations between logging calls (type: int, default: 1)

59 | log_interval: 1

60 |

61 | # Number of samples between optimizer steps across data-parallel ranks (type: int, default: 512)

62 | global_batch_size: 512

63 |

64 | # Number of samples per data-parallel rank (type: int, default: 4)

65 | micro_batch_size: 32

66 |

67 | # Number of iterations with learning rate warmup active (type: int, default: 2000)

68 | lr_warmup_steps: 1000

69 |

70 | # Number of epochs to train on (type: Optional[int], default: null)

71 | epochs:

72 |

73 | # Total number of tokens to train on (type: Optional[int], default: 3000000000000)

74 | max_tokens: 3000000000000

75 |

76 | # Limits the number of optimizer steps to run. (type: Optional[int], default: null)

77 | max_steps:

78 |

79 | # Limits the length of samples. Off by default (type: Optional[int], default: null)

80 | max_seq_length: 512

81 |

82 | # Whether to tie the embedding weights with the language modeling head weights. (type: Optional[bool], default: False)

83 | tie_embeddings: true

84 |

85 | # (type: Optional[float], default: 1.0)

86 | max_norm: 1.0

87 |

88 | # (type: float, default: 4e-05)

89 | min_lr: 0.0

90 |

91 | # Evaluation-related arguments. See ``litgpt.args.EvalArgs`` for details

92 | eval:

93 | # Number of optimizer steps between evaluation calls (type: int, default: 1000)

94 | interval: 2000

95 |

96 | # Number of tokens to generate (type: Optional[int], default: null)

97 | max_new_tokens:

98 |

99 | # Number of iterations (type: int, default: 100)

100 | max_iters: 100

101 |

102 | # Whether to evaluate on the validation set at the beginning of the training

103 | initial_validation: false

104 |

105 | # Whether to evaluate on the validation set at the end the training

106 | final_validation: false

107 |

108 | # Optimizer-related arguments

109 | optimizer:

110 | class_path: torch.optim.AdamW

111 |

112 | init_args:

113 | # (type: float, default: 0.001)

114 | lr: 0.0005

115 |

116 | # (type: float, default: 0.01)

117 | weight_decay: 0.1

118 |

119 | # (type: tuple, default: (0.9,0.999))

120 | betas:

121 | - 0.9

122 | - 0.95

123 |

124 | # How many devices/GPUs to use. Uses all GPUs by default. (type: Union[int, str], default: auto)

125 | devices: auto

126 |

127 | # How many nodes to use. (type: int, default: 1)

128 | num_nodes: 1

129 |

130 | # Optional path to the tokenizer dir that was used for preprocessing the dataset. Only some data

131 | # module require this. (type: Optional[Path], default: null)

132 | tokenizer_dir: Chinese_LLM_From_Scratch/References/chatglm3-6b

133 |

134 | # The name of the logger to send metrics to. (type: Literal['wandb', 'tensorboard', 'csv'], default: tensorboard)

135 | logger_name: wandb

136 |

137 | # The random seed to use for reproducibility. (type: int, default: 42)

138 | seed: 42

139 |

--------------------------------------------------------------------------------

/Journey/Day01/Day01.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀Day01

2 |

3 | ## 参考项目搜集

4 |

5 | - [nano-llama31](https://github.com/karpathy/nano-llama31/tree/master)

6 |

7 | - Karpathy大神的项目,用700多行代码完成了一个尽可能低依赖的最简洁`Llama3.1`实现,能够进行训练、微调和推理(跪拜🧎♂️)

8 |

9 | - [TinyLlama](https://github.com/jzhang38/TinyLlama/blob/main/README_zh-CN.md)

10 |

11 | - `TinyLlama`项目在3万亿tokens上进行预训练,构建一个拥有`1.1B`参数的`Llama`模型

12 |

13 | - 采用了与`Llama 2`完全相同的架构和分词器

14 |

15 | - [baby-llama2-chinese](https://github.com/DLLXW/baby-llama2-chinese?tab=readme-ov-file)

16 |

17 | - 中文数据从头训练+SFT的一个小参数实现,可以在`24G`单卡运行;目前包含:**预训练**、**SFT指令微调**,**奖励模型**以及**强化学习**待做(但似乎已经断更3个月)

18 |

19 | - 基于`Llama 2`架构

20 |

21 | - [ChatLM-mini-Chinese](https://github.com/charent/ChatLM-mini-Chinese)

22 |

23 | - 中文对话0.2B小模型(ChatLM-Chinese-0.2B),开源所有**数据集来源、数据清洗、tokenizer训练、模型预训练、SFT指令微调、RLHF优化**等流程的全部代码

24 |

25 | - 支持下游任务`sft`微调,给出了三元组信息抽取任务的微调示例

26 |

27 | - 有意思的是作者选的模型架构是`T5`,还有另一个衍生项目用的是`phi-2`架构

28 |

29 | 除了第一个K神的项目是关于模型实现,后面三个项目的`README.md`文件看一遍下来,对于后续整体的实现流程心里便能有了一个大致的概念。

30 |

31 | 之后遇到了实际问题时再去里面寻找细节来参考。

32 |

33 | ## 数据集确定

34 |

35 | 这个计划的主要目地是能从头熟悉一遍大模型训练的流程,所以不需要收集大量的文本数据集(我显然也没有那么多的GPU资源能让我在超大的数据集上快速训练🤷♂️)

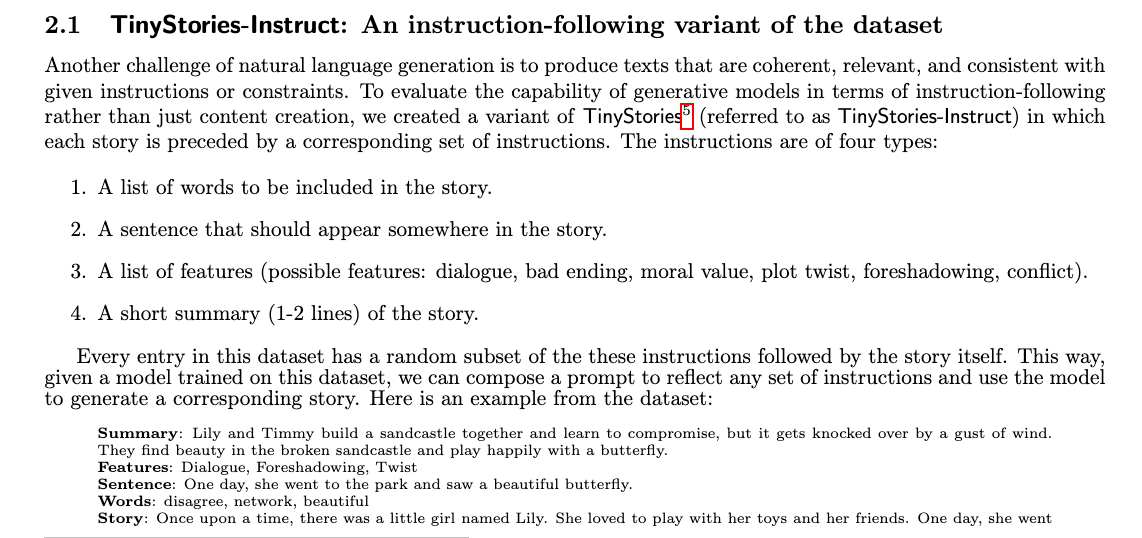

36 |

37 | 之前看到微软的一篇论文[TinyStories](https://arxiv.org/abs/2305.07759),探索的是语言模型在多小的情况下还能流利地讲故事。

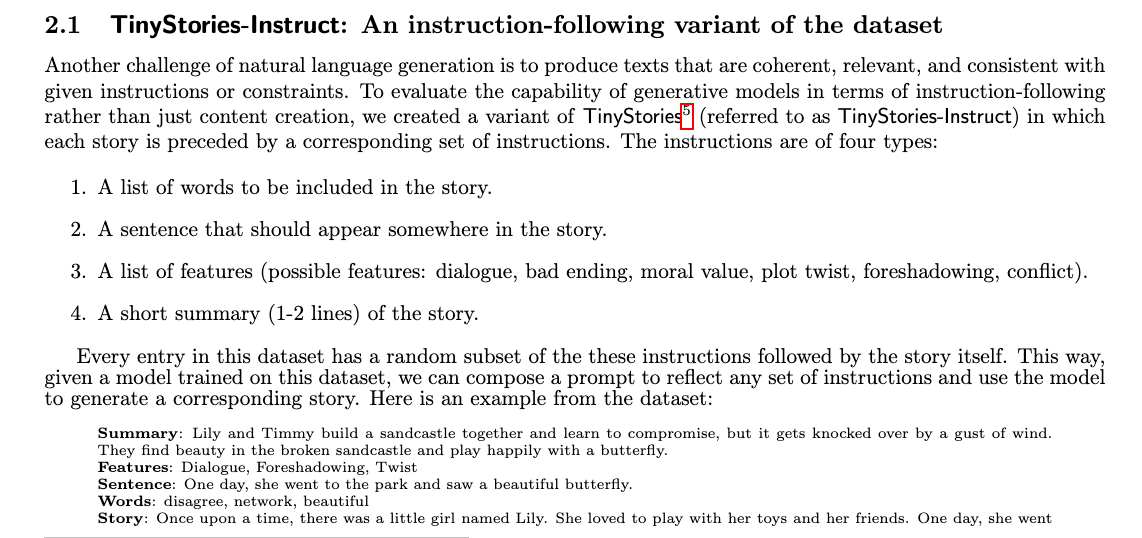

38 |

39 | 为此他们构造了一个小数据集,包含了一些小故事,我觉得这个数据集很适合我这个项目的目标,所以决定使用这个数据集。

40 |

41 | 由于希望在中文数据集上进行实践,所以原本的打算是通过机器翻译把数据集翻译一遍。

42 |

43 | 结果发现已经有人做了这个工作,所以我打算直接使用这个翻译好的[数据集](https://huggingface.co/datasets/adam89/TinyStoriesChinese)。🙏感谢大佬们的无私奉献。

44 |

45 | 一个样例如下:

46 | ```json

47 | {

48 | "story": "\n\nLily and Ben are friends. They like to play in the park. One day, they see a big tree with a swing. Lily wants to try the swing. She runs to the tree and climbs on the swing.\n\"Push me, Ben!\" she says. Ben pushes her gently. Lily feels happy. She swings higher and higher. She laughs and shouts.\nBen watches Lily. He thinks she is cute. He wants to swing too. He waits for Lily to stop. But Lily does not stop. She swings faster and faster. She is having too much fun.\n\"Can I swing too, Lily?\" Ben asks. Lily does not hear him. She is too busy swinging. Ben feels sad. He walks away.\nLily swings so high that she loses her grip. She falls off the swing. She lands on the ground. She hurts her foot. She cries.\n\"Ow, ow, ow!\" she says. She looks for Ben. She wants him to help her. But Ben is not there. He is gone.\nLily feels sorry. She wishes she had shared the swing with Ben. She wishes he was there to hug her. She limps to the tree. She sees something hanging from a branch. It is Ben's hat. He left it for her.\nLily smiles. She thinks Ben is nice. She puts on his hat. She hopes he will come back. She wants to say sorry. She wants to be friends again.",

49 | "instruction": {

50 | "prompt:": "Write a short story (3-5 paragraphs) which only uses very simple words that a 3 year old child would understand. The story should use the verb \"hang\", the noun \"foot\" and the adjective \"cute\". The story has the following features: the story should contain at least one dialogue. Remember to only use simple words!\n\nPossible story:",

51 | "words": [

52 | "hang",

53 | "foot",

54 | "cute"

55 | ],

56 | "features": [

57 | "Dialogue"

58 | ]

59 | },

60 | "summary": "Lily and Ben play in the park and Lily gets too caught up in swinging, causing Ben to leave. Lily falls off the swing and hurts herself, but Ben leaves his hat for her as a kind gesture.",

61 | "source": "GPT-4",

62 | "story_zh": "莉莉和本是朋友。他们喜欢在公园里玩。有一天,他们在一棵大树下看到了一个秋千。莉莉想试试那个秋千。她跑到树下,爬上了秋千。\n\"推我,本!\"她说。本轻轻地推了她一下。莉莉感到很开心。她越荡越高,笑着喊叫。\n本看着莉莉。他觉得她很可爱。他也想荡秋千。他在莉莉停下来之后等着。但是莉莉没有停下来。她越荡越快。她玩得太高兴了。\n\"我也可以荡秋千吗,莉莉?\"本问。莉莉没听到他的话。她忙着荡秋千。本觉得很难过。他走开了。\n莉莉荡得太高,失去了平衡。她从秋千上摔下来,落在地上。她扭伤了脚。她哭了起来。\n\"哎呀,哎呀,哎呀!\"她说。她在找本。她希望他能帮助她。但本不在那里。他走了。\n莉莉感到很抱歉。她希望她能和本分享秋千。她希望他在那里拥抱她。她一瘸一拐地走到树下。她看到有什么东西挂在树枝上。那是本的帽子。他留给她的。\n莉莉笑了。她觉得本很好。她戴上了他的帽子。她希望他会回来。她想道歉。她想再次成为朋友。"

63 | }

64 | ```

65 |

66 | ### 数据清洗

67 | 在标准的流程里,**文本数据量会非常大**且来自于不同的来源,无论从**质量**上和**内容重复度**上都需要进行清洗。

68 |

69 | 由于这个数据集是一个单独的小数据集,所以我打算先**跳过这一步**。

70 |

71 | 不过这里还是简单说一下数据清洗的一些方法:

72 | - 去除重复数据

73 | - 当量级巨大的时候一般会采用`SimHash`或者`MinHash`的方法

74 | - 短文本过滤(太短的文本对于模型训练而言意义不大,可以直接去除)

75 | - 去除低质量数据

76 | - 一般会采用一些规则或者模型来判断文本的质量,例如:**语法错误、拼写错误、不合理内容、无意义数据**等

77 | - 这一步的成本会比较高,因为需要人工标注或者构建模型(但高质量的数据对于模型训练是非常重要的)

78 |

79 | ## 训练框架选择

80 |

81 | 一个好的训练框架还是很重要的。

82 |

83 | 在上面的参考项目中发现了这个名为[⚡️litgpt](https://github.com/Lightning-AI/litgpt/tree/main)的大模型预训练/微调/部署框架,而且其模型实现代码是基于上面Karpahty大神的`nano-llama31`项目。

84 |

85 | 框架已经支持了`20+`大模型,包括最新的`Llama 3.1`。大概看了一下代码仓库,结构清晰且简洁。

86 |

87 |

88 |

89 | 另外一个框架是[Llama-Factory](https://github.com/hiyouga/LLaMA-Factory/blob/main/README_zh.md),已经有29k的stars,支持`100+`大模型(尤其是对国内的开源模型支持很好)。

90 |

91 |

92 |

93 | 所以我决定花时间简单了解一下这两个框架然后选一个作为后续的训练工具。

94 |

95 | 个人觉得如今的大模型训练框架已经非常成熟,大家都在追求**更高的性能和更好的易用性**,所以**选择一个好的框架**对于后续的工作来说是非常重要的。

96 |

97 | 也没有必要自己造轮子,毕竟大家都在造了,我们只需要选择一个适合自己的就好了。

98 |

99 | > 经过调研发现`Llama-Factory`似乎~~只能支持和发布的开源模型参数一致的模型(也可能是我看的不仔细没有找到修改配置的地方,如果是这样欢迎大家指出)~~。

100 | >

101 | > 而litgpt则支持自定义模型参数,

102 | > 由于我后面是希望限制参数量级在一个很小的范畴,所以决定使用litgpt作为后续的训练工具。

103 |

104 | ⚠️更新:

105 |

106 | 后续也找到了`Llama-Factory`里从0训练并且修改参数的方法(修改`config.json`的配置,并且添加`train_from_scratch=True`参数),

107 |

108 | 但`litgpt`的代码架构更加简洁,没有过多的抽象和封装,并且有一些训练加速的优化(`Llama-Factory`是基于`transformers`库),

109 |

110 | 因此最后还是决定使用`litgpt`。

111 |

112 | ## 小结

113 | 1. 确定了项目的数据集来源

114 | 2. 了解了一些数据清洗的方法

115 | 3. 选择了`litgpt`作为后续的训练工具

116 | 4. 了解了一些参考项目,对后续的实现流程有了一个大致的概念

117 |

--------------------------------------------------------------------------------

/Journey/Day02/Day02.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀Day02

2 |

3 |

4 |

5 | > 原本是计划直接进入「**数据处理**」阶段的,但由于实在精力有限,就拆成两期:这次先说说`Tokenizer`,下一期说**数据处理**。

6 | >

7 | > 由于`Tokenizer`的训练算是一个相对独立的过程,且训练相对来说比较简单,因此我也打算偷懒先用国内大厂开源的,之后有时间再自己训练实现一个。

8 | >

9 | > 其实**分词器**这块的内容经常容易被大家忽略,但实际上是非常重要的,因为它直接决定了模型的输入,进而影响到模型的训练效果。

10 | >

11 | > 这部分内容我自己此前也没怎么深入研究过,所以这次也是一边学习一边写,权当补课了,如果有错误的地方,欢迎指正。

12 |

13 | ## Tokenizer选择

14 |

15 | **tokenization**是大模型训练的第一步,是将文本转换为模型可以理解的数字表示(后面也能反向decode回来)。

16 |

17 | 其中目前比较主流的是[BPE(Byte Pair Encoding)](https://zhuanlan.zhihu.com/p/424631681)(详细的介绍可以参考链接文章,下面通过例子简单介绍一下原理)。

18 |

19 | **BPE**是一种简单的数据压缩形式,这种方法用数据中不存在的一个字节表示最常出现的连续字节数据。这样的替换需要重建全部原始数据。

20 |

21 | ### BPE简介

22 |

23 | 假设我们要编码如下数据

24 |

25 | > aaabdaaabac

26 |

27 | 字节对“aa”出现次数最多,所以我们用数据中没有出现的字节“Z”替换“aa”得到替换表

28 |

29 | > Z <- aa

30 |

31 | 数据转变为

32 |

33 | > ZabdZabac

34 |

35 | 在这个数据中,字节对“Za”出现的次数最多,我们用另外一个字节“Y”来替换它(这种情况下由于所有的“Z”都将被替换,所以也可以用“Z”来替换“Za”),得到替换表以及数据

36 |

37 | > Z <- aa

38 | > Y <- Za

39 |

40 | > YbdYbac

41 |

42 | 我们再次替换最常出现的字节对得到:

43 |

44 | > Z <- aa

45 | > Y <- Za

46 | > X <- Yb

47 |

48 | > XdXac

49 |

50 | 由于不再有重复出现的字节对,所以这个数据不能再被进一步压缩。

51 |

52 | 解压的时候,就是按照相反的顺序执行替换过程。

53 |

54 |

55 |

56 |

57 |

58 |

59 | ### 测试Tokenizer(以ChatGLM3-6B的tokenizer为例)

60 |

61 |

62 | ```python

63 | from transformers import AutoTokenizer

64 |

65 | tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm3-6b", trust_remote_code=True)

66 | ```

67 |

68 |

69 | 编码

70 |

71 |

72 | ```python

73 | print(tokenizer("这是一个测试"))

74 | ```

75 |

76 |

77 |

78 | ```

79 | {'input_ids': [64790, 64792, 30910, 36037, 32882], 'attention_mask': [1, 1, 1, 1, 1], 'position_ids': [0, 1, 2, 3, 4]}

80 | ```

81 |

82 |

83 |

84 | 反编码

85 |

86 |

87 | ```python

88 | print(tokenizer.decode(tokenizer("这是一个测试")["input_ids"]))

89 | ```

90 |

91 |

92 |

93 | ```

94 | '[gMASK] sop 这是一个测试'

95 | ```

96 |

97 |

98 |

99 | ⚠️这里可以发现反向解码的时候,多出来了`[gMASK]`和`sop`这两个「奇怪」的token,原因下面会讲到。

100 |

101 | 我们看看词表的大小:

102 |

103 |

104 | ```python

105 | print(tokenizer.vocab_size)

106 | ```

107 |

108 |

109 |

110 |

111 | ```

112 | 64798

113 | ```

114 |

115 |

116 |

117 | 这里我们写一个函数,针对数据集里的一行`json`文本做处理,得到整行中文文本的编码数组。

118 |

119 |

120 | ```python

121 | import numpy as np

122 |

123 |

124 | def process_line(line, tokenizer, add_eos=True, dtype=np.uint16):

125 | js = json.loads(line)

126 | story = js["story_zh"]

127 | story = tokenizer.encode(story, add_special_tokens=False)

128 | if add_eos:

129 | story.append(tokenizer.eos_token_id)

130 | # 这里可以用np.unint16,因为我们的vocab_size是小于65536的

131 | arr = np.array(story, dtype=dtype)

132 | return arr

133 | ```

134 |

135 | ❗️这里有几个需要注意的点:

136 | - `add_special_tokens`参数的作用是添加特殊token。

137 | 是chatglm自定义的例如[gMASK]/sop,属于glm架构里特有的(可以参考[这里](https://github.com/THUDM/ChatGLM3/issues/183))。

138 |

139 | 由于我们后续并不使用glm的架构,因此这里不需要添加,**直接设置为False**。

140 | - 需要在末尾加上`eos`标记对应的token_id。

141 | - chatglm3-6b使用的词表大小为`64798`,刚好在uint16的表示范围内,所以上面我们给numpy.array设置了`dtype=np.uint16`。

142 |

143 | 拿一行测试一下:

144 |

145 |

146 | ```python

147 | import json

148 |

149 | with open("../../Data/TinyStoriesChinese/train/data00_zh.jsonl", "r") as f:

150 | for line in f.readlines():

151 | data = process_line(line, tokenizer)

152 | print(data)

153 | print(tokenizer.decode(data))

154 | break

155 | ```

156 | ```

157 | [30910 56623 56623 54542 50154 31761 31155 31633 31815 54534 32693 54662

158 | 55409 31155 35632 31123 31633 34383 57427 47658 54578 34518 31623 55567

159 | 55226 31155 56623 56623 54695 39887 32437 55567 55226 31155 54790 41309

160 | 52624 31123 56856 32660 55567 55226 31155 13 30955 54834 54546 31123

161 | 54613 31404 30955 36213 31155 54613 36660 54563 54834 43881 32024 31155

162 | 56623 56623 32707 54657 33436 31155 54790 54937 56567 40714 31123 38502

163 | 56653 55483 31155 13 54613 32984 56623 56623 31155 54572 31897 54790

164 | 54657 35245 31155 36551 54695 56567 55567 55226 31155 33152 56623 56623

165 | 51556 31797 39055 31155 31694 56623 56623 31631 51556 31155 54790 54937

166 | 56567 54937 54929 31155 54790 55409 40915 34492 54537 31155 13 30955

167 | 54546 32591 56567 55567 55226 55398 31123 56623 56623 31514 30955 54613

168 | 54761 31155 56623 56623 54721 33906 31804 54887 31155 54790 46977 56567

169 | 55567 55226 31155 54613 31897 32960 54597 31155 54572 54942 34675 31155

170 | 13 56623 56623 56567 40915 54589 31123 36467 33501 31155 54790 54708

171 | 55567 55226 54547 57456 32246 31123 36712 34245 31155 54790 56901 55328

172 | 54537 55673 31155 54790 56399 37247 31155 13 30955 58394 56657 31123

173 | 58394 56657 31123 58394 56657 31404 30955 36213 31155 35957 55227 54613

174 | 31155 54790 31772 47554 31934 54790 31155 54688 54613 33551 33892 31155

175 | 54572 34247 31155 13 56623 56623 32707 54657 52992 31155 54790 31772

176 | 54790 54558 54542 54613 32097 55567 55226 31155 54790 31772 33152 33892

177 | 37322 54790 31155 54790 54531 60337 54531 57635 54563 35220 52624 31155

178 | 54790 31857 33277 32086 44829 49102 54547 31155 35328 43352 41147 31155

179 | 54572 42393 32233 31155 13 56623 56623 40466 31155 54790 31897 54613

180 | 33058 31155 54790 55947 32660 31804 41147 31155 54790 31772 38711 33857

181 | 31155 54790 54695 37300 31155 54790 54695 32462 31705 31761 31155 2]

182 | 莉莉和本是朋友。他们喜欢在公园里玩。有一天,他们在一棵大树下看到了一个秋千。莉莉想试试那个秋千。她跑到树下,爬上了秋千。

183 | "推我,本!"她说。本轻轻地推了她一下。莉莉感到很开心。她越荡越高,笑着喊叫。

184 | 本看着莉莉。他觉得她很可爱。他也想荡秋千。他在莉莉停下来之后等着。但是莉莉没有停下来。她越荡越快。她玩得太高兴了。

185 | "我也可以荡秋千吗,莉莉?"本问。莉莉没听到他的话。她忙着荡秋千。本觉得很难过。他走开了。

186 | 莉莉荡得太高,失去了平衡。她从秋千上摔下来,落在地上。她扭伤了脚。她哭了起来。

187 | "哎呀,哎呀,哎呀!"她说。她在找本。她希望他能帮助她。但本不在那里。他走了。

188 | 莉莉感到很抱歉。她希望她能和本分享秋千。她希望他在那里拥抱她。她一瘸一拐地走到树下。她看到有什么东西挂在树枝上。那是本的帽子。他留给她的。

189 | 莉莉笑了。她觉得本很好。她戴上了他的帽子。她希望他会回来。她想道歉。她想再次成为朋友。

190 | ```

191 |

192 |

193 | ### 选择ChatGLM3-6B的tokenizer的原因

194 |

195 | 该词表大小为`64798`,值得注意的是:这是一个很**妙**的数字,因为它**刚好在uint16的表示范围(0~65535的无符号整数)**,每一个token只需要两个字节即可表示。

196 |

197 | 当我们的语料较大时候,相比常用的`int32`可以**节省一半的存储空间**。

198 |

199 | 另外这里选择一个小尺寸的词表还有一个更重要的原因:我们后面的模型会选择一个小参数量的,如果词表过大,会导致**大部分参数被embedding层占用**,而无法训练出更好的模型。

200 |

201 | ## 小结

202 | 1. 首先熟悉了一下`BPE`的原理

203 | 2. 测试了一下`ChatGLM3-6B`的tokenizer

204 | 3. 编写了一个函数,用于将一行json文本转换为token_id数组

205 | 4. 解释了为什么选择`ChatGLM3-6B`的tokenizer

206 |

207 |

--------------------------------------------------------------------------------

/Journey/Day_Final/Day_final.md:

--------------------------------------------------------------------------------

1 | 这个系列陆陆续续更新了`13`期,总算是在**粗粒度**上把大模型的训练流程走了一遍。

2 |

3 | 在`64G`内存 + `3090 Ti`单卡配置上完成了以下的主要内容:

4 |

5 | 1. 预训练数据的预处理:批量并行的`tokenization`

6 | 2. `0.044B`参数量的`Tinystories(Chinese)`故事模型预训练

7 | 3. 基于大模型(吴恩达`translation-agent`)的`SFT`数据批量翻译

8 | 4. `SFT`训练(包含全参数和`LoRA`两种方式)

9 | 5. `DPO`数据生成

10 | 6. `DPO`训练

11 |

12 | 过程中也不乏许多对**模型实现细节**和**训练框架源码**的深入阅读和理解,以及一些**算法原理**的学习/复习。

13 |

14 | 无论效果好坏,细节是否到位,自己还是觉得收获颇丰的,这一期打算做个大汇总,也算是给这段学习一个完整的交代,同时方便有需要的小伙伴查阅。

15 |

16 | > 整个过程里的尝试和经验不一定具备广泛的普适性,个人水平也十分有限,欢迎大家批评指正。

17 |

18 | 当然,这次总结并不代表这部分的学习就彻底结束了,一些更多的**尝试和思考**还在继续,后面会陆续进行**补充更新**。

19 |

20 |

21 |

22 |

23 | ## 「从零手搓中文大模型」传送门

24 |

25 | 先列一波整个系列的全部相关内容传送门,**想直接看经验总结的可以跳到后面哈**。

26 |

27 | ### 代码传送门

28 |

29 | > https://github.com/puppyapple/Chinese_LLM_From_Scratch

30 |

31 | ### 视频传送门

32 |

33 | > https://space.bilibili.com/341251360/channel/collectiondetail?sid=3724215

34 |

35 | (视频制作不易,所以进度相比公众号文章会慢很多,目前还在努力更新中🤣)

36 |

37 | ### 公众号合集传送门

38 |

39 | [#从零手搓中文大模型](https://mp.weixin.qq.com/mp/appmsgalbum?__biz=MzkyMzczMjkxMA%3D%3D&action=getalbum&album_id=3599032183991779337&scenenote=https://mp.weixin.qq.com/s?__biz%3DMzkyMzczMjkxMA%3D%3D%26mid%3D2247484081%26idx%3D1%26sn%3Da740d8346704d27dc215950d4ce1d99b%26chksm%3Dc00d71f4e1214c2fe35302fe98ec6f076f29eea2dcd67568a3861863ba6c7e6f4832e89bd955%26scene%3D126%26sessionid%3D1727572824%26subscene%3D91%26clicktime%3D1727572828%26enterid%3D1727572828%26ascene%3D3%26devicetype%3DiOS18.0%26version%3D18003424%26nettype%3D3G+%26abtest_cookie%3DAAACAA%253D%253D%26lang%3Dzh_CN%26countrycode%3DCN%26fontScale%3D100%26exportkey%3Dn_ChQIAhIQW8oJys10cUzrj5zuSU%252BgVxLZAQIE97dBBAEAAAAAAHzMJ7V4CqgAAAAOpnltbLcz9gKNyK89dVj0sfQwZoaQr6vXojy9g0gYCI6hqbyXfvmfGWyzXj89VcxBNbuR8UWmidc%252BZmUF7swRYb8m%252B2xvF3w5fnuadG8%252BJGgBjcdjxf7HCNRfjL1PgQtGWh2VnTyvx%252FXzrqVXYUBpVTQtVBuyiX1nHVUMHr794yaLscaxaDJW497sreHaivMobvVpeRHMVxsd2nDJ%252FQ1SZhYwoN6ZvQUwB9iQsbEyBN7Idn2CKc7%252F8I2Sx%252BXt7%252FTf8cI%253D%26pass_ticket%3DuYco99quUGGX4QRAQ9HXe0zE2X3NtF%252FtqemWE%252BE9lnPOBmDjyzH5rX2KPimEbPQK%26wx_header%3D3&nolastread=1&devicetype=iMac+MacBookAir10,1+OSX+OSX+14.5+build(23F79)&version=13080810&lang=zh_CN&nettype=WIFI&ascene=0&fontScale=100&uin=&key=)

40 |

41 | ### 公众号每日传送门

42 |

43 | [从零手搓中文大模型|Day01|打卡第一天,欢迎大家监督催更](https://mp.weixin.qq.com/s/kbmkdkukkvnGMCzRD2Z1mQ)

44 |

45 | [从零手搓中文大模型|Day02|Tokenizer & BPE](https://mp.weixin.qq.com/s/LD2LTtEz1bvSdxZkIO1ePg)

46 |

47 | [从零手搓中文大模型|Day03|数据预处理](https://mp.weixin.qq.com/s/bVueRGPp_JqXh4N74A-OPg)

48 |

49 | [从零手搓中文大模型|Day04|模型参数配置和训练启动|我的micro模型跑起来啦!](https://mp.weixin.qq.com/s/ZpaO2cxVrTOlBFw45rIqiQ)

50 |

51 | [我的超迷你大模型会讲故事啦|从零手搓中文大模型|Day05](https://mp.weixin.qq.com/s/M7RmebRDvfMXomHln6R5PQ)

52 |

53 | [从零手搓中文大模型|Day06|预训练阶段代码汇总和整理](https://mp.weixin.qq.com/s/D2DCf7iq0A6BRY46X1KN8g)

54 |

55 | [吴恩达老师帮我构造指令微调(SFT)数据|从零手搓中文大模型|Day07](https://mp.weixin.qq.com/s/NnPNkiYoXAwD21Bb3id31g)

56 |

57 | [大模型SFT敲黑板知识点(这次吴恩达老师也帮不了我了)|从零手搓中文大模型|Day08](https://mp.weixin.qq.com/s/_me0CJVrxlQ1Y_JaFfEXhg)

58 |

59 | [说出来你可能不信:0.044B的大模型也能指令遵从呀|从零手搓中文大模型|Day09](https://mp.weixin.qq.com/s/c8FwjnVSr4Il4JYVroWdRQ)

60 |

61 | [手搓了好多天搓累了,歇下来聊聊自己对大模型和人工智能的一些拙见吧|从零手搓中文大模型|中秋特别篇](https://mp.weixin.qq.com/s/vRVhDCPmUybgy5T2jurPiA)

62 |

63 | [只要我的大模型参数量够小,刷数据就再也没有爆显存的烦恼|从零手搓中文大模型|Day11](https://mp.weixin.qq.com/s/K9hnUpQ0mAl0400QCbkgpQ)

64 |

65 | [万万没想到,我被transformers库里这个不负责任的简化代码给整破防了|从零手搓中文大模型|Day12](https://mp.weixin.qq.com/s/GnHxguhtZjh5SiFLU2CGkA)

66 |

67 | [哈哈哈哈果不其然,SFT质量不到位的情况下进行DPO,无异于屎上雕花|从零手搓中文大模型|Day13](https://mp.weixin.qq.com/s/aGpKf4a0iFrIgPqZ0VAotA)

68 |

69 |

70 | ## 踩坑/经验记录

71 |

72 | 这里不光记录自己实践过程中学到的**个人认为比较重要的点**,也会记录一些来自留言区小伙伴的**高质量反馈**,包括我还未来得及去尝试实践的建议。

73 |

74 | 重要性不分先后。

75 |

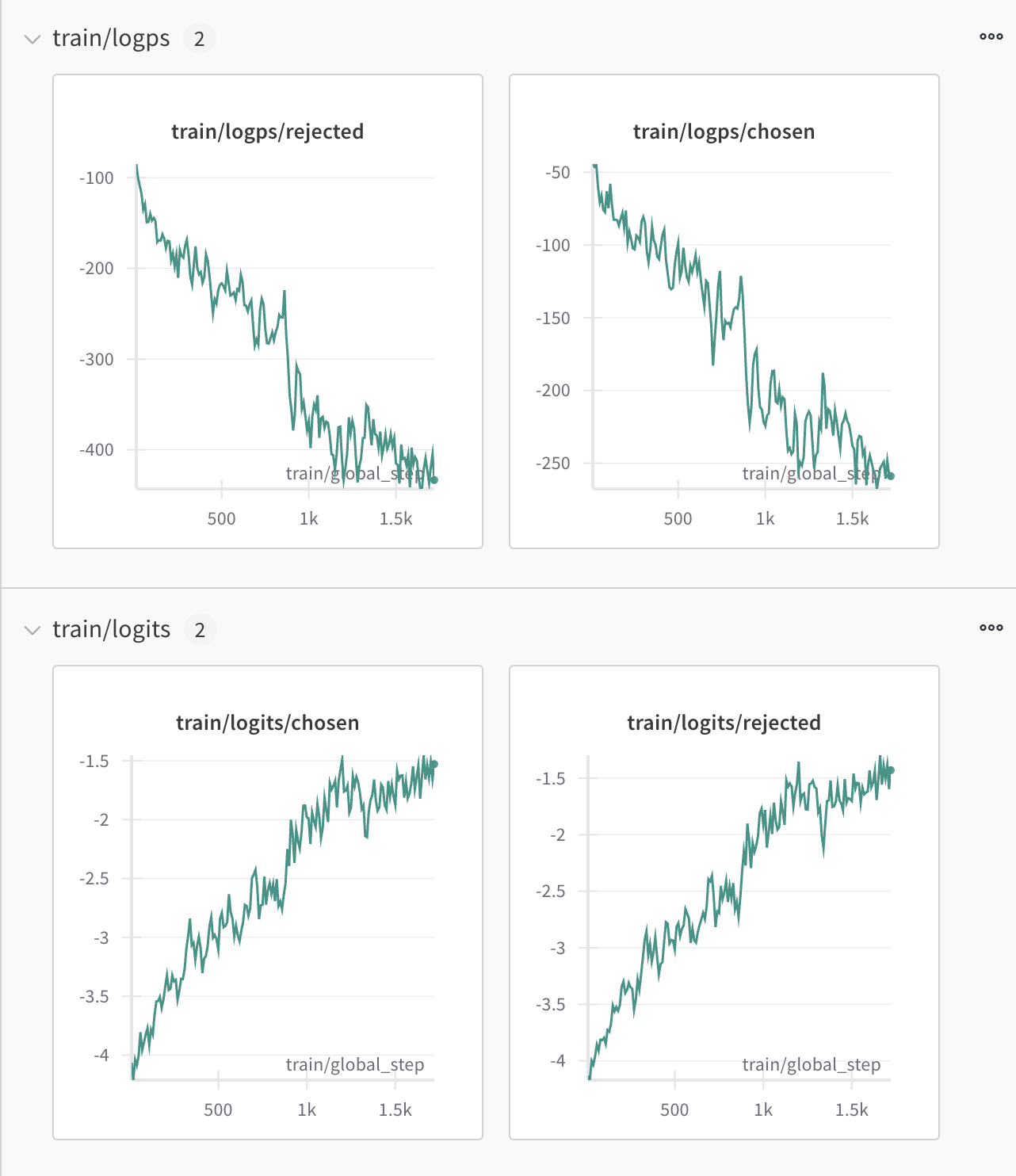

76 | ### Pretrain

77 |

78 | 1. `learning rate`的选择对模型的收敛效率影响真的很大,尤其是**模型参数**和**数据量**都不是完全参考已有的开源实现而是有很多**自定义**的情况下,学习率就不能迷信已有的经验值,需要自己尝试。例如设置多个`learning rate`,然后训练少量`steps`,观察损失的下降趋势,从而选择一个合适的`learning rate`。

79 |

80 | 2. 无论是垂域还是通用域数据,务必做好数据的**去重**;目前没有确切的研究表明同一条数据被模型学习多少次是合适的,但无论如何,增大两条近似重复数据之间的**距离**总是有益的。

81 |

82 | 3. 如果和我一样想训练一个**小语言模型(SLM)**,`tokenizer`最好是根据自己的数据集专门训练一个,主要是为了减少不必要的`vocabulary`,从而减少`embedding`参数在整个模型中的占比,能有更多的参数用来学习数据本身。

83 |

84 | > 举个例子,在我的故事数据集里其实`6-7k`的词汇量就基本上覆盖了全部的数据了,采用一些开源的`tokenizer`得到的`vocab size`往往至少也有`30k`以上,这样就会导致`embedding`层占用了过大的参数。

85 |

86 | 4. 预训练数据集量级大的时候,一定要做数据`tokenization`的预处理,在训练过程中转`token`是对`GPU`的一种「**侮辱**」。

87 |

88 | ## SFT

89 |

90 | 1. 无论是全参数微调还是`LoRA`,`SFT`首当其冲的**必要条件**是数据集的质量,否则再怎么优化炼丹术也只可能是**garbage in, garbage out**。

91 |

92 | 2. 指令**数据的配比**目前看来对模型的指令遵循能力影响很大(尤其是偏通用能力搭建的场景下),有条件的话可以多做一些不同配比的实验。这次我是纯故事生成场景,只有单一能力要求和垂直数据,所以还没有做这方面的实践尝试。

93 |

94 | 3. `SFT`数据量级较大的时候,的训练**轮数**不宜过多,否则容易导致模型过拟合(当然过拟合总好过欠拟合);相反,数据量级较小的时候,可以适当增加训练轮数让模型学习指令。

95 |

96 | 4. 根据`SFT`领域数据和预训练模型的差异,以及对模型能力最终效果(通用还是纯垂直领域)的期待,需要决策是否**使用SFT数据加入continue pretrain**,以及**SFT阶段是否要混入通用指令数据**。

97 |

98 | 5. 更高级一些的(包括在预训练阶段也是),学习数据的**顺序**对模型效果的影响也很大,甚至会造成**灾难性遗忘**;这个也容易理解,模型学知识和我们人是一样的,先学什么,后学什么,顺序不同,结果也会不同。

99 |

100 | ## RLHF

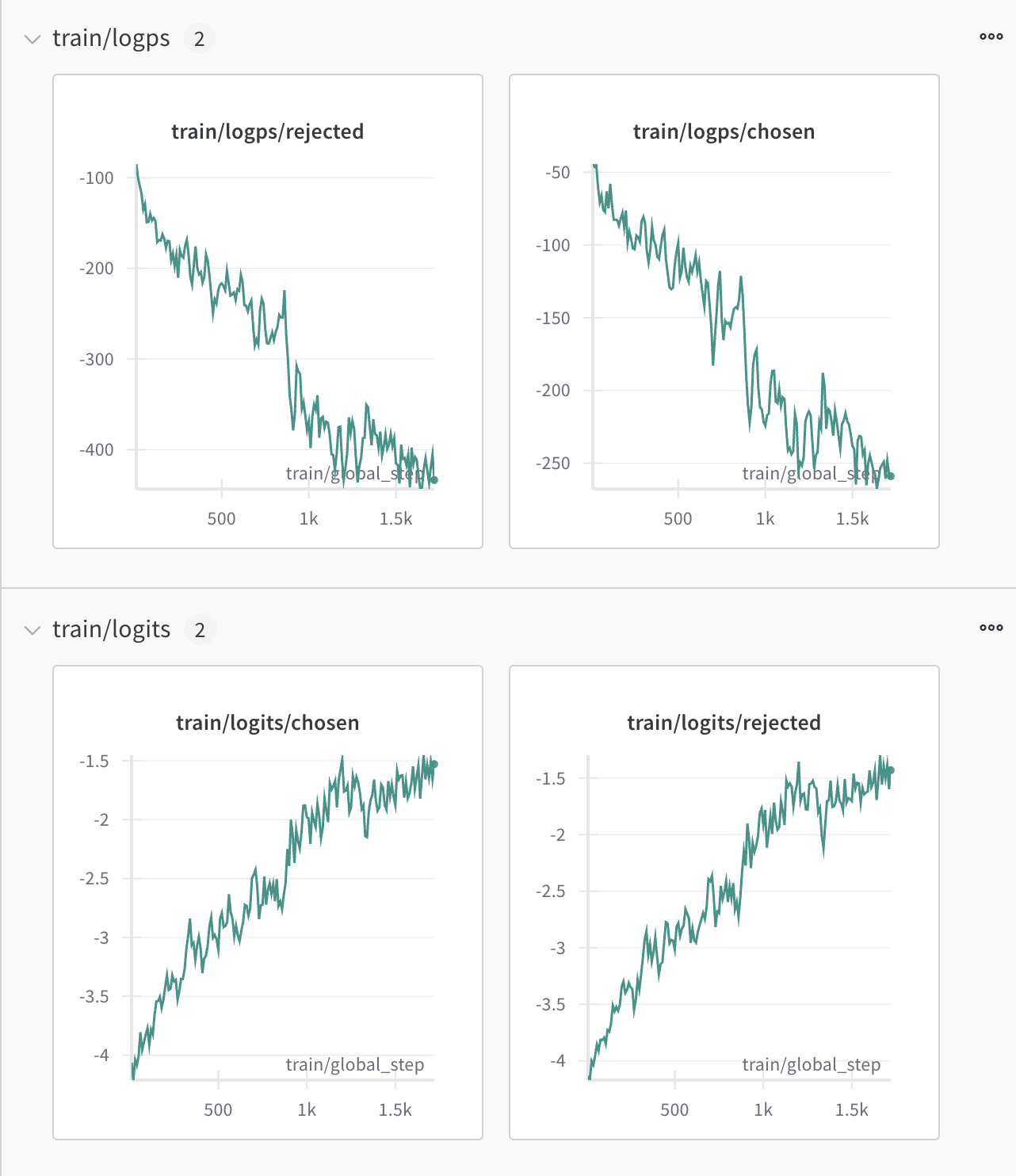

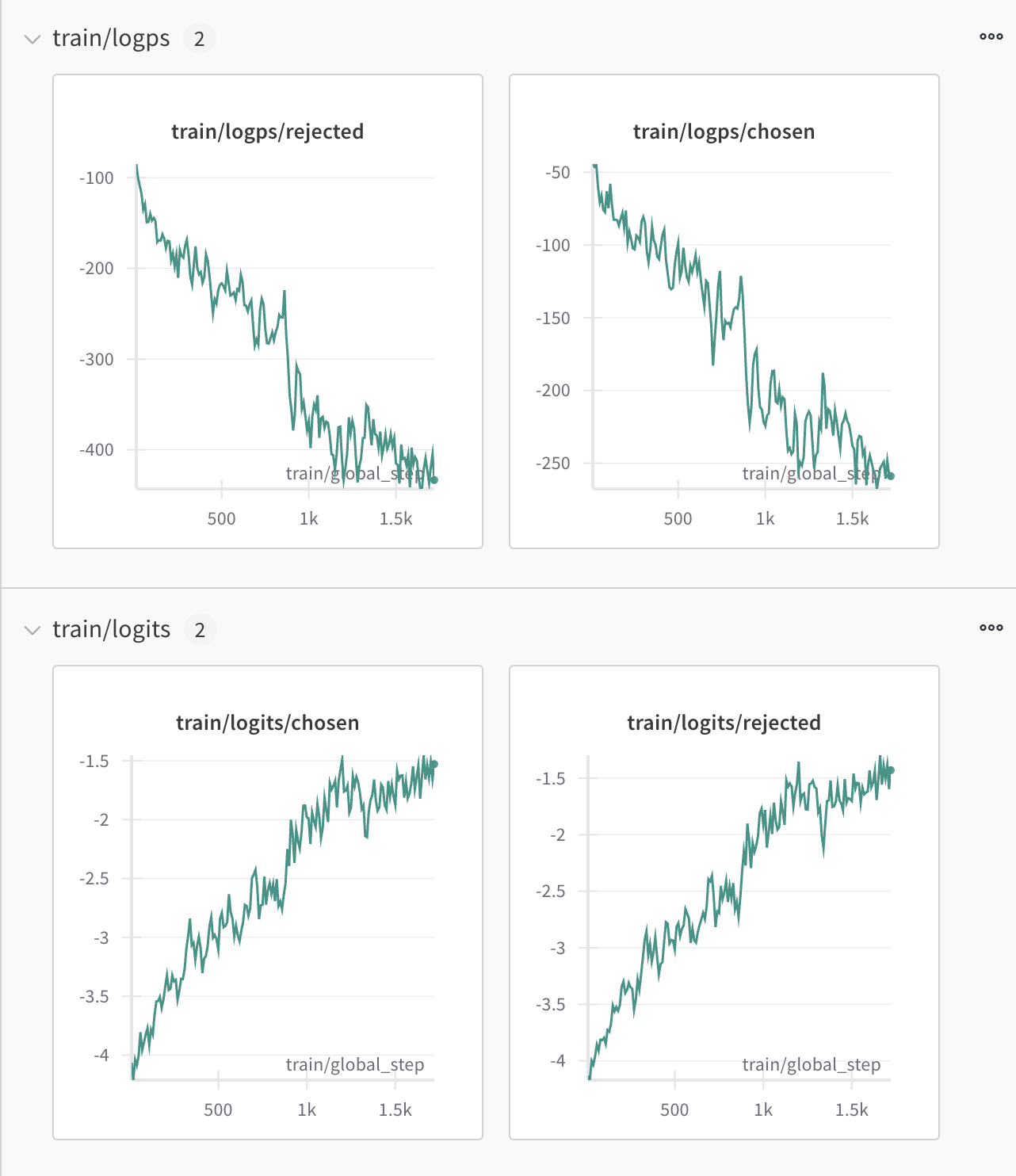

101 |

102 | 这一部分了解的确实不多,只是跑通了`DPO`的流程,这里记录一下来自**留言区小伙伴**的反馈和建议:

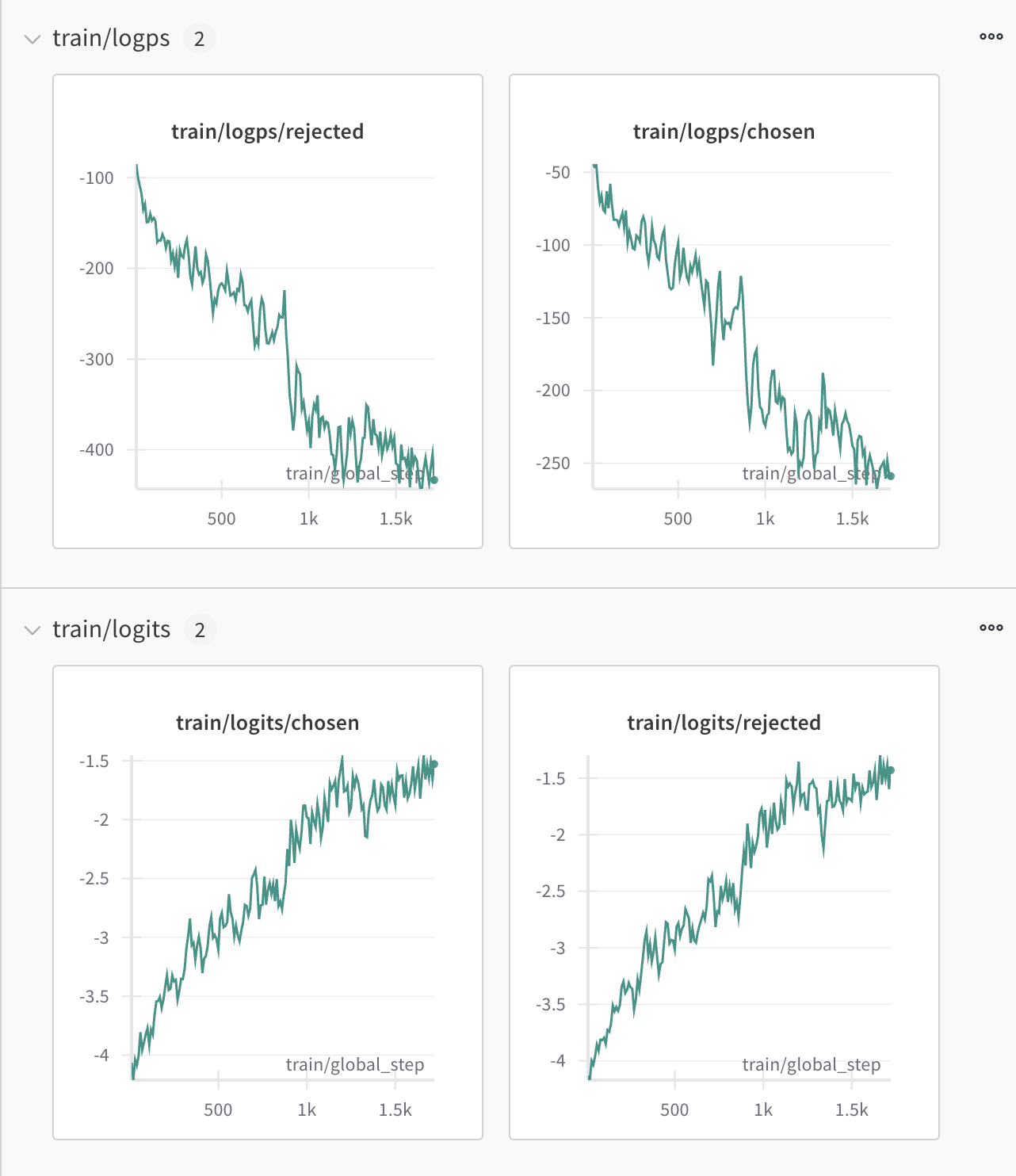

103 |

104 | 1. `offline dpo`无法更新采样,一定是不如`iterative online dpo`的 —— @tomiaoooo。不过后者的实践难度可能会大很多,作为一个个人学习目的主导的实践项目,我可能没有能力去尝试了,后面有理论学习方面的收获的话也尽量分享出来。

105 |

106 | 2. `DPO`这类相比于`PPO`更简单的`RLHF`算法,其实对数据集质量的要求反而更大了 —— @阿白。

107 |

108 | 3. 基座模型比较好的话,`KTO(Model Alignment as Prospect Theoretic Optimization)`的效果不错,甚至可以省去`SFT`阶段,直接用`KTO`进行`RLHF`—— @风飘絮。

109 |

110 | 4. 目前看起来,实际落地的模型测评显示`simpo`表现不错,值得测试 —— @最美的梦给未来的自己。

111 |

112 | 5. `DPO`之类的算法对`SFT`之后的`Instruct Model`的质量有很大依赖,如果`SFT`效果不佳,`DPO`大概起不到预期的效果,甚至可能适得其反。

113 |

114 |

115 | ## 重要参考资料大汇总

116 | `13 Days`的学习实践工程中,我重点参考过的全部资料,包括**技术博客和开源的Repo**,为我的项目顺利走通提供了极大的帮助,强烈推荐给大家,排名不分先后。

117 |

118 | 1. [LLM训练-pretrain](https://zhuanlan.zhihu.com/p/718354385) 知乎大佬`ybq`分享的预训练经验帖,非常详细,强烈推荐当作**八股文**学习背诵。

119 |

120 | 2. [LLM-SFT-trick](https://zhuanlan.zhihu.com/p/682604566) 详细介绍了作者大模型指令微调的实践经验,干货非常多。

121 |

122 | 3. [minimind](https://github.com/jingyaogong/minimind) 一个大佬开源的和我这个类似的「**从零**」构建大模型项目,**中文开放域** + **小参数量级**,从零实现了对话大模型。

123 |

124 | 4. [Lightning-AI/litgpt](https://github.com/Lightning-AI/litgpt/tree/main) 一个轻量级的大模型训练框架,没有复杂的抽象很封装,非常适合`DIY`。

125 |

126 | 5. [jzhang38/TinyLlama](https://github.com/jzhang38/TinyLlama) 基于上面的`litgpt`框架实现的`TinyLlama`,在3万亿`token`数据上训练的`1.1B`参数量模型。

127 |

128 | 6. [zh-babyllama2chinese](https://github.com/DLLXW/baby-llama2-chinese) 一个小参数量(`500M-1B`)的**中文**`Llama2`仓库

129 |

130 | ## 后续计划

131 |

132 | 我个人还是对大模型的**应用**更感兴趣一些,因此后面除了逐渐完成此前一些还没有做过的尝试,我下一步的主要计划是「**从零构建**」一个基于**语言模型(Large or small都可能)**的**应用**,学习实践更多应用层的工程和理论知识。

133 |

134 | 至于具体选择什么样的应用,目前还在绞尽脑汁思索中,如果大家有什么建议也欢迎留言交流哈。

135 |

136 |

--------------------------------------------------------------------------------

/Journey/Day09/Day09.md:

--------------------------------------------------------------------------------

1 | # 从零手搓中文大模型|🚀 Day09

2 |

3 | 微软的`Tinystories`论文里,是直接在200w条`Instruction`数据上做的全量`pretrain`来验证小参数`LLM`的指令遵从效果的。

4 |

5 | 为了挖掘`SLM`的潜力,我想看看在超小规模参数的情况下,少量(相比于`pretrain`)数据的`SFT`是否能起作用。

6 |

7 | (当然还有一个原因是要把`Instruction`数据全通过`GPT API`翻译一遍还是相当贵的😂)。

8 |

9 | ## 全参数SFT训练实验🧪

10 |

11 | 上一期分享了一些`SFT`训练相关的知识点,里面提到了关于训练模式的选择。

12 |

13 | 我的这个项目里,用于`SFT`训练的数据和之前预训练的数据分布是非常相似的,所以这里不打算将`SFT`数据用于`continue pretrain`,而是直接将`SFT`数据用于`finetuning`。

14 |

15 | 由于`SFT`全量`finetuning`其实本质上和`pretrain`没有什么差别,只是在计算`loss`的时候对`prompt`部分做了一个`mask`,所以这里就不对训练参数配置做过多的介绍了。

16 |

17 | > 这里额外提一点,我在上构造的数据基础上做了一个增强的操作(用`GPT API`翻译还是太贵了😂)。

18 | >

19 | > 具体操作是:将上期用吴恩达老师的`translation-agent`翻译构造的数据里的指令部分里的多个约束抽取成了`key: value`,然后随机排列,输出还是故事本身不变,这样就得到了很多新的数据(从之前的1.3w条数据增加到了7.1w条)。

20 | >

21 | > 另外还有一个潜在的好处就是可以让模型知道指令内部的多个约束的顺序是不敏感的,只要输出符合所有指令的约束就可以。

22 |

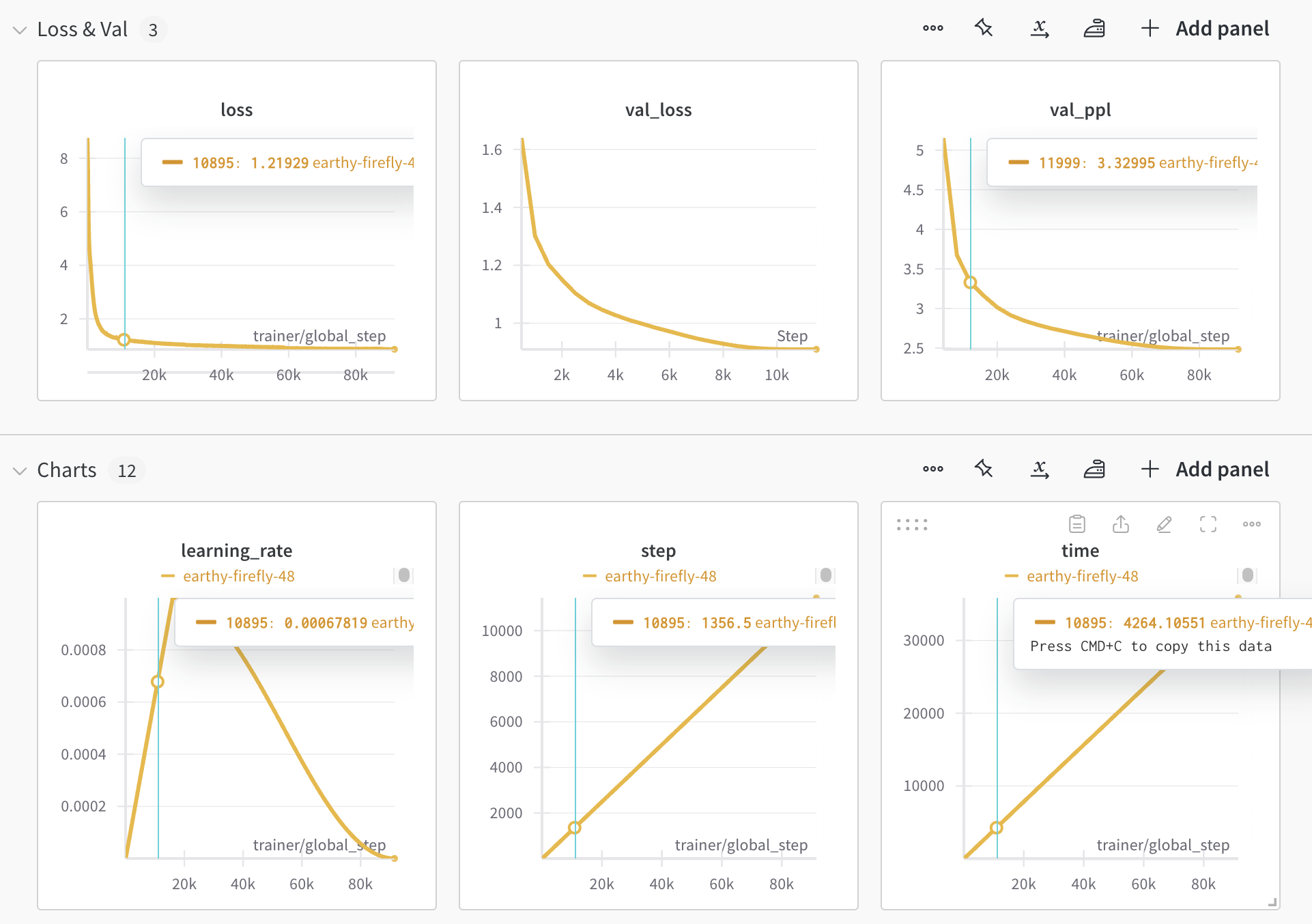

23 | 我简单地做了几组实验:

24 |

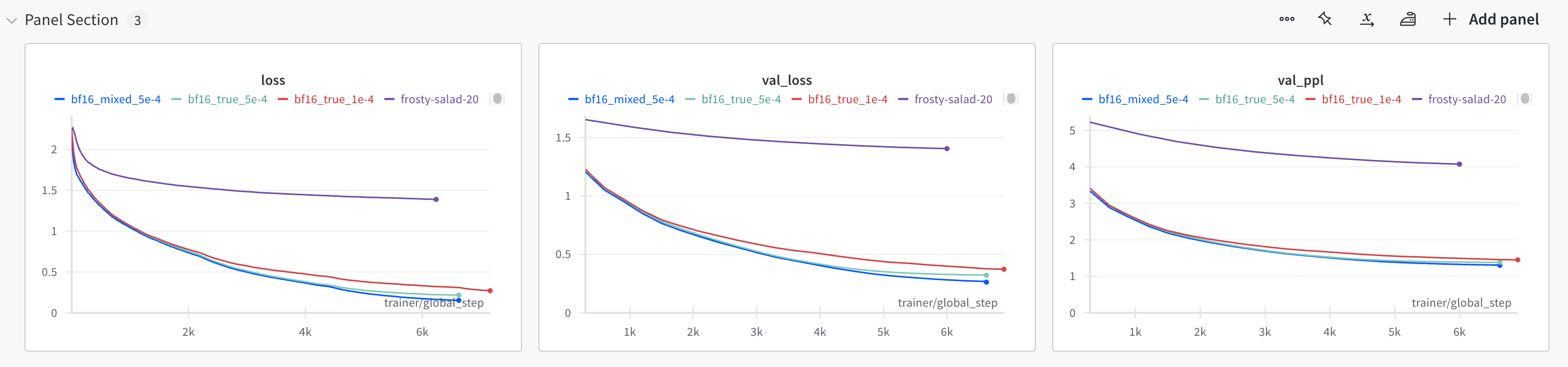

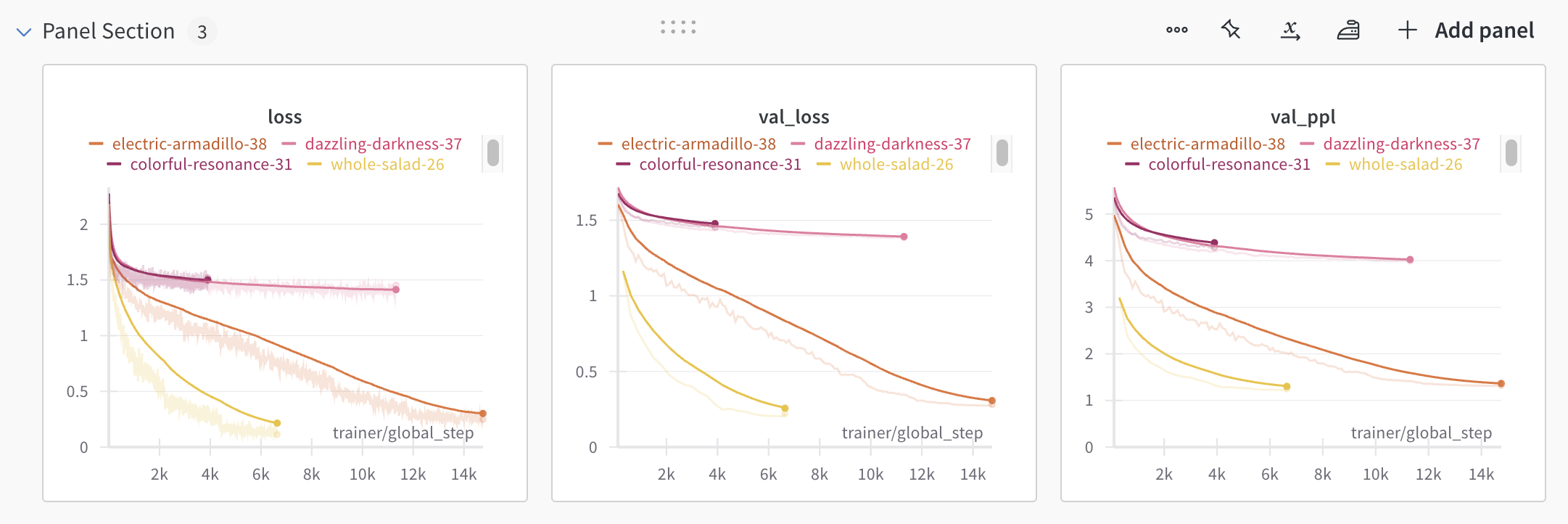

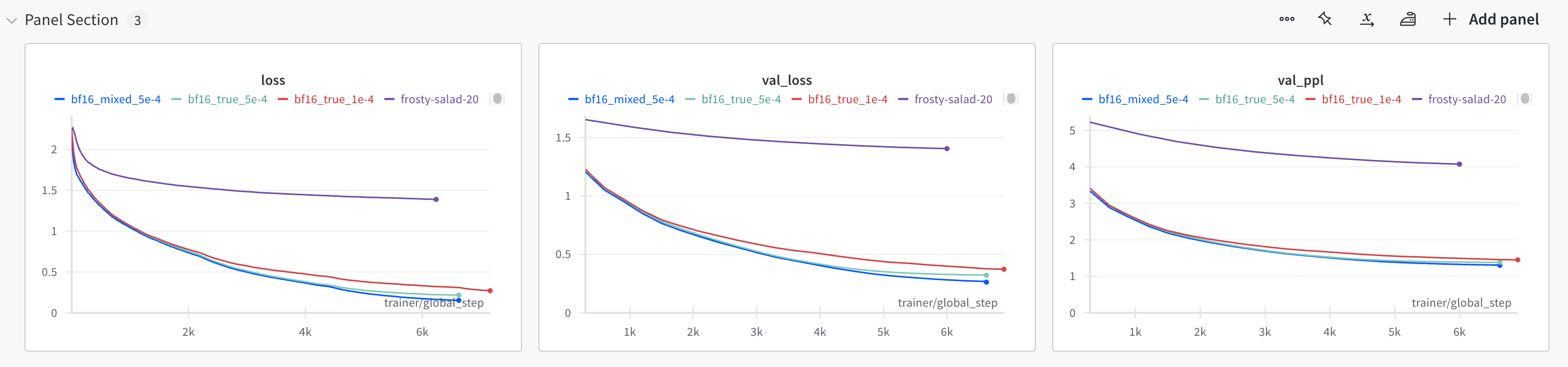

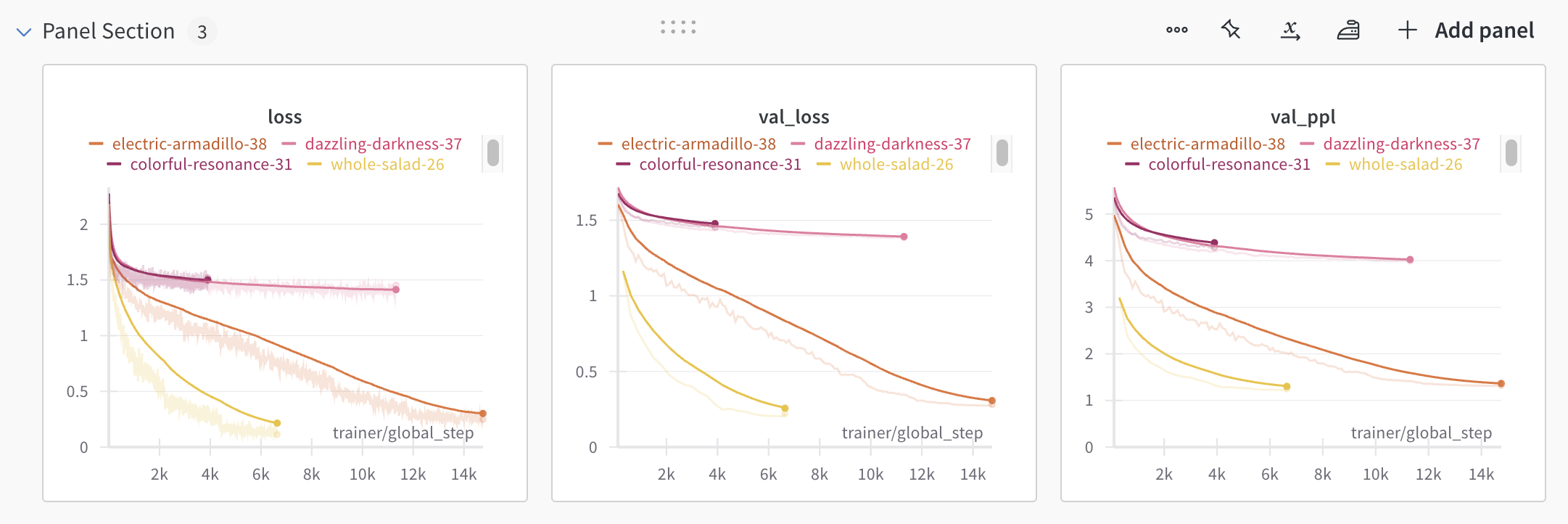

25 | 🟣 `learning_rate = 1e-4, bf16-true`

26 |

27 | 🔴 `learning_rate = 5e-4, bf16-true`

28 |

29 | 🟢 `learning_rate = 5e-4, bf16-true`,但学习率下降比前两者速度更快

30 |

31 | 🔵 `learning_rate = 5e-4, bf16-mixed`,学习率和上一个一样

32 |

33 |

34 |

35 | > 为了方便观察,图里的曲线都是经过平滑之后的。

36 |

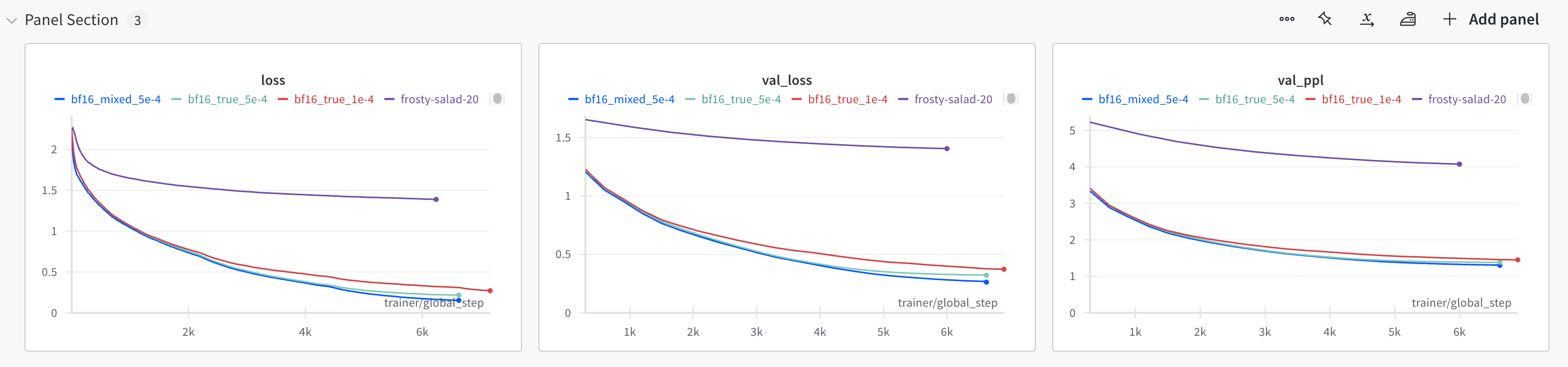

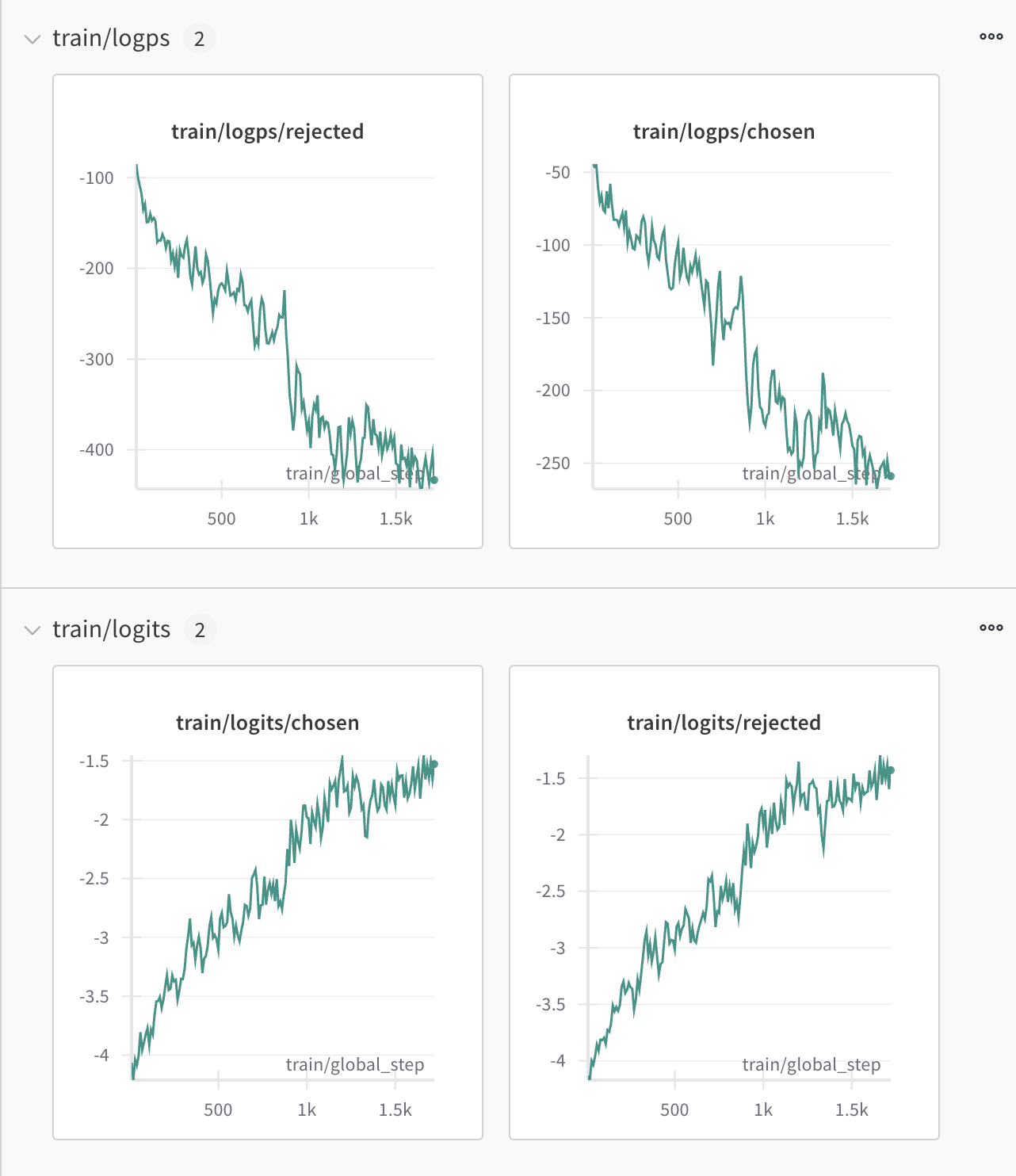

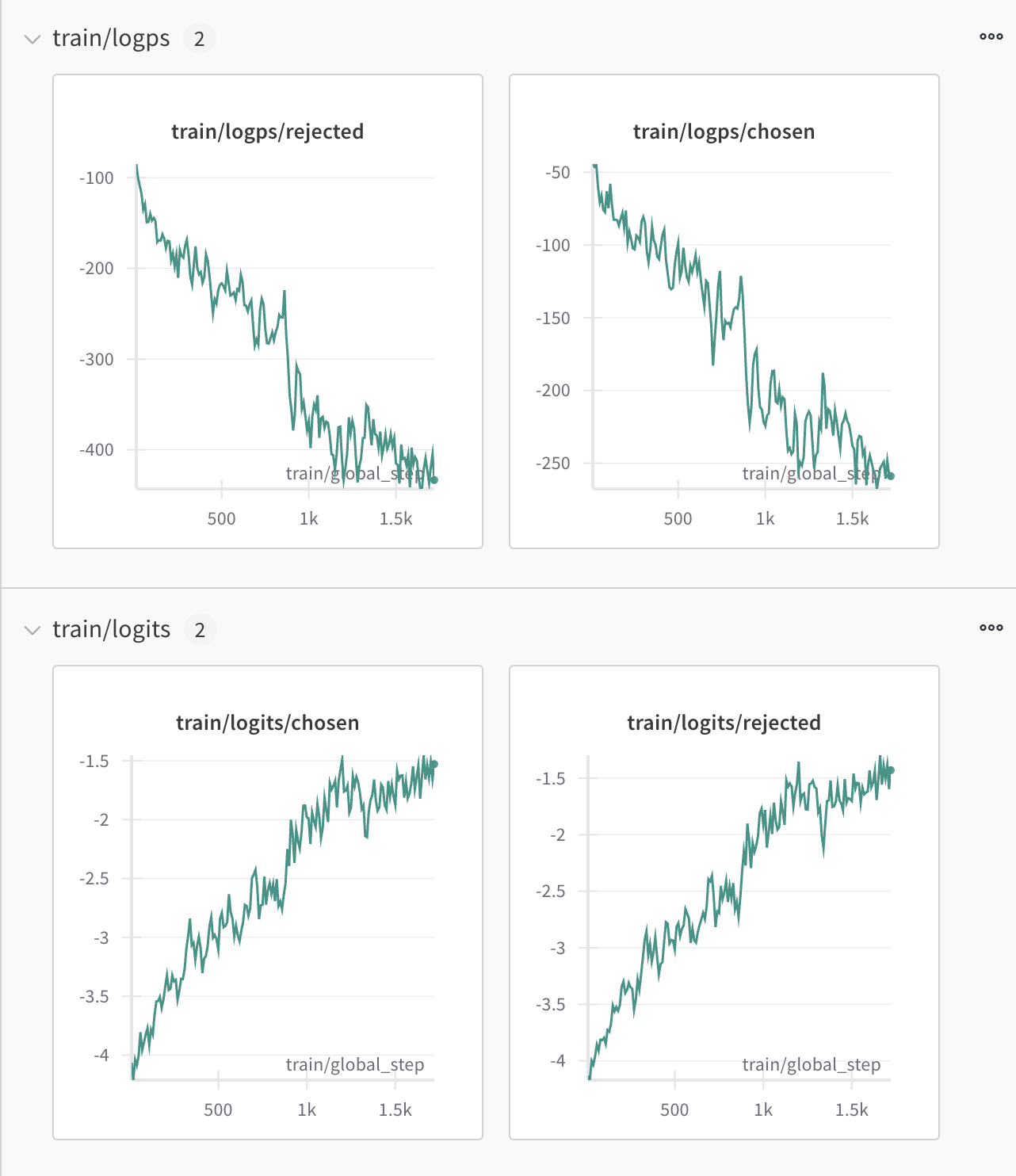

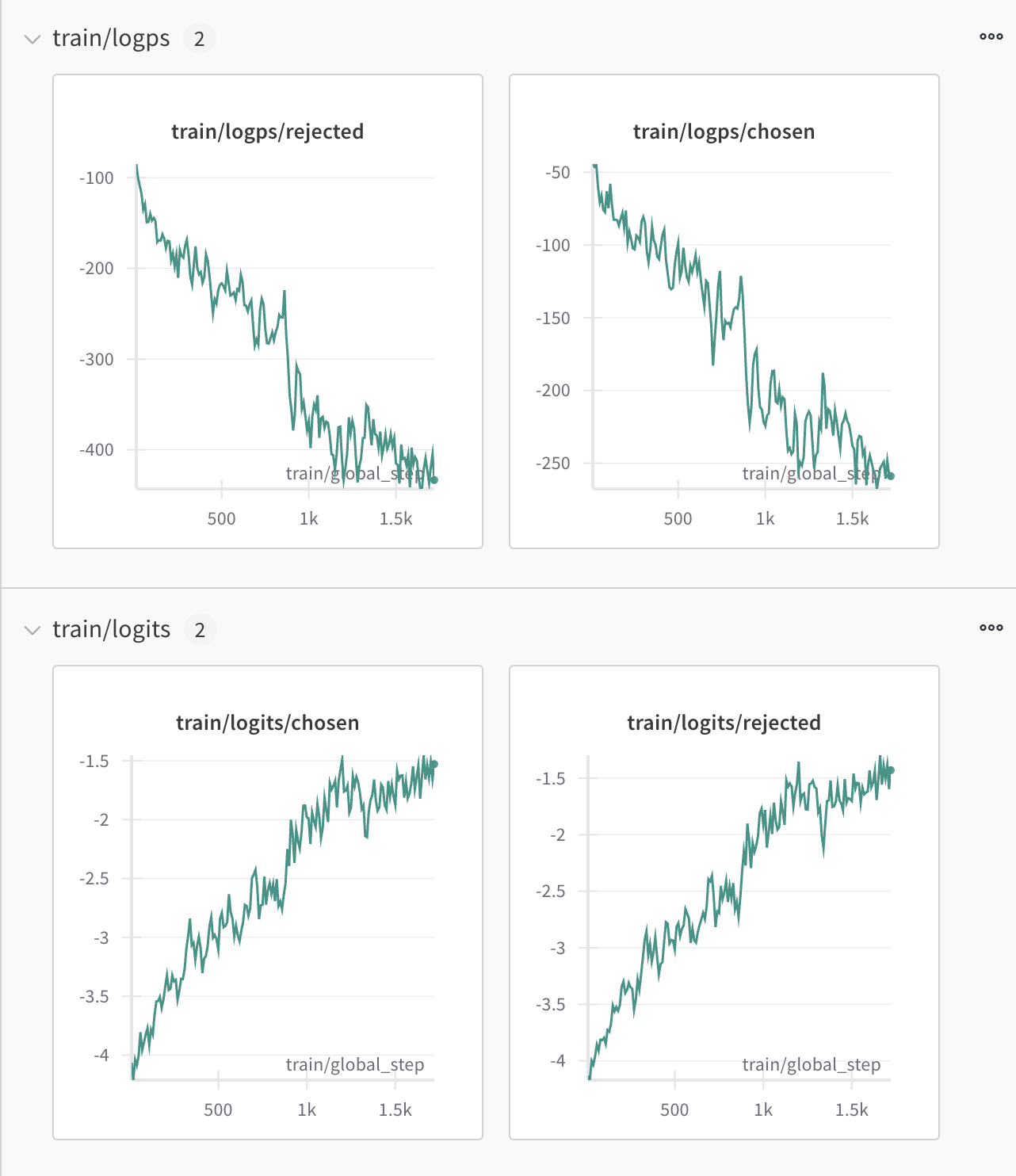

37 | 可以发现几个问题🤔:

38 |

39 | 1. 学习率使用`pretrain`的1/5的时候(`1e-4`),收敛程度不如使用和`pretrain`时一样的`5e-4`。

40 |

41 | 和上一期里搜集的经验描述有些不一致(`SFT`阶段的`learning_rate`使用`pretrain`的1/10的建议)。

42 |

43 | 我个人理解是因为我的`SFT`数据和`pretrain`数据非常相似,且指令相对简单/单一(只是在故事前面加了一些约束文本),所以即使用比较大的学习率也没有出现震荡发散的情况,反而很容易收敛。

44 |

45 | 2. 学习率被设置得下降更快的这一组,收敛速度也更快一些,这个也容易理解:在后期,模型已经非常接近最优解了,这时候学习率下降得快,可以更精细地学习以逼近最优解。

46 | 3. 使用`bf16-mixed`的这一组,收敛速度和前一个差不多,但是loss整体还要更低一些

47 |

48 | ### 结果测试

49 | #### 单一约束

50 |

51 | 我随便构造了几个简单的测试用例,其中的指令都只包含单一的约束。