├── .gitignore

├── LICENSE

├── README.md

├── SUMMARY.md

├── book.json

├── chapter2.md

├── chapter2

├── 0c23bb5c3335df21eafb04c3ec3feeb9.png

├── 0d9efd7d6113fc8ae6ead068d65f69a3.png

├── 56760245043951a56bc5f202ccbc74f4.png

└── 5af6d65cbb1e756e48484e4dd2af99f8.png

├── chapter3.md

├── chapter3

├── Marathon填写信息.png

├── Marathon搭建.png

├── Marathon运行信息.png

├── README.md

├── bamboo_1.png

├── bamboo_v2.png

├── bamboo_v3.png

├── bamboo_v4.png

├── bamboo_v5.png

├── bamboo_v6.png

├── bamboo_v7.png

├── bamboo_v8.png

├── docker.md

├── marathon.md

├── marathon_salve-02.png

├── marathon_salve_01.png

├── marathon_slave-03.png

├── mesos_bamboo_1.png

├── mesos_cluster_master.png

├── mesos_floow节点.png

├── mesos_master节点.png

├── mesos搭建.png

├── mesos正在运行信息.png

├── set_up.md

├── summary.md

├── think_about.md

└── zatan.md

├── chapter4

├── 12DF1664-8DE5-4AEE-B420-94D14F6E6543.png

├── Cluster-mesos.png

├── README.md

├── chapter4.md

├── mesos-cluster.png

├── singa on mesos.png

├── singa运行结果1.png

└── singa运行结果2.png

├── chapter5.md

├── chapter6.md

├── chapter7.md

├── chapter7

├── ContinuousDeliveryMatrix.png

├── Jenkins - scm-sync-config - Display Status.png

├── Jenkins - scm-sync-configuration - Comment prompt2.png

├── building-jobs.png

├── challenges.md

├── ci.md

├── ebay-mesos-jenkins.png

├── how-jenkins-master-run-on-mesos.png

├── how-marathon-run-jenkins-on-mesos.png

├── jenkins-config-slave.png

├── jenkins-configure.png

├── jenkins-framework-on-mesos.png

├── jenkins-master-on-marathon.png

├── jenkins-master-on-mesos-slave-2.png

├── jenkins-master-on-mesos-slave.png

├── jenkins-mesos-configure.png

├── jenkins-on-mesos.md

├── jenkins-slave-detail.png

├── jenkins-slave.png

├── jenkins-utilization.png

├── jenkins.md

├── refers.md

├── summary.md

└── test-job-config.png

├── concepts

├── concepts.md

├── index.md

└── objects.md

├── mesos-frameworks

├── README.md

├── assets

│ └── mesos-frameworks-periodic-table.png

├── chronos

│ ├── README.md

│ ├── assets

│ │ ├── chronos-architecture.png

│ │ ├── chronos-create-hello.png

│ │ ├── chronos-download.png

│ │ ├── chronos-ha.graphml

│ │ ├── chronos-ha.png

│ │ ├── chronos-hello-chronos-finished.png

│ │ ├── chronos-hello-chronos-output.png

│ │ ├── chronos-hello-finished-1.png

│ │ ├── chronos-homepage.png

│ │ ├── chronos-internal.png

│ │ ├── chronos-on-marathon-staged.png

│ │ ├── chronos-registered.png

│ │ ├── create-chronos-on-marathon.png

│ │ └── hello-chronos-script.png

│ ├── basics.md

│ ├── job.md

│ ├── setup.md

│ └── summary.md

├── marathon

│ ├── README.md

│ ├── app.md

│ ├── assets

│ │ ├── docker-2048-v2.json

│ │ ├── docker-2048-v3.json

│ │ ├── docker-2048.json

│ │ ├── marathon-api-create-app.png

│ │ ├── marathon-constraints.png

│ │ ├── marathon-docker-2048-created-by-api.png

│ │ ├── marathon-docker-2048-health-check.png

│ │ ├── marathon-docker-2048-running.png

│ │ ├── marathon-docker-2048-task.png

│ │ ├── marathon-docker-2048.png

│ │ ├── marathon-hello-marathon-1.png

│ │ ├── marathon-hello-marathon-detail.png

│ │ ├── marathon-hello-marathon-stdout.png

│ │ ├── marathon-new-app-1.png

│ │ ├── marathon-new-docker-2048.png

│ │ ├── marathon-registered.png

│ │ ├── marathon-scale-application.png

│ │ ├── marathon-web-ui-home.png

│ │ └── mesos-slave-active-tasks.png

│ ├── basics.md

│ ├── setup.md

│ └── summary.md

├── overview.md

├── spark

│ ├── README.md

│ ├── assets

│ │ ├── download-spark-hadoop.png

│ │ ├── download-spark.png

│ │ ├── spark-components.png

│ │ ├── spark-driver-mesos.png

│ │ ├── spark-framework-registered.png

│ │ ├── spark-homepage.png

│ │ ├── spark-worker-homepage.png

│ │ └── spark-worker-registered.png

│ ├── basics.md

│ ├── job.md

│ ├── setup.md

│ └── summary.md

└── summary.md

├── mesos

├── assets

│ ├── mesos-3-slaves.png

│ ├── mesos-arch.png

│ ├── mesos-frameworks-list.png

│ ├── mesos-frameworks.png

│ ├── mesos-goto-leader.png

│ ├── mesos-master-web.png

│ ├── mesos-offer.png

│ ├── mesos-offers.png

│ ├── mesos-slave-detail.png

│ ├── mesos-slaves-list.png

│ ├── mesosphere-download.png

│ ├── mesosphere-homepage.png

│ ├── zookeeper-download.png

│ └── zookeeper-project.png

├── build-a-mesos-cluster.md

├── how-mesos-works.md

└── summary.md

├── mesosben_shen_shi_yi_ge_fen_bu_shi_zi_yuan_diao_du.png

├── mesosshi-zhan-pian.md

├── rong_qi_bian_pai_ff1a.png

└── wercker.yml

/.gitignore:

--------------------------------------------------------------------------------

1 | # Node rules:

2 | ## Grunt intermediate storage (http://gruntjs.com/creating-plugins#storing-task-files)

3 | .grunt

4 |

5 | ## Dependency directory

6 | ## Commenting this out is preferred by some people, see

7 | ## https://docs.npmjs.com/misc/faq#should-i-check-my-node_modules-folder-into-git

8 | node_modules

9 |

10 | # Book build output

11 | _book

12 |

13 | # eBook build output

14 | *.epub

15 | *.mobi

16 | *.pdf

17 |

--------------------------------------------------------------------------------

/LICENSE:

--------------------------------------------------------------------------------

1 | Apache License

2 | Version 2.0, January 2004

3 | http://www.apache.org/licenses/

4 |

5 | TERMS AND CONDITIONS FOR USE, REPRODUCTION, AND DISTRIBUTION

6 |

7 | 1. Definitions.

8 |

9 | "License" shall mean the terms and conditions for use, reproduction,

10 | and distribution as defined by Sections 1 through 9 of this document.

11 |

12 | "Licensor" shall mean the copyright owner or entity authorized by

13 | the copyright owner that is granting the License.

14 |

15 | "Legal Entity" shall mean the union of the acting entity and all

16 | other entities that control, are controlled by, or are under common

17 | control with that entity. For the purposes of this definition,

18 | "control" means (i) the power, direct or indirect, to cause the

19 | direction or management of such entity, whether by contract or

20 | otherwise, or (ii) ownership of fifty percent (50%) or more of the

21 | outstanding shares, or (iii) beneficial ownership of such entity.

22 |

23 | "You" (or "Your") shall mean an individual or Legal Entity

24 | exercising permissions granted by this License.

25 |

26 | "Source" form shall mean the preferred form for making modifications,

27 | including but not limited to software source code, documentation

28 | source, and configuration files.

29 |

30 | "Object" form shall mean any form resulting from mechanical

31 | transformation or translation of a Source form, including but

32 | not limited to compiled object code, generated documentation,

33 | and conversions to other media types.

34 |

35 | "Work" shall mean the work of authorship, whether in Source or

36 | Object form, made available under the License, as indicated by a

37 | copyright notice that is included in or attached to the work

38 | (an example is provided in the Appendix below).

39 |

40 | "Derivative Works" shall mean any work, whether in Source or Object

41 | form, that is based on (or derived from) the Work and for which the

42 | editorial revisions, annotations, elaborations, or other modifications

43 | represent, as a whole, an original work of authorship. For the purposes

44 | of this License, Derivative Works shall not include works that remain

45 | separable from, or merely link (or bind by name) to the interfaces of,

46 | the Work and Derivative Works thereof.

47 |

48 | "Contribution" shall mean any work of authorship, including

49 | the original version of the Work and any modifications or additions

50 | to that Work or Derivative Works thereof, that is intentionally

51 | submitted to Licensor for inclusion in the Work by the copyright owner

52 | or by an individual or Legal Entity authorized to submit on behalf of

53 | the copyright owner. For the purposes of this definition, "submitted"

54 | means any form of electronic, verbal, or written communication sent

55 | to the Licensor or its representatives, including but not limited to

56 | communication on electronic mailing lists, source code control systems,

57 | and issue tracking systems that are managed by, or on behalf of, the

58 | Licensor for the purpose of discussing and improving the Work, but

59 | excluding communication that is conspicuously marked or otherwise

60 | designated in writing by the copyright owner as "Not a Contribution."

61 |

62 | "Contributor" shall mean Licensor and any individual or Legal Entity

63 | on behalf of whom a Contribution has been received by Licensor and

64 | subsequently incorporated within the Work.

65 |

66 | 2. Grant of Copyright License. Subject to the terms and conditions of

67 | this License, each Contributor hereby grants to You a perpetual,

68 | worldwide, non-exclusive, no-charge, royalty-free, irrevocable

69 | copyright license to reproduce, prepare Derivative Works of,

70 | publicly display, publicly perform, sublicense, and distribute the

71 | Work and such Derivative Works in Source or Object form.

72 |

73 | 3. Grant of Patent License. Subject to the terms and conditions of

74 | this License, each Contributor hereby grants to You a perpetual,

75 | worldwide, non-exclusive, no-charge, royalty-free, irrevocable

76 | (except as stated in this section) patent license to make, have made,

77 | use, offer to sell, sell, import, and otherwise transfer the Work,

78 | where such license applies only to those patent claims licensable

79 | by such Contributor that are necessarily infringed by their

80 | Contribution(s) alone or by combination of their Contribution(s)

81 | with the Work to which such Contribution(s) was submitted. If You

82 | institute patent litigation against any entity (including a

83 | cross-claim or counterclaim in a lawsuit) alleging that the Work

84 | or a Contribution incorporated within the Work constitutes direct

85 | or contributory patent infringement, then any patent licenses

86 | granted to You under this License for that Work shall terminate

87 | as of the date such litigation is filed.

88 |

89 | 4. Redistribution. You may reproduce and distribute copies of the

90 | Work or Derivative Works thereof in any medium, with or without

91 | modifications, and in Source or Object form, provided that You

92 | meet the following conditions:

93 |

94 | (a) You must give any other recipients of the Work or

95 | Derivative Works a copy of this License; and

96 |

97 | (b) You must cause any modified files to carry prominent notices

98 | stating that You changed the files; and

99 |

100 | (c) You must retain, in the Source form of any Derivative Works

101 | that You distribute, all copyright, patent, trademark, and

102 | attribution notices from the Source form of the Work,

103 | excluding those notices that do not pertain to any part of

104 | the Derivative Works; and

105 |

106 | (d) If the Work includes a "NOTICE" text file as part of its

107 | distribution, then any Derivative Works that You distribute must

108 | include a readable copy of the attribution notices contained

109 | within such NOTICE file, excluding those notices that do not

110 | pertain to any part of the Derivative Works, in at least one

111 | of the following places: within a NOTICE text file distributed

112 | as part of the Derivative Works; within the Source form or

113 | documentation, if provided along with the Derivative Works; or,

114 | within a display generated by the Derivative Works, if and

115 | wherever such third-party notices normally appear. The contents

116 | of the NOTICE file are for informational purposes only and

117 | do not modify the License. You may add Your own attribution

118 | notices within Derivative Works that You distribute, alongside

119 | or as an addendum to the NOTICE text from the Work, provided

120 | that such additional attribution notices cannot be construed

121 | as modifying the License.

122 |

123 | You may add Your own copyright statement to Your modifications and

124 | may provide additional or different license terms and conditions

125 | for use, reproduction, or distribution of Your modifications, or

126 | for any such Derivative Works as a whole, provided Your use,

127 | reproduction, and distribution of the Work otherwise complies with

128 | the conditions stated in this License.

129 |

130 | 5. Submission of Contributions. Unless You explicitly state otherwise,

131 | any Contribution intentionally submitted for inclusion in the Work

132 | by You to the Licensor shall be under the terms and conditions of

133 | this License, without any additional terms or conditions.

134 | Notwithstanding the above, nothing herein shall supersede or modify

135 | the terms of any separate license agreement you may have executed

136 | with Licensor regarding such Contributions.

137 |

138 | 6. Trademarks. This License does not grant permission to use the trade

139 | names, trademarks, service marks, or product names of the Licensor,

140 | except as required for reasonable and customary use in describing the

141 | origin of the Work and reproducing the content of the NOTICE file.

142 |

143 | 7. Disclaimer of Warranty. Unless required by applicable law or

144 | agreed to in writing, Licensor provides the Work (and each

145 | Contributor provides its Contributions) on an "AS IS" BASIS,

146 | WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or

147 | implied, including, without limitation, any warranties or conditions

148 | of TITLE, NON-INFRINGEMENT, MERCHANTABILITY, or FITNESS FOR A

149 | PARTICULAR PURPOSE. You are solely responsible for determining the

150 | appropriateness of using or redistributing the Work and assume any

151 | risks associated with Your exercise of permissions under this License.

152 |

153 | 8. Limitation of Liability. In no event and under no legal theory,

154 | whether in tort (including negligence), contract, or otherwise,

155 | unless required by applicable law (such as deliberate and grossly

156 | negligent acts) or agreed to in writing, shall any Contributor be

157 | liable to You for damages, including any direct, indirect, special,

158 | incidental, or consequential damages of any character arising as a

159 | result of this License or out of the use or inability to use the

160 | Work (including but not limited to damages for loss of goodwill,

161 | work stoppage, computer failure or malfunction, or any and all

162 | other commercial damages or losses), even if such Contributor

163 | has been advised of the possibility of such damages.

164 |

165 | 9. Accepting Warranty or Additional Liability. While redistributing

166 | the Work or Derivative Works thereof, You may choose to offer,

167 | and charge a fee for, acceptance of support, warranty, indemnity,

168 | or other liability obligations and/or rights consistent with this

169 | License. However, in accepting such obligations, You may act only

170 | on Your own behalf and on Your sole responsibility, not on behalf

171 | of any other Contributor, and only if You agree to indemnify,

172 | defend, and hold each Contributor harmless for any liability

173 | incurred by, or claims asserted against, such Contributor by reason

174 | of your accepting any such warranty or additional liability.

175 |

176 | END OF TERMS AND CONDITIONS

177 |

178 | Copyright 2017 Xiao Deshi

179 |

180 | Licensed under the Apache License, Version 2.0 (the "License");

181 | you may not use this file except in compliance with the License.

182 | You may obtain a copy of the License at

183 |

184 | http://www.apache.org/licenses/LICENSE-2.0

185 |

186 | Unless required by applicable law or agreed to in writing, software

187 | distributed under the License is distributed on an "AS IS" BASIS,

188 | WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

189 | See the License for the specific language governing permissions and

190 | limitations under the License.

191 |

--------------------------------------------------------------------------------

/README.md:

--------------------------------------------------------------------------------

1 | # Mesos最佳实践指南(Mesos Handbook)

2 |

3 | ## 前言

4 |

5 | 肖德时篇

6 |

7 | Apache Mesos是Apache软件基金会下属的顶级开源项目,它是目前开源分布式集群领域少数应用在生产环境的基础设施软件,通常被用户类比于Linux操作系统的中心系统-Kernel,在全球知名的互联网公司Twitter、AirBnb、Apple、Netflix等公司内部支撑着众多核心的业务系统。随着近几年云计算技术的发展,大量的创业公司也把Mesos系统选择为下一代云平台的核心组件,为搭建分布式系平台系统构建强有力的底座支撑。

8 |

9 | 笔者是在加入创业公司之后才开始接触Apache Mesos系统的。初次使用的过程中映像深刻的地方就是搭建一套分布式容器平台很容易上手,使用规则也非常符合新用户的习惯。但是在深度使用Mesos系统之后发现,对于初学者本地环境的多样性问题,Mesos系统并不能快速的解决问题。所以,Apache Mesos的使用体验并没有Docker Swarm那样轻量级别,让开发者快速部署一套Mesos环境还是很困难的事情。这个问题一直到Cisco开源了一套MiniMesos之后才得到一定的缓解。MiniMesos项目是通过Docker Compose编排系统来在本地开发环境自动构建一套Apache Zookeeper + Apache Mesos + Marathon + Consul + Mesos DNS + Registrator全家桶。可以方便开发者快速通过这套Mesos环境一键部署全家桶完成Mesos环境的部署,方便调度框架的二次开发工作。Cisco就是利用这套miniMesos工具快速做出了一个Elasticsearch on mesos应用调度框架。

10 |

11 | Mesos社区拥有很多中国开发者,大家也非常热情和耐心帮助Mesos社区的成长,大家通过大量的Mesos使用经实践已经积累了很多案例,所以我期望通过本书的汇总学习,给读者提供一份完整学习体系的Mesos使用手册。在此感谢这些作者的贡献。

12 |

13 | * 陈显鹭 - 灵雀云开发工程师\(xianlubird@gmail.com\)

14 | * 徐磊 - 去哪儿系统开发工程师\(49068995@qq.com\)

15 | * 赵英俊 - 城云科技(杭州)有限公司\(zyj@citycloud.com.cn\)

16 | * 周伟涛 - 阿里云\(zhouwtlord@gmail.com)

17 | * 杨成伟 - 爱奇艺\(me@chengweiyang.cn\)

18 |

19 | 还有最后,作为本书的作者,一直忙于创业、朋友、家庭的事务权衡之中。期间经历了二孩的出生。所以我将把这本书作为礼物献给我的妻子和二个宝宝。谢谢他们对我事业默默的支持。

20 |

21 | 在写作本书时,安装的所有组件、所用示例和操作等皆基于 **Mesos 1.3.1** 版本。

22 |

23 | [文章目录](SUMMARY.md)

24 |

25 | GitHub 地址: https://github.com/xiaods/mesos-handbook

26 |

27 | Gitbook 在线浏览:https://xiaods.gitbooks.io/mesos-handbook/

28 |

29 | ## 如何使用本书

30 |

31 | **在线浏览**

32 |

33 | 访问 [gitbook](https://xiaods.gitbooks.io/mesos-handbook/)

34 |

35 | **注意**:文中涉及的配置文件和代码链接在 gitbook 中会无法打开,请下载 github

36 | 源码后,在 MarkDown

37 | 编辑器中打开,点击链接将跳转到你的本地目录,推荐使用[typora](https://www.typora.io)。

38 |

39 | **本地查看**

40 |

41 | 1. 将代码克隆到本地

42 | 2. 安装 gitbook:[Setup and Installation of GitBook](https://github.com/GitbookIO/gitbook/blob/master/docs/setup.md)

43 | 3. 执行 gitbook serve

44 | 4. 在浏览器中访问http://localhost:4000

45 | 5. 生成的文档在 `_book` 目录下

46 |

47 | ## 贡献文档

48 |

49 | ### 文档的组织规则

50 |

51 | - 如果要创建一个大的主题就在最顶层创建一个目录;

52 | - 如果要创建一个大的主题就在最顶层创建一个目录;

53 | - 全书五大主题,每个主题一个目录,其下不再设二级目录;

54 | - 所有的图片都放在最顶层的 `images` 目录下,原则上文章中用到的图片都保存在本地;

55 | - 所有的文档的文件名使用英文命名,可以包含数字和中划线;

56 | - `etc`、`manifests`目录专门用来保存配置文件和文档中用到的其他相关文件;

57 |

58 | ### 添加文档

59 |

60 | 1. 在该文章相关主题的目录下创建文档;

61 | 2. 在 `SUMMARY.md` 中在相应的章节下添加文章链接;

62 | 3. 执行 `gitbook serve` 测试是否报错,访问 http://localhost:4000 查看该文档是否出现在相应主题的目录下;

63 | 4. 提交PR

64 |

65 |

66 |

67 | ## 关于

68 |

69 | [贡献者列表](https://github.com/xiaods/mesos-handbook/graphs/contributors)

70 |

71 |

72 |

73 |

--------------------------------------------------------------------------------

/SUMMARY.md:

--------------------------------------------------------------------------------

1 | # Summary

2 |

3 | - [1. 前言](README.md)

4 | - [2. Mesos理论篇](concepts/index.md)

5 | - [2.1 设计理念](concepts/concepts.md)

6 | - [2.2 主要概念](concepts/objects.md)

7 | - [3.Mesos实战篇](mesosshi-zhan-pian.md)

8 | - [Mesos搭建日志处理系统实战](chapter2.md)

9 | - [Mesos搭建企业级容器云实战](chapter3.md)

10 | - [Mesos搭建企业级容器云项目概述](chapter3/README.md)

11 | - [docker基础知识介绍](chapter3/docker.md)

12 | - [Marathon Framework 介绍](chapter3/marathon.md)

13 | - [容器云平台基础概述](chapter3/think_about.md)

14 | - [容器云搭建](chapter3/set_up.md)

15 | - [关于容器云平台的其他一些杂谈](chapter3/zatan.md)

16 | - [Mesos搭建大数据平台Hadoop和深度机器学习平台Singa实战](chapter4/README.md)

17 | - [Mesos搭建分布式生物信息算法计算系统实战](chapter5.md)

18 | - [Mesos搭建视频压缩批处理系统实战](chapter6.md)

19 | - [7 Mesos搭建持续集成系统实战](chapter7.md)

20 | - [7.1 Mesos 搭建持续集成系统概述](chapter7/summary.md)

21 | - [7.2 持续集成概念介绍](chapter7/ci.md)

22 | - [7.3 Jenkins 开源软件介绍](chapter7/jenkins.md)

23 | - [7.4 持续集成系统搭建](chapter7/jenkins-on-mesos.md)

24 | - [7.5 持续集成系统的维护心得](chapter7/challenges.md)

25 | - [7.6 参考](chapter7/refers.md)

26 |

--------------------------------------------------------------------------------

/book.json:

--------------------------------------------------------------------------------

1 | {

2 | "title": "Mesos Handbook",

3 | "description": "Let's play fun with Mesos!",

4 | "language": "zh-cn",

5 | "author": "Xiao Deshi",

6 | "plugins": [

7 | "github",

8 | "codesnippet",

9 | "splitter",

10 | "page-toc-button",

11 | "image-captions",

12 | "page-footer-ex",

13 | "editlink",

14 | "-lunr", "-search", "search-plus"

15 | ],

16 | "pluginsConfig": {

17 | "github": {

18 | "url": "https://github.com/xiaods/mesos-handbook"

19 | },

20 | "editlink": {

21 | "base": "https://github.com/xiaods/mesos-handbook/blob/master/",

22 | "label": "编辑本页"

23 | }

24 | },

25 | "page-footer-ex": {

26 | "copyright": "Xiao Deshi",

27 | "update_label": "最后更新:",

28 | "update_format": "YYYY-MM-DD HH:mm:ss"

29 | },

30 | "image-captions": {

31 | "caption": "图片 - _CAPTION_"

32 | }

33 | }

--------------------------------------------------------------------------------

/chapter2.md:

--------------------------------------------------------------------------------

1 | # Mesos搭建日志处理系统实战

2 |

3 | ## 平台介绍

4 | 我们是在今年的5月份开始调研并尝试使用Mesos,第一个试点就是我们的日志平台,我们将日志分析全部托管在Mesos平台上。日志平台面向业务线开发、测试、运营人员,方便定位、追溯线上问题和运营报表。

5 |

6 |

7 |

8 | 这个是我们平台的结构概览。

9 |

10 | 日志分析我们使用ELK(Elasticsearch、Logstash、Kibana),这三个应该说是目前非常常见的工具了。而且方案成熟,文档丰富,社区活跃(以上几点可以作为开源选型的重要参考点)。稍微定制了下Kibana和Logstash,主要是为了接入公司的监控和认证体系。

11 |

12 | 日志的入口有很多,如kernel、mail、cron、dmesg等日志通过rsyslog收集。业务日志通过flume收集,容器日志则使用mozilla的heka和fluentd收集。

13 |

14 | 这里稍稍给heka和fluentd打个广告,两者配合收集Mesos平台内的容器日志非常方便,可以直接利用MESOS_TASK_ID区分容器(此环境变量由Mesos启动容器时注入)。而且我们也有打算用heka替换logstash。

15 |

16 | ## Mesos技术栈

17 |

18 | 下面主要分享一下Mesos这块,我们使用了两个框架:Marathon和Chronos,另外自己开发了一个监控框架Universe。

19 |

20 | 先说Marathon,eventSubscriptions是个好功能,通过它的httpcallback可以有很多玩法,群里经常提到的bamboo就是利用这个功能做的。利用好这个功能,做容器监控就非常简单了。

21 |

22 | 接着是Marathon的重启(更新),推荐设置一下minimumHealthCapacity,这样可以减少重启(更新)时的资源占用,防止同时启动多个运行实例时消耗过多集群资源。

23 |

24 | 服务发现,Marathon提供了servicerouter.py导出haproxy配置,或者是bamboo,但是我们现在没有使用这两个。而是按协议分成了两部分,HTTP协议的服务是使用OpenResty开发了一个插件,动态加载Marathon(Mesos)内的应用信息,外部访问的时候proxy_pass到Mesos集群内的一个应用,支持upstream的配置。

25 |

26 | 非HTTP的应用,比如集群内部的statsd的UDP消息,我们就直接用Mesos DNS + 固定端口来做了。随即端口的应用依赖entrypoint拉取域名+端口动态替换。

27 |

28 | 带有UNIQUE attribute的应用,官方目前还无法做到自动扩容,从我们的使用情况来看,基于UNIQUE方式发布的应用全部是基础服务,比如statsd、heka(收集本机的Docker日志)、cAdvisor(监控容器)等,集群新加机器的时候Marathon不会自动scale UNIQUE实例的数量,这块功能社区正在考虑加进去。我们自己写了一个daemon,专门用来监控UNIQUE的服务,发现有新机器就自动scale,省的自己上去点了。

29 |

30 |

31 |

32 |

33 | 另外一个问题,资源碎片化,Marathon只是个框架,关注点也不在这里。Mesos的UI里虽然有统计,但是很难反应真实的情况,于是我们就自己写了一个Mesos的框架,专门来计算资源碎片和真实的余量,模拟发布情况,这样我们发布新应用或者扩容的时候,就知道集群内真实的资源余量能否支持本次发布,这些数据会抄送一份给我们的监控/报警系统。Chronos我们主要是跑一些定时清理和监控的脚本。

34 |

35 | Docker这块,我们没有做什么改动,网络都使用host模式。Docker的监控和日志上面也提到了,我们用的是cAdvisor和heka,很好很强大,美中不足的是cAdvisor接入我们自己的监控系统要做定制。

36 |

37 | 我们也捣鼓了一个Docker SSH Proxy,可能是我们更习惯用虚拟机的缘故吧,有时候还是喜欢进入到容器里去干点啥的(其实业务线对这个需求更强烈),就是第一张图里的octopus,模拟docker exec -it的工作原理,对接Mesos和Marathon抓取容器信息。这样开发人员在自己机器上就能SSH到容器内部debug了,也省去了申请机器账号的时间了。

38 |

39 | ## 应用方案

40 |

41 | 接着说说我们的日志平台。这个平台的日志解析部分全部跑在Mesos上,平台自身与业务线整合度比较深,对接了一些内部系统,主要是为了考虑兼容性和业务线资源复用的问题,我尽量省略与内部系统关联的部分,毕竟这块不是通用性的。

42 |

43 | 平台目前跑了有600+的容器,网络是Docker自带的host模式,每天给业务线处理51亿+日志,延时控制在60~100ms以内。

44 |

45 | 最先遇到的问题是镜像,是把镜像做成代码库,还是一个运行环境?或者更极端点,做一个通用的base image?结合Logstash、heka、statsd等应用特点后,我们发现运行环境更适合,这些应用变化最大的经常是配置文件。所以我们先剥离配置文件到GitLab,版本控制交给GitLab,镜像启动后再根据tag拉取。

46 |

47 | 另外,Logstash的监控比较少,能用的也就一个metrics filter,写Ruby代码调试不太方便。索性就直接改了Logstash源码,加了一些监控项进去,主要是监控两个Queue的状态,顺便也监控了下EPS和解析延时。

48 |

49 | Kafka的partition lag统计跑在了Chronos上,配合我们每个机房专门用来引流的Logstash,监控业务线日志的流量变得轻松多了。

50 |

51 |

52 |

53 | 容器监控最开始是自己开发的,从Mesos的接口里获取的数据,后来发现hostname:UNIQUE的应用Mesos经常取不到数据,就转而使用cAdvisor了,对于Mesos/Marathon发布的应用,cAdvisor需要通过libcontainer读取容器的config.json文件,获取ENV列表,拿到MESOS_TASK_ID和MARATHON_APP_ID,根据这两个值做聚合后再发到statsd里(上面提到的定制思路)。

54 |

55 | 发布这块我们围绕这Jenkins做了一个串接。业务线的开发同学写filter并提交到GitLab,打tag就发布了。发布的时候会根据集群规划替换input和output,并验证配置,发布到线上。本地也提供了一个sandbox,模拟线上的环境给开发人员debug自己的filter用。

56 |

57 |

58 |

59 | 同时发布过程中我们还会做一些小动作,比如Kibana索引的自动创建,Dashboard的导入导出,尽最大可能减少业务线配置Kibana的时间。每个应用都会启动独立的Kibana实例,这样不同业务线间的ACL也省略了,简单粗暴,方便管理。没人使用的时候自动回收Kibana容器,有访问了再重新发一个。

60 |

61 | 除了ELK,我们也在尝试Storm on Mesos,感觉这个坑还挺多的,正在努力的趟坑中。扫清后再与大家一起交流。

--------------------------------------------------------------------------------

/chapter2/0c23bb5c3335df21eafb04c3ec3feeb9.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter2/0c23bb5c3335df21eafb04c3ec3feeb9.png

--------------------------------------------------------------------------------

/chapter2/0d9efd7d6113fc8ae6ead068d65f69a3.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter2/0d9efd7d6113fc8ae6ead068d65f69a3.png

--------------------------------------------------------------------------------

/chapter2/56760245043951a56bc5f202ccbc74f4.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter2/56760245043951a56bc5f202ccbc74f4.png

--------------------------------------------------------------------------------

/chapter2/5af6d65cbb1e756e48484e4dd2af99f8.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter2/5af6d65cbb1e756e48484e4dd2af99f8.png

--------------------------------------------------------------------------------

/chapter3.md:

--------------------------------------------------------------------------------

1 |

2 | * [Mesos 搭建企业级容器云项目概述](chapter3/summary.md)

3 |

4 | * [Docker 基础知识介绍](chapter3/docker.md)

5 |

6 | * [Marathon Framework 介绍](chapter3/marathon.md)

7 |

8 | * [容器云平台基础概述](chapter3/think_about.md)

9 |

10 | * 容器云平台搭建

11 |

12 | * 企业级容器云的一些坑

13 |

--------------------------------------------------------------------------------

/chapter3/Marathon填写信息.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/Marathon填写信息.png

--------------------------------------------------------------------------------

/chapter3/Marathon搭建.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/Marathon搭建.png

--------------------------------------------------------------------------------

/chapter3/Marathon运行信息.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/Marathon运行信息.png

--------------------------------------------------------------------------------

/chapter3/README.md:

--------------------------------------------------------------------------------

1 | # Mesos搭建企业级容器云项目概述

2 |

3 | 随着docker的兴起,容器一词变得十分的火热,到处都可以看到容器的身影。身在云计算时代,不讨论一下容器,都不好意思说自己是做云计算的。

4 |

5 | 引领这一浪潮的,莫过于docker这一项技术。docker使用Linux的namespace和cgroups实现了容器级别的隔离,然后又加入了image这一概念,使得部署变得十分简单。现在只需要开发代码,build一个镜像,然后就可以借助docker的东风将它无障碍的部署到各种linux发行版中,甚至是 Windows。很好的解决了线上环境和开发环境不同带来的问题,让程序的部署变得更加简单。

6 |

7 | 更加让人激动的是,项目被docker容器化后,就具有了可以扩容的能力。你可以简单的将项目由一个实例变成两个或者更多个而无需复杂的线上配置。而且容器化后的项目可以很好的在分布式环境中运行,自由在多个主机之间迁移。这是传统项目所不具备的。

8 |

9 | 分布式应用在传统项目里门槛很高,会有各种各样的问题。但是现在借助mesos,我们可以非常容易的管理众多主机组成的集群,就像操作一台大型机器一样。

10 |

11 | 对于长时间运行的任务,marathon framewor很好的帮助我们解决了调度和监控的问题。使用它可以很方便的在mesos集群中启动容器,然后对他进行健康监控。

12 |

13 | 在集群中运行的容器随时都会被扩容或者迁移到其他机器,那么对于他们的访问,也就是服务发现,一般使用反向代理技术来解决,我们使用开源项目bamboo来实现这样的功能。

14 |

15 | 高可用也是企业级云平台一个非常重要的问题。mesos默认使用zookeeper来完成主从节点的选择和高可用,后面我们也会详细介绍。

16 |

17 | 综上是搭建一个企业级容器云平台需要的基础构建,可以看到,几乎清一色的开源项目。后面我们会以此为例子,一步步搭建一个分布式容器云平台。

18 |

19 | FIXME: private docker-registry。

20 |

--------------------------------------------------------------------------------

/chapter3/bamboo_1.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_1.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v2.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v2.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v3.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v3.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v4.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v4.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v5.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v5.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v6.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v6.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v7.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v7.png

--------------------------------------------------------------------------------

/chapter3/bamboo_v8.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/bamboo_v8.png

--------------------------------------------------------------------------------

/chapter3/docker.md:

--------------------------------------------------------------------------------

1 | # docker基础知识介绍

2 |

3 | 什么是docker,引用官方的一句话

4 |

5 | > Build, Ship and Run Any Application, Anywhere

6 |

7 | docker就是一个这样的工具。它可以帮助开发者很方便的去构建,部署,运行自己的程序。它可以让你非常迅速的测试和部署你的项目到生产环境中。

8 |

9 | 对于docker的具体实现和原理我们不多讲,让我们直接来做一个简单的例子来体验一下docker的魅力。

10 |

11 | 首先你需要在你自己的机器上安装docker,详细的安装文档请参考 [Docker 官方文档](https://docs.docker.com/installation)(FIXME: hard copy book isn't a browser, URL is meanningless)。

12 |

13 | 这里以在 Ubuntu 14.04 系统上安装 Docker 为例。

14 |

15 | curl -sSL https://get.docker.com | sh

16 |

17 | 一段美妙的小脚本就被安装到了你的机器上,他完成了你安装docker需要的所有内容。下面我们就开始使用它吧。

18 |

19 | 如果我们以一个简单的小应用来演示肯定激发不了你的兴趣,那么我们以安装一个wordpress为例,看看docker是如何快速安装一个wordpress 的。

20 |

21 | 以前安装wordpress,你可能需要去了解PHP,mysql,然后还有你的服务器的系统,最后才是去安装wordpress。非常的麻烦,但是如果我们换一种方式,使用docker来安装呢。

22 |

23 | docker run -d -p 80:80 --name wordpress index.alauda.cn/alauda/wordpress

24 |

25 | 运行以上命令,docker就会自动从灵雀云平台拉取wordpress镜像,这个镜像是已经被build好的,包含了PHP,mysql和wordpress,你所做的工作就是等待docker帮你启动起来以后,在浏览器上访问你服务器的IP就可以看到wordpress的安装页面,然后一步步的点击页面安装即可。对于你的mysql密码

26 |

27 | echo $(docker logs wordpress | grep password)

28 | 这个命令就可以获得mysql密码,填写到网页中,这样你就得到了一个可以运行的wordpress,然后开始愉快的使用他吧。

29 |

30 | 是不是感受到了docker的威力。其实这只是docker强大功能的冰山一角。快速部署是docker其中一个特性。你不需要去登录到服务器,将运行环境一个一个的安装好,最后再部署你自己的代码。docker像集装箱一样,帮助你打包好了一切,你只需要开箱使用即可。就像我们刚才的例子,我们还可以非常简单的再次运行刚才的命令,只需要换一下映射的端口,就可以再启动一个wordpress,这是安装原生应用所不敢想象的。

31 |

32 | docker由client,daemon,registry组成。下面图就列出了docker的基本结构。

33 | (FIXME:local image)

34 |

35 | 更加细节的docker介绍和讲解请参考docker文档。

36 |

37 |

38 |

39 |

--------------------------------------------------------------------------------

/chapter3/marathon.md:

--------------------------------------------------------------------------------

1 | # Marathon Framework 介绍

2 |

3 | 前面章节已经介绍了Mesos,我们就不再冗余。对于在Mesos上面长时间运行的服务,Mesos提供了Framework来帮助解决调度,健康监控的功能。

4 |

5 | 每一个运行在Mesos上的容器,都会运行一段时间,对外或者对其他应用提供服务。当启动一个容器的时候,到底这个容器该被分配到Mesos集群上的哪台机器上,运行过程中如果容器异常退出了,能否报告健康状态或者重启这个容器,有些容器在运行中需要公开端口,但是用户没有显示指定,需要系统来动态的决定分配给一个什么端口。上面的这些功能,marathon framework都帮我们做了,下面我们来介绍一下这个framework。

6 |

7 |

8 |

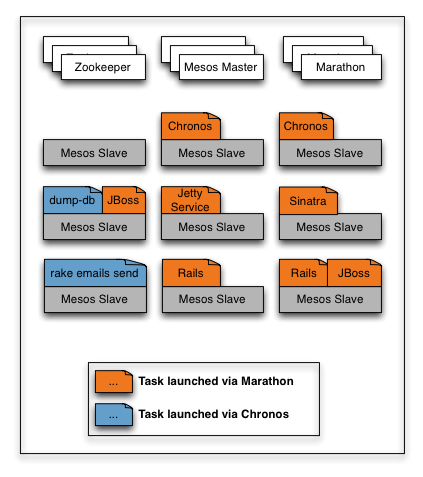

9 | 这张图是Marathon官方用来描述Marathon工作状态的一个例子。由于加入了chronos可能显的有些复杂,我们只关心Marathon的部分。(FIXME: re-draw a graph)

10 |

11 | 首先看到,由于Marathon是Mesos的一个framework,因此他需要运行在Mesos上。当然,运行Mesos需要依赖zookeeper去做选举和一些数据一致性的问题。可以看到,橘黄色部分的任务都是被Marathon启动的,他们被分配到了一个个Mesos slave上面,然后在运行过程中,如果服务宕掉了,Marathon会去重新启动它,保证你服务在一直运行的过程。用户所需要操作的就是向Marathon rest API 发送创建服务请求,剩下的事情Marathon就会帮你做好。

12 |

13 | 更加具体的信息请参考[Marathon文档](https://mesosphere.github.io/marathon/docs/).下面我们就动手搭建一个简单的Marathon例子来体验一下。

14 |

15 | 官方文档里面介绍了安装方式是原生安装,我们将会使用docker安装方式,更加快捷方便。

16 |

17 | # Mesos容器化安装

18 |

19 | 在运行Marathon之前,我们需要有一个Mesos环境,作为例子,我们先搭建一个简单的单节点master。Mesos在运行的时候需要master来分配资源和管理salve,而真正干活的则是slave节点。

20 |

21 | 首先是运行zookeeper,因为Mesos需要使用zookeeper来管理集群。

22 |

23 | docker run -d -e MYID=1 -e SERVERS=172.31.35.175 --name=zookeeper --net=host --restart=always mesoscloud/zookeeper:3.4.6-ubuntu-14.04

24 |

25 | 我们使用zookeeper 3.4.6版本。`MYID`为当前zookeeper的ID用来在zookeeper集群中标示,`SERVERS`为机器IP,`--net`为网络方式,我们使用host共享宿主机网络方式。 `--restart`是指定当容器异常退出的时候由docker daemon帮助你重启,最后是镜像的名称。

26 |

27 | 下面来部署Mesos master。

28 |

29 | docker run -d -e MESOS_HOSTNAME=172.31.35.175 -e MESOS_IP=172.31.35.175 -e MESOS_QUORUM=1 -e MESOS_ZK=zk://172.31.35.175:2181/mesos --name mesos-master --net host --restart always mesoscloud/mesos-master:0.23.0-ubuntu-14.04

30 |

31 | 这个参数比较多,我们来一一解释一下。

32 |

33 | - `MESOS_HOSTNAME`是用来指定当前Mesos master的主机名

34 | - `MESOS_IP`是当前机器的IP

35 | - `MESOS_QUORUM`为mesos master的数量,当前为单节点,后面我们会使用高可用模式。

36 | - `MESOS_ZK`是zookeeper的地址,mesos用来向其中写入数据来保证一致性。

37 |

38 | 后面的参数前面已经说过了,都是类似的。

39 |

40 | Mesos的master有了,那么下面就是干活的slave了。你可以将slave部署到一台新的机器上,也可以部署在和master的同一台机器上,由于我们只是使用一下Marathon的例子,不需要特别的复杂,因此可以将slave部署在一台机器上。

41 |

42 | docker run -d -e MESOS_HOSTNAME=172.31.35.175 -e MESOS_IP=172.31.35.175 -e MESOS_MASTER=zk://172.31.35.175:2181/mesos -v /sys/fs/cgroup:/sys/fs/cgroup -v /var/run/docker.sock:/var/run/docker.sock --name mesos-slave --net host --privileged --restart always mesoscloud/mesos-slave:0.23.0-ubuntu-14.04

43 |

44 | slave的参数也不少,前面两个MESOS_HOSTNAME和 MESOS_IP是指你部署这个salve所在机器的IP,MESOS_MASTER是指zookeeper所在服务器的地址,mesos通过这个节点去寻找master通信,zookeeper可以保证master的可用性。(FIXME:这里就一个 master,zookeeper 无能为力,实战最好还是介绍下 multiple node 的情况)

45 |

46 | 后面的参数就有些复杂。`-v`是docker挂载vloumn的命令,可以将宿主机的磁盘内容挂载到容器内部的指定位置。这里挂载了`cgroup`和`docker.sock`。原因是docker需要使用cgroup来实现容器隔离,而docker.sock是docker daemon通信的通道。将这两个目录挂载到容器里面,这样运行在容器里面的mesos slave就可以通过他们来管理宿主机的docker daemon从而实现在宿主机上启动和管理容器。

47 |

48 | 这里面有一个新的参数,`privileged`。 默认情况下,docker的privileged是关闭的。目的是为了限制容器内部去访问宿主机的设备。比如你想在容器内部运行一个docker daemon默认情况下就是不支持的。如果你设置了`privileged`,那么容器就能去接触到宿主机的所有设备,这里设置 `privileged` 选项是因为 mesos-slave 需要执行一些特权操作,例如:控制 cgroups。

49 |

50 | 这样一个mesos环境就搭建好了,可以访问一下IP:5050看一下效果。mesos默认开启5050端口提供浏览器访问。

51 | 你的页面应该和这个类似,左侧是mesos集群的一些信息,右侧为目前正在运行的任务和已经运行完毕的任务,如果你没有运行过,那么就不会有记录。

52 |

53 |

54 | # Marathon环境搭建

55 |

56 | 通过前面的步骤,我们已经有了一个可用的Mesos集群环境,那么下面我们就可以在这个环境下运行Marathon framework了。

57 |

58 | docker run -d -e MARATHON_HOSTNAME=172.31.35.175 -e MARATHON_HTTPS_ADDRESS=172.31.35.175 -e MARATHON_HTTP_ADDRESS=172.31.35.175 -e MARATHON_MASTER=zk://172.31.35.175:2181/mesos -e MARATHON_ZK=zk://172.31.35.175:2181/marathon --name marathonv0.11.1 --net host --restart always mesosphere/marathon:v0.11.1

59 |

60 | Marathon的参数也是比较多的。`MARATHON_HOSTNAME`是部署Marathon本机的IP。`MARATHON_HTTPS_ADDRESS`是部署Marathon的机器IP。`MARATHON_MASTER`为mesos所在zookeeper的节点,因为Marathon作为一个framework需要注册到mesos上。`MARATHON_ZK`为Marathon所在zookeeper的节点。

61 |

62 | 这样我们就安装好了Marathon环境,使用浏览器请求一下Marathon所在IP:8080看一下效果。

63 |

64 | 这样Marathon的环境就搭建好了。我们可以使用右上角的New App来创建一个简单的应用。

65 |

66 | {

67 | "id": "basic-0",

68 | "cmd": "while [ true ] ; do echo 'Hello Marathon' ; sleep 5 ; done",

69 | "cpus": 0.1,

70 | "mem": 10.0,

71 | "instances": 1

72 | }

73 |

74 | 只需要在弹出框里面填写上对应的信息即可。

75 |

76 |

77 |

78 | 在这里你就可以看到运行的效果,这样就代表运行成功,Marathon给这个实例分配了机器资源,他就成功的运行在了mesos集群中。

79 |

80 | 我们也可以访问5050端口,在mesos控制台信息里面,也可以看到正在运行的任务。

81 |

82 |

--------------------------------------------------------------------------------

/chapter3/marathon_salve-02.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/marathon_salve-02.png

--------------------------------------------------------------------------------

/chapter3/marathon_salve_01.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/marathon_salve_01.png

--------------------------------------------------------------------------------

/chapter3/marathon_slave-03.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/marathon_slave-03.png

--------------------------------------------------------------------------------

/chapter3/mesos_bamboo_1.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos_bamboo_1.png

--------------------------------------------------------------------------------

/chapter3/mesos_cluster_master.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos_cluster_master.png

--------------------------------------------------------------------------------

/chapter3/mesos_floow节点.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos_floow节点.png

--------------------------------------------------------------------------------

/chapter3/mesos_master节点.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos_master节点.png

--------------------------------------------------------------------------------

/chapter3/mesos搭建.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos搭建.png

--------------------------------------------------------------------------------

/chapter3/mesos正在运行信息.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter3/mesos正在运行信息.png

--------------------------------------------------------------------------------

/chapter3/set_up.md:

--------------------------------------------------------------------------------

1 | # 容器云搭建

2 |

3 | 本章我们将开始真正的环境搭建。

4 |

5 | 提前声明,在整个项目中,我们使用四台服务器。

6 |

7 | Node1 : 172.31.35.175

8 | Node2 : 172.31.23.17

9 | Node3 : 172.31.40.200

10 | Node4 : 172.31.37.173

11 |

12 | #zookeeper 集群

13 | 前面章节我们搭建的zookeeper是单点的,这里我们需要搭建一个zookeeper集群,这里我们先搭建一个拥有三个节点的zookeeper集群。

14 |

15 | 首先在Node1上:

16 |

17 | docker run -d -e MYID=1 -e SERVERS=172.31.35.175,172.31.23.17,172.31.40.200 --name=zookeeper --net=host --restart=always mesoscloud/zookeeper:3.4.6-ubuntu-14.04

18 |

19 | 其中的参数,`MYID`为zookeeper集群中的唯一值,用来确定当前节点在集群中的ID。`SERVERS`为指定当前集群每个zookeeper节点所在服务器的IP。

20 |

21 | 然后在Node2上:

22 |

23 | docker run -d -e MYID=2 -e SERVERS=172.31.35.175,172.31.23.17,172.31.40.200 --name=zookeeper --net=host --restart=always mesoscloud/zookeeper:3.4.6-ubuntu-14.04

24 |

25 | Node3:

26 |

27 | docker run -d -e MYID=3 -e SERVERS=172.31.35.175,172.31.23.17,172.31.40.200 --name=zookeeper --net=host --restart=always mesoscloud/zookeeper:3.4.6-ubuntu-14.04

28 |

29 | 启动完毕后,我们进入各个机器的容器查看zookeeper启动情况。

30 |

31 | root@ip-172-31-23-17:/opt/zookeeper/bin# ./zkServer.sh status

32 | JMX enabled by default

33 | Using config: /opt/zookeeper/bin/../conf/zoo.cfg

34 | Mode: leader

35 |

36 | root@ip-172-31-35-175:/opt/zookeeper/bin# ./zkServer.sh status

37 | JMX enabled by default

38 | Using config: /opt/zookeeper/bin/../conf/zoo.cfg

39 | Mode: follower

40 |

41 | root@ip-172-31-40-200:/opt/zookeeper/bin# ./zkServer.sh status

42 | JMX enabled by default

43 | Using config: /opt/zookeeper/bin/../conf/zoo.cfg

44 | Mode: follower

45 |

46 | 可以看到,`172.31.23.17`为leader,其他的为follower,这样zookeeper集群就搭建完毕了。

47 |

48 | #Mesos 集群搭建

49 | 前面章节我们搭建的mesos集群都是单master节点,生产环境下一定是需要HA的。因此我们这里搭建一个三个master节点的mesos集群。

50 |

51 | docker run -d -e MESOS_HOSTNAME=172.31.35.175 -e MESOS_IP=172.31.35.175 -e MESOS_QUORUM=2 -e MESOS_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos --name mesos-master --net host --restart always mesoscloud/mesos-master:0.23.0-ubuntu-14.04

52 |

53 | 这是在机器Node1上执行的命令。其中的参数没什么变化,只是zk那里加了三个zookeeper节点。同样的在Node2,和Node3上执行类似的命令。

54 |

55 | docker run -d -e MESOS_HOSTNAME=172.31.23.17 -e MESOS_IP=172.31.23.17 -e MESOS_QUORUM=2 -e MESOS_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos --name mesos-master --net host --restart always mesoscloud/mesos-master:0.23.0-ubuntu-14.04

56 |

57 | docker run -d -e MESOS_HOSTNAME=172.31.40.200 -e MESOS_IP=172.31.40.200 -e MESOS_QUORUM=2 -e MESOS_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos --name mesos-master --net host --restart always mesoscloud/mesos-master:0.23.0-ubuntu-14.04

58 |

59 | 这样我们尝试访问其中一个Node的页面。

60 |

61 |

62 | 可以看到当前访问的节点并不是master节点,说明在这三个节点的选举中,他没有被选举上。mesos会自动帮你跳转到当前master节点所在的服务器。

63 |

64 |

65 | 这样一个具有三个master节点的mesos集群就配置好了,如果其中一个master宕机,另外两个master就会选举出来一个新的master,保证当前集群不会因为没有master而宕掉。

66 |

67 | 我们在zookeeper的mesos znode上也可以看到选举的结果信息。

68 |

69 | [zk: 127.0.0.1:2181(CONNECTED) 5] get /mesos/info_0000000003

70 | !20151103-021835-3358072748-5050-1????

71 | '"master@172.31.40.200:5050*

72 | cZxid = 0x100000016

73 | ctime = Tue Nov 03 02:18:22 UTC 2015

74 | mZxid = 0x100000016

75 | mtime = Tue Nov 03 02:18:22 UTC 2015

76 | pZxid = 0x100000016

77 | cversion = 0

78 | dataVersion = 0

79 | aclVersion = 0

80 | ephemeralOwner = 0x350cb21c20f0004

81 | dataLength = 94

82 | numChildren = 0

83 |

84 | 我们向其中加入一个slave实验一下。

85 |

86 | docker run -d -e MESOS_HOSTNAME=172.31.35.175 -e MESOS_IP=172.31.35.175 -e MESOS_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -v /sys/fs/cgroup:/sys/fs/cgroup -v /var/run/docker.sock:/var/run/docker.sock --name mesos-slave --net host --privileged --restart always mesoscloud/mesos-slave:0.23.0-ubuntu-14.04

87 |

88 |

89 |

90 | 可以看到,salve已经注册成功,这样我们就搭建了一个具有三个master节点的mesos集群。

91 |

92 | #Marathon 搭建

93 | 有了Mesos集群,搭建Marathon 就变得非常的简单。Marathon默认支持高可用模式。只要多个运行的Marathon 实例使用同一个zookeeper集群即可,zookeeper来保证Marathon的leader失效时的选举等问题。

94 |

95 | docker run -d -e MARATHON_HOSTNAME=172.31.35.175 -e MARATHON_HTTPS_ADDRESS=172.31.35.175 -e MARATHON_HTTP_ADDRESS=172.31.35.175 -e MARATHON_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -e MARATHON_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/marathon -e MARATHON_EVENT_SUBSCRIBER=http_callback --name marathonv0.11.1 --net host --restart always mesosphere/marathon:v0.11.1

96 |

97 | 首先我们在Node1上起了一个Marathon实例。这里面的参数前面都讲过,主要的改变就是由原来的一个zookeeper节点变成了一个zookeeper集群。`MARATHON_EVENT_SUBSCRIBER=http_callback`这里多了一个参数。这个参数是开启Marathon的事件订阅模式,我们使用了`http_callback`,这样我们可以通过注册一个http回调事件,当Marathon启动,关闭,或者扩容某个实例的时候,我们都可以接收到通知,这为我们下一步做服务发现提供了数据源。

98 |

99 | 为了防止单点问题,我们启动三个Marathon实例,下面我们分别在Node2和Node3上面再启动两个Marathon实例。

100 |

101 | docker run -d -e MARATHON_HOSTNAME=172.31.23.17 -e MARATHON_HTTPS_ADDRESS=172.31.23.17 -e MARATHON_HTTP_ADDRESS=172.31.23.17 -e MARATHON_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -e MARATHON_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/marathon -e MARATHON_EVENT_SUBSCRIBER=http_callback --name marathonv0.11.1 --net host --restart always mesosphere/marathon:v0.11.1

102 |

103 | docker run -d -e MARATHON_HOSTNAME=172.31.40.200 -e MARATHON_HTTPS_ADDRESS=172.31.40.200 -e MARATHON_HTTP_ADDRESS=172.31.40.200 -e MARATHON_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -e MARATHON_ZK=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/marathon -e MARATHON_EVENT_SUBSCRIBER=http_callback --name marathonv0.11.1 --net host --restart always mesosphere/marathon:v0.11.1

104 |

105 | 这样我们就启动了含有三个实例的Marathon集群。由于这三个Marathon实例都是共享一个zookeeper集群,因此他们的数据也是同步的。你在其中任何一个节点创建的应用在其他两个Marathon实例上也可以看到。

106 |

107 |

108 | 可以看到,三个tab页面分别打开的的三个服务器上的Marathon页面。我们在请求第一台机器的Marathon创建一个简单的服务。

109 |

110 | 在第一个tab上我们已经可以看到了这个被创建的服务,现在我们切换到第三个tab看一下。

111 |

112 | 可以看到,在第三个tab页面上,看到了和第一个tab一样的效果。这就说明了,目前的Marathon集群,他们之间的数据是共享的,在其中任何一个实例上创建服务,其他的实例都可以看到。我们进入zookeeper里面看一下Marathon集群的状态信息。

113 |

114 | [zk: 127.0.0.1:2181(CONNECTED) 3] ls /marathon/leader

115 | [member_0000000001, member_0000000002, member_0000000000]

116 | 可以看到leader节点下有三个member,对应着我们启动的三个实例。每个member节点里面记录的信息就是当前这个实例额一些具体的状态。

117 |

118 | [zk: 127.0.0.1:2181(CONNECTED) 6] get /marathon/leader/member_0000000000

119 | 172.31.35.175:8080

120 | cZxid = 0x100000020

121 | ctime = Wed Nov 04 07:11:13 UTC 2015

122 | mZxid = 0x100000020

123 | mtime = Wed Nov 04 07:11:13 UTC 2015

124 | pZxid = 0x100000020

125 | cversion = 0

126 | dataVersion = 0

127 | aclVersion = 0

128 | ephemeralOwner = 0x350cb21c20f0006

129 | dataLength = 18

130 | numChildren = 0

131 | 这样我们就搭建起来了一个高可用模式的Marathon集群。

132 |

133 | #Bamboo 搭建

134 | 经过前面的步骤,我们已经有了一个可以运行和管理docker容器的集群环境。我们现在可以通过Marathon启动一个或多个容器,他会被分配到我们集群salve上运行。在运行过程中,Marathon可以保证我们容器运行状态的监控,宕掉重启等活动。但是一般来说,mesos和marathon集群都是搭建在内网或者一个不可以被外部直接访问的网络环境里面,我们需要一个出口,通过这个出口外部可以访问我们容器内提供的服务。而且一般来说,Marathon管理的容器,被分配的salve机器不一定是同一台,在scale和update的时候,会出现IP的变换,这就需要我们有一套服务发现的机制。

135 |

136 | Marathon其实提供了服务发现的功能。通过在运行Marathon的机器上跑一个haproxy,Marathon在服务有变动的时候,自动生成haproxy配置文件,然后重启。这种方式对于简单的应用来说应该足够,但是对于需要多租户,自定义ACL规则等功能,这个就显得不太足够。还好Marathon提供了Event_Callback功能,我们可以通过注册事件回调,获取Marathon上运行容器的信息,然后根据某些haproxy模板来自动生成haproxy配置文件,reload后就可以访问。

137 |

138 | 上面说的这些功能已经被一个名为bamboo的开源项目实现。[地址](https://github.com/QubitProducts/bamboo)。他不仅提供了上面提到的服务发现等功能,还可以自定义ACL规则,这样就给我们做服务发现提供了很大的空间。bamboo提供了rest api,我们可以很方便的把它集成到我们自己的项目中。

139 |

140 |

141 |

142 | 这是bamboo的部署图。在每个slave上部署一个haproxy加bamboo,然后他们之间可以负载均衡,通过zookeeper同步数据。当Marathon运行的容器有变化的时候,会通过http_call_back通知bamboo,然后bamboo就可以感知变化,我们就可以通过api或者bamboo的页面设置这个容器的acl访问规则,这样就完成了外部访问容器提供的服务的功能。下面我们来搭建Haproxy和bamboo。

143 |

144 | 首先我们在Node3,Node4上分别启动一个mesos_slave。

145 |

146 | docker run -d -e MESOS_HOSTNAME=172.31.40.200 -e MESOS_IP=172.31.40.200 -e MESOS_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -v /sys/fs/cgroup:/sys/fs/cgroup -v /var/run/docker.sock:/var/run/docker.sock --name mesos-slave --net host --privileged --restart always mesoscloud/mesos-slave:0.23.0-ubuntu-14.04

147 |

148 | docker run -d -e MESOS_HOSTNAME=172.31.37.173 -e MESOS_IP=172.31.37.173 -e MESOS_MASTER=zk://172.31.35.175:2181,172.31.23.17:2181,172.31.40.200:2181/mesos -v /sys/fs/cgroup:/sys/fs/cgroup -v /var/run/docker.sock:/var/run/docker.sock --name mesos-slave --net host --privileged --restart always mesoscloud/mesos-slave:0.23.0-ubuntu-14.04

149 |

150 | 如果你有更多机器,可以按照上面的命令,更改一下MESOS_HOSTNAME和 MESOS_IP就可以非常简单的继续向我们现在的集群增加节点。

151 |

152 |

153 |

154 | 通过查看mesos页面,我们可以看到目前我们有两个slave提供服务。现在我们向这两个slave部署bamboo。

155 |

156 | 首先向Node4部署一个bamboo。

157 |

158 | docker run -d -p 8000:8000 -p 80:80 -e MARATHON_ENDPOINT=http://172.31.35.175:8080,http://172.31.23.17:8080,http://172.31.40.200:8080 -e BAMBOO_ENDPOINT=http://公网IP:8000 -e BAMBOO_ZK_HOST=172.31.23.17:2181,172.31.40.200:2181,172.31.35.175:2181 -e BAMBOO_ZK_PATH=/bamboo -e BIND=":8000" -e CONFIG_PATH="config/production.example.json" -e BAMBOO_DOCKER_AUTO_HOST=true xianlubird/bamboo

159 |

160 | 这里面的参数,其中8000是bamboo公开的端口,我们可以通过这个端口访问他的控制页面,或者通过这个端口请求他的rest api。80端口是公开给haproxy使用,这个镜像里面内置了haproxy,你不需要自己再安装haproxy。`MARATHON_ENDPOINT`是Marathon集群的地址,bamboo通过这个地址向Marathon注册回调事件通知函数。`BAMBOO_ENDPOINT`为bamboo的公开访问的地址,你应该填充你自己的可以被外访问的公网IP地址。`BAMBOO_ZK_HOST`为zookeeper集群的地址,bamboo通过这个同步各个节点的数据。`BAMBOO_ZK_PATH`为bamboo使用的znode名称.`CONFIG_PATH`为bamboo使用的配置文件,虽然已经有一些配置通过环境变量的方式传进去了,但是像haproxy的模板格式,重启haproxy的命令等还是需要配置文件导入的。这里直接使用的官方默认的部署配置文件,你也可以针对这个配置文件按做自己的定制。

161 |

162 | {

163 | "Marathon": {

164 | "Endpoint": "http://marathon1:8080,http://marathon2:8080,http://marathon3:8080"

165 | },

166 |

167 | "Bamboo": {

168 | "Endpoint": "http://haproxy-ip-address:8000",

169 | "Zookeeper": {

170 | "Host": "zk01.example.com:2181,zk02.example.com:2181",

171 | "Path": "/marathon-haproxy/state",

172 | "ReportingDelay": 5

173 | }

174 | },

175 |

176 | "HAProxy": {

177 | "TemplatePath": "config/haproxy_template.cfg",

178 | "OutputPath": "/etc/haproxy/haproxy.cfg",

179 | "ReloadCommand": "haproxy -f /etc/haproxy/haproxy.cfg -p /var/run/haproxy.pid -D -sf $(cat /var/run/haproxy.pid)",

180 | "ReloadValidationCommand": "haproxy -c -f "

181 | },

182 |

183 | "StatsD": {

184 | "Enabled": false,

185 | "Host": "localhost:8125",

186 | "Prefix": "bamboo-server.development."

187 | }

188 | }

189 |

190 | 部署完毕后,我们可以访问bamboo所在的机器的8000端口。

191 |

192 | 这里就可以看到bamboo的界面,说明我们部署成功。下面我们向Maraton提交一个容器,我们使用`tutum/hello-world`这个image,来测试一下bamboo的效果。

193 |

194 | 向Marathon提交运行容器,你可以使用Marathon的网页,但是更通用的方式是通过Marathon的restapi来提交,这样更加容易的集成到开发环境中,我们使用Marathon的python 库来提交请求。

195 |

196 | def create_docker_app():

197 | url = 'http://172.31.23.17:8080'

198 | c = MarathonClient(url)

199 | app = MarathonApp(

200 | id='docker-01',

201 | cmd='',

202 | cpus=0.3,

203 | mem=30,

204 | container={

205 | 'type': 'DOCKER',

206 | 'docker': {

207 | 'image': 'tutum/hello-world',

208 | 'network': 'BRIDGE',

209 | 'portMappings': [{

210 | 'containerPort': 80,

211 | 'hostPort': 0,

212 | }]

213 | }

214 | }

215 | )

216 | c.create_app('hello-001', app)

217 |

218 | 你可以向你Marathon集群的任何一个节点发起部署请求。

219 |

220 | 可以看到Marathon已经运行起来了这个容器,他被部署到Node4机器上,被分配了一个31162端口。由于这些都是内网IP,我们无法通过外网访问,现在我们再来看一下bamboo的页面.

221 |

222 | 可以看到bamboo已经检测到了新启动的容器,现在我们通过bamboo给他设置ACL规则。

223 |

224 | 现在我们访问一下bamboo所在机器的http://IP/hello

225 |

226 | 可以看到,我们部署的容器已经可通过haproxy解析访问到了。

227 |

228 | #Bamboo Ha Mode

229 | 下面我们在Node3上面再部署一个Bamboo实例。

230 |

231 | docker run -d -p 8000:8000 -p 80:80 -e MARATHON_ENDPOINT=http://172.31.35.175:8080,http://172.31.23.17:8080,http://172.31.40.200:8080 -e BAMBOO_ENDPOINT=http://52.32.37.21:8000 -e BAMBOO_ZK_HOST=172.31.23.17:2181,172.31.40.200:2181,172.31.35.175:2181 -e BAMBOO_ZK_PATH=/bamboo -e BIND=":8000" -e CONFIG_PATH="config/production.example.json" -e BAMBOO_DOCKER_AUTO_HOST=true xianlubird/bamboo

232 |

233 | 下面我们分别访问Node3的bamboo和Node4的bamboo,并且同时访问Node3/hello和Node4/hello,看一下效果。

234 |

235 | 可以看到,无论通过哪一个bamboo实例,我们都可以访问到刚才创建的容器。我们进入bamboo容器内部可以看到他生成的haproxy.cfg

236 |

237 | # Template Customization

238 | frontend http-in

239 | bind *:80

240 |

241 |

242 | acl ::hello-001-aclrule path_beg -i /hello

243 | use_backend ::hello-001-cluster if ::hello-001-aclrule

244 |

245 |

246 | stats enable

247 | # CHANGE: Your stats credentials

248 | stats auth admin:admin

249 | stats uri /haproxy_stats

250 |

251 |

252 | backend ::hello-001-cluster

253 | balance leastconn

254 | option httpclose

255 | option forwardfor

256 |

257 | server ::hello-001-172.31.37.173-31162 172.31.37.173:31162

258 |

259 | 下面我们将当前的一个实例scale到三个。

260 |

261 | 可以看到,他们中,有一个实例被分配到了Node3,另外两个实例在Node4。我们现在什么都不需要操作,继续访问我们刚才访问容器的路径,Node4 IP/hello。可以发现容器是可以正常访问的,而且打开bamboo的控制页面可以看到。

262 |

263 |

264 | bamboo自动检测到了目前实例已经变成了3个,而且帮助我们使用haproxy做了负载均衡。当我们的容器扩容缩容,或者迁移的时候,IP地址发生了变化,我们不需要去关心,我们只需要继续访问我们刚才 设置好的路径,bamboo会帮我们做好这些。我们再来看一下现在haproxy的配置文件。

265 |

266 | #Template Customization

267 | frontend http-in

268 | bind *:80

269 |

270 | acl ::hello-001-aclrule path_beg -i /hello

271 | use_backend ::hello-001-cluster if ::hello-001-aclrule

272 |

273 |

274 | stats enable

275 | # CHANGE: Your stats credentials

276 | stats auth admin:admin

277 | stats uri /haproxy_stats

278 |

279 |

280 | backend ::hello-001-cluster

281 | balance leastconn

282 | option httpclose

283 | option forwardfor

284 |

285 | server ::hello-001-172.31.37.173-31162 172.31.37.173:31162

286 | server ::hello-001-172.31.40.200-31770 172.31.40.200:31770

287 | server ::hello-001-172.31.37.173-31195 172.31.37.173:31195

288 |

289 | 可以看到,bamboo已经帮我们发现了新创建的服务的Ip和端口,并且生成了haproxy的配置文件,并在这三台服务器中做了负载,以后我们不管是scale到0还是scale到10个,bamboo都可以帮助我们自动生成haproxy的配置文件并生效,我们需要做的就是继续访问以前的域名就可以继续使用我们的服务。这样就做到了服务发现和自动的负载均衡。

290 |

291 | 这样我们就完成了一个基本的高可用的容器云平台的搭建。当然,如果要想把这个流程自动化起来,可能还需要再这个基础上增加一些功能,必须使用他们的restapi 提交请求,而不是使用网页等等。对于数据的持久化,volumn的挂载,我们没有做过多的讨论。后面我们会提及一下实现的思路。

292 |

293 |

--------------------------------------------------------------------------------

/chapter3/summary.md:

--------------------------------------------------------------------------------

1 | # Mesos搭建企业级容器云项目概述

2 |

3 | 随着docker的兴起,容器一词变得十分的火热,到处都可以看到容器的身影。身在云计算时代,不讨论一下容器,都不好意思说自己是做云计算的。

4 |

5 | 引领这一浪潮的,莫过于docker这一项技术。docker使用Linux的namespace和cgroups实现了容器级别的隔离,然后又加入了image这一概念,使得部署变得十分简单。现在只需要开发代码,build一个镜像,然后就可以借助docker的东风将它无障碍的部署到各种linux发行版中。很好的解决了线上环境和开发环境不同带来的问题,让程序的部署变得更加简单。

6 |

7 | 更加让人激动的是,项目被docker容器化后,就具有了可以扩容的能力。你可以简单的将项目由一个实例变成两个或者更多个而无需复杂的线上配置。而且容器化后的项目可以很好的在分布式环境中运行,自由在多个主机之间迁移。这是传统项目所不具备的。

8 |

9 | 分布式应用在传统项目里门槛很高,会有各种各样的问题。但是现在借助mesos,我们可以非常容易的管理众多主机组成的集群,就像操作一台大型机器一样。

10 |

11 | 对于docker容器这种长时间运行的任务,marathon framewor很好的帮助我们解决了调度和监控的问题。使用它可以很方便的在mesos集群启动容器,然后对他进行健康监控。

12 |

13 | 在集群中运行的容器随时都会被扩容或者迁移到其他机器,那么对于他们的访问,也就是服务发现,一般会使用一些负载均衡器来解决,我们使用开源项目bamboo来实现这样的功能。

14 |

15 | 高可用也是企业级云平台一个非常重要的问题。mesos默认使用zookeeper来完成主从节点的选择和高可用,后面我们也会详细介绍。

16 |

17 | 综上是搭建一个企业级容器云平台需要的基础构建,可以看到,几乎清一色的开源项目。后面我们会以此为例子,一步步搭建一个分布式容器云平台。

--------------------------------------------------------------------------------

/chapter3/think_about.md:

--------------------------------------------------------------------------------

1 | # 容器云平台基础概述

2 |

3 | 经过前面的搭建,我们已经拥有了一个mesos集群和一个Marathon framework。而对于企业级容器云平台来说,拥有这些还是不足的。

4 |

5 | 设想一下企业级容器云实际使用情况。我们需要一个高可用的环境。因此需要zookeeper多节点,mesos master 多节点以做备份。然后Marathon 也有ha模式,可以有效的防止master失效导致环境不可用。

6 |

7 | 实际使用中,我们应该会使用Marathon的rest api来发起部署请求,将我们需要部署的镜像和相关的环境变量交给Marathon,这样的功能一定是集成到我们自己的一个平台里面的。在Marathon部署的时候,我们的容器可能会被分配到一个随机的节点,因此我们需要一种服务发现机制。一般来说,mesos 和Marathon都是部署在内网环境中,一般不允许外部直接访问。我们应该有一个节点专门负责对外访问的负载均衡的功能。Marathon本身内置了服务发现的功能。我们可以通过开启他来让Marathon帮助你自动生成haproxy的配置文件,然后reload来实现服务发现。但是这样可定制性不是很强,而且因为和Marathon绑定,我们不太容易迁移和扩展。因此我们这里使用bamboo这个开源项目来做服务发现。bamboo是一个使go开发的能够自动生成haproxy的配置文件然后reload的项目。他的信息来源是通过注册了Marathon的事件订阅机制,Marathon再有变化的时候会自动通知它,然后bamboo就会完成一系列的生成配置文件然后reload haproxy的功能。关于bamboo的详细介绍可以看[这里](https://github.com/QubitProducts/bamboo)。

8 |

9 | 由于bamboo也提供了rest api,因此我们可以很方便的使用代码去完成服务发现,到最终部署的服务可以被外网访问到这一个完整的流程,下面我们就开始搭建。

--------------------------------------------------------------------------------

/chapter3/zatan.md:

--------------------------------------------------------------------------------

1 | # 关于容器云平台的其他一些杂谈

2 |

3 | 前面我们搭建的这个平台,大部分操作都是通过使用框架提供的网页来操作,实际生产环境中,肯定需要我们自己来实现一套自动化的系统来帮助我们完成这些事情。我们可以根据前面章节提供的这些开源组件以及他们的功能来开发自己的容器云平台。

4 |

5 |

6 | #对于数据持久化

7 | 前面章节我们搭建的mesos集群和Marathon集群都没提及数据持久化问题。其实docker对于数据持久化做的很方便,只需要使用volume将需要存储的路径挂载到宿主机的磁盘上即可。我们可以根据需要,将mesos的日志文件或者zookeeper的存储文件挂载到自己指定的地方即可。其实我们在运行的时候,这些container在dockerfile中声明了vloume,docker会在自己的/var/lib/docker/volume文件夹中存储容器中挂载出来的目录。

8 |

9 | 这是对于基础平台的数据持久化。但是如果是运行在我们平台上的容器,如果他被scale到别的机器或者被重启后迁移,他挂载在宿主机的磁盘数据如何跟随他自己迁移呢。这里推荐使用flocker。flocker可以将docker的volume在不同主机之间迁移,保证用户的数据不被丢失。这里有一个官方demo的架构图。

10 |

11 |

12 |

13 | 当左侧的node1失效的时候,salve宕机,flocker可以自动将存储在EBS volume上的数据同步到node2上,这样就可以实现docker volume的迁移,对于数据库等应用非常的适合。具体的搭建步骤参考[flocker-marathon](https://clusterhq.com/2015/10/06/marathon-ha-demo/)。

14 |

15 | #流程的优化

16 | 如何将我们前面搭建的架构使用代码串联起来,也是实际搭建容器云平台的一个问题。首先对于这些image的获取,docker pull 官方的image会比较慢,可以通过加速器来加快流程。可以使用[灵雀云](http://www.alauda.cn/)提供的镜像加速服务来快速pull镜像,如果有能力也可以自己搭建一个registry,自己管理images。

17 |

18 | Marathon的client可以根据自己的语言喜好,有各种版本的client。整个平台创建一个容器的流程大概如下。根据用户选择的image和填写的参数以及环境变量等,使用client向Marathon发送请求,然后Marathon接受请求后开始部署。部署完毕后,bamboo就发现了这个服务的IP和port等信息,然后调用bamboo的rest api,给这个服务添加acl规则,这个时候bamboo就会根据你的规则生成对应的haproxy配置文件,然后haproxy会进行reload来使新的服务生效,这个时候就可以根据IP或者域名访问到部署上去的服务。

19 |

20 | 如果用户需要扩容,client可以直接向Marathon发送扩容的请求,Marathon就会完成扩容的动作,并且bamboo会自动发现实例数量的变化,reload haproxy,用户这边没有任何感知就可以继续使用原来的域名访问他们的服务,但是这时候后台已经有多个服务在通过haproxy的负载均衡策略提供服务。这样一个基本的容器云服务平台就搭建完成,也可以基本的使用,我们可以很方便的通过增加mesos slave来向集群添加机器,mesos和Marathon会帮我们做好机器之间的选择与部署。

21 |

--------------------------------------------------------------------------------

/chapter4/12DF1664-8DE5-4AEE-B420-94D14F6E6543.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter4/12DF1664-8DE5-4AEE-B420-94D14F6E6543.png

--------------------------------------------------------------------------------

/chapter4/Cluster-mesos.png:

--------------------------------------------------------------------------------

https://raw.githubusercontent.com/xiaods/mesos-handbook/16c395ffa746f9b5a26a3f105772c9ec67247a60/chapter4/Cluster-mesos.png

--------------------------------------------------------------------------------

/chapter4/README.md:

--------------------------------------------------------------------------------

1 | # Mesos搭建大数据平台Hadoop和深度机器学习平台Singa实战

2 |

3 | # Mesos系统简介

4 |

5 | Mesos是一个跨应用集群的共享资源调度和隔离的分布式集群管理系统,它可以在集群应用如:Hadoop MapReduce、Hbase、MPI等之间共享资源并保证各个应用之间的隔离。Mesos是Apache基金会的顶级项目,一经推出就饱受推崇和关注,Twitter是最早的将其应用在自己生态系统架构中的公司。在Twitter内部,Mesos被当作成了DCOS系统,几乎所有的应用服务都使用Mesos进行分布式资源调度。随后像APPLE这样的大型科技公司也将Mesos引入到自己的数据中心,随着越来越多的大型公司将Mesos作为自己数据中心的操作系统,Mesos作为DCOS的应用被广泛的讨论和应用实践。在国内也有Mesos作为DCOS的用案例,如数人云等。

6 |

7 | ## 1.1、Mesos与其他分布式调度系统的对比

8 |

9 | ### 1.1.1 Mesos VS Kubernetes

10 |

11 | 关于Mesos在前面一小节已经根据官方的定义进行了说明,那么关于Kubernetes官方的定义是这样的:Kubernetes is an open source orchestration system for Docker containers.\(Kubernetes是一个开源的Docker容器调度编排系统。)

12 | 换句话说,Kubernetes是一个Docker容器的高级管理系统,可以从集群应用层面出发满足对应用进行集群化部署、管理的需求。下图可以很形象的说明这种特性:

13 |

14 |

15 | (图片来自Kuberbetes官网)

16 |

17 | 关于Mesos和Kubernetes的区别,我准备这样表述:Mesos更偏重于对应用资源的分布式调度和管理,它只负责资源的均衡分布式调度,至于资源的使用是由各种框架来实现的。而Kubernetes更偏重于提供一个基于Docker容器的轻量级应用集群部署平台,它着重于如何更有效的帮助开发运维人员实现一个应用的分布式集群部署。

18 |

19 | 对于到底是Mesos更有前景还是Kubernetes能够取代Mesos这里不做争论,我认为这两个项目都是非常优秀的开源项目,在不同的应用场景下具备各自不同的优势,如对于一些非分布式任务型的应用(如一些移动APP),这些应用更多的通过分布式集群部署实现服务的负载均衡和弹性伸缩以及快速迭代部署,那么这种情况下我认为面向应用且被各大软将厂商支持的Kubernetes更有优势;而对于一些分布式任务型的应用(如Hadoop、spark等),这些应用是通过分布式集群资源调度系统实现计算资源的逻辑上一致性,进而实现任务的并行计算等功能,那么这种情况下我认为面向底层资源并采用双层调度机制的Mesos更具优势。

20 |

21 | ### 1.1.2 Mesos VS Yarn

22 |

23 | 对于YARN的介绍在百度百科是这样描述的:YARN (Yet Another Resource Negotiator,另一种资源协调者)是一种新的 Hadoop 资源管理器,它是一个通用资源管理系统,可为上层应用提供统一的资源管理和调度,它的引入为集群在利用率、资源统一管理和数据共享等方面带来了巨大好处。

24 |

25 | Mesos和Yarn都采用了双层调度机制,这种机制很好的解决了集中式资源调度机制在资源集群调度过程中扩展性差、兼容性不好的问题。Mesos和Yarn都是面向底层资源调度的分布式集群系统,其应用场景基本是类似的(Hadoop、spark等),但是由于Yarn是从Hadoop1.0发展出来的,所以在Hadoop体系的项目以及基于这些项目的应用对Yarn都有比较好的兼容性和丰富的应用实践。

26 | 关于Mesos与Yarn的对比,每个我只从一个优势方面阐述一下。Mesos相对与Yarn的优势之一是它的二层调度机制更开放,在第一层对资源的调度颗粒度更大,这样的好处是给予第二层调度机制的资源管理权限更大,对计算框架的限制更少,这是因为Mesos的二层调度机制是基于Resoure Officer的,而Yarn是基于solt的。Yarn相对对于Mesos的优势之一是其具备成熟的生态圈,特别是在Hadoop系统中,各个子项目都有基于Yarn的成熟应用实践和丰富的生态群应用。

27 |

28 | ## 1.3 搭建环境简介

29 |

30 | 本次搭建的环境以及下一节的Mesos集群的部署都是参考我之前在Dockerone上写的一篇文章,因为这个环境是现成的且结构比较全(3个maste节点和3个slave节点\),而且那篇部署教程在写完之后我自己还进行过重新部署,是写的比较全面且坑比较少的部署教程。以下是部署环境的简介:

31 |

32 |

33 | 如图所示其中master节点都需要运行ZooKeeper、Mesos-master、Marathon,在slave节点上只需要运行master-slave就可以了,但是需要修改ZooKeeper的内容来保证slave能够被master发现和管理。为了节约时间和搞错掉,我在公司内部云平台上开一个虚拟机把所有的软件都安装上去,做成快照进行批量的创建,这样只需要在slave节点上关闭ZooKeeper、Mesos-master服务器就可以了,在文中我是通过制定系统启动规则来实现的。希望我交代清楚了,现在开始部署。

34 |

35 | ## 1.4 Mesos集群部署

36 |

37 | ### 1.4.1准备部署环境

38 |

39 | * 在Ubuntu 14.04的虚拟机上安装所有用到软件,并保证虚拟机可以上互联网。

40 |

41 | * 安装Python依赖

42 | * `apt-get install curl python-setuptools python-pip python-dev python-protobuf`

43 | * 安装配置zookeeper

44 | * \`\`\`apt-get install ZooKeeperd &

45 | echo 1 \| sudo dd of=/var/lib/ZooKeeper/myid\`\`\`

46 | * 安装配置Mesos-master和Mesos-slave

47 | * `curl-fL http://downloads.Mesosphere.io/master/ubuntu/14.04/Mesos_0.19.0~ubuntu14.04%2B1_amd64.deb -o /tmp/Mesos.deb`

48 | * `dpkg -i /tmp/Mesos.deb`

49 | * `mkdir -p /etc/Mesos-master`

50 | * `echo in_memory | sudo dd of=/etc/Mesos-master/registry`

51 | * 安装配置Mesos的Python框架

52 | * `curl -fL http://downloads.Mesosphere.io/master/ubuntu/14.04/Mesos-0.19.0_rc2-py2.7-linux-x86_64.egg -o /tmp/Mesos.egg`

53 | * `easy_install /tmp/Mesos.egg`

54 | * 下载安装Mesos管理Docker的代理组件Deimos

55 | * `pip install deimos`

56 | * 配置Mesos使用Deimos

57 | * `mkdir -p /etc/mesos-slave`

58 | * `echo /usr/local/bin/deimos | sudo dd of=/etc/Mesos-slave/containerizer_path`

59 | * `echo external | sudo dd of=/etc/Mesos-slave/isolation`

60 | * 安装Docker

61 | * `echo deb http://get.Docker.io/ubuntu Docker main | sudo tee /etc/apt/sources.list.d/Docker.list`

62 | * `sudo apt-key adv --keyserver keyserver.ubuntu.com --recv-keys 36A1D7869245C8950F966E92D8576A8BA88D21E9`

63 | * `apt-get update && apt-get install lxc-Docker`

64 | 至此在一个虚拟机上就完成了所有组件的安装部署,下面就是对虚拟机打快照,然后快速的复制出6个一样的虚拟机,按照上图的ip配置进行配置之后就可以进入下个阶段,当然为了保险你可以测试一下上处组件是否安装成功和配置正确。如果你没有使用云平台,或者不具备快照功能,那就只能在6个虚拟机上重复6遍上处过程了。

65 |

66 | ### 1.4.2、在所有的节点上配置ZooKeeper

67 |

68 | 在配置maser节点和slave节点之前,需要先在所有的6个节点上配置一下ZooKeeper,配置步骤如下:

69 |

70 | * 修改zk的内容

71 | * `sudo vi /etc/Mesos/zk`

72 | * 将zk的内容修改为如下:

73 | * `zk://10.162.2.91:2181,10.162.2.92:2181,10.162.2.93:2181/Mesos`

74 |

75 | ### 1.4.3配置集群中的三个master节点

76 |

77 | 在所有的master节点上都要进行如下操作:

78 |

79 | * 修改ZooKeeper的myid的内容

80 | * `sudo vi /etc/zooKeeper/conf/myid`

81 | * 将三个master节点的myid按照顺序修改为1,2,3。

82 | * 修改ZooKeeper的zoo.cfg

83 | * `sudo vi/etc/zooKeeper/conf/zoo.cfg`

84 | * 配置内容如下:

85 | * `server.1=10.162.2.91:2888:3888`

86 | * `server.2=10.162.2.92:2888:3888`

87 | * `server.3=10.162.2.93:2888:3888`

88 | * 修改Mesos的quorum

89 | * `sudo vi /etc/mesos-master/quorum`

90 | * 将值修改为2。

91 | * 配置master节点的Mesos 识别ip和和hostname\(以在master1上的配置为例)

92 | * `echo 10.162.2.91 | sudo tee /etc/mesos-master/ip`

93 | * `sudo cp /etc/mesos-master/ip /etc/mesos-master/hostname`

94 | * 配置master节点服务启动规则(重启不启动slave服务)

95 | * \`\`\`sudo stop Mesos-slave

96 | echo manual \| sudo tee /etc/init/Mesos-slave.override\`\`\`

97 |

98 | ### 1.4.4、配置集群中的的slave节点

99 |

100 | * 配置slave节点的服务启动规则(重启不启动zookeeper和slave服务)

101 | * `sudo stop zooKeeper`

102 | * `echo manual | sudo tee /etc/init/zooKeeper.override`

103 | * `echo manual | sudo tee /etc/init/mesos-master.override`

104 | * `sudo stop mesos-master`

105 | * 配置slave节点的识别ip和hostname(以slave1节点为例)

106 | * `echo 192.168.2.94 | sudo tee /etc/mesos-slave/ip`

107 | * `sudo cp /etc/Mesos-slave/ip /etc/mesos-slave/hostname`

108 |

109 | ### 1.4.5、在集群的所有节点上启动相应的服务

110 |

111 | * 启动master节点的服务(zookeeper和mesos-master服务)

112 | * `initctl reload-configuration`

113 | * `service zookeeper start`

114 | * `service mesos-master start`

115 | * 启动slave节点上的相应服务(mesos-slave服务)

116 | * `sudo start mesos-slave`

117 |

118 | ### 1.4.5、Troubleshooting

119 |

120 | 由于有的网络情况和设备情况不一样,所以选举的过程有的快有的慢,但刷新几次就可以完成选举。当发现slave节点有些正常有些不正常时,可以通过reboot来促使自己被master发现。

121 |

122 | ## 1.5、Hadoop在Mesos集群上部署

123 |

124 | ### 1.5.1、部署前准备

125 |

126 | * 在部署和HDFS初始化过程中都需要跨节点的操作和SSH,因此首先在Mesos集群的所有节点上关闭防火墙。如下:

127 | * `chkconfig iptables off`(在root用户下操作)

128 | * 关闭selinux

129 | * `setenforce 0`\(在root用户下操作)

130 | * 在HDFS部署中,或者说在分布式架构的部署过程中节点之间的通信都是以主机名为地址标识,因此要保证每个节点主机名的唯一。

131 | * 在Master1节点上配置hostname:

132 | * `vi /etc/hostname`

133 | * `master1`

134 | * 在Masrer1节点上配置hosts

135 | * `vi /etc/hosts`

136 | * `127.0.0.1 localhost`

137 | * `10.162.2.91 master1`

138 | * `10.162.2.92 master2`

139 | * `10.162.2.93 master3`

140 | * `10.162.2.94 slave1`

141 | * `10.162.2.95 slave2`

142 | * `10.162.2.96 slave3`

143 | * 在其他节点上都参照上述配置进行修改hostname和hosts.

144 | * 在部署HDFS和Hadoop时,需要使用非root用户来进行操作,虽然大部分情况下也可以在root用户下操作,但以往的经验是非root用户下操作部署更顺畅。

145 | * 添加新的用户

146 | * `addusr hadoop`

147 | * 重置hadoop用户的密码

148 | \*`passwd hadoop`

149 |

150 | ### 1.5.2、在Mesos集群中部署HDFS

151 |

152 | * 本次案例的集群中master有三个节点,slave有三个节点,在master节点中使用zookeeper进行服务选举,在部署HDFS时也会用到zookeeper进行namenode节点的选举。

153 |

154 | ### 在master节点上部署namenode

155 |

156 | * 创建一个文件目录用于

157 | * `mkdir -p /mnt/cloudera-hdfs/1/dfs/nn /nfsmount/dfs/nn`

158 | * 修改文件目录的用户权限,给上一步创建的文件目录添加用户hadoop操作权限

159 | * `chown -R hadoop:hadoop /mnt/cloudera-hdfs/1/dfs/nn /nfsmount/dfs/nn`

160 | * 修改文件目录的操作权限

161 | * `chmod 700 /mnt/cloudera-hdfs/1/dfs/nn /nfsmount/dfs/nn`

162 | * 使用apt-get 安装hadoop-hdfs-namenode,这样可以避免使用二进制文件在编译过程中遇到的坑。

163 | * `wget http://archive.cloudera.com/cdh5/one-click-install/precise/amd64/cdh5-repository_1.0_all.deb`

164 | * `sudo dpkg -i cdh5-repository_1.0_all.deb`

165 | * `sudo apt-get update; sudo apt-get install hadoop-hdfs-namenode`

166 | \*`cp /etc/hadoop/conf.empty/log4j.properties/etc/hadoop/conf.name/log4j.properties`

167 |

168 | ### 1.5.3、在slave节点上部署datanode

169 |

170 | * 创建挂载目录

171 | * `mkdir -p /mnt/cloudera-hdfs/1/dfs/dn /mnt/cloudera-hdfs/2/dfs/dn /mnt/cloudera-hdfs/3/dfs/dn /mnt/cloudera-hdfs/4/dfs/dn`

172 | * 修改挂在目录所属的用户组

173 | * `chown -R hadoop:hadoop /mnt/cloudera-hdfs/1/dfs/dn/mnt/cloudera-hdfs/2/dfs/dn /mnt/cloudera-hdfs/3/dfs/dn /mnt/cloudera-hdfs/4/dfs/dn`

174 | * 使用apt-get 安装hadoop-hdfs-datanode

175 | * `wget http://archive.cloudera.com/cdh5/one-click-install/precise/amd64/cdh5-repository_1.0_all.deb`

176 | * `dpkg -i cdh5-repository_1.0_all.deb`

177 | * `sudo apt-get update; sudo apt-get install hadoop-hdfs-datanode`

178 | * `sudo apt-get install hadoop-client`

179 |

180 | ### 1.5.4、 格式化并启动namenode节点

181 |

182 | * `sudo -u hadoop hadoop namenode -format`

183 | * `service hadoop-hdfs-namenode start`

184 |

185 | ### 1.5.5、启动slave节点

186 |

187 | * `service hadoop-hdfs-datanode start`

188 |

189 | ### 1.5.6 配置服务自启动

190 |

191 | * 在namenode节点上

192 | * `update-rc.d hadoop-hdfs-namenode defaults`

193 | * `update-rc.d zookeeper-server defaults`

194 | \*在slave节点上

195 | * `update-rc.d hadoop-hdfs-datanode defaults`

196 |

197 | ## 1.6、在Mesos集群中部署Hadoop

198 |

199 | ### 1.6.1、Hadoop的基本安装

200 |

201 | * 下载Hadoop安装文件包

202 | * `wget http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.3.0-cdh5.1.2.tar.gz`

203 | * 将安装文件包解压缩

204 | * `tar zxf hadoop-2.3.0-cdh5.1.2.tar.gz`

205 | * 下载hadooponmesos二进制文件

206 | * `git clone https://github.com/mesos/hadoop.git hadoopOnMesos`

207 | * 使用mvn编译hadooponmesos文件

208 | * `mvn package`

209 | * 注意:mvn package要在下载的hadoopOnMesos文件夹中执行,编译好后可以在target文件夹中找到一个编译好的jar文件。

210 |

211 | * 将编译好的jar文件拷贝到hadoo-hdfs安装文件夹和下载的hadoop安装文件夹中

212 |

213 | * `cp hadoopOnMesos/target/hadoop-mesos-0.1.0.jar /usr/lib/hadoop-0.20-mapreduce/lib/`

214 | * `cp hadoopOnMesos/target/hadoop-mesos-0.1.0.jar hadoop-2.3.0-cdh5.1.2/share/hadoop/common/lib/`

215 | * 配置CDH5使用MRv1,因为在MRv2中hadoop的任务调度是使用yarn的

216 | * `cd hadoop-2.3.0-cdh5.1.2`

217 | * `mv bin bin-mapreduce2`

218 | * `mv examples examples-mapreduce2`

219 | * `ln -s bin-mapreduce1 bin`

220 | * `ln -s examples-mapreduce1 examples`

221 | * `pushd etc`

222 | * `mv hadoop hadoop-mapreduce2`

223 | * `ln -s hadoop-mapreduce1 hadoop`

224 | * `popd`

225 | * `pushd share/hadoop`

226 | * `rm mapreduce`

227 | * `ln -s mapreduce1 mapreduce`

228 | * `popd`

229 | * 配置Hadoop运行所需的环境和配置文件:

230 | * `cp target/hadoop-mesos-0.1.0.jar /usr/lib/hadoop-0.20-mapreduce/lib`

231 | * \*/上一步是将hadoopOnmesos编译好的jar包放到hadoop调用库文件夹中,以便hadoop可以使用mesos调度资源运行job任务。

232 | * `vim /etc/profile.d/hadoop.sh`

233 | * `export HADOOP_MAPRED_HOME=/usr/lib/hadoop-0.20-mapreduce`

234 | * `export MESOS_NATIVE_JAVA_LIBRARY=/usr/local/lib/libmesos.so`

235 | * \*/上一步是在hadoop的运行脚本中配置HOME路径和Mesos的原生库。

236 | * `chmod +x /etc/profile.d/hadoop.sh`

237 | * `/etc/profile.d/hadoop.sh`

238 | * `cd ..`

239 | * `rm hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz`

240 | * \*/删除下载的cdh5原始文件

241 | * `tar czf hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz hadoop-2.3.0-cdh5.1.2/`

242 | * \*/上一步是将配置好的hadoop安装文件重新打包

243 | * `hadoop dfs -put hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz /`

244 | * \*/上一步是将打包好的hadoop安装包上传到hdfs上

245 |

246 | ### 1.6.2、 Hadoop配置文件配置

247 |

248 | * 配置mapred-site.xml

249 | * `vi /etc/hadoop/conf.cluster-name/mapred-site.xml`

250 | * mapred-site.xml需要配置文件内容

251 | * `mapred.jobtracker.taskScheduler`

252 | * `org.apache.hadoop.mapred.MesosScheduler`

253 | * \*/上一步是通过配置mapred的jobtrackerd.taskSchedule来告诉Hadoop使用Mesos来调度管理任务。

254 | * `mapred.mesos.taskScheduler`

255 | * `org.apache.hadoop.mapred.JobQueueTaskScheduler`

256 | * `mapred.mesos.master`

257 | * `zk:10.162.2.91:2181,10.162.2.92:2181,10.162.2.93:2181/mesos`

258 | * \*/上一步配置是保证mapred能够准确的找到mesos master节点通过zookeeper选举出来的的主节点。

259 | * `mapred.mesos.executor.uri`

260 | * `hdfs:/10.162.2.92:9000/hadoop-2.3.0-cdh5.1.2-mesos.0.20.tar.gz`

261 | * \*/上一步是配置hadoop的路径,这样mapred可以知道到那里调用hadoop代码执行task,这里10.162.2.92是本地主机的IP地址,在10.162.2.91主机上时就改成10.162.2.91.

262 | * `mapred.job.tracker`

263 | * `10.162.2.92:9001`

264 | * \*/上一步是配置jobtracker的主机IP地址,和上一步一样这要配置本机的IP地址

265 | * 配置本地的Mesos原生库

266 | * `vim /usr/lib/hadoop-0.20-mapreduce/bin/hadoop-daemon.sh`

267 | * `export MESOS_NATIVE_JAVA_LIBRARY=/usr/local/lib/libmesos.so`

268 | \*完成上述配置后尝试启动jobtracker,验证是否安装部署成功。

269 | * `service hadoop-0.20-mapreduce-jobtracker start`

270 | * 可以通过jps查看jobtracker进程是否在运行

271 | * `jps`

272 |

273 | ### 1.6.3、 在其他namenode和datanode上完成部署

274 |

275 | * 在其他两个Master节点上完成相应的配置

276 | * 将之前重新打包好的hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz发送到三个datanode节点上

277 | * `scp -r hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz hadoop@10.162.2.94:/hadoop`

278 | * `scp -r hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz hadoop@10.162.2.95:/hadoop`

279 | * `scp -r hadoop-2.3.0-cdh5.1.2-mesos-0.20.tar.gz hadoop@10.162.2.96:/hadoop`

280 | \*重启HDFS的nomenode和datanode

281 |

282 | ## 1.7 Troubleshoting

283 |

284 | 注意:在每次重启HDFS服务的时候,需要先确保Mesos集群是正常运行的。namenode重启的时候可以先重新format一下。

285 |

286 | ## 1.8、基于Mesos搭建深度机器学习平台Singa

287 |

288 | ### 1.8.1、 Singa项目简介

289 |

290 | Singa是由NUS、浙江大学、网易联合进行开发并开源的一个深度机器学习平台,其设计目的是为多种深度学习模型(如CNN、DBN\)提供一个有效的、易用的、高扩展的分布式实现平台。在Singa平台上,用户可以像在Hadoop上实现Map/Reducer一样轻易的训练他们所需要的抽象的深度学习模型。Singa的详细信息可以访问[https://wiki.apache.org/incubator/SingaProposal。](https://wiki.apache.org/incubator/SingaProposal。)

291 |

292 | ### 1.8.2、 Singa on mesos部署架构

293 |

294 | Singa在设计其底层的资源调度系统时选择了Mesos这一优秀的分布式集群资源调度系统,如下图所示:

295 |

296 |