215 |

216 |

217 |

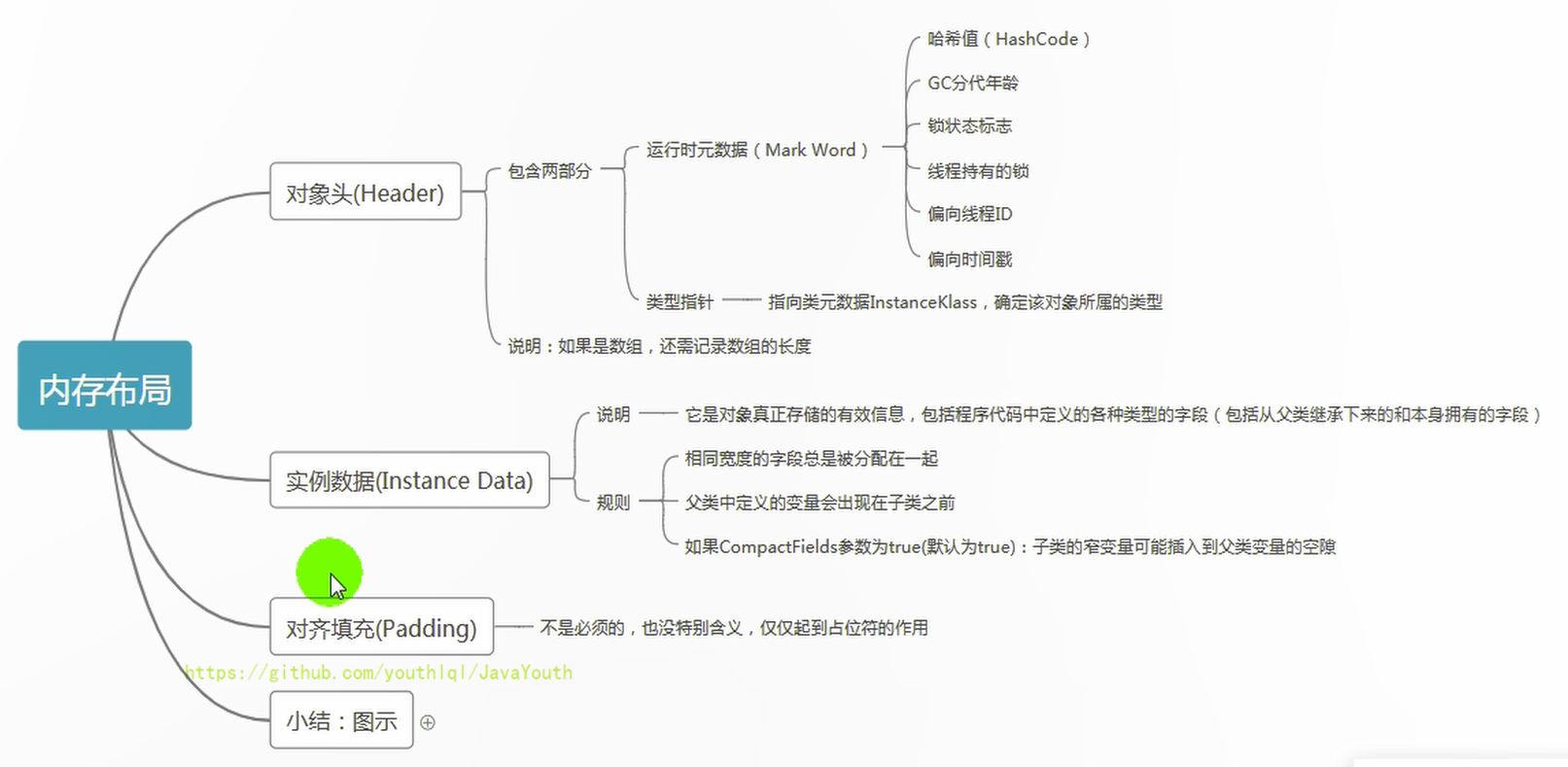

218 | > **内存布局总结**

219 |

220 | ```java

221 | public class Customer{

222 | int id = 1001;

223 | String name;

224 | Account acct;

225 |

226 | {

227 | name = "匿名客户";

228 | }

229 | public Customer(){

230 | acct = new Account();

231 | }

232 | public static void main(String[] args) {

233 | Customer cust = new Customer();

234 | }

235 | }

236 | class Account{

237 |

238 | }

239 | ```

240 |

241 |

242 |

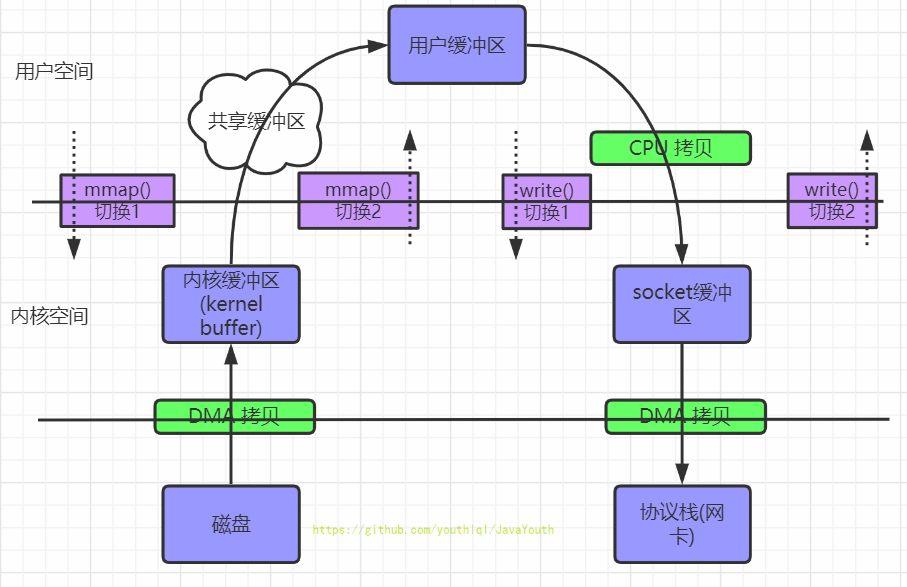

243 | 图解内存布局

244 |

245 |

215 |

216 |

217 |

218 | > **内存布局总结**

219 |

220 | ```java

221 | public class Customer{

222 | int id = 1001;

223 | String name;

224 | Account acct;

225 |

226 | {

227 | name = "匿名客户";

228 | }

229 | public Customer(){

230 | acct = new Account();

231 | }

232 | public static void main(String[] args) {

233 | Customer cust = new Customer();

234 | }

235 | }

236 | class Account{

237 |

238 | }

239 | ```

240 |

241 |

242 |

243 | 图解内存布局

244 |

245 |  246 |

247 |

248 |

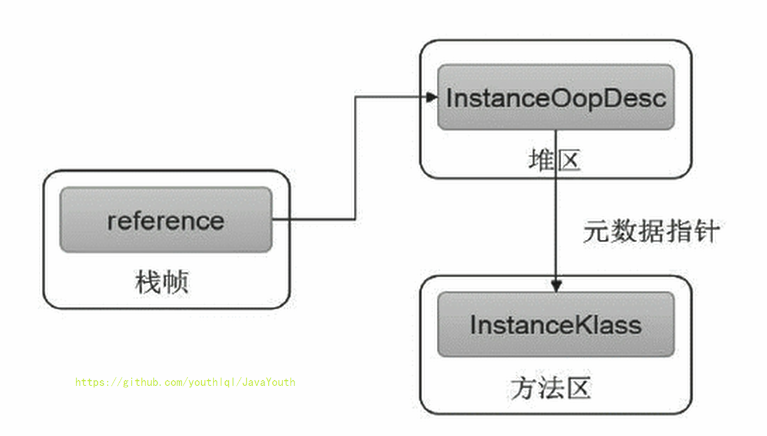

249 | 对象的访问定位

250 | ---------

251 |

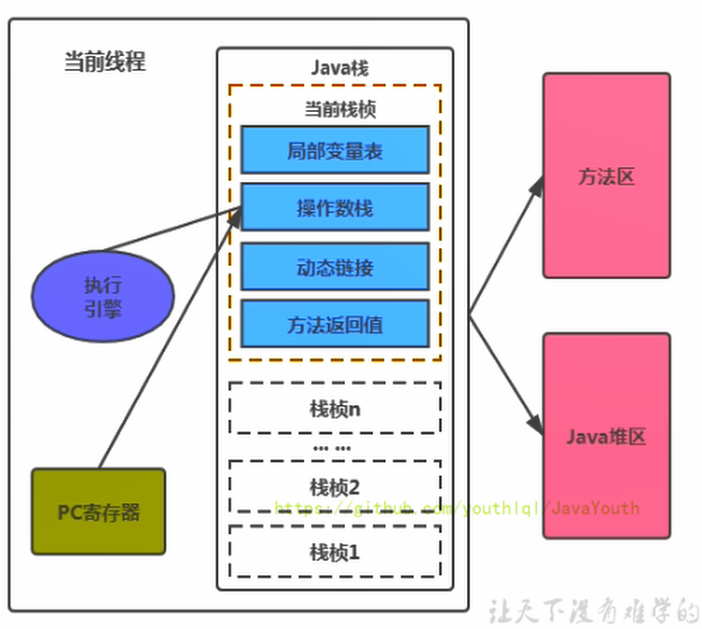

252 | **JVM是如何通过栈帧中的对象引用访问到其内部的对象实例呢?**

253 |

254 |

246 |

247 |

248 |

249 | 对象的访问定位

250 | ---------

251 |

252 | **JVM是如何通过栈帧中的对象引用访问到其内部的对象实例呢?**

253 |

254 |  255 |

256 | 定位,通过栈上reference访问

257 |

258 | **对象的两种访问方式:句柄访问和直接指针**

259 |

260 | **1、句柄访问**

261 |

262 | 1. 缺点:在堆空间中开辟了一块空间作为句柄池,句柄池本身也会占用空间;通过两次指针访问才能访问到堆中的对象,效率低

263 | 2. 优点:reference中存储稳定句柄地址,对象被移动(垃圾收集时移动对象很普遍)时只会改变句柄中实例数据指针即可,reference本身不需要被修改

264 |

265 |

255 |

256 | 定位,通过栈上reference访问

257 |

258 | **对象的两种访问方式:句柄访问和直接指针**

259 |

260 | **1、句柄访问**

261 |

262 | 1. 缺点:在堆空间中开辟了一块空间作为句柄池,句柄池本身也会占用空间;通过两次指针访问才能访问到堆中的对象,效率低

263 | 2. 优点:reference中存储稳定句柄地址,对象被移动(垃圾收集时移动对象很普遍)时只会改变句柄中实例数据指针即可,reference本身不需要被修改

264 |

265 |  266 |

267 |

268 |

269 | **2、直接指针(HotSpot采用)**

270 |

271 | 1. 优点:直接指针是局部变量表中的引用,直接指向堆中的实例,在对象实例中有类型指针,指向的是方法区中的对象类型数据

272 | 2. 缺点:对象被移动(垃圾收集时移动对象很普遍)时需要修改 reference 的值

273 |

274 |

266 |

267 |

268 |

269 | **2、直接指针(HotSpot采用)**

270 |

271 | 1. 优点:直接指针是局部变量表中的引用,直接指向堆中的实例,在对象实例中有类型指针,指向的是方法区中的对象类型数据

272 | 2. 缺点:对象被移动(垃圾收集时移动对象很普遍)时需要修改 reference 的值

273 |

274 |  --------------------------------------------------------------------------------

/docs/JVM/JVM系列-第3章-运行时数据区.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: JVM系列-第3章-运行时数据区

3 | tags:

4 | - JVM

5 | - 虚拟机

6 | categories:

7 | - JVM

8 | - 1.内存与垃圾回收篇

9 | keywords: JVM,虚拟机。

10 | description: JVM系列-第3章-运行时数据区。

11 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/jvm.png'

12 | abbrlink: a7ad3cab

13 | date: 2020-11-09 15:38:42

14 | ---

15 |

16 |

17 |

18 |

19 |

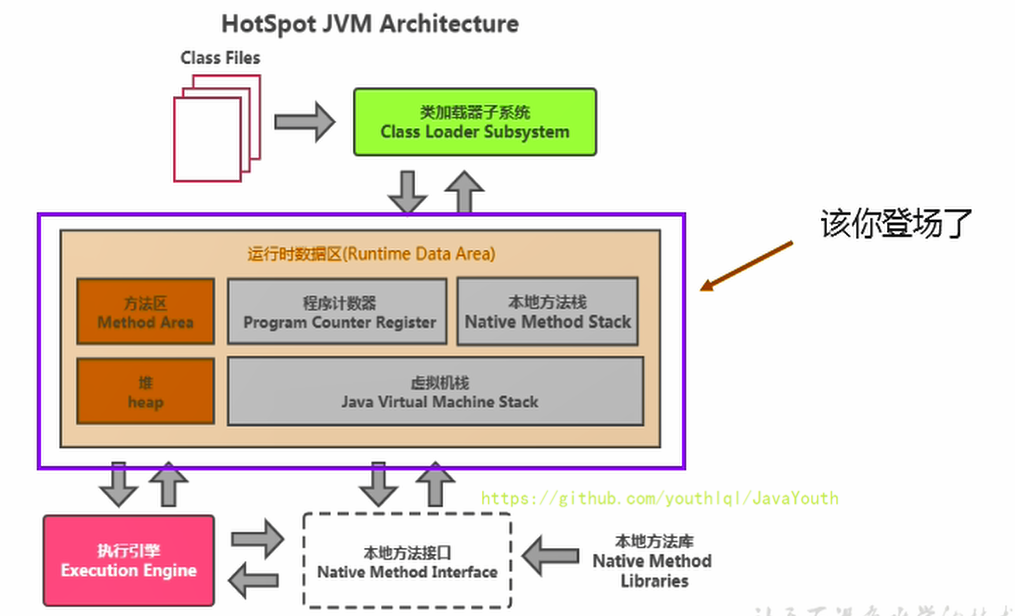

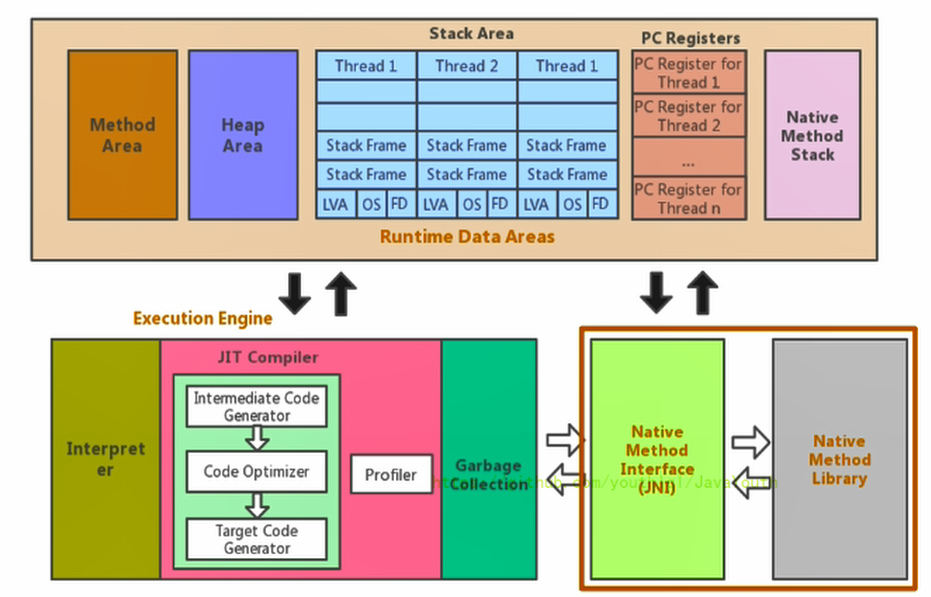

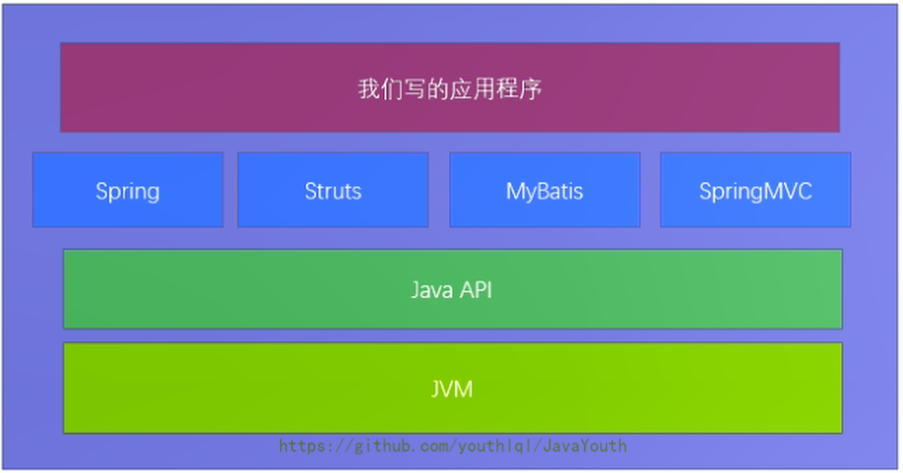

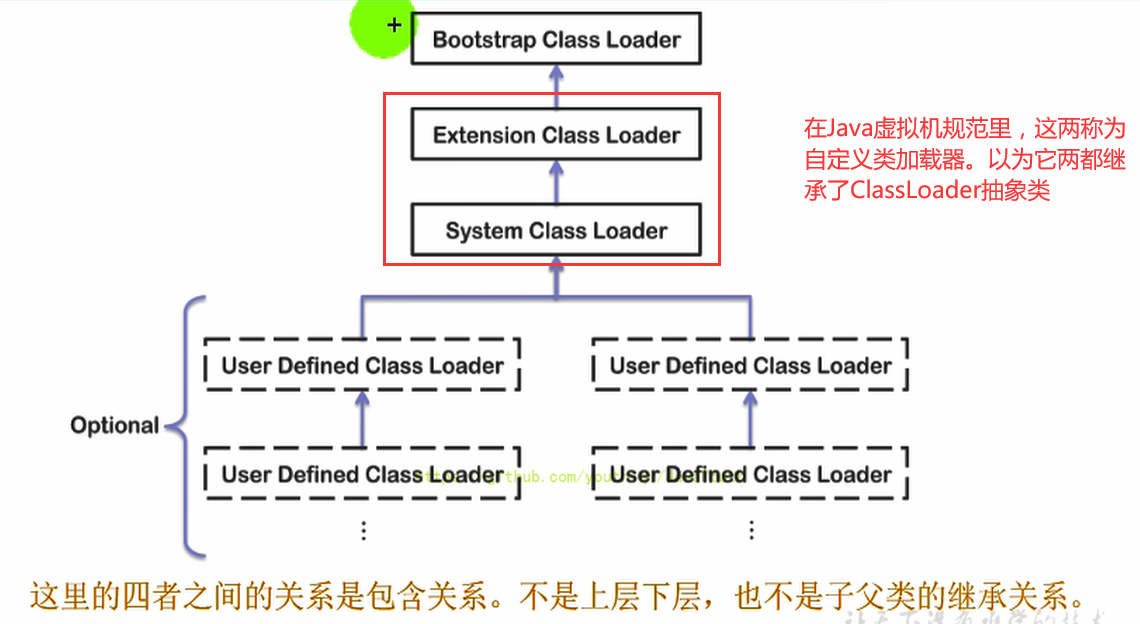

20 | > 此章把运行时数据区里比较少的地方讲一下。虚拟机栈,堆,方法区这些地方后续再讲。

21 |

22 | 运行时数据区概述及线程

23 | =================

24 |

25 | 前言

26 | ----

27 |

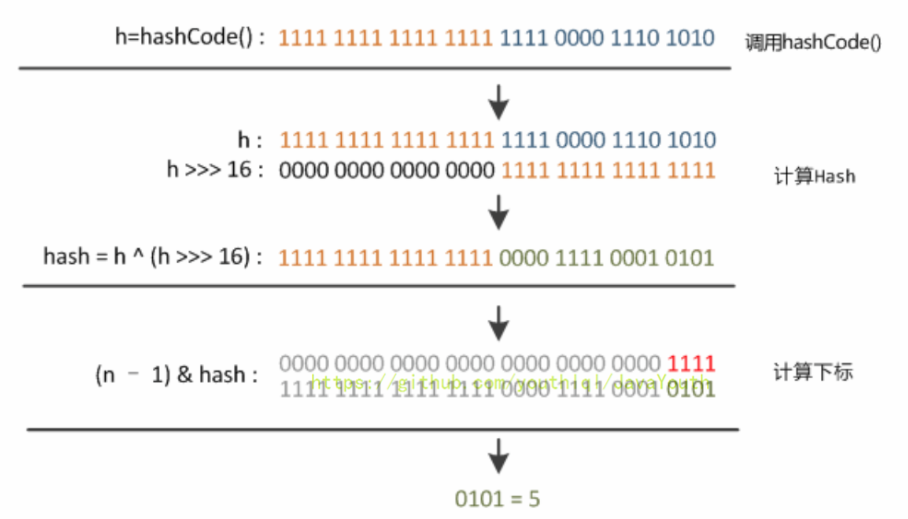

28 | 本节主要讲的是运行时数据区,也就是下图这部分,它是在类加载完成后的阶段

29 |

30 |

--------------------------------------------------------------------------------

/docs/JVM/JVM系列-第3章-运行时数据区.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: JVM系列-第3章-运行时数据区

3 | tags:

4 | - JVM

5 | - 虚拟机

6 | categories:

7 | - JVM

8 | - 1.内存与垃圾回收篇

9 | keywords: JVM,虚拟机。

10 | description: JVM系列-第3章-运行时数据区。

11 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/jvm.png'

12 | abbrlink: a7ad3cab

13 | date: 2020-11-09 15:38:42

14 | ---

15 |

16 |

17 |

18 |

19 |

20 | > 此章把运行时数据区里比较少的地方讲一下。虚拟机栈,堆,方法区这些地方后续再讲。

21 |

22 | 运行时数据区概述及线程

23 | =================

24 |

25 | 前言

26 | ----

27 |

28 | 本节主要讲的是运行时数据区,也就是下图这部分,它是在类加载完成后的阶段

29 |

30 |  31 |

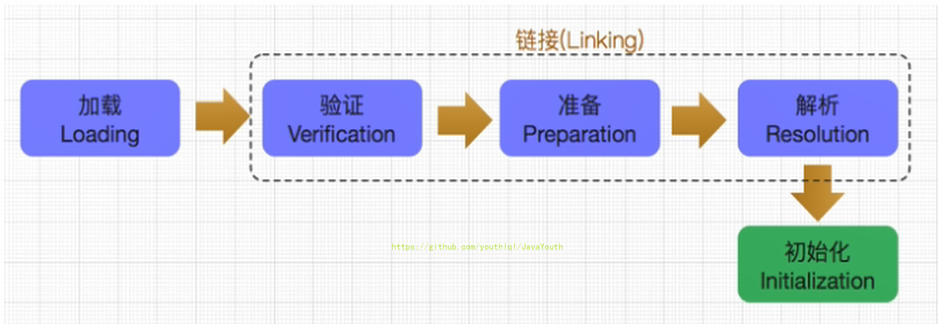

32 | 当我们通过前面的:类的加载 --> 验证 --> 准备 --> 解析 --\> 初始化,这几个阶段完成后,就会用到执行引擎对我们的类进行使用,同时执行引擎将会使用到我们运行时数据区

33 |

34 |

31 |

32 | 当我们通过前面的:类的加载 --> 验证 --> 准备 --> 解析 --\> 初始化,这几个阶段完成后,就会用到执行引擎对我们的类进行使用,同时执行引擎将会使用到我们运行时数据区

33 |

34 |  35 |

36 | 类比一下也就是大厨做饭,我们把大厨后面的东西(切好的菜,刀,调料),比作是运行时数据区。而厨师可以类比于执行引擎,将通过准备的东西进行制作成精美的菜品。

37 |

38 |

35 |

36 | 类比一下也就是大厨做饭,我们把大厨后面的东西(切好的菜,刀,调料),比作是运行时数据区。而厨师可以类比于执行引擎,将通过准备的东西进行制作成精美的菜品。

37 |

38 |  39 |

40 |

41 |

42 | 运行时数据区结构

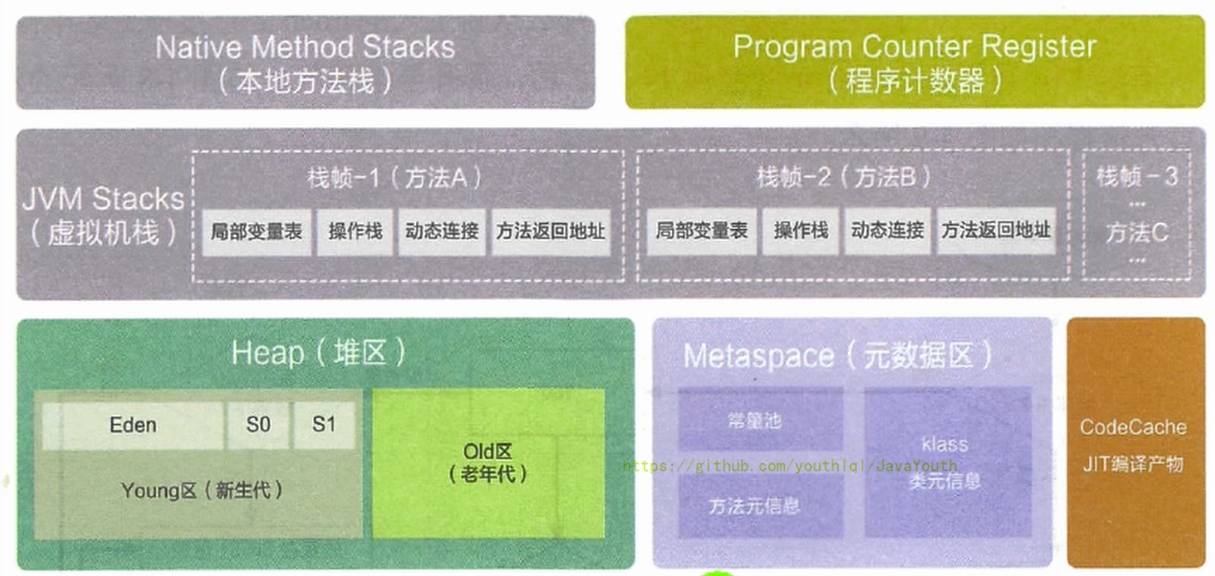

43 | ----------

44 |

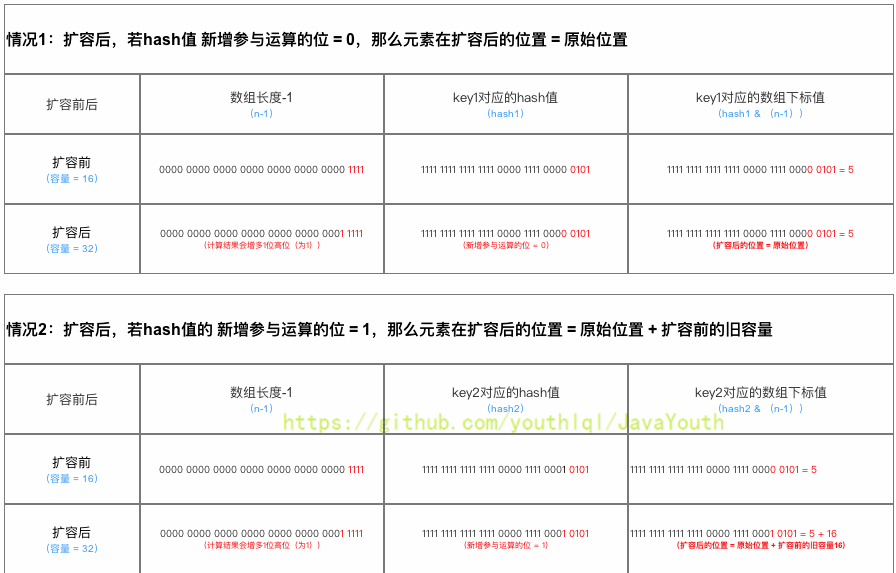

45 | ### 运行时数据区与内存

46 |

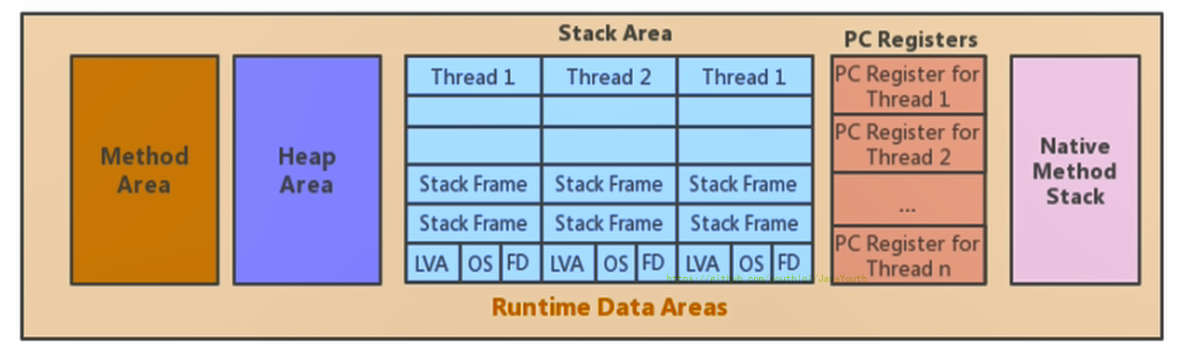

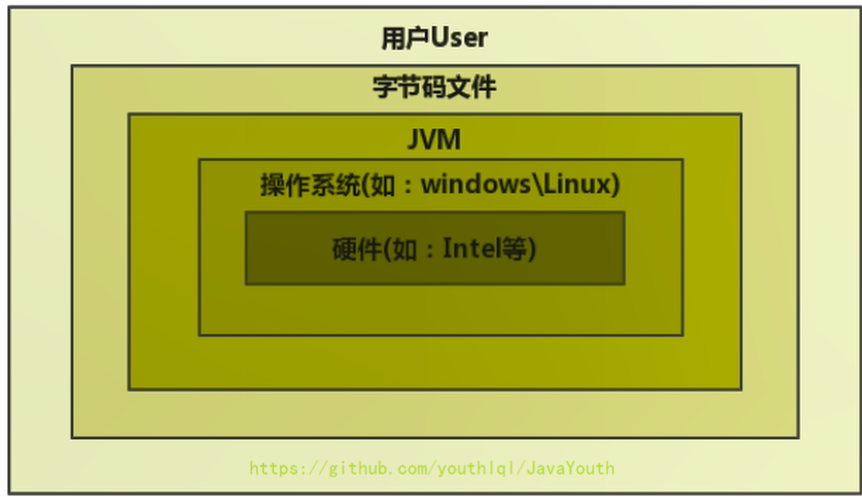

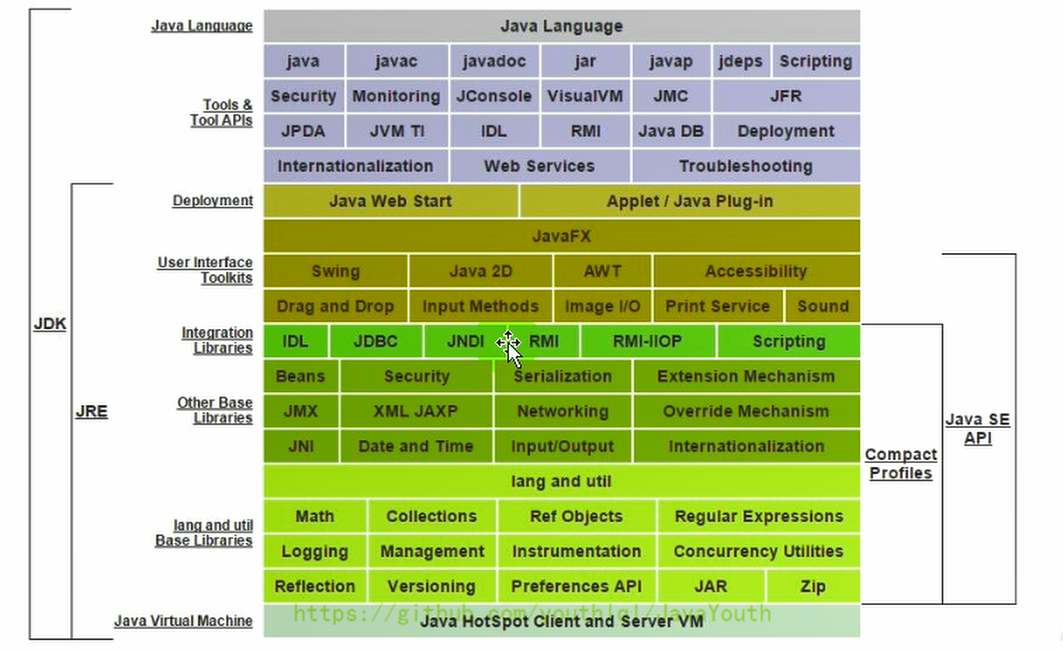

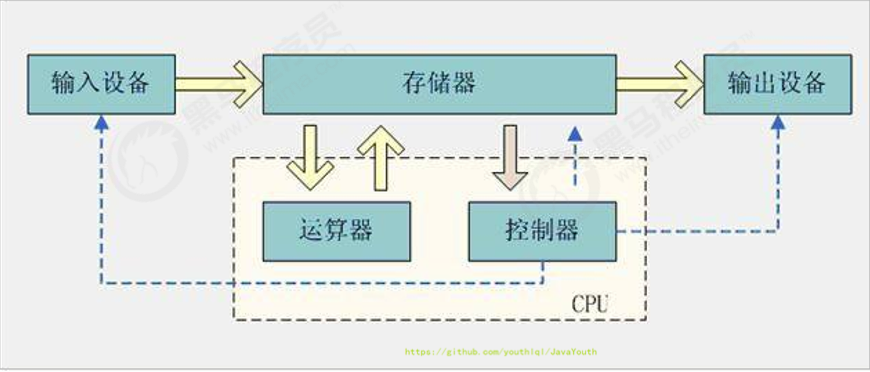

47 | 1. 内存是非常重要的系统资源,是硬盘和CPU的中间仓库及桥梁,承载着操作系统和应用程序的实时运行。JVM内存布局规定了Java在运行过程中内存申请、分配、管理的策略,保证了JVM的高效稳定运行。**不同的JVM对于内存的划分方式和管理机制存在着部分差异**。结合JVM虚拟机规范,来探讨一下经典的JVM内存布局。

48 |

49 | 2. 我们通过磁盘或者网络IO得到的数据,都需要先加载到内存中,然后CPU从内存中获取数据进行读取,也就是说内存充当了CPU和磁盘之间的桥梁

50 |

51 | > 下图来自阿里巴巴手册JDK8

52 |

53 |

39 |

40 |

41 |

42 | 运行时数据区结构

43 | ----------

44 |

45 | ### 运行时数据区与内存

46 |

47 | 1. 内存是非常重要的系统资源,是硬盘和CPU的中间仓库及桥梁,承载着操作系统和应用程序的实时运行。JVM内存布局规定了Java在运行过程中内存申请、分配、管理的策略,保证了JVM的高效稳定运行。**不同的JVM对于内存的划分方式和管理机制存在着部分差异**。结合JVM虚拟机规范,来探讨一下经典的JVM内存布局。

48 |

49 | 2. 我们通过磁盘或者网络IO得到的数据,都需要先加载到内存中,然后CPU从内存中获取数据进行读取,也就是说内存充当了CPU和磁盘之间的桥梁

50 |

51 | > 下图来自阿里巴巴手册JDK8

52 |

53 |  54 |

55 |

56 |

57 | ### 线程的内存空间

58 |

59 | 1. Java虚拟机定义了若干种程序运行期间会使用到的运行时数据区:其中有一些会随着虚拟机启动而创建,随着虚拟机退出而销毁。另外一些则是与线程一一对应的,这些与线程对应的数据区域会随着线程开始和结束而创建和销毁。

60 |

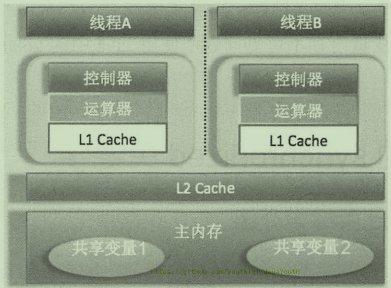

61 | 2. 灰色的为单独线程私有的,红色的为多个线程共享的。即:

62 | - 线程独有:独立包括程序计数器、栈、本地方法栈

63 | - 线程间共享:堆、堆外内存(永久代或元空间、代码缓存)

64 |

65 |

54 |

55 |

56 |

57 | ### 线程的内存空间

58 |

59 | 1. Java虚拟机定义了若干种程序运行期间会使用到的运行时数据区:其中有一些会随着虚拟机启动而创建,随着虚拟机退出而销毁。另外一些则是与线程一一对应的,这些与线程对应的数据区域会随着线程开始和结束而创建和销毁。

60 |

61 | 2. 灰色的为单独线程私有的,红色的为多个线程共享的。即:

62 | - 线程独有:独立包括程序计数器、栈、本地方法栈

63 | - 线程间共享:堆、堆外内存(永久代或元空间、代码缓存)

64 |

65 |  66 |

67 |

68 |

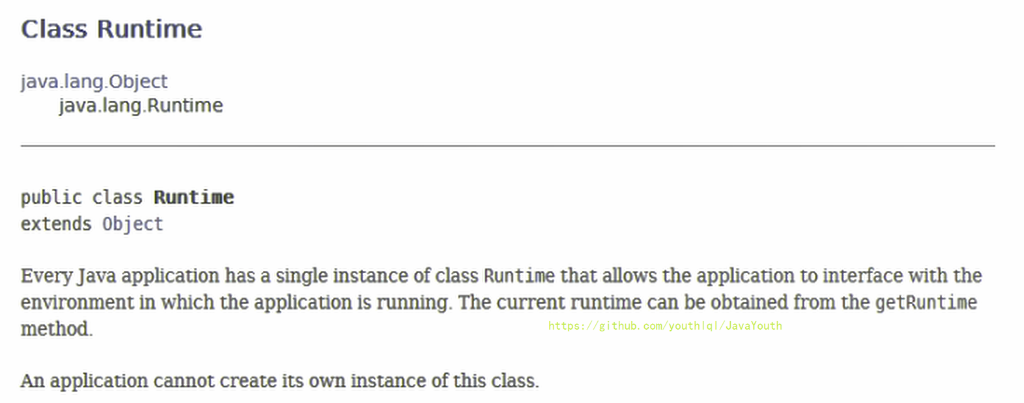

69 | ### Runtime类

70 |

71 | **每个JVM只有一个Runtime实例**。即为运行时环境,相当于内存结构的中间的那个框框:运行时环境。

72 |

73 |

66 |

67 |

68 |

69 | ### Runtime类

70 |

71 | **每个JVM只有一个Runtime实例**。即为运行时环境,相当于内存结构的中间的那个框框:运行时环境。

72 |

73 |  74 |

75 |

76 |

77 | 线程

78 | ----

79 |

80 | ### JVM 线程

81 |

82 |

83 |

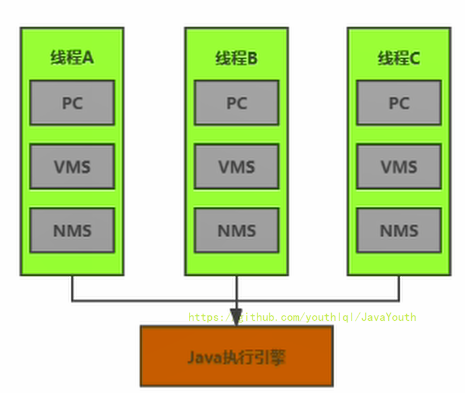

84 | 1. 线程是一个程序里的运行单元。JVM允许一个应用有多个线程并行的执行

85 | 2. **在Hotspot JVM里,每个线程都与操作系统的本地线程直接映射**

86 | - 当一个Java线程准备好执行以后,此时一个操作系统的本地线程也同时创建。Java线程执行终止后,本地线程也会回收

87 | 4. 操作系统负责将线程安排调度到任何一个可用的CPU上。一旦本地线程初始化成功,它就会调用Java线程中的run()方法

88 |

89 | > 关于线程,并发可以看笔者的Java并发系列

90 |

91 |

92 |

93 | ### JVM 系统线程

94 |

95 |

96 |

97 | - 如果你使用jconsole或者是任何一个调试工具,都能看到在后台有许多线程在运行。这些后台线程不包括调用`public static void main(String[])`的main线程以及所有这个main线程自己创建的线程。

98 |

99 | - 这些主要的后台系统线程在Hotspot JVM里主要是以下几个:

100 |

101 | 1. **虚拟机线程**:这种线程的操作是需要JVM达到安全点才会出现。这些操作必须在不同的线程中发生的原因是他们都需要JVM达到安全点,这样堆才不会变化。这种线程的执行类型括"stop-the-world"的垃圾收集,线程栈收集,线程挂起以及偏向锁撤销

102 | 2. **周期任务线程**:这种线程是时间周期事件的体现(比如中断),他们一般用于周期性操作的调度执行

103 | 3. **GC线程**:这种线程对在JVM里不同种类的垃圾收集行为提供了支持

104 | 4. **编译线程**:这种线程在运行时会将字节码编译成到本地代码

105 | 5. **信号调度线程**:这种线程接收信号并发送给JVM,在它内部通过调用适当的方法进行处理

106 |

107 |

108 |

109 | 程序计数器(PC寄存器)

110 | ===========

111 |

112 | PC寄存器介绍

113 | ----------

114 |

115 | > 官方文档网址:https://docs.oracle.com/javase/specs/jvms/se8/html/index.html

116 |

117 |

74 |

75 |

76 |

77 | 线程

78 | ----

79 |

80 | ### JVM 线程

81 |

82 |

83 |

84 | 1. 线程是一个程序里的运行单元。JVM允许一个应用有多个线程并行的执行

85 | 2. **在Hotspot JVM里,每个线程都与操作系统的本地线程直接映射**

86 | - 当一个Java线程准备好执行以后,此时一个操作系统的本地线程也同时创建。Java线程执行终止后,本地线程也会回收

87 | 4. 操作系统负责将线程安排调度到任何一个可用的CPU上。一旦本地线程初始化成功,它就会调用Java线程中的run()方法

88 |

89 | > 关于线程,并发可以看笔者的Java并发系列

90 |

91 |

92 |

93 | ### JVM 系统线程

94 |

95 |

96 |

97 | - 如果你使用jconsole或者是任何一个调试工具,都能看到在后台有许多线程在运行。这些后台线程不包括调用`public static void main(String[])`的main线程以及所有这个main线程自己创建的线程。

98 |

99 | - 这些主要的后台系统线程在Hotspot JVM里主要是以下几个:

100 |

101 | 1. **虚拟机线程**:这种线程的操作是需要JVM达到安全点才会出现。这些操作必须在不同的线程中发生的原因是他们都需要JVM达到安全点,这样堆才不会变化。这种线程的执行类型括"stop-the-world"的垃圾收集,线程栈收集,线程挂起以及偏向锁撤销

102 | 2. **周期任务线程**:这种线程是时间周期事件的体现(比如中断),他们一般用于周期性操作的调度执行

103 | 3. **GC线程**:这种线程对在JVM里不同种类的垃圾收集行为提供了支持

104 | 4. **编译线程**:这种线程在运行时会将字节码编译成到本地代码

105 | 5. **信号调度线程**:这种线程接收信号并发送给JVM,在它内部通过调用适当的方法进行处理

106 |

107 |

108 |

109 | 程序计数器(PC寄存器)

110 | ===========

111 |

112 | PC寄存器介绍

113 | ----------

114 |

115 | > 官方文档网址:https://docs.oracle.com/javase/specs/jvms/se8/html/index.html

116 |

117 |  118 |

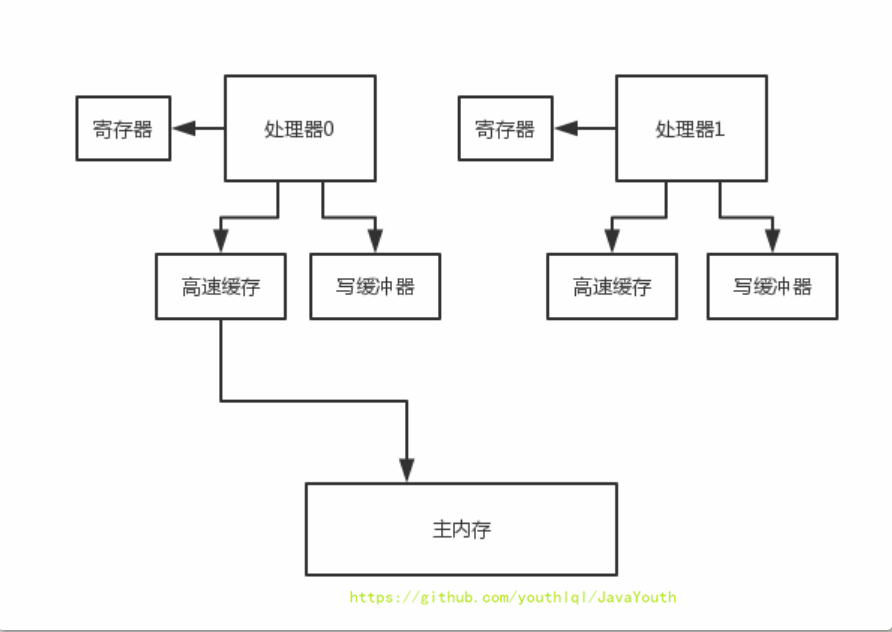

119 | 1. JVM中的程序计数寄存器(Program Counter Register)中,Register的命名源于CPU的寄存器,**寄存器存储指令相关的现场信息**。CPU只有把数据装载到寄存器才能够运行。

120 | 2. 这里,并非是广义上所指的物理寄存器,或许将其翻译为PC计数器(或指令计数器)会更加贴切(也称为程序钩子),并且也不容易引起一些不必要的误会。**JVM中的PC寄存器是对物理PC寄存器的一种抽象模拟**。

121 | 3. 它是一块很小的内存空间,几乎可以忽略不记。也是运行速度最快的存储区域。

122 | 4. 在JVM规范中,每个线程都有它自己的程序计数器,是线程私有的,生命周期与线程的生命周期保持一致。

123 | 5. 任何时间一个线程都只有一个方法在执行,也就是所谓的**当前方法**。程序计数器会存储当前线程正在执行的Java方法的JVM指令地址;或者,如果是在执行native方法,则是未指定值(undefned)。

124 | 6. 它是**程序控制流**的指示器,分支、循环、跳转、异常处理、线程恢复等基础功能都需要依赖这个计数器来完成。

125 | 7. 字节码解释器工作时就是通过改变这个计数器的值来选取下一条需要执行的字节码指令。

126 | 8. 它是**唯一一个**在Java虚拟机规范中没有规定任何OutofMemoryError情况的区域。

127 |

128 |

129 |

130 |

131 | ## PC寄存器的作用

132 |

133 | PC寄存器用来存储指向下一条指令的地址,也即将要执行的指令代码。由执行引擎读取下一条指令,并执行该指令。

134 |

135 |

118 |

119 | 1. JVM中的程序计数寄存器(Program Counter Register)中,Register的命名源于CPU的寄存器,**寄存器存储指令相关的现场信息**。CPU只有把数据装载到寄存器才能够运行。

120 | 2. 这里,并非是广义上所指的物理寄存器,或许将其翻译为PC计数器(或指令计数器)会更加贴切(也称为程序钩子),并且也不容易引起一些不必要的误会。**JVM中的PC寄存器是对物理PC寄存器的一种抽象模拟**。

121 | 3. 它是一块很小的内存空间,几乎可以忽略不记。也是运行速度最快的存储区域。

122 | 4. 在JVM规范中,每个线程都有它自己的程序计数器,是线程私有的,生命周期与线程的生命周期保持一致。

123 | 5. 任何时间一个线程都只有一个方法在执行,也就是所谓的**当前方法**。程序计数器会存储当前线程正在执行的Java方法的JVM指令地址;或者,如果是在执行native方法,则是未指定值(undefned)。

124 | 6. 它是**程序控制流**的指示器,分支、循环、跳转、异常处理、线程恢复等基础功能都需要依赖这个计数器来完成。

125 | 7. 字节码解释器工作时就是通过改变这个计数器的值来选取下一条需要执行的字节码指令。

126 | 8. 它是**唯一一个**在Java虚拟机规范中没有规定任何OutofMemoryError情况的区域。

127 |

128 |

129 |

130 |

131 | ## PC寄存器的作用

132 |

133 | PC寄存器用来存储指向下一条指令的地址,也即将要执行的指令代码。由执行引擎读取下一条指令,并执行该指令。

134 |

135 |  136 |

137 |

138 |

139 | 举例

140 | ------

141 |

142 | ```java

143 | public class PCRegisterTest {

144 |

145 | public static void main(String[] args) {

146 | int i = 10;

147 | int j = 20;

148 | int k = i + j;

149 |

150 | String s = "abc";

151 | System.out.println(i);

152 | System.out.println(k);

153 |

154 | }

155 | }

156 | ```

157 |

158 | 查看字节码

159 |

160 | > 看字节码的方法:https://blog.csdn.net/21aspnet/article/details/88351875

161 |

162 | ```java

163 | Classfile /F:/IDEAWorkSpaceSourceCode/JVMDemo/out/production/chapter04/com/atguigu/java/PCRegisterTest.class

164 | Last modified 2020-11-2; size 675 bytes

165 | MD5 checksum 53b3ef104479ec9e9b7ce5319e5881d3

166 | Compiled from "PCRegisterTest.java"

167 | public class com.atguigu.java.PCRegisterTest

168 | minor version: 0

169 | major version: 52

170 | flags: ACC_PUBLIC, ACC_SUPER

171 | Constant pool:

172 | #1 = Methodref #6.#26 // java/lang/Object."

136 |

137 |

138 |

139 | 举例

140 | ------

141 |

142 | ```java

143 | public class PCRegisterTest {

144 |

145 | public static void main(String[] args) {

146 | int i = 10;

147 | int j = 20;

148 | int k = i + j;

149 |

150 | String s = "abc";

151 | System.out.println(i);

152 | System.out.println(k);

153 |

154 | }

155 | }

156 | ```

157 |

158 | 查看字节码

159 |

160 | > 看字节码的方法:https://blog.csdn.net/21aspnet/article/details/88351875

161 |

162 | ```java

163 | Classfile /F:/IDEAWorkSpaceSourceCode/JVMDemo/out/production/chapter04/com/atguigu/java/PCRegisterTest.class

164 | Last modified 2020-11-2; size 675 bytes

165 | MD5 checksum 53b3ef104479ec9e9b7ce5319e5881d3

166 | Compiled from "PCRegisterTest.java"

167 | public class com.atguigu.java.PCRegisterTest

168 | minor version: 0

169 | major version: 52

170 | flags: ACC_PUBLIC, ACC_SUPER

171 | Constant pool:

172 | #1 = Methodref #6.#26 // java/lang/Object." 272 |

273 |

274 |

275 | 两个面试题

276 | -------

277 |

278 | **使用PC寄存器存储字节码指令地址有什么用呢?**或者问**为什么使用 PC 寄存器来记录当前线程的执行地址呢?**

279 |

280 | 1. 因为CPU需要不停的切换各个线程,这时候切换回来以后,就得知道接着从哪开始继续执行

281 |

282 | 2. JVM的字节码解释器就需要通过改变PC寄存器的值来明确下一条应该执行什么样的字节码指令

283 |

284 |

285 |

272 |

273 |

274 |

275 | 两个面试题

276 | -------

277 |

278 | **使用PC寄存器存储字节码指令地址有什么用呢?**或者问**为什么使用 PC 寄存器来记录当前线程的执行地址呢?**

279 |

280 | 1. 因为CPU需要不停的切换各个线程,这时候切换回来以后,就得知道接着从哪开始继续执行

281 |

282 | 2. JVM的字节码解释器就需要通过改变PC寄存器的值来明确下一条应该执行什么样的字节码指令

283 |

284 |

285 |  286 |

287 |

288 |

289 | **PC寄存器为什么被设定为私有的?**

290 |

291 | 1. 我们都知道所谓的多线程在一个特定的时间段内只会执行其中某一个线程的方法,CPU会不停地做任务切换,这样必然导致经常中断或恢复,如何保证分毫无差呢?**为了能够准确地记录各个线程正在执行的当前字节码指令地址,最好的办法自然是为每一个线程都分配一个PC寄存器**,这样一来各个线程之间便可以进行独立计算,从而不会出现相互干扰的情况。

292 | 2. 由于CPU时间片轮限制,众多线程在并发执行过程中,任何一个确定的时刻,一个处理器或者多核处理器中的一个内核,只会执行某个线程中的一条指令。

293 | 3. 这样必然导致经常中断或恢复,如何保证分毫无差呢?每个线程在创建后,都会产生自己的程序计数器和栈帧,程序计数器在各个线程之间互不影响。

294 |

295 | > 注意并行和并发的区别,笔者的并发系列有讲

296 |

297 |

298 |

299 | CPU 时间片

300 | ---------

301 |

302 | 1. CPU时间片即CPU分配给各个程序的时间,每个线程被分配一个时间段,称作它的时间片。

303 |

304 | 2. 在宏观上:我们可以同时打开多个应用程序,每个程序并行不悖,同时运行。

305 |

306 | 3. 但在微观上:由于只有一个CPU,一次只能处理程序要求的一部分,如何处理公平,一种方法就是引入时间片,**每个程序轮流执行**。

307 |

308 |

309 |

286 |

287 |

288 |

289 | **PC寄存器为什么被设定为私有的?**

290 |

291 | 1. 我们都知道所谓的多线程在一个特定的时间段内只会执行其中某一个线程的方法,CPU会不停地做任务切换,这样必然导致经常中断或恢复,如何保证分毫无差呢?**为了能够准确地记录各个线程正在执行的当前字节码指令地址,最好的办法自然是为每一个线程都分配一个PC寄存器**,这样一来各个线程之间便可以进行独立计算,从而不会出现相互干扰的情况。

292 | 2. 由于CPU时间片轮限制,众多线程在并发执行过程中,任何一个确定的时刻,一个处理器或者多核处理器中的一个内核,只会执行某个线程中的一条指令。

293 | 3. 这样必然导致经常中断或恢复,如何保证分毫无差呢?每个线程在创建后,都会产生自己的程序计数器和栈帧,程序计数器在各个线程之间互不影响。

294 |

295 | > 注意并行和并发的区别,笔者的并发系列有讲

296 |

297 |

298 |

299 | CPU 时间片

300 | ---------

301 |

302 | 1. CPU时间片即CPU分配给各个程序的时间,每个线程被分配一个时间段,称作它的时间片。

303 |

304 | 2. 在宏观上:我们可以同时打开多个应用程序,每个程序并行不悖,同时运行。

305 |

306 | 3. 但在微观上:由于只有一个CPU,一次只能处理程序要求的一部分,如何处理公平,一种方法就是引入时间片,**每个程序轮流执行**。

307 |

308 |

309 |  310 |

311 |

312 |

313 | # 本地方法接口

314 |

315 | ## 本地方法

316 |

317 |

310 |

311 |

312 |

313 | # 本地方法接口

314 |

315 | ## 本地方法

316 |

317 |  318 |

319 |

320 |

321 | 1. 简单地讲,**一个Native Method是一个Java调用非Java代码的接囗**一个Native Method是这样一个Java方法:该方法的实现由非Java语言实现,比如C。这个特征并非Java所特有,很多其它的编程语言都有这一机制,比如在C++中,你可以用extern 告知C++编译器去调用一个C的函数。

322 | 4. “A native method is a Java method whose implementation is provided by non-java code.”(本地方法是一个非Java的方法,它的具体实现是非Java代码的实现)

323 | 5. 在定义一个native method时,并不提供实现体(有些像定义一个Java interface),因为其实现体是由非java语言在外面实现的。

324 | 6. 本地接口的作用是融合不同的编程语言为Java所用,它的初衷是融合C/C++程序。

325 |

326 |

327 |

328 |

329 |

330 | ## 举例

331 |

332 |

333 |

334 | 需要注意的是:标识符native可以与其它java标识符连用,但是abstract除外

335 |

336 | ```java

337 | public class IHaveNatives {

338 | public native void Native1(int x);

339 |

340 | public native static long Native2();

341 |

342 | private native synchronized float Native3(Object o);

343 |

344 | native void Native4(int[] ary) throws Exception;

345 |

346 | }

347 |

348 | ```

349 |

350 |

351 |

352 | ## 为什么要使用 Native Method?

353 |

354 | Java使用起来非常方便,然而有些层次的任务用Java实现起来不容易,或者我们对程序的效率很在意时,问题就来了。

355 |

356 |

357 |

358 | ### 与Java环境外交互

359 |

360 | **有时Java应用需要与Java外面的硬件环境交互,这是本地方法存在的主要原因**。你可以想想Java需要与一些**底层系统**,如操作系统或某些硬件交换信息时的情况。本地方法正是这样一种交流机制:它为我们提供了一个非常简洁的接口,而且我们无需去了解Java应用之外的繁琐的细节。

361 |

362 |

363 |

364 | ### 与操作系统的交互

365 |

366 | 1. JVM支持着Java语言本身和运行时库,它是Java程序赖以生存的平台,它由一个解释器(解释字节码)和一些连接到本地代码的库组成。

367 | 2. 然而不管怎样,它毕竟不是一个完整的系统,它经常依赖于一底层系统的支持。这些底层系统常常是强大的操作系统。

368 | 3. **通过使用本地方法,我们得以用Java实现了jre的与底层系统的交互,甚至JVM的一些部分就是用C写的**。

369 | 4. 还有,如果我们要使用一些Java语言本身没有提供封装的操作系统的特性时,我们也需要使用本地方法。

370 |

371 |

372 |

373 | ### Sun’s Java

374 |

375 | 1. Sun的解释器是用C实现的,这使得它能像一些普通的C一样与外部交互。jre大部分是用Java实现的,它也通过一些本地方法与外界交互。

376 | 2. 例如:类java.lang.Thread的setPriority()方法是用Java实现的,但是它实现调用的是该类里的本地方法setPriority0()。这个本地方法是用C实现的,并被植入JVM内部在Windows 95的平台上,这个本地方法最终将调用Win32 setpriority() API。这是一个本地方法的具体实现由JVM直接提供,更多的情况是本地方法由外部的动态链接库(external dynamic link library)提供,然后被JVM调用。

377 |

378 |

379 |

380 | ### 本地方法的现状

381 |

382 | 目前该方法使用的越来越少了,除非是与硬件有关的应用,比如通过Java程序驱动打印机或者Java系统管理生产设备,在企业级应用中已经比较少见。因为现在的异构领域间的通信很发达,比如可以使用Socket通信,也可以使用Web Service等等,不多做介绍。

383 |

384 |

385 |

386 | # 本地方法栈

387 |

388 | 1. **Java虚拟机栈于管理Java方法的调用,而本地方法栈用于管理本地方法的调用**。

389 | 2. 本地方法栈,也是线程私有的。

390 | 3. 允许被实现成固定或者是可动态扩展的内存大小(在内存溢出方面和虚拟机栈相同)

391 | * 如果线程请求分配的栈容量超过本地方法栈允许的最大容量,Java虚拟机将会抛出一个stackoverflowError 异常。

392 | * 如果本地方法栈可以动态扩展,并且在尝试扩展的时候无法申请到足够的内存,或者在创建新的线程时没有足够的内存去创建对应的本地方法栈,那么Java虚拟机将会抛出一个outofMemoryError异常。

393 | 4. 本地方法一般是使用C语言或C++语言实现的。

394 | 5. 它的具体做法是Native Method Stack中登记native方法,在Execution Engine 执行时加载本地方法库。

395 |

396 |

318 |

319 |

320 |

321 | 1. 简单地讲,**一个Native Method是一个Java调用非Java代码的接囗**一个Native Method是这样一个Java方法:该方法的实现由非Java语言实现,比如C。这个特征并非Java所特有,很多其它的编程语言都有这一机制,比如在C++中,你可以用extern 告知C++编译器去调用一个C的函数。

322 | 4. “A native method is a Java method whose implementation is provided by non-java code.”(本地方法是一个非Java的方法,它的具体实现是非Java代码的实现)

323 | 5. 在定义一个native method时,并不提供实现体(有些像定义一个Java interface),因为其实现体是由非java语言在外面实现的。

324 | 6. 本地接口的作用是融合不同的编程语言为Java所用,它的初衷是融合C/C++程序。

325 |

326 |

327 |

328 |

329 |

330 | ## 举例

331 |

332 |

333 |

334 | 需要注意的是:标识符native可以与其它java标识符连用,但是abstract除外

335 |

336 | ```java

337 | public class IHaveNatives {

338 | public native void Native1(int x);

339 |

340 | public native static long Native2();

341 |

342 | private native synchronized float Native3(Object o);

343 |

344 | native void Native4(int[] ary) throws Exception;

345 |

346 | }

347 |

348 | ```

349 |

350 |

351 |

352 | ## 为什么要使用 Native Method?

353 |

354 | Java使用起来非常方便,然而有些层次的任务用Java实现起来不容易,或者我们对程序的效率很在意时,问题就来了。

355 |

356 |

357 |

358 | ### 与Java环境外交互

359 |

360 | **有时Java应用需要与Java外面的硬件环境交互,这是本地方法存在的主要原因**。你可以想想Java需要与一些**底层系统**,如操作系统或某些硬件交换信息时的情况。本地方法正是这样一种交流机制:它为我们提供了一个非常简洁的接口,而且我们无需去了解Java应用之外的繁琐的细节。

361 |

362 |

363 |

364 | ### 与操作系统的交互

365 |

366 | 1. JVM支持着Java语言本身和运行时库,它是Java程序赖以生存的平台,它由一个解释器(解释字节码)和一些连接到本地代码的库组成。

367 | 2. 然而不管怎样,它毕竟不是一个完整的系统,它经常依赖于一底层系统的支持。这些底层系统常常是强大的操作系统。

368 | 3. **通过使用本地方法,我们得以用Java实现了jre的与底层系统的交互,甚至JVM的一些部分就是用C写的**。

369 | 4. 还有,如果我们要使用一些Java语言本身没有提供封装的操作系统的特性时,我们也需要使用本地方法。

370 |

371 |

372 |

373 | ### Sun’s Java

374 |

375 | 1. Sun的解释器是用C实现的,这使得它能像一些普通的C一样与外部交互。jre大部分是用Java实现的,它也通过一些本地方法与外界交互。

376 | 2. 例如:类java.lang.Thread的setPriority()方法是用Java实现的,但是它实现调用的是该类里的本地方法setPriority0()。这个本地方法是用C实现的,并被植入JVM内部在Windows 95的平台上,这个本地方法最终将调用Win32 setpriority() API。这是一个本地方法的具体实现由JVM直接提供,更多的情况是本地方法由外部的动态链接库(external dynamic link library)提供,然后被JVM调用。

377 |

378 |

379 |

380 | ### 本地方法的现状

381 |

382 | 目前该方法使用的越来越少了,除非是与硬件有关的应用,比如通过Java程序驱动打印机或者Java系统管理生产设备,在企业级应用中已经比较少见。因为现在的异构领域间的通信很发达,比如可以使用Socket通信,也可以使用Web Service等等,不多做介绍。

383 |

384 |

385 |

386 | # 本地方法栈

387 |

388 | 1. **Java虚拟机栈于管理Java方法的调用,而本地方法栈用于管理本地方法的调用**。

389 | 2. 本地方法栈,也是线程私有的。

390 | 3. 允许被实现成固定或者是可动态扩展的内存大小(在内存溢出方面和虚拟机栈相同)

391 | * 如果线程请求分配的栈容量超过本地方法栈允许的最大容量,Java虚拟机将会抛出一个stackoverflowError 异常。

392 | * 如果本地方法栈可以动态扩展,并且在尝试扩展的时候无法申请到足够的内存,或者在创建新的线程时没有足够的内存去创建对应的本地方法栈,那么Java虚拟机将会抛出一个outofMemoryError异常。

393 | 4. 本地方法一般是使用C语言或C++语言实现的。

394 | 5. 它的具体做法是Native Method Stack中登记native方法,在Execution Engine 执行时加载本地方法库。

395 |

396 |  397 |

398 |

399 |

400 | **注意事项**

401 |

402 | 1. 当某个线程调用一个本地方法时,它就进入了一个全新的并且不再受虚拟机限制的世界。它和虚拟机拥有同样的权限。

403 | * 本地方法可以通过本地方法接口来访问虚拟机内部的运行时数据区

404 | * 它甚至可以直接使用本地处理器中的寄存器

405 | * 直接从本地内存的堆中分配任意数量的内存

406 | 2. 并不是所有的JVM都支持本地方法。因为Java虚拟机规范并没有明确要求本地方法栈的使用语言、具体实现方式、数据结构等。如果JVM产品不打算支持native方法,也可以无需实现本地方法栈。

407 | 3. 在Hotspot JVM中,直接将本地方法栈和虚拟机栈合二为一。

408 |

409 |

--------------------------------------------------------------------------------

/docs/JVM/JVM系列-第8章-执行引擎.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: JVM系列-第8章-执行引擎

3 | tags:

4 | - JVM

5 | - 虚拟机

6 | categories:

7 | - JVM

8 | - 1.内存与垃圾回收篇

9 | keywords: JVM,虚拟机。

10 | description: JVM系列-第8章-执行引擎。

11 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/jvm.png'

12 | abbrlink: 408712f4

13 | date: 2020-11-15 19:48:42

14 | ---

15 |

16 |

17 |

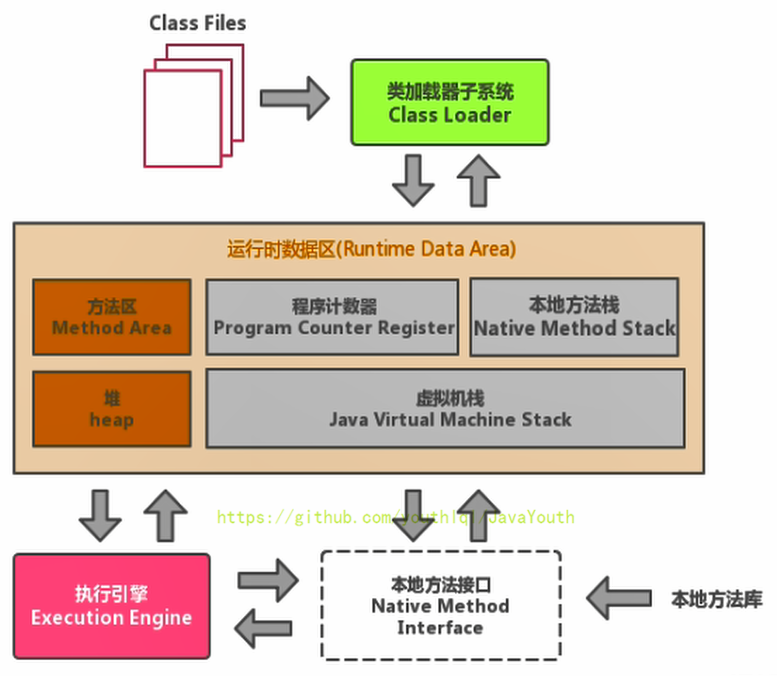

18 | 执行引擎

19 | ===========

20 |

21 | 执行引擎概述

22 | --------

23 |

24 |

25 |

26 |

397 |

398 |

399 |

400 | **注意事项**

401 |

402 | 1. 当某个线程调用一个本地方法时,它就进入了一个全新的并且不再受虚拟机限制的世界。它和虚拟机拥有同样的权限。

403 | * 本地方法可以通过本地方法接口来访问虚拟机内部的运行时数据区

404 | * 它甚至可以直接使用本地处理器中的寄存器

405 | * 直接从本地内存的堆中分配任意数量的内存

406 | 2. 并不是所有的JVM都支持本地方法。因为Java虚拟机规范并没有明确要求本地方法栈的使用语言、具体实现方式、数据结构等。如果JVM产品不打算支持native方法,也可以无需实现本地方法栈。

407 | 3. 在Hotspot JVM中,直接将本地方法栈和虚拟机栈合二为一。

408 |

409 |

--------------------------------------------------------------------------------

/docs/JVM/JVM系列-第8章-执行引擎.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: JVM系列-第8章-执行引擎

3 | tags:

4 | - JVM

5 | - 虚拟机

6 | categories:

7 | - JVM

8 | - 1.内存与垃圾回收篇

9 | keywords: JVM,虚拟机。

10 | description: JVM系列-第8章-执行引擎。

11 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/jvm.png'

12 | abbrlink: 408712f4

13 | date: 2020-11-15 19:48:42

14 | ---

15 |

16 |

17 |

18 | 执行引擎

19 | ===========

20 |

21 | 执行引擎概述

22 | --------

23 |

24 |

25 |

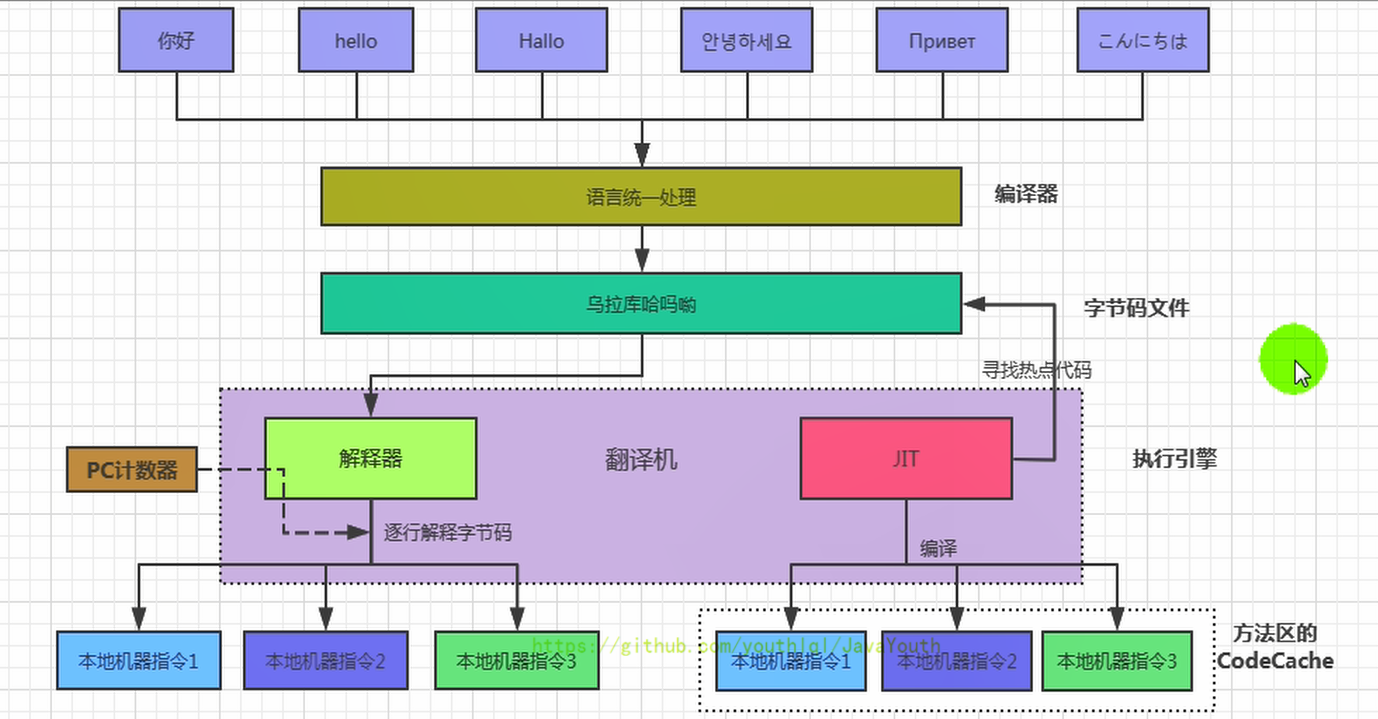

26 |  27 |

28 | ### 执行引擎概述

29 |

30 |

31 |

32 | 1. 执行引擎是Java虚拟机核心的组成部分之一。

33 | 2. “虚拟机”是一个相对于“物理机”的概念,这两种机器都有代码执行能力,其区别是物理机的执行引擎是直接建立在处理器、缓存、指令集和操作系统层面上的,而**虚拟机的执行引擎则是由软件自行实现的**,因此可以不受物理条件制约地定制指令集与执行引擎的结构体系,**能够执行那些不被硬件直接支持的指令集格式**。

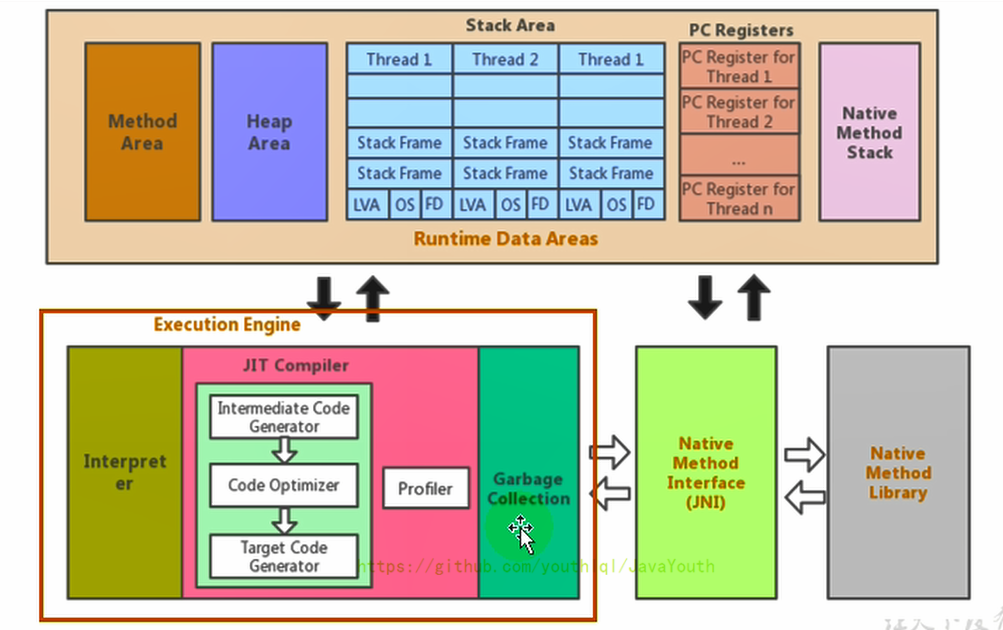

34 | 3. JVM的主要任务是负责**装载字节码到其内部**,但字节码并不能够直接运行在操作系统之上,因为字节码指令并非等价于本地机器指令,它内部包含的仅仅只是一些能够被JVM所识别的字节码指令、符号表,以及其他辅助信息。

35 | 4. 那么,如果想要让一个Java程序运行起来,执行引擎(Execution Engine)的任务就是**将字节码指令解释/编译为对应平台上的本地机器指令才可以**。简单来说,JVM中的执行引擎充当了将高级语言翻译为机器语言的译者。

36 |

37 |

27 |

28 | ### 执行引擎概述

29 |

30 |

31 |

32 | 1. 执行引擎是Java虚拟机核心的组成部分之一。

33 | 2. “虚拟机”是一个相对于“物理机”的概念,这两种机器都有代码执行能力,其区别是物理机的执行引擎是直接建立在处理器、缓存、指令集和操作系统层面上的,而**虚拟机的执行引擎则是由软件自行实现的**,因此可以不受物理条件制约地定制指令集与执行引擎的结构体系,**能够执行那些不被硬件直接支持的指令集格式**。

34 | 3. JVM的主要任务是负责**装载字节码到其内部**,但字节码并不能够直接运行在操作系统之上,因为字节码指令并非等价于本地机器指令,它内部包含的仅仅只是一些能够被JVM所识别的字节码指令、符号表,以及其他辅助信息。

35 | 4. 那么,如果想要让一个Java程序运行起来,执行引擎(Execution Engine)的任务就是**将字节码指令解释/编译为对应平台上的本地机器指令才可以**。简单来说,JVM中的执行引擎充当了将高级语言翻译为机器语言的译者。

36 |

37 |  38 |

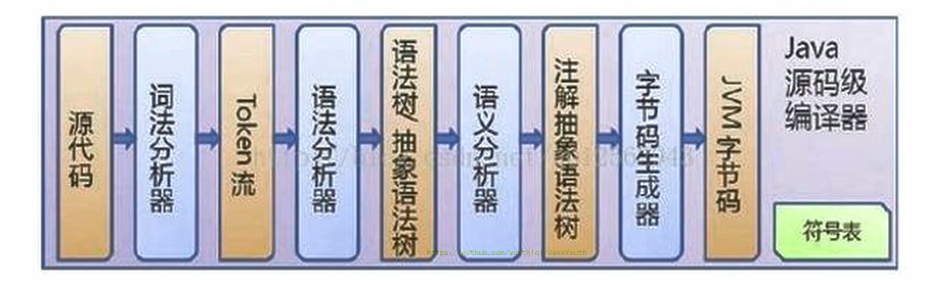

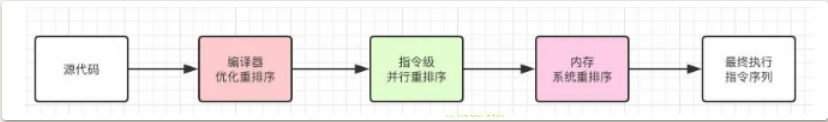

39 | 1、前端编译:从Java程序员-字节码文件的这个过程叫前端编译

40 |

41 | 2、执行引擎这里有两种行为:一种是解释执行,一种是编译执行(这里的是后端编译)。

42 |

43 |

44 |

45 | ### 执行引擎工作过程

46 |

47 | > **执行引擎工作过程**

48 |

49 | 1. 执行引擎在执行的过程中究竟需要执行什么样的字节码指令完全依赖于PC寄存器。

50 | 2. 每当执行完一项指令操作后,PC寄存器就会更新下一条需要被执行的指令地址。

51 | 3. 当然方法在执行的过程中,执行引擎有可能会通过存储在局部变量表中的对象引用准确定位到存储在Java堆区中的对象实例信息,以及通过对象头中的元数据指针定位到目标对象的类型信息。

52 | 4. 从外观上来看,所有的Java虚拟机的执行引擎输入、处理、输出都是一致的:输入的是字节码二进制流,处理过程是字节码解析执行、即时编译的等效过程,输出的是执行过程。

53 |

54 |

38 |

39 | 1、前端编译:从Java程序员-字节码文件的这个过程叫前端编译

40 |

41 | 2、执行引擎这里有两种行为:一种是解释执行,一种是编译执行(这里的是后端编译)。

42 |

43 |

44 |

45 | ### 执行引擎工作过程

46 |

47 | > **执行引擎工作过程**

48 |

49 | 1. 执行引擎在执行的过程中究竟需要执行什么样的字节码指令完全依赖于PC寄存器。

50 | 2. 每当执行完一项指令操作后,PC寄存器就会更新下一条需要被执行的指令地址。

51 | 3. 当然方法在执行的过程中,执行引擎有可能会通过存储在局部变量表中的对象引用准确定位到存储在Java堆区中的对象实例信息,以及通过对象头中的元数据指针定位到目标对象的类型信息。

52 | 4. 从外观上来看,所有的Java虚拟机的执行引擎输入、处理、输出都是一致的:输入的是字节码二进制流,处理过程是字节码解析执行、即时编译的等效过程,输出的是执行过程。

53 |

54 |  55 |

56 |

57 |

58 | Java代码编译和执行过程

59 | ----------------

60 |

61 | ### 解释执行和即时编译

62 |

63 |

64 |

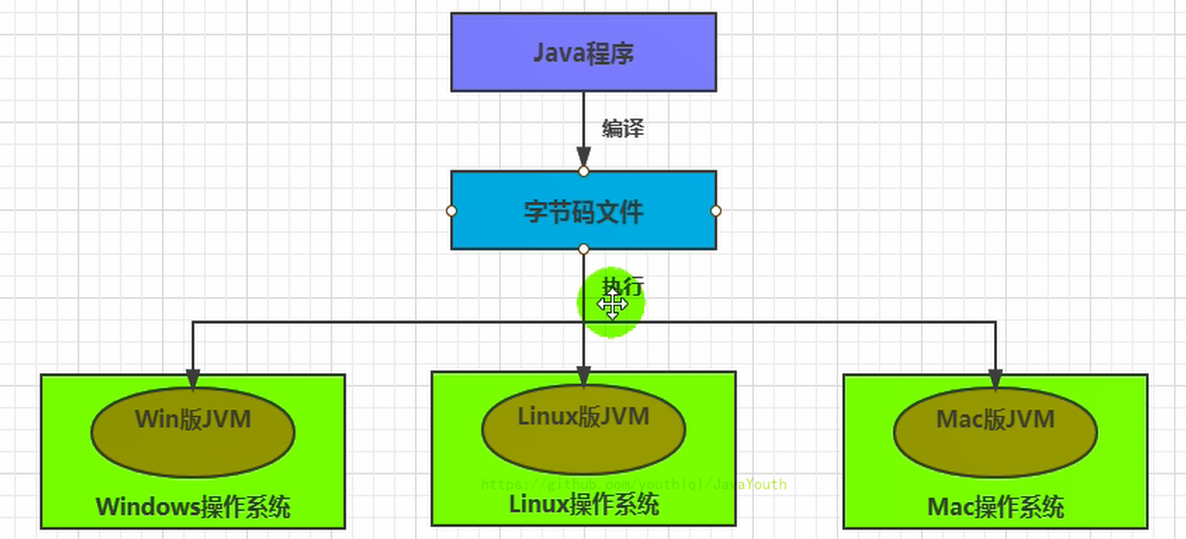

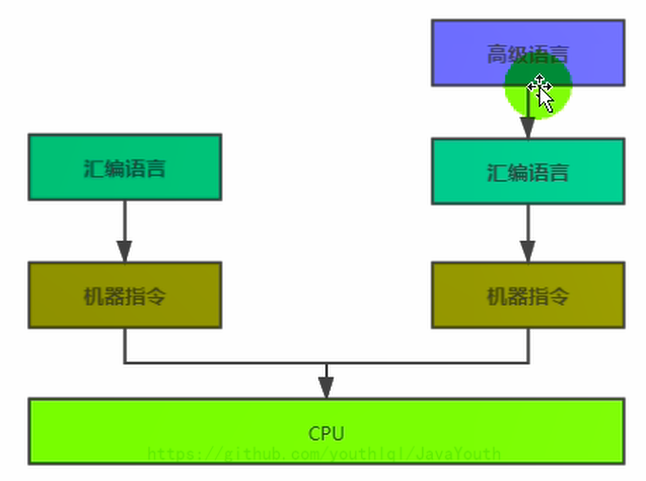

65 | 大部分的程序代码转换成物理机的目标代码或虚拟机能执行的指令集之前,都需要经过下图中的各个步骤:

66 |

67 | 1. 前面橙色部分是编译生成生成字节码文件的过程(javac编译器来完成,也就是前端编译器),和JVM没有关系。

68 |

69 | 2. 后面绿色(解释执行)和蓝色(即时编译)才是JVM需要考虑的过程

70 |

71 |

72 |

73 |

74 |

55 |

56 |

57 |

58 | Java代码编译和执行过程

59 | ----------------

60 |

61 | ### 解释执行和即时编译

62 |

63 |

64 |

65 | 大部分的程序代码转换成物理机的目标代码或虚拟机能执行的指令集之前,都需要经过下图中的各个步骤:

66 |

67 | 1. 前面橙色部分是编译生成生成字节码文件的过程(javac编译器来完成,也就是前端编译器),和JVM没有关系。

68 |

69 | 2. 后面绿色(解释执行)和蓝色(即时编译)才是JVM需要考虑的过程

70 |

71 |

72 |

73 |

74 |  75 |

76 |

77 | 3. javac编译器(前端编译器)流程图如下所示:

78 |

79 |

75 |

76 |

77 | 3. javac编译器(前端编译器)流程图如下所示:

78 |

79 |  80 |

81 |

82 |

83 | 4. Java字节码的执行是由JVM执行引擎来完成,流程图如下所示

84 |

85 |

80 |

81 |

82 |

83 | 4. Java字节码的执行是由JVM执行引擎来完成,流程图如下所示

84 |

85 |  86 |

87 |

88 |

89 |

90 |

91 | ### 什么是解释器?什么是JIT编译器?

92 |

93 | 1. 解释器:当Java虚拟机启动时会根据预定义的规范对字节码采用**逐行**解释的方式**执行**,将每条字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

94 | 2. JIT(Just In Time Compiler)编译器:就是虚拟机将源代码**一次性直接**编译成和本地机器平台相关的机器语言,**但并不是马上执行**。

95 |

96 |

97 |

98 | **为什么Java是半编译半解释型语言?**

99 |

100 | 1. JDK1.0时代,将Java语言定位为“解释执行”还是比较准确的。再后来,Java也发展出可以直接生成本地代码的编译器。

101 | 2. 现在JVM在执行Java代码的时候,通常都会将解释执行与编译执行二者结合起来进行。

102 | 3. JIT编译器将字节码翻译成本地代码后,就可以做一个缓存操作,存储在方法区的JIT 代码缓存中(执行效率更高了),并且在翻译成本地代码的过程中可以做优化。

103 |

104 |

105 |

106 | **用图总结一下**

107 |

108 |

86 |

87 |

88 |

89 |

90 |

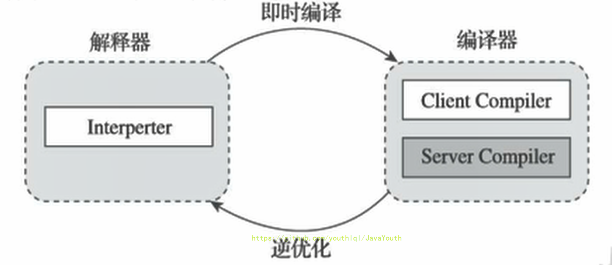

91 | ### 什么是解释器?什么是JIT编译器?

92 |

93 | 1. 解释器:当Java虚拟机启动时会根据预定义的规范对字节码采用**逐行**解释的方式**执行**,将每条字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

94 | 2. JIT(Just In Time Compiler)编译器:就是虚拟机将源代码**一次性直接**编译成和本地机器平台相关的机器语言,**但并不是马上执行**。

95 |

96 |

97 |

98 | **为什么Java是半编译半解释型语言?**

99 |

100 | 1. JDK1.0时代,将Java语言定位为“解释执行”还是比较准确的。再后来,Java也发展出可以直接生成本地代码的编译器。

101 | 2. 现在JVM在执行Java代码的时候,通常都会将解释执行与编译执行二者结合起来进行。

102 | 3. JIT编译器将字节码翻译成本地代码后,就可以做一个缓存操作,存储在方法区的JIT 代码缓存中(执行效率更高了),并且在翻译成本地代码的过程中可以做优化。

103 |

104 |

105 |

106 | **用图总结一下**

107 |

108 |  109 |

110 | 机器码 指令 汇编语言

111 | -------------

112 |

113 | ### 机器码

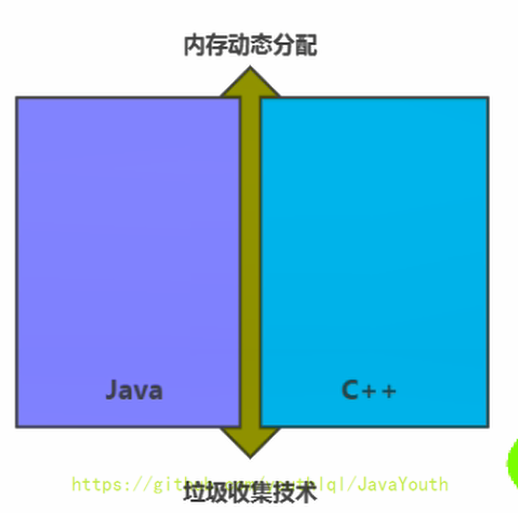

114 |

115 |

116 |

117 | 1. 各种用二进制编码方式表示的指令,叫做机器指令码。开始,人们就用它采编写程序,这就是机器语言。

118 | 2. 机器语言虽然能够被计算机理解和接受,但和人们的语言差别太大,不易被人们理解和记忆,并且用它编程容易出差错。

119 | 3. 用它编写的程序一经输入计算机,CPU直接读取运行,因此和其他语言编的程序相比,执行速度最快。

120 | 4. 机器指令与CPU紧密相关,所以不同种类的CPU所对应的机器指令也就不同。

121 |

122 |

123 |

124 | ### 指令和指令集

125 |

126 | **指令**

127 |

128 | 1. 由于机器码是由0和1组成的二进制序列,可读性实在太差,于是人们发明了指令。

129 |

130 | 2. 指令就是把机器码中特定的0和1序列,简化成对应的指令(一般为英文简写,如mov,inc等),可读性稍好

131 |

132 | 3. 由于不同的硬件平台,执行同一个操作,对应的机器码可能不同,所以不同的硬件平台的同一种指令(比如mov),对应的机器码也可能不同。

133 |

134 |

135 |

136 |

137 | **指令集**

138 |

139 | 不同的硬件平台,各自支持的指令,是有差别的。因此每个平台所支持的指令,称之为对应平台的指令集。如常见的

140 |

141 | 1. x86指令集,对应的是x86架构的平台

142 | 2. ARM指令集,对应的是ARM架构的平台

143 |

144 |

145 |

146 | ### 汇编语言

147 |

148 |

149 |

150 | 1. 由于指令的可读性还是太差,于是人们又发明了汇编语言。

151 | 2. 在汇编语言中,用助记符(Mnemonics)代替机器指令的操作码,用地址符号(Symbol)或标号(Label)代替指令或操作数的地址。

152 | 3. 在不同的硬件平台,汇编语言对应着不同的机器语言指令集,通过汇编过程转换成机器指令。

153 | 4. 由于计算机只认识指令码,所以用汇编语言编写的程序还必须翻译(汇编)成机器指令码,计算机才能识别和执行。

154 |

155 |

156 |

157 | ### 高级语言

158 |

159 |

160 |

161 | 1. 为了使计算机用户编程序更容易些,后来就出现了各种高级计算机语言。高级语言比机器语言、汇编语言更接近人的语言

162 |

163 | 2. 当计算机执行高级语言编写的程序时,仍然需要把程序解释和编译成机器的指令码。完成这个过程的程序就叫做解释程序或编译程序。

164 |

165 |

166 |

167 |

109 |

110 | 机器码 指令 汇编语言

111 | -------------

112 |

113 | ### 机器码

114 |

115 |

116 |

117 | 1. 各种用二进制编码方式表示的指令,叫做机器指令码。开始,人们就用它采编写程序,这就是机器语言。

118 | 2. 机器语言虽然能够被计算机理解和接受,但和人们的语言差别太大,不易被人们理解和记忆,并且用它编程容易出差错。

119 | 3. 用它编写的程序一经输入计算机,CPU直接读取运行,因此和其他语言编的程序相比,执行速度最快。

120 | 4. 机器指令与CPU紧密相关,所以不同种类的CPU所对应的机器指令也就不同。

121 |

122 |

123 |

124 | ### 指令和指令集

125 |

126 | **指令**

127 |

128 | 1. 由于机器码是由0和1组成的二进制序列,可读性实在太差,于是人们发明了指令。

129 |

130 | 2. 指令就是把机器码中特定的0和1序列,简化成对应的指令(一般为英文简写,如mov,inc等),可读性稍好

131 |

132 | 3. 由于不同的硬件平台,执行同一个操作,对应的机器码可能不同,所以不同的硬件平台的同一种指令(比如mov),对应的机器码也可能不同。

133 |

134 |

135 |

136 |

137 | **指令集**

138 |

139 | 不同的硬件平台,各自支持的指令,是有差别的。因此每个平台所支持的指令,称之为对应平台的指令集。如常见的

140 |

141 | 1. x86指令集,对应的是x86架构的平台

142 | 2. ARM指令集,对应的是ARM架构的平台

143 |

144 |

145 |

146 | ### 汇编语言

147 |

148 |

149 |

150 | 1. 由于指令的可读性还是太差,于是人们又发明了汇编语言。

151 | 2. 在汇编语言中,用助记符(Mnemonics)代替机器指令的操作码,用地址符号(Symbol)或标号(Label)代替指令或操作数的地址。

152 | 3. 在不同的硬件平台,汇编语言对应着不同的机器语言指令集,通过汇编过程转换成机器指令。

153 | 4. 由于计算机只认识指令码,所以用汇编语言编写的程序还必须翻译(汇编)成机器指令码,计算机才能识别和执行。

154 |

155 |

156 |

157 | ### 高级语言

158 |

159 |

160 |

161 | 1. 为了使计算机用户编程序更容易些,后来就出现了各种高级计算机语言。高级语言比机器语言、汇编语言更接近人的语言

162 |

163 | 2. 当计算机执行高级语言编写的程序时,仍然需要把程序解释和编译成机器的指令码。完成这个过程的程序就叫做解释程序或编译程序。

164 |

165 |

166 |

167 |  168 |

169 |

170 |

171 | ### 字节码

172 |

173 |

174 |

175 | 1. 字节码是一种中间状态(中间码)的二进制代码(文件),它比机器码更抽象,需要直译器转译后才能成为机器码

176 |

177 | 2. 字节码主要为了实现特定软件运行和软件环境、与硬件环境无关。

178 |

179 | 3. 字节码的实现方式是通过编译器和虚拟机器。编译器将源码编译成字节码,特定平台上的虚拟机器将字节码转译为可以直接执行的指令。

180 |

181 | 4. 字节码典型的应用为:Java bytecode

182 |

183 |

184 |

185 |

186 |

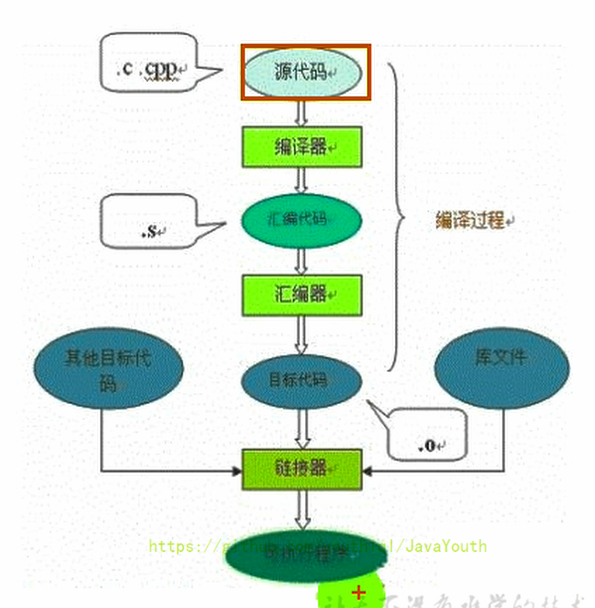

187 | ### C、C++源程序执行过程

188 |

189 | **编译过程又可以分成两个阶段:编译和汇编。**

190 |

191 | 1. 编译过程:是读取源程序(字符流),对之进行词法和语法的分析,将高级语言指令转换为功能等效的汇编代码

192 |

193 | 2. 汇编过程:实际上指把汇编语言代码翻译成目标机器指令的过程。

194 |

195 |

196 |

168 |

169 |

170 |

171 | ### 字节码

172 |

173 |

174 |

175 | 1. 字节码是一种中间状态(中间码)的二进制代码(文件),它比机器码更抽象,需要直译器转译后才能成为机器码

176 |

177 | 2. 字节码主要为了实现特定软件运行和软件环境、与硬件环境无关。

178 |

179 | 3. 字节码的实现方式是通过编译器和虚拟机器。编译器将源码编译成字节码,特定平台上的虚拟机器将字节码转译为可以直接执行的指令。

180 |

181 | 4. 字节码典型的应用为:Java bytecode

182 |

183 |

184 |

185 |

186 |

187 | ### C、C++源程序执行过程

188 |

189 | **编译过程又可以分成两个阶段:编译和汇编。**

190 |

191 | 1. 编译过程:是读取源程序(字符流),对之进行词法和语法的分析,将高级语言指令转换为功能等效的汇编代码

192 |

193 | 2. 汇编过程:实际上指把汇编语言代码翻译成目标机器指令的过程。

194 |

195 |

196 |  197 |

198 |

199 |

200 | 解释器

201 | -----

202 |

203 | ### 为什么要有解释器

204 |

205 |

206 |

207 | 1. JVM设计者们的初衷仅仅只是单纯地为了满足Java程序实现跨平台特性,因此避免采用静态编译的方式由高级语言直接生成本地机器指令,从而诞生了实现解释器在运行时采用逐行解释字节码执行程序的想法(也就是产生了一个中间产品**字节码**)。

208 |

209 | 2. 解释器真正意义上所承担的角色就是一个运行时“翻译者”,将字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

210 |

211 | 3. 当一条字节码指令被解释执行完成后,接着再根据PC寄存器中记录的下一条需要被执行的字节码指令执行解释操作。

212 |

213 |

214 |

197 |

198 |

199 |

200 | 解释器

201 | -----

202 |

203 | ### 为什么要有解释器

204 |

205 |

206 |

207 | 1. JVM设计者们的初衷仅仅只是单纯地为了满足Java程序实现跨平台特性,因此避免采用静态编译的方式由高级语言直接生成本地机器指令,从而诞生了实现解释器在运行时采用逐行解释字节码执行程序的想法(也就是产生了一个中间产品**字节码**)。

208 |

209 | 2. 解释器真正意义上所承担的角色就是一个运行时“翻译者”,将字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

210 |

211 | 3. 当一条字节码指令被解释执行完成后,接着再根据PC寄存器中记录的下一条需要被执行的字节码指令执行解释操作。

212 |

213 |

214 |  215 |

216 |

217 |

218 | ### 解释器的分类

219 |

220 |

221 |

222 | 1. 在Java的发展历史里,一共有两套解释执行器,即古老的**字节码解释器**、现在普遍使用的**模板解释器**。

223 | * 字节码解释器在执行时通过纯软件代码模拟字节码的执行,效率非常低下。

224 | * 而模板解释器将每一条字节码和一个模板函数相关联,模板函数中直接产生这条字节码执行时的机器码,从而很大程度上提高了解释器的性能。

225 | 2. 在HotSpot VM中,解释器主要由Interpreter模块和Code模块构成。

226 | * Interpreter模块:实现了解释器的核心功能

227 | * Code模块:用于管理HotSpot VM在运行时生成的本地机器指令

228 |

229 | ### 解释器的现状

230 |

231 |

232 |

233 | 1. 由于解释器在设计和实现上非常简单,因此除了Java语言之外,还有许多高级语言同样也是基于解释器执行的,比如Python、Perl、Ruby等。但是在今天,基于解释器执行已经沦落为低效的代名词,并且时常被一些C/C++程序员所调侃。

234 |

235 | 2. 为了解决这个问题,JVM平台支持一种叫作即时编译的技术。即时编译的目的是避免函数被解释执行,而是将整个函数体编译成为机器码,每次函数执行时,只执行编译后的机器码即可,这种方式可以使执行效率大幅度提升。

236 |

237 | 3. 不过无论如何,基于解释器的执行模式仍然为中间语言的发展做出了不可磨灭的贡献。

238 |

239 |

240 |

241 |

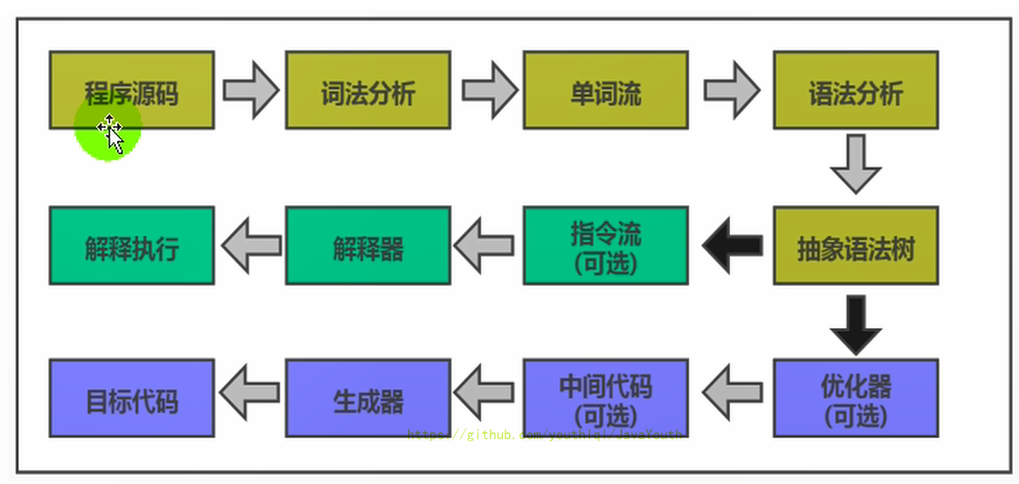

242 | ## JIT编译器

243 |

244 |

245 |

246 | ### Java 代码执行的分类

247 |

248 | 1. 第一种是将源代码编译成字节码文件,然后在运行时通过解释器将字节码文件转为机器码执行

249 |

250 | 2. 第二种是编译执行(直接编译成机器码)。现代虚拟机为了提高执行效率,会使用即时编译技术(JIT,Just In Time)将方法编译成机器码后再执行

251 |

252 |

253 |

254 |

255 | 1. HotSpot VM是目前市面上高性能虚拟机的代表作之一。**它采用解释器与即时编译器并存的架构**。在Java虚拟机运行时,解释器和即时编译器能够相互协作,各自取长补短,尽力去选择最合适的方式来权衡编译本地代码的时间和直接解释执行代码的时间。

256 | 3. 在今天,Java程序的运行性能早已脱胎换骨,已经达到了可以和C/C++ 程序一较高下的地步。

257 |

258 |

259 |

260 | ### 为啥我们还需要解释器呢?

261 |

262 | 1. 有些开发人员会感觉到诧异,既然HotSpot VM中已经内置JIT编译器了,那么为什么还需要再使用解释器来“拖累”程序的执行性能呢?比如JRockit VM内部就不包含解释器,字节码全部都依靠即时编译器编译后执行。

263 |

264 | 2. JRockit虚拟机是砍掉了解释器,也就是只采及时编译器。那是因为呢JRockit只部署在服务器上,一般已经有时间让他进行指令编译的过程了,对于响应来说要求不高,等及时编译器的编译完成后,就会提供更好的性能

265 |

266 |

267 | **首先明确两点:**

268 |

269 | 1. 当程序启动后,解释器可以马上发挥作用,**响应速度快**,省去编译的时间,立即执行。

270 | 2. 编译器要想发挥作用,把代码编译成本地代码,**需要一定的执行时间**,但编译为本地代码后,执行效率高。

271 |

272 | **所以:**

273 |

274 | 1. 尽管JRockit VM中程序的执行性能会非常高效,但程序在启动时必然需要花费更长的时间来进行编译。对于服务端应用来说,启动时间并非是关注重点,但对于那些看中启动时间的应用场景而言,或许就需要采用解释器与即时编译器并存的架构来换取一个平衡点。

275 | 2. 在此模式下,在Java虚拟器启动时,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成后再执行,这样可以省去许多不必要的编译时间。随着时间的推移,编译器发挥作用,把越来越多的代码编译成本地代码,获得更高的执行效率。

276 | 3. 同时,解释执行在编译器进行激进优化不成立的时候,作为编译器的“逃生门”(后备方案)。

277 |

278 | ### 案例

279 |

280 |

281 |

282 | - 当虚拟机启动的时候,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成再执行,这样可以省去许多不必要的编译时间。随着程序运行时间的推移,即时编译器逐渐发挥作用,根据热点探测功能,将有价值的字节码编译为本地机器指令,以换取更高的程序执行效率。

283 |

284 |

285 |

286 | 1. 注意解释执行与编译执行在线上环境微妙的辩证关系。**机器在热机状态(已经运行了一段时间叫热机状态)可以承受的负载要大于冷机状态(刚启动的时候叫冷机状态)**。如果以热机状态时的流量进行切流,可能使处于冷机状态的服务器因无法承载流量而假死。

287 |

288 | 2. 在生产环境发布过程中,以分批的方式进行发布,根据机器数量划分成多个批次,每个批次的机器数至多占到整个集群的1/8。曾经有这样的故障案例:某程序员在发布平台进行分批发布,在输入发布总批数时,误填写成分为两批发布。如果是热机状态,在正常情况下一半的机器可以勉强承载流量,但由于刚启动的JVM均是解释执行,还没有进行热点代码统计和JIT动态编译,导致机器启动之后,当前1/2发布成功的服务器马上全部宕机,此故障说明了JIT的存在。—**阿里团队**

289 |

290 |

291 |

215 |

216 |

217 |

218 | ### 解释器的分类

219 |

220 |

221 |

222 | 1. 在Java的发展历史里,一共有两套解释执行器,即古老的**字节码解释器**、现在普遍使用的**模板解释器**。

223 | * 字节码解释器在执行时通过纯软件代码模拟字节码的执行,效率非常低下。

224 | * 而模板解释器将每一条字节码和一个模板函数相关联,模板函数中直接产生这条字节码执行时的机器码,从而很大程度上提高了解释器的性能。

225 | 2. 在HotSpot VM中,解释器主要由Interpreter模块和Code模块构成。

226 | * Interpreter模块:实现了解释器的核心功能

227 | * Code模块:用于管理HotSpot VM在运行时生成的本地机器指令

228 |

229 | ### 解释器的现状

230 |

231 |

232 |

233 | 1. 由于解释器在设计和实现上非常简单,因此除了Java语言之外,还有许多高级语言同样也是基于解释器执行的,比如Python、Perl、Ruby等。但是在今天,基于解释器执行已经沦落为低效的代名词,并且时常被一些C/C++程序员所调侃。

234 |

235 | 2. 为了解决这个问题,JVM平台支持一种叫作即时编译的技术。即时编译的目的是避免函数被解释执行,而是将整个函数体编译成为机器码,每次函数执行时,只执行编译后的机器码即可,这种方式可以使执行效率大幅度提升。

236 |

237 | 3. 不过无论如何,基于解释器的执行模式仍然为中间语言的发展做出了不可磨灭的贡献。

238 |

239 |

240 |

241 |

242 | ## JIT编译器

243 |

244 |

245 |

246 | ### Java 代码执行的分类

247 |

248 | 1. 第一种是将源代码编译成字节码文件,然后在运行时通过解释器将字节码文件转为机器码执行

249 |

250 | 2. 第二种是编译执行(直接编译成机器码)。现代虚拟机为了提高执行效率,会使用即时编译技术(JIT,Just In Time)将方法编译成机器码后再执行

251 |

252 |

253 |

254 |

255 | 1. HotSpot VM是目前市面上高性能虚拟机的代表作之一。**它采用解释器与即时编译器并存的架构**。在Java虚拟机运行时,解释器和即时编译器能够相互协作,各自取长补短,尽力去选择最合适的方式来权衡编译本地代码的时间和直接解释执行代码的时间。

256 | 3. 在今天,Java程序的运行性能早已脱胎换骨,已经达到了可以和C/C++ 程序一较高下的地步。

257 |

258 |

259 |

260 | ### 为啥我们还需要解释器呢?

261 |

262 | 1. 有些开发人员会感觉到诧异,既然HotSpot VM中已经内置JIT编译器了,那么为什么还需要再使用解释器来“拖累”程序的执行性能呢?比如JRockit VM内部就不包含解释器,字节码全部都依靠即时编译器编译后执行。

263 |

264 | 2. JRockit虚拟机是砍掉了解释器,也就是只采及时编译器。那是因为呢JRockit只部署在服务器上,一般已经有时间让他进行指令编译的过程了,对于响应来说要求不高,等及时编译器的编译完成后,就会提供更好的性能

265 |

266 |

267 | **首先明确两点:**

268 |

269 | 1. 当程序启动后,解释器可以马上发挥作用,**响应速度快**,省去编译的时间,立即执行。

270 | 2. 编译器要想发挥作用,把代码编译成本地代码,**需要一定的执行时间**,但编译为本地代码后,执行效率高。

271 |

272 | **所以:**

273 |

274 | 1. 尽管JRockit VM中程序的执行性能会非常高效,但程序在启动时必然需要花费更长的时间来进行编译。对于服务端应用来说,启动时间并非是关注重点,但对于那些看中启动时间的应用场景而言,或许就需要采用解释器与即时编译器并存的架构来换取一个平衡点。

275 | 2. 在此模式下,在Java虚拟器启动时,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成后再执行,这样可以省去许多不必要的编译时间。随着时间的推移,编译器发挥作用,把越来越多的代码编译成本地代码,获得更高的执行效率。

276 | 3. 同时,解释执行在编译器进行激进优化不成立的时候,作为编译器的“逃生门”(后备方案)。

277 |

278 | ### 案例

279 |

280 |

281 |

282 | - 当虚拟机启动的时候,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成再执行,这样可以省去许多不必要的编译时间。随着程序运行时间的推移,即时编译器逐渐发挥作用,根据热点探测功能,将有价值的字节码编译为本地机器指令,以换取更高的程序执行效率。

283 |

284 |

285 |

286 | 1. 注意解释执行与编译执行在线上环境微妙的辩证关系。**机器在热机状态(已经运行了一段时间叫热机状态)可以承受的负载要大于冷机状态(刚启动的时候叫冷机状态)**。如果以热机状态时的流量进行切流,可能使处于冷机状态的服务器因无法承载流量而假死。

287 |

288 | 2. 在生产环境发布过程中,以分批的方式进行发布,根据机器数量划分成多个批次,每个批次的机器数至多占到整个集群的1/8。曾经有这样的故障案例:某程序员在发布平台进行分批发布,在输入发布总批数时,误填写成分为两批发布。如果是热机状态,在正常情况下一半的机器可以勉强承载流量,但由于刚启动的JVM均是解释执行,还没有进行热点代码统计和JIT动态编译,导致机器启动之后,当前1/2发布成功的服务器马上全部宕机,此故障说明了JIT的存在。—**阿里团队**

289 |

290 |

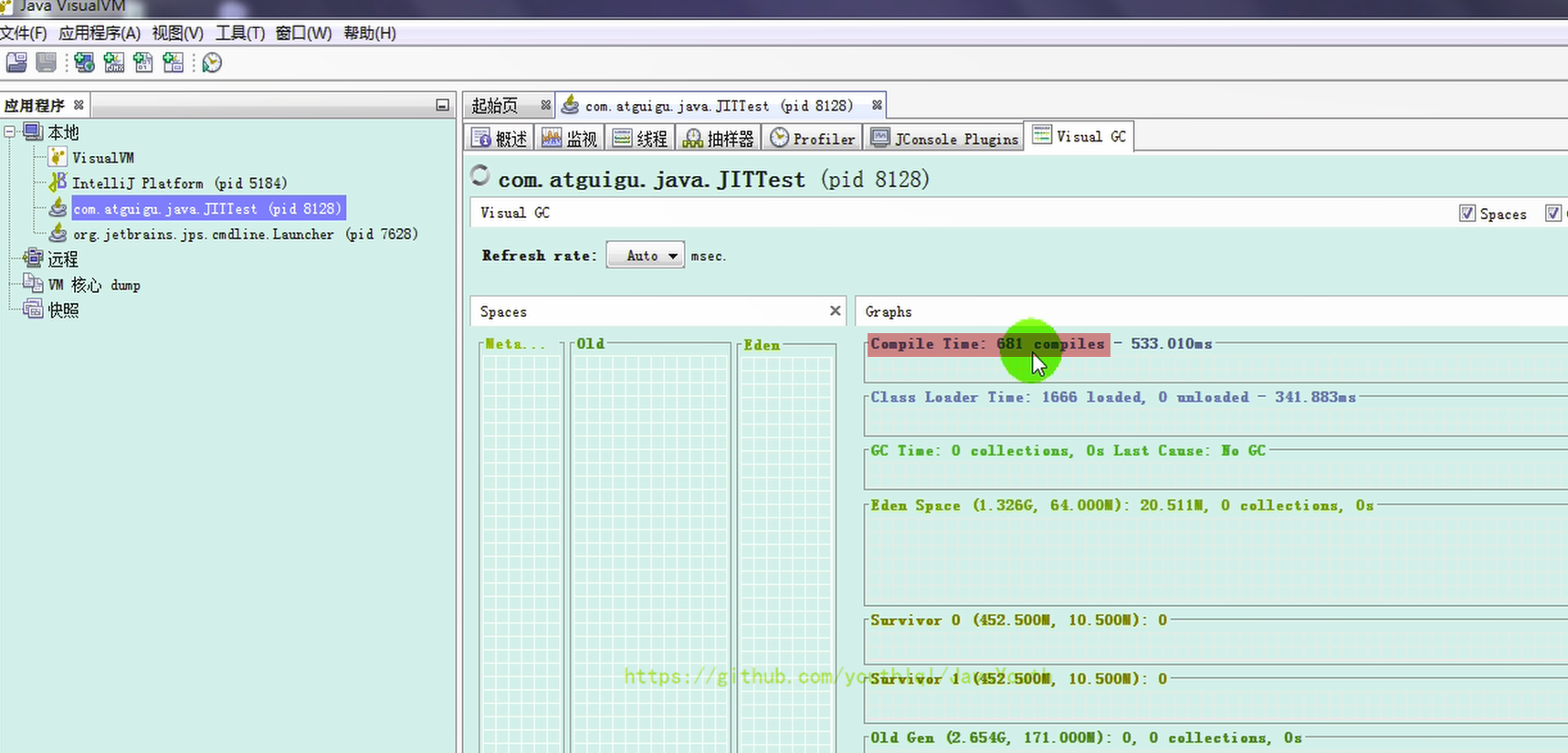

291 |  292 |

293 |

294 |

295 |

296 |

297 | ```java

298 | public class JITTest {

299 | public static void main(String[] args) {

300 | ArrayList

292 |

293 |

294 |

295 |

296 |

297 | ```java

298 | public class JITTest {

299 | public static void main(String[] args) {

300 | ArrayList 321 |

322 |

323 |

324 | ### JIT编译器相关概念

325 |

326 |

327 |

328 | 1. Java 语言的“编译期”其实是一段“不确定”的操作过程,因为它可能是指一个前端编译器(其实叫“编译器的前端”更准确一些)把.java文件转变成.class文件的过程。

329 | 2. 也可能是指虚拟机的后端运行期编译器(JIT编译器,Just In Time Compiler)把字节码转变成机器码的过程。

330 | 3. 还可能是指使用静态提前编译器(AOT编译器,Ahead of Time Compiler)直接把.java文件编译成本地机器代码的过程。(可能是后续发展的趋势)

331 |

332 |

333 |

334 | **典型的编译器:**

335 |

336 | 1. 前端编译器:Sun的javac、Eclipse JDT中的增量式编译器(ECJ)。

337 | 2. JIT编译器:HotSpot VM的C1、C2编译器。

338 | 3. AOT 编译器:GNU Compiler for the Java(GCJ)、Excelsior JET。

339 |

340 |

341 |

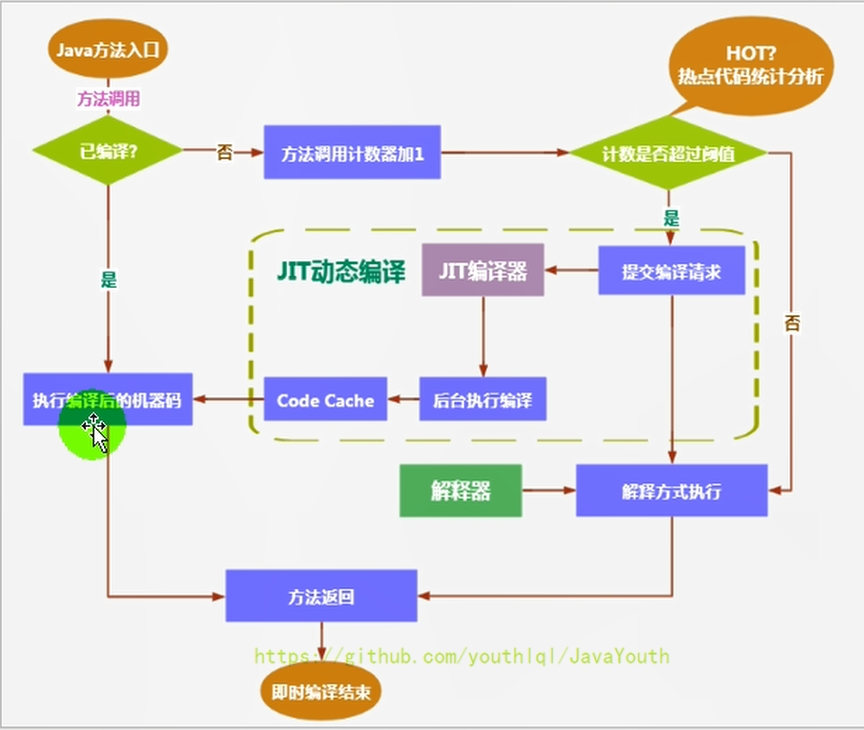

342 | ### 热点代码及探测方式

343 |

344 |

345 |

346 | 1. 当然是否需要启动JIT编译器将字节码直接编译为对应平台的本地机器指令,则需要根据代码被调用**执行的频率**而定。

347 | 2. 关于那些需要被编译为本地代码的字节码,也被称之为**“热点代码”**,JIT编译器在运行时会针对那些频繁被调用的“热点代码”做出**深度优化**,将其直接编译为对应平台的本地机器指令,以此提升Java程序的执行性能。

348 | 3. 一个被多次调用的方法,或者是一-个方法体内部循环次数较多的循环体都可以被称之为“热点代码”,因此都可以通过JIT编译器编译为本地机器指令。由于这种编译方式发生在方法的执行过程中,因此也被称之为栈上替换,或简称为OSR (On StackReplacement)编译。

349 | 4. 一个方法究竟要被调用多少次,或者一个循环体究竟需要执行多少次循环才可以达到这个标准?必然需要一个明确的阈值,JIT编译器才会将这些“热点代码”编译为本地机器指令执行。这里主要依靠热点探测功能。

350 | 5. **目前HotSpot VM所采用的热点探测方式是基于计数器的热点探测**。

351 | 6. 采用基于计数器的热点探测,HotSpot VM将会为每一个方法都建立2个不同类型的计数器,分别为方法调用计数器(Invocation Counter)和回边计数器(Back Edge Counter)。

352 | 1. 方法调用计数器用于统计方法的调用次数

353 | 2. 回边计数器则用于统计循环体执行的循环次数

354 |

355 |

356 |

357 | #### 方法调用计数器

358 |

359 |

360 |

361 | 1. 这个计数器就用于统计方法被调用的次数,它的默认阀值在Client模式下是1500次,在Server模式下是10000次。超过这个阈值,就会触发JIT编译。

362 |

363 | 2. 这个阀值可以通过虚拟机参数 -XX:CompileThreshold 来人为设定。

364 |

365 | 3. 当一个方法被调用时,会先检查该方法是否存在被JIT编译过的版本

366 |

367 | * 如果存在,则优先使用编译后的本地代码来执行

368 | * 如果不存在已被编译过的版本,则将此方法的调用计数器值加1,然后判断方法调用计数器与回边计数器值之和是否超过方法调用计数器的阀值。

369 | * 如果已超过阈值,那么将会向即时编译器提交一个该方法的代码编译请求。

370 | * 如果未超过阈值,则使用解释器对字节码文件解释执行

371 |

372 |

321 |

322 |

323 |

324 | ### JIT编译器相关概念

325 |

326 |

327 |

328 | 1. Java 语言的“编译期”其实是一段“不确定”的操作过程,因为它可能是指一个前端编译器(其实叫“编译器的前端”更准确一些)把.java文件转变成.class文件的过程。

329 | 2. 也可能是指虚拟机的后端运行期编译器(JIT编译器,Just In Time Compiler)把字节码转变成机器码的过程。

330 | 3. 还可能是指使用静态提前编译器(AOT编译器,Ahead of Time Compiler)直接把.java文件编译成本地机器代码的过程。(可能是后续发展的趋势)

331 |

332 |

333 |

334 | **典型的编译器:**

335 |

336 | 1. 前端编译器:Sun的javac、Eclipse JDT中的增量式编译器(ECJ)。

337 | 2. JIT编译器:HotSpot VM的C1、C2编译器。

338 | 3. AOT 编译器:GNU Compiler for the Java(GCJ)、Excelsior JET。

339 |

340 |

341 |

342 | ### 热点代码及探测方式

343 |

344 |

345 |

346 | 1. 当然是否需要启动JIT编译器将字节码直接编译为对应平台的本地机器指令,则需要根据代码被调用**执行的频率**而定。

347 | 2. 关于那些需要被编译为本地代码的字节码,也被称之为**“热点代码”**,JIT编译器在运行时会针对那些频繁被调用的“热点代码”做出**深度优化**,将其直接编译为对应平台的本地机器指令,以此提升Java程序的执行性能。

348 | 3. 一个被多次调用的方法,或者是一-个方法体内部循环次数较多的循环体都可以被称之为“热点代码”,因此都可以通过JIT编译器编译为本地机器指令。由于这种编译方式发生在方法的执行过程中,因此也被称之为栈上替换,或简称为OSR (On StackReplacement)编译。

349 | 4. 一个方法究竟要被调用多少次,或者一个循环体究竟需要执行多少次循环才可以达到这个标准?必然需要一个明确的阈值,JIT编译器才会将这些“热点代码”编译为本地机器指令执行。这里主要依靠热点探测功能。

350 | 5. **目前HotSpot VM所采用的热点探测方式是基于计数器的热点探测**。

351 | 6. 采用基于计数器的热点探测,HotSpot VM将会为每一个方法都建立2个不同类型的计数器,分别为方法调用计数器(Invocation Counter)和回边计数器(Back Edge Counter)。

352 | 1. 方法调用计数器用于统计方法的调用次数

353 | 2. 回边计数器则用于统计循环体执行的循环次数

354 |

355 |

356 |

357 | #### 方法调用计数器

358 |

359 |

360 |

361 | 1. 这个计数器就用于统计方法被调用的次数,它的默认阀值在Client模式下是1500次,在Server模式下是10000次。超过这个阈值,就会触发JIT编译。

362 |

363 | 2. 这个阀值可以通过虚拟机参数 -XX:CompileThreshold 来人为设定。

364 |

365 | 3. 当一个方法被调用时,会先检查该方法是否存在被JIT编译过的版本

366 |

367 | * 如果存在,则优先使用编译后的本地代码来执行

368 | * 如果不存在已被编译过的版本,则将此方法的调用计数器值加1,然后判断方法调用计数器与回边计数器值之和是否超过方法调用计数器的阀值。

369 | * 如果已超过阈值,那么将会向即时编译器提交一个该方法的代码编译请求。

370 | * 如果未超过阈值,则使用解释器对字节码文件解释执行

371 |

372 |  373 |

374 |

375 |

376 | #### 热度衰减

377 |

378 |

379 |

380 | 1. 如果不做任何设置,方法调用计数器统计的并不是方法被调用的绝对次数,而是一个相对的执行频率,即**一段时间之内方法被调用的次数**。当超过一定的时间限度,如果方法的调用次数仍然不足以让它提交给即时编译器编译,那这个方法的调用计数器就会被减少一半,这个过程称为方法调用计数器热度的衰减(Counter Decay),而这段时间就称为此方法统计的半衰周期(Counter Half Life Time)(半衰周期是化学中的概念,比如出土的文物通过查看C60来获得文物的年龄)

381 | 2. 进行热度衰减的动作是在虚拟机进行垃圾收集时顺便进行的,可以使用虚拟机参数 -XX:-UseCounterDecay 来关闭热度衰减,让方法计数器统计方法调用的绝对次数,这样的话,只要系统运行时间足够长,绝大部分方法都会被编译成本地代码。

382 | 6. 另外,可以使用-XX:CounterHalfLifeTime参数设置半衰周期的时间,单位是秒。

383 |

384 |

385 |

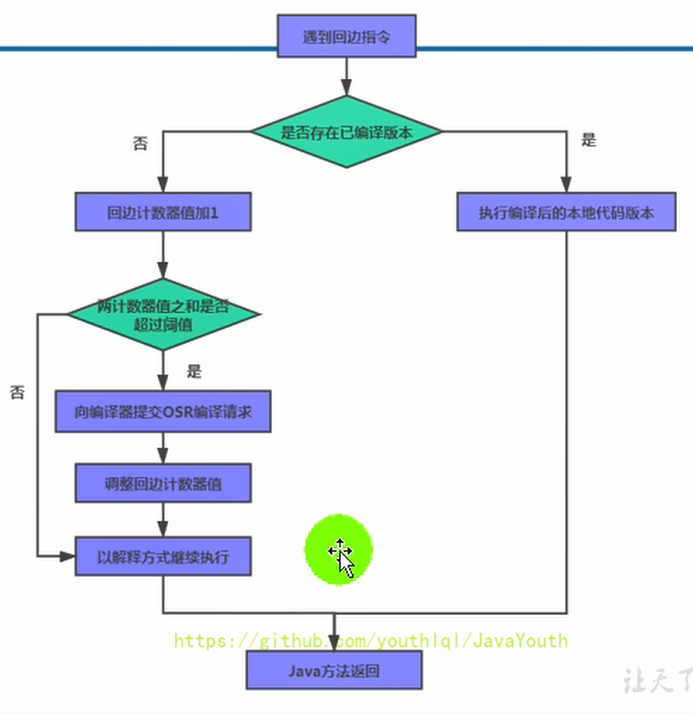

386 | #### 回边计数器

387 |

388 | 它的作用是统计一个方法中循环体代码执行的次数,在字节码中遇到控制流向后跳转的指令称为“回边”(Back Edge)。显然,建立回边计数器统计的目的就是为了触发OSR编译。

389 |

390 |

373 |

374 |

375 |

376 | #### 热度衰减

377 |

378 |

379 |

380 | 1. 如果不做任何设置,方法调用计数器统计的并不是方法被调用的绝对次数,而是一个相对的执行频率,即**一段时间之内方法被调用的次数**。当超过一定的时间限度,如果方法的调用次数仍然不足以让它提交给即时编译器编译,那这个方法的调用计数器就会被减少一半,这个过程称为方法调用计数器热度的衰减(Counter Decay),而这段时间就称为此方法统计的半衰周期(Counter Half Life Time)(半衰周期是化学中的概念,比如出土的文物通过查看C60来获得文物的年龄)

381 | 2. 进行热度衰减的动作是在虚拟机进行垃圾收集时顺便进行的,可以使用虚拟机参数 -XX:-UseCounterDecay 来关闭热度衰减,让方法计数器统计方法调用的绝对次数,这样的话,只要系统运行时间足够长,绝大部分方法都会被编译成本地代码。

382 | 6. 另外,可以使用-XX:CounterHalfLifeTime参数设置半衰周期的时间,单位是秒。

383 |

384 |

385 |

386 | #### 回边计数器

387 |

388 | 它的作用是统计一个方法中循环体代码执行的次数,在字节码中遇到控制流向后跳转的指令称为“回边”(Back Edge)。显然,建立回边计数器统计的目的就是为了触发OSR编译。

389 |

390 |  391 |

392 |

393 |

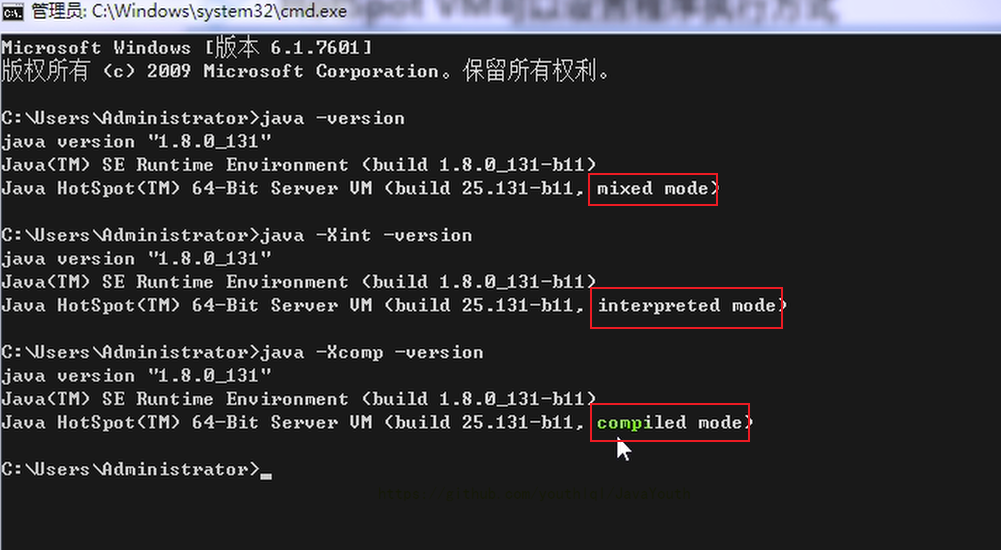

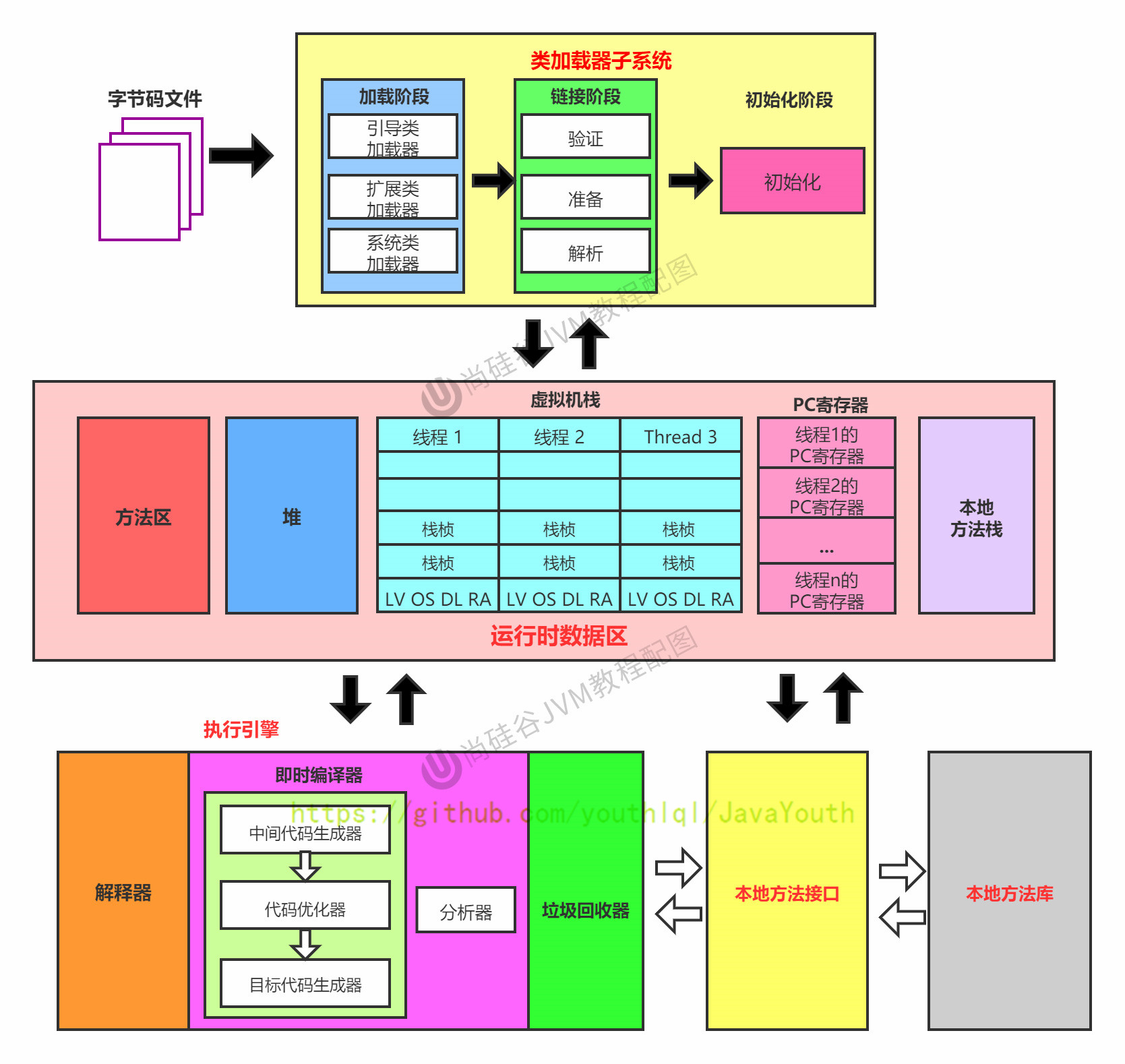

394 | ### HotSpotVM可以设置程序执行方法

395 |

396 | 缺省情况下HotSpot VM是采用解释器与即时编译器并存的架构,当然开发人员可以根据具体的应用场景,通过命令显式地为Java虚拟机指定在运行时到底是完全采用解释器执行,还是完全采用即时编译器执行。如下所示:

397 |

398 | 1. -Xint:完全采用解释器模式执行程序;

399 | 2. -Xcomp:完全采用即时编译器模式执行程序。如果即时编译出现问题,解释器会介入执行

400 | 3. -Xmixed:采用解释器+即时编译器的混合模式共同执行程序。

401 |

402 |

403 |

404 |

391 |

392 |

393 |

394 | ### HotSpotVM可以设置程序执行方法

395 |

396 | 缺省情况下HotSpot VM是采用解释器与即时编译器并存的架构,当然开发人员可以根据具体的应用场景,通过命令显式地为Java虚拟机指定在运行时到底是完全采用解释器执行,还是完全采用即时编译器执行。如下所示:

397 |

398 | 1. -Xint:完全采用解释器模式执行程序;

399 | 2. -Xcomp:完全采用即时编译器模式执行程序。如果即时编译出现问题,解释器会介入执行

400 | 3. -Xmixed:采用解释器+即时编译器的混合模式共同执行程序。

401 |

402 |

403 |

404 |  405 |

406 |

407 |

408 | **代码测试**

409 |

410 | ```java

411 | /**

412 | * 测试解释器模式和JIT编译模式

413 | * -Xint : 6520ms

414 | * -Xcomp : 950ms

415 | * -Xmixed : 936ms

416 | */

417 | public class IntCompTest {

418 | public static void main(String[] args) {

419 |

420 | long start = System.currentTimeMillis();

421 |

422 | testPrimeNumber(1000000);

423 |

424 | long end = System.currentTimeMillis();

425 |

426 | System.out.println("花费的时间为:" + (end - start));

427 |

428 | }

429 |

430 | public static void testPrimeNumber(int count){

431 | for (int i = 0; i < count; i++) {

432 | //计算100以内的质数

433 | label:for(int j = 2;j <= 100;j++){

434 | for(int k = 2;k <= Math.sqrt(j);k++){

435 | if(j % k == 0){

436 | continue label;

437 | }

438 | }

439 | //System.out.println(j);

440 | }

441 |

442 | }

443 | }

444 | }

445 |

446 | ```

447 |

448 | 结论:只用解释器执行是真的慢

449 |

450 | ### HotSpotVM JIT 分类

451 |

452 |

453 |

454 | 在HotSpot VM中内嵌有两个JIT编译器,分别为Client Compiler和Server Compiler,但大多数情况下我们简称为C1编译器 和 C2编译器。开发人员可以通过如下命令显式指定Java虚拟机在运行时到底使用哪一种即时编译器,如下所示:

455 |

456 | 1. -client:指定Java虚拟机运行在Client模式下,并使用C1编译器;

457 | * C1编译器会对字节码进行简单和可靠的优化,耗时短,以达到更快的编译速度。

458 | 2. -server:指定Java虚拟机运行在server模式下,并使用C2编译器。

459 | * C2进行耗时较长的优化,以及激进优化,但优化的代码执行效率更高。(使用C++)

460 |

461 |

462 |

463 |

464 |

465 | ### C1和C2编译器不同的优化策略

466 |

467 | 1. 在不同的编译器上有不同的优化策略,C1编译器上主要有方法内联,去虚拟化、元余消除。

468 | * 方法内联:将引用的函数代码编译到引用点处,这样可以减少栈帧的生成,减少参数传递以及跳转过程

469 | * 去虚拟化:对唯一的实现樊进行内联

470 | * 冗余消除:在运行期间把一些不会执行的代码折叠掉

471 | 2. C2的优化主要是在全局层面,逃逸分析是优化的基础。基于逃逸分析在C2上有如下几种优化:

472 | * 标量替换:用标量值代替聚合对象的属性值

473 | * 栈上分配:对于未逃逸的对象分配对象在栈而不是堆

474 | * 同步消除:清除同步操作,通常指synchronized

475 |

476 | > 也就是说之前的逃逸分析,只有在C2(server模式下)才会触发。那是否说明C1就用不了了?

477 |

478 | ### 分层编译策略

479 |

480 |

481 |

482 | 1. 分层编译(Tiered Compilation)策略:程序解释执行(不开启性能监控)可以触发C1编译,将字节码编译成机器码,可以进行简单优化,也可以加上性能监控,C2编译会根据性能监控信息进行激进优化。

483 |

484 | 2. 不过在Java7版本之后,一旦开发人员在程序中显式指定命令“-server"时,默认将会开启分层编译策略,由C1编译器和C2编译器相互协作共同来执行编译任务。

485 |

486 |

487 |

488 |

489 | 1. 一般来讲,JIT编译出来的机器码性能比解释器解释执行的性能高

490 | 2. C2编译器启动时长比C1慢,系统稳定执行以后,C2编译器执行速度远快于C1编译器

491 |

492 |

493 |

494 | #### Graal 编译器

495 |

496 |

497 |

498 | * 自JDK10起,HotSpot又加入了一个全新的即时编译器:Graal编译器

499 | * 编译效果短短几年时间就追平了G2编译器,未来可期(对应还出现了Graal虚拟机,是有可能替代Hotspot的虚拟机的)

500 | * 目前,带着实验状态标签,需要使用开关参数去激活才能使用

501 |

502 | -XX:+UnlockExperimentalvMOptions -XX:+UseJVMCICompiler

503 |

504 |

505 |

506 |

507 | #### AOT编译器

508 |

509 |

510 |

511 | 1. jdk9引入了AoT编译器(静态提前编译器,Ahead of Time Compiler)

512 |

513 | 2. Java 9引入了实验性AOT编译工具jaotc。它借助了Graal编译器,将所输入的Java类文件转换为机器码,并存放至生成的动态共享库之中。

514 |

515 | 3. 所谓AOT编译,是与即时编译相对立的一个概念。我们知道,即时编译指的是**在程序的运行过程中**,将字节码转换为可在硬件上直接运行的机器码,并部署至托管环境中的过程。而AOT编译指的则是,**在程序运行之前**,便将字节码转换为机器码的过程。

516 |

517 | .java -> .class -> (使用jaotc) -> .so

518 |

519 |

520 |

521 |

522 | **AOT编译器编译器的优缺点**

523 |

524 | **最大的好处:**

525 |

526 | 1. Java虚拟机加载已经预编译成二进制库,可以直接执行。

527 | 2. 不必等待即时编译器的预热,减少Java应用给人带来“第一次运行慢” 的不良体验

528 |

529 |

530 |

531 | **缺点:**

532 |

533 | 1. 破坏了 java “ 一次编译,到处运行”,必须为每个不同的硬件,OS编译对应的发行包

534 | 2. 降低了Java链接过程的动态性,加载的代码在编译器就必须全部已知。

535 | 3. 还需要继续优化中,最初只支持Linux X64 java base

--------------------------------------------------------------------------------

/docs/os/操作系统-IO与零拷贝.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: 操作系统-IO与零拷贝

3 | tags:

4 | - 操作系统

5 | - os

6 | - IO

7 | - 零拷贝

8 | categories:

9 | - 操作系统

10 | keywords: 操作系统,IO,零拷贝

11 | description: 基本面试会问到的IO进行了详解,同时本篇文章也对面试以及平时工作中会看到的零拷贝进行了充分的解析。万字长文系列,读到就是赚到。

12 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/os_logo.jpg'

13 | abbrlink: e959db2e

14 | date: 2021-04-08 15:21:58

15 | ---

16 |

17 |

18 |

19 |

20 |

21 |

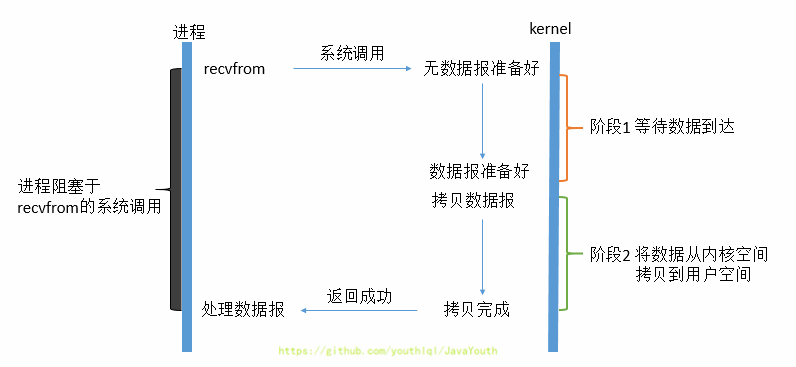

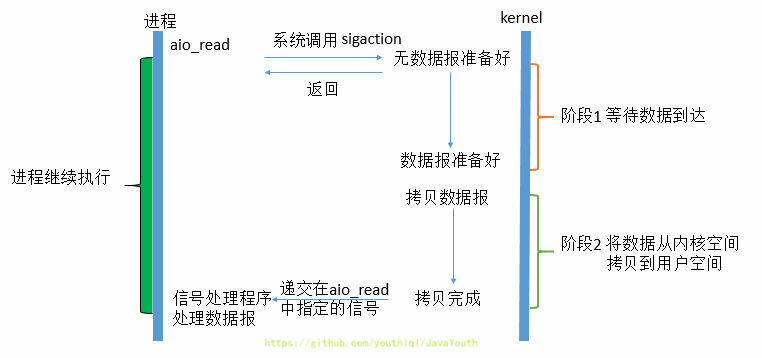

22 |

23 | >

24 | > 1. 本篇文章对于IO相关内容并没有完全讲完,不过也讲的差不多了,基本面试会问到的都讲了,如果想看的更细的,推荐**《操作系统导论》**这本书。

25 | > 2. 同时本篇文章也讲了面试以及平时工作中会看到的零拷贝,因为和IO有比较大的关系,就在这篇文章写一下。

26 | > 3. 零拷贝很多开源项目都用到了,netty,kafka,rocketmq等等。所以还是比较重要的,也是面试常问

27 | > 4. 流程图为processOn手工画的

28 |

29 | # IO

30 |

31 | ## 阻塞与非阻塞 I/O 和 同步与异步 I/O

32 |

33 | > 这应该是大家看到很多文章对IO的一种分类,这只是IO最常见的一种分类。是从是否阻塞,以及是否异步的角度来分类的

34 |

35 | 在这里,我们以一个网络IO来的read来举例,它会涉及到两个东西:一个是产生这个IO的进程,另一个就是系统内核(kernel)。当一个read操作发生时,它会经历两个阶段:

36 |

37 | **阶段1:**等待数据准备

38 |

39 | **阶段2:**数据从内核空间拷贝到用户进程缓冲区的过程

40 |

41 |

42 |

43 | ### 阻塞IO

44 |

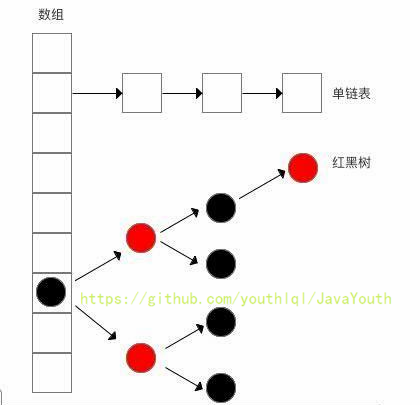

45 | 1. 当用户进程进行recvfrom这个系统调用,内核就开始了IO的第一个阶段:等待数据准备。

46 | 2. 于network io来说,很多时候数据在一开始还没有到达(比如,还没有收到一个完整的TCP包),这个时候**内核**就要等待足够的数据到来。

47 | 3. 而在用户进程这边,整 个进程会被阻塞。当**内核**一直等到数据准备好了,它就会将数据从**内核**中拷贝到用户内存,然后**内核**返回果,用户进程才解除 block的状态,重新运行起来。

48 | 4. **所以,blocking IO的特点就是在IO执行的两个阶段都被block了。**

49 |

50 |

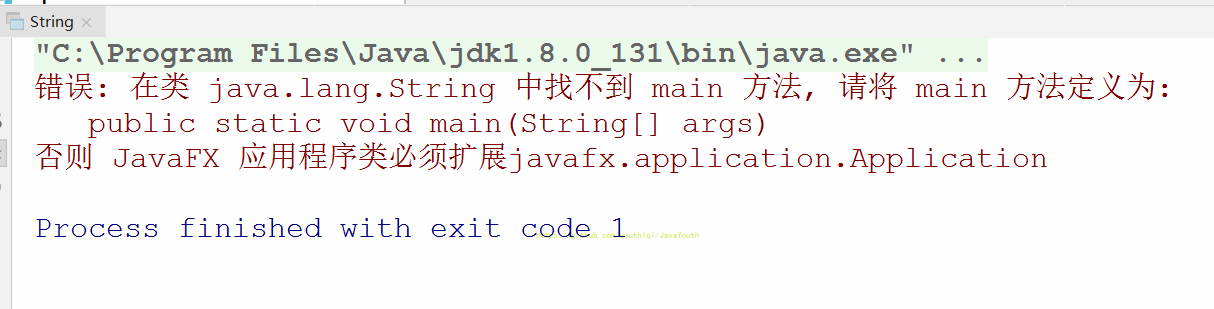

405 |

406 |

407 |

408 | **代码测试**

409 |

410 | ```java

411 | /**

412 | * 测试解释器模式和JIT编译模式

413 | * -Xint : 6520ms

414 | * -Xcomp : 950ms

415 | * -Xmixed : 936ms

416 | */

417 | public class IntCompTest {

418 | public static void main(String[] args) {

419 |

420 | long start = System.currentTimeMillis();

421 |

422 | testPrimeNumber(1000000);

423 |

424 | long end = System.currentTimeMillis();

425 |

426 | System.out.println("花费的时间为:" + (end - start));

427 |

428 | }

429 |

430 | public static void testPrimeNumber(int count){

431 | for (int i = 0; i < count; i++) {

432 | //计算100以内的质数

433 | label:for(int j = 2;j <= 100;j++){

434 | for(int k = 2;k <= Math.sqrt(j);k++){

435 | if(j % k == 0){

436 | continue label;

437 | }

438 | }

439 | //System.out.println(j);

440 | }

441 |

442 | }

443 | }

444 | }

445 |

446 | ```

447 |

448 | 结论:只用解释器执行是真的慢

449 |

450 | ### HotSpotVM JIT 分类

451 |

452 |

453 |

454 | 在HotSpot VM中内嵌有两个JIT编译器,分别为Client Compiler和Server Compiler,但大多数情况下我们简称为C1编译器 和 C2编译器。开发人员可以通过如下命令显式指定Java虚拟机在运行时到底使用哪一种即时编译器,如下所示:

455 |

456 | 1. -client:指定Java虚拟机运行在Client模式下,并使用C1编译器;

457 | * C1编译器会对字节码进行简单和可靠的优化,耗时短,以达到更快的编译速度。

458 | 2. -server:指定Java虚拟机运行在server模式下,并使用C2编译器。

459 | * C2进行耗时较长的优化,以及激进优化,但优化的代码执行效率更高。(使用C++)

460 |

461 |

462 |

463 |

464 |

465 | ### C1和C2编译器不同的优化策略

466 |

467 | 1. 在不同的编译器上有不同的优化策略,C1编译器上主要有方法内联,去虚拟化、元余消除。

468 | * 方法内联:将引用的函数代码编译到引用点处,这样可以减少栈帧的生成,减少参数传递以及跳转过程

469 | * 去虚拟化:对唯一的实现樊进行内联

470 | * 冗余消除:在运行期间把一些不会执行的代码折叠掉

471 | 2. C2的优化主要是在全局层面,逃逸分析是优化的基础。基于逃逸分析在C2上有如下几种优化:

472 | * 标量替换:用标量值代替聚合对象的属性值

473 | * 栈上分配:对于未逃逸的对象分配对象在栈而不是堆

474 | * 同步消除:清除同步操作,通常指synchronized

475 |

476 | > 也就是说之前的逃逸分析,只有在C2(server模式下)才会触发。那是否说明C1就用不了了?

477 |

478 | ### 分层编译策略

479 |

480 |

481 |

482 | 1. 分层编译(Tiered Compilation)策略:程序解释执行(不开启性能监控)可以触发C1编译,将字节码编译成机器码,可以进行简单优化,也可以加上性能监控,C2编译会根据性能监控信息进行激进优化。

483 |

484 | 2. 不过在Java7版本之后,一旦开发人员在程序中显式指定命令“-server"时,默认将会开启分层编译策略,由C1编译器和C2编译器相互协作共同来执行编译任务。

485 |

486 |

487 |

488 |

489 | 1. 一般来讲,JIT编译出来的机器码性能比解释器解释执行的性能高

490 | 2. C2编译器启动时长比C1慢,系统稳定执行以后,C2编译器执行速度远快于C1编译器

491 |

492 |

493 |

494 | #### Graal 编译器

495 |

496 |

497 |

498 | * 自JDK10起,HotSpot又加入了一个全新的即时编译器:Graal编译器

499 | * 编译效果短短几年时间就追平了G2编译器,未来可期(对应还出现了Graal虚拟机,是有可能替代Hotspot的虚拟机的)

500 | * 目前,带着实验状态标签,需要使用开关参数去激活才能使用

501 |

502 | -XX:+UnlockExperimentalvMOptions -XX:+UseJVMCICompiler

503 |

504 |

505 |

506 |

507 | #### AOT编译器

508 |

509 |

510 |

511 | 1. jdk9引入了AoT编译器(静态提前编译器,Ahead of Time Compiler)

512 |

513 | 2. Java 9引入了实验性AOT编译工具jaotc。它借助了Graal编译器,将所输入的Java类文件转换为机器码,并存放至生成的动态共享库之中。

514 |

515 | 3. 所谓AOT编译,是与即时编译相对立的一个概念。我们知道,即时编译指的是**在程序的运行过程中**,将字节码转换为可在硬件上直接运行的机器码,并部署至托管环境中的过程。而AOT编译指的则是,**在程序运行之前**,便将字节码转换为机器码的过程。

516 |

517 | .java -> .class -> (使用jaotc) -> .so

518 |

519 |

520 |

521 |

522 | **AOT编译器编译器的优缺点**

523 |

524 | **最大的好处:**

525 |

526 | 1. Java虚拟机加载已经预编译成二进制库,可以直接执行。

527 | 2. 不必等待即时编译器的预热,减少Java应用给人带来“第一次运行慢” 的不良体验

528 |

529 |

530 |

531 | **缺点:**

532 |

533 | 1. 破坏了 java “ 一次编译,到处运行”,必须为每个不同的硬件,OS编译对应的发行包

534 | 2. 降低了Java链接过程的动态性,加载的代码在编译器就必须全部已知。

535 | 3. 还需要继续优化中,最初只支持Linux X64 java base

--------------------------------------------------------------------------------

/docs/os/操作系统-IO与零拷贝.md:

--------------------------------------------------------------------------------

1 | ---

2 | title: 操作系统-IO与零拷贝

3 | tags:

4 | - 操作系统

5 | - os

6 | - IO

7 | - 零拷贝

8 | categories:

9 | - 操作系统

10 | keywords: 操作系统,IO,零拷贝

11 | description: 基本面试会问到的IO进行了详解,同时本篇文章也对面试以及平时工作中会看到的零拷贝进行了充分的解析。万字长文系列,读到就是赚到。

12 | cover: 'https://npm.elemecdn.com/lql_static@latest/logo/os_logo.jpg'

13 | abbrlink: e959db2e

14 | date: 2021-04-08 15:21:58

15 | ---

16 |

17 |

18 |

19 |

20 |

21 |

22 |

23 | >

24 | > 1. 本篇文章对于IO相关内容并没有完全讲完,不过也讲的差不多了,基本面试会问到的都讲了,如果想看的更细的,推荐**《操作系统导论》**这本书。

25 | > 2. 同时本篇文章也讲了面试以及平时工作中会看到的零拷贝,因为和IO有比较大的关系,就在这篇文章写一下。

26 | > 3. 零拷贝很多开源项目都用到了,netty,kafka,rocketmq等等。所以还是比较重要的,也是面试常问

27 | > 4. 流程图为processOn手工画的

28 |

29 | # IO

30 |

31 | ## 阻塞与非阻塞 I/O 和 同步与异步 I/O

32 |

33 | > 这应该是大家看到很多文章对IO的一种分类,这只是IO最常见的一种分类。是从是否阻塞,以及是否异步的角度来分类的

34 |

35 | 在这里,我们以一个网络IO来的read来举例,它会涉及到两个东西:一个是产生这个IO的进程,另一个就是系统内核(kernel)。当一个read操作发生时,它会经历两个阶段:

36 |

37 | **阶段1:**等待数据准备

38 |

39 | **阶段2:**数据从内核空间拷贝到用户进程缓冲区的过程

40 |

41 |

42 |

43 | ### 阻塞IO

44 |

45 | 1. 当用户进程进行recvfrom这个系统调用,内核就开始了IO的第一个阶段:等待数据准备。

46 | 2. 于network io来说,很多时候数据在一开始还没有到达(比如,还没有收到一个完整的TCP包),这个时候**内核**就要等待足够的数据到来。

47 | 3. 而在用户进程这边,整 个进程会被阻塞。当**内核**一直等到数据准备好了,它就会将数据从**内核**中拷贝到用户内存,然后**内核**返回果,用户进程才解除 block的状态,重新运行起来。

48 | 4. **所以,blocking IO的特点就是在IO执行的两个阶段都被block了。**

49 |

50 |  51 |

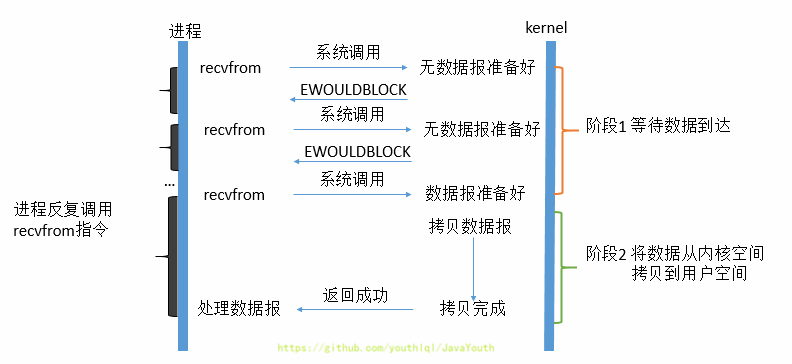

52 |

53 |

54 | ### 非阻塞IO

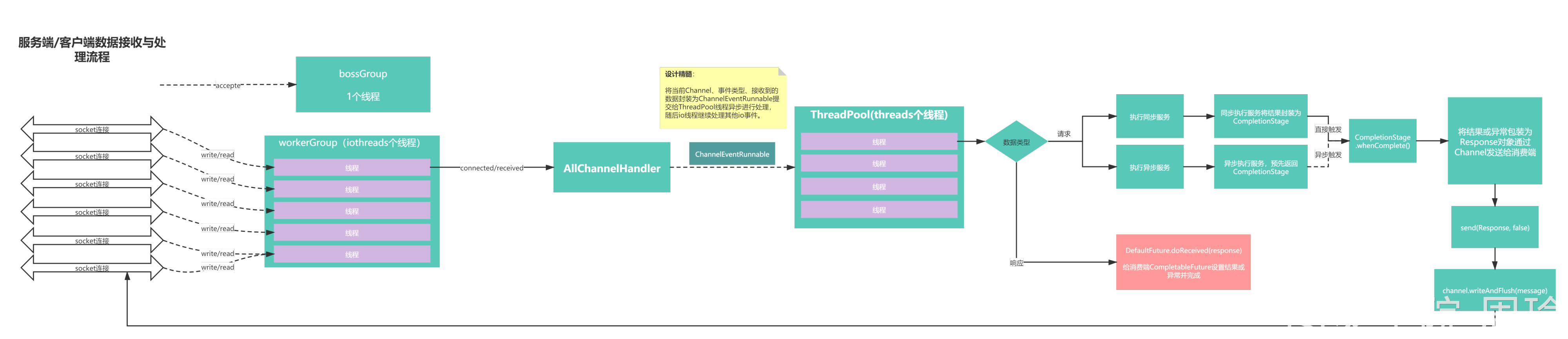

55 |

56 | 1. 当用户进程发出read操作时,如果kernel中的数据还没有准备好,那么它并不会block用户进程,而是立刻返回一个error。

57 | 2. 从用户进程角度讲 ,它发起一个read操作后,并不需要等待,而是马上就得到了一个结果。用户进程判断结果是一个error时,它就知道数据还没有准备好。用户线程需要不断地发起IO请求,直到数据到达后,才真正读取到数据,继续执行。

58 | 3. 虽然用户线程每次发起IO请求后可以立即返回,但是为了等到数据,仍需要不断地轮询、重复请求,消耗了大量的CPU的资源。一般很少直接使用这种模型,而是在其他IO模型中使用非阻塞IO这一特性。

59 | 4. **所以,用户进程第一个阶段不是阻塞的,需要不断的主动询问内核数据好了没有;第二个阶段依然总是阻塞的。**

60 |

61 |

51 |

52 |

53 |

54 | ### 非阻塞IO

55 |

56 | 1. 当用户进程发出read操作时,如果kernel中的数据还没有准备好,那么它并不会block用户进程,而是立刻返回一个error。

57 | 2. 从用户进程角度讲 ,它发起一个read操作后,并不需要等待,而是马上就得到了一个结果。用户进程判断结果是一个error时,它就知道数据还没有准备好。用户线程需要不断地发起IO请求,直到数据到达后,才真正读取到数据,继续执行。

58 | 3. 虽然用户线程每次发起IO请求后可以立即返回,但是为了等到数据,仍需要不断地轮询、重复请求,消耗了大量的CPU的资源。一般很少直接使用这种模型,而是在其他IO模型中使用非阻塞IO这一特性。

59 | 4. **所以,用户进程第一个阶段不是阻塞的,需要不断的主动询问内核数据好了没有;第二个阶段依然总是阻塞的。**

60 |

61 |  62 |

63 |

64 |

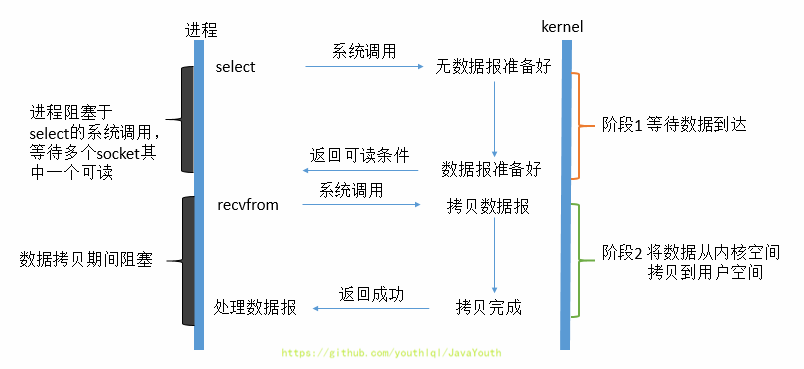

65 | ### IO多路复用

66 |

67 | > 1. 应用程序每次轮询内核的 I/O 是否准备好,感觉有点傻乎乎,因为轮询的过程中,应用程序啥也做不了,只是在循环。

68 | >

69 | > 2. 为了解决这种傻乎乎轮询方式,于是 **I/O 多路复用**技术就出来了,如 select、poll,它是通过 I/O 事件分发,当内核数据准备好时,再以事件通知应用程序进行操作。

70 | >

71 | > 3. 这个做法大大改善了应用进程对 CPU 的利用率,在没有被通知的情况下,应用进程可以使用 CPU 做其他的事情。

72 | >

73 | > 下面是大概的过程

74 |

75 | 1. IO多路复用模型是建立在内核提供的多路分离函数select基础之上的,使用select函数可以避免同步非阻塞IO模型中轮询等待的问题。利用了新的select系统调用,由内核来负责本来是请求进程该做的轮询操作

76 | 2. 它的基本原理就是select /epoll这个函数会不断的轮询所负责的所有socket,当某个socket有数据到达了,就通知用户进程,正式发起read请求。

77 | 3. 从流程上来看,使用select函数进行IO请求和同步阻塞模型没有太大的区别,甚至还多了添加监视socket,以及调用select函数的额外操作,效率更差。但是,使用select以后最大的优势是用户可以在一个线程内同时处理多个socket的IO请求。用户可以注册多个socket,然后不断地调用select读取被激活的socket(也就是数据准备好了的socket),即可达到在同一个线程内同时处理多个IO请求的目的。而在同步阻塞模型中,必须通过多线程的方式才能达到这个目的。

78 |

79 |

62 |

63 |

64 |

65 | ### IO多路复用

66 |

67 | > 1. 应用程序每次轮询内核的 I/O 是否准备好,感觉有点傻乎乎,因为轮询的过程中,应用程序啥也做不了,只是在循环。

68 | >

69 | > 2. 为了解决这种傻乎乎轮询方式,于是 **I/O 多路复用**技术就出来了,如 select、poll,它是通过 I/O 事件分发,当内核数据准备好时,再以事件通知应用程序进行操作。

70 | >

71 | > 3. 这个做法大大改善了应用进程对 CPU 的利用率,在没有被通知的情况下,应用进程可以使用 CPU 做其他的事情。

72 | >

73 | > 下面是大概的过程

74 |

75 | 1. IO多路复用模型是建立在内核提供的多路分离函数select基础之上的,使用select函数可以避免同步非阻塞IO模型中轮询等待的问题。利用了新的select系统调用,由内核来负责本来是请求进程该做的轮询操作

76 | 2. 它的基本原理就是select /epoll这个函数会不断的轮询所负责的所有socket,当某个socket有数据到达了,就通知用户进程,正式发起read请求。

77 | 3. 从流程上来看,使用select函数进行IO请求和同步阻塞模型没有太大的区别,甚至还多了添加监视socket,以及调用select函数的额外操作,效率更差。但是,使用select以后最大的优势是用户可以在一个线程内同时处理多个socket的IO请求。用户可以注册多个socket,然后不断地调用select读取被激活的socket(也就是数据准备好了的socket),即可达到在同一个线程内同时处理多个IO请求的目的。而在同步阻塞模型中,必须通过多线程的方式才能达到这个目的。

78 |

79 |  80 |

81 | **select函数**

82 |

83 | > handle_events:实现事件循环

84 | >

85 | > handle_event:进行读/写等操作

86 |

87 | 1. 使用select函数的优点并不仅限于此。虽然上述方式允许单线程内处理多个IO请求,但是每个IO请求的过程还是阻塞的(在select函数上阻塞),平均时间甚至比同步阻塞IO模型还要长。

88 | 2. 如果用户线程只注册自己感兴趣的socket或者IO请求,然后去做自己的事情,等到数据到来时再进行处理,则可以提高CPU的利用率。

89 | 3. IO多路复用模型使用了Reactor设计模式实现了这一机制。

90 | 4. 通过Reactor的方式,可以将用户线程轮询IO操作状态的工作统一交给handle_events事件循环进行处理。用户线程注册事件处理器之后可以继续执行做其他的工作(异步),而Reactor线程负责调用内核的select函数检查socket状态。当有socket被激活时(就是数据准备好的时候),则通知相应的用户线程(或执行用户线程的回调函数),执行handle_event进行数据读取、处理的工作。

91 | 5. 由于select函数是阻塞的,因此多路IO复用模型也被称为异步阻塞IO模型。注意,这里的所说的阻塞是指select函数执行时线程被阻塞,而不是指socket。(一般在使用IO多路复用模型时,socket都是设置为NONBLOCK的,不过这并不会产生影响,因为用户发起IO请求时,数据已经到达了,用户线程一定不会被阻塞。)

92 |

93 |

80 |

81 | **select函数**

82 |

83 | > handle_events:实现事件循环

84 | >

85 | > handle_event:进行读/写等操作

86 |

87 | 1. 使用select函数的优点并不仅限于此。虽然上述方式允许单线程内处理多个IO请求,但是每个IO请求的过程还是阻塞的(在select函数上阻塞),平均时间甚至比同步阻塞IO模型还要长。

88 | 2. 如果用户线程只注册自己感兴趣的socket或者IO请求,然后去做自己的事情,等到数据到来时再进行处理,则可以提高CPU的利用率。

89 | 3. IO多路复用模型使用了Reactor设计模式实现了这一机制。

90 | 4. 通过Reactor的方式,可以将用户线程轮询IO操作状态的工作统一交给handle_events事件循环进行处理。用户线程注册事件处理器之后可以继续执行做其他的工作(异步),而Reactor线程负责调用内核的select函数检查socket状态。当有socket被激活时(就是数据准备好的时候),则通知相应的用户线程(或执行用户线程的回调函数),执行handle_event进行数据读取、处理的工作。

91 | 5. 由于select函数是阻塞的,因此多路IO复用模型也被称为异步阻塞IO模型。注意,这里的所说的阻塞是指select函数执行时线程被阻塞,而不是指socket。(一般在使用IO多路复用模型时,socket都是设置为NONBLOCK的,不过这并不会产生影响,因为用户发起IO请求时,数据已经到达了,用户线程一定不会被阻塞。)

92 |

93 |  94 |

95 |

96 |

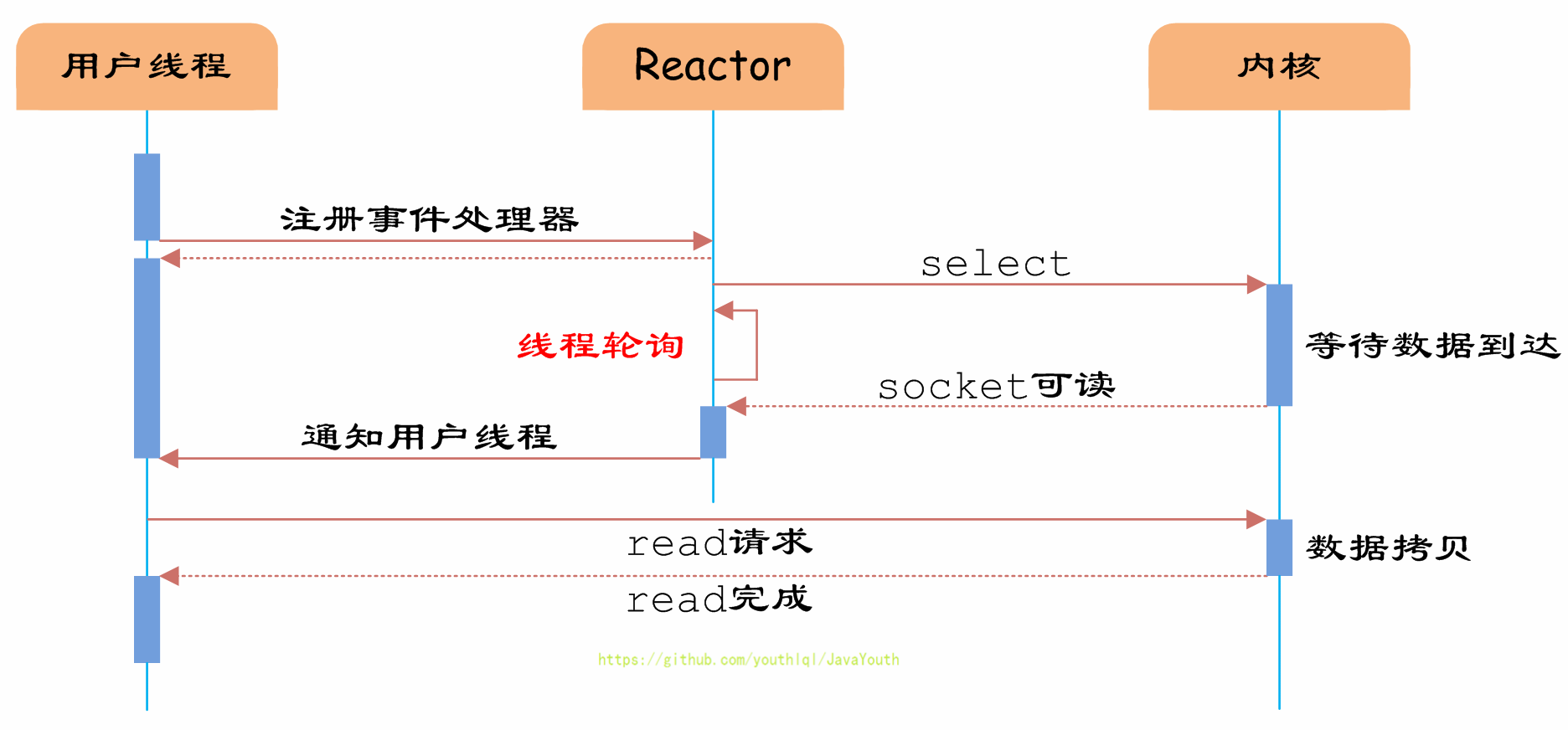

97 | ### 异步IO

98 |

99 | - 实际上,无论是阻塞 I/O、非阻塞 I/O,还是基于非阻塞 I/O 的多路复用**都是同步调用。因为它们在 read 调用时,内核将数据从内核空间拷贝到应用进程空间,这个阶段都是需要等待的。**

100 | - 而真正的**异步 I/O** 是「内核数据准备好」和「数据从内核态拷贝到用户态」这两个过程都不用等待

101 |

102 |

103 |

104 | 1. 真正”的异步IO需要操作系统更强的支持。在IO多路复用模型中,由用户线程自行读取数据、处理数据。

105 | 2. 而在异步IO模型中,用户进程发起read操作之后,立刻就可以开始去做其它的事。

106 | 3. 而另一方面,从**内核**的角度,当它受到一个异步读之后,首先它会立刻返回,所以不会对用户进程产生任何阻塞。然后,内核会等待数据准备完成,然后将数据拷贝到用户内存,当这一切都 完成之后,**内核**会给用户进程发送一个信号,告诉它read操作完成了,用户线程直接使用即可。 在这整个过程中,进程完全没有被阻塞。

107 | 4. 异步IO模型使用了Proactor设计模式实现了这一机制。**(具体怎么搞得,看上面的文章链接)**

108 |

109 |

94 |

95 |

96 |

97 | ### 异步IO

98 |

99 | - 实际上,无论是阻塞 I/O、非阻塞 I/O,还是基于非阻塞 I/O 的多路复用**都是同步调用。因为它们在 read 调用时,内核将数据从内核空间拷贝到应用进程空间,这个阶段都是需要等待的。**

100 | - 而真正的**异步 I/O** 是「内核数据准备好」和「数据从内核态拷贝到用户态」这两个过程都不用等待

101 |

102 |

103 |

104 | 1. 真正”的异步IO需要操作系统更强的支持。在IO多路复用模型中,由用户线程自行读取数据、处理数据。

105 | 2. 而在异步IO模型中,用户进程发起read操作之后,立刻就可以开始去做其它的事。

106 | 3. 而另一方面,从**内核**的角度,当它受到一个异步读之后,首先它会立刻返回,所以不会对用户进程产生任何阻塞。然后,内核会等待数据准备完成,然后将数据拷贝到用户内存,当这一切都 完成之后,**内核**会给用户进程发送一个信号,告诉它read操作完成了,用户线程直接使用即可。 在这整个过程中,进程完全没有被阻塞。

107 | 4. 异步IO模型使用了Proactor设计模式实现了这一机制。**(具体怎么搞得,看上面的文章链接)**

108 |

109 |  110 |

111 |

112 |

113 | > 有一篇文章以实际例子讲解的比较形象

114 | >

115 | > [漫画讲IO](https://mp.weixin.qq.com/s?__biz=Mzg3MjA4MTExMw==&mid=2247484746&idx=1&sn=c0a7f9129d780786cabfcac0a8aa6bb7&source=41&scene=21#wechat_redirect)

116 |

117 | ## 直接与非直接I/O

118 |

119 | 1. 磁盘 I/O 是非常慢的,所以 Linux 内核通过减少磁盘 I/O 次数来减少I/O时间,在系统调用后,会把用户数据拷贝到内核中缓存起来,这个内核缓存空间也就是【页缓存:PageCache】,只有当缓存满足某些条件的时候,才发起磁盘 I/O 的请求。

120 |

121 | 2. **根据是「否利用操作系统的页缓存」,可以把文件 I/O 分为直接 I/O 与非直接 I/O**:

122 |

123 | * 直接 I/O,不会发生内核缓存和用户程序之间数据复制,跳过操作系统的页缓存,直接经过文件系统访问磁盘。

124 | * 非直接 I/O,正相反,读操作时,数据从内核缓存中拷贝给用户程序,写操作时,数据从用户程序拷贝给内核缓存,再由内核决定什么时候写入数据到磁盘。

125 |

126 | 3. 想要实现直接I/O,需要你在系统调用中,指定 O_DIRECT 标志。如果没有设置过,默认的是非直接I/O。

127 |

128 |

129 |

130 | 在进行写操作的时候以下几种场景会触发内核缓存的数据写入磁盘:

131 |

132 | > 以下摘自---**《深入linux内核架构》**

133 | >

134 | > **1、**

135 | >

136 | > 可能因不同原因、在不同的时机触发不同的刷出数据的机制。

137 | >

138 | > - 周期性的内核线程,将扫描脏页的链表,并根据页变脏的时间,来选择一些页写回。如果系统不是太忙于写操作,那么在脏页的数目,以及刷出页所需的硬盘访问操作对系统造成的负荷之间,有一个可接受的比例。

139 | >

140 | > - 如果系统中的脏页过多(例如,一个大型的写操作可能造成这种情况),内核将触发进一步的机制对脏页与后备存储器进行同步,直至脏页的数目降低到一个可接受的程度。而“脏页过多”和“可接受的程度”到底意味着什么,此时尚是一个不确定的问题,将在下文讨论。

141 | >

142 | > - 内核的各个组件可能要求数据必须在特定事件发生时同步,例如在重新装载文件系统时。

143 | >

144 | > 前两种机制由内核线程pdflush实现,该线程执行同步代码,而第三种机制可能由内核中的多处代码触发。

145 | >

146 | >

147 | >

148 | > **2、**

149 | >

150 | > 可以从用户空间通过各种系统调用来启用内核同步机制,以确保内存和块设备之间(完全或部分)的数据完整性。有如下3个基本选项可用。

151 | >

152 | > 1. 使用sync系统调用刷出整个缓存内容。在某些情况下,这可能非常耗时。

153 | >

154 | > 2. 各个文件的内容(以及相关inode的元数据)可以被传输到底层的块设备。内核为此提供了fsync和fdatasync系统调用。尽管sync通常与上文提到的系统工具sync联合使用,但fsync和fdatasync则专用于特定的应用程序,因为刷出的文件是通过特定于进程的文件描述符(在第8章介绍)来选择的。因而,没有一个通用的用户空间工具可以回写特定的文件。

155 | > 3. msync用于同步内存映射

156 |

157 | 1、我们先来说脏页

158 |

159 | 脏页-linux内核中的概念,因为硬盘的读写速度远赶不上内存的速度,系统就把读写比较频繁的数据事先放到内存中,以提高读写速度,这就叫高速缓存,linux是以页作为高速缓存的单位,当进程修改了高速缓存里的数据时,该页就被内核标记为脏页,内核将会在合适的时间把脏页的数据写到磁盘中去,以保持高速缓存中的数据和磁盘中的数据是一致的。

160 |

161 | 2、通过对上面的解读,我们用通俗的语言翻译以下

162 |

163 | - 周期性的扫描脏页,如果发现脏页存在的时间过了某一时间时,也会把该脏页的数据刷到磁盘上

164 |

165 | * 当发现脏页太多的时候,内核会把一定数量的脏页数据写到磁盘上;

166 | * 用户主动调用 `sync`,`fsync`,`fdatasync`,内核缓存会刷到磁盘上;

167 |

168 | ## 缓冲与非缓冲I/O

169 |

170 | 1. 文件操作的标准库是可以实现数据的缓存,那么**根据「是否利用标准库缓冲」,可以把文件 I/O 分为缓冲 I/O 和非缓冲 I/O**:

171 |

172 | * 缓冲 I/O,利用的是标准库的缓存实现文件的加速访问,而标准库再通过系统调用访问文件。

173 | * 非缓冲 I/O,直接通过系统调用访问文件,不经过标准库缓存。

174 |

175 | 2. 这里所说的「缓冲」特指标准库内部实现的缓冲。比方说,很多程序遇到换行时才真正输出,而换行前的内容,其实就是被标准库暂时缓存了起来,这样做的目的是,减少系统调用的次数。

176 | 3. 非缓冲io,因为没有标准库提供的缓冲,只能用操作系统的缓存区,会造成很多次的系统调用,降低效率

177 | 4. 带缓存IO也叫标准IO,符合ANSI C 的标准IO处理,不依赖系统内核,所以移植性强,我们使用标准IO操作很多时候是为了减少对read()和write()的系统调用次数,带缓存IO其实就是在用户层再建立一个缓存区,这个缓存区的分配和优化长度等细节都是标准IO库代你处理好了,不用去操心。

178 |

179 |

180 |

181 | > 标准 I/O 库提供缓冲的目的是尽可能减少使用 read 和 write 调用的次数(见图 3-6,其中显示了在不同缓冲区长度情况下,执行 I/O 所需的 CPU 时间量)。它也对每个 I/O流自动地进行缓冲管理,从而避免了应用程序需要考虑这一点所带来的麻烦。遗憾的是,标准 I/O 库最令人迷惑的也是它的缓冲。

182 | >

183 | > 标准 I/O提供了以下3 种类型的缓冲。

184 | >

185 | > 1. 全缓冲。在这种情况下,在填满标准 I/O 缓冲区后才进行实际 I/O 操作。对于驻留在磁盘上的文件通常是由标准 IO库实施全缓冲的。在一个流上执行第一次 I/O 操作时,相关标准 I/O函数通常调用 malloc (见7.8 节)获得需使用的缓冲区。

术语冲洗(fush)说明标准 UO 缓冲区的写操作。缓冲区可由标准 I/O 例程自动地冲洗(例如,当填满一个缓冲区时),或者可以调用函数 fflush 冲洗一个流。值得注意的是,在 UNTX环境中,fush有两种意思。在标准 I/O库方面,flush(冲洗)意味着将缓冲区中的内容写到磁盘上(该缓冲区可能只是部分填满的)。在终端驱动程序方面(例如,在第 18章中所述的tcflush函数),flush(刷清)表示丢弃已存储在缓冲区中的数据。

186 | >2. 行缓冲。在这种情况下,当在输入和输出中遇到换行符时,标准 I/O 库执行 I/O 操作。这允许我们一次输出一个字符(用标准 I/O 函数fputc),但只有在写了一行之后才进行实际 I/O操作。当流涉及一个终端时(如标准输入和标准输出),通常使用行缓冲。

对于行缓冲有两个限制。第一,因为标准 I/O 库用来收集每一行的缓冲区的长度是固定的。所以只要填满了缓冲区,那么即使还没有写一个换行符,也进行 I/O 操作。第二,任何时候只要通过标准 I/O 库要求从(a)一个不带缓冲的流,或者(b)一个行缓冲的流(它从内核请求需要 数据)得到输入数据,那么就会冲洗所有行缓冲输出流。在(b)中带了一个在括号中的说明,其理由是,所需的数据可能已在该缓冲区中,它并不要求一定从内核读数据。很明显,从一个不带缓冲的流中输入(即(a)项)需要从内核获得数据。

187 | > 3. 不带缓冲。标准 I/O 库不对字符进行缓冲存储,例如,若用标准 I/O 函数 fputs 写 15个字符到不带缓冲的流中,我们就期望这 15 个字符能立即输出,很可能使用 3.8 节的write 函数将这些字符写到相关联的打开文件中。

188 |

189 |

190 |

191 | # 零拷贝

192 |

193 | > 讲零拷贝前,讲一下前置知识

194 |

195 | ## 标准设备

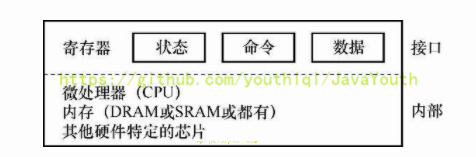

196 |

197 | 1. 来看一个标准设备(不是真实存在的,相当于一个逻辑上抽象的东西),通过它来帮助我们更好地理解设备交互的机制。可以看到一个包含两部分重要组件的设备。第一部分是向系统其他部分展现的硬件接口(interface)。同软件一样,硬件也需要一些接口,让系统软件来控制它的操作。因此,所有设备都有自己的特定接口以及典型交互的协议。

198 |

199 |

110 |

111 |

112 |

113 | > 有一篇文章以实际例子讲解的比较形象

114 | >

115 | > [漫画讲IO](https://mp.weixin.qq.com/s?__biz=Mzg3MjA4MTExMw==&mid=2247484746&idx=1&sn=c0a7f9129d780786cabfcac0a8aa6bb7&source=41&scene=21#wechat_redirect)

116 |

117 | ## 直接与非直接I/O

118 |

119 | 1. 磁盘 I/O 是非常慢的,所以 Linux 内核通过减少磁盘 I/O 次数来减少I/O时间,在系统调用后,会把用户数据拷贝到内核中缓存起来,这个内核缓存空间也就是【页缓存:PageCache】,只有当缓存满足某些条件的时候,才发起磁盘 I/O 的请求。

120 |

121 | 2. **根据是「否利用操作系统的页缓存」,可以把文件 I/O 分为直接 I/O 与非直接 I/O**:

122 |

123 | * 直接 I/O,不会发生内核缓存和用户程序之间数据复制,跳过操作系统的页缓存,直接经过文件系统访问磁盘。

124 | * 非直接 I/O,正相反,读操作时,数据从内核缓存中拷贝给用户程序,写操作时,数据从用户程序拷贝给内核缓存,再由内核决定什么时候写入数据到磁盘。

125 |

126 | 3. 想要实现直接I/O,需要你在系统调用中,指定 O_DIRECT 标志。如果没有设置过,默认的是非直接I/O。

127 |

128 |

129 |

130 | 在进行写操作的时候以下几种场景会触发内核缓存的数据写入磁盘:

131 |

132 | > 以下摘自---**《深入linux内核架构》**

133 | >

134 | > **1、**

135 | >

136 | > 可能因不同原因、在不同的时机触发不同的刷出数据的机制。

137 | >

138 | > - 周期性的内核线程,将扫描脏页的链表,并根据页变脏的时间,来选择一些页写回。如果系统不是太忙于写操作,那么在脏页的数目,以及刷出页所需的硬盘访问操作对系统造成的负荷之间,有一个可接受的比例。

139 | >

140 | > - 如果系统中的脏页过多(例如,一个大型的写操作可能造成这种情况),内核将触发进一步的机制对脏页与后备存储器进行同步,直至脏页的数目降低到一个可接受的程度。而“脏页过多”和“可接受的程度”到底意味着什么,此时尚是一个不确定的问题,将在下文讨论。

141 | >

142 | > - 内核的各个组件可能要求数据必须在特定事件发生时同步,例如在重新装载文件系统时。

143 | >

144 | > 前两种机制由内核线程pdflush实现,该线程执行同步代码,而第三种机制可能由内核中的多处代码触发。

145 | >

146 | >

147 | >

148 | > **2、**

149 | >

150 | > 可以从用户空间通过各种系统调用来启用内核同步机制,以确保内存和块设备之间(完全或部分)的数据完整性。有如下3个基本选项可用。

151 | >

152 | > 1. 使用sync系统调用刷出整个缓存内容。在某些情况下,这可能非常耗时。

153 | >

154 | > 2. 各个文件的内容(以及相关inode的元数据)可以被传输到底层的块设备。内核为此提供了fsync和fdatasync系统调用。尽管sync通常与上文提到的系统工具sync联合使用,但fsync和fdatasync则专用于特定的应用程序,因为刷出的文件是通过特定于进程的文件描述符(在第8章介绍)来选择的。因而,没有一个通用的用户空间工具可以回写特定的文件。

155 | > 3. msync用于同步内存映射

156 |

157 | 1、我们先来说脏页

158 |

159 | 脏页-linux内核中的概念,因为硬盘的读写速度远赶不上内存的速度,系统就把读写比较频繁的数据事先放到内存中,以提高读写速度,这就叫高速缓存,linux是以页作为高速缓存的单位,当进程修改了高速缓存里的数据时,该页就被内核标记为脏页,内核将会在合适的时间把脏页的数据写到磁盘中去,以保持高速缓存中的数据和磁盘中的数据是一致的。

160 |

161 | 2、通过对上面的解读,我们用通俗的语言翻译以下

162 |

163 | - 周期性的扫描脏页,如果发现脏页存在的时间过了某一时间时,也会把该脏页的数据刷到磁盘上

164 |

165 | * 当发现脏页太多的时候,内核会把一定数量的脏页数据写到磁盘上;

166 | * 用户主动调用 `sync`,`fsync`,`fdatasync`,内核缓存会刷到磁盘上;

167 |

168 | ## 缓冲与非缓冲I/O

169 |

170 | 1. 文件操作的标准库是可以实现数据的缓存,那么**根据「是否利用标准库缓冲」,可以把文件 I/O 分为缓冲 I/O 和非缓冲 I/O**:

171 |

172 | * 缓冲 I/O,利用的是标准库的缓存实现文件的加速访问,而标准库再通过系统调用访问文件。

173 | * 非缓冲 I/O,直接通过系统调用访问文件,不经过标准库缓存。

174 |

175 | 2. 这里所说的「缓冲」特指标准库内部实现的缓冲。比方说,很多程序遇到换行时才真正输出,而换行前的内容,其实就是被标准库暂时缓存了起来,这样做的目的是,减少系统调用的次数。

176 | 3. 非缓冲io,因为没有标准库提供的缓冲,只能用操作系统的缓存区,会造成很多次的系统调用,降低效率

177 | 4. 带缓存IO也叫标准IO,符合ANSI C 的标准IO处理,不依赖系统内核,所以移植性强,我们使用标准IO操作很多时候是为了减少对read()和write()的系统调用次数,带缓存IO其实就是在用户层再建立一个缓存区,这个缓存区的分配和优化长度等细节都是标准IO库代你处理好了,不用去操心。

178 |

179 |

180 |

181 | > 标准 I/O 库提供缓冲的目的是尽可能减少使用 read 和 write 调用的次数(见图 3-6,其中显示了在不同缓冲区长度情况下,执行 I/O 所需的 CPU 时间量)。它也对每个 I/O流自动地进行缓冲管理,从而避免了应用程序需要考虑这一点所带来的麻烦。遗憾的是,标准 I/O 库最令人迷惑的也是它的缓冲。

182 | >

183 | > 标准 I/O提供了以下3 种类型的缓冲。

184 | >

185 | > 1. 全缓冲。在这种情况下,在填满标准 I/O 缓冲区后才进行实际 I/O 操作。对于驻留在磁盘上的文件通常是由标准 IO库实施全缓冲的。在一个流上执行第一次 I/O 操作时,相关标准 I/O函数通常调用 malloc (见7.8 节)获得需使用的缓冲区。

术语冲洗(fush)说明标准 UO 缓冲区的写操作。缓冲区可由标准 I/O 例程自动地冲洗(例如,当填满一个缓冲区时),或者可以调用函数 fflush 冲洗一个流。值得注意的是,在 UNTX环境中,fush有两种意思。在标准 I/O库方面,flush(冲洗)意味着将缓冲区中的内容写到磁盘上(该缓冲区可能只是部分填满的)。在终端驱动程序方面(例如,在第 18章中所述的tcflush函数),flush(刷清)表示丢弃已存储在缓冲区中的数据。

186 | >2. 行缓冲。在这种情况下,当在输入和输出中遇到换行符时,标准 I/O 库执行 I/O 操作。这允许我们一次输出一个字符(用标准 I/O 函数fputc),但只有在写了一行之后才进行实际 I/O操作。当流涉及一个终端时(如标准输入和标准输出),通常使用行缓冲。

对于行缓冲有两个限制。第一,因为标准 I/O 库用来收集每一行的缓冲区的长度是固定的。所以只要填满了缓冲区,那么即使还没有写一个换行符,也进行 I/O 操作。第二,任何时候只要通过标准 I/O 库要求从(a)一个不带缓冲的流,或者(b)一个行缓冲的流(它从内核请求需要 数据)得到输入数据,那么就会冲洗所有行缓冲输出流。在(b)中带了一个在括号中的说明,其理由是,所需的数据可能已在该缓冲区中,它并不要求一定从内核读数据。很明显,从一个不带缓冲的流中输入(即(a)项)需要从内核获得数据。

187 | > 3. 不带缓冲。标准 I/O 库不对字符进行缓冲存储,例如,若用标准 I/O 函数 fputs 写 15个字符到不带缓冲的流中,我们就期望这 15 个字符能立即输出,很可能使用 3.8 节的write 函数将这些字符写到相关联的打开文件中。

188 |

189 |

190 |

191 | # 零拷贝

192 |

193 | > 讲零拷贝前,讲一下前置知识

194 |

195 | ## 标准设备

196 |

197 | 1. 来看一个标准设备(不是真实存在的,相当于一个逻辑上抽象的东西),通过它来帮助我们更好地理解设备交互的机制。可以看到一个包含两部分重要组件的设备。第一部分是向系统其他部分展现的硬件接口(interface)。同软件一样,硬件也需要一些接口,让系统软件来控制它的操作。因此,所有设备都有自己的特定接口以及典型交互的协议。

198 |

199 |  200 |

201 | 2. 第2部分是它的内部结构(internal structure)。这部分包含设备相关的特定实现,负责具体实现设备展示给系统的抽象接口。

202 |

203 | ## 标准协议

204 |

205 | 1. 在上图中,一个(简化的)设备接口包含3个寄存器:一个状态(status)寄存器,可以读取并查看设备的当前状态;一个命令(command)寄存器,用于通知设备执行某个具体任务;一个数据(data)寄存器,将数据传给设备或从设备接收数据。通过读写这些寄存器,操作系统可以控制设备的行为

206 | 2. 我们现在来描述操作系统与该设备的典型交互,以便让设备为它做某事。协议如下:

207 |

208 | ```c++

209 | While (STATUS == BUSY);//wait until device is not busy

210 |

211 | Write data to DATA register

212 | Write command to COMMAND register

213 | (Doing so starts the device and executes the command)

214 |

215 | While (STATUS == BUSY);//wait until device is done with your request

216 | ```

217 |

218 | 3. 该协议包含4步。

219 | - 第1步,操作系统通过反复读取状态寄存器,等待设备进入可以接收命令的就绪状态。我们称之为轮询(polling)设备(基本上,就是问它正在做什么)。

220 | - 第2步,操作系统下发数据到数据寄存器。例如,你可以想象如果这是一个磁盘,需要多次写入操作,将一个磁盘块(比如4KB)传递给设备。如果主CPU参与数据移动(就像这个示例协议一样),我们就称之为编程的I/O(programmedI/O,PIO)。

221 | - 第3步,操作系统将命令写入命令寄存器;这样设备就知道数据已经准备好了,它应该开始执行命令。最后一步,操作系统再次通过不断轮询设备,等待并判断设备是否执行完成命令(有可能得到一个指示成功或失败的错误码)。

222 | 4. 这个简单的协议好处是足够简单并且有效。但是难免会有一些低效和不方便。我们注意到这个协议存在的第一个问题就是轮询过程比较低效,在等待设备执行完成命令时浪费大量CPU时间,如果此时操作系统可以切换执行下一个就绪进程,就可以大大提高CPU的利用率。

223 |

224 | > 关键问题:如何减少轮询开销操作系统检查设备状态时如何避免频繁轮询,从而降低管理设备的CPU开销?

225 |

226 | ## 利用中断减少CPU开销

227 |

228 | **概念:**有了中断后,CPU 不再需要不断轮询设备,而是向设备发出一个请求,然后就可以让对应进程睡眠,切换执行其他任务。当设备完成了自身操作,会抛出一个硬件中断,引发CPU跳转执行操作系统预先定义好的中断服务例程(InterruptService Routine,ISR),或更为简单的中断处理程序(interrupt handler)。中断处理程序是一小段操作系统代码,它会结束之前的请求(比如从设备读取到了数据或者错误码)并且唤醒等待I/O的进程继续执行。

229 |

230 | **例子:**

231 |

232 | 1. 没有中断时:进程1在CPU上运行一段时间(对应CPU那一行上重复的1),然后发出一个读取数据的I/O请求给磁盘。如果没有中断,那么操作系统就会简单自旋,不断轮询设备状态,直到设备完成I/O操作(对应其中的p)。当设备完成请求的操作后,进程1又可以继续运行。

233 |

234 |

200 |

201 | 2. 第2部分是它的内部结构(internal structure)。这部分包含设备相关的特定实现,负责具体实现设备展示给系统的抽象接口。

202 |

203 | ## 标准协议

204 |

205 | 1. 在上图中,一个(简化的)设备接口包含3个寄存器:一个状态(status)寄存器,可以读取并查看设备的当前状态;一个命令(command)寄存器,用于通知设备执行某个具体任务;一个数据(data)寄存器,将数据传给设备或从设备接收数据。通过读写这些寄存器,操作系统可以控制设备的行为

206 | 2. 我们现在来描述操作系统与该设备的典型交互,以便让设备为它做某事。协议如下:

207 |

208 | ```c++

209 | While (STATUS == BUSY);//wait until device is not busy

210 |

211 | Write data to DATA register

212 | Write command to COMMAND register

213 | (Doing so starts the device and executes the command)

214 |

215 | While (STATUS == BUSY);//wait until device is done with your request

216 | ```

217 |

218 | 3. 该协议包含4步。

219 | - 第1步,操作系统通过反复读取状态寄存器,等待设备进入可以接收命令的就绪状态。我们称之为轮询(polling)设备(基本上,就是问它正在做什么)。

220 | - 第2步,操作系统下发数据到数据寄存器。例如,你可以想象如果这是一个磁盘,需要多次写入操作,将一个磁盘块(比如4KB)传递给设备。如果主CPU参与数据移动(就像这个示例协议一样),我们就称之为编程的I/O(programmedI/O,PIO)。

221 | - 第3步,操作系统将命令写入命令寄存器;这样设备就知道数据已经准备好了,它应该开始执行命令。最后一步,操作系统再次通过不断轮询设备,等待并判断设备是否执行完成命令(有可能得到一个指示成功或失败的错误码)。

222 | 4. 这个简单的协议好处是足够简单并且有效。但是难免会有一些低效和不方便。我们注意到这个协议存在的第一个问题就是轮询过程比较低效,在等待设备执行完成命令时浪费大量CPU时间,如果此时操作系统可以切换执行下一个就绪进程,就可以大大提高CPU的利用率。

223 |

224 | > 关键问题:如何减少轮询开销操作系统检查设备状态时如何避免频繁轮询,从而降低管理设备的CPU开销?

225 |

226 | ## 利用中断减少CPU开销

227 |

228 | **概念:**有了中断后,CPU 不再需要不断轮询设备,而是向设备发出一个请求,然后就可以让对应进程睡眠,切换执行其他任务。当设备完成了自身操作,会抛出一个硬件中断,引发CPU跳转执行操作系统预先定义好的中断服务例程(InterruptService Routine,ISR),或更为简单的中断处理程序(interrupt handler)。中断处理程序是一小段操作系统代码,它会结束之前的请求(比如从设备读取到了数据或者错误码)并且唤醒等待I/O的进程继续执行。

229 |

230 | **例子:**

231 |

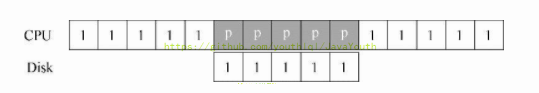

232 | 1. 没有中断时:进程1在CPU上运行一段时间(对应CPU那一行上重复的1),然后发出一个读取数据的I/O请求给磁盘。如果没有中断,那么操作系统就会简单自旋,不断轮询设备状态,直到设备完成I/O操作(对应其中的p)。当设备完成请求的操作后,进程1又可以继续运行。

233 |

234 |  235 |

236 | 2. 有了中断后:中断允许计算与I/O重叠(overlap),这是提高CPU利用率的关键。我们利用中断并允许重叠,操作系统就可以在等待磁盘操作时做其他事情。

237 |

238 |

235 |

236 | 2. 有了中断后:中断允许计算与I/O重叠(overlap),这是提高CPU利用率的关键。我们利用中断并允许重叠,操作系统就可以在等待磁盘操作时做其他事情。

237 |

238 |  239 |

240 | - 在这个例子中,在磁盘处理进程1的请求时,操作系统在CPU上运行进程2。磁盘处理完成后,触发一个中断,然后操作系统唤醒进程1继续运行。这样,在这段时间,无论CPU还是磁盘都可以有效地利用。

241 |

242 | > 注意,使用中断并非总是最佳方案。假如有一个非常高性能的设备,它处理请求很快:通常在CPU第一次轮询时就可以返回结果。此时如果使用中断,反而会使系统变慢:切换到其他进程,处理中断,再切换回之前的进程代价不小。因此,如果设备非常快,那么最好的办法反而是轮询。如果设备比较慢,那么采用允许发生重叠的中断更好。如果设备的速度未知,或者时快时慢,可以考虑使用混合(hybrid)策略,先尝试轮询一小段时间,如果设备没有完成操作,此时再使用中断。这种两阶段(two-phased)的办法可以实现两种方法的好处。

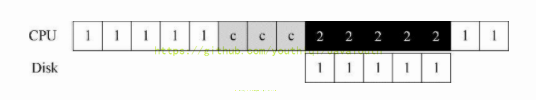

243 |

244 | 中断仍旧存在的缺点:

245 |

246 |

239 |

240 | - 在这个例子中,在磁盘处理进程1的请求时,操作系统在CPU上运行进程2。磁盘处理完成后,触发一个中断,然后操作系统唤醒进程1继续运行。这样,在这段时间,无论CPU还是磁盘都可以有效地利用。

241 |

242 | > 注意,使用中断并非总是最佳方案。假如有一个非常高性能的设备,它处理请求很快:通常在CPU第一次轮询时就可以返回结果。此时如果使用中断,反而会使系统变慢:切换到其他进程,处理中断,再切换回之前的进程代价不小。因此,如果设备非常快,那么最好的办法反而是轮询。如果设备比较慢,那么采用允许发生重叠的中断更好。如果设备的速度未知,或者时快时慢,可以考虑使用混合(hybrid)策略,先尝试轮询一小段时间,如果设备没有完成操作,此时再使用中断。这种两阶段(two-phased)的办法可以实现两种方法的好处。

243 |

244 | 中断仍旧存在的缺点:

245 |

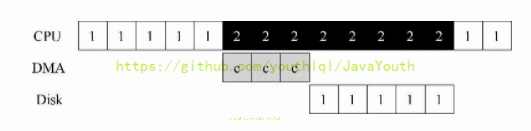

246 |  247 |

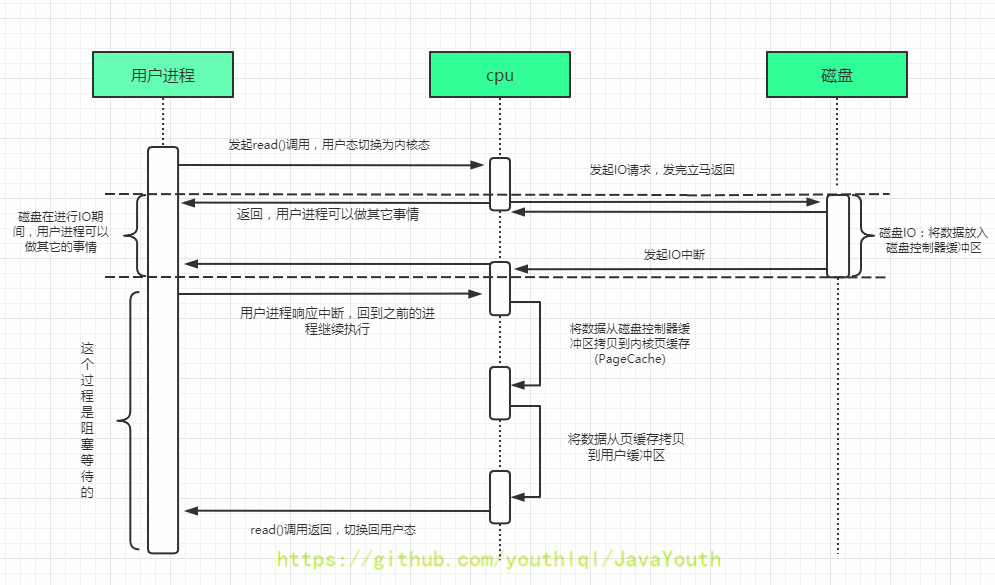

248 | IO过程简述:

249 |

250 | 1. 用户进程调用 read 方法,向cpu发出 I/O 请求

251 | 2. cpu向磁盘发起IO请求给磁盘控制器,**之后立马返回**。返回之后cpu可以切换到其它进程执行其他任务

252 | 3. 磁盘控制器收到指令后,于是就开始进行磁盘IO,磁盘IO完成后会把数据放入到磁盘控制器的内部缓冲区中,然后产生一个**中断**

253 | 4. CPU 收到中断信号后,停下手头的工作,接着把磁盘控制器的缓冲区的数据读进内核的页缓存【这个过程是可以用DMA进行优化的】。

254 | 5. 接着将数据从内核页缓存拷贝到用户进程空间【这个过程想要优化,只能用到我们上面说的异步IO】

255 | 6. 最后read()调用返回。

256 |

257 | > 注意:

258 | >

259 | > 1. 这里很多博客画的图是错的,讲的也是错的。使用中断减少CPU开销时,在进行磁盘IO期间,CPU可以执行其他的进程不必等待磁盘IO。【因为这是《操作系统导论》里的原话】

260 |

261 |

262 |

263 | ## 利用DMA进行更高效的数据传送

264 |

265 | > 这里为什么要特别强调原文呢?因为可以让读者读的安心,这本经典书籍总不会出错吧

266 |

267 | > 《操作系统导论》原文:

268 | >

269 | > 标准协议还有一点需要我们注意。具体来说,如果使用编程的I/O将一大块数据传给设备,CPU又会因为琐碎的任务而变得负载很重,浪费了时间和算力,本来更好是用于运行其他进程。下面的时间线展示了这个问题:

270 | >

271 | >

247 |

248 | IO过程简述:

249 |

250 | 1. 用户进程调用 read 方法,向cpu发出 I/O 请求

251 | 2. cpu向磁盘发起IO请求给磁盘控制器,**之后立马返回**。返回之后cpu可以切换到其它进程执行其他任务

252 | 3. 磁盘控制器收到指令后,于是就开始进行磁盘IO,磁盘IO完成后会把数据放入到磁盘控制器的内部缓冲区中,然后产生一个**中断**

253 | 4. CPU 收到中断信号后,停下手头的工作,接着把磁盘控制器的缓冲区的数据读进内核的页缓存【这个过程是可以用DMA进行优化的】。

254 | 5. 接着将数据从内核页缓存拷贝到用户进程空间【这个过程想要优化,只能用到我们上面说的异步IO】

255 | 6. 最后read()调用返回。

256 |

257 | > 注意:

258 | >

259 | > 1. 这里很多博客画的图是错的,讲的也是错的。使用中断减少CPU开销时,在进行磁盘IO期间,CPU可以执行其他的进程不必等待磁盘IO。【因为这是《操作系统导论》里的原话】

260 |

261 |

262 |

263 | ## 利用DMA进行更高效的数据传送

264 |

265 | > 这里为什么要特别强调原文呢?因为可以让读者读的安心,这本经典书籍总不会出错吧

266 |

267 | > 《操作系统导论》原文:

268 | >

269 | > 标准协议还有一点需要我们注意。具体来说,如果使用编程的I/O将一大块数据传给设备,CPU又会因为琐碎的任务而变得负载很重,浪费了时间和算力,本来更好是用于运行其他进程。下面的时间线展示了这个问题:

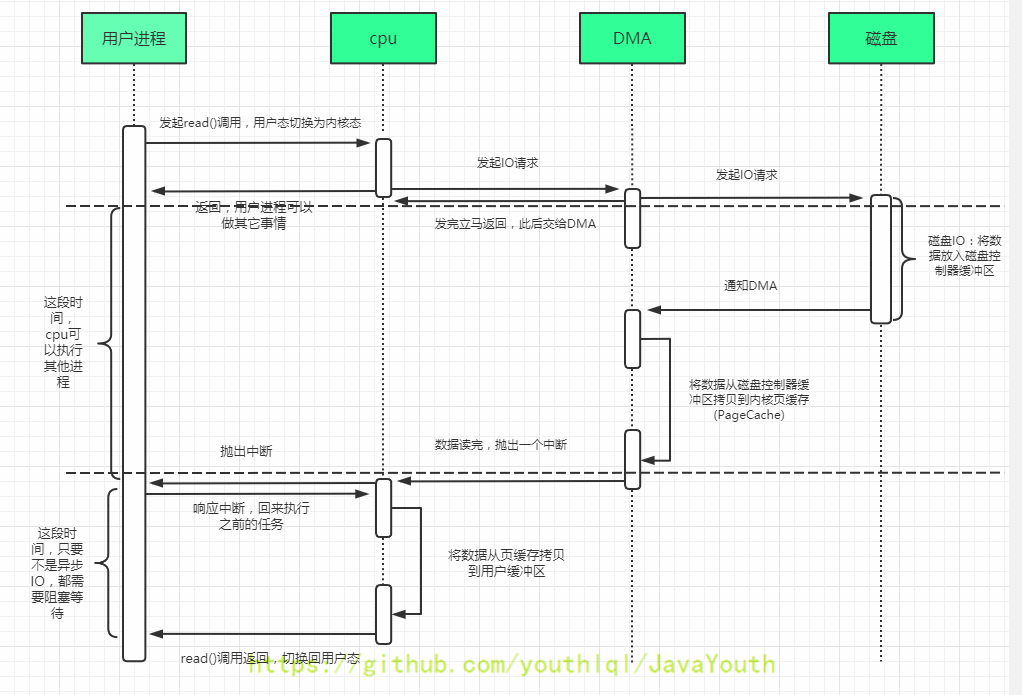

270 | >

271 | >  272 | >

273 | > 进程1在运行过程中需要向磁盘写一些数据,所以它开始进行I/O操作,将数据从内存拷贝到磁盘(其中标示c的过程)。**拷贝结束后,磁盘上的I/O操作开始执行,此时CPU才可以处理其他请求。**

274 |

275 | 也就是说在从**内存拷贝到磁盘或者从磁盘拷贝到内存**这个过程是可以使用DMA(Direct Memory Access)优化的,怎么优化呢?

276 |

277 | > 原文:

278 | >